text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Dagaz: эволюция вместо революции

***В этом мире того, что хотелось бы нам НЕТ!

Мы верим, что в силах его изменить ДА!

Юрий Шевчук***

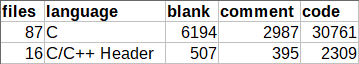

Те из вас, кто читал мои статьи, должны знать о том, что я, довольно давно, занимаюсь изучением метаигровой системы [Zillions of Games](http://www.zillions-of-games.com). За всё это время, я разработал чуть менее полусотни [игр](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?searchauthor=498) и изучил эту платформу вдоль и поперёк. Моей целью является разработка аналогичной (а желательно более функциональной) системы с открытым исходным кодом. О ходе этой работы я и хочу рассказать.

**По образу и подобию**

-----------------------

Как я уже сказал, я очень хорошо понимаю как именно работает Zillions of Games. Мне не мешает отсутствие её исходных кодов, поскольку я не собираюсь заниматься портацией этого продукта. Речь идёт о разработке новой системы с нуля, с учётом достоинств (и в ещё большей степени недостатков) всех известных мне, на текущий момент, метаигровых платформ. Перечислю их:

* [Zillions of Games](http://www.zillions-of-games.com) — наиболее известная метаигровая система, о которой я много писал

* [Axiom Development Kit](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=1452) — довольно интересный проект, реализованный как модуль расширения Zillions of Games, но способный также работать и автономно

* [The LUDÆ project](http://www.di.fc.ul.pt/~jpn/ludae/index.htm) — Забавная система, предназначенная для автоматизированной разработки новых настольных игр

* [Jocly](https://www.jocly.com/#/about) — Современная и очень интересная разработка (к сожалению, качество реализованных под неё игр оставляет желать лучшего)

Все эти продукты работают и делают ровно то, для чего они и предназначены — помогают, с затратой больших или меньших усилий, создавать компьютерные реализации разнообразных настольных игр. Речь идёт не только о Шашках и Шахматах! Количество и (что самое главное) разнообразие уже созданных игр превосходит все ожидания. В этом главное достоинство метаигровых систем — работающий прототип новой и достаточно сложной настольной игры можно создать буквально за пару часов!

**Ложка дёгтя**

Главный их недостаток также очевиден. Ни одному универсальному игровому «движку» никогда не сравняться (по производительности) с программами специализированными, ориентированными на одну и только одну настольную игру. С этим напрямую связана и «интеллектуальность» ботов, призванных составить компанию игроку-человеку, пребывающему в одиночестве. Все универсальные игровые системы играют очень слабо, но поскольку речь, как правило, идёт о довольно экзотических играх, это не является очень большой проблемой. Вряд ли программе повезёт встретиться с человеком, играющим, например, в [Chu Shogi](https://ru.wikipedia.org/wiki/%D0%A2%D1%8E_%D1%81%D1%91%D0%B3%D0%B8) на уровне гроссмейстера.

Помимо этого общего недостатка (а также фатального недостатка, связанного с закрытостью исходных кодов), каждый из перечисленных проектов обладает и индивидуальными особенностями. Так, Zillions of Games использует [лиспо](https://ru.wikipedia.org/wiki/%D0%9B%D0%B8%D1%81%D0%BF)-подобный [DSL](https://ru.wikipedia.org/wiki/%D0%9F%D1%80%D0%B5%D0%B4%D0%BC%D0%B5%D1%82%D0%BD%D0%BE-%D0%BE%D1%80%D0%B8%D0%B5%D0%BD%D1%82%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%BD%D1%8B%D0%B9_%D1%8F%D0%B7%D1%8B%D0%BA), весьма облегчающий процесс описания настольных игр, но несколько ограничивающий функциональность доступную разработчику. Реализовать, с его помощью, можно [действительно](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=1001) [очень](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=10) [многое](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=244), но далеко не всё. Некоторые игры, такие как "[Ритмомахия](https://habrahabr.ru/post/234587/)" или "[Каури](http://www.iggamecenter.com/info/ru/kauri.html)", разработать на чистом [ZRF](https://ru.wikipedia.org/wiki/Zillions_of_Games) решительно невозможно. Иные, наподобие "[Ko Shogi](https://en.wikipedia.org/wiki/Ko_shogi)" или "[Gwangsanghui](https://en.wikipedia.org/wiki/Janggi_variants)", сделать можно, но столь сложным образом, что существенно страдает их производительность (а следовательно и «интеллект» AI).

Расширение Axiom Development Kit появилось как попытка улучшения Zillions of Games. Поскольку эта библиотека оперирует числами (а не только булевскими флагами, как Zillions of Games), такие игры как «Ритмомахия» становятся [реализуемыми](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=2282), но сам процесс разработки местами напоминает кошмар (я немного [писал](https://habrahabr.ru/post/276329/) об этом). В качестве DSL, Axiom использует Forth Script (подмножество языка [Форт](https://ru.wikipedia.org/wiki/%D0%A4%D0%BE%D1%80%D1%82_(%D1%8F%D0%B7%D1%8B%D0%BA_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F))) и этот язык (а главное отладка программ на нём) **действительно** намного сложнее тёплого и лампового ZRF. Кроме того, сделать с его помощью можно далеко не всё. Разработка таких игр как "[Таврели](http://cyclowiki.org/wiki/%D0%A0%D1%83%D1%81%D1%81%D0%BA%D0%B8%D0%B5_%D1%88%D0%B0%D1%85%D0%BC%D0%B0%D1%82%D1%8B)" или, упомянутая выше «Каури», по прежнему, не представляется возможной.

Про «LUDÆ» я мало что могу рассказать (поскольку никогда не видел этого продукта вживую), что же касается Jocly, то недостатком этой системы (на мой взгляд) является полный отказ от использования какого либо DSL для описания игр. Фактически, это [MVC](https://ru.wikipedia.org/wiki/Model-View-Controller)-фреймворк для разработки настольных игр на языке JavaScript. Даже внесение довольно тривиальных изменений в уже разработанные игры превращается в весьма трудоёмкий [процесс](https://habrahabr.ru/post/280334/). Игры, созданные самими авторами, также не лишены серьёзных ошибок (я связываю это со сложностью процесса разработки). Например, в "[Алькуэрке](https://www.jocly.com/#/game/alquerque-bell)" возникают ситуации при которых одни и те же фигуры «берутся» по нескольку раз за ход, а в "[Турецких шашках](https://www.jocly.com/#/game/turkish-draughts)" ошибочно действует правило "[Турецкого удара](https://ru.wikipedia.org/wiki/%D0%A2%D1%83%D1%80%D0%B5%D1%86%D0%BA%D0%B8%D0%B9_%D1%83%D0%B4%D0%B0%D1%80)" — главное что отличает эту игру от других [шашечных систем](https://ru.wikipedia.org/wiki/%D0%A8%D0%B0%D1%88%D0%BA%D0%B8#.D0.A2.D1.83.D1.80.D0.B5.D1.86.D0.BA.D0.B8.D0.B5).

Знакомство с Jocly подтолкнуло меня к пересмотру некоторых решений. Для дальнейшей разработки я твёрдо решил использовать JavaScript, поскольку это очевидно наиболее простой путь к созданию расширяемой и кроссплатформенной системы с современным интерфейсом. Однопоточность немного отпугивает, но, на самом деле, этот момент важен исключительно для AI (да и в нём, использовать многопоточность правильно совсем не просто), а мы уже (для себя) выяснили, что AI не самая сильная сторона метаигровых систем.

С другой стороны, для меня совершенно очевидна необходимость наличия некоего DSL для описания наиболее рутинных моментов настольных игр. Непосредственное использование JavaScript для разработки всей игровой модели придаёт процессу небывалую гибкость, но требует усердия и сосредоточенности (и, как показала практика, даже их наличие не сильно помогает). В идеале, хотелось бы обеспечить совместимость с базовым ZRF, чтобы иметь возможность запускать в новой системе, если и не все [две с половиной тысячи игр](http://www.zillions-of-games.com/games/index.html), то, хотя бы, значительную их часть. Вот что [пишут](http://wiki.jocly.com/index.php/Comparison_with_Zillions_of_Games) по этому поводу разработчики Jocly:

> *In ZoG, games are described in a lisp-based language called ZRF. This gives a nice formal framework to the game rules, but introduces a number of limitations when ZRF has no predefined instruction for a given feature. The Jocly approach is quite different since games are developed in Javascript and use APIs to define the rules and user interface. The good with Jocly is that developers can do almost anything they want, the bad is that they must write more code.

>

>

>

> In theory, it would be possible to write a ZRF interpretor in Javascript for Jocly to run any ZoG game. If you are willing to develop that kind of tool, let us know.*

Я решил двинуться по этому пути, сосредоточившись, правда, не на интерпретации, а на своего рода «компиляции» ZRF-файла в описание игры для Jocly. Постоянный разбор текстового файла, пусть даже и содержащего очень простое описание игры, на языке напоминающем Лисп — это не та задача, которой хотелось бы заниматься в JavaScript.

**Подробности**

Я решил создать [приложение](https://github.com/GlukKazan/JoclyGames/tree/master/Z2J/src/java), превращающее исходный [zrf-файл](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/zrf/example.zrf), содержащий описание игры, в [форму](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/zrf/example.js), пригодную для загрузки в модель Jocly. Например, вместо [этого](http://embed.jocly.net/jocly/plazza/file-access?game=turkish-draughts&file=checkersbase-model.js) файла (для просмотра всех открытых текстов платформы Jocly можно использовать [Jocly Inspector](http://embed.jocly.net/jocly/plazza/inspector#/)). Разумеется, требовалась [прослойка](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/js/debug/zrf-model.js), способная «склеить» это описание с моделью Jocly. Z2J-транслятор однократно выполняет ту работу, которой не хотелось бы заниматься в JavaScript-приложении постоянно. Например:

**Следующее описание игровой доски**

```

(grid

(start-rectangle 6 6 55 55)

(dimensions

("a/b/c/d/e/f/g/h" (50 0)) ; files

("8/7/6/5/4/3/2/1" (0 50)) ; ranks

)

(directions (n 0 -1) (s 0 1) (e 1 0) (w -1 0))

)

```

**Превращается в ...**

```

design.addDirection("w");

design.addDirection("e");

design.addDirection("s");

design.addDirection("n");

design.addPosition("a8", [0, 1, 8, 0]);

design.addPosition("b8", [-1, 1, 8, 0]);

...

```

Фактически, это описание графа, вершинами которого являются отдельные позиции на доске, а дугами (ориентированными) — направления, в которых фигуры могут перемещаться. Целые числа, указанные в массивах, ассоциированных с вершинами графа, представляют собой смещения внутри линейного массива всех позиций, используемых в игре (нулевое значение смещения обозначает отсутствие дуги). При использовании такого подхода, навигация по любому направлению сводится к одному арифметическому сложению:

**ZrfDesign.navigate**

```

ZrfDesign.prototype.navigate = function(aPlayer, aPos, aDir) {

var dir = aDir;

if (typeof this.players[aPlayer] !== "undefined") {

dir = this.players[aPlayer][aDir];

}

if (this.positions[aPos][dir] !== 0) {

return aPos + this.positions[aPos][dir];

} else {

return null;

}

}

```

Ну ладно, есть ещё опциональное изменение направления перемещения, в зависимости от игрока выполняющего ход (так называемая «симметрия»), позволяющее, например, описывать перемещения всех пешек (и чёрных и белых) как перемещение «на север». Если ход будет выполняться чёрными, направление будет изменено на «южное» автоматически. «Нулевая симметрия» позволяет описывать «оппозитные» перемещения для каждого направления (во многих играх это бывает полезно):

```

design.addPlayer("White", [1, 0, 3, 2]);

```

Несколько сложнее преобразуются правила перемещения фигур.

**Ход шашки**

```

(define checker-shift (

$1 (verify empty?)

(if (in-zone? promotion)

(add King)

else

add

)

))

```

**Превращается в ...**

```

design.addCommand(1, ZRF.FUNCTION, 24); // from

design.addCommand(1, ZRF.PARAM, 0); // $1

design.addCommand(1, ZRF.FUNCTION, 22); // navigate

design.addCommand(1, ZRF.FUNCTION, 1); // empty?

design.addCommand(1, ZRF.FUNCTION, 20); // verify

design.addCommand(1, ZRF.IN_ZONE, 0); // promotion

design.addCommand(1, ZRF.FUNCTION, 0); // not

design.addCommand(1, ZRF.IF, 4);

design.addCommand(1, ZRF.PROMOTE, 1); // King

design.addCommand(1, ZRF.FUNCTION, 25); // to

design.addCommand(1, ZRF.JUMP, 2);

design.addCommand(1, ZRF.FUNCTION, 25); // to

design.addCommand(1, ZRF.FUNCTION, 28); // end

```

Это команды стековой машины, каждая из которых очень проста. Например, команда **PARAM** достаёт числовое значение из массива параметров прикреплённого к шаблону хода (набору команд) и помещает его на стек. Она позволяет параметризировать шаблоны ходов, передавая направления перемещения в параметрах:

**Описание фигуры**

```

design.addPiece("Man", 0);

design.addMove(0, 0, [3, 3], 0);

design.addMove(0, 0, [0, 0], 0);

design.addMove(0, 0, [1, 1], 0);

design.addMove(0, 1, [3], 1);

design.addMove(0, 1, [0], 1);

design.addMove(0, 1, [1], 1);

```

В качестве третьего параметра передаётся «режим» хода — числовое значение, позволяющее, помимо всего прочего, отделить «тихие» ходы (в шашках) от выполнения взятий. Вся тройка (шаблон + параметры + режим хода) составляет **полное** описание одного из возможных ходов, выполняемых фигурой.

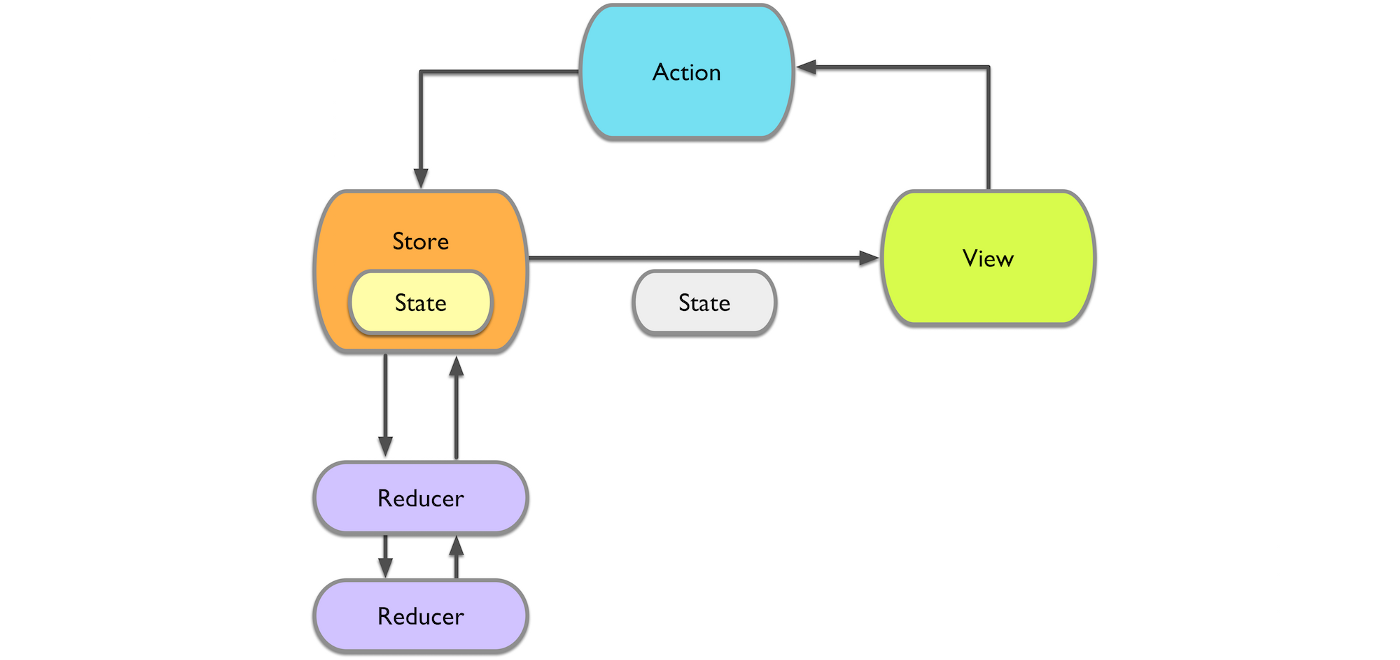

Jocly построена по классической [MVC](https://ru.wikipedia.org/wiki/Model-View-Controller)-схеме. Для разработки новой игры требуется написать её модель и представление. Модель определяет правила игры, а представление — то, как игра будет показана пользователю. Контроллер, написанный разработчиками, берёт на себя всё остальное (включая зашитых в него ботов).

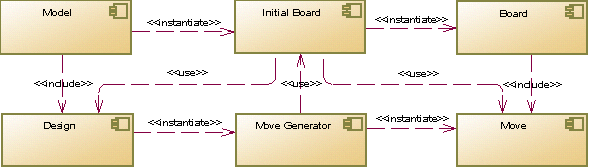

Архитектура универсальной модели, реализуемой **Z2J** также не очень сложна. Основу составляет компонент **Design**, содержащий неизменяемое описание правил игры. Состояние игры (размещение фигур на доске) хранится в экземплярах класса **Board**. Данные этих компонентов также не изменяются. Выполняя ход (применяя объект **Move** к **Board**), мы создаём новое состояние. Старое остаётся неизменным!

Для генерации хода (создания объекта **Move**), используется текущее состояние **Board**, но одного лишь его недостаточно для реализации всех возможностей ZRF. В процессе генерации хода, ZRF может использовать переменные (флаги и позиционные флаги), не являющиеся частью игрового состояния. Всем этим, а также логикой выполнения команд стековой машины, занимается **Move Generator**. Если говорить вкратце, такова архитектура модуля [zrf-model.js](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/js/debug/zrf-model.js).

**Дьявол в деталях**

--------------------

Итак, я собирался встроить в Jocly свою модель (zrf-model.js), сконфигурированную [результатом компиляции](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/zrf/example.js) "[Турецких шашек](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/zrf/example.zrf)", вместо [модели](http://embed.jocly.net/jocly/plazza/file-access?game=turkish-draughts&file=checkersbase-model.js) Jocly и попытаться запустить всё это, не внося каких либо изменений в [представление](http://embed.jocly.net/jocly/plazza/file-access?game=turkish-draughts&file=checkers-xd-view.js) игры. Оглядываясь назад, я понимаю, что идея была авантюрной (почему — расскажу ниже), но именно с этого я начал. От модели требовалось немного:

1. Хранение текущего состояния игры

2. Генерация всех ходов, допустимых для текущего состояния игры

3. Изменение состояния игры, путём применения к нему одного из сгенерированных ходов

Сложность заключалась в том, что ход, далеко не всегда, сводится к простому перемещению одной из фигур по доске. В наиболее общей форме, ход состоит из последовательности следующих элементарных действий:

* **move** — Перемещение фигуры из одной позиции в другую

* **capture** — Удаление фигуры с одной из позиций на доске

* **drop** — Добавление (сброс) новой фигуры на доску

Например, взятие фигуры в шашках состоит из одного перемещения своей фигуры и взятия фигуры противника (при этом, взятие не «шахматное», поскольку позиция, с которой оно выполняется, не совпадает с конечной позицией перемещения фигуры), а ходы в таких играх как "[Рендзю](https://ru.wikipedia.org/wiki/%D0%A0%D1%8D%D0%BD%D0%B4%D0%B7%D1%8E)" состоят из единичных сбросов фигур на доску. Не следует думать, что при выполнении хода может перемещаться всего одна фигура! Так, при выполнении [рокировки](https://ru.wikipedia.org/wiki/%D0%A0%D0%BE%D0%BA%D0%B8%D1%80%D0%BE%D0%B2%D0%BA%D0%B0) в шахматах, ладья и король перемещаются одновременно, в рамках одного неделимого хода.

**Как это работает**

Генерация хода сводится к формированию списка элементарных действий, выполняемых в правильной последовательности. Это просто последовательная интерпретация команд стековой машины:

**ZrfMoveGenerator.generate**

```

ZrfMoveGenerator.prototype.generate = function() {

this.cmd = 0;

while (this.cmd < this.template.commands.length) {

var r = (this.template.commands[this.cmd++])(this);

if (r === null) break;

this.cmd += r;

if (this.cmd < 0) break;

}

}

```

Если опустить подробности, связанные с проверками необходимых условий (не нахождение полей под шахом, неподвижность фигур до выполнения хода и т.п.), код выполнения короткой рокировки, выраженный на ZRF может выглядеть так:

**Рокировка**

```

(define O-O (

e e to e

cascade w w

add

))

```

**Превращается в ...**

```

design.addCommand(0, ZRF.FUNCTION, 24); // from

design.addCommand(0, ZRF.PARAM, 0); // e

design.addCommand(0, ZRF.FUNCTION, 22); // navigate

design.addCommand(0, ZRF.PARAM, 1); // e

design.addCommand(0, ZRF.FUNCTION, 22); // navigate

design.addCommand(0, ZRF.FUNCTION, 25); // to

design.addCommand(0, ZRF.PARAM, 2); // e

design.addCommand(0, ZRF.FUNCTION, 22); // navigate

design.addCommand(0, ZRF.FUNCTION, 24); // from

design.addCommand(0, ZRF.PARAM, 3); // w

design.addCommand(0, ZRF.FUNCTION, 22); // navigate

design.addCommand(0, ZRF.PARAM, 4); // w

design.addCommand(0, ZRF.FUNCTION, 22); // navigate

design.addCommand(0, ZRF.FUNCTION, 25); // to

design.addCommand(0, ZRF.FUNCTION, 28); // end

```

Помимо параметризованной навигации, всё сводится к перемещению фигур, взятых командой **from** (неявно выполняемой в начале хода и при выполнении команды **cascade**), на поле указанное командой **to** (также формируемой неявно). Сам обработчик команды выглядит элементарно:

**Model.Move.ZRF\_TO**

```

Model.Game.functions[Model.Move.ZRF_TO] = function(aGen) {

if (aGen.pos === null) {

return null;

}

if (typeof aGen.piece === "undefined") {

return null;

}

aGen.movePiece(aGen.from, aGen.pos, aGen.piece);

delete aGen.from;

delete aGen.piece;

return 0;

}

ZrfMoveGenerator.prototype.movePiece = function(aFrom, aTo, aPiece) {

this.move.movePiece(aFrom, aTo, aPiece, this.level);

if (aFrom !== aTo) {

this.setPiece(aFrom, null);

}

this.setPiece(aTo, aPiece);

}

ZrfMove.prototype.movePiece = function(from, to, piece, part) {

this.actions.push([ from, to, piece, part ]);

}

```

Но всё это — только часть проблемы! В шашках, фигура может (и более того, обязана) выполнить несколько взятий «по цепочке». Пока не выполнены все взятия, ход не передаётся другому игроку. С точки зрения модели и для AI, это один ход! С контроллером и представлением всё немного сложнее. В пользовательском интерфейсе игры, каждое шашечное взятие (частичный ход), должно выполняться по отдельности. Пользователь (игрок) должен иметь возможность выбора того или иного частичного хода на каждом этапе выполнения длинного составного хода.

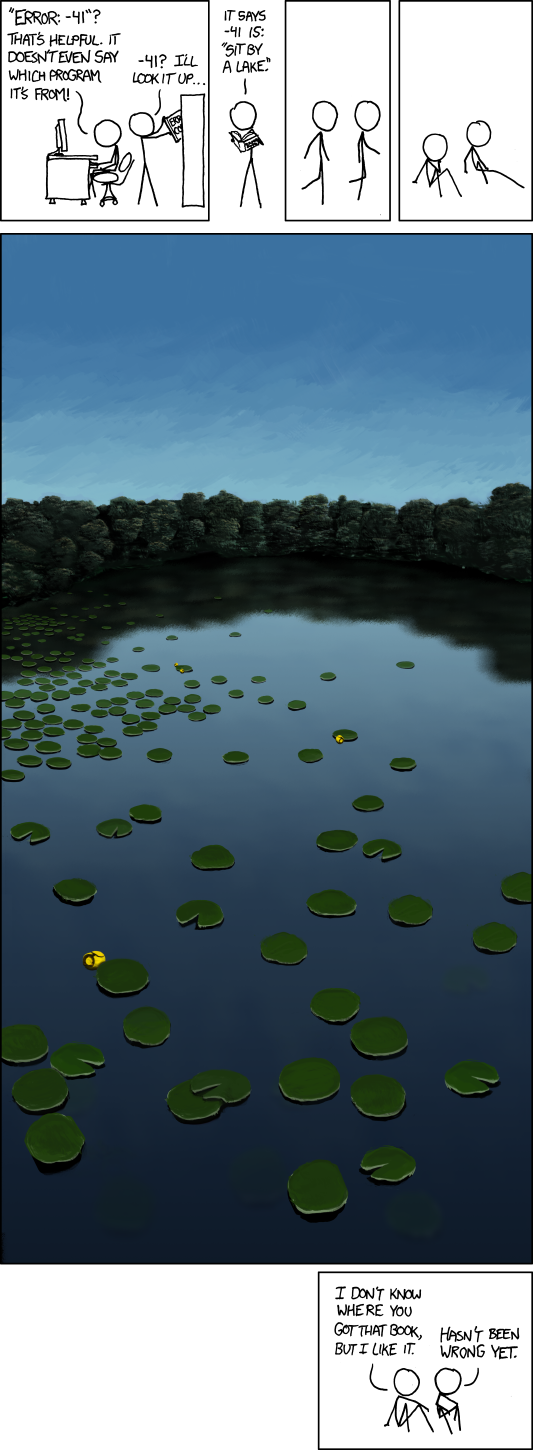

**Конечно, это не единственно возможный подход**

В Zillions of Games, отдельным ходом считается каждый частичный ход. Это упрощает пользовательский интерфейс, но, с другой стороны, не только усложняет жизнь AI, но и ведёт к более серьёзным проблемам.

Здесь показана последовательность позиций, возникающих при выполнении составного хода в игре "[Mana](https://fr.wikipedia.org/wiki/Mana_(jeu))", разработанной Клодом Лероем в 2005 году. По правилам игры, белый Damyo должен выполнить три последовательных шага, по горизонтали или вертикали, на соседнюю пустую позицию. При этом, все шаги **должны** быть сделаны и фигуре **запрещается возвращаться** на ранее пройденные позиции. Как легко видеть, фигура может загнать себя в «тупик», выбрав неправильную последовательность частичных ходов. В Zillions of Games эта проблема неразрешима!

С Шашками всё тоже не просто. Практически во всех традиционных шашечных играх (за исключением [Фанороны](https://ru.wikipedia.org/wiki/%D0%A4%D0%B0%D0%BD%D0%BE%D1%80%D0%BE%D0%BD%D0%B0)), игрок **обязан** продолжать взятия, пока есть такая возможность. Это означает, что выполняя частичный ход содержащий взятие, мы ещё не знаем, завершает он **допустимый** составной ход или нет.

**Разумеется, с этим можно бороться ...**

но это уже сильно напоминает…

**''закат Солнца вручную''**

```

(define checker-captured-find

mark

(if (on-board? $1)

$1

(if (and enemy? (on-board? $1) (empty? $1) (not captured?))

(set-flag more-captures true)

)

)

back

)

(define king-captured-find

mark

(while (and (on-board? $1) (empty? $1))

$1

)

(if (on-board? $1)

$1

(if (and enemy? (empty? $1) (not captured?))

(set-flag more-captures true)

)

)

back

)

(define checker-jump (

(verify (not captured?))

$1

(verify enemy?)

(verify (not captured?))

$1

(verify empty?)

(set-flag more-captures false)

(if (in-zone? promotion)

(king-captured-find $1)

(king-captured-find $2)

(king-captured-find $3)

else

(checker-captured-find $1)

(checker-captured-find $2)

(checker-captured-find $3)

)

(if (flag? more-captures)

(opposite $1)

(markit)

$1

)

(if (not (flag? more-captures))

(opposite $1)

(if enemy?

capture

)

$1

(capture-all)

)

(if (in-zone? promotion)

(if (flag? more-captures)

(add-partial King jumptype)

else

(add-partial King notype)

)

else

(if (flag? more-captures)

(add-partial jumptype)

else

(add-partial notype)

)

)

))

```

Более того, во многих шашечных играх, таких как "[Международные шашки](https://ru.wikipedia.org/wiki/%D0%9C%D0%B5%D0%B6%D0%B4%D1%83%D0%BD%D0%B0%D1%80%D0%BE%D0%B4%D0%BD%D1%8B%D0%B5_%D1%88%D0%B0%D1%88%D0%BA%D0%B8)", действует «правило большинства», согласно которому игрок обязан взять максимально возможное количество фигур противника. В некоторых играх уточняется, что приоритетным должно рассматриваться взятие наибольшего количество дамок. Рассматривая каждый частичный ход по отдельности, Zillions of Games вынужденно прибегает к «магии опций»:

* **(option «pass partial» true)** — разрешает прерывать цепочку взятий

* **(option «maximal captures» true)** — взять максимальное количество фигур

* **(option «maximal captures» 2)** — взять максимальное количество дамок (если количество взятых дамок одинаково — брать максимальное количество фигур)

А теперь, просто сравните этот хардкод с тем,…

**как аналогичную проверку выполняет Jocly**

```

if(aGame.g.captureLongestLine) {

var moves0=this.mMoves;

var moves1=[];

var bestLength=0;

for(var i in moves0) {

var move=moves0[i];

if(move.pos.length==bestLength)

moves1.push(move);

else if(move.pos.length>bestLength) {

moves1=[move];

bestLength=move.pos.length;

}

}

this.mMoves=moves1;

}

```

Когда весь составной ход доступен целиком, ничто не мешает просто подсчитать количество выполняемых им взятий.

Генерация составного хода — это самое простое применение ZrfMoveGenerator. Каждый экземпляр генератора формирует свой частичный ход, а сами частичные ходы сцепляются в «цепочку» составного хода. К сожалению, это не единственный способ, которым ZRF может пользоваться, чтобы определять ходы. Рассмотрим очень простой кейс, описывающий фигуру, двигающуюся через пустые поля в одном направлении (такую как [Слон](https://ru.wikipedia.org/wiki/%D0%A1%D0%BB%D0%BE%D0%BD_(%D1%88%D0%B0%D1%85%D0%BC%D0%B0%D1%82%D1%8B)), [Ладья](https://ru.wikipedia.org/wiki/%D0%9B%D0%B0%D0%B4%D1%8C%D1%8F_(%D1%88%D0%B0%D1%85%D0%BC%D0%B0%D1%82%D1%8B)) и [Ферзь](https://ru.wikipedia.org/wiki/%D0%A4%D0%B5%D1%80%D0%B7%D1%8C) в [Шахматах](https://ru.wikipedia.org/wiki/%D0%A8%D0%B0%D1%85%D0%BC%D0%B0%D1%82%D1%8B)):

**Шахматный Rider**

```

(define slide (

$1 (while empty? add $1)

(verify enemy?)

add

))

```

Можно видеть, что команда **add**, завершающая формирование хода, используется в теле цикла. Это означает, что фигура может остановиться на любом пустом поле, по пути следования до вражеской фигуры (и это будет считаться корректным ходом). Разумеется, от такого цикла можно избавиться, переписав определение:

**В некоторых играх на ZRF приходится использовать такой способ**

```

(define slide-1 (

$1 (verify enemy?)

add

))

(define slide-2 (

$1 (verify empty?)

$1 (verify enemy?)

add

))

(define slide-3 (

$1 (verify empty?)

$1 (verify empty?)

$1 (verify enemy?)

add

))

...

```

Команда **add**, выполняемая в теле цикла, приводит к формированию недетерминированного хода. Фигура может остановиться или пойти дальше. Для ZrfMoveGenerator, это означает необходимость клонирования. Генератор создаёт полную копию своего состояния и помещает её в стек, для последующей генерации, после чего, текущая копия завершает формирование хода. Вот как это выглядит:

**Перемещение дамки**

```

(define king-shift (

$1 (while empty?

add $1

)

))

```

**превращается в ...**

```

design.addCommand(3, ZRF.FUNCTION, 24); // from

design.addCommand(3, ZRF.PARAM, 0); // $1

design.addCommand(3, ZRF.FUNCTION, 22); // navigate

design.addCommand(3, ZRF.FUNCTION, 1); // empty?

design.addCommand(3, ZRF.FUNCTION, 0); // not

design.addCommand(3, ZRF.IF, 7);

design.addCommand(3, ZRF.FORK, 3);

design.addCommand(3, ZRF.FUNCTION, 25); // to

design.addCommand(3, ZRF.FUNCTION, 28); // end

design.addCommand(3, ZRF.PARAM, 1); // $2

design.addCommand(3, ZRF.FUNCTION, 22); // navigate

design.addCommand(3, ZRF.JUMP, -8);

design.addCommand(3, ZRF.FUNCTION, 28); // end

```

Команда **FORK** клонирует генератор хода вместе со всем его текущим состоянием и работает как условный переход. В порождённом генераторе, управление перейдёт к следующей команде, а родитель передаст управление на заданное параметром количество шагов (да-да это очень сильно напоминает создание процесса в Linux).

**Бремя совместимости**

Для того, чтобы ZRF-описания игр работали после «трансляции» их на JavaScript, недостаточно просто выполнить аналогичные команды в том же порядке. Семантика операций (в части взаимодействия с состоянием доски) должна полностью совпадать с используемой Zillions of Games. Чтобы вы представляли себе всю степень запутанности вопроса, вкратце перечислю основные пункты:

* Во время генерации хода, доска доступна в том состоянии, каким оно было на момент начала генерации. Перемещаемая фигура не убирается с исходного поля и, разумеется, не устанавливается на текущее. Это требование понятно (особенно если вспомнить об иммутабельности доски), но в реальной жизни бывает крайне неудобным.

* Состояние флагов (битовых переменных) и позиционных флагов (битовых переменных, привязанных к конкретным позициям) доступно лишь в процессе генерации хода. В случае Zillions of Games, рассматривающей каждый частичный ход как отдельный, это сильно снижает их полезность, но мы должны обеспечить аналогичную семантику, чтобы всё работало.

* Хранение атрибутов (именованных битовых флагов, привязанных к фигурам) не ограничено генерацией хода. Атрибуты — часть состояния доски. Кстати, сами фигуры тоже иммутабельны, изменяя им какой либо из атрибутов, мы создаём новую фигуру.

* Поскольку состояние доски доступно на момент начала генерации хода, прочитать атрибут можно лишь по месту начального расположения фигуры, но если мы хотим изменить атрибут, то делать это надо на той позиции, где фигура завершает своё перемещение (то есть окажется в момент завершения хода). Если изменить атрибут на другом поле (например на исходном) — фатальной ошибки не произойдёт. Значение просто не установится.

* Каскадные ходы не передаются при клонировании ходов. Вернее передаются, но только если отключена опция "**discard cascades**". Ни разу не видел игры, где это используется!

* Промежуточные взятия и сбросы фигур также не передаются в клонированный ход. В результате, взятие дамкой в «Русских шашках» превращается в настоящую головоломку (от точки возможного завершения хода командой **add**, выполняемой в цикле, необходимо двигаться назад, чтобы взять ранее перепрыгнутую вражескую фигуру.

* Мы не можем взять фигуру, у которой на том же ходу изменился тип, значение атрибута или владелец! Это больше похоже на баг, но из песни слова не выкинешь.

* Если ход завершается на позиции содержащей фигуру, «шахматное взятие» выполняется автоматически. Если на том же поле вызвать команду **capture** явно, будет удалена и та фигура, которая выполняла ход (таким образом можно делать фигуры-камикадзе). Аналогичным образом (командой **create**) можно менять тип и владельца фигуры.

* Если включена опция отложенного взятия, при продолжении хода, все взятия фигур должны перемещаться в последний частичный ход составного хода. Этой опции, по понятным причинам, нет в ZRF, но когда она нужна, её так не хватает! Реализация правила "[Турецкого удара](https://ru.wikipedia.org/wiki/%D0%A2%D1%83%D1%80%D0%B5%D1%86%D0%BA%D0%B8%D0%B9_%D1%83%D0%B4%D0%B0%D1%80)" в ZRF — это форменное мучение! К счастью, мы рассматриваем составной ход целиком. Почему бы не реализовать такую полезную опцию?

Это не полный список. Просто первое, что пришло в голову. Помимо этого, необходимо реализовать цикл перебора всех своих фигур, способных выполнить перемещение (в Zillions of Games, игрок может двигать только свои фигуры), а также всех пустых полей, на которые фигуру можно «сбросить».

**Всё вместе это выглядит как-то так**

```

var CompleteMove = function(board, gen) {

var t = 1;

if (Model.Game.passPartial === true) {

t = 2;

}

for (var pos in board.pieces) {

var piece = board.pieces[pos];

if ((piece.player === board.player) || (Model.Game.sharedPieces === true)) {

for (var move in Model.Game.design.pieces[piece.type]) {

if ((move.type === 0) && (move.mode === gen.mode)) {

var g = f.copy(move.template, move.params);

if (t > 0) {

g.moveType = t;

g.generate();

if (g.moveType === 0) {

CompleteMove(board, g);

}

} else {

board.addFork(g);

}

t = 0;

}

}

}

}

}

ZrfBoard.prototype.generateInternal = function(callback, cont) {

this.forks = [];

if ((this.moves.length === 0) && (Model.Game.design.failed !== true)) {

var mx = null;

for (var pos in this.pieces) {

var piece = this.pieces[pos];

if ((piece.player === this.player) || (Model.Game.sharedPieces === true)) {

for (var move in Model.Game.design.pieces[piece.type]) {

if (move.type === 0) {

var g = Model.Game.createGen(move.template, move.params);

g.init(this, pos);

this.addFork(g);

if (Model.Game.design.modes.length > 0) {

var ix = Model.find(Model.Game.design.modes, move.mode);

if (ix >= 0) {

if ((mx === null) || (ix < mx)) {

mx = ix;

}

}

}

}

}

}

}

for (var tp in Model.Game.design.pieces) {

for (var pos in Model.Game.design.positions) {

for (var move in Model.Game.design.pieces[tp]) {

if (move.type === 1) {

var g = Model.Game.createGen(move.template, move.params);

g.init(this, pos);

g.piece = new ZrfPiece(tp, this.player);

g.from = null;

g.mode = move.mode;

this.addFork(g);

if (Model.Game.design.modes.length > 0) {

var ix = Model.find(Model.Game.design.modes, move.mode);

if (ix >= 0) {

if ((mx === null) || (ix < mx)) {

mx = ix;

}

}

}

}

}

}

}

while ((this.forks.length > 0) && (callback.checkContinue() === true)) {

var f = this.forks.shift();

if ((mx === null) || (Model.Game.design.modes[mx] === f.mode)) {

f.generate();

if ((cont === true) && (f.moveType === 0)) {

CompleteMove(this, f);

}

}

}

if (cont === true) {

Model.Game.CheckInvariants(this);

Model.Game.PostActions(this);

if (Model.Game.passTurn === 1) {

this.moves.push(new ZrfMove());

}

if (Model.Game.passTurn === 2) {

if (this.moves.length === 0) {

this.moves.push(new ZrfMove());

}

}

}

}

if (this.moves.length === 0) {

this.player = 0;

}

return this.moves;

}

```

Алгоритм построен таким образом, чтобы продолжения ходов «затирали» свои более короткие «префиксы» (разумеется, если не включена опция "**pass partial**").

Используя два этих способа (выстраивание генераторов ходов в «цепочку» и клонирование) можно реализовать любые конструкции языка ZRF. Конечно, реализация получается не простой и, в силу необходимости обеспечения совместимости с семантикой ZRF, довольно запутанной. Это не очень большая проблема, если код работает. Проблема в том, что сам ZRF далеко не идеален!

**Разжать пальцы**

------------------

Этот год начался с разочарований. Для начала, я зашёл в тупик в своих [попытках](https://habrahabr.ru/post/309096/) создания универсального [DSL](https://ru.wikipedia.org/wiki/%D0%9F%D1%80%D0%B5%D0%B4%D0%BC%D0%B5%D1%82%D0%BD%D0%BE-%D0%BE%D1%80%D0%B8%D0%B5%D0%BD%D1%82%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%BD%D1%8B%D0%B9_%D1%8F%D0%B7%D1%8B%D0%BA), пригодного для простого описания всех известных мне настольных игр. Универсально, в принципе, получалось, «понятно» — нет. Даже относительно простые игры, такие как [Фанорона](https://ru.wikipedia.org/wiki/%D0%A4%D0%B0%D0%BD%D0%BE%D1%80%D0%BE%D0%BD%D0%B0), норовили описаться в какой-то ужас.

**Вроде этого**

(\*)[p]|((\1[ex])\*;~1(~1[ex])\*)

**Даже на ZRF это выглядит понятнее**

```

(define approach-capture (

$1

(verify empty?)

to

$1

(verify enemy?)

capture

(while (enemy? $1) $1 capture)

(add-partial capturing)

))

(define withdrawl-capture (

$1

(verify empty?)

to

back

(opposite $1)

(verify enemy?)

capture

(while (enemy? (opposite $1)) (opposite $1) capture)

(add-partial capturing)

))

```

C Jocly дело тоже как-то сразу не задалось. Мне не понравилась её архитектура. Начнём с того, что для хранения состояния доски в ней используется мутабельный синглтон Model.Board. Как с этим работать AI-боту — ума не приложу. Но главное даже не в этом. [Одна](http://embed.jocly.net/jocly/plazza/file-access?game=english-draughts&file=checkersbase-model.js) модель в ней совершенно не похожа на [другую](http://embed.jocly.net/jocly/plazza/file-access?game=3dchess&file=base-model.js) (просто не имеет ничего общего). При этом, активно используются «магические» члены, наподобие **mWho** или **mMoves**, а представление должно «знать» о том как устроена модель, поскольку использует её наравне с контроллером!

Мои надежды «подменить» модель были заранее обречены на неудачу! То есть, мне вполне возможно и удастся подменить [модель](http://embed.jocly.net/jocly/plazza/file-access?game=turkish-draughts&file=turkish-model.js) "[Турецких шашек](https://ru.wikipedia.org/wiki/%D0%A2%D1%83%D1%80%D0%B5%D1%86%D0%BA%D0%B8%D0%B5_%D1%88%D0%B0%D1%88%D0%BA%D0%B8)" так, чтобы с ней работало соответсвующее [представление](http://embed.jocly.net/jocly/plazza/file-access?game=turkish-draughts&file=turkish-xd-view.js), но для любой другой игры (даже для "[Английских шашек](http://embed.jocly.net/jocly/plazza/file-access?game=english-draughts&file=draughts-model.js)") пришлось бы начинать всё с начала, потому что её модель от «Турецких шашек» отличалается весьма значительно. Я понимал, что не готов, помимо модели, заниматься ещё и разработкой представления и пребывал в глубокой депрессии. А потом, в работу включился [jonic](https://habr.com/ru/users/jonic/) и на горизонте немного посветлело.

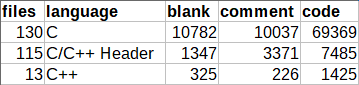

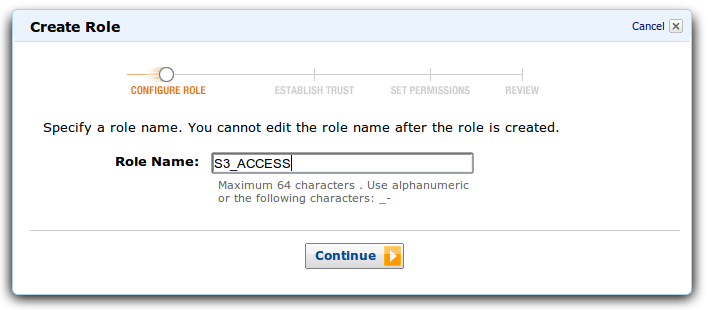

Мы решили отказаться от попыток интеграции с Jocly и разработать недостающие контроллеры (для сетевых и локальных игр, а также утилиту autoplay), представления (2D и 3D), а также ботов (в ассортименте) самостоятельно. Причём, всей этой работой согласился заняться [jonic](https://habr.com/ru/users/jonic/), чтобы я смог сосредоточиться на работе над моделью. Первым делом я избавился от дурацких унаследованных ограничений Jocly. Да, теперь модель поддерживает игры для более чем двух игроков! А потом я вошёл во вкус…

**Это список запланированных мной опций**

* **maximal-captures = true** — Правило большинства (например в «Международных шашках»)

* **pass-partial = true** — Возможность прерывания составного хода (как в «Фанороне»)

* **pass-turn = true** — Возможность пропуска хода

* **pass-turn = forced** — Возможность пропуска хода при отсутствии других ходов

* **discard-cascades = true** — Сброс каскадных перемещений при завершении версии хода

* **include-off-pieces = true** — Учёт фигур находящихся в резерве при подсчёте

* **recycle-captures = true** — Перевод игр в резерв при выполнении взятия

* **smart-moves = true** — Режим «интеллектуального» UI (при наличии единственного хода)

* **smart-moves = from** — Перемещает фигуру при указании стартовой позиции

* **smart-moves = to** — Перемещает фигуру при указании целевой позиции

* **zrf-advanced = true** — Все опции zrf-advanced

* **zrf-advanced = simple** — Упрощённая семантика перемещения фигур при генерации хода

* **zrf-advanced = fork** — Взятия и сбросы переносятся через ZRF\_FORK

* **zrf-advanced = composite** — Доступность флагов установленных предыдущими частичными ходами

* **zrf-advanced = mark** — Поддержка вложенных вызовов mark/back

* **zrf-advanced = delayed** — Реализация правила «Турецкого удара» (во всех шашках, кроме турецких)

* **zrf-advanced = last** — Очистка пометок last-from и last-to при завершении составного хода

* **zrf-advanced = shared** — Возможность хода чужими фигурами (как в «Ставропольских шашках»)

* **zrf-advanced = partial** — Возможность продолжения составного хода не только фигурой, завершившей частичных ход

* **zrf-advanced = numeric** — Поддержка работы с числовыми значениями (как в «Ритмомахии»)

* **zrf-advanced = foreach** — Поддержка оператора foreach для поиска позиции на доске

* **zrf-advanced = repeat** — Поддержка команды повторения хода (пропуск хода всеми игроками)

* **zrf-advanced = player —** Поддержка команд для определения текущего игрока, следующего, принадлежности фигур

* **zrf-advanced = global** — Поддержка глобальных значений состояния (как в Axiom)

* **board-model = heap** — Хранение неупорядоченного множества фигур на позиции (как в манкалах)

* **board-model = stack** — Хранение упорядоченного множества фигур на позиции (как в «Столбовых шашках»)

* **board-model = quantum** — Квантовая доска (фигура одновременно присутствует на нескольких позициях)

Я же говорил, что ограничения ZRF мне тоже не нравятся? Меньшая часть этих опций — унаследованные настройки Zillions of Games, поддерживать которые необходимо. Остальное — расширения, доселе в ZRF не виданные. Так все опции **zrf-advanced** (их можно включить все вместе, одной командой) — расширяют семантику ZRF, делая её более удобной (я постарался учесть [пожелания](http://www.frontiernet.net/~alcove/chess/zogfeedback.html) [пользователей](http://zillionsofgames.com/discus/messages/5/174.html?1079204040) Zillions of Games), а опции **board-model** — вводят новые типы досок.

**Об этом стоит сказать подробнее**

Работая с фигурами на доске, Zillions of Games придерживается некоторых соглашений. В частности, одно игровое поле не может быть занято более чем одной фигурой. Следствием этого является упрощённая реализация «шахматного взятия» (не требуется явно вызывать **capture** для удаления фигуры на целевом поле). Разумеется, не во всех играх это удобно. Существует целая [категория](http://www.di.fc.ul.pt/~jpn/gv/towers.htm) игр (таких как "[Пулук](https://fr.wikipedia.org/wiki/Puluc)" и "[Столбовые шашки](https://ru.wikipedia.org/wiki/%D0%A1%D1%82%D0%BE%D0%BB%D0%B1%D0%BE%D0%B2%D1%8B%D0%B5_%D1%88%D0%B0%D1%88%D0%BA%D0%B8)"), в которых по доске перемещаются «стопки» фигур, установленных друг на друга.

До тех пор, пока «стопки» имеют ограниченную и небольшую высоту, можно схитрить, объявив каждое возможное [размещение](https://ru.wikipedia.org/wiki/%D0%A0%D0%B0%D0%B7%D0%BC%D0%B5%D1%89%D0%B5%D0%BD%D0%B8%D0%B5) фигур отдельным типом фигуры. Но возможность такого решения — скорее исключение, чем правило. Уже при увеличении размера стопки до 6 фигур, количество типов фигур, необходимых для реализации каждого размещения, превышает возможности Zillions of Games. С этим тоже можно бороться, переходя на работу с трёхмерными досками, но гораздо удобнее иметь возможность работы с упорядоченными наборами (размещениями) фигур.

Комбинаторные [сочетания](https://ru.wikipedia.org/wiki/%D0%A1%D0%BE%D1%87%D0%B5%D1%82%D0%B0%D0%BD%D0%B8%D0%B5) также востребованы в настольных играх. [Манкалы](https://ru.wikipedia.org/wiki/%D0%9C%D0%B0%D0%BD%D0%BA%D0%B0%D0%BB%D0%B0) являются древнейшим и едва ли не наиболее массовым их семейством. Пока речь идёт о камнях одного цвета, можно использовать тот же фокус с назначением отдельного типа фигуры каждому сочетанию (разработка манкал на ZRF трудоёмка, но вполне возможна), но существуют манкалы, использующие камни [двух](http://mancala.wikia.com/wiki/Kauri) и [более](http://mancala.wikia.com/wiki/10_Mighty_Men) типов. Есть и другие игры (такие как [Ритмомахия](https://en.wikipedia.org/wiki/Rithmomachy)), в которых возможность манипуляции неупорядоченными наборами фигур крайне востребована.

Квантовые доски — наиболее эзотерическая разновидность. В этих играх, одна фигура может **одновременно** присутствовать на нескольких полях доски (с различной вероятностью). Я не уверен, что буду делать этот тип досок, но игры, в которых такие доски востребованы, определённо [существуют](https://arxiv.org/pdf/1603.04751v2.pdf).

Сами опции реализованы как подгружаемые JavaScript-модули. Например, если в игре (как в «Международных шашках») требуется брать максимальное количество фигур, необходимо загрузить соответствующий [модуль](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/js/debug/maximal-captures.js), после загрузки **zrf-model**. Подключение модуля производится функцией checkVersion:

**В ZRF-файле**

```

...

(option "maximal captures" true)

...

```

**В JavaScript-файле**

```

...

design.checkVersion("z2j", "1");

design.checkVersion("zrf", "2.0");

design.checkVersion("maximal-captures", "true");

...

```

Модель проверит совместимость версий затребованных модулей и подключит соответствующие опции. Этот расширяемый механизм натолкнул меня на интересную мысль. В некоторых играх существуют правила, реализовать которые, используя только ZRF, дьявольски трудно. В большинстве случаев, эти правила сводятся к дополнительным проверкам, влияющим на возможность выполнения того или иного хода. Вынесение проверок в подгружаемые опции избавит меня от необходимости расширения базового языка для их реализации (что было бы совсем не просто).

**Стоит отметить, что разработчики Zillions of Games пошли по тому же пути**

Они прекрасно осознавали, что хотя правила некоторых игр (например Го) и могут быть описаны на ZRF (очень сложно), это никак не поможет AI, встроенному в Zillions of Games, справиться с самими играми. В программу была добавлена возможность «расширения» игр, [подключением](http://www.zillions-of-games.com/progsample.html) специально разработанных DLL-модулей. Хотя API этих расширений довольно неудобно и рассчитано лишь на взаимодействие с AI, некоторые разработчики стали использовать подключаемые библиотеки и [для генерации ходов](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=14).

Апофеозом работы в этом направлении стала разработка Грегом Шмидтом его [Axiom Development Kit](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=1452) — погружаемой библиотеки, выполняющей генерацию ходов, на основании описаний игр, выполненном на языке ForthScript. Она многократно расширила возможности Zillions of Games, но не сделала процесс разработки более комфортным. Используя JavaScript, я нахожусь в более выгодном положении. По крайней мере, мне не придётся компилировать свои расширения!

Поясню на примере. Существует разновидность «Турецких шашек», о которой я узнал совсем недавно. Единственное отличие «Бахрейнских шашек» от турецких заключается в том, что в них запрещено отвечать нападением на нападение противника. Можно съесть напавшую фигуру или уйти из под удара, но нельзя напасть на другую фигуру в ответ! С учётом того, что правило распространяется и на дамки, реализация этой игры на ZRF получилась довольно [сложной](https://github.com/GlukKazan/ZoG/blob/master/Rules/BahrainDama.zrf) и, что самое главное, не очень «прозрачной». Но если я использую расширяемые опции, мне нет никакой необходимости усложнять код в ZRF!

**Bahrain Dama**

```

(variant

(title "Bahrain Dama")

(option "bahrain dama extension" true)

)

```

Я могу взять "[Турецкие шашки](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/zrf/example.zrf)" и подключить опцию выполняющую необходимые проверки. Подгружаемый модуль подменяет метод постобработки хода и, при необходимости, может запретить ранее сгенерированный ход! Сама [логика](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/js/debug/bahrain-dama-extension.js) проверки может быть сколь угодно сложной, она всё равно будет понятнее аналогичной реализации на ZRF! Дело не ограничивается дополнительной валидацией уже сгенерированных ходов. Опция может «обогащать» ход! Например, выполняя ход в "[Го](https://ru.wikipedia.org/wiki/%D0%93%D0%BE)", необходимо сделать следующее:

* Проверить 4 соседних камня (3 на границе доски или 2 в углу).

* Если соседний камень принадлежит врагу, построить «связную» группу камней, в которую он входит, и сосчитать количество её дамэ (свободных пунктов, с которыми граничит группа).

* Если вражеская группа не граничит со свободными пунктами — удалить все её камни.

* Если ни одна из вражеских групп не удалена, построить группу, содержащую только что добавленный камень

* Если у построенной группы нет дамэ, запретить ход (Строго говоря, не всегда. [Правилами Инга](https://ru.wikipedia.org/wiki/%D0%9F%D1%80%D0%B0%D0%B2%D0%B8%D0%BB%D0%B0_%D0%98%D0%BD%D0%B3%D0%B0) разрешён суицид групп, состоящих из более чем одного камня).

Всё это можно «спрятать» в [JavaScript-расширение](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/js/debug/go-extension.js)! Оно не только выполнит необходимые проверки, но и дополнит ход удалением вражеских камней. ZRF-описание игры становится [элементарным](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/zrf/go.zrf)! Более того, тоже расширение подходит и для других игр! Например, для "[Многоцветного Го](http://senseis.xmp.net/?MultiColorGo)".

**Больше чем один ход...**

--------------------------

Расширяемые опции позволили взглянуть на проект по новому, но одна маленькая задача по прежнему не давала мне покоя. В некоторых играх, при определённых условиях, допускается взятие с доски **любой** фигуры противника. Например, в "[Мельнице](http://www.iggamecenter.com/info/ru/ninemenmorris.html)":

* Игроки ставят на доску и перемещают свои фигуры, стараясь поставить 3 фигуры «в ряд».

* Если это удаётся, игрок получает право снять с доски любую фигуру противника.

* При этом, должно отдаваться предпочтение фигурам не стоящим «в ряду» (фигуры составляющие ряд берутся в последнюю очередь).

* Если у игрока остаётся 3 фигуры, он получает возможность перемещать их в **любое** место доски (не только по отмеченным линиям).

* Проигрывает игрок, у которого осталось меньше 3 фигур.

[Нельзя сказать](http://www.zillions-of-games.com/cgi-bin/zilligames/submissions.cgi?do=show;id=428), что это нереализуемо на ZRF, но код получается **очень** запутанный. Ну и вообще, генерация набора ходов, одинаковых практически во всём, кроме забираемой фигуры — довольно унылое решение. Я подумал, что было бы гораздо удобнее, если бы в действиях ходов можно было использовать **массивы** позиций:

```

ZrfMove.prototype.capturePiece = function(pos, part) {

- this.actions.push([ pos, null, null, part]);

+ this.actions.push([ [pos], null, null, part]);

}

```

Это была довольно-таки глобальная [переделка](https://github.com/GlukKazan/JoclyGames/commit/5ddcd5cf5edb17757127eb242a77da297c48292d) кода, но [unit-тесты](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/tests/checkers-test.js), в очередной раз, помогли. Пока такие недетерминированные ходы планируется формировать только из JavaScript-расширений, в рамках «обогащения» ходов, формируемых максимально простым ZRF-описанием игры. Если говорить о "[Мельнице](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/js/debug/morris-extension.js)", то речь идёт о всё том же добавлении в ход взятий фигур. Просто вместо набора одиночных взятий, добавляется одно недетерминированное:

**Магия недетерминизма**

```

Model.Game.CheckInvariants = function(board) {

var design = Model.Game.design;

var cnt = getPieceCount(board);

for (var i in board.moves) {

var m = board.moves[i];

var b = board.apply(m);

for (var j in m.actions) {

fp = m.actions[j][0];

tp = m.actions[j][1];

pn = m.actions[j][3];

if ((fp !== null) && (tp !== null)) {

if (checkLine(b, tp[0], board.player) === true) {

var all = [];

var captured = [];

var len = design.positions.length;

for (var p = 0; p < len; p++) {

var piece = b.getPiece(p);

if (piece.player !== board.player) {

if ((checkLine)(b, p, b.player) === false) {

captured.push(p);

}

all.push(p);

}

}

if (captured.length === 0) {

captured = all;

}

if (captured.length > 0) {

captured.push(null);

m.actions.push([captured, null, null, pn]);

}

}

...

break;

}

}

}

CheckInvariants(board);

}

```

Но это более широкая концепция. Не только взятие может быть недетерминированным! Помните, что в «Мельнице» есть правило, по которому три оставшиеся фигуры игрока могут прыгать «куда угодно». Фактически, это недетерминированное перемещение на любую свободную позицию:

**Ещё немного магии**

```

...

if (cnt === 3) {

var len = design.positions.length;

for (var p = 0; p < len; p++) {

if (p !== tp[0]) {

var piece = board.getPiece(p);

if (piece === null) {

tp.push(p);

}

}

}

}

...

```

Перемещаемая фигура также может быть массивом! Согласно правилам превращения в Шахматах, пешка, достигая последней горизонтали, может превратиться в любую из 4 фигур (Конь, Слон, Ладья, Ферзь), на выбор игрока. Это ни что иное как недетерминированное превращение, выполняемое при перемещении фигуры. В ZRF-коде пешку можно превратить, например, в ферзя, а в [JavaScript-расширении](https://github.com/GlukKazan/JoclyGames/blob/master/Z2J/src/js/debug/chess-promotion.js):

**... обогатить это превращение**

```

var promote = function(arr, name, player) {

var design = Model.Game.design;

var t = design.getPieceType(name);

if (t !== null) {

arr.push(design.createPiece(t, player));

}

}

Model.Game.CheckInvariants = function(board) {

var design = Model.Game.design;

for (var i in board.moves) {

var m = board.moves[i];

for (var j in m.actions) {

fp = m.actions[j][0];

tp = m.actions[j][1];

if ((fp !== null) && (tp !== null)) {

var piece = board.getPiece(fp[0]);

if ((piece !== null) && (piece.getType() === "Pawn")) {

var p = design.navigate(board.player, tp[0], design.getDirection("n"));

if (p === null) {

var promoted = [];

promote(promoted, "Queen", board.player);

promote(promoted, "Rook", board.player);

promote(promoted, "Knight", board.player);

promote(promoted, "Bishop", board.player);

if (promoted.length > 0) {

m.actions[j][2] = promoted;

}

}

}

break;

}

}

}

CheckInvariants(board);

}

```

Для контроллера изменяется немногое. Получив от модели ход, допустимый для текущего состояния доски, он должен проверить размер массивов в каждом из действий. Если передаётся более одного элемента, контроллер должен перебрать все возможные варианты, формируя детерминированные ходы. Думаю, не стоит говорить о том, что с подобным недетерминизмом следует быть осторожным. Декартово произведение нескольких независимых позиций способно породить просто невероятное количество различных ходов!

**Промежуточные итоги**

-----------------------

В целом, могу сказать, что мне нравится направление развитие проекта. Я отказался от идеи создания чего-то революционно нового (хоть это было и не просто) и сосредоточился на достижимых, но ни чуть не менее интересных целях. Можно сказать, что из двух известных птиц я предпочитаю «журавля в руках». Работа над проектом помогает освоить новый для меня язык, а присоединение к проекту нового, более опытного разработчика несёт надежду, что работа всё-таки увенчается успехом. Я отказался от «революции», но проект продолжает эволюционировать!

|

https://habr.com/ru/post/320474/

| null |

ru

| null |

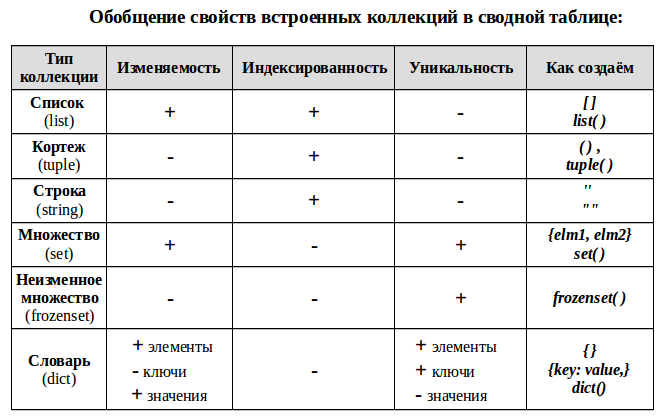

# Python: коллекции, часть 1/4: классификация, общие подходы и методы, конвертация

| Часть 1 | [Часть 2](https://habrahabr.ru/post/319200/ "Python: коллекции, часть 2/4: индексирование, срезы, сортировка") | [Часть 3](https://habrahabr.ru/post/319876/ "Python: коллекции, часть 3/4: объединение коллекций, добавление и удаление элементов") | [Часть 4](https://habrahabr.ru/post/320288/ "Python: коллекции, часть 4/4: Все о выражениях-генераторах, генераторах списков, множеств и словарей") |

| --- | --- | --- | --- |

Коллекция в Python — программный объект (переменная-контейнер), хранящая набор значений одного или различных типов, позволяющий обращаться к этим значениям, а также применять специальные функции и методы, зависящие от типа коллекции.

Частая проблема при изучении коллекций заключается в том, что разобрав каждый тип довольно детально, обычно потом не уделяется достаточного внимания разъяснению картины в целом, не проводятся чёткие сходства и различия между типами, не показывается как одну и туже задачу решать для каждой из коллекций в сравнении.

Вот именно эту проблему я хочу попытаться решить в данном цикле статей – рассмотреть ряд подходов к работе со стандартными коллекциями в Python в сравнении между коллекциями разных типов, а не по отдельности, как это обычно показывается в обучающих материалах. Кроме того, постараюсь затронуть некоторые моменты, вызывающие сложности и ошибки у начинающих.

**Для кого:** для изучающих Python и уже имеющих начальное представление о коллекциях и работе с ними, желающих систематизировать и углубить свои знания, сложить их в целостную картину.

**Будем рассматривать** стандартные встроенные коллекционные типы данных в Python: список (list), кортеж (tuple), строку (string), множества (set, frozenset), словарь (dict). Коллекции из модуля collections рассматриваться не будут, хотя многое из статьи должно быть применимым и при работе с ними.

#### ОГЛАВЛЕНИЕ:

1. Классификация коллекций;

2. [Общие подходы к работе с коллекциями;](#2)

3. [Общие методы для части коллекций;](#3)

4. [Конвертирование коллекций](#4).

1. Классификация коллекций

--------------------------

### Пояснения терминологии:

**Индексированность** – каждый элемент коллекции имеет свой порядковый номер — индекс. Это позволяет обращаться к элементу по его порядковому индексу, проводить слайсинг («нарезку») — брать часть коллекции выбирая исходя из их индекса. Детально эти вопросы будут рассмотрены в дальнейшем в отдельной статье.

**Уникальность** – каждый элемент коллекции может встречаться в ней только один раз. Это порождает требование неизменности используемых типов данных для каждого элемента, например, таким элементом не может быть список.

**Изменяемость** коллекции — позволяет добавлять в коллекцию новых членов или удалять их после создания коллекции.

#### Примечание для словаря (dict):

* сам словарь изменяем — можно добавлять/удалять новые пары ключ: значение;

* значения элементов словаря — изменяемые и не уникальные;

* а вот ключи — не изменяемые и уникальные, поэтому, например, мы не можем сделать ключом словаря список, но можем кортеж. Из уникальности ключей, так же следует уникальность элементов словаря — пар ключ: значение.

UPD: [Важное замечание](https://habrahabr.ru/post/319164/#comment_10002362) от [sakutylev](https://habr.com/en/users/sakutylev/): Для того, чтобы объект мог быть ключом словаря, он должен быть хешируем. У кортежа, возможен случай, когда его элемент является не хешируемым объектом, и соответственно сам кортеж тогда тоже не является хешируемым и не может выступать ключом словаря.

```

a = (1, [2, 3], 4)

print(type(a)) #

b = {a: 1} # TypeError: unhashable type: 'list'

```

* UPD: Благодарю [morff](https://habr.com/en/users/morff/) за внимательность — *{}* без значений создают словарь, а со значениями, в зависимости от синтаксиса могут создавать как множество, так и словарь:

```

a = {}

print(type(a)) #

b = {1, 2, 3}

print(type(b)) #

c = {'a': 1, 'b': 2}

print(type(c)) #

```

2 Общие подходы к работе с любой коллекцией

-------------------------------------------

Разобравшись в классификацией, рассмотрим что можно делать с любой стандартной коллекцией независимо от её типа (в примерах список и словарь, но это работает и для всех остальных рассматриваемых стандартных типов коллекций):

```

# Зададим исходно список и словарь (скопировать перед примерами ниже):

my_list = ['a', 'b', 'c', 'd', 'e', 'f']

my_dict = {'a': 1, 'b': 2, 'c': 3, 'd': 4, 'e': 5, 'f': 6}

```

### 2.1 Печать элементов коллекции с помощью функции **print**()

```

print(my_list) # ['a', 'b', 'c', 'd', 'e', 'f']

print(my_dict) # {'a': 1, 'c': 3, 'e': 5, 'f': 6, 'b': 2, 'd': 4}

# Не забываем, что порядок элементов в неиндексированных коллекциях не сохраняется.

```

### 2.2 Подсчёт количества членов коллекции с помощью функции **len**()

```

print(len(my_list)) # 6

print(len(my_dict)) # 6 - для словаря пара ключ-значение считаются одним элементом.

print(len('ab c')) # 4 - для строки элементом является 1 символ

```

### 2.3 Проверка принадлежности элемента данной коллекции c помощью оператора **in**

**x in s** — вернет True, если элемент входит в коллекцию s и False — если не входит

Есть и вариант проверки не принадлежности: **x not in s**, где есть по сути, просто добавляется отрицание перед булевым значением предыдущего выражения.

```

my_list = ['a', 'b', 'c', 'd', 'e', 'f']

print('a' in my_list) # True

print('q' in my_list) # False

print('a' not in my_list) # False

print('q' not in my_list) # True

```

Для **словаря** возможны варианты, понятные из кода ниже:

```

my_dict = {'a': 1, 'b': 2, 'c': 3, 'd': 4, 'e': 5, 'f': 6}

print('a' in my_dict) # True - без указания метода поиск по ключам

print('a' in my_dict.keys()) # True - аналогично примеру выше

print('a' in my_dict.values()) # False - так как 'а' — ключ, не значение

print(1 in my_dict.values()) # True

```

Можно ли проверять пары? Можно!

```

print(('a',1) in my_dict.items()) # True

print(('a',2) in my_dict.items()) # False

```

Для **строки** можно искать не только один символ, но и подстроку:

```

print('ab' in 'abc') # True

```

### 2.4 Обход всех элементов коллекции в цикле **for in**

В данном случае, в цикле будут последовательно перебираться элементы коллекции, пока не будут перебраны все из них.

```

for elm in my_list:

print(elm)

```

#### Обратите внимание на следующие моменты:

* **Порядок** обработки элементов для не индексированных коллекций будет не тот, как при их создании

* У прохода в цикле по **словарю** есть свои особенности:

```

for elm in my_dict:

# При таком обходе словаря, перебираются только ключи

# равносильно for elm in my_dict.keys()

print(elm)

for elm in my_dict.values():

# При желании можно пройти только по значениям

print(elm)

```

Но чаще всего нужны пары ключ(key) — значение (value).

```

for key, value in my_dict.items():

# Проход по .items() возвращает кортеж (ключ, значение),

# который присваивается кортежу переменных key, value

print(key, value)

```

* **Возможная ошибка**: Не меняйте количество элементов коллекции в теле цикла во время итерации по этой же коллекции! — Это порождает не всегда очевидные на первый взгляд ошибки.

Чтобы этого избежать подобных побочных эффектов, можно, например, итерировать копию коллекции:

```

for elm in list(my_list):

# Теперь можете удалять и добавлять элементы в исходный список my_list,

# так как итерация идет по его копии.

```

### 2.5 Функции **min**(), **max**(), **sum**()

* Функции **min**(), **max**() — поиск минимального и максимального элемента соответственно — работают не только для числовых, но и для строковых значений.

* **sum**() — суммирование всех элементов, если они все числовые.

```

print(min(my_list)) # a

print(sum(my_dict.values())) # 21

```

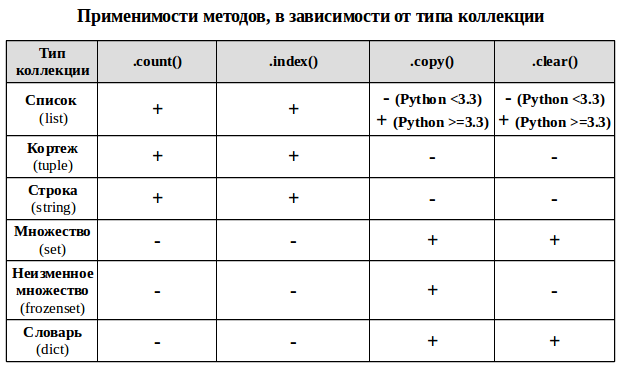

3 Общие методы для части коллекций

----------------------------------

Ряд методов у коллекционных типов используется в более чем одной коллекции для решения задач одного типа.

UPD: Важные дополнения в третьей статье: [Добавление и удаление элементов изменяемых коллекций](https://habrahabr.ru/post/319876/#4).

### Объяснение работы методов и примеры:

* .**count**() — метод подсчета определенных элементов для неуникальных коллекций (строка, список, кортеж), возвращает сколько раз элемент встречается в коллекции.

```

my_list = [1, 2, 2, 2, 2, 3]

print(my_list.count(2)) # 4 экземпляра элемента равного 2

print(my_list.count(5)) # 0 - то есть такого элемента в коллекции нет

```

* .**index**() — возвращает минимальный индекс переданного элемента для индексированных коллекций (строка, список, кортеж)

```

my_list = [1, 2, 2, 2, 2, 3]

print(my_list.index(2)) # первый элемент равный 2 находится по индексу 1 (индексация с нуля!)

print(my_list.index(5)) # ValueError: 5 is not in list - отсутствующий элемент выдаст ошибку!

```

* .**copy**() — метод возвращает неглубокую (не рекурсивную) копию коллекции (список, словарь, оба типа множества).

```

my_set = {1, 2, 3}

my_set_2 = my_set.copy()

print(my_set_2 == my_set) # True - коллекции равны - содержат одинаковые значения

print(my_set_2 is my_set) # False - коллекции не идентичны - это разные объекты с разными id

```

* .**clear**() — метод изменяемых коллекций (список, словарь, множество), удаляющий из коллекции все элементы и превращающий её в пустую коллекцию.

```

my_set = {1, 2, 3}

print(my_set) # {1, 2, 3}

my_set.clear()

print(my_set) # set()

```

### Особые методы сравнения множеств (set, frozenset)

* set\_a.**isdisjoint**(set\_b) — истина, если set\_a и set\_b не имеют общих элементов.

* set\_b.**issubset**(set\_a) — если все элементы множества set\_b принадлежат множеству set\_a, то множество set\_b целиком входит в множество set\_a и является его подмножеством (set\_b — подмножество)

* set\_a.**issuperset**(set\_b) — соответственно, если условие выше справедливо, то set\_a — надмножество

```

set_a = {1, 2, 3}

set_b = {2, 1} # порядок элементов не важен!

set_c = {4}

set_d = {1, 2, 3}

print(set_a.isdisjoint(set_c)) # True - нет общих элементов

print(set_b.issubset(set_a)) # True - set_b целиком входит в set_a, значит set_b - подмножество

print(set_a.issuperset(set_b)) # True - set_b целиком входит в set_a, значит set_a - надмножество

```

При равенстве множеств они одновременно и подмножество и надмножество друг для друга

```

print(set_a.issuperset(set_d)) # True

print(set_a.issubset(set_d)) # True

```

4 Конвертация одного типа коллекции в другой

--------------------------------------------

В зависимости от стоящих задач, один тип коллекции можно конвертировать в другой тип коллекции. Для этого, как правило достаточно передать одну коллекцию в функцию создания другой (они есть в таблице выше).

```

my_tuple = ('a', 'b', 'a')

my_list = list(my_tuple)

my_set = set(my_tuple) # теряем индексы и дубликаты элементов!

my_frozenset = frozenset(my_tuple) # теряем индексы и дубликаты элементов!

print(my_list, my_set, my_frozenset) # ['a', 'b', 'a'] {'a', 'b'} frozenset({'a', 'b'})

```

### Обратите внимание, что при преобразовании одной коллекции в другую возможна потеря данных:

* При преобразовании в множество теряются дублирующие элементы, так как множество содержит только уникальные элементы! Собственно, проверка на уникальность, обычно и является причиной использовать множество в задачах, где у нас есть в этом потребность.

* При конвертации индексированной коллекции в неиндексированную теряется информация о порядке элементов, а в некоторых случаев она может быть критически важной!

* После конвертации в не изменяемый тип, мы больше не сможем менять элементы коллекции — удалять, изменять, добавлять новые. Это может привести к ошибкам в наших функциях обработки данных, если они были написаны для работы с изменяемыми коллекциями.

### Дополнительные детали:

* Способом выше не получится создать **словарь**, так как он состоит из пар ключ: значение.

Это ограничение можно обойти, создав словарь комбинируя ключи со значениями с использованием zip():

```

my_keys = ('a', 'b', 'c')

my_values = [1, 2] # Если количество элементов разное -

# будет отработано пока хватает на пары - лишние отброшены

my_dict = dict(zip(my_keys, my_values))

print(my_dict) # {'a': 1, 'b': 2}

```

* Создаем **строку** из другой коллекции:

```

my_tuple = ('a', 'b', 'c')

my_str = ''.join(my_tuple)

print(my_str) # abc

```

* **Возможная ошибка**: Если Ваша коллекция содержит изменяемые элементы (например список списков), то ее нельзя конвертировать в не изменяемую коллекцию, так как ее элементы могут быть только не изменяемыми!

```

my_list = [1, [2, 3], 4]

my_set = set(my_list) # TypeError: unhashable type: 'list'

```

**Примечание**: Самые мощные и гибкие способы — генераторы коллекций будут рассмотрены отдельно [в четвертой части цикла](https://habrahabr.ru/post/320288/ "Python: коллекции, часть 4/4: Все о выражениях-генераторах, генераторах списков, множеств и словарей"), так как там много нюансов и вариантов использования, на которых редко заостряют внимание, и требуется детальный разбор.

UPD: [ShashkovS](https://habr.com/en/users/shashkovs/) в [комментариях](https://habrahabr.ru/post/319164/#comment_10003430) выложил ссылки на важную и полезную информацию по алгоритмической сложности операций с коллекциями:

* [TimeComplexity (aka «Big O» or «Big Oh»)](https://wiki.python.org/moin/TimeComplexity) (на английском)

* [Complexity of Python Operations](https://www.ics.uci.edu/~pattis/ICS-33/lectures/complexitypython.txt) (на английском)

| Часть 1 | [Часть 2](https://habrahabr.ru/post/319200/ "Python: коллекции, часть 2/4: индексирование, срезы, сортировка") | [Часть 3](https://habrahabr.ru/post/319876/ "Python: коллекции, часть 3/4: объединение коллекций, добавление и удаление элементов") | [Часть 4](https://habrahabr.ru/post/320288/ "Python: коллекции, часть 4/4: Все о выражениях-генераторах, генераторах списков, множеств и словарей") |

| --- | --- | --- | --- |

#### Приглашаю к обсуждению:

* Если я где-то допустил неточность или не учёл что-то важное — пишите в комментариях, важные комментарии будут позже добавлены в статью с указанием вашего авторства.

* Если какие-то моменты не понятны и требуется уточнение — пишите ваши вопросы в комментариях — или я или другие читатели дадут ответ, а дельные вопросы с ответами будут позже добавлены в статью.

|

https://habr.com/ru/post/319164/

| null |

ru

| null |

# Главный секрет блока else в циклах пайтона

Это короткая статья для новичков. Наверняка вы знаете, что в пайтоне для циклов `for` и `while` предусмотрен блок `else`. И с этим блоком возникает много путаницы, потому что его действие на первый взгляд неинтуитивно. Приходится тратить немного времени или заглядывать в документацию каждый раз, когда он встречается:

```

for f in files:

if f.uuid == match_uuid:

break

else:

raise FileNotFound()

```

Когда будет исключение: когда файл не найден? Когда найден? Когда список пуст? На этот вопрос сложно ответить, потому что блок `else` находится на одном уровне с блоком `for` и кажется, что это какое-то условие, относящиеся к самому списку; например, когда `for` не нашел ни одной записи. Но достаточно знать главный секрет блока `else` для циклов, чтобы больше никогда не терять на это время:

Блок `else` после циклов относится не к самому циклу, а к оператору `break`!

============================================================================

И действительно, блок `else` выполнится в любом случае, если только выполнение цикла не было прервано оператором `break`, `return` или `raise`.

Если читать пример выше так: «если файл имеет нужный нам uuid, то закончить цикл, иначе вызвать исключение», то все становится на свои места.

|

https://habr.com/ru/post/510426/

| null |

ru

| null |

# Functional components with React Hooks. Why it's better?

When React.js 16.8 was released we got the opportunity to use React Hooks. Hooks make us able to write fully-functional components using functions. We can use all React.js features and do in in more convenient way.

A lot of people don't agree with Hooks conception. In this article I'd like to tell about some important advantages React Hooks give you and why we need to write with Hooks.

I will not talk about how to use hooks. It is not very important for the examples. If you want to read something on this topic, you can use [official documentation](https://reactjs.org/docs/hooks-reference.html). Also, if this topic will be interesting for you, I will write more about Hooks.

Hooks allow us to reuse our code easily

---------------------------------------

Let's imagine a component rendering a simple form. It can be something showing us a few inputs and allow us to change it's values.

With the class notation, there will be something like this:

```

class Form extends React.Component {

state = {

// Fields values

fields: {},

};

render() {

return (

{/\* Inputs render \*/}

);

};

}

```

Let's imagine now that we want to automatically save our fields values to a backend whenever they changed. I suggest to skip the definition of external functions like `shallowEqual` and `debounce`.

```

class Form extends React.Component {

constructor(props) {

super(props);

this.saveToDraft = debounce(500, this.saveToDraft);

};

state = {

// Fields values

fields: {},

// Draft saving meta

draft: {

isSaving: false,

lastSaved: null,

},

};

saveToDraft = (data) => {

if (this.state.isSaving) {

return;

}

this.setState({

isSaving: true,

});

makeSomeAPICall().then(() => {

this.setState({

isSaving: false,

lastSaved: new Date(),

})

});

}

componentDidUpdate(prevProps, prevState) {

if (!shallowEqual(prevState.fields, this.state.fields)) {

this.saveToDraft(this.state.fields);

}

}

render() {

return (

{/\* Draft saving meta render \*/}

{/\* Inputs render \*/}

);

};

}

```

The same component with Hooks:

```

const Form = () => {

// Our state

const [fields, setFields] = useState({});

const [draftIsSaving, setDraftIsSaving] = useState(false);

const [draftLastSaved, setDraftLastSaved] = useState(false);

useEffect(() => {

const id = setTimeout(() => {

if (draftIsSaving) {

return;

}

setDraftIsSaving(true);

makeSomeAPICall().then(() => {

setDraftIsSaving(false);

setDraftLastSaved(new Date());

});

}, 500);

return () => clearTimeout(id);

}, [fields]);

return (

{/\* Draft saving meta render \*/}

{/\* Inputs render \*/}

);

}

```

As we see, there is not a big difference here. We replaced `this.state` with `useState` hook and saving the draft in `useEffect` hook now.

The difference I want to show here is (there is another differences too, but I'll concentrate on this one): we can easily extract this code from our component and use it somewhere else:

```

// useDraft hook can be used in any other component

const useDraft = (fields) => {

const [draftIsSaving, setDraftIsSaving] = useState(false);

const [draftLastSaved, setDraftLastSaved] = useState(false);

useEffect(() => {

const id = setTimeout(() => {

if (draftIsSaving) {

return;

}

setDraftIsSaving(true);

makeSomeAPICall().then(() => {

setDraftIsSaving(false);

setDraftLastSaved(new Date());

});

}, 500);

return () => clearTimeout(id);

}, [fields]);

return [draftIsSaving, draftLastSaved];

}

const Form = () => {

// Our state

const [fields, setFields] = useState({});

const [draftIsSaving, draftLastSaved] = useDraft(fields);

return (

{/\* Draft saving meta render \*/}

{/\* Inputs render \*/}

);

}

```

And we can use `useDraft` hook in other components! It is, of course, a very simple example, but code reusing is pretty important this and the example shows how easy it is with Hooks.

Hooks allow us to write component in more intuitive way

-------------------------------------------------------

Let's imagine a class component rendering, for example, a chat screen, chats list and message form. Like this:

```

class ChatApp extends React.Component {

state = {

currentChat: null,

};

handleSubmit = (messageData) => {

makeSomeAPICall(SEND_URL, messageData)

.then(() => {

alert(`Message is sent to chat ${this.state.currentChat}`);

});

};

render() {

return (

{

this.setState({ currentChat });

}} />

);

};

}

```

Then imagine our user using this chat component:

* They open chat 1

* They send a message (let's imagine some slow network)

* They open chat 2

* They see an alert about theirs message:

+ "Message is sent to chat 2"

But they're sent a message to the second chat, how did it happend? It was because the class method work with current value, not the value we had when we was starting a message request. It's not a big deal with a simple components like this, but it can be a source of bugs in more complex systems.

In the other hand, functional components acts in other way:

```

const ChatApp = () => {

const [currentChat, setCurrentChat] = useState(null);

const handleSubmit = useCallback(

(messageData) => {

makeSomeAPICall(SEND_URL, messageData)

.then(() => {

alert(`Message is sent to chat ${currentChat}`);

});

},

[currentChat]

);

render() {

return (

);

};

}

```

Let's imagine our user:

* They open chat 1

* They send a message (let's imagine some slow network)

* They open chat 2

* They see an alert about theirs message:

+ "Message is sent to chat 1"

Well, what's changed? Now we are working with a value, captured in render moment. We're creating a new `handleSubmit` every time `currentChat` changed. It allow us to forget about future changes and think about **now**.

*Every component render capturing everything it use*.

Hooks make components lifecycle gone

------------------------------------