text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# LabVIEW — первое знакомство

Здравствуйте, коллеги!

В относительно небольшой статье мне хотелось бы рассказать о языке программирования LabVIEW. Этот весьма любопытный продукт к сожалению не пользуется широкой популярностью, и мне хотелось бы в некоторой степени восполнить имеющийся пробел.

Что же такое «LabVIEW»?

LabVIEW — это один из основных продуктов компании [National Instruments](http://www.ni.com). Прежде всего надо отметить, что LabVIEW — это аббревиатура, которая расшифровывается как **Lab**oratory **V**irtual **I**nstrumentation **E**ngineering **W**orkbench. Уже в названии прослеживается ориентация на лабораторные исследования, измерения и сбор данных. Действительно, построить SCADA — систему в LabVIEW несколько проще чем при использовании «традиционных» средств разработки. В данной статье мне хотелось бы показать, что возможная область применения LabVIEW несколько шире. Это принципиально иной язык программирования, или если хотите целая «философия» программирования. Функциональный язык, заставляющий несколько иначе мыслить и порой предоставляющий совершенно фантастические возможности для разработчика. Является ли LabVIEW языком программирования вообще? Это спорный вопрос — здесь нет стандарта, как, например ANSI C. В узких кругах разработчиков мы говорим, что пишем на языке «G». Формально такого языка не существует, но в этом и заключается прелесть этого средства разработки: от версии к версии в язык вводятся всё новые конструкции. Сложно представить, что в следующей реинкарнации Си появится, например, новая структура для for-цикла. А в LabVIEW такое вполне возможно.

Впрочем надо заметить, что LabVIEW входит в рейтинг языков программирования [TIOBE](http://www.tiobe.com/index.php/content/paperinfo/tpci/index.html), занимая на данный момент тридцатое место — где-то между Прологом и Фортраном.

NI LabVIEW — история создания

-----------------------------

Компания National Instruments была создана в 1976 году тремя основателями — Джеффом Кодоски (Jeff Kodosky), Джеймсом Тручардом (James Truchard) и Биллом Новлиным (Bill Nowlin) в американском городе Остин (Austin), штат Техас. Основной специализацией компании являлись инструментальные средства для измерений и автоматизация производства.

Первая версия LabVIEW увидела свет спустя десять лет после создания компании — в 1986 году (это была версия для Apple Mac). Инженеры NI решили бросить вызов «традиционным» языкам программирования и создали полностью графическую среду разработки. Основным идеологом графического подхода стал Джефф. Год за годом выпускались новые версии. Первой кроссплатформенной версией (включая Windows) была третья версия, выпущенная в 1993 году. Актуальной на данный момент является версия 8.6, вышедшая в прошлом году.

В Остине и по сегодняшний день располагается головной офис компании. Сегодня в компании работают почти четыре тысячи человек, а офисы находятся почти в сорока странах (есть также офис и в России)

Моё знакомство с LabVIEW

------------------------

Моё знакомство с LabVIEW произошло почти десять лет назад. Я начал трудиться по новому контракту, и мой тогдашний шеф вручил мне пачку дисков со словами «теперь ты будешь работать на этом». Я установил LabVIEW (это была пятая версия), и поигравшись некоторое время заявил, что на ЭТОМ ничего серьёзного не сделать, уж лучше я «по старинке» на Delphi… На что он мне сказал — ты просто не распробовал. Поработай недельку-другую. Через некоторое время я пойму, что ни на чём другом, кроме LabVIEW, я уже писать не смогу. Я просто влюбился в этот язык, хотя это и не была «любовь с первого взгляда».

Вообще говоря, довольно сложно сравнивать графический и текстовый языки программирования. Это, пожалуй, сравнение из разряда «PC» против «MAC» или «Windows» против «Linux» — можно спорить сколько угодно, но спор абсолютно лишён смысла — каждая система имеет право на существование и у каждой найдутся как сторонники так и противники, кроме того у каждого продукта своя ниша. LabVIEW – всего лишь инструмент, хотя и весьма гибкий.

Так что же такое LabVIEW?

-------------------------

LabVIEW — это кроссплатформенная графическая среда разработки приложений. LabVIEW — в принципе универсальный язык программирования. И хотя этот продукт порой тесно связан с аппаратным обеспечением National Instruments, он тем не менее не связан с конкретной машиной. Существуют версии для Windows, Linux, MacOS. Исходные тексты переносимы, а программы будут выглядеть одинаково во всех системах. Код, сгенерированный LabVIEW также может быть также исполнен на Windows Mobile или PalmOS (справедливости ради надо отметить, что поддержка PalmOS прекращена, впрочем здесь сама Palm больше виновата). Этот язык может с успехом использоваться для создания больших систем, для обработки текстов, изображений и работы с базами данных.

LabVIEW — весьма высокоуровневый язык. Однако ничто не мешает включать «низкоуровневые» модули в LabVIEW-программы. Даже если вы хотите использовать ассемблерные вставки — это тоже возможно, надо лишь сгенерировать DLL и вставить вызовы в код. С другой стороны, высокоуровневый язык позволяет запросто производить весьма нетривиальные операции с данными, на которые в обычном языке могли уйти многие строки (если не десятки строк) кода. Впрочем, ради справедливости надо отметить, что некоторые операции низкоуровневых языков (например, работу с указателями), не так просто реализовать в LabVIEW ввиду его «высокоуровневости». Разумеется, язык LabVIEW включает основные конструкции управления, имеющие аналоги и в «традиционных» языках:

* переменные (локальные или глобальные)

* ветвление (case structure)

* For – циклы с проверкой завершения и без.

* While – циклы

* Группировка операций.

LabVIEW – программа и возможности языка

---------------------------------------

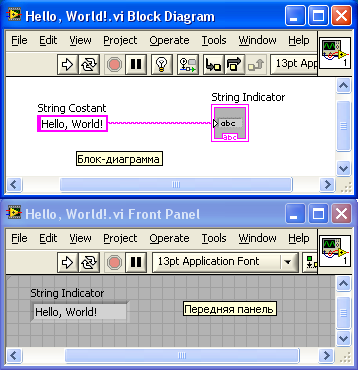

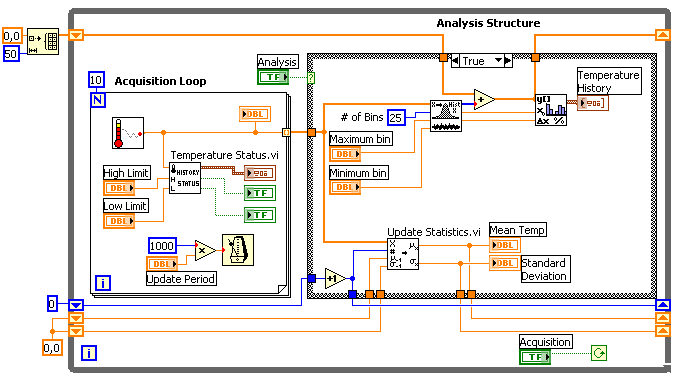

В LabVIEW разрабатываемые программные модули называются «Virtual Instruments» (Виртуальные Инструменты) или по-простому VI. Они сохраняются в файлах с расширением \*.vi. VIs – это кирпичики, из которых состоит LabVIEW – программа. Любая LabVIEW программа содержит как минимум один VI. В терминах языка Си можно достаточно смело провести аналогию с функцией с той лишь разницей, что в LabVIEW одна функция содержится в одном файле (можно также создавать библиотеки инструментов). Само собой разумеется, один VI может быть вызван из другого VI. В принципе каждый VI состоит из двух частей — Блок-Диаграмма (Block Diagram) и Передняя Панель (Front Panel). Блок-диаграмма — это программный код (точнее визуальное графическое представление кода), а Передняя панель — это интерфейс. Вот как выглядит классический пример Hello, World!:

В основе LabVIEW лежит парадигма потоков данных. В вышеприведённом примере константа и терминал индикатора соединены между собой линией. Эта линия называется Wire. Можно назвать её «проводом». По проводам передаются данные от одних элементов другим. Вся эта концепция называется Data Flow. Суть Блок Диаграммы — это узлы (ноды), выходы одних узлов присоединены ко входам других узлов. Узел начнёт выполнение только тогда, когда прибудут все необходимые для работы данные. На диаграмме вверху две ноды. Одна из них — константа. Этот узел самодостаточен — он начинает выполнение немедленно. Второй узел — индикатор. Он отобразит данные, которые передаёт константа (но не сразу, а как только данные прибудут от константы).

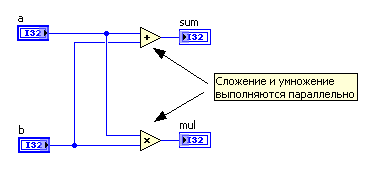

Вот чуть более сложный пример: сложение и умножение двух чисел. В традиционных языках мы напишем что-то вроде

`int a, b, sum, mul;

//...

sum = a + b;

mul = a * b;`

Вот как это выглядит в LabVIEW:

Обратите внимание на то, что сложение и умножение автоматически выполняются параллельно. На двухпроцессорной машине будут автоматически задействованы оба процессора.

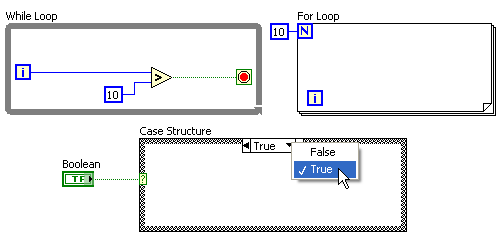

А вот как выглядят while / for циклы и if / then / else структура:

Как уже упоминалось, все элементы будут выполняться параллельно. Вам не нужно задумываться о том, как распараллелить задачу на несколько потоков, которые можно выполнять параллельно на нескольких процессорах. В последних версиях можно даже явно указать на каком из процессоров должен выполняться тот или иной while-цикл. Сейчас существуют надстройки и для текстовых языков, позволяющие запросто добиться поддержки многопроцессорных систем, однако так просто, как на LabVIEW, это пожалуй нигде не реализовано. (ну вот, я всё же скатился на сравнение с текстовыми языками). Если уж мы заговорили о многопоточности, то надо также отметить, что в распоряжении разработчика богатый выбор инструментов для синхронизации потоков — семафоры, очереди, рандеву, и т.д.

LabVIEW включает в себя богатые наборы элементов для построения пользовательских интерфейсов. Уж на что быстро «набрасывались» интерфейсы в Дельфи, а в LabVIEW этот процесс происходит ещё стремительнее.

Стандартная поставка LabVIEW включает в себя также блоки для работы с ini файлами, реестром, функции для работы с двоичными и тестовыми файлами, математические функции, мощные инструменты для построения графиков (а куда же без этого в лаборатории-то), а в дополнение к уже упомянутой возможности вызовов DLL, LabVIEW позволяет работать с ActiveX компонентами и .net. Начиная с восьмой версии в LabVIEW была добавлена поддержка классов — язык стал объектно-ориентированным. Реализованную поддержку нельзя назвать полной, однако основные черты объектно-ориентированных языков — наследование и полиморфизм присутствуют. Также функциональность языка можно расширить дополнительными модулями, например NI Vision Toolkit – для обработки изображений и машинного зрения и другие. А при помощи модуля Applcation Builder можно сгенерировать исполняемый exe-файл. С помощью [Internet Toolkit](http://sine.ni.com/nips/cds/view/p/lang/en/nid/2501) можно работать с ftp серверами, c помощью [Database Connectivity Toolkit](http://sine.ni.com/nips/cds/view/p/lang/en/nid/6429) — с базами данных и т.д.

Часто можно услышать мнение, что графический код плохо читаем. Действительно, с непривычки обилие иконок и проводников несколько шокирует. Также начинающие разработчики создают программы-«простыни» и программы-«спагетти». Однако опытный LabVIEW-разработчик никогда не создаст диаграмм, превышающих размер экрана, даже если программа состоит из сотен модулей. Хорошо разработанная программа фактически «самодокументируется», поскольку в основе уже лежит графическое представление.

Довольно долгое время, программируя на LabVIEW, я пребывал в полной уверенности, что LabVIEW — это интерпретатор и блок-диаграммы постоянно интерпретируются ядром. После разговоров с инженерами NI выяснилось, что это не так. LabVIEW — это компилятор (качество кодогенерации, впрочем оставляет желать лучшего). Зато компиляция происходит «на лету» — в любой момент разработки программа всегда готова к запуску. Также LabVIEW-код может быть скомпилирован в полноценный исполнямый файл, который может быть запущен на компьютере без установленной LabVIEW (правда он требует LabVIEW Run-Time). Также можно собрать установочный пакет-инсталлятор, сторонних утилит типа InstallShield при этом не требуется.

Дальнейшее и более детальное описание возможностей пакета выходит за рамки данной статьи, я же просто предлагаю попробовать (ссылки даны ниже). Как говорили великие «… единственный способ освоить новый язык программирования — писать на нём программы». Ну а опытные программисты смогут экстраполировать полученные знания на свои собственные нужды.

#### Ссылки по теме

На английском языке:

* [www.ni.com — Cайт компании National Instruments](http://www.ni.com/)

* [Всё про LabVIEW от производителя](http://www.ni.com/labview/)

* [Демо-версия (надо зарегистрироваться)](http://www.ni.com/labview/try/daq.htm)

* [LabVIEW-форум (присутствуют разработчики)](http://forums.ni.com/ni/board?board.id=170)

По-русски:

* [Среда графического программирования LabVIEW](http://digital.ni.com/worldwide/russia.nsf/web/all/23397941744210A886257023004E7BDB)

* [Вводный курс в LabVIEW (PDF 1 MB)](http://digital.ni.com/worldwide/russia.nsf/87e62f4c89ea9df9862564250075e6e4/84c00b5dd58d55758625745d004c7e5e/$FILE/ATTWBQDX/LabVIEW%208.5.%20Вводный%20курс.pdf)

|

https://habr.com/ru/post/57859/

| null |

ru

| null |

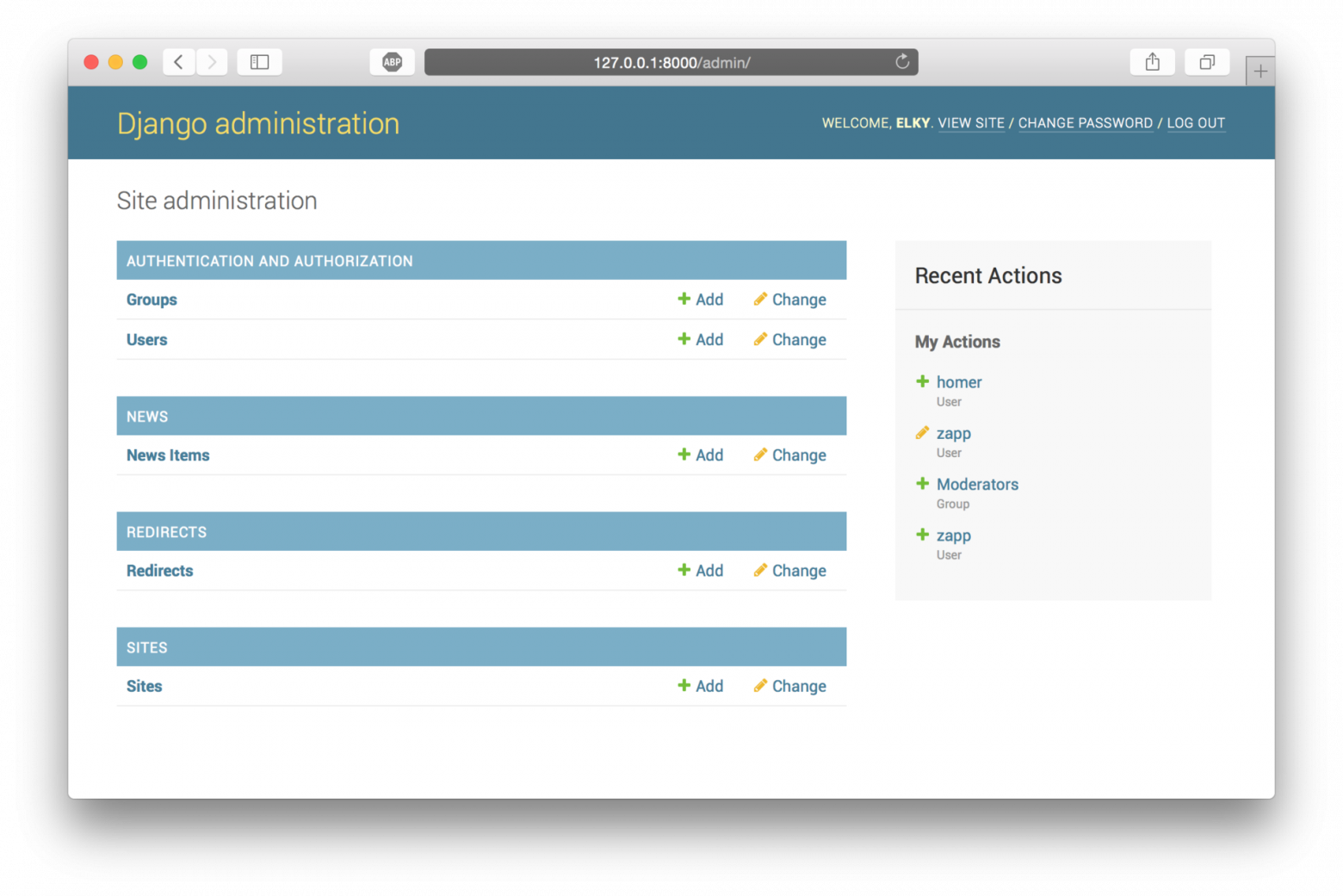

# Что бы я хотел знать когда начинал изучать Django? — очень общий взгляд

Здесь на Хабре много различных инструкций по использованию Django. Эти инструкции часто включают много кода и представляют последовательность шагов, которые нужно сделать, чтобы создать проект.

Когда я начинал изучать Django и Wagtail по таким инструкциям, меня часто смущало, что пара команд создает кучу непонятных файлов (особенно на самом старте). Последующее описание этих файлов в инструкциях содержало слишком много деталей, которые трудно было усвоить за раз.

В этом посте я бы хотел посмотреть на Django с очень «философского вида» — минимум кода, максимум общих фактов. Думаю, что такой взгляд поможет тем, кто хочет начать изучать Django но теряется на старте.

Хочу также сказать, что не являюсь профессионалом по части веб-программирования — я в этой области скорее любитель, которого интересуют исключительно личные проекты — один из них сайт по расшифровке данных ДНК тестов <https://ru.bezoder.com> — написан на Wagtail.

Сначала давайте вспомним, что сайт в интернете это просто программа, которая, возможно, работает почти на таком же компьютере, что находится перед вами.

Ваш компьютер (телефон и т.п.) посылает какой-то запрос к чужому компьютеру в интернет, тот его обрабатывает и отвечает. При обработке чужой компьютер, возможно, делает запрос или производит запись в базу данных. Теперь представим, что необходимо запрограммировать компьютер в интернете, чтобы он правильно обрабатывал каждый запрос.

Это можно сделать вообще на каком угодно языке программирования — вы получаете запрос и на его основе что-то выполняете. Но представьте сколько может быть вариантов как запрограммировать этот компьютер — их может быть бесконечно много! Например, можно написать функцию что-то вроде:

```

Если запрос == google.ru:

ответ "Привет"

Если запрос == google.de:

ответ "Hallo"

...

```

Думаю, понятно, что это был бы ужасный вариант программирования.

Нам нужно сделать все так, чтобы код был читаемым, безопасным, легко дополняемым, использовал какие-то возможности языка, на котором написан…

С таким набором задач нужно придумать какую-то концепцию.

### Концепция Django

Django предлагает все разделить на "**слои**". Слои отвечают за разные составляющие вашей программы. Между слоями есть связь, но она не затрудняет разработку каждого слоя изолированно (без большого внимания к другим слоям) — в Django это называется loose coupling.

Вот несколько важных слоев Django:

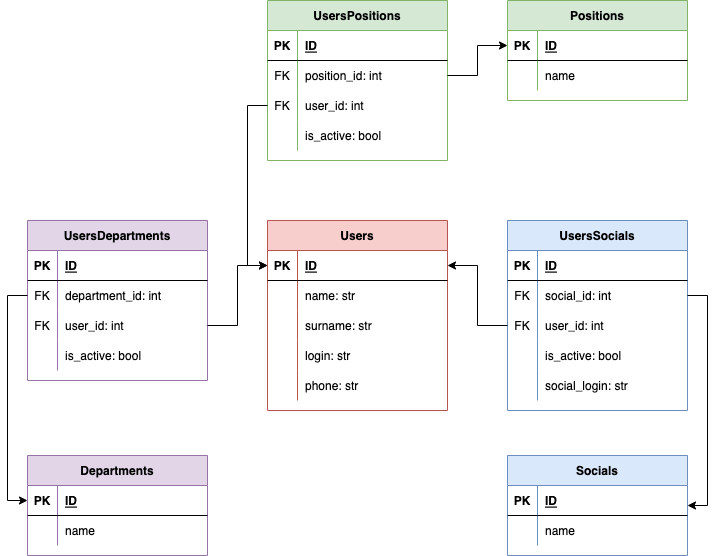

* **Модели** (Models) это слой ваших данных и то как вы их храните их в базе данных

* **Виды** (views) этот слой собирает все данные которые необходимо для создания веб страниц или обработки данных, отправленных через формы

* **Шаблоны** (Templates) этот слой получает данные из видов и отображает их на вебстранице (в этом слое вы работаете уже с html)

* **Ссылки** (url) этот слой организует работу ссылок на вашем сайте на какую ссылку нужно создавать какой вид и какой шаблон

* **Формы** (Forms) этот слой помогает создавать и обрабатывать веб формы для данных от пользователей

* ...

Django дает инструменты для создания таких слоев и функционирование программы заключается в обмене данными между слоями.

Тут я немного подробнее остановлюсь на слоях Модели, Виды и Шаблоны.

### Слой модели

Первый и, наверно, самый важный слой это **модели**(models) — отвечает за базу данных. База данных это много всяких таблиц — например, может быть таблица «пользователи» такого вида:

| | | | |

| --- | --- | --- | --- |

| ID | name | surname | karma |

| 1 | Михаил | Трунов | 2 |

Как видите, в базе каждая строка это запись, относящаяся к пользователю сайта. В строке есть данные различного типа — в нашем случае числа и текст.

Распространенным языком баз данных является SQL — определенными командами вы можете создавать новые таблицы в базе или вносить и получать данные в и из существующих таблиц.

У SQL есть уязвимости — [подробнее](https://habr.com/ru/post/148151/). Вкратце — если определенным образом расставить кавычки и точки с запятой в данных, которые отправляются в SQL команду, часть этих данных может быть интерпретирована как составляющая SQL команды.

Django берет всю головную боль, связанную с проблемами SQL на себя — вам даже не надо знать SQL, чтобы пользоваться Django, от вас нужен только python — Django сам сформирует SQL команды для создания таблиц, поиска и записи данных в таблицы и все это будет безопасно.

Идея Django в том, что классы на python повторяют структуру таблиц вашей базы данных.

То есть, для таблицы выше я могу создать класс в python что-то вроде:

```

class User:

def __init__(id, name, surname, karma)

self.id = id

self.name = name

...

```

но как связать такой класс с базой данных? Вот тут начинается магия Django:

```

# мы просто импортируем модуль models из Django

from django.db import models

# создаем класс, который наследует models.Model

class CustomUser(models.Model):

# создаем поля для базы данных в классе

name = models.CharField(max_length = 20)

...

karma = models.FloatField(...)

...

# Еще одна таблица в базе данных - статья

class Article(models.Model):

# создаем название и содержание статьи

title = models.CharField(...)

content = models.TextField(...)

...

```

Вы просто используете django.db.models.Model чтобы создать класс, далее каждое поле в вашем классе это также поле, взятое из django.db.models. В моем случае поле name это текстовое поле CharField, поле karma это число float. Список всех полей (Field types) есть в [официальной документации](https://docs.djangoproject.com/en/3.0/ref/models/fields/).

У каждого поля есть опции (Field options) — в коде выше опция это *max\_length = 20*. Опции зависят от полей, которые вы создаете в базе — например, max\_length = 20 это максимальная длина в символах поля name в базе. В документации по ссылке выше также описаны опции для всех полей.

На основе этого кода Django сам создаст таблицу в базе данных и то, что я назвал полями в классе будут столбцами в этой таблице. Django дает вам также удобные команды в python как получать или записывать значения в базу данных. Все делается с помощью методов models.Model а также абстракции «Manager», отвечающей в Django за коммуникацию с базой данных (в данном посте я эти абстракции детально не рассматриваю). Например, *CustomUser.objects.filter(name=«Михаил»)* вернет всех пользователей с именем «Михаил».

Такая связь между строками в базе данных и объектами (экземплярами, инстансами) в Python называется Object-relational mapping — в нашем случае Django-ORM.

А наши модели повторяют структуру базы данных и при этом являются классами в Python. Это значит, что к моделям (классы в Python) можно добавить методы. Например, продолжая логику сайта Хабр, я могу добавить метод для изменения кармы:

```

from django.db import models

class CustomUser(models.Model):

...

# пример метода в модели Django

def change_karma(self, other):

....

if ...:

self.karma = self.karma +1

...

else:

...

```

Тут *other* — это другой пользователь. Как вы знаете здесь определенная логика добавления кармы. Всю эту логику я могу, например, создать в указанном методе.

В Django вы думаете какие таблицы хотите создать в своей базе и потом просто создаете классы python по примеру выше.

### Слой виды

Следующим важным, на мой взгляд, слоем является слой **видов** (views). Ваши модели это некоторые абстракции, с которыми вам удобно работать или они интуитивно понятны. Но, когда вы хотите что-то показать пользователям, то, возможно, вас будут интересовать иные абстракции.

Например, вы создали три модели в Django: CustomUser, Article и Advertisement с разными полями. Модель Article это статья сайта, Advertisement — это реклама, которую вы показываете на сайте, CustomUser — зарегистрированный пользователь сайта.

Когда вы захотите создать вебстраницу со статьей, то вам понадобятся данные сразу из нескольких ваших моделей — разумеется вы хотите показать все поля в самой статье (название, содержание и т.д.), вы, скорее всего, также хотите показать какую-то рекламу рядом с этой статьей. Причем реклама зависит не от содержания статьи а от поведения пользователя CustomUser. При таком подходе будет нужна какая-то логика — как собирать данные. Так, слой view в данном случае и будет подходящим местом для этой логики. Тут можно собрать все данные, которые будут относиться к тому, что вы хотите показать.

Есть два типа видов view в Django — функциональный и классовый.

Функциональный вид это просто Python функция с аргументом request — это запрос к вашему сайту. В нем содержится информация о пользователе, типе запроса и многом другом. На основе этой информации вы формируете ответ и возвращаете его в своей функции.

Еще один тип view — классовый. Он позволяет создавать виды не на основе функций, а виды как экземпляры классов. Тут Django предоставляет также кучу всяких облегчающих жизнь классов и функций. Предположим, вы хотите создать вид на основе статьи Article:

```

# импорт полезного класса

from django.views.generic import DetailView

# импорт созданной в другом файле модели Article

from .models import Article

# создание классового вида

class ArticleDetailView(DetailView):

# модель на основе которой мы хотим создать вид

model = Article

# имя, которое будет использовано в html шаблоне (это другой слой - рассмотрим далее)

context_object_name = 'article'

# имя html шаблона, на основе которого будет создана веб страница

template_name = 'article/article_detail.html'

```

Классовый вид на основе DetailView автоматически соберет всю информацию модели Article и затем отправит ее в следующий слой Django:

### Слой шаблоны

В коде выше *template\_name* это переменная для названия html шаблона, который будет использован для формирования веб страницы, которая и будет показана пользователю. Вот пример кода из такого шаблона:

```

{{ article.title }}

===================

{{ article.content }}

```

*{{ article.title }}* и *{{ article.content }}* это название статьи и ее содержание, заключенные в html теги. *title* и *content* повторяют название полей модели Article, которую вы создали в слое Модели. Слово *article* мы указали в *context\_object\_name* в виде. В результате обработки Django вставит соответствующие поля из Article в шаблон.

### Резюме

Это общий взгляд на некоторые Django слои. Описанная концепция позволяет разделить отдельные блоки программы. В слое модели вы создаете удобные абстракции вашей базы данных, в слое виды вы решаете, какие данные вы хотите показать, и в слое шаблоны вы создаете уже дизайн ваших страниц на основе html и добавляете в шаблоны немного логики с помощью языка *Jinja* — это из примера с фигурными скобками — *{{ article.name }}*.

Я тут не затронул довольно много важных тем — например связи между вашими моделями. У каждой статьи может быть один автор или несколько авторов — Django с легкостью справится с любым из перечисленных вариантов, и с помощью одной строки в Python вы сможете получить автора статьи или же коллекцию авторов в виде экземпляров класса Автор, созданного на основе models.Model.

### Но откуда столько файлов?

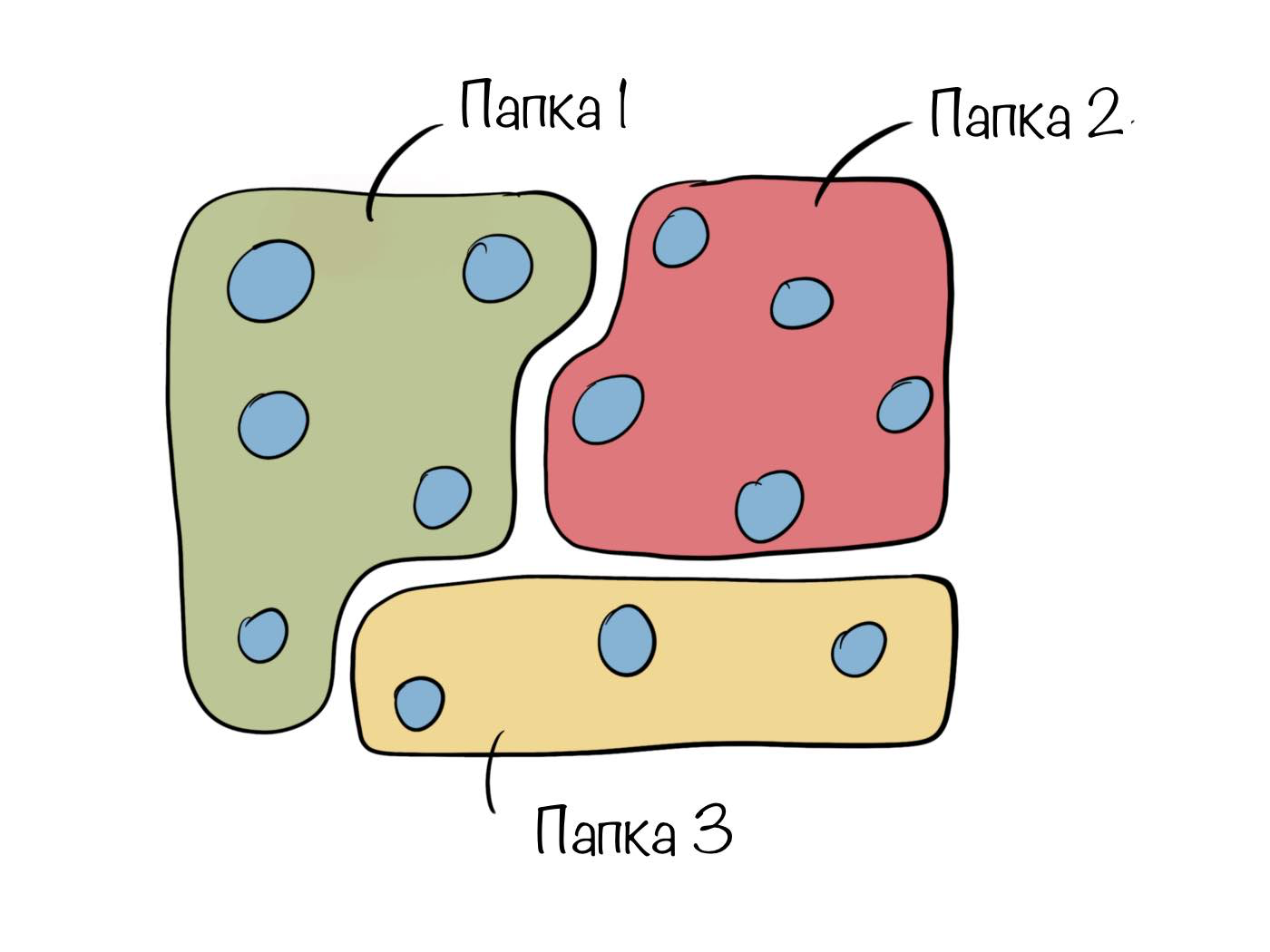

Если вы создаете какое-то сложное приложение с кучей Моделей, видов и т.п. то это огромное количество кода надо как-то разбить на отдельные файлы. И файлы желательно организовать по папкам так, чтобы файл с моделями статьи был в той же папке что и виды статьи.

Вот тут приходит еще одна ключевая идея Django — приложения, которые заслуживают отдельного поста.

|

https://habr.com/ru/post/508100/

| null |

ru

| null |

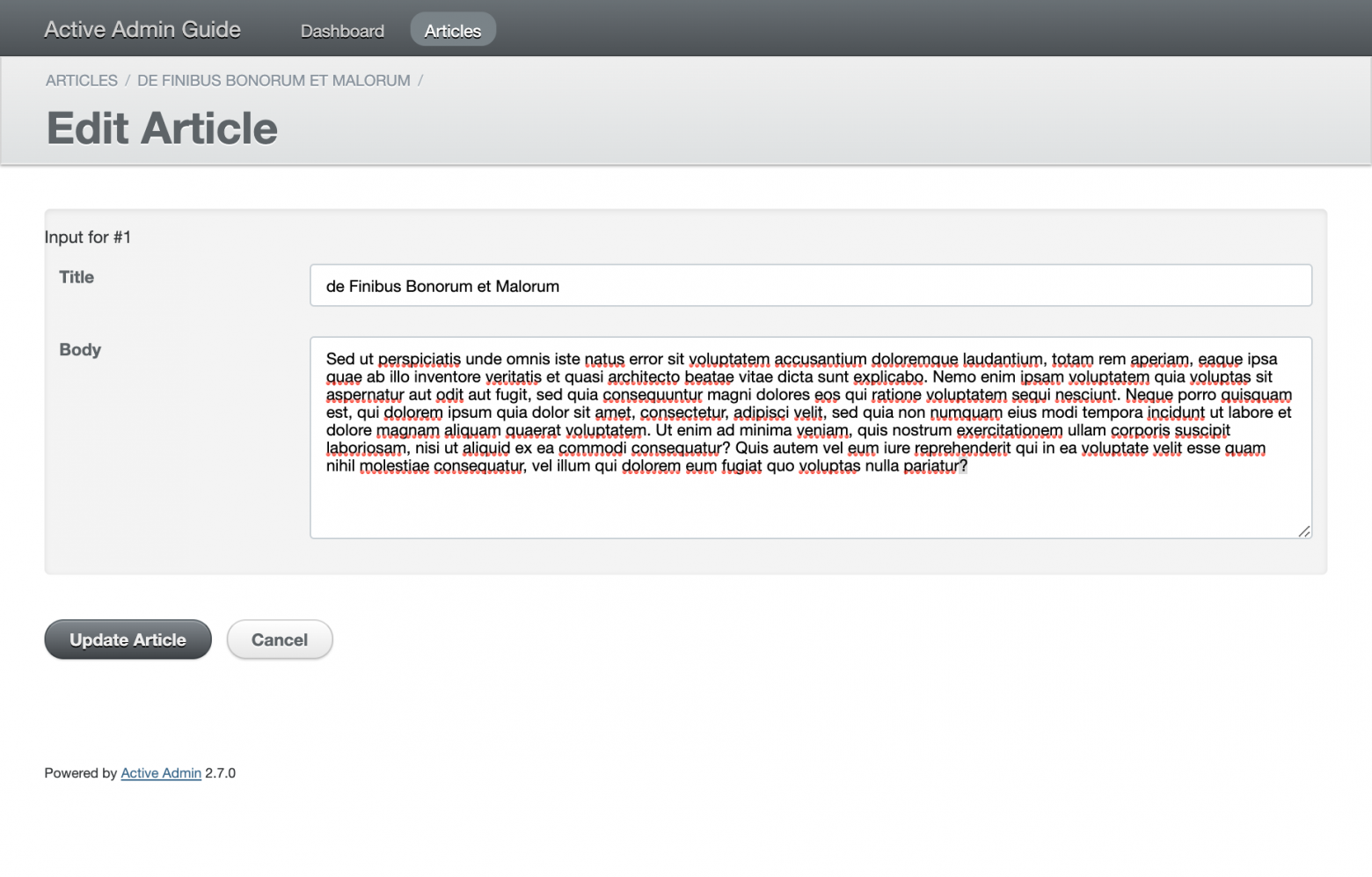

# Неофициальный гайд по Active Admin

Статья про **Ruby** в блоге компании **ДомКлик**! Как так получилось, что в молодую компанию завезли [мертвый язык](https://isrubydead.com)? Секрет в том, что на Ruby можно быстро написать и протестировать бизнес-идею. И делается это не без помощи **Rails** и **Active Admin** — библиотеки, которая позволяет быстро создать админку с минимальными затратами сил и времени.

Часто можно встретить мнение, что Active Admin хорош только для 15-минутного блога. Мы в ДомКлик считаем (и доказываем на практике), что из этой библиотеки можно выжать намного больше.

Я расскажу про некоторые подходы, которые мы применяем при работе с Active Admin.

Active Admin базируется на нескольких библиотеках, среди которых я бы выделил `arbre`, `formtastic`, `inherited_resources` и `ransack`. Каждая из них отвечает за свою часть и заслуживает отдельного рассмотрения. Начнем по алфавиту — с библиотеки, которая отпочковалась от самого Active Admin.

Arbre: кастомизация компонентов

-------------------------------

Одна из проблем Active Admin — на глазах распухающие файлы ресурсов: фильтры, дополнительные action'ы, верстка страниц, формы, и всё это в одном файле. Где-то вдали слышен протяжный стон одинокого пуриста «где же single responsibility?» Не завезли. Но давайте разберемся, как можно изолировать часть верстки в отдельных классах.

**Arbre** — библиотека для описания шаблонов с помощью Ruby. Вот пример простейшей страницы, написанной с помощью DSL Arbre:

```

html do

head do

title('Welcome page')

end

body do

para('Hello, world')

end

end

```

DSL расширяется с помощью компонентов. Например, в Active Admin это `tabs`, `table_for`, `paginated_collection` и даже сами страницы. Продолжим знакомство с библиотекой рассмотрением структуры простейшего Arbre компонента.

### Arbre: hello world компонент

Как и все компоненты Arbre, наш `Admin::Components::HelloWorld` наследован от класса `Arbre::Component`:

```

# app/admin/components/hello_world.rb

module Admin

module Components

class HelloWorld < Arbre::Component

builder_method :hello_world

def build(attributes = {})

super(attributes)

text_node('Hello world!')

add_class('hello-world')

end

def tag_name

'h1'

end

end

end

end

```

Начнем сверху вниз: `builder_method` определяет метод, с помощью которого мы сможем создать компонент при использовании DSL. Аргументы, переданные в компонент, попадут в метод `#build`.

В Arbre каждый компонент — это отдельный DOM-элемент (напоминает механизм работы современных frontend-фреймворков, только датируется 2012 годом). По умолчанию все компоненты представляют из себя `div`, чтобы изменить это поведение, можно переопределить метод `#tag_name`. Метод `#add_class`, как не сложно догадаться, добавляет атрибут `class` к корневому DOM-элементу.

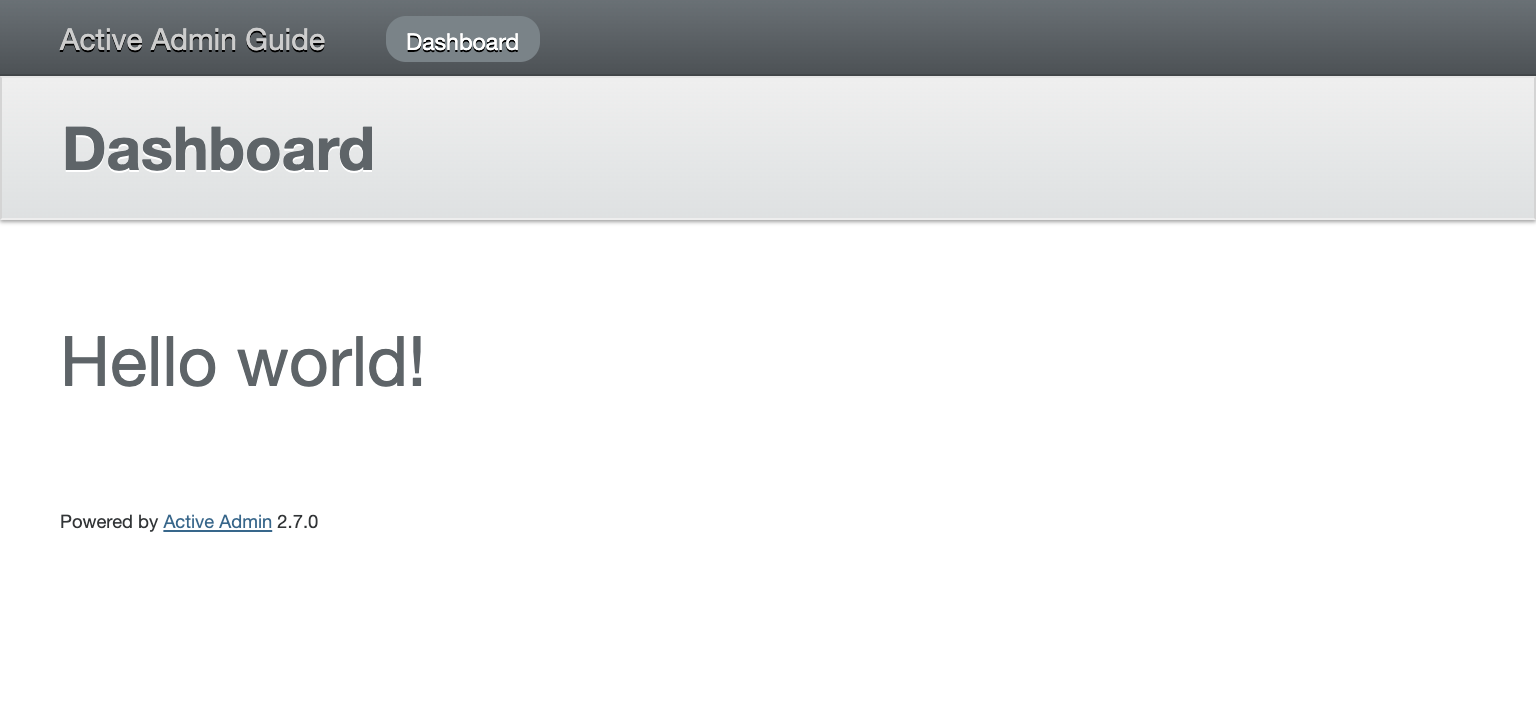

Осталось вызвать наш новый компонент. Для примера, сделаем это в `app/admin/dashboard.rb`

```

# app/admin/dashboard.rb

ActiveAdmin.register_page 'Dashboard' do

menu priority: 1, label: proc { I18n.t('active_admin.dashboard') }

content do

hello_world

end

end

```

Теперь рассмотрим пример небольшого рефакторинга админки с использованием собственного компонента.

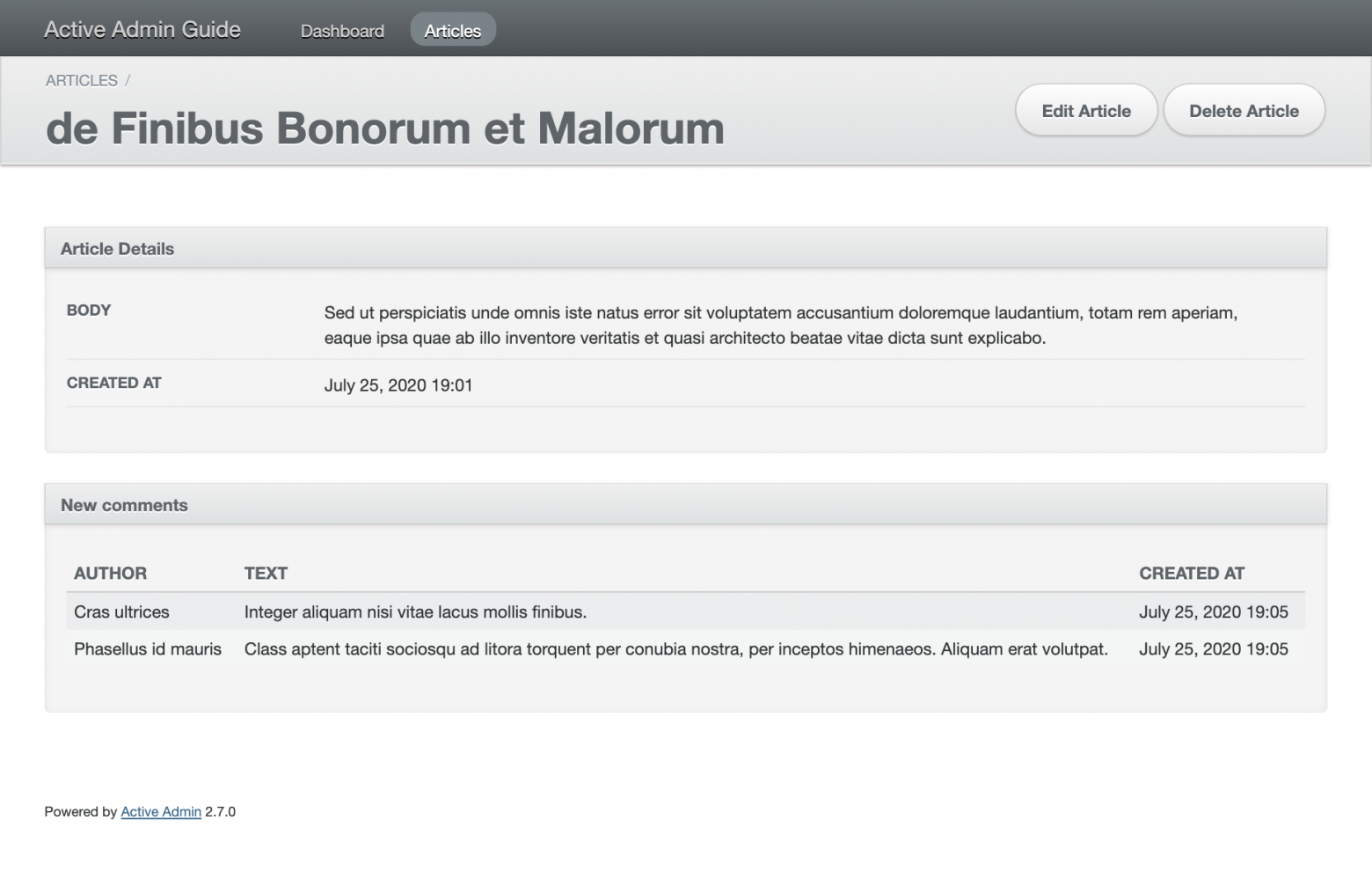

### Arbre: пример из реальной жизни (почти)

Для того, чтобы понять, как использовать Arbre в условиях, приближенных к боевым, возьмем синтетический пример. Предположим, что у нас есть блог с записями (`Article`) и комментариями (`Comment`) со связью 1:M. Нам необходимо вывести 10 последних комментариев на странице конкретной записи (блок `show`).

```

# app/admin/articles.rb

ActiveAdmin.register Article do

permit_params :title, :body

show do

attributes_table(:body, :created_at)

panel I18n.t('active_admin.articles.new_comments') do

table_for resource.comments.order(created_at: :desc).first(10) do

column(:author)

column(:text)

column(:created_at)

end

end

end

end

```

А теперь вынесем таблицу с комментариями в отдельный компонент. Создадим новый класс и унаследуем его от `ActiveAdmin::Views::Panel`. Если создать новый компонент с нуля (как в `hello_world` выше) и в нем вызвать `panel`, то `panel` окажется внутри еще одного `div`, а это наверняка поломает верстку.

Мы в нашей команде разместили бы этот класс в `app/admin/components/articles/new_comments.rb`, но это вкусовщина. Просто знайте, что Active Admin автоматически загрузит всё, что находится внутри `app/admin/**/*`:

```

# app/admin/components/articles/new_comments.rb

module Admin

module Components

module Articles

class NewComments < ActiveAdmin::Views::Panel

builder_method :articles_new_comments

def build(article)

super(I18n.t('active_admin.articles.new_comments'))

table_for last_comments(article) do

column(:author)

column(:text)

column(:created_at)

end

end

private

def last_comments(article)

article.comments

.order(created_at: :desc)

.first(10)

end

end

end

end

end

```

Теперь заменим `panel` в `app/admin/articles.rb` на вызов нашего нового компонента и передадим в него `resource`:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

permit_params :title, :body

show do

attributes_table(:body, :created_at)

articles_new_comments(resource)

end

end

```

Красота! Отмечу, что `resource` можно было бы не передавать в компонент, а использовать через контекст. Однако, явно передав `resource`, мы ослабили связность компонента, что позволит переиспользовать его в будущем.

К слову о переиспользовании, всё содержимое блока `show` (как и других блоков с шаблонами) можно вынести в partial:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

show do

render('show', article: resource)

end

end

```

```

# app/views/admin/articles/_show.html.arb

panel(ActiveAdmin::Localizers.resource(active_admin_config).t(:details)) do

attributes_table_for(article, :body, :created_at)

end

articles_new_comments(article)

```

Само собой, вы можете использовать знакомый `.erb` и другие шаблонизаторы, но, пожалуй, оставим это в качестве факультатива.

### Arbre: что еще посмотреть

Прежде всего, я посоветовал бы ознакомиться с описанием компонентов Active Admin в официальной [документации](https://activeadmin.info/12-arbre-components.html).

Для более глубокого изучения можно посмотреть код [`базовых компонентов из arbre`](https://github.com/activeadmin/arbre/blob/master/lib/arbre/element.rb) и [`компонентов activeadmin`](https://github.com/activeadmin/activeadmin/tree/master/lib/active_admin/views/components), ведь часто именно на их основе будут строиться ваши собственные. Кроме того, обратите внимание на gem [activeadmin\_addons](https://github.com/platanus/activeadmin_addons), в котором есть множество интересных компонентов.

Ну, а если вы вдруг до сих пор не пишете код без ошибок, то стоит обратить внимание на то, как можно [тестировать компоненты](https://github.com/activeadmin/activeadmin/blob/master/spec/unit/views/components/panel_spec.rb).

Formtastic: кастомизация форм

-----------------------------

**Formtastic** — библиотека для описания форм с помощью DSL. Простейшая форма выглядит вот так:

```

semantic_form_for object do |f|

f.inputs

f.actions

end

```

В этом примере Formtastic автоматически вытаскивает все атрибуты из переданного объекта `object` и подставляет их в форму с типами input'ов по-умолчанию. Список доступных типов input'ов можно найти в [README](https://github.com/formtastic/formtastic#the-available-inputs). Как и Arbre, Formtastic можно расширить с помощью создания собственных классов-компонентов. Для того, чтобы разобраться в базовых вещах, давайте создадим hello world компонент.

### Formtastic: hello world компонент

По аналогии с компонентами Arbre, разместим новый класс в `app/admin/inputs`:

```

# app/admin/inputs/hello_world_input.rb

class HelloWorldInput

include Formtastic::Inputs::Base

def to_html

"Input for ##{object.public_send(method)}"

end

end

```

Чтобы вызвать новый input, достаточно указать его название в параметре `:as`, например, так:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

form do |f|

f.inputs do

f.input(:id, as: :hello_world)

f.input(:title)

f.input(:body)

end

f.actions

end

end

```

Все необходимые для отрисовки формы параметры (в том числе `object` и символ `method`) попадают в `#initialize`, определенный в модуле [`Formtastic::Inputs::Base`](https://github.com/formtastic/formtastic/blob/master/lib/formtastic/inputs/base.rb). За отображение input'а отвечает метод `#to_html`.

Может показаться что этот пример бесполезен, но на самом деле на его основе мы в компании рендерим read-only поля. Давайте добавим всего пару методов, доступных в Formtastic, и превратим наш hello world в полезный read-only input. Следите за руками:

```

# app/admin/inputs/hello_world_input.rb

class HelloWorldInput

include Formtastic::Inputs::Base

def to_html

input_wrapping do

label_html <<

object.public_send(method).to_s

end

end

end

```

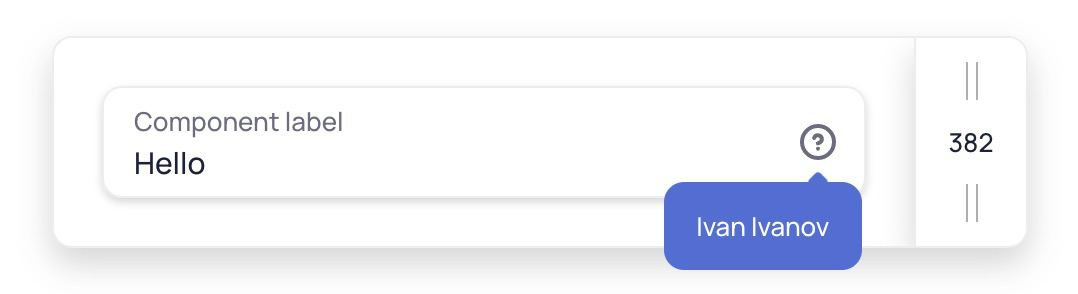

Всё, что мы добавили — это два метода с говорящими названиями. `input_wrapping` пришел из модуля [`Formtastic::Inputs::Base::Wrapping`](https://github.com/formtastic/formtastic/blob/master/lib/formtastic/inputs/base/wrapping.rb) и отвечает за обертку input'а. В том числе, он включает в себя элементы для вывода ошибок и подсказок. `label_html` из модуля [`Formtastic::Inputs::Base::Labelling`](https://github.com/formtastic/formtastic/blob/master/lib/formtastic/inputs/base/labelling.rb) рендерит лейбл для input'а. Эти два хелпера мгновенно превращают наш hello world в применимый в бою input (разве что нейминг класса бы еще поправить).

Теперь мы можем перейти к чуть более сложному примеру, который продемонстрирует, как можно интегрировать в форму JS-библиотеку.

### Formtastic: пример из реальной жизни (почти)

Возьмем за основу очередной выдуманный пример, который продемонстрирует, как работать с HTML, CSS и JS. То есть покроет все шаги написания нового input'а.

Предположим, что к нам пришел запрос от редактора блога: при написании статьи он хотел бы прямо в форме ввода видеть количество слов. Как известно, в мире JavaScript'ов для всего существуют библиотеки, для нашей задачи такая тоже нашлась: [Countable.js](https://github.com/RadLikeWhoa/Countable). Давайте возьмем стандартный input для текста и расширим его, добавив подсчет слов.

Прикинем, что нам потребуется для реализации нового input'а:

* взять существующий текстовый input и добавить к нему `div` для вывода количества слов;

* добавить CSS-стили для нового `div`;

* вызвать Countable.js на нужном нам поле и записать с его помощью информацию о количестве слов в новый `div`.

Начнем с создания нового класса и наследуем его от [`Formtastic::Inputs::TextInput`](https://github.com/formtastic/formtastic/blob/master/lib/formtastic/inputs/text_input.rb). Добавим дополнительный атрибут `class="countable-input"` к элементу `textarea`, и рядом с ним создадим новый пустой `div` с атрибутом `class="countable-content"`:

```

# app/admin/inputs/countable_input.rb

class CountableInput < Formtastic::Inputs::TextInput

def to_html

input_wrapping do

label_html <<

builder.text_area(method, input_html_options.merge(class: 'countable-input')) <<

template.content_tag(:div, '', class: 'countable-content')

end

end

end

```

Посмотрим, что нового у нас добавилось. `input_html_options`— метод [родительского класса](https://github.com/formtastic/formtastic/blob/master/lib/formtastic/inputs/text_input.rb) с говорящим именем. `builder` — инстанс класса [`ActiveAdmin::FormBuilder`](https://github.com/activeadmin/activeadmin/blob/master/lib/active_admin/form_builder.rb), наследник [`ActionView::Helpers::FormBuilder`](https://github.com/rails/rails/blob/master/actionview/lib/action_view/helpers/form_helper.rb). `template` — это контекст, в котором исполняются темплейты (то есть огромный набор view-helper'ов). Таким образом, если нам нужно создать кусочек формы, то обращаемся к `builder`. А если хотим использовать что-то типа `link_to`, то нам поможет `template`.

Библиотеку Countable.js завендорим: положим в директорию `app/assets/javascripts/inputs/countable_input` и добавим простенький `.js` файл, который будет вызывать Countable.js и закидывать информацию в `div.countable-content` (прошу сильно не пинать ногами за JS-спагетти):

```

// app/assets/javascripts/inputs/countable_input.js

//= require ./countable_input/countable.min.js

const countable_initializer = function () {

$('.countable-input').each(function (i, e) {

Countable.on(e, function (counter) {

$(e).parent().find('.countable-content').html('words: ' + counter['words']);

});

});

}

$(countable_initializer);

$(document).on('turbolinks:load', countable_initializer);

```

И теперь подтягиваем файл в `app/assets/javascripts/active_admin.js`:

```

// app/assets/javascripts/active_admin.js

// ...

//= require inputs/countable_input

```

Последний штрих — добавляем CSS-файл и подгружаем его в `app/assets/stylesheets/active_admin.scss`:

```

// app/assets/stylesheets/inputs/countable_input.scss

.countable-content {

float: right;

font-weight: bold;

}

```

```

// app/assets/stylesheets/active_admin.scss

// ...

@import "inputs/countable_input";

```

Вот и всё, наш input готов. Осталось только вызвать его в форме:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

form do |f|

f.inputs do

f.input(:id, as: :hello_world)

f.input(:title)

f.input(:body, as: :countable)

end

f.actions

end

end

```

Таким образом мы создаем кастомные компоненты для форм в своих проектах. Например, файловые загрузчики или input'ы с хитрым автозаполнением. В подобных компонентах чуть больше кода, но подход остается неизменным.

### Formtastic: пламенный привет пуристам

Как и в случае с компонентами Arbre, формы можно выносить в partial'ы, хотя синтаксис немного отличается:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

form(partial: 'form')

end

```

```

# app/views/admin/articles/_form.html.arb

active_admin_form_for resource do

inputs(:title, :body)

actions

end

```

Недостаток этого подхода в том, что формы лежат где-то глубоко в директории `views`. На мой взгляд, это немного усложняет навигацию по коду, но тут на вкус и цвет, как говорится.

### Formtastic: что еще посмотреть

Formtastic — достаточно обширная библиотека, и я настоятельно рекомендую прочитать подробный [README](https://github.com/formtastic/formtastic#the-available-inputs), чтобы ознакомиться со всеми возможностями кастомизации. Также будет полезно посмотреть уже упомянутый [activeadmin\_addons](https://github.com/platanus/activeadmin_addons). В этом gem'е есть множество дополнительных input'ов, которые наверняка пригодятся в хозяйстве.

Отдельно замечу, что хотя в статье я разделил Formtastic и Arbre по разным блокам, они прекрасно работают вместе, ведь вы можете создавать формы или части форм в качестве Arbre-компонентов.

Inherited Resources — кастомизация контроллеров

-----------------------------------------------

Чтобы понять. откуда берется магический `resource`, как поменять поведение при сохранении. и многое другое, нам будет необходимо познакомиться с еще одним gem'ом.

**Inherited Resources** — библиотека, призванная избавить контроллеры от однообразной CRUD-рутины.

Библиотека, с одной стороны, простая, а с другой обширная. Поэтому галопом по Европам рассмотрим несколько полезных методов:

```

class ArticlesController < InheritedResources::Base

respond_to :html

respond_to :json, only: :index

actions :index, :new, :create

def update

resource.updated_by = current_user

update! { articles_path }

end

end

```

Итак, `.respond_to` отвечает за доступные форматы. Все вызовы `.respond_to` «складываются», а не переопределяют друг друга. Чтобы сбросить форматы, понадобится метод `.clear_respond_to`.

`.actions` определяет доступные CRUD-методы (`index`, `show`, `new`, `edit`, `create`, `update` и `destroy`).

`resource` — один из доступных хелперов, среди которых:

```

resource #=> @article

collection #=> @articles

resource_class #=> Article

```

И наконец, `#update!` — это просто `alias` для `#update`, который можно использовать при перегрузке методов вместо `super`.

Отдельно рассмотрим применение метода `.has_scope`. Предположим, что в классе `Article` определен scope `:published`:

```

class Article < ApplicationRecord

scope :published, -> { where(published: true) }

end

```

Тогда мы можем использовать в контроллере метод `.has_scope`:

```

class ArticlesController < InheritedResources::Base

has_scope :published, type: :boolean

end

```

`.has_scope` добавляет возможность фильтрации с помощью query-параметров. В примере выше мы сможем применить scope `:published`, если обратимся к коллекции по URL `/articles?published=true`.

Подробное описание этих и других возможностей библиотеки можно найти в обширном [README](https://github.com/activeadmin/inherited_resources). А мы, пожалуй, остановимся на этом и перейдем, наконец, к взаимодействию с Active Admin.

### Inherited Resources: расширение контроллера

Все контроллеры Active Admin наследованы от [`InheritedResources::Base`](https://github.com/activeadmin/inherited_resources/blob/master/app/controllers/inherited_resources/base.rb), а это значит, что у нас есть возможность модифицировать их поведение, используя методы библиотеки.

Например, список доступных action'ов контроллера определяется следующим образом:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

actions :all, :except => [:destroy]

end

```

Отлично, мы убрали action удаления статьи. Кажется, всё очевидно: используем ресурс Active Admin как контроллер. Но не будем спешить с выводами и попробуем добавить еще одну фичу.

По умолчанию Active Admin включает рендеринг всех страниц в качестве HTML, JSON и XML (а `index` доступен еще и в формате CSV). Попробуем избавимся от XML-рендеринга нашей страницы с помощью знакомых нам методов:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

clear_respond_to

respond_to :html, :json

respond_to :csv, only: :index

end

```

Ой, теперь мы получили ошибку `undefined method 'clear_respond_to' for #`.

Дело в том, что когда мы описываем класс-ресурс, мы находимся в контексте `ActiveAdmin::ResourceDSL`, а не в контексте контроллера. Код из предыдущего примера работает только потому, что `ActiveAdmin::ResourceDSL` делегирует контроллеру метод `#actions`.

Но не отчаивайтесь, чтобы добраться до контроллера и выполнить код в его контексте, необходимо всего-навсего вызвать метод `#controller`:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

controller do

clear_respond_to

respond_to :html, :json

respond_to :csv, only: :index

end

end

```

Вуаля, теперь `localhost:3000/admin/articles.xml` возвращает ошибку. А что на счет модификации поведения action'ов?

### Inherited Resources: перегрузка методов

Предположим, что при сохранении нам необходимо задать атрибут `Article#created_by_admin`. Воспользуемся для этого возможностью перегрузки метода `#create`:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

controller do

def create

build_resource

@article.created_by_admin = true

create!

end

end

end

```

Итак, мы вызываем `build_resource` — метод, который инициализирует новый объект и присваивает его переменной `@article`. Далее задаем атрибут `created_by_admin` и вызываем `create!` (он же `super`), который продолжает оперировать созданным нами `@article`.

Хотелось бы отдельно отметить: будьте внимательны с хелперами. Inherited Resources активно использует instance-переменные для кеширования. В данном случае это помогло нам создать и модифицировать объект, но при неаккуратном использовании, результаты могут быть неожиданными (проверено на собственной шкуре).

А теперь вернемся на пару шагов назад, к моменту, когда мы отключали XML-рендеринг статей. Что, если мы хотим убрать рендеринг XML из всех ресурсов? Не будем же мы писать один и тот же код в каждом новом классе?

### Расширение базового контроллера

Не будем! Давайте создадим модуль, который скорректирует поведение класса `ActiveAdmin::ResourceController`:

```

# lib/active_admin/remove_xml_rendering_extension.rb

module ActiveAdmin

module RemoveXmlRenderingExtension

def self.included(base)

base.send(:clear_respond_to)

base.send(:respond_to, :html, :json)

base.send(:respond_to, :csv, only: :index)

end

end

end

```

В метод `.included` будет передан расширяемый класс, к которому будут применены нужные нам модификаторы. Воспользуемся инициализатором Active Admin и подключим новый модуль к [`ActiveAdmin::ResourceController`](https://github.com/activeadmin/activeadmin/blob/master/lib/active_admin/resource_controller.rb):

```

# config/initializers/active_admin.rb

require 'lib/active_admin/remove_xml_rendering_extension'

ActiveAdmin::ResourceController.send(

:include,

ActiveAdmin::RemoveXmlRenderingExtension

)

# ...

```

Немного магии метапрограммирования с `#include` и `#included`, и готово! Теперь ни один ресурс не ответит на формат `.xml`.

К слову, если вы думали, что `#prepend`, `#include` и `#extend` — это методы из вопросов, которыми на собеседованиях валят неугодных, то боюсь вас разочаровать. Когда возникает необходимость модифицировать код внешней библиотеки, подобные подходы нередко становятся единственным доступным инструментом.

### Inherited Resources: что еще посмотреть

Прежде всего обратите внимание на подробный [README](https://github.com/activeadmin/inherited_resources). Помимо этого посмотрите на то, как устроены контроллеры в Active Admin, обратите внимание на логику авторизации и другие мелочи, вроде дополнительных хелперов.

Ransack: кастомизация фильтров

------------------------------

По умолчанию Active Admin на каждой index-странице предоставляет развесистый блок с фильтрацией, из которого чаще приходится убирать лишнее, нежели добавлять что-то свое. Но на самом деле это лишь верхушка айсберга под названием Ransack.

**Ransack** — библиотека для создания поисковых форм, которая позволяет собирать сложные SQL-запросы, интерпретируя переданные имена параметров. Звучит сложно, но я уверен, пример позволит быстро разобраться. о чем идет речь.

Предположим, что нам необходимо фильтровать записи блога (`Article`) по вхождению строки в название (`title`). С помощью Ransack мы можем это сделать следующим образом:

```

Article.ransack(title_cont: 'Домклик').result

```

Постфикс `_cont` — это один из множества предикатов, доступных в Ransack. Предикаты определяют то, какой SQL-запрос будет сгенерирован для поиска. Подробно обо всех доступных предикатах можно прочитать в [официальной wiki](https://github.com/activerecord-hackery/ransack/wiki/Basic-Searching).

А теперь чуть усложним задачу: заказчик попросил нас добавить фильтр, который позволит искать вхождение строки одновременно и в заголовке, и в теле (`body`). С Ransack это проще некуда:

```

Article.ransack(title_or_body_cont: 'active admin').result

```

Помимо этого, Ransack позволяет искать записи, обращаясь к связанным моделям. Для демонстрации, добавим возможность искать статьи по тексту комментариев (`Comment#text`):

```

Article.ransack(comments_text_cont: 'I hate type annotations!').result

```

Как несложно догадаться, подобные конструкции могут быстро разрастись. Да и использование сложных параметров в нескольких местах может привести к проблемам. В качестве решения Ransack предлагает использовать `#ransack_alias`. Добавим к поиску по тексту комментария поиск по его автору и дадим короткий alias: `comments`, который в дальнейшем можно будет использовать с нужными нам предикатами:

```

# app/models/article.rb

class Article < ActiveRecord::Base

has_many :comments

ransack_alias :comments, :comments_text_or_comments_author

end

Article.ransack(comments_cont: 'Matz').result

```

Разобравшись с тем, как Ransack позволяет структурировать запросы, перейдем, наконец, к тому, как мы можем использовать это в Active Admin.

### Ransack: использование составных фильтров

Возьмем за основу примеры выше и используем их в качестве фильтров для ресурса Active Admin:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

preserve_default_filters!

filter :title_or_body_cont,

as: :string,

label: I18n.t('active_admin.filters.title_or_body_cont')

filter :comments,

as: :string

end

```

Вот и всё, весьма прямолинейно. Разве что отмечу метод `#preserve_default_filters!`, который оставляет на месте стандартные фильтры.

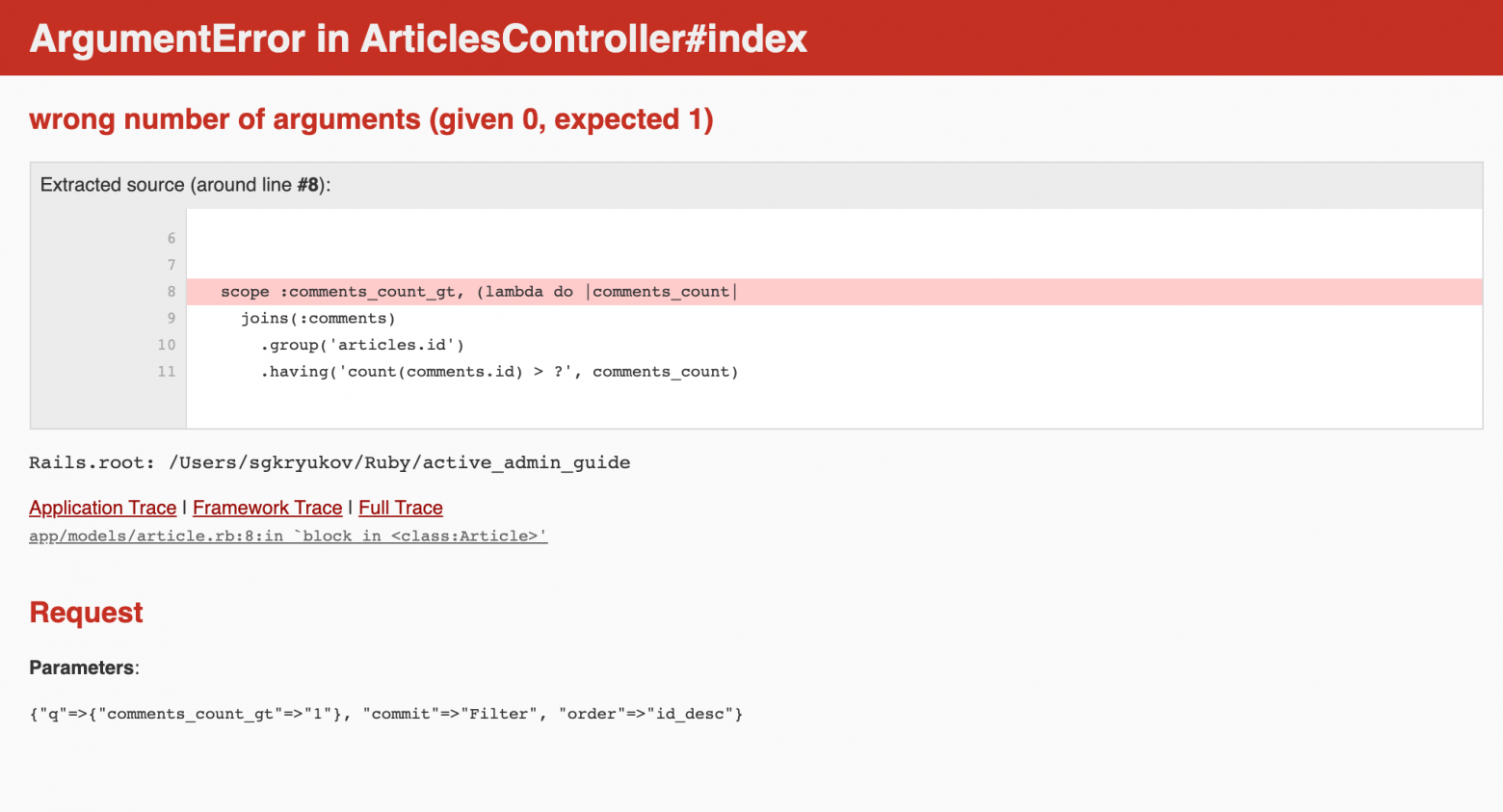

### Ransack: использование scope-фильтров

По умолчанию Ransack позволяет фильтровать по всем атрибутам и связям модели. Это может быть опасно с точки зрения безопасности, поэтому обратите внимание на возможность ограничения доступа к определенным полям и связям с помощью методов `ransackable_attributes`, `ransackable_associations` и `ransackable_scopes`. Вопросы авторизации я хотел бы оставить за рамками данной статьи (тем более, что у Active Admin в документации есть [подробный раздел](https://activeadmin.info/13-authorization-adapter.html)), поэтому обратим внимание лишь на метод `ransackable_scopes`.

В отличие от других методов авторизации, `ransackable_scopes` по умолчанию запрещает использование любых scope'ов. Таким образом, чтобы иметь возможность фильтровать по scope (или по любому другому методу класса модели), необходимо вернуть его название из `.ransackable_scopes`.

Для примера, добавим фильтр по количеству комментариев с использованием `scope`:

```

# app/models/article.rb

class Article < ActiveRecord::Base

has_many :comments

scope :comments_count_gt, (lambda do |comments_count|

joins(:comments)

.group('articles.id')

.having('count(comments.id) > ?', comments_count)

end)

def self.ransackable_scopes(auth_object = nil)

[:comments_count_gt]

end

end

```

Обратите внимание на `auth_object`: в теории, это объект по которому можно определить стратегию авторизации. Я бы ожидал, что сюда будет передаваться `current_user`, однако Active Admin этого не делает.

Мы добавили scope и вернули его название в `.ransackable_scopes`, осталось только добавить фильтр в ресурс Active Admin:

```

# app/admin/articles.rb

ActiveAdmin.register Article do

filter :comments_count_gt,

as: :number,

label: I18n.t('active_admin.filters.comments_count_gt')

```

Осталась одна мелочь: если мы попробуем отфильтровать все статьи с двумя и более комментариями — всё отлично, но если попробовать подать единицу, то мы получим ошибку:

Это нам «помогло» приведение типов, которое по историческим причинам делает Ransack. Чтобы отключить сомнительную фичу, мы добавим инициализатор с заданным параметром `sanitize_custom_scope_booleans`:

```

# /config/initializers/ransack.rb

Ransack.configure do |config|

config.sanitize_custom_scope_booleans = false

end

```

Готово, теперь наш фильтр работает, даже если мы подадим `1` в качестве аргумента, и мы умеем использовать фильтры на основе scope'ов.

### Ransack: что еще посмотреть

Прежде всего, стоит еще раз заглянуть в документацию Active Admin [про фильтры](https://activeadmin.info/3-index-pages.html#index-filters). Продолжить обзор можно в официальных README и wiki, в которых, помимо всего прочего, вы сможете найти view-хелперы для создания своих поисковых форм.

Для особо запущенных случаев вы можете обратить внимание на то, как создавать [собственные предикаты](https://github.com/activerecord-hackery/ransack/wiki/Custom-Predicates), и на [Ransackers](https://github.com/activerecord-hackery/ransack/wiki/Using-Ransackers) — расширения, которые преобразуют параметры напрямую в Arel (внутренняя библиотека ActiveRecord, используемая для конструирования SQL-запросов).

Итоги

-----

Надеюсь, что после этой статьи вы взглянули на Active Admin с новой стороны и, возможно, захотели зарефакторить класс-другой в своих проектах. Ведь Active Admin позволяет быстро запустить рабочую систему и направить все силы frontend-разработчиков на полезный для конечного пользователя продукт.

Я старался не сильно пересекаться с официальной [документацией Active Admin](https://activeadmin.info/documentation.html), в которой можно найти описание множества интересных возможностей библиотеки, например, авторизацию или использование декораторов.

Также в очередной раз упомяну [activeadmin\_addons](https://github.com/platanus/activeadmin_addons), в котором, помимо множества компонентов, доступна симпатичная тема для Active Admin. Обратите внимание на то, как она устроена, если захотите сделать свою тему для админки и использовать ее во всех проектах (именно так и сделано у нас в Домклике).

|

https://habr.com/ru/post/514506/

| null |

ru

| null |

# Поворотный энкодер: насколько сложен он может быть

Как вы [могли заметить](https://hackaday.com/2022/04/13/arming-with-an-os/), я давно [работаю с процессором STM32 ARM при помощи Mbed](https://hackaday.com/2022/04/19/arm-pumps-up-the-volume-with-mbed-and-a-potentiometer/). Были времена, когда Mbed был весьма прост, но многое изменилось с тех пор, как он превратился в Mbed OS. К сожалению, это означает, что многие примеры и библиотеки, которые вы могли бы найти, с относительно новой системой работать не будут.

Мне нужен был поворотный энкодер — и я вытянул дешевый экземпляр из одного набора «49 плат для Arduino», какие продаются повсюду. Уверен, это не самый филигранный поворотный энкодер из имеющихся в природе, но для поставленной задачи его должно было хватить. К сожалению, в Mbed OS нет драйвера для такого датчика, а первые несколько сторонних библиотек, которые я нашел, либо работали по принципу опроса, либо не компилировались под последнюю версию Mbed. Разумеется, для чтения поворотного энкодера никакой магии не требуется. Но насколько сложно самостоятельно написать для него код? В самом деле, довольно сложно. Подумал, поделюсь моим кодом и расскажу, как к этому коду пришел.

Есть реально много способов, какими можно читать поворотный энкодер. Есть, наверное, методы получше моего. Кроме того, эти дешевые механические датчики просто ужасны. Если вы пытаетесь выполнить высокоточную работу, то, пожалуй, вам лучше подыскать другую технологию, например, взять оптический преобразователь. Упоминаю об этом, поскольку почти невозможно безукоризненно прочитать данные с поворотного энкодера.

Так что цель моя была проста: хотел найти что-нибудь, управляемое прерываниями. Найденные мной образцы по большей части требовали периодически вызывать некоторую функцию или устанавливать прерывание таймера. Затем соорудили машину состояний, чтобы отслеживать состояние энкодера. Это хорошо, но такая конструкция будет отжирать много процессорного времени только лишь для проверки энкодера, даже если он не движется. Процессор STM32 может с легкостью выполнять прерывания при изменении пина, и именно этого я хотел.

Загвоздка

---------

Проблема, разумеется, в том, что механические переключатели подвержены дребезгу. Поэтому приходится отфильтровать этот дребезг на аппаратном или на программном уровне. Я в самом деле не хотел устанавливать какого-либо дополнительного оборудования сверх конденсатора, поэтому всю обработку собирался осуществлять программно.

Кроме того, я собирался обойтись только абсолютно необходимым минимумом прерываний. В системе Mbed обрабатывать прерывания легко, но в ней наблюдается небольшая задержка. На самом деле, закончив с делом и измерив задержку, я обнаружил, что с ней не все так плохо – об этом расскажу чуть ниже. Как бы то ни было, я решил попробовать обойтись лишь парой прерываний.

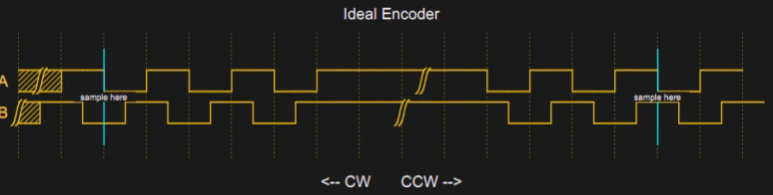

Теория

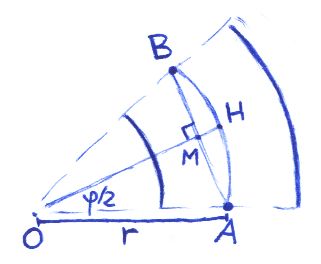

------

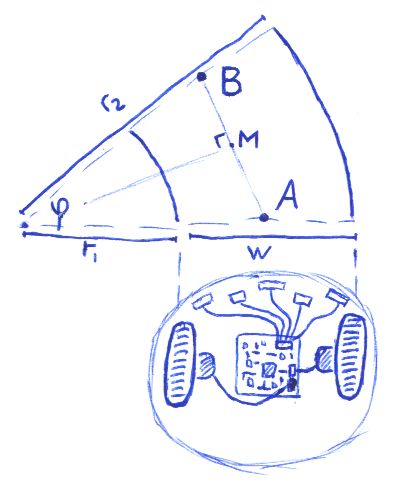

Теоретически, прочитать энкодер – проще простого. У него два выхода, назовем их A и B. Перещелкиваешь рычажок – и эти выходы испускают импульсы. Механическая компоновка внутри такова, что, когда рычажок поворачивается в одном направлении, импульсы от A на 90 градусов опережают импульсы от B. Если перещелкнуть рычажок в другую сторону, фаза будет обратной.

Обычно считается, что импульсы положительны, но на практике в большинстве энкодеров будет контакт с землей и подтягивающий резистор, поэтому на самом деле выходы зачастую имеют высокий логический уровень, а импульсы – низкий. Это видно на схеме: когда рычажок никто не перещелкивает, наблюдается длинный участок высокого сигнала.

В левой части схемы отметим, что сигнал B всякий раз падает перед сигналом A. Если замерить B на нисходящем фронте A, то в таком случае у вас всегда получится 0. Ширина импульсов, конечно же, зависит от скорости перещелкивания. Перещелкивая рычажок в другую сторону, оказываемся на правой стороне схемы. Здесь сигнал A сначала идет на низкий уровень. Если замерить B в той же точке, что и в предыдущем примере, то теперь он будет равен 1.

Обратите внимание: нет никакого волшебства ни с A, ни с B, ни с метками, указывающими движение по часовой стрелке или против часовой стрелки. Все это, в сущности, означает «туда» или «сюда». Если вам не нравится, как движется энкодер, то просто можете поменять местами A и B или сделать это на уровне программы. Я выбрал эти направления произвольно. Как правило, считается, что канал A «ведет» по часовой стрелке, но это зависит и от того, какой фронт сигнала вы измеряете и как все подключили. На программном уровне обычно добавляем единицу к счетчику в одном направлении и вычитаем единицу из счетчика в другом – чтобы представлять, где вы окажетесь со временем.

Есть много способов читать подобный ввод. Если вы замеряете его, то весьма просто собрать из двух битов машину состояний – и таким образом обрабатывать ввод. Вывод образует код Грея, что позволяет вам отбросить плохие состояния и плохие переходы между состояниями. Однако, если вы уверены в вашем входном сигнале, то все может быть гораздо проще. Просто читаем B на фронте A (или наоборот). Можно проверить второй фронт, если хочется добиться немного большей надежности.

Практика

--------

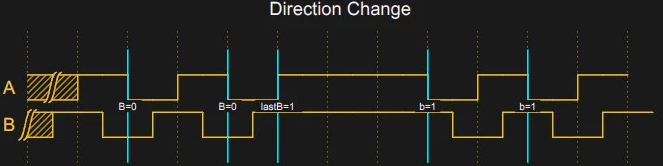

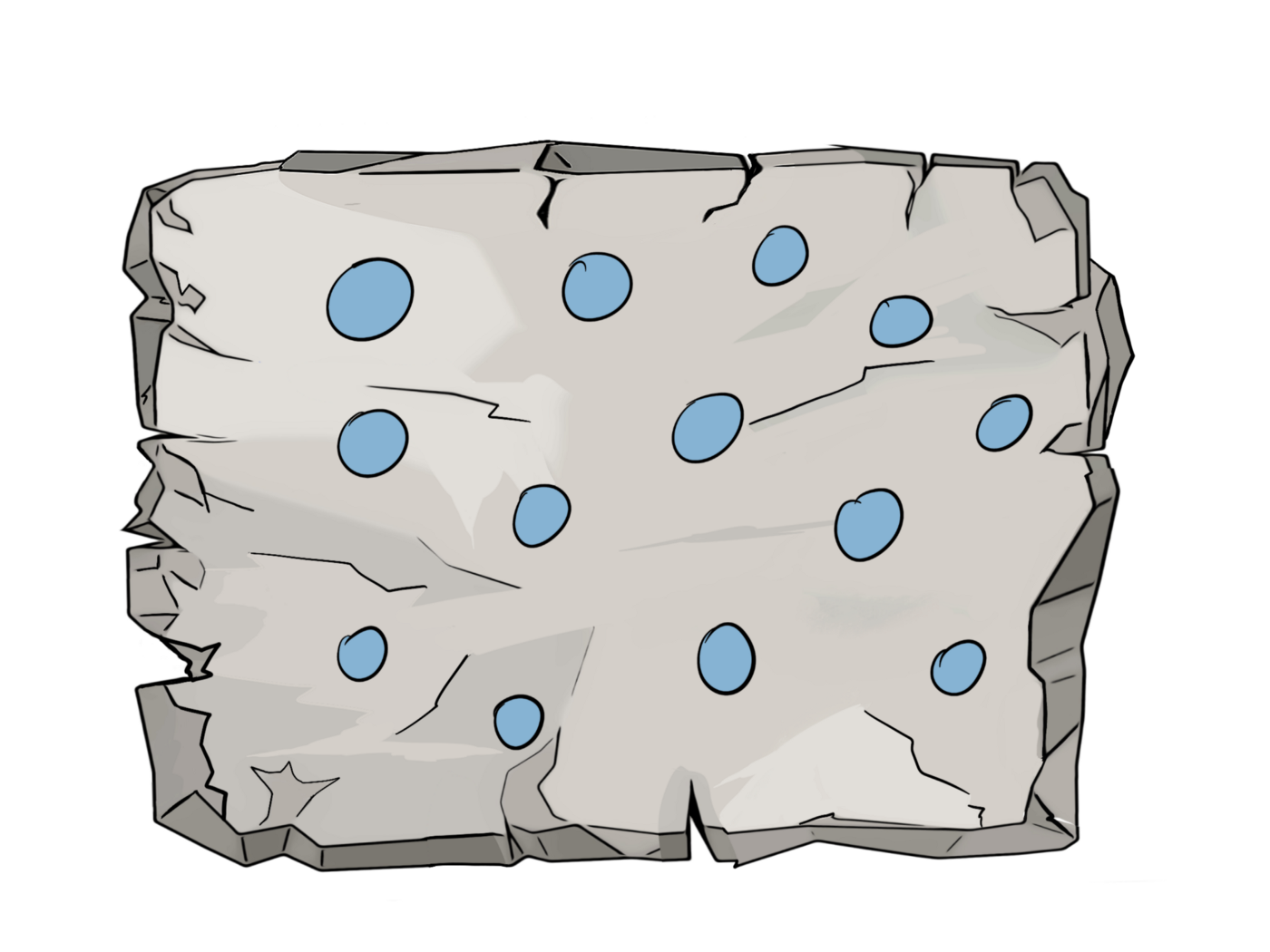

В реальности, к сожалению, механические энкодеры выглядят не так, как на вышеприведенной схеме. Скорее, они выглядят вот так:

Здесь возникает проблема. Если сделать прерывание по обоим фронтам входа A (верхняя линия в области видимости), то получим серию импульсов по обоим фронтам. Обратите внимание: состояния B отличаются на каждом фронте A, поэтому, если у вас в сумме получится четное количество импульсов, то общий счет будет равен нулю. Если вам повезет, то вы можете получить нечетное число в правильном направлении. Либо в неправильном. Что за каша.

Но на замеряемом фронте A значение B незыблемо. Нижняя линия в области видимости кажется прямой, поскольку все переходы B слишком мелкие и не видны в масштабах экрана. В этом и есть секрет, как с легкостью устранить дребезг энкодера. Когда A меняется, B стабильно и наоборот. Поскольку перед нами код Грея, в этом есть смысл, но это же обстоятельство позволяет запрограммировать простой декодер.

План

----

Наш план таков: заметить, когда A переходит с верхнего уровня на нижний, и именно тогда прочитать B. Далее игнорировать A, пока B не изменится. Конечно же, если вы хотите отслеживать B, то возникнет такая же проблема, поэтому его нужно замкнуть на значение A, которое в момент изменения будет стабильным. Я в данном случае не хочу использовать еще два прерывания, поэтому стану следовать такой логике:

1. Когда A падает, записать состояние B и обновить счетчик. Затем установить флаг блокировки.

2. Если A снова падает, то: если флаг блокировки установлен или B не изменилось – ничего не делать .

3. Когда A поднимается, то: если B изменилось, записать состояние B и снять флаг блокировки.

В области видимости вышеприведенной линии на первой ямке в верхней линии мы должны прочитать B. После этого никакие переходы, возникшие на экране, не дадут никакого эффекта, поскольку B не изменилось. Восходящий фронт за пределами экрана, возникающий после того, как B претерпит шумный переход из верхнего в нижнее состояние, как раз и разблокирует алгоритм.

Проблема

--------

Но здесь есть проблема. Вся схема основана на допущении, что B будет отличаться на истинном восходящем фронте A по сравнению с нисходящим. В таком случае B не меняется, но мы все равно хотим при этом принимать фронт A. Это происходит, когда вы меняете направления. Если вы отслеживали B, то эта задача решается легко, но в таком случае понадобилось бы больше кода и еще два прерывания. Вместо этого я решил, что, если у вас в распоряжении рычажок, и вы будете бешено перещелкивать его туда-сюда, то даже не заметите, что одна или две проверки энкодера прошли неправильно. Заметите только в случае, если сами произведете тонкую настройку, а затем целенаправленно перещелкнете рычажок в другую сторону.

Когда вы полагаете, что предыдущее состояние B вам известно, и за последнее время (допустим, за несколько сотен миллисекунд) ничего не изменилось, то код «забудет», каково было состояние B и, таким образом, следующий сигнал B будет считаться действительным, что бы ни случилось.

Я воспользовался фичей `Kernel::Clock::now` из Mbed. Непонятно, требуется ли от вас вызывать ее из обработчика прерывания (ISR), но я так и делаю и, как кажется, тут все работает без проблем.

Единственное, что остается сделать – убедиться, что значение счетчика не

изменится прямо в процессе его считывания. Чтобы в этом убедиться, я отключил прерывания прямо перед актом считывания.

Код

---

Весь код выложен на [GitHub](https://github.com/wd5gnr/MbedQuadratureEncoder). Если вы продрались через мои объяснения, то вам не составит труда его прочитать.

```

void Encoder::isrRisingA()

{

int b=BPin; // прочитать B

if (lock && lastB==b) return; // не время для блокировки

// если lock=0 и _lastB==b, то две эти строки ничего не делают

// но, если lock = 1 и/или _lastB!=b, то в одной из них что-то делается

lock=0;

lastB=b;

locktime=Kernel::Clock::now()+locktime0; // даже если не заблокировано,

// выдержать задержку для lastB

}

// Падающий фронт – там, где выполняется счет

// Обратите внимание: если выдержать паузу в бит, то блокировка истечет,

// так как в противном случае

// нам также придется отслеживать B, чтобы знать,

// состоялось ли изменение направления

// Здесь очень хочется попытаться взаимно заблокировать/разблокировать ISR,

// но в реальной практике

// за фронтами следует ряд дребезжащих фронтов, пока B стабильно

// B изменится, пока A стабильно

// Поэтому, если вы не хотите также наблюдать B в сравнении с A,

// то придется пойти на какой-то компромисс,

// и на практике это работает достаточно хорошо

void Encoder::isrFallingA()

{

int b;

// снять блокировку в случае timedout, и в любом случае забыть lastB,

// если мы достаточно давно не видели фронт

if (locktime

```

Установить прерывание просто, поскольку есть класс `InterruptIn`. Он подобен объекту `DigitalIn`, но предусматривает способ прикрепления функции к восходящему или нисходящему фронту. В данном случае используем обе.

Задержка

--------

Я заинтересовался, сколько времени требуется на обработку прерывания в такой конфигурации, так что этот код будет доступен, если установить `#define TEST_LATENCY 1`. Также можете посмотреть видео о том, что у меня получилось, но, если вкратце: чтобы получить прерывание, уходило не более 10 микросекунд, часто даже около пяти.

Настроить энкодер как следует оказалось немного сложнее, чем я полагал, но, в основном, потому, что мне не хотелось обрабатывать дополнительных прерываний. Было бы достаточно просто изменить код так, чтобы он отслеживал пин B относительно пина A и правильно представлял бы правильное состояние B. Если вы попробуете внести такую модификацию, то вот еще идея: измеряя время между прерываниями, также можно составить представление, насколько быстро вращается энкодер, а это может пригодиться в некоторых практических контекстах.

Если вы хотите [освежить знания о коде Грея](https://hackaday.com/2017/01/25/fifty-shades-of-gray-code/) и вспомнить, в чем он может быть полезен – об этом я говорил ранее. Если все это кажется вам до странности знакомым, напомню, что в 2017 году я писал об [использовании энкодера со старой версией Mbed](https://hackaday.com/2017/01/11/encoders-spin-us-right-round/). Тогда я использовал готовую библиотеку, периодически опрашивавшую входные значения при прерываниях таймера. Но, как я и говорил, такие задачи, как описанная здесь, всегда можно решить несколькими способами.

|

https://habr.com/ru/post/663060/

| null |

ru

| null |

# Exponator – расширение для просмотра EXIF-данных фотографий

Я достаточно давно хотел сделать расширение, которое позволяло бы просматривать данные об экспозиции фотографии, которые хранятся в EXIF. И вот, вдохновленный постом «[Создание расширения для Google Chrome](http://habrahabr.ru/blogs/google_chrome/75639/)» решил-таки потратить на это время.

Ссылка на расширение: [Exponator](https://chrome.google.com/extensions/detail/npdclakkbcpndnjlnajapdlbdncpijdg).

Под катом будет кратко рассказано о процессе создания, нескольких подводных камнях и задан вопрос опытным разработчикам. :-)

Сперва я озаботился поиском javascript-библиотеки, которая бы читала EXIF блок из jpeg файлов: изобретать велосипед никакого желания не было. Почти сразу я нашел необходимое на сайте Nihigoloc: <http://www.nihilogic.dk/labs/exif/>. В библиотеке скрипт проходит по всем изображением, скачивает их в бинарном виде, проверяет наличие EXIF-данных, парсит их и добавляет новое поле к исходному изображению. Практически то, что нужно.

Вторым шагом стало изучение [документации](http://code.google.com/chrome/extensions/index.html) и более подробное прочтение статьи про создание расширения. Для расширения не нужна кнопка в строке адреса, да и страница настроек на данном этапе лишняя. Недолго думая я открыл раздел [Content Scripts](http://code.google.com/chrome/extensions/content_scripts.html) и приступил к третьему шагу: написал, казалось бы, рабочий код, который, как ни странно, не заработал.

При этом дебаггер Хрома (я даже не ожидал, что он настолько хорош) ни на что не ругался: *XMLHttpRequest* отправлялся, а ответа не было. Я убил на это около часа, а потом узнал, что Content-скрипты не могут обращаться к данным вне домена страницы. А фотографии, в большинстве своем, хостятся на серверах, отличных от тех на которых отображаются.

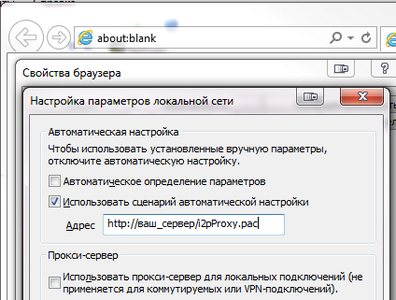

Решением задачи оказалась [фоновая страница](http://code.google.com/chrome/extensions/background_pages.html), которая ограничивается только в манифесте расширения в разделе permissions. Если там указать http://\*/, то из фоновой страницы можно будет послать запрос на любой домен. Кусок манифеста:

> `"background\_page": "background.html",

>

>

>

> "permissions": [

>

> "http://\*/"

>

> ],

>

>

>

> "content\_scripts": [

>

> {

>

> "matches": ["http://\*/\*"],

>

> "js": [ "EXIF.js", "js.js"],

>

> "run\_at": "document\_start"

>

> }

>

> ]

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Но решение одной задачи влечет за собой появление следующей: как фоновой странице обмениваться данными с Content Script? Документация описывает [два способа](http://code.google.com/chrome/extensions/messaging.html): разовый запрос и соединение, которое может жить неопределенное время. Мне нужно было отправить в фоновую страницу ссылку на изображение, загрузить ее там, а назад вернуть массив с разобранными EXIF-данными. По логике вещей мне вполне подходит разовый запрос, но я не смог разобраться в том, как он работает. А обычное соединение пошло сразу.

В результате в фоновой странице был добавлен обработчик сообщений, который получает адрес изображения, скачивает картинку, достает из нее необходимые данные и, пользуясь тем же портом, отправляет их обратно:

> `chrome.extension.onConnect.addListener(function(port) {

>

> port.onMessage.addListener(function(imgSrc) {

>

> BinaryAjax(

>

> imgSrc,

>

> function(HTTP) {

>

> var EXIF = EXIF.findEXIFinJPEG(HTTP.binaryResponse);

>

> port.postMessage(EXIF);

>

> }

>

> )

>

> });

>

> });

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

А в скрипте страницы создается порт, отправляется ссылка на изображение, а при получении ответного сообщения массив данных присваивается полю *exifdata*:

> `var port = chrome.extension.connect({name: "exif"});

>

> port.onMessage.addListener(function(oEXIF) {

>

> oImg.exifdata = oEXIF || {};

>

> });

>

> port.postMessage(oImg.src);

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

После чего из EXIF берутся диафрагма, выдержка и светочувствительность и добавляются к *Title* изображения:

Вопрос к залу: возможно ли получить доступ к кэшу Хрома? Кэширует ли Хром *XMLHttpRequest*? А то сейчас каждое изображение скачивается дважды: один раз при загрузке страницы, второй раз при получении EXIF-данных.

Ссылка на расширение: [Exponator](https://chrome.google.com/extensions/detail/npdclakkbcpndnjlnajapdlbdncpijdg).

UPD: Некоторые картинки могут не работать. Почему-то некоторые сервера не дают их загрузить.

UPD: При желании шаблон можно изменить в настройках.

UPD: Символ \* в шаблоне выводит все доступные поля EXIF.

|

https://habr.com/ru/post/76030/

| null |

ru

| null |

# Кондиционер айтишника. Часть II

В этой части расскажу вариант «простой» [интеграции кондиционера](https://habr.com/ru/post/448826/) (а вообще, практически любого устройства, управляемого через ИК) с помощью WiFi<=>IR-шлюза.

Для того, чтобы было интереснее — выбрал популярный шлюз (кстати, Яндекс для своей Алисы как раз его и использует). Купить такой можно на Али, цена что-то около 1200 рублей (у Яндекса — дороже).

Устройство довольно компактное (легко умещается в ладони), из видимых органов есть один маленький ненаваязчивый синий светодиод и кнопка для сопряжения. Все остальное скрыто за черным ИК-прозрачным корпусом. В качестве источника питания можно использовать любой доступный USB-порт (БП, комп и т.п.). Шлюз подключается к нему с помощью microUSB-кабеля (из комплекта поставки или любым удобным).

Особенность этого устройства — он построен на «хорошо известном в узких кругах» esp8266, а это значит, что достаточно несложно его можно «приручить».

Вариант «для самых маленьких»

-----------------------------

Прежде чем перешивать устройство, попробовал использовать его в штатном режиме: установил приложение TuyaSmart на телефон (есть версии как под Android, так и под iPhone), а дальше все просто:

* регистрируемся в приложении,

* проходим небольшого мастера по подключению нового устройства (для этого шлюз надо подключить к питанию и ввести его в режим «сопряжения» с помощью единственной кнопки на нем,

* после появления шлюза в приложении, создаем новый «пульт управления» — еще один небольшой мастер, где выбирается тип устройства (в моем случае — Кондиционер), дальше выбирается производитель (Electrolux-а в приложении нет, но замечательно заработало при выборе Midea). Тут же придумываем «имя» нового пульта (я выбрал «Mr.White»).

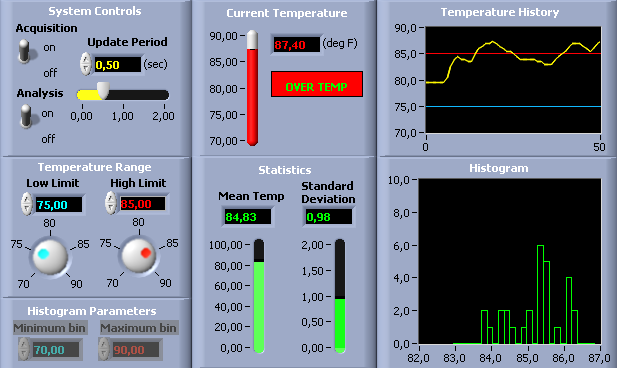

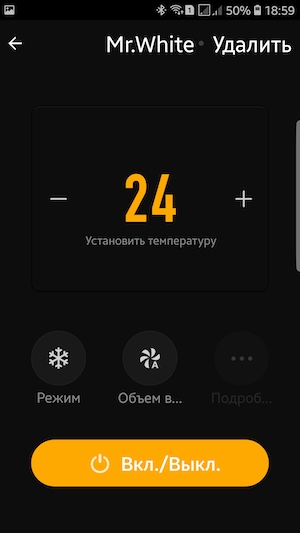

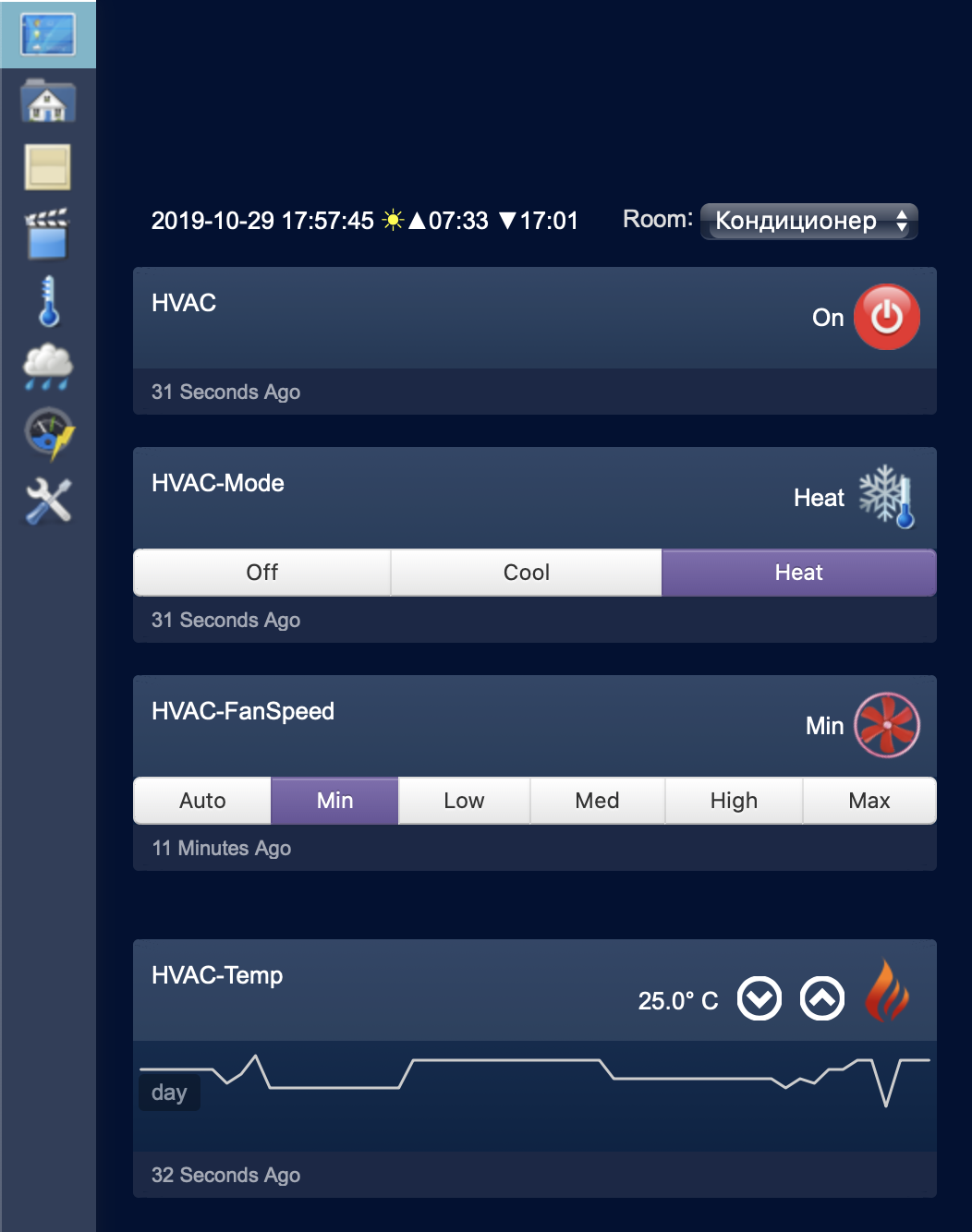

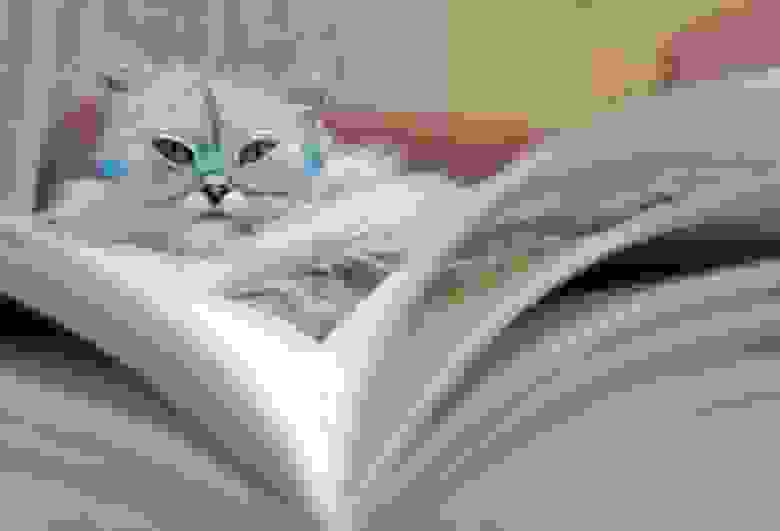

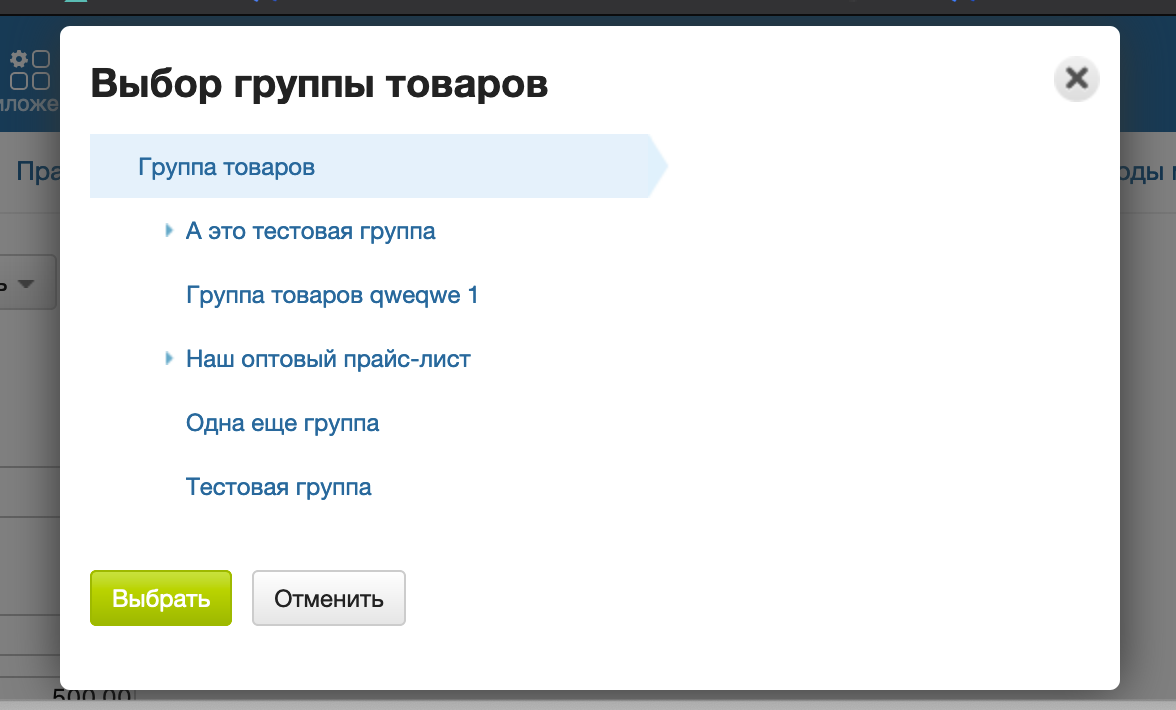

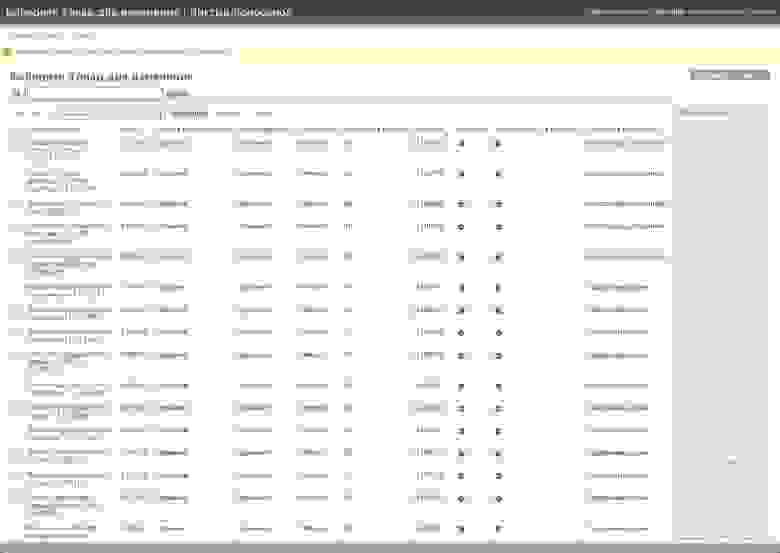

Вот и все. После этого на телефоне появляется примерно такой пульт управления:

С его помощью можно управлять основными базовыми функциями:

* включение/выключение,

* установка температуры,

* выбор режима работы («Авто», «Охлаждение», «Обогрев», «Вентилятор»),

* выбор скорости вентилятора («Авто», «Низкий», «Средний», «Высокий»).

В общем, уже можно пользоваться для удаленного управления, но где же тут «умный дом» и интеграция?

Поскольку это простой путь — с умным домом тут плохо, а вот с интеграцией — несколько лучше.

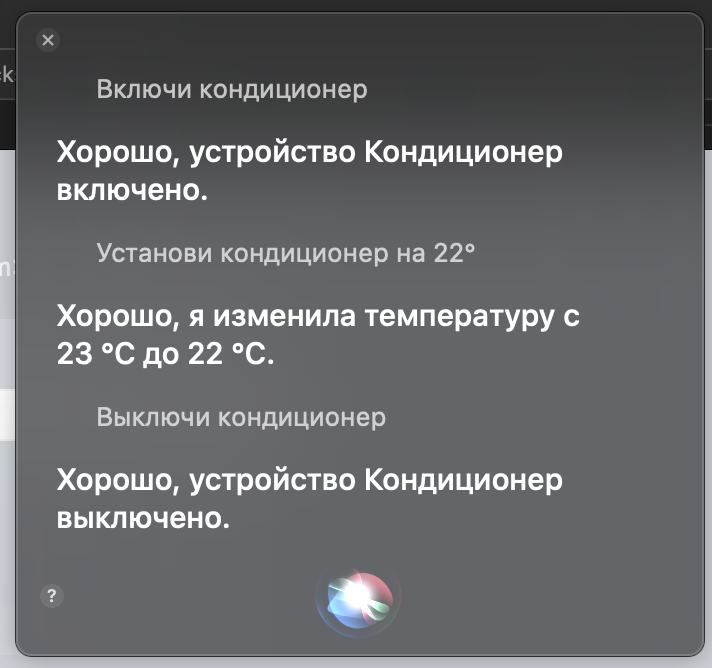

Сначала «ложка дегтя» — интеграции с Apple HomeKit нет, так что Siri — пока «недоступна», а вот с другими конкурирующими платформами все гораздо веселее:

* Для Amazon Alexa — есть скилл Tuya Smart. Достаточно его активировать и указать в нем свой аккаунт, который завели при регистрации в приложении — появляется возможность голосового управления кондиционером.

* Аналогичным образом можно подключить Tuya Smart и к Google Ассистенту.

В обоих случаях русский язык не поддерживается, но голосом управляется легко и просто. Я нашел следующие команды:

— Alexa, turn on Mr.White

— Hey, Google, set Mr.White to 24 degrees

— Alexa, turn off Mr.White

Напомню, голосовое управление у меня реализовано с помощью Amazon Echo Dot и Google Home Mini — оба устройства идентично отрабатывают команды.

Кстати, какими голосовыми командами можно управлять режимом работы и скоростью воздушного потока — я не нашел. Если кто-то подскажет — буду благодарен.

А дальше была сделана «полу-автоматическая» интеграция с УД: при повышении температуры в комнате выше пороговой — контроллер УД отправляет сообщение с требованием включить кондиционер, а я, удаленно, с помощью приложения TuyaSmart — включал кондиционер в нужном режиме.

Решение «так себе», конечно, но уже хоть как-то можно пользоваться.

Но ведь это не наш путь — двигаемся дальше:

Путь джедая

-----------

### Вскрытие и подготовка

Есть вариант прошить устройство и без вскрытия, способ описан [вот тут](https://github.com/ct-Open-Source/tuya-convert).

Мне этот способ показался излишне сложным (столько телодвижений, когда для прошивки требуется всего-то 4 проводка подпаять), да и интересно было заглянуть внутрь.

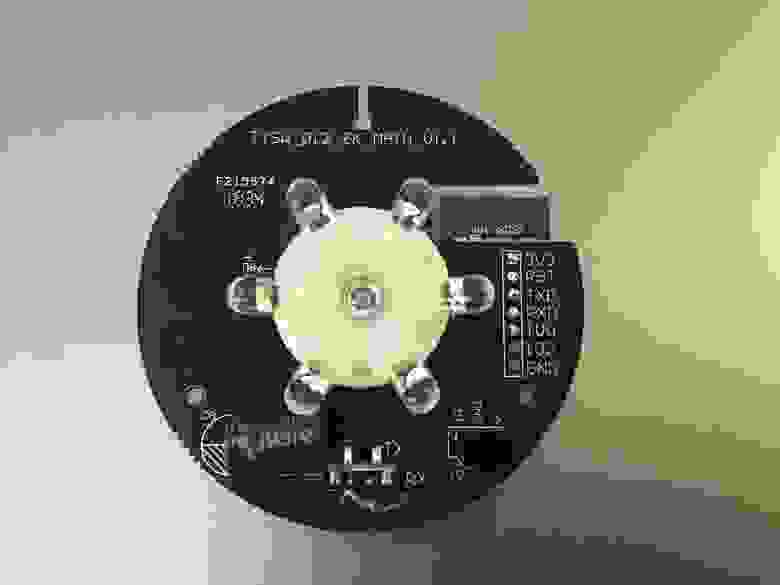

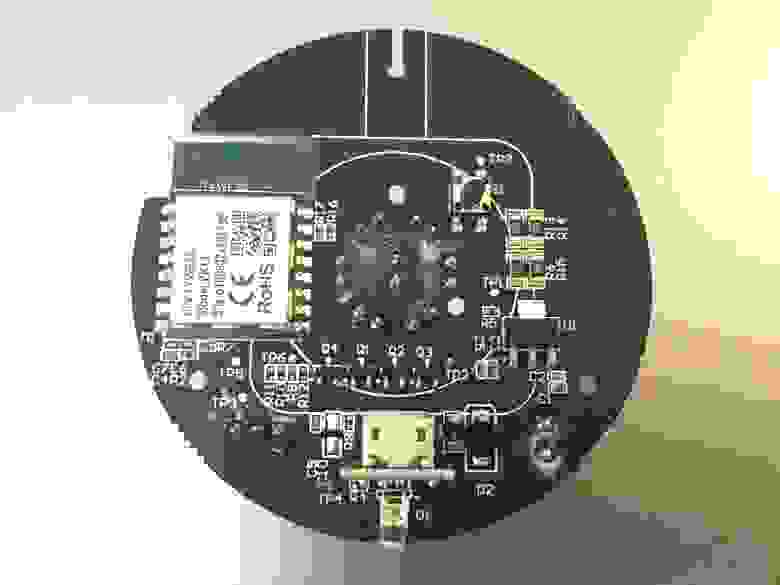

К сожалению, я в процессе увлекся и забыл сфотографировать, поэтому покажу чужие фотографии:

Больше фото можно [посмотреть тут](https://github.com/arendst/Tasmota/wiki/ytf-ir-bridge).

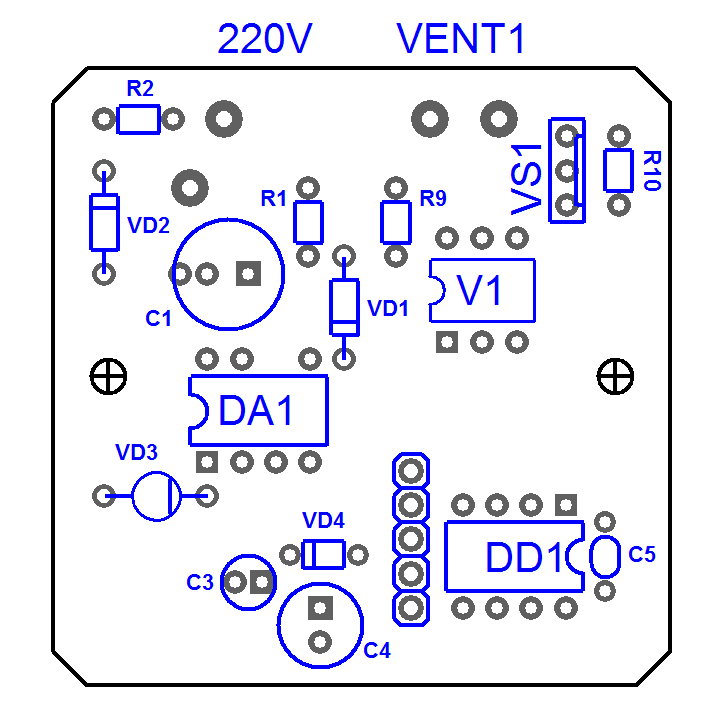

На фото хорошо видно, что используется модуль TYWE3S ([даташит](https://fccid.io/2AFNL-TYWE3S/User-Manual/Users-Manual-3525098) на который находится очень просто в Google).

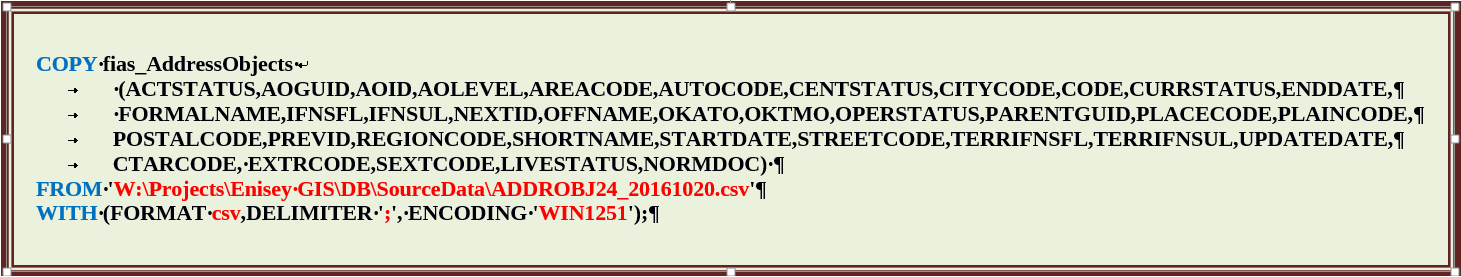

Теперь надо прошить модуль. Оригинальная прошивка затирается и восстановить ее невозможно.

Прошивка делается очень просто: берем среду Arduino (или Atom, или что-то еще — выбирайте на свой вкус). Загружаем в среду разработки скетч с прошивкой [Tasmota](https://github.com/arendst/Tasmota). Дальше подключаем на модуле TYWE3S RX, TX, GND, VCC от любого usb-serial (не перепутайте — нужно 3.3В питания и соответствующие уровни сигналов, если будет 5В — придется заказывать новый шлюз). Перед подачей питания не забываем замкнуть (любым удобным способом) GPIO0 модуля на землю, тем самым переводя модуль в режим прошивки. Прошиваем.

Конфигурировать прошивку не требуется — все можно оставить в коде «как есть», нам просто нужно «приручить» модуль.

Если все сделано верно (после отключения проводов для прошивки, конечно), включаем шлюз. На телефоне или компьютере включаем поиск WiFi-сетей — должна появиться новая сеть с именем sonoff-xxxx (где xxxx — цифры), которую поднимает наше устройство.

Подключаемся к этой сети и заходим по адресу: [192.168.4.1](http://192.168.4.1) — это уже веб-интерфейс нашего шлюза.

Для начала в настройках шлюза укажем домашнюю WiFi-сеть и пароль к ней (устройство перезагрузится и подключится к домашней сети). Дальше уже все действия проще делать в ней. Естественно, надо любым удобным образом узнать, какой адрес получил шлюз в домашней сети.

Заходим на [страницу с релизами прошивки Tasmota](https://github.com/arendst/Tasmota/releases). Скачиваем два файла — sonoff-minimal.bin и sonoff-ir.bin

Теперь с помощью веб-интерфейса шлюза делаем обновление прошивки в два этапа — сначала шьем «минимальную» версию, а вторым шагом — sonoff-ir.

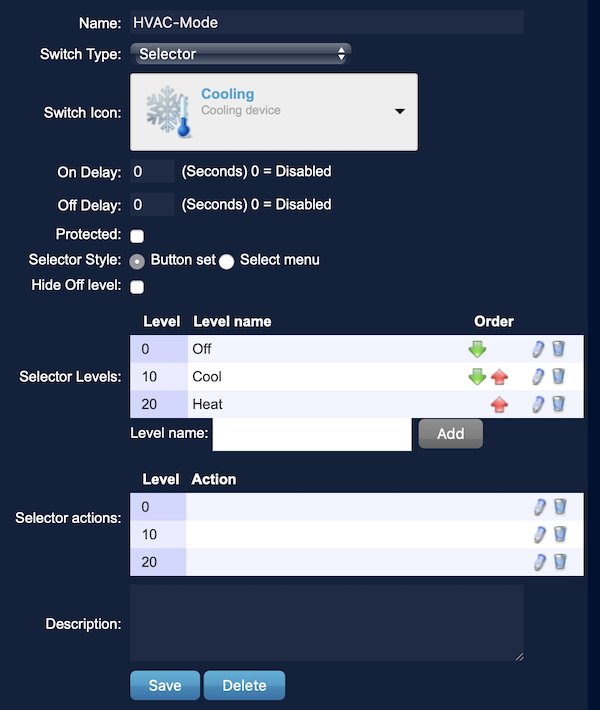

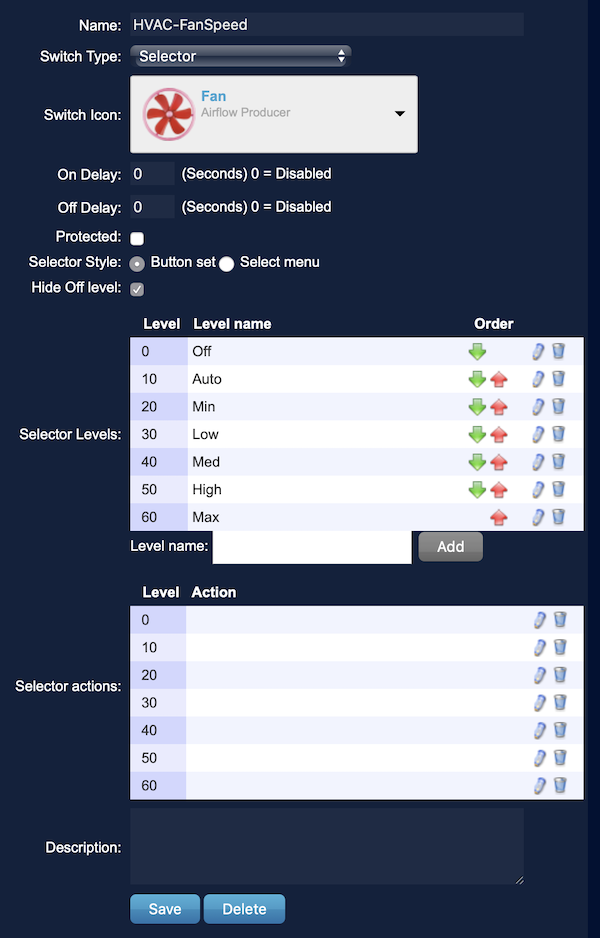

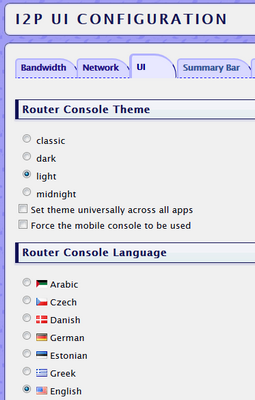

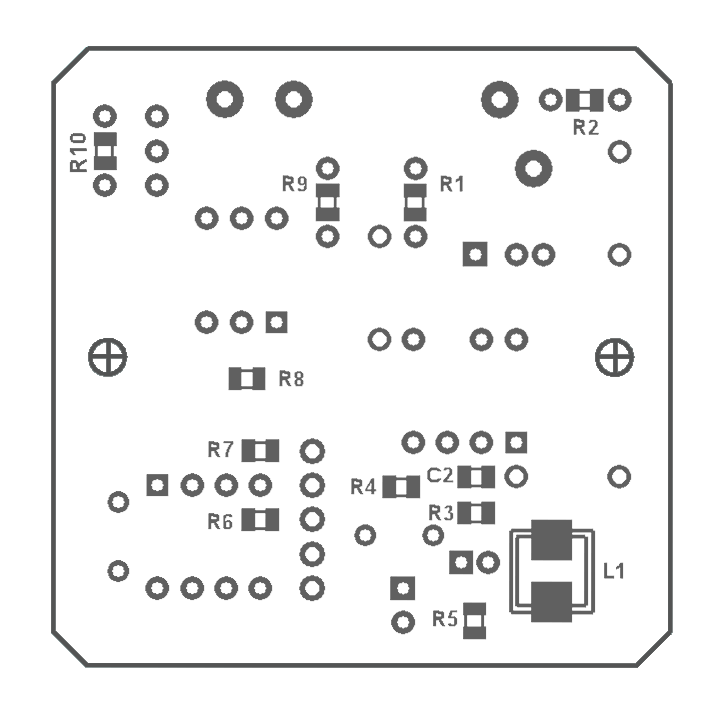

После всех этих нехитрых действий у нас в руках уже будет модуль с актуальной версией прошивки, осталось его только сконфигурировать следующим образом:

Собственно, это минимальная необходимая конфигурация — в описываемом примере будем взаимодействовать с модулем с помощью GET-запросов (хотя можно и через MQTT).

Проверить работу модуля, а заодно и узнать кое-что полезное можно в его консоли (ссылка на нее доступна с заглавной страницы веб-интерфейса). Открываем консоль и смотрим, как «живет» модуль.

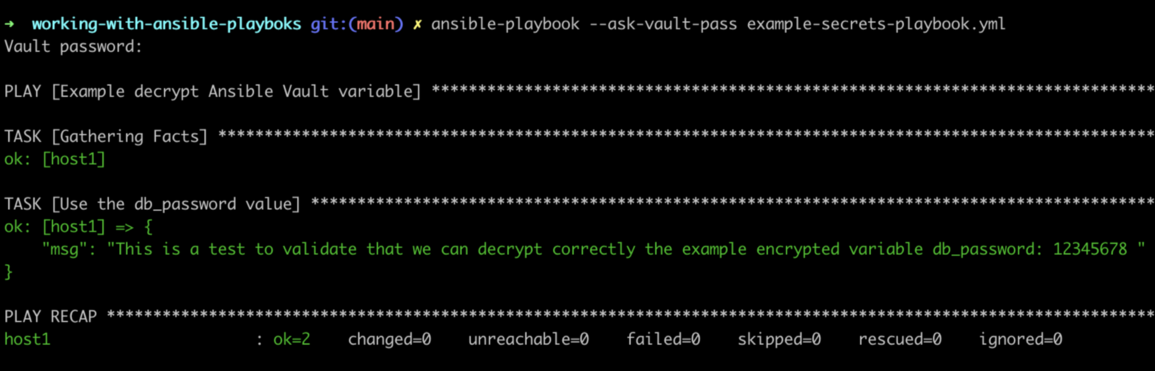

Теперь уже можно начать изучать интерфейс управления кондиционером. Для этого берем в руки штатный пульт от кондиционера и нажимаем кнопку включения. Если все хорошо, то в консоли появится строчка типа:

```