text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Опыт запуска AHCI в VxWorks653

Введение

--------

Я занимаюсь разработкой приложений и драйверов для различных устройств авиационного применения. В Авиации используются ОС с более жесткими требованиями к надежности(ARINC 653), такие как VxWorks653, PikeOS или LynkOS. Разрабатывая приложения для авионики возникла проблема медленного доступа к данным на твердотельных накопителях подключенным по интерфейсу ATA. Это происходило из-за использования медленного программного интерфейса ATA. Я решил эту проблему реализацией драйвера AHCI.

В этой статье Я хочу кратко описать работу AHCI.

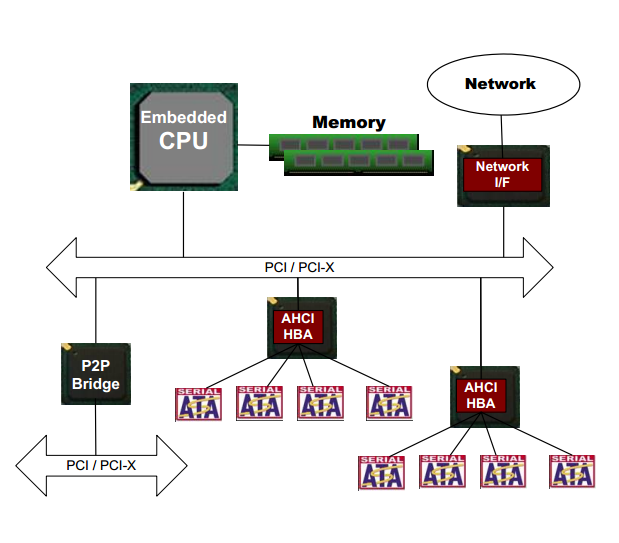

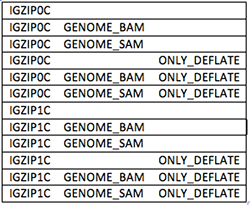

*Архитектура устройства с AHCI контроллером.*

Описание AHCI

-------------

Advanced Host Controller Interface (AHCI) — механизм, используемый для подключения накопителей информации по протоколу Serial ATA.

Для работы с устройством в режиме AHCI следует выполнить следующие действия:

* Настроить контроллер AHCI

* Заполнить структуры управления

* Выставить флаг запуска в контроллере

* Дождаться пока контроллер через DMA прочитает из памяти структуры со списком команд и после этого вернет данные в буферы, указанный в структурах. После выполнения всех действий выставляется флаг завершения транзакции.

* Profit!

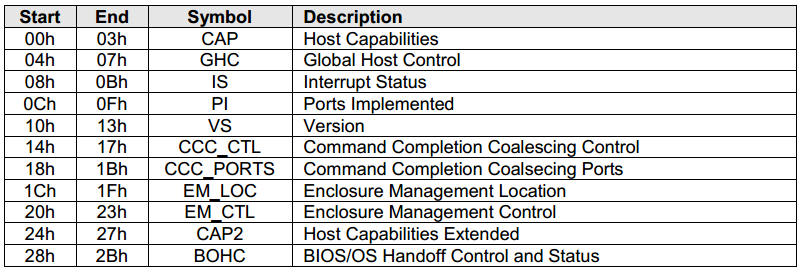

Все взаимодействие с регистрами AHCI происходит через окно PCIe BAR5. Он называется ABAR(AHCI Base Address Region).

*Распределение адресного пространства ABAR.*

### Настройка контроллера AHCI

Спецификация протокола находится в открытом доступе по адресу: [www.intel.com/content/www/us/en/io/serial-ata/ahci.html](http://www.intel.com/content/www/us/en/io/serial-ata/ahci.html)

Текущая последняя версия AHCI — 1.3.1

Сначала ищем все контроллеры массовой памяти на шине PCIe. Нас интересуют устройства имеющие class id 0x01 (mass storage device) и subclass id 0x06 (serial ATA).

Настройка контроллера заключается в следующих действиях:

* Сбросить контроллер;

* Включить AHCI

* Записать физические адреса списков команд и FIS в ABAR

* Установить необходимые флаги

* Настроить прерывания

Через регистры AHCI — ABAR можно сделать ограниченное количество действий — настроить работу AHCI, прочитать ее версию, и т.д. Доступ к конфигурации носителя данных и к самим данным через эти регистры не возможен.

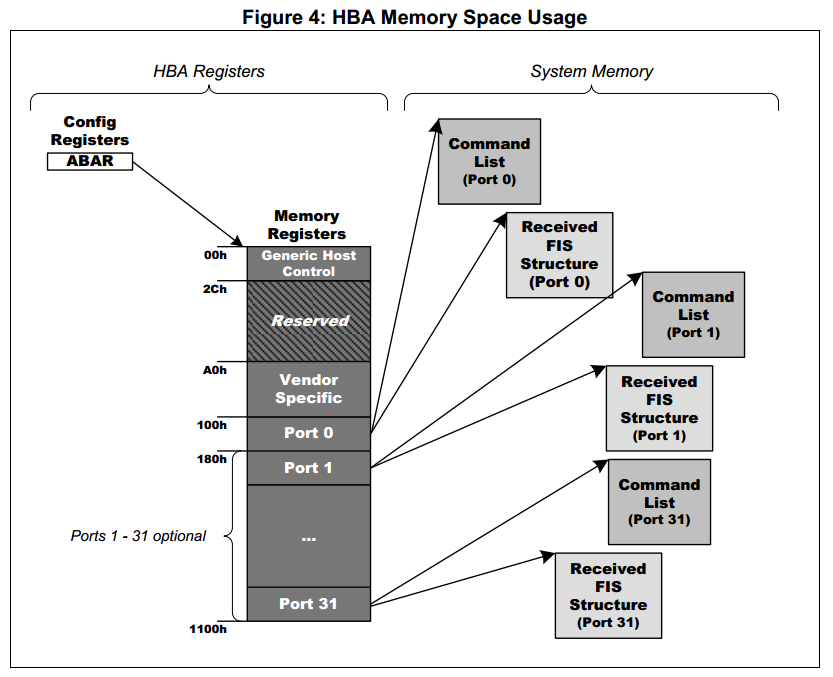

Для получения доступа используются специальные списки команд. Списки команд хранятся в ОЗУ вычислителя. Физический адрес этих списков записывается в контроллер AHCI. AHCI контроллер сам обращается по DMA к ОЗУ вычислителя, считывает списки команд, выполняет их и считывает записывает блоки памяти из ОЗУ. Архитектура распределения памяти показана на рисунке ниже. пр инициализации ОС должна распределить необходимые массивы в памяти, вычислить их физический адрес и на этапе инициализации их адреса записываются в соответствующие регистры ABAR.

*Распределение памяти в ABAR — HBA*

### Заполнение структур управления

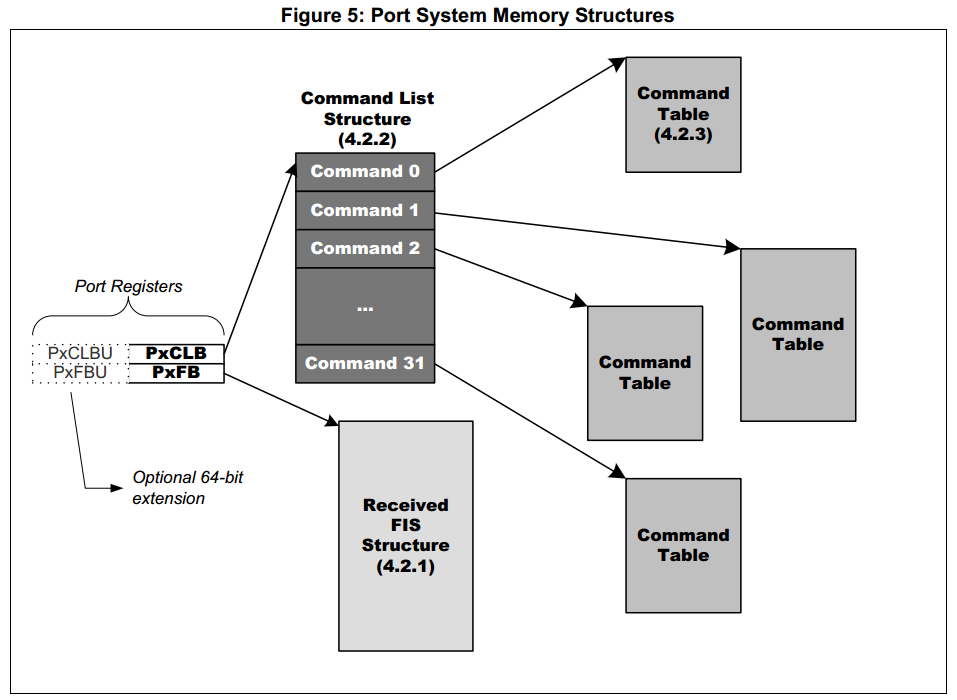

Для каждого порта в ABAR должны быть указаны 2 структуры — список команд и FIS.

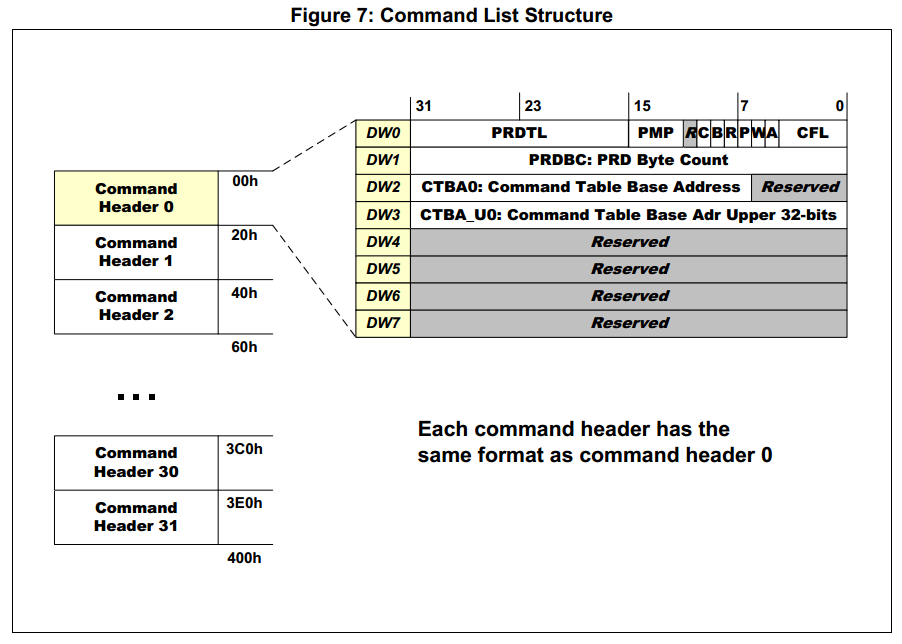

Список команд состоит из 2 частей — одного заголовка списка команд.

В заголовке указывается размер списка команд, размер FIS и ссылка на физический адрес самого списка команд.

В списке команд содержится адреса буферов, которые понадобятся при выполнении команды, указанной в FIS, и из размеры.

*Структуры порта AHCI*

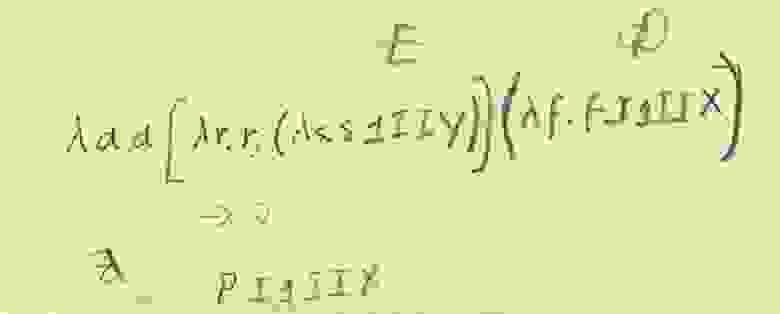

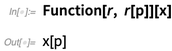

Формирование Command header:

`opts = (20 >> 2) | (sg_count << 16);

pp->cmd_slot->opts = cpu_to_le32(opts);

pp->cmd_slot->status = 0;

pp->cmd_slot->tbl_addr = cpu_to_le32(pp->cmd_tbl & 0xffffffff);

pp->cmd_slot->tbl_addr_hi = 0;`

Здесь заполняется поле CFL значением размера FIS(у меня константа 20) в двойных словах. Поле PRDTL заполняется количество используемых буферов по 4Мб.

*Формат заголовка списка команд*

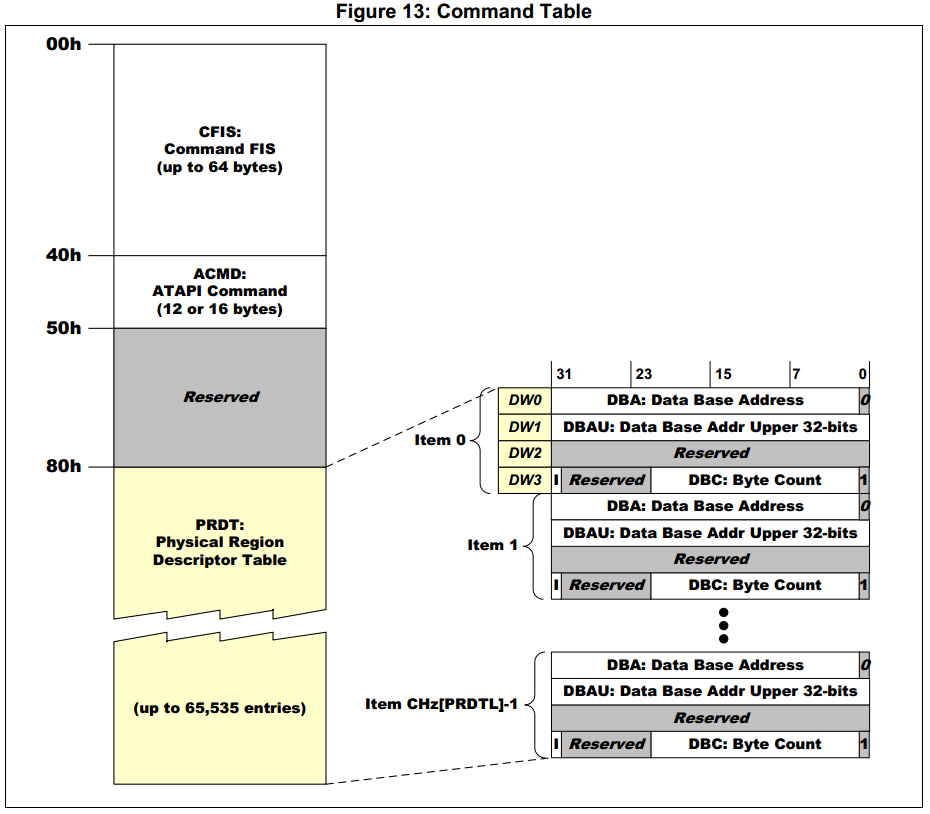

Формирование таблицы команд:

```

#define MAX_DATA_BYTE_COUNT (4*1024*1024)

sg_count = ((buf_len - 1) / MAX_DATA_BYTE_COUNT) + 1;

for (i = 0; i < sg_count; i++) {

ahci_sg->addr =

cpu_to_le32((uint32_t) buf + i * MAX_DATA_BYTE_COUNT);

ahci_sg->addr_hi = 0;

ahci_sg->flags_size = cpu_to_le32(0x3fffff &

(buf_len < MAX_DATA_BYTE_COUNT

? (buf_len - 1)

: (MAX_DATA_BYTE_COUNT - 1)));

ahci_sg++;

buf_len -= MAX_DATA_BYTE_COUNT;

}

return sg_count;

```

Функция заполняет структуру в котором указывает какие буферы будут участвовать в передачи данных. Так как размер буфера в записи не может превышать 4Мб, то функция занимается разбиением буфера на несколько, если его размер превышает 4Мб.

*Формат таблицы команд*

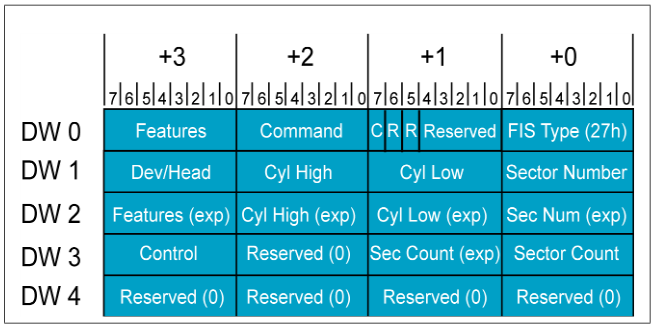

Описание FIS в документации на AHCI нет. Следует искать его в описании на SATA. В структуре FIS описывается код операции (Чтение идентификации, чтение, запись, и др.) и параметры (смещение, размер, и д.р.).

*Структура FIS*

При чтении идентификационной информации о накопителе формируется следующий FIS:

```

memset(fis, 0, 20);

fis[0] = 0x27;

fis[1] = 1 << 7;

fis[2] = ATA_CMD_IDENT;

```

При запросе записи блока данных формируется FIS:

```

memset(fis, 0, 20);

/* Construct the FIS */

fis[0] = 0x27; /* Host to device FIS. */

fis[1] = 1 << 7; /* Command FIS. */

fis[2] = ATA_CMD_WR_DMA; /* Command byte. */

/* LBA address, only support LBA28 in this driver */

fis[4] = ((unsigned char) (start))&0xff;

fis[5] = ((unsigned char) (start>>8))&0xff;

fis[6] = ((unsigned char) (start>>16))&0xff;

fis[7] = (((unsigned char) (start>>24)) & 0x0f) | 0xe0;

/* Sector Count */

fis[12] = (unsigned char) blocks & 0xff;

fis[13] = ((unsigned char) (blocks>>8))&0xff;

```

При запросе чтения блока данных формируется FIS:

```

memset(fis, 0, 20);

/* Construct the FIS */

fis[0] = 0x27; /* Host to device FIS. */

fis[1] = 1 << 7; /* Command FIS. */

fis[2] = ATA_CMD_RD_DMA; /* Command byte. */

/* LBA address, only support LBA28 in this driver */

fis[4] = ((unsigned char) (start))&0xff;

fis[5] = ((unsigned char) (start>>8))&0xff;

fis[6] = ((unsigned char) (start>>16))&0xff;

fis[7] = (((unsigned char) (start>>24)) & 0x0f) | 0xe0;

/* Sector Count */

fis[12] = (unsigned char) count & 0xff;

fis[13] = ((unsigned char) (count >> 8))&0xff;

```

### Запуск на выполнение

После того как контроллер через ABAR настроен, все списки в памяти подготовлены, достаточно записать 0x1 в PORT\_CMD\_ISSUE и дождаться, пока флаг сбросится. Ждать можно в цикле(я поступил именно так) или по прерыванию.

Сразу после записи в PORT\_CMD\_ISSUE — контроллер через DMA будет обращаться в ОЗУ процессора и выполнять те действия, которые от него ожидали.

Так в результате выполнения операции чтения мы получим в в буферах, указанных в списке команд данные из носителя.

Заключение

----------

До использования AHCI в проекте скорость чтения/записи была: ~100кб/с

После использования AHCI в проекте скорость чтения/записи стала: 30 / 10 Мб/с

|

https://habr.com/ru/post/280254/

| null |

ru

| null |

# Конь мой Вороной

Здорово, гении. Раньше я тоже был гением, а теперь игрушки пишу для iPhone. Последнюю неделю Apple и Google меня сильно взволновали, пытаясь лишить приложений и доходов. Пришлось вспотеть и сделать 7 игр за 7 дней на Swift 3.0. При этом в старый Obj-C код былых игр я не заглядывал — настолько проще делать приложения на новом языке.

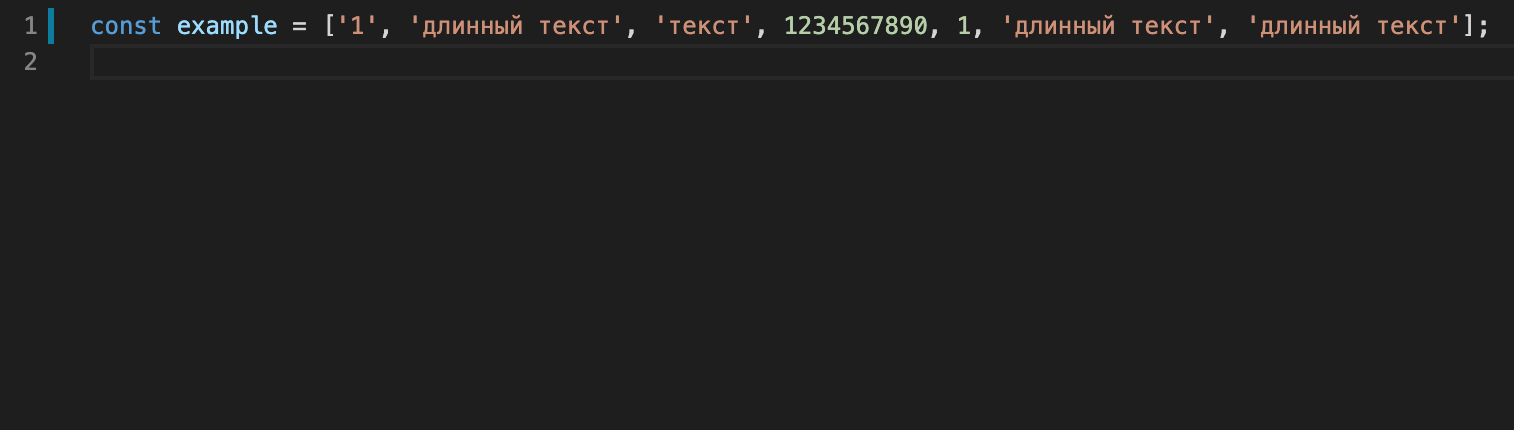

Раньше, когда был гением, мне каждый раз приходилось заново писать функцию сортировки (как элемент игры) и затем гордитьсяя этим. Боже, какой я был идиот. Впрочем, не сильно я изменился. Но изменился инструмент. Смотрите, как теперь выглядит сортировка на Swift 3.0.

```

let vtxSorted = vtx.sorted(by:{ $0.yPosition > $1.yPosition })

```

И все! Массив вершин VTX отсортирован по координате Y…

Да зачем это надо? А вот зачем…

Сортировка по координате нужна для построения диаграммы Вороного, о чем было немало статей на Хабре.

### Диаграмма Вороного

Все вы знаете про convex-hull и как его строить. По-русски это называется диаграмма Вороного. Напомню для пхпешников, что это сетка, равноудаленая от всех точек, набросанных на плоскость в беспорядке. Заменим плоскость на экран iPhone, точки на жирные белые пикселы и получим такую картинку.

Симпатично и сразу хочется написать какую-нибудь игру. Так я и сделал в далеком 2009 году, когда ты, читатель, не знал даже про Руби, который теперь вместо Анны Карениной лежит на рельсах.

Да и пусть лежит, а мы уносимся вдаль — вот тогда я сделал игру на OpenGL и не заработал на ней ничего. Возможно, долларов 50 за 5 лет я и получил, но это вряд ли.

Но игра классная. Тычешь пальцем в экран и нервничаешь, что не успеваешь убрать все клетки с доски. Что еще надо для счастья? Ну, может немножечко конфет и варенья. Тем более, в самом расцвете сил.

И потому я решил переделать игру на новый лад. Как раз, в интернете попалась яркая картинка с горячей темой о выборах в США, её я и сделал иконкой приложения. Точки заменил на Клинтониху и Трамп-пам-пама, сетку на Штаты — и бросился программировать на чистом Swift.

### Засада с OpenGL

Зачем OpenGL? Чтобы рисовать текстурированные треугольники. Заливка чистым цветом — это в сад. Детский сад.У нас будет только хардкор!

А-а-а-! Нету! Я не про защитника Зенита. Нету API на Swift для вызова OpenGL функций! Прикиньте, перцы! Ладно, поиграем желваками и попробуем metal. Это модная библиотека, которую Apple сделал вместо OpenGL, с похожим функционалом и интерфейсом, но, якобы, работающей быстрее на родном железе.

### Засада с Металлом

Эта библиотека не работает на симуляторе! Атас! При Джобсе такого не было. Держите меня 100 человек! Три тысячи чертей. Жизнь, кажется, прожита зря. И вот грустный, с разрушенной мечтой, я брел под внезапным балканским дождем и слушал ржанье местных парней. Впрочем, девушке ржали еще громче. Как вдруг, как шашечки зеленоглазого такси, меня осенила мысль — а не надо никаких библиотек, добрый человек! Я смогу нарисовать треугольник с текстурой сам, на чистом UIKit, на милом сердцу Стриже. И даже не треугольник, а целый полигон, что еще круче.

Как? а вот смотрите код, русский язык здесь бессилен.

```

var mask = CAShapeLayer()

mask.frame = groundTrump.layer.bounds

let path = CGMutablePath()

for t in app.trumpTriangles {

if t.flag == 0 {

path.closeSubpath() // закрываем треугольник

path.move(to: t.p) // начинаем новый

} else {

path.addLine(to: t.p) // бежим по вершинам диаграммы

}

}

mask.path = path

groundTrump.layer.mask = mask1

```

Да, маска рулит и я её знаю. И вы теперь тоже знаете. Идем дальше, нужно написать алгоритм построения сетки. Я люблю сетки, у меня диссертация была про безсеточные методы (SPH). Здесь P — particles.

Между прочим, на github лежат заморские алгоритмы построения сетки диаграммы Вороного на Swift 3.0. Целых два. К сожалению, первый из них не учитывает прямоугольную границу, другой работает с ошибками погрешности. Пришлось писать программу самому, что было чудесно, мозги свернулись набекрень, по часовой стрелке. Именно по часовой стрелке я обхожу каждую вершину в отдельности и весь массив точек в целом. Метод Флетчера не использовал, сортировал точки по углу и жарил тупо O(N^2). На 50 точках это не принципиально, хотя на iPhone 4S заметно тормозит. Но у кого сейчас iPhone 4S? Даже редакторы Хабре их не юзают.

Что еще? Игра не выложена в магазин, возможно завтра займусь, а вам предлагаю взглянуть на видео *геймплея* и восхитится моей изумительной работой в комментариях.

Чао, видимся.

|

https://habr.com/ru/post/312840/

| null |

ru

| null |

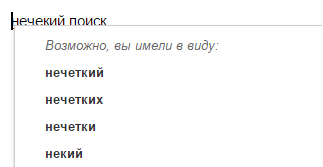

# Нечеткий поиск в словаре с универсальным автоматом Левенштейна. Часть 1

Нечеткий поиск строк является весьма дорогостоящей в смысле вычислительных ресурсов задачей, особенно если вам необходима высокая точность получаемых результатов. В статье описан алгоритм нечеткого поиска в словаре, который обеспечивает высокую скорость поиска при сохранении 100% точности и сравнительно низком потреблении памяти. Именно автомат Левенштейна позволил разработчикам Lucene повысить скорость нечеткого поиска [на два порядка](http://blog.mikemccandless.com/2011/03/lucenes-fuzzyquery-is-100-times-faster.html)

### Введение

Нечеткий поиск строк в словаре является основой для построения современных систем проверки орфографии, которые используются в текстовых редакторах, системах оптического распознавания символов и поисковых системах. Кроме того, нечеткий поиск находит применение при решении ряда вычислительных задач биоинформатики.

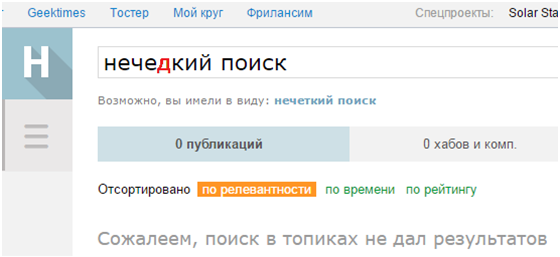

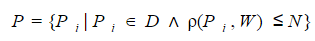

Формальное определение задачи нечеткого поиска в словаре можно сформулировать следующим образом. Для заданного поискового запроса **W** необходимо выбрать из словаря **D** подмножество **P** всех слов, мера отличия которых **р** от поискового запроса не превышает некоторого порогового значения **N**:

Степень отличия двух слов может быть измерена, например, при помощи расстояния [Левенштейна](http://ru.wikipedia.org/wiki/%D0%A0%D0%B0%D1%81%D1%81%D1%82%D0%BE%D1%8F%D0%BD%D0%B8%D0%B5_%D0%9B%D0%B5%D0%B2%D0%B5%D0%BD%D1%88%D1%82%D0%B5%D0%B9%D0%BD%D0%B0) или [Дамерау-Левенштейна](http://en.wikipedia.org/wiki/Damerau%E2%80%93Levenshtein_distance).

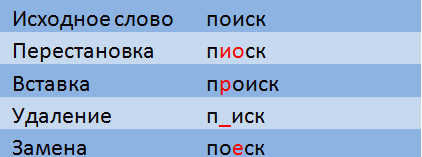

Расстояние Левенштейна это мера отличия двух строк, определяемая как минимальное количество операций вставки, удаления и замены символов, необходимых для перевода одной строки в другую.

При расчете расстояния Дамерау-Левенштейна допускаются также транспозиции (перестановки двух соседних символов).

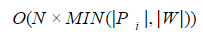

Несколько лет назад на Хабре уже был [пост](http://habrahabr.ru/post/114997/) от [ntz](https://habr.com/users/ntz/) посвященный нечеткому поиску в словаре и тексте — подробнее о расстояниях Левенштейна и Дамерау-Левенштейна можно прочесть там. Я лишь напомню, что временная сложность проверки условия

**р(Pi, W)<=N** при помощи методов динамического программирования оценивается как

,

где **|Pi|,|W|** — длина строки и запроса соответственно. Поэтому при решении практических задач полный перебор значений словаря с проверкой каждого слова, как правило, неприемлем.

Следует отметить, что не каждый алгоритм нечеткого поиска обеспечивает нахождение по запросу **W** абсолютно всех слов из словаря **D**, удовлетворяющих условию **р(Pi, W)<=N**. Поэтому есть смысл говорить о точности поиска как об отношении количества найденных результатов к действительному количеству слов в словаре, удовлетворяющих заданному условию. Например, точность поиска методом n-грамм автор уже упомянутого мной [поста](http://habrahabr.ru/post/114997/) оценил в 65%.

### Недетерминированный автомат Левенштейна

Автор предполагает, что читатель знаком с основами теории автоматов и формальных языков и воздержится от изложения терминологии этой предметной области. Вместо этого я сразу перейду к делу.

Для решения практических задач используется детерминированный конечный автомат Левенштейна (если быть до конца точным — то его имитация). Однако, чтобы понять принципы работы детерминированного конечного автомата Левенштейна, лучше предварительно рассмотреть работу недетерминированной версии.

**Автоматом Левенштейна для слова W** будем называть конечный автомат **AN(W)**, принимающий слово **S** тогда и только тогда, когда расстояние Левенштейна (Дамерау-Левенштейна) между словами **W** и **S** не превышает заданного значения **N**.

Конечный автомат Левенштейна для слова **W** и допустимого количества модификаций **N** может быть задан в виде упорядоченной пятерки элементов **AN(W)=0,F,V>**, где:

**E** — алфавит автомата;

**Q** — множество внутренних состояний;

**q0** — начальное состояние, принадлежит множеству Q;

**F** — множество заключительных, или конечных состояний

**V** — функция переходов, определяющая в какое (какие) состояния возможен переход из текущего состояния при поступлении на вход автомата очередного символа.

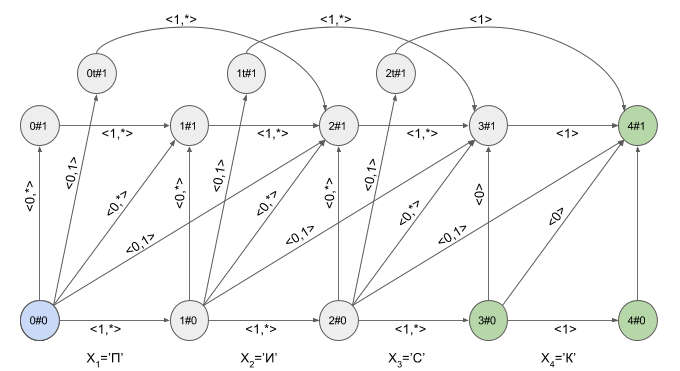

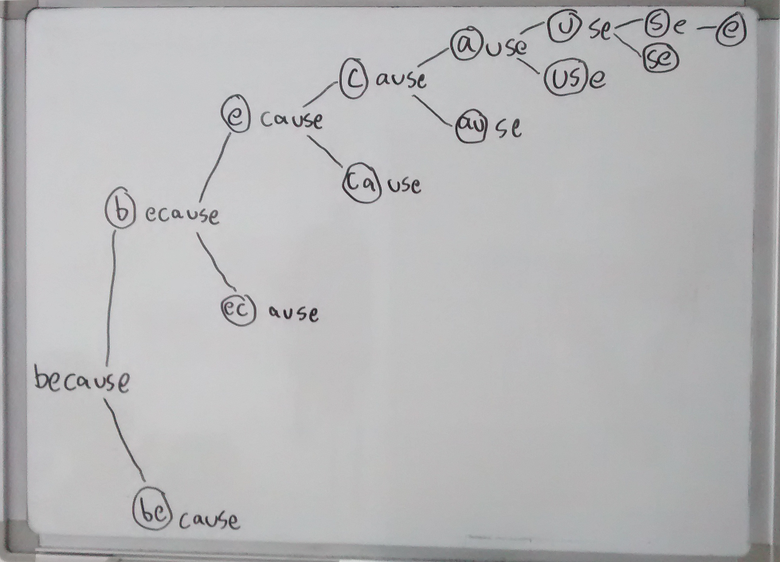

Состояния недетерминированного автомата Левенштейна **AN(W)** принято обозначать как **i#e**, где **i=0..|W|**, **e=0..N**. Если автомат находится в состоянии **i#e**, это говорит о том, что в автомат введено **i** “корректных” символов и обнаружено **e** модификаций. Поскольку мы рассматриваем автомат, который поддерживает транспозиции (т.е в качестве **р(S,W)** используется расстояние Дамерау-Левенштейна), то множество состояний должно быть дополнено состояниями **{iT#e}**, где **i=0..|W|-1**, **e=1..N**.

Начальным состоянием автомата является состояние **0#0**.

Множество заключительных состояний включает в себя такие состояния **i#e**, для которых выполняется условие **|W| — i <= N — e**.

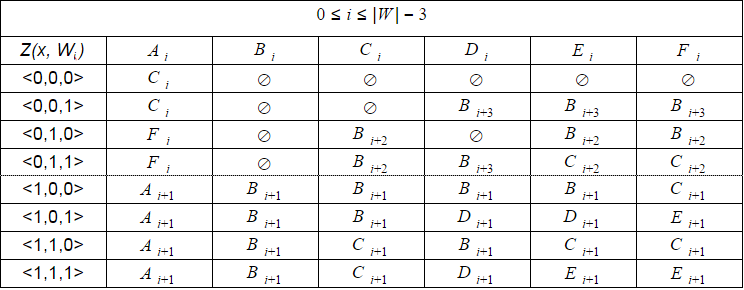

Исходя из физического смысла состояний автомата, нетрудно определить состав допустимых переходов. Функция переходов автомата Левенштейна задается в виде таблицы.

Если вам интересно строгое математическое обоснование состава состояний автомата и других вышеизложенных тезисов, вы можете найти его в [статье Шульца и Михова (2002)](http://link.springer.com/article/10.1007%2Fs10032-002-0082-8#page-1).

**Характеристическим вектором Z(x, Wi)** для символа **x** называется битовый вектор длины **min(N + 1, |W| — i)**, **k**-й элемент которого равен **1**, если **(i+k)**-й символ строки **W** равен **x**, и **0** в противном случае. Например, для **W**=”ПИСК”

**Z(‘П’, W0 )** = <1, 0>, а **Z(‘П’, W1 )** = <0, 0>.

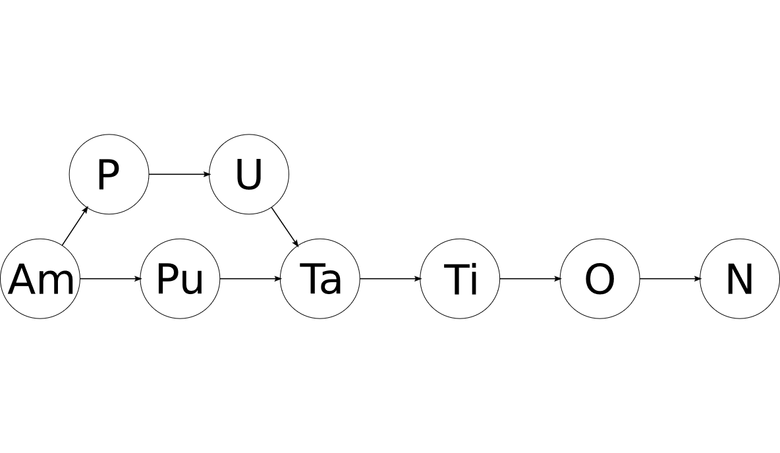

Графическое представление автомата Левенштейна для **W**=”ПИСК” и **N**=1 приведено на рисунке. Переходы автомата подписаны соответствующими им характеристическими векторами.

Зеленым цветом выделены конечные состояния автомата. Светло-синим — текущее (активное) состояние автомата.

Переход по горизонтальным стрелкам осуществляется тогда, когда в автомат введен “корректный” символ.

Переход по вертикальным стрелкам соответствует предположению о том, что очередной введенный в автомат символ вставлен в исходное слово **W** перед **(i+1)**-м символом. При переходе по вертикальным стрелкам автомат “обнаруживает” модификацию слова **W** — значение **e** при этом увеличивается на **1**.

Переход из состояния **i#e** в состояние **(i+1)#e+1** соответствует предположению о том, что очередной символ заменяет **(i +1)**-й символ в слове **W**.

Переход из состояния **i#e** в состояние **(i + 2)#e+1** соответствует предположению о том, что очередной символ соответствует **(i + 2)**-му символу в слове **W**, а **(i + 1)**-й символ слова **W** пропущен в слове **S**.

Наверное, вы уже догадались, что переход в состояние **iT#e** предполагает, что обнаружена транспозиция **(i + 1)**-го и **(i + 2)**-го символов слова **W**.

Теперь давайте посмотрим как это работает. Ввод в автомат нового символа я буду обозначать изогнутой красной стрелкой, а справа от стрелки указывать значение характеристического вектора. Вот так автомат **A1(«ПИСК»)** будет работать при вводе в него слова “ПОИСК”.

Обратите внимание, фактически последовательность смены состояний автомата определяется не конкретным словом, подаваемым на вход автомата, а лишь последовательностью характеристических векторов. Эта последовательность может оказаться одинаковой для двух разных слов. Например, если автомат настроен на слово “мама”, то последовательность характеристических векторов будет одинаковой для слов “лама”, “рама”, “дама” и т.п.

Другой интересный факт состоит в том, что структура допустимых переходов автомата не изменяется для **i=0..|W| — (N+1)**.

Эти два обстоятельства делают возможным при программной реализации алгоритмов нечеткого поиска использовать не рассчитываемый для каждого конкретного слова автомат, а его универсальную имитацию. Именно поэтому в заголовке поста идет речь об “универсальном” автомате Левенштейна.

Расчет автомата для конкретного слова **S** сводится в этом случае к простому расчету характеристических векторов для каждого символа **x** слова **S**. Смена состояний программно реализуется как простое увеличение двух переменных **e**, **i** на определяемую по универсальным таблицам величину. [Шульц и Михов (2002)](http://link.springer.com/article/10.1007%2Fs10032-002-0082-8#page-1) показали, что расчет всех характеристических векторов для слова **S** может быть произведен за время **O(|S|)**. Это и есть временная сложность работы автомата.

Символы слова **S** последовательно подаются на вход автомата. Если после подачи некоторого символа становится понятно, что расстояние между строками **S** и **W** превышает пороговое значение **N**, то автомат оказывается в “пустом” состоянии — активные состояния у автомата отсутствуют. В этом случае необходимость расчета характеристических векторов для оставшихся символов слова **S** отпадает.

Вот так автомат “отработает” слово **S**=”ИКС” при **W**=”ПИСК”:

После ввода символа “И” в автомате появилось сразу четыре активных состояния, однако уже после ввода символа “К” активных состояний не осталось — автомат оказался в состоянии ошибки и не принял слово “ИКС”. При этом расчет характеристических векторов для символа “С” не осуществлялся.

### Детерминированный автомат Левенштейна

В соответствии с [теоремой о детерминизации](https://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D0%BD%D0%B5%D1%87%D0%BD%D1%8B%D0%B9_%D0%B0%D0%B2%D1%82%D0%BE%D0%BC%D0%B0%D1%82) для любого недетерминированного конечного автомата может быть построен эквивалентный ему детерминированный конечный автомат. Зачем нам нужен детерминированный автомат? Просто при программной реализации он будет работать быстрее. Главным образом за счет того, что может иметь всего одно текущее состояние и, как следствие, при вводе очередного символа будет необходимо рассчитывать только один характеристический вектор и определять только один переход по таблице переходов.

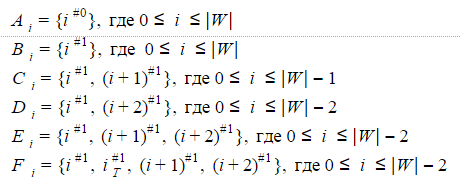

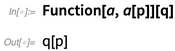

Если для рассмотренного выше недетерминированного автомата Левенштейна **А1(W)** последовательно перебрать все возможные значения характеристических векторов, то можно убедиться, что одновременно активными могут быть состояния, составляющие одно из следующих множеств:

Шесть вышеперечисленных множеств и будут представлять собой состояния детерминированного автомата Левенштейна для **N**=1. Точнее автомат будет иметь по шесть состояний для **i=0..|W|-2**, три состояния для **i=|W|-1** и еще два состояния для **i=|W|**.

Размерность характеристического вектора для детерминированного автомата может быть вычислена как **2N+1**. Тогда таблица переходов автомата для слова из **|W|** букв при **N**=1 должна иметь **22x1+1** строк и **6x(|W|-1)+3+2** столбцов (например, 8х35 для слова из 6 букв). Кроме того, такую таблицу придется рассчитывать для каждого значения **|W|** отдельно. Это не очень удобно и требует дополнительного времени для расчета или дополнительной памяти для хранения.

Однако, как я уже писал выше, состав допустимых переходов автомата не меняется для **i=0..|W| — (2N + 1)**. Поэтому при программной реализации гораздо удобнее имитировать детерминированный автомат вместо расчета реального. Для этого достаточно хранить значение смещения **i** и использовать универсальную таблицу переходов с восемью строками и шестью столбцами. Такую таблицу можно рассчитать заранее.

По мере увеличения **i** некоторые состояния автомата становятся недостижимыми, поэтому для **i=|W|-2..|W|** должны быть предусмотрены отдельные таблицы меньшего размера.

Далее, говоря о детерминированном автомате Левенштейна я буду подразумевать именно вышеописанную универсальную имитацию.

С увеличением **N** количество состояний растет по экспоненте. Так, для **N**=2 детерминированный автомат может иметь 42 состояния, для **N**=3 уже несколько сотен. А значит и потребление памяти будет пропорционально **O(N2)**.

Начальным состоянием детерминированного автомата Левенштейна будет являться состояние **A0**.

Какие состояния будут конечными? Те, которым соответствуют конечные состояния недетерминированного автомата. Для **N**=1 это будут состояния **A|W|**, **B|W|**, **A|W|-1**, **C|W|-1**, **D|W|-2**, **E|W|-2**, **F|W|-2**.

Поскольку количество переходов между шестью состояниями весьма велико, а физический смысл состояний детерминированного автомата Левенштейна не очевиден, я не буду приводить здесь его графическое представление. Считаю, что картинка получается не совсем наглядной. Если вы все-таки хотите её увидеть, то можете найти в статье [Михова и Шульца (2004)](http://www.cis.uni-muenchen.de/people/Schulz/Pub/aspaperCISreport.pdf). Я же приведу еще один пример работы недетерминированного автомата, но на этот раз буду указывать в каком состоянии в каждый момент находится его детерминированный эквивалент.

### Программная реализация детерминированного автомата Левенштейна

Программную реализацию автомата Левенштейна я написал на C# — мне наиболее привычен этот язык. Исходники вы можете найти [здесь](http://github.com/ibendrup/LevenshteinAutomaton). Универсальные таблицы переходов реализованы в виде полей статического класса ParametricDescription. В классе представлены универсальные таблицы переходов для **N**=1,2.

Помимо таблиц переходов, класс ParametricDescription содержит также таблицы инкремента смещения. Инкремент смещения — это величина, на которую нужно увеличить значение **i** при переходе в следующее состояние.

Сам автомат Левенштейна реализован в классе LevTAutomataImitation. Все методы класса весьма просты и я не буду описывать их подробно. При выполнении нечеткого поиска в словаре достаточно создавать один экземпляр класса на запрос.

Обратите внимание — создание экземпляра класса LevTAutomataImitation выполняется за малое постоянное время для любых значений **W**, **S**, **N**. В экземпляре класса хранится лишь значение **W** и вспомогательные переменные малого размера.

Чтобы отобрать из массива строк только те строки, которые отстоят от заданной на расстояние Дамерау-Левенштейна не более 2, вы можете использовать следующий код:

```

//Misspelled word

string wordToSearch = "fulzy";

//Your dictionary

string[] dictionaryAsArray = new string[] { "fuzzy", "fully", "funny", "fast"};

//Maximum Damerau-Levenstein distance

const int editDistance = 2;

//Constructing automaton

LevTAutomataImitation automaton = new LevTAutomataImitation (wordToSearch, editDistance);

//List of possible corrections

IEnumerable corrections = dictionaryAsArray.Where(str => automaton.AcceptWord(str));

```

Приведенный код реализует простейший алгоритм нечеткого поиска в словаре с использованием автомата Левенштейна — алгоритм полного перебора. Конечно же, это не самый эффективный алгоритм. О более эффективных алгоритмах поиска с использованием автомата Левенштейна я расскажу во [второй части статьи](http://habrahabr.ru/post/276019).

### Ссылки

1. Исходные коды к статье на [C#](http://github.com/ibendrup/LevenshteinAutomaton)

2. Расстояние [Левенштейна](http://ru.wikipedia.org/wiki/%D0%A0%D0%B0%D1%81%D1%81%D1%82%D0%BE%D1%8F%D0%BD%D0%B8%D0%B5_%D0%9B%D0%B5%D0%B2%D0%B5%D0%BD%D1%88%D1%82%D0%B5%D0%B9%D0%BD%D0%B0)

3. Расстояние [Дамерау-Левенштейна](http://en.wikipedia.org/wiki/Damerau%E2%80%93Levenshtein_distance)

4. [Конечный автомат](http://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D0%BD%D0%B5%D1%87%D0%BD%D1%8B%D0%B9_%D0%B0%D0%B2%D1%82%D0%BE%D0%BC%D0%B0%D1%82)

5. [Хороший пост о нечетком поиске в словаре и тексте](http://habrahabr.ru/post/114997)

6. Краткое описание автомата [Левенштейна](http://en.wikipedia.org/wiki/Levenshtein_automaton)

7. Подробное математическое описание автомата Левенштейна в статье [Шульца и Михова (2002)](http://link.springer.com/article/10.1007%2Fs10032-002-0082-8#page-1)

8. Еще одна статья [Михова и Шульца (2004)](http://www.cis.uni-muenchen.de/people/Schulz/Pub/aspaperCISreport.pdf) на ту же тему

9. История внедрения автомата Левенштейна в нечеткий поиск [Lucene](http://blog.mikemccandless.com/2011/03/lucenes-fuzzyquery-is-100-times-faster.html)

10. Реализации на java: [раз](http://github.com/universal-automata/liblevenshtein-java) и [два](http://github.com/itdraft/levenshtein-automaton)

11. [Вторая часть моей публикации](http://habrahabr.ru/post/276019)

|

https://habr.com/ru/post/275937/

| null |

ru

| null |

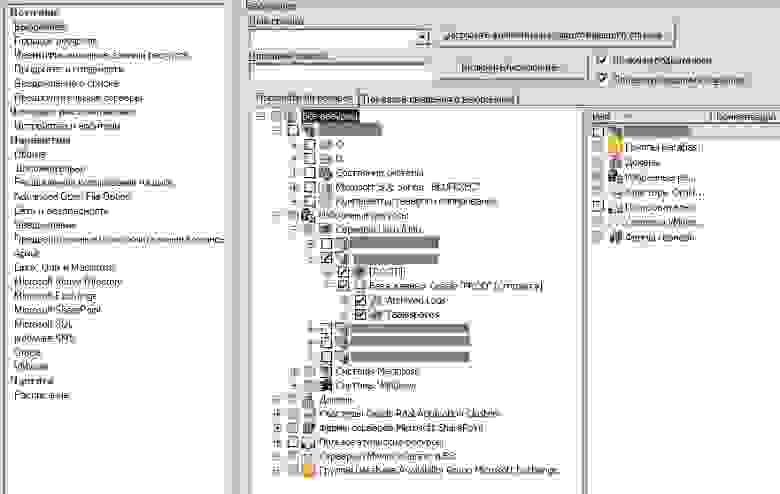

# Symantec Backup Exec: резервное копирование Oracle, установленного на Linux

Backup Exec – надежная система резервного копирования, корпоративного уровня. Установка и настройка этого продукта уже была описана ранее на хабре, сложностей никаких нет все просто и интуитивно понятно. Большим плюсом этого средства резервного копирования является, то что эта программа может бэкапить практически все ПО используемое на предприятии, перечислим основные возможности копирования:

• Способно копировать Windows, Linux, Macintosh;

• VMWare и ESX

• Домены Active Directory

• Состояние системы (System state)

• Фермы Microsoft Sharepoint

• Microsoft Exchange

• Базы данных MSSQL и Oracle, также Oracle Real Application Clusters

• Пользовательские ресурсы

• И многое другое.

Это всего не большой список возможности, преимущество в том, что одним продуктом можно заменить несколько утилит и наблюдать все бэкапы в одном месте или получать сообщения о сбоях.

Управление продуктом интуитивно понятно, но есть нюансы, в частности настройки бэкапа и восстановления Oracle, установленного на Linux, тут придётся изучить документацию, что бы разобраться. Постараюсь рассказать самые основные проблемы с которыми можно столкнуться и как их обойти во время резервного копирования Oracle, установленного на Linux.

Для начала необходимо установить клиента на Linux сервер. Обычный способ меню «Сервис –Установить агенты на другие сервера» c linux не всегда работает. Поэтому будем ставить вручную: в дистрибутиве BE имеется архив RALUS\_RMALS\_RAMS-xxxx.tar.gz в каталоге LinuxUnixMac. Копируем его на Linux сервер, распаковываем и запускам (установка и настройка выполняется под root):

```

tar –xzvf RALUS_RMALS_RAMS-xxxx.tar.gz

cd RALUS_RMALS_RAMS-xxxx

./installralus

```

Отвечаем утвердительно на все вопросы и указываем IP сервера, где установлен сам Backup Exec. Во время установки предложит создать группу beoper. Добавьте сразу в эту группу пользователя от которого работает Oracle на linux. После этого необходимо настроить агента для работы с Oracle:

```

cd /opt/VRTSralus/bin/

./AgentConfig

Symantec Backup Exec Remote Agent Utility

Choose one of the following options:

1. Configure database access

2. Configure Oracle instance information

3. Quit

Please enter your selection: 1

Configuring machine information

Choose one of the following options:

1. Add system credentials for Oracle operations

2. Edit system credentials used for Oracle operations

3. Remove system credentials used for Oracle operations

4. View system credentials used for Oracle operations

5. Quit

Please enter your selection: 1

Enter a user name that has local system credentials: <имя пользователя под которым работает oracle>

Enter the password:

Re-enter password:

Validating credentials.......

Do you want to use the full computer name/IP address for Oracle operations? (Y/N):Y

Enter the full computer name or IP address:

Do you want to use a custom port to connect to the media server during Oracle operations? (Y/N): N

Commit Oracle operation settings to the configuration file? (Y/N): Y

SUCCESS: Successfully added the entry to the configuration file.

Configuring the Oracle Agent

Choose one of the following options:

1. Add a new Oracle instance to protect

2. Edit an existing Oracle instance

3. Delete an existing Oracle instance

4. View Oracle instance entries that have been added in the Remote Agent Utility

5. Quit

Please enter your selection: 1

Select an Oracle instance to configure

Entry 1.

Enter the number 0 to go back

Enter your selection: 1

Enter the Oracle database SYSDBA user name:

Enter the Oracle database SYSDBA password:

Re-enter password:

Validating credentials.......

Enter the media server name or IP address:

Do you use a recovery catalog? (Y/N):N

Do you want to use a customized job template? (Y/N): N

Commit Oracle operation settings to the configuration file? (Y/N): Y

SUCCESS: Successfully added the entry to the configuration file.

```

Во время настройки клиента BE, сервер БД Oracle должен быть запущен. Если возникнет проблема:

```

oracle: error while loading shared libraries: libhasgen10.so: cannot open shared object file: No such file or directory

Failed to login.

```

То перед запуском конфигурации клиента необходимо установить переменные окружения для Oracle. Если вы столкнулись с такой проблемой, то и при запуске службы в дальнейшем потребуется устанавливать переменные.

```

--->>> No Oracle instances were discovered. Do you want to enter one? (Y/N):Y

Enter the Oracle instance: SM1

--->>> The entry could not be validated. Ensure that the instance is configured correctly.

```

Такое сообщение может возникать, если у Вас отсутствует файл oratab, проверьте права на него и его содержимое (SID и путь к ORACLE\_HOME).

Установка и настройка клиента завершена, перезапускаем службу и переходим на сторону сервера BE.

```

/etc/init.d/VRTSralus.init restart

```

Обратите внимание, чтобы настроить резервное копирование необходимо, чтобы БД Oracle была в режиме архивирования, проверяем так:

```

SQL> select log_mode from sys.v$database;

LOG_MODE

------------

NOARCHIVELOG ---- не подходит исправляем

SQL> shu immediate

SQL> startup mount

SQL> alter database archivelog;

SQL> alter database open;

```

На серверной стороне Backup Exec сразу выполняем такие действий (поможет избежать множества проблем при подключении):

```

Меню > Сервис > Параметры > Oracle > Изменить список > Создать (Указать имя сервера, где установлен Oracle и пользователя под, которым запускается БД).

```

Далее все банально, Меню > Файл > Создать > Задание резервного копирования.

> Когда необходимо настроить горячий бэкап Oracle Database — то не нужно копировать базу (файлы БД) как папку.

Если ранее все было выполнено правильно, то в разделе Серверы Linux/Unix появится имя вашего сервера БД, нажимая на + возле [ROOT] у Вас запросит учетные данные, нажимая создать, укажите учетные данные пользователя Linux под которым запущена БД. На + База данных Oracle, необходимо также нажать кнопку создать и указать данные пользователя БД, а именно пользователя sys, который был указан клиенту и у которого есть полномочия sysdba. Теперь мы можем выбирать каталог для сохранения ORACLE\_HOME (уберите галку на папке с файлами БД, выполнять бэкап этих файлов можно, когда БД остановлена), и установите флажок напротив «База данных oracle» (для «гарячего» копирования). Пройдитесь по вкладкам, все достаточно понятно. На вкладке Oracle рекомендую установить флажок «Удалить скопированные файлы журнала» — это будет означать, что после копирования архивлогов на сервер бэкапа они будут удалены с сервера БД, иначе у Вас может закончится место на диске БД, и придется удалять журналы в ручную. Настраиваем копирование на диск или на ленту на вкладке «Устройства и носители», Устанавливаем расписание – нажимаем «Выполнить немедленно» — будет сформирован общий список установленных вами параметров, проверяем нажимаем ОК и наблюдаем выполнение в разделе «Монитор заданий».

Если Ваша БД Oracle большая и часто используемая, то лучше сделать дополнительное задание для копирования только архивных журналов, таким образом снизится время потери информации и место на диске с БД будет чаше очищаться.

|

https://habr.com/ru/post/275449/

| null |

ru

| null |

# Правила эффективного использования jQuery

Здесь приведен ряд очень простых правил, следуя которым, ваше сотрудничество с jQuery не будет омрачено скрежетом напрягшегося браузера. Конечно, не так часто случается, что скорость работы javascript’а оказывается критичной, однако такое все же может произойти, и произойти в самый неподходящий момент. Поэтому, лучше держать эти правила в голове и не пренебрегать ими.

#### 1. Эффективный поиск элементов

Быстрее всего происходит поиск элементов по идентификатору: $('#someId'), вторым по быстродействию, является поиск по имени тега: $('tagName'). Высокая скорость их выполнения связана с тем, что для их реализации используются внутренние функции javascript: getElementById() и getElementsByTagName(). В связи с этим, появляются несколько правил.

(Для большей наглядности, укажу текст страницы, к которому будут применен JS-код из примеров)

> `<div id="content">

>

> <form method="post" action="/">

>

> <h2>Выбери цветh2>

>

> <ul id="color\_light">

>

> <li><input type="radio" class="on" name="light" value="red" /> Красныйli>

>

> <li><input type="radio" class="off" name="light" value="yellow" /> Желтыйli>

>

> <li><input type="radio" class="off" name="light" value="green" /> Зеленыйli>

>

> ul>

>

> <input class="button" id="color\_button" type="submit" value="Go" />

>

> form>

>

> div>

>

> \* This source code was highlighted with Source Code Highlighter.`

**1.** Если вы ищете один элемент, используйте поиск по идентификатору:

`$('#color_button')` – будет выполнен максимально быстро

`$('#content .button')` – будет медленнее

`$('.button:first')` – еще медленнее

**2.** Если вы ищете группу элементов, указывайте ближайшего общего родственника, обладающего идентификатором:

`$('#content input')` будет эффективнее, чем просто `$('input')`.

**3.** Если вы ищете элементы по классу, указывайте имя тега:

`$('input.button')` выполнит поиск быстрее, чем $('.button'). В первом случае, jQuery вначале найдет все элементы input, и уже среди них будет искать элементы с классом button. А во втором случае, для этого будет произведен перебор всех элементов страницы.

Из всего сказанного, можно вывести два основных правила:

1) Для поиска одного элемента, используйте поиск по id: `$('#someId')`

2) При поиске группы элементов, старайтесь придерживаться следующей формулы: `$('#someId tagName.someClass')`

И еще, не пытайтесь улучшить поиск по id с помощью следующих комбинаций:

`$('tagName#someId')

$('#wrapId #someId')`

Это только замедлит выполнение поиска.

#### 2. Используйте результат поиска элементов повторно

Не следует производить поиск одних и тех же элементов снова и снова, это достаточно дорогостоящая процедура, даже если вы используете самый быстрый селектор:

> `$('#myElement').bind('click', function(){...});

>

> . . .

>

> $('#myElement').css('border', '3px dashed yellow');

>

> . . .

>

> $('#myElement').fadeIn('slow');`

В этом случае, jQuery каждый раз будет осуществлять поиск элемента с идентификатором myElement. Гораздо разумнее будет найти элемент один раз, сохранить его, а затем применять к нему необходимые операции:

> `var myElement = $('#myElement');

>

> . . .

>

> myElement.bind('click', function(){...});

>

> . . .

>

> myElement.css('border', '3px dashed yellow');

>

> . . .

>

> myElement.fadeIn('slow');`

Если на протяжении работы вашего скрипта часто используются одни и те же элементы, то будет разумно найти эти элементы только один раз и сохранить результат в глобальной переменной:

> `window.elements;

>

> function init()

>

> {

>

> elements = $('#someId tagName.someClass');

>

> }`

Правда, иногда, необходимо совершать манипуляции с разными группами элементов, которые, однако, являются связанными. Например, это могут быть элементы формы, с которыми необходимо совершать много манипуляций. В таком случае, нам постоянно придется искать нужные элементы:

> `$('#myForm input:checkbox') // все флажки

>

> $('#myForm input:text') // все текстовые поля

>

> $('#myForm input:text[value != ""]') // все непустые текстовые поля

>

> . . .`

Вместо этого, можно найти все элементы формы один раз, и при необходимости доставать оттуда необходимые:

> `var inputs = $('#myForm input');

>

> inputs.filter(':checkbox') // найдем все флажки

>

> inputs.filter(':text') //найдем все текстовые поля

>

> inputs.filter(':text[value != ""]') // найдем все непустые текстовые поля

>

> . . .`

Или, вам может потребоваться совершать много манипуляций с элементами списка, в том числе удалять и добавлять их. В таком случае, «кэшировать» элементы списка не будет хорошей идеей, поскольку их состав будет постоянно меняться, а «кэш» оказываться неактуальным. Однако, можно сохранить объект самого списка в глобальной переменной, что тоже значительно сократит вычислительные затраты:

> `myList = $('#myList');

>

> . . .

>

> myList.find('li:first').remove(); // найдем и удалим первый элемент списка

>

> myList.find('li.showed').hide(); // скроем все элементы списка с классом showed`

#### 3. Избегайте лишних манипуляций c DOM

Основной идеей здесь является то, что если вы хотите внести ряд изменений на странице (добавить/изменить элемены), проделывайте эти манипуляции локально и только после этого вносите изменения в DOM. Например, если вы хотите добавить в список сто новых элементов, то ошибочным будет делать это поэлементно:

> `var top_100_list = [...]; // содержимое новых элементов

>

> $mylist = $('#mylist'); // необходимый список

>

>

>

> for (var i=0; i< top_100_list.length; i++)

>

> $mylist.append('- ' + top\_100\_list[i] + '

> ');`

гораздо эффективнее будет вставить сразу все элементы:

> `var top_100_list = [...]; // содержимое новых элементов

>

> var li_items = ""; // вставляемый html-текст

>

> $mylist = $('#mylist'); // необходимый список

>

>

>

> for (var i=0; i< top_100_list.length; i++)

>

> li_items += '- ' + top\_100\_list[i] + '

> ';

>

> $mylist.append(li_items);`

Еще больший выигрыш можно получить, если группа вставляемых элементов окажется «обернутой» одним элементом. Поэтому, если бы у нас была задача заменить содержимое списка сотней новых элементов, то самым оптимальным, был бы такой вариант:

> `var top_100_list = [...]; // содержимое новых элементов

>

> var new_ul = ""; // вставляемый html-текст

>

> $mylist = $('#mylist'); // необходимый список

>

>

>

> for (var i=0; i< top\_100\_list.length; i++)

>

> new\_ul += '* ' + top\_100\_list[i] + '

> ';

>

> new\_ul += "

> ";

>

> $mylist.replaceWith(new_ul);`

Изменять элементы локально, поможет метод [clone()](http://jquery.page2page.ru/index.php5/Клонирование_элементов), который создает копии элементов, вместе со всем их содержимым. Произведя все необходимые изменения с копиями, можно вставить их обратно в DOM, вместо старых версий (это можно сделать с помощью метода [replaceWith()](http://jquery.page2page.ru/index.php5/Замена_элементов)).

#### 4. Используйте делегирование событий

Иногда, приходится устанавливать одинаковые обработчики событий на большую группу элементов. Например, может потребоваться установить обработчики нажатия мышью, элементам списка. В таких случаях, вместо того, чтобы устанавливать обработчики на каждый элемент списка, можно установить один обработчик на сам список. Как известно, стандартные события javascript, вызванные на каком-либо элементе, затем вызываются на всех его предках (родительском элементе, затем прародительском и.т.д). Поэтому, после того, как событие произойдет на конкретном элементе списка, оно будет вызвано на объекте самого списка. Понять, у кого именно произошло событие, поможет передаваемый в обработчик [объект event](http://jquery.page2page.ru/index.php5/Объект_event), а точнее, его свойство event.target. Оно всегда содержит DOM-объект первоначального источника события:

> `$('#myList').click(function(event){

>

> $(event.target).addClass('clicked'); // добавим нажатому элементу класс clicked

>

> });`

|

https://habr.com/ru/post/103174/

| null |

ru

| null |

# Туториал по JUnit 5 - Аннотация @BeforeEach

> Это продолжение туториала по JUnit 5. Введение опубликовано [здесь](https://habr.com/ru/post/590607/).

>

>

Аннотация `@BeforeEach` используется для обозначения того, что аннотированный метод должен выполняться перед каждым методом `@Test, @RepeatedTest, @ParameterizedTest,` или `@TestFactory` в текущем классе.

Аннотация JUnit 5 [@BeforeEach](http://junit.org/junit5/docs/current/api/org/junit/jupiter/api/BeforeEach.html) является одним из методов жизненного цикла и заменяет аннотацию `@Before` в JUnit 4.

По умолчанию тестовые методы будут выполняться в том же потоке, что и аннотированный `@BeforeEach` метод.

### 1. Использование @BeforeEach

* Добавьте аннотацию `@BeforeEach` к методу, как указано ниже:

```

@BeforeEach

public void initEach(){

//test setup code

}

@Test

void succeedingTest() {

//test code and assertions

}

```

* Аннотированный `@BeforeEach` метод НЕ ДОЛЖЕН быть статическим**,** иначе он вызовет ошибку времени выполнения.

```

@BeforeEach

public static void initEach(){

//test setup code

}

//Error

org.junit.platform.commons.JUnitException: @BeforeEach method 'public static void com.howtodoinjava.junit5.examples. JUnit5AnnotationsExample.initEach()' must not be static.

at org.junit.jupiter.engine.descriptor. LifecycleMethodUtils.assertNonStatic(LifecycleMethodUtils.java:73)

```

> **@BeforeEach в родительском и дочернем классах**

>

> Метод `@BeforeEach` наследуется от родительских классов (или интерфейсов) до тех пор, пока они не *скрыты* или не *переопределены*.

>

> Кроме того, каждый метод с аннотацией `@Before` из родительских классов (или интерфейсов) будет выполняться перед каждым методом с аннотацией `@Before` в дочерних классах.

>

>

### 2. Пример @BeforeEach

Мы использовали `Calculator` класс и добавили один метод `add()`.

5 раз протестируем с помощью аннотации `@RepeatedTest`. Аннотация `@RepeatedTest` вызовет выполнение теста `add`() 5 раз.

Аннотированный `@BeforeEach` метод должен выполняться при каждом вызове тестового метода.

```

import org.junit.jupiter.api.Assertions;

import org.junit.jupiter.api.BeforeAll;

import org.junit.jupiter.api.BeforeEach;

import org.junit.jupiter.api.DisplayName;

import org.junit.jupiter.api.RepeatedTest;

import org.junit.jupiter.api.RepetitionInfo;

import org.junit.jupiter.api.Test;

import org.junit.jupiter.api.TestInfo;

public class BeforeEachTest {

@DisplayName("Add operation test")

@RepeatedTest(5)

void addNumber(TestInfo testInfo, RepetitionInfo repetitionInfo) {

System.out.println("Running test -> " + repetitionInfo.getCurrentRepetition());

Assertions.assertEquals(2, Calculator.add(1, 1), "1 + 1 should equal 2");

}

@BeforeAll

public static void init(){

System.out.println("BeforeAll init() method called");

}

@BeforeEach

public void initEach(){

System.out.println("BeforeEach initEach() method called");

}

}

```

Это класс калькулятора:

```

public class Calculator

{

public int add(int a, int b) {

return a + b;

}

}

```

Теперь выполните тест, и вы увидите вывод консоли ниже:

```

ВыходBeforeAll init() method called

BeforeEach initEach() method called

BeforeEach initEach() method called

Running test -> 1

BeforeEach initEach() method called

Running test -> 2

BeforeEach initEach() method called

Running test -> 3

BeforeEach initEach() method called

Running test -> 4

BeforeEach initEach() method called

Running test -> 5

```

Очевидно, что аннотированный `@BeforeEach` метод `initEach()` вызывается один раз при вызове тестового метода.

Хорошего изучения!!!

> [Скачать исходный код](https://github.com/lokeshgupta1981/Junit5Examples/tree/master/JUnit5Examples)

>

>

|

https://habr.com/ru/post/590741/

| null |

ru

| null |

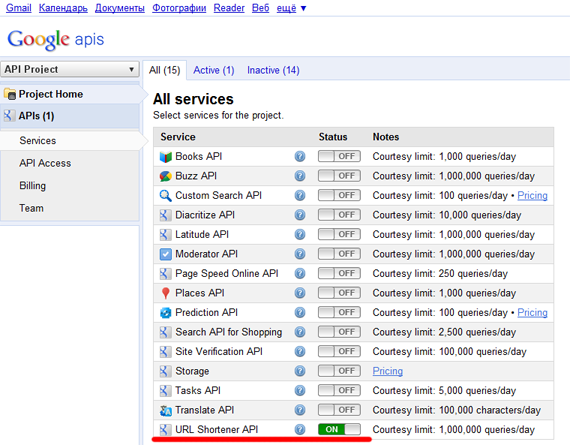

# Написание базового wave-робота на python'e

По лету мне достался инвайт в гугльвейв песочницу. Но в этой самой песочнице было очень много народу, все волны были публичными, и мой бедный нетбук только с большим скрипом переваривал всю эту активность, так что, немного поигравшись, на сендбокс я забил :)

И вот недавно мой аккаунт в сендбоксе превратился в аккаунт в лайвпревью, и я, разослав инвайты тем, до кого добрался, и ожидая, пока хоть кто-то из знакомых их получит, сел разбираться с роботским апи.

Результатом разбирательств стал такой вот базовый робот: [email protected], который умеет пока всего-ничего:

*по команде !br:bor! достать случайную цитату с баша

по команде !br:rb! достать фото дня с [rosbest](http://rosbest.ru)'а

по команде !br:BakaRobo! откликнуться :)

и ругаться в ответ на все незнакомые команды.*

И в процессе создания я понял забавную вещь: для вейв-роботов разработана большая, клевая апишка… Практически не документированная на текущий момент :) По крайней мере, референс по питоновской апи — это просто генеренный перечень классов и функций, из которого не понятно практически ничего.

И вот, потратив некоторое время на чтение разных доков и семплов, я, как мне кажется, выделил некоторый базовый набор информации, необходимой для того, чтобы сделать уже какого-то полезного робота. О всех этих нужных штуках я и хочу рассказать, может быть, не слишком хорошо структурировано :)

Начнем с того, что роботов размещать следует на [Google App Engine](http://appspot.com). Как создать там приложение и скачать инструментарий для коммитов кода я рассказывать не буду — там все очень понятно объяснено.

Итак, мы скачали инструменты, и в некоей папке на диске у нас возникла примерно такая картинка:

`.

..

google_appengine

our_robot`

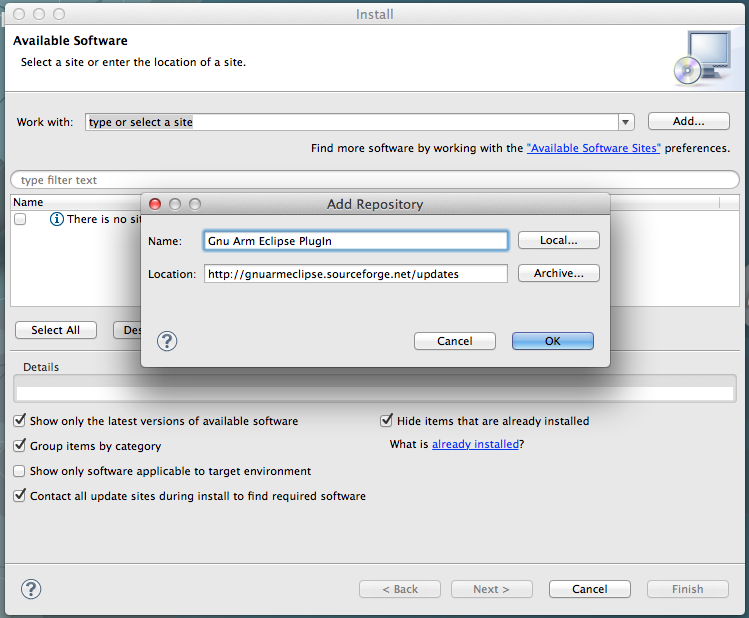

Где our\_robot — папка, в которой будет наш робот. И вот в эту-то папку мы и скачиваем и распаковываем вот [этот](http://wave-robot-python-client.googlecode.com/files/wave-robot-api-20090916.zip) архивчик с code.google.com — это, собственно, питоновская апишка.

Теперь мы готовы к собственно разработке.

*На всякий случай: коммит кода в аппенджин делается так:

python ./google\_appengine/appcfg.py update ./our\_robot/ — потом нас спрашивают о мыле и пароле и дают залить файло.*

В базовом случае главных файлов в проекте будет три:

```

our_robot.py - собственно, код робота

app.yaml - нечто вроде манифеста

_wave/capabilities.xml - файлик, объявляющий эвенты, которые хочет слушать робот.

```

**Дополнение** от [farcaller](http://farcaller.habrahabr.ru/):

*Питоновый апи xml-ку кастати сам генерирует, на базе аргументов к robot.Robot, а вот жавовому надо писать ручками*.

Так что, видимо, от некоторого количества телодвижений в процессе разработки можно отказаться.

*Список эвентов можно посмотреть [тут](http://wave-robot-python-client.googlecode.com/svn/trunk/pydocs/toc-waveapi.events-module.html), но самые важные для робота, на мой взгляд, это:

**WAVELET\_SELF\_ADDED** — срабатывает, когда робота добавляют в волну, в этот момент неплохо показать маленькое инфо по использованию;

**BLIP\_SUBMITTED** — срабатывает, когда создается/редактируется блип волны, причем не в момент написания текста, а когда уже жмякнута кнопка «Done».*

Поехали дальше.

Манифест app.yaml выглядит, судя по туториалу на code.google.com, примерно так:

`application: **our\_robot**

version: **1**

runtime: python

api_version: 1

handlers:

- url: /_wave/.*

script: **our\_robot.py**

- url: /assets

static_dir: assets

- url: /**icon.png**

static_files: **icon.png**

upload: **icon.png**`

Тут, вроде, все понятно. Название робота, версии, чем запускаем, версия апи и хендлеры для разных урлов.

Единственное, на что следует обратить внимание — это "-url: /icon.png" в разделе хендлеров. Этого, кажется, нету в туториале, конструкция позволяет задать способ обращения с иконкой робота. Рисуем ее в пнгшку, сохраняем в папку робота, объявляем внутри питоновского файла :)

capabilities.xml, опять же, по тутору, выглядит тоже незамысловато:

> `</fontxml version="1.0" encoding="utf-8"?>

>

> <w:robot xmlns:w="http://wave.google.com/extensions/robots/1.0">

>

> <w:capabilities>

>

> <w:capability name="WAVELET\_SELF\_ADDED" content="true" />

>

> <w:capability name="BLIP\_SUBMITTED" content="true" />

>

> w:capabilities>

>

> <w:version>1w:version>

>

> w:robot>

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Собственно, в этом файле и менять-то особо нечего: только номер версии да эвенты, которые мы хотим слушать.

А вот после того, как вся эта предварительная суматоха закончилась и начинается, собственно, довольно приятная возня с написанием питоновского кода робота.

Для начала я опишу общую структуру кода, как он приводится в примерах и туториале, а потом накидаю всяких минорных полезностей, которых в туториале нет, в референсе до них еще надо докопаться :), так что мне пришлось добывать их из примеров.

Итак, в общем и целом код болванки для робота выглядит примерно так:

> `from waveapi import events

>

> from waveapi import model

>

> from waveapi import robot

>

> **def** OnRobotAdded(properties, context):

>

> pass

>

> **def** OnBlipSubmitted(properties, context):

>

> pass

>

> if \_\_name\_\_ == '\_\_main\_\_':

>

> myRobot = robot.Robot('our\_robot',

>

> image\_url='http://our\_robot.appspot.com/icon.png', #иконка контакта для робота

>

> version='2.3', #версия

>

> profile\_url='http://our\_robot.appspot.com/') #адрес профиля контакта

>

> # Назначаем события:

>

> myRobot.RegisterHandler(events.WAVELET\_SELF\_ADDED, OnRobotAdded)

>

> myRobot.RegisterHandler(events.BLIP\_SUBMITTED, OnBlipSubmitted)

>

> # Запуск

>

> myRobot.Run()

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

И как бы вроде бы все замечательно и понятно. Но когда начинаешь писать собственно функции событий, понимаешь, что совершенно неясно, как, к примеру, заменить кусок текста на другой кусок текста, не говоря уже о том, чтобы что-нибудь покрасить или подчеркнуть.

В результате не слишком долгого, но довольно упорного ресерча я нарыл вот такой вот список полезных методов, которого мне хватило для написания робота:

Во-первых, чтобы в функциях обработки событий достать блип, с которым событие произошло (если, конечно, это событие произошло с блипом), используем

**blip = context.GetBlipById(properties['blipId'])**

Во-вторых, чтобы получить текст блипа и с ним оперировать, делаем

**doc = blip.GetDocument()

contents = doc.GetText()**

Соответственно, чтобы заменить некоторый кусок текста на другой, используем на полученный doc

**doc.SetTextInRange(model.document.Range(НАЧАЛО, КОНЕЦ), НОВЫЙ\_ТЕКСТ)**

Чтобы вставить кусок текста в любое место:

**doc.InsertText(НАЧАЛО, ТЕКСТ)**

Чтобы добавить кусок текста в конец:

**doc.AppendText(ТЕКСТ)**

Чтобы вставить картинку:

В конец — **doc.AppendElement(model.document.Image(АДРЕС\_КАРТИНКИ, ШИРИНА, ВЫСОТА, ATTACHMENT\_ID, АЛЬТ))**

В определенное место — **doc.InsertElement(НАЧАЛО, model.document.Image(АДРЕС\_КАРТИНКИ, ШИРИНА, ВЫСОТА, ATTACHMENT\_ID, АЛЬТ))**

В общем, полезно посмотреть вот [этот](http://wave-robot-python-client.googlecode.com/svn/trunk/pydocs/waveapi.ops.OpBasedDocument-class.html) референс для того, чтобы узнать, что можно делать с документом. Для того, чтобы узнать виды элементов, которые можно создавать, смотрим референсы по waveapi.document.\* — там есть и Image, и Link и даже Gadget.

Дальше. Все оформление и разные другие полезности блипа хранятся в так называемой аннотации. С ней все просто:

**doc.SetAnnotation(model.document.Range(НАЧАЛО, КОНЕЦ), ТИП, ЗНАЧЕНИЕ)**

Причем ТИП — это штука, которая описывает, что за аннотацию мы добавляем. Самый важный, имхо, это 'style/STYLE\_PROP', где STYLE\_PROP — это запись css атрибута в js виде.

*Вдруг кто не знает — это трансформированная запись свойств css, используемая в js-скриптах, показать ее суть проще на примерах :) Например, color — это просто color, а вот font-size — это fontSize. В смысле, там, где в css дефис, в этой записи дефиса нет, но каждое слово кроме первого начинается с большой буквы. backgroundColor, backgroundImage, marginTop, и так далее.*

Убираются они так же незамысловато, можно тупо убить все аннотации одного типа, например, про цвет шрифта, или цвет фона, вот такой функой:

**doc.DeleteAnnotationsByName(ТИП)**

А можно почистить от аннотаций определенного типа только некоторый диапозон текста:

**doc.DeleteAnnotationsInRange(model.document.Range(НАЧАЛО, КОНЕЦ), ТИП)**

Аннотации полезны еще тем, что в них можно хранить любую инфу, которая относится к этому блипу.

Чтобы аннотировать блип целиком, используем:

**doc.AnnotateDocument(ТИП, ЗНАЧЕНИЕ)**

Чтобы узнать, есть ли в блипе какой-то тип аннотации, вызывается

**doc.HasAnnotation(ТИП)**

Вот где-то такой набор, как мне кажется, уже позоляет создавать роботов, которые могут делать нечто полезное. Конечно, за рамками текста осталось, например, применение GAE системы баз данных и прочие приятные вещи, но, надеюсь, текст не будет полностью бесполезен.

*P.S.: Кстати, замеченная мной бага, которая сильно помешала разработке поначалу: в вкладке логов в appspot'е (единственном доступном нам инструменте дебага) уровень показываемых сообщений по дефолту выставлен в Error. Хохма в том, что если в записи лога сначала идет кусок уровня, например, Info, и только потом кусок с ошибкой — такую запись нам не покажут. Так что — переставляем уровень оповещений на Debug и радуемся возможности рассмотреть все случившиеся ошибки.

P.P.S.: Спасибо, перенес в соответствующий блог.*

|

https://habr.com/ru/post/72923/

| null |

ru

| null |

# Кэш для фильтров AngularJS с помощью Lo-Dash

Пишу диплом где решаю одну из задач — реализация анонимного быстрого веб чата. Быстрого во всех смыслах — загрузка, работа приложения, использование (прочь авторизацию). Выбор остановил на связке: [Node.js фреймворк SocketStream](http://github.com/socketstream/socketstream) и [AngularJS](http://angularjs.org/) на стороне клиента. В процессе работы столкнулся с проблемой — повторные расчёты производимые фильтрами на одной и той же модели. Детали проблемы и решение под катом.

---

**Уровень подготовки читателя:**

**AngularJS:** средний (создание фильтров)

**Lo-Dash:** «видел-щупал»

[Перейти сразу к решению](#solution)

#### Проблема в деталях

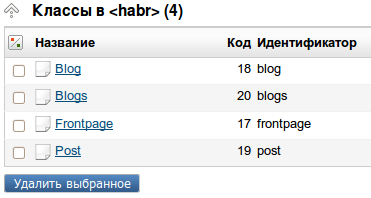

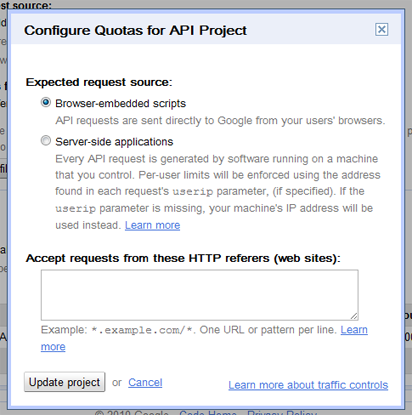

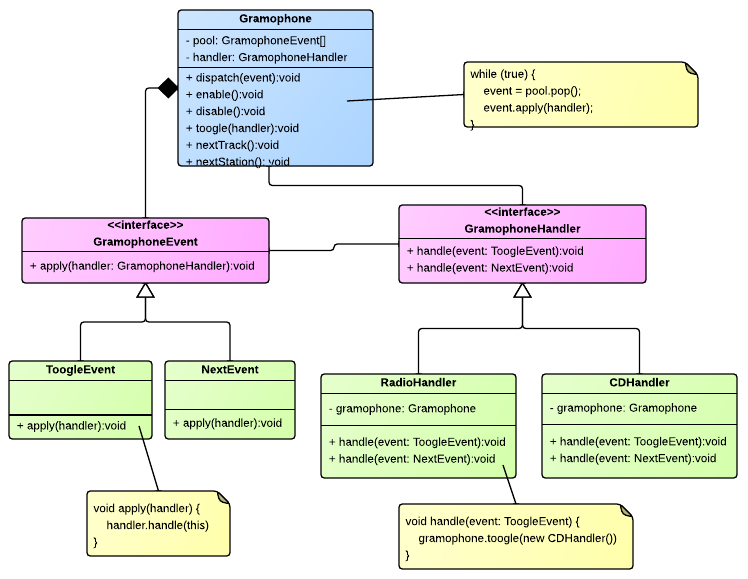

У нас есть большой массив, с которым наше приложение постоянно работает манипулируя его элементами. К массиву нужно применять комплексный фильтр, например, сортировка по дате и выделение элементов имеющих определённое свойство. Перенесём эту проблему в прикладную область — упрощённая версия моего чата. Элементами массива являются чаты (комнаты/круги) которые содержат сообщения. Чат имеет такую структуру:

```

{

id: 'rE4aA',

title: 'Тема чата',

online: 3,

recent: 0, // Количество новых сообщений

messages: [] // Сообщения

}

```

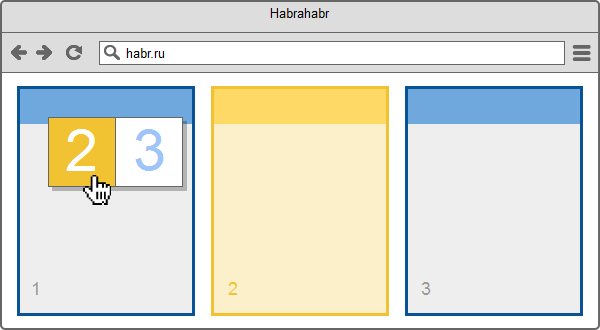

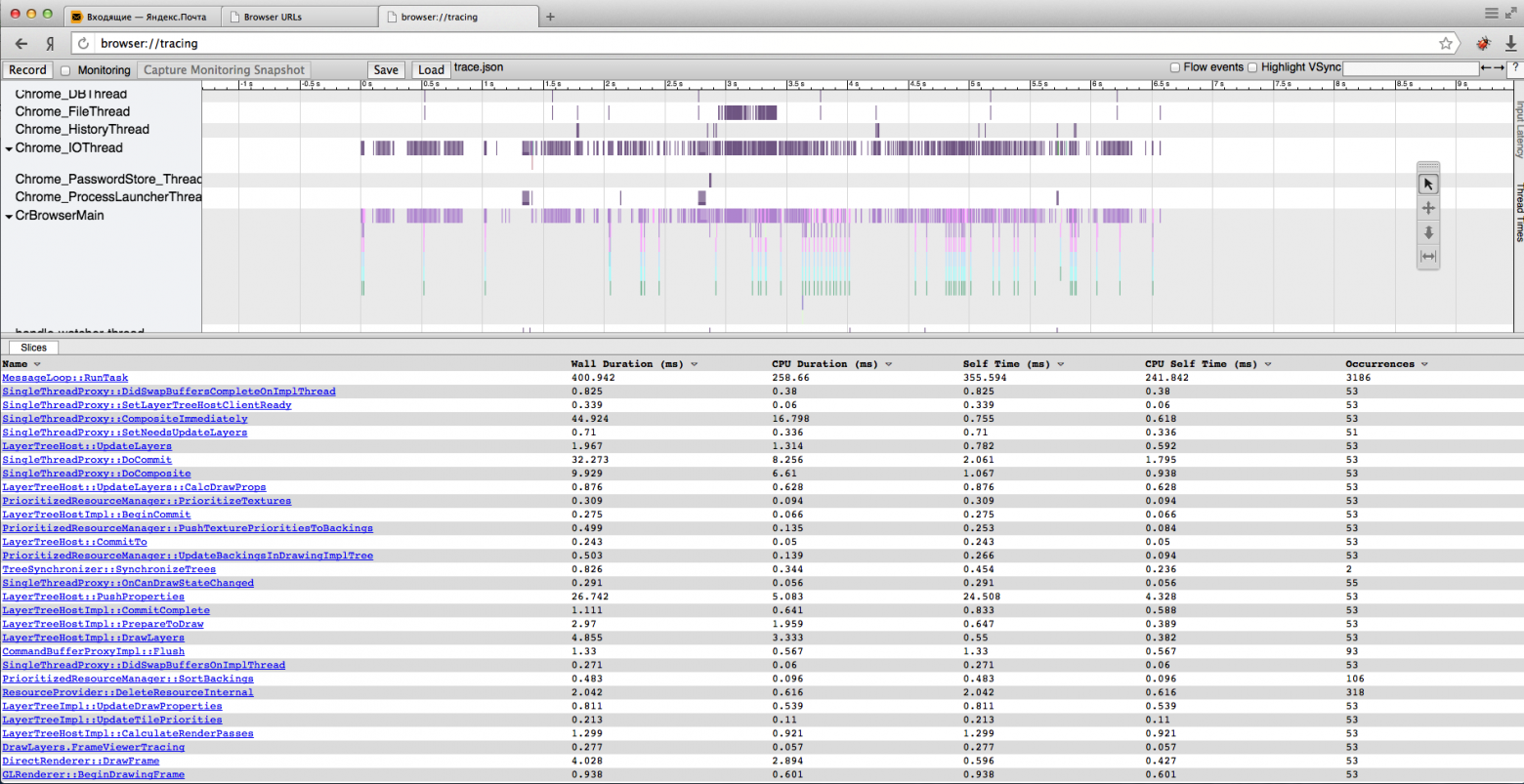

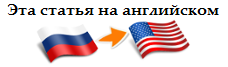

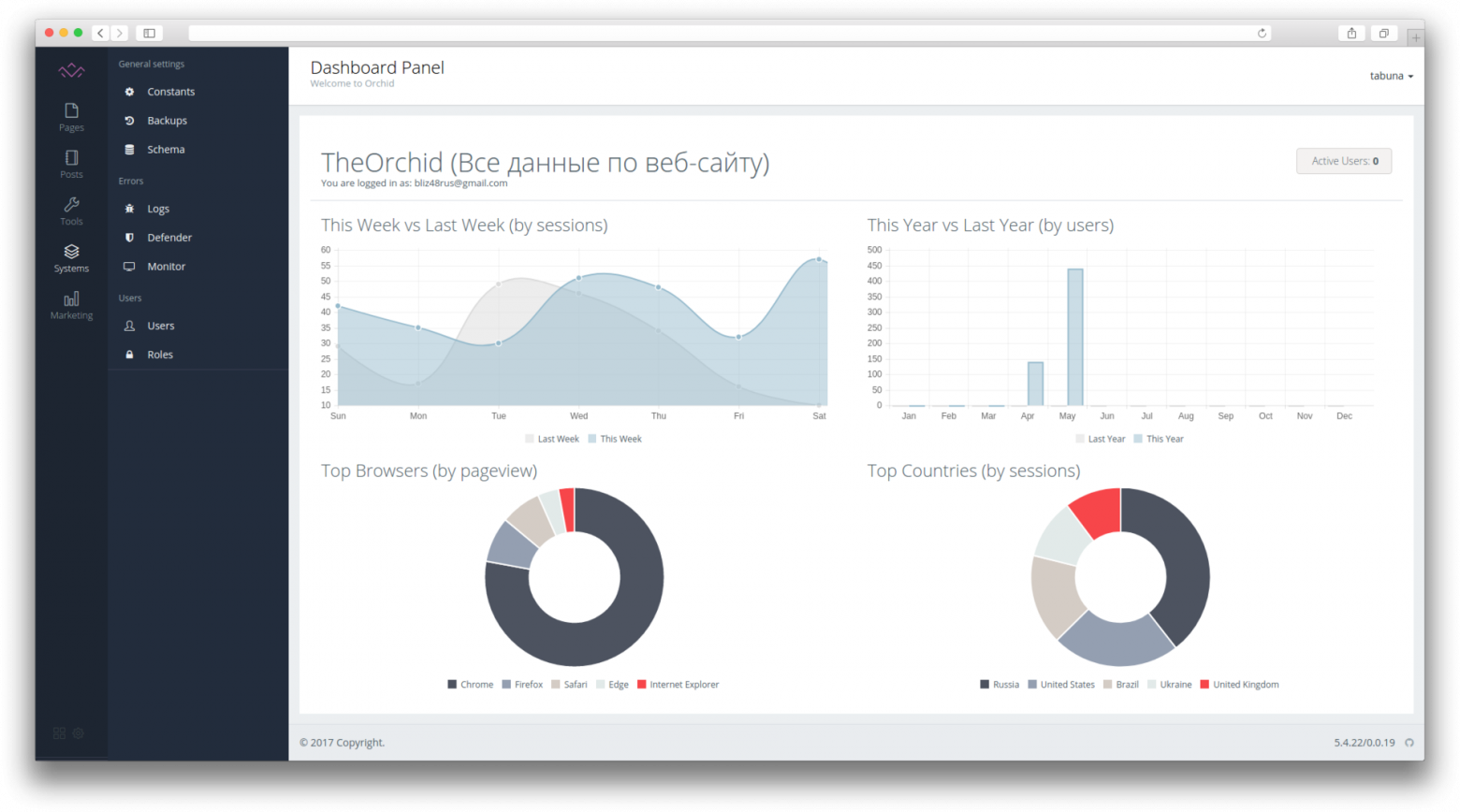

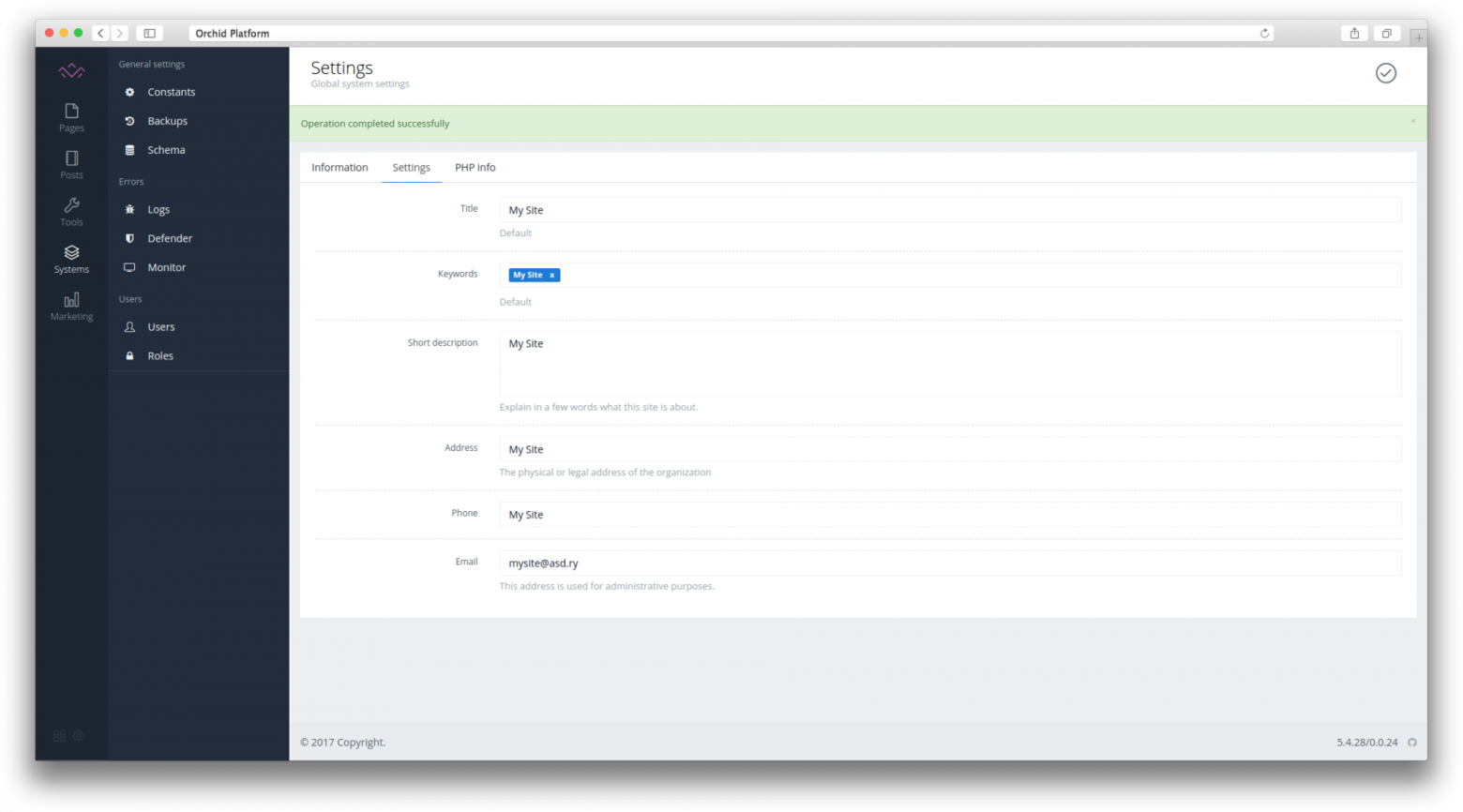

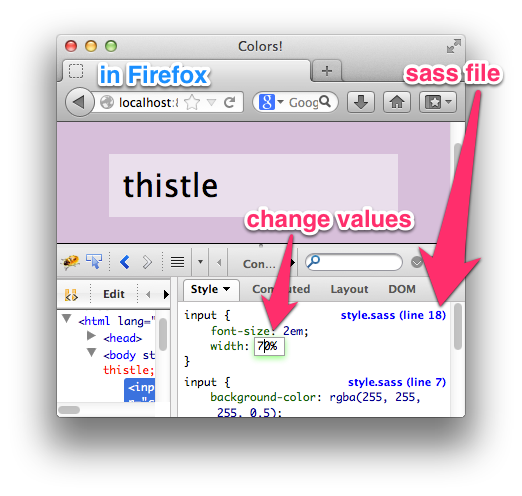

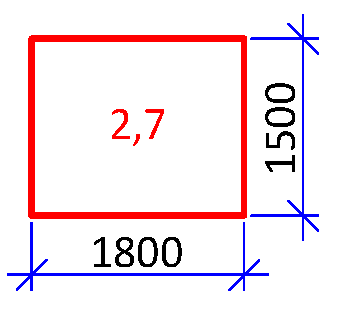

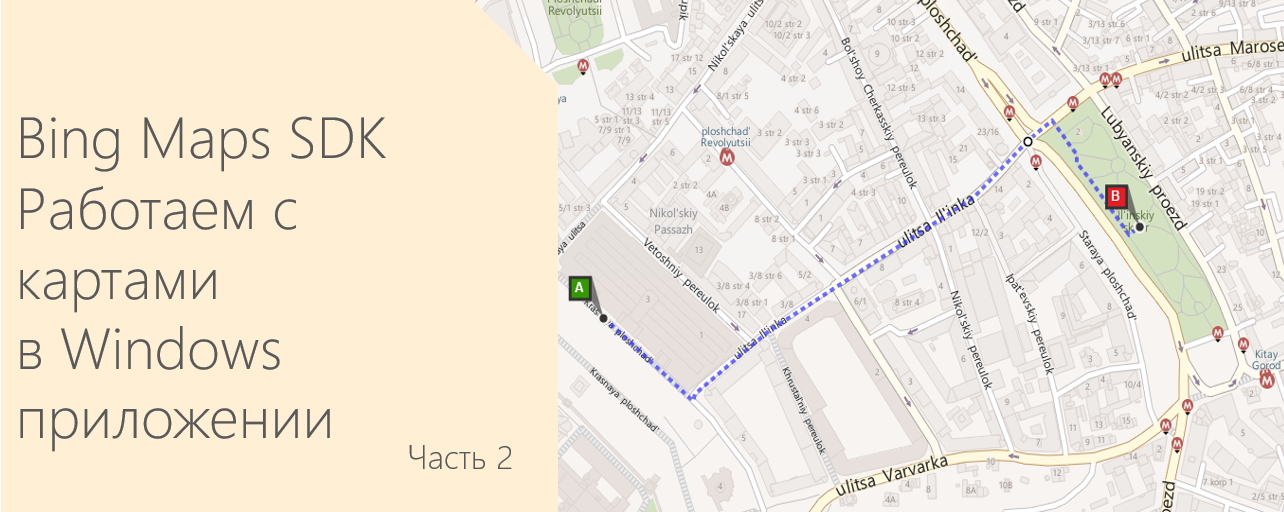

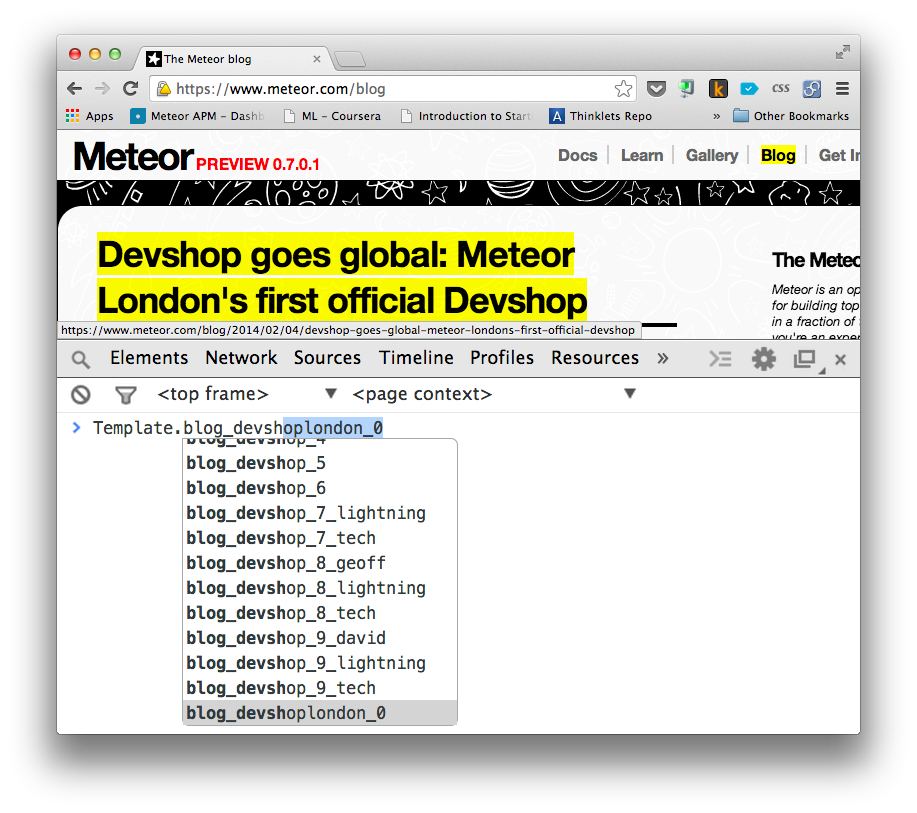

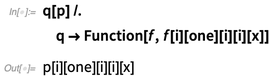

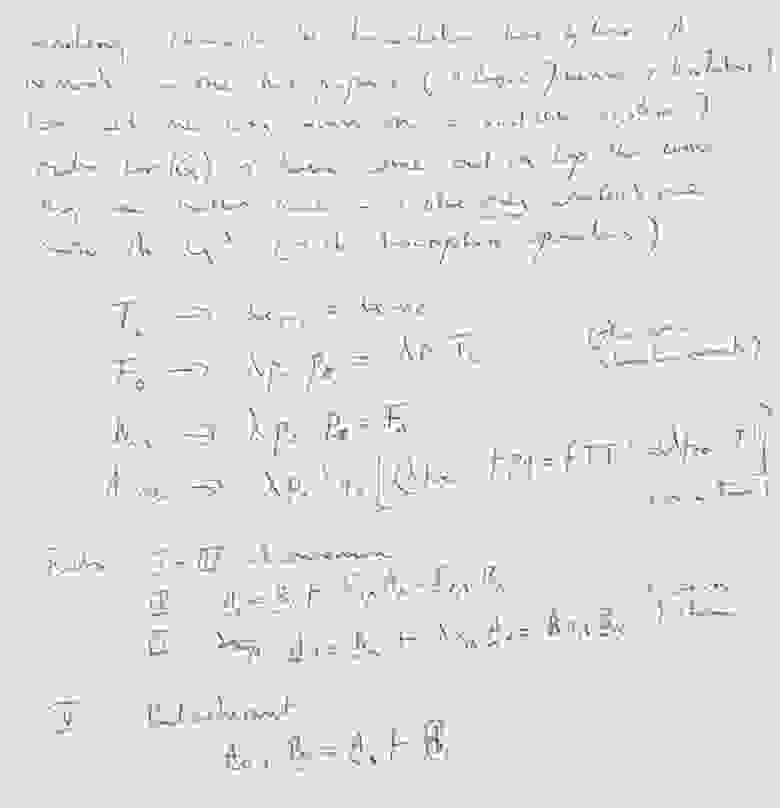

Я хочу выводить на страницу с помощью директивы `ngRepeat` {N} количество чатов (зависит от размера экрана). И хочу выводить контекстное меню, которое появляется по клику правой кнопки мыши на заголовок любого из чатов и позволяет переместить выбранный чат на место другого. Вот так это выглядит:

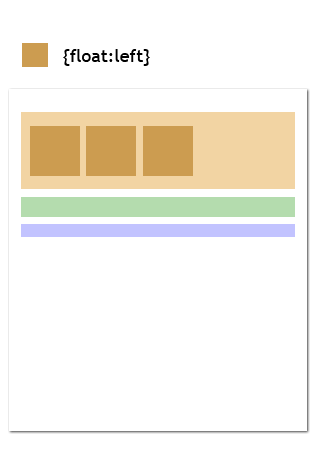

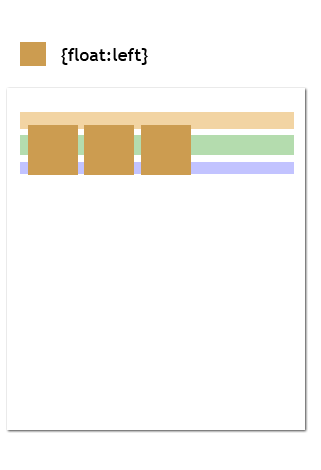

*Клик правой кнопкой на заголовке чата*

*Подсветка чата, на место которого метим перемещение*

Такой функционал можно реализовать создав два списка с директивой `ngRepeat` и применением фильтра. Для чатов фильтр должен уметь сортировать по количеству новых сообщений (свойство recent) и сокращать количество элементов (чатов) до числа {N} которое рассчитывается от размера окна браузера. Для контекстного меню — тот-же фильтр исключая текущий элемент (чат на заголовок которого нажали).

Код фильтра:

```

angular.module('app')

.filter('opened', ['$rootScope', function($s){

return function(o){

console.log('Применён фильтр «opened»');

var count = $s.count; // Количество чатов, число {N}

return _(o) // Оборачиваем массив в Lo-Dash

.sortBy('recent') // Сортируем от меньшего к большему

.reverse() // Реверсируем (от большего к меньшему)

.first(count) // Выделяем первые {N} чатов

.value() // Забираем результат

}

}]);

```

Применив этот фильтр к аргументу-массиву переданному каждой директиве `ngRepeat` увидим, что в консоли сообщение «Применён фильтр «opened» показано дважды. Это значит, что половина ресурсов была потрачена фильтром впустую. Такое удобство как контекстное меню умножило в два раза время рендеринга актуального состояния приложения. А если я продолжу добавлять функционал использующий те же данные с фильтрами, положение ещё сильней усугубится.

#### Решение проблемы

Решение заключается в создании функции которая возвращает отфильтрованный массив. Эта функция используется вместо исходного массива без использования нативного провайдера фильтров. Функция оборачивается в [Lo-Dash](http://lodash.com/) свойство [memoize](http://lodash.com/docs#memoize), которая реализует функционал кеширования. Ниже я расскажу, как работает memoize и дам пример-реализацию.

#### Lo-Dash свойство memoize

**Аргументы:**

1. `Функция-вычислитель` *(обязателен)* — кешированный результат этой функции выдаёт memoize

2. `Функция-распознаватель` *(опционален)* — результат функции является ключом кэша (проверяет уникальность)

\_.memoize(fn, [fn]) возвращает функцию, при первом вызове которой производит расчёт, запоминает результат (создает кэш) и возвращает его. При последующих вызовах возвращает кэш. Всё это справедливо для единственного кэш-ключа.

Ключ кэша определяется результатом от функции, которая передаётся вторым аргументом. По умолчанию (если не определён второй аргумент) memoize использует первый аргумент как ключ кэша.

#### На ярком примере

В конце короткого листинга будет ссылка на демонстрацию, но я предлагаю обратить внимание на комментарии в коде.

Создаём простой контроллер с одним склеенным объектом «form»:

```

function MyController($scope){

$scope.form = {

input: {key:'', val:''}, // Этот объект будем заполнять новыми значениями

array: [

{key:'pear', val:'Груша'}, // Предустановка

{key:'melon', val:'Дыня'},

{key:'ananas', val:'Ананас'},

{key:'cherry', val:'Вишня'}

],

order: 'key', // По умолчанию сортируем по свойству key (2 ключа key/val)

check: false, // Это нужно для теста с доп. ключами кэша (2 ключа — true/false)

add: function(){ // Метод добавляет новые значения из формы в общий котёл

this.array.push(angular.copy(this.input));

this.filtered.cache = {} // Сбрасываем весь кэш

},

filtered: _.memoize( // Обращаем внимание

function(){

console.log('Фильтровал с параметрами: ' + this.order + ' и ' + this.check);

return _.sortBy(this.array, this.order)

},

function(){ // Генератор кэш-ключей

// Результат всегда конвертируется в строку

return [this.order, this.check]

}

)

}

}

```

Немного HTML:

```

Добавить

Сортировка по свойству:

{{el.key}} — "{{el.val}}"

для проверки кэш-ключа и только

---

```

{{form.filtered()|json}}

```

```

|

https://habr.com/ru/post/200130/

| null |

ru

| null |

# Как правильно писать статьи о программировании для начинающих

В последнее время на Хабре стало появляться довольно много статей о тех или иных аспектах программирования, которые позиционируются как статьи для «начинающих». Между тем, как раз для начинающих эти статьи часто являются непонятными: иногда — слишком сложными, иногда — не отвечающими на те вопросы, на которые должны, иногда — тяжелыми для восприятия.

Попробуем разобраться, как должна быть написана статья, если вы хотите, чтобы она не только понравилась, но и была полезна читателям.

#### Определите целевую аудиторию

Начните с определения вашей целевой аудитории. Понятие «начинающий» — весьма размыто. Вот несколько совершенно разных категория людей, которых можно назвать «начинающими»:

* Человек, который вообще никогда не слышал о программировании, и хочет научиться писать код.

* Человек, который знает некоторые теоретические основы (что делает компилятор, чем компиляция отличается от интерпретации, как вообще происходит процесс написания кода), но никогда не писал код сам

* Человек, который занимался программированием, но хочет перейти на несколько другой профиль (например, человек верстал простенькие сайты и знает javascript, но хочет научиться делать десктопные приложения)

* Наконец, человек, который достаточно неплохо знаком с программированием, но хочет изучить новый для себя язык или технологию.

Думаю очевидно, что статьи, ориентированные на людей с разным уровнем, будут выглядеть совершенно по-разному. Тем не менее, большинство статей с пометкой «для начинающих» ориентированы на людей, которые с программированием знакомы поверхностно.

#### Определите начальные знания, необходимые для понимания Вашей статьи

Согласитесь, не так сложно написать в самом начале нечто вроде:

> «Для понимания этой статьи читатель должен обладать начальными знаниями о C:

>

> — уметь компилировать и запускать приложение

>

> — знать синтаксис, основные типы данных и структуры управления»

>

>

Это не отнимает много времени, но очень сильно помогает читателям. Поверьте, если вы начинайте статью так:

> Скомпилируйте следующий код:

>

>

> ```

> int main(int argc, char *argv[])

> {

> cout<<"Hello, world!";

> }

>

> ```

>

>

>

то читатели могут вообще не понять, что от них требуется. Не забывайте, когда-то вы тоже не умели пользоваться компилятором.

#### Оформите статью как можно лучше

Хорошее и грамотное оформление — один из ключей к легкому пониманию материала.

###### Старайтесь писать весь код целиком

Я видел статьи и книги, в которых код приводился разрозненными кусками. Это приводит к тому, что читателю тяжело понять код, не говоря уж о том, что он не может этот код просто скопировать и запустить. Конечно, вы можете, например, писать разные функции в разных листингах. Это даже хорошо, так как облегчает понимание. Но не стоит разрывать на части логически однородный участок кода.

Не пишите так:

> Пример программы, выводящей «Hello, World»:

>

>

> ```

> //Начнем писать код

> int main(int argc, char *argv[])

> {

> cout<<"Hello, world!";

>

> ```

>

>

>

>

> Какой-то (возможно, весьма полезный)

>

> многострочный комментарий от автора

>

>

>

>

> ```

> //Продолжение

> return 0;

> }

>

> ```

>

>

>

Пишите так:

> Пример программы, выводящей «Hello, World»:

>

>

> ```

> #include

> using namespace std;

>

> int main(int argc, char \*argv[])

> {

> cout<<"Hello, world!";

> return 0;

> }

>

> ```

>

>

>

>

> Вот здесь можно писать длинный и развернутый комментарий, и даже еще раз написать ту строку

>

>

> ```

> cout<<"Hello, world!";

>

> ```

> к которой он относится.

>

>

Если вам необходимо разбить код на несколько листингов, то было бы неплохо в конце статьи еще раз привести весь код в одном листинге, или даже дать ссылку, по которой этот код можно скачать.

###### Всегда проверяйте код, прежде чем вставить его в статью

Читателю меньше всего хочется сидеть и пытаться понять, почему пример из статьи не работает.

По этой же причине, если ваш код каким-то образом зависит от среды или компилятора, укажите это отдельно.

###### Всегда комментируйте код

Я миллион раз видел, как в книге встречается листинг на 3 страницы без единого комментария, а затем сплошным текстом идет описание того, что этот код делает. Такие вещи очень сложно читать. Попробуйте написать короткие комментарии в самом коде:

>

> ```

> #include //необходимо для использования cout

> using namespace std; //cout находится в пространстве имен std

>

> int main(int argc, char \*argv[])

> {

> cout<<"Hello, world!"; //вывод строки "hello, world"

> return 0;

> }

>

> ```

>

>

>

Не забывайте, что если для вас значение какой-то строки очевидно, то это не значит, что оно очевидно для всех. Если вы хотите подробно прокомментировать код, то неплохо будет вставлять номера строк. Не нужно нумеровать все строки подряд, достаточно сделать так:

>

> ```

> 1 #include

> using namespace std;

>

> 4 int main(int argc, char \*argv[])

> {

> 6 cout<<"Hello, world!";

> return 0;

> }

>

> ```

>

>

> В строке **1** мы подключаем заголовочный файл , который содержит классы, функции и переменные, необходимые для работы с потоковым вводом-выводом в C++. Мы подключаем этот файл для того, чтобы использовать объект cout, который представляет собой стандартный поток вывода.

>

>

>

> В строке **4** начинается функция main — именно с этого места начнется работа нашей программы.

>

>

>

> Наконец, в строке **6** мы выводим фразу «Hello, world» в стандартный поток вывода cout. Для этого применяется довольно простой синтаксис с использованием оператора <<. Слева от оператора записывается объект потока (в нашем случае cout), справа — выражение, которое должно быть выведено в этот поток.

>

>

Если вы хотите, чтобы читатель мог скопировать и запустить код, вы можете указать номера строк в комментариях, хотя это и менее наглядно:

>

> ```

> #include //(1) необходимо для использования cout

> using namespace std; //(2) cout находится в пространстве имен std

>

> int main(int argc, char \*argv[])

> {

> cout<<"Hello, world!"; //(6) вывод строки "hello, world"

> return 0;

> }

>

> ```

>

>

>

###### Поставьте себя на место читателя

Представьте, какие места в ваших примерах могут быть не очень понятны, и объясните их поподробнее. Если вам лень описывать какие-то вещи, которые легко найти в интернете или книгах, просто дайте ссылку на ресурс, где об этом можно почитать.

###### Постарайтесь не слишком усложнять код и избегайте перфекционизма

Не забывайте, вы пишите статью для новичка. Если вы можете сделать код проще, лучше это сделать. Если вы хотите показать, что код можно улучшить (пусть даже он усложнится), то напишите об этом после простого решения. Представьте, что вы объясняете человеку как работает оператор return, и для примера решили написать функцию, которая сравнивает два числа и возвращает наибольшее (или любое, если числа равны). Не стоит писать что-то вроде

>

> ```

> template T compare(T a, T b)

> {

> return a>b?a:b;

> }

>

> ```

>

>

>

Напишите простой и понятный кусок кода:

>

> ```

> int compare(int a, int b)

> {

> if(a>b)

> {

> return a;

> }

> else

> {

> return b;

> }

> }

>

> ```

>

>

>

Пусть его можно улучшить десять раз — это не важно, если ваша задача — показать суть метода, а не его конкретную реализацию.

###### Старайтесь придерживаться одного уровня во всей статье

Если вы начинайте писать статью на базовом уровне и подробно рассказываете о простых вещах, то делайте это до самого конца статьи. Если на середине статьи вы вдруг перестанете объяснять какие-то вещи, то читатель может совершенно потерять нить статьи и запутаться.

###### Придерживайтесь одного стиля во всей статье

Не важно, пишете ли вы в «академическом» стиле, или в стиле «а теперь, чувак, откомпилируем наше творение». Важно, чтобы вы были последовательны и не переключались с формального повествования на неформальное и обратно по десять раз за статью.

###### Старайтесь структурировать свои мысли

Вы рассказываете о программировании — а это значит, что ваше повествование, скорее всего, достаточно легко разделить на ключевые части. Старайтесь всегда делать это, потому что структурированную статью гораздо легче читать и понимать. Сплошная стена текста крайне сложна для восприятия, даже если сам текст рассказывает о достаточно простых вещах.

###### Старайтесь помочь читателю

Будьте вежливы в комментариях. Если вас попросят объяснить что-то подробнее, или добавить что-то в статью, постарайтесь это сделать (конечно, если у вас есть на это силы и время).

#### Заключение

Надеюсь, моя статья поможет авторам сделать свои статьи более понятными, а значит — и более популярными. Пожалуйста, пишите в комментах, если вы не согласны с какими-то пунктами, или хотите добавить что-то свое.

|

https://habr.com/ru/post/144652/

| null |

ru

| null |

# Шрифты в Ubuntu

Есть очень простой способ улучшить внешний вид шрифтов во многими любимой убунте.

Для этого достаточно создать один файлик: ~/.fonts.conf

И поместить в него следующее:

`<?xml version="1.0"?>

<!DOCTYPE fontconfig SYSTEM "fonts.dtd">

<fontconfig><br/>

<match target="font"><br/>

<edit name="autohint" mode="assign"><br/>

<bool>true</bool><br/>

</edit><br/>

</match><br/>

</fontconfig><br/>

</code><br/>

Далее делаем logout.<br/>

<br/>

Заходим в System(система) -> Preferences(настройки) -> Appearance(внешний вид)<br/>

Попадаем на вкладку Fonts(шрифты)<br/>

Полные решимости жмем Advanced(дополнительно)<br/>

И играемся с настройками на свой вкус не забыв выбрать Subpixel smoothing(субпиксельное сглаживание)<br/>

И наслаждаемся, разумеется.<br/>

<br/>

По просьбе <a href="https://habrahabr.ru/users/nblxa/" class="user_link">nblxa</a> прикладываю скриншот:<br/>

до:<br/>

<a href="http://img407.imageshack.us/my.php?image=screenshot1rz7.png"><img src="https://habr.com/images/px.gif#%3D%22http%3A%2F%2Fimg407.imageshack.us%2Fimg407%2F6804%2Fscreenshot1rz7.th.png%22" alt="Free Image Hosting at www.ImageShack.us"/></a><br/>

после:<br/>

<a href="http://img293.imageshack.us/my.php?image=screenshotog3.png"><img src="https://habr.com/images/px.gif#%3D%22http%3A%2F%2Fimg293.imageshack.us%2Fimg293%2F9838%2Fscreenshotog3.th.png%22" alt="Free Image Hosting at www.ImageShack.us"/></a><br/>

<br/>

P.S. настоятельно рекомендую всем посмотреть <a href="http://habrahabr.ru/blogs/ubuntu/42498/#comment_1048915">комментарий</a> <a href="https://habrahabr.ru/users/izenfire/" class="user_link">iZENfire</a>, после этих действий пропали последние недочеты.<br/>

</div>`

|

https://habr.com/ru/post/42498/

| null |

ru

| null |

# Checking the GCC 10 Compiler with PVS-Studio

The GCC compiler is written with copious use of macros. Another check of the GCC code using PVS-Studio once again confirms the opinion of our team that macros are evil in the flesh. Not only does the static analyzer struggle with reviewing such code, but also a developer. GCC developers are certainly used to the project and are well versed in it. Nonetheless, it is very difficult to understand something on the third hand. Actually, due to macros, it was not possible to fully perform code checking. However, the PVS-Studio analyzer, as always, showed that it can find errors even in compilers.

Time to Double-Check the GCC Compiler Code

------------------------------------------

The last time I [checked](https://www.viva64.com/en/b/0425/) the GCC compiler four years ago. Time flies quickly and imperceptibly, and somehow I completely forgot to return to this project and recheck it. The post "[Static analysis in GCC 10](https://developers.redhat.com/blog/2020/03/26/static-analysis-in-gcc-10/)" pushed me back to this idea.

Actually, it is no secret that compilers have their own built-in static code analyzers and they are also developing. Therefore, from time to time we write articles that the PVS-Studio static analyzer can find errors even inside compilers and that we are worth our salt :).