text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

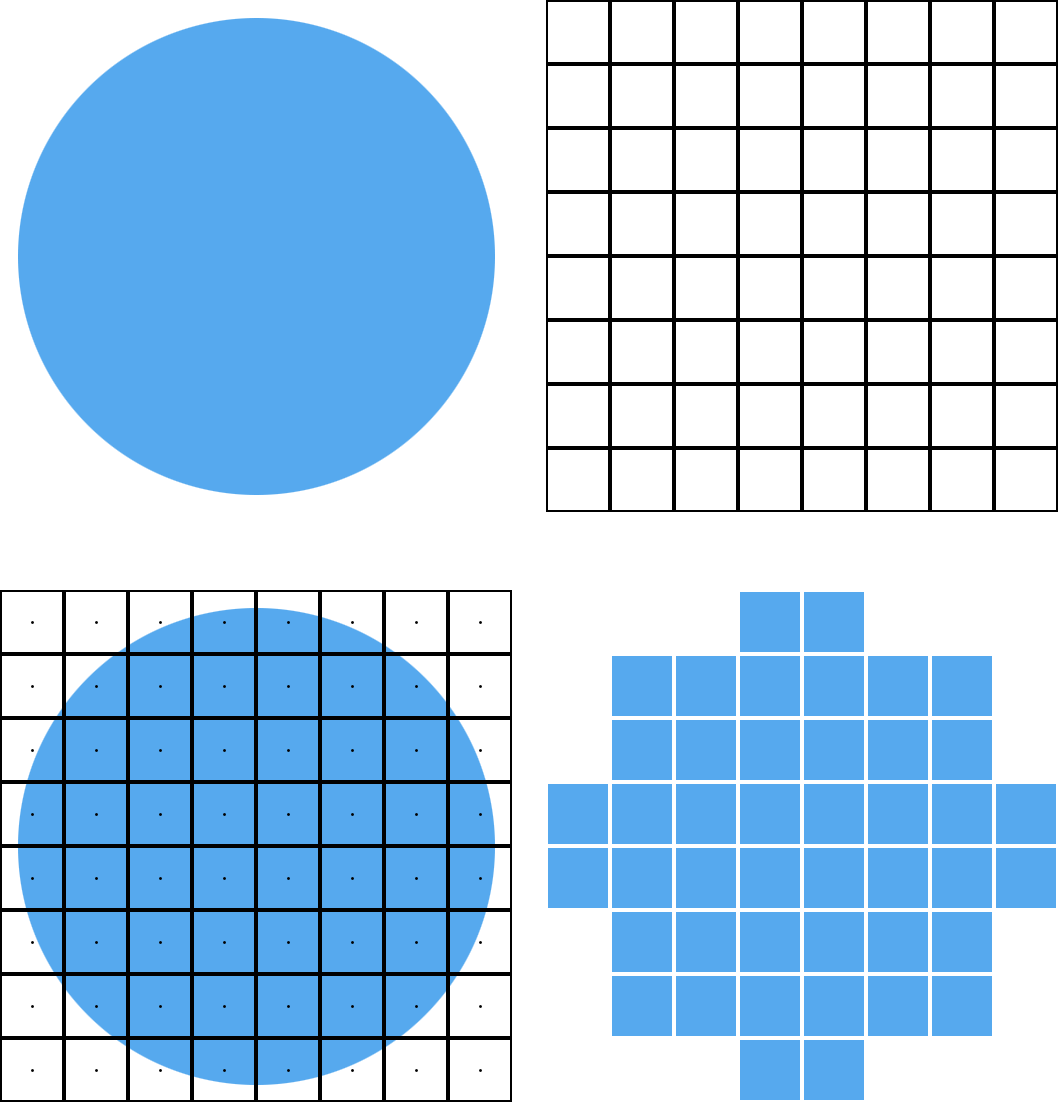

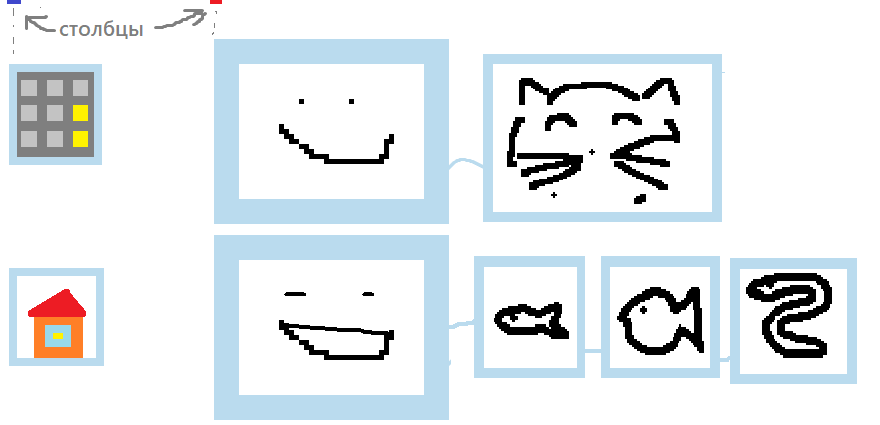

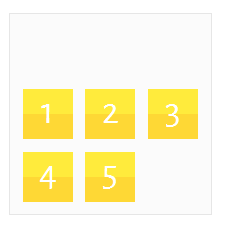

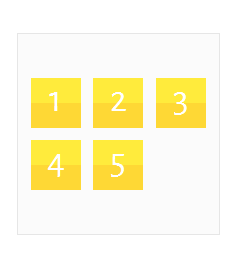

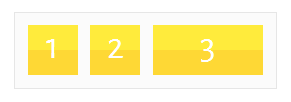

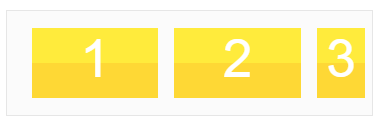

# Keras Functional API в TensorFlow

В Keras есть два API для быстрого построения архитектур нейронных сетей Sequential и Functional. Если первый позволяет строить только последовательные архитектуры нейронных сетей, то с помощью Functional API можно задать нейронную сеть в виде произвольного направленного ациклического графа, что дает намного больше возможностей для построения сложных моделей. В материале перевод руководства, посвященного особенностям Functional API, с сайта TensorFlow.

Введение

--------

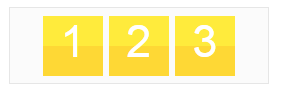

Functional API позволяет создавать модели более гибко чем Sequential API, он может обрабатывать модели с нелинейной топологией, модели с общими слоями, и модели с несколькими входами или выходами.

Он основан на том, что модель глубоко обучения обычно представляет собой ориентированный ациклический граф (DAG) слоев

Functional API — это набор инструментов для **построения графа слоев**.

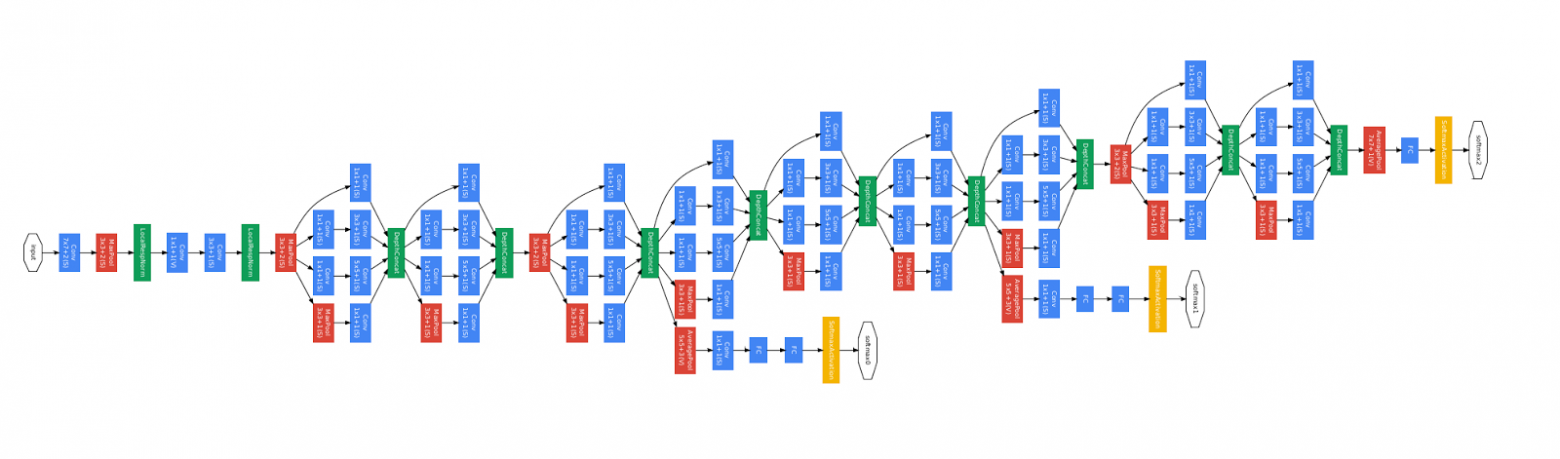

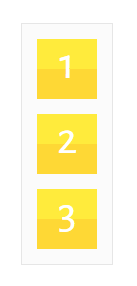

Рассмотрим следующую модель:

> (вход: 784-мерный вектор)

>

> ↧

>

> [Плотный слой (64 элемента, активация relu)]

>

> ↧

>

> [Плотный слой (64 элемента, активация relu)]

>

> ↧

>

> [Плотный слой (10 элементов, активация softmax)]

>

> ↧

>

> (выход: вероятностное распределение на 10 классов)

Это простой граф из 3 слоев.

Для построения этой модели с помощью Functional API, вам надо начать с создания входного узла:

```

from tensorflow import keras

inputs = keras.Input(shape=(784,))

```

Здесь мы просто указываем размерность наших данных: 784-мерных векторов. Обратите внимание, что количество данных всегда опускается, мы указываем только размерность каждого элемента. Для ввода предназначенного для изображений размеров `(32, 32, 3)`, мы бы использовали:

```

img_inputs = keras.Input(shape=(32, 32, 3))

```

То, что возвращает `inputs`, содержит информацию о размерах и типе данных которые вы планируете передать в вашу модель:

```

inputs.shape

```

```

TensorShape([None, 784])

```

```

inputs.dtype

```

```

tf.float32

```

Вы создаете новый узел в графе слоев, вызывая слой на этом объекте `inputs`:

```

from tensorflow.keras import layers

dense = layers.Dense(64, activation='relu')

x = dense(inputs)

```

«Вызов слоя» аналогичен рисованию стрелки из «входных данных» в созданный нами слой. Мы «передаем» входные данные в `dense` слой, и мы получаем `x`.

Давайте добавим еще несколько слоев в наш граф слоев:

```

x = layers.Dense(64, activation='relu')(x)

outputs = layers.Dense(10, activation='softmax')(x)

```

Сейчас мы можем создать `Model` указав его входы и выходы в графе слоев:

```

model = keras.Model(inputs=inputs, outputs=outputs)

```

Посмотрим еще раз полный процесс определения модели:

```

inputs = keras.Input(shape=(784,), name='img')

x = layers.Dense(64, activation='relu')(inputs)

x = layers.Dense(64, activation='relu')(x)

outputs = layers.Dense(10, activation='softmax')(x)

model = keras.Model(inputs=inputs, outputs=outputs, name='mnist_model')

```

Давайте посмотрим как выглядит сводка модели:

```

model.summary()

```

```

Model: "mnist_model"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

img (InputLayer) [(None, 784)] 0

_________________________________________________________________

dense_3 (Dense) (None, 64) 50240

_________________________________________________________________

dense_4 (Dense) (None, 64) 4160

_________________________________________________________________

dense_5 (Dense) (None, 10) 650

=================================================================

Total params: 55,050

Trainable params: 55,050

Non-trainable params: 0

_________________________________________________________________

```

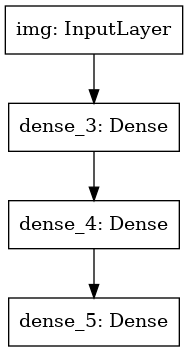

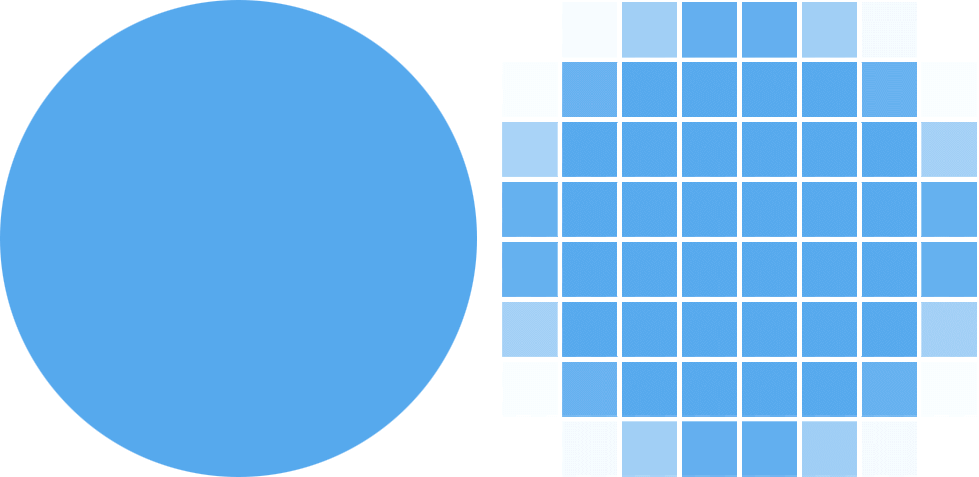

Мы также можем начертить модель в виде графа:

```

keras.utils.plot_model(model, 'my_first_model.png')

```

И опционально выведем размерности входа и выхода каждого слоя на построенном графе:

```

keras.utils.plot_model(model, 'my_first_model_with_shape_info.png', show_shapes=True)

```

Это изображение и код который мы написали идентичны. В версии кода, связывающие стрелки просто заменены операциями вызова.

«Граф слоев» это очень интуитивный ментальный образ для модели глубокого обучения, а Functional API это способ создания моделей которые близко отражают этот ментальный образ.

Обучение, оценка и вывод

------------------------

Обучение, оценка и вывод работают для моделей построенных с использованием Functional API точно так же как и в Sequential моделях.

Рассмотрим быструю демонстрацию.

Тут мы загружаем датасет изображений MNIST, преобразуем его в векторы, обучаем модель на данных (мониторя при этом качество работы на проверочной выборке), и наконец мы оцениваем нашу модель на тестовых данных:

```

(x_train, y_train), (x_test, y_test) = keras.datasets.mnist.load_data()

x_train = x_train.reshape(60000, 784).astype('float32') / 255

x_test = x_test.reshape(10000, 784).astype('float32') / 255

model.compile(loss='sparse_categorical_crossentropy',

optimizer=keras.optimizers.RMSprop(),

metrics=['accuracy'])

history = model.fit(x_train, y_train,

batch_size=64,

epochs=5,

validation_split=0.2)

test_scores = model.evaluate(x_test, y_test, verbose=2)

print('Test loss:', test_scores[0])

print('Test accuracy:', test_scores[1])

```

Сохранение и сериализация

-------------------------

Сохранение и сериализация для моделей построенных с использованием Functional API работает точно так же как и для Sequential моделей.

Стандартным способом сохранения Functional модели является вызов `model.save(`) позволяющий сохранить всю модель в один файл.

Позже вы можете восстановить ту же модель из этого файла, даже если у вас больше нет доступа к коду создавшему модель.

Этот файл включает:

* Архитектуру модели

* Значения весов модели (которые были получены во время обучения)

* Конфигурация обучения модели (то что вы передавали в `compile`)

* Оптимизатор и его состояние, если оно было (это позволяет возобновить обучение с того места, где вы остановились)

```

model.save('path_to_my_model.h5')

del model

# Recreate the exact same model purely from the file:

model = keras.models.load_model('path_to_my_model.h5')

```

Использование одного и того же графа слоев для определения нескольких моделей

-----------------------------------------------------------------------------

В Functional API, модели создаются путем указания входных и выходных данных в графе слоев. Это значит что один граф слоев может быть использован для генерации нескольких моделей.

В приведенном ниже примере мы используем один и тот же стек слоев для создания двух моделей:

модель `кодировщика (encoder)` которая преобразует входные изображения в 16-мерные вектора, и сквозную модель `автокодировщика (autoencoder)` для обучения.

```

encoder_input = keras.Input(shape=(28, 28, 1), name='img')

x = layers.Conv2D(16, 3, activation='relu')(encoder_input)

x = layers.Conv2D(32, 3, activation='relu')(x)

x = layers.MaxPooling2D(3)(x)

x = layers.Conv2D(32, 3, activation='relu')(x)

x = layers.Conv2D(16, 3, activation='relu')(x)

encoder_output = layers.GlobalMaxPooling2D()(x)

encoder = keras.Model(encoder_input, encoder_output, name='encoder')

encoder.summary()

x = layers.Reshape((4, 4, 1))(encoder_output)

x = layers.Conv2DTranspose(16, 3, activation='relu')(x)

x = layers.Conv2DTranspose(32, 3, activation='relu')(x)

x = layers.UpSampling2D(3)(x)

x = layers.Conv2DTranspose(16, 3, activation='relu')(x)

decoder_output = layers.Conv2DTranspose(1, 3, activation='relu')(x)

autoencoder = keras.Model(encoder_input, decoder_output, name='autoencoder')

autoencoder.summary()

```

Обратите внимание, что мы делаем архитектуру декодирования строго симметричной архитектуре кодирования, так что мы получим размерность выходных данных такую же как и входных данных `(28, 28, 1)`. Обратным к слою `Conv2D` является слой `Conv2DTranspose`, а обратным к слою `MaxPooling2D` будет слой `UpSampling2D`.

Модели можно вызывать как слои

------------------------------

Вы можете использовать любую модель так, как если бы это был слой вызывая ее на `Input` или на выход другого слоя.

Обратите внимание, что вызывая модель, вы не только переиспользуете ее архитектуру, вы также повторно используете ее веса. Давайте увидим это в действии. Вот другой взгляд на пример автокодировщика, когда создается модель кодировщика, модель декодировщика, и они связываются в два вызова для получения модели автокодировщика:

```

encoder_input = keras.Input(shape=(28, 28, 1), name='original_img')

x = layers.Conv2D(16, 3, activation='relu')(encoder_input)

x = layers.Conv2D(32, 3, activation='relu')(x)

x = layers.MaxPooling2D(3)(x)

x = layers.Conv2D(32, 3, activation='relu')(x)

x = layers.Conv2D(16, 3, activation='relu')(x)

encoder_output = layers.GlobalMaxPooling2D()(x)

encoder = keras.Model(encoder_input, encoder_output, name='encoder')

encoder.summary()

decoder_input = keras.Input(shape=(16,), name='encoded_img')

x = layers.Reshape((4, 4, 1))(decoder_input)

x = layers.Conv2DTranspose(16, 3, activation='relu')(x)

x = layers.Conv2DTranspose(32, 3, activation='relu')(x)

x = layers.UpSampling2D(3)(x)

x = layers.Conv2DTranspose(16, 3, activation='relu')(x)

decoder_output = layers.Conv2DTranspose(1, 3, activation='relu')(x)

decoder = keras.Model(decoder_input, decoder_output, name='decoder')

decoder.summary()

autoencoder_input = keras.Input(shape=(28, 28, 1), name='img')

encoded_img = encoder(autoencoder_input)

decoded_img = decoder(encoded_img)

autoencoder = keras.Model(autoencoder_input, decoded_img, name='autoencoder')

autoencoder.summary()

```

Как вы видите, модель может быть вложена: модель может содержать подмодель (поскольку модель можно рассматривать как слой).

Распространенным вариантом использования вложения моделей является *ensembling*.

В качестве примера, вот как можно объединить набор моделей в одну модель которая усредняет их прогнозы:

```

def get_model():

inputs = keras.Input(shape=(128,))

outputs = layers.Dense(1, activation='sigmoid')(inputs)

return keras.Model(inputs, outputs)

model1 = get_model()

model2 = get_model()

model3 = get_model()

inputs = keras.Input(shape=(128,))

y1 = model1(inputs)

y2 = model2(inputs)

y3 = model3(inputs)

outputs = layers.average([y1, y2, y3])

ensemble_model = keras.Model(inputs=inputs, outputs=outputs)

```

Манипулирование сложными топологиями графов

-------------------------------------------

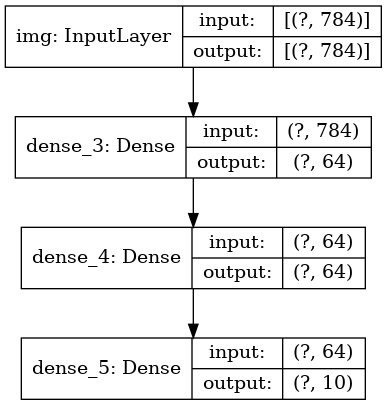

### Модели с несколькими входами и выходами

Functional API упрощает манипуляции с несколькими входами и выходами. Это не может быть сделано с Sequential API.

Вот простой пример.

Допустим, вы создаете систему для ранжирования клиентских заявок по приоритетам и направления их в нужный отдел.

У вашей модели будет 3 входа:

* Заголовок заявки (текстовые входные данные)

* Текстовое содержание заявки (текстовые входные данные)

* Любые теги добавленные пользователем (категорийные входные данные)

У модели будет 2 выхода:

* Оценка приоритета между 0 и 1 (скалярный сигмоидный выход)

* Отдел который должен обработать заявку (softmax выход относительно множества отделов)

Давайте построим модель в несколько строк с помощью Functional API.

```

num_tags = 12 # Количество различных тегов проблем

num_words = 10000 # Размер словаря полученный в результате предобработки текстовых данных

num_departments = 4 # Количество отделов для предсказаний

title_input = keras.Input(shape=(None,), name='title') # Последовательность целых чисел переменной длины

body_input = keras.Input(shape=(None,), name='body') # Последовательность целых чисел переменной длины

tags_input = keras.Input(shape=(num_tags,), name='tags') # Бинарный вектор размера `num_tags`

# Вложим каждое слово заголовка в 64-мерный вектор

title_features = layers.Embedding(num_words, 64)(title_input)

# Вложим каждое слово текста в 64-мерный вектор

body_features = layers.Embedding(num_words, 64)(body_input)

# Сокращаем последовательность вложенных слов заголовка до одного 128-мерного вектора

title_features = layers.LSTM(128)(title_features)

# Сокращаем последовательность вложенных слов заголовка до одного 32-мерного вектора

body_features = layers.LSTM(32)(body_features)

# Объединим все признаки в один вектор с помощью конкатенации

x = layers.concatenate([title_features, body_features, tags_input])

# Добавим логистическую регрессию для прогнозирования приоритета по признакам

priority_pred = layers.Dense(1, activation='sigmoid', name='priority')(x)

# Добавим классификатор отделов прогнозирующий на признаках

department_pred = layers.Dense(num_departments, activation='softmax', name='department')(x)

# Создание сквозной модели, предсказывающей приоритет и отдел

model = keras.Model(inputs=[title_input, body_input, tags_input],

outputs=[priority_pred, department_pred])

```

Давайте начертим граф модели:

```

keras.utils.plot_model(model, 'multi_input_and_output_model.png', show_shapes=True)

```

При компиляции этой модели, мы можем присвоить различные функции потерь каждому выходу.

Вы даже можете присвоить разные веса каждой функции потерь, чтобы варьировать их вклад в общую функцию потерь обучения.

```

model.compile(optimizer=keras.optimizers.RMSprop(1e-3),

loss=['binary_crossentropy', 'categorical_crossentropy'],

loss_weights=[1., 0.2])

```

Так как мы дали имена нашим выходным слоям, мы можем также указать функции потерь:

```

model.compile(optimizer=keras.optimizers.RMSprop(1e-3),

loss={'priority': 'binary_crossentropy',

'department': 'categorical_crossentropy'},

loss_weights=[1., 0.2])

```

Мы можем обучить модель передавая списки массивов Numpy входных данных и меток:

```

import numpy as np

# Dummy input data

title_data = np.random.randint(num_words, size=(1280, 10))

body_data = np.random.randint(num_words, size=(1280, 100))

tags_data = np.random.randint(2, size=(1280, num_tags)).astype('float32')

# Dummy target data

priority_targets = np.random.random(size=(1280, 1))

dept_targets = np.random.randint(2, size=(1280, num_departments))

model.fit({'title': title_data, 'body': body_data, 'tags': tags_data},

{'priority': priority_targets, 'department': dept_targets},

epochs=2,

batch_size=32)

```

При вызове fit с объектом `Dataset`, должны возвращаться либо кортеж списков, таких как `([title_data, body_data, tags_data], [priority_targets, dept_targets])`, либо кортеж словарей `({'title': title_data, 'body': body_data, 'tags': tags_data}, {'priority': priority_targets, 'department': dept_targets})`.

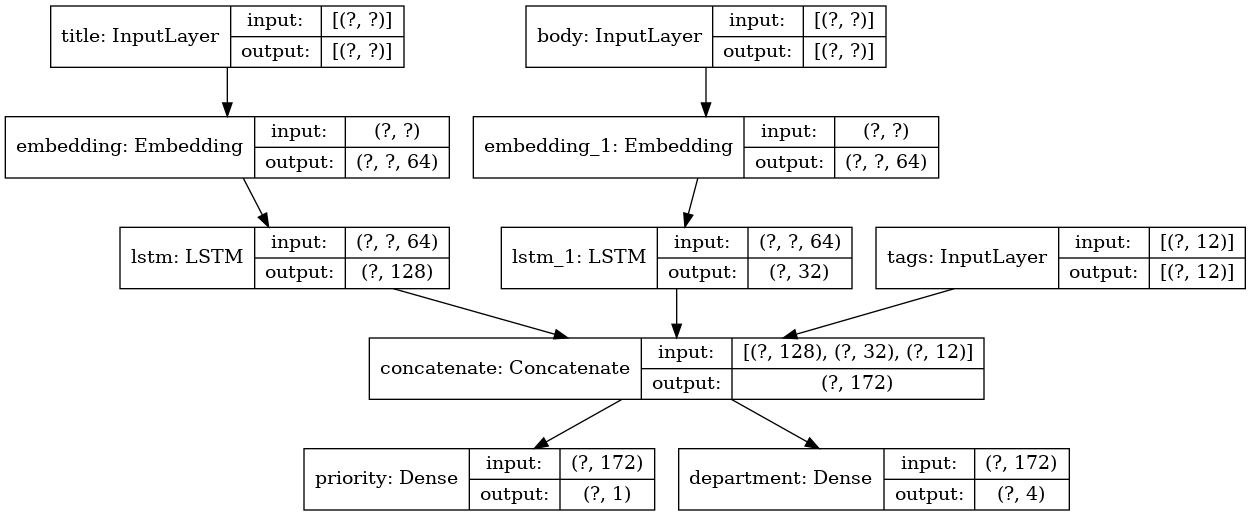

### Учебная resnet модель

В дополнение к моделям с несколькими входами и выходами, Functional API упрощает манипулирование топологиями с нелинейной связностью, то есть моделями, в которых слои не связаны последовательно. Такие модели также не может быть реализованы с помощью Sequential API (это видно из названия).

Распространенный пример использования этого — residual connections.

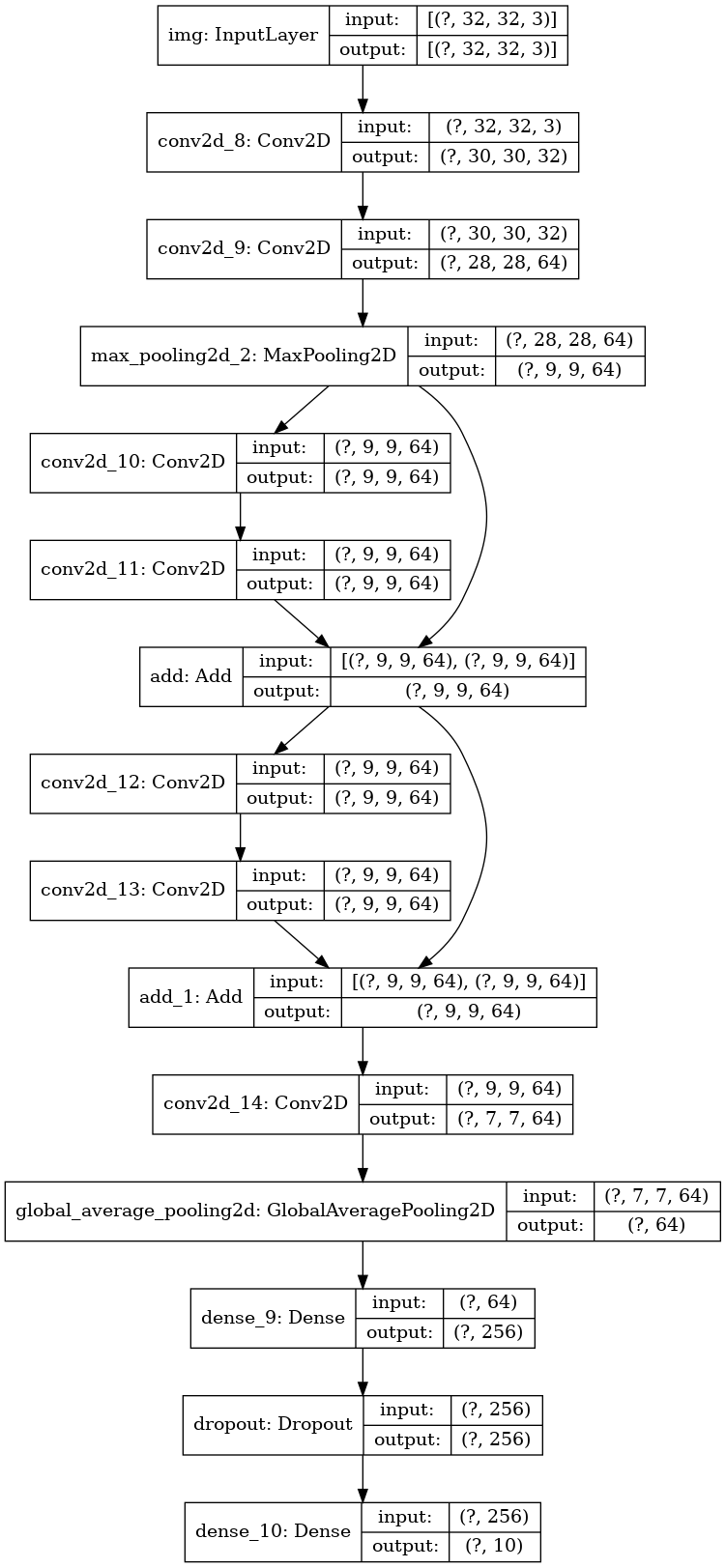

Давайте построим учебную ResNet модель для CIFAR10 чтобы продемонстрировать это.

```

inputs = keras.Input(shape=(32, 32, 3), name='img')

x = layers.Conv2D(32, 3, activation='relu')(inputs)

x = layers.Conv2D(64, 3, activation='relu')(x)

block_1_output = layers.MaxPooling2D(3)(x)

x = layers.Conv2D(64, 3, activation='relu', padding='same')(block_1_output)

x = layers.Conv2D(64, 3, activation='relu', padding='same')(x)

block_2_output = layers.add([x, block_1_output])

x = layers.Conv2D(64, 3, activation='relu', padding='same')(block_2_output)

x = layers.Conv2D(64, 3, activation='relu', padding='same')(x)

block_3_output = layers.add([x, block_2_output])

x = layers.Conv2D(64, 3, activation='relu')(block_3_output)

x = layers.GlobalAveragePooling2D()(x)

x = layers.Dense(256, activation='relu')(x)

x = layers.Dropout(0.5)(x)

outputs = layers.Dense(10, activation='softmax')(x)

model = keras.Model(inputs, outputs, name='toy_resnet')

model.summary()

```

Давайте начертим граф модели:

```

keras.utils.plot_model(model, 'mini_resnet.png', show_shapes=True)

```

И обучим ее:

```

(x_train, y_train), (x_test, y_test) = keras.datasets.cifar10.load_data()

x_train = x_train.astype('float32') / 255.

x_test = x_test.astype('float32') / 255.

y_train = keras.utils.to_categorical(y_train, 10)

y_test = keras.utils.to_categorical(y_test, 10)

model.compile(optimizer=keras.optimizers.RMSprop(1e-3),

loss='categorical_crossentropy',

metrics=['acc'])

model.fit(x_train, y_train,

batch_size=64,

epochs=1,

validation_split=0.2)

```

Совместное использование слоев

------------------------------

Другим хорошим использованием Functional API являются модели, использующие общие слои. Общие слои — это экземпляры слоев, которые переиспользуются в одной и той же модели: они изучают признаки, которые относятся к нескольким путям в графе слоев.

Общие слои часто используются для кодирования входных данных, которые поступают из одинаковых пространств (скажем, из двух разных фрагментов текста, имеющих одинаковый словарь), поскольку они обеспечивают обмен информацией между этими различными данными, что позволяет обучать такие модели на меньшем количестве данных. Если определенное слово появилось на одном из входов, это будет способствовать его обработке на всех входах, которые проходят через общий уровень.

Чтобы совместно использовать слой в Functional API, просто вызовите тот же экземпляр слоя несколько раз. Например, здесь слой `Embedding` используется совместно на двух текстовых входах:

```

# Вложения для 1000 различных слов в 128-мерные вектора

shared_embedding = layers.Embedding(1000, 128)

# Целочисленные последовательности переменной длины

text_input_a = keras.Input(shape=(None,), dtype='int32')

# Целочисленные последовательности переменной длины

text_input_b = keras.Input(shape=(None,), dtype='int32')

# Мы переиспользуем тот же слой для кодирования на обоих входах

encoded_input_a = shared_embedding(text_input_a)

encoded_input_b = shared_embedding(text_input_b)

```

Извлечение и повторное использование узлов в графе слоев

--------------------------------------------------------

Поскольку граф слоев, которыми вы манипулируете в Functional API, является статической структурой данных, к ней можно получить доступ и проверить ее. Именно так мы строим Functional модели, например, в виде изображений.

Это также означает, что мы можем получить доступ к активациям промежуточных слоев («узлов» в графе) и использовать их в других местах. Это чрезвычайно полезно для извлечения признаков, например!

Давайте посмотрим пример. Это модель VGG19 с весами предобученными на ImageNet:

```

from tensorflow.keras.applications import VGG19

vgg19 = VGG19()

```

И это промежуточные активации модели, полученные путем запроса к структуре данных графа:

```

features_list = [layer.output for layer in vgg19.layers]

```

Мы можем использовать эти признаки для создания новой модели извлечения признаков, которая возвращает значения активаций промежуточного уровня — и мы можем сделать все это в 3 строчки

```

feat_extraction_model = keras.Model(inputs=vgg19.input, outputs=features_list)

img = np.random.random((1, 224, 224, 3)).astype('float32')

extracted_features = feat_extraction_model(img)

```

Это удобно при реализации neural style transfer, как и в других случаях.

Расширение API при помощи написания кастомных слоев

---------------------------------------------------

`tf.keras` обладает широким набором встроенных слоев. Вот несколько примеров:

Сверточные слои: `Conv1D`, `Conv2D`, `Conv3D`, `Conv2DTranspose`, и т.д.

Слои пулинга: `MaxPooling1D`, `MaxPooling2D`, `MaxPooling3D`, `AveragePooling1D`, и т.д.

Слои RNN: `GRU`, `LSTM`, `ConvLSTM2D`, и т.д.

`BatchNormalization`, `Dropout`, `Embedding`, и т.д.

Если вы не нашли то, что вам нужно, легко расширить API создав собственный слой.

Все слои сабклассируют класс `Layer` и реализуют:

Метод `call`, определяющий вычисления выполняемые слоем.

Метод `build`, создающий веса слоя (заметим что это всего лишь стилевое соглашение; вы можете также создать веса в `__init__`).

Вот простая реализация `Dense` слоя:

```

class CustomDense(layers.Layer):

def __init__(self, units=32):

super(CustomDense, self).__init__()

self.units = units

def build(self, input_shape):

self.w = self.add_weight(shape=(input_shape[-1], self.units),

initializer='random_normal',

trainable=True)

self.b = self.add_weight(shape=(self.units,),

initializer='random_normal',

trainable=True)

def call(self, inputs):

return tf.matmul(inputs, self.w) + self.b

inputs = keras.Input((4,))

outputs = CustomDense(10)(inputs)

model = keras.Model(inputs, outputs)

```

Если вы хотите, чтобы ваш пользовательский слой поддерживал сериализацию, вы также должны определить метод `get_config`, возвращающий аргументы конструктора экземпляра слоя:

```

class CustomDense(layers.Layer):

def __init__(self, units=32):

super(CustomDense, self).__init__()

self.units = units

def build(self, input_shape):

self.w = self.add_weight(shape=(input_shape[-1], self.units),

initializer='random_normal',

trainable=True)

self.b = self.add_weight(shape=(self.units,),

initializer='random_normal',

trainable=True)

def call(self, inputs):

return tf.matmul(inputs, self.w) + self.b

def get_config(self):

return {'units': self.units}

inputs = keras.Input((4,))

outputs = CustomDense(10)(inputs)

model = keras.Model(inputs, outputs)

config = model.get_config()

new_model = keras.Model.from_config(

config, custom_objects={'CustomDense': CustomDense})

```

Опционально, вы также можете реализовать метод класса `from_config (cls, config)`, который отвечает за пересоздание экземпляра слоя, учитывая его словарь конфигурации. Реализация по умолчанию `from_config` выглядит так:

```

def from_config(cls, config):

return cls(**config)

```

Когда использовать Functional API

---------------------------------

Как определить когда лучше использовать Functional API для создания новой модели, или просто сабклассировать `Model` напрямую?

В целом, Functional API более высокоуровневый и простой в использовании, он имеет ряд функций, которые не поддерживаются сабклассированными моделями.

Однако, сабклассирование Model дает вам большую гибкость при создании моделей, которые не описываются легко в виде направленного ациклического графа слоев (например, вы не сможете реализовать Tree-RNN с Functional API, вам нужно сабклассировать напрямую `Model`).

### Cильные стороны Functional API:

Свойства перечисленные ниже являются все верными и для Sequential моделей (которые также являются структурами данных), но они верны для сабклассированных моделей (которые представляют собой код Python, а не структуры данных).

#### С Functional API получается более короткий код.

Нет `super(MyClass, self).__init__(...)`, нет `def call(self, ...):`, и т.д.

Сравните:

```

inputs = keras.Input(shape=(32,))

x = layers.Dense(64, activation='relu')(inputs)

outputs = layers.Dense(10)(x)

mlp = keras.Model(inputs, outputs)

```

С сабклассированной версией:

```

class MLP(keras.Model):

def __init__(self, **kwargs):

super(MLP, self).__init__(**kwargs)

self.dense_1 = layers.Dense(64, activation='relu')

self.dense_2 = layers.Dense(10)

def call(self, inputs):

x = self.dense_1(inputs)

return self.dense_2(x)

# Создадим экземпляр модели.

mlp = MLP()

# Необходимо создать состояние модели.

# У модели нет состояния пока она не была вызвана хотя бы раз.

_ = mlp(tf.zeros((1, 32)))

```

#### Ваша модель валидируется по ходу ее написания

В Functional API входные спецификации (shape и dtype) создаются заранее (через `Input`), и каждый раз, когда вы вызываете слой, слой проверяет, что спецификации переданные ему соответствует его предположениям, если это не так то вы получите полезное сообщение об ошибке.

Это гарантирует, что любая модель которую вы построите с Functional API запустится. Вся отладка (не относящаяся к отладке сходимости) будет происходить статично во время конструирования модели, а не во время выполнения. Это аналогично проверке типа в компиляторе.

#### Вашу Functional модель можно представить графически, а также она проверяема.

Вы можете начертить модель в виде графа, и вы легко можете получить доступ к промежуточным узлам графа, например, чтобы извлечь и переиспользовать активации промежуточных слоев, как мы видели в предыдущем примере:

```

features_list = [layer.output for layer in vgg19.layers]

feat_extraction_model = keras.Model(inputs=vgg19.input, outputs=features_list)

```

Поскольку Functional модель это скорее структура данных чем кусок кода, она безопасно сериализуется и может быть сохранена в виде одного файла который позволяет вам воссоздать в точности ту же модель без доступа к исходному коду.

### Слабые стороны Functional API

#### Он не поддерживает динамичные архитектуры.

Functional API обрабатывает модели как DAG слоев. Это справедливо для большинства архитектур глубокого обучения, но не для всех: например, рекурсивные сети или Tree RNN не соответствуют этому предположению и не могут быть реализованы в Functional API.

#### Иногда вам просто нужно написать все с нуля.

При написании продвинутых архитектур вы можете захотеть сделать то, что выходит за рамки «определения DAG слоев»: например, вы можете использовать несколько пользовательских методов обучения и вывода на экземпляре вашей модели. Это требует сабклассирования.

Сочетание и комбинирование различных стилей API

-----------------------------------------------

Важно отметить, что выбор между Functional API или сабклассированием Model не является бинарным решением, которое ограничивает вас одной категорией моделей. Все модели в API tf.keras могут взаимодействовать друг с другом, будь то Sequential модели, Functional модели или сабклассированные Models/Layers, написанные с нуля.

Вы всегда можете использовать Functional модель или Sequential модель как часть сабклассированного Model/Layer:

```

units = 32

timesteps = 10

input_dim = 5

# Define a Functional model

inputs = keras.Input((None, units))

x = layers.GlobalAveragePooling1D()(inputs)

outputs = layers.Dense(1, activation='sigmoid')(x)

model = keras.Model(inputs, outputs)

class CustomRNN(layers.Layer):

def __init__(self):

super(CustomRNN, self).__init__()

self.units = units

self.projection_1 = layers.Dense(units=units, activation='tanh')

self.projection_2 = layers.Dense(units=units, activation='tanh')

# Our previously-defined Functional model

self.classifier = model

def call(self, inputs):

outputs = []

state = tf.zeros(shape=(inputs.shape[0], self.units))

for t in range(inputs.shape[1]):

x = inputs[:, t, :]

h = self.projection_1(x)

y = h + self.projection_2(state)

state = y

outputs.append(y)

features = tf.stack(outputs, axis=1)

print(features.shape)

return self.classifier(features)

rnn_model = CustomRNN()

_ = rnn_model(tf.zeros((1, timesteps, input_dim)))

```

Обратно, вы можете использовать любой сабклассированный Layer или Model в Functional API в том случае если реализован метод `call` который соответствует одному из следующих паттернов:

`call(self, inputs, **kwargs)` где `inputs` это тензор или вложенная струтура тензоров (напр. список тензоров), и где `**kwargs` это нетензорные аргументы (не входные данные).

`call(self, inputs, training=None, **kwargs)` где `training` это булево значение показывающее в каком режиме должен вести себя слой, обучения или вывода.

`call(self, inputs, mask=None, **kwargs)` где `mask` это тензор булевой маски (полезно для RNN, например).

`call(self, inputs, training=None, mask=None, **kwargs)` — конечно вы можете иметь одновременно оба параметра определяющих поведение слоя.

В дополнение, если вы реализуете метод `get\_config` на вашем пользовательском Layer или Model, Functional модели которые вы создадите с ним будут сериализуемы и клонируемы.

Далее приведем небольшой пример где мы используем кастомный RNN написанный с нуля Functional модели:

```

units = 32

timesteps = 10

input_dim = 5

batch_size = 16

class CustomRNN(layers.Layer):

def __init__(self):

super(CustomRNN, self).__init__()

self.units = units

self.projection_1 = layers.Dense(units=units, activation='tanh')

self.projection_2 = layers.Dense(units=units, activation='tanh')

self.classifier = layers.Dense(1, activation='sigmoid')

def call(self, inputs):

outputs = []

state = tf.zeros(shape=(inputs.shape[0], self.units))

for t in range(inputs.shape[1]):

x = inputs[:, t, :]

h = self.projection_1(x)

y = h + self.projection_2(state)

state = y

outputs.append(y)

features = tf.stack(outputs, axis=1)

return self.classifier(features)

# Заметьте что мы задаем статичный размер пакета для входных данных

# аргументом `batch_shape`, потому что внутренние вычисления `CustomRNN` требуют

# фиксированного размера пакета (когда мы создает нулевые тензоры `state`).

inputs = keras.Input(batch_shape=(batch_size, timesteps, input_dim))

x = layers.Conv1D(32, 3)(inputs)

outputs = CustomRNN()(x)

model = keras.Model(inputs, outputs)

rnn_model = CustomRNN()

_ = rnn_model(tf.zeros((1, 10, 5)))

```

Это завершает наше руководство по Functional API!

Теперь у вас под рукой мощный набор инструментов для построения моделей глубокого обучения.

*После проверки перевод появится также на сайте Tensorflow.org. Если вы хотите поучаствовать в переводе документации сайта Tensorflow.org на русский, обращайтесь в личку или комментарии. Любые исправления и замечания приветствуются. В качестве иллюстрации использовалось изображение модели GoogLeNet, которая тоже является направленным ациклическим графом.*

|

https://habr.com/ru/post/483664/

| null |

ru

| null |

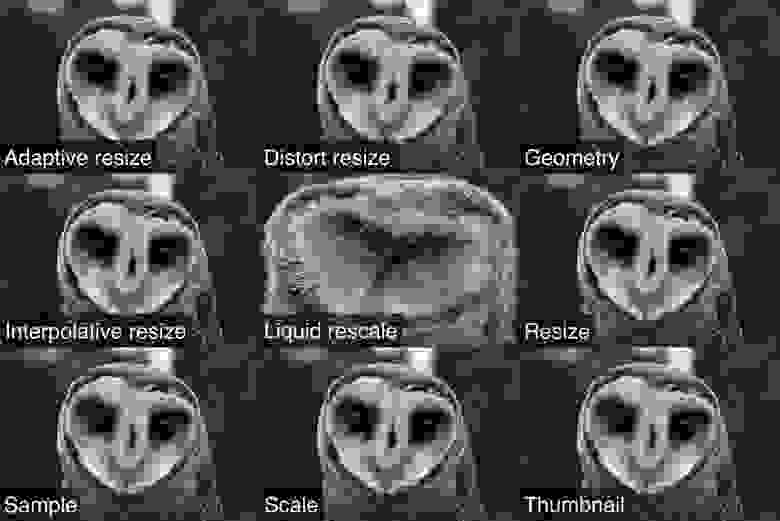

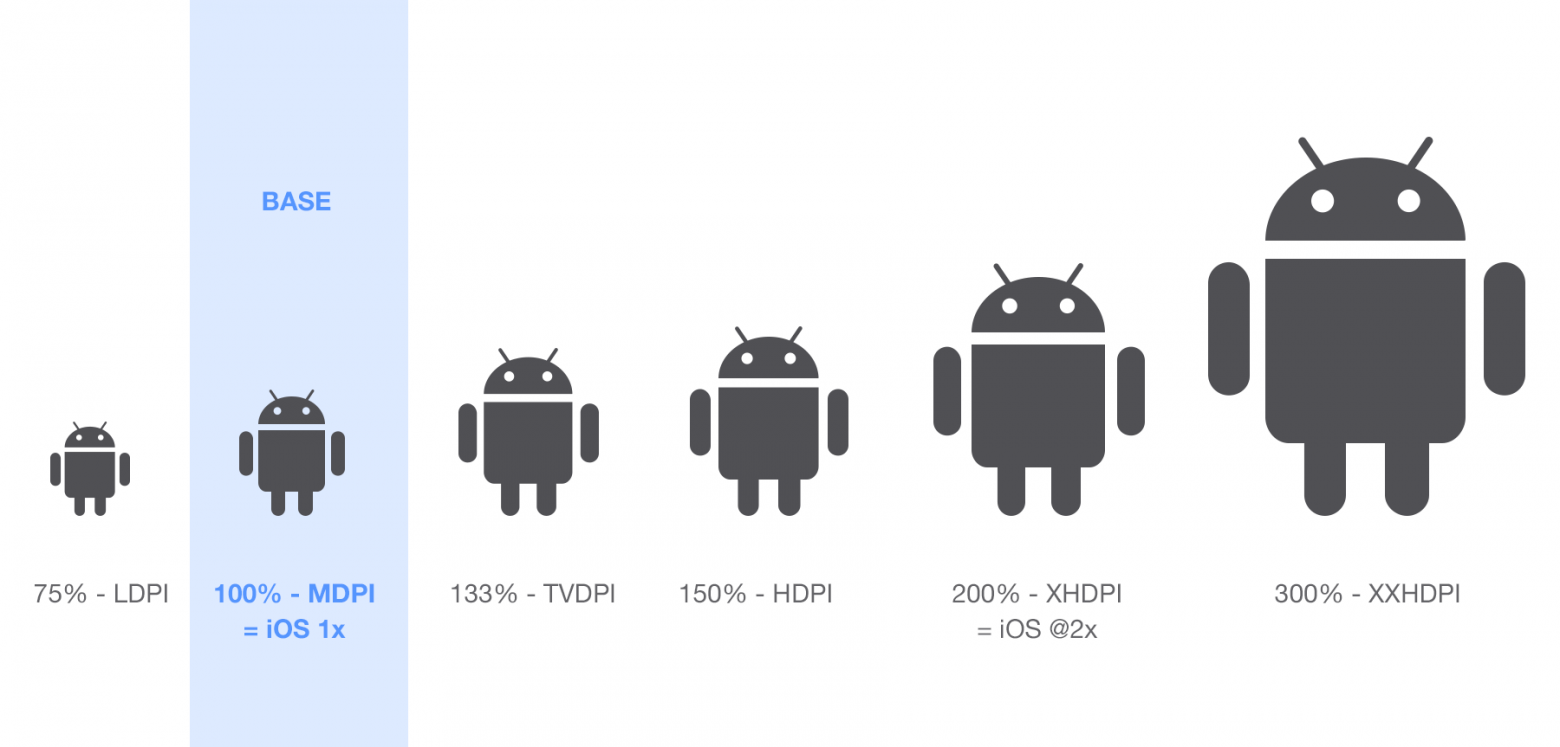

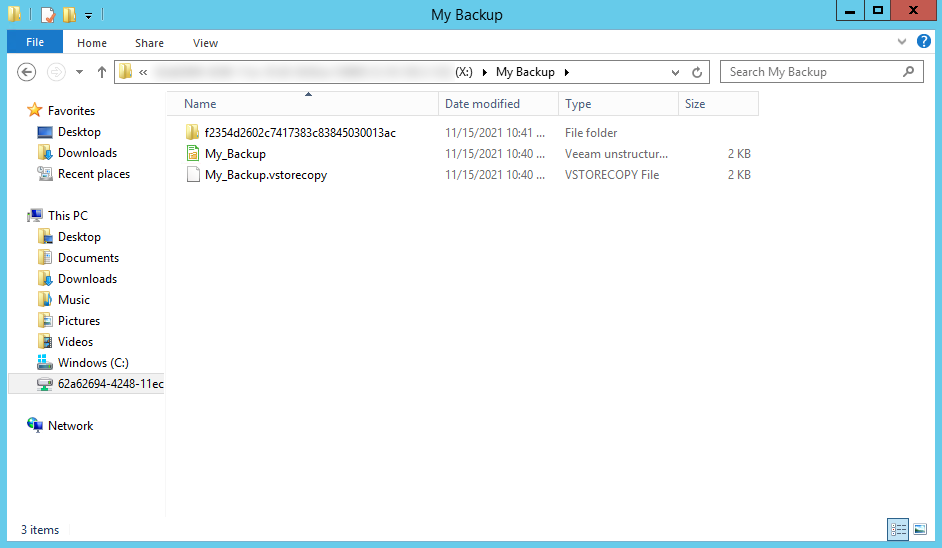

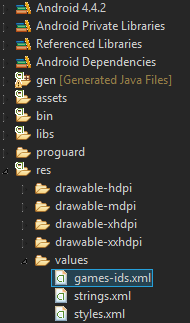

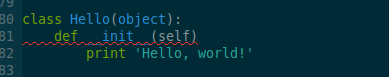

# Фото из Android смартфона в Qt Widgets

Если у вас нет времени читать или информация известна, окончательный код получения полноразмерного изображения из камеры Android-смартфона расположен в конце статьи.

Описание проблемы

-----------------

Если вы пишете кросс-платформенное приложение, то для получения изображения из камеры для ПК можно воспользоваться классом [**QCamera**](https://doc.qt.io/qt-5/qcamera.html), [пример](https://doc.qt.io/qt-5/qtmultimedia-multimediawidgets-camera-example.html) для работы с которым описан в документации Qt.

В соответствии с указанным примером мы добавляем в .pro файл

`QT += multimedia multimediawidgets`

Далее создаём виджет в своей программе, отображающий изображение из веб-камеры и сохраняющий его в [QPixmap](https://doc.qt.io/qt-5/qpixmap.html) или [QImage](https://doc.qt.io/qt-5/qimage.html) для дальнейшего использования.

Когда возникает задача сделать то-же самое на Android, то выясняется, что **multimediawidgets** не поддерживаются данной ОС и камера снимать и сохранять снимки будет, но что она отображает в текущий момент будет загадкой, т. к. [**QCameraViewfinder**](https://doc.qt.io/qt-5/qcameraviewfinder.html) использует **multimediawidgets** и на Android не отображает ничего. Дальнейший поиск решения проблемы приводит к двум вариантам решения:

1. использовать [QML](https://doc.qt.io/qt-5/qtqml-index.html) и написать свой [Qt Quick-элемент](https://doc.qt.io/qt-5/qtquickcontrols-index.html), выполняющий эту функцию, затем состыковать его остальной частью приложения на [Qt Widgets](https://doc.qt.io/qt-5/qtwidgets-index.html), С++;

2. использовать приложение по-умолчанию Android-смартфона для получения фотографии, затем обработать её в своём приложении.

### Рассмотрим первый вариант

Если вы С++ программист [Qt Widgets](https://doc.qt.io/qt-5/qtwidgets-index.html), то очередное эпизодическое углубление в [QML](https://doc.qt.io/qt-5/qtqml-index.html) займёт у вас время, добавим к этому время на написание [Qt Quick-элемента](https://doc.qt.io/qt-5/qtquickcontrols-index.html), стыковки этого элемента с С++ кодом, отладки написанного кода. Если вы не профессионал в [QML](https://doc.qt.io/qt-5/qtqml-index.html) получается долго и сложно.

### Рассмотрим второй вариант

В Android-смартфоне уже есть приложение по-умолчанию, прекрасно выполняющее нужную функцию, нужно им просто воспользоваться, применив Java-вызовы ([JNI — Java Native Interface](https://ru.wikipedia.org/wiki/Java_Native_Interface)) из С++ кода при помощи [**QtAndroid**](https://doc.qt.io/qt-5/qtandroid.html). Выглядит проще. Полностью работающего кода в интернете я не нашёл, и, изучив опыт других, опираясь на [документацию разработчка на Android](https://developer.android.com/reference) написал собственный.

Как это сделать

---------------

Если у вас нет времени читать или информация известна, окончательный код получения полноразмерного изображения из камеры Android-смартфона расположен в конце статьи.

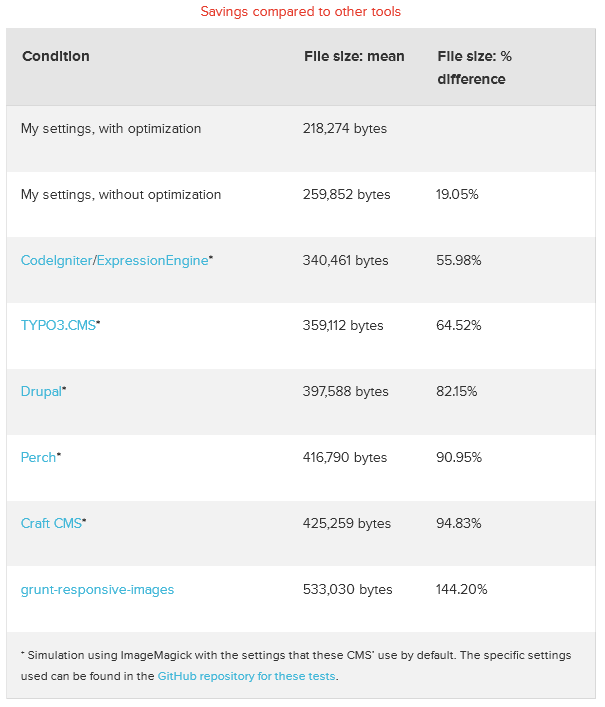

Прочитав статью [Получить фотографии на Android](https://developer.android.com/training/camera/photobasics) я сделал вывод, что применив данный метод можно получить или миниатюру изображения в виде массива пикселей или сохранить изображение в файл. Поискав готовые решения, я нашёл на [GitHub подходящий код](https://github.com/minixxie/examples/blob/master/qt-for-mobile/TestExternalAndroidCamera1/MyController.cpp), который должен был выполнить нужную мне задачу. При его проверке, оказалось, что он устарел и теперь приводит к [FileUriExposedException](https://developer.android.com/reference/android/os/FileUriExposedException) исключению, причины возникновения которого описаны в вышеуказанной ссылке на статью.

Чтобы разобраться самостоятельно, как оно работает, начнём с простой задачи, не требующей обращения к файлам и множества Java-вызовов — получению миниатюры.

### Получение миниатюры

Начнём с .pro файла.

Он должен содержать следующие строки для поддержки Android.

```

android {

QT +=androidextras

}

```

Для получения результата нам понадобится класс, унаследованный от [QAndroidActivityResultReceiver](https://doc.qt.io/qt-5/qandroidactivityresultreceiver.html). Если требуется, чтобы объект нашего класса высылал изображение при помощи сигнала, то он также должен быть унаследован от любого класса Qt, имеющего базовый класс [QObject](https://doc.qt.io/qt-5/qobject.html).

Заголовочный файл (.h) класса имеет вид:

```

#ifndef CAMSHOT_H

#define CAMSHOT_H

#include

#include

#include

#include

#include

#include

#include

#include

class CamShot : public QObject, public QAndroidActivityResultReceiver

{

Q\_OBJECT

public:

CamShot(QObject \*parent = nullptr):QObject(parent),QAndroidActivityResultReceiver(){}

static const int RESULT\_OK = -1;

static const int REQUEST\_IMAGE\_CAPTURE = 1;

static const int REQUEST\_TAKE\_PHOTO = REQUEST\_IMAGE\_CAPTURE;

void handleActivityResult(int receiverRequestCode, int resultCode, const QAndroidJniObject &data) override;

static QImage camThumbnailToQImage(const QAndroidJniObject &data);

public slots:

void aMakeShot();

signals:

void createNew(const QImage &img);

};

#endif // CAMSHOT\_H

```

Заголовочный файл (.cpp) класса имеет вид:

```

QImage CamShot::camThumbnailToQImage(const QAndroidJniObject &data){

QAndroidJniObject bundle = data.callObjectMethod("getExtras","()Landroid/os/Bundle;");

qDebug()<<"bundle.isValid() "<()));

qDebug()<<"aBitmap.isValid() "<("getWidth");

jint aBitmapHeight = aBitmap.callMethod("getHeight");

QAndroidJniEnvironment env;

const int32\_t aBitmapPixelsCount = aBitmapWidth \* aBitmapHeight;

jintArray pixels = env->NewIntArray(aBitmapPixelsCount);

jint aBitmapOffset = 0;

jint aBitmapStride = aBitmapWidth;

jint aBitmapX = 0;

jint aBitmapY = 0;

aBitmap.callMethod("getPixels","([IIIIIII)V", pixels, aBitmapOffset, aBitmapStride, aBitmapX, aBitmapY, aBitmapWidth, aBitmapHeight);

jint \*pPixels = env->GetIntArrayElements(pixels, nullptr);

QImage img(aBitmapWidth, aBitmapHeight, QImage::Format\_ARGB32);

int lineSzB = aBitmapWidth \* sizeof(jint);

for (int i = 0; i < aBitmapHeight; ++i){

uchar \*pDst = img.scanLine(i);

const uchar \*pSrc = reinterpret\_cast(pPixels + aBitmapWidth \* i + aBitmapWidth);

memcpy(pDst, pSrc, lineSzB);

}

env->DeleteLocalRef(pixels); //env->ReleaseIntArrayElements(pixels, pPixels, 0); отвязывает указатель на данные массива от массива, а надо удалить сам массив, поэтому DeleteLocalRef.

return img;

}

void CamShot::aMakeShot() {

QAndroidJniObject action = QandroidJniObject::fromString("android.media.action.IMAGE\_CAPTURE");

//Если необходимо указать Java-класс (не аргумент функции), то указывается полное имя класса (точки-разделители заменяются на "/"), например "android/content/Intent", "java/lang/String".

//Если аргумент функции Java-объект, то писать имя класса начиная с "L" и ";" в конце, например "Landroid/content/Intent ;", "Ljava/lang/String;".

//Если примитивный тип или массив, то указываются соответствующие символы без разделителей, например "V" (void) или "[IIIIIII" (массив jint, и 6 jint за ним)

//Символы, соответствия примитивны типам:

QAndroidJniObject intent=QAndroidJniObject("android/content/Intent","(Ljava/lang/String;)V", action.object());

QtAndroid::startActivity(intent, REQUEST\_IMAGE\_CAPTURE, this);

}

void CamShot::handleActivityResult(int receiverRequestCode, int resultCode, const QAndroidJniObject &data){

if ( receiverRequestCode == REQUEST\_IMAGE\_CAPTURE && resultCode == RESULT\_OK )

{

const QImage thumbnail (camThumbnailToQImage(data));

if (!thumbnail.isNull())

emit createNew(thumbnail);

}

}

```

#### Разберём приведённый код

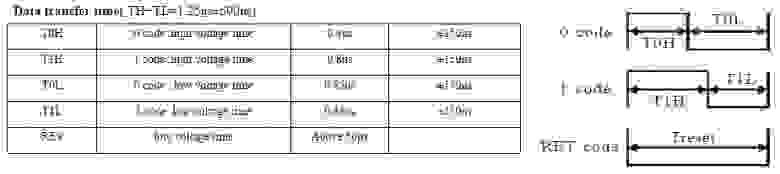

#### Краткие правила указания аргументов в JNI-вызовах

1. если необходимо указать имя Java-класса (не в качестве аргумента Java-функции), то указывается полное имя класса (точки-разделители заменяются на "**/**"), например "**android/content/Intent**", "**java/lang/String**";

2. если аргумент функции Java-объект, то писать имя его класса начиная с "**L**" и "**;**" в конце, например "**Landroid/content/Intent;**", "**Ljava/lang/String;**";

3. если примитивный тип или массив, то указываются соответствующие сигнатуры (символы без разделителей), например "**V**" (void), "**I**" (jint) или "**[IIIIIII**" (массив jint, и 6 jint за ним);

4. сигнатуры примитивных типов:

| C/C++ | JNI | Java | Signature |

| --- | --- | --- | --- |

| uint8\_t/unsigned char | jboolean | bool | Z |

| int8\_t/char/signed char | jbyte | byte | B |

| uint16\_t/unsigned short | jchar | char | C |

| int16\_t/short | jshort | short | S |

| int32\_t/int/(long) | jint | int | I |

| int64\_t/(long)/long long | jlong | long | J |

| float | jfloat | float | F |

| double | jdouble | double | D |

| void | | void | V |

5. сигнатуры массивов:

| JNI | Java | Signature |

| --- | --- | --- |

| jbooleanArray | bool[] | [Z |

| jbyteArray | byte[] | [B |

| jcharArray | char[] | [C |

| jshortArray | short[] | [S |

| jintArray | int[] | [I |

| jlongArray | long[] | [L |

| jfloatArray | float[] | [F |

| jdoubleArray | double[] | [D |

| jarray | type[] | [Lfully/qualified/type/name; |

| jarray | String[] | [Ljava/lang/String; |

Чтобы получить доступ к элементам массива, необходимо использовать JNI-методы объекта класса [QAndroidJniEnvironment](https://doc.qt.io/qt-5/qandroidjnienvironment.html), например такие как: NewIntArray, GetIntArrayElements, DeleteLocalRef GetArrayLength,GetObjectArrayElement, SetObjectArrayElement, и т.д.

Подробнее можно прочитать в презентации (pdf) [Practical Qt on Android JNI — qtcon](https://www.google.com/url?sa=t&rct=j&q=&esrc=s&source=web&cd=&cad=rja&uact=8&ved=2ahUKEwjTqrvL0_3uAhXukosKHfHTAQIQFjABegQIAhAD&url=https%3A%2F%2Fconf.qtcon.org%2Fsystem%2Fattachments%2F132%2Foriginal%2FQtCon16.pdf%253F1473147092&usg=AOvVaw29H2FMnsBW5AMFGk0lNwot).

В заголовочном файле class **CamShot** содержит:

1. значения констант, взятых их [документации разработчка Android](https://developer.android.com/training/camera/photobasics) (так код короче и меньше Java-вызовов);

2. переопределение абстрактного метода `void handleActivityResult(int receiverRequestCode, int resultCode, const QAndroidJniObject &data) override;` в который будет передаваться Java-объект класса [Intent](https://developer.android.com/reference/android/content/Intent?hl=en) с миниатюрой изображения;

3. статический метод

`static QImage camThumbnailToQImage(const QAndroidJniObject &data);`

извлекающий из Java-объекта класса [Intent](https://developer.android.com/reference/android/content/Intent?hl=en) Java-объект класса [Bitmap](https://developer.android.com/reference/android/graphics/Bitmap), копирующий пиксели в массив пкселей (32-битных значений) и построчно копирующий эти пиксели в [QImage](https://doc.qt.io/qt-5/qimage.html);

4. общедоступный слот

`void aMakeShot();`

вызывающий операцию по фотографированию изображения и получению его миниатюры;

5. сигнал

`void createNew(const QImage &img);`

высылающий полученную миниатюру потребителю.

В методе void **aMakeShot**() создаётся Java-объект [Intent](https://developer.android.com/reference/android/content/Intent?hl=en) в который передаётся строка со значением, указывающим, что необходимо сделать — произвести захват изображения. После этого сформированное действие ([Intent](https://developer.android.com/reference/android/content/Intent?hl=en)) отправляется на исполнение ([Activity](https://developer.android.com/reference/android/app/Activity)).

В процессе выполнения действия будет запущено приложение по-умолчанию для фотографирования. Как только фотография будет сделана и подтверждена пользователем, будет произведён вызов виртуального метода ***handleActivityResult***, в котором осуществляется проверка: является ли выполненное действие запрошенным и успешно выполненным. Если да, то вызовем статический метод **camThumbnailToQImage** получения изображения [QImage](https://doc.qt.io/qt-5/qimage.html) из Java-объекта класса [Bitmap](https://developer.android.com/reference/android/graphics/Bitmap) и при успешном результате отправим полученное изображение потребителю сигналом Qt.

Рассмотрим статический метод

`static QImage camThumbnailToQImage(const QAndroidJniObject &data) override;`

Интересующее нас изображение передаётся в блоке дополнительных данных Java-объекта класса [Intent](https://developer.android.com/reference/android/content/Intent?hl=en) и является Java-объектом класса [Bundle](https://developer.android.com/reference/android/os/Bundle), чтобы его получить нужно воспользоваться методом объекта [Intent](https://developer.android.com/reference/android/content/Intent?hl=en):

[Bundle getExtras()](https://developer.android.com/reference/android/content/Intent#getExtras())

В [Bundle](https://developer.android.com/reference/android/os/Bundle) хранятся ассоциативные пары <ключ-строка>:<значение>. В статье [получить фотографии на Android](https://developer.android.com/training/camera/photobasics) указан ключ, по которому располагается миниатюра. Это строка "data".

Получим Java-объект класса [Bitmap](https://developer.android.com/reference/android/graphics/Bitmap) по ключу, воспользовавшись методом объекта [Intent](https://developer.android.com/reference/android/content/Intent?hl=en):

[T getParcelableExtra (String name)](https://developer.android.com/reference/android/content/Intent#getParcelableExtra(java.lang.String))

Cобрать из [Bitmap](https://developer.android.com/reference/android/graphics/Bitmap) [QImage](https://doc.qt.io/qt-5/qimage.html) сразу не получится, т. к. у [Bitmap](https://developer.android.com/reference/android/graphics/Bitmap) нет указателя на данные изображения вместе с заголовком его формата. Поэтому получим его размер (ширину и высоту) в пискселях и создадим [QImage](https://doc.qt.io/qt-5/qimage.html) аналогичного размера для копирования значений пикселей в него.

Для переноса значений пикселей из [Bitmap](https://developer.android.com/reference/android/graphics/Bitmap) в [QImage](https://doc.qt.io/qt-5/qimage.html) воспользуемся методом объекта [Bitmap](https://developer.android.com/reference/android/graphics/Bitmap):

[void getPixels (int[] pixels, int offset, int stride, int x, int y, int width, int height)](https://developer.android.com/reference/android/graphics/Bitmap#getPixels(int%5B%5D,%20int,%20int,%20int,%20int,%20int,%20int))

Для этого понадобится создать линейный массив значений пикселей

`jintArray pixels = env->NewIntArray(aBitmapPixelsCount);`После того, как пиксели будут скопированы, получим указатель на начало массива, который можно использовать в C++ коде:

`jint *pPixels = env->GetIntArrayElements(pixels, nullptr);`

Затем в цикле построчно скопируем значения пикселей из массива в изображение [Qimage](https://doc.qt.io/qt-5/qimage.html). По завершению копирования освобождаем память, выделенную под массив значений пикселей

`env->DeleteLocalRef(pixels);`

и возвращаем результат в виде [QImage](https://doc.qt.io/qt-5/qimage.html).

Отлично. Миниатюра изображения получена.

Получение полноразмерного изображения

-------------------------------------

Для получения полноразмерного изображения необходимо воспользоваться классом [FileProvider](https://developer.android.com/reference/kotlin/androidx/core/content/FileProvider?hl=en), чтобы получить разделяемый [Uri](https://developer.android.com/reference/android/net/Uri.html) для файла фотоснимка. Обращаю ваше внимание, что у Android, по крайней мере, их два:

1. androidx.core.content.FileProvider;

2. android.support.v4.content.FileProvider.

Первый — самый современный, не поддерживается Qt, а для использования второго необходимо настроить среду QtCreator:

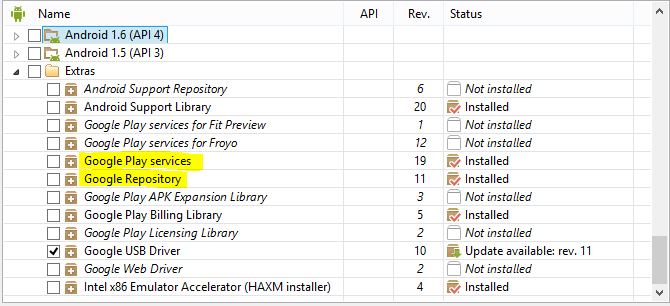

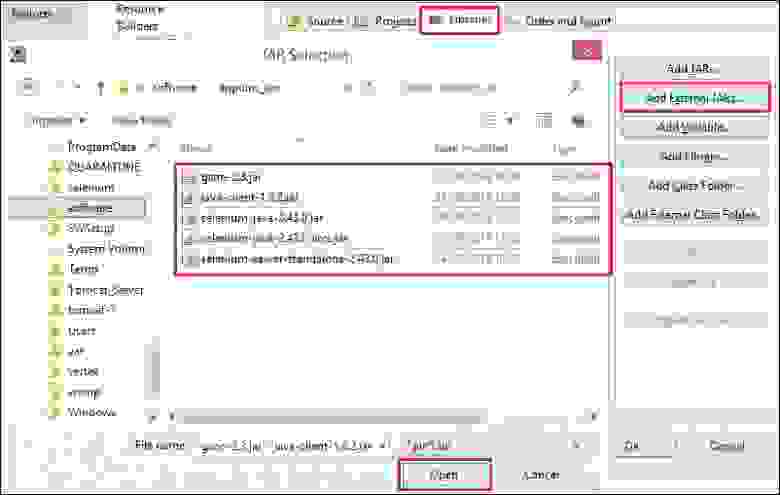

#### Установить дополнительные репозитории

Главное меню (сверху)→ «Инструменты» → «Параметры» → «Устройства»→ вкладка «Android»→ вкладка «SDK Manager»→Развернуть элемент списка «Инструменты» в список→ «Extras»→ «Android Support Repository» - поставить флажок установить и нажить на кнопку «Применить» справа.

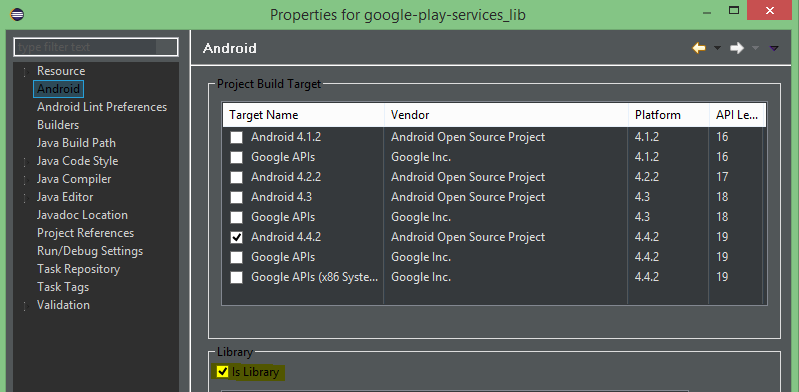

#### Заменить автогенерируемые файлы настройки сборки для Android собственными

Перейти на боковой панели QtCreator на вкладку «Проекты». В левой области окна «Сборка и запуск»→ «Сборка». Тогда в правой области окна «Build Android APK» → «Create Templates». В появившемся диалоговом окне установить флажок «Копировать файлы Gradle в каталог Android», нажать на кнопку «Завершить»:

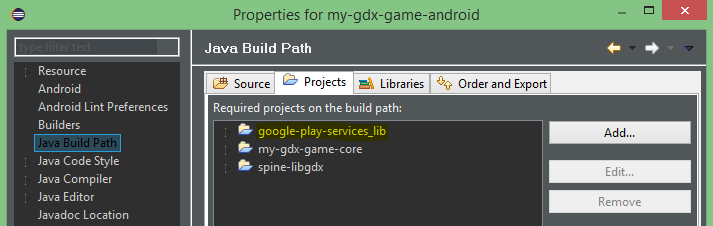

#### Добавить каталог со своими настройками сборки в проект

В каталоге с исходными кодами вашего приложения появится каталог «android», который необходимо добавить в проект.

#### Настроить в файле проекта отключаемую возможность поддержки Android

Если приложение кросс-платформенное и предполагается компиляция не только на Android, то в .pro файле необходимо добавить директиву android: перед каждым добавленным файлом:

```

android {

QT +=androidextras

}

# …

DISTFILES += \

android: android/AndroidManifest.xml \

android: android/build.gradle \

android: android/gradle/wrapper/gradle-wrapper.jar \

android: android/gradle/wrapper/gradle-wrapper.properties \

android: android/gradlew \

android: android/gradlew.bat \

android: android/res/values/libs.xml \

todo.txt

```

#### Отредактировать AndroidManifest.xml

Отредактировать файл «AndroidManifest.xml» в android/AndroidManifest.xml, добавив в секцию после

```

<!-- For adding service(s) please check: https://wiki.qt.io/AndroidServices ->

```

текст:

```

```

#### Создать файл с указанием каталога совместного использования с другими приложениями

Это нужно для того, чтобы приложение фотографирования по-умолчанию могло передать нашему приложению файл.

В каталоге сборки, там где находится автогенерируемый файл «AndroidManifest.xml» внутри каталога «res» рядом с каталогом «values», создать каталог «xml», а в нём файл «file\_paths.xml» (… /abin/AndroidManifest.xml) (… /abin/res/xml/file\_paths.xml). В созданный файл поместить следующие строки:

```

xml version="1.0" encoding="utf-8"?

```

где shared/ имя каталога в каталоге файлов нашего приложения

#### Добавить компонент, содержащий FileProvider в сборку

Отредактировать файл android/build.gradle, добвив в секцию dependencies текст:

```

compile'com.android.support:support-v4:25.3.1'

```

секция целиком выглядит так:

```

dependencies {

implementation fileTree(dir: 'libs', include: ['*.jar', '*.aar'])

compile'com.android.support:support-v4:25.3.1'

}

```

Данная инструкция сработает, если был установлен Android Support Repository.

Настройка выполнена на основании статьи [Sharing Files on Android or iOS from or with your Qt App - Part 4](https://www.qt.io/blog/2018/11/06/sharing-files-android-ios-qt-app-part-4) и подобных статей на эту тему.

Заголовочный файл (.h) класса имеет вид:

```

#ifndef CAMSHOT_H

#define CAMSHOT_H

#include

#include

#include

#include

#include

#include

#include

#include "auxfunc.h"

class CamShot : public QObject, public QAndroidActivityResultReceiver

{

Q\_OBJECT

public:

static const int RESULT\_OK = -1;

static const int REQUEST\_IMAGE\_CAPTURE = 1;

static const int REQUEST\_TAKE\_PHOTO = REQUEST\_IMAGE\_CAPTURE;

enum ImgOrientation {ORIENTATION\_UNDEFINED = 0, ORIENTATION\_NORMAL = 1, ORIENTATION\_FLIP\_HORIZONTAL = 2, ORIENTATION\_ROTATE\_180 = 3, ORIENTATION\_FLIP\_VERTICAL = 4, ORIENTATION\_TRANSPOSE = 5,

ORIENTATION\_ROTATE\_90 = 6, ORIENTATION\_TRANSVERSE = 7, ORIENTATION\_ROTATE\_270 = 8};

void handleActivityResult(int receiverRequestCode, int resultCode, const QAndroidJniObject &data) override;

static QImage aBitmapToQImage(const QAndroidJniObject &aBitmap);

static QImage camThumbnailToQImage(const QAndroidJniObject &data);

ImgOrientation needRotateAtRightAngle();

QImage camImageToQImage();

static void applyOrientation(QImage &img, const ImgOrientation &orientation);

explicit CamShot(QObject \*parent = nullptr):QObject(parent),QAndroidActivityResultReceiver(){}

~CamShot();

private:

QAndroidJniObject tempImgURI;

QAndroidJniObject tempImgFile;

QAndroidJniObject tempImgAbsPath;

bool \_thumbnailNotFullScaleRequested;

public slots:

void aMakeShot(const bool &thumbnailNotFullScale = false);

signals:

void createNew(const QImage &img);

};

#endif // CAMSHOT\_H

```

Заголовочный файл (.cpp) класса имеет вид:

```

QImage CamShot::aBitmapToQImage(const QAndroidJniObject &aBitmap){

if (!aBitmap.isValid())

return QImage();

jint aBitmapWidth = aBitmap.callMethod("getWidth");

jint aBitmapHeight = aBitmap.callMethod("getHeight");

QAndroidJniEnvironment env;

const int32\_t aBitmapPixelsCount = aBitmapWidth \* aBitmapHeight;

jintArray pixels = env->NewIntArray(aBitmapPixelsCount);

jint aBitmapOffset = 0;

jint aBitmapStride = aBitmapWidth;

jint aBitmapX = 0;

jint aBitmapY = 0;

aBitmap.callMethod("getPixels","([IIIIIII)V", pixels, aBitmapOffset, aBitmapStride, aBitmapX, aBitmapY, aBitmapWidth, aBitmapHeight);

jint \*pPixels = env->GetIntArrayElements(pixels, nullptr);

QImage img(aBitmapWidth, aBitmapHeight, QImage::Format\_ARGB32);

int lineSzB = aBitmapWidth \* sizeof(jint);

for (int i = 0; i < aBitmapHeight; ++i){

uchar \*pDst = img.scanLine(i);

const uchar \*pSrc = reinterpret\_cast(pPixels + aBitmapWidth \* i + aBitmapWidth);

memcpy(pDst, pSrc, lineSzB);

}

env->DeleteLocalRef(pixels); //env->ReleaseIntArrayElements(pixels, pPixels, 0); отвязывает указатель на данные массива от массива, а надо удалить сам массив, поэтому DeleteLocalRef.

return img;

}

QImage CamShot::camThumbnailToQImage(const QAndroidJniObject &data){

//Получить дополнительный данные

QAndroidJniObject bundle = data.callObjectMethod("getExtras","()Landroid/os/Bundle;");

qDebug()<<"bundle.isValid() "< миниатюры - объекта типа Bitmap (Java)

QAndroidJniObject bundleKey = QAndroidJniObject::fromString("data");

//Получить по ключу "data" дополнительный данные: миниатюру в виде объекта Bitmap

const QAndroidJniObject aBitmap (data.callObjectMethod("getParcelableExtra", "(Ljava/lang/String;)Landroid/os/Parcelable;", bundleKey.object()));

qDebug()<<"aBitmap.isValid() "<());

qDebug()<<"bitmap.isValid() "<("delete");

return img;

}

CamShot::ImgOrientation CamShot::needRotateAtRightAngle(){

//Вызов конструктора объекта

QAndroidJniObject exifInterface = QAndroidJniObject("android/media/ExifInterface","(Ljava/lang/String;)V",

tempImgAbsPath.object());

qDebug() << \_\_FUNCTION\_\_ << "exifInterface.isValid()=" << exifInterface.isValid();

QAndroidJniObject TAG\_ORIENTATION = QAndroidJniObject::getStaticObjectField("android/media/ExifInterface", "TAG\_ORIENTATION");

qDebug() << \_\_FUNCTION\_\_ << "TAG\_ORIENTATION.isValid()=" << TAG\_ORIENTATION.isValid()<("getAttributeInt","(Ljava/lang/String;I)I",TAG\_ORIENTATION.object(),static\_cast(ORIENTATION\_UNDEFINED));

return static\_cast(orientation);

}

void CamShot::applyOrientation(QImage &img, const ImgOrientation &orientation){

switch (orientation){

case ORIENTATION\_UNDEFINED:

case ORIENTATION\_NORMAL:

break;

case ORIENTATION\_FLIP\_HORIZONTAL:{

img = img.mirrored(true, false);

break;

}

case ORIENTATION\_ROTATE\_180:

Aux::rotateImgCW180(img);

break;

case ORIENTATION\_FLIP\_VERTICAL:{

img = img.mirrored(false, true);

break;

}

case ORIENTATION\_TRANSPOSE:{

img = img.mirrored(true, false);

Aux::rotateImgCW270(img);

break;

}

case ORIENTATION\_ROTATE\_90:

Aux::rotateImgCW90(img);

break;

case ORIENTATION\_TRANSVERSE:{

img = img.mirrored(true, false);

Aux::rotateImgCW90(img);

break;

}

break;

case ORIENTATION\_ROTATE\_270:

Aux::rotateImgCW270(img);

break;

}

}

void CamShot::handleActivityResult(int receiverRequestCode, int resultCode, const QAndroidJniObject &data){

if ( receiverRequestCode == REQUEST\_IMAGE\_CAPTURE && resultCode == RESULT\_OK )

{

if (\_thumbnailNotFullScaleRequested){

const QImage thumbnail (camThumbnailToQImage(data));

if (!thumbnail.isNull())

emit createNew(thumbnail);

return;

}

const ImgOrientation orientation = needRotateAtRightAngle();

QImage image (camImageToQImage());

if (!image.isNull()){

applyOrientation(image, orientation);

emit createNew(image);

}

}

}

void CamShot::aMakeShot(const bool &thumbnailNotFullScale) {

QAndroidJniObject action = QAndroidJniObject::fromString("android.media.action.IMAGE\_CAPTURE");

//Вызов конструктора объекта

QAndroidJniObject intent=QAndroidJniObject("android/content/Intent","(Ljava/lang/String;)V",

action.object());

qDebug() << \_\_FUNCTION\_\_ << "intent.isValid()=" << intent.isValid();

\_thumbnailNotFullScaleRequested = thumbnailNotFullScale;

if (thumbnailNotFullScale) {

//Для получения миниатюры

QtAndroid::startActivity(intent, REQUEST\_IMAGE\_CAPTURE, this);

return;

}

//Для получения изображения в файл

QAndroidJniObject context = QtAndroid::androidContext();

QString contextStr (context.toString());

qDebug() <<"Context: "<());

qDebug() << \_\_FUNCTION\_\_ << "sharedFolder.isValid()=" << sharedFolder.isValid()<("mkdirs");

Q\_UNUSED(sharedFolderCreated);

//Прежде чем пытаться создать файл с заданным именем, нужно проверить файл с этим именем на существование

//Предположительно путь к этому файлу

QAndroidJniObject suggestedFilePath = QAndroidJniObject::fromString(extDirAbsPathStr+"/"+"\_tmp.jpg");

qDebug() << \_\_FUNCTION\_\_ << "suggestedFilePath.isValid()=" << suggestedFilePath.isValid()<());

qDebug() << \_\_FUNCTION\_\_ << "fileExistsCheck.isValid()=" << tempImgFile.isValid()<("delete");

Q\_UNUSED(deleted);

}

//Создать физический файл для записи в него изображения по указанному пути

const jboolean fileCreated = tempImgFile.callMethod("createNewFile");

Q\_UNUSED(fileCreated);

//Абсолютный путь к созданному файлу в виде строки

tempImgAbsPath = tempImgFile.callObjectMethod("getAbsolutePath","()Ljava/lang/String;");

qDebug() << \_\_FUNCTION\_\_ << "tempImgAbsPath.isValid()=" << tempImgAbsPath.isValid()<(), QAndroidJniObject::fromString(contextFileProviderStr).object(), tempImgFile.object());

qDebug() << \_\_FUNCTION\_\_ << "tempImgURI.isValid()=" << tempImgURI.isValid()<(), tempImgURI.object());

qDebug() << \_\_FUNCTION\_\_ << "intent.isValid()=" << intent.isValid();

QtAndroid::startActivity(intent, REQUEST\_IMAGE\_CAPTURE, this);

}

```

Так-же статические методы класса **Aux** для поворота изображения.

Заголовочный файл (.h) класса **Aux** имеет вид:

```

#ifndef AUXFUNC_H

#define AUXFUNC_H

#include

#include

#include

#include

#include

#include

class Aux

{

public:

static void resizeCenteredImg(QImage \*image, const QSize &newSize, const QColor bgColor);

static void rotateImg(QImage &img, qreal degrees);

static void rotateImgCW90(QImage &img);

static void rotateImgCW180(QImage &img);

static void rotateImgCW270(QImage &img);

};

#endif // AUXFUNC\_H

```

Файл исходного кода (.cpp) класса **Aux** имеет вид:

```

void Aux::resizeCenteredImg(QImage *image, const QSize &newSize, const QColor bgColor){

if (image->size() == newSize)

return;

const QSize szDiff = newSize - image->size();

QImage newImage(newSize, QImage::Format_ARGB32);

newImage.fill(bgColor);

QPainter painter(&newImage);

painter.drawImage(QPoint(szDiff.width()/2, szDiff.height()/2), *image);

*image = newImage;

}

void Aux::rotateImg(QImage &img, qreal degrees){

QPoint center = img.rect().center();

QMatrix matrix;

matrix.translate(center.x(), center.y());

matrix.rotate(degrees);

img = img.transformed(matrix, Qt::SmoothTransformation);

}

void Aux::rotateImgCW90(QImage &img){

const int w = img.width();

const int h = img.height();

const int maxDim = std::max(w, h);

resizeCenteredImg(&img, QSize(maxDim, maxDim), Qt::white);

rotateImg(img, 90);

resizeCenteredImg(&img, QSize(h, w), Qt::white);

}

void Aux::rotateImgCW180(QImage &img){

rotateImg(img, 180);

}

void Aux::rotateImgCW270(QImage &img){

const int w = img.width();

const int h = img.height();

const int maxDim = std::max(w, h);

resizeCenteredImg(&img, QSize(maxDim, maxDim), Qt::white);

rotateImg(img, 270);

resizeCenteredImg(&img, QSize(h, w), Qt::white);

}

```

Указанный метод позволяет получить за один раз или миниатюру или полноразмерное изображение.

Результат зависит от переданного логического параметра «**thumbnailNotFullScale**». Если он равен логической единице, то будет получена миниатюра, если логическому нулю, то полноразмерное изображение. Попытка получить миниатюру при запросе сохранения полноразмерного изображения в файл приведёт к исключению в JNI-вызовах.

Если миниатюра всегда ориентирована правильно, то полноразмерное изображение направлено в одну строну и его необходимо поворачивать. Информацию о необходимых преобразованиях можно получить из exif-свойств изображения при помощи [ExifInterface](https://developer.android.com/reference/android/media/ExifInterface). В обнаруженных в интернете [Java-примерах](https://stackoverflow.com/questions/14066038/why-does-an-image-captured-using-camera-intent-gets-rotated-on-some-devices-on-a) преобразование к нормальной ориентации производится в Java-коде, в случае с Qt нет смысла мучить себя трудно отлаживаемыми, громоздкими JNI-вызовами и проще выполнить все необходимые преобразования в Qt.

|

https://habr.com/ru/post/544614/

| null |

ru

| null |

# Поделки из нерабочих HDD — мини-помпа

Понадобилась мне как-то для будущих самоделок водяная помпа. Да не простая — с ограничениями по габаритам — толщина до 25мм, ширина до 50мм (длина — уже можно варьировать). Из желаемых характеристик — напор 1м и расход 100л/ч. Не найдя в продажах желаемого (в основном — по габаритам), по своей ~~упоротой~~упорной натуре приступил к реализации своего решения данного вопроса!

**Внимание — много фото!**

#### «Мозги» и немного предыстории:

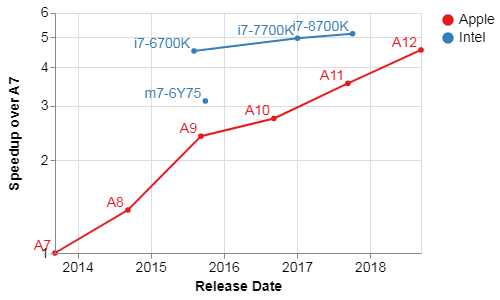

Строго говоря, идея использовать для помп моторчики HDD не нова. C 2009 года ведётся целая ветка на [одном известном форуме](https://forums.overclockers.ru/viewtopic.php?f=47&t=331512). Так что изначально был нацелен на изготовление помпы из «ноутбучного» жёсткого диска и поиска подходящего драйвера c интегрированными силовыми ключами и бессенсорным управлением.

Но «из коробки» перенять опыт мне не удалось. Череда тестов с разными драйверами (MTD6501C, DRV11873 и ряда прочих китайских поделок) давали неутешительный итог: более крупные моторы от 3.5 дисков работают идеально. А вот с мелкими моторами в лучшем случае удается запустить единицы, и те работают крайне нестабильно. С таким неутешительным результатом давняя идея была заброшена и находилась на грани забвения.

Но относительно недавно наткнулся на довольно любопытный драйвер от TI — [DRV10987](http://www.ti.com/lit/ds/symlink/drv10987.pdf). При своих скромных габаритах обладает довольно внушительным потенциалом:

* Рабочее напряжение от 6v до 28v

* Интегрированный понижающий преобразователь на 5v (можно запитать МК для управления)

* Постоянный рабочий ток до 2А (пиковый — 3А)

* Огромное число программно определяемых параметров (задание значений конфигурационных регистров по шине I2C) для управления работой мотора

* Автоматический перезапуск мотора после аварийной остановки / сбое (если условия возникновения сбоя прошли)

* Защита от перегрузки по току

* Защита от перенапряжения

* Детектирование остановки/блокировки ротора

* Отключение при перегреве контроллера

Вооружившись *ардуинкой* (да простят меня за это ругательное слово местные электронщики) для задания параметров, изготовленной ЛУТом платой под данный драйвер, углубился в опыты по запуску моторчиков. Что же, данный контроллер меня не разочаровал! Несмотря на примененный метод «научного тыка» при подборе параметров, удалось найти подход к любому мотору от HDD!

Помог мне в этом самописный [**онлайн-конфигуратор настроек**](http://f0319644.xsph.ru/). Пользуйтесь на здоровье!)

**Вот скетч по заливке параметров через ардуино:**

```

#include

#include

#define I2C\_DRV10983\_Q1\_ADR 0x52

#define Fault\_Reg 0x00

#define MotorSpeed\_Reg 0x01

#define DeviceIDRevisionID\_Reg 0x08

#define SpeedCtrl\_Reg 0x30

#define EEPROM\_Access\_Code\_Reg 0x31

#define EEPROM\_EeReady\_Reg 0x32

#define EEPROM\_Iindividual\_Access\_Adr\_Reg 0x33

#define EEPROM\_Individual\_Access\_Data\_Reg 0x34

#define EEPROM\_Access\_Reg 0x35

#define EECTRL\_Reg 0x60

void setup() {

Serial.begin(9600);

Wire.begin();

}

byte readByAdress(byte reg\_adr, unsigned int &result) { //I2C write 2-byte register

byte i = 0, err = 0;

byte bytes[2] = {0, 0};

Wire.beginTransmission(I2C\_DRV10983\_Q1\_ADR);

Wire.write(reg\_adr);

err = Wire.endTransmission();

if(err!=0)

return err;

Wire.requestFrom(I2C\_DRV10983\_Q1\_ADR, 2);

while(Wire.available())

{

bytes[i] = Wire.read();

i++;

}

result = ((bytes[0] << 8) | bytes[1]);

return 0;

}

byte writeByAdress(byte reg\_adr, unsigned int value) { //I2C read 2-byte register

byte bytes[2];

bytes[1] = value & 0xFF;

bytes[0] = (value >> 8) & 0xFF;

Wire.beginTransmission(I2C\_DRV10983\_Q1\_ADR);

Wire.write(reg\_adr);

Wire.write(bytes,2);

return Wire.endTransmission();

}

boolean flag = true;

void loop() {

if(flag){

unsigned int onReady = 0;

writeByAdress(EECTRL\_Reg, 0xFFFF);

writeByAdress(EEPROM\_Access\_Code\_Reg, 0x0000); //Reset EEPROM\_Access\_Code\_Reg

writeByAdress(EEPROM\_Access\_Code\_Reg, 0xC0DE); //Set EEPROM\_Access\_Code\_Reg

while(onReady == 0){ // Wait EEPROM ready

readByAdress(EEPROM\_EeReady\_Reg, onReady);

}

Serial.println("EEPROM\_Access.");

onReady = 0;

//Write values on shadow registers

//writeByAdress(EEPROM\_Access\_Reg, 0x1000); //Not use EEPROM storage. Store values in shadow registers

writeByAdress(0x90, 0x154F);

writeByAdress(0x91, 0x042C);

writeByAdress(0x92, 0x0090);

writeByAdress(0x93, 0x09EA);

writeByAdress(0x94, 0x3FAF);

writeByAdress(0x95, 0xFC33);

writeByAdress(0x96, 0x016A);

writeByAdress(EEPROM\_Access\_Reg,0x0006); //EEPROM mass access enabled && update

while(onReady == 0 ){ // Wait EEPROM ready

readByAdress(EEPROM\_EeReady\_Reg, onReady);

}

Serial.println("EEPROM\_Update.");

writeByAdress(EECTRL\_Reg, 0x0000); //Run motor

flag = false;

}

}

```

Затем уже были заказаны в поднебесной более презентабельные платки:

После регистрации (ну вот так требуют) можете бесплатно скачать файлы проекта. Или сразу же заказать платы **[здесь](https://www.pcbway.com/project/shareproject/DRV10987___DRV10983_Q1_BLDC_Motor_Driver.html)**.

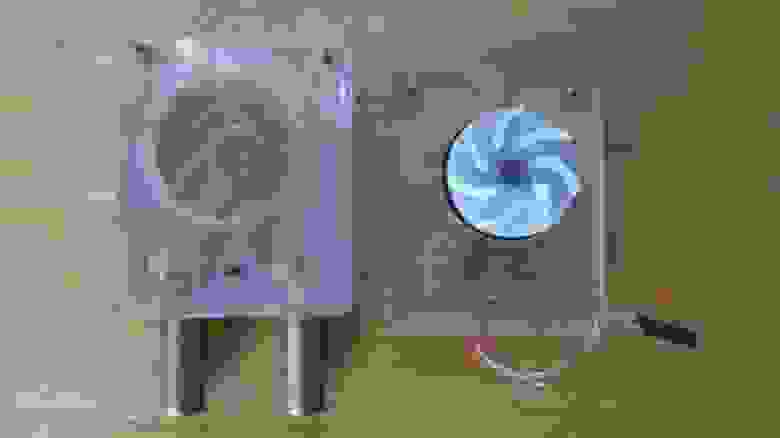

#### О «пересадке сердца»

Осталось дело за малым — достать из корпуса HDD мотор, который кстати говоря, в 2.5 дисках (и в большинстве 3.5) является его неотъемлемой частью. Вкратце можно процесс описать известной фразой "**Пилите, Шура, пилите!**":

*Из фанеры изготавливается внешняя направляющая под коронку по металлу с креплением к корпусу диска. Для сохранности шлейф мотора приклеивается к его основанию, чтобы не был срезан коронкой*

*После высверливания получаем кругляшки с моторчиком. После обработки напильником получаем диаметр основания около 25мм.*

#### Подготовка реципиента к трансплантации:

Мозги и сердце будущей помпы отлично ладят друг с другом и готовы обрести новое место обитания. Так что самое время подумать о корпусе и крыльчатке.

Так как нужно получить при малом рабочем объеме высокое давление, крыльчатку спроектировал с 7 лучами:

*Печать на 3D принтере поликарбонатом*

[3D модель](https://www.dropbox.com/s/zduf1fged3udccm/%D0%9A%D1%80%D1%8B%D0%BB%D1%8C%D1%87%D0%B0%D1%82%D0%BA%D0%B0%20%D0%BF%D0%BB%D0%B0%D1%81%D1%82%D0%B8%D0%BA%207%20%D0%BB%D0%BE%D0%BF%D0%B0%D1%81%D1%82%D0%B5%D0%B9%20V2.stl?dl=0)

Поликарбонат — вещь для корпуса отличная. Но печатать целый корпус им дорого. Куски толстых листов очень трудно найти да и фрезеровка не бесплатна (для меня). Зато у рекламщиков за спасибо можно выпросить обрезки от листов толщиной 4мм и 2мм. Так что корпус проектировался для последующего нарезания лазером деталей и их склейкой в единое целое без необходимости фрезеровки. Потребуется разве что высверливание отверстий под фитинги и гайки.

*Вид 3D модели*

[3D модель](https://www.dropbox.com/s/hcy0j1uma204ffu/%D0%9A%D0%BE%D1%80%D0%BF%D1%83%D1%81%20-%20%D0%B4%D0%B5%D1%82%D0%B0%D0%BB%D0%B8.step?dl=0)

*Набор деталей для склейки «топа» помпы. В местах сопряжения каналов притока и оттока срезаны грани*

#### Ход операции:

Тут хотелось бы сделать лирическое отступление и напомнить желающим повторить и не только, что дихлорэтан, которым проводилась склейка — ~~содержит мало витаминов и вдыхать нужно больше~~ довольно токсичное и летучее вещество. Работы с ним нужно проводить или на открытом воздухе или в хорошо вентилируемом помещении.

*Стек деталей «топа» на сушке после склейки — верх-приток-сепаратор-крыльчатка-ротор. Аналогично склеивается основание для мотора (или изготовить из 6мм куска поликарбоната целиком)*

*После склейки высверливаются отверстия для фитинга — 8мм латунной трубки по насечкам на детали «сепаратор»*

*Старый добрый состав БФ-4 как по мне дает надежную склейку латуни и поликарбоната*

*Тем же клеем приклеивается основание мотора в нижней части помпы. В верхней части рассверливаются (**не** насквозь!) отверстия под вклейку гаек-заклепок М3. И на фото видна прокладка из тонкого силикона*

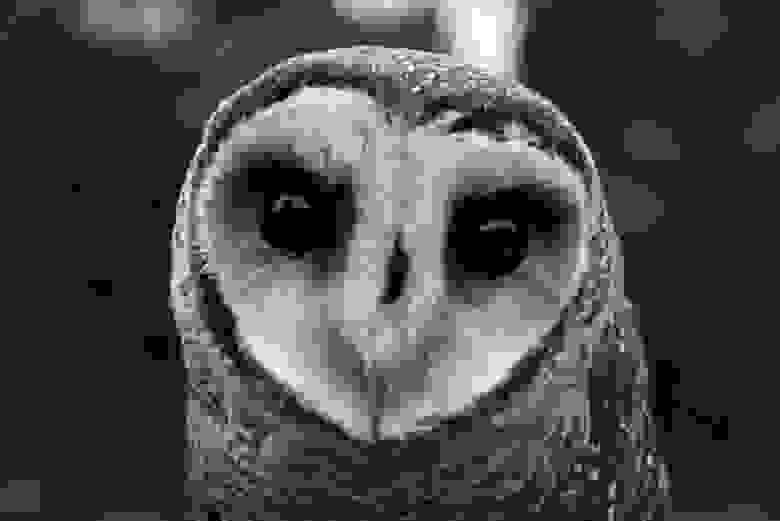

#### Тестирование:

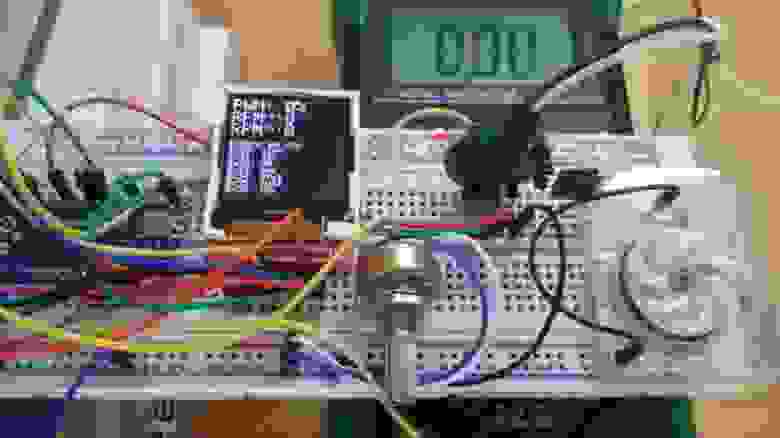

Вот и пришла пора проверить в работе самоделку. Для этого был наскоро собран тестовый стенд. Так как Хабр читают ~~дети~~ серьезные разработчики, у которых внешний вид и состав стенда может вызвать приступы паники, ужаса и дезориентации, хотел его спрятать под спойлер… но надеюсь, всё обойдётся, и потом не говорите, что я вас, уважаемые читатели, не предупреждал!

*Ардуинка подаёт управляющий сигнал PWM, коэффициент заполнения которого задается вручную переменным резистором, считывает значение конфигурационных регистров, а так же определяет скорость вращения как через внутренние регистры драйвера (RPMrg), так и по сигналу FG (RPMfg). Питание мотора — 12v*

*Запуск мотора без нагрузки. Регулировка оборотов и замер энергопотребления*

Мотор успешно стартует от 6% управляющего PWM сигнала. А в конце видео видно, как на высоких оборотах значения скорости во внутреннем регистре «подвисают» на интервале от 10к до 13к оборотов, хотя через выход FG частота фиксируется без изменений.

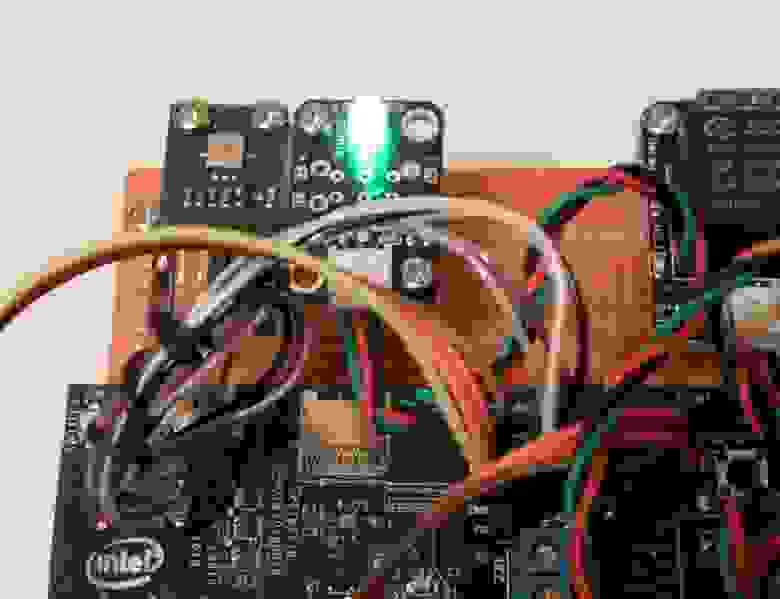

С холостым ходом всё понятно — получили 13к оборотов при напряжении 12v и потреблении 0.16A. Но собиралась водяная помпа, а я тут воздух гоняю. Так что следующий этап — сопровождение домочадцев на улицу, дабы не мешались, и оккупация ванной комнаты!

*Делать замеры и снимать видео у меня, увы, не получилось. Так что обойдемся фото общего плана. К измерительному оборудованию добавились секундомер и банка на 3л*

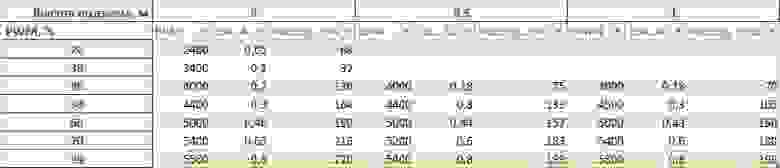

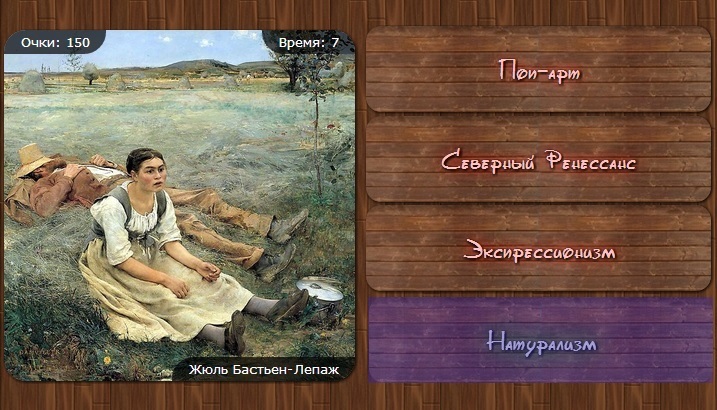

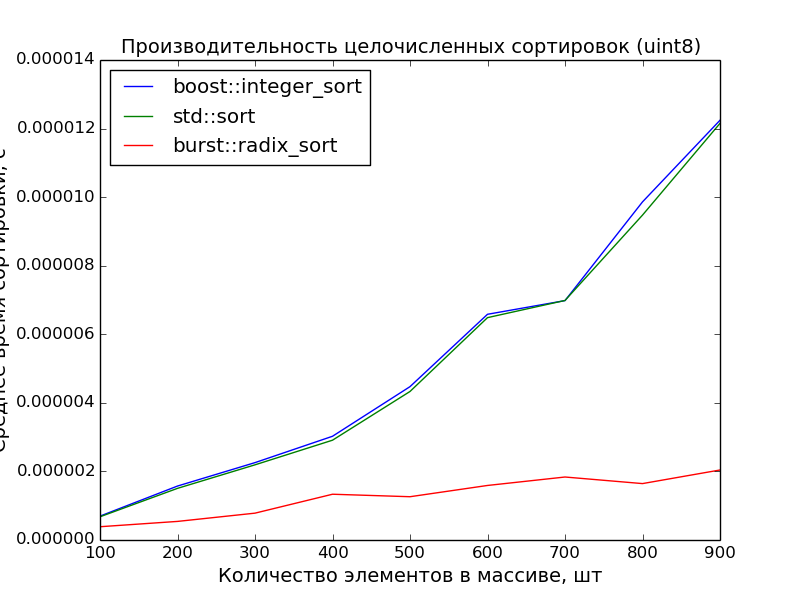

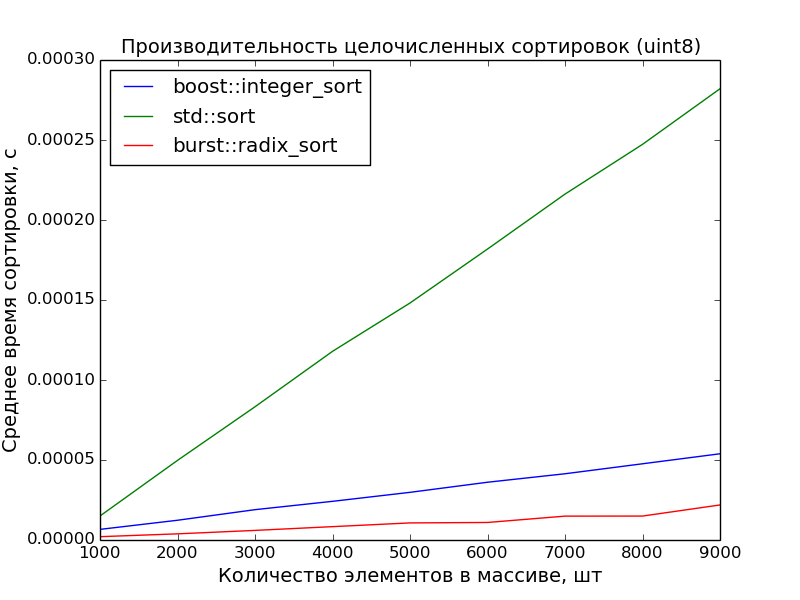

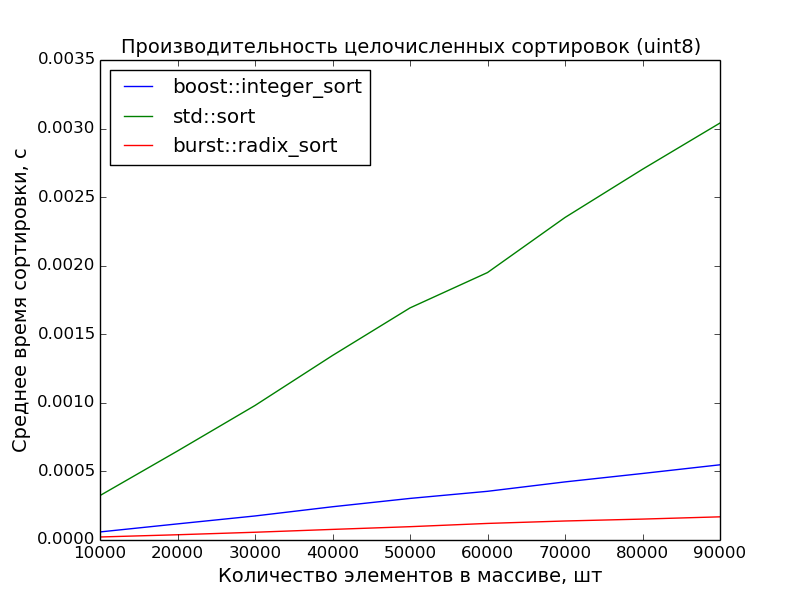

*По итогам замеров получилась вот такая таблица*

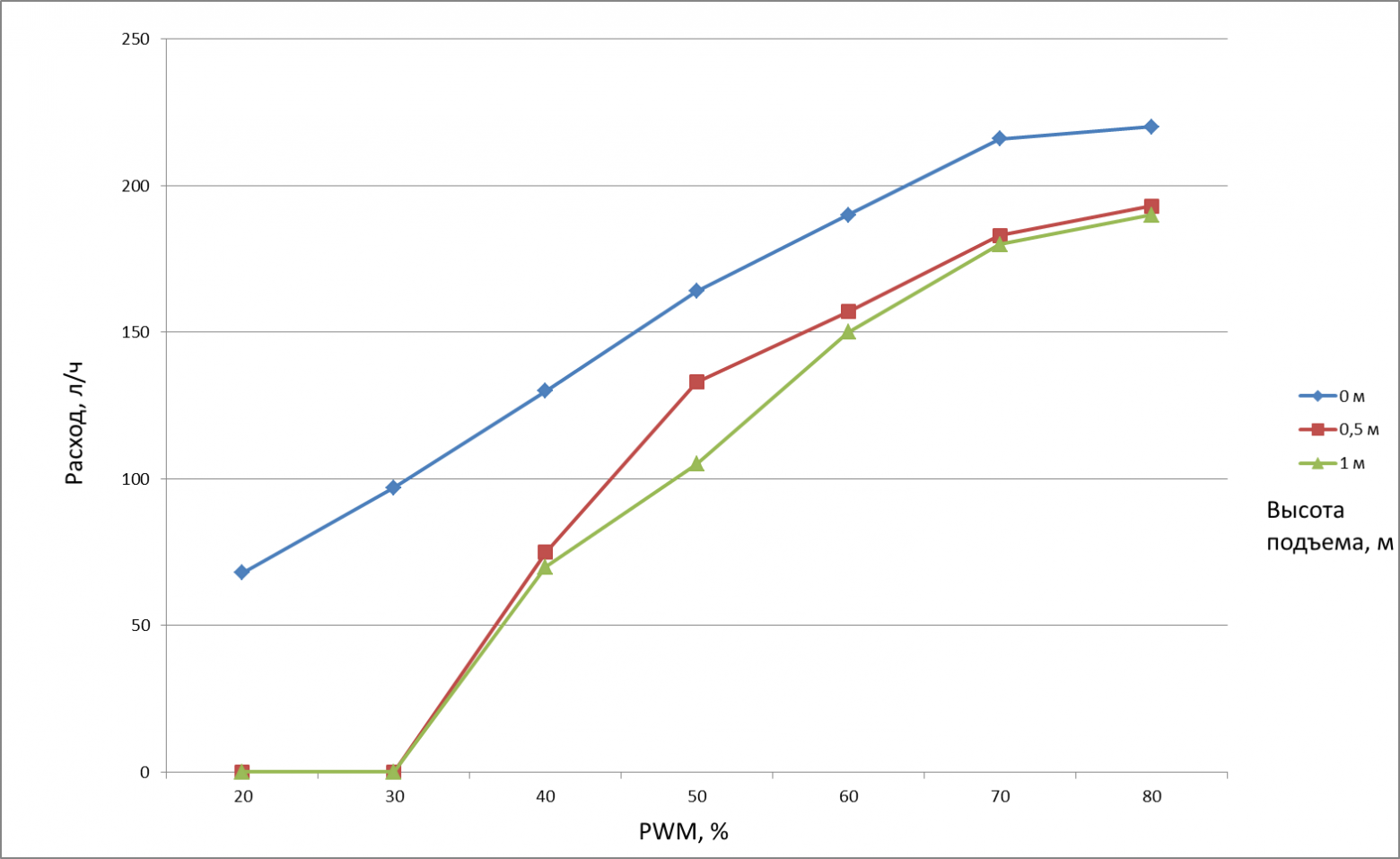

*График расхода*

Как итог — данная поделка целиком удовлетворяет моим требованиям. А в случае поломки, благодаря разборной конструкции и наличию в любых ремонтных мастерских / сервисных центрах ящиков с дохлыми 2.5HDD — починить не составит труда. И путь к дальнейшему построению СВО открыт! Так что продолжение следует!

|

https://habr.com/ru/post/460070/

| null |

ru

| null |

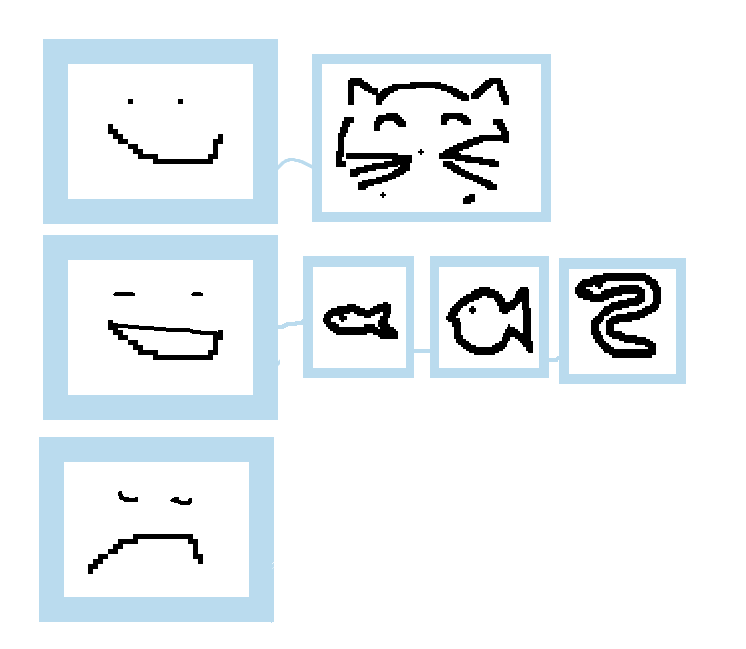

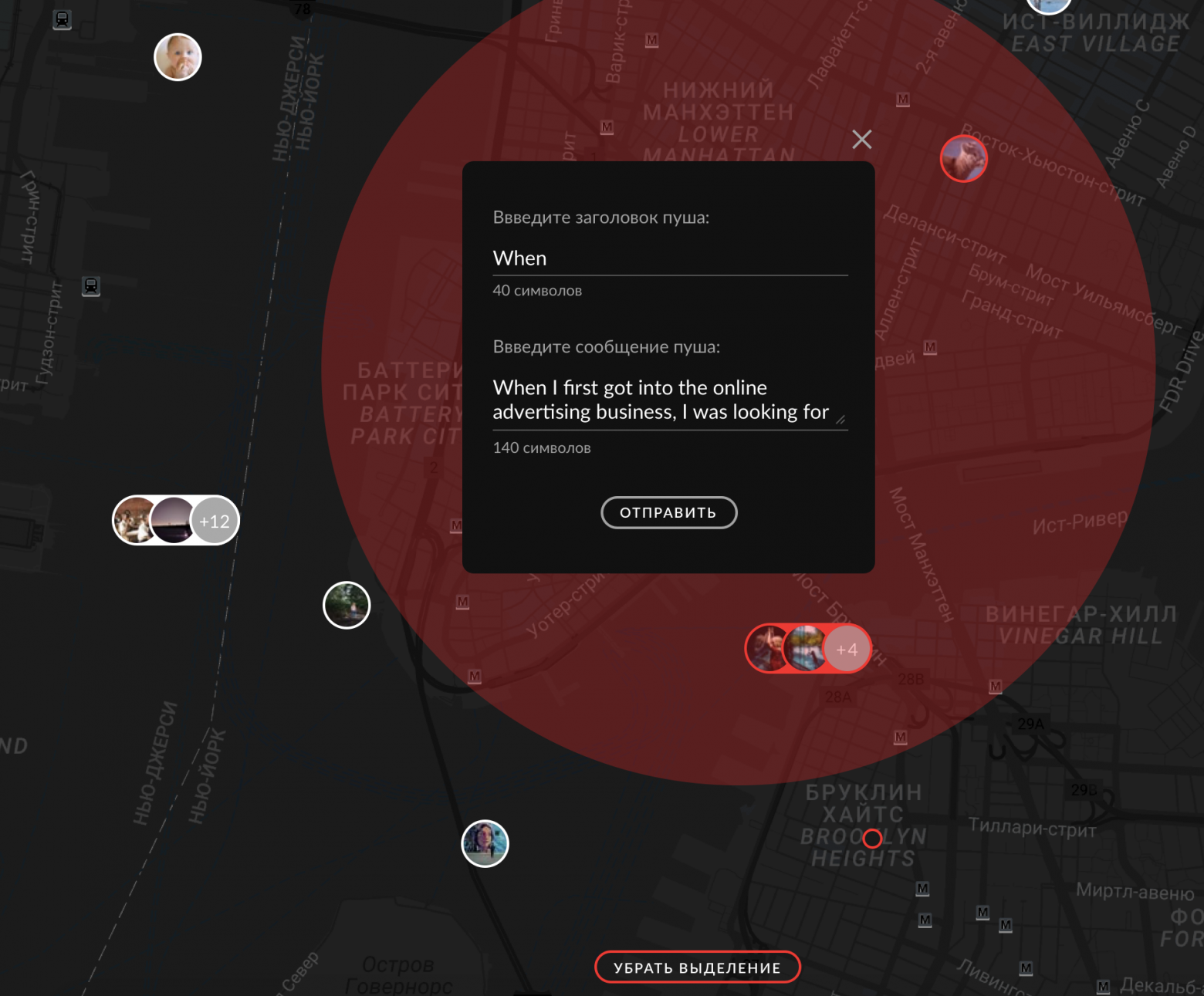

# Don't forget about Open Graph

[Open Graph](http://ogp.me) protocol is a web standard originally developed by Facebook that turns any webpage into a graph object with title, description, image and so on. Even though there is no direct correlation between OG meta tags and improved SEO rankings, it still drives more traffic to your webpage by making it more “attractive” in social networks (Facebook, Twitter, Linkedin, etc).

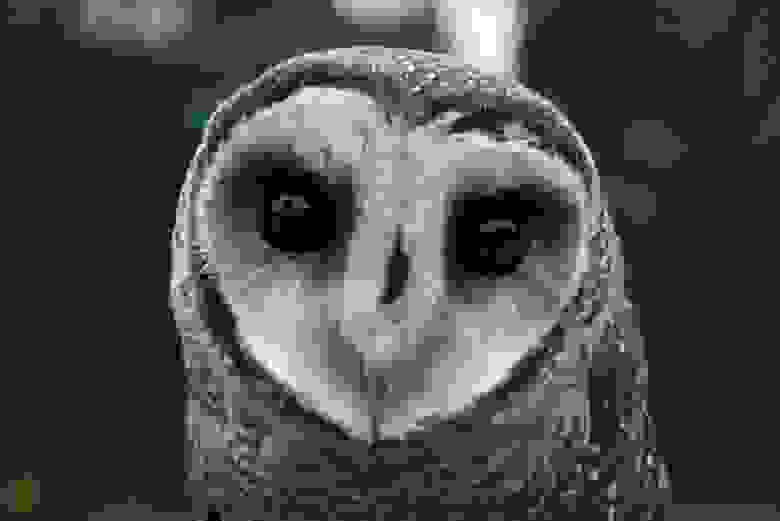

An example of a link shared in Twitter that has «og:image» and «og:title».

### Adding OG (and not only) meta tags into your React app

Without further due let’s jump into newly created React app with `create-react-app` and OG meta tags to `/public/index.html`. It should look like something like this:

```

Awesome App

This app works best with JavaScript enabled.

```

### Dynamic tags

Now, what if I need to generate tags dynamically for every page? That’s easy!

We’ll use [React Helmet](https://github.com/nfl/react-helmet). So let’s create a separate component for document head management, which will dynamically set title, description, image for the page.

```

import React from 'react';

import Helmet from 'react-helmet';

function SEO({ pageProps }) {

return (

{pageProps.title}

)

}

export default SEO;

```

Wherever we want to set our meta tags, we’ll just mount SEO component to necessary arguments just like

|

https://habr.com/ru/post/471604/

| null |

en

| null |

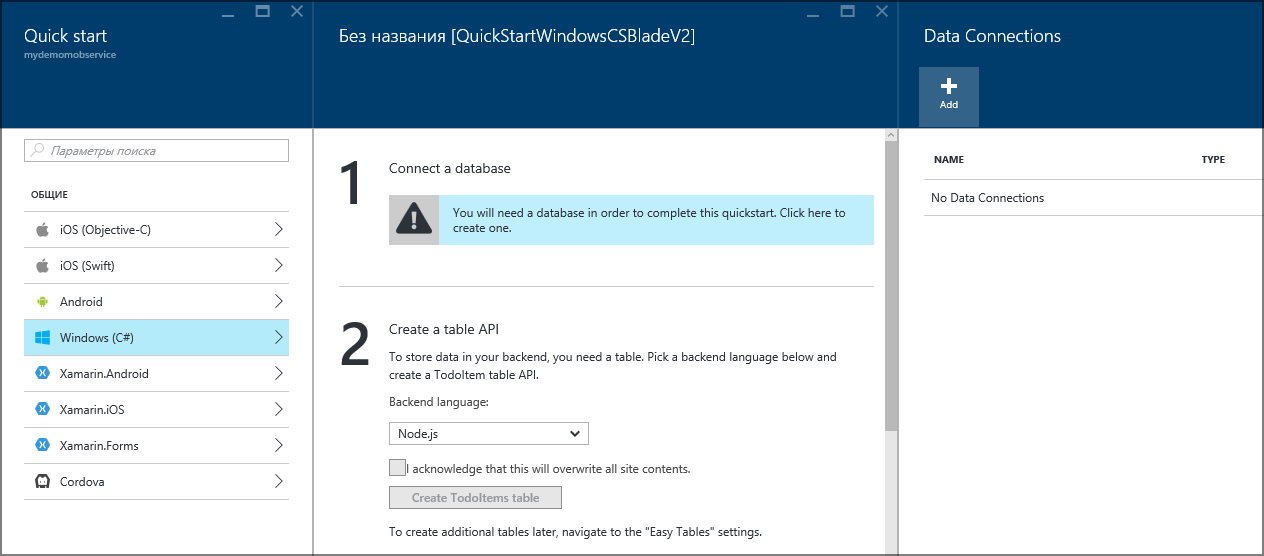

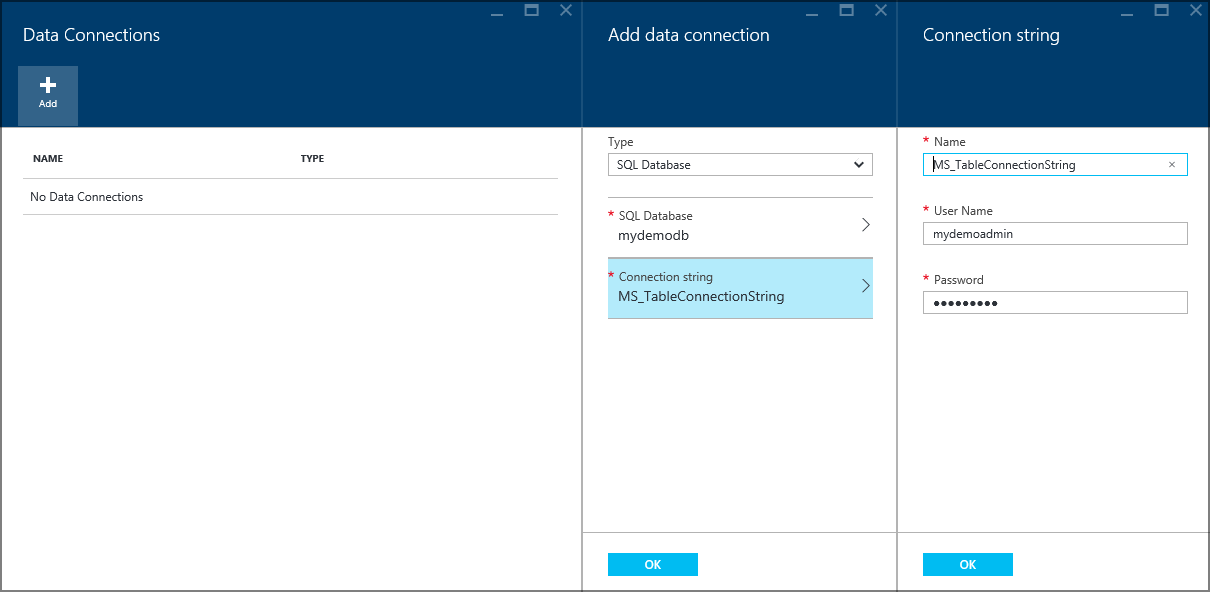

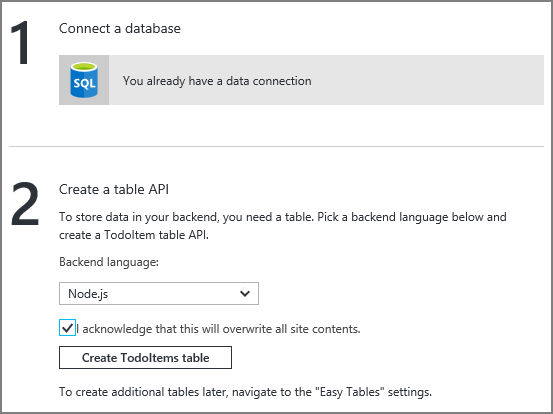

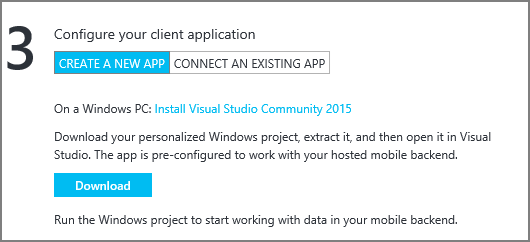

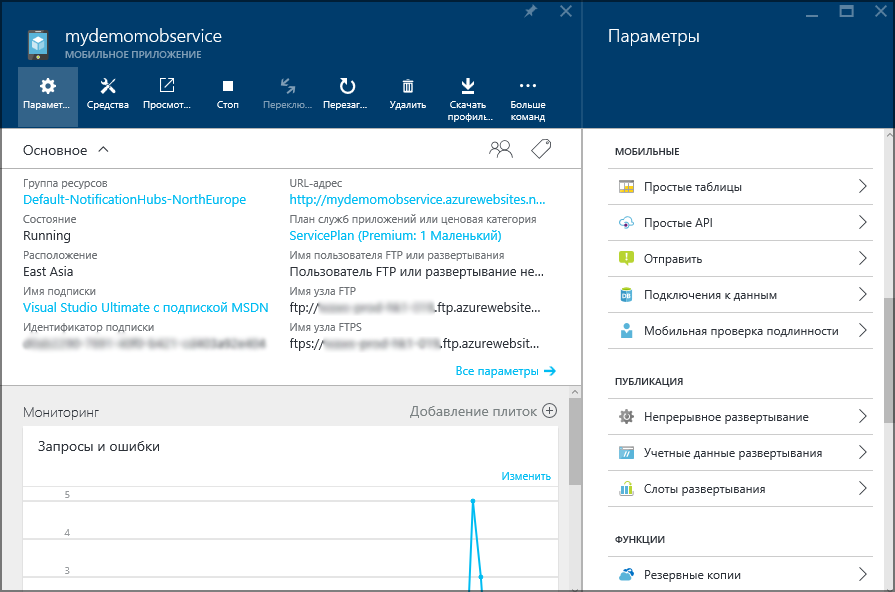

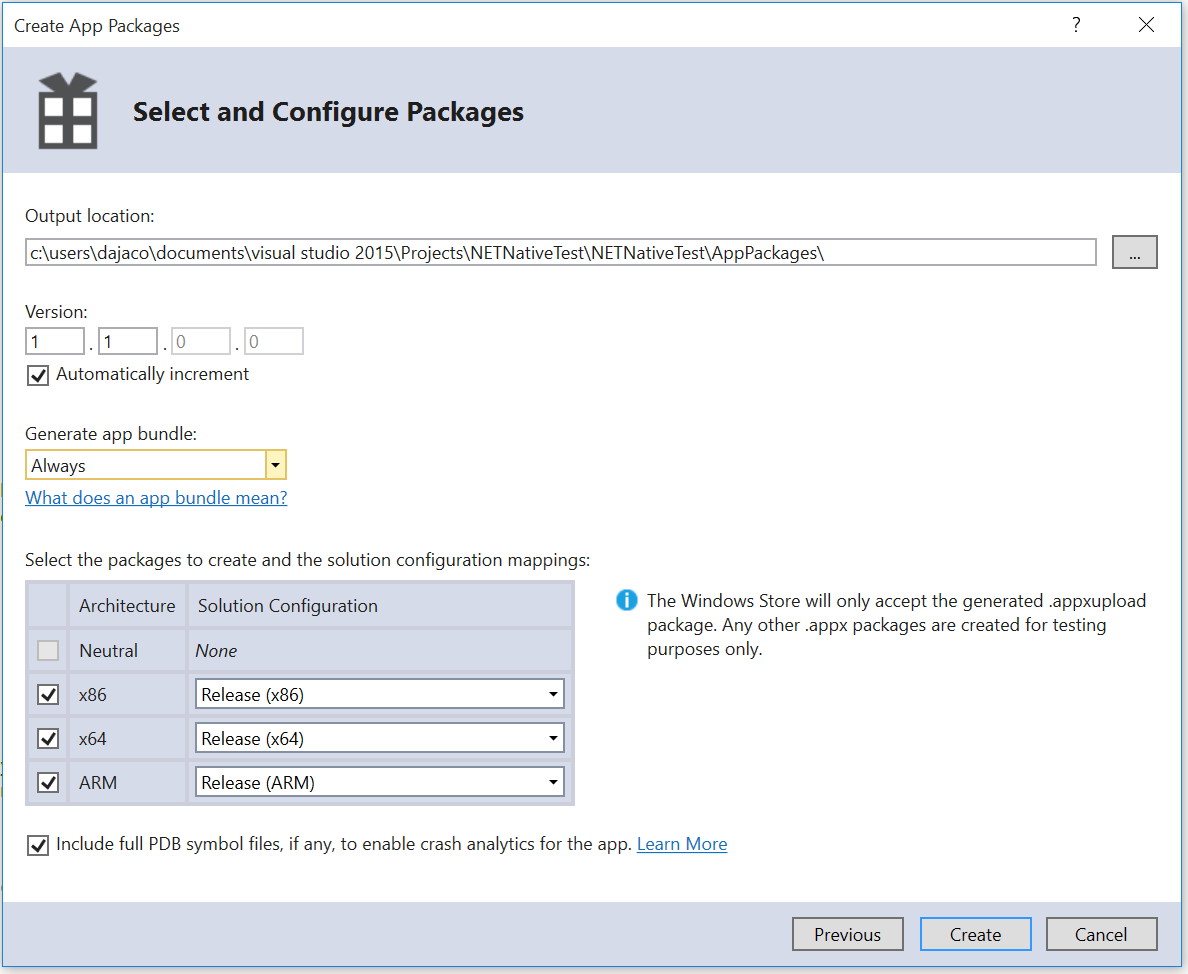

# Intel Edison. Работа с облаком Intel IoT Analytics: управление устройством

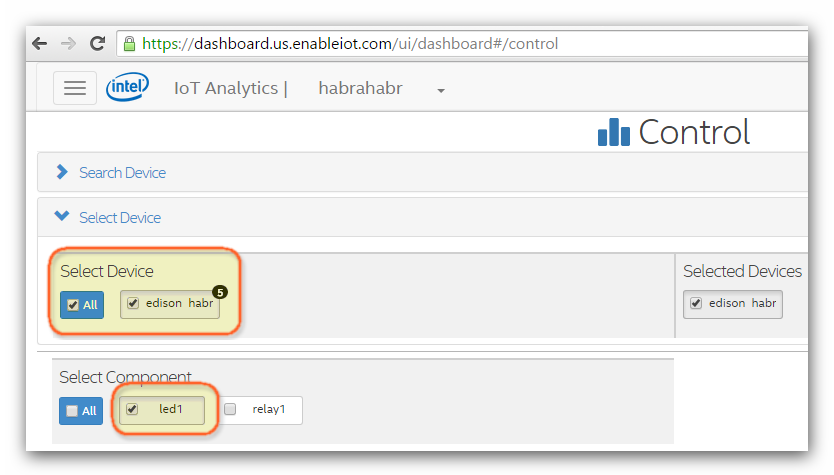

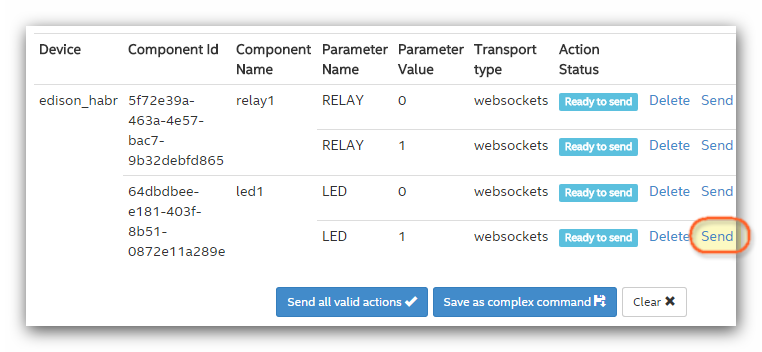

Продолжение работы с облаком [Intel IoT Analytics](https://dashboard.us.enableiot.com), будет посвящена обратной связи с устройством, отправка команд для управления устройством. Первая часть [Intel Edison. Работа с облаком Intel IoT Analytics: регистрация и отправка данных](http://geektimes.ru/post/255578/). Реализуем операции включения/выключения светодиода и реле. Для демонстрации, возьмем стенд из предыдущего поста.

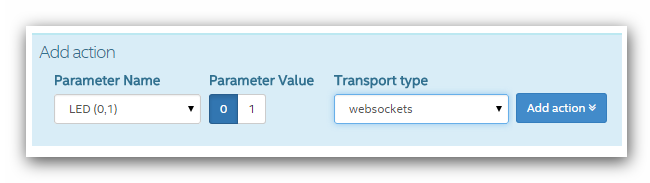

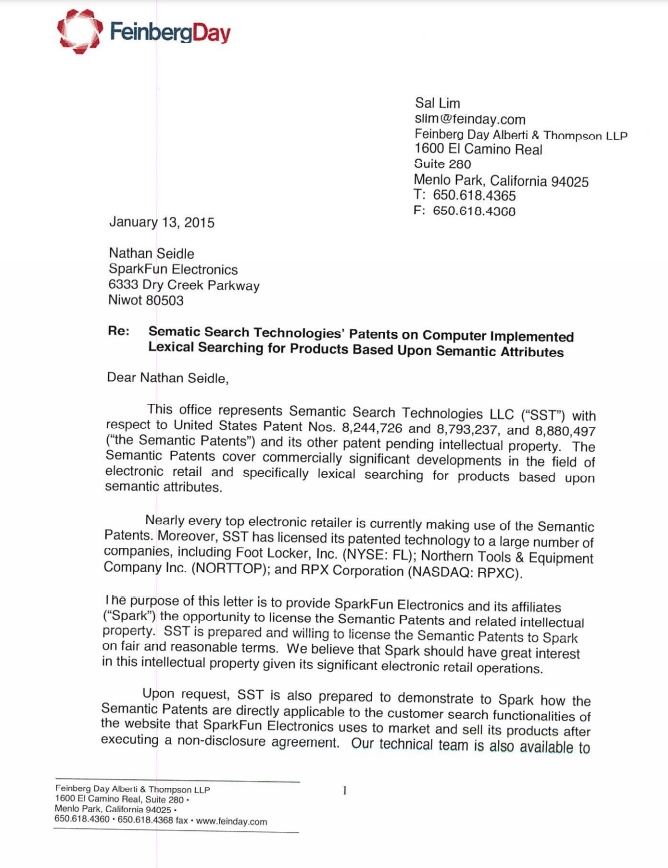

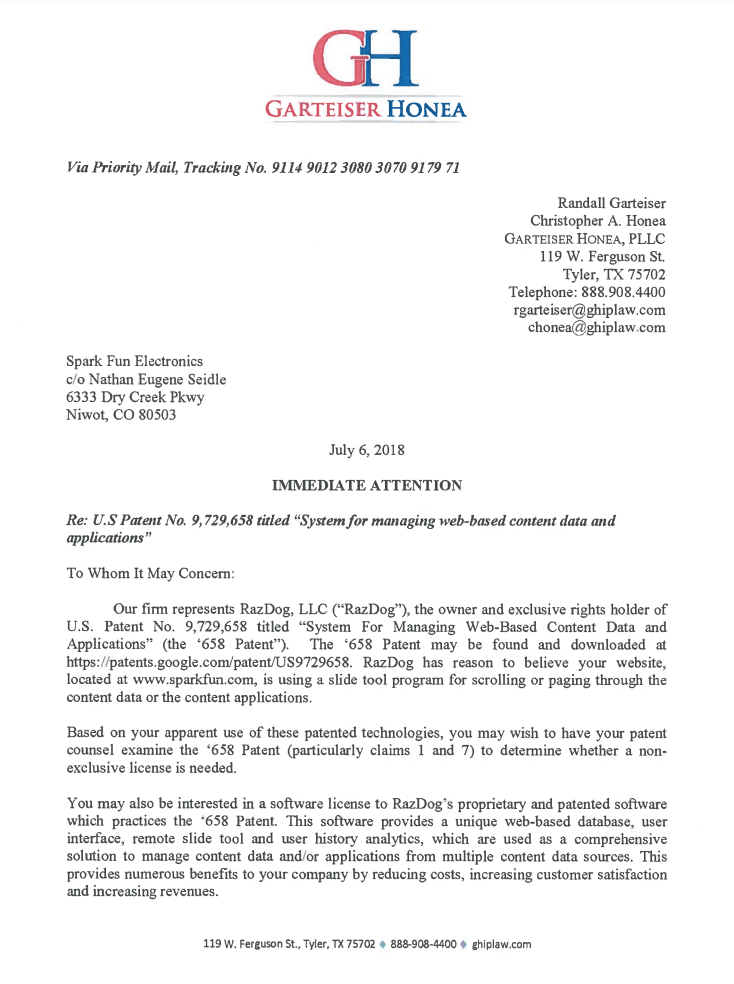

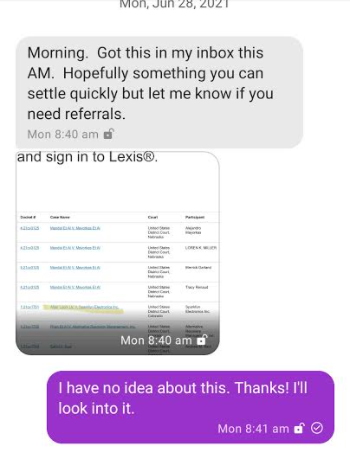

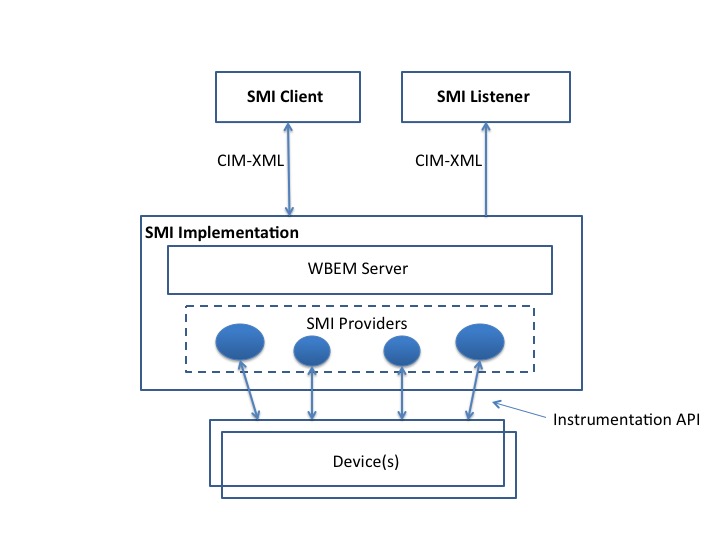

Для отправки команд устройству используется специальный тип компонента — **Actuation**. В предыдущем посте рассматривался тип компонента “sensor”, который позволяет отправлять данные с устройства. **Actuation** передает данные по протоколу MQTT и WebSocket. Этот тип компонента вызывает команду “command String” и для нее параметры имя/значение.

**Регистрация Actuation в облаке Intel IoT Analytics**

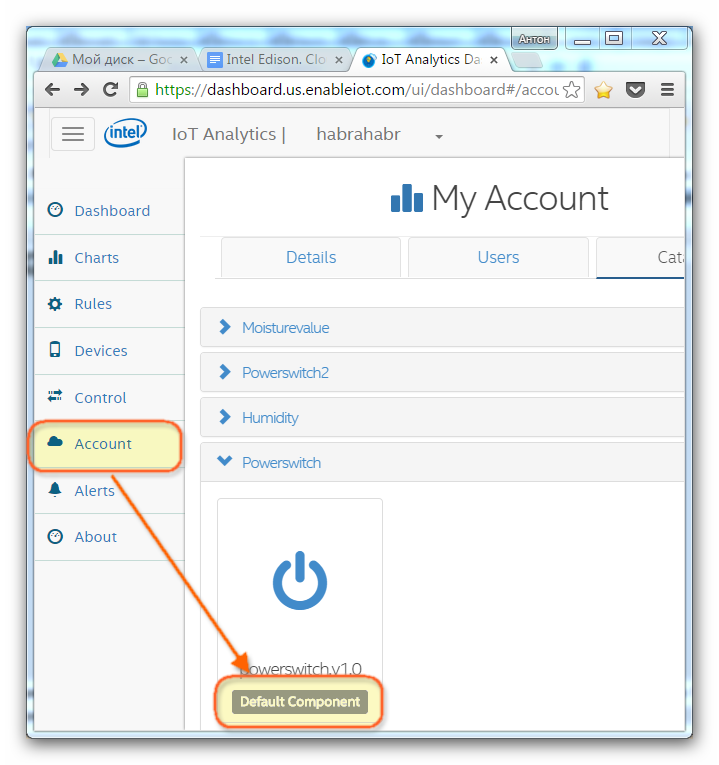

Рассмотрим **Actuation** заданный по умолчанию, который подойдет без изменений для светодиода. Откроем раздел **Account**, раздел **Catalog**, компонент **Powerswitch.v1.0**

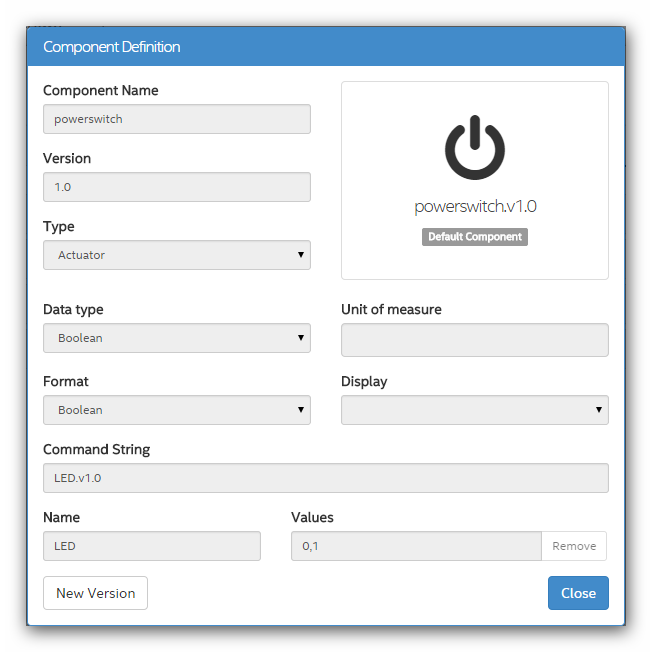

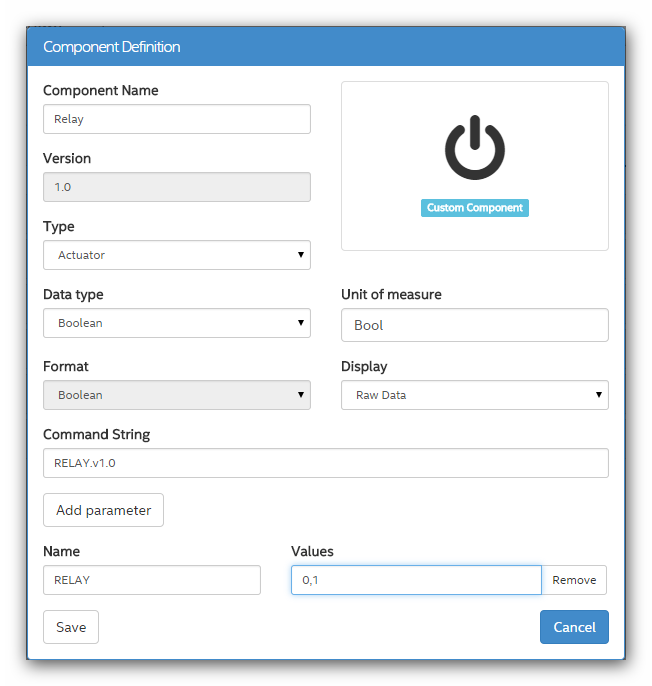

Окно свойств компонента Powerswitch.v1.0

Тип компонента **Actuator**. Т.к. светодиод может быть только в двух состояниях, то тип данных **Boolean**. **LED.v1.0** — команда для светодиода. Ключ/значение, название — **LED**, принимаемое значение **0 или 1**.

Реле является однотипным компонентом со светодиодом, поэтому так же создадим **Actuator** для реле.

Типы компонентов созданы.

**Настройка iotkit agent на Intel Edison**

Теперь требуется зайти по SSH на Intel Edison. В предыдущем посте была выполнена настройка Wi-Fi, поэтому можно подключиться к устройству по ЛВС.

Поддержка компонента **Actuation** заявлена только с версии агента 1.5.2 и выше. Рекомендуется обновить агента до последней актуальной версии.

Узнать версию агента:

# iotkit-admin -V

Команда обновления агента:

# npm update iotkit-agent

В последней версии агента появилась возможность работать по WebSocket. Для работы по WebSocket требуется настроить агента командой:

# iotkit-admin protocol rest+ws

Перевести обратно в режим работы по MQTT:

`# iotkit-admin protocol mqtt`

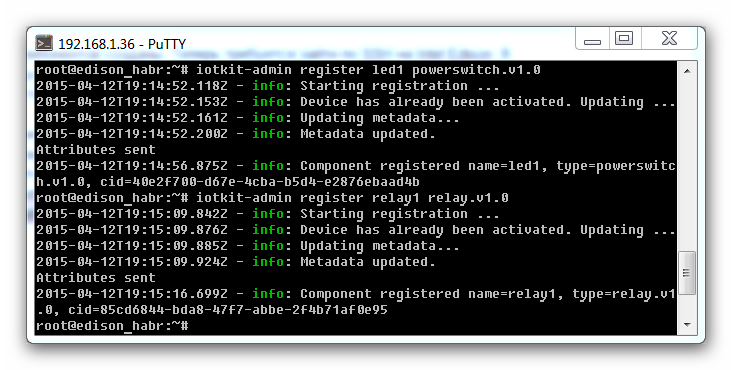

**Выполним регистрацию Actuator для светодиода и реле на Intel Edison.**

Регистрация датчиков выполняется командой **# iotkit-admin register [имя\_датчика] [тип\_датчика]**. Выполним команды:

# iotkit-admin register led1 powerswitch.v1.0

# iotkit-admin register relay1 relay.v1.0

**Подготовка скетча для Arduino**

Компоненты зарегистрированы. Теперь подготовим скетч для Arduino, в качество основы возьмём пример [IoTKitActuationExample](https://github.com/enableiot/iotkit-samples/tree/master/arduino/IoTkit/examples/IoTKitActuationExample)

**Рассмотрим код:**

Функция **void setup()**, ничем не отличается от предыдущего примера.

В функцию **void loop()**, вносится функция для периодической проверки полученных сообщений, где json — указатель на сообщение в формате JSON.

```

void loop() {

iotkit.receive(callback);

delay(5000);

}

```

Функция **void callback(char\* json)**

```

void callback(char* json) {

Serial.println(json);

aJsonObject* parsed = aJson.parse(json);

if (&parsed == NULL) {

// invalid or empty JSON

Serial.println("recieved invalid JSON");

return;

}

```

Если присутствуют поступившие данных, то далее следуем их разбор.

```

aJsonObject* component = aJson.getObjectItem(parsed, "component");

aJsonObject* command = aJson.getObjectItem(parsed, "command");

aJsonObject* argv = aJson.getObjectItem(parsed, "argv");

aJsonObject* argvArray = argv->child;

aJsonObject* name = argvArray->child; // name : on