text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Использование Nginx FastCGI Cache

**FastCGI Cache** — это система кэширования данных реализованая на уровне HTTP-сервера **Nginx**.

Преимущество **FastCGI Cache** заключается в том, что Nginx вернёт закешированный ответ пользователю сразу, как только получит запрос, при этом слой приложения не будет вовсе обрабатывать поступивший HTTP-запрос, если он имеется в кэше Nginx.

Использование FastCGI Cache — отличный способ снизить нагрузку на вашу систему.

Если на вашем сайте есть страницы, которые изменяются редко или задержка обновления информации на некоторое время не критична, то FastCGI Cache именно то, что нужно.

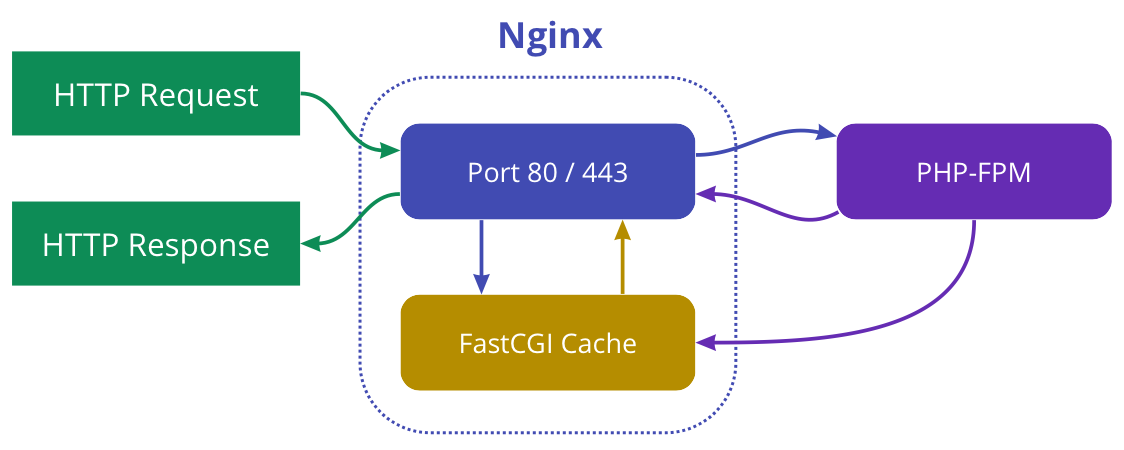

Схема работы Nginx FastCGI Cache

--------------------------------

Если на сервер Nginx пришёл HTTP-запрос и некоторое время назад ответ на такой же запрос был помещён в кэш, то Nginx не станет передавать данный запрос на выполнение PHP-FPM, в место этого Nginx вернёт результат из кэша.

Задача

------

Предположим у нас есть web-система управления полётом на луну, которая написана на PHP. Каждый пользователь должен ввести свой логин и пароль, чтобы войти в систему и оказаться на главной странице космического приложения.

Главная страница нашего ресурса, на которую попадают пользователи прошедшие этап аутентификации, очень популярная. Все пользователи ежедневно многократно просматривают эту страницу. На ней выводится большое количество всевозможных данных. Чтобы сгенерировать эту страницу требуется выполнить порядка тридцати SQL-запросов в различные базы данных.

Важно отметить, у пользователей данные, которые они видят на главной странице могут отличаться.

Нам известно, что информация, которая выводится на этой странице может обновляться с задержкой в один час. Данные не потеряют свою ценность даже есть они немного устареют.

**Что из этого следует?**

* У каждого пользователя, прошедшего аутентификацию должна быть своя версия кэша главной страницы.

* До ввода логина и пароля и после этого главная страница системы выглядит по-разному. Не прошедшие аутентификацию пользователи видят только форму для входа в систему.

* Мы можем хранить данные в кэше в течение 1 часа.

### Решение

Изначально наш виртуальных хост сконфигурирован следующим образом:

```

http {

include /etc/nginx/mime.types;

server {

listen 80;

index index.php index.html;

server_name moon-flight.aero;

error_log /var/log/nginx/moon-flight.aero.error.log;

access_log /var/log/nginx/moon-flight.aero.access.log

root /var/www/moon-flight.aero/public;

location / {

try_files $uri $uri/ /index.php?$query_string;

}

location ~ \.php$ {

try_files $uri =404;

fastcgi_split_path_info ^(.+\.php)(/.+)$;

fastcgi_pass unix:/var/run/php/php7.3-fpm.sock;

fastcgi_index index.php;

include fastcgi_params;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

fastcgi_param PATH_INFO $fastcgi_script_name;

}

}

}

```

Первое, что мы сделаем добавим директиву **fastcgi\_cache\_path** в в контексте **http**.

```

fastcgi_cache_path /tmp/nginx_cache levels=1:2 keys_zone=fastcgicache:10m inactive=70m max_size=512m;

```

Первый аргумент **/tmp/nginx\_cache** определяет место на сервере, где будет сохранён кэш. Папка **/tmp** нам подходит, так как она очищается автоматически при перезапуске сервера. Важно отметить, что всё, что будет хранится в **/tmp/nginx\_cache**так же будет находится в оперативной памяти**.**

Второй аргумент — это уровень подпапок. Мы указали **levels=1:2**. Это означает, что уровень вложенности будет равняться **2**.Нас это устраивает, так как в одной папке у нас не будет большого количества файлов, а значит и замедление доступа к файлам нам не грозит.

Третий аргумент — имя зоны разделяемой памяти кэша. Запись **keys\_zone=fastcgicache:10m** означает, что названием зоны является **fastcgicache,** а **10m** — это размер зоны в мегабайтах. Зона размеров в 10 Мб может хранить данные для примерно 80 000 ключей. Конечно, название зоны может быть другим.

Четвёртый аргумент — **inactive=70m,**определяет интервал времени, после истечении которого данные автоматически удаляются, в случае, если они не используются. Другими словами, если к данным кэша не обращаются в течение времени, заданного параметром **inactive**, то данные удаляются, независимо от их свежести. По умолчанию **inactive** равен **10 минутам**.

Пятый аргумент **max\_size=512m** — устанавливает верхний предел размера кэша. По умолчанию используется всё дисковое пространство. При достижении лимита, Nginx удалит наименее востребованные данные.

Далее мы должны задать ключ для кэширования данных. Это можно сделать при помощи директивы **fastcgi\_cache\_key**. Данная директива может быть указана в контекстах **http**, **server** и **location**.

Укажим в контексте **server**директиву**fastcgi\_cache\_key**:

```

fastcgi_cache_key "$scheme$request_method$host$request_uri$cookie_codeAuth";

```

Здесь мы указали несколько переменных:

— **$scheme**

— **$request\_method**

— **$host**

—**$request\_uri**

— **$cookie\_codeAuth**

Давайте разберёмся с ними подробнее. Нам важно понимать, какие значения будут принимать эти переменные.

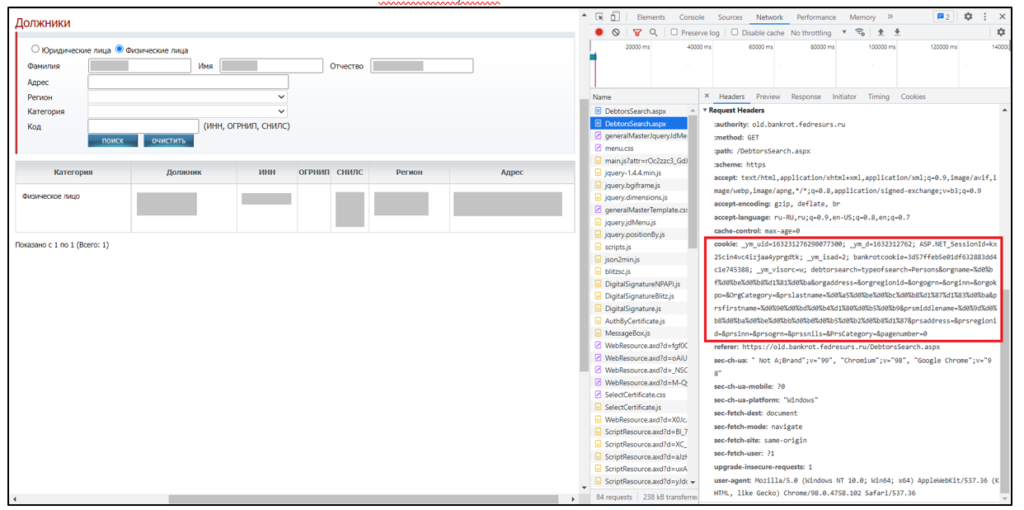

Рассмотрим пример, допустим залогиненный пользователь указал в браузере такой запрос:

`http://moon-flight.aero/search/?query=10`

После выполнения этого запроса **Nginx** присвоит следующие значения нашим переменным:

| | |

| --- | --- |

| **Переменная** | **Значение** |

| $scheme | `http` |

| $request\_method | `GET` |

| $host | `moon-flight.aero` |

| $request\_uri | `/search/?query=10` |

| $cookie\_codeAuth | Будет иметь значение параметра Cookie **codeAuth,** который был передан браузером в заголовках запроса. В вашей системе аналогичная переменная Cookie может называть по-другому. |

В нашем случае у каждого пользователя, который успешно прошёл процедуру аутентификации в Cookie имеется переменная **codeAuth.**Эта переменная определяет активную сессию аутентификации.

Nginx позволяет получать значение переменных Cookie, для этого мы должны использовать такой шаблон`$cookie_имя.`

В нашем примере мы исходим из того, что заголовках HTTP-запроса присутствует подобная строка:

`Cookie: codeAuth=a7e30fbb7f4513redfd22049c6b5dzme306f4e`

Ключ**"$scheme$request\_method$host$request\_uri$cookie\_codeAuth"** выглядит не очень изящно, но ондаёт нам возможность для каждого пользователя, который заходит на страниц сайта сформировать свой собственный кэш. Значение переменной **$cookie\_codeAuth** для каждого залогиненного пользователя будет уникальным.

Двигаемся дальше.

Теперь нам нужно описать условия работы кэша в контексте **server** и определить директивы **fastcgi\_cache**, **fastcgi\_cache\_valid**, **fastcgi\_cache\_bypass** и **fastcgi\_no\_cache** в контексте **location**.

Опишем условия работы нашего кэша в контексте **server**.

**Мы хотим кэшировать:**

* Только главную страницу, то есть переменная **$request\_uri** должна иметь значение `"/"`.

* Запросы типа **GET** и никакие другие. Следовательно значение переменной **$request\_method** должно равняться `GET`.

* Только те запросы, в которых нет **GET** параметров. Значит переменная **$query\_string**должна содержать пустую строку `""`.

Эти **3** условия мы запишем так (в контексте **server**):

```

set $no_cache 0;

if ($request_method != GET) {

set $no_cache 1;

}

if ($query_string != "") {

set $no_cache 1;

}

if ($request_uri != "/") {

set $no_cache 1;

}

```

Теперь определим директивы **fastcgi\_cache**, **fastcgi\_cache\_valid**, **fastcgi\_cache\_bypass** и **fastcgi\_no\_cache** в контексте **location**.

```

fastcgi_cache fastcgicache;

fastcgi_cache_valid 200 60m;

fastcgi_cache_bypass $no_cache;

fastcgi_no_cache $no_cache;

```

**Что значат эти директивы?**

**fastcgi\_cache** — задаёт название зоны разделяемой памяти, используемой для кэширования. Название зоны мы указывали ранее в директиве **fastcgi\_cache\_path**.

**fastcgi\_cache\_valid** — задаёт время кэширования HTTP-кода ответа. В нашем случае мы установили время равно 60 минут для кода 200.

**fastcgi\_cache\_bypass** — задаёт условие, при котором ответ не будет браться из кэша. Если значение непустое или не равно **0**, то ответ не берётся из кэша.

**fastcgi\_no\_cache** — задаёт условия, при котором ответ не будет сохраняться в кэш. Если значение непустое или не равно **0**, то ответ не будет сохранён в кэше.

Файл конфигурации можно сохранить и выполнить команду:

`sudo service nginx reload`

Всё должно работать.

**Но как узнать, что данные кэшируются и мы получаем результат из кэша?**

Очень просто. Нужно добавить специальный заголовок, и передать в него переменную **$upstream\_cache\_status**.

В секцию **server** добавим директиву **add\_header**со следующими параметрами:

```

add_header x-fastcgi-cache $upstream_cache_status;

```

**x-fastcgi-cache**— это название нашего заголовка.

Переменная **$upstream\_cache\_status** может иметь следющие значения:

* MISS

* BYPASS

* EXPIRED

* STALE

* UPDATING

* REVALIDATED

* HIT

Если страница получена из кэша, то вы увидите значение **HIT**.

Финальный файл конфигурации со всеми добавленными директивами будет выглядеть так:

```

http {

include /etc/nginx/mime.types;

fastcgi_cache_path /tmp/nginx_cache levels=1:2 keys_zone=fastcgicache:10m inactive=70m max_size=512m;

server {

listen 80;

index index.php index.html;

server_name moon-flight.aero;

error_log /var/log/nginx/moon-flight.aero.error.log;

access_log /var/log/nginx/moon-flight.aero.access.log

root /var/www/moon-flight.aero/public;

fastcgi_cache_key "$scheme$request_method$host$request_uri$cookie_codeAuth";

set $no_cache 0;

if ($request_method != GET) {

set $no_cache 1;

}

if ($query_string != "") {

set $no_cache 1;

}

if ($request_uri != "/") {

set $no_cache 1;

}

location / {

try_files $uri $uri/ /index.php?$query_string;

}

add_header x-fastcgi-cache $upstream_cache_status;

location ~ \.php$ {

fastcgi_cache fastcgicache;

fastcgi_cache_valid 200 60m;

fastcgi_cache_bypass $no_cache;

fastcgi_no_cache $no_cache;

try_files $uri =404;

fastcgi_split_path_info ^(.+\.php)(/.+)$;

fastcgi_pass unix:/var/run/php/php7.3-fpm.sock;

fastcgi_index index.php;

include fastcgi_params;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

fastcgi_param PATH_INFO $fastcgi_script_name;

}

}

}

```

Полезные команды

----------------

Проверить синтаксис файлов конфигурации Nginx можно следующей командой:

`sudo nginx -t`

Для того, чтобы изменения конфигурации вступили в силу, выполните:

`sudo service nginx reload`

Тестирование производительности при помощи Apache Bench

-------------------------------------------------------

Утилита **Apache Bench** позволяет проверить скорость работы веб-приложения. C помощью Apache Bench можно отправить заданное количество запросов на указанный адрес и при этом определить число запросов, которые будут отправлены одновременно. Так же есть возможность указать требуемые заголовки и передать значения переменных cookies.

Установим **Apache Bench** на виртуальный сервер **Ununtu**.

Выполним команду:

`sudo apt-get update`

Затем:

`sudo apt-get install apache2-utils`

### Условия тестирования

Нам нужно зафиксировать производительность нашей системы управления полётом на луну с выключенным кэшем и с работающим.

**Запуск Apache Bench при выключенном кэше**

Чтобы **FastCGI Cache** перестал работать нужно в нашем файле конфигурации виртуального хоста установить значение переменной **$no\_cache** равным **1**.

После внесения изменений в конфигурацию не забудьте выполнить команду `sudo service nginx reload`

Теперь запустим тестирование. На виртуальном сервере, на котором установлен **Apache Bench** выполним команду:

```

ab -c 5 -n 100 -C "codeAuth=a7e30fbb7f4513redfd22049c6b5dzme306f4e" http://moon-flight.aero

```

На `http://moon-flight.aero` будет отправлено **100** запросов, при этом одновременно будет устанавливаться **5** подключений. Флаг `-C` используется для того, чтобы в запросе содержался параметр cookie **codeAuth**.

Результат:

```

This is ApacheBench, Version 2.3 <$Revision: 1843412 $>

Copyright 1996 Adam Twiss, Zeus Technology Ltd, http://www.zeustech.net/

Licensed to The Apache Software Foundation, http://www.apache.org/

Benchmarking moon-flight.aero (be patient).....done

Server Software: nginx/1.14.0

Server Hostname: moon-flight.aero

Server Port: 80

Document Path: /

Document Length: 31134 bytes

Concurrency Level: 5

Time taken for tests: 2.978 seconds

Complete requests: 100

Failed requests: 0

Total transferred: 3150400 bytes

HTML transferred: 3113400 bytes

Requests per second: 33.58 [#/sec] (mean)

Time per request: 148.878 [ms] (mean)

Time per request: 29.776 [ms] (mean, across all concurrent requests)

Transfer rate: 1033.25 [Kbytes/sec] received

Connection Times (ms)

min mean[+/-sd] median max

Connect: 23 29 5.0 27 50

Processing: 58 112 17.1 113 142

Waiting: 58 112 17.0 113 142

Total: 85 141 16.7 142 176

Percentage of the requests served within a certain time (ms)

50% 142

66% 149

75% 154

80% 159

90% 163

95% 166

98% 170

99% 176

100% 176 (longest request)

```

Потребовалось почти **3 секунды**, чтобы выполнить **100 запросов**. Скорость передачи — **33.58 запросов в секунду**.

**Запуск Apache Bench при работающем кэше**

Чтобы включить кэширование нужно в файле конфигурации виртуального хоста установить значение переменной **$no\_cache** равным **0**.

После внесения изменений в конфигурацию не забудьте выполнить команду `sudo service nginx reload`

Теперь снова запустим тестирование:

```

ab -c 5 -n 100 -C "codeAuth=a7e30fbb7f4513redfd22049c6b5dzme306f4e" http://moon-flight.aero

```

Результат будет следующий:

```

This is ApacheBench, Version 2.3 <$Revision: 1843412 $>

Copyright 1996 Adam Twiss, Zeus Technology Ltd, http://www.zeustech.net/

Licensed to The Apache Software Foundation, http://www.apache.org/

Benchmarking moon-flight.aero (be patient).....done

Server Software: nginx/1.14.0

Server Hostname: moon-flight.aero

Server Port: 80

Document Path: /

Document Length: 31134 bytes

Concurrency Level: 5

Time taken for tests: 1.068 seconds

Complete requests: 100

Failed requests: 0

Total transferred: 3150104 bytes

HTML transferred: 3113400 bytes

Requests per second: 93.64 [#/sec] (mean)

Time per request: 53.398 [ms] (mean)

Time per request: 10.680 [ms] (mean, across all concurrent requests)

Transfer rate: 2880.52 [Kbytes/sec] received

Connection Times (ms)

min mean[+/-sd] median max

Connect: 23 31 6.5 27 47

Processing: 14 17 7.8 16 93

Waiting: 14 17 7.8 16 93

Total: 37 47 10.1 44 122

Percentage of the requests served within a certain time (ms)

50% 44

66% 49

75% 52

80% 54

90% 56

95% 61

98% 63

99% 122

100% 122 (longest request)

```

Потребовалась всего **1 секунда**, чтобы выполнить **100 запросов**. Скорость передачи теперь — **93.64** **запросов в секунду**.

---

**Использованные материла и полезные ссылки:**

Описание модуля *ngx\_http\_fastcgi\_module* доступно по ссылке: [http://nginx.org/ru/docs/http/ngx*http*fastcgi\_module.html](http://nginx.org/ru/docs/http/ngx_http_fastcgi_module.html)

Видео о том, как настроить FastCGI Cache Nginx: <https://www.youtube.com/watch?v=Nri2KOI3HJo&t=66s>

Документация Apache Bench: <https://httpd.apache.org/docs/2.4/programs/ab.html>

|

https://habr.com/ru/post/521108/

| null |

ru

| null |

# [iOS] Создание статической библиотеки Static Library с использованием Cocoapods

Предыстория и сразу к делу

--------------------------

В свое время мне понадобилось обернуть написанный модуль в библиотеку. Порядочно погуглив, я нашел кучу туториалов, суть которых - создается библиотека с одним-двумя .swift - файлами. У меня же был целый проект, да еще с подами (а ля Alamofire, Moya, EasyPeasy и др), и ***создание библиотеки именно этим и усложнялось***, было непонятно как переносить поды, нужно ли их вообще переносить и как в целом правильно сбилдить такую библиотеку.

**P.S**. Данный туториал не претендует на полноту теории, скорее он из раздела "как сделать правильно и чтоб работало".

**P.P.S.** Статья будет написана как расширение обычных туториалов для случая использования в библиотеке Static Library - cocoapods, но ее можно использовать и как просто туториал для создания Static Library.

[Как создать фреймворк Universal Framework с использованием Cocoapods я писал здесь](https://habr.com/ru/post/586756/)

> Тестировалось на xcode 12.4, swift 5

>

>

1. Билдим библиотеку

--------------------

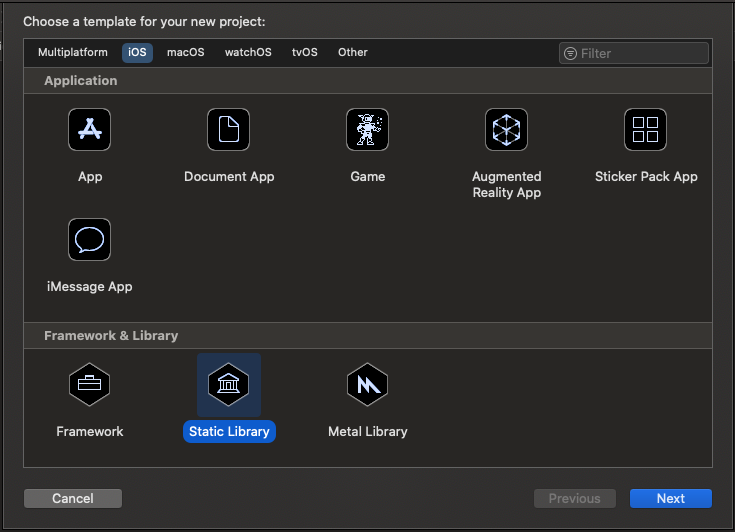

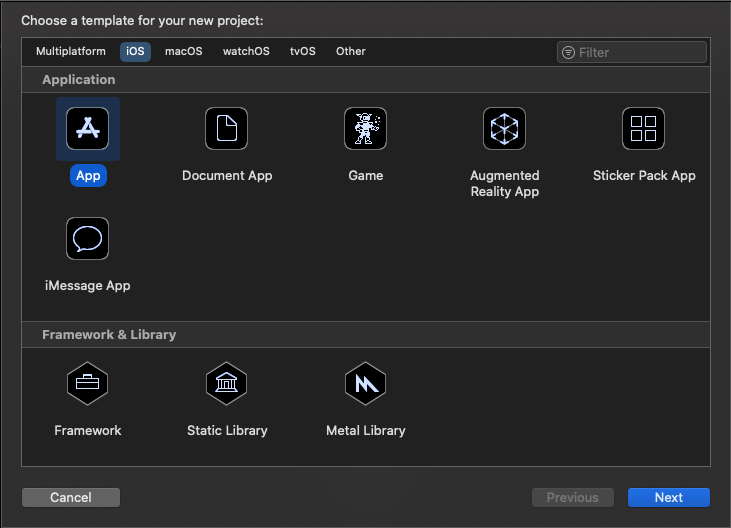

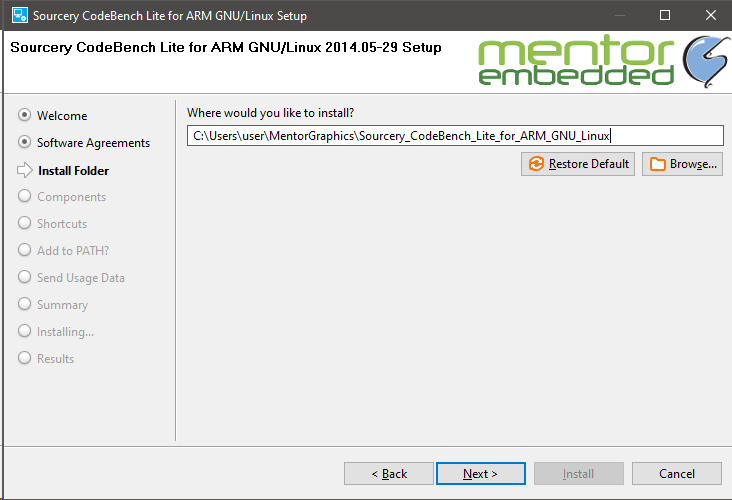

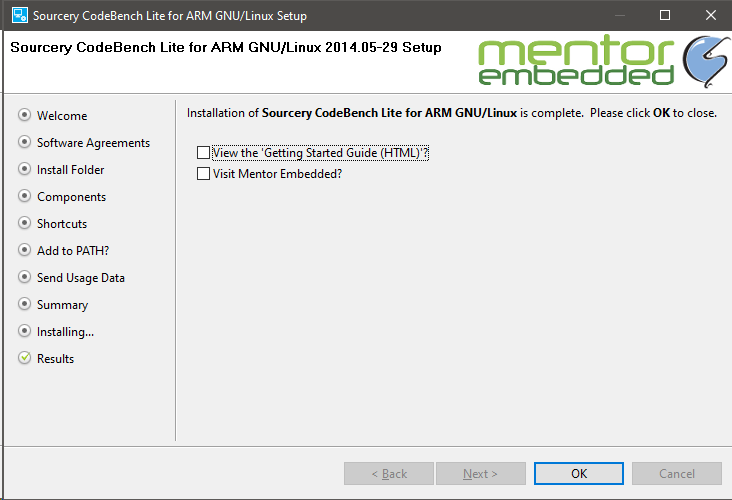

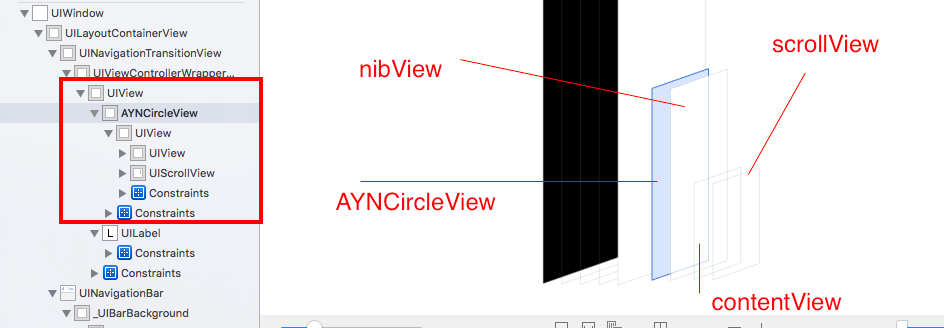

Итак, начинаем, cоздаем новый проект в xcode:

Выбираем Static Library, жмем Next,

библиотеку назовем **StaticLibraryExample - рекомендую давать название без пробелов!**

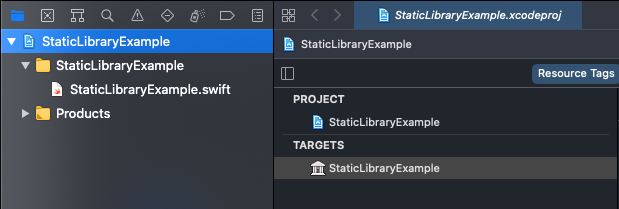

Получаем пустую библиотеку с одним автоматически созданным файлом StaticLibraryExample.swift:

Теперь мы можем использовать созданный файл(или удалить его), а также создать бесконечно своих файлов и добавить их в библиотеку.

> *Не забываем указывать модификаторы доступа* ***public*** *и* ***open*** *для классов свойств и функций!*

>

>

> Шрифты, локализацию Localizable.strings, картинки Assets не вносим в библиотеку, их добавим в клиентский проект отдельно!

>

>

Если же у нас имеется проект, который нужно сделать подмодулем(как было в моем случае), то берем все необходимые файлы и копируем их из этого проекта в нашу библиотеку:

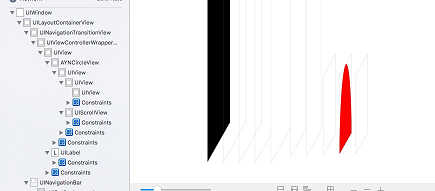

Получаем что то наподобие(автоматический созданный файл StaticLibraryExample я удалил):

Теперь попробуем сбилдить нашу библиотеку (неважно на симуляторе или устройстве), нажимаем ***Ctrl+B***. Если в вашей библиотеке нет cocoapods зависимостей то все компилируется успешно - ***билдим проект на устройстве и симуляторе*** и переходим к пункту 2 туториала.

Если же есть, то вы получите ошибку наподобие этой:

Окей, создаем новый Podfile с необходимыми подами, например мне нужны были следующие(какие поды дело несущественное):

```

platform :ios, '13.0'

target 'Static Library Example' do

pod 'Moya'

pod 'Alamofire'

pod 'Kingfisher'

pod 'EasyPeasy'

pod 'KeychainAccess'

pod 'SwiftPhoneNumberFormatter'

end

```

Устанавливаем поды - ***pod install***. Открываем созданный workspace (на установке подов я не останавливаюсь).

Билдим библиотеку ***для симулятора и устройства***, все должно быть успешно, если есть ошибки рекомендую в Targets -> StaticLibraryExample -> Build phases в разделе Library search paths удалить все, кроме $(inherited).

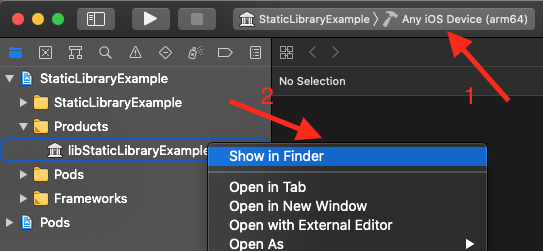

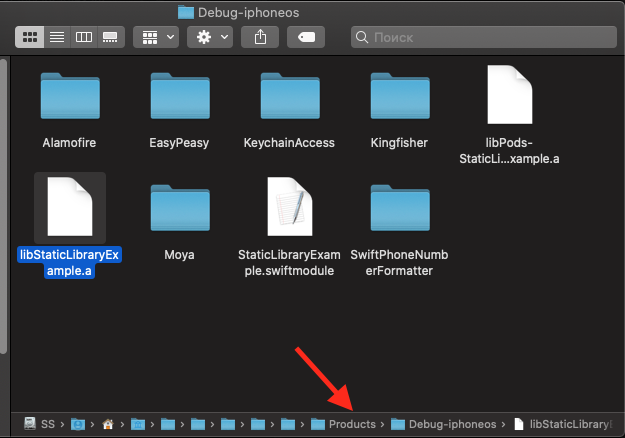

После того как все билдится успешно, файл библиотеки перестанет подсвечиваться красным, и, нажав на него правой кнопкой и выбрав ***Show In Finder***, мы можем найти его на диске (один файл для iphoneos и второй для iphonesimulator):

В итоге на первом этапе для нас главное получить эти два файла библиотеки - один для айфона, второй - для симулятора.

2. Компилируем Universal Static Library

---------------------------------------

Под Universal Static Library имеется в виду библиотека (файл), который подходит и под устройство и под симулятор.

> *Сразу отмечу, что ее можно создать через терминал, такой способ есть во многих туториалах, однако создавать через агрегатор намного удобнее, к тому же если вы что что измените в библиотеке и вам необходимо будет ее пересобрать, то будет достаточно сбилдить агрегатор еще раз.*

>

>

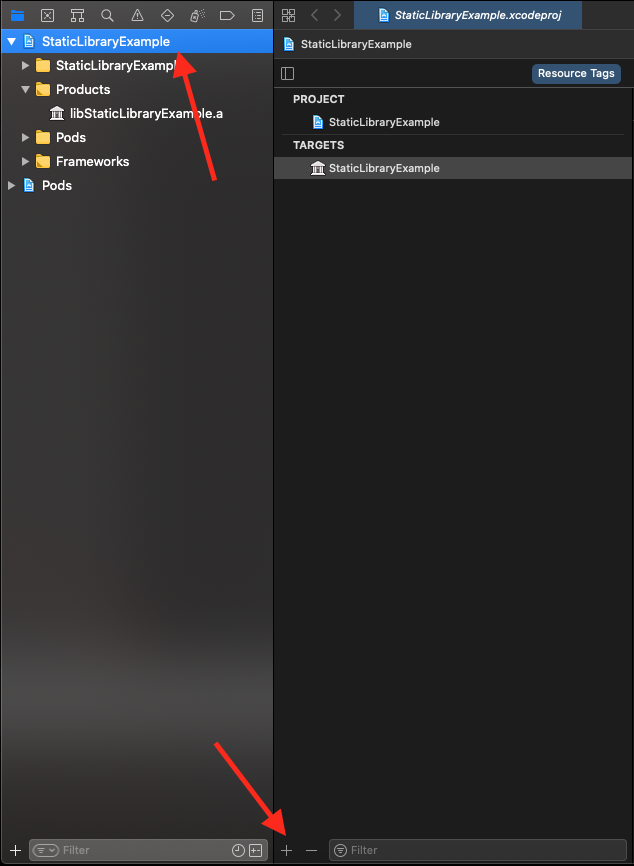

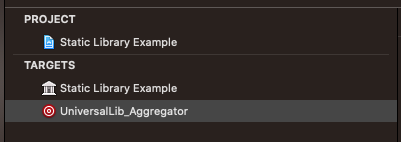

Добавляем новый таргет - Aggregator:

Жмем Next, назовем агрегатор UniversalLib\_Aggregator, жмем Готово:

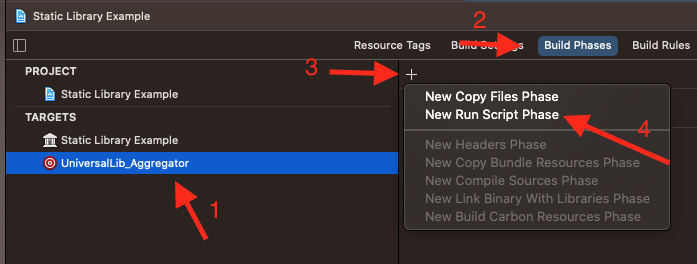

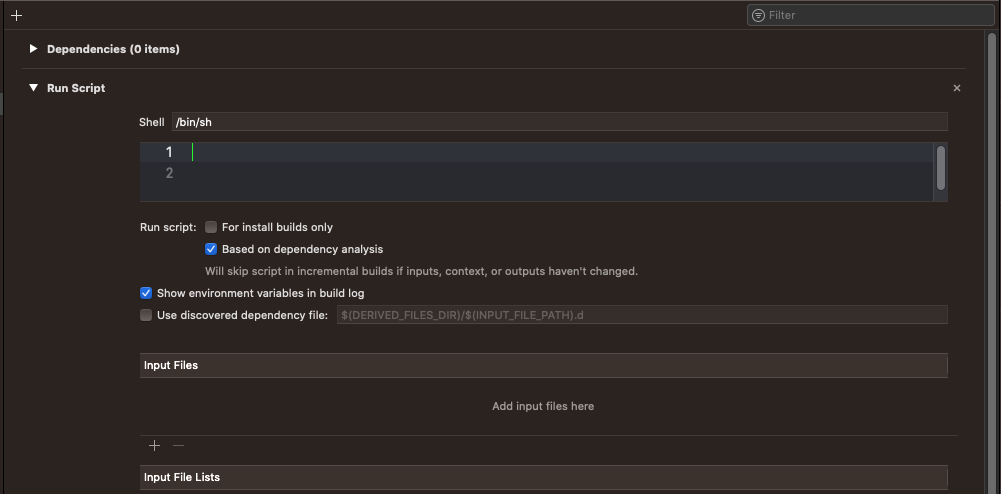

Далее добавим Run Script Phase - код, который будет выполняться при билде этого агрегатора:

Удаляем все что там написано:

И вставляем код, который я нашел на просторах интернета. Этот код универсален для любой вашей будущей библиотеки, только в переменную LIB\_NAME необходимо вписывать имя проекта(библиотеки):

```

# 1: Declare variables

# Вписываем имя библиотеки:

LIB_NAME="StaticLibraryExample"

RESULT_DIR="libUniversal"

BUILD_DIR_SIMULATOR="Debug-iphonesimulator"

BUILD_DIR_DEVICE="Debug-iphoneos"

LIB_BINARY_NAME="lib$LIB_NAME.a"

LIB_BINARY_NAME_SIMULATOR="lib$LIB_NAME-simulator.a"

LIB_BINARY_NAME_DEVICE="lib$LIB_NAME-device.a"

SWIFTMODULE_DIR=$LIB_NAME".swiftmodule"

# 2: Билд

# Билдим для симулятора

xcodebuild -target $LIB_NAME -configuration ${CONFIGURATION} -sdk iphonesimulator -arch x86_64 BUILD_DIR="${BUILD_DIR}" BUILD_ROOT="${BUILD_ROOT}"

# Билдим для устройства

xcodebuild -target $LIB_NAME ONLY_ACTIVE_ARCH=NO -configuration ${CONFIGURATION} -sdk iphoneos BUILD_DIR="${BUILD_DIR}" BUILD_ROOT="${BUILD_ROOT}"

# 3: Операции с бинарными файлами

# Переходим в билд директорию

cd $BUILD_DIR

# Удаляем результат предыдущей сборки

rm -rf $BUILD_DIR/$RESULT_DIR 2> /dev/null

# Создаем новую директорию для библиотеки

mkdir $RESULT_DIR

# Копируем двоичный файл симулятора

# в директорию библиотеки и переименовываем его

cp ./$BUILD_DIR_SIMULATOR/$LIB_BINARY_NAME ./$RESULT_DIR/$LIB_BINARY_NAME_SIMULATOR

# Копируем двоичный файл устройства

# в директорию библиотеки и переименовываем его

cp ./$BUILD_DIR_DEVICE/$LIB_BINARY_NAME ./$RESULT_DIR/$LIB_BINARY_NAME_DEVICE

# Создаем нашу universal библиотеку(второе название "fat")

lipo -create ./$RESULT_DIR/$LIB_BINARY_NAME_SIMULATOR ./$RESULT_DIR/$LIB_BINARY_NAME_DEVICE -output ./$RESULT_DIR/$LIB_BINARY_NAME

# Удаляем двоичные файлы симулятора и устройства:

rm ./$RESULT_DIR/$LIB_BINARY_NAME_SIMULATOR

rm ./$RESULT_DIR/$LIB_BINARY_NAME_DEVICE

# 4: Создаем .swiftmodule

#

# Создаем директорию

mkdir $RESULT_DIR/$SWIFTMODULE_DIR

# Копируем 'swiftmodule' симулятора в созданную директорию

cp -r $BUILD_DIR_SIMULATOR/$SWIFTMODULE_DIR $RESULT_DIR

# Копируем 'swiftmodule' устройства в созданную директорию

cp -r $BUILD_DIR_DEVICE/$SWIFTMODULE_DIR/* $RESULT_DIR/$SWIFTMODULE_DIR

# Удаляем билд директорию

rm -rf $PROJECT_DIR/build

```

Билдим наш агрегатор ***Ctrl+B***:

После успешного билда открываем файл библиотеки:

Да, открывается наш старый файл библиотеки для устройства из папки Debug-iphoneos, нам нужно перейти на уровень вверх (например щелкнув два раза на ***Products***):

Перейдя в ***Products,*** мы видим нашу Universal Library:

В итоге на этом этапе мы получили нашу Universal Library, все файлы которой находятся в папке libUniversal (Обратите внимание что имя универсальной библиотеки тоже задается в скрипте переменной **RESULT\_DIR**).

3. Интегрируем Static Library в ClientApp

-----------------------------------------

> Под "ClientApp" имеется в виду любой проект

>

>

Итак, осталось самое простое - внедряем библиотеку в проект.

Создаем новый xcode проект, выбираем App, жмем Next, назовем проект ClientApp

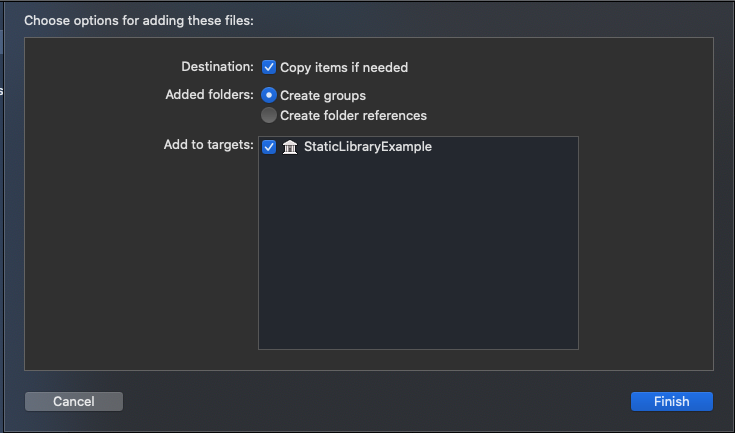

Переносим нашу папку libUniversal в наш проект:

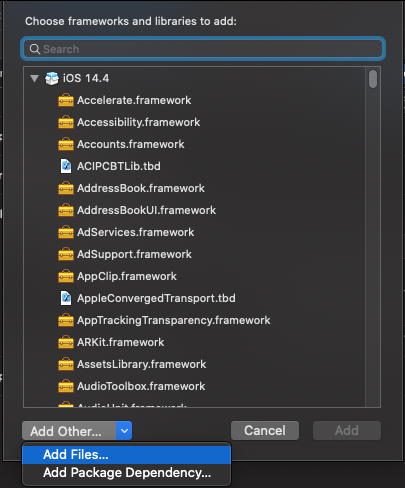

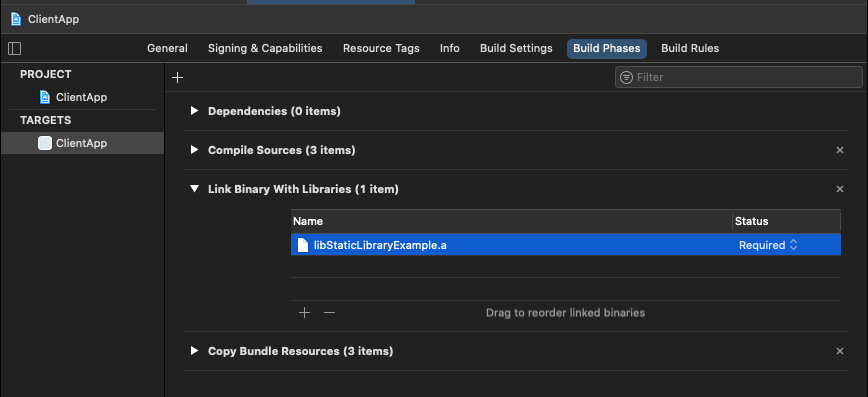

Далее добавляем файл библиотеки libStaticLibraryExample.a в проект:

Должно получиться так:

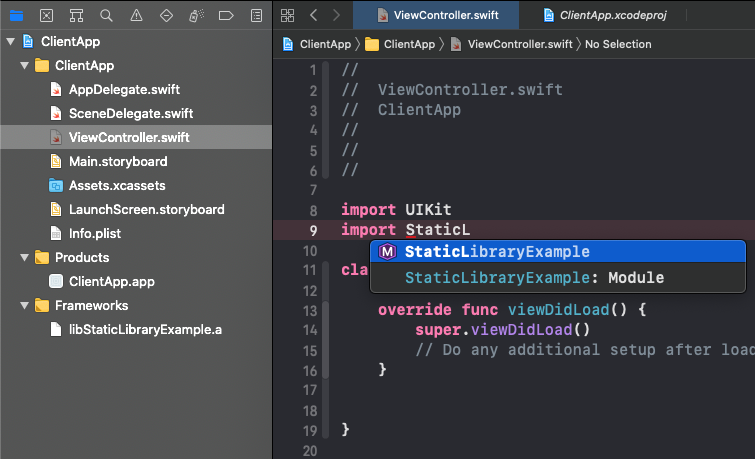

Далее нам нужно заполнить раздел Import Paths:

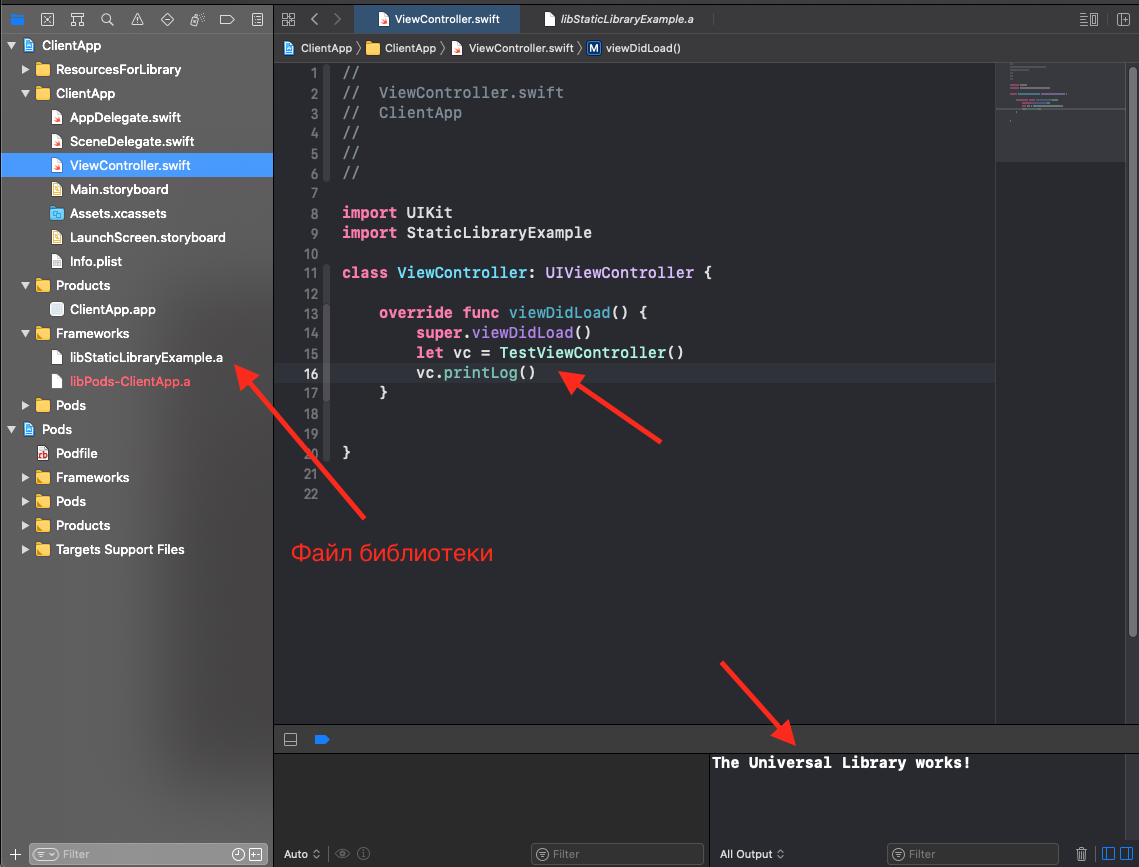

Переходим во ViewController.swift и импортируем нашу библиотеку:

Билдим проект ***Ctrl+B,*** если вы не используете cocoapods, то все должно сбилдиться и нашу библиотеку можно использовать! (переходите к пункту 4. Тестирование)

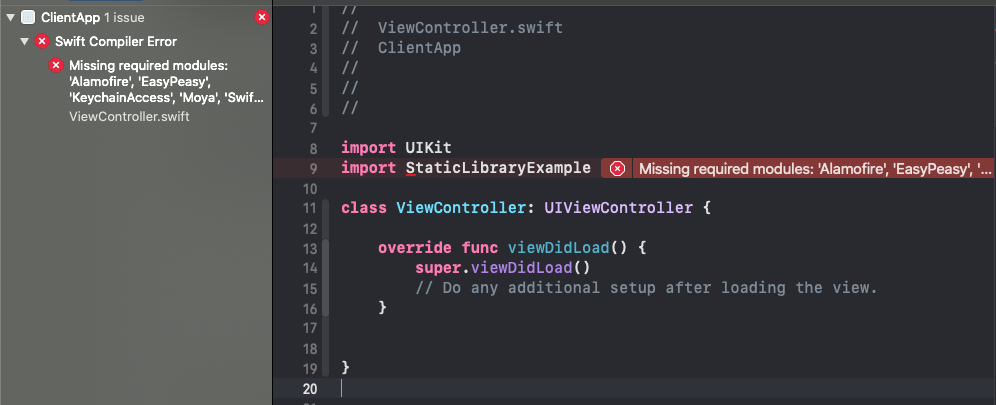

Если же используем поды то необходимо в ClientApp установить те же поды, что были у нас при компилировании библиотеки. Также я столкнулся с такой ошибкой:

Решается так: Чистим проект Product -> Clean Build Folder, затем открываем Terminal (необязательно по пути где наш проект), вставляем следующий код(чистим папку DerivedData):

```

rm -rf ~/Library/Developer/Xcode/DerivedData

```

Затем билдим проект снова, получаем закономерную ошибку, что наши поды не обнаружены:

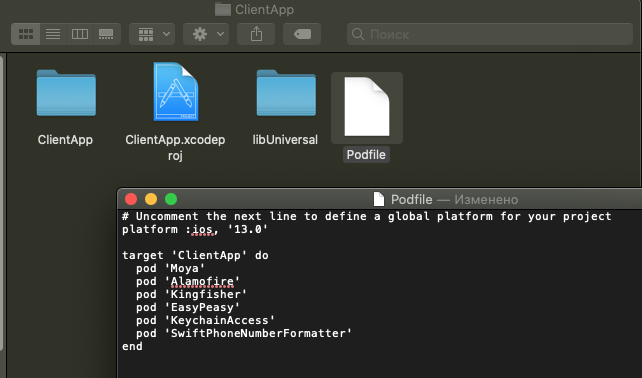

Устанавливаем Pods - код для Podfile берем из Static Library (см. выше):

Открываем **ClientApp.xcworkspace**, и билдим проект - убеждаемся, что все успешно!

> Не забудьте перенести шрифты(а также добавить данные о них в Info.plist), файлы локализации Localizable.strings, а также добавить картинки в Assets! Т.е. все те файлы которые вам не нужны в вашей библиотеке, но нужны для запуска ClientApp.

>

>

4. Тестируем

------------

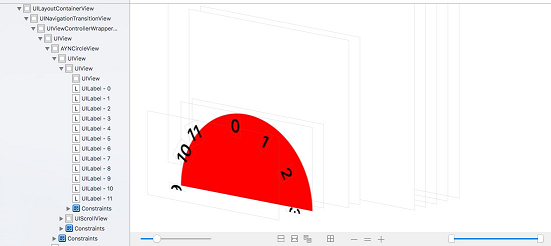

В моей библиотеке Static Library Example был такой класс:

```

public class TestViewController: UIViewController {

public override func viewDidLoad() {

super.viewDidLoad()

}

public func printLog() {

print("The Universal Library works!")

}

}

```

Как видите это простой класс для тестирования работоспособности библиотеки, который содержит в себе публичную функцию **printLog().**

Давайте вызовем эту функцию из нашего ClientApp:

Отлично! Библиотека работает, вы можете использовать классы, функции и свойства доступных файлов библиотеки!

|

https://habr.com/ru/post/586562/

| null |

ru

| null |

# Micro Frontend Архитектура на примере Angular

В наше цифровое время веб-приложения становятся все более масштабней и сложней. Такие веб-приложения могут быть разделены на несколько модулей, разработанных отдельными командами, которые удобно запускать в производство по отдельности.

По мере того, как приложения со временем усложняются, требуя масштабируемости «на лету» и высокой скорости реагирования, архитектура микро-фронтенд, основанная на компонентах Angular, становится все более эффективным решением для сложных веб-приложений.

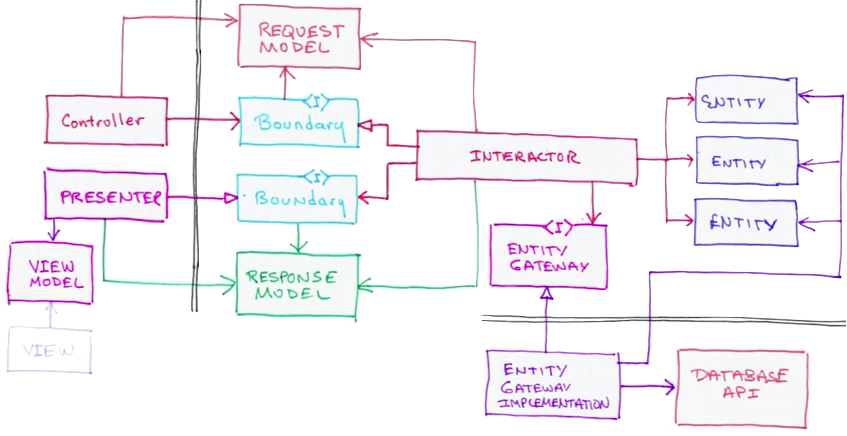

Микро-фронтенд — это архитектура, которая рассматривает веб-приложение как набор приложений, разрабатываемых отдельными командами. Каждая команда специализируется на определенной области бизнеса или цели. Такая кросс-функциональная команда создает функциональность сверху донизу, от сервера до пользовательского интерфейса.

### Плюсы микро-фронтенд архитектуры

* **Автоматизация CI /CD.** Поскольку каждое приложение интегрируется и развертывается независимо, это упрощает CI/CD. Так как все модули разделены, то не нужно беспокоиться обо всем приложении при внедрении нового модуля. Если в коде модуля есть ошибка, CI/CD прервет весь процесс сборки.

Гибкость команд разработчиков. Многочисленные команды могут разрабатывать и развивать информационные системы, работая по отдельности.

* **Единая ответственность.** Каждая команда микро-фронтеда на 100% фокусируется на функциональности своего микро-фронтенд приложения.

* **Возможность повторного использования.** Микро-фронтенд приложение может быть повторно использовано несколькими командами в разных системах.

* **Технологический агностицизм.** Архитектура микро-фронтенд не зависит от технологии. Возможно использовать компоненты, разработанные на разных фреймворков веб-разработки (React, Vue, Angular и т.д.).

* **Простой порог входа в систему.** Небольшие модули легче изучать и понимать новым разработчикам, входящим в команды, чем монолитную архитектуру с огромной структурой кода.

### Демонстрационное приложение

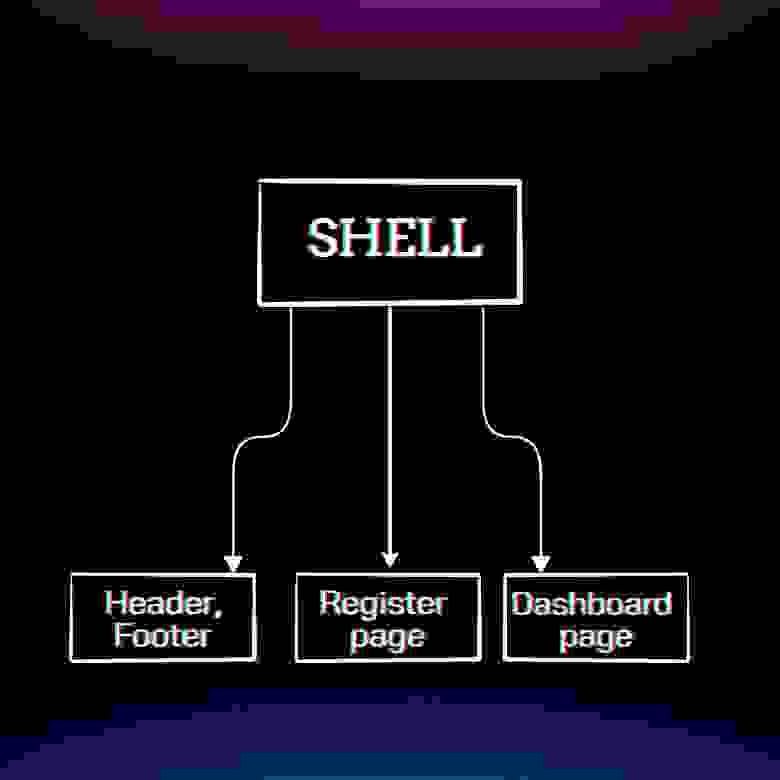

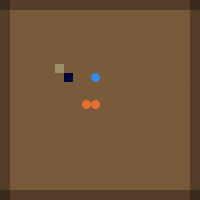

Мы разработаем приложение с микро-фронтенд архитектурой, показанное на рисунке ниже:

### Модуль Header & Footer

Эта часть содержит по крайней мере 2 компонента, готовых к экспорту. Прежде всего, нам нужно создать новое приложение и настроить angular builder, который позволит нам использовать пользовательские конфигурации webpack.

`ng new layout

npm i --save-dev ngx-build-plus`

Теперь нам нужно создать webpack.config.js и webpack.prod.config.js файлы в корне нашего приложения.

```

// webpack.config.js

const webpack = require("webpack");

const ModuleFederationPlugin =require("webpack/lib/container/ModuleFederationPlugin");

module.exports = {

output: {

publicPath: "http://localhost:4205/",

uniqueName: "layout",

},

optimization: {

runtimeChunk: false,

},

plugins: [

new ModuleFederationPlugin({

name: "layout",

library: { type: "var", name: "layout" },

filename: "remoteEntry.js",

exposes: {

Header: './src/app/modules/layout/header/header.component.ts',

Footer: './src/app/modules/layout/footer/footer.component.ts'

},

shared: {

"@angular/core": { singleton: true, requiredVersion:'auto' },

"@angular/common": { singleton: true, requiredVersion:'auto' },

"@angular/router": { singleton: true, requiredVersion:'auto' },

},

}),

],

};

// webpack.prod.config.js

module.exports = require("./webpack.config");

```

Модуль Federation позволяет нам совместно использовать общие пакеты npm между различными микро-фронтендами. Это уменьшает полезную нагрузку для модулей с отложенной загрузкой.

Мы можем настроить минимально необходимую версию, допускается две или более версий для одного пакета. Более подробная информация о возможных вариантах плагина находится здесь: [ссылка на плагин](https://webpack.js.org/concepts/module-federation/).

У нас есть exposes раздел, здесь мы можем определить, какие элементы нам нужно разрешить экспортировать из нашего приложения. В нашем случае мы экспортируем только 2 компонента.

Теперь нужно добавить пользовательский конфигурационный файл в angular.json и изменить сборщик по умолчанию на ngx-build-plus:

```

{

...

"projects": {

"layout": {

"projectType": "application",

"schematics": {

"@schematics/angular:component": {

"style": "scss"

},

"@schematics/angular:application": {

"strict": true

}

},

"root": "",

"sourceRoot": "src",

"prefix": "app",

"architect": {

"build": {

"builder": "ngx-build-plus:browser",

"options": {

"outputPath": "dist/layout",

"index": "src/index.html",

"main": "src/main.ts",

"polyfills": "src/polyfills.ts",

"tsConfig": "tsconfig.app.json",

"inlineStyleLanguage": "scss",

"assets": [

"src/favicon.ico",

"src/assets"

],

"styles": [

"src/styles.scss"

],

"scripts": [],

"extraWebpackConfig": "webpack.config.js"

},

"configurations": {

"production": {

"budgets": [

{

"type": "initial",

"maximumWarning": "500kb",

"maximumError": "1mb"

},

{

"type": "anyComponentStyle",

"maximumWarning": "2kb",

"maximumError": "4kb"

}

],

"extraWebpackConfig": "webpack.prod.config.js",

"fileReplacements": [

{

"replace": "src/environments/environment.ts",

"with": "src/environments/environment.prod.ts"

}

],

"outputHashing": "all"

},

"development": {

"buildOptimizer": false,

"optimization": false,

"vendorChunk": true,

"extractLicenses": false,

"sourceMap": true,

"namedChunks": true

}

},

"defaultConfiguration": "production"

},

"serve": {

"builder": "ngx-build-plus:dev-server",

"configurations": {

"production": {

"browserTarget": "layout:build:production"

},

"development": {

"browserTarget": "layout:build:development",

"extraWebpackConfig": "webpack.config.js",

"port": 4205

}

},

"defaultConfiguration": "development"

},

"extract-i18n": {

"builder": "@angular-devkit/build-angular:extract-i18n",

"options": {

"browserTarget": "layout:build"

}

},

"test": {

"builder": "ngx-build-plus:karma",

"options": {

"main": "src/test.ts",

"polyfills": "src/polyfills.ts",

"tsConfig": "tsconfig.spec.json",

"karmaConfig": "karma.conf.js",

"inlineStyleLanguage": "scss",

"assets": [

"src/favicon.ico",

"src/assets"

],

"styles": [

"src/styles.scss"

],

"scripts": [],

"extraWebpackConfig": "webpack.config.js"

}

}

}

}

},

"defaultProject": "layout"

}

```

### Модуль Register Page

Этот модуль будет содержать всю логику для страницы входа / регистрации.

Также создаем приложение и устанавливаем пользовательский сборщик для использования конфигураций webpack.

`ng new registerPage

npm i --save-dev ngx-build-plus`

После этого создаем webpack.config.js и webpack.prod.config.js

```

// webpack.config.js

const webpack = require("webpack");

const ModuleFederationPlugin = require("webpack/lib/container/ModuleFederationPlugin");

module.exports = {

output: {

publicPath: "http://localhost:4201/",

uniqueName: "register",

},

optimization: {

runtimeChunk: false,

},

plugins: [

new ModuleFederationPlugin({

name: "register",

library: { type: "var", name: "register" },

filename: "remoteEntry.js",

exposes: {

RegisterPageModule:

"./src/app/modules/register/register-page.module.ts",

},

shared: {

"@angular/core": { singleton: true, requiredVersion: 'auto' },

"@angular/common": { singleton: true, requiredVersion: 'auto' },

"@angular/router": { singleton: true, requiredVersion: 'auto' },

},

}),

],

};

// webpack.prod.config.js

module.exports = require("./webpack.config");

```

Как можно заметить, здесь мы экспортируем только модуль страницы регистрации. Мы можем использовать его как модуль с отложенной загрузкой.

Кроме того, нам нужно изменить builder по умолчанию на ngx-build-plus и добавить конфигурации webpack в файл angular.json (так же, как мы делали для предыдущего модуля).

### Модуль Dashboard

Этот модуль предоставляет данные для авторизованного пользователя. Так же создаем приложение со своим конфигурационным файлом webpack:

```

// webpack.config.js

const webpack = require("webpack");

const ModuleFederationPlugin = require("webpack/lib/container/ModuleFederationPlugin");

module.exports = {

output: {

publicPath: "http://localhost:4204/",

uniqueName: "dashboard",

},

optimization: {

runtimeChunk: false,

},

plugins: [

new ModuleFederationPlugin({

name: "dashboard",

library: { type: "var", name: "dashboard" },

filename: "remoteEntry.js",

exposes: {

DashboardModule:

"./src/app/modules/dashboard/dashboard.module.ts",

},

shared: {

"@angular/core": { singleton: true, requiredVersion:'auto' },

"@angular/common": { singleton: true, requiredVersion:'auto' },

"@angular/router": { singleton: true, requiredVersion:'auto' },

},

}),

],

};

```

### Главное приложение Shell

Основное приложение, которое загружает все микро-фронтенды в одно, называется Shell.

`ng new shell

npm i --save-dev ngx-build-plus`

Добавляем пользовательский конфигурационный webpack:

```

// webpack.config.js

const webpack = require("webpack");

const ModuleFederationPlugin = require("webpack/lib/container/ModuleFederationPlugin");

module.exports = {

output: {

publicPath: "http://localhost:4200/",

uniqueName: "shell",

},

optimization: {

runtimeChunk: false,

},

plugins: [

new ModuleFederationPlugin({

shared: {

"@angular/core": { eager: true, singleton: true },

"@angular/common": { eager: true, singleton: true },

"@angular/router": { eager: true, singleton: true },

},

}),

],

};

```

Настроим конфигурационный webpack в файле angular.json.

В environment/environment.ts мы объявляем все микро-фронтенды (для версии prod нам нужно заменить адрес локального хоста на развернутый общедоступный адрес):

```

export const environment = {

production: false,

microfrontends: {

dashboard: {

remoteEntry: 'http://localhost:4204/remoteEntry.js',

remoteName: 'dashboard',

exposedModule: ['DashboardModule'],

},

layout: {

remoteEntry: 'http://localhost:4205/remoteEntry.js',

remoteName: 'layout',

exposedModule: ['Header', 'Footer'],

}

}

};

```

Создадим утилиты для объединения модулей.

```

// src/app/utils/federation-utils.ts

type Scope = unknown;

type Factory = () => any;

interface Container {

init(shareScope: Scope): void;

get(module: string): Factory;

}

declare const __webpack_init_sharing__: (shareScope: string) => Promise;

declare const \_\_webpack\_share\_scopes\_\_: { default: Scope };

const moduleMap: Record = {};

function loadRemoteEntry(remoteEntry: string): Promise {

return new Promise((resolve, reject) => {

if (moduleMap[remoteEntry]) {

return resolve();

}

const script = document.createElement('script');

script.src = remoteEntry;

script.onerror = reject;

script.onload = () => {

moduleMap[remoteEntry] = true;

resolve(); // window is the global namespace

};

document.body.append(script);

});

}

async function lookupExposedModule(

remoteName: string,

exposedModule: string

): Promise {

// Initializes the share scope. This fills it with known provided modules from this build and all remotes

await \_\_webpack\_init\_sharing\_\_('default');

const container = window[remoteName] as Container;

// Initialize the container, it may provide shared modules

await container.init(\_\_webpack\_share\_scopes\_\_.default);

const factory = await container.get(exposedModule);

const Module = factory();

return Module as T;

}

export interface LoadRemoteModuleOptions {

remoteEntry: string;

remoteName: string;

exposedModule: string;

}

export async function loadRemoteModule(

options: LoadRemoteModuleOptions

): Promise {

await loadRemoteEntry(options.remoteEntry);

return lookupExposedModule(

options.remoteName,

options.exposedModule

);

}

```

и утилиты для сборки lazy loaded маршрутов:

```

// src/app/utils/route-utils.ts

import { loadRemoteModule } from './federation-utils';

import { Routes } from '@angular/router';

import { APP_ROUTES } from '../app.routes';

import { Microfrontend } from '../core/services/microfrontends/microfrontend.types';

export function buildRoutes(options: Microfrontend[]): Routes {

const lazyRoutes: Routes = options.map((o) => ({

path: o.routePath,

loadChildren: () => loadRemoteModule(o).then((m) => m[o.ngModuleName]),

canActivate: o.canActivate,

pathMatch: 'full'

}));

return [

...APP_ROUTES,

...lazyRoutes

];

}

```

Нам нужно определить микро-фронтеннд сервис:

```

// src/app/core/services/microfrontends/microfrontend.service.ts

import { Injectable } from '@angular/core';

import { Router } from '@angular/router';

import { MICROFRONTEND_ROUTES } from 'src/app/app.routes';

import { buildRoutes } from 'src/app/utils/route-utils';

@Injectable({ providedIn: 'root' })

export class MicrofrontendService {

constructor(private router: Router) {}

/*

* Initialize is called on app startup to load the initial list of

* remote microfrontends and configure them within the router

*/

initialise(): Promise {

return new Promise((resolve) => {

this.router.resetConfig(buildRoutes(MICROFRONTEND\_ROUTES));

return resolve();

});

}

}

```

Файл для типа:

```

// src/app/core/services/microfrontends/microfrontend.types.ts

import { LoadRemoteModuleOptions } from "src/app/utils/federation-utils";

export type Microfrontend = LoadRemoteModuleOptions & {

displayName: string;

routePath: string;

ngModuleName: string;

canActivate?: any[]

};

```

Нам нужно определить микро-фронтеды согласно маршрутам:

```

// src/app/app.routes.ts

import { Routes } from '@angular/router';

import { LoggedOnlyGuard } from './core/guards/logged-only.guard';

import { UnloggedOnlyGuard } from './core/guards/unlogged-only.guard';

import { Microfrontend } from './core/services/microfrontends/microfrontend.types';

import { environment } from 'src/environments/environment';

export const APP_ROUTES: Routes = [];

export const MICROFRONTEND_ROUTES: Microfrontend[] = [

{

...environment.microfrontends.dashboard,

exposedModule: environment.microfrontends.dashboard.exposedModule[0],

// For Routing, enabling us to ngFor over the microfrontends and dynamically create links for the routes

displayName: 'Dashboard',

routePath: '',

ngModuleName: 'DashboardModule',

canActivate: [LoggedOnlyGuard]

},

{

...environment.microfrontends.registerPage,

exposedModule: environment.microfrontends.registerPage.exposedModule[0],

displayName: 'Register',

routePath: 'signup',

ngModuleName: 'RegisterPageModule',

canActivate: [UnloggedOnlyGuard]

}

]

```

Сервис в нашем основном приложении:

```

// src/app/app.module.ts

import { APP_INITIALIZER, NgModule } from '@angular/core';

import { BrowserModule } from '@angular/platform-browser';

import { RouterModule } from '@angular/router';

import { AppRoutingModule } from './app-routing.module';

import { AppComponent } from './app.component';

import { APP_ROUTES } from './app.routes';

import { LoaderComponent } from './core/components/loader/loader.component';

import { NavbarComponent } from './core/components/navbar/navbar.component';

import { MicrofrontendService } from './core/services/microfrontends/microfrontend.service';

export function initializeApp(

mfService: MicrofrontendService

): () => Promise {

return () => mfService.initialise();

}

@NgModule({

declarations: [

AppComponent,

NavbarComponent,

LoaderComponent

],

imports: [

BrowserModule,

AppRoutingModule,

RouterModule.forRoot(APP\_ROUTES, { relativeLinkResolution: 'legacy' }),

],

providers: [

MicrofrontendService,

{

provide: APP\_INITIALIZER,

useFactory: initializeApp,

multi: true,

deps: [MicrofrontendService],

},

],

bootstrap: [AppComponent]

})

export class AppModule { }

```

Необходимо загрузить Footer и Header компоненты. Для этого нам надо обновить app компонент:

```

// src/app/app.component.html

```

а файл src/app/app.component.ts будет выглядеть так:

```

import {

ViewContainerRef,

Component,

ComponentFactoryResolver,

OnInit,

AfterViewInit,

Injector,

ViewChild

} from '@angular/core';

import { RouteConfigLoadEnd, RouteConfigLoadStart, Router } from '@angular/router';

import { loadRemoteModule } from './utils/federation-utils';

import { environment } from 'src/environments/environment';

@Component({

selector: 'app-root',

templateUrl: './app.component.html',

styleUrls: ['./app.component.scss']

})

export class AppComponent implements AfterViewInit, OnInit{

@ViewChild('header', { read: ViewContainerRef, static: true })

headerContainer!: ViewContainerRef;

@ViewChild('footer', { read: ViewContainerRef, static: true })

footerContainer!: ViewContainerRef;

loadingRouteConfig = false;

constructor(private injector: Injector,

private resolver: ComponentFactoryResolver,

private router: Router

) {}

ngOnInit() {

this.router.events.subscribe(event => {

if (event instanceof RouteConfigLoadStart) {

this.loadingRouteConfig = true;

} else if (event instanceof RouteConfigLoadEnd) {

this.loadingRouteConfig = false;

}

});

}

ngAfterViewInit(): void {

// load header

loadRemoteModule({

...environment.microfrontends.layout,

exposedModule: environment.microfrontends.layout.exposedModule[0],

})

.then(module => {

const factory = this.resolver.resolveComponentFactory(module.HeaderComponent);

this.headerContainer?.createComponent(factory, undefined, this.injector);

});

// load footer

loadRemoteModule({

...environment.microfrontends.layout,

exposedModule: environment.microfrontends.layout.exposedModule[1],

})

.then(module => {

const factory = this.resolver.resolveComponentFactory(module.FooterComponent);

this.footerContainer?.createComponent(factory, undefined, this.injector);

});

}

}

```

### Взаимодействие между микро-фронтендами

У нас есть несколько способов обмена данными между различными микро-фронтендами. В нашем случае мы решили использовать пользовательское событие для связи. Пользовательское событие позволяет нам отправлять пользовательские данные с помощью полезной нагрузки события.

Один модуль должен отправлять пользовательские события следующим образом:

```

const busEvent = new CustomEvent('app-event-bus', {

bubbles: true,

detail: {

eventType: 'auth-register',

customData: 'some data here'

}

});

dispatchEvent(busEvent);

```

Другие микро-фронтенды могут подписаться на это событие:

```

onEventHandler(e: CustomEvent) {

if (e.detail.eventType === 'auth-register') {

const isLogged = Boolean(localStorage.getItem('token'));

this.auth.isLogged = isLogged;

if (isLogged) {

this.router.navigate(['/']);

} else {

this.router.navigate(['/signup']);

}

}

}

ngOnInit() {

this.$eventBus = fromEvent(window, 'app-event-bus').subscribe((e) => this.onEventHandler(e));

// ...

}

```

### Заключение

Архитектура микро-фронтендов приобретает все большую и большую популярность, поскольку с течением времени кодовые базы веб-приложений становятся все более сложными. Крайне важно уметь проводить четкие границы между микро-фронтед приложениями и командами их разрабатывающих. Очень важно установить правильное взаимодействия и согласованность между техническими командами, что позволит успешно разрабатывать, развивать, поддерживать и внедрять сложные веб-приложения.

[Все исходники на github](https://github.com/incora-dev/Microfrontend-Angular)

|

https://habr.com/ru/post/659199/

| null |

ru

| null |

# Графы для самых маленьких: BFS 0-1

Добрый день, уважаемые хабровчане!

В предыдущих постах уже рассказывалось о двух алгоритмах, с помощью которых можно найти путь сквозь лабиринт: [DFS](http://habrahabr.ru/post/200074/) и [BFS](http://habrahabr.ru/post/200252/). Всех, кто хочет еще немного поиздеваться над нашим лабиринтом, прошу под кат.

#### Новая постановка задачи

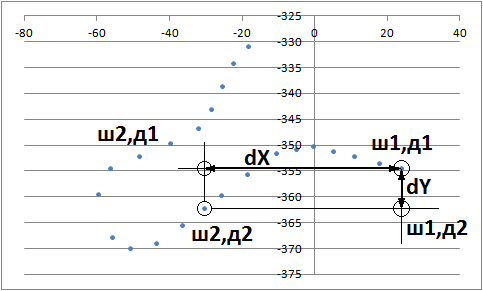

Добавим в лабиринт телепорты — теперь в некоторых комнатах будут находиться устройства, используя которые можно попасть в другую комнату за нулевое время.

Или, говоря более формально, теперь каждое ребро помечено временем, которое требуется на переход по нему — это 0 или 1. А цель все та же — найти кратчайший с точки зрения времени путь из начальной вершины в конечную.

#### Решение

Мы уже знаем один алгоритм, позволяющий найти кратчайший путь — это BFS, соответственно, хочется придумать какой-то алгоритм на его основе.

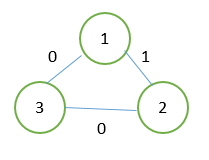

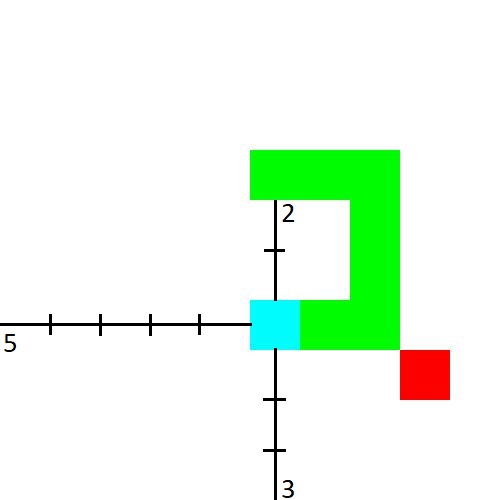

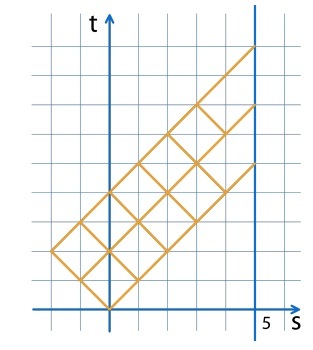

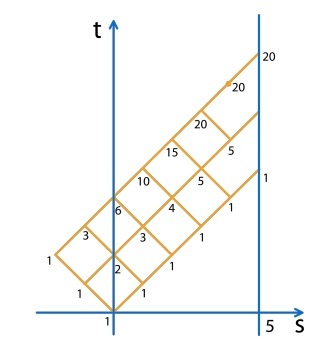

Если мы применим BFS в его обычном виде к графу, изображенному на рисунке, произойдет ошибка: расстояние до вершины 2 будет посчитано при обработке вершины 1, после чего может начаться обработка вершины 2, несмотря на то, что расстояние до нее не является оптимальным. Ошибка произошла из-за того, что был нарушен основной инвариант BFS: вершины рассматривались не в порядке увеличения расстояния.

Для того, чтобы вершины рассматривались в порядке увеличения расстояния, нужно добавлять вершины, к которым ведут ребра веса 0, в начало очереди (и, таким образом, использовать не очередь, а дек).

#### Реализация

Предполагается, что граф представлен в виде vector>> edges, где edges[v] — массив ребер, исходящих из вершины v. Каждое ребро задается парой чисел — номером конечной вершины и весом.

Расстояния до вершин хранятся в vector d, причем изначально все элементы этого массива — числа, заведомо большие, чем расстояния до всех вершин.

**BFS 0-1**

```

void BFS()

{

// Инициализация

deque q;

q.push\_back(start);

d[start] = 0;

// Главный цикл

while (!q.empty())

{

// Достаем вершину

int v = q.front();

q.pop\_front();

// Смотрим на всех ее соседей

for (int i = 0; i < (int)edges[v].size(); ++i)

{

// Если можно улучшить известное расстояние

if (d[edges[v][i].first] > d[v] + edges[v][i].second)

{

// То улучшаем его и добавляем вершину в дек

d[edges[v][i].first] = d[v] + edges[v][i].second;

// Если ребро бесплатное, то в начало

if (edges[v][i].second == 0)

{

q.push\_front(edges[v][i].first);

}

// Иначе - в конец

else

{

q.push\_back(edges[v][i].first);

}

}

}

}

}

```

#### Сложность алгоритма

Для каждого ребра и каждой вершины выполняется константное количество действий, поэтому временная сложность алгоритма — O(V+E).

Каждая вершина, очевидно, попадает в дек не более двух раз, поэтому количество используемой алгоритмом памяти — O(V).

|

https://habr.com/ru/post/200560/

| null |

ru

| null |

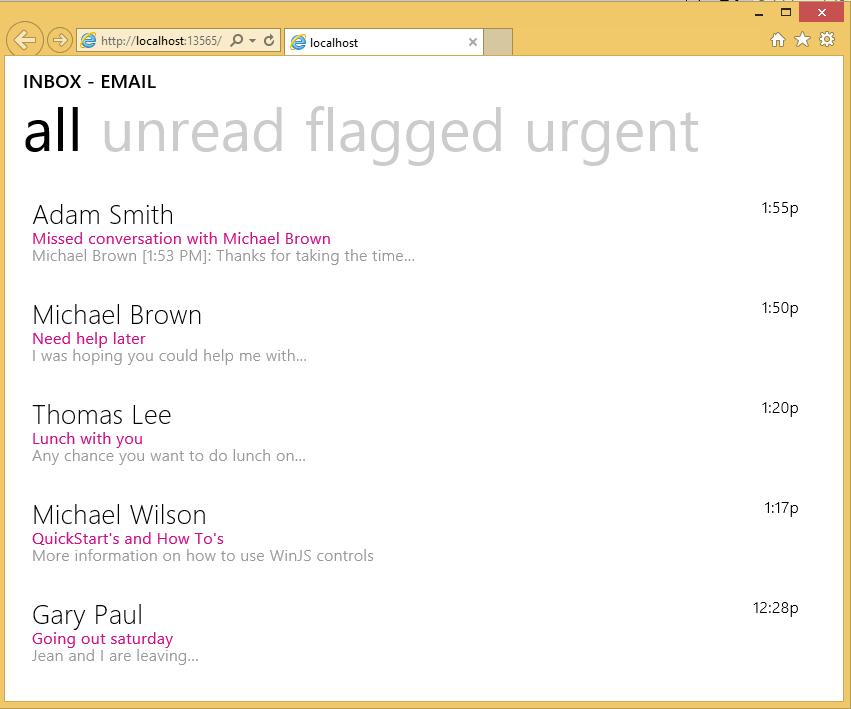

# Регулярные выражения Oracle. Опасный диапазон

Разработчик Oracle, часто использующий в коде [регулярные выражения](http://docs.oracle.com/database/121/ADFNS/adfns_regexp.htm#ADFNS9999), особенно на базах с православными настройками, рано или поздно может столкнуться с явлением, которое, кроме как мистикой, никак не назовешь. Длительные поиски причин возникновения проблемы могут привести к потере веса, аппетита и спровоцировать различного рода психосоматические расстройства — все это я сейчас и попробую предотвратить. А поможет мне в этом функция regexp\_replace. Она может иметь до 6 аргументов:

**REGEXP\_REPLACE** (

1. исходная\_строка,

2. шаблон,

3. заменяющая\_строка,

4. позиция начала поиска совпадения с шаблоном (по умолчанию 1),

5. номер вхождения шаблона в исходную строку (по умолчанию 0 – все вхождения),

6. модификатор (пока что темная лошадка)

)

Возвращает измененную исходную\_строку, в которой все вхождения шаблона заменены значением, переданным в параметре заменяющая\_строка. Зачастую пользуются короткой версией функции, где заданы 3 первых аргумента, что бывает достаточно для решения многих задач. Я тоже так сделаю. Допустим, нам нужно в строке 'MASK: lower case' замаскировать все строчные символы звездочками. Для задания диапазона строчных символов должен подойти шаблон '[a-z]'. Проверяем

```

select regexp_replace('MASK: lower case', '[a-z]', '*') as result from dual

```

Ожидание

```

+------------------+

| RESULT |

+------------------+

| MASK: ***** **** |

+------------------+

```

Реальность

```

+------------------+

| RESULT |

+------------------+

| *A**: ***** **** |

+------------------+

```

Если на вашей базе это явление не воспроизвелось, значит вам пока повезло. Но чаще начинаются копания в кодировках, конвертации строк из одного набора символов в другой и со временем наступает примерно такое состояние

**Постановка диагноза.**

Возникает вопрос – что же такого особенного в букве 'А', что она не заменилась, ведь остальные прописные символы тоже не должны были. Может, кроме нее есть еще какие-то правильные буквы? Надо смотреть весь алфавит прописных символов.

```

select regexp_replace('ABCDEFJHIGKLMNOPQRSTUVWXYZ', '[a-z]', '*') as alphabet from dual

+----------------------------+

| ALPHABET |

+----------------------------+

| A************************* |

+----------------------------+

```

Однако.

А прикол вот в чем. Если явно не задан 6-й аргумент функции – модификатор, например, 'i' – регистронезависимость, или 'с' – регистрозависимость при сравнении исходной строки с шаблоном, то регулярное выражение по умолчанию использует NLS\_SORT параметр сессии / базы. У меня он такой:

```

select value from sys.nls_session_parameters where parameter = 'NLS_SORT'

+---------+

| VALUE |

+---------+

| RUSSIAN |

+---------+

```

Этот параметр задает способ сортировки в ORDER BY. Если речь идет о сортировке простых одиночных символов, то каждому из них в двоичном представлении соответствует некоторое число (NLSSORT–код) и сортировка на самом деле происходит по величине этих чисел.

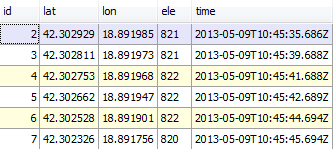

Для наглядного примера возьмем несколько первых и несколько последних символов алфавита, как строчных, так и прописных, и поместим их в условно неупорядоченный табличный набор, назовем его ABC. Затем отсортируем этот набор по полю SYMBOL и рядом с каждым символом отобразим его NLSSORT–код в HEX формате.

```

with ABC as (

select column_value as symbol

from table(sys.odcivarchar2list('A','B','C','X','Y','Z','a','b','c','x','y','z'))

)

select symbol,

nlssort(symbol) nls_code_hex

from ABC

order by symbol

```

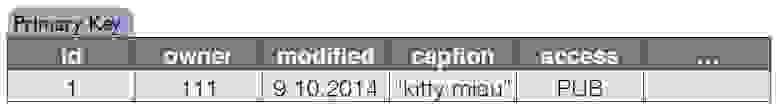

| SYMBOL | NLS\_CODE\_HEX |

| --- | --- |

| A | 14000100 |

| a | 14000200 |

| B | 19000100 |

| b | 19000200 |

| C | 1E000100 |

| c | 1E000200 |

| X | 7D000100 |

| x | 7D000200 |

| Y | 82000100 |

| y | 82000200 |

| Z | 87000100 |

| z | 87000200 |

В запросе указан ORDER BY по полю SYMBOL, но по факту в базе сортировка прошла по значениям из поля NLS\_CODE\_HEX.

Теперь вернемся к диапазону из шаблона и посмотрим на таблицу – что находится по вертикали между символом 'a' (код 14000200) и 'z' (код 87000200)? Все, кроме прописной буквы 'A'. Вот это все звездочкой и заменилось. А код 14000100 буквы 'A' в диапазон замены от 14000200 до 87000200 не попал.

С кириллицей такая же история. Ниже запрос с подобными результатами, их причины теперь понять не сложно.

```

select 1 id, regexp_replace('ABCDEFJHIGKLMNOPQRSTUVWXYZ', '[a-z]', '*') result from dual union all

select 2, regexp_replace('abcdefjhigklmnopqrstuvwxyz', '[A-Z]', '*') from dual union all

select 3, regexp_replace('АБВГДЕЁЖЗИЙКЛМНОПРСТУФХЦЧШЩЭЮЯ', '[а-я]', '*') from dual union all

select 4, regexp_replace('абвгдеёжзийклмнопрстуфхцчшщэюя', '[А-Я]', '*') from dual

```

| ID | RESULT |

| --- | --- |

| 1 | A\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\* |

| 2 | \*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*z |

| 3 | А\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\* |

| 4 | \*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*\*я |

**Лечение.**

Явно указывать модификатор регистрозависимости

```

select regexp_replace('MASK: lower case', '[a-z]', '*', 1, 0, 'c') from dual

+------------------+

| RESULT |

+------------------+

| MASK: ***** **** |

+------------------+

```

В некоторых источниках пишут, что модификатор 'c' задается по умолчанию, но только что мы увидели, что это не совсем так. А если кто не увидел, значит, NLS\_SORT параметр его сессии / базы скорее всего установлен в BINARY и сортировка идет по соответствию с реальными кодами символов. Действительно, если изменить параметр сессии, проблема уйдет.

```

ALTER SESSION SET NLS_SORT=BINARY;

select regexp_replace('MASK: lower case', '[a-z]', '*') as result from dual

+------------------+

| RESULT |

+------------------+

| MASK: ***** **** |

+------------------+

```

Тесты, если что, проводились в Oracle 12c.

А пока все. Доброго здоровья.

|

https://habr.com/ru/post/269387/

| null |

ru

| null |

# Отлов и обработка исключений в Yii2

В Yii2 по-умолчанию все Exception обрабатываются, за это отвечает специальный обработчик. Если при обработке запроса возникает нехорошая ситуация (например, пришли некорректные данные от клиента), то можно выбросить исключение. Обработчик сформирует человекообразный ответ.

Интересно, что в таком случае ошибка “Warning: Uncaught exception” в лог ошибок не выводится. Может создаться впечатление, что все исключения перехватываются средствами фреймворка. Но это не так. На наш проект некоторое время назад натравили средство мониторинга (в нашем случае New Relic), которое информацию обо всех выброшенных исключениях отображает в ошибках (именно как “Warning: Uncaught exception”), считает эти исключения необработанными. С этим надо было что-то делать.

Ниже расскажу о схеме обработки исключений, которую в итоге выбрал. Вполне возможно, что кому-то это еще пригодится.

#### Почему обработанные исключения считаются не пойманными

В Yii2 обработчик ошибок задается функцией [set\_exception\_handler()](http://php.net/manual/ru/function.set-exception-handler.php). Эта функция определяет обработчик для не пойманных исключений. При этом исключения хоть и обрабатываются, но остаются-таки не пойманными. Чтобы исключения считались пойманными, их все равно надо явно ловить, оборачивая вызовы в try-catch. В каждом экшне каждого контроллера делать этого очень не хотелось. Я считаю удобным иметь единую точку перехвата.

В Yii2, как оказалось, для этого есть готовый вариант — если выбросить исключение [yii\base\ExitException](http://www.yiiframework.com/doc-2.0/yii-base-exitexception.html) (или потомка от него), то такое исключение обрабатывается средствами фреймворка. Для наглядности, вот как это сделано в Application::run():

```

public function run()

{

try {

$this->state = self::STATE_BEFORE_REQUEST;

$this->trigger(self::EVENT_BEFORE_REQUEST);

$this->state = self::STATE_HANDLING_REQUEST;

$response = $this->handleRequest($this->getRequest());

$this->state = self::STATE_AFTER_REQUEST;

$this->trigger(self::EVENT_AFTER_REQUEST);

$this->state = self::STATE_SENDING_RESPONSE;

$response->send();

$this->state = self::STATE_END;

return $response->exitStatus;

} catch (ExitException $e) {

$this->end($e->statusCode, isset($response) ? $response : null);

return $e->statusCode;

}

}

```

#### “Хорошие” и “плохие” исключения

Мне удобно выбрасывать исключения с целью завершения обработки запроса в двух случаях.

1. Если ничего не сломалось, просто имеет место мелкое недоразумение — пришел кривой веб-запрос на клиент или не нашлось каких-то не особо критичных запрашиваемых данных.

2. Если что-то сломалось.

В первом случае не надо логировать событие как ошибку и разбираться с этим не надо.

Во втором случае надо логировать проблему, чтобы знать о случившемся и разбираться с проблемой.

Для первого случая я создал такой класс, унаследованный от yii\base\ExitException. Чтобы результатом работы скрипта была не пустая страница, прямо в исключении генерируется ответ.

```

php

namespace app\components;

use yii;

use yii\base\ExitException;

/**

* Исключение, которое будет автоматически обрабатываться на уровне yii\base\Application

*/

class GoodException extends ExitException

{

/**

* Конструктор

* @param string $name Название (выведем в качестве названия страницы)

* @param string $message Подробное сообщение об ошибке

* @param int $code Код ошибки

* @param int $status Статус ответа

* @param \Exception $previous Предыдущее исключение

*/

public function __construct($name, $message = null, $code = 0, $status = 500, \Exception $previous = null)

{

# Генерируем ответ

$view = yii::$app-getView();

$response = yii::$app->getResponse();

$response->data = $view->renderFile('@app/views/exception.php', [

'name' => $name,

'message' => $message,

]);

# Возвратим нужный статус (по-умолчанию отдадим 500-й)

$response->setStatusCode($status);

parent::__construct($status, $message, $code, $previous);

}

}

```

А также создано еще представление.

```

php

/* @var $this yii\web\View */

/* @var $name string */

/* @var $message string */

/* @var $exception Exception */

use yii\helpers\Html;

$this-title = $name;

?>

php $this-beginContent('@app/views/layouts/main.php'); ?>

= Html::encode($this-title) ?>

==============================

= nl2br(Html::encode($message)) ?

The above error occurred while the Web server was processing your request.

Please contact us if you think this is a server error. Thank you.

php $this-endContent(); ?>

```

#### Итого

Таким образом, чтобы выбросить “культурное” исключение, пишем:

```

# Выбрасываем исключение, которое будет поймано

throw new GoodException('Проблемка', 'Эта проблема аккуратно обрабатывается');

```

Такие исключения будут перехвачены и на клиент вернется аккуратный ответ. В лог ошибок такие события попадать не будут.

Все остальные исключения, если вы их явно не поймаете, ловиться не будут. И будут попадать в ошибки. Т.е. для второго случая можно писать

```

throw new yii\base\ErrorException('Эта проблема критичная');

```

|

https://habr.com/ru/post/264863/

| null |

ru

| null |

# Как происходит рендеринг экрана сообщений ВКонтакте

Что делает ВКонтакте, чтобы уменьшить лаги отрисовки? Как отобразить очень большое сообщение и не убить UiThread? Как уменьшить задержки при скролле в RecyclerView?

Мой опыт основан на работе отрисовки экрана сообщений в Android-приложении VK, в котором необходимо показывать огромное количество информации с минимумом тормозов на UI.

Я программирую под Android уже почти десять лет, ранее занимался фрилансом для PHP/Node.js. Сейчас — старший Android-разработчик ВКонтакте.

Под катом — видео и расшифровка моего доклада с конференции Mobius 2019 Moscow.

В докладе раскрываются три темы

-------------------------------

* [Стандартные решения — базовые принципы того, как устроен экран сообщений VK.](#ordinary)

* [Нестандартные решения — малоизвестные или оригинальные решения, которые позволяют минимизировать лаги UI.](#extrodinary)

* [Альтернативы — о различных библиотеках и реализациях, а также о том, почему разработчики VK их не использовали.](#alt)

Посмотрите на экран:

Это сообщение где-то на пять экранов. И они вполне могут у нас быть (в случае пересылок сообщений). Стандартные средства уже не будут работать. Даже на топовом девайсе всё может лагать.

Ну и, помимо этого, сам UI довольно разнообразен:

* даты и индикаторы подгрузки,

* сервисные сообщения,

* текст (emoji, link, email, hashtags),

* клавиатура ботов,

* ~40 способов отображения аттачей,

* дерево пересланных сообщений.

Встаёт вопрос: как сделать так, чтобы количество лагов было как можно меньше? Как в случае простых сообщений, так и в случае объемных (edge-case из видео выше).

Стандартные решения

-------------------

### RecyclerView и его надстройки

Есть различные надстройки над RecyclerView.

* setHasFixedSize (`boolean`)

Многие считают, что этот флаг нужен тогда, когда элементы списка имеют одинаковый размер. Но на самом деле, судя по документации, всё наоборот. Это когда размер RecyclerView постоянный и не зависит от элементов (грубо говоря, не wrap\_content). Установка флага помогает немного повысить скорость у RecyclerView, чтобы он избежал лишних вычислений.

* setNestedScrollingEnabled (`boolean`)

Незначительная оптимизация, отключающая поддержку NestedScroll. У нас на этом экране нет CollapsingToolbar или других фич, зависящих от NestedScroll, поэтому можем смело выставить этот флаг в false.

* setItemViewCacheSize (`cache_size`)

Настройка внутреннего кэша RecyclerView.

Многие думают, что механика RecyclerView — это:

* есть ViewHolder, отображаемый на экране;

* есть RecycledViewPool, хранящий ViewHolder;

* когда ViewHolder уходит с экрана — он помещается в RecycledViewPool.

На практике всё немного сложнее, ведь между этими двумя вещами есть промежуточный кеш. Он называется ItemViewCache. В чём его суть? Когда ViewHolder уходит с экрана, он помещается не в RecycledViewPool, а в промежуточный кеш (ItemViewCache). Все изменения в адаптере применяются как к видимым ViewHolder, так и к ViewHolder внутри ItemViewCache. А к ViewHolder внутри RecycledViewPool изменения не применяются.

Через setItemViewCacheSize мы можем задать размер этого промежуточного кеша.

Чем он больше, тем быстрее будет скролл на небольшие расстояния, но операции обновления будут выполняться дольше (из-за ViewHolder.onBind и т. д.).

Как реализован RecyclerView и как устроен его кеш — довольно большая и сложная тема. Можно прочитать большую [статью](https://android.jlelse.eu/anatomy-of-recyclerview-part-1-a-search-for-a-viewholder-404ba3453714), где детально рассказывают про всё.

### Оптимизация OnCreate/OnBind

Ещё одно классическое решение — оптимизация onCreateViewHolder/onBindViewHolder:

* лёгкая верстка (стараемся максимально использовать FrameLayout либо Custom ViewGroup),

* тяжёлые операции (парсинг ссылок/emoji) делаются асинхронно на этапе загрузки сообщений,

* StringBuilder для форматирования имени, даты, etc.,

* и прочие решения, сокращающие время работы этих методов.

### Отслеживание Adapter.onFailedToRecyclerView()

У вас есть список, в котором какие-то элементы (или их часть) анимируются с альфой. В тот момент, когда View, будучи в процессе анимации, уходит с экрана, то она не уходит в RecycledViewPool. Почему? RecycledViewPool видит, что View сейчас анимируется за счёт флага View.hasTransientState, и просто её игнорирует. Поэтому в следующий раз при скролле вверх-вниз картинка не будет браться из RecycledViewPool, а создастся заново.

Самое правильное решение — когда ViewHolder уходит с экрана, нужно отменять все анимации.

Если же нужен хотфикс как можно скорее или вы ленивый разработчик, то в методе onFailedToRecycle можно просто всегда возвращать true и всё будет работать, но я бы не советовал так делать.

### Отслеживание Overdraw и Profiler

Классический способ обнаружения проблем — отслеживание overdraw и profiler.

Overdraw — количество перерисовок пикселя: чем меньше слоев и чем меньше перерисовывается пиксель, тем быстрее. Но по моим наблюдениям, в современных реалиях, это уже не так сильно влияет на performance.

Profiler — он же Android Monitor, который есть в Android Studio. В нём можно проанализировать все вызываемые методы. Например, открыть сообщения, прокрутить вверх-вниз и посмотреть, какие методы вызывались и сколько они заняли времени.

Всё, что находится в левой половине, — это системные вызовы Android, которые нужны, чтобы создать/отрисовать View/ViewHolder. На них мы либо не можем повлиять, либо нужно будет потратить много усилий.

Правая половина — наш код, который исполняется во ViewHolder.

Блок вызовов под №1 — это вызов регулярных выражений: где-то недосмотрели и забыли вынести операцию на фоновый поток, тем самым замедлив скролл на ~20%.

Блок вызовов под №2 — Fresco, библиотека для отображения картинок. Она местами не оптимальна.Пока непонятно, что делать с этим лагом, но если получится решить, то сэкономим ещё ~15%.

То есть, исправив эти проблемы, мы можем получить прирост ~35%, а это довольно круто.

### DiffUtil

Многие из вас используют DiffUtil в стандартном виде: есть два списка — вызвали, сравнили и запушили изменения. Выполнять всё это на основном потоке немного затратно, потому что список может быть очень большим. Так что обычно вычисление DiffUtil запускается на фоновом потоке.

ListAdapter и AsyncListDiffer это делают за вас. ListAdapter расширяет обычный Adapter и запускает всё асинхронно — достаточно сделать submitList и весь расчёт изменений улетает на внутренний фоновый поток. ListAdapter умеет учитывать кейс частых обновлений: если его вызвать три раза подряд, он возьмёт только последний результат.

Сам DiffUtil мы используем только для каких-то структурных изменений — появления сообщения, его изменения и удаления. Для некоторых быстроизменяемых данных он не подходит. Например, когда загружаем фото или проигрываем аудио. Такие события происходят часто — несколько раз в секунду, и если каждый раз запускать DiffUtil, то получится очень много лишней работы.

### Анимации

Когда-то очень давно был фреймворк Animation — довольно скудный, но всё же уже что-то. Работали с ним так:

```

view.startAnimation(TranslateAnimation(fromX = 0, toX = 300))

```

Проблема в том, что параметр getTranslationX() до анимации и после будет возвращать одно и то же значение. Это потому, что Animation менял визуальное представление, но при этом не менял физические свойства.

В Android 3.0 появился фреймворк Animator, более корректный, потому что он менял конкретное физическое свойство объекта.

Позже появился ViewPropertyAnimator и все до сих пор не очень понимают его отличие от Animator.

Поясню. Допустим, вам нужно сделать translation по диагонали — сместить View по осям x,y. Скорее всего, вы бы написали типичный код:

```

val animX = ObjectAnimator.ofFloat(view, “translationX”, 100f)

val animY = ObjectAnimator.ofFloat(view, “translationY”, 200f)

AnimatorSet().apply {

playTogether(animX, animY)

start()

}

```

А можно сделать короче:

```

view.animate().translationX(100f).translationY(200f)

```

Когда вы исполняете view.animate(), вы неявно запускаете ViewPropertyAnimator.

Зачем он нужен?

1. Проще читать и поддерживать код.

2. Batch операций анимации.

В нашем прошлом кейсе мы изменяли два свойства. Когда мы делаем это через аниматоры, то тики анимаций будут вызываться отдельно для каждого Animator. То есть setTranslationX и setTranslationY будут вызваны раздельно, и View будет производить операции обновления отдельно.

В случае ViewPropertyAnimator изменение происходит одновременно, поэтому получается экономия за счёт меньшего количества операций и само изменение свойств лучше оптимизировано.

Подобного можно достичь и с помощью Animator, но придётся писать больше кода. Помимо этого, используя ViewPropertyAnimator, можно быть уверенным, что анимации будут максимально оптимизированы. Почему? В Android есть RenderNode (DisplayList). Очень грубо говоря, они кешируют результат onDraw и используют его при перерисовке. ViewPropertyAnimator работает напрямую с RenderNode и применяет анимации к ней, избегая вызовы onDraw.

Многие свойства View тоже могут напрямую влиять на RenderNode, но не все. То есть при использовании ViewPropertyAnimator вы гарантированно задействуете максимально производительный способ. Если у вас вдруг есть какие-то анимации, которые не могут быть выполнены с помощью ViewPropertyAnimator, то, возможно, стоит задуматься и изменить их.

### Анимации: TransitionManager

Обычно у людей возникает ассоциация, что этот фреймворк используется для перехода с одной Activity на другую. На самом деле, он может использоваться иначе и очень упрощать реализацию анимации изменения структуры. Допустим, у нас есть экран, на котором играет голосовое сообщение. Мы закрываем его крестиком, и плашка уходит наверх. Как это сделать? Анимация довольно сложная: плеер закрывается с альфой, при этом двигается не через translation, а меняет свою высоту. Одновременно с этим наш список поднимается наверх и тоже меняет высоту.

Если бы плеер был частью списка, то анимации было бы сделать довольно просто. Но у нас плеер это не элемент списка, а вполне самостоятельная View.

Возможно, мы бы начали писать какой-нибудь Animator, затем столкнулись бы с проблемами, крашами, начали бы пилить костыли и ещё в два раза увеличили код. И получили бы что-то, как на экране ниже.

С помощью TransitionManager всё можно сделать проще:

```

TransitionManager.beginDelayedTransition(

viewGroup = ,

transition = AutoTransition())

playerView.visibility = View.GONE

```

Вся анимация происходит автоматически под капотом. Это выглядит как магия, но если углубиться внутрь и посмотреть, как это работает, то выяснится, что TransitionManager просто подписывается на все View, ловит изменения их properties, высчитывает diff, создаёт нужные аниматоры или ViewPropertyAnimator, где нужно, и делает всё максимально производительно. TransitionManager позволяет нам делать анимации в разделе сообщений быстрыми и простыми в реализации.

Нестандартные решения

---------------------

Это самая фундаментальная вещь, на которой основан performance и последующие за ним проблемы. Что делать, когда ваше сообщение находятся на 10 экранах? Если обратить внимание, то все наши элементы располагаются ровно друг под другом. Если мы примем, что ViewHolder это не одно сообщение, а десятки различных ViewHolder-ов, тогда всё становится сильно проще.

Для нас не проблема, что сообщение стало на 10 экранов, ведь теперь мы отображаем в конкретном примере всего лишь шесть ViewHolder-ов. Мы получили лёгкую верстку, код проще поддерживать, да и проблем особых нет, кроме одной — как это сделать?

Есть простые ViewHolder — это классические разделители даты, Load more и так далее. И BaseViewHolder — условно базовый ViewHolder для сообщения. У него есть базовая реализация и несколько конкретных — TextViewHolder, PhotoViewHolder, AudioViewHolder, ReplyViewHolder и так далее. Всего их около 70.

### За что отвечает BaseViewHolder

BaseViewHolder отвечает только за то, чтобы отрисовать аватарку и нужный кусок bubble, а также линию для пересланных сообщений — голубую слева.

Конкретную реализацию контента осуществляют уже другие наследники BaseViewHolder: TextViewHolder отображает только текст, FwdSenderViewHolder — автора пересланного сообщения, AudioMsgViewHolder — голосовое сообщение и так далее.

Возникает проблема: что делать с шириной? Представьте, что сообщение хотя бы на два экрана. Не очень понятно, какую ширину выставить, потому что половина видна, половина не видна (и ещё даже не создалась). Измерить абсолютно всё нельзя, потому что это лагает. Приходится немного костылить, увы. Есть простые случаи, когда сообщение очень простое: чисто текст или голосовое — в общем, состоит из одного Item.

В этом случае используем классический wrap\_content. Для сложного кейса, когда сообщение состоит из нескольких кусков, мы берём и форсируем каждому ViewHolder фиксированную ширину. Конкретно здесь — 220 dp.

Если текст очень короткий и сообщение пересланное, остаётся пустое пространство справа. От этого никуда не деться, потому что перформанс важнее. За несколько лет использования жалоб не было — может, кто-то и замечал, но в целом все привыкли.

Есть edge-кейсы. Если на какое-то сообщение отвечаем стикером, то мы можем указать ширину конкретно для такого кейса, чтобы выглядело симпатичнее.

Мы разбиваем на ViewHolder-ы на этапе загрузки сообщений: запускаем фоновую загрузку сообщения, преобразуем в item, они напрямую отображаются во ViewHolder-ы.

### Глобальный RecycledViewPool

Механика использования нашего мессенджера такова, что люди не сидят в одном чате, а постоянно ходят между ними. В стандартном подходе, когда зашли в чат и вышли из него, RecycledViewPool (и ViewHolder в нём) просто уничтожаются, и мы каждый раз тратим ресурсы создание ViewHolder.

Это можно решить глобальным RecycledViewPool:

* в рамках Application живёт RecycledViewPool как синглтон;

* переиспользуется на экране сообщений, когда пользователь ходит между экранами;

* устанавливается как RecyclerView.setRecycledViewPool(pool).

Есть и подводные камни, важно помнить две вещи:

* вы зашли на экран, нажали back, вышли. Проблема в том, что те ViewHolder, что были на экране, выбрасываются, а не возвращаются в pool. Это исправляется так:

```

LinearLayoutManager.recycleChildrenOnDetach = true

```

* RecycledViewPool имеет ограничения: для каждого ViewType может храниться не больше пяти ViewHolder.

Если на экране отобразились 9 TextView, в RecycledViewPool вернутся только пять item-ов, а остальные будут выброшены. Размер RecycledViewPool можно поменять:

RecycledViewPool.setMaxRecycledViews(viewType, size)