text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# COBOL и $2 020 202,02

В прошлые годы, даже в последние год-два мне иногда попадались новости, что кому-то пришёл счёт или чек на смешную сумму 2 020 202 доллара… и 02 цента.

Если вы такое увидите, то (почти наверняка) это ошибка программирования на COBOL. Большинство программистов COBOL совершают эту глупую ошибку, и я не исключение.

Проблема вызвана тем, как именно мы обычно инициализируем запись. Возьмём такую маленькую программу:

```

identification division.

program-id.

mistake.

data division.

working-storage section.

* *** Input record, typically maintained on disk/tape somewhere.

01 dr-datarec.

03 dr-name pic x(20).

03 dr-amount pic s9(7)v99, comp-3.

* *** print record, sent to a line printer.

01 dt-detail.

03 dt-name pic x(20).

03 filler pic x.

03 dt-amount pic z,zzz,zz9.99.

procedure division.

move spaces to dr-datarec.

move "test" to dr-name.

move 100 to dr-amount.

move spaces to dt-detail.

move dr-name to dt-name.

move dr-amount to dt-amount.

display dt-detail.

stop run.

```

В этой программе входная запись `dr-datarec`. Обычно она идёт откуда-то с диска, но для этого простого теста создаётся вручную.

Как только получена входная запись, выполняются вычисления, а затем запись выводится с помощью `dt-detail`.

Проблема в том, как создаётся запись `dr-datarec`. Обратите внимание, как перемещаются пробелы для её инициализации. Это был типичный метод инициализации записи.

Таким образом, пробелы есть во всех полях PIC X. Но! Все поля COMP-3 также инициализируются, только не до нуля. Программист должен быть уверен, что для всех полей COMP-3 создаются допустимые значения. В тестовой программе это делается правильно:

```

move spaces to dr-datarec.

move "test" to dr-name.

move 100 to dr-amount.

```

В поле `dr-amount` явно есть 100. После запуска получается:

```

./mistake

test 100.00

```

Что делать, если допущена ошибка кодирования и запись `dr-amount` не инициализирована должным образом?

Там всё ещё есть пробелы ASCII. Это шестнадцатеричное значение 20 или двоичное 0010 0000.

COMP-3 хранит цифры в виде четырёхбитных «нибблов», поэтому один пробел отображается как 20. Если у вас 9 цифр, как у dr-amount, то для этого требуется 10 нибблов памяти (9 нибблов для цифр и один для знака) или 5 байт.

Перемещение пробелов в `dr-datarec` приведёт к тому, что в это поле сохранится 5 пробелов или шестнадцатеричное значение 2020202020. Если попытаться использовать неинициализированную переменную, это интерпретируется как 2 020 202,02.

Если закомментировать инициализацию `dr-amount`, то можно принудительно вызвать эту ошибку:

```

move spaces to dr-datarec.

move "test" to dr-name.

* move 100 to dr-amount.

```

Теперь при запуске программы:

```

./mistake

test 2,020,202.02

```

Чтобы исправить эту проблему, COBOL 85 ввёл глагол INITIALIZE. Вместо перемещения пробелов в запись вы её инициализируете, а она переместит пробелы в буквенно-цифровые поля, а нули — в числовые:

```

* move spaces to dr-datarec.

initialize dt-detail.

move "test" to dr-name.

* move 100 to dr-amount.

```

Результат выполнения:

```

./mistake

test 0.00

```

Так что в следующий раз, когда увидите бедную вдову, которой пришёл счёт за коммунальные услуги $2 020 202,02, вы будете точно знать, что произошло!

|

https://habr.com/ru/post/526646/

| null |

ru

| null |

# Почтовые рассылки на базе DIVной верстки: это возможно!

Тема почтовых рассылок на хабре поднималась буквально недавно, но там не освещался один важдый момент: как обеспечить редактируемость контента этой рассылки после красивой и аккуратной верстки.

Ведь если сверстано на таблицах, с пустыми gif'ами для отступов — результат «монолитный», но не дай бог такое редактировать контент-менеджеру. Моментально всё поедет, да и не умеют нормально визивиги работать с таким ужасом.

Так можно ли подготовить нормальную, дивную верстку, которая легко поддерживается, удобно собирается в рассылках из частей, может редактироваться из визивига, и при этом будет хорошо смотреться в почте?

Не буду повторяться, вкратце, требования к HTML файлу, отсылаемому клиенту:

1. Никаких внешних стилей, никаких тегов

|

https://habr.com/ru/post/123757/

| null |

ru

| null |

# Скрипт Automator, загружающий изображения на Habrastorage: второе пришествие

Некоторое время назад я сделал [скрипт](http://habrahabr.ru/post/207282/), который загружает изображения на Habrastorage прямо из файлового менеджера. Но вот беда: после [обновления](http://habrahabr.ru/company/tm/blog/139897/) он перестал работать.

Но вчера мне все-таки надоело загружать фотографии через веб-интерфейс, и я пошел чинить скрипт.

За решение надо ставить плюсики в карму пользователю [avalak](https://habrahabr.ru/users/avalak/), который рассказал как это сделать в моем [вопросе](http://toster.ru/q/75434) на тостере. Тостер — торт!

Итак, как теперь загружать изображения?

Раньше для загрузки картинок использовалась вот такая команда:

`curl -F "Filedata=@/Users/vvzvlad/Documents/REVIEWS/003.jpg" "http://habrastorage.org/uploadController/?username=vvzvlad&userkey=7a25d94cde460365b6f7ce137675c623ec"`

С новой версией HS она приняла вот такой вид:

`curl --cookie "habrastorage_sid= fs5csqksk0hdm5mq3o91cmdm97" --form "files[]=@/Users/vvzvlad/Documents/REVIEWS/003.jpg --header "X-Requested-With: XMLHttpRequest" --header "Referer: habrastorage.org" --request POST habrastorage.org/main/upload`

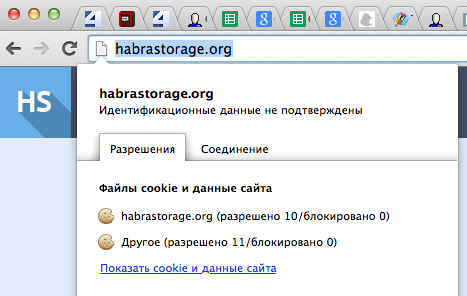

Авторизация теперь происходит не по коду, а по содержимому куки. Чтобы его узнать, надо зайти на хабрасторедж, нажать(в хроме) на пустой листик перед адресом и выбрать «Показать cookie и данные сайта»:

После чего найти ее в списке и скопировать содержимое:

И вставить ее в скрипт:

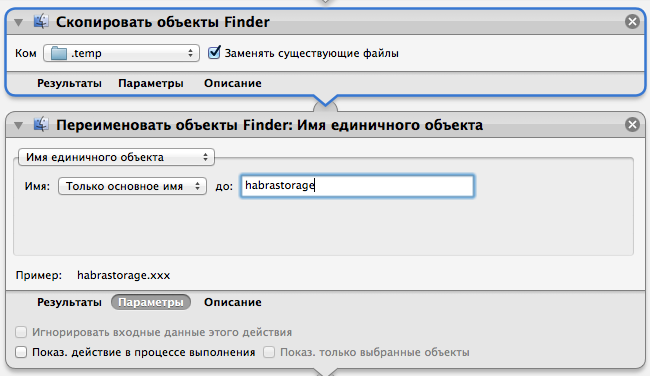

Кстати, у предыдущей версии скрипта были определенные проблемы с именами папок и файлов, содержащими пробелы. Чтобы избежать этого, сделаем вот так:

Мы перемещаем файл во временную папку, переименовываем его, чтобы убрать пробелы в имени и загружаем. А после загрузки — удаляем:`rm "$FILE"`

Еще из нового — у меня картинка вставляется в текст черновика автоматически. Делается это следующей конструкцией:

`set the clipboard to ""

display notification input with title "Картинка загружена"

tell application "Google Chrome" to activate

tell application "System Events" to key code 9 using command down`

Первая строка — формирует из адреса картинки тег изображения, вторая показывает уведомление, третья — делает приложение «Chrome» активным, а четвертая виртуально нажимает кнопку cmd+v.

Как обычно, файл со службой лежит вот [тут](https://www.dropbox.com/s/cskmuqujb4bluob/%D0%A1%D1%81%D1%8B%D0%BB%D0%BA%D0%B0%20%D0%BD%D0%B0%20%D0%BA%D0%B0%D1%80%D1%82%D0%B8%D0%BD%D0%BA%D1%83%20%D0%B2%20%D1%85%D1%80%D0%BE%D0%BC.zip). Надо распаковать архив и его содержимое переместить в /Users/User/Library/Services/. Открыть его, щелкнув два раза на файл, и вставить свою куку внутрь.

Правда, что делать с протухающей через несколько дней кукой — я еще не знаю. Пока буду копировать вручную.

|

https://habr.com/ru/post/214347/

| null |

ru

| null |

# Новый баг в реализации POP3 в Outlook 2016 удаляет письма

Microsoft признала [баг](https://support.microsoft.com/en-us/kb/3145116) в Outlook 2016 последней версии 16.0.6568.2025. Если программа получает письма по протоколу POP3 и в настройках указано «Удалять с сервера через Х дней», то письма удаляются с сервера немедленно.

С другой стороны, если эта опция отключена, то письма дублируются.

Microsoft пока думает над решением проблемы, а в качестве обходного маневра рекомендует откатиться на предыдущую версию. Для этого нужно отключить автоматические обновления в `File->Office Account->Update Options`, а затем запустить из командной строки команду

`C:\Program Files\Common Files\Microsoft shared\ClickToRun\officec2rclient.exe" /update user updatetoversion=16.0.6366.2068`

Другой вариант — использовать IMAP вместо POP3.

|

https://habr.com/ru/post/391149/

| null |

ru

| null |

# RSA шифрование через библиотеку OpenSSL в Delphi

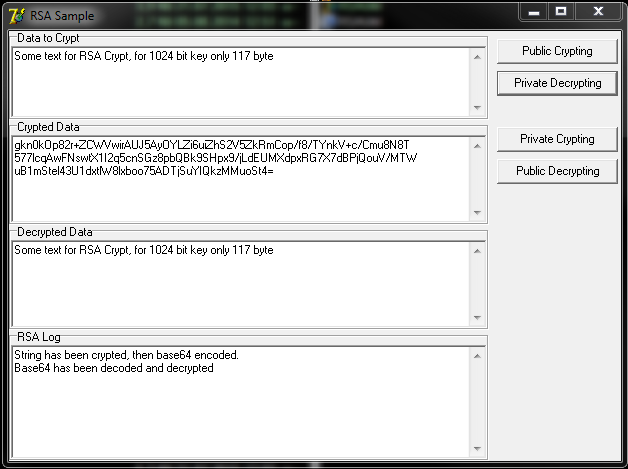

По долгу службы в разработчиках повстречалась задача шифровать текстовые строки алгоритмом RSA, используя публичный и секретный ключи в PEM формате. При изучении данного вопроса выбор пал на использование библиотеки OpenSSL. Хочу поделиться примерами реализации функциональности шифрования на Delphi. Действия выполнялись в ОС Windows, среда разработки Borland Delphi 7.

#### С чего начать?

В первую очередь необходим пакет openssl, а точнее библиотека libeay32.dll. И для подключения библиотеки нам понадобится готовый юнит [libeay32.pas](https://github.com/ddlencemc/RSA-via-OpenSSL-libeay32/blob/master/libeay32.pas), который необходимо подключить к проекту. В моем примере отсутствует функциональность генерации ключей из проекта, как это сделать можно будет почитать в материале по ссылке снизу статьи. Для генерации пары ключей я использовал сам openssl следующими командами из cmd:

*Генерируем приватный ключ и из него извлекаем публичным ключ*

```

openssl genrsa 1024 > private.pem

openssl rsa -in private.pem -pubout > public.pem

```

Где 1024 является битностью ключа. Отмечу, что от битности ключа зависит и длина строки для шифрования. Если ключ 1024 бита, то зашифровать сможем всего 128 байт, тот самый размер, которому равен размеру ключа. Ниже покажу функцию, определяющие размер структуры RSA ключа. Но это не все. Данный буфер уменьшится на 11 байт, если во время шифрования указать параметр **padding**, отвечающего за выравнивания данных — **PKCS#1**.

Сгенерировав ключ в 2048 бит, сможем зашифровать 256 байт. При этом увеличивается размер выходного шифрованного текста, даже если будет зашифрован всего 1 байт.

Для моей задачи было достаточно 117 байт, в которые умещались карточные данные, размер строк в базе, конечно же, значительно вырос. Но того требует безопасность.

#### Основные функции

Основное, что мы будем использовать для шифрования, — это:

###### Инициализация крипто функций

```

OpenSSL_add_all_algorithms;

OpenSSL_add_all_ciphers;

OpenSSL_add_all_digests;

ERR_load_crypto_strings;

ERR_load_RSA_strings;

```

Destroy

```

EVP_cleanup;

ERR_free_strings;

```

###### Чтение ключей

```

//чтение секретного ключа в формате PEM, возвращает структуру RSA

//Где bp файл ключа, возвращаемый в RSA структуру указывающей x, cb – адрес функции запрашиваемая пароль к ключу.

function PEM_read_bio_PrivateKey(bp: pBIO; var x: pEVP_PKEY;

cb: TPWCallbackFunction; u: pointer): pEVP_PKEY; cdecl;

//чтение публичного ключа в формате PEM, возвращает структуру RSA

function PEM_read_bio_PUBKEY(bp: pBIO; var x: pEVP_PKEY;

cb: TPWCallbackFunction; u: pointer): pEVP_PKEY; cdecl;

```

###### И функции шифрации/дешифрации

```

//Шифрование/дешифрование flen размера буфера from в буфер _to используя структуру RSA ключа загруженного ранее в режиме выравнивания

//данных padding. Получаем длину шифрованного/дешифрованного буфера или -1 при ошибке

//Шифрование публичным ключом

function RSA_public_encrypt(flen: integer; from: PCharacter; _to: PCharacter; rsa: pRSA; padding: integer): integer; cdecl;

//Шифрование секретным ключом

function RSA_private_encrypt(flen: integer; from: PCharacter; _to: PCharacter; rsa: pRSA; padding: integer): integer; cdecl;

//Дешифрование публичным ключом

function RSA_public_decrypt(flen: integer; from: PCharacter; _to: PCharacter; rsa: pRSA; padding: integer): integer; cdecl;

//Дешифрование секретным ключом

function RSA_private_decrypt(flen: integer; from: PCharacter; _to: PCharacter; rsa: pRSA; padding: integer): integer; cdecl;

```

#### Приступим к реализации

Итак, мы имеем сгенерированные ключи, dll-ка лежит в папке с проектом, liblea32.pas подключен в uses. Вызываем процедуры инициализации openssl:

```

procedure LoadSSL;

begin

OpenSSL_add_all_algorithms;

OpenSSL_add_all_ciphers;

OpenSSL_add_all_digests;

ERR_load_crypto_strings;

ERR_load_RSA_strings;

end;

procedure FreeSSL;

begin

EVP_cleanup;

ERR_free_strings;

end;

```

##### Пишем функции загрузки ключей.

KeyFile – пусть до ключа ('C:\key.pem'):

```

function LoadPublicKey(KeyFile: string) :pEVP_PKEY ;

var

mem: pBIO;

k: pEVP_PKEY;

begin

k:=nil;

mem := BIO_new(BIO_s_file()); //BIO типа файл

BIO_read_filename(mem, PAnsiChar(KeyFile)); // чтение файла ключа в BIO

try

result := PEM_read_bio_PUBKEY(mem, k, nil, nil); //преобразование BIO в структуру pEVP_PKEY, третий параметр указан nil, означает для ключа не нужно запрашивать пароль

finally

BIO_free_all(mem);

end;

end;

function LoadPrivateKey(KeyFile: string) :pEVP_PKEY;

var

mem: pBIO;

k: pEVP_PKEY;

begin

k := nil;

mem := BIO_new(BIO_s_file());

BIO_read_filename(mem, PAnsiChar(KeyFile));

try

result := PEM_read_bio_PrivateKey(mem, k, nil, nil);

finally

BIO_free_all(mem);

end;

end;

```

###### Вызов функций чтения ключей и обработка ошибок

```

var

FPublicKey: pEVP_PKEY;

FPrivateKey: pEVP_PKEY;

err: Cardinal;

…

FPublicKey := LoadPublicKey(‘C:\public.key’);

FPrivateKey := LoadPrivateKey(‘C:\private.key’);

//if FPrivateKey = nil then // если ключ не вернулся, то читаем ошибку

if FPublicKey = nil then

begin

err := ERR_get_error;

repeat

log.Lines.Add(string(ERR_error_string(err, nil)));

err := ERR_get_error;

until err = 0;

end;

```

##### Шифрование (Публичным ключом)

```

var

rsa: pRSA; // структура RSA

size: Integer;

FCryptedBuffer: pointer; // Выходной буфер

b64, mem: pBIO;

str, data: AnsiString;

len, b64len: Integer;

penc64: PAnsiChar;

size: Integer;

err: Cardinal

begin

rsa := EVP_PKEY_get1_RSA(FPrivateKey); // Получение RSA структуры

EVP_PKEY_free(FPrivateKey); // Освобождение pEVP_PKEY

size := RSA_size(rsa); // Получение размера ключа

GetMem(FCryptedBuffer, size); // Определение размера выходящего буфера

str := AnsiString(‘Some text to encrypt’); // Строка для шифрования

//Шифрование

len := RSA_public_encrypt(Length(str), // Размер строки для шифрования

PAnsiChar(str), // Строка шифрования

FCryptedBuffer, // Выходной буфер

rsa, // Структура ключа

RSA_PKCS1_PADDING // Определение выравнивания

);

if len > 0 then // длина буфера после шифрования

begin

// полученный бинарный буфер преобразуем в человекоподобный base64

b64 := BIO_new(BIO_f_base64); // BIO типа base64

mem := BIO_push(b64, BIO_new(BIO_s_mem)); // Stream

try

BIO_write(mem, FCryptedBuffer, len); // Запись в Stream бинарного выходного буфера

BIO_flush(mem);

b64len := BIO_get_mem_data(mem, penc64); //получаем размер строки в base64

SetLength(data, b64len); // задаем размер выходному буферу

Move(penc64^, PAnsiChar(data)^, b64len); // Перечитываем в буфер data строку в base64

finally

BIO_free_all(mem);

end;

end

else

begin // читаем ошибку, если длина шифрованной строки -1

err := ERR_get_error;

repeat

log.Lines.Add(string(ERR_error_string(err, nil)));

err := ERR_get_error;

until err = 0;

end;

RSA_free(rsa);

end;

```

##### Дешифрование (секретным ключом)

```

var

rsa: pRSA;

out_: AnsiString;

str, data: PAnsiChar;

len, b64len: Integer;

penc64: PAnsiChar;

b64, mem, bio_out, bio: pBIO;

size: Integer;

err: Cardinal;

begin

//ACryptedData : string; // Строка в base64

rsa := EVP_PKEY_get1_RSA(FPublicKey);

size := RSA_size(rsa);

GetMem(data, size); // Определяем размер выходному буферу дешифрованной строки

GetMem(str, size); // Определяем размер шифрованному буферу после конвертации из base64

//Decode base64

b64 := BIO_new(BIO_f_base64);

mem := BIO_new_mem_buf(PAnsiChar(ACryptedData), Length(ACryptedData));

BIO_flush(mem);

mem := BIO_push(b64, mem);

BIO_read(mem, str , Length(ACryptedData)); // Получаем шифрованную строку в бинарном виде

BIO_free_all(mem);

// Дешифрование

len := RSA_private_decrypt(size, PAnsiChar(str), data, rsa, RSA_PKCS1_PADDING);

if len > 0 then

begin

// в буфер data данные расшифровываются с «мусором» в конца, очищаем, определяем размер переменной out_ и переписываем в нее нужное количество байт из data

SetLength(out_, len);

Move(data^, PAnsiChar(out_ )^, len);

end

else

begin // читаем ошибку, если длина шифрованной строки -1

err := ERR_get_error;

repeat

log.Lines.Add(string(ERR_error_string(err, nil)));

err := ERR_get_error;

until err = 0;

end;

end;

```

##### И заключении пример чтения ключа «зашитого» в приложение

В примере указан приватный ключ и его чтение, с таким же успехом «зашивается» и читается публичный ключ функцией **PEM\_read\_bio\_PUBKEY**

```

var

mem, keybio: pBIO;

k: pEVP_PKEY;

keystring: AnsiString;

begin

keystring :=

'-----BEGIN RSA PRIVATE KEY-----' + #10 +

'MIICXgIBAAKBgQCfydli2u2kJfb2WetkOekjzQIg7bIuU7AzAlBUPuA72UYXWnQ/' + #10 +

'XcdSzEEMWSBLP7FO1vyVXR4Eb0/WqthF0ZViOK5bCN9CnR/1GMMiSqmIdByv/gUe' + #10 +

'Z/UjGrKmxeQOoa2Yt0MJC64cNXgnKmYC7ui3A12LlvNdBBEF3WpcDbv+PQIDAQAB' + #10 +

'AoGBAJnxukKHchSHjxthHmv9byRSyw42c0g20LcUL5g6y4Zdmi29s+moy/R1XOYs' + #10 +

'p/RXdNfkQI0WnWjgZScIij0Z4rSs39uh7eQ5qxK+NH3QIWeR2ZNIno9jAXPn2bkQ' + #10 +

'odS8FPzbZM9wHhpRvKW4FNPXqTc3ZkTcxi4zOwOdlECf9G+BAkEAzsJHgW1Isyac' + #10 +

'I61MDu2qjMUwOdOBYS8GwEBfi/vbn/duwZIBXG/BZ7Pn+cBwImfksEXwx0MTkgF3' + #10 +

'gyaChUSu+QJBAMXX3d94TwcF7lG9zkzc+AR/Onl4Z5UAb1GmUV57oYIFVgW1RIOk' + #10 +

'vqynXWrTjTOg9C9j+VEpBG67LcnkwU16JmUCQH7pukKz9kAhnw43PcycDmhCUgvs' + #10 +

'zCn/V8GCwiOHAZT7qLyhBrzazHj/cZFYknxMEZAyHk3x2n1w8Q9MACoVsuECQQDF' + #10 +

'U7cyara31IyM7vlS5JpjMdrKyPLXRKXDFFXYHQtLubLA4rlBbBHZ9txP7kzJj+G9' + #10 +

'WsOS1YxcPUlAM28xrYGZAkEArVKJHX4dF8UUtfvyv78muXJZNXTwmaaFy02xjtR5' + #10 +

'uXWT1QjVN2a6jv6AW7ukXiSoE/spgfvdoriMk2JSs88nUw==' + #10 +

'-----END RSA PRIVATE KEY-----' ;

k := nil;

keybio := BIO_new_mem_buf(Pchar(keystring), -1);

mem := BIO_new(BIO_s_mem());

BIO_read(mem, PAnsiChar(keystring), length(PAnsiChar(keystring)));

try

result := PEM_read_bio_PrivateKey(keybio, k, nil, nil);

finally

BIO_free_all(mem);

end;

end;

```

На этом мои примеры реализации заканчиваются. Исходники проекта доступны на [Github](https://github.com/ddlencemc/RSA-via-OpenSSL-libeay32).

##### Иточники:

* Статья Владимира Мешкова [«Используем средства библиотеки OpenSSL для криптографической защиты данных»](https://www.opennet.ru/docs/RUS/use_openssl/)

* [Пример шифрования файла](http://www.disi.unige.it/person/FerranteM/delphiopenssl/RSAEncrypt.html)

* [Пример чтения ключа с запросом пароля от автора libeay32.pas](http://www.disi.unige.it/person/FerranteM/delphiopenssl/AskPassphrase.html)

* [Создание пары ключей, проверка отпечатка SHA1 и кое что еще](http://www.disi.unige.it/person/FerranteM/delphiopenssl/)

**UPD**

Из дискуссий в комментариях внесу дополнения: если мы зашифровываем нужную нам строку **публичным** ключом, то расшифровывается она только **секретным** и наоборот — если секретным, то расшифровать можно только публичным ключом. В моем случае у клиента публичный ключ, которым он шифрует данные и только на сервере их можно расшифровать секретным ключом.

|

https://habr.com/ru/post/280302/

| null |

ru

| null |

# Почему мы стали использовать препроцессор Stylus в Яндекс.Почте, а также о библиотеке, помогающей жить с IE

Сегодня я хочу рассказать о том, почему и как мы пришли к использованию препроцессора Stylus в разработке Яндекс.Почты, а также описать используемый нами метод работы со стилями для IE. Он очень легко реализуется именно с помощью препроцессоров и делает поддержку IE простой и удобной. Мы разработали для этого специальную библиотеку, которой тоже поделимся — [if-ie.styl](https://github.com/kizu/if-ie.styl).

Это только первая статья из серии статей об использовании препроцессора Stylus в Яндекс.Почте, которые мы готовим к публикации.

Как мы пришли к использованию препроцессоров

--------------------------------------------

Хотя внешне Яндекс.Почта выглядит как одностраничное приложение, внутри неё содержится огромное число всевозможных блоков, их модификаций и контекстов, в которых эти блоки и модификации могут оказаться.

Кроме того, у неё уже больше тридцати тем оформления. Есть темы со светлым фоном и с тёмным, есть темы, которые различаются между собой только цветами, а есть и такие, в которых почти весь интерфейс вылеплен из пластилина вручную (<http://habrahabr.ru/company/yandex/blog/110556/>). В некоторых темах только одно фоновое изображение, а в других фон может меняться — случайно или в зависимости от времени суток и погоды.

Из-за всего этого появляется множество вариаций визуального представления интерфейса, что заставляет чуть иначе относиться к процессу разработки, искать инстурменты, более подходящие к решению задачи.

Когда мы только запускали интерфейс «neo2», мы выбрали знакомое нам решение — шаблонизатор Template Toolkit 2, с несколько нестандартным сценарием его использования для генерации CSS, а не HTML. Поначалу нам были нужны только переменные, но со временем темы усложнялись, и в итоге оказалось, что такой инструмент неудобен. Громоздкий синтаксис, отсутствие специализированных под CSS функций и общее чувство использования инструмента не по назначению заставили искать другие варианты. Мы поняли, что нам не обойтись без препроцессора.

Выбор препроцессора

-------------------

Выбирали между тремя вариантами: Sass, Less и Stylus. Процесс был довольно простым: мы взяли несколько имеющихся блоков, после чего попробовали переверстать их, используя каждый из препроцессоров.

[**Less**](http://lesscss.org) показался поначалу очень простым и удобным: он использует привычный синтаксис CSS и его можно применять в браузере, что удобно для отладки. Но при попытке сделать что-то сложное его возможностей уже не хватает. Что можно сделать без массивов, циклов и нормальных условных конструкций? Не так много.

После Less [**Sass**](http://sass-lang.com) оказался очень приятным: мощный, с хорошим сообществом и всевозможными дополнительными библиотеками вроде [Compass](http://compass-style.org/). Однако нашёлся один серьёзный недостаток: в Sass очень негибкий parent reference (использование символа `&` в селекторах для указания на родительский селектор). Из-за этого возникает несколько проблем, и все они заключаются в том, что `&` нельзя использовать для префиксного определения множественных классов, уточнения элемента или конкатенации классов. Вот несколько примеров того, что умеют другие препроцессоры, но что может вызвать ошибку в Sass:

* `&__bar`, применённое для селектора `.foo`, должно давать `.foo__bar` — подобные конструкции нужны для упрощения использования БЭМ-наименования и очень удобны, когда нужно сгенерировать в цикле множество модификаторов.

* `.baz&`, применённое для селектора `.foo .bar`, должно дать мультикласс `.baz.foo .bar`, но так в Sass сделать не получится: можно будет дать мультикласс только к `.bar`, если написать `&.baz`, но не наоборот.

* `button&`, применённое к `.foo`, должно бы уточнить селектор до `button.foo`, но — увы.

И всё было бы не так плохо, если бы в Sass можно было использовать указатель на родительский селектор в интерполяции. Но нет — Sass сначала разворачивает интерполяцию и только потом пытается применить селектор, выдавая ошибку.

Обиднее всего то, что подобное поведение — не баг, а *фича*. И меняться это [не будет](https://github.com/nex3/sass/issues/282#issuecomment-4031055). Такая уж идеология у синтаксиса Sass.

[**Stylus**](http://learnboost.github.com/stylus/) оказался самым новым из препроцессоров, и в конце концов наш выбор пал на него. Да, он сыроват, в нём встречаются неприятные баги, его комьюнити не такое большое, и разработка идёт не так быстро, как того хотелось бы. Но для наших задач он подошёл лучше всего, и вот почему:

* Stylus — очень гибкий препроцессор, и часто он оказывается гораздо гибче того же Sass. Например, parent references Stylus раскрывает идеально.

* В Stylus есть такая штука как *прозрачные миксины* — возможность вызвать функцию как обычное CSS-свойство. То есть сначала определить `foo(bar)`, а потом вызвать её как `foo: 10px`. Такая запись будет равнозначна вызову `foo(10px)`. Для обычных функций это не всегда удобно, но зато позволяет переопределить любое имеющееся свойство. Скажем, можно переопределить `margin` в `padding`. Если серьёзно, то при использовании подобной функциональности можно легко запутаться и усложнить понимание того, что же делает код: ведь не всегда будет ясно, какие функции были определены выше по коду и что произойдёт в результате вызова очередного свойства.

Однако прозрачные миксины очень сильно упрощают поддержку, например, браузерных префиксов. Не нужно запоминать, какие префиксы имеет то или иное свойство, и заботиться о том, нужно ли для очередного свойства писать специальную конструкцию. Достаточно просто всегда писать без префиксов, а об их добавлении позаботится подключённая библиотека (мы используем для этого [свой форк](https://github.com/kizu/nib/tree/new-gradients) [nib](https://github.com/visionmedia/nib/)).

* Stylus написан на JS. Это значит, что его проще поддерживать и править в нём баги (все разработчики интерфейса Яндекс.Почты гораздо лучше знают JS, чем Ruby). К тому же это позволяет проще использовать Stylus в цепочке с другими инструментами на node.js (например, [CSSO](https://github.com/css/csso/)).

В Stylus есть ещё много очень разных полезных вещей, но именно приведённые выше заставили нас сделать выбор в его пользу.

Конечно, кроме преимуществ, у Stylus есть и недостатки. И основной из них — гибкий синтаксис — авторы препроцессора считают его главным достоинством. Погнавшись за гибкостью, они целиком реализовали только синтаксис, основанный на отступах, тогда как вариант «а-ля CSS» кое-как прикручен сверху, и не получится просто так взять и переименовать `.css` в `.styl` — не все варианты написания CSS заработают и в Stylus. Но мы решили, что возможности, которые даёт нам этот препроцессор, делают его недостатки не такими значительными, поэтому пришлось смириться с некоторой капризностью парсера (и начать использовать синтаксис, основанный на отступах).

Подытоживая рассказ про выбор, стоит отметить, что Sass и Stylus — два почти равнозначных варианта. Каждый из них имеет как свои преимущества и уникальные фичи, так и недостатки. Если вы уже используете какой-то из этих препроцессоров и вас всё устраивает — отлично, можно не думать о поиске нового. Но если вы только подходите к выбору или же с используемым препроцессором вам становится тесно, попробуйте сравнить все варианты. Лучший способ это сделать — примерить каждый препроцессор к своей задаче. Сверстав часть вашего проекта на каждом из препроцессоров, вы поймёте, какие их возможности вам важны, а какие — нет. Только не забывайте, что препроцессор — это не просто другой синтаксис, но и другой подход: при подобной перевёрстке можно заодно и отрефакторить код, сделав что-то оптимальнее, чем было с простым CSS.

Библиотека [if-ie.styl](https://github.com/kizu/if-ie.styl)

-----------------------------------------------------------

Во время перевода Яндекс.Почты на Stylus стало понятно, что препроцессор может предоставить возможности, которых у нас не было при использовании обычного CSS. Мы давно использовали в Почте разделение стилей для обычных браузеров и для старых версий IE. Все стили раскладывались по файловой структуре [согласно БЭМ](http://ru.bem.info/method/filesystem/), и для каждого блока рядом создавалось два файла: `b-block.css` и `b-block.ie.css`.

В первый файл шли стили для всех браузеров, а во второй, соответственно, только те, что были нужны для Internet Explorer. Тут надо отметить, что по ряду причин мы переводим IE8 в режим совместимости с IE7, а также, перестав поддерживать IE6, отправляем его на «облегчённую» версию Почты. Таким образом, у нас есть две разных версии стилей: одна для всех браузеров, вторая — для всех старых версий IE. Всё собиралось автоматически — сначала собиралась таблица стилей «для всех», после чего к ней добавлялись все стили из файлов `.ie.css` — и получалась таблица стилей для IE.

Каждый браузер получает только свою таблицу стилей — для этого мы используем условные комментарии, примерно так:

```

```

Поначалу подобное разделение стилей работало хорошо, однако с появлением препроцессора возник вопрос: а нельзя ли сделать лучше?

Оказалось, что можно.

Так появилась библиотека для Stylus — «[if-ie.styl](https://github.com/kizu/if-ie.styl)». На самом деле это не совсем библиотека, скорее — методология того, как нужно работать со стилями для IE. Ничего секретного в этой методологии нет, поэтому мы решили выложить её на Гитхаб под лицензией MIT. Вы можете совершенно спокойно использовать её для своего проекта, сообщать о найденных ошибках или и даже самостоятельно их исправлять — Open Source, все дела. А может быть, у кого-то появится возможность переписать её для другого препроцессора? Форкайте проект или создавайте новый, взяв методологию за основу — будет здорово.

### Основа методологии

В основе методологии лежит очень простая идея: мы создаём переменную `ie`, которая будет равна `false` для всех обычных браузеров, и `true`, когда мы захотим получить стили для IE. После этого можно использовать только одну основную таблицу стилей, в которой разграничивать стили для разных браузеров обычными условиями. Простой пример: возьмём файл `style.styl`:

```

ie ?= false

.foo

overflow: hidden

zoom: 1 if ie

```

Такой код на Stylus по умолчанию — для обычных браузеров — станет вот таким CSS:

```

.foo {

overflow: hidden;

}

```

Так как переменная `ie` была `false`, условие `if ie` не сработало, и свойство `zoom` не вошло в эту таблицу стилей.

Теперь создадим рядом `style_ie.styl`:

```

ie = true

@import style.styl

```

Если скормить такой код Stylus, то мы получим:

```

.foo {

overflow: hidden;

zoom: 1;

}

```

Это именно то, что нам и требовалось — отдельная таблица, в которой есть стили, нужные только в IE.

При этом, если мы захотим написать какие-то стили только для обычных браузеров, мы сможем использовать условие `if !ie` — и фильтровать стили станет очень просто.

### Дополнительные возможности if-ie.styl

Конечно же, этого нам показалось мало и мы решили добавить всяких полезных функций, которые бы оптимизировали многое в нашем коде. Так и получилась «библиотека».

Для её использования подключение стилей будет выглядеть чуть иначе.

Файл `style.styl` станет таким:

```

@import if-ie.styl

.foo

overflow: hidden

zoom: 1

```

A `style_ie.styl` таким:

```

ie = true

@import if-ie.styl

@import style.styl

```

Отличий, в сравнении с вариантом без дополнительных функций, два:

1. В обоих файлах нужно подключать библиотеку *до* всех остальных стилей, и обязательно оба раза. (Может показаться, что хватило бы только первого — ведь таблица стилей для IE уже содержит основную таблицу стилей — но тогда некоторые последующие возможности не будут работать). В этом файле уже определяется `ie ?= false`, и поэтому в основной таблице стилей не нужно это явно прописывать.

2. В таблице стилей для IE пропало условие `if ie` — это показана работа первой фичи библиотеки: свойство `zoom` автоматически появится только в таблице стилей для IE. Конечно, и в обычных браузерах можно использовать это свойство, но на практике такая необходимость случается *крайне* редко, так что можно облегчить основную таблицу стилей хотя бы чуть-чуть.

В коде Stylus подобные функции очень легко определять. В данном случае новый прозрачный миксин будет выглядеть так:

```

zoom()

zoom: arguments if ie

```

Этим кодом мы создаём функцию `zoom`, которая пропишет соответствующее свойство с любыми переданными аргументами только в том случае, если мы в данный момент собираем стили для IE.

### `inline-block`

Широко известно, что в старых версиях IE у свойства `display` «из коробки» нет поддержки значения `inline-block`. В IE есть аналогичный механизм, но он срабатывает только для инлайновых элементов и только если у них включён механизм hasLayout. Совершенно случайно `display: inline-block` в IE как раз его включает, но «забывает» переключить элемент в `display: inline`, поэтому подобная запись не будет работать для изначально блочных элементов вроде . Так что наиболее простой способ гарантированно применить инлайн-блочное поведение к любому элементу в IE — прописать только для него `zoom: 1; display: inline;`.

В if-ie.styl свойство `display` так будет делать автоматически и только для IE. Обычные браузеры увидят `display: inline-block`, тогда как IE получит только `zoom: 1; display: inline;`. Тут кто-то мог бы заметить, что вторая запись длиннее первой, и для изначально инлайновых блоков можно было бы и сэкономить… Но если внимательно подсчитать, то экономия окажется всего в один байт. Это не стоит того, чтобы всё время следить — инлайновый ли блок изначально или нет. Тем более что в идеале вёрстка не должна зависеть от того, к какому элементу она применяется.

### Переопределение CSS3-свойств

Если мы по умолчанию не отдаём обычным браузерам `zoom: 1`, разделив все стили на два файла (как было, в общем-то, и до внедрения препроцессоров), то с препроцессорами можно задуматься и над тем, как облегчить и таблицу стилей для IE.

С помощью Stylus это делается очень просто, при этом можно сэкономить довольно много байт: ведь что нам точно в старых IE не нужно, так это свойства с префиксами.

Выше в статье я уже упомянул, что мы используем библиотеку [nib](https://github.com/visionmedia/nib/) — эта библиотека определяет прозрачные миксины для большинства новых CSS-cвойств, например, для транзишнов. В итоге в стилях для Stylus мы пишем просто `transition: opacity .3s` и в результате получаем это свойство со всеми нужными префиксами. Но в IE нам не только префиксы не нужны, но и само свойство! А значит, мы можем в нашей библиотеке переопределить это и многие другие свойства так, чтобы они ничего не возвращали.

Делается это примерно так:

```

if ie

transition()

z if 0

transition-property()

z if 0

// …

```

Тут всё почти понятно: одним условием мы только для IE переопределяем сразу все нужные свойства. Однако из-за особенностей Stylus приходится в определении функции написать хотя бы одно правило — `z if 0` получается довольно коротким.

В итоге IE вместо определённого в nib миксина `transition` видит тот, что мы определили в if-ie.styl, и полученная таблица стилей окажется гораздо легче, чем раньше — почти всё ненужное из неё будет вырезано.

### `rgba-ie`

Не будем раздувать статью и описывать всё, что есть в if-ie.styl — в документации к проекту это уже [подробно описано](https://github.com/kizu/if-ie.styl#clip-support).

Однако нужно рассказать ещё про одну функцию, которая оказалась нам очень полезна в рамках тематизации Яндекс.Почты. Это функция `rgba-ie`. На самом деле эта функция могла бы называться просто `rgba`, но в Stylus есть баг: функции, определённые в JS, не получается переопределять так же, как те, что были определены в Stylus, так что тут пришлось создать новую.

Что же она делает? Старые IE не поддерживают значения цвета, заданные в формате rgba. Поэтому обычно разработчики либо прописывают соответствующие цвета дважды — сначала для старых IE в обычном hex-формате, а потом уже всем нормальным браузерам в желаемом `rgba` — либо используют modernizr и уже с помощью него и класса `.rgba` задают соответствующие цвета там, где это нужно. Но для фолбеков в IE каждый раз всё равно приходится вычислять примерный цвет того, во что мы будем в нём деградировать. Чаще всего это будет нужный цвет, наложенный поверх фона страницы или среднего фона элемента, над которым будет применён цвет в `rgba`.

Функция `rgba-ie` из if-ie.styl сильно упрощает эту задачу: дублируя возможности обычной функции `rgba`, мы получаем ещё один опциональный параметр, который можно передать в функцию — цвет фона для фолбека. По умолчанию этот параметр задан в `#FFF`.

Простой пример:

```

.foo

color: rgba-ie(0,0,0,0.5)

```

В обычных браузерах этот цвет будет обычным `rgba(0,0,0,0.5)`, но в IE он превратится в `#808080` — то есть в соответствующий цвет, наложенный поверх белого.

Более сложный пример, с целевым фоном в качестве последнего аргумента (и с использованием одной из фич Stylus — возможности указать вместо трёх цифр `r`, `g` и `b` цвет в hex):

```

.foo

background: rgba-ie(#FFDE00, .42, #19C261)

```

В этом примере для нормальных браузеров будет цвет `rgba(255,222,0,0.42)`, а вот IE получит правильный `#7ace38`.

При этом есть возможность задать и фолбек по умолчанию с помощью переменной `$default_rgba_fallback`.

В итоге можно очень сильно упростить себе жизнь, если использовать функцию `rgba-ie` вместо обычного `rgba` — об IE в этом случае можно будет почти не вспоминать.

|

https://habr.com/ru/post/169415/

| null |

ru

| null |

# Яндекс.Блиц. 12 алгоритмических задач отборочного раунда и их разборы

В конце сентября мы рассказывали, что решили попробовать провести контест, где желающие могут потренироваться в решении задач, максимально приближенных к «боевым». Так участники могут понять, какого формата задания получают разработчики на собеседованиях в Яндексе (этим интересуются очень многие), а самое главное — с чем они сталкиваются, работая над Поиском. Типичная задача на собеседовании — составить алгоритм, доказать его корректность, предложить пути оптимизации. Если человек разбирается в алгоритмах, то он быстро сумеет их реализовывать на любом доступном ему языке.

В Блице можно использовать Java, C++, C# или Python. Кроме того, участие в контесте дает возможность проверить свои знания. Если в итоге вы понимаете, что их стоит подтянуть, — это тоже результат. Кстати, тогда вам может пригодиться специализация на курсере [«Алгоритмы и структуры данных»](https://www.coursera.org/specializations/data-structures-algorithms), в создании которой Яндекс участвовал.

[](https://habrahabr.ru/company/yandex/blog/340784/)

Давайте теперь разберем задачи, которые предлагались в отборочном раунде. У нас было несколько одинаковых по сложности вариантов, каждый из которых содержал по шесть задач. Мы разберем один набор задач полностью, а также наиболее интересные задачи из других наборов. К слову, из 1762 участников квалификационного раунда в финал прошли лишь 263. Так что задачи оказались не самыми простыми.

«Игра»

------

Условие

=======

Петя и Вася играют в игру: они по очереди берут из колоды карточки, на которых написаны целые неповторяющиеся положительные числа (первый карточку всегда берет Петя). Карточки игроки берут по одной сверху колоды. После этого они сравнивают значения, записанные на карточках: игрок, у которого меньше, тянет еще одну карточку и оставляет ее у себя. Когда все карточки заканчиваются, Петя и Вася считают сумму значений, написанных на этих карточках. Проигрывает тот, у кого сумма получается меньше, чем у другого игрока.

Им надоело вручную тянуть карточки и сравнивать значения. Они попросили вас написать программу, которая по исходному набору карточек будет определять победителя.

Гарантируется, что для любого теста победителя можно будет определить однозначно.

**Дополнительные параметры**#### Формат входных данных

В первой строке входных данных записано целое число , кратное трем, — общее количество карточек .

В следующей строке записаны  различных целых положительных чисел  — значения, написанные на карточках в том порядке, в котором Петя и Вася будут их раздавать .

#### Формат выходных данных

В единственной строке выведите Petya, если в игре побеждает Петя, или Vasya, если в игре побеждает Вася.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

3

1 2 3

```

|

```

Petya

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

3

1 4 2

```

|

```

Vasya

```

|

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 64 МБ

Решение

=======

Пожалуй, самый простой способ решить эту задачу — смоделировать игру на данной последовательности чисел. Пока у нас еще есть входные данные, получим тройку чисел из входного потока, добавим первое число к общему количеству очков у Пети, а второе — к общему количеству очков у Васи. После этого сравним два числа, взятых из входного потока. Если первое меньше второго, то к очкам Пети прибавим еще и третье число, а если второе меньше первого — прибавим третье к очкам Васи. Когда входные данные закончатся, сравним общее количество набранных очков и выведем победителя. Решение задачи упрощает тот факт, что все входные данные корректны и не может возникнуть так называемых пограничных ситуаций, когда, например, количество очков на вытянутых игроками карточках совпадает либо когда оба участника в конце игры набирают одинаковое количество очков.

«Сложные числа»

---------------

Условие

=======

Обозначим через  сумму цифр натурального числа .

Будем говорить, что натуральное число  сложное, если не существует такого натурального числа  что

Найдите наименьшее сложное число.

Решение

=======

Здесь можно придумать математическое решение, однако от нас требуется лишь найти наименьшее число, удовлетворяющее условию задачи. При этом ни доказательство, ни код писать не нужно, а времени на остальные задачи у нас не так много. Поэтому можно вместо поиска обоснованного решения воспользоваться перебором. Вот один из вариантов перебора: посчитаем значение функции для всех  от 1 до некоторого предела (например, до миллиона) и, если оно целое, запомним, что такое число  точно не будет сложным. Затем выведем наименьшее натуральное число, которое мы не запоминали в процессе вычисления нашей функции. В нашем примере это будет число 61.

«Турнирная таблица»

===================

Условие

=======

Многие программисты любят играть в футбол. Некоторые даже любят проводить свои турниры. Но они не хотят следить за тем, кто сколько очков набрал и какое место занял, они хотят просто складывать результаты матчей в базу данных, после чего получать турнирную таблицу с количеством набранных очков и итоговым положением.

Одна из таких групп программистов попросила вас помочь им и, пока они собирают команды и проводят свой турнир, написать программу, которая будет строить итоговую турнирную таблицу.

**Дополнительные параметры**#### Формат входных данных

Входные данные представляют собой набор строк, каждая строка описывает ровно один сыгранный матч. В каждой строке записаны названия играющих друг с другом команд и результат матча. Названия и результат разделяются знаком тире, отбитым с обеих сторон пробелами. Каждое название состоит только из латинских букв, начинается с заглавной буквы, все остальные буквы строчные, гарантируется что длина каждого названия не превосходит 30 символов. Счет записывается в виде A:B, где A — количество голов, забитых первой командой, а B — количество голов, забитых второй командой. Победившей считается команда, забившая больше голов. Если забито одинаковое количество голов, результатом матча считается ничья. За победу команде присуждается три очка, за ничью — одно, за поражение — ноль.

Гарантируется, что нет ни одной пары команд с одинаковыми названиями, что ни одна пара команд не играла между собой более одного раза. Общее число команд-участников не превосходит 100. Ни в одном матче не было забито больше ста голов.

#### Формат выходных данных

Вам нужно построить турнирную таблицу с результатами.

Каждая строка таблицы — представление результатов каждой из команд, команды должны быть упорядочены в лексикографическом порядке. В первом столбце содержится порядковый номер команды, во втором — название. Далее следуют  столбцов, в каждом из которых содержится информация об играх с остальными командами: в случае победы в ячейке должна присутствовать буква W, в случае поражения — L, в случае ничьей — D, если участники не играли друг с другом — пробел, если заполняется ячейка матча игрока с самим собой, то туда следует поставить символ X.

В последних двух столбцах должно быть выписано количество набранных командой очков и итоговое место. Команда A занимает более высокое место, чем команда B, если она набрала большее количество очков, или они обе набрали одинаковое количество очков, но команда A одержала больше побед, чем команда B. Если же число очков и число побед у команд одинаковое, они занимают одно и то же место. Для простоты награждения требуется присудить только места с первого по третье.

Все столбцы должны иметь минимально возможную ширину, чтобы вместить данные в каждой строке. Для столбцов, содержащих порядковые номера, количество набранных очков и занятые места, все данные выравниваются по правому краю, все названия выравниваются по левому краю, после каждого названия в таблице должен гарантированно присутствовать пробел.

Оформляя таблицу, ориентируйтесь на примеры.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

Linux - Gentoo - 1:0

Gentoo - Windows - 2:1

Linux - Windows - 0:2

```

|

```

+-+--------+-+-+-+-+-+

|1|Gentoo |X|L|W|3|1|

+-+--------+-+-+-+-+-+

|2|Linux |W|X|L|3|1|

+-+--------+-+-+-+-+-+

|3|Windows |L|W|X|3|1|

+-+--------+-+-+-+-+-+

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

Cplusplus - C - 1:0

Cplusplus - Php - 2:0

Java - Php - 1:0

Java - C - 2:2

Java - Perl - 1:1

Java - Haskell - 1:1

```

|

```

+-+----------+-+-+-+-+-+-+-+-+

|1|C |X|L| |D| | |1|3|

+-+----------+-+-+-+-+-+-+-+-+

|2|Cplusplus |W|X| | | |W|6|1|

+-+----------+-+-+-+-+-+-+-+-+

|3|Haskell | | |X|D| | |1|3|

+-+----------+-+-+-+-+-+-+-+-+

|4|Java |D| |D|X|D|W|6|2|

+-+----------+-+-+-+-+-+-+-+-+

|5|Perl | | | |D|X| |1|3|

+-+----------+-+-+-+-+-+-+-+-+

|6|Php | |L| |L| |X|0| |

+-+----------+-+-+-+-+-+-+-+-+

```

|

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 64 МБ

Решение

=======

В работе программиста достаточно часто встречаются такие задачи, когда нужно получить данные, имеющие некоторый заранее обговоренный формат, и выдать результат в том виде, в котором его ждет на вход следующий элемент конвейера. Эта задача — именно про правильную обработку данных и их вывод в нужном формате. Основная сложность здесь — написать парсер входных данных и хранилище. Парсер принимает на вход строку и сохраняет результаты игры между двумя командами, а хранилище содержит названия команд и результаты.

Из-за достаточно небольшого объема входных данных можно применять не сложные структуры, а стандартные механизмы любого из доступных языков. Например, при использовании C++ подойдет контейнер `std::map`. Ключом в контейнере будет название команды, а значением — информация о ней: количество набранных очков, число побед и результаты игр с другими командами. Результаты тоже можно хранить в `std::map`, где ключ — название оппонента, а значение — результат матча.

Разобьем на части каждую из строк входного потока и обновим информацию о каждом из участников. `std::map`, выбранный в качестве хранилища, позволяет нам хранить все названия в лексикографическом порядке, поэтому для формирования итоговой таблицы нам нужно всего лишь проитерироваться по элементам хранилища. Когда весь входной поток обработан, посчитаем итоговое место каждого из участников: выберем все пары вида «количество очков — число побед» и упорядочим их в порядке убывания, расставив соответствующие места для первых трех результатов. Кроме того, при пост-обработке мы можем посчитать необходимое количество символов для каждого из столбцов результирующей таблицы, а затем аккуратно реализовать вывод таблицы в выходной поток.

«Кошельки и монеты»

-------------------

Условие

=======

Программист Петя очень любит складывать все имеющиеся у него деньги в кошельки и фиксировать, сколько денег лежит в каждом кошельке. Для этого он сохраняет в файле набор целых положительных чисел — количество денег, которое лежит в каждом из его кошельков (Петя не любит, когда хотя бы один из его кошельков пустует). Петя хранит все деньги в монетах, номинал каждой монеты — 1 условная единица.

Однажды у Пети сломался блок магнитных головок и ему пришлось восстанавливать данные с жесткого диска. Он хочет проверить, корректно ли восстановились данные, и просит вас убедиться, что можно ту сумму денег, которая у него была, разложить во все его кошельки, чтобы получились те же числа, что и в восстановленном файле.

**Дополнительные параметры**#### Формат входных данных

В первой строке выходных данных содержится натуральное число   — количество кошельков у Пети.

Во второй строке через пробел записаны данные из восстановленного файла:  натуральных чисел , каждое из которых означает, сколько денег лежит в -м кошельке у Пети .

В третьей строке записано натуральное число   — общая сумма денег, которая была у Пети до того, как он разложил ее по кошелькам.

#### Формат выходных данных

Если в восстановленном файле нет ошибки, и исходную сумму можно разложить по кошелькам с указанной конфигурацией, выведите Yes. Если такой конфигурации не может существовать, выведите No.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

2

2 3

5

```

|

```

Yes

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

2

2 3

4

```

|

```

No

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

2

2 3

3

```

|

```

Yes

```

|

#### Примечания

В первом примере у Пети есть два кошелька, в первом лежат две монеты, во втором — три. Конфигурации, приведенной во втором примере, не может существовать, поэтому файл восстановлен некорректно. В третьем примере предложенная конфигурация возможна: во втором кошельке лежит одна монета и первый кошелек, внутри которого лежат две монеты.

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 64 МБ

Решение

=======

Здесь требовалось понять, что в кошельке может лежать несколько других кошельков, где, в свою очередь, лежат монеты. Один из тестовых примеров явно показывал возможность такой ситуации. С учетом этого задача достаточно легко сводится к известной [задаче о рюкзаке](https://ru.wikipedia.org/wiki/%D0%97%D0%B0%D0%B4%D0%B0%D1%87%D0%B0_%D0%BE_%D1%80%D0%B0%D0%BD%D1%86%D0%B5), которая решается методом динамического программирования. Возьмем самый вместительный кошелек и наполним его монетами. Если этого сделать нельзя (то есть количество монет меньше, чем необходимо положить в самый большой кошелек) — способа разложить монеты по кошелькам не существует. Если же у нас получилось наполнить самый большой кошелек — возьмем все оставшиеся монеты и попытаемся найти способ разложить их по оставшимся кошелькам. Здесь мы — прямо как в задаче про рюкзак — делаем выбор. Только там мы бы выбирали, положить ли очередной предмет в рюкзак.

Ограничения позволяют нам выделить память под массив, размер которого равен оставшемуся числу монет. Затем проверим каждый оставшийся кошелек на предмет того, можем ли мы заполнить его оставшимся числом монет. Если существует способ распределить монеты по некоторому подмножеству кошельков, то поместим все неиспользованные кошельки в самый большой, предварительно переложив из него в них нужное количество монет. Если же оставшиеся монеты нельзя распределить между некоторым подмножеством оставшихся кошельков — успешной конфигурации не существует.

«Хорошая последовательность»

----------------------------

Условие

=======

Последовательность точек на плоскости называется тривиальной, если она является строго упорядоченной по возрастанию или по убыванию расстояния до одной из точек этой последовательности.

Последовательность точек в трехмерном пространстве называется хорошей, если ни одна из последовательностей, полученных взятием проекции исходной на одну из базовых плоскостей   и  не является тривиальной.

Дана последовательность из  точек с целочисленными координатами в трехмерном пространстве. Необходимо найти такую нечетную перестановку ее индексов, что после ее применения последовательность становится хорошей.

Гарантируется, что решение существует.

**Дополнительные параметры**#### Формат входных данных

В первой строке входных данных записано целое число  , в следующих  строчках через пробел записаны по три целочисленных координаты   каждой из точек.

Гарантируется, что проекции всех точек на любую из базовых плоскостей различны.

#### Формат выходных данных

Выведите  чисел: искомая перестановка индексов от 1 до . Если существует несколько решений, выведите любое из них. Числа в строке следует разделять пробелами.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

4

1 1 1

2 4 16

3 9 81

4 16 256

```

|

```

1 2 4 3

```

|

#### Примечания

Инверсией в перестановке  порядка  называется всякая пара индексов  такая, что  и . Четность числа инверсий в перестановке определяет четность перестановки.

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 64 МБ

Решение

=======

Для корректного решения задачи нам вполне достаточно оценить, сколько существует тривиальных перестановок. В каждой из плоскостей их число пропорционально , где  — общее количество точек. Значит, всего в пространстве их будет . При этом общее число перестановок, которое может послужить корректным ответом, равно  (деление происходит из-за того, что нам нужны только нечетные перестановки). Получается, что непригодных ответов гораздо меньше, чем тех, которые нас устраивают. Следовательно, мы можем просто осуществить перебор нечетных перестановок. Ответом будет первая перестановка, которая не является тривиальной при построении ее проекции ни на одну из трех плоскостей.

«Интересное путешествие»

========================

Условие

=======

Не секрет, что некоторые программисты очень любят путешествовать. Хорошо всем известный программист Петя тоже очень любит путешествовать, посещать музеи и осматривать достопримечательности других городов.

Для перемещений из города в город он предпочитает использовать машину. При этом он заправляется только на станциях в городах, но не на станциях по пути. Поэтому он очень аккуратно выбирает маршруты, чтобы машина не заглохла в дороге. А еще Петя очень важный член команды, поэтому он не может себе позволить путешествовать слишком долго. Он решил написать программу, которая поможет ему с выбором очередного путешествия. Но так как сейчас у него слишком много других задач, он попросил вас помочь ему.

Расстояние между двумя городами считается как сумма модулей разности по каждой из координат. Дороги есть между всеми парами городов.

**Дополнительные параметры**#### Формат входных данных

В первой строке входных данных записано количество городов  (). В следующих  строках даны два целых числа: координаты каждого города, не превосходящие по модулю миллиарда. Все города пронумерованы числами от 1 до  в порядке записи во входных данных.

В следующей строке записано целое положительное число , не превосходящее двух миллиардов, — максимальное расстояние между городами, которое Петя может преодолеть без дозаправки машины.

В последней строке записаны два различных числа — номер города, откуда едет Петя, и номер города, куда он едет.

#### Формат выходных данных

Если существуют пути, удовлетворяющие описанным выше условиям, то выведите минимальное количество дорог, которое нужно проехать, чтобы попасть из начальной точки маршрута в конечную. Если пути не существует, выведите -1.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

7

0 0

0 2

2 2

0 -2

2 -2

2 -1

2 1

2

1 3

```

|

```

2

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

4

0 0

1 0

0 1

1 1

2

1 4

```

|

```

1

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

4

0 0

2 0

0 2

2 2

1

1 4

```

|

```

-1

```

|

#### Ограничение по времени: 1 секунда

#### Ограничение по памяти: 64 МБ

Решение

=======

Вначале из имеющихся точек нужно построить граф. Для этого переберем все пары точек и, если расстояние между ними меньше заданного ограничения, добавим в граф ребро между вершинами. После построения графа запустим поиск в ширину из города, откуда Петя начинает свое путешествие. Как только он достигнет точки назначения, завершим наш алгоритм и выведем количество пройденных нами ребер. Если алгоритм завершился, а мы так и не достигли пункта назначения, то он недостижим из исходного города, поэтому следует вывести -1. Общая сложность описанного алгоритма — , где  — число городов.

«Разделение числа»

==================

Условие

=======

Дано число . Разбейте десятичную запись числа  на максимальное возможное количество различных чисел.

Использовать числа с незначащими нулями не разрешается.

**Дополнительные параметры**#### Формат входных данных

В единственной строке входных данных задано число  ().

#### Формат выходных данных

Выведите разбиение числа  на различные части. Между частями поставьте знак «-». Если есть несколько возможных разбиений, выведите любое.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

0

```

|

```

0

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

101

```

|

```

10-1

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

102

```

|

```

1-0-2

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

11

```

|

```

11

```

|

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 64 МБ

Решение

=======

Несмотря на то, что исходное число может быть очень большим, количество способов разбить его на части зависит не от значения, а от количества знаков в числе. В худшем случае число состоит из 18 десятичных знаков (вариант 1019 мы не рассматриваем — там только один вариант разбиения). Значит, знак «-» мы можем поставить только в 17 различных позициях. В каждой из этих позиций мы можем как поставить знак, так и опустить его. Другими словами, существует всего 217 способов выбрать разбиение для самых больших чисел. Это около 105 вариантов. Переберем их все, отсечем те, которые нас не устраивают (то есть при которых получаются одинаковые числа), и выберем вариант, содержащий наибольшее количество частей.

«Максимальный урон»

===================

Условие

=======

Программист Игорь очень любит играть в компьютерные игры. Больше всего Игорю нравятся стратегии, особенно те моменты, когда он отправляет группы своих юнитов атаковать вражеские базы. Игорь довольно давно играет в стратегии, поэтому у него есть четко отработанный план действий при атаке: он разбивает все свои юниты на группы и отправляет их в атаку поочередно. При этом Игорь считает, что общий урон, который будет нанесен в атаке, равен произведению размеров групп. Он пытается разбить свои юниты на группы так, чтобы максимизировать общий урон.

В последнее время Игорь стал часто проигрывать. Он уверен, что проблема в том, что в одной из групп после разбиения получается несчастливое количество юнитов. Он пытается переделать свой алгоритм разбиения и попросил вас посчитать, какой максимальный общий урон смогут нанести его группы, если среди них не будет ни одной, содержащей несчастливое количество юнитов.

**Дополнительные параметры**#### Формат входных данных

В единственной строке входных данных через пробел записаны натуральные числа  и   — количество юнитов, которые есть у Игоря, и число юнитов в группе, которое Игорь считает несчастливым.

#### Формат выходных данных

Выведите максимально возможный общий урон по модулю 109 + 7.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

8 2

```

|

```

16

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

9 3

```

|

```

20

```

|

#### Примечания

В первом примере для максимизации общего урона следует разбить юниты на две группы по 4 юнита в каждом, во втором примерe — на две группы: в первой 4 юнита, во второй — 5.

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 64 МБ

Решение

=======

Если бы не дополнительный запрет на использование групп определенного размера, который в условии назван несчастливым, то произведение было бы максимальным при разбиении исходного числа на группы по 3 юнита. Если общее число юнитов нацело делится на 3 — просто разбиваем их на группы по 3 юнита. Если остаток от деления на 3 равен 1, то отделяем группу из четырех юнитов (если, конечно, изначально у нас больше одного юнита), а в остальные группы определяем по 3 юнита. И наконец, если остаток от деления на 3 равен 2 — отделяем группу из двух юнитов, а в остальные определяем по 3 юнита.

Докажем, что такое разбиение корректно. Попробуем доказать это методом от противоположного. Предположим сначала, что в нашем разбиении есть числа  ≥ 5. Но тогда мы можем заменить  на два числа: -3 и 3. На общую сумму замена никак не повлияет, а произведение чисел 3 и -3 всегда больше чем  при  ≥ 5. Так что чисел, превосходящих или равных 5 в нашей последовательности существовать не может. Предположим, что в ней есть число 4, но мы можем заменить его на две двойки, никак не повлияв на значения суммы и произведения, поэтому давайте так и поступим. Далее, в нашей последовательности не может быть больше двух двоек, иначе мы могли бы заменить любые три из них на две тройки. Значение суммы от этого бы не поменялось, а значение произведения увеличилось бы (8 = 2⋅2⋅2 < 3⋅3 = 9). Следовательно, трех или большего числа двоек тоже не может быть. Ну и кроме того, у нас не может быть единиц (только если исходная сумма сама не равна единице). Таким образом, наша результирующая последовательность может состоять только из троек и не более чем двух двоек, что мы и показали выше.

Вернемся к ограничению на несчастливый размер группы. Если он превышает значение 3 — наше решение останется точно таким же. Если он равен 3, то, перебрав маленькие размеры групп вручную, будем разбивать последовательность на группы размером 2. Если изначально число юнитов нечетное, то дополнительно возьмем группу, состоящую из 5 юнитов (поскольку одна группа размера 5 обеспечит большее финальное значение, нежели 2 группы по 2 юнита и одна группа из одного юнита). Если же исключены размеры группы, равные 2, то используем алгоритм деления на группы по 3 юнита. Наконец, если их начальное число не делится на 3 нацело, возьмем в качестве размера дополнительных групп не 2, а 4 юнита.

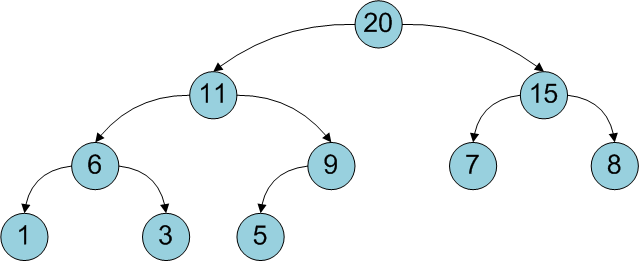

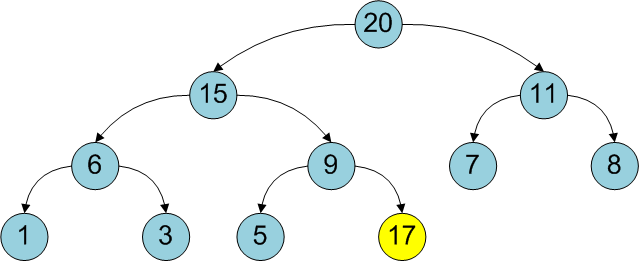

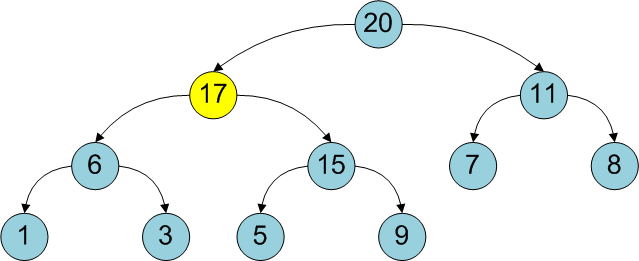

«Красно-черные деревья»

=======================

### Условие

Красно-черным деревом называется дерево, у которого все вершины покрашены в красный или черный цвет и есть еще дополнительные свойства:

* Корень черного цвета.

* Каждая вершина либо имеет два потомка, либо является листом (не имеет потомков).

* Все листья дерева черного цвета.

* У красных вершин оба потомка имеют черный цвет.

* Количество черных вершин на пути от корня до любого листа дерева одинаково.

Найдите число неизоморфных красно-черных деревьев с заданным числом вершин. Два красно-черных дерева  и  являются изоморфными, если существует биекция между вершинами деревьев , удовлетворяющая условиям:

* , т. е. корень переходит в корень.

* Если  и у вершины  есть дети ( и ), то и у вершины  есть дети ( и ), при этом или  и , или  и .

*  сохраняет цвет вершин, то есть .

**Дополнительные параметры**#### Формат входных данных

В первой строке задано число вершин дерева  ().

#### Формат выходных данных

Выведите число неизоморфных красно-черных деревьев с  вершинами по модулю 109 + 7.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

5

```

|

```

1

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

7

```

|

```

2

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

6

```

|

```

0

```

|

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 256 МБ

Решение

=======

Задачу можно решить методом динамического программирования, однако она немного сложнее, чем те задачи, которые мы решали этим же методом выше.

Обозначим как ![$CountBlack[N][H]$](https://habrastorage.org/getpro/habr/formulas/d1c/184/590/d1c184590a4919622867fb4fd019b595.svg) количество различных с точностью до изоморфизма красно-черных деревьев с черным корнем, которые состоят из  вершин и у которых количество черных вершин от корня до листьев равно . За ![$CountRed[N][H]$](https://habrastorage.org/getpro/habr/formulas/236/df2/717/236df27176c9c2e0e0d22759c64fbb3d.svg) мы обозначим такие же деревья с красным корнем. Это будет нарушать свойство черного корня у красно-черных деревьев, однако такое допущение нужно нам для вычисления результата.

Как вычислить значение ![$CountBlack[N][H]$](https://habrastorage.org/getpro/habr/formulas/d1c/184/590/d1c184590a4919622867fb4fd019b595.svg)? Корнем у него может быть любое число  от 1 до . Тогда в левом поддереве будет содержаться  вершина, а в правом —  вершин. Сколько поддеревьев может получиться в левом поддереве? Если его корень черный, то число поддеревьев равно ![$CountBlack[i-1][H-1]$](https://habrastorage.org/getpro/habr/formulas/e51/476/a2f/e51476a2f9f653c0f99f83fc575ea882.svg), а если красный, то ![$CountRed[i-1][H-1]$](https://habrastorage.org/getpro/habr/formulas/8dc/5be/85a/8dc5be85a9d431d07b89244cdfa5e65c.svg). Аналогично для правого поддерева: ![$CountBlack[j][H-1]$](https://habrastorage.org/getpro/habr/formulas/f32/470/243/f32470243fea8d8d7b46c30278c4d1a9.svg), если корень поддерева черный, и ![$CountRed[j][H-1]$](https://habrastorage.org/getpro/habr/formulas/547/de3/035/547de30358f115e036155ec1c64d9ec1.svg), если корень красный. Просуммируем числа, полученные для левого и правого поддеревьев: ![$CountLeft = CountBlack[i-1][H-1] + CountRed[i-1][H-1]$](https://habrastorage.org/getpro/habr/formulas/5ef/827/939/5ef827939a6aafcf299534ed750f5f7b.svg) и ![$CountRight = CountBlack[j][H-1] + CountRed[j][H-1].$](https://habrastorage.org/getpro/habr/formulas/f03/a4d/3cc/f03a4d3ccb47c18f181f4df72c50501b.svg) Получим общее количество поддеревьев, которые могут быть в нашем дереве с корнем в вершине . Поскольку нам нужно вычислить количество деревьев с точностью до изоморфизма, достаточно посчитать ответ для . Если , то прибавим к ответу ![$CountBlack[N][H]$](https://habrastorage.org/getpro/habr/formulas/d1c/184/590/d1c184590a4919622867fb4fd019b595.svg) произведение числа поддеревьев слева и справа: . Если же мы строим оба поддерева из одинакового числа элементов (), то к результату нужно прибавить  вариантов.

При вычислении значения ![$CountRed[N][H]$](https://habrastorage.org/getpro/habr/formulas/236/df2/717/236df27176c9c2e0e0d22759c64fbb3d.svg) давайте действовать тем же способом, но с двумя замечаниями. Во-первых, число черных вершин во втором индексе не изменяется, поскольку наш корень красный. А во-вторых, раз у красного корня не может быть красных потомков, то слева и справа у нас могут быть только деревья с черными корнями. Следовательно, если мы выбрали число  в качестве нашего красного корня, то количество деревьев слева равно ![$CountBlack[i-1][H]$](https://habrastorage.org/getpro/habr/formulas/5b2/8e7/8b5/5b28e78b57914500f1cbdb3b5957b858.svg), а количество деревьев справа — ![$CountBlack[j][H]$](https://habrastorage.org/getpro/habr/formulas/e29/c9a/5b4/e29c9a5b41db0cd823fd3f6e14289080.svg). Остальные вычисления аналогичны первому случаю.

Чтобы посчитать ответ для исходной задачи, нам нужно вычислить ![$CountBlack[N][H]$](https://habrastorage.org/getpro/habr/formulas/d1c/184/590/d1c184590a4919622867fb4fd019b595.svg) для всех возможных . Количество черных вершин от корня до любого из листьев [пропорционально](https://ru.wikipedia.org/wiki/%D0%9A%D1%80%D0%B0%D1%81%D0%BD%D0%BE-%D1%87%D0%B5%D1%80%D0%BD%D0%BE%D0%B5_%D0%B4%D0%B5%D1%80%D0%B5%D0%B2%D0%BE#.D0.94.D0.BE.D0.BA.D0.B0.D0.B7.D0.B0.D1.82.D0.B5.D0.BB.D1.8C.D1.81.D1.82.D0.B2.D0.BE_.D0.B0.D1.81.D0.B8.D0.BC.D0.BF.D1.82.D0.BE.D1.82.D0.B8.D1.87.D0.B5.D1.81.D0.BA.D0.B8.D1.85_.D0.B3.D1.80.D0.B0.D0.BD.D0.B8.D1.86) логарифму от количества элементов в дереве. Следовательно, достаточно рассмотреть черные высоты, не превосходящие . Переберем все  от 1 до 20 и просуммируем все значения ![$CountBlack[N][H]$](https://habrastorage.org/getpro/habr/formulas/d1c/184/590/d1c184590a4919622867fb4fd019b595.svg). Полученная сумма и будет ответом к задаче.

«Все кроме одной»

=================

### Условие

Даны  перестановок из  элементов, каждая из которых принадлежит к одному из  типов.

Посчитайте позицию первого элемента, если последовательно применить эти  перестановок, убрав одну из них.

**Дополнительные параметры**#### Формат входных данных

В первой строке входных данных заданы числа  и  (, ).

В следующих  строках записано по  чисел. -е число описывает позицию, на которую нужно переставить -й элемент.

В следующей строке записано число  (). В следующей строке записаны  чисел от 1 до  — типы перестановок в начальном наборе.

#### Формат выходных данных

Для каждой из  перестановок выведите в отдельной строке позицию первого элемента, если последовательно применить все остальные перестановки.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

3 2

1 3 2

2 3 1

3

1 2 1

```

|

```

3

1

2

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

2 2

1 2

2 1

3

1 2 1

```

|

```

2

1

2

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

1 1

1

1

1

```

|

```

1

```

|

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 128 МБ

Решение

=======

Обозначим за ![$prefix[i]$](https://habrastorage.org/getpro/habr/formulas/249/279/8c4/2492798c470212e17796d0549a2b63cc.svg) перестановку, которая получается при последовательном выполнении всех перестановок от первой до -й из нашего набора, содержащего  перестановок. За ![$suffix[i]$](https://habrastorage.org/getpro/habr/formulas/923/2eb/88a/9232eb88a40d138e97f129584b4ac181.svg), в свою очередь, обозначим перестановку, которая получается при последовательном выполнении всех перестановок от -й до -й. Легко увидеть, что, зная ![$prefix[i-1]$](https://habrastorage.org/getpro/habr/formulas/09a/4cc/fb6/09a4ccfb64a0a88d42b5f9188523320d.svg), мы можем получить ![$prefix[i]$](https://habrastorage.org/getpro/habr/formulas/249/279/8c4/2492798c470212e17796d0549a2b63cc.svg), просто применив к ![$prefix[i-1]$](https://habrastorage.org/getpro/habr/formulas/09a/4cc/fb6/09a4ccfb64a0a88d42b5f9188523320d.svg) -ю перестановку из нашего набора. При этом сложность такого вычисления — , где  — количество элементов в перестановке. Значит, мы можем последовательно вычислить все перестановки ![$prefix[i]$](https://habrastorage.org/getpro/habr/formulas/249/279/8c4/2492798c470212e17796d0549a2b63cc.svg) для  от 1 до  за время . Аналогично мы можем вычислить все перестановки ![$suffix[i]$](https://habrastorage.org/getpro/habr/formulas/923/2eb/88a/9232eb88a40d138e97f129584b4ac181.svg), если увидим, что ![$suffix[i]$](https://habrastorage.org/getpro/habr/formulas/923/2eb/88a/9232eb88a40d138e97f129584b4ac181.svg) получается применением ![$suffix[i+1]$](https://habrastorage.org/getpro/habr/formulas/a2a/bd1/d40/a2abd1d40064ea33a9c4518ef49a8bc5.svg) к -й перестановке. Тогда чтобы вычислить, какой элемент будет на первой позиции, если мы исключим некую -ю перестановку из нашего списка, нам достаточно применить к перестановке ![$prefix[j-1]$](https://habrastorage.org/getpro/habr/formulas/468/b27/fd8/468b27fd84a90c7b6bae1a87deb97fd4.svg) перестановку ![$suffix[j+1]$](https://habrastorage.org/getpro/habr/formulas/f51/ff1/aaa/f51ff1aaa6c516c4109d4081db070bc5.svg). Обозначив за ![$prefix[0]$](https://habrastorage.org/getpro/habr/formulas/013/a43/0f6/013a430f6a6a1aba301759a34d37a33f.svg) и ![$suffix[k+1]$](https://habrastorage.org/getpro/habr/formulas/d77/f72/c0a/d77f72c0a91a70c2065f29d0c41984e5.svg) тождественные перестановки и проверив все  от 1 до , мы получим ответ к задаче. Поскольку для каждого  время применения одной перестановки к другой пропорционально , итоговая сложность алгоритма — .

«Вложенные прямоугольники»

==========================

### Условие

На клетчатой плоскости отмечено  клеток.

Для раскрашивания этих клеток проводятся следующие операции. На каждом шаге выбирается прямоугольник минимальной площади, содержащий все отмеченные, но не окрашенные, клетки, и все клетки на его границе перекрашиваются в новый цвет.

Определите, через сколько шагов неокрашенных клеток не останется.

**Дополнительные параметры**#### Формат входных данных

В первой строке входных данных задано число   — количество отмеченных клеток. В следующих  строках заданы целые координаты -й отмеченной клетки  . Все отмеченные клетки различны.

#### Формат выходных данных

Выведите число шагов, после которых не останется неокрашенных клеток.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

1

-1 -1

```

|

```

1

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

3

-1 -1

0 0

1 1

```

|

```

2

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

5

0 1

1 0

1 1

2 1

3 2

```

|

```

2

```

|

#### Ограничение по времени: 2 секунды

#### Ограничение по памяти: 64 МБ

Решение

=======

Отсортируем отмеченные клетки по вертикали и горизонтали. Заведем массив флагов, в котором будет отмечено, какие точки уже выброшены. Для нахождения самого внешнего прямоугольника будем поддерживать 4 итератора, которые указывают на невыброшенные клетки — первую и последнюю для горизонтального и вертикального порядка соответственно. На каждом шаге будем вначале сдвигать итераторы до тех пор, пока не найдем невыброшенные клетки. Затем будем сдвигать итераторы до тех пор, пока не изменится соответствующая координата клетки. Отметим все пройденные клетки как выброшенные в массиве флагов.

«Игра с числами»

================

Условие

=======

Дана последовательность  положительных чисел . Пока среди них есть различные, выполняется следующая операция: выбирается некоторое максимальное число и из него вычитается минимальное число.

Через сколько операций числа станут одинаковыми?

**Дополнительные параметры**#### Формат входных данных

В первой строке входных данных задано число  (). В следующей строке заданы  чисел  ().

#### Формат выходных данных

Количество операций, после которых все числа станут одинаковыми.

#### Примеры

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

2

1 1

```

|

```

0

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

3

9 6 3

```

|

```

3

```

|

| | |

| --- | --- |

| **Ввод** | **Вывод** |

|

```

6

1000000000 1000000000 1000000000 1000000000 1000000000 1

```

|

```

4999999995

```