text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

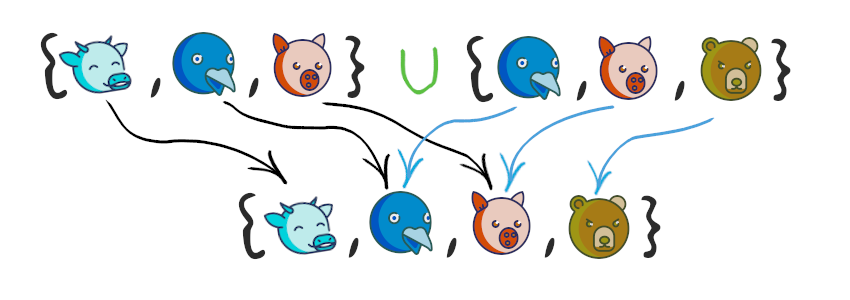

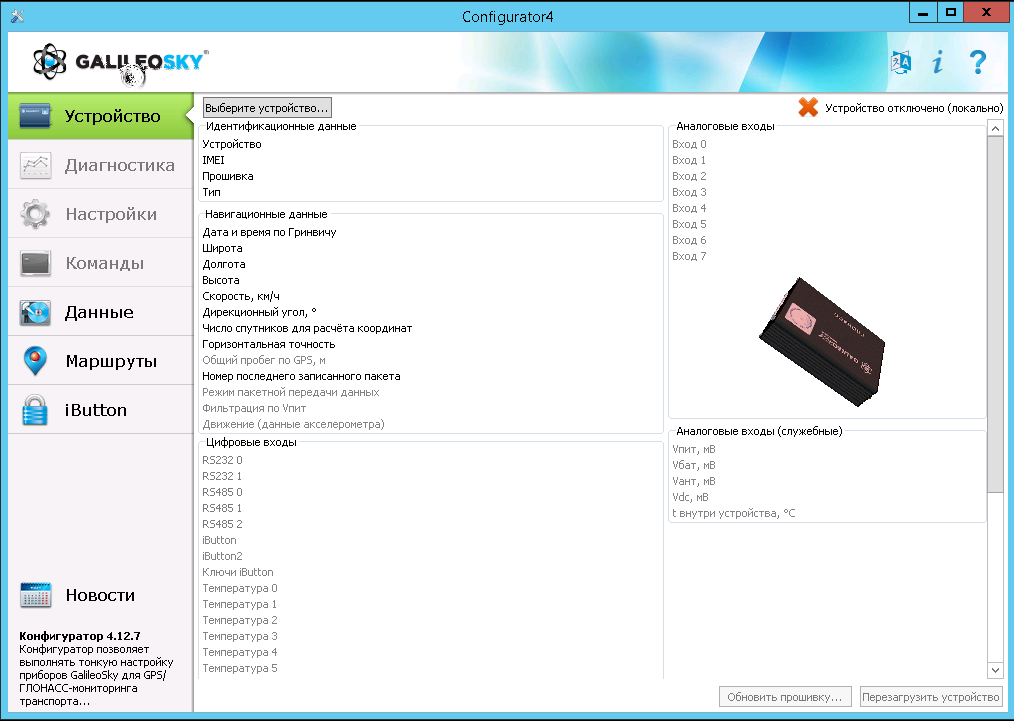

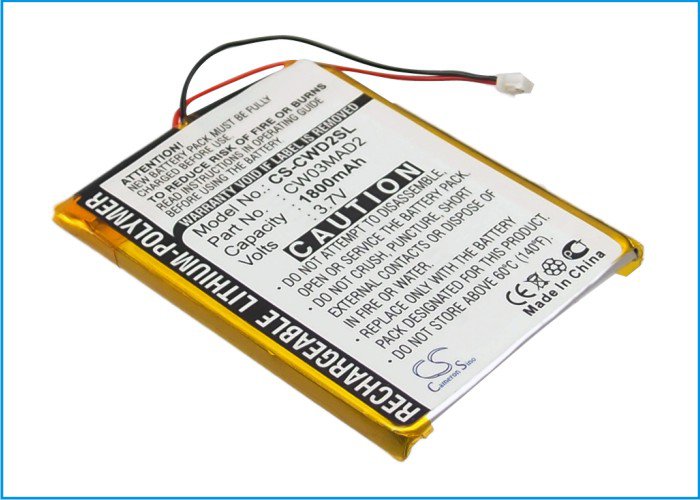

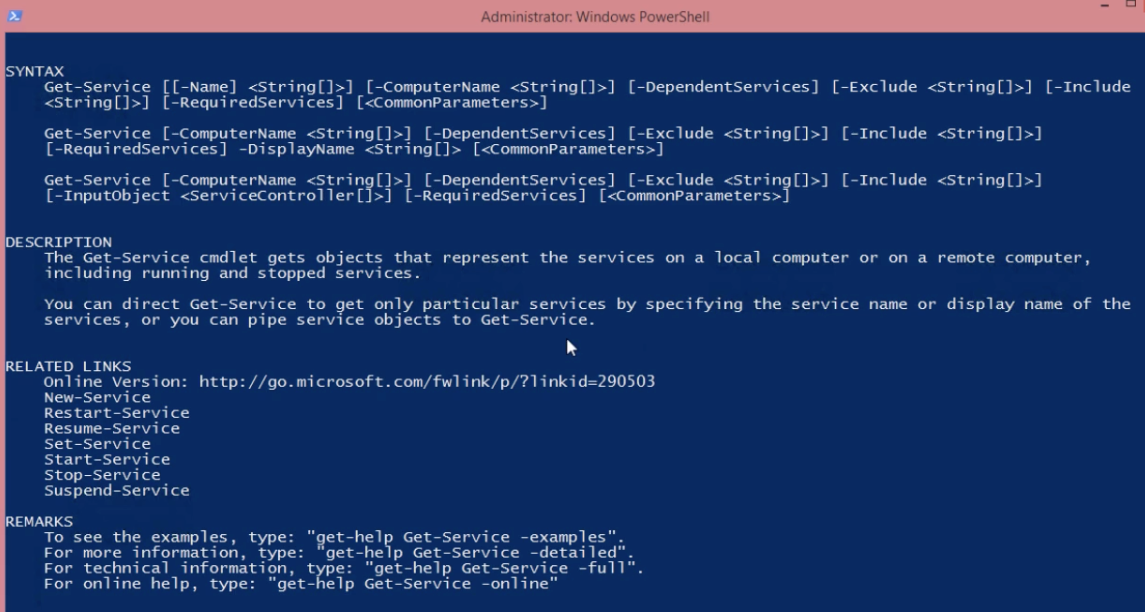

# Как мы выкручиваемся в условиях постоянной нехватки чипов (часть 1)

Проблемами с постоянной нехваткой микросхем сейчас никого не удивить. Началось это всё ещё в конце 2020 года, в начале 2021 стала сильно тяжелее, с введением санкций в 2022 году стал просто кошмар!

Я сейчас с грустью вспоминаю времена, например, 2019 года, когда при заказе партии микроконтроллеров в 2-3 тыс. шт. я выбирал на складах поставщиков самую низкую цену при этом ориентируясь на срок поставки в 1-4 дня! Тогда остатки у них в 20-30 тыс. шт. считались нормальным явлением.

Начиная с 2021 года такие цифры тоже ещё можно было увидеть, но сроки выросли до 15-30 дней. Сейчас реальность такова, что поставка в течение 30 дней считается уже большой удачей, если удаётся отхватить партию микросхем хотя бы в 500-1000 шт. Обычный срок 50-60 дней. При этом даже при своевременной оплате счёта нельзя быть уверенным в поставке. У нас до сих пор из 10 заказов отменяется почти половина. Объясняют это тем, что "кто-то уже перехватил данную партию", хотя мы давно уже платим вперёд и держим у поставщиков на депозите определённый запас денежных средств для мгновенной оплаты.

Про такие моменты, конечно, можно рассуждать ещё долго, но я хотел бы коснуться некоторых технических нюансов, которые всплыли из-за всей этой ситуации.

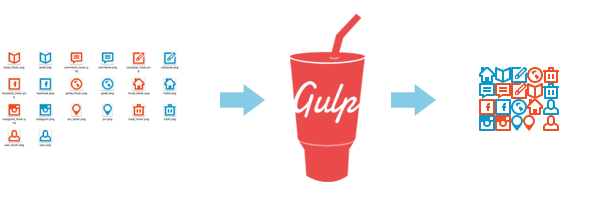

Из-за проблем с поставками мы постоянно занимаемся поиском аналогов всех используемых микросхем. И если с той же I2C-памятью, драйверами RS-232, RS-485 проблем нет, так как их всегда можно чем-то заменить, то вот с микроконтроллерами и преобразователями питания большие проблемы. Про спец. микросхемы вообще молчу. Сейчас мы стараемся их не использовать вообще.

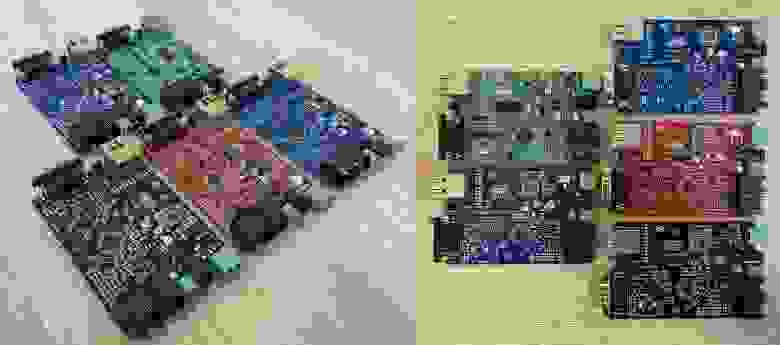

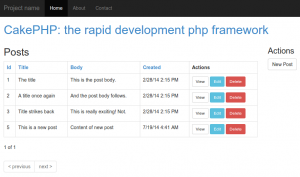

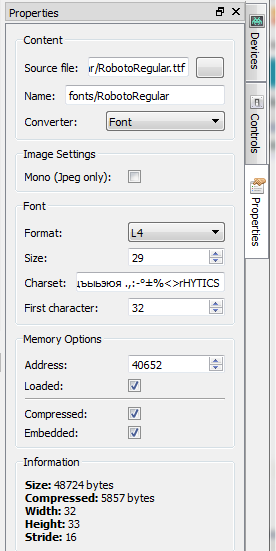

В первой части статьи пойдёт речь о микроконтроллерах. Так сложилось, что мы используем в основном продукцию компании Microchip. Уже в прошлом году под текущие проекты было практически нереально оперативно приобретать более-менее приличные партии одного вида микроконтроллеров. Поэтому нам пришлось в одном и том же устройстве использовать различные модели. Сейчас разнообразие моделей только в одном контроллере мониторинга и управления ИБП ["СКУП-2"](https://spd.net.ru/Hardware/SKUP-2) достигает **8 шт**!

Это порождает следующие проблемы:

1. Необходимость изготовления различных печатных плат под разные корпуса микросхем.

2. Необходимость сборки универсальной прошивки под все типы микроконтроллеров.

Первую проблему решаем так:

По возможности пытаемся объединять на одной плате посадочные места под два типа микросхем. Сейчас вариант с TQFP + QFN является для нас фактически нормой:

Тут ещё добавляется проблема с Ethernet-контроллером, который тоже получается доставать в двух видах – корпус SOIC с шагом 1,27 мм и корпус SSOP с шагом 0,65 мм. Но под него универсальное посадочное место сделать не получилось.

В итоге мы имеем целый набор плат с различными комбинациями контактных площадок. Но, надо сказать, что проблема с платами в целом решается не так уж и сложно.

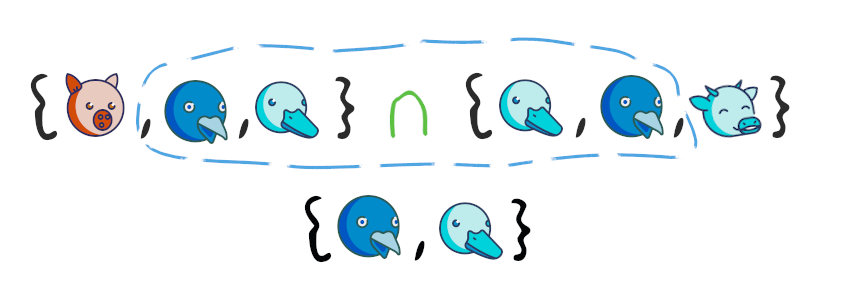

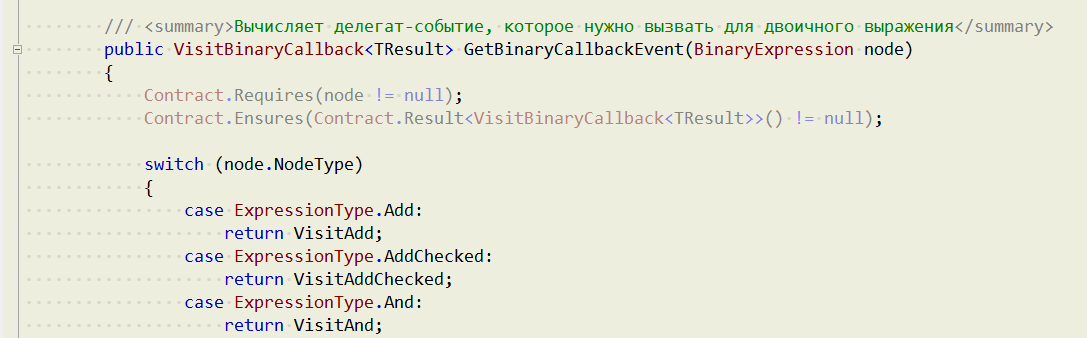

А вот с созданием единой прошивки пришлось попотеть. Понятно, что она "единая" только абстрактно. Мы используем микроконтроллеры совершенно разных подсемейств, у которых периферия отличается очень сильно. Например, PIC18F46K22 и PIC18F46Q43.

Поэтому пришлось в первую очередь максимально переработать наши библиотеки для работы с периферией. В них появилось большое количество define’ов, но в итоге получилось свести всё к единому стилю. Полностью отличается только начальная инициализация микроконтроллеров, но и тут мы постарались максимально унифицировать её в пределах похожих подсемейств.

Далее мы добавили в каждую прошивку функцию для определения "типа микроконтроллера", по факту просто код модели. Это нужно для софта верхнего уровня при обновлении "прошивки". Код представляет собой одну букву от A до Z за исключением буквы X (об этом будет ниже). Таким образом, у нас на данный момент есть возможность использования 25 типов микроконтроллеров в одном устройстве. Надеюсь, что этим всё и ограничится 😁.

Разработку "прошивок" для микроконтроллеров мы осуществляем в среде MPLAB X. Там есть очень удобная штука в настройках проекта – конфигурации. Для каждого типа микроконтроллера мы задаём свои уникальные параметры: адрес расположения загрузчика и т.п. В результате весь проект можно отлаживать на какой-то одной модели (стараемся брать самую "дохлую" в плане периферии и памяти, например, PIC18F46K22), а затем уже пересобирать под все остальные типы:

В итоге мы получаем набор hex-файлов, которые фактически должны идти на одну и ту же плату, но с разными моделями микроконтроллеров. Чтобы пользователь не мог перепутать и залить "прошивку" от другой модели мы поступили следующим образом.

Написали небольшую утилитку, которая из набора этих hex’ов формирует единый контейнер (фактически это ZIP-архив), содержащий все эти файлы, а также небольшой XML-документ, в котором прописано соответствие нужного файла и "типа микроконтроллера".

Вот пример такого документа:

```

```

Здесь имеется определённая гибкость. К примеру, одна прошивка может соответствовать разным типам микроконтроллеров. Также контейнер может содержать дополнительные файлы, например, Web-интерфейс устройства. Они тоже содержатся в списке. При этом наши hex-файлы имеют дополнительную метаинформацию: номер версии, дату и время сборки, код устройства, имя файла Web-интерфейса и т.п. Подобные данные оформляются в виде строк, начинающихся с точки с запятой:

```

;ENCODED=1

;VERSION=2.0 b649

;DATETIME=08.04.2022 14:38:07

;DEVICE_ID=27

;DEVICE_REV=AX

;BIN_FILE=site.bin

:020000040000FA

:101300002AB1DF95673F2061BFEE81DB3A00F0FA3A

:101310005EAA8A2CEEDDBDF6D15F3A338EF1A1F2E2

:1013200045430F31ED59674497E1A1C68F666A9E28

:101330006A75295983376CE7288E96B3F83612D42C

```

Эта информация добавляется автоматически отдельной утилитой после окончания сборки прошивки.

При формировании контейнера проверяются все "перекрёстные ссылки", а также совпадение номеров версий для всех видов "прошивок".

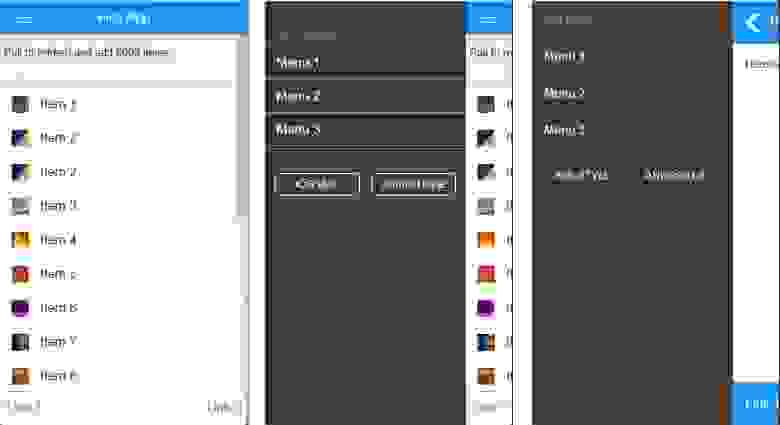

При обновлении "прошивки" софт для ПК считывает "тип микроконтроллера" с платы и достаёт из контейнера нужный hex-файл. В случае группового обновления устройств для каждого из них эта процедура повторяется автоматически:

Особняком в данной системе стоят платы, выпущенные до 2020 года, когда чип использовался всегда один. Они тогда ещё не имели функции считывания "типа микроконтроллера". Для таких вариантов у нас используется "прошивка по умолчанию". В контейнере она помечается буквой X. В большинстве случаев такой микроконтроллер поддерживается и сейчас, поэтому подобные прошивки идут, как правило, с двухбуквенным типом: AX, BX и пр.

В следующей части я расскажу как мы делаем свои субмодули, тоже с целью максимальной универсализации.

|

https://habr.com/ru/post/665834/

| null |

ru

| null |

# C++ — это замечательно, и вот почему

C++ — один из самых непонятных языков в современной поп-культуре разработчиков программного обеспечения. Люди часто сравнивают его с C, потому что это "низкоуровневый" язык. Следовательно, он получил репутацию эзотерического языка, который интересует только параноиков производительности. Это далеко не так. Я программирую на C++ в качестве основного языка уже некоторое время, и опыт разработчика на самом деле очень хорош — гораздо лучше, чем можно было себе представить.

В этой статье мне хотелось бы развенчать некоторые распространенные мифы о C++, которые я слышал до того, как начал его использовать. Затем расскажу о реальных супервозможностях, которые предоставляет C++ и которых нет у большинства других языков.

### Миф 1: запомни это, запомни то

Мы все знаем, что C печально известен ручным управлением памятью, например, с помощью `malloc` и `free`. С ними трудно работать, они приводят к множеству ошибок, которые нужно проверять вручную, и в целом являются настоящим кошмаром. Когда люди слышат, что C++ также отличается высокой производительностью, то думают, что это происходит за счет того, что все особенности распределения памяти такие же, как и в C, следовательно, из этого делается вывод, что и здесь всё будет ужасно. Это категорически неверно.

Уже некоторое время в C++ существуют умные указатели. Используя их, можно добиться того же поведения, что и с объектами в других языках, таких как Java и Python. В частности, `std::shared_ptr` работает, оборачивая обычный объект в копируемый и перемещаемый объект с механизмом подсчета ссылок. Таким образом, когда ни один код не ссылается на `shared_ptr`, он благополучно ликвидируется и освобождается, как в большинстве языков. Простейший способ создания разделяемого указателя выглядит следующим образом:

```

std::shared_ptr cat(new Pet("cat"));

// or

std::shared_ptr cat = std::make_shared("cat");

```

Хотя это общий шаблон для большинства других языков, C ++ позволяет вам дополнительно контролировать, как осуществляется доступ к объекту, например, используя `unique_ptr`, но об этом позже.

В целом, с использованием умных указателей, управлять памятью в C++ не сложнее, чем в других языках. Это сделано *преднамеренно*, поскольку вам необходимо уточнить, каким будет ожидаемое поведение, потому что вы по-прежнему можете создавать и передавать обычные указатели старым добрым (безобразным?) способом.

Как правило, при умелом их использовании вы также вряд ли столкнетесь с ошибками сегментации, которые были очень распространены в C.

### Миф 2: он старый и неактуальный

C++ очень активно поддерживается, и новые возможности продолжают регулярно появляться. Я думаю, что одной из самых распространенных "новых" функций во многих языках, которыми люди восхищаются, являются лямбды. Конечно, в C++ нет лямбд, верно? Ошибаетесь. Лямбда-функция в C++ может быть определена как:

```

auto square = [=](int x) { return x * x; };

```

Для контекста, Java получила лямбды в 2014 году с выходом Java 8. В C++ лямбды появились с C++11 (2011). Вот так.

И продолжают выходить важные обновления, например, C++20 совсем недавно, которые добавляют еще больше возможностей, чтобы упростить работу с C++. Например, аргументы переменной длины уже давно есть в C++ благодаря вариативным шаблонам. Дженерики также отлично работают в C++, хотя и не так, как вы привыкли в Java. Эти возможности продолжают улучшать способы разработки программного обеспечения.

### Миф 3: легко ошибиться

Напротив, несмотря на то, что изучение некоторых его особенностей может занять некоторое время, в C++ очень сложно сделать так, чтобы ваш код сделал нежелательные вещи. Например, во многих объектно-ориентированных языках нет поддержки "чистых" функций, то есть функций, которые гарантированно неизменяемы. В C++ вы можете пометить методы класса как `const`, если они не изменяют его состояние. Затем эти методы также можно вызывать для постоянных экземпляров класса. Вот пример:

```

class Greeting {

public:

Greeting(std::string greeting) : greeting_(greeting) {}

std::string get_greeting() const {

return greeting_;

}

std::string set_greeting(std::string new_) {

greeting_ = new_;

}

private:

std::string greeting_;

};

```

Теперь вы можете инициализировать этот класс как константу и по-прежнему вызывать геттер. Когда вы попытаетесь изменить состояние класса, компилятор будет ругаться!

```

const Greeting g("hello");

g.get_greeting(); // returns "hello"

g.set_greeting("hi"); // does not compile

```

Если быть точным, эти функции не являются полностью чистыми в том смысле, что если вы неправильно напечатаете некоторые из ваших переменных, то возможно искажение ресурсов. Например, если у вас есть указатель `const` на не `const`-объект, то изменение указателя невозможно, но возможно изменение объекта, на который он указывает. Однако этих проблем обычно можно избежать, правильно задавая указатель (т.е. сделав его `const`-указателем на `const`-объект).

Может показаться, будто я противоречу сам себе, упоминая такой крайний случай в распространенном примере использования. Тем не менее, я не думаю, что это опровергает мое основное утверждение: В C++ трудно ошибиться, если вы знаете, чего хотите, поскольку он дает вам инструменты для выражения в коде именно того, что вам нужно. Хотя такие языки программирования, как Python, могут абстрагировать все это от вас, они обходятся гораздо дороже. Представьте, что вы идете в магазин мороженого, а вам подают только шоколад, потому что большинство людей обычно хотят именно его - это и есть Python. В зависимости от того, как вы на это посмотрите, конечно, в некотором смысле с шоколадом сложнее ошибиться, но в целом не магазин, а сам пользователь должен определять, что ему нужно.

Хорошая `const`-ность — это большой плюс, но есть еще несколько вещей, которые позволяет делать C++ и которые предотвращают появление багов в продакшене больших проектов. Он позволяет вам настраивать семантику перемещения/копирования/удаления для классов, которые вы разрабатываете, если вам это необходимо. Позволяет передавать данные по значению и использовать такие расширенные возможности, как множественное наследование. Все эти вещи делают C++ менее строгим.

### Миф 4: он многословен

Хорошо, здесь есть доля истины. Придя из Python, где люди так устали от ввода numpy, что все коллективно решили импортировать его как np, ввод более 2 букв действительно кажется многословным. Но современный C++ гораздо менее многословен, чем раньше! Например, вывод типов, как в Go, стал доступен в C++ с введением ключевого слова auto.

```

auto x = 1;

x = 2; // works

x = "abc"; // compilation error

```

Вы также можете использовать `auto` в типах возвращаемого значения:

```

auto func(int x) { return x * x; }

```

Можно использовать его в циклах, например, для перебора карт:

```

for (auto& [key, value]: hashmap) {...}

```

`auto` не означает, что типы являются динамическими — они все еще выводятся во время компиляции и после присвоения не могут быть изменены. Возможно, это и к лучшему. На практике для больших кодовых баз, пожалуй, также помогает удобочитаемость, если вместо `auto` вводить полный тип. Тем не менее, такая возможность существует, если это вам потребуется.

Вы также можете указывать псевдонимы типов и/или пространств имен, как в Python. Например, можно сделать что-то вроде:

```

using tf = tensorflow;

// Now you can use tf::Example instead of tensorflow::Example.

```

Шаблоны C++ (похожие на Java Generics, но при этом довольно разные) также помогают значительно сократить дублирование кода и могут оказаться элегантным решением для многих случаев использования.

В целом, C++ определенно более многословен, чем большинство новых языков программирования, таких как Kotlin и Python. Однако он не намного больше, чем C#, Java или даже JavaScript, и их многословность не сильно повлияла на популярность этих языков.

### Миф 5: трудно делать простые вещи

Здесь снова не все так однозначно. Обычные операции, такие как объединение строк разделителем, сложнее, чем нужно. Однако эта проблема довольно легко решается с помощью библиотек с открытым исходным кодом, таких как [Abseil](https://abseil.io/) от Google, содержащих тысячи вспомогательных функций, с которыми очень легко работать. Помимо строковых утилит, Abseil также содержит специальные реализации хэшмапов, хелперов параллелизма и инструментов отладки. Другие библиотеки, такие как Boost, облегчают работу с BLAS-функциями (например, точечными продуктами, матричными умножениями и т.д.) и отличаются высокой производительностью.

Использование библиотек само по себе может быть сложной задачей в C++ с необходимостью поддерживать файлы CMake, хотя во многом они мало чем отличаются от файлов gradle или package.json в других языках. Однако, опять же, инструмент сборки [Bazel](https://bazel.build/) от Google с открытым исходным кодом чрезвычайно упрощает работу даже с кросс-языковыми сборками. К нему нужно привыкнуть, но он обеспечивает действительно быструю сборку и в целом очень удобен для разработчиков.

**Сверхвозможности**

Итак, развеяв все эти распространенные мифы о C++, вот некоторые вещи в C++, которые многие другие языки не позволяют вам делать:

**Настройте семантику ваших классов**

Предположим, у вас есть класс, который содержит большие данные. Вы бы предпочли, чтобы они не копировались, а всегда передавались по ссылке. Как разработчик интерфейса вы можете это реализовать. Более того, при необходимости вы можете настроить, как именно будет происходить копирование данных.

Что насчет перемещения объектов — вместо того, чтобы копировать все данные из предыдущего блока памяти в новый, а затем удалять старый, может быть вы можете оптимизировать это, просто переключая местоположение указателей.

Уничтожение объектов — при выходе объекта из области видимости, возможно, вы автоматически хотите освободить некоторые ресурсы (например, мьютексы, которые автоматически освобождаются в конце функции). Это работает примерно так же, как функция defer в Go.

Как дизайнер интерфейса, вы можете настроить каждый маленький аспект того, как пользователи будут использовать ваш класс. В большинстве случаев в этом нет необходимости, однако, если возникает такая потребность, C++ позволяет вам полностью выразить свои потребности. Это очень мощный инструмент, который может сэкономить вашей компании многие часы потраченного времени на крупных проектах.

**Оптимизируйте процесс доступа к памяти**

Выше я вкратце упомянул об умных указателях. Помимо `shared_ptr`, вы также можете использовать `unique_ptr`, который гарантирует, что только один объект может обладать ресурсом. Наличие одного владельца данных упрощает организацию и обсуждение крупных проектов. На самом деле, хотя `shared_ptr` наиболее близко имитирует Java и другие языки OOP, в целом лучше использовать `unique_ptr`. Это также повышает безопасность языка.

Вы также можете задать константы времени компиляции, позволяющие компилятору выполнять больше работы во время сборки, чтобы двоичный файл в целом работал быстрее.

**Строгая типизация**

В целом, я заметил, что работу с типизированными объектами в C++ намного легче отлаживать, чем в других языках. Например, после нескольких часов отладки проекта на JavaScript я обнаружил, что ошибка возникала из-за того, что я передавал 1 аргумент в функцию с 2 аргументами. При этом JavaScript не выдавал никаких ошибок и просто производил нежелательные результаты. Я бы предпочел, чтобы ошибка возникла при компиляции, а не во время выполнения.

Однако существует множество типизированных языков, поэтому использование этой суперспособности может показаться излишним. Но C++ делает больше. Во-первых, C++ позволяет передавать что-либо по ссылке, по указателю или по значению. Это означает, что вы можете передать ссылку на целое число и попросить функцию изменить его вместо того, чтобы использовать возвращаемое значение (в некоторых случаях это может быть удобно). Это также означает, что при необходимости вы можете выполнять операции в памяти, используя указатель на что угодно. Обычно, однако, вы хотите передавать объекты в виде постоянной ссылки (например, const A&), что не приведет к копированию и защитит ваш объект от непреднамеренного мутирования. Это сильные гарантии, и благодаря им ваш код становится намного проще для понимания. В TypeScript, например, вы не можете переназначить `const`-объект, но *можете* мутировать его.

**Предостережения**

Итак, C++ - это здорово и все такое, но есть очевидные ограничения относительно его использования. На нем можно легко писать микросервисы (например, на gRPC), но я бы, скорее всего, не стал использовать C++ для реального веб-сервера (для этого лучше применить TypeScript). Несмотря на его скорость, я бы не стал использовать C++ для анализа данных (для этого я бы, скорее всего, выбрал pandas). Есть некоторые вещи, для которых C++ подходит отлично, а для других он просто не годится. В конечном счете, вы все равно должны выбрать правильный инструмент для той работы, которую собираетесь выполнить. Надеюсь, эта статья сделала C++ немного более привлекательным в ваших глазах, чем вы привыкли его видеть.

---

> Материал подготовлен в рамках курса [**«C++ Developer. Basic».**](https://otus.pw/Pkr3/)

>

>

|

https://habr.com/ru/post/575964/

| null |

ru

| null |

# Инвентаризация малой кровью

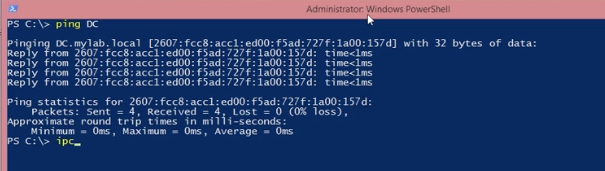

Однажды потребовалось провести «инвентаризацию», то есть узнать за каким компьютером, какой пользователь сидит.

Вариант пройти по рабочим местам посмотреть, поспрашивать, был отброшен, как еретический.

Так как все пользователи заведены в Службе каталогов Active Directory, так же, как и рабочие места, родилась идея выдрать всю необходимую информацию из AD. Можно, конечно было обратиться к администратору домена и спросить все данные у него, но мы не ищем легких путей.

Итак, для инвентаризации Нужно:

* Сетевое имя компьютера.(Все компьтеры под Win разных версий)

* Мак адрес этого компьютера.(Все компьютеры находятся в одной подсети 255.255.0.0)

* ФИО пользователя, который за этим компом закреплен.

И самое главное условие — это крайнее нежелание ставить на комп каких-либо сторонних приложений, писать приложение на «правильных» языках, тоже было лень. Поэтому для реализации был выбран VBS, так как в нем есть все, что необходимо и ничего дополнительно ставить не нужно и среда для него самая легковесная — notepad.exe.

С сетевыми именами все просто, они есть в службе каталогов. Пример работы с AD из VBS нагуглился довольно быстро. Для получения списка атрибутов объектов использовался скрипт написанный

товарищем Andrew J. Healey [listAllProperties](http://halfloaded.com/blog/list-all-user-object-attributes-in-active-directory-schema-whew/)

Так что получить имена компьютеров получилось таким нехитрым скриптом.

```

set cn=CreateObject("ADODB.Connection")

set cmd=CreateObject("ADODB.Command")

cn.Provider="ADsDSOObject"

cn.Open "Active Directory Provider"

set cmd.ActiveConnection=cn

используя SQL диалект запросов к Active directory выбираем все обекты класса "Computer"

cmd.CommandText="SELECT * FROM 'LDAP://DC=***,DC=ru' WHERE objectClass='Computer'"

set objRecordSet=cmd.Execute

on error resume next

do while Not objRecordSet.Eof

set objComputer=GetObject(objRecordSet("adspath"))

'путем бесчеловечных экспериментов было выяснено, что если путь содержит данную фразу

'то это демонтированное оборудование, или уволенный работник

if(inSTR(1,objComputer.distinguishedName,"OU=Garbage",vbTextCompare) = 0)then

wscript.echo objComputer.CN 'В данном поле и хранилось заветное сетевое имя

end if

objRecordSet.MoveNext

Loop

```

Далее, нужно получить мак адрес этих компов. Тут все просто, при помощи стандартной утилиты «nbtstat» с параметром "-a" можно получить искомое(есть конечно еще вариант с arp -a, но работает не всегда).

```

set oShell=Wscript.CreateObject("wscript.shell")

set re=new regexp

'Регулярка для поиска MAC адреса

re.Pattern = "[0-9A-F]{2}-[0-9A-F]{2}-[0-9A-F]{2}-[0-9A-F]{2}-[0-9A-F]{2}-[0-9A-F]{2}"

' В данном случае ComputerNetworkName имя компа которое мы взяли из AD

set oExec=oShell.Exec("nbtstat -a" & ComputerNetworkName)

for each obj in re.execute(oExec.StdOut.ReadAll)

GetData=obj.value

next

```

Теперь возникает вопрос: «А где собсно взять список пользователей зарегистрированных на данном компьютере?». Путем непродолжительного гугления было найдено множество способов, которые сводились к удаленному выполнению wmi скрипта. Этот путь мне не подходил, так как в домене запрещено удаленное выполнение скриптов. И тут вспомнилось, что в Windows по умолчанию доступны для чтения по сети, 2 ветки реестра, а именно «HKEY\_USERS» и «HKEY\_LOCAL\_MACHINE».

Значит, получить SID для зарегистрированных пользователей можно получить при помощи утилиты «reg» и в этом нам поможет код, который мы использовали для получения MAC адреса, все, что в нем нужно изменить так это шаблон для регулярки, и текст команды.

```

set oShell=Wscript.CreateObject("wscript.shell")

set re=new regexp

'Регулярка для поиска SID в выводе команды reg query

re.Pattern = "S-\d+-\d+-\d+-\d+-\d+-\d+-\d+"

' В данном случае ComputerNetworkName имя компа которое мы взяли из AD

set oExec=oShell.Exec("reg query \\" & iComputerNetworkName&"\HKEY_USERS")

for each obj in re.execute(oExec.StdOut.ReadAll)

GetData=obj.value

next

```

Ну, хорошо сиды у нас есть, но они на ФИО не похожи, совсем. Чтобы получить ФИО опять придется обращаться к AD.

У каждого объекта в AD есть поле «objectSID», а значит выбрать инфу о пользователе можно, поэтому самому сиду. Для этого возьмем код, который мы использовали для получения списка компьютеров, и изменим в нем запрос в поле «cmd.commandtext»:

```

dim cn,cmd,objRecordSet

set cn=CreateOBject("ADODB.Connection")

set cmd=CreateObject("ADODB.Command")

cn.Provider="ADsDSOObject"

cn.Open "Active Directory Provider"

set cmd.ActiveConnection=cn

' objSid это сиды которые мы получили из реестра.

cmd.CommandText="SELECT * FROM 'LDAP://DC=***,DC=ru' where objectClass='User' and objectSid='"& objSid &"' "

set objRecordSet=cmd.Execute

'Вдруг пользователя с таким сидом нет

if( not objRecordSet.Eof) then

set objUser=GetObject(objRecordSet("adspath"))

if(inSTR(1,objUser.distinguishedName,"OU=Garbage",vbTextCompare) = 0)then

' Если он всетаки есть, и еще и не в мусоре, выводим его данные.

Wscript.Echo objUser.FirstName &" "& objUser.LastName &" "& objUser.Patronim

end if

end if

```

Ну, вот и все нужные данные получены, причем, даже если они изменятся в дальнейшем получить их, не будет проблемой (если конечно служба каталогов не будет реорганизована). И что самое главное не пришлось бегать, всему предприятию в поисках компов и пользователей.

|

https://habr.com/ru/post/147555/

| null |

ru

| null |

# Организация автоматического запуска автотестов с использованием Downstream pipelines в GitLab CI

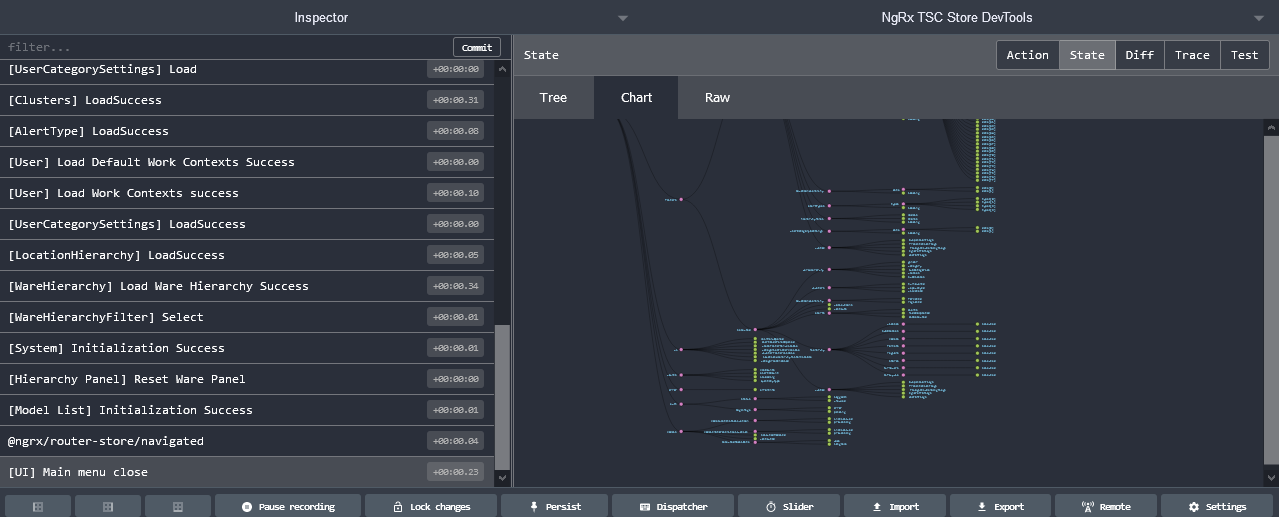

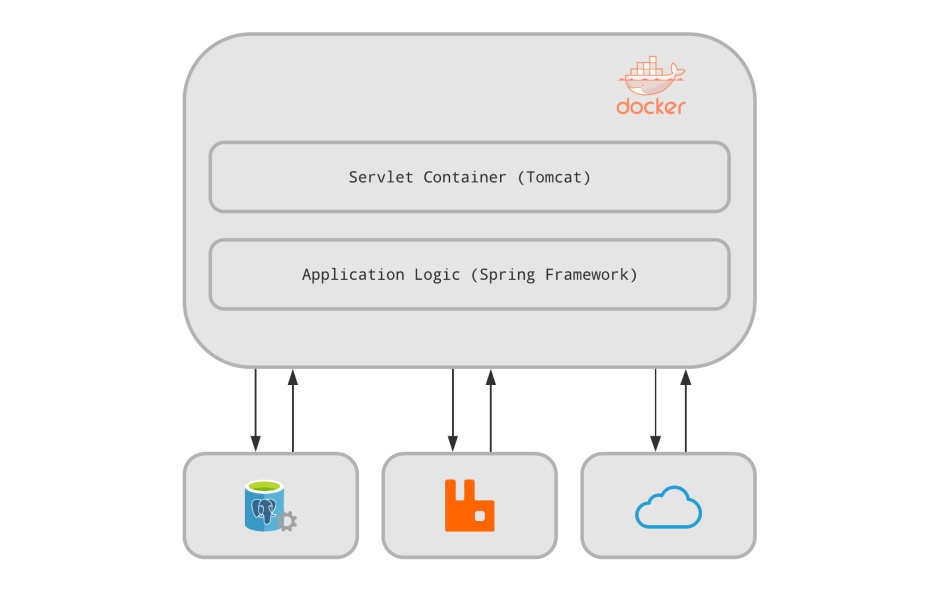

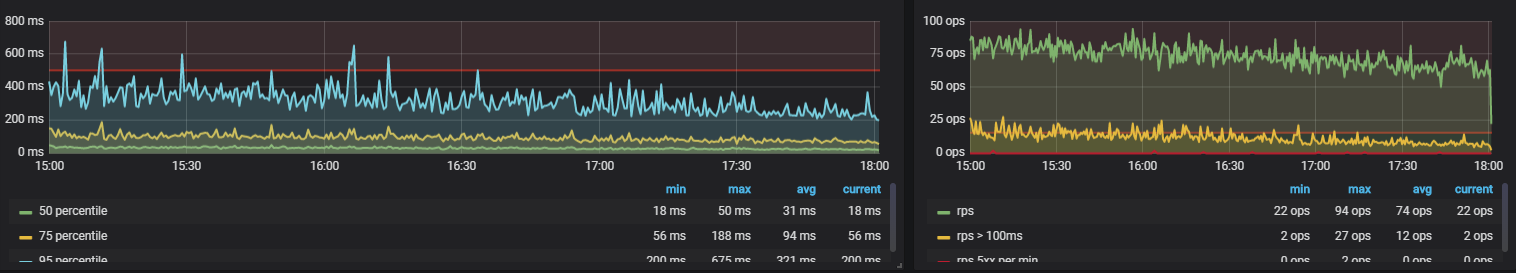

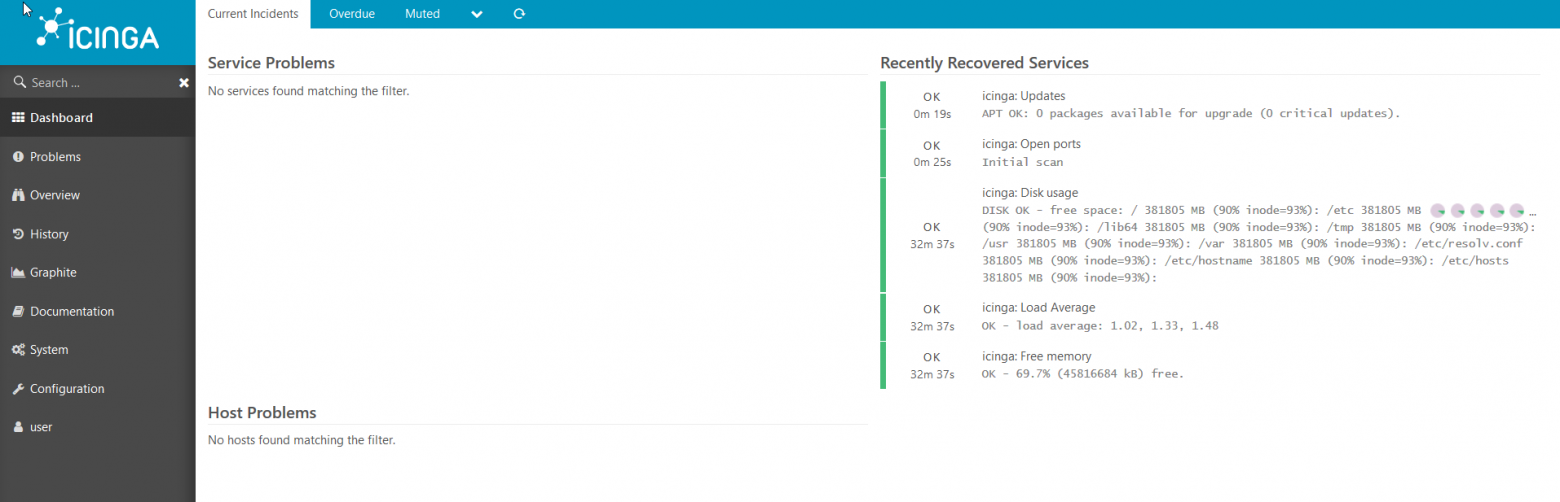

Привет, Хабр! Меня зовут Андрей, я SDET-специалист SimbirSoft. В практике CI/CD один из общепринятых стандартов — настройка автоматического запуска автотестов при деплое сервиса на стенды. То есть при запуске сборки мы сразу видим, как пройдут смоук-автотесты, и на основе отчета решаем, передавать сборку дальше QA-команде или дорабатывать. Это упрощает работу команды и позволяет быстрее исправлять ошибки, что критично важно для бизнеса.

Работу над иллюстрацией мы тоже отчасти автоматизировали, создав ее с помощью нейросети Midjourney.

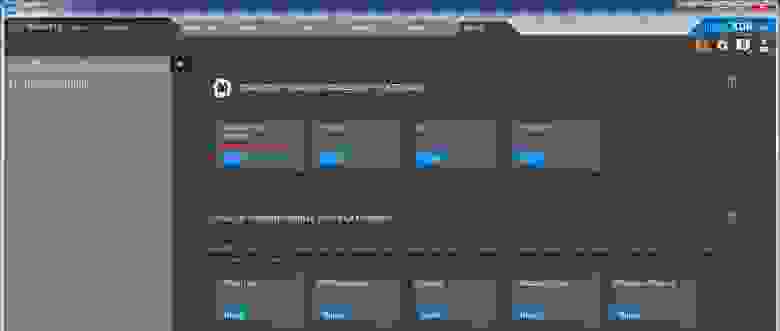

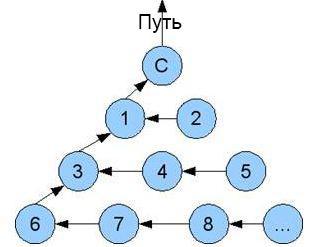

Мы разберем автоматический запуск автотестов с использованием Downstream pipelines в GitLab CI на примере проекта с несколькими микросервисами. Они должны триггерить разные группы автотестов, а также имеют разные точки входа, то есть базовые URL. Выглядит это так:

Пайплайн сборки сервисов

------------------------

Допустим, .gitlab-ci.yml в сборке микросервиса выглядит так:

```

stages:

- build

- deploy

- test

build job:

stage: build

script:

- echo "Build service"

deploy job:

stage: deploy

script:

- echo "Deploy service"

when: on_success

```

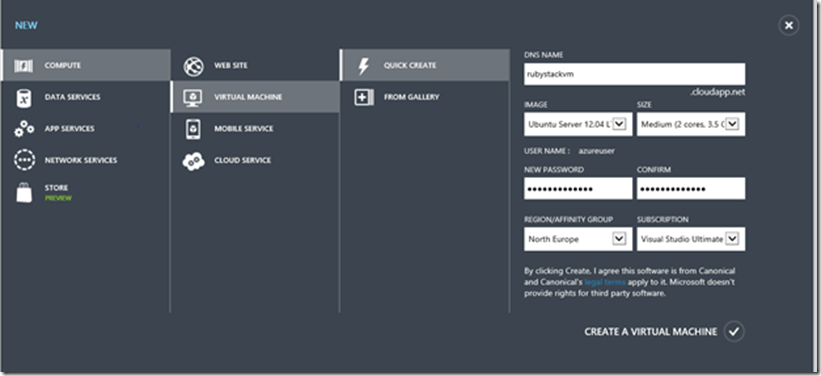

Сервис при сборке хранит в переменных среды необходимый URL, который далее станет точкой входа для автотестов (например, [app.testing.com](https://app.testing.com/) или [app.staging.com](https://app.staging.com/)). Если этого URL в переменных нет, вы можете добавить разные переменные для разных окружений в настройках этого пайплайна. Сделать это можно в UI GitLab тут Setting -> CI/CD -> Variables, например PARENT\_URL для разных Environment scope.

Пойдем по пути использования одного фреймворка с автотестами для этих микросервисов. Мы хотим, чтобы фреймворк жил отдельным пайплайном и мог автономно запускаться без привязки к микросервису.

**Для чего нужен автономный запуск?** Когда мы написали новый тест-сьюит, и его запуск успешно прошел локально, необходимо проверить, как его прогон пройдет в CI/CD, так как там автотесты могут упасть. Это может быть связано с тем, что под капотом Selenoid автотест может работать иначе, или скорость обработки данных БД чрезмерно высока, и в неё не успевают прилетать сообщения из другого сервиса.

Чтобы автотесты запускались автоматом при деплое сервиса, и при этом сохранялась необходимая автономность, мы будем использовать [Downstream pipelines](https://docs.gitlab.com/ee/ci/pipelines/downstream_pipelines.html).

Добавляем в .gitlab-ci.yml сборки микросервиса триггер для запуска автотестов:

```

testing_job:

stage: test

variables:

PARENT_MARK: "smoke_service_a" # Здесь Вы можете указать метку, которую хотите передавать в автозапуск тестов

# Для второго микросервиса здесь будет соответственно PARENT_MARK: "smoke_service_b"

PARENT_URL: "https://rickandmortyapi.com/api" # Здесь я имитирую передачу сервисом необходимого URL

trigger: ansid63/just_ci

rules:

- if: $CI_COMMIT_BRANCH == "main"

```

В trigger мы передаем путь к нашему проекту с автотестами в GitLab CI. Поле rules в данном случае устанавливает условие, что автотесты необходимо триггерить при мерже в ветку main.

Пайплайн проекта с автотестами

------------------------------

Переходим к проекту с автотестами. Я сделал небольшой проект с API тестами для проверки работы связки пайплайнов:

В проекте должен быть подключен [GitLab Runner](https://docs.gitlab.com/runner/install/windows.html). Если вы запускаете проект на gitlab.com, возможно, вам будет достаточно Runner, предлагаемого сервисом GitLab.

В conftest.py я выдергиваю базовый URL для запуска автотестов:

```

from pytest import fixture

def pytest_addoption(parser):

parser.addoption(

"--url",

action="store",

default="https://rickandmortyapi.com/api")

@fixture()

def url(request):

return request.config.getoption("--url")

```

Dockerfile собирает контейнер с автотестами и зависимостями, в автотестах используются библиотеки pytest и requests.

```

FROM python:3.9.13-slim

COPY . .

RUN pip3 install -r requirements.txt --no-cache-dir

```

Папка tests содержит один файл с автотестами.

Давайте разберем пайплайн в .gitlab-ci.yml проекта с автотестами:

```

stages:

- build # Этап сборки контейнера с автотестами и зависимостями

- test # Этап запуска автотестов

variables:

TEST_MARK:

value: "smoke_service_a" # Дефолтная mark для pytest

TEST_PATH:

value: "tests"

# Т.к. мы прокидываем --url, pytest очень просит указать путь к местоположению тестов

TEST_URL:

value: "https://rickandmortyapi.com/api" # Дефолтный URL для pytest

AQA_GIT_TAG: v0.1.0 # Тэг для контейнера с автотестами

AQA_IMAGE: "${CI_REGISTRY_IMAGE}/autotests:${AQA_GIT_TAG}" # Путь к контейнеру с автотестами

.docker-registry: &docker-registry

- echo $CI_REGISTRY_PASSWORD | docker login -u gitlab-ci-token -p $CI_JOB_TOKEN $CI_REGISTRY

# Шаблон для авторизации в СI registry

build_autotest_image:

# Данный этап с условием only позволяет нам собирать контейнер только при git push

# и избежать постоянной пересборки контейнера при запуске автотестов.

stage: build

image: gitlab/dind

services:

- docker:dind

before_script:

- *docker-registry # Авторизация в СI registry

script:

- docker build -t ${AQA_IMAGE} . # Собираем контейнер с автотестами и зависимостями

- docker push ${AQA_IMAGE} # Пушим контейнер в СI registry

only:

refs:

- pushes # Сборка контейнера происходит только при git push в проекте с автотестами

test job 1: # Запуск автотестов при триггере от сборки микросервиса

stage: test

image: "${AQA_IMAGE}"

script:

- pytest -m $PARENT_MARK $TEST_PATH --url $PARENT_URL # Запускаем автотесты

rules:

- if: $CI_PIPELINE_SOURCE == "pipeline"

# Согласно данному правилу, этот процесс запускается в случае, если пайплайн триггериться

test job 2: # Запуск автотестов при ручном запуске

stage: test

image: "${AQA_IMAGE}"

script:

- pytest -m $TEST_MARK $TEST_PATH --url $TEST_URL # Запускаем автотесты

rules:

- if: $TEST_FROM == "handheld"

# Запуск происходит когда в Run Pipeline передаем TEST_FROM == "handheld"

```

Запуск автотестов

-----------------

При запуске сборки и деплоя микросервиса у нас автоматически стартуют автотесты:

Если автотесты пройдут с ошибками, билд будет обозначен как failed и подсветится красным. Таким образом команда разработки получит информацию о работоспособности данного конкретного билда системы. В случае, если вы не хотите «фейлить» деплой, а лишь подсветить, что прогон автотестов прошел с падениями, следует добавить allow\_failure: true в джобу stage: test.

Если мы хотим запустить автотесты для дефолтных значений в нашем проекте с автотестами, мы переходим во вкладку CI/CD GitLab, нажимаем Run pipeline. В появившемся окне необходимо выбрать branch, а в Variables добавить TEST\_FROM со значением handheld, нажать кнопку Run pipeline. В качестве результата вы получите прогон автотестов с меткой smoke\_service\_a и дефолтным URL <https://rickandmortyapi.com/api>.

Если вам нужна более гибкая настройка и нужен запуск ветки develop, метки smoke\_service\_b, файла с автотестами по пути tests/test\_api.py::TestRickAndMortyApi и с определенным входным URL, это можно сделать так:

Нажимаете Run pipeline, получаете необходимый вам запуск автотестов. В чем плюс этого подхода — он даёт вам высокую гибкость относительно вариантов запуска.

Вместо вывода

-------------

Downstream pipelines предоставляет возможность взаимодействия нескольких проектов, а также возможность передачи необходимых переменных из одного проекта в другой, на основании чего вы можете строить необходимые вам зависимости. Вы добавляете модульности вашей системе и предоставляете готовое решение для автотестов. Для обновления схемы работы автотестов не нужно будет править несколько пайплайнов, а работать только с одним. И это сможет сделать команда автотестирования, которая отвечает за свой пайплайн.

Если вы используете один стенд для запуска автотестов, и прогон автотестов необходим при сборке одного сервиса, можно также использовать Downstream\_pipelines для автономности проекта с автотестами.

**Спасибо за внимание!**

**Полезные материалы для разработчиков мы также публикуем в наших соцсетях –**[**ВКонтакте**](https://vk.com/simbirsoft)**и**[**Telegram**](https://t.me/simbirsoft_dev)**.**

|

https://habr.com/ru/post/715028/

| null |

ru

| null |

# Тестирование проброса GPU на AMD Ryzen 7 5700G APU

[](https://habr.com/ru/company/ruvds/blog/583784/)

Проброс видеокарты с помощью VFIO может быть знаком немногим, но по факту является очень удобным способом решить ряд насущных задач и упростить рабочий процесс в целом. В этом проекте мы настроим нужную конфигурацию из под Fedora 34 и поочередно пробросим две разные видеокарты в VM, попутно оценив полученную производительность.

Вступление

----------

Прежде чем перейти ко всем подробностям, хочу вкратце описать, с чем вообще мы будем иметь дело, так как эти темы могут оказаться для вас незнакомыми. Технология VFIO является достаточно нишевой, и о ней мало кто знает.

* [Проброс GPU](https://wiki.archlinux.org/title/PCI_passthrough_via_OVMF): процесс, в котором виртуальной машине (VM) предоставляется в пользование выделенная видеокарта. Это позволяет выполнять внутри VM рабочие нагрузки, ориентированные на GPU, например, игры или иные задачи, опирающиеся на производительность GPU.

* [VFIO](https://www.kernel.org/doc/Documentation/vfio.txt): фреймворк, позволяющий выполнить эту операцию.

* [IOMMU](https://en.wikipedia.org/wiki/Input%E2%80%93output_memory_management_unit): аппаратная особенность, которая все это поддерживает.

* [virt-manager](https://virt-manager.org/): приложение GUI, через которое я управляю VM.

Какой вообще смысл заморачиваться и реализовывать подобное?

* Вы пользуетесь Linux, но хотите иногда запускать игры без перезагрузки под Windows.

* Вы хотите выполнять все рабочие, игровые и серверные процессы на одной машине.

* Вы просто не хотите собирать выделенный ПК под игры и предпочтете задействовать имеющиеся ресурсы на основной машине.

* Вам нужно больше контроля над установкой Windows, потому что Microsoft вы не доверяете.

* Вам нужно больше контроля над установкой Windows, а также возможность возвращать этот процесс к более ранней точке, используя файловую систему с поддержкой снимков состояния (BTRFS, ZFS).

* У вас есть несколько отдельных VM для разных целей, но вы хотите задействовать один GPU для всех.

При этом нужно помнить, что используемое вами аппаратное обеспечение играет здесь важную роль, поскольку является основой работоспособности всего решения. Вот некоторые из требований, которые необходимо учесть:

* Видеокарта, которую вы хотите пробросить, должна поддерживать UEFI. Ускорители, выпущенные в течение последних пяти лет, должны такую поддержку иметь. Если же у вас старенькая модель, которую вы хотите использовать для тестирования, то она может показать себя недостаточно хорошо.

* Вам понадобится достаточно мощный CPU и большой объем RAM, так как, по сути, вы будете запускать отдельный ПК внутри основного.

* Материнская плата должна поддерживать IOMMU и иметь группы IOMMU, позволяющие изолировать GPU и передать в распоряжение VM только его. Ребята на канале [Level1Techs](https://www.youtube.com/user/teksyndicate) делают много обзоров на материнские платы, и Венделл, в том числе, обсуждает группы IOMMU, а также пригодность плат для VFIO. Также не будет лишним поискать в интернете энтузиастов, которые уже купили такую плату. Есть вероятность, что они поделились информацией о поддержке в ней IOMMU. [Вот неплохой скрипт](https://wiki.archlinux.org/title/PCI_passthrough_via_OVMF#Ensuring_that_the_groups_are_valid), который позволит выполнить проверку доступности групп IOMMU.

* Некоторые игры могут накладывать бан, если обнаружат запуск из-под VM. Это здорово, что в них реализована защита от читерства, но, к сожалению, пользователи VFIO в данном случае страдают несправедливо.

Так что, если вы много играете в соревновательные игры, то лучше прояснить этот момент заранее.

Надеюсь, что данное введение помогло вам понять, что к чему. Теперь же окунемся в сам процесс.

Настройка

---------

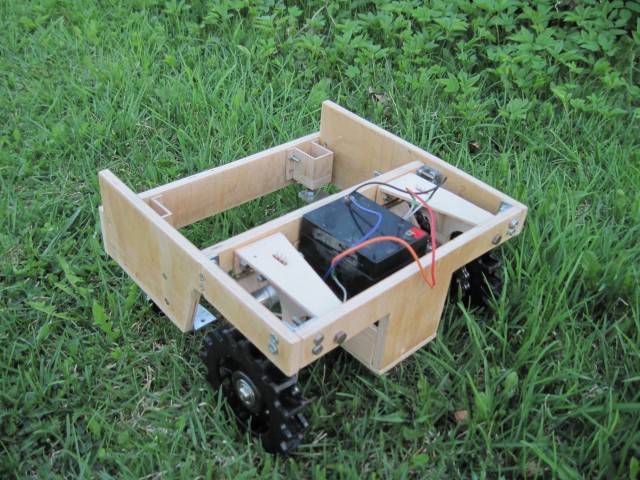

Мы будем тестировать эту конфигурацию на оборудовании, о котором [я уже писал](https://ounapuu.ee/posts/2021/08/07/amd-ryzen-7-5700-first-impressions). Особенность данной конфигурации в том, что мы используем AMD Ryzen 7 5700 APU на материнской плате mITX и один выделенный GPU. Это дает нам большие возможности в малых масштабах.

Да, существуют конфигурации, в которых можно реализовать VFIO с помощью одного GPU и пробросить его между основной ОС и VM, но такой конфиг будет сложновато использовать.

В качестве ОС у меня стоит Fedora 34. Для того чтобы все наладить, я воспользовался несколькими ресурсами:

* [Руководство начинающего](https://forum.level1techs.com/t/the-vfio-and-gpu-passthrough-beginners-resource/129897) с форумов Level1Techs.

* [Руководство по Fedora](https://forum.level1techs.com/t/fedora-33-ultimiate-vfio-guide-for-2020-2021-wip/163814) от Венделла из Level1Techs

* [Прекрасное Wiki-руководство по Arch](https://wiki.archlinux.org/title/PCI_passthrough_via_OVMF#Ensuring_that_the_groups_are_valid), где освещается большая часть из того, что нужно знать о настройке всего необходимого. Причем это руководство полезно не только для Arch, так как многое из описанного в нем применимо к любому дистрибутиву.

Тестирование

------------

Начальное тестирование я решил произвести с Nvidia GT710. Она медленная, плохо работает под Linux с опен-сорсными драйверами Nouveau, но зато оказалась под рукой. Еще я недавно услышал, что Nvidia все-таки повернулись лицом к клиентам, [позволив использовать видеокарты GeForce в VM Windows 10 без костылей](https://www.nvidia.com/en-us/geforce/news/outriders-game-ready-driver/).

Сам процесс тестирования относительно прост. Единственные сложности, с какими я столкнулся – это проблемы [PEBCAK](https://en.wiktionary.org/wiki/PEBCAK). Возможно, причина была в том, что тестированием я занимался уже после работы. Основная проблема – это небольшие опечатки в конфигурации `dracut` или ошибки в ID устройств, добавляемых в параметры загрузки ядра. Когда я это выяснил и исправил, процесс пошел как по маслу.

Все руководство я здесь переписывать не стану – если вас заинтересуют дополнительные детали, прошу обратиться к приведенным выше ресурсам. К тому же эти ресурсы наверняка будут оперативнее обновляться в случае каких-либо нововведений или появления дополнительных возможностей.

Что касается самого процесса, то в общих чертах нужно проделать следующее:

* Убедится, что IOMMU активирована в настройках UEFI. По умолчанию эта опция наверняка установлена на `auto`, так что обязательно переключите на `enabled`.

* Установить видеокарту, которую планируете пробрасывать, и подключить к ней монитор.

* Установить в Fedora пакеты виртуализации: `sudo dnf install @virtualization`.

* Включить IOMMU и предварительно загрузить модуль ядра VFIO, добавив в параметры загрузки `amd_iommu=on rd.driver.pre=vfio-pci`.

+ Я использую GRUB2, так что эти параметры находятся в `/etc/sysconfig/grub`.

+ Для применения изменений нужно повторно сгенерировать конфигурацию GRUB. Из-под Fedora это делается с помощью `grub2-mkconfig -o /etc/grub2-efi.cfg`

* Получить ID устройств для видеокарты и связанного аудиоустройства, которые планируется пробрасывать.

+ Чтобы просмотреть устройства и их ID, выполните `lspci -nnk`. ID будут выглядеть как `1002:aaf0`.

* Привяжите GPU к `vfio-pci`, чтобы избежать перехвата драйвером видеокарты управления ей. В противном случае пробросить видеокарту в VM не удастся.

+ Я решил пойти простым путем и добавил ID устройств в параметры ядра: `vfio-pci.ids=1002:67df,1002:aaf0`.

+ В связи с этим мне пришлось еще раз сгенерировать конфигурацию GRUB.

* Убедитесь, что `initramfs` загружает необходимые драйверы `vfio` на ранней стадии загрузки.

+ В случае с Fedora 34 это означает создание файла `/etc/dracut.conf.d/10-vfio.conf` с содержимым `add_drivers+=" vfio_pci vfio vfio_iommu_type1 vfio_virqfd "`.

+ Убедитесь в отсутствии опечаток.

+ Повторно сгенерируйте `initramfs`: `dracut -f`.

* Перезагружайте!

* Используя `virt-manager`, выберите VM, которой хотите пробросить видеокарту, и добавьте два устройства PCIe: видеокарту и связанное с ней аудиоустройство.

+ Если VM у вас еще не настроена, то перейдите к стандартной установке пока без проброса. Не забудьте создать UEFI VM, иначе могут возникнуть проблемы. Настроить это можно в разделе "\_Overview\_" `virt-manager` путем выбора чипсета Q35 и установки прошивки на `OVMF_CODE.df`.

+ Если вы пробросили GPU, то не забудьте удалить из VM устройство `Display Spice`.

+ Если вам также нужен контроль над VM, то нужно дополнительно пробросить USB-устройства, например, беспроводной приемник Logitech.

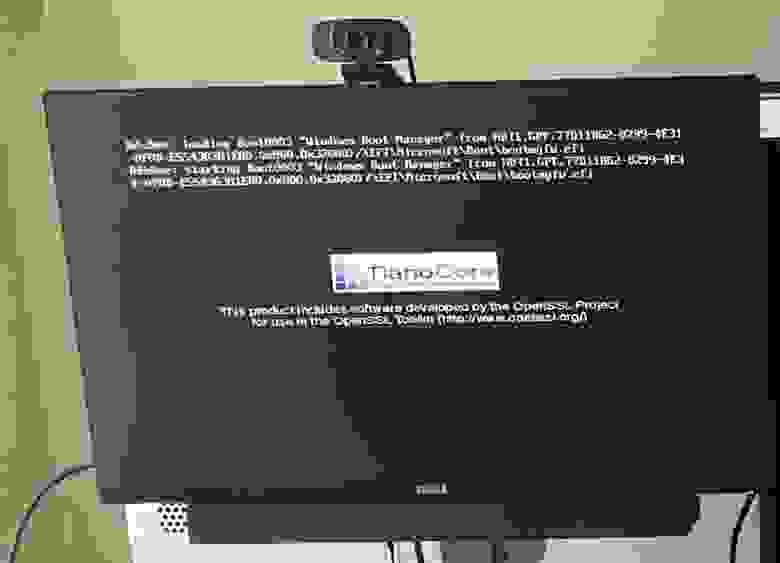

* Запустите VM и можете быть довольны, если на экране подключенного к проброшенной видеокарте монитора появится эмблема TianoCore.

*Если вы это видите, значит, проброс выполнен успешно. Поздравляю!*

Результаты для Nvidia GT 710

----------------------------

Начальное тестирование с Nvidia GT710 прошло успешно. Под «успешно» я подразумеваю, что видеокарта вывела изображение без автоматической установки своих драйверов.

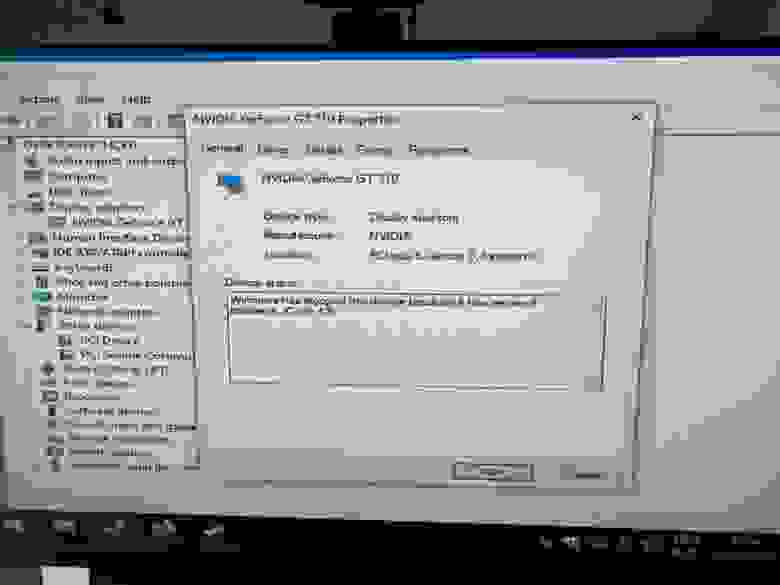

*Печально известный код ошибки Nvidia: 43*

Чтобы исправить эту проблему, я скачал последние официальные драйверы Nvidia, чего оказалось достаточно – ошибка 43 исчезла.

*Если ваша видеокарта исправно отображается в Device Manager, то все в порядке.*

Однако веселья поубавилось, когда стало очевидно, что моя видеокарта слаба. Очень слаба. Несмотря на это, я решил продемонстрировать ее вычислительную удаль, скачав [демку Art of Rally](https://funselektor.itch.io/art-of-rally).

> Примечание: игра просто улетная, обязательно попробуйте!

И демка запустилась! Не идеально, но все же запустилась.

*Не передается: ужасная частота кадров.*

Удовлетворенный результатами, я решил пойти до конца и заменить эту карту на AMD RX570, которую «одолжил» у [недавно собранного ПК](https://ounapuu.ee/posts/2021/08/21/turning-leftover-parts-into-a-decent-gaming-pc/).

Результаты для AMD RX 570

-------------------------

Переставив видеокарту, я поменял ID устройств на новые значения и продолжил приключение с VFIO. На этот раз Windows автоматически установила драйверы видео, и все заработало сходу. Хотя это меня удивило, так как в моем опыте всегда что-то да идет не так. Всегда.

Я установил последние драйверы с сайта AMD и продолжил тестирование.

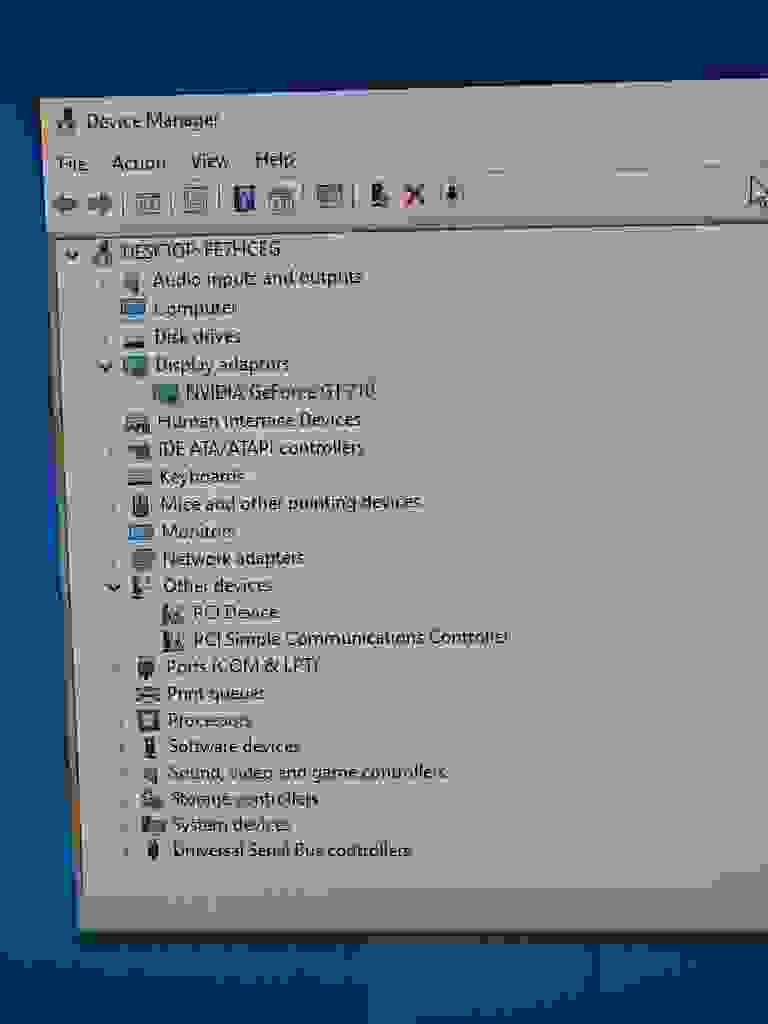

Furmark? Работает ожидаемым образом.

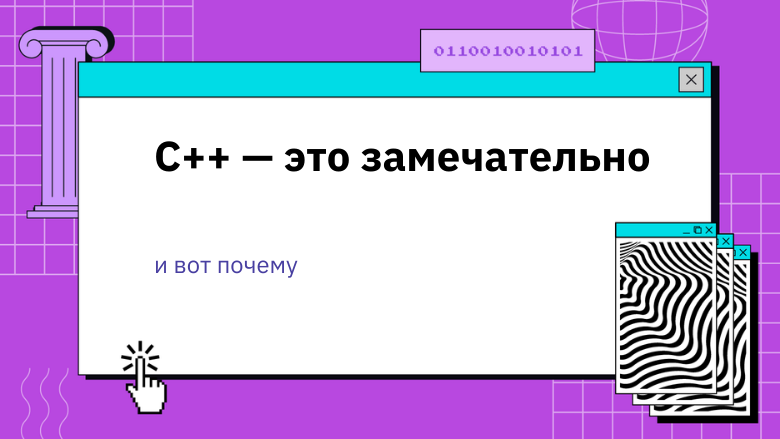

*VM слева, показатели быстродействия VM справа, куча кабелей повсюду*

GTA IV? Лагает не по-детски, но работает.

*Слева: GTA IV напрямую с GPU. Справа: стриминг GTA IV через Parsec*

В этой ситуации VM получила 4 ядра CPU, и я не делал ни привязки потоков к процессору, ни каких-либо оптимизаций, так что результат получился неплохой.

Хранилище

---------

Так как я собрал этот конфиг на своей текущей рабочей/серверной машине, ситуация с хранилищем оказалась витиеватой. Другая VM, которая выполняет все службы, имеет полный доступ к двум дискам по 12Тб, а сетевое хранилище мне настраивать не хотелось. Единственными свободными точками у меня были:

* Раздел 120Гб на NVMe SSD. Достаточно для хранения системных файлов Windows 10.

* 2 раздела по 250Гб на SATA 1TB SSD. Как раз впору для хранения моих недавних игр, но не более. Настроены в чередующейся конфигурации под Windows.

Позже я решил расширить разделы под хранение игр до 375Гб, для чего потребовалось избавиться от дополнительного резервного пространства. Такая настройка вполне неплоха, но я теряю некоторые выгоды от виртуализации Windows.

Относительно передачи этого хранилища VM у меня было два варианта:

* Продолжить использовать виртуальный диск SATA: работает из коробки, но может проседать в производительности.

* Использовать `virtio`: необходимо вручную загрузить и установить драйверы для распознания этих дисков Windows, хотя быстродействие должно оказаться выше, чем в случае с SATA.

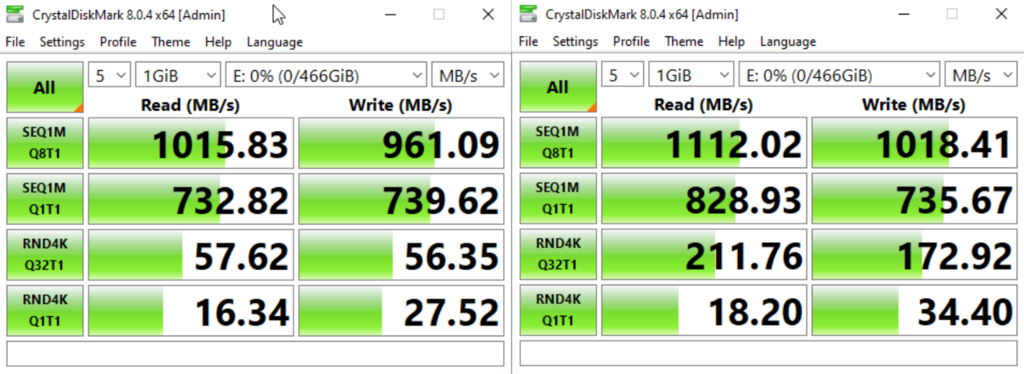

Я начал с SATA и провел сравнение с `virtio` при помощи CrystalDiskMark.

*Слева: SATA. Справа: virtio*

Virtio несколько вырвался вперед в этих сравнениях, но меня бы наверняка устроила и производительность SATA.

Заключение

----------

Одна из основных причин, по которым я настраиваю подобные сборки – это сам процесс воплощения технической идеи. Звучит странно, но иногда меня больше радует сам факт успешного завершения технической части и реализация чего-то нового, чем реальное дальнейшее использование этого.

Ранее я получил смешанный результат [проброса видеокарты на ноутбуке ThinkPad T430 с eGPU](https://www.reddit.com/r/linuxmasterrace/comments/7ry4jr/gta_v_on_arch_linux_how_i_managed_to_get_gpu/), умудрившись запустить на виртуальной машине GTA V, хотя в другой тестовой сессии возникли проблемы, вызванные, как оказалось, дефектом CPU (множество ошибок PCIe).

В дальнейшем я планирую продолжить подобные эксперименты. Хочу задействовать эту VM в качестве игровой, чтобы стримить с нее игры через [Parsec](https://parsec.app/) на любое устройство. Один из вариантов – это использовать [Nvidia Shield TV](https://www.nvidia.com/en-us/shield/shield-tv/) в качестве маломощного блока, способного выполнять стриминг. В качестве альтернативы можно сделать сборку на базе миниатюрного ПК Dell/Lenovo/HP, который имеет достаточно мощи для работы с 4K дисплеем, потребляя при этом не так много энергии. Подробнее об этом в будущих постах.

Что касается хранилища, то я планирую его скорый апгрейд. Либо поменяю только диски, либо обновлю всю сборку, так как ATX-платы поддерживают больше SATA подключений и карт расширений. Если еще вписать все это в корпус типа [Masterbox Q500L](https://www.coolermaster.com/catalog/cases/mid-tower/masterbox-q500l/), снарядив его хорошим БП, то даже тогда получится все еще относительно небольшая конфигурация.

[](http://ruvds.com/ru-rub?utm_source=habr&utm_medium=article&utm_campaign=Bright_Translate&utm_content=testirovanie_probrosa_gpu_na_amd_ryzen_7_5700g_apu)

|

https://habr.com/ru/post/583784/

| null |

ru

| null |

# Об ответственном использовании Google Таблиц в роли баз данных

Хотя технологии баз данных и другие подобные инструменты существуют много лет и в наши дни чрезвычайно развиты, им всё ещё нелегко обойти самые обычные электронные таблицы в плане универсальности и интуитивной понятности. Правда, базы данных, основанные на электронных таблицах, лучше не применять в по-настоящему серьёзных проектах. Например — в приложениях, используемых для работы с данными о тех, кто заболел COVID-19. Но тот факт, что буквально все вокруг знают о том, как пользоваться электронными таблицами, означает, что таблицы отлично подходят для маленьких проектов, реализуемых в разнородных командах, когда просматривать и редактировать данные может понадобиться людям, далёким от программирования.

В этом руководстве я расскажу о том, как использовать Google Таблицы в роли базы данных. Рассмотренный мной учебный проект будет оснащён API, работать с которым можно по HTTP. Здесь мы воспользуемся [Autocode](https://autocode.com/) — платформой для разработки Node.js-API, поддерживающей удобный редактор кода. Мы развернём простое приложение и организуем процесс прохождения аутентификации Google. Кроме того, я расскажу об ограничениях Google Таблиц, среди которых можно отметить возможности их применения в больших проектах. Я расскажу и о ситуациях, в которых тем, кто пользуется Google Таблицами, есть смысл поискать более продвинутые альтернативы.

[](https://habr.com/ru/company/ruvds/blog/523168/)

*База данных, основанная на электронной таблице*

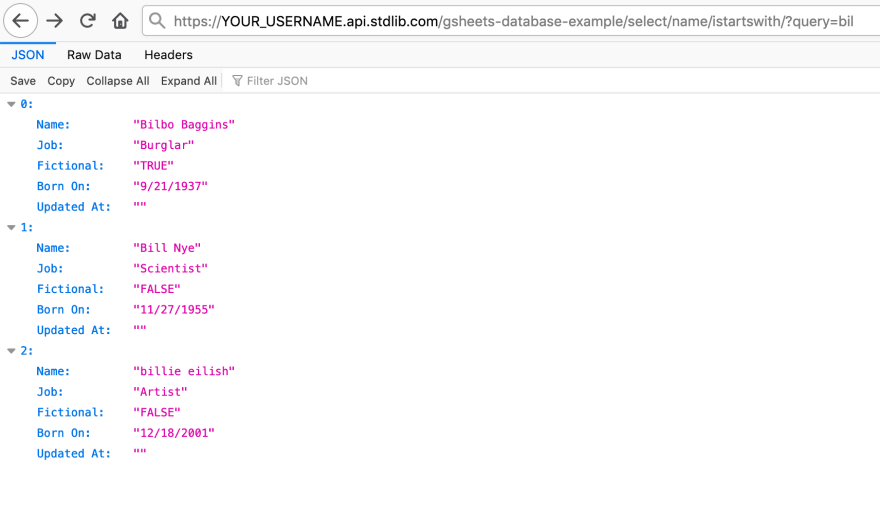

Вот пример запроса к базе данных, основанной на электронной таблице, который возвращает записи обо всех людях и других существах, имена которых начинаются с `bil`. Регистр символов при этом не учитывается.

```

$ curl --request GET --url \

'https://YOUR_USERNAME.api.stdlib.com/gsheets-database-example/select/name/istartswith/?query=bil'

```

Вот что приходит в ответ на этот запрос:

```

[

{

"Name": "Bilbo Baggins",

"Job": "Burglar",

"Fictional": "TRUE",

"Born On": "9/21/1937",

"Updated At": ""

},

{

"Name": "Bill Nye",

"Job": "Scientist",

"Fictional": "FALSE",

"Born On": "11/27/1955",

"Updated At": ""

},

{

"Name": "billie eilish",

"Job": "Artist",

"Fictional": "FALSE",

"Born On": "12/18/2001",

"Updated At": ""

}

]

```

Для того чтобы воспроизвести у себя мои эксперименты вам понадобится лишь учётная запись Google и бесплатный аккаунт на autocode.com.

Краткий обзор проекта

---------------------

Для тех, кому не терпится приняться за дело, я подготовил сильно сжатый вариант этого материала, приведённый в этом разделе.

Итак, для того чтобы воспользоваться Google Таблицами в роли базы данных, вам, для начала понадобится сделать себе копию моей таблицы, перейдя по [этой](https://docs.google.com/spreadsheets/u/1/d/1Lhj0s2X9YD_4WIQ3DpubXLKevok4PqFP3EwDzVLDqyQ/template/preview) ссылке и щёлкнув по кнопке `Использовать шаблон`, расположенной в правом верхнем углу страницы. В результате у вас, в вашей учётной записи Google, окажется таблица, с которой мы будем работать.

После того, как вы это сделаете, посетите [эту](https://autocode.com/app/googlesheets/gsheets-database-example/) страницу на сайте Autocode, дающую доступ к простому приложению, использующему Google Таблицы в роли базы данных. Если хотите — посмотрите код этого приложения, а потом установите его в своём аккаунте Autocode, нажав на большую зелёную кнопку. Когда вам предложат подключить приложение к таблице — следуйте инструкциям. Подключите к Autocode свою учётную запись Google и выберите таблицу, копию которой вы создали на предыдущем шаге.

После этого ваше приложение должно заработать! Попробуйте, воспользовавшись соответствующими URL, обратиться к нескольким конечным точкам, взгляните на то, что произойдёт, на то, как работает база данных, основанная на электронной таблице. Примеры запросов к базе данных можно найти ниже, в разделе Конечные точки.

Ограничения

-----------

Краткий обзор проекта может создать впечатление того, что работа с базой данных, основанной на Google Таблицах, организована крайне просто. Тут может возникнуть вопрос о том, почему соответствующий функционал не входит в состав инструментов, предлагаемых Google.

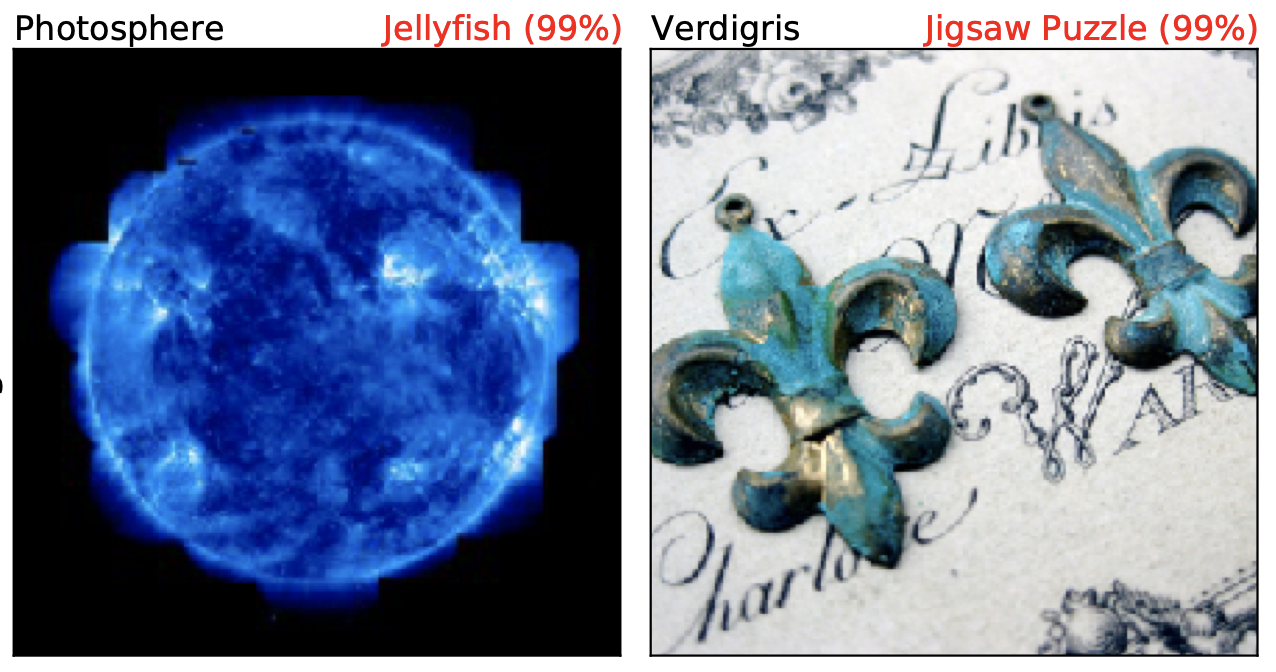

Хотя использование бэкенда, который можно подготовить к работе за 30 секунд, выглядит крайне привлекательным, особенно учитывая универсальность готового решения и широкие возможности по работе с данными, у такого подхода есть вполне очевидные ограничения. Так, при использовании электронной таблицы в роли базы данных в нашем распоряжении не будет возможностей, встроенных в платформу, позволяющих работать с несколькими таблицами, или позволяющих настраивать взаимоотношения таблиц. Тут нет концепции ограничения типов данных, хранящихся в столбцах таблиц, нет понятия «транзакция», нет встроенных средств создания резервных копий данных, нет стандартных средств шифрования. Поэтому важные данные, вроде тех, что связаны с COVID-19, вероятно, лучше хранить где-нибудь ещё.

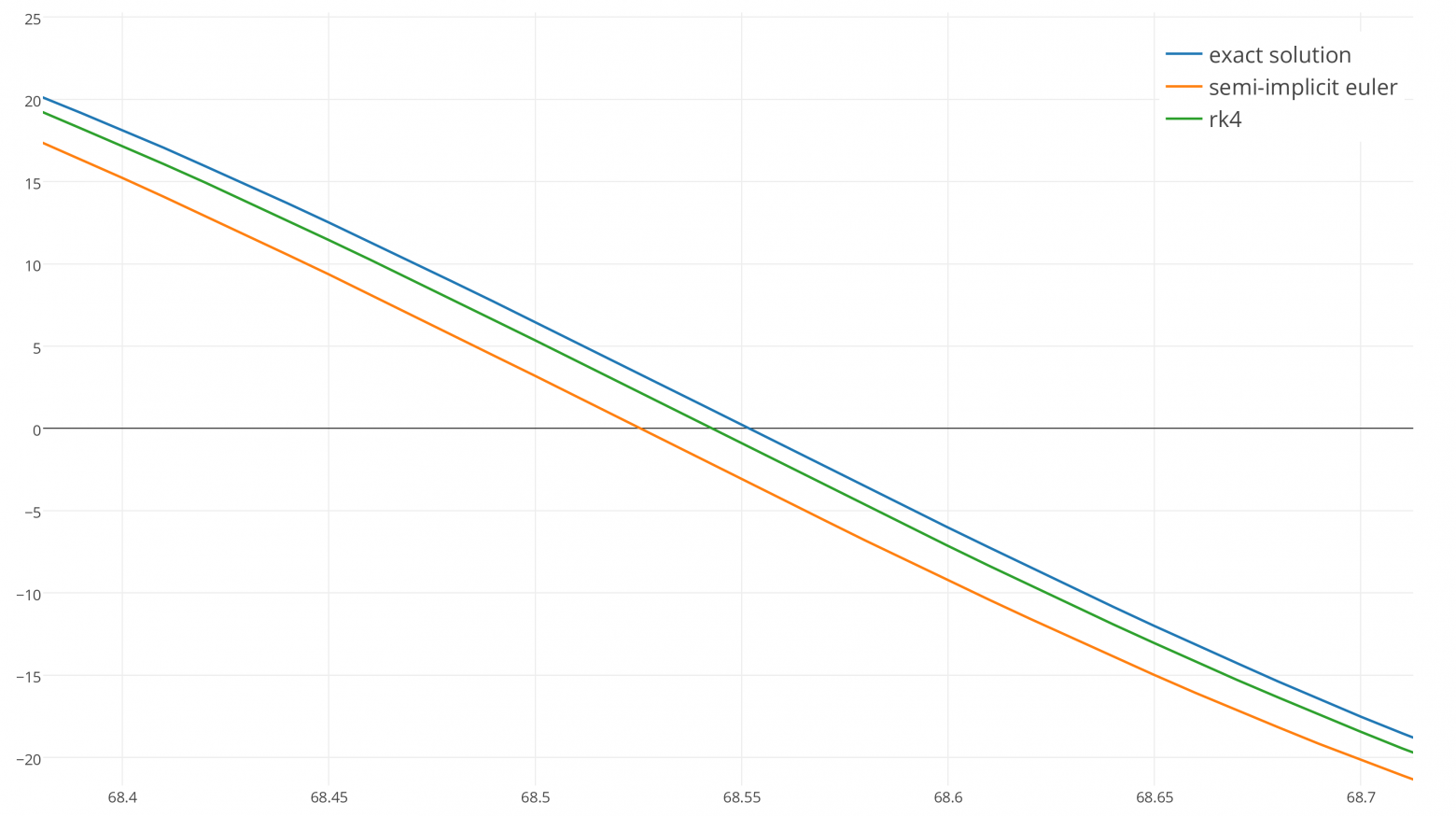

Если говорить о масштабируемости решения, то размеры электронных таблиц, с которыми можно работать в сервисе Google Таблицы, [жёстко ограничены 5000000 ячеек](https://support.google.com/drive/answer/37603) (включая пустые ячейки). Когда я попытался это проверить, то, создавая таблицу соответствующего размера, я встретился с серьёзными проблемами, касающимися производительности. Произошло это ещё до того, как таблица достигла максимально допустимого размера.

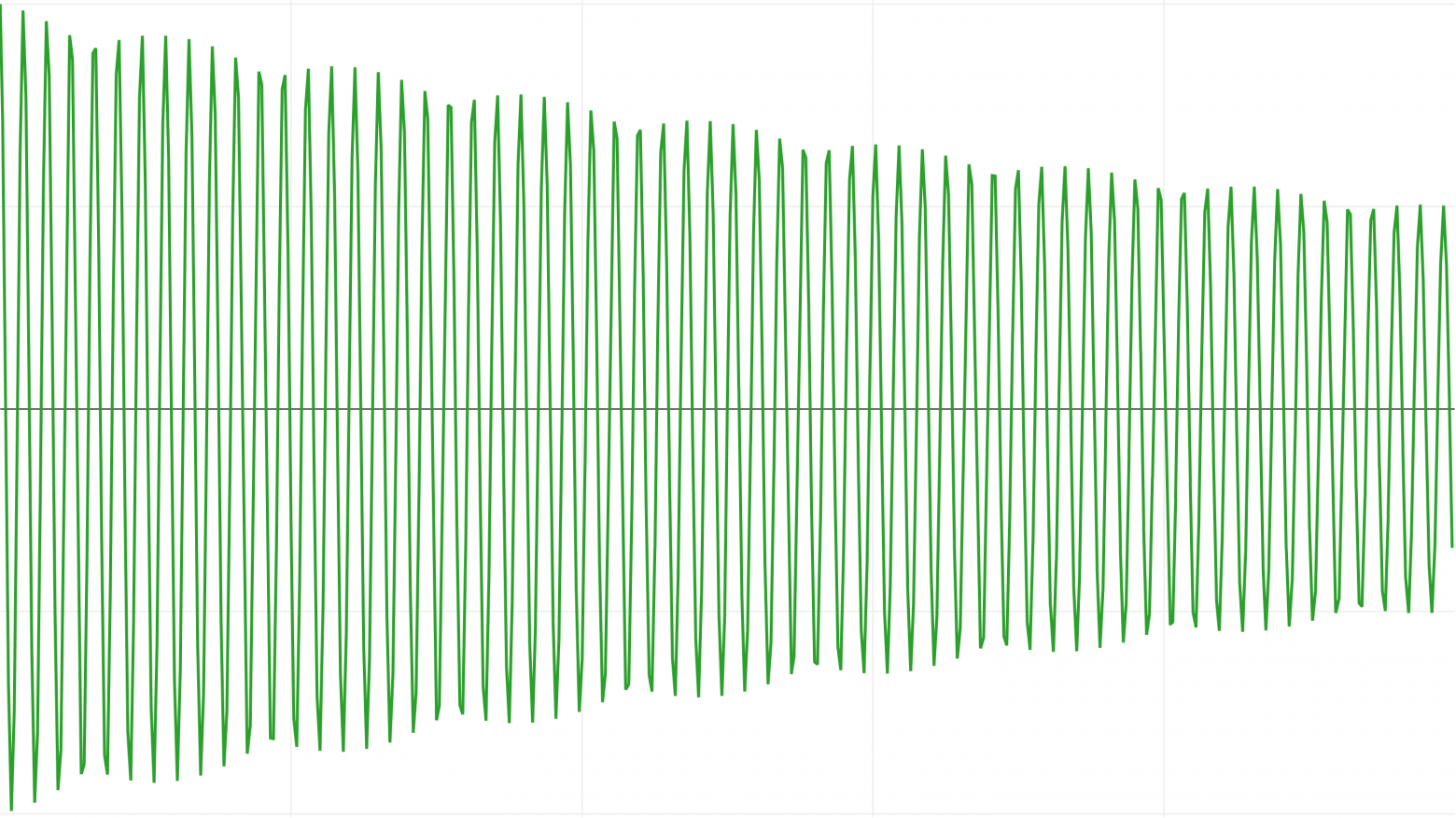

*Проблемы с производительностью*

Крупномасштабные операции, вроде вставки в таблицу большого количества ячеек, сначала замедляются, а потом, на уровне примерно в 1 миллион ячеек, начинают давать сбои. Работа с большими таблицами выглядит довольно медленной.

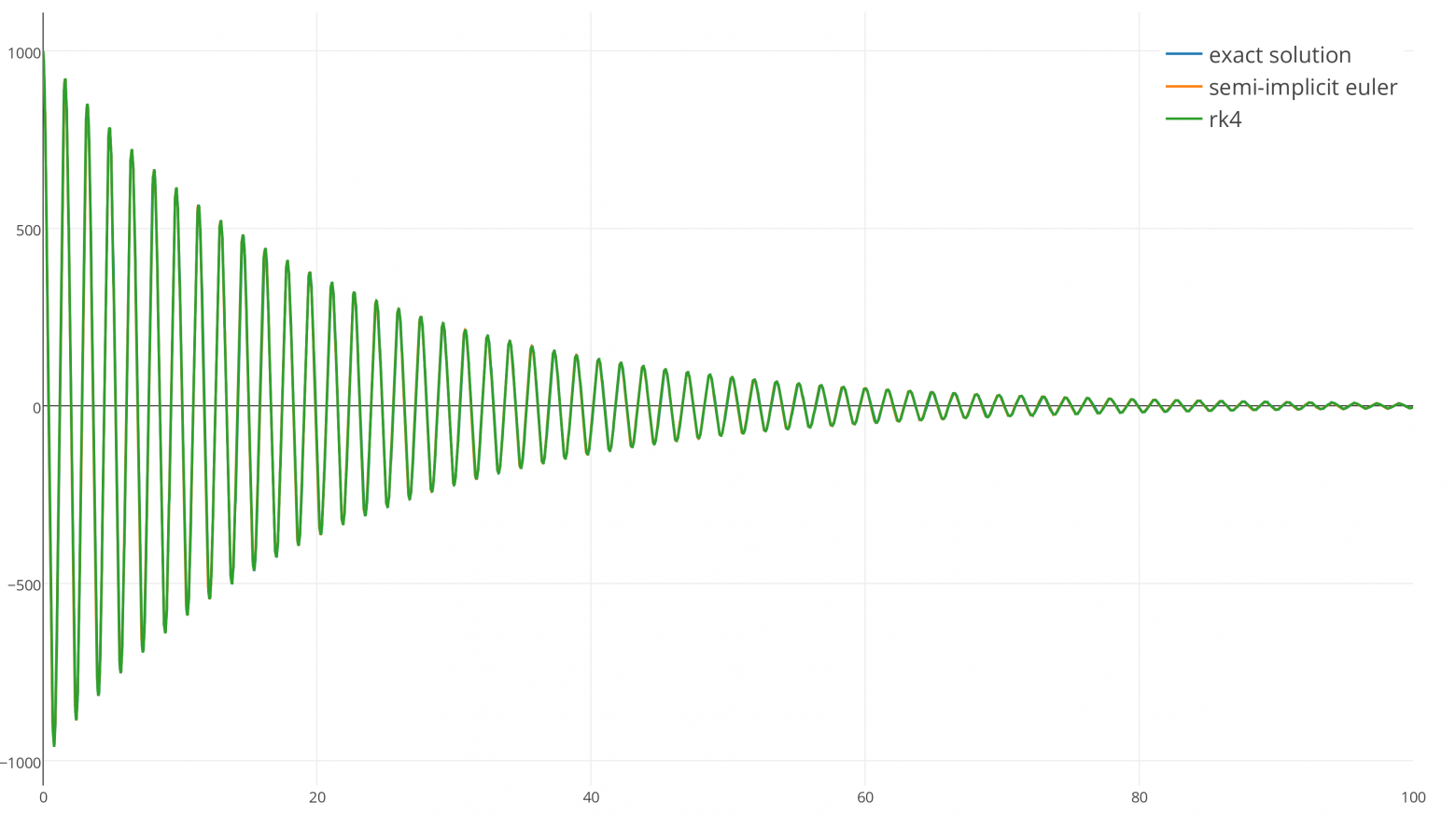

Мои эксперименты, касающиеся работы с таблицами посредством API, показали похожие результаты. А именно, возникает такое ощущение, что скорость выполнения запросов линейно зависит от количества ячеек.

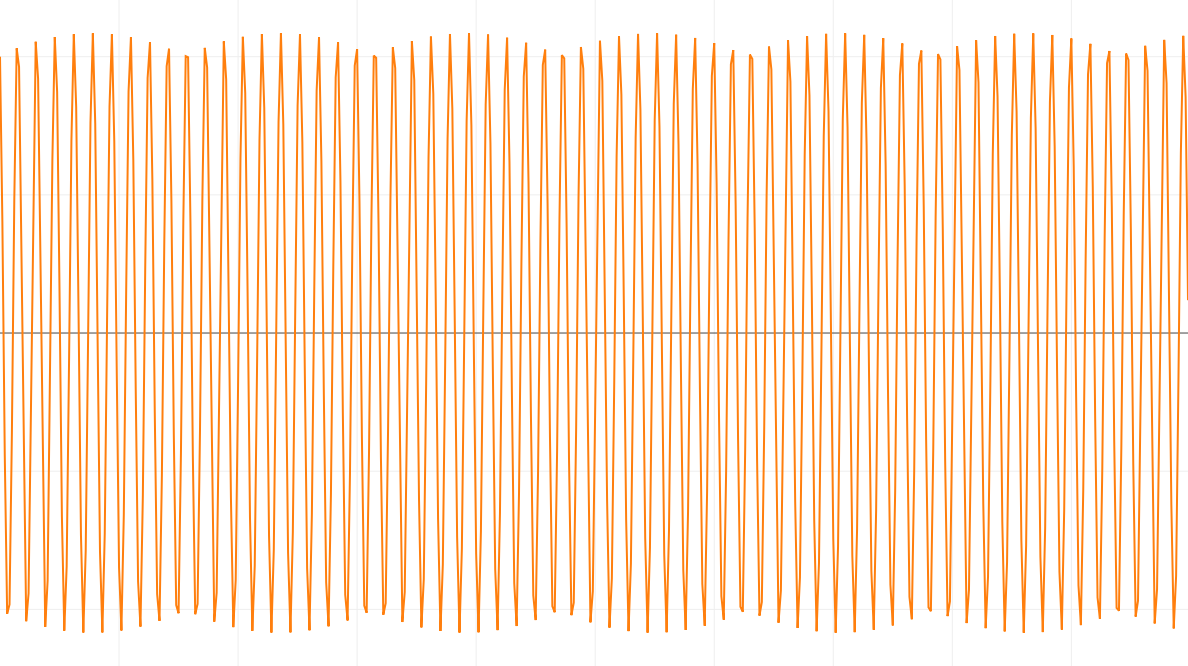

*Исследования быстродействия API*

Запросы становятся недопустимо медленными при достижении отметки примерно в 500000 ячеек. Но при этом запросы, если речь идёт о 100000 ячеек, выполняются менее чем за 2 секунды. Это говорит о том, что если вы планируете работать с наборами данных, размеры которых превышают несколько сотен тысяч ячеек, то, вероятно, разумнее будет выбрать что-то, лучше поддающееся масштабированию.

Работа с базой данных

---------------------

После того, как вы подключили копию электронной таблицы к приложению на Autocode и установили это приложение в свою учётную запись, платформа Autocode сама решит вопросы аутентификации приложения в Google, используя его токен (взгляните на строку `const lib = require('lib')({token: process.env.STDLIB_SECRET_TOKEN})`, которая находится над кодом, имеющим отношение к конечным точкам).

В описании каждой конечной точки имеется Node.js-код, отвечающий за выполнение запроса, в котором вызываются методы API [googlesheets.query](https://autocode.com/lib/googlesheets/query). Эти методы принимают параметр `range`, содержащий данные в формате [A1](https://developers.google.com/sheets/api/guides/concepts). Этот параметр описывает часть таблицы, которую вызов API должен считать частью базы данных.

```

let queryResult = await lib.googlesheets.query['@0.3.0'].select({

range: `A:E`,

bounds: 'FULL_RANGE',

where: [{

'Name__istartswith': query

}]

});

```

Значение `A:E`, записанное в `range`, представляет собой сокращённую запись следующего указания системе: «используй, в качестве базы данных, все строки в столбцах от A до E». Запрос интерпретирует первую строку каждого столбца этого диапазона как имя для данных, хранящихся в столбце. Если выполнить запрос, код которого показан выше, обратившись к таблице, копию которой вам предлагалось сделать в начале материала, то в ходе выполнения запроса будут проверены значения строк в столбце `A` (он называется `Names`), в них будет осуществляться поиск того, что задано параметром `query`.

Подобные обращения к API используют язык запросов [KeyQL](https://github.com/FunctionScript/KeyQL). На странице этого проекта, если интересно, вы можете найти его подробное описание и примеры запросов.

Обращение к конечным точкам

---------------------------

Как уже было сказано, к конечным точкам нашего API можно обращаться посредством HTTP-запросов. Поэтому с ними можно работать, используя `fetch`, `cURL`, или HTTP-клиент, который вам нравится. Для работы с ними можно пользоваться и браузером.

*Обращение к API с использованием браузера*

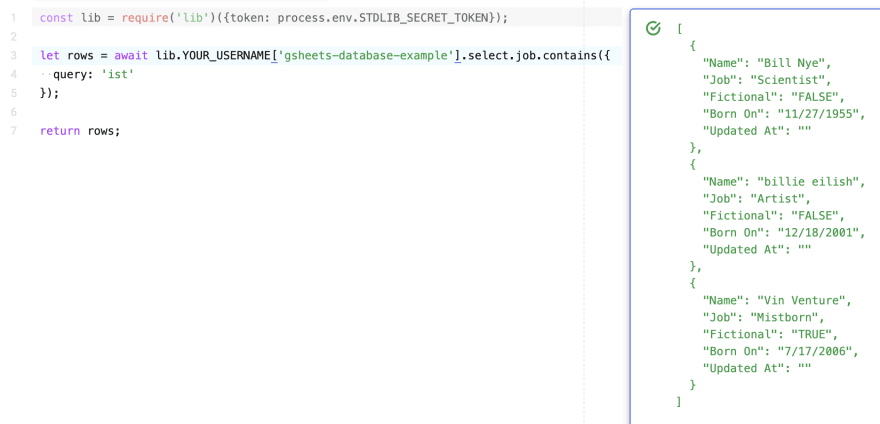

Можно даже воспользоваться той же Node.js-библиотекой, [lib-node](https://github.com/stdlib/lib-node/), которая применяется в коде конечных точек для вызова API Google Таблиц.

*Использование lib-node*

Конечные точки реагируют на `GET` — и `POST`-запросы. При обработке `GET`-запросов их параметры берутся из строки запроса. При обработке `POST`-запросов параметры берутся из тела запроса. У каждой конечной точки, чтобы сделать работу с ними понятнее, есть набор параметров, применяемых по умолчанию. Ниже приведены примеры работы с конечными точками нашей системы.

Конечные точки

--------------

### ▍functions/select/job/contains.js

Эта конечная точка демонстрирует пример реализации KeyQL-запроса `contains`. Она выполняет запросы на поиск строк таблицы, поле `Job` которых содержит подстроку (чувствительную к регистру), соответствующую параметру `query`. Выполним следующий запрос к базе данных, представленной нашей экспериментальной таблицей:

```

$ curl --request GET --url \

'https://YOUR_USERNAME.api.stdlib.com/gsheets-database-example/select/job/contains/?query=ist'

```

Вот каким будет результат выполнения этого запроса:

```

[

{

"Job": "Mistborn",

"Born On": "2006-07-17",

"Fictional": "TRUE",

"Name": "Vin Venture",

"Updated At": ""

},

{

"Job": "Scientist",

"Born On": "1955-11-27",

"Name": "Bill Nye",

"Fictional": "FALSE",

"Updated At": ""

},

{

"Job": "Artist",

"Born On": "2001-12-18",

"Name": "billie eilish",

"Fictional": "FALSE",

"Updated At": ""

}

]

```

### ▍functions/select/born\_on/date\_gt.js

Эта конечная точка реализует KeyQL-запрос `date_gt`. А именно, речь идёт о поиске строк, в которых значение поля `Born On` идёт после значения, заданного в `query` и представленного в формате `ГГГГ/ММ/ДД`. Опробуем эту конечную точку:

```

$ curl --request GET --url \

'https://YOUR_USERNAME.api.stdlib.com/gsheets-database-example/select/born_on/date_gt/?query=2000/01/01'

```

Вот что получится:

```

[

{

"Job": "Mistborn",

"Born On": "2006/07/17",

"Fictional": "TRUE",

"Name": "Vin Venture",

"Updated At": ""

},

{

"Job": "Artist",

"Born On": "2001/12/18",

"Name": "billie eilish",

"Fictional": "FALSE",

"Updated At": ""

}

]

```

### ▍functions/select/name/istartswith.js

В этой конечной точке используется KeyQL-запрос `istartswith`. Тут выполняется поиск строк таблицы, содержимое поля `Name` которых начинается с того, что задано с помощью `query` (без учёта регистра символов). Испытаем эту конечную точку:

```

$ curl --request GET --url \

'https://YOUR_USERNAME.api.stdlib.com/gsheets-database-example/select/name/istartswith/?query=bil'

```

Посмотрим на результаты выполнения запроса:

```

[

{

"Job": "Scientist",

"Born On": "1955-11-27",

"Name": "Bill Nye",

"Fictional": "FALSE",

"Updated At": ""

},

{

"Job": "Artist",

"Born On": "2001-12-18",

"Name": "billie eilish",

"Fictional": "FALSE",

"Updated At": ""

},

{

"Job": "Burglar",

"Born On": "1937-09-21",

"Fictional": "TRUE",

"Name": "Bilbo Baggins",

"Updated At": ""

}

]

```

### ▍functions/insert.js

Эта конечная точка реализует возможности по вставке данных в таблицу. Она, при вызове API [googlesheets.query.insert](https://autocode.com/lib/googlesheets/query/#insert), передаёт свои входные параметры в параметр `fieldsets`. Например, для того чтобы добавить в таблицу запись о человеке с именем `Bill Gates`, можно выполнить следующий запрос (все параметры записаны в нижнем регистре):

```

$ curl --request POST \

--header "Content-Type: application/json" \

--data '{"name":"Bill Gates","job":"CEO","fictional":false,"bornOn":"10/28/1955"}' \

--url 'https://YOUR_USERNAME.api.stdlib.com/gsheets-database-example/insert/'

```

Обратите внимание на то, что API Autocode основано на понятных именах конечных точек, это сделано для того чтобы минимизировать число ошибок, которые могут возникнуть при работе с API.

### ▍functions/update.js

Эта конечная точка демонстрирует пример запроса на обновление данных. Речь идёт о запросе, который записывает соответствующее значение в поля `Updated At` строк таблицы, содержащих сведения о людях и других существах, имена которых в точности соответствуют параметру `name`. Этот запрос обновляет другие поля подобных записей в соответствии с параметрами, переданными конечной точке. Здесь используется API [googlesheets.query.update](https://autocode.com/lib/googlesheets/query/#update).

Рассмотрим пример. Нам нужно обновить поле `Job` для записи, в поле `Name` которой записано `Bilbo Baggins`. Новым значением поля `Job` должно стать `Ring Bearer`. Достичь этой цели можно так:

```

$ curl --request POST \

--header "Content-Type: application/json" \

--data '{"name":"Bilbo Baggins","job":"Ring Bearer"}' \

--url 'https://YOUR_USERNAME.api.stdlib.com/gsheets-database-example/update/'

```

Используя подобные запросы, учитывайте то, что они могут повлиять на множество строк, соответствующих параметрам таких запросов.

### ▍functions/delete.js

Эта конечная точка реализует запрос на удаление данных. В частности, она удаляет из таблицы записи, поле `Name` которых в точности соответствует параметру запроса `name`. Тут используется API [googlesheets.query.delete](https://autocode.com/lib/googlesheets/query/#delete).

Например, для удаления записи `Bilbo Baggins` из таблицы можно выполнить такой запрос:

```

$ curl --request GET --url \

'https://YOUR_USERNAME.api.stdlib.com/gsheets-database-example/delete/?name=Bilbo%20Baggins'

```

Подобный запрос, как и запрос на обновление данных, может воздействовать на несколько строк таблицы.

Пользуетесь ли вы Google Таблицами в роли баз данных?

[](http://ruvds.com/ru-rub?utm_source=habr&utm_medium=article&utm_campaign=perevod&utm_content=ob_otvetstvennom_ispolzovanii_google_tablic_v_roli_baz_dannyx#order)

[](http://ruvds.com/ru-rub/news/read/123?utm_source=habr&utm_medium=article&utm_campaign=perevod&utm_content=ob_otvetstvennom_ispolzovanii_google_tablic_v_roli_baz_dannyx)

|

https://habr.com/ru/post/523168/

| null |

ru

| null |

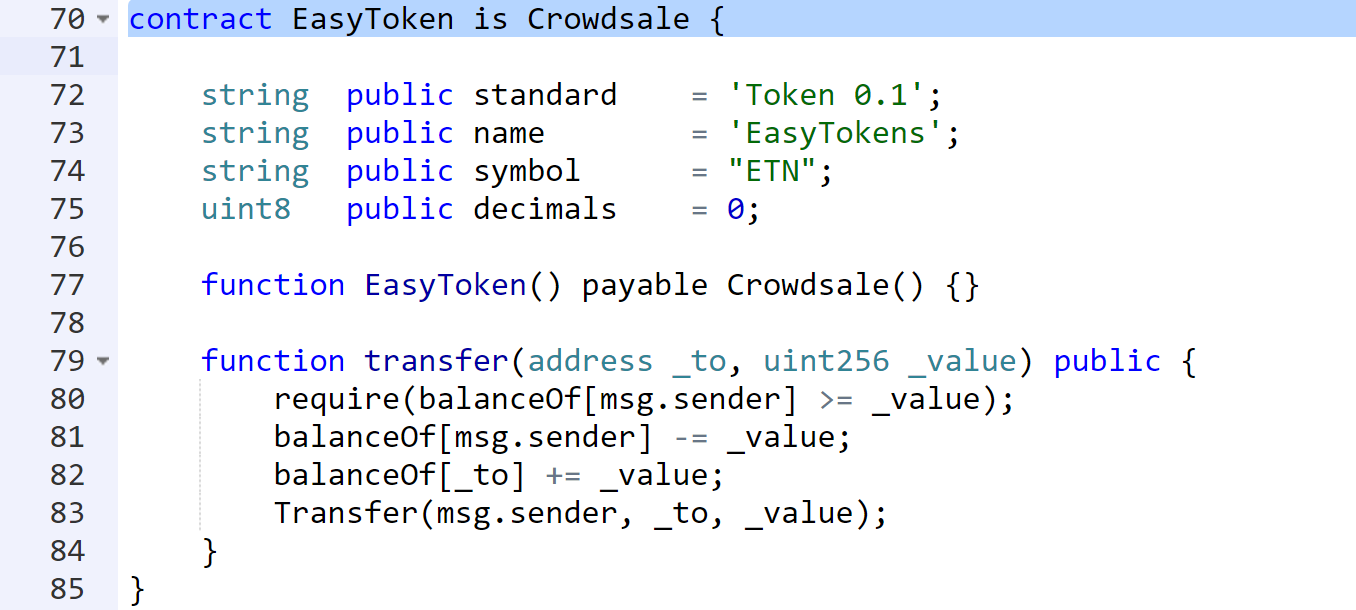

# Rust vs. State

**Важно**: для комфортного прочтения статьи нужно уметь читать исходный код на Rust и понимать, почему оборачивать всё в `Rc>` — плохо.

Введение

--------

Rust не принято считать объектно-ориентированным языком: в нём нет наследования реализации; инкапсуляции на первый взгляд тоже нет; наконец, столь привычные ООП-адептам графы зависимостей мутабельных объектов здесь выглядят максимально уродливо (вы только посмотрите на все эти `Rc>` и `Arc>`!)

Правда, наследование реализации уже как несколько лет считают вредным, а гуру ООП говорят очень правильные вещи вроде "хороший объект — иммутабельный объект". Вот мне и стало интересно: насколько хорошо объектное мышление и Rust сочетаются друг с другом *на самом деле*?

Первым подопытным кроликом станет паттерн State, чистой реализации которого и посвящена эта статья.

Он был выбран не просто так: этому же паттерну посвящена [глава](https://doc.rust-lang.org/1.30.0/book/2018-edition/ch17-03-oo-design-patterns.html) из The Rust Book. Цель той главы была в том, чтобы показать, что объектно-ориентированный код на Rust пишут только плохие мальчики и девочки: здесь вам и лишний `Option`, и тривиальные реализации методов нужно копипастить во все реализации типажа. Но стоит применить пару трюков, и весь бойлерплейт пропадёт, а читаемость — повысится.

Масштаб работ

-------------

В оригинальной статье моделировался workflow поста в блоге. Проявим фантазию и адаптируем исходное описание под суровые русские реалии:

1. Любая статья на Хабре когда-то была пустым черновиком, который автор должен был наполнить содержимым.

2. Когда статья готова, она отправляется на модерацию.

3. Как только модератор одобрит статью, она публикуется на Хабре.

4. Пока статья не опубликована, пользователи не должны видеть её содержимое.

Любые нелегальные действия со статьей не должны иметь эффекта (например, нельзя опубликовать из песочницы не одобренную статью).

Листинг ниже демонстрирует код, соответствующий описанию выше.

```

// main.rs

use article::Article;

mod article;

fn main() {

let mut article = Article::empty();

article.add_text("Rust не принято считать ООП-языком");

assert_eq!(None, article.content());

article.send_to_moderators();

assert_eq!(None, article.content());

article.publish();

assert_eq!(Some("Rust не принято считать ООП-языком"), article.content());

}

```

`Article` пока выглядит следующим образом:

```

// article/mod.rs

pub struct Article;

impl Article {

pub fn empty() -> Self {

Self

}

pub fn add_text(&self, _text: &str) {

// no-op

}

pub fn content(&self) -> Option<&str> {

None

}

pub fn send_to_moderators(&self) {

// no-op

}

pub fn publish(&self) {

// no-op

}

}

```

Это проходит все ассерты, кроме последнего. Неплохо!

Реализация паттерна

-------------------

Добавим пока пустой типаж `State`, состояние `Draft` и пару полей в `Article`:

```

// article/state.rs

pub trait State {

// empty

}

// article/states.rs

use super::state::State;

pub struct Draft;

impl State for Draft {

// nothing

}

// article/mod.rs

use state::State;

use states::Draft;

mod state;

mod states;

pub struct Article {

state: Box,

content: String,

}

impl Article {

pub fn empty() -> Self {

Self {

state: Box::new(Draft),

content: String::new(),

}

}

// ...

}

```

### Беды с ~~башкой~~ дизайном

Далее нужно добавить первый метод в наш типаж `State`, который отправит наш пост на модерацию. Если слепо повторять реализацию паттерна из других языков, в голову должно придти что-то подобное:

```

trait State {

fn send_to_moderators(&mut self) -> &dyn State;

}

```

Очевидно, это не подойдёт, потому что единственная валидная ссылка, которую можно будет вернуть из такой функции — это ссылка на себя.

А если хранить состояние в куче?

```

pub trait State {

fn send_to_moderators(&mut self) -> Box;

}

```

Уже лучше. Но в большинстве случаев состояние должно возвращать себя же. И что, каждый раз копировать себя и класть новую копию в кучу?

В оригинальном туториале было выбрано следующее решение:

```

pub trait State {

fn send_to_moderators(self: Box) -> Box;

}

```

Но у этого решения есть один серьёзный недостаток: мы не можем сделать его автоматическую имплементацию (возвращать `self`). Потому что для этого нужно, чтобы `Self: Sized`, т.е. размер объекта был фиксирован и известен на момент компиляции. Но это лишает нас возможности создавать trait object, т.е. никакого динамического диспатча не будет.

### Решение

Вместо этого мы воспользуемся следующей эвристикой: вместо того, чтобы возвращать данные, будем возвращать описание того, что мы хотим сделать. В данном случае мы будем возвращать структуру, которая может содержать состояние для перехода, а может и не содержать; отсутствие значения будет означать, что состояние менять не нужно.

P.S.: это решение честно [подсмотрено](https://docs.amethyst.rs/master/amethyst/enum.Trans.html) в игровом движке Amethyst.

```

use crate::article::Article;

pub trait State {

fn send_to_moderators(&mut self) -> Transit {

Transit(None)

}

}

pub struct Transit(pub Option>);

impl Transit {

pub fn to(state: impl State + 'static) -> Self {

Self(Some(Box::new(state)))

}

pub fn apply(self, article: &mut Article) -> Option<()> {

article.state = self.0?;

Some(())

}

}

```

Теперь мы, наконец, готовы реализовать эту функцию для `Draft`:

```

// article/states.rs

use super::state::{State, Transit};

pub struct Draft;

impl State for Draft {

fn send_to_moderators(&mut self) -> Transit {

Transit::to(PendingReview)

}

}

pub struct PendingReview;

impl State for PendingReview {

// nothing

}

// article/mod.rs

impl Article {

// ...

pub fn send_to_moderators(&mut self) {

self.state.send_to_moderators().apply(self);

}

// ...

}

```

### Осталось совсем чуть-чуть

Добавление состояния для опубликованной статьи тривиально: добавляем структуру `Published`, реализуем для неё типаж `State`, добавляем в этот типаж метод `publish` и переопределяем его для `PendingReview`. Ещё нужно не забыть вызвать этот метод внутри `Article::publish` :)

Осталось делегировать управление контентом статьи состояниям. Добавим метод `content` в типаж `State`, переопределим реализацию для `Published` и, собственно, делегируем управление контентом из `Article`:

```

// article/mod.rs

impl Article {

// ...

pub fn content(&self) -> Option<&str> {

self.state.content(self)

}

// ...

}

// article/state.rs

pub trait State {

// ...

fn content<'a>(&self, _article: &'a Article) -> Option<&'a str> {

None

}

}

// article/states.rs

impl State for Published {

fn content<'a>(&self, article: &'a Article) -> Option<&'a str> {

Some(&article.content)

}

}

```

Хмм, почему же ассерт всё ещё вызывает панику? Ах да, мы же забыли само действие добавления текста!

```

impl Article {

// ...

pub fn add_text(&mut self, text: &str) {

self.content.push_str(text);

}

// ...

}

```

(Голосом Лапенко) Как говорят в Америке, быстро и грязно.

Все ассерты работают! Работа сделана!

Однако, если бы наш `Article` публиковался не на Хабре, а на каком-то другом ресурсе, вполне могло бы оказаться, что менять текст уже опубликованной статьи нельзя. Что тогда делать? Делегировать работу состояниям, конечно же! Но это мы оставим в качестве упражнения пытливым читателям.

Вместо заключения

-----------------

Исходный код можно найти [в этом репо](https://github.com/TurtlePU/rust-state).

Как мы видим на примере этой задачи, перенос ООП-паттернов в Rust не только реален, но и приносит не так много головной боли, как может показаться. Достаточно смотреть на вопрос чуть-чуть по-другому.

В следующих статьях, если они будут, я хочу разобрать ещё несколько самых интересных для переноса в Rust паттернов. Например, Observer: я пока вообще без понятия, как там обойтись без `Arc>`!

Спасибо за внимание, до скорых встреч.

|

https://habr.com/ru/post/516784/

| null |

ru

| null |

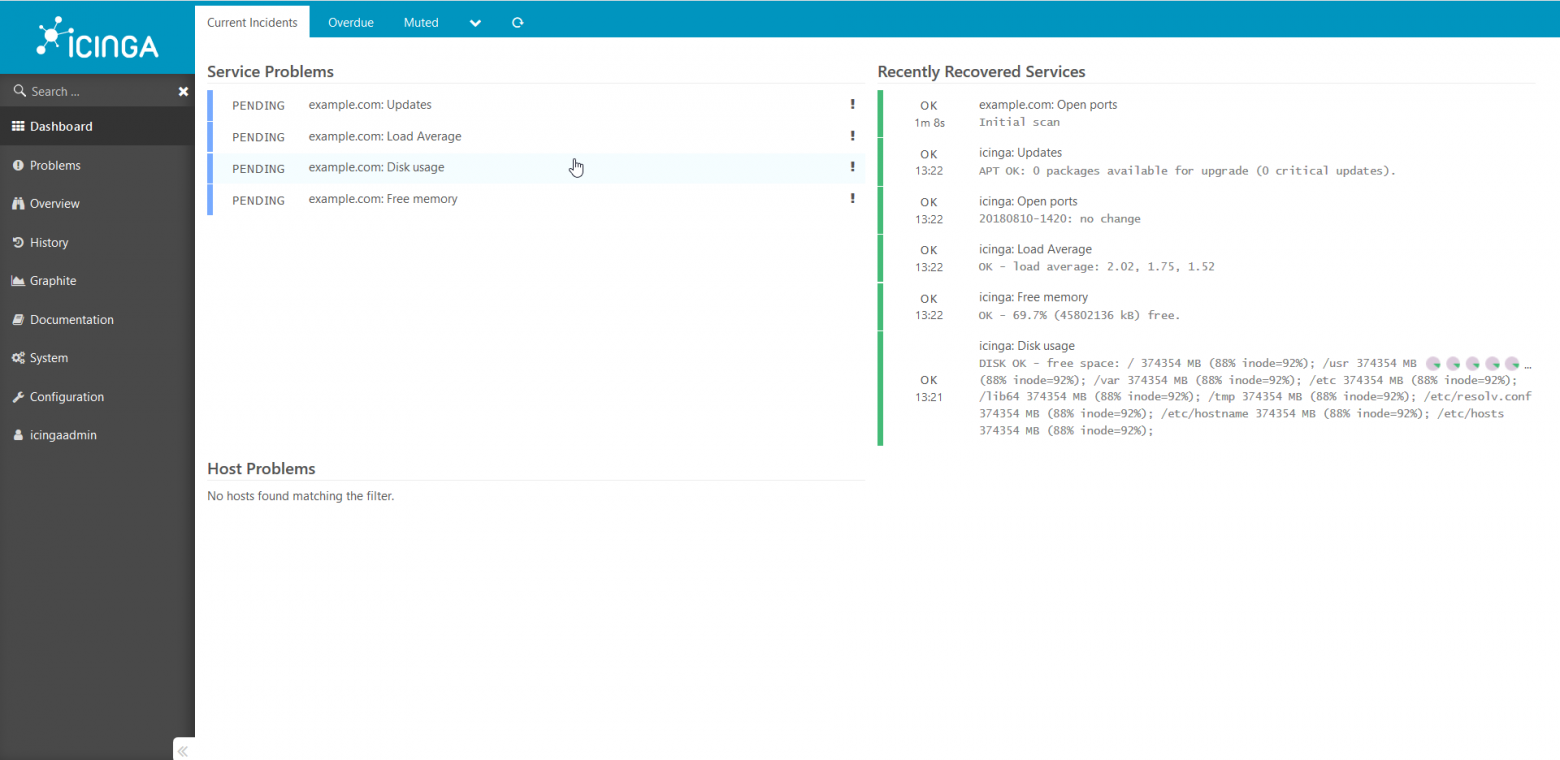

# Сегодня паттерн Посетитель в Java уже не нужен – лучше использовать переключатели паттернов

В современном языке Java паттерн Посетитель (Visitor) уже не нужен. Он отлично компенсируется использованием запечатанных типов и переключателей, использующих сопоставление с шаблоном – в таком случае те же цели достигаются проще и меньшим объемом кода.

Всякий раз, оказываясь в ситуации, где мог бы применяться [паттерн Посетитель](https://en.wikipedia.org/wiki/Visitor_pattern), подумайте, не воспользоваться ли вместо него более современными возможностями языка Java. Разумеется, эти возможности могут использоваться и в других обстоятельствах, но в этой статье мы обсудим сравнительно узкую тему: чем заменить паттерн Посетитель. Для этого я начну с максимально краткого введения и приведу пример, а затем объясню, как достичь тех же целей более простым (и кратким) кодом.

▚ Паттерн Посетитель

--------------------

[Википедия сообщает](https://ru.wikipedia.org/wiki/%D0%9F%D0%BE%D1%81%D0%B5%D1%82%D0%B8%D1%82%D0%B5%D0%BB%D1%8C_(%D1%88%D0%B0%D0%B1%D0%BB%D0%BE%D0%BD_%D0%BF%D1%80%D0%BE%D0%B5%D0%BA%D1%82%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F)):

> Паттерн проектирования «Посетитель» позволяет открепить алгоритм от структуры того объекта, которым он оперирует. Практический результат такого открепления – способность добавлять новые операции к имеющимся структурам объектов, не модифицируя эти структуры.

>

>

Основная мотивация здесь – именно в том, чтобы не изменять структуру. Если над объектом производится много операций, либо производимые над ним операции сильно отличаются, то реализация их на уже вовлеченных типах может легко перегрузить типы массой функций, не связанных друг с другом. Разумеется, изменить эти типы получится лишь в том случае, если они не обременены зависимостями.

Основная мотивация: не изменять типы.

При использовании паттерна «Посетитель» каждая операция реализуется в Посетителе так, что затем она передается структуре объектов, а та передает Посетителю те объекты, из которых состоит. Структура ничего не знает ни об одном конкретном Посетителе, поэтому может свободно создаваться всякий раз, когда понадобится та или иная операция.

Вот пример из Википедии (немного сокращенный):

```

public class VisitorDemo {

public static void main(final String[] args) {

Car car = new Car();

car.accept(new CarElementPrintVisitor());

}

}

// Супертип всех объектов в структуре

interface CarElement {

void accept(CarElementVisitor visitor);

}

// Супертип всех операций

interface CarElementVisitor {

void visit(Body body);

void visit(Car car);

void visit(Engine engine);

}

class Body implements CarElement {

@Override

public void accept(CarElementVisitor visitor) {

visitor.visit(this);

}

}

class Engine implements CarElement {

@Override

public void accept(CarElementVisitor visitor) {

visitor.visit(this);

}

}

class Car implements CarElement {

private final List elements;

public Car() {

this.elements = List.of(new Body(), new Engine());

}

@Override

public void accept(CarElementVisitor visitor) {

for (CarElement element : elements) {

element.accept(visitor);

}

visitor.visit(this);

}

}

class CarElementPrintVisitor implements CarElementVisitor {

@Override

public void visit(Body body) {

System.out.println("Visiting body");

}

@Override

public void visit(Car car) {

System.out.println("Visiting car");

}

@Override

public void visit(Engine engine) {

System.out.println("Visiting engine");

}

}

```

Тут есть целый ряд вещей, которые я сделал бы иначе (CarнаследуетCarElement? Серьезно?!), но, чтобы не усложнять сравнения, я решил как можно ближе придерживаться оригинала.

Про паттерн Посетитель написано уже очень много (варианты использования, предпосылки, реализация, ограничения, т.д.), поэтому нет необходимости все это здесь повторять. Давайте просто предположим, что оказались в ситуации, где использовать этот паттерн действительно целесообразно. Так вот, что мы применили бы вместо него.

▚ Языковые возможности

----------------------

В современном языке Java есть более удобные способы достичь тех целей, для которых предназначается паттерн Посетитель – поэтому он становится избыточен.

### ▚ Определение дополнительных операций

Основная задача паттерна «Посетитель» - обеспечить реализацию нового функционала, такого, который тесно связан с коллекцией типов, но:

* Не изменяя этих типов (кроме одноразовой настройки новой конфигурации).

* При этом обеспечивая удобство поддержки того кода, который получится в результате.

Это достигается так:

* Вы можете создавать отдельную реализацию Посетителя для каждой операции (не трогая тех типов, над которыми она производится).

* От каждого Посетителя требуется, чтобы он мог обрабатывать все релевантные классы (в противном случае они не скомпилируются).

Вот эта часть паттерна:

```

// При добавлении нового посещенного типа заставим его реализовать

// этот интерфейс. Единственная приемлемая реализация

// `accept` - это `visitor.visit(this)`, которая (пока)

// не компилируется

// ~> проследить ошибку

interface CarElement {