text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Web Testing Specific (особенности тестирования Web)

##### Анатолий Рыжаков

QA Engineer в Space307

Салют, Хабр!

Меня зовут Анатолий, и я работаю в компании [Space307](https://space307.com/) в должности QA-инженер.

Долгим и упорным трудом я искал и собирал воедино, на мой взгляд, самую полезную информацию, которая поможет разобраться в специфике Web-тестирования.

Всё это по итогу разрослось и преобразовалось в некий гайд, хотя по задумке должно было быть кратеньким документом для внутреннего пользования.

Отдельное спасибо хочу выразить коллегам, которые помогали в составлении, дополнении и ревью этой статьи. Simply the best!

Перед прочтением: ничто в этом мире не идеально, поэтому о каких-либо замечаниях, дополнениях, уточнениях и недопониманиях пишите обязательно, но аргументированно и в конструктивной манере, пожалуйста :)

Всю полезность из фидбэка переработаю для прокачки этой статьи.

| | |

| --- | --- |

| Целевая аудитория | - Junior QA Engineer;- Кто не знаком с Web'ом, но интересуется;- Кто хочет освежить знания о Web'е. |

| Цель | Собрать максимум возможной информации о Web, чтобы представить её в единой статье для QA:- Здесь не будет примеров конкретных тест-кейсов- Здесь будет общее представление о специфике Web'а- На что обращать внимание при подготовке к тестированию Web'а- Некая усреднённая модель (из чего состоит Web-приложение)- Инструменты, которые помогут в тестировании Web'а |

**Fast Travel:**

* [Класс: Устройство](#ustroistvo)

* [Класс: Браузер (Обозреватель)](#brauzer)

* [Класс: Вёрстка](#verstka)

* [Класс: Ввод (Управление)](#vvod)

* [Класс: Настройка браузера (ПО для браузера)](#nastrojka)

* [Класс: Данные](#dannye)

* [Класс: Технологии](#tehnologii)

* [Класс: Нагрузка](#nagruzka)

* [Класс: Инструменты](#instrumenty)

### Web-ориентированное тестирование (+ основные особенности Web-приложений)

| | |

| --- | --- |

| **Область** | Окружение |

| **Класс** | Устройство |

| **Объекты** | - Desktop (стационарный ПК, ноутбук)- Mobile (смартфон, планшет)- Other (SmartTV, игровая консоль) |

* Устройство — это некая «база», на которой будет происходить взаимодействие с Web'ом, то, какими характеристиками обладает устройство, какие браузеры поддерживаются на устройстве, какие способы ввода/вывода так или иначе влияют на это взаимодействие.

* В зависимости от устройства определяется, какую версию Web'а открывать: Desktop или Mobile.

* Некоторые Web-сайты (Web-приложения) не имеют Mobile версий.

* На мобильных устройствах присутствует возможность переключаться на обычную (desktop) версию Web'а.

Например, переключение на Desktop версию в мобильном браузере Google Chrome:1. Перейти на Web-сайт

2. Открыть меню мобильного браузера

3. Выбрать опцию «Версия для ПК» ("Desktop site")

* На ПК присутствует возможность эмулировать мобильную версию Web'а.

На примере браузера Google Chrome (с помощью DevTools):1. Открыть DevTools инструменты разработчика (F12 по умолчанию)

2. Включить панель инструментов устройства ("Toggle Device Toolbar")

3. В выпадающем списке "Dimensions" выбрать эмулируемое мобильное устройство

* Основные различия между Mobile Web и Desktop Web: органы управления страницей (курсор или тап), приоритезация контента, навигация на странице (вертикальная или горизонтальная), набор и расположение UI элементов (в т.ч. и текст), интеграция с функционалом устройства (например GPS).

* Ещё существует такое понятие как PWA ("**Progressive Web Application**") версия Web-страницы (или Web-приложения), которая по своей сути представляет функциональную и визуальную «трансформацию» в мобильное приложение с помещением иконки на домашний экран/рабочий стол для быстрого доступа к нему.

PWA на примере Google Maps:Чтобы узнать, поддерживает ли Web-сайт PWA версию, необходимо:

1. Открыть меню мобильного браузера

2. Проверить наличие опции "Установка приложения" ("Install app")

3. Установить PWA приложение

4. Запустить PWA приложение

5. PWA версия Google Maps выглядит так:

* Также можно установить PWA версию и на ПК:

или

Вот так выглядит desktop версия PWA:

---

| | |

| --- | --- |

| **Область** | Клиент |

| **Класс** | Браузер (Обозреватель) |

| **Объекты** | - Google Chrome- Firefox- Safari- Opera- Microsoft Edge- Web Desktop App (Chromium)- UC Browser- Стандартные браузеры на Android (Mi Browser, Samsung Internet Browser, HUAWEI Browser и др.) |

* Если устройство это «база», то браузер — это точка входа в Web. Клиент, с помощью которого уже происходит непосредственное общение с Web'ом, отображение страниц и взаимодействие пользователя с этими страницами.

* Браузер состоит из: движка (**Engine**), пользовательского интерфейса (**UI**), хранилища данных (**Data**), движка JavaScript (**Interpreter**), механизма визуализации (**Render**), сетевых протоколов (**Networking**).

* На разных (поддерживаемых) браузерах должно быть одинаково:

+ Отображение элементов UI на странице (их наличие, расположение, соответствие дизайну).

+ Работа функциональности (отправка запросов, изменение параметров, нотификации).

+ Воспроизведение встроенного контента (видео, аудио, электронные документы).

* Для кросс-браузерного тестирования могут использоваться такие сервисы как [SMARTBEAR CrossBrowserTesting](https://crossbrowsertesting.com/) или [BrowserStack](https://www.browserstack.com/), которые предоставляют доступ к широкому спектру различных видов и версий браузеров.

Кейс с реальным примером — воспроизведение звуков в Chrome и Safari:*В браузере есть различные события, на которых завязана работа части функционала. Одно из таких событий — "onClick": браузер «слушает», когда произойдёт клик мышкой. На это событие было завязано воспроизведение звуков, и, когда клик происходил, браузер запоминал, что нужно проиграть звук в определённый момент. Однако в браузере Safari этот механизм работал иначе чем в Google Chrome — если обновить страницу, то браузер «забывал» о том, что событие "onClick" уже было и звук в нужный момент не проигрывался.*

* Существует возможность протестировать Web на ещё не релизных версиях браузеров (Например: Chrome Beta, Chrome Dev, Chrome Canary).

* Продолжая разговор о разных версиях, стоит учитывать, что есть различия между старыми и новыми версиям. Дефекты в старой версии или критические изменения в новой могут повлиять на стабильную работу Web-страницы (например, 100-ый номер версии браузера, который мог неправильно интерпретировать сайты).

Change Log и Release Notes разных браузеров:Здесь представлены ссылки на списки разных версий наиболее популярных браузеров, в которых можно просмотреть все изменения от версии к версии:

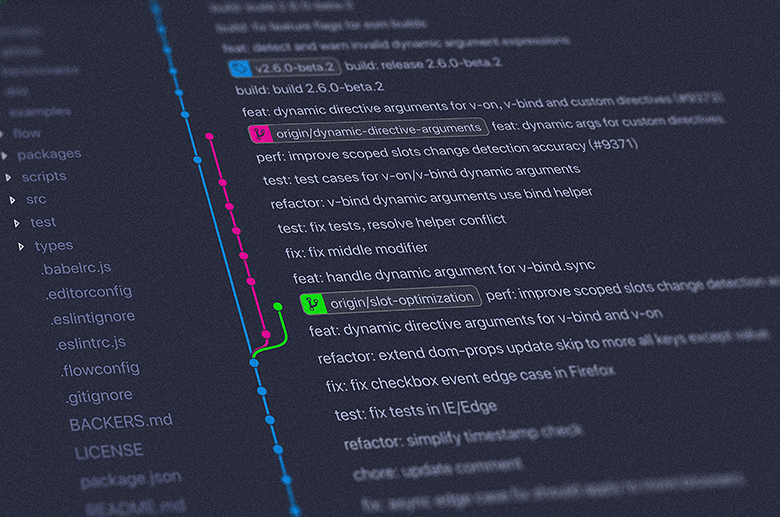

Chrome: [https://chromium.googlesource.com/chromium/src](https://chromium.googlesource.com/chromium/src/)

Firefox: [https://www.mozilla.org/en-US/firefox/releases](https://www.mozilla.org/en-US/firefox/releases/)

Opera: [https://blogs.opera.com/desktop/changelog-for-86](https://blogs.opera.com/desktop/changelog-for-86/)

Safari: <https://developer.apple.com/documentation/safari-release-notes>

* И в довершение тематики разновидностей браузеров хотелось бы отметить такой момент как "Geo-Specific". Иными словами, версии браузеров, специфичные для какого-то определённого гео/страны/региона (Например: "Coc Coc" для Вьетнама).

* В настоящий момент самый популярным браузером является Google Chrome, который использует движок Blink (этот движок также используется в Opera, Microsoft Edge).

Статистика по браузерам на 2021 год (По версии Affde):

---

| | |

| --- | --- |

| **Область** | Экран (Окно) |

| **Класс** | Вёрстка |

| **Объекты** | - Разрешение- Соотношение сторон- Ориентация- Страница- Масштаб- Адаптация- Элементы |

* Вёрстка Web-страницы (**Layout**) — это структура документа на основе HTML-разметки с использованием CSS-стилей.

* Сама по себе Web-страница, особенно если это Web-приложение, представляет из себя UI, который должен соответствовать неким UX стандартам:

+ UI (**User Interface**) — пользовательский интерфейс как средство взаимодействия с Web-страницей.

+ UX (**User Experience**) — пользовательский опыт как ожидания для взаимодействия с Web-страницей.

* Для UI части Web'а, как правило, существует дизайн-макет, который определяет характеристики для каждого UI элемента на странице:

+ размеры в пикселях

+ форму

+ цвет

+ отступы относительно других элементов и др.

* Помимо отдельных элементов, на макете отражено и их расположение на странице, представляя полную композицию.

Дизайн также определяет следующие условия для корректного отображения вёрстки:* допустимое разрешение экрана и соотношение сторон

* возможность адаптации страницы

* границы, на которых происходит переключение на адаптивный дизайн (точки перехода)

* наличие мобильной версии страницы

* особенности разных браузеров

* поддерживаемый масштаб страницы

* Основываясь на таком макете, в той или иной мере можно протестировать вёрстку страницы и отдельные UI элементы на соответствие их дизайну в разных тестовых средах и окружениях.

* Для эмуляции различных разрешений, соотношений сторон и прочего на ПК в DevTools присутствует инструмент "Toggle Device Toolbar".

Некоторые полезные функции "Device Toolbar" для тестирования страницы:1. Открыть DevTools инструменты разработчика (F12 по умолчанию).

2. Включить панель инструментов устройства ("Toggle Device Toolbar").

3. В выпадающем списке "Dimensions" выбрать пресет с необходимым для теста разрешением.

4. Разрешение можно выставлять и в ручную, какое угодно (для этого необходимо "Dimensions" переключить в режим "Responsive").

5. Чтобы проверить Web на адаптив, в режиме "Responsive" можно сдвигать стороны эмулируемого экрана. Но обычно этого не требуется, когда точно известны поддерживаемые разрешения для Web'а.

6. Ориентация из "книжной" в "альбомную" переключается с помощью кнопки "Rotate".

7. Из дополнительных инструментов в этом окне возможно ещё пригодиться:

* Show rulers (Показывает линейку для разрешения окна)

* Show media queries (Показывает CSS медиа-запросы, которые передают параметры стилей для отображения элементов на странице с установленным разрешением окна)

* Capture screenshot (Capture full size screenshot) (Сделать скриншот Web-страницы в установленном разрешении окна)

* Менять масштаб страницы можно с помощью так же встроенного в браузер инструмента (в настройках страницы или по горячим клавишам):

* Для того, чтобы узнать характеристики (атрибуты) конкретного элемента на странице (его размеры, HEX-код цвета и пр.), вновь потребуется обратиться к DevTools.

Инспектирование элементов на странице с помощью DevTools:1. Открыть DevTools инструменты разработчика (F12 по умолчанию).

2. Включить режим инспектирования ("Select an element in the page to inspect it").

3. Навести курсор на требуемый элемент на странице (элемент и его границы должны подсвечиваться, а также должен открыться тултип с атрибутами элемента).

4. Кликнуть по выделенному элементу, для открытия его атрибутов в DevTools.

5. На соседней вкладке будет находиться информация о CSS-стилях элемента.

6. Если открыть вкладку с элементами без инспектирования, то страница будет представлена в виде HTML-разметки, и может иметь вложенную структуру.

При инспектировании элемента структура будет разворачиваться:

7. Во вкладке "Elements" можно наблюдать, как меняются атрибуты элемента при взаимодействии с ним.

8. При необходимости во вкладке "Elements" можно редактировать атрибуты любого элемента для специфических проверок.

| |

| --- |

| **А вы знали?**Если вписать в DevTools консоль команду "`document.body.contentEditable = true" (без кавычек),`то можно будет редактировать любой текстовый элемент на странице до её обновления. |

| |

| --- |

| **Называй UI элементы правильно!**Для облегчения коммуникации между дизайнерами и разработчиками, тестировщику важно поддерживать профессиональную этику и называть вещи своими именами. |

Общепринятые наименования UI элементов для Web'а:* Страница (**Page**) — общий элемент-объект, на котором базируются все остальные.

* Контент (**Content**) — наполнение страницы текстом, изображениями, прочими мультимедиа ресурсами.

* Шапка (**Header**) — самая верхняя часть страницы.

* Подвал (**Footer**) — самая нижняя часть страницы.

* Поле ввода/Пользовательский ввод (**Input Field/User Input**) — текстовое или числовое поле, в которое можно ввести данные непосредственно с клавиатуры.

* Кнопка (**Button**) — классическая кнопка для функционального взаимодействия посредством UI.

* Радио-кнопка (**Radio button**) — кнопка-переключатель, которая позволяет выбрать только один пункт из списка.

* Флажки (**Flag**) — UI элементы которые имеют два состояния: включён/выключен:

– Чек-бокс (**Checkbox**) — поле с отметкой.

– Ползунок (**Slider**) — скользящая кнопка, может использоваться для подчёркивания выбора.

– Переключатель (**Toggle**) — «рубильник».

* Выпадающий список (**Dropdown**) — поле с выпадающим списком для выбора.

* Пикер (**Picker/Datepicker/Timepicker**) — интерактивный выбор даты/времени в календарях и прочих подобных конструкциях.

* Подсказка (**Tooltip**) — появляется при наведении курсора (hover) на UI элемент.

* Пагинация (**Pagination**) — нумерация страниц/элементов, объединённых одним свойством (например, страницы отчёта).

* Иконка (**Icon**) — пиктограмма, небольшое изображение необходимое для визуальной навигации. Пример иконок меню для сортировки контента/элементов на странице или для открытия контекстных меню:

* Модальное окно (**Modal**) — окно, которое открывается «поверх» всей станицы и блокирует взаимодействие с ней.

* Поп-ап (**Popup**) — всплывающее окно, схоже с тултипом, но с возможностью взаимодействия с ним (по аналогии с модальным окном).

* Форма (**Form**) — по свойствам схожа с модальным окном, но имеет иное предназначение (например: анкета, обратная связь, оплата).

* «Хлебные крошки» (**Breadcrumb**) — элемент навигации в виде последовательности, который показывает, на каком разделе сайта находится пользователь.

* Боковая панель (**Sidebar**).

* Лента (**Feed**) — упорядоченный набор контента, основанный на модульности.

* Карусель (**Carousel**) — «прокрутка» для просмотра набора контента.

* Карточка (**Card**) — небольшой прямоугольный модуль, может содержать текст, кнопки, мультимедиа.

* Лоадер (**Loader**) — как правило выглядит в виде wait-индикатора, визуально отражающий загрузку контента или иных данных на странице.

* Строка загрузки (**Progress bar**) — визуализация процесса, прохождения прогресса, загрузки.

Разумеется, здесь не отражены все существующие элементы UI.

Более того, появление новых элементов так или иначе происходит в стремительно развивающемся Web-дизайне, новые решения по UX порождают новый UI.

Но основной поинт мысли в том, что у всего есть своё название.

* Виды тестирования, которые могут применяться:

+ UI/UX тестирование (объединяет в себе «тестирование вёрстки» и "Usability-тестирование")

+ Кросс-браузерное тестирование (включает в себя «тестирование совместимости»)

+ Тестирование локализации (также может быть частью "UI/UX тестирования")

+ Тестирование интернационализации (что также может проводиться в рамках "UI/UX тестирования")

---

| | |

| --- | --- |

| **Область** | Взаимодействие |

| **Класс** | Ввод (Управление) |

| **Объекты** | - Клавиатура- Мышь- Тачпад- Тачскрин- Комбинации горячих клавиш- Экранная клавиатура- UI браузера (кнопки навигации)- Контекстное меню |

* Для функционального взаимодействия с UI на странице (для отдельных элементов) должен быть предусмотрен пользовательский ввод.

* Некоторые элементы UI могут предусматривать ввод для разных типов устройств (например, вписать дату с клавиатуры или выбрать дату в пикере с помощью мыши).

* Разными типами устройств может достигаться и разное поведение на странице (например, скролл с помощью тачпада может оказаться плавнее, чем колёсиком мыши).

* Также для подтверждения ввода в поле или отправки формы может послужить клавиша "Enter" (даже если рядом с полем/формой будет кнопка, реагирующая на инпут от мыши).

* Для мобильной версии Web предусматривается возможность вызова экранной клавиатуры для ввода значений вручную.

* Существует множество типов элементов, предусматривающих взаимодействие со страницей:

Примеры типов UI input-элементов (элементы с функциональным взаимодействием):* "**text**" — однострочное текстовое поле

* "**number**" — однострочное числовое поле

* "**password**" — однострочное текстовое поле поле, скрывает вводимые значения

* "**tel**" — однострочное поле для ввода телефонного номера по заданной маске (например "**+7(\_ \_ *)* \_ *-* *-* \_**")

* "**search**" — однострочное текстовое поле для поиска

* "**checkbox**" — флажок для выбора/отмены выбора отдельных вариантов

* "**radio**" — переключатель для выбора только одного значения из нескольких вариантов

* "**range**" — диапазон в виде слайдера для визуального управления вводом не отображая точных значений

* "**button**" — обычная кнопка

* "**submit**" — кнопка для отправки формы

* "**reset**" — кнопка для сброса содержимого формы к значениям по-умолчанию

* "**date**" — пикер для выбора даты (год, месяц, день, без времени)

* "**datetime-local**" ("datetime") — пикер для выбора даты и времени (без часового пояса)

* "**time**" — пикер для ввода времени (без часового пояса)

* "**week**" — пикер для выбора даты в формате: номер недели, год

* "**month**" — пикер для выбора в формате: месяц, год

* "**color**" — пикер для выбора цвета или открытия палитры цветов

* "**file**" — кнопка для выбора файла

* "**image**" — графическая кнопка "submit"

* "**email**" — поле для ввода почты, отличается от "text" наличием атрибутов проверки вводимых данных

* "**url**" — поле для ввода адреса, отличается от "text" наличием атрибутов проверки вводимых данных

Пример HTML кода с input-элементом типа "search":

* У каждого такого элемента как правило существует ряд атрибутов, которые определяют состояние и/или поведение для этого элемента:

Примеры наиболее распространённых атрибутов UI input-элементов:* "**minlength**" — определяет минимальный набор символов для текстовых полей

* "**maxlength**" — определяет максимальный набор символов для текстовых полей

* "**min**" — определяет минимальное значение для числовых полей

* "**max**" — определяет максимальное значение для числовых полей

* "**step**" — задаёт шаг прибавляемых значений для числовых полей

* "**size**" — определяет размер элемента

* "**value**" — устанавливает начальное значение для элемента

* "**pattern**" — шаблон, по которому проводится проверка на валидность заполненного поля (использует регулярные выражения - "RegExp")

* "**placeholder**" — текст/подсказка внутри поля

* "**autocomplete**" — возможность для автозаполнения поля (если в браузере сохранены данные пользователя, например email)

* "**checked**" — состояние вкл/выкл для чек-боксов и радио-кнопок

* "**required**" — устанавливает обязательность заполнения поля

* "**src**" — источник, где хранится изображение

* "**height**" — задаёт высоту для изображения

* "**width**" — задаёт ширину для изображения

* Помимо отдельных UI элементов также существует и возможность управления страницей с помощью UI браузера. Это может быть как панель навигации («вперёд», «назад», «обновить»), так и горячие клавиши для вызова таких инструментов, как «найти на странице».

* Виды тестирования, которые могут применяться:

+ Функциональное UI тестирование

+ Исследовательское тестирование ("Exploratory testing")

+ Ad-Hoc тестирование ("Интуитивное тестирование")

+ Кросс-браузерное тестирование

---

| | |

| --- | --- |

| **Область** | Конфигурация |

| **Класс** | Настройка браузера (ПО для браузера) |

| **Объекты** | - Плагины (Расширения)- Встроенные инструменты- Разрешения (Permissions) |

* При работе с Web'ом стоит помнить о том, что у каждого браузера есть набор встроенных инструментов. Например, такие как "Opera Turbo Mode" для повышения скорости загрузки страниц (посредством выделенных серверов Opera для сжатия изображений).

* К тому же для большинства браузеров существует огромный набор "3-rd party" расширений/дополнений, которые способны работать в фоне.

* Всё вышеперечисленное может так или иначе отразиться на работе Web'а и/или сервисов.

Кейс с реальным примером — AdBlock и Google Analytics:*Во время тестирования GA-сервиса на продакшене было замечено, что не собирается статистика по определённым событиям (должен был быть детект на включение тоггла и далее передача этой статистики в аналитику).*

*Как выяснилось, всему виной включённый AdBlock, который заблокировал работу GA-сервиса, и тем самым «саботировал» отправку данных. Добавить страницу в список разрешённых оказалось мало, и пришлось полностью отключить это расширение.*

* Некоторые расширения приносят пользу для тестирования. Более того, такие расширения пишутся специально для удобства Web-тестирования (подробнее об этом будет в конце).

* В современных браузерах встроен обширный модуль, который отвечает за конфиденциальность и безопасность. Он управляет разрешениями для страницы и определяет:

+ Будут ли появляться push-уведомления (нотификации)

+ Будут ли на странице проигрывать звуки

+ Будет ли доступ к микрофону или камере

+ Сможет ли осуществляться сбор геоданных

+ Произойдёт ли блокирование всплывающего окна, переадресации или рекламы

+ Сможет ли загружаться контент на странице (картинки, JavaScript, шрифты)

Как изменить разрешения сайтов (на примере Chrome):1. В адресной строке сайта есть соответствующая иконка в виде замка (или треугольника с предупреждением или знака информации).

2. По нажатию на эту иконку откроется поп-ап со сведениями о странице.

3. Выбрать пункт «Настройки сайтов».

4. Произойдёт переход в раздел [chrome://settings/content](https://chrome://settings/content) к настройкам конкретного сайта, где можно будет увидеть все существующие разрешения и задать правила для их выдачи.

Если в правилах для разрешения выставлено «Спрашивать», то в момент такого обращения браузер вызовет поп-ап с запросом, что делать с этим разрешением. Например при сработке push-уведомлений:

* Виды тестирования, которые могут применяться:

+ Функциональное тестирование

+ Конфигурационное тестирование

+ Кросс-браузерное тестирование

---

| | |

| --- | --- |

| **Область** | Ресурсы |

| **Класс** | Данные |

| **Объекты** | - Клиент-Сервер- Create, Read, Update, Delete- Валидация на стороне клиента- Валидация на стороне сервера |

* Когда речь заходит о таком понятии как Web-приложение, то так или иначе подразумевается обработка данных (создание, чтение, изменение, удаление — "CRUD").

* Вводимые пользователем данные должны быть провалидированы для избежания сбоя в работе Web-приложения (например, если пользователь вместо числа вводит текст).

* Такая проверка на корректность может проводиться как со стороны Frontend части приложения, так и со стороны Backend.

* На стороне Frontend для валидации вводимых данных используются ранее описанные типы элементов и атрибуты. Таким образом, клиент будет выступать неким гарантом, проверяя эти данные сперва на своей стороне, а затем передавая уже провалидированные на сервер, как бы защищая его от некорректного ввода.

* Однако:

+ Запрос от клиента можно перехватить и модифицировать, отправив на сервер всё что угодно, тем самым поставив под угрозу его работоспособность.

+ Клиентская часть может быть с дефектом, не проверяя валидацию поля или же правила проверки данные будут отличаться от тех, что ожидает сервер.

+ А в некоторых случаях API (для взаимодействия с сервером) может быть открыт и/или передаваться для интеграции в сторонние приложения.

* Поэтому, чтобы обезопасить сервер, существует валидация на стороне Backend, и в случае отправки запроса с некорректными данными он вернёт ошибку и не станет дальше обрабатывать такой запрос.

* Стоит упомянуть и о времени жизни (Time to Live — TTL) сессии на Backend, по истечению которой клиент не сможет послать запрос на сервер. Вернее сможет, но сервер вернёт соответствующую ошибку. Это дополнительный механизм защиты сервера, и регулируется он на Backend. Клиент может поддерживать сессию в активном состоянии, например, передавая на сервер keep-alive запросы.

* Cache, Cookie, Session Storage и Local Storage — это локальные «хранилища» данных, которые использует браузер для обмена с сервером.

* У всех этих «хранилищ» свои задачи:

+ Cache ("Кэш") — сохраняет, например, различный контент, загруженный с сервера, и затем уже переиспользуется с локального диска (если контент не изменился на сервере), чтобы не скачивать его постоянно.

+ Cookie ("Куки") — хранят в себе данные об авторизации пользователя на сайте, его настройках для этого сайта и используются для отслеживания сессии.

+ Local Storage — хранит различные данные, например, о настройках пользователя для сайта, которые могут быть использованы в разных сессиях.

+ Session Storage — так же как и Local Storage хранит данные, но только пока активна сессия. После закрытия браузера или вкладки Session Storage очищается.

Где хранятся Cache, Cookie, Local и Session Storage:1. Открыть DevTools инструменты разработчика (F12 по умолчанию).

2. Перейти во вкладку "Application".

В разделе **Cache Storage** кэшируются отдельные файлы, для которых используются методы Cache API:

* В остальном же кэш записывается локально на устройство, и его расположение зависит от операционной системы (например, в Windows: %LOCALAPPDATA%LocalGoogleChromeUser DataDefault).

* Кэш хранится в специальном для браузера формате, поэтому просто так открыть эти файлы не получится (есть специальные программы для просмотра содержимого, но обычно это не требуется).

* Расположение кэша Google Chrome в разных операционных системах: [User Data Directory](https://chromium.googlesource.com/chromium/src/+/master/docs/user_data_dir.md).

* Каких-то специфичных действий над кэшем производить не приходится, наиболее ходовое действие — это очистка кэша, чтобы подгрузить более свежие ресурсы с Web-сервера.

* В разделе **Cookie** можно видеть, какие куки передаются от клиента с запросом.

* Куки можно модифицировать (подменять) и переотправлять с запросом. Например, в DevTools, это можно сделать через двойной клик, на интересующем поле ("Value", "HttpOnly" и т.д.) или через контекстное меню:

* Также можем очистить cookie для отдельно взятого ресурса (при необходимости):

* В разделе **Session Storage** хранятся временные параметры пока активна сессия (открыто окно/вкладка):

* Здесь уже можно модифицировать значения ключей, добавлять новые ключи, удалять старые, если это необходимо.

* Ну и разумеется можно их полностью очистить (по аналогии с cookie).

* В разделе **Local Storage** хранятся постоянные параметры, пока их не удалит сам пользователь:

* И аналогично Session Storage здесь можно модифицировать значения ключей, добавлять новые ключи, удалять старые, если это необходимо.

* И само собой очистить полностью Local Storage:

**Полная очистка кэша и куки:**

1. В меню браузера Chrome навести на «Дополнительные инструменты».

2. Выбрать «Очистить данные просмотров».

3. Установить период, за который будет производиться очистка (например, за всё время).

4. Установить нужные чек-боксы («Файлы cookie и другие данные сайтов», «Изображение и другие файлы, сохранённые в кеше») и нажать «Удалить данные».

Режим инкогнито в браузере:

При открытии окна в режиме инкогнито браузер как бы начинает работу «с чистого листа», не используя старый кэш и куки.

Он записывает эти данные до тех пор, пока открыто окно в этом режиме. После закрытия окна, все эти «временные» кэш, куки и прочие исторические данные удаляются.

Это может помочь в тестировании, если надо проверить свежие изменения во Frontend части через новую сессию, не очищая кэш и/или куки.

* Клиент и сервер общаются между собой посредством HTTP (запрос/ответ).

* Существует набор кодов (ответов) при общении между клиентом и сервером. По этим кодам можно оценивать работу того или иного запроса от клиента к серверу.

Примеры наиболее распространённых кодов состояний HTTP:Стоит начать с того, что существует 5 категорий кодов:

* Информационные (код начинается с 1)

* Успешные (код начинается с 2)

* Перенаправления (код начинается с 3)

* Клиентские ошибки (код начинается с 4)

* Серверные ошибки (код начинается с 5)

И самые популярные из этих кодов:

* 101 ("Switching Protocols") — переключение протоколов обмена с сервером, например с HTTP на WS

* 200 ("OK") — успешная обработка запроса

* 304 ("Not Modified") — сообщает, что запрашиваемый ресурс не был изменён и будет загружен из кэша

* 400 ("Bad Request") — некорректные параметры запроса

* 401 ("Unautorized") — для выполнения запроса необходима авторизоваться

* 403 ("Forbidden") — доступ к запрашиваемому ресурсу запрещён

* 404 ("Not Found") — запрашиваемый ресурс не найден

* 500 ("Internal Server Error") — любая внутренняя ошибка, вызванная работой сервера

* 502 ("Bad Gateway") — сетевая ошибка на стороне сервера, говорит о его недоступности

* 503 ("Service Unavailable") — сервис для обработки запроса перегружен и не может выполнить этот запрос

* 504 ("Gateway Timeout") — превышение времени ожидания ответа от сервера

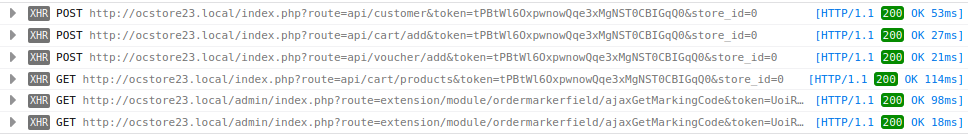

* Для того, чтобы посмотреть, какие ресурсы загрузились на странице, и какими запросами вызывались эти ресурсы, нам снова поможет DevTools.

Вкладка "Network":1. Открыть DevTools инструменты разработчика (F12 по умолчанию).

2. Обновить страницу, которую необходимо исследовать (для того, чтобы DevTools перехватил все ресурсы этой страницы, а вернее HTTP-трафик).

3. Перейти во вкладку "Network".

4. В списке ресурсов найти и выбрать необходимый (уже здесь по полю "Status" можно увидеть, с каким кодом выполнился запрос).

5. В открывшейся информации о запросе, во вкладке "Headers", в блоке "General", в поле "Status Code" видно, с каким кодом выполнился выбранный запрос.

6. В этой же вкладке отображаются все заголовки отправляемого запроса и полученного ответа ("Request Headers" и "Response Headers").

7. Во вкладке "Response" будет содержаться ответ от сервера на отправленный запрос (обычно ответ от сервера выглядит в формате JSON).

**Маркировка запросов с ошибкой**

В DevTools подсвечиваются красным цветом те ресурсы, которые не загрузились или запрос вернулся с ошибкой.

Что ещё может пригодиться при использовании вкладки "Network" в DevTools:

* Включение постоянного логирования запросов ("Preserve Log"), чтобы их список в таблице не очищался при обновлении страницы.

* Отключение кэширования для загружаемых ресурсов ("Disable cache"), чтобы запрашиваемые ресурсы каждый раз загружались с сервера, а не из локального кэша.

* Эмуляция состояния соединения ("Throttling") для проверки работы запросов при медленном соединении. Есть предустановленные пресеты, но можно добавить и свои.

* Фильтр для типов ресурсов (Наиболее используемые: "Fetch/XHR" — отображает Rest API запросы, "Doc" — HTML-страницы, "WS" — отображает web-socket соединения).

* Вкладка "Timing", чтобы оценить сколько ушло времени на загрузку того или иного ресурса.

* Вкладка "Cookie", в которой видно, какие куки передаются с запросом "Request Cookies" (или возвращаются с ответом "Response Cookies").

* Контекстное действие для быстрой очистки кэша и куки в браузере.

* Блокировка запросов по конкретному URL или всего домена полностью:

* Возможность скопировать запрос в удобном формате — допустим, чтобы передать его разработчику или использовать для переотправки в Postman (например, "Copy as cURL"):

* Важным инструментом в поиске ошибок на странице выступает консоль браузера.

Вкладка "Console":1. Открыть DevTools инструменты разработчика (F12 по умолчанию).

2. Перейти во вкладку "Console".

3. В открывшемся окне будут видны различные сообщения, исходящие от страницы, в том числе и ошибки (подсвечены красным цветом).

Что ещё может пригодиться при использовании консоли DevTools:

* Включение постоянного логирования, чтобы консоль не очищалась после обновления страницы ("Console Settings" → "Preserve Log").

* Настройка уровней логирования, чтобы собирать в консоль например только ошибки ("Log level").

* Сайд-бар консоли, для удобства сортировки сообщений ("Show console sidebar").

* Опция "Show timestamps" отобразит в консоли время возникновения сообщения/предупреждения/ошибки ("Settings" → "Preferences" → "Console").

* В качестве дополнения — существует внутренняя интерпретация ошибок в браузере, которые могут возникать при загрузке страницы.

Примеры некоторых ошибок в Google Chrome:* **ERR\_NAME\_NOT\_RESOLVED** — несуществующий веб-адрес

* **ERR\_INTERNET\_DISCONNECTED** — устройство не подключено к Интернету

* **ERR\_CONNECTION\_TIMED\_OUT** (**ERR\_TIMED\_OUT**) — для подключения к веб-странице потребовалось слишком много времени. Возможные причины: либо скорость соединения слишком низкая, либо страницу пытается открыть слишком много пользователей

* **ERR\_CONNECTION\_RESET** — соединение со страницей было прервано

* **ERR\_NETWORK\_CHANGED** — при загрузке страницы устройство отключилось от сети или подключилось к новой

* **ERR\_CONNECTION\_REFUSED** — страница не позволила Chrome подключиться к ней

* **ERR\_CACHE\_MISS** — страница просит повторно отправить ранее введенные данные

* **ERR\_EMPTY\_RESPONSE** — сайт не отправил данные и, возможно, недоступен

* **ERR\_SSL\_PROTOCOL\_ERROR** — страница отправила данные, непонятные для Chrome

* **ERR\_BAD\_SSL\_CLIENT\_AUTH\_CERT** — не удается войти на сайт (например, банка или организации) из-за ошибки в сертификате клиента

Эти ошибки можно увидеть при попытке браузером открыть страницу или же в консоли, когда проблема возникает с отдельно взятым ресурсом/сервисом/запросом. Примеры таких ошибок:

Полный список ошибок можно посмотреть здесь: [chrome://network-errors](https://chrome://network-errors/).

* Виды тестирования которые могут применяться:

+ Функциональное тестирование

+ Тестирование API

+ Тестирование безопасности

---

| | |

| --- | --- |

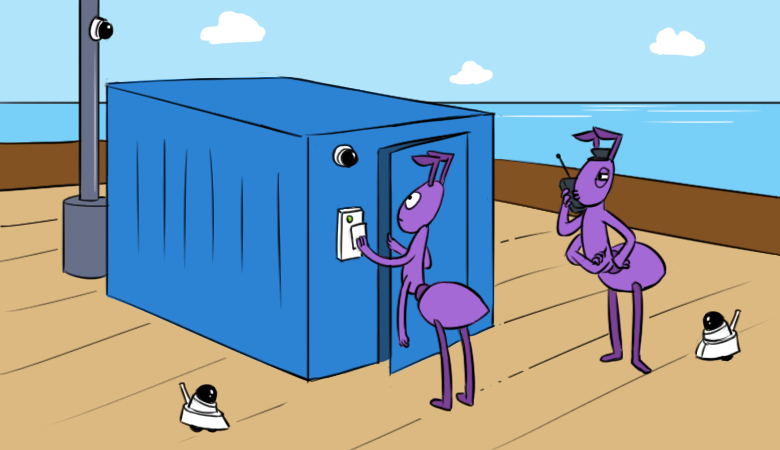

| **Область** | Архитектура |

| **Класс** | Технологии |

| **Объекты** | - URL-адрес- HTTP-протокол- Web-сервер- Frontend- Backend |

* Так что же на самом деле происходит, когда открывается страница в браузере? В этом блоке будет рассматриваться некий среднестатистический прообраз абстрактного Web-приложения, особенности его строения и поведения.

* **Web-приложение** — клиент-серверное приложение, состоящее из Frontend и Backend частей, взаимодействие с которым происходит посредством браузера.

* Заглянем же «под капот» такого Web-приложения:

Browser — точка входаРанее уже упоминалось, из чего состоит браузер, но на данной схеме более наглядно показано, как основные модули браузера взаимодействуют друг с другом:

Это позволяет понять, что Web-браузер представляет из себя сложную конструкцию, особенность работы или сбой в которой может повлиять на отображение клиентской части приложения, загрузку контента и взаимодействие со страницей.

URL-адрес — путь до ресурса**URL** ("Uniform Resource Locator") — это единый локатор ресурсов, стандарт, который используется для указания пути.

И вот в уже открывшемся браузере мы вводим в адресной строке необходимый URL-адрес.

Прежде чем мы начнём переход по этому адресу, следует разобрать, из чего собственно состоит адрес:

1. **Протокол** (например: "http://", "https://")

2. **Доменное имя** (например: "[www.google.com](https://www.google.com/)")

3. **TCP порт** (например: ":80", ":443")

4. **Адрес раздела или ресурса** (например: "/product/search" или "/about/unwanted-software-policy.html")

5. **Дополнительные параметры** (например: "?utm\_source=google&hl=en-RU&fg=1")

6. **Якорь** (например: "#tag")

Не все из этих параметров обязательны в URL. Например, TCP-порт, т.к. подразумевается, что работа HTTP и HTTPS протоколов будет осуществляться на их стандартных портах.

В качестве дополнения — прочие понятия, связанные с URL'ом:

* **Ссылка** ("Link") — синоним для таких понятий как URL-адрес и Web-адрес

* **Абсолютный URL** — полный URL-адрес web-сайта (например: "[http://www.google.com](https://www.google.com/)")

* **Относительный URL** — указывает путь к разделу и/или документу внутри сайта (например: "/about/")

* **Гиперссылка** ("Hyperlink") — в отличие от обычной ссылки это UI элемент страницы, при нажатии на который осуществляется переход на другой адрес. Если адрес ведёт на этот же сайт, то это внутренняя гиперссылка. Если адрес ведёт на другой сайт, то это уже внешняя гиперссылка.

* **Якорь** ("Anchor Link", "Page Jump", "Jump to") — это метка с уникальным именем, ссылающаяся на определённое место Web-страницы. Указывается в конце URL'а, и перед такой меткой ставится символ #

* **Глубинные ссылки** ("Deeplink") — это ссылка, которая перенаправляет пользователя в конкретный раздел сайта (например, к настройкам, скрытым где-то в глубине сайта)

* **Переадресация** ("Redirect") — это перенаправление пользователя с одного URL-адреса на другой URL-адрес

HTTP, HTTPS — запросы и ответыПри «вызове» URL-адреса начинается «общение» между браузером и Web-сервером посредством HTTP-запросов и HTTP-ответов.

**HTTP** ("Hyper Text Transfer Protocol") — протокол прикладного уровня для передачи данных, использующий надёжное TCP соединение.

И его защищённая версия **HTTPS** ("Hyper Text Transfer Protocol Secure"), которая использует SSL/TLS-сертификат для безопасного подключения к сайту.

Этот протокол также используется и в Frontend-Backend взаимодействии (через REST).

HTTP — это основополагающая сетевого общения на прикладном уровне.

**HTTP-запрос** ("Request") состоит из:

* Строки запроса:

+ HTTP метод — "HTTP Method"/"Request Method" (например: "GET", "PUT", "POST", "HEAD", "OPTION")

+ Путь запроса — "Request Target"/"Request URL" (Например: "<https://www.google.com/>")

+ Версия HTTP протокола — "HTTP Version" (Например: "HTTP/1.1")

* Заголовков запроса:

+ Основной заголовок — "General Headers" (например: "Connection")

+ Заголовок запроса — "Request Headers" (например: "User-Agent")

+ Заголовок ресурса — "Representation Headers" (например: "Content-Type")

* Тело запроса (необязательный параметр, требуется только для отправки на сервер, например, с помощью метода "POST"):

+ ИЛИ Одноресурсное тело — "Single-resource body" (состоит из одного файла и определяется заголовками "Content-Type" и "Content-Lenght" из "Representation Headers")

+ ИЛИ Многоресурсное тело — "Multiple-resource body" (состоит из раздельных частей/сегментов, хранящих свой бит информации. Обычно используется в HTML-формах)

Пример строки запроса и заголовков HTTP-запроса:

**HTTP-ответ** ("Response") состоит из:

* Строки состояния:

+ Версия HTTP протокола "HTTP Version" (например: "HTTP/1.1")

+ Код состояния — "Status Code" (например: "404")

+ Пояснение — "Status Text" (например: "Not Found")

* Заголовков ответа:

+ Основной заголовок — "General Headers" (например: "Connection")

+ Заголовок ответа — "Response Headers" (например: "Accept-Ranges")

+ Заголовки ресурса — "Entity Headers" (например: "Content-Lenght")

* Тело ответа:

+ ИЛИ Одноресурсное тело известной длины — "Single-resource body" (состоит из одного файла и определяется заголовками "Content-Type" и "Content-Lenght" из "Entity Headers")

+ ИЛИ Одноресурсное тело неизвестной длины — "Single-resource body" (состоит из одного файла, разбитого на небольшие части ("chunks") и определяется заголовком "Transfer-Encoding" из "General Headers")

+ ИЛИ Многоресурсное тело — "Multiple-resource body" (состоит из раздельных частей/сегментов, хранящих свой бит информации. Используется редко)

Пример строки состояния и заголовков HTTP-ответа:

Host, DNS, CDN, Web-Server — расположение и доступность ресурсовПосле того, как мы «сообщили» браузеру о необходимости перейти по указанному URL-адресу, происходит примерно следующее:

* С помощью браузера пользователь отправляет запрос на проверку доменного имени из URL'а.

* После проверки URL выясняется, за каким IP-адресом «закреплено» это доменное имя.

* Устанавливается соединение с сервером, где хранятся ресурсы Web-приложения, по TCP (Transmission Control Protocol).

* Отправляется HTTP-запрос на получение ресурсов Web-приложения. Ожидается ответ.

* Сервер обрабатывает запрос и отправляет ответ пользователю.

* И только теперь пользователю возвращаются запрошенные по указанному URL'у данные.

#### DNS-Server, Hosting Server, Web-Server

Доменное имя, по которому будет доступны Web-ресурсы, это отдельный разговор. Но для краткости стоит упомянуть, что:

* Чтобы использовать новое доменное имя, его необходимо зарегистрировать (через регистратор доменных имён).

* За каждым доменным именем должен быть закреплен внешний IP-адрес (для доступа по сети интернет).

* Необходимо произвести настройку на хостинге, чтобы по зарегистрированному доменному имени были доступны Web-ресурсы хранящиеся на сервере.

**DNS-сервер** ("Domain Name System Server", "DNS Server") — это сервер, который хранит IP-адреса для доменных имён и предоставляет эти данные по запросу. Отвечает за проверку/сопоставление доменного имени к IP-адресу и наоборот.

**Хостинг сервер** ("Hosting Server") — это сервер, который предоставляется как услуга, на котором будут размещаться различные Web-ресурсы, доступные по сети интернет. Обычно представляет из себя набор hardware оснащённого серверного оборудования, установленный в стойках или шкафах, на которое установлена серверная операционная система или система виртуализации. Всё это работает под управлением общей биллинговой системы и прочими системами мониторинга.

Хостинги бывают:

* Виртуальный ("Shared") — один большой сервер, на котором работает множество виртуальных от разных владельцев.

* Виртуальный выделенный "VPS/VDS" ("Virtual Private Server", "Virtual Dedicated Server") — в пользование отводится часть удаленного сервера.

* Выделенный ("Dedicated") — отдельный удаленный сервер, который находится под полным управлением владельца размещаемых Web-ресурсов.

* Облачный ("Cloud") — фактически схож с VPS/VDS, однако использует одновременно ресурсы нескольких серверов.

На этой картинке видно, по какой схеме работает обращение от пользователя к хостинг серверу, на котором размещаются ресурсы нашего абстрактного Web-приложения:

**Web-сервер** ("Web-Server") — это программный сервер, который управляет Web-ресурсами, отвечает на HTTP-запросы, может выступать в качестве прокси, иметь расширенные настройки окружения и администрирования этих Web-ресурсов.

Зачастую, под понятие Web-сервер подпадает более широкий спектр понятий, включая в этот список и само «железо», на котором работает HTTP-сервер.

Наиболее популярные Web-сервера (HTTP-сервера):

* Apache

* Nginx

* Microsoft IIS (Internet Information Services)

* Google Web Server

* Glassfish

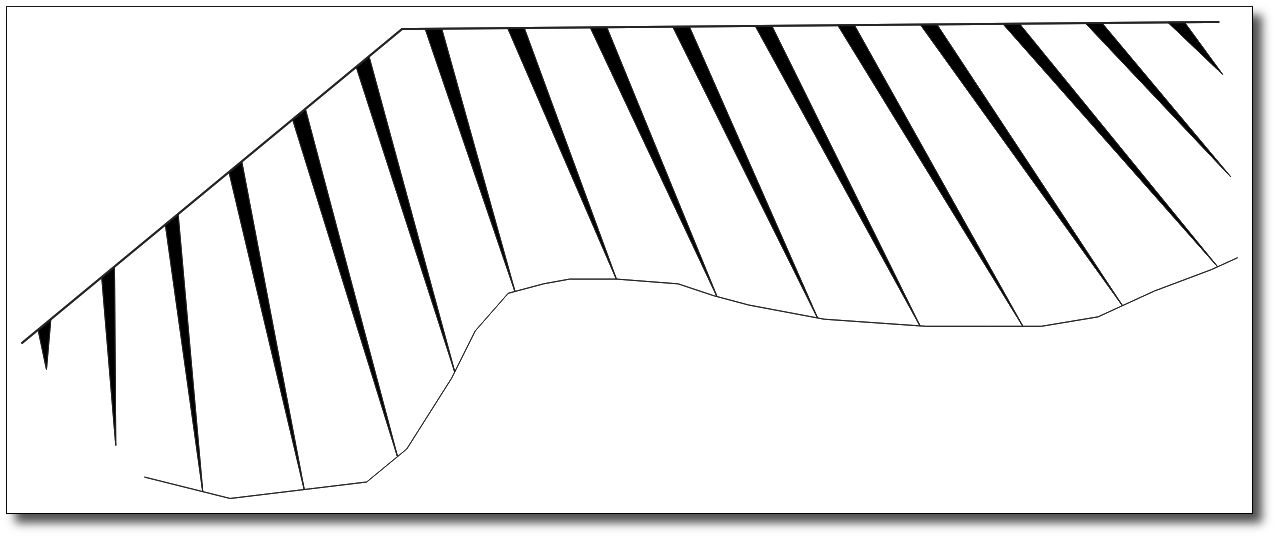

В качестве наглядного примера — картинка с web-интерфейсом администрирования Glassfish Web-сервера. Эта картинка, разумеется, не даёт всех ответов о возможностях настроек Web-серверов, но она отлично показывает их охват:

#### CDN — Content Delivery Network

Но что делать, если сервер с Web-ресурсами у нас находится в одном гео, а пользователи подключаются с другого? Например, сервер расположен в Европе, а пользователи подключаются из Латинской Америки или Океании. Для таких пользователей обращение за Web-ресурсами будет утомительно долгим и нестабильным.

Для решения этого вопроса используется схема с CDN.

**CDN** ("Content Delivery Network") — это географически распределённая сетевая инфраструктура, обеспечивающая быструю доставку доставку Web-ресурсов.

CDN состоит из:

* Origin — сервера, на котором хранятся исходные Web-ресурсы, раздаваемые через CDN.

* PoP ("Point of Presence"), Edge — кэширующего сервера в составе CDN, расположенного в определённой географической локации.

Пользователи из разных гео подключаются к ближайшему к ним Edge серверу и загружают Web-ресурсы с этого сервера.

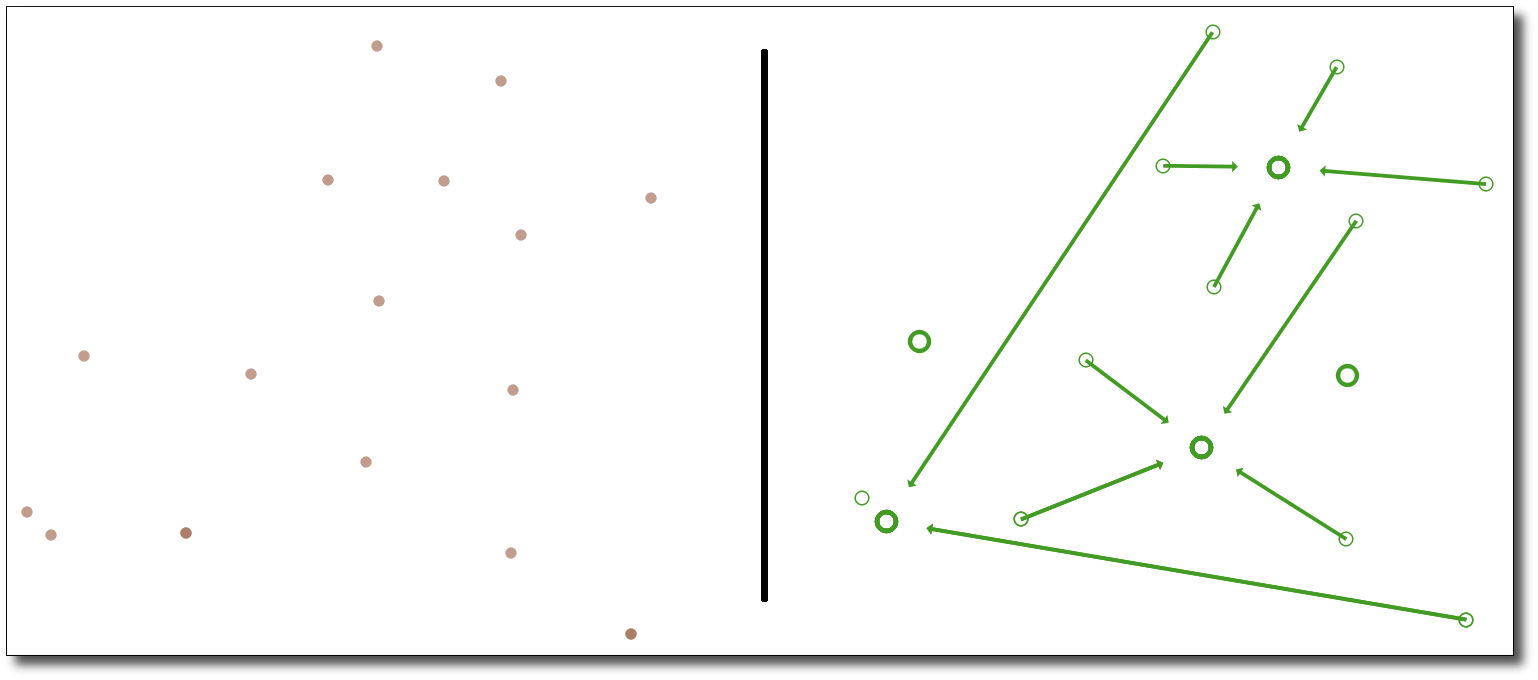

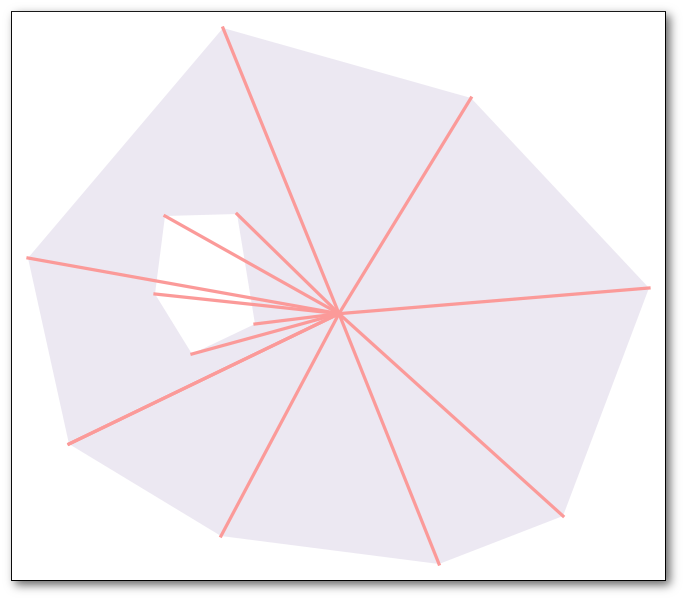

Картинка, ярко демонстрирующая разницу при использовании разных схем подключения к Origin серверу — без CDN и с CDN соответственно:

И ещё одно изображение работы CDN для закрепления:

### TCP/IP

Всё же стоит вкратце упомянуть и про стек протоколов TCP/IP, модель которого постоянно используется при обмене клиента и сервера.

Сетевая модель описывает процесс передачи цифровых данных: по каким уровням проходят данные, какие протоколы задействованы на разных уровнях.

За единицу информации в сети принято считать пакет.

**Пакет** ("Network packet", "Packet") — это оформленный блок данных, передаваемый по сети.

Пакеты состоят из:

* Версии пакета (IPv4, IPv6)

* Заголовка (граница, от которой начинаются данные)

* Приоритета пакета (QoS — "Quality of Service", ToS — "Type of Service")

* Длины/размера пакета (в байтах, данные + заголовок)

* Тэга (идентификатора)

* Флага (фрагментированный или не фрагментированный пакет)

* Смещения фрагмента ("Fragment Offset")

* Времени жизни (TTL — "Time to Live")

* Протокола (TCP — "Traffic Control Protocol", UDP — "User Datagram Protocol", ICMP — "Internet Control Message Protocol" или другие)

* Контрольной суммы заголовка ("Header Checksum")

* IP-адреса источника

* IP-адреса назначения

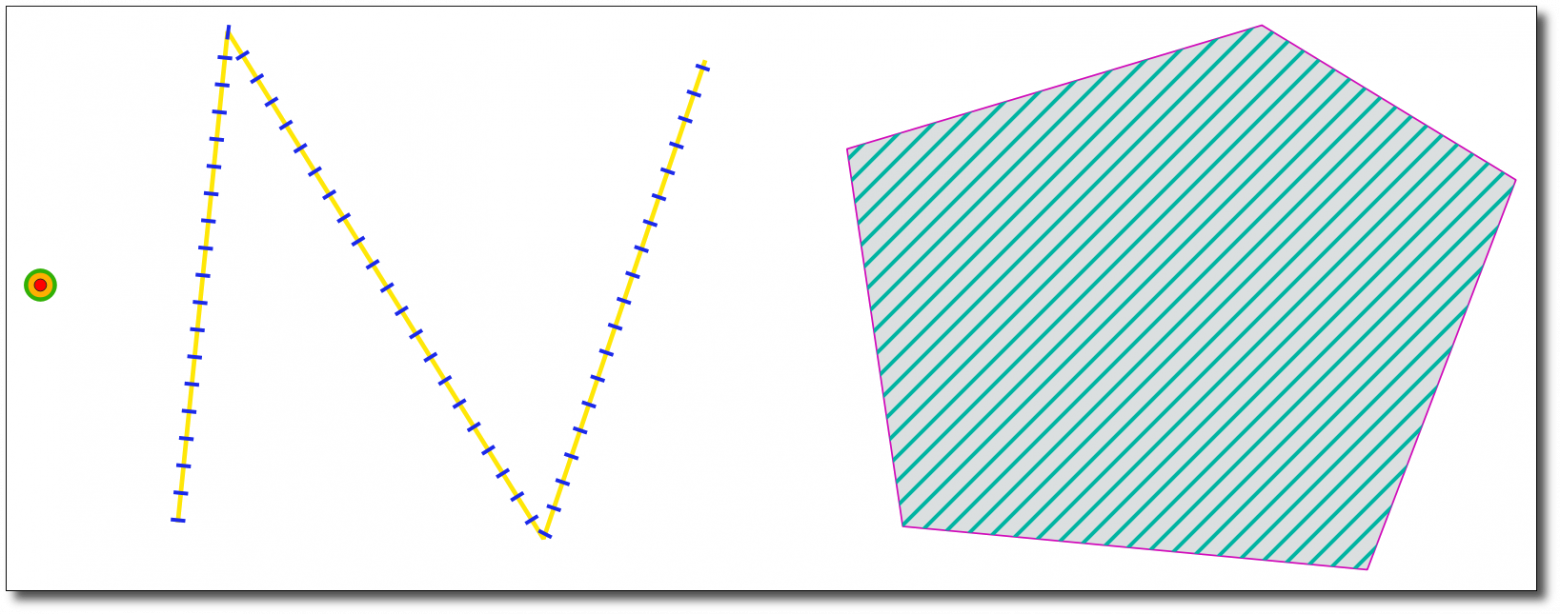

Сравнение уровней двух самых популярных концепций сетевых моделей:

Протоколы и среды передачи данных на разных уровнях модели TCP/IP:

Подводя черту под этим блоком, хочется сказать, что, когда мы говорим о взаимодействии «клиент-сервер», то подразумеваем общение Frontend и Backend части приложения (хотя в большинстве случаев под это понятие может подпадать общение Web-браузер — Web-сервер).

Но важно понимать, что на пути к этому общению стоит вереница других серверов, начиная от серверов на сети провайдера, заканчивая серверами на хостинге. А помимо серверов существует огромный «зоопарк» из сетевого оборудования L2/L3 уровней со своими настройками, характеристиками и... Впрочем, это уже совсем другая история :)

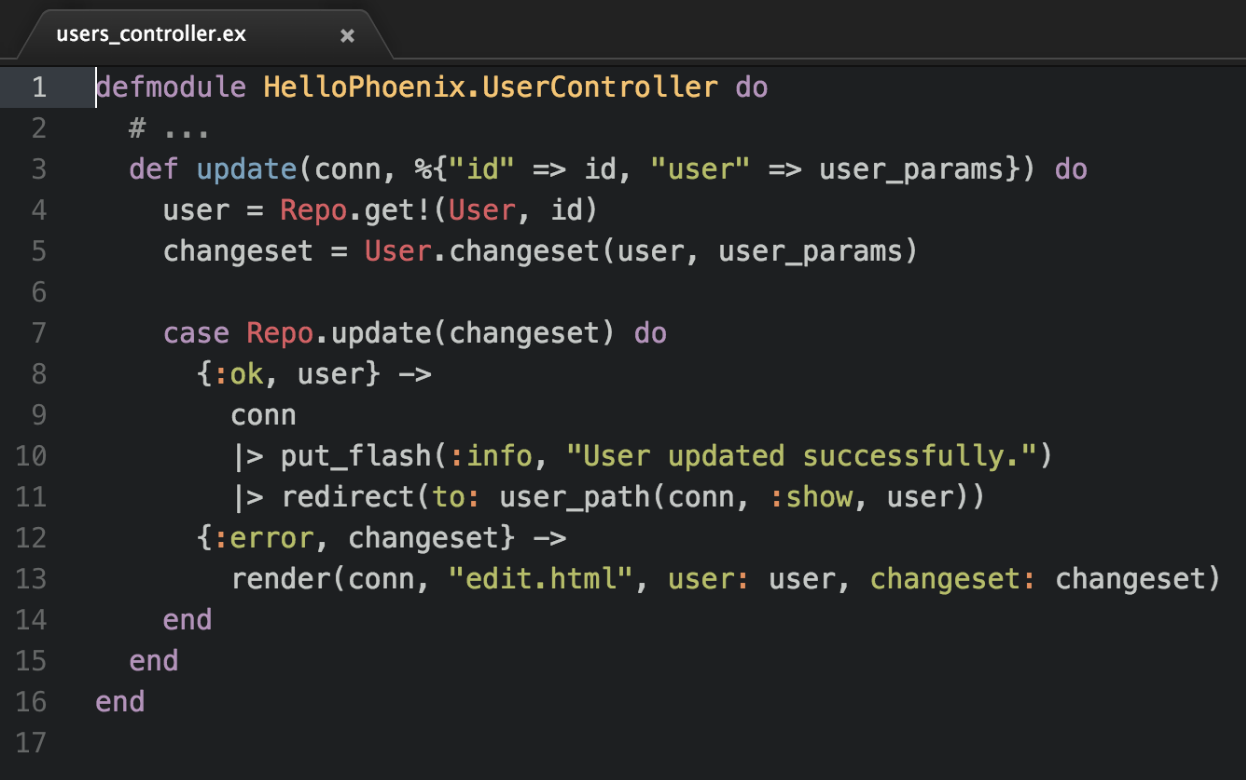

Frontend — клиентский код (DOM, HTML, CSS, JS, Media, WebGL ...)И вот мы дошли до момента, когда (через тернии сетевых хитросплетений) Web-сервер нам вернул статус 200 ("OK") на запрос по указанному URL-адресу, что же будет происходить дальше?

А дальше происходит «получение» клиентской части для того, чтобы пользователь мог взаимодействовать с нашим абстрактным Web-приложением.

При этом инициатором HTTP-запросов будет выступать уже не Web-браузер, а клиентский код, который будет дозапрашивать ресурсы, необходимые для полной загрузки страницы, выполнять подключение к Backend и различным сервисам.

#### Структура клиентской части

**Frontend** ("Front-end") — клиентская сторона web-интерфейса для взаимодействия с сервисом (Web-приложением).

Страница и все элементы на ней в современном браузере загружаются как DOM-дерево и имеют вложенную структуру.

**DOM** ("Document Object Model") — это объектная модель представления HTML-документа в виде дерева тэгов, выступающая как некий программный интерфейс, необходимый для взаимодействия с HTML-элементами через JavaScript.

Схематичное представление DOM:

Структура DOM:

**HTML** ("HyperText Markup Language") — язык разметки для Web-страниц (в настоящее время используется HTML5 версия языка).

| |

| --- |

| Разработчик: [World Wide Web Consortium](https://www.w3.org/) (W3C), [WHATWG](https://whatwg.org/) (Развитие технологий и стандартов) |

| Спецификация: [HTML Living Standard](https://html.spec.whatwg.org/), [HTML5](https://www.w3.org/TR/2011/WD-html5-20110405) |

Синтаксис HTML состоит из HTML-элементов, которые определяют тэги и атрибутов этих тэгов.

Тэг ("HTML Tag") — часть синтаксического блока, которая размечает область, где будет находится содержимое HTML-элемента и задают его тип.

HTML-элементы состоят из:

* Тэг открытия — определяет, где начинается элемент (например: "")

* Тэг закрытия — определяет, где заканчивается элемент (например: "")

* Атрибут и его значение — дополнительные свойства тэга (например: "href="[http://www.google.com](https://www.google.com/)"")

* Содержимое — текстовое наполнение, находящееся между тэгом открытия и тэгом закрытия

* Комментарий — необязательное свойство) (например: "")

Несколько примеров HTML тэгов:

— (основной тэг) сообщает о том, что это HTML-документ (является корневым тэгом)

— (основной тэг) содержит техническую информацию

— заголовок страницы

— задаёт CSS стили для страницы<br/><script> — хранит JavaScript код и/или параметры для него (например, путь до отдельного JS-файла)<br/><body> — (основной тэг) определяет видимую часть страницы</p><details class="spoiler"><summary>Пример HTML-страницы пустой вкладки из Google Chrome:</summary><div class="spoiler\_\_content"><pre><code><!doctype html><html dir="ltr" lang="ru"> <head> <meta charset="utf-8"> <title>Новая вкладка</title> <style> body { background: #35363A; margin: 0; } #backgroundImage { border: none; height: 100%; pointer-events: none; position: fixed; top: 0; visibility: hidden; width: 100%; } [show-background-image] #backgroundImage { visibility: visible; }

**CSS** ("Cascading Style Sheets") — язык описания внешнего вида HTML-документа.

| |

| --- |

| Разработчик: [World Wide Web Consortium](https://www.w3.org/) (W3C) |

| Спецификация: [CSS Specification](https://www.w3.org/Style/CSS/specs.en.html) |

Как было сказано ранее, в тэге

|

https://habr.com/ru/post/668974/

| null |

ru

| null |

# Восстановление приложения при запуске со стартового экрана без потери предыдущего состояния в WP8

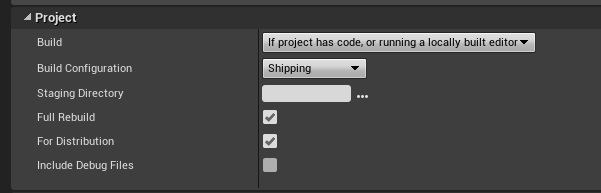

Windows Phone 8 принесла такую замечательную возможность, как быстрое возобновление состояния приложения после его перезапуска из списка приложений или через плитку начального экрана с полным сохранением состояния и истории навигации внутри приложения (для возможности последующей навигации используя кнопку Назад так, как если бы приложение никуда и не сворачивалось).

Если вы уже пробовали пользоваться Windows 8 и приложениями из Windows Store, вы, возможно, заметили, что при запуске приложения со стартового экрана вы вернетесь именно к тому месту приложения, на котором вы его оставили. Именно такого результата мы и добьемся в нашем приложении для Windows Phone 8.

Итак, начнем.

#### WMAppManifest.xml

Для начала, давайте откроем файл манифеста нашего приложения (кликнув по нему в Solution Explorer и выбрав View Source, в английской редакции Visual Studio). Все, что нам нужно сделать, это добавить в элемент **DefaultTask** атрибут под названием **ActivationPolicy** со значением **Resume**. Вот так:

```

```

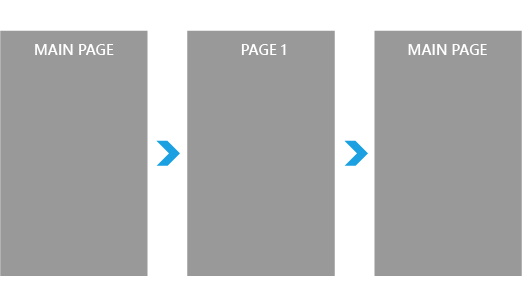

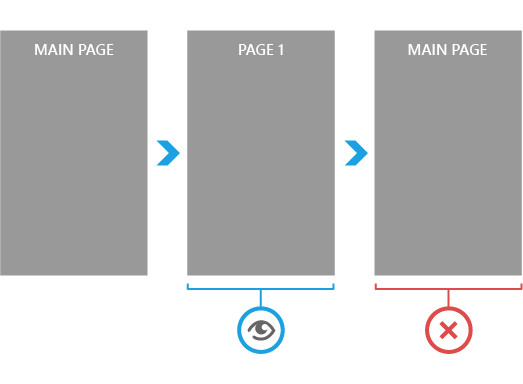

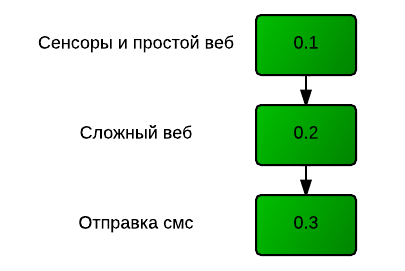

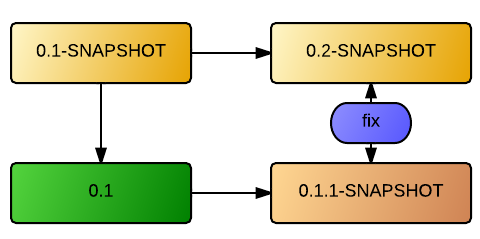

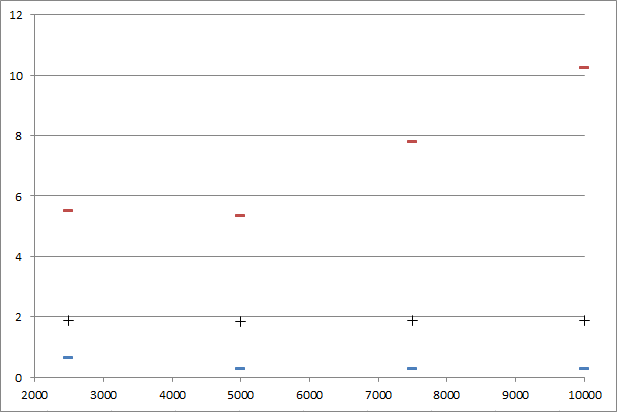

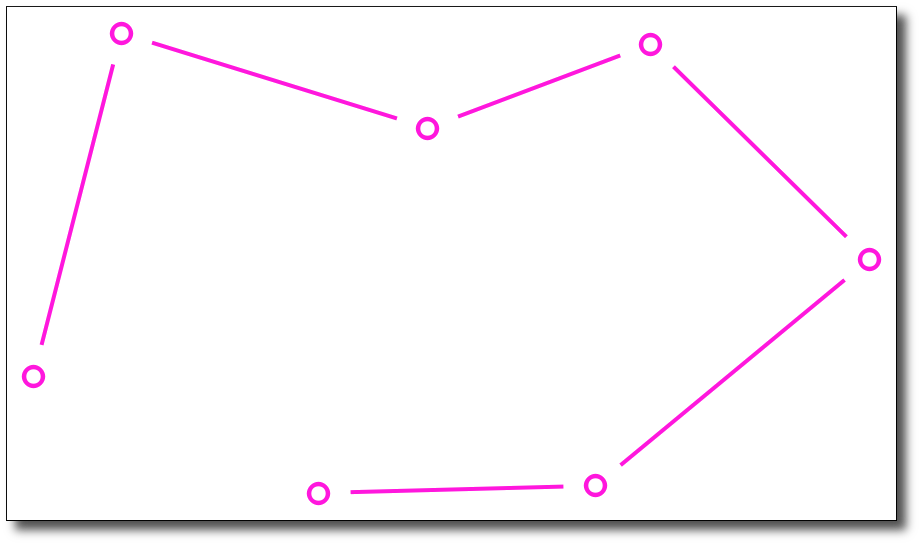

По большому счету, этим изменением мы добились того, что наше приложение при перезапуске через стартовый экран/список приложений стало восстанавливаться к своему предыдущему состоянию плюс переходу на страницу, указанную в атрибуте NavigationPage элемента DefaultTask манифеста нашего приложения. Сразу после этого, история навигации нашего приложения выглядит вот так:

Это немного ускорило перезапуск за счет того, что система больше не очищает состояние и не запускает приложение с нуля. Но, мы идём дальше.

#### App.xaml.cs

Теперь мы должны отменить этот ненужный нам переход на главную страницу после перезапуска приложения. Для этого, нам нужно немножко отредактировать файл App.xaml.cs (можно заметить, что SDK почему-то не хочет работать так, как описано на MSDN, поэтому мы пойдем немного другим путём).

Для начала, давайте добавим приватное нестатическое поле типа System.Boolean в наш класс App и назовём его \_reset.

```

private bool _reset;

```

Следующим шагом, нужно найти приватный метод InitializePhoneApplication (он автоматически создается шаблоном по-умолчанию) и настроить инициализацию RootFrame, определив наши обратотчики для событий Navigating и Navigated.

```

RootFrame.Navigating += RootFrame_Navigating;

RootFrame.Navigated += RootFrame_Navigated;

```

Последним шагом будет модификация тел методов-обработчиков этих событий.

```

private void RootFrame_Navigating(object sender, NavigatingCancelEventArgs e)

{

if (_reset && e.IsCancelable && e.Uri.OriginalString == "/MainPage.xaml")

{

e.Cancel = true;

reset = false;

}

}

private void RootFrame_Navigated(object sender, NavigationEventArgs e)

{

_reset = e.NavigationMode == NavigationMode.Reset;

}

```

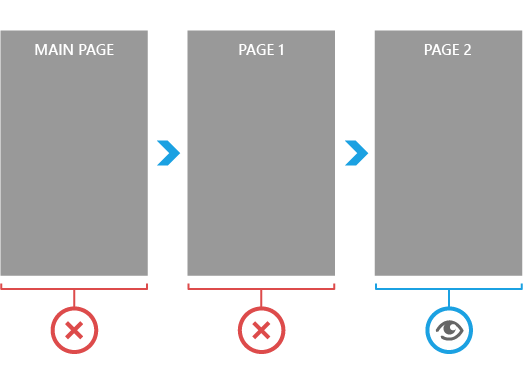

И это всё, цель достигнута. Теперь, после возобновления приложения при его перезапуске, пользователь будет попадать именно туда, откуда он покинул это приложение.

Буквально за считанные минуты мы сделали наше приложение гораздо более приятным в работе.

Можно так же дополнительно поиграться и, например, при возобновлении очищать историю кнопки Назад, сохранив при этом только состояние текущей страницы. Для этого в обработчике события Navigated необходимо добавить следующую строчку:

```

if (e.NavigationMode == NavigationMode.Reset) while (RootFrame.RemoveBackEntry() != null);

```

На этом всё, спасибо за внимание.

#### Примечание

В оригинальной статье отсутствовали некоторые моменты из [официальной документации](http://msdn.microsoft.com/ru-ru/library/windowsphone/develop/jj735579.aspx), которые я посчитал уместным добавить на суд читателей.

|

https://habr.com/ru/post/157379/

| null |

ru

| null |

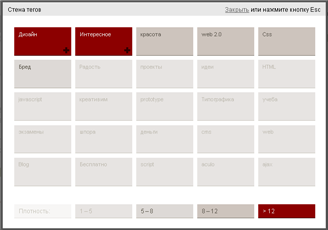

# Стена тегов

Облако тегов, в привычном своем виде, уже мозолит глаза. Хочу поделится с Вами отличным дизайнерским ходом для отображения тегов в виде кирпичиков, которые меняют цвет в зависимости от своей плотности.

Выглядит просто великолепно. Так как wordpress самая популярная платформа для блогов, то показывать мы будем именно на нем.

Живой пример

------------

[](http://chernev.ru/stena-tegov.html)

\* К сожалению пример прямо на хабре показать не получится, нажмите на картинку и посмотрите его на моей страничке.

Реализация

----------

Для реализации нашей нам понадобятся Jquery и дополнение к нему Thickbox. Все необходимые скрипты и таблицы стилей я нежно упаковал в один архив который можно будет скачать в конце этой заметки.

Для начала подключим необходимые нам таблицы стилей и скрипты. Скачиваем архив и распаковываем его в папку с вашей темой оформления, а после добавьте следующий код в шапку вашего блога между тегами `<head>head>`:

> <script type=«text/javascript» src="<font color="#ff0000"php bloginfo('stylesheet\_directory'); ?>/jquery.js">

>

>

|

https://habr.com/ru/post/28415/

| null |

ru

| null |

# Мифы и реальность ООП

([Источник](https://en.wikipedia.org/wiki/File:Russian-Matroshka_no_bg.jpg))

Хочу внести свои «5 копеек» в неутихающий спор противников и сторонников ООП. Из недавних публикаций на эту тему можно отметить ярко негативный заголовок [«Чем быстрее вы забудете ООП, тем лучше для вас и ваших программ»](https://habr.com/ru/post/451982/), более миролюбивый [«Хватит спорить про функциональное программирование и ООП»](https://habr.com/ru/post/450300/) и умеренно позитивный [«Объектно ориентированное програмирование в графических языках»](https://habr.com/ru/post/451148/).

Но на идею этой заметки меня натолкнул [комментарий](https://habr.com/ru/post/453170/#comment_20204330) к другой статье:

> Отличный пример для того, что ООП — это просто ужас. Система трейтов отлично реализует ваш случай, и совершенно не требует отвечать на Экзистенциальный Вопрос Объектного Программирования — «Что Есть Объект?». [...] Забудьте про ООП, это была удачная для GUI метафора, которую попытались возвести в статус религии.

На мой взгляд, это очень показательный типичный комментарий, где критикуется не сам ОО подход (даже отдается должное ООП в GUI), но мифы, возникшие вокруг ООП. Таким образом, на мой взгляд, правы все: и сторонники, когда указывают на удобства ООП, например, при программировании GUI, и противники, когда негодуют на возведение ООП в статус серебряной пули, абсолютного оружия.

Сразу стоит отметить, что в каждом ОО ЯП свой ОО подход, иногда сильно, иногда не очень сильно отличающийся от других ОО подходов. Буду исходить из умеренного простого подхода ОО Паскаля, заложенного еще в Turbo Pascal 5.5 и окончательно оформившегося к Delphi 7 (можно отметить и близкие по концепции ЯП других производителей, например, Think Pascal для MacOS). В этом ОО подходе есть основополагающие принципы: инкапсуляция, наследование (простое), полиморфизм; и существенные ограничения: например, нет по сути очень непростого [множественного наследования](https://ru.wikipedia.org/wiki/%D0%9C%D0%BD%D0%BE%D0%B6%D0%B5%D1%81%D1%82%D0%B2%D0%B5%D0%BD%D0%BD%D0%BE%D0%B5_%D0%BD%D0%B0%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5).

Как уже написал в [комментарии](https://habr.com/ru/post/451148/#comment_20147910) к упомянутой выше статье — переход от классического Паскаля к ОО Паскалю выглядел, на мой взляд, очень наглядным и оправданным:

> Простейшая инкапсуляция уже есть в записях (record). Далее понятие о наследовании приходит в таких простых примерах:

>

>

>

>

> ```

> type

> TCoord = record // координаты точки

> x, y : integer

> end;

> TRect = record // прямоугольник

> leftTop, RBot : TCoord;

> end;

>

> ```

>

>

>

>

> Остается заменить слово «record» на слово «class» (с указанием имени предка в скобках), разрешить записывать заголовки методов внутри таких «записей» и оговорить несложные правила полиморфизма.

Приведенный пример — реализация графических примитивов, это уже более широкая задача, чем задачи GUI. Здесь иерархия объектов выглядит очевидной и не возникает отмеченного выше «Экзистенциального Вопроса „Что Есть Объект?“». — Понятно, что точка — объект и прямоугольник — другой объект. Но в общем случае четко выделить объекты и расположить их в единственно правильную иерархию далеко не всегда возможно. Здесь противники ООП правы, но дело в том, что это не нужно! ОО подход часто называют модельным подходом (одним из). Основной принцип модельного подхода — моделирование не всех свойств прототипа, а только некоторых, значимых свойств для целей данной модели. Хрестоматийный пример — испытание модели самолета в аэродинамической трубе. Очевидно, что для таких испытаний не нужно делать у модели двигатели, иллюминаторы, шасси, убранные при полете в корпус и кресла в салоне, как и сам салон — достаточно выстругать эту модель из цельного куска дерева, воспроизведя только предполагаемые обводы корпуса. Такие испытания проводят не только для реальных моделей в реальной трубе, но и для виртуальных моделей в виртуальной трубе. Если реализовать виртуальное испытание с применением ООП, то принципы будут аналогичные реальным испытаниям — ненужные свойства и обекты в программу не попадут. Но если мы захотим повторно использовать код этой модели для моделирования дизайна самолета, то можем столкнуться с иерархическими проблемами при добавлении новых объектов. Является ли это недостатком именно ООП? — На мой взгляд нет: всякое моделирование сопряжено с жесткими ограничениями. Более того, для моделирования существует ряд других сложных принципиальных проблем. Подробнее см.:

*Блехман И.И., Мышкис А.Д., Пановко Я.Г. Механика и прикладная математика. Логика и особенности приложений математики.

Мышкис А. Д., Элементы теории математических моделей. Изд. 3-е, исправленное. М.: КомКнига, 2007*

В приведенных книгах упомянуто много источников на тему моделирования, в том числе цитируется следующий пример. Если поставить 3 табуретки друг на друга, то эта конструкция будет вполне устойчивой, чтобы водрузить на нее бумажный кубик для школьного урока рисования. Но эта же конструкция явно неустойчива, чтобы с ее помощью поменять сгоревшую лампочку. Никакая математика сделать такие выводы не сможет. Таким образом, существует не чисто математическая проблема интерпретации результатов моделирования. Эта проблема будет возникать в любой реализации модели: как с применением, так и без применения ООП. Но люди склонны к когнитивному искажению, и зачастую обвиняют инструмент-зеркало в отображении неприятной им информации ;)

В конце прошлого века всемирно известные люди [Билл Гейтс](https://ru.wikipedia.org/wiki/%D0%93%D0%B5%D0%B9%D1%82%D1%81,_%D0%91%D0%B8%D0%BB%D0%BB), [Филипп Кан](https://ru.wikipedia.org/wiki/%D0%9A%D0%B0%D0%BD,_%D0%A4%D0%B8%D0%BB%D0%B8%D0%BF%D0%BF), [Бьёрн Страуструп](https://ru.wikipedia.org/wiki/%D0%A1%D1%82%D1%80%D0%B0%D1%83%D1%81%D1%82%D1%80%D1%83%D0%BF,_%D0%91%D1%8C%D1%91%D1%80%D0%BD), [Никлаус Вирт](https://ru.wikipedia.org/wiki/%D0%92%D0%B8%D1%80%D1%82,_%D0%9D%D0%B8%D0%BA%D0%BB%D0%B0%D1%83%D1%81) и др., не желая того, заложили бомбу под ООП, слишком восторженно его пропагандируя. Почти все им поверили, и только сейчас наступило отрезвление. Но этот процесс отрезвления опасен другой крайностью — попытками полного отказа от зарекомендовавших себя во многих областях технологий. Только попыткой — вряд ли это возможно, хотя бы потому, что:

> [прежде всего](https://habr.com/ru/post/451982/#comment_20168798) забыть ООП [...] не реально, т.к. очень многие IDE имеют графические инструменты для создания GUI, и эти инструменты генерируют ОО код.

На мой взгляд, как и в случае любой модели, от модели с применением ООП не стоит ждать, что она чудесным образом раскроет все тайны мироздания. Каждая модель адекватна только в своих узких рамках: «что заложено — то и получим». При этом, согласно требованию естественно-научного подхода, каждый результат, полученный на модели, должен быть перепроверен экспериментально. Но при таких природных ограничениях существуют не всеми осознанные бонусы: к моделированию зачастую возможен примитивно-формальный подход. Так, в случае ООП не нужно пытаться вникнуть глубже возможного при определении объектов и их иерархии. ([Аналогично, например, в химии](https://habr.com/ru/post/339752/): современные химики знают, что атом не шарик, а химическая связь не стержень фиксированной длины, но это не мешает им использовать шаростержневые модели и структурные формулы.) — Иерархия нужна, чтобы навести порядок в коде модели, но она никогда не будет в точности отвечать гораздо более сложному, чем всякая модель, прототипу.

|

https://habr.com/ru/post/453836/

| null |

ru

| null |

# Помощь друзьям с использованием OSS для удаленного администрирования при наличии публичного IP-адреса

У многих из нас есть родственники и друзья, которые не очень хорошо разбираются в компьютерах и периодически просят помочь настроить то или иное программное обеспечение. В таких случаях помогать можно подключившись к компьютеру пользователя через программу удаленного администрирования. Давайте рассмотрим вариант подключения к удаленным компьютерам без использования проприетарного ПО.

Для подключения к компьютерам других пользователей можно воспользоваться [такими программами](https://habr.com/ru/post/514142/), как TeamViewer, AnyDesk, Ammyy и т.п. Но использование проприетарных решений всегда ставит нас в зависимость от вендора, и иногда это вызывает непредвиденные проблемы. Например, пользователи могут столкнуться с внезапным появлением сообщения «Обнаружено коммерческое использование», после которого программа прекращает нормально функционировать в бесплатном режиме. Для предприятия логичным шагом будет покупка лицензии, но если среди наших пользователей только родственники и друзья, то покупка лицензии представляется не всегда лучшим выбором. Существует программное обеспечение, распространяющееся под свободными лицензиями и позволяющее решить нашу задачу без дополнительных затрат. Исторически программы для удаленного администрирования предназначены для работы в локальной сети, и главным ограничением для их использования является отсутствие прямой связи с компьютером пользователя.

Для предлагаемого мной решения обязательным условием является наличие публичного IP-адреса, через который будет подниматься SSH-туннель. Варианты организации SSH-туннелей хорошо описаны в сети, например, можно почитать [тут](https://habr.com/ru/post/331348/). Условно будем называть администратором человека, оказывающего помощь, а пользователем — человека, к компьютеру которого требуется подключиться. Рассматривать будем вариант, когда администратор имеет публичный IP-адрес. Для однократных подключений этот вариант выглядит наиболее удобным, потому что не требует постоянно включенного ПО ни на сервере, ни на клиенте.

Предположим, что администратор работает на компьютере PC1, а подключиться требуется к пользовательскому компьютеру PC2. Оба компьютера под управлением ОС Windows.

IP-адреса указаны для примера, и в скриптах их надо заменять на свои. В случае использования внешнего SSH-сервера (например, VPS/VDS, которые сейчас зачастую можно найти дешевле стоимости публичного IP у некоторых провайдеров) изменения потребуются в организации SSH-туннеля, что не должно представлять особой сложности и в статье не описывается.

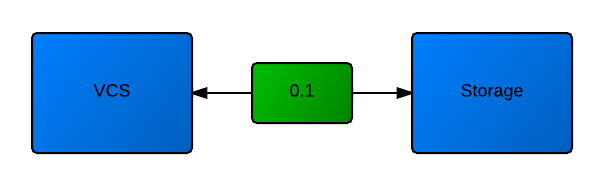

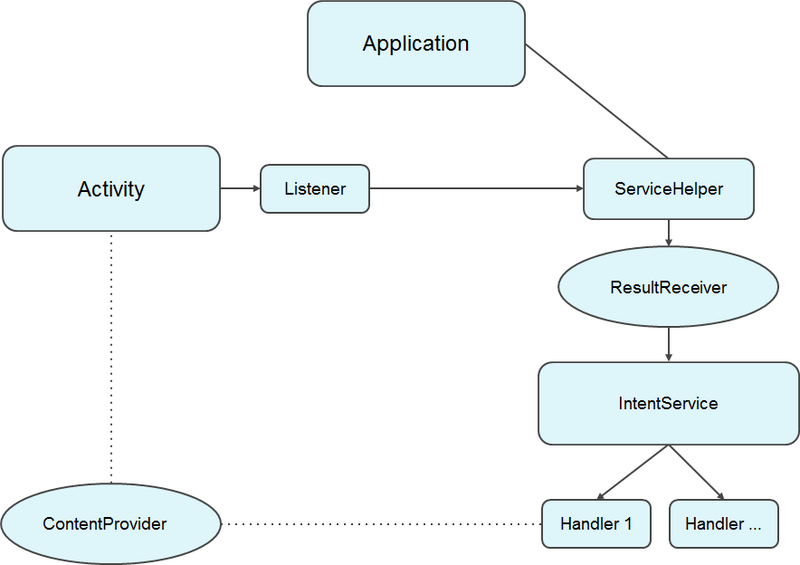

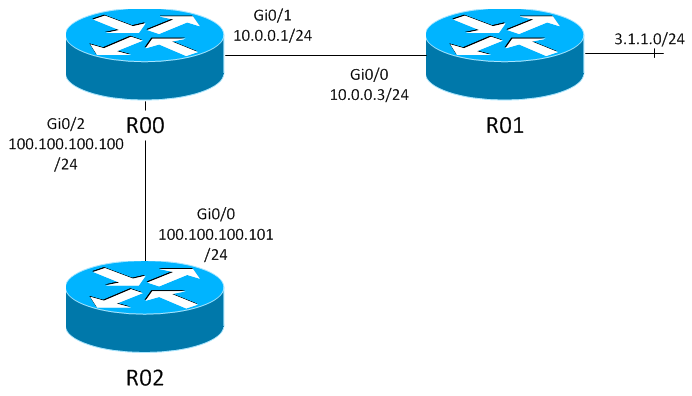

Суть предлагаемой схемы работы:

1. На публичном IP открывается порт для входящих соединений и пробрасывается на администраторский компьютер PC1, на котором на этом порте запускается SSH-сервер.

2. На пользовательском компьютере PC2 запускается SSH-клиент, который подключается к SSH-серверу PC1 и пробрасывает на него локальный порт.

3. На PC2 запускается VNC-сервер, ожидающий соединения на локальном порте PC2.

4. На PC1 запускается VNC-клиент, который подключается к локальному порту PC1, проброшенному по SSH с PC2.

То есть компьютер PC1 будет выступать одновременно в роли SSH-сервера и VNC-клиента, а пользовательский компьютер PC2 — SSH-клиента и VNC-сервера.

Требования к функциональности:

1. Удаленный доступ должен работать только тогда, когда это ожидается администратором и пользователем.

2. Не должно быть возможности подключиться к сеансу третьему лицу или перехватить передаваемые данные (предполагаем, что используемое ПО не содержит уязвимостей, а используемые компьютеры не содержат вредоносного ПО).

3. Пользователь не должен испытывать существенных затруднений при развертывании ПО на своей стороне.

4. Дистрибутивы для разных пользователей должны быть независимы, механизм создания дистрибутива для нового пользователя должен быть максимально упрощен.

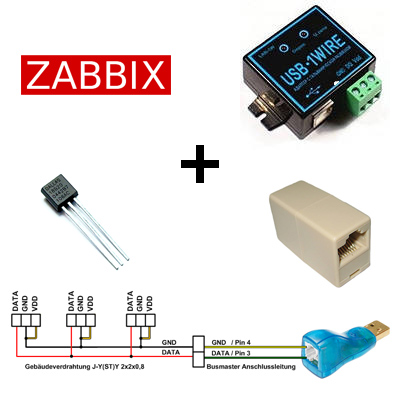

Для реализации будем использовать:

1. SSH (сервер и клиент), например [этот](https://github.com/PowerShell/Win32-OpenSSH/releases).

2. VNC (сервер и клиент), например [этот](https://www.tightvnc.com/).

TightVNC я выбрал из-за наличия актуальной сборки VNC-сервера под Windows [под лицензией GNU GPL](https://www.tightvnc.com/licensing-tvnserver.php), и возможности передавать файлы между сервером и клиентом. Из дистрибутивов потребуются файлы: libcrypto.dll, ssh.exe, ssh-keygen.exe, sshd.exe, tvnserver.exe и tvnviewer.exe. Решение проверялось на Windows 7 и Windows 10 (разных версий), но должно работать на любых ОС, где можно запустить SSH и VNC.

> В Windows 10 SSH-клиент предустановлен (как минимум, начиная с версии 1809) по пути "%SystemRoot%\System32\OpenSSH\ssh.exe", но для универсальности SSH-клиент включен в архив.

>

>

Для каждого пользователя будет создаваться отдельный независимый дистрибутив. Все действия выполняются запуском bat-файлов.

Администраторская часть дистрибутива

------------------------------------

Для начала рассмотрим состав файлов на стороне администратора PC1 (SSH-сервер и VNC-клиент):

* authorized\_keys — содержит открытый ключ SSH-клиента, необходим для подключения клиента к нашему серверу;

* ssh\_host\_rsa\_key — закрытый ключ SSH-сервера;

* sshd\_config — минимально необходимый конфиг SSH-сервера;

* run\_sshd.bat — скрипт запуска SSH-сервера;

* ssh\_host\_rsa\_key.pub — открытый ключ SSH-сервера (вообще говоря, для запуска сервера не нужен, используется на клиенте);

* libcrypto.dll, sshd.exe и tvnviewer.exe — ранее распакованные бинарники.

Запуск сервера осуществляется запуском файла run\_sshd.bat.

```

set ssh_bin=%~dp0

"%ssh_bin%sshd.exe" -f "%~dp0sshd_config" -h "%~dp0ssh_host_rsa_key" -E "%~dp0sshd.log"

```

Используемые параметры:

* `%~dp0` — [путь к каталогу](https://stackoverflow.com/questions/5034076/what-does-dp0-mean-and-how-does-it-work) запускаемого скрипта;

* `-f config_file` — путь к файлу конфигурации;

* `-h host_key_file` — путь к закрытому ключу сервера;

* `-E log_file` — путь к log-файлу (опционально).

Бинарники не обязательно держать в том же каталоге, можно разместить их в общем каталоге для всех клиентов и указать путь через переменную `ssh_bin`.

У используемого sshd версии 8.1.0.0p1-Beta есть особенности: для запуска обязательно надо указывать полный путь к sshd.exe, а authorized\_keys должен находиться по пути "%USERPROFILE%.ssh\authorized\_keys". То есть перед запуском сервера открытый ключ клиента обязательно должен быть добавлен в "%USERPROFILE%.ssh\authorized\_keys". Либо при запуске sshd можно [использовать опцию](https://www.ssh.com/academy/ssh/sshd#command-line-options) `-o AuthorizedKeysFile=<...>`.

Содержимое sshd\_config:

```

PubkeyAuthentication yes

PasswordAuthentication no

SyslogFacility LOCAL0

Port 11111

```

Описание опций:

* `PubkeyAuthentication` — [разрешает](https://help.ubuntu.ru/wiki/ssh) аутентификацию на основе открытого ключа;

* `PasswordAuthentication` — запрещает аутентификацию с использованием пароля;

* `SyslogFacility` — категория журналирования [для сохранения лога в файл](https://github.com/PowerShell/Win32-OpenSSH/wiki/sshd_config);

* `Port` — номер порта, который слушает сервер.

Если в логах sshd.log возникает ошибка "WARNING: UNPROTECTED PRIVATE KEY FILE!", то надо поправить права на файле:

```

icacls.exe "ssh_host_rsa_key" /remove "%COMPUTERNAME%\%USERNAME%"

icacls.exe "ssh_host_rsa_key" /inheritance:r

icacls.exe "ssh_host_rsa_key" /grant "%COMPUTERNAME%\%USERNAME%:(R)"

```

В некоторых случаях (если sshd видит проблему с правами на файле с ключами) на SSH-клиенте возникает ошибка: "Permission denied (publickey,keyboard-interactive)". При этом в логах SSH-сервера при включенной отладке (опция `-d`) можно увидеть: "Bad permissions. Try removing permissions for user: ..." В этом случае надо поправить права на файле authorized\_keys, изменить их можно тем же способом, что и для файла ssh\_host\_rsa\_key выше.

Пользовательская часть дистрибутива

-----------------------------------

На стороне пользователя PC2 (SSH-клиент и VNC-сервер) нам потребуются следующие файлы:

* id\_rsa — закрытый ключ клиента;

* id\_rsa.pub — открытый ключ клиента (для запуска на клиенте не требуется - используется на сервере);

* known\_hosts — содержит публичный IP-адрес SSH-сервера и его открытый ключ;

* tightvnc.reg — настройки tightVNC-сервера;

* prepare.bat — скрипт подготовки (запускается на клиенте однократно);

* run.bat — скрипт запуска SSH-клиента и VNC-сервера;

* libcrypto.dll, ssh.exe, tvnserver.exe — ранее распакованные бинарники.

Перед запуском на стороне пользователя необходимо произвести настройки, которые объединены в файле prepare.bat. Этот скрипт выполняется однократно при первичной настройке компьютера пользователя и делает следующее:

1. Настраивает права доступа к закрытому ключу (иначе SSH-клиент не запускается).

```

icacls.exe "%~dp0id_rsa" /remove "%COMPUTERNAME%\%USERNAME%"

icacls.exe "%~dp0id_rsa" /inheritance:r

icacls.exe "%~dp0id_rsa" /grant "%COMPUTERNAME%\%USERNAME%:(R)"

```

2. Настраивает VNC-сервер. Здесь возможны два варианта. Если прав локального администратора у пользователя нет, то настройки VNC надо импортировать в ветку HKEY\_CURRENT\_USER и запускать tvnserver.exe от имени пользователя.

```

reg.exe import tightvnc.reg

```

Но это ограничит возможности удаленного помощника: нельзя будет управлять приложениями, требующими повышения привилегий. Если пользователь готов дать удаленному помощнику права локального администратора, то настройки надо экспортировать в ветку HKEY\_LOCAL\_MACHINE и запускать tvnserver.exe как сервис. Для установки tvnserver как сервиса надо запустить (от имени администратора):

```

regedit /s "%~dp0tightvnc.reg"

"%~dp0tvnserver.exe" -install

sc config tvnserver start= demand

```

Последняя строка нужна для того, чтобы наш сервис запускался по требованию (только когда это нужно пользователю).

Запуск на стороне пользователя выполняется с помощью файла run.bat. Вариант без прав локального администратора:

```

start tvnserver.exe

"%~dp0ssh.exe" -fN -n -R 55555:127.0.0.1:33333 [email protected] -p 11111 -i "%~dp0id_rsa" -o "UserKnownHostsFile=""%~dp0known_hosts""" -E "%~dp0ssh.log"

tvnserver.exe -controlapp -shutdown

```

Вариант с правами локального администратора:

```

"%~dp0tvnserver.exe" -start

"%~dp0ssh.exe" -fN -n -R 55555:127.0.0.1:33333 [email protected] -p 11111 -i "%~dp0id_rsa" -o "UserKnownHostsFile=""%~dp0known_hosts""" -E "%~dp0ssh.log"

"%~dp0tvnserver.exe" -stop

```

В скрипте сначала запускается VNC-сервер, потом устанавливается соединение с SSH-сервером. Консольное окно c SSH-клиентом будет висеть до конца сеанса. По нему, кстати, можно диагностировать проблемы: если окно пропало, значит что-то пошло не так и надо смотреть в ssh.log. Расширенное журналирование можно включить опцией `-vvvv`.

> Важно! Порядок запуска сервера и клиента имеет значение: запускать SSH-клиент имеет смысл только при работающем SSH-сервере.

>

>

Параметры запуска SSH-клиента:

* `-fN` — [фоновый режим](http://rus-linux.net/MyLDP/sec/reverse-SSH-tunnel.html);

* `-n` — [предотвращает чтение из stdin](https://man.openbsd.org/ssh) (используется в фоновом режиме);

* `-R` — определяет реверсный туннель, перенаправляющий трафик с порта 55555 компьютера PC1 на порт 33333 компьютера PC2;

* `username@ip` — %USERNAME% пользователя, под которым запущен sshd на PC1, и публичный IP SSH-сервера;

* `-p` — публичный порт SSH-сервера (для простоты считаем, что порт прокидывается через NAT без изменения номера);

* `-i` — путь к закрытому ключу клиента;

* `-o UserKnownHostsFile` — путь к файлу с публичным ключом сервера;

* `-E` — путь к log-файлу.

Подготовка tightvnc.reg

-----------------------

Для подготовки конфига TightVNC надо запустить VNC-сервер (например, на виртуальной машине), настроить порт для соединений (в нашем случае 33333) и ограничить доступ к удаленному управлению. Остальные настройки на усмотрение администратора. Предлагаю доступ ограничить следующим образом: разрешить только Loopback Connections — установить флаги "Allow loopback connections" и "Allow only loopback connections". Еще можно настроить правила подключения.

После настроек надо выгрузить ветку из реестра: `HKEY_LOCAL_MACHINE\Software\TightVNC\Server` (или `HKEY_CURRENT_USER\Software\TightVNC\Server`, если VNC-сервер запускался без расширенных привилегий). Также для исключения ситуации, когда у пользователя были в реестре неподходящие настройки VNC-сервера, можно добавить в начало reg-файла строки `[-HKEY_LOCAL_MACHINE\Software\TightVNC\Server]` и/или `[-HKEY_CURRENT_USER\Software\TightVNC\Server]`.

После запуска run\_sshd.bat на сервере и run.bat на клиенте администратор может подключиться к компьютеру пользователя командой

```

tvnviewer.exe 127.0.0.1:55555

```

Генератор дистрибутива

----------------------

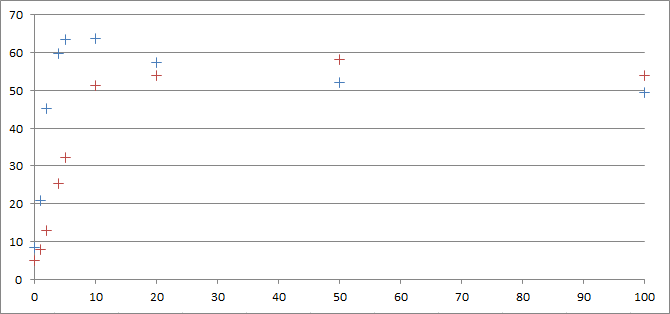

Для упрощения создания дистрибутива для нового пользователя предлагается сделать простой генератор, который представляет собой обычный bat-файл. Текст максимально простой; единственное, на что можно обратить внимание, это формирование файла known\_hosts. В нём перед отрытым ключом должен находиться IP-адрес SSH-сервера. Для этого IP-адрес записывается во временный файл (без перевода строки), а после объединения IP и ключа временный файл удаляется. IP-адрес и номера портов надо указывать свои, для примера использовались следующие:

* `1.2.3.4` — публичный IP-адрес администратора;

* `11111` — открытый порт на публичном IP-адресе, который пробрасывается на открытый порт 11111 на PC1 (требуется корректно настроить firewall на всех узлах);

* `33333` — порт на PC2, на котором VNC-сервер ожидает соединение;

* `55555` — порт на PC1, к которому подключается VNC-клиент (на PC1).

> В качестве имени пользователя `username` надо указать имя аккаунта администратора, под которым запускается SSH-сервер. Тестировались только варианты с именем латинскими буквами без пробелов. Как поведет себя система, если имя будет кириллицей или содержать пробелы, не проверялось. Также для читабельности убраны разные проверки на ошибки, потому что в bat это выглядит несколько монструозно. Для демонстрации рабочей концепции обработка ошибок не обязательна.

>

>

Основной скрипт генерации:

```

set ssh_srv_ip=1.2.3.4