text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Перевод Google TypeScript Style Guide

Здравствуйте, уважаемые читатели Хабра!

Как известно, при разработке и ведении проектов, одним из важных моментов является поддержка единого стиля в коде. Зачастую за основу берут какое-то общепризнанное руководство по стилю и дорабатывают его под свои нужды. И если в случае с JavaScript уже есть множество общеизвестных руководств, то с TypeScript дела обстоят несколько иначе. Конечно, если у вас в коде особенности TypeScript используются в мизерной доле, отдельное руководство по нему будет излишним, но если вы хотите использовать TypeScript более серьезно — рекомендации из готового руководства могут оказаться вполне полезными.

В начале 2021 года разработчики из Google выложили у себя в [репозитории](https://github.com/google/styleguide) руководство по стилю TypeScript ([Google TypeScript Style Guide](https://google.github.io/styleguide/tsguide.html)), в котором было описано множество специфических правил применения этого языка, с учетом их опыта. Т.к. я уже сталкивался с их [GTS](https://github.com/google/gts) (сборная солянка из форматтера и линтера для TS), мне стало любопытно ознакомиться с этим руководством, тем более оно, что логично, опирается на уже существующее руководство по JavaScript ([Google JavaScript Style Guide](https://google.github.io/styleguide/jsguide.html)). Даже если это руководство и не использовать в полной мере, оттуда вполне можно почерпнуть несколько полезных правил.

### Причины создания перевода

Найти перевод этого руководства для TypeScript мне не удалось, но зато на глаза попалась статья на Хабре: «[Перевод Google JavaScript Style Guide](https://habr.com/ru/post/487122/)» от пользователя [@RostislavDugin](/users/RostislavDugin), в которой был представлен перевод руководства по стилю для JavaScript. В статье автор описал проблемы с которыми столкнулся при переводе того руководства и текст которого он охарактеризовал так:

> *"Написано довольно сухо, иногда сложными конструкциями и некоторые моменты даже спустя какое-то время приходится перечитывать по несколько раз, чтобы точно понять смысл"*

>

>

И к сожалению, руководство для TypeScript обладало теми же самыми проблемами. Не всем оказалось легко вникать в подобный текст, что усложняет его использование в команде разработчиков и поэтому было решено сделать перевод этого руководства. Помимо этого были и другие причины:

1. Новички при чтении оригинала, часто пользуются автоматическими переводчиками, которые страдают тем, что и «*should*» и «*must*» часто переводят как «*должен*» — а многими это слово воспринимается «*строго обязательным к исполнению*», что может привести к некорректному пониманию правил руководства. Причем не все обращают внимание на стандарт [RFC2119](https://datatracker.ietf.org/doc/html/rfc2119), на который ссылается руководство и в котором четко расписано применение в документации «*MUST*», «*SHOULD*», «*MAY*» и пр.

2. В руководстве есть несколько выражений и терминов, требующих дополнительного пояснения. Например, не каждый захочет разбираться в том, что подразумевается под термином «*google3*».

3. В руководстве присутствует несколько ошибок, которые могут ввести в заблуждение (правки они [не принимают](https://google.github.io/styleguide/#contributing)).

### Разбор проблемной ситуации из оригинального руководства

Рассмотрим ситуацию с «возможной» ошибкой на примере представленного в руководстве «плохого» кода:

```

export let foo = 3;

window.setTimeout(() => {

foo = 4;

}, 1000);

```

В оригинале указано, что «*в чистом ES6,* `foo` *мутабельно и импортеры будут наблюдать изменение через секунду, а в TS при* ***реэкспортировании*** *данного кода, импортеры не увидят изменений*».

К сожалению, этот пример может некоторых сбить с толку, ибо в TS 3.9, при использовании ненативных модулей на подобии CommonJS, данное поведение было [приведено в соответствии с ES6](https://github.com/microsoft/TypeScript/wiki/Breaking-Changes#exports-now-use-getters-for-live-bindings), т.е. в TS < 3.9, `foo` через секунду будет равен 3, а в TS >= 3.9, `foo` будет 4. Вы можете сами ознакомиться с этим примером в онлайн-песочнице:

* [пример с TS >= 3.9](https://codesandbox.io/s/frosty-bhaskara-b4w8it)

* [пример с TS < 3.9](https://codesandbox.io/s/recursing-browser-rq3922)

Т.к. еще много где используется старый TypeScript и не все знакомы с такими нюансами, я посчитал нужным прокомментировать подобные моменты в переводе.

### Использование Markdown вместо HTML

Оригинальный перевод распространяется в формате HTML, что не очень удобно для подобной документации, поэтому все делалось сразу в формате Markdown (спецификация [GFM](https://github.github.com/gfm/)), который был более подходящим под подобный контент, удобен в плане поддержки, да и в том же GitHub его можно редактировать прямо из веб-интерфейса. Но т.к. не хотелось зависеть от GitHub и его просмотрщика — сделал на всякий случай простую и минималистичную веб-страничку, собираемую из Markdown. Для оформления был взят гитхабовский [Primer.css](https://primer.style/css/), который визуально многим знаком, легко поддерживает адаптивность и модный нынче «ночной режим» браузера.

Пара слов о использовании Primer.css для оформления документацииСам по себе этот фреймворк достаточно любопытный и активно развивается, хотя и страдает некоторыми багами. Разрабатывает этот продукт [команда из Github](https://primer.style/about/#team) и успешно использует в своих проектах. Для документации, генерируемой из Markdown, там есть [готовый компонент](https://primer.style/css/components/markdown), который позволяет легко сделать вполне лаконичное отображение (с поддержкой ночной темы браузера). Я думаю, многие видели, как отображается в Github отрендеренный Markdown — так вот, это оно.

> **В итоге позвольте поделиться с вами ссылкой на** [**перевод руководства Google по стилю написания кода на языке TypeScript**](https://olegbarabanov.github.io/google-typescript-style-guide-ru/) **(+ напрямую** [**Markdown**](https://github.com/olegbarabanov/google-typescript-style-guide-ru/blob/main/src/google-typescript-style-guide-ru.md) **или** [**зеркало веб-версии**](https://ts-guide.olegbarabanov.ru/google/) **- просто на случай проблем с GitHub) — искренне надеюсь, что кому-нибудь это пойдет во благо и принесет пользу.**

>

>

P.S. Перевод делал из-за необходимости в нем (я не профессиональный переводчик, да и гуманитарные навыки хромают). При переводе важно было не отходить от оригинала, поэтому текст местами может читаться тяжело. Если в переводе вы обнаружите какие-либо ошибки, неточности или моменты, которые могут потребовать разъяснения, вы можете указать об этом в [репозитории перевода](https://github.com/olegbarabanov/google-typescript-style-guide-ru) (issue, pull request и пр.).

|

https://habr.com/ru/post/674628/

| null |

ru

| null |

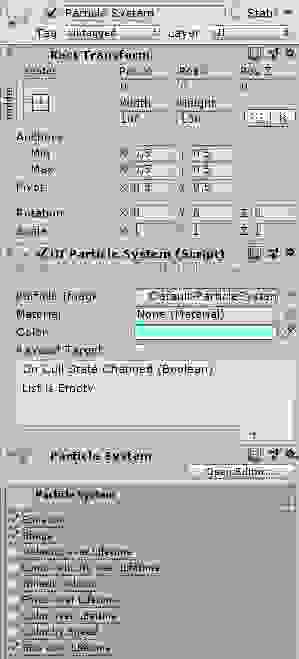

# Набор методов для работы со списками в AngularJS

Часто приходится работать с примитивными списками, поэтому, чтобы не писать одни и те же методы, собрал их в одном сервисе. Немного расскажу о нем, как о примере вынесения функциональности из контроллеров.

[Демка](http://tamtakoe.ru/demos/list.html), [песочница](http://plnkr.co/edit/1jHL9FX9yxR7PlN03j1i?p=preview) (с демкой играются многие, так что данные могут скакать)

Как видно из примера, у нас проблема: куча списков со схожей функциональностью (добавление, удаление, сортировка элементов — что еще может быть у списков :-).

#### Сервис

Описывать одни и те же методы в контроллерах явно не лучшая идея. К счастью, Ангуляр предлагает несколько способов вынесения общего кода с использованием сервисов. Подробнее о них можно почитать [здесь](http://habrahabr.ru/post/190342/).

Для нашей задачи используется наиболее простой тип: фабрика:

```

angular.module('oi.list', [])

.factory('oiList', function () {

return function (scope, Resource) {

scope.items = Resource.query()

scope.add = Resource.add()

...

}

}

```

Теперь, внедряя наш сервис в контроллер, получаем функцию, которая записывает в область видимости все необходимые методы.

```

.controller('MyCtrl', ['$scope', 'ListRes', function ($scope, ListRes) {

oiList($scope, ListRes);

}])

```

#### Кэширование

Хорошо, но можно еще улучшить. При получении данных аяксом ($resource, $http) Ангуляр по-умолчанию кеширует полученные данные. Это означает, например, что загрузив в ng-view страницу с данными, уйдя с нее и снова вернувшись не придется загружать данные заново, т.к. они берутся из кэша.

К сожалению, это работает только в элементарных случаях. Ангуляр кэширует именно запросы, а не модель. Т.е. загрузив и закэшировав массив данных с помощью `Resource.query()`, Ангуляр не возьмет данные из кэша если запросить их для отдельного элемента с помощью `resArr[0].get()`, потому что запрос будет уже другим. Так как кэш никак не связан с моделью, то его обновление при обновлении модели превращается в нетривиальную задачу.

Для решения этих проблем добавим в приложение сервис `oiListCache` типа `value`. В нем будет храниться ссылка на модель. Если при загрузке данных видим, что ссылка пустая, загружаем с сервера, иначе берем модель по ссылке.

```

.value('oiListCache', {cacheRes: {}})

.factory('oiList', ['oiListCache', function (oiListCache) {

return function (scope, cache, Resource) {

if (angular.equals(oiListCache.cacheRes[cache], [])) {

//Загружаем данные с сервера и записываем в кэш

scope.items = oiListCache.cacheRes[cache] = Resource.query();

} else {

//Загружаем данные из кэша

scope.items = oiListCache.cacheRes[cache];

}

}

}

```

Для каждой модели используем характеризующую ее строку `cache`, чтобы разные модели имели бы раздельный кэш.

#### Методы

Внутри модуля куча функций для работы со списками. У меня такой набор, у вас может несколько отличаться. Немного остановлюсь на методе, который будет у каждого: добавление нового элемента. Проще всего показывать элемент пользователю, когда он уже добавлен в базу и известен его айдишник. Минус в том, что пользователю придется ждать ответа с сервера.

Лучший способ — показать новый элемент сразу, а к базе привязать после получения ответа. И тут кроется большой подвох. Что делать, если пользователь удалил элемент у которого пока нет айдишника? Или одновременно добавил несколько элементов? В таком случае использую счетчик добавляемых/удаляемых элементов. При отправке запроса на добавление/удаление счетчик увеличивается, при получении ответа уменьшается. Код приводить не буду, его легко найти в [песочнице.](http://plnkr.co/edit/1jHL9FX9yxR7PlN03j1i?p=preview)

#### Известные проблемы

Не планировал делать модуль открытым проектом, но раз уж выложил в статье, то и об известных мне проблемах упомяну. Тем более, вдруг кто-то посоветует что-нибудь дельное.

1. В качестве параметров принимаются объект `Resource` и ключ для кэша `cache`. Если бы из ресурса можно было бы вытащить его имя, то оно бы отлично заменило ключ кэша. К сожалению, не представляю как его достать.

2. При каждом изменении списка новое расположение элементов отправляется на сервер функцией sort(). Проблема в том, что без `scope.$$phase || scope.$apply()` отправка изменений происходит через раз.

3. Сейчас модель записывается в область видимости под именем scope.items, которое нельзя поменять на другое. Выносить имя отдельной настройкой в параметры не хочется. Хочется в контроллере писать `$scope.modelname = oiList($scope, 'list', ListRes)`, но при этом ломается биндинг, т.к. при получении данных с сервера не происходит их прямое присвоение области видимости.

|

https://habr.com/ru/post/190370/

| null |

ru

| null |

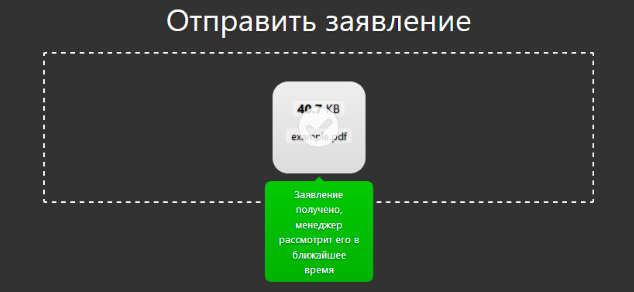

# Быстрый деплой ReportPortal-а в целях ознакомления

Некоторое время назад решил я воочию посмотреть что же такое [ReportPortal](https://reportportal.io), но эта заметка не о том, что это за монстр и что он умеет или не умеет, а о том, как его быстро задеплоить с целью «познакомиться» и «пощупать».

На вики самого репортпортала есть [документация по установке](https://reportportal.io/docs/Installation-steps), следуя ей я и действовал. Был установлен докер на Win10 + пошаговое следование инструкции, но что-то «не взлетело». Процесс был повторён несколько раз и, таки, в итоге всё получилось. В общем, промучался долго, ещё и сам докер нервы потрепал (ну для юникса он писан). В итоге, хотя после всех действий оно всё и работало, но решил я это дело убить и сделать всё на виртуалке.

Это было предисловие, теперь к сути.

Много лет пользовался virtualBox и всё, в принципе, устраивало, но недавно познакомился с built-in в Windows Hyper-V и решил попробовать сделать всё с ним. В отличии от виртуалбокса мне очень понравилась возможность «не видеть» вообще виртуалку — т.е. она где-то там в фоне крутится, ну и пусть крутится себе, не мозоля глаза на таскбаре + не надо качать образы, устанавливать что-то, т.к. у Hyper-V уже есть образы с предустановленной системой (выбор небольшой, надеюсь, будет расширяться, но нам его хватит).

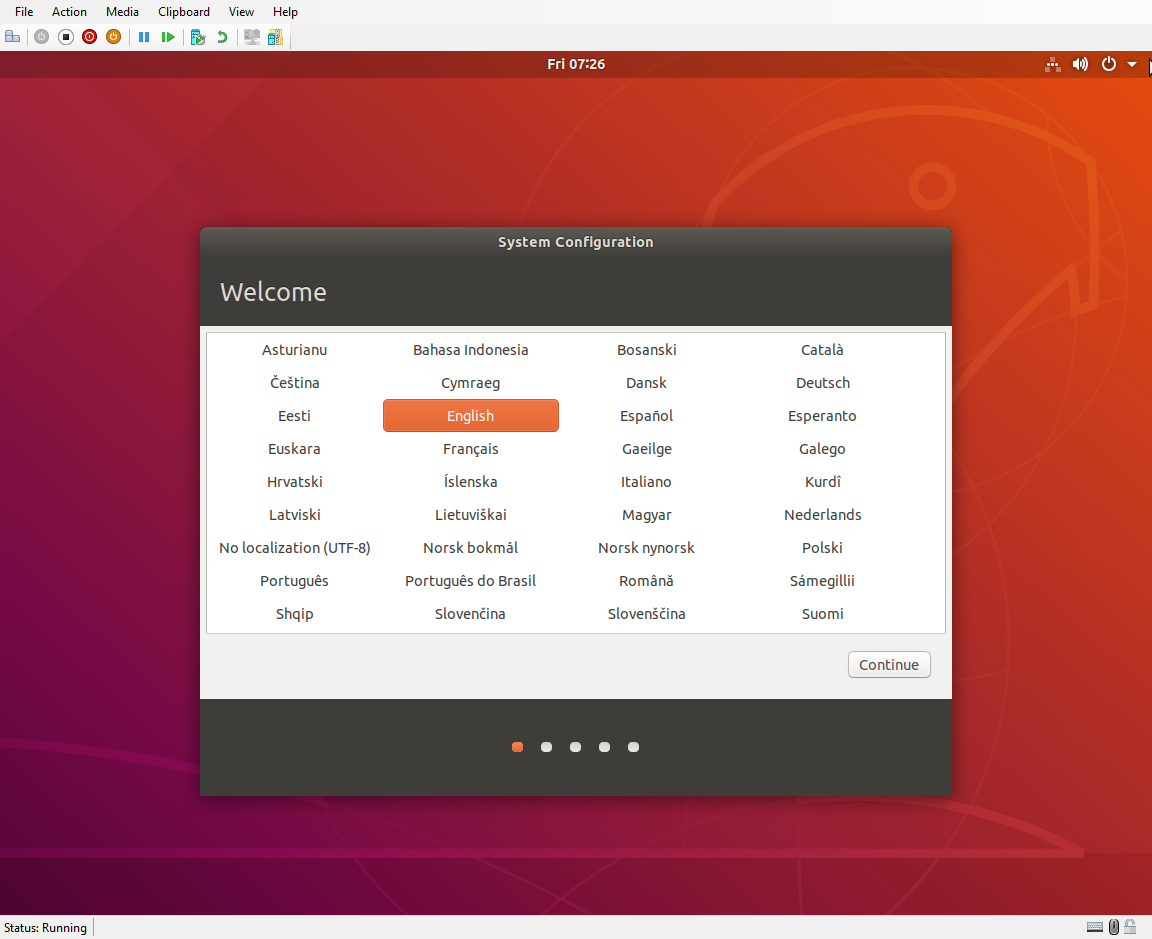

Теперь пошагово (весь процесс с хорошим интернетом занимает 15 минут):

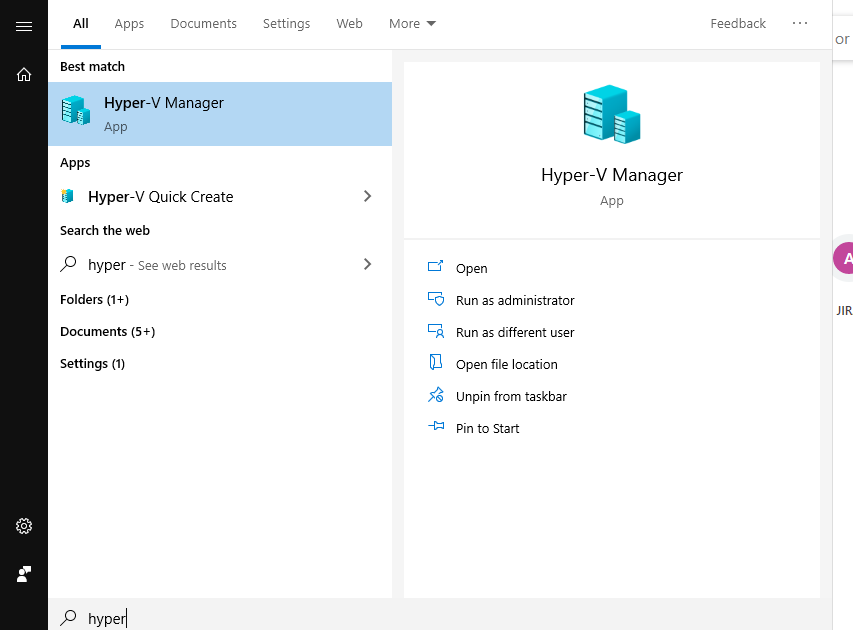

1. Открываем Hyper-V manager:

2. На имени своего компьютера клик правой кнопкой мыши и выбираем ''Quick create"

3. В открывшемся окне выбираем Ubuntu 18… и жмём «Create virtual machine»

4. Идём завариваем чай и ждём, пока скачается и распакуется образ

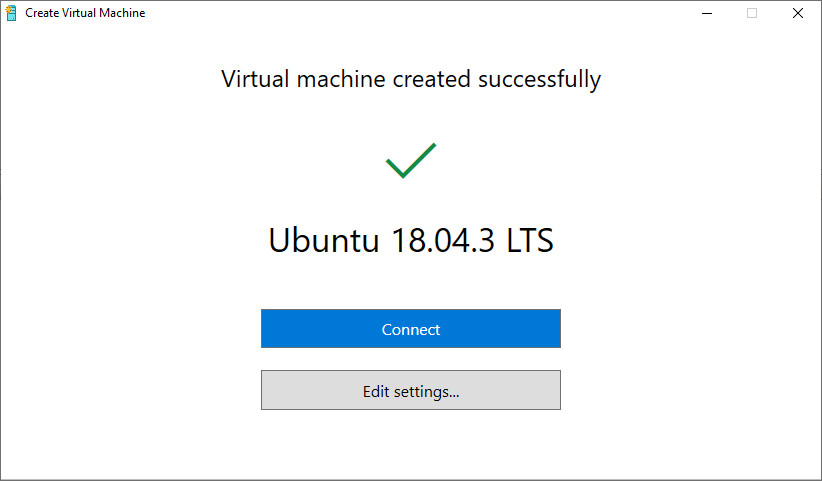

5. Когда процесс скачивания и распаковки завершится — мы увидим такое окно.

Не спешим запускать виртуалку, а зайдём в настройки по кнопке «Edit settings...»

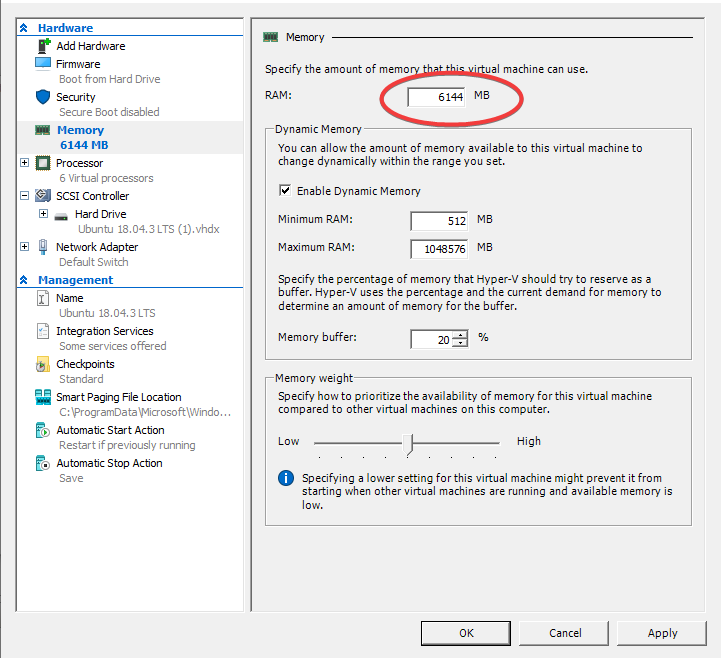

6. Так как репортпортал очень прожорливая штука — дадим виртуалке больше памяти (я дал 6 Гб)

7. Сохраняем настройки и жмём синуюю кнопку «Connect». Виртуалка ещё не запустилась, мы просто подключились к ней (aka remote desktop). Вот тут уже жмём «Start»:

8. Когда наша Ubuntu загрузилась, т.к. система не была установлена обычным образом, нам необходимо ввести данные такие как язык системы, часовой пояс, имя пользователя и пароль.

9. Всё, наша Ubuntu up and running.

Теперь открываем терминал и понеслась:

1. Опциональный шаг, если мы хотим подключаться по SSH (putty...) к нашей виртуалке без открытия её ремоутом.

выполняем в терминале:

```

sudo su

```

```

apt update

```

```

apt install openssh-server

```

2. Устанавливаем курл (понадобится чуть позже) и докер.

Если пропустили первый пункт — продолжаем работу в терминале. Если установили SSH, то можно продолжить, подключившись к виртуалке через Putty (либо аналог).

2.a Курл:

```

apt install curl

```

2.b Docker & docker-compose

```

apt install docker.io

```

```

apt install docker-compose

```

3. Устанавливаем репортпортал

3.a Качаем docker-compose.yml:

```

curl https://raw.githubusercontent.com/reportportal/reportportal/master/docker-compose.yml -o docker-compose.yml

```

3.b Опционально. По умолчанию репортпортал «слушает» порт 8080. Мне этот порт нужен был для другого сервиса (selenoid-ui), я решил «дать» репортпорталу другой порт.

Для этого редактируем docker-compose.yml:

```

nano docker-compose.yml

```

Ищем секцию:

```

gateway:

image: traefik:1.6.6

ports:

- "8080:8080" # HTTP exposed

# - "8081:8081" # HTTP Administration exposed

command:

- --consulcatalog.endpoint=registry:8500

- --defaultEntryPoints=http

- --entryPoints=Name:http Address::8080

- --web

- --web.address=:8081

restart: always

```

Редактируем её следушим образом:

```

gateway:

image: traefik:1.6.6

ports:

- ":8080"

expose:

- "8080"

# - "8081:8081" # HTTP Administration exposed

command:

- --consulcatalog.endpoint=registry:8500

- --defaultEntryPoints=http

- --entryPoints=Name:http Address::8080

- --web

- --web.address=:8081

restart: always

```

где — номер порта, который Вы хотите дать репортпорталу. Я вписал «8888»

3с. Устанавливаем репортпортал:

```

docker-compose -p reportportal up -d --force-recreate

```

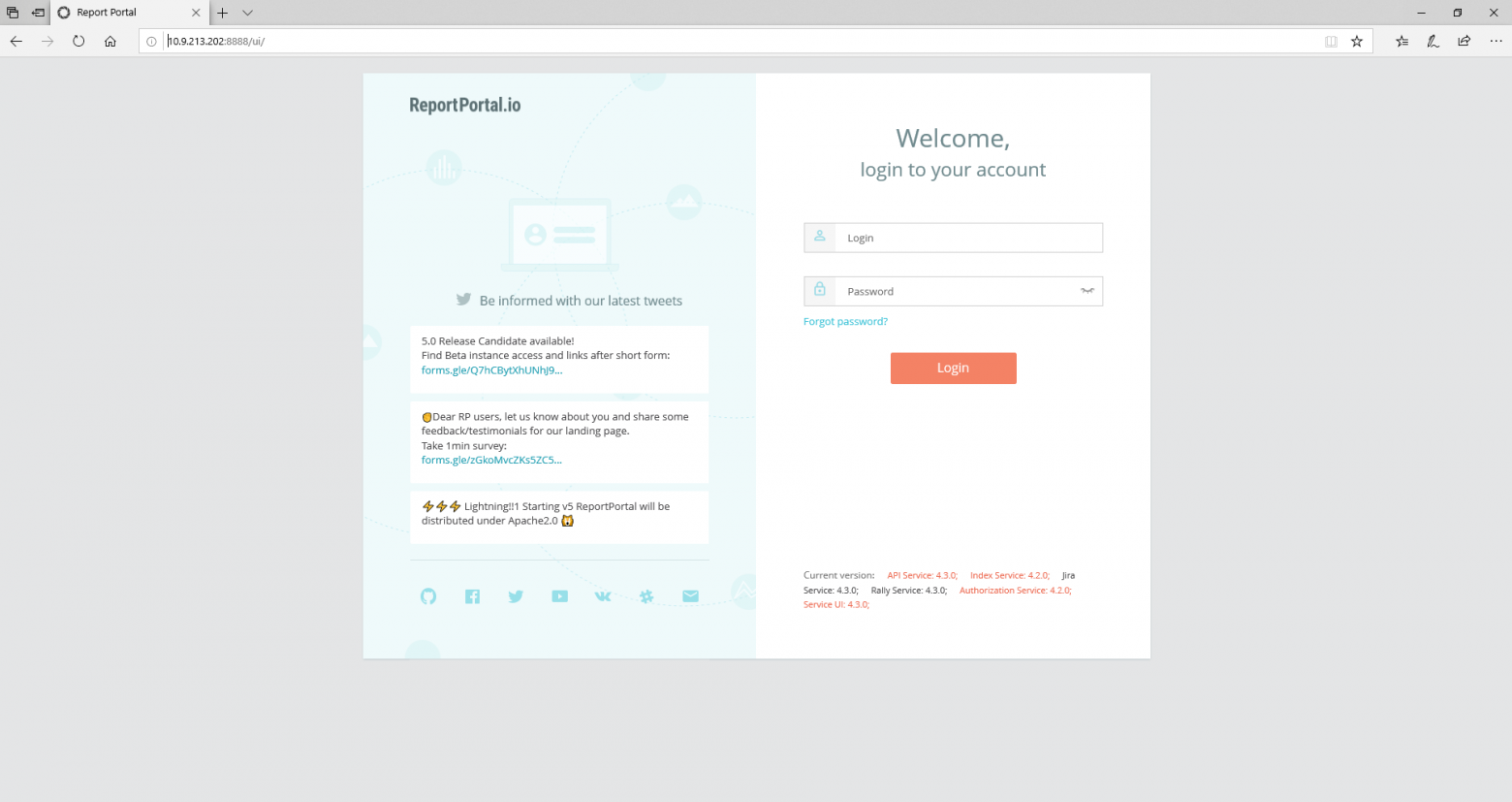

Скачаются образы, создадутся докер-контейнеры и запустятся сами. После того, как в консоли весь процесс закончится — подождите минутку — дайте всему запуститься как нужно и можете в браузере на реальной машине своей открывать репортпортал по IP виртуальной машины и выбранному Вами (или стандартном 8080) порту.

Залогинимся встроенным админом: `superadmin\erebus`

Напоследок: Теперь мы можем просто закрыть окно с виртуалкой (она останется работать в фоне и не будет мозолить глаза). Чтобы опять открыть её — вовзращаемся в Hyper-V manager и делаем даблклик по виртуалке в списке.

|

https://habr.com/ru/post/476674/

| null |

ru

| null |

# Как стать экспертом для поисковых систем

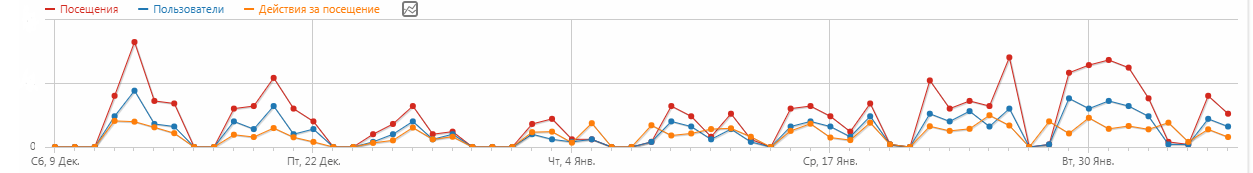

Не так давно я познакомился с описанием [E-A-T алгоритма от Google](https://www.google.ru/search?q=google+expertise+authoritativeness+trustworthiness+EAT), который расшифровывается как «Expertise, Authoritativeness, Trustworthiness» (экспертность, авторитетность, достоверность). И мне, как автору, который пишет для разных сайтов стало интересно — насколько я сам соответствую критериям этого алгоритма и могу ли повлиять на текущую ситуацию. Тем более, что некоторые заготовки в виде [открытой гугл таблицы для учета и мониторинга собственных публикаций LynxReport](https://habr.com/ru/post/485594/) уже были.

*Google Таблицы → Node.js → Google Charts → Сайт-визитка → Топ-3 место в поиске ФИО + специализация*

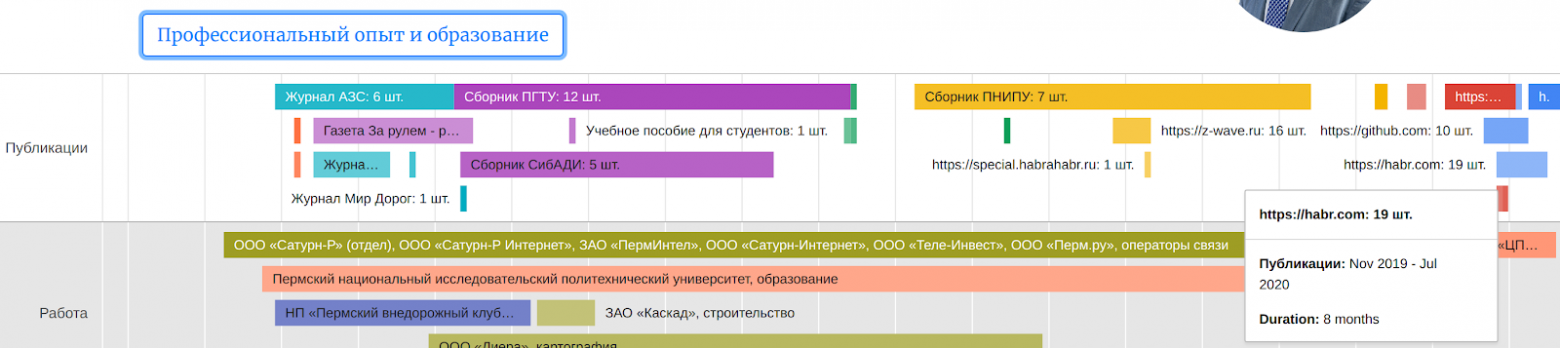

На основании данных таблицы я решил дополнить сайт-визитку, сведениями о публикациях, которые бы генерировались автоматически. Что я хотел получить:

1. Актуальную сводку публикаций, расположенную [на временной шкале Google Charts](https://developers.google.com/chart/interactive/docs/gallery/timeline?hl=ru).

2. Автоматическую генерацию выходных данных и ссылок на статьи из гугл таблицы в html версию визитки.

3. PDF версии статей со всех сайтов, из-за опасений закрытия некоторых старых сайтов в будущем.

Как получилось [можно посмотреть здесь](https://empenoso.github.io/). Реализовано на платформе Node.js с использованием Bootstrap, Google Charts и Google Таблицы для хранения исходных данных.

Исходные данные о публикациях в Google Spreadsheet

--------------------------------------------------

Гугл-таблица [LynxReport: учёт публикаций](https://docs.google.com/spreadsheets/d/123I74Ys0WtAl6DQx8uExYC6AEbB-6w9FMQisNfmuWBo/edit#gid=0) содержит все исходные данные и аналитику по публикациям. Я поддерживаю актуальность сведений на вкладке «Данные», вручную вписывая новые ссылки на статьи, остальное скачивается по большей части автоматически.

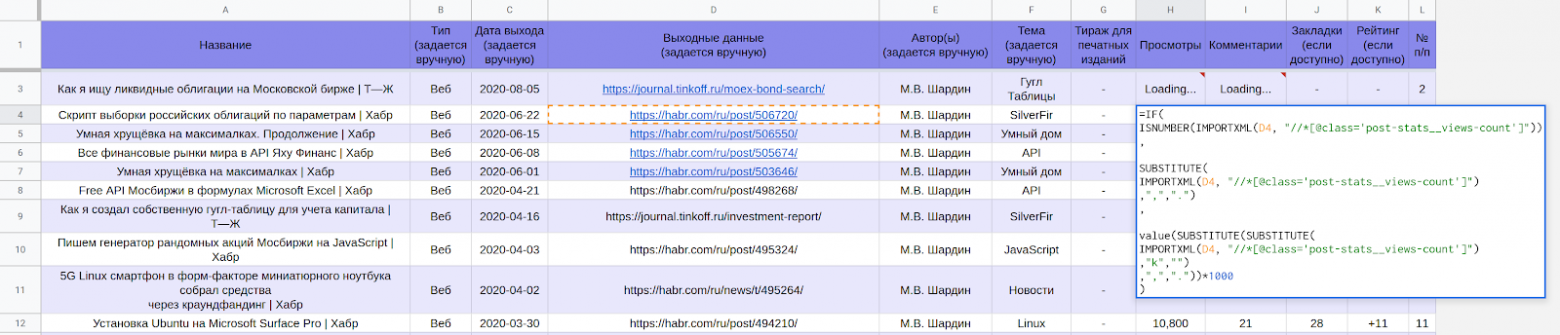

*Часть таблицы* [*LynxReport: учёт публикаций*](https://docs.google.com/spreadsheets/d/123I74Ys0WtAl6DQx8uExYC6AEbB-6w9FMQisNfmuWBo/edit#gid=0) *с исходными данными*

Актуальные данные по просмотрам и комментариям подгружаются через формулы.

Например, чтобы получить количество просмотров со страниц Хабра в ячейке гугл таблиц используется формула:

```

=IF(

ISNUMBER(IMPORTXML(D6, "//*[@class='post-stats__views-count']"))

,

SUBSTITUTE(

IMPORTXML(D6, "//*[@class='post-stats__views-count']")

,",",".")

,

value(SUBSTITUTE(SUBSTITUTE(

IMPORTXML(D6, "//*[@class='post-stats__views-count']")

,"k","")

,",","."))*1000

)

```

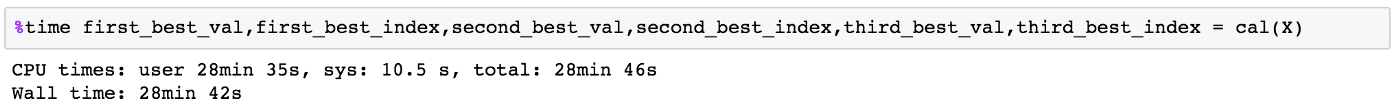

Формулы это не самый быстрый вариант и для того, чтобы получить несколько сотен позиций приходится ждать около получаса. После окончания загрузки можно видеть все цифры как на скриншоте ниже. Они дают ответы какие темы популярны, а какие нет.

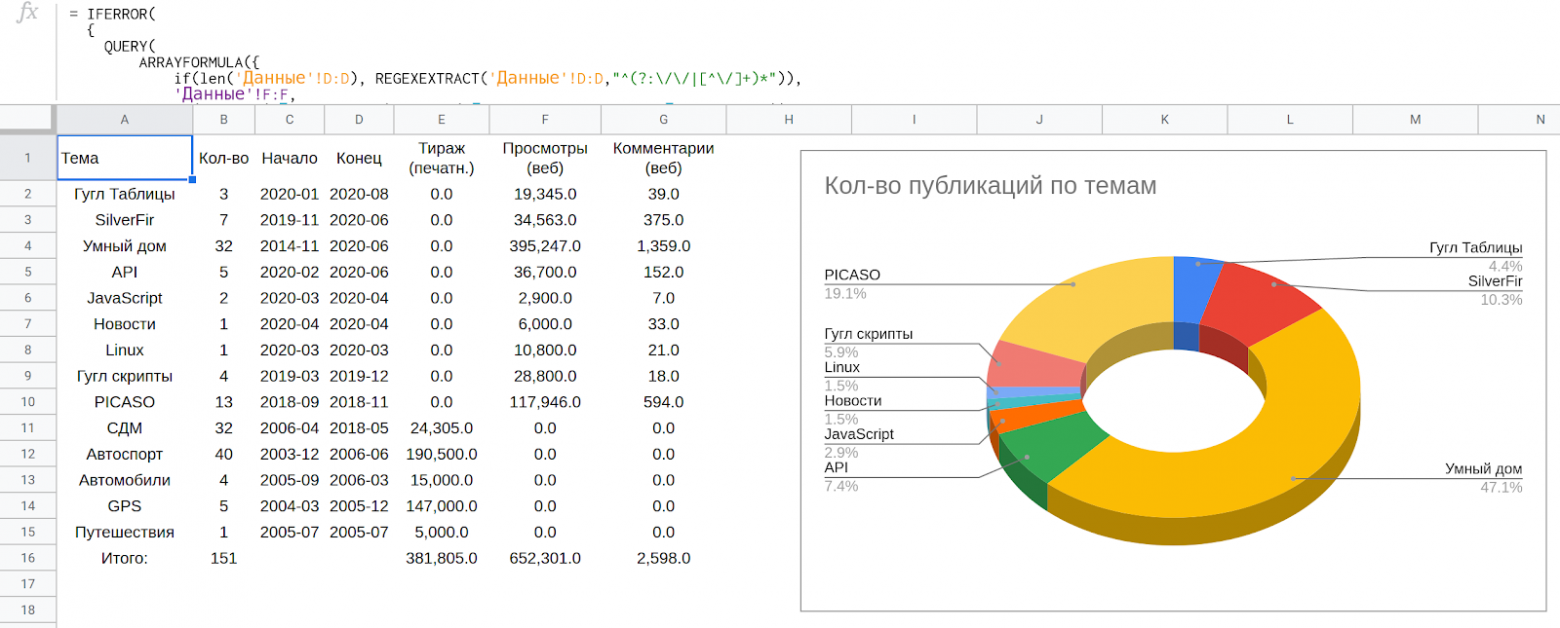

*Часть таблицы* [*LynxReport: учёт публикаций*](https://docs.google.com/spreadsheets/d/123I74Ys0WtAl6DQx8uExYC6AEbB-6w9FMQisNfmuWBo/edit#gid=0) *с аналитикой*

Считывание данных из Таблицы и преобразование в формат Google Charts

--------------------------------------------------------------------

Чтобы трансформировать эти сводные данные из гугл таблицы [в сайт-визитку](https://empenoso.github.io/) мне надо было преобразовать данные в формат [временной шкалы Google Charts](https://developers.google.com/chart/interactive/docs/gallery/timeline?hl=ru).

*Получившаяся временная шкала Google Charts* [*на сайте-визитке*](https://empenoso.github.io/)

Для того, чтобы корректно отрисовать такой график данные должны быть организованы следующим образом:

*Данные для Google Charts* [*на сайте-визитке*](https://empenoso.github.io/) *в html виде*

Чтобы выполнять все преобразования автоматически я написал под Node.js скрипт, который [доступен на GitHub](https://github.com/empenoso/LynxReport).

Если вы не знакомы с Node.js, то в своей предыдущей статье я подробно расписал как можно воспользоваться скриптом под разными системами:

1. Windows

2. macOS

3. Linux

Ссылка с [инструкциями здесь](https://habr.com/ru/post/506720/#NodeJS). Принцип аналогичен.

*Работа* [*скрипта по преобразованию в нужный формат данных и генерации pdf версий статей с сайтов*](https://github.com/empenoso/LynxReport) (все строки обрабатываются мгновенно — я специально поставил задержку, чтобы записать это видео)

Для того считывать данные из гугл таблицы в автоматическом режиме я пользуюсь [авторизацией по ключу](https://theoephraim.github.io/node-google-spreadsheet/#/getting-started/authentication?id=api-key).

Получить этот ключ можно [в консоли управления проектами гугла](https://console.cloud.google.com/apis/credentials):

*Учетные данные в Google Cloud Platform*

После завершения работы скрипта должны сгенерироваться два текстовых файла с html данными графиков и все pdf копии онлайн статей.

Данные из текстовых файлов я импортирую в html код сайта-визитки.

Генерация pdf копий статей с сайтов

-----------------------------------

При помощи [Puppeteer](https://developers.google.com/web/tools/puppeteer?hl=ru) сохраняю текущий вид статей вместе со всеми комментариями в pdf виде.

Если не ставить задержку, то несколько десятков статей по списку можно сохранить в виде pdf файлов всего за несколько минут.

А задержка нужна для того чтобы на некоторых сайтах ([например на Т—Ж](https://journal.tinkoff.ru/moex-bond-search/)) успели подгрузиться комментарии.

Результаты

----------

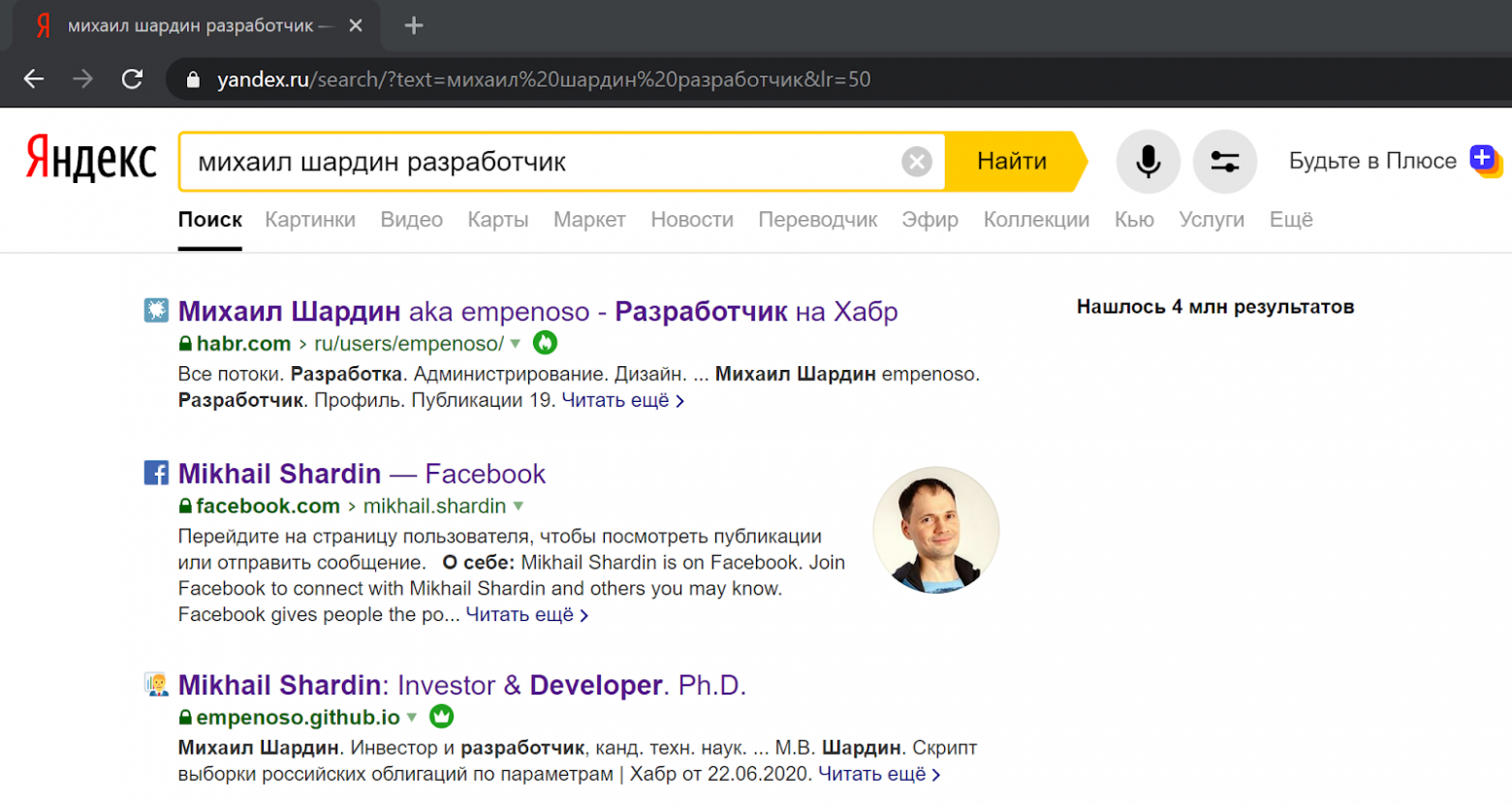

Поскольку написание скрипта затевалось с целью большего соответствия поисковым алгоритмам, то оценить результаты можно воспользовавшись поиском.

Поиск по имени и фамилии + указание специализации в обоих случаях возвращает ссылки на мои статьи и даже сайт-визитку:

В выдаче [Яндекса](https://yandex.ru/search/?text=%D0%BC%D0%B8%D1%85%D0%B0%D0%B8%D0%BB%20%D1%88%D0%B0%D1%80%D0%B4%D0%B8%D0%BD%20%D1%80%D0%B0%D0%B7%D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%87%D0%B8%D0%BA&lr=50):

В выдаче [Гугла](https://www.google.ru/search?ie=UTF-8&q=%D0%BC%D0%B8%D1%85%D0%B0%D0%B8%D0%BB%20%D1%88%D0%B0%D1%80%D0%B4%D0%B8%D0%BD%20%D0%B8%D0%BD%D0%B2%D0%B5%D1%81%D1%82%D0%BE%D1%80):

Пока что не могу решить — стоит ли регистрировать отдельное доменное имя, если визитка empenoso.github.io и так находится на верхних строчках поиска?

Вместо заключения

-----------------

1. Возможно, эта статья заставит кого-то задуматься о том, как он выглядит в интернете.

2. Возможно, эта статья поможет кому-то наладить учёт и организацию публикаций.

3. Исходный код скрипта расположен [на GitHub](https://github.com/empenoso/LynxReport).

**UPD.** Доменное имя таки зарегистрировал: <https://shardin.name/>

Автор: [Михаил Шардин](https://shardin.name/)

17 августа 2020 г.

|

https://habr.com/ru/post/515316/

| null |

ru

| null |

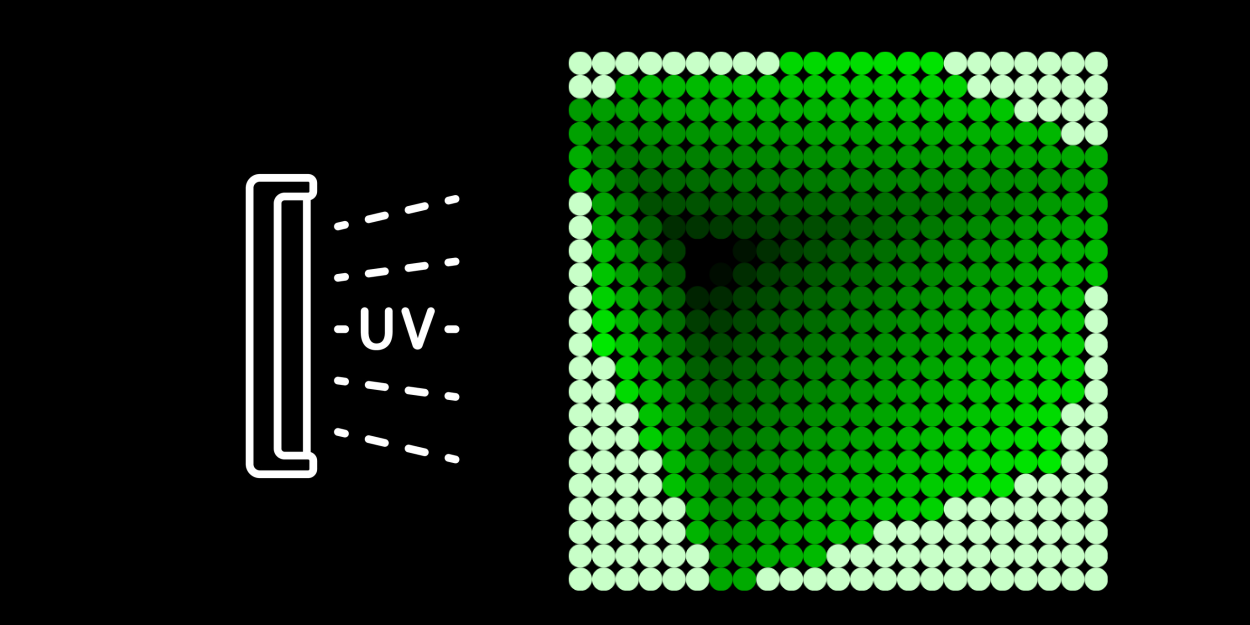

# Простая реализация FDTD на Java

**FDTD** (*Finite Difference Time Domain*) — метод конечных разностей во временной области — самый «честный» метод решения задача электродинамики от низких частот до видимого диапазона. Суть — решение уравнений Максвелла «в лоб». [Здесь](http://ru.wikipedia.org/wiki/%D0%9C%D0%B5%D1%82%D0%BE%D0%B4_%D0%BA%D0%BE%D0%BD%D0%B5%D1%87%D0%BD%D1%8B%D1%85_%D1%80%D0%B0%D0%B7%D0%BD%D0%BE%D1%81%D1%82%D0%B5%D0%B9_%D0%B2%D0%BE_%D0%B2%D1%80%D0%B5%D0%BC%D0%B5%D0%BD%D0%BD%D0%BE%D0%B9_%D0%BE%D0%B1%D0%BB%D0%B0%D1%81%D1%82%D0%B8) неплохо расписано. Особенно посмотрите сетку.

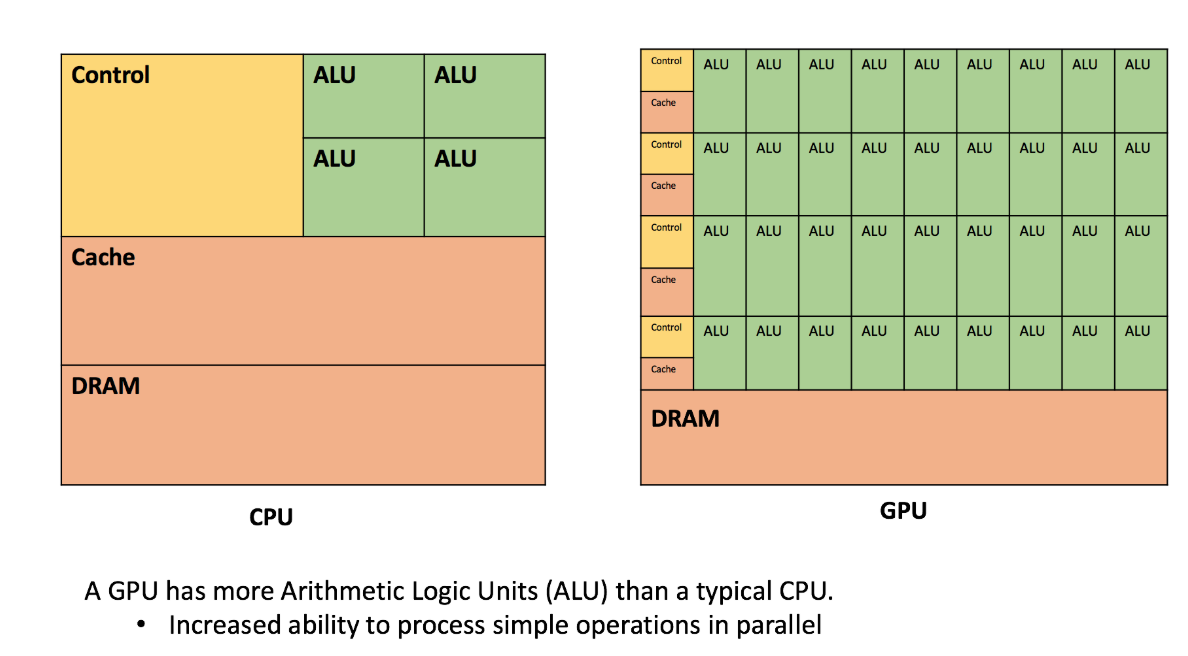

Задача решалась в двумерном случае простой явной разностной схемой. Неявные схемы я не люблю, и они требуют много памяти. Расчет с нормальной точностью требует сеток малого шага, по сравнению с более простыми методами требуется очень много времени. Поэтому максимальный упор был сделан на производительность.

Представлена реализация алгоритма на Java и C++.

Предисловие

-----------

Около шести лет основным моим языком для расчетов и мелочей был Matlab. Причина — простота написания и визуализации результата. А так как перешел я с Borland C++ 3.1, то прогресс возможностей был очевиден. (В Python я никогда не шарил, а в С++ тогда слабо).

FDTD нужен был мне для расчетов как надежный и достоверный метод. Начал изучать вопрос в 2010–11 годах. Имеющиеся пакеты или было непонятно, как использовать, или не умели то, что мне нужно. Решил написать свою программу для четкого контроля над всем. Прочитав классическую статью «*Numerical solution of initial boundary value problems involving Maxwell’s equations in isotropic media*», написал трехмерный случай, но потом упростил его до двумерного. Почему 3D — это сложно, объясню потом.

Потом максимально оптимизировал и упрощал код Matlab. После всех улучшений получилось, что сетка 2000х2000 проходится за 107 минут. На i5-3.8 ГГц. Тогда такой скорости хватало. Из полезного было то, что в Матлабе сразу шел расчет комплексных полей, и легко было показывать картинки распространения. Также все считалось на даблах, потому что на скорость Матлаба практически не влияло. Да, стандартный мой расчет — один проход света по фотонному кристаллу.

Проблемы было две. Понадобилось с высокой точностью вычислять спектры, а для этого использовать большую ширину сетки. А физическое увеличение области по обеим координатам в 2 раза увеличивает время расчета в 8 раз (размер кристалла\*время прохода).

Matlab я продолжал использовать, но стал Java-программистом. И, сравнивая производительность разных алгоритмов, **начал что-то подозревать**. К примеру, сортировка пузырьком — только циклы, массивы и сравнения — в Матлабе работает в **6 раз медленнее**, чем в С++ или Java. И этого для него еще хорошо. Пятимерный цикл для гипотезы Эйлера в Матлабе раз в 400 дольше.

Вначале принялся писать FDTD на C++. Там был встроенный std::complex. Но тогда я забросил эту идею. (В Матлабе не такие скобочки, копипаст не работал, пришлось потратить каплю времени). Сейчас проверил C++ — **комплексная математика дает потери скорости в 5 раз**. Это слишком много. В результате написал на Java.

Немного о вопросе «Почему на Java?». Детали производительности опишу потом. Если коротко — на простом не ООП коде, только арифметика и циклы — C++ с оптимизацией О3 или такой же скорости, или до +30% быстрее. Просто сейчас я лучше разбираюсь в Java, интерфейсе и работе с графикой.

FDTD – детальнее

----------------

Теперь перейдем к коду. Попытаюсь показать все, с объяснениями задачи и алгоритма. В двумерном случае система уравнений Максвелла распадается на две независимых подсистемы — ТЕ и ТМ волны. Код показан для ТЕ. Имеются 3 компоненты — электрическое поле Ez и магнитные Hx, Hy. Для упрощения время имеет размерность метров.

Изначально я думал, что от float смысла нет, так как все вычисления приводятся к double. Поэтому приведу код для double — в нем меньше лишнего. Все массивы имеют размеры +1, чтоб индексы совпадали с матрицами Матлаба (от 1, а не от 0).

Где-то в начальном коде:

```

public static int nx = 4096;// ширина области. Степень 2 для Фурье.

public static int ny = 500;// длина области

```

Основной метод:

**Инициализация начальных переменных**

```

public static double[][] callFDTD(int nx, int ny, String method) {

int i, j;// индексы для циклов

double x; //метрическая координата

final double lambd = 1064e-9; // Длина волны в метрах

final double dx = lambd / 15; // размер шага сетки. Максимум λ/10. Чем меньше, тем выше точность.

final double dy = dx; //реально в коде не используется. Ячейки квадратные

final double period = 2e-6; // поперечный период решетки фотонного кристалла

final double Q = 1.0;// специфическое отношение

final double n = 1;// минимальный показатель преломления кристалла

final double prodol = 2 * n * period * period / lambd / Q; //продольный период

final double omega = 2 * PI / lambd; // циклическая частота световой волны

final double dt = dx / 2; // шаг по времени. НЕ больше, чем по координате

final double tau = 2e-5 * 999;// время затухания источника света. Нужно для запуска коротких импульсов. Если большое, затухание незаметно.

final double s = dt / dx; //отношение шага по времени и пространству

final double k3 = (1 - s) / (1 + s);// для граничных условий

final double w = 19e-7;// полуширина гауссова пучка

final double alpha = sin(0.0 / 180 * PI);// угол лазерного пучка от нормали. В радианах.

double[][] Ez = new double[nx + 1][ny + 1];

double[][] Hx = new double[nx][ny]; // основные массивы полей

double[][] Hy = new double[nx][ny];

```

```

final int begin = 10; // координата, где пустота сменяется кристаллом. Без необходимости много не ставить.

final double mod = 0.008 * 2;//максимальная глубина модуляции диэлектрической проницаемости = 2*Δn;

final double ds = dt * dt / dx / dx;// константа для подгона систем исчисления

```

Инициализация диэлектрической проницаемости (решетка кристалла). Точнее, обратная величина с константами. Используется дискретная функция (0 или 1). Это мне кажется ближе к реальным образцам. Конечно, сюда можно написать что угодно:

```

double[][] e = new double[nx + 1][ny + 1];

for (i = 1; i < nx + 1; i++) {

for (j = 1; j < ny + 1; j++) {

e[i][j] = ds / (n + ((j < begin) ? 0 : (mod / 2) * (1 + signum(-0.1 + cos(2 * PI * (i - nx / 2.0 + 0.5) * dx / period) * sin(2 * PI * (j - begin) * dy / prodol)))));

}

}

```

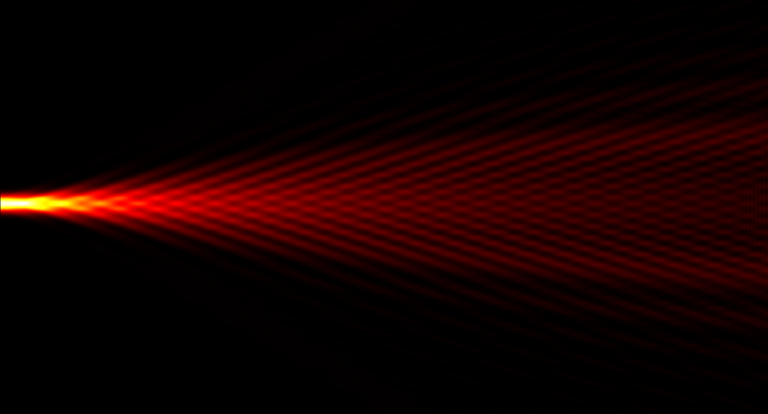

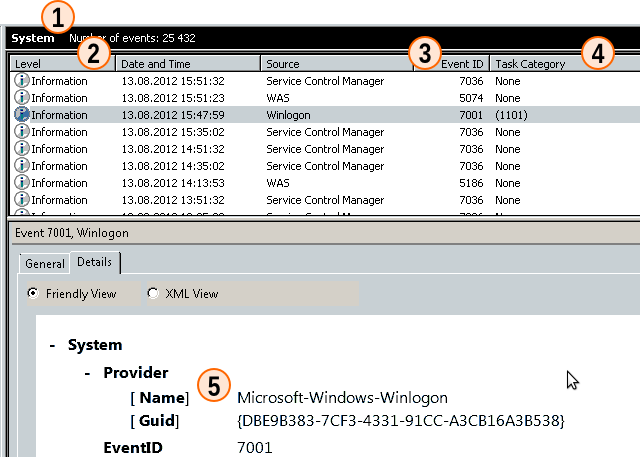

Решетка кристалла выглядит примерно так:

Массивы, используемые для граничных условий:

```

double[][] end = new double[2][nx + 1];

double[][] top = new double[2][ny + 1];

double[][] bottom = new double[2][ny + 1];

```

Предел счета по времени. Поскольку у нас шаг dt = dx / 2, стандартный коэффициент 2. Если среда плотная, или нужно идти под углом — больше.

```

final int tMax = (int) (ny * 2.2);

```

Начинаем главный цикл:

```

for (int t = 1; t <= tMax; t++) {

double tt = Math.min(t * s + 10, ny - 1);

```

Переменная tt тут учитывает ограничение скорости света, с небольшим запасом. Мы будем считать только ту область, куда свет мог дойти.

Вместо комплексных чисел я считаю отдельно две компоненты — синус и косинус. Я подумал, что для скорости лучше скопировать кусок, чем делать выбор внутри цикла. Возможно, заменю на вызов функции или лямбду.

```

switch (method) {

case "cos":

for (i = 1; i <= nx - 1; i++) {

x = dx * (i - (double) nx / 2 + 0.5); // поперечная координата в метрах

Ez[i][1] = exp(-pow(x, 2) / w / w - (t - 1) * dt / tau) * cos((x * alpha + (t - 1) * dt) * omega);

}

break;

```

**sin**

```

case "sin":

for (i = 1; i <= nx - 1; i++) {

x = dx * (i - (double) nx / 2 + 0.5);

Ez[i][1] = exp(-pow(x, 2) / w / w - (t - 1) * dt / tau) * sin((x * alpha + (t - 1) * dt) * omega);

}

break;

}

```

Тут у нас на вход области (в крайнюю левую координату) поступает гауссов луч полуширины w, под углом alpha, осцилирующий во времени. Именно так и возникает «лазерное» излучение нужной нам частоты/длины волны.

Дальше копируем временные массивы под поглощающие граничные [условия Мура](http://ieeexplore.ieee.org/document/4091495/):

```

for (i = 1; i <= nx; i++) {

end[0][i] = Ez[i][ny - 1];

end[1][i] = Ez[i][ny];

}

System.arraycopy(Ez[1], 0, top[0], 0, ny + 1);

System.arraycopy(Ez[2], 0, top[1], 0, ny + 1);

System.arraycopy(Ez[nx - 1], 0, bottom[0], 0, ny + 1);

System.arraycopy(Ez[nx], 0, bottom[1], 0, ny + 1);

```

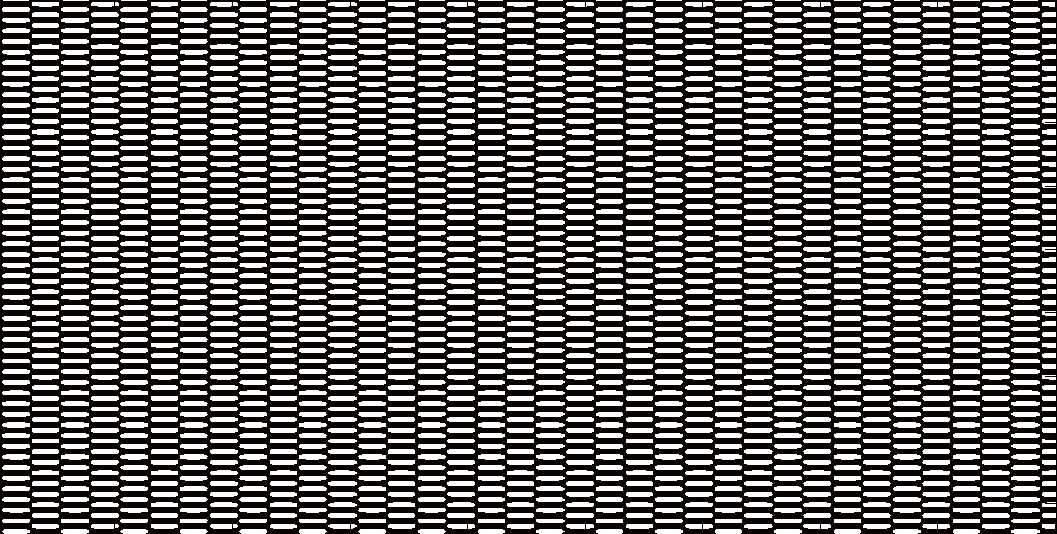

Теперь переходим к главному вычислению — следующему шагу по полю. Особенность уравнений Максвелла — изменение во времени магнитного поля зависит только от электрического, и наоборот. Это позволяет написать простую разностную схему. Исходные формулы были такие:

Все лишние константы я пересчитал заранее, заменил размерность Н, внес и учел диэлектрическую проницаемость. Поскольку оригинальные формулы для сетки, сдвинутой на 0,5, нужно не ошибиться с индексами массивов Е и Н. они разной длины — Е на 1 больше.

Цикл по области для Е:

```

for (i = 2; i <= nx - 1; i++) {

for (j = 2; j <= tt; j++) {//можно ли тут оптимизировать порядок доступа к ячейкам?

Ez[i][j] += e[i][j] * ((Hx[i][j - 1] - Hx[i][j] + Hy[i][j] - Hy[i - 1][j]));

}

}

```

А теперь наконец-то применяем граничные условия. Они нужны потому, что разностная схема не считает крайние ячейки — для них нет формул. Если ничего не делать, свет будет отражаться от стенок. Поэтому применяем метод, минимизирующий отражение при нормальном падении. Обрабатываем три стороны — верх, низ и право. Потери производительности на граничные условия около 1% (тем меньше, чем больше задача).

```

for (i = 1; i <= nx; i++) {

Ez[i][ny] = end[0][i] + k3 * (end[1][i] - Ez[i][ny - 1]);//end

}

for (i = 1; i <= ny; i++) {

Ez[1][i] = top[1][i] + k3 * (top[0][i] - Ez[2][i]);//verh kray

Ez[nx][i] = bottom[0][i] + k3 * (bottom[1][i] - Ez[nx - 1][i]);

}

```

Слева граница особая — в ней генерится луч. Также, как в прошлый раз. Просто на 1 шаг дальше по времени.

**Лазер**

```

switch (method) {

case "cos":

for (i = 1; i <= nx - 1; i++) {

x = dx * (i - (double) nx / 2 + 0.5);

Ez[i][1] = exp(-pow(x, 2) / w / w - (t - 1) * dt / tau) * cos((x * alpha + t * dt) * omega);

}

break;

case "sin":

for (i = 1; i <= nx - 1; i++) {

x = dx * (i - (double) nx / 2 + 0.5);

Ez[i][1] = exp(-pow(x, 2) / w / w - (t - 1) * dt / tau) * sin((x * alpha + t * dt) * omega);

}

break;

}

```

Осталось только посчитать магнитное поле:

```

for (i = 1; i <= nx - 1; i++) { // main Hx Hy

for (j = 1; j <= tt; j++) {

Hx[i][j] += Ez[i][j] - Ez[i][j + 1];

Hy[i][j] += Ez[i + 1][j] - Ez[i][j];

}

}

} // конец 3-мерного цикла.

```

И еще мелочи: передать конечный отрезок для вычисления преобразования Фурье — нахождения картины в дальней зоне (пространство направлений):

```

int pos = method.equals("cos") ? 0 : 1; //какую из компонент записывать

BasicEx.forFurier[pos] = new double[nx]; //там в коде массив для Фурье

int endF = (int) (ny * 0.95);// произвольная координата в конце

for (i = 1; i <= nx; i++) {

BasicEx.forFurier[pos][i - 1] = Ez[i][endF];

for (j = 1; j <= ny; j++) {

Ez[i][j] = abs(Ez[i][j]);// ABS

} //я вот сейчас понял, что брать модуль не надо - я потом беру квадарат

}

Hx = null; //я верю, что это очистит память

Hy = null;

e = null;

return Ez;

}

```

**Потом складываем квадраты двух компонент, и выводим картинку интенсивности.**

```

for (int i = 0; i < nx + 1; i++) {

for (int j = 0; j < ny + 1; j++) {

co.E[i][j] = co.E[i][j] * co.E[i][j] + si.E[i][j] * si.E[i][j];

}

}

```

Отдельно берем преобразование Фурье:

```

fft.fft(forFurier[0], forFurier[1]);

```

Поскольку в быстром Фурье не разбираюсь, взял [первый попавшийся](https://www.ee.columbia.edu/~ronw/code/MEAPsoft/doc/html/FFT_8java-source.html). Минус — ширина только степень двойки.

О производительности

--------------------

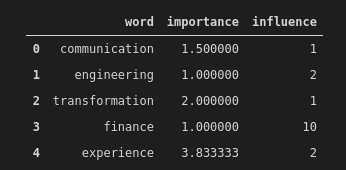

Переходим к самому интересному для меня — что хорошего мы получили, перейдя с Матлаба на Java. В Матлабе я в свое время оптимизировал все, что смог. В Java — в основном внутренний цикл (сложность n^3). У Матлаба уже учтено то, что он считает сразу две компоненты. Скорость на первом этапе (больше — лучше):

| | |

| --- | --- |

| Matlab | 1 |

| Matlab матричный | 3,4 /**5.1** (float) |

| Java double | 50 |

| C++ gcc double | 48 |

| C++ MSVS double | 55 |

| C++ gcc float | 73 |

| C++ MSVS float | 79 |

**UPD.** Добавил результат Матлаба, в котором двойные циклы заменил на вычитание матриц.

Опишем основных участников состязания.

* Matlab — 2011b и 2014. Переход на 32-битные числа дает очень малый прирост скорости.

* Java — вначале 7u79, но в основном 8u102. Мне показалось, что 8 немного лучше, но детально не сравнил.

* Microsoft VisualStudio 2015 конфигурация release

* MinGW, gcc 4.9.2 32 bit, декабрь 2014, всегда оптимизация O3. march=core i7, без AVX. AVX у меня на ноуте нет, там где есть прироста не давал.

**Тестовые машины:*** Pentium 2020m 2.4 GHz, ddr3-1600 1 канал

* Core i5-4670 3.6–3.8 GHz, ddr3-1600 2 канала

* Core i7-4771 3.7–3.9 GHz, ddr3-1333 2 канала

* Athlon x3 3.1 GHz, ddr3-1333, очень медленный контролер памяти.

2-ядерный этап

--------------

Вначале я считал ТЕ и ТМ компоненты последовательно. Кстати, это единственный вариант при нехватке памяти. Потом написал два потока — простые Runnable. Вот только прогресса была мало. Всего на 20-22% быстрее, чем 1-поточное. Начал искать причины. Потоки работали нормально. 2 ядра стабильно грузились на 100%, не давая жить ноуту.

Потом я посчитал производительность. Получилось, что она упирается в скорость оперативной памяти. Код уже работал на пределе чтения. «Пришлось» переходить на **float**. Проверка точности показала, что никаких смертельных погрешностей нет. Визуальной разницы однозначно нет. Суммарная энергия отличалась в 8 знаке. После интегрального преобразования максимум спектра — на 0,7e-6. *Возможно, дело в том, что Java все считает в 64-битной точности, и только потом преобразовывает в 32.*

Но главное — получил рывок производительности. Общий эффект от 2 ядер и перехода на float +87–102%. (Чем быстрее память и больше ядер, тем лучше прирост). Athlon x3 дал мало прироста.

Реализация на С++ аналогичная — через std::thread (смотри в конце).

Текущие скорости (2 threads):

| | |

| --- | --- |

| Java double | 61 |

| Java float | 64-101 |

| C++ gcc float | 87-110 |

| C++ gcc 6.2 64 native | 99-122 |

| Visual Studio | 112-**149** |

(новые компиляторы дают очень высокую, по сравнению с Java, производительность на 16384. Java и GCC-4.9 32 при этом проваливаются).

Все оценки проводились для однократного запуска расчета. Потому-что, если повторно запускать из GUI, не закрывая программу, дальше скорость возрастает. Имхо, jit-оптимизация рулит.

4-ядерный этап

--------------

Мне казалось, что еще есть куда ускоряться. Я принялся за 4-поточный вариант. Суть — область делится пополам и считается в 2 потоках, вначале по Е, потом по Н.

Вначале написал его на Runnable. Получилось ужасно — ускорение было только для очень большой ширины области. Слишком большие затраты на порождение новых потоков. Потом освоил java.util.concurrent. Теперь у меня был фиксированный пул потоков, которым давались задания:

```

public static ExecutorService service = Executors.newFixedThreadPool(4);

//……

cdl = new CountDownLatch(2);

NewThreadE first = new NewThreadE(Ez, Hx, Hy, e, 2, nx / 2, tt, cdl);

NewThreadE second = new NewThreadE(Ez, Hx, Hy, e, nx / 2 + 1, nx - 1, tt, cdl);

service.execute(first);

service.execute(second);

try {

cdl.await();

} catch (InterruptedException ex) {

}

```

**И для Н:**

```

cdl = new CountDownLatch(2);

NewThreadH firstH = new NewThreadH(Ez, Hx, Hy, 1, nx / 2, tt, cdl);

NewThreadH secondH = new NewThreadH(Ez, Hx, Hy, nx/2+1, nx-1, tt, cdl);

service.execute(firstH);

service.execute(secondH);

try {

cdl.await();

} catch (InterruptedException ex) {

}

```

Внутри потока выполняются пол цикла.

**class NewThreadE**

```

public class NewThreadE implements Runnable {

float[][] Ez;

float[][] Hx;

float[][] Hy;

float[][] e;

int iBegin;

int iEnd;

float tt;

CountDownLatch cdl;

public NewThreadE(float[][] E, float[][] H, float[][] H2, float[][] eps,

int iBegi, int iEn, float ttt, CountDownLatch cdl) {

this.cdl = cdl;

Ez = E;

Hx = H;

Hy = H2;

e = eps;

iBegin = iBegi;

iEnd = iEn;

tt = ttt;

}

@Override

public void run() {

for (int i = iBegin; i <= iEnd; i++) { // main Ez

for (int j = 2; j <= tt; j++) {

Ez[i][j] += e[i][j] * ((Hx[i][j - 1] - Hx[i][j] + Hy[i][j] - Hy[i - 1][j]));

}

}

cdl.countDown();

}

}

```

Аналогичный класс для Н — просто другие границы и свой цикл.

Теперь прирост от 4 потоков есть всегда — от 23 до 49% (.jar). Чем меньше ширина, тем лучше — судя по скорости, мы влезаем в кеш-память. Наибольшая польза будет, если считать длинные узкие задачи.

| | |

| --- | --- |

| Java float 4потока | 86–151 |

| C++ gcc float 4потока | 122–162 (ближе 128) |

| C++ gcc 6.2 64 native | 124–173 |

| Visual Studio | 139–183 |

Реализация на С++ пока содержит только простые std::thread. Поэтому для нее чем шире, тем лучше. Ускорение С++ от 5% при ширине 1024 до 47% на 16384.

**UPD.** **Добавил результаты GCC 6.2-64 и VisualStudio.** VS быстрее старого GCC на 13–43%, нового на 3–11%. Главные фишки 64-битных компиляторов — более быстрая работа на широких задачах. Также, поскольку Java лучше распараллеливается на малых задачах (кеш), а С++ на широких — на широких задачах Visual Studio на 61% быстрее Джавы.

Как мы видим, в самом лучшем случае прирост Java 49% — как почти 3 ядра. Поэтому имеем забавный факт — при малых задачах лучше всего ставить newFixedThreadPool(3);

Для больших — по количеству потоков в процессоре — 4 или 6-8. Укажу еще забавный факт. На Атлоне х3 был очень слабый прогресс от перехода на float и 2 потоков — 32% от обеих оптимизаций. Прирост от «4»-ядерного кода на С++ также невелик — 67% между 1 и 4 ядрами (оба float). Списывать можно на медленный контролер памяти и 32-битную Винду.

Но 4-ядерный Java-код отработал отлично. При 3 потоках Екзекутора +50,2% от 2-ядерной версии для больших задач. Почему-то худшая 2-ядерная реализация усилилась максимально возможной многоядерной.

Последнее замечание по 4-ядерному коду в Java. Текущие затраты времени:

| | |

| --- | --- |

| Основные 2-мерные циклы Е и Н | 83% |

| Прочее, считая начальную инициализацию всего | 16% |

| Порождение (4) потоков | Около 1% (0,86 по профилировщику) |

Я постарался максимально оптимизировать основные циклы, думая что остальное тратит мало времени.

Выкладываю также полный код 4-ядерного случая на С++:

**.cpp**

```

#include

#include

#include

#include

#include

using namespace std;

void thE (float\*\* &Ez, float\*\* &Hx, float\*\* &Hy, float\*\* &e,

int iBegin, int iEnd, int tt)

{

for (int i = iBegin; i <= iEnd; i++) // main Ez

{

for (int j = 2; j <= tt; j++)

{

Ez[i][j] += e[i][j] \* ((Hx[i][j - 1] - Hx[i][j] + Hy[i][j] - Hy[i - 1][j]));

}

}

}

void thH (float\*\* &Ez, float\*\* &Hx, float\*\* &Hy,

int iBegin, int iEnd, int tt)

{

for (int i = iBegin; i <= iEnd; i++)

{

for (int j = 1; j <= tt; j++)

{

Hx[i][j] += Ez[i][j] - Ez[i][j + 1];

Hy[i][j] += Ez[i + 1][j] - Ez[i][j];

}

}

}

void FDTDmainFunction (char m)

{

//m=c: cos, else sin

int i,j;

float x;

const float dx=0.5\*1e-7/1.4;

const float dy=dx;

const float period=1.2e-6;

const float Q=1.5;

const float n=1;//ne используется в Эпсилон матрице пока =1

const float lambd=1064e-9;

const float prodol=2\*n\*period\*period/lambd/Q;

const int nx=1024;

const int ny=700;

float \*\*Ez = new float \*[nx+1];

for (i = 0; i < nx+1; i++)

{

Ez[i] = new float [ny+1];

for (j=0; j

```

delete[] пока нет, потому что нужно же результат где-то использовать :)

Это самый простой код, без нормальной решетки и граничных условий. Интересно, **можно ли в С++ эффективнее объявлять 2-мерные массивы и вызывать потоки?**

### 8 ядер

А больше ядер у меня нет. Если бы мои задачи не упирались в память, делил бы дальше. Вроде, ThreadPool дает малые затраты. Или переходить на Fork-Join Framework.

Я мог бы проверить — отказаться от первых двух потоков, и делить одну задачу на 4-8 кусков на i7. Но смысл будет, только если кто-то протестирует на машине с быстрой памятью — DDR-4 или 4 канала.

Лучший способ избавиться от нехватки скорости памяти — видеокарты. Переходить на Cuda мне мешает брат, который запрещает обновлять видеодрайвер (незнание С и Cuda).

Итог и послесловия

------------------

Я могу быстро решить любую нужную мне 2-мерную задачу с хорошей точностью. Сетка 4096х2000 проходится на 4-ядернике за 106 секунд. Это будет 300 микрон х 40 слоев — максимальные образцы у нас.

В 2D при 32-битной точности требуется немного памяти — 4байта\*4массива\*2 комплексных компоненты = 32 байта / пиксель в худшем случае.

**В 3D все намного хуже.** Компонент уже шесть. Можно отказаться от двух потоков — считать компоненты последовательно и писать на винт. Можно не хранить массив диэлектрической проницаемости, а считать в цикле или обойтись очень маленьким периодическим участком. Тогда в 16 ГБ оперативы (максимум у меня на работе) влезет область 895х895х895. Это будет нормально «чтоб посмотреть». Зато считаться будет «всего» 6–7 часов один проход. Если задачу хорошо поделится на 4 параллельных потока. И если пренебречь вычислением ε.

Только для спектра мне не хватит. При ширине 1024 я не вижу необходимые детали. Нужно 2048. А это 200+ ГБ памяти. Поэтому трехмерный случай — это сложно. Если не разрабатывать код с кеширующими ССД.

**P.S.** Оценки скорости были довольно приблизительные. Я проверял Матлаб только на малых задачах. Сейчас проверил Java — задачу 2048\*1976 (аналог 2000\*2000) на 4-ядернике. Время расчета 45,5 секунд. Ускорение от Матлаба **141 раз** (точно).

#### Возможные планы на будущее:

\*) Проверить скорость чистого С (не ++). По benchmarksgame он всегда быстрее.

1) Проверить комплексные классы в С и Java. Может, в С они реализованы достаточно быстро. Правда, боюсь, все они будут больше 8 байт.

2) Закинуть все 2- и 4-ядерные версии в MSVS, найти настройки оптимизации.

3) Проверить, могут ли лябмды/стримы ускорить основной цикл или дополнителные.

4) Сделать нормальный GUI для выбора всего и визуализации результатов.

99) Написать Cuda-версию.

Если кому-то интересно, опишу FDTD и другие методы рассчетов, фотонные кристаллы.

На Github выложил 2 версии:

1) [2-поточная с зачатками интерфейса](https://github.com/VolodymyrKoliadenko/FDTD-2threads) выбора параметров

2) [4-поточная](https://github.com/VolodymyrKoliadenko/FDTD_4_threads)

Обе рисуют картинку и спектр. Просто пока пиксель в пиксель — не берите ширину выше 2048. Еще умеют принимать размеры области из консоли.

|

https://habr.com/ru/post/319216/

| null |

ru

| null |

# Новости из мира OpenStreetMap № 510 (21.04.2020-27.04.2020)

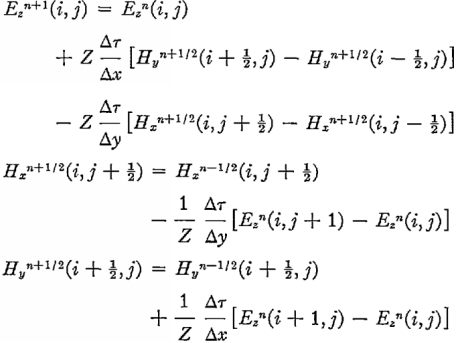

Последние слоги в названиях немецких городов и деревень [1](#wn510_22349) | [Tobias Kauer](https://github.com/tobiaskauer/the-end-is-near) | map data [OpenStreetMap contributors](https://wiki.osmfoundation.org/wiki/Licence/Licence_and_Legal_FAQ#How_should_I_attribute_you.3F)

Картографирование

-----------------

* Пользователь alexkemp в своем блоге подробно [рассказал](https://www.openstreetmap.org/user/alexkemp/diary/392796), как он картирует в OSM школы, состоящие из нескольких зданий и огромной прилегающей территорией. На примере школы [Heath Mount](https://www.openstreetmap.org/relation/11018342#map=17/51.85404/-0.08814) в Хартфорде (Англия), он описывает этапы отрисовки в редакторе JOSM.

* Российский пользователь CupIvan [сделал](https://osm.cupivan.ru/russian_post/#505/?z=12&lat=56.21978220572216&lon=43.47358703613281) валидатор, который показывает на карте почтовые отделения. Оранжевым цветом обозначаются те, которые внесены в OSM с ошибкой или в неполном объеме, синим — все ок. Он предлагает всем [присоединиться](https://www.openstreetmap.org/user/CupIvan/diary/392846) к его маленькой картоакции и привести к единому виду все почтовые отделения России.

* Андре Банчиу из картографической команды компании Telenav [сообщила](https://lists.openstreetmap.de/pipermail/frankfurt/2020-April/000114.html), что в скором времени планируют улучшить дорожный граф двух немецких городов: Франкфурта и Рюссельхайма. Они хотят актуализировать разметку улиц, ограничение поворотов и геометрию дорог. Поэтому она просит сообщество OSM помочь им с контактами местных картографов и источниками данных.

Сообщество

----------

* Существует множество мест в интернете, где общаются участники OSM. Один из наших читателей сообщил, что количество подписчиков [discord](https://discordapp.com/)-канала «OSM World» более 1 тыс человек. Хотите присоединиться к нему? Вот специальная [ссылка](https://discordapp.com/invite/SRZUYUz) для этого.

* Пользователь Rohubi в своем посте [анализирует](https://www.openstreetmap.org/user/Robhubi/diary/392875) различия между профилями рельефа одних и тех же велосипедных маршрутов, которые выдают различные соответствующие онлайн-сервисы, берущих частично данные из OSM, а частично из наборов данных о рельефе. Особенно заметно, что профили маршрутов на сервисе [Waymarked Trails](http://waymarkedtrails.org) четко [сглаживаются](https://cycling.waymarkedtrails.org/help/rendering/elevationprofiles), что связано с использованием модели данных высот ASTER второй версии.

* Российский пользователь Zkir сделал [видеообзор](https://www.youtube.com/watch?v=M78057UUDVg) мобильного приложения StreetComplete, с помощью которого можно улучшать OSM со смартфона.

Фонд OpenStreetMap

------------------

* В свободный доступ выложены [повестка дня](https://wiki.osmfoundation.org/wiki/Board/Minutes/2020-03-F2F), [задачи](https://wiki.osmfoundation.org/wiki/Board/Minutes/2020-03-F2F/Action_Items) каждого члена Совета Фонда OSM и части протокола заседания Совета Фонда OSM от 21 и 22 марта 2020 года. Особое внимание уделите [протоколу](https://wiki.osmfoundation.org/wiki/Board/Minutes/2020-03-F2F/Dialogue_with_OSM_System_Administrators) беседы с системными администраторами.

* Выложены протоколы заседаний следующих рабочих групп Фонда OSM:

+ [Рабочей группы по инфраструктуре](https://wiki.osmfoundation.org/wiki/Operations/Minutes/2020-04-10) от 10 апреля

+ [Рабочей группы по инженерии](https://wiki.osmfoundation.org/wiki/Working_Group_Minutes/EWG_2020-04-16) от 16 апреля

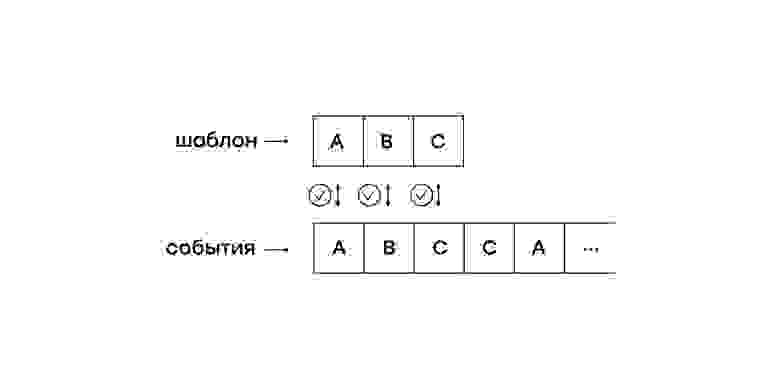

* Пользователь SunCobalt [обратил](https://www.openstreetmap.org/user/SunCobalt/diary/392827) внимание на тот факт, что в OSM, как проекте, постепенно накапливается все больше и больше различных правил, политик, условий использования и пр. — их уже столько, что обычному человеку весьма затруднительно все их прочитать.

События

-------

* Ежегодное собрание австрийской ассоциации OSM [состоится](https://www.openstreetmap.at/2020/04/mitgliederversammlung-2020/) 7 мая 2020 года в онлайне в мессенджере Jitsi. К участию в мероприятии приглашаются лица, не являющиеся членами ассоциации.

Карты

-----

* Новости о французском сервисе Ça reste ouvert (на нем можно увидеть какие места открыты даже во время карантина в связи с COVID-19):

+ Его копия запущена на 15 языках, включая [каталанский и галисийский](https://twitter.com/osmgalicia/status/1254070504333467652?s=19)

+ Возможно выбрать организацию из списка, а также указать подкатегорию;

+ также есть мобильное приложение на [Android](https://play.google.com/store/apps/details?id=com.transway.caresteouvert) и [iOS](https://apps.apple.com/fr/app/%C3%A7a-reste-ouvert/id1506199151) с инструкциями на английском, французском и немецком языке, но в любом случае поддерживающее все 15 языков;

+ появилась возможность добавить данные о наличии масок и дезинфицирующих средств для рук в аптеках и других магазинах, однако эти данные не импортируются в OSM, поскольку ожидается, что они будут регулярно меняться; эта функция полезна для стран, где маски являются обязательными..

* Эрик Гандерсен (генеральный директор компании Mapbox) в [статье](https://blog.mapbox.com/alternate-care-sites-to-expand-bed-capacity-in-los-angeles-mapped-by-urbanfootprint-eb2551b7622d) на Medium «Альтернативные площадки по уходу за больными для расширения койко-мест в Лос-Анджелесе, нанесенные на карту UrbanFootprint» рассказывает о ряде карт, созданных [UrbanFootprint](https://urbanfootprint.com/) для борьбы с COVID-19.

* Пользователь Dhelfer сообщил в эльзасском [списке рассылки](http://listes.openstreetmap.fr/wws/arc/local-alsace/2020-04/msg00002.html) и [Twitter](https://twitter.com/d_helfer/status/1252882904545284114) о том, что появился tile-сервер, названия на котором выполнены на эльзасском диалекте.

* Австрийский пользователь gsa [сделал](https://nuntius35.gitlab.io/pharmacies/) карту, на которой отображается аптеки, а также то, что использует на своих сайтах такие термины, как «гомеопатия», «соли Шюсслера» или "[Цветы Баха](https://en.wikipedia.org/wiki/Bach_flower_remedies)", т. е. немецкие слова Homöopathie, Schüsslersalze, Bachblüten, которые он называет коллективно «эзотерическими».

Переходим на OSM

----------------

* Министр внутренних дел Украины Арсен Аваков [опубликовал](https://twitter.com/AvakovArsen/status/1252135265063383041) карту облетов пожаров в зоне отчуждения Чернобыльской АЭС. Карта сделана на основе OSM.

* Facebook сделал [карту](https://covid-survey.dataforgood.fb.com/) распространения COVID-19 в США. В качестве подложки используется OSM.

* Сервис измерения скорости в интернете SpeedTest сделал [карту](https://www.speedtest.net/ookla-5g-map) внедрения сетей 5G в мире. В качестве подложки используется OSM.

Программирование

----------------

* Иван Бегтин [разработал](https://github.com/datacoon/undatum) инструмент для обработки данных с помощью командной строчки undatum. Утилита позволяет конвертировать, разбивать, рассчитывать частоту, статистику и проверять данные в CSV, JSON и BSON файлах.

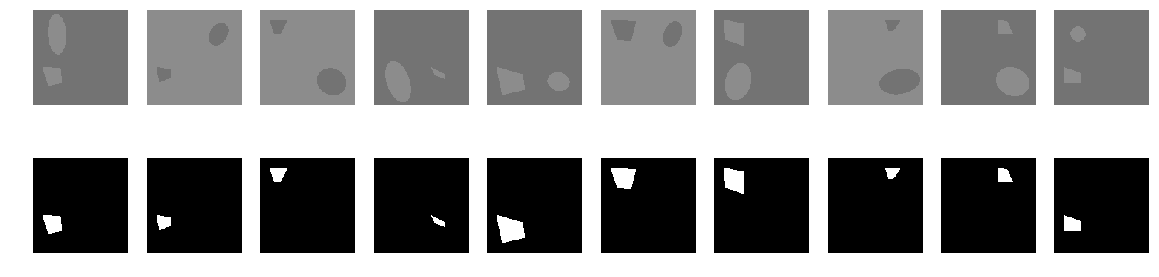

* Рори МакКен рассказал в своем [блоге](https://www.openstreetmap.org/user/%E1%9A%9B%E1%9A%8F%E1%9A%92%E1%9A%90%E1%9A%94%E1%9A%8F%E1%9A%94%E1%9A%8B%E1%9A%9C%20%F0%9F%8F%B3%EF%B8%8F%E2%80%8D%F0%9F%8C%88/diary/392855) о программном [обеспечении](https://www.technomancy.org/openstreetmap/heatmaps/), созданном им для создания тепловых карт на основе данных OSM. В своем посте он показывает его возможности, на примере карт сделанных на основе тега `sport=*`.

Релизы

------

* Вышла новая версия сервиса [Maputnik 1.7.0](https://maputnik.github.io/blog/2020/04/23/release-v1.7.0). О новых функциях можно прочитать в блоге.

Знаете ли вы …

--------------

* … о сервисе [Procedural City Generator](https://probabletrain.itch.io/city-generator), который создает вымышленные города в американском ортогональном стиле.

* … о сервисе [MapCraft](https://mapcraft.nanodesu.ru/)? Это [инструмент](https://wiki.openstreetmap.org/wiki/RU:MapCraft), который позволяет проводить акции по совместному картированию в OSM и не только.

* … о движении "[Картографы ООН](https://wiki.openstreetmap.org/wiki/Unite_Maps_Initiative/UN_Mappers)"? Оно появилось не так давно, но его участниками уже стали многие картографы, которые помогают ООН в реализации ее миротворческих и гуманитарных акций. Они картируют в OSM развивающиеся страны, тем самым помогают в обеспечении [повседневной деятельности](https://wiki.openstreetmap.org/wiki/Unite_Maps_Initiative) ООН в этих странах. [Задания](https://wiki.openstreetmap.org/wiki/Unite_Maps_Initiative/UN_Mappers#Mapathons_and_Events) от «Картографов ООН» можно найти в Менеджере задач HOT в разделе «UN Mappers».

OSM в СМИ

---------

* Кайли Фой из Массачусетского технологического института [сообщил](https://techxplore.com/news/2020-04-lidar-artificial-intelligence-road-status.html) о тестировании бортовой платформы [Lidar](https://ru.wikipedia.org/wiki/%D0%9B%D0%B8%D0%B4%D0%B0%D1%80) в паре с алгоритмами искусственного интеллекта для определения состояния дорог после катастрофы с целью прокладки таких маршрутов, которые бы учитывали и обходили разрушенные участки дорог. Идентифицированная сеть дорог с распознанными аномалиями объединена с OpenStreetMap для создания полезной сети для планирования маршрутов.

Другие «гео» события

--------------------

* Степень развития сети пешеходных дорожек или, как их еще называют тротуаров, оказывает значительное влияние на то, насколько легким может быть соблюдение правила социальной дистанции между людьми во время пандемии коронавируса. На данный момент есть две карты, которые показывают ширину тротуаров в [Нью-Йорк](https://twitter.com/tranopticon/status/1252219107790987264) и [Париж](https://twitter.com/Lelievre_Adrien/status/1252650394808987648). Во многих районах обоих городов большинство тротуаров слишком узки и не позволяют пешеходам сохранять между собой необходимую дистанцию (1,5-2 метра или 6 футов). Исторически сложилось так, что картографирование ширины тротуаров в OSM было уделом весьма малочисленной группы лиц. Настало время это исправить и собрать нужную информацию.

* Картограф Дэниел Хаффман написал в своем [блоге](https://somethingaboutmaps.wordpress.com/2020/04/13/an-atlas-of-north-american-rivers/) о только что завершенном проекте «Атлас североамериканских рек» — интересном атласе основных рек США, Мексики и Канады.

* Сайт Citylab [попросил](https://www.citylab.com/life/2020/04/neighborhood-maps-coronavirus-lockdown-stay-at-home-art/610018/) своих читателей нарисовать карты тех миров, которые им доступны во время изоляции в связи с коронавирусом. Они нарисовали тесные планы квартир, прогулки по всем санитарным правилам и людей, которых им не хватает.

* Роджер Кейн [опубликовал](https://talkinghumanities.blogs.sas.ac.uk/2020/04/09/how-we-make-maps-and-why-the-university-of-chicago-press-history-of-cartography-1987-2024/) в журнале Talking Humanities статью ‘Как мы делаем карты и почему", посвященную истории картографии. Он ссылается на страницу проекта "[История картографии](https://geography.wisc.edu/histcart/)", где вы можете найти ссылки на книги, начиная с «картографии в доисторическое, древнее и средневековое время» и заканчивая «картографией в двадцатом веке».

* [1] «Конец близок» — это часто (неправильно) употребляемая фраза. На этот раз Тобиас Кауэр использовал этот термин для названия своей [карты](https://tobiaskauer.org/projects/end/), на которой показаны последние слоги немецких названий городов и деревень. Исходный код [доступен](https://github.com/tobiaskauer/the-end-is-near) на GitHub.

* 20 апреля 2020 года в ряде городов России [прошли](https://takiedela.ru/news/2020/04/20/miting-onlayn/) онлайн-митинги, на которых граждане выразили свое недовольство относительно политики, проводимой правительством. Граждане митинговали в мобильном приложении Яндекс.Навигатор. Они оставляли сообщения со своими требования на карте возле зданий, где находятся органы власти.

---

Общение российских участников OpenStreetMap идёт в [чатике](https://t.me/ruosm) Telegram и на [форуме](http://forum.openstreetmap.org/viewforum.php?id=21). Также есть группы в социальных сетях [ВКонтакте](https://vk.com/openstreetmap), [Facebook](https://www.facebook.com/openstreetmap.ru), но в них в основном публикуются новости.

[Присоединяйтесь к OSM!](https://www.openstreetmap.org/user/new)

---

Предыдущие выпуски: [509](https://habr.com/ru/post/500250/), [508](https://habr.com/ru/post/499044/), [507](https://habr.com/ru/post/497838/), [506](https://habr.com/ru/post/496754/), [505](https://habr.com/ru/post/495706/)

|

https://habr.com/ru/post/501254/

| null |

ru

| null |

# Создание Telegram бота на PHP #1: основные понятия для работы с API

Всем привет, это первый урок из курса по разработке ботов для Telegram. В данном курсе, мы с вами разберём как создавать ботов для Telegram на PHP. Я расскажу вам как отправлять текстовые сообщения, как отправлять файлы, как получать и обрабатывать сообщения от пользователей и по итогу мы с вами напишем скрипт для быстрого создания бота для Telegram на PHP.

В первом уроке мы с вами рассмотрим основные понятия связанные с API. Я вам расскажу что такое API методы, хуки, покажу на примере Telegram построение URL для создания запросов и расскажу о том как создаются простые API запросы на PHP.

Полный список всех записей курса находится [на сайте](https://prog-time.ru/course_cat/telegram-bot-basic/) или [в публикациях на Хабр](https://habr.com/ru/users/Prog-Time/posts/).

Для отправки и получения запросов через API, вам лучше использовать виртуальный хостинг, так как локальный хостинг не сможет получать данные через хуки.

### Основные понятия

Давайте рассмотрим основные понятия для работы с API.

**API (Application Programming Interface)** — это набор способов и правил, по которым различные программы общаются между собой и обмениваются данными.

**Метод API** — это определённое действие, которое должно выполнить приложение основываясь на полученных данных (отправить сообщение, вернуть список чатов, отправить картинку и т.д.)

**Token (токен)** — это уникальный ключ бота, необходимый для отправки запросов.

### Как отправлять HTTP запросы на PHP

Для отправки HTTP запросов можно использовать функцию **file\_get\_contents()**, где в качестве первого главного параметра указывается ссылка. Данная функция отлично подходит для отправки GET запросов, но к сожалению с помощью функции **file\_get\_contents()** нельзя отправлять POST запросы и поэтому для отправки POST запросов мы будем использовать библиотеку Curl.

**Curl**— это библиотека предназначенная для получения и передачи данных через такие протоколы, как HTTP, FTP, HTTPS.

Подробнее о Curl вы можете почитать [на моём сайте](https://prog-time.ru/parsing-php-ottachivaem-curl/).

### Виды взаимодействия с приложением через API

Существует 2 вида взаимодействия с приложением через API. Первое это от**клиента к серверу**, а второе от **сервера к клиенту**. **Клиентом**в данном случае является ваше приложение (сайт), а в качестве **сервера**выступает сайт на который вы отправляете запросы (в нашем случае, это Telegram).

**API запрос** — это способ общения с программой, по средствам отправки данных от **клиента**— **серверу**.

**Hooks (Хуки)** — это способ общения с программой, по средствам отправки данных от **сервера**— **клиенту**. То есть при определённых изменениях в программе, сервер (приложение) будет отправлять данные на указанный скрипта клиента.

### Документация для работы с API Telegram

Все методы и параметры для запросов вы можете найти в официальной документации Telegram.

Telegram Bot API — <https://core.tlgr.org/bots/api>

К данному сайту мы будем ссылаться на протяжение всего курса.

### Работа с документацией для Telegram

Документация для создания Telegram ботов разделена на несколько разделов.

В разделе **Recent changes** вы можете найти информацию об обновлениях Telegram. Здесь описаны версии и нововведения которые были внесены в функционал мессенджера.

Разделы **Authorizing your bot** и **Making requests** описывают способы авторизации ботов и способы создания запросов для работы с ботами.

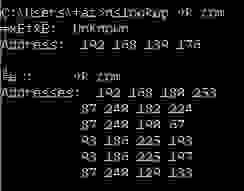

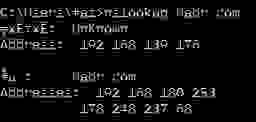

Раздел **Getting updates** описывает способы получения обновлений взаимодействия с ботами. При взаимодействие пользователя с ботов, все его действия, по стандарту, записываются на сервера Telegram, и для того чтобы получить к ним доступ, необходимо отправить запрос **getUpdates**.

Отправив запрос **getUpdates** вы можете получить id последнего пользователя который написал боту, узнать его ник, текст сообщения и дату отправки. Если бот добавлен в сообщество, то вы можете получить id сообщества.

В разделе **Getting updates** так же описаны правила настройки хуков, что позволяет отправлять любые изменения на сервер разработчика. Но об этом мы поговорим позднее, сейчас давайте продолжим знакомство с документацией.

Следующий раздел, который нас интересует называется — **Available types**. Данный раздел описывает все типы данных которые возвращает нам Telegram. Когда ваш скрипт отправляет запрос, то обработав его, Telegram вернёт вам ответ в формате JSON строки, в котором описаны специальные параметры.

Например если вы отправляете сообщение, то Telegram вернёт вам массив в котором указаны id созданного сообщения, id пользователя, дата создания сообщения и много другое. Все эти данные вы можете разобрать и записать в базу данных.

Далее описан раздел, с которым нам придётся работать больше всего — это **Available methods**, методы для взаимодействия с ботом. Советую вам пройтись по всем методам и изучить все возможности работы с ботами.

Вкратце скажу что здесь описаны методы для отправки сообщений, файлов, изображений и многое другое. Все методы имеют понятные названия и описанные параметры, что позволяет легко читать документацию, даже без знания английского языка.

Ну и в конце у нас описаны методы для работы со стикерами, играми в Telegram, методы для работы с оплатой в Telegram.

### Структура URL для отправки запросов в Telegram

API Telegram имеет простую и понятную структуру урлов для отправки запросов.

Вот пример URL для создания запросов к боту:

```

https://api.telegram.org/bot{token}/{method}

```

**{token}** — это уникальный ключ, который выдаётся при создание бота;

**{method}** — это метод запроса по которому мы будем получать или отправлять определённые данные. В зависимости от названия метода, мы будем выполнять разные действия.

### Примеры URL для запросов

Данные примеры используются только для наглядности построения URL, токен указанный в URL не привязан ни к одному боту!

Вот так выглядит отправка сообщений методом GET. Первая часть URL содержит домен **api.telegram.org**, далее прописываем строку bot с токеном который нам даётся при создание бота, после чего указываем метод **sendMessage**и перечисляем GET параметры.

```

https://api.telegram.org/bot546445612928:AAHjk6643OYgWHim_TICgsaF9NDDVXYnKzA/sendMessage?chat_id=&text=

```

Отправка файлов в чат выглядит аналогично, только метод **sendMessage**заменяется на **sendDocument**. И здесь не перечисляются GET параметры, после указания метода, так как мы отправляем данные методом POST.

```

https://api.telegram.org/bot543264456928:AAHjk6643OYgWHim_TICgsaF9NDDVXYnKzA/sendDocument

```

Отправка изображений в чат:

```

https://api.telegram.org/bot546413456928:AAHjk6643OYgWHim_TICgsaF9NDDVXYnKzA/sendPhoto

```

На этом знакомство с документацией Telegram заканчивается. В следующем уроке, мы с вами создадим первого бота и попробуем отправить простые запросы.

Второй урок уже на Хабре - <https://habr.com/ru/post/697000/>

|

https://habr.com/ru/post/696864/

| null |

ru

| null |

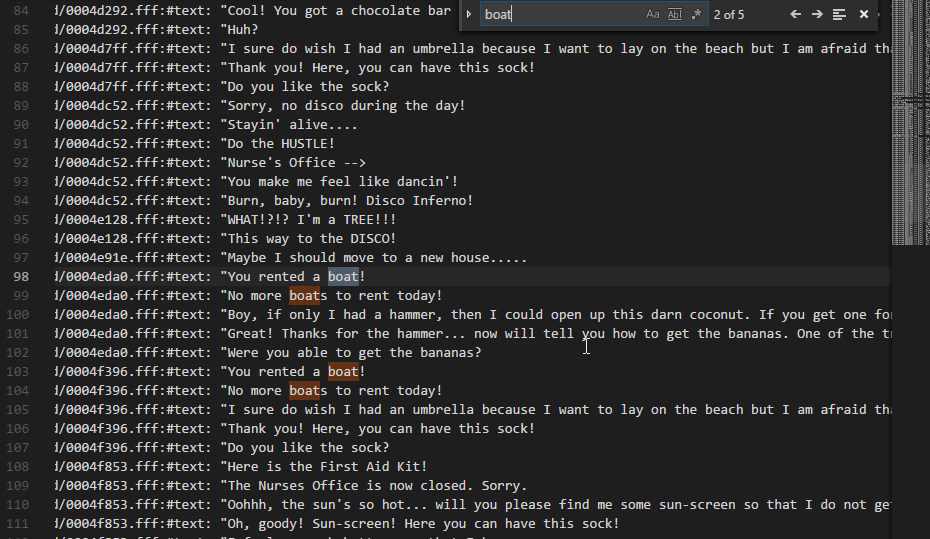

# Облегчаем жизнь разработчику мобильных игр

Всем привет,

Сделать хорошую игру — это далеко не вся работа. Для того, чтобы получить законченный продукт, который можно будет успешно распространять, необходимо интегрировать в игру разного рода маркетинговые инструменты: трекинг реферальных установок, баннерокрутилки и офферволлы, модули подписки на новостную рассылку и показа других хороших игр, различные партнерские SDK и т.д. и т.п. В этом посте я расскажу, какие инструменты для этого используем в Alawar мы и наши разработчики. Возьмем как пример наши iOS-проекты.

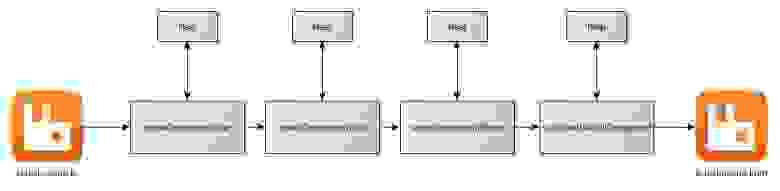

Проанализировав основные маркетинговые инструменты, которые используются на рынке, мы выделили некоторые группы инструментов, которые обладают общими признаками. Например, практически все такие SDK требуют инициализации сессии в методах application:didFinishLaunchingWithOptions: или applicationDidBecomeActive:. Там же отрабатывают все инсталл-трекеры.

Пуш-нотификации регистрируются всегда одними и теми же вызовами.

Реферрал-трекерам как правило нужна информация после успешного совершения ин-аппа. А сами ин-аппы нужно валидировать.

И еще обычно все эти же места хочется «обвесить» ивентами для сбора статистики, например, через Flurry.

Также стоит отметить, что эти задачи – общие для всех проектов, отличия только в айдишниках и прочих apiKey-ях для сторонних сервисов.

Геймдев под iOS устроен так, что без маркетинга – никуда. Но разработчики в первую очередь должны (и хотят) думать и работать непосредственно над игрой, а не заморачиваться «маркетинговым обвесом». Для того, чтобы это стало возможным, издатели предоставляют своим разработчикам различные SDK, фреймворки и т.п. Alawar – не исключение. Мы подготовили Alawar iOS Framework, который включает в себя все необходимые маркетинговые модули актуальных версий и «делает немножко магии».

За «немножко магии» отвечает замечательный рантайм Objective-C и его возможности по микшированию кода.

Так, например, чтобы стартовать сессии для нескольких SDK в методе application:didFinishLaunchingWithOptions: нам нужно «перехватить» этот вызов у Application Delegate и добавить к нему свою имплементацию. Для этого создаем категорию над UIApplication, ловим метод setDelegate:

```

@interface UIApplication(AlawarFramework)

@end

@implementation UIApplication(AlawarFramework)

+ (void) load {

method_exchangeImplementations(class_getInstanceMethod(self, @selector(setDelegate:)), class_getInstanceMethod(self, @selector(af_setDelegate:)));

}

- (void) af_setDelegate:(id)delegate {

Method method = nil;

method = class\_getInstanceMethod([delegate class], @selector(application:didFinishLaunchingWithOptions:));

if (method) {

class\_addMethod([delegate class], @selector(application:AFDidFinishLaunchingWithOptions:), (IMP)AFdynamicDidFinishLaunching, "v@:::");

method\_exchangeImplementations(class\_getInstanceMethod([delegate class], @selector(application:didFinishLaunchingWithOptions:)), class\_getInstanceMethod([delegate class], @selector(application:AFDidFinishLaunchingWithOptions:)));

} else {

class\_addMethod([delegate class], @selector(application:didFinishLaunchingWithOptions:), (IMP)AFdynamicDidFinishLaunching, "v@:::");

}

// устанавливаем "родного" делегата

[self af\_setDelegate:delegate];

}

BOOL AFdynamicDidFinishLaunching(id self, SEL \_cmd, id application, id launchOptions) {

// вызываем "родной" метод, если был реализован

if ([self respondsToSelector:@selector(application:AFDidFinishLaunchingWithOptions:)]) {

result = (BOOL) [self application:application AFDidFinishLaunchingWithOptions:launchOptions];

} else {

[self applicationDidFinishLaunching:application];

result = YES;

}

// тут инициализируем библиотеки, стартуем сессии и т.д.

return result;

}

@end

```

Аналогичным образом подмешиваем работу со сторонними библиотеками в applicationDidBecomeActive, инициализируем пуш-нотификации и т.п.

Разработчикам же остается только добавить фреймворк к своему Xcode-проекту и выставить флаг линкера –all\_load.

Несколько иная ситуация с ин-аппами, их валидацией и регистрацией в реферрал-трекерах и статистике. Здесь мы решали еще одну побочную задачу. Разработчики проводят первичное тестирование под своим Apple-аккаунтом и с одними айдишниками ин-аппов, а при прохождении QA в издательстве и публикации в стор используется другой аккаунт и другие айдишники.

Для решения этих задач мы реализовали свое API «обертку» над API StoreKit и дополнительные протоколы для уведомления делегатов о результатах валидации платежа. При этом все идентификаторы продуктов вынесены в отдельный настроечный конфиг.

Таким образом, разработчик использует API аналогичное StoreKit-у, но уже без необходимости обвешивать покупки статистикой, самостоятельно реализовывать валидацию и т.д.

В завершении статьи отметим, что аналогичный инструментарий мы предоставляем также для платформы Android.

|

https://habr.com/ru/post/199348/

| null |

ru

| null |

# Как создать своего бота для Skype. Что не написано в документации

Некоторое время назад [я рассказывал](https://habrahabr.ru/post/280490/) о [своем боте](https://telegram.me/metricsbot) для Telegram, который умеет данные из Google Analytics показывать. А тут Microsoft [объявила](https://geektimes.ru/post/273618/) о запуске ботов в Skype — самое время изучить как это работает. Под катом — небольшое описание возможных проблем. Кому не терпится посмотреть результат, вот он — [MetricsBot](https://join.skype.com/bot/e3ba95a8-33a8-423b-8ec9-5f81badb343e) [](https://join.skype.com/bot/e3ba95a8-33a8-423b-8ec9-5f81badb343e).

Bot Framework vs. Skype Bot API

===============================

Для начала стоит понять, что есть [Bot Framework](http://botframework.com), который позволяет создавать ботов для многих мессенджеров, в т.ч. и для Skype, а есть [Skype Bot API](https://developer.microsoft.com/en-us/skype/bots), который позволяет создавать ботов именно для Skype. У каждого своя документация, свой каталог ботов (?) и своя регистрация ботов. Вроде очевидно, что это разные вещи, но я потратил довольно много времени пытаясь разобраться в документации Bot Framework'a и в регистрации бота в нем, когда ожидал, что создаю бота без фрейворка. Далее речь будет идти именно про Skype Bot API, Bot Framework нам не нужен, регистрировать там тоже ничего не надо. Есть Skype SDK для [Node.js](https://devportalassets.azureedge.net/files/skype-sdk.tar.gz) и для [C#](https://devportalassets.azureedge.net/files/Microsoft.Skype.Bots.1.0.39.113.nupkg). Их я тоже не использовал, т.к. писал бота на Python.

Полезные ссылки

===============

Для начала небольшой набор полезных ссылок (все ссылки — на английском языке):

* [Введение](https://developer.microsoft.com/en-us/skype/bots/docs)

* [Описание API](https://developer.microsoft.com/en-us/skype/bots/docs/api/chat)

* [Свои приложения](https://apps.dev.microsoft.com/#/appList) (тут необходимо создать новое приложение и получить app id и client secret)

* [Управление своими ботами](https://developer.microsoft.com/en-us/skype/bots/manage) (здесь необходимо создать нового бота, указав app id полученный ранее)

* [Видео про создание бота](https://channel9.msdn.com/events/Build/2016/T611)

В принципе, из документации понятно как работает бот и как он взаимодействует со Skype'ом, потому эту часть описывать не буду — расскажу о сложностях.

Авторизация

===========

Это оказалось самой трудоемкой для меня частью. В документации говорится, что для авторизации необходимо получить токен, а затем использовать его в заголовке HTTP при каждом обращении:

`Authorization: Bearer oauth2-token`

Однако в документации почему-то забыли указать какой scope необходимо использовать для получения токена. Правильный ответ (можно найти в коде Node.js SDK) — `https://graph.microsoft.com/.default`.

Но тут начинается самое интересное — если создавать URL для подтверждения пользователем (=владельцем бота), потом получать *auth\_code*, а потом попытаться обменять этот код на *access token*, то проблема возникнет на первом же шаге — при открытии созданного URL, Microsoft ругается на неправильный scope. Правильного scope, кстати, нет в списке возможных вариантов в [документации Microsoft](https://graph.microsoft.io/en-us/docs/authorization/permission_scopes). Я пытался указывать другой scope — `openid offline_access https://graph.microsoft.com/user.read`, в этом случае мне удавалось получить token, только вот с ним взаимодействовать со Skype не удавалось.

Решение оказалось неожиданным — для получения access\_token, необходимо было отправить обычный POST запрос:

`curl -X POST -H "Cache-Control: no-cache" -H "Content-Type: application/x-www-form-urlencoded" -d 'client_id=&client\_secret=&grant\_type=client\_credentials&scope=https%3A%2F%2Fgraph.microsoft.com%2F.default' 'https://login.microsoftonline.com/common/oauth2/v2.0/token'`

В ответ возвращается *access\_token* и *expires\_in* (без какого-либо *refresh\_token*). Такого OAuth я еще не встречал.

Отправка сообщений

==================

Отправка сообщений довольно проста —

`POST /v2/conversations/8:alice/activities HTTP/1.1

Host: apis.skype.com

Authorization: Bearer oauth2-token

{

"message": {"content" : "Hi! (wave)"}

}`

Запросы отправляются на apis.skype.com. В документации забыли указать, что запросы должны уходить по http**s**.

В тексте можно использовать html-теги. Какие точно — пока неизвестно (в документации списка нет).

Есть интересные и неописанные ограничения на отправляемый текст. Например, в тексте нельзя использовать символы *&*, *<* и *>*. Отсутствие возможности передать символ *&* создает проблему при передаче ссылок. Еще одна проблема при передаче ссылок — автоматически создаваемые превью для каждой ссылки. В моем боте [MetricsBot](https://join.skype.com/bot/e3ba95a8-33a8-423b-8ec9-5f81badb343e) в тексте приглашения три ссылки, Skype создает три превью. Отключить это пока нельзя.

Публикация бота

===============