text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

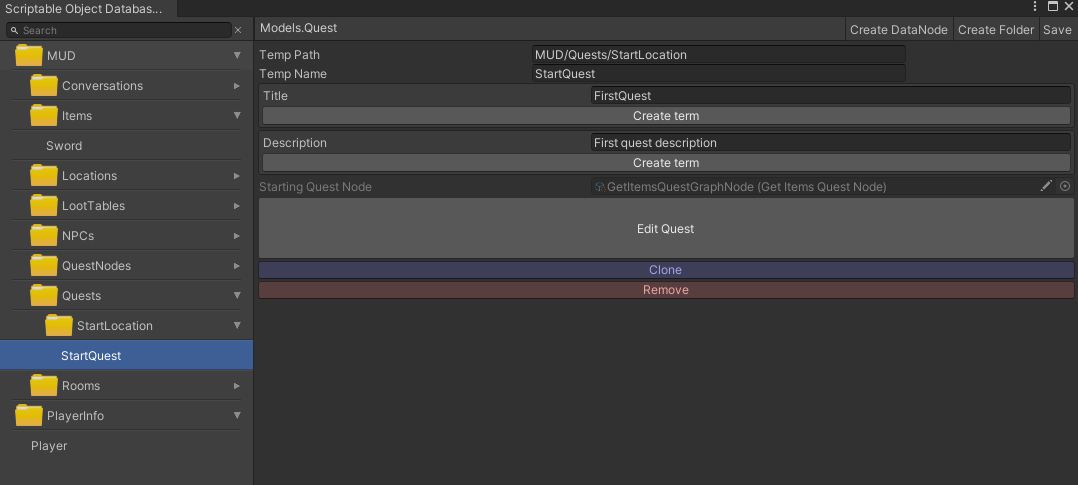

# Префиксная оптимизация регулярных выражений на Java

Я хочу рассказать о простом способе оптимизации регулярных выражений, а точнее словарей. Я видел некоторые проекты, которые [оптимизируют конечные автоматы](http://www.brics.dk/automaton), [пакеты которые делают быструю разметку словаря в тексте](http://alias-i.com/lingpipe/docs/api/com/aliasi/dict/ExactDictionaryChunker.html), но так чтобы просто взять словарь и собрать регулярное выражение, которое можно было бы передать любому движку регулярных выражений — такого пока не видел.

Итак проблема, есть огромный словарь городов и надо найти в тексте все эти фразы. Наивный подход заключается в склеивании по or этих слов, таким образом получается такое выражение (city1|city2|city3|...cityN). При обработке такого выражения обычный NDA движок (к которым относится большинство, в том числе JDK) будет делать по крайней мере N проверок на каждый символ в тексте, в худшем же случае(когда текущее слово отличается на последней букве от всех слов в словаре) количество проверок будет равно количеству букв в словаре.

Это плохо, но можно сделать лучше.

Типичное свойство языка это избыточность. В данном случае это повторяемость последовательности букв. Здесь я расскажу о самом простом способе оптимизации — префиксной оптимизации.

Если слова начинаются с одинаковых префиксов, то вычисления будут выполнятся один раз для любого префикса. Итак мы строим Trie по нашему словарю, а затем конвертируем его в строку регулярного выражения.

**Класс описывающий дерево**

```

class Node {

char ch = START;

List nodes = Lists.newArrayList();

void add(String str) {

if (str.length() == 0) return;

char chNew = str.charAt(0);

for (Node n : nodes) {

if (n.ch == chNew) {

n.add(str.substring(1));

return;

}

}

Node newNode = new Node();

newNode.ch = chNew;

newNode.add(str.substring(1));

nodes.add(newNode);

}

String toRegexp() {...}

}

```

Как мы видим его основной метод add проверяет есть ли первый символ среди его детей, если нет, то создает и отдает тому поддереву, которое начинается с этого символа.

Таким образом в данной структуре любой префикс хранится только один раз(путь по дереву) и переиспользуется когда встречается в наших строках.

Второй метод конвертирует дерево в регулярное выражение.

```

String toRegexp() {

StringBuilder str = new StringBuilder();

if (ch == START) {

} else if (ch == END) {

} else {

//convert special characters like {}[].

String newStr = escapeRegexp(String.valueOf(ch));

str.append(newStr);

}

if (nodes.size() > 1) {

str.append("(?:");

for (Node n : nodes) {

str.append("");

str.append(n.toRegexp());

str.append("|");

}

str.setLength(str.length() - 1);

str.append(')');

} else if (nodes.size() == 1) {

str.append(nodes.get(0).toRegexp());

}

return str.toString();

}

}

```

**Вот рабочий код**

```

public static String convertListToRegexp(final boolean useNonCapturingGroups, String... strs) {

Arrays.sort(strs,

new Comparator() {

public int compare(String o1, String o2) {

int res = o2.length() - o1.length();

if (res != 0) {

return res;

}

return o1.compareTo(o2);

}

});

Node root = new Node();

for (String str : strs) {

root.add(str + "$");

}

return root.toRegexp();

}

```

**и пример**

```

//create array of your entries

String[] examples = new String[]{"javvva", "javggaaa", "javajava", "adsasd", "adasddsa"};

//convert them to optimal regexp

String optimizedRegexp = RegExpUtils.convertListToRegexp(true, examples);

Assert.assertEquals("(?:ad(?:asddsa|sasd)|jav(?:ajava|ggaaa|vva))", optimizedRegexp);

//check that it is works

for(String s : examples) Assert.assertTrue(s.matches(optimizedRegexp));

```

|

https://habr.com/ru/post/117177/

| null |

ru

| null |

# Обновление MySQL (Percona Server) с 5.7 до 8.0

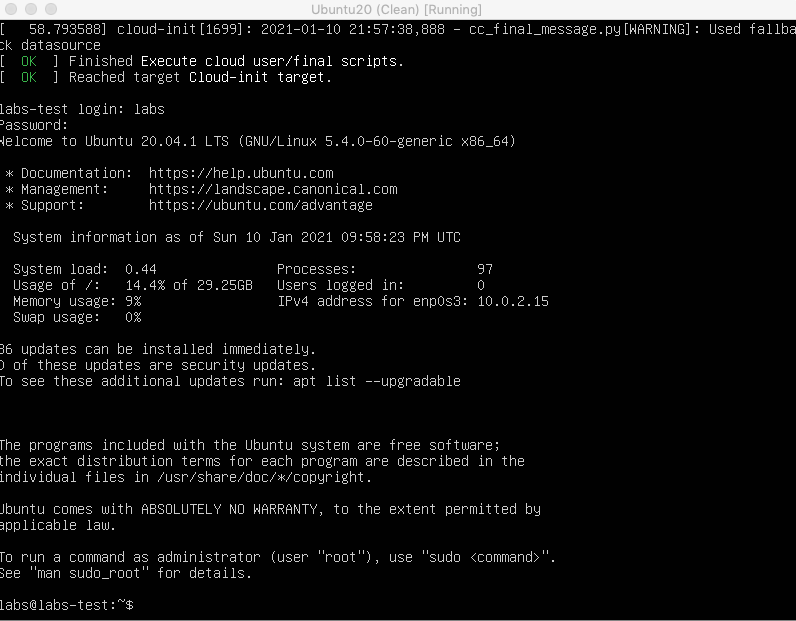

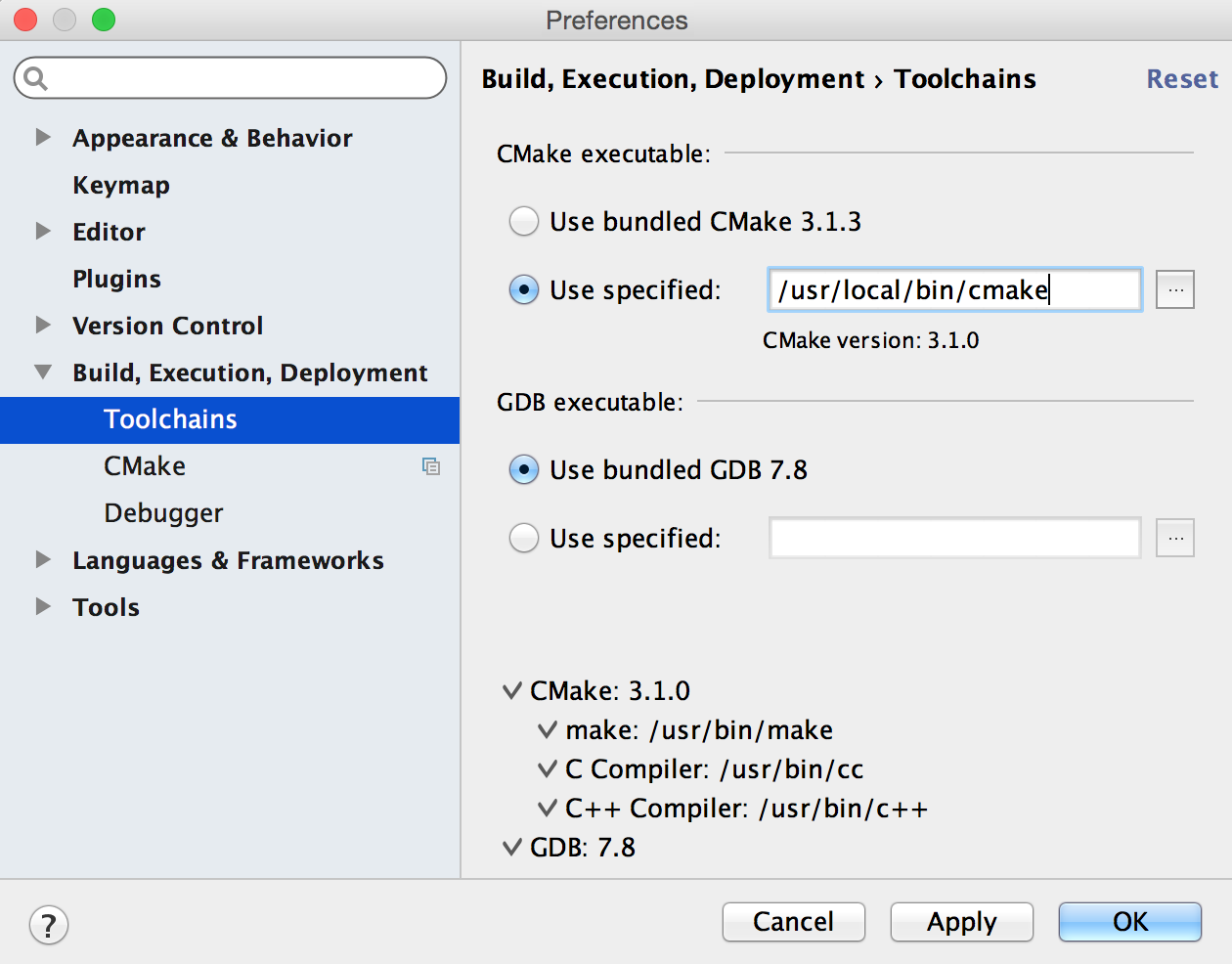

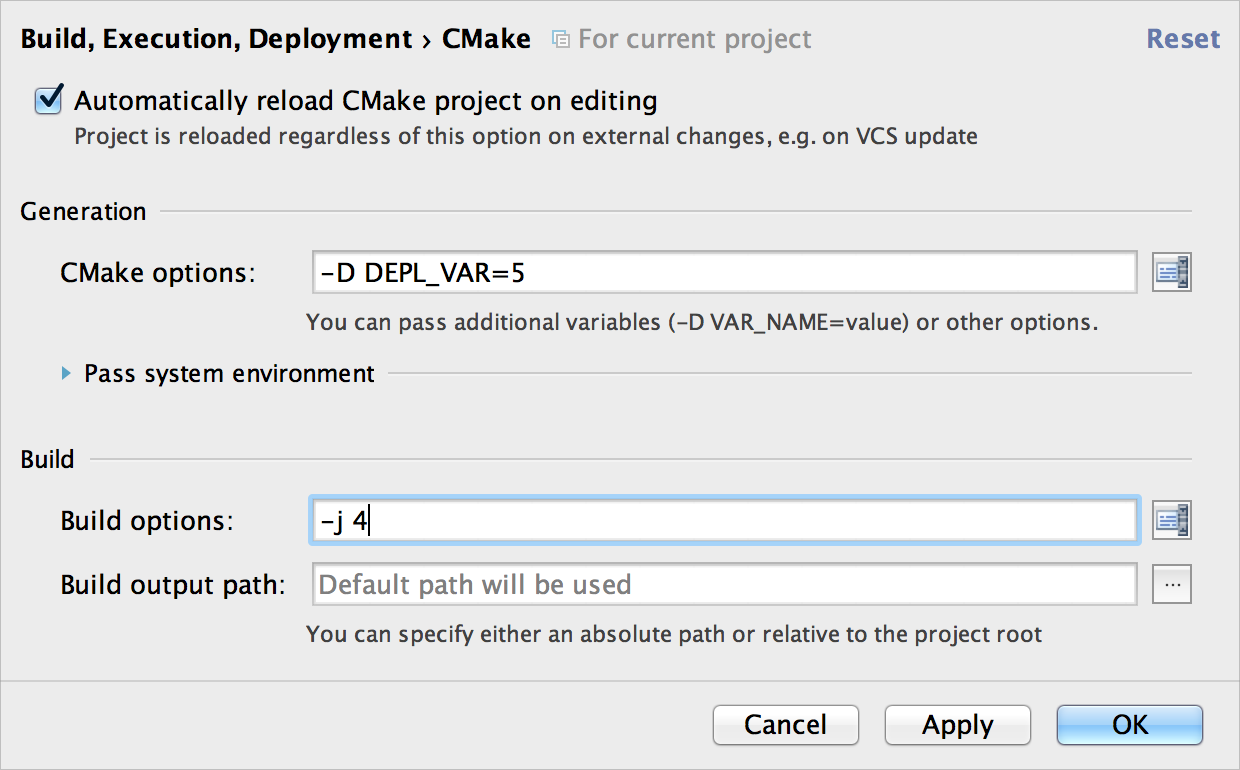

Прогресс не стоит на месте, поэтому причины обновиться на актуальные версии MySQL становятся всё более весомыми. Не так давно в одном из наших проектов настало время обновлять уютные кластеры Percona Server 5.7 до 8-й версии. Всё это происходило на платформе Ubuntu Linux 16.04. Как выполнить подобную операцию с минимальным простоем и с какими проблемами мы столкнулись при обновлении — читайте в этой статье.

Подготовка

----------

Любое обновление сервера баз данных скорее всего связано с перенастройкой базы: изменений требований к лимитам на системные ресурсы и исправлением конфигов базы, которые надо очистить от устаревших директив.

Перед обновлением мы обязательно обратимся к официальной документации:

* [MySQL 8 release notes](https://dev.mysql.com/doc/relnotes/mysql/8.0/en/news-8-0-0.html);

* [руководство по обновлению от MySQL](https://dev.mysql.com/doc/refman/8.0/en/upgrading.html);

* [руководство по обновлению от Percona](https://www.percona.com/doc/percona-server/LATEST/upgrading_guide.html);

* [руководство MySQL по обновлению реплик и мастеров](https://dev.mysql.com/doc/refman/8.0/en/replication-upgrade.html).

И составим план действий:

1. Исправить конфигурационные файлы, удалив устаревшие директивы.

2. Проверить совместимость утилитами.

3. Обновить slave-базы, поставив пакет `percona-server-server`.

4. Обновить мастер, поставив тот же пакет.

Разберём каждый пункт плана и посмотрим, что же может пойти не так.

**ВАЖНО!** Процедура обновления MySQL-кластера на базе Galera имеет свои тонкости, которые в статье не описаны. Не стоит использовать эту инструкцию в таком случае.

Часть 1: Проверка конфигов

--------------------------

В 8-й версии MySQL убрали `query_cache`. Вообще-то он был [признан устаревшим](https://dev.mysql.com/doc/refman/5.7/en/query-cache.html) еще в версии 5.7, но теперь и [удалён вовсе](https://dev.mysql.com/doc/refman/8.0/en/added-deprecated-removed.html). Соответственно, необходимо убрать связанные директивы. А для кэширования запросов теперь можно использовать внешние инструменты — например, [ProxySQL](https://www.percona.com/blog/2018/02/07/proxysql-query-cache/).

Так же в конфиге нашлись устаревшие директивы про `innodb_file_format`. Если в MySQL 5.7 имелась возможность выбора формата InnoDB, то 8-я версия уже работает [только с форматом Barracuda](https://dev.mysql.com/worklog/task/?id=7704).

Наш итог — удаление следующих директив:

* `query_cache_type`, `query_cache_limit` и `query_cache_size`;

* `innodb_file_format` и `innodb_file_format_max`.

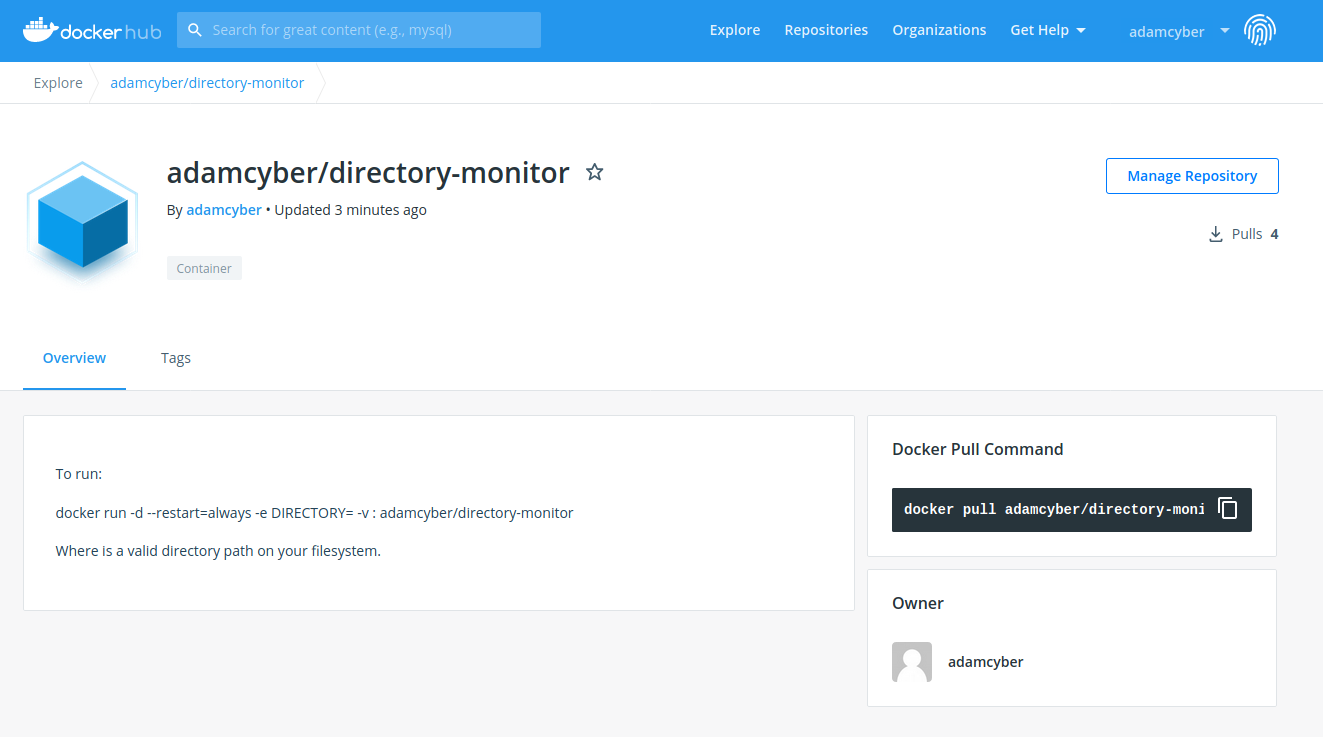

Для проверки воспользуемся Docker-образом Percona Server. Конфиг сервера поместим в директорию `mysql_config_test`, а рядом создадим директории для данных и логов. Пример теста конфигурации percona-server:

```

mkdir -p {mysql_config_test,mysql_data,mysql_logs}

cp -r /etc/mysql/conf.d/* mysql_config_test/

docker run --name some-percona -v $(pwd)/mysql_config_test:/etc/my.cnf.d/ -v $(pwd)/mysql_data/:/var/lib/mysql/ -v $(pwd)/mysql_logs/:/var/log/mysql/ -e MYSQL_ROOT_PASSWORD=${MYSQL_PASSWORD} -d percona:8-centos

```

Итог: либо в логах Docker, либо в директории с логами — в зависимости от ваших конфигов — появится файл, в котором будут описаны проблемные директивы.

Вот что было у нас:

```

2020-04-03T12:44:19.670831Z 0 [Warning] [MY-011068] [Server] The syntax 'expire-logs-days' is deprecated and will be removed in a future release. Please use binlog_expire_logs_seconds instead.

2020-04-03T12:44:19.671678Z 0 [Warning] [MY-013242] [Server] --character-set-server: 'utf8' is currently an alias for the character set UTF8MB3, but will be an alias for UTF8MB4 in a future release. Please consider using UTF8MB4 in order to be unambiguous.

2020-04-03T12:44:19.671682Z 0 [Warning] [MY-013244] [Server] --collation-server: 'utf8_general_ci' is a collation of the deprecated character set UTF8MB3. Please consider using UTF8MB4 with an appropriate collation instead.

```

Таким образом, нам потребовалось еще разобраться с кодировками и заменить устаревшую директиву `expire-logs-days`.

Часть 2: Проверка работающих установок

--------------------------------------

В документации по обновлению есть 2 утилиты для проверки базы на совместимость. Их использование помогает администратору проверить совместимость имеющейся структуры данных.

Начнём с классической утилиты mysqlcheck. Достаточно просто запустить:

```

mysqlcheck -u root -p --all-databases --check-upgrade

```

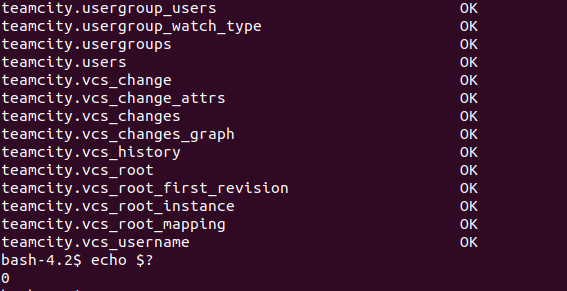

Если проблемы не обнаружены, утилита завершится с кодом 0:

Кроме того, в современных версиях MySQL доступна утилита [mysql-shell](https://dev.mysql.com/doc/mysql-shell/8.0/en/) (в случае Percona это пакет `percona-mysql-shell`). Она является заменой классическому клиенту `mysql` и совмещает в себе функции клиента, редактора SQL-кода и инструменты администрирования MySQL. Для проверки сервера перед обновлением можно через неё выполнить следующую команду:

```

mysqlsh -- util check-for-server-upgrade { --user=root --host=1.1.1.1 --port=3306 } --config-path=/etc/mysql/my.cnf

```

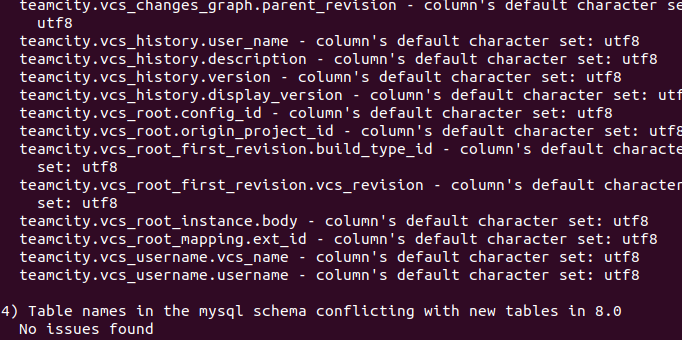

И вот какие замечания мы получили:

В общем, ничего критичного — только предупреждения о кодировках *(см. ниже)*. Общий результат выполнения:

Мы решили, что обновление должно пойти без проблем.

Замечание о предупреждениях выше, свидетельствующих проблемы с кодировками. Дело в том, что UTF-8 в MySQL до недавнего времени [не являлась «настоящей» UTF-8](https://mathiasbynens.be/notes/mysql-utf8mb4), так как хранила всего 3 байта вместо 4. В MySQL 8 это наконец-то [решили исправить](https://dev.mysql.com/doc/refman/8.0/en/charset-unicode-utf8mb3.html): алиас `utf8` вскоре будет вести на кодировку `utf8mb4`, а старые столбцы в таблицах станут `utf8mb3`. В дальнейшем кодировка `utf8mb3` будет удалена, но не в данном релизе. Поэтому мы решили исправить кодировки уже на работающей инсталляции СУБД, после её обновления.

Часть 3: Обновление серверов

----------------------------

Что же может пойти не так, когда есть столь шикарный план?.. Прекрасно понимая, что нюансы всегда случаются, первый эксперимент мы провели на dev-кластере MySQL.

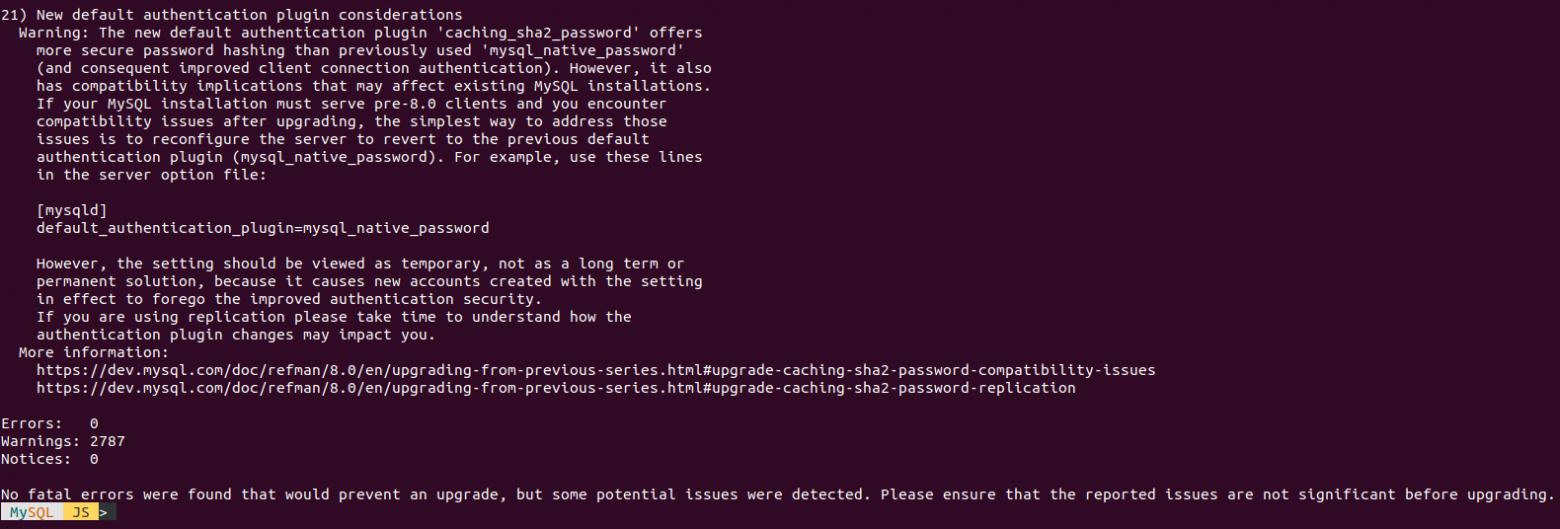

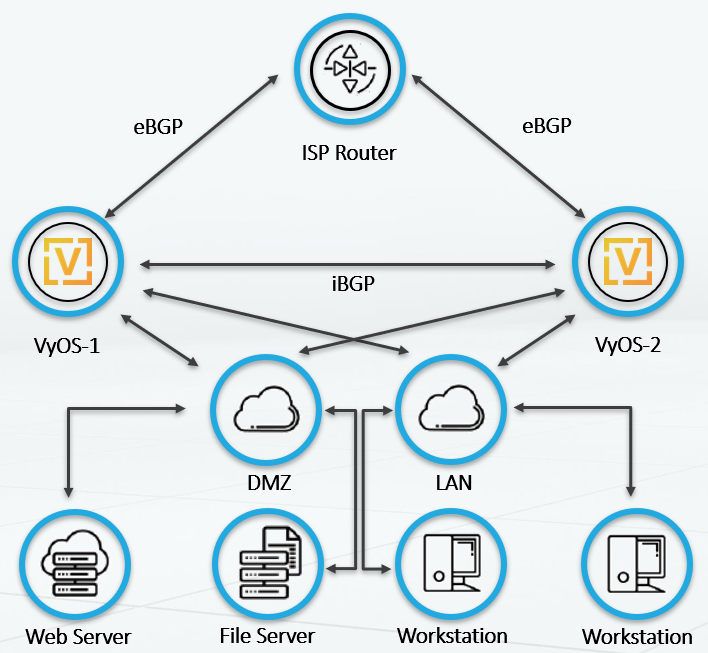

Как уже упоминалось, [официальная документация](https://dev.mysql.com/doc/refman/8.0/en/replication-upgrade.html) освещает вопрос обновления MySQL-серверов с репликами. Суть сводится к тому, что сначала стоит обновлять все реплики (slave), так как MySQL 8 умеет реплицироваться с мастера версии 5.7. Некоторая сложность заключается в том, что у нас используется режим **master <-> master**, когда удалённый мастер находится в режиме **read-only**. То есть фактически боевой трафик поступает в один ЦОД, а 2-й является резервным.

Топология выглядит следующим образом:

Обновление должно начаться с реплик *mysql replica dc 2*, *mysql master dc 2* и *mysql replica dc 1*, а закончиться — сервером *mysql master dc 1*. Для пущей надёжности мы остановили виртуальные машины, сделали их снапшоты, а непосредственно перед обновлением остановили репликацию командой `STOP SLAVE`. В остальном же обновление выглядит так:

1. Каждую реплику перезапускаем, добавив в конфиги 3 опции: `skip-networking`, `skip-slave-start`, `skip-log-bin`. Дело в том, что обновление базы генерирует бинарные логи с обновлением системных таблиц. Данные директивы гарантируют, что в базе не будет изменения данных приложения, а в бинарные логи не попадет информация об обновлении системных таблиц. Это позволит избежать проблем при возобновлении репликации.

2. Устанавливаем пакет `percona-server-server`. Важно отметить, что в версии MySQL 8 **не** требуется запускать команду `mysqlupgrade` после обновления сервера.

3. После успешного старта еще раз перезапускаем сервер — уже без параметров, которые добавлялись в первом пункте.

4. Убеждаемся, что репликация успешно работает: проверяем `SHOW SLAVE STATUS` и смотрим, что обновляются таблицы со счетчиками в базе приложения.

Всё это выглядит достаточно просто: обновление dev прошло успешно. Ок, можно спокойно планировать ночное обновление для production.

Не было печали — prod мы обновляли

----------------------------------

Однако перенос успешного опыта dev на production не обошёлся без сюрпризов.

К счастью, сам процесс обновления начинается с реплик, поэтому, встретив сложности, мы остановили работы и восстановили реплику из снапшота. Исследование проблем перенесли на следующее утро. В логах оказались следующее записи:

```

2020-01-14T21:43:21.500563Z 2 [ERROR] [MY-012069] [InnoDB] table: t1 has 19 columns but InnoDB dictionary has 20 columns

2020-01-14T21:43:21.500722Z 2 [ERROR] [MY-010767] [Server] Error in fixing SE data for db1.t1

2020-01-14T21:43:24.208365Z 0 [ERROR] [MY-010022] [Server] Failed to Populate DD tables.

2020-01-14T21:43:24.208658Z 0 [ERROR] [MY-010119] [Server] Aborting

```

Исследование архивов различных почтовых рассылок в Google привело к пониманию, что такая проблема возникает из-за [бага MySQL](https://bugs.mysql.com/bug.php?id=87229). Хотя скорее это даже баг утилит `mysqlcheck` и `mysqlsh`.

Оказывается, в MySQL сменили способ представления данных для десятичных полей (int, tinyint и т.п.), поэтому внутри mysql-server используется другой способ их хранения. Если ваша база данных **изначально** была в версии 5.5 или 5.1, а затем вы обновлялись до 5.7, то, возможно, требуется произвести `OPTIMIZE` для некоторых таблиц. Тогда MySQL обновит файлы с данными, переведя их на актуальный формат хранения.

Также это можно проверить утилитой `mysqlfrm`:

```

mysqlfrm --diagnostic -vv /var/lib/mysql/db/table.frm

...

'field_length': 8,

'field_type': 246, # формат поля

'field_type_name': 'decimal',

'flags': 3,

'flags_extra': 67,

'interval_nr': 0,

'name': 'you_decimal_column',

...

```

Если `field_type` у вас равен 0, то в таблице используется старый тип — надо проводить `OPTIMIZE`. Однако, если стоит значение 246 — у вас уже новый тип. Подробнее с типами можно ознакомиться в [коде](https://github.com/mysql/mysql-server/blob/5.7/include/mysql.h.pp#L6).

Более того, в [данном баге](https://bugs.mysql.com/bug.php?id=87229) рассматривается вторая возможная причина, которая обошла нас стороной, — это отсутствие InnoDB-таблиц в системной таблице `INNODB_SYS_TABLESPACES`, если они, таблицы, создавались в версии 5.1. Чтобы избежать проблем при обновлении, можно воспользоваться [приложенным SQL-скриптом](https://bugs.mysql.com/file.php?id=25767&bug_id=87229).

Почему же у нас не возникло таких проблем на dev? База туда периодически копируется с production — таким образом, **таблицы пересоздаются**.

К сожалению, на реально работающей большой БД не получится просто взять и выполнить повсеместный `OPTIMIZE`. Здесь поможет percona-toolkit: для операции online OPTIMIZE отлично подходит утилита pt-online-schema-change.

Обновленный план стал получился таким:

1. Провести оптимизацию всех таблиц.

2. Провести обновление баз данных.

Чтобы проверить его и заодно выяснить время обновления, мы отключили одну из реплик, а для всех таблиц запустили следующую команду:

```

pt-online-schema-change --critical-load Threads_running=150 --alter "ENGINE=InnoDB" --execute --chunk-size 100 --quiet --alter-foreign-keys-method auto h=127.0.0.1,u=root,p=${MYSQL_PASSWORD},D=db1,t=t1

```

Обновление таблиц производится без продолжительных блокировок благодаря тому, что утилита создает новую временную таблицу, в которую копирует данные из основной таблицы. В момент, когда обе таблицы идентичны, исходная таблица блокируется и подменяется новой. В нашем случае тестовый запуск показал, что для обновления всех таблиц потребуется около суток, но при этом копирование данных вызывало слишком большую нагрузку на диски.

Чтобы этого избежать, на production мы добавили к команде аргумент `--sleep` со значением 10 — этот параметр регулирует длину ожидания после переноса пачки данных в новую таблицу. Так можно снизить нагрузку, если реально запущенное приложение требовательно к времени ответа.

После выполнения оптимизации обновление прошло успешно.

### … но не до конца!

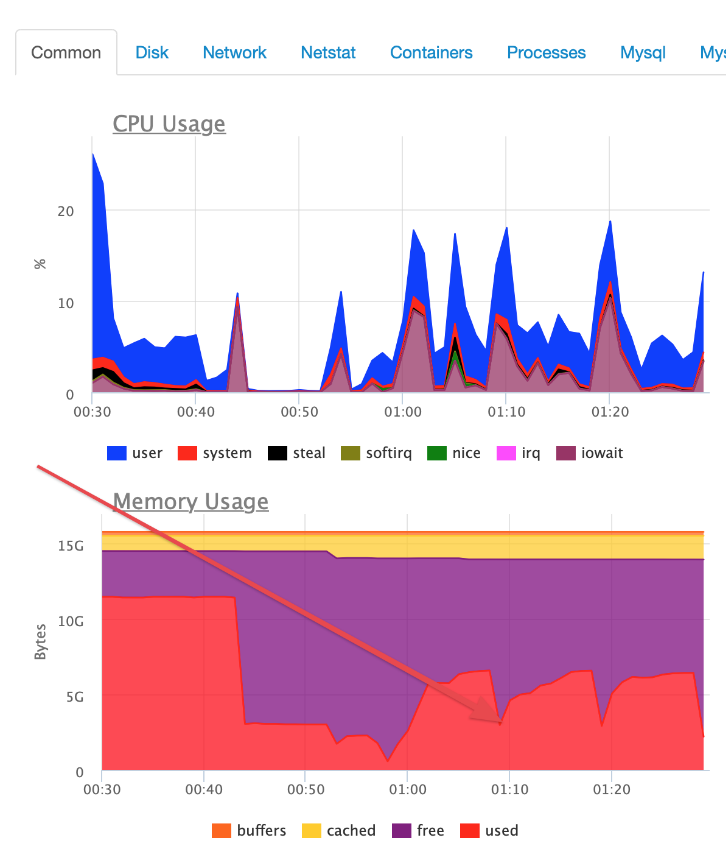

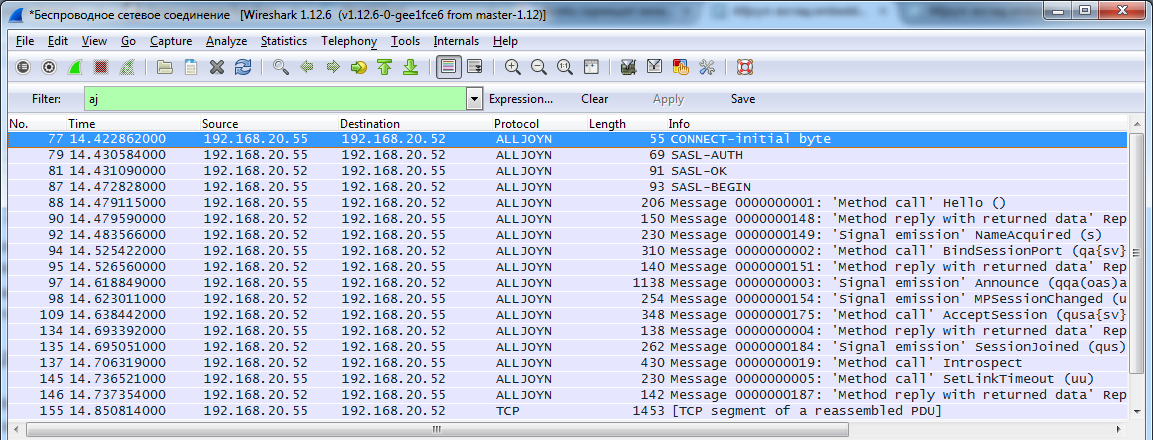

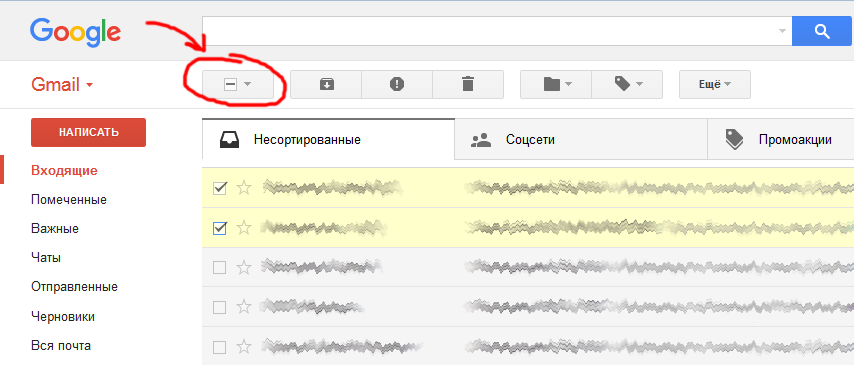

Уже через полчаса после обновления клиент пришел с проблемой. База работала очень странно: периодически начинались **сбросы подключений**. Вот как это выглядело в мониторинге:

На скриншоте виден пилообразный график, связанный с тем, что часть потоков MySQL-сервера периодически падали с ошибкой. В приложении появились ошибки:

```

[PDOException] SQLSTATE[HY000] [2002] Connection refused

```

Беглый осмотр логов выявил, что демон mysqld не мог получить требуемые ресурсы у операционной системы. Разбираясь с ошибками, мы обнаружили в системе **«бесхозные» файлы политик apparmor**:

```

# dpkg -S /etc/apparmor.d/cache/usr.sbin.mysqld

dpkg-query: no path found matching pattern /etc/apparmor.d/cache/usr.sbin.mysqld

# dpkg -S /etc/apparmor.d/local/usr.sbin.mysqld

dpkg-query: no path found matching pattern /etc/apparmor.d/local/usr.sbin.mysqld

# dpkg -S /etc/apparmor.d/usr.sbin.mysqld

mysql-server-5.7: /etc/apparmor.d/usr.sbin.mysqld

# dpkg -l mysql-server-5.7

rc mysql-server-5.7 5.7.23-0ubuntu0.16.04.1 amd64

```

Эти файлы образовались при обновлении на MySQL 5.7 пару лет назад и принадлежат удалённому пакету. Удаление файлов и перезапуск службы apparmor решил проблему:

```

systemctl stop apparmor

rm /etc/apparmor.d/cache/usr.sbin.mysqld

rm /etc/apparmor.d/local/usr.sbin.mysqld

rm /etc/apparmor.d/usr.sbin.mysqld

systemctl start apparmor

```

В заключение

------------

Любая, даже самая простая операция, может привести к неожиданным проблемам. И даже наличие продуманного плана не всегда гарантирует ожидаемый результат. Теперь в любые планы обновления у нашей команды входит еще и обязательная чистка лишних файлов, которые могли появиться в результате последих действий.

А этим не очень профессиональным графическим творчеством я бы хотел сказать огромное спасибо компании Percona за их отличные продукты!

P.S.

----

Читайте также в нашем блоге:

* «[Базы данных и Kubernetes (обзор и видео доклада)](https://habr.com/ru/company/flant/blog/431500/)»;

* «[Kubernetes tips & tricks: ускоряем bootstrap больших баз данных](https://habr.com/ru/company/flant/blog/417509/)»;

* «[6 практических историй из наших SRE-будней](https://habr.com/ru/company/flant/blog/471892/)»;

* «[Одна история с оператором Redis в K8s и мини-обзор утилит для анализа данных этой БД](https://habr.com/ru/company/flant/blog/480722/)»;

* «[Беспростойная миграция MongoDB в Kubernetes](https://habr.com/ru/company/flant/blog/461149/)».

|

https://habr.com/ru/post/500706/

| null |

ru

| null |

# Tips and tricks from my Telegram-channel @pythonetc, May 2019

It is a new selection of tips and tricks about Python and programming from my Telegram-channel @pythonetc.

← [Previous publications](https://habr.com/ru/search/?q=%5Bpythonetc%20eng%5D&target_type=posts)

`break` statement suppresses exception if used in the `finally` clause even when the `except` block is not presented:

```

for i in range(10):

try:

1 / i

finally:

print('finally')

break

print('after try')

print('after while')

```

Output:

```

finally

after while

```

The same is true for `continue`, however it can’t be used in `finally` until Python 3.8:

```

SyntaxError: 'continue' not supported inside 'finally' clause

```

You can add Unicode characters in a string literal not only by its number, but by also by its name.

```

>>> '\N{EM DASH}'

'—'

>>> '\u2014'

'—'

```

It’s also compatible with f-strings:

```

>>> width = 800

>>> f'Width \N{EM DASH} {width}'

'Width — 800'

```

There are six magic methods for Python objects that define comparison rules:

* `__lt__` for `<`

* `__gt__` for `>`

* `__le__` for `<=`

* `__ge__` for `>=`

* `__eq__` for `==`

* `__ne__` for `!=`

If some of these methods are not defined or return `NotImplemented`, the following rules applied:

* `a.__lt__(b)` is the same as `b.__gt__(a)`

* `a.__le__(b)` is the same as `b.__ge__(a)`

* `a.__eq__(b)` is the same as `not a.__ne__(b)` (mind that `a` and `b` are not swapped in this case)

However, `a >= b` and `a != b` don’t automatically imply `a > b`. The `functools.total_ordering` decorator create all six methods based on `__eq__` and one of the following: `__lt__`, `__gt__`, `__le__`, or `__ge__`.

```

from functools import total_ordering

@total_ordering

class User:

def __init__(self, pk, name):

self.pk = pk

self.name = name

def __le__(self, other):

return self.pk <= other.pk

def __eq__(self, other):

return self.pk == other.pk

assert User(2, 'Vadim') < User(13, 'Catherine')

```

Sometimes you want to use both decorated and undecorated versions of a function. The easiest way to achieve that is to forgo the special decorator syntax (the one with `@`) and create the decorated function manually:

```

import json

def ensure_list(f):

def decorated(*args, **kwargs):

result = f(*args, **kwargs)

if isinstance(result, list):

return result

else:

return [result]

return decorated

def load_data_orig(string):

return json.loads(string)

load_data = ensure_list(load_data_orig)

print(load_data('3')) # [3]

print(load_data_orig('4')) 4

```

Alternatively, you can write another decorator, that decorate a function while preserving its original version in the `orig` attribute of the new one:

```

import json

def saving_orig(another_decorator):

def decorator(f):

decorated = another_decorator(f)

decorated.orig = f

return decorated

return decorator

def ensure_list(f):

...

@saving_orig(ensure_list)

def load_data(string):

return json.loads(string)

print(load_data('3')) # [3]

print(load_data.orig('4')) # 4

```

If all decorators you are working with are created via `functools.wraps` you can use the `__wrapped__` attribute to access the undecorated function:

```

import json

from functools import wraps

def ensure_list(f):

@wraps(f)

def decorated(*args, **kwargs):

result = f(*args, **kwargs)

if isinstance(result, list):

return result

else:

return [result]

return decorated

@ensure_list

def load_data(string):

return json.loads(string)

print(load_data('3')) # [3]

print(load_data.__wrapped__('4')) # 4

```

Mind, however, that it doesn’t work for functions that are decorated by more than one decorator: you have to access `__wrapped__` for each decorator applied:

```

def ensure_list(f):

...

def ensure_ints(f):

@wraps(f)

def decorated(*args, **kwargs):

result = f(*args, **kwargs)

return [int(x) for x in result]

return decorated

@ensure_ints

@ensure_list

def load_data(string):

return json.loads(string)

for f in (

load_data,

load_data.__wrapped__,

load_data.__wrapped__.__wrapped__,

):

print(repr(f('"4"')))

```

Output:

```

[4]

['4']

'4'

```

The `@saving_orig` mentioned above accepts another decorator as an argument. What if that decorator can be parametrized? Well, since parameterized decorator is a function that returns an actual decorator, this case is handled automatically:

```

import json

from functools import wraps

def saving_orig(another_decorator):

def decorator(f):

decorated = another_decorator(f)

decorated.orig = f

return decorated

return decorator

def ensure_ints(*, default=None):

def decorator(f):

@wraps(f)

def decorated(*args, **kwargs):

result = f(*args, **kwargs)

ints = []

for x in result:

try:

x_int = int(x)

except ValueError:

if default is None:

raise

else:

x_int = default

ints.append(x_int)

return ints

return decorated

return decorator

@saving_orig(ensure_ints(default=0))

def load_data(string):

return json.loads(string)

print(repr(load_data('["2", "3", "A"]')))

print(repr(load_data.orig('["2", "3", "A"]')))

```

The `@saving_orig` decorator doesn’t really do what we want if there are more than one decorator applied to a function. We have to call `orig` for each such decorator:

```

import json

from functools import wraps

def saving_orig(another_decorator):

def decorator(f):

decorated = another_decorator(f)

decorated.orig = f

return decorated

return decorator

def ensure_list(f):

...

def ensure_ints(*, default=None):

...

@saving_orig(ensure_ints(default=42))

@saving_orig(ensure_list)

def load_data(string):

return json.loads(string)

for f in (

load_data,

load_data.orig,

load_data.orig.orig,

):

print(repr(f('"X"')))

```

Output:

```

[42]

['X']

'X'

```

We can fix it by supporting arbitrary number of decorators as `saving_orig` arguments:

```

def saving_orig(*decorators):

def decorator(f):

decorated = f

for d in reversed(decorators):

decorated = d(decorated)

decorated.orig = f

return decorated

return decorator

...

@saving_orig(

ensure_ints(default=42),

ensure_list,

)

def load_data(string):

return json.loads(string)

for f in (

load_data,

load_data.orig,

):

print(repr(f('"X"')))

```

Output:

```

[42]

'X'

```

Another solution is to make `saving_orig` smart enough to pass `orig` from one decorated function to another:

```

def saving_orig(another_decorator):

def decorator(f):

decorated = another_decorator(f)

if hasattr(f, 'orig'):

decorated.orig = f.orig

else:

decorated.orig = f

return decorated

return decorator

@saving_orig(ensure_ints(default=42))

@saving_orig(ensure_list)

def load_data(string):

return json.loads(string)

```

If a decorator you are writing becomes too complicated, it may be reasonable to transform it from a function to a class with the `__call__` method

```

class SavingOrig:

def __init__(self, another_decorator):

self._another = another_decorator

def __call__(self, f):

decorated = self._another(f)

if hasattr(f, 'orig'):

decorated.orig = f.orig

else:

decorated.orig = f

return decorated

saving_orig = SavingOrig

```

The last line allows you both to name class with camel case and keep the decorator name in snake case.

Instead of modifying the decorated function you can create another callable class to return its instances instead of a function:

```

class CallableWithOrig:

def __init__(self, to_call, orig):

self._to_call = to_call

self._orig = orig

def __call__(self, *args, **kwargs):

return self._to_call(*args, **kwargs)

@property

def orig(self):

if isinstance(self._orig, type(self)):

return self._orig.orig

else:

return self._orig

class SavingOrig:

def __init__(self, another_decorator):

self._another = another_decorator

def __call__(self, f):

return CallableWithOrig(self._another(f), f)

saving_orig = SavingOrig

```

View the whole code [here](https://repl.it/@VadimPushtaev/orig6)

|

https://habr.com/ru/post/454648/

| null |

en

| null |

# Ещё один тип XSS-атаки на сайт

Привет, Хабр! Вчера вечером жена пожаловалась, что не может зайти на сайт детской одежды, потому что с него перебрасывает на совершенно посторонний ресурс. Проверяю сам — действительно, во время загрузки главной страницы (или любой другой, если успеть перейти по ссылке с загружающейся страницы) внезапно перебрасывает на другой домен.

На улице сентябрь и холодает, поэтому решил не отступать перед проблемой и выбрать-таки ребёнку демисезонный костюм, попутно разобравшись в чём же дело!

Первое и очевидное, что приходит в голову — поискать явный редирект на странице. Открываю исходный код страницы в попытке найти что-нибудь такое:

```

```

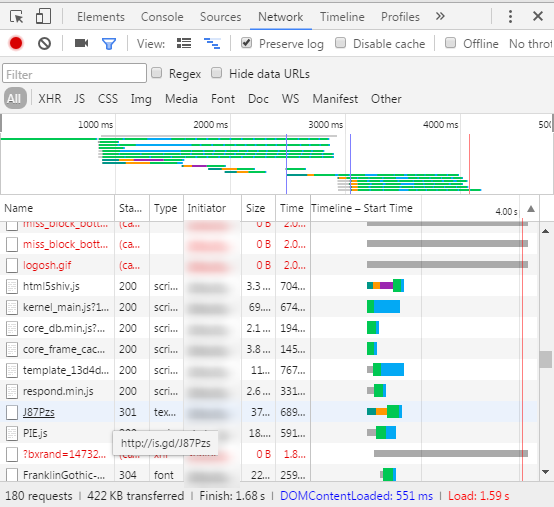

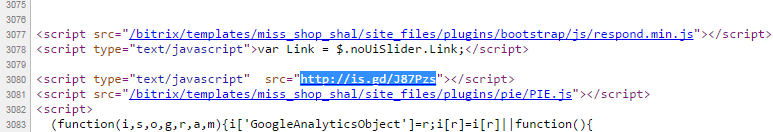

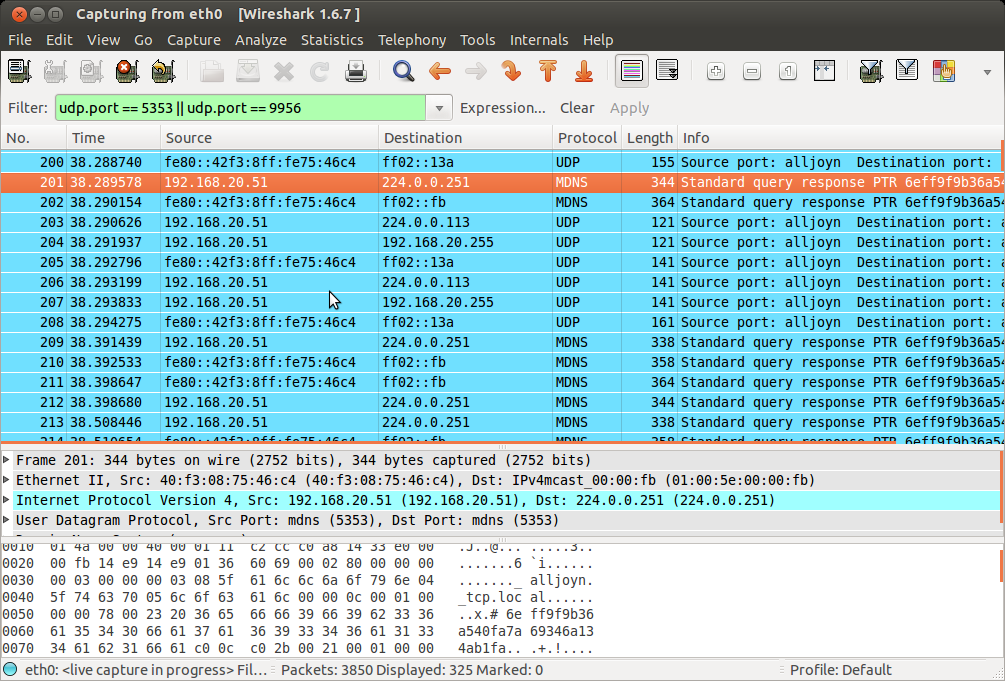

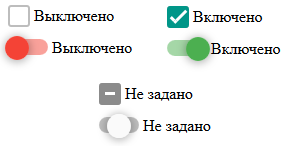

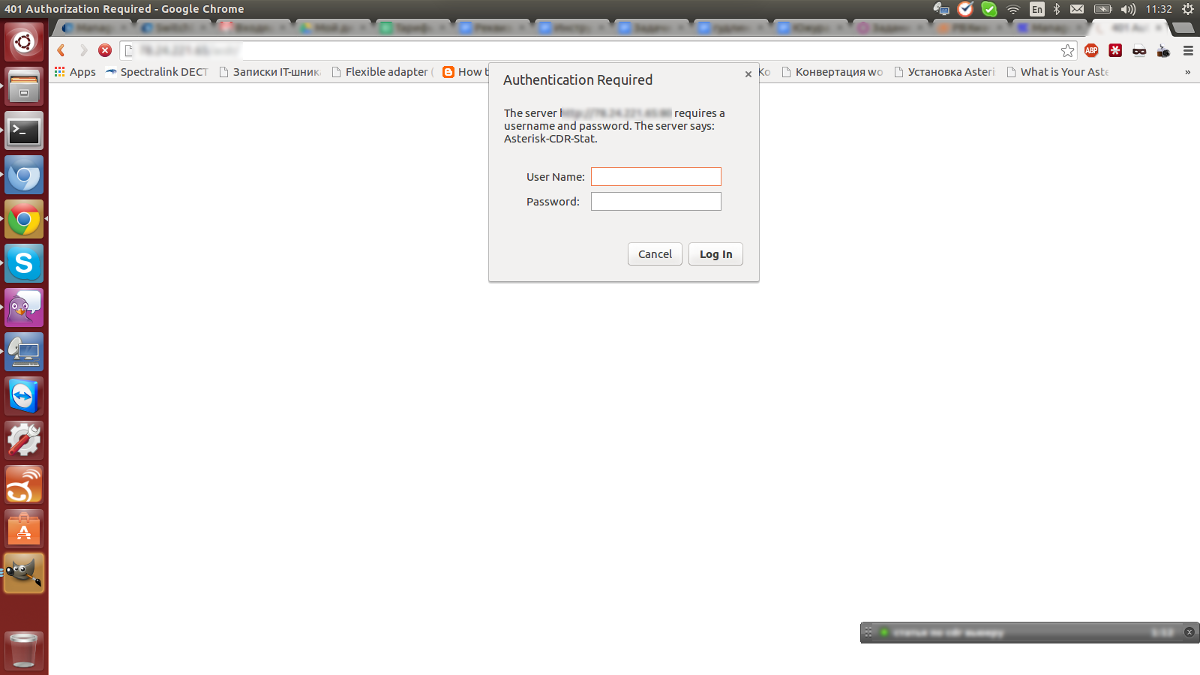

Безрезультатно, к тому же это было бы слишком просто. Раз нет стандартного редиректа, следовательно он реализован средствами JS. Проверяем гипотезу отключением JS в браузере — страница загрузилась, никуда не перекидывает. При этом window.location на странице нигде не используется, подменяющего URL тоже нет. Глянем, какие ресурсы закачивает браузер:

Сразу бросается в глаза подозрительный URL, по запросу к которому возвращается HTTP код 301: [is.gd/J87Pzs](http://is.gd/J87Pzs)

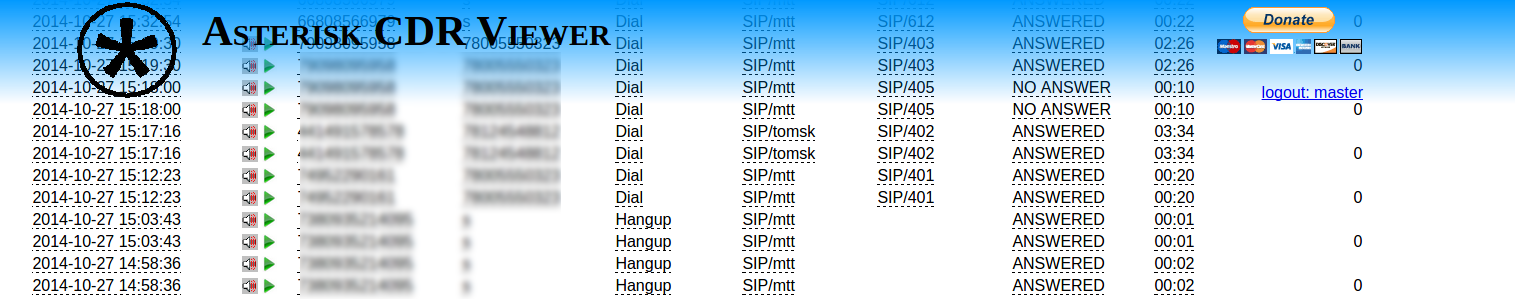

По этому URL быстро находим строчку в исходниках страницы:

Отмечу, что эта строчка присутствует на всех страницах, где смотрел.

Хм, необходимо разобраться, что же такое происходит по этой ссылке: [is.gd/J87Pzs](http://is.gd/J87Pzs).

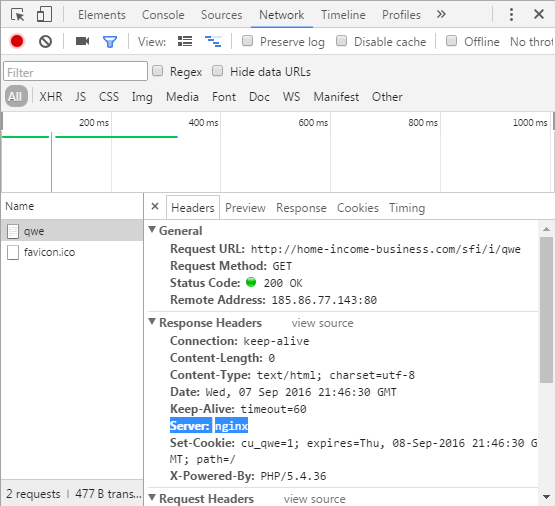

is.gd — это типичный «ссылкоукорачиватель». За данным URL стоит следующий: [home-income-business.com/sfi/i/qwe](http://home-income-business.com/sfi/i/qwe)

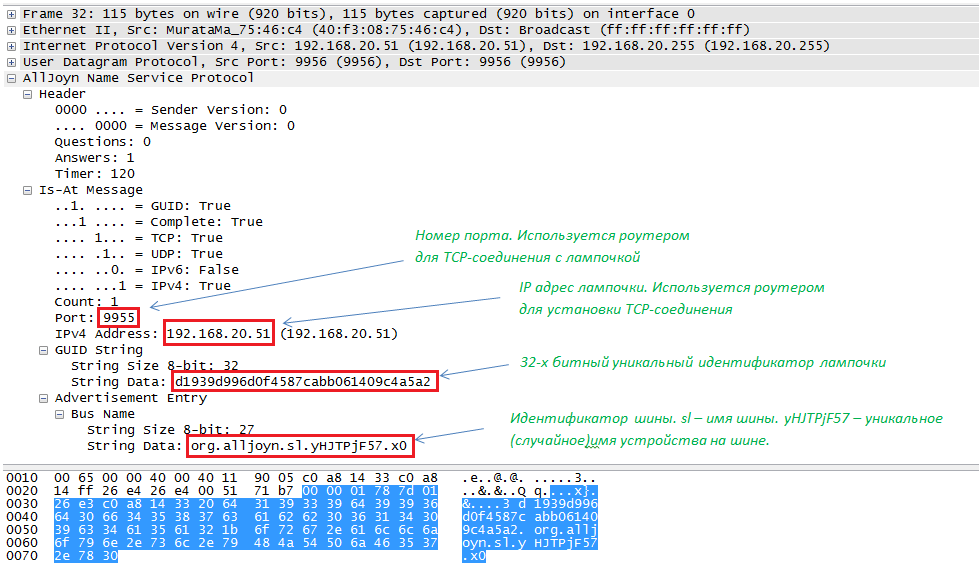

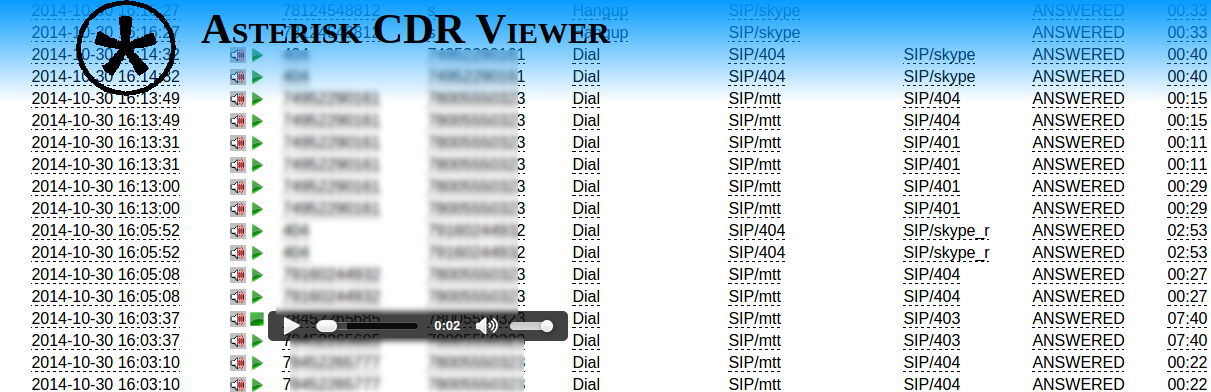

GET-запрос на него возвращает такой контент:

```

function process(){ window.location = "http://подозрительный-сайт-точка-ру/"; } window.onerror = process; process()

```

Дело уже можно было бы закрывать, как в этот момент я переключаюсь на другую точку доступа к Интернет, а проблема (внезапно) исчезает: HTTP-запрос по последнему URL в цепочке начинает возвращать пустой контент! Что за?! Переключаемся опять на другую точку доступа — зловредный код снова отдаётся. А это уже интереснее! Выходит, **в зависимости от ip-адреса отдаётся разное содержимое**. Как такое может быть? Например, в nginx есть специальный модуль [geo](http://nginx.org/en/docs/http/ngx_http_geo_module.html), с использованием которого можно настроить подобное поведение. Содержимое HTTP-ответа косвенно подтверждает вышесказанное:

Зачем делать атаку с редиректом на другой сайт? Причин может быть множество, в том числе меркантильных, например, для осуществления нечестной конкуренции или привлечения трафика на сайт.

**При этом владелец сайта-жертвы может даже не догадываться, что находится под атакой**, поскольку с его ip-адресов сайт будет прекрасно открываться и работать, а с других… Пользователи, зайдя на такой сайт, вероятно просто уйдут и не будут заморачиваться.

Я заморочился. И написал на e-mail, указанный в контактах. А уже на следующий день, то есть сегодня, со мной связался администратор сайта, которому я подробно изложил проблему. И, пока я писал этот пост и готовил картинки, проблему уже исправили, удалив зловредный скрипт со страниц сайта!

Вероятно, вам интересно узнать, как же зловредный код оказался на страницах сайта: администратор высказал предположение, что это его предшественник оставил «подарок».

##### Выводы:

* Самый эффективный способ предупреждения внедрения таких скриптов — не использовать подгружаемые со сторонних сайтов ресурсы;

* Для исключения их выполнения также можно применять [Content Security Policy](https://www.w3.org/TR/CSP/), используя HTTP-заголовок *Content-Security-Policy* (*X-WebKit-CSP* для старых версий Chrome и *X-Content-Security-Policy* для старых версий Firefox и IE 10-11), который в силу своей относительной молодости и статуса Candidate Recomendation [не поддерживается](http://caniuse.com/#feat=contentsecuritypolicy) в старых браузерах;

* И по возможности отправлять баг-репорты, так мы сможем сделать Интернет чище.

**P.S.** Посчитал неуместным указывать подвергшийся атаке сайт.

|

https://habr.com/ru/post/310482/

| null |

ru

| null |

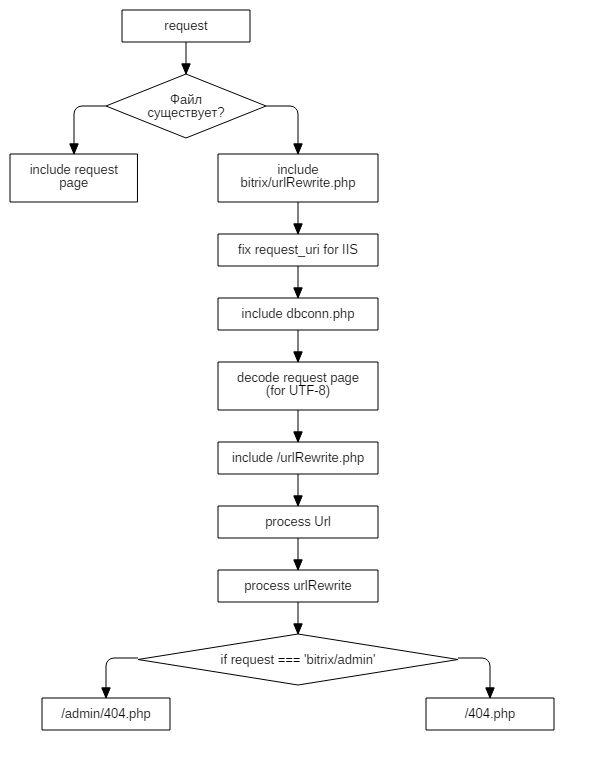

# Сервисный маршрутизатор Alcatel Lucent в качестве шлюза для домена доступа

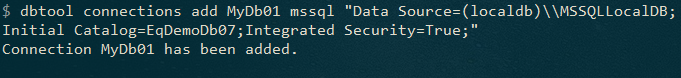

Для многих первое знакомство с сервисными маршрутизаторами Alcatel Lucent (ныне Nokia) становится не очень приятным в связи с особым взгядом вендора на модель предоставления сервиса. В отличие от оборудования Cisco, не всегда очевидно, как заставить работать такое устройство в простом сценарии: маршрутизатор для нескольких коммутаторов доступа (обычно такие коммутаторы соединяются в кольцо). Тем, кто разочаровался, не обнаружив команду spanning-tree в режиме конфигурации, посвящается.

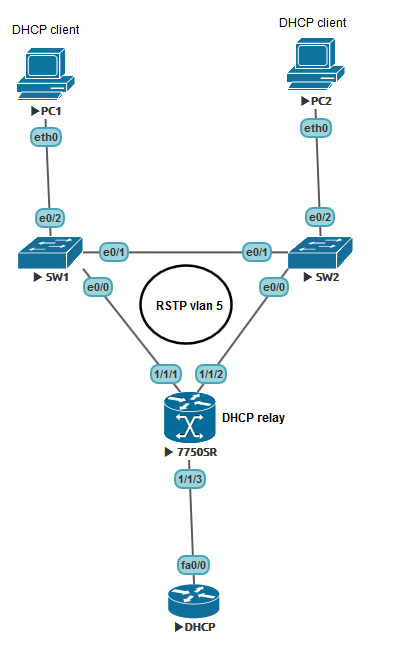

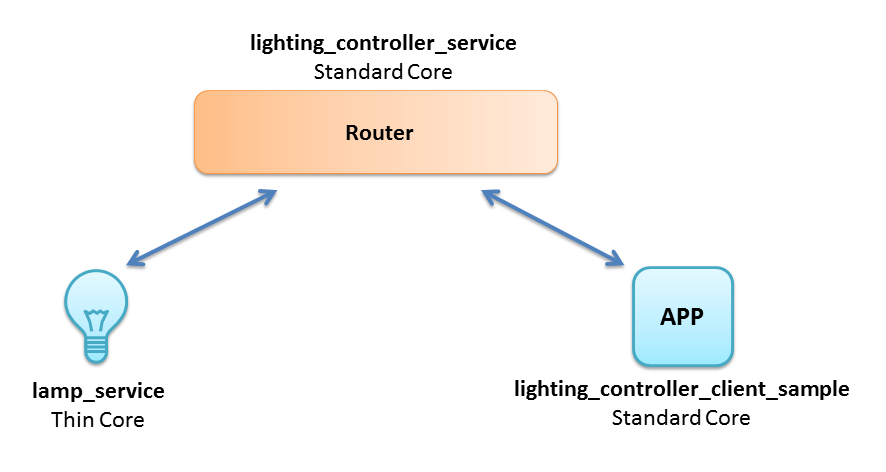

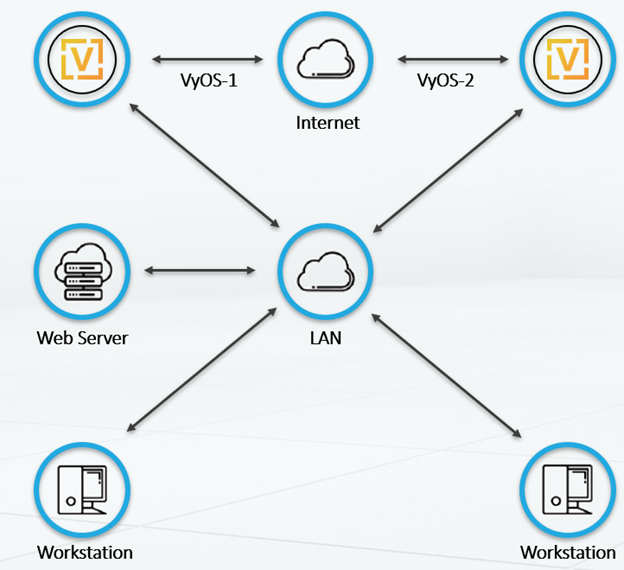

Представьте себе простую топологию:

Два коммутатора доступа, соединенных в кольцо с маршрутизатором, устройство с TimOS на борту (в этом случае — эмулятор SR7750) и внешний DHCP сервер, обслуживающий несколько IP сетей. В такой ситуации у 7750 возникает несколько альтер эго:

1) Default gateway. PC1 и PC2 вполне закономерно хотят общаться с внешними сетями, поэтому необходимо предоставить для них IP адрес, куда можно отсылать все неугодные пакеты.

2) DHCP realy. Поскльку сообщение discover отсылается броадкастом, его необходимо отправить на внешний сервер юникаст сообщением.

3) RSTP root bridge. Вряд ли рационально давать возможность коммутатору доступа становиться рутом.

Сразу оговорюсь, что SR7750 — маршрутизатор. Он не предназначен для коммутации трафика между двумя интерфейсами, не поддерживает SVI в классическом виде со всеми вытекающими. Для использования устройства в такой топологии необходимо создать импровизированный и очень простенький VPLS (хотя, конечно, в случае двух интерфейсов подошел бы и псевдопровод). Для конфигурации VPLS в нашем случае совершенно не обязательно понимать принципы работы MPLS.

Итак, приступим.

**Не забудьте сконфигурировать карточку в эмуляторе.**

```

card 1

card-type iom3-xp-b

mda 1

mda-type m5-1gb-sfp-b

no shutdown

exit

no shutdown

```

Если вы не используете эмулятор, типы карточек и модулей можно определить нехитрыми командами:

```

show card

show mda

```

0. Нашим предварительным шагом будет конфигурация пользователя. VPLS с точки зрения SR — это сервис, а любой сервис должен принадлежать пользователю.

```

customer 5 create

description "Access ring 1"

exit

```

1. Сконфигурируем интерфейсы 1/1/1 и 1/1/2.

```

port 1/1/1

ethernet

mode access

encap-type dot1q

exit

no shutdown

exit

port 1/1/2

ethernet

mode access

encap-type dot1q

exit

no shutdown

exit

```

После этого командой `show port` можно убедиться, что настройки корректны. Обратите внимание, что MTU стал 1518 = 1500 для IP + 14 Ethernet + 4 dot1q vlan. Вполне закономерно, что при конфигурации QinQ устройство само определит размер кадра в 1522.

**Спойлер**`===============================================================================

Ports on Slot 1

===============================================================================

Port Admin Link Port Cfg Oper LAG/ Port Port Port C/QS/S/XFP/

Id State State MTU MTU Bndl Mode Encp Type MDIMDX

-------------------------------------------------------------------------------

1/1/1 Up Yes Up 1518 1518 - accs dotq xcme GIGE-LX 10KM

1/1/2 Up Yes Up 1518 1518 - accs dotq xcme GIGE-LX 10KM`

2. Сконфигурируем сервис VPLS.

```

service

vpls 5 customer 5 create

allow-ip-int-binding

stp

priority 4096

no shutdown

exit

service-name "Access-ring-1"

sap 1/1/1:5 create

exit

sap 1/1/2:5 create

exit

no shutdown

exit

exit

```

**SAP** (Service access point) — это attachment circuit в чуть более известной терминологии. Точка, к которой подключается абонентское устройство. В нашем случае — коммутатор доступа. Число после двоеточия — номер влана.

Именно здесь мы включаем STP. По умолчанию режим работы — RSTP, а наши SAP будут point-to-point интерфейсами с точки зрения STP. Priority 4096 задаем с умыслом превратить наш псевдокоммутатор в root bridge.

`allow-ip-int-binding` необходим для того, чтобы разрешить привязывать IP интерфейс (читай SVI) к нашему VPLS. Этот интерфейс будет привязываться с использованием имени нашего сервиса.

Базовую проверку можно провести с помощью `show service id 5 base`

**Спойлер**`===============================================================================

Service Basic Information

===============================================================================

Service Id : 5 Vpn Id : 0

Service Type : VPLS

Name : Access-ring-1

Description : (Not Specified)

Customer Id : 5 Creation Origin : manual

Last Status Change: 12/06/2016 21:37:01

Last Mgmt Change : 12/06/2016 21:37:01

Etree Mode : Disabled

Admin State : Up Oper State : Up

MTU : 1514 Def. Mesh VC Id : 5

SAP Count : 2 SDP Bind Count : 0

Snd Flush on Fail : Disabled Host Conn Verify : Disabled

Propagate MacFlush: Disabled Per Svc Hashing : Disabled

Allow IP Intf Bind: Enabled

Def. Gateway IP : None

Def. Gateway MAC : None

Temp Flood Time : Disabled Temp Flood : Inactive

Temp Flood Chg Cnt: 0

VSD Domain : none

-------------------------------------------------------------------------------

Service Access & Destination Points

-------------------------------------------------------------------------------

Identifier Type AdmMTU OprMTU Adm Opr

-------------------------------------------------------------------------------

sap:1/1/1:5 q-tag 1518 1518 Up Up

sap:1/1/2:5 q-tag 1518 1518 Up Up

===============================================================================`

3. Итак, интерфейс.

```

service

ies 15 customer 5 create

interface "DGW-1" create

address 10.0.0.6/29

dhcp

server 10.10.10.10

relay-unicast-msg

no shutdown

exit

vpls "Access-ring-1"

exit

exit

no shutdown

exit

```

Как видно, здесь мы убили двух зайцев разом: и default gateway сконфигурировали, и DHCP Relay клиентам предоставили. Заметьте, что IES и VPLS — сервисы разные, с разными id.

Проверить, что интерфейс UP можно с помощью `show service id 15 interface`

**Спойлер**`===============================================================================

Interface Table

===============================================================================

Interface-Name Adm Opr(v4/v6) Type Port/SapId

IP-Address PfxState

-------------------------------------------------------------------------------

DGW-1 Up Up/-- IES rvpls

10.0.0.6/29 n/a

-------------------------------------------------------------------------------

Interfaces : 1

===============================================================================`

4. Сконфигурируем интерфейс в сторону ядра, где расположен DHCP сервер. Для простоты добьемся связности с сервером статическим маршрутом. Не забываем о значении MTU со стороны ядра.

Включаем интерфейс:

```

port 1/1/3

ethernet

exit

no shutdown

exit

```

Настраиваем IP часть:

```

router

interface "To-CORE"

address 172.16.0.0/31

port 1/1/3

no shutdown

exit

interface "system"

no shutdown

exit

static-route 10.10.10.10/32 next-hop 172.16.0.1

```

Таблицу маршрутизации можно посмотреть с помощью `show router route-table`

**Спойлер**`===============================================================================

Route Table (Router: Base)

===============================================================================

Dest Prefix[Flags] Type Proto Age Pref

Next Hop[Interface Name] Metric

-------------------------------------------------------------------------------

10.0.0.0/29 Local Local 00h17m25s 0

DGW-1 0

10.10.10.10/32 Remote Static 00h05m05s 5

172.16.0.1 1

172.16.0.0/31 Local Local 00h05m05s 0

To-CORE 0

-------------------------------------------------------------------------------

No. of Routes: 3

Flags: n = Number of times nexthop is repeated

B = BGP backup route available

L = LFA nexthop available

S = Sticky ECMP requested

===============================================================================`

На этом нехитрая, но немного непривычная настройка Alcatel завершена. На первый взгляд здесь не хватает VRRP, однако по-хорошему для включения VRRP необходимо добавить MPLS интерфейс между двумя маршрутизаторами. Помимо SAP в наш VPLS добавятся SDP. Но это уже совсем другая история.

Версия ПО: TiMOS-B-12.0.R6.

Картинка и консоль: [UNL](http://www.unetlab.com/)

Спасибо за внимание.

|

https://habr.com/ru/post/317138/

| null |

ru

| null |

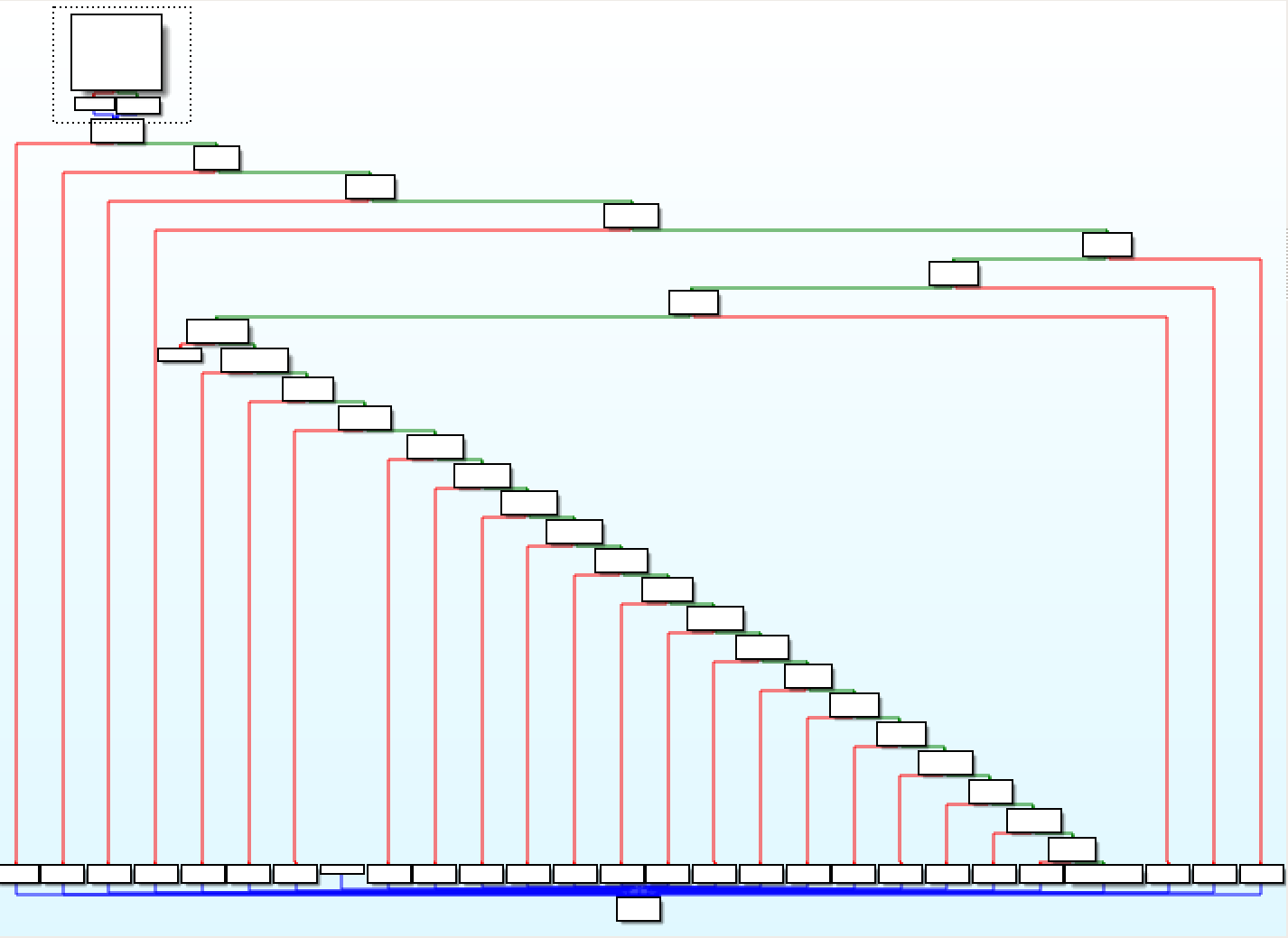

# Как работает ZFS — часть 2: metaslab

В [первой части](http://habrahabr.ru/post/160943/) я описал как организованы данные на vdev в ZFS. Вторая часть описывает как работает алгоритм выбора собственно места, куда запись будет идти в данный момент.

Здесь я немного усложню задачу — в первой части был описан только один vdev; здесь их у нас будет несколько, поскольку алгоритм должен выбрать и vdev, куда мы будем писать блок данных, и metaslab внутри vdev'a. В продакшн системе может быть несколько десятков vdev, и правильно распределить данные по ним критично — перебалансировать их мы уже не сможем без копирования всех данных. Цель правильного алгоритма — распараллелить данные так, чтобы на каждом девайсе их было примерно одинаковое количество, выровнять неравномерное заполнение, но и не перегрузить один из девайсов (это будет тормозить запись на весь пул).

```

NAME STATE READ WRITE CKSUM

tank ONLINE 0 0 0

c1t6d0 ONLINE 0 0 0

c1t5d0 ONLINE 0 0 0

```

Для начала, важное замечание: ZFS рассчитан на то, что все девайсы в пуле имеют одинаковый размер. Иначе, например если добавить 2Тб диск в пул из 1Тб дисков, на 2Тб диске в результате окажется в два раза больше данных, и он начнёт влиять на суммарный IOPs системы — алгоритм аллокатора учитывает процент заполнения, а не количество данных в байтах.

На данный момент в ZFS есть четыре алгоритма аллокатора. Переменная [`zfs_metaslab_ops`](http://src.illumos.org/source/xref/illumos-gate/usr/src/uts/common/fs/zfs/metaslab.c#694) содержит поинтер на структуру `space_map_ops_t`, в которой есть поинтеры на семь функций, которые использует каждый конкретный алгоритм. Например, в Illumos используется алгоритм `metaslab_df`, и соответствующий стракт с поинтерами на функции выглядит вот так:

```

static space_map_ops_t metaslab_df_ops = {

metaslab_pp_load,

metaslab_pp_unload,

metaslab_df_alloc,

metaslab_pp_claim,

metaslab_pp_free,

metaslab_pp_maxsize,

metaslab_df_fragmented

};

```

Пять из этих функций используются во всех алгоритмах; разница собственно только в `metaslab_*_alloc()` и `metaslab_*_fragmented()` — сам аллокатор, и функция, которая решает насколько фрагментировано свободное место в конкретном metaslab. Аллокаторы, которые можно использовать: DF (Dynamic-Fit), FF (First-Fit), и два экспериментальных, CDF и NDF — что они означают, не знает никто.

FF из них самый простой — он пишет куски данных в первое попавшееся свободное место при трассировке АВЛ-дерева по порядку, и разделяет блоки записи на сегменты, если они не влезают. За счёт этого, FF — очень медленный алгоритм, так как для записи одного блока он должен трассировать всё дерево, пока не наберётся достаточное количество сегментов. Для записи 1ГБ данных, например, worst case — 20 млн сегментов по 512 байт, и очень сильная фрагментация данных как результат. FF используется другими алгоритмами как последний вариант, если они не могут найти место по-другому — например, DF изпользует FF если в данном метаслабе меньше 4% свободного места (`int metaslab_df_free_pct = 4;`). Единственный плюс FF в том, что он единственный может заполнить фрагментированный метаслаб на 100%.

\*DF алгоритмы работают по другому — они строят карту свободного места `freemap` в том метаслабе, в который на данный момент идёт запись, сортируют ее по размеру и/или близости кусков непрерывного свободного места, и пытаются выбрать наиболее оптимальный вариант размещения данных с точки зрения скорости записи, количества движений головки диска, и минимальной фрагментации записываемых данных.

Например, для всех них работает функция `metaslab_weight()`, которая даёт небольшой приоритет метаслабам, которые находятся на внешних регионах пластины диска (для short-stroke эффекта). Если использовать только SSD, то имеет смысл тюнить ZFS, отключая эту часть алгоритма, потому-что к SSD short-stroking не применим.

Итак, в алгоритмы аллокатора данные попадают из [ZIO](http://src.illumos.org/source/xref/illumos-gate/usr/src/uts/common/fs/zfs/zio.c) [pipeline](http://src.illumos.org/source/xref/illumos-gate/usr/src/uts/common/fs/zfs/zio.c#2974) — оттуда вызываются функции `metaslab_alloc()` (сам аллокатор для записи) и `metaslab_free()` (освобождаем место, собираем мусор).

```

metaslab_alloc(spa_t *spa, metaslab_class_t *mc, uint64_t psize, blkptr_t *bp,

int ndvas, uint64_t txg, blkptr_t *hintbp, int flags)

```

Туда передаётся: `*spa` — поинтер на структуру самого массива данных (zpool); \*mc — класс метаслабов, в котором в том числе есть поинтер на `zfs_metaslab_ops`; `psize` — размер данных; `*bp` — поинтер на сам блок; `ndvas` — количество независимых копий данных, которое требуется для данного блока (1 для данных; 2 для большинства метаданных; 3 в некоторых случаях для метаданных, которые находятся высоко в АВЛ-дереве. Смысл в дупликации метаданных в том, что если единственный блок с метаданными для сегмента дерева утерян, мы теряем всё, что находится под ним. Такие блоки называются ditto blocks, и алгоритм старается писать их на разные vdevы).

Далее, `txg` — порядковый номер группы транзакций, которую мы пишем; `*hintbp` — подсказка, используемая для того, чтобы блоки которые рядом логически были также рядом на диске, и шли на тот же vdev; `flags` — 5 бит, которые позволяют аллокатору узнать нужно ли использовать какие-либо специфические варианты аллокации — использовать или игнорировать подсказку `*hintbp`, и использовать ли ganging (просьба писать группу child блоков на тот же vdev, что и их header, для более эффективной работы ZFS prefetch и vdev cache).

```

define METASLAB_HINTBP_FAVOR 0x0

define METASLAB_HINTBP_AVOID 0x1

define METASLAB_GANG_HEADER 0x2

define METASLAB_GANG_CHILD 0x4

define METASLAB_GANG_AVOID 0x8

```

```

/*

* Allow allocations to switch to gang blocks quickly. We do this to

* avoid having to load lots of space_maps in a given txg. There are,

* however, some cases where we want to avoid "fast" ganging and instead

* we want to do an exhaustive search of all metaslabs on this device.

* Currently we don't allow any gang, zil, or dump device related allocations

* to "fast" gang.

*/

#define CAN_FASTGANG(flags) \

(!((flags) & (METASLAB_GANG_CHILD | METASLAB_GANG_HEADER | \

METASLAB_GANG_AVOID)))

```

```

/*

* If we are doing gang blocks (hintdva is non-NULL), try to keep

* ourselves on the same vdev as our gang block header. That

* way, we can hope for locality in vdev_cache, plus it makes our

* fault domains something tractable.

*/

```

Далее, собственно, идёт самая важная часть кода, в которой логика самого выбора метаслаба для записи: `metaslab_alloc_dva()`. В функции почти 200 строк хитрого кода, который я попытаюсь объяснить.

Сначала, мы берём все группы метаслабов для всех vdev'ов, и проходимся по ним циклом аллокатора (`mg_rotor`), используя подсказки, если они есть. Мы пропускаем vdev'ы, на которые запись в данный момент нежелательна, например те, в которых умер один из дисков, или идёт восстановление raidz-группы. (Don't allocate from faulted devices.) Мы также пропускаем диски, на которых были какие-то ошибки записи, для данных у которых на дисках будет только одна копия. (Avoid writing single-copy data to a failing vdev.)

Ротор работает по кругу пока не кончатся данные, отправленные на запись. Внутри этого цикла, по очереди выбирается оптимальный vdev, потом в нём, используя `metaslab_group_alloc()`, выбирается лучший метаслаб, потом решаем сколько данных записать в этот метаслаб, сравнивая процент использования vdev'a с другими. Эта часть кода очень критична, поэтому привожу ее полностью:

```

offset = metaslab_group_alloc(mg, psize, asize, txg, distance,

dva, d, flags);

if (offset != -1ULL) {

/*

* If we've just selected this metaslab group,

* figure out whether the corresponding vdev is

* over- or under-used relative to the pool,

* and set an allocation bias to even it out.

*/

if (mc->mc_aliquot == 0) {

vdev_stat_t *vs = &vd->vdev_stat;

int64_t vu, cu;

vu = (vs->vs_alloc * 100) / (vs->vs_space + 1);

cu = (mc->mc_alloc * 100) / (mc->mc_space + 1);

/*

* Calculate how much more or less we should

* try to allocate from this device during

* this iteration around the rotor.

* For example, if a device is 80% full

* and the pool is 20% full then we should

* reduce allocations by 60% on this device.

*

* mg_bias = (20 - 80) * 512K / 100 = -307K

*

* This reduces allocations by 307K for this

* iteration.

*/

mg->mg_bias = ((cu - vu) *

(int64_t)mg->mg_aliquot) / 100;

}

```

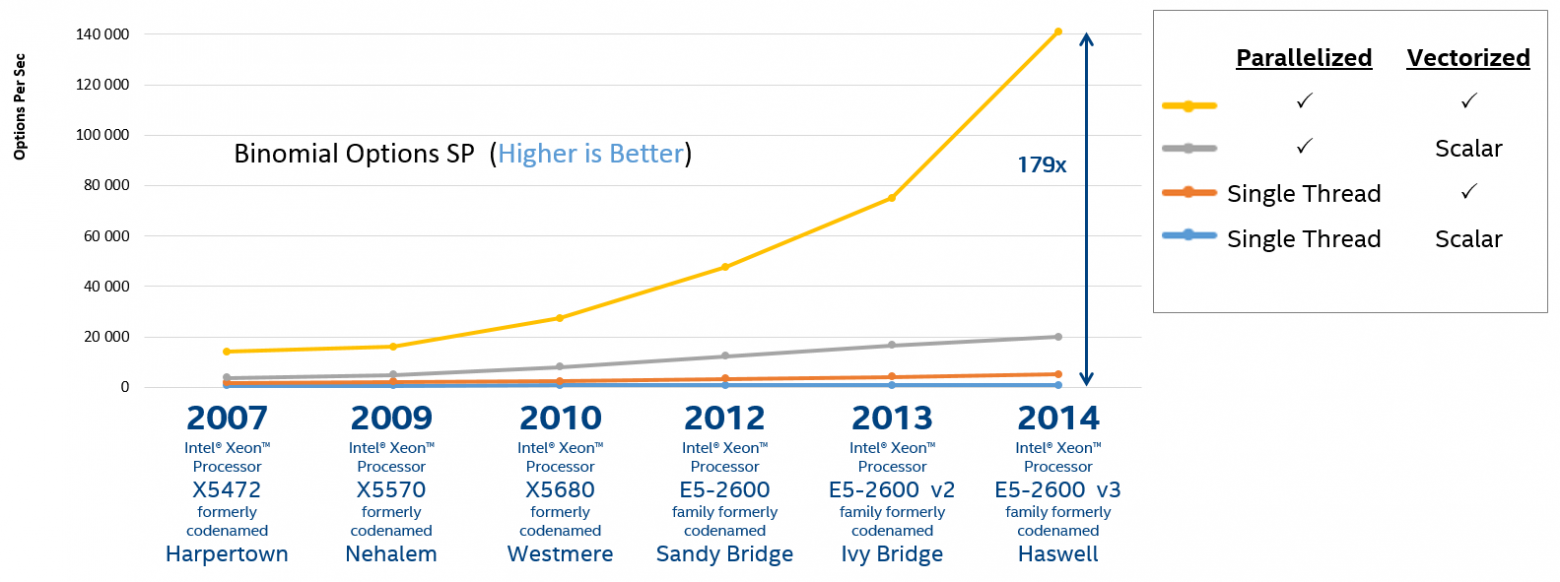

Например, если нам надо записать 1МБ данных на массив из двух дисков, ~~один из которых заполнен на 20%, а второй — на 80%, мы запишем 819КБ на первый, и 205КБ на второй.~~ *Поправка: сравнивается свободное место в пуле, и свободное место в vdev'e, так что результат будет немного другим.*Здесь, кстати, можно сделать одну очень интересную вещь — несколько месяцев назад я добавил статистику latency для каждого vdeva в ZFS (она находится в `vdev_stat_t->vs_latency[]` в NexentaStor; в Illumos пока не добавили), и её можно использовать в качестве одного из факторов при записи новых данных, либо учитывая и её и свободное место в какой-либо пропорции, либо используя только её. Такой изменённый алгоритм я тоже написал, но он пока не используется в продакшн-системах. Он имеет смысл когда либо в массиве есть диски разного типа и скорости, либо когда один из дисков начинает умирать (тормозить), но пока не настолько плох, и на нём нет ошибок.

Наконец, итерация за итерацией, цикл отправляет все данные на запись в metaslab group, и заканчивается для этой transaction group (txg), a в группе метаслабов работает система [`metaslab_weight()`](http://src.illumos.org/source/xref/illumos-gate/usr/src/uts/common/fs/zfs/metaslab.c#785) (см. начало статьи), и через систему [`space map`](http://src.illumos.org/source/xref/illumos-gate/usr/src/uts/common/fs/zfs/space_map.c#84), учитывая maxfree (максимальный кусок непрерывного свободного места), с помощью трассировки АВЛ-деревьев и соответствующего алгоритма (DF, FF, CDF, NDF) распихивает данные оптимальным для алгоритма образом, после чего мы наконец получаем физический адрес блока, в который мы будем писать на диск, и данные идут в очередь на запись в `sd` (Scsi Device) драйвер.

|

https://habr.com/ru/post/161055/

| null |

ru

| null |

# Контрактное программирование в PHP

В реальной жизни мы повсюду сталкиваемся с различными контрактами: при устройстве на работу, при выполнении работ, при подписании взаимных соглашений и многими другими. Юридическая сила контрактов гарантирует нам защиту интересов и не допускает их нарушения без последствий, что дает нам уверенность в том, что те пункты, которые описаны в контракте — будут выполнены. Эта уверенность помогает нам планировать время, планировать расходы, а также планировать необходимые ресурсы. А что если и программный код будет описываться контрактами? Интересно? Тогда добро пожаловать под кат!

#### Введение

Сама идея контрактного программирования возникла в 90-х годах у Бертрана Мейера при разработке объектно-ориентированного языка программирования [Eiffel](http://ru.wikipedia.org/wiki/%D0%AD%D0%B9%D1%84%D0%B5%D0%BB%D1%8C_(%D1%8F%D0%B7%D1%8B%D0%BA_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F)). Суть идеи Бертрана была в том, что нужно было иметь инструмент для описания формальной верификации и формальной спецификации кода. Такой инструмент давал бы конкретные ответы: «метод обязуется сделать свою работу, если вы выполните условия, необходимые для его вызова». И контракты как нельзя лучше подходили для данной роли, потому что позволяли описать что будет получено от системы (спецификация) в случае соблюдения предусловий (верификация). С тех пор появилось множество реализаций данной методики программирования как на уровне конкретного языка, так и в виде отдельных библиотек, позволяющих задавать контракты и проводить их верификацию с помощью внешнего кода. К сожалению, в PHP нет поддержки контрактного программирования на уровне самого языка, поэтому реализация может быть выполнена только с помощью сторонних библиотек.

#### Контракты в коде

Так как контрактное программирование было разработано для объектно-ориентированного языка, то не сложно догадаться, что основными рабочими элементами для контрактов являются классы, методы и свойства.

###### Предусловия

Самым простым вариантом контракта являются *предусловия* — требования, которые должны быть выполнены перед конкретным действием. В рамках ООП все действия описываются методами в классах, поэтому предусловия применяются к методами, а их проверка происходит в момент вызова метода, но до выполнения самого тела метода. Очевидное использование — проверка валидности переданных параметров в метод, их структуры и корректности. То есть с помощью предусловий мы описываем в контракте все то, с чем мы точно работать не будем. Это же здорово!

Чтобы не быть голословным, давайте рассмотрим пример:

```

class BankAccount

{

protected $balance = 0.0;

/**

* Deposits fixed amount of money to the account

*

* @param float $amount

*/

public function deposit($amount)

{

if ($amount <= 0 || !is_numeric($amount)) {

throw new \InvalidArgumentException("Invalid amount of money");

}

$this->balance += $amount;

}

}

```

Мы видим, что метод пополнения баланса в неявном виде требует числового значения величины суммы пополнения, которая также должна быть строго больше нуля, в противном случае будет выброшено исключение. Это типичный вариант предусловия в коде. Однако он имеет несколько минусов: мы вынуждены искать глазами эти проверки и, находясь в другом классе, не можем быстро оценить наличие/отсутствие таких проверок. Также, без наличия явного контракта, нам придется помнить о том, что в коде класса есть необходимые проверки входящих аргументов и нам не надо волноваться за них. Еще один фактор: эти проверки выполняются всегда, как в режиме разработки, так и боевом режиме работы приложения, что незначительно влияет в отрицательную сторону на скорость работы приложения.

В плане реализации предусловий, в PHP существует специальная конструкция для проверки утверждений — [assert()](http://php.net/assert). Большое ее преимущество в том, что проверки можно отключать в боевом режиме, заменяя весь код команды на единственный NOP. Давайте посмотрим на то, как можно описать предусловие с помощью данной конструкции:

```

class BankAccount

{

protected $balance = 0.0;

/**

* Deposits fixed amount of money to the account

*

* @param float $amount

*/

public function deposit($amount)

{

assert('$amount>0 && is_numeric($amount); /* Invalid amount of money /*');

$this->balance += $amount;

}

}

```

Хочу обратить внимание на то, что предусловия в рамках контрактов служат для проверки логки работы программы и не отвечают за валидность параметров, переданных от клиента. Контракты отвечают только за взаимодействие внутри самой системы. Поэтому пользовательский ввод должен всегда фильтроваться с помощью фильтров, так как утверждения могут быть отключены.

###### Постусловия

Следующая категория контрактов — *постусловия*. Как можно догадаться из названия, данный тип проверки выполняется после того, как было выполнено тело метода, но до момента возврата управления в вызывающий код. Для нашего метода `deposit` из примера мы можем сформировать следующее постусловие: баланс счета после вызова метода должен равняться предыдущему значению баланса плюс величина пополнения. Осталось дело за малым — описать все это в виде утверждения в коде. Но вот здесь нас поджидает первое разочарование: как же сформировать это требование в коде, ведь мы сперва изменим баланс в теле самого метода, а потом попытаемся проверить утверждение, где нужно старое значение баланса. Здесь может помочь клонирование объекта перед выполнением кода и проверка пост-условий:

```

class BankAccount

{

protected $balance = 0.0;

/**

* Deposits fixed amount of money to the account

*

* @param float $amount

*/

public function deposit($amount)

{

$__old = clone $this;

assert('$amount>0 && is_numeric($amount); /* Invalid amount of money /*');

$this->balance += $amount;

assert('$this->balance == $__old->balance+$amount; /* Contract violation /*');

}

}

```

Еще одно разочарование поджидает нас при описании постусловий для методов, возвращающих значение:

```

class BankAccount

{

protected $balance = 0.0;

/**

* Returns current balance

*/

public function getBalance()

{

return $this->balance;

}

}

```

Как здесь описать контрактное условие, что метод должен возвращать текущий баланс? Так как пост-условие выполняется после тела метода, то мы наткнемся на `return` раньше, чем сработает наша проверка. Поэтому придется изменить код метода, чтобы сохранить результат в переменную `$__result` и сравнить потом с `$this->balance`:

```

class BankAccount

{

protected $balance = 0.0;

/**

* Returns current balance

*/

public function getBalance()

{

$__result = $this->balance;

assert('$__result == $this->balance; /* Contract violation /*');

return $__result;

}

}

```

И это для простого метода, не говоря уже о том случае, когда метод большой и в нем несколько точек возврата. Как вы уже догадались, на этом этапе идеи об использовании контрактного программирования в проекте на PHP быстро умирают, так как язык не поддерживает необходимых управляющих конструкций. Но есть решение! И о нем будет написано ниже, наберитесь немного терпения.

###### Инварианты

Нам осталось рассмотреть еще один важный тип контрактов: *инварианты*. Инварианты — это специальные условия, которые описывают целостное состояние объекта. Важной особенностью инвариантов является то, что они проверяются всегда после вызова любого публичного метода в классе и после вызова конструктора. Так как контракт определяет состояние объекта, а публичные методы — единственная возможность изменить состояние извне, то мы получаем полную спецификацию объекта. Для нашего примера хорошим инвариантом может быть условие: баланс счета никогда не должен быть меньше нуля. Однако, с инвариантами в PHP дело обстоит еще хуже чем с постусловиями: нет никакой возможности легко добавить проверку во все публичные методы класса, чтобы после вызова любого публичного метода можно было проверить необходимое условие в инварианте. Также нет возможности обращаться к предыдущему состоянию объекта `$__old` и возвращаемому результату `$__result`. Без инвариантов нет контрактов, поэтому долгое время не было никаких средств и методик для реализации данного функционала.

#### Новые возможности

Встречайте, PhpDeal — экспериментальный DbC-[фреймворк для контрактного программирования в PHP](https://github.com/lisachenko/php-deal).

После того, как был разработан [фреймворк Go! AOP для аспектно-ориентированного программирования в PHP](https://github.com/lisachenko/go-aop-php), у меня в голове крутились мысли насчет автоматической валидации параметров, проверки условий и много-много другого. Триггером к созданию проекта для контрактного программирования послужило обсуждение на [PHP.Internals](http://grokbase.com/t/php/php-internals/141wpxrw6r/dbc-for-php) . Удивительно, но с помощью АОП задача решалась всего в пару действий: нужно было описать аспект, который будет перехватывать выполнение методов, помеченных с помощью контрактных аннотаций, и выполнять нужные проверки до или после вызова метода.

Давайте посмотрим на то, как можно использовать контракты с помощью этого фреймворка:

```

use PhpDeal\Annotation as Contract;

/**

* Simple trade account class

* @Contract\Invariant("$this->balance > 0")

*/

class Account implements AccountContract

{

/**

* Current balance

*

* @var float

*/

protected $balance = 0.0;

/**

* Deposits fixed amount of money to the account

*

* @param float $amount

*

* @Contract\Verify("$amount>0 && is_numeric($amount)")

* @Contract\Ensure("$this->balance == $__old->balance+$amount")

*/

public function deposit($amount)

{

$this->balance += $amount;

}

/**

* Returns current balance

*

* @Contract\Ensure("$__result == $this->balance")

* @return float

*/

public function getBalance()

{

return $this->balance;

}

}

```

Как вы заметили, все контракты описываются в виде аннотаций внутри док-блоков и содержат необходимые условия внутри самой аннотации. Не нужно менять оригинальный исполняемый код класса, он остается таким же чистым, как и код без контрактов.

Предусловия задаются с помощью аннотации `Verify` и определяют те проверки, которые будут выполнены в момент вызова метода, но до выполнения самого тела метода. Предусловия работают в области видимости метода класса, поэтому имеют доступ ко всем свойствам, включая приватные, а также имеют доступ к параметрам метода.

Постусловия задаются аннотацией, имеющей стандартное название `Ensure` в терминах контрактного программирования. Код имеет аналогичную область видимости, что и сам метод, помимо этого, доступны переменные `$__old` с состоянием объекта до выполнения метода и переменная `$__result`, содержащая в себе то значение, которое было возвращено из данного метода.

Благодаря использованию АОП стало возможным реализовать даже инварианты — они элегантно описываются в виде аннотаций `Invariant` в док-блоке класса и ведут себя аналогично постусловиям, но для всех методов.

Во время экспериментов с кодом я обнаружил удивительное сходство контрактов с интерфейсам в PHP. Если стандартный интерфейс определят требования к стандарту взаимодействия с классом, то контракты позволяют описывать требования к состоянию инстанса класса. Применяя описание контракта в интерфейсе, удается описывать требования как к взаимодействию с объектом, так и к состоянию объекта, которое будет потом реализовано в классе:

```

use PhpDeal\Annotation as Contract;

/**

* Simple trade account contract

*/

interface AccountContract

{

/**

* Deposits fixed amount of money to the account

*

* @param float $amount

*

* @Contract\Verify("$amount>0 && is_numeric($amount)")

* @Contract\Ensure("$this->balance == $__old->balance+$amount")

*/

public function deposit($amount);

/**

* Returns current balance

*

* @Contract\Ensure("$__result == $this->balance")

*

* @return float

*/

public function getBalance();

}

```

Дальше начинается самое интересное: при создании класса и определении нужного метода любая современная IDE переносит все аннотации из описания метода в интерфейсе в сам класс. А это позволяет движку PhpDeal их находить и обеспечивать автоматическую проверку контрактов в каждом конкретном классе, реализующем данный интерфейс. Для желающих пощупать все собственными руками — можно скачать проект с гитхаба, установить все зависимости с помощью композера, настроить локальный веб-сервер на эту папку и потом просто открыть в браузере код из папки [demo](https://github.com/lisachenko/php-deal/tree/master/demo)

#### Заключение

Контрактное программирование в PHP — абсолютно новая парадигма, которая может использоваться для защитного программирования, для улучшения качества кода и обеспечения читаемости контрактов, определяемых в виде требований и спецификаций. Большой плюс данной реализации в том, что код классов остается читаемым, сами аннотации читаются как документация, а также то, что в боевом режиме проверка может быть полностью отключена и не требует абсолютно никакого времени на дополнительные ненужные проверки в коде. Интересный факт: сам фреймоврк содержит лишь пару аннотаций и один класс аспекта, который связывает эти аннотации с конкретной логикой.

Благодарю за внимание!

Ссылки по теме:

1. [Wikipedia — контрактное программирование](http://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D0%BD%D1%82%D1%80%D0%B0%D0%BA%D1%82%D0%BD%D0%BE%D0%B5_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5)

2. [Фреймворк PhpDeal для контрактного программирования в PHP](https://github.com/lisachenko/php-deal)

3. [Фреймворк Go! AOP для аспектно-ориентированного программирования в PHP](https://github.com/lisachenko/go-aop-php)

|

https://habr.com/ru/post/214371/

| null |

ru

| null |

# Оформляем текстовые поля при помощи JQuery themes

Почтеннейшая публика,

Фреймворк JQuery themes позволяет легко и быстро придать одинаковый стиль всем виджетам из набора JQuery UI. Однако, простых элементов это не касается — они остаются серыми и унылыми. Мне захотелось оформить в том же стиле все остальные поля. Начнем с текстовых.

Писать специальный виджет для этого будет overkill, ограничимся простым скриптом, который подключим в Master Page:

````

$(function () {

$('input:text, input:password, textarea')

.addClass('ui-widget ui-state-default ui-corner-all')

.hover(

function () {

$(this).switchClass('ui-state-default', 'ui-state-hover', 1);

},

function () {

$(this).switchClass('ui-state-hover', 'ui-state-default', 1);

})

.focus(function () {

$(this).addClass("ui-state-focus");

})

.blur(function () {

$(this).removeClass("ui-state-focus");

});

});

````

Вначале подключаем классы по умолчанию: ui-widget — базовый, ui-state-default — для состояния «по умолчанию», и ui-corner-all для закругления углов (не работает в IE). Метод hover задает два поведения: при наведении мышки мы меняем дефолтный класс на ui-state-hover (третий аргумент — для того, чтобы убрать плавный переход), а когда мышку убираем — все возвращается. Ну, а для событий focus и blur пишем два разных обработчика.

**update**

Чтобы все это работало, нужно подключить следующие скрипты:

JQuery

JQueryUI

И CSS Вашей любимой темы отсюда:

[jqueryui.com/themeroller](http://jqueryui.com/themeroller/)

Пост предназначен для новичков в JQuery. Я только что провел пару часов, разбираясь со всеми этими классами, захотелось сэкономить другим время…

**update2**

Рано я бросился писать пост, факт. Текстовым полям по дефолту надо ставить класс «ui-widget ui-widget-content ui-corner-all», по focus — добавлять класс «ui-state-highlight», а по hover вообще непонятно, что делать. Они уже год планируют добавить классы типа ui-form-default и ui-form-hover для таких случаев.

|

https://habr.com/ru/post/94701/

| null |

ru

| null |

# php-cs-fixer: Пишем свой фиксер

Качество кода не только в том, как он работает, но и в том как выглядит. То, что единый в рамках кампании code style — это очень важная вещь — в наши дни убеждать уже никого не нужно. Код должен быть не только написан, но и оформлен. В плане оформления PHP кода, утилита [php-cs-fixer](https://github.com/FriendsOfPHP/PHP-CS-Fixer) давно уже стала стандартом. Использовать ее довольно просто, есть куча правил и можно удобно забиндить ее запуск на какую-нибудь комбинацию клавиш в шторме или на pre-commit hook в гите. Все это легко гуглится и подробно разбирается в сотнях статей. А мы сегодня поговорим о другом. Хотя в php-cs-fixer есть большое количество разных фиксеров, но что, если нам понадобится такой, которого там нет? Как написать собственный фиксер?

### Фиксер?

Вообще, что такое фиксер? Фиксер, это небольшой класс, который фиксит ваш код, приводит его к какому-то виду. Я не стал выдумывать глупые или сложные кейсы для нового фиксера, и решил взять какой-нибудь вполне реальный. Например, приведение всех ключевых слов в коде к нижнему регистру. За это отвечает фиксер *LowercaseKeywordsFixer*. Давайте на его примере научимся создавать собственные фиксеры.

### Фиксим

Итак, вы уже выполнили

```

git clone https://github.com/FriendsOfPHP/PHP-CS-Fixer.git

composer install

```

Наш подопытный фиксер состоит из двух частей:

Сам фиксер:

`src/Fixer/Casing/LowercaseKeywordsFixer.php`

И тест:

`tests/Fixer/Casing/LowercaseKeywordsFixerTest.php`

*LowercaseKeywordsFixer.php* — это файл, который содержит класс фиксера. Каждый фиксер должен наследоваться от абстрактного класса *PhpCsFixer\AbstractFixer,* а значит содержать методы:

```

getDefinition();

isCandidate(Tokens $tokens);

applyFix(\SplFileInfo $file, Tokens $tokens);

```

К этим методам мы еще вернемся. Давайте теперь рассмотрим очень важное для нас понятие: Token.

### Token в PHP

Если вы хорошо знакомы с PHP, то понятие токенов для вас не ново. На русском их еще иногда называют “метками”. Токены — это языковые лексемы PHP. Например, если взять такой простенький код:

```

php

foreach ($a as $B) {

try {

new $c($a, isset($b));

} catch (\Exception $e) {

exit(1);

}

}</code

```

и разбить его на токены, то получим массив из 54 элементов. Вторым элементом будет:

```

Array

(

[0] => 334

[1] => foreach

[2] => 3

)

```

Где 334 — это идентификатор токена. То есть не этого конкретного токена, а этого типа токенов. Другими словами, все токены, представляющие конструкцию foreach — будут иметь идентификатор 382. Этому идентификатору соответствует константа *T\_FOREACH*. Список всех констант можно посмотреть [в документации](http://php.net/manual/ru/tokens.php).

Очень важный момент. **Идентификаторы меняются от версии к версии PHP интерпретатора**, ваш код никогда не должен зависеть от конкретных цифр, только [константы](http://php.net/manual/ru/tokens.php)!

Подробнее про токены можно почитать в [документации](http://php.net/manual/ru/ref.tokenizer.php).

### Token в php-cs-fixer

В php-cs-fixer есть два класса для работы с токенами:

*PhpCsFixer\Tokenizer\Tokens* для работы с массивом токенов, и

*PhpCsFixer\Tokenizer\Token* для работы с одним токеном.

Рассмотрим некоторые полезные методы.

**Token:**

```

equals($other, $caseSensitive = true)

```

Проверяет, что переданный первым параметром токен эквивалентен текущему. Это самый правильный способ проверить, что токены равны.

```

equalsAny(array $others, $caseSensitive = true);

```

Проверяет, что один из переданных в первом параметре токенов равен текущему.

```

getContent();

```

Получить содержимое токена.

```

setContent($content);

```

Задать содержимое токена.

```

isChanged();

```

Был ли токен уже модифицирован.

```

isKeyword();

isNativeConstant();

isMagicConstant();

isWhitespace();

```

Названия говорят сами за себя.

[Подробнее](https://github.com/FriendsOfPHP/PHP-CS-Fixer/blob/master/src/Tokenizer/Token.php)

**Tokens:**

```

findBlockEnd($type, $searchIndex, $findEnd = true);

```

Найти конец блока типа $type (фигурные, квадратные или круглые скобки), начиная от токена с индексом $searchIndex. Если третьим параметром передать true — то метод будет искать начало блока, а не конец.

```

findGivenKind($possibleKind, $start = 0, $end = null);

```

Найти токены заданного типа (типов, если передать массив) начиная с токена под индексом $start и до токена под индексом $end.

```

generateCode();

```

Сгенерировать PHP код из набора токенов.

```

generatePartialCode($start, $end);

```

Сгенерировать PHP код из набора токенов между $start и $end

```

getNextTokenOfKind($index, array $tokens = array(), $caseSensitive = true);

```

Найти следующий токен определенного типа

```

getNextMeaningfulToken($index);

getPrevMeaningfulToken($index);

```

Найти следующий/предыдущий токен, содержащий что-то, кроме пробелов и комментариев.

```

insertAt($index, $items);

```

Добавить в коллекцию новый токен, после $index

```

overrideAt($index, $token);

```

Заменить токен с индексом $index на переданный вторым параметром.

[Подробнее](https://github.com/FriendsOfPHP/PHP-CS-Fixer/blob/master/src/Tokenizer/Tokens.php)

### Пишем фиксер

Теперь к самому фиксеру.

Напомню, что мы пишем фиксер, который приводит все ключевые слова PHP к нижнему регистру. Класс фиксера будет находиться в файле

`src/Fixer/Casing/LowercaseKeywordsFixer.php`

Для начала нам нужно определить, попадает ли код под наш кейс. В нашем случае нам надо обработать любой код, который содержит ключевые слова php. Определим метод *isCandidate*.

```

public function isCandidate(Tokens $tokens)

{

return $tokens->isAnyTokenKindsFound(Token::getKeywords());

}

```

Теперь нам нужно описать наш фиксер. Для этого определим метод:

```

public function getDefinition()

{

return new FixerDefinition(

'PHP keywords MUST be in lower case.',

array(

new CodeSample(

'php

FOREACH($a AS $B) {

TRY {

NEW $C($a, ISSET($B));

WHILE($B) {

INCLUDE "test.php";

}

} CATCH(\Exception $e) {

EXIT(1);

}

}

'

),

)

);

}</code

```

Этот метод возвращает объект *FixerDefinition*, конструктор которого принимает два параметра: короткое описание фиксера (оно будет в документации в файле [README.rst](https://github.com/FriendsOfPHP/PHP-CS-Fixer/blob/master/README.rst)) и небольшой пример кода для исправления (он нигде отображаться не будет, но участвует в тестах).

Также мы можем реализовать метод

```

public function getPriority()

{

return 0;

}

```

Который возвращает приоритет фиксера, если нам понадобится запускать свой фиксер до или после других фиксеров. В нашем случае, наш фиксер никак не зависит от остальных, так что можно не реализовывать метод, оставив значение 0 из родительского класса.

Все приготовления закончены, давайте реализуем метод, который будет фиксить код.

Нам нужно, пробежать по всему коду, если токен — ключевое слово, то привести его к нижнему регистру:

```

protected function applyFix(\SplFileInfo $file, Tokens $tokens)

{

foreach ($tokens as $token) {

if ($token->isKeyword()) {

$token->setContent(strtolower($token->getContent()));

}

}

}

```

В итоге должен получиться примерно [такой файл](https://github.com/FriendsOfPHP/PHP-CS-Fixer/blob/master/src/Fixer/Casing/LowercaseKeywordsFixer.php).

### Что дальше

У нас есть работающий фиксер. Это здорово. Осталось совсем чуть-чуть. Давайте напишем для него тест. Наш тест будет находиться в файле

`tests/Fixer/Casing/LowercaseKeywordsFixerTest.php`

Это обычный PHPUnit тест, разве что у него есть свой метод

```

doTest($expected, $input = null, \SplFileInfo $file = null)

```

который первым параметром принимает ожидаемый результат, а вторым — первоначальный код. Тестовый метод:

```

/**

* @param string $expected

* @param null|string $input

*

* @dataProvider provideExamples

*/

public function testFix($expected, $input = null)

{

$this->doTest($expected, $input);

}

```

Напишем провайдер данных:

```

public function provideExamples()

{

return array(

array('php $x = (1 and 2);', '<?php $x = (1 AND 2);'),

array('<?php foreach(array(1, 2, 3) as $val) {}', '<?php FOREACH(array(1, 2, 3) AS $val) {}'),

array('<?php echo "GOOD AS NEW";'),

array('<?php echo X::class ?', 'php echo X::ClASs ?'),

);

}

```

В итоге получаем такой [код](https://github.com/FriendsOfPHP/PHP-CS-Fixer/blob/master/tests/Fixer/Casing/LowercaseKeywordsFixerTest.php).