text

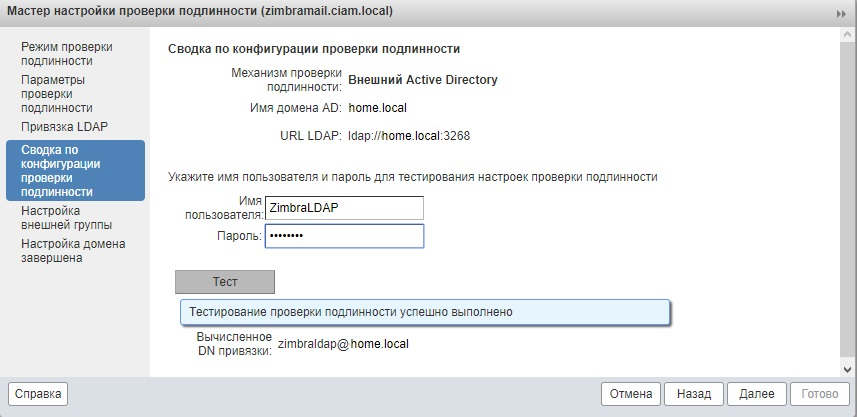

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# MakiseGUI — бесплатная библиотека графического интерфейса для микроконтроллеров

Существует множество библиотек графического интерфейса для микроконтроллеров и встраиваемых систем, но многие из них имеют ограниченный функционал, сложность в использовании и интеграции, необходимость обязательного использования внешней оперативной памяти, а некоторые стоят больше, чем ваш проект целиком. Из-за этих причин и многих других было решено писать свою библиотеку.

Назвал я её [MakiseGui](https://github.com/SL-RU/MakiseGUI).

Перед началом разработки я поставил себе цели:

* Простота конечной разработки. Писать интерфейс не должно быть сложнее, чем используя WindowsForms и тп

* Простота интеграции. Встроить и запустить интерфейс в приложении должно быть максимально просто на любом железе или ПО.

* Чистый Си. Был использован только gnu-c99 и из библиотек только stdlib

* Минимальное потребление RAM. Возможность использования на средних микроконтроллерах без внешней памяти(примерно 40kb с цветным дисплеем 320х240).

* Достаточное количество графических элементов для комфортной разработки. Простое добавление новых.

* opensource лицензия и бесплатное использование даже в коммерческих проектах

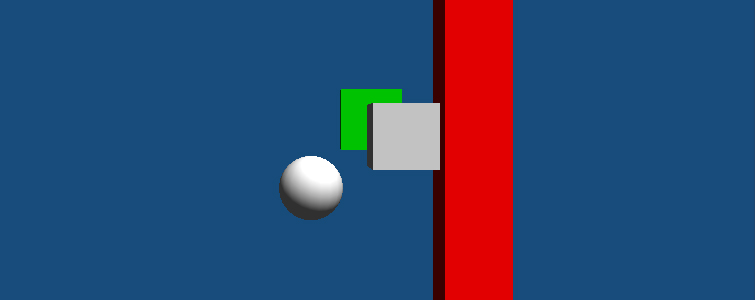

Пример без объяснений.

======================

В качестве демонстрации возможностей библиотеки и примеров использования может быть использован проект созданный специально для этих целей: <https://github.com/SL-RU/MakiseSDLTest>

Он использует SDL2 для отрисовки и ввода и имеет примеры использования всех элементов и почти всех функций системы. Может быть скомпиллирован и запущен на любом linux дистрибутиве. На windows тоже, но лишь теоретически — сам не пробовал.

Видео работы:

Структура

=========

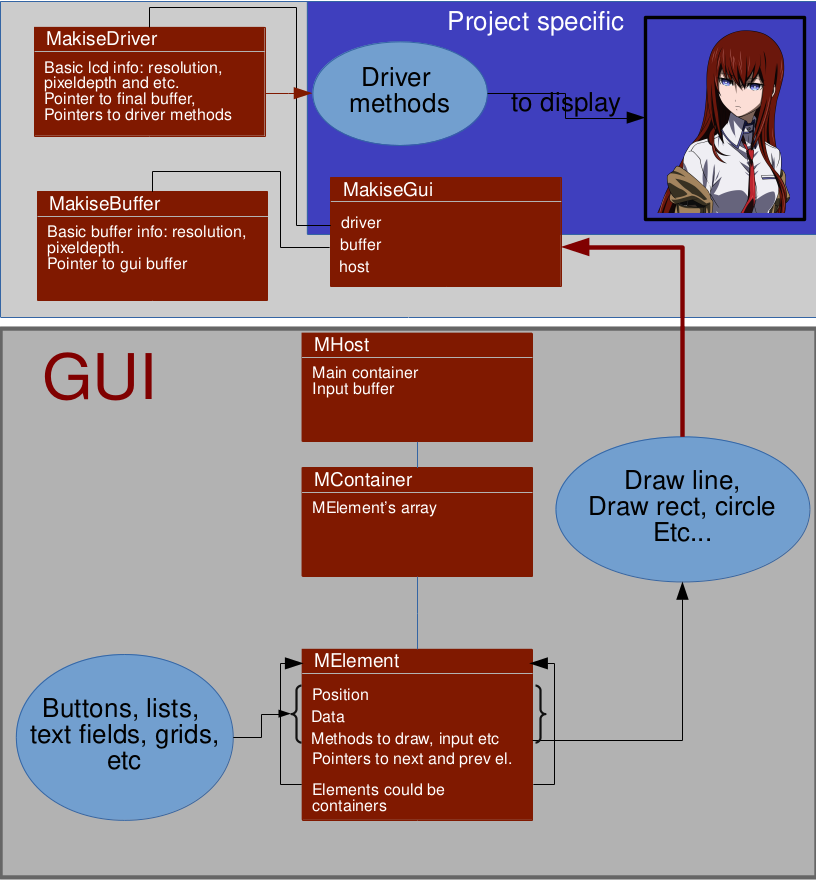

Библиотека состоит из трёх чётко разделённых частей:

1) Ядро. Ядро состоит из интерфейса к драйверу, функций отрисовки в драйвер и функций отрисовки примитивов в буфер.

2) Драйвер. Драйвер обеспечивает всё общение с железом и с ПО, поэтому под каждую задачу придётся писать обычно свой, чтобы учесть все моменты(DMA, прерывания и тд). Драйвер лишь обеспечивает передачу изображения из буфера на железо и очищает буфер изображения. Как примеры, в проекте есть драйверы для дисплея на ili9340, а так же SDL2 для отладки библиотеки на компьютере. Ядро и драйвер могут работать отдельно, без GUI.

3) Сам GUI. Занимает бОльшую часть системы, тут воплощены все необходимые функции для работы интерфейса: контейнеры, элементы, системы отрисовки, фокуса, ввода, обработки событий и прочего.

GUI

===

Разработка графического интерфейса максимально приближена к объектно-ориентированному для максимальной простоты конечного программирования. Благодаря этому она имеет некоторые приятные особенности

Простейший пример, создающий кнопку на экране:

```

MHost host; //базовая структура системы, root-контейнер, содержащий все другие контейнеры и элементы.

//метод будет вызыван при нажатии на кнопку

void click(MButton *b)

{

printf("Button was clicked"); //выводим сообщение в стандартный поток

b->text = "Clicked!"; //меняем текст кнопки

}

MButton button; //структура, содержащая всю информацию о кнопке

void create_gui()

{

//создаём кнопку

m_create_button(&button, //указатель на структуру кнопки

host->host, //контейнер, в который будет добавлена кнопка после создания. В данном случае это контейнер MHost'a

mp_rel(20, 20, //координаты элемента относительно левого верхнего угла

90, 30), //ширина, высота

"Click me", //текст кнопки

//События

&click, //Вызывается при нажатии на кнопку

0, //Вызывается до обработки нажатия, может прервать обработку нажатия

0, //Вызывается при действиях с фокусом кнопки

&ts_button //стиль кнопки

);

}

void main()

{

//тут была инициализация MakiseGui, драйвера, MakiseBuffer и MHost. Запуск драйвера.

create_gui();

while(1)

{

//драйвер вызывает функции рисовки

//совершается ввод

//и логика

}

}

```

Итого, этот пример создаёт на экране кнопку при нажатии на которую в стандартном потоке вывода появится надпись "Button was clicked" и текст кнопки изменится.

Инициализация

-------------

Инициализация предполагает только лишь запуск драйвера, задание размеров и выделение памяти для структур и буферов элементов. Чисто формальная операция. Как инициализировать систему можно поглядеть тут: <https://github.com/SL-RU/MakiseSDLTest/blob/master/src/main.c> в методе start\_m();

Для начала использования GUI нужно создать makise\_config.h и сконфигурировать его. В этом файле задаются системные дефайны и выбираются нужные драйверы дисплея. <https://github.com/SL-RU/MakiseSDLTest/blob/master/makise_config.h>

Ввод

----

Ввод приспособлен для работы в мультипоточных приложениях — он имеет очередь событий, которые посылаются интерфейсу при вызове makise\_gui\_input\_perform(host);

Любое событие ввода представлено структурой MInputData.

Возможен ввод кнопок(список стандартных в makise\_gui\_input.h MInputKeyEnum), символов(пока нигде не используется) и ввод курсора(сенсорный экран или мышь). В примере с SDL используется ввод с клавиатуры и ввод мышью.

Контейнеры.

-----------

MContainer — структура контейнера.

Контейнеры содержат связанный список элементов. Из контейнеров можно удалять или добавлять элементы, перемещать их и совершать другие операции.

Позиция элемента в контейнере прямо влияет на очередь отрисовки и ввода.

Линкованый список осуществляется при помощи указателей на первый и последний элемент списка MElement и в структуре MElement имеются указатели на следующий и предыдущий элемент.

Элементы.

---------

Любой элемент представлен ввиде структуры MElement, которая содержит в себе информацию о элементе, указатели на функции отрисовки, ввода, фокуса и тд элемента и указатель на его содержимое.

На данный момент существуют следующие элементы:

* MButton — кнопка. Которая отображает текст посылает события при нажатии

* MCanvas — простейший контейнер, который просто содержит элементы.

* MLable — простейшее текстовое поле

* MTextField — текстовое поле, поддерживающее перенос слов и переносы

* MSlider — слайдер

* MToggle — кнопка имеющая два состояния.

* MSList — список. Может быть как просто списком, так и radio-кнопками, так и чекбосками. Поддерживает обычные списки и динамические линкованные.

* MTabs — вкладки. Несколько переключаемых контейнеров.

Лучшей документацией являются примеры, поэтому для каждого элемента есть свои примеры использования. Как сложные, так и простые.

Количество элементов будет пополняться со временем. Да, тут нет многих необходимых функций — графики, изображения и тд. Но для моих целей они пока не нужны, но если вскоре понадобятся, то буду добавлять и публиковать в библиотеку. Так же не стесняйтесь добавлять свои или править существующие! Пулл-реквесты приветствуются.

Стили

-----

Стиль элемента определяет его внешний вид. Cтиль задаёт цвета элемента в определённом состоянии. За это отвечают структуры MakiseStyle и MakiseStyleTheme. MakiseStyle содержит несколько MakiseStyleTheme для определённых состояний, а так же параметры шрифта.

Для кнопки стиль может выглядеть так:

```

MakiseStyle ts_button =

{

MC_White, //основной цвет. Не несёт никакого значения

&F_Arial24,//Шрифт стиля

0, //межстрочное расстояние

//цвет заднего фона | шрифта бортик есть ли двойной бортик

{MC_Black, MC_Gray, MC_Gray, 0 }, //когда кнопка не активна

{MC_Black, MC_White, MC_White, 0 }, //нормальное состояние

{MC_White, MC_Green, MC_White, 0 }, //в фокусе

{MC_Green, MC_White, MC_White, 0 }, //когда была кликнута

};

```

Фокус

-----

Фокус определяет к какому элементу пойдёт ввод. Для управления фокусом существуют следующие функции:

```

MFocusEnum makise_g_focus(MElement *el, MFocusEnum event); //фокусирует или расфокусирует нужный элемент

MFocusEnum makise_g_host_focus_next(MHost *host);//переведёт фокус на следующий по очереди элемент

MFocusEnum makise_g_host_focus_prev(MHost *host);//на предыдущий

```

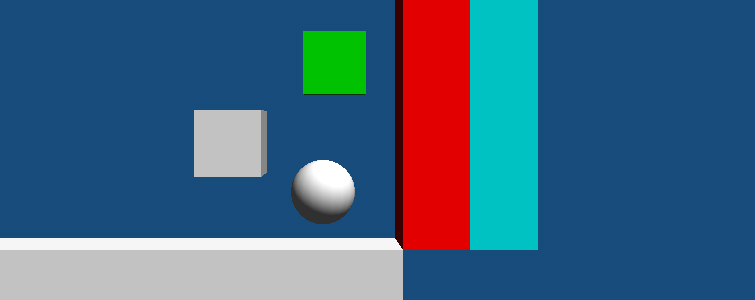

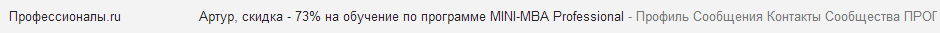

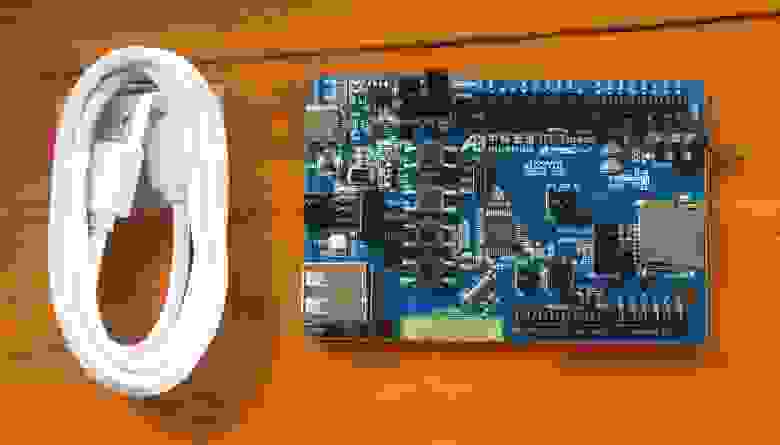

Пример работы на микроконтроллере

---------------------------------

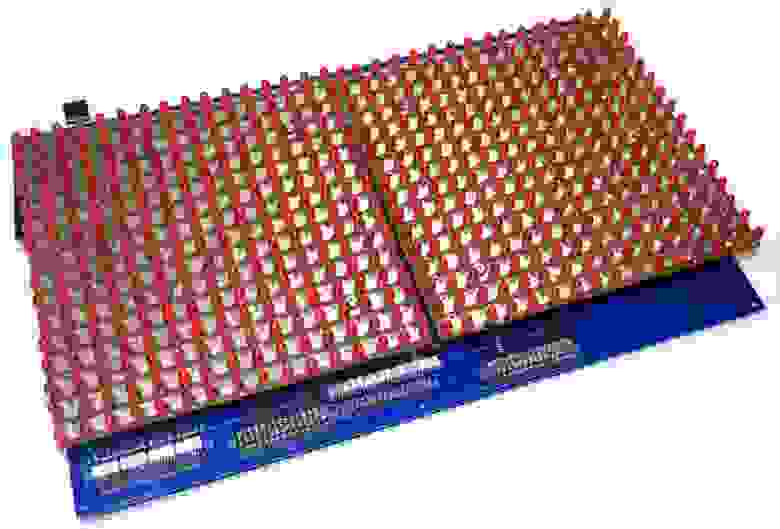

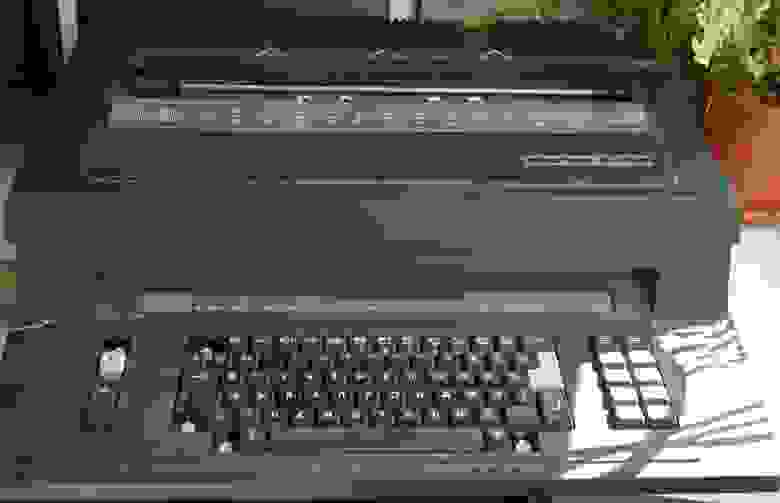

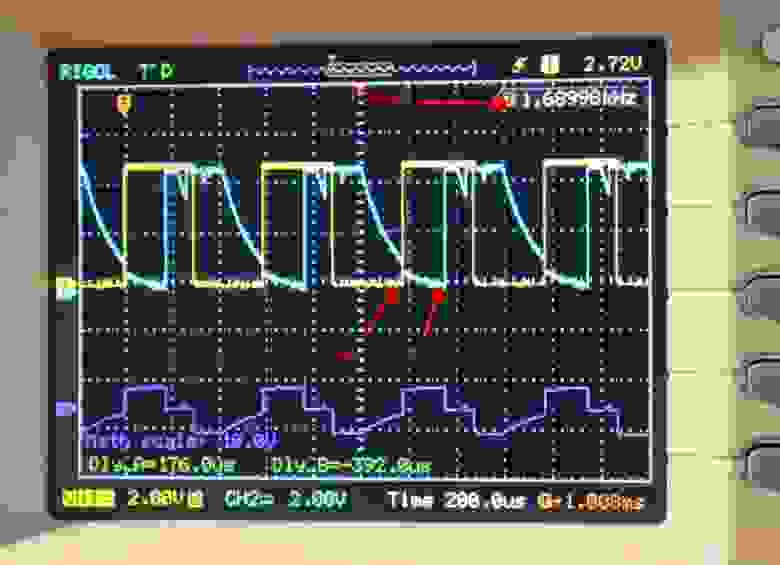

Так же был написан пример библиотеки для STM32 микроконтроллеров. Был использован МК STM32f437VGT6 с тактовой частотой 180МГц и 2.2" дисплей 230х320 пикселей на контроллере ILI9341. Управления с компьютерной клавиатуры по UART.

Код примера: <https://github.com/SL-RU/MakiseILI9341Test>

Видео примера:

Немножко документации есть в репозитории. Но вся основная документация находиться в комментариях к функциям и в примерах. Задавайте вопросы! На основе них я буду дописывать документацию. Много моментов не было затронуто в статье или затронуто мимоходом. Если статья найдёт популярность, то с удовольствием напишу ещё несколько, например про создание драйвера для STM32 + tft дисплей, подключенный по FSMC для данного GUI.

Есть много моментов которые нужно совершенствовать в библиотеки и есть много путей развития. Но на данный момент библиотека является совершенно рабочей и стабильной.

Лицензия проекта — MIT. Вы можете использовать библиотеку и исходный код как хотите и где хотите, даже использовать без проблем в коммерческих проектах, но в то же время я не даю никаких гарантий по работе библиотеки — всё как есть.

Если вы что-то хотите поменять в коде, исправить найденный баг или ошибку, то пишите в issue в репозитории или даже кидайте пуллреквесты.

Буду рад вопросам и пожеланиям!

|

https://habr.com/ru/post/325692/

| null |

ru

| null |

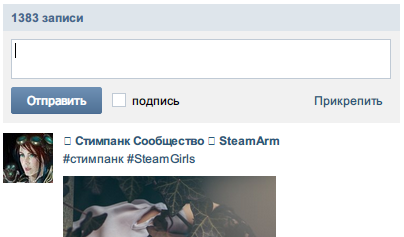

# Отложенный постинг Вконтакте с помощью xStarter

#### Опять соц. сети?

Я хочу поделится с хабрасообществом своим нехитрым решением отложенного постинга VK. Да, я тоже скептически относился к рекламе в соц. сетях, но ведь глупо не попробовать. Ежедневная посещаемость этого ресурса сравнима yandex.ru ([пруф1](http://naked-science.ru/article/media/23-09-2013-624) [пруф2](http://telecomblog.ru/internet-novosti/poseshaemost-vkontakte-bet-rekord)), не говоря уже про то, что это просто наилучшее место для “направленной” рекламы.

Небольшое справка.

Моя группа посвящена Стимпанку и Дизельпанку, на базе которой, потом, мы с моей невестой будем создавать фотоателье с прокатом костюмов сделанных вручную. Новостной сайт по данной тематике (Стим, Дизель, Викторианская эпоха) сейчас находится еще в стадии разработки. Все тянем своими силами.

И так допустим, что вы тоже выбрали Вконтакте и в качестве рекламной платформы уже используете страницу/группу и действительно хотите, чтобы ваши посты просмотрело наибольшее количество народу. Какое самое удачное время для этого? Должно быть это [прайм тайм](http://ru.wikipedia.org/wiki/%D0%9F%D1%80%D0%B0%D0%B9%D0%BC-%D1%82%D0%B0%D0%B9%D0%BC). Только думаю, что опытные блогеры и “админы” популярных сообществ поспорили бы с этим утверждением, так что жду комментариев.

Главное, что какое бы время не являлось наиболее “хлебным”, необязательно проводить его сидя за компьютером. Ведь все мы знаем, что жизнь коротка, ну и блаблабла…

**А мой сервис лучше**Вопрос: А мой сервис лучше \*service name, почему не использовать его?

Ответ: Ты молодец \*habrauser, что нашел свое решение и написал столь ценный комментарий.

Вдвойне молодец, если оставил исходник. И да, есть много сервисов хороших, платный и бесплатных, которые справляются с этой достаточно тривиальной задачей на ура.

Я ведь не говорю, что мое решение единственное, лучшее или то, что оно, не дай Кришна, идеальное

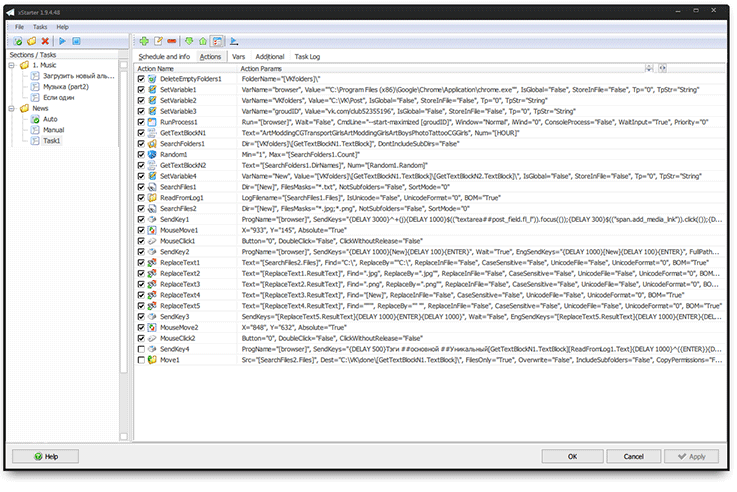

#### Подходим к сути

Что собой представляет [xStarter](http://www.xstarter.com/rus/index.html) справка с офф. сайта:

*xStarter автоматизирует выполнение повседневных задач по планировщику или событиям системы.*

На самом же деле, эта программа создана для таких бездарей как я. С самого детства смотрящего на любого программиста, как на человека обладающего магической силой, естественно одетого в остроконечную шляпу и с посохом на перевес идущего спасать какое-нибудь свой Эндор. Взгляд этот затуманен. Даже нет, он отравлен безграничной горечью и завистью. Я почти серьезно.

xStarter способен автоматизировать сотни различных задач, которые вы совершаете в Windows ежедневно. Например: запуск команд по расписанию, программ, нажатие клавиш и мыши по координатам, отслеживание изменений в файловой системе и тому подобное. По сути, мы здесь сталкиваемся с очень продвинутым макрос-редактором. Стоит ли говорить, на сколько это экономит время? Разработчик утверждает, что аж в 30%. Хм… Ну вполне может быть.

**А как же \*nix?**Вопрос: А nix?

Ответ: К сожалению нет, не нашел аналога. Подскажите, буду признателен**Почему не AutoIT?**Вопрос: Почему xStarter лучше, чем AutoIT или \*мой любимый язык программирования.

Ответ: Бритва оккама. Не нашел более простого для себя способа, с учетом, что в своей жизни ни строчки кода не написал. Однако пока я разрабатывал данный метод, то решил в дальнейшем обязательно заняться изучением чего-нибудь серьезного. Надеюсь, что в той-же мере это может подтолкнуть и других далеких от программирования людей, которые дочитают этот пост до конца и попробуют сделать что-нибудь свое.

К тому же, в отличии от AutoIT, xStarter имеет чертовски удобный интерфейс для написания собственных скриптов.

Самое главное, в нем можно начать сразу работать, при этом лишь изредка вспоминать, что можно иногда и справку открыть. Интересно и то, что упоминания об xStarter на Хабре встречаются довольно редко.

Не будем долго и нудно изучать интерфейс программы, а лучше непосредственно перейдем к самому построению задачи. Уже там, шаг за шагом, мы рассмотрим каждое из действий и как они работают.

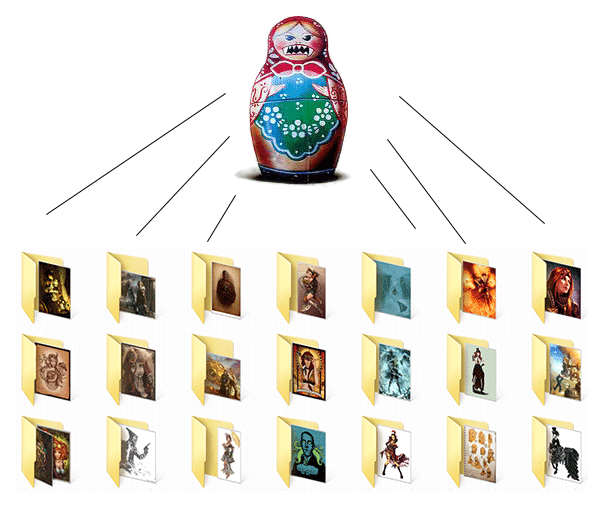

Предварительно: я создал несколько директорий, каждая из которых является названием раздела группы. К примеру, на C:\VK\Post\ находятся 7 поддиректорий: Art, Boys, Girls, CG, Modding, Photo, Transport.

Внутри этих 7-ми директорий также несколько поддиректорий, каждая из которых уже является самим постом.

Пост должен быть такого вида – несколько изображений и один \*.txt файл со статьей.

**Вот, для наглядности я набросал схему:**

Теперь отпетросяновшись вдоволь, мы продолжаем

#### Понеслась. Открываем xStarter и создаем новую задачу

Сразу прикидываем, в какое именно время она будет выполнятся. Допустим, укажем, чтобы задача запускалась по расписанию, эдак раз в пол часа. Зачем так мудрить с расписанием спросите вы? Да, можно просто поставить 30 минутный интервал выполнения, но только с помощью расписания можно запускать обновление нескольких категорий группы в рамках одной задачи.

Заводим себе три переменные:

**SerVariable1** browser = путь к веб-браузеру для дальнейшего запуска.

**SerVariable2** VKFolders = путь к категориям Вконтакта на локальном диске

**SerVariable3** groudID = ссылка на группу

Это не обязательно, но так легче будет разобрать некоторые моменты, а вам проще будет поменять их на свои:**Скрин**

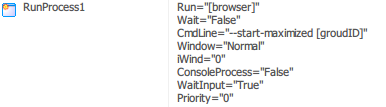

Запускаем браузер:

**RunProcess1** Run = [browser] в параметрах пишем --start-maximized [groudID]**Скрин**

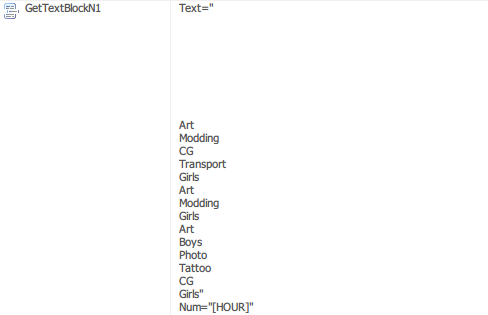

Создаем новое действие GetTextBlockN и указываем название категорий. Учитываем и то, что название раздела будет взято из строки под номером, который совпадает с часом запуска задачи. Проще говоря, если автоматическое время запуска 18:00 или 18:40, то будет возвращена 18-я строка.

**GetTextBlockN1** Num = [HOUR] (текущий час).

**Скрин**

Пускай новости для публикации будут выбираться случайным образом, а для этого необходимо указать следующие:

**SearchFolders1** Dir = [VKfolders]\[GetTextBlockN1.TextBlock]

Это поиск директории внутри раздела, который выдал GetTextBlockN1.

**Random1** Min = “1", Max = "[SearchFolders1.Count]"

Cброс случайного числа, между 1 до общее количество найденных директории в разделе.

**GetTextBlockN2** Text = "[SearchFolders1.DirNames]", Num = "[Random1.Random]"

Возвращает рандомную строку из списка директорий в SearchFolders1

**Скрин**

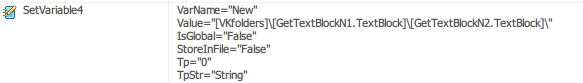

Опять же это не обязательно, но чтобы нам было проще, мы из полученных данных создадим еще одну переменную:

**SerVariable4** New = [VKfolders]\[GetTextBlockN1.TextBlock]\[GetTextBlockN2.TextBlock]\

**Скрин**

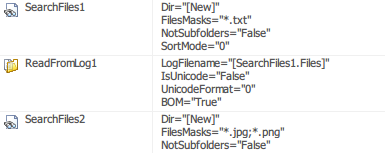

Используем новую переменную для поиска графических и текстовых файлов внутри директорий:

**SearchFiles1** [New] по маске \*.txt

Ищем \*.txt файл с текстом для новости.

**ReadFromLog1** Text = [SearchFiles1.Files]

Если таковой файл не будет найден, то ничего страшного, тогда будут опубликованы только изображения.

**SearchFiles2** [New] по маске \*.jpg;\*.png

Это поиск изображений, аналогично SearchFiles1.

**Скрин**

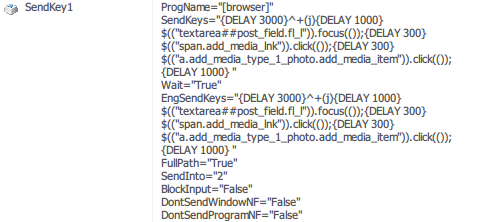

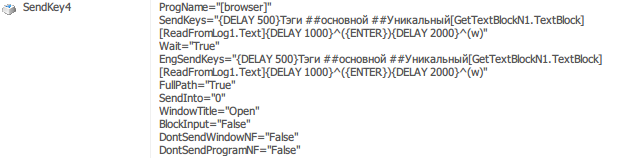

Создаем действие нажатия клавиш в браузере, для нового сообщения.

И да, для запуска Java консоли, потребуется расширение [Web Developer](http://chrispederick.com/work/web-developer/) (подходит для большинства браузеров, кроме IE)

Наверняка можно обойтись и одной командой, но если честно, я плохо знаю jquery, так что:

**SendKey1**

> {DELAY 3000}^+(j){DELAY 1000}

>

> $((«textarea##post\_field.fl\_l»)).focus(());{DELAY 300}

>

> $((«span.add\_media\_lnk»)).click(());{DELAY 300}

>

> $((«a.add\_media\_type\_1\_photo.add\_media\_item»)).click(());

>

> {DELAY 300}

**Скрин**

Самый известный на земле Кэп, просит пояснить, что {DELAY} является паузой в мс. Соответственно, в зависимости от загруженности браузера, скорости канала и всего прочего, возможно вам придется искать свои оптимальные значения. У меня все работает на двух совершенно разных конфигурациях.

Опять же из за незнания основ jquery, в нашем море есть еще небольшой костыль. Для запуска диалога загрузки файлов, необходимо добавить нажатие левой кнопки мыши по элементу на самом сайте. Простите, ребят.

**MouseMove1**

Нужные координаты можно получить в самой задаче, просто ткнув курсором в необходимое пространство.

**MouseClick1**

Координаты для разрешения 1920 на 1080 примерно такие:

**Скрин**

Далее, переход в рандомную директорию с новостью:

**SendKey2**

{DELAY 1000}[New]

{DELAY 100}{ENTER}

**Скрин**

Теперь нужно привести список файлов с графикой в божеский вид:

**ReplaceText1** [SearchFiles2.Files]

`C:\ заменяем на "C:\`

**ReplaceText2** [ReplaceText1.ResultText]

`.jpg на .jpg"`

**ReplaceText3** [ReplaceText2.ResultText]

`.png в .png"`

**ReplaceText4** [ReplaceText3.ResultText]

Удаляем путь к файлу

`[New] на`

**ReplaceText5** [ReplaceText4.ResultText]

`“`

`” заменяем на “ “`

**Скрин**

Полученный список файлов такого формата: “file1.jpg” “file2.png” “file3.jpg” — мы скармливаем браузеру для выгрузки файлов:

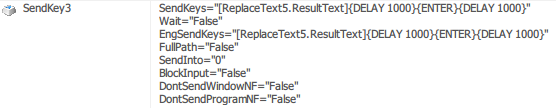

**SendKey3** [ReplaceText5.ResultText]{DELAY 1000}{ENTER}{DELAY 1000}

**Скрин**

Кликаем на окно для создания нового сообщения:

**MouseMove2**

Ищите собственные координаты.

**Mouse Click2**

**Скрин**

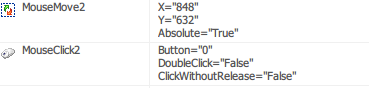

Отправляем текст в диалоговое окно:

**SendKey4** {DELAY 500}##Tag ##Tag[GetTextBlockN1.TextBlock]

[ReadFromLog1.Text]{DELAY 1000}^({ENTER}){DELAY 2000}^(w)

Первая строка, это тэги. Например, я использую #стимпанк и #Steam(меняется в зависимости от расписания).

Вторая, это текст, который находился в \*.txt. Третья – отправить сообщение и через две секунды закрыт вкладку браузера.

**Скрин**

Ну и наконец, удаляем и перемещаем использованные файлы:

**Move1** [SearchFiles2.Files] в C:\VK\done\[GetTextBlockN1.TextBlock]\

**Delete1** [SearchFiles1.Files]

**Скрин**

[Можете посмотреть в моей группе, что из этого получается в итоге.](http://vk.com\club52355196)

Еще рекомендую, после создания переменных добавить действие на удаление пустых директорий.

Иногда Chrome “держит” explorer и не позволяет этого сделать:

**DeleteEmptyFolders** [VKfolders]\

#### Я ничего не понял, дайте мне поковырять готовое

И вот такие дела народ.

Конечно с первого взгляда это может показаться сложным, но вы можете [взять уже готовый скрипт](https://dl.dropboxusercontent.com/u/19039103/AutoVKcom.xstk) и доработать его.

Так, а что еще можно сделать, для того, чтобы еще улучшить эту задачу?

Проще всего создать тоже самое задание, но только добавить возможность при запуске выбирать раздел для публикации. Или например, можно прикрепить к изображениям уникальные водяные знаки. Добавить проверку, из серии – не пора ли раздел пополнять?

С различными способами уведомления. Можно даже запускать задачу не по расписанию, а с помощью SMS (при наличии GSM модема).

В рамках остального — можно создать задачи для автоматической загрузки mp3 файлов, с публикацией. Можно даже использовать xStarter для раскрутки самой группы.

В общем, если всемогущие НЛО примет эту статью на ура, то обязательно ждите новых. Спасибо за внимание!

|

https://habr.com/ru/post/202174/

| null |

ru

| null |

# Эпл испортила мне ноутбук почти сразу после покупки и до сих пор не собирается чинить

Как вы понимаете, это крик души. Уже больше года я «счастливый» обладатель 13-дюймового Macbook Pro 2019 года за 170 тысяч рублей.

Когда я его покупал, я естественно знал, что у этих ноутбуков было полно проблем с клавиатурой и обрывами шлейфа экрана, но это была уже третья реинкарнация и все обзоры говорили в пользу того, что большинство проблем уже решено. В принципе так и есть: за вычетом пару раз западавшего пробела, клавиатура не сильно парит. Беда пришла с другой стороны.

Артефакты

=========

Ноутбук поставлялся с операционной системой Mojave 10.14.5 и пару месяцев после покупки все было нормально, но потом вышло обновление 10.14.6 и начался [нехорошие явления]. В случайные моменты времени со случайной частотой стали появляться «битые кадры». Преимущественно в нижней части экрана появлялись полоски высотой 2-3 сантиметра с мусором из видеопамяти ровно на одном кадре изображения. Иногда их могло не быть полдня, иногда они появлялись каждые 30 секунд. Звучит не очень страшно: небольшая полоска всего на 1/60 секунды, но в реальности глаз замечает такое резкое движение, мозг моментально реагирует на раздражитель, ты становишься нервным.

Естественно, я рассматривал вариант, что проблема с железом. Но слишком уж очевидной была связь между началом бага и обновлением на 10.14.6. Кроме того, очень похожая проблема появилась у моего друга с прошкой 2015 года и тоже после обновления на 10.14.6. Ну и в сети стали появляться сообщения от людей с [точно такой же проблемой](https://www.reddit.com/r/macbookpro/comments/cqk1hv/screen_flickering_on_2019_macbook_pro_running/) (кто-то даже смог [поймать это на видео](https://www.reddit.com/r/macbookpro/comments/ck5fh0/2019_macbook_pro_13/)). Естественно никакие сбросы никаких PRAM не помогали. Люди обращались в сервисный центр, там разводили руками, может быть меняли ноут на такой же, и всегда проблема оставалась.

Шло время, я ставил каждое минорное обновление в надежде что вот-вот Эпл исправит этот очевидный косяк, мешающий пользоваться ноутом. Но обновления приходили, а артефакты не пропадали. В конце концов вышла macOS Catalina и была надежда, что Эпл просто забили на старую ось и исправили все в новой. Хоть я и не хотел обновляться, мне пришлось это сделать чтобы хотя бы убедиться, что это не аппаратный баг. Артефакты пропали, но всё оказалось не так просто.

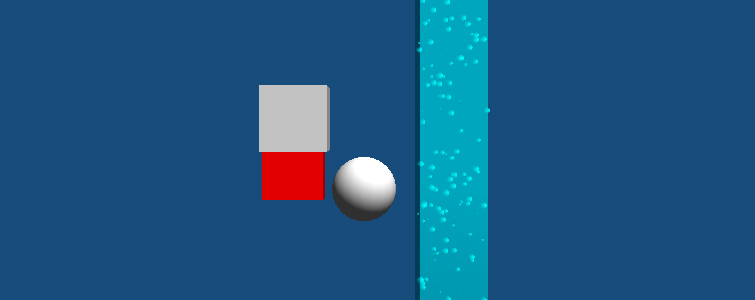

Мерцание

========

С обновлением на Catalina примерно с такой же периодичностью и частотой стала резко меняться «теплота» изображения. Чаще всего это происходит в часы рассвета или заката, когда солнце не сильно высоко. Вы наверное думаете: «что за бред я несу». Дело в том, что в ноутбуке есть технология True Tone, которая подстраивает теплоту изображения под окружение. И соответственно есть сенсор, который наблюдает за светом окружения. Обычно изменения происходят плавно и на небольшие значения. Но в Catalina в определенные часы экран начинает мигать раз в 10 секунд, [становясь похожим на новогоднюю гирлянду](https://discussions.apple.com/thread/250512841).

Вам наверное интересно, пропадает ли мерцание, если выключить True Tone совсем. Пропадает. И я не проверял, но скорее всего эти два бага связаны и артефакты в 10.14.6 тоже пропадают без True Tone. Но есть две причины, почему я не могу просто выключить True Tone и забыть об этом ужасе.

1. Я купил ноутбук, который продавался как набор функций, среди которых был True Tone. Мне нравится изображение с True Tone больше, чем без него. Я не хочу «выключить и забыть», я хочу, чтобы Эпл починила то, за что я заплатил.

2. Выключение True Tone приводит к [ещё одному багу](https://support.google.com/chrome/thread/8654678?hl=en). Я не знаю, какая тут связь, но без True Tone, когда гаснет подсветка клавиатуры после N секунд бездействия, и я касаюсь тачпада, например, чтобы проскролить документ, ввод лагает на секунду. Вроде тоже звучит не фатально, но это очень мерзкое залипание, от которого дискомфортно и оно реально мешает читать документы не меньше, чем мерцающий экран.

Даунгрейд

=========

Ок, если всё плохо, но когда-то было хорошо, почему бы не вернуть все назад? — думал я. Конечно, нельзя откатить существующую систему, но можно же поставить заново 10.14.5 и спокойно пользоваться работающим ноутом. Как я уже говорил, Каталину я ставил лишь для того, чтобы убедиться что аппаратных проблем нет. И вот недавно я решился потратить два выходных дня чтобы решить эту проблему: поставить 10.14.5 и настроить систему заново, так сказать переустановить шиндовс.

И знаете, что? ~~Оказалось, что **это невозможно**!~~ Начнем с того, что было не так-то просто вообще найти образ 10.14.5. Но даже с ним ~~Эпл закрыла любую возможность поставить 10.14.5 на ноутбук.~~ Любая установка не начиналась без подключения к интернету, какие бы защиты я не отключал, на какие бы ухищрения не шел. А любая установка 10.14.5 **с интернетом** заканчивалась тем, что ставилась 10.14.6. И да, артефакты все так же присутствовали.

**Upd.** Оказалось, основная проблема именно в том, что крайне сложно найти где-то хороший образ установщика, а то, что я находил ноутбук считал за бета-версию и поэтому отказывался ставить при наличии более новой. Ни на сайте поддержки Эпл, ни через `softwareupdate` нельзя получить установочный образ 10.14.5. Помог [сторонний скрипт](https://github.com/munki/macadmin-scripts) создания инсталятора, который в комментариях подсказал [ghostinushanka](https://habr.com/ru/users/ghostinushanka/).

В итоге

=======

Как видите, дело не в какой-то конкретной проблеме. Это целая россыпь и вереница программных проблем, которые тянут одна другую. Все они массовые, раздражающие, существуют уже долгое время, нет никакой надежды что это будет исправлено. ~~Не существует никакой комбинации софта/настроек, которую я бы мог поставить, чтобы все работало.~~

|

https://habr.com/ru/post/518088/

| null |

ru

| null |

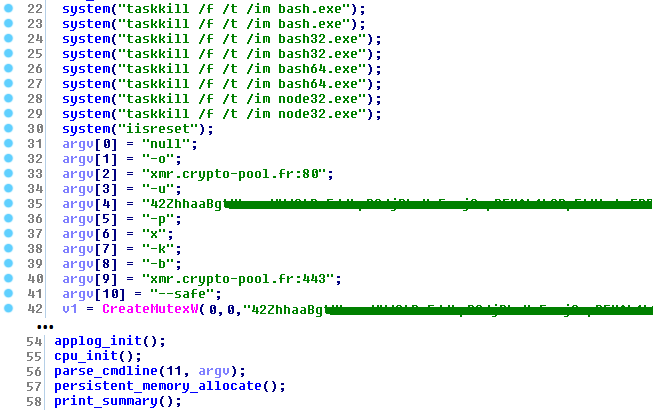

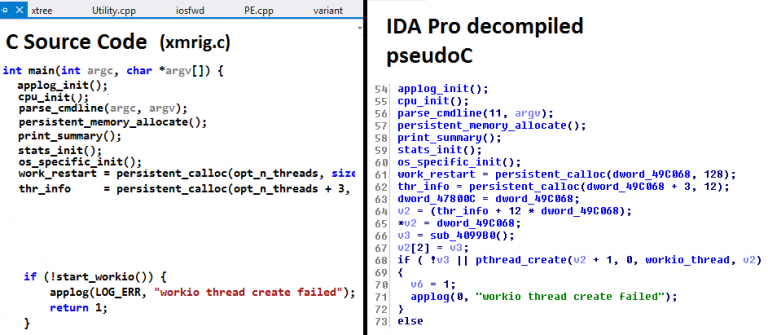

# Новый руткит для 64-разрядной системы Linux: внедрение iframe

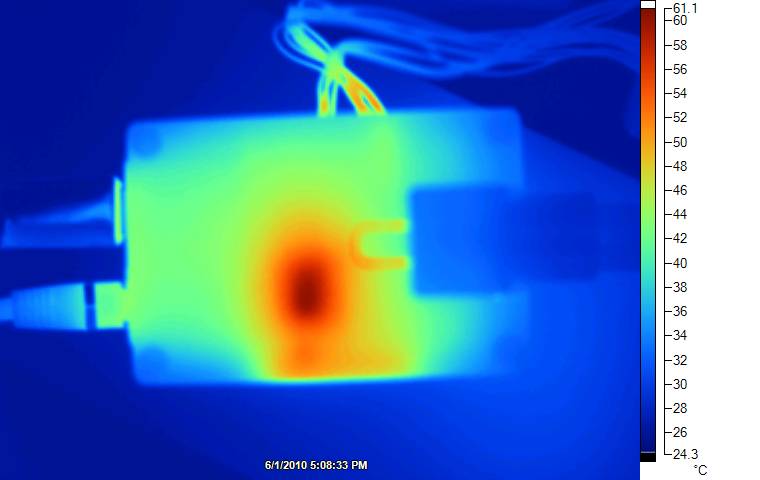

Несколько дней назад в [списке рассылки Full Disclosure](http://seclists.org/fulldisclosure/2012/Nov/94) появилось сообщение об интересной вредоносной программе для Linux. Это очень любопытный образец – не только потому, что он предназначен для 64-разрядных платформ Linux и скрывает свое присутствие в системе с помощью хитроумных методов, но прежде всего из-за необычного функционала, связанного с заражением сайтов, размещенных на подвергшемся атаке HTTP-сервере. Таким образом, мы имеем дело с вредоносной программой, используемой для организации drive-by загрузок вредоносного ПО.

[](http://www.securelist.com/ru/images/pictures/klblog/207764327.png)

Вредоносный модуль создан специально для версии ядра 2.6.32-5-amd64. Это новейший вариант ядра, используемый в 64-разрядной системе Debian версии Squeeze. Исполняемый файл имеет размер более 500 кБ, но это связано с тем, что он был скомпилирован с отладочной информацией. Возможно, модуль находится на стадии разработки: создается впечатление, что некоторые функции не до конца отлажены или, может быть, еще не полностью реализованы.

Вредоносная программа обеспечивает свой автозапуск, добавляя строку в скрипт /etc/rc.local:

`insmod /lib/modules/2.6.32-5-amd64/kernel/sound/module_init.ko`

После своей загрузки в память руткит использует один из двух методов для получения kernel symbols и их записи в файл /.kallsyms\_tmp:

`/bin/bash -c cat /proc/kallsyms > /.kallsyms_tmp

/bin/bash -c cat /boot/System.map-`uname -r` > /.kallsyms_tmp`

Затем он извлекает адреса памяти нескольких функций и переменных ядра и сохраняет их в памяти для дальнейшего использования.

[](http://www.securelist.com/ru/images/pictures/klblog/207764329.png)

Временный файл немедленно удаляется:

`rm /.kallsyms_tmp -f`

Чтобы скрыть файлы и строку стартового скрипта, запускающую вредоносную программу, руткит перехватывает следующие функции ядра путем сплайсинга или замены адреса в памяти на указатели собственных вредоносных функций руткита:

`vfs_readdir

vfs_read

filldir64

filldir`

В дополнение к сокрытию собственного модуля вредоносная программа пытается скрыть следующие файлы и потоки:

`zzzzzz_command_http_inject_for_module_init

zzzzzz_write_command_in_file

module_init.ko

sysctl.conf

/usr/local/hide/first_hide_file/*

/ah34df94987sdfgDR6JH51J9a9rh191jq97811/*

backconnect_command_thread_name

new_backconnect_command_thread_name

read_command_http_inject_thread_name

write_startup_command_thread_name

write_se_linux_command_thread_name

get_http_inj_from_server_thread_name`

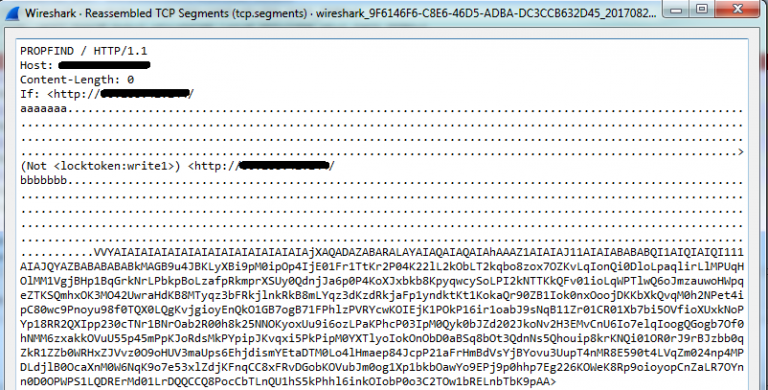

Интересен механизм внедрения плавающего фрейма (iFrame): вредоносная программа подменяет системную функцию tcp\_sendmsg, отвечающую за построение TCP-пакетов, собственной функцией. Таким образом, вредоносные фреймы внедряются в HTTP-трафик путем непосредственной модификации исходящих TCP-пакетов.

[](http://www.securelist.com/ru/images/pictures/klblog/207764331.png)

Для получения актуального внедряемого блока данных вредоносная программа соединяется с сервером управления (C&C), используя для аутентификации зашифрованный пароль.

[](http://www.securelist.com/ru/images/pictures/klblog/207764333.png)

Нам не удалось соединиться с сервером управления через порт, используемый вредоносной программой, однако вредоносный сервер все еще активен; на нем размещен и другой инструментарий для UNIX-подобных операционных систем, в частности, инструменты для очистки журналов.

До сих пор в большинстве сценариев drive-by атак механизм автоматического внедрения вредоносного кода был реализован с помощью простого PHP-скрипта. Но в данном случае мы имеем дело с гораздо более сложным механизмом – применением руткит-компонента режима ядра, использующего сложные технологии перехвата, что позволяет сделать процесс внедрения более прозрачным (незаметным) и низкоуровневым, чем когда-либо ранее. Этот руткит, который в данный момент находится на стадии разработки, демонстрирует новый подход к организации drive-by атак. Несомненно, можно ожидать появления других подобных вредоносных программ в будущем.

Превосходный подробный анализ этого руткита был недавно опубликован в [блоге CrowdStrike](http://blog.crowdstrike.com/2012/11/http-iframe-injecting-linux-rootkit.html).

Продукты «Лаборатории Касперского» детектируют данный руткит как

`Rootkit.Linux.Snakso.a`

|

https://habr.com/ru/post/159935/

| null |

ru

| null |

# Средства миграции данных Android и улучшение поддержки приложений

Привет, Хабр! Представляю вашему вниманию перевод статьи [«Discover tools for Android data migration and improve your app retention»](http://android-developers.googleblog.com/2018/02/discover-tools-for-android-data.html) авторов Sean McQuillan и Prateek Tandon.

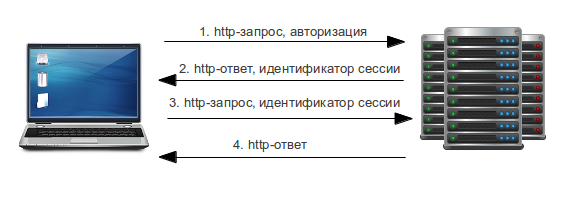

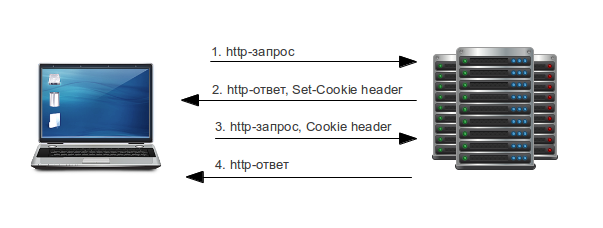

Пользователи создают учетные записи, активируют их, а затем сохраняются, когда многократно запускают приложение. Обычно пользователю не нужно повторно вводить пароль для Android-приложения в течение многих лет, то есть до тех пор, пока он не купит новый телефон.

Покупка нового телефона — это редкое событие для многих людей, может пройти несколько лет между обновлением устройств. Существует несколько инструментов, которые помогут пользователям войти в систему, когда они будут использовать приложение на новом телефоне.

### Резервное копирование данных приложения

Автозагрузка должна быть настроена для каждого приложения. Эта функция автоматически создает резервные копии данных приложения. Поэтому, когда люди получают новый телефон, их данные из приложений автоматически восстанавливаются до запуска приложения.

Чтобы настроить автозагрузку приложения, вам необходимо установить правила включения и исключения:

AndroidManifest.xml

```

```

xml/autobackup.xml

```

xml version="1.0" encoding="utf-8"?

```

При настройке правил include и exclude важно избегать хранения конфиденциальных пользовательских данных в Auto Backup, хотя это отличное место для хранения пользовательских настроек и другого содержимого приложения.

Чтобы реализовать отслеживание для Auto Backup, зарегистрируйте BackupAgent и прослушайте onQuotaExceeded обратный вызов. Если ваше приложение превышает предел резервной копии 25 МБ, этот обратный вызов будет уведомлением о сбое. В хорошо сконфигурированном приложении этого никогда не произойдет, поэтому вы можете отслеживать его как отчет о сбое.

### Оптимизируйте вход в систему

Пользователи не хотят повторно вводить логин и пароль. Существует несколько способов для решения этой задачи:

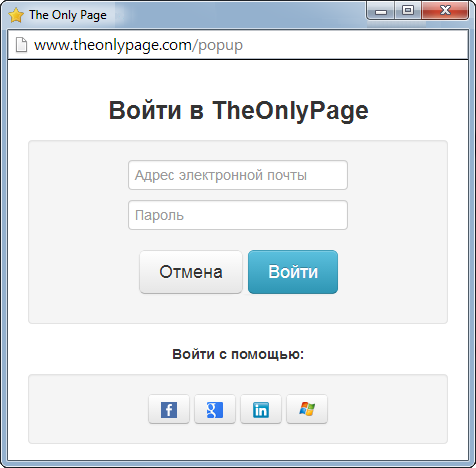

1. Используя Google Sign-In, пользователи могут войти в систему со своей учетной записью Gmail или любым адресом электронной почты. Самое главное, им не нужно запоминать пароль. Помимо улучшения регистрации и активации, включение входа в Google также поможет с сохранением, поскольку позволяет тем, кто получает новые телефоны, активироваться с помощью одной кнопки или даже автоматически. Еще вы можете использовать Google Sign-In для входа в систему приложений iOS, Web и Android. Также если ваше приложение использует Firebase Auth для обработки входа в Google.

2. Сделайте процесс входа проще с помощью Google Smart Lock и Autofill. Эти две функции работают рука об руку, чтобы помочь людям безопасно получить доступ к своим паролям. Autofill был представлен в Android O и будет предлагать автоматически сохранять пароли пользователя в хранилище данных Smart Lock или в предпочтительном диспетчере паролей при входе в систему. Настройте подсказки автозаполнения и исключите поля, которые не должны быть заполнены Autofill.

```

```

3. Интеграция Smart Lock с API для безопасного хранения паролей. Smart Lock обратно совместим с API 9 и отлично работает на устройствах со старыми версиями Android, которые не работают с Autofill. Подобно Autofill, Smart Lock API предложит спасти пароли пользователя после входа в систему. Программный поиск Smart Lock API позволяет автоматически возвратиться к пользовательскому входу даже на новых устройствах и в Chrome. Чтобы поддержать эту функцию Smart Lock, вам нужно будет включить в приложение какой-то код; проверьте Codelab, чтобы узнать, как интегрировать Smart Lock для паролей в приложение. Также не забудьте связать свое приложение с веб-сайтом, чтобы обеспечить беспрепятственный доступ к Chrome с помощью Autofill и Smart Lock.

4. Используя API переноса учетных записей, подумайте заранее, чтобы ваше приложение могло передавать учетные данные со старого телефона на новый. Приложение использует зашифрованный bluetooth или кабель, и вы можете передавать данные с телефонов с интерфейсом API 14 или выше. Перенос учетной записи происходит, когда пользователь вашего приложения настраивает свой новый телефон в первый раз, когда ваше приложение будет повторно установлено из Google Play, учетные данные вашего приложения будут доступны при первом запуске.

Codelabs

Также можно настроить автозагрузку для Android Codelab и SmartLock Codelab.

Теперь вы можете облегчить миграцию данных благодаря набору инструментов: передача настроек с помощью Auto Backup, улучшение входа в систему с помощью входа в аккаунт Google, Smart Lock для паролей, автозаполнение и API перенос аккаунта.

|

https://habr.com/ru/post/350114/

| null |

ru

| null |

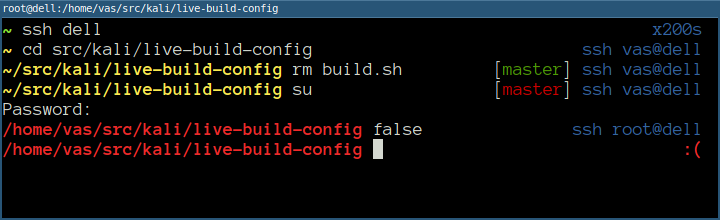

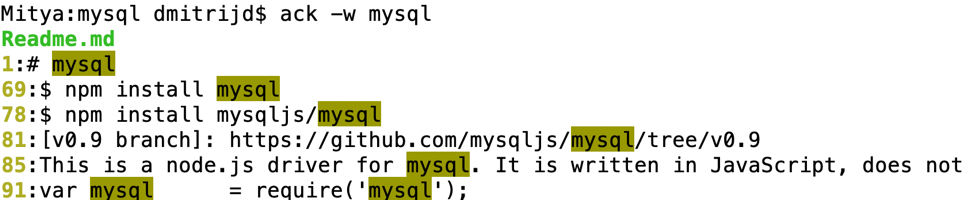

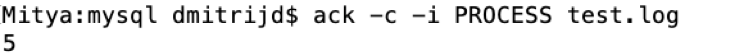

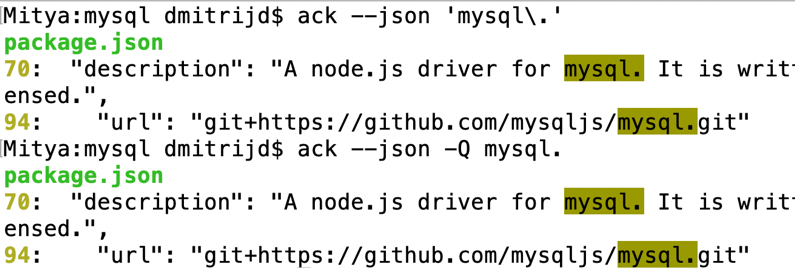

# Работаем в консоли быстро и эффективно

В сети можно встретить много советов по эффективной работе в консоли. В большинстве таких статей авторы рассказывают про банальности типа "выучите горячие клавиши" или "`sudo !!` запустит последнюю команду под sudo". Я же расскажу о том, что делать, когда вы уже выучили горячие клавиши и знаете про `sudo !!`.

### Терминал должен запускаться мгновенно

Сколько времени вам нужно, чтобы запустить терминал? А ещё один? Долгое время мой терминал запускался сочетанием Ctrl+Alt+T и я думал, что это быстро. Но когда я переехал с Openbox на i3, то стал запускать терминал через Win+Enter, это сочетание было в конфиге по умолчанию. И знаете что? Я больше не считаю, что Ctrl+Alt+T — это быстро.

Разумеется, прикол не в выигрыше миллисекунд, а в том, что вы открываете терминал на уровне рефлексов, совершенно не замечая этого.

Если вы часто работаете в терминале, но для его запуска тянетесь к мышке, то попробуйте настроить удобную горячую клавишу. Я уверен, вам понравится.

### Zsh вместо Bash

Это холиварная тема, знаю. Zsh стоит поставить хотя бы ради трёх фич: продвинутый автокомплит, коррекция опечаток и множественный pathname completition: когда один Tab превращает `/u/s/d` в `/usr/share/doc`. Arch Linux уже давно перешёл на zsh в своём установочном диске. Я надеюсь что однажды zsh станет дефолтным шеллом в Ubuntu. Это будет исторический момент.

Начать использовать zsh вообще не сложно. Установите его через менеджер пакетов и возьмите какой-нибудь готовый конфиг. Я рекомендую конфиг, который используется в Arch Linux:

```

wget -O ~/.zshrc https://git.grml.org/f/grml-etc-core/etc/zsh/zshrc

```

Осталось только поменять "шелл по-умолчанию" на zsh и перелогиниться.

```

chsh -s $(which zsh)

```

Всё, продолжайте работать как будто ничего не произошло.

### Каким должен быть shell prompt

Shell prompt (приглашение командной строки) — это тот маленький текст, который выводится в терминале перед вашей командой. Его нужно настроить под свой характер работы. Воспринимайте его как приборную панель автомобиля. Поместите туда полезную информацию, пусть он будет помогать ориентироваться. Сделайте его удобным, особенно если видите его каждый день!

Shell prompt должен показывать текущий каталог шелла. Если текущий каталог не выводится в shell prompt, вам придётся держать его в голове и периодически проверять командой `pwd`. Не надо так. Держите в голове более важные вещи и не тратьте время на команду `pwd`.

Если вы периодически переключаетесь со своего пользователя на рута, вам нужна индикация текущего пользователя. Зачастую важно не конкретное имя пользователя, а его статус (обычный или рут). Проще всего это сделать цветом: красный shell prompt у рута, зелёный у своего пользователя. Так вы ни за что не спутаете рутовый шелл с обычным.

Если вы подключаетесь к серверам по ssh, то вам нужно как-то отличать свой локальный шелл от серверного. Для этого shell prompt должен содержать имя хоста, а ещё лучше — индикатор ssh-соединения.

Shell prompt умеет показывать код возврата последней команды. Напомню, что нулевой код возврата означает, что команда завершилась успешно, ненулевой — команда завершилась неуспешно. Код возврата последней команды можно узнать командой `echo $?`, но набирать это всё на клавиатуре слишком долго. Пусть лучше shell prompt сообщит, если команда завершилась неуспешно.

Если вы работаете с git-репозиториями, то будет нелишним выводить в shell prompt статус репозитория: текущую ветку и состояние рабочей директории. Так вы сэкономите время на командах `git status` и `git branch` и не ошибётесь веткой при коммите.

Кто-то добавляет в свой shell prompt часы или имя виртуального терминала (tty), или какие-то произвольные закорючки. Это всё лишнее. Лучше оставить побольше места для команд.

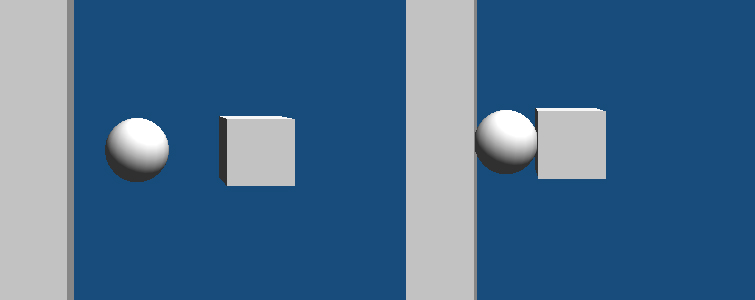

Мой shell prompt в разных условиях выглядит так:

На скриншоте видно, что схожую задачу выполняет заголовок окна терминала. Это тоже кусок приборной панели и его тоже можно настроить.

Как это всё реализовать в своём `.zshrc`? За левый prompt отвечает переменная `PROMPT`, за правый — `RPROMPT`. Определить статус пользователя (обычный или рут) поможет переменная `EUID`, а наличие ssh-соединения — `SSH_CLIENT` или `SSH2_CLIENT`. Получаем такую заготовку:

```

if [[ -n "$SSH_CLIENT" || -n "$SSH2_CLIENT" ]]; then

if [[ $EUID == 0 ]]; then

PROMPT=...

else

PROMPT=...

fi

else # not SSH

if [[ $EUID == 0 ]]; then

PROMPT=...

else

PROMPT=...

fi

fi

```

Я специально не указываю готовый к копипасту код, потому что конкретная реализация — это дело вкуса. Если же вы не хотите заморачиваться и мой скриншот не вызывает у вас отвращения, можете взять конфиг с [гитхаба](https://github.com/laurvas/dotfiles/blob/master/zsh/prompt.zsh).

Резюме:

* Необходимый минимум — это текущий каталог.

* Рутовый шелл должен быть хорошо заметен.

* Имя пользователя не несёт полезной нагрузки, если вы всегда сидите под одним пользователем.

* Хостнэйм полезен, если вы подключаетесь к серверам по SSH. Не обязателен, если всегда работаете на одной машине.

* Неуспешное завершение последней команды полезно видеть сразу.

* Статус git-репозитория экономит время на командах `git status` и `git branch` и является дополнительной защитой от дурака.

### Активное использование истории команд

Бо́льшую часть команд в своей жизни вы вводите больше одного раза, а значит было бы удобно выдёргивать их из истории вместо того, чтобы набирать заново. Все современные шеллы умеют запоминать историю команд и предоставляют несколько способов поиска по этой истории.

Возможно вы уже умеете копаться в истории сочетанием Ctrl+R. У него есть два существенных недостатка:

1. Чтобы начать поиск, поле ввода должно быть пустым. Т.е. в случае "начал набирать команду — вспомнил про поиск" придётся стереть начатое, нажать Ctrl+R и повторить ввод. Это очень долго.

2. Поиск "вперёд" по умолчанию не работает, т.к. Ctrl+S останавливает терминал.

Как работает самый быстрый и удобный поиск:

1. вы начинаете набирать команду,

2. вы вспоминаете про поиск,

3. вы нажимаете хоткей и шелл предлагает команды из истории, которые начинались точно так же.

Например, вы хотите синхронизировать некий локальный каталог с удалённым с помощью `rsync`. Вы уже делали это пару часов назад и хотите вытащить команду из истории. Набираете `rsync`, один-два раза нажимате некую комбинацию, и вот заветная команда готова к запуску. Вам не надо предварительно включать режим поиска по истории, shell prompt не меняется на `(reverse-i-search)':`, ничего никуда не прыгает. Вы просто перебираете команды из истории. Так же, как и стрелочками ↑↓ вы перебираете ранее введённые команды, только с фильтром по началу комады. Это чертовски удобно и экономит уйму времени.

В оболочках fish и ipython такой поиск уже назначен на стрелочки. Я думаю что многие перешли на fish только ради такого поведения стрелочек.

В bash и zsh по-умолчанию такой поиск не работает, его надо включить руками. Я настроил PgUp для поиска назад и PgDown для поиска вперёд. Далековато до них тянуться, но я уже привык. Возможно в будущем переназначу на что-нибудь поближе, например Ctrl+P и Ctrl+N.

Для bash надо добавить пару строк в `/etc/inputrc` или `~/.inputrc`:

```

"\e[5~": history-search-backward

"\e[6~": history-search-forward

```

Если вы взяли готовый `zshrc`, то там поиск скорее всего уже назначен на PgUp и PgDown. Если нет, то добавьте в `~/.zshrc`

```

bindkey "^[[5~" history-beginning-search-backward # pg up

bindkey "^[[6~" history-beginning-search-forward # pg down

```

Любопытно, что со временем я стал писать команды из расчёта, что позже буду поднимать их из истории. Вот несколько приёмов:

**Объединение команд,** которые всегда выполняются друг за другом

```

ip link set eth1 up && dhclient eth1

mkdir /tmp/t && mount /dev/sdb1 /tmp/t

```

**Абсолютные пути вместо относительных** позволяют запускать команду, находясь в любом каталоге:

`vim ~/.ssh/config` вместо `vim .ssh/config`, `systemd-nspawn /home/chroot/stretch` вместо `systemd-nspawn stretch` и т.д.

**Подстановка по маске (wildcard)** делает команды более универсальными. Обычно использую с `chmod` и `chown`.

```

chown root:root /var/www/*.sq && chmod 644 /var/www/*.sq

```

### Горячие клавиши

Перечислю необходимый минимум.

Alt+. — подставляет последний аргумент предыдущей команды. Также можно набрать последовательность `!$`.

Ctrl+A, Ctrl+E — переход к началу и концу редактируемой команды соответственно.

Ctrl+U, Ctrl+Y — вырезать всё в буфер обмена, вставить из буфера. Выручает, когда печатаешь сложную команду, а потом понимаешь, что перед ней надо выполнить другую. Хм, куда бы припрятать текущий ввод? Вот сюда и припрятать.

Ctrl+W — стирает одно слово слева от курсора. Если зажать и удерживать, быстро очищает командную строку. По умолчанию текст не удаляется, а помещается в буфер (который для Ctrl+Y).

Ctrl+K — удаляет от курсора и до конца строки. Ctrl+A, Ctrl+K быстро очищает командную строку.

PgUp, PgDown, Ctrl+R — поиск по истории.

Ctrl+L — очистить терминал.

### Отзывчивость клавиатуры

Расскажу про маленькую настройку, которая позволяет быстрее скроллить, перемещаться по тексту или стирать. Что мы делаем, когда хотим стереть что-то длинное? Зажимаем Backspace и смотрим как курсор бежит назад, забирая лишние буквы. Что при этом происходит? При нажатии Backspace стирается один символ, затем идёт небольшая задержка, затем срабатывает автоповтор: Backspace убирает символы один за другим, как будто по нему постоянно стучат.

Я рекомендую отрегулировать задержку и частоту работы автоповтора под скорость своих пальцев. Задержка перед срабатыванием автоповтора нужна когда вы хотите удалить только один символ — она даёт вам время отпустить клавишу. Слишком долгая задержка заставляет ждать автоповтора. Не настолько долго, чтобы раздражать, но достаточно, чтобы тормозить перенос мыслей из головы в компьютер. Чем выше частота повтора, тем быстрее стирается текст, и тем сложнее вовремя остановить этот процесс. Суть настройки заключается в поиске золотой середины.

Итак, волшебная команда:

```

xset r rate 190 20

```

190 — длительность задержки в миллисекундах,

20 — частота в количестве повторений в секунду.

Я рекомендую начать с этих значений и понемногу уменьшать задержку до появления ложных срабатываний, затем чуть-чуть вернуть назад. Если установить очень короткую задержку, то клавиатурой станет невозможно пользоваться. Придётся перезагружать X-сервер или компьютер целиком. Так что будьте аккуратнее.

Чтобы сохранить параметры, добавьте эту команду куда-нибудь в автостарт иксов.

### Индикатор завершения процесса

Мне довольно часто приходится запускать долгие процессы: какой-нибудь жирный бэкап, копирование по сети, распаковку/запаковку архивов, сборку пакетов и т.д. Обычно я запускаю такой процесс, переключаюсь на другую задачу и периодически поглядываю не завершился ли мой долгий процесс. Бывает, что я сильно погружаюсь в работу и забываю о нём. Решение — добавить нотификацию завершения процесса, которая выведет меня из транса.

Для этого можно использовать разные средства: notify-send, dzen2, beep, aplay. Все они по-своему хороши, но не работают по ssh. Поэтому я использую terminal beep:

```

long-running-command; echo $'\a'

```

В кодировке ASCII есть символ 0x7, именуемый [bell](https://en.wikipedia.org/wiki/Bell_character). Он предназначен для того, чтобы пищать PC-спикером. PC-спикер — это несовременно, он не везде есть, а ещё его не слышно в наушниках. Поэтому некоторые терминалы применяют так называемый visual bell. Я использую urxvt, и он делает visual bell включением флага urgency. Это когда окно сообщает вам, что оно требует внимания.

Вы можете прямо сейчас проверить как ваш терминал реагирует на символ bell:

```

sleep 3; echo $'\a'

```

Три секунды даётся, чтобы вы успели переключиться на другое окно, иначе может не сработать.

К сожалению, visual bell через urgency есть не во всех терминалах. Я проверил самые популярные.

| терминал | visual bell через urgency |

| --- | --- |

| konsole | включается в настройках |

| urxvt | есть |

| xfce4-terminal | включается в настройках |

| xterm | нет |

| cool-retro-term | нет |

| lxterminal | нет |

| gnome-terminal | нет |

Писать `echo $'\a'` слишком долго, поэтому я сделал алиас `wake`.

### Алиасы

Команды `cp`, `scp` и `rm` всегда должны работать рекурсивно. Аргумент `-r` — это просто дурное легаси! У `cp` ещё можно найти оправдание:

```

cp * foodir

```

скопирует в foodir только файлы, а с ключом `-r` подумает, что вы решили скопировать foodir в самого себя. Но как часто вам нужна эта фича?

У `rm` и `scp` вообще нет оправданий, они просто зануды! Похожая ситуация с ключом `-p` у команды `mkdir`. Так что смело добавляем в `~/.zshrc`

```

alias cp='cp -r'

alias scp='scp -r'

alias rm='rm -r'

alias mkdir='mkdir -p'

```

Ух, как же я раньше без этого жил! Можно пойти ещё дальше и добавить `-f` у `rm`, но на свой страх и риск. Я пока себя сдерживаю.

Разные вариации `ls` вы скорее всего уже используете, ведь это самые популярные алиасы.

```

alias ls='ls -F --color=auto'

alias la='ls -A --color=auto'

alias ll='ls -l --color=auto -h'

alias lla='ll -A --color=auto -h'

```

Ну и цветной grep намного приятнее бесцветного:

```

alias grep='grep --colour=auto'

```

Не забывайте, что алиасы не работают в скриптах! Там надо указывать все ключи.

### Слепой метод печати

Как бы банально это ни было, но слепой десятипальцевый метод печати позволяет быстрее печатать. Поначалу будет тяжело, но со временем вы разгонетесь до невиданных ранее скоростей.

Осваивать слепой метод печати лучше всего на каникулах или в отпуске, когда вас никто не торопит. В процессе обучения ни в коем случае нельзя спешить. Ваша задача — *запомнить* где какая буква находится. Причём не столько мозгом, сколько мышцами. Лучше набирать медленно, но без ошибок, чем быстро с ошибками. Помните: мастера добиваются высоких скоростей не за счёт быстрых пальцев, а потому что не делают ошибок.

Не стоит поначалу увлекаться клавогонками. Психологически тяжело оставаться хладнокровным во время соревнований. Учитесь на тренажёрах. Хорошо, когда тренажёр предлагает слова, которые можно мысленно произнести. Я учился на онлайн-тренажёрах [vse10](https://vse10.ru/) и [typingstudy](https://www.typingstudy.com/ru/). Известный тренажёр "Соло на клавиатуре" мне показался бестолковым.

Начинать стоит с центрального ряда "фывапролджэ". Только после того, как вы запомните где какая клавиша расположена, стоит двигаться дальше. Только после этого.

Делайте перерывы. Давайте отдых мозгу и пальцам. Чувствуете, что посыпались ошибки — пора делать перерыв.

Сначала я освоил слепой метод печати на русском языке и прифигел от ускорения. Сейчас совершенствую навык в английской раскладке.

|

https://habr.com/ru/post/425137/

| null |

ru

| null |

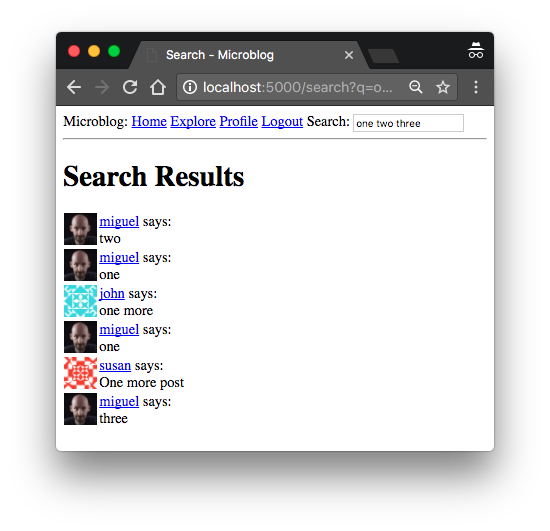

# Мега-Учебник Flask, Часть XVI: Полнотекстовый поиск

(издание 2018)

--------------

### *Miguel Grinberg*

---

[Туда](https://habrahabr.ru/post/351218/) [Сюда](https://habrahabr.ru/post/352266/)

Это шестнадцатая часть серии Мега-учебников Flask, в которой я собираюсь добавить в микроблог возможность полнотекстового поиска.

Под спойлером приведен список всех статей этой серии 2018 года.

**Оглавление*** [**Глава 1: Привет, мир!**](https://habrahabr.ru/post/346306/)

* [**Глава 2: Шаблоны**](https://habrahabr.ru/post/346340/)

* [**Глава 3: Веб-формы**](https://habrahabr.ru/post/346342/)

* [**Глава 4: База данных**](https://habrahabr.ru/post/346344/)

* [**Глава 5: Пользовательские логины**](https://habrahabr.ru/post/346346/)

* [**Глава 6: Страница профиля и аватары**](https://habrahabr.ru/post/346348/)

* [**Глава 7: Обработка ошибок**](https://habrahabr.ru/post/346880/)

* [**Глава 8: Подписчики, контакты и друзья**](https://habrahabr.ru/post/347450/)

* [**Глава 9: Разбивка на страницы**](https://habrahabr.ru/post/347926/)

* [**Глава 10: Поддержка электронной почты**](https://habrahabr.ru/post/348566/)

* [**Глава 11: Реконструкция**](https://habrahabr.ru/post/349060/)

* [**Глава 12: Дата и время**](https://habrahabr.ru/post/349604/)

* [**Глава 13: I18n и L10n**](https://habrahabr.ru/post/350148/)

* [**Глава 14: Ajax**](https://habrahabr.ru/post/350626/)

* [**Глава 15: Улучшение структуры приложения**](https://habrahabr.ru/post/351218/)

* [**Глава 16: Полнотекстовый поиск**](https://habrahabr.ru/post/351900/)(Эта статья)

* [**Глава 17: Развертывание в Linux**](https://habrahabr.ru/post/352266/)

* [**Глава 18: Развертывание на Heroku**](https://habrahabr.ru/topic/post/352830/)

* [**Глава 19: Развертывание на Docker контейнерах**](https://habrahabr.ru/topic/post/353234/)

* [**Глава 20: Магия JavaScript**](https://habrahabr.ru/post/353804/)

* [**Глава 21: Уведомления пользователей**](https://habrahabr.ru/post/354322/)

* [**Глава 22: Фоновые задачи**](https://habrahabr.ru/post/354752/)

* [**Глава 23: Интерфейсы прикладного программирования (API)**](https://habr.com/ru/post/358152/)

*Примечание 1: Если вы ищете старые версии данного курса, это [здесь](https://blog.miguelgrinberg.com/post/the-flask-mega-tutorial-part-i-hello-world-legacy "здесь").*

*Примечание 2: Если вдруг Вы захотели бы выступить в поддержку моей(Мигеля) работы, или просто не имеете терпения дожидаться статьи неделю, я (Мигель Гринберг)предлагаю полную версию данного руководства(на английском языке) в виде электронной книги или видео. Для получения более подробной информации посетите [learn.miguelgrinberg.com](http://learn.miguelgrinberg.com "learn.miguelgrinberg.com").*

Цель этой главы — реализовать функцию поиска для Microblog, чтобы пользователи могли находить интересные сообщения с использованием привычного языка. Для многих типов веб-сайтов можно просто позволить Google, Bing и т. д. Индексировать весь контент и предоставлять результаты поиска через свои API поиска. Это работает для сайтов, которые имеют в основном статические страницы, например форум. Но в моем приложении основной единицей контента является пользовательский пост, который представляет собой небольшую часть всей веб-страницы. Поиск, который мне нужен, относится к этим отдельным сообщениям в блоге, а не целым страницам. Например, если я ищу слово «собака», то хочу видеть сообщения, которые включают это слово в блогах разных пользователей. Проблема в том, что страница, которая показывает все сообщения, в которых есть слово «собака» (или любой другой возможный термин поиска), не существует как страница в блоге, которую могут найти и индексировать большие поисковые системы, поэтому у меня нет другого выбора, кроме как сотворить свою собственную функцию поиска.

*Ссылки GitHub для этой главы:* [Browse](https://github.com/miguelgrinberg/microblog/tree/v0.16), [Zip](https://github.com/miguelgrinberg/microblog/archive/v0.16.zip), [Diff](https://github.com/miguelgrinberg/microblog/compare/v0.15...v0.16).

Введение в полнотекстовые поисковые системы

-------------------------------------------

Поддержка полнотекстового поиска не стандартизирована, как реляционные базы данных. Существует несколько полнотекстовых движков с открытым исходным кодом: [Elasticsearch](https://www.elastic.co/products/elasticsearch), [Apache Solr](http://lucene.apache.org/solr/), [Whoosh](http://whoosh.readthedocs.io/), [Xapian](https://xapian.org/), [Sphinx](http://sphinxsearch.com/) и т.д. Как будто этого недостаточно! Есть несколько баз данных, которые также предоставляют возможности поиска, сравнимые с выделенными поисковыми системами, такими как те, которые я перечислил выше. [SQLite](https://www.sqlite.org/), [MySQL](https://www.mysql.com/) и [PostgreSQL](https://www.postgresql.org/) предлагают некоторую поддержку для поиска текста, а также базы данных NoSQL, такие как [MongoDB](https://www.mongodb.com/) и [CouchDB](http://couchdb.apache.org/).

Если вам интересно, какие из них могут работать в приложении Flask, ответ — все они! Это одна из сильных сторон Flask, он делает свою работу и не упрямится. Так что это лучший выбор?

По моему мнению, из списка специализированных поисковых систем Elasticsearch — особенно выделяется. И как самый популярный, и значимый стоит первым в качестве символа «E» в стеке ELK для индексирования логов, совместно с Logstash и Kibana. Использование возможностей поиска в одной из реляционных баз данных может быть хорошим выбором, но с учетом того факта, что SQLAlchemy не поддерживает эту функциональность, мне пришлось бы обрабатывать поиск с помощью необработанных SQL-инструкций или найти пакет с доступом к текстовым запросам, а также возможность совместного использования с SQLAlchemy.

Основываясь на выше сказанном, я выбираю Elasticsearch, но собираюсь реализовать все функции индексирования текста и поиска таким образом, чтобы очень легко переключиться на другой движок. Это позволит заменить мою реализацию альтернативной версией на основе другого механизма, просто переписав несколько функций в одном модуле.

Существует несколько способов установки Elasticsearch, включая установку в один клик или zip-файл с бинарниками, которые необходимо установить самостоятельно, и даже образ Docker. В [документации](https://www.elastic.co/guide/en/elasticsearch/reference/current/install-elasticsearch.html) есть страница установки с подробной информацией обо всех этих опциях. Если вы используете Linux, у вас, вероятно, будет доступный пакет для вашего дистрибутива. Если Вы используете Mac и у вас установлен Homebrew, то вы можете просто запустить `brew install elasticsearch`.

После установки Elasticsearch на компьютер можно проверить, работает ли он, введя `http://localhost:9200` в адресной строке браузера, которая должна возвращать некоторую основную информацию о сервисе в формате JSON.

Поскольку управляться Elasticsearch будет из Python, я буду использовать клиентскую библиотеку Python:

```

(venv) $ pip install elasticsearch

```

Теперь не помешает обновить файл *requirements.txt*:

```

(venv) $ pip freeze > requirements.txt

```

Elasticsearch Tutorial

----------------------

Для начала я покажу вам основы работы с Elasticsearch из оболочки Python. Это поможет вам ознакомиться с этим сервисом и понять его реализацию, о которой я расскажу позже.

Чтобы создать подключение к Elasticsearch, создайте экземпляр класса `Elasticsearch`, передав URL-адрес подключения в качестве аргумента:

```

>>> from elasticsearch import Elasticsearch

>>> es = Elasticsearch('http://localhost:9200')

```

Данные в Elasticsearch при записи *индексируются*. В отличие от реляционной базы данных, это всего лишь объект [JSON](http://www.json.org/). Следующий пример записывает объект в поле типа `text`, под индексом `my_index`:

```

>>> es.index(index='my_index', doc_type='my_index', id=1, body={'text': 'this is a test'})

```

При желании index может хранить документы разных типов, и в этом случае аргумент `doc_type` может быть установлен в разные значения в соответствии с этими различными форматами. Я собираюсь хранить все документы в том же формате, поэтому я устанавливаю тип документа равным имени индекса.

Для каждого сохраненного документа Elasticsearch получает уникальный идентификатор и объект JSON с данными.

Давайте сохраним второй документ по этому же индексу:

```

>>> es.index(index='my_index', doc_type='my_index', id=2, body={'text': 'a second test'})

```

И теперь, когда в этом индексе есть два документа, я могу выполнить поиск в свободной форме. В этом примере я буду искать `this test`:

```

>>> es.search(index='my_index', doc_type='my_index',

... body={'query': {'match': {'text': 'this test'}}})

```

Ответ `es.search()` представляет собой словарь Python с результатами поиска:

```

{

'took': 1,

'timed_out': False,

'_shards': {'total': 5, 'successful': 5, 'skipped': 0, 'failed': 0},

'hits': {

'total': 2,

'max_score': 0.5753642,

'hits': [

{

'_index': 'my_index',

'_type': 'my_index',

'_id': '1',

'_score': 0.5753642,

'_source': {'text': 'this is a test'}

},

{

'_index': 'my_index',

'_type': 'my_index',

'_id': '2',

'_score': 0.25316024,

'_source': {'text': 'a second test'}

}

]

}

}

```

Здесь видно, что поиск вернул два документа, каждый со своей оценкой. Документ с большей оценкой содержит два слова, которые я искал, а другой документ содержит только одно. Но, как вы видите, даже лучший результат не имеет большой балл, потому что слова не совсем соответствуют тексту.

Теперь посмотрим результат для поиска слова `second`:

```

>>> es.search(index='my_index', doc_type='my_index',

... body={'query': {'match': {'text': 'second'}}})

{

'took': 1,

'timed_out': False,

'_shards': {'total': 5, 'successful': 5, 'skipped': 0, 'failed': 0},

'hits': {

'total': 1,

'max_score': 0.25316024,

'hits': [

{

'_index': 'my_index',

'_type': 'my_index',

'_id': '2',

'_score': 0.25316024,

'_source': {'text': 'a second test'}

}

]

}

}

```

Полученная оценка довольно низкая, потому что мой поиск не соответствует тексту в этом документе, но поскольку только один из двух документов содержит слово "second", другой документ вообще не отображается.

Объект запроса Elasticsearch имеет много параметров и все они хорошо [документированы](https://www.elastic.co/guide/en/elasticsearch/reference/current/search-request-body.html). Среди них такие, как разбиение на страницы и сортировка, так же, как и в случае реляционных баз данных.

Не стесняйтесь добавить больше записей в этот индекс и попробовать различные варианты поиска. Когда вы закончите экспериментировать, можно удалить индекс с помощью следующей команды:

```

>>> es.indices.delete('my_index')

```

Конфигурация Elasticsearch

--------------------------

Интеграция Elasticsearch в приложение является отличным примером крутости Flask. Этот сервис и пакет Python, который не имеет ничего общего с Flask, но я все же постараюсь получить приличный уровень интеграции. Начну с конфигурации, которую буду писать в словаре `app.config` для Flask:

> *config.py*: Elasticsearch Конфигурация.

```

class Config(object):

# ...

ELASTICSEARCH_URL = os.environ.get('ELASTICSEARCH_URL')

```

Как и во многих других записях конфигурации, URL-адрес подключения для Elasticsearch будет получен из переменной среды. Если переменная не определена, получим значение `None`, и это будет сигнал для отключения Elasticsearch. Сделано это в основном для удобства, что бы не вынуждать всегда иметь службу Elasticsearch при работе с приложением, и в частности при выполнении модульных тестов. Поэтому, чтобы убедиться, что сервис используется, мне нужно определить переменную среды `ELASTICSEARCH_URL`, либо непосредственно в терминале, либо добавив ее *.env* файл следующим образом:

```

ELASTICSEARCH_URL=http://localhost:9200

```

Elasticsearch создает проблему, потому что не декорирован расширением Flask. Я не могу создать экземпляр Elasticsearch в глобальной области, как в приведенных выше примерах, потому что для его инициализации мне нужен доступ к `app.config`, который становится доступным только после вызова функции `create_app()`. Поэтому я решил добавить атрибут `elasticsearch` в экземпляр `app` в функции фабрики приложений:

> *app/**init**.py*: Elasticsearch instance.

```

# ...

from elasticsearch import Elasticsearch

# ...

def create_app(config_class=Config):

app = Flask(__name__)

app.config.from_object(config_class)

# ...

app.elasticsearch = Elasticsearch([app.config['ELASTICSEARCH_URL']]) \

if app.config['ELASTICSEARCH_URL'] else None

# ...

```

Добавление нового атрибута в экземпляр `app` может показаться немного странным, но объекты Python не слишком строги в своей структуре, новые атрибуты могут быть добавлены к ним в любое время. Альтернативой, которую вы также можете рассмотреть, является создание подкласса `Flask` (возможно, назовем его `Microblog`) с атрибутом elasticsearch, определенным в его функции `__init__()`.

Обратите внимание, как я использую [условное выражение](https://docs.python.org/3/reference/expressions.html#conditional-expressions), чтобы присвоить `None` экземпляру Elasticsearch, если URL-адрес службы Elasticsearch не был определен в среде.

Абстракция Full-Text Search

---------------------------

Как я сказал во введении к главе, я хочу упростить возможный переход от Elasticsearch к другим поисковым системам. И я не хочу кодировать эту функцию специально для поиска сообщений в блоге, а предпочитаю разрабатывать решение, которое в будущем я могу легко распространить на другие модели, если мне это понадобится. По всем этим причинам, я решил создать абстракцию для функции поиска. Идея состоит в том, чтобы разработать функцию в общих терминах, поэтому я не буду предполагать, что модель `Post` является единственной, которая должна быть проиндексирована, и я также не буду предполагать, что Elasticsearch является предпочтительным индекс-движком. Но если я не могу делать никаких предположений ни о чем, как я могу сделать эту работу?

Первое, что мне нужно, это как-то найти общий способ указать, какая модель и какое поле или поля в ней должны быть индексированы. Я хочу сказать, что любая модель, которая нуждается в индексации должна определить атрибут класса `__searchable__`, содержащий поля, которые должны быть включены в индекс. Для модели Post это будет выглядеть так:

> *app/models.py*: Add a \_\_searchable\_\_ attribute to the Post model.

```

class Post(db.Model):

__searchable__ = ['body']

# ...

```

Здесь говорится, что эта модель должна иметь индексирование поля `body`. Поясню для ясности! Этот атрибут `__searchable__`, который я добавил, является просто переменной, у него нет никакого поведения, связанного с ним. Это просто поможет мне написать мои функции индексирования в общем виде.

Я собираюсь написать весь код, который взаимодействует с индексом Elasticsearch в модуле *app/search.py*. Идея состоит в том, чтобы сохранить весь код Elasticsearch в этом модуле. Остальная часть приложения будет использовать функции в этом новом модуле для доступа к индексу и не будет иметь прямого доступа к Elasticsearch. Это важно, потому что если однажды я решу, что мне больше не нравится Elasticsearch и соберусь переключиться на другой движок, все, что мне нужно сделать, это перезаписать функции в этом одном модуле, и приложение будет продолжать работать по-прежнему.

Для этого приложения я решил, что мне нужно три вспомогательные функции, связанные с индексированием текста: мне нужно:

* добавить записи в полнотекстовый индекс,

* удалить записи из индекса (при условии, что в один прекрасный день я поддержу удаление сообщений в блоге),

* выполнить поисковый запрос.

Вот модуль *app/search.py*, который реализует эти три функции для Elasticsearch, используя функциональность, которую я показал вам выше с консоли Python:

> app/search.py: Search functions.

```

from flask import current_app

def add_to_index(index, model):

if not current_app.elasticsearch:

return

payload = {}

for field in model.__searchable__:

payload[field] = getattr(model, field)

current_app.elasticsearch.index(index=index, doc_type=index, id=model.id,

body=payload)

def remove_from_index(index, model):

if not current_app.elasticsearch:

return

current_app.elasticsearch.delete(index=index, doc_type=index, id=model.id)

def query_index(index, query, page, per_page):

if not current_app.elasticsearch:

return [], 0

search = current_app.elasticsearch.search(

index=index, doc_type=index,

body={'query': {'multi_match': {'query': query, 'fields': ['*']}},

'from': (page - 1) * per_page, 'size': per_page})

ids = [int(hit['_id']) for hit in search['hits']['hits']]

return ids, search['hits']['total']

```

Все эти функции начинаются с проверки определен ли `app.elasticsearch`. В случае `None` выходим из функции без каких-либо действий. Это значит, что в случае когда сервер Elasticsearch не настроен, приложение продолжит работать без возможности поиска и без каких-либо ошибок. Насколько это удобно станет понятно во время разработки или при выполнении модульных тестов.

Функции принимают в качестве аргумента имя index. Во всех вызовах, которые я передаю Elasticsearch, я использую это имя в качестве имени индекса, а также в качестве типа документа, как я уже делал это в примерах консоли Python.

Функции, добавляющие и удаляющие записи из индекса, принимают модель SQLAlchemy в качестве второго аргумента. Функция `add_to_index()` использует переменную класса `__searchable__`, добавленную в модель для построения документа, вставленного в индекс. Если вы помните, документы Elasticsearch также нуждались в уникальном идентификаторе. Для этого я использую поле `id` модели SQLAlchemy, которая также является уникальной. Использование одного и того же значения `id` для SQLAlchemy и Elasticsearch очень полезно при выполнении поиска, поскольку оно позволяет мне связывать записи в двух базах данных. Еще один прикол, заключается в том, что если вы попытаетесь добавить запись с существующим идентификатором, то Elasticsearch заменит старую запись новой, поэтому `add_to_index()` может использоваться как для новых объектов, так и для измененных.

Я не показывал вам функцию `es.delete ()`, которую я раньше использовал в `remove_from_index()`. Эта функция удаляет документ, хранящийся под данным идентификатором. Вот хороший пример удобства использования одного и того же идентификатора для связывания записей в обеих базах данных.

Функция `query_index()` принимает имя индекса и текст для поиска, а также элементы управления разбиением на страницы, так что результаты поиска могут быть разбиты на страницы как результаты Flask-SQLAlchemy. Вы уже видели пример использования функции `es.search()` из консоли Python. Вызов, который я выдаю, довольно похож, но вместо использования типа запроса `match`, я я решил использовать `multi_match`, который может выполнять поиск по нескольким полям. Имя поля `*`, дает установку Elasticsearch просматривать все поля для поиска индекса. Это полезно, чтобы сделать эту функцию универсальной, так как разные модели могут иметь разные имена полей в индексе.

Аргумент `body` у `es.search()` дополняет сам запрос аргументом разбиения на страницы. Аргументы `from` и `size` определяют, какое подмножество всего набора результатов необходимо вернуть. Elasticsearch не предоставляет полноценный объект `Pagination`, подобный объекту Flask-SQLAlchemy, поэтому мне придется самому написать процедуру разбиения на страницы, чтобы вычислить значение `from`.

Оператор `return` в функции `query_index()` несколько посложнее. Он возвращает два значения: первое — список идентификационных элементов для результатов поиска, а второй — общее количество результатов. Оба они получены из словаря Python, возвращаемого функцией `es.search()`. Если вам не знакомо выражение, которое я использую для получения списка идентификаторов, то поясню: её зовут `list comprehension` (генератор списков), и это фантастическая функция языка Python, которая позволяет вам преобразовывать списки из одного формата в другой. В этом случае я использую генератор списка, чтобы извлечь значения `id` из гораздо большего списка результатов, предоставленных Elasticsearch.

Это слишком запутанно? Возможно, демонстрация этих функций в консоли Python может помочь вам понять их получше. В следующем сеансе я вручную добавляю все сообщения из базы данных в индекс Elasticsearch. В моей тестовой базе данных у меня было несколько сообщений, в которых были цифры "one", "two", "three", "four" и «пять», поэтому я использовал их в поисковых запросах. Возможно, вам придется адаптировать свой запрос для соответствия содержимому вашей базы данных:

```

>>> from app.search import add_to_index, remove_from_index, query_index

>>> for post in Post.query.all():

... add_to_index('posts', post)

>>> query_index('posts', 'one two three four five', 1, 100)

([15, 13, 12, 4, 11, 8, 14], 7)

>>> query_index('posts', 'one two three four five', 1, 3)

([15, 13, 12], 7)

>>> query_index('posts', 'one two three four five', 2, 3)

([4, 11, 8], 7)

>>> query_index('posts', 'one two three four five', 3, 3)

([14], 7)

```

Запрос, который я отправил, возвращает семь результатов. Поначалу я запросил 1 страницу со 100 пунктами на страницу и получил все семь возможных. Затем следующие три примера показывают, как я могу разбивать страницы способом очень похожим, на то, как я это сделал для Flask-SQLAlchemy, за исключением того, что результаты приходят в виде списка идентификаторов вместо объектов SQLAlchemy.

Если вы хотите сохранить все в чистоте, удалите индекс `posts` после того, как наэкспериментируетесь с ним:

```

>>> app.elasticsearch.indices.delete('posts')

```

Интеграция поиска с SQLAlchemy

------------------------------

Решение, которое я показал вам в предыдущем разделе, приемлемое, но у него все еще есть несколько нерешенных проблем. Первая и наиболее очевидная заключается в том, что результаты приходят в виде списка числовых идентификаторов. Это очень неудобно, поскольку мне нужны модели SQLAlchemy, чтобы я мог передавать их в шаблоны для визуализации, и мне нужен способ заменить этот список чисел соответствующими моделями из базы данных. Вторая проблема заключается в том, что это решение требует, чтобы приложение явной выдавало вызовы индексирования. Сообщения добавляются или удаляются, что не страшно, но не идеально, поскольку ошибка, которая вызывает пропущенные индексации вызова при внесении изменений на стороне SQLAlchemy не собираются быть легко обнаружены. Две базы данных будут рассинхронизироваться все больше и больше каждый раз при возникновении ошибки и вы, вероятно это не заметите какое то время. Лучшим решением было бы автоматическое включение этих вызовов при внесении изменений в базу данных SQLAlchemy.

Проблема замены идентификаторов объектами может быть решена путем создания запроса SQLAlchemy, который прочитает эти объекты из базы данных. Это звучит просто, но реализовать эффективное выполнение одного запроса на самом деле не так то просто.

Для решения второй проблемы (автоматического отслеживания изменений индексирования) я решил выполнять обновления индекса Elasticsearch из *events* (событий) SQLAlchemy. SQLAlchemy предоставляет большой список событий, о которых приложения могут получать уведомления. Например, для каждого commit-а (*фиксации изменений*) сеанса, я мог бы иметь функцию в приложении, вызываемом SQLAlchemy, в которой мог применять те же обновления, которые были сделаны в сеансе SQLAlchemy к индексу Elasticsearch.

Для реализации решений этих двух задач я собираюсь написать класс *mixin*. Помните занятия миксином? В [главе 5](https://habrahabr.ru/post/346346/) я добавил класс `UserMixin` из Flask-Login в пользовательскую модель, чтобы доверить ему некоторые функции, которые требовались Flask-Login. Для поддержки поиска я собираюсь определить свой собственный класс `SearchableMixin`, который при подключении к модели даст ему возможность автоматически управлять полнотекстовым индексом, связанным с моделью SQLAlchemy. Класс mixin будет выступать в качестве "связующего" слоя между мирами SQLAlchemy и Elasticsearch, предоставляя решения двух проблем, о которых я говорил выше.

Позвольте мне показать вам реализацию, а затем я рассмотрю некоторые интересные детали. Обратите внимание на использование нескольких передовых методов, так что вам нужно будет внимательно изучить этот код, чтобы полностью понять его.

> *app/models.py*: SearchableMixin class.

```

from app.search import add_to_index, remove_from_index, query_index

class SearchableMixin(object):

@classmethod

def search(cls, expression, page, per_page):

ids, total = query_index(cls.__tablename__, expression, page, per_page)

if total == 0:

return cls.query.filter_by(id=0), 0

when = []

for i in range(len(ids)):

when.append((ids[i], i))

return cls.query.filter(cls.id.in_(ids)).order_by(

db.case(when, value=cls.id)), total

@classmethod

def before_commit(cls, session):

session._changes = {

'add': list(session.new),

'update': list(session.dirty),

'delete': list(session.deleted)

}

@classmethod

def after_commit(cls, session):

for obj in session._changes['add']:

if isinstance(obj, SearchableMixin):

add_to_index(obj.__tablename__, obj)

for obj in session._changes['update']:

if isinstance(obj, SearchableMixin):

add_to_index(obj.__tablename__, obj)

for obj in session._changes['delete']:

if isinstance(obj, SearchableMixin):

remove_from_index(obj.__tablename__, obj)

session._changes = None

@classmethod

def reindex(cls):

for obj in cls.query: