text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

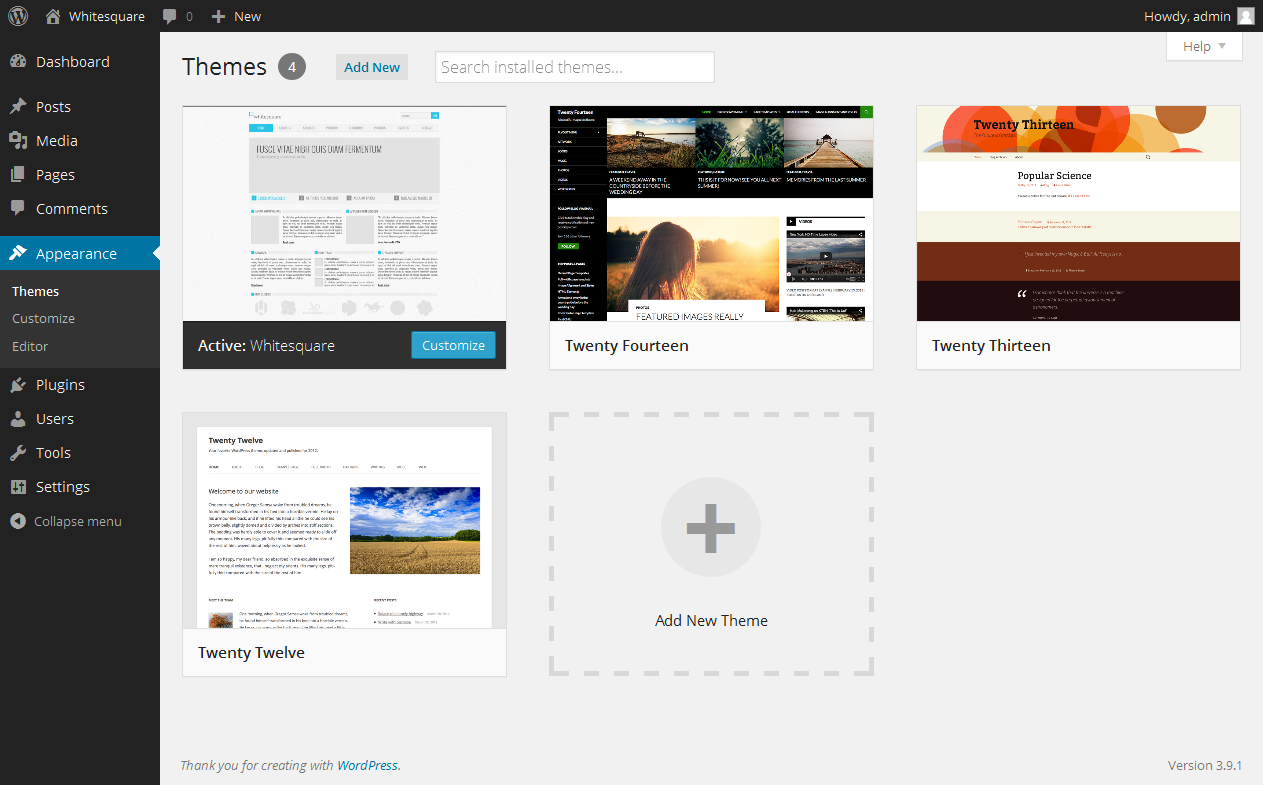

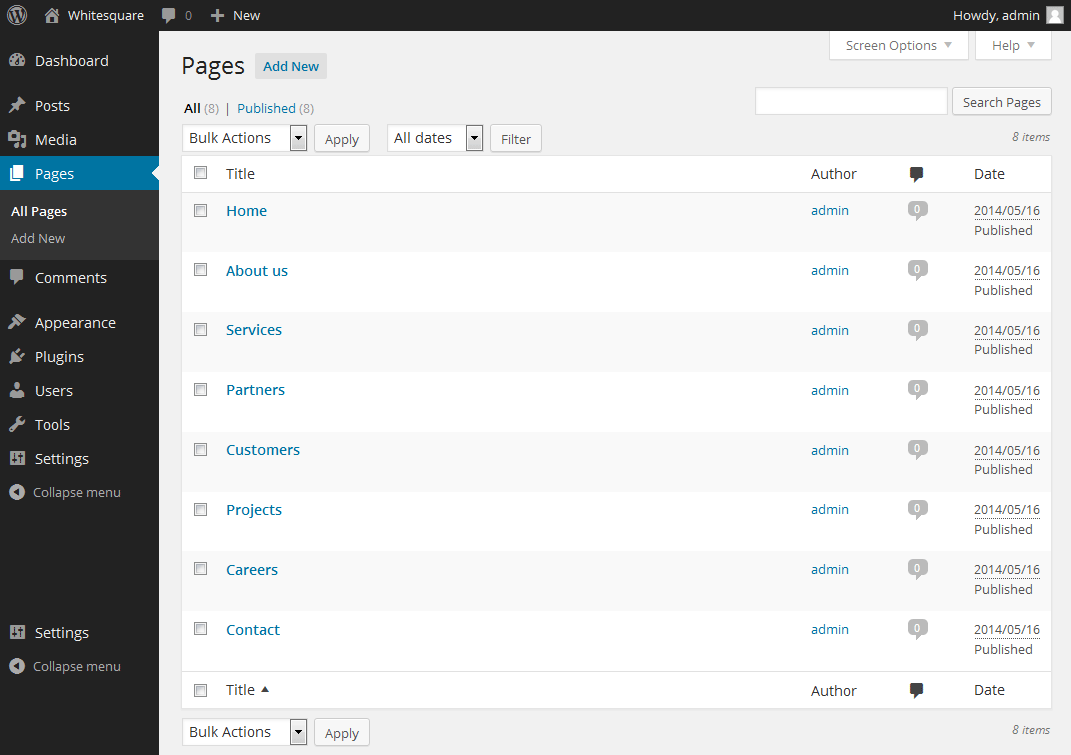

# Установка, настройка и тестирование Fedora 21 Workstation на личном или игровом компьютере

9-го декабря вышла новая Fedora 21 Workstation, которую по совокупности параметров можно назвать «самым свежим и стабильным» Линукс-десктопом.

За время использования и тестирования Fedora я проникся к этой платформе глубокой симпатией и хочу поделиться этим теплом и знаниями о ней с вами.

В течение года я наблюдал за её работой в качестве рабочего и игрового места в разных ситуациях — от станций с «умирающим» железом до нового игрового ноутбука Asus G750JM с Nvidia Optimus.

Собранные заметки получились несколько шершавыми, старающимися охватить одновременно и новичков в Линуксе, и опытных пользователей с разработчиками. Прошу простить. Хочу донести большой объем информации в одной статье: и по общей настройке и установке Федоры, и по технологии Nvidia Optimus на ноутбуках, wi-fi с проприетарными драйверами, о настройке симпатичных шрифтов в Java и IDE от JetBrains, запуску игр в Steam на дискретной видеокарте, о результатах сравнительного тестирования игр, графики и браузеров между Федорой и Windows 8.1, и даже об установлении одного «абсолютного» рекорда.

Хочу отметить, что свежие десктопные Линуксы также отличаются качественной поддержкой дисплеев высокого разрешения с хорошей отрисовкой шрифтов и оконных элементов, предоставляют высочайшую степень различных персональных настроек, «хаков» и возможностей оперирования с приложениями. Всё это позволяет не только значительно повысить эффективность своей работы, но и сделать это с комфортом для глаз.

Поскольку темы личной эффективности, комфортной для глаз темизации и различных «хаков» достаточно обширны и специфичны, в будущем я посвящу им две или три углубленных статьи. А в данном документе будет общая выжимка информации именно по настройке и общему использованию Fedora 21.

Содержание

----------

[О дистрибутиве Fedora](#about_fedora)

[Установка Fedora 21 Workstation](#install_fedora)

[Последовательная настройка](#overall_setup)

* [Чтобы заработал Wi-Fi на ноутбуке, если он не работает](#setup_wifi)

* [Первое — обновляем систему](#update_system)

* [Замедлить мышку](#slowdown_mouse)

* [Если ставите Fedora в виртуальную машину (VirtualBox)](#virt_fedora)

[Общие настройки системы](#main_setup)

* [Добавляем себе возможность использовать sudo](#add_sudo)

* [Установка Midnight Commander (mc)](#install_mc)

* [Шрифт в системной консоли](#sys_fonts)

[Gnome 3 — рабочая среда по-умолчанию](#gnome3)

* [Первым делом — утилита для настройки Gnome 3 и шрифтов](#gnome_tweak)

* [Сворачивание-разворачивание окон — шоткеи и кнопки](#gnome_shortkeys)

* [Удобные дополнения Gnome](#gnome_extensions)

* [Тонкости файлового менеджера Nautilus](#nautilus)

* [Добавить средства управления пакетами програм](#yumex)

* [Сетевые аккаунты — синхронизация с почтой, контактами и календарем Google](#gnome_online_accounts)

[Шрифты](#fonts)

* [Заменяем тонкие шрифты в IDE от JetBrains (IntelliJ, PyCharm и другие) и в Java](#fonts_jetbrains)

[Среды разработки и редакторы для языка программирования Python](#python_ide)

[Подключение к репозитариям RPMFUSION](#rpmfusion)

[Видео, аудио и книги](#video_audio_books)

* [Видеопроигрыватели](#video_players)

* [Аудиопрогрыватели + Вконтакте](#audio_players_vk)

* [Если вашим программам все ещё не хватает кодеков](#codecs)

* [Как слушать аудиокниги](#audiobook_players)

* [Как читать книги](#book_readers)

[Установка Дропбокса](#dropbox)

[Установка мессенджеров](#messenger)

* [Skype](#skype)

* [Viber](#viber)

* [Telegram](#telegram)

[Установка браузеров и flash](#browsers_and_flash)

* [Google Chrome](#chrome)

* [Установка Хромиума](#chromium)

* [Flash для браузеров и для системы](#flash)

[Проприетарные видеодрайверы](#videodrivers)

* [Nvidia «обычная»](#nvidia)

* [Проприетарные драйвера ATI](#ati)

* [Nvidia Optimus — установка Bumblebee](#nvidia_optimus)

* [Как запускать программы и игры в Steam на дискретной карте](#steam_optimus)

[Бенчмарки: Fedora 21 Optimus / Primus / Windows 8.1](#benchmarks)

* [Кроссплатформенный бенчмарк GPU — GPUTest](#gputest)

* [Кроссплатформенный бенчмарк Geekbench](#geekbench)

* [Решение проблемы с неработающим WebGL у Хрома](#chrome_webgl_optimus)

* [Бенчмарки для браузеров](#browser_benchmark)

* [Основная информация по моей системе для уточнения бенчмарков](#benchmark_base)

[Steam и игры](#steam)

[Запускаем Windows-игры и Windows-программы](#windows_play)

[Программы для рисования](#drawning_tools)

[KDE](#kde)

* [Офис Calligra](#calligra)

* [Настройка KDE](#setup_kde)

* [Синхронизация контактов, календаря и почты Google](#kde_sync_google)

* [Устранение проблемы многократного запуска некоторых QT-программ](#kde_qt_instances)

[Изучение иностранных языков](#foreign_languages)

* [Словарь с произношением — StarDict](#stardict)

* [Anki и карточки](#anki)

[Проблема с появившимся тихим шумом в наушниках](#noise_in_headset)

[Завершение](#ending)

О дистрибутиве Fedora

---------------------

Начиная с версии 21 установочный дистрибутив Федора разделен на 3 типа по предназначению: для рабочей станции, сервера и облака. Ознакомиться с ними можно на обновленном сайте Fedora, где это хорошо оформлено и описано: [getfedora.org](https://getfedora.org)

Официальная информация о релизе Fedora 21: [fedoramagazine.org/announcing-fedora-21](http://fedoramagazine.org/announcing-fedora-21)

Информация о релизе плюс много скриншотов: [www.webupd8.org/2014/12/fedora-21-available-for-download.html](http://www.webupd8.org/2014/12/fedora-21-available-for-download.html)

Краткий обзор возможностей Gnome 3.14, являющегося основной рабочей средой в Fedora 21 Workstation:

Fedora 21 Workstation сейчас позиционируется как отличная рабочая станция для разработчиков с минимальным отвлечением от работы. В систему включено большое количество необходимых инструментов, а также самый свежий софт для использования, тестов и исследований среды.

Среди заметных плюсов Федоры хочу отметить отсутствие необходимости подключать сторонние ненадежные репозитории для получения свежего программного обеспечения. Подавляющее большинство полезных программ уже находится в репозитарии rpmfusion и неплохо тестируется на совместимость с основным репозитарием Федоры. Это очень хорошо сказывается на стабильности и предсказуемости всей системы.

Конечно надо отметить, что самый свежий софт несет в себе не только новые возможности и плюсы в работе, но и иногда «болеет» проблемами роста (как, например, происходило некоторое время назад с Gnome 3). Однако в большинстве случаев такие проблемы решаются либо использованием альтернативы (в моем случае тогда это был KDE), или другими способами.

Возвращаясь к надежности Федоры: начав работать с ней после других дистрибутивов Линукса вы можете отметить снижение скорости обновления и установки пакетов, т.к. в системе по-умолчанию включены дополнительные шаги проверки до и после установки пакетов. До установки — выполнение тестовых транзакций без внесения изменений на диск, после — верификация выполненной транзакции.

Как я упоминал выше, Федора в целом на мой взгляд очень надежный дистрибутив, и даже в некоторых ситуациях работы на сбойном железе она неплохо на нем выживает.

Также отмечу, что все больше производителей софта в последнее время, в том числе и проприетарного, выпускают готовые пакеты и тестируют их именно для Fedora (а не только для Ubuntu). Среди них Viber, Dropbox и другие.

Установка Fedora 21 Workstation

-------------------------------

Скачать торрент со стандартным образом для живого тестирования и установки на рабочую станцию:

для 64-битных систем [torrent.fedoraproject.org/torrents/Fedora-Live-Workstation-x86\_64-21.torrent](http://torrent.fedoraproject.org/torrents/Fedora-Live-Workstation-x86_64-21.torrent)

для 32-битных [torrent.fedoraproject.org/torrents/Fedora-Live-Workstation-i686-21.torrent](http://torrent.fedoraproject.org/torrents/Fedora-Live-Workstation-i686-21.torrent)

Данный образ базируется на рабочей среде Gnome 3, как основной для Workstation.

Другие варианты скачивания образа Fedora 21 для рабочих станций: [getfedora.org/en/workstation/download](https://getfedora.org/en/workstation/download)

Торренты всех доступных вариантов образов Fedora 21, включая так называемые «спины», в которых вместо Gnome используются другие среды рабочего стола: KDE, Xfce, LXDE, Mate и т.д.: [torrent.fedoraproject.org](http://torrent.fedoraproject.org)

А более подробную информацию о «спинах» можно найти тут: [spins.fedoraproject.org](http://spins.fedoraproject.org)

Видео процесса установки Федоры на рабочую станцию и первого знакомства с ней:

Руководство по процессу установки: [docs.fedoraproject.org/install-guide](http://docs.fedoraproject.org/install-guide)

Как сделать загрузочную флешку: [docs.fedoraproject.org/en-US/Fedora/20/html/Burning\_ISO\_images\_to\_disc/Making\_USB\_Media.html](http://docs.fedoraproject.org/en-US/Fedora/20/html/Burning_ISO_images_to_disc/Making_USB_Media.html)

Во избежание проблем, которые иногда случаются при записи флешки, и препятствуют нормальному запуску системы с неё, рекомендую по-возможности пользоваться старой надежной dd (/dev/sdc — ваше устройство с флешкой):

```

sudo dd if=~/Download/Fedora-Live-Workstation-x86_64-21-5.iso of=/dev/sdc

```

Не забудьте перед запуском и установкой с флешки проверить в биосе переменную «Secure Boot Menu» в разделе «Security» — она должна быть выключена для нормальной установки новой системы. Также в биосе для удобной работы с подключенным монитором можете в разделе «Boot» включить опцию «Launch CSM» (Launch Compatibility Support Module). По-крайне мере так эти переменные выглядят на моем ноутбуке.

Если вы хотите проапгрейдить свою Fedora 20 до свежей версии 21 без переустановки:

[fedoramagazine.org/upgrading-to-fedora-21-workstation-from-fedora-20](http://fedoramagazine.org/upgrading-to-fedora-21-workstation-from-fedora-20)

Теперь переходим к последовательной настройке системы и программ в ней.

Последовательная настройка

==========================

Чтобы заработал Wi-Fi на ноутбуке, если он не работает

------------------------------------------------------

Если ваш чип Wi-Fi относится к сериям Broadcom's BCM4311-, BCM4312-, BCM4313-, BCM4321-, BCM4322-, BCM43224-, BCM43225-, BCM43227- или BCM43228, то вам потребуется установка проприетарных драйверов, чтобы он заработал корректно.

Посмотреть модель вашей карты в терминале можно командой lspci

У меня стоит Broadcom Corporation BCM4352 802.11ac Wireless Network Adapter (rev 03)

После того как мы убедились, что наша карта относится к вышеуказанным сериям, будем ставить для нее драйвера. Вам потребуется интернет через кабель Ethernet или придется вынимать пакеты вручную через другой компьютер. Ниже я описываю самый простой вариант, когда у вас работает интернет через кабель.

Сперва надо подключить репозиторий rpmfusion — информация об этом находится в статье ниже. После его подключения возвращайтесь обратно сюда.

Итак, рекомендуемый вариант установки драйвера для нашего wi-fi следующий:

```

su - -c "yum install kmod-wl"

```

Команда спросит пароль рута. На вопрос «установить-ли с зависимостями» отвечаете «y».

Подробнее о данной установке тут: [www.cyberciti.biz/faq/fedora-linux-install-broadcom-wl-sta-wireless-driver-for-bcm43228](http://www.cyberciti.biz/faq/fedora-linux-install-broadcom-wl-sta-wireless-driver-for-bcm43228)

У меня этого оказалось недостаточно в связи с багом, речь о котором идет тут:

[ask.fedoraproject.org/en/question/57806/broadcom-4321-wireless-not-working-in-fedora-21](https://ask.fedoraproject.org/en/question/57806/broadcom-4321-wireless-not-working-in-fedora-21)

И потребовалось сделать ещё несколько манипуляций:

```

su - -c "yum reinstall kmod-wl akmod-wl"

su - -c "yum install akmods kernel-devel"

su - -c "yum update"

```

Перезагружаемся.

```

su - -c "akmods"

```

(эта команда заново пересобирает модуль для wi-fi, здесь может потребоваться команда akmodsbuild от пользователя)

Перезагрузиться.

```

su - -c "modprobe wl"

```

(загружаем модуль для wi-fi)

После этого модуль wi-fi наконец заработал и я смог отсоединить провод Ethernet, почувствовав свободу.

Для информации оставлю здесь одну из свежих, но не проверенных рекомендаций по установке этого-же драйвера:

```

su - -c "yum install broadcom-wl kmod-wl akmod-wl rfkill"

su - -c "rfkill list"

su - -c "rfkill unblock all"

```

Дальнейшие действия выполняются после установки Федоры на жесткий диск и загрузки с него.

Первое — обновляем систему

--------------------------

Это важно! Без обновления системы могут получиться неприятности при установке следующих пакетов, необходимых для компиляции доп.модулей и другие нестыковочки.

Для этого нажимаем Win и пишем первый буквы «te» или «те» (Gnome ищет одновременно и по русскому и по английскому названию программ) дальше остаётся нажать Enter и запустить терминал. Это информация для новичков в Gnome 3.

Дальше в нем переходим в выполнение команд от рута:

```

su -

```

Вы можете ускорить загрузку пакетов из репозитория, если будут выбираться самые быстрые зеркала.

Для этого достаточно установить дополнение к yum, тестирующее сервера на скорость отклика, и переключающееся на самые быстрые из них:

```

yum install yum-plugin-fastestmirror

```

И, наконец, выполняем обновление всех установленных в системе пакетов:

```

yum update

```

Замедлить мышку

---------------

У некоторых из нас мышки поддерживают разное разрешение сенсора (1000...8000 dpi).

В Linux может оказаться, что ваша мышь слишком шустрая, и снизить её скорость обычными средствами настройки в графическом режиме невозможно.

Для этих случаев есть простое решение с замедлением указателя:

надо прописать конфиг для Иксов, в котором указать торможение как постоянную переменную.

В моем случае достаточно двухкратного торможения, отображаемого в значении ConstantDeceleration.

Выглядит вот так:

```

$ cat /etc/X11/xorg.conf

Section "InputClass"

Identifier "Logitech Gaming Mouse G600"

MatchIsPointer "on"

MatchProduct "Logitech Gaming Mouse G600"

Option "ConstantDeceleration" "2"

EndSection

```

Узнать название своей мышки можно вот так:

```

$ xinput list

⎡ Virtual core pointer id=2 [master pointer (3)]

⎜ ↳ Virtual core XTEST pointer id=4 [slave pointer (2)]

⎜ ↳ Logitech Gaming Mouse G600 id=12 [slave pointer (2)]

...

```

Существует возможность установить замедление и через команду xinput, не прибегая к конфигу иксов, но такой вариант ограничен номерами указателя мыши в системе, которые меняются при перевтыкании мыши в другой порт или иногда при перезагрузке.

Если ставите Fedora в виртуальную машину (VirtualBox)

-----------------------------------------------------

От рута выполняем:

```

yum install binutils gcc make patch libgomp glibc-headers glibc-devel kernel-headers kernel-devel dkms

```

Больше информации по данной теме: [www.if-not-true-then-false.com/2010/install-virtualbox-with-yum-on-fedora-centos-red-hat-rhel](http://www.if-not-true-then-false.com/2010/install-virtualbox-with-yum-on-fedora-centos-red-hat-rhel)

Затем в самой виртуалке в меню выбираем Devices — Insert Guest Additional CD image

VirtualBox скачает нужный файл образа дополнений гостевой ОС.

Виртуальная Федора обнаружит «вставленный диск» и предложит автозапуск находящей на ней программы установки.

После запуска этой программы и предложения авторизоваться паролем рут не забудьте, что, возможно, надо переключиться обратно на английскую раскладку (Alt+Shift), т.к. в Федоре будет стоять русский ввод по-умолчанию (теперь при выбранной русской локали при инсталляции русский-же и является языком для ввода с клавиатуры по-умолчанию).

Результаты выполнения программы установки дополнений гостевой ОС выведутся в этом-же терминали.

При успешной установке модулей и после перезагрузки гостевая Федора будет удобная для использования в виртуальной машине — реагировать на изменений размеров её окна, корректно переходить в Fullscreen и т.д.

И можно будет переходить к дальнейшей настройке или экспериментам.

Напоминаю, что в виртуалке переключение по системным консолям производится не привычными Ctrl+Alt+F1..F7, а с помощью хост-клавиши: правый контрол + F1..F7

Общие настройки системы

-----------------------

### Добавляем себе возможность использовать sudo

Выполняем от рута

```

usermod sampleusername -a -G wheel

```

где sampleusername — логин вашего пользователя

Более подробная информация на эту тему: [fedoraproject.org/wiki/Configuring\_Sudo](http://fedoraproject.org/wiki/Configuring_Sudo)

После выполнения команды выходим из системы (logout) и входим снова.

Подсказка новичкам:

1. Чтобы выйти из рута в консоли набираем exit, затем или exit ещё раз, или закрываем окно (мышкой или хоткеем Alt+F4).

2. Чтобы выйти из Gnome щелкаем справа вверху по треугольнику или рядом с ним (тоже среагирует выпаданием этого меню), дальше щелкаем по имени нашего пользователя, под ним появляется «Завершить сеанс», кликаем по этому пункту.

3. Чтобы войти и правильно указать пароль, если он у вас в английской раскладке, не забудьте опять на неё переключить по Alt+Shift.

После этого все команды «от рута» можно выполнять через sudo.

### Установка Midnight Commander (mc)

Мне очень удобен и привычен MC, поэтому на любой новой системе я начинаю с его установки.

```

sudo yum install mc

```

Если пользуетесь MC и привыкли выходить из него по F10, то в терминале Гнома нужно отключить шоткей вызов меню гномовского терминала по F10:

«Правка» — «Параметры» — Включить быструю клавишу доступа к меню (по-умолчанию F10)

Или переназначить её.

### Шрифт в системной консоли

Если вы выбрали русский как основной язык системы при установке, значит системная консоль тоже будет с правильным русским.

Однако если вы ставили, выбрав английский, то русские символы в системной консоли будут отображаться квадратиками или кракозябриками.

Чтобы это «вылечить» надо в /etc/profile.local прописать строчку

```

setfont Cyr_a8x16

```

Gnome 3 — рабочая среда по-умолчанию

------------------------------------

Основной распространяемый вариант Fedora 21 Workstation по-умолчанию несет в своей основе рабочую среду Gnome 3.14

У этого решения есть свои плюсы и минусы.

Среди плюсов — интересная для некоторых динамика работы с окнами, рабочими столами, и информацией.

Возможность искать одновременно и программы, и сервисы, и свои контакты, и много другой информации.

Но здесь я опишу что с ней можно сделать для уютного обживания. :)

Если Вы не планируете работать с Gnome или воспользовались «спином» с другой рабочей средой, то можете пропустить этот раздел.

Обзоры возможностей последней версии Gnome с картинками и видео вы можете посмотреть тут:

[www.opennet.ru/opennews/art.shtml?num=40669](http://www.opennet.ru/opennews/art.shtml?num=40669)

[www.webupd8.org/2014/09/gnome-314-released-see-whats-new.html](http://www.webupd8.org/2014/09/gnome-314-released-see-whats-new.html)

### Первым делом — утилита для настройки Gnome 3 и шрифтов

Устанавливаем:

```

sudo yum install gnome-tweak-tool

```

Запускаем:

клавиша Win, затем набираем «tw» или «доп», Enter

Вкладка (кнопка) «Шрифты».

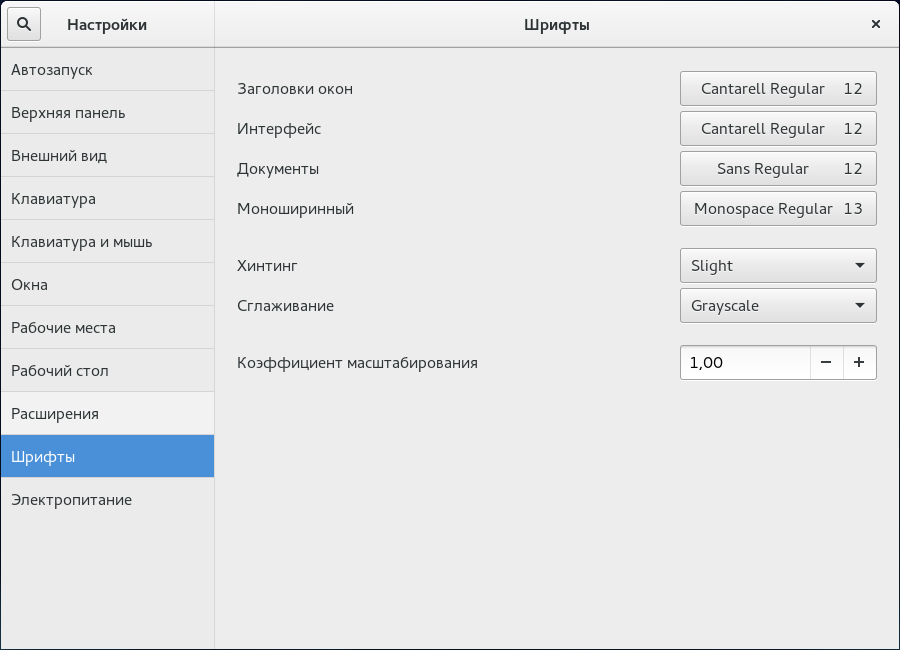

На ней мы можем увеличить все шрифты на 1-2 пункта для лучшей читабельности, а также выбрать вариант сглаживания (хинтинга), который лучше подходит для нашего монитора и личных предпочтений. Я предпочитаю вариант хинтинга «slight».

Скриншот окна найстроки шрифтов с указанными изменениями:

Окно терминала с открытым MC после применения изменений:

### Сворачивание-разворачивание окон — шоткеи и кнопки

Установив утилиту «тонкой» настройки Gnome мы можем управлять отображение кнопок в заголовках окон.

В Gnome Tweak Tool (она-же «Дополнительные параметры») в разделе «Окна» можно включить отображение привычных кнопок «Развернуть» и «Свернуть» в заголовке окон, возле кнопки «Закрыть».

Я этими кнопками не пользуюсь. В Гноме стандартный шоткей сворачивания окна: Win+H

У меня он также вызывается и нажатием на дополнительную кнопку мышки.

Также удобно использовать шоткеи Win + стрелка, они разворачивают-восстанавливают окна в разных направлениях.

### Удобные дополнения Gnome

Желающие использовать под полезный контент максимум места на экране, особенно владельцы ноутбуков и нетбуков, могут поставить 2 дополнения для Gnome:

1. Maximus Two [extensions.gnome.org/extension/844/maximus-two](https://extensions.gnome.org/extension/844/maximus-two)

2. Frippery Move Clock [extensions.gnome.org/extension/2/move-clock](https://extensions.gnome.org/extension/2/move-clock)

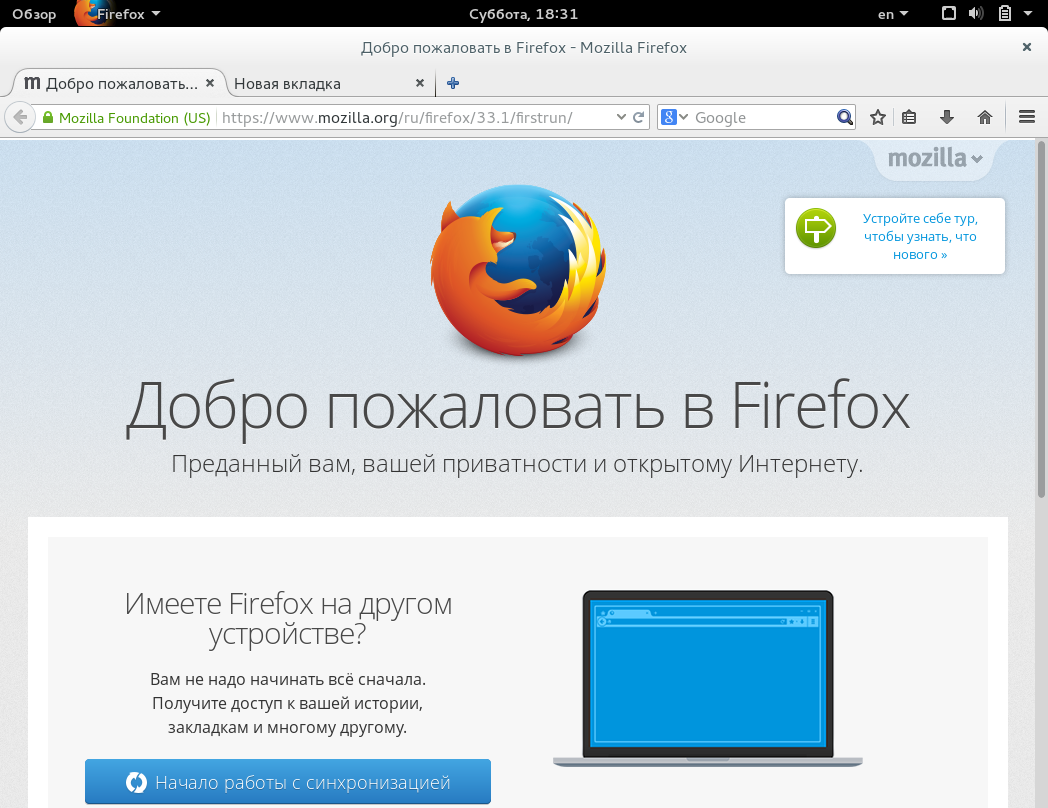

Скриншот Firefox в Gnome 3 без указанных дополнений:

И после установки дополнений, расширяющих полезное пространство:

Есть и другие варианты дополнений, аналогичные вышеуказанным.

Вообще, к Гному создано много полезных дополнений. Найти их можно на сайте [extensions.gnome.org](https://extensions.gnome.org)

Например, «Bumblebee» для владельцев ноутбуков с технологией Optimus, которое иконкой отображает использование дискретной карты в системе (установку, настройку и бенчмарки Nvidia Optimus и Bumblebee я буду рассматривать отдельно ниже). Или дополнение ускоряющее анимацию работы с окнами в Gnome.

Есть обзоры — что именно стоит поставить из дополнений на Gnome 3. Так что если вам симпатичная данная среда — не поленитесь ознакомиться с ними, выйдя на них через искомые для вас ключевые фразы.

Часто, люди используют восстановление привычного вида среды — нижней панели с запущенными программами, обычного трея с кучей иконок запущенных программ и расширенное меню для операций на окном через него.

Мне это не нужно, так как я стараюсь минимизировать любые отвлекающие факторы, и идея спрятать иконки меня вполне устраивает. При этом оповещения в системе сделаны ненавязчиво и доходчиво, их не так легко пропустить.

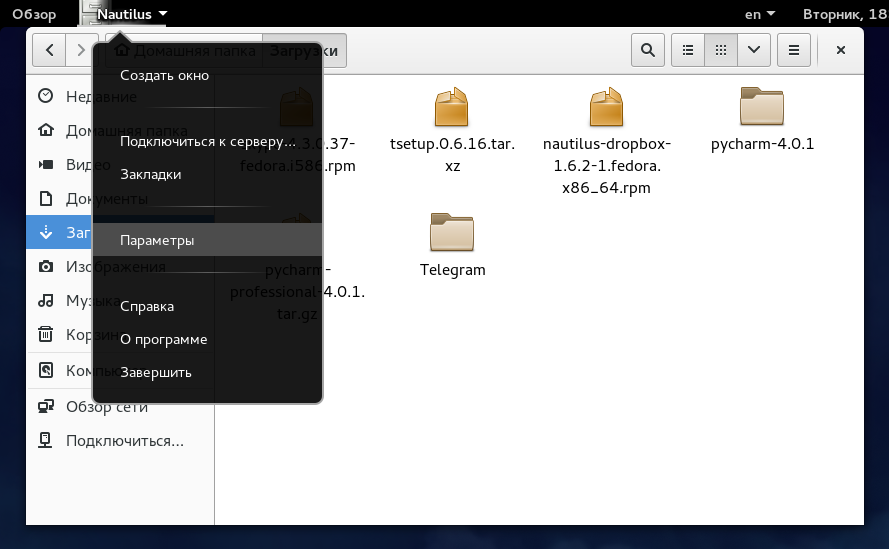

### Тонкости файлового менеджера Nautilus

По-умолчанию сортировка не выставляет папки до списка файлов, отображается всё в перемешку.

Исправляем:

Nautilus — Параметры -> отмечаем чекбокс «Помещать папки перед файлами»

Также, я предпочитаю перемещаться по компьютеру без двойных щелчков мышки. Если вы согласны со мной, что действие в 1 клик приятней — в том-же окне переключитесь на вкладку «Поведение», и отметьте в «Поведение» — «Открывать объекты одним щелчком».

После этого можно закрыть окно настройки.

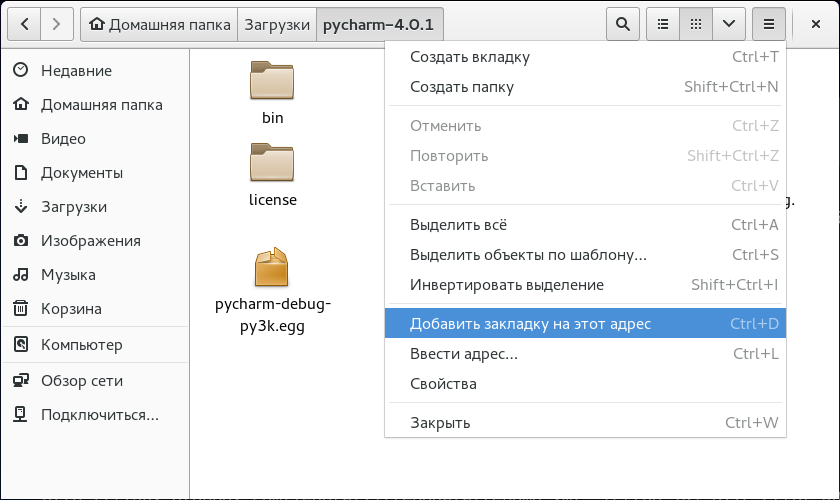

У файлового менеджера Nautilus есть неочевидная возможность добавлять свои «точки входа» — закладки на нужные вам адреса. Для этого, находясь по нужному адресу или в нужном каталоге, нажимаем Ctrl+D или выбираем мышкой иконку с горизонтальными черточками, и там в меню щелкаем по «Добавить закладку на этот адрес».

После этого слева внизу появится закладка с вашим адресом или папкой. Можете организовать их перетаскиванием мышкой, удалить вызвав контекстное меню, переименовать или производить другие требуемые операции.

### Добавить средства управления пакетами програм

Стандартное средство управления программами в Gnome ориентировно не на пакеты а на избранные программы. Чтобы получить возможность более полно изучать репозитарии доступного программного обеспечения и управлять ими, надо установить Yumex или использовать предустановленный Apper в KDE.

Устанавливаем Yumex:

```

sudo yum install yumex

```

### Сетевые учетные записи — синхронизация с почтой, контактами и календарем Google

В Гном встроена отличная интеграция с вашими основными данными из аккаунта Гугла, а также с множеством других сетевых сервисов.

Достаточно зайти в главное меню системы и написать «сете» — появится предложение выбрать настройку раздела «Сетевые учетные записи».

Указав свои параметры доступа к Гуглу и подтвердив их кодом (если у вас двухэтапная авторизация), вы получаете интеграцию календаря, задач, контактов и почты со своей системой.

Так, при клике по времени будет появляться информация о ваших ближайших событиях календаря. А при вбивании части имени одного из ваших контактов в главном меню системы его карточка будет появляться у вас прямо перед глазами. Далее вы сможете связаться с ним в 2 клика.

И удобство сетевых записей этим не ограничивается. Попробуйте!

Шрифты

------

У меня LCD мониторы и я предпочитаю шрифты с легким сглаживанием. Отсюда переменные в следующем конфиге.

Если вам нравится другое значение сглаживания (среднее, сильное или без него)- можете подставить соответствующее значение для переменной hintstyle вместо hintslight: hintmedium, hintfull или hintnone.

Также вам может потребоваться внести изменения и в переменную lcdfilter. Но подробнее об этом вы можете прочитать, например, тут [wiki.archlinux.org/index.php/font\_configuration](https://wiki.archlinux.org/index.php/font_configuration)

Приведенный ниже текст конфига улучшает шрифты во множестве программ, включая Firefox, KDE со штатной настройкой сглаживания «Как в системе» и в запущенных из-под него программах.

Вам необходимо создать файл /etc/fonts/local.conf со следующим содержимым:

```

xml version='1.0'?

rgb

true

hintslight

lcddefault

false

~/.fonts

```

После этого выходим из сеанса, и входим заново.

Система теперь полноценно узнала о том, какое сглаживание шрифтов вы хотите использовать.

В некоторых случаях требуется изменение стандартного dpi экрана, чтобы шрифты и графика после приведенных настроек действительно были отличными.

Этот момент я пока оставляю вам на самостоятельную проработку, если поймете, что вам надо его выполнить для обретения счастья на вашей системе.

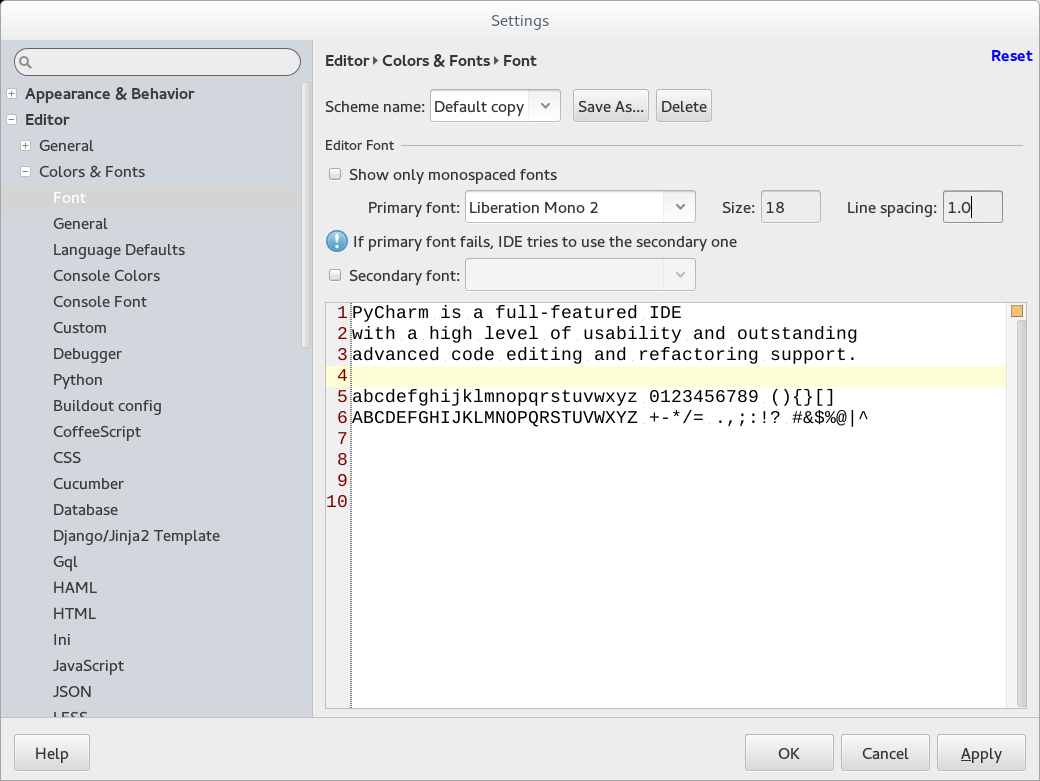

### Заменяем тонкие шрифты в IDE от JetBrains (IntelliJ, PyCharm и другие) и в Java

Хотя некоторым нравятся именно вариант тонких шрифтов, есть большая группа людей, которым нужна более «плотная», весомая отрисовка шрифтов. И если, например, в Eclipse с «плотными» шрифтами все в порядке, то вот популярные среды разработки от JetBrains несут на себе печать Явы и иногда вызывают отторжение своими шрифтами.

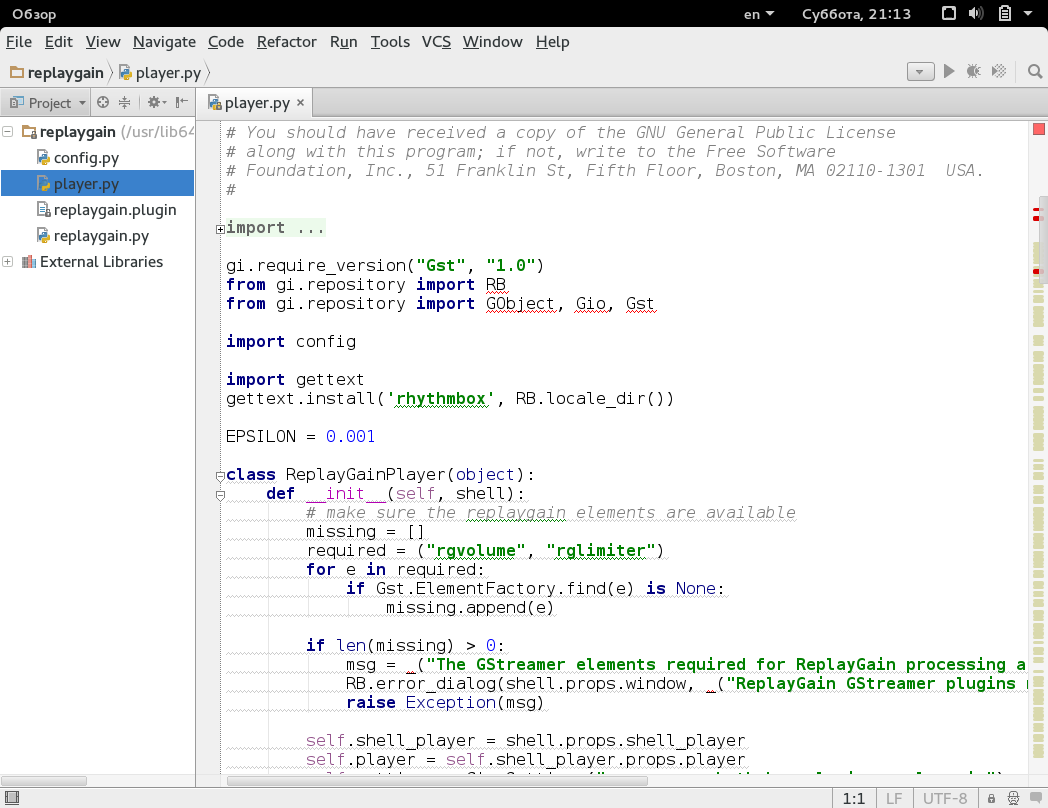

Pycharm с дефолтным шрифтом — Gnome 3

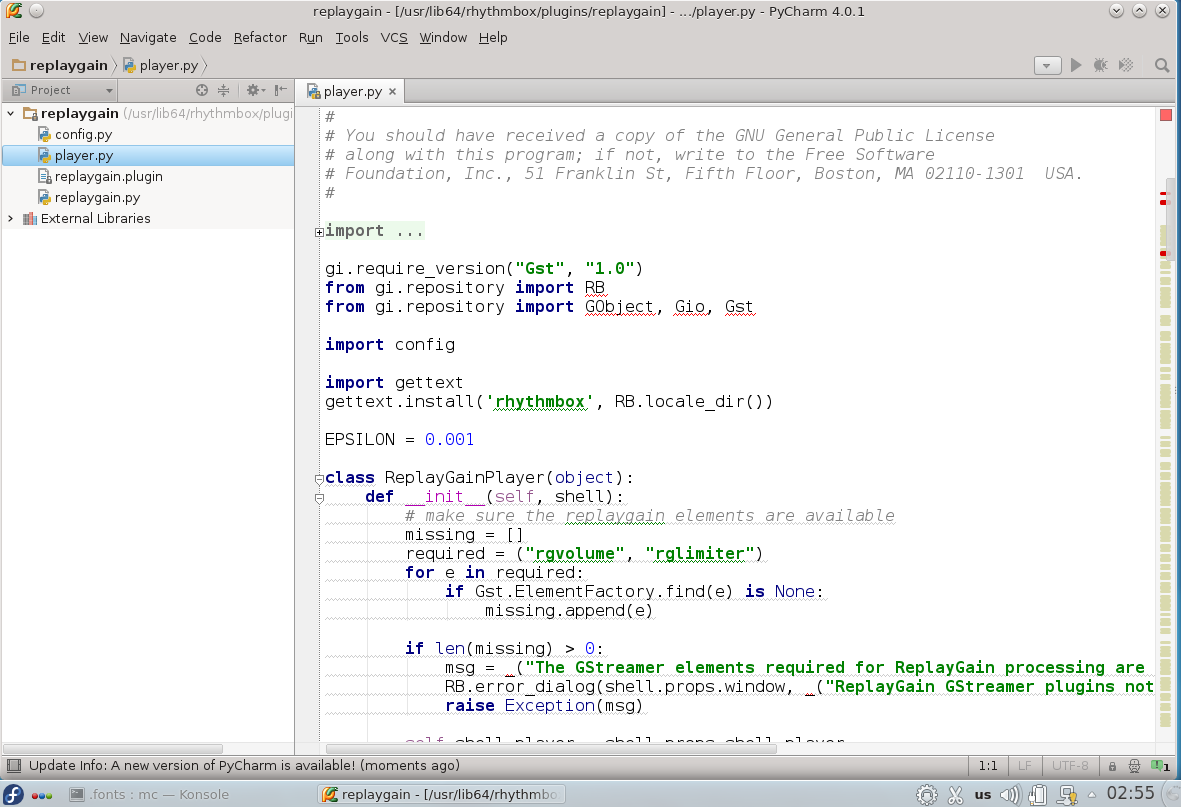

Pycharm с дефолтным шрифтом — KDE

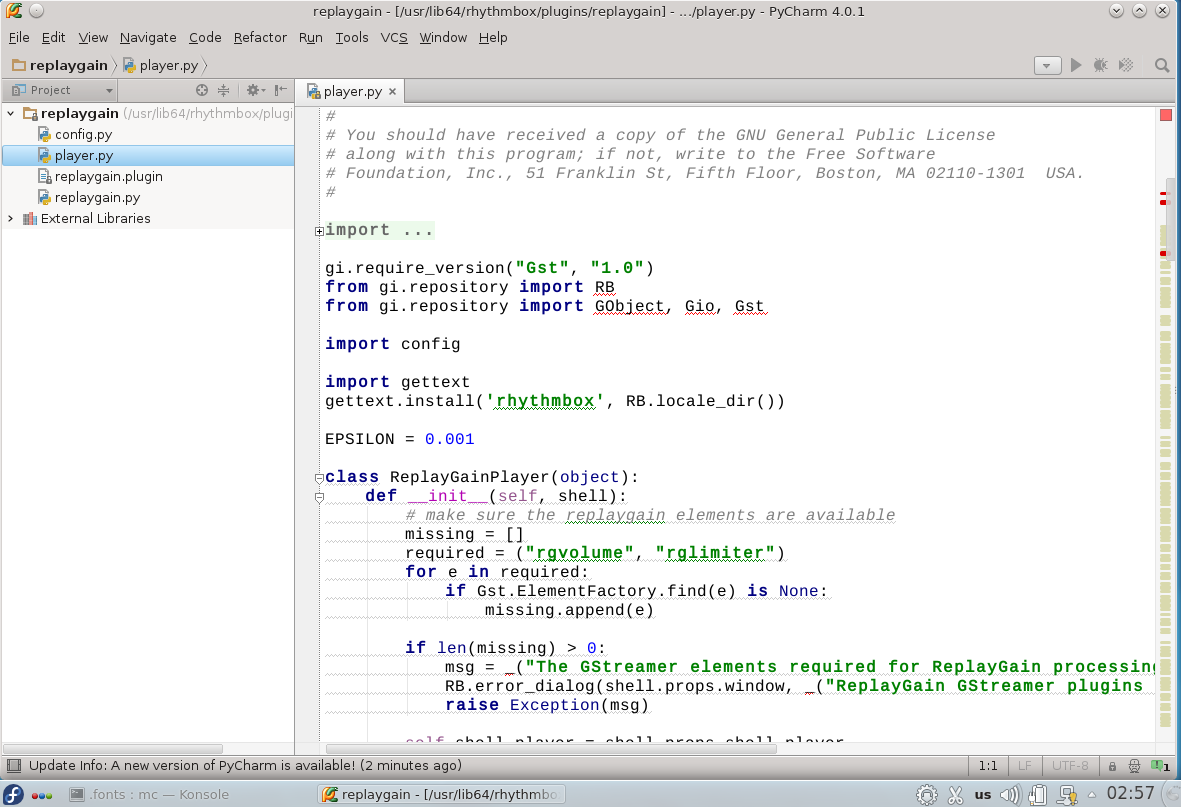

Pycharm с описанным ниже изменением шрифта — KDE

Ниже я опишу один из самых рабочих вариантов решения данной проблемы (подходящий и для Мака), в результате чего мы получим в нужных нам программах «плотные» шрифты, которые выглядят по мнению некоторых разработчиков куда лучше, чем в Windows.

Основная идея проста — если Java не обрабатывает инструкции хинтинга шрифта корректно, то надо эти инструкции из шрифта просто удалить.

Вот как это делается:

1. Выбираем любимые шрифты, которые хотим использовать в IntelliJ IDEA и других IDE этой линейки.

Например, Liberation Sans и Liberation Mono.

2. Устанавливаем программу редактирования шрифтов:

```

sudo yum install fontforge

```

3. Запускаем её и открываем нужный нам шрифт для изменения.

Например из каталога /usr/share/fonts/liberation/ следующие файлы:

LiberationSans-Regular.ttf

LiberationMono-Regular.ttf

4. Нажимаем Ctrl+A, чем выделяем все символы шрифта. В меню «Хинты» выбираем пункт «Очистить инструкции».

5. В меню «Элемент» — «Информация о шрифте» во все поля названий добавляем цифру «2», чтобы в поле «Название шрифта» стояло «LiberationSans2». Нажимаете Ок. Сразу-же программа сообщит что шрифт не имеет уникального идентификатора, а несет старый. Щелкаете на кнопку «Изменить», и нашему шрифту будет сгенерирован новый UID.

6. Меню «Файл» — «Создать шрифты». В появившемся окне справа щелкаем на иконку гаечного ключа и выбираем опцию «Показывать скрытые файлы». Затем переходим в домашний каталог и создаем в нем папку .fonts (если её там ещё нет). Сохраняем наш шрифт с новым именем (например LiberationSans2.ttf ). Я обычно выбираю тип сохраняемого файла TrueType. Если будут сообщения об ошибках типа самопересечения — жмите Ок. Пусть сохраняет.

Повторяем для другого выбранного шрифта. Затем закрываем оба окошка, отказавшись от сохранения шрифтов в формате sfd.

Теперь в нашей системе появились два наших новых шрифта, которые симпатично выглядят в нужных нам программах. Заходим в настройки IntelliJ и указываем использовать новый шрифт в редакторе.

Краткое сравнение результата с дефолтным шрифтом в Windows:

**Полноразмерные скриншоты с шрифтами под Gnome 3 и Windows 8.1**Полноразмерные скриншоты с шрифтами под Gnome 3 и Windows 8.1

Подробнее о методах улучшения шрифтов в Яве тут:

[superuser.com/questions/614960/how-to-fix-font-anti-aliasing-in-intellij-idea-when-using-high-dpi/623596#623596](http://superuser.com/questions/614960/how-to-fix-font-anti-aliasing-in-intellij-idea-when-using-high-dpi/623596#623596)

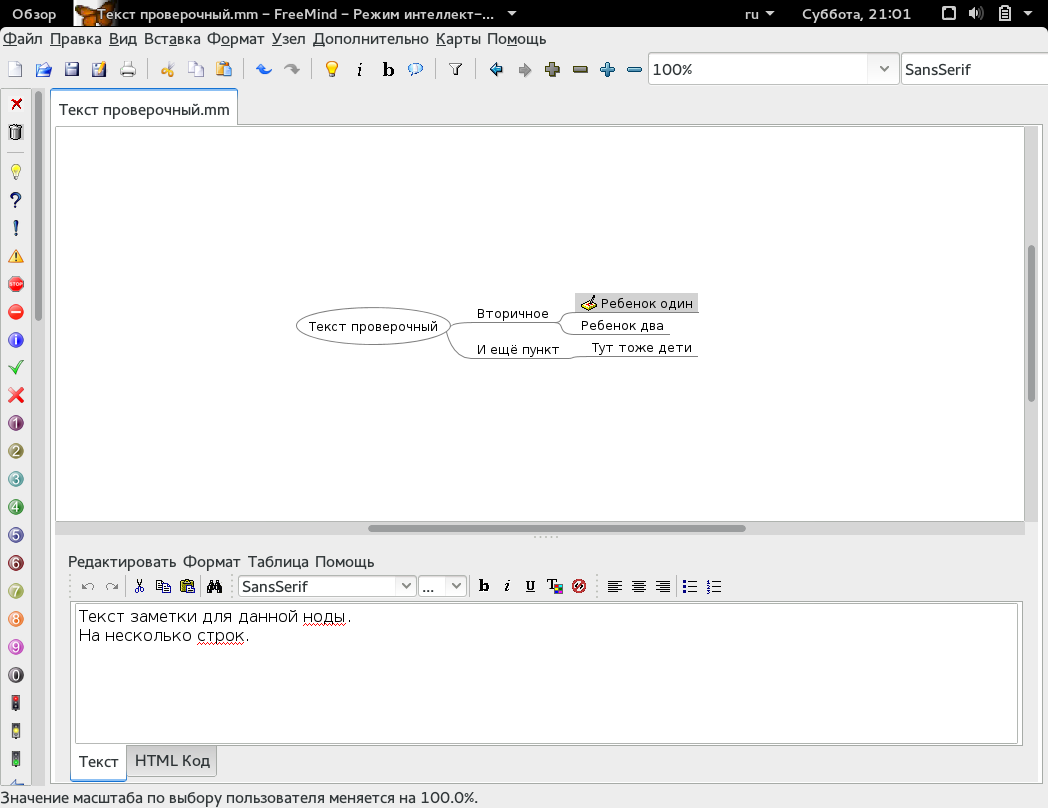

К сожалению, подобная замена шрифтов не работает с популярной программой составления диаграм связи (mind map) — Freemind. Шрифты в ней всё-равно остаются тонкими.

Однако есть хорошая коммерческая альтернатива этой программе, у которой нет проблем со шрифтами — **XMind**, которой можно пользоваться как бесплатно, так и доплатив за некоторые продвинутые возможности. Ознакомиться с нею можно на сайте [www.xmind.net](http://www.xmind.net)

Если хотите её попробовать — скчайте для Федоры Portable версию программы отсюда [www.xmind.net/download/portable](http://www.xmind.net/download/portable)

Распакуйте архив, зайдите в созданную папку вида xmind-portable-3.5… затем в папку соответствующую архитектуре вашего дистрибутива (например, в XMind\_Linux\_64bit ) и запустите файл XMind

Вы можете самостоятельно создать ярлык для меню для этой программы в ~/.local/share/applications по аналогии с ярлыками из /usr/share/applications

Среды разработки и редакторы для языка программирования Python

--------------------------------------------------------------

Так как споры вокруг шрифтов в Linux лично я встречаю в основном в темах по разработке, то сразу привожу небольшую выжимку информации для работающих с Питоном, чтобы они могли проверить шрифты в своих рабочих инструментах. Все эти программы, кроме коммерческих, доступны из основных репозиториев. У всех из них после проведенной настройки с шрифтами все должно быть хорошо.

Те, кому это не актуально — переходите к следующему пункту. Там мы начинаем подготовку к просмотру видео, работе с flash и прочими «полезностями».

**Geany**

Отличный быстрый редактор / мини-IDE.

```

sudo yum install geany geany-plugins-common geany-themes

```

В yumex вы найдете к нему много полезных дополнений. Цветовые схемы и другое настраивается через «Правка» — «Настройки».

**Eclipse + pydev**

Широко известный, кроссплатформенный пакет с плагином, расширяющим его работу с Питоном.

```

sudo yum install eclipse-pydev

```

Будет предложено установить также и множество зависимостей. Соглашайтесь.

Настройки всего и вся в «Окно» — «Параметры». Шрифты работают нормально «из коробки».

Есть альтернативная коммерческая сборка от автора pydev — **LiClipse** [www.liclipse.com](http://www.liclipse.com)

**Kdevelop + kdev-python**

Среда разработки, реализованная под KDE. Отличается шустрой работой, неплохой реализацией работы с Питоном.

```

sudo yum install kdevelop kdevelop-python

```

Также в комплекте Федоры доступны для установки и **другие открытые редакторы и IDE**, в которых можно работать с Питоном: ninja-ide, spe, PyPE, spyder, anjuta, eric

Ознакомьтесь с ними, если приведенные выше и ниже решения вам не подходят или вам просто любопытно.

Из **коммерческих** хочу отметить 4 основных кроссплатформенных решения:

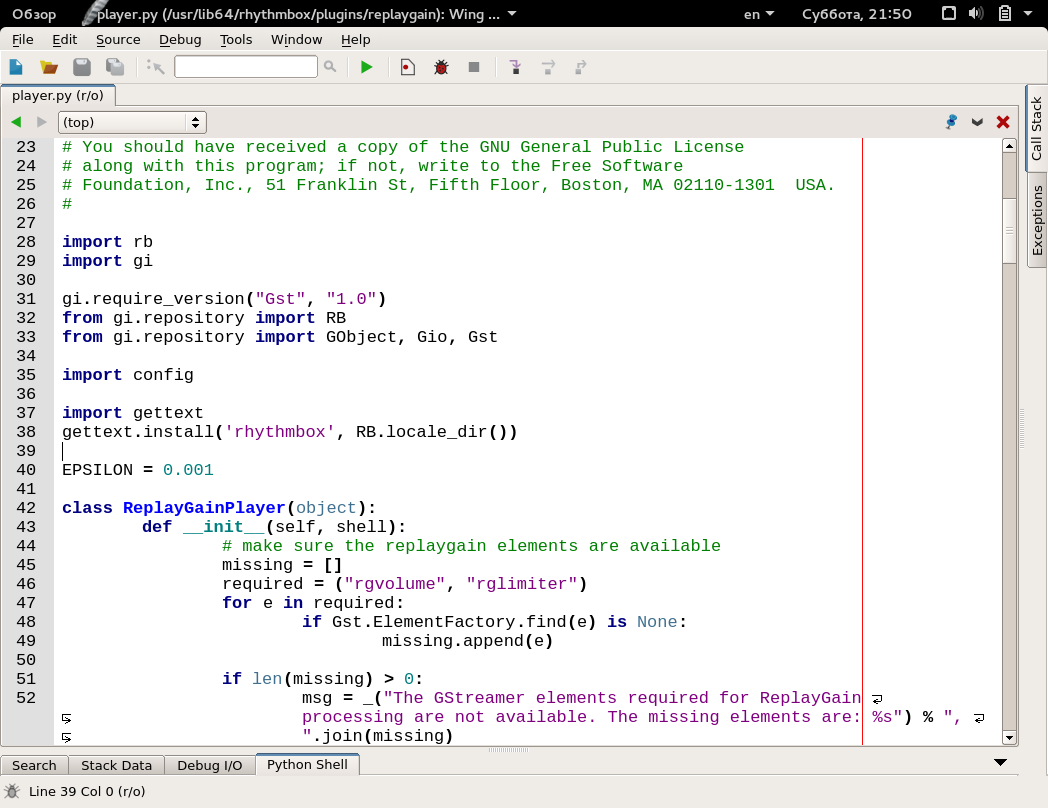

**Pycharm**

Широко известная IDE для Питона. Многие считают её лучшей. Не отличается высочайшей надежностью и устойчивостью, но зато славится хорошим автодополнением.

[www.jetbrains.com/pycharm/download](https://www.jetbrains.com/pycharm/download)

Есть платный и бесплатный (Community Edition) варианты.

Изменение настроек в «Файл» — «Настройки».

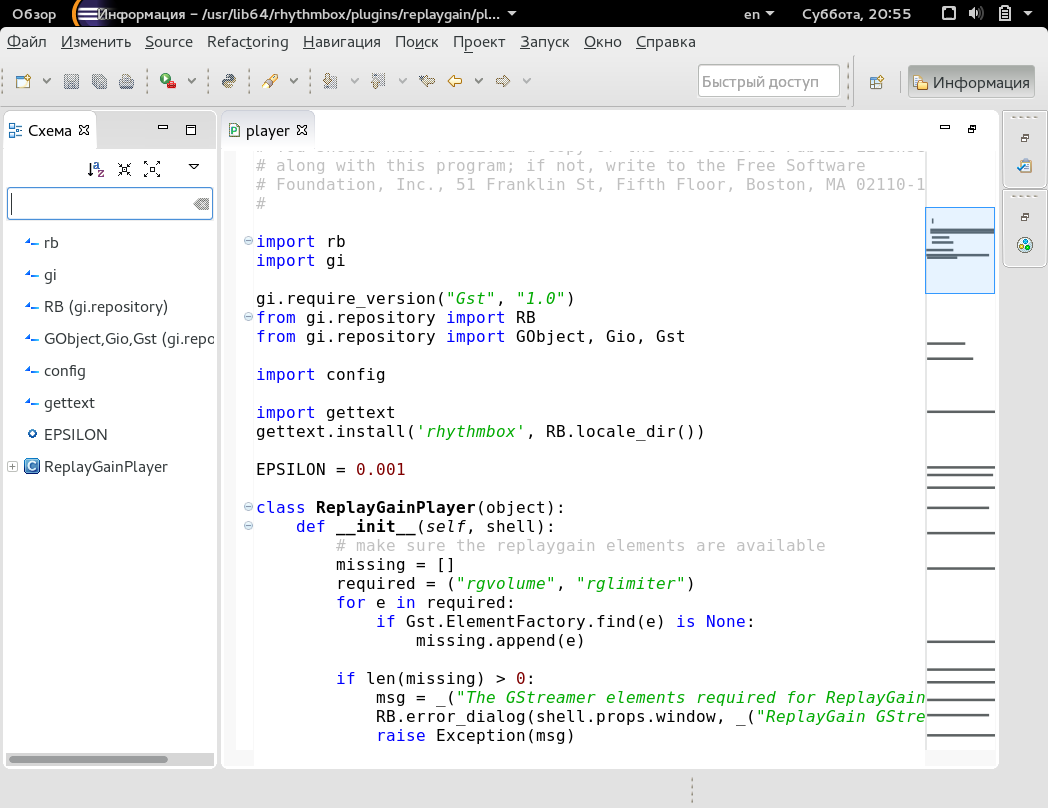

**Wing IDE**

Кто-то её любит и считает «номером 1», кому-то она совершенно не нравится. Многие обзоры признают её сильные стороны и сохраняют за ней как минимум «номер 2» из коммерческих IDE. Не зависит от Java.

[wingware.com/downloads](https://wingware.com/downloads)

Есть платный и бесплатный (Wing IDE 101) варианты.

Пару недель назад можно было приобрести коммерческую лицензию всего за 2100 рублей.

Шрифты настраиваются без проблем.

**Komodo IDE**

Считается более слабой IDE для Питона по сравнению с предыдущими, однако на неё тоже можно обратить внимание и протестировать в работе.

[komodoide.com](http://komodoide.com)

**Sublime Text**

Широко известный редактор с возможностью расширения для лучшей работы с Питоном.

[www.sublimetext.com/3](http://www.sublimetext.com/3)

Дальше возвращаемся обратно к настройке первоочередных потребностей в Fedora 21.

Подключение к репозитариям RPMFUSION

------------------------------------

Чтобы получить возможность ставить в Fedora дополнительные видеоплееры, видеокодеки, flash, несвободные программы и много чего ещё, надо подключиться к основным дополнительным репозиториям: Rpmfusion Free и NonFree

Самый простой вариант — выполнить команду в терминале:

```

su -c 'yum localinstall --nogpgcheck http://download1.rpmfusion.org/free/fedora/rpmfusion-free-release-$(rpm -E %fedora).noarch.rpm http://download1.rpmfusion.org/nonfree/fedora/rpmfusion-nonfree-release-$(rpm -E %fedora).noarch.rpm'

```

Другие варианты подключения вы можете посмотреть на официальном сайте репозитория в разделе «Настройка» [rpmfusion.org/Configuration](http://rpmfusion.org/Configuration)

Видео, аудио и книги

--------------------

### Видеопроигрыватели

Из видеопроигрывателей я лично предпочитаю MPV — у него выше скорость отклика, меньше задержек при перемотке, визуальный минимализм и при этом достаточный функционал для постоянного использования.

Устанавливается MPV очень легко (должны быть подключены репозитарии rpmfusion):

```

sudo yum install mpv

```

Мой конфиг для mpv, который надо положить по адресу ~/.config/mpv/mpv.conf

```

# Сохранять позицию, на которой остановились при просмотре

save-position-on-quit=yes

# Запускать просмотр в fullscreen

fs=yes

# Отключить встроенное в программу управление звуком и использовать системный миксер, когда он доступен

softvol=no

# Прогресс-бар делаем тонким, полупрозрачным, и переносим его в низ экрана

osd-bar-align-y=1

osd-bar-h=1

osd-border-size=1

osd-color='#aaaaaaaa'

```

Подробнее о настройках MPV можно прочитать тут:

[wiki.archlinux.org/index.php/Mpv](https://wiki.archlinux.org/index.php/Mpv)

[github.com/mpv-player/mpv/blob/master/etc/example.conf](https://github.com/mpv-player/mpv/blob/master/etc/example.conf)

Шоткеи MPV в целом аналогичны mplayer. Отмечу несколько особо важных для меня:

**j** — переключение субтитров

**#** — переключение аудиодорожки

**D** — включение деинтерлейса (когда видео в горизонтальную полоску по типу ТВ)

Подробнее: [manpages.ubuntu.com/manpages/trusty/man1/mpv.1.html](http://manpages.ubuntu.com/manpages/trusty/man1/mpv.1.html)

Также можно установить проигрыватели с привычным графическим интерфейсом: smplayer и vlc

```

sudo yum install smplayer vlc

```

Дополнительно к этим проигрывателеям вы можете установить темы и прочие полезности, заглянув в список доступных пакетов.

Указанные выше проигрыватели в зависимостях несут с собой основные кодеки, которые требуются для воспроизведения видео.

Обращу ваше внимание, что иногда программы в процессе установки зависимостей подключают ответвление rpmfusion «rawhide», предназначенное для нестабильной Федоры. Рекомендую не соглашаться на подключение этого репозитория или отключать его в дальнейшем в Yumex, проверяя включены-ли rpmfusion для fedora 21. Вероятно, в ближайших обновлениях эта проблема будет исправлена, но всё-таки будьте внимательны.

### Аудиопрогрыватели + Вконтакте

**Rhythmbox**

Уже есть в установленных по-умолчанию программах в Гноме.

Эквалайзер к плееру ставится отдельно. Смотрите в списке пакетов в yumex или apper.

Плагин Rhytmbox для Вконтакта: [github.com/radistmorse/rhythmbox-vk](https://github.com/radistmorse/rhythmbox-vk)

Немного о нем и его установке на русском: [boutnew.ru/tehnika-i-tehnologii/muzyika-s-vk-com-cherez-rhythmbox-na-ubuntu-12-04-12-10-13-04-13-10.html](http://boutnew.ru/tehnika-i-tehnologii/muzyika-s-vk-com-cherez-rhythmbox-na-ubuntu-12-04-12-10-13-04-13-10.html)

Плагин простой, есть только общий поиск по всем композициям.

**Exaile**

[www.exaile.org](http://www.exaile.org)

Ставится из штатных репозитариев.

Есть плагин для Вконтакте. Методы установки плагина оставляю на ваши изыскания.

**Clementine**

[www.clementine-player.org/ru](https://www.clementine-player.org/ru)

Ставится из штатных репозитариев.

Вроде, есть плагин для Вконтакте. Методы установки плагина также оставляю на ваши изыскания.

Из плюсов — «легче» следующего Амарока.

**Amarok**

[amarok.kde.org](https://amarok.kde.org)

Имеет смысл ставить при установке KDE (об установке KDE будет ниже). Также идет в штатных репозитариях.

Установка плагина Вконтакте производится в несколько шагов:

1. В настройках Амарок в разделе «Скрипты» щелкаем по кнопке «Управление скриптами»

2. В поле поиска по доступным скриптам вбиваем «vk»

3. Появляется единственный скрипты, он-же нам и нужен. Кликаем по кнопке рядом с ним «Установить».

4. Перезагружаем Амарок

5. В настройках выбираем пукто «Авторизация vk», вбиваем нужные данные.

Можно слушать музыку Вконтакте — как свою так и своих друзей, или воспользоваться поиском по всей доступной.

### Если вашим программам все ещё не хватает кодеков

```

sudo yum install gstreamer1-libav gstreamer1-plugins-bad-free-extras gstreamer1-plugins-bad-freeworld gstreamer1-plugins-good-extras gstreamer1-plugins-ugly gstreamer-ffmpeg xine-lib-extras xine-lib-extras-freeworld k3b-extras-freeworld gstreamer-plugins-bad gstreamer-plugins-bad-free-extras gstreamer-plugins-bad-nonfree gstreamer-plugins-ugly gstreamer-ffmpeg

```

### Как слушать аудиокниги

С прослушиванием аудиокниг отлично справляется медиаплеер Banshee который входит в стандартный репозиторий Fedora 21:

```

sudo yum install banshee banshee-community-extensions

```

Программа по своим функциям является аналогом Rhythmbox. Подробнее о ней на [banshee.fm](http://banshee.fm)

Чтобы прослушать книги надо выполнить 2 шага:

1. Добавить папки с книгами в библиотеку Banshee (как обычную музыку)

2. Затем нужные «альбомы»-книги перетащить мышкой в раздел Аудиокниги.

После вам станет доступно запоминание позиции в книге и прочие приятности.

### Как читать книги

**fb2 / epub**

Calibre (для просмотра есть отдельная программка, идущая в комплекте) или fbreader

```

sudo yum install calibre fbreader

```

**pdf**

Отлично справляются штатные читалки pdf: evince (Gnome) или okular (KDE)

**djvu**

В Gnome нужно дополнение к evince

```

sudo yum install evince-djvu

```

а в KDE штатное средство просмотра документов уже умеет работать с этим форматом.

**Управление библиотекой и конвертация всего во все** — Calibre

Установка Дропбокса

-------------------

Заходим на [www.dropbox.com/install?os=lnx](https://www.dropbox.com/install?os=lnx)

Скачиваем пакет в подходящем формате.

Устанавливаем (двойной клик мышкой в файловом менеджере и нажатие кнопки «Установить»).

В главном меню запускаем свежеустановленный Dropbox. Даем ему возможность докачать свой установщик. Затем настраиваем привычные параметры своего аккаунта и синхронизации.

Примечание: пока репозитория дропбокса для Fedora 21 не существует, так что придется добавить ему опцию «пропускать, если недоступен»:

```

sudo yum-config-manager --save --setopt=Dropbox.skip_if_unavailable=true

```

Позднее он появится, и все будет работать ок.

Установка мессенджеров

----------------------

### Skype

Заходим на офф.сайт, скачиваем для федоры пакет со Скайпом:

[www.skype.com/ru/download-skype/skype-for-computer](http://www.skype.com/ru/download-skype/skype-for-computer)

Затем устанавливаем его двойным кликом и кнопкой «Установить» (или «Ок», если вы уже поставили yumex и он запускается вместо штатного установщика пакетов).

Все зависимости (которых множество, и все обязательно в 32-разрядной архитектуре) будут поставлены вместе со Скайпом, так что доставлять дополнительно, обычно, не нужно.

Для привычной работы со скайпом в Gnome 3 можно установить дополнение, которое добавит иконку скайпа в панель:

[extensions.gnome.org/extension/696/skype-integration](https://extensions.gnome.org/extension/696/skype-integration)

или

[extensions.gnome.org/extension/192/status-icon-fixer](https://extensions.gnome.org/extension/192/status-icon-fixer)

Если при работе скайпа будут проблемы со звуком, попробуйте запустить его следующей командой:

```

env PULSE_LATENCY_MSEC=30 skype %U

```

Также, можно попробовать использовать вместо цифры 30 цифру 60.

Если это решает проблему, можете переименовать /usr/bin/skype в /usr/bin/skype2, создать пустой файл /usr/bin/skype и прописать в нем следующие строчки:

```

#!/bin/sh

env PULSE_LATENCY_MSEC=30 skype2 %1 &

```

Сохранить и назначить права на выполнение:

```

sudo chmod +x /usr/bin/skype

```

Плюс такого варианта — любой запуск скайпа позволит ему нормально работать со звуком.

Или, если вам не нравится предыдущий вариант, можно сделать по-другому:

1.

```

sudo mcedit /usr/share/applications/skype.desktop

```

2. вместо строки Exec=skype %U записать вышеуказанную

```

Exec=env PULSE_LATENCY_MSEC=30 skype %U

```

Обычный запуск через иконку будет теперь работать со звуком нормально.

Однако запуск непосредственно команды «skype» так и будет шуметь и хрипеть.

### Viber

Скчиваем RPM-пакет с официального сайта [viber.com/products/linux](http://viber.com/products/linux)

Устанавливаем его (двойной клик мышкой, «Установить»)

Остается только запустить свежеустановленный Вайбер из главного меню.

### Telegram

С официального сайта [desktop.telegram.org](https://desktop.telegram.org) скачиваем пакет, который нам предлагают для Линукса. Распаковываем («Распаковать сюда», например). Заходим в свежесозданную папку «Telegram» и двойным кликом запускаем бинарник с аналогичным названием. Клиент запущен и работает.

Остается его при желании добавить в автозагрузку.

Подсказка:

Сначала создаете новый файл в ~/.local/share/applications по аналогии с файлами из /usr/share/applications

Затем добавляете его в «Дополнительные параметры» — «Автозапуск»

Установка браузеров и flash

---------------------------

Firefox стоит в системе по-умолчанию.

### Google Chrome

Для установки скачиваем с официального сайта нужную версию:

Stable [www.google.ru/chrome/browser/desktop](https://www.google.ru/chrome/browser/desktop)

Beta [www.google.com/chrome/browser/beta.html](https://www.google.com/chrome/browser/beta.html)

Выбираем свою 64- или 32-битный пакет для Fedora. Скачиваем. Устанавливаем двойным кликом.

Все необходимые зависимости подтянутся автоматически.

В комплекте самый свежий флеш, реакция внутри флеша на глобальные шоткеи и т.д.

Если вы, например, установили стабильный Хром, а затем хотите заменить его на бету, сделайте следующее:

1.

```

sudo yum remove google-chrome

```

2.

```

sudo yum install google-chrome-beta

```

### Установка Хромиума

Если вас не устраивает Хром от Гугла или хочется чего-то дополнительного в том-же духе.

В силу проблем с лицензиями Хромиума в основных репозиториях для Федоры нет. Однако он есть в неофициальном репозитарии Copr в «русской Федоре». Подробнее об этом [copr.fedoraproject.org/coprs/churchyard/chromium-russianfedora](http://copr.fedoraproject.org/coprs/churchyard/chromium-russianfedora)

Устанавливается Хромиум так:

1. Сохраняем файл [copr.fedoraproject.org/coprs/churchyard/chromium-russianfedora/repo/fedora-21/churchyard-chromium-russianfedora-fedora-21.repo](http://copr.fedoraproject.org/coprs/churchyard/chromium-russianfedora/repo/fedora-21/churchyard-chromium-russianfedora-fedora-21.repo) на диск

2. кладем его в каталог /etc/yum.repos.d

3.

```

sudo yum install chromium

```

### Flash для браузеров и для системы

Для 64bit системы:

```

sudo yum install http://linuxdownload.adobe.com/adobe-release/adobe-release-x86_64-1.0-1.noarch.rpm

```

Для 32bit:

```

sudo yum install http://linuxdownload.adobe.com/adobe-release/adobe-release-i386-1.0-1.noarch.rpm

```

Дальше для обоих систем:

```

sudo rpm --import /etc/pki/rpm-gpg/RPM-GPG-KEY-adobe-linux

sudo yum install flash-plugin

```

Остается только перезапустить браузер (в данном случае предполагается Firefox).

В Хроме свой собственный флеш.

А вот для Хромиума надо дополнительно установить симлинк на флеш руками.

Система 64bit:

```

sudo ln -s /usr/lib64/mozilla/plugins/libflashplayer.so /usr/lib64/chromium-browser/plugins/libflashplayer.so

```

Система 32bit:

```

sudo ln -s /usr/lib/mozilla/plugins/libflashplayer.so /usr/lib/chromium-browser/plugins/libflashplayer.so

```

Подробнее о об установке флеша под Федора: [ask.fedoraproject.org/en/question/10217/how-to-install-adobe-flash-on-fedora](https://ask.fedoraproject.org/en/question/10217/how-to-install-adobe-flash-on-fedora)

Проприетарные видеодрайверы

---------------------------

Указанные ниже драйвера надо ставить после подключения репозиториев rpmfusion (которое было описано раньше).

### Nvidia «обычная»

**Вариант 1 — совсем простой**

```

yum update

```

Перегружаемся если было обновлено что-то в системе

```

yum install akmod-nvidia xorg-x11-drv-nvidia-libs kernel-devel

```

Информация о способе: [jsn-techtips.blogspot.ru/2013/12/fedora-20-nvidia.html](http://jsn-techtips.blogspot.ru/2013/12/fedora-20-nvidia.html)

**Вариант 2 — немного другой**

```

sudo yum install akmod-nvidia

```

Чтобы работало ускорение в видеоплеере:

```

sudo yum install vdpauinfo libva-vdpau-driver libva-utils

```

При загрузке проверить, чтобы не грузился старый драйвер:

```

lsmod |grep nouveau

```

Если надо удалить старый драйвер Nvidia:

```

sudo yum remove xorg-x11-drv-nvidia\*

```

Если после установки драйвера Nvidia перестали грузиться иксы:

1. Проверяем ошибку

```

sudo akmod --force

```

2. Возможно надо установить исходники ядра:

```

sudo yum install kernel-devel

```

3. Снова запустить

```

sudo akmod --force

```

4. Если все ок — перезапускаем систему и должно работать.

Как резервный вариант отказа от попытки загрузки с новыми драйверами достаточно просто удалить (переименовать) файл /etc/X11/xorg.conf (сейчас он по-умолчанию в системах отсутствует, а создается инсталляторами типа Nvidia).

Подробнее об установке драйверов для Nvidia разных серий:

[blog.xenodesystems.com/2014/12/como-instalar-drivers-propietarios.html](http://blog.xenodesystems.com/2014/12/como-instalar-drivers-propietarios.html)

[rpmfusion.org/Howto/nVidia](http://rpmfusion.org/Howto/nVidia)

### Проприетарные драйвера ATI

Тут я с вашего позволения отделаюсь ссылкой на материалы.

На русском [Wiki Федоры](http://wiki.russianfedora.pro/index.php?title=%D0%A3%D1%81%D1%82%D0%B0%D0%BD%D0%BE%D0%B2%D0%BA%D0%B0_%D0%B4%D1%80%D0%B0%D0%B9%D0%B2%D0%B5%D1%80%D0%BE%D0%B2_ATI) и актуальный опыт коллеги из Испании [blog.xenodesystems.com/2014/12/como-instalar-drivers-propietarios-ati.html](http://blog.xenodesystems.com/2014/12/como-instalar-drivers-propietarios-ati.html)

### Nvidia Optimus — установка Bumblebee

Nvidia Optimus это технология, которая позволяет на ноутбуке выбрать видеокарту для работы текущего приложения — интегрированную от Intel (экономичную) или мощную дискретную от NVIDIA.

Ссылка на понятно руководство как ставить и что делать: [fedoraproject.org/wiki/Bumblebee](http://fedoraproject.org/wiki/Bumblebee)

Не забывайте подставлять правильную цифру «21» там, где требуется указание номера Федоры, вместо «20».

Обращаю внимание, что мне пришлось снизить уровень внимательности системы безопасности Linux с «высокого» до «среднего», чтобы у меня заработала вторая (дискретная) видеокарта. Подробнее об этом в самом конце моих злоключений в данном разделе.

Вероятно, упомянутые дополнительные шаги 1..3 можно было и не проходить. Однако привожу эту информацию на случай, если кому-то понадобится сравнить это со своим опытом.

1. Если появляется ошибка при запуске приложения через optirun вида

```

[ERROR]Cannot access secondary GPU - error: [XORG] (EE) No devices detected.

[ERROR]Aborting because fallback start is disabled.

```

или

```

Cannot access secondary GPU - error: [XORG] (EE) systemd-logind: failed to get session

```

то вам нужно в настройках проверить правильный BusID вашей Nvidia-карты. Выполните в терминале:

```

lspci | egrep 'VGA|3D'

```

Пример вывода данной команды:

```

00:02.0 VGA compatible controller: Intel Corporation 3rd Gen Core processor Graphics Controller (rev 09)

01:00.0 VGA compatible controller: NVIDIA Corporation GF108M [GeForce GT 630M] (rev ff)

```

Заменив все точки на двоеточия — номера впереди будут обозначать BusID видеокарт, в примере получаем следующий BusID для карты nvidia:

BusID 01:00:0

Дальше правим конфигурационный файл xorg.conf.nvidia:

```

sudo gedit /etc/bumblebee/xorg.conf.nvidia

```

В этом файле приведен закомментированный пример указания BusID, по данному примеру указываем строчкой ниже правильный BusID (если номер BusID примера является правильным, то можно просто данную строчку раскомментировать, убрав '#'). В результате получится примерно следующее (в вашем случае номера могут быть другими):

```

# BusID "PCI:02:00:0"

BusID "PCI:01:00:0"

```

Дополнительная информация на [help.ubuntu.ru/wiki/bumblebee](http://help.ubuntu.ru/wiki/bumblebee)

2. В логах появляется следующая ошибка:

```

[ERROR]Cannot access secondary GPU - error: [XORG] (EE) [drm] failed to open device

```

Если в системе установлен драйвер nvidia и при этом присутствует загруженный модуль nouveau, тогда убедитесь в следующем:

в наличии строчки Driver=nvidia конфигурационного файла /etc/bumblebee/bumblebee.conf

в системе должен присутствовать один из файлов с содержимым blacklist nouveau:

```

$ grep -R nouveau /etc/modprobe.d/*

```

Больше информации на <https://ru.opensuse.org/SDB:Bumblebee>

3. Как добавить свободный драйвер в черный список:

[setiathome.berkeley.edu/forum\_thread.php?id=74094](http://setiathome.berkeley.edu/forum_thread.php?id=74094)

[kaischroed.wordpress.com/howto-install-nvidia-driver-on-fedora-replacing-nouveau](http://kaischroed.wordpress.com/howto-install-nvidia-driver-on-fedora-replacing-nouveau)

Открываем в редакторе файл

```

sudo mcedit /etc/modprobe.d/blacklist.conf

```

и добавить в конце файла строчку 'blacklist nouveau'

Если это не изменит ситуации можно удалить свободные драйвера полностью:

```

sudo yum remove xorg-x11-drv-nouveau.x86_64

```

Затем я оОбнаружил что в данный момент драйвер NVidia в черном списке:

```

cat /etc/modprobe.d/modprobe.conf

blacklist nvidia

```

Закомментировал эту строчку и перегрузился, но проблема осталась.

4. Шаг, решивший проблему. Указанные выше ошибки возникают в Fedora из-за SELinux при самом высоком уровне безопасности («enforcing»). Достаточно снизить его до уровня «permissive» и проблема уходит.

Узнать текущие настройки SELinux:

```

/usr/sbin/getenforce

/usr/sbin/sestatus

```

Редактируем конфиг:

```

sudo mcedit /etc/selinux/config

```

в нем находим переменную SELINUX= и выставляем ей следующее значение:

```

SELINUX=permissive

```

Перегружаемся.

После перезагрузки оказалось что проблема действительно была в строгой политике SELinux, и что теперь программы отлично запускаются и на второй (мощной) видеокарте.

Более подробная информация об [изменении настроек SELinux указана в документации к Федоре](http://docs.fedoraproject.org/ru-RU/Fedora/13/html/Security-Enhanced_Linux/sect-Security-Enhanced_Linux-Working_with_SELinux-Enabling_and_Disabling_SELinux.html).

### Как запускать программы и игры в Steam на дискретной карте

Обращаю ваше внимание, что установка Стима и исправление ошибок с его работоспособностью (если вы с такими столкнетесь) описана немного ниже. Для указания параметров запуска игр на дискретной карте из Стима он должен у вас нормально работать.

Заходим в Стим, в свою библиотеку («Library»). На игре кликаем правой кнопкой мышки и выбираем «Свойства» («Properties»). «Установить параметры запуска» («Set Launch Options ..») и указываем следующее:

```

optirun -b primus %command%

```

Сохраняем. Можно запускать эту игру.

Другие варианты команд запуска игр и сравнение их скорости можно посмотреть по ссылкам:

[forum.ubuntu.ru/index.php?topic=209722.0](http://forum.ubuntu.ru/index.php?topic=209722.0)

[support.steampowered.com/kb\_article.php?ref=6316-GJKC-7437](https://support.steampowered.com/kb_article.php?ref=6316-GJKC-7437)

### Бенчмарки: Fedora 21 Optimus / Primus / Windows 8.1

За несколько недель работа с бетой Федоры у меня было достаточно времени, чтобы потестить её в качестве основного рабочего и игрового места, а также сравнить её (условную) производительность с имеющимся на моем игровом ноутбуке Win8.1

Самое первое тестирование — по FPS в Serious Sam 3 на «ультра»-настройках.

В Windows 8.1 видим на выбранной карте средний FPS в районе 30-55. Иногда достигает «предельных» 60.

В Fedora 21 с вышеуказанной командой запуска практически стабильные 60 fps, иногда падающие до 55. В редких случаях удавалось отметить 48.

Верхний предел в 60 объясняется просто — это частота обновления моего монитора, и при обычных настройках большинство программ не генерируют больше этого значения.

Так, в Linux выкрутить FPS в программе на максимум часто позволяет команда запуска

```

vblank_mode=0 optirun -b primus %command%

```

Однако иногда она работает куда медленнее других вариантов ( optirun или optirun -b primus )

Пояснения по параметру vblank\_mode:

[askubuntu.com/questions/285342/why-does-vblank-mode-improve-framerate-drastically-in-benchmarks](http://askubuntu.com/questions/285342/why-does-vblank-mode-improve-framerate-drastically-in-benchmarks)

#### Кроссплатформенный бенчмарк GPU — GPUTest

Сайт программы: [www.geeks3d.com/gputest](http://www.geeks3d.com/gputest)

Windows, OpenGL 4.4.0

FurMark — 1186 points (FPS: 19)

TessMark X8 — 10306 points (FPS: 171)

TessMark X16 — 9006 points (FPS: 150)

TessMark X32 — 7499 points (FPS: 125)

TessMark x64 — 4460 points (FPS: 74)

GiMark — 1922 points (FPS: 32)

PixMark JuliaFP32 — 9079 points (FPS: 151)

PixMark JuliaFP64 — 765 points (FPS: 12)

PixMark Piano — 443 points (FPS: 7)

PixMark Volplosion — 1412 points (FPS: 23)

Plot3D — 11127 points (FPS: 186)

Итого **57205** очков.

Linux, OpenGL 4.4.0 (команда *optirun*)

FurMark — 1655 points (FPS: 27)

TessMark X8 — 8914 points (FPS: 148)

TessMark X16 — 8322 points (FPS: 138)

TessMark X32 — 6346 points (FPS: 105)

TessMark X64 — 3598 points (FPS: 59)

GiMark — 1633 points (FPS: 27)

PixMark JuliaFP32 — 5843 points (FPS: 97)

PixMark JuliaFP64 — 612 points (FPS: 10)

PixMark Piano — 355 points (FPS: 5)

PixMark Volplosion — 1065 points (FPS: 17)

Plot3D — 8914 points (FPS: 148)

Итого **47257** очков.

На общем фоне выделяется тест FurMark, в котором под Linux производительность радикально лучше чем в Win. В остальных идет проседание.

Linux, OpenGL 4.4.0 (команда *vblank\_mode=0 optirun -b primus*)

FurMark — 1868 points (FPS: 31)

TessMark X8 — 11448 points (FPS: 190)

TessMark X16 — 11521 points (FPS: 192)

TessMark X32 — 11072 points (FPS: 184)

TessMark X64 — 4831 points (FPS: 80)

GiMark — 1842 points (FPS: 30)

PixMark JuliaFP32 — 9831 points (FPS: 163)

PixMark JuliaFP64 — 625 points (FPS: 10)

PixMark Piano — 357 points (FPS: 5)

PixMark Volplosion — 1153 points (FPS: 19)

Plot3D — 11395 points (FPS: 189)

Итого **65943** очков.

А тут заметны очень забавные результаты на серии TessMark. Есть комментарии по этому поводу?

Особняком идет тест Triangle — в нем под Linux наблюдается провальное отставание:

Win Triangle — 21966 points (FPS: 366)

Lin *optirun* Triangle — 10179 points (FPS: 169)

Lin *vblank\_mode=0 optirun -b primus* Triangle — 11594 points (FPS: 193)

#### Кроссплатформенный бенчмарк Geekbench

Взят из магазина Steam. Ниже приведена только итоговая информация, т.к. результат у систем практически одинаковый.

Linux

Integer Score 3651 15278

Floating Point Score 3540 16041

Memory Score 3314 3631

Geekbench Score 3539 13253

Windows

Integer Score 3623 14898

Floating Point Score 3474 15923

Memory Score 3233 3578

Geekbench Score 3485 13044

В Win наблюдается несколько меньшая общая производительность.

Перед переходом к бенчмаркам браузеров мы временно решим проблему Хрома под Линуксом с работой на дискретной карте.

#### Решение проблемы с неработающим WebGL у Хрома

Чтобы работал WebGL под optirun в Google Chrome обычно советуют в его флагах включить возможность работать с WebGL ( Disable WebGL: Enable → Disable ) или запускать

```

optirun google-chrome --ignore-gpu-blacklist

```

Один из советов [askubuntu.com/questions/110132/problem-with-running-webgl-with-chrome](http://askubuntu.com/questions/110132/problem-with-running-webgl-with-chrome)

Однако у меня *optirun google-chrome-beta* отказывался запускаться со следующими ошибками:

```

'librrfaker.so' from LD_PRELOAD cannot be preloaded (cannot open shared object file)

```

Проблема проявлялась несмотря на то, что в системе уже установлены virtualgl обоих архитектур 32-bit и 64-bit (у меня 64-битная система).

Указания в переменной LD\_LIBRARY\_PATH где искать нужны библиотеки результата не дало.

Пробовал запускать через sudo, на случай если ругается на установленный бит защиты, но и это не возымело действия. Подробнее о ситуации с битом защиты [lists.fedoraproject.org/pipermail/scm-commits/Week-of-Mon-20130506/1014107.html](https://lists.fedoraproject.org/pipermail/scm-commits/Week-of-Mon-20130506/1014107.html)

Чтобы детализировать проблему запускал с параметром *LIBGL\_DEBUG=verbose primusrun…*

В результате гугления нашел временное решение проблемы на [code.google.com/p/chromium/issues/detail?id=351804](https://code.google.com/p/chromium/issues/detail?id=351804)

Рекомендуют отключать «песочницу» в Хроме, т.к. она в текущих его версиях с дискретной картой под Линукс работать не может. Для этого надо запускать Хром с флагом *--disable-gpu-sandbox*

Убеждаемся, что WebGL стал работать: переходим в Хроме по адресу *chrome://gpu*

WebGL заработал и теперь можно переходить к тестированию и сравнениям.

#### Бенчмарки для браузеров

По результатам проведенных тестов наблюдается интересная тенденция — браузеры в Linux серьёзно переигрывают своих собратьев, работающих в Widows. Более того Хрому под Линукс удалось показать абсолютно лучший результат в тесте [www.wirple.com/bmark](http://www.wirple.com/bmark) который когда-либо был измерен.

Напоминаю, что у меня присутствует Nvidia Optimus, и если не указано иное — браузеры запускались на обычной видеокарте. В противном случае я указываю основные модификаторы запуска, чтобы был понятен контекст замера. Также часто встречалась ситуация когда дискретная карта ничего не изменяла в результатах теста. В этом случае я просто не привожу значения запуска с ней.

**Тест 1** — [peacekeeper.futuremark.com](http://peacekeeper.futuremark.com)

Windows

Firefox 34 — 3661

Chrome 40 — 4313

Linux

Firefox 34 — 6433

*optirun* Firefox 34 — 6441

Chrome — 5837

Варианты запуска Хрома с optirun, vblank или nosandbox только немного ухудшали результат.

**Тест 2** — [browsermark.rightware.com](http://browsermark.rightware.com)

Windows

Firefox — 3306

Chrome — 5525

*на дискретной карте* Chrome — 6527

Linux

Firefox — 5167

*optirun* Firefox — 5468

*nosandbox* Chrome — 7138

*vblank + nosandbox* Chrome — 7223

На эти цифры Хрома тест сообщил мне:

*Desktop Linux with Google Chrome 40 is faster than 99% of all Desktops tested so far.*

**Тест 3** — [www.wirple.com/bmark](http://www.wirple.com/bmark)

Windows

Firefox: 1281 (Canvas score — Test 1: 77 — Test 2: 630, WebGL score — Test 1: 274 — Test 2: 300)

Chrome: 3172 (Canvas score — Test 1: 535 — Test 2: 1537, WebGL score — Test 1: 629 — Test 2: 471)

Linux

Firefox: 1116 (Canvas score — Test 1: 188 — Test 2: 354, WebGL score — Test 1: 306 — Test 2: 268)

*optirun* Firefox: 1546 (Canvas score — Test 1: 466 — Test 2: 372, WebGL score — Test 1: 361 — Test 2: 347)

А вот с параметром vblank произошло снижение производительности.

Chrome: 2506 (Canvas score — Test 1: 629 — Test 2: 614, WebGL score — Test 1: 677 — Test 2: 586)

И вот рекордная команда:

```

optirun -b primus google-chrome-beta --disable-gpu-sandbox --enable-webgl --ignore-gpu-blacklist

```

Chrome: **4240** (Canvas score — Test 1: 794 — Test 2: 2222, WebGL score — Test 1: 677 — Test 2: 547)

На этот результат тест мне сообщил о победе следующее:

*Your results compared to other users:

You score better than 100% of all users so far!

You score better than 100% of the people who use the same browser and OS!*

Это **лучший результат**, который отмечал данный тест за время своего существования.

Добавление к «рекордной» команде параметра vblank\_mode=0 сильно ухудшило результат

*+vblank\_mode* Chrome: 3363 (Canvas score — Test 1: 769 — Test 2: 1443, WebGL score — Test 1: 626 — Test 2: 525)

На этом я заканчиваю с информацией о результатах тестирования.

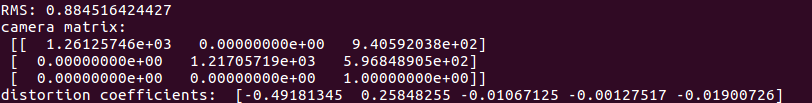

#### Основная информация о моей системе для уточнения бенчмарков

Ноутбук Asus G750JM

CPU: Intel I7-4710HQ/BGA

RAM: DDR3L 1600 8Gb\*2

Nvidia Optimus

Дискретная видеокарта Nvidia GeForce GTX 860M с 2 Гб видеопамяти

Windows 8.1

Nvidia: 344.48

Chrome Beta: 40.0.2214.10

Firefox: 34

Linux 3.17.4-300

Nvidia: 340.46

Firefox: 33.1

Chrome Beta: 40.0.2214.10

Теперь вернемся к настройке и использовании программ в Fedora 21.

Steam и игры

------------

Установка Steam

После включения ранее указанного репозитория RPMFusion выполняем

```

sudo yum install steam

```

После этого рекомендуют перегрузить систему.

Если у вас 64-разрядная система, то для корректной работы Стима придется доустановить 32-битные версии некоторых программ:

1. Чтобы корректно работал flash видео-плеер в магазине Стим:

```

sudo yum install http://linuxdownload.adobe.com/adobe-release/adobe-release-i386-1.0-1.noarch.rpm

sudo yum install flash-plugin.i386

```

2. Чтобы корректно работало 3D ускорение для Wine, который используют некоторые программы из Стима а также при получении ошибки:

```

OpenGL GLX context is not using direct rendering, which may cause performance problems.

```

Надо вернуться к установке драйверов для Nvidia и поставить 32-битную версию:

[rpmfusion.org/Howto/nVidia#x86\_64\_.2864bit.29\_users](http://rpmfusion.org/Howto/nVidia#x86_64_.2864bit.29_users)

Например, найти xorg-x11-drv-nvidia-libs для 32bit версии и установить её.

3. При возникновении ошибки

```

libGL error: Couldn't dlopen libudev.so.1 or libudev.so.0, driver detection may be broken.

Finished uploading minidump (out-of-process): success = no

error: libcurl.so: cannot open shared object file: No such file or directory

/home/vyacheslav/.local/share/Steam/steam.sh: line 730: 3585 Segmentation fault

```

Нужно поставить вот это:

```

sudo yum install systemd-libs.i686

```

Подробнее на [ask.fedoraproject.org/en/question/54746/steam-wont-run](https://ask.fedoraproject.org/en/question/54746/steam-wont-run)

Запускаем Windows-игры и Windows-программы

------------------------------------------

Для этого есть отличный пакет PlayOnLinux: [www.playonlinux.com/ru](https://www.playonlinux.com/ru)

Ставится легко прямо с сайта. Оставляю вам его на самостоятельную проработку.

Программы для рисования

-----------------------

Для редактирования растровых изображений отлично подходит известный GIMP [www.gimp.org](http://www.gimp.org)

```

sudo yum install gimp gimp-elsamuko gimp-data-extras

```

Также есть дополнительные плугины и расширения для GIMP. Посмотрите в yumex/apper.

Для редактирования векторных — Inkscape [inkscape.org](https://inkscape.org)

```

sudo yum install inkscape

```

В рассматриваемой ниже KDE есть также свои варианты программ для растровой и векторной графики:

Krita (растр) и Karbon (вектор). Они входят в офисный пакет KDE — Calligra. Его установка будет рассмотрена ниже.

KDE

---

Как установить KDE, если по-умолчанию у вас установлена другая рабочая среда:

```

sudo yum install @kde-desktop

```

Также устанавливаем KDE-программы для удобной работы с архивами и просмотра pdf:

```

sudo yum install ark okular

```

После установки KDE надо перегрузиться и на экране входа в систему под полем логина щелкнуть по иконке зубчатого колесика. В выпавшем меню выбрать «Рабочий стол Plasma» и выполнить вход.

Если хотите установить любимый многими аудио-плеер Amarok:

```

sudo yum install amarok

```

Если хотите не только установить KDE но и переключиться на использование менеджера дисплея KDM, то надо сделать следующее:

1. Устанавливаем KDM:

```

sudo yum install kdm

```

2. Устанавливаем программу переключения менеджеров дисплея:

```

sudo yum install system-switch-displaymanager-gnome

```

3. Запускаем программу system-switch-displaymanager и в открывшемся выбираем KDM.

### Офис Calligra

В Fedora по-умолчанию установлен LibreOffice. Если вам хочется попробовать чего-то ещё — обратите внимание на офис KDE — Calligra, включающий также программы для рисования в растре (Krita) и векторе (Karbon).

Поставить офис:

```

sudo yum install calligra

```

В Calligra входит очень много всего интересного, что не ставится по-умолчанию, так что рекомендую интересующимся поискать эти пакеты со словом «calligra» в Yumex/Apper.

Если вы хотите обойтись только программами для рисования, а не ставить все основные офисные программы Calligra то можно сделать так:

```

sudo yum install calligra-krita calligra-karbon

```

В определенном смысле они являются аналогами Gimp и Inkscape.

Подсказка по работе колесика мыши в Krita:

Чтобы вернуть в Krita привычный скроллинг колесиком мыши по вертикали надо зайти в настройки «Settings» — «Configure Krita ..» -> Canvas Input Settings — Zoom Canvas

Для обоих Mouse Wheel два раза щелкнуть по выбранному Input и указать модификатор, например, привычный Ctrl. Таким образом получим приближение и удаление при вращении колесика мыши при зажатом Ctrl. Простое вращение колесика будет скролить картинку вверх и вниз. Нажимаем «Ok» и закрываем окно настроек.

### Настройка KDE

Общий интерфейс KDE куда более привычен пользователям чем Gnome 3. Так что остановлюсь только на нескольких моментах, которые меняю у себя в первую очередь.

**Шрифты**

Главное меню -> Параметры системы -> Оформление приложений (находятся в середине второго раздела иконок). Открываем вкладку «Шрифты».

Для комфортной работы на мониторах с высоким разрешением необходимо увеличить размер всех шрифтов примерно на 1-2 единицы.

Примечание:

Иногда программы QT могут использовать в качестве одного из основных размер шрифта, записанного как «Панель инструментов». Обратите на это внимание при необходимости дополнительно увеличить их шрифт.

Затем надо откорректировать сглаживание шрифтов, чтобы оно распространялось и на Gnome-программы, запущенные из-под KDE: в том-же окне настройки шрифтов в пункте «Использовать сглаживание:» выбираем «включено» и щелкаем кнопку «настроить». Выставляем «использовать межтотечное сглаживание» — rgb и «стиль хинтинга» — легкий (напоминаю, что я предпочитаю легкое сглаживание, а вы можете указать другой).

### Синхронизация контактов, календаря и почты Google

Как настроить работу с контактами и календарем Google:

1. Запускаем Kontact, в нем добавляем новый календарь Гугла, там-же добавляем новую адресную книгу из Гугла (задачи Гугла тоже будут проимпортированы)

2. Чтобы можно было искать нужные контакты в строке быстрого поиска Krunner, запускаемого в системе по Alt+F2:

в левой части этой строки поиска нажимаем значок настройки, в появившемся окне отмечаем поиск по контактам и (если хотите) события календаря.

К сожалению, полной поддержки Gmail в Kontact и KMail этой версии KDE сделать пока не успели. Однако разработчики трудятся над этим и обещают скоро выпустить.

Сейчас есть возможность подключиться к Gmail как к обычному IMAP-ящику с периодичностью проверки в 5 минут.

### Устранение проблемы многократного запуска некоторых QT-программ

Рекомендую сразу в конце файла ~/.bash\_profile прописать следующие строчки:

```

TMPDIR=/var/tmp

export TMPDIR

```

После этого выйти из сеанса и зайти заново.

Таким образом решается проблема многократных запусков копий одной и той-же QT-программы.

Например, торрент-клиента qbittorrent при открытии торрентов из Firefox.

Изучение иностранных языков

---------------------------

### Словарь с произношением — StarDict

Отличная программа, которая может на лету сканировать все, что вы выделяете мышкой, и тут-же давать под курсором мыши небольшое всплывающее окно с переводом или ещё и воспроизводить произношение данного слова.

Устанавливаем программу:

```

sudo yum install stardict

```

Скачиваем словари для StarDict на любом известном вам крупном трекере торрентов. Там-же в раздачах есть пояснения — как и куда устанавливать скачиваемые словари.

Кратко об установке в Linux:

1. кладем словари в каталог /usr/share/stardict/dic или ~/.stardict/dic

2. звуковые файлы из архива распаковываются в любую папку на диске, затем открываем Stardict --> Настройки --> Звуки. В поле «RealPeopleTTS search path» прописать путь к каталогу со звуками, например, /home/your\_name/.stardict/en\_snd/

Перезапустить Stardict. После этого произнесение слов станет доступно.

### Anki и карточки

Также в Fedora доступна программа Anki для работы с карточками.

Однако эту тему я оставляю на вашу собственную проработку.

На мой взгляд практика с вышеописанными словарными статьями является более насыщенной, менее трудоемкой, лишенной сторонних ошибок и ограниченности смысловых переводов.

Проблема с появившимся тихим шумом в наушниках

----------------------------------------------

Эта проблема не зависит от Fedora, однако я приведу варианты борьбы с ней.

Среди вариантов решения проблемы появившегося под Linux шума в наушниках можно выделить следующие:

1. Отключение звуковой карты от DVD-привода

2. Отключение системного динамика в BIOS

3. Уменьшение разгона системы (как CPU так и видео)

4. Переназначение выхода на наушники программой hdajackretask

Устанавливаем пакет, содержащий эту программу:

```

sudo yum install alsa-utils

```

Запускаем *hdajackretask* и смотрим — что назначено выходу на наушники. Если назначение не верно — можно переназначить и получить звук получше. Подробнее о решении: [ubuntuforums.org/showthread.php?t=2249130](http://ubuntuforums.org/showthread.php?t=2249130)

5. Замена кабеля у наушников на кабель с высоким сопротивлением (у наушников с малым сопротивлением внутренний усилитель звука может вызывать постоянные тихие шумы, как в моей модели ноутбука)

6. Замена наушников на наушники с высоким сопротивлением

7. Использование внешней аудиокарты или предусилителя для наушников

Завершение

----------

На этом данную статью, составленную из «путевых» заметок моих приключений, я заканчиваю.

Надеюсь, вы отнесетесь с теплом к новой Федоре, попробуете её и напишете об этом пару строк в комментариях.

При желании, в дальнейшем можно будет собрать информацию и для следующей статьи о ней. | https://habr.com/ru/post/245651/ | null | ru | null |

# Централизованное управление CBPolicyD в мультисерверной инфраструктуре Zimbra OSE

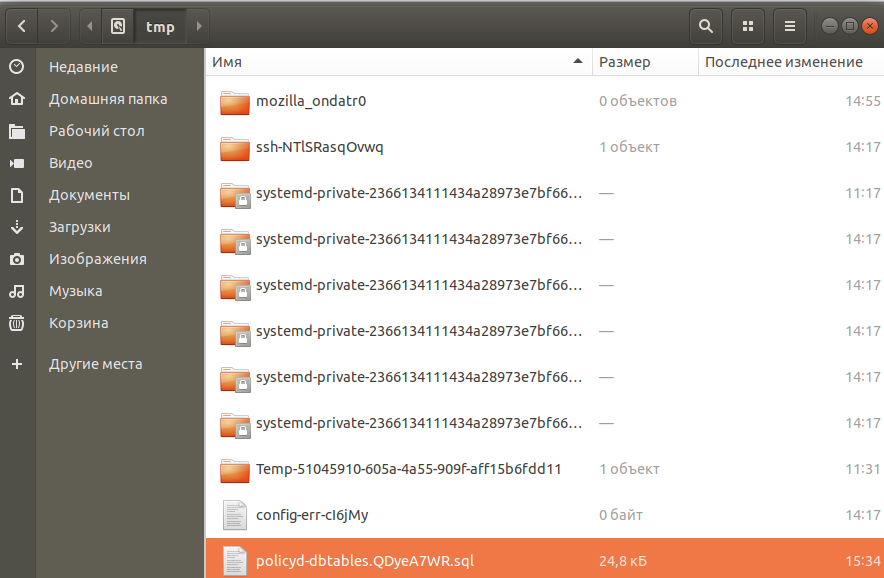

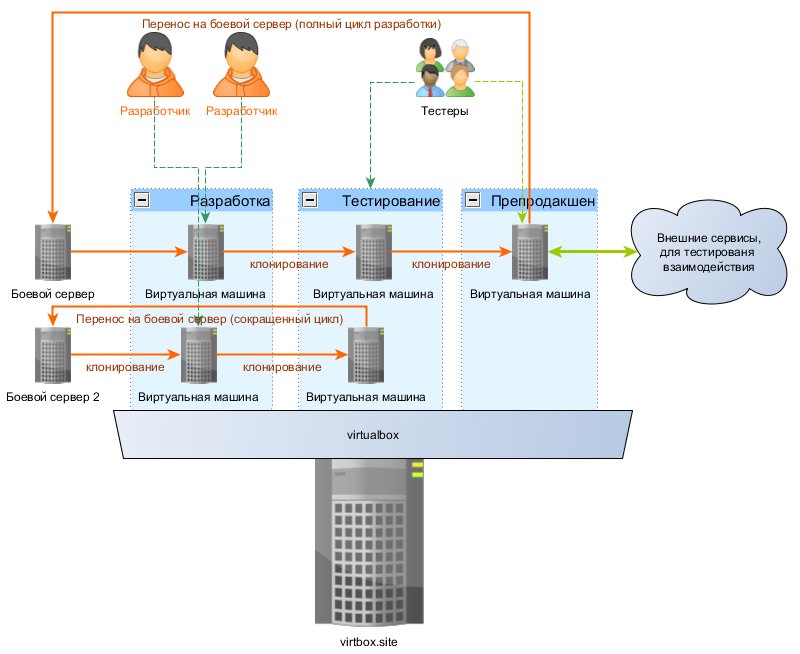

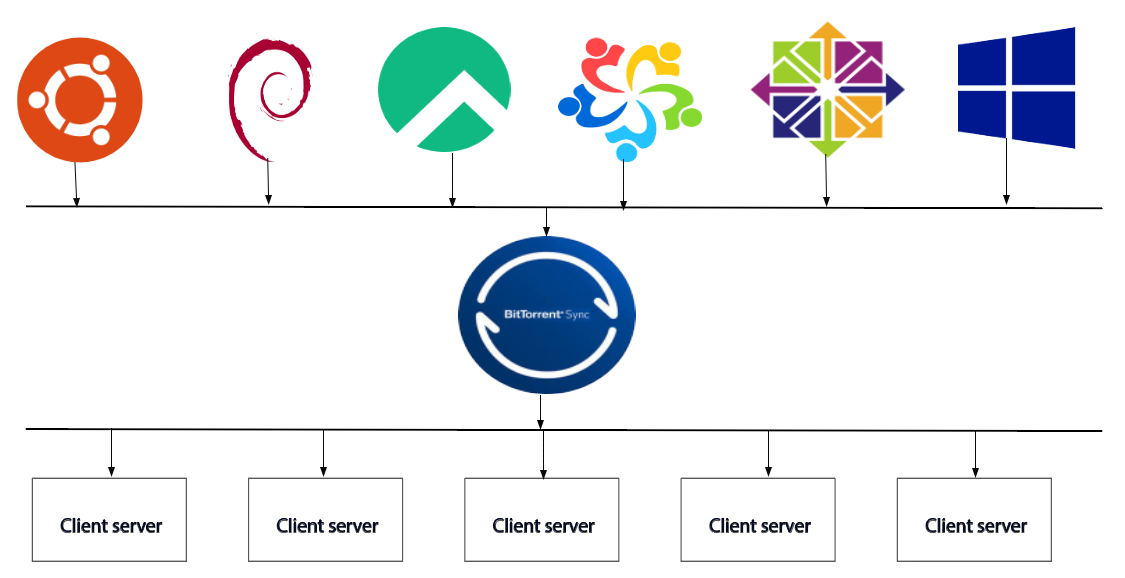

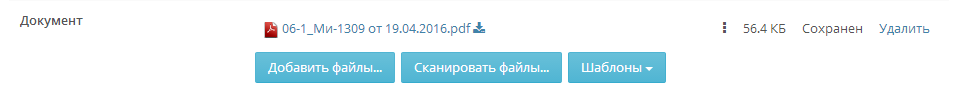

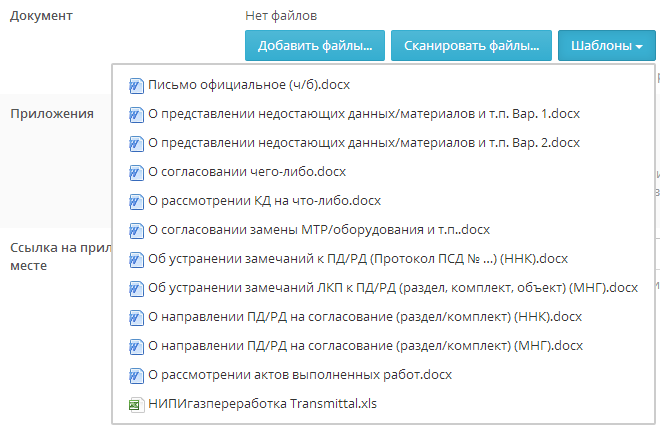

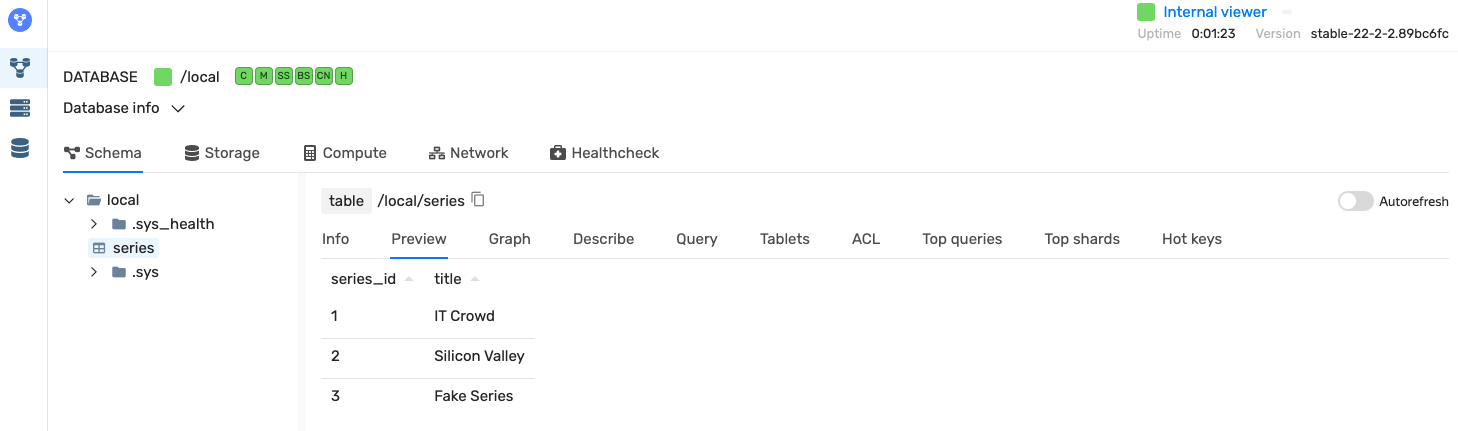

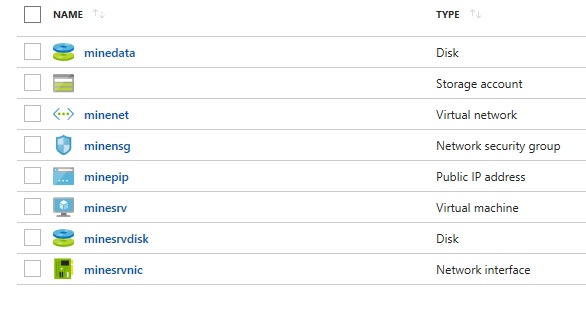

CBPolicyD является универсальным инструментом для управления политиками в Postfix. Он входит в комплект поставки Zimbra OSE и ранее мы рассказывали о том, как настраивать CBPolicyD на своем почтовом сервере и создавать в нем различные политики, которые позволяют повысить уровень защищенности сервера от кибератак. Однако все данные ранее рекомендации были применимы к односерверной инфраструктуре Zimbra OSE, так как CBPolicyD по умолчанию использует автономную СУБД SQLite 3 для хранения и управления политиками, а это означает, что созданная на одном сервере политика не будет иметь силы на другом сервере и каждый раз для внедрения новой политики, администратору придется создавать ее на каждом сервере MTA. В случае с односерверной инфраструктурой это допустимо, однако когда речь идет о мультисерверной инфраструктуре Zimbra OSE, необходимо чтобы созданная политика применялась сразу на всех MTA. Это облегчает не только процесс создания политик, но и процесс управления ими. Для того, чтобы созданная политика автоматически применялась на всех MTA в инфраструктуре, необходимо подключить ее к глобальной СУБД MariaDB. Плюсом использования MariaDB является то, что эта СУБД более отказоустойчива, чем SQLite 3. То есть при больших нагрузках на MTA CBPolicyD гарантированно не будет пропускать письма, не соответствующие настроенным политикам. В данной статье мы расскажем о том, как это сделать.

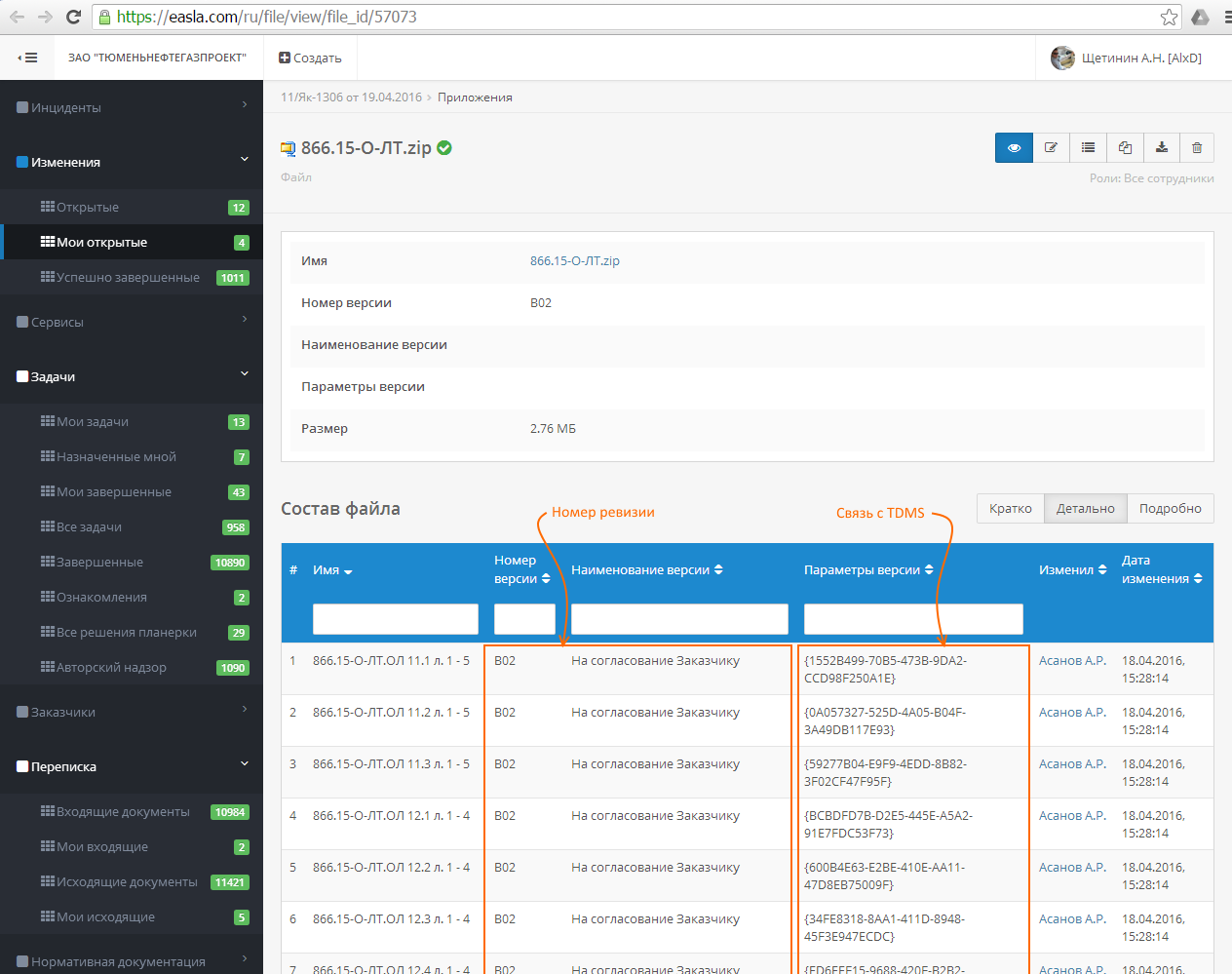

Данная инструкция описывает настройку в инфраструктуре Zimbra OSE с несколькими серверами MTA. Для того, чтобы подключить CBPolicyD на всех MTA к единой СУБД MariaDB, мы добавим в инфраструктуру Zimbra OSE выделенный сервер, на котором установим копию MariaDB и настроим ее в качестве бэкенда ко всем CBPolicyD в инфраструктуре.

Для выделенного сервера сервера MariaDB, с учетом запущенной на нем Ubuntu Server, потребуются два ядра vCPU, 4 Гб оперативной памяти, а также около 20 Гб на диске. Для установки MariaDB выполните на сервере следующие команды:

**sudo apt install mariadb-server

sudo /usr/bin/mysql\_secure\_installation**

В файле /etc/mysql/mariadb.conf.d/50-server.cnf поменяйте значение строки port на 7306, а также закомментируйте строку bind-address

Изложенные ниже инструкции по подключению CBPolicyD к единой СУБД MariaDB необходимо выполнить на каждом сервере MTA. После того как все PolicyD в инфраструктуре будут подключены к единой СУБД, созданные на одном из серверов политики будут автоматически распространяться на всю инфраструктуру Zimbra OSE. Выделенный узел MariaDB в нашем случае имеет доменное имя [mysql.example.ru](http://mysql.example.ru) и IP-адрес 192.168.0.104, а сервер MTA - [mta.example.ru](http://mta.example.ru) и 192.168.0.105.

Для подключения CBPolicyD к серверу с MariaDB, в первую очередь необходимо на выделенном сервере MariaDB привязать порт 7306/TCP к IP-адресу 0.0.0.0. Для этого отредактируйте файл /opt/zimbra/conf/my.cnf на сервере MTA и приведите соответствующую строку к виду: bind-address=0.0.0.0.

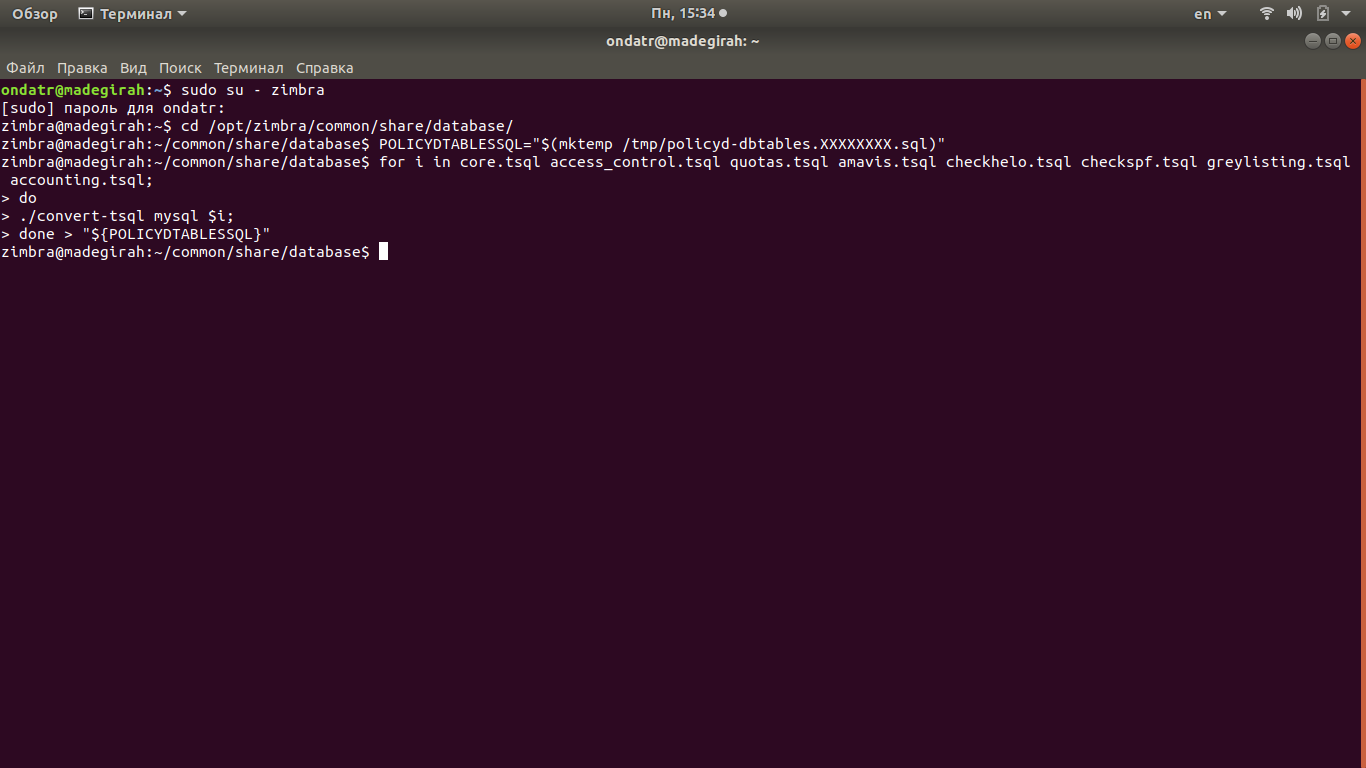

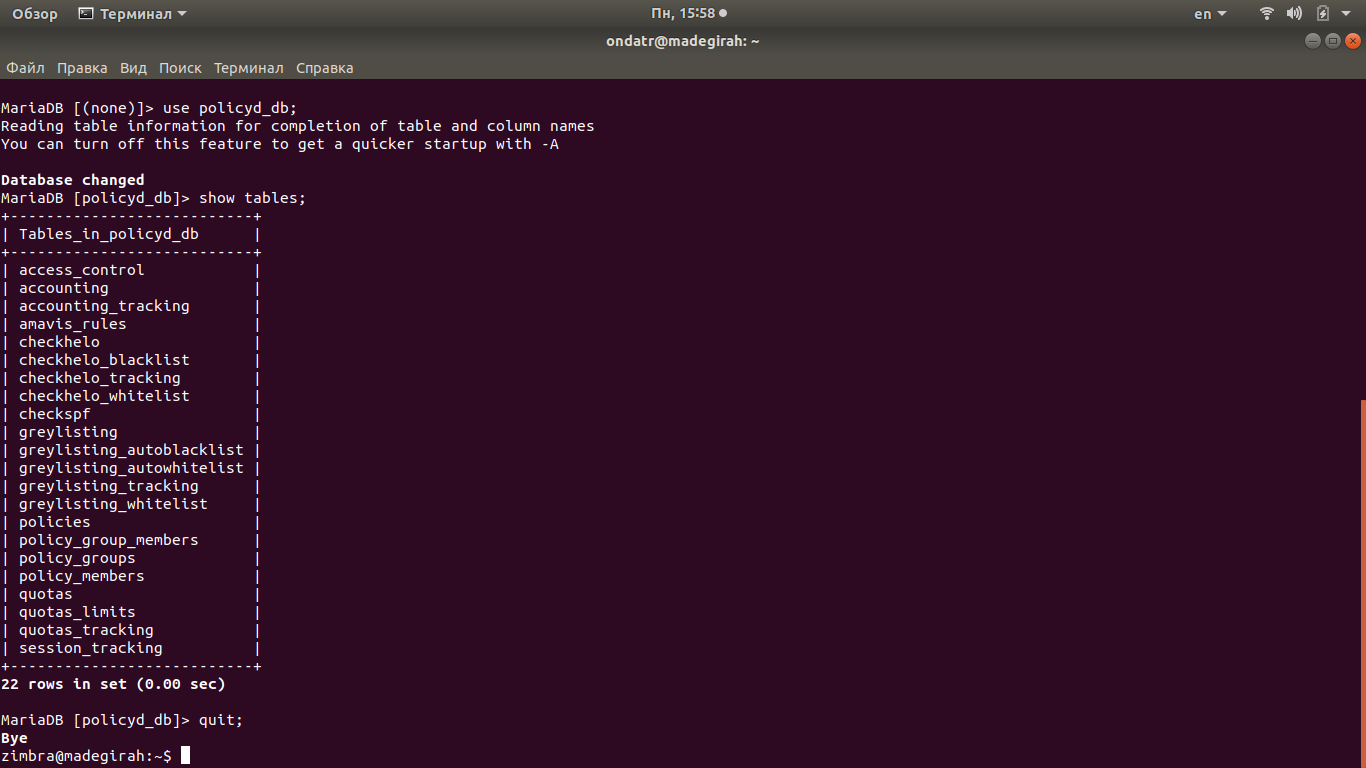

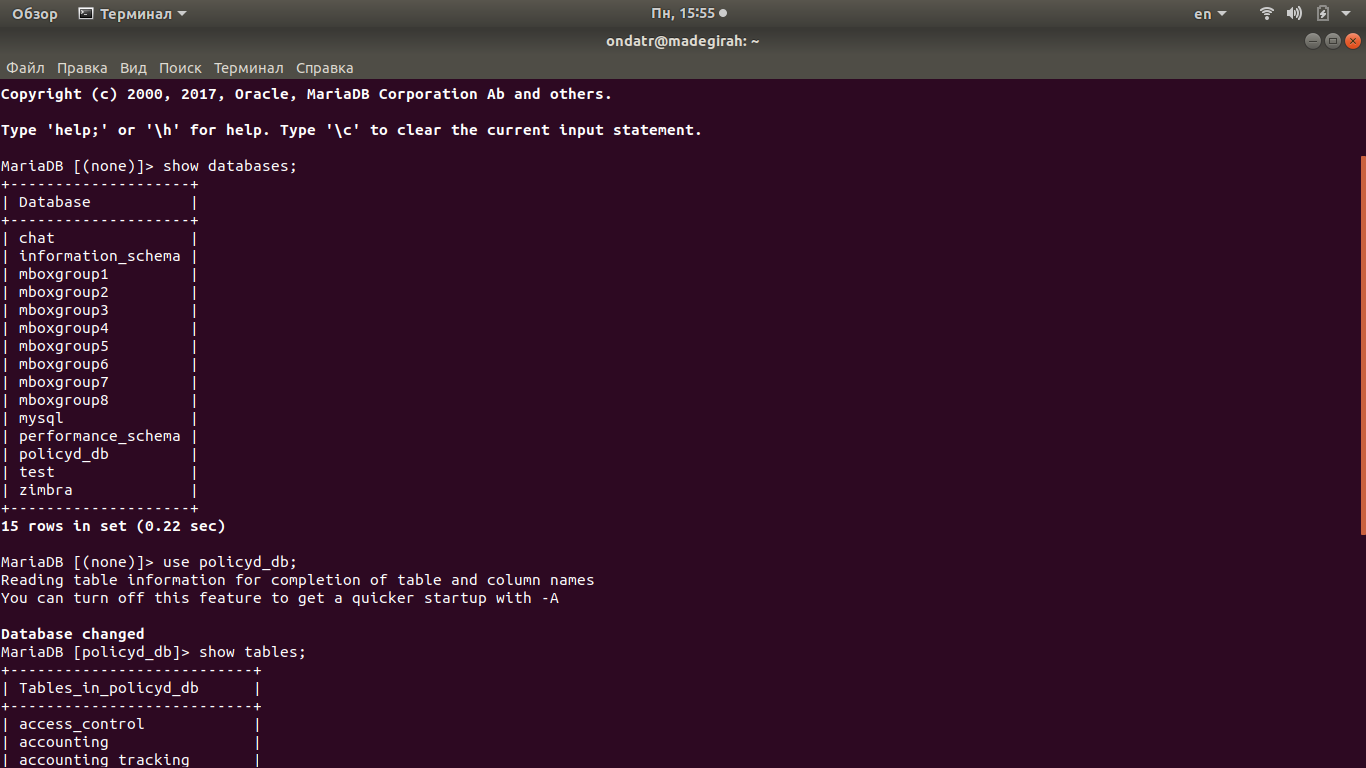

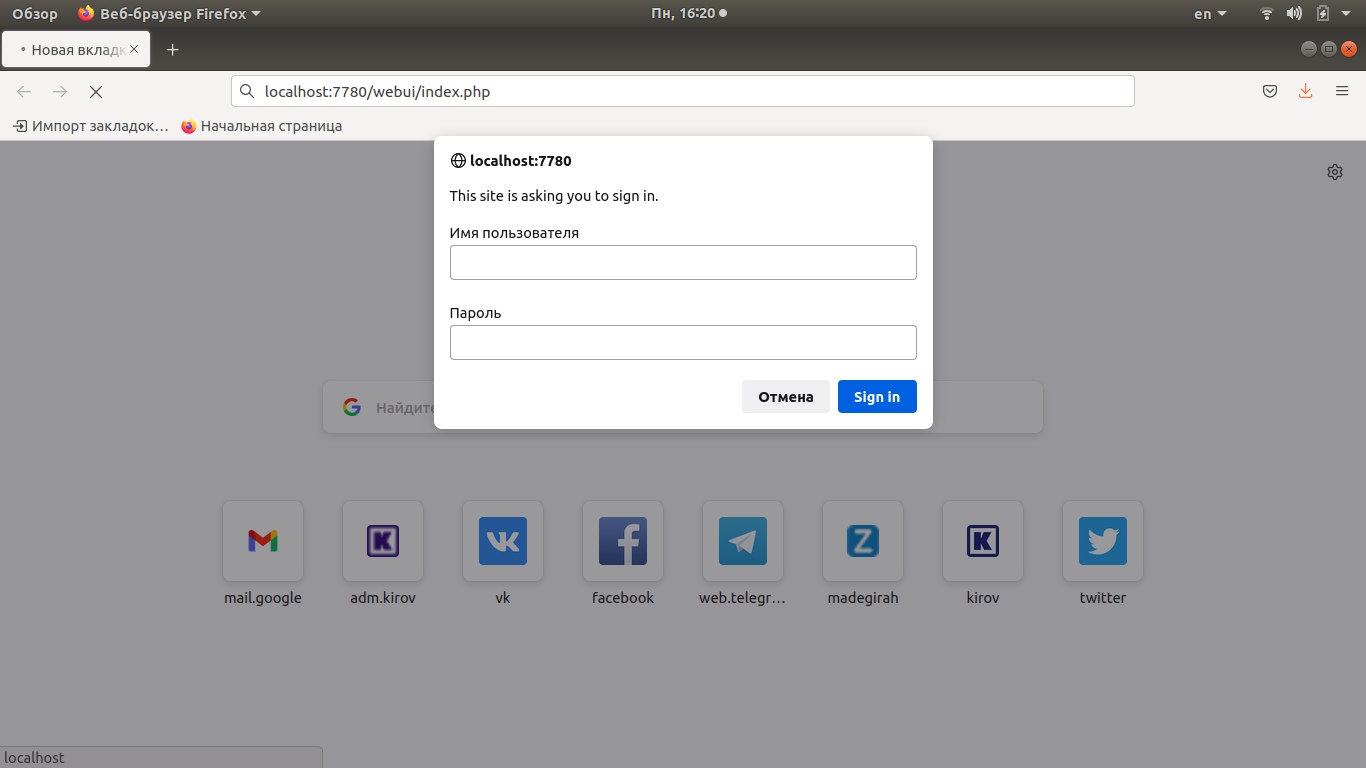

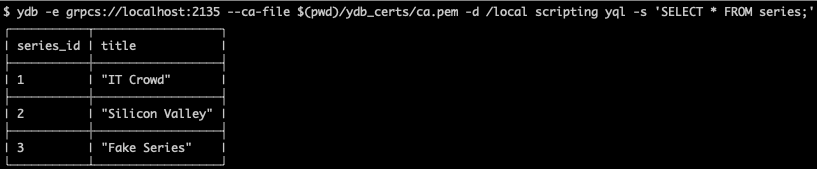

После этого необходимо создать на сервере MariaDB базу данных под названием “policyd\_db” и пользователя “ad-policyd\_db”. Делается это при помощи следующих команд:

```

mysql

MariaDB [(none)]> create database policyd_db CHARACTER SET 'UTF8';

MariaDB [(none)]> create user 'ad-policyd_db'@'127.0.0.1' identified by 'P@ssw0rD';

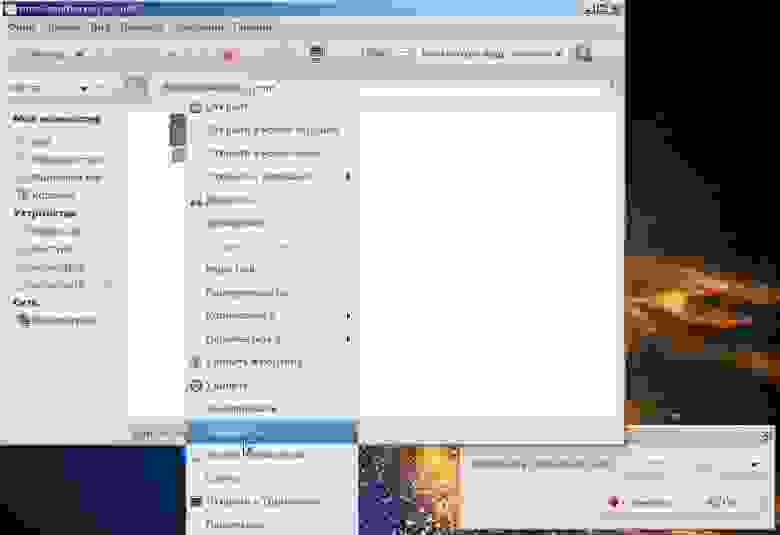

MariaDB [(none)]> grant all privileges on policyd_db.* to 'ad-policyd_db'@'192.168.0.105' identified by 'P@ssw0rD' with grant option;