text

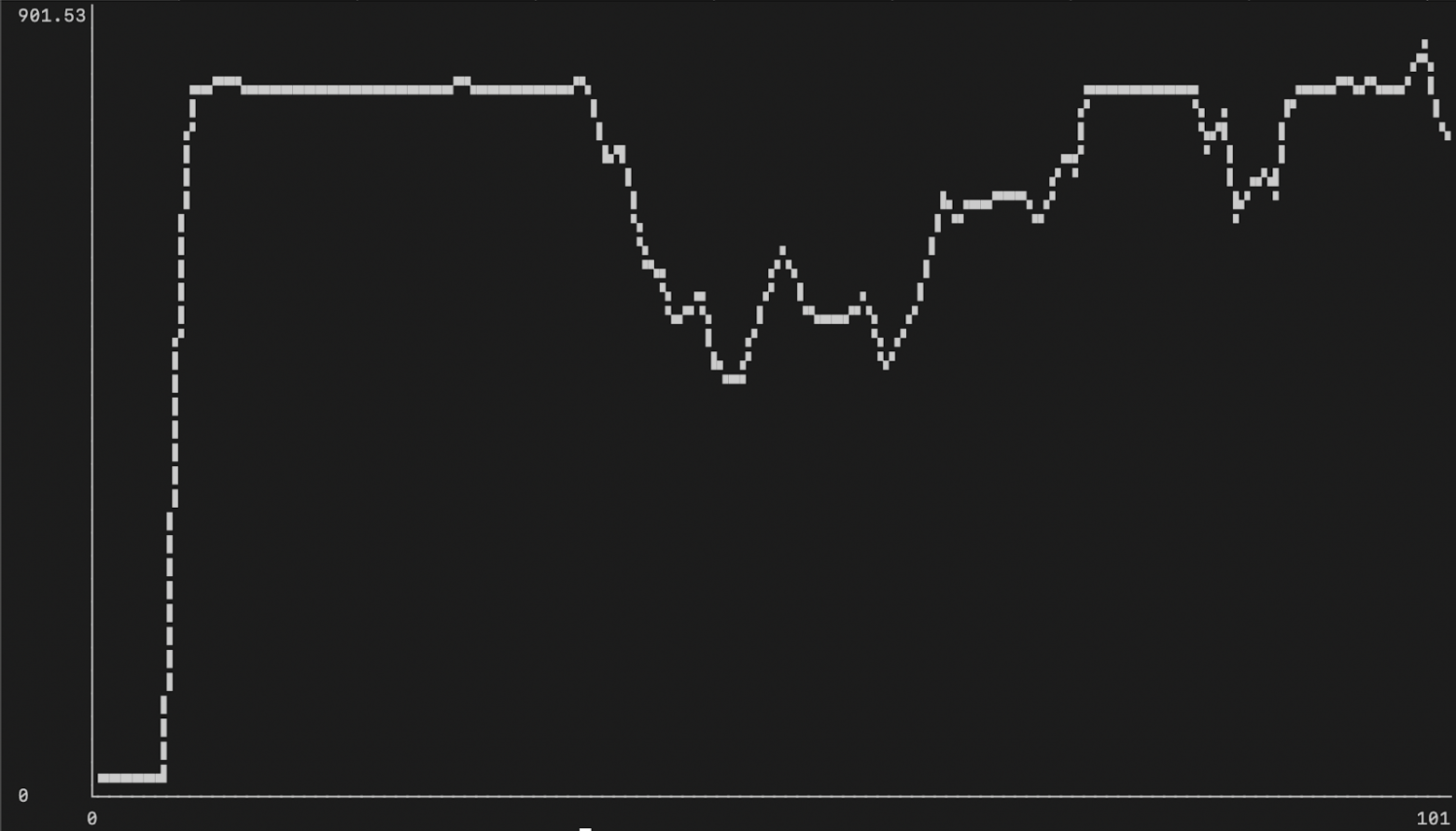

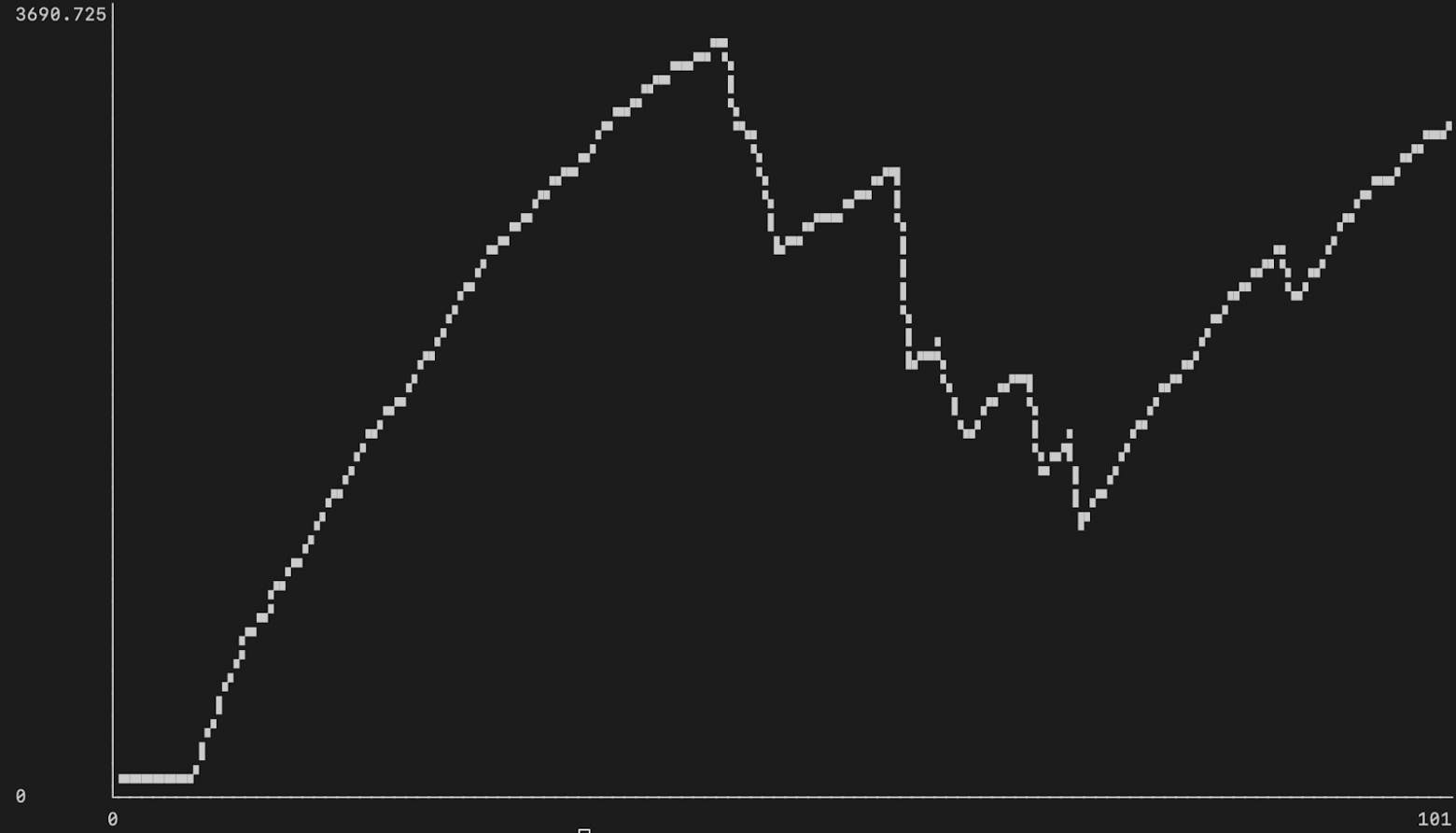

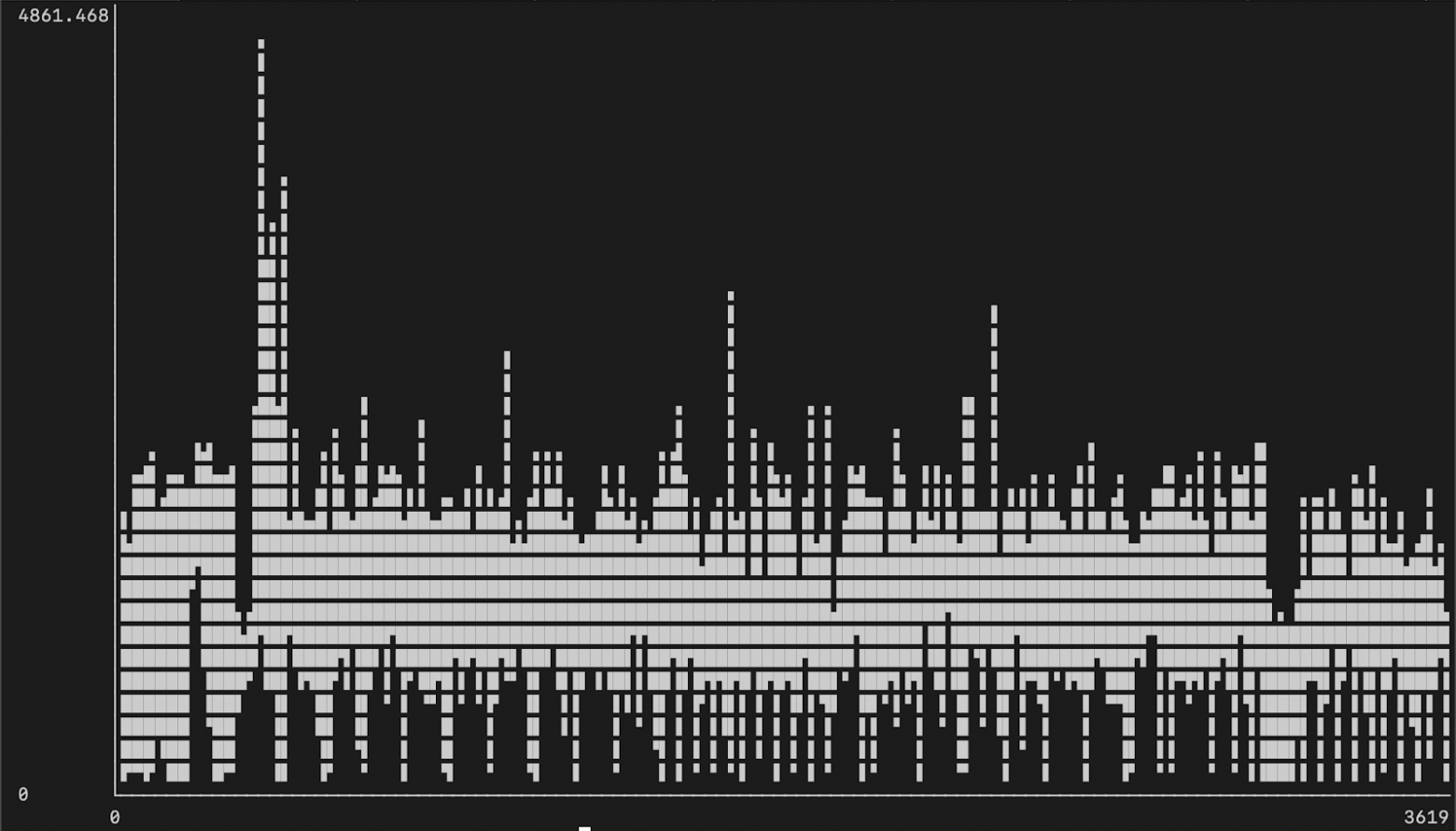

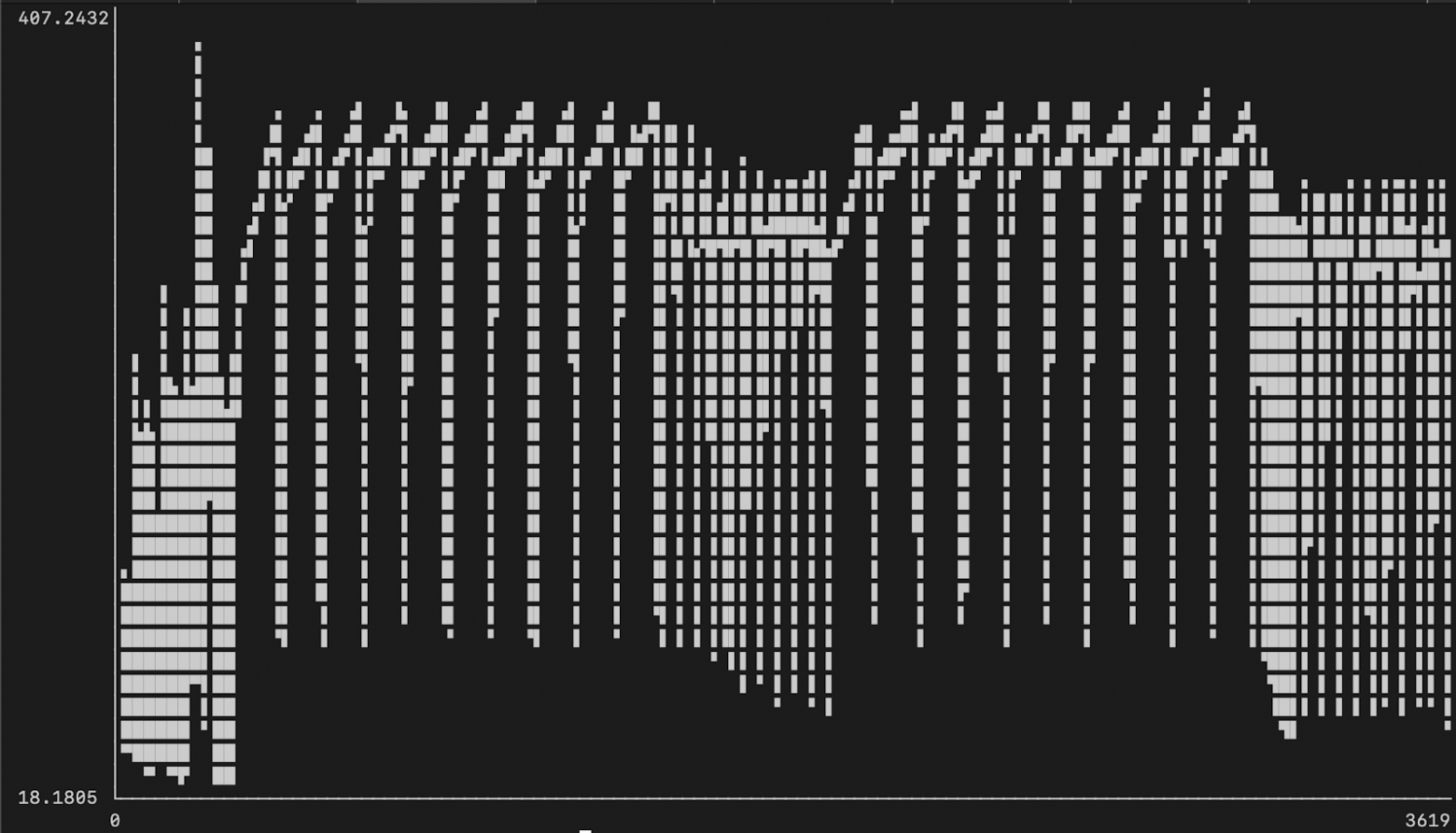

stringlengths 20

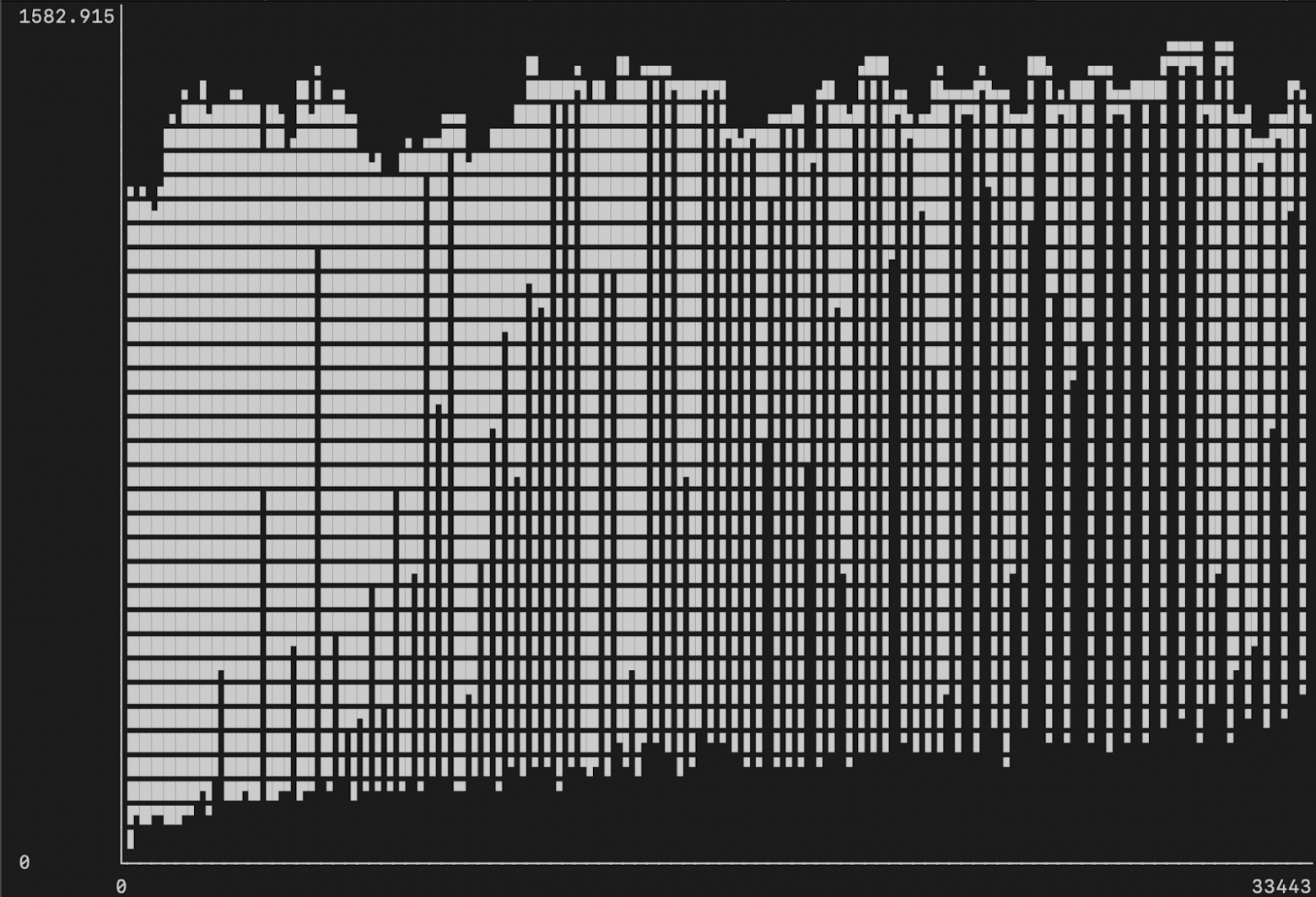

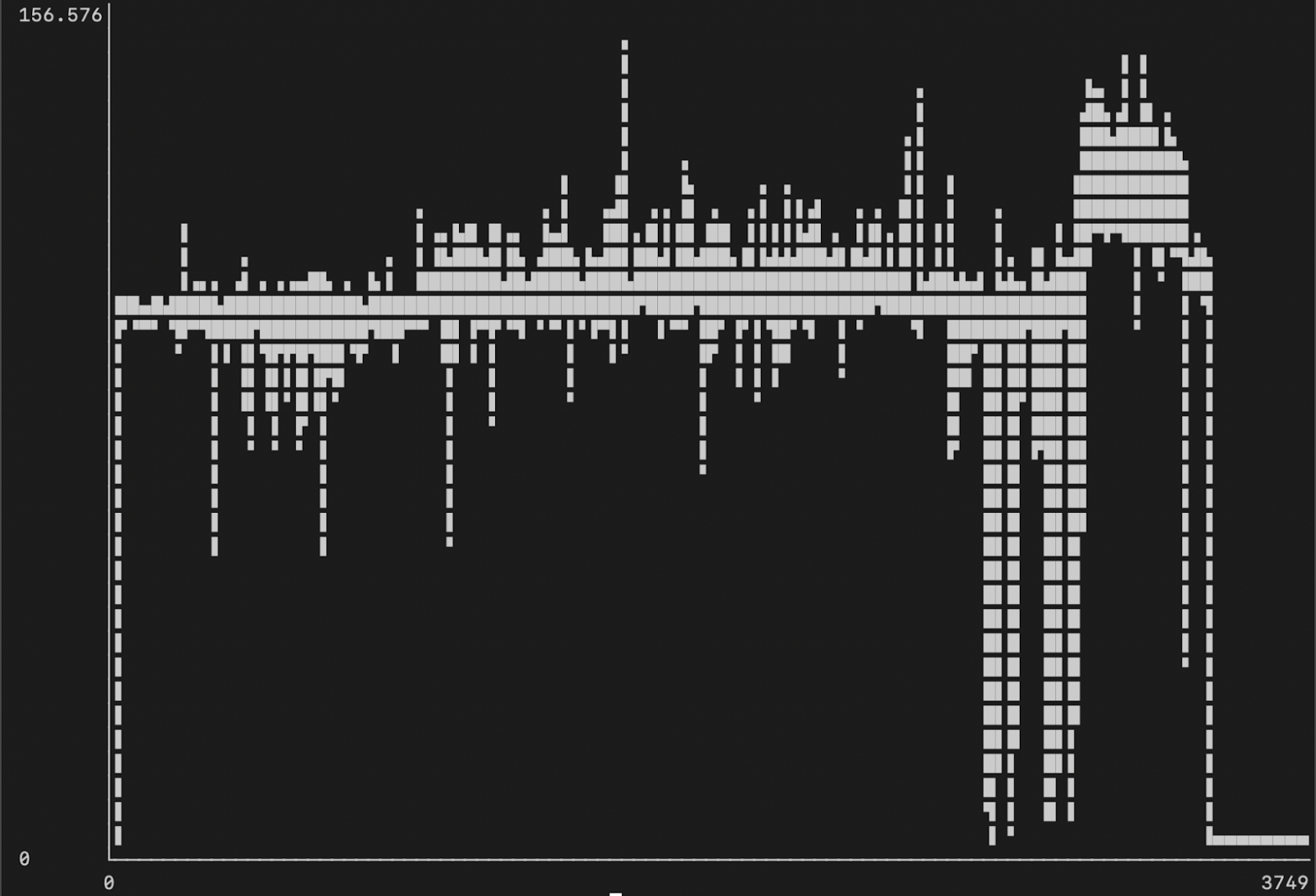

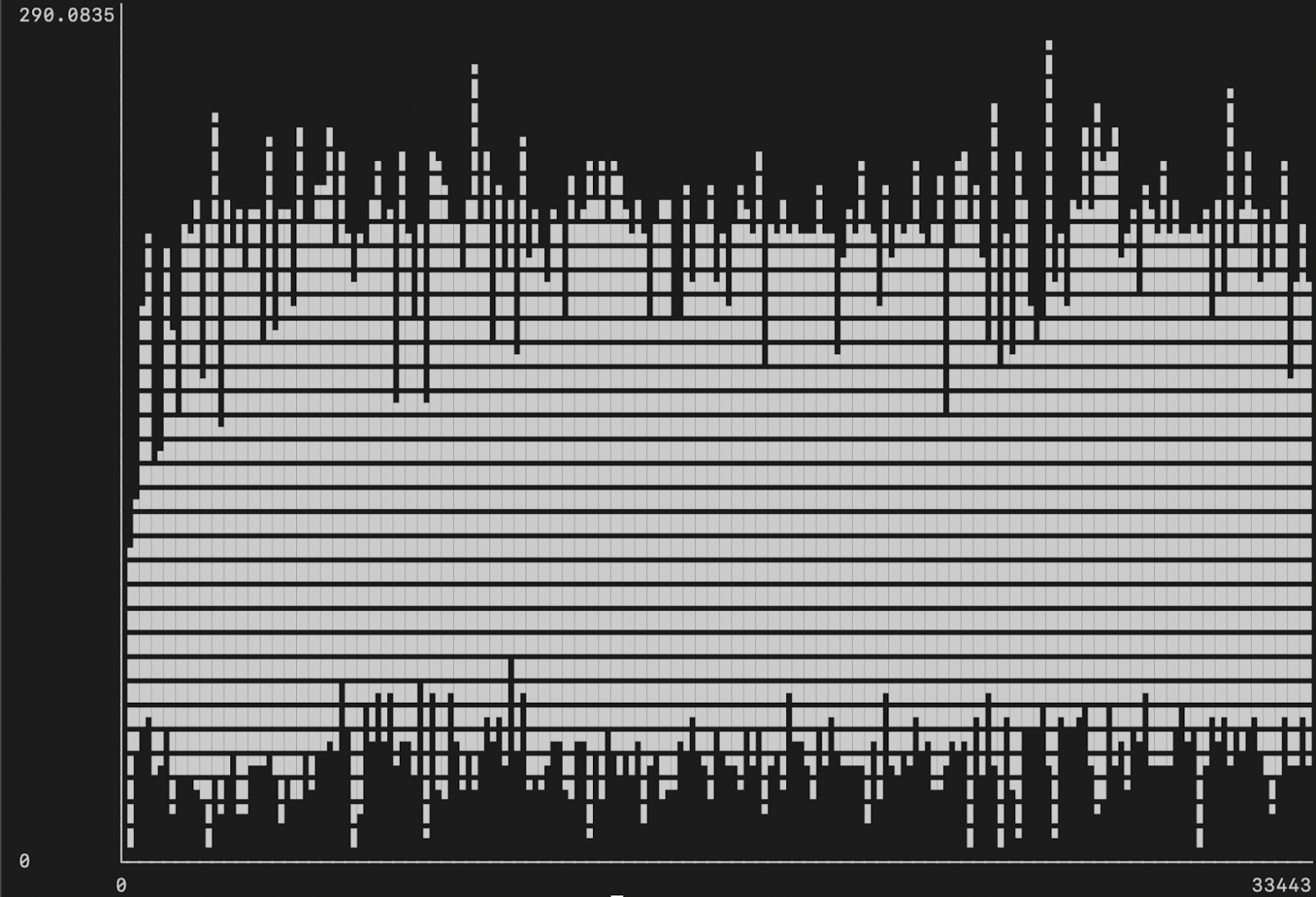

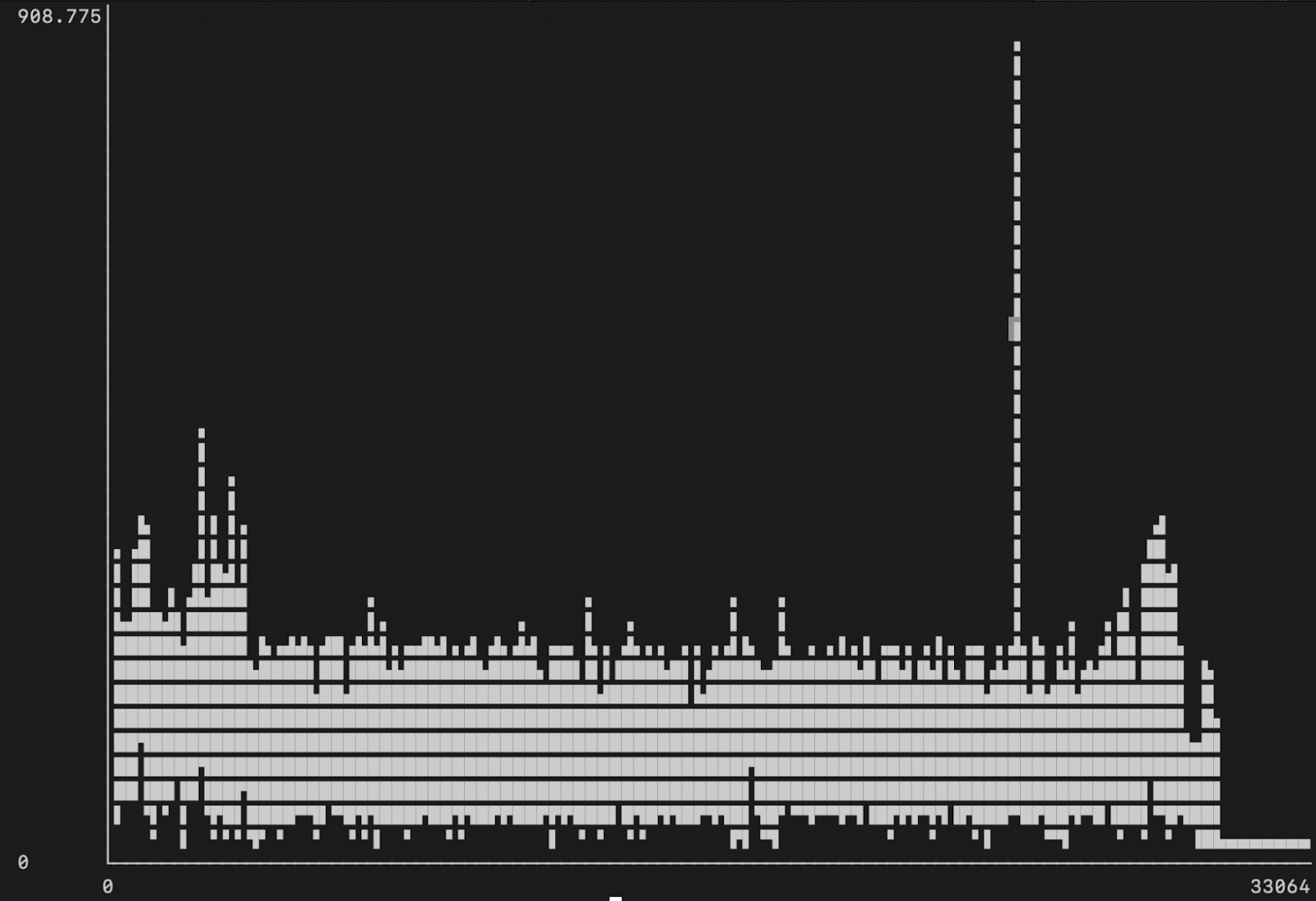

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Emacs для начинающих: введение

#### Ist das Emacs? Sehr gut!

Начну с небольшой истории. Лет так 15 назад ездил я на подработку сисадмином программистом в славный городе Mannheim, West Germany. Когда я приехал на работу и развернул своё рабочее окружение, большинство дойчей вообще не сильно поняли в чём я работаю, а вот директор конторы сразу мне сказал: «Ist das Emacs? **Sehr gut!**», добавив также что никто кто из текущих программистов не смог его освоить. А по честному, не такой уж я особенный — мне просто повезло: готовый конфиг мне дал один добрый человек, и помог мне разобраться с редактором на первых шагах. Я, в свою очередь хочу поделиться своим опытом с остальными, и решил сделать серию статей для начинающих и не очень, с рассмотрением разных полезных фич emacs.

В этой статье я также хочу пошатнуть сложившийся миф — что Emacs — сложный в работе/настройке редактор. Я считаю, что правильно начав, процесс изучения не будет сложным, и надеюсь, доставит Вам массу удовольствия от использования удобного, мощного и быстрого инструмента как в работе так в жизни.

Первое — слабость emacs в его силе. *Легкость освоения (learnability) пострадала от простоты переконфигурирования* — каждый перестраивает радактор под себя, и часто настолько кардинально, что другой пользователь того же редактора может его не узнать.

Мой конфиг .emacs обростал новыми фичами последние 15 лет, и в этом одна из проблем Emacs: дать готовый конфиг в руки начинающему просто, а вот будет ли с этого толк? Расшарю я его допустим сейчас на Web (как впрочем уже давно собственно [и сделано](http://avk-emacs.hg.public.halogen-dg.com/)) как сотни других энтузиастов. Но, начинаещему это этого проку мало, т к скорее всего он сможет сделать только две вещи (из которых скорее всего не будет делать ни одну, по причине изначальной лени): (1) или взять конфиг целиком со всеми кастомными наворотами и дополнениями, или (2) попытаться скрестить «бульдога с носорогом» и надёргать рецептов из нескольких конфигов разных вендоров — а это долго, муторно.

Разрабочики Emacs пытаются снизить барьер входа новичков пытаясь выдать что то похожее на общепритяные стандарты (CUA mode: Ctrl+C, Ctrl+V, запись \*scratch\*, и т п) но этого явно мало для редактора с 20ти летней историей — барьер для освоения держится на высоте, отсекая новичков.

Я решил пойти другим путём и облегчить понимание того, насколько им нужна та или иная фича, сделав демонстрацию каждой. Вместо того, чтобы просто выложить свой конфиг (типа «кто надо тот разберётся») я постараюсь его сам разобрать по кусочкам, объяснив каждый отдельный модуль и настройку.

Ведь не бывает идеального конфига «для всех», и то, что хорошо для меня, может оказаться неудобным допустим тому же веб дизайнеру.

Поэтому, эта статья не будет описывать какую то отдельную фичу — я пройдусь по всем, удобным с моей точки зрения. Это будет [не]большой Tutorial который позволит выбрать то, что нужно каждому по отдельности.

#### Введение

В введении в emacs показан сам редактор, комбинации клавиш для начального изучения, и объяснения по ходу дела базовой концепции редактирования.

Изучение emacs чем-то сродни изучению иностранного языка: материала много, комбинации клавиш учить надо (не обязательно, но надо, если хотите, чтобы была практическая польза), некоторые новые концепции надо понять.

Базовые клавиши

* C-x C-f — открыть файл

* C-x C-s — записать файл

* C-x C-c — выход из редактора

Buffers (buffer — открытый файл)

* C-x b — перейти в другой открытый файл

* C-x C-b — показать все открытые файлы,

* C-x k — закрыть файл (но не редактор)

Окна

* C-x 2 — разбить окно по горизонтали

* C-x 3 — разбить окно по вертикали

* C-x 0 — закрыть окно

* C-x 1 — оставить только одно открытое окно

Видео:

После просмотра этого видео также рекомендую пройти английский туториал по emacs, который доступен в самом редакторе по клавише: C-h t.

#### IDO-mode

Удобный режим для быстрого доступа к файлам, открытым файлам, и другим спискам внутри редактора. В совокупности с активированным uniquify режимом позволяет \*очень\* быстро найти нужное.Особенности: по клавише C+<пробел> начинается ввод новой подстроки. По клавише C-f идёт fallback (возврат) на обычный (не-IDO) ввод.

Видео:

Настройка:

```

(require 'uniquify)

(require 'ido)

(ido-mode t)

```

#### Работа с файлами удалённо по протоколам SSH, FTP, Samba и т п

Возможно это не самая навороченная фича emacs, т к многие скажут что намного проще

зайти на удалённый сервер консолью и там уже всё отредактировать. Но консоль, увы не так удобна как GUI приложение, также часто файл удобнее и быстрее редактируется локально, и записывается уже результат, а не медленные нажатия клавиш в случае консоли. Открыв несколько файлов удалённо, легко можно перебрасывать куски текста любой длинны и содержания, избегая использования мышового буфера.

Видео:

Настройка:

```

(require 'tramp)

```

##### В заключение

Emacs — действительно не сильно сложный редактор. Но это как раз тот пример, когда освоив минимум, нелья на этом останавливаться, ибо сила emacs — в доступных библиотеках и дополнительных функциях. Единственный способ добиться максимального результата — это выучить комбинации клавиш, названия функций и сами по себе концепции и функционал.

В следующих статьях по этой теме я опишу работу с Dired (файл менеджер), работу с системами контроля версий на примере SVN и Mercurial, работу по поиску текста (rgrep), закладки по тексту, интерактивный показ ошибок, среду разработки для Python и многое другое. Просьба коментировать какие именно дополнительные функции интересны. | https://habr.com/ru/post/139697/ | null | ru | null |

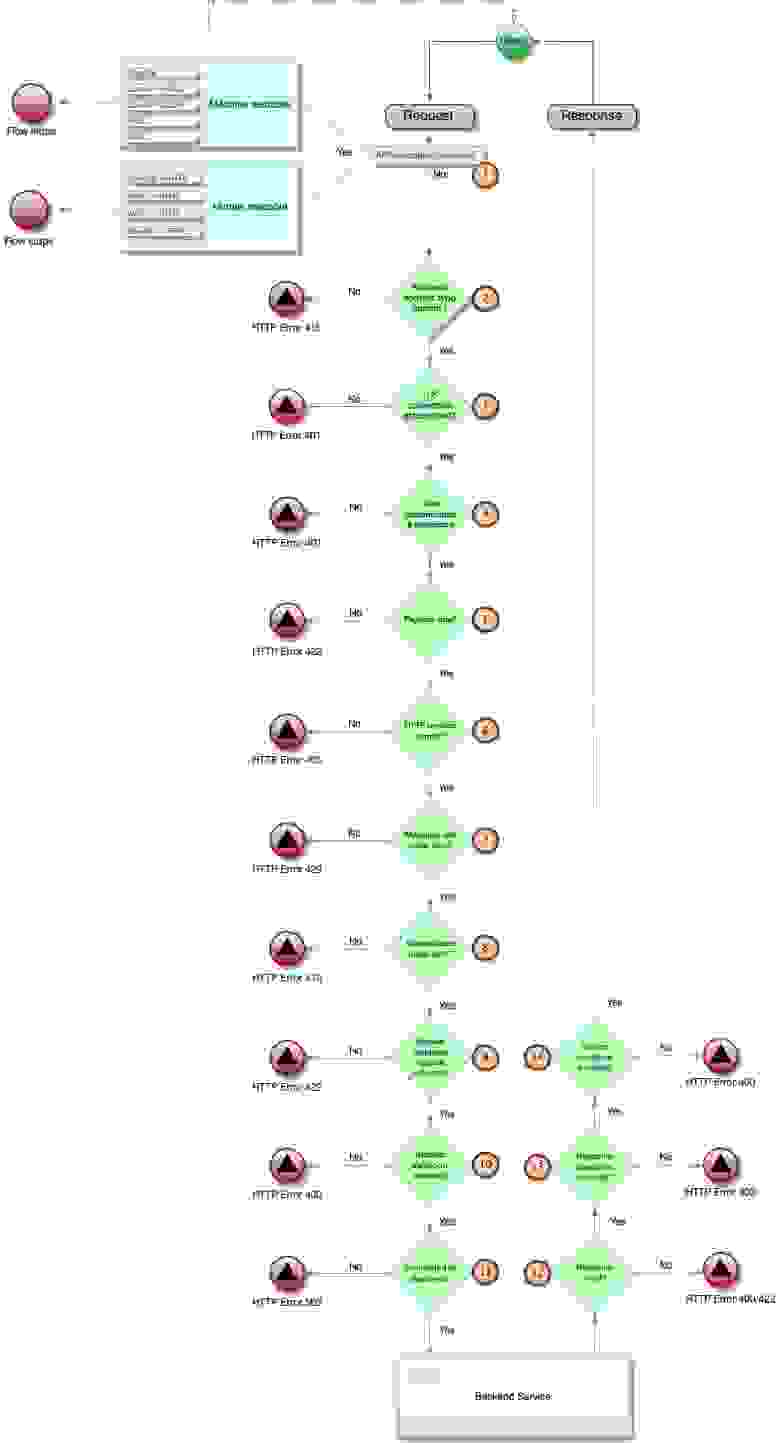

# Кастомизация контролов Docsvision, или «Такой же, но с перламутровыми пуговицами»

Всем привет. Меня зовут Илья Постников. Я старший разработчик ПО в подразделении «Автоматизации бизнес-процессов» компании Digital Design. В этой статье я хотел бы поделиться опытом кастомизации контролов для web-клиента системы Docsvision (DV). Данная информация будет полезна инженерам, обслуживающим Docsvision и знакомым на начальном уровне с веб-технологиями React/Node.js и .Net MVC.

В Docsvision уже присутствует большой набор контролов для реализации основной логики решений. Все контролы DV ориентированы на работу со справочниками и инфраструктурой DV. Но в реальных компаниях, как правило, уже имеется набор легаси-информационных систем, данные из которых необходимо обрабатывать в DV. Пользователи DV знают про набор шлюзов для интеграций с различными системами при исполнении Workflow-процессов. Но при работе в web-клиенте подобные средства пока еще не реализованы. Не нужно отчаиваться, выход всегда есть!

В моей практике у одного из наших очень крупных заказчиков при внедрении web-клиента Docsvision возникла «интеграционная» проблема. В наличии уже была успешно функционирующая система по сбору заявок и обращений граждан через web-портал. С помощью Docsvision необходимо было реализовать логику обработки зарегистрированных на портале обращений. Имеющийся web-портал, естественно, ничего «не знал» о Docsvision. Равно как и логика web-портала была до поры неизвестна Docsvision. Одной из проблем стала фиксация данных о пользователях портала в карточках Docsvision. Идентификаторы пользователей должны были каким-то образом выбираться оператором и сохраняться в карточках web-клиента Docsvision. Список пользователей портала постоянно обновлялся, поэтому вариант с единовременной миграцией в справочник контрагентов Docsvision не подходил. Необходимо было найти решение этой и схожих с ней проблем.

Вообще, как показал опыт, довольно частая потребность заказчика – выбирать информацию на веб-странице из уже имеющейся внешней системы и сохранять полученные сведения в полях секций DV. При этом контрол, который оперирует данными, не должен выбиваться из общей стилистики страницы. Для примера, пусть таким контролом будет выпадающий список Dropdown из конструктора разметок DV. Из «внешней» системы будем запрашивать:

1. Числовой идентификатор пользователя.

2. ФИО пользователя (будет отображаться в выпадающем списке).

После выбора пользователя и сохранения карточки его идентификатор должен быть зафиксирован в указанном поле секции DV.

Наша задача – сделать отдельный контрол, схожий по поведению с Dropdown, который можно будет добавить на страницу в конструкторе разметок.

В вашем случае это может быть любой другой стандартный контрол DV, взятый за основу. Моя цель – показать «стандартный» путь для кастомизации :)

Будем использовать только общедоступные ресурсы для разработки.

Полагаю, что у вас есть установленный лицензионный или триальный web-клиент Docsvision версии не ниже 11.

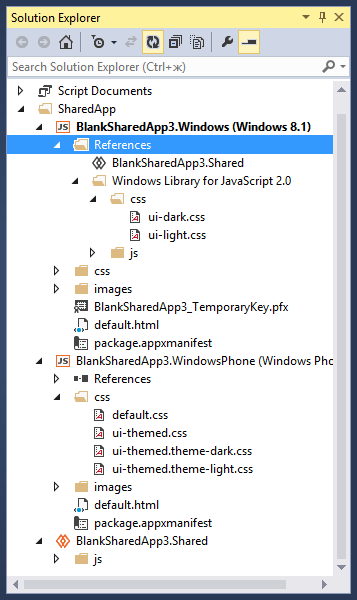

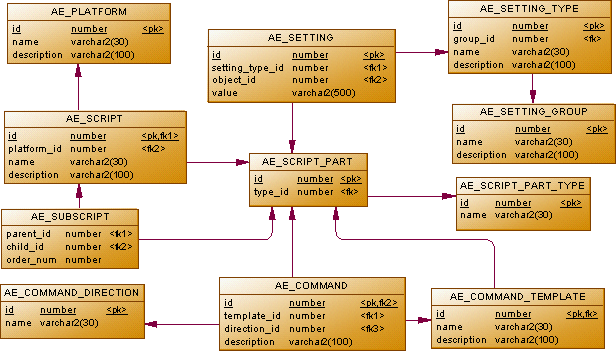

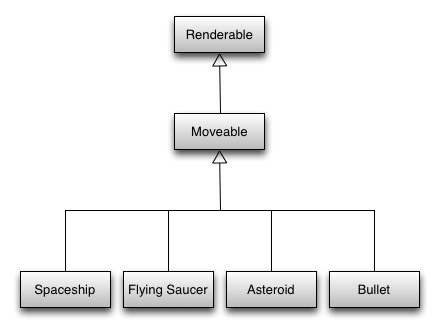

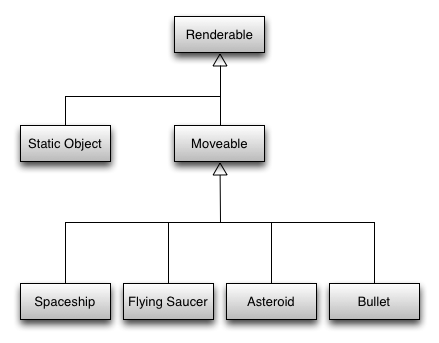

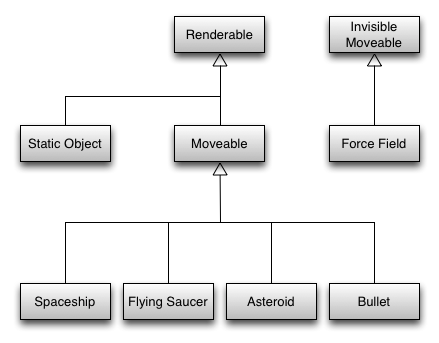

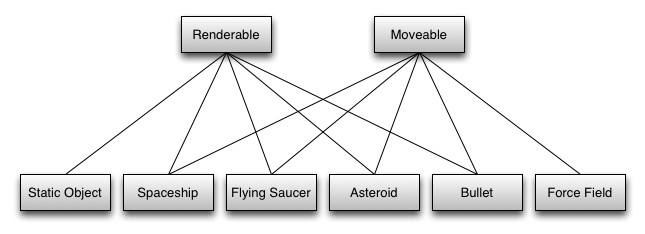

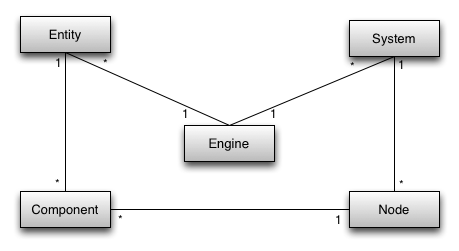

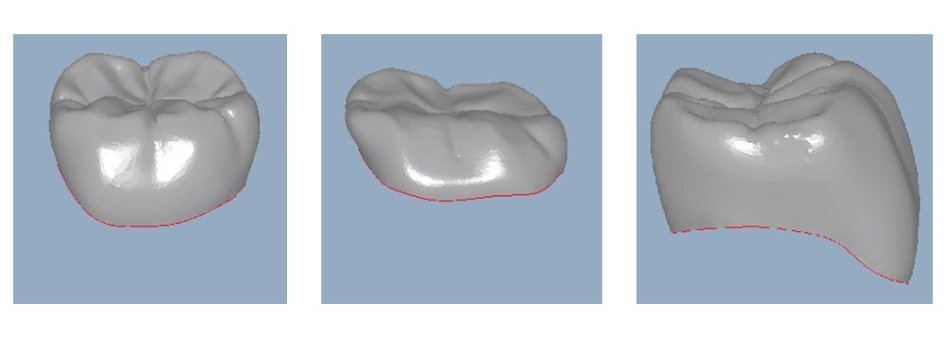

### Программная архитектура будущего контрола

Будем называть контрол по аналогии с контролом-родителем – DropdownOutUser. Для реализации контрола с заданными характеристиками понадобится создать решение из 3 проектов:

1. Веб-расширение контрола, оформленное как «классический» фронтовый проект для сборки под NodeJS. Понадобится установить NodeJS v14.17.0. [В примерах DV уже есть реализация нескольких самостоятельных контролов в каталоге](https://github.com/Docsvision/WebClient-Samples/tree/master/Controls). Все контролы DV выполнены с помощью фреймворка React.js.

2. Проект серверного расширения – бэк нашего контрола. Будет содержать метод в контроллере для получения ИД и ФИО пользователя из возможной «внешней» системы. Взаимодействие с фронтом будет осуществляться по паттерну MVC.

3. Расширение для конструктора разметок – это DLL-библиотека, которая добавит описание и настройки DropdownOutUser в конструктор разметок DV (подробно о конструкторе разметок можно [прочитать здесь](https://docsvision.com/docs/webclient/5.5.16/LayoutDesignerUserGuide/index.html)).

### Реализация фронтового веб-расширения

1. Сформируем пока пустой фронтовый проект. Образец можно взять из [моего репозитория](https://github.com/postilya1972/DropdownOutUser/tree/master/DigDes.WC.DropdownOutUser.WE) или из [примеров DV](https://github.com/Docsvision/WebClient-Samples/tree/master/Controls/CheckBox/CheckBoxWebExtension). Cкопируйте файлы в свой каталог. Данные репозитории содержат конфигурации для получения конечного js-бандла при помощи сборщика rollup.js.

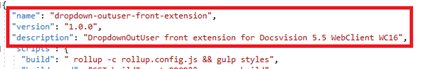

2. Настраиваем файл package.json:

1. Указываем нужные версии двух стандартных библиотек web-клиента в разделе зависимостей. Для 16 версии web-клиента:

2. Описываем название, версию и описание контрола

3. Если вы ещё не установили Node.js версии 14.7.0, самое время это сделать. Дистрибутив можно скачать [здесь](https://nodejs.org/ru/download/).

4. Из каталога, в котором располагается файл package.json, из командной строки запускаем команду: `npm install`

При этом будет создан каталог node\_modules и в него будут загружены все необходимые библиотеки и их зависимости.

5. Теперь очень важный момент, без которого все усилия были бы тщетны. В каталоге установки веб-клиента (обычно это “C:\Program Files (x86)\Docsvision\WebClient\5.5\Site\Content\App”) на вашем сервере лежат все исходники контролов на языке TypeScript! Остается только найти папку нужного контрола. Исходники нашего Dropdown лежат в каталоге “C:\Program Files (x86)\Docsvision\WebClient\5.5\Site\Content\App\Platform\Controls\Dropdown”.

Копируем файлы Dropdown.tsx и DropdownImpl.tsx в каталог \src\Controls\DropdownOutUser нашего фронтенд-проекта.

Файл Dropdown.tsx содержит классы с описанием параметров, сервисов, событий и логики привязки контрола. DropdownImpl.tsx содержит реакт-компоненту на основе классов. Большинство контролов DV имеют схожую архитектуру.

6. Во избежание конфликтов и недоразумений переименуем названия классов, содержащих “Dropdown” в “DropdowOutUser” в обоих файлах.

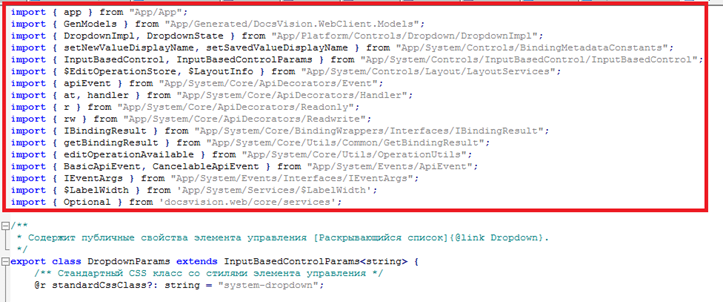

7. В начале tsx-файлов исходников содержатся привязки к стандартному расположению ресурсов в коде DV. Закомментируйте или удалите импорт ресурсов:

У нас нет кода DV, но есть установленные в пункте 4 библиотеки. Надо «перепривязать» необходимые ресурсы (в основном из @docsvision/webclient). Для быстрого поиска ресурсов в библиотеках рекомендую использовать VSCode или Visual Studio с соответствующими расширениями. В результате должно получиться что-то вроде:

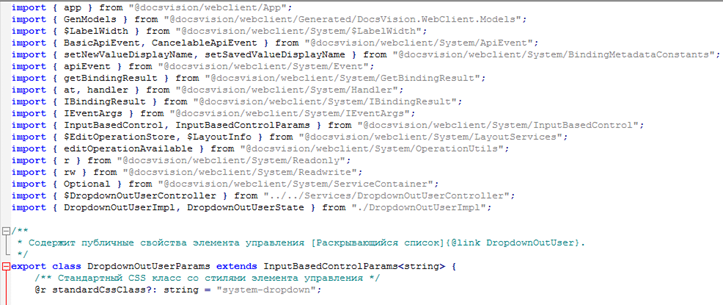

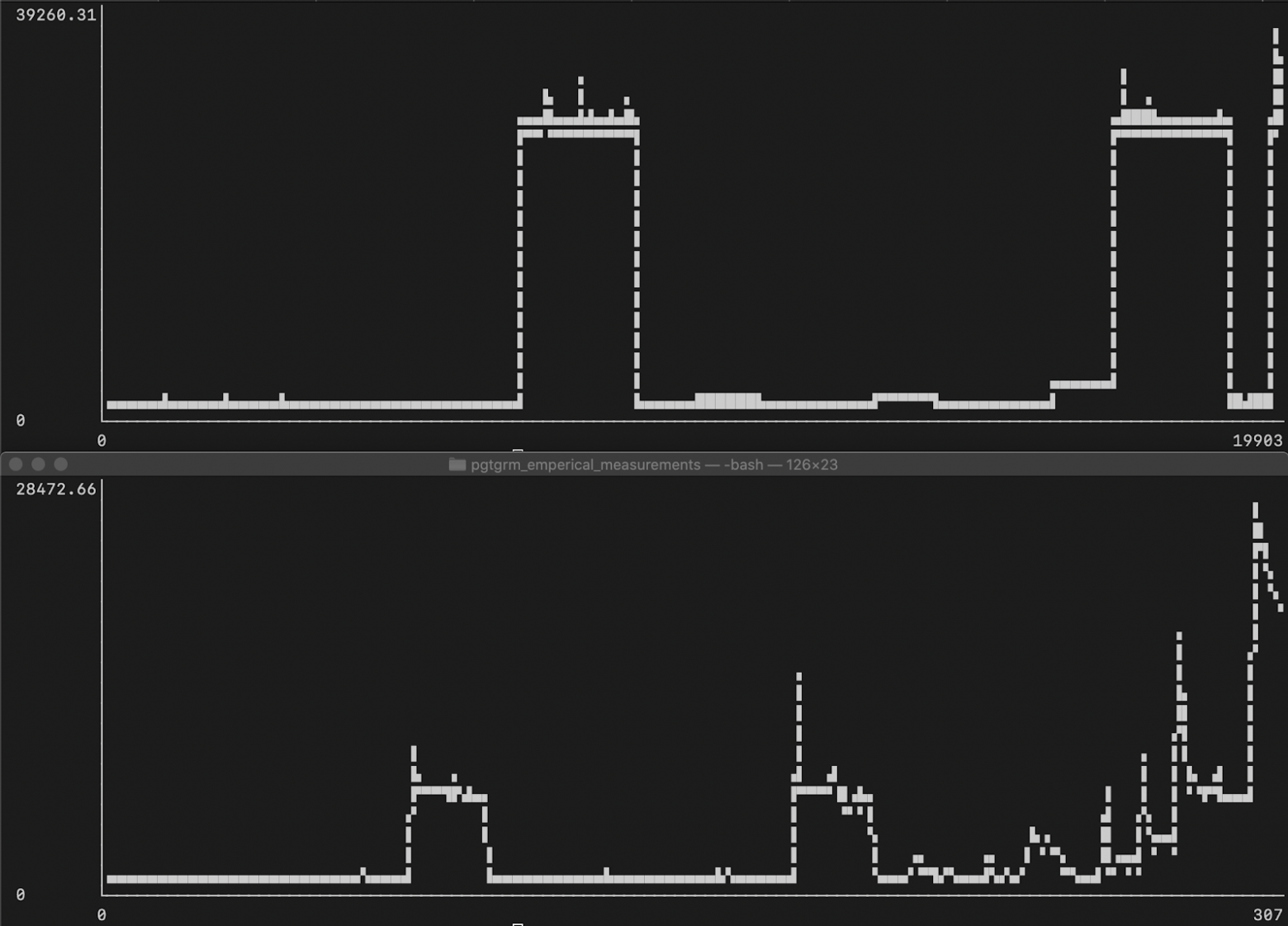

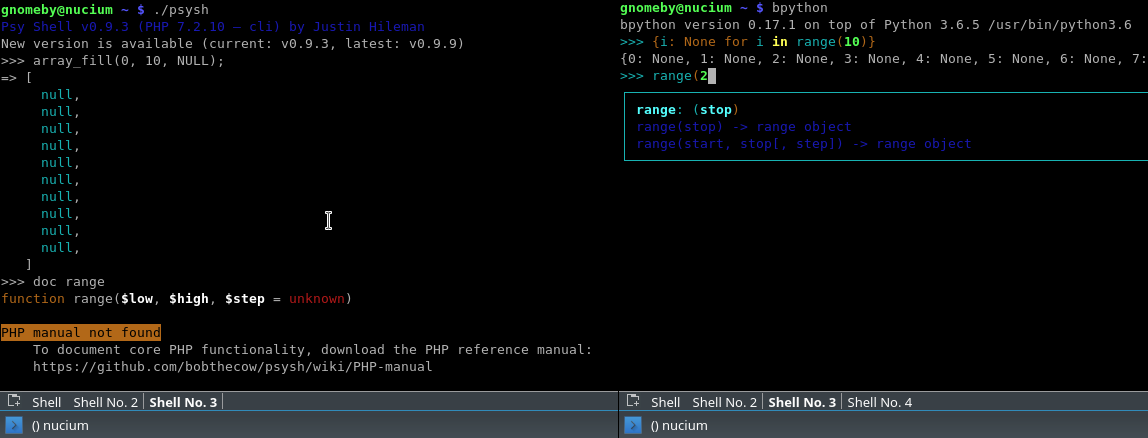

8. Попробуем собрать получившийся вариант. Для этого из командной строки в основном каталоге расширения (там где лежит package.json) запускаем команду: npm run build. Команда запустит сборщик rollup для js-бандла и gulp для css. При успешной сборке вы должны увидеть картинку наподобие этой:

Фактически мы заново собрали новый вариант контрола Dropdown :)

Если появились сообщения об ошибках, то скорее всего в пункте 7 были неверно указаны привязки.

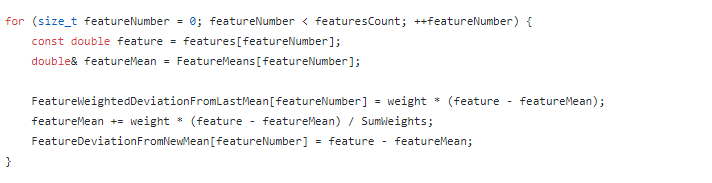

9. Здесь и начинается часть, касаемая кастомизации. Напомню, нам надо реализовать запрос к серверу веб-клиента, чтобы получить массив объектов, содержащих Ид и ФИО пользователей.

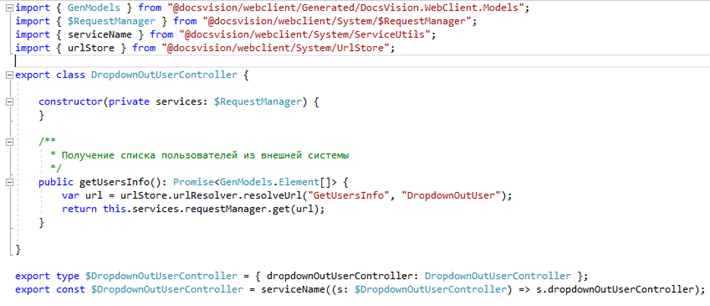

1. Добавим во фронт-проект файл \src\Services\DropdownOutUserController.ts с реализацией сервис-контроллера. Можно написать свой вариант запроса через fetch или XMLHttp, но удобнее воспользоваться имеющимся в DV фронтовым сервисом $RequestManager. Он содержит необходимые компоненты для отправки и получения результатов http-запросов GET и POST. Сервис-контроллер будет содержать один единственный метод getUserInfo, возвращающий через Promise-объект массив элементов GenModels.Element[]

GenModels.Element – уже имеющийся тип(интерфейс) в DV.

Можно использовать любой другой подходящий или создать свой тип. Лишь бы он соответствовал данным, получаемым с сервера при запросе.

2. Для того чтобы воспользоваться созданным сервис-контроллером, его надо не забыть добавить в файле Dropdown.tsx в параметр services:

Импорт добавляем в заголовок файла:

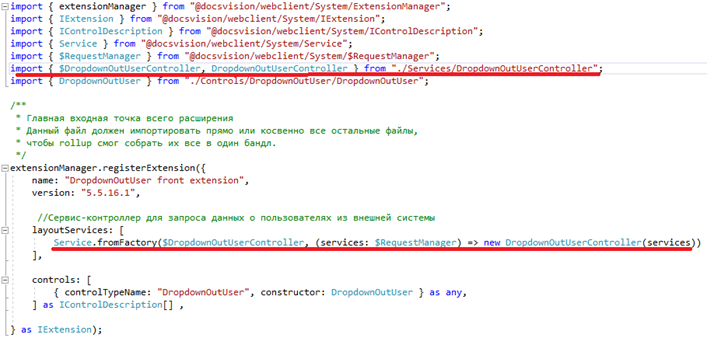

3. Для того чтобы наш контроллер попал в результирующий js-бандл, надо добавить его описание в начальную точку сборки приложения – файл Index.ts по определенным правилам. Это является гарантией того, что сервис-контроллер будет создан и проинициализирован при загрузке нашего контрола.

10. И, наконец, осталось указать в коде вызов нашего сервис контроллера. Для этого удобно использовать методы жизненного цикла React-контролов. Самым подходящим является componentDidMount. Он вызывается сразу после загрузки контрола и первоначального рендеринга. Добавим в него вызов нашего метода getUsersInfo:

После возврата и парсинга результатов запроса (это всё делается в сервисе $RequestManager) в users появляется массив с нужными нам Ид и ФИО пользователей. Остается только присвоить новое значение стейту (переменному параметру react) items в методе setState. setState вызовет повторный рендеринг компоненты и контрол отрисуется уже с полученными значениями в выпадающем списке.

11. Пробуем собрать бандл через команду `npm run build`.

12. Если на этапе 11 не возникло ошибок, полученный бандл DropdownOutUser\DigDes.WC.DropdownOutUser.WE\output\Content\Modules\DigDes.WC.DropdownOutUser.WE\extension.js (а заодно extension.js.map) можно смело скопировать на сервер web-клиента в каталог веб-расширений: “C:\Program Files (x86)\Docsvision\WebClient\5.5\Site\Content\Modules\DigDes.WC.DropdownOutUser.WE”.

Реализация серверного расширения (бэкэнд)

-----------------------------------------

Серверное расширение контрола будет содержать MVC-контроллер с методом, возвращающим Ид и ФИО пользователя из предполагаемой внешней системы. В методе контроллера будем вызывать внутренний сервис, который будет производить запрос данных. Реализация данного сервиса зависит от информационной системы предприятия и в каждом конкретном случае может быть индивидуальной. Это может быть и ADO-клиент для большинства известных БД или .NET клиент для WCF/Web API сервисов и многое другое. Непосредственная разработка этого сервиса в тему данной статьи не входит. В нашей реализации ограничимся возвратом тестового списка с небольшим набором тестовых данных.

Расширение будет исполняться в среде web-клиента DV и должно быть построено по определенным правилам с использованием определенных версий DV-библиотек. [Примеры подобных реализаций есть в репозитории DV](https://github.com/Docsvision/WebClient-Samples/tree/master/Controls/AcquaintancePanel/AcquaintancePanelServerExtension).

**Итак, приступим к реализации.**

1. Для начала создадим в Visual Studio солюшен (DropdownOutUser) и добавим в него проект .Net Framework 4.6 с названием DropdownOutUser.SE (аббревиатура SE – server extension).

2. Также понадобится набор DLL-библиотек специфических версий. К счастью, у DV есть такой каталог <https://github.com/Docsvision/WebClient-Samples/tree/master/Assemblies>. Скопируем его в корень нашего решения.

3. Подключим в проект через “Add Refernces” следующие библиотеки:

* **Autofac.dll** из Assemblies\Autofac (для версий web-клиента 15 и выше)

* **Autofac.Extras.Ordering.dll** из Assemblies\Autofac (для версий web-клиента 15 и выше)

* **DocsVision.BackOffice.ObjectModel.dll** из Assemblies\Docsvision

* **DocsVision.BackOffice.WebClient.dll** из Assemblies\Docsvision

* **DocsVision.Platform.ObjectManager.dll** из Assemblies\Docsvision

* **DocsVision.Platform.ObjectModel.dll** из Assemblies\Docsvision

* **DocsVision.Platform.WebClient.dll** из Assemblies\Docsvision

* **Docsvision.WebClient.Extensibility.dll** из Assemblies\Docsvision

* **DocsVision.WebClientLibrary.ObjectModel.dll** из Assemblies\Docsvision

* **System.Web.Http.dll** из Assemblies\Microsoft

* **System.Web.Mvc.dll** из Assemblies\Microsoft

* **System.Web.Optimization.dll** из Assemblies\Microsoft

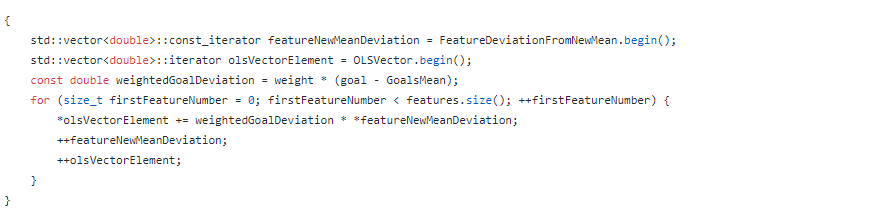

4. Добавим в каталог Controllers нашего проекта файл контроллера DropdownOutUserController.cs. Контроллер наследуется от System.Web.Mvc.Controller.

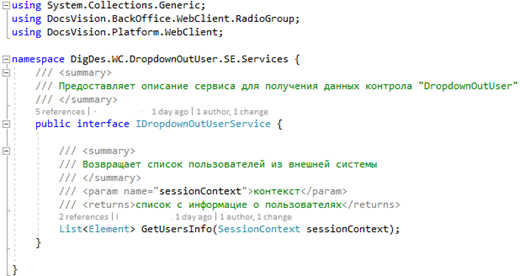

5. Создадим описание интерфейса сервиса, получающего данные из внешней ИС в виде файла IDropdowOutUserService.cs. Для удобства расположим его в отдельном каталоге Services.

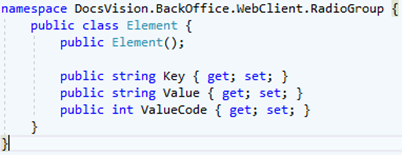

Обратите внимание, что в качестве элемента возвращаемого списка используется имеющийся в DV класс “Element” из пространства имен Docsvision.BackOffice.WebClient.RadioGroup

Класс полностью соответствует фронтовому ts-интерфейсу GenModels.Element из пункта 9.1. Можно создать свою модель. Главный критерий – соответствие модели на фронте.

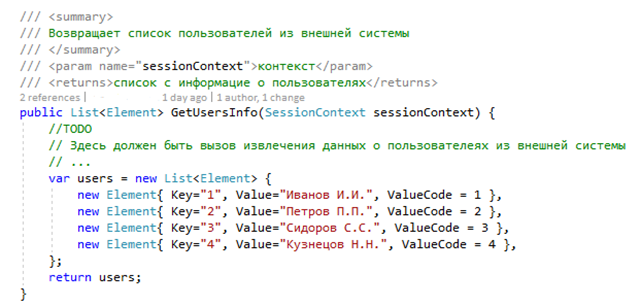

6. Теперь реализуем сервис на основе описанного интерфейса в файле DropdownOutUserService.cs. Единственный метод сервиса GetUsersInfo в нашем случае просто возвращает список “Element” для теста.

В случае наличия «настоящей» ИС рекомендую агрегировать всю логику по аутентификции/авторизации и обработке данных в подобном сервисе.

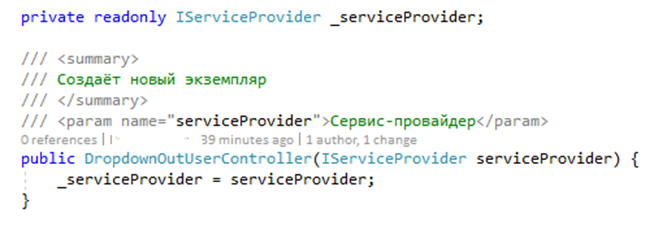

7. Вернемся в файл контроллера и создадим конструктор контроллера с одним входным параметром типа System.IServiceProvider. Сохраним его значение в переменной класса \_serviceProvider.

Данный провайдер может понадобиться в методах сервисов для получения других сервисов и операций с данными DV. В нашем примере он не используется.

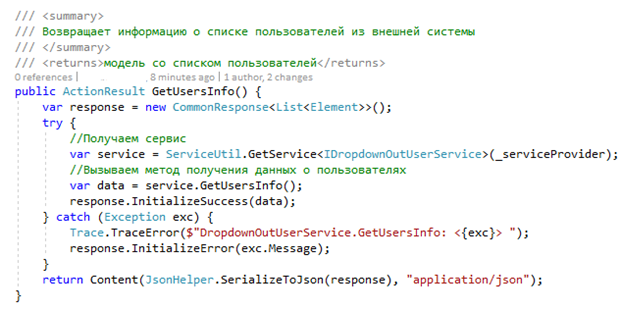

8. Добавим основной метод GetUserInfo в контроллер:

Для извлечения сервиса используем конструкцию ServiceUtil.GetService из пространства имен Docsvision.Platform.WebClient.Helpers. Полученный результат из метода GetUserInfo возвращаем через обертку CommonResponse. Обертка нужна для того, чтобы web-клиент DV мог стандартным образом обработать успешные или ошибочные результаты запроса. Помимо самого списка пользователей со свойствами ответ будет содержать дополнительную информацию. В принципе, можно этого и не делать, но тогда придётся самим обрабатывать ошибки и десериализовывать результаты запроса на фронте. Успешный ответ инициализируем через метод InitializeSuccess, ошибку через InitializeError. В случае ошибки в браузере появится модальное сообщение DV с текстом, указанном в параметре метода.

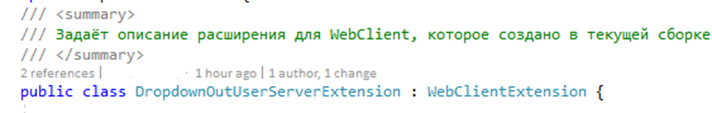

9. Осталось добавить описание расширения в корень текущего проекта DropdownOutUserServerExtension.cs. Описание представляет собой класс, унаследованный от WebClientExtension (пространство имен DocsVision.WebClient.Extensibility).

В версиях web-клиента>=15 потребуется описать созданный нами сервис DropdowOutUserService, а также название и версию расширения. В версиях <15 потребуется описать контроллер и некоторые другие параметры. В DV используется реализация Ioс – контейнера из пакета Autofac.

Теперь при загрузке расширения в среде IIS наш сервис будет гарантированно создан и проинициализирован.

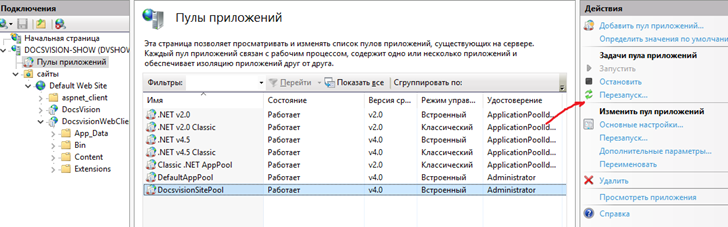

10. Компилируем проект. Полученную сборку переносим на сервер ВК DV в отдельный каталог. В нашем случае это “C:\Program Files (x86)\Docsvision\WebClient\5.5\Site\Extensions\DropdownOutUser.SE\DropdownOutUser.SE.dll”.

После этого пул приложений в IIS, к которому привязан web-клиент DV, необходимо перезапустить.

Остановка пула и веб-сайта также потребуется, если вы захотите обновить сборку, так как она будет блокирована.

Если после запуска пула/сайта в журнале web-клиента (по умолчанию, C:\Program Files (x86)\Docsvision\WebClient\5.5\Logs\WebClient.log) не было зафиксировано явных ошибок, то мы практически в шаге от успеха :)

### Реализация расширения для конструктора разметок (КР)

Для того чтобы наш контрол DropdownOutUser можно было добавлять в нужное место разрабатываемой разметки во встроенном WYSIWUG-редакторе, необходимо создать дополнительную библиотеку – расширение конструктора разметок. Расширение создается по определенным правилам с использованием библиотек DV.

1. Добавим в наше решение еще один .Net – проект с названием DropdownOutUser.DE (здесь аббревиатура DE-designer extension).

2. В пункте 2 реализации SE мы уже обращались к каталогу Assemblies. Теперь через “Add References” подключите к проекту следующие сборки:

* **DocsVision.BackOffice.ObjectModel.dll** из Assemblies\Docsvision

* **DocsVision.BackOffice.WebClient.dll** из Assemblies\Docsvision

* **DocsVision.LayoutEditor.ObjectModel.dll** из Assemblies\Docsvision

* **DocsVision.Platform.ObjectManager.dll** из Assemblies\Docsvision

* **DocsVision.Platform.ObjectModel.dll** из Assemblies\Docsvision

* **DocsVision.Platform.StorageServer.dll** из Assemblies\Docsvision

* **DocsVision.Platform.WebClient.dll** из Assemblies\Docsvision

* **DocsVision.Platform.WebLayoutsDesignerExtension.dll** из Assemblies\Docsvision

* **DocsVision.WebClient.Extensibility.dll** из Assemblies\Docsvision

* **DocsVision.WebClientLibrary.ObjectModel.dll** из Assemblies\Docsvision

* **WebLayoutsDesigner.exe** из Assemblies\Docsvision

* **Xceed.Wpf.Toolkit.Fixed.dll** из Assemblies\Others

3. Добавим файл с ресурсами Resources.resx – для англоязычной и Resources.ru.resx – для русскоязычной версий.

Укажем в них параметры:

* ControlName – отображаемое название контрола в КР

* ControlGroup – отображаемое название группы контролов в КР

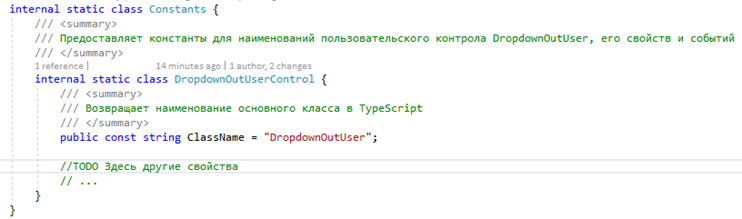

4. Создадим статический класс с константами. Укажем обязательную константу ClassName с названием контрола. Оно понадобится DV для поиска соответствующего js-класса на фронте.

5. Добавим файл DropdownOutUserDesignerExtension.cs с описанием расширения. Он содержит класс унаследованный от WebLayoutsDesignerExtension (пространство имен DocsVision.Platform.Tools.LayoutEditor.Extensibility).

В этом классе необходимо описать как необходимые для работы контрола стандартные параметры, так и дополнительные кастомные. Например, это может быть имя внешней БД или сервиса. При загрузке страницы эти свойства будут передаваться в ts-класс, описывающий параметры нашего контрола (DropdownOutUserParams). В нашем проекте таких параметров нет.

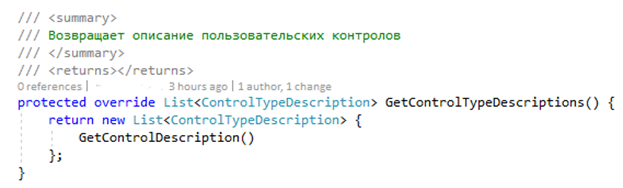

6. Основная декларация контрола происходит в методе GetControlTypeDescriptions. Метод возвращает список описаний контролов.

У нас один контрол, параметры которого задаются в GetControlDescription.

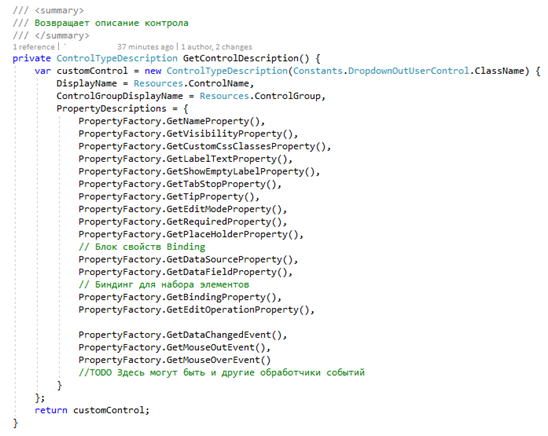

Создаем класс описание через new ControlTypeDescription с указанием имени контрола в качестве параметра конструктора. В свойствах задаем отображаемое в КР имя и группу из пункта 3. В объект PropertyDescriptions добавляем фабрики свойств PropertyFactory для отображаемых в правой части КР параметров.

Среди них стоит отметить GetDataSourceProperty и GetDataFieldPropertу. Методы отвечают за создание свойств для указания секции и поля DV с целью сохранения выбранного значения.

7. Компилируем сборку. Полученную библиотеку DropdownOutUser.DE.dll и папку с ресурсами копируем в каталог на сервере web-клиента DV: “C:\Program Files (x86)\Docsvision\WebClient\5.5\Plugins\DropdownOutUser.DE”

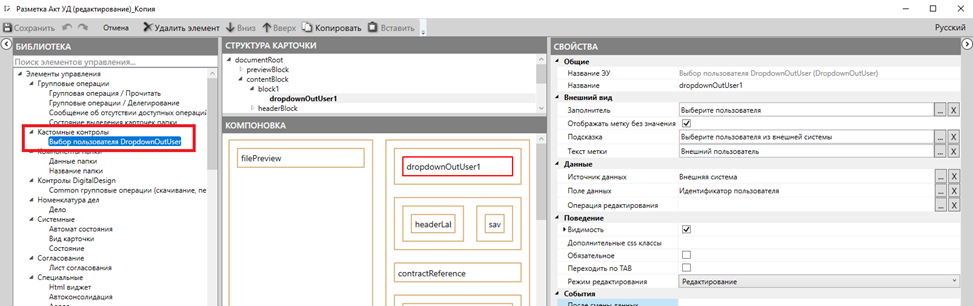

8. Запускаем КР и выбираем подходящую разметку, в которую будем добавлять наш контрол. Например, пусть это будет копия стандартной разметки договорного акта. Если всё было сделано верно, в левой части КР должен появиться наш контрол в указанной в пункте 3 группе контролов:

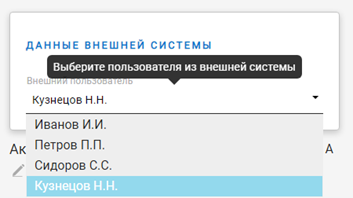

Вставьте драг-н-дропом его в нужный блок разметки. Укажите секцию и поле DV для сохранения выбранного значения в параметрах “Источник данных” и “Поле данных”. Сохраните разметку.

### Запуск и проверка в браузере

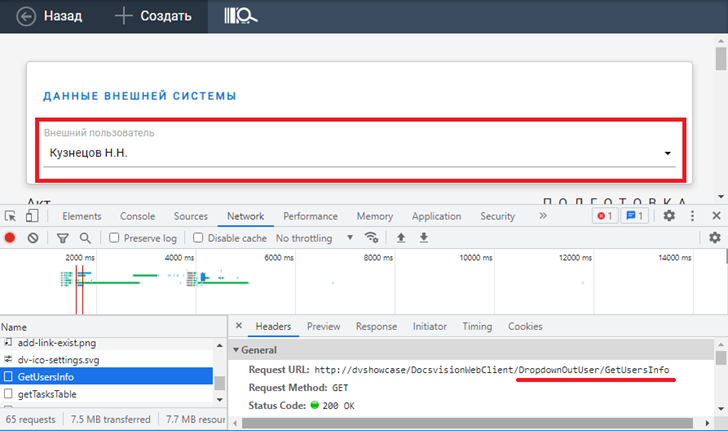

Запустим созданную разметку в браузере и проверим результат работы средствами разработчика в браузере (F12):

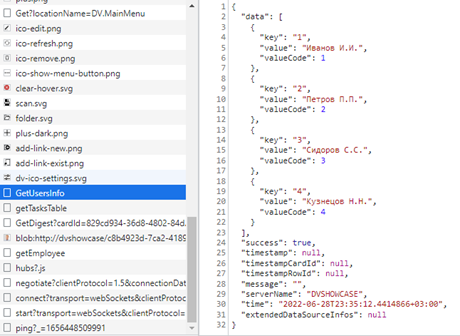

В разделе Network должен появиться вызов метода DropdownOutUser/GetUsersInfo со статусом 200. В разделе Response должны отобразиться полученные из “внешней системы” данные:

Обратите внимание, что помимо json-массива с описанием пользователей присутствуют дополнительные свойства: “success”, “time”, “timestamp” и некоторые другие. Это те самые поля, необходимые для стандартной обработки запросов средствами web-клиента DV.

Мы не добавляли дополнительных css-классов. Визуальное поведение контрола DropdownOutUser ничем не должно отличаться от его “прародителя” – Dropdown.

Спасибо за прочтение!

> [**Репозиторий с исходниками решения**](https://github.com/postilya1972/DropdownOutUser)

>

> | https://habr.com/ru/post/675980/ | null | ru | null |

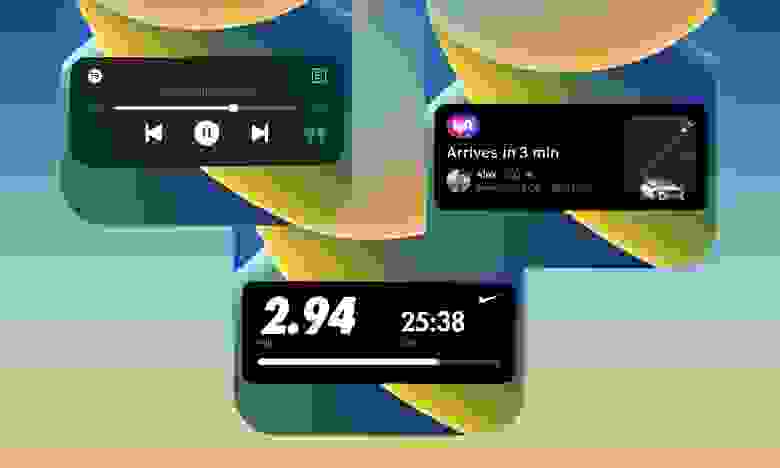

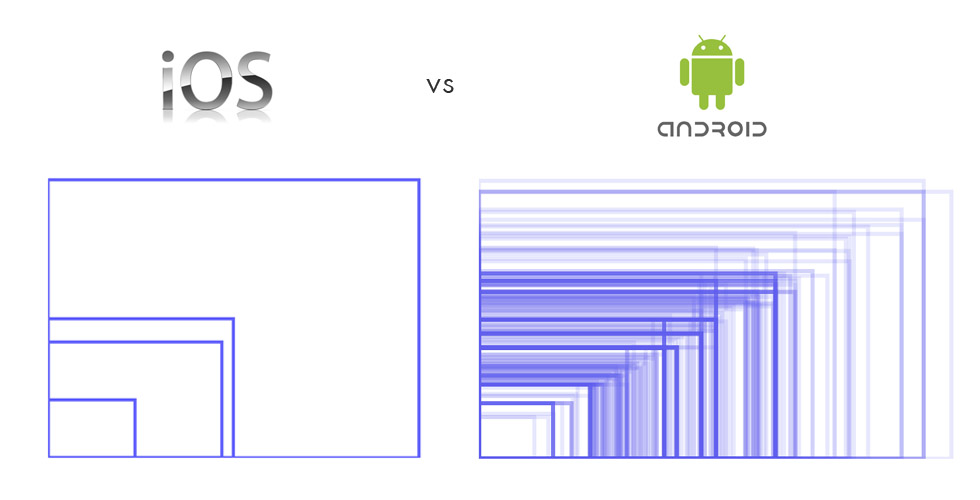

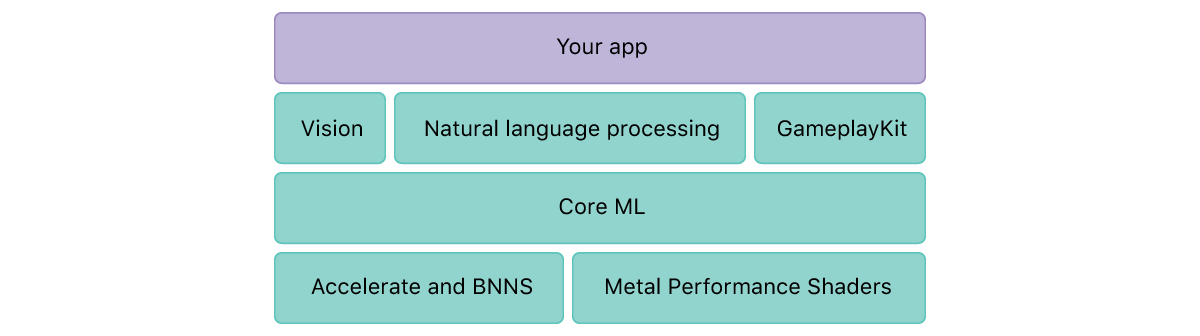

# «Оживляем» наше iOS-приложение с помощью Live Activity

В то время как Android-устройства в целом ушли в направлении простых вырезов в экране под фронтальную камеру или даже подэкранных фронталок, Apple создала совершенно новый пользовательский опыт благодаря своему новому пространству для размещения камеры — «челке» (the notch). Сегодня мы с вами обсудим, как реализовать нечто подобное в iOS.

Виджеты, которые Apple представила в iOS 14, позволяют нам просматривать информацию прямо на наших главных экранах.

Но что, если мы пойдем еще дальше и представим контекстно-зависимую информацию, которая всплывает при необходимости и не задерживается на экране слишком долго? А что, если бы это было реализовано таким образом, чтобы все это гармонично работало с самым большим обновлением для фронтальной панели, которое наши iPhone видели с момента появления челки? Больше никаких «а что, если» — встречайте Dynamic Island.

Мы уже делились своими впечатлениями о [Dynamic Island и Live Activities с точки зрения дизайна](https://infinum.com/blog/start-designing-for-dynamic-island-and-live-activities/), и теперь пришло время показать вам, как можно их реализовать.

iPhone 14 Pro и 14 Pro Max — единственные устройства, поддерживающие Dynamic Island, но Live Activity поддерживаются всеми телефонами, на которых может быть установлена iOS 16.1. Итак, давайте разберемся, что необходимо для их интеграции в ваши приложения.

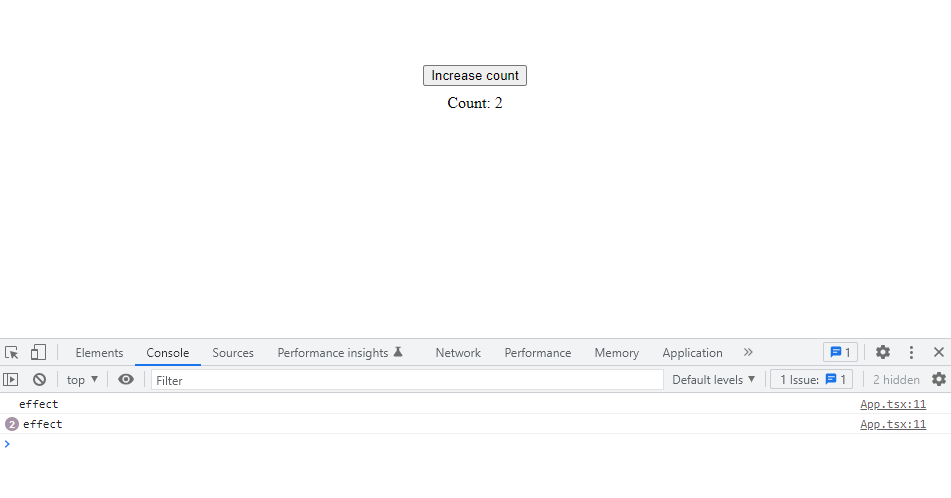

#### Жизненный цикл Live Activity

Жизненный цикл — это одна из самых важных вещей, которые следует учитывать при создании приложений. Live Activity может находиться в трех состояниях:

* Еще не запущено

* Запущено

* Завершено

Ваше приложение может иметь несколько Live Activity одновременно, поэтому очень важно отслеживать каждое Activity. Перед запуском Activity необходимо указать, какие данные оно должно использовать. Поскольку мы говорим о Live Activity, вы можете догадаться, что некоторые данные будут меняться с течением времени. Данные вашей Live Activity разделены на динамические и статические. Динамические данные могут обновляться с течением времени, а статические — нет.

В качестве примера давайте рассмотрим `FormulaAttributes`, которая будет содержать оба типа данных:

```

struct FormulaAttributes: ActivityAttributes {

public typealias RaceState = ContentState

// Здесь вы предоставляете динамические данные

public struct ContentState: Codable, Hashable {

var driverInFront: String

var driverTeam: String

}

// А здесь вы предоставляете статические данные

var lastPlaceDriver: String

}

```

После того, как Activity было запущено, оно может существовать в течение восьми часов, прежде чем оно будет остановлена системой. Восьми часов более чем достаточно для большинства вариантов использования Activity, но иногда у пользователей могут случаться восьмичасовые перелеты, и тогда это восьмичасовое ограничение может вызывать некоторые сложности.

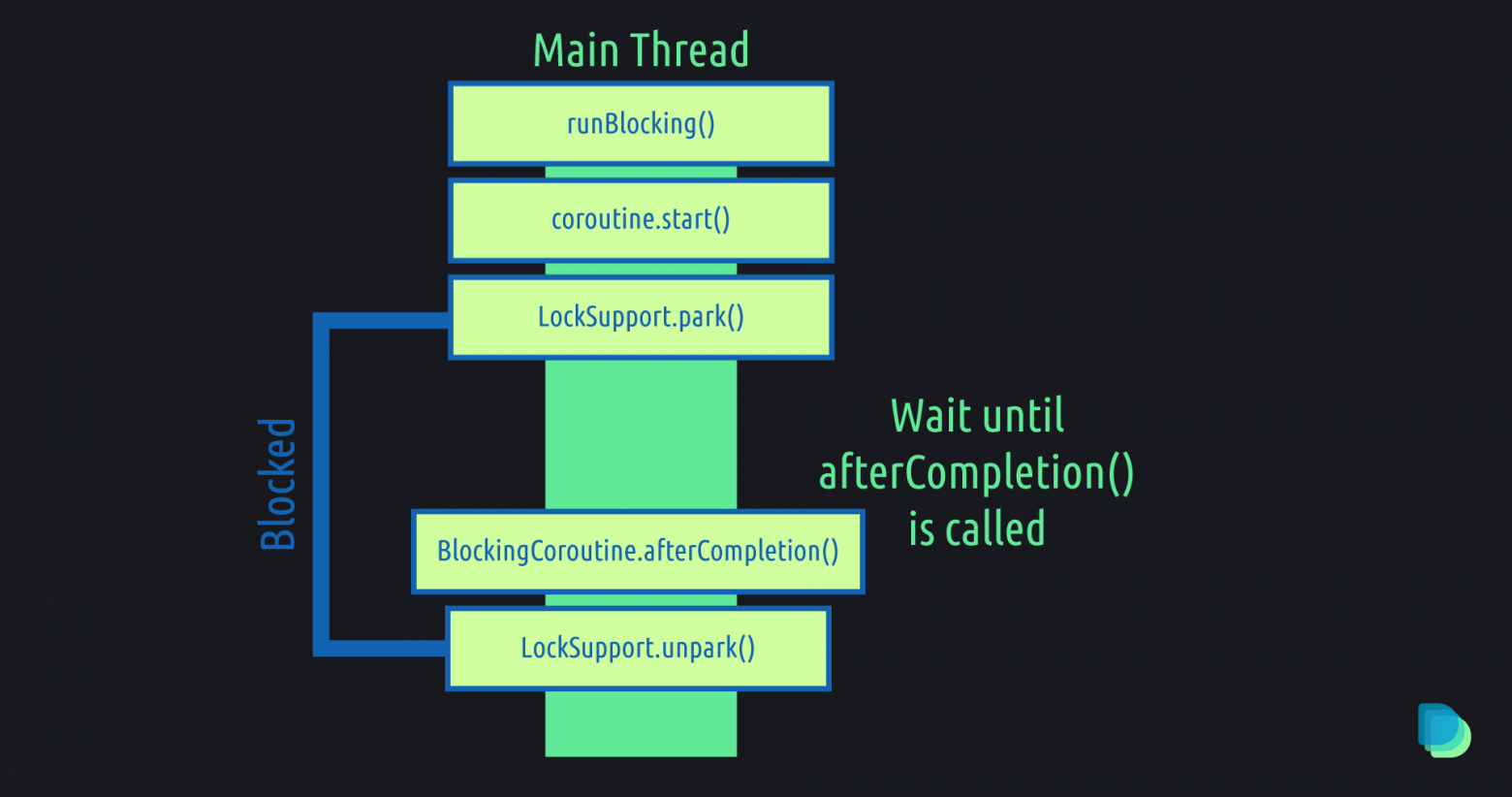

Как только Live Activity запущено и работает, вы можете обновлять динамические данные этого Activity. Следует отметить, что вы не можете обновлять Live Activity посредством вызовов API, как вы можете это делать с другими виджетами. Вместо этого вы должны обновлять его через ваше приложение или push-уведомления.

После того, как вы завершите его, по умолчанию Live Activity по-прежнему будет доступно на экране блокировки еще четыре часа. Вы можете указать, хотите ли вы немедленно уничтожить Live Activity на экране блокировки, в противном случае система сама сделает это за вас через четыре часа.

Убедитесь, что вы обновили Live Activity после его завершения, если вы не сразу удаляете его с экрана блокировки, чтобы отобразить правильное состояние. Таким образом, ваши пользователи будут видеть актуальную информацию и знать, что Live Activity было завершено с последними результатами.

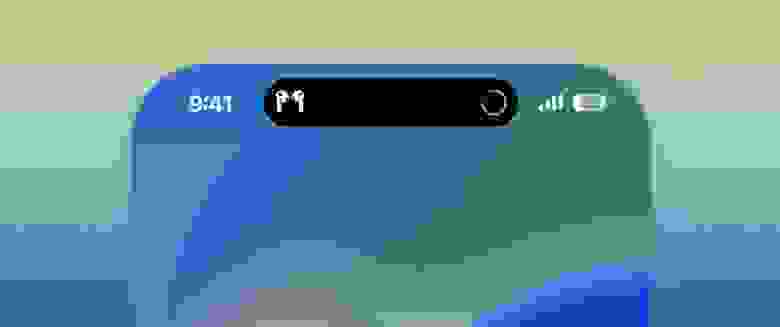

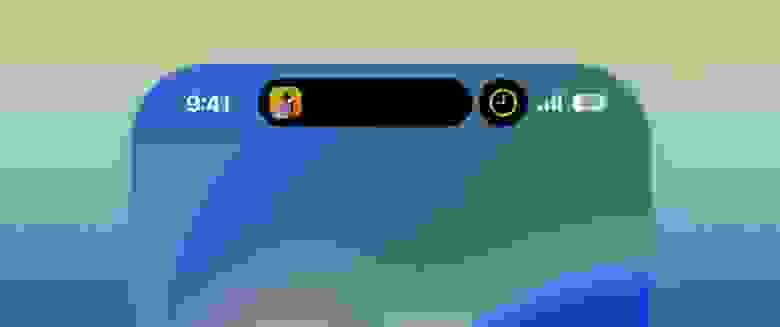

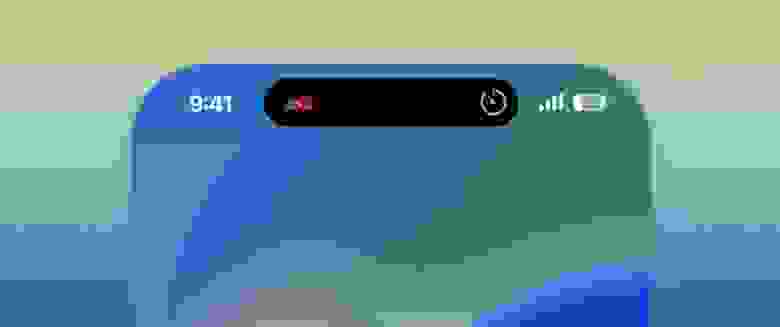

#### Сколько у Live Activity представлений?

Как упоминалось ранее, вы можете отображать Live Activity на экране блокировки, Dynamic Island или баннере на устройствах, которые не поддерживают Dynamic Island. При разработке для устройств с поддержкой Dynamic Island существует пять представлений:

* Минимальное (Minimal)

* Ведущее (Leading)

* Замыкающее (Trailing)

* Расширенное (Expanded)

* Для экрана блокировки (Lock Screen)

Каждое из этих представлений может сильно отличаться от остальных.

#### Минимальное представление

Как следует из названия, оно должно быть минимальным. Например, это может быть изображение, которое однозначно представляет ваше приложение. Минимальное представление отображается с правой стороны от Dynamic Island (с небольшим отступом), когда одновременно запущены сразу несколько Live Activity. Тап по представлению приведет пользователя прямо в ваше приложение.

#### Ведущее и замыкающее представления

Ведущее (Leading) представление будет отображаться в левой части Dynamic Island. Вы можете отобразить какую-нибудь актуальную информацию из вашего приложения, связанную с Live Activity. Но старайтесь сильно не перегружать информацией это представление.

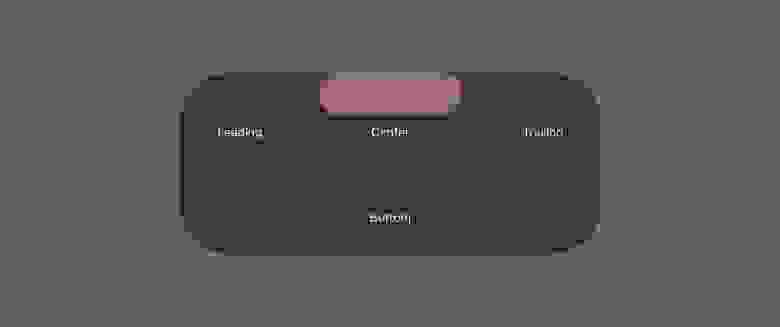

Замыкающее (Trailing) представление будет отображаться с правой стороны Dynamic Island. Оно работает точно так же, как ведущее представление, которое вы можете наблюдать на изображении, где представлен пример Live Activity для отслеживания Formula1, над которым мы будем работать в этом примере.

#### Расширенное представление

Расширенное (Expanded) представление отображается если пользователь зажимает Live Activity. Оно используется для отображения дополнительной информации об Activity. В нашем примере мы будем держать пользователя в курсе, какой гонщик лидирует, а какой движется последним. Как вы можете видеть на изображении ниже, Макс уже на первом месте, а Латифи на последнем — вполне привычное зрелище, если вы следите за F1 в последнее время.

Этот пример довольно прост — вы можете кастомизировать его, настроив представления в определенных областях расширенного представления, и система сама попытается все правильно соразмерить на основе предоставленных вами представлений. На изображении ниже вы можете увидеть, какие области есть в расширенным представлением.

#### Представление для экрана блокировки

Мы будем использовать аналогичный пример, чтобы показать, как это выглядит на экране блокировки. Важным моментом здесь является то, что в этом случае мы можем использовать другое представление. Это позволяет нам повторно использовать существующий пользовательский интерфейс или создавать новые представления в зависимости от ситуации для Dynamic Island и Live Activity отдельно. Ниже представлен пример, демонстрирующий это.

#### Создаем наше первое Live Activity

Прежде всего, Live Activity доступны в iOS 16.1, и в этом примере я буду использовать Beta Xcode 14.1.

После того, как вы решили, какое приложение вы хотите “оживить”, зайдите в Xcode и в разделе “Targets” найдите знак “+”, где вы сможете добавить расширение с виджетами (Widget Extension).

После того, как вы добавили расширение с виджетами, проследуйте в файл **Info.plist** вашего приложения, добавьте логический флаг для разрешения “Supports Live Activities” и установите для него значение “YES”.

Теперь мы готовы начинать представление. Во-первых, мы определим `FormulaAttributes`, который я упоминал выше. Он соответствует протоколу `ActivityAttributes`, который помогает нам определять динамические данные внутри нашей структуры. Убедитесь, что при создании файла `FormulaAttributes.swift` вы включаете его как в таргеты и приложения, и виджета.

Прежде чем мы углубимся в код, хочу предупредить, при запуске Activity ваше приложение должно быть на переднем плане (*foreground*), в то время как вы можете обновить или завершить его можно уже и в фоновом режиме (*background*).

### Запуск Live Activity

Сначала мы добавим кнопку и ссылку на наше Activity внутри `ContentView`. Activity будет установлено как опциональное, поскольку мы хотим создать его, когда оно нам понадобится, а ссылку нам нужно сохранить, чтобы мы могли позже обновить правильное Live Activity.

```

struct ContentView: View {

@State var activity: Activity?

var body: some View {

VStack(spacing: 20) {

Button(action: { activity = startActivity() }, label: { Text("Start Activity") })

}

}

}

```

Компилятор жалуется нам, что нет функции `startActivity`, поэтому мы добавим его в приватное расширение `ContentView`. Функция `startActivity` возвращает только что созданное Activity.

```

private extension ContentView {

func startActivity() -> Activity<FormulaAttributes>? {

var activity: Activity<FormulaAttributes>?

let attributes = FormulaAttributes(lastPlaceDriver: "Nicholas Latifi")

do {

let contentState = FormulaAttributes.ContentState(

driverInFront: "Max Verstappen",

driverTeam: "Red Bull racing"

)

activity = try Activity<FormulaAttributes>.request(attributes: attributes, contentState: contentState)

} catch {

print(error.localizedDescription)

}

return activity

}

}

```

Теперь, когда мы рассмотрели реализацию нашего Live Activity, мы можем приступить к изучению обновлений Activity.

#### Обновление Live Activity

Добавьте еще одну кнопку внутри `ContentView`, точно такую же, как мы добавили, чтобы запустить Activity и вызвать `updateActivity`. Внутри приватного расширения `ContentView` добавьте следующую функцию:

```

func updateActivity() {

Task {

let contentState = FormulaAttributes.ContentState(

driverInFront: "not Lewis Hamilton",

driverTeam: "Mercedes"

)

await activity?.update(using: contentState)

}

}

```

Функция получит ссылку, которую мы сохранили для нашей Activity, и вызовет функцию`.update(using:)` с новым содержимым. Она обернута в `Task`, так как это асинхронная функция.

В этом примере показано, как обновить наше Live Activity из приложения, но, как упоминалось ранее, вы также можете сделать это с помощью push-уведомлений. Код будет немного отличаться от нашего примера — вам нужно будет запустить Live Activity, указав параметр `pushType`. Чтобы оно могло получать уведомления, вам нужно будет отправить `pushToken` из вашей Live Activity на сервер.

#### Завершение Live Activity

Завершение Live Activity также можно выполнить из приложения и с помощью уведомлений. Как я уже упоминал ранее, убедитесь, что вы обновили Live Activity актуальной информацией, прежде чем завершить его.

Добавьте еще одну кнопку в `ContentView`, которая будет ссылаться на функцию `endActivity`. Внутри приватного расширения `ContentView` добавьте следующую функцию:

```

func endActivity() {

Task {

for activity in Activity.activities {

await activity.end(dismissalPolicy: .immediate)

}

}

}

```

Функция `endActivity` проходит через все запущенные Live Activity с `FormulaAttributes` и завершает их, указав, что они должны немедленно удалить Activity с экрана блокировки. Как и функция `update(using:)`, `end(dismissalPolicy:)` также является асинхронной функцией.

#### Пользовательский интерфейс Live Activity

Поскольку в этом примере мы используем только виджет Live Activity, мы снабдим его аннотацией `[@main](/users/main)[@main](/users/main)`. Если вы используете больше виджетов, сгруппируйте их в `WidgetBundle`. В приведенном ниже коде показан пользовательский интерфейс для виджета Formula1, который использовался для создания предыдущих скриншотов.

```

@main

struct FormulaActivityWidget: Widget {

var body: some WidgetConfiguration {

ActivityConfiguration(for: FormulaAttributes.self) { context in

// Создайте здесь представление, которое будет отображаться на экране блокировки и на главном экране в виде баннера

// Для устройств, которые не поддерживают Dynamic Island

} dynamicIsland: { context in

DynamicIsland {

// Это содержимое будет отображаться, когда пользователь расширяет Island

DynamicIslandExpandedRegion(.center) {

VStack {

Text("Driver in front is \(context.state.driverInFront) 🏎")

Text("Last place driver is \(context.attributes.lastPlaceDriver)")

}

}

} compactLeading: {

// Это представление отображается в левой части Dynamic Island

Text("🏎")

} compactTrailing: {

// Это представление отображается в правой части Dynamic Island

Image(systemName: "timer")

} minimal: {

// Это представление будет отображаться, когда одновременно запущено несколько Activity

Text("🏎")

}

}

}

}

```

Внутри виджета мы указываем `ActivityConfiguration` и какие атрибуты он будет использовать. Сначала мы настроим представления на Dynamic Island, а потом добавим представление экран блокировки.

Чтобы упростить пример, я использовал только центральную область расширенного представления, внутри которого собираюсь установить некоторые данные. После этого будет замыкание, описывающее, какую часть Dynamic Island оно покрывает, чтобы вы могли разместить любое представление, который вы хотите, чтобы он отображал.

Теперь мы можем настроить экран блокировки и домашний баннер. Вот представление экрана блокировки, которое будет иметь ссылку на контекст из наших атрибутов, чтобы его можно было правильно обновить.

```

struct LockScreenLiveActivityView: View {

let context: ActivityViewContext

var body: some View {

VStack {

Text(“Driver in front is \(context.state.driverInFront) 🏎“)

Spacer()

Text(“Last place driver is \(context.attributes.lastPlaceDriver) 🏎“)

}

.activitySystemActionForegroundColor(.white)

.activityBackgroundTint(.cyan)

}

}

```

После того, как вы создали представление для экрана блокировки, инициализируйте его внутри замыкания для `ActivityConfiguration`. Вот и все, теперь вы можете запустить приложение и протестировать его.

### Добавление диплинка внутри расширенного представления

Поскольку Live Activity — это виджет, он может создавать глубокие ссылки (DeepLink) на ваше приложение. Каждое представление Live Activity может вести к разным местам внутри вашего приложения, но Apple по-прежнему рекомендует, чтобы ведущее и замыкающее представления вели к одному и тому же месту. DeepLinking — отличный инструмент для добавления в расширенное представление, где у вас может быть несколько представлений, некоторые из которых могут перемещаться туда, куда вам нужно.

#### Вещи, на которые следует обратить внимание в

* Live Activity, можно отключить в настройках приложении. Вы можете проверять, сделано ли это, и предоставить пользователю грамотное объяснение, сообщив ему, что он упускает.

* Обязательно уделите внимание обработке ошибок. Пользователи могут запускать несколько Live Activity одновременно, да вы и сами можете достичь состояния, когда ваше приложение запускает слишком много Activity. В ваших же интересах убедиться, что такой сценарий исключен.

* Система игнорирует любые модификаторы анимации при определении пользовательского интерфейса Live Activity, но вы можете изменить анимацию, которую Apple использует, чтобы создать более уникальный опыт.

* Live Activity будет отображаться в темной цветовой схеме, когда включена функция Always-On Retina

* Используйте обновления приложений вместе с обновлениями push-уведомлений. Иногда пользователь может не получить push-уведомление из-за отсутствия подключения к интернету или из-за того, что Live Activity завершилась.

* При использовании push-уведомлений учитывайте, что система может ограничить ваши push-уведомления, и пользователь может не получить их, если вы отправили их слишком много. Это очень важно, если вы создаете Live Activity для такой темы, как Formula1, где у вас будет очень много обновлений. Один из способов повысить шансы отправки push-уведомления — седлать его низкоприоритетным, но никто не может гарантировать, что пользователь его получит.

* Система может отображать Live Activity даже на устройствах, которые не поддерживают Dynamic Island в виде баннера на главном экране, но только в том случае, если приложение определяет, что обновление достаточно важно, чтобы отвлекать на себя пользователя.

#### Финишная черта

Live Activity — это новый способ мгновенного отображения информации. Анимации и различные представления делают Live Activity уникальными среди других виджетов. Адаптируйте Live Activity к потребностям вашего приложения и сделайте их уникальным, но приятным для пользователей опытом.

PS: Нам, вероятно, даже не нужно обновлять наше Live Activity, так как Макс, скорее всего, в очередной раз выиграл.

---

Материал подготовлен в преддверии старта курса ["iOS Developer. Professional"](https://otus.pw/zaQ9/)

Недавно прошел открытый урок «Пример реализации технологии Flux на SwiftUI», на котором мы рассмотрели некоторые проблемы и сложности реализации MVVM на SwiftUI, а также попробовали применить Flux архитектуру для реализации небольшого приложения. Если интересно, запись вебинара можно посмотреть [по ссылке.](https://otus.pw/9H6M/) | https://habr.com/ru/post/701104/ | null | ru | null |

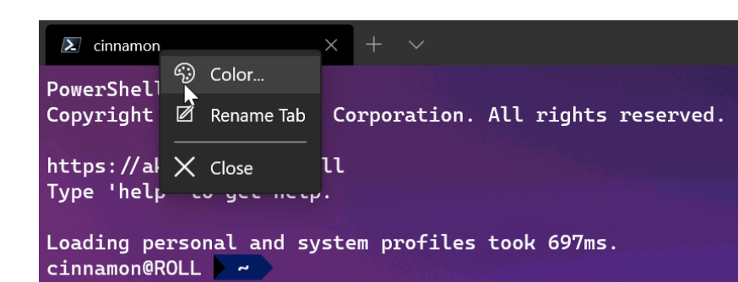

# 3 пути кастомизации Windows Terminal

Привет, Хабр! Начиная с момента [анонса](https://habr.com/ru/company/microsoft/blog/452338/) на Microsoft Build 2019 и заканчивая выпусками версий [1.0](https://habr.com/ru/company/microsoft/blog/502944/), [1.1](https://habr.com/ru/company/microsoft/blog/507680/) и [1.2](https://habr.com/ru/company/microsoft/blog/512638/), Терминал вызывает большой интерес со стороны сообщества разработчиков. Мы очень рады этому и стараемся реализовывать все больше полезных и интересных функций.

Сегодня представляем вашему вниманию 3 пути кастомизации [Windows Terminal](https://www.microsoft.com/ru-ru/p/windows-terminal/9n0dx20hk701?activetab=pivot:overviewtab). Среди них настройки цветовых схем, настройки вкладок, настройки курсоров. Заглядывайте под кат!

Windows Terminal представляет собой новое, современное, быстрое, эффективное, мощное и производительное приложение терминала для пользователей таких программ и оболочек командной строки, как Command Prompt, PowerShell и WSL.

К его основным функциям можно отнести поддержку нескольких вкладок, панелей, символов Unicode и UTF-8, модуль отрисовки текста с ускоренным GPU, а также возможность создания собственных тем и настройки текста, цвета, фона и привязок клавиш.

Сегодня мы рассмотрим три варианта настройки Терминала в соответствии с вашими предпочтениями цвета, курсора и вкладок.

Выберите свои цвета

-------------------

Windows Terminal включает следующие [цветовые схемы](https://docs.microsoft.com/en-us/windows/terminal/customize-settings/color-schemes) в файл defaults.json:

* Campbell

* Campbell Powershell

* Vintage

* One Half Dark

* One Half Light

* Solarized Dark

* Solarized Light

* Tango Dark

* Tango Light

Доступ к данному файлу можно получить, удерживая клавишу Alt и нажимая кнопку «Settings».

Для наглядности ниже представлена схема Vintage:

Чтобы настроить схему внутри одного из профилей командной строки, добавьте свойство colorScheme с именем цветовой схемы в качестве значения.

```

“colorScheme”: “COLOR SCHEME NAME”

```

Каждый параметр, кроме имени, принимает значение цвета в виде строки в шестнадцатеричном формате («#rgb» или «#rrggbb»). Параметры cursorColor и selectionBackground являются необязательными.

**Имя свойства:** theme

**Степень необходимости:** Необязательный

**Принимает:** “system”, “dark”, “light”

**Значение по умолчанию:** “system”

Создайте свой курсор

--------------------

Вне зависимости от того, являетесь ли вы приверженцем «старой школы» или «современной», Терминал предлагает полный набор параметров (отвечающих за форму, цвет и высоту), позволяющих создать курсор на любой вкус.

Вы предпочитаете горизонтальный или вертикальный курсор? Линию или «box»? Просто скажите Терминалу.

Этот параметр задает форму курсора для профиля. Возможны следующие курсоры: “bar” ( ┃ ), “vintage” ( ▃ ), “underscore” ( ▁ ), “filledBox” ( █ ), “emptyBox” ( ▯ ).

**Имя свойства:** cursorShape

**Степень необходимости:** Необязательный

**Принимает:** “bar”, “vintage”, “underscore”, “filledBox”, “emptyBox”

**Значение по умолчанию:** “bar”

Вы можете переопределить cursorColor, установленный в цветовой схеме, если задано значение colorScheme. Принимает значение цвета в виде строки в шестнадцатеричном формате (“#rgb” или “#rrggbb”).

cursorHeight задает процентную высоту курсора, начиная с нижнего. Это будет работать только в том случае, если для параметра cursorShape задано значение “vintage”. Принимаются целые числа от 25 до 100.

Настройте вкладки по своему вкусу

---------------------------------

В Windows Terminal вы можете легко [переименовывать и перекрашивать](https://docs.microsoft.com/en-us/windows/terminal/tips-and-tricks) вкладки. Просто щелкните правой кнопкой мыши вкладку и выберите «Rename Tab», чтобы переименовать вкладку для текущего сеанса. Этот параметр изменит заголовок вкладки на текстовое поле, куда можно будет ввести свое название.

Сделайте то же самое, чтобы перекрасить вкладку. Выберите цвет в заранее определенном списке или нажмите «Custom», чтобы выбрать цвет из палитры либо задать нужный с помощью значения RGB/HSV или шестнадцатеричного значения.

**Совет:** используйте тот же оттенок, который используется в качестве цвета фона для получения красивого бесшовного окна!

Для получения большей информации о параметрах вкладок, рекомендуем ознакомиться с [данным](https://docs.microsoft.com/en-us/windows/terminal/tutorials/tab-title) руководством.

Также советуем загрузить Windows Terminal Preview из [Microsoft Store](https://aka.ms/terminal-preview) или со страницы выпусков на [GitHub](https://github.com/microsoft/terminal/releases). Благодаря ему вы можете быть вовлечены в разработку Windows Terminal и использовать новейшие функции, как только они будут разработаны. | https://habr.com/ru/post/514598/ | null | ru | null |

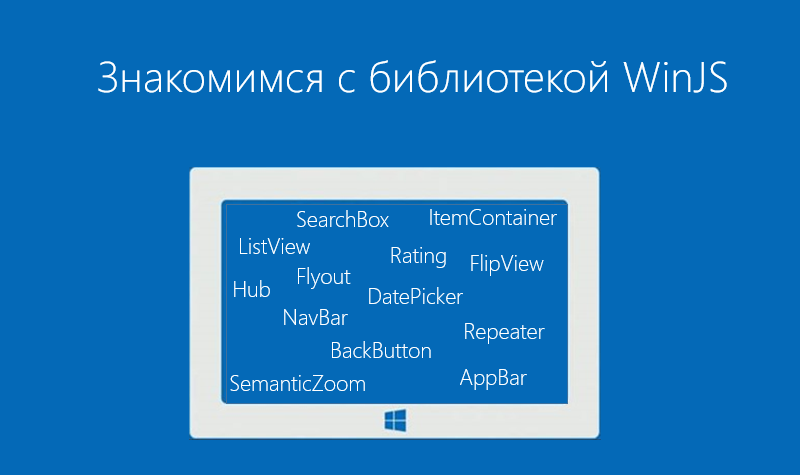

# Знакомимся с элементами управления библиотеки WinJS

Всем привет!

Сегодня мы с вами будем говорить об элементах управления библиотеки WinJS, об основных вещах, которые нужно знать при создании приложений с ее помощью.

Библиотека WinJS в [текущей версии](https://github.com/winjs/winjs/wiki/How-to-create-a-custom-build-of-WinJS) состоит из двух частей: base.js и ui.js, отвечающих, соответственно, за ряд базовой функциональности и создание элементов управления и работу с ними. Для стилизации элементов управления к библиотеке также прилагаются наборы стилей ui-light.css и ui-dark.css.

Давайте познакомимся с ui-частью, с основными элементами управления, входящими в библиотеку WinJS, а также рассмотрим базовые вещи, необходимые для работы с WinJS.

Основные элементы управления, входящие в библиотеку WinJS

---------------------------------------------------------

| | | |

| --- | --- | --- |

| **Элемент управления** | **Описание** | **Визуальное отображение** |

| **[AppBar](http://msdn.microsoft.com/ru-ru/library/windows/apps/br229670.aspx)** | Панель приложения с набором команд. | |

| **[BackButton](http://msdn.microsoft.com/ru-ru/library/windows/apps/dn255082.aspx)** | Кнопка «Назад» для перехода к предыдущему экрану. В Windows Phone имеет встроенную аппаратную или программную реализацию. | |

| **[DatePicker](http://msdn.microsoft.com/ru-ru/library/windows/apps/br211681.aspx)** | Элемент управления для выбора даты. Позволяет выбрать месяц, день и год. | |

| **[FlipView](http://msdn.microsoft.com/ru-ru/library/windows/apps/br211711.aspx)** | Элемент управления FlipView используется для отображения коллекции элементов. В каждый момент времени отображается только один объект. | |

| **[Flyout](http://msdn.microsoft.com/ru-ru/library/windows/apps/br211726.aspx)** | Элемент управления Flyout используется для отображения всплывающего окна на странице. Его можно также применять для вывода различных предупреждений, сообщений. | |

| **[ListView](http://msdn.microsoft.com/ru-ru/library/windows/apps/br211837.aspx)** | Элемент управления ListView является одним из основных элементов в библиотеке WinJS. С его помощью вы можете отображать различные списки объектов – файлы, фотографии, фильмы и т.д. | |

| **[ItemContainer](http://msdn.microsoft.com/ru-ru/library/windows/apps/dn255188.aspx)** | Создает элемент, по которому можно проводить пальцем, сжимать и перетаскивать. Используйте ItemContainer, когда необходимо отобразить элементы, но нет потребности во всех возможностях элемента управления ListView. | |

| **[NavBar](http://msdn.microsoft.com/ru-ru/library/windows/apps/dn301893.aspx)** | Тип панели приложения AppBar, отображающий команды навигации. | |

| **[Rating](http://msdn.microsoft.com/ru-ru/library/windows/apps/br211895.aspx)** | Позволяет вводить и отображать поставленные оценки. По умолчанию можно выставлять оценки от 1 до 5 посредством выбора соответствующего количества звезд. | |

| **[Repeater](http://msdn.microsoft.com/ru-ru/library/windows/apps/dn301916.aspx)** | Формирует HTML-код на основе набора данных и шаблона. По сути – простой список без дополнительно функциональности ListView. | |

| **[SearchBox](http://msdn.microsoft.com/ru-ru/library/windows/apps/dn301949.aspx)** | Позволяет выполнять поисковые запросы и выбирать предлагаемые варианты. | |

| **[SemanticZoom](http://msdn.microsoft.com/ru-ru/library/windows/apps/br229690.aspx)** | Позволяет пользователям переключаться между двумя видами с разным масштабом, предоставляемыми дочерними элементами управления. Один дочерний элемент управления предоставляет вид с уменьшенным масштабом, другой — вид с увеличенным масштабом. | |

| **[TimePicker](http://msdn.microsoft.com/ru-ru/library/windows/apps/br229736.aspx)** | Позволяет пользователям выбрать время. Позволяет выбрать часы, минуты и время суток (AM/PM) | |

| **[ToggleSwitch](http://msdn.microsoft.com/ru-ru/library/windows/apps/hh701411.aspx)** | Является аналогом элемента checkbox в HTML. Включает или отключает элемент. | |

| **[Tooltip](http://msdn.microsoft.com/ru-ru/library/windows/apps/br229763.aspx)** | Отображает подсказку с поддержкой форматированного содержимого (например, изображения и форматированный текст), чтобы предоставить больше информации об объекте. | |

| **[x-ms-webview](http://msdn.microsoft.com/ru-ru/library/windows/apps/dn301831.aspx)** | Отображает HTML-содержимое. С помощью этого элемента управления можно отображать веб-страницы приложения. | |

Список всех доступных элементов управления можно найти [здесь](http://msdn.microsoft.com/ru-ru/library/windows/apps/hh465453.aspx).

С основными элементами управления мы познакомились, теперь пришло время разобраться с тем, как подключить библиотеку WinJS и добавить элементы управления в приложение.

Как подключить библиотеку WinJS

-------------------------------

Для того, чтобы подключить библиотеку WinJS, достаточно указать на нее 3 ссылки в главном HTML файле приложения.

Ссылки на библиотеку для Windows:

```

```

Ссылки на библиотеку для Windows Phone:

```

```

Обратите внимание:

Ссылки на WinJS для Windows и Windows Phone приложений различаются, в том числе версией.

Одна из ссылок, которую нужно указывать в HTML файле определяет тему, которая будет использоваться в приложении. В состав библиотеки WinJS для Windows включены две темы оформления – темная (ui-dark.css) и светлая (ui-light.css). Вам необходимо выбрать тему для своего приложения вручную. В случае работы с Windows Phone, Вы можете предоставить выбор пользователю, указав ui-themed, или явно задав тему аналогично подходу в Windows.

Как добавить элемент управления в приложение

--------------------------------------------

Все элементы управления в библиотеке WinJS задаются через атрибут [data-win-control](http://msdn.microsoft.com/en-us/library/windows/apps/hh440969.aspx) с нужным значением (WinJS.UI.\*\*\*\*) в соответствующем элементе разметки. Например, чтобы добавить FlipView, присвойте атрибуту [data-win-control](http://msdn.microsoft.com/en-us/library/windows/apps/hh440969.aspx) значение [WinJS.UI.FlipView](http://msdn.microsoft.com/en-us/library/windows/apps/br211837.aspx).

```

```

Библиотека WinJS автоматически создаст на базе этого блока элемент с необходимыми стилями и разметкой. Также, через атрибут [data-win-options](http://msdn.microsoft.com/en-us/library/windows/apps/hh440971) в разметке можно указать параметры создания элемента.

```

```

Для работы некоторых элементов управления необходимы дополнительные данные, например, источник изображений. Давайте посмотрим, как добавить данные в элемент управления.

Как добавить данные в элемент управления

----------------------------------------

За определение данных, которые хранятся в элементе управления, отвечает свойство [itemDataSource](http://msdn.microsoft.com/ru-ru/library/windows/apps/hh700703.aspx). Для того, чтобы указать, какие данные будут использоваться, присваиваем атрибуту [data-win-options](http://msdn.microsoft.com/en-us/library/windows/apps/hh440971) значение itemDataSource.

```

```

К примеру, если для работы элемента управления требуются картинки, то для их представления можно использовать объект [WinJS.Binding.List](http://msdn.microsoft.com/en-us/library/windows/apps/Hh700774.aspx).

Обратите внимание, что при декларативном описании переменная с данными должна быть видна в глобальном контексте.

Для корректного отображения данных необходимо определить шаблон. Посмотрим, как это сделать.

Как определить шаблон для отображения данных в элементе управления

------------------------------------------------------------------

Для того, чтобы определить, как будут отображаться данные, задайте шаблон [WinJS.Binding.Template](http://msdn.microsoft.com/en-us/library/windows/apps/br229723.aspx) для каждого элемента. Создайте блок div и присвойте атрибуту [data-win-control](http://msdn.microsoft.com/en-us/library/windows/apps/hh440969.aspx) значение WinJS.Binding.Template.

Например, определим шаблон для отображения картинки с заголовком.

```

![]()

####

```

Обратите внимание, что мы определяем привязку данных при помощи атрибута [data-win-bind](http://msdn.microsoft.com/ru-ru/library/windows/apps/hh440968.aspx).

Инициализация WinJS.UI.

-----------------------

Итак, мы научились создавать элементы управления, теперь нам нужно разобраться с тем, как их инициализировать.

После того, как приложение запущено, наступает событие [activated](http://msdn.microsoft.com/ru-ru/library/windows/apps/br212679.aspx). После этого можно инициализировать элементы управления WinJS. Это происходит внутри функции [WinJS.UI.processAll](http://msdn.microsoft.com/ru-ru/library/windows/apps/hh440975.aspx).

В самом простом случае функция обработки запуска приложения выглядит следующим образом:

```

(function () {

"use strict";

var app = WinJS.Application;

app.addEventListener("activated", function (args) {

WinJS.UI.processAll();

});

app.start();

})();

```

Если вы хотите обработать только конкретный DOM-узел, то используйте функцию [WinJS.UI.process](http://msdn.microsoft.com/en-us/library/windows/apps/hh440976.aspx). Также вы можете создавать элементы управления напрямую в коде на JavaScript, используя соответствующие объекты из WinJS.UI.\*.

### Дополнительные ссылки

[Список элементов управления (HTML)](http://msdn.microsoft.com/ru-ru/library/windows/apps/hh465453.aspx)

[Краткое руководство: добавление элементов управления WinJS и стилей (HTML)](http://msdn.microsoft.com/ru-ru/library/windows/apps/hh465493.aspx)

[MVA курс по мобильной разработке для веб-разработчиков](http://www.microsoftvirtualacademy.com/training-courses/mobile-development-for-web-developers-rus)

[Скачать Microsoft Visual Studio можно здесь](http://www.visualstudio.com/) | https://habr.com/ru/post/238709/ | null | ru | null |

# Новый агент пользователя Googlebot для смартфонов

###### Уровень подготовки веб-мастера: высокий

Google индексирует контент, оптимизированный для обычных мобильных телефонов и смартфонов с широким набором функций и возможностей, с помощью разных поисковых роботов. Но мы заметили, что, так как они оба называются `Googlebot-Mobile`, это нередко вызывает путаницу. Например, веб-мастера, намереваясь запретить сканирование и индексацию сайта для простых мобильных телефонов с ограниченными техническими возможностями, по ошибке запрещают сканирование сайта для всех устройств. Конечно, все это отрицательно сказывается на посещаемости веб-сайта.

#### Новый Googlebot для смартфонов

Чтобы веб-мастерам было проще разобраться в настройках, через 3–4 недели мы переименуем агент пользователя в нашем поисковом роботе для смартфонов. Название `Googlebot-Mobile` будет заменено на `Googlebot` с добавлением слова mobile в строку агента пользователя. Вы можете сравнить отличия ниже.

###### Googlebot – новый агент пользователя для смартфонов:

```

Mozilla/5.0 (iPhone; CPU iPhone OS 6_0 like Mac OS X) AppleWebKit/536.26 (KHTML, like Gecko) Version/6.0 Mobile/10A5376e Safari/8536.25 (compatible;**Googlebot**/2.1; +http://www.google.com/bot.html)

```

###### Googlebot-Mobile – старый агент пользователя для смартфонов, который вскоре будет заменен:

```

Mozilla/5.0 (iPhone; CPU iPhone OS 6_0 like Mac OS X) AppleWebKit/536.26 (KHTML, like Gecko) Version/6.0 Mobile/10A5376e Safari/8536.25 (compatible; Googlebot-Mobile/2.1; +http://www.google.com/bot.html)

```

Эти изменения касаются только `Googlebot-Mobile` для смартфонов. У обычного робота `Googlebot` останется тот же агент пользователя, а у двух оставшихся поисковых роботов `Googlebot-Mobile` в строке агента пользователя по-прежнему будут указаны телефоны среднего класса. Как это выглядит, смотрите ниже.

###### Агент пользователя у обычного поискового робота Googlebot:

```

Mozilla/5.0 (compatible; Googlebot/2.1;

+http://www.google.com/bot.html)

```

###### Агенты пользователя у двух поисковых роботов Googlebot-Mobile для телефонов среднего класса:

* `SAMSUNG-SGH-E250/1.0 Profile/MIDP-2.0 Configuration/CLDC-1.1 UP.Browser/6.2.3.3.c.1.101 (GUI) MMP/2.0 (compatible; Googlebot-Mobile/2.1; +http://www.google.com/bot.html)`

* `DoCoMo/2.0 N905i(c100;TB;W24H16) (compatible; Googlebot-Mobile/2.1; +http://www.google.com/bot.html)`

Проверить, смогут ли эти поисковые роботы проиндексировать ваш сайт, можно с помощью функции "[Просмотреть как Googlebot](https://support.google.com/webmasters/answer/158587?hl=ru)" в [Инструментах для веб-мастеров](http://goo.gl/vuLCH). Полный список наших поисковых роботов опубликован в [Справочном центре](https://support.google.com/webmasters/answer/1061943?hl=ru).

#### Сканирование и индексирование

Обратите внимание, что **после смены поискового агента новый `Googlebot` для смартфонов будет руководствоваться правилами в `robots.txt`, метатеге robots и HTTP-заголовках, которые касаются `Googlebot`, а не `Googlebot-Mobile`**. Вот, например, правило в `robots.txt`, запрещающее сканировать сайт как обычному роботу `Googlebot`, так и новому роботу `Googlebot` для смартфонов:

```

User-agent: Googlebot

Disallow: /

```

А такое правило в `robots.txt` запретит сканирование поисковым роботам Google для простых мобильных телефонов:

```

User-agent: Googlebot-Mobile

Disallow: /

```

По нашим подсчетам, это обновление затронет менее 0,001% веб-страниц, но при этом позволит веб-мастерам точнее управлять сканированием и индексацией их контента. Если у вас возникнут вопросы, вы можете:

* ознакомиться с [рекомендациями по оптимизации сайтов для смартфонов](https://developers.google.com/webmasters/smartphone-sites/);

* узнать, [как управлять разрешениями поисковых роботов Googlebot на сканирование и индексирование](https://developers.google.com/webmasters/control-crawl-index/);

* задать вопрос здесь в комментариях, на [форуме для веб-мастеров](http://productforums.google.com/forum/#!categories/webmaster-ru), в [сообществе для веб-мастеров](https://plus.sandbox.google.com/communities/107952911147065863501) или принять участие в [регулярных видеовстречах с веб-мастерами](http://goo.gl/AlqUZU). | https://habr.com/ru/post/210118/ | null | ru | null |

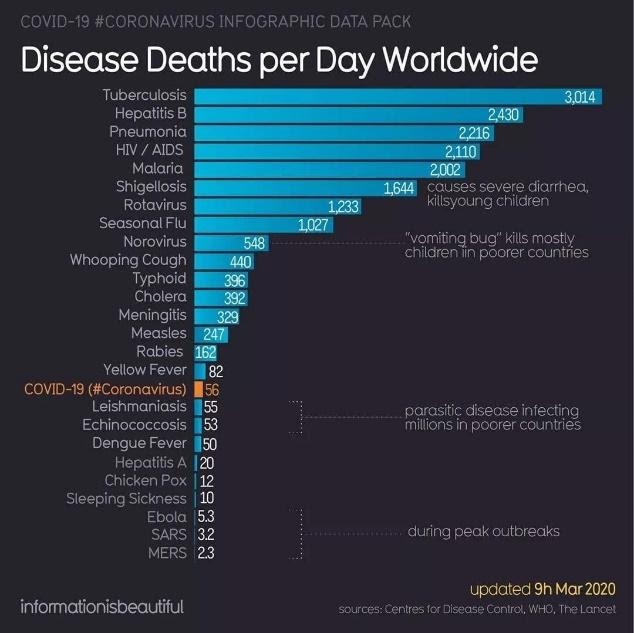

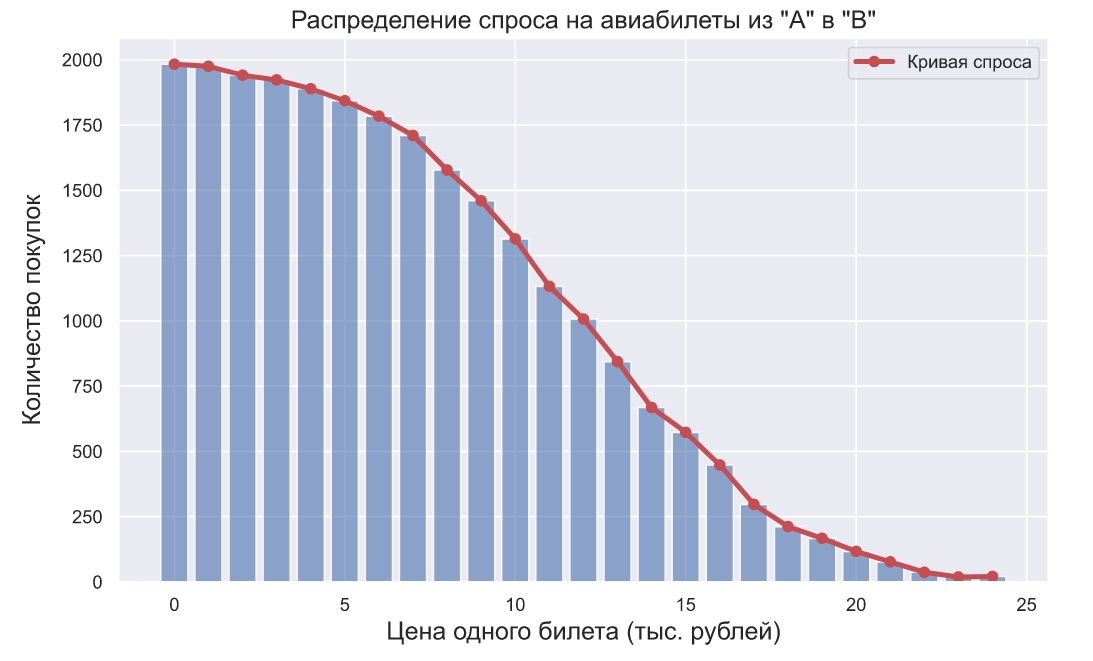

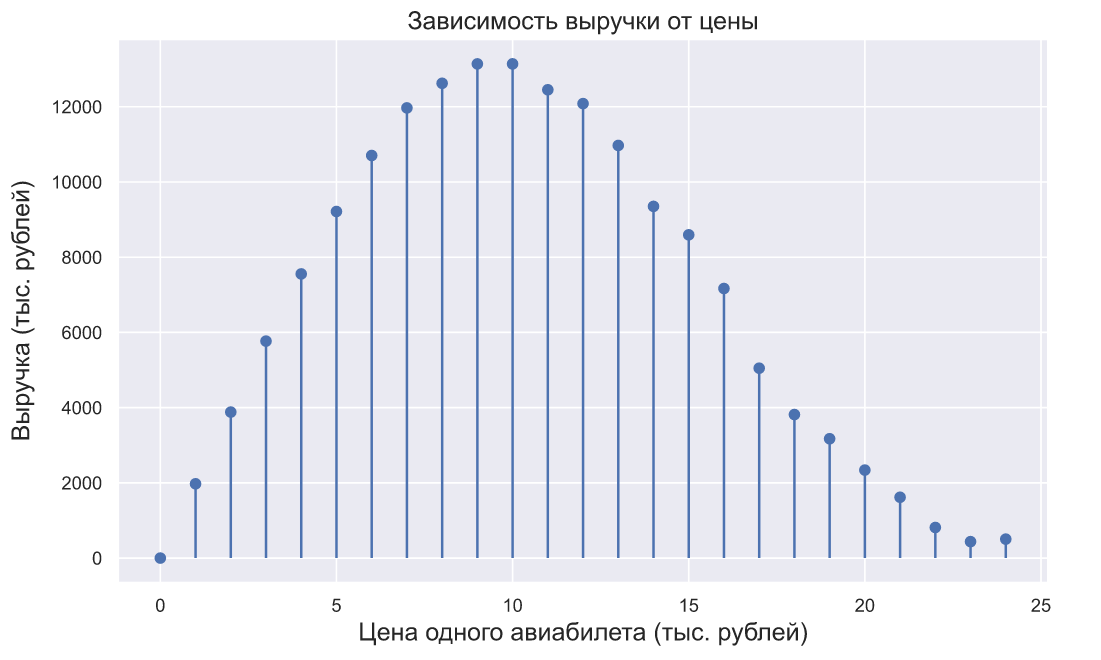

# Как сделать тематическое моделирование форума быстро или что беспокоит людей с целиакией

---

В данной статье я расскажу и покажу на примере, о том, как человек с минимальным Data Science опытом, смог собрать данные из форума и сделать тематическое моделирование постов с использованием LDA модели, и выявил наболевшие темы людей с глютеновой непереносимостью.

В прошлом году мне нужно было срочно подтянуть свои знания в области машинного обучения. Я менеджер продуктов для Data Science, Machine Learning и AI, или по-другому Technical Product Manager AI/ML. Одних бизнес навыков и умения разрабатывать продукты, как это обычно бывает в проектах, направленных на пользователей не в технической сфере, не достаточно. Необходимо понимать основные технические концепции индустрии ML, и если нужно, суметь самому написать пример для демонстрации продукта.

Я около 5 лет разрабатывала Front-end проекты, разрабатывала сложные веб приложения на JS и React, но машинным обучением, ноутбуками и алгоритмами никогда не занималась. Поэтому, когда я увидела новость от [Отус](https://otus.ru/), что у них открывается пятимесячный экспериментальный [курс по Машинному обучению](https://otus.pw/DnQy/), я, не долго думая, решила пройти пробное тестирование и попала на курс.

В течении пяти месяцев, каждую неделю проходили двухчасовые лекции и домашние задания к ним. Там я узнала об основах ML: различные алгоритмы регрессии, классификации, ансамбли моделей, градиентный бустинг и даже немного затронули облачные технологии. В принципе, если внимательно слушать каждую лекцию, то примеров и объяснений хватает вполне для выполнения домашних заданий. Но все же иногда, как и в любом другом кодинг проекте, приходилось обращаться к документации. Учитывая мою полную рабочую занятость, учиться было достаточно удобно, так как я всегда могла пересмотреть запись онлайн лекции.

В конце обучения данного курса, всем нужно было сдавать итоговый проект. Идея проекта возникла довольно спонтанно, в это время я начала обучение предпринимательству в Stanford, где я попала в команду, которая работала над проектом для людей с глютеновой непереносимостью. В ходе маркет исследования, мне было интересно узнать, что беспокоит, о чем говорят, на что жалуются люди с данной особенностью.

По ходу исследования, я нашла форум на [celiac.com](https://www.celiac.com/forums/) с огромным количеством материала по целиакии. Было очевидно, что пролистывать в ручную и читать больше 100 тысячи постов нецелесообразно. Так мне пришла идея, применить знания, которые я получила на данном курсе: собрать все вопросы и комментарии с форума из определенного топика и сделать тематическое моделирование с наиболее часто встречающимися словами в каждом из них.

### Шаг 1. Сбор данных с форума

Форум из себя представляет множество топиков различного размера. Всего суммарно на данном форуме около 115 000 топиков и около миллиона постов, с комментариями к ним. Меня интересовала конкретная подтема [“Coping with Celiac Disease”](https://www.celiac.com/forums/forum/5-coping-with-celiac-disease/), что в переводе буквально означает “Справляться с Целиакией”, если по-русски, то тут подразумевается больше “продолжать жить с диагнозом целиакия и как-то справляться с трудностями”. В этой под-теме около 175 000 постов с комментариями.

Скачивание данных происходило в два этапа. Для начала мне пришлось пройтись по всем страницам под топика и собрать все ссылки ко всем постам, для того, чтобы на следующем этапе, я уже могла собрать комментарий.

```

url_coping = 'https://www.celiac.com/forums/forum/5-coping-with-celiac-disease/'

```

Так как форум оказался довольно старый, мне очень повезло и особо каких-либо секьюрных заморочек у сайта не было, поэтому чтобы собрать данные, достаточно было использовать комбинацию *User-Agent* из библиотеки *fake\_useragent*, *Beautiful Soup* для работы с html разметкой и знать количество страниц:

```

# Get total number of pages

def get_pages_count(url):

response = requests.get(url, headers={'User-Agent': UserAgent().chrome})

soup = BeautifulSoup(response.content, 'html.parser')

last_page_section = soup.find('li', attrs = {'class':'ipsPagination_last'})

if (last_page_section):

count_link = last_page_section.find('a')

return int(count_link['data-page'])

else:

return 1

coping_pages_count = get_pages_count(url_coping)

```

И далее скачать HTML DOM каждой страницы, чтобы легко и просто вытаскивать данные из них с помощью питоновской библиотеки *BeautifulSoup*.

```

# collect pages

def retrieve_pages(pages_count, url):

pages = []

for page in range(pages_count):

response = requests.get('{}page/{}'.format(url, page), headers={'User-Agent': UserAgent().chrome})

soup = BeautifulSoup(response.content, 'html.parser')

pages.append(soup)

return pages

coping_pages = retrieve_pages(coping_pages_count, url_coping)

```

Для скачивания данных, мне нужно было определить необходимые поля для анализа: найти значения этих полей в DOM и сохранить в dictionary. Я сама пришла из Front-end бекграунда, поэтому работа с домом и объектами для меня была тривиальной.

```

def collect_post_info(pages):

posts = []

for page in pages:

posts_list_soup = page.find('ol', attrs = {'class': 'ipsDataList'}).findAll('li', attrs = {'class': 'ipsDataItem'})

for post_soup in posts_list_soup:

post = {}

post['id'] = uuid.uuid4()

# collecting titles and urls

title_section = post_soup.find('span', attrs = {'class':'ipsType_break ipsContained'})

if (title_section):

title_section_a = title_section.find('a')

post['title'] = title_section_a['title']

post['url'] = title_section_a['data-ipshover-target']

# collecting author & last action

author_section = post_soup.find('div', attrs = {'class':'ipsDataItem_meta'})

if (author_section):

author_section_a = post_soup.find('a')

author_section_time = post_soup.find('time')

post['author'] = author_section_a['data-ipshover-target']

post['last_action'] = author_section_time['datetime']

# collecting stats

stats_section = post_soup.find('ul', attrs = {'class':'ipsDataItem_stats'})

if (stats_section):

stats_section_replies = post_soup.find('span', attrs = {'class':'ipsDataItem_stats_number'})

if (stats_section_replies):

post['replies'] = stats_section_replies.getText()

stats_section_views = post_soup.find('li', attrs = {'class':'ipsType_light'})

if (stats_section_views):

post['views'] = stats_section_views.find('span', attrs = {'class':'ipsDataItem_stats_number'}).getText()

posts.append(post)

return posts

```

Итого у меня собралось около 15450 постов в данной тематике.

```

coping_posts_info = collect_post_info(coping_pages)

```

Теперь их можно было перенести в DataFrame, чтобы они красивенько там лежали, и заодно сохранила их в csv файле, чтобы не пришлось еще раз ждать когда данные соберутся с сайта, если случайно сломается notebook или я где случайно переопределю переменную.

```

df_coping = pd.DataFrame(coping_posts_info,

columns =['title', 'url', 'author', 'last_action', 'replies', 'views'])

# format data

df_coping['replies'] = df_coping['replies'].astype(int)

df_coping['views'] = df_coping['views'].apply(lambda x: int(x.replace(',','')))

df_coping.to_csv('celiac_forum_coping.csv', sep=',')

```

После сбора коллекции постов, я перешла к сбору самих комментарий.

```

def collect_postpage_details(pages, df):

comments = []

for i, page in enumerate(pages):

articles = page.findAll('article')

for k, article in enumerate(articles):

comment = {

'url': df['url'][i]

}

if(k == 0):

comment['question'] = 1

else:

comment['question'] = 0

# collecting comments

comment_section = article.find('div', attrs = {'class':'ipsComment_content'})

if (comment_section):

comment_section_p = comment_section.find('p')

if(comment_section_p):

comment['comment'] = comment_section_p.getText()

comment['date'] = comment_section.find('time')['datetime']

author_section = article.find('strong')

if (author_section):

author_section_url = author_section.find('a')

if (author_section_url):

comment['author'] = author_section_url['data-ipshover-target']

comments.append(comment)

return comments

coping_data = collect_postpage_details(coping_comments_pages, df_coping)

df_coping_comments.to_csv('celiac_forum_coping_comments_1.csv', sep=',')

```

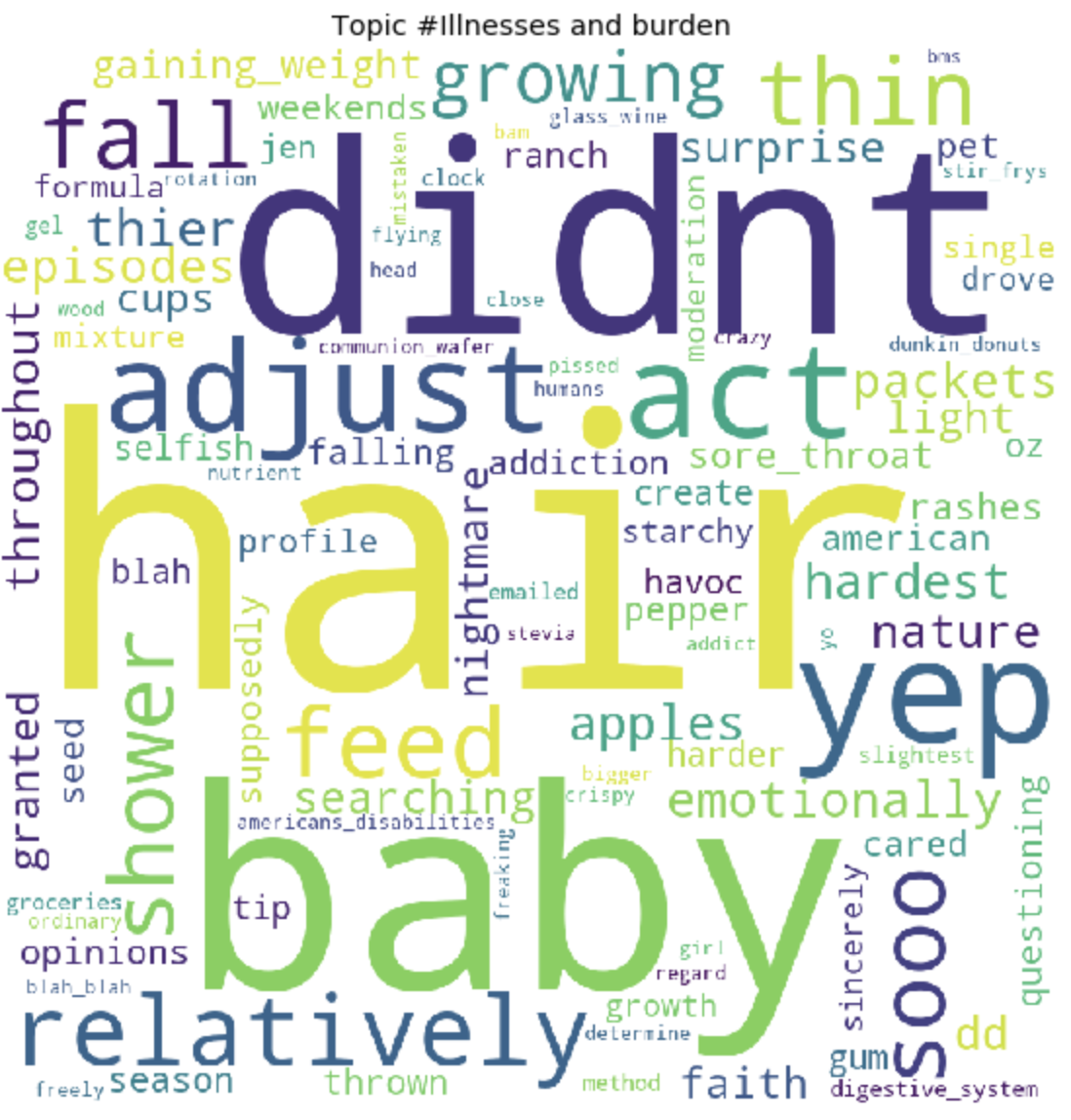

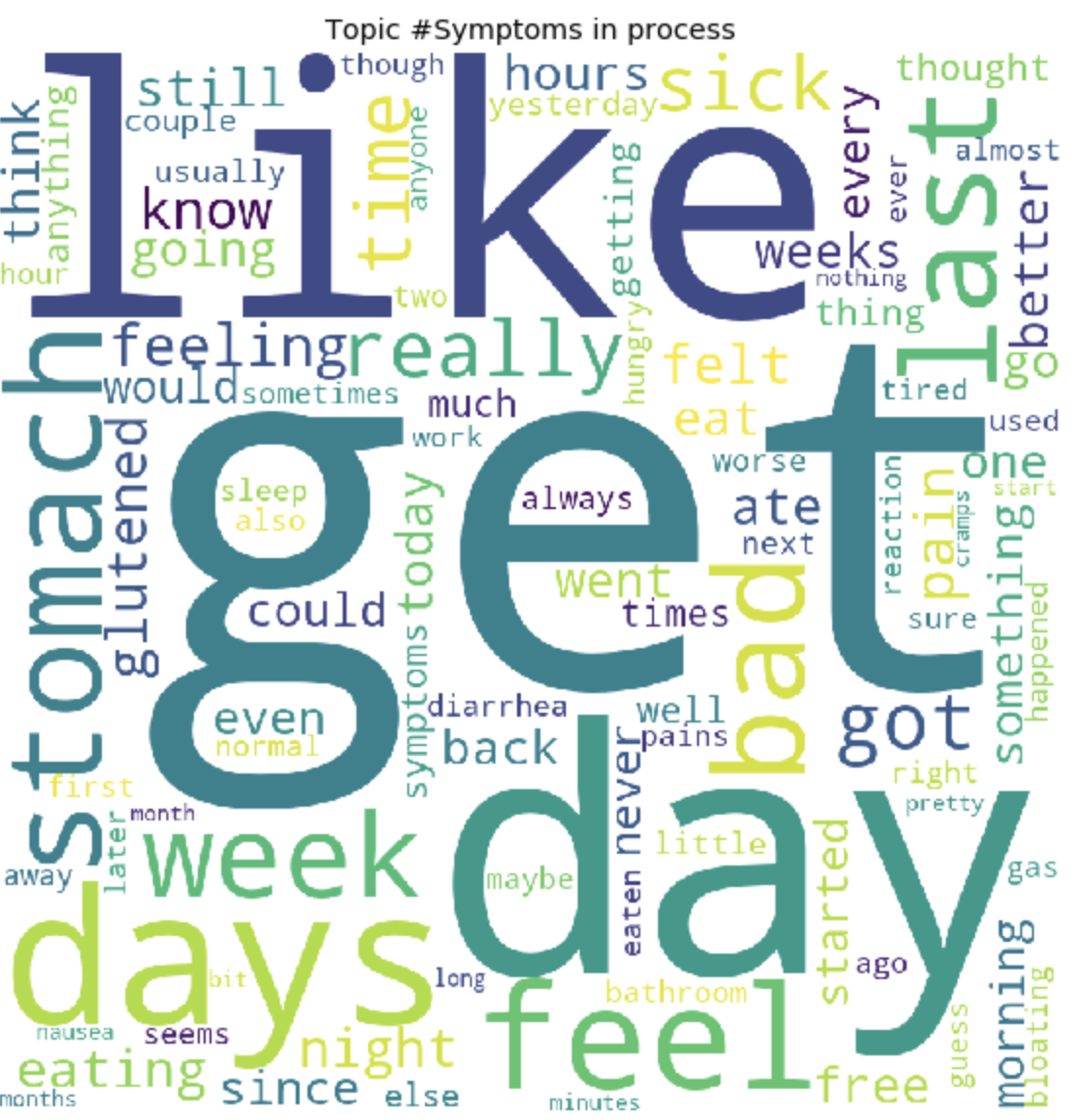

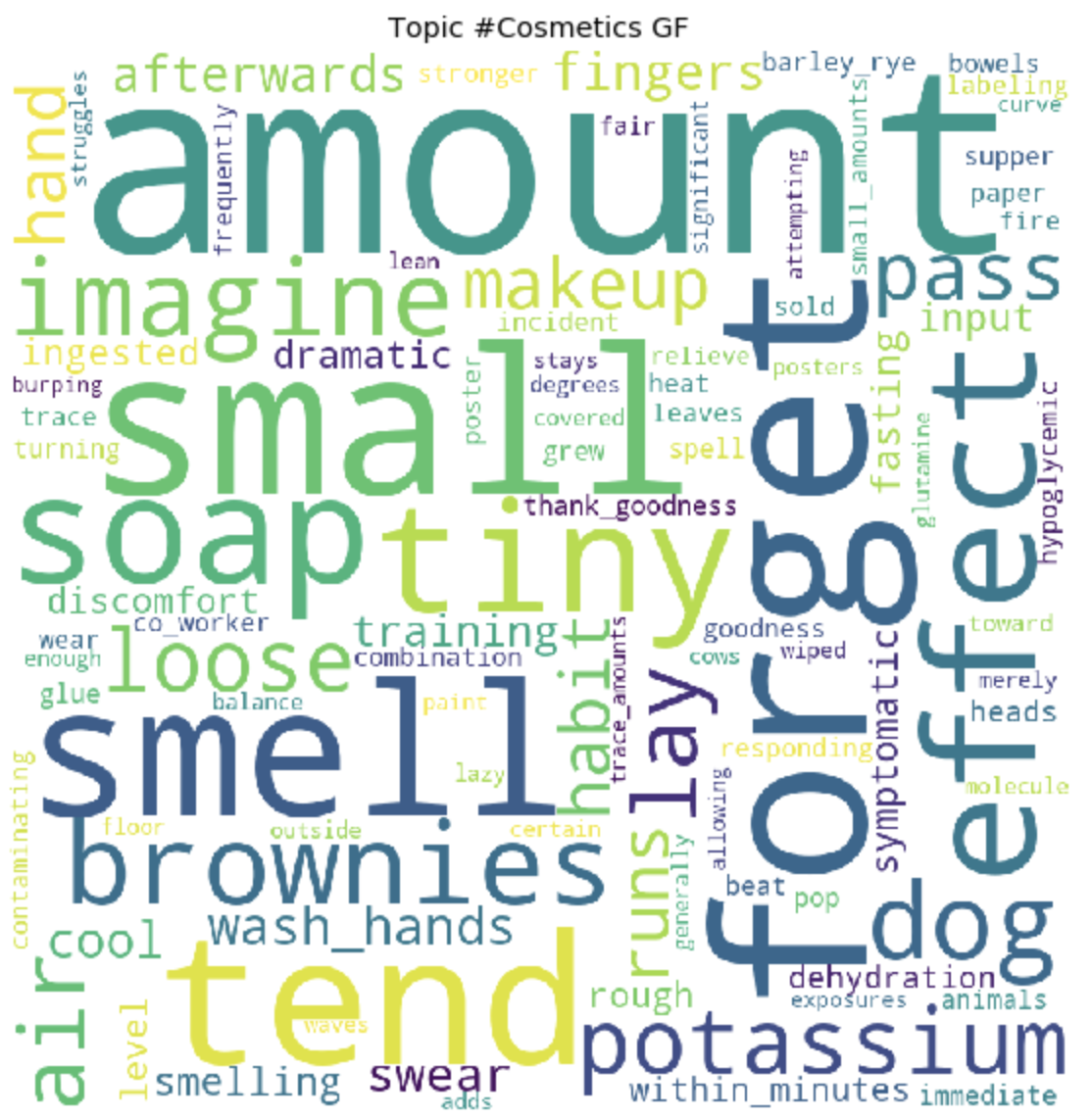

### ШАГ 2 Анализ данных и тематическое моделирование

В предыдущем шаге мы собрали данные с форума и получили итоговые данные в виде 153777 строк вопросов и комментариев.

Но просто собранные данные не интересны, поэтому первым делом, мне захотелось провести очень простую аналитику: я вывела статистику для топ 30 самых просматриваемых топиков и 30 самых комментируемых топиков.

Самые просматриваемые посты не совпали с самими комментируемыми. Заголовки комментируемых постов, даже с первого взгляда, заметны. Их названия имеют более эмоциональный окрас: *“Я ненавижу, Я ненавижу, Я ненавижу”* или “*Высокомерные комментарии”* или *“Вау, я в беде”*. А самые просматриваемые, больше имеют формат вопроса: *“Можно ли есть сою?”, “Почему не могу нормально усваивать воду?”* и другие.

Несложный анализ текста мы сделали. Чтобы перейти непосредственно, к более сложному анализу, нужна подготовка самих данных перед подачей ее на вход LDA модели для разбивки по темам. Для этого избавимся от комментариев содержащих меньше 30 слов, для того, чтобы отфильтровать спам и бессмысленные короткие комментарии. Приведем их к нижнему регистру.

```

# Let's get rid of text < 30 words

def filter_text_words(text, min_words = 30):

text = str(text)

return len(text.split()) > 30

filtered_comments = filtered_comments[filtered_comments['comment'].apply(filter_text_words)]

comments_only = filtered_comments['comment']

comments_only= comments_only.apply(lambda x: x.lower())

comments_only.head()

```

Удалим ненужные стоп слова, чтобы очистить нашу текстовую подборку

```

stop_words = stopwords.words('english')

def remove_stop_words(tokens):

new_tokens = []

for t in tokens:

token = []

for word in t:

if word not in stop_words:

token.append(word)

new_tokens.append(token)

return new_tokens

tokens = remove_stop_words(data_words)

```

А также добавим биграммы и сформируем bag of words, чтобы выделить устойчивые словосочетания, например, *как gluten\_free, support\_group*, ну и другие словосочетания, которые сгруппировавшись несут определенный смысл.

```

bigram = gensim.models.Phrases(tokens, min_count=5, threshold=100)

bigram_mod = gensim.models.phrases.Phraser(bigram)

bigram_mod.save('bigram_mod.pkl')

bag_of_words = [bigram_mod[w] for w in tokens]

with open('bigrams.pkl', 'wb') as f:

pickle.dump(bag_of_words, f)

```

Теперь мы наконец-то готовы к непосредственно самой тренировке LDA модели.

```

id2word = corpora.Dictionary(bag_of_words)

id2word.save('id2word.pkl')

id2word.filter_extremes(no_below=3, no_above=0.4, keep_n=3*10**6)

corpus = [id2word.doc2bow(text) for text in bag_of_words]

lda_model = gensim.models.ldamodel.LdaModel(

corpus,

id2word=id2word,

eval_every=20,

random_state=42,

num_topics=30,

passes=5

)

lda_model.save('lda_default_2.pkl')

topics = lda_model.show_topics(num_topics=30, num_words=100, formatted=False)

```

По окончанию тренировки, мы, в конечном итоге, получаем результат сформировавшихся топиков. Которые я прикрепила в конце этого поста.

```

for t in range(lda_model.num_topics):

plt.figure(figsize=(15, 10))

plt.imshow(WordCloud(background_color="white", max_words=100, width=900, height=900, collocations=False)

.fit_words(dict(topics[t][1])))

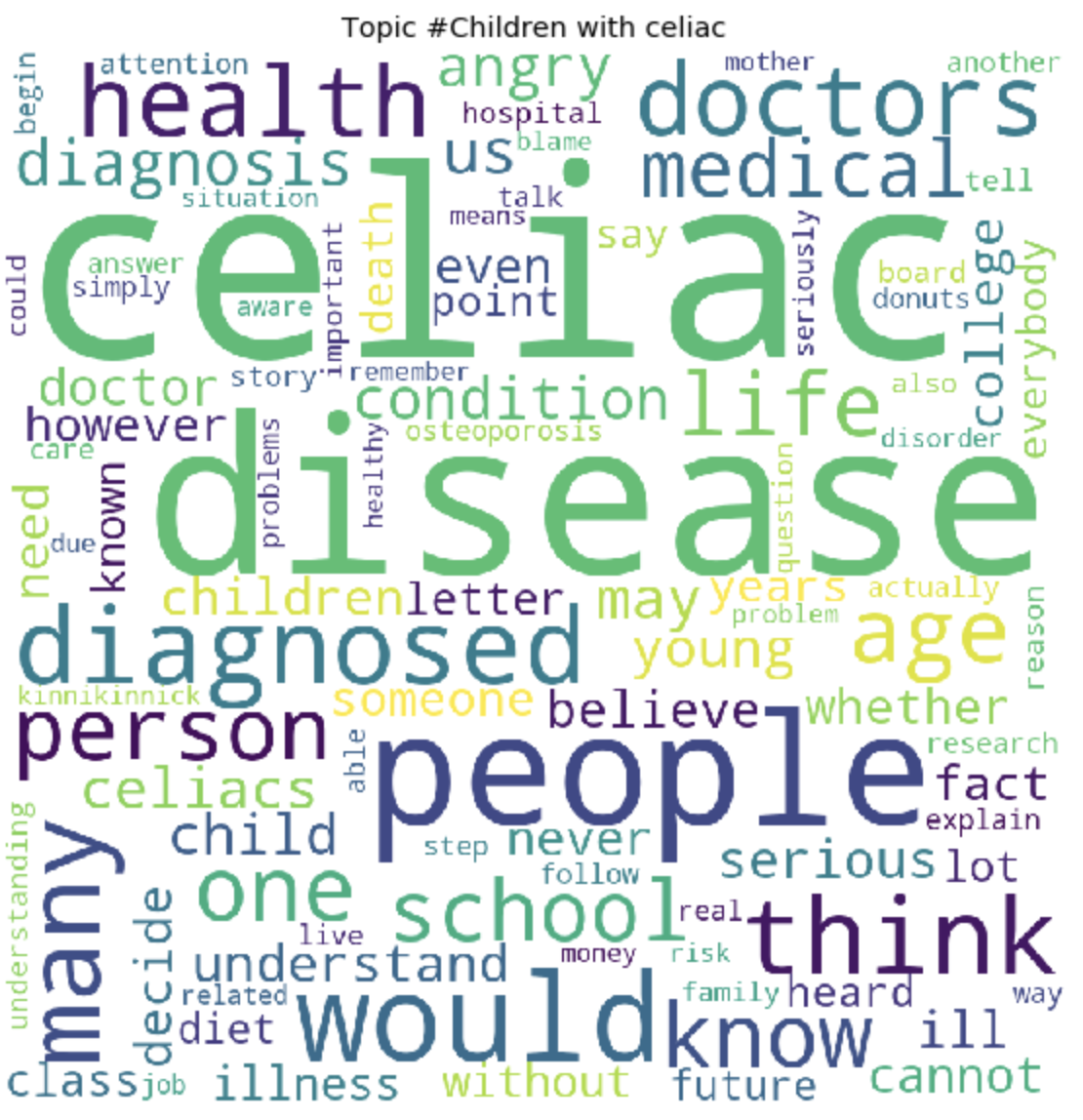

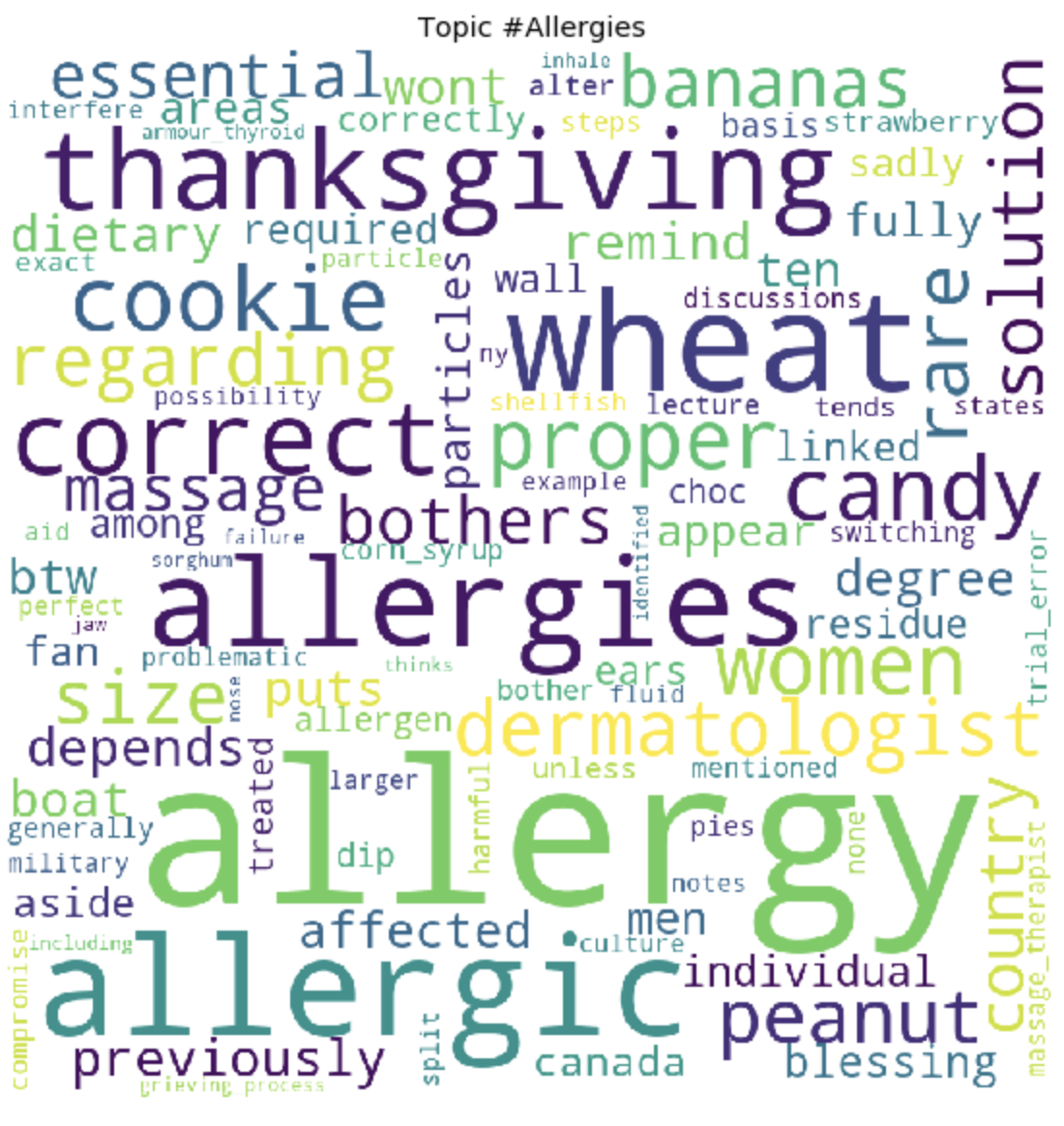

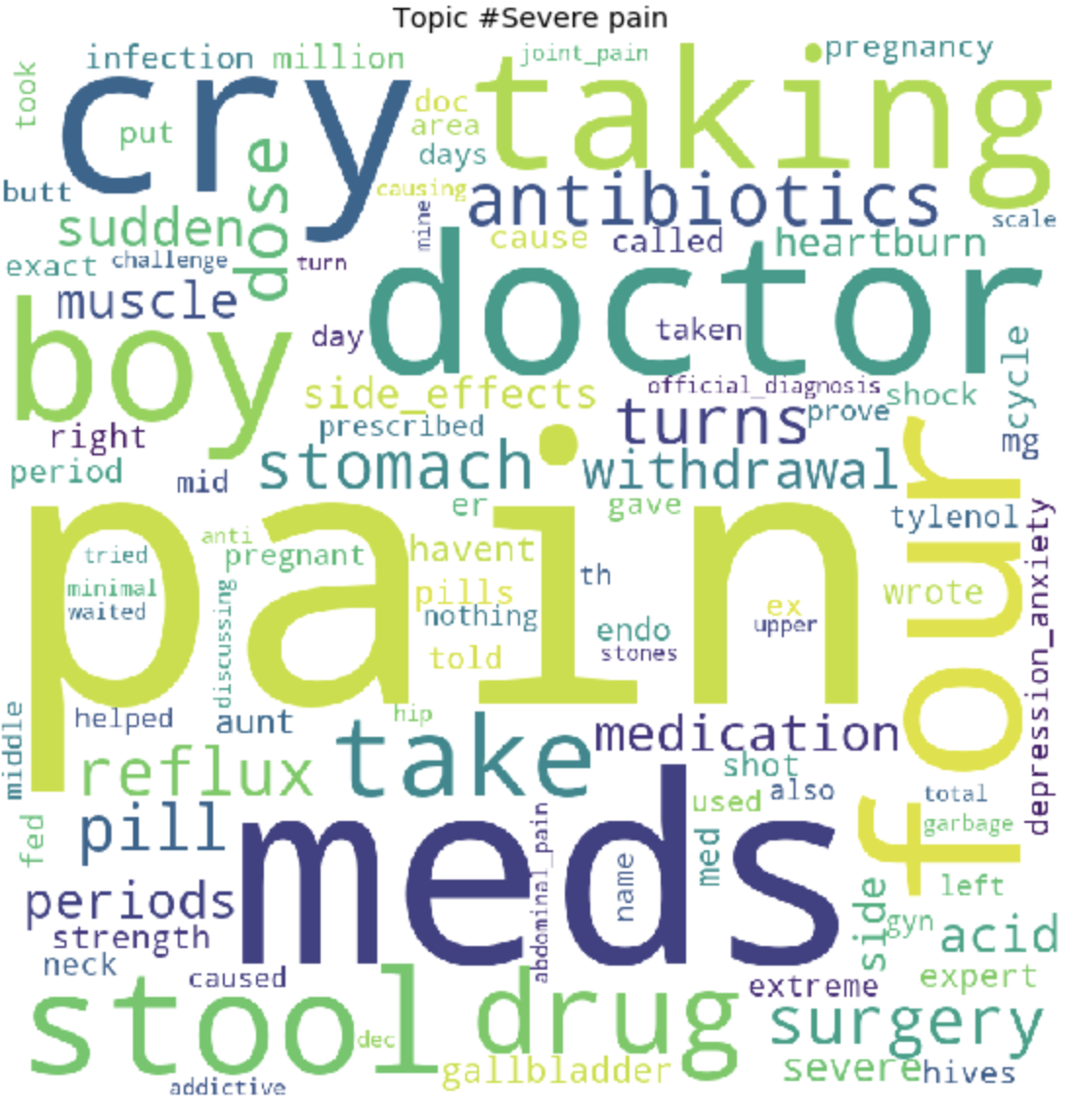

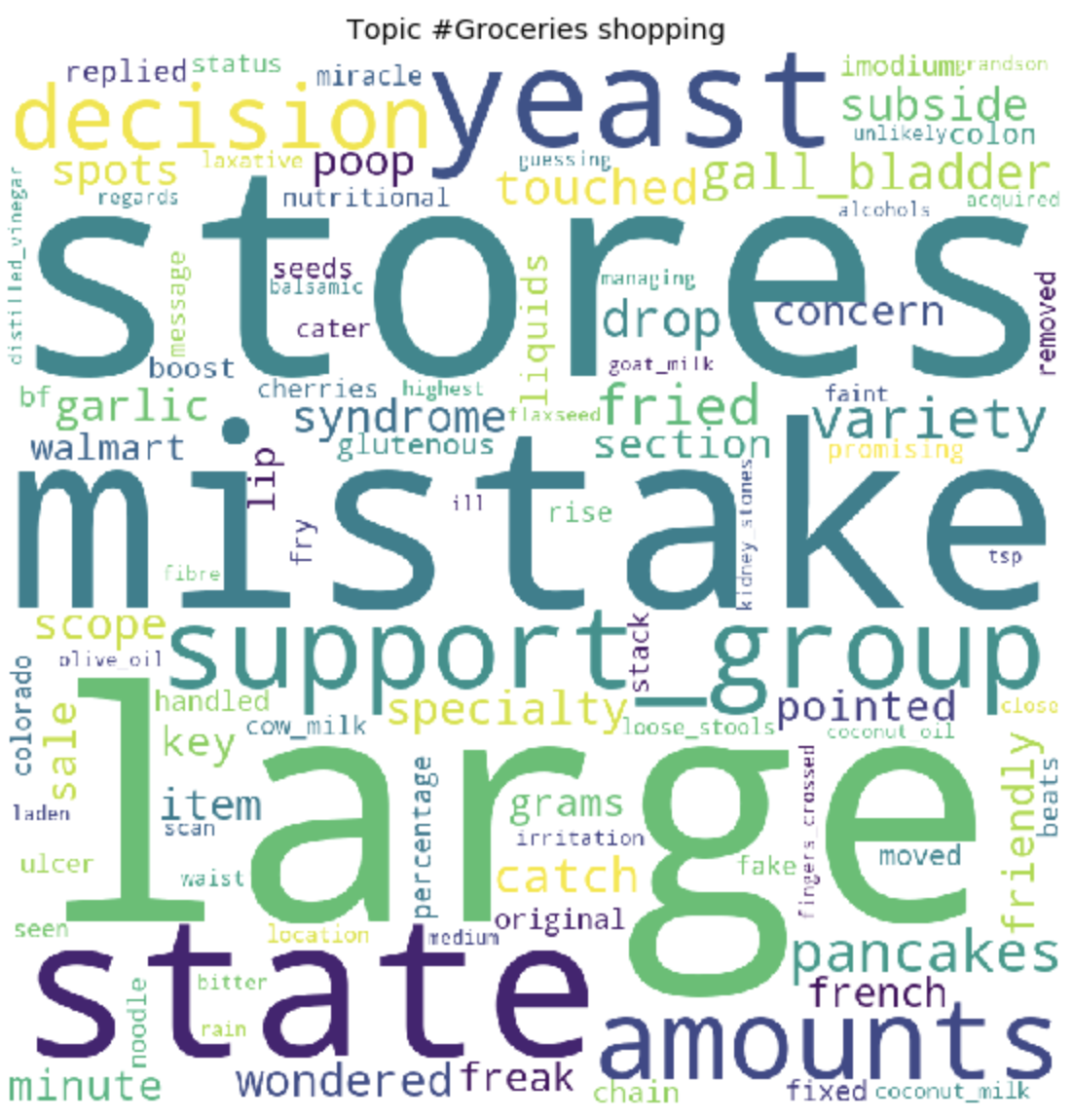

plt.axis("off")

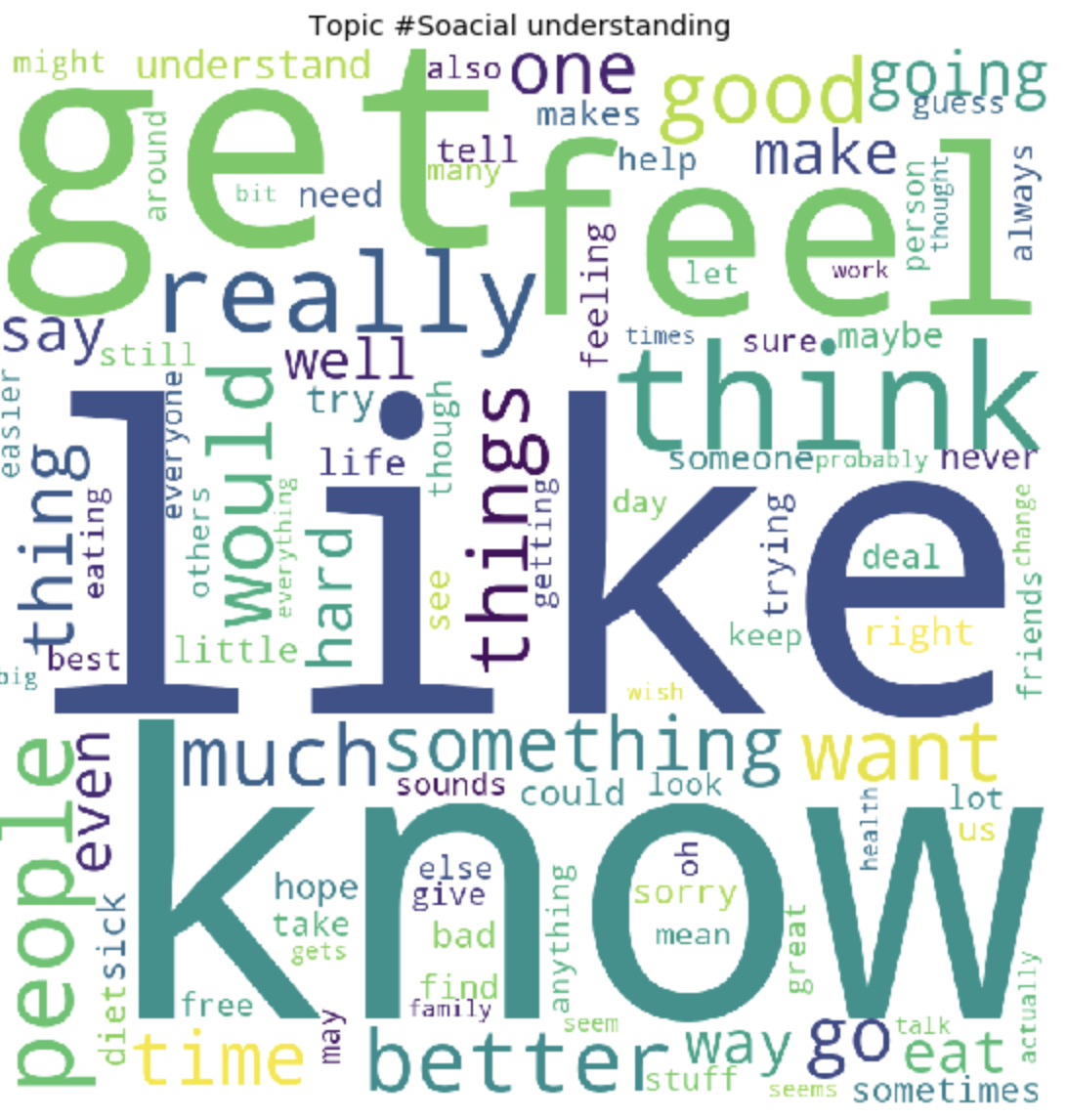

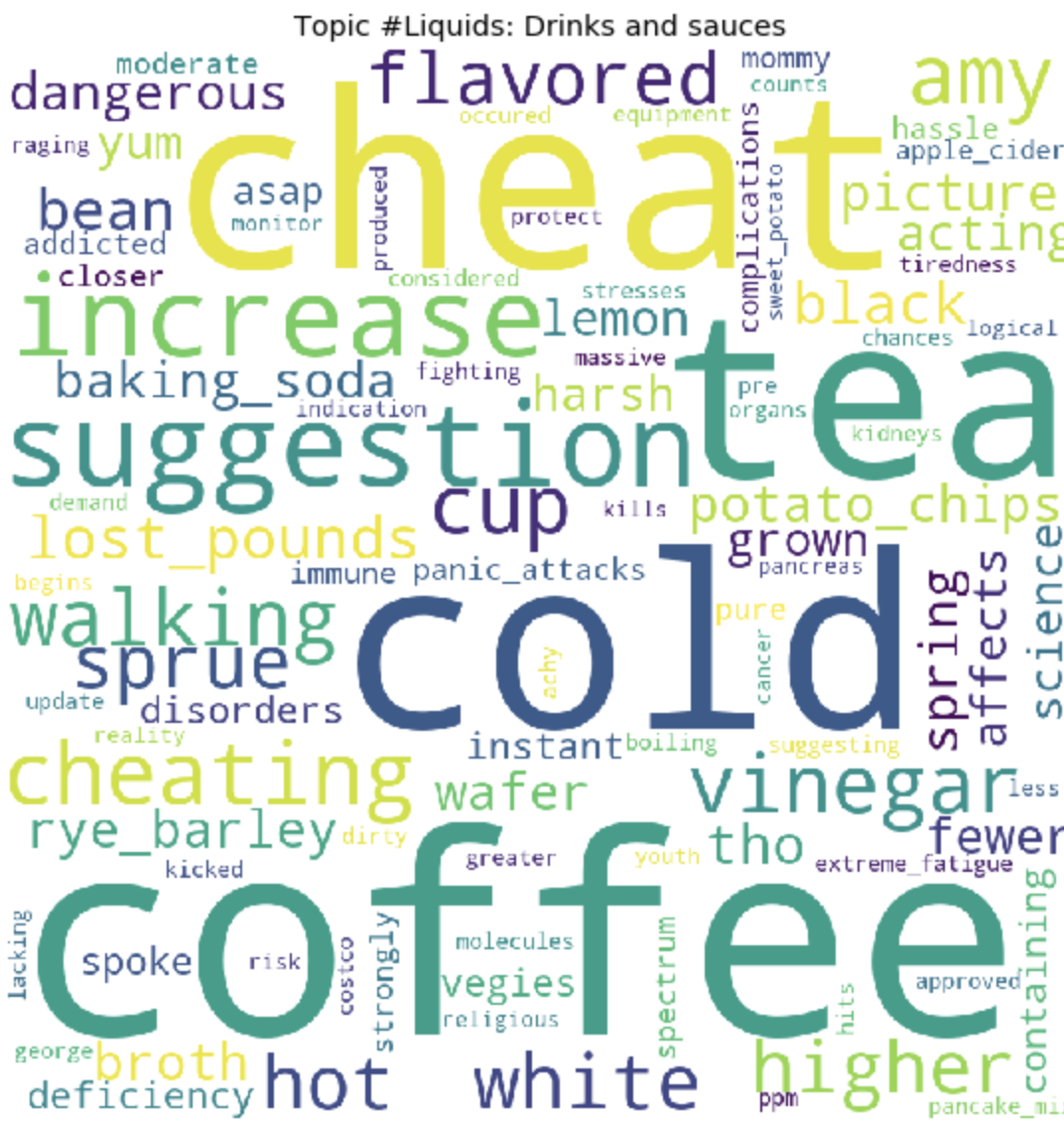

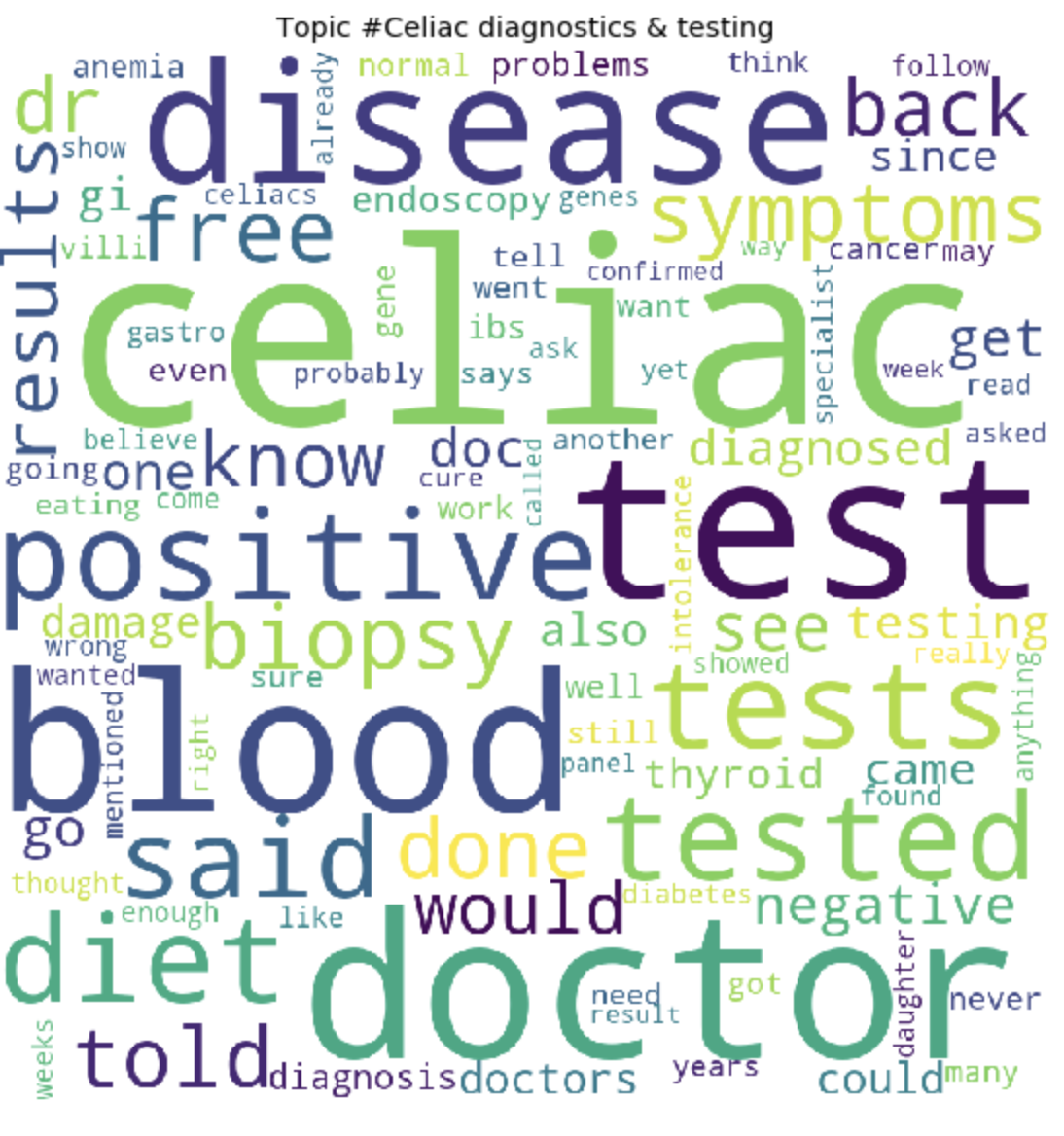

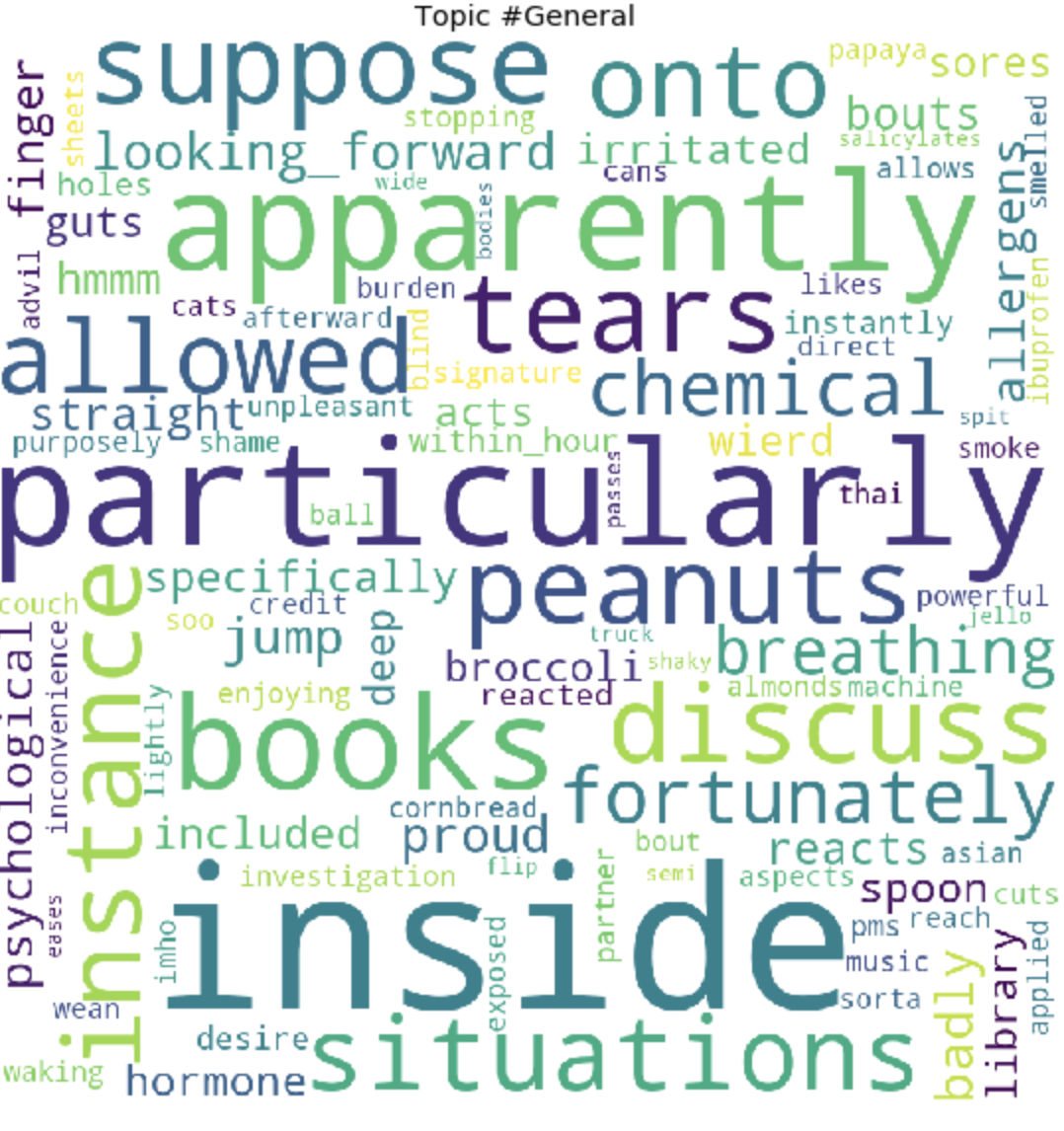

plt.title("Topic #" + themes_headers[t])

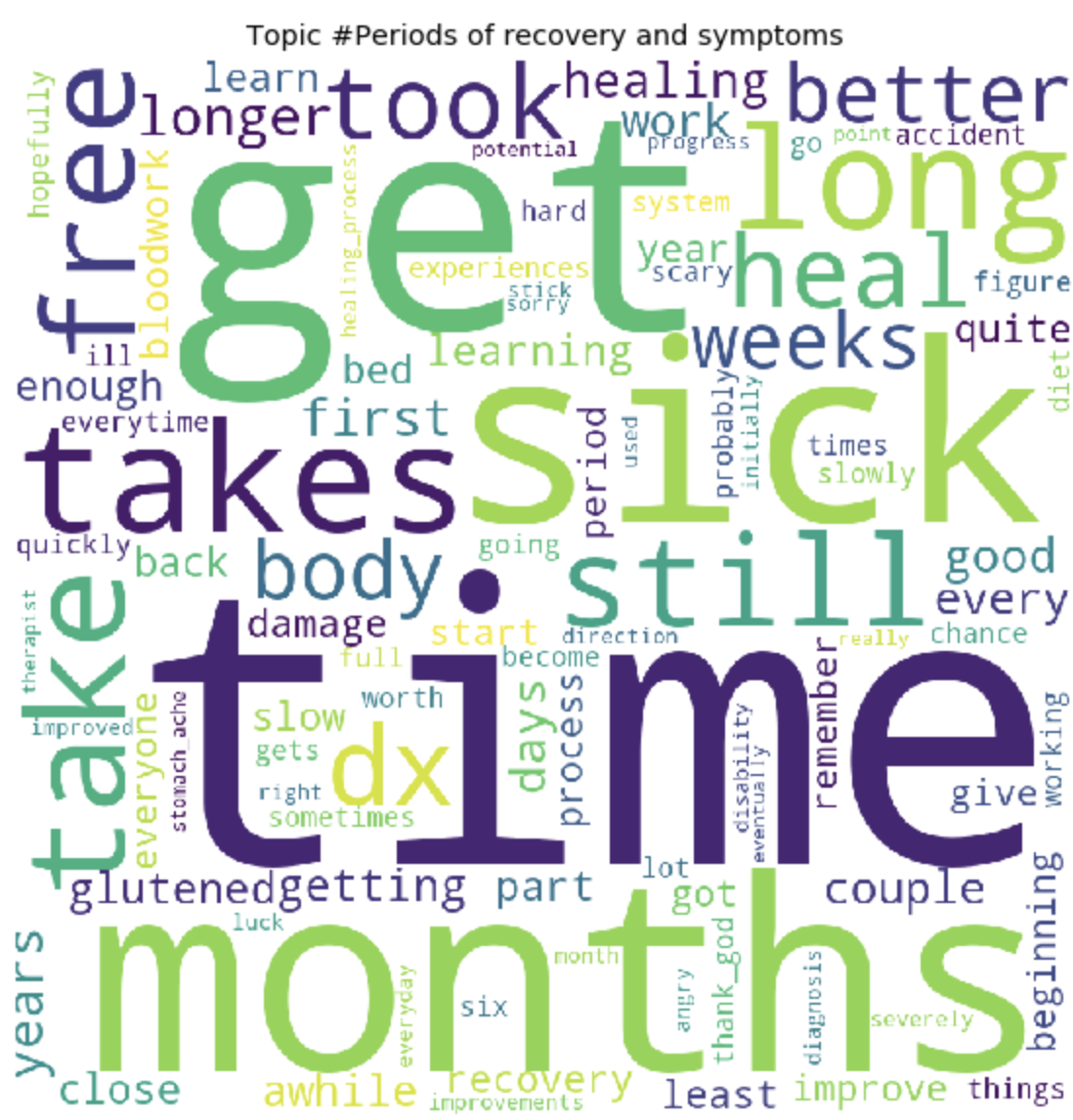

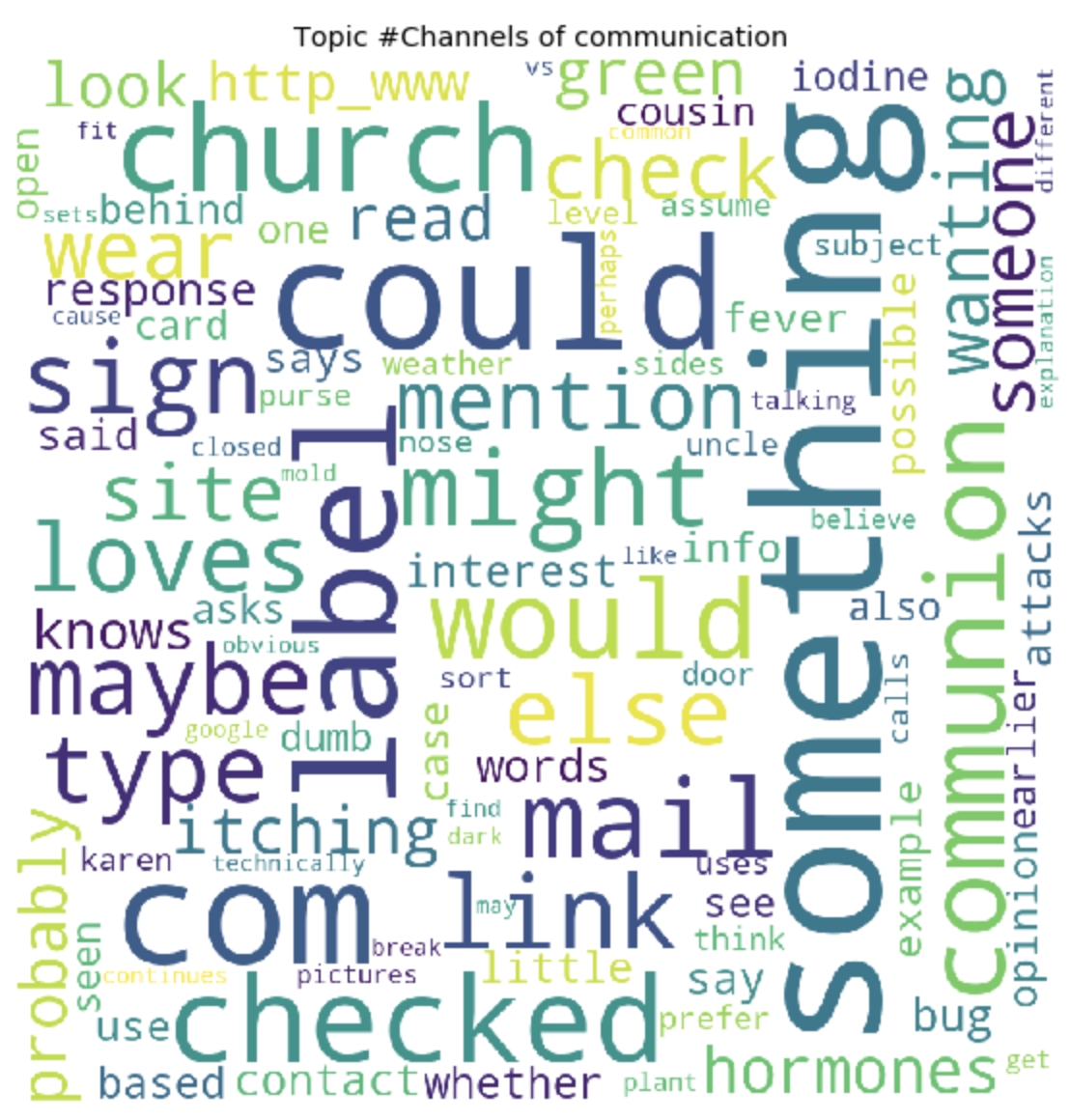

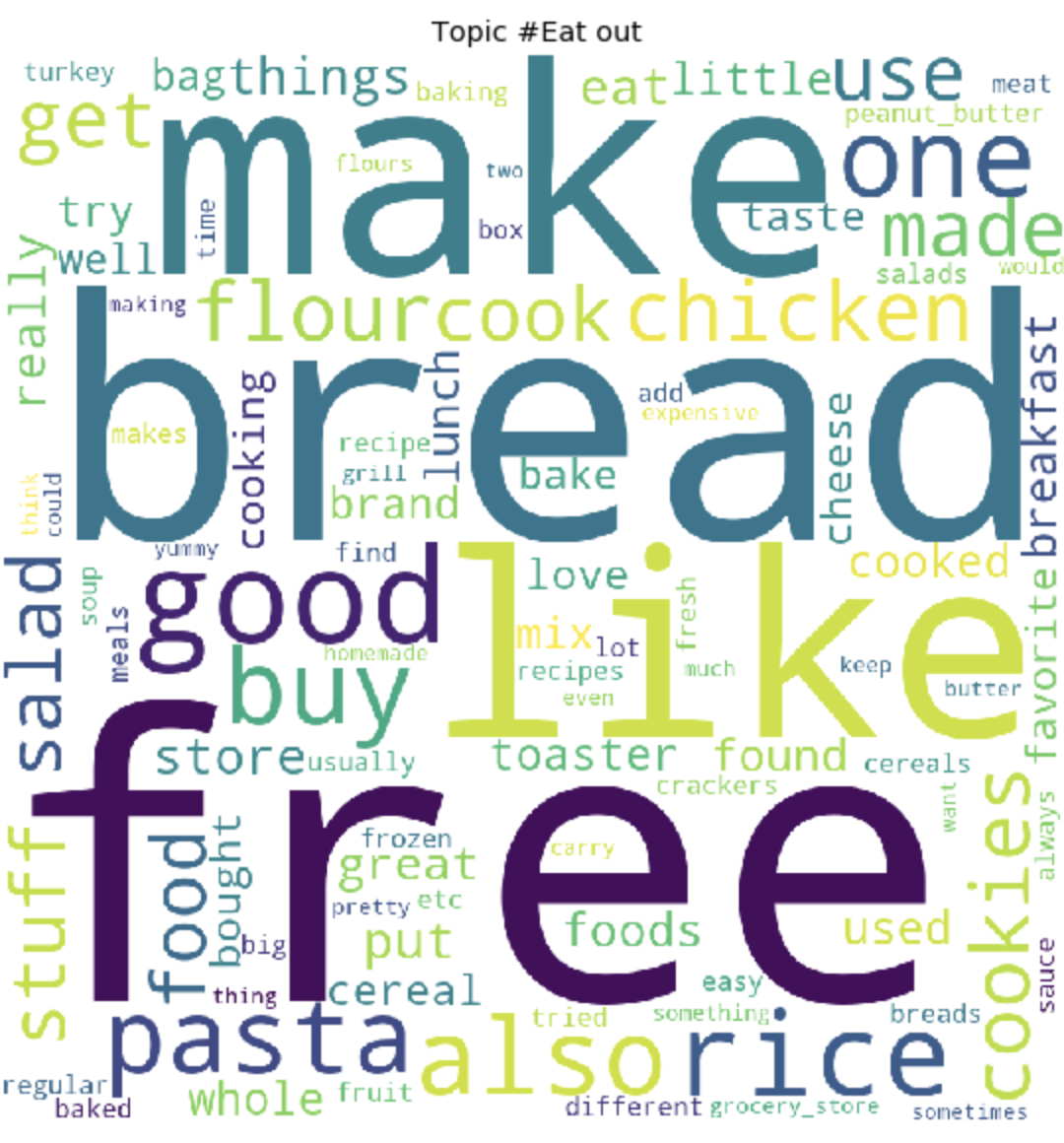

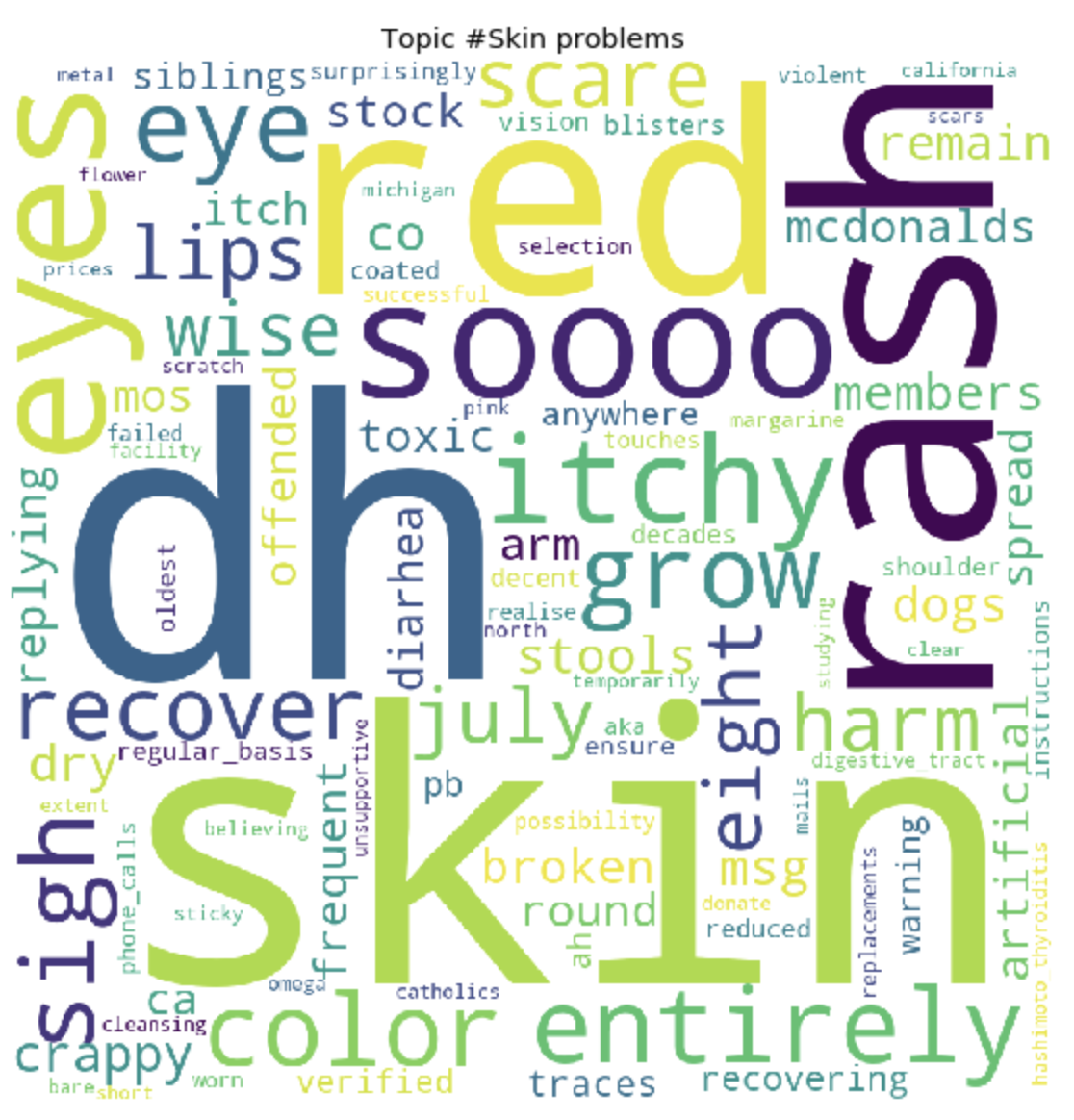

plt.show()

```

Как это может быть заметно, топики получились довольно отличимы по содержанию друг от друга. По ним становится ясно, о чем ведутся разговоры у людей с глютеновой непереносимостью. В основном, про продукты питания, походы в рестораны, загрязнения пищи глютеном, ужасными болями, лечением, походами по докторам, семье, непониманием и прочими вещами, с которыми им приходится сталкиваться людям каждый день, в связи со свой проблемой.

Вот и все. Спасибо всем за внимание. Надеюсь этот материал вам оказался интересным и полезным. И все же так как я не DS разработчик, то не судите строго. Если есть, что добавить или улучшить, всегда приветствую конструктивную критику, пишите.

Для просмотра 30 топиков

**Осторожно, много изображений**

---

[Узнать подробнее о курсе «Machine Learning» от OTUS](https://otus.pw/DnQy/).

--- | https://habr.com/ru/post/503398/ | null | ru | null |

# Разработка виджета под Android

На Хабре уже достаточно статей о том, как разработать «hello world»-виджет для устройств на базе Android. Еще больше об этом можно почитать в сети, в том числе и на сайте Google для [разработчиков](http://developer.android.com/index.html), [StackOverflow](http://www.stackoverflow.com/) и других ресурсах. Казалось бы, все подробно разжевано, есть сотни примеров — зачем же писать очередную статью, когда вокруг и так достаточно информации?

Однако, когда мы начали разработку виджета, нам пришлось потратить несколько недель на то, чтобы разобраться с нюансами и реализовать проект так, как мы задумали его изначально.

Надеемся, наш опыт поможет сэкономить время на реализацию вашего виджета.

#### Подготовка

Для разработки была выбрана [Android Stuido](http://developer.android.com/sdk/installing/studio.html).Продукт еще очень сырой, не все разработчики готовы на него перейти, но отличная работа Preview и широкие возможности системы сборки Gradle берут верх над всеми недочетами. Поэтому мы рискнули попробовать, и, как оказалось, не зря.

Для тестирования, помимо непосредственной отладки на тестовом смартфоне, мы также использовали программные эмуляторы. Стандартным пользоваться достаточно проблематично, были рассмотрены различные высокопроизводительные эмуляторы [Android-x86](http://suse.me/soft/android-x86/all/), [AndroVM](http://suse.me/soft/androvm/all/), [Genymotion](http://suse.me/soft/genymotion/all/), Manymo и другие. В итоге мы выбрали Genymotion — он подкупил своей простотой установки и скоростью работы Android-x86, [подробная инструкция по настройке и установке](http://habrahabr.ru/post/130201/) — необходим для тестирования на устройствах с Android 4.0 и ниже.

Данные эмуляторы отлично работают под различными ОС: Linux, Mac, Windows, у разработчиков бывают разные предпочтения, а переубеждать их неправильно, так что кроссплатформенные инструменты выручают.

Также эти программы помогают при автоматизированном тестировании: тесты написаны с использованием Android Instrumentation Framework, JUnit, Robotium. Подробнее об этом в следующей статье, которую мы опубликуем в ближайшее время :)

#### Проектирование

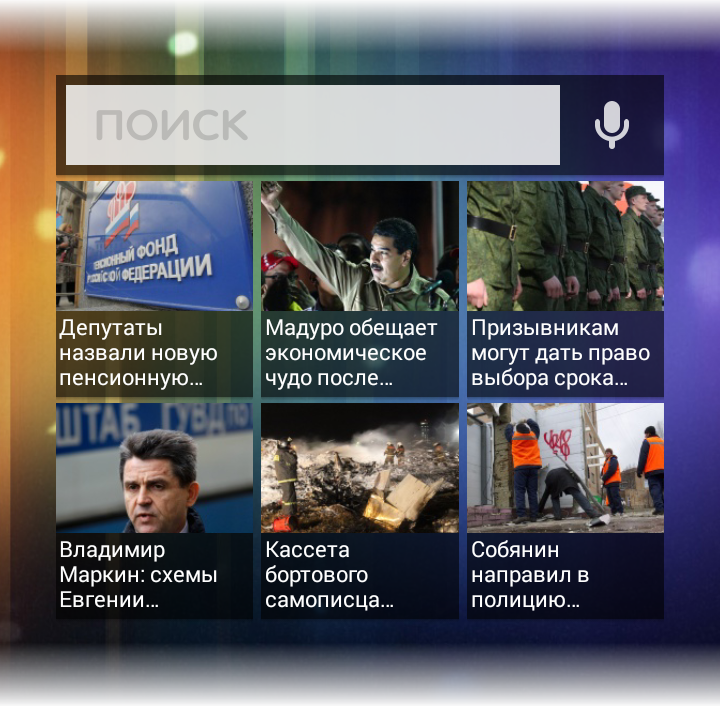

Итак, мы хотим, чтобы пользователь видел поисковую форму, кнопку голосовых запросов, а при увеличении доступного размера виджета — анонсы актуальных новостей.

По данным Google Play, в мире зарегистрировано около 4500 видов различных устройств с поддержкой Android.