text

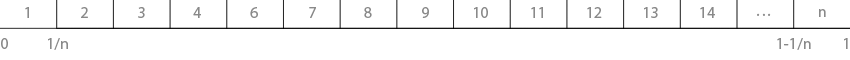

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

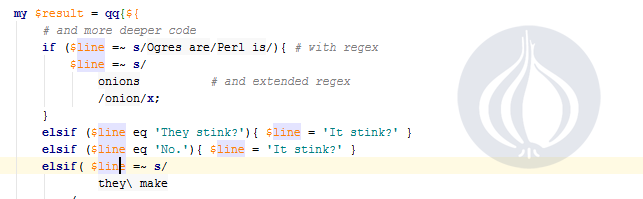

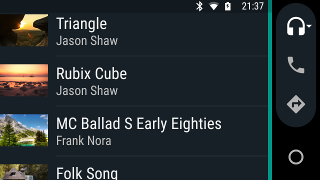

# Вышла версия 1.5 Perl плагина для IntelliJ IDEA

Вышел знаковый для меня релиз плагина. Год назад я начал работу над ним и иногда не верится что все это было сделано. В репозиторий прошло более двух тысяч коммитов.

Данная версия привносит поддержку POD, хелперов для Mojolicious, контекстную подсказку и много приятных мелочей.

Что новенького?

---------------

* Поддержка POD файлов и инлайн документации: парсинг, подсветка, авто-дополнение, навигация по ссылкам и документируемым элементам, рефакторинг первого и второго

* Контекстная подсказка: по нажатию сочетания Ctrl+Q вы можете получить подсказку как по perl-элементам, так и по вашим функциям, если вы, конечно, ведете документацию

* Поддержка хелперов для Mojolicious. Для явно заданных хелперов теперь работает навигация, авто-дополнение и рефакторинг. Хитроумные конструкции вроде `$app->helper($_, sub{}) for @something;` плагин не понимает (tnx [greyhard](https://habrahabr.ru/users/greyhard/))

* Добавлна новая аннотация `#@inject`, которая позволяет инжектировать другие языки в строки. Изначально подобная возможность была только для here-doc на основе теста маркера, теперь можно делать то же самое и в строках, что может быть очень удобно для, например, коротких запросов. Аннотация может быть расположена перед строкой, стейтментом со строкой или в конце строки. Последний вариант может вносить путанницу и должен рассматриваться как эскпериментальный. Нужен [фидбек](https://github.com/hurricup/Perl5-IDEA/issues/1072)

* Методы классов теперь корректно рефакторятся в дочерних классах и, опционально, в родительских

* Пакеты теперь можно создавать по полному имени, папки для пути будут созданы автоматически

* Базовая поддержка синтаксиса [TryCatch](http://search.cpan.org/~ash/TryCatch/lib/TryCatch.pm), а именно: `catch{}`, `catch($var){}` и `catch(Foo::Bar $var){}`

* Инспекшен для ненужных явных неймспейсов. Например, когда вы вызываете функцию `Foo::Bar::somesub()` из неймспейса `Foo::Bar`

* Лексические переменные теперь находятся вверху списка авто-дополнения

* Значительно улучшена и ускорена работа парсера для незаконченных выражений. Ситуации когда во время ввода отключается подсветка половины файла ниже практически исчезла, а ошибки стали более адекватны

* Добавлен экшен для депарса файла с помощью `B::Deparse`, что может быть крайне удобно при работе с чужим кодом (за идею спасибо [лекциям от Мейл.ру](https://www.youtube.com/playlist?list=PLrCZzMib1e9pJchUR-KGNJvz2BA6XjIPr))

* Добавлен аннотатор [`Perl::Critic`](http://search.cpan.org/~thaljef/Perl-Critic/). Плагин умеет запускать его и отмечать в коде выданные им замечания. Все настройки должны быть в файле `.perlcriticrc` в корне проекта или настроены через окружение. Никакого UI для настроек в настоящий момент нет

* Добавлен экшен переформатирования с помощью [`Perl::Tidy`](http://search.cpan.org/~shancock/Perl-Tidy/). Аналогично критику, все настройке в корне проекта в файле `.perltidyrc` или в окружении. UI для настроек в этой версии отсутствует.

Список багкфиксов можно найти в релиз-ноутсах на странице плагина в репозитории JetBrains (см.ниже).

Что дальше?

-----------

Дебаггер близко…

Ссылки

------

* Плагин в репозитории JetBrains: [plugins.jetbrains.com/plugin/7796](http://plugins.jetbrains.com/plugin/7796)

* Плагин на GitHub: [github.com/hurricup/Perl5-IDEA](http://github.com/hurricup/Perl5-IDEA)

* Наш Твиттер: [twitter.com/CamelcadeIDE](https://twitter.com/CamelcadeIDE)

Приятного кодинга и всем поддерживающим — спасибо за поддержку, без вас я бы не продержался этот год. | https://habr.com/ru/post/282592/ | null | ru | null |

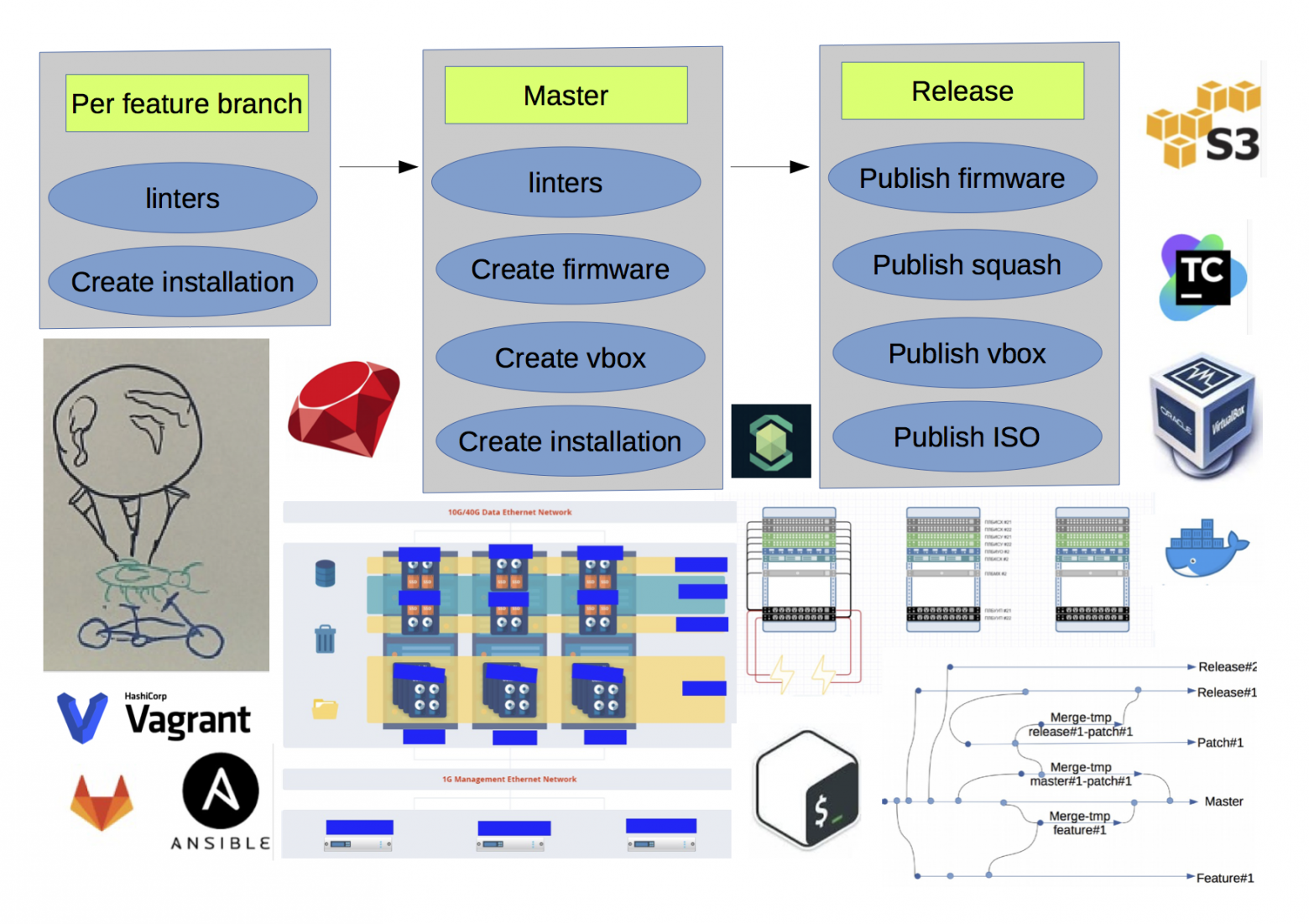

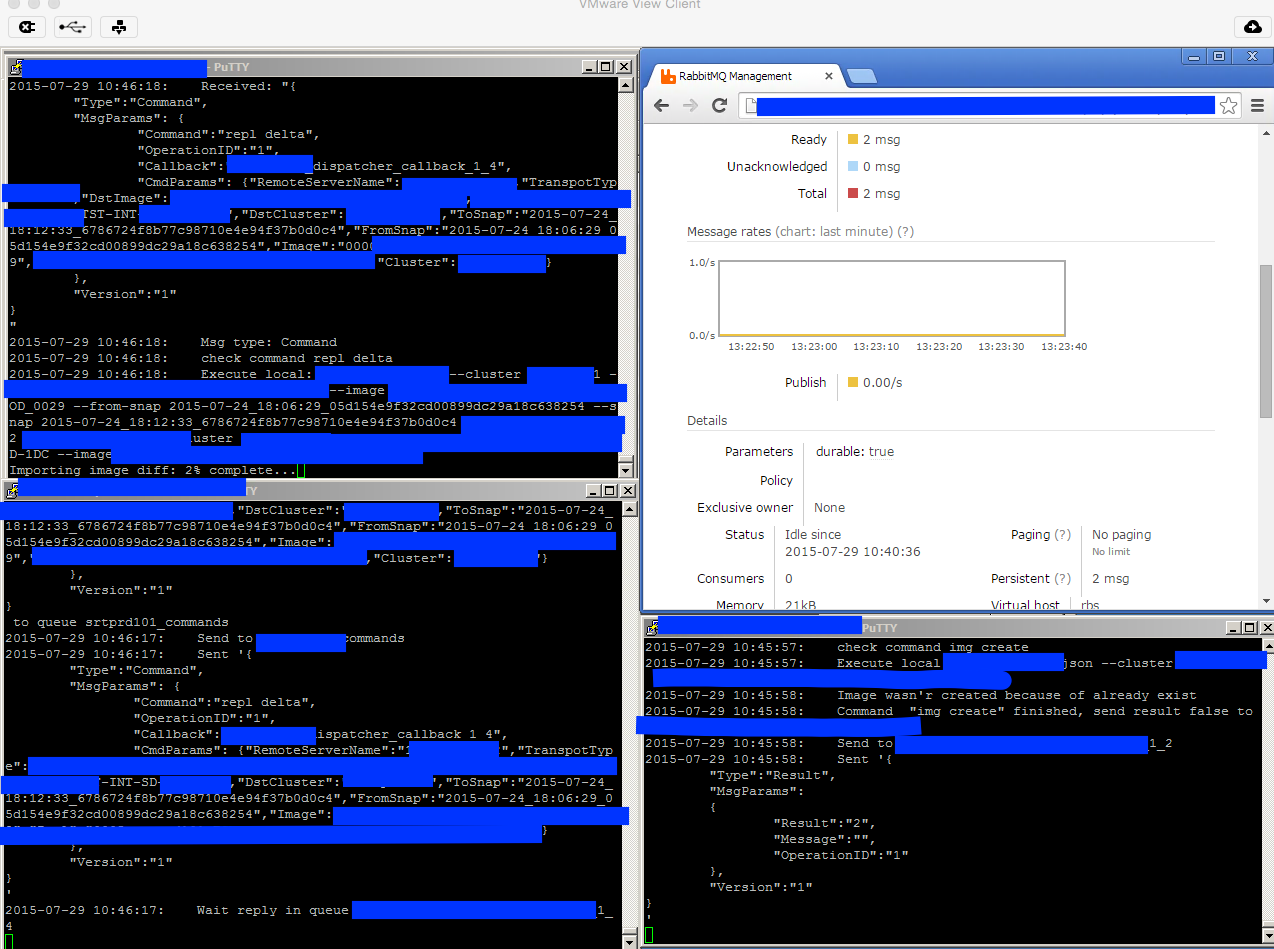

# DSP на .Net под Windows. Джедайской Силы Пост

Всем привет!

В [первой статье](http://habrahabr.ru/company/targetix/blog/261191/) мы рассказали о нашей инфраструктуре в целом. Теперь пришло время сосредоточиться на конкретных продуктах. В этой статье речь пойдёт о DSP. Как многие знают, DSP (Demand Side Platform) — автоматизированная система покупки рекламы. Требования к системе жёсткие: она должна держать высокую нагрузку (тысячи запросов в секунду), быстро отвечать (до 50 мс, а то и меньше) и, самое главное, выбирать максимально подходящие объявления. Чаще всего такие проекты разрабатываются под Linux, мы же смогли создать по-настоящему высокопроизводительный сервис под Windows Server. Как этого добиться, и как это удалось нам? Об этом я и расскажу.

У нас DSP состоит из двух приложений: собственно биддер — Windows-сервис для взаимодействия с SSP, и DspDelivery — ASP.NET приложение для конечной доставки и регистрации интерактивных действий пользователя. С доставкой всё более-менее просто, а вот на биддер посмотрим повнимательнее.

Платформа

---------

В качестве платформы используется .NET, основной язык — C#. Раз мы пишем биддер, то нам нужен веб-сервер и обвязка. Сначала мы пошли по простому пути: прикрутили IIS, создали ASP.NET-приложение с фреймворком ASP.NET Web API и начали пилить бизнес-логику. Быстро стало понятно, что вся эта конструкция не держит больше 500-700 запросов в секунду. Как бы мы ни заклинали IIS, ни подкручивали 100500 параметров, проблема не решалась. И совсем доставало, что залезть внутрь IIS нет возможности, а значит полного контроля над ситуацией нам не добиться. IIS — пресловутый черный ящик, в котором тяжело что-то кардинально изменить.

Тогда мы попробовали сервер проекта Katana (реализация OWIN-инфраструктуры от Microsoft). Katana — проект с открытым исходным кодом, поэтому можно было увидеть внутренности. К тому же, у Web API есть поддержка OWIN, а значит, сильно менять код не придется. Katana предоставляет возможность работать как с IIS, так и с их простым сервером, написанным на основе .NET-овского HttpListener. Именно его мы и взяли. Результат порадовал: теперь сервер держал около 2000 запросов в секунду, а ASP.NET приложение трансформировалось в Windows-сервис.

Однако нагрузка на сервера увеличивалась, пилились новые фичи. Становилось понятно, что и этот вариант нас тоже не устраивает. Тогда мы пошли на кардинальные меры: от всей Катаны остался только HttpListener с небольшой обвязкой для асинхронности, от Web API не осталось ничего, то есть приложение стало полностью заточено под HTTP-запросы для биддера. В результате сервер стал способен обрабатывать до 9000 запросов в секунду. Вывод прост: вся OWIN- и Web API-обвязка оказывает критическое влияние на высокопроизводительные приложения. Хотите быстрее — пишите проще и неуниверсально. (Это не говорит о том, что внутри приложения должен быть ядерный говнокод. У нас всё модульно, вполне расширяемо: DI, паттерны и всё такое). Пример кода обработки запросов:

```

var listener = new HttpListener();

listener.IgnoreWriteExceptions = true;

// Настройка прослушиваемых хостов

listener.Start();

var listenThread = new Thread(() =>

{

while (listener.IsListening)

{

try

{

var result = listener.BeginGetContext(ar =>

{

try

{

var context = listener.EndGetContext(ar);

byte[] buffer = null;

object requestObj = "";

if (context.Request.HttpMethod == "POST")

{

try

{

if (context.Request.RawUrl.Contains("/openrtb"))

{

buffer = HandleOpenRtbRequestAndGetResponseBuffer(context.Request, out requestObj);

}

else if (context.Request.RawUrl.Contains("/doubleclick"))

{

buffer = HandleDoubleClickRtbRequestAndGetResponseBuffer(context.Request, out requestObj);

}

// обработки от других систем

}

catch (Exception ex)

{

// Логгирование

}

if (buffer != null)

{

WriteNotEmptyResponse(context.Response, buffer, "application/json");

}

else

{

WriteEmptyResponse(context.Response);

}

}

else

{

WriteNotFoundResponse(context.Response);

}

context.Response.Close();

}

catch (Exception ex)

{

// Логгирование

}

}, listener);

result.AsyncWaitHandle.WaitOne();

}

catch (Exception ex)

{

// Логгирование

}

});

listenThread.Start();

```

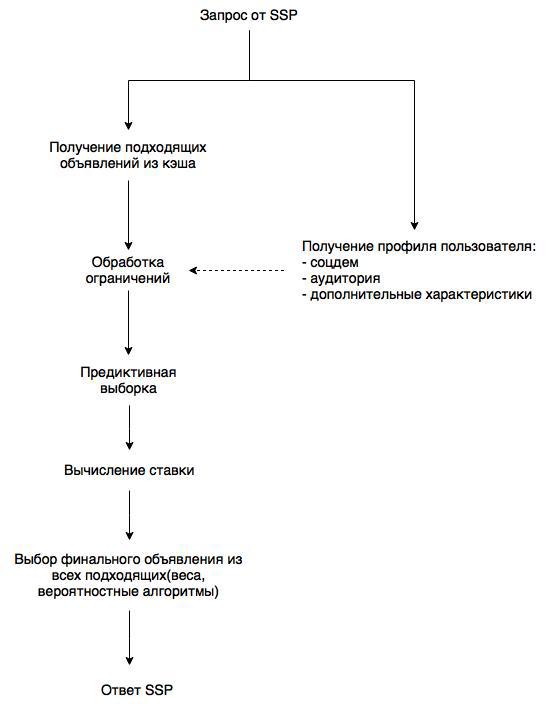

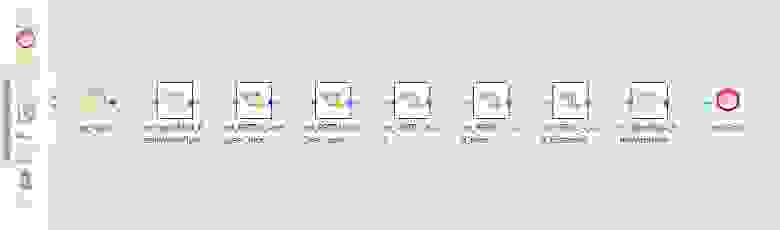

Схема работы

------------

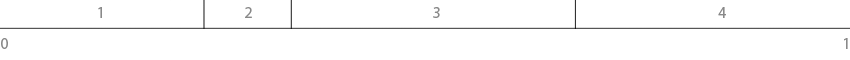

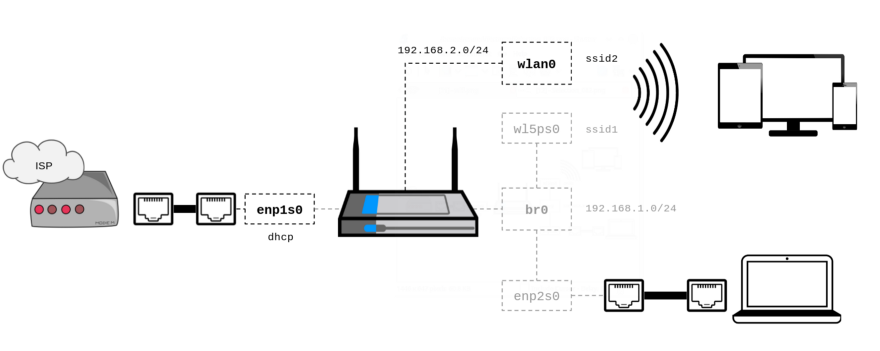

Вернёмся к предметной области и посмотрим на схему работы биддера:

Схема упрощенная, однако по ней понятно, на что стоит обратить внимание. Во-первых, инвентарь (то есть список объявлений с ограничениями). Список хранится в памяти и раз в минуту обновляется. А вот за профилем пользователя необходимо каждый раз лезть в базу. В этой же базе DMP обновляет профили, что позволяет не тратить ресурсы на удаленное взаимодействие с источниками данных. Ограничения задаются по гибкой схеме: любые атомарные фильтры (принадлежность к аудитории, гео, черно-белые списки доменов, соцдем и т.д.) объединяются в любые последовательности и/или-контейнеров. Предиктор позволяет наилучшим образом оптимизировать покупку. И здесь мы подходим к вопросу выбора базы данных. Без быстрого и масштабируемого решения невозможно обеспечить максимальную производительность.

База данных

-----------

Здесь нам тоже не удалось попасть с первого раза и начинали мы с красивых раскрученных решений (нет, не с MS SQL). Сначала взяли MongoDB (2.4): привлекали хорошая производительность, JSON-схема, репликация, шардирование из коробки, якобы простая поддержка расширения кластера. На деле всё оказалось не столь радужно. Блокировки на операциях записи сильно тормозили работу системы, шардирование оказалось сложно конфигурируемым (до сих пор помню как мы спорили, какой ключ шарда для коллекции выбрать) — данные никак не хотели распределяться равномерно, а сброс данных на диск (не столь частый, впрочем) добавлял дополнительных блокировок.

Следующей попыткой была Couchbase. Здесь уже не было блокировок и структура данных была попроще — обычное key-value. Но недостатки всё равно имелись: нагрузка на дисковую подсистему была чрезмерной, а также недостаточная конфигурируемость и отвратительная расширяемость (вернее отсутствие таковой). Техподдержка тоже оставляла желать лучшего.

Но именно тогда у суровой и дорогой БД Aerospike появилась свободная лицензия. Это оказалось подходящим решением. Возросла скорость, упала нагрузка на диск, упростилось конфигурирование кластера. У Aerospike тоже находились баги. Но после описания проблемы на форуме (например, [проблема с выборкой по диапазону](https://discuss.aerospike.com/t/query-by-range-does-not-return-all-data/421)) она оперативно фиксилась в обновлении. В итоге у нас Aerospike-кластер из 7 серверов, легко обрабатывающий всю нагрузку.

Интеграция

----------

Главная интеграция DSP — это, конечно, сторонние SSP. И они явно делятся на две всем известные группы: российские и западные. С российскими всё просто: они работают по протоколу OpenRTB 2.\* и отличаются только наличием или отсутствием дополнительных фич (типа поддержки fullscreen-баннера). Каждая западная SSP работает по собственному протоколу и интеграция занимает не столь короткое время. То есть приходится реализовывать поддержку их протокола. Самый известный пример — Google.

Стоит сказать про чисто техническое взаимодействие. Во-первых, информация о действиях посетителей посылается в DMP через Apache Flume. Ещё одно направление: выгрузка статистики в Trading Desk. В данном случае соотвествующий сервис Trading Desk сам запрашивает статистику за некоторый минимальный период и получает её в запакованном виде (zMQ + MessagePack). после чего группирует и записывает в свою БД (как раз так работает [Hybrid](http://hybrid.ru/)).

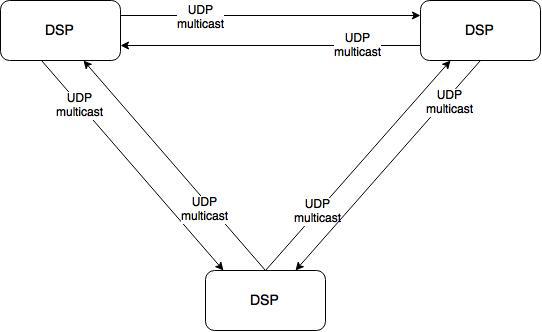

Синхронизация

-------------

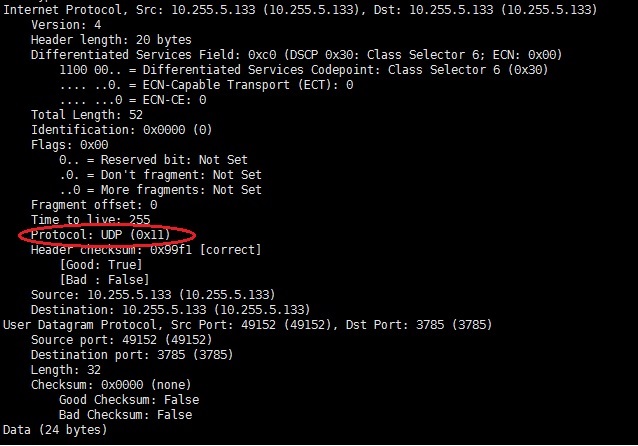

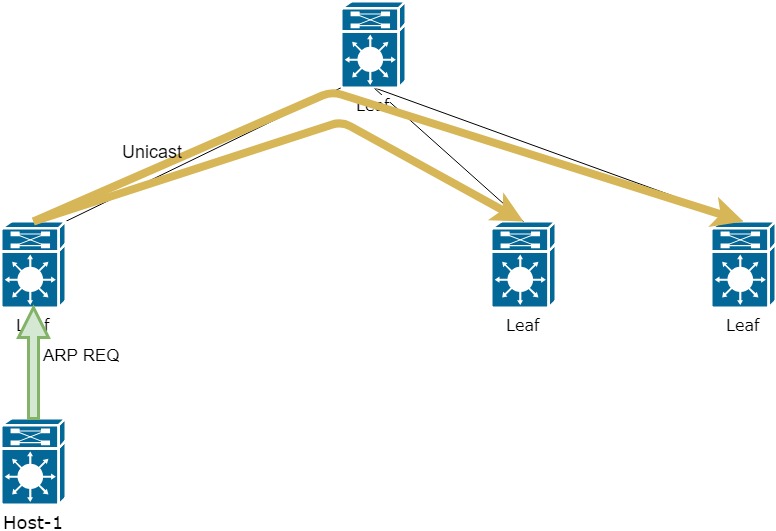

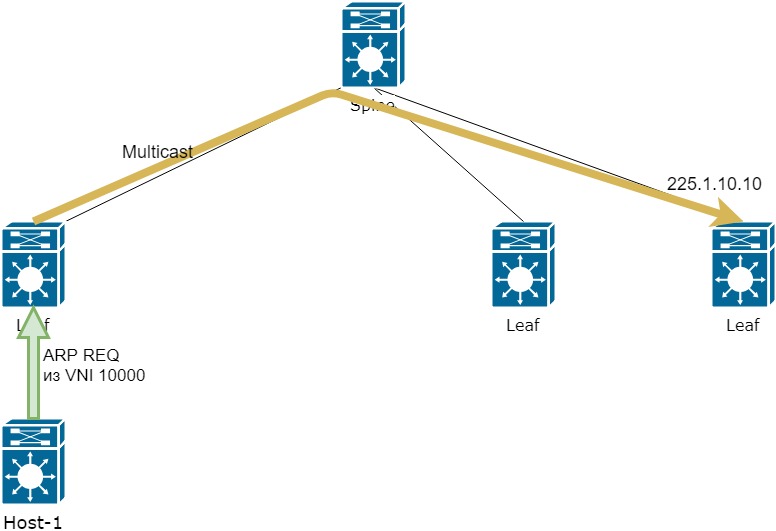

Теперь поднимемся на уровень выше и посмотрим на систему целиком. Это 10 серверов, на каждом по одному экземпляру DSP. Для корректной работы инстансам нужно обмениваться данными. Например, о степени откуртки кампании (чтобы избежать перекрута) и корректной работы ограничения показов конкретной кампании конкретному пользователю (frequency capping). Для этого при каждом действии посетителя рассылается уведомление другим инстансам DSP по UDP multicast. Таким образом производится синхронизация. Никаких суровых фреймворков тут не используется, только чистый и незамутненный хардкор.

Результат

---------

В итоге мы получили высокопроизводительную и отказоустойчивую систему, где каждый сервер обрабатывает до 9000 запросов в секунду с ответом до 10 мс. Мы прошли непростой путь и теперь точно понимаем, какой должна быть современная DSP и знаем на практике, как её построить. Впереди у нас планы по интеграции с новыми системами, улучшению оптимизации закупок и распределения бюджета. И ещё много всего интересного))

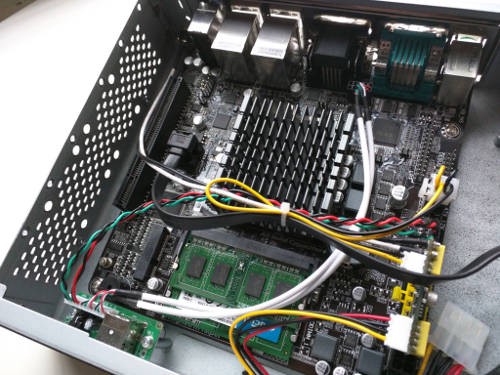

Для интересующихся, конфигурация системы:

* 10 серверов (Windows Server 2008 R2) для приложения (bidder + delivery) — 2x Xeon E5 2620 по 6 ядер на каждый, 64 ГБ ОЗУ,

* 7 серверов (CentOS 6.6) Aerospike — 1x Xeon E5 2620, 200 ГБ ОЗУ. | https://habr.com/ru/post/261745/ | null | ru | null |

# Java. Adapter Pattern in Game Server

AdapterАдаптер — это шаблон структурного проектирования, который позволяет объектам с несовместимыми интерфейсами взаимодействовать друг с другом.

Также известен как “Обертка”.

### Проблема

Чтобы продемонстрировать этот шаблон, я буду использовать упрощенный пример игровой механики, в которой есть интерфейс **IEnemy**, но один из врагов отличается от других и не имеет реализации метода атаки. Вместо этого, этот конкретный враг (**SpecialEnemy**) накладывает заклинания.

### Решение

Вы можете создать **адаптер**. Это специальный объект, который преобразует интерфейс одного объекта, чтобы другой объект мог его понять. Адаптер оборачивает один из объектов, чтобы скрыть сложность преобразования, происходящего за кулисами. Обернутый объект даже не знает об адаптере. Например, вы можете обернуть объект, который работает в метрах и километрах, с помощью адаптера, который преобразует все данные в британские единицы, такие как футы и мили. Адаптеры могут не только преобразовывать данные в различные форматы, но также могут помогать объектам с разными интерфейсами взаимодействовать друг с другом. Вот как это работает:

1. Адаптер получает интерфейс, совместимый с одним из существующих объектов.

2. Используя этот интерфейс, существующий объект может безопасно вызывать методы адаптера.

3. При получении вызова адаптер передает запрос второму объекту, но в формате и порядке, которые ожидает второй объект.

Иногда даже можно создать двусторонний адаптер, который может конвертировать вызовы в обоих направлениях. Вернемся к нашему игровому приложению. Чтобы решить дилемму несовместимых врагов, вы можете создать адаптер **EnemyAdapter** для каждого класса особенных врагов, с которым ваш код работает напрямую. Затем вы настраиваете свой код для связи с **SpecialEnemy** только через эти адаптеры. Когда адаптер получает вызов, он переводит входящие атаки в кастование спеллов.

### Структура

Существует несколько видов адаптеров

**Object adapter**В этой реализации используется принцип композиции объектов: адаптер реализует интерфейс одного объекта и обертывает другой. Его можно реализовать на всех популярных языках программирования.

**Class adapter**В этой реализации используется наследование: адаптер наследует интерфейсы от обоих объектов одновременно. Обратите внимание, что этот подход может быть реализован только в языках программирования, поддерживающих множественное наследование, таких как C ++.

### Применимость

**Используйте класс Adapter, если вы хотите использовать какой-либо существующий класс, но его интерфейс несовместим с остальной частью вашего кода.**

Шаблон адаптера позволяет вам создать класс среднего уровня, который служит транслятором между вашим кодом и унаследованным классом, сторонним классом или любым другим классом со странным интерфейсом.

Используйте шаблон, если вы хотите повторно использовать несколько существующих подклассов, в которых отсутствуют некоторые общие функции и нельзя добавить в суперкласс.

Вы можете расширить каждый подкласс и добавить недостающие функции в новые дочерние классы. Однако вам придется продублировать код во всех этих новых классах, что очень плохо "пахнет".

Гораздо более элегантным решением было бы поместить недостающие функции в класс адаптера. Затем вы должны обернуть объекты с недостающими функциями внутри адаптера, динамически получая необходимые функции. Чтобы это работало, целевые классы должны иметь общий интерфейс, а поле адаптера должно следовать за этим интерфейсом. Этот подход очень похож на шаблон **Decorator**.

### Реализация

Добавляем специальных врагов.

Создадим класс **SpecialEnemy**, использующий метод **CastSpell**.

```

class SpecialEnemy {

public String castSpell() {

return "using spell";

}

}

```

Я буду использовать строку возврата, чтобы упростить процесс.

Затем, создадим интерфейс **IEnemy** для управления поведением врагов, в данном случае это только один метод для атаки

```

interface IEnemy {

String attack();

}

```

Теперь нам нужно реализовать этот интерфейс в классе **EnemyAdapter**, который соединит обе части вместе.

```

class EnemyAdapter implements IEnemy {

SpecialEnemy e = new SpecialEnemy();

public string attack() {

return e.CastSpell();

}

}

```

Нам нужно добавить ссылку на **SpecialEnemy**, чтобы иметь доступ к методу **CastSpell**. Таким образом, мы можем использовать метод атаки без реализации его в **SpecialEnemy**. Или мы можем создать конструктор и передать туда экземпляр **SpecialEnemy**.

```

class EnemyAdapter implements IEnemy {

SpecialEnemy e;

EnemyAdapter(SpecialEnemy se) {

this.e = se;

}

public string attack() {

return e.CastSpell();

}

}

```

Последний шаг - вызвать метод **Enemy Attack** в клиентском классе.

```

class Main {

public static void main(String[] args) {

IEnemy enemy = new EnemyAdapter();

System.out.println(enemy.Attack());

}

}

```

В качестве вывода мы получаем строку «использование заклинания». Этот пример был слишком упрощен, но он демонстрирует идею, лежащую в основе этого простого шаблона. Надеюсь, он вам понравился и был полезен. | https://habr.com/ru/post/577220/ | null | ru | null |

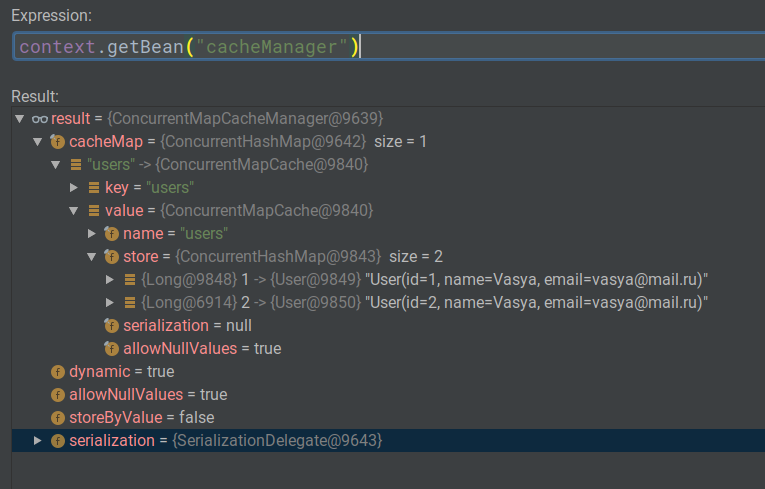

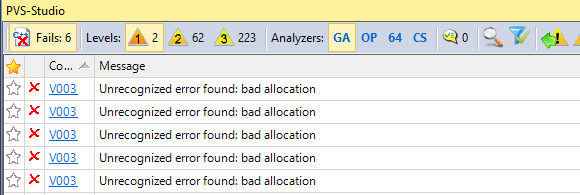

# PVS-Studio покопался во внутренностях Linux (3.18.1)

Соавтор: Святослав Размыслов [SvyatoslavMC](https://habrahabr.ru/users/svyatoslavmc/).

В рекламных целях мы решили попробовать проверить ядро Linux с помощью нашего статического анализатора кода. Эта задача интересна своей сложностью. Исходные коды Linux чем только не проверялись и проверяются. Поэтому найти хоть что-то новое, весьма сложная задача. Но если получится, то это будет хорошая рекламная заметка о возможностях анализатора PVS-Studio.

Что мы проверяли

----------------

Ядро Linux было взято с сайта [The Linux Kernel Archives](https://www.kernel.org/). Проверялась [Latest Stable Kernel 3.18.1](https://www.kernel.org/pub/linux/kernel/v3.x/linux-3.18.1.tar.xz).

К тому моменту, как я пишу эту статью, уже появилось ядро 3.19-rc1. К сожалению, проверка проекта и написание статьи занимают немало времени. Поэтому будем довольствоваться проверкой не самой последней версии.

Тем, кто скажет, что мы должны были проверить именно самую последнюю версию, я хочу ответить следующее.1. Мы регулярно [проверяем большое количество проектов](http://www.viva64.com/ru/a/0084/). Помимо бесплатной проверки проектов, у нас много других задач. И поэтому нет никакой возможности начинать всё сначала, только потому, что появилась новая версия. Так мы можем никогда ничего не опубликовать :).

2. 99% найденных ошибок осталось на своём месте. Так что эту статью смело можно использовать чтобы немного улучшить код ядра Linux.

3. Цель статьи — реклама PVS-Studio. Если мы можем найти ошибки в проекте версии X, то мы сможем найти что-то и в версии Y. Наши проверки достаточно поверхностны (мы не знакомы с проектом) и их целью является написание вот таких статей. Настоящую пользу проекту приносит приобретение лицензии на PVS-Studio и его регулярное использование.

Как мы проверяли

----------------

Для проверки ядра использовался статический анализатор кода [PVS-Studio](http://www.viva64.com/ru/pvs-studio/) версии 5.21.

Для проверки Linux Kernel был использован дистрибутив Ubuntu-14.04, для которого имелось много подробных инструкций по конфигурированию и сборке ядра. Анализатор проверяет [препроцессированные файлы](http://www.viva64.com/ru/t/0076/), которые лучше получать для успешно компилируемых файлов, поэтому сборка проекта один из самых важных этапов проверки.

Далее была написана небольшая утилита на C++, которая для каждого запущенного процесса компилятора сохраняла командную строку, текущую директорию и переменные окружения. Читателям, знакомым с продуктами PVS-Studio, должна сразу вспомниться утилита [PVS-Studio Standalone](http://www.viva64.com/ru/b/0243/), которая позволяет проверить любой проект под Windows. Там для обращения к процессам используется WinAPI, поэтому для Linux данный механизм мониторинга был переписан, остальной же код, связанный с запуском препроцессирования и проверки, был полностью перенесён, и проверка ядра Linux стала лишь вопросом времени.

В начале о безопасности

-----------------------

Как-то так сложилось, что анализатор PVS-Studio воспринимают исключительно как инструмент для поиска ошибок. Но никто не обращает внимание, что PVS-Studio умеет обнаруживать и ряд уязвимостей. Мы, конечно, виноваты в этом сами. Надо немного выправить ситуацию.

Можно по-разному воспринимать те сообщения, которые выдаёт PVS-Studio. Например, с одной стороны это опечатка, а с другой может быть уязвимостью. Всё зависит от точки зрения.

Хочу предложить рассмотреть несколько предупреждений, которые PVS-Studio выдал при анализе Linux. Я не говорю, что анализатор нашёл уязвимость в Linux. Но рассматриваемые предупреждения вполне могли бы это сделать.

### Опасное использование функции memcmp()

```

static unsigned char eprom_try_esi(

struct atm_dev *dev, unsigned short cmd,

int offset, int swap)

{

unsigned char buf[ZEPROM_SIZE];

struct zatm_dev *zatm_dev;

int i;

zatm_dev = ZATM_DEV(dev);

for (i = 0; i < ZEPROM_SIZE; i += 2) {

eprom_set(zatm_dev,ZEPROM_CS,cmd); /* select EPROM */

eprom_put_bits(zatm_dev,ZEPROM_CMD_READ,ZEPROM_CMD_LEN,cmd);

eprom_put_bits(zatm_dev,i >> 1,ZEPROM_ADDR_LEN,cmd);

eprom_get_byte(zatm_dev,buf+i+swap,cmd);

eprom_get_byte(zatm_dev,buf+i+1-swap,cmd);

eprom_set(zatm_dev,0,cmd); /* deselect EPROM */

}

memcpy(dev->esi,buf+offset,ESI_LEN);

return memcmp(dev->esi,"\0\0\0\0\0",ESI_LEN);

}

```

Предупреждение PVS-Studio: V642 Saving the 'memcmp' function result inside the 'unsigned char' type variable is inappropriate. The significant bits could be lost breaking the program's logic. zatm.c 1168

Обратите внимание на оператор 'return' в самом конце тела функции.

Функция 'memcmp' возвращает следующие значения типа 'int':* < 0 — buf1 less than buf2;

* 0 — buf1 identical to buf2;

* > 0 — buf1 greater than buf2;

Обратите внимание:* "> 0", означает любые числа, а вовсе не 1;

* "< 0", это не обязательно -1.

Возвращаемыми значениями могут быть: -100, 2, 3, 100, 256, 1024, 5555 и так далее. Это значит, что этот результат нельзя преобразовывать в тип 'unsigned char' (это тип, который возвращает функция).

В результате неявного приведения типа могут быть отброшены значащие биты, что приведет к нарушению логики выполнения программы.

Опасность такого рода ошибок заключается в том, что возвращаемое значение может зависеть от архитектуры и реализации конкретной функции на данной архитектуре. Например, программа будет корректно работать в 32-битном варианте и некорректно в 64-битном.

Ну и что? Подумаешь, неправильно будет проверено что-то, связанное с EPROM. Ошибка, конечно, но при чём тут уязвимость?

А то, что диагностика V642 может выявить и уязвимость! Не верите? Пожалуйста, вот идентичный код из MySQL/MariaDB.

```

typedef char my_bool;

...

my_bool check(...) {

return memcmp(...);

}

```

Не PVS-Studio нашёл эту ошибку. Но мог бы.

Эта ошибка послужила причиной серьезной уязвимости в MySQL/MariaDB до версий 5.1.61, 5.2.11, 5.3.5, 5.5.22. Суть в том, что при подключении пользователя MySQL /MariaDB вычисляется токен (SHA от пароля и хэша), который сравнивается с ожидаемым значением функцией 'memcmp'. На некоторых платформах возвращаемое значение может выпадать из диапазона [-128..127]. В итоге, в 1 случае из 256 процедура сравнения хэша с ожидаемым значением всегда возвращает значение 'true', независимо от хэша. В результате, простая команда на bash даёт злоумышленнику рутовый доступ к уязвимому серверу MySQL, даже если он не знает пароль. Причиной этому стал код в файле 'sql/password.c', показанный выше. Более подробное описание этой проблемы можно прочитать здесь: [Security vulnerability in MySQL/MariaDB](http://seclists.org/oss-sec/2012/q2/493).

Вернёмся теперь к Linux. Вот ещё один опасный фрагмент кода:

```

void sci_controller_power_control_queue_insert(....)

{

....

for (i = 0; i < SCI_MAX_PHYS; i++) {

u8 other;

current_phy = &ihost->phys[i];

other = memcmp(current_phy->frame_rcvd.iaf.sas_addr,

iphy->frame_rcvd.iaf.sas_addr,

sizeof(current_phy->frame_rcvd.iaf.sas_addr));

if (current_phy->sm.current_state_id == SCI_PHY_READY &&

current_phy->protocol == SAS_PROTOCOL_SSP &&

other == 0) {

sci_phy_consume_power_handler(iphy);

break;

}

}

....

}

```

Предупреждение PVS-Studio: V642 Saving the 'memcmp' function result inside the 'unsigned char' type variable is inappropriate. The significant bits could be lost breaking the program's logic. host.c 1846

Результат работы функции memcmp() помещается в переменную other, имеющую тип unsigned char. Не думаю, что эта какая-то уязвимость, но работа SCSI контроллера в опасности.

Ещё парочку таких мест можно найти здесь:* V642 Saving the 'memcmp' function result inside the 'unsigned char' type variable is inappropriate. The significant bits could be lost breaking the program's logic. zatm.c 1168

* V642 Saving the 'memcmp' function result inside the 'unsigned char' type variable is inappropriate. The significant bits could be lost breaking the program's logic. host.c 1789

### Опасное использование функции memset()

Продолжим искать опасные места. Обратим свой взор на функции, которые «подчищают» за собой приватные данные. Обычно это различные функции шифрования. К сожалению, не всегда обнуление памяти написано правильно. И тогда можно получить крайне неприятный результат. Подробнее про эти неприятные моменты можно узнать из этой статьи: "[Перезаписывать память — зачем?](http://www.viva64.com/ru/k/0041/)".

Рассмотрим пример неправильного кода:

```

static int crypt_iv_tcw_whitening(....)

{

....

u8 buf[TCW_WHITENING_SIZE];

....

out:

memset(buf, 0, sizeof(buf));

return r;

}

```

Предупреждение PVS-Studio: V597 The compiler could delete the 'memset' function call, which is used to flush 'buf' buffer. The RtlSecureZeroMemory() function should be used to erase the private data. dm-crypt.c 708

На первый взгляд всё хорошо. Функция crypt\_iv\_tcw\_whitening() выделила на стеке временный буфер, что-то зашифровала, а затем обнулила буфер с приватными данными с помощью вызова функции memset(). Но, на самом деле, вызов функции memset() будет удалён компилятором при оптимизации. С точки зрения языка C/C++ после обнуления буфера он никак не используется. А значит буфер можно не обнулять.

При этом, заметить такую ошибку крайне сложно. Написать юнит-тест сложно. Под отладчиком такая ошибка тоже не будет видна (в Debug-версии будет присутствовать вызов функции memset).

При этом хочу подчеркнуть. Это не «теоретически-возможное поведение компилятора», а очень даже практическое. Компиляторы действительно удаляют вызов функции memset(). Подробнее про это можно прочитать в описании диагностики [V597](http://www.viva64.com/ru/d/0208/).

PVS-Studio неуместно рекомендует использовать функцию RtlSecureZeroMemory(), так как ориентирован на Windows. В Linux такой функции, конечно, нет. Но здесь главное предупредить, а подобрать нужную функцию уже не сложно.

Следующий аналогичный пример:

```

static int sha384_ssse3_final(struct shash_desc *desc, u8 *hash)

{

u8 D[SHA512_DIGEST_SIZE];

sha512_ssse3_final(desc, D);

memcpy(hash, D, SHA384_DIGEST_SIZE);

memset(D, 0, SHA512_DIGEST_SIZE);

return 0;

}

```

Предупреждение PVS-Studio: V597 The compiler could delete the 'memset' function call, which is used to flush 'D' buffer. The RtlSecureZeroMemory() function should be used to erase the private data. sha512\_ssse3\_glue.c 222

А ниже пример, где могут быть не обнулены сразу 4 буфера: keydvt\_out, keydvt\_in, ccm\_n, mic. Код взят из файла security.c (строки 525 — 528).

```

int wusb_dev_4way_handshake(....)

{

....

struct aes_ccm_nonce ccm_n;

u8 mic[8];

struct wusb_keydvt_in keydvt_in;

struct wusb_keydvt_out keydvt_out;

....

error_dev_update_address:

error_wusbhc_set_gtk:

error_wusbhc_set_ptk:

error_hs3:

error_hs2:

error_hs1:

memset(hs, 0, 3*sizeof(hs[0]));

memset(&keydvt_out, 0, sizeof(keydvt_out));

memset(&keydvt_in, 0, sizeof(keydvt_in));

memset(&ccm_n, 0, sizeof(ccm_n));

memset(mic, 0, sizeof(mic));

if (result < 0)

wusb_dev_set_encryption(usb_dev, 0);

error_dev_set_encryption:

kfree(hs);

error_kzalloc:

return result;

....

}

```

И последний пример, где в памяти остаётся «болтаться» какой-то пароль:

```

int

E_md4hash(const unsigned char *passwd, unsigned char *p16,

const struct nls_table *codepage)

{

int rc;

int len;

__le16 wpwd[129];

/* Password cannot be longer than 128 characters */

if (passwd) /* Password must be converted to NT unicode */

len = cifs_strtoUTF16(wpwd, passwd, 128, codepage);

else {

len = 0;

*wpwd = 0; /* Ensure string is null terminated */

}

rc = mdfour(p16, (unsigned char *) wpwd, len * sizeof(__le16));

memset(wpwd, 0, 129 * sizeof(__le16));

return rc;

}

```

Предупреждение PVS-Studio: V597 The compiler could delete the 'memset' function call, which is used to flush 'wpwd' buffer. The RtlSecureZeroMemory() function should be used to erase the private data. smbencrypt.c 224

На этом остановлюсь. Ещё 3 неудачных memset() можно найти здесь:* sha256\_ssse3\_glue.c 214

* dev-sysfs.c 104

* qp.c 143

### Опасные проверки

У анализатора PVS-Studio есть диагностика V595, которая выявляет ситуации, когда указатель в начале разыменовывается, а потом проверяется на равенство NULL. Иногда с этой диагностикой всё просто и понятно. Рассмотрим такой простой случай:

```

static int tc_ctl_action(struct sk_buff *skb, struct nlmsghdr *n)

{

struct net *net = sock_net(skb->sk);

struct nlattr *tca[TCA_ACT_MAX + 1];

u32 portid = skb ? NETLINK_CB(skb).portid : 0;

....

}

```

Предупреждение PVS-Studio: V595 The 'skb' pointer was utilized before it was verified against nullptr. Check lines: 949, 951. act\_api.c 949

Здесь всё просто. Если указатель 'skb' будет равен нулю, то быть беде. Указатель разыменовывается в первой строке.

Следует отметить, что анализатор ругается не потому, что увидел разыменование непроверенного указателя. Так было бы слишком много ложных срабатываний. Ведь не всегда аргумент функции может быть равен 0. Возможно, проверка осуществлялась где-то ещё.

Логика работы иная. PVS-Studio считает код опасным, если указатель разыменовывается, а потом ниже проверяется. Если указатель проверяют, то предполагают, что он может быть равен 0. Следовательно это повод выдать предупреждение.

С этим простым примером разобрались. Но нам интересен вовсе не он.

Теперь перейдём к более сложному случаю, связанному с оптимизациями, которые выполняют компиляторы.

```

static int podhd_try_init(struct usb_interface *interface,

struct usb_line6_podhd *podhd)

{

int err;

struct usb_line6 *line6 = &podhd->line6;

if ((interface == NULL) || (podhd == NULL))

return -ENODEV;

....

}

```

Предупреждение PVS-Studio: V595 The 'podhd' pointer was utilized before it was verified against nullptr. Check lines: 96, 98. podhd.c 96

Это пример кода, увидев который, люди начинают спорить и говорить, что всё хорошо. Они рассуждают так.

Пусть указатель podhd равен NULL. Некрасиво выглядит выражение &podhd->line6. Но ошибки нет. Здесь нет доступа к памяти. Просто вычисляется адрес одного из членов класса. Да, значение указателя 'line6' некорректно. Оно указывает «в никуда». Но ведь этот указатель не используется. Вычислили некорректный адрес, ну и что? Ниже в коде расположена проверка и если 'podhd', то функция завершит свою работу. Указатель 'line6' нигде не используется, а значит на практике никакой ошибки не будет.

Господа, вы не правы! Так делать всё равно нельзя. Не ленитесь и исправляйте такой код.

При оптимизации компилятор рассуждает так. Вот здесь указатель разыменовывается: podhd->line6. Ага, программист знает что делает. Значит указатель здесь точно не равен нулю. Отлично, запомним это.

Дальше компилятор встречает проверку:

```

if ((interface == NULL) || (podhd == NULL))

return -ENODEV;

```

И оптимизирует её. Он считает, что указатель 'podhd' не равен нулю. Поэтому он сократит проверку до:

```

if ((interface == NULL))

return -ENODEV;

```

Как и в случае с memset() дополнительная сложность в том, что мы не увидим отсутствие проверки в Debug() версии. Такую ошибку очень сложно искать.

В результате, если передать в функцию нулевой указатель, то функция не вернёт статус (-ENODEV), а продолжит свою работу. Последствия могут быть непредсказуемы.

Важно следующее. Компилятор может удалить важную проверку указателя из плохо написанного кода. Т.е. существуют функции, которые только кажется, что проверяют указатели. На самом деле, они будут работать с нулевым указателем. Не знаю, можно ли это как-то использовать. Но, на мой взгляд, такую ситуацию вполне можно рассматривать как потенциальную уязвимость.

Ещё один подобный пример:

```

int wpa_set_keys(struct vnt_private *pDevice, void *ctx,

bool fcpfkernel) __must_hold(&pDevice->lock)

{

....

if (is_broadcast_ether_addr(¶m->addr[0]) ||

(param->addr == NULL)) {

....

}

```

Предупреждение PVS-Studio: V713 The pointer param->addr was utilized in the logical expression before it was verified against nullptr in the same logical expression. wpactl.c 333

Компилятор при оптимизации может сократить проверку до:

```

if (is_broadcast_ether_addr(¶m->addr[0]))

```

Ядро Linux большое. Так что предупреждений V595 было выдано более 200 штук. К своему стыду, я поленился их просматривать и выбрал только один пример для статьи. Остальные подозрительные места я предлагаю изучить кому-то из разработчиков. Я привожу их списком: [Linux-V595.txt](http://www.viva64.com/external-pictures/txt/Linux-V595.txt).

Да, далеко не все эти предупреждения указывают на реальную ошибку. Часто указатель точно не может быть равен нулю. Тем не менее, этот список стоит изучить. Почти наверняка можно найти пару десятков настоящих ошибок.

Найденные подозрительные места

------------------------------

Возможно, не все фрагменты кода, описанные в статье, содержат реальную ошибку. Однако, они крайне подозрительны и требуют пристального внимания для изучения.

### Некорректные логические условия

```

void b43legacy_phy_set_antenna_diversity(....)

{

....

if (phy->rev >= 2) {

b43legacy_phy_write(

dev, 0x0461, b43legacy_phy_read(dev, 0x0461) | 0x0010);

....

} else if (phy->rev >= 6)

b43legacy_phy_write(dev, 0x049B, 0x00DC);

....

}

```

Предупреждение PVS-Studio: V695 Range intersections are possible within conditional expressions. Example: if (A < 5) {… } else if (A < 2) {… }. Check lines: 2147, 2162. phy.c 2162

Второе условие никогда не выполняется. Для наглядности упростим код:

```

if ( A >= 2)

X();

else if ( A >= 6)

Y();

```

Как видите, не существует такого значения в переменной 'A', при котором будет вызвана функция Y().

Рассмотрим другие похожие случаи. В пояснении они не нуждаются.

```

static int __init scsi_debug_init(void)

{

....

if (scsi_debug_dev_size_mb >= 16)

sdebug_heads = 32;

else if (scsi_debug_dev_size_mb >= 256)

sdebug_heads = 64;

....

}

```

Предупреждение PVS-Studio: V695 Range intersections are possible within conditional expressions. Example: if (A < 5) {… } else if (A < 2) {… }. Check lines: 3858, 3860. scsi\_debug.c 3860

```

static ssize_t ad5933_store(....)

{

....

/* 2x, 4x handling, see datasheet */

if (val > 511)

val = (val >> 1) | (1 << 9);

else if (val > 1022)

val = (val >> 2) | (3 << 9);

....

}

```

Предупреждение PVS-Studio: V695 Range intersections are possible within conditional expressions. Example: if (A < 5) {… } else if (A < 2) {… }. Check lines: 439, 441. ad5933.c 441

Есть ещё парочка схожих ситуаций, которые не буду приводить, чтобы не делать статью излишне длинной:* V695 Range intersections are possible within conditional expressions. Example: if (A < 5) {… } else if (A < 2) {… }. Check lines: 1417, 1422. bnx2i\_hwi.c 1422

* V695 Range intersections are possible within conditional expressions. Example: if (A < 5) {… } else if (A < 2) {… }. Check lines: 4815, 4831. stv090x.c 4831

Теперь рассмотрим другую разновидность подозрительных условий.

```

static int dgap_parsefile(char **in)

{

....

int module_type = 0;

....

module_type = dgap_gettok(in);

if (module_type == 0 || module_type != PORTS ||

module_type != MODEM) {

pr_err("failed to set a type of module");

return -1;

}

....

}

```

Предупреждение PVS-Studio: V590 Consider inspecting the 'module\_type == 0 || module\_type != 68' expression. The expression is excessive or contains a misprint. dgap.c 6733

Я не знаком с кодом и у меня нет идей, как должна выглядеть эта проверка. Поэтому воздержусь от комментариев. Вот ещё одно похожее место: * V590 Consider inspecting the 'conc\_type == 0 || conc\_type != 65' expression. The expression is excessive or contains a misprint. dgap.c 6692

### «Вырви глаз»

В ходе изучения сообщений анализатора я встретил функцию name\_msi\_vectors(). Она хоть и короткая, но читать ее совершенно не хочется. Видимо, именно поэтому она содержит очень подозрительную строчку.

```

static void name_msi_vectors(struct ipr_ioa_cfg *ioa_cfg)

{

int vec_idx, n = sizeof(ioa_cfg->vectors_info[0].desc) - 1;

for (vec_idx = 0; vec_idx < ioa_cfg->nvectors; vec_idx++) {

snprintf(ioa_cfg->vectors_info[vec_idx].desc, n,

"host%d-%d", ioa_cfg->host->host_no, vec_idx);

ioa_cfg->vectors_info[vec_idx].

desc[strlen(ioa_cfg->vectors_info[vec_idx].desc)] = 0;

}

}

```

Предупреждение: V692 An inappropriate attempt to append a null character to a string. To determine the length of a string by 'strlen' function correctly, a string ending with a null terminator should be used in the first place. ipr.c 9409

Подозрительной является последняя строка:

```

ioa_cfg->vectors_info[vec_idx].

desc[strlen(ioa_cfg->vectors_info[vec_idx].desc)] = 0;

```

Сейчас я её упрощу и сразу станет понятно, что здесь что-то не так:

```

S[strlen(S)] = 0;

```

В таком действии нет никакого смысла. Ноль будет записан туда, где он уже находится. Есть подозрение, что хотели сделать что-то другое.

### Бесконечное ожидание

```

static int ql_wait_for_drvr_lock(struct ql3_adapter *qdev)

{

int i = 0;

while (i < 10) {

if (i)

ssleep(1);

if (ql_sem_lock(qdev,

QL_DRVR_SEM_MASK,

(QL_RESOURCE_BITS_BASE_CODE | (qdev->mac_index)

* 2) << 1)) {

netdev_printk(KERN_DEBUG, qdev->ndev,

"driver lock acquired\n");

return 1;

}

}

netdev_err(qdev->ndev,

"Timed out waiting for driver lock...\n");

return 0;

}

```

Предупреждение PVS-Studio: V654 The condition 'i < 10' of loop is always true. qla3xxx.c 149

Функция пытается залочить драйвер. Если это не получается, она ждёт 1 секунду и повторяет попытку. Всего должно быть сделано 10 попыток.

Но, на самом деле, будет бесконечное количество попыток. Причина в том, что переменная 'i' нигде не увеличивается.

### Неправильная информация об ошибке

```

static int find_boot_record(struct NFTLrecord *nftl)

{

....

if ((ret = nftl_read_oob(mtd, block * nftl->EraseSize +

SECTORSIZE + 8, 8, &retlen,

(char *)&h1) < 0) ) {

printk(KERN_WARNING "ANAND header found at 0x%x in mtd%d, "

"but OOB data read failed (err %d)\n",

block * nftl->EraseSize, nftl->mbd.mtd->index, ret);

continue;

....

}

```

Предупреждение PVS-Studio: V593 Consider reviewing the expression of the 'A = B < C' kind. The expression is calculated as following: 'A = (B < C)'. nftlmount.c 92

Если возникнет ошибка, функция должна распечатать о ней информацию. В том числе должен быть распечатан код ошибки. Но, на самом деле, будет распечатано (err 0) или (err 1), а не настоящий код ошибки.

Причина — программист запутался в приоритетах операции. В начале он хотел поместить результат работы функции nftl\_read\_oob() в переменную 'ret'. Затем он хочет сравнить эту переменную с 0. Если (ret < 0), то нужно распечатать сообщение об ошибке.

На самом деле, все работает не так. В начале результат работы функции nftl\_read\_oob() сравнивается с 0. Результатом сравнения является значение 0 или 1. Этот значение будет помещено в переменную 'ret'.

Таким образом, если функция nftl\_read\_oob() вернула отрицательное значение, то ret == 1. Будет выведено сообщение, но неправильное.

В условии видно, что используются дополнительные скобки. Неизвестно, были они написаны чтобы подавить предупреждение компилятора о присваивании внутри 'if' или чтобы явно указать последовательность операций. Если второе, то мы имеем дело с опечаткой — закрывающаяся скобка стоит не на своём месте. Правильно будет так:

```

if ((ret = nftl_read_oob(mtd, block * nftl->EraseSize +

SECTORSIZE + 8, 8, &retlen,

(char *)&h1)) < 0 ) {

```

### Подозрение на опечатку

```

int wl12xx_acx_config_hangover(struct wl1271 *wl)

{

....

acx->recover_time = cpu_to_le32(conf->recover_time);

acx->hangover_period = conf->hangover_period;

acx->dynamic_mode = conf->dynamic_mode;

acx->early_termination_mode = conf->early_termination_mode;

acx->max_period = conf->max_period;

acx->min_period = conf->min_period;

acx->increase_delta = conf->increase_delta;

acx->decrease_delta = conf->decrease_delta;

acx->quiet_time = conf->quiet_time;

acx->increase_time = conf->increase_time;

acx->window_size = acx->window_size; <<<---

....

}

```

Предупреждение PVS-Studio: V570 The 'acx->window\_size' variable is assigned to itself. acx.c 1728

Везде поля одной структуры копируются в поля другой структуры. И только в одном месте вдруг написано:

```

acx->window_size = acx->window_size;

```

Это ошибка? Или так и задумывалось? Я не могу дать ответ.

### Подозрительное восьмеричное число

```

static const struct XGI330_LCDDataDesStruct2 XGI_LVDSNoScalingDesData[] = {

{0, 648, 448, 405, 96, 2}, /* 00 (320x200,320x400,

640x200,640x400) */

{0, 648, 448, 355, 96, 2}, /* 01 (320x350,640x350) */

{0, 648, 448, 405, 96, 2}, /* 02 (360x400,720x400) */

{0, 648, 448, 355, 96, 2}, /* 03 (720x350) */

{0, 648, 1, 483, 96, 2}, /* 04 (640x480x60Hz) */

{0, 840, 627, 600, 128, 4}, /* 05 (800x600x60Hz) */

{0, 1048, 805, 770, 136, 6}, /* 06 (1024x768x60Hz) */

{0, 1328, 0, 1025, 112, 3}, /* 07 (1280x1024x60Hz) */

{0, 1438, 0, 1051, 112, 3}, /* 08 (1400x1050x60Hz)*/

{0, 1664, 0, 1201, 192, 3}, /* 09 (1600x1200x60Hz) */

{0, 1328, 0, 0771, 112, 6} /* 0A (1280x768x60Hz) */

^^^^

^^^^

};

```

Предупреждение PVS-Studio: V536 Be advised that the utilized constant value is represented by an octal form. Oct: 0771, Dec: 505. vb\_table.h 1379

Все числа в этой структуре заданы в десятичном формате. И вдруг встречается одно восьмеричное число: 0771. Анализатор это насторожило. И меня тоже.

Есть подозрение, что этот ноль написан для того, чтобы красиво выровнять столбик. Но тогда это явно некорректное значение.

### Подозрительная строка

```

static void sig_ind(PLCI *plci)

{

....

byte SS_Ind[] =

"\x05\x02\x00\x02\x00\x00"; /* Hold_Ind struct*/

byte CF_Ind[] =

"\x09\x02\x00\x06\x00\x00\x00\x00\x00\x00";

byte Interr_Err_Ind[] =

"\x0a\x02\x00\x07\x00\x00\x00\x00\x00\x00\x00\x00\x00\x00";

byte CONF_Ind[] =

"\x09\x16\x00\x06\x00\x00\0x00\0x00\0x00\0x00";

^^^^^^^^^^^^^^^^^^^

....

}

```

Предупреждение PVS-Studio: V638 A terminal null is present inside a string. The '\0x00' characters were encountered. Probably meant: '\x00'. message.c 4883

В массивах содержатся некие магические значения. Подозрение вызывает содержимое массива CONF\_Ind[]. В нем чередуются нулевые символы с текстом «x00». Мне кажется, это опечатка и, на самом деле, должно быть написано так:

```

byte CONF_Ind[] =

"\x09\x16\x00\x06\x00\x00\x00\x00\x00\x00";

```

Т.е. '0' перед 'x' лишний и написан случайно. В результате «x00» интерпретируется как текст, а не как код символа.

### Подозрительное форматирование кода

```

static int grip_xt_read_packet(....)

{

....

if ((u ^ v) & 1) {

buf = (buf << 1) | (u >> 1);

t = strobe;

i++;

} else

if ((((u ^ v) & (v ^ w)) >> 1) & ~(u | v | w) & 1) {

....

}

```

Предупреждение PVS-Studio: V705 It is possible that 'else' block was forgotten or commented out, thus altering the program's operation logics. grip.c 152

Я не думаю, что здесь есть ошибка. Но код отформатирован очень плохо. Поэтому и привожу его в статье. Лучше лишний раз проверить.

### Неопределённое поведение в операциях сдвига

```

static s32 snto32(__u32 value, unsigned n)

{

switch (n) {

case 8: return ((__s8)value);

case 16: return ((__s16)value);

case 32: return ((__s32)value);

}

return value & (1 << (n - 1)) ? value | (-1 << n) : value;

}

```

Предупреждение PVS-Studio: V610 Undefined behavior. Check the shift operator '<<. The left operand '-1' is negative. hid-core.c 1016

Сдвиг отрицательных значений приводит к неопределённому поведению. Про это я много раз писал и не буду останавливаться на этом подробно. Тем, кто не знает в чём тут дело, предлагаю для ознакомления статью "[Не зная брода, не лезь в воду. Часть третья (про сдвиги)](http://www.viva64.com/ru/b/0142/)".

Предвижу возражение в духе: «но ведь работает!». Возможно и работает. Но, я думаю, ядро Linux это не то место, где можно полагаться на такой подход. Код лучше переписать.

Таких сдвигов весьма много, поэтому я собрал их в отдельный файл: [Linux-V610.txt](http://www.viva64.com/external-pictures/txt/Linux-V610.txt).

### Путаница с enum

Есть вот таких два enum:

```

enum iscsi_param {

....

ISCSI_PARAM_CONN_PORT,

ISCSI_PARAM_CONN_ADDRESS, <<<<----

....

};

enum iscsi_host_param {

ISCSI_HOST_PARAM_HWADDRESS,

ISCSI_HOST_PARAM_INITIATOR_NAME,

ISCSI_HOST_PARAM_NETDEV_NAME,

ISCSI_HOST_PARAM_IPADDRESS, <<<<----

ISCSI_HOST_PARAM_PORT_STATE,

ISCSI_HOST_PARAM_PORT_SPEED,

ISCSI_HOST_PARAM_MAX,

};

```

Обратите внимание на константу ISCSI\_PARAM\_CONN\_ADDRESS и ISCSI\_HOST\_PARAM\_IPADDRESS. Их названия похожи. Видимо, это и стало причиной путаницы.

Рассмотрим фрагмент кода:

```

int iscsi_conn_get_addr_param(

struct sockaddr_storage *addr,

enum iscsi_param param, char *buf)

{

....

switch (param) {

case ISCSI_PARAM_CONN_ADDRESS:

case ISCSI_HOST_PARAM_IPADDRESS: <<<<----

....

case ISCSI_PARAM_CONN_PORT:

case ISCSI_PARAM_LOCAL_PORT:

....

default:

return -EINVAL;

}

return len;

}

```

Предупреждение PVS-Studio: V556 The values of different enum types are compared: switch(ENUM\_TYPE\_A) { case ENUM\_TYPE\_B:… }. libiscsi.c 3501

Константа ISCSI\_HOST\_PARAM\_IPADDRESS не относится к enum iscsi\_param. Скорее всего это опечатка, и должна использоваться константа ISCSI\_PARAM\_CONN\_ADDRESS.

Аналогичные предупреждения PVS-Studio:* V556 The values of different enum types are compared: switch(ENUM\_TYPE\_A) { case ENUM\_TYPE\_B:… }. svm.c 1360

* V556 The values of different enum types are compared: switch(ENUM\_TYPE\_A) { case ENUM\_TYPE\_B:… }. vmx.c 2690

* V556 The values of different enum types are compared: switch(ENUM\_TYPE\_A) { case ENUM\_TYPE\_B:… }. request.c 2842

* V556 The values of different enum types are compared: switch(ENUM\_TYPE\_A) { case ENUM\_TYPE\_B:… }. request.c 2868

### Странный цикл

Здесь я не смогу показать фрагмент кода. Фрагмент большой, и я не знаю, как его сократить и красиво отформатировать. Поэтому я напишу псевдокод.

```

void pvr2_encoder_cmd ()

{

do {

....

if (A) break;

....

if (B) break;

....

if (C) continue;

....

if (E) break;

....

} while(0);

}

```

Цикл выполняется 1 раз. Есть подозрение, что такая конструкция создана для того, чтобы обойтись без оператора goto. Если что-то пошло не так, вызывается оператор 'break', и начинают выполняться операторы, расположенные после цикла.

Меня смущает, что в одном месте написан оператор 'continue', а не 'break'. При этом работает оператор 'continue', как 'break'. Поясню.

Вот что говорит стандарт:

§6.6.2 in the standard: «The continue statement (...) causes control to pass to the loop-continuation portion of the smallest enclosing iteration-statement, that is, to the end of the loop.» (Not to the beginning.)

Таким образом, после вызова оператора 'continue' будет проверено условие (0), и цикл завершится так как условие ложно.

Возможно 2 варианта.1. Код корректен. Оператор 'continue' должен прерывать цикл. Тогда я рекомендую заменить его для единообразия на 'break', чтобы он не путал разработчиков, которые будут работать с этим кодом в дальнейшем.

2. Оператор 'continue' должен по задумке программиста возобновлять цикл. Тогда код некорректен и его следует переписать.

### Copy-Paste ошибка

```

void dm_change_dynamic_initgain_thresh(

struct net_device *dev, u32 dm_type, u32 dm_value)

{

....

if (dm_type == DIG_TYPE_THRESH_HIGH)

{

dm_digtable.rssi_high_thresh = dm_value;

}

else if (dm_type == DIG_TYPE_THRESH_LOW)

{

dm_digtable.rssi_low_thresh = dm_value;

}

else if (dm_type == DIG_TYPE_THRESH_HIGHPWR_HIGH) <<--

{ <<--

dm_digtable.rssi_high_power_highthresh = dm_value; <<--

} <<--

else if (dm_type == DIG_TYPE_THRESH_HIGHPWR_HIGH) <<--

{ <<--

dm_digtable.rssi_high_power_highthresh = dm_value; <<--

} <<--

....

}

```

Предупреждение PVS-Studio: V517 The use of 'if (A) {...} else if (A) {...}' pattern was detected. There is a probability of logical error presence. Check lines: 1755, 1759. r8192U\_dm.c 1755

Код писался с помощью Copy-Paste и в одном блоке текста забыли заменить:* DIG\_TYPE\_THRESH\_HIGHPWR\_HIGH на DIG\_TYPE\_THRESH\_HIGHPWR\_LOW

* rssi\_high\_power\_highthresh на rssi\_high\_power\_lowthresh

Плюс прошу разработчиков посмотреть сюда:* V517 The use of 'if (A) {...} else if (A) {...}' pattern was detected. There is a probability of logical error presence. Check lines: 1670, 1672. rtl\_dm.c 1670

* V517 The use of 'if (A) {...} else if (A) {...}' pattern was detected. There is a probability of logical error presence. Check lines: 530, 533. ioctl.c 530

### Повторная инициализация

Есть странные места, где переменной два раза подряд присваивают разные значения. Думаю, стоит проверить эти участки кода.

```

static int saa7164_vbi_fmt(struct file *file, void *priv,

struct v4l2_format *f)

{

/* ntsc */

f->fmt.vbi.samples_per_line = 1600; <<<<----

f->fmt.vbi.samples_per_line = 1440; <<<<----

f->fmt.vbi.sampling_rate = 27000000;

f->fmt.vbi.sample_format = V4L2_PIX_FMT_GREY;

f->fmt.vbi.offset = 0;

f->fmt.vbi.flags = 0;

f->fmt.vbi.start[0] = 10;

f->fmt.vbi.count[0] = 18;

f->fmt.vbi.start[1] = 263 + 10 + 1;

f->fmt.vbi.count[1] = 18;

return 0;

}

```

Предупреждение PVS-Studio: V519 The 'f->fmt.vbi.samples\_per\_line' variable is assigned values twice successively. Perhaps this is a mistake. Check lines: 1001, 1002. saa7164-vbi.c 1002

```

static int saa7164_vbi_buffers_alloc(struct saa7164_port *port)

{

....

/* Init and establish defaults */

params->samplesperline = 1440;

params->numberoflines = 12; <<<<----

params->numberoflines = 18; <<<<----

params->pitch = 1600; <<<<----

params->pitch = 1440; <<<<----

params->numpagetables = 2 +

((params->numberoflines * params->pitch) / PAGE_SIZE);

params->bitspersample = 8;

....

}

```

Предупреждения:* V519 The 'params->numberoflines' variable is assigned values twice successively. Perhaps this is a mistake. Check lines: 118, 119. saa7164-vbi.c 119

* V519 The 'params->pitch' variable is assigned values twice successively. Perhaps this is a mistake. Check lines: 120, 121. saa7164-vbi.c 121

Заключение

----------

В любом большом проекте можно найти какие-то ошибки. Ядро Linux не стало исключением. Однако, разовые проверки кода статическим анализатором является неправильным способом его применения. Да, они позволяют написать вот такую рекламную статью, но приносят мало пользы проекту.

Используйте статический анализ регулярно, и вы сэкономите массу времени, обнаруживая ряд ошибок на самом раннем этапе их возникновения. Защити свой проект от багов с помощью статического анализатора!

Предлагаю всем желающим попробовать [PVS-Studio](http://www.viva64.com/ru/pvs-studio/) на своих проектах. Анализатор работает в среде Windows. Если кто-то хочет использовать его при разработке крупных Linux приложений, то [напишите нам](http://www.viva64.com/ru/about-feedback/), и мы обсудим возможные варианты заключения контракта по адаптации PVS-Studio для ваших проектов и задач.

Эта статья на английском

------------------------

Если хотите поделиться этой статьей с англоязычной аудиторией, то прошу использовать ссылку на перевод: Andrey Karpov. [PVS-Studio dives into Linux insides (3.18.1)](http://www.viva64.com/en/b/0299/).

**Прочитали статью и есть вопрос?**Часто к нашим статьям задают одни и те же вопросы. Ответы на них мы собрали здесь: [Ответы на вопросы читателей статей про PVS-Studio и CppCat, версия 2014](http://www.viva64.com/ru/a/0085/). Пожалуйста, ознакомьтесь со списком. | https://habr.com/ru/post/247271/ | null | ru | null |

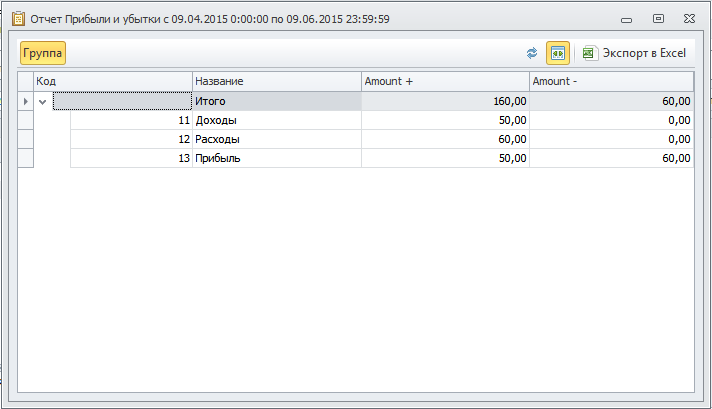

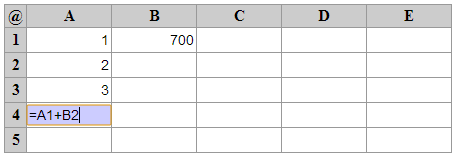

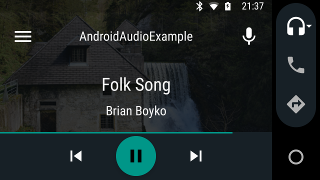

# Готовим отчетность для совета директоров за 20 минут

Продолжу рассказ о возможностях [платформы Ultima Businessware](http://www.ultimabusinessware.com/). Сегодня — о нашем средстве для подготовки специальной отчетности. Средство это действительно возникло как ответ на необходимость оперативно получать отчет в привычном для руководителей высшего звена виде. И первые отчеты сделанные с его помощью были P&L и Balance.

Для лучшего понимания этой статьи очень полезно прочитать мою статью [о устройстве системы](http://habrahabr.ru/company/ultima/blog/243743/) и [небольшую вводную из документации](http://www.ultimabusinessware.com/architecture/) у нас на сайте.

На всякий случай попробую коротко повторить необходимый минимум.

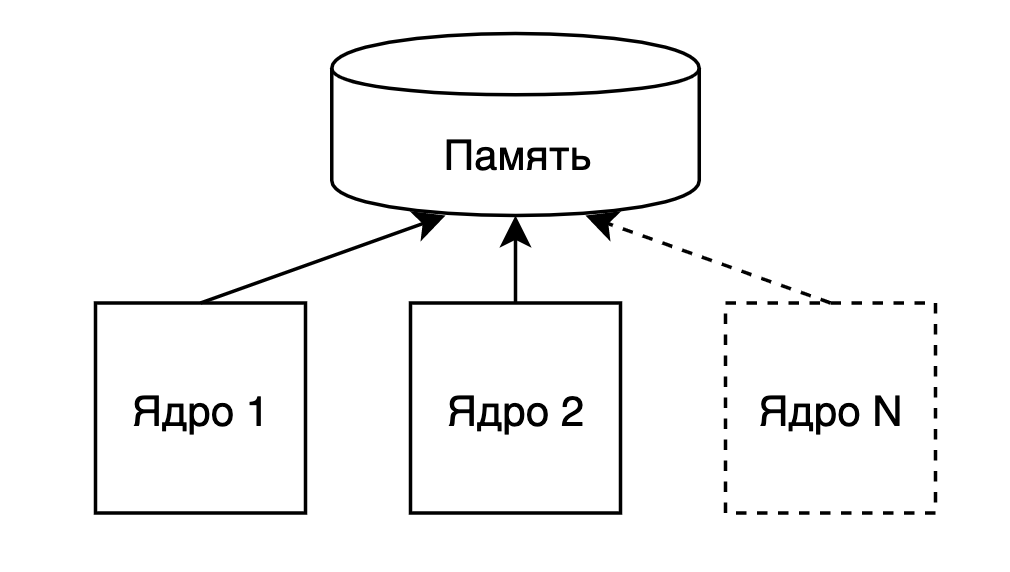

Данные о измеримых показателях мы храним в так называемых итогах. В каком-то смысле это аналог куба из OLAP. Или регистра для знакомых с 1С. У итога есть измерения и переменные. Итоги изменяют свое значение *транзакциями*, которые генерируются документами. Все транзакции сохраняются, и можно вычислить состояние итога на любой момент времени. Транзакция в свою очередь содержит измерения и дельту для каждой из переменных.

На основе описания итога система может построить произвольный отчет. Данные можно сгруппировать по измерениям (или связанным справочникам), а каждая переменная раскладывается на 4 компоненты: Входящий и исходящий остаток (значение переменной на начало и конец периода) и дебет и кредит (сумма положительных и отрицательных дельт).

Например, в системе есть итог Реализация с измерениями клиент, товар, склад и переменными количество и сумма.

Соответственно, из него мы знаем, сколько товара какому клиенту и с какого склада продали и по какой цене (если быть точным, то и с какой себестоимостью и с какой прибылью). Второй важный итог — Затраты с измерением статья затрат и переменной сумма. В простейшем случае этих двух итогов достаточно, чтобы построить отчет о прибылях и убытках (P&L).

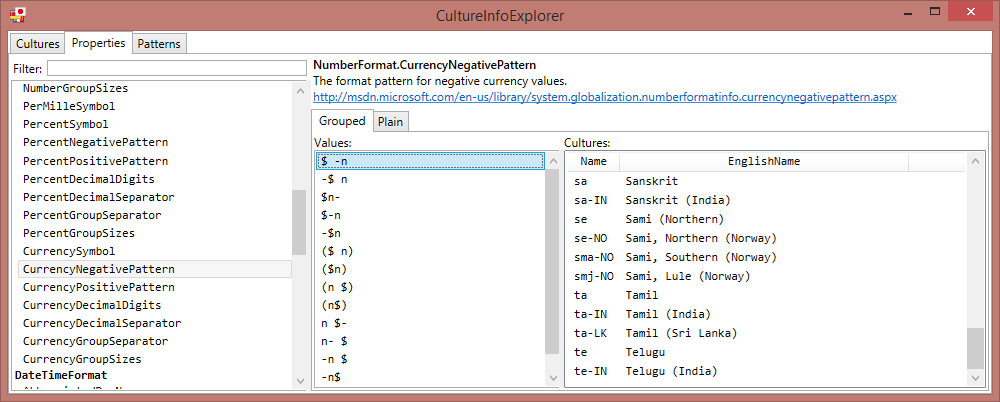

Отчет о прибылях и убытках имеет совершенно конкретный вид в МСФО. Соответственно, требуется средство для преобразования данных из итогов в заданный вид. Это, конечно, легко сделать с помощью печатной формы, но мы захотели иметь возможность разворачивать статьи этого отчета. А для этого у нас уже есть форма анализа итогов! Это значит, надо описать, какие преобразования надо провести с итогами и как объединить переменные и измерения различных итогов. Великолепно с такой реляционной алгеброй справляется SQL, но мы хотели дать возможность настраивать такие отчеты самим пользователям системы. Этот механизм мы назвали виртуальными итогами.

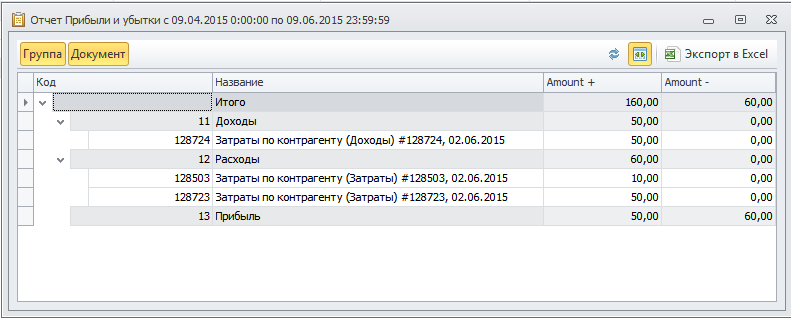

Итак, вот пример описания отчета о прибылях и убытках:

```

// dimensions and variables

dim AgentID (Agent): ru(Контрагент)

dim CostItemID (CostItem): ru(Статья затрат)

dim OfficeID (Office): ru(Офис)

dim FrcID (FRC): ru(ЦФО)

var Amount: ru(Сумма)

// calculated groups

group Income: ru(Доходы)

var Amount

total Expense: -Amount.Sub

total Sale: -Amount.Sub

end

group Outcome: ru(Расходы)

var Amount

total Expense: Amount.Add

end

group Profit: ru(Прибыль)

no details

var Amount

group Income: Amount

group Outcome: -Amount

end

```

Да, этот отчет описывается на синтетическим языком. Как показала практика, в текстовом виде это делать удобнее, чем в любом (придуманном нами) конструкторе.

Итак, поскольку мы описываем новый итог, то в начале перечисляются измерения и переменные этого итога.

Dim соответственно dimension название измерения, далее в скобках указывается справочник, из которого берутся значения для данного измерения и наконец локализация.

Аналогично описываются переменные, тут она одна — Amount.

Примитивный отчет о прибылях и убытках должен иметь вид

Итого:

Доход:

Расход:

Соответственно в группу Доход мы включаем дебет составляющую переменной Amount итогов Sale (Реализация) и Expense(Затраты).

В группу расход попадают все положительные затраты.

И наконец группа Прибыль состоит из (суммы) двух групп Расход (с обратным знаком) и доход.

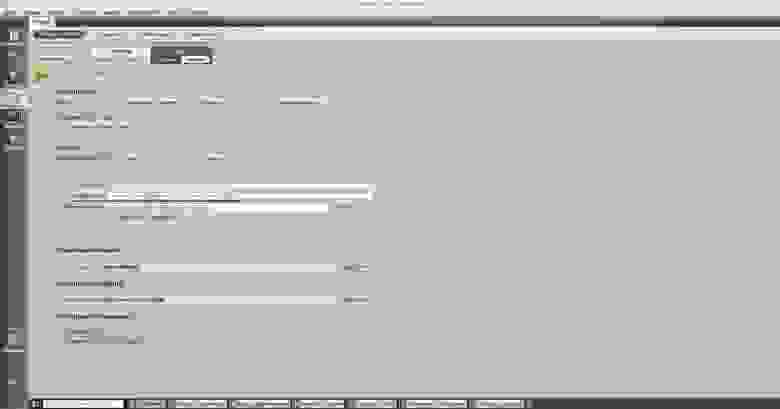

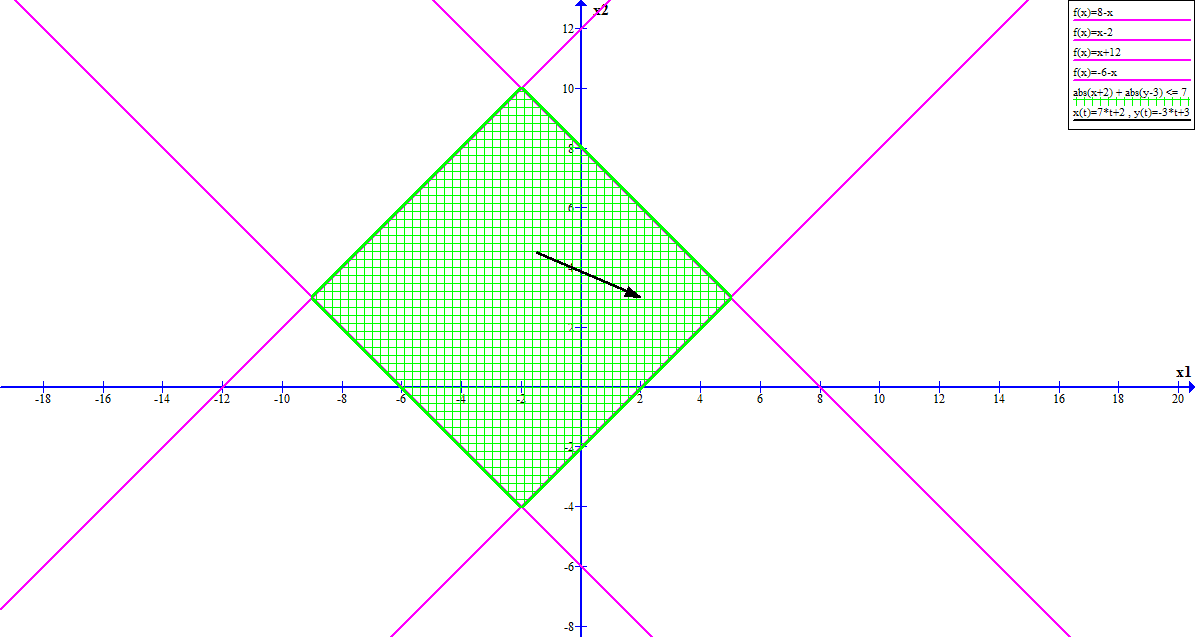

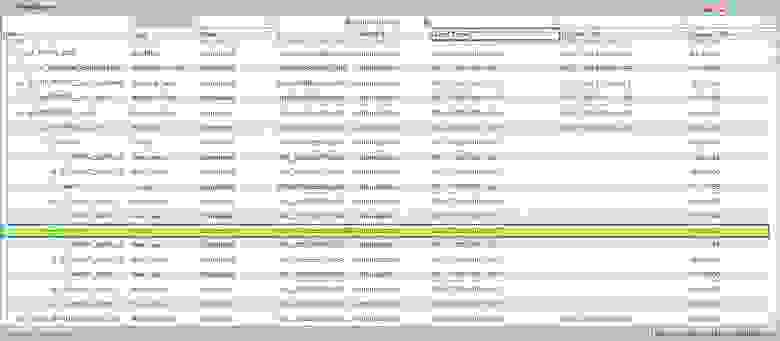

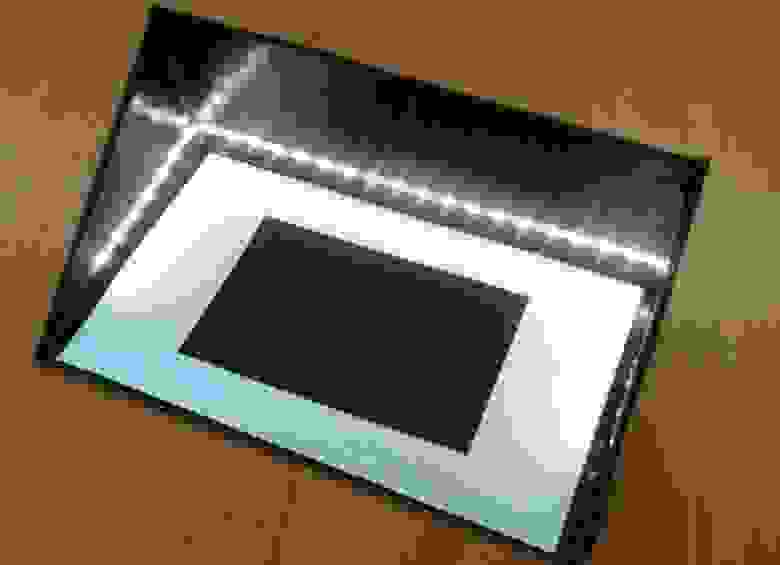

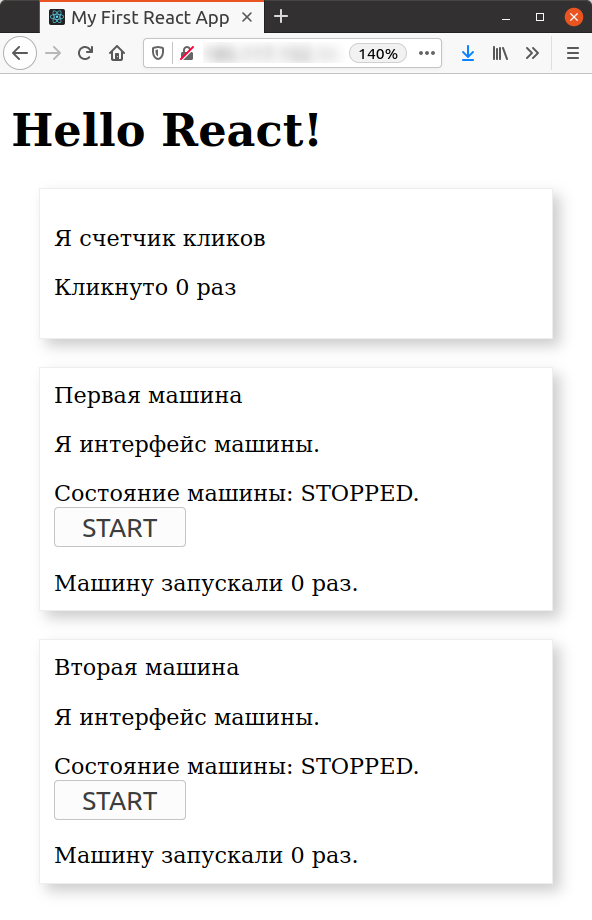

В результате, система генерирует такую форму для настройки отчета:

И вот такой будет результат:

Однако, мы ведь добавили измерения к этому итогу, давайте посмотрим, какие документы сформировали эти цифры:

Аналогично, можем дробить отчет по статьям затрат и прочим измерениям.

Для упрощения синтаксиса пришлось пойти по большое число соглашений. Например, по умолчанию измерения сопоставляются просто по совпадению наименований.

Рассмотрим более сложный пример. Есть итог, на котором происходит конвертация валюты и, соответственно копится убыток от операций конвертации. Этот убыток мы (как топ-менеджеры) хотим рассматривать как статью затрат убытки от конвертации. Однако, в итоге конвертация нет ни одно из измерений нашего итога. Не беда, из можно задать:

```

group Outcome: ru(Расходы)

var Amount

total Expense: Amount.Add

total Convertation: Amount

value CostItemID: 192

value OfficeID: none

value FrcID: none

value AgentID: none

end

```

Зафиксировав таким образом статью затрат мы можем увидеть убыток от операций по конвертации на соответствующей строчке статьи затрат.

Синтаксис позволяет накладывать фильтры. Например, можно сделать группу «Баланс поставщиков» в которую будут входить только контрагенты, лежащие в папке поставщики. Фильтр задается ключевым словом filter и далее задается измерение и условие фильтрации.

Однако, иногда встречаются условия, невыразимые в рамках этого простого языка запросов и тогда его можно расширить за счет предикатов. Предикат в данном случае — формулируемое разработчиком выражение на SQL которое можно интегрировать в язык описания виртуального итога. Для примера — создать группу по итогу с балансами контрагентов, куда попадут только те, у кого есть неоплаченные заказы с учетом товарных кредитов и отсрочек платежа.

Я не ставлю целью подробно описать весь механизм и синтаксис языка в этой статье (для этого есть документация). Однако, надеюсь пролить свет на возможности системы и удобство разработки. Описанные механизмы позволяют обходится без сторонних средств анализа данных, что значительно сокращает бюджет внедрения. Но главное — оперативный и скольугодно детализированный доступ к данным у аналитиков и руководства компанией. Это реальное конкурентное преимущество! | https://habr.com/ru/post/259923/ | null | ru | null |

# Выразительный JavaScript: Тайная жизнь объектов

#### Содержание

* [Введение](http://habrahabr.ru/post/240219/)

* [Величины, типы и операторы](http://habrahabr.ru/post/240223/)

* [Структура программ](http://habrahabr.ru/post/240225/)

* [Функции](http://habrahabr.ru/post/240349/)

* [Структуры данных: объекты и массивы](http://habrahabr.ru/post/240813/)

* [Функции высшего порядка](http://habrahabr.ru/post/241155/)

* [Тайная жизнь объектов](http://habrahabr.ru/post/241587/)

* [Проект: электронная жизнь](http://habrahabr.ru/post/241776/)

* [Поиск и обработка ошибок](http://habrahabr.ru/post/242609/)

* [Регулярные выражения](http://habrahabr.ru/post/242695/)

* [Модули](http://habrahabr.ru/post/243273/)

* [Проект: язык программирования](http://habrahabr.ru/post/243277/)

* [JavaScript и браузер](http://habrahabr.ru/post/243311/)

* [Document Object Model](http://habrahabr.ru/post/243815/)

* [Обработка событий](http://habrahabr.ru/post/244041/)

* [Проект: игра-платформер](http://habrahabr.ru/post/244405/)

* [Рисование на холсте](http://habrahabr.ru/post/244545/)

* [HTTP](http://habrahabr.ru/post/245145/)

* [Формы и поля форм](http://habrahabr.ru/post/245731/)

* [Проект: Paint](http://habrahabr.ru/post/245767/)

* [Node.js](http://habrahabr.ru/post/245775/)

* [Проект: веб-сайт по обмену опытом](http://habrahabr.ru/post/246331/)

* [Песочница для кода](http://eloquentjavascript.net/code)

*Проблема объектно-ориентированных языков в том, что они тащат с собой всё своё неявное окружение. Вам нужен был банан – а вы получаете гориллу с бананом, и целые джунгли впридачу.

Джо Армстронг, в интервью Coders at Work*

Термин «объект» в программировании сильно перегружен значениями. В моей профессии объекты – стиль жизни, тема священных войн и любимое заклинание, не теряющий своей магической силы.

Стороннему человеку всё это непонятно. Начнём же с краткой истории объектов как концепции в программировании.

#### История

Эта история, как большинство историй о программировании, начинается с проблемы сложности. Одна из идей говорит, что сложность можно сделать управляемой, разделив её не небольшие части, изолированные друг от друга. Эти части стали называть объектами.

Объект – твёрдая скорлупа, скрывающая липкую сложность внутри, и вместо неё предлагающая нам несколько ручек настройки и контактов (вроде методов), представляющих интерфейс, посредством которого объект нужно использовать. Идея в том, что интерфейс относительно прост, и при работе с ним позволяет игнорировать все сложные процессы, происходящие внутри объекта.

*Простой интерфейс может прятать много сложного*

Для примера представьте объект, обеспечивающий интерфейс к участку экрана. С его помощью можно рисовать фигуры или выводить текст на этот участок, но при этом все детали, касающиеся превращения текста или фигур в пиксели, скрыты. У вас есть набор методов, к примеру drawCircle, и это всё, что вам нужно знать для использования такого объекта.

Такие идеи получили развитие в 70-80 годах, а в 90-х их вынесла на поверхность рекламная волна – революция объектно-ориентированного программирования. Внезапно большой клан людей объявил, что объекты – это правильный способ программирования. А всё, что не имеет объектов, является устаревшей ерундой.

Такой фанатизм всегда приводит к куче бесполезной чуши, и с тех пор идёт что-то вроде контрреволюции. В некоторых кругах объекты вообще имеют крайне плохую репутацию.

Я предпочитаю рассматривать их с практической, а не идеологической точки зрения. Есть несколько полезных идей, в частности инкапсуляция (различие между внутренней сложностью и внешней простотой), которые были популяризованы объектно-ориентированной культурой. Их стоит изучать.

Эта глава описывает довольно эксцентричный подход JavaScript к объектам, и то, как они соотносятся с классическими объектно-ориентированными техниками.

#### Методы

Методы – свойства, содержащие функции. Простой метод:

```

var rabbit = {};

rabbit.speak = function(line) {

console.log("Кролик говорит '" + line + "'");

};

rabbit.speak("Я живой.");

// → Кролик говорит 'Я живой.'

```

Обычно метод должен что-то сделать с объектом, через который он был вызван. Когда функцию вызывают в виде метода – как свойство объекта, например object.method() – специальная переменная this в её теле будет указывать на вызвавший её объект.

```

function speak(line) {

console.log("А " + this.type + " кролик говорит '" + line + "'");

}

var whiteRabbit = {type: "белый", speak: speak};

var fatRabbit = {type: "толстый", speak: speak};

whiteRabbit.speak("Ушки мои и усики, " + "я же наверняка опаздываю!");

// → А белый кролик говорит ' Ушки мои и усики, я же наверняка опаздываю!'

fatRabbit.speak("Мне бы сейчас морковочки.");

// → А толстый кролик говорит 'Мне бы сейчас морковочки.'

```

Код использует ключевое слово this для вывода типа говорящего кролика.

Вспомните, что методы apply и bind принимают первый аргумент, который можно использовать для эмуляции вызова методов. Этот первый аргумент как раз даёт значение переменной this.

Есть метод, похожий на apply, под названием call. Он тоже вызывает функцию, методом которой является, только принимает аргументы как обычно, а не в виде массива. Как apply и bind, в call можно передать значение this.

```

speak.apply(fatRabbit, ["Отрыжка!"]);

// → А толстый кролик говорит 'Отрыжка!'

speak.call({type: "старый"}, "О, господи.");

// → А старый кролик говорит 'О, господи.'

```

#### Прототипы

Следите за руками.

```

var empty = {};

console.log(empty.toString);

// → function toString(){…}

console.log(empty.toString());

// → [object Object]

```

Я достал свойство пустого объекта. Магия!

Ну, не магия, конечно. Я просто не всё рассказал про то, как работают объекты в JavaScript. В дополнение к набору свойств, почти у всех также есть прототип. Прототип – это ещё один объект, который используется как запасной источник свойств. Когда объект получает запрос на свойство, которого у него нет, это свойство ищется у его прототипа, затем у прототипа прототипа, и т.д.

Ну а кто же прототип пустого объекта? Это великий предок всех объектов, Object.prototype.

```

console.log(Object.getPrototypeOf({}) == Object.prototype);

// → true

console.log(Object.getPrototypeOf(Object.prototype));

// → null

```

Как и следовало ожидать, функция Object.getPrototypeOf возвращает прототип объекта.

Прототипические отношения в JavaScript выглядят как дерево, а в его корне находится Object.prototype. Он предоставляет несколько методов, которые появляются у всех объектов, типа toString, который преобразует объект в строковый вид.

Прототипом многих объектов служит не непосредственно Object.prototype, а какой-то другой объект, который предоставляет свои свойства по умолчанию. Функции происходят от Function.prototype, массивы – от Array.prototype.

```

console.log(Object.getPrototypeOf(isNaN) == Function.prototype);

// → true

console.log(Object.getPrototypeOf([]) == Array.prototype);

// → true

```

У таких прототипов будет свой прототип – часто Object.prototype, поэтому он всё равно, хоть и не напрямую, предоставляет им методы типа toString.

Функция Object.getPrototypeOf возвращает прототип объекта. Можно использовать Object.create для создания объектов с заданным прототипом.

```

var protoRabbit = {

speak: function(line) {

console.log("А " + this.type + " кролик говорит '" + line + "'");

}

};

var killerRabbit = Object.create(protoRabbit);

killerRabbit.type = "убийственный";

killerRabbit.speak("ХРЯЯЯСЬ!");

// → А убийственный кролик говорит ' ХРЯЯЯСЬ!'

```

Прото-кролик работает в качестве контейнера свойств, которые есть у всех кроликов. Конкретный объект-кролик, например убийственный, содержит свойства, применимые только к нему,- например, свой тип,- и наследует разделяемые с другими свойства от прототипа.

#### Конструкторы

Более удобный способ создания объектов, наследуемых от некоего прототипа – конструктор. В JavaScript вызов функции с предшествующим ключевым словом new приводит к тому, что функция работает как конструктор. У конструктора будет в распоряжении переменная this, привязанная к свежесозданному объекту, и если она не вернёт непосредственно другое значение, содержащее объект, этот новый объект будет возвращён вместо него.

Говорят, что объект, созданный при помощи new, является экземпляром конструктора.

Вот простой конструктор кроликов. Имена конструкторов принято начинать с заглавной буквы, чтобы отличать их от других функций.

```

function Rabbit(type) {

this.type = type;

}

var killerRabbit = new Rabbit("убийственный");

var blackRabbit = new Rabbit("чёрный");

console.log(blackRabbit.type);

// → чёрный

```

Конструкторы (а вообще-то, и все функции) автоматически получают свойство под именем prototype, которое по умолчанию содержит простой и пустой объект, происходящий от Object.prototype. Каждый экземпляр, созданный этим конструктором, будет иметь этот объект в качестве прототипа. Поэтому, чтобы добавить кроликам, созданным конструктором Rabbit, метод speak, мы просто можем сделать так:

```

Rabbit.prototype.speak = function(line) {

console.log("А " + this.type + " кролик говорит '" + line + "'");

};

blackRabbit.speak("Всем капец...");

// → А чёрный кролик говорит 'Всем капец...'

```

Важно отметить разницу между тем, как прототип связан с конструктором (через свойство prototype) и тем, как у объектов есть прототип (который можно получить через Object.getPrototypeOf). На самом деле прототип конструктора — Function.prototype, поскольку конструкторы – это функции. Его свойство prototype будет прототипом экземпляров, созданных им, но не его прототипом.

#### Перезагрузка унаследованных свойств

Когда вы добавляете свойство объекту, есть оно в прототипе или нет, оно добавляется непосредственно к самому объекту. Теперь это его свойство. Если в прототипе есть одноимённое свойство, оно больше не влияет на объект. Сам прототип не меняется.

```

Rabbit.prototype.teeth = "мелкие";

console.log(killerRabbit.teeth);

// → мелкие

killerRabbit.teeth = "длинные, острые и окровавленные";

console.log(killerRabbit.teeth);

// → длинные, острые и окровавленные

console.log(blackRabbit.teeth);

// → мелкие

console.log(Rabbit.prototype.teeth);

// → мелкие

```

На диаграмме нарисована ситуация после прогона кода. Прототипы Rabbit и Object находятся за killerRabbit на манер фона, и у них можно запрашивать свойства, которых нет у самого объекта.

Перезагрузка свойств, существующих в прототипе, часто приносит пользу. Как в примере с зубами кролика её можно использовать для выражения каких-то исключительных характеристик у более общих свойств, в то время как обычные объекты просто используют стандартные значения, взятые у прототипов.

Также она используется для назначения функциям и массивам разных методов toString.

```

console.log(Array.prototype.toString == Object.prototype.toString);

// → false

console.log([1, 2].toString());

// → 1,2

```

Вызов toString массива выводит результат, похожий на .join(",") – получается список, разделённый запятыми. Вызов Object.prototype.toString напрямую для массива приводит к другому результату. Эта функция не знает ничего о массивах, и просто помещает слово object с имененм типа между квадратными скобками:

```

console.log(Object.prototype.toString.call([1, 2]));

// → [object Array]

```

#### Нежелательное взаимодействие прототипов

Прототип помогает в любое время добавлять новые свойства и методы всем объектам, которые основаны на нём. К примеру, нашим кроликам может понадобиться танец.

```

Rabbit.prototype.dance = function() {

console.log("А " + this.type + " кролик танцует джигу.");

};

killerRabbit.dance();

// → А убийственный кролик танцует джигу.

```

Это удобно. Но в некоторых случаях это приводит к проблемам. В предыдущих главах мы использовали объект как способ связать значения с именами – мы создавали свойства для этих имён, и давали им соответствующие значения. Вот пример из 4-й главы:

```

var map = {};

function storePhi(event, phi) {

map[event] = phi;

}

storePhi("пицца", 0.069);

storePhi("тронул дерево", -0.081);

```

Мы можем перебрать все значения фи в объекте через цикл for/in, и проверить наличие в нём имени через оператор in. К сожалению, нам мешается прототип объекта.

```

Object.prototype.nonsense = "ку";

for (var name in map)

console.log(name);

// → пицца

// → тронул дерево

// → nonsense

console.log("nonsense" in map);

// → true

console.log("toString" in map);

// → true

// Удалить проблемное свойство

delete Object.prototype.nonsense;

```

Это же неправильно. Нет события под названием “nonsense”. И тем более нет события под названием “toString”.

Занятно, что toString не вылезло в цикле for/in, хотя оператор in возвращает true на его счёт. Это потому, что JavaScript различает счётные и несчётные свойства.

Все свойства, которые мы создаём, назначая им значение – счётные. Все стандартные свойства в Object.prototype – несчётные, поэтому они не вылезают в циклах for/in.

Мы можем объявить свои несчётные свойства через функцию Object.defineProperty, которая позволяет указывать тип создаваемого свойства.

```

Object.defineProperty(Object.prototype, "hiddenNonsense", {enumerable: false, value: "ку"});

for (var name in map)

console.log(name);

// → пицца

// → тронул дерево

console.log(map.hiddenNonsense);

// → ку

```

Теперь свойство есть, а в цикле оно не вылезает. Хорошо. Но нам всё ещё мешает проблема с оператором in, который утверждает, что свойства Object.prototype присутствуют в нашем объекте. Для этого нам понадобится метод hasOwnProperty.

```

console.log(map.hasOwnProperty("toString"));

// → false

```

Он говорит, является ли свойство свойством объекта, без оглядки на прототипы. Часто это более полезная информация, чем выдаёт оператор in.

Если вы волнуетесь, что кто-то другой, чей код вы загрузили в свою программу, испортил основной прототип объектов, я рекомендую писать циклы for/in так:

```

for (var name in map) {

if (map.hasOwnProperty(name)) {

// ... это наше личное свойство

}

}

```

#### Объекты без прототипов

Но кроличья нора на этом не заканчивается. А если кто-то зарегистрировал имя hasOwnProperty в объекте map и назначил ему значение 42? Теперь вызов map.hasOwnProperty обращается к локальному свойству, в котором содержится номер, а не функция.