text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Grails, jQuery, AJAX: делаем anchor-навигацию. Часть 1

### AJAX и все, все, все

В [предыдущей серии](http://habrahabr.ru/blogs/groovy_grails/92248/) мы делали простенькое Grails-приложение с использованием jQuery, а также решили для себя, что использовать jQuery в Grails можно и даже нужно. Обсудим более серьезные вещи, которые можно сделать с такой связкой.

Нетрудно заметить, что все больше сайтов используют AJAX и частичные обновления страниц, причем в невероятном количестве. В частности, «начиненные» AJAX ссылки могут использоваться для внутренней навигации по странице, переключения каких-то вкладок. Это хорошо тем, что

**А)** меньше данных нужно перегонять от сервера — только нужный кусок страницы и

**Б)** веб-страницы часто загружают просто гигантские CSS и JavaScript-файлы, которые при AJAX-обновлении можно повторно не загружать.

Итак, очень распространено построение приложений по сценарию: одна большая «стартовая» страница, загружающая весь JavaScript-код и CSS и более мелкие «внутренние» функциональные блоки, загружаемые через AJAX. С этим есть ряд проблем:

1. В результате AJAX-действий внутреннее состояние страницы не отражено в адресной строке браузера.

2. Как следствие, внутренние страницы не могут быть запомнены в закладки, нельзя «отправить ссылку другу».

3. Не работает Back/Forward навигация в браузере, т.к. AJAX-ссылки не попадают в историю браузера.

Однако крупные сайты нашли некое «хакерское» решение, которое мы сейчас рассмотрим и напишем небольшой свой собственный аналог на Grails и jQuery.

### Anchor-навигация

Дело в том, что на самом деле можно изменить адресную строку браузера без перезагрузки страницы, если менять только якорь (anchor), т.е. последнюю часть адресной строки, следующей за решеткой — `#`. Браузер воспринимает это переход внутри страницы, причем спокойно игнорирует ситуацию, когда нужного якоря на странице нет, просто обновляя адрес и **историю**. Это как раз нам и нужно. Если сохранять состояние страницы внутри якоря, тогда можно будет к нему вернуться через закладку и можно пользоваться Back/Forward переходами (!). При этом базовый URL страницы не изменится и перезагрузки страницы не произойдет.

За примерами реализации подобного решения далеко ходить не нужно. Такая схема применяется в Facebook, Gmail, Google Picasa Web Albums, в значительном объеме это можно увидеть на odnoklassniki.ru. Библиотека Google Web Toolkit целиком базируется на anchor-навигации.

Скажем, в Gmail можно получить прямую ссылку на письмо, причем ссылка будет bookmarkable. Ссылка будет выглядеть примерно вот так:

`mail.google.com/mail/?shva=1**#inbox/12c5f14c01a5473c**`

Ежу ясно, что `12c5f14c01a5473c` — это какой-то внутренний ID письма.

### Пишем приложение

Подумаем на тему реализации такого подхода. Адресная строка меняется просто:

```

document.location.hash = '#myAnchor';

```

(либо напрямую через ссылку

```

[My Link](#myAnchor)

```

).

Начнем писать Grails-приложение с интригующим названием **my-app** с навигацией, целиком основанной на AJAX. У нашего приложения будет три вкладки:

Внешне это выглядит как обычная страница, но мы хотим добиться, чтобы обновлялась только внутренняя часть страницы без полной перезагрузки.

Для начала нарисуем SiteMesh layout примерно такого вида:

`grails-app/views/layouts/main.gsp`

```

...

%{-- Навигационные ссылки --}%

[Рецепты](#do/receipts)

[Где купить](#do/buy)

[Отзывы](#do/feedback)

%{-- Тело страницы --}%

...

```

Здесь пока никаких сюрпризов. Как видим, ссылки ничем не отличаются от обычных anchor-ссылок. Как же они работают? Для этого напишем такой код на jQuery:

`web-app/js/application.js`

```

// Здесь сохраняем текущее состояние страницы

var currentState = '';

function buildURL(anchor) {

return document.location.toString().substr(0, document.location.toString().indexOf('#')) +

anchor.substr(1);

}

function clickNavLink() {

// Уже там?

var href = $(this).attr('href');

// Игнорируем переход на уже загруженную страницу

if (href == currentState) {

return false;

}

if (document.location.hash != href) {

document.location.hash = href;

}

// Загружаем страницу

var link = this;

// Показываем индикатор загрузки

$(this).parent().find('.busy').show();

$(this).hide();

var targetURL = buildURL(href);

currentState = href; // сразу поменяем состояние, чтобы избежать повторных кликов

$.ajax({

context:$('#pageContent'),

url:targetURL,

dataType:'html',

method:'GET',

complete: function() {

// Отмечаем активную ссылку.

$(link).show();

updateNavLinks();

},

success: function(data) {

// Обновляем "динамическую" часть страницы.

$('#pageContent').html(data);

}

});

return true;

}

// Обновляем состояние ссылок, чтобы отметить активные/неактивные

function updateNavLinks() {

$('a.navlink').each(function(i) {

var href = $(this).attr('href');

$(this).parent().find('.busy').hide();

if (href == currentState) {

$(this).addClass('disabled');

} else {

$(this).removeClass('disabled');

}

});

}

// Финал. Вешаем события на навигационные ссылки.

jQuery(document).ready(function() {

$('a.navlink').each(function() { $(this).click(clickNavLink); });

});

```

Здесь все довольно просто: текущее состояние страницы мы храним в JavaScript-переменной **currentState**. Внутреннюю страницу при клике на ссылку загружаем через AJAX, результат AJAX-вызова сохраняем в **div#pageContent**. При этом URL загружаемой страницы формируется путем добавления anchor-пути к базовому адресу страницы, т.е.

```

/my-app/#do/receipts => /my-app/do/receipts

```

Это простое правило сразу помогает нам понять, что делает ссылка. Для того, чтобы обознать ссылку как «текущую», мы назначаем ей класс `disabled`. В CSS (который я приводить не буду) этот класс будет отображаться другим цветом, чтобы было видно, какая ссылка является текущей (visited).

### Серверная часть

Теперь хорошо бы сделать серверную начинку. Я написал простейший контроллер для обработки всех трех ссылок:

`grails-app/controllers/DoSomethingController.groovy`

```

class DoSomethingController {

def receipts = {

[receipts:['Курица с мандаринами', 'Пельмешки']]

}

def buy = {

[places:['Ларёк у метро', 'Чебуречная №1']]

}

def feedback = {

[feedback:['нравится','не нравится','не нравится, но ем!']]

}

}

```

и к нему сделал три простенькие страницы. Приведу только одну из них:

`grails-app/views/doSomething/receipts.gsp`

```

<%--

Список рецептов

--%>

<%@ page contentType="text/html;charset=UTF-8" %>

Чего и как приготовить поесть

=============================

* ${receipt.encodeAsHTML()}

```

Теперь повесим контроллер на наши ссылки **/do/\***:

`grails-app/conf/UrlMappings.groovy`

```

class UrlMappings {

static mappings = {

"/do/$action?/$id?" {

controller = 'doSomething'

}

}

}

```

Однако этого недостаточно. Есть проблемы: нашу клиентскую и серверную часть надо доработать, о чем напишу в [следующей части](http://habrahabr.ru/blogs/groovy_grails/108650/). | https://habr.com/ru/post/108611/ | null | ru | null |

# Android NDK: работа с OpenSL ES

День добрый, Хабражители.

Я ранее [писал](http://habrahabr.ru/post/176559/) про OpenAL. Позже товарищ [zagayevskiy](https://habrahabr.ru/users/zagayevskiy/) [написал](http://habrahabr.ru/post/176933/) хорошую статью по OpenSL ES. В одной из наших игр, дабы не переписывать весь код по работе со звуком, мы не стали переписывать всё на OpenSL ES (при порте на Android). В игре использовалось не так много звуков, поэтому проблем с OpenAL не было. А вот в последней игре у нас использовалось много звуков (специфика игры обязывает), вот тут-то мы и столкнулись с большой проблемой (задержки при воспроизведении — меньшая из них). Было решено переписать всё на [OpenSL ES](http://suvitruf.ru/2014/04/05/3457/). Для этого я написал парочку враперов, про которые уже рассказывал. Решил поделиться этим и на хабре, может кому-то пригодится.

1. [Краткое описание OpenSL ES](#anc1).

2. [Аудио контент](#anc2).

3. [Немного про обёртки](#anc3).

4. [Принцип работы с объектами](#anc4).

5. [Инициализация библиотеки (контекста)](#anc5).

6. [Работа со звуками](#anc6).

7. [Проигрывание PCM](#anc7).

8. [Проигрывание сжатых форматов](#anc8).

9. [Заключение](#anc9).

10. [Доп. информация](#anc10).

#### Краткое описание OpenSL ES

Доступно сие дело с Android API 9 (Android 2.3) и выше. Некоторые возможности доступны лишь в Android API 14 (Android 4.0) и выше. OpenSL ES предоставляет интерфейс на языке С, который также можно вызывать из C++, предоставляющий те же возможности, что и части Android Java API по работе со звуками: * [android.media.MediaPlayer](http://developer.android.com/reference/android/media/MediaPlayer.html)

* [android.media.MediaRecorder](http://developer.android.com/reference/android/media/MediaRecorder.html)

**Примечание**: хотя оно и основано на OpenSL ES, это API не является полной реализацией любого профиля из OpenSL ES 1.0.1.

Либа, как вы могли догадаться, написана на чистом C. По-сему полноценного ООП там нет. Используются специальные структуры (назовём их псевдообъектно-ориентированными структуры (: ), которые представляют собой обычные структуры языка C, содержащие указатели на функции, получающие первым аргументом указатели на саму структуру. Что-то вроде this в С++, но явно. В OpenSL ES два вида таких структур:

* **Объект** (`SLObjectItf`) – абстракция набора ресурсов, предназначенная для выполнения определенного круга задач и хранения информации об этих ресурсах. При создании объекта определяется его тип, определяющий круг задач, которые можно решать с его помощью.

* **Интерфейс** (`SLEngineItf`, `SLSeekItf` и тд) – абстракция набора взаимосвязанных функциональных возможностей, предоставляемых конкретным объектом. Интерфейс включает в себя множество методов, используемых для выполнения действий над объектом. Интерфейс имеет тип, определяющий точный перечень методов, поддерживаемых данным интерфейсом. Интерфейс определяется его идентификатором, который можно использовать в коде для ссылки на тип интерфейса (например `SL_IID_VOLUME, SL_IID_SEEK`). Все константы и названия интерфейсов довольно очевидные, так что проблем особых возникнуть не должно.

**Если обобщить**: объекты используются для выделения ресурсов и получения интерфейсов. А уже потом с помощью этих интерфейсов работаем с объектом. Один объект может иметь несколько интерфейсов (для изменения громкости, для изменения позиции т.п.). В зависимости от устройства (или типа объекта), некоторые интерфейсы могут быть недоступны. Скажу наперёд, вы можете стримить аудио из вашей директории assets, используя `SLDataLocator_AndroidFD`, который поддерживает интерфейс для перемещения позиции по треку. В тоже время, вы можете загрузить файл целиком в буфер (используя `SLDataLocator_AndroidFD`), и проигрывать уже оттуда. Но этот объект не поддерживает интерфейс `SL_IID_SEEK`, посему переместиться по треку не получится =/

#### Аудио контент

Есть много способов, чтобы упаковать аудио-контент в приложение:

* **Resources**. Размещая аудио файлы в **res/raw/** директории, можно легко получить к ним доступ с помощью API для [Resources](http://developer.android.com/reference/android/content/res/Resources.html). Однако нет прямого нативного доступа к этим ресурсам, поэтому вам придётся их скопировать из Java кода.

* **Assets**. Размещая аудио файлы в директории **assets/**, вы сможете получить к ним доступ из C++ с помощаью нативного менеджера. См. хэдеры **android/asset\_manager.h и android/asset\_manager\_jni.h** для дополнительной информации.

* **Сеть**. Можно использовать URI data locator для проигрывания аудио непосредственно из сети. Не забываем про необходимые пермишены для этого (:

* **Локальная файловая система**. The URI data locator поддерживает схему **file:** для доступа к локальным файлам, при условии, что файлы доступны приложению (ну, то есть, прочитать файлы из внутреннего хранилища другого приложения не получится). Обратите внимание, что в Android доступ к файлам ограничивается с помощью механизмов Linux user ID и group ID.

* **Запись**. Ваше приложение может записывать аудио с микрофона, сохранить контент, а позже проиграть.

* **Compiled and linked inline**. Вы можете непосредственно запихать аудио контент в библиотеку, а затем проиграть с помощью buffer queue data locator. Это очень хорошо подходит для коротких композиций в PCM формате. PCM данные конвертируются в hex строку с использование bin2c tool.

* **Генерация в реальном времени**. Приложение может генерировать (синтезировать) данные PCM на лету, а затем воспроизводить с помощью buffer queue data locator.

#### Немного про мои обёртки

Я вообще поклонник ООП, поэтому стараюсь как-то сгруппировать определённый функционал Си-методов и обернуть своими классами, чтобы в дальнейшем было удобно работать. По аналогии с тем, как я это делал для [OpenAL](http://suvitruf.ru/2013/04/19/3149/), появились классы:

1. `OSLContext`. Он ответственен за инициализацию библиотеки и создание экземпляров нужных буферов.

2. `OSLSound`. Базовый класс для работы со звуками.

3. `OSLWav`. Класс для работы с WAV. Наследуется от OSLSound, чтобы сохранить общий интерфейс для работы. Для работы с ogg можно потом создать класс OSLOgg, как я в OpenAL делал. Такое разграничение сделал, так как у этих форматов кардинально отличается процесс загрузки. WAV – чистый формат, там достаточно просто прочитать байты, ogg же надо ещё декомпрессить с помощью [Ogg Vorbis](http://svn.xiph.org/trunk/Tremor/), про mp3 вообще молчу (:

4. `OSLMp3`. Класс для работы с Mp3. Наследуется от OSLSound, чтобы сохранить общий интерфейс для работы. Класс вообще ничего почти не реализует у меня, потому что mp3 стримлю. Но если захотите декодировать mp3 с помощью какого-нибудь lame или ещё чего-нить, то в методе load(char\* filename) можете реализовать декодирование и использовать BufferPlayer.

5. `OSLPlayer`. Собственно, основной класс по работе со звуком. Дело в том, что механизм работы в OpenSL ES не такой как в OpenAL. В OpenAL есть специальная структура для буфера и источника звука (на который мы навешиваем буфер). В OpenSL ES же всё крутится вокруг плейеров, которые бывают разные.

6. `OSLBufferPlayer`. Используем этот плейер, когда хотим загрузить файл целиком в память. Как правило, используется для коротеньких звуковых эффектов (выстрел, взрыв и т.п.). Как уже говорил, не поддерживает интерфейс `SL_IID_SEEK`, посему переместиться по треку не получится.

7. `OSLAssetPlayer`, позволяет стримить из директории assets (то есть, не грузить весь файл в память). Использовать для проигрывания длинных треков (музыки фоновой, например).

#### Принцип работы с объектами

Весь цикл работы с объектами примерно такой:

1. Получить объект, указав желаемые интерфейсы.

2. Реализовать его, вызвав `(*obj)->Realize(obj, async)`.

3. Получить необходимые интерфейсы вызвав `(*obj)-> GetInterface (obj, ID, &itf)`

4. Работать через интерфейсы.

5. Удалить объект и очистить используемые ресурсы, вызвав `(*obj)->Destroy(obj)`.

#### Инициализация библиотеки (контекста)

Для начала необходимо добавить в секцию **LOCAL\_LDLIBS** файла **Android.mk** в jni директории флаг lOpenSLES: `LOCAL_LDLIBS += -lOpenSLES` и два заголовочных файла подключить:

```

#include

#include

```

Теперь необходимо создать объект, через который будем работать с библиотекой, (что-то аналогичное контексту в OpenAL) с помощь метода `slCreateEngine`. Полученный объект становится центральным объектом для доступа к OpenSL ES API. Далее инициализируем объект с помощью метода `Realize`.

```

result = slCreateEngine(&engineObj, //pointer to object

0, // count of elements is array of additional options

NULL, // array of additional options

lEngineMixIIDCount, // interface count

lEngineMixIIDs, // array of interface ids

lEngineMixReqs);

if (result != SL_RESULT_SUCCESS ) {

LOGE("Error after slCreateEngine");

return;

}

result = (*engineObj)->Realize(engineObj, SL_BOOLEAN_FALSE );

if (result != SL_RESULT_SUCCESS ) {

LOGE("Error after Realize");

return;

}

```

Теперь необходимо получить интерфейс `SL_IID_ENGINE`, через который будет осуществляться доступ к динамикам, проигрыванию звуков и тд.

```

result = (*engineObj)->GetInterface(engineObj, SL_IID_ENGINE, &engine);

if (result != SL_RESULT_SUCCESS ) {

LOGE("Error after GetInterface");

return;

}

```

Остаётся получить и инициализировать объект OutputMix для работы с динамиками с помощью метода `CreateOutputMix`:

```

result = (*engine)->CreateOutputMix(engine, &outputMixObj, lOutputMixIIDCount, lOutputMixIIDs, lOutputMixReqs);

if(result != SL_RESULT_SUCCESS){

LOGE("Error after CreateOutputMix");

return;

}

result = (*outputMixObj)->Realize(outputMixObj, SL_BOOLEAN_FALSE);

if(result != SL_RESULT_SUCCESS){

LOGE("Error after Realize");

return;

}

```

Помимо инициализации основных объектов в конструкторе моего врапера `OSLContext` происходит инициализация всех необходимых плееров. Максимально возможно число плееров ограничено. Рекомендую создавать не более 20.

```

void OSLContext::initPlayers(){

for(int i = 0; i< MAX_ASSET_PLAYERS_COUNT; ++i)

assetPlayers[i] = new OSLAssetPlayer(this);

for(int i = 0; i< MAX_BUF_PLAYERS_COUNT; ++i)

bufPlayers[i] = new OSLBufferPlayer(this);

}

```

#### Работа со звуками

По сути, можно разделить на две категории типы звуков: чистые (не сжатые данные) PCM, которые содержатся в WAV и сжатые форматы (mp3, ogg и т.п.). Mp3 и ogg можно декодировать и получить всё те же несжатые звуковые данные PCM. Для работы с PCM используем BufferPlayer. Для сжатых форматов AssetPlayer, так как декодирование файлов будет довольно затратно. Если взять mp3, то аппаратно его декодировать на старых телефонах не получится, а с помощью сторонних софтверных решений декодирование займёт не один десяток секунд, что, согласитесь, не приемлемо. К тому же, слишком много весить будут такие PCM данные.

При вызове метода player() запрашивает свободный плеер у контекста (`OSLContext`). Если необходимо зацикливание звука, то получим `OSLAssetPlayer`, в другом случае `OSLBufferPlayer`.

#### Проигрывание PCM

Про чтение самого WAV писать снова не буду, можно посмотреть про это в статье про OpenAL. В этой же статье расскажу как с помощью полученных PCM данных создать BufferPlayer.

**Инициализация BufferPlayer для работы с PCM**

```

locatorBufferQueue.locatorType = SL_DATALOCATOR_ANDROIDSIMPLEBUFFERQUEUE;

locatorBufferQueue.numBuffers = 16;

// описание формата аудио, об этом чуть ниже расскажу

SLDataFormat_PCM formatPCM;

formatPCM.formatType = SL_DATAFORMAT_PCM;

formatPCM.numChannels = 2;

formatPCM.samplesPerSec = SL_SAMPLINGRATE_44_1;// header.samplesPerSec*1000;

formatPCM.bitsPerSample = SL_PCMSAMPLEFORMAT_FIXED_16 ;//header.bitsPerSample;

formatPCM.containerSize = SL_PCMSAMPLEFORMAT_FIXED_16;// header.fmtSize;

formatPCM.channelMask = SL_SPEAKER_FRONT_LEFT|SL_SPEAKER_FRONT_RIGHT ;

formatPCM.endianness = SL_BYTEORDER_LITTLEENDIAN;

audioSrc.pLocator = &locatorBufferQueue

audioSrc.pFormat = &formatPCM

locatorOutMix.locatorType = SL_DATALOCATOR_OUTPUTMIX;

locatorOutMix.outputMix = context->getOutputMixObject();

audioSnk.pLocator = &locatorOutMix

audioSnk.pFormat = NULL;

// создание плеера

const SLInterfaceID ids[2] = {SL_IID_ANDROIDSIMPLEBUFFERQUEUE,/*SL_IID_MUTESOLO,*/

/*SL_IID_EFFECTSEND,SL_IID_SEEK,*/

/*SL_IID_MUTESOLO,*/ SL_IID_VOLUME};

const SLboolean req[2] = {SL_BOOLEAN_TRUE,SL_BOOLEAN_TRUE};

result = (*context->getEngine())->CreateAudioPlayer(context->getEngine(),

&playerObj, &audioSrc, &audioSnk,2, ids, req);

assert(SL_RESULT_SUCCESS == result);

result = (*playerObj)->Realize(playerObj, SL_BOOLEAN_FALSE );

assert(SL_RESULT_SUCCESS == result);

if (result != SL_RESULT_SUCCESS ) {

LOGE("Can not CreateAudioPlayer %d", result);

playerObj = NULL;

}

// получение интерфейса

result = (*playerObj)->GetInterface(playerObj, SL_IID_PLAY, &player);

assert(SL_RESULT_SUCCESS == result);

// получение интерфейса для работы с громкостью

result = (*playerObj)->GetInterface(playerObj, SL_IID_VOLUME, &fdPlayerVolume);

assert(SL_RESULT_SUCCESS == result);

result = (*playerObj)->GetInterface(playerObj, SL_IID_ANDROIDSIMPLEBUFFERQUEUE, &bufferQueue);

assert(SL_RESULT_SUCCESS == result);

```

В целом ничего сложного нет. Вот только есть ОГРОМНАЯ проблема. Обратите внимание на структуру `SLDataFormat_PCM`. Почему я явно сам заполнил параметры, а не прочитал из хэдеров WAV-файла? Потому что у меня все WAV файлы в едином формате, т.е. одно и тоже количество каналов, частота, битрейт и т.д. Дело в том, что если вы создадите буфер и в параметрах укажите 2 канала, а попытаетесь проиграть дорожку с 1 каналом, то приложение упадёт. Единственный вариант – переинициализировать целиком буфер, если у файла другой формат. Но ведь вся прелесть как раз в том, что мы плеер инициализируем 1 раз, а потом просто меняем буфер на нём. По-этому, тут два варианта, либо создавать несколько плееров с различными параметрами, либо все ваши .wav файлы приводить к одному формату. Ну, или же инициализировать буфер каждый раз заново -\_-

Помимо интерфейса для громкости есть ещё два других интерфейса:

* `SL_IID_MUTESOLO` для управления каналами (только для многоканального звука, это указывается в поле numChannels структуры SLDataFormat\_PCM).

* `SL_IID_EFFECTSEND` для наложения эффектов (по спецификации – только эффект реверберации).

Добавление звука в очередь при выборе плеера и установки звука на него:

```

void OSLBufferPlayer::setSound(OSLSound * sound){

if(bufferQueue == NULL)

LOGD("bufferQueue is null");

this->sound = sound;

(*bufferQueue)->Clear(bufferQueue);

(*bufferQueue)->Enqueue(bufferQueue, sound->getBuffer() , sound->getSize());

}

```

#### Проигрывание сжатых форматов

В WAV все звуки хранить не вариант. И не потому что что сами файлы много места занимают (хотя и это тоже), просто когда вы их в память загрузите, то просто не хватит оперативки для этого (:

Я создаю классы для каждого из форматов, чтобы в будущем, если понадобиться, писать часть по декодированию в них. Для mp3 есть класс `OSLMp3`, который, по сути, лишь имя файла хранит для того, чтобы в будущем установить на плеер. Тоже самое можно для ogg сделать и других поддерживаемых форматов.

Приведу полностью метод по инициализации, пояснения в комментариях.

**Инициализация AssetPlayer для работы со сжатыми форматами**

```

void OSLAssetPlayer::init(char * filename){

SLresult result;

AAsset* asset = AAssetManager_open(mgr, filename, AASSET_MODE_UNKNOWN);

if (NULL == asset) {

return JNI_FALSE;

}

// открываем дескриптор

off_t start, length;

int fd = AAsset_openFileDescriptor(asset, &start, &length);

assert(0 <= fd);

AAsset_close(asset);

// настраиваем данные по файлу

SLDataLocator_AndroidFD loc_fd = {SL_DATALOCATOR_ANDROIDFD, fd, start, length};

SLDataFormat_MIME format_mime = {SL_DATAFORMAT_MIME, NULL, SL_CONTAINERTYPE_UNSPECIFIED};

SLDataSource audioSrc = {&loc_fd, &format_mime};

SLDataLocator_OutputMix loc_outmix = {SL_DATALOCATOR_OUTPUTMIX, context->getOutputMixObject()};

SLDataSink audioSnk = {&loc_outmix, NULL};

// создаём плеер

const SLInterfaceID ids[3] = {SL_IID_SEEK, SL_IID_MUTESOLO, SL_IID_VOLUME};

const SLboolean req[3] = {SL_BOOLEAN_TRUE, SL_BOOLEAN_TRUE, SL_BOOLEAN_TRUE};

result = (*context->getEngine())->CreateAudioPlayer(context->getEngine(), &playerObj, &audioSrc, &audioSnk,

3, ids, req);

assert(SL_RESULT_SUCCESS == result);

// реализуем плеер

result = (*playerObj)->Realize(playerObj, SL_BOOLEAN_FALSE);

assert(SL_RESULT_SUCCESS == result);

// получаем интерфейс для работы со звуком

result = (*playerObj)->GetInterface(playerObj, SL_IID_PLAY, &player);

assert(SL_RESULT_SUCCESS == result);

// получение интерфейса для перемещения по файлу

result = (*playerObj)->GetInterface(playerObj, SL_IID_SEEK, &fdPlayerSeek);

assert(SL_RESULT_SUCCESS == result);

// получение интерфейса для управления каналами

result = (*playerObj)->GetInterface(playerObj, SL_IID_MUTESOLO, &fdPlayerMuteSolo);

assert(SL_RESULT_SUCCESS == result);

// получение интерфейса для управления громокстью

result = (*playerObj)->GetInterface(playerObj, SL_IID_VOLUME, &fdPlayerVolume);

assert(SL_RESULT_SUCCESS == result);

// задаём необходимо ли зацикливание файла

result = (*fdPlayerSeek)->SetLoop(fdPlayerSeek, sound->isLooping() ? SL_BOOLEAN_TRUE : SL_BOOLEAN_FALSE, 0, SL_TIME_UNKNOWN);

assert(SL_RESULT_SUCCESS == result);

// return JNI_TRUE;

}

```

#### Заключение

OpenSL ES достаточно прост в изучении. Да и возможностей у него не мало (к примеру можно записывать аудио). Жаль только, что с кроссплатформенностью проблемы. OpenAL кроссплатформенный, но на Android ведёт себя не очень. Есть у OpenSL пара минусов, странное поведение callback’ов, не все возможности спецификации поддерживаются и т.д. Но в целом, простота реализации и стабильная работы покрывают эти минусы.

Сорсы можно взять на [github.com](https://github.com/Suvitruf/Android-ndk/tree/master/OpenSLES)

#### Доп. инфа

Интересное чтиво по теме:

1. [The Standard for Embedded Audio Acceleration](http://www.khronos.org/opensles/) на сайте разработчика.

2. [The Khronos Group Inc. OpenSL ES Specification](http://www.khronos.org/registry/sles/specs/OpenSL_ES_Specification_1.1.pdf "OpenSL ES Specification").

3. Android NDK. Разработка приложений под Android на С/С++.

4. [Ogg Vorbis](http://svn.xiph.org/trunk/Tremor/) | https://habr.com/ru/post/235795/ | null | ru | null |

# Разбор калифорнийского исследования про лояльность владельцев EV

Несколько месяцев назад в СМИ нашумела работа группы из Университета Калифорнии [Discontinuance among California’s electric vehicle buyers: Why are some consumers abandoning their electric vehicles?](https://escholarship.org/uc/item/11n6f4hs), целью которой было изучение причин, по которым владельцы “чистых” автомобилей (на батареях - BEV, водородных топливных ячейках - FCEV и подключаемые гибриды - PHEV) от них отказываются и возвращаются обратно к “грязным” ДВС.

Для получения этой информации было опрошено почти 5 тыс владельцев автомобилей в Калифорнии о сроках владения автомобилем, демографических данных, наличии зарядного устройства дома, дальних поездках и т.п. Опрошенные владельцы приобрели автомобили с 2013 по 2018 годы; опрос проводился в 2019 году.

В процессе работы с данными в числе прочего была получена интересная цифра: около **21%** владельцев “новых” автомобилей возвращаются к “старым” ДВС. Эта цифра меня несколько удивила, так как мой личный опыт общения с "электроводами" говорит об обратном: редкий водитель согласится покупать ДВС после езды на электричке, так что давайте разберемся, что же на самом деле говорят исходные данные работы ([они свободно доступны](https://datadryad.org/stash/dataset/doi:10.25338/B8WS6R)).

```

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

sns.set(style="darkgrid")

data = pd.read_excel("Discontinaunce_of_PEVs_in_California_Data_2021.03.01.xlsx")

```

### По сменившим авто водителям

Один из ключевых моментов работы - тот факт, что исследователей интересовали только владельцы, которые **уже поменяли** свой автомобиль на новый, таким образом, проголосовав “за” или “против” электричек кошельком, так что давайте отбросим данные владельцев, которые продолжают пользоваться старым автомобилем.

```

changed = data[data["[s] Discontinuance (inc. purchased lease) 2"] != "Original"]

changed["Continued"] = changed["[s] Discontinuance (inc. purchased lease) 2"].map(lambda c: c == "Continued" and 1 or 0)

```

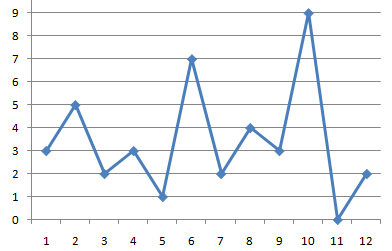

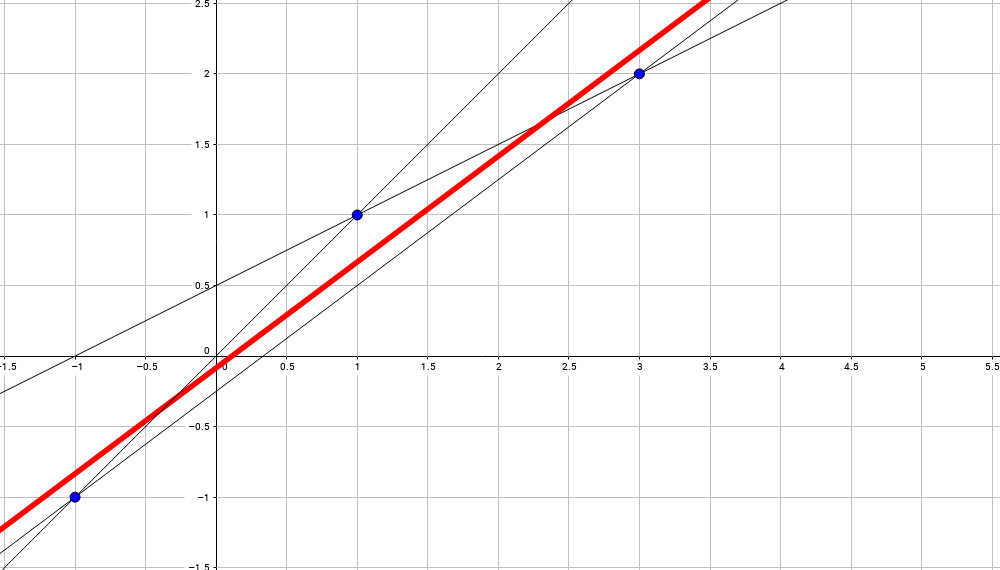

Но посмотрим на распределение "отказников" и "фанатов" в зависимости от запаса хода автомобиля:

```

fig = sns.histplot(changed[changed["Continued"] == 1]["[s] Electric driving range"], color="g")

fig = sns.histplot(changed[changed["Continued"] == 0]["[s] Electric driving range"], color="r")

plt.show()

```

Здесь явно видны две большие группы: авто с малым (до 150 миль) запасом хода, это в основном PHEV и т.н. "compliance cars", выпускавшиеся автоконцернами в начале 2010-х для соответствия калифорнийскому законодательству, и авто с "достаточным" запасом хода (больше 150 миль) - "теслы" и водородные автомобили. Давайте посмотрим, каков процент "отказников" в этих 4 группах:

```

phevs = changed[changed["oldcartype. {TOKEN:ATTRIBUTE_2} 2"] == "PHEV"]

len(phevs[phevs["Continued"] == 0]) / len(phevs)

```

```

0.2165206508135169

```

```

evs = changed[changed["oldcartype. {TOKEN:ATTRIBUTE_2} 2"] == "BEV"]

compliance = evs[evs["[s] Electric driving range"] < 150]

len(compliance[compliance["Continued"] == 0]) / len(compliance)

```

```

0.22209944751381216

```

```

fcevs = changed[changed["oldcartype. {TOKEN:ATTRIBUTE_2} 2"].isnull()]

len(fcevs[fcevs["Continued"] == 0]) / len(fcevs)

```

```

0.6097560975609756

```

```

teslas = evs[evs["[s] Electric driving range"] >= 150]

len(teslas[teslas["Continued"] == 0]) / len(teslas)

```

```

0.09852216748768473

```

```

len(changed[changed["Continued"] == 0]) / len(changed)

```

```

0.21498204207285787

```

И логичным образом, в выводах исследователей “лояльность” тут коррелирует с наличием зарядки дома, частотой длительных поездок и т.п.

### По всем водителям

А теперь - представим, что нам не нужно выяснять причины “лояльности”, а лишь понять, насколько владельцы автомобилей “нового поколения” ими довольны. Для этого возьмем все данные, включая тех водителей, кто продолжает ездить на своем старом автомобиле (если бы они были им недовольны - они бы его сменили).

```

data["Continued"] = data["[s] Discontinuance (inc. purchased lease) 2"].map(lambda c: c in ["Continued", "Original"] and 1 or 0)

```

Распределение:

```

fig = sns.histplot(data[data["Continued"] == 1]["[s] Electric driving range"], color="g")

fig = sns.histplot(data[data["Continued"] == 0]["[s] Electric driving range"], color="r")

plt.show()

```

И процент "отказников" по группам:

```

phevs = data[data["oldcartype. {TOKEN:ATTRIBUTE_2} 2"] == "PHEV"]

len(phevs[phevs["Continued"] == 0]) / len(phevs)

```

```

0.0857709469509172

```

```

evs = data[data["oldcartype. {TOKEN:ATTRIBUTE_2} 2"] == "BEV"]

compliance = evs[evs["[s] Electric driving range"] < 150]

len(compliance[compliance["Continued"] == 0]) / len(compliance)

```

```

0.14105263157894737

```

```

fcevs = data[data["oldcartype. {TOKEN:ATTRIBUTE_2} 2"].isnull()]

len(fcevs[fcevs["Continued"] == 0]) / len(fcevs)

```

```

0.15432098765432098

```

```

teslas = evs[evs["[s] Electric driving range"] >= 150]

len(teslas[teslas["Continued"] == 0]) / len(teslas)

```

```

0.016260162601626018

```

```

len(data[data["Continued"] == 0]) / len(data)

```

```

0.08665977249224405

```

Итак, по исходной методике имеем:

* FCEV: 60.9% “отказников”

* BEV с малым запасом хода: 22.2%

* PHEV: 21.6%

* BEV с достаточным запасом хода: 9.8%

* Итого: 21.5%

По всем водителям:

* FCEV: 15.4% “отказников”

* BEV с малым запасом хода: 14.1%

* PHEV: 8.5%

* BEV с достаточным запасом хода: 1.6%

* Итого: 8.7%

### Вывод

Если считать статистику по всем водителям, что логичнее для оценки уровня лояльности, получаем **8.7%** “отказников”, что уже более чем вдвое ниже распиаренной цифры в 21%.

Причем, бОльшая их часть -

* FCEV, инфраструктура для которых даже в Калифорнии до сих пор в зачаточном состоянии, а в соседних штатах - вовсе отсутствует

* Compliance cars, которые изначально создавались не для массовых продаж и масштабной конкуренции с ДВС

* PHEV, которые часто покупаются как ДВС, без каких-либо изменений в паттернах использования, исключительно ради полагающихся субсидий штата (благодаря которым PHEV может оказаться дешевле “обычного” гибрида)

Среди же всех владельцев BEV с приемлемым запасом хода (от 150 миль, 241 км) отказались от электротяги всего **1.6%** владельцев.

В общем, busted. | https://habr.com/ru/post/590363/ | null | ru | null |

# Что я не ожидал увидеть в тесте Java Programmer I (1Z0-803)

Здесь нету примеров идеального кода, пяти шагов «как получить сертификат с вероятностью 100%, гарантия». Нету даже фотографий котиков :/

#### В лучших стилях жанра «Смотрите, я получил сертификат!»

##### Случилось это...

В Праге, в центре тестирования Gopas, посредником был [«Pearson VUE»](http://vue.com/). Стоимость — 245 USD.

##### Довела меня до этого...

Обещанная на работе прибавка к зарплате. [Осертифицироваться](http://stihi.ru/2009/12/06/2645) я хотел давно, но всегда успешно находил отговорку для переноса экзамена на «более подходящее время».

##### Терпение и труд все перетрут

Если у вас есть опыт программирования на Java (каких-нибудь 1+ лет), то особая подготовка не нужна, просмотрите темы экзамена и восстановите возможные пробелы. Лично я глянул [sample questions](http://education.oracle.com/pls/web_prod-plq-dad/db_pages.getpage?page_id=303&p_certName=SQ1Z0_803) и попросил экзамен не с самого утра дабы выспаться.

##### Неожиданности

Следующие примеры не делают экзамен сложным, но упоминание о них, вероятно, может быть полезными для людей, которые тоже решили пренебречь подготовкой.

1. **Изменение и передача аргумента в одной строчке**, по типу

```

doStuff(i++, ++j, (k+=1));

```

«И где неожиданность?» — спросите вы.

Да, ничего сложного, но… В начале теста было два-три примера где нужно просто определить результат вызова метода с подобными изменениями аргументов. А потом где-то в 15-ти (число очень «на глаз») вопросах над аргументами по-разному «издевались» и от этого зависел правильный ответ, хотя пример был на совершенно другую тему. Т.е. если вдруг по каким-то причинам вы запутались с аргументами, то получите вдобавок минусы по наследованию и обработке исключений например.

2. **== vs. equals**

Тема заезженная и я предполагал, что Oracle захочет основательно ее проверить, но количество вопросов на эту тему превысило мои ожидания. На вскидку их было около десяти (всего вопросов 90). Мы люди взрослые и оператор "==" для сравнения объектов обычно не используем, поэтому некоторые нюансы забываются. В основном надо было оценить результат сравнения String'ов, было банальное типа

```

String s = "im string";

String s2 = new String("im string");

System.out.println(s == s2);

System.out.println(s.equals(s2));

```

а было и что-то типа

```

public class HelloWorlder {

public String name;

public HelloWorlder(String name){

this.name = name;

}

public static void main(String[] args){

HelloWorlder h = new HelloWorlder("String");

HelloWorlder h2 = new HelloWorlder("String");

System.out.println(h.name == h2.name);

System.out.println(h.name.equals(h2.name));

}

}

```

Кроме String'ов сравнивали объекты без переопределенного equals, но это просто к слову.

3. **«Сделай это инкапсулированно» — говорили они.**

Попалось мне такое три раза, всегда давался класс (или два) и предлагались на выбор несколько изменений кода (типа поменять видимость переменной, добавить метод и т.п.). Два вопроса были абсолютно нормальными, а вот в третьем путем исключения остался один вариант — объявить переменную с default visibility как final. Инкапсуляция. Я допускаю, что что-нибудь упускаю, но остальные варианты определенно не подходили.

4. **Семь раз отмерь**

Как я и догадывался из [sample questions](http://education.oracle.com/pls/web_prod-plq-dad/db_pages.getpage?page_id=303&p_certName=SQ1Z0_803), очень много вопросов было на внимательность. Примеры:

* большой кусок кода, который запускался

```

public static int main(String[] args)

```

или

```

public static void main(String args)

```

* Высчитывания сколько раз в консоль выпишется какая-нибудь цифра в результате выполнения while-цикла вложенного в for-цикл, каждый имеет continue, break, exceptions и т.п. Не торопимся и считаем, времени у нас достаточно.

* Compilation failed, Runtime exception, Exception at line «n» и т.п. Такие варианты ответов попадаются часто (самый популярный — Compilation failed). В каждом таком примере необходимо внимательно смотреть все названия, декларации, вызываемые методы, параметры и т.д.

Но бояться нечего, большинство вопросов близки к практике. Есть и интересные вопросы, мне понравилось задание «выберите три **bad practices**» из предложенных, запомнилась инициализация char массива

```

char[] array = { 97, 'b' };

```

надо было вспомнить, что 97 это 'a'.

Если вам кажется, что сертификат стоит дороже, чем польза от него, то можете попробовать договориться с работодателем на оплату оного, лично мне удалось.

Не забываем, что 1 / 2 = 0, спасибо за внимание :)

**Послесловие:** При написании поста постоянно вспоминал пословицу «Краткость — сестра таланта».

**UPD:** все вопросы из [здесьссылка](https://www.google.cz/url?sa=t&rct=j&q=&esrc=s&source=web&cd=2&ved=0CDcQFjAB&url=http%3A%2F%2Fwww.techexams.ws%2Fdemo%2F1z0-803.pdf&ei=x4ZdUvKeO4irhQekjIFA&usg=AFQjCNFA7ltxNKC0UhodNUe7LzSR-Qt9RA&sig2=YY8lDd3TXnn29OxprLsgNA&bvm=bv.53899372,d.bGE&cad=rja) очень похожи на реальные | https://habr.com/ru/post/197694/ | null | ru | null |

# SObjectizer: проблема перегрузки агентов и средства борьбы с ней

В предыдущих статьях мы несколько раз упоминали о такой проблеме, как перегрузка агентов. Что это такое? Чем это грозит? Как с этим бороться? Обо всем этом мы и поговорим сегодня.

Проблема перегрузки агентов возникает, когда какому-то агенту отсылается больше сообщений, чем он успевает обрабатывать. В результате очереди сообщений постоянно увеличиваются в размерах. Растущие очереди расходуют память. Расход памяти ведет к замедлению работы приложения. Из-за замедления проблемный агент начинает обрабатывать сообщения дольше, что увеличивает скорость роста очередей сообщений. Что способствует более быстрому расходу памяти. Что ведет к еще большему замедлению приложения. Что ведет к еще более медленной работе проблемного агента… Как итог, приложение медленно и печально деградирует до полной неработоспособности.

Проблема усугубляется еще и тем, что взаимодействие посредством асинхронных сообщений и использование подхода fire-and-forget прямо таки провоцирует возникновение перегрузок (fire-and-forget – это когда агент A получает входящее сообщение M1, выполняет его обработку и отсылает исходящее сообщение M2 агенту B не заботясь о последствиях).

Действительно, когда send отвечает только за постановку сообщения в очередь агента-приемника, то отправитель не блокируется на send-е, даже если получатель не справляется со своим потоком сообщений. Это и создает предпосылки для того, чтобы отправители сообщений не заботились о том, а способен ли получатель справится с нагрузкой.

К сожалению, нет универсального рецепта по борьбе с перегрузками, пригодного для всех ситуаций. Где-то можно просто терять новые сообщения, адресованные перегруженному агенту. Где-то это недопустимо, но зато можно выбрасывать самые старые сообщения, которые стоят в очереди слишком долго и уже перестали быть актуальными. Где-то вообще нельзя терять сообщения, но зато можно при перегрузке переходить к другому способу обработки сообщений. Например, если агент отвечает за изменение размера фотографий для отображения на Web-страничке, то при перегрузке агент может переключиться на более грубый алгоритм ресайзинга: качество фотографий упадет, зато очередь фотографий для обработки будет рассасываться быстрее.

Поэтому хороший инструмент для защиты от перегрузок должен быть заточен под конкретную задачу. Из-за этого долгое время в SObjectizer никаких готовых механизмов, доступных пользователю «из коробки», не было. Пользователь решал свои проблемы сам.

Одним из самых практичных способов защиты от перегрузки, по нашему опыту, оказался подход с использованием двух агентов: collector и performer. Агент-collector накапливает входящие сообщения, подлежащие обработке, в каком-то подходящем контейнере. Агент-performer обрабатывает сообщения, которые собрал агент-collector.

Фокус в том, что агенты collector и performer привязываются к разным рабочим контекстам. Поэтому, если агент-performer начинает притормаживать, то это не сказывается на работе collector-а. Как правило, агент-collector обрабатывает свои события очень быстро: обработка обычно заключается в сохранении нового сообщения в какую-то отдельную очередь. Если эта отдельная очередь переполнена, то агент-collector может сразу вернуть отрицательный ответ на новое сообщение. Или же выбросить какое-то старое сообщение из очереди. Так же агент-collector может периодически проверять время пребывания сообщений в этой отдельной очереди: если какое-то сообщение ждало обработки слишком долго и перестало быть актуальным, то агент-collector выбрасывает его из очереди (возможно, отсылая при этом какой-то отрицательный ответ инициатору данного сообщения).

Агент-performer же, как правило, обрабатывает свои входящие сообщения намного дольше, чем агент-collector, что логично, т.к. ответственность за собственно прикладную работу лежит на performer-е. Агент-performer сам запрашивает у агента-collector-а следующую порцию сообщений для обработки.

В самом простом случае агент-performer завершает обработку текущего сообщения и отсылает агенту-collector-у запрос на выдачу очередного подлежащего обработки сообщения. Получив этот запрос агент-collector выдает агенту-performer-у первое сообщение из своей очереди.

В состав SObjectizer-а включено несколько примеров, демонстрирующих различные вариации на тему collector-ов и performer-ов. С описаниями этих примеров можно ознакомиться в Wiki проекта ([№1](https://sourceforge.net/p/sobjectizer/wiki/so-5.5%20By%20Example%20Work%20Generation/), [№2](https://sourceforge.net/p/sobjectizer/wiki/so-5.5%20By%20Example%20Collector%20and%20Performer%20Pair/), [№3](https://sourceforge.net/p/sobjectizer/wiki/so-5.5%20By%20Example%20Collector%20and%20Many%20Performers/), [№4](https://sourceforge.net/p/sobjectizer/wiki/so-5.5%20By%20Example%20Simple%20Message%20Deadline/)).

По мере накопления опыта использования SObjectizer и по результатам многочисленных обсуждений мы пришли к тому, что не смотря на возможность сделать своими руками схемы защиты от перегрузок разной степени сложности и эффективности, в самом SObjectizer так же хотелось бы иметь какой-то базовый механизм. Пусть не продвинутый, но зато доступный прямо «из коробки», что особенно востребовано при быстром прототипировании.

Таким механизмом стали лимиты для сообщений (т.н. [message limits](https://sourceforge.net/p/sobjectizer/wiki/so-5.5%20In-depth%20-%20Message%20Limits/)). Агент может указать, сколько экземпляров сообщений конкретного типа он разрешает сохранить в очереди сообщений. И что следует делать с «лишними» экземплярами. Превышение заданного лимита – это перегрузка и SObjectizer реагирует на нее одним из следующих способов:

* выбрасывает новое сообщение как будто его не было;

* пересылает сообщение на другой mbox. Эта реакция выполняется в предположении, что другой получатель сможет обработать лишнее сообщение;

* трансформировать лишнее сообщение в сообщение другого типа и отослать новое сообщение на некоторый mbox. Эта реакция может позволить, например, сразу отослать отрицательный ответ отправителю сообщения;

* прерывает работу приложения посредством вызова std::abort(). Этот вариант подходит для случаев, когда нагрузка превышает все мыслимые пределы и шансов на восстановление работоспособности практически нет, поэтому лучше прерваться и рестартовать, чем продолжать накапливать сообщение в очередях.

Давайте посмотрим, как лимиты сообщений могут помогать справляться с перегрузками (исходный текст примера можно найти [в этом репозитории](https://github.com/Stiffstream/habrhabr_article_overload_ru)).

Предположим, что нам нужно обрабатывать запросы на ресайз картинок до заданного размера. Если таких запросов скапливается больше 10, то нам нужно обрабатывать новые запросы с помощью другого алгоритма, более быстрого, но менее точного. Если же и это не помогает, то лишние запросы мы будем специальным образом логировать и отсылать инициатору пустую картинку результирующего размера.

Создадим трех агентов. Первый агент будет выполнять нормальную обработку изображений. Лишние изображения, которые он не в состоянии быстро отресайзить, посредством message\_limit будут отсылаться второму агенту.

```

// Тип агента, который выполняет нормальную обработку картинок.

class accurate_resizer final : public agent_t {

public :

accurate_resizer( context_t ctx, mbox_t overload_mbox )

// Лимиты настраиваются при создании агента и не могут меняться

// впоследствии. Поэтому конструируем лимиты сообщений как уточнение

// контекста, в котором агенту предстоит работать дальше.

: agent_t( ctx

// Ограничиваем количество ждущих соообщений resize_request

// с автоматическим редиректом лишних экземпляров другому

// обработчику.

+ limit_then_redirect< resize_request >(

// Разрешаем хранить всего 10 запросов...

10,

// Остальное пойдет на этот mbox.

[overload_mbox]() { return overload_mbox; } ) )

{...}

...

};

```

Второй агент выполняет более быструю, но более грубую обработку изображений. Поэтому у него лимит на количество сообщений в очереди будет повыше. Лишние сообщения редиректятся третьему агенту:

```

// Тип агента, который выполняет грубую обработку картинок.

class inaccurate_resizer final : public agent_t {

public :

inaccurate_resizer( context_t ctx, mbox_t overload_mbox )

: agent_t( ctx

+ limit_then_redirect< resize_request >(

// Разрешаем хранить всего 20 запросов...

20,

// Остальное пойдет на этот mbox.

[overload_mbox]() { return overload_mbox; } ) )

{...}

...

};

```

Третий агент вместо ресайза выполняет генерацию пустой картинки. Т.е. когда все плохо и нагрузка оказалась ну очень высокой, то лучше уж оставлять вместо картинок пустые места, чем впадать в полный ступор. Однако, генерация пустой картинки не происходит мгновенно, поэтому можно ожидать, что и у третьего агента будет некий разумный лимит для ожидающих запросов. А вот если этот лимит превышается, то, пожалуй, лучше грохнуть все приложение через std::abort, дабы после рестарта оно могло начать работу заново. Возможно, тормоза с обработкой потока запросов вызваны каким-то неправильным поведением приложения, а рестарт позволит начать все заново «с чистого листа». Поэтому третий агент тупо заставляет вызвать std::abort при превышении лимита. Примитивно, но чрезвычайно действенно:

```

// Тип агента, который не выполняет никакой обработки картинки,

// а вместо этого возвращает пустую картинку заданного размера.

class empty_image_maker final : public agent_t {

public :

empty_image_maker( context_t ctx )

: agent_t( ctx

// Ограничиваем количество запросов 50-тью штуками.

// Если их все-таки оказывается больше, значит что-то идет

// совсем не так, как задумывалось и лучше прервать работу

// приложения.

+ limit_then_abort< resize_request >( 50 ) )

{...}

...

};

```

А все вместе агенты могут создаваться, например, таким образом:

```

// Вспомогательная функция для создания агентов для рейсайзинга картинок.

// Возвращается mbox, на который следует отсылать запросы для ресайзинга.

mbox_t make_resizers( environment_t & env ) {

mbox_t resizer_mbox;

// Все агенты будут иметь собственный контекст исполнения (т.е. каждый агент

// будет активным объектом), для чего используется приватный диспетчер

// active_obj.

env.introduce_coop(

disp::active_obj::create_private_disp( env )->binder(),

[&resizer_mbox]( coop_t & coop ) {

// Создаем агентов в обратном порядке, т.к. нам нужны будут

// mbox-ы на которые следует перенаправлять "лишние" сообщения.

auto third = coop.make_agent< empty_image_maker >();

auto second = coop.make_agent< inaccurate_resizer >( third->so_direct_mbox() );

auto first = coop.make_agent< accurate_resizer >( second->so_direct_mbox() );

// Последним создан агент, который будет первым в цепочке агентов

// для ресайзинга картинок. Его почтовый ящик и будет ящиком для

// отправки запросов.

resizer_mbox = first->so_direct_mbox();

} );

return resizer_mbox;

}

```

В общем, механизм message limits позволяет в простых случаях обходиться без разработки кастомных агентов collector-ов и performer-ов. Хотя полностью заменить их и не может (так, message limits не позволяет автоматически выбрасывать из очереди самые старые сообщения – это связано с организацией очередей заявок у диспетчеров).

Итак, попробуем кратко резюмировать. Если ваше приложение состоит из агентов, взаимодействующих исключительно через асинхронные сообщения, и вы любите использовать подход fire-and-forget, то перегрузка агентов вам практически гарантирована. В идеале для защиты своих агентов вам бы следовало использовать что-то вроде пар из collector-performer-агентов, логика поведения которых заточена под вашу задачу. Но, если вам не нужно идеальное решение, а достаточно «дешево и сердито», то на помощь придут лимиты для сообщений, которые SObjectizer предоставляет «из коробки».

PS. Возникновение перегрузок возможно не только для акторов/агентов в рамках Модели Акторов, но и при использовании CSP-шных каналов. Поэтому в SObjectizer аналоги CSP-шных каналов, [message chains](https://sourceforge.net/p/sobjectizer/wiki/so-5.5%20In-depth%20-%20Message%20chains/), так же содержат средства защиты от перегрузки, в чем-то похожие на message limits. | https://habr.com/ru/post/310818/ | null | ru | null |

# Userscript чтобы убрать красные сообщения от Google+

Google+ может напрягать своими сообщениями. Я сразу же убрал все сообщения по электронной почте в настройках. Красные сообщения в черной полоске вверху напрягают чуть меньше, но они проходят красной ниткой через все остальные продукты компании добра.

Избавиться от них в почте, документах, календаре помогает простой юзерскрипт:

<http://userscripts.org/scripts/show/105894>

[Исходный код](http://userscripts.org/scripts/review/105894) совсем простой. По сути, это одна строчка:

`try {document.getElementById("gbg1").style.display = 'none';} catch(e) { }`

Вы можете установить его в Chrome просто нажав зеленую кнопку «Install». Если вы не доверяте содержимому скрипта — скачайте его (например, на рабочий стол), нажав «Сохранить как» на этой кнопке. Посмотрите код внимательно, может быть, подправьте (возможно, вам хочется видеть сообщения в Reader). Откройте новую вкладку в Chrome и перетащите файл мышкой туда, согласитесь с установкой. | https://habr.com/ru/post/123278/ | null | ru | null |

# Android архитектура клиент-серверного приложения

Клиент-серверные приложения являются самыми распространенными и в то же время самыми сложными в разработке. Проблемы возникают на любом этапе, от выбора средств для выполнения запросов до методов кэширования результата. Если вы хотите узнать, как можно грамотно организовать сложную архитектуру, которая обеспечит стабильную работу вашего приложения, прошу под кат.

Конечно, сейчас уже не 2010 год, когда разработчикам приходилось использовать [знаменитые паттерны A/B/C](https://docs.google.com/a/dz.ru/file/d/0B2dn_3573C3RdlVpU2JBWXdSb3c/edit) или вообще запускать AsyncTask-и ~~и сильно бить в бубен~~. Появилось большое количество различных библиотек, которые позволяют вам без особых усилий выполнять запросы, в том числе и асинхронно. Эти библиотеки весьма интересны, и нам тоже стоит начать с выбора подходящей. Но для начала давайте немного вспомним, что у нас уже есть.

Раньше в Android единственным доступным средством для выполнения сетевых запросов был клиент Apache, который на самом деле далек от идеала, и не зря сейчас Google усиленно старается избавиться от него в новых приложениях. Позже плодом стараний разработчиков Google стал класс HttpUrlConnection. Он ситуацию исправил не сильно. По-прежнему не хватало возможности выполнять асинхронные запросы, хотя модель HttpUrlConnection + Loaders уже является более-менее работоспособной.

2013 год стал в этом плане весьма эффективным. Появились замечательные библиотеки Volley и Retrofit. Volley — библиотека более общего плана, предназначенная для работы с сетью, в то время как Retrofit специально создана для работы с REST Api. И именно последняя библиотека стала общепризнанным стандартом при разработке клиент-серверных приложений.

У Retrofit, по сравнению с другими средствами, можно выделить несколько основных преимуществ:

1) Крайне удобный и простой интерфейс, который предоставляет полный функционал для выполнения любых запросов;

2) Гибкая настройка — можно использовать любой клиент для выполнения запроса, любую библиотеку для разбора json и т.д.;

3) Отсутствие необходимости самостоятельно выполнять парсинг json-а — эту работу выполняет библиотека Gson (и уже [не только Gson](https://github.com/square/retrofit/blob/master/CHANGELOG.md#version-200-beta1-2015-08-27));

4) Удобная обработка результата и ошибок;

5) Поддержка Rx, что тоже является немаловажным фактором сегодня.

Если вы еще не знакомы с библиотекой Retrofit, самое время [изучить ее](http://square.github.io/retrofit/). Но я в любом случае сделаю небольшое введение, а заодно мы немного рассмотрим новые возможности версии 2.0.0 (советую также посмотреть [презентацию по Retrofit 2.0.0](https://speakerdeck.com/jakewharton/simple-http-with-retrofit-2-droidcon-nyc-2015)).

В качестве примера я выбрал [API для аэропортов](https://support.travelpayouts.com/hc/ru/articles/203956153-API-%D0%B4%D0%BB%D1%8F-%D0%B8%D1%81%D0%BF%D0%BE%D0%BB%D1%8C%D0%B7%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F-%D0%B2-%D0%BC%D0%BE%D0%B1%D0%B8%D0%BB%D1%8C%D0%BD%D1%8B%D1%85-%D0%BF%D1%80%D0%B8%D0%BB%D0%BE%D0%B6%D0%B5%D0%BD%D0%B8%D1%8F%D1%85) за его максимальную простоту. И мы решаем самую банальную задачу — получение списка ближайших аэропортов.

В первую очередь нам нужно подключить все выбранные библиотеки и требуемые зависимости для Retrofit:

```

compile 'com.squareup.retrofit:retrofit:2.0.0-beta1'

compile 'com.squareup.retrofit:converter-gson:2.0.0-beta1'

compile 'com.squareup.okhttp:okhttp:2.0.0'

```

Мы будем получать аэропорты в виде списка объектов определенного класса. **Поэтому этот класс надо создать**

```

public class Airport {

@SerializedName("iata")

private String mIata;

@SerializedName("name")

private String mName;

@SerializedName("airport_name")

private String mAirportName;

public Airport() {

}

}

```

Создаем сервис для запросов:

```

public interface AirportsService {

@GET("/places/coords_to_places_ru.json")

Call> airports(@Query("coords") String gps);

}

```

*Примечание про Retrofit 2.0.0*

Раньше для выполнения синхронных и асинхронных запросов мы должны были писать разные методы. Теперь при попытке создать сервис, который содержит void метод, вы получите ошибку. В Retrofit 2.0.0 интерфейс Call инкапсулирует запросы и позволяет выполнять их синхронно или асинхронно.

**Раньше**

```

public interface AirportsService {

@GET("/places/coords_to_places_ru.json")

List airports(@Query("coords") String gps);

@GET("/places/coords\_to\_places\_ru.json")

void airports(@Query("coords") String gps, Callback> callback);

}

```

**Сейчас**

```

AirportsService service = ApiFactory.getAirportsService();

Call> call = service.airports("55.749792,37.6324949");

//sync request

call.execute();

//async request

Callback> callback = new RetrofitCallback>() {

@Override

public void onResponse(Response> response) {

super.onResponse(response);

}

};

call.enqueue(callback);

```

Теперь создадим вспомогательные методы:

```

public class ApiFactory {

private static final int CONNECT_TIMEOUT = 15;

private static final int WRITE_TIMEOUT = 60;

private static final int TIMEOUT = 60;

private static final OkHttpClient CLIENT = new OkHttpClient();

static {

CLIENT.setConnectTimeout(CONNECT_TIMEOUT, TimeUnit.SECONDS);

CLIENT.setWriteTimeout(WRITE_TIMEOUT, TimeUnit.SECONDS);

CLIENT.setReadTimeout(TIMEOUT, TimeUnit.SECONDS);

}

@NonNull

public static AirportsService getAirportsService() {

return getRetrofit().create(AirportsService.class);

}

@NonNull

private static Retrofit getRetrofit() {

return new Retrofit.Builder()

.baseUrl(BuildConfig.API_ENDPOINT)

.addConverterFactory(GsonConverterFactory.create())

.client(CLIENT)

.build();

}

}

```

Отлично! Подготовка завершена, и теперь мы можем выполнить запрос:

```

public class MainActivity extends AppCompatActivity implements Callback> {

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity\_main);

AirportsService service = ApiFactory.getAirportsService();

Call> call = service.airports("55.749792,37.6324949");

call.enqueue(this);

}

@Override

public void onResponse(Response> response) {

if (response.isSuccess()) {

List airports = response.body();

//do something here

}

}

@Override

public void onFailure(Throwable t) {

}

}

```

Все кажется очень простым. Мы без особых усилий создали нужные классы, и уже можем делать запросы, получать результат и обрабатывать ошибки, и все это буквально за 10 минут. Что же еще нужно?

Однако такой подход является в корне неверным. Что будет, если во время выполнения запроса пользователь повернет устройство или вообще закроет приложение? С уверенностью можно сказать только то, что нужный результат вам не гарантирован, и мы недалеко ушли от первоначальных проблем. Да и запросы в активити и фрагментах никак не добавляют красоты вашему коду. Поэтому пора, наконец, вернуться к основной теме статьи — построение архитектуры клиент-серверного приложения.

В данной ситуации у нас есть несколько вариантов. Можно воспользоваться любой библиотекой, которая обеспечивает грамотную работу с многопоточностью. Здесь идеально подходит фреймворк Rx, тем более что Retrofit его поддерживает. Однако построить архитектуру с Rx или даже просто использовать функциональное реактивное программирование — это нетривиальные задачи. Мы пойдем по более простому пути: воспользуемся средствами, которые предлагает нам Android из коробки. А именно, лоадерами.

Лоадеры появились в версии API 11 и до сих пор остаются очень мощным средством для параллельного выполнения запросов. Конечно, в лоадерах можно делать вообще что угодно, но обычно их используют либо для чтения данных с базы, либо для выполнения сетевых запросов. И самое важное преимущество лоадеров — через класс LoaderManager они связаны с жизненным циклом Activity и Fragment. Это позволяет использовать их без опасения, что данные будут утрачены при закрытии приложения или результат вернется не в тот коллбэк.

Обычно модель работы с лоадерами подразумевает следующие шаги:

1) Выполняем запрос и получаем результат;

2) Каким-то образом кэшируем результат (чаще всего в базе данных);

3) Возвращаем результат в Activity или Fragment.

*Примечание*

Такая модель хороша тем, что Activity или Fragment не думают, как именно получаются данные. Например, с сервера может вернуться ошибка, но при этом лоадер вернет закэшированные данные.

Давайте реализуем такую модель. Я опускаю подробности того, как реализована работа с базой данных, при необходимости вы можете посмотреть пример на Github (ссылка в конце статьи). Здесь тоже возможно множество вариаций, и я буду рассматривать их по очереди, все их преимущества и недостатки, пока, наконец, не дойду до модели, которую считаю оптимальной.

*Примечание*

Все лоадеры должны работать с универсальным типом данных, чтобы можно было использовать интерфейс LoaderCallbacks в одной активити или фрагменте для разных типов загружаемых данных. Первым таким типом, который приходит на ум, является Cursor.

*Еще одно примечание*

Все модели, связанные с лоадерами, имеют небольшой недостаток: для каждого запроса нужен отдельный лоадер. А это значит, что при изменении архитектуры или, например, переходе на другую базу данных, мы столкнемся с большим рефакторингом, что не слишком хорошо. Чтобы максимально обойти эту проблему, я буду использовать базовый класс для всех лоадеров и именно в нем хранить всю возможную общую логику.

#### Loader + ContentProvider + асинхронные запросы

Предусловия: есть классы для работы с базой данных SQLite через ContentProvider, есть возможность сохранять сущности в эту базу.

В контексте данной модели крайне сложно вынести какую-то общую логику в базовый класс, поэтому в данном случае это всего лишь лоадер, от которого удобно наследоваться для выполнения асинхронных запросов. Его содержание не относится непосредственно к рассматриваемой архитектуре, поэтому он в спойлере. Однако вы также можете использовать его в своих приложениях:

**BaseLoader**

```

public class BaseLoader extends Loader {

private Cursor mCursor;

public BaseLoader(Context context) {

super(context);

}

@Override

public void deliverResult(Cursor cursor) {

if (isReset()) {

if (cursor != null) {

cursor.close();

}

return;

}

Cursor oldCursor = mCursor;

mCursor = cursor;

if (isStarted()) {

super.deliverResult(cursor);

}

if (oldCursor != null && oldCursor != cursor && !oldCursor.isClosed()) {

oldCursor.close();

}

}

@Override

protected void onStartLoading() {

if (mCursor != null) {

deliverResult(mCursor);

} else {

forceLoad();

}

}

@Override

protected void onReset() {

if (mCursor != null && !mCursor.isClosed()) {

mCursor.close();

}

mCursor = null;

}

}

```

Тогда лоадер для загрузки аэропортов может выглядеть следующим образом:

```

public class AirportsLoader extends BaseLoader {

private final String mGps;

private final AirportsService mAirportsService;

public AirportsLoader(Context context, String gps) {

super(context);

mGps = gps;

mAirportsService = ApiFactory.getAirportsService();

}

@Override

protected void onForceLoad() {

Call> call = mAirportsService.airports(mGps);

call.enqueue(new RetrofitCallback>() {

@Override

public void onResponse(Response> response) {

if (response.isSuccess()) {

AirportsTable.clear(getContext());

AirportsTable.save(getContext(), response.body());

Cursor cursor = getContext().getContentResolver().query(AirportsTable.URI,

null, null, null, null);

deliverResult(cursor);

} else {

deliverResult(null);

}

}

});

}

}

```

И теперь мы наконец можем использовать его в UI классах:

```

public class MainActivity extends AppCompatActivity implements LoaderManager.LoaderCallbacks {

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity\_main);

getLoaderManager().initLoader(R.id.airports\_loader, Bundle.EMPTY, this);

}

@Override

public Loader onCreateLoader(int id, Bundle args) {

switch (id) {

case R.id.airports\_loader:

return new AirportsLoader(this, "55.749792,37.6324949");

default:

return null;

}

}

@Override

public void onLoadFinished(Loader loader, Cursor data) {

int id = loader.getId();

if (id == R.id.airports\_loader) {

if (data != null && data.moveToFirst()) {

List airports = AirportsTable.listFromCursor(data);

//do something here

}

}

getLoaderManager().destroyLoader(id);

}

@Override

public void onLoaderReset(Loader loader) {

}

}

```

Как видно, здесь нет ничего сложного. Это абсолютно стандартная работа с лоадерами. На мой взгляд, лоадеры предоставляют идеальный уровень абстракции. Мы загружаем нужные данные, но без лишних знаний о том, как именно они загружаются.

Эта модель стабильная, достаточно удобная для использования, но все же имеет недостатки:

1) Каждый новый лоадер содержит свою логику для работы с результатом. Этот недостаток можно исправить, и частично мы сделаем это в следующей модели и полностью — в последней.

2) Второй недостаток намного серьезнее: все операции с базой данных выполняются в главном потоке приложения, а это может приводить к различным негативным последствиям, даже до остановки приложения при очень большом количестве сохраняемых данных. Да и в конце концов, мы же используем лоадеры. Давайте делать все асинхронно!

#### Loader + ContentProvider + синхронные запросы

Спрашивается, зачем мы выполняли запрос асинхронно с помощью Retrofit-а, когда лоадеры и так позволяют нам работать в background? Исправим это.

Эта модель упрощенная, но основное отличие заключается в том, что асинхронность запроса достигается за счет лоадеров, и работа с базой уже происходит не в основном потоке. Наследники базового класса должны лишь вернуть нам объект типа Cursor. Теперь базовый класс может выглядеть следующим образом:

```

public abstract class BaseLoader extends AsyncTaskLoader {

public BaseLoader(Context context) {

super(context);

}

@Override

protected void onStartLoading() {

super.onStartLoading();

forceLoad();

}

@Override

public Cursor loadInBackground() {

try {

return apiCall();

} catch (IOException e) {

return null;

}

}

protected abstract Cursor apiCall() throws IOException;

}

```

И тогда реализация абстрактного метода может выглядеть следующим образом:

```

@Override

protected Cursor apiCall() throws IOException {

AirportsService service = ApiFactory.getAirportsService();

Call> call = service.airports(mGps);

List airports = call.execute().body();

AirportsTable.save(getContext(), airports);

return getContext().getContentResolver().query(AirportsTable.URI, null, null, null, null);

}

```

Работа с лоадером в UI у нас никак не изменилась.

По факту, эта модель является модификацией предыдущей, она частично устраняет ее недостатки. Но на мой взгляд, этого все равно недостаточно. Тут можно снова выделить недостатки:

1) В каждом лоадере присутствует индивидуальная логика сохранения данных.

2) Возможна работа только с базой данных SQLite.

И наконец, давайте полностью устраним эти недостатки и получим универсальную и почти идеальную модель!

#### Loader + любое хранилище данных + синхронные запросы

Перед рассмотрением конкретных моделей я говорил о том, что для лоадеров мы должны использовать единый тип данных. Кроме Cursor ничего на ум не приходит. Так давайте создадим такой тип! Что должно в нем быть? Естественно, он не должен быть generic-типом (иначе мы не сможем использовать коллбэки лоадера для разных типов данных в одной активити / фрагменте), но в то же время он должен быть контейнером для объекта любого типа. И вот здесь я вижу единственное слабое место в этой модели — мы должны использовать тип Object и выполнять unchecked преобразования. Но все же, это не столь существенный минус. Итоговая версия данного типа выглядит следующим образом:

```

public class Response {

@Nullable private Object mAnswer;

private RequestResult mRequestResult;

public Response() {

mRequestResult = RequestResult.ERROR;

}

@NonNull

public RequestResult getRequestResult() {

return mRequestResult;

}

public Response setRequestResult(RequestResult requestResult) {

mRequestResult = requestResult;

return this;

}

@Nullable

public T getTypedAnswer() {

if (mAnswer == null) {

return null;

}

//noinspection unchecked

return (T) mAnswer;

}

public Response setAnswer(@Nullable Object answer) {

mAnswer = answer;

return this;

}

public void save(Context context) {

}

}

```

Данный тип может хранить результат выполнения запроса. Если мы хотим что-то делать для конкретного запроса, нужно унаследоваться от этого класса и переопределить / добавить нужные методы. Например, так:

```

public class AirportsResponse extends Response {

@Override

public void save(Context context) {

List airports = getTypedAnswer();

if (airports != null) {

AirportsTable.save(context, airports);

}

}

}

```

Отлично! Теперь напишем базовый класс для лоадеров:

```

public abstract class BaseLoader extends AsyncTaskLoader {

public BaseLoader(Context context) {

super(context);

}

@Override

protected void onStartLoading() {

super.onStartLoading();

forceLoad();

}

@Override

public Response loadInBackground() {

try {

Response response = apiCall();

if (response.getRequestResult() == RequestResult.SUCCESS) {

response.save(getContext());

onSuccess();

} else {

onError();

}

return response;

} catch (IOException e) {

onError();

return new Response();

}

}

protected void onSuccess() {

}

protected void onError() {

}

protected abstract Response apiCall() throws IOException;

}

```

Этот класс лоадера является конечной целью данной статьи и, на мой взгляд, отличной, работоспособной и расширяемой моделью. Хотите перейти с SQLite, например, на Realm? Не проблема. Рассмотрим это в качестве следующего примера. Классы лоадеров не изменятся, изменится только модель, которую вы бы в любом случае редактировали. Не удалось выполнить запрос? Не проблема, доработайте в наследнике метод apiCall. Хотите очистить базу данных при ошибке? Переопределите onError и работайте — этот метод выполняется в фоновом потоке.

А любой конкретный лоадер можно представить следующим образом (опять-таки, покажу только реализацию абстрактного метода):

```

@Override

protected Response apiCall() throws IOException {

AirportsService service = ApiFactory.getAirportsService();

Call> call = service.airports(mGps);

List airports = call.execute().body();

return new AirportsResponse()

.setRequestResult(RequestResult.SUCCESS)

.setAnswer(airports);

}

```

*Примечание*

При неудачно выполненном запросе будет выброшен Exception, и мы попадем в catch-ветку базового лоадера.

В итоге мы получили следующие результаты:

1) Каждый лоадер зависит исключительно от своего запроса (от параметров и результата), но при этом он не знает, что он делает с полученными данными. То есть он будет меняться только при изменении параметров конкретного запроса.

2) Базовый лоадер управляет всей логикой выполнения запросов и работы с результатами.

3) Более того, сами классы модели тоже не имеют понятия о том, как устроена работа с базой данных и прочее. Все это вынесено в отдельные классы / методы. Я этого нигде не указывал явно, но это можно посмотреть в примере на Github — ссылка в конце статьи.

#### Вместо заключения

Чуть выше я обещал показать еще один пример — переход с SQLite на Realm — и убедиться, что мы действительно не затронем лоадеры. Давайте сделаем это. На самом деле, кода здесь совсем чуть-чуть, ведь работа с базой у нас сейчас выполняется лишь в одном методе (я не учитываю изменения, связанные со спецификой Realm, а они есть, в частности, правила именования полей и работа с Gson; их можно посмотреть на Github).

Подключим Realm:

```

compile 'io.realm:realm-android:0.82.1'

```

И изменим метод save в AirportsResponse:

```

public class AirportsResponse extends Response {

@Override

public void save(Context context) {

List airports = getTypedAnswer();

if (airports != null) {

AirportsHelper.save(Realm.getInstance(context), airports);

}

}

}

```

**AirportsHelper**

```

public class AirportsHelper {

public static void save(@NonNull Realm realm, List airports) {

realm.beginTransaction();

realm.clear(Airport.class);

realm.copyToRealm(airports);

realm.commitTransaction();

}

@NonNull

public static List getAirports(@NonNull Realm realm) {

return realm.allObjects(Airport.class);

}

}

```

Вот и все! Мы элементарным образом, не затрагивая классы, которые содержат другую логику, изменили способ хранения данных.

#### Все-таки заключение

Хочу выделить один достаточно важный момент: мы не рассмотрели вопросы, связанные с использованием закэшированных данных, то есть при отстуствии интернета. Однако стратегия использования закэшированных данных в каждом приложении индивидуальна, и навязывать какой-то определенный подход я не считаю правильным. ~~Да и так статья растянулась.~~

В итоге мы рассмотрели основные вопросы организации архитектуры клиент-серверных приложений, и я надеюсь, что эта статья помогла вам узнать что-то новое и что вы будете использовать какую-либо из перечисленных моделей в своих проектах. Кроме того, если у вас есть свои идеи, как можно организовать такую архитектуру, — пишите, я буду рад обсудить.

Спасибо, что дочитали до конца. Удачной разработки!

P.S. [Обещанная ссылка на код на GitHub.](https://github.com/ArturVasilov/RetrofitLoadersSample) | https://habr.com/ru/post/265405/ | null | ru | null |

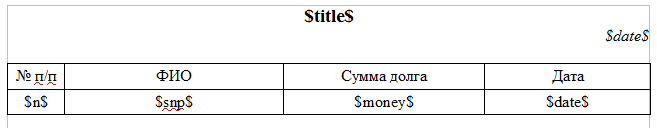

# «Mальчики — налево, девочки — направо», или добавляем поле «Gender» в БД Oracle

> … имеется три типа драконов: нулевые, мнимые и отрицательные. Все они не существуют, однако каждый тип — на свой особый манер. Мнимые и нулевые драконы, называемые на профессиональном языке мнимоконами и нульконами, не существуют значительно менее интересным способом, чем отрицательные.

>

> Станислав Лем,

>

> Кибериада

#### Преамбула

Конструктивной критики статьи [«Проблемы слияния записей в сложносвязанной таблице Oracle»](http://habrahabr.ru/post/188084/) пост. Попытаемся проанализировать методы решения задачи выявления пола человека на основе его клиентских данных в БД Oracle.

#### Исходные данные

Пусть есть некая подопытная БД на Oracle, содержащая данные о клиентах в таблице hotel.cards. Как минимум, у нас есть фамилия (cards.last\_name), имя (cards.first\_name) клиента… и, возможно, даже отчество (cards.middle\_name).Давайте посмотрим, что мы можем извлечь из этих данных.

#### Отчество

Самое однозначное и тривиальное решение по выявлению пола нашего клиента дает информация о его отчестве. Суффиксов русских отчеств в русском языке не так уж и много.

**Википедия об отчествах**Отчества, образованные от мужских имён второго склонения, образуются добавлением к основе суффиксов -ович/-овна, -евич/-евна: Роман — Романович, Николай — Николаевич; при этом имена оканчивающиеся на -ий меняют его на -ь-: Виталий — Витальевич.

Отчества мужчин, образованные от мужских имён первого склонения, образуются добавлением к основе суффикса -ич: Никита — Никитич, Лука — Лукич.

Отчества женщин, образованные от мужских имён первого склонения, образуются добавлением к основе суффикса -ична, если окончание было безударным, и -инична, если ударение падало на окончание: Ники́та — Никитична, но Лука́ — Лукинична.

Собственно, если все отчества внесены в базу, то поле пол можно заполнить весьма тривиальным способом.

**Консоль пользователя oracle на сервере БД**sqlplus / as sysdba

alter table hotel.cards add gender varchar2(10);

update hotel.cards hc set hc.gender = 'male' where hc.middle\_name like '%ич';

update hotel.cards hc set hc.gender = 'female' where hc.middle\_name like '%на';

commit;

Но данный способ далеко не всегда применим по ряду причин:

1) система разработана зарубежным заказчиком, и схема БД не предусматривает отчеств;

2) наши клиенты-иностранцы в загранпаспортах не имеют поля «Отчество», и наши операторы не уточняют у них эти данные.