text

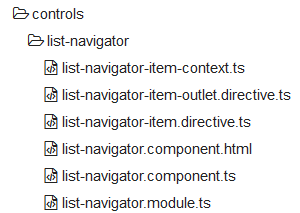

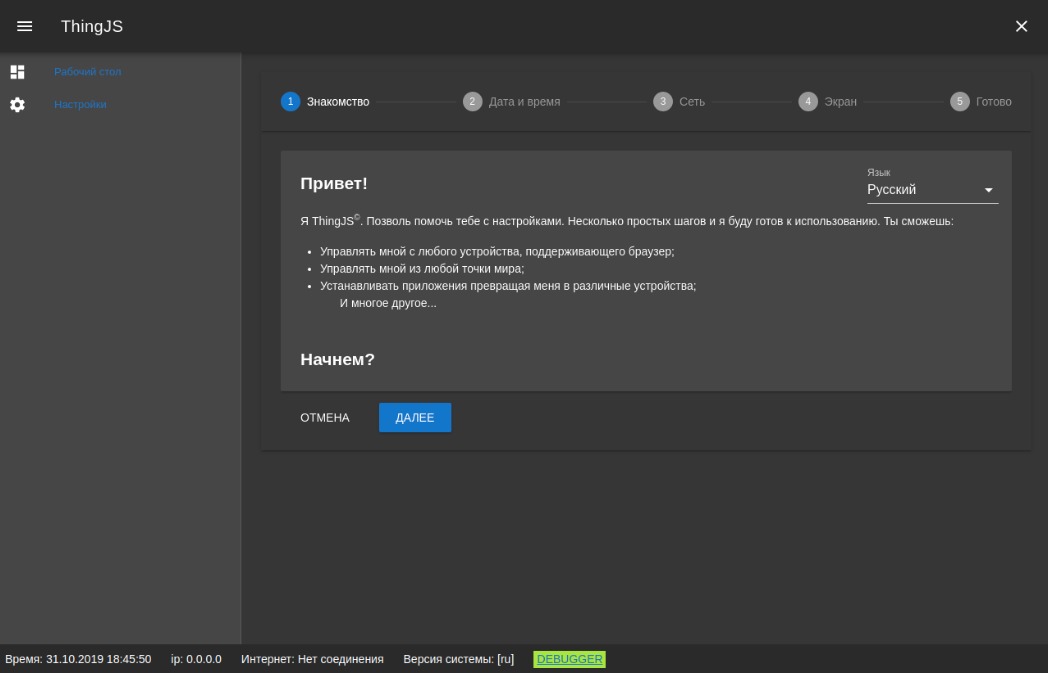

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

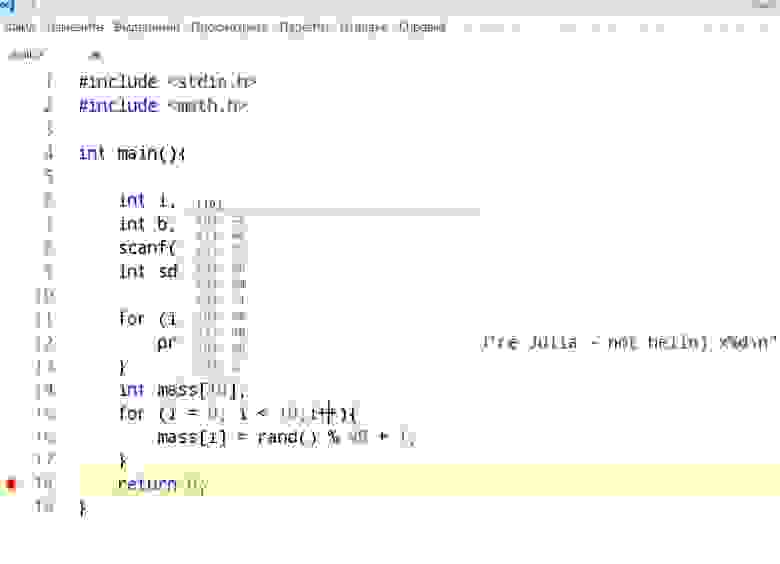

# Старый код в новой обёртке — как наша команда избавлялась от legacy

В этой статье я — Станислав Решетнев, Teamlead команды разработки Link Building в компании Sape — хочу рассказать об опыте нашей компании по избавлению от legacy. Многие компании сталкиваются с проблемой legacy-монолита, когда технический долг накапливается на протяжении долгих лет и разрыв по технологическому стеку становится всё больше похожим на пропасть. Нам удалось найти решение, позволившее провести полное обновление, и заодно выполнить другие бизнес-задачи.

Начну с описания технического стека (по той части, которая имеет значение для данной статьи). На момент старта преобразования системы мы располагали сервисами, написанными на:

* Symfony 1 / Doctrine 1. Контент страниц генерируется на бэкенде, а в качестве шаблонизатора используется PHP;

* процедурном PHP времён версии 5.3, но переведёнными на PHP 7.0. Шаблонизатор — Smarty;

* Zend 1, который был с течением времени сильно доработан. Шаблонизатор — Smarty.

Нашей целью было создание объединённого приложения на основе современного стека. Бэкенд строился на Symfony 5 / 6, а используемые отдельные сервисы выносились за контуры приложения. Фронтенд представлял собой SPA, работающее с бэкендом по OpenApi.

План по модернизации в общих чертах был таким:

1. Все legacy-сервисы получают интерфейс OpenAPI.

2. Новое приложение использует legacy-сервисы в режиме клиента OpenAPI, в то же время предоставляя свой серверный интерфейс OpenAPI.

3. Новая бизнес-логика пишется в новом приложении, а фоново происходит постепенный транзит бизнес-логики из legacy в новое приложение.

Работа ещё продолжается, но первый этап уже завершился и, на мой взгляд, успешно. Стартовали мы полтора года назад и уже запустили новое приложение.

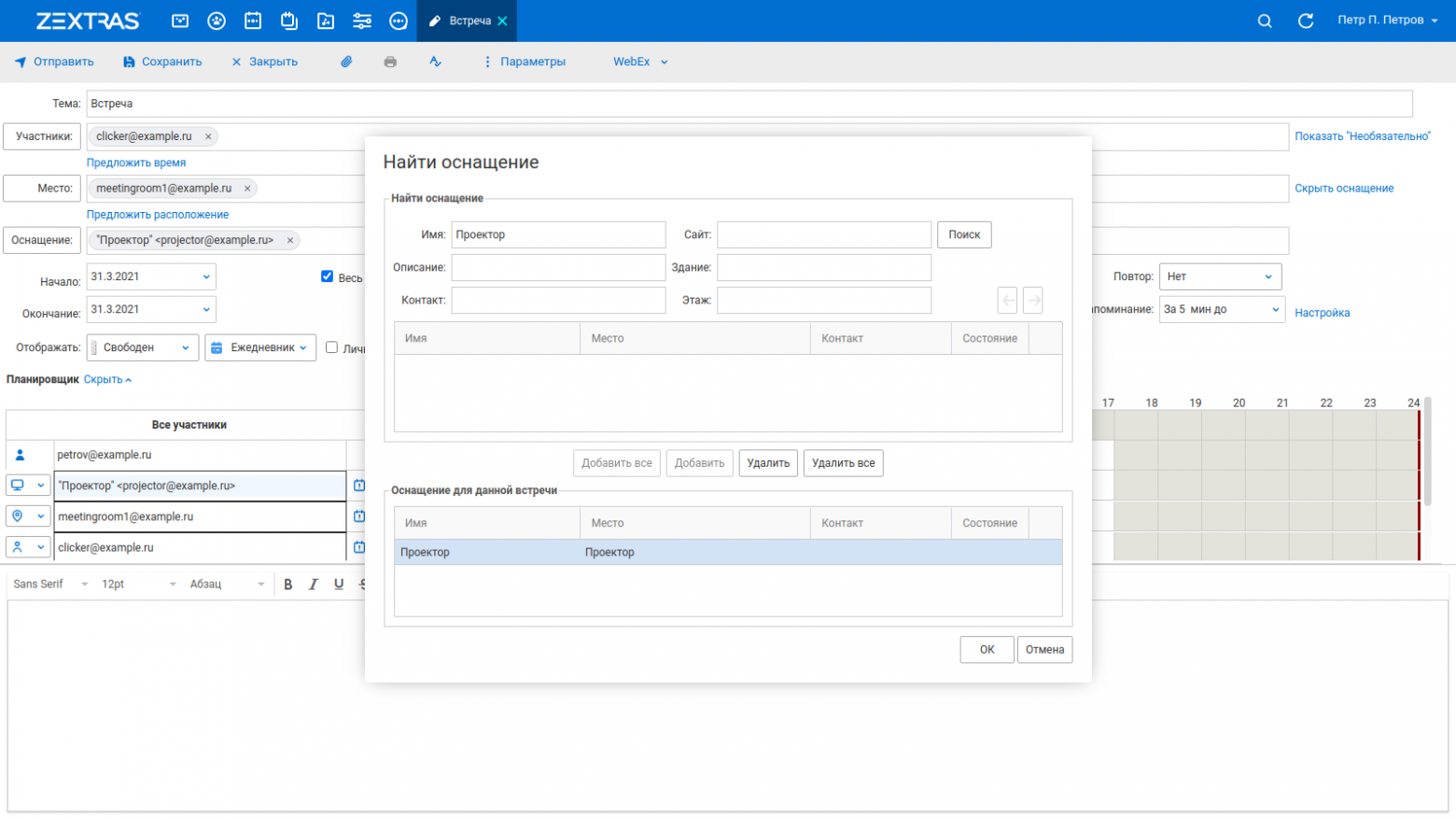

Так сейчас выглядит интерфейс нашего сервиса**Проблемные места**

Не буду подробно останавливаться на проблемах, которые вызывает legacy. Запутанная логика, вследствие чего разработчик тратит больше времени на погружение и исследование, а не на реализацию. Любое изменение в коде похоже на хождение по минному полю, поскольку может сказаться на части системы, которая, казалось бы, не имеет к нему отношения. Да и сложно найти перспективного разработчика, готового провести лучшие годы своей жизни, копаясь в завалах старого и непонятного кода.

Поговорим о том, насколько проблемной может стать переработка кода, написанного на Symfony 1.

> [Symfony](https://ru.wikipedia.org/wiki/Symfony) — свободный фреймворк, написанный на PHP.

>

> Версия 1.4 (финальная в ветке 1.xx). Появилась в ноябре 2009 г. Версия PHP: начиная с 5.2.4. Окончание поддержки: ноябрь 2012. ORM: Propel или Doctrine 1.

>

>

Выбор Symfony в качестве фреймворка казался настоящим прорывом. Он использовал передовые подходы к разработке. В состав поставки входила консольная утилита, выполнявшая ряд рутинных задач, в том числе миграцию СУБД. Symfony позволял легко написать свою команду, присутствовала система событий (Event Dispatcher). Была ORM — всемогущая Doctrine, были настройки в yaml-файлах. Админку можно было и вовсе генерировать на основе этих конфигураций. Существовали концепции форм и фильтров форм, что позволяло структурированно оперировать входными данными. Использовался шаблонизатор, дружелюбный для программиста — PHP. Казалось бы, всё замечательно! Но во что это превратилось с годами?

Возьмём пример: создание заявки. Заявка (Advert) — это сущность, создаваемая заказчиком для передачи её исполнителю (вебмастеру). В процессе создания заявки мы проходим через следующие абстракции:

* Шаблон на PHP — *newSuccess.php*, в котором мы корректируем цены с учётом дополнительных услуг, получаем информацию по площадкам, выводим настройки специфичные для пользователя. Как ни присматривай за изменениями в коде, сама возможность занести бизнес-логику в шаблон выглядит привлекательно. Из лучших побуждений, с целью экономии времени, фронтендер или бэкендер напрямую обращаются ко внутренним сервисам и начинают формировать свои структуры и переформатировать данные.

* Действие в контроллере — *\advertActions::executeCreate*, в котором мы обработаем запрос для передачи в сервис создания. Если это — PHP-код, то почему бы не написать в нём логику преобразования каких-нибудь данных? Сформируем контент заявки. Подкорректируем свойства сущности заявки в соответствии со вновь открывшимися данными о пользователе и заполненных полях. Обработаем случай, если надо создать не заявку, а её черновик. В общем, действий на 400+ строк кода. А кто сказал, что нельзя сделать это тут?

* Биндинг данных из запроса с формой в *AdvertForm*. Создадим виджеты, кое-что сделаем с оформлением формы — всё вполне легально и не рушит архитектуру. Но заодно и поменяем настройку сущности заявки на этапе биндинга, потому что тут же как раз всё под рукой.

* Создадим заявку через сервис *AdvertService*. Тут самое раздолье в плане бизнес-логики: несколько десятков всяких проверок и преобразований. Ходим из метода в метод, что-нибудь меняем у сущности, пока не дойдём непосредственно до сохранения в БД. Сервис модели — это ведь самое подходящее место, чтобы написать много, очень многоопераций с данными?

* Выполним сохранение сущности в *\Advert::save*. Тут разработчик понимает, что ещё ~~не всё успел сказать~~ не всю бизнес-логику успел описать. Метод сохранения в базу очень хорош, чтобы описать всё, что должно делаться автоматически при любом сохранении. Здесь мы можем обновить поля сущности как для существующей, так и для новой. Сходить в биллинг, во внешний партнёрский сервис, чтобы обновить там статус. Заодно обновить по условию ряд полей (и получить 200+ строк логики, не считая вложенных методов).

Стоит учитывать, что Symfony 1 использует подход богатой модели предметной области.

> [Богатая модель предметной области](https://habr.com/ru/post/346016/) (БМПО, Rich Domain Model) — в ней классы, представляющие сущности предметной области, содержат в себе и данные, и всю бизнес-логику.

>

>

Такой подход, как показывает практика, провоцирует переплетение бизнес-логики и логики из инфраструктурного слоя. Рядом располагаются хуки для работы с БД и методы для всего, что связано с сущностью.

Итого получается 5 логических зон или слоёв, где может оказаться бизнес-логика, не считая косвенно связанных сервисов и моделей, на которые тоже оказывается влияние. При этом, данные оформлены в виде нетипизированной структуры — массива, который меняется и дополняется с помощью разных методов на манер матрешки. Выяснение, что же случилось с данными по ходу обработки, превращается в детектив.

Глядя на всё это, наша команда решила не пытаться на данном этапе распутать логику, чтобы формализовать её и перенести в новое приложение. Вместо этого мы обернули код с уровня контроллера (уровень Controller из MVC) в дополнительный слой — внешний интерфейс на базе OpenAPI.

**Коротко об OpenAPI**

OpenAPI-спецификация — это контракт (соглашение) между фронтендом и бэкендом. В нём описываются адреса для обращения, форматы запросов и ответов, оперируемые сущности.

> [OpenAPI](https://ru.wikipedia.org/wiki/OpenAPI_(%D1%81%D0%BF%D0%B5%D1%86%D0%B8%D1%84%D0%B8%D0%BA%D0%B0%D1%86%D0%B8%D1%8F)) представляет собой формализованную спецификацию и полноценный фреймворк для описания, создания, использования и визуализации веб-сервисов REST.

>

>

OpenAPI имеет развитую экосистему, которая включает в себя множество [инструментов](https://openapi.tools/) для различных языков.

Благодаря формализации в общении между фронтом и бэком, появляются такие возможности как автогенерация кода и автотестов, создание имитаторов как бэкенда, так и фронтенда, автовалидация запросов и ответов, а также автоматизированное создание документации.

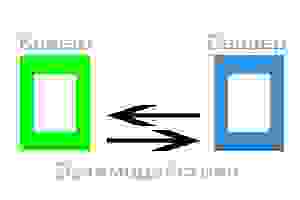

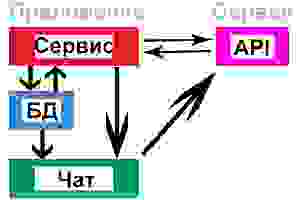

Преобразование наших legacy-сервисов в OpenAPI-сервисы позволило использовать их уже в качестве подсистем в новом приложении:

**Добавляем OpenAPI поверх legacy**

Мы выбрали слой Controller / Presenter в качестве места для создания обёртки вокруг legacy-логики (в Symfony и Zend это контроллеры). Далее разберём, как мы справились с этой задачей в Symfony 1.

Первым делом описали в спецификации на каждый сервис структуры запросов и ответов и вручную создали классы, отображающие эти объекты. Это было необходимо, чтобы максимально структурировать данные из legacy-action контроллеров. Новые контроллеры оперировали только объектами, принудительно преобразуя исходный запрос в приложение, а также получая ответ от старых контроллеров.

Например, метод создания заявки в OpenAPI описан так (в сокращении):

```

"/rest/Adverts/projectId/{projectId}": {

"post": {

"tags": [

"Adverts"

],

"summary": "Создание классической заявки",

"operationId": "createAdvert",

"parameters": [

{

"$ref": "#/components/parameters/projectId"

}

],

"requestBody": {

"content": {

"application/json": {

"schema": {

"type": "object",

"properties": {

"sitesIds": {

"type": "array",

"items": {

"$ref": "#/components/parameters/siteId"

},

"minItems": 1

},

"links": {

"$ref": "#/components/schemas/AdvertLinks"

},

"description": {

"type": "string",

"title": "Комментарий вебмастеру",

"minLength": 3

}

}

}

},

"required": true

},

"responses": {

"200": {

"description": "Результат создания классической заявки",

"content": {

"application/json": {

"schema": {

"type": "object",

"properties": {

"advertIds": {

"type": "array",

"title": "Массив ID созданных заявок",

"items": {

"type": "integer",

"format": "int32",

"title": "ID созданной заявки",

"minimum": 0

}

}

}

}

}

}

}

}

}

}

```

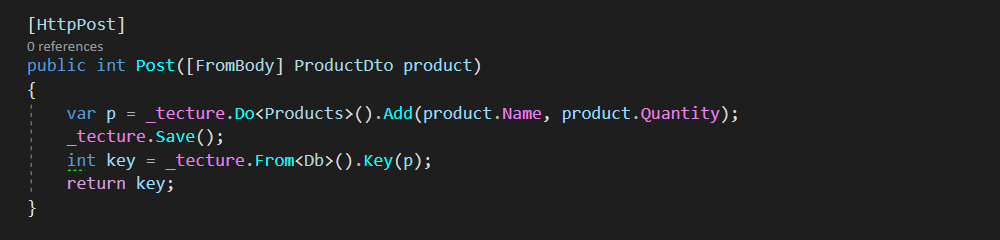

При этом бэкенд оперирует ответом как объектом:

```

php

declare(strict_types=1);

/**

* Объект ответа API-метода Adverts.createAdvert.

*/

class AdvertsCreateAdvertResponse

{

/** @var int[] Массив ID созданных заявок */

public $advertIds;

}

</code

```

Преобразование ответов старых контроллеров происходит через метод-wrapper *responseWrapper()*, который:

* собирает все входящие данные из GET и POST-параметров;

* вызывает legacy-метод контроллера, перехватывая отображения flash с ошибками (это уведомления в Symfony1) и преобразуя их в структуры с ошибками в OpenAPI, а также, блокируя redirect, перехватывает возникающие исключения, преобразуя их в структуры ошибок, описанные в спецификации;

* упаковывает ответ в JSON.

Также применяется метод для перехвата возвращаемых параметров из varHolder — *getActionResultValues()*. VarHolder — это способ Symfony 1 для передачи данных в шаблоны для рендеринга. Из контекста класса контроллера виртуальные переменные через $this выставляются вот так:

```

$this->project = $user->findProject($project_id);

```

Наш метод *getActionResultValues()* создаёт имитацию запроса из браузера для legacy-action, перехватывает любые исключения и преобразует их в ошибки, а также собирает все результаты из varHolder. И, разумеется, блокирует рендеринг.

В итоге обработка выглядит так:

1. В нашем методе-обёртке мы заполняем из параметров запроса данные, пригодные для legacy-контроллера:

```

$this->getRequest()->setParameter('form', $form_data);

$this->getRequest()->setParameter('type', $link_type);

$this->getRequest()->setParameter('project_id', $project_id);

```

2. При помощи вспомогательного метода нового контроллера *$this->getActionResultValues('advert', 'create')* получаем всё, что он в итоге собирался отрисовать в шаблоне.

3. Формируем объект ответа в соответствии с OpenAPI.

4. Передаём результат для дооформления в *responseWrapper()*, который может по ходу поймать исключения более высокого уровня.

Адаптация бэкенда в Zend 1 была сделана похожим образом, но несколько проще: там не пришлось перехватывать рендер в Smarty. В нашем распоряжении оказались пусть и плохо организованные, но сервисы, методы которых мы смогли использовать.

**В заключение**

Адаптация под OpenAPI старых сервисов позволила в краткие сроки и с наименьшими усилиями создать современный интерфейс для наших legacy-сервисов. Сервис на Symfony 1 мы смогли адаптировать за 14 человеко-дней (не считая решения предварительных организационных вопросов и обучения). В итоге получилось около 70 API-методов. Это открыло нам дорогу для дальнейшей модернизации системы.

Команда Sape построила и успешно запустила новое приложение, объединившее логику из legacy-подсистем. При этом мы начали процесс переноса бизнес-логики в новое приложение. Благодаря этому, например, смогли привлечь новых разработчиков, которым не приходится сталкиваться с нашим legacy.

Если есть интерес к этой и смежным темам, пишите в комментариях — буду делиться опытом. | https://habr.com/ru/post/697904/ | null | ru | null |

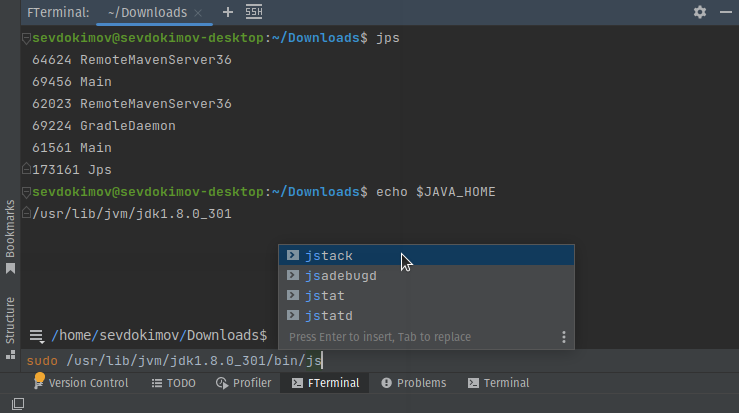

# Графический интерфейс для bash, делаем работу в командной строке удобнее

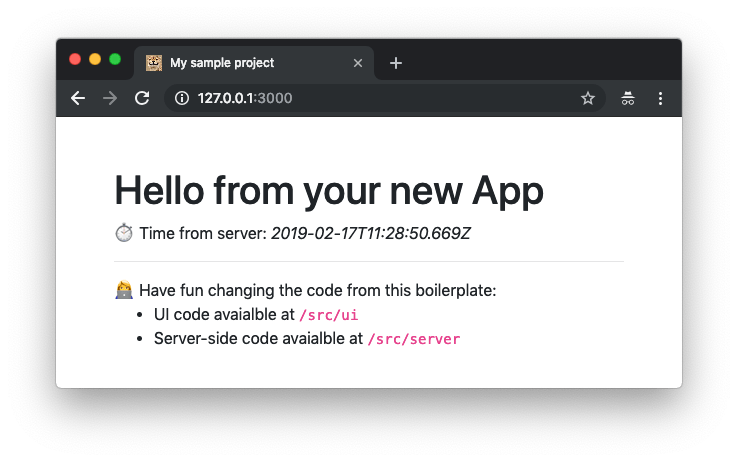

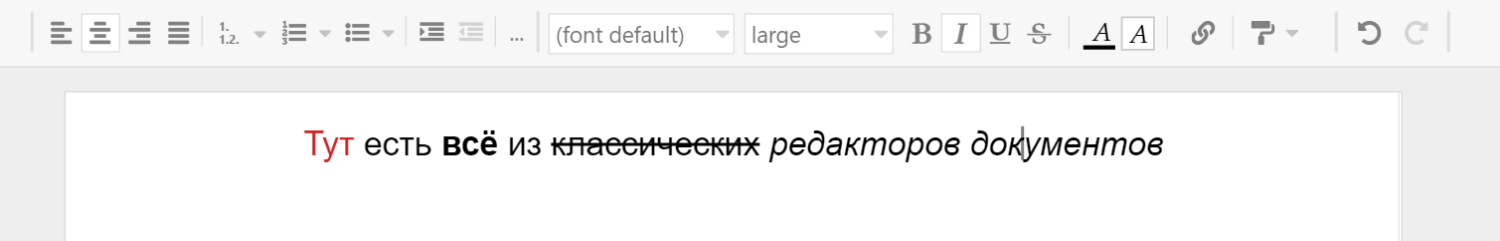

Когда пишешь код в IntelliJ IDEA, привыкаешь что везде есть подсказки, везде где можно работает комплишен, всегда можно одним кликом перейти на декларацию метода или на его юсаджи. После этого интерфейс командной строки выглядит как-то бедно. Конечно, он очень хорошо продуман, сделан настолько удобным, насколько это возможно в текстовом UI, но в графическом UI возможностей намного больше. Представляю вам [плагин](https://plugins.jetbrains.com/plugin/18857-friendly-terminal) для JetBrains IDE, позволяющий работать в командной строке cо всеми удобствами IDE.

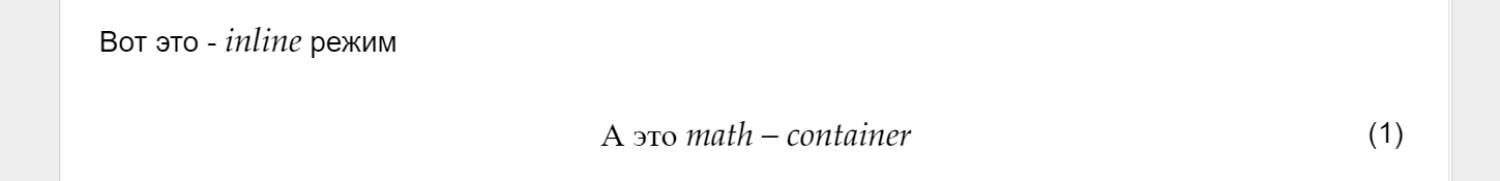

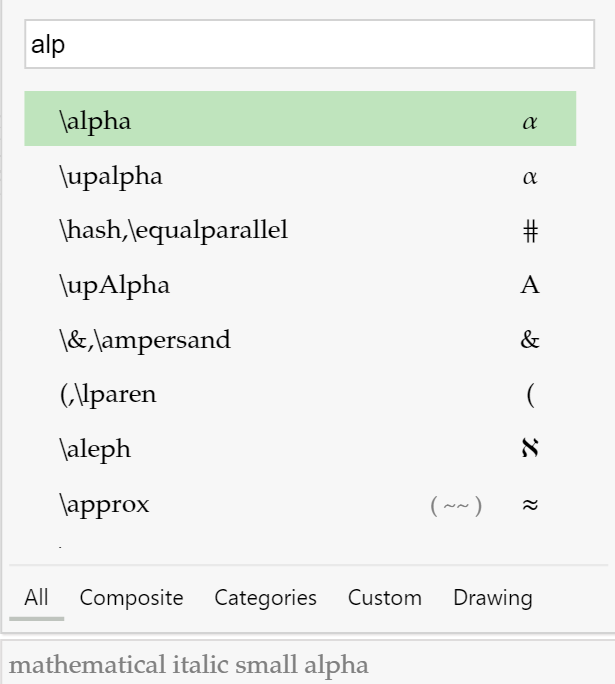

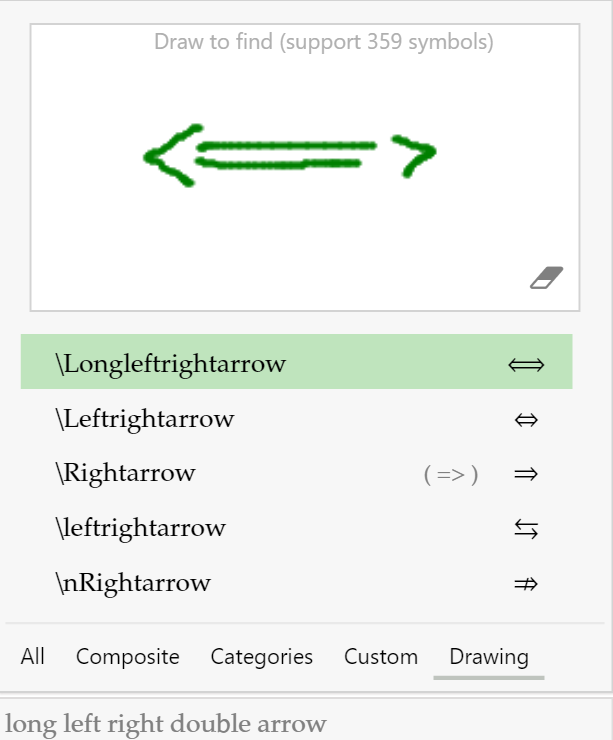

Плагин [Friendly Terminal](https://plugins.jetbrains.com/plugin/18857-friendly-terminal) позволяет печатать команду в редакторе IDE. Такой редактор удобнее чем текстовая командная строка, потому что в нём есть подсветка синтаксиса, продуманный комплишен, показ документации, работают привычные сочетания клавиш, можно перемещать курсор мышкой и т.д.

После запуска команды, пользователь переключается в текстовую консоль, где команда выполняется, так, как будто её запустили обычном терминале.

После завершения исполнения команды, пользователь возвращается в GUI интерфейс, где показан output команды и можно вводить следующую. Bash сессия в текстовой консоли висит в бэкграунде и ждёт пока не будет запущена следующая команда.

Output показывается средствами IDE, что позволяет сделать его интерактивным. Например, команда`ls /opt/my-app/conf` выведет список файлов в директории /opt/my-app/conf, и эти имена файлов будут кликабельны, при нажатии c Ctrl файлы открываются в редакторе IDE, так же, из контекстного меню доступны свойства файла, копирование полного пути, и т.д.

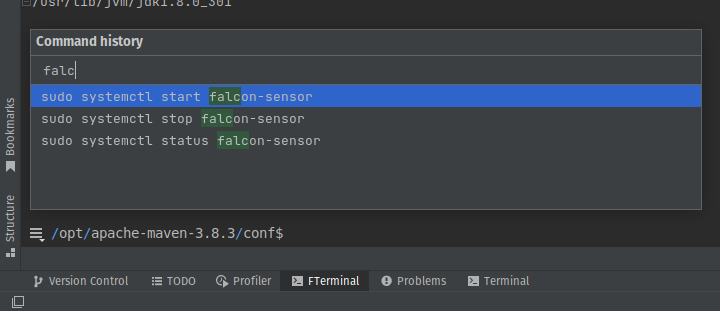

Поиск команды в истории происходит во всплывающем окне, что позволяет видеть сразу несколько вариантов, в отличие от стандартного текстового терминала, где показывается только один вариант и легко пропустить нужный нажимая Ctrl+R.

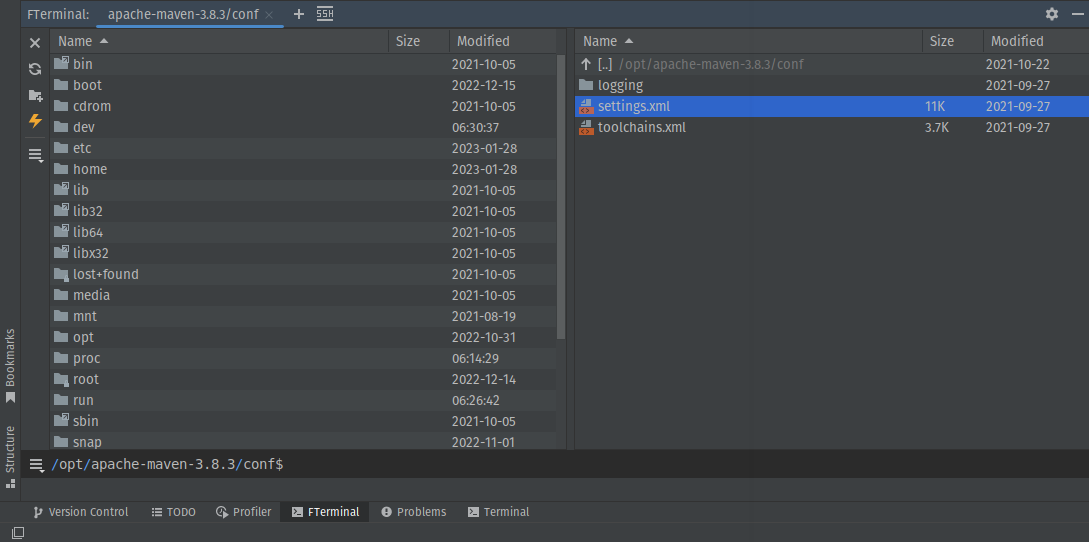

### File Manager

Навигация по файловой системе с помощью команд `cd`и `ls` — не самая удобная вещь, поэтому в плагине есть встроенный файловый менеджер типа Total Commander. Можно нажать `Ctrl+O` и откроются 2 файловых панели. В них можно ходить по директориям, копировать файлы, удалять файлы и т.д. Если вы на удалённой машине, то можно скачать файл или загрузить с локальной машины.

SSH

---

Командная строка используется, в основном, для доступа к удаленным машинам через SSH, поэтому все фичи должны работать даже если терминал подключен к удалённой машине. Было бы мало толка если бы GUI работал только локально. Это накладывает некоторые ограничения на способ получения данных. Допустим, пользователь открыл историю команд, плагину надо как-то узнать что там за история команд на удалённой машине. На локальной всё просто — можно прочитать историю из файла "~/.bash\_history" , а для связи с удалённой есть только bash сессия, которая висит в бэкграунде, пока пользователь находится в GUI панели. Через эту bash сессиию и происходит загрузка всех данных. Например можно получить историю команд запустив `history` и распарсив результат, для комплишена имён файлов и навигации по файловой системе в File Manager запускается `ls`. Чтобы технические команды не зафлудили историю, они начинаются с пробела. Bash не сохраняет команду в истории, если она начинается с пробела.

Я писал, что можно открывать файлы в редакторе IDE, это работает и через SSH. В этом случае, файл скачивается в temporary директорию. Если его изменить, изменения можно выгрузить обратно нажав "Upload changes". [video](https://www.youtube.com/watch?v=lXT4eUoAIz4&t=12s&ab_channel=SergeyEvdokimov)

Представляю что об этом думают фанаты vim... Но на вкус и цвет товарищей нет, этот плагин для любителей IntelliJ IDEA.

Маленькие, но полезные фичи

---------------------------

* `Ctrl+Shift+Space` (smart completion) предлагает команды из истории, совпадающие по префиксу с тем что уже напечатано.

* Иногда хочется взглянуть на вывод последней команды отдельно от всего остального, для этого можно нажать `Ctrl+Shift-O` или соответствующую иконку в конце вывода, и он откроется во всплывающем окне на весь экран.

* Можно нажать `Alt-Up`, чтобы переместить курсор из строки ввода команды, в консоль, где печатается output команд, это позволяет что-нибудь скопировать без использования мыши. Дальнейшие нажатия Alt-Up / Alt-Down перемещают курсор к выводу следующей / предыдущей команды.

* Нажатие `Alt+F12` открывает терминал, в каком-бы месте IDE вы не находились.

### Ограничения

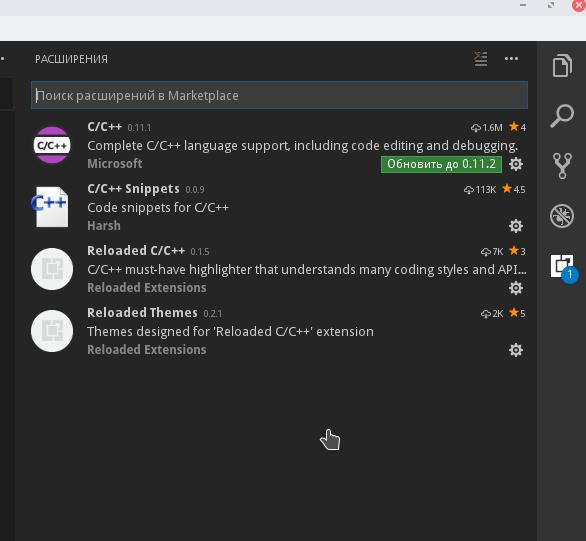

[Friendly Terminal](https://plugins.jetbrains.com/plugin/18857-friendly-terminal) работает только с Linux консолью. В Windows может работать только в WSL (Windows Subsystem for Linux) или как SSH клиент для подключения к Linux машинам. Работать с CMD или PowerShell не может. Теоретически, можно сделать поддержку Cygwin, но пока не сделано.

Ссылка на плагин: <https://plugins.jetbrains.com/plugin/18857-friendly-terminal>

Буду рад любым отзывам.

P.S. Выяснилось что есть проблемы с работой под MacOS и под Ubuntu, если она руссифицирована. Исправлю в ближайшее время. | https://habr.com/ru/post/715824/ | null | ru | null |

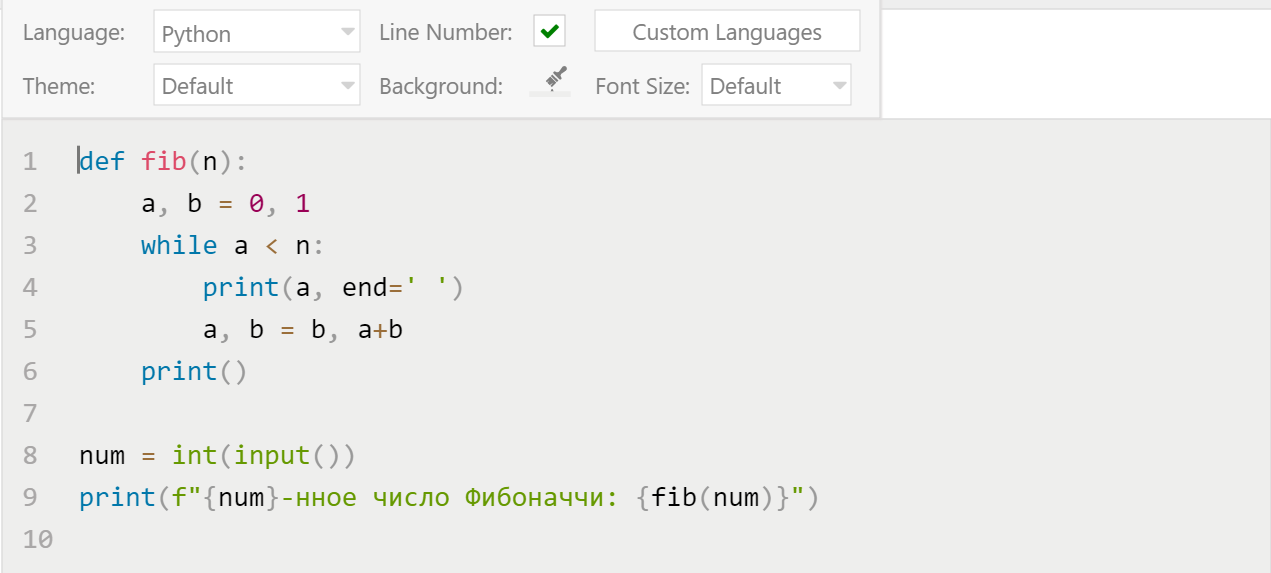

# Behavior-Driven Testing для iOS используя Quick и Nimble

После прочтения данной статьи, вы сможете использовать **Quick** и **Nimble** в своих проектах!

Написание прекрасных работоспособных приложений — одно дело, но написание хороших тестов, которые подтверждают ожидаемое поведение вашего приложения, — задача намного сложнее. В этой статье мы рассмотрим один из доступных подходов тестирования приложений, behavior-driven testing, используя два чрезвычайно популярных фреймворка под названием [Quick](https://github.com/Quick/Quick) и [Nimble](https://github.com/Quick/Nimble).

Вы узнаете о *behavior-driven testing*: изучите что это такое, почему это чрезвычайно мощная концепция и насколько легко писать читабельные тесты с помощью фреймворков Quick и Nimble.

Вы будете писать тесты для удивительно простой и забавной игры под названием **AppTacToe**, в которой вы играете в игру Tic Tac Toe против компьютера, изображая iOS персонажа, играющего против злого Android игрока!

**Примечание:** *Для лучшего понимания данной статьи предполагается что у Вас есть наличие базовых знаний темы Unit Testing и использования XCTestCase.*

Несмотря на то, что вы можете продолжить прочтение данной статьи без наличия этих знаний, все же рекомендуется ознакомится со статьёй [iOS Unit Testing and UI Testing Tutorial](https://www.raywenderlich.com/150073/ios-unit-testing-and-ui-testing-tutorial) для повторения ранее изученных основ.

### Начало

Лучший способ начать написание тестов — это работать над настоящим приложением, которым в вашем случае будет игра AppTacToe, представленная ранее.

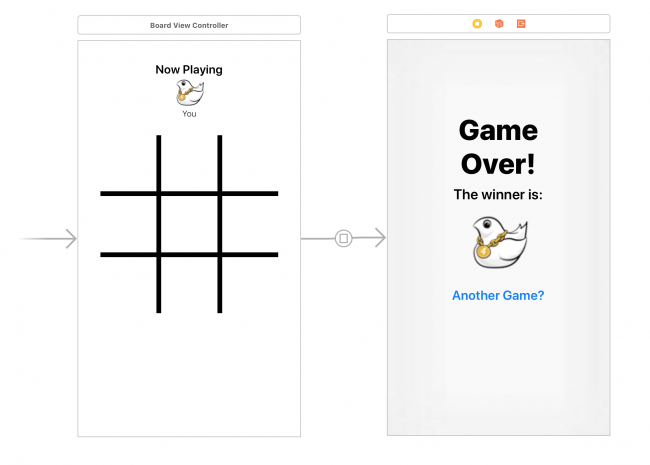

[Загрузите стартовый проект](https://koenig-media.raywenderlich.com/uploads/2018/03/AppTacToe.zip), который содержит все необходимое для работы, он уже содержит Quick и Nimble. После загрузки откройте **AppTacToe.xcworkspace**.

Откройте **Main.storyboard** и изучите базовую структуру приложения. Она состоит из двух экранов: **Board**, в котором происходит сама игра, и экран «*Game Over screen*», отвечающий за отображение результата игры.

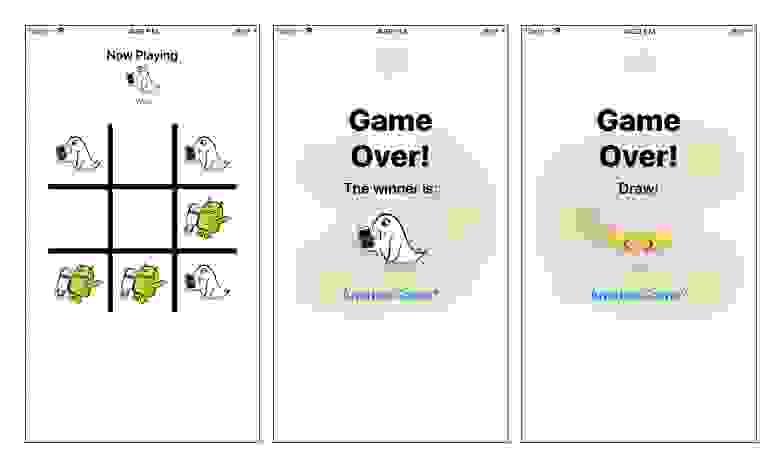

Скомпилируйте и запустите приложения, и сыграйте в одну или две быстрых игры, чтобы познакомится с игрой.

Вы также увидите полезное логирование, которое отображается в консоли, дублируя ход игры и отображая итоговую доску, после завершения игры.

**Примечание:** *Не беспокойтесь, если заметите незначительные ошибки во время игры; вы исправите их, вовремя работы над данной статьей!*

Большая часть бизнес логики приложения содержится в одном из двух файлов:

**Components/Board.swift**: Этот файл обеспечивает логическую реализацию игры Tic Tac Toe. В нем нету элементов **UI** интерфейса, связанного с данной игрой.

**ViewControllers/BoardViewController.swift**: Это основной игровой экран. Он использует вышеупомянутый класс **Board** для игры и несет ответственность за отображение состояния игры на экране устройства и обработку взаимодействия с пользователем.

То, что вам действительно необходимо протестировать в этом случае, это бизнес логику игры, поэтому вы будете писать тесты для класса **Board**.

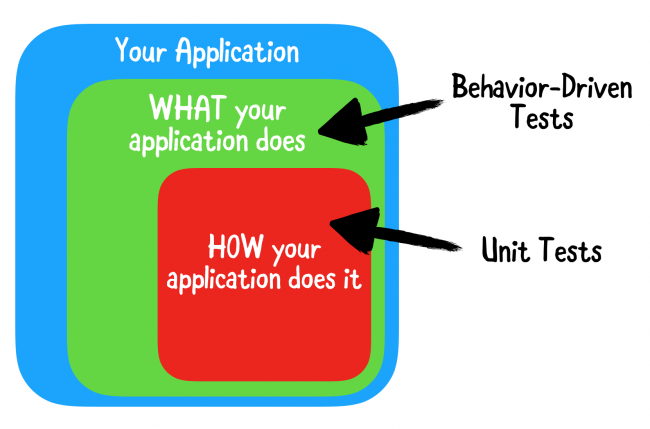

### Чем же является Behavior-Driven Testing?

Приложение состоит из множества фрагментов кода. В традиционных модульных тестах вы проверяете всевозможные элементы каждой из этих частей. Вы предоставляете некоторые данные для некоторого фрагмента кода и утверждаете, что он возвращает ожидаемый результат.

Недостатком такого подхода является то, что он подчеркивает необходимость проверки внутренней работы приложения. Это означает, что вы тратите больше времени на тестирование деталей реализации, а затем на фактическую бизнес-логику, которая является реальным мясом вашего продукта!

Было бы неплохо, если бы вы могли просто подтвердить, что приложение ведет себя так, как ожидалось, независимо от того, как оно было реализовано.

Давайте познакомимся с behavior-driven тестированием!

При behavior-driven testing (или **BDT**), ваши тесты основаны на user stories, которые описывают некоторые конкретные ожидаемые действия приложения. Вместо проверки деталей реализации вы фактически проверяете то, что важно больше всего: правильно ли приложение выполняет user stories?

Этот подход делает тесты чрезвычайно читабельными и поддерживаемыми, а также помогает описать поведение логических частей в приложении другим разработчикам, которым однажды выпадает шанс разобраться в вашем коде.

Вот некоторые примеры пользовательских историй, которые вы могли бы написать как часть игры AppTacToe:

*Выполнение одиночного игрового действия переключает на другого игрока.

Выполнение двух игровых действий должно переключить обратно на первого игрока.

Выполнение выигрышного хода должно перевести игру в состояние Победа.

Выполнение хода, после которого больше нет ходов, переводит игру в состояние Ничья.*

### Роль Quick и Nimble в Behavior-Driven Testing

Тесты написаны на основе способа управления поведением и user stories, являются простыми предложениями на английском языке. Это значительно облегчает их понимание по сравнению с обычными Unit тестами, которые вы привыкли писать.

Quick и Nimble обеспечивают чрезвычайно мощный синтаксис, позволяющий писать тесты, которые читаются точно так же, как и обычные предложения, позволяя вам легко и быстро описывать поведение, которое вы хотите проверить. Внутри они работают точно так же, как и обычные XCTestCase(s).

Quick обеспечивает большую часть базового синтаксиса и возможностей, связанных с написанием тестов управляемых поведением, в то время как Nimble — это его сопутствующий фреймворк. Он предоставляет дополнительные выразительные возможности сопоставления и утверждения посредством Matchers, о которых вы узнаете чуть позже в этой статье.

### Анатомия быстрого теста

Разбейте одну из пользовательских историй на три статьи на основе [GWT](https://en.wikipedia.org/wiki/Given-When-Then) — Given (действие/поведение, которое вы описываете), When (контекст этого действия/поведения) и Then (то что вы ожидаете увидеть):

**Given/Дано:** Пользователь играет.

**When/Когда:** Это один ход.

**Then/Следовательно:** Ход должен передаться другому игроку.

В Quick вы используете три функции: describe, context и it.

### Написание первого теста

Наборы тестов в Quick называются Specs, и каждый созданный вами такой набор должен наследоваться от QuickSpec, таким же образом, как вы наследуете от XCTestCase в тестах. Набор тестов включает в себя основной метод spec(), который будет содержать все ваши тестовые примеры.

Стартовый проект уже содержит пустой набор тестов. Откройте файл **AppTacToeTests / BoardSpec.swift** и посмотрите на набор тестов BoardSpecс наследуемой от QuickSpec и содержащей единственный метод *spec()*, в котором вы будете работать.

Примечание: Когда вы откроете файл **BoardSpec.swift**, вы увидите сообщение об ошибке No such module 'Quick' или ‘Nimble’. Не волнуйтесь, так как это просто ошибка в Xcode, не связанная с проектом. Ваш код будет компилироваться и работать без каких-либо проблем.

Начните с добавления следующего кода внутрь метода *spec()*:

```

var board: Board! // 1

beforeEach { // 2

board = Board()

}

```

Этот код выполняет два действия:

1. Определяет глобальную переменную board, которая будет использоваться в тестах.

2. Устанавливаем для переменной board новый экземпляр Board перед каждым тестом, используя замыкание beforeEach с Quick's.

При помощи определенного базового шаблона вы можете начать написание первого теста!

По замыслу этого приложения, игра всегда начинается с Cross (то есть — или так или так., X), а противник будет Naught (то есть, O).

Начнем с первой *user story*, упомянутой выше: После выполнение первого хода следующий ход должен сделать второй игрок.

Добавьте следующий код сразу после окончания замыкания *beforeEach*:

```

describe("playing") { // 1

context("a single move") { // 2

it("should switch to nought") { // 3

try! board.playRandom() // 4

expect(board.state).to(equal(.playing(.nought))) // 5

}

}

}

```

Вот что делает этот код:

1. **describe()** используется для определения того, какие действия или поведение вы будете тестировать.

2. **context()** используется для определения конкретного контекста действия, которое вы будете тестировать.

3. **it()** используется для определения конкретного ожидаемого результата для теста.

4. Вы выполняете случайный ход используя метод *playRandom()* в классе Board.

5. Вы утверждаете, что состояние Board изменено на *.playing(.nought)*. На этом этапе используется метод *equal()* из Nimble, который является одной из многих доступных функций, которые можно использовать для утверждения соответствия конкретных условий ожидаемому значению.

**Примечание:** *Возможно, вы заметили принудительный вызов try и неявно unwrapped опционал для определения тестовых глобальных переменных. Хотя такой вариант обычно и не одобряется при написании кода в самом приложении, это довольно распространенная практика при написании тестов.*

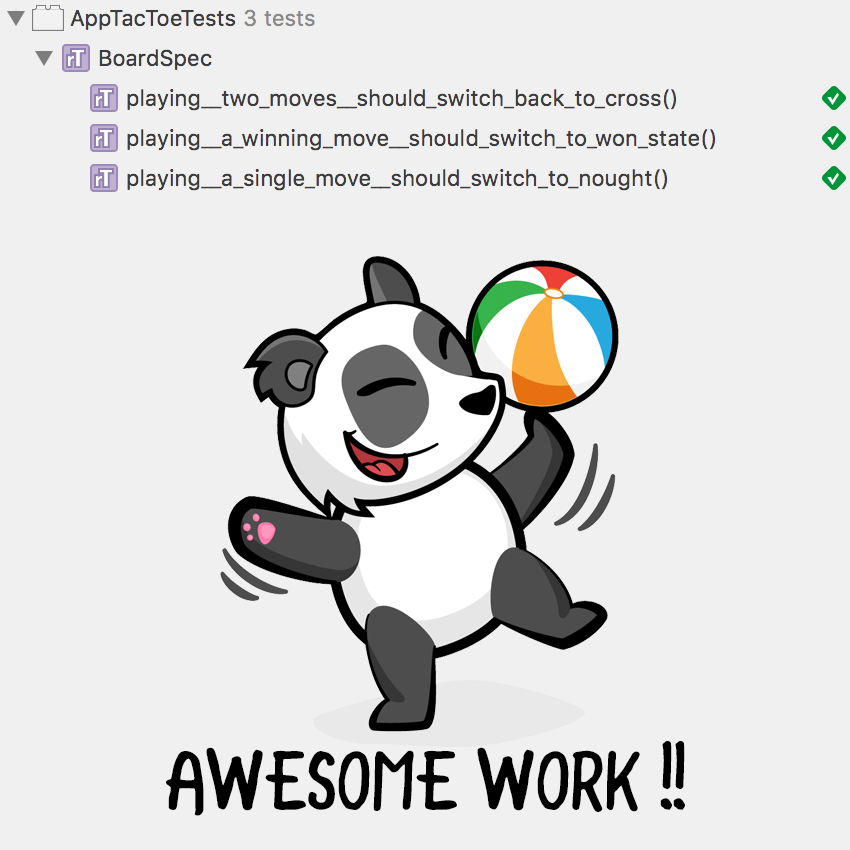

Запустите тесты, перейдя в панель меню **Product ▸ Test** или с помощью сочетания клавиш **Command+U**.

Так, вы увидите выполнение своего первого теста. **Потрясающие!**

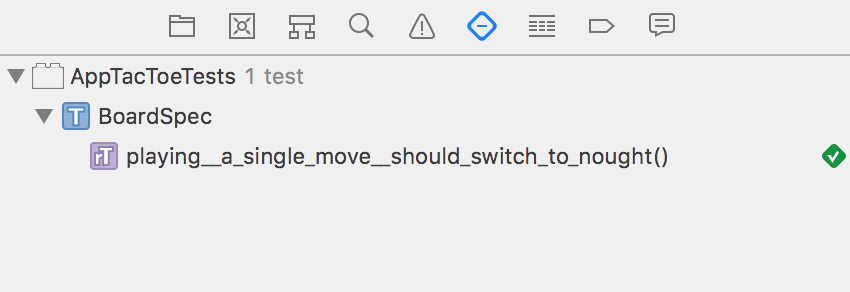

После выполнения теста, вкладка Test navigator должна выглядеть так:

Вы уже заметили несколько интересных моментов, просмотрев код. Прежде всего, это чрезвычайно читабельный код. Просмотрев код теста, любой человек может относительно легко прочитать его, как простое предложение на английском:

Выполнение одиночного хода переключает на второго игрока.

На данном этапе Вы познакомились с простым использованием Nimble Matchers. Nimble использует эти сопоставления, чтобы вы могли получить ожидаемый результат теста очень быстрым способом, подобно простым предложениям. *equal()* — это только одна из функций сопоставления, которая доступная в Nimble. Вы даже можете создавать свои собственные функции.

### Следующий тест

Вторая user story — “После второго хода должно переключится обратно на первого игрока” — звучит довольно похоже на user story.

Добавьте следующий код сразу после окончания предыдущего метода **context()**, внутри закрывающей фигурной скобки **describe()**:

```

context("two moves") { // 1

it("should switch back to cross") {

try! board.playRandom() // 2

try! board.playRandom()

expect(board.state) == .playing(.cross) // 3

}

}

```

Этот тест похож на предыдущий, но отличается только тем, что вы делаете два хода вместо одного.

Вот что тест выполняет:

1. Вы определяете новый **describe()** для создания контекста «двух ходов». Вы можете иметь любое количество блоков **describe()** и **context()**, и они могут даже содержаться внутри друг друга. Поскольку вы все еще тестируете геймплей, вы добавили контекст внутри describe(«playing»).

2. Вы совершаете для последовательных хода.

3. Вы утверждаете, что **state** доски сейчас является *.playing(.cross)*. Обратите внимание, что на этот раз вы использовали регулярный оператор равенства ==, вместо синтаксиса *.to(equal())*, который вы использовали ранее. Сопоставление Nimble’s equal() обеспечивает свои собственные перегруженные операторы, которые можно выбрать на свой вкус.

### Arrange, Act & Assert

Те тесты, которые вы только что написали, были относительно простыми и понятными. Вы выполняете одиночный вызов на пустом board и утверждаете ожидаемый результат. Обычно, большинство сценариев более сложны, что требует немного дополнительной работы.

Следующие две user stories будут сложнее:

*Выполнение выигрышного хода должно переключить в состояние Победы.

Выполнение выхода из игры не производит никаких действий, а только переход в состояние Завершения игры.*

В обеих этих *user stories* вам нужно сделать некоторые шаги на игровой доске, чтобы Вы могли проверить ее состояние, свое утверждение.

Эти тесты обычно делятся на три этапа: **Arrange, Act and Assert**.

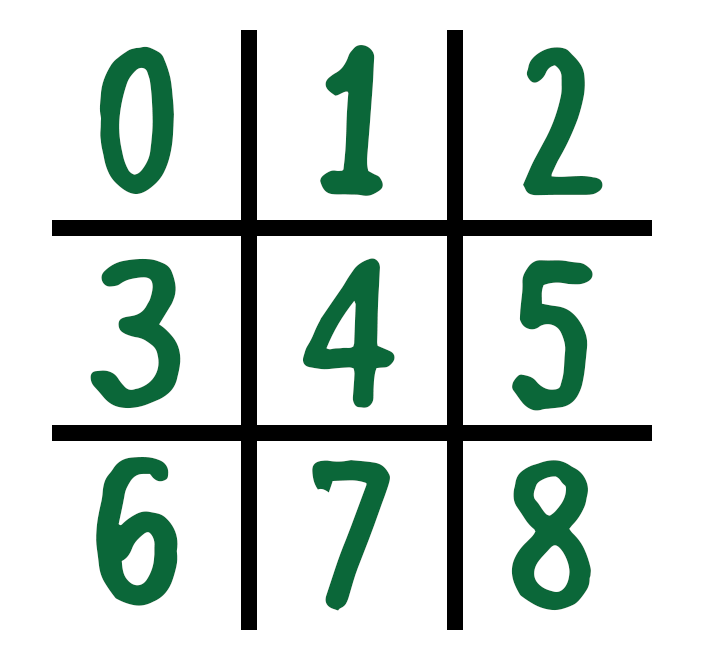

Прежде чем планировать тесты, вы должны понять, как реализована платформа **Tic Tac Toe**.

Board моделируется как Array, состоящий из 9 ячеек, адресованных с использованием индексов от 0 до 8.

При каждом шаге игрок выполняет один ход. Чтобы написать тест для симуляции победы пользователя, вам нужно будет привести **Board** до состояния, когда следующий ход будет выигрышным.

Теперь, когда вы понимаете, как работает Board, пришло время написать этот тест.

Добавьте следующий код ниже вашего предыдущего контекста “two moves” **context()**:

```

context("a winning move") {

it("should switch to won state") {

// Arrange

try! board.play(at: 0)

try! board.play(at: 1)

try! board.play(at: 3)

try! board.play(at: 2)

// Act

try! board.play(at: 6)

// Assert

expect(board.state) == .won(.cross)

}

}

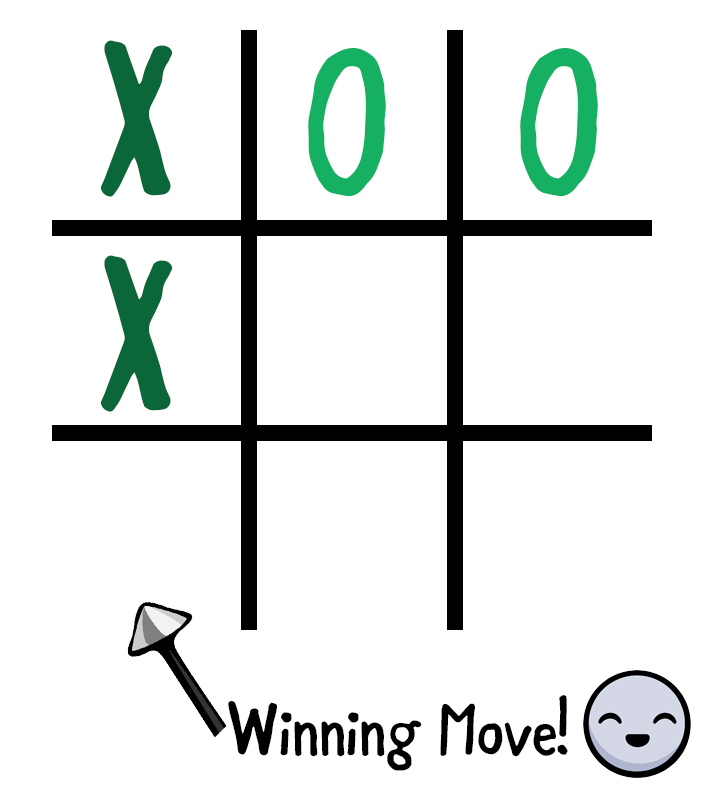

```

Вот что реализует данный код:

**Arrange:** Вы организовываете Вoard, чтобы подготовить ее до состояния, когда следующий ход будет выигрышным. Вы делаете это, выполняя ходы обоих игроков в свою очередь; начиная с X в точке 0, в точке 1, X в 3 и наконец в 2.

**Act:** Вы выполняете ход Cross (X) на позицию 6. В текущем состоянии Board, этот ход должен привести к выигрышному состоянию.

**Assert:** Вы указываете, что игру выиграет Крестик (Х), и и Board перейдет в состояние Выигрыш (.won (.cross))

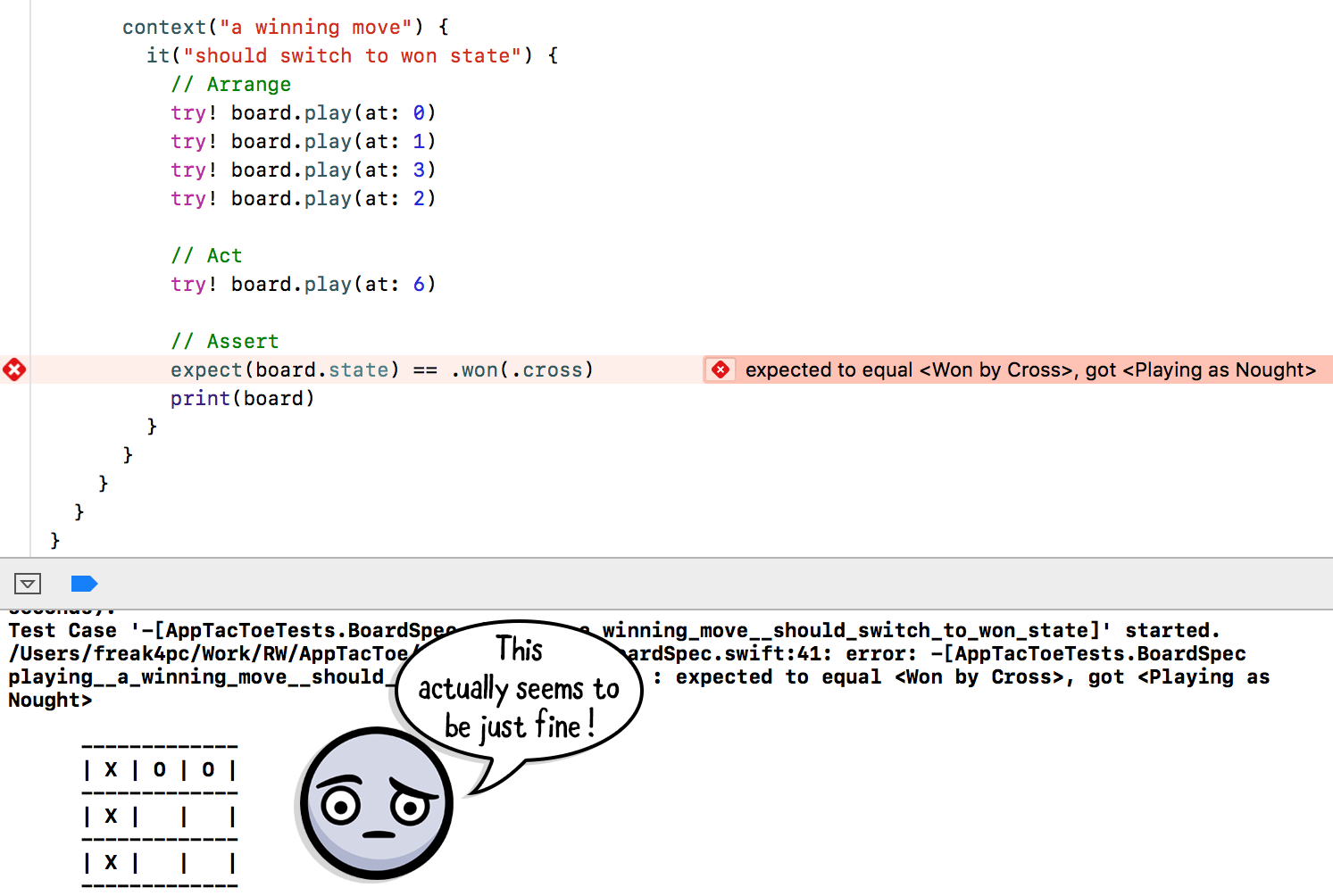

Запустите тест еще раз, используйте сочетание клавиш **Command+U**.

Что-то не так; вы сделали все верные шаги, но тест неожиданно провалился.

Добавьте следующий код непосредственно под строкой *expect()*, чтобы увидеть ошибку:

```

print(board)

```

Отобразив **Board** сразу же после блока **Assert**, вы получите детальное разъяснение данной ситуации:

Как видите, Board должен находиться в состоянии Победы, но тест все еще не работает. Похоже, вы нашли ошибку.

Перейдите в вкладку *Project navigator* и откройте **Board.swift**. Перейдите на вычисленное свойство **isGameWon** в строке 120.

Код в этом разделе проверяет все возможные выигрышные позиции по строкам, столбцам и диагоналям. Но, глядя на столбцы, у кода, похоже, только 2 столбца проверены, и на самом деле отсутствует один из вариантов выигрыша. Упс!

Добавьте следующую строку кода непосредственно ниже комментария **// Columns**:

```

[0, 3, 6],

```

Запустите тесты еще раз и насладитесь тремя зелеными маркеры!

Такой сценарий будет намного сложнее обнаружить с помощью обычных Unit тестов. Поскольку вы используете тестирование, основанное на поведении, вы фактически протестировали конкретный вариант использования приложения и обнаружили ошибку. Исправление основной реализации зафиксировало протестированное поведение, разрешив проблему, которую испытывала ваша пользовательская история.

**Примечание:** *Во время работы над одним конкретным тестом или конкретным контекстом тестов вы можете не захотеть запускать все свои тесты сразу, чтобы вы могли сосредоточиться конкретно над одним тестом.

К счастью, Quick предоставляет очень простой способ сделать это. Просто добавьте f (стоит для фокусировки ) перед любым из имен тестовых функций — имея it(), context() и describe (), становятся fit(), fcontext() и fdescribe()

Например, после замены it(«should switch to won state») на fit(«should switch to won state»), будет запускаться только этот конкретный тест, пропуская остальную часть тестового набора. Просто не забудьте удалить его после того, как вы закончите, иначе только часть ваших тестов будет работать!*

### Маленькое упражнение

Время для вызова. У вас есть одна последняя user story, которую вы еще не тестировали: Выполнение хода, после которого больше нет ходов, переводит игру в состояние Ничья.

Используя предыдущие примеры, напишите тест, чтобы проверить правильность определения Вoard.

**Примечание:** *Чтобы достичь состояния выхода, вы можете последовательно воспроизводить следующие позиции: **0, 2, 1, 3, 4, 8, 6, 7**.*

В этом состоянии игровая позиция 5 должна приводить к тому, что ваш Вoard находится в состоянии draw.

Кроме того, используя метода .draw может запутать **Xcode**. Если это так, используйте полное выражение: *Board.State.draw*.

Если у вас не получилось роить это задание, вот решение:

```

context("a move leaving no remaining moves") {

it("should switch to draw state") {

// Arrange

try! board.play(at: 0)

try! board.play(at: 2)

try! board.play(at: 1)

try! board.play(at: 3)

try! board.play(at: 4)

try! board.play(at: 8)

try! board.play(at: 6)

try! board.play(at: 7)

// Act

try! board.play(at: 5)

// Assert

expect(board.state) == Board.State.draw

}

}

```

### Счастливый Путь — это не единственный путь

Все тесты, которые вы написали до сих пор, имеют одну общую черту: они описывают правильное поведение вашего приложения, следуя счастливому пути (**happy path**). Вы подтвердили, что, когда игрок воспроизводит правильные ходы, игра ведет себя правильно. Но как насчет не очень счастливого пути?

При написании тестов вы не должны забывать о концепции ожидаемых ошибок. У вас, как разработчика, должна быть возможность подтвердить правильность поведения Вoard даже если ваш игрок ведет себя не правильно (например, совершает неразрешенный ход).

Рассмотрите две последние user stories этого туториала:

*делая ход, который уже был сделан, должно вызвать ошибку.

делая ход, после того как игра выиграна, должно вызывать ошибку.*

Nimble предоставляет удобного сопоставителя с именем **throwError()**, которого вы можете использовать для проверки этого поведения.

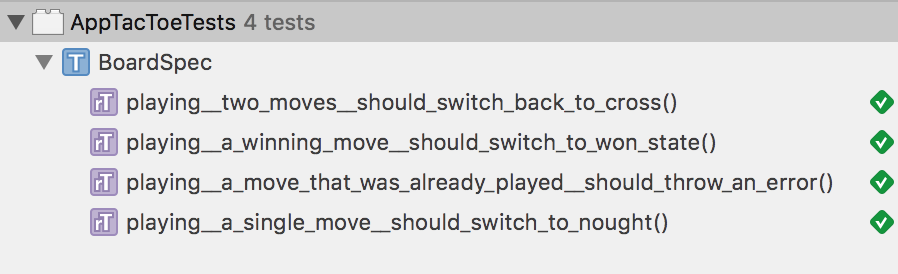

Начните с проверки того, что уже воспроизведенный ход не может быть воспроизведен снова.

Добавьте следующий код прямо под последним **context()**, который вы добавили, но все еще внутри блока **describe(«playing»)**:

```

context("a move that was already played") {

it("should throw an error") {

try! board.play(at: 0) // 1

// 2

expect { try board.play(at: 0) }

.to(throwError(Board.PlayError.alreadyPlayed))

}

}

```

Вот что выполняет данный код:

1. Вы выполняете ход в положение 0.

2. Вы воспроизводите ход в одну и ту же позицию и ожидаете, что он выбросит **Board.PlayerError.alreadyPlayed**. Когда вы утверждаете, что ошибка отображена, expect принимает замыкание, в котором вы можете запустить код, вызывающий ошибку.

Как вы и ожидали от Quick-тестов, утверждение читается так же, как английское предложение: expect playing the board to throw error – already played(ожидается, что дальнейшая игра вызовет ошибку «уже сыграно»).

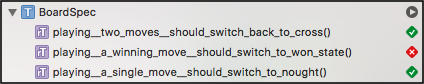

Запустите набор тестов еще раз, перейдя в **Product ▸ Test** или используйте сочетание клавиш **Command+U**.

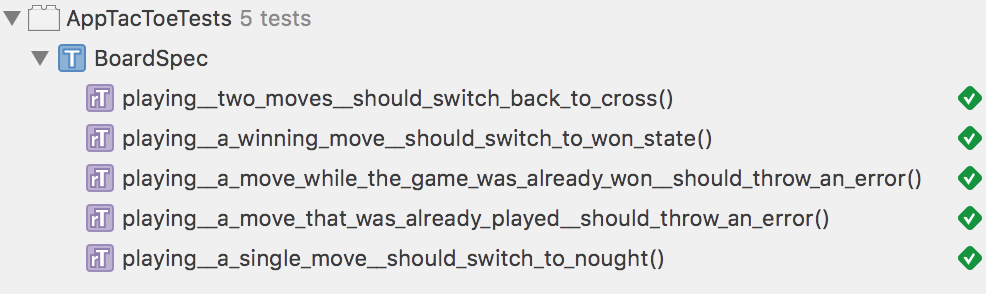

Последняя user story, которую вы собираетесь сегодня изучить, будет: Делая ход, после того как игра выиграна, должно вызывать ошибку.

Этот тест должен быть относительно похож на предыдущие тесты **Arrange, Act и Assert**: вам нужно привести board в выигрышное состояние, а затем попытаться сыграть еще один шаг, пока board будет в этом состоянии.

Добавьте следующий код прямо под последним **context()**, который вы добавили для предыдущего теста:

```

context("a move while the game was already won") {

it("should throw an error") {

// Arrange

try! board.play(at: 0)

try! board.play(at: 1)

try! board.play(at: 3)

try! board.play(at: 2)

try! board.play(at: 6)

// Act & Assert

expect { try board.play(at: 7) }

.to(throwError(Board.PlayError.noGame))

}

}

```

Основываясь на знаниях, которые вы получили в этом уроке, вы должны чувствовать себя как дома, работая с этим тестом!

Вы подводите board к состоянию Выигрыш (.won (.cross)), воспроизведя 5 шагов… Затем вы **Act и Assert**, пытаясь сыграть ход, пока board уже находится в состоянии Выигрыш, и ожидает отображения **Board.PlayError.noGame**.

Запустите свой пакет тестов еще раз и похлопайте себя по спине пройдя все эти тесты!

### Пользовательские сопоставления

При написании тестов в этой статье вы уже использовали несколько сопоставлений, встроенных в Nimble: equal() (и его == оператор перегрузки), и **.throwError()**.

Иногда вы хотите создать свои собственные сопоставления, чтобы инкапсулировать некоторую сложную форму сопоставления или повысить читаемость некоторых ваших существующих тестов.

Подумайте о том, как улучшить читаемость user story *«побеждающий ход должен переключить состояние на Выигрыш»*, упомянутого ранее:

**expect(board.state) == .won(.cross)**

Перефразируйте данный код, как предложение на английском языке: *expect board to be won by cross (ожидается, что борд выиграет Крестик(х))*. Тогда тест будет иметь следующий вид:

**expect(board).to(beWon(by: .cross))**

Сопоставители в Nimble — это не что иное, как простые функции, возвращающие Predicate , где generic T — тип, с которым вы сравниваете. В вашем случае T будет иметь тип Board.

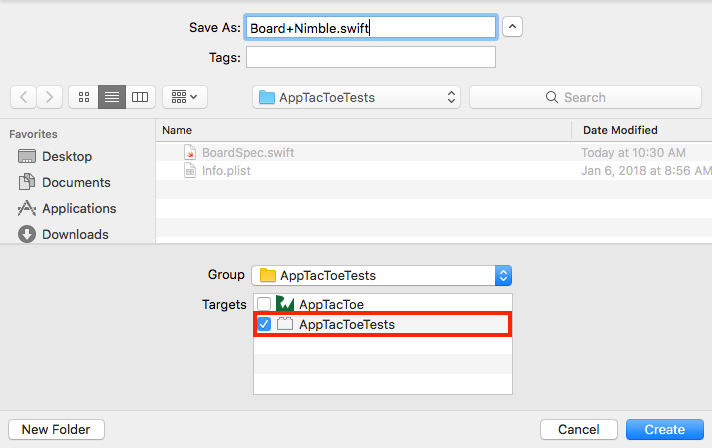

В навигаторе проекта щелкните правой кнопкой мыши папку **AppTacToeTests** и выберите New File. Выберите **Swift File** и нажмите **Next**. Назовите свой файл **Board+Nimble.swift**. Убедитесь, что вы правильно установили файл в качестве члена вашей целевой задачи **AppTacToeTests**:

Замените стандартный **import Foundation** тремя следующими импортами:

```

import Quick

import Nimble

@testable import AppTacToe

```

Этот код выполняет импорт Quick и Nimble, а также импортирует вашу главную цель, поэтому вы можете использовать Board в своем сопоставлении.

Как упоминалось ранее, Matcher — это простая функция, возвращающая **Predicate** типа Board.

Добавьте основную часть сопоставления внизу импорта:

```

func beWon(by: Board.Mark) -> Predicate {

return Predicate { expression in

// Error! ...your custom predicate implementation goes here

}

}

```

Этот код определяет сопоставление **beWon(by:)** которое возвращает Predicate , поэтому он правильно сопоставляется с Board.

Внутри вашей функции вы возвращаете новый экземпляр Predicate, передавая ему замыкание с единственным аргументом — expression — которое является значением или выражением, с которым вы сравниваете. Замыкание должно вернуть PredicateResult.

На этом этапе вы увидите ошибку компиляции, поскольку результат еще не возвращен. Далее это будет исправлено.

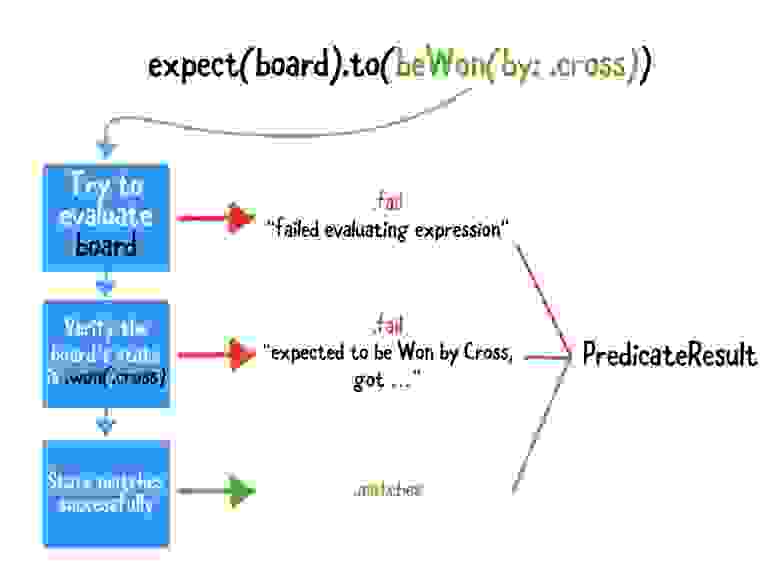

Чтобы создать **PredicateResult**, вы должны учитывать следующие случаи:

Как работает сопоставление **beWon(by :)**

Добавьте следующий код внутрь замыкания Predicate, заменив комментарий, // Error!:

```

// 1

guard let board = try expression.evaluate() else {

return PredicateResult(status: .fail,

message: .fail("failed evaluating expression"))

}

// 2

guard board.state == .won(by) else {

return PredicateResult(status: .fail,

message: .expectedCustomValueTo("be Won by \(by)", "\(board.state)"))

}

// 3

return PredicateResult(status: .matches,

message: .expectedTo("expectation fulfilled"))

```

Вначале эта предикативная реализация может показаться запутанной, но все довольно просто, если выполнить ее шаг за шагом:

1. Вы пытаетесь оценить выражение, переданное в **expect()**. В этом случае выражение является самим board. Если оценка была провалена, вы возвращаете неудачный PredicateResult с соответствующим сообщением.

2. Вы подтверждаете, что состояние board равно **.won(by)**, где by — аргумент, переданный функции Matcher. Если состояние не совпадает, вы возвращаете ошибку PredicateResult с сообщением **.expectedCustomValueTo**.

3. Наконец, если все выглядит хорошо и проверено, вы возвращаете успешный **PredicateResult**.

Это оно! Откройте **BoardSpec.swift** и замените следующую строку:

```

expect(board.state) == .won(.cross)

```

использовав новое сопоставление:

```

expect(board).to(beWon(by: .cross))

```

Запустите тесты еще раз, перейдя в Product ▸ Test или используйте сочетание клавиш Command + U. Вы должны увидеть, что все ваши тесты все еще проходят, но на этот раз с новым Matcher!

### Что далее?

Теперь у вас есть знания, необходимые для написания тестов, ориентированых на поведение, в приложении.

Вы узнали все о тестировании *user stories*, вместо того, чтобы тестировать детали реализации, и как **Quick** помогает этого достичь. Вы также узнали о сопоставлениях **Nimble** и даже написали свое собственное сопоставление. Здорово!

Чтобы начать работу с **Quick** и **Nimble** в своем собственном проекте, начните с руководства по установке и [выберите способ установки](https://github.com/Quick/Quick/blob/master/Documentation/en-us/InstallingQuick.md), который будет приемлемым для вашего проекта.

Когда у вы все настроите, и захотите узнать больше о Quick, перейдите по ссылке под названием [официальная документация Quick's](https://github.com/Quick/Quick/tree/master/Documentation/en-us). Прочтите также [Readme Nimble](https://github.com/Quick/Nimble/blob/master/README.md), чтобы ознакомиться с огромным количеством доступных сопоставлений и возможностей. | https://habr.com/ru/post/352694/ | null | ru | null |

# Языковые модели как двигатель прогресса: необычные применения для GPT-3

В начале лета разработчики из OpenAI представили языковую модель GPT-3, созданную для написания связного текста на основе заданного материала. Её обучали на 570 гигабайтах содержимого веб-страниц, википедии и художественной литературы, что почти в 15 раз превышает объем датасета для GPT-2. Модель отлично пишет стихи и прозу, умеет переводить на некоторые языки, разгадывать анаграммы и отвечать на вопросы по прочитанному материалу. Творчество языковых моделей становится всё труднее отличить от настоящего текста, и GPT-3 не исключение. Например: [Как я, специалист по ИИ, на ИИ-текст купился](https://habr.com/ru/post/511764/).

Но особенность GPT-3 не только в крутой работе с текстом — это не особенно выделяет её среди остальных моделей. На самом деле её возможности кажутся безграничными, а примеры поражают. Судите сами: получая на вход простейший императивный запрос, GPT-3 может писать код, верстать, составлять запросы, вести учёт, искать информацию и многое другое.

**Осторожно, трафик!**

### Код

Достаточно скормить модели пару обучающих примеров, и она сможет писать небольшие конструкции вроде верстки или описания ML-моделей:

**[Генератор вёрстки в JSX](https://twitter.com/sharifshameem/status/1282676454690451457)**

> Your browser does not support HTML5 video.

>

> Эту демку написал Sharif Shameem как прототип фронтенд-конструктора. Получить доступ к ней можно, заполнив [эту форму](https://docs.google.com/forms/d/e/1FAIpQLSeI-QTsXJV0cF5MuB7RwgA0QdHEWn7E6zrs7dCHDLHA3s64Dg/viewform).

**[Императивная вёрстка](https://twitter.com/sharifshameem/status/1283322990625607681)**

> Your browser does not support HTML5 video.

>

> Похожая версия от того же автора. Кажется, эпоха wysiwyg'a скоро закончится.

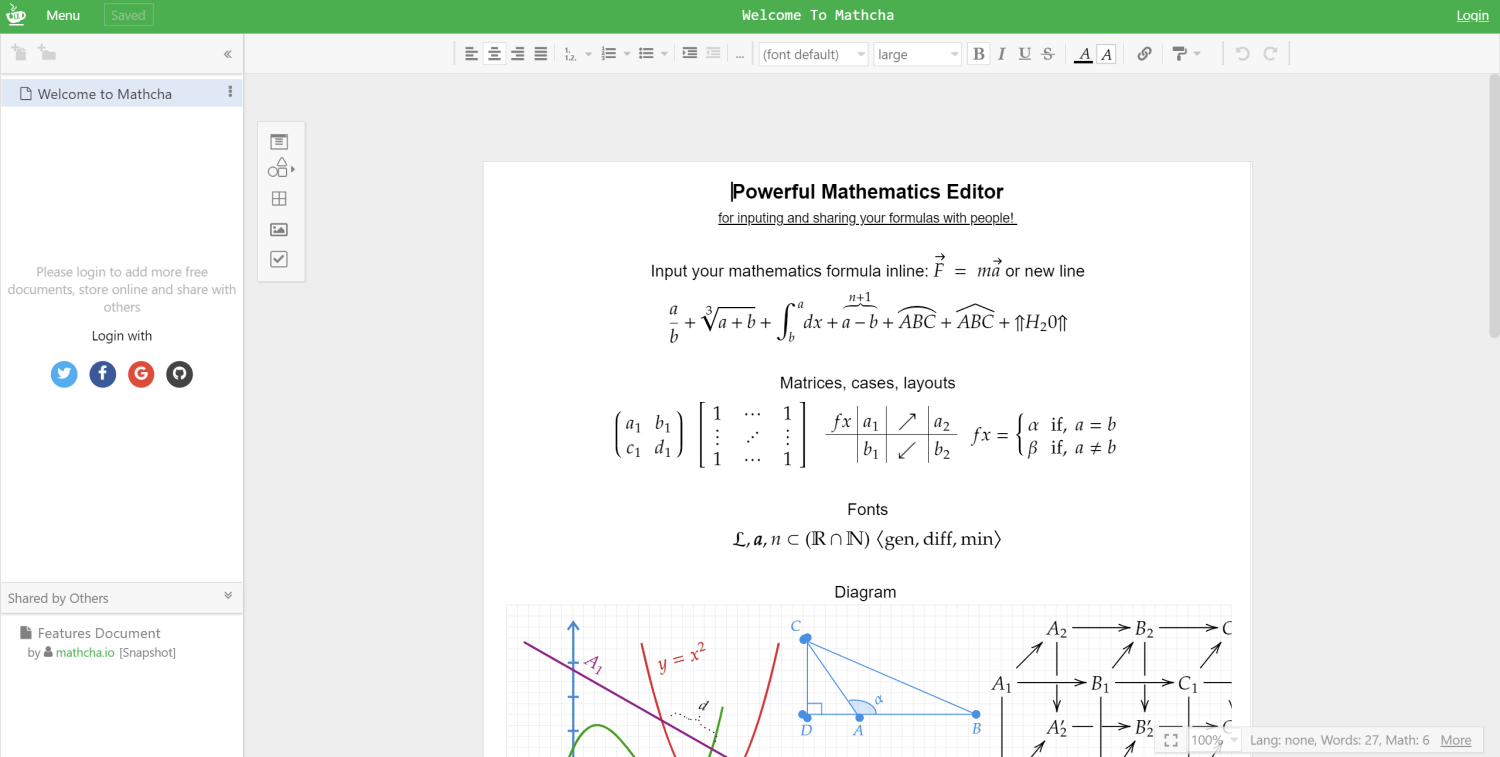

**[Создание модели машинного обучения](https://twitter.com/mattshumer_/status/1287125015528341506)**

> Your browser does not support HTML5 video.

>

> Восстание самовоспроизводящихся машин уже не за горами!

**[SQL запросы из текста](https://twitter.com/FaraazNishtar/status/1285934622891667457)**

> Your browser does not support HTML5 video.

>

> Вряд ли модель обучена всей мощи SQL, но простые запросы она парсит легко, а это уже неплохо.

**[Регулярные выражения](https://twitter.com/parthi_logan/status/1286818567631982593)**

> Your browser does not support HTML5 video.

>

> Эта демка работает не совсем корректно, но уже должна быть исправлена. Записаться на тест можно [тут](https://losslesshq.com/).

### Дизайн

**[Плагин для Figma](https://twitter.com/jsngr/status/1284511080715362304)**

> Your browser does not support HTML5 video.

>

> Уже нашумевшая в интернете демка плагина для Figma, собирающая дизайн приложений по текстовому запросу.

**[Продвинутая версия](https://twitter.com/dhvanilp/status/1286452207513038848)**

> Your browser does not support HTML5 video.

>

> “В целом, я очень впечатлен, что модели GPT-3 способны выдавать синтаксически правильный JSON исходя из всего двух-трех примеров. Несмотря на сложность самого JSON, GPT-3 работает корректно более чем в 90% случаев."

>

> [Ветка в твиттере](https://twitter.com/dhvanilp/status/1286452210314784769?s=20)

### Текст

**[Рерайтинг и кликбейт](https://twitter.com/IntuitMachine/status/1286974653345542145)**

> Your browser does not support HTML5 video.

>

> Здесь же можно преобразовать свой текст под стили разных писателей или даже сделать из него кликбейтный заголовок.

**[Email-автоответчик](https://twitter.com/OthersideAI/status/1285776335638614017)**

> Your browser does not support HTML5 video.

>

> Подстраивается под авторский стиль и отвечает по заданным пунктам. Для тех, у кого нет времени на формальности.

### Разное

**[Google Spreadsheets](https://twitter.com/pavtalk/status/1285410751092416513)**

> Your browser does not support HTML5 video.

>

> Универсальная функция `=GPT3()` — мультитул для таблиц. На момент записи демки умела искать население в штатах, ники людей в твиттере и место их работы, и выполняла различные подсчёты.

>

> Уже шутят про следующий уровень, функцию `=DOMYWORK()`. Вкалывают роботы...

**[Расчеты и финансовая отчетность](https://twitter.com/itsyashdani/status/1285695850300219392)**

> Your browser does not support HTML5 video.

>

> Вы описываете свои транзакции (в том числе довольно сложные), модель парсит их в скрипт на питоне, который заполняет/обновляет гугл-таблицу. Я не бухгалтер, но по-моему это очень круто, особенно для пет-проекта, написанного на выходных.

**[Мемы](https://twitter.com/wowitsmrinal/status/1287175391040290816)**

> Your browser does not support HTML5 video.

>

> Иногда выходит и правда неплохо! Впервые после лебедевских логотипов мемы от искусственного интеллекта способны конкурировать с созданными вручную.

Заключение

----------

Функционал GPT-3 не ограничен машинными текстами. Разработчики из самых разных направлений встраивают эту модель в свои инструменты, и уже можно ожидать новую волну стартапов на её основе. К сожалению, сейчас GPT-3 доступна только по инвайту от OpenAI в рамках бета-тестирования, но позже её откроют для коммерческого использования. Некоторые демки доступны по записи, так что поиграться с моделью можно уже сейчас.

Всё чаще звучат страшилки об искусственном интеллекте, заменяющем программистов, и похоже что рано или поздно это всё-таки случится. Поживём — увидим.

---

#### На правах рекламы

Многие наши клиенты уже оценили преимущества **эпичных серверов**!

Это [мощные виртуальные серверы](https://vdsina.ru/cloud-servers?partner=habr55) с процессорами AMD EPYC, частота ядра CPU до 3.4 GHz. Максимальная конфигурация позволит оторваться на полную — 128 ядер CPU, 512 ГБ RAM, 4000 ГБ NVMe. Поспешите заказать!

[](https://vdsina.ru/cloud-servers?partner=habr55) | https://habr.com/ru/post/513792/ | null | ru | null |

# Компонент «Фильтрация и управление фильтрами» 1.2 для MODX Revolution

Наконец-то дошли руки довести до ума компонент «Фильтрация и управление фильтрами» (tagManager). Первая его версия была очень сырая, даже пришлось сделать дополнительно упрощённый вариант фильтрации. Теперь всё, что было задумано реализовано в нормальном виде и хочу рассказать об этом компоненте сообществу MODX и всем интересующимся.

Функции:

* Сортировка групп фильтров и отдельно их значений.

* Настройка активности групп фильтров и отдельных значений (чекбокс).

* Изменение значений (по двойному клику появляется поле) для всех товаров, у которых есть это значение.

* Ajax-фильтрация и сортировка товаров в каталоге.

* Выводится число товаров по каждому фильтру. Блокируется получение пустого результата поиска.

* Поддержка типов ввода TV с выбором одновременно нескольких значений — Флажки(checkbox), Список (множественный выбор).

Как работает компонент управления фильтрами описывать долго и нудно, поэтому я решил сделать видео:

Была задача чтобы при фильтрации невозможно было получить результат «ничего не найдено». При этом у каждого фильтра должна выводиться циферка, показывающая количество товаров по этому фильтру. Т.е. вместо одного запроса получалось около 20 (конкретно в моём случае). Конечно, данные товаров можно было индексировать и кэшировать, но и это по расчётам не дало бы требуемого результата. Всё должно работать максимально быстро. Поэтому было решено часть работы по фильтрации (точнее основную часть) переложить на «клиента» (JavaScript).

Для вывода блоков фильтров на сайте используется сниппет «tmCatalogFilters».

Пример вызова:

```

[[tmCatalogFilters?

&jsMap=`1`

&innerTpl=`filters_innerTpl`

&outerTpl=`filters_outerTpl`

]]

```

**innerTpl** — Чанк шаблона строки с фильтром. По умолчанию `@ FILE core/components/tag\_manager/elements/chunks/innerTpl.tpl`.

**outerTpl** — Чанк шаблона блока фильтров. По умолчанию `@ FILE core/components/tag\_manager/elements/chunks/outerTpl.tpl`.

**skipTV** — ID TV через запятую, фильтры по которым выводить не нужно.

**jsMap** — Создавать JS-объект данных товаров. Используется для фильтрации и быстрого показа количества товаров по каждому фильтру.

Примеры чанков innerTpl и outerTpl прилагаются (core/components/tag\_manager/elements/chunks/).

Вызов данного сниппета рекоммендуется кэшировать (скобки без "!"). Создаётся JS-объект со всеми параметрами товаров и по этом данным осуществляется поиск (на JavaScript). На сервер отправляется только список ID товаров.

Для вывода товаров используется сниппет «tmGetProducts». Никаких параметров у этого сниппета нет. Это «обёртка», которая использует сниппеты «getPage» и «getResources». Параметры он применяет по имени набора параметров, созданного для сниппета «getPage». Это имя нужно указать в конфигурации компонента («Настройки системы» -> «tag\_manager» -> «tag\_mgr.propertySetName»). Также этот набор параметров применяет php-скрипт, который возвращает данные при ajax-запросах (происходит синхронизация настроек).

В шаблоне каталога, где будут выводиться фильтры, нужно подключить необходимые JS-скрипты и CSS-файлы (прилагается пример).

```

```

Нужно настроить скрипт **filters.js** под вашу вёрстку. В коде есть комментарии.

Это краткая инструкция. Более подробная с примерами включена в пакет (core/components/tag\_manager/docs/readme.txt).

Компонент был сделан для студии [«Симпл Дрим»](http://www.simpledream.ru/), потом доработан. Спасибо им, что разрешили поделиться с общественностью.

[Демо](http://demo-revo.modx-shopkeeper.ru/catalog/kompyuteryi/komplektuyushhie/)

[Скачать](http://modx.com/extras/package/tagmanager) (можно установить через «Управление пакетами» в админке)

[Исходный код](https://bitbucket.org/andchir/tagmanager/src) | https://habr.com/ru/post/150357/ | null | ru | null |

# Pythonic

Итак, что же это значит, когда кто-либо говорит, что foo выглядит как pythonic? Что значит, когда кто-либо смотрит в наш код и говорит, что он unpythonic? Давайте попробуем разобраться.

В Python-сообществе существует неологизм *pythonic*, который можно трактовать по разному, но в общем случае он характеризует стиль кода. Поэтому утверждение, что какой-либо код является pythonic, равносильно утверждению, что он написан в соответствии с идиома Python’a. Аналогично, такое утверждение в отношении интерфейса, или какой-либо функциональности, означает, что он (она) согласуется с идиомами Python’a и хорошо вписывается в экосистему.

Напротив, метка *unpythonic* означает, что код представляет собой грубую попытку записать код какого-либо другого языка программирования в синтаксисе Python, а не идиоматическую трансформацию.

Понятие Pythonicity плотно связано с минималистической концепцией Python’a и уходом от принципа «существует много способов сделать это». Нечитабельный код, или непонятные идиомы – все это unpythonic.

При переходе от одного языка к другому, некоторые вещи должны быть «разучены». Что мы знаем из других языков программирования, что не будет к месту в Python’e?

#### Используйте стандартную библиотеку

Стандартная библиотека – наш друг. Давайте использовать ее.

```

>>> foo = "/home/sa"

>>> baz = "somefile"

>>> foo + "/" + baz # unpythonic

'/home/sa/somefile'

>>> import os.path

>>> os.path.join(foo, baz) # pythonic

'/home/sa/somefile'

>>>

```

Другие полезные функции в *os.path*: *basename()*, *dirname()* и *splitext()*.

```

>>> somefoo = list(range(9))

>>> somefoo

[0, 1, 2, 3, 4, 5, 6, 7, 8]

>>> import random

>>> random.shuffle(somefoo) # pythonic

>>> somefoo

[8, 4, 5, 0, 7, 2, 6, 3, 1]

>>> max(somefoo) # pythonic

8

>>> min(somefoo) # pythonic

0

>>>

```

Существует много полезных встроенных функций, о которых многие люди по каким-либо причинам не знают. Например, *min()* и *max()*. Стандартная библиотека включает много полезных модулей. Например, *random*, который содержит кучу функционала, который люди по незнанию реализую самостоятельно.

#### Создание пустых списков, кортежей, словарей и т.д.

```

>>> bar = list() # unpythonic

>>> type(bar)

>>> del bar

>>> bar = [] # pythonic

>>> type(bar)

>>> foo = {}

>>> type(foo)

>>> baz= set() # {} is a dictionary so we need to use set()

>>> type(baz)

>>>

```

#### Использование обратной косой черты

Т.к. Python трактует перенос строки как разделитель выражений, и т.к. выражения очень часто не вмещаются в одну строку, многие люди поступают вот так:

```

if foo.bar()['first'][0] == baz.ham(1, 2)[5:9] and \ # unpythonic

verify(34, 20) != skip(500, 360):

pass

```

Использование «\» не является хорошей идеей. Такой подход может вызвать неприятный баг: случайный пробел после косой черты сделает строку неправильной. В лучшем случае мы получим syntax error, но если код предствляет что-то вроде этого:

```

value = foo.bar()['first'][0]*baz.ham(1, 2)[5:9] \ # unpythonic

+ verify(34, 20)*skip(500, 360)

```

Тогда он будет просто нерабочим. Лучше использовать неявное продолжение строки в скобках. Подобный код является пуленепробиваемым:

```

value = (foo.bar()['first'][0]*baz.ham(1, 2)[5:9] # pythonic

+ verify(34, 20)*skip(500, 360))

```

#### Import

Не используйте «[from foo import \*](http://www.markus-gattol.name/ws/python.html#from_foo_import_star)». [Здесь](http://www.markus-gattol.name/ws/python.html#import_matters) и [здесь](http://www.markus-gattol.name/ws/python.html#import_order) можно найти более подробную информацию.

#### Общие исключения

Python имеет выражение «*except*», которое отлавливает все исключения. Т.к. любая ошибка генерирует исключение, такой код может сделать многие ошибки программирования похожими на ошибки времени исполнения, и затруднят отладку программы. Следующий пример является исчерпывающим:

```

try:

foo = opne("somefile") # misspelled "open"

except:

sys.exit("could not open file!")

```

Вторая строчка генерирует «*NameError*», который будет отловлен, что семантически неверно, поскольку «except» написан для отлавливания «*IOError*». Лучше написать такой код:

```

try:

foo = opne("somefile")

except IOError:

sys.exit("could not open file")

```

Когда Вы запустите этот код, Python сгенерирует «NameError», и Вы моментально увидите и исправите ошибку.

Поскольку «except» отлавливает все исключения, включая «*SystemExit*», «*KeyboardInterrupt*», и «*GeneratorExit*» (которые по сути не являются ошибками и не должны отлавливаться пользовательским кодом), использование голого «except» в любом случае плохая идея. В ситуациях, когда нам нужно все-таки покрыть все возможные исключительные ситуации, мы можем использовать базовый класс для всех исключений – «*Exception*».

#### Нам редко нужны счетчики

```

>>> counter = 0 # unpythonic

>>> while counter < 10:

... # do some stuff

... counter += 1

...

...

>>> counter

10

>>> for counter in range(10): # pythonic

... # do some stuff

... pass

...

...

>>>

```

Другой пример:

```

>>> food = ['donkey', 'orange', 'fish']

>>> for i in range(len(food)): # unpythonic

... print(food[i])

...

...

donkey

orange

fish

>>> for item in food: # pythonic

... print(item)

...

...

donkey

orange

fish

>>>

```

#### Явные итераторы

Внутри Python использует много итераторов… для циклов не должно быть исключений:

```

>>> counter = 0 # unpythonic

>>> while counter < len(somecontainer):

... callable_consuming_container_elements(somecontainer[counter])

... counter += 1

...

...

>>> for item in somecontainer: # pythonic

... callable_consuming_container_elements(item)

...

...

>>>

```

Можно сказать, что для простых вещей мы не должны явно создавать итераторы. Есть ряд случаев, когда явные итераторы будут полезны. Например, когда мы что-то обрабатываем, останавливаемся, делаем что-либо еще, затем возвращаемся назад и продолжаем. Итератор запоминает наше положение, и это прекрасно:

```

>>> somecontainer = list(range(7))

>>> type(somecontainer)

>>> somecontainer

[0, 1, 2, 3, 4, 5, 6]

>>> somecontaineriterator = iter(somecontainer)

>>> type(somecontaineriterator)

```

Теперь мы можем начать использовать наш итератор:

```

>>> for item in somecontaineriterator: # start consuming the iterable somecontainer

... if item < 4:

... print(item)

...

... else:

... break # breaks out of the nearest enclosing for/while loop

...

...

...

0

1

2

3

```

Не дайте себя обмануть, итератор остановился на «*somecontaineriterator[5]*», который равен 4, а не 3. Давайте посмотрим, что будет дальше:

```

>>> print("Something unrelated to somecontaineriterator.")

Something unrelated to somecontaineriterator.

>>> next(somecontaineriterator) # continues where previous for/while loop left off

5

>>> next(somecontaineriterator)

6

>>> next(somecontaineriterator)

Traceback (most recent call last): # we have exhausted the iterator

File "", line 1, in

StopIteration

>>>

```

Некоторым может показаться, что данный пример неоднозначен, на самом деле это не так. Итератор в цикле проходит массив, выходит из цикла по *break* на индексе 5 (значение внутри равно 4). Затем мы совершаем некие действия (выводим текст в консоль), и после этого продолжаем перебор итератора. Вот и все.

#### Присваивание

[Здесь](http://www.markus-gattol.name/ws/python.html#chained_assignment) можно почитать подробно.

#### Циклы только когда это действительно необходимо

Существует много случаев, для которых в других языках программирования мы бы использовали выражения циклов, но в случае Python в этом нет необходимости.

Python предоставляет много высокоуровневого функционала для оперирования любыми объектами. Для последовательностей это могут быть функции *zip()*, *min()*, *max()*. Затем, это такие вещи, как «list comprehensions», генераторы, «set comprehensions» и т.д.

Дело в том, что если мы сохраняем наши данные в базовых структурах Python, таких как списки, кортежи, словари, множества и д.р., мы получаем кучу функционала для работы с ними «из коробки». Даже если мы нуждаемся в специфичной структуре, скорее всего не составит труда создать ее, используя базовый структуры данных. Итак, в чем же преимущества. Как мы можем получить список имен некоторых людей, хранящийся в дисковом файле.

```

sa@wks:/tmp$ cat people.txt

Dora

John

Dora

Mike

Dora

Alex

Alex

sa@wks:/tmp$ python

>>> with open('people.txt', encoding='utf-8') as a_file: # context manager

... { line.strip() for line in a_file } # set comprehension

...

...

{'Alex', 'Mike', 'John', 'Dora'}

>>>

```

Никаких циклов, пользовательских структур данных, убраны лишние пробелы и дубликаты, все pythonic ;-]

#### Кортежи – это не просто read-only списки

Это распространенное заблуждение. Очень часто списки и кортежи применяются для одних и тех же целей. Списки предназначены для хранения однотипных данных. В то время как кортежи – для объединения данных разного типа в набор. Другими словами

*Целое — больше чем сумма его частей.

— Аристотель (384 д.н.э — 322 д.н.э)*

```

>>> person = ("Steve", 23, "male", "London")

>>> print("{} is {}, {} and lives in {}.".format(person[0], person[1], person[2], person[3]))

Steve is 23, male and lives in London.

>>> person = ("male", "Steve", 23, "London") #different tuple, same code

>>> print("{} is {}, {} and lives in {}.".format(person[0], person[1], person[2], person[3]))

male is Steve, 23 and lives in London.

>>>

```

Индекс в кортеже несет смысловую нагрузку. Давайте сравним эти структуры:

```

>>> foo = 2011, 11, 3, 15, 23, 59

>>> foo

(2011, 11, 3, 15, 23, 59) # tuple

>>> list(range(9))

[0, 1, 2, 3, 4, 5, 6, 7, 8] # list

>>>

```

* Первая из них, кортеж, представляет собой структуру, где позиция элемента несет некий смысл (Первый элемент — год).

* Вторая же, список, представляет собой последовательность, в которой значения функционально равнозначны, индекс не несет никакого смысла.

Отличный пример использования обоих структур – метод fetchmany() из Python DB API, который возвращает результат как список кортежей.

#### Классы не предназначены для группировки функциональности

C# и Java содержат код только внутри классов. В итоге возникают утилитарные классы, содержащие одни статические методы. Например, математическая функция *sin()*. В Python мы просто используем модуль верхнего уровня:

```

sa@wks:/tmp$ echo -e 'def sin():\n pass' > foo.py; cat foo.py

def sin():

pass

sa@wks:/tmp$ python

>>> import foo

>>> foo.sin()

>>>

```

#### Скажите нет геттерам и сеттерам

Способ достичь инкапсуляции в Python – использование свойств, а не геттеров и сеттеров. Используя свойства, мы можем изменить атрибуты объекта и исправить реализацию, не затрагивая вызываемый код (читайте, stable API).

#### Функции являются объектами

В Python – все является объектами. Функции тоже объекты. Функции – это объекты, которые можно вызывать.

```

>>> somefoo = [{'price': 9.99}, {'price': 4.99}, {'price': 10}]

>>> somefoo

[{'price': 9.99}, {'price': 4.99}, {'price': 10}]

>>> def lookup_price(someobject):

... return someobject['price']

...

...

>>> somefoo.sort(key=lookup_price) # pass function object lookup_price

>>> somefoo

[{'price': 4.99}, {'price': 9.99}, {'price': 10}] # in-place sort of somefoo took place

>>> type(somefoo)

>>> type(somefoo[0])

>>>

```

Между *lookup\_price* и *lookup\_price()* существует разница — последнее вызывает функцию, а первое смотрим биндинг по имени *lookup\_price*. Это дает нам возможность использовать функции в роли обычных объектов. | https://habr.com/ru/post/114731/ | null | ru | null |

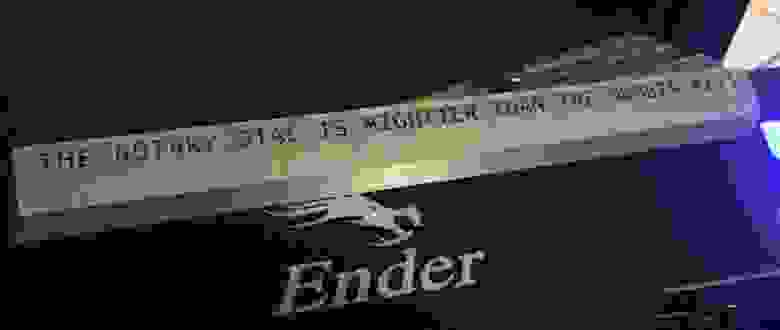

# Совмещая несовместимое: клавиатура с дисковым номеронабирателем

А вы ностальгируете по старым дисковым телефонам? Некоторые люди настолько не могут без них жить, что прикрутили телефонный номеронабиратель к современной клавиатуре. Почему бы и нет, в самом деле?

### Прошивка

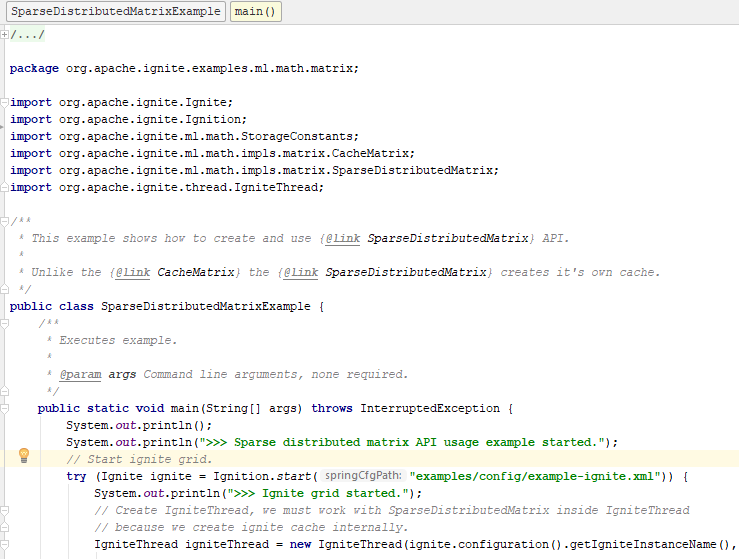

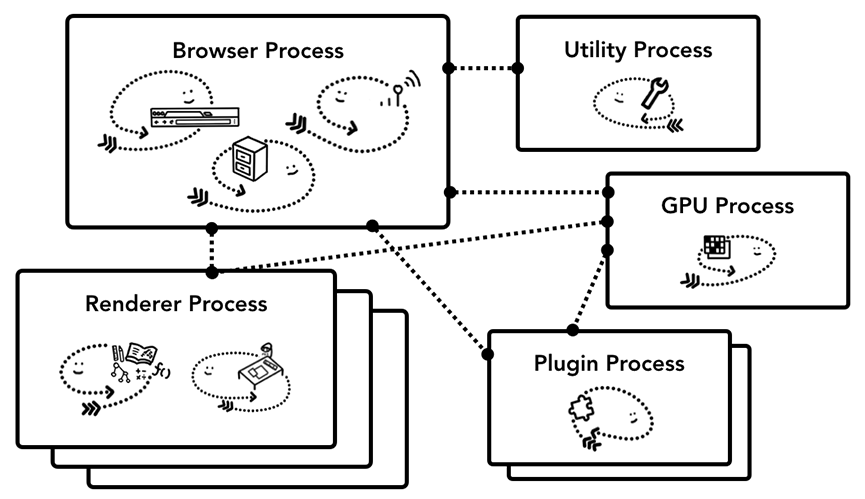

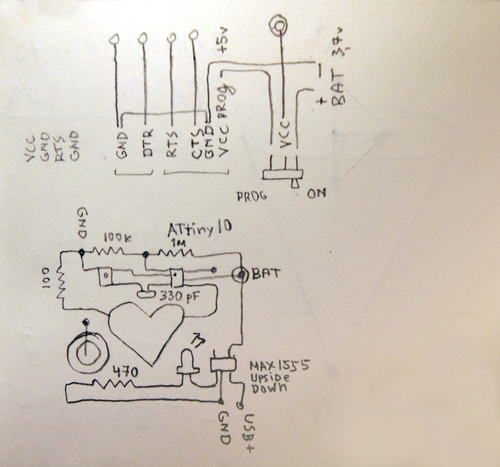

Идея в том, чтобы сделать красиво и функционально. Чтобы с помощью диска действительно можно было вводить цифры. Ещё планировалось удалить числовой ряд клавиатуры, чтобы вместо него поворотный диск работал.

Поворотный диск имеет две основные пары контактов. Одна размыкается, когда диск перемещается на 1 позицию, а другая создаёт характерную серию импульсов при отпускании (один импульс на числовую позицию). Можно было бы использовать прерывание при смене контакта, но шкала времени настолько велика, что ожидание получается приемлемым. Я использовал DFRobot Beetle, так как его встроенный ATMega32u4 имеет родной USB HID.

```

while (digitalRead(ACTIVE)) // Active-low

{

int count = 0;

while (!digitalRead(ACTIVE))

{

if (digitalRead(PULSE))

{

count += 1;

delay(50);

}

}

if (count >= 2)

{

count /= 2;

count = (count == 10) ? 0 : count;

Keyboard.print(count);

}

}

```

Кажется, что каждый импульс считывается дважды. Пожалуй, я должен был тщательно его изучить на наличие проблем, но он и так работает вполне адекватно. (В моей первой попытке была задержка всего 10 мс, что эмпирически привело к семикратному считыванию каждого импульса).

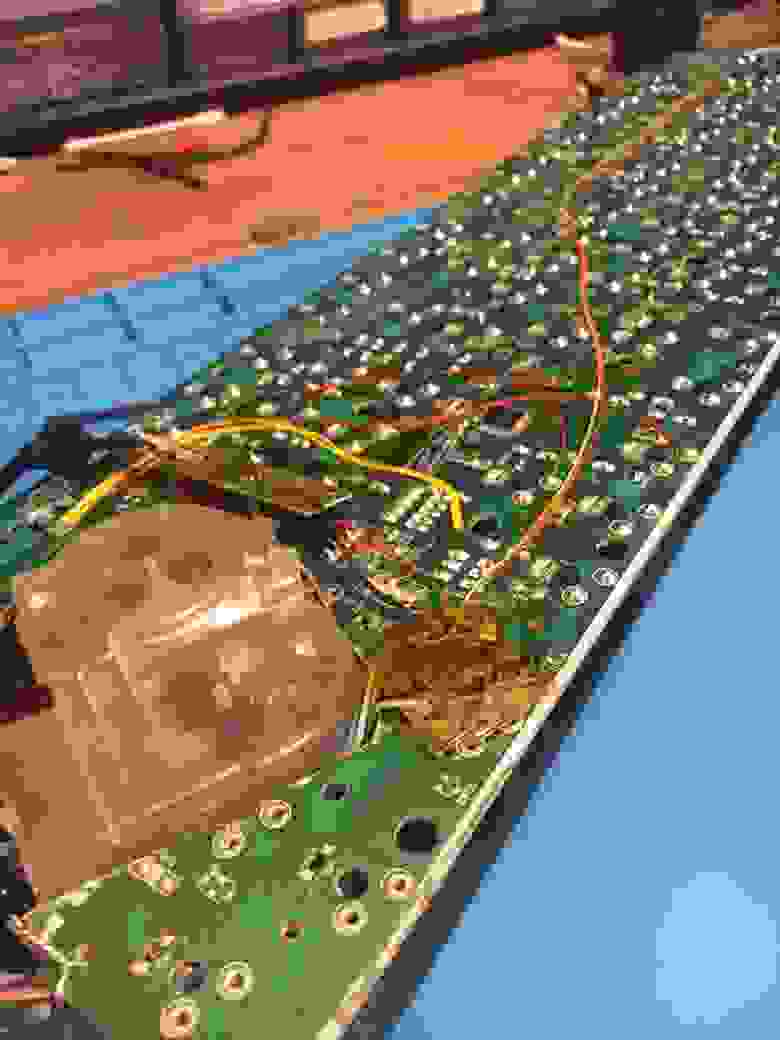

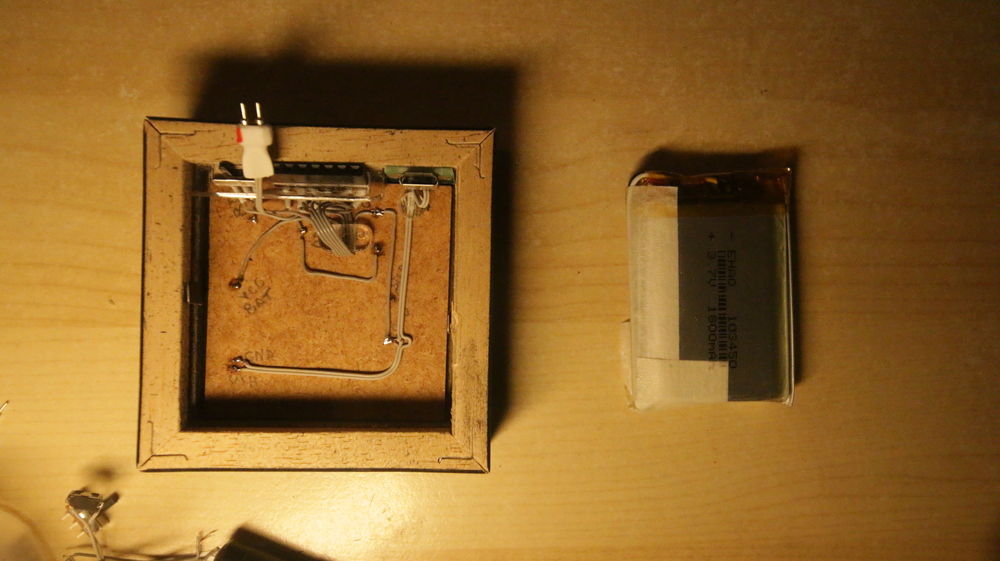

### Электрика

Для питания этой клавиатуры нужны два кабеля: один для Arduino и один для оригинального контроллера клавиатуры. Меня больше устраивал такой вариант: вставить концентратор USB в клавиатуру, припаяв к нему Arduino и контроллер.

Это позволило мне припаять встроенный USB-порт клавиатуры к восходящему соединению концентратора. Таким образом, когда я подключаю свой самодельный USB-концентратор к компьютеру, сохраняется иллюзия USB-устройства с одним кабелем.

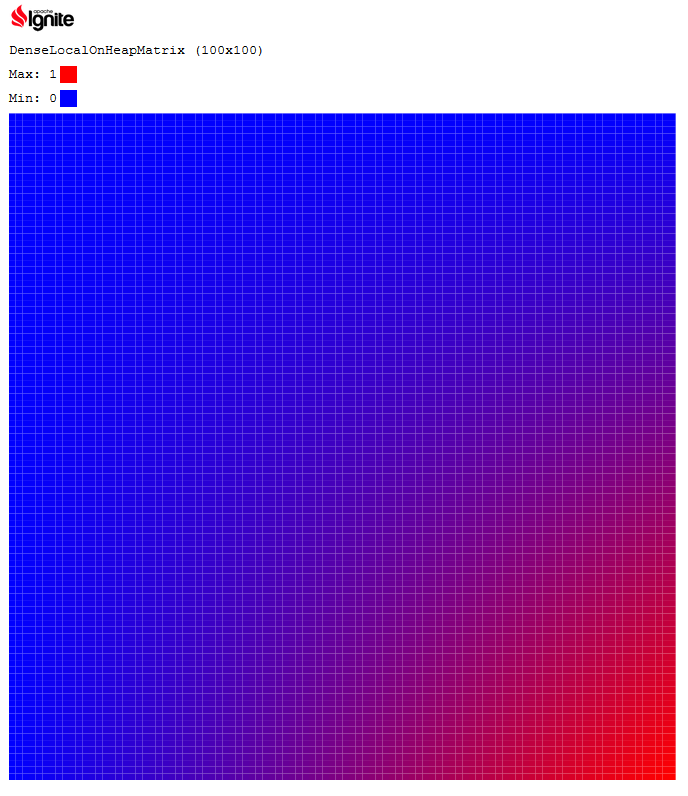

Самый дешевый концентратор с удобным форм-фактором, который я смог найти, был этим дурацким зверем с тремя портами:

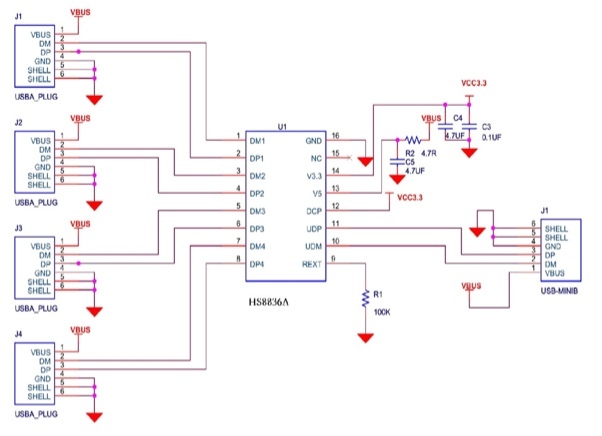

Интересно, что верхний порт концентратора действительно совместим с SuperSpeed: пары SSRX+/- и SSTX+/- представляют собой полностью независимый интерфейс от D+/-пары, используемой для Full-Speed или High-Speed USB, и поэтому могут быть направлены непосредственно на порт без промежуточного узла.

Чип, выполняющий всю тяжелую работу в этом концентраторе, является монолитным HS8836A, который предположительно рассчитан на высокоскоростной USB-трафик и имеет впечатляюще малое количество вспомогательных компонентов.

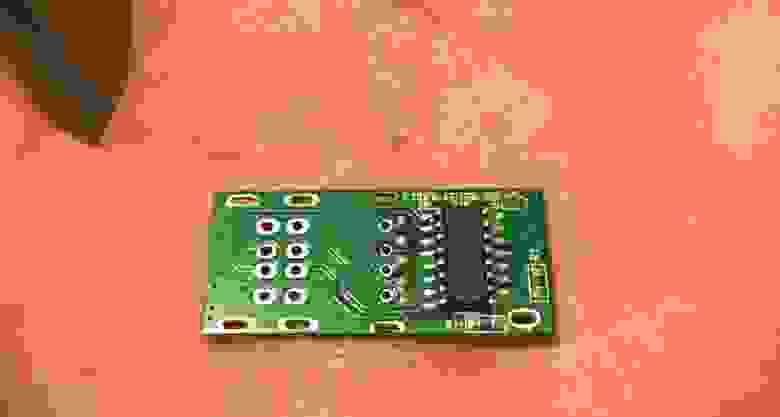

В моём случае нужно было просто аккуратно отпаять существующие порты, чтобы не расплавить микросхему концентратора и подключить USB-сигналы от клавиатуры и Arduino. Обратите внимание, насколько компактна эта плата благодаря HS8836A:

Для подключения данных к Arduino я использовал несколько экранированных дифференциальных линий от проводов дисплея LVDS iMac, потому что они очень удачно валялись среди прочего хлама. Подозреваю, что импеданс полностью выключен, но USB 1.1 удивительно надёжен.

### Клавиатура

Чтобы заменить цифровой блок клавиатуры на поворотный диск, мне пришлось удалить все переключатели для неё. Это было легко, так как данная клавиатура имеет одностороннюю печатную плату, а моя присоска для пайки весьма удобна.

Можно было бы разместить основание циферблата поверх печатной платы, но в этом случае сам циферблат находился бы очень высоко.

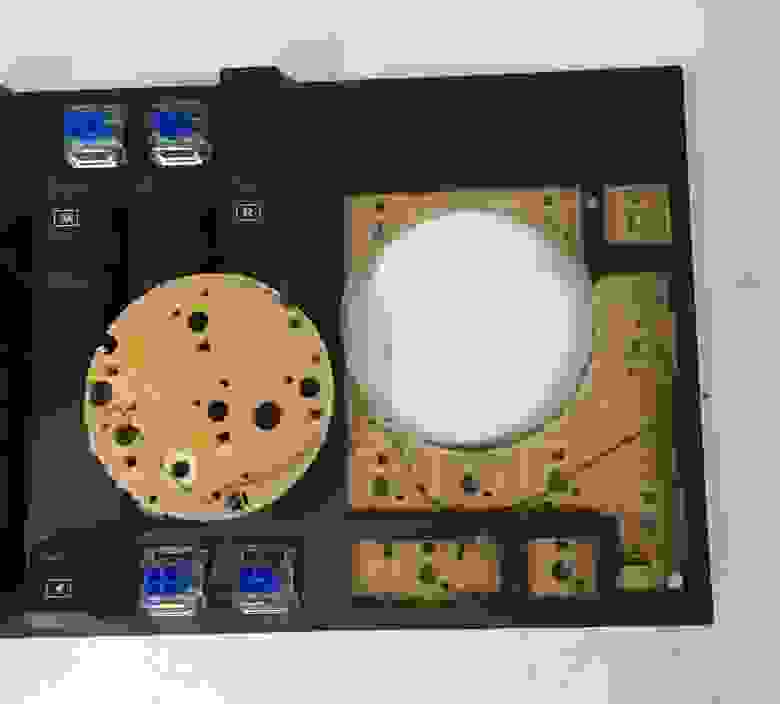

Потом я понял, что если сделать прорезь под циферблат, то получится расположить его на уровне клавиш, как показано ниже:

Это влечет за собой прорезание дорожек в нижней части печатной платы. Они позволяют клавиатуре сканировать все клавиши, чтобы определить, какие из них были нажаты. Я потратил много времени, исследуя дорожки мультиметром и делая перемычки для их замены.

Из-за моей неосторожности пришлось ещё немного потрудиться - когда я подключил плату, то понял, что сломал кластер клавиш со стрелками. Забавный факт: матрица клавиатуры на этой плате также используется для индивидуального включения светодиодов, поэтому, если клавиатура не может подсветить какую-то клавишу, она также не сможет ее прочитать.

После обработки клавиатуры кольцевой пилой, осциллирующим резаком и дремелем мне удалось прикрепить диск к остаткам клавиатурной платы.

Закончив работу с проводкой USB, я убедиться, что ещё не сжёг ничего важного (обратите внимание, что индикаторы клавиатуры горят — это указывает на то, что, по крайней мере, питание подаётся).

### 3D-печать

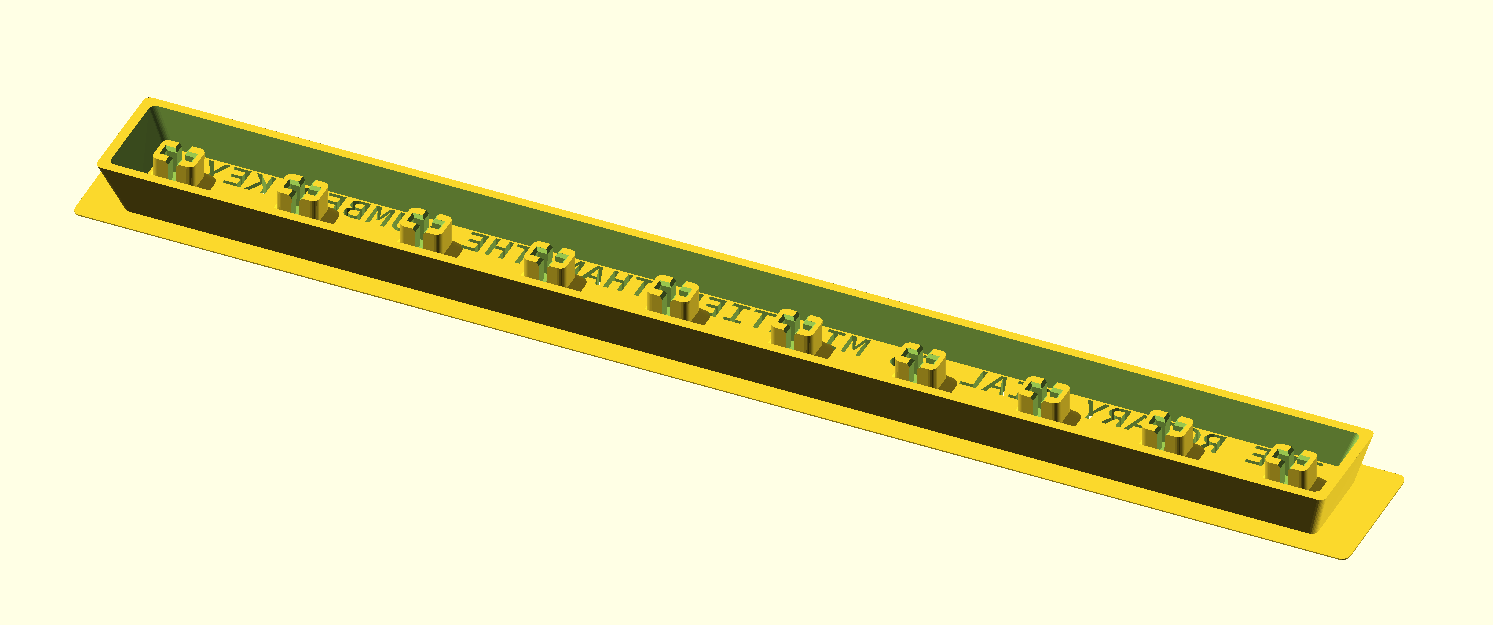

Я решил напечатать на 3D-принтере кожух, чтобы скрыть внутренности циферблата. Всё же мне не хотелось получить совсем уж ужасное детище.

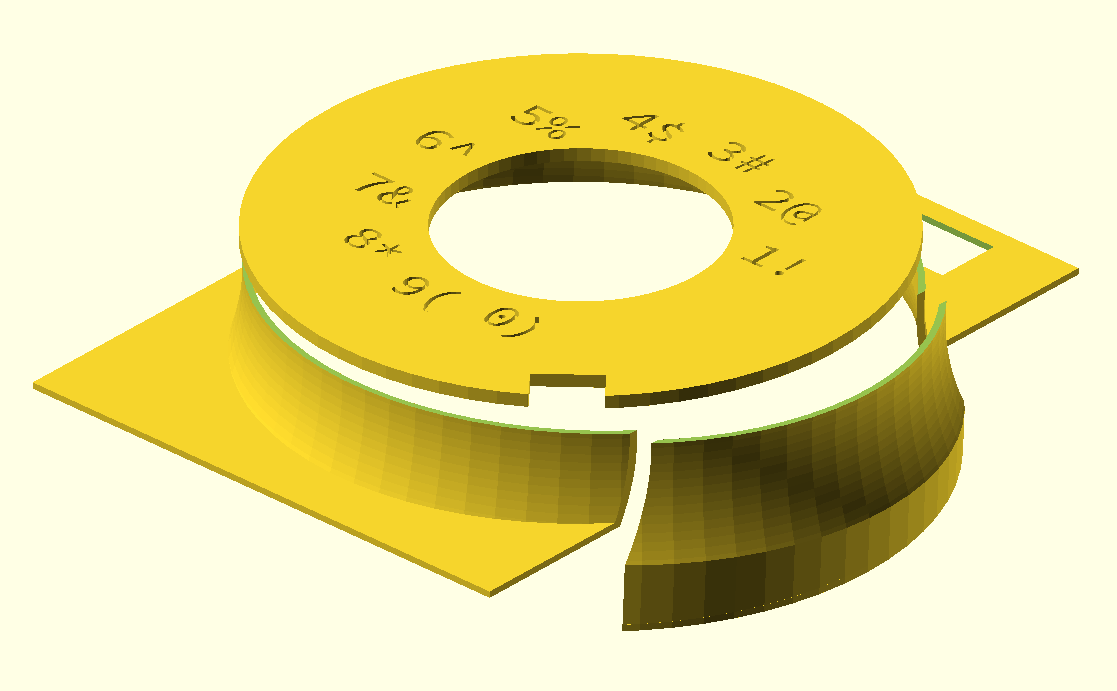

Раньше я ничего не проектировал в 3D CAD, так что пришлось чуть-чуть изучить OpenSCAD - ровно настолько, чтобы все мои друзья-механики с криками разбежались. На самом деле этого было достаточно, чтобы спроектировать базу с цифрами, которая будет крепиться на основание клавиатуры.

Мне кажется, очень здорово иметь функционально определённый язык для создания твёрдых предметов. В любой момент можно немного поменять настройки и параметры, не переделывая всё заново.

(По иронии судьбы я умудрился потерять файл OpenSCAD, поэтому итоговый рендеринг был сделан путём импорта STL в OpenSCAD).

Нужный результат получился не сразу, но в итоге у меня всё получилось с помощью функции экспорта SVG OpenSCAD и многократной печати объекта до получения нужного угла наклона.

Конечно, окончательная напечатанная деталь все ещё была немного смещена, и мне пришлось вырезать в ней выемку, чтобы получить правильный угол.

Кроме того, пришлось немного подрезать металл основания поворотного диска, но после небольшой шлифовки у меня получилось собрать всё вместе. Я использовал сварку трением с перемешиванием, чтобы соединить все три детали вместе, вставив кусок нити в свой дремель и проведя им по швам. Это значительно сложнее, чем кажется, и в тот момент я зауважал людей, которые делают это в промышленных масштабах из нержавеющей стали, например, для топливных баков ракеты SLS.

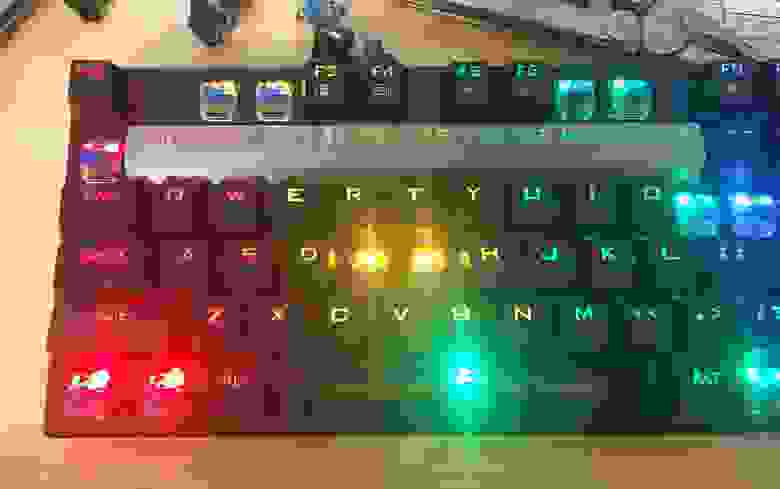

Параметрический колпачок

------------------------

Просто выдрать из клавиатуры числовой ряд, чтобы принудительно использовать вместо него поворотный диск, было бы достаточно забавно, но я решил, что будет интереснее напечатать специальный колпачок для клавиатуры 10U, который бы соответствовал профилю существующих клавиш и позволял светодиодам просвечивать сквозь себя. Это стало возможным благодаря невероятному [генератору параметрических клавиш](https://github.com/rsheldiii/KeyV2) для OpenSCAD, который я нашёл на GitHub.

```

include <./includes.scad>

$stem_positions = [[19.05*-4.5,0], [19.05*-3.5,0], [19.05*-2.5,0], [19.05*-1.5,0], [19.05*-0.5,0], [19.05*0.5,0], [19.05*1.5,0], [19.05*2.5,0], [19.05*3.5,0], [19.05*4.5,0]];

$inset_legend_depth = 3;

$font="Source Code Pro:style=Semibold";

oem_row(1) upside_down() u(10) dishless() legend("THE ROTARY DIAL IS MIGHTIER THAN THE NUMBER KEYS", [0, -0.8], 4.5) key();

```

Из-за того, что Cura пасует, когда дело доходит до объектов с внутренними вырезами, мне пришлось вручную определить края, чтобы крышка клавиатуры не отслаивалась. Да, проекции OpenSCAD ужасно требовательны к вычислительным ресурсам, но есть лучший способ сделать это:

```

difference() {

scale([1.07, 1.5])

linear_extrude(height=0.2)

projection(cut=true) oem_row(1) u(10) upside_down() dishless() key();

linear_extrude(height=0.2)

projection(cut=true) oem_row(1) u(10) upside_down() dishless() key();

};

```

После того, как я установил стабилизирующие клавишные переключатели, я наклеил кусок липкой ленты поверх колпачка клавиш и залил туда остатки суперклея, чтобы заполнить вырезы. Двумя днями позже клей полностью застыл.

Пожалуй, разумнее было бы нанести несколько тонких слоёв, так как суперклей затвердевает под воздействием влаги, и поэтому нижняя часть, та, что ближе к верхней части колпачка, сохла слишком долго.

Да, он действительно печатает “the rotary dial is mightier than the number keys” (поворотный диск мощнее, чем цифровые клавиши) при нажатии. Я подключил все три переключателя, поддерживающие колпачок клавиатуры, параллельно и подключил их к неиспользуемому входному контакту на Arduino.

Окончательная сборка

--------------------

Мой кожух пришлось приклеить горячим клеем к клавиатуре, который также намертво зафиксировал кучу винтов, скрепляющих клавиатуру. Хорошо, что у меня никогда не будет ошибок в проводке, так ведь? ….Никогда не будет, да?

Ну, я нечаянно обрезал одну из дорожек для клавиши со стрелкой вниз. Не представляю, как это могло произойти. Хотя я утверждаю, что vimkeys должно быть достаточно, нефункциональные клавиши немного смущают, особенно когда клавиатура заклеена.

Я решил эту проблему с помощью отрезного колеса на дремеле. Я разрезал заднюю часть клавиатуры под клавишей со стрелкой вниз и рядом с Arduino, что позволило мне выловить провода от этой клавиши к Arduino и заодно проникнуться уважением к чувакам, которые строят корабли в бутылке. Благодаря одностороннему характеру печатной платы клавиатуры было нетрудно изолировать ножки переключателя от схемы клавиатуры с помощью припоя и термоусадки.

Другая проблема была хуже: я принёс клавиатуру в офис коллеги, пока он был на обеденном перерыве, но подключил его к KVM. К сожалению, KVM прослушивает только HID-устройства, такие как клавиатуры и мыши, а это означает, что мой умный USB-концентратор посередине не был распознан, и, следовательно, клавиатура вообще не работала. Как стыдно…

Реакция коллег была очень разной. От “это действительно работает?” до “господи, неужели у кого-то НАСТОЛЬКО много свободного времени”?

А вот ещё картинки чудо-устройства:

А вы что скажете?

---

#### Что ещё интересного есть в блоге Cloud4Y

→ [Информационная безопасность и глупость: необычные примеры](https://habr.com/ru/company/cloud4y/blog/696078/)

→ [NAS за шапку сухарей](https://habr.com/ru/company/cloud4y/blog/703540/)

→ [Как распечатать цветной механический телевизор на 3D-принтере](https://habr.com/ru/company/cloud4y/blog/668962/)

→ [Создание e-ink дисплея с прогнозом погоды](https://habr.com/ru/company/cloud4y/blog/699638/)

→ [Аналоговый компьютер Telefunken RA 770](https://habr.com/ru/company/cloud4y/blog/701274/)

Подписывайтесь на наш [Telegram](https://t.me/cloud4y)-канал, чтобы не пропустить очередную статью. Пишем только по делу. А ещё напоминаем про второй сезон нашего сериала ITить-колотить. Его можно посмотреть на [YouTube](https://youtu.be/8arneYYzsJw)и [ВКонтакте](https://vk.com/video/playlist/-114833493_1). | https://habr.com/ru/post/708154/ | null | ru | null |

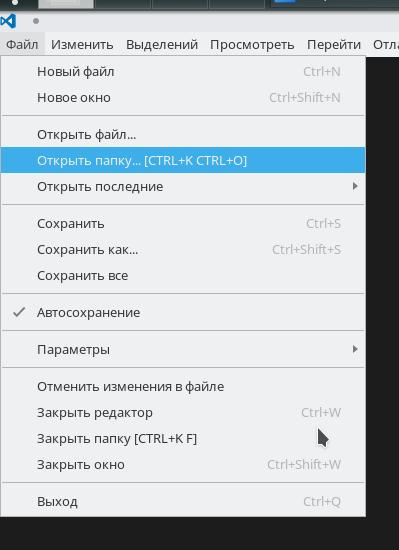

# Slackware. Утилита Src2pkg или как не сделать из слаки свалку

Рано или поздно любой начинающий линуксоид столкнется с необходимостью собирать программу из исходников. Причины на это могут быть самые разные, начиная от спортивного интереса и заканчивая самописной/самоисправленной программой.

Набрав в гугле «как собрать программу из исходников» начинающий линуксоид сразу наткнется на известную мантру:

`./configure

make

make install`

Вот таким вот образом система и превращается в помойку. Вот поставили вы таким образом сотню программ, а теперь попробуйте-ка удалить 50 из них. В лучшем случае вам поможет скачка той же версии исходников, что и установленная программа, ./configure с теми же параметрами, make и только затем make uninstall, и то если разработчик позаботился о деинсталляции своего творения. В худшем случае-ползайте по всем папкам вашей системы и вычищайте руками все файлы, связанные с программой.

И тот, и другой способ нудные, долгие и с кучей нюансов. Поэтому мы будем изучать другой способ установки программ, на примере ОС Slackware 13.

Итак. Для начала спешу всех слаководов обрадовать (и огорчить слаконенавистников). **Менеджер пакетов в слаке есть, был и будет есть**.