text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

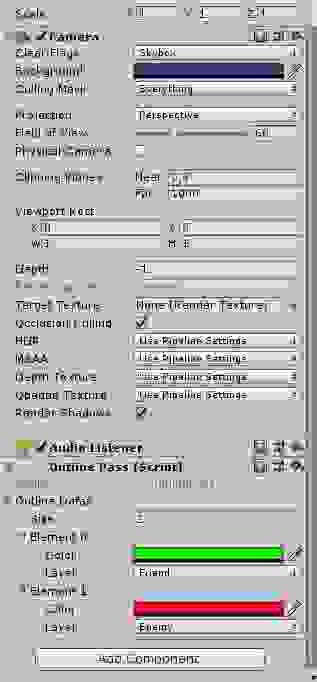

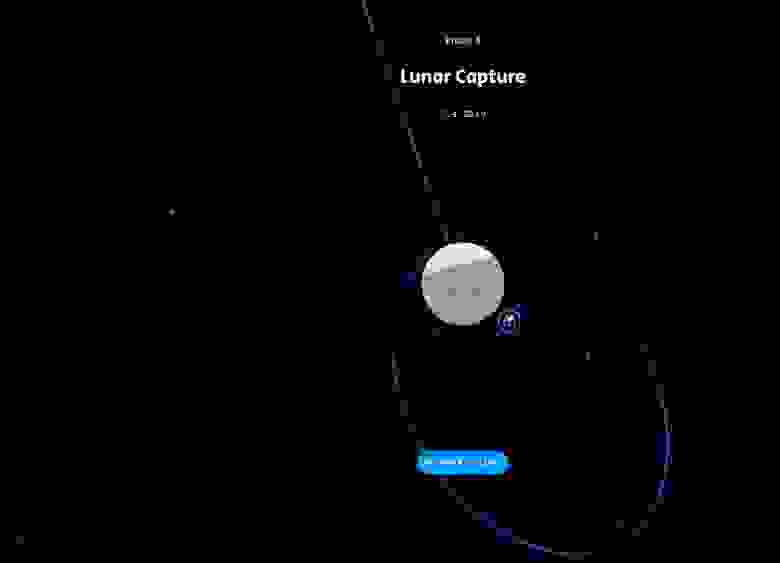

# MEDIAPIPE – AI инструмент для Computer vision

Не секрет, что задача по поиску человека на видео или фото всегда была актуальна. Но что если один инструмент объединяет в себе, помимо просто детектирования человека, еще и поиск полной маски человеческого лица, расположение рук и пальцев, да и вообще полностью позу человека? Именно такой open-source инструмент создала всем известная компания google.

Mediapipe уже довольно активно, а главное, эффективно используется для детектирования многочисленных лиц на фото, для обучения моделей распознавания эмоций, для качественного выполнения упражнений при занятиях спортом, для преобразования языка жестов в письменный язык и много другое!

Я же хочу поделиться с вами своим опытом изучения инструмента mediapipe. И для начала покажу вывод, где вы сможете наблюдать работу трех моделей: нахождения рук, нахождения точек лица, определения позы человека и, в конце концов, все вместе.

Итак, чуть подробнее о каждом инструменте.

——- Код для запуска Hand Detection с настройками ——-

```

import cv2

import numpy as np

import mediapipe as mp

import time

import os

# Подключаем камеру

cap = cv2.VideoCapture(0)

cap.set(3, 640) # Width

cap.set(4, 480) # Lenght

cap.set(10, 100) # Brightness

mpHands = mp.solutions.hands

hands = mpHands.Hands(False)

npDraw = mp.solutions.drawing_utils

pTime = 0

cTime = 0

#Зацикливаем получение кадров от камеры

while True:

success, img = cap.read()

img = cv2.flip(img,1) # Mirror flip

imgRGB = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

results = hands.process(imgRGB)

if results.multi_hand_landmarks:

for handLms in results.multi_hand_landmarks:

for id, lm in enumerate(handLms.landmark):

h,w,c = img.shape

cx, cy = int(lm.x*w), int(lm.y*h)

# print(id, lm)

if id == 8 or id == 12:

cv2.circle(img, (cx,cy),10,(255,0,255),cv2.FILLED)

npDraw.draw_landmarks(img, handLms, mpHands.HAND_CONNECTIONS)

cTime = time.time()

fps = 1/(cTime-pTime)

pTime = cTime

cv2.putText(img, str(int(fps)),(10,30), cv2.FONT_HERSHEY_PLAIN, 2, (255,0,0), 2) # ФреймРейт

cv2.imshow('python', img)

if cv2.waitKey(20) == 27: # exit on ESC

break

cv2.destroyWindow("python")

cap.release()

cv2.waitKey(1)

```

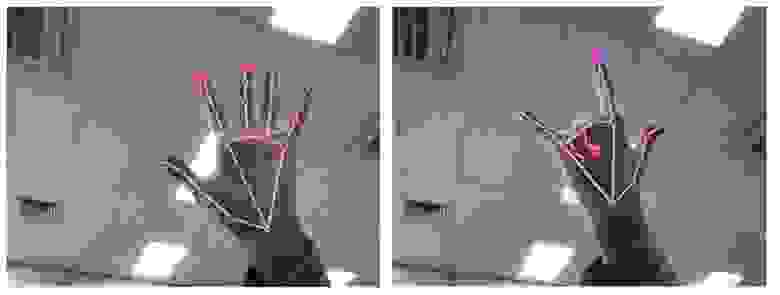

**Hand Detection**

Собственно, вся суть заключается в поиске 3 значений в пространстве для каждый из 21 точки руки.

Зная точное расположение этих точек, можно строить различные модели. Само же детектирование руки можно крайне гибко настраивать – от минимальной и максимальной точности для определения рук до количества рук на кадре. На снимках выше можно заметить выделенные точки на двух пальцах (это я добавил выделение с помощью cv) и, что очень важно, крайне хорошо найдены точки скрытых пальцев.

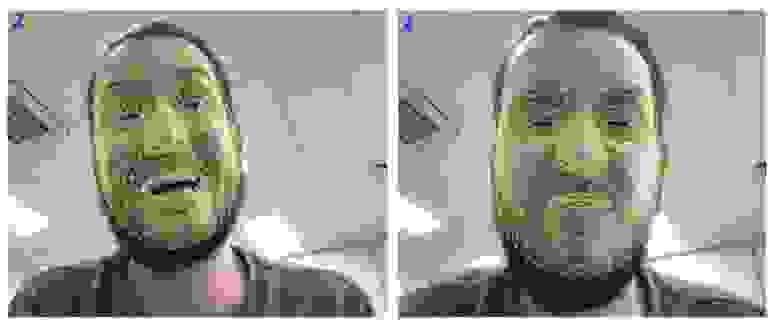

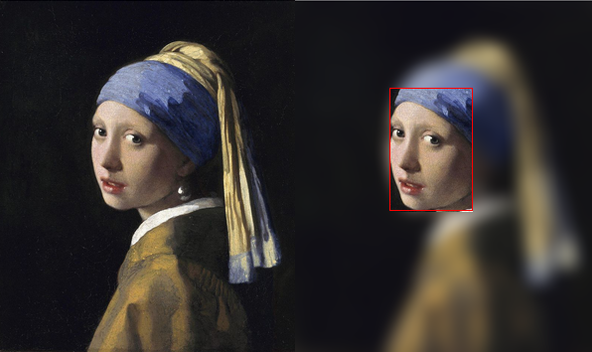

**Face Mesh**

Как говорится – результат на лицо! Суть работы ровно такая же- найти 3 координаты в пространстве определенных точек. Только теперь не на руках, а на лице человека, и самих точек не 21, а 468! Именно с подобной технологией делаются все, полюбившиеся пользователями Instagram, маски. Но на одних развлечениях сценарии использования точно не кончаются.

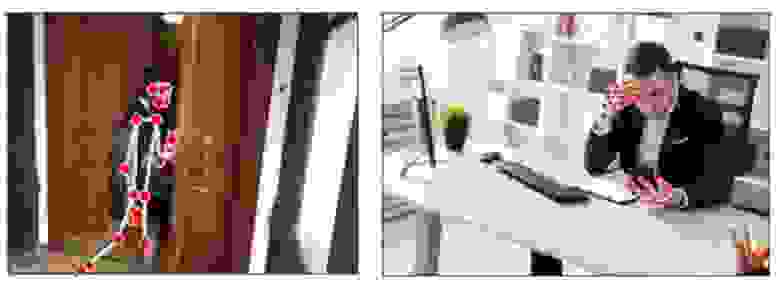

**Poseestimation + Holistic**

Я думаю, что принцип поиска позы вам уже ясен! 33 точки по всему телу (на снимке без ног) в трехмерном пространстве. Бонусом я запустил сразу 3 модели одновременно.

——- Код для запуска всех модулей одновременно ——-

```

import cv2

import numpy as np

import mediapipe as mp

import time

import os

# Подключаем камеру

cap = cv2.VideoCapture(0)

cap.set(3, 640) # Width

cap.set(4, 480) # Lenght

cap.set(10, 100) # Brightness

mp_drawing = mp.solutions.drawing_utils

mp_holistic = mp.solutions.holistic

pTime = 0

cTime = 0

#Зацикливаем получение кадров от камеры

while True:

with mp_holistic.Holistic(min_detection_confidence=0.5, min_tracking_confidence=0.5) as holistic:

ret, frame = cap.read()

# Recolor Feed

image = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

# Make Detections

results = holistic.process(image)

# print(results.face_landmarks)

# face_landmarks, pose_landmarks, left_hand_landmarks, right_hand_landmarks

# Recolor image back to BGR for rendering

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

# Draw face landmarks

mp_drawing.draw_landmarks(image, results.face_landmarks, mp_holistic.FACEMESH_TESSELATION,

mp_drawing.DrawingSpec(color=(80,110,10), thickness=1, circle_radius=1),

mp_drawing.DrawingSpec(color=(80,256,121), thickness=1, circle_radius=1)

)

# Right hand

mp_drawing.draw_landmarks(image, results.right_hand_landmarks, mp_holistic.HAND_CONNECTIONS)

# Left Hand

mp_drawing.draw_landmarks(image, results.left_hand_landmarks, mp_holistic.HAND_CONNECTIONS)

# Pose Detections

mp_drawing.draw_landmarks(image, results.pose_landmarks, mp_holistic.POSE_CONNECTIONS)

cTime = time.time()

fps = 1/(cTime-pTime)

pTime = cTime

cv2.putText(image, str(int(fps)),(10,30), cv2.FONT_HERSHEY_PLAIN, 2, (255,0,0), 2) # ФреймРейт

cv2.imshow('python', image)

if cv2.waitKey(1) == 27: # exit on ESC

break

cv2.destroyWindow("python")

cap.release()

cv2.waitKey(1)

```

Давайте рассмотрим на более конкретных примерах:

С целью безопасности важно не допускать неквалифицированных работников в серверную или клиентов в рабочую зону. C данным инструментом от google мы сможем уберечься от подобных ситуаций.

Конечно же использование телефона в рабочее время — крайне нежелательно. Уже научно доказано, что постоянное наличие телефона в руках плохо сказывается на производительности сотрудника. К тому же, бывают случаи, когда сотрудникам недопустимо брать телефоны клиентов в руки. С mediapipe можем проверить и это.

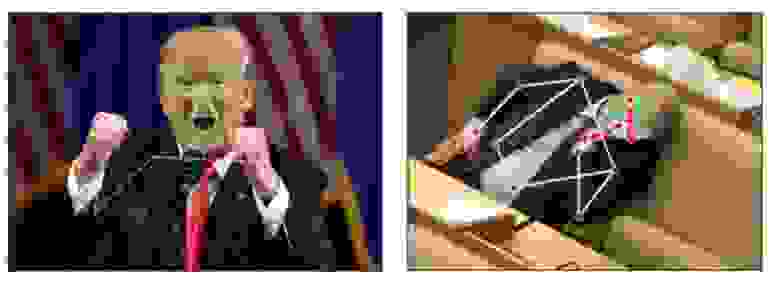

Как определить насколько приятным оказалось общение клиента с менеджером? С mediapipe мы без проблем можем разобрать различные эмоции.

Никакому работодателю не понравится, когда работник спит в течении рабочего дня. Но не всегда есть время и возможность следить за этим. Теперь мы с легкостью можем идентифицировать спящего человека по позе и закрытым глазам.

Собственно, я вам показал только малую часть того, что на самом деле умеет mediapipe – на все не хватило бы и десятка статей! Но поверьте, разбираться в данном инструменте- крайне интересно! А если вы ведете разработку на android или владеете с++, тогда вам открыты еще больше функций mediapipe:

* Расположение зрачков глаз

* Сегментация волос

* Выделение границ объектов в 3D кубе

* Детектирование различных объектов

* Следование камеры за движением объекта

И многое другое!

Кроме того, что у данного инструмента огромное количество различных сценариев применения (а учитывая, что различные функции можно комбинировать- еще больше!), его метрики качества очень даже хороши. Да еще и запускается mediapipe без GPU. Чтобы убедиться в правильности работы, вам обязательно нужно попробовать самим “поиграться” с данным инструментом!

[Ссылка](https://codepen.io/mediapipe/pen/RwGWYJw) не моя, но как обзор возможностей – идеально.

Ну и сама [документация](https://google.github.io/mediapipe/) со всеми примерами и бейзлайнами.

А дальше все ограничивается лишь вашей фантазией!) | https://habr.com/ru/post/596043/ | null | ru | null |

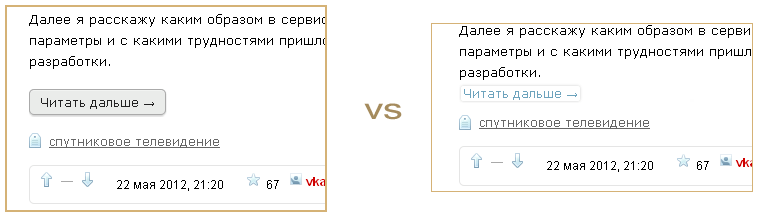

# Как создать идеальный Pull Request

С ростом компании меняются люди и проекты. Не так давно в блоге GitHub появилась интересная статья, в которой автор рассказывает, как делать, а как лучше не делать Pull Request’ы. Перевод, традиционно, спрятан под катом.

### **Правильный подход к написанию Pull Request**

* Четко определите **назначение** этого pull request. Например:

```

Упрощение отображения…

Исправление обработки…

```

* Будет хорошо, если вы включите краткое описание зачем вообще делалась эта работа (включая релевантные ссылки). Не стоит рассчитывать, что читающий реквест разработчик будет знаком со всей историей.

* Имейте в виду, что этот реквест потенциально может читать любой сотрудник компании. Возможно, через год.

* Явно пишите, какую реакцию вы ожидаете в ответ на этот реквест. Хотите ли вы от читающего что-то, кроме merge? Просто посмотреть на код, оценить техническую реализацию, критика дизайна, ревью текста и так далее.

* Явно указывайте **когда** вы ожидаете ответ. Если реквест в процессе работы, то общепринятой практикой является добавление префикса “[WIP]” (work in progress) к его описанию. Это позволит читающим отгрузить вам ранние комментарии, при этом понимая, что они смотрят не на законченную работу.

* @Упоминайте тех, кого вы хотели бы видеть в обсуждении реквеста. И упоминайте почему, для этого есть специальный синтаксис:

```

/cc @jesseplusplus for clarification on this logic

```

* @Упоминать можно не только разработчиков, но и команды. То же относится к причинам, что и зачем вы хотите с ними обсудить:

```

/cc @github/security, any concerns with this approach?

```

### **Реакция на чужой pull request**

* Постарайтесь изучить контекст, в котором случился этот Pull Request: связанные задачи, обсуждения, история вопроса. Если все это есть, конечно.

* Если Pull Request вызывает у вас инстинктивную негативную реакцию – возьмите тайм-аут в несколько минут и еще раз все внимательно осмотрите. Возможно, автор не идиот у вас просто случилась ошибка коммуникации. Такое встречается на удивление часто.

* Спрашивайте, а не предлагайте. Простой и эффективный психологический трюк для облегчения коммуникаций. Фраза «Что ты думаешь насчет использования…?» гораздо меньше провоцирует на конфликт, нежели «~~убей себя~~ не делай так».

* Старайтесь объяснять, почему необходимо поменять код (противоречит [стилю кодирования](https://github.com/github/swift-style-guide)? Персональное предпочтение?)

* Предлагайте пути упростить и улучшить код. Это воспринимается намного лучше, чем просто критика «все плохо».

* Кстати, о критике. Старайтесь избегать оценок вроде «глупо» по отношению к чужой работе. Очень хорошо помогает наладить коммуникации.

* Скромнее надо быть. Для дела надо – «не уверен, но давай попробуем…» помогает найти общий язык намного лучше, чем «я 20 лет этим занимаюсь. Делай вот так и не спрашивай почему».

* Избегайте гипербол («НИКОГДА не делай…»). Все их воспринимают совсем по-разному.

* Ставьте своей целью развитие профессиональных качеств, знаний компании и увеличения качества продукта. Звучит заезжено? Да, но обычно ставят цель потешить свое самолюбие за счет критики.

* Учитывайте «negative bias» онлайн коммуникаций (для нейтрального содержания мы всегда предполагаем негативный тон). Чтобы не расставлять по тексту смайлики, можно воспользоваться «позитивным» языком.

* Если «позитивный» язык использовать трудно (журналисты много лет этому учатся не просто так), то на помощь приходят… эмодзи, как это ни странно. Сравните: ":sparkles: :sparkles: Looks good :+1: :sparkles: :sparkles:” и “Looks good”.

### **Чужая реакция на ваш pull request**

* По возможности начинайте ответ со слов благодарности, особенно если реакция на ваш реквест противоречива.

* Если что-то не понятно – не стесняйтесь задавать уточняющие вопросы («I don’t understand, can you clarify?»). Это намного эффективнее, чем пытаться самому «придумать» что имел в виду другой разработчик.

* Сами старайтесь предоставлять всю уточняющую информацию и рассказывать о причинах тех или иных решений в коде.

* Старайтесь отвечать на каждый комментарий.

* Линкуйте коммиты и другие пулл реквесты («Good call! Done in 1682851”)

* Если обсуждение начало перерастать в дебаты, остановитесь и спросите себя, имеет ли смысл продолжать диалог в письменной форме. Практика показывает, что в большинстве случаев гораздо удобнее обсудить все в скайпе или другом голосовом чате, а затем дописать в виде текста только краткую выжимку и результат обсуждения.

На написание поста меня вдохновил вот этот [guide](https://github.com/thoughtbot/guides/tree/master/code-review). Я описал приемы, которые мы используем в свой работе и та культура, которой мы стараемся придерживаться. Надеемся, что вы найдете среди них что-нибудь полезное.

Успешных коммуникаций! | https://habr.com/ru/post/279703/ | null | ru | null |

# Всем по сообщению

В сегодняшних веб-приложениях часто требуется выдать посетителю некоторое оповещение. Будь то «Ваш комментарий сохранён и ожидает модерации» или же «Благодарим за проявленный интерес, мы обязательно вышлем Вам приглашение, как только откроемся», эти небольшие сообщения появляются то тут, то там постоянно, так что весьма здорово иметь удобный интерфейс для отображения их пользователю.

Идущее в поставке с Django приложение аутентификации и авторизации (django.contrib.auth) всегда включало базовый функционал для отображения всплывающих сообщений пользователю, но он имел несколько досадных недостатков. В Django 1.2 же теперь есть совершенно новый фреймворк для таких сообщений, написанный в первую очередь Тобаясом Макналти (Tobias McNulty).

#### Так что же было не так со старым способом?

Поскольку старая система сообщений является частью django.contrib.auth, вы должны подключить это приложение, чтобы воспользоваться малой его частью, отвечающей за оповещения. Но бывает, что вам не нужны аутентификация и авторизация, но нужны эти маленькие сообщения. Или, возможно, вы используете своё собственное приложение аутентификации. Или же, наоборот, вы используете django.contrib.auth, но вам не нужны сообщения. В Django 1.2 у вас наконец появилась возможность для всего этого.

Кроме того, старая система хранит сообщения в базе данных. И хоть это и нормально для многих проектов, всё-таки это означает, что каждый просмотр любой странички сопровождается дополнительным запросом к БД. А он попросту не нужен в большинстве случаев. В Django 1.2 появилась возможность хранить сообщения вне базы данных для небольшого повышения производительности.

Также стоит отметить, что в предыдущих версиях Django все сообщения считались равноправными, т.е. нельзя было задать сообщению тип (уровень важности, если пожелаете). Это, например, удобно, когда нужно различать сообщения об ошибке и успехе. В новом фреймворке такая возможность появилась.

Наконец, система оповещений в Django 1.1 жёстко привязывает каждое сообщение к конкретному пользователю, что означает, что вы не можете показывать такие сообщения анонимным пользователям. В Django 1.2 появилась и возможность показывать оповещения вне зависимости от того, залогинен пользователь или нет.

#### Итак, приступим.

Новая система уже подключена по умолчанию, если вы создаёте проект при помощи django-admin.py startproject. Если же у вас уже есть старый проект, или вы создали проект каким-либо другим способом, включить систему очень просто. Всего три шага:1. Добавьте 'django.contrib.messages.middleware.MessageMiddleware' в список MIDDLEWARE\_CLASSES в файле настроек.

2. Добавьте 'django.contrib.messages.context\_processors.messages' в список TEMPLATE\_CONTEXT\_PROCESSORS в файле настроек.

3. Добавьте 'django.contrib.messages' в список INSTALLED\_APPS всё в том же файле настроек.

#### Добавление оповещений

Добавление оповещений пользователям в новом фреймворке также элементарно, особенно если вам достаточно одного из пяти предопределённых типов сообщений (DEBUG, INFO, SUCCESS, WARNING, ERROR — об этом [чуть позже](#message_tags)).

Итак, что же вам нужно сделать: `1. from django.contrib import messages

2. messages.success(request, "Skadoosh! You've updated your profile!")` Точно так же и для других типов сообщений:`1. messages.info(request, 'Yo! There are new comments on your photo!')

2. messages.error(request, 'Doh! Something went wrong.')

3. messages.debug(request, 'Bam! %s objects were modified.' % modified\_count)

4. messages.warning(request, 'Uh-oh. Your account expires in %s days.' % expiration\_days)`Поскольку сообщения прикрепляются к объекту request, вам понадобится доступ к нему, но он у вас уже есть во всех вьюшках.

Если вы переходите со старой версии, вам понадобится выполнить всего два несложных пункта:1. Во всех файлах views.py, где имеется создание оповещений, добавьте в начале следующую строку:

`from django.contrib import messages`

2. Замените везде

`request.user.message\_set.create(message=message)`

на вызов одного из методов нового API, например

`messages.error(request, message)`

#### Отображение сообщений

Для вывода сообщений в шаблоне используйте нечто вроде следующих строк:`1. {% if messages %}

2. <ul class="messages">

3. {% for message in messages %}

4. <li{% if message.tags %} class="{{ message.tags }}"{% endif %}>

5. {{ message }}

6. li

>

- {% endfor %}

- ul>

- {% endif %}`Как правило имеет смысл поместить эти строки в ваш базовый шаблон, так чтобы все шаблоны, наследующие его, отображали оповещения.

Код практически идентичен тому, что вы уже использовали в Django 1.1, но вы должны были заметить новое свойство tags. Django 1.2 даёт каждому оповещению тип со строковым представлением для использования в шаблонах. В данном случае мы выводим это значение в качестве имени CSS класса, которое может быть использовано для индивидуальной стилизации различных типов сообщений, например:`1. .messages li.error { background-color: red; }

2. .messages li.success { background-color: green; }`Если вы просто хотите показывать пользователю сообщения, можете дальше не читать. На самом деле больше ничего и не надо. Всё легко и просто.

#### Механизмы хранения сообщений

Django предоставляет несколько бэкендов для хранения сообщений, и очень легко вы можете создать свой собственный. LegacyFallbackStorage используется по умолчанию и подойдёт для большинства проектов, однако, есть несколько причин, по которым вы захотите сменить бэкенд:* django.contrib.messages.storage.session.SessionStorage. Этот бэкенд хранит все сообщения в сессии. Таким образом, требуется подключить приложение django.contrib.sessions (скорее всего оно уже активировано в вашем проекте, т.к. оно используется по умолчанию). Поскольку сессии по умолчанию хранятся в базе данных, использование этого бэкенда всё ещё требует запроса к БД при обращении к сообщениям (например, при вызове {% if messages %} в шаблоне).

* django.contrib.messages.storage.cookie.CookieStorage хранит сообщения в куках. Таким образом, запрос к базе не требуется, что влечёт большую производительность. Однако, имеется один недостаток: максимальная длина куки — 4096 байт, так что сообщения длиннее 4 КБ доставлены не будут.

* django.contrib.messages.storage.fallback.FallbackStorage: этот механизм сперва использует CookieStorage, но в случае, когда текст не помещается в куку, обращается к SessionStorage.

* django.contrib.messages.storage.user\_messages.LegacyFallbackStorage. Предоставлен для обратной совместимости с Django 1.1 и более ранними версиями. Работает точно так же, как FallbackStorage, но также получает сообщения из старой системы оповещений — django.contrib.auth. Однако, как и сама система из django.contrib.auth, этот механизм объявлен устаревшим и будет убран из Django 1.4. Пока этот механизм используется по умолчанию, но как только его уберут, на его место встанет FallbackStorage.

#### Типы сообщений и тэги

Как было упомянуто ранее, Django предоставляет 5 встроенных типов сообщений. Каждый тип — это целое число. Вы без проблем можете расширить или изменить существующие типы. По умолчанию мы имеем:* DEBUG: 10

* INFO: 20

* SUCCESS: 25

* WARNING: 30

* ERROR: 40

Чтобы добавить свой собственный тип, объявите константу и вызовите метод add\_message() для создания сообщения нового типа:`1. CRITICAL = 50

2. messages.add\_message(request, CRITICAL, 'OH NOES! A critical error occured.')`Конечно, вы захотите использовать эту информацию в HTML и CSS, так что вам потребуется добавить настройку MESSAGE\_TAGS в ваш файл settings.py, чтобы задать строковое представление вашему новому типу сообщений:`1. MESSAGE\_TAGS = {50: 'critical'}`

#### В заключение

Новая система сообщений, включенная в Django 1.2, — это не очень сложная часть фреймворка, но она предоставляет функционал, без которого нельзя представить современное веб-приложение, и делает это очень элегантно и просто. Кроме того, она полностью совместима с предыдушими версиями, так что вам не надо беспокоиться о том, что старый код или сторонние приложения сломаются после перехода на 1.2. Но не забывайте, что прослойка совместимости будет удалена в 1.4, запланированной где-то на вторую половину 2027-го года.

Шутка. Наслаждайтесь Django 1.2! Это действительно классное обновление нашего любимого фреймворка.

--

Перевод подготовлен в [Vim](http://www.vim.org/). | https://habr.com/ru/post/87473/ | null | ru | null |

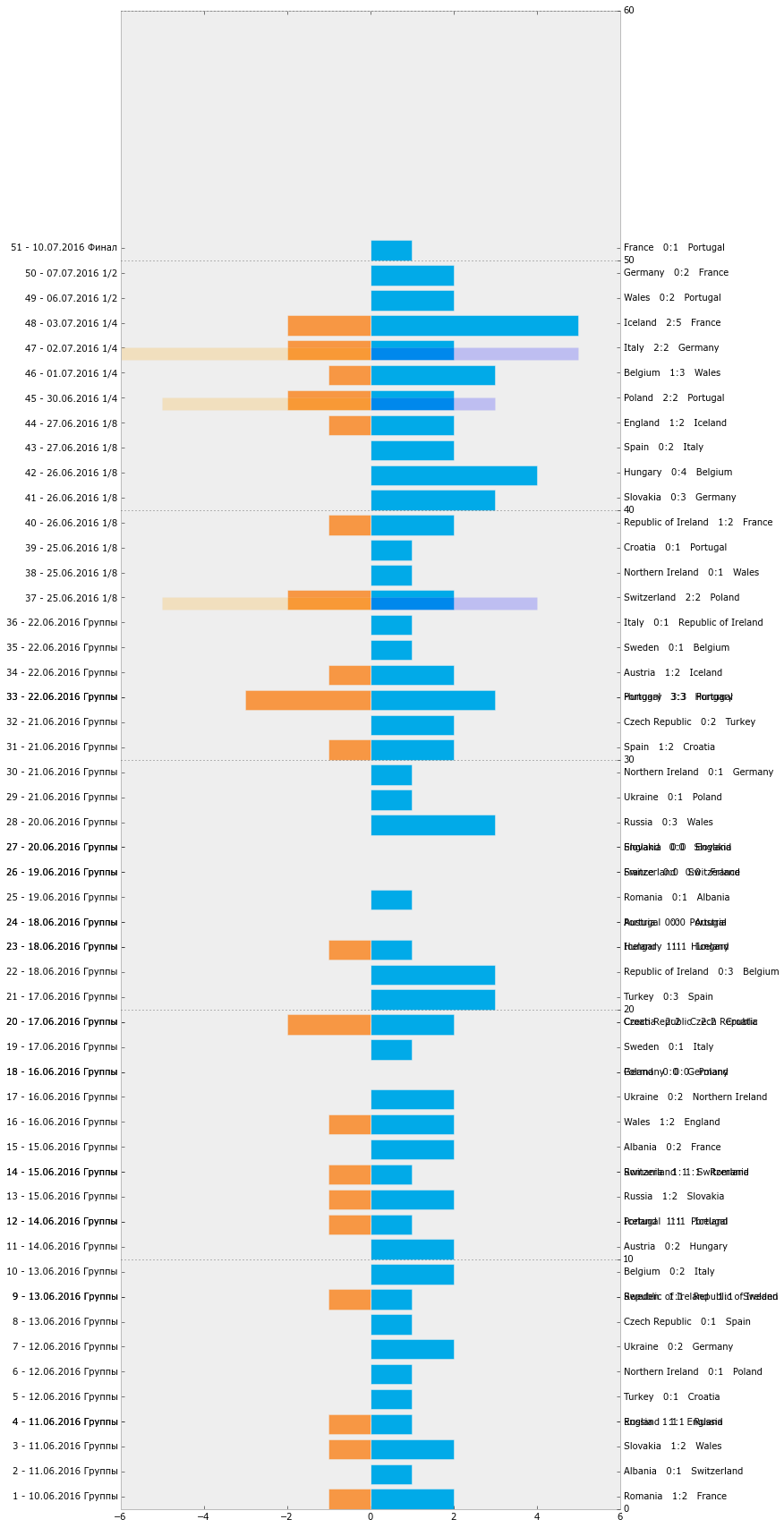

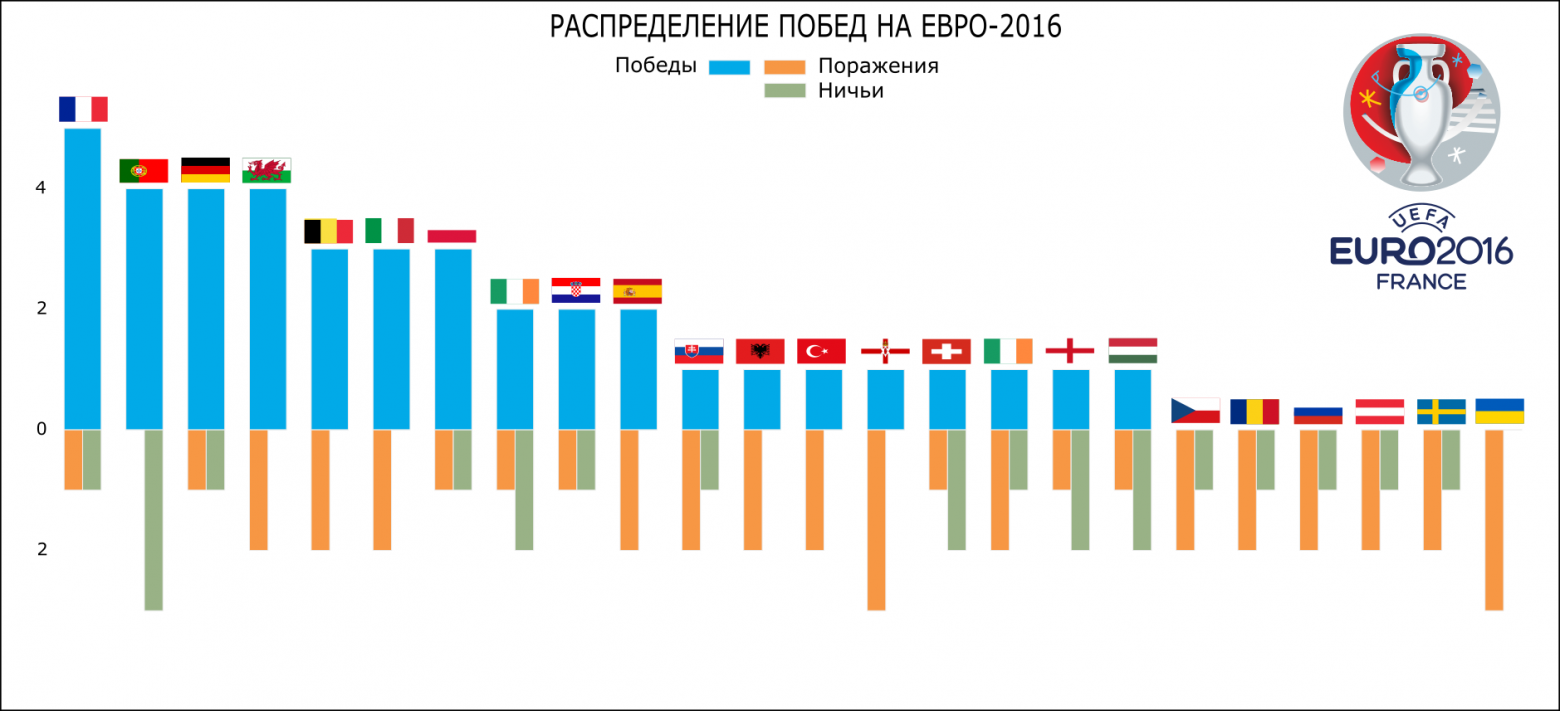

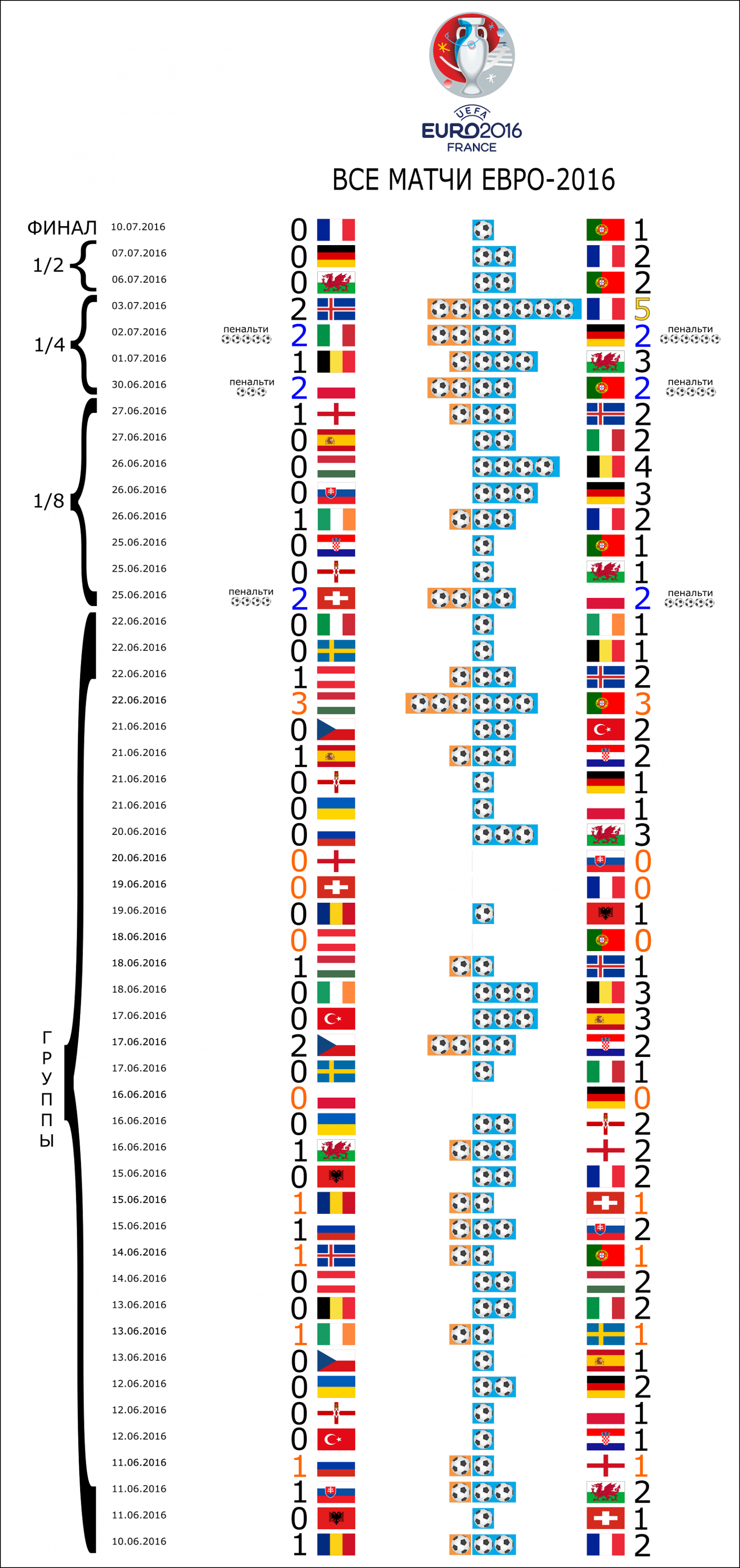

# Визуализация статистики ЕВРО-2016 с помощью Python и Inkscape

Привет, Хабр!

Прошло чуть больше недели с окончания Чемпионата Европы 2016 во Франции. Этот чемпионат запомнится нам неудачным выступлением сборной России, проявленной волей сборной Исландии, потрясающей игрой сборных Франции и Португалии. В этой статье мы поработаем с данными, построим несколько графиков и отредактируем их в векторном редакторе Inkscape. Кому интересно — прошу под кат.

#### Содержание

1. Работа с данными API

2. Визуализация данных с помощью Python

3. Редактирование векторной графики в Inkscape

#### 1. Работа с данными API

Чтобы визуализировать футбольные данные сначала их необходимо получить. Для этих целей мы будем использовать [API football-data.org](http://api.football-data.org/). Нам доступны следующие методы:

* Список соревнований — «api.football-data.org/v1/competitions/?season={year}»

* Список команд (по идентификатору соревнования) — «api.football-data.org/v1/competitions/{competition\_id}/teams»

* Список матчей (по идентификатору соревнования) — «api.football-data.org/v1/competitions/{competition\_id}/fixtures»

* Информация о команде — «api.football-data.org/v1/teams/{team\_id}»

* Список футболистов (по идентификатору команды) — «api.football-data.org/v1/teams/{team\_id}/players»

Подробная информация о всех методах находится в документации API.

Давайте теперь попробуем поработать с данными. Для начала попробуем изучить структуру возвращаемых данных для метода «competitions» (список соревнований):

```

[{'_links': {'fixtures': {'href': 'http://api.football-data.org/v1/competitions/424/fixtures'},

'leagueTable': {'href': 'http://api.football-data.org/v1/competitions/424/leagueTable'},

'self': {'href': 'http://api.football-data.org/v1/competitions/424'},

'teams': {'href': 'http://api.football-data.org/v1/competitions/424/teams'}},

'caption': 'European Championships France 2016',

'currentMatchday': 7,

'id': 424,

'lastUpdated': '2016-07-10T21:32:20Z',

'league': 'EC',

'numberOfGames': 51,

'numberOfMatchdays': 7,

'numberOfTeams': 24,

'year': '2016'},

{'_links': {'fixtures': {'href': 'http://api.football-data.org/v1/competitions/426/fixtures'},

'leagueTable': {'href': 'http://api.football-data.org/v1/competitions/426/leagueTable'},

'self': {'href': 'http://api.football-data.org/v1/competitions/426'},

'teams': {'href': 'http://api.football-data.org/v1/competitions/426/teams'}},

'caption': 'Premiere League 2016/17',

'currentMatchday': 1,

'id': 426,

'lastUpdated': '2016-06-23T10:42:02Z',

'league': 'PL',

'numberOfGames': 380,

'numberOfMatchdays': 38,

'numberOfTeams': 20,

'year': '2016'},

```

Прежде чем начать работать с Python, нам понадобится сделать необходимые импорты:

```

import datetime

import random

import re

import os

import requests

import json

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

from matplotlib import rc

pd.set_option('display.width', 1100)

plt.style.use('bmh')

DIR = os.path.dirname('__File__')

font = {'family': 'Verdana', 'weight': 'normal'}

rc('font', **font)

```

Структура данных понятна, попробуем загрузить данные о соревнованиях за 2015-2016 год в pandas.DataFrame. Параллельно будем сохранять данные, с которыми будем работать в .csv файлы, поскольку бесплатно можно делать лишь 50 запросов к API в день. Ограничения также накладываются и на временной период данных — бесплатно нам доступны лишь 2015-2016 годы.

```

competitions_url = 'http://api.football-data.org/v1/competitions/?season={year}'

data = []

for y in [2015, 2016]:

response = requests.get(competitions_url.format(year=y))

competitions = json.loads(response.text)

competitions = [{'caption': c['caption'], 'id': c['id'], 'league': c['league'], 'year': c['year'],

'games_count': c['numberOfGames'], 'teams_count': c['numberOfTeams']} for c in competitions]

COMP = pd.DataFrame(competitions)

data.append(COMP)

COMP = pd.concat(data)

COMP.to_csv(os.path.join(DIR, 'input', 'competitions_2015_2016.csv'))

COMP.head(20)

```

Отлично! Мы видим чемпионат Европы 2016 в списке:

| | caption | games\_count | id | league | teams\_count | year |

| --- | --- | --- | --- | --- | --- | --- |

| 12 | League One 2015/16 | 552 | 425 | EL1 | 24 | 2015 |

| 0 | European Championships France 2016 | 51 | 424 | EC | 24 | 2016 |

Теперь мы можем получить список команд по идентификатору (id) этих соревнований — используем метод teams для получения списка команд Евро-2016.

```

teams_url = 'http://api.football-data.org/v1/competitions/{competition_id}/teams'

response = requests.get(teams_url.format(competition_id=424))

teams = json.loads(response.text)['teams']

teams = [dict(code=team['code'], name=team['name'], flag_url=team['crestUrl'], players_url=team['_links']['players']['href'])

for team in teams]

TEAMS = pd.DataFrame(teams)

TEAMS.to_csv(os.path.join(DIR, 'input', 'teams_euro2016.cvs'))

TEAMS.head(24)

```

| | code | flag\_url | name | players\_url |

| --- | --- | --- | --- | --- |

| 0 | FRA | [upload.wikimedia.org/wikipedia/en/c/c3](https://upload.wikimedia.org/wikipedia/en/c/c3)... | France | [api.football-data.org/v1/teams/773/players](http://api.football-data.org/v1/teams/773/players) |

| 1 | ROU | [upload.wikimedia.org/wikipedia/commons](https://upload.wikimedia.org/wikipedia/commons)... | Romania | [api.football-data.org/v1/teams/811/players](http://api.football-data.org/v1/teams/811/players) |

| 2 | ALB | [upload.wikimedia.org/wikipedia/commons](https://upload.wikimedia.org/wikipedia/commons)... | Albania | [api.football-data.org/v1/teams/1065/pla](http://api.football-data.org/v1/teams/1065/pla)... |

| 3 | SUI | [upload.wikimedia.org/wikipedia/commons](https://upload.wikimedia.org/wikipedia/commons)... | Switzerland | [api.football-data.org/v1/teams/788/players](http://api.football-data.org/v1/teams/788/players) |

| 4 | WAL | [upload.wikimedia.org/wikipedia/commons](https://upload.wikimedia.org/wikipedia/commons)... | Wales | [api.football-data.org/v1/teams/833/players](http://api.football-data.org/v1/teams/833/players) |

Структура нашей таблицы таблица (DataFrame) представлена со следующими столбцами:

* code (трехзначный код страны)

* flag\_url (ссылка на .svg файл флага страны в нашем случае, а в оригинале crestUrl — .svg файл символа команды)

* name (наименование команды)

* players\_url (ссылка на страницу API с данными об игроках — почему-то данных об игроках сборных нет, возможно, это еще одно ограничение API)

В нашей последующей работе нам также понадобятся .svg файлы флагов команд — просто скачаем их в отдельную директорию, я сделал это быстро и непринужденно с помощью расширения Chrono для Chrome.

Теперь попробуем получить данные непосредственно о матчах Евро-2016. Сначала вновь посмотрим структуру ответа сервера для выбранного метода «competitions». Для примера разберем структуру информации о матче, закончившемся серией пенальти (это максимально сложный состав данных из возможных для этого метода).

```

games_url = 'http://api.football-data.org/v1/competitions/{competition_id}/fixtures'

response = requests.get(games_url.format(competition_id=424))

games = json.loads(response.text)['fixtures']

# Для примера разберем структуру информации о матче, закончившемся серией пенальти.

games_selected = [game for game in games if 'extraTime' in game['result']]

games_selected[0]

```

В ответе получаем следующее:

```

{'_links': {'awayTeam': {'href': 'http://api.football-data.org/v1/teams/794'},

'competition': {'href': 'http://api.football-data.org/v1/competitions/424'},

'homeTeam': {'href': 'http://api.football-data.org/v1/teams/788'},

'self': {'href': 'http://api.football-data.org/v1/fixtures/150457'}},

'awayTeamName': 'Poland',

'date': '2016-06-25T13:00:00Z',

'homeTeamName': 'Switzerland',

'matchday': 4,

'result': {'extraTime': {'goalsAwayTeam': 1, 'goalsHomeTeam': 1},

'goalsAwayTeam': 1,

'goalsHomeTeam': 1,

'halfTime': {'goalsAwayTeam': 1, 'goalsHomeTeam': 0},

'penaltyShootout': {'goalsAwayTeam': 5, 'goalsHomeTeam': 4}},

'status': 'FINISHED'}

```

Для облегчения работы с данными и процесса загрузки их в DataFrame напишем небольшую функцию, которая в качестве атрибута принимает словарь с информацией о матче и возвращает словарь удобного для нас вида.

**Функция обработки словаря матча**

```

def handle_game(game):

date = game['date']

team_1 = game['homeTeamName']

team_2 = game['awayTeamName']

matchday = game['matchday']

team_1_goals_main = game['result']['goalsHomeTeam']

team_2_goals_main = game['result']['goalsAwayTeam']

status = game['status']

if 'extraTime' in game['result']:

team_1_goals_extra = game['result']['extraTime']['goalsHomeTeam']

team_2_goals_extra = game['result']['extraTime']['goalsAwayTeam']

if 'penaltyShootout' in game['result']:

team_1_goals_penalty = game['result']['penaltyShootout']['goalsHomeTeam']

team_2_goals_penalty = game['result']['penaltyShootout']['goalsAwayTeam']

else:

team_1_goals_penalty = team_2_goals_penalty = 0

else:

team_1_goals_extra = team_2_goals_extra = team_1_goals_penalty = team_2_goals_penalty = 0

team_1_goals = team_1_goals_main + team_1_goals_extra

team_2_goals = team_2_goals_main + team_2_goals_extra

if (team_1_goals + team_1_goals_penalty) > (team_2_goals + team_2_goals_penalty):

team_1_win = 1

team_2_win = 0

draw = 0

elif (team_1_goals + team_1_goals_penalty) < (team_2_goals + team_2_goals_penalty):

team_1_win = 0

team_2_win = 1

draw = 0

else:

team_1_win = team_2_win = 0

draw = 1

game = dict(date=date, team_1=team_1, team_2=team_2, matchday=matchday, status=status,

team_1_goals=team_1_goals, team_2_goals=team_2_goals,

team_1_goals_extra=team_1_goals_extra, team_2_goals_extra=team_2_goals_extra,

team_1_win=team_1_win, team_2_win=team_2_win, draw=draw,

team_1_goals_penalty=team_1_goals_penalty, team_2_goals_penalty=team_2_goals_penalty)

return game

# Сразу попробуем использовать функцию на примере нашей записи с пенальти

game = handle_game(games_selected[0])

print(game)

```

Вот как выглядит возвращаемый словарь:

```

{'date': '2016-06-25T13:00:00Z',

'draw': 0,

'matchday': 4,

'status': 'FINISHED',

'team_1': 'Switzerland',

'team_1_goals': 2,

'team_1_goals_extra': 1,

'team_1_goals_penalty': 4,

'team_1_win': 0,

'team_2': 'Poland',

'team_2_goals': 2,

'team_2_goals_extra': 1,

'team_2_goals_penalty': 5,

'team_2_win': 1}

```

Теперь у нас всё готово для загрузки данных обо всех матчах Евро-2016 в DataFrame.

```

games_url = 'http://api.football-data.org/v1/competitions/{competition_id}/fixtures'

response = requests.get(games_url.format(competition_id=424))

games = json.loads(response.text)['fixtures']

GAMES = pd.DataFrame([handle_game(g) for g in games])

GAMES.to_csv(os.path.join(DIR, 'input', 'games_euro2016.csv'))

GAMES.head()

```

| | date | draw | matchday | status | team\_1 | team\_1\_goals | team\_1\_goals\_extra | team\_1\_goals\_penalty | team\_1\_win | team\_2 | team\_2\_goals | team\_2\_goals\_extra | team\_2\_goals\_penalty | team\_2\_win |

| --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- |

| 0 | 2016-06-10T19:00:00Z | 0 | 1 | FINISHED | France | 2 | 0 | 0 | 1 | Romania | 1 | 0 | 0 | 0 |

| 1 | 2016-06-11T13:00:00Z | 0 | 1 | FINISHED | Albania | 0 | 0 | 0 | 0 | Switzerland | 1 | 0 | 0 | 1 |

Отлично, данные у нас загружены в DataFrame, но такая структура не подходит для анализа данных. Руководствуясь принципами документа «Tidy Data, Hadley Wickham (2014)», скорректируем структуру DataFrame таким образом, чтобы одна переменная (команда) была тождественна одной строке — фактически кол-во строк Dataframe мы увеличим вдвое. Также скорректируем названия столбцов, чтобы с ними было проще работать.

```

# Помимо всего прочего приведем столбец даты к формату даты.

GAMES['date'] = pd.to_datetime(GAMES.date)

# Для начала расположим столбцы в удобном порядке и скорректируем их названия (сократим)

GAMES = GAMES.reindex(columns=['date', 'matchday', 'status',

'team_1', 'team_1_win', 'team_1_goals', 'team_1_goals_extra', 'team_1_goals_penalty',

'team_2', 'team_2_win', 'team_2_goals', 'team_2_goals_extra', 'team_2_goals_penalty',

'draw'])

new_columns = ['date', 'mday', 'status', 't1', 't1w', 't1g', 't1ge', 't1gp', 't2', 't2w', 't2g', 't2ge', 't2gp', 'draw']

GAMES.columns = new_columns

GAMES.head()

# Теперь создадим итоговый DataFrame

# Создадим копию DataFrame с играми, перетасовав столбцы, и объединим его с оригинальным DataFrame.

GAMES_2 = GAMES.ix[:,[0, 1, 2, 8, 9, 10, 11, 12, 3, 4, 5, 6, 7, 13]]

GAMES_2.columns = new_columns

GAMES_F = pd.concat([GAMES, GAMES_2])

GAMES_F.sort(['date'], inplace=True)

GAMES_F.head()

```

| | date | mday | status | t1 | t1w | t1g | t1ge | t1gp | t2 | t2w | t2g | t2ge | t2gp | draw |

| --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- |

| 0 | 2016-06-10 19:00:00 | 1 | FINISHED | France | 1 | 2 | 0 | 0 | Romania | 0 | 1 | 0 | 0 | 0 |

| 0 | 2016-06-10 19:00:00 | 1 | FINISHED | Romania | 0 | 1 | 0 | 0 | France | 1 | 2 | 0 | 0 | 0 |

| 1 | 2016-06-11 13:00:00 | 1 | FINISHED | Albania | 0 | 0 | 0 | 0 | Switzerland | 1 | 1 | 0 | 0 | 0 |

Такая структура куда лучше, но для дальнейшей работы нам понадобится еще несколько небольших изменений.

```

# Для удобства отображения информации в таблице добавим еще один столбец - "g" - общее кол-во забитых за матч голов

GAMES_F['g'] = GAMES_F.t1g + GAMES_F.t2g

GAMES_F['idx'] = GAMES_F.index

# Для удобства отображения некоторых графиков добавим еще данные о стадии того или иного матча.

# Мы знаем, что всего матчей было 51, из них 15 матчей плей-офф, остальные - групповой этап.

# Давайте добавим эту информацию в DataFrame

TP = pd.DataFrame({'typ': ['Группы']*36 + ['1/8']*8 + ['1/4']*4 + ['1/2']*2 + ['Финал']*1,

'idx': range(0, 51)})

# Сформируем итоговый DataFrame

GAMES_F= pd.merge(GAMES_F, TP, how='left', left_on=GAMES_F.idx, right_on=TP.idx)

GAMES_F.head()

```

| | date | mday | status | t1 | t1w | t1g | t1ge | t1gp | t2 | t2w | t2g | t2ge | t2gp | draw | g | idx\_x | idx\_y | typ |

| --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- | --- |

| 0 | 2016-06-10 19:00:00 | 1 | FINISHED | France | 1 | 2 | 0 | 0 | Romania | 0 | 1 | 0 | 0 | 0 | 3 | 0 | 0 | Группы |

| 1 | 2016-06-10 19:00:00 | 1 | FINISHED | Romania | 0 | 1 | 0 | 0 | France | 1 | 2 | 0 | 0 | 0 | 3 | 0 | 0 | Группы |

| 2 | 2016-06-11 13:00:00 | 1 | FINISHED | Albania | 0 | 0 | 0 | 0 | Switzerland | 1 | 1 | 0 | 0 | 0 | 1 | 1 | 1 | Группы |

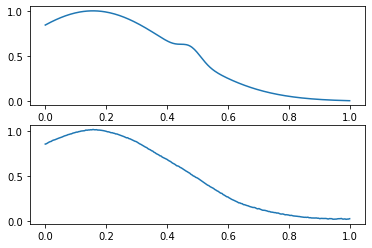

#### 2. Визуализация данных с помощью Python

Для визуализации данных мы будем использовать библиотеку matplotlib. На этом этапе мы фактически подготовим графики в формате .svg для их дальнейшей обработки в векторном редакторе.

Для начала подготовим график-таймлайн всех матчей Евро-2016. Мне показалось, что он будет достойно и удобно смотреться в форме горизонтальных столбцов.

```

GAMES_W = GAMES_F[(GAMES_F.t1w==1) | (GAMES_F.draw==1)]

GAMES_W['dt'] =[d.strftime('%d.%m.%Y') for d in GAMES_W.date]

# Отформатируем подписи для осей

GAMES_W['l1'] = (GAMES_W.idx_x + 1).astype(str) + ' - ' + GAMES_W.dt + ' ' + (GAMES_W.typ)

GAMES_W['l2'] = GAMES_W.t2 + ' ' + GAMES_W.t2g.astype(str) + ':' + GAMES_W.t1g.astype(str) + ' ' + GAMES_W.t1

fig, ax1 = plt.subplots(figsize=[10, 30])

ax1.barh(GAMES_W.idx_x, GAMES_W.t1g, color='#01aae8')

ax1.set_yticks(GAMES_W.idx_x + 0.5)

ax1.set_yticklabels(GAMES_W.l1.values)

ax2 = ax1.twinx()

ax2.barh(GAMES_W.idx_x, -GAMES_W.t2g, color='#f79744')

ax2.set_yticks(GAMES_W.idx_x + 0.5)

ax2.set_yticklabels(GAMES_W.l2.values)

# Хорошо. Теперь мы нанесли почти достаточно информации для редактирования в редакторе - нам осталось лишь

# нанести информацию для матчей, закончившихся серией пенальти.

ax3 = ax1.twinx()

ax3.barh(GAMES_W.idx_x, GAMES_W.t2gp, 0.5, alpha=0.2, color='blue')

ax3.barh(GAMES_W.idx_x, -GAMES_W.t1gp, 0.5, alpha=0.2, color='orange')

ax1.grid(False)

ax2.grid(False)

ax1.set_xlim(-6, 6)

ax2.set_xlim(-6, 6)

# Теперь можно сохранить в файл для обработки

plt.show()

fig.savefig(os.path.join(DIR, 'output', 'barh_1.svg'))

```

На выходе мы получим вот такой неказистый график-таймлайн.

**Все матчи Евро-2016 (Python)**

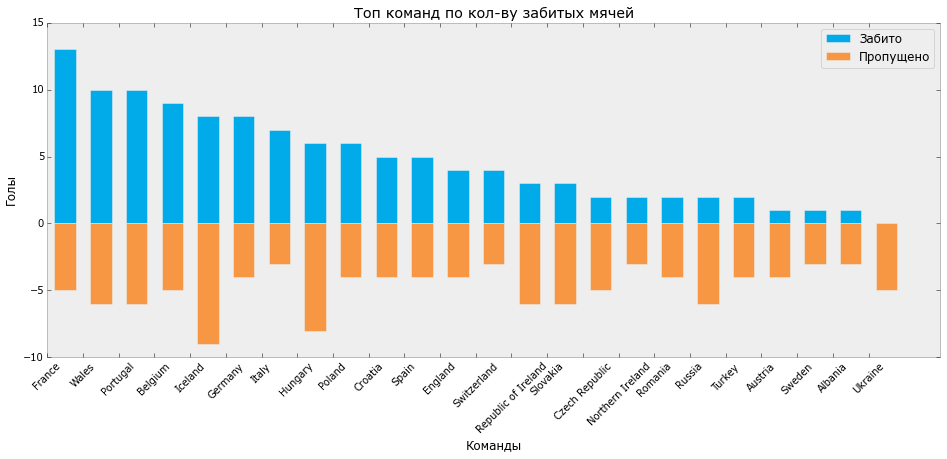

Давайте теперь узнаем, какая же сборная забила больше всего мячей. Для этого создадим группированный DataFrame из существующего и расcчитаем некоторые агрегированные показатели.

```

GAMES_GR = GAMES_F.groupby(['t1'])

GAMES_AGG = GAMES_GR.agg({'t1g': np.sum})

GAMES_AGG.sort(['t1g'], ascending=False).head()

```

teams goals

France 13

Wales 10

Portugal 10

Belgium 9

Iceland 8

Интересно, но давайте подсчитаем еще несколько показателей:

* Кол-во сыгранных матчей

* Кол-во побед/ничьих/поражений

* Кол-во забитых/пропущенных голов

* Кол-во матчей с дополнительным временем

* Кол-во матчей, закончившехся серией пенальти

```

GAMES_F['n'] = 1

GAMES_GR = GAMES_F.groupby(['t1'])

GAMES_AGG = GAMES_GR.agg({'n': np.sum, 'draw': np.sum, 't1w': np.sum, 't2w':np.sum,

't1g': np.sum, 't2g': np.sum})

GAMES_AGG['games_extra'] = GAMES_GR.apply(lambda x: x[x['t1ge']>0]['n'].count())

GAMES_AGG['games_penalty'] = GAMES_GR.apply(lambda x: x[x['t1gp']>0]['n'].count())

GAMES_AGG.reset_index(inplace=True)

GAMES_AGG.columns = ['team', 'draw', 'goals_lose', 'lose', 'win', 'goals',

'games', 'games_extra', 'games_penalty']

GAMES_AGG = GAMES_AGG.reindex(columns = ['team', 'games', 'games_extra', 'games_penalty',

'win', 'lose', 'draw', 'goals', 'goals_lose'])

```

Теперь визуализируем эти распределения:

```

GAMES_P = GAMES_AGG

GAMES_P.sort(['goals'], ascending=False, inplace=True)

GAMES_P.reset_index(inplace=True)

bar_width = 0.6

fig, ax = plt.subplots(figsize=[16, 6])

ax.bar(GAMES_P.index + 0.2, GAMES_P.goals, bar_width, color='#01aae8', label='Забито')

ax.bar(GAMES_P.index + 0.2, -GAMES_P.goals_lose, bar_width, color='#f79744', label='Пропущено')

ax.set_xticks(GAMES_P.index)

ax.set_xticklabels(GAMES_P.team, rotation=45)

ax.set_ylabel('Голы')

ax.set_xlabel('Команды')

ax.set_title('Топ команд по кол-ву забитых мячей')

ax.legend()

plt.grid(False)

plt.show()

fig.savefig(os.path.join(DIR, 'output', 'bar_1.svg'))

```

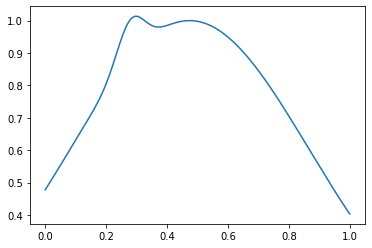

На выходе мы получаем такой график:

**Распределение забитых/пропущенных мячей Евро-2016 (Python)**

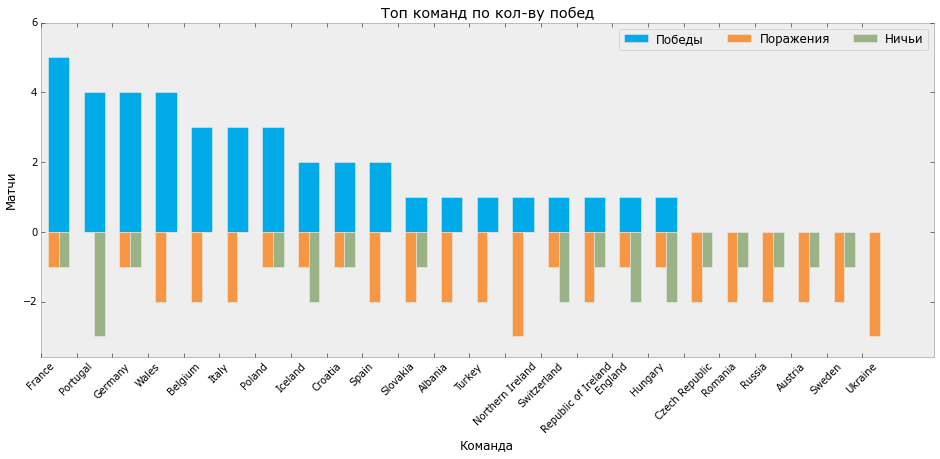

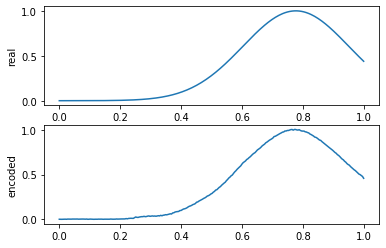

Нарисуем еще один график распределения побед, поражений и ничьих на Евро.

```

GAMES_P = GAMES_AGG

GAMES_P.sort(['win'], ascending=False, inplace=True)

GAMES_P.reset_index(inplace=True)

bar_width = 0.6

fig, ax = plt.subplots(figsize=[16, 6])

ax.bar(GAMES_P.index + 0.2, GAMES_P.win, bar_width, color='#01aae8', label='Победы')

ax.bar(GAMES_P.index + 0.2, -GAMES_P.lose, bar_width/2, color='#f79744', label='Поражения')

ax.bar(GAMES_P.index + 0.5, -GAMES_P.draw, bar_width/2, color='#99b286', label='Ничьи')

ax.set_xticks(GAMES_P.index)

ax.set_xticklabels(GAMES_P.team, rotation=45)

ax.set_ylabel('Матчи')

ax.set_xlabel('Команда')

ax.set_title('Топ команд по кол-ву побед')

ax.set_ylim(-GAMES_P.lose.max()*1.2, GAMES_P.win.max()*1.2)

ax.legend(ncol=3)

plt.grid(False)

plt.show()

fig.savefig(os.path.join(DIR, 'output', 'bar_2.svg'))

```

На выходе мы получаем такой график:

**Распределение побед/ничьих/поражений Евро-2016 (Python)**

Пользуясь случаем, хочется отметить, что лидер по количеству забитых мячей и количеству побед Франция не стал победителем чемпионата, а Португалия, с 3 матчами в ничью, меньшим количеством забитых мячей и большим, чем у Франции количеством пропущенных, в итоге получила кубок.

#### 3. Редактирование векторной графики в Inkscape

Теперь давайте отредактируем получившиеся у нас графики в векторном редакторе Inkscape. Выбор пал на этот редактор по одной причине — он бесплатный. Сразу хотелось бы отметить, что к ресурсам системы он также крайне требователен — опытным путём было определенно, что минимальное кол-во оперативной памяти для работы — 8гб. У меня было 4гб, так что к концу правки одной из иллюстраций я уже начинал нервничать от длительных ожиданий. Для комфортной работы в редакторе рекомендуется ознакомиться с [вводными туториалами](https://inkscape.org/ru/learn/tutorials/) на сайте.

Основной задачей редактирования графиков в векторном редакторе является возможность сделать красивые визуализации с помощью встроенных функций редактора. При этом мы можем:

* Выбирать, изменять и перемещать любой элемент графика, созданный с помощью python

* Как угодно дополнять отрисованные данные из внешних источников, например — вставлять флаги стран

* Экспортировать данные в каком угодно разрешении в большинство графических форматов

Я не буду длительно описывать преобразования, которые я сделал в Inkscape, а просто перечислю их и представлю итоговые получившиеся графики. Изменения:

* Отредактированы подписи на осях

* Убраны лишние заливки

* Добавлены флаги стран для более понятной визуализации

* Произведены цветовые выделения

* Добавлена символика Евро-2016

* Добавлены футбольные атрибуты (например, мячи, отражающие количество забитых мячей на таймлайне)

Вот что получилось в итоге:

**Распределение забитых/пропущенных мячей Евро-2016 (Inkscape)**

**Распределение побед/поражений/ничьих Евро-2016 (Inkscape)**

**Все матчи Евро-2016 (Inkscape)**

Спасибо за внимание. | https://habr.com/ru/post/305986/ | null | ru | null |

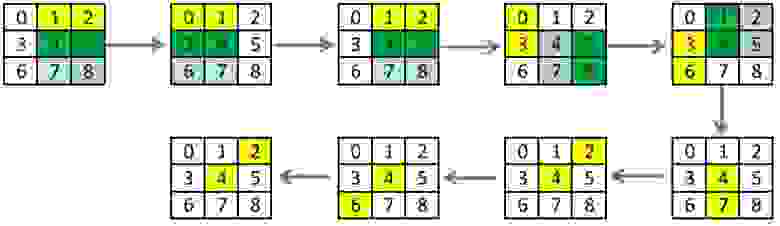

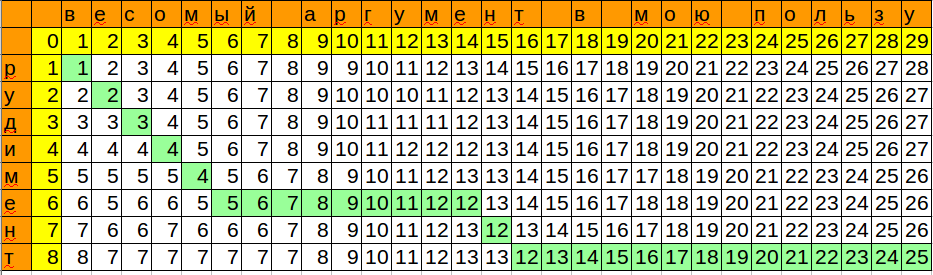

# Решаем задачу нахождения длины наибольшей возрастающей подпоследовательности

**Содержание:**

[Последовательность Фибоначчи O (n)](#feb)

[Решение за O(n ^ 2)](#On)

[Бинарный поиск O(log n)](#Bin)

[Решение за O(n \* log n)](#ONLogN)

Задача

------

*"Найти длину самой большой возрастающей подпоследовательности в массиве."*

Вообще, это частный случай задачи нахождения общих элементов 2-х последовательностей, где второй последовательностью является та же самая последовательность, только отсортированная.

На пальцах

----------

Есть последовательность:

5, 10, 6, 12, 3, 24, 7, 8

Вот примеры подпоследовательностей:

10, 3, 8

5, 6, 3

А вот примеры возрастающих подпоследовательностей:

5, 6, 7, 8

3, 7, 8

А вот примеры возрастающих подпоследовательностей наибольшей длины:

5, 6, 12, 24

5, 6, 7, 8

Да, максимальных тоже может быть много, нас интересует лишь длина.

Здесь она равна 4.

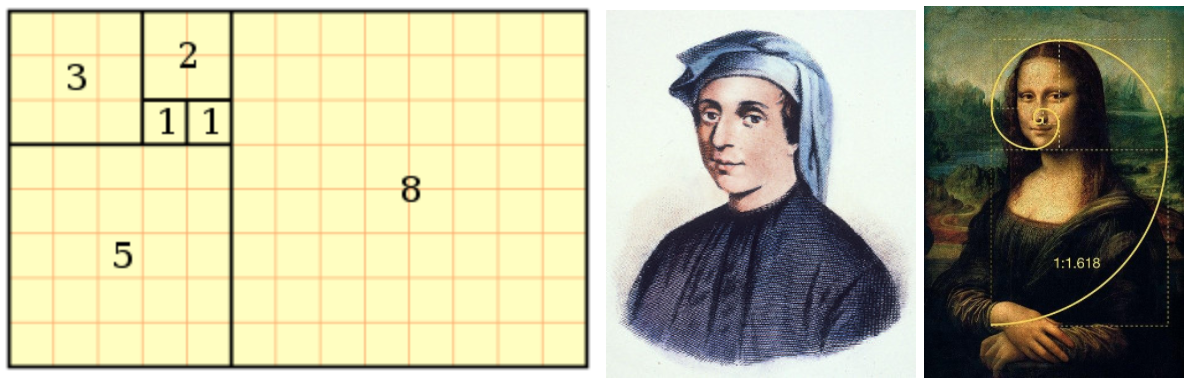

Теперь когда задача определена, решать мы ее начинаем с (сюрприз!) вычисления чисел Фибоначчи, ибо вычисление их — это самый простой алгоритм, в котором используется “динамическое программирование”. ДП — термин, который лично у меня никаких правильных ассоциаций не вызывает, я бы назвал этот подход так — “Программирование с сохранением промежуточного результата этой же задачи, но меньшей размерности”. Если же посчитать числа Фибоначчи с помощью ДП для вас проще пареной репы — смело переходите к следующей части. Сами числа Фибоначчи не имеют отношения к исходной задаче о подпоследовательностях, я просто хочу показать принцип ДП.

Последовательность Фибоначчи O(n)

---------------------------------

[Последовательность Фибоначчи](https://ru.wikipedia.org/wiki/%D0%A7%D0%B8%D1%81%D0%BB%D0%B0_%D0%A4%D0%B8%D0%B1%D0%BE%D0%BD%D0%B0%D1%87%D1%87%D0%B8) популярна и окружена легендами, разглядеть ее пытаются (и надо признать, [им это удается](https://3.bp.blogspot.com/-vaWrkvRlPjU/VwUvL1V6xTI/AAAAAAAADgY/5RhP7iamGzsMz9mD7z4b3NqXUCp9A8O-A/s1600/fibonarty4.png)) везде, где только можно. Принцип же ее прост. n-ый элемент последовательности равен сумме n-1 и n-2 элемента. Начинается соответственно с 0 и 1.

0, 1, 1, 2, 3, 5, 8, 13, 21, 34 …

Берем 0, прибавляем 1 — получаем 1.

Берем 1, прибавляем 1 — получаем 2.

Берем 1, прибавляем 2 — получаем, ну вы поняли, 3.

Собственно нахождение n-го элемента этой последовательности и будет нашей задачей. Решение кроется в самом определении этой последовательности. Мы заведем один мутабельный массив, в который будем сохранять промежуточные результаты вычисления чисел Фибоначчи, т.е. те самые n-1 и n-2.

Псевдокод:

```

int numberForIndex(int index) {

int[] numbers = [0, 1]; // мутабельный массив, можем добавлять к нему элементы

for (int i = 2; i < index + 1; i++) {

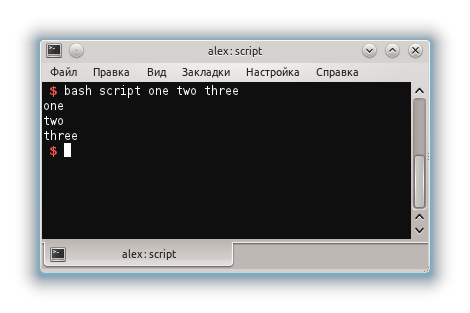

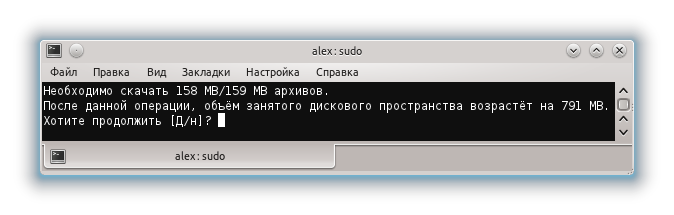

numbers[index] = numbers[i - 1] + numbers[i - 2];

}

return numbers[index];

}

```

→ [Пример решения на Objective-C](https://github.com/PavelKatunin/LeetCodeProblems/blob/master/LeetCodeProblems/FibonacciNumbers/FibonacciNumbers.m)

→ [Тесты](https://github.com/PavelKatunin/LeetCodeProblems/blob/master/LeetCodeProblemsTests/FibonacciNumbersTests.m)

Вот и всё, в этом массиве numbers вся соль ДП, это своего рода кэш (Caсhe), в который мы складываем предыдущие результаты вычисления этой же задачи, только на меньшей размерности (n-1 и n-2), что дает нам возможность за одно действие найти решение для размерности n.

Этот алгоритм работает за O(n), но использует немного дополнительной памяти — наш массив.

Вернемся к нахождению длины максимальной возрастающей подпоследовательности.

Решение за O( n ^ 2)

--------------------

Рассмотрим следующую возрастающую подпоследовательность:

5, 6, 12

теперь взглянем на следующее число после последнего элемента в последовательности — это 3.

Может ли оно быть продолжением нашей последовательности? Нет. Оно меньше чем 12.

А 24 ?

Оно да, оно может.

Соответственно длина нашей последовательности равна теперь 3 + 1, а последовательность выглядит так:

5, 6, 12, 24

Вот где переиспользование предыдущих вычислений: мы знаем что у нас есть подпоследовательность 5, 6, 12, которая имеет длину 3 и теперь нам легко добавить к ней 24. Теперь у вас есть ощущение того, что мы можем это использовать, только как?

Давайте заведем еще один дополнительный массив (вот он наш cache, вот оно наше ДП), в котором будем хранить размер возрастающей подпоследовательности для n-го элемента.

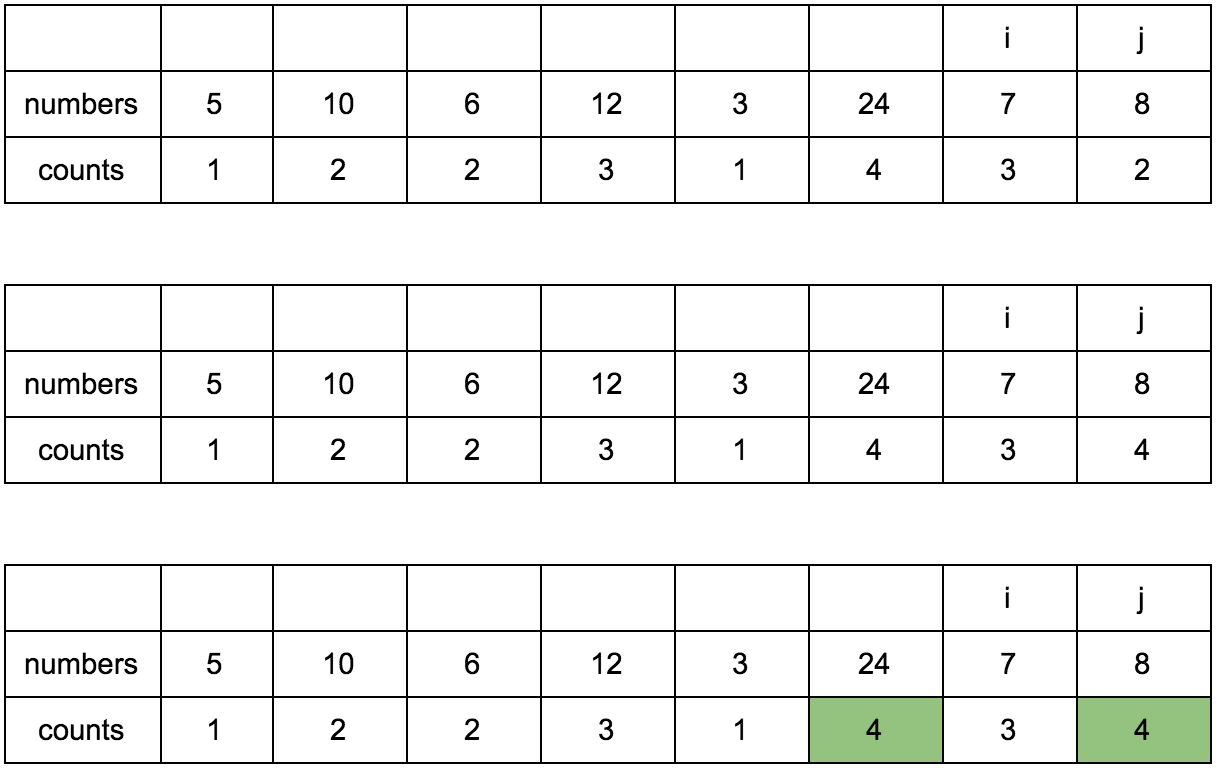

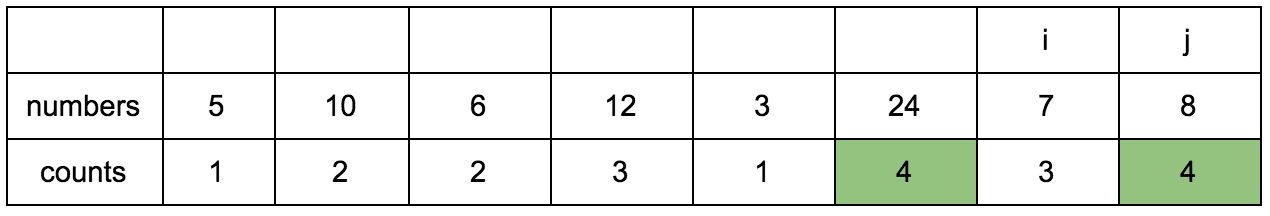

Выглядеть это будет так:

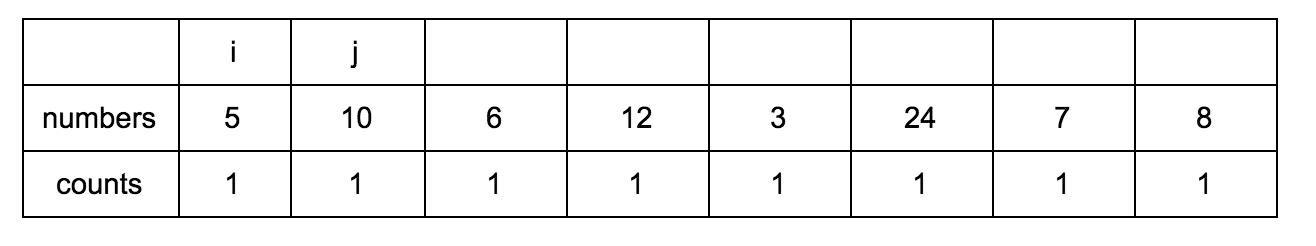

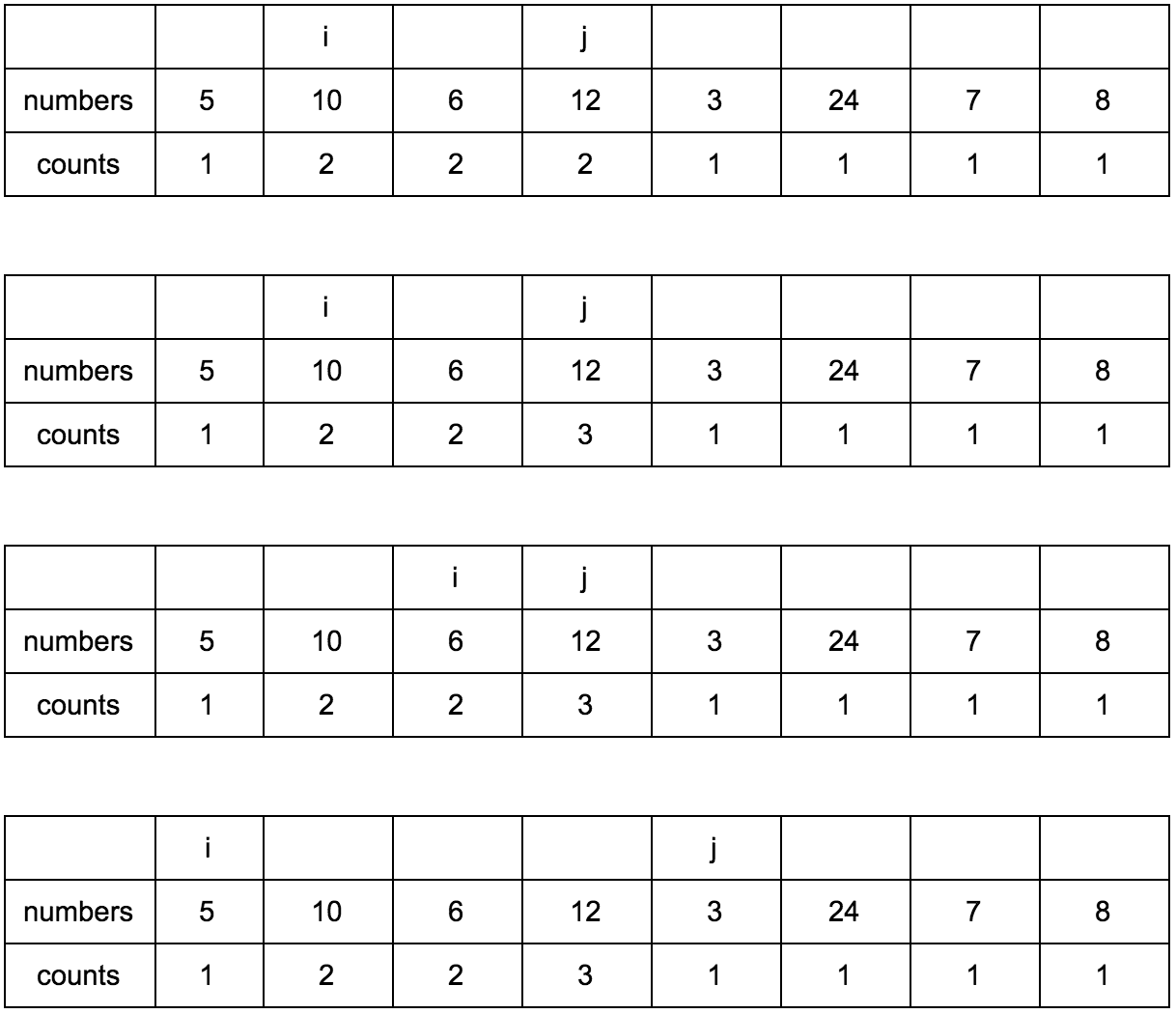

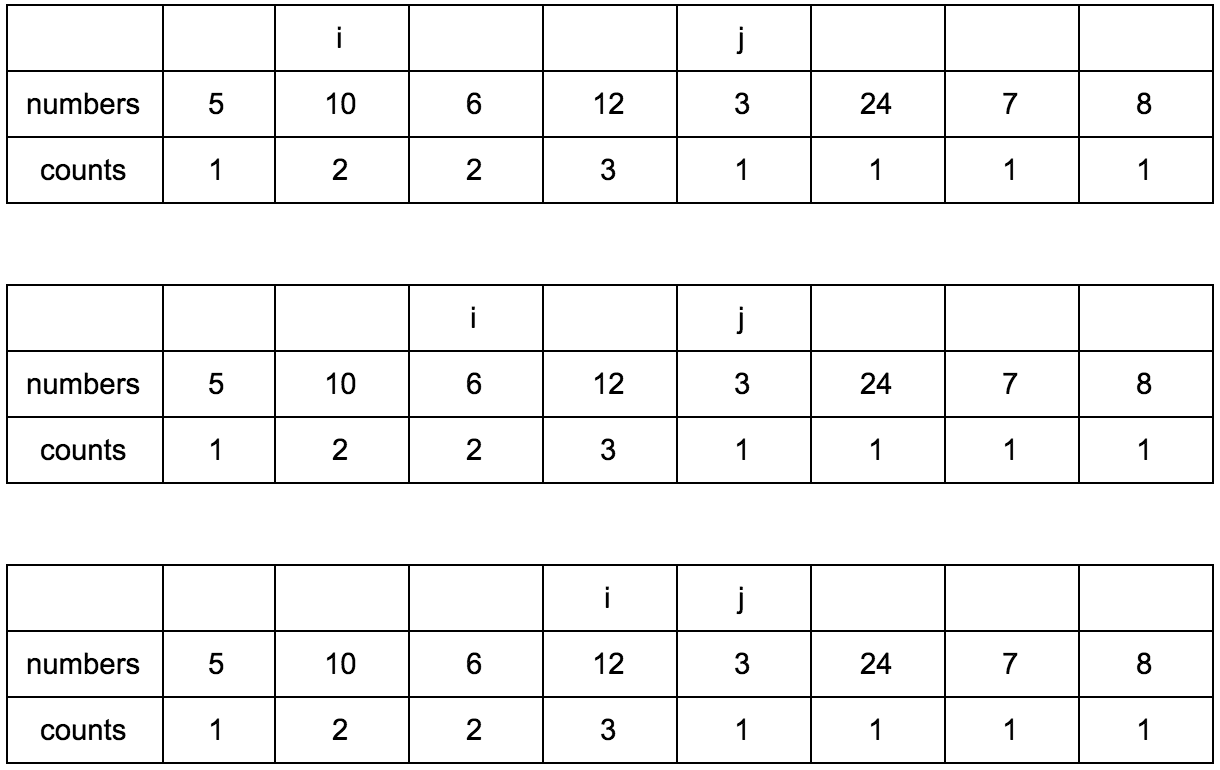

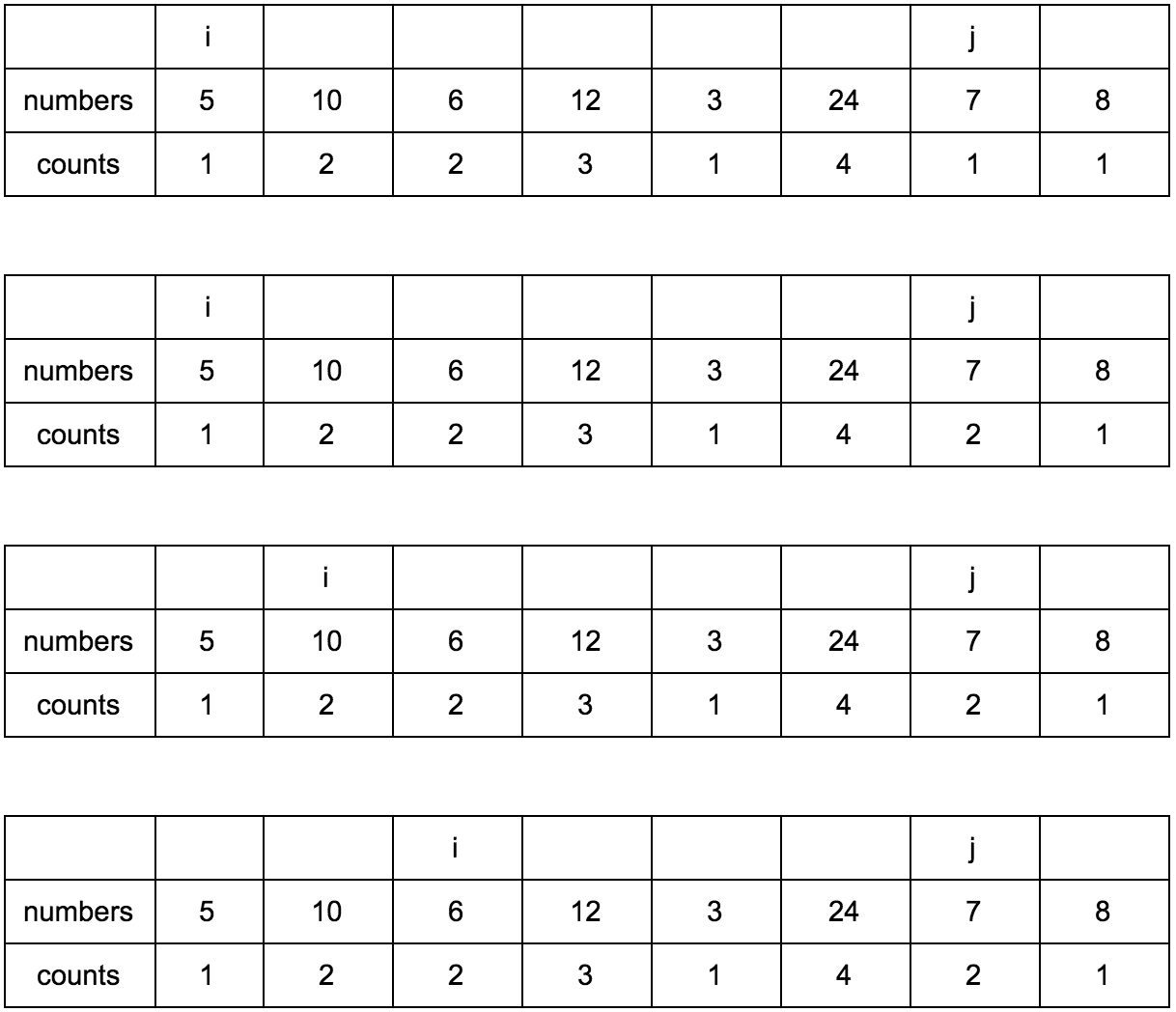

Наша задача — заполнить массив counts правильными значениями. Изначально он заполнен единицами, так как каждый элемент сам по себе является минимальной возрастающей подпоследовательностью.

“Что за загадочные i и j?” — спросите вы. Это индексы итераторов по массиву, которые мы будем использовать. Изменяться они будут с помощью двух циклов, один в другом. i всегда будет меньше чем j.

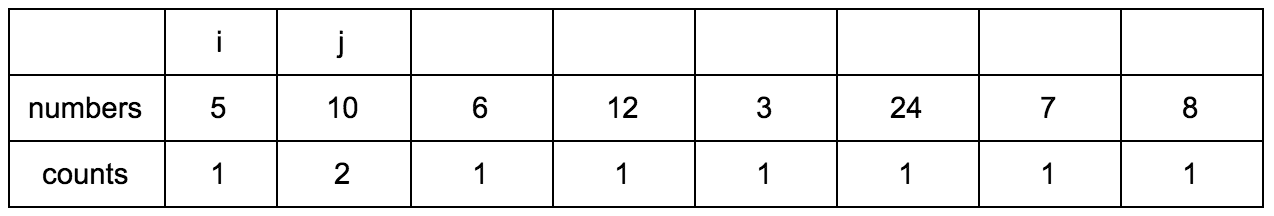

Сейчас j смотрит на 10 — это наш кандидат в члены последовательностей, которые идут до него. Посмотрим туда, где i, там стоит 5.

10 больше 5 и 1 <= 1, counts[j] <= counts[i]? Да, значит counts[j] = counts[i] + 1, помните наши рассуждения в начале?

Теперь таблица выглядит так.

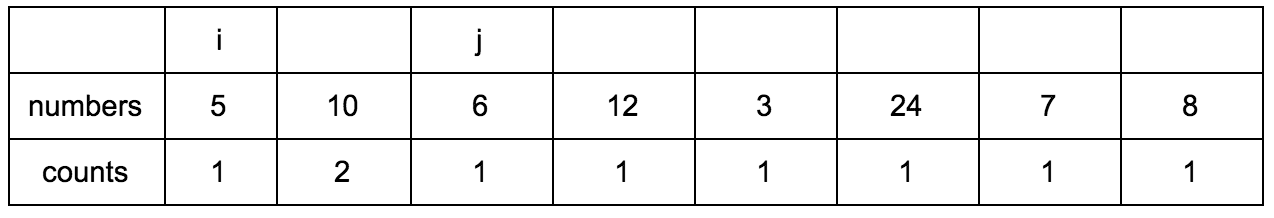

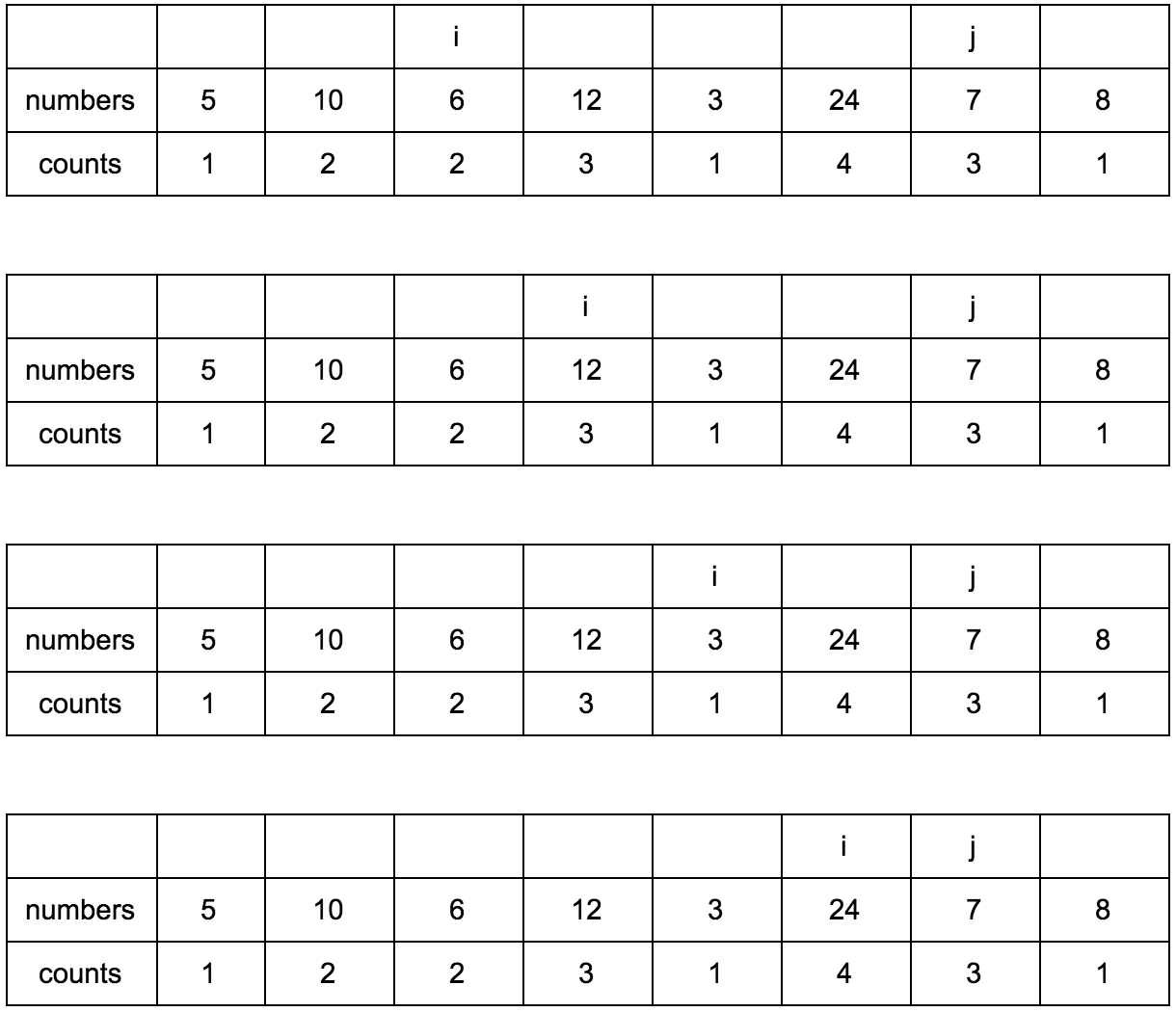

Смещаем j.

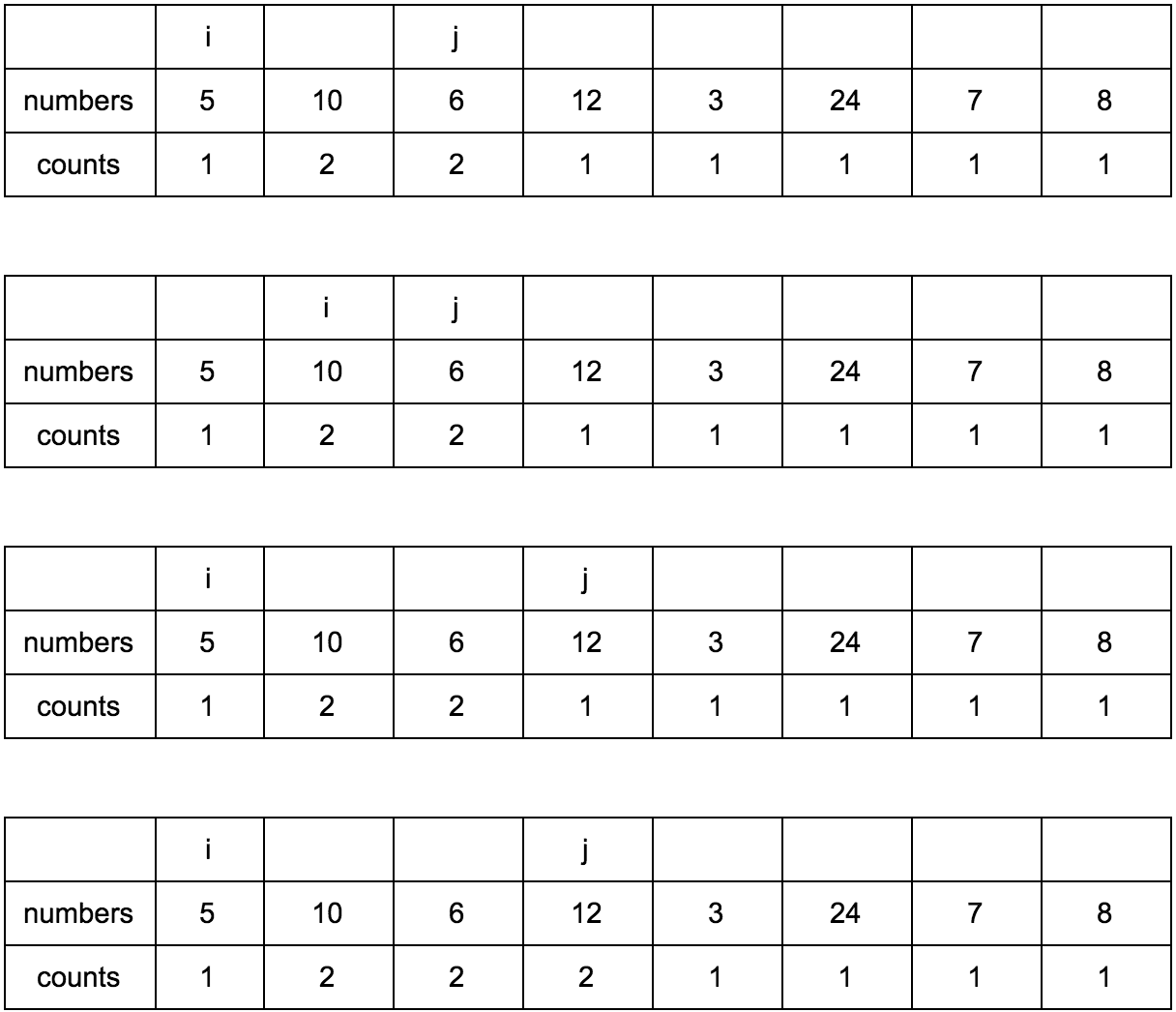

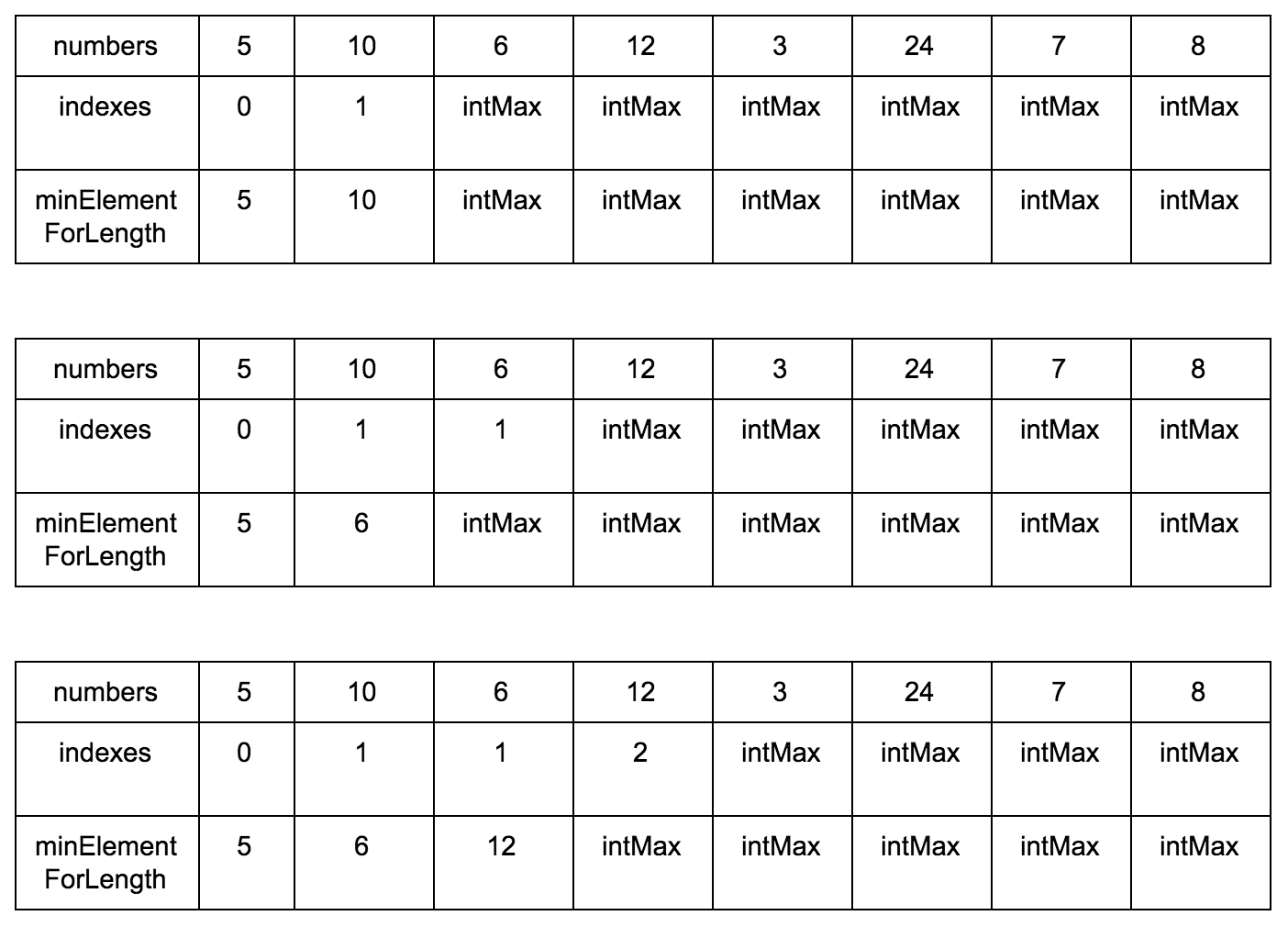

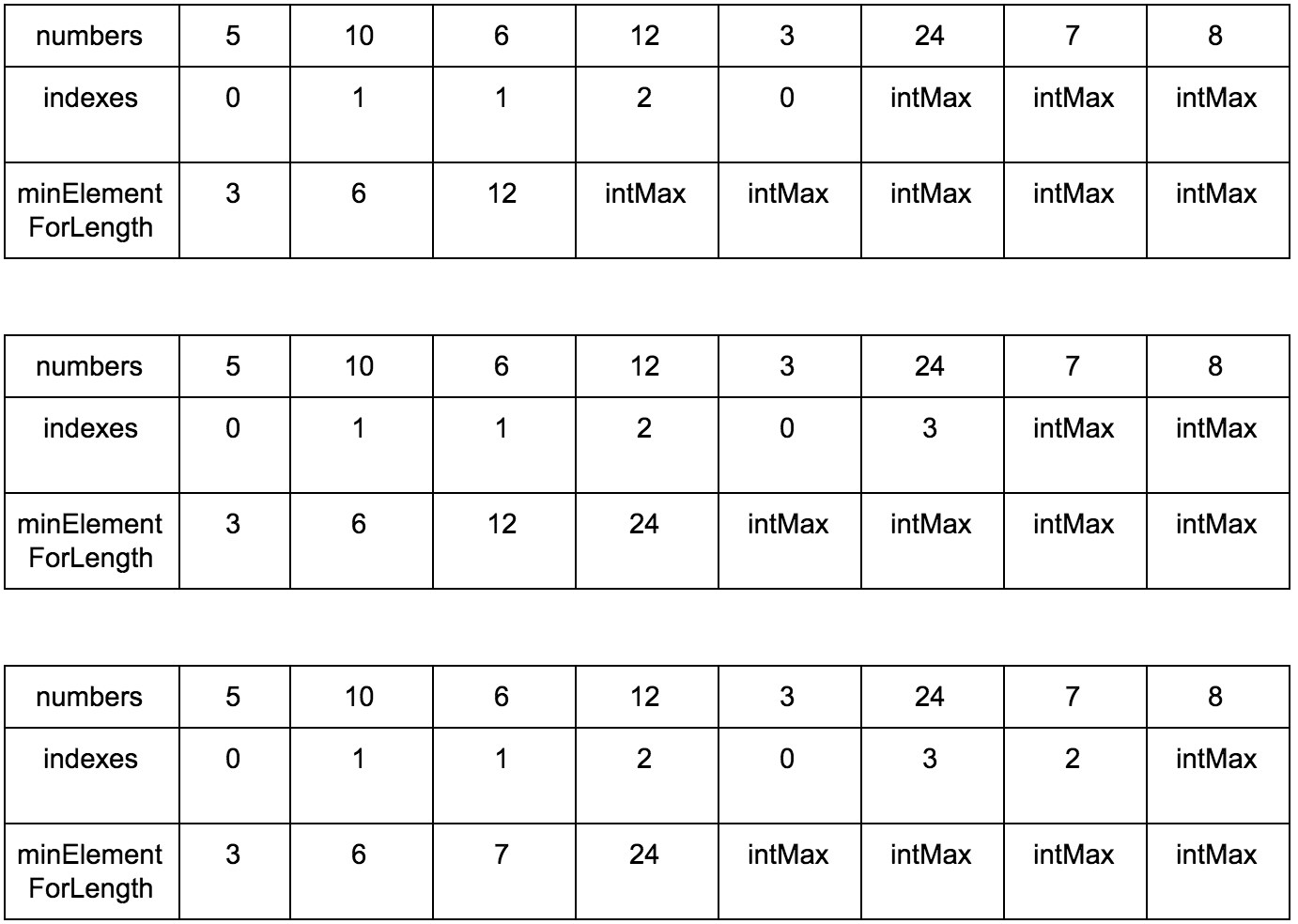

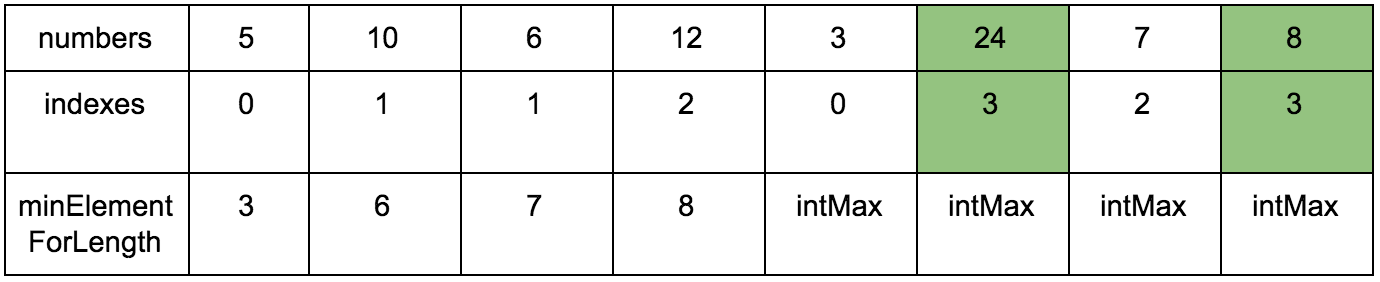

**Промежуточные шаги, их много**

Результат:

Имея перед глазами эту таблицу и понимая какие шаги нужно делать, мы теперь легко можем реализовать это в коде.

**Псевдокод:**

```

int longestIncreasingSubsequenceLength( int numbers[] ) {

if (numbers.count == 1) {

return 1;

}

int lengthOfSubsequence[] = Аrray.newArrayOfSize(numbers.count, 1);

for (int j = 1; j < numbers.count; j++) {

for (int k = 0; k < j; k++) {

if (numbers[j] > numbers[k]) {

if (lengthOfSubsequence[j] <= lengthOfSubsequence[k]) {

lengthOfSubsequence[j] = lengthOfSubsequence[k] + 1;

}

}

}

}

int maximum = 0;

for (int length in lengthOfSubsequence) {

maximum = MAX(maximum, length);

}

return maximum;

}

```

→ [Реализация на Objective-C](https://github.com/PavelKatunin/LeetCodeProblems/blob/master/LeetCodeProblems/LongestIncreasingSubsequence/LongestIncreasingSubsequenceNSquared.m)

→ [Тесты](https://github.com/PavelKatunin/LeetCodeProblems/blob/master/LeetCodeProblemsTests/LongestIncreasingSubsequenceTests.m)

Вы не могли не заметить два вложенных цикла в коде, а там где есть два вложенных цикла проходящих по одному массиву, есть и квадратичная сложность O(n^2), что обычно не есть хорошо.

Теперь, если вы [билингвал](https://twitter.com/verschroben_/status/931623485058748416), вы несомненно зададитесь вопросом “Can we do better?”, обычные же смертные спросят “Могу ли я придумать алгоритм, который сделает это за меньшее время?”

Ответ: “да, можете!”

Чтобы сделать это нам нужно вспомнить, что такое бинарный поиск.

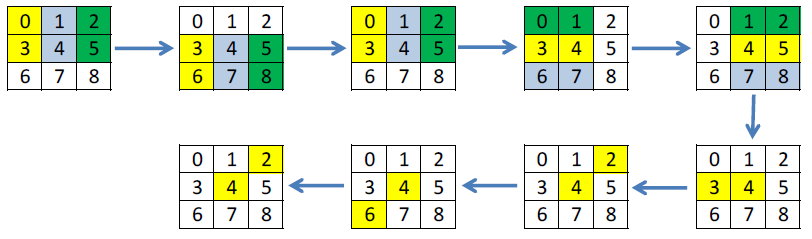

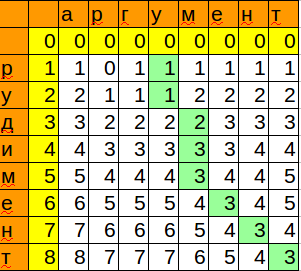

Бинарный поиск O(log n)

-----------------------

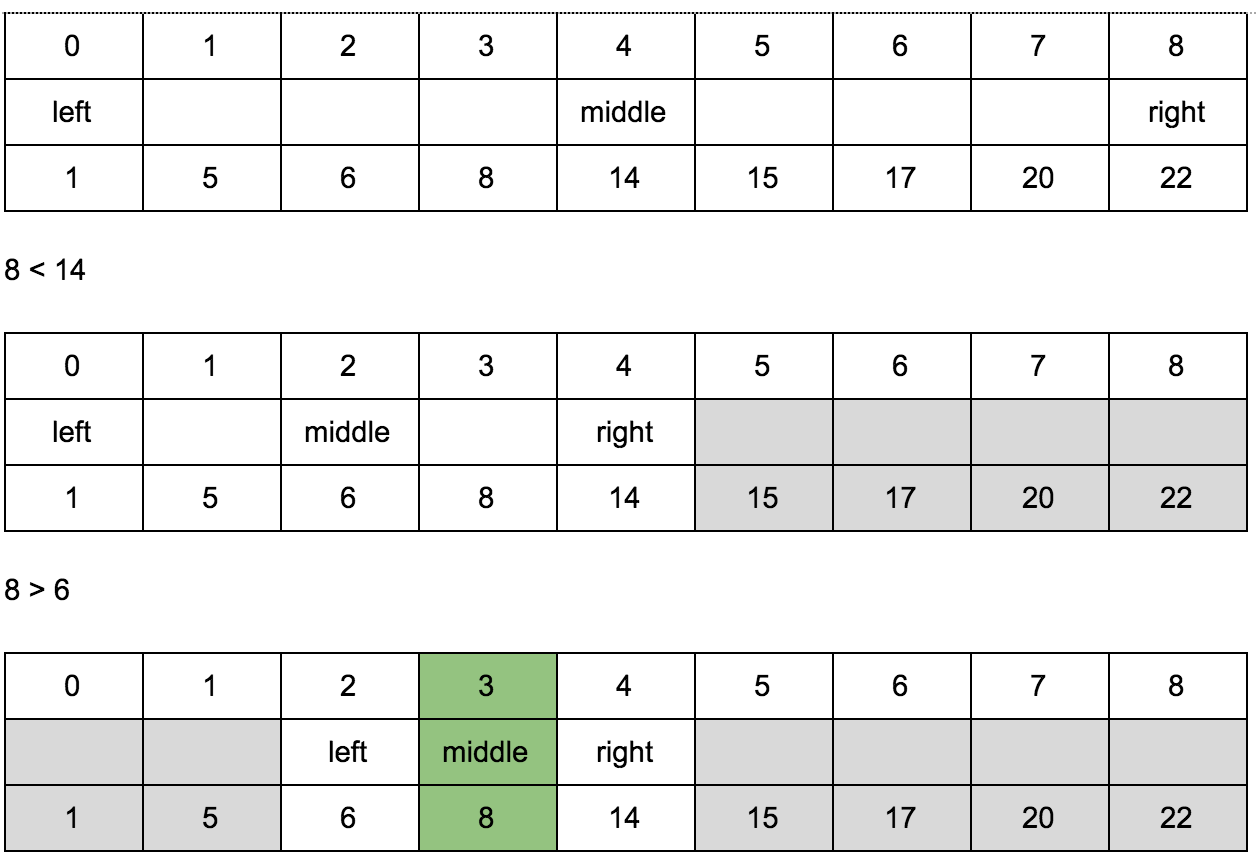

[Бинарный поиск](https://ru.wikipedia.org/wiki/%D0%94%D0%B2%D0%BE%D0%B8%D1%87%D0%BD%D1%8B%D0%B9_%D0%BF%D0%BE%D0%B8%D1%81%D0%BA) работает только на отсортированных массивах. Например, нам нужно найти позицию числа n в отсортированном массиве:

1, 5, 6, 8, 14, 15, 17, 20, 22

Зная что массив отсортирован, мы всегда можем сказать правее или левее определенного числа в массиве искомое число должно находиться.

Мы ищем позицию числа 8 в этом массиве. С какой стороны от середины массива оно будет находиться? 14 — это число в середине массива. 8 < 14 — следовательно 8 левее 14. Теперь нас больше не интересует правая часть массива, и мы можем ее отбросить и повторять ту же самую операцию вновь и вновь пока не наткнемся на 8. Как видите, нам даже не нужно проходить по всем элементам массива, сложность этого алгоритма < O( n ) и равна O (log n).

Для реализации алгоритма нам понадобятся 3 переменные для индексов: left, middle, right.

Ищем позицию числа 8.

Мы отгадали где находится 8 с трёх нот.

**Псевдокод:**

```

int binarySearch(int list [], int value) {

if !list.isEmpty {

int left = list.startIndex

int right = list.endIndex-1

while left <= right {

let middle = left + (right - left)/2

if list[middle] == value{

return middle

}

if value < list[middle]{

right = middle - 1

}

else{

left = middle + 1

}

}

}

return nil

}

```

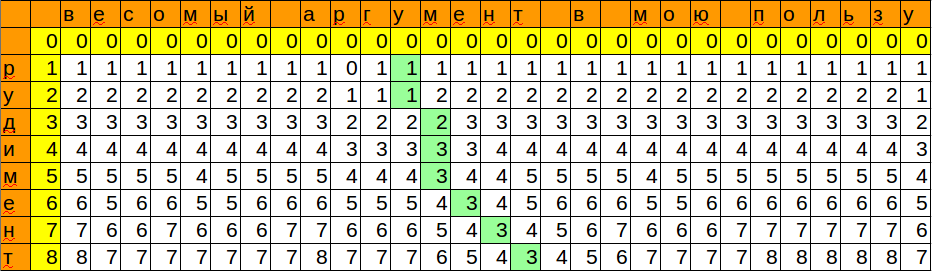

Решение за O (n \* log n)

-------------------------

Теперь мы будем проходить по нашему исходному массиву при этом заполняя новый массив, в котором будет храниться возрастающая подпоследовательность. Еще один плюс этого алгоритма: он находит не только длину максимальной возрастающей подпоследовательности, но и саму подпоследовательность.

Как же двоичный поиск поможет нам в заполнении массива подпоследовательности?

С помощью этого алгоритма мы будем искать место для нового элемента в вспомогательном массиве, в котором мы храним для каждой длины подпоследовательности минимальный элемент, на котором она может заканчиваться.

Если элемент больше максимального элемента в массиве, добавляем элемент в конец. Это просто.

Если такой элемент уже существует в массиве, ничего особо не меняется. Это тоже просто.

Что нам нужно рассмотреть, так это случай когда следующий элемент меньше максимального в этом массиве. Понятно, что мы не можем его поставить в конец, и он не обязательно вообще должен являться членом именно максимальной последовательности, или наоборот, та подпоследовательность, которую мы имеем сейчас и в которую не входит этот новый элемент, может быть не максимальной.

Все это запутанно, сейчас будет проще, сведем к рассмотрению 2-х оставшихся случаев.

1. Рассматриваемый элемент последовательности (x) меньше чем наибольший элемент в массиве (Nmax), но больше чем предпоследний.

2. Рассматриваемый элемент меньше какого-то элемента в середине массива.

В случае 1 мы просто можем откинуть Nmax в массиве и поставим на его место x. Так как понятно, что если бы последующие элементы были бы больше чем Nmax, то они будут и больше чем x — соответственно мы не потеряем ни одного элемента.

Случай 2: для того чтобы этот случай был нам полезен, мы заведем еще один массив, в котором будем хранить размер подпоследовательности, в которой этот элемент является максимальным. Собственно этим размером и будет являться та позиция в первом вспомогательном массиве для этого элемента, которую мы найдем с помощью двоичного поиска. Когда мы найдем нужную позицию, мы проверим элемент справа от него и заменим на текущий, если текущий меньше (тут действует та же логика как и в первом случае)

Не расстраивайтесь, если не все стало понятно из этого текстового объяснения, сейчас я покажу все наглядно.

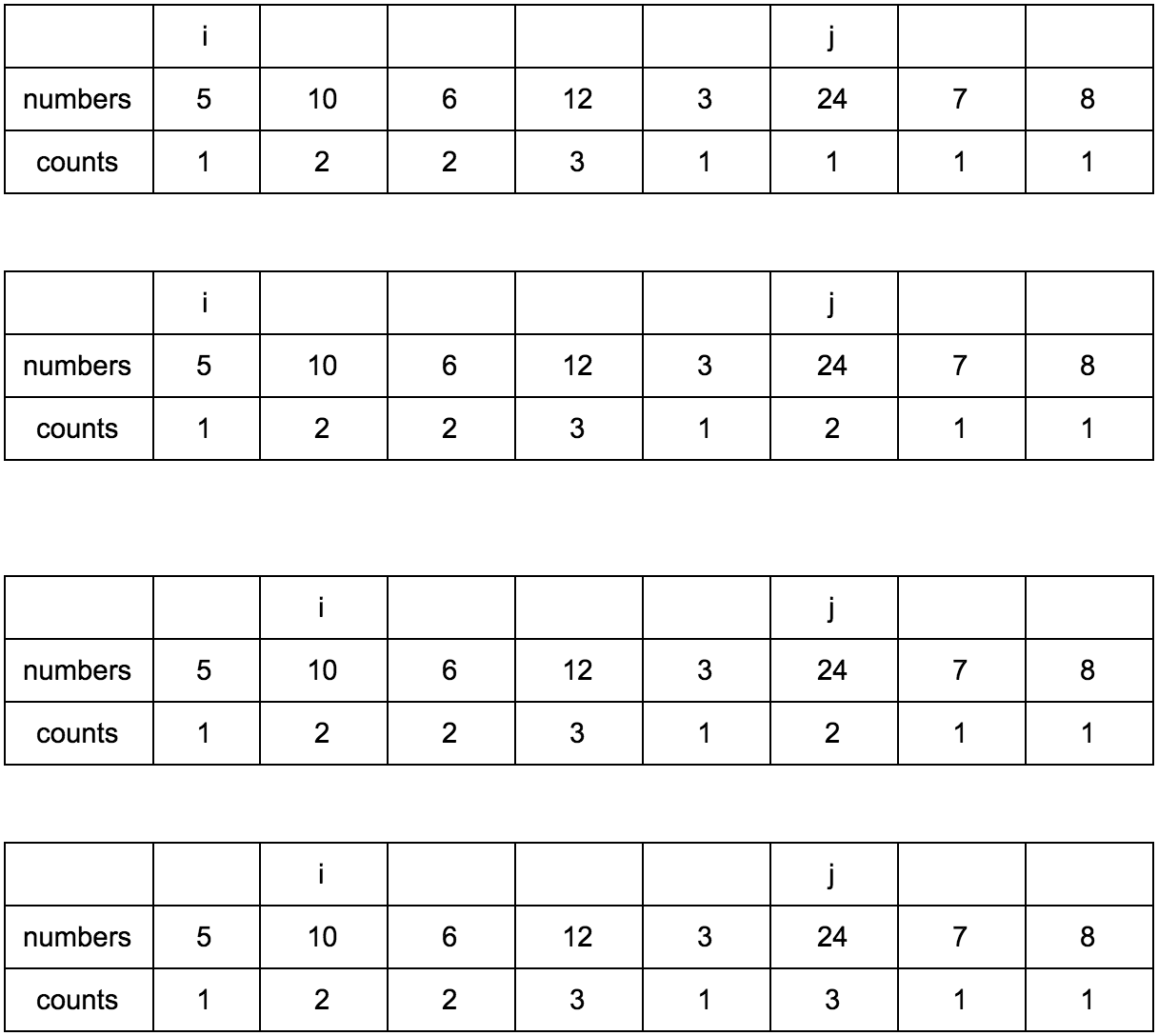

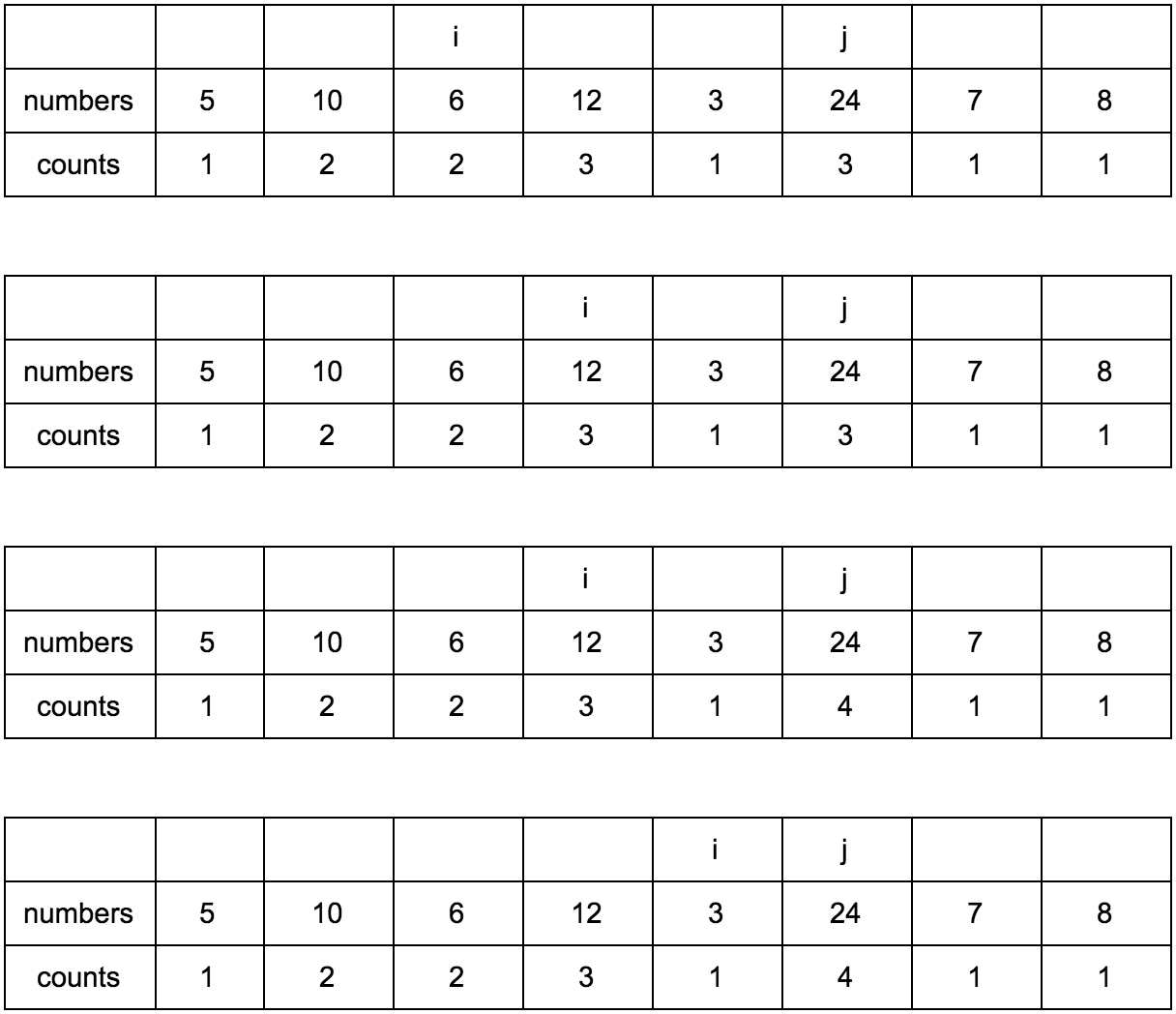

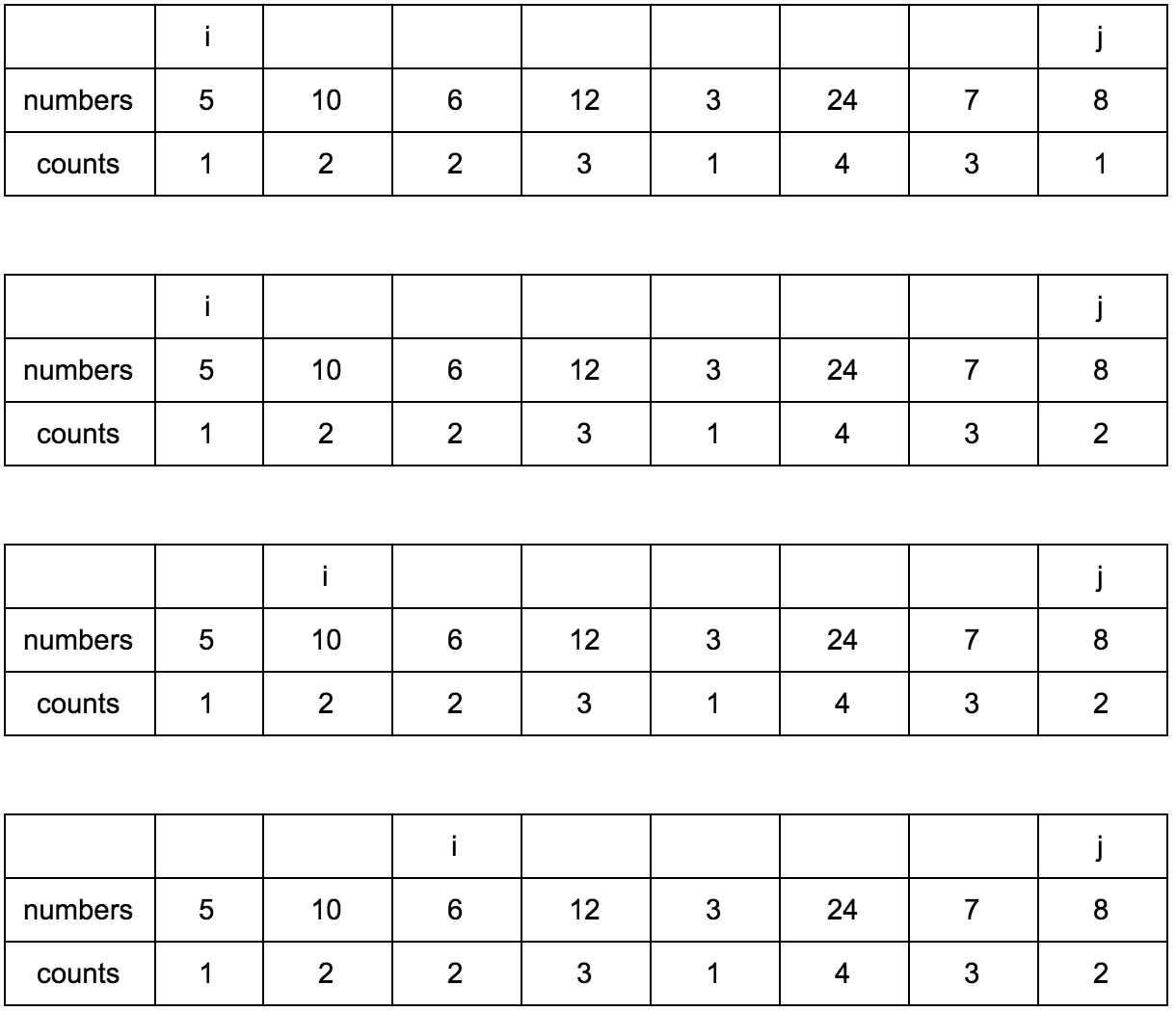

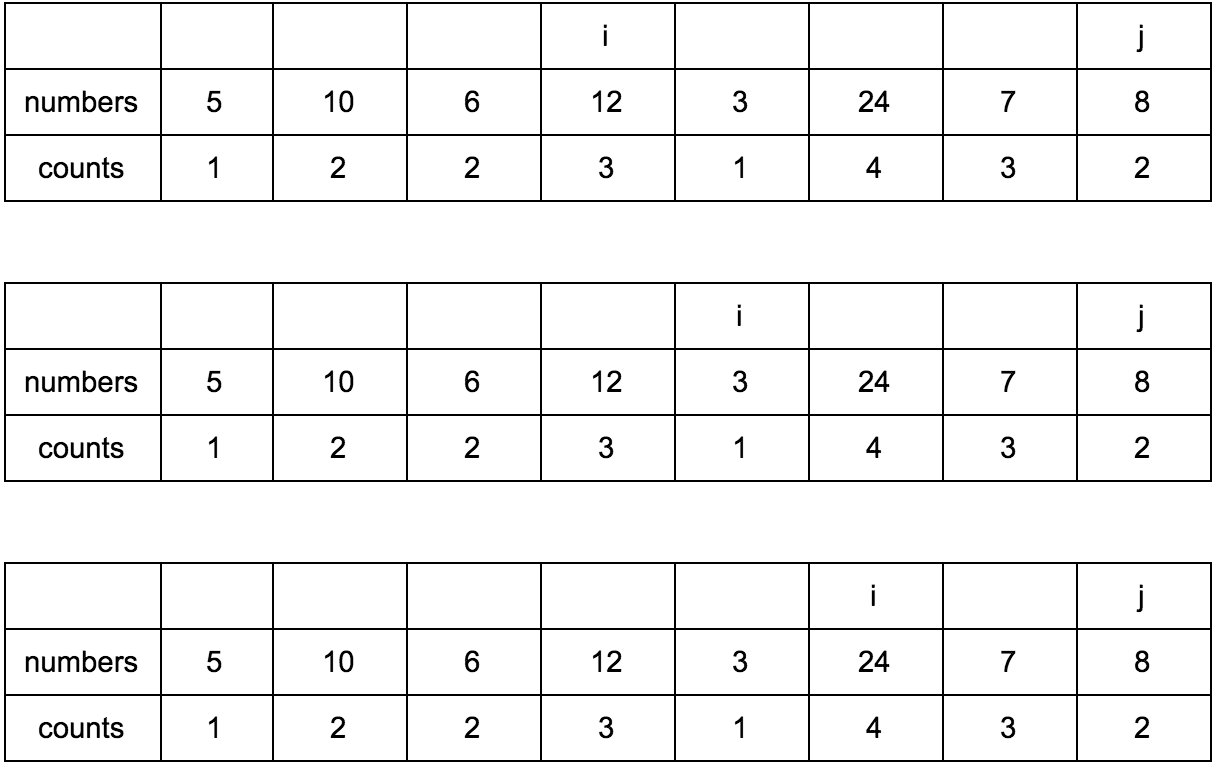

Нам нужны:

1. Исходная последовательность

2. Создаем мутабельный массив, где будем хранить возрастающие элементы для подпоследовательности

3. Создаем мутабельный массив размеров подпоследовательности, в которой рассматриваемый элемент является максимальным.

**Промежуточные шаги**

Результат:

**Псевдокод:**

```

int longestIncreasingSubsequenceLength(int numbers[]) {

if (numbers.count <= 1) {

return 1;

}

int lis_length = -1;

int subsequence[];

int indexes[];

for (int i = 0; i < numbers.count; ++i) {

subsequence[i] = INT_MAX;

subsequence[i] = INT_MAX;

}

subsequence[0] = numbers[0];

indexes[0] = 0;

for (int i = 1; i < numbers.count; ++i) {

indexes[i] = ceilIndex(subsequence, 0, i, numbers[i]);

if (lis_length < indexes[i]) {

lis_length = indexes[i];

}

}

return lis_length + 1;

}

int ceilIndex(int subsequence[],

int startLeft,

int startRight,

int key){

int mid = 0;

int left = startLeft;

int right = startRight;

int ceilIndex = 0;

bool ceilIndexFound = false;

for (mid = (left + right) / 2; left <= right && !ceilIndexFound; mid = (left + right) / 2) {

if (subsequence[mid] > key) {

right = mid - 1;

}

else if (subsequence[mid] == key) {

ceilIndex = mid;

ceilIndexFound = true;

}

else if (mid + 1 <= right && subsequence[mid + 1] >= key) {

subsequence[mid + 1] = key;

ceilIndex = mid + 1;

ceilIndexFound = true;

} else {

left = mid + 1;

}

}

if (!ceilIndexFound) {

if (mid == left) {

subsequence[mid] = key;

ceilIndex = mid;

}

else {

subsequence[mid + 1] = key;

ceilIndex = mid + 1;

}

}

return ceilIndex;

}

```

→ [Реализация на Objective-C](https://github.com/PavelKatunin/LeetCodeProblems/blob/master/LeetCodeProblems/LongestIncreasingSubsequence/LongestIncreasingSubsequenceNLogN.m)

→ [Тесты](https://github.com/PavelKatunin/LeetCodeProblems/blob/master/LeetCodeProblemsTests/LongestIncreasingSubsequenceTests.m)

Итоги

-----

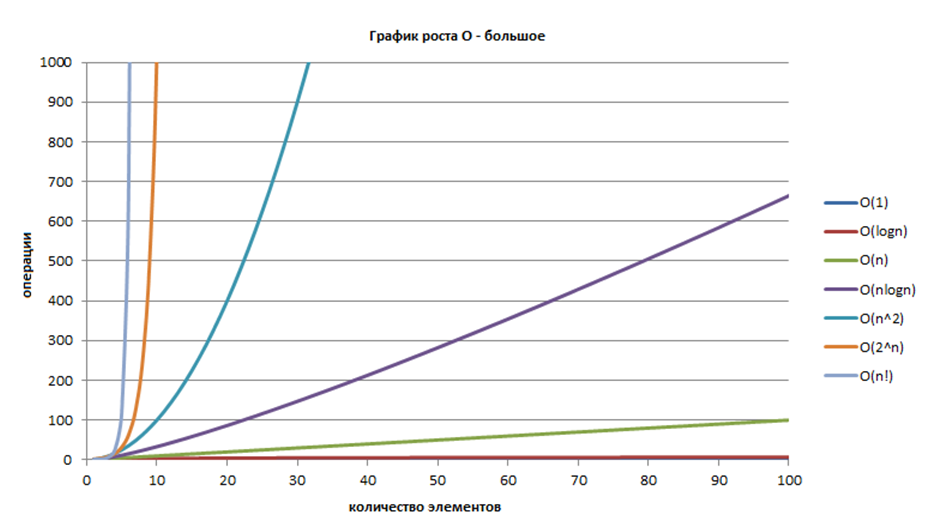

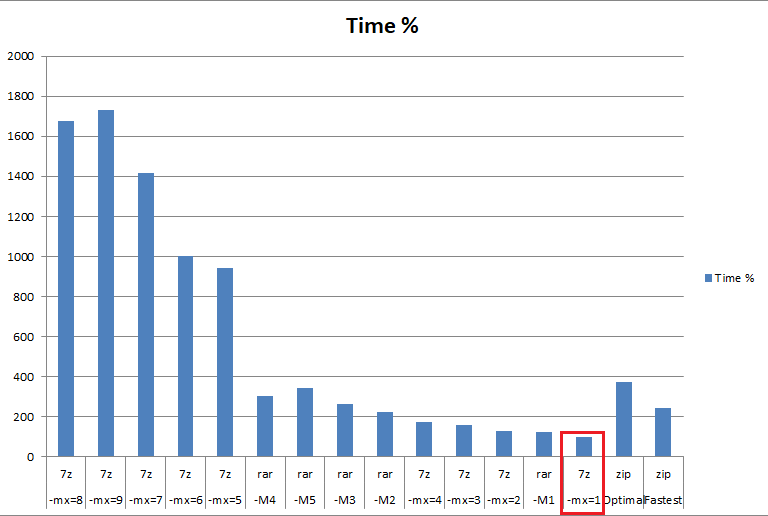

Мы с вами сейчас рассмотрели 4 алгоритма разной сложности. Это сложности, с которыми вам приходится встречаться постоянно при анализе алгоритмов:

О( log n ), О( n ), О( n \* log n ), О( n ^ 2 )

Эта картинка из вот этой [статьи](https://habrahabr.ru/post/188010/)

Еще мы рассмотрели примеры использования Динамического Программирования, тем самым расширив наш инструмент разработки и понимания алгоритмов. Эти принципы пригодятся вам при изучении других проблем.

Для лучшего понимания я рекомендую вам закодировать эти проблемы самим на привычном вам языке. А еще было бы здорово, если бы вы запостили ссылку на ваше решение в комментах.

Еще предлагаю подумать над тем как доработать последний алгоритм за O (n \* log n ) так чтобы вывести еще и саму наибольшую подпоследовательность. Ответ напишите в комментах.

Всем спасибо за внимание, до новых встреч!

Ссылки:

[Вопрос на Stackoverflow.com](https://stackoverflow.com/questions/12346348/find-the-longest-increasing-subsequence-of-a-list-in-c)

[Примеры реализации на C++ и Java](http://www.geeksforgeeks.org/?p=9591)

[Видео с объяснением](https://www.hackerrank.com/challenges/longest-increasing-subsequent/problem) | https://habr.com/ru/post/343210/ | null | ru | null |

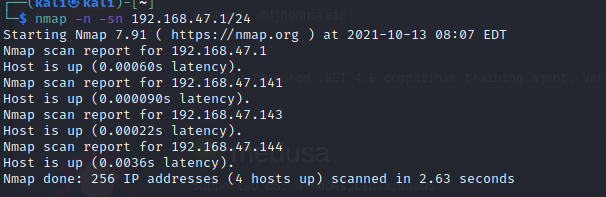

# Tizen: подводим итоги

Наша команда написала три заметки, связанные с анализом кода операционной системы Tizen. Операционная система содержит много кода и поэтому является благодатной почвой для написания различных статей. Думаю, что к Tizen мы ещё вернёмся в будущем, но сейчас нас ждут другие интересные проекты. Поэтому я подведу некоторые итоги проделанной работы и отвечу на ряд вопросов, возникших после опубликованных ранее статей.

Проделанная работа

------------------

Итак, наша команда написала 3 статьи:

1. Андрей Карпов. [27000 ошибок в операционной системе Tizen](https://habrahabr.ru/company/pvs-studio/blog/332912/). Фундаментальная статья, демонстрирующая всю важность использования статического анализа в больших проектах. Статический анализатор PVS-Studio отлично показал, как много различных паттернов ошибок он может обнаруживать в C/C++ коде.

2. Андрей Карпов. [Поговорим о микрооптимизациях на примере кода Tizen](https://habrahabr.ru/company/pvs-studio/blog/333474/). На примере Tizen продемонстрировано, какие микрооптимизации кода предлагает анализатор PVS-Studio. Старый код править не стоит, но разрабатывать новый код с учетом этих рекомендаций следует однозначно.

3. Сергей Хренов. [Продолжаем изучать Tizen: C# компоненты оказались высокого качества](https://habrahabr.ru/company/pvs-studio/blog/333694/). А вот здесь анализатор PVS-Studio не смог проявить себя. Неудача. Зато эта статья показывает, что мы честны в своих исследованиях. Удалось найти много интересных ошибок в C и C++ коде — мы написали про это. Не удалось найти ошибок в C# коде — про это мы тоже написали.

По итогам публикаций возникло два больших обсуждения: [первое](https://www.reddit.com/r/programming/comments/6n0kgy/good_news_samsungs_tizen_no_longer_worst_code/) на Reddit, [второе](https://news.ycombinator.com/item?id=14752446) на Hacker News. Также появилось несколько новостных постов. Основные:

* [Good news: Samsung's Tizen no longer worst code ever. Bad news: It's still pretty awful](https://www.theregister.co.uk/2017/07/12/samsungs_tizen_no_longer_worst_ever/)

* [Researcher Claims Samsung's Tizen OS is Poorly Programmed; Contains 27,000 Bugs!](http://thehackernews.com/2017/07/samsung-tizen-os-security.html)

Всё это и натолкнуло меня на мысль обсудить несколько дополнительных тем и ответить на некоторые вопросы, которые поднимались в дискуссиях.

Надо всё переписать на Rust

---------------------------

В последнее время активизировались энтузиасты, агитирующие везде использовать Rust. Особенно бурный всплеск дискуссии на эту тему последовал после статьи "[Rewrite the Linux kernel in Rust?](https://dominuscarnufex.github.io/cours/rs-kernel/en.html)".

Отметились эти энтузиасты и в комментариях к нашим статьям. Их предложение: чтобы не было таких ошибок, надо переписать всё на Rust.

На самом деле, мне всё равно, будет что-то переписываться или нет. В мире написано так много кода на C и C++, что еще лет 50 анализатору PVS-Studio будет что проверять. Уж если до сих пор используются статические анализаторы для Cobol, то для C и C++ они также будут требоваться ещё многие десятилетия.

И тем не менее, я не могу обойти эту тему стороной. Вы серьезно предлагаете переписывать такие проекты на Rust? Вот взять и переписать 72 MLOC кода на Rust? Да это же сумасшествие!

Это потребует невероятного количества времени и сил. Более того, потратив много лет на разработку, вы в результате получите ровно то же, что уже и так существовало! Намного лучше было бы вложить эти человеко-годы в создание чего-то нового в уже существующем проекте.

Кто-то возразит, что после такого переписывания код станет лучше и надёжнее. Вот вообще нет такой гарантии. В крупных проектах значение языка не так велико. Вдобавок, многие библиотеки на C или C++ давно отлажены, а при переписывании придётся изобретать велосипеды, которые долгие годы будут радовать пользователей разнообразнейшими ошибками.

Я считаю, тот, кто предлагает переписать 72 MLOC кода, просто некомпетентен. Это можно простить новичку, но если это говорит человек с опытом работы, то он, видимо, тролль.

3.3% — это очень маленькая выборка и ваша оценка количества ошибок неверна

--------------------------------------------------------------------------

Да, такой подход может дать неточный результат. Но переживать об этом есть смысл, если мы проверили 1000, 3000 или 10000 строк кода. Переживать стоит и в том случае, если проверялся только один проект, написанный одной командой. В другом проекте плотность ошибок может сильно отличаться.

Но я напомню, что мною (при помощи анализатора PVS-Studio) было проверено 2 400 000 строк кода на C/C++. Это много! Это размер некоторых проектов.

При этом проверялся код разных проектов. Я использовал метод выборки «пальцем в небо». Очень хороший, честный способ. Вот список изученных мною проектов:

> alsa-lib-1.0.28, aspell-0.60.6.1, augeas-1.3.0, bind-9.11.0, efl-1.16.0, enlightenment-0.20.0, ise-engine-anthy-1.0.9, bluetooth-frwk-0.2.157, capi-appfw-application-0.5.5, capi-base-utils-3.0.0, capi-content-media-content-0.3.10, capi-maps-service-0.6.12, capi-media-audio-io-0.3.70, capi-media-codec-0.5.3, capi-media-image-util-0.1.15, capi-media-player-0.3.58, capi-media-screen-mirroring-0.1.78, capi-media-streamrecorder-0.0.10, capi-media-vision-0.3.24, capi-network-bluetooth-0.3.4, capi-network-http-0.0.23, cynara-0.14.10, e-mod-tizen-devicemgr-0.1.69, ise-engine-default-1.0.7, ise-engine-sunpinyin-1.0.10, ise-engine-tables-1.0.10, isf-3.0.186, org.tizen.app-selector-0.1.61, org.tizen.apps-0.3.1, org.tizen.bluetooth-0.1.2, org.tizen.browser-3.2.0, org.tizen.browser-profile\_common-1.6.4, org.tizen.classic-watch-0.0.1, org.tizen.d2d-conv-setting-profile\_mobile-1.0, org.tizen.d2d-conv-setting-profile\_wearable-1.0, org.tizen.download-manager-0.3.21, org.tizen.download-manager-0.3.22, org.tizen.dpm-toolkit-0.1, org.tizen.elm-demo-tizen-common-0.1, org.tizen.indicator-0.2.53, org.tizen.inputdelegator-0.1.170518, org.tizen.menu-screen-1.2.5, org.tizen.myplace-1.0.1, org.tizen.privacy-setting-profile\_mobile-1.0.0, org.tizen.privacy-setting-profile\_wearable-1.0.0, org.tizen.quickpanel-0.8.0, org.tizen.screen-reader-0.0.8, org.tizen.service-plugin-sample-0.1.6, org.tizen.setting-1.0.1, org.tizen.settings-0.2, org.tizen.settings-adid-0.0.1, org.tizen.telephony-syspopup-0.1.6, org.tizen.voice-control-panel-0.1.1, org.tizen.voice-setting-0.0.1, org.tizen.volume-0.1.149, org.tizen.w-home-0.1.0, org.tizen.w-wifi-1.0.229, org.tizen.watch-setting-0.0.1, security-manager-1.2.17.

Вряд ли мне «повезло» взять столько проектов, относящихся к одной команде. Очевидно, что здесь трудились разные команды специалистов.

Поэтому можно считать, что полученное значение плотности обнаруживаемых ошибок является средним и для оставшейся части проекта.

Всё не так плохо, как вы утверждаете

------------------------------------

После публикации моей статьи «27000 errors in the Tizen operating system» в интернете появилось несколько неграмотных новостей, где люди написали про большое количество уязвимостей, найденных в Tizen. Например, можно было встретить вот такие неграмотные заголовки «В коде операционной системы Tizen зафиксировано 27000 уязвимостей». Это, естественно, не соответствует действительности. Давайте я поясню почему.

Сразу скажу, что я писал не про уязвимости, а про ошибки. И ещё, в статье я нигде не говорил, что Tizen является некачественным кодом. Да, я говорю, что анализатор PVS-Studio выявляет много ошибок, однако в любом большом проекте ошибок будет много. Поэтому общее количество ошибок ещё не говорит о качестве кода.

Давайте теперь немного подробнее поговорим про уязвимости. Среди всех ошибок, которые встречаются в программах, выделяют security weaknesses. Их особенность в том, что возможно стечение обстоятельств, когда эта ошибка может использоваться злоумышленником. Эти типы ошибок описаны в [CWE](https://cwe.mitre.org/). CWE is a community-developed list of common software security weaknesses.

В своей статье я классифицирую многие ошибки по классификации CWE. Однако это ещё ничего не значит. Дело в том, что такие ошибки удается очень редко использовать как уязвимости. Другими словами, очень редко удаётся превратить CWE в CVE. Подробнее с терминологией можно ознакомиться [здесь](https://cwe.mitre.org/about/faq.html).

Ещё раз подчерку, что использовать ошибку как уязвимость можно очень-очень редко. В подавляющем большинстве случаев, ошибка — это просто ошибка, которая хоть и неприятна пользователям программы, но не доставляет проблем безопасности.

27000 ошибок говорит о хорошем или плохом качестве кода? Невозможно сказать. Однако это не является страшным числом, как может показаться на первый взгляд. Следует учитывать, что общий объём кода составляет 72 500 000 строк на языке C, C++ (без учёта комментариев). Получается, что анализатор PVS-Studio выявляет приблизительно 0,37 ошибки на 1000 строк кода. Или другими словами около 1 ошибки на 3000 строк кода.

**Примечание.** Не стоит путать это с общим количеством ошибок в коде Tizen. Это то, что мы можем выявить, а не то, сколько их всего там есть. Прошу обратить на это внимание, так как некоторые неправильно интерпретируют данные.

Итак, PVS-Studio выявляет приблизительно 0,37 ошибок на 1000 строк кода. Это много или мало? Скорее, средне. Бывает лучше и хуже. Вот некоторые примеры:

* Notepad++: [мы находим](https://www.viva64.com/ru/b/0511/) около 2 errors per 1000 lines of code.

* Far Manager for Linux: мы [находим](https://www.viva64.com/ru/b/0478/) около 0.46 errors per 1000 lines of code.

* Tor project: мы вообще ничего [не находим](https://www.viva64.com/ru/b/0507/). Плотность 0.

Подведём итоги. На самом деле никакой сенсации нет. Шокирует число в 27000 ошибок, но такая внушительная цифра связана с большим размером проекта Tizen. Если взять другой большой проект, там тоже будет много ошибок.

Целью моей статьи было показать, что инструмент PVS-Studio может быть полезен проекту Tizen. И кажется, мне это удалось. Однако я вовсе не ожидал той бурной реакции и обсуждения, которые возникли вокруг этой статьи. Мы регулярно пишем подобные заметки. С ними можно [ознакомиться здесь](https://www.viva64.com/ru/inspections/).

В статье не указан процент ложных срабатываний

----------------------------------------------

Начну издалека. К сожалению, многие читатели знакомятся со статьями очень невнимательно. В результате они довольно часто неправильно воспринимают числа, которые в них указываются. Я уже хорошо знаком с этим эффектом и стараюсь учитывать это в статьях. Например, в статье про «27000 ошибок» я специально дважды написал, что я нашел 900 ошибок, изучив 3.3% кода. При этом подчеркивал, что речь идёт именно об ошибках, а не о количестве выданных анализатором предупреждений.

И хотя я подстраховался, всё равно появился вот этот комментарий:

*900 варнингов в аналоге Lint'а не означает 900 багов. Я бы даже сказал, что эти показатели вообще не связаны никак. Наверняка, там обнаружены ошибки в форматировании кода, областях видимости переменных и т.д. В топку таких аналитегов.*

Человек не читал статью, но увидел число 900 и спешит поделиться своим мнением с другими.

Вот именно по этой причине я не пишу о количестве ложных срабатываний. Люди увидят какое-то число, а потом многие годы везде будут писать в комментариях «это плохой анализатор, у которого процент ложных срабатываний составляет NN».

Всё дело в том, что анализатор требует настройки. Причем большинство ложных срабатываний относится к небольшому количеству макросов. Я уже не раз демонстрировал в некоторых своих статьях, как подавление предупреждений для нескольких макросов резко уменьшает количество ложных срабатываний.

Точно так же дело обстоит и с Tizen. Однако боюсь, на эти объяснения и примеры мало кто обратит внимание. Зато все запомнят число, означающее большой процент ложных срабатываний.

Возникает логичный вопрос: Тогда почему бы вам не настроить статический анализатор и не показать сразу хороший результат?

Отвечаю. Это займёт время, а меня ещё ждут такие интересные проекты, как iOS или Android. Однако это не главная причина, почему я не хочу этим заниматься. Дело в том, что непонятно где остановиться. Я знаю, что, приложив усилия, мы сможем свести количество ложных срабатываний до нуля, ну или почти до нуля. Например, мы сводили до нуля количество ложных срабатываний, когда работали над проектом Unreal Engine (см. статьи [1](https://www.unrealengine.com/en-US/blog/how-pvs-studio-team-improved-unreal-engines-code), [2](https://www.unrealengine.com/en-US/blog/static-analysis-as-part-of-the-process)).

Итак, если я с помощью настроек уменьшу количество ложных срабатываний до какого-то очень маленького процента, мне скажут, что это нечестно. Получается, что с одной стороны мне будет хотеться оставить как можно меньше ложных срабатываний, с другой стороны я должен не перестараться, показав слишком идеальный вариант. Что-то мне всё это не нравится. Я считаю, что лучше вообще тогда ничего не делать.

Так как же программисту понять, хорошо работает наш анализатор или плохо? Очень просто! Нужно его [скачать](https://www.viva64.com/ru/pvs-studio-download/) и попробовать проверить рабочий проект. Cразу станет понятно, нравится он или нет. И будет сразу видно, как много ложных срабатываний и какого они типа. После чего, возможно, ваша компания с удовольствием пополнит [список наших клиентов](https://www.viva64.com/ru/customers/).

Только прошу не совершать ошибку и не пробовать анализатор на маленьких проектах или вообще тестовых примерах. Причины:

* [Ощущения, которые подтвердились числами](https://www.viva64.com/ru/b/0158/) (в маленьких проектах, низкая плотность ошибок).

* [Почему я не люблю синтетические тесты](https://www.viva64.com/ru/b/0471/) (тесты не отображают реальные типы ошибок).

**Update.** Вношу это примечание уже после написания статьи. Хорошо, читатели победили. Я сдаюсь и привожу число. Я провёл исследование EFL Core Libraries и вычислил, что статический анализатор PVS-Studio будет выдавать около 10-15% ложных срабатываний. Вот статья про это: [Характеристики анализатора PVS-Studio на примере EFL Core Libraries](https://habrahabr.ru/company/pvs-studio/blog/334554/).

Достаточно -Wall -Wextra -Werror

--------------------------------

Как всегда, прозвучали комментарии о том, что современные компиляторы сами хорошо умеют выполнять статический анализ кода и дополнительные инструменты не нужны.

Дополнительные инструменты нужны. Статические анализаторы — это специализированные инструменты, которые всегда опережают компиляторы своими диагностическими возможностями. За это они и получают деньги от своих клиентов.

Впрочем, кроме слов у меня есть и доказательства. Каждый раз, когда мы проверяем какой-нибудь компилятор, мы находим там ошибки:

* [Проверка LLVM (Clang)](https://www.viva64.com/ru/b/0108/) (август 2011), [вторая проверка](https://www.viva64.com/ru/b/0155/) (август 2012), [третья проверка](https://www.viva64.com/ru/b/0446/) (октябрь 2016)

* [Проверка GCC](https://www.viva64.com/ru/b/0425/) (август 2016)

* В случае Visual C++ мы проверяли системные библиотеки. Раз мы находим там ошибки, значит Visual C++ их не видит. [Проверка библиотек Visual C++](https://www.viva64.com/ru/b/0163/) (сентябрь 2012), [вторая проверка](https://www.viva64.com/ru/b/0288/) (октябрь 2014), [третья проверка](https://www.viva64.com/ru/b/0502/) (май 2017).

При этом не стоит забывать, что статический анализ — это не только предупреждения, это ещё и инфраструктура. Вот некоторые возможности PVS-Studio:

* Удобная и простая интеграция с Visual Studio 2010-2017.

* Интеграция с SonarQube.

* Утилита BlameNotifier. Инструмент позволяет рассылать письма разработчикам об ошибках, которые PVS-Studio нашел во время ночного прогона.

* Mass Suppression — позволяет подавить все старые сообщения, чтобы анализатор выдавал 0 срабатываний. К подавленным сообщениям всегда можно вернуться позже. Возможность безболезненно внедрить PVS-Studio в существующий процесс разработки и сфокусироваться на ошибках только в новом коде.

* Сохранение и загрузка результатов анализа: можно ночью проверить код, сохранить результаты, а утром загрузить их и смотреть.

* Поддержка IncrediBuild.

* Mark as False Alarm — разметка в коде, чтобы не ругаться конкретной диагностикой в конкретном фрагменте файла.

* Интерактивная фильтрация результатов анализа (лога) в окне PVS-Studio: по коду диагностики, по имени файла, по включению слова в текст диагностики.

* Статистика ошибок в Excel — можно посмотреть темпы правки ошибок, количество ошибок во времени и т.п.

* Автоматическая проверка на наличие новых версий PVS-Studio (как при работе в IDE, так и при ночных сборках).

* Использование относительных путей в файлах отчета для возможности переноса отчета на другую машину.

* CLMonitoring — проверка проектов, у которых нет файлов Visual Studio (.sln/.vcxproj); если вдруг вам не хватит функциональности CLMonitoring, то вы можете интегрировать PVS-Studio в любую Makefile-based систему сборки вручную.

* pvs-studio-analyzer — утилита аналогичная CLMonitoring, но работающая под Linux.

* Возможность исключить из анализа файлы по имени, папке или маске.

Подробнее про всё это можно узнать в [документации](https://www.viva64.com/ru/m/).

Нет цены

--------

Да, на сайте у нас нет цены. Это стандартная практика компаний, продающих решения в сфере статического анализа кода.

Мы позиционируем PVS-Studio как B2B решение. При продаже компаниям необходимо обсудить множество моментов, которые влияют на цену лицензии. Вывешивать какую-то конкретную цену на сайт не имеет смысла и продуктивнее сразу приступить к обсуждению.

Почему мы не работаем с индивидуальными разработчиками? [Мы пробовали, но у нас не получилось](https://www.viva64.com/ru/b/0320/).

Впрочем, индивидуальные разработчики могут воспользоваться одним из вариантов бесплатной лицензии:

* Для этого они должны согласиться с условием модификации кода: [как использовать PVS-Studio бесплатно](https://www.viva64.com/ru/b/0457/).

* Также мы бесплатно [предоставляем анализатор PVS-Studio экспертам безопасности](https://www.viva64.com/ru/b/0510/).

* Бесплатную версию может получить любой [Microsoft MVP](https://www.viva64.com/ru/n/0089/).

Представителей компаний я приглашаю пообщаться по [почте](https://www.viva64.com/ru/about-feedback/).

Не все участки, которые вы упоминаете в статье, являются настоящими ошибками

----------------------------------------------------------------------------

Да, возможно что-то окажется не ошибкой при более тщательном изучении кода. С другой стороны, при тщательном анализе может выясниться, что я, наоборот, пропускал некоторые ошибки. Например, я поленился изучать предупреждения [V730](https://www.viva64.com/ru/w/V730/) — Not all members of a class are initialized inside the constructor. Очень трудоёмко пытаться понять в чужом коде, является ли ошибкой, что какой-то член класса остался неинициализированным. Однако, если этим заняться, наверняка найдутся настоящие ошибки.

Давайте разберем один из таких случаев. Код относится к проекту org.tizen.browser-profile\_common-1.6.4.

Для начала рассмотрим определение класса *BookmarkItem*.

```

class BookmarkItem

{

public:

BookmarkItem();

BookmarkItem(

const std::string& url,

const std::string& title,

const std::string& note,

unsigned int dir = 0,

unsigned int id = 0

);

virtual ~BookmarkItem();

void setAddress(const std::string & url) { m_url = url; };

std::string getAddress() const { return m_url; };

void setTitle(const std::string & title) { m_title = title; };

std::string getTitle() const { return m_title; };

void setNote(const std::string& note){m_note = note;};

std::string getNote() const { return m_note;};

void setId(int id) { m_saved_id = id; };

unsigned int getId() const { return m_saved_id; };

....

....

bool is_folder(void) const { return m_is_folder; }