text

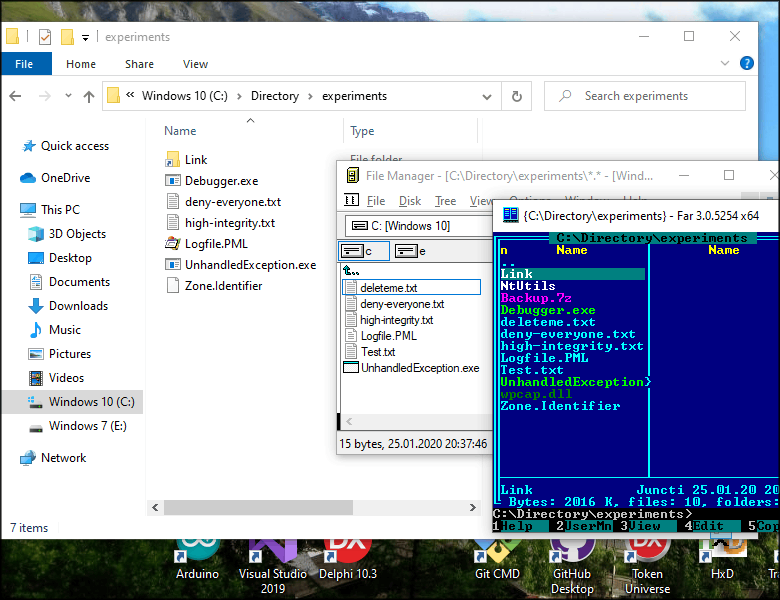

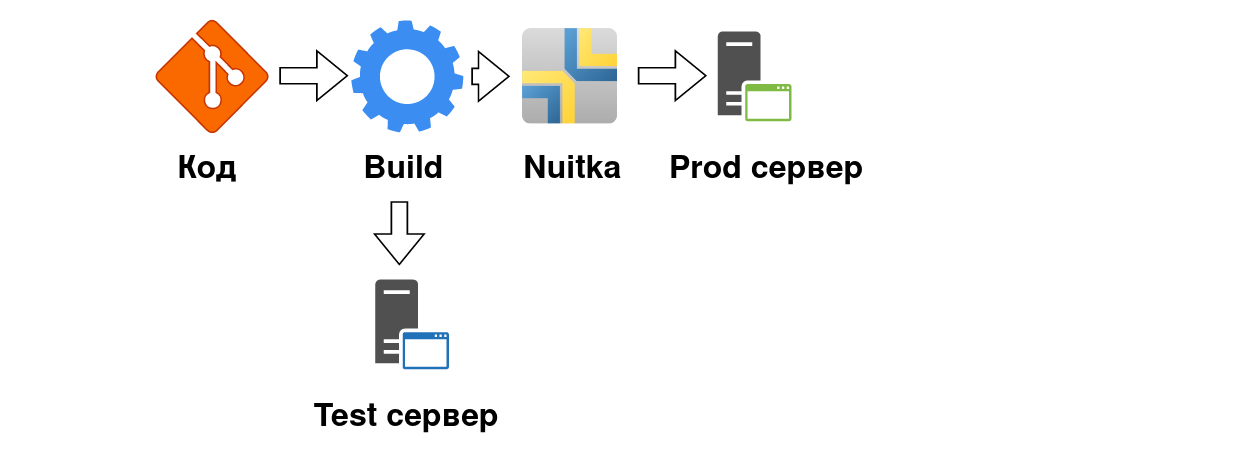

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Класс для проигрывания аудио из приложений iOS

Добрый день, Хабрасообщество!

Я хотел бы поделиться решением проблемы проигрывания аудио из приложений iOS. Мы столкнулись с этим в процессе разработки очередного приложения: нам хотелось запускать и останавливать воспроизведение музыки и звуковых эффектов в разных местах, зачастую находящихся в разных классах приложения.

Обычно “болванка” необходимого функционала для этого копируется и адаптируется под конкретный сценарий использования. Мы делали это не раз и решили, что пришло время для более элегантного решения. Таким решением оказалось сделать “синглтон”, который был бы не только доступен из разных мест в приложении, но и сэкономил бы ресурсы системы в случае использования одного и того же аудио несколько раз.

Имплементация

-------------

В iOS, воспроизвести звуки можно [несколькими способами](http://developer.apple.com/library/ios/#documentation/AudioVideo/Conceptual/MultimediaPG/UsingAudio/UsingAudio.html#//apple_ref/doc/uid/TP40009767-CH2). Система разделяет звуки на “системные” – короткие звуки, которые проигрываются чтобы проинформировать пользователя о каком-то действии; например “озвучить” нажатие на кнопку или подтвердить отправку электронной почты. Другая категория это “музыка” – продолжительное аудио, такое как песни, мелодии и т.д. В нашем случае — это была мелодия, написанная для приложения замечательным композитором Бахтияром Аманжолом.

Проигрывание коротких звуков обеспечивaется с помощью “[System Sound Services](http://developer.apple.com/library/ios/#documentation/AudioToolbox/Reference/SystemSoundServicesReference/Reference/reference.html)”. Воспроизведение более продолжительного аудио обеспечивается целой серией средств, работающих на разных уровнях абстракции; мы приняли решение воспользоваться [AVAudioPlayer](http://developer.apple.com/library/ios/#DOCUMENTATION/AVFoundation/Reference/AVAudioPlayerClassReference/Reference/Reference.html).

Для удобства использования, мы решили дать доступ к функционалу посредством “методов класса” нежели чем “методов объекта”. В результате, проиграть звук можно посредством вот такого кода:

```

[MCSoundBoard playSoundForKey:@"ding"];

```

Для того чтобы реализовать такого рода вызов и, одновременно, кэшировать фрагменты аудио, мы использовали шаблон “синглтон”. Синглтоны в Objective-C можно реализовать многими способами. Исследуя эту проблему, мы набрели на очень аккуратный метод, описанный [здесь](http://lukeredpath.co.uk/blog/a-note-on-objective-c-singletons.html). Вот как выглядит необходимый код:

```

+ (MCSoundBoard *)sharedInstance

{

__strong static id _sharedObject = nil;

static dispatch_once_t onceToken;

dispatch_once(&onceToken, ^{

_sharedObject = [[self alloc] init];

});

return _sharedObject;

}

```

Затем мы определили “публичные” методы (обратите внимание что это – методы класса):

```

+ (void)addSoundAtPath:(NSString *)filePath forKey:(id)key;

+ (void)playSoundForKey:(id)key;

+ (void)addAudioAtPath:(NSString *)filePath forKey:(id)key;

+ (void)playAudioForKey:(id)key;

+ (void)stopAudioForKey:(id)key;

+ (void)pauseAudioForKey:(id)key;

```

Эти публичные статичные методы вызывают методы объекта синглтона:

```

- (void)addSoundAtPath:(NSString *)filePath forKey:(id)key

{

NSURL* fileURL = [NSURL fileURLWithPath:filePath];

SystemSoundID soundId;

AudioServicesCreateSystemSoundID((__bridge CFURLRef)fileURL, &soundId);

[_sounds setObject:[NSNumber numberWithInt:soundId] forKey:key];

}

+ (void)addSoundAtPath:(NSString *)filePath forKey:(id)key

{

[[self sharedInstance] addSoundAtPath:filePath forKey:key];

}

```

Fade–out

--------

На этом, “музыкальный” функционал приложения был готов. Осталось избавиться от слишком «резких» включений и выключений музыки. Решением стало постепенно добавлять или убавлять уровень звука. AVFoundation такой возможности не давал. К счастью реализовать это с помощью основной библиотеки не так уж сложно:

```

- (void)fadeOutAndStop:(NSTimer *)timer

{

AVAudioPlayer *player = timer.userInfo;

float volume = player.volume;

volume = volume - 1.0 / MCSOUNDBOARD_AUDIO_FADE_STEPS;

volume = volume < 0.0 ? 0.0 : volume;

player.volume = volume;

if (volume == 0.0) {

[timer invalidate];

[player pause];

}

}

- (void)stopAudioForKey:(id)key fadeOutInterval:(NSTimeInterval)fadeOutInterval

{

AVAudioPlayer *player = [_audio objectForKey:key];

// If fade in inteval interval is not 0, schedule fade in

if (fadeOutInterval > 0) {

NSTimeInterval interval = fadeOutInterval / MCSOUNDBOARD_AUDIO_FADE_STEPS;

[NSTimer scheduledTimerWithTimeInterval:interval

target:self

selector:@selector(fadeOutAndStop:)

userInfo:player

repeats:YES];

} else {

[player stop];

}

}

```

Вот и все. Надеюсь, материал поможет людям столкнувшимся с аналогичной задачей.

Дополнительно: [Страница MCSoundBoard на GitHub](https://github.com/Baglan/MCSoundBoard) | https://habr.com/ru/post/148886/ | null | ru | null |

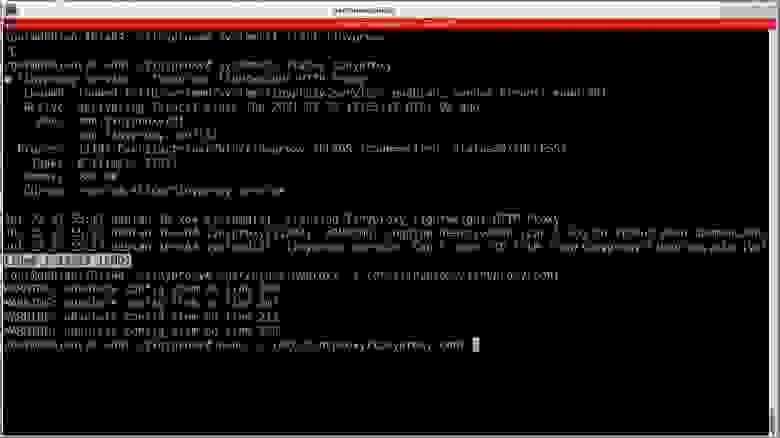

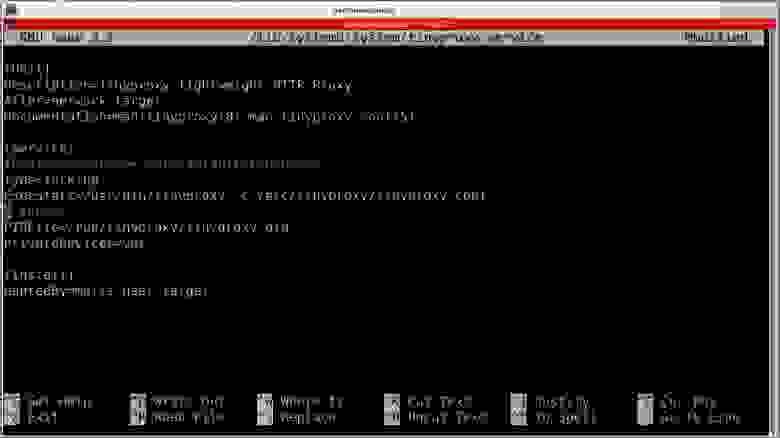

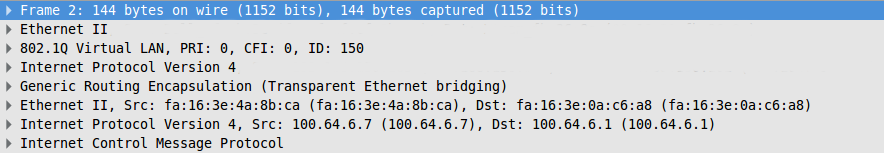

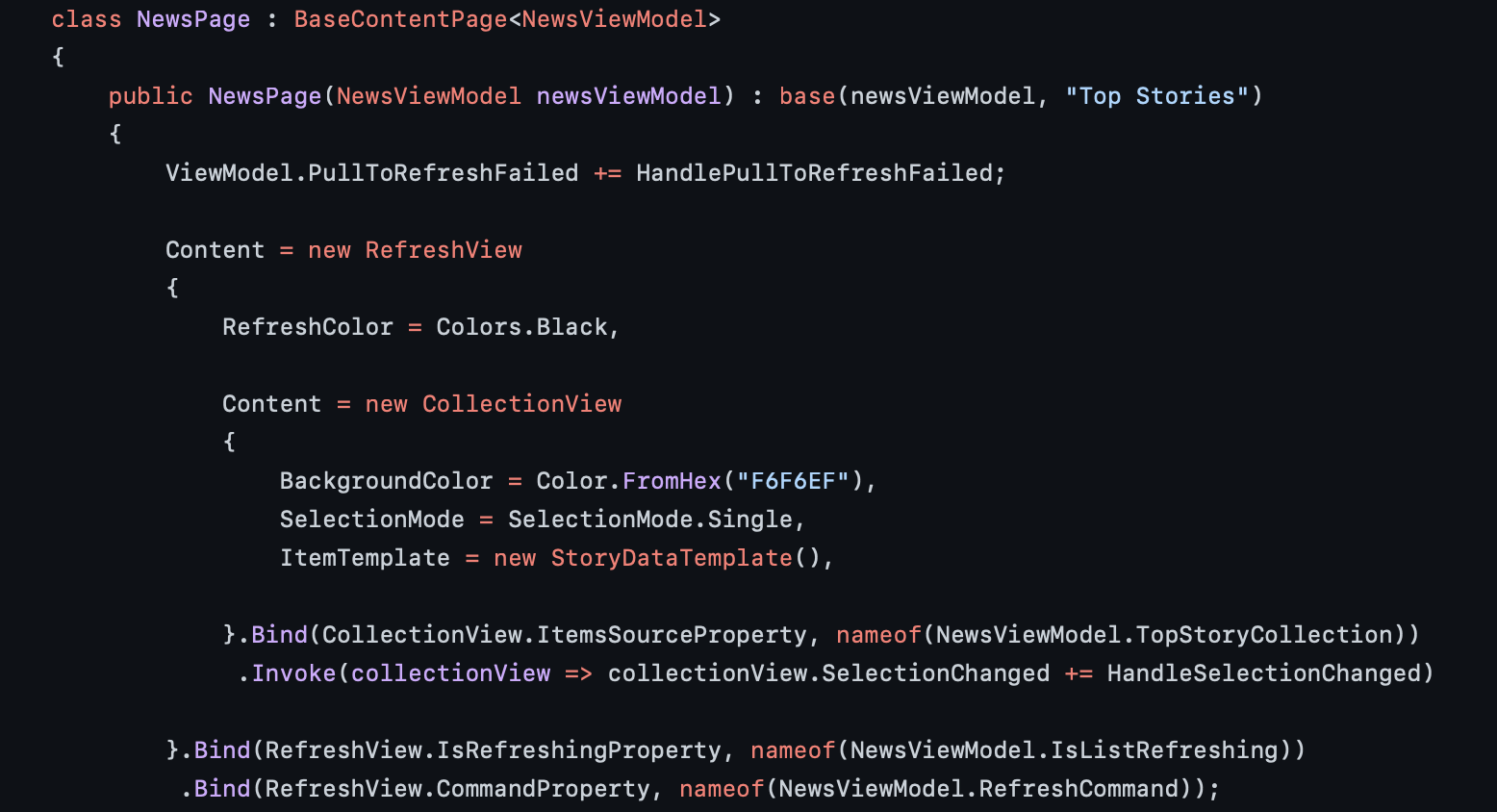

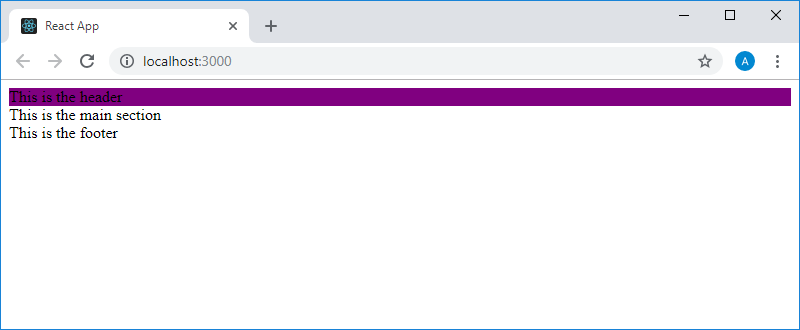

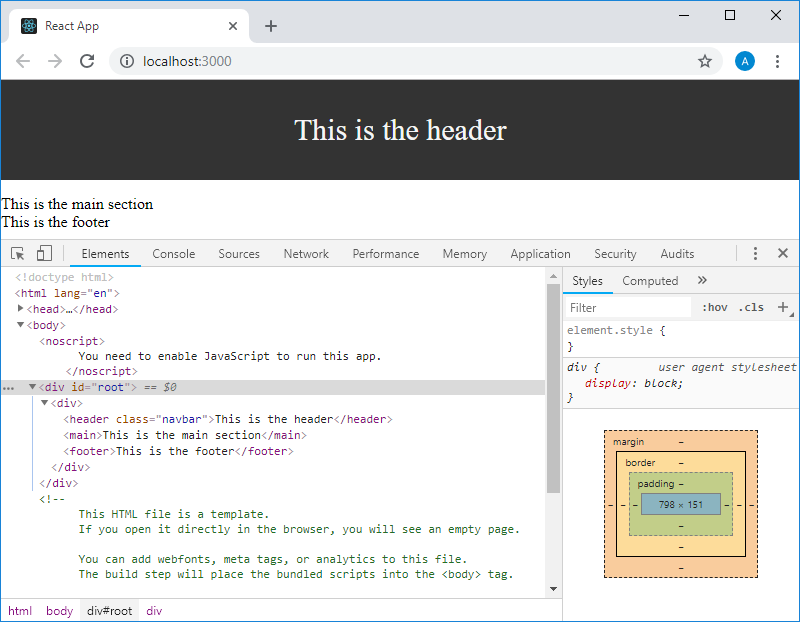

# UI тесты в Xcode с Embassy и Succulent

Всем привет!

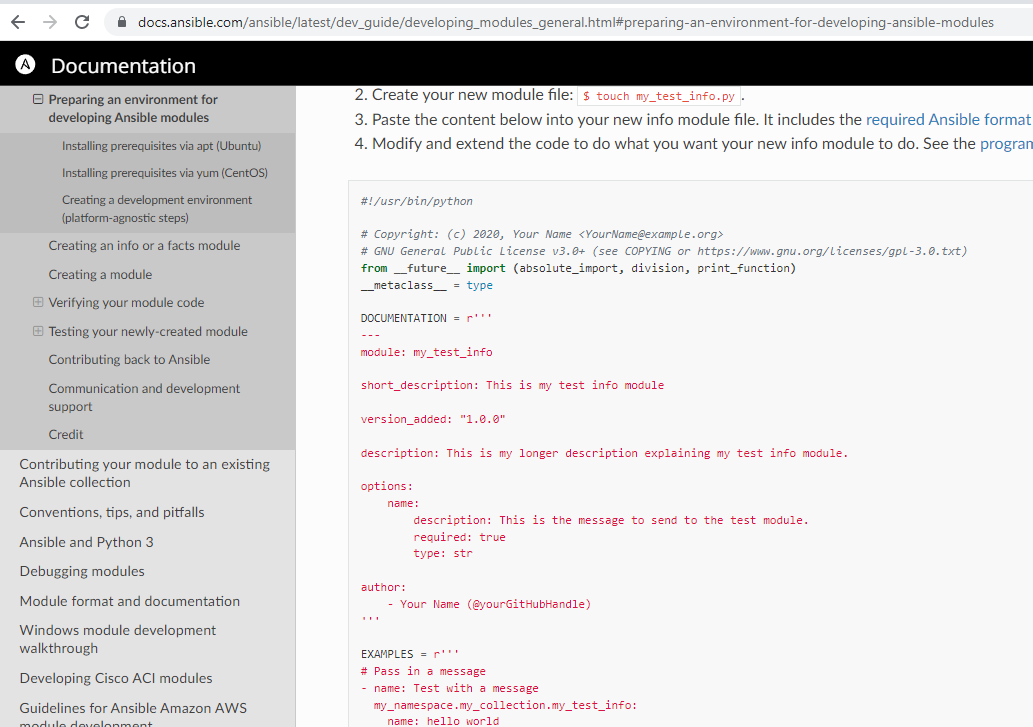

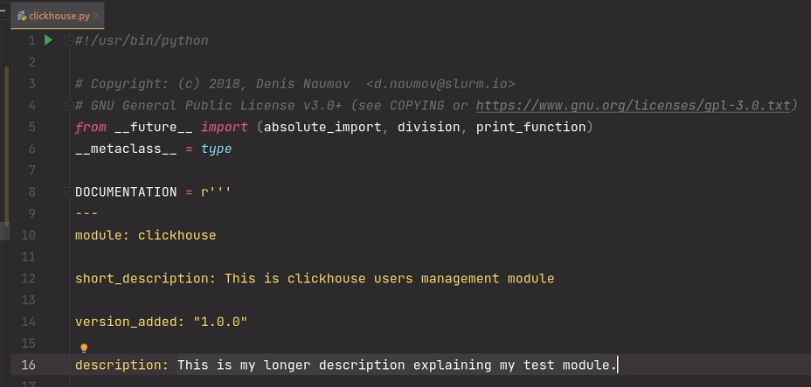

Очередная новинка в списке наших курсов: [«Разработчик iOS»](https://otus.pw/uyyi/), а значит пришло время интересных штук, которые мы находили за время подготовки курса. В этой заметке автор разбирает как записывать и воспроизводить запросы API для работы UI тестов.

Поехали.

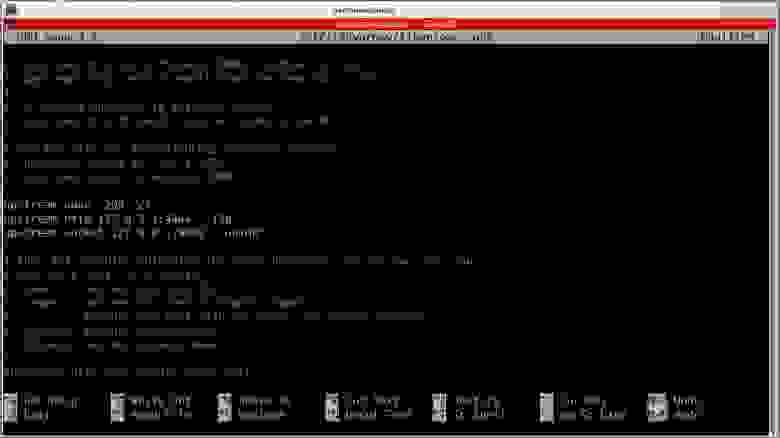

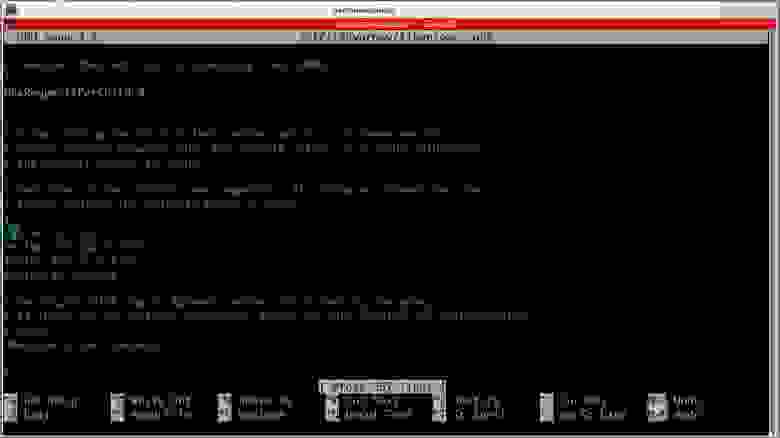

Недавно я интегрировал [Embassy](https://github.com/envoy/Embassy) и [Succulent](https://github.com/cactuslab/Succulent) в свои UI тесты. Если вам нужно запустить UI тесты для приложения, использующего данные API, это руководство может предложить альтернативу mock / stub.

Проблемы:

* Приложение использует данные API для заполнения UI ;

* Использование stub’ов может потребовать написания и поддержки большого количества файлов;

* При использование mock’ов, логика приложения может отличаться от фактического сетевого вызова;

* Использование настоящего API соединения — СОВЕРШЕННО ИСКЛЮЧЕНО, слишком много переменных и сбоев

**Решение с помощью Embassy + Succulent**

Решение заключается в создании локального сервера, на который направлено ваше приложение (с помощью Embassy), и в записи/ответах на сетевые вызовы (с помощью Succulent).

При первом запуске теста, стандартные сетевые вызовы будут выполнены и записаны в файл трассировки.

В следующий раз эти же сетевые вызовы получат ответ автоматически. Круто, не правда ли? Не нужно писать mock’и, можно симулировать лаги и ошибки, и все это запускается внутри билд-машины, внутри XCtest!

**Как этим пользоваться?**

1. Скачайте и установите под Succulent. Во время написания этой статьи пода не было на cocoapods.com, поэтому нужно скачать источник и добавить его в ваш под-файл следующим образом:

```

target “UI Tests” do

inherit! :search_paths

pod ‘Succulent’, :path => ‘Succulent/’

end

```

Succulent требуется Embassy и он будет установлен автоматически.

2. Создайте новый файл UI теста и скопируйте инструкцию из [Succulent GitHub](https://github.com/cactuslab/Succulent). В итоге должен получиться такой файл:

```

import Succulent

@testable import TestAppUITests

class SucculentTestUITest: XCTestCase {

private var succulent: Succulent!

var session: URLSession!

var baseURL: URL!

/// The name of the trace file for the current test

private var traceName: String {

return self.description.trimmingCharacters(in: CharacterSet(charactersIn: "-[] ")).replacingOccurrences(of: " ", with: "_")

}

/// The URL to the trace file for the current test when running tests

private var traceUrl: URL? {

let bundle = Bundle(for: type(of: self))

return bundle.url(forResource: self.traceName, withExtension: "trace", subdirectory: "Traces")

}

/// The URL to the trace file for the current test when recording

private var recordUrl: URL {

let bundle = Bundle(for: type(of: self))

let recordPath = bundle.infoDictionary!["TraceRecordPath"] as! String

return URL(fileURLWithPath: "\(recordPath)/\(self.traceName).trace")

}

override func setUp() {

super.setUp()

continueAfterFailure = false

if let traceUrl = self.traceUrl { // Replay using an existing trace file

succulent = Succulent(traceUrl: traceUrl)

} else { // Record to a new trace file

succulent = Succulent(recordUrl: self.recordUrl, baseUrl: URL(string: "https//base-url-to-record.com/")!)

}

succulent.start()

let app = XCUIApplication()

app.launchEnvironment["succulentBaseURL"] = "http://localhost:\(succulent.actualPort)/"

app.launch()

}

override func tearDown() {

super.tearDown()

}

}

```

При запуске Succulent есть возможность указать базовый URL, благодаря которому все запросы, включающие базовый URL, будут записаны, а все прочие проигнорированы.

3. Добавьте следующую строку в Info.plist цели вашего UI теста:

```

TraceRecordPath

$(PROJECT\_DIR)/Succulent/Traces

```

4. Направьте приложение на локальный сервер.

Чтобы сделать это внутри вашего основного приложения, необходимо проверить существует ли переменная окружения “succulentBaseURL” и настроена ли она.

Она показывает url вашего локального веб-сервера и настраивается в setUp функции, которую скопировали выше в пункте 2.

```

#if DEBUG

if let localServerUrl = ProcessInfo.processInfo.environment[“succulentBaseURL”] {

return URL(string: localServerUrl)!

}

#endif

```

Вот, пожалуй, и все!

Теперь когда вы сделаете простой тест и запустите его, Succulent запишет запрос API и создаст .trace файл в папке Traces директории цели вашего UI теста. Когда вы запустите этот же тест в следующий раз, он проверит, существует ли файл и запустит его.

Вы можете открывать .trace файлы напрямую из Xcode, смотреть все сетевые запросы и изменять их по необходимости.

Надеюсь, статья оказалась полезной, вот пицца:

THE END

Как обычно ждём комментарии, вопросы и прочее тут или можно заглянуть на [День открытых дверей](https://otus.pw/YBvl/) и задать вопрос [преподавателю](https://otus.pw/IOaO/) там. | https://habr.com/ru/post/412955/ | null | ru | null |

# Создание полосы прокрутки картинок а-ля iPhoto. Часть 1

Начав программировать под iPad, я не нашёл компонента, подобного полосе прокрутки в приложении iPhoto для iPad.

Я попробовал реализовать что-то подобное.

Сначала, создадим ImageScrubberToolbar, который унаследуем от UIToolbar.

``> @interface ImageScrubberToolbar : UIToolbar

>

> {

>

> IBOutlet id delegate;

>

> NSArray \* imagesArray;

>

> NSMutableArray \* imageViewsArray;

>

> UIImageView \* selectionImageView;

>

> }

>

> @property (nonatomic, retain) id delegate;

>

> -(void) setImagesArray:(NSArray \*) array;

>

> @end

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Теперь добавим private-методы ImageScrubberToolbar в m-файл.

``> @interface ImageScrubberToolbar()

>

> -(int) checkTouchPosition:(CGPoint) aPoint;

>

> -(void) slideSelection:(CGPoint) aTouchPoint;

>

> -(float) leftMargin;

>

> -(float) rightMargin;

>

> @end

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Опишем протокол делегата для реакции на событие выбора изображения.

``> @protocol ImageScrubberToolbarDelegate

>

> -(void)imageSelected:(int) anIndex;

>

> @end

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

В метод `– (id)initWithCoder:(NSCoder *)aDecoder` мы добавим кастомную инициализацию.

``> // Custom initialization

>

> imageViewsArray = [[NSMutableArray alloc] init];

>

>

>

> //setting custom height

>

> [self setFrame:CGRectMake(self.frame.origin.x, self.frame.origin.y - 36, self.frame.size.width, 80)];

>

>

>

> //setting image for selection

>

> UIImage \* img = [UIImage imageWithContentsOfFile:[NSString stringWithFormat:@"%@/%@",[[NSBundle mainBundle] resourcePath],@"selection.png"]];

>

>

>

> selectionImageView = [[UIImageView alloc] initWithImage:img];

>

> [self addSubview:selectionImageView];

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Теперь реализуем метод `-(void) setImagesArray:(NSArray *) array` для задания массива отображаемых картинок.

``> if (imagesArray != array)

>

> {

>

> //release old array of images

>

> [imagesArray release];

>

>

>

> //remove old image views

>

> for (UIImageView \* v in imageViewsArray)

>

> {

>

> [v removeFromSuperview];

>

> }

>

> [imageViewsArray removeAllObjects];

>

>

>

> //set new array of images

>

> imagesArray = [array retain];

>

>

>

> //calculate margins

>

> float leftMargin = [self leftMargin];

>

> float topMargin = (self.frame.size.height - SMALL\_SIZE)/2.f;

>

>

>

> for (int i=0; i<[imagesArray count]; i++)

>

> {

>

> UIImage \* img = [imagesArray objectAtIndex:i];

>

>

>

> //create new image view

>

> UIImageView \* imgView = [[UIImageView alloc] initWithImage:img];

>

> [imageViewsArray addObject:imgView];

>

> [self addSubview:imgView];

>

>

>

> //disallow user interaction with image view

>

> imgView.userInteractionEnabled = NO;

>

>

>

> //set position

>

> imgView.frame = CGRectMake(leftMargin + SMALL\_SIZE\*i,

>

> topMargin,

>

> SMALL\_SIZE,

>

> SMALL\_SIZE);

>

> }

>

> [selectionImageView setFrame:CGRectMake(leftMargin, 0, SMALL\_SIZE, LARGE\_SIZE)];

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Следующий шаг — реализация методов для проверки точки касания и сдвига окошка выбора.

``> -(int) checkTouchPosition:(CGPoint) aPoint

>

> {

>

> float leftMargin = [self leftMargin];

>

> // float topMargin = (self.frame.size.height - SMALL\_SIZE)/2.f;

>

>

>

> return (aPoint.x - leftMargin)/SMALL\_SIZE;

>

> }

>

>

>

> -(void) slideSelection:(CGPoint) aTouchPoint

>

> {

>

> float x\_min = [self leftMargin] - SMALL\_SIZE/2.f;

>

>

>

> if (aTouchPoint.x < x\_min)

>

> {

>

> return;

>

> }

>

> int pos = [self checkTouchPosition:aTouchPoint];

>

>

>

> if (pos > [imagesArray count] - 1)

>

> {

>

> return;

>

> }

>

>

>

> float x\_pos = aTouchPoint.x - SMALL\_SIZE/2.f;

>

>

>

> if (x\_pos < x\_min)

>

> {

>

> x\_pos = x\_min;

>

> }

>

> else

>

> {

>

> float x\_max = [self rightMargin] - SMALL\_SIZE/2.f;

>

> if (x\_pos > x\_max)

>

> {

>

> x\_pos = x\_max;

>

> }

>

> }

>

> [UIView beginAnimations:nil context:NULL];

>

> [UIView setAnimationDuration:ANIMATION\_DURATION];

>

>

>

> [selectionImageView setFrame:CGRectMake(x\_pos,

>

> 0,

>

> SMALL\_SIZE,

>

> LARGE\_SIZE)];

>

>

>

> [UIView commitAnimations];

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Для обработки событий касания добавьте следующий код.

``> -(void) touchesBegan:(NSSet \*)touches withEvent:(UIEvent \*)event

>

> {

>

> if ([touches count] != 1)

>

> {

>

> return;

>

> }

>

>

>

> UITouch \* touch = [touches anyObject];

>

> CGPoint p = [touch locationInView:self];

>

> [self slideSelection:p];

>

> }

>

>

>

> -(void) touchesMoved:(NSSet \*)touches withEvent:(UIEvent \*)event

>

> {

>

> if ([touches count] != 1)

>

> {

>

> return;

>

> }

>

>

>

> UITouch \* touch = [touches anyObject];

>

> CGPoint p = [touch locationInView:self];

>

>

>

> [self slideSelection:p];

>

> }

>

>

>

> -(void) touchesEnded:(NSSet \*)touches withEvent:(UIEvent \*)event

>

> {

>

> if ([touches count] != 1)

>

> {

>

> return;

>

> }

>

>

>

> UITouch \* touch = [touches anyObject];

>

> CGPoint p = [touch locationInView:self];

>

> int pos = [self checkTouchPosition:p];

>

>

>

> if (pos < 0)

>

> {

>

> pos = 0;

>

> }

>

> else if (pos > [imagesArray count] - 1)

>

> {

>

> pos = [imagesArray count] - 1;

>

> }

>

>

>

> float leftMargin = [self leftMargin];

>

> [UIView beginAnimations:nil context:NULL];

>

> [UIView setAnimationDuration:ANIMATION\_DURATION];

>

>

>

> [selectionImageView setFrame:CGRectMake(leftMargin + SMALL\_SIZE\*pos,

>

> 0,

>

> SMALL\_SIZE,

>

> LARGE\_SIZE)];

>

> [UIView commitAnimations];

>

> [delegate imageSelected:pos];

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Следующие шаги — добавление ImageScrubberToolbarDelegate в реализуемые нашим Application Delegate протоколы, добавление outlet'a ImageScrubberToolbar в члены Application Delegate и реализация метода `-(void)imageSelected:(int) anIndex` .

Итак, мы реализовали все главные классы и методы.

Наш ImageScrubberToolbar будет выглядеть так —

Вы можете скачать [исходный код](http://depositfiles.com/files/2ejg9umjv) проекта ImageScrubber.

Продолжение смотрите [здесь](http://habrahabr.ru/blogs/macosxdev/90702/)``````` | https://habr.com/ru/post/90488/ | null | ru | null |

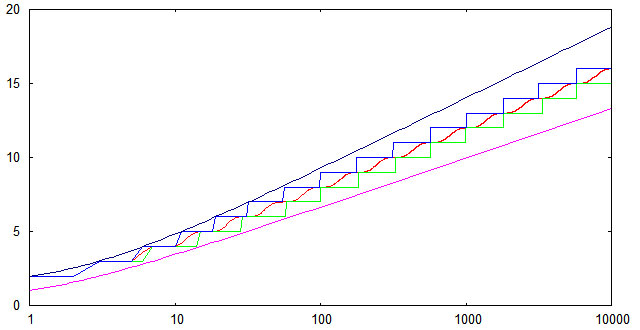

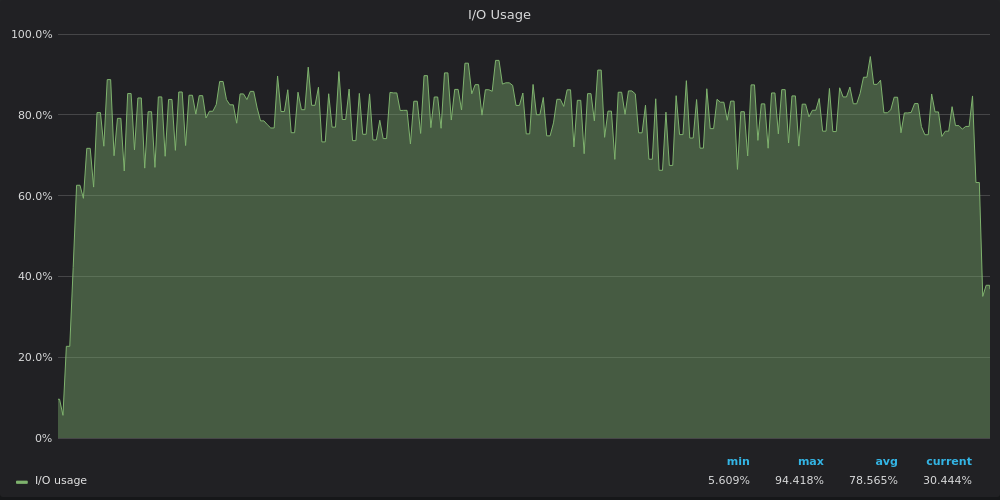

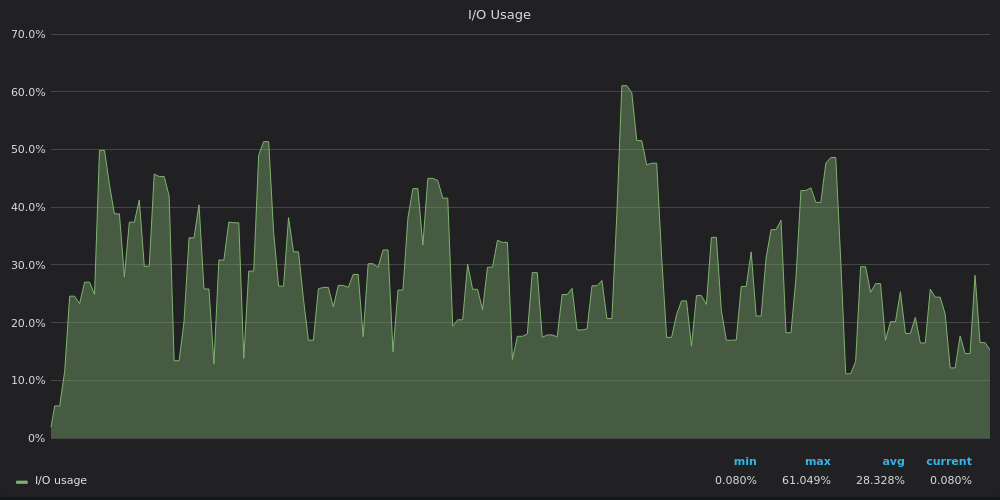

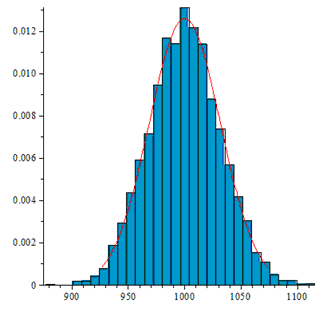

# Управление растущими нагрузками в Postgres: 5 советов от Instagram

С тех пор как число активных пользователей Instagram стало постоянно расти, Postgres оставался нашим надежным фундаментом и неизменным хранилищем данных для большинства данных, создаваемых пользователями. И хотя меньше года назад мы писали о том, как мы храним большое количество данных на Instagram при 90 лайках в секунду, сейчас мы обрабатываем более 10000 лайков в секунду – и наша основная технология хранения данных не изменилась.

За последние два с половиной года, мы поняли несколько вещей и подобрали пару инструментов для масштабирования Postgres и мы хотим ими поделиться – то, что мы хотели бы знать при запуске Instagram. Некоторые из них специфичны для Postgres, другие представлены также и в других базах данных. Чтобы знать, как мы горизонтально масштабируем Postgres, смотрите наш пост [Sharding and IDs at Instagram](http://instagram-engineering.tumblr.com/post/10853187575/sharding-ids-at-instagram)

#### 1. Частичные индексы (Partial Indexes)

Если вы часто используете в ваших запросах фильтры по конкретной характеристике, и эта характеристика представлена в меньшей части строк вашей базы, частичные индексы могут вам серьезно помочь.

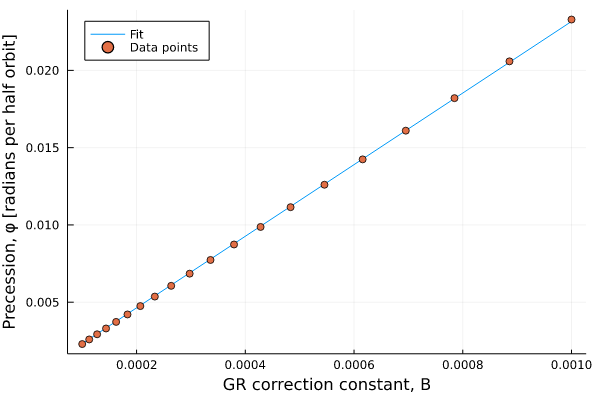

Например, при поиске тегов в Instagram, мы пытаемся поднять наверх теги, по которым может быть найдено много фотографий. Хотя мы используем такие технологии, как ElasticSearch для более пристрастных поисков в нашем приложении, это единственный случай, когда база данных неплохо справляется самостоятельно. Давайте посмотрим, как Postgres действует при поиске тегов, сортируя их по количеству фотографий:

```

EXPLAIN ANALYZE SELECT id from tags WHERE name LIKE 'snow%' ORDER BY media_count DESC LIMIT 10;

QUERY PLAN

Limit (cost=1780.73..1780.75 rows=10 width=32) (actual time=215.211..215.228 rows=10 loops=1)

-> Sort (cost=1780.73..1819.36 rows=15455 width=32) (actual time=215.209..215.215 rows=10 loops=1)

Sort Key: media_count

Sort Method: top-N heapsort Memory: 25kB

-> Index Scan using tags_search on tags_tag (cost=0.00..1446.75 rows=15455 width=32) (actual time=0.020..162.708 rows=64572 loops=1)

Index Cond: (((name)::text ~>=~ 'snow'::text) AND ((name)::text ~<~ 'snox'::text))

Filter: ((name)::text ~~ 'snow%'::text)

Total runtime: 215.275 ms

(8 rows)

```

Заметьте, Postgres должен отсортировать 15 тысяч строк для получения верного результата. И так как теги (например) представляют собой шаблон с длинным хвостом, мы можем вместо этого попытаться сначала показать теги, для которых есть 100 или более фото, итак:

```

CREATE INDEX CONCURRENTLY on tags (name text_pattern_ops) WHERE media_count >= 100

```

И наш план запроса теперь выглядит так:

```

EXPLAIN ANALYZE SELECT * from tags WHERE name LIKE 'snow%' AND media_count >= 100 ORDER BY media_count DESC LIMIT 10;

QUERY PLAN

Limit (cost=224.73..224.75 rows=10 width=32) (actual time=3.088..3.105 rows=10 loops=1)

-> Sort (cost=224.73..225.15 rows=169 width=32) (actual time=3.086..3.090 rows=10 loops=1)

Sort Key: media_count

Sort Method: top-N heapsort Memory: 25kB

-> Index Scan using tags_tag_name_idx on tags_tag (cost=0.00..221.07 rows=169 width=32) (actual time=0.021..2.360 rows=924 loops=1)

Index Cond: (((name)::text ~>=~ 'snow'::text) AND ((name)::text ~<~ 'snox'::text))

Filter: ((name)::text ~~ 'snow%'::text)

Total runtime: 3.137 ms

(8 rows)

```

Заметьте, что Postgres должен теперь обойти только 169 строк, что намного быстрее. Планировщик запросов Postgres'а также хорош и в вычислении ограничений – если позже вы решите, что хотите получать только теги, для которых есть не менее 500 фото, т.е. из подмножества индекса – он все равно будет использовать верный частичный индекс.

#### 2. Функциональные индексы (Functional Indexes)

Для некоторых из наших таблиц, нам нужно индексировать строки (например, 64-символьные base64 токены), довольно длинные, для того, чтобы создавать по ним индекс — это выльется в дублирование большого количества информации. В этом случае очень полезны могут быть функциональные индексы Postgres'а:

```

CREATE INDEX CONCURRENTLY on tokens (substr(token, 0, 8))

```

Таким образом, Postgres, используя индекс, находит по префиксу множество записей, а затем фильтрует их, находя нужную. Индекс при этом занимает в 10 раз меньше места, чем если бы мы делали индекс по всей строке.

#### 3. pg\_reorg для сжатия

По прошествии какого-то времени, таблицы Postgres могут быть фрагментированы на диске (из-за конкурентной модели MVCC Postgres'а, например). Также, чаще всего, вставка строк осуществляется не в том порядке, в котором вы хотите их получать. Например, если вы часто запрашиваете все лайки, созданные одним пользователем, было бы неплохо, если бы эти лайки были записаны на диске непрерывно, чтобы минимизировать поиски по диску.

Нашим решением для этого является использование утилиты pg\_reorg, которая выполняет такие шаги в процессе оптимизации таблицы:

1. Получает эксклюзивную блокировку на таблицу

2. Создает временную таблицу для аккумуляции изменений, и добавляет триггер на исходную таблицу, который реплицирует любые изменения в эту временную таблицу

3. Делает CREATE TABLE используя SELECT FROM…ORDER BY, который создает новую таблицу в индексированном порядке на диске

4. Синхронизирует изменения из временной таблицы, которые произошли после того, как был запущен SELECT FROM

5. Переключает на новую таблицу

Есть некоторые особенности в получении блокировки и т.п., но это описание общего подхода. Мы проверили данный инструмент и провели некоторое количество тестов, прежде чем запустить его в продакшен, и мы провели множество реорганизаций на сотнях машин без всяких проблем.

#### 4. WAL-E для архивации и бекапов WAL

Мы используем и вносим свой вклад в разработку [WAL-E](https://github.com/heroku/WAL-E), набор инструментов платформы Heroku для непрерывной архивации WAL (Write-Ahead Log) файлов Postgres. Использование WAL-E сильно упростило наш процесс бекапирования и запуска новой реплики базы.

По сути, WAL-E — это программа, которая архивирует все WAL файлы, генерируемые вашим PG сервером, на Amazon S3, используя archive\_command Postgres'a. Эти WAL файлы могут быть использованы, в комбинации с бекапом базы, для восстановления базы в любую точку, начиная с этого бекапа. Комбинация обычных бекапов и WAL файлов дает нам возможность быстро запустить новую реплику только для чтения или failover slave (реплика на случай отказа основной базы).

Мы сделали простой скрипт-обертку для мониторинга повторяющихся сбоев при архивации файла, и он [доступен на GitHub](https://gist.github.com/4550560).

#### 5. Режим автокоммита и асинхронный режим в psycopg2

Через какое-то время мы начали использовать более продвинутые возможности psycopg2, Python-драйвера для Postgres.

Первая — это режим автокоммита (autocommit mode). В этом режиме psycopg2 не требует BEGIN/COMMIT ни для каких запросов, вместо этого каждый запрос запускается в отдельной транзакции. Это в особенности полезно для запросов выборки из базы, для которых использование транзакций не имеет смысла. Включить режим очень просто:

```

connection.autocommit = True

```

Это значительно сократило общение между нашими серверами и базами, а также снизило затраты CPU на машинах баз данных. Позже, мы использовали PGBouncer для распределения соединений, это позволило соединениям быстрее возвращаться в пул.

Больше деталей о том, как это работает в Django [здесь](http://thebuild.com/blog/2009/11/07/django-postgresql-and-autocommit/).

Другая полезная возможность в psycopg2 — это возможность регистрировать [wait\_callback](http://initd.org/psycopg/docs/advanced.html#support-for-coroutine-libraries) для вызова подпрограмм. Ее использование позволяет делать параллельные запросы по нескольким соединениям единовременно, что полезно для запросов, затрагивающих множество нод – сокет просыпается и оповещает, когда появляются данные для обработки (мы используем модуль Python'а select для обработки пробуждений). Это также хорошо работает с кооперативными многопоточными библиотеками, такими как eventlet или gevent. Пример реализации – [psycogreen](http://pypi.python.org/pypi/psycogreen/1.0).

В общем и целом, мы очень удовлетворены производительностью и надежностью Postgres'а. Если вы заинтересованы в работе над одной из самых больших сборок Postgres, вместе с маленькой командой инфраструктурных хакеров, мы на связи по адресу infrajobs <собака> instagram.com

*От переводчика:

Прошу ошибки перевода и орфографические слать в личку. А если вы заинтересованы в работе над мобильными приложениями в маленькой, но очень гордой команде, располагающейся в Санкт-Петербурге — мы тоже на связи, и рассматриваем предложения!* | https://habr.com/ru/post/171217/ | null | ru | null |

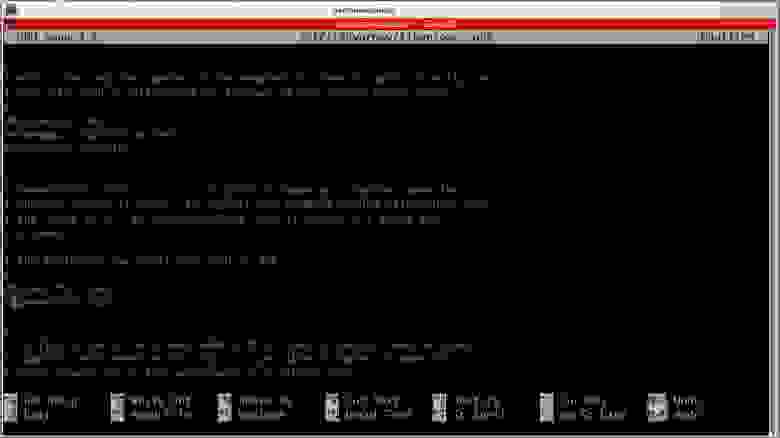

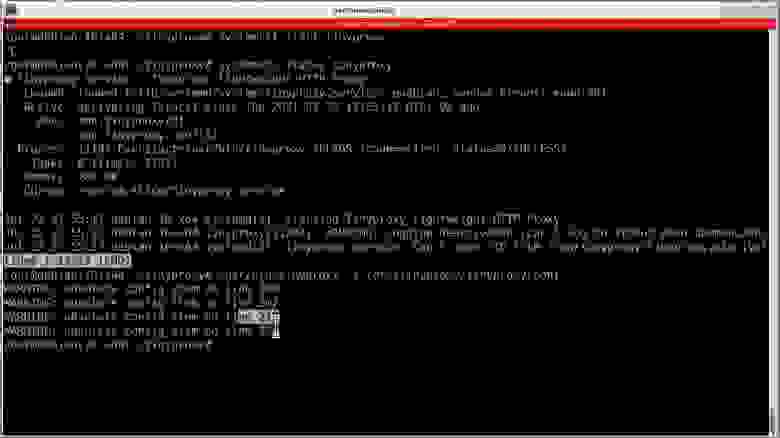

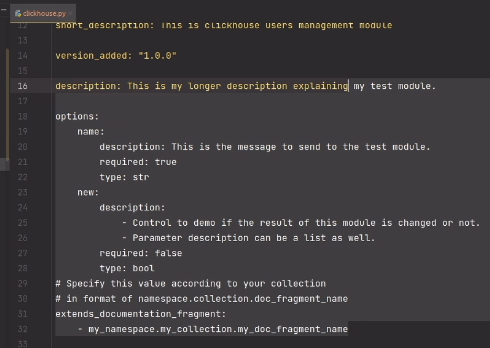

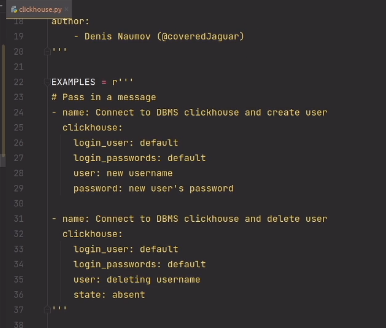

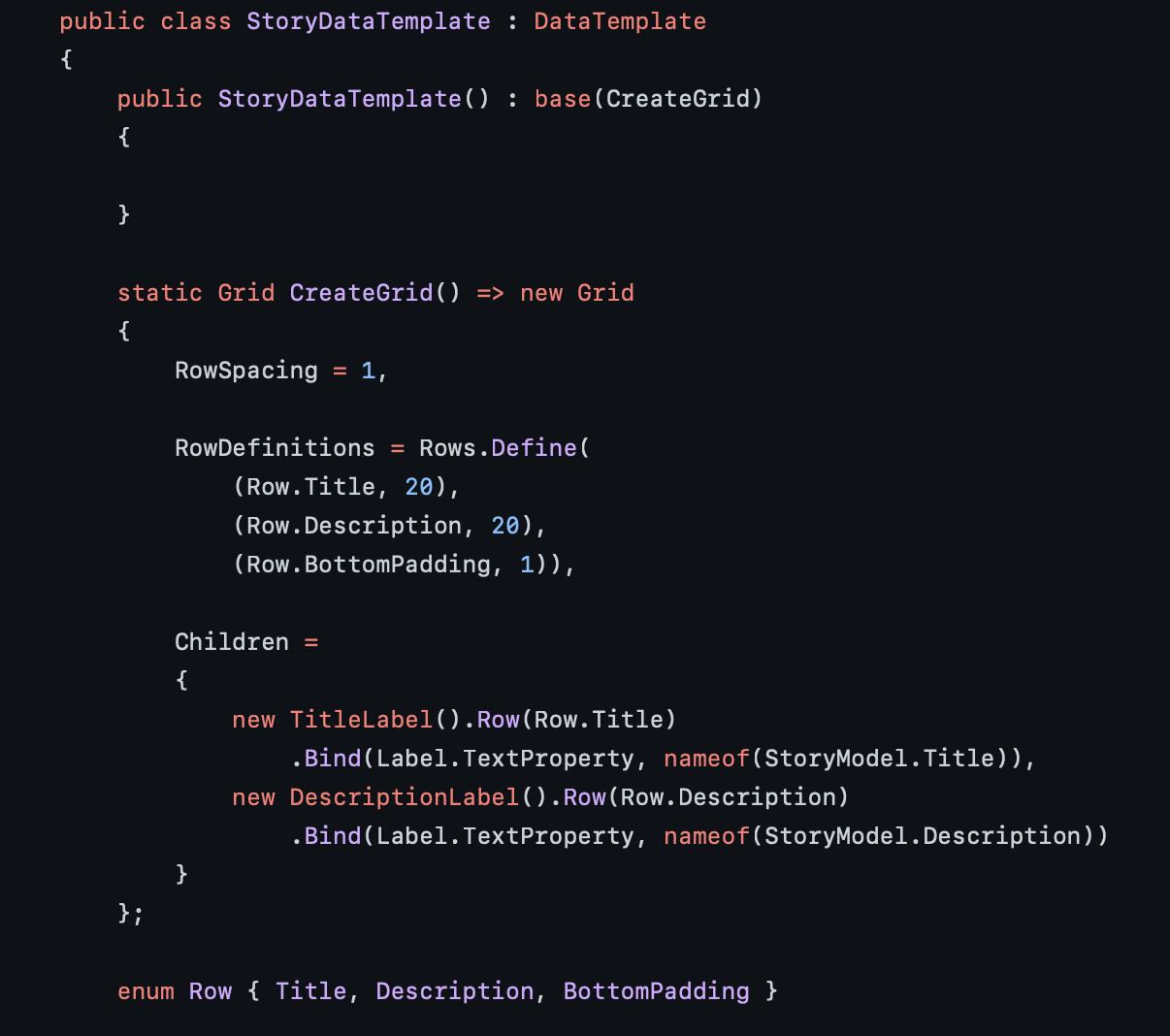

# Автоматизация работы в SAP с помощью VBScript

За несколько лет работы в SAP, как пользователя, я составил большое количество различных скриптов для облегчения работы в SAP, т.к. SAP «из коробки» довольно неудобен для быстрой и эффективной работы. Особенно раздражает то, что за один раз невозможно вставить в таблицу больше строк, чем отображается на экране. Приходится вставлять частями, прокручивая таблицу. На невысоком широкоформатном мониторе так вообще ужасно неудобно. Я как-то давно, еще до составления скриптов, свой монитор ставил вертикально и поворачивал изображение, чтобы отображалось больше строк.

Решил поделиться своими наработками с общественностью.

Добиться разработки нужных для работы вещей в компании практически (и фактически) нереально. Компания крупная, бюрократия, куча согласований, жалко денег на программистов SAP, множество посредников-отделов и т.д. Поэтому я потихоньку самостоятельно автоматизировал свою (и не только свою) работу с помощью VBScript. Запуск «левых» exe на компьютерах компании запрещен всякими политиками, настройками и сторонними программами, а вот VBScript спокойно запускается.

Основной методикой составления скриптов была запись действий в макрос средствами самого SAP с дальнейшим разбором записанного, изучением справки, поиском информации в интернете и т.д. и т.п.

В интернете множество примеров работы с SAP с помощью VBScript, который запускается двойным кликом по vbs-файлу, но они практически все рассчитаны на работу с первым окном SAP. В начале таких примеров обычно есть код *session.findById(«wnd[0]»).maximize*, разворачивающий окно SAP. Работать с такими скриптами, «заточенными» под первое окно – неудобно по следующим причинам:

1. Окно SAP Logon должно быть закрыто или свернуто в трей. Иначе скрипт будет пытаться работать в нем.

2. В первом окне может выполняться другая транзакция, или будут находиться результаты работы транзакции, или будет открыта транзакция для ввода параметров. В общем, если в первом окне будет открыто что-то, кроме меню – запуск транзакции через скрипт не сработает.

3. В первом окне может быть открыто подключение к другому серверу.

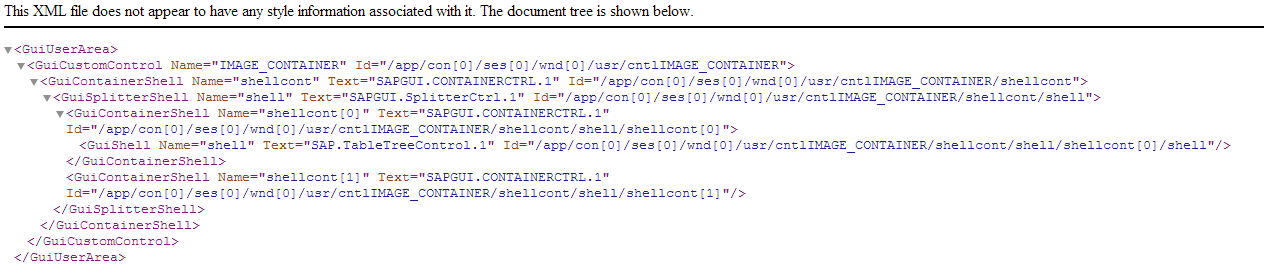

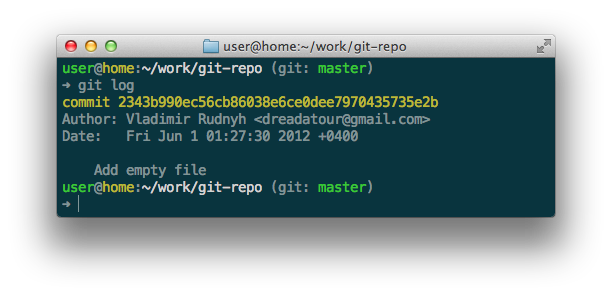

Себе в помощь дополнительно написал скрипт, который выгружает в XML-файл дерево GUI-элементов первого окна SAP. Получается так:

**Перебор GUI-элементов SAP**

```

Dim currentNode

Set xmlParser = CreateObject("Msxml2.DOMDocument")

' Создание объявления XML

xmlParser.appendChild(xmlParser.createProcessingInstruction("xml", "version='1.0' encoding='windows-1251'"))

Set SapGuiAuto = GetObject("SAPGUI")

Set application = SapGuiAuto.GetScriptingEngine

Set connection = application.Children(0)

Set session = connection.Children(0)

WScript.ConnectObject session, "on"

WScript.ConnectObject application, "on"

' Максимизируем окно SAP

session.findById("wnd[0]").maximize

enumeration "wnd[0]"

'enumeration "wnd[0]/usr"

MsgBox "Готово!", vbSystemModal Or vbInformation

Sub enumeration(SAPRootElementId)

Set SAPRootElement = session.findById(SAPRootElementId)

'Создание корневого элемента

Set XMLRootNode = xmlParser.appendChild(xmlParser.createElement(SAPRootElement.Type))

enumChildrens SAPRootElement, XMLRootNode

xmlParser.save("C:\SAP_tree.xml")

End Sub

Sub enumChildrens(SAPRootElement, XMLRootNode)

For i = 0 To SAPRootElement.Children.Count - 1

Set SAPChildElement = SAPRootElement.Children.ElementAt(i)

' Создаем узел

Set XMLSubNode = XMLRootNode.appendChild(xmlParser.createElement(SAPChildElement.Type))

' Атрибут Name

Set attrName = xmlParser.createAttribute("Name")

attrName.Value = SAPChildElement.Name

XMLSubNode.setAttributeNode(attrName)

' Атрибут Text

If (Len(SAPChildElement.Text) > 0) Then

Set attrText = xmlParser.createAttribute("Text")

attrText.Value = SAPChildElement.Text

XMLSubNode.setAttributeNode(attrText)

End If

' Атрибут Id

Set attrId = xmlParser.createAttribute("Id")

attrId.Value = SAPChildElement.Id

XMLSubNode.setAttributeNode(attrId)

' Если текущий объект - контейнер, то перебираем дочерние элементы

If (SAPChildElement.ContainerType) Then enumChildrens SAPChildElement, XMLSubNode

Next

End Sub

```

Комментируя одну из строк:

* enumeration «wnd[0]»

* enumeration «wnd[0]/usr»

получаем результаты обхода элементов либо всего окна SAP, либо только UserArea (без меню, тулбара, строки статуса).

Несколько нюансов:

1. Если какой-то элемент не видим на экране, то он не существует, и не найдется ни по имени, ни по ID. Чтобы до него добраться, нужно развернуть и сделать видимыми все вышестоящие элементы. Например:

* В транзакции ME51N невозможно указать «Примечание заголовка» если заголовок свернут. Надо предварительно развернуть заголовок.

* В транзакции ME21N, чтобы добраться до поля «Наш знак» – нужно не только развернуть заголовок, но и переключиться на вкладку «Связь».

2. При обновлении экрана практически все GUI-объекты создаются заново, и их нужно заново искать по имени или ID. При обращении к объектам, созданным в скрипте до обновления экрана – произойдет ошибка.

3. Все команды VBScript, взаимодействующие с GUI-элементами SAP, выполняются в синхронном режиме, т.е. выполнение кода VBScript не идет дальше, пока SAP не отработает команду. Это очень удобно, не нужно вставлять везде паузы и/или циклы, проверяя изменения на экране или ожидая появления какого-либо окна с сообщением.

4. Во время работы скрипта и его взаимодействия с одним окном (режимом) SAP — можно спокойно работать как в других режимах SAP, так и в самой Windows или других приложениях.

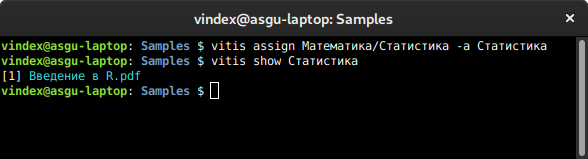

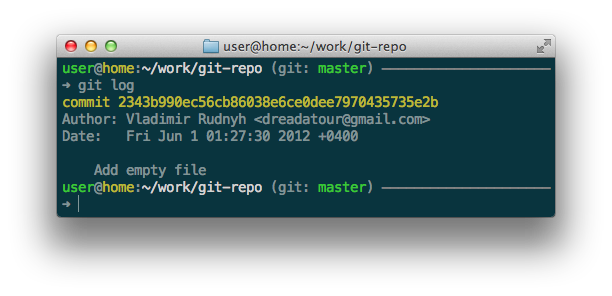

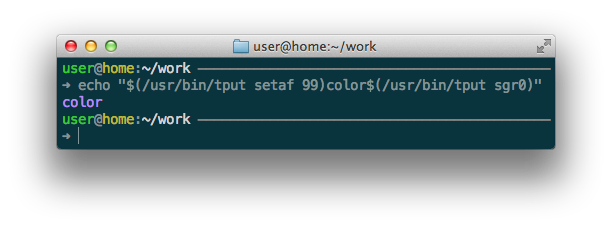

Мои скрипты запускаются прямо из SAP. Для этого в SAP в избранном создается объект типа «Web-адрес или файл» с указанием полного пути к файлу скрипта.

Для работы скриптов я использую файлы WSF (Windows Script File), которые состоят из двух частей:

1. Общий файл под громким названием SDK.vbs, содержащий код, используемый в каждом скрипте, плюс несколько функций и процедур, которые используются не во всех скриптах.

2. Собственно, сам VBScript, который выполняет мои задачи. VBScript выполняет команды именно в том окне SAP, из которого запущен.

**Структура файла WSF**

```

…

Код скрипта

…

```

Т.е. WSF может состоять из нескольких скриптов (на различных языках программирования), как раскиданных по отдельным файлам, так и прописанных в самом WSF. При запуске WSF сначала выполняется код из файла SDK.vbs, а потом уже код самого скрипта. Т.к. WSF запускается прямо из SAP – то он гарантированно будет выполняться именно в том же окне, из которого запущен. Активная сессия определяется командой *Set session = application.ActiveSession()*.

SDK.vbs состоит из кода подключения к SAP и определения активной сессии, и нескольких вспомогательных процедур и функций.

Далее в скрипте для удобства работы определяются несколько объектов и переменных:

* Wnd0 и UserArea – используются практически везде,

* Menubar, Statusbar и UserName – в некоторых скриптах.

Дополнительные процедуры и функции:

1. Запуск транзакции.

2. Эмуляция нажатия кнопок Enter, F3, F5, F8.

3. Диалог открытия csv- или txt-файла с возможностью создания файла для записи. Файл для записи создается в той же папке и имеет такое же имя, но перед расширением добавляется «out». Файлы для чтения не должны быть в кодировке UTF-8 с BOM, т.к. при чтении первой строки дополнительно считываются три байта в начале файла (#EFBBBF), которые вызывают ошибку при вставке прочитанной строки в какое-либо поле SAP.

4. Заполнение одной строки в таблице (для транзакции ME51N).

5. Работа с буфером обмена.

**SDK.vbs**

```

' Создаем объект WScript.Shell

Set WshShell = WScript.CreateObject("WScript.Shell")

'''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''

' Подключение к SAP

'''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''

' Создаем объект

Set SapGuiAuto = GetObject("SAPGUI")

' Создаем объект типа GuiApplication (COM-интерфейс)

Set application = SapGuiAuto.GetScriptingEngine()

' Создаем объект типа GuiSession - это сессия, которой соответствует активное окно SAP

' Т.е. при запуске WSF сам скрипт будет выполняться в том же окне SAP, из которого запущен

Set session = application.ActiveSession()

WScript.ConnectObject session, "on"

WScript.ConnectObject application, "on"

' Создаем объект типа GuiMainWindow

Set Wnd0 = session.findById("wnd[0]")

' Создаем объект типа GuiMenubar

Set Menubar = Wnd0.findById("mbar")

' Создаем объект типа GuiUserArea

Set UserArea = Wnd0.findById("usr")

' Создаем объект типа GuiStatusbar

Set Statusbar = Wnd0.findById("sbar")

' Определяем логин пользователя

UserName = session.Info.User

'''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''

' Вспомогательные процедуры и функции

'''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''

' Запуск транзакции

Sub startTransaction(transaction_name)

session.StartTransaction transaction_name

End Sub

' Нажатие кнопки "Enter"

Sub pressEnter()

Wnd0.sendVKey 0

End Sub

' Нажатие кнопки F2

Sub pressF2()

Wnd0.sendVKey 2

End Sub

' Нажатие кнопки F3

Sub pressF3()

Wnd0.sendVKey 3

End Sub

' Нажатие кнопки F5

Sub pressF5()

Wnd0.sendVKey 5

End Sub

' Нажатие кнопки F8

Sub pressF8()

Wnd0.sendVKey 8

End Sub

' Диалог выбора файла, создание потоков чтения из файла и записи в файл

Function selectFile(createOuputFile)

Set objDialog = CreateObject("UserAccounts.CommonDialog")

' Заполняем свойства и открываем диалог

With objDialog

.InitialDir = WshShell.SpecialFolders("Desktop") ' Начальная папка - рабочий стол

.Filter = "Текстовые файлы (*.csv;*.txt)|*.csv;*.txt"

result = .ShowOpen

End With

' Если файл не выбран - выходим

If (result = 0) Then WScript.Quit

inputFile = objDialog.FileName ' Полный путь к выбранному файлу

Set fso = CreateObject("Scripting.FileSystemObject")

Set inputStream = fso.OpenTextFile(inputFile)

' Создавать выходной файл?

If (createOuputFile) Then

outputFile = Left(inputFile, Len(inputFile) - 3) & "out" & Right(inputFile, 4)

Set outputStream = fso.CreateTextFile(outputFile, True)

' Возвращаем массив из потока чтения из файла и потока записи в файл

selectFile = Array(inputStream, outputStream)

Else

' Возвращаем поток чтения из файла

Set selectFile = inputStream

End If

End Function

' Заполняем одну строку в таблице (для ME51N)

Sub fill_row(row, material, kolvo, zavod, zatreboval)

Set grid = session.findById(UserArea.findByName("GRIDCONTROL", "GuiCustomControl").Id & "/shellcont/shell")

grid.modifyCell row, "KNTTP", "K" ' Тип контировки

grid.modifyCell row, "MATNR", material ' Материал

grid.modifyCell row, "MENGE", kolvo ' Количество

grid.modifyCell row, "NAME1", zavod ' Завод

grid.modifyCell row, "LGOBE", "0001" ' Склад

grid.modifyCell row, "AFNAM", zatreboval ' Затребовал

End Sub

' Set, get and clear ClipBoard text in VBScript

' CLEAR - QuickClip("")

' SET - QuickClip("Hello World!")

' GET - Result = QuickClip(Null)

Function QuickClip(input)

'@description: A quick way to set and get your clipboard.

'@author: Jeremy England (SimplyCoded)

If IsNull(input) Then

QuickClip = CreateObject("HTMLFile").parentWindow.clipboardData.getData("Text")

If IsNull(QuickClip) Then QuickClip = ""

Else

CreateObject("WScript.Shell").Run "mshta.exe javascript:eval(""document.parentWindow.clipboardData.setData('text','" & Replace(Replace(input, "'", "\\u0027"), """", "\\u0022") & "');window.close()"")", 0, True

End If

End Function

```

Далее приведу примеры скриптов с комментариями и небольшим описанием.

**Запуск транзакции IQ09, вставка серийников из буфера обмена, выполнение транзакции.**

```

' Запускаем транзакцию

startTransaction("IQ09")

' Кнопка "Многократный выбор" серийников

UserArea.findById("btn%\_SERNR\_%\_APP\_%-VALU\_PUSH").Press()

' Кнопка "Загрузка из буфера"

session.findById("wnd[1]/tbar[0]/btn[24]").Press()

' Кнопка "Скопировать" (F8)

pressF8()

' Кнопка "Выполнить" (F8)

pressF8()

```

Т.е. непосредственно перед запуском скрипта необходимо скопировать в буфер обмена столбец из серийных номеров, например, из Excel или текстового файла.

**Поступление материала за текущий месяц (транзакция MB51).**

```

' Определяем первый и последний дни текущего месяца

curr\_date = Date()

curr\_month = Month(curr\_date)

curr\_year = Year(curr\_date)

curr\_day = Day(curr\_date)

date\_begin = DateSerial(curr\_year, curr\_month, 1)

date\_end = DateSerial(curr\_year, curr\_month + 1, 0)

' Запускаем транзакцию

startTransaction("MB51")

' Заполняем/очищаем поля ввода

UserArea.findById("ctxtMATNR-LOW").Text = "100000" ' Материал

UserArea.findById("ctxtWERKS-LOW").Text = "9999" ' Завод

UserArea.findById("ctxtLGORT-LOW").Text = "0001" ' Склад

UserArea.findById("ctxtBWART-LOW").Text = "101" ' Вид движения

UserArea.findById("ctxtBUDAT-LOW").Text = date\_begin ' Дата проводки - начало интервала

UserArea.findById("ctxtBUDAT-HIGH").Text = date\_end ' Дата проводки - конец интервала

UserArea.findById("ctxtLIFNR-LOW").Text = ""

UserArea.findById("ctxtBUKRS-LOW").Text = ""

UserArea.findById("ctxtEBELN-LOW").Text = "" ' Заказ на поставку

UserArea.findById("txtMAT\_KDPO-LOW").Text = "" ' Поз. заказа клиента

UserArea.findById("txtZEILE-LOW").Text = "" ' Поз. док. материала

UserArea.findById("txtMBLNR-LOW").Text = "" ' Документ материала

UserArea.findById("txtMJAHR-LOW").Text = "" ' ГодДокумМатериала

pressF8()

' Кнопка "Подробный список"

Wnd0.findById("tbar[1]/btn[48]").Press()

' Меню "Параметры настройки -> Вариант просмотра -> Выбрать..."

Menubar.findById("menu[3]/menu[2]/menu[1]").Select()

' Выбираем форматы "X СпецифДляПользов"

session.findById("wnd[1]/usr/ssubD0500\_SUBSCREEN:SAPLSLVC\_DIALOG:0501/cmbG51\_USPEC\_LBOX").Key = "X"

' Клик по 3-му формату сверху

session.findById("wnd[1]/usr/ssubD0500\_SUBSCREEN:SAPLSLVC\_DIALOG:0501/cntlG51\_CONTAINER/shellcont/shell").currentCellRow = 3

session.findById("wnd[1]/usr/ssubD0500\_SUBSCREEN:SAPLSLVC\_DIALOG:0501/cntlG51\_CONTAINER/shellcont/shell").clickCurrentCell()

```

В начале скрипта определяются первый и последний дни текущего месяца. Дополнительно очищаются некоторые поля ввода, которые могут быть заполнены после предыдущего запуска транзакции. Для таблицы используется предварительно созданный формат (специфический для пользователя), который должен быть третьим в списке. Порядковый номер формата легко исправить в коде.

**Исходящие поставки за прошлый месяц (транзакция VL06O).**

```

' Определяем первый и последний дни прошлого месяца

curr\_date = Date()

curr\_month = Month(curr\_date)

curr\_year = Year(curr\_date)

curr\_day = Day(curr\_date)

curr\_month = curr\_month - 1

date\_begin = DateSerial(curr\_year, curr\_month, 1)

date\_end = DateSerial(curr\_year, curr\_month + 1, 0)

' Запускаем транзакцию

startTransaction("VL06O")

' Кнопка "Список поставок - исх. п"

UserArea.findById("btnBUTTON6").Press()

' Кнопка "Вызвать вариант..."

Wnd0.findById("tbar[1]/btn[17]").Press()

' Вводим имя формата

session.findById("wnd[1]/usr/txtV-LOW").Text = "MY\_FORMAT"

' Кнопка "Выполнить" (F8)

pressF8()

' Вводим интервал

UserArea.findById("ctxtIT\_WTIST-LOW").Text = date\_begin

UserArea.findById("ctxtIT\_WTIST-HIGH").Text = date\_end

' Кнопка "Выполнить" (F8)

pressF8()

' Кнопка "Выбрать формат..."

Wnd0.findById("tbar[1]/btn[33]").Press()

' Выбираем форматы "X СпецифДляПользов"

session.findById("wnd[1]/usr/ssubD0500\_SUBSCREEN:SAPLSLVC\_DIALOG:0501/cmbG51\_USPEC\_LBOX").Key = "X"

' Клик по 3-му формату

session.findById("wnd[1]/usr/ssubD0500\_SUBSCREEN:SAPLSLVC\_DIALOG:0501/cntlG51\_CONTAINER/shellcont/shell").currentCellRow = 3

session.findById("wnd[1]/usr/ssubD0500\_SUBSCREEN:SAPLSLVC\_DIALOG:0501/cntlG51\_CONTAINER/shellcont/shell").clickCurrentCell()

```

В начале скрипта определяются первый и последний дни прошлого месяца. Остальные параметры запуска транзакции хранятся в предварительно созданном формате MY\_FORMAT\_2. Для таблицы так же используется предварительно созданный формат (специфический для пользователя), который должен быть третьим в списке.

**Извлечение среднескользящих цен (транзакция MM43).**

```

zavod = InputBox("Введите код завода")

If (zavod = "") Then WScript.Quit

' Диалог выбора файла

streams = selectFile(True)

Set inputStream = streams(0)

Set outputStream = streams(1)

' Запускаем транзакцию

startTransaction("MM43")

' Читаем строки из файла, пока не достигнем конца

Do While (Not inputStream.AtEndOfLine)

' Вводим завод

UserArea.findById("ctxtRMMW1-VZWRK").Text = zavod

' Считываем материал из файла

material = inputStream.ReadLine()

' Вставляем материал

UserArea.findById("ctxtRMMW1-MATNR").Text = material

' Кнопка "Enter"

pressEnter()

' Вкладка "Логистика: ЦентрРасп"

UserArea.findById("tabsTABSPR1/tabpSP05").Select()

' Кнопка "Бухучет"

UserArea.findById("tabsTABSPR1/tabpSP05/ssubTABFRA1:SAPLMGMW:2004/subSUB9:SAPLMGD2:2480/btnMBEW\_PUSH").Press()

' Извлекаем цену

price = UserArea.findById("subSUB3:SAPLMGD2:2802/txtMBEW-VERPR").Text

' Убираем точку в цене

price = Replace(price, ".", "")

' Кнопка "Назад" (F3)

pressF3()

' Кнопка "Назад" (F3)

pressF3()

' Записываем в файл материал и цену

outputStream.WriteLine(material & vbTab & price)

Loop

' Кнопка "Назад" (F3)

pressF3()

inputStream.Close()

outputStream.Close()

MsgBox "Готово!", vbSystemModal Or vbInformation

```

Материалы, по которым надо получить среднескользящие цены – находятся в текстовом файле и расположены в столбец. Скрипт запускает транзакцию MM43, потом переключается по вкладкам, нажимает кнопку, чтобы добраться до нужного поля. Полученную цену записывает в новый файл вместе с материалом (через табуляцию).

**Список транспортировок с датами окончания погрузки (транзакция VT16).**

```

' Определяем первый день текущего месяца

curr\_date = Date()

curr\_month = Month(curr\_date)

curr\_year = Year(curr\_date)

date\_begin = DateSerial(curr\_year, curr\_month, 1)

' Запускаем транзакцию

startTransaction("VT16")

' Кнопка "Enter"

pressEnter()

' Интервал "ТекущКонецПогрз"

UserArea.findById("ctxtK\_DALEN-LOW").Text = date\_begin

UserArea.findById("ctxtK\_DALEN-HIGH").Text = "31.12.9999"

' Вид транспортировки

UserArea.findById("ctxtK\_SHTYP-LOW").Text = "0001"

' Заполняем пункты отгрузки

UserArea.findById("btn%\_A\_VSTEL\_%\_APP\_%-VALU\_PUSH").Press()

Set table = session.findById("wnd[1]/usr/tabsTAB\_STRIP/tabpSIVA/ssubSCREEN\_HEADER:SAPLALDB:3010/tblSAPLALDBSINGLE")

table.findById("ctxtRSCSEL\_255-SLOW\_I[1,0]").Text = "1111"

table.findById("ctxtRSCSEL\_255-SLOW\_I[1,1]").Text = "2222"

table.findById("ctxtRSCSEL\_255-SLOW\_I[1,2]").Text = "3333"

session.findById("wnd[1]/tbar[0]/btn[8]").Press()

' Кнопка "Выполнить" (F8)

pressF8()

' Пункт меню "Параметры настройки -> Варианты просмотра -> Выбрать..."

Menubar.findById("menu[3]/menu[0]/menu[1]").Select()

' Выбираем первый формат в списке

session.findById("wnd[1]/usr/lbl[1,3]").setFocus()

' Кнопка "Enter"

pressEnter()

```

Транспортировки выбираются из интервала – с первого дня текущего месяца по 31.12.9999. Дата первого дня текущего месяца определяется в начале скрипта. Указываются пункты отгрузки. Для сформированного отчета выбирается первый формат в списке.

Следующие три скрипта предназначены для проводки отгруженных поставок датой, равной дате окончания погрузки.

**Отгруженные, но не проведенные, исходящие поставки (транзакция VL06O).**

```

' Запускаем транзакцию

startTransaction("VL06O")

' Кнопка "Список поставок - исх. п"

UserArea.findById("btnBUTTON6").Press()

' Кнопка "Вызвать вариант..."

Wnd0.findById("tbar[1]/btn[17]").Press()

' Вводим имя формата

session.findById("wnd[1]/usr/txtV-LOW").Text = "MY\_FORMAT\_2"

' Очищаем поле "Создал"

session.findById("wnd[1]/usr/txtENAME-LOW").Text = ""

' Кнопка "Выполнить"

pressF8()

' Кнопка "Выполнить"

pressF8()

```

Для таблицы используется предварительно созданный формат.

**Запуск транзакции VT16, вставка номеров поставок из буфера обмена, выполнение транзакции.**

```

' Запускаем транзакцию

startTransaction("VT16")

' Закрываем ненужное окошко

session.findById("wnd[1]/tbar[0]/btn[0]").Press()

' Кнопка "Многократный выбор" исходящих поставок

UserArea.findById("btn%\_S\_VBELN\_%\_APP\_%-VALU\_PUSH").Press()

' Кнопка "Загрузка из буфера"

session.findById("wnd[1]/tbar[0]/btn[24]").Press()

' Кнопка "Скопировать" (F8)

pressF8()

' Кнопка "Выполнить" (F8)

pressF8()

' Пункт меню "Параметры настройки -> Варианты просмотра -> Выбрать..."

Menubar.findById("menu[3]/menu[0]/menu[1]").Select()

' Выбираем первый формат в списке

session.findById("wnd[1]/usr/lbl[1,3]").setFocus()

' Кнопка "Enter"

pressEnter()

```

Аналогично, столбец из номеров поставок необходимо предварительно скопировать в буфер обмена.

**Отгруженные, но не проведенные, исходящие поставки по транспортировкам из буфера обмена (транзакция VL06O).**

```

' Запуск транзакции

startTransaction("VL06O")

' Кнопка "Для ОМ"

UserArea.findById("btnBUTTON4").Press()

' Удаление начальной и конечной дат "Дата ПлановДвижМтр"

UserArea.findById("ctxtIT\_WADAT-LOW").Text = ""

UserArea.findById("ctxtIT\_WADAT-HIGH").Text = ""

' Кнопка "Многократный выбор" транспортировок

UserArea.findById("btn%\_IT\_TKNUM\_%\_APP\_%-VALU\_PUSH").Press()

' Кнопка "Загрузка из буфера"

session.findById("wnd[1]/tbar[0]/btn[24]").Press()

' Кнопка "Выполнить" (F8)

pressF8()

' Кнопка "Выполнить" (F8)

pressF8()

' Если нет кнопки "Ракурс позиции" - то и поставок нет

If (Wnd0.findById("tbar[1]/btn[18]").Text = "Ракурс позиции") Then

' Выделяем все

UserArea.findById("cntlGRID1/shellcont/shell").selectAll

' Меню "Последующие функции -> Выполнить проводку отпуска материала"

Menubar.findById("menu[4]/menu[7]").Select()

' В появившемся окне стираем два первых символа (день месяца) в поле ввода даты фактического движения материала

WshShell.SendKeys "{HOME}{DELETE}{DELETE}"

Else

MsgBox "Поставок нет!", vbSystemModal Or vbExclamation

' Кнопка "Назад" (F3)

pressF3()

' Кнопка "Назад" (F3)

pressF3()

End If

```

Столбец с номерами транспортировок необходимо предварительно скопировать в буфер обмена из результатов работы транзакции VT16 (предыдущий скрипт). После окончания работы транзакции:

1. Если поставок в отчете нет – выводится соответствующее сообщение, далее скрипт завершает работу.

2. Если поставки в отчете есть – выбирается пункт меню «Выполнить проводку отпуска материала», в появившемся окошке с датой проводки стираются два первых символа (т.е. день). Далее скрипт завершает работу, а пользователю необходимо ввести нужный день и нажать Enter.

Наличие/отсутствие поставок в отчете определяется по наличию/отсутствию меню. Предварительно включается обработка ошибок скриптом.

Пока писал статью, решил объединить первые два скрипта для проводки отгруженных поставок в один.

**Список транспортировок на отгруженные, но не проведенные, исходящие поставки.**

```

'##############################################################

' Запускаем первую транзакцию

startTransaction("VL06O")

' Кнопка "Список поставок - исх. п"

UserArea.findById("btnBUTTON6").Press()

' Кнопка "Вызвать вариант..."

Wnd0.findById("tbar[1]/btn[17]").Press()

' Вводим имя формата

session.findById("wnd[1]/usr/txtV-LOW").Text = "MY\_FORMAT\_3"

' Очищаем поле "Создал"

session.findById("wnd[1]/usr/txtENAME-LOW").Text = ""

' Кнопка "Выполнить"

pressF8()

' Кнопка "Выполнить"

pressF8()

Set grid = UserArea.findById("cntlGRID1/shellcont/shell") ' GuiGridView

rowCount = grid.RowCount ' Всего заполненных строк

visibleRowCount = grid.VisibleRowCount ' Количество видимых строк

' Прокручиваем таблицу до конца, чтобы скопировались все поставки

firstVisibleRow = visibleRowCount

Do While (firstVisibleRow < rowCount)

grid.firstVisibleRow = firstVisibleRow

firstVisibleRow = firstVisibleRow + visibleRowCount

Loop

' Выделяем столбец с поставками

grid.SelectColumn("VBELN")

' Копируем в буфер выделенный столбец с помощью контекстного меню

grid.ContextMenu()

grid.SelectContextMenuItemByText "Скопировать текст"

' Выходим в меню SAP

pressF3()

pressF3()

pressF3()

'##############################################################

' Запускаем вторую транзакцию

startTransaction("VT16")

' Закрываем ненужное окошко

session.findById("wnd[1]/tbar[0]/btn[0]").Press()

' Кнопка "Многократный выбор" исходящих поставок

UserArea.findById("btn%\_S\_VBELN\_%\_APP\_%-VALU\_PUSH").Press()

' Кнопка "Загрузка из буфера"

session.findById("wnd[1]/tbar[0]/btn[24]").Press()

' Кнопка "Скопировать" (F8)

pressF8()

' Кнопка "Выполнить" (F8)

pressF8()

' Пункт меню "Параметры настройки -> Варианты просмотра -> Выбрать..."

Menubar.findById("menu[3]/menu[0]/menu[1]").Select()

' Выбираем первый формат в списке (должен быть "Lexa\_1")

session.findById("wnd[1]/usr/lbl[1,3]").setFocus()

' Кнопка "Enter"

pressEnter()

```

В скрипте используется копирование столбца с номерами поставок из транзакции VL06O с предварительной прокруткой таблицы до конца (чтобы скопировались все поставки).

**Массовое прописывание даты и времени «ПланировТранс» во входящих поставках (транзакция VL32N).**

```

data\_prihoda = InputBox("Введите дату в формате: 010213, 01022013, 01.02.13, 01.02.2013")

If (data\_prihoda = "") Then WScript.Quit

vremya\_prihoda = InputBox("Введите время в формате: 0130, 01:30")

If (vremya\_prihoda = "") Then WScript.Quit

' Диалог выбора файла

Set inputStream = selectFile(False)

' Запускаем транзакцию

startTransaction("VL32N")

' Перебираем строки, пока не встретится пустая

Do While (Not inputStream.AtEndOfLine)

' Читаем строку из файла

postavka = inputStream.ReadLine()

' Вставляем номер поставки

UserArea.findById("ctxtLIKP-VBELN").Text = postavka

' Нажимаем "Enter"

pressEnter()

' Переключаемся на вкладку "Транспортировка"

UserArea.findById("tabsTAXI\_TABSTRIP\_OVERVIEW/tabpT\02").Select()

' Вставляем дату

UserArea.findById("tabsTAXI\_TABSTRIP\_OVERVIEW/tabpT\02/ssubSUBSCREEN\_BODY:SAPMV50A:1208/ctxtLIKP-TDDAT").Text = data\_prihoda

' Вставляем время

UserArea.findById("tabsTAXI\_TABSTRIP\_OVERVIEW/tabpT\02/ssubSUBSCREEN\_BODY:SAPMV50A:1208/ctxtLIKP-TDUHR").Text = vremya\_prihoda

' Нажимаем "Enter" один раз или несколько, если проблемы с датой

Do

' Нажимаем "Enter"

pressEnter()

Loop While (Len(Statusbar.text) > 0)

' Нажимаем "Сохранить"

Wnd0.findById("tbar[0]/btn[11]").Press()

Loop

' Нажимаем "Назад"

pressF3()

inputStream.Close()

MsgBox "Готово!", vbSystemModal Or vbInformation

```

Номера входящих поставок должны быть в текстовом файле в один столбец. Скрипт запрашивает дату и время, после этого перебирает все поставки, прописывает «ПланировТранс», сохраняет поставку. Если в строке статуса появляется какое-либо сообщение – скрипт нажимает Enter до тех пор, пока строка статуса не станет пустой.

**Перенос несерийного товара между складами (транзакция MB1B).**

```

' Завод

zavod = InputBox("Введите код завода")

If (zavod = "") Then WScript.Quit

' Склад-отправитель

sklad\_source = InputBox("Введите код склада-отправителя")

If (sklad\_source = "") Then WScript.Quit

' Склад-получатель

sklad\_destination = InputBox("Введите код склада-получателя")

If (sklad\_destination = "") Then WScript.Quit

' Диалог выбора файла

Set inputStream = selectFile(False)

' Запускаем транзакцию

startTransaction("MB1B")

' Вводим вид движения

UserArea.findById("ctxtRM07M-BWARTWA").Text = "311"

' Вводим завод

UserArea.findById("ctxtRM07M-WERKS").Text = zavod

' Вводим склад-отправитель

UserArea.findById("ctxtRM07M-LGORT").Text = sklad\_source

' Кнопка "Enter"

pressEnter()

' Вводим склад-получатель

UserArea.findById("ctxtMSEGK-UMLGO").Text = sklad\_destination

' Кнопка "Enter"

pressEnter()

' Определяем количество строк в таблице

Set simpleContainer = UserArea.findById("sub:SAPMM07M:0421")

RowCount = simpleContainer.LoopRowCount

intRow = 2

' Читаем строки из файла, пока не достигнем конца

Do While (Not inputStream.AtEndOfLine)

' Читаем строку из файла

stroka = inputStream.ReadLine()

' Разбиваем строку по символам табуляции

arr = Split(stroka, vbTab)

material = arr(0)

kolvo = Replace(arr(1), " ", "") ' Убираем пробелы в количестве

SAP\_pos = (intRow - 2) Mod RowCount

UserArea.findById("sub:SAPMM07M:0421/ctxtMSEG-MATNR[" & SAP\_pos & ",7]").Text = material

UserArea.findById("sub:SAPMM07M:0421/txtMSEG-ERFMG[" & SAP\_pos & ",26]").Text = kolvo

' Нажимаем кнопку "Новый", если таблица закончилась

If (SAP\_pos = (RowCount - 1)) Then Wnd0.findById("tbar[1]/btn[19]").Press()

intRow = intRow + 1

If (intRow > 1000) Then

inputStream.Close()

MsgBox "Заполнено 999 позиций!", vbSystemModal Or vbCritical

WScript.Quit

End If

Loop

' Кнопка "Enter"

pressEnter()

inputStream.Close()

MsgBox "Готово!", vbSystemModal Or vbInformation

```

Скрипт в начале работы запрашивает завод и склады, далее читает из текстового файла материал и количество (разделенные табуляцией), вводит их в таблицу, автоматически прокручивая ее. За один запуск скрипта можно перенести не более 1000 позиций.

**Перенос серийного товара между складами (транзакция MB1B).**

```

' Завод

zavod = InputBox("Введите код завода")

If (zavod = "") Then WScript.Quit

' Склад-отправитель

sklad\_source = InputBox("Введите код склада-отправителя")

If (sklad\_source = "") Then WScript.Quit

' Склад-получатель

sklad\_destination = InputBox("Введите код склада-получателя")

If (sklad\_destination = "") Then WScript.Quit

' Диалог выбора файла

Set inputStream = selectFile(False)

' Запускаем транзакцию

startTransaction("MB1B")

' Вводим вид движения

UserArea.findById("ctxtRM07M-BWARTWA").Text = "311"

' Вводим завод

UserArea.findById("ctxtRM07M-WERKS").Text = zavod

' Вводим склад-отправитель

UserArea.findById("ctxtRM07M-LGORT").Text = sklad\_source

' Кнопка "Enter"

pressEnter()

' Вводим склад-получатель

UserArea.findById("ctxtMSEGK-UMLGO").Text = sklad\_destination

' Кнопка "Enter"

pressEnter()

' Определяем количество строк в таблице

Set simpleContainer = UserArea.findById("sub:SAPMM07M:0421")

RowCount = simpleContainer.LoopRowCount

intRow = 2

' Читаем строки из файла, пока не достигнем конца

Do While (Not inputStream.AtEndOfLine)

' Читаем строку из файла

stroka = inputStream.ReadLine()

' Разбиваем строку по символам табуляции

arr = Split(stroka, vbTab)

material = arr(0)

serial = arr(1)

SAP\_pos = (intRow - 2) Mod RowCount

UserArea.findById("sub:SAPMM07M:0421/ctxtMSEG-MATNR[" & SAP\_pos & ",7]").Text = material

UserArea.findById("sub:SAPMM07M:0421/txtMSEG-ERFMG[" & SAP\_pos & ",26]").Text = "1"

' Кнопка "Enter"

pressEnter()

' Вставляем серийник

session.findById("wnd[1]/usr/tblSAPLIPW1TC\_SERIAL\_NUMBERS/ctxtRIPW0-SERNR[0,0]").Text = serial

' Кнопка "ОК"

session.findById("wnd[1]/tbar[0]/btn[0]").Press()

' Нажимаем кнопку "Новый", если таблица закончилась

If (SAP\_pos = (RowCount - 1)) Then Wnd0.findById("tbar[1]/btn[19]").Press()

intRow = intRow + 1

If (intRow > 1000) Then

inputStream.Close()

MsgBox "Заполнено 999 позиций!", vbSystemModal Or vbCritical

WScript.Quit

End If

Loop

' Нажимаем "Enter"

pressEnter()

inputStream.Close()

MsgBox "Готово!", vbSystemModal Or vbInformation

```

Скрипт работает аналогично предыдущему скрипту, только в файле вместо количества должен быть серийник, а в табличной части скрипт сам ставит по каждому материалу количество 1.

**Создание заявки (транзакция ME51N).**

```

zavod = 8888

zatreboval = 12345

mvz = "7777666666"

note = "Примечание к заявке"

' Список товаров. Если какой-то товар не нужен, нужно проставить 0 в количестве

itemsArray = Array( \_

Array(111111, 50, "Бумага А4"), \_

Array(222222, 50, "Бумага туалетная"), \_

Array(333333, 0, "Жидкое мыло"), \_

Array(444444, 0, "Краска штемпельная"), \_

Array(555555, 10, "Маркер"), \_

Array(666666, 0, "Скобы для степлера"), \_

)

' Запускаем транзакцию

startTransaction("ME51N")

' Выбираем нужный вид заявки - NB

UserArea.findByName("MEREQ\_TOPLINE-BSART", "GuiComboBox").Key = "NB"

' Разворачиваем верхний контейнер, если он развернут

Set buttonTop = UserArea.findByName("SUB1:SAPLMEVIEWS:4000", "GuiSimpleContainer").findByName("DYN\_4000-BUTTON", "GuiButton")

If (Right(buttonTop.Tooltip, 2) = "F2") Then buttonTop.Press()

' Заполняем примечание заголовка

guiTexteditId = UserArea.findByName("TEXT\_EDITOR\_0101", "GuiCustomControl").Id & "/shellcont/shell"

UserArea.findById(guiTexteditId).Text = note

pos = 0

For Each item In itemsArray

If (item(1) > 0) Then

' Заполняем одну строку в таблице

fill\_row pos, item(0), item(1), zavod, zatreboval

' Кнопка "Enter"

pressEnter()

' Прописываем МВЗ

UserArea.findByName("COBL-KOSTL", "GuiCTextField").Text = mvz

' Кнопка "Enter"

pressEnter()

pos = pos + 1

End If

Next

MsgBox "Готово!", vbSystemModal Or vbInformation

```

Предварительно в скрипте проставляются количества для материалов, которые должны быть в заявке. Если указано 0, то такой материал в заявку не добавляется. Для каждого материала в заявке автоматически прописывается МВЗ. Скрипт не рассчитан на работу с большим количеством материалов (они не влезут в видимую часть таблицы).

Есть еще другие и более сложные скрипты, где используется три транзакции в одном скрипте, но там транзакции специфические для компании.

На этом пока все... | https://habr.com/ru/post/341576/ | null | ru | null |

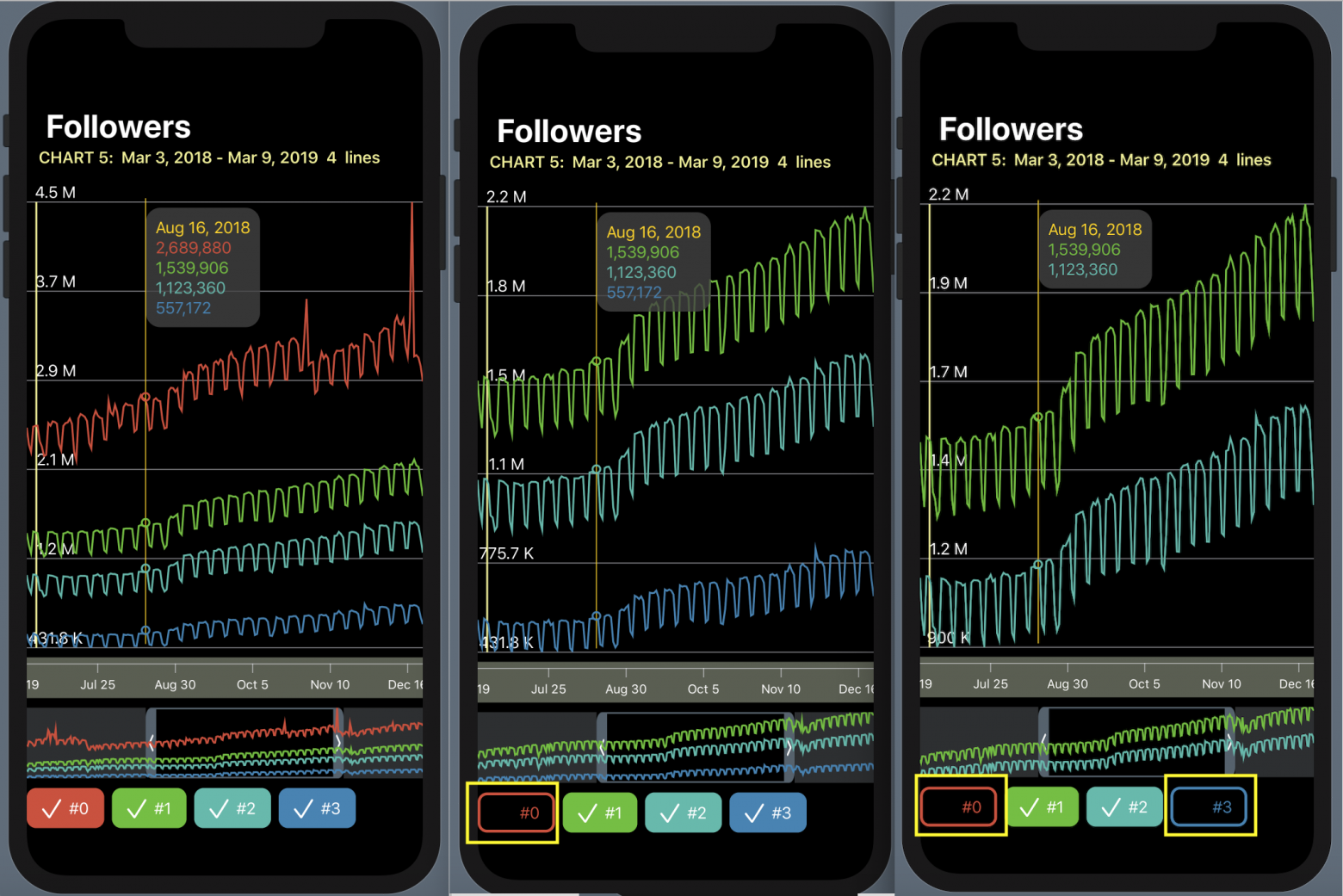

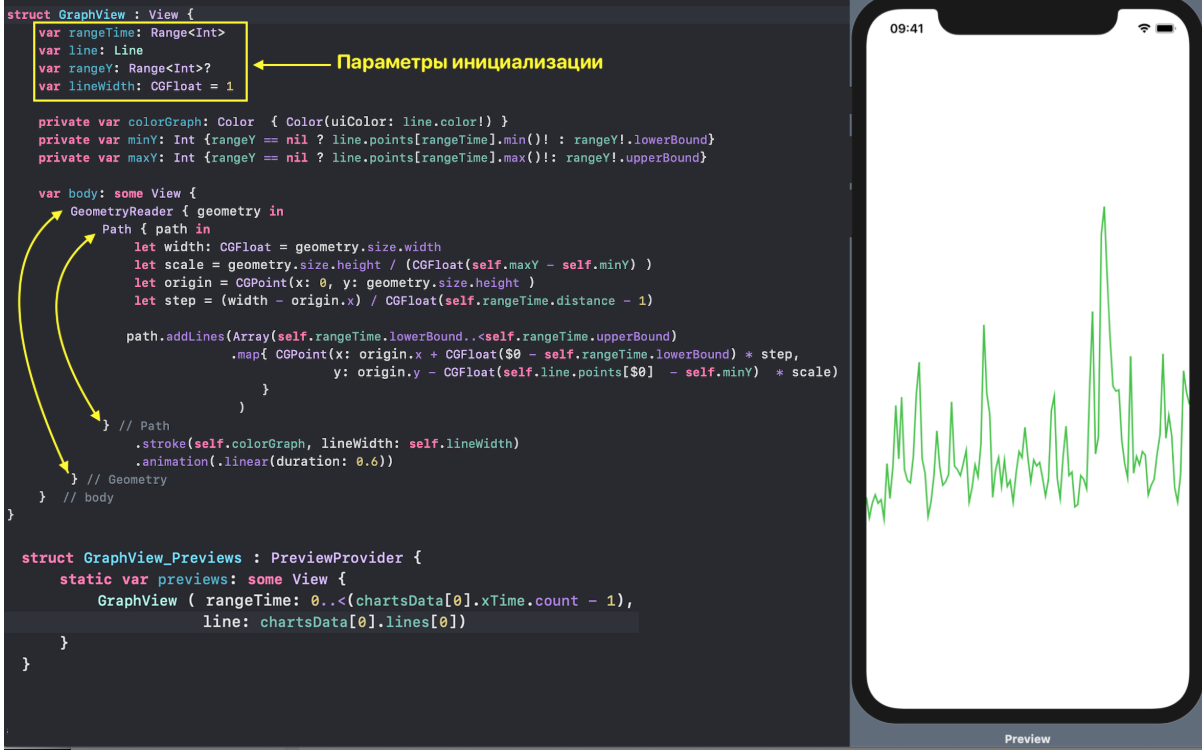

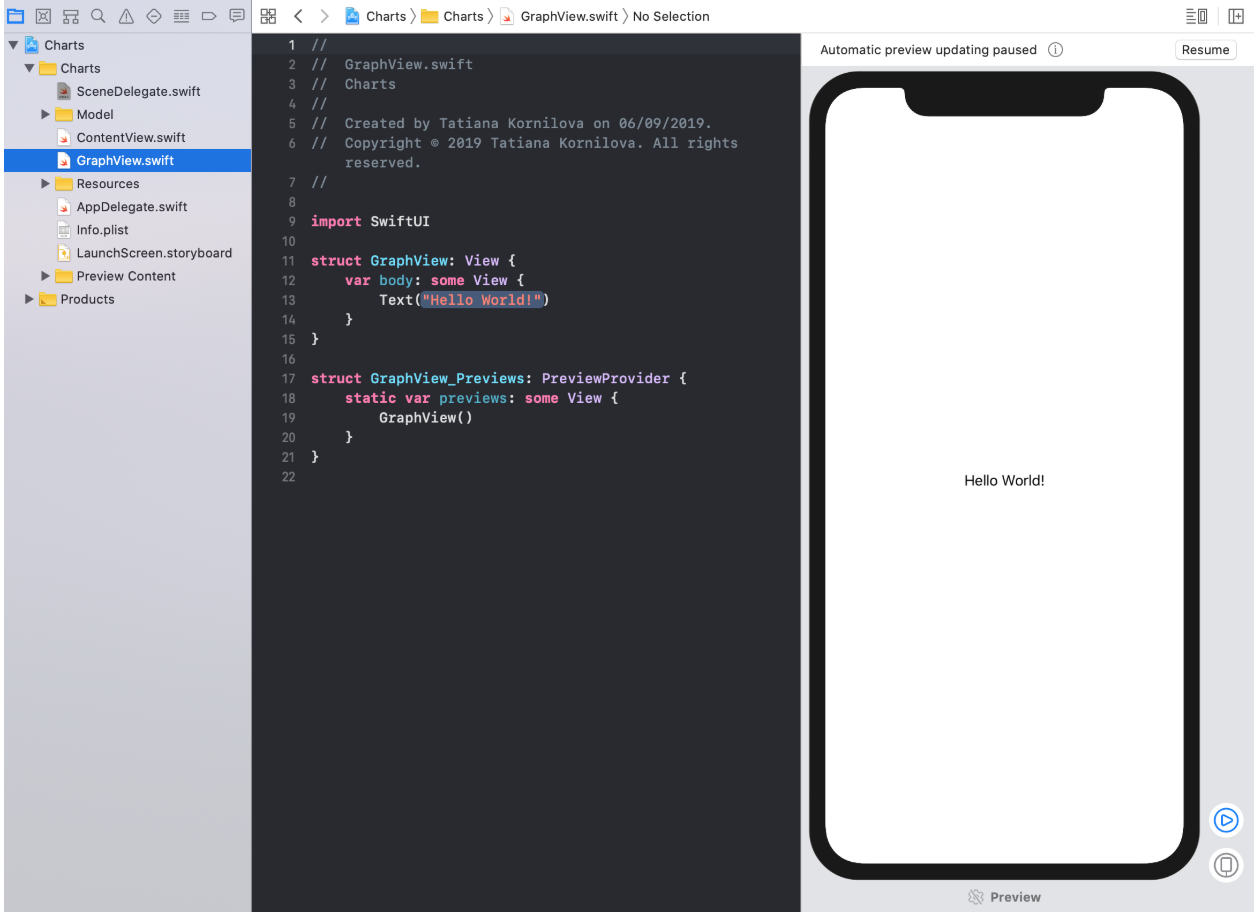

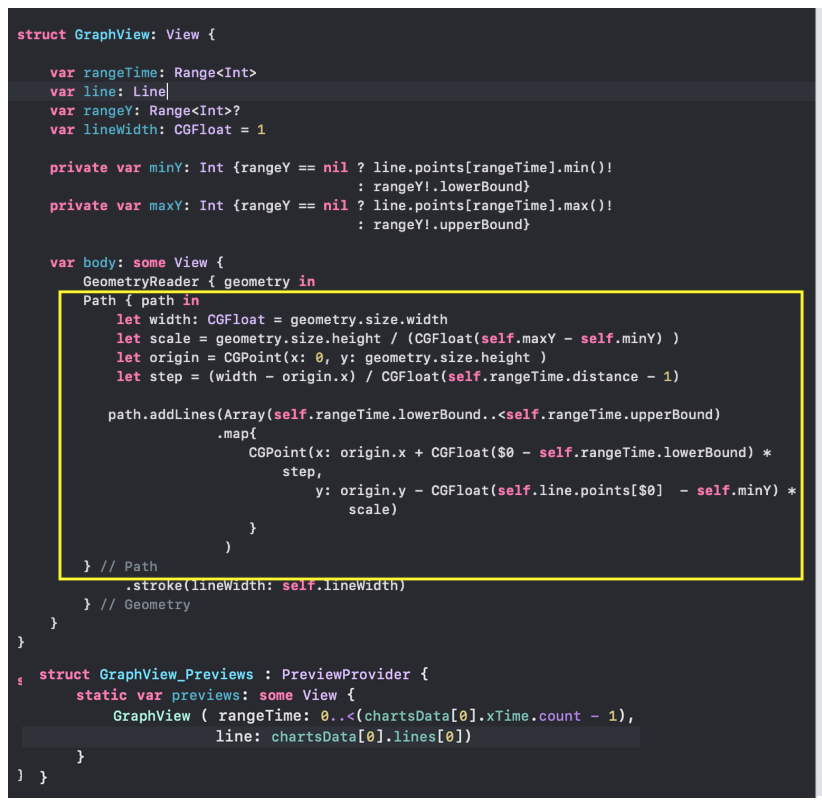

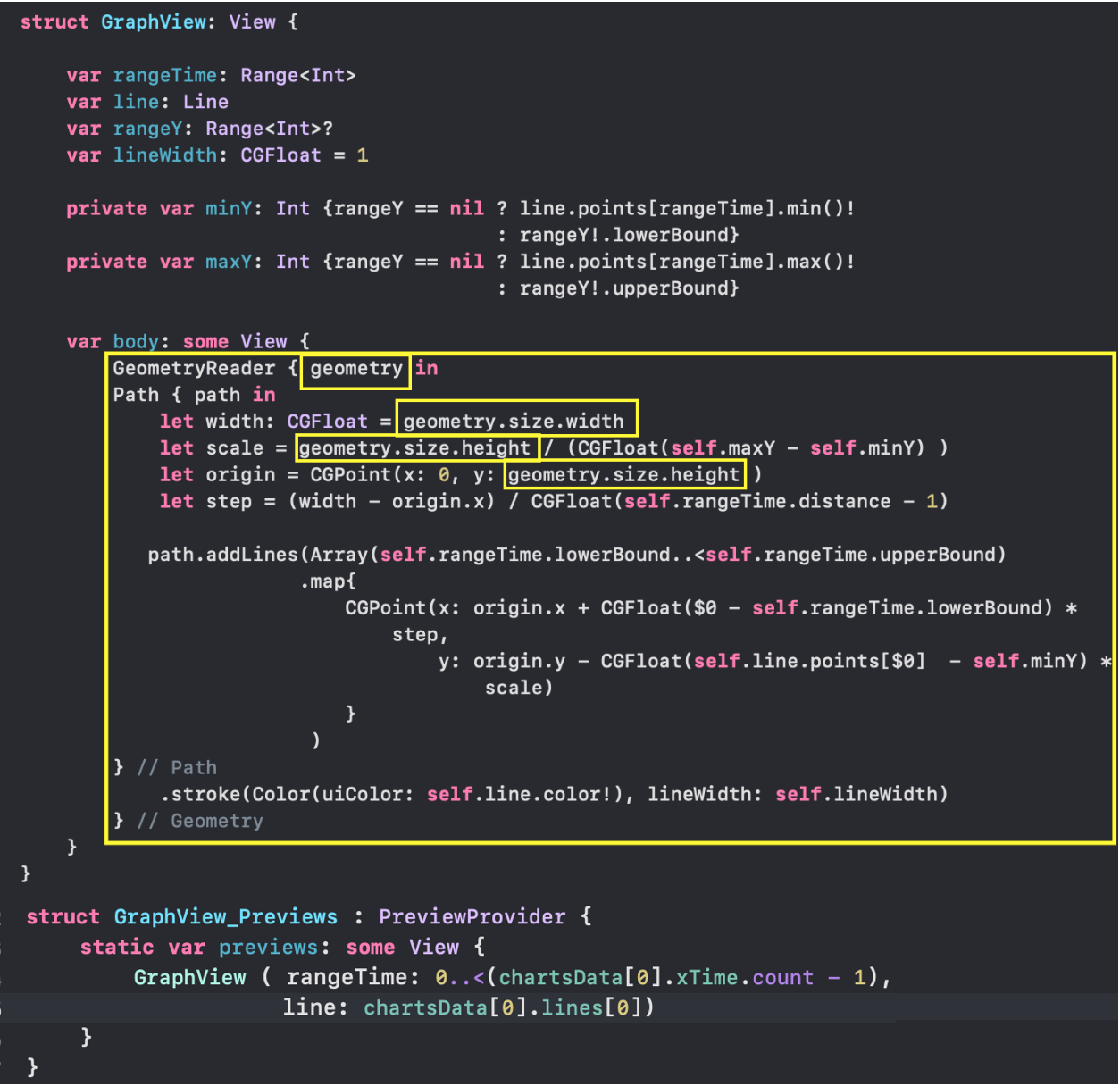

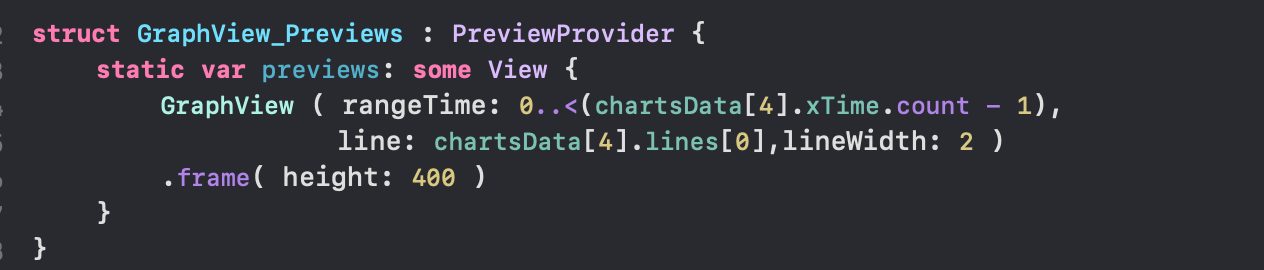

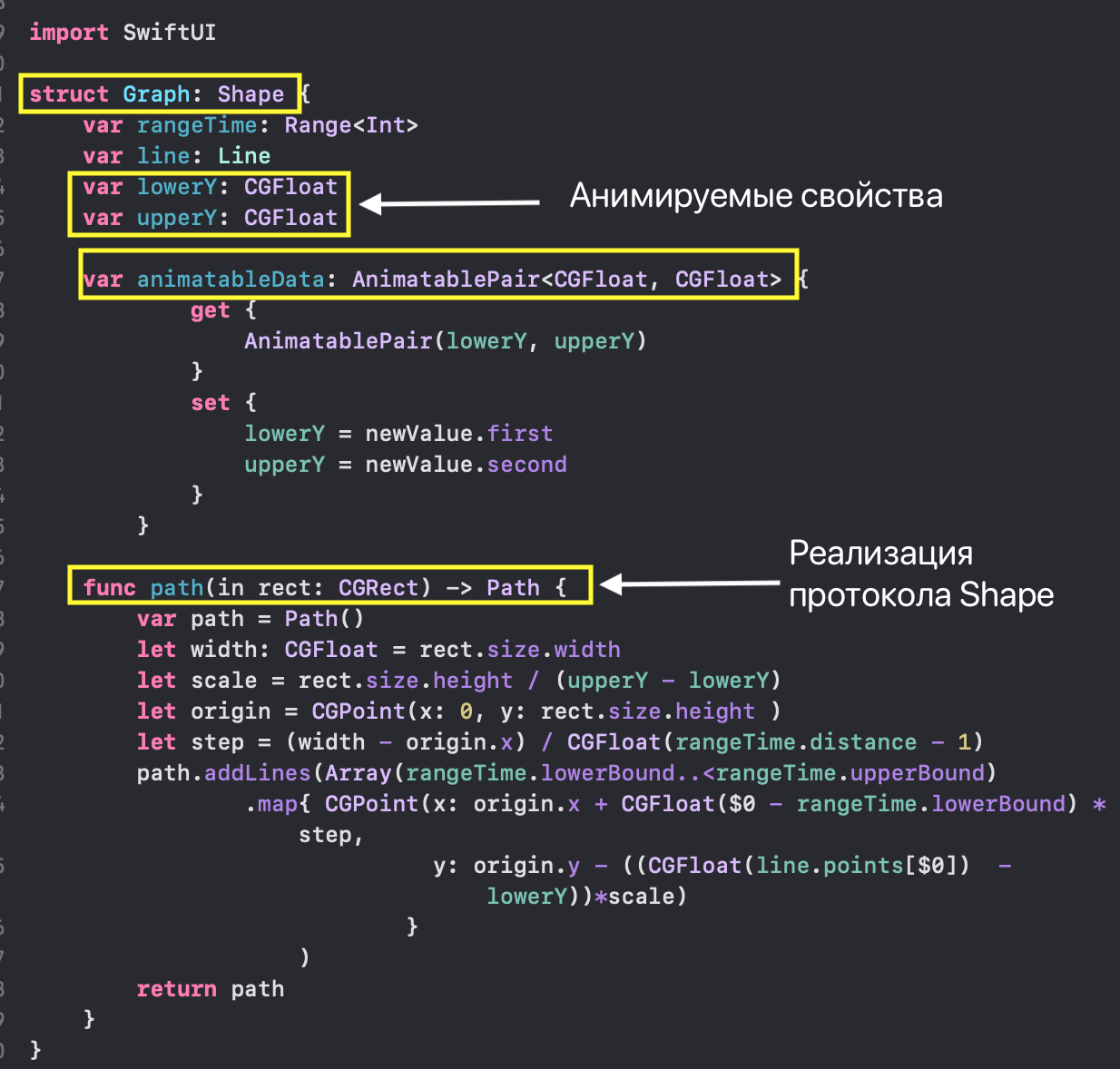

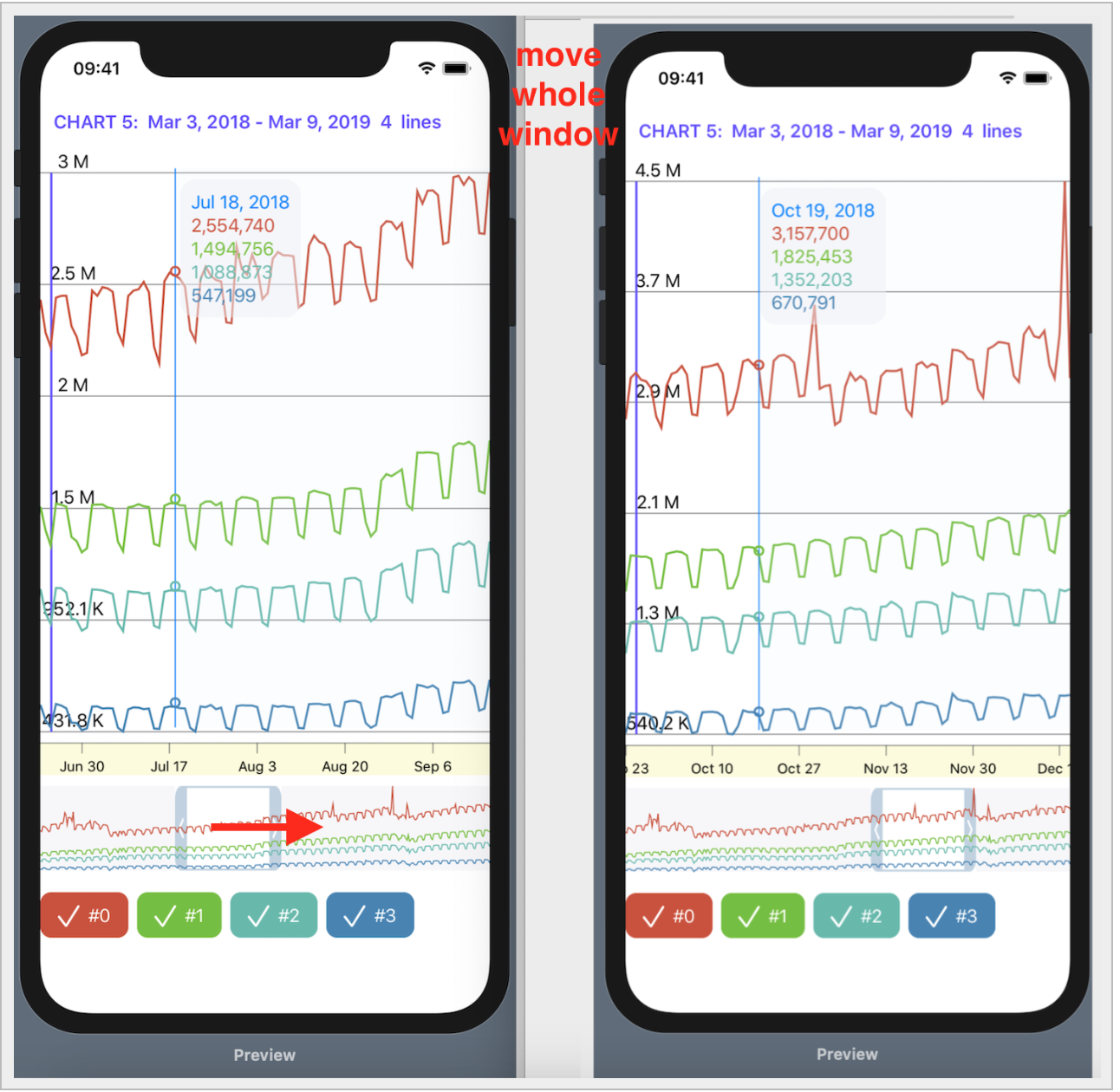

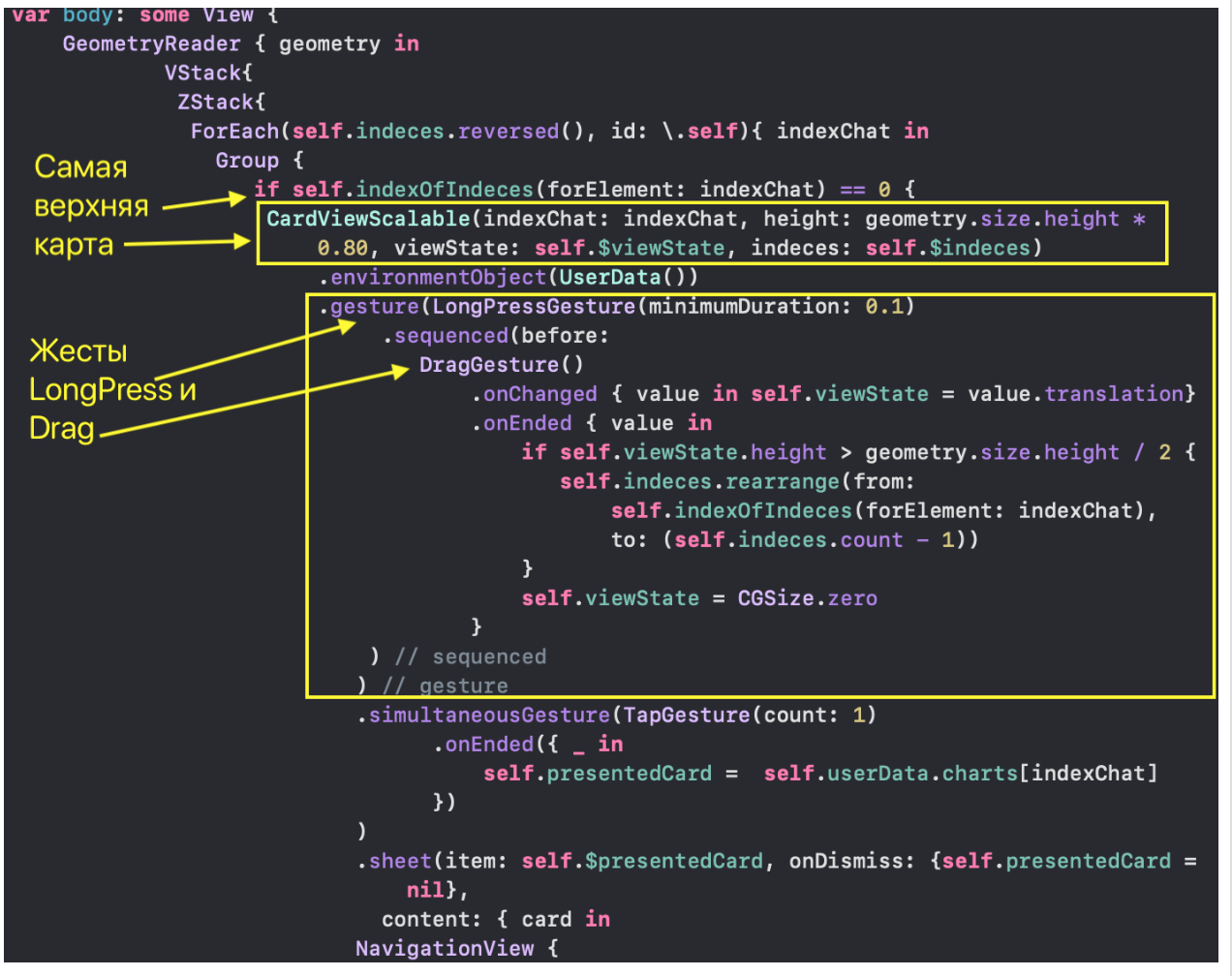

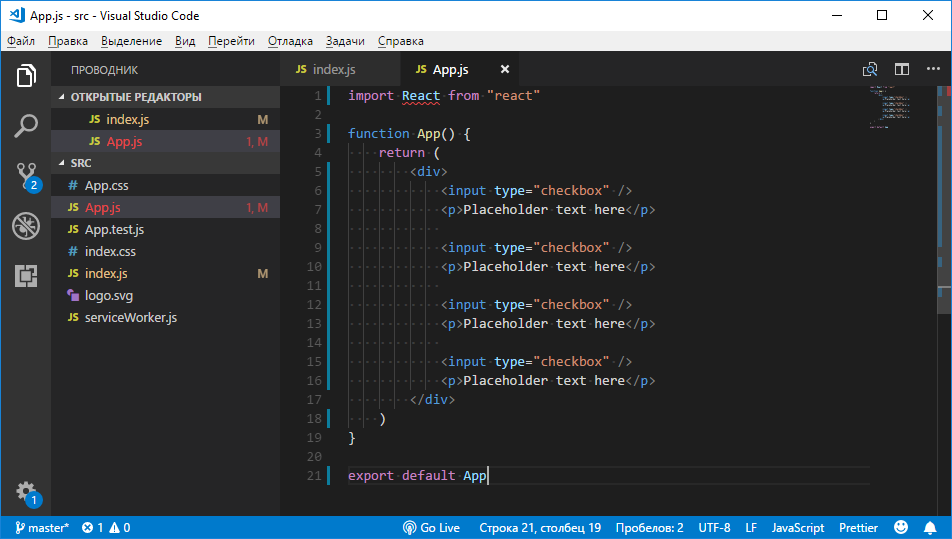

# SwiftUI для прошлого конкурсного задания Telegram Charts (март 2019 года): все просто

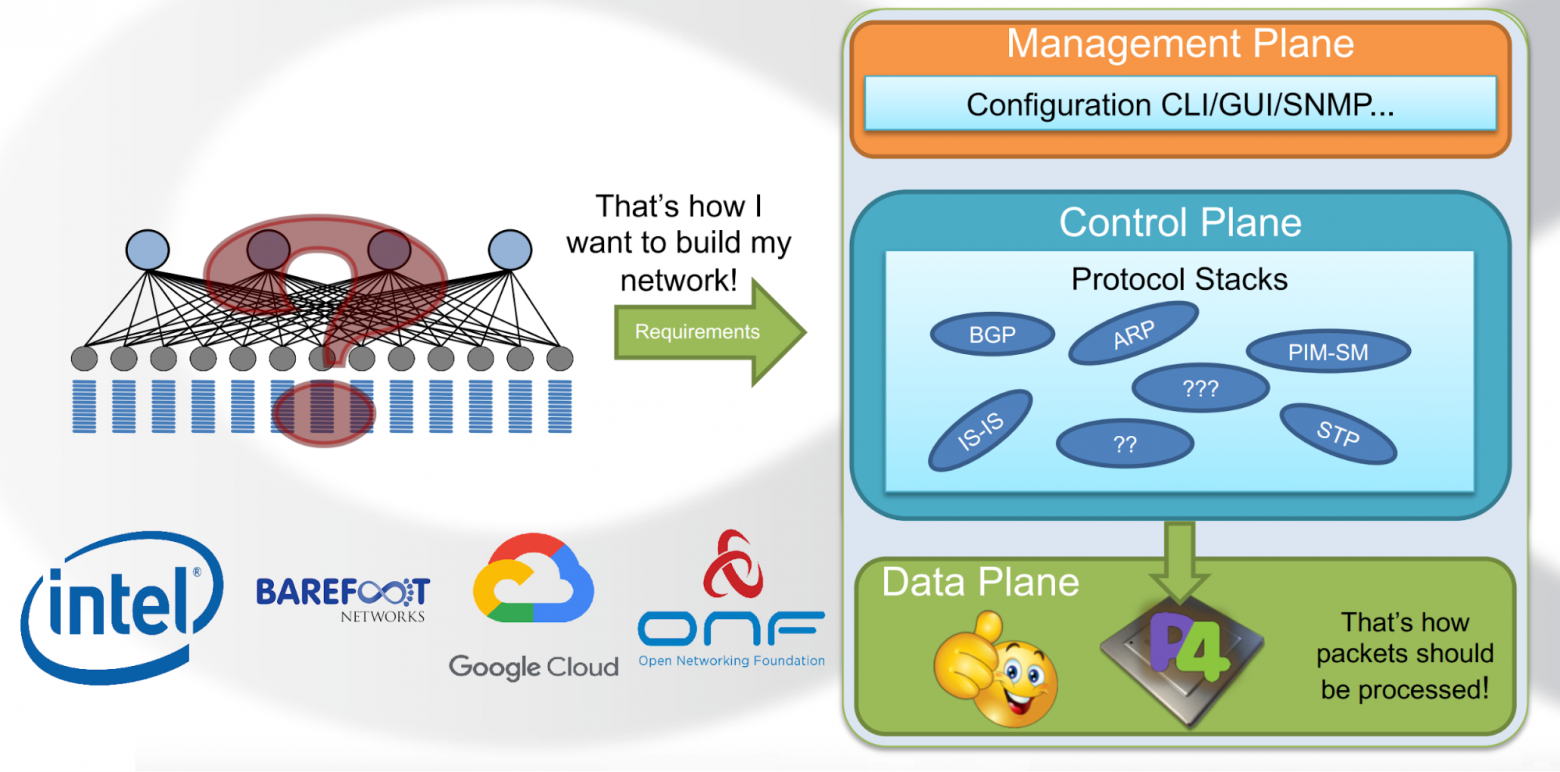

Сразу начну с замечания о том, что приложение, о котором пойдет речь в этой статье, требует [Xcode 11](https://developer.apple.com/xcode/) и [MacOS Catalina](https://www.apple.com/ru/macos/catalina/) , если вы хотите использовать `Live Previews`, и `Mojave`, если будете пользоваться симулятором. Код приложения находится на [Github](https://github.com/BestKora/ChartsView-SwiftUI).

В этом году на [WWDC 2019](https://developer.apple.com/videos/), `Apple` анонсировала `[SwiftUI](https://developer.apple.com/videos/play/wwdc2019/204/)`, новый декларативный способ построения пользовательского интерфейса (UI) на всех устройствах `Apple`. Это практически полное отступление от привычного нам `UIKit`, и я — как и многие другие разработчики — очень хотела посмотреть этот новый инструмент в действии.

В этой статье представлен опыт решение с помощью `SwiftUI` некоторой задачи, код которой в рамках `UIKit` несопоставимо более сложный и его не удается на мой взгляд представить в читабельном виде.

Задача связанна с прошлым конкурсом [Telegram](https://telegram.org/) для `Android`, `iOS` and `JS` разработчиков, который проходил в период 10 — 24 марта 2019 года. В этом конкурсе была предложена простая задача графического отображения интенсивности использования некоторого ресурса в интернете в зависимости от времени на основе `JSON` данных. Как `iOS` разработчик вы должны использовать язык`Swift` для представления на конкурс кода, написанного «с нуля» без использования каких-либо посторонних специализированных библиотек для построения графиков.

Эта задача требовала навыков работы с графическими и анимационными возможностями iOS: [Core Graphics](https://developer.apple.com/documentation/coregraphics), [Core Animation](https://developer.apple.com/documentation/quartzcore), [Metal](https://developer.apple.com/documentation/metal), [OpenGL ES](https://developer.apple.com/documentation/opengles/). Некоторые из этих инструментов являются низкоуровневыми, не объектно-ориентированными средствами программирования. По существу, в `iOS` не было приемлемых шаблонов для решения подобных, казалось бы, легких на первый взгляд графических задач. Поэтому каждый конкурсант изобретал свой собственный аниматор ([Render](https://github.com/zSOLz/TelegramContest)) на основе [Metal](https://github.com/AndreLami/TelegramCharts), [CALayers](https://github.com/backmeupplz/speznaz), [OpenGL](https://github.com/Moonko/RACharts), [CADisplayLink](https://github.com/AlexandrGraschenkov/TelegramChart). Это порождало тонны кода, из которого ничего не удавалось заимствовать и развивать, так как это чисто «авторские» работы, которые реально могут развивать только авторы. Однако так быть не должно.

И вот в начале июня на [WWDC 2019](https://developer.apple.com/videos/) появляется `SwifUI` - новый `framework`, разработанный `Apple`, написанный на `Swift` и предназначенный для декларативного описания пользовательского интерфейса (`UI`) в коде. Вы определяете, какие `subviews` показываются в вашем `View`, какие данные заставляют эти `subviews` изменяться, какие модификаторы к ним нужно применить, чтобы заставить их позиционироваться в нужном месте, иметь нужный размер и стиль. Не менее важным элементом `SwiftUI` является управление потоком изменяемых пользователем данных, которые в свою очередь обновляют `UI`.

В этой статье я хочу показать, как просто и быстро решается та самая задача конкурса [Telegram](https://telegram.org/) на `SwiftUI`. Кроме того это очень увлекательный процесс.

Задание

=======

Конкурсное приложение должно показывать одновременно на экране 5 «наборов Графиков», используя предоставленные `Telegram` данные. Для одного «набора Графиков» `UI` выглядит следующим образом:

В верхней части расположена «зона Графиков» с общим масштабом по обычной оси Y с отметками и горизонтальными линиями сетки. Чуть ниже расположена «бегущая строка» с временными отметками по оси X в виде дат.

Еще ниже располагается так называемый «mini map» (как в `Xcode 11`), то есть прозрачное «окошко», определяющее ту часть временного отрезка наших «Графиков», которая более подробно представлена в верхней «зоне Графиков». Этот «mini map» можно не только перемещать вдоль оси `X`, но и менять его ширину, что сказывается на временном масштабе в «зоне Графиков».

С помощью `checkboxs`, окрашенных в цвета «Графиков» и снабженных их названиями, можно отказаться от показа соответствующего этому цвету «Графика» в «зоне Графиков».

Таких «наборов Графиков» много, в нашем тестовом примере их, например, 5, и все они должны располагаться на одном экране.

В `UI`, проектируемом с помощью `SwiftUI` нет необходимости в кнопке переключения между `Dark` и `Light` режимами, это уже встроено в `SwiftUI`. Кроме того, в `SwiftUI` гораздо больше возможностей комбинирования «наборов Графиков» (то есть множества представленных выше экранов), чем просто прокручиваемая вниз таблица, и мы рассмотрим некоторые из этих очень интересных вариантов.

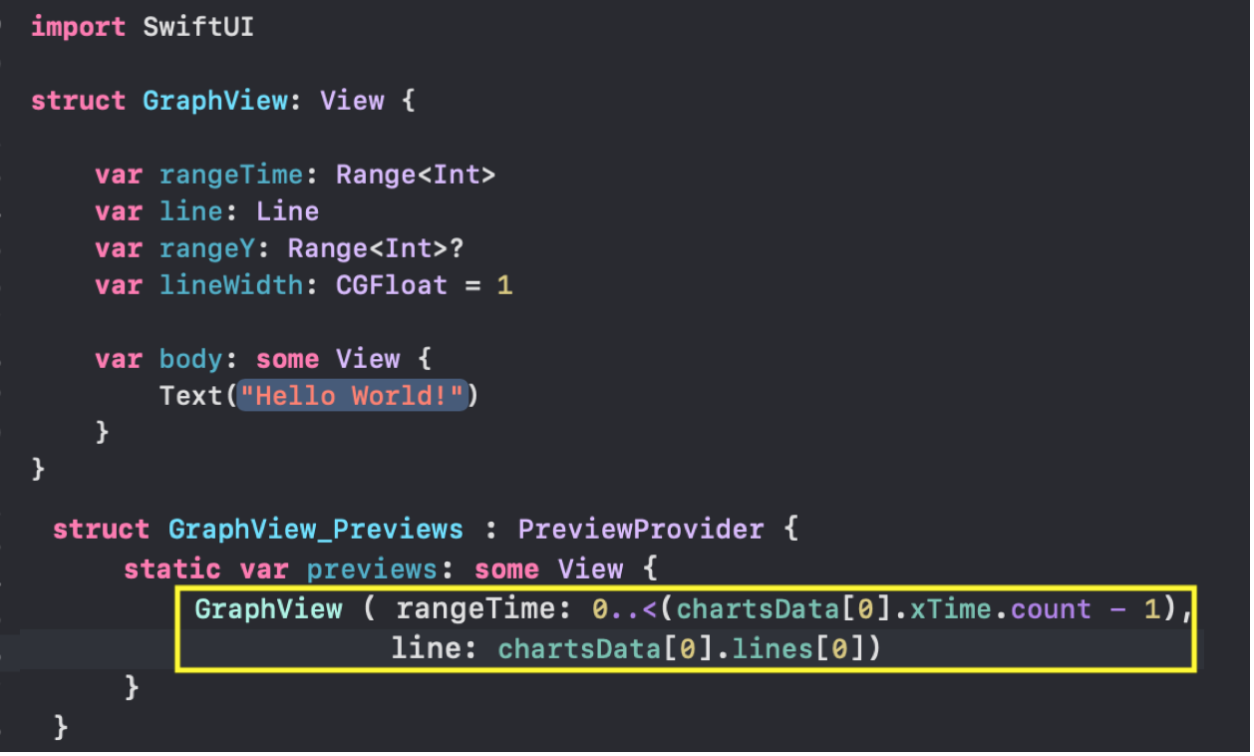

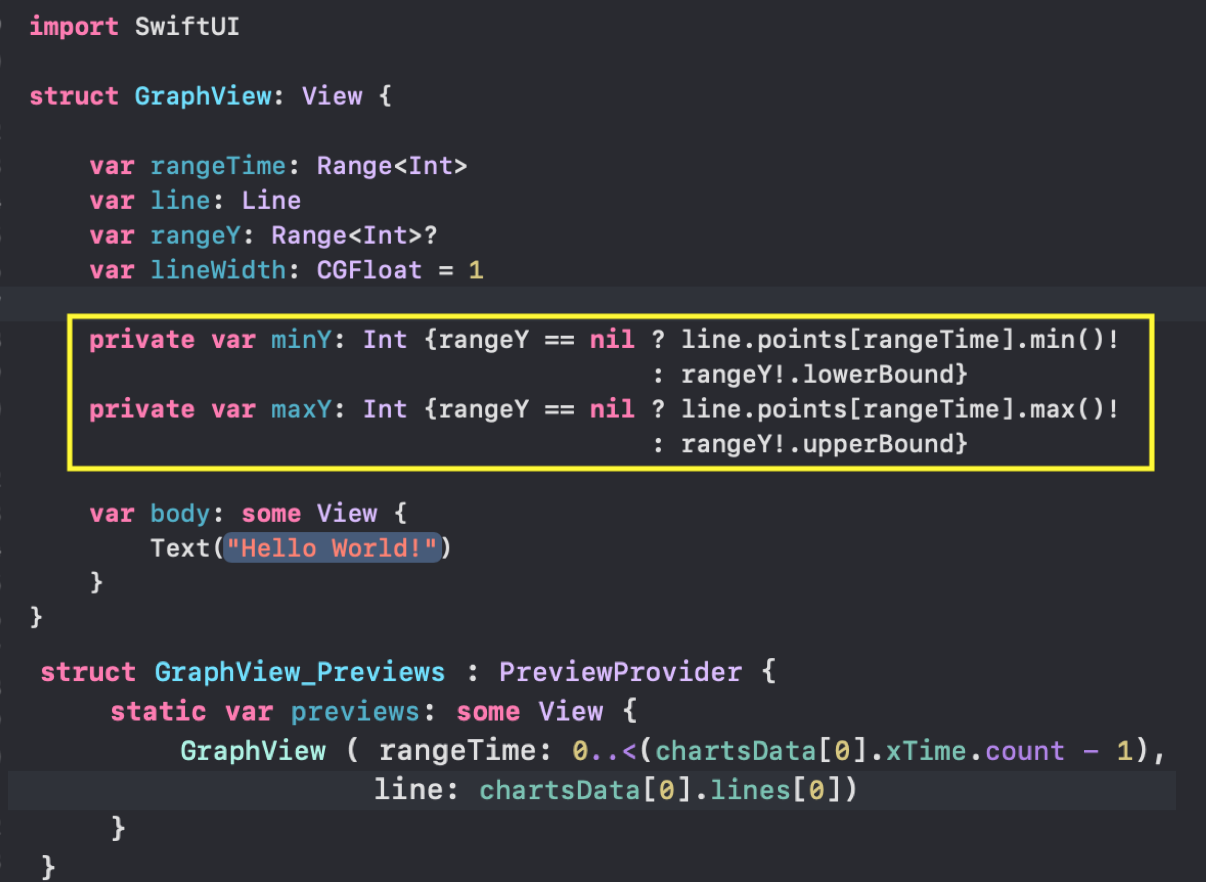

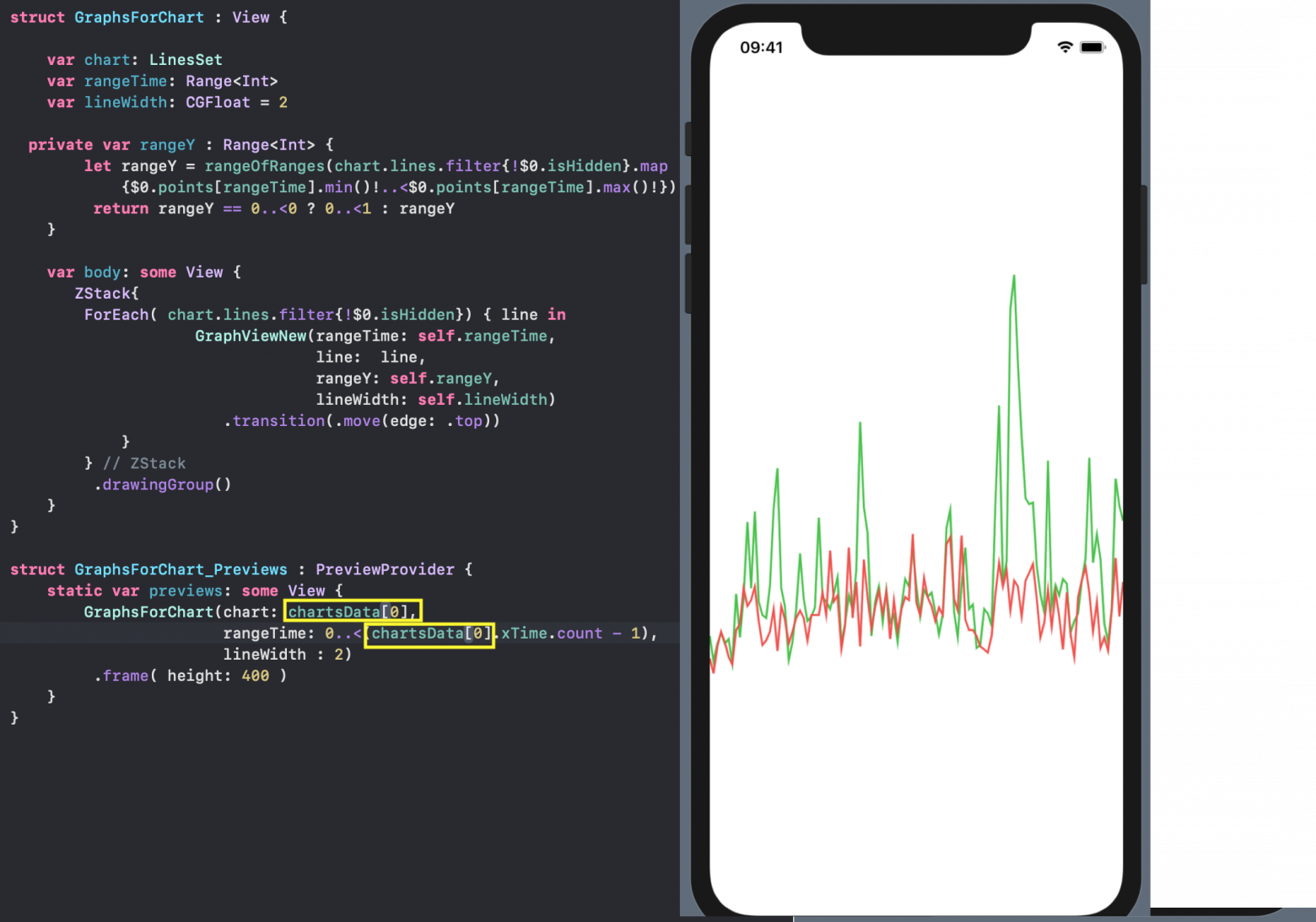

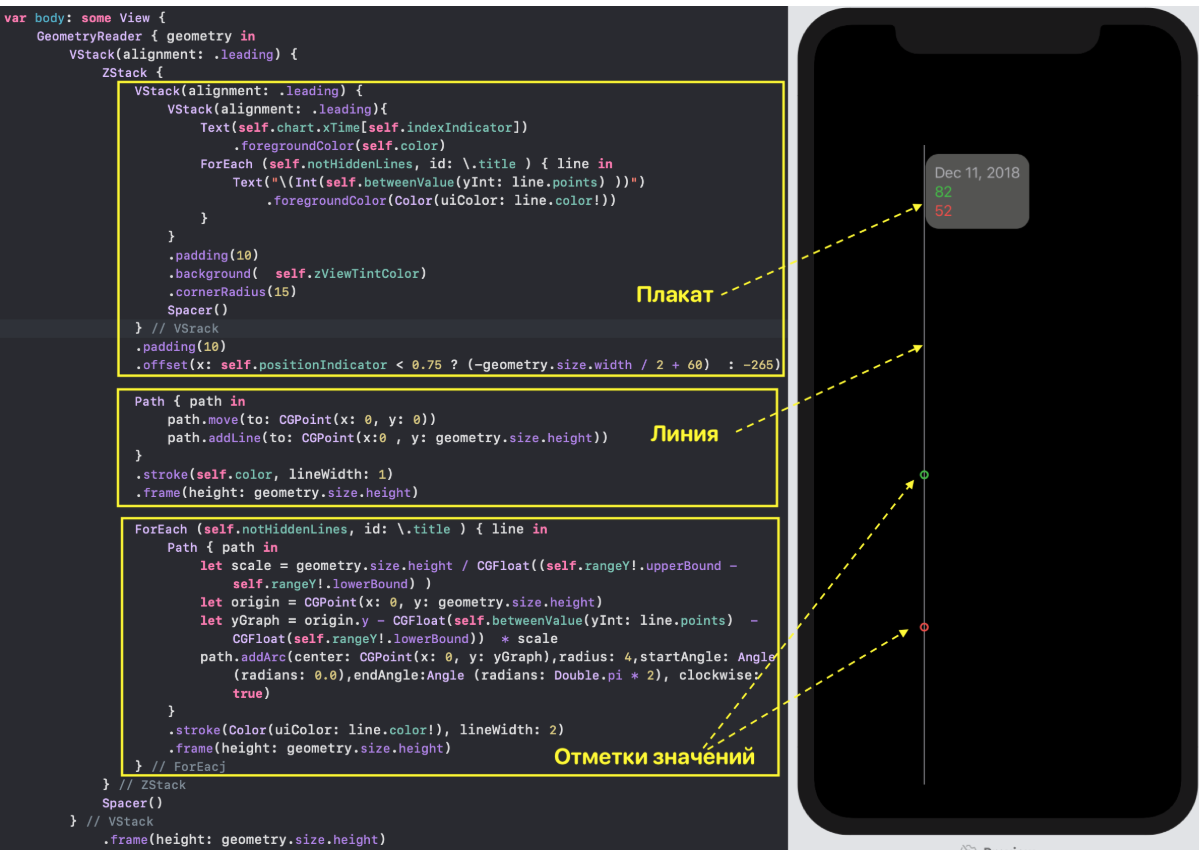

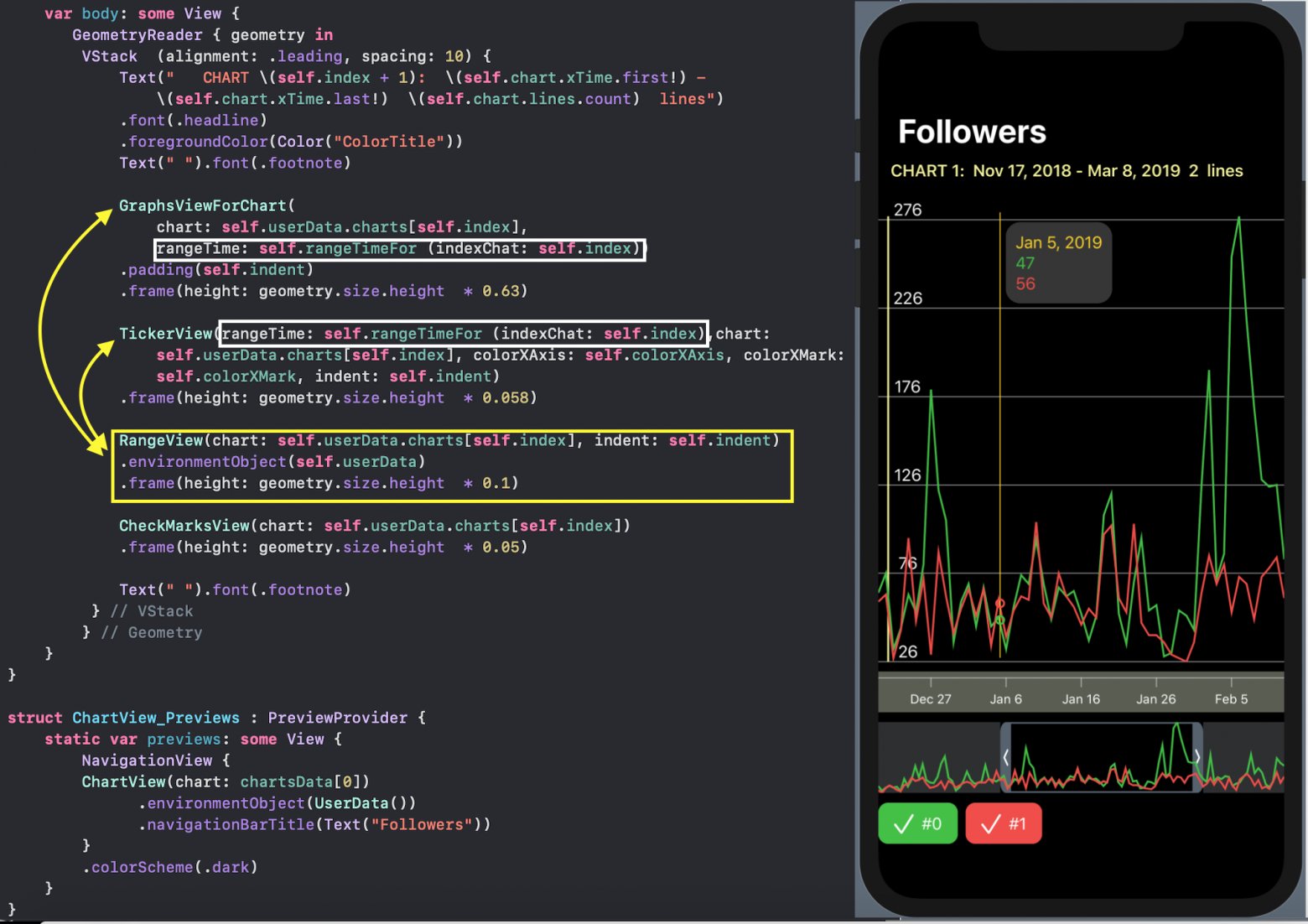

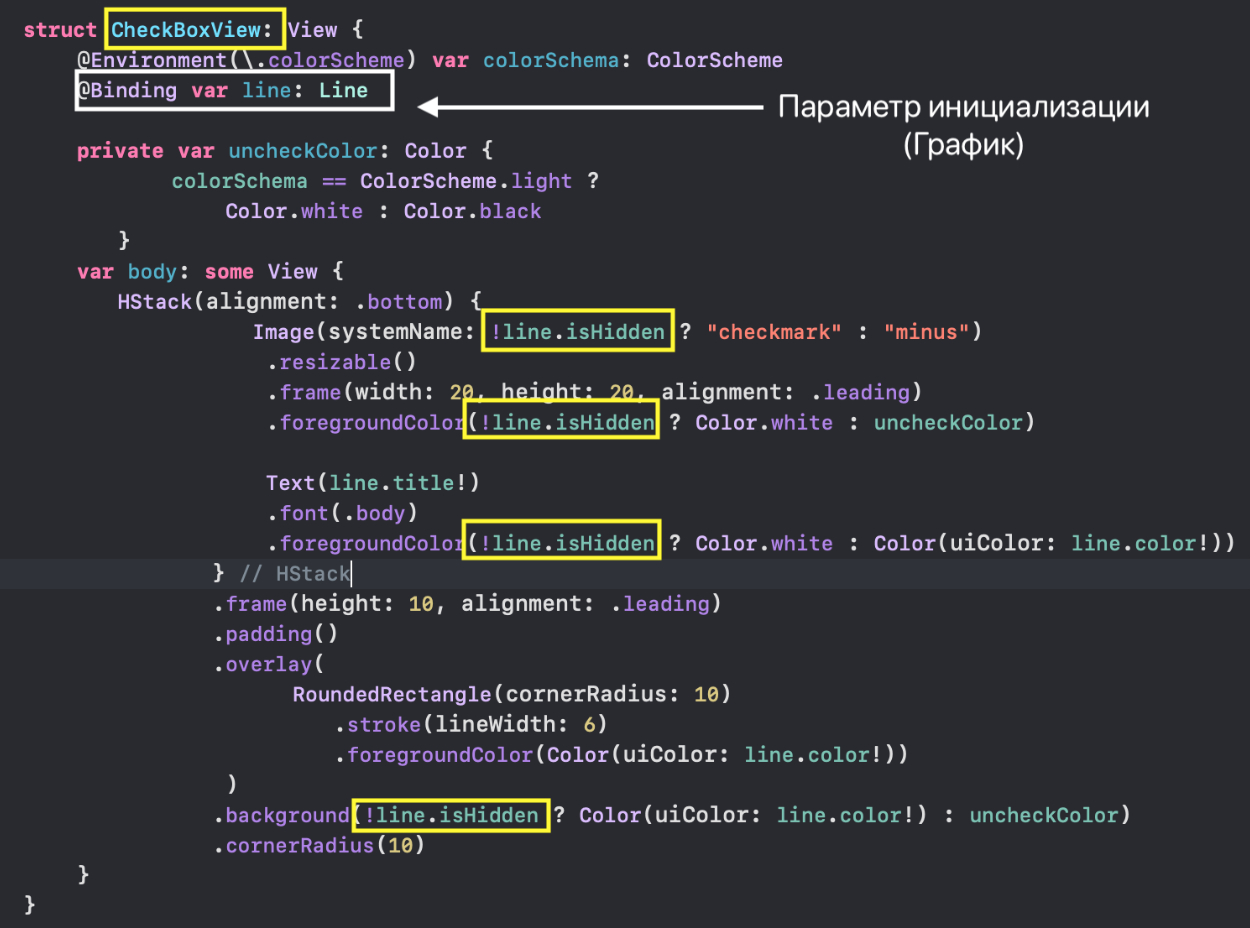

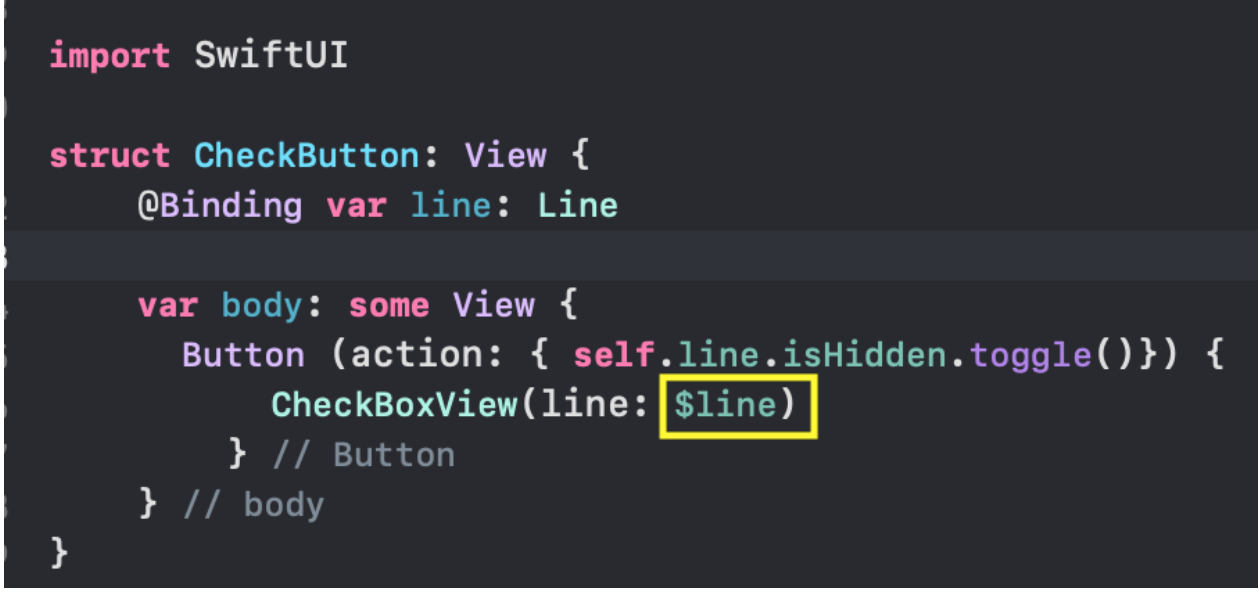

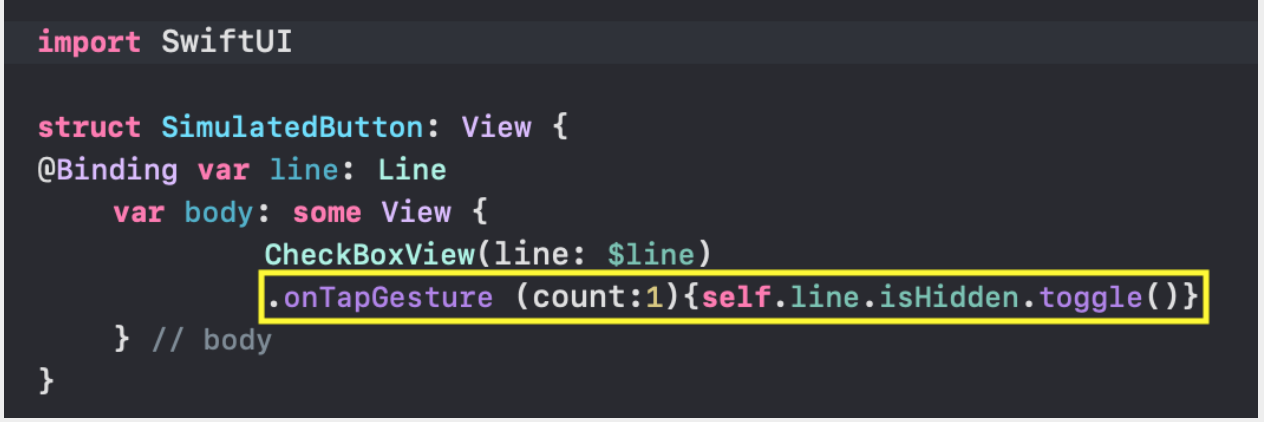

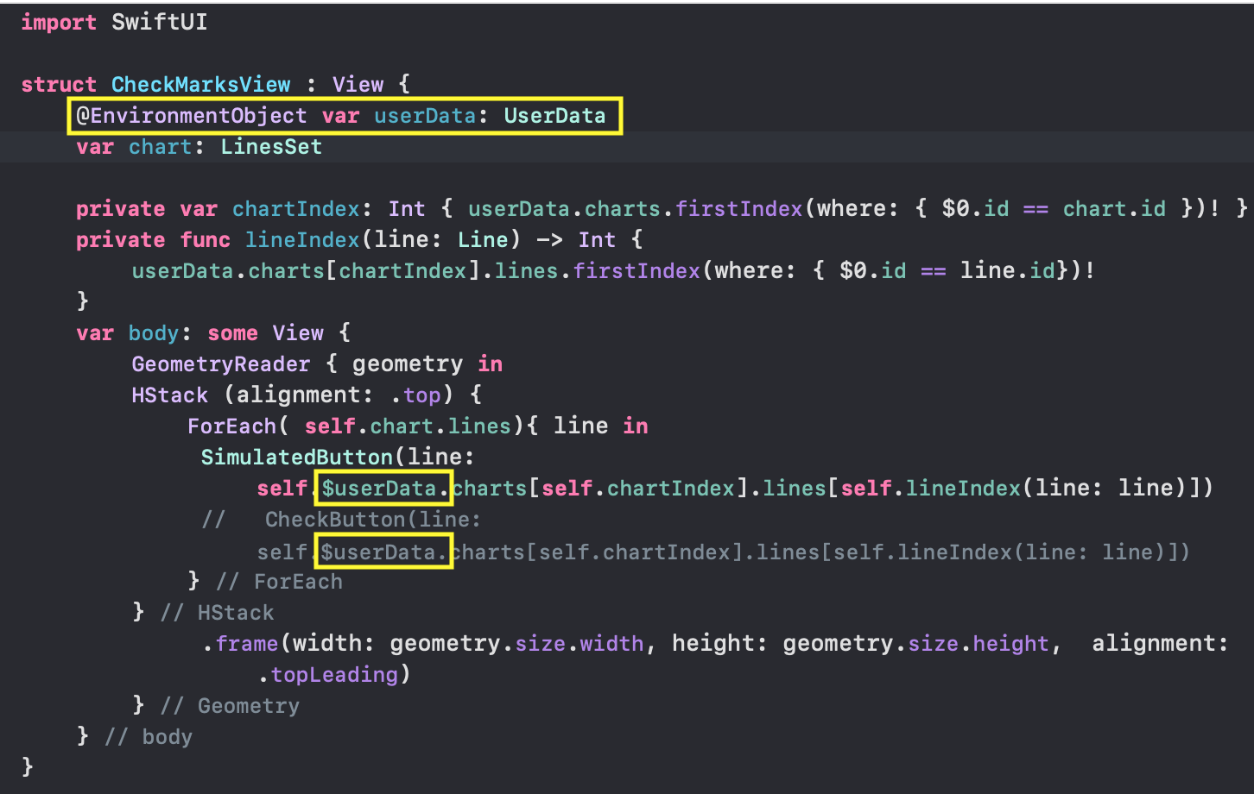

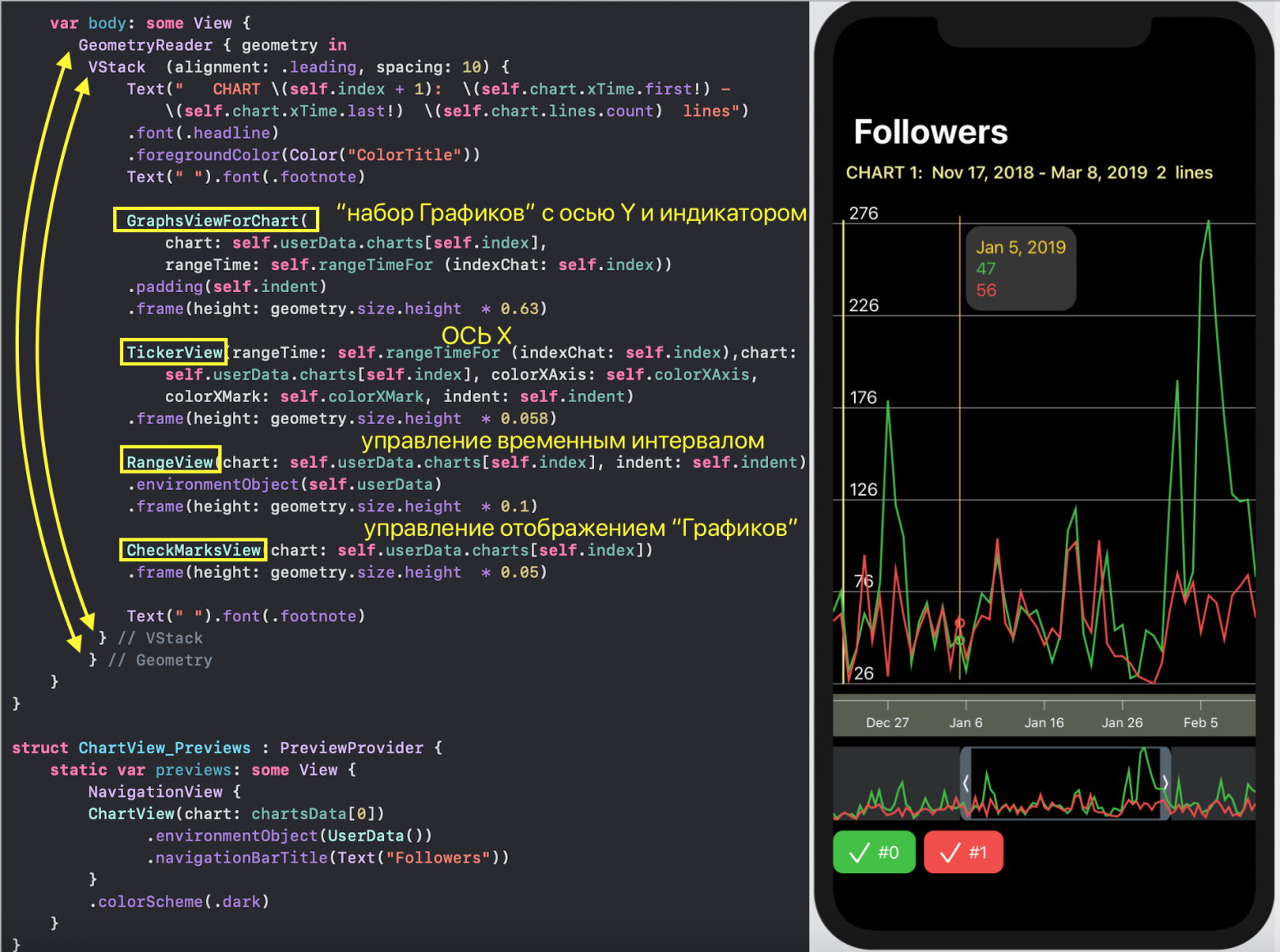

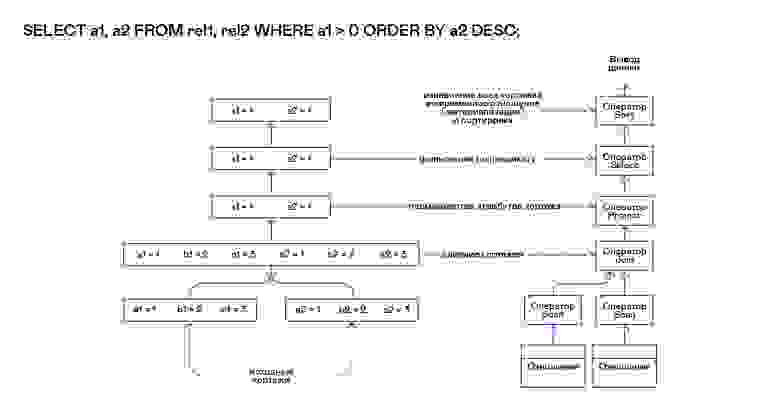

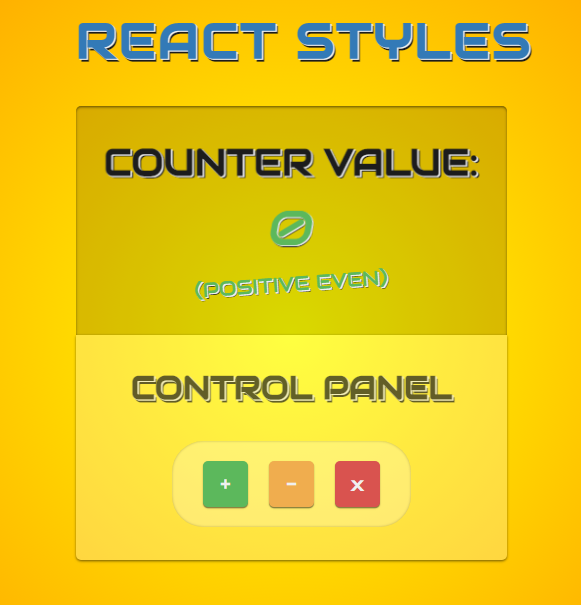

Но сначала остановимся на отображении одного «набора Графиков», для которого в `SwiftUI` создадим `ChartView`:

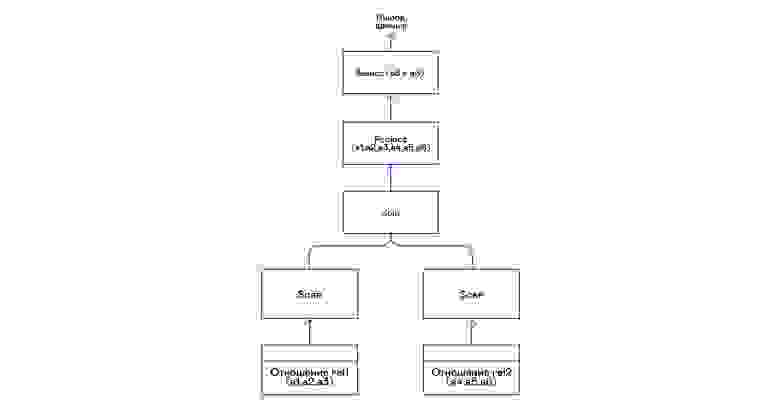

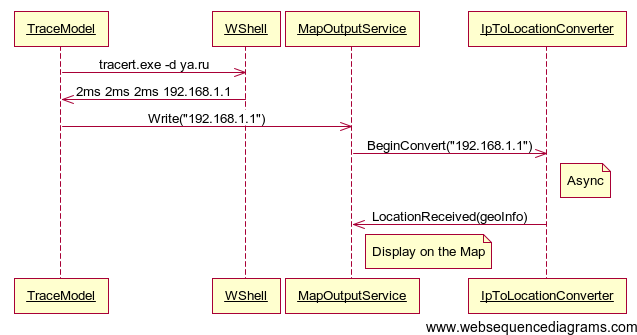

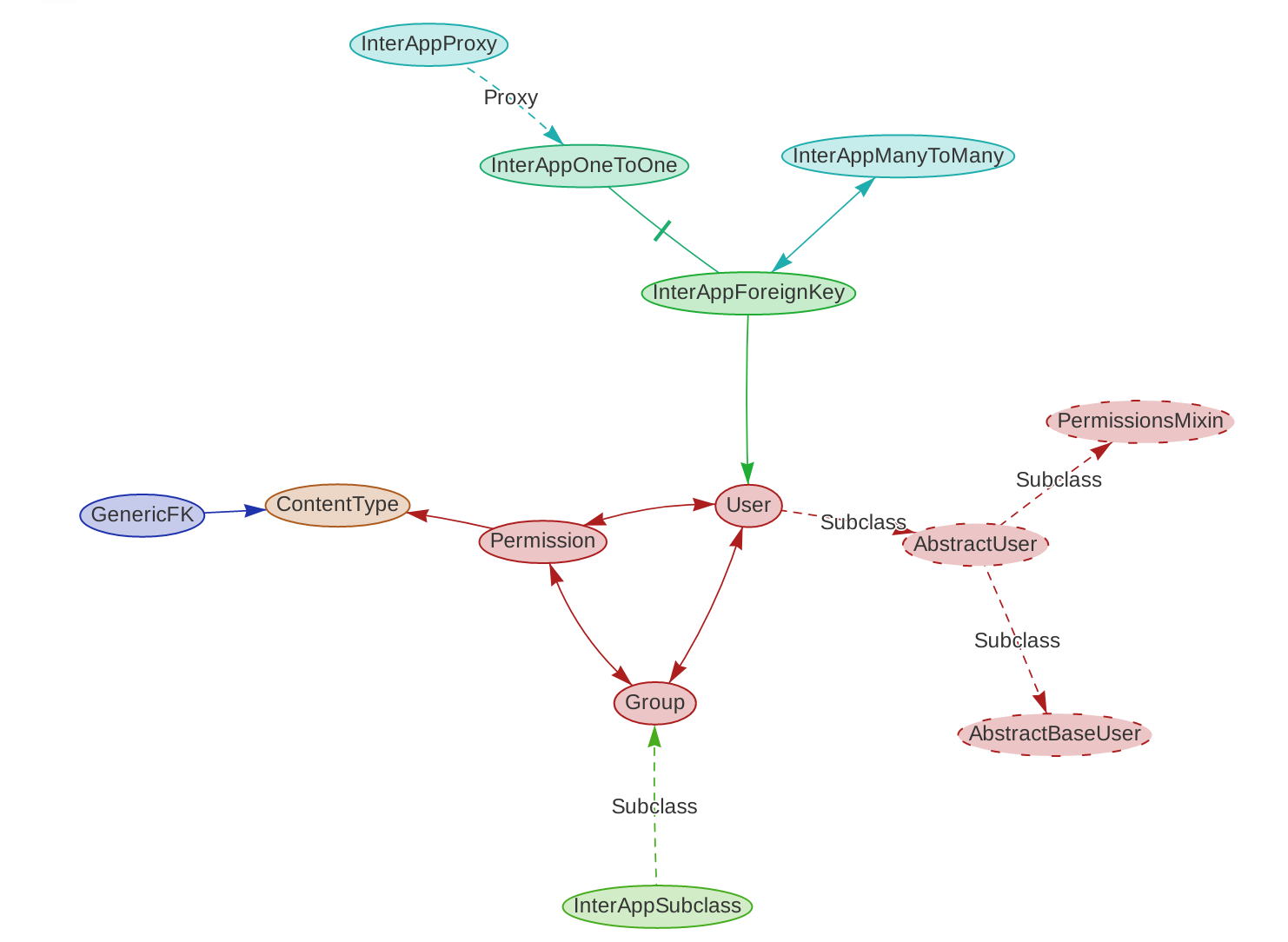

`SwiftUI` позволяет создавать и тестировать сложный `UI` по маленьким кусочкам, а потом очень просто собирать эти кусочки в пазл. Мы так и поступим. Наш `ChartView` очень хорошо расщепляется на эти маленькие кусочки:

* `GraphsForChart` — это собственно графики, построенные для одного конкретного «набора Графиков». «Графики» показаны для временного диапазона, управляемого пользователем с помощью «mini map» `RangeView`, который будет представлен ниже.

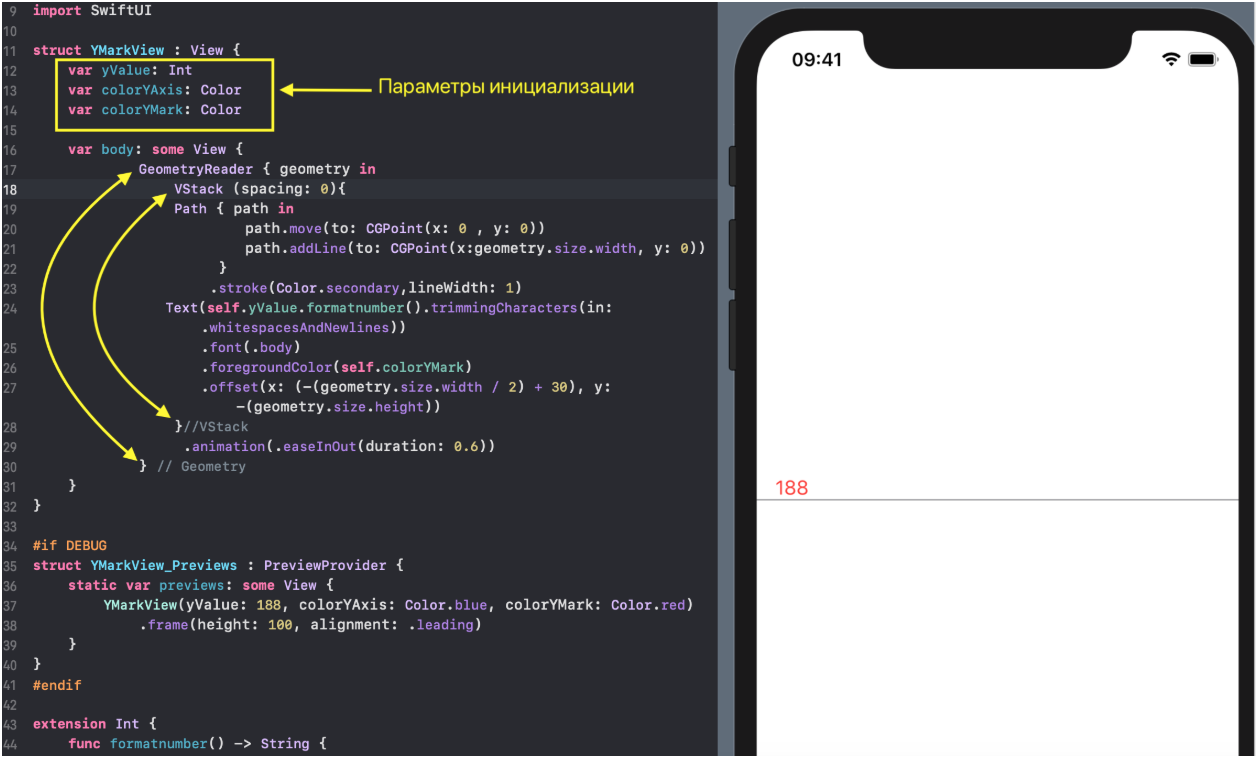

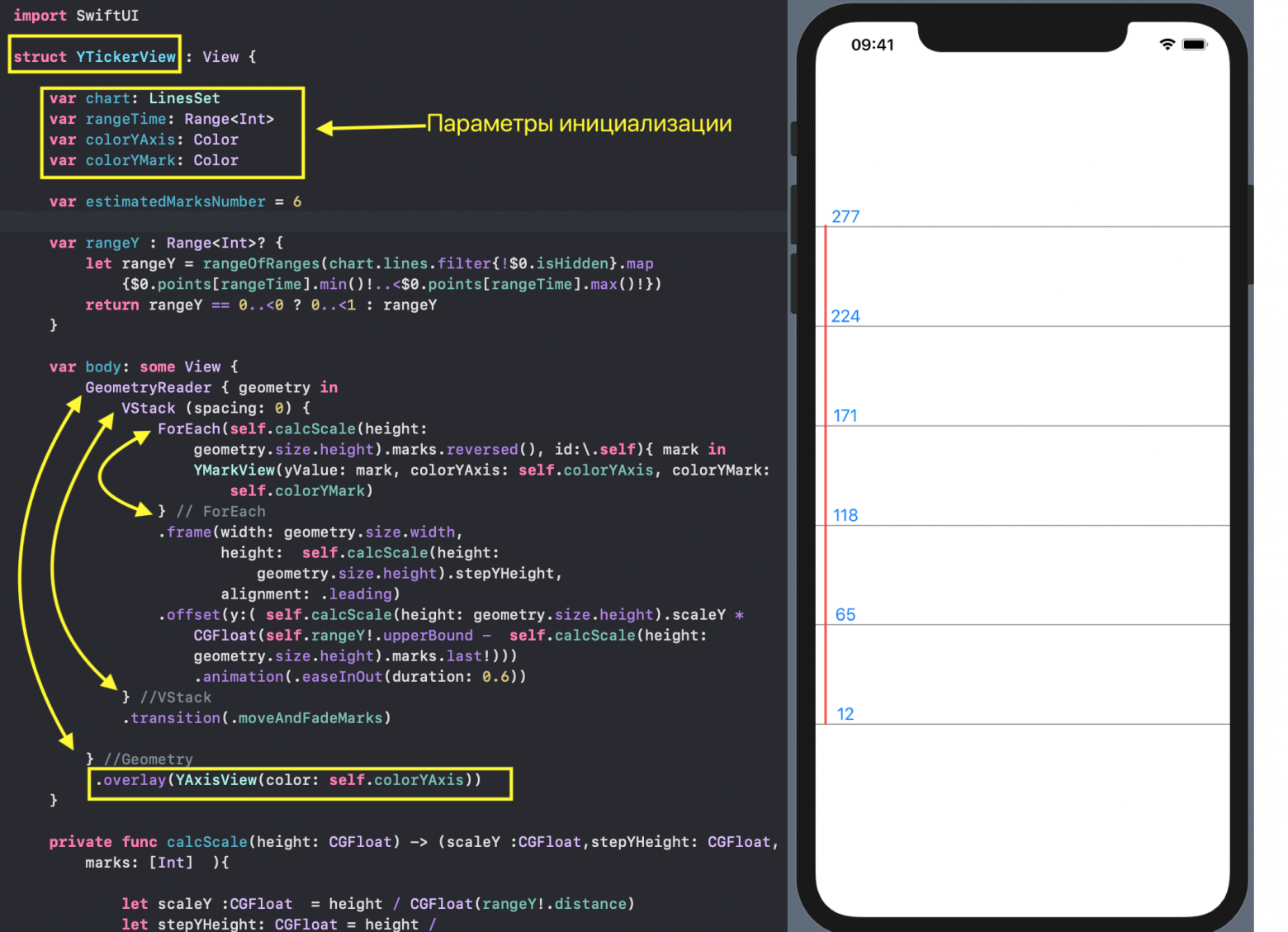

* `YTickerView` — ось `Y` с отметками и соответствующей горизонтальной сеткой.

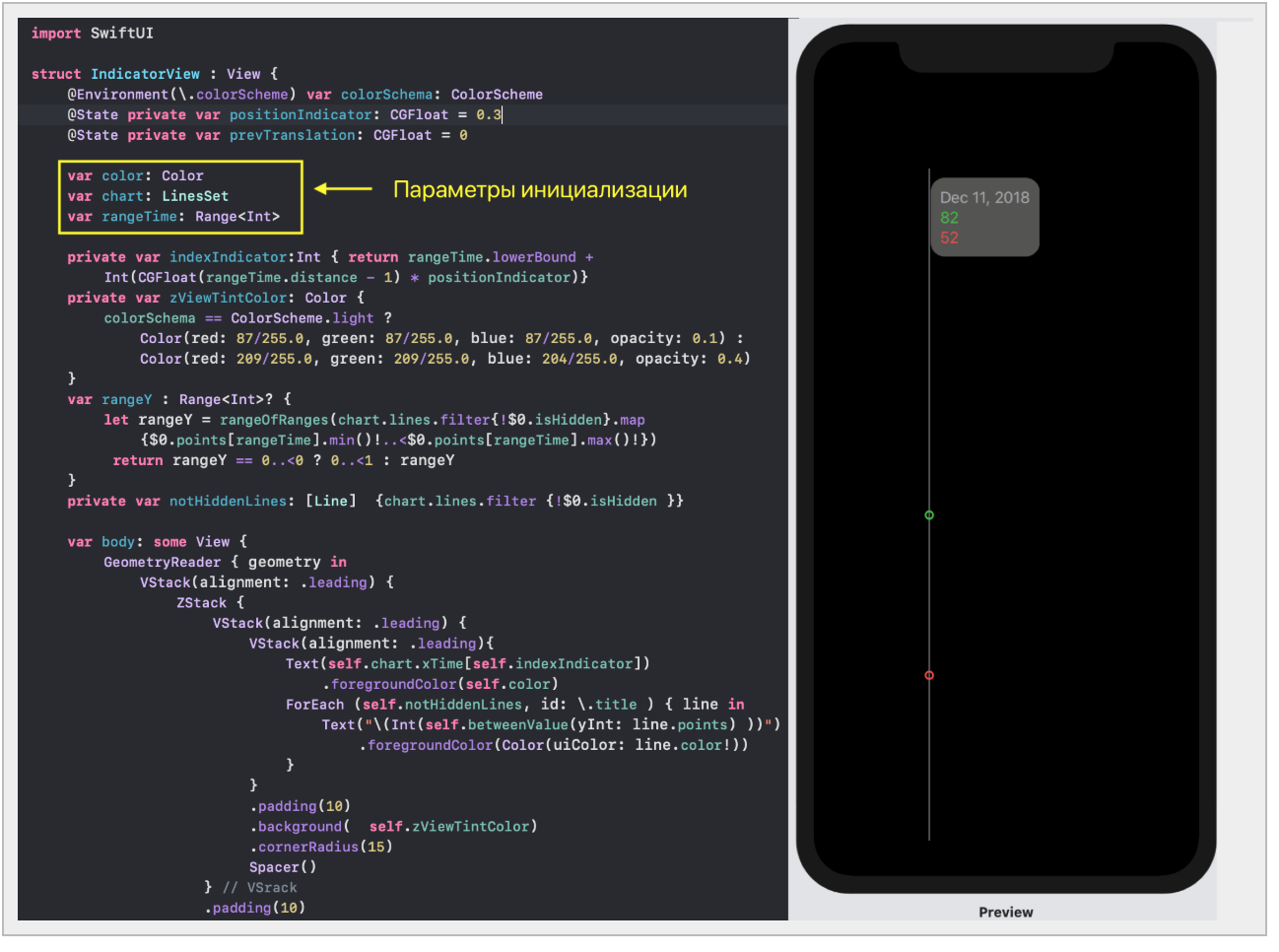

* `IndicatorView` — горизонтально перемещаемый пользователем индикатор, позволяющий посмотреть значения «Графиков» и времени для соответствующего положения индикатора на временной на оси `X`.

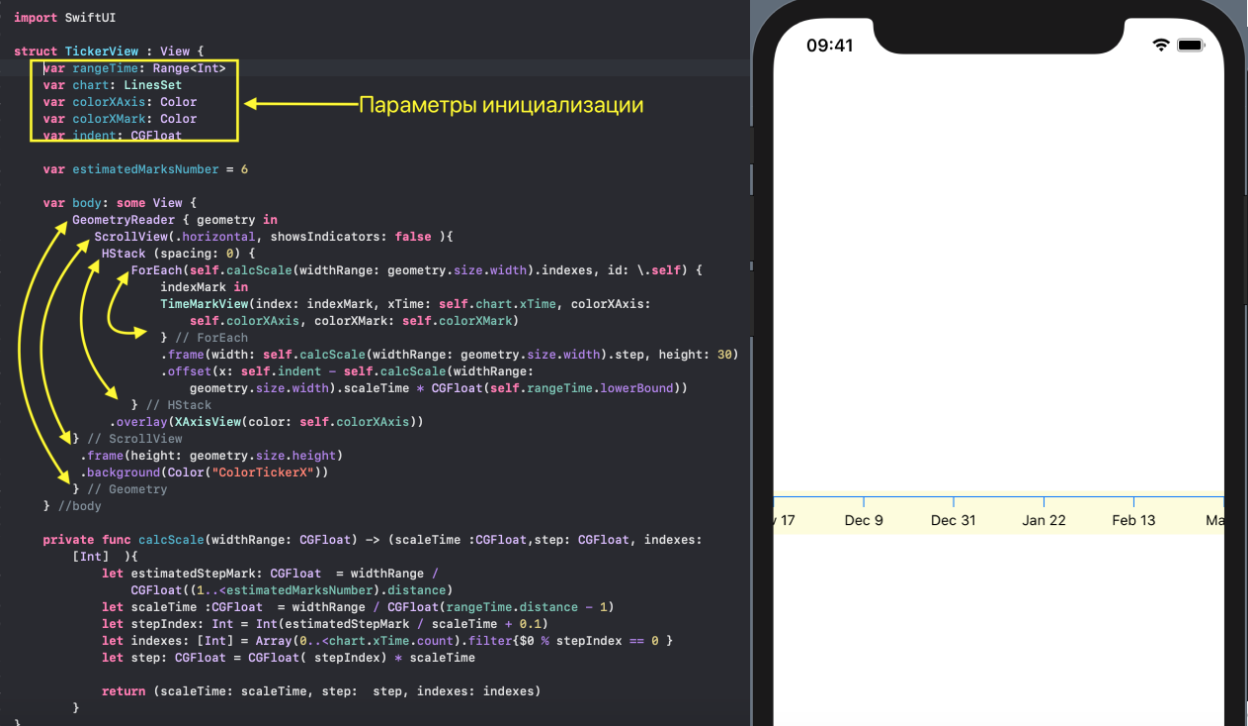

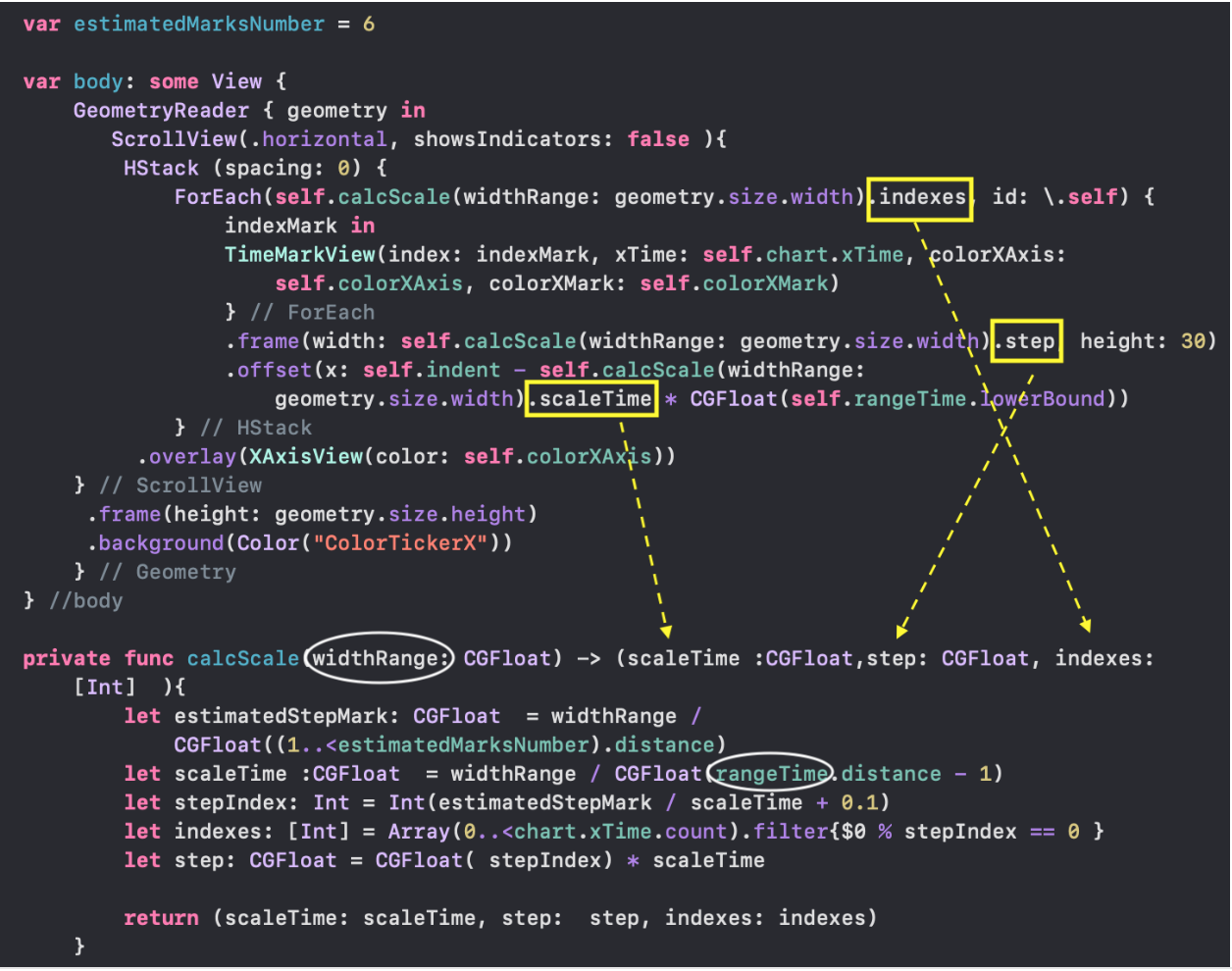

* `TickerView` — «бегущая строка», показывающая временные отметки на оси `X` в виде дат,

* `RangeView` — временное «окошко», настраиваемое пользователем с помощью жестов, для задания временного интервала «Графиков»,

* `CheckMarksView` — содержит «кнопки», окрашенные в цвета «Графиков» и позволяющие управлять присутствием «Графика» на `ChartView` .

С `ChartView` пользователь может взаимодействовать тремя способами:

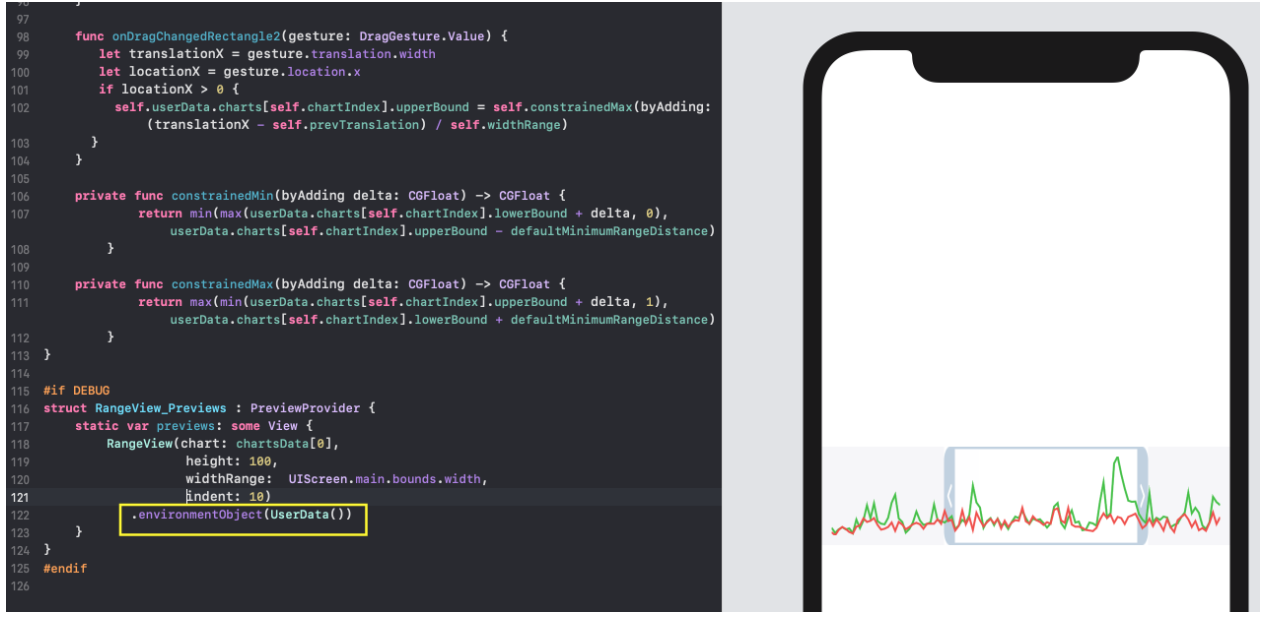

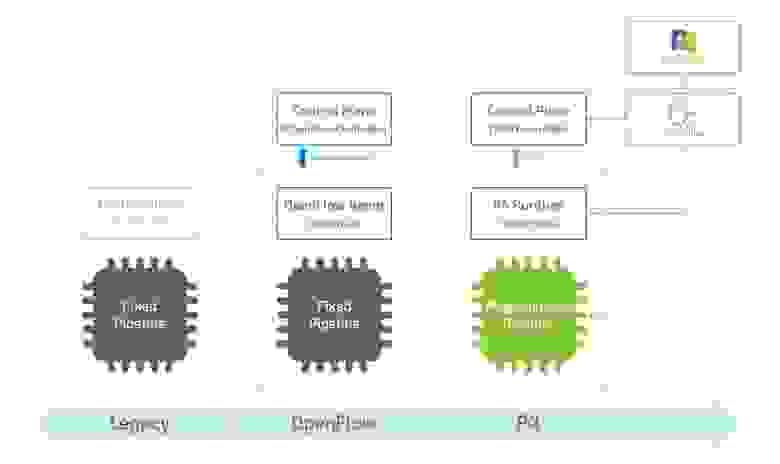

1. управлять«mini map» с помощью жеста `DragGesture` — он может сдвигать временное «окошко» вправо и влево и уменьшать / увеличивать его размер:

2. перемещать в горизонтальном направлении индикатор, показывающий значения «Графиков» в фиксированный момент времени:

3. скрывать / показывать определенные «Графики» с помощью кнопок, окрашенных в цвета «Графиков» и расположенных в самом низу `ChartView`:

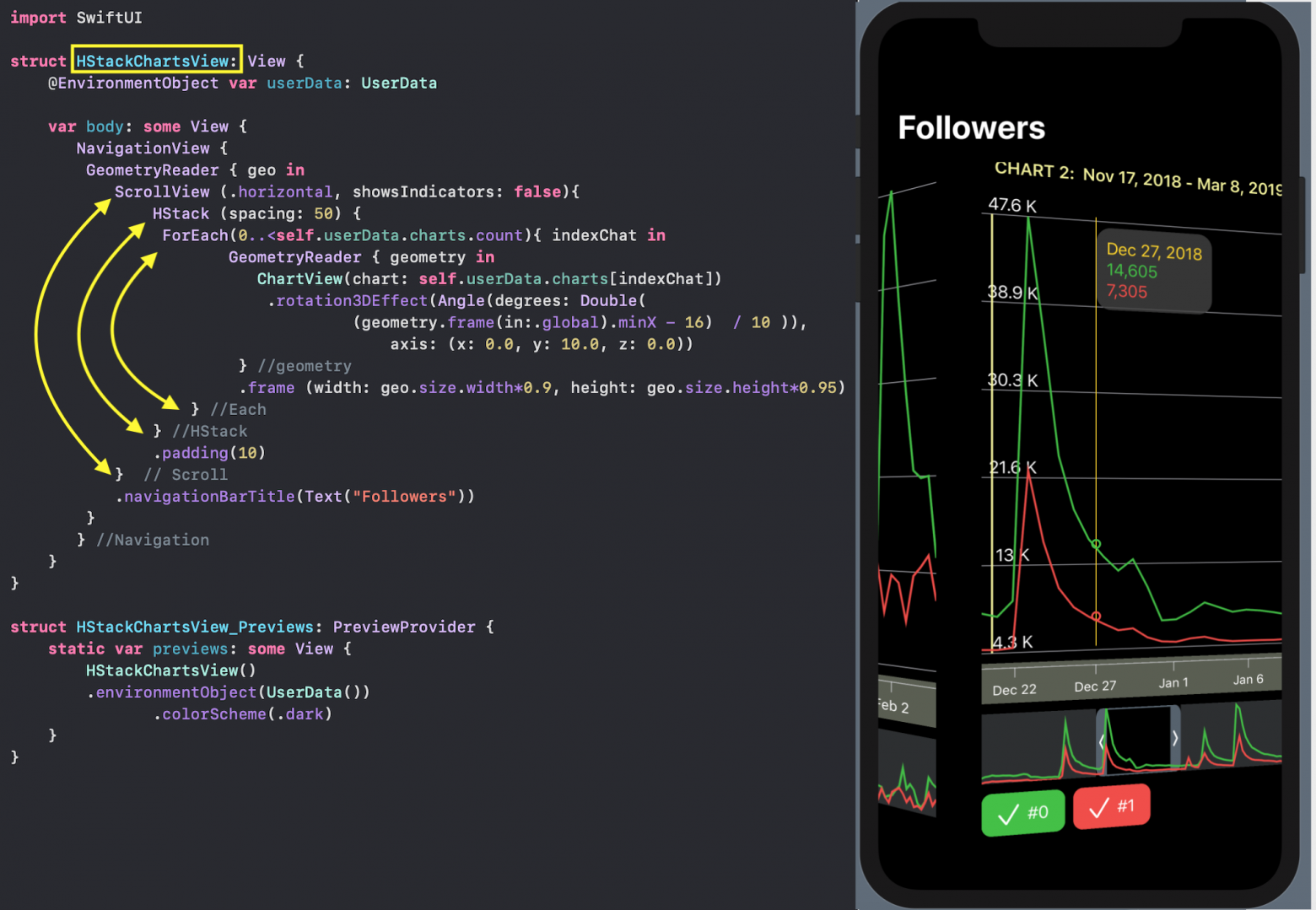

Мы можем комбинировать различные «Наборы Графиков» ( их у нас 5 в тестовых данных) разными способами, например, расположив их все одновременно на одном экране с помощью списка `List` (наподобие прокручиваемой вниз-вверх таблицы):

или с помощью `ScrollView` и горизонтального стека `HStack` c 3D эффектом:

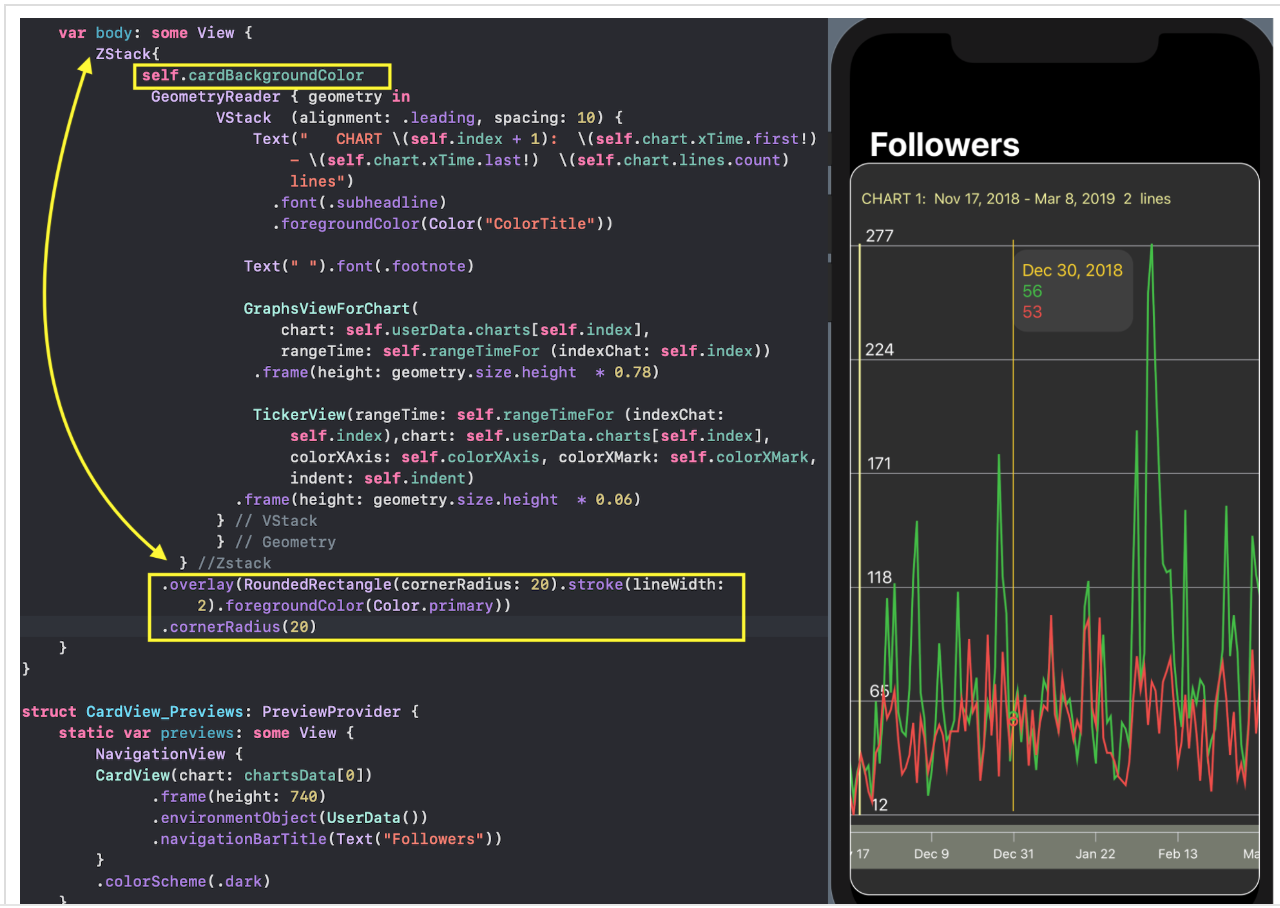

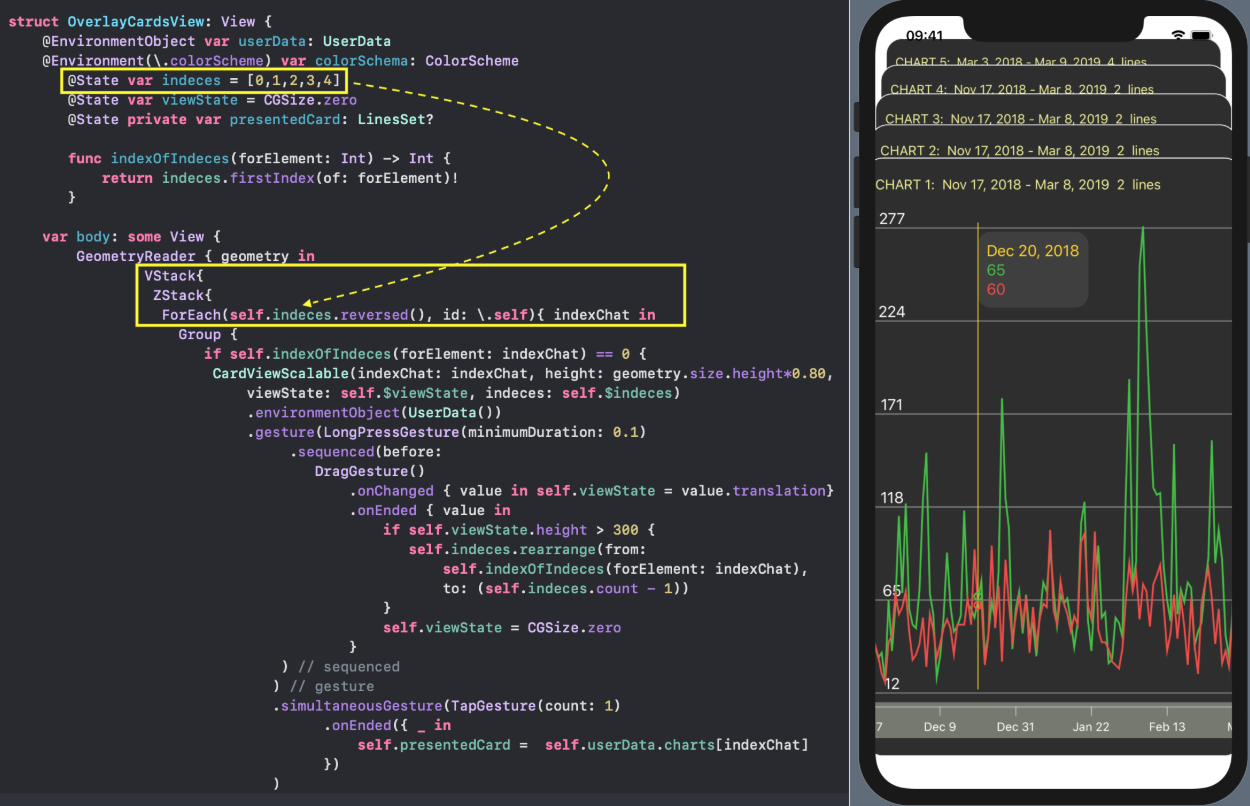

… или в виде `ZStack` наложенных друг на друга «карт», порядок которых можно менять: верхнюю «карту» с "«набором Графиков» можно оттянуть вниз достаточно далеко, чтобы посмотреть на следующую карту, и если продолжать тянуть ее вниз, то она «уходит» на последнее место в `ZStack`, а вперед «выходит» эта следующая «карта»:

В этих сложных `UI` — «прокручиваемая таблица», горизонтальный стек с `3D` эффектом, `ZStack` наложенных друг на друга «карт» — полноценно работают все средства взаимодействия с пользователем: перемещение по временной шкале и изменение «масштаба» `mini - map`, индикатор и кнопки скрытия «Графиков».

Далее мы будем подробно рассматривать проектирование этого `UI` с помощью `SwiftUI` — от простейших элементов к их более сложным композициям. Но сначала поймем структуру данных, которыми мы располагаем.

Итак, решение нашей задачи разбилось на несколько этапов:

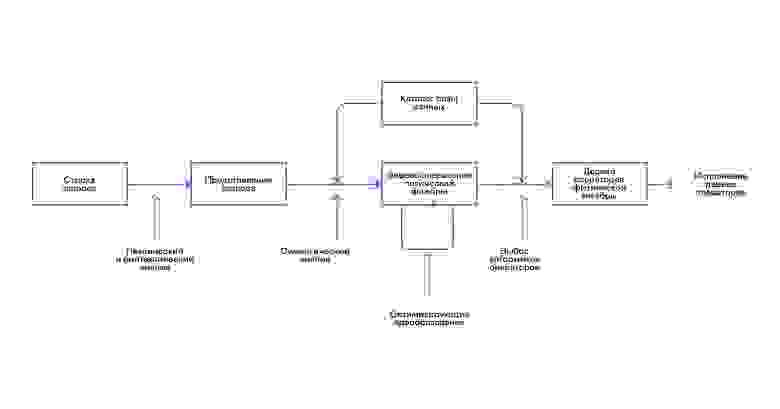

* Закачать данные из `JSON`-файла и представить их в удобном «внутреннем» формате

* Создать `UI` для одного «набора Графиков»

* Комбинировать различные «наборы Графиков»

Закачиваем данные

-----------------

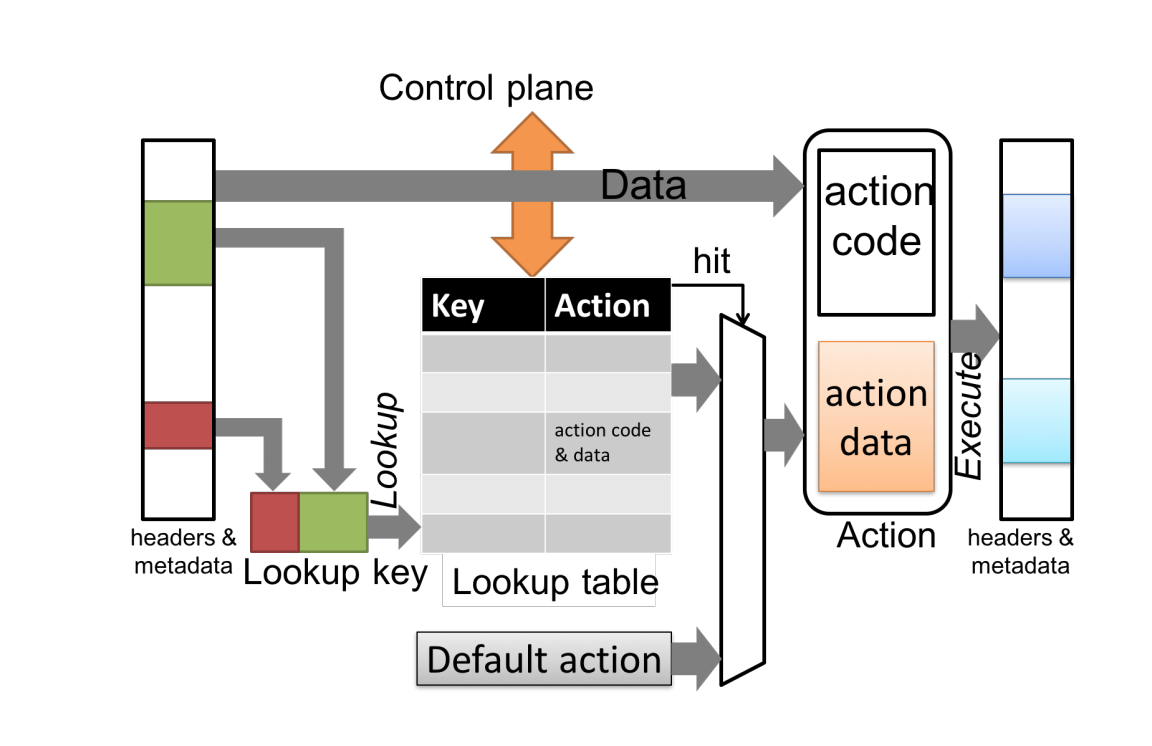

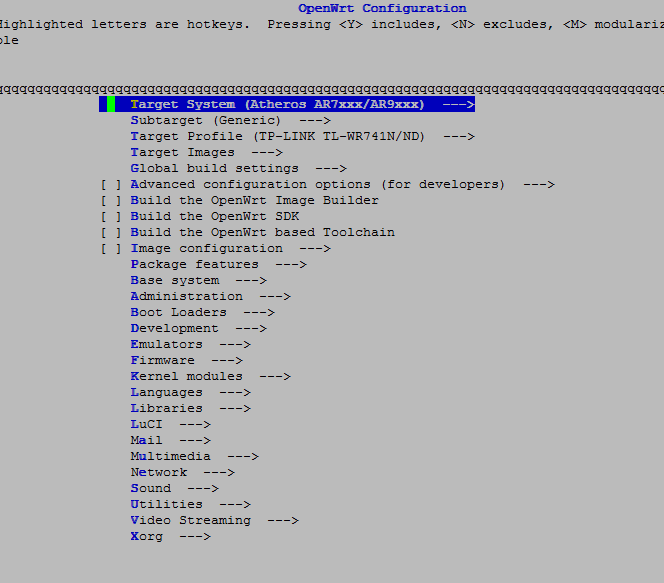

В наше распоряжение [Telegram](https://telegram.org/) предоставил [JSON](https://t.me/contest/15) данные, содержащие несколько «наборов Графиков». Каждый отдельный «набор Графиков» `chart` содержит несколько «Графиков» (или «Линий») `chart.columns`. У каждого «Графика» («Линии») есть метка в позиции `0` — `"x"`, `"y0"`, `"y1"`, `"y2"`, `"y3"`, за которой следуют либо значения времени на оси X («x»), либо значения «Графика» («Линии») (`"y0"`, `"y1"`, `"y2"`, `"y3"`) на оси `Y` :

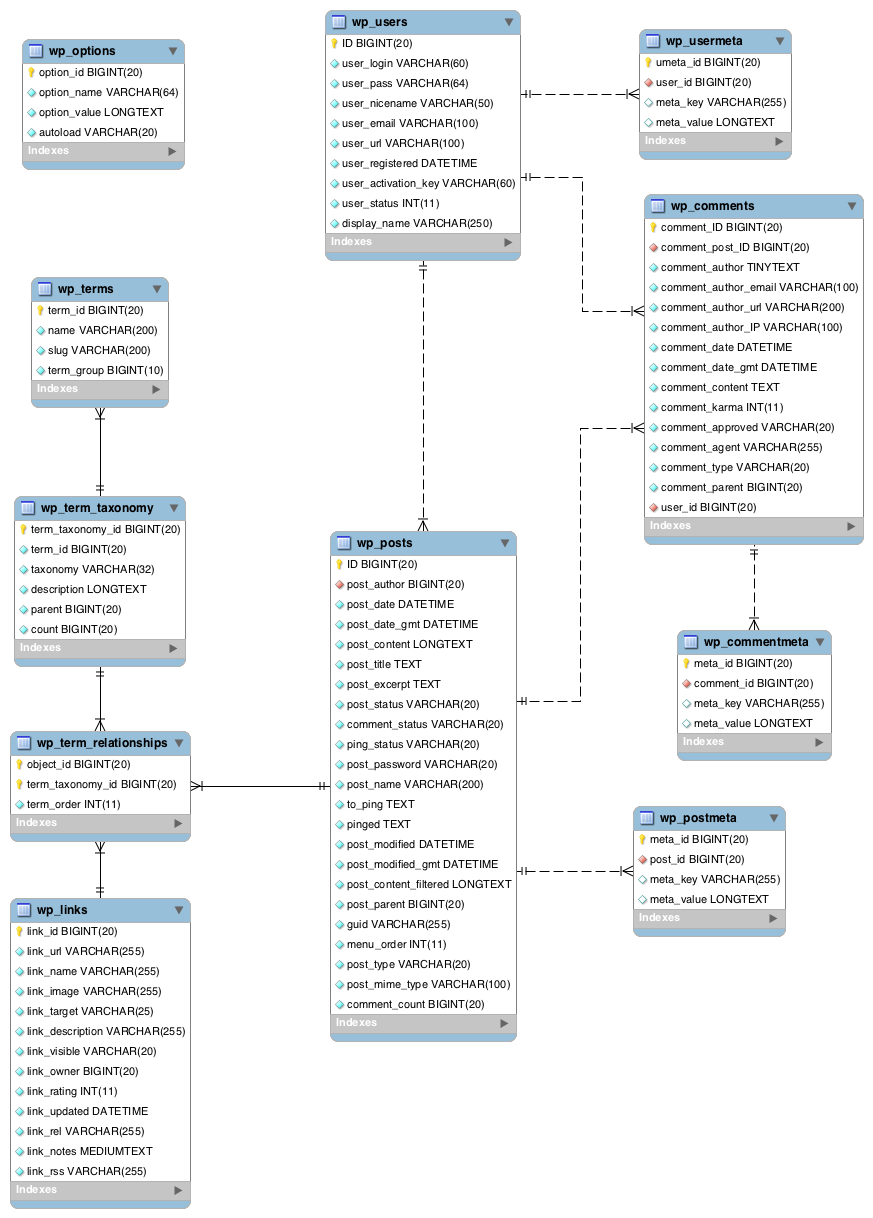

Присутствие всех «Линий» в «наборе Графиков» — необязательно. Значения для «столбца» x представляют собой UNIX метки времени в миллисекундах.

Кроме того, каждый отдельный «набор Графиков» `chart` снабжается цветами `chart.colors` в формате 6-ти шестнадцатеричных цифр (например, "#AAAAAA") и именами `chart.names`.

Для построения Модели данных, находящихся в `JSON`-файле, я воспользовалась прекрасным сервисом [quicktype](https://t.me/contest/15). На этом сайте вы вставляете кусок текста из `JSON` файла и указываете язык программирования (`Swift`), имя структуры (`Chart`), которая сформируется после «парсинга» этих `JSON` данных и всё.

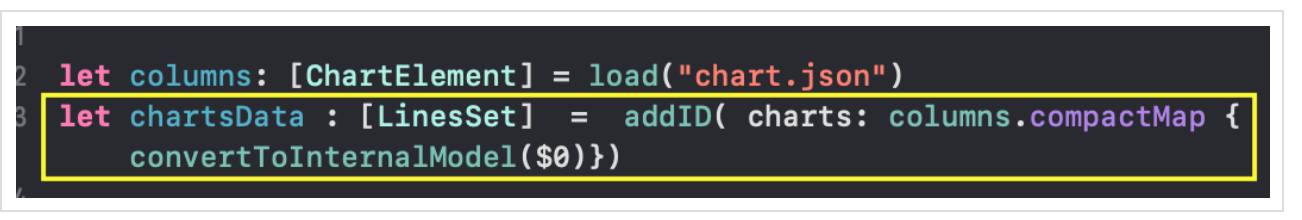

В центральной части экрана формируется код, который мы скопируем в наше приложение в отдельный файл с именем `Chart.swift`. Именно там мы будем размещать Модель данных JSON формата. Воспользовавшись заимствованным из [демонстрационных примерах SwiftUI](https://developer.apple.com/tutorials/swiftui/building-lists-and-navigation) `Generic` загрузчиком `load` данных из `JSON` файла в Модель, я получила массив `columns: [ChartElement]`, представляющий собой совокупность «наборов Графиков» в заданном `Telegram` формате.

Cтруктура данных `ChartElement`, содержащая массивы разнотипных элементов, не очень подходит для интенсивной интерактивной работы с графиками, кроме того метки времени представлены в `UNIX` формате в миллисекундах (например, `1542412800000, 1542499200000, 1542585600000, 1542672000000`), а цвета — в формате 6-ти шестнадцатеричных цифр (например, `"#AAAAAA"`).

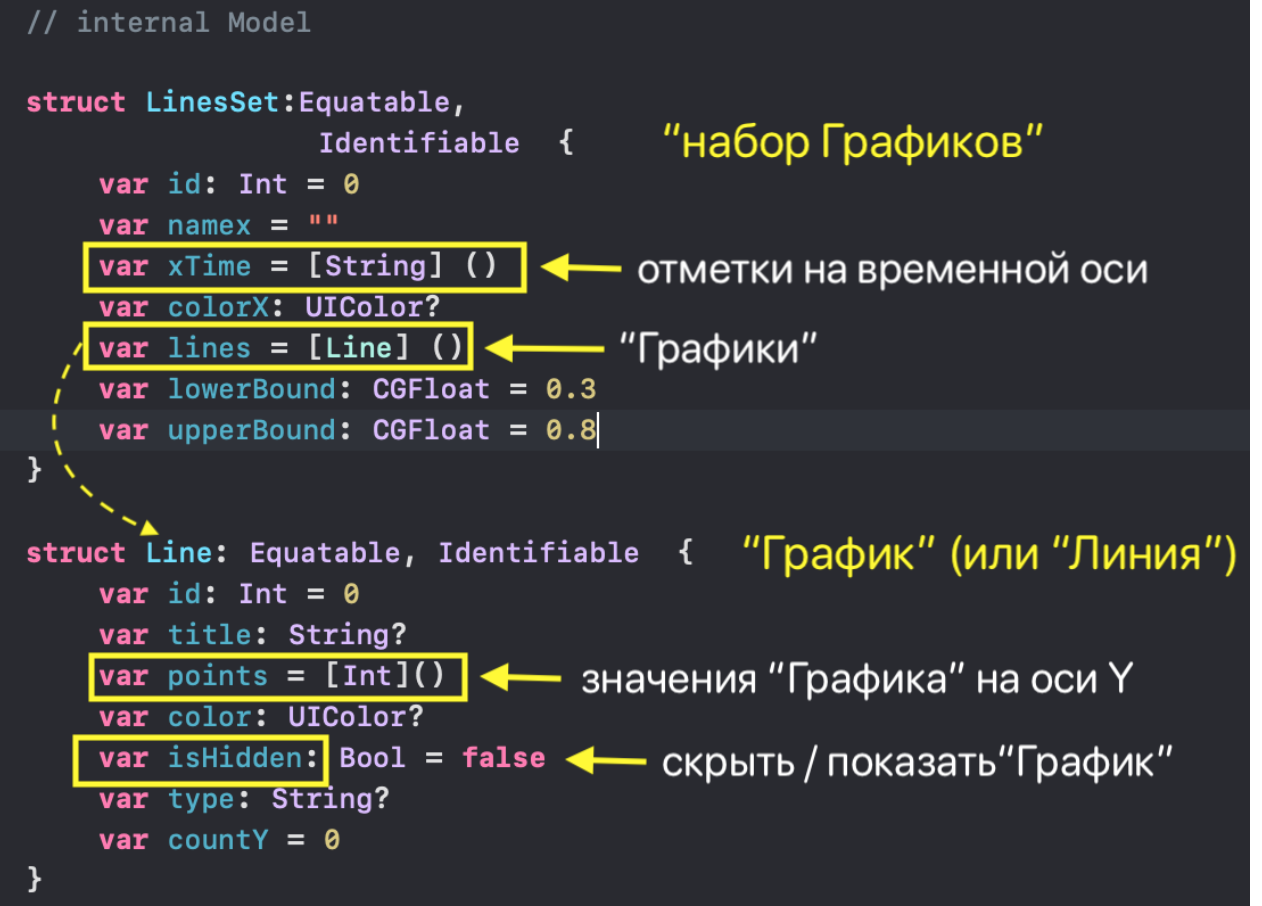

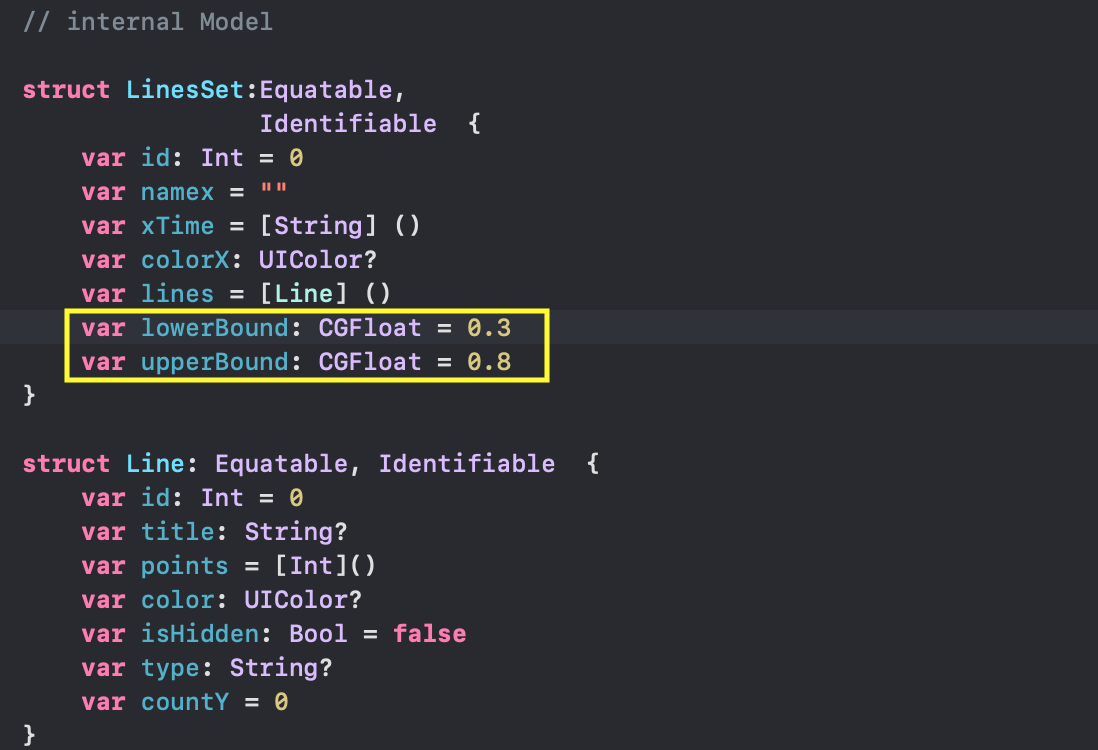

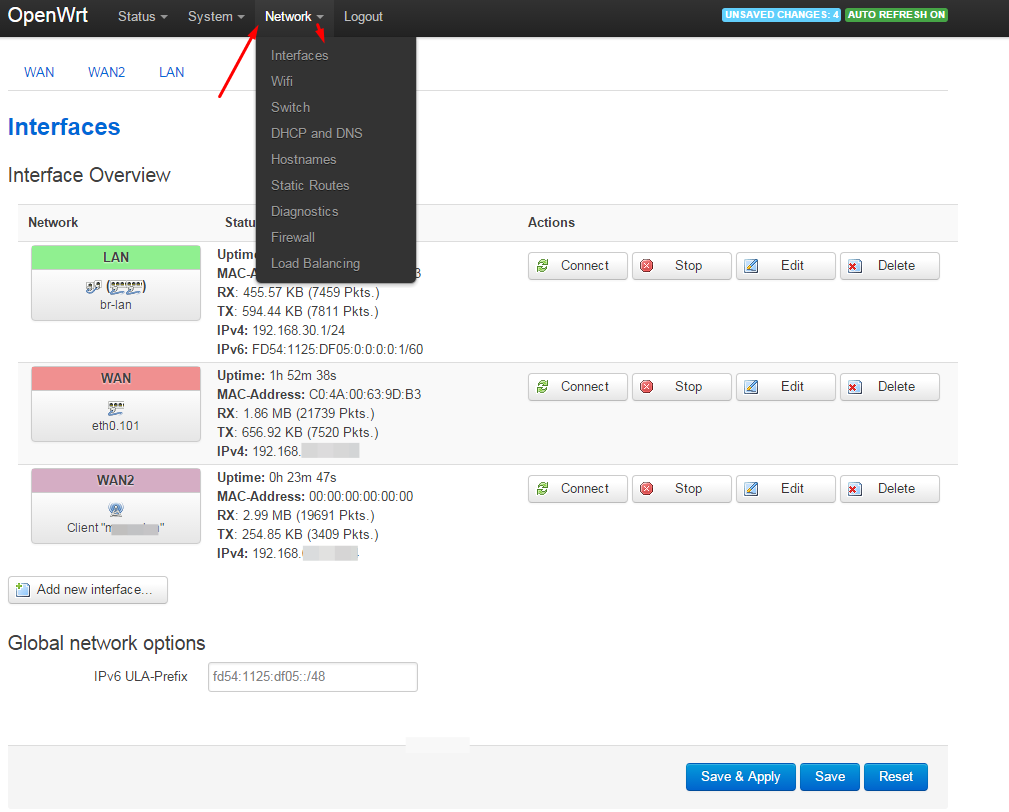

Поэтому внутри нашего приложения мы будем пользоваться теми же данными, но в другом «внутреннем» и довольно простом формате `[LinesSet]`. Массив `[LinesSet]` представляет собой совокупность «наборов Графиков» `LinesSet`, каждый из которых содержит временные метки `xTime` в формате `"Feb 12, 2019"` (ось `X`) и несколько «Графиков»`lines` (ось `Y`):

Данные для каждого «Графика»( «Линии») `Line` представлены

* массивом целых чисел `points: [Int]`,

* именем «Графика» `title: String`,

* типом «Графика» `type: String?`,

* цветом `color : UIColor` в свойственном для `Swift` формате `UIColor`,

* количеством точек `countY: Int`.

Кроме того, любой «График» может быть скрыт или показан в зависимости от значения `isHidden: Bool`. Параметры `lowerBound` и `upperBound` регулировки временного диапазона принимают значения от `0` до `1` и показывают для заданного «набора Графиков» не только размер временного «окошка» «mini map» (`upperBound` - `lowerBound`), но и его местоположение на временной оси `X`:

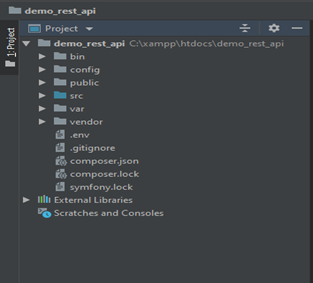

Структуры `JSON` данных `[ChartElement]` и структуры данных «внутреннего» представления `LinesSet` и `Line` находятся в файле **Chart.swift**. Код для загрузки `JSON` данных и преобразования их во внутреннюю структуру находится в файле **Data.swift**. Подробно об этих преобразованиях можно узнать [здесь](https://bestkora.com/IosDeveloper/swiftui-dlya-konkursnogo-zadaniya-telegram-10-24-marta-2019-goda/).

В результате мы получили данные о «наборах Графиков» во внутреннем формате в виде массива `chartsData`.

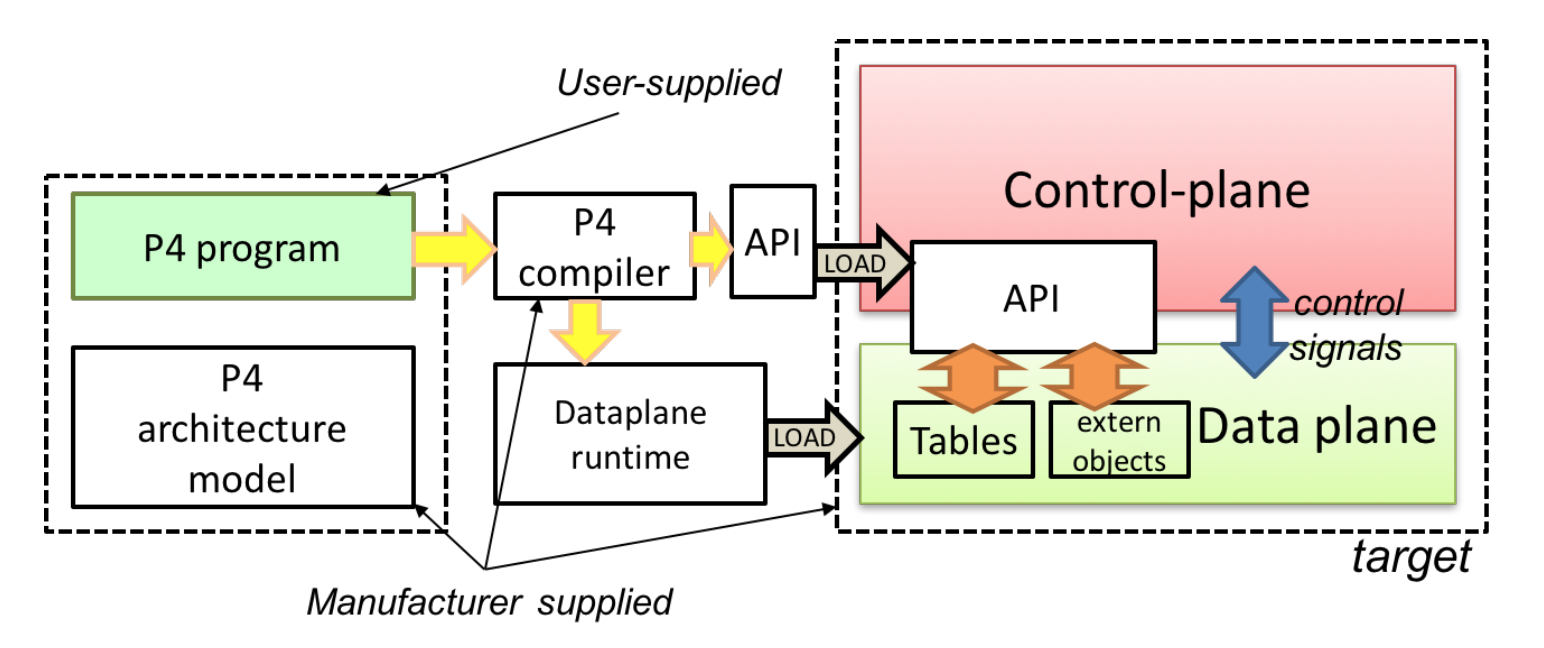

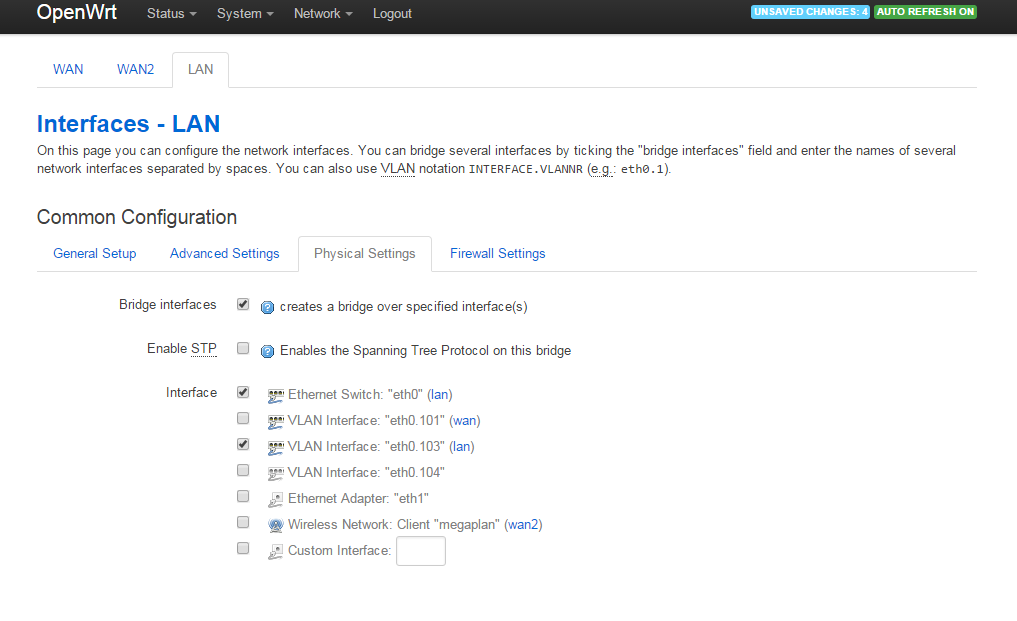

Это и есть наша `Модель` данных, но для работы в `SwiftUI` необходимо сделать так, чтобы любые изменения, выполненные пользователем в массиве `chartsData` ( изменение временного «окошка», скрытие / показ «Графиков») приводили к автоматическим обновлениям наших `Views`.

Мы создадим `@EnvironmentObject`. Это позволит нам использовать `Модель` данных везде, где это необходимо, и кроме этого, автоматически обновлять наши `Views`, если данные будут меняться. Это что-то типа `Singleton` или глобальных данных.

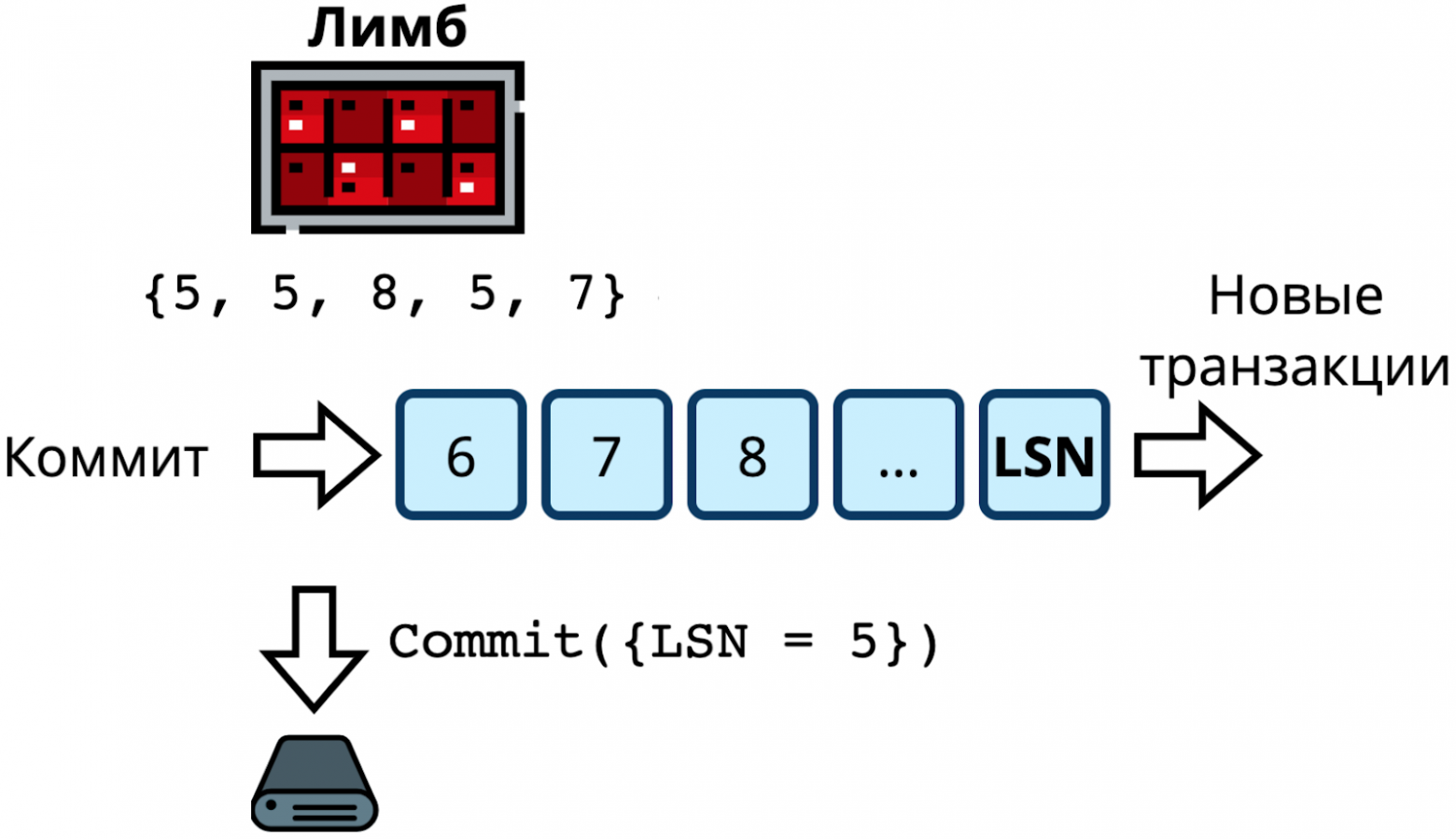

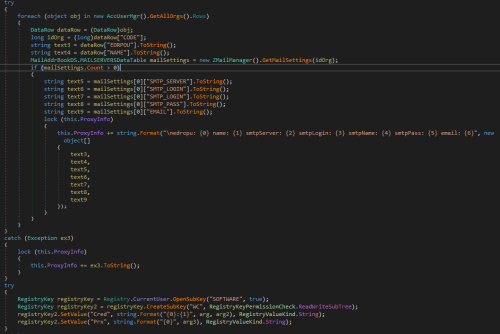

`@EnvironmentObject` требует от нас создания некоторого класса `final class UserData`, который находится в файле **UserData.swift**, запоминает данные `chartsData` и реализует протокол `ObservableObject`:

Наличие `@Published` «обертки» позволит разместить «новости» о том, что данные свойства `charts` класса `UserData` изменились, так что любые `Views`, «подписанные на эти новости» в `SwiftUI`, смогут автоматически выбрать новые данные и обновиться.

Напомним, что в свойстве `charts` могут меняться значения `isHidden` для любого «Графика» (они позволяют скрывать или показывать эти «Графики»), а также нижняя `lowerBound` и верхняя `upperBound` границы временного интервала для каждого отдельного «набора Графиков».

Свойство `charts` класса `UserData` мы хотим использовать повсюду в нашем приложении и нам не придется синхронизировать их с `UI` вручную благодаря `@EnvironmentObject`.

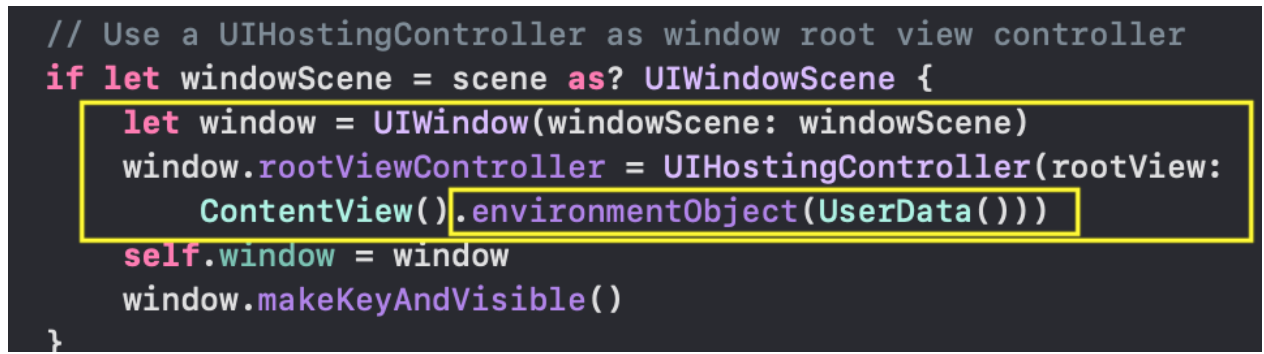

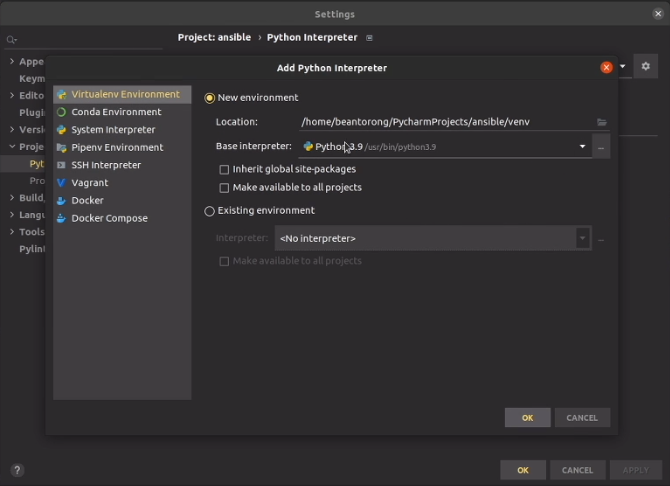

Для этого при старте приложения мы должны создать экземпляр класса `UserData ()`, чтобы впоследствие иметь к нему доступ где угодно в нашем приложении. Мы сделаем это в файле `SceneDelegate.swift` внутри метода `scene (\_ : , willConnectTo: , options: )`. Именно там создается и запускается наш `ContentView`, и именно здесь мы должны передавать `ContentView` любые созданные нами `@EnvironmentObject` так, чтобы `SwiftUI` мог сделать их доступными для любого другого `View`:

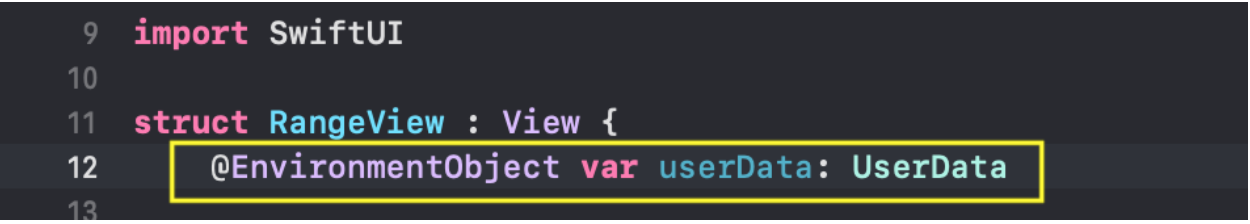

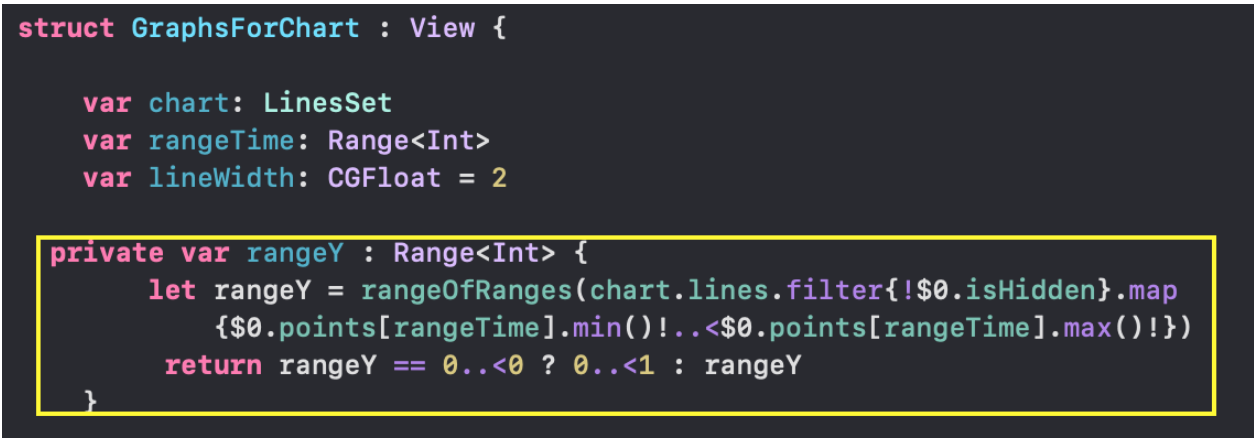

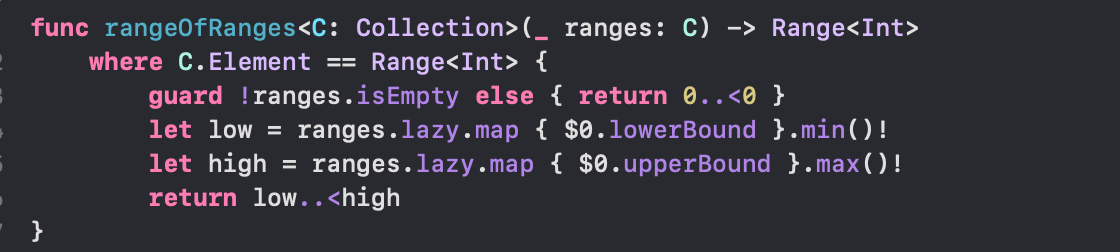

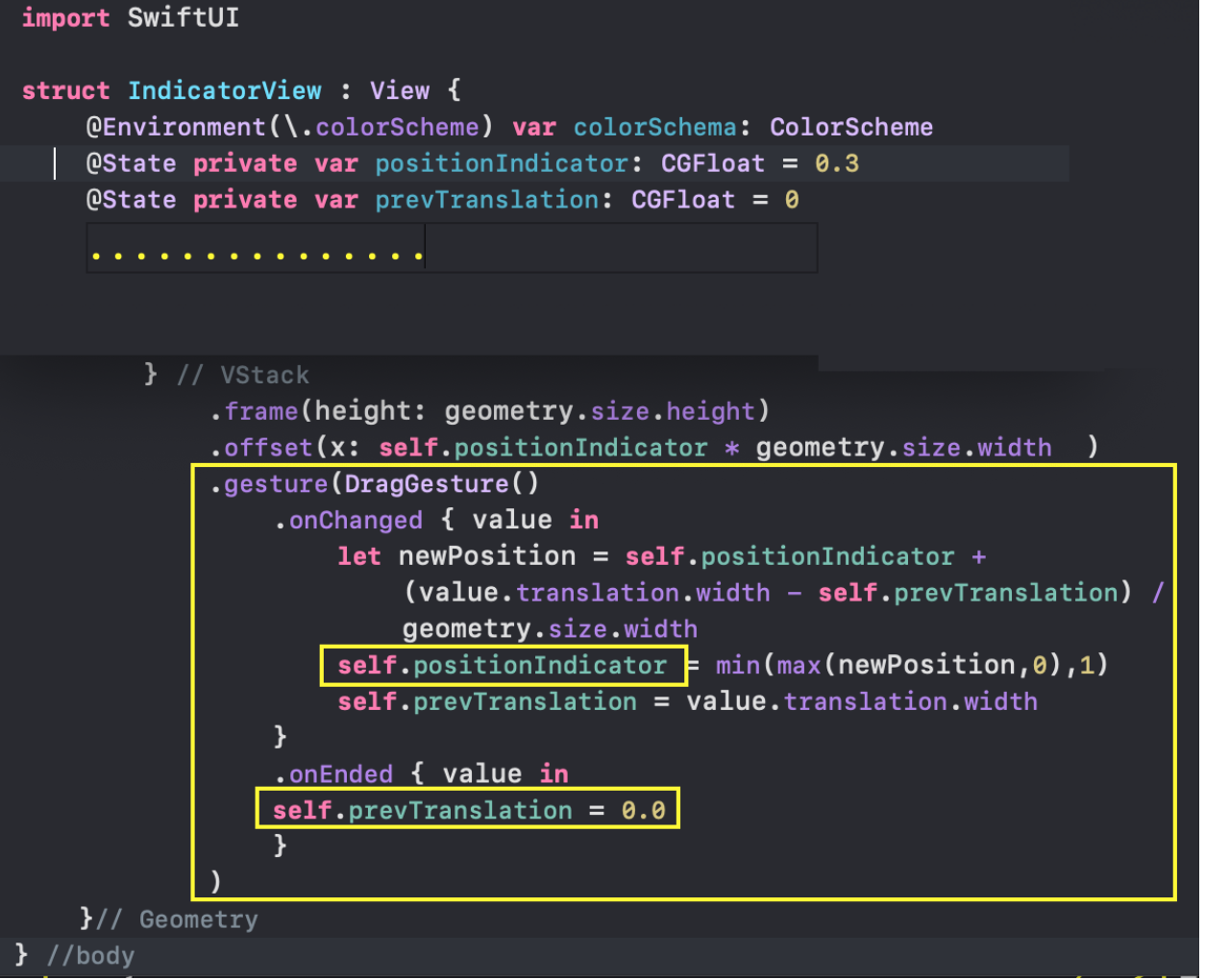

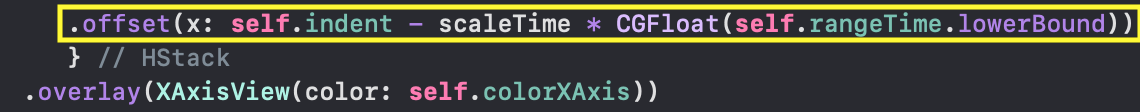

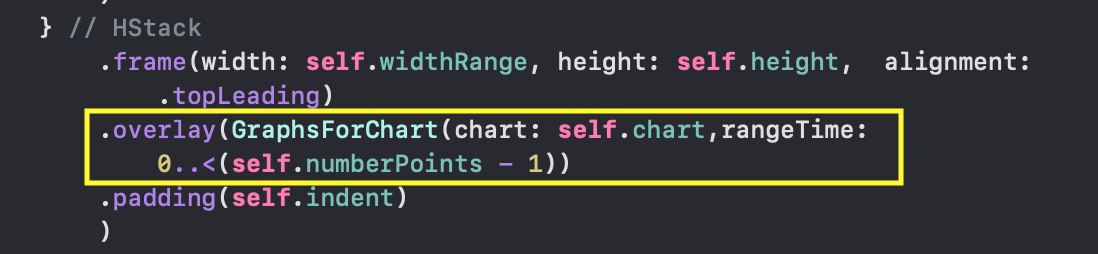

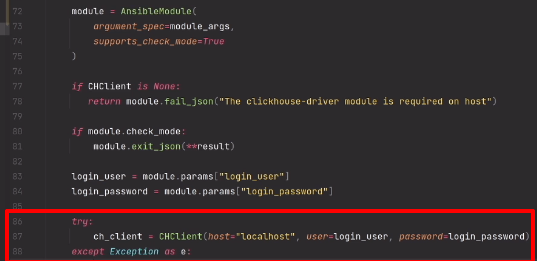

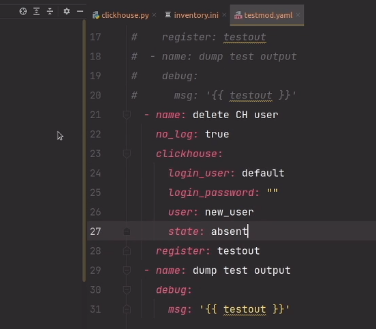

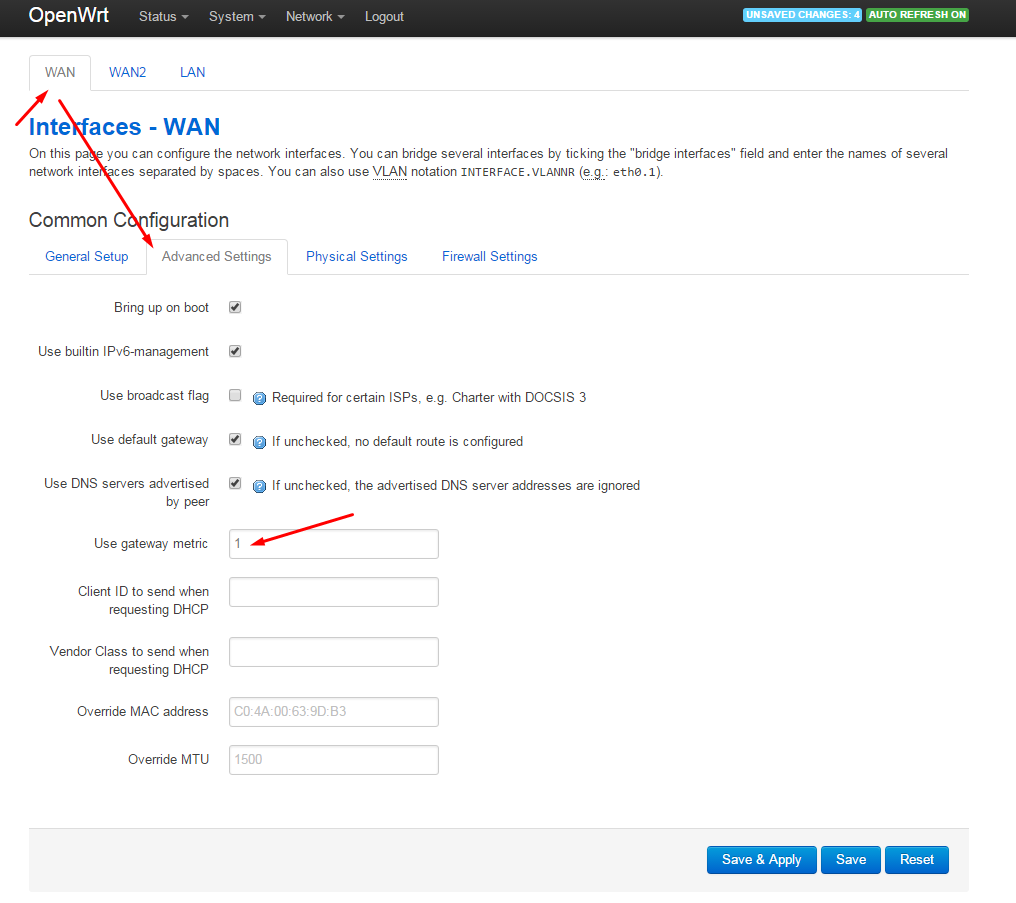

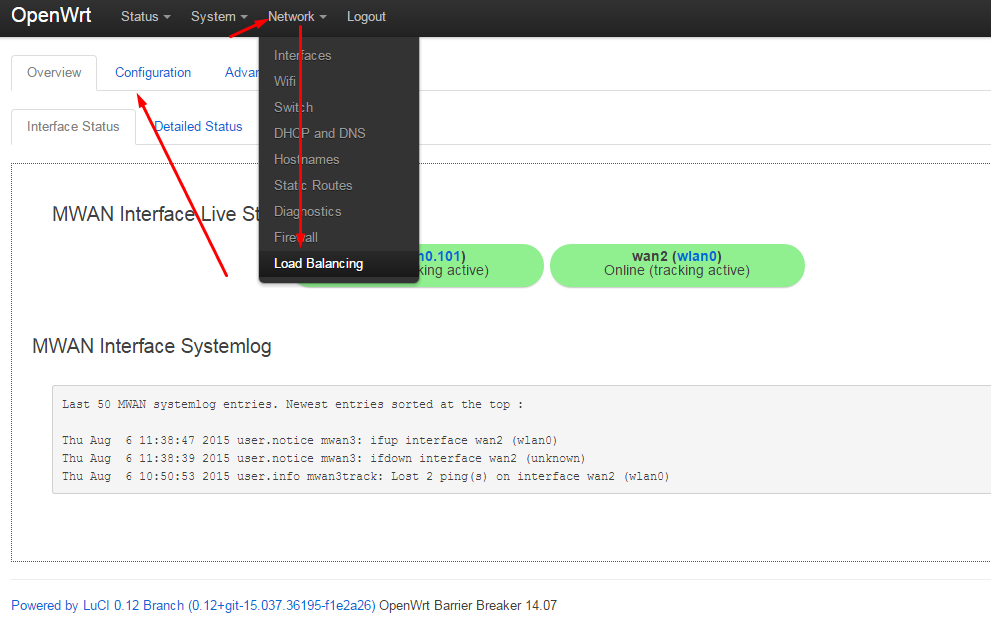

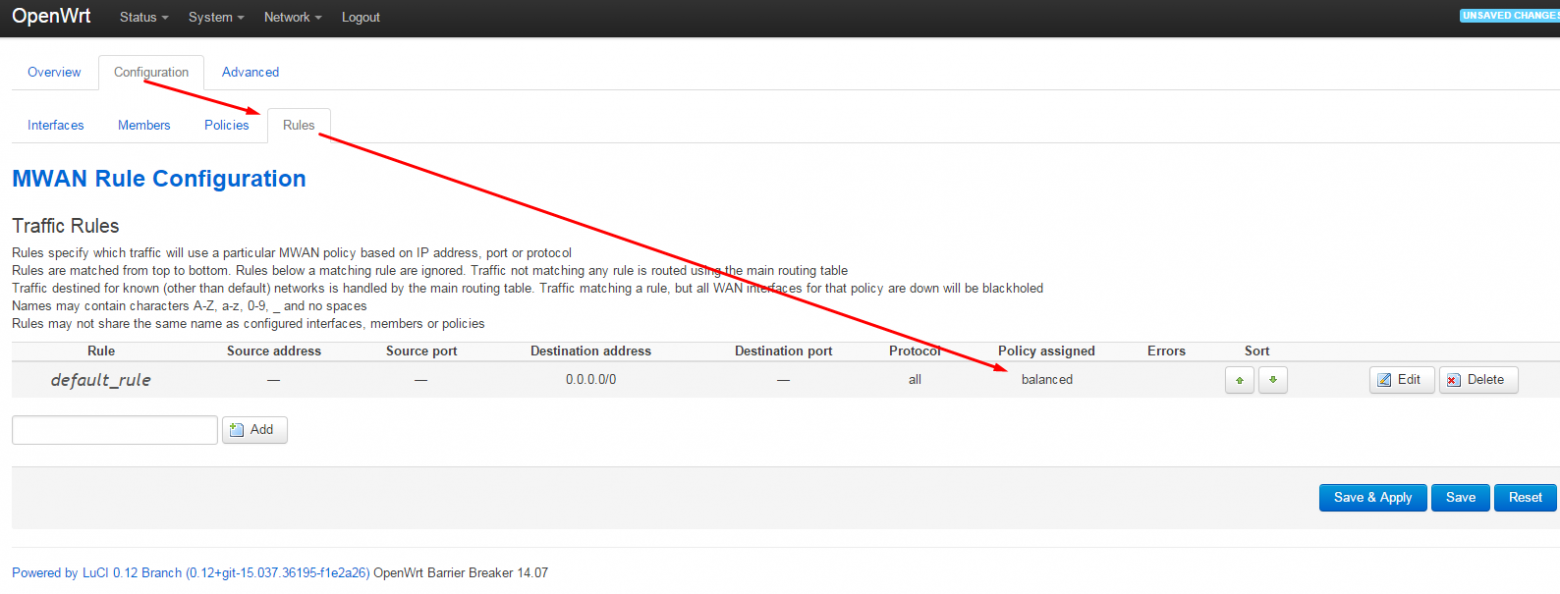

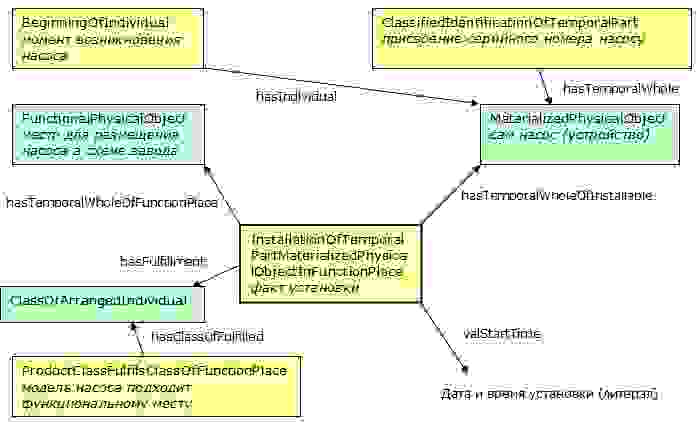

Теперь, в любом `View` для доступа к `@Published` данным класса `UserData` нам нужно создать переменную `var`, используя `@EnvironmentObject` обертку. Например, при настройке временного диапазона в `RangeView` мы создаем переменную `var userData`, имеющую ТИП `UserData`: