text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

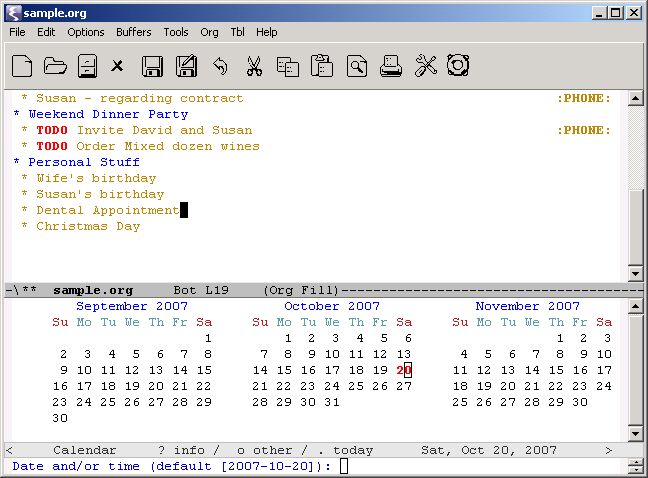

# Генерация одноразовых паролей при помощи смартфона

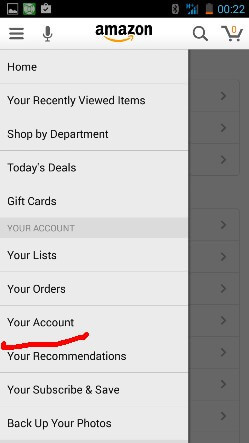

**Пролог:** данная статья готовилась в течении прошлой недели и была отправлена как статья для песочницы в воскресную ночь. Сегодня я получил инвайт, но так же обнаружил статью с похожей тематикой — [К вопросу о двухфакторной аутентификации с помощью мобильных устройств](http://habrahabr.ru/company/symantec/blog/122855/), так что я полностью согласен с автором этой статьи — «что слишком много в последнее время совпадений». Статью решил публиковать как она была изначально задумана, добавил только ссылки на исходники.

После недавних публикаций на Хабрахабре посвященных безопасности, паролям, переборе паролей и т.п. мне в голову пришла идея авторизации при помощи одноразовых паролей которые генерируются специальным приложением на смартфонах пользователей. Идея очень похожа на идею которая используется в устройствах SecureID (и которые тоже недавно освещались на Хабрахабре). Современные смартфоны доступны все большему количеству людей и их возможностей вполне достаточно для реализации подобной схемы. В данной статье я хочу описать идею взаимодействия связки смартфон + веб сайт, некоторые особенности реализации и показать работающий прототип.

Идея проста — при регистрации на сайте пользователю опционально может предоставляться возможность использовать для авторизации специальное приложение, установленное на смартфоне, для генерации одноразовых паролей. Для этого на стороне сервера каждому пользователю генерируется уникальный секретный ключ, который должен быть передан на смартфон. Далее на основе этого ключа приложение на стороне смартфона будет генерировать одноразовые пароли. Время жизни каждого пароля ограничено. Т.к. все современные смартфоны оснащаются камерами, то самым простейшим способом передачи секретного ключа, по моему мнению, является считывание и распознование QR-кода который содержит секретный ключ при помощи камеры смартфона. Можно конечно вводить ключ вручную, отправлять при помощи SMS, скачивать файл с ключом по сгенерированной сервером ссылке, но такие решения не всегда удобны. Данный способ не претендует быть основным способом авторизации на сайтах, но может быть использован как опциональное средство авторизации.

Последовательность действий пользователя при регистрации на сайте следующая:

* при регистрации на сайте (или после регистрации) пользователь может выбрать дополнительный вариант аутентифкации при помощи одноразовых паролей.

* если такой вариант выбран, то сервер генерирует секретный ключ, сохраняет его в базе и ассоциирует его с пользователем.

* После создания секретного ключа, пользователю генерируется изображение с QR-кодом, который содержит секретный ключ.

* пользователь считывает значение секретного ключа при помощи камеры смартфона.

* приложение на смартфоне сохраняет секретный ключ, ассоциирует его с сайтом и использует для генерации одноразовых паролей.

[QR-коды](http://ru.wikipedia.org/wiki/QR-%D0%BA%D0%BE%D0%B4) были выбраны из-за достаточно широкой рапространенности, так же используя QR-коды можно передавать довольно большие объемы данных (сотни и тысячи символов), но ничто не мешает использовать любые другие способы кодирования данных.

За основу генерации отдноразовых паролей был взят алгоритм [HOTP](http://en.wikipedia.org/wiki/HOTP). Алгоритм является открытым стандартом и находится в свободном доступе. Так же для него есть соответсвующий [RFC 4226](http://tools.ietf.org/html/rfc4226).

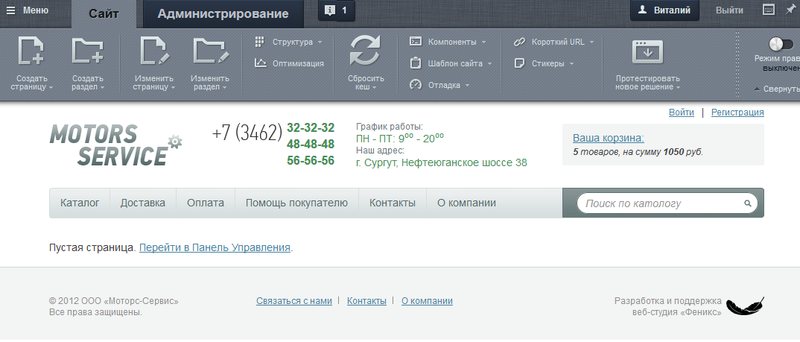

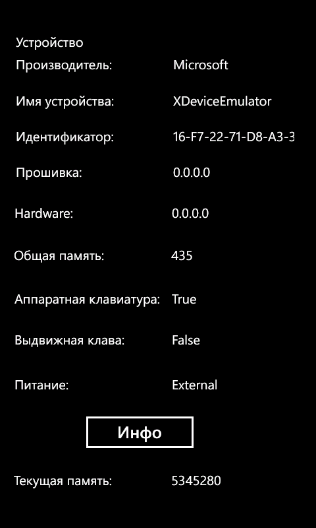

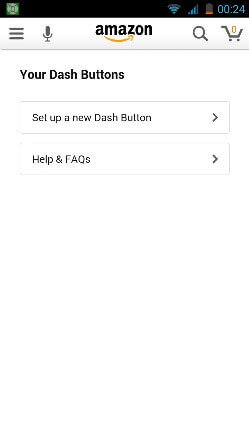

Для реализации и проверки идеи была выбрана связка Google App Engine + смартфон на базе Android. Демо-версия сайта расположена по адресу <http://grey-box.appspot.com/> там же есть ссылка на небольшое демо-приложение для смартфона на базе Android, поддерживаются версии Android OS от 1.6 и выше. Оба приложения достаточно простые, так что я не буду описывать их детально, остановлюсь только на наиболее интересных моментах.

Основой обоих приложений является вычисление одноразовых паролей. Каждый раз когда пользователь хочет авторизоваться на сайте он генерирует одноразовый пароль на смартфоне, используя специальное приложение. Пароли привязаны ко времени и имеют ограниченный срок действия. Когда пользователь вводит созданный пароль, сервер выполняет те же самые действия — генерирует пароль на своей стороне. Если пароли совпадают то авторизация проходит успешно. Чтобы сгенерировать одинаковые пароли сервер и смартфон должны создавать пароли на основе одинаковых начальных данных. Этими начальными данными являются секретный ключ пользователя и текущее время. Когда сервер генерирует секретный ключ он так же сохраняет в какой момент времени был сгенерирован ключ (в виде unix timestamp). Секретный ключ и время генерации ключа кодируются в QR-код и передаются на сматфон. Приложение на смартфоне считывает секретный ключ и время генерации ключа и вычисляет разницу между временем на строне сервера и на стороне сматрфона. В дальнейшем эта разница используется чтобы синхронизировать время.

На стороне сервера должно выполнятся 3 основных действия:

* генерация секретного ключа

* генерация QR-кода

* генерация и проверка одноразового пароля

Ниже приведены соответсвующие части кода на Python.

```

# создание секретного ключа.

import time

import hmac

from hashlib import sha1

...

OTP_TTL = 300 # время жизни одноразового пароля, в секундах

# входные данные

username = request.get(“username”)

timestamp = int(time.time()) / OTP_TTL

# создать секретный ключ

secret_key = hmac.new(str(timestamp) + username, digestmod=sha1).hexdigest().upper()

# далее сохранить ключ в базе и т.п.

```

Для генерация картинки с QR-кодом простейшим вариантом является использование любого сервиса для генерации различных штрих-кодов. Таких сервисов довольно много, в данной системе был использован сервис который предоставляет корпорация Google — [Google Charts Tools](https://chart.googleapis.com). Данный сервис позволяет генерировать различные графики, диаграммы и различные штрих-коды в том числе. Подобный способ был использован исключительно по соображениям простоты реализации, для реальных систем лучше генерировать штрих-коды на стороне сервера.

```

QR_TPL = "https://chart.googleapis.com/chart?chs=100x100&cht=qr&chl=%s&choe=UTF-8"

qr_url = QR_TPL % ('%s:%s' % (secret_key, timestamp))

# далее полученная ссылка используется в HTML шаблоне страницы регистрации.

...

```

Генерация одноразового пароля.

```

import time

import hmac

from hashlib import sha1

…

OTP_TTL = 300 # время жизни одноразового пароля, в секундах

TRUNCATE_MASK = 0x7FFFFFFF # маска для сброса самого старшего бита

MOD = 1000000 # используется чтобы получить заданное число цифр одноразового пароля

# входные данные

username = request.get("username")

password = request.get("password")

# получить секретный ключ пользователя из базы

st = storage.gql("where user = :1", username).get()

secret_key =st.secret_key

# получить timestamp

timestamp = int(time.time()) / OTP_TTL

# создать одноразвый пароль ...

one_time_password = str((int(hmac.new(secret_key, str(timestamp), sha1).hexdigest(), 16) & TRUNCATE_MASK) % MOD)

# ... и сравнить его с паролем который ввел пользователь

if password == one_time_password:

# успешная авторизация

else:

# ошибка

```

На стороне сматрфона выполняются 2 основных действия:

* считывание и распознавания QR-кода с последующим сохранением данных

* генерция одноразового пароля

Для считывания и распознавания штрих-кодов существует несколько библиотек, пожалуй самой активно используемой и распространенной является открытая библиотека [Zxing](http://code.google.com/p/zxing/). Данная библиотека поддерживает ряд платформ, включая Google Android и Apple iOS. На основе этой библиотеки так же реализовано открытое приложение **Barcode Scanner**, данное приложение также достаточно распространено и часто является предустановленным на многих современных смартфонах на базе Android. Первоначально было задумано интегрировать данную библиотеку в приложение, но после продолжительных поисков в интеренете и документации пришло осознание того что это не самый быстрый и легкий путь. Было решено использовать механизм вызовов intent который предоставляет платформа Android. При таком подходе значительно проще интегрировать необходимую функциональность в приложение, хотя пользователям и прийдется дополнительно устанавливать **Barcode Scanner** в случае необходимости. Это минус такого подхода, но есть и плюсы — не приходится сопровождать и поддерживать все возможные модели смартфонов, нынешние и будущие — этим занимается команда разработчиков **Zxing**. Так же можно реализовать поддержку других приложений для распознавания штрих-кодов и не ограничиваться одним **Barcode Scanner**.

Далее приведен небольшой фрагмент кода на Java который используется для вызова и обработки ответа приложения **Barcode Scanner**.

```

...

// вызов Barcode Scanner Intent, например по нажатию на кнопку

Intent intent = new Intent("com.google.zxing.client.android.SCAN");

intent.putExtra("SCAN_MODE", "QR_CODE_MODE");

startActivityForResult(intent, 0);

...

// метод в котором обрабатывается результат полученный после возврата из приложения Barcode Scanner

public void onActivityResult(int requestCode, int resultCode, Intent intent) {

if (requestCode == 0) {

if (resultCode == RESULT_OK) {

// получаем распознанную строку с данными

String contents = intent.getStringExtra("SCAN_RESULT");

// … обработка и сохранение полученных данных …

}

}

}

...

```

Генерация одноразового пароля.

```

// использованные библиотеки

import java.math.BigInteger;

import java.security.InvalidKeyException;

import java.security.NoSuchAlgorithmException;

import javax.crypto.Mac;

import javax.crypto.spec.SecretKeySpec;

...

// константы, назначение аналогичное константам описанных для сервера

long OTP_TTL = 300;

long TRUNCATE_MASK = 0x7FFFFFFF;

long MOD = 1000000;

...

// получить сохраненный секретный ключ

String secret_key = key_storage.getString("secret_key", "");

// вычислить время на сервере

long time_delta = key_storage.getLong("time_delta", 0);

long local_time = (System.currentTimeMillis()/1000) / TIME_MASK;

long server_time = local_time + time_delta;

try {

SecretKeySpec keySpec = new SecretKeySpec(secret_key.getBytes(), "HmacSHA1");

Mac mac = Mac.getInstance("HmacSHA1");

mac.init(keySpec);

byte[] result = mac.doFinal(Long.toString(server_time).getBytes());

password = Long.toString((new BigInteger(1, result).intValue() & TRUNCATE_MASK) % MOD);

} catch (NoSuchAlgorithmException e) {

...

} catch (InvalidKeyException e) {

...

}

// показать пользователю полученный пароль

...

```

Простой прототип сайта и демо-приложение для смартфонов доступно по адресу <http://grey-box.appspot.com/>. Приложение для Android называется **Auth ID** и не требует каких-либо специальных разрешений или прав доступа для работы. Единственное требование — это наличие приложения **Barcode Scanner**, которое используется для сканирования QR-кодов. На данный момент функциональность приложения **Auth ID** минимальна, приложение может сохранять ключ только для одного пользователя и только для демо-сайта. Если регистрироваться под другим пользователем то секретный ключ будет переписан поверх существующего. В дальнейшем можно добавить сохранение ключей для различных сайтов и пользователей, все это конечно при условии что данная схема авторизации получит рапространение. Буду рад любым комментариям и пожеланиям.

Ссылки:

<http://ru.wikipedia.org/wiki/QR-%D0%BA%D0%BE%D0%B4> – что такое QR-коды

<http://en.wikipedia.org/wiki/HOTP> — описание алгоритма HOTP

<http://tools.ietf.org/html/rfc4226> – RFC 4226 для алгоритма HOTP

<https://chart.googleapis.com> – Google Chart Tools

<http://code.google.com/p/zxing/> — библиотека Zxing для сканирования и распознавания различных штрих-кодов.

<http://grey-box.appspot.com/> — демо-версия сайта и приложения иллюстрирующие идею.

P.S. Исходники доступны после тестовой регистрации и логина. Код тестовый и создавался исключительно для проверки работоспособности идеи, не рекомендуется для реального использования. | https://habr.com/ru/post/122927/ | null | ru | null |

# AndEngine GLES2 — Живые обои

Зимой прошлого года (скорее всего в солнечный день:) я заинтересовался графической библиотекой AndEngine, так как захотелось поработать с двумерной графикой на мобильном телефоне (с использованием OpenGL), и это решение мне показалось наиболее интересным и доступным. Сделав несколько графических приложений, я решил создать живые обои, тем более что в поставке с AndEngine идёт специальная библиотека для создания таковых. Теперь поделюсь своим опытом создания живых обоев с вами.

Специально для этого я подготовил [проект](http://www.anprog.com/documents/AE_gles2_LiveWallpaper.zip) (обладает обильными комментариями), «шаблон» для показа принципа работы живых обоев.

**Подготовка**

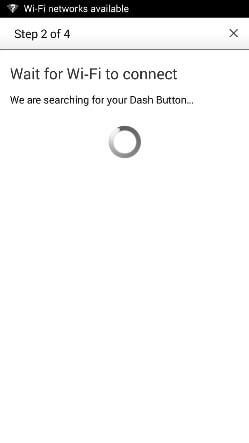

Прежде всего необходимо установить сам AndEngine и в частности библиотеку AndEngineLiveWallpaperExtension (рекомендую сразу установить все доступные библиотеки) так как она будет являться базой. Так как эта статья не является базовой для изучения AndEngine я не буду рассказывать как установить библиотеки, тем более что данную информацию вы можете легко найти, например здесь — <http://www.matim-dev.com/how-to-setup-andengine.html>. Теперь вам необходимо открыть прилагаемый проект и запустить его. Если он сразу не запустится, то скорее всего вам необходимо проверить подключенные библиотеки к проекту. В итоге у вас должно получиться что то типа этого — <http://youtu.be/HRKzBma9vz0>

**Функционал**

А теперь кратко и по порядку (большая часть функционал также относится ко всем другим AndEngine GLES2 приложениям). Предком главного класса проекта является «BaseLiveWallpaperService», именно этот класс отвечает за всю работу с GLES2. Обязательными для переопределения являются функции:

```

onSurfaceChanged

onCreateEngineOptions

onCreateResources

onCreateScene

```

*public void onSurfaceChanged(final GLState pGLState, final int pWidth, final int pHeight)* — функция определения размера экрана и установки камеры.

*public EngineOptions onCreateEngineOptions()* — функция настройки работы движка живых обоев. Данная функция возвращает в систему выбранные параметры для настройки GLES2.

*public void onCreateResources(OnCreateResourcesCallback pOnCreateResourcesCallback)* — как понятно из названия, данная функция предназначена для создания всех (медиа) ресурсов которые будут участвовать в работе приложения.

*public void onCreateScene(OnCreateSceneCallback pOnCreateSceneCallback)* — функция создания сцены и размещения на ней всех желаемых объектов.

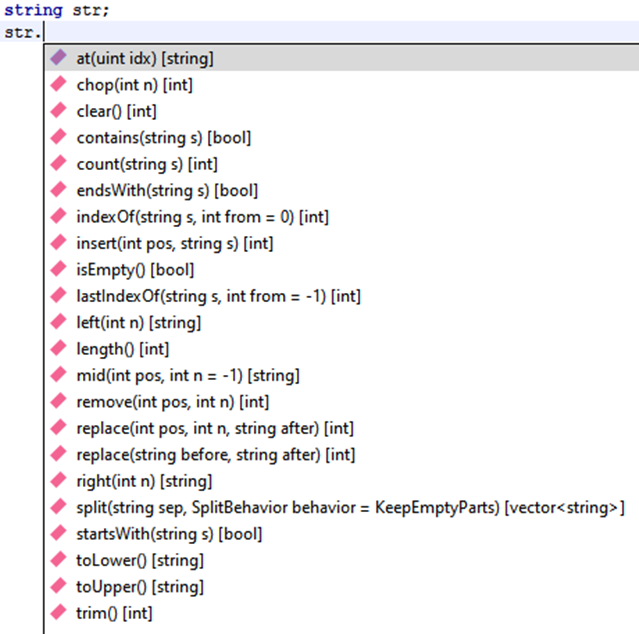

**Загрузка тестур**

Загрузка текстуры происходит в три этапа: определение атласа; определение текстуры; загрузка текстуры в атлас. Рассмотрим их на примере загрузки заднего фона:

```

this.mOnScreenControlTexture0 = new BitmapTextureAtlas(this.getTextureManager(), 1930, 1050, TextureOptions.BILINEAR_PREMULTIPLYALPHA);

this.bg_TextureRegion = BitmapTextureAtlasTextureRegionFactory.createFromAsset(this.mOnScreenControlTexture0,this,"gfx/bg.jpg", 0, 0);

this.getEngine().getTextureManager().loadTexture(this.mOnScreenControlTexture0);

```

В первой строке определяется размер для атласа текстур. Нужно заранее определить какие текстуры и в каком порядке расположатся на данном атласе и рассчитать его размер. Если неправильно рассчитать положение текстур в атласе или сделать его меньше требуемого размера, то программа будет работать не корректно. В нашем случае в атласе будет располагаться всего одна картинка (спрайт) и поэтому размер атласа будет ровняться размеру картинки.

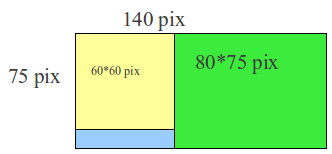

В случае если требуется загрузить две картинки (спрайта) и более, то размер атласа придётся высчитывать. Например: Мы хотим загрузить две картинки размером 60\*60 и 80\*75 пикселей. Для нахождения ширины атласа сложим ширину первой и второй картинки, получим 140. При этом высота атласа должна ровняться наибольшей из этих картинок. При необходимости компоновка атласа может быть любой сложности, всё ограничивается только фантазией программиста и максимальными размерами (2048\*2048).

Во второй строке определяется объект через который в дальнейшем можно получить интересующую текстуру. Аргументы конструктора следующие: атлас для хранения текстуры; контекст; адрес расположения текстуры; координата по Х, начиная с которой располагается текстура; координата по Y, начиная с которой располагается текстура. Все текстуры должны храниться в парке «gfx» (*проект/assets/gfx*).

В третьей строке находится сам загрузчик, с помощью которого загружается вся графика в атлас.

**Создание сцены**

Сцена создается всего одной строкой — mScene= new Scene(), далее происходит самое интересное — размещение всех нужных объектов на сцене. Главной строительной единицей всех приложений строящихся с помощью AndEngine, являются спрайты (так как библиотека работает исключительно с двумерными объектами). Рассмотрим пример создания простого спрайта:

```

bg = new Sprite(0, 0, this.bg_TextureRegion, getVertexBufferObjectManager());

bg.setSize(bg.getWidth() * 2, bg.getHeight() * 2);

bg.setPosition(10, 20);

mScene.attachChild(bg);

```

В первой строке создаётся спрайт. У конструктора следующие аргументы: положение на сцене по оси Х; положение на сцене по оси Y; объект текстуры; менеджер буфера. Во второй строке переопределяется размер спрайта, по умолчанию он равен размеру текстуры. В третьей строке переопределяется позиция спрайта на экране. В четвертой строке спрайт непосредственно добавляется на экран.

Если вы посмотрите код прилагаемого примера, то заметите что в нем определен класс Sun. Он является потомком класса Sprite. В этом классе прописана логика анимации объекта, которая заключается в повороте объекта относительно своего центра.

Также определен класс LiveWallpapperSettings, который отвечает за настройку живых обоев. Так как это достаточно стандартная вещь, логику работы настроек описывать не буду (интересующую информацию вы легко найдете в Яндексе либо в других поисковых машинах).

**Заключение**

Библиотека очень проста в использовании и функциональна. Главным её недостатком является механизм замораживания, который срабатывает при скрытии обоев и не всегда отключается при продолжении их показа. Данный минус явно прослеживается когда обои имеют относительно большое количество спрайтов на сцене (как например здесь — <https://play.google.com/store/apps/details?id=com.livewallpaper.summermeado_wfull>). Если кто-то решил проблему с замораживанием, пожалуйста поделитесь решением.

Я намеренно не стал раздувать пример и добавлять максимальное количество функционала чтобы показать, что графические приложения для Android это быстро и просто.

Удачного тестирования!

Проект живых обоев — <http://www.anprog.com/documents/AE_gles2_LiveWallpaper.zip> | https://habr.com/ru/post/192092/ | null | ru | null |

# Сервис мониторинга свободного места на Bash

Добрый день! Хотелось бы рассказать Вам об очередном велосипедостроении. Просматривая Хабр, я наткнулся на замечательную статью: [Bash: запускаем демон с дочерними процессами](http://habrahabr.ru/post/151771/). После прочтения возникла идея написать что-нибудь полезное, с преферансом и куртизантками, куда же без этого.

##### Вводная:

**ОС:** Astra Linux 1.2 (1.3)

Из вводной следуют два вывода:

1. Нельзя устанавливать не сертифицированное ПО, иначе мы словим лютую попаболь с двух направлений (Заказчик и Руководство).

2. Т.к. мы настоящие пионеры и не ищем легких путей, то вывод команды df нас не интересует.

Основные моменты построения демона на bash рассказывать не буду, это прекрасно описано в [статье](http://habrahabr.ru/post/151771/) указанной выше, поэтому перейдем сразу к рабочему телу :).

Для начала укажем переменные, которые будем использовать:

```

# Эти две переменные думаю не надо объяснять

PID_FILE="/run/ac_check_disk_space.pid"

LOG_FILE="/var/log/ac_check_disk_space.log"

# Период проверки

# Префикс после числа может принимать следующие значения:

# s - секунды

# m - минуты

# h - часы

# d - дни

# Если префикс не выставлен, то по умолчанию используются секунды

CHECK_PERIOD="1m"

# Форма записи:

# Имя диска:Объем оставшегося места для срабатывания триггера

# Пример записи для 2 дисков:

# CHECK_DISKS=('/dev/sda1:10G' '/dev/sda3:10G')

# Префик после числа может принимать следующие значения:

# K - Килобайты

# M - мегабайты

# G - Гигабайты

# Если префикс не выставлен, то по умолчанию используются байты

CHECK_DISKS=('/dev/sda1:10G' '/dev/sda3:10G')

# Переменные замены:

# :host: - Имя хоста

# :disk: - Имя диска

# :mount_point: - Точка монтирования

# :disk_total: - Общий объем диска

# :disk_avaiable: - Объем доступный для прользователя

# :disk_checked_size: - Порог срабатывания тригера

MAIL_SUBJECT_TEMPLATE="ACHTUNG: :host: low disk space on :disk: mounted to :mount_point:!"

MAIL_BODY_TEMPLATE="Details: Total disk size :disk_total:, Avaiable size: :disk_avaiable:, Trigger size: :disk_checked_size:"

MAIL_RCPT=('[email protected]')

```

Т.к. вывод [df](http://linux.die.net/man/1/df) нас не интересует, то получить информацию о состоянии файловой системы можно через [stat](http://linux.die.net/man/1/stat). но для этого необходимо знать каталог, куда смонтирована данная файловая система. Эти данные хранятся в файле /proc/mounts, но есть небольшая заковырка, там имя диска может быть представлено как привычным именем устройства (например /dev/sda1), так и UUID(ом) устройства (например /dev/disk/by-uuid/xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxxxxxx). Для приведения всего этого в божеский вид, нам поможет утилита [blkid](http://linux.die.net/man/8/blkid) (locale/print block device attributes).

Итак начнем заполнять функцию *start()*, проверку запуска от рута и проверку на вторую копию процесса опустим, перейдем сразу к составлению словаря соответствия имени устройства к точке монтирования

```

# Получаем списки дисков по именам и UUID

disks=$(blkid | grep -v swap | awk '{print $1}' | sed -e s/://)

uuids=$(blkid | grep -v swap | awk '{print $1}' | sed -e s/UUID=// | sed -e s/\*//g)

# Инициализация массива привязки диска к точке монтирования

mounts=()

# Заполняем массив по имени диска

for (( i=0; i<${#disks[*]}; i++ )); do

mount_point=( `cat /proc/mounts | grep ${disks[$i]} | awk '{print $2}'` )

if [[ ! -z $mount_point ]]; then

mounts=("${mounts[@]}" "${disks[$i]}:$mount_point")

fi

done

# Заполняем массив по UUID

for (( i=0; i<${#uuids[*]}; i++ )); do

mount_point=( `cat /proc/mounts | grep ${uuids[$i]} | awk '{print $2}'` )

if [[ ! -z $mount_point ]]; then

disk=`blkid -U ${uuids[$i]}`

mounts=("${mounts[@]}" "$disk:$mount_point")

fi

done

# Проверка, существуют ли разделы указанные в файле настройки и составление массива дисков для проверки

exists=0

checked_disks=()

for mount in "${mounts[@]}"; do

mount_disk="${mount%%:*}"

for check in "${CHECK_DISKS[@]}"; do

check_disk="${check%%:*}"

if [ $check_disk == $mount_disk ]; then

check_size="${check##*:}"

size=$(calculate_space_prefix $check_size)

checked_disks=("${checked_disks[@]}" "$check_disk:$size")

exists=1

fi

done

done

if [ $exists -eq 0 ]; then

echo "Can not find disks, please check your configuration file"

exit 1

fi

```

Как можете заметить в файле настроек есть переменная *CHECK\_DISKS* которая является массивом проверяемых дисковых разделов. Размер, при котором необходимо устраивать панику указан в доступной для понимания человеком форме, для перевода используем функцию *calculate\_space\_prefix*. Функция получает размер и префикс, и переводит это хозяйство в байты.

```

function calculate_space_prefix()

{

local value=$1

local result=$2

local size=0

local prefix=""

prefix="${value: -1}"

len="${#value}"

len=$(($len - 1))

size="${value:0:$len}"

case $prefix in

"K")

size=$(($size * 1024))

;;

"M")

size=$(($size * 1048576))

;;

"G")

size=$(($size * 1073741824))

;;

*)

#size=$(($size * 1073741824))

;;

esac

echo $size

}

```

Теперь рассмотрим основной цикл. В нем проходим по массиву *checked\_disks*, в котором указан раздел и порог свободного места меньше которого необходимо ударятся во все тяжкие. Как говорилось выше, для получения информации о разделе используется команда [stat](http://linux.die.net/man/1/stat), нам необходим следующий ее синтаксис.

```

stat -f <точка монтирования> -c "%b %a %s"

# Где:

# %b - Общее количество блоков данных в файловой системе

# %a - Количество свободных блоков, доступных для обычного пользователя

# %s - Размер блока

```

Если мы не хотим, чтобы пользователь при получении письма счастья о том, что у него заканчивается место на разделе, сидел с калькулятором и пересчитывал байты в удобочитаемый вид, то напишем еще одну функцию.

```

function calculate_return_space_prefix()

{

local value=$1

local space=$2

local size=0

prefix="${value: -1}"

case $prefix in

"K")

size=$(($space / 1024))

;;

"M")

size=$(($space / 1048576))

;;

"G")

size=$(($space / 1073741824))

;;

*)

;;

esac

echo $size

}

```

Как видите, это та же функция *calculate\_space\_prefix*, только наоборот.

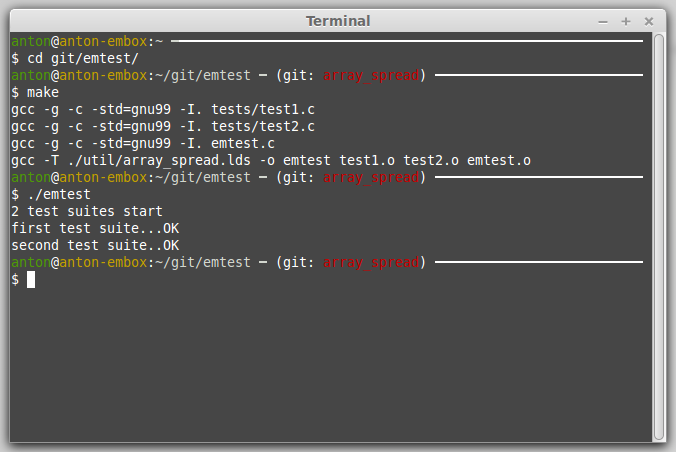

Итак, теперь все готово, для основного цикла сервиса. Комментариев там маловато, но думаю и без них основной принцип понятен: проверяй, проверяй и еще раз проверяй, а потом уже пиши письма.

```

# Основной цикл

while [ 1 ]; do

for checked in "${checked_disks[@]}"; do

checked_disk="${checked%%:*}"

checked_size="${checked##*:}"

for mount in "${mounts[@]}"; do

mount_disk="${mount%%:*}"

mount_point="${mount##*:}"

if [ $mount_disk == $checked_disk ]; then

disk_all=( `stat -f $mount_point -c "%b"` )

disk_avaiable=( `stat -f $mount_point -c "%a"` )

disk_block_size=( `stat -f $mount_point -c "%s"` )

disk_all=$(($disk_all * $disk_block_size))

disk_avaiable=$(($disk_avaiable * $disk_block_size))

if [ $disk_avaiable -le $checked_size ]; then

_log "Low disk size on $checked_disk mounted to $mount_point. Total size: $disk_all, avaiable size: $disk_avaiable, trigger size: $checked_size."

# Переводим байты в удобочитаемый формат

for check in "${CHECK_DISKS[@]}"; do

check_disk="${check%%:*}"

check_size="${check##*:}"

if [ $check_disk == $checked_disk ]; then

disk_all=$(calculate_return_space_prefix $check_size $disk_all)

disk_avaiable=$(calculate_return_space_prefix $check_size $disk_avaiable)

checked_size=$(calculate_return_space_prefix $check_size $checked_size)

prefix="${check_size: -1}"

fi

done

subject=`echo -e ${MAIL_SUBJECT_TEMPLATE} | sed -e "s|:host:|$host|g" | sed -e "s|:disk:|$checked_disk|g" | sed -e "s|:mount_point:|$mount_point|g" | sed -e "s|:disk_total:|${disk_all}${prefix}|g" | sed -e "s|:disk_avaiable:|${disk_avaiable}${prefix}|g" | sed -e "s|:disk_checked_size:|${checked_size}${prefix}|g"`

body=`echo -e ${MAIL_BODY_TEMPLATE} | sed -e "s|:host:|$host|g" | sed -e "s|:disk:|$checked_disk|g" | sed -e "s|:mount_point:|$mount_point|g" | sed -e "s|:disk_total:|${disk_all}${prefix}|g" | sed -e "s|:disk_avaiable:|${disk_avaiable}${prefix}|g" | sed -e "s|:disk_checked_size:|${checked_size}${prefix}|g"`

for rcpt in "${MAIL_RCPT[@]}"; do

echo "$body" | mail -s "$subject" "$rcpt"

done

fi

fi

done

done

sleep "${CHECK_PERIOD}"

done

```

Если кого заинтересует, то полный листинг сервиса под спойлером

**Полный листинг**

```

#!/usr/bin/env bash

set -e

set -m

### BEGIN INIT SCRIPT

# Provides: ac_check_disk_space

# Required-Start: $local_fs $syslog

# Required-Stop: $local_fs

# Default-Start: 2 3 4 5

# Default-Stop: 0 1 6

# Short-Description: ac_check_disk_space

# Description: Service to monitoring disk space for Astra Linux

### END INIT SCRIPT

usage()

{

echo -e "Usage:\n$0 (start|stop|restart)"

}

_log()

{

# Сдвигаем влево входные параметры

#shift

ts=`date +"%b %d %Y %H:%M:%S"`

hn=`cat /etc/hostname`

echo "$ts $hn ac_check_disk_space[${BASHPID}]: $*"

}

check_conf_file()

{

if [ -e "/etc/ac/check_disk_space.conf" ]; then

source "/etc/ac/check_disk_space.conf"

else

echo "Can not find configuration file (/etc/ac/check_disk_space.conf)"

exit 0

fi

}

function calculate_space_prefix()

{

local value=$1

local result=$2

local size=0

local prefix=""

prefix="${value: -1}"

len="${#value}"

len=$(($len - 1))

size="${value:0:$len}"

case $prefix in

"K")

size=$(($size * 1024))

;;

"M")

size=$(($size * 1048576))

;;

"G")

size=$(($size * 1073741824))

;;

*)

#size=$(($size * 1073741824))

;;

esac

echo $size

}

function calculate_return_space_prefix()

{

local value=$1

local space=$2

local size=0

prefix="${value: -1}"

case $prefix in

"K")

size=$(($space / 1024))

;;

"M")

size=$(($space / 1048576))

;;

"G")

size=$(($space / 1073741824))

;;

*)

;;

esac

echo $size

}

start()

{

#trap 'echo "1" >> /tmp/test' 1 2 3 15

# Проверяем запуск от рута

if [ $UID -ne 0 ]; then

echo "Root privileges required"

exit 0

fi

# Проверяем наличие конфига

check_conf_file

# Проверка на вторую копию

if [ -e ${PID_FILE} ]; then

_pid=( `cat ${PID_FILE}` )

if [ -e "/proc/${_pid}" ]; then

echo "Daemon already running with pid = $_pid"

exit 0

fi

fi

touch ${LOG_FILE}

# Получаем списки дисков по именам и UUID

disks=( `blkid | grep -v swap | awk '{print $1}' | sed -e s/://` )

uuids=( `blkid | grep -v swap | awk '{print $2}' | sed -e s/UUID=// | sed -e s/\"//g` )

# Инициализация массива привязки диска к точке монтирования

mounts=()

# Заполняем массив по имени диска

for (( i=0; i<${#disks[*]}; i++ )); do

mount_point=( `cat /proc/mounts | grep ${disks[$i]} | awk '{print $2}'` )

if [[ ! -z $mount_point ]]; then

mounts=("${mounts[@]}" "${disks[$i]}:$mount_point")

fi

done

# Заполняем массив по UUID

for (( i=0; i<${#uuids[*]}; i++ )); do

mount_point=( `cat /proc/mounts | grep ${uuids[$i]} | awk '{print $2}'` )

if [[ ! -z $mount_point ]]; then

disk=`blkid -U ${uuids[$i]}`

mounts=("${mounts[@]}" "$disk:$mount_point")

fi

done

# Проверка, существуют ли диски указанные в файле настройки и составление массива дисков для проверки

exists=0

checked_disks=()

for mount in "${mounts[@]}"; do

mount_disk="${mount%%:*}"

for check in "${CHECK_DISKS[@]}"; do

check_disk="${check%%:*}"

if [ $check_disk == $mount_disk ]; then

check_size="${check##*:}"

size=$(calculate_space_prefix $check_size)

checked_disks=("${checked_disks[@]}" "$check_disk:$size")

exists=1

fi

done

done

if [ $exists -eq 0 ]; then

echo "Can not find disks, please check your configuration file"

exit 1

fi

# Копия предыдущего лога

cp -f ${LOG_FILE} ${LOG_FILE}.prev

# Имя хоста

host=( `cat /etc/hostname` )

# Демонизация процесса =)

cd /

exec > ${LOG_FILE}

exec 2> /dev/null

exec < /dev/null

# Форкаемся

(

# ; rm -f ${PID_FILE}; exit 255;

# SIGHUP SIGINT SIGQUIT SIGTERM

#trap '_log "Daemon stop"; rm -f ${PID_FILE}; cp ${LOG_FILE} ${LOG_FILE}.prev; exit 0;' 1 2 3 15

_log "Daemon started"

# Основной цикл

while [ 1 ]; do

for checked in "${checked_disks[@]}"; do

checked_disk="${checked%%:*}"

checked_size="${checked##*:}"

for mount in "${mounts[@]}"; do

mount_disk="${mount%%:*}"

mount_point="${mount##*:}"

if [ $mount_disk == $checked_disk ]; then

disk_all=( `stat -f $mount_point -c "%b"` )

disk_avaiable=( `stat -f $mount_point -c "%a"` )

disk_block_size=( `stat -f $mount_point -c "%s"` )

disk_all=$(($disk_all * $disk_block_size))

disk_avaiable=$(($disk_avaiable * $disk_block_size))

if [ $disk_avaiable -le $checked_size ]; then

_log "Low disk size on $checked_disk mounted to $mount_point. Total size: $disk_all, avaiable size: $disk_avaiable, trigger size: $checked_size."

# Переводим байты в удобочитаемый формат

for check in "${CHECK_DISKS[@]}"; do

check_disk="${check%%:*}"

check_size="${check##*:}"

if [ $check_disk == $checked_disk ]; then

disk_all=$(calculate_return_space_prefix $check_size $disk_all)

disk_avaiable=$(calculate_return_space_prefix $check_size $disk_avaiable)

checked_size=$(calculate_return_space_prefix $check_size $checked_size)

prefix="${check_size: -1}"

fi

done

subject=`echo -e ${MAIL_SUBJECT_TEMPLATE} | sed -e "s|:host:|$host|g" | sed -e "s|:disk:|$checked_disk|g" | sed -e "s|:mount_point:|$mount_point|g" | sed -e "s|:disk_total:|${disk_all}${prefix}|g" | sed -e "s|:disk_avaiable:|${disk_avaiable}${prefix}|g" | sed -e "s|:disk_checked_size:|${checked_size}${prefix}|g"`

body=`echo -e ${MAIL_BODY_TEMPLATE} | sed -e "s|:host:|$host|g" | sed -e "s|:disk:|$checked_disk|g" | sed -e "s|:mount_point:|$mount_point|g" | sed -e "s|:disk_total:|${disk_all}${prefix}|g" | sed -e "s|:disk_avaiable:|${disk_avaiable}${prefix}|g" | sed -e "s|:disk_checked_size:|${checked_size}${prefix}|g"`

for rcpt in "${MAIL_RCPT[@]}"; do

echo "$body" | mail -s "$subject" "$rcpt"

done

fi

fi

done

done

sleep "${CHECK_PERIOD}"

done

)&

# Пишем pid потомка в файл

echo $! > ${PID_FILE}

}

stop()

{

check_conf_file

if [ -e ${PID_FILE} ]; then

_pid=( `cat ${PID_FILE}` )

if [ -e "/proc/${_pid}" ]; then

kill -9 $_pid

result=$?

if [ $result -eq 0 ]; then

echo "Daemon stop."

else

echo "Error stop daemon"

fi

else

echo "Daemon is not run"

fi

else

echo "Daemon is not run"

fi

}

restart()

{

stop

start

}

case $1 in

"start")

start

;;

"stop")

stop

;;

"restart")

restart

;;

*)

usage

;;

esac

exit 0

```

Теперь о замеченном косяке (с которым лень разбираться и исправлять):

1. Скрипт обрабатывает посылаемые ему сигналы с задержкой указанной в переменной *CHECK\_PERIOD*, а не моментально. К сожалению, ни как не могу вспомнить как это называется, но зависит именно из-за цикла.

Вот вроде и все, о чем я хотел поведать. Всем бобра! | https://habr.com/ru/post/245107/ | null | ru | null |

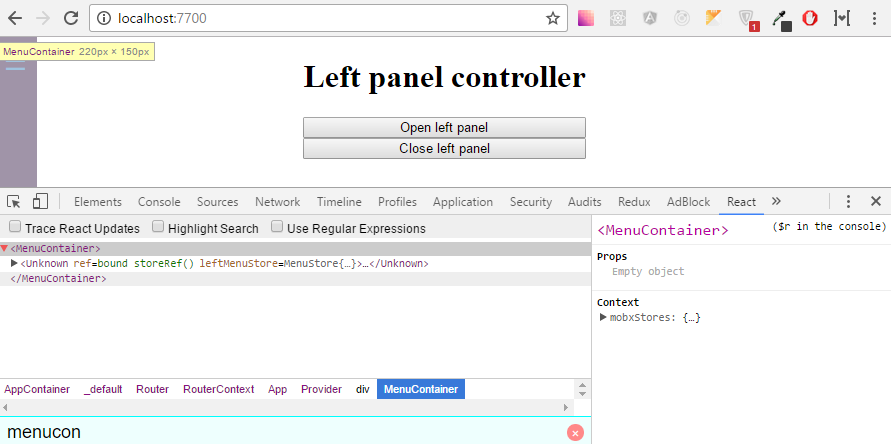

# Книга «React и Redux: функциональная веб-разработка»

[](https://habrahabr.ru/company/piter/blog/346754/) Привет, Хаброжители! В декабре мы издали книгу Алекса Бэнкса и Евы Порселло, цель которой — научить писать эффективные пользовательские интерфейсы при помощи React и систематизация новых технологий, позволяющая сразу же приступить к работе с React. Чтение книги не предполагает никаких предварительных знаний React. Все основы библиотеки будут представлены с самого начала. Сейчас мы рассмотрим раздел «Управление состоянием React»

До сих пор свойства использовались только для обработки данных в компонентах React. Свойства имеют неизменяемый характер. После отображения свойства компонента не изменяются. Чтобы изменить пользовательский интерфейс, понадобится другой механизм, способный заново отобразить дерево компонента с новыми свойствами. Состояние React является его неотъемлемой частью, предназначенной для управления данными, которые будут изменяться внутри компонента. Когда состояние приложения меняется, пользовательский интерфейс отображается заново, чтобы отразить эти нововведения.

Пользователи взаимодействуют с приложениями. Они перемещаются по данным, ищут их, фильтруют, выбирают, добавляют, обновляют и удаляют. Когда пользователь работает с приложением, состояние программы изменяется, и эти перемены отображаются для пользователя в UI. Появляются и исчезают экраны и панели меню. Меняется видимое содержимое. Включаются и выключаются индикаторы. В React пользовательский интерфейс отражает состояние приложения.

Состояние может быть выражено в компонентах React с единственным объектом JavaScript. В момент изменения своего состояния компонент отображает новый пользовательский интерфейс, показывающий эти изменения. Что может быть функциональнее? Получая данные, компонент React отображает их в виде UI. На основе их изменения React будет обновлять интерфейс, чтобы отразить эти перемены наиболее рациональным образом.

Посмотрим, как можно встроить состояние в наши компоненты React.

### Внедрение состояния компонента

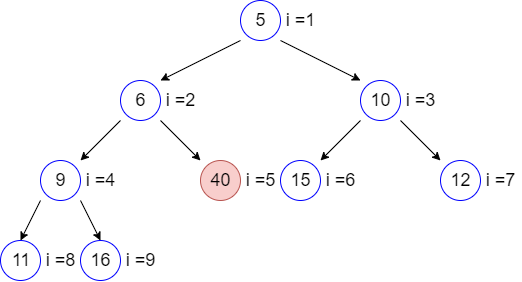

Состояние представляет данные, которые при желании можно изменить внутри компонента. Чтобы показать это, рассмотрим компонент StarRating (рис. 6.7).

Этот компонент требует два важных фрагмента данных: общее количество звезд для отображения и рейтинг, или количество выделенных звезд.

Нам нужен компонент Star, реагирующий на щелчки кнопкой мыши и имеющий свойство selected. Для каждой звезды может использоваться функциональный компонент, не имеющий состояния:

```

const Star = ({ selected=false, onClick=f=>f }) =>

Star.propTypes = {

selected: PropTypes.bool,

onClick: PropTypes.func

}

```

Каждый элемент звезды Star будет состоять из контейнера div, включающего атрибут class со значением 'star'. Если звезда выбрана, то к ней дополнительно будет добавлен атрибут class со значением 'selected'. У этого компонента также имеется дополнительное свойство onClick. Когда пользователь щелкает кнопкой мыши на контейнере div какой-нибудь звезды, вызывается данное свойство. Притом родительский компонент, StarRating, будет оповещен о щелчке на компоненте Star.

Компонент Star является функциональным, не имеющим состояния. Исходя из самого названия его категории, в таком компоненте использовать состояние невозможно. Их предназначение — входить в качестве дочерних в состав более сложных компонентов, имеющих состояние. Чем больше компонентов не имеет состояния, тем лучше.

Теперь, получив компонент Star, мы можем воспользоваться им для создания компонента StarRating. Из своих свойств компонент StarRating станет получать общее количество отображаемых звезд. А рейтинг, значение которого пользователь сможет изменять, будет сохранен в состоянии.

Сначала рассмотрим способ внедрения состояния в компонент, определенный с помощью метода createClass:

```

const StarRating = createClass({

displayName: 'StarRating',

propTypes: {

totalStars: PropTypes.number

},

getDefaultProps() {

return {

totalStars: 5

}

},

getInitialState() {

return {

starsSelected: 0

}

},

change(starsSelected) {

this.setState({starsSelected})

},

render() {

const {totalStars} = this.props

const {starsSelected} = this.state

return (

{[...Array(totalStars)].map((n, i) =>

this.change(i+1)}

/>

)}

{starsSelected} of {totalStars} stars

)

}

})

```

Используя метод createClass, состояние можно инициализировать, добавив к конфигурации компонента метод getInitialState и возвратив объект JavaScript, который изначально устанавливает для переменной состояния starsSelected значение 0.

При отображении компонента общее количество звезд, totalStars, берется из свойств компонента и применяется с целью отобразить указанное количество элементов Star. При этом для инициализации нового массива указанной длины, отображаемого на элементы Star, с конструктором Array используется оператор распространения.

Когда компонент отображается на экране, переменная состояния starsSelected деструктурируется из элемента this.state. Он используется для отображения рейтинга в виде текста в элементе абзаца, а также для подсчета количества выбранных звезд, выводимых на экран. Каждый элемент Star получает свое свойство selected путем сравнения своего индекса с количеством выбранных звезд. Если выбрано три звезды, то первые три элемента Star установят для своего свойства selected значение true, а все остальные звезды будут иметь для него значение false.

И наконец, когда пользователь щелкает кнопкой мыши на отдельно взятой звезде, индекс конкретно этого элемента Star увеличивается на единицу и отправляется функции change. Данное значение увеличивается на единицу, поскольку предполагается наличие у первой звезды рейтинга 1, даже притом, что индекс у нее равен нулю.

Инициализация состояния в классе компонента ES6 немного отличается от аналогичного процесса с использованием метода createClass. В этих классах состояние может быть инициализировано в конструкторе:

```

class StarRating extends Component {

constructor(props) {

super(props)

this.state = {

starsSelected: 0

}

this.change = this.change.bind(this)

}

change(starsSelected) {

this.setState({starsSelected})

}

render() {

const {totalStars} = this.props

const {starsSelected} = this.state

return (

{[...Array(totalStars)].map((n, i) =>

this.change(i+1)}

/>

)}

{starsSelected} of {totalStars} stars

)

}

}

StarRating.propTypes = {

totalStars: PropTypes.number

}

StarRating.defaultProps = {

totalStars: 5

}

```

При установке компонента ES6 вызывается его конструктор со свойствами, внедренными в качестве первого аргумента. В свою очередь, эти свойства отправляются родительскому классу путем вызова метода super. В данном случае родительским является класс React.Component. Вызов super инициализирует экземпляр компонента, а React.Component придает этому экземпляру функциональную отделку, включающую управление состоянием. После вызова super можно инициализировать переменные состояния нашего компонента.

После инициализации состояние функционирует точно так же, как и в компонентах, созданных с помощью метода createClass. Оно может быть изменено только путем вызова метода this.setState, который обновляет указанные части объекта состояния. После каждого вызова setState вызывается функция отображения render, обновляющая пользовательский интерфейс в соответствии с новым состоянием.

### Инициализация состояния из свойств

Значения состояния можно инициализировать с помощью поступающих свойств. Применение этой схемы может быть вызвано всего лишь несколькими обстоятельствами. Чаще всего ее задействуют при создании компонента, предназначенного для многократного применения среди приложений в различных деревьях компонентов.

При использовании метода createClass весьма приемлемым способом инициализации переменных состояния на основе поступающих свойств будет добавление метода componentWillMount. Он вызывается один раз при установке компонента, и из этого метода можно вызвать метод this.setState(). В нем также имеется доступ к this.props; следовательно, чтобы помочь процессу инициализации состояния, можно воспользоваться значениями из this.props:

```

const StarRating = createClass({

displayName: 'StarRating',

propTypes: {

totalStars: PropTypes.number

},

getDefaultProps() {

return {

totalStars: 5

}

},

getInitialState() {

return {

starsSelected: 0

}

},

componentWillMount() {

const { starsSelected } = this.props

if (starsSelected) {

this.setState({starsSelected})

}

},

change(starsSelected) {

this.setState({starsSelected})

},

render() {

const {totalStars} = this.props

const {starsSelected} = this.state

return (

{[...Array(totalStars)].map((n, i) =>

this.change(i+1)}

/>

)}

{starsSelected} of {totalStars} stars

)

}

})

render(

,

document.getElementById('react-container')

)

```

Метод componentWillMount является частью жизненного цикла компонента. Он может использоваться для инициализации состояния на основе значений свойств в компонентах, созданных с помощью метода createClass, или в компонентах класса ES6. Более подробно жизненный цикл компонента будет рассмотрен в следующей главе.

Инициализировать состояние внутри класса компонента ES6 можно более простым способом. Конструктор получает свойства в виде аргумента, поэтому просто воспользуемся аргументом props, переданным конструктору:

```

constructor(props) {

super(props)

this.state = {

starsSelected: props.starsSelected || 0

}

this.change = this.change.bind(this)

}

```

В большинстве случаев нужно избегать установки переменных состояния из свойств. Подобными схемами стоит пользоваться только в самых крайних случаях. Добиться этого не трудно, поскольку при работе с компонентами React ваша задача заключается в ограничении количества компонентов, имеющих состояние.

### Состояние внутри дерева компонента

Собственное состояние может быть у всех ваших компонентов, но должно ли оно у них быть? Причина удовольствия, получаемого от использования React, не кроется в охоте за переменными состояния по всему вашему приложению, а исходит из возможности создания простых в понимании масштабируемых приложений. Самое важное, что можно сделать с целью облегчить понимание вашей программы, — это свести к необходимому минимуму количество компонентов, использующих состояние.

Во многих приложениях React есть возможность сгруппировать все данные состояний в корневом компоненте. Данные состояний можно передать вниз по дереву компонентов через свойства, а вверх по дереву к корневому компоненту — через двустороннюю привязку функций. В результате все состояние вашего приложения в целом будет находиться в одном месте. Часто это называют «единым источником истины».

Далее мы рассмотрим, как создаются уровни презентации, где все состояния хранятся в одном месте, в корневом компоненте.

### Новый взгляд на приложение органайзера цветов

Органайзер образцов цвета позволяет пользователям добавлять, называть, оценивать и удалять цвета в видоизменяемых ими списках. Все состояние органайзера может быть представлено с помощью одного массива:

```

{

colors: [

{

"id": "0175d1f0-a8c6-41bf-8d02-df5734d829a4",

"title": "ocean at dusk",

"color": "#00c4e2",

"rating": 5

},

{

"id": "83c7ba2f-7392-4d7d-9e23-35adbe186046",

"title": "lawn",

"color": "#26ac56",

"rating": 3

},

{

"id": "a11e3995-b0bd-4d58-8c48-5e49ae7f7f23",

"title": "bright red",

"color": "#ff0000",

"rating": 0

}

]

}

```

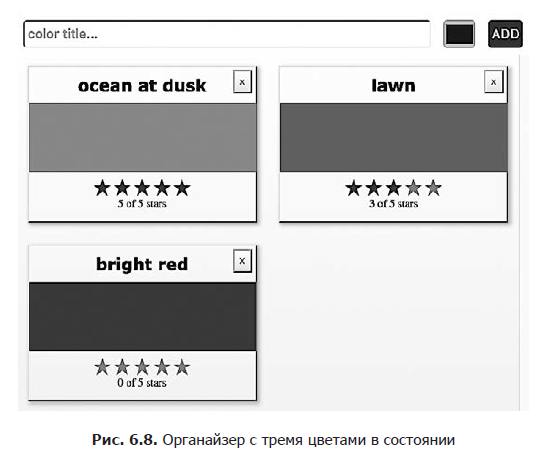

Из этого массива следует, что нам нужно отобразить три цвета: океана в сумерки (ocean at dusk), зеленого газона (lawn) и ярко-красного оттенка (bright red) (рис. 6.8). Массив предоставляет шестнадцатеричные значения, соответствующие тому или иному цвету, и текущий рейтинг для каждого из них, выводимый на экран. Он также дает возможность уникальной идентификации каждого цвета.

Эти данные состояния будут управлять приложением. Они станут использоваться для создания пользовательского интерфейса при каждом изменении этого объекта. Когда пользователи добавляют или удаляют цвета, эти образцы добавляются в массив или удаляются из него. Когда пользователи дают оценку цветам, рейтинги последних изменяются в массиве.

### Передача свойств вниз по дереву компонентов

Ранее в данной главе был создан компонент StarRating, сохраняющий рейтинг в состоянии. В органайзере цветов рейтинг сохраняется в каждом объекте цвета. Намного рациональнее будет рассматривать StarRating в качестве презентационного компонента и объявлять его как функциональный компонент, не имеющий состояния. Презентационные компоненты отвечают только за образ, создаваемый приложением на экране. Они лишь отображают элементы DOM или другие презентационные компоненты. Все данные передаются этим компонентам через свойства, а из них передаются через функции обратного вызова.

Чтобы превратить компонент StarRating в чисто презентационный, нужно убрать из него состояние. В презентационных компонентах используются только свойства. Поскольку состояние из этого компонента убирается в момент, когда пользователь изменяет оценку, соответствующие данные будут переданы из данного компонента через функцию обратного вызова:

```

const StarRating = ({starsSelected=0, totalStars=5, onRate=f=>f}) =>

{[...Array(totalStars)].map((n, i) =>

onRate(i+1)}/>

)}

{starsSelected} of {totalStars} stars

```

Во-первых, starsSelected больше не является переменной состояния, теперь это свойство. Во-вторых, к данному компоненту добавлено свойство в onRate, представляющее собой функцию обратного вызова. Вместо того чтобы при изменении пользователем оценки вызвать setState, теперь starsSelected вызывает onRate и отправляет оценку в качестве аргумента.

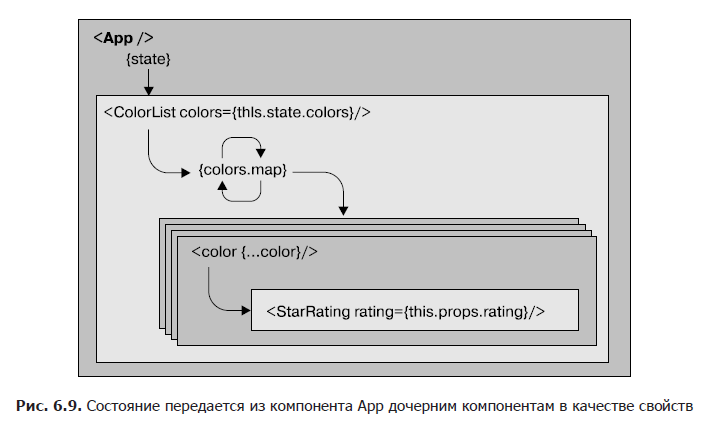

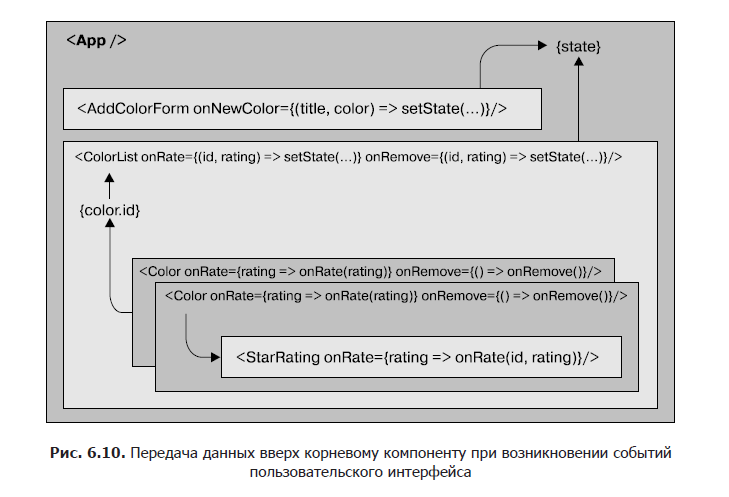

Ограничение, накладываемое на состояние, — размещение его только в одном месте, в корневом компоненте, — означает, что все данные должны передаваться вниз дочерним компонентам в качестве свойств (рис. 6.9).

В органайзере состояние складывается из массива образцов цвета, объявленного в компоненте App. Эти цвета передаются вниз компоненту ColorList в качестве свойства:

```

class App extends Component {

constructor(props) {

super(props)

this.state = {

colors: []

}

}

render() {

const { colors } = this.state

return (

)

}

}

```

Изначально массив цветов пуст, поэтому компонент ColorList вместо каждого цвета будет отображать сообщение. Когда в массиве имеются цвета, данные для каждого отдельно взятого образца передаются компоненту Color в качестве свойств:

```

const ColorList = ({ colors=[] }) =>

{(colors.length === 0) ?

No Colors Listed. (Add a Color)

:

colors.map(color =>

)

}

```

Теперь компонент Color может отобразить название и шестнадцатеричное значение цвета и передать его оценку вниз компоненту StarRating в качестве свойства:

```

const Color = ({ title, color, rating=0 }) =>

{title}

=======

```

Количество выбранных звезд, starsSelected, в звездном рейтинге поступает из оценки каждого цвета. Все данные состояния для каждого цвета переданы вниз по дереву дочерним компонентам в качестве свойств. Когда в корневом компоненте происходят изменения в данных, React, чтобы отразить новое состояние, вносит изменения в пользовательский интерфейс наиболее рациональным образом.

### Передача данных вверх по дереву компонентов

Состояние в органайзере цветов может быть обновлено только путем вызова метода setState из компонента App. Если пользователи инициируют какие-либо изменения из пользовательского интерфейса, то для обновления состояния введенные ими данные нужно будет передать вверх по дереву компонентов компоненту App (рис. 6.10). Эта задача может быть выполнена с помощью свойств в виде функций обратного вызова.

Чтобы добавить новые цвета, нужен способ уникальной идентификации каждого образца. Этот идентификатор будет использоваться для определения местоположения цвета в массиве состояния. Для создания абсолютно уникальных идентификаторов можно воспользоваться библиотекой uuid:

```

npm install uuid --save

```

Все новые цвета будут добавляться в органайзер из компонента AddColorForm, который был создан ранее в разделе «Ссылки». У этого компонента имеется дополнительное свойство в виде функции обратного вызова onNewColor. Когда пользователь добавляет новый цвет и отправляет данные формы, вызывается функция обратного вызова onNewColor с новым названием и шестнадцатеричным значением, полученными от пользователя:

```

import { Component } from 'react'

import { v4 } from 'uuid'

import AddColorForm from './AddColorForm'

import ColorList from './ColorList'

export class App extends Component {

constructor(props) {

super(props)

this.state = {

colors: []

}

this.addColor = this.addColor.bind(this)

}

addColor(title, color) {

const colors = [

...this.state.colors,

{

id: v4(),

title,

color,

rating: 0

}

]

this.setState({colors})

}

render() {

const { addColor } = this

const { colors } = this.state

return (

)

}

}

```

Все новые цвета могут быть добавлены из метода addColor в компонент App. Эта функция привязана к компоненту в конструкторе, следовательно, у нее есть доступ к this.state и к this.setState.

Новые цвета добавляются путем объединения текущего массива цветов с новым объектом цвета. Идентификатор для последнего устанавливается функцией v4, принадлежащей библиотеке uuid. Таким образом создается уникальный идентификатор для каждого цвета. Название и цвета передаются методу addColor из компонента AddColorForm. И наконец, исходным значением для оценки каждого цвета будет ноль.

Когда пользователь добавляет цвет с помощью компонента AddColorForm, метод addColor обновляет состояние, используя новый список цветов. Как только состояние будет обновлено, компонент App заново отобразит дерево компонентов, применяя новый список. После каждого вызова установки состояния setState вызывается метод отображения render. Новые данные передаются вниз по дереву в качестве свойств и служат для построения пользовательского интерфейса.

Если пользователь хочет оценить или удалить цвет, то нам нужно собрать информацию об этом образце. У каждого цвета будет кнопка удаления: если пользователь нажмет ее, то мы будем знать, что он хочет удалить данный цвет. Кроме того, в случае изменения пользователем оценки цвета с помощью компонента StarRating нам нужно изменить рейтинг этого цвета:

```

const Color = ({title,color,rating=0,onRemove=f=>f,onRate=f=>f}) =>

{title}

=======

X

```

Информация, которая будет изменяться в данном приложении, сохраняется в списке цветов. Поэтому к каждому цвету следует добавить свойства в виде функций обратного вызова onRemove и onRate, чтобы данные соответствующих событий удаления и оценки передавались вверх по дереву. Свойства в виде функций обратного вызова onRemove и onRate также будут иметься у компонента Color. Когда цвета оцениваются или удаляются, компонент ColorList должен оповестить свой родительский компонент App о том, что этот цвет нужно оценить или удалить:

```

const ColorList = ({ colors=[], onRate=f=>f, onRemove=f=>f }) =>

{(colors.length === 0) ?

No Colors Listed. (Add a Color)

:

colors.map(color =>

onRate(color.id, rating)}

onRemove={() => onRemove(color.id)} />

)

}

```

Компонент ColorList вызовет onRate, если какие-либо цвета оценены, или же onRemove при удалении каких-либо цветов. Этот компонент управляет коллекцией цветов, отображая их на отдельно взятые компоненты Color. Когда отдельно взятые цвета оцениваются или удаляются, ColorList идентифицирует цвет, который подвергся воздействию, и передает эту информацию своему родительскому компоненту через свойство в виде функции обратного вызова.

Родительским для ColorList является компонент App. В нем методы rateColor и removeColor могут быть добавлены и привязаны к экземпляру компонента в конструкторе. Как только понадобится оценить или удалить цвет, эти методы обновят состояние. Они добавлены к компоненту ColorList в качестве свойств в виде функций обратного вызова:

```

class App extends Component {

constructor(props) {

super(props)

this.state = {

colors: []

}

this.addColor = this.addColor.bind(this)

this.rateColor = this.rateColor.bind(this)

this.removeColor = this.removeColor.bind(this)

}

addColor(title, color) {

const colors = [

...this.state.colors,

{

id: v4(),

title,

color,

rating: 0

}

]

this.setState({colors})

}

rateColor(id, rating) {

const colors = this.state.colors.map(color =>

(color.id !== id) ?

color :

{

...color,

rating

}

)

this.setState({colors})

}

removeColor(id) {

const colors = this.state.colors.filter(

color => color.id !== id

)

this.setState({colors})

}

render() {

const { addColor, rateColor, removeColor } = this

const { colors } = this.state

return (

)

}

}

```

Оба метода: и rateColor, и removeColor — ожидают получения идентификатора того цвета, который оценивается или удаляется. ID записывается в компоненте ColorList и передается в качестве аргумента методам rateColor или removeColor. Метод rateColor находит оцениваемый цвет и изменяет его рейтинг в состоянии. Для создания нового массива состояния без удаленного цвета метод removeColor использует метод Array.filter.

После вызова метода setState пользовательский интерфейс отображается заново с новыми данными состояния. Все данные, изменившиеся в этом приложении, управляются из одного компонента, App. Приведенный подход существенно упрощает понимание того, какие именно данные используются приложением для создания состояния и как они будут изменены.

Компоненты React отличаются высокой надежностью. Они предоставляют четко выраженный способ управления свойствами и их проверки, обмена данными с дочерними элементами и управления данными состояния из-за пределов компонента. Эти свойства дают возможность создать превосходно масштабируемые уровни презентации.

Уже не раз упоминалось, что состояние предназначено для данных, подвергаемых изменениям. Состояние также можно использовать в вашем приложении для кэширования данных. Например, если имеется список записей, в котором пользователь может вести поиск, то этот список можно в ходе поиска сохранить в состоянии.

Часто высказываются рекомендации ограничивать присутствие состояния корневыми компонентами. Такой подход будет встречаться во многих приложениях React. Как только ваше приложение достигнет определенного размера, двусторонняя привязка данных и свойства, передаваемые явным образом, могут принести массу неудобств.

Чтобы управлять состоянием и сократить объем шаблонного кода в подобных ситуациях, можно применять шаблон проектирования Flux и Flux-библиотеки, подобные Redux.

React — относительно небольшая библиотека, и на данный момент мы рассмотрели основную часть ее функциональных возможностей. В следующей главе мы обсудим такие основные свойства компонентов React, как жизненный цикл компонента и компоненты высшего порядка.

» Более подробно с книгой можно ознакомиться на [сайте издательства](https://www.piter.com/collection/all/product/react-i-redux-funktsionalnaya-veb-razrabotka)

» [Оглавление](http://storage.piter.com/upload/contents/978544610668/978544610668_X.pdf)

» [Отрывок](http://storage.piter.com/upload/contents/978544610668/978544610668_p.pdf)

Для Хаброжителей скидка 20% по купону — **React** | https://habr.com/ru/post/346754/ | null | ru | null |

# Возможно ли подружить Gitlab CI + Docker + Systemd

Микрозаметка о том, как запустить Docker с Systemd внутри Gitlab CI Runner'a. Возможно кому-то будет полезна, возможно кто-то решал уже подобную задачу другими способами и будет интересно если поделитесь в комментариях.

**Предисловие**Был развернут Gitlab Runner внутри Docker контейнера. В какой-то момент появилась идея собирать внутри одного контейнера всю необходимую инфраструктуру (например, PostgreSQL и Tomcat) для установки приложения после этапа компиляции и прогона автотестов. Сам контейнер инфраструктуры был уже собран на основе образа Debian с Systemd и отлично работал. Но при использовании внутри Runner'a начались неожиданные проблемы. Код шага был для простоты допустим будет такой:

```

run-autotests:

image: debian/systemd

before_script:

- cp backend.jar /opt/

- cd /opt

script:

- java -jar autotests.jar

```

Кажется все нормальным, но при запуске шаг свалится с ошибкой, что systemd не запущен как процесс с ID 1 или возможно другая ошибка будет, что systemd вообще не запущен.

Казалось бы в чем проблема?

Как выяснилось — по свежим issue на самом Gitlab я не один такой столкнулся с этой проблемой.

Проблема в том, что Gitlab Runner для Docker контейнера всегда переписывает команду CMD, т.е. запускает контейнер такой командой:

```

docker run --cmd /bin/bash ...

```

И переопределить гитлабовскую CMD нельзя, можно использовать только entrypoint внутри ci скрипта, но танцы с ним ни к чему не привели.

Все роли были покрыты тестами molecule и они успешно проходили тесты внутри GitLab runner'a. Обратив на это внимание я подумал, а почему бы не запускать контейнер с systemd внутри запущенного Runner'a, г\*мор, конечно, но результат мне был важнее сложностей. Просто запускать с помощью докеровских команд контейнер можно, но не эффективно, да и обработки ошибок не будет — как-то слишком не предсказуемый результат может получиться, поэтому решил написать маленькую поделку на Python, которая просто будет запускать контейнер, копировать в него архив с нужными файлами и выполнять список команд внутри контейнера.

→ Код лежит здесь: [GitHub](https://github.com/seregaSLM/gitlab-ci-docker-systemd)

Запустить можно так:

```

cd

pip install virtualenv

virtualenv venv

source venv/bin/activate

pip install -r requirements.txt

python main.py \

--image dramaturg/docker-debian-systemd # используемый образ

[--network host] # тип сети если требуется

[--volumes] "/sys/fs/cgroup:/sys/fs/cgroup:ro" "<другие>" # данный volume обязателен для systemd, можно дописать свои через пробел

[--cmd] "/lib/systemd/systemd" # команда, которую нужно выполнить во время запуска, если нужно переопределить из контейнера

[--data-archive] /opt/data.tar # полный путь до архива \*.tar или \*.tar.gz

[--data-unarchive-path] /opt/data/logs # путь куда будет разархивированы файлы, будет создан если не существует

[--privileged] # для запуска systemd обязателен, вопрос с более низкими привилегиями не рассматривался

--exec-commands "touch /opt/example.log" "{bash} ls -la /opt" "mkdir -p /opt/tmp" # список команд в кавычках разделенных пробелом

```

Команды в [] необязательны. Специальный макрос {bash} нужен для команд, которые требуют оболочки, например, ls -la и др. Он будет заменен в процессе выполнения на **/bin/bash -c «command»**.

На Python'e писал первый раз, так что не стоит ругать. Возможно в коде или при запуске возникнут проблемы, попытаюсь быстро исправить. Здесь я попытался объяснить общую простую идею способа запуска. Поделитесь опытом своих решений если возникали похожие проблемы.

**Об используемом образе dramaturg/docker-debian-systemd**К данному образу претензий нет, но по началу возникала ошибка, которая всплывала в консоли хостовой машины, что некоторые файлы, которые создает systemd уже существуют. В Nginx сервисе не было такой проблемы, а в PostgreSQL проявлялись. Решением оказалось удаление блока «VOLUME [ „/sys/fs/cgroup“, „/run“, „/run/lock“, „/tmp“ ]», после этого все заработало как часы. | https://habr.com/ru/post/413375/ | null | ru | null |

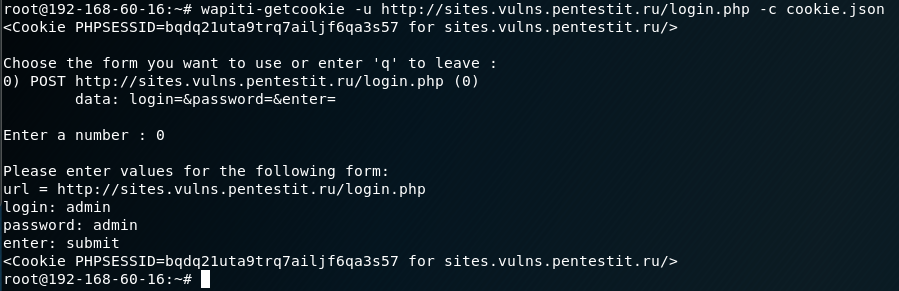

# Мы два года развивали свою систему мониторинга. Кликай, чтобы…

Всем привет!

Я уже рассказывал в этом блоге об [организации модульной системы мониторинга](https://habr.com/ru/company/avito/blog/335410/) для микросервисной архитектуры и о [переходе с Graphite+Whisper на Graphite+ClickHouse для хранения метрик](https://habr.com/ru/company/avito/blog/343928/) в условиях высоких нагрузок. После чего мой коллега [Сергей Носков](https://habr.com/ru/users/albibek/) [писал](https://habr.com/ru/company/avito/blog/354714/) о самом первом звене нашей системы мониторинга — разработанном нами [Bioyino](http://bit.ly/2Noxg1M), распределённом масштабируемом агрегаторе метрик.

Пришло время немного освежить информацию о том как мы готовим мониторинг в Авито — последняя наша статья была аж в далеком 2018 году, и за это время было несколько интересных изменений в архитектуре мониторинга, управлении триггерами и нотификациями, различные оптимизации данных в ClickHouse и прочие нововведения, о которых я как раз и хочу вам рассказать.

Но давайте начнем по порядку.

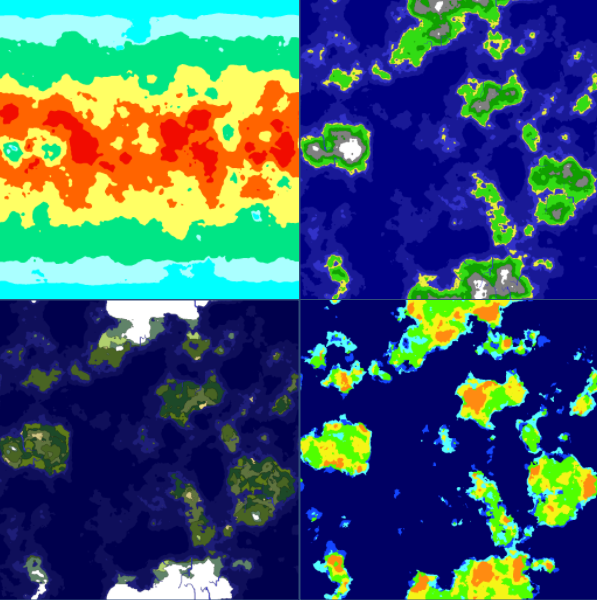

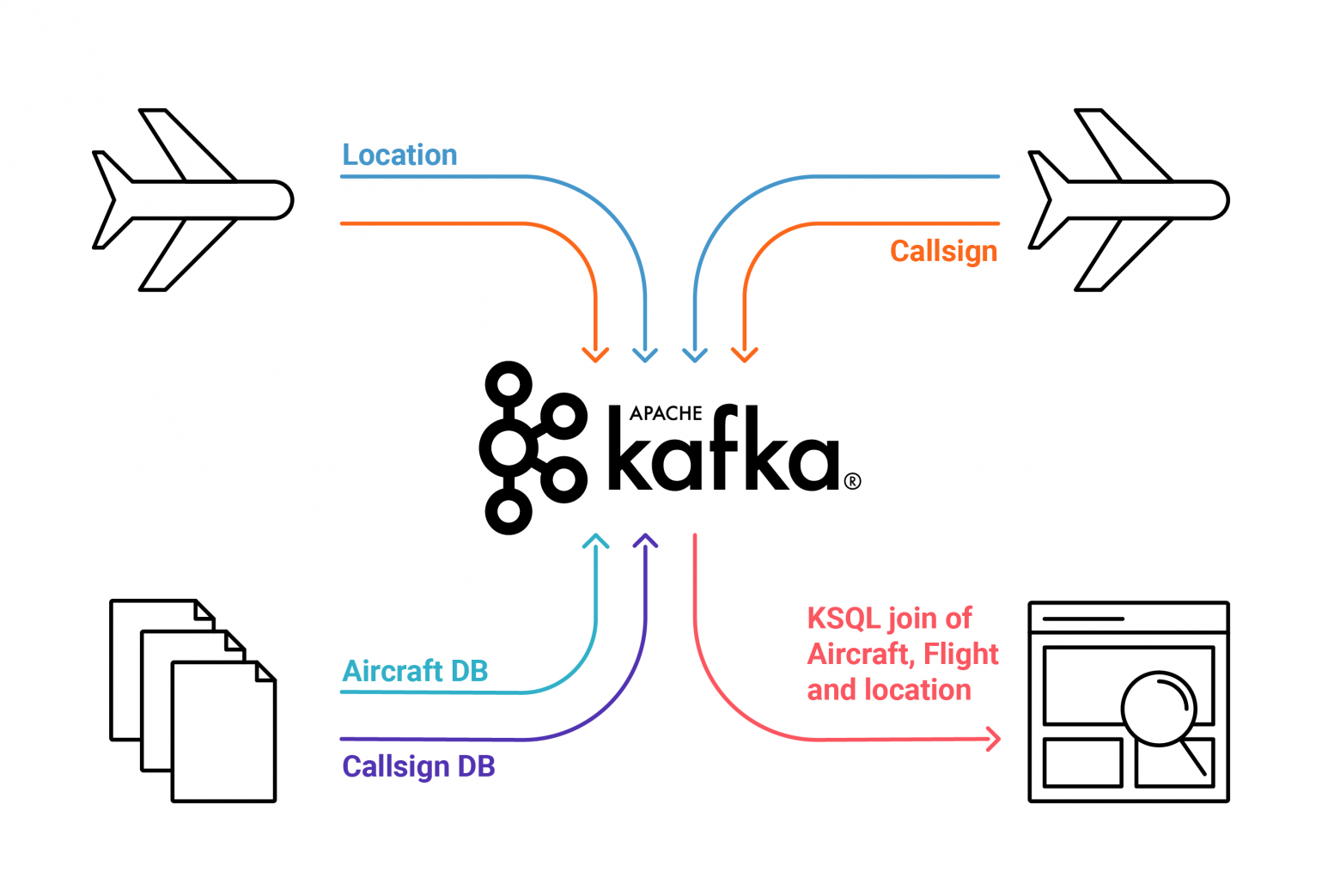

[В далеком 2017](https://habr.com/ru/company/avito/blog/335410/) я показывал схему взаимодействия компонентов, актуальную на тот момент, и хотел бы продемонстрировать её еще раз, дабы вам не пришлось лишний раз переключаться по вкладкам.

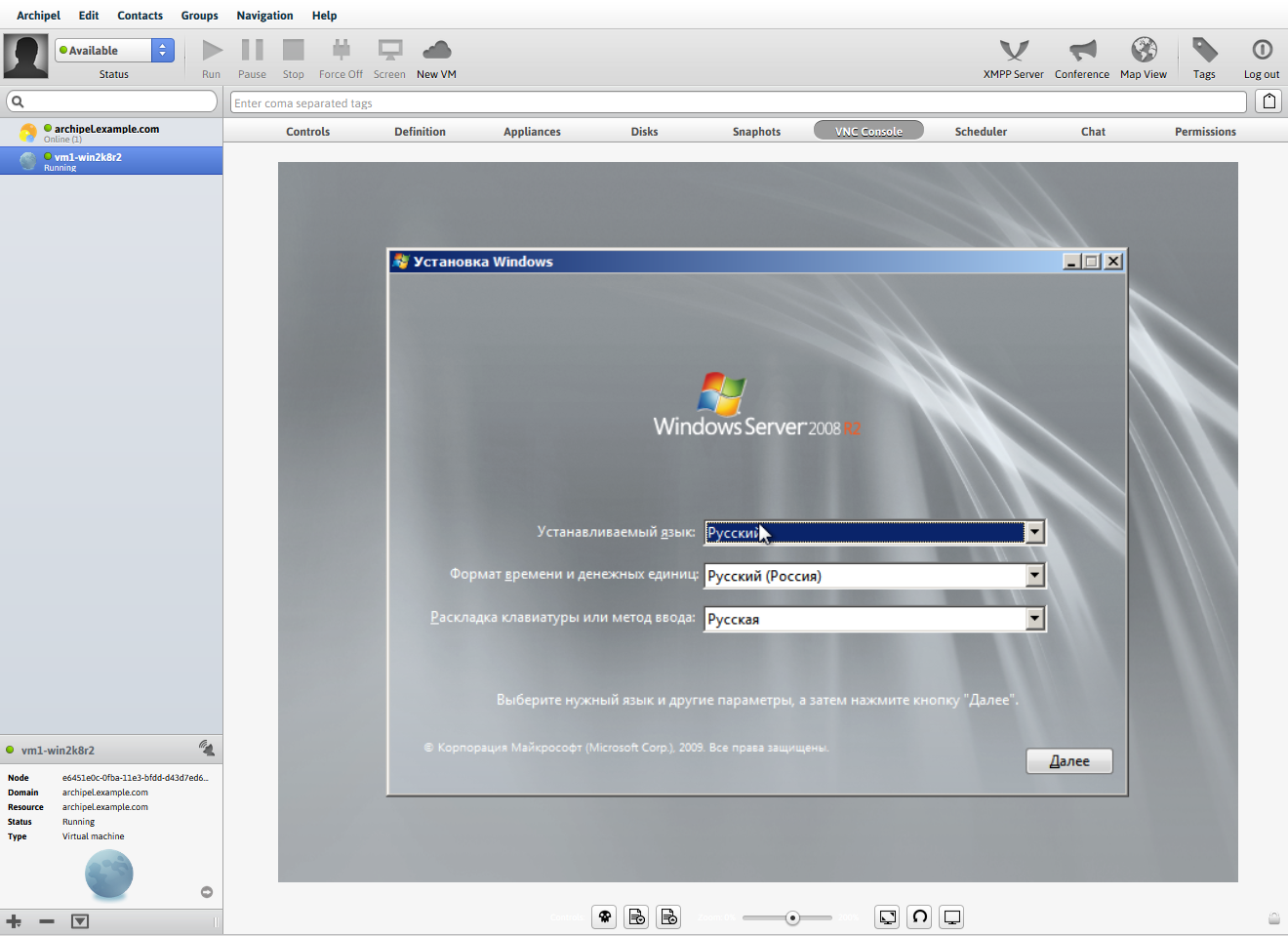

[](https://hsto.org/web/496/bcb/c37/496bcbc373834816b098a71ca4298906.JPG)

С того момента произошло следующее.

* Количество серверов в кластере Graphite выросло с 3 до 6.

(`56 CPU 2.60GHz, 384GB RAM, 10 SSD SAS 745GB, Raid 6, 10GBit/s Net`).

* Мы заменили [brubeck](https://github.com/github/brubeck) на [bioyino](https://github.com/avito-tech/bioyino) — нашу собственную имплементацию [StatsD](https://github.com/statsd/statsd) на Rust, и даже целую [статью про это написали](https://habr.com/ru/company/avito/blog/354714/). Правда, после выхода статьи мы подвезли в него поддержку тегов (Graphite) и [Raft](https://github.com/Albibek/raft-consensus) для выбора лидера.

* Мы проработали возможность использовать [bioyino](https://github.com/avito-tech/bioyino) в качестве StatsD-агента и разместили такие агенты рядом с инстансами монолита, а также там, где это было необходимо в k8s.

* Мы наконец-то избавились от старой системы мониторинга Munin (формально она у нас ещё есть, но её данные уже нигде не используются).

* Сбор данных из кластеров Kubernetes был организован через Prometheus/Federations, так как Heapster в новых версиях Kubernetes не поддержали.

Мониторинг

==========

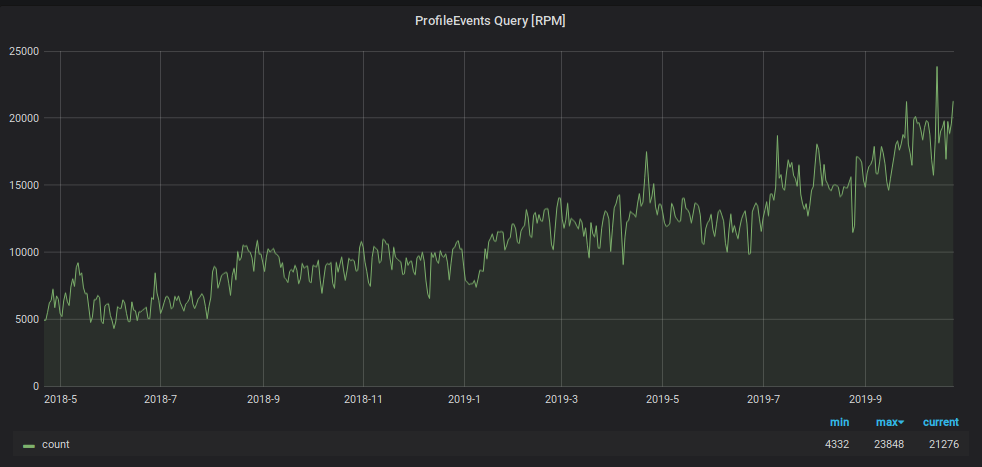

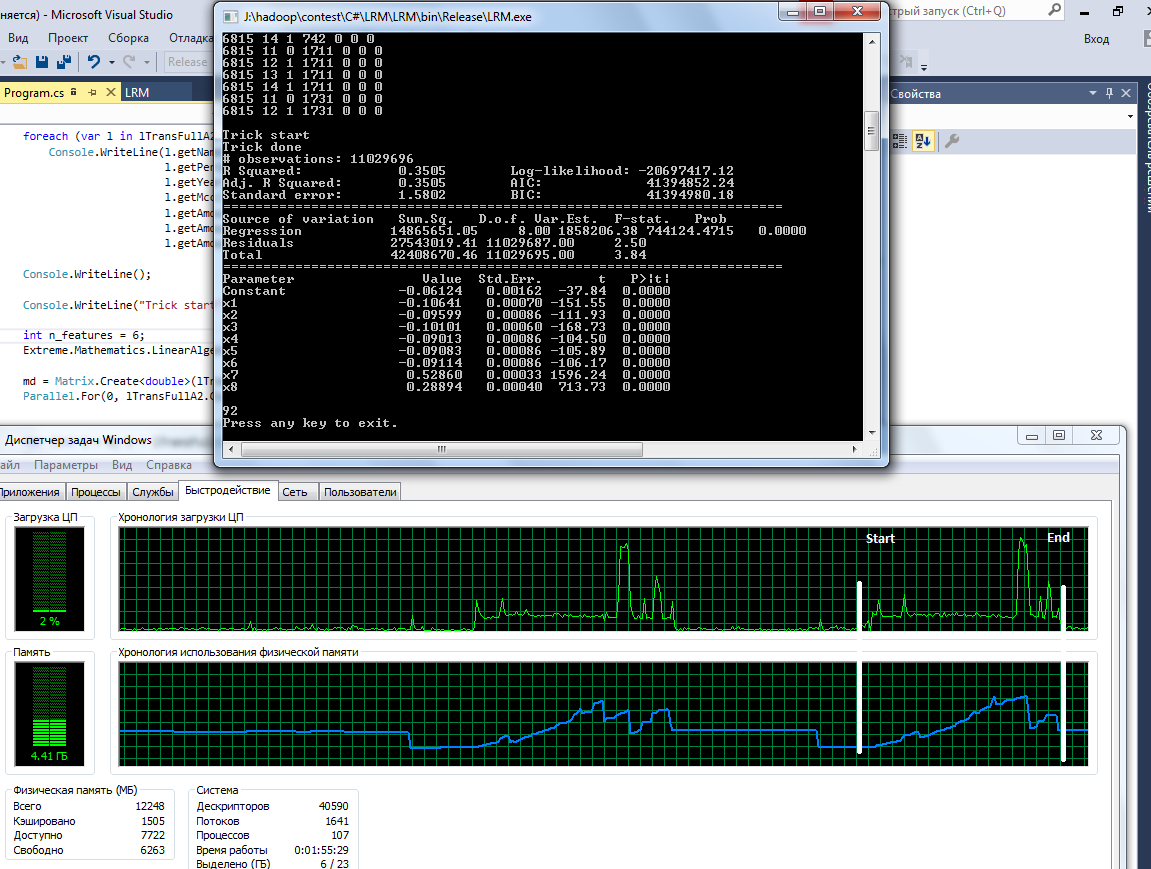

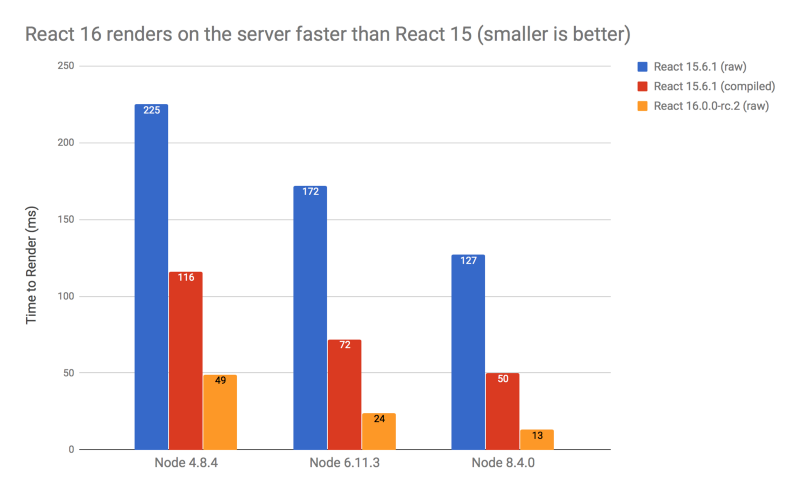

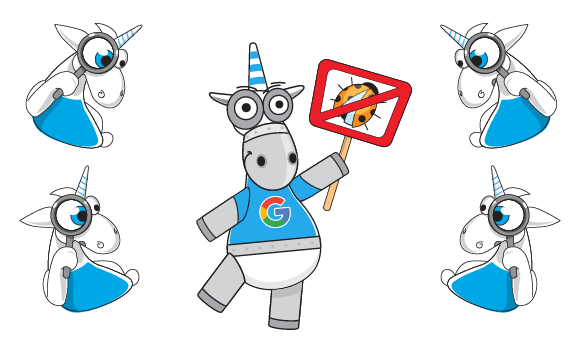

За два прошедших года количество принимаемых и обрабатываемых метрик выросло примерно в 9 раз.

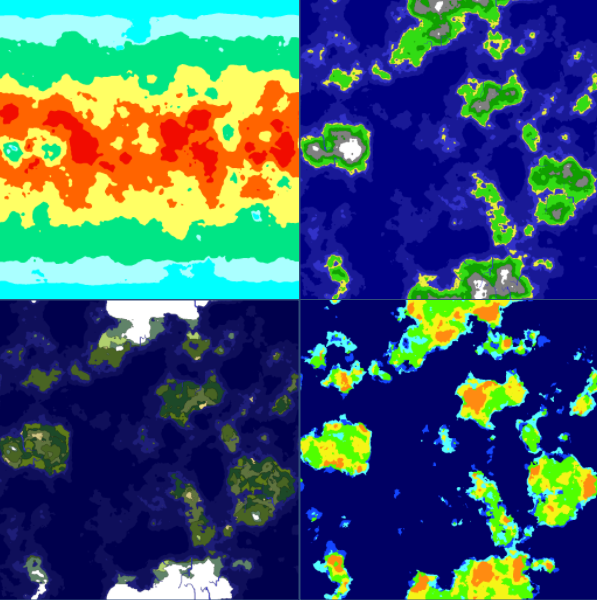

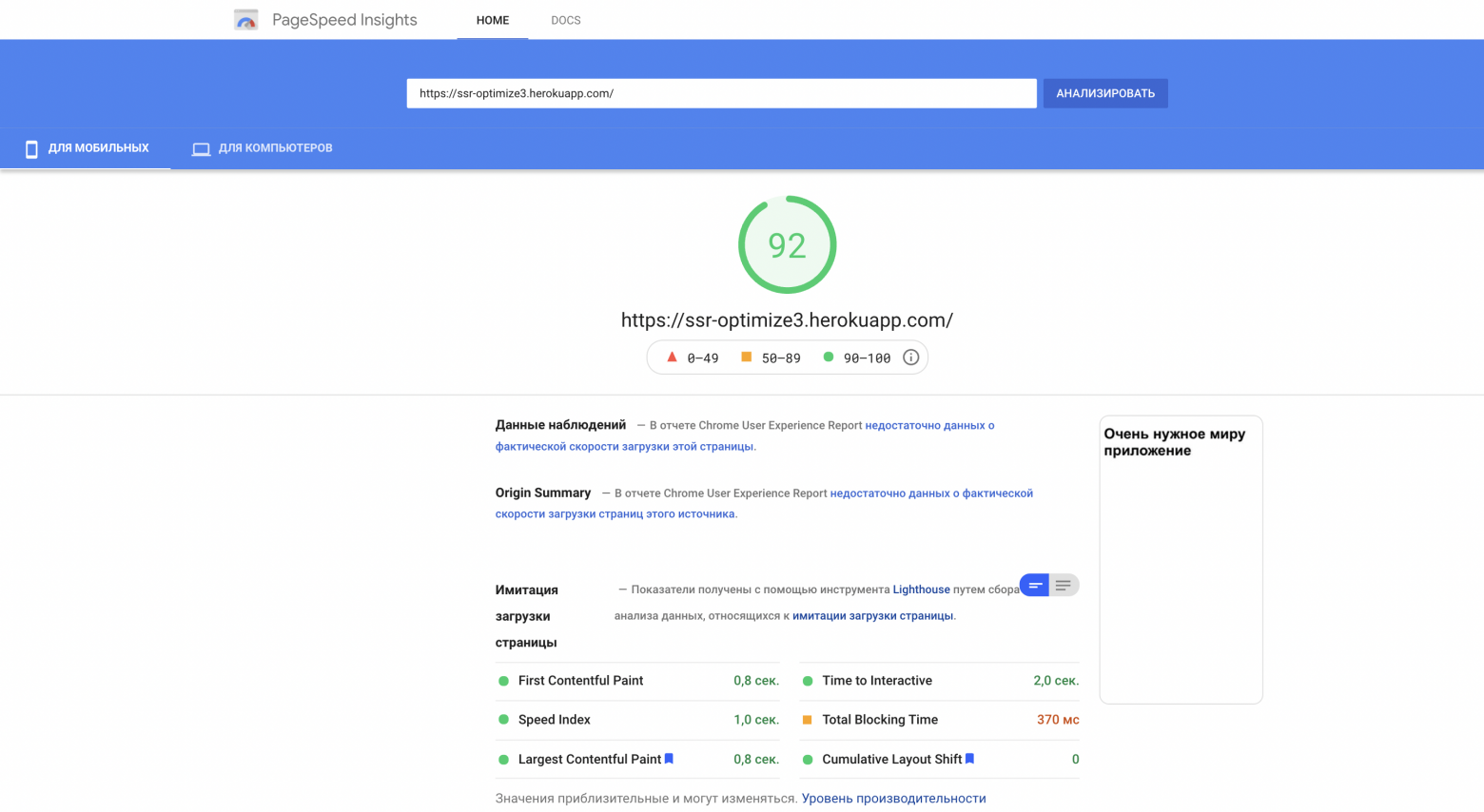

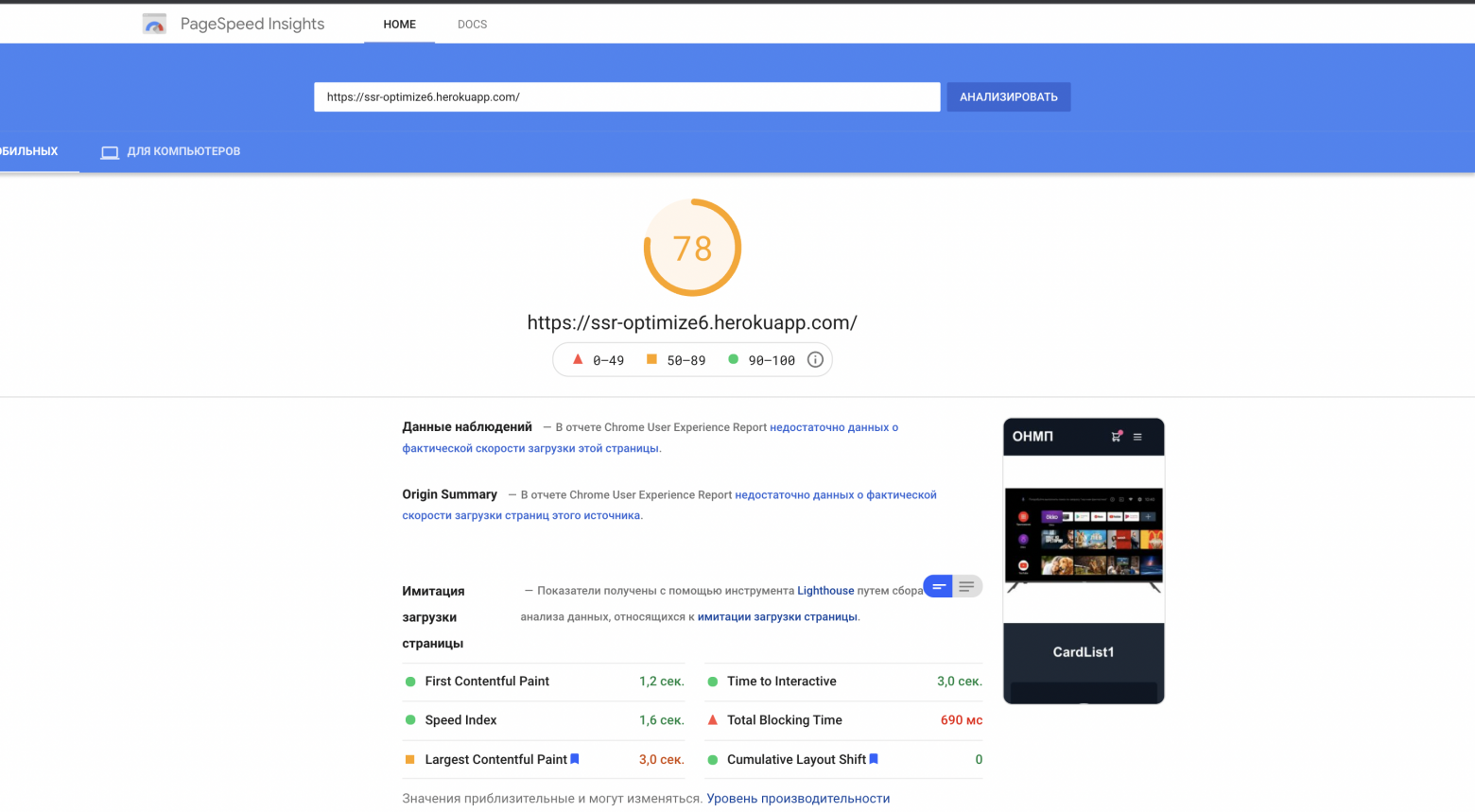

[](https://habrastorage.org/webt/r2/yu/zm/r2yuzm1rt5ok64zh2utwrpdtzbk.png)

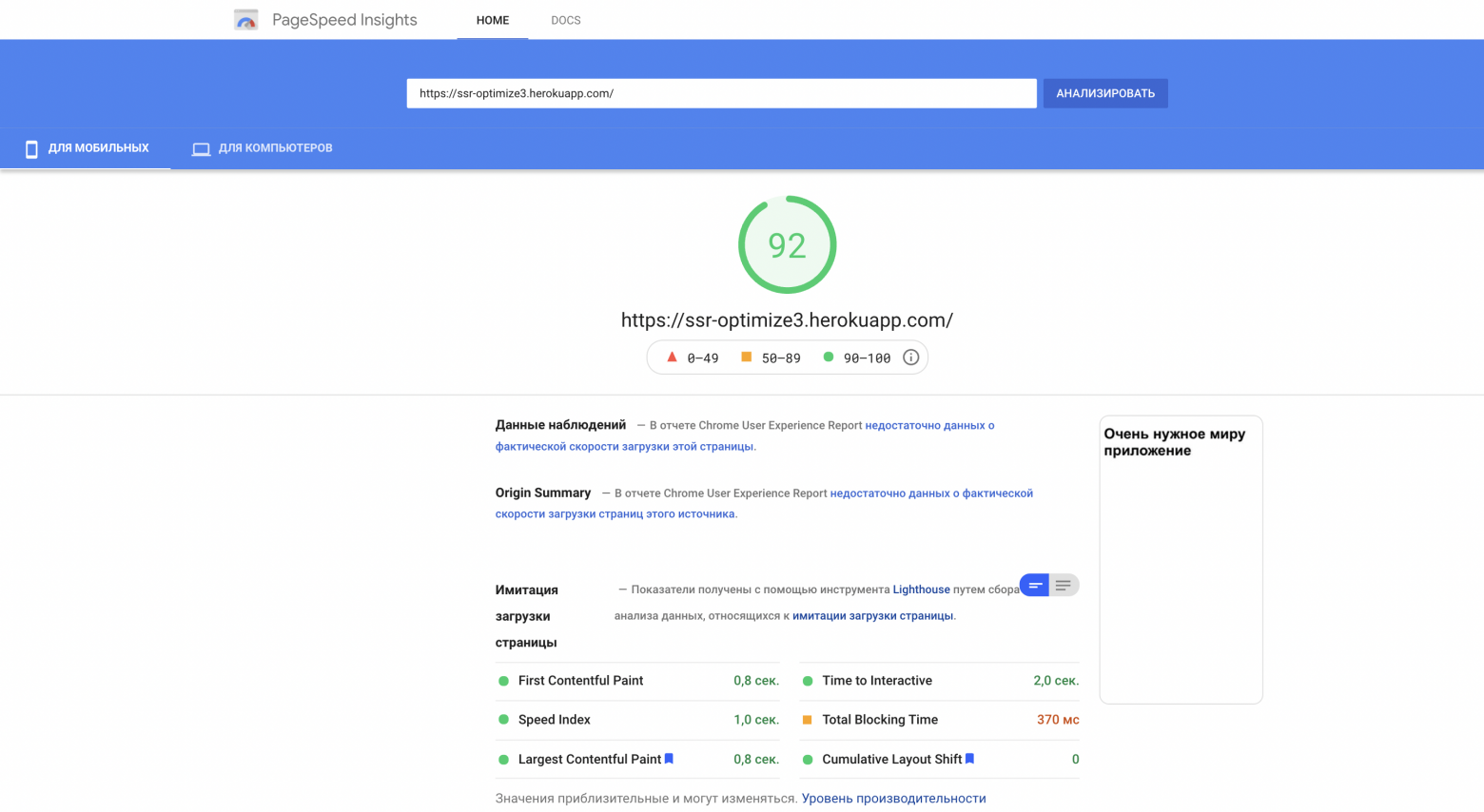

Процент занимаемого места на серверах также неумолимо ползёт вверх, и мы предпринимаем различные шаги по его понижению. Это хорошо видно на графике.

[](https://habrastorage.org/webt/s2/uj/ml/s2ujmlqnrsoo0yb0kgtxkdcf4ek.png)

Что именно мы делаем?

* Начали применять комплексные методы сжатия на колонки с данными.

```

ALTER TABLE graphite.data MODIFY COLUMN Time UInt32 CODEC(Delta, ZSTD)

```

* Продолжаем схлопывать данные старше пяти недель с тридцатисекундных интервалов до пятиминутных. Для этого у нас есть задание cron, которое раз в месяц запускает (примерно) следующую процедуру:

```

10 10 10 * * clickhouse-client -q "select distinct partition from system.parts where active=1 and database='graphite' and table='data' and max_date between today()-55 AND today()-35;" | while read PART; do clickhouse-client -u systemXXX --password XXXXXXX -q "OPTIMIZE TABLE graphite.data PARTITION ('"$PART"') FINAL";done

```

* Мы расшардировали таблицы с данными. Теперь у нас три шарда по две реплики в каждом с ключом шардирования по хэшу от имени метрики. Такой подход дает нам возможность производить [rollup процедуры](https://clickhouse.yandex/docs/ru/operations/table_engines/graphitemergetree/#konfiguratsiia-rollup), так как все значения по конкретной метрике находятся в пределах одного шарда, а дисковое пространство на всех шардах утилизируется равномерно.

Схема [Distributed таблицы](https://clickhouse.yandex/docs/ru/operations/table_engines/distributed/) выглядит следующим образом.

```

CREATE TABLE graphite.data_all (

`Path` String,

`Value` Float64,

`Time` UInt32,

`Date` Date,

`Timestamp` UInt32

)

ENGINE = Distributed (

'graphite_cluster',

'graphite',

'data',

jumpConsistentHash(cityHash64(Path), 3)

)

```

Мы также назначили пользователю "default" readonly-права и перекинули выполнение процедур записи в таблицы на отдельного пользователя `systemXXX`.

Конфигурация кластера Graphite в ClickHouse выглядит следующим образом.

```

true

graphite-clickhouse01

9000

systemXXX

XXXXXX

graphite-clickhouse04

9000

systemXXX

XXXXXX

true

graphite-clickhouse02

9000

systemXXX

XXXXXX

graphite-clickhouse05

9000

systemXXX

XXXXXX

true

graphite-clickhouse03

9000

systemXXX

XXXXXX

graphite-clickhouse06

9000

systemXXX

XXXXXX

```

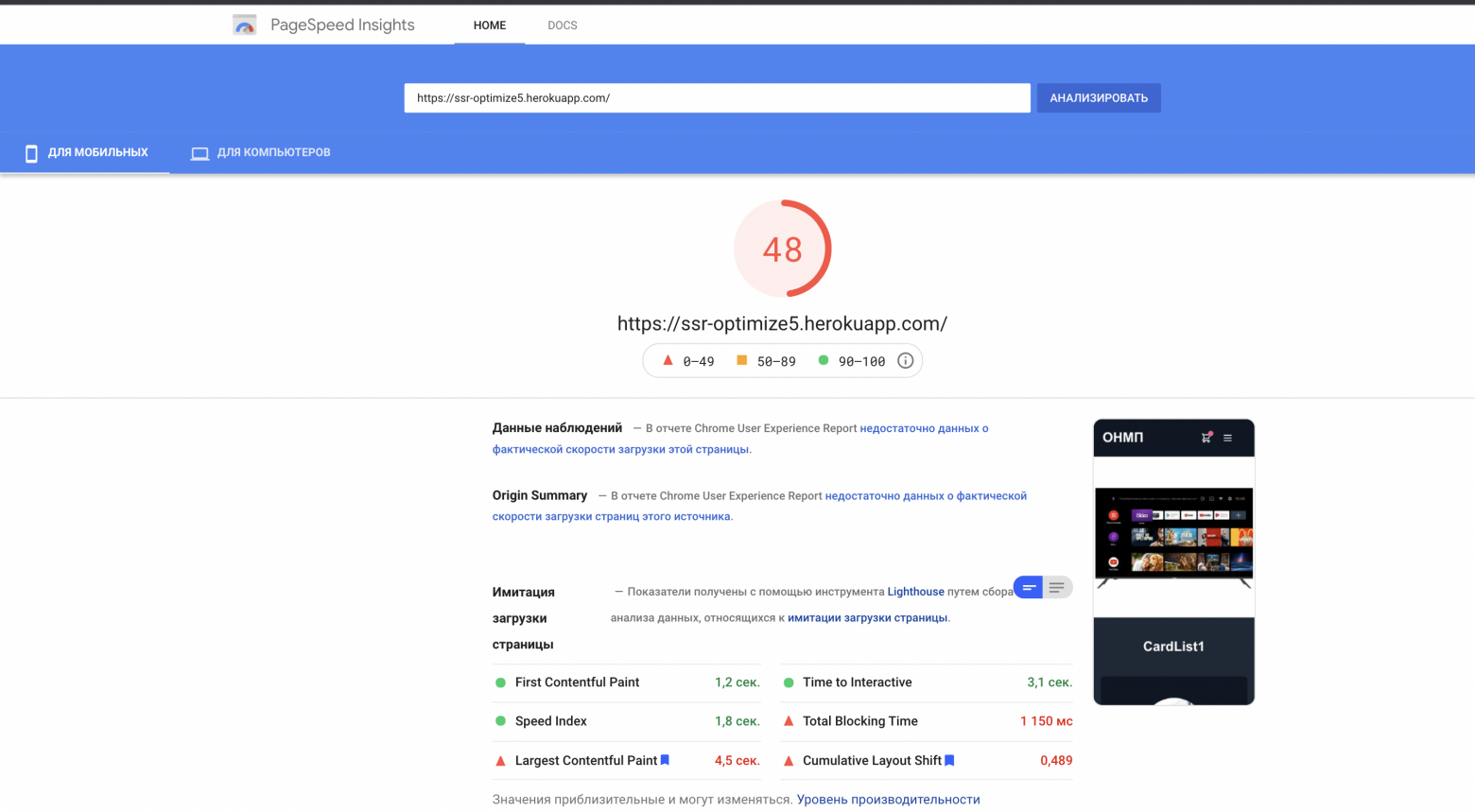

Помимо нагрузки на запись, выросло количество запросов на чтение данных из Graphite. Эти данные используются для:

* обработки триггеров и формирования алертов;

* отображения графиков на мониторах в офисе и экранах ноутбуков и ПК растущего числа сотрудников компании.

[](https://habrastorage.org/webt/ch/rb/wh/chrbwhdiyl3x3cxjqmwgtohph6y.png)

Чтобы мониторинг не утонул под этой нагрузкой, мы использовали ещё один хак: данные за последние два дня мы храним в отдельной «маленькой» табличке, и все читающие запросы за последние два дня мы отправляем туда, снижая нагрузку на основную шардированную таблицу. Так же для этой «маленькой» таблички мы применили реверсивную схему хранения метрик, что значительно ускорило поиск находящихся в ней данных и организовали для неё дневное партиционирование. Cхема этой таблички выглядит следующим образом.

```

CREATE TABLE graphite.data_reverse (

`Path` String,

`Value` Float64,

`Time` UInt32 CODEC(Delta(4), ZSTD(1)),

`Date` Date,

`Timestamp` UInt32

)

ENGINE = ReplicatedGraphiteMergeTree (

'/clickhouse/tables/{cluster}/data_reverse',

'{replica}',

'graphite_rollup'

) PARTITION BY Date

ORDER BY (Path, Time)

SETTINGS index_granularity = 4096

```

Чтобы направлять в неё данные, мы добавили в конфигурационный файл приложения [carbon-clickhouse](https://github.com/lomik/carbon-clickhouse) новую секцию.

```

[upload.graphite_reverse]

type = "points-reverse"

table = "graphite.data_reverse"

threads = 2

url = "http://systemXXX:XXXXXXX@localhost:8123/"

timeout = "60s"

cache-ttl = "6h0m0s"

zero-timestamp = true

```

Чтобы удалять партиции старше двух дней, мы написали задание cron. Оно выглядит примерно так.

```

1 12 * * * clickhouse-client -q "select distinct partition from system.parts where active=1 and database='graphite' and table='data_reverse' and max_date

```

Чтобы читать из таблицы данные, в конфигурационном файле [graphite-clickhouse](https://github.com/lomik/graphite-clickhouse) добавили секцию:

```

[[data-table]]

table = "graphite.data_reverse"

max-age = "48h"

reverse = true

```

В результате мы имеем таблицу с 100% данных, реплицированных на все шесть серверов, которые обрабатывают всю читающую нагрузку от запросов с окном менее двух суток (а таких у нас 95%). А также мы имеем шардированную таблицу с 1/3 данных на каждом шарде, обеспечивающую чтение всех исторических данных. И пусть таких запросов кратно меньше, нагрузка от них значительно выше.

Что же происходит с CPU?! В результате роста объемов записываемых и читаемых данных в кластере Graphite, выросла и суммарная CPU-нагрузка на серверы. Выглядит она примерно так.

[](https://habrastorage.org/webt/_u/mg/m3/_umgm3dd9lgetkopu45jjrqqodw.png)

Хочется обратить внимание на следующий нюанс: половина CPU уходит на парсинг и первичную обработку метрик в [carbon-c-relay](https://github.com/grobian/carbon-c-relay) (v3.2 от 2018-09-05, отвечает за транспорт метрик), который размещен на трёх серверах из шести. Как видно по графику, именно эти три сервера и находятся в ТОПе.

Алертинг

========

В качестве системы алертинга у нас по-прежнему [Moira](https://github.com/moira-alert) и написанный под неё [moira-client](https://github.com/moira-alert/python-moira-client). Для гибкого управления триггерами, нотификациями и эскалациями, мы используем декларативное описание, которое назвали alert.yaml. Оно генерируется автоматически при создании сервиса через PaaS (подробнее об этом можно почитать в статье Вадима Мадисона [«Что мы знаем о микросервисах»](https://habr.com/ru/company/avito/blog/454780/)) и размещается в его репозитории. Для работы с alert.yaml мы сделали обвязку над moira-client и назвали её alert-autoconf (планируем заопенсорсить). В сборке сервиса в TeamCity есть шаг с экспортом триггеров и нотификаций в Moira через alert-autoconf. При коммите изменений в alert.yaml запускаются автотесты, которые проверяют валидность yaml-файла, а также делают запросы в Graphite по каждому шаблону метрик с целью проверить их корректность.

Для инфраструктурных команд, не использующих PaaS, мы организовали отдельный репозиторий под названием Alerting. В нем сделали структуру вида: Команда/Проект/alert.yaml. К каждому alert.yaml мы генерируем отдельную сборку в TeamCity, которая прогоняет тесты и пушит содержимое alert.yaml в Moira.

Таким образом все наши сотрудники могут управлять своими триггерами, нотификациями и эскалациями, используя единый подход.

Так как раньше у нас уже были триггеры, заведённые через GUI, мы реализовали возможность выгрузить их в формате yaml. Содержимое полученного yaml-документа можно вставить в alert.yaml практически без дополнительных преобразований, после чего запушить изменения в мастер. В ходе сборки alert-autoconf поймет, что такой триггер уже существует и зарегистрирует его в нашем реестре в Redis.

А ещё не так давно мы обзавелись дежурной сменой инженеров 24х7. Для того, чтобы передать триггеры им на обслуживание, достаточно в своем alert.yaml корректно заполнить описание «что делать, если ты это видишь», поставить тег [24x7] и запушить изменения в мастер. После раскатки alert.yaml'а все описанные в нем триггеры автоматически попадут под круглосуточное наблюдение смены 24х7. У — Упрощай! Красота!

Сбор бизнес-метрик

==================

С момента выхода прошлой [статьи](https://habr.com/ru/company/avito/blog/354714/) про сбор и обработку бизнес-метрик наш [bioyino](http://bit.ly/2Noxg1M) стал ещё лучше.

1. Вместо выбора лидера через [Consul](https://www.consul.io/) используется встроенный [Raft](https://github.com/Albibek/raft-consensus).

2. Корректно обрабатываются [теги в формате Graphite](https://graphite.readthedocs.io/en/latest/tags.html).

3. Появилась возможность использовать [bioyino](https://github.com/avito-tech/bioyino) (StatsD-server) в качестве агента.

4. Для подсчета уникальных значений поддерживается формат "set".

5. Финальную агрегацию метрик можно делать в несколько потоков.

6. Данные можно отправлять в Graphite чанками в несколько параллельных соединений.

7. Исправлены все найденные баги.

Сейчас это работает так.

Мы стали активно внедрять StatsD-агенты рядом со всеми крупными крупными генераторами метрик: в контейнерах с инстансами монолита, в подах k8s рядом с сервисами, на хостах с инфраструктурными компонентами и т. д.

Statsd-агент размещается рядом с приложением. Он принимает метрики от этого приложения всё так же по UDP, но уже не используя сетевую подсистему (за счёт оптимизаций в ядре Linux). Все события предагрегируются, и собранные данные ежесекундно (интервал можно настроить) отправляются в основной кластер серверов StatsD (bioyino0[1-3]) в формате Cap’n Proto.

Дальнейшая обработка и агрегация метрик, выбор лидера в StatsD-кластере и отправка лидером метрик в Graphite практически не изменились. Про это вы можете подробно прочитать [в нашей прошлой статье](https://habr.com/ru/company/avito/blog/354714/).

Что же касается цифр, то они следующие.

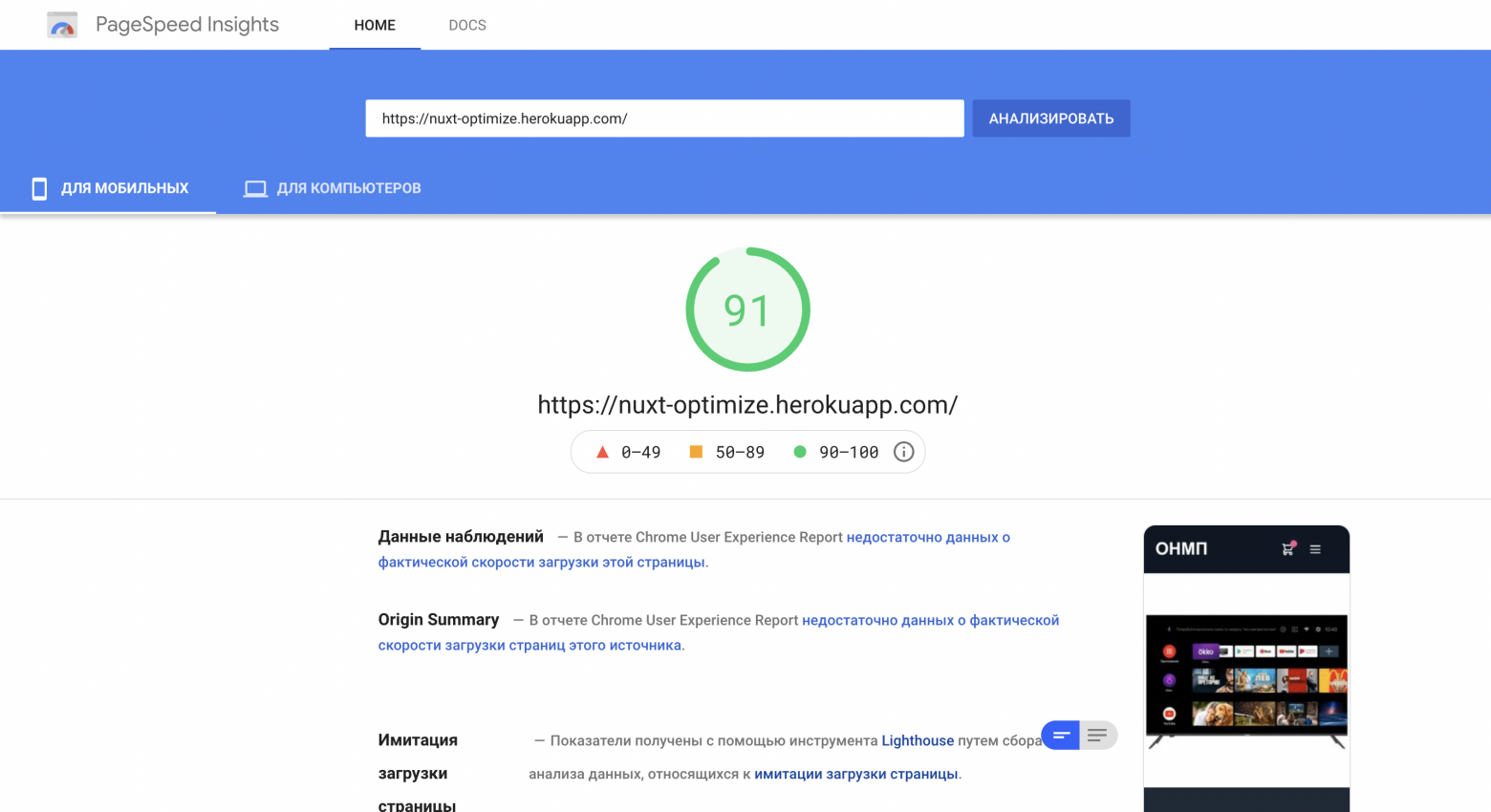

*График полученных StatsD-событий*

[](https://habrastorage.org/webt/m2/td/56/m2td56sycgexhmsupyp7nfmp2hw.png)

*График метрик, отправленных из StatsD в Graphite*

[](https://habrastorage.org/webt/m2/td/56/m2td56sycgexhmsupyp7nfmp2hw.png)

Итого

=====

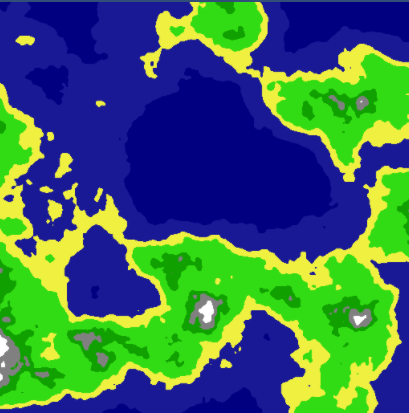

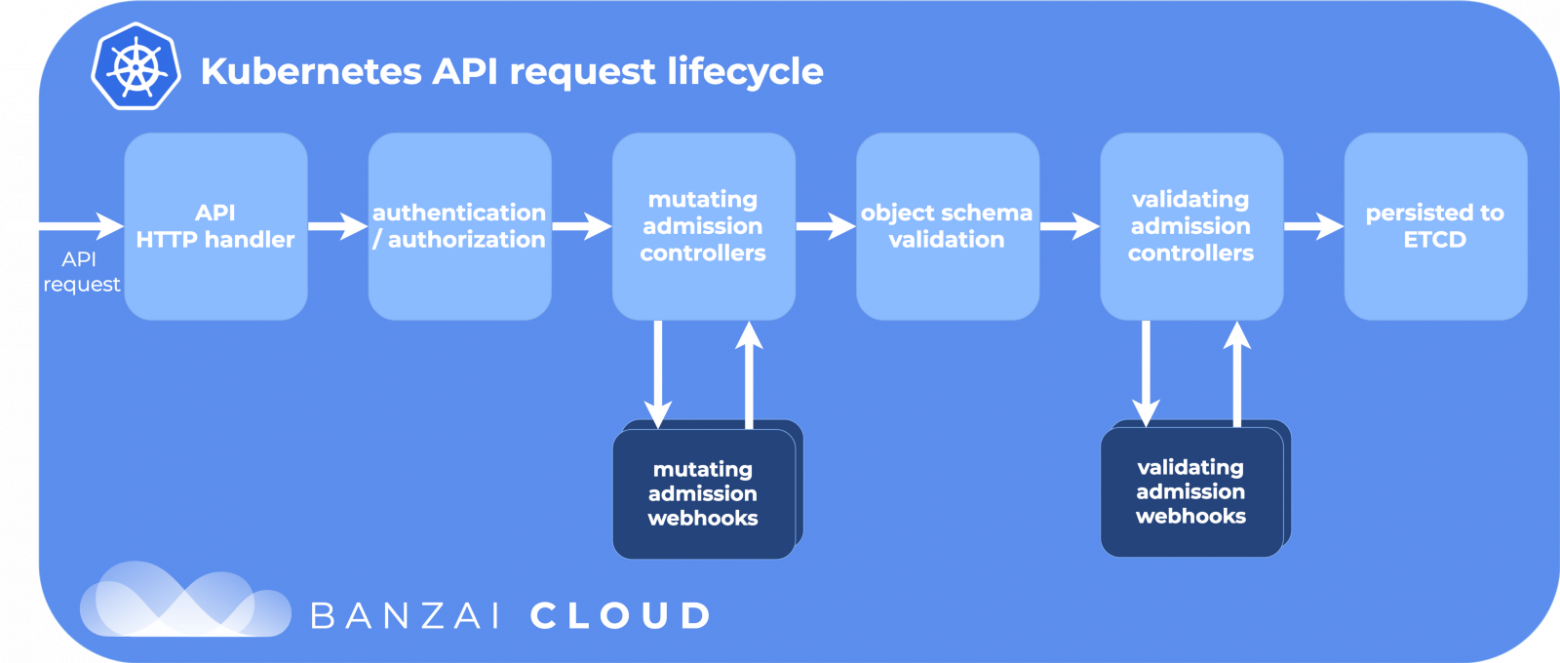

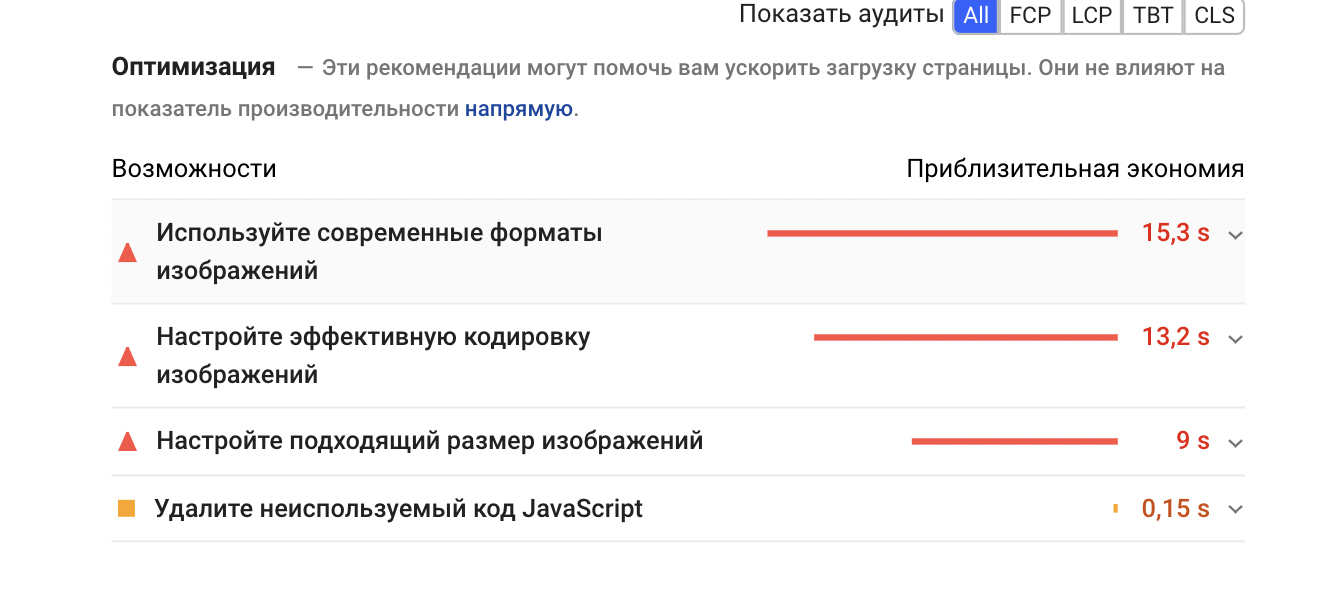

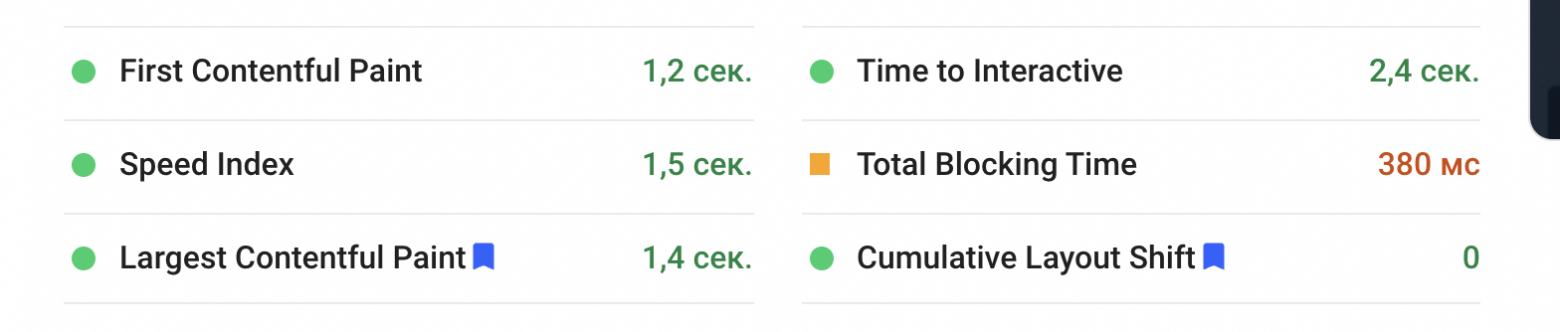

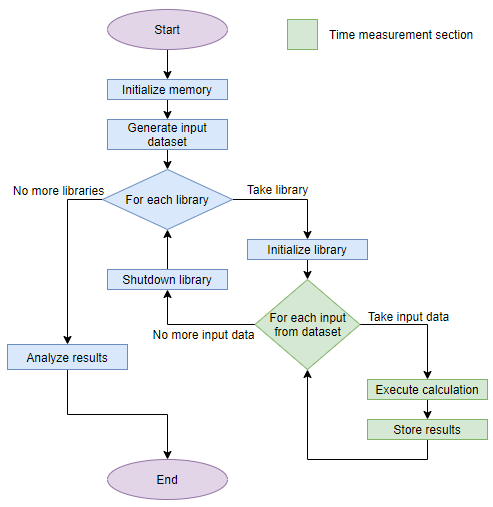

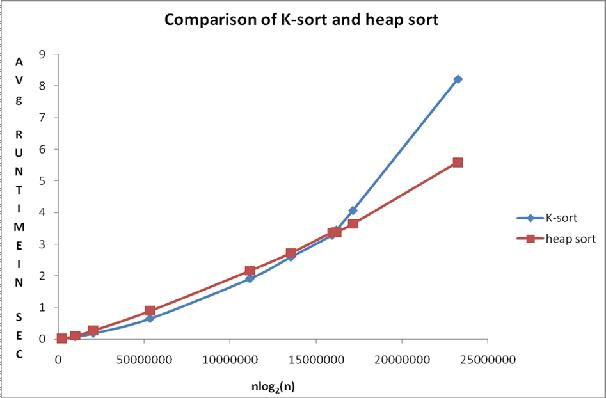

Общая схема взаимодействия компонентов мониторинга на данный момент выглядит так.

[](https://habrastorage.org/webt/n6/ym/-b/n6ym-bcuyt3a3ctoda93lassduo.png)

Суммарное количество значений метрик: 2 189 484 898 474.

Общая глубина хранения метрик: 3 года.

Количество уникальных имен метрик: 6 585 413 171.

Количество триггеров: 1053, они обслуживают от 1 до 15k метрик.

**Планы на ближайшее будущее:**

* начать переводить продуктовые сервисы на тегированную схему хранения метрик;

* добавить в кластер Graphite еще три сервера;

* подружить Moira с [персистентной тканью](https://habr.com/ru/company/avito/blog/462937/);

* [найти](http://bit.ly/2NkYzuF) ещё одного разработчика в команду мониторинга.