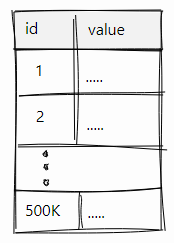

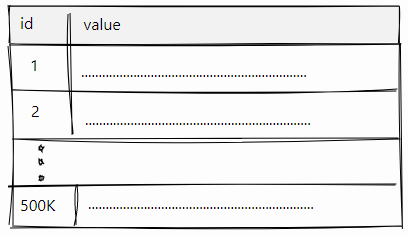

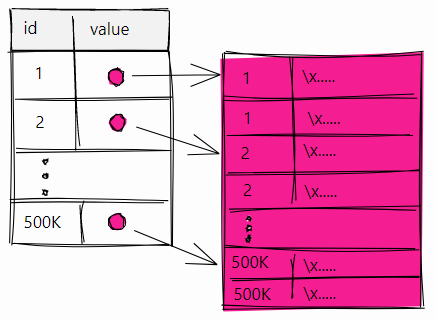

text

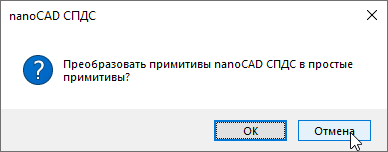

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Дайджест интересных материалов из мира Drupal #7

Всем привет!

Самое интересное и полезное из мира Drupal за прошедшие 3 недели в нашем седьмом выпуске.

### По-русски

Начнём с материалов в рунете:

1. По традиции несколько полезных сниппетов от xandeadx: «[Оплата доступа к ноде с помощью Робокассы](http://xandeadx.ru/blog/drupal/827)», «[Taxonomy Menu и названия пунктов меню из поля термина](http://xandeadx.ru/blog/drupal/831)», «[Программно авторизовать пользователя по uid](http://xandeadx.ru/blog/drupal/826)».

2. Павла Китаева не отпускает Form API :) Читайте его статью «[Создание новых типов элементов формы HTML5](http://drupalfly.ru/station/new-type-element-html5-in-my-form)».

3. Макс Корейченко [размышляет](http://koreychenko.ru/content/pochemu-vash-sayt-na-drupal-medlennyy-i-chto-nuzhno-delat-chtoby-ego-uskorit) на тему производительности и [делится своим подходом к аяксификации](http://www.drupal.ru/node/116446).

4. «[Такой замечательный баг нашел, или это фича?](http://makeyoulivebetter.org.ua/node/575)» — пишет автор блога «Make You Live Better | Сексуальные опыты с Drupal CMF» после ночи с модулем Context :)

5. @kalabro [рассказала](http://dru.io/question/892#rate-node-951-1-3), как можно подключать PHP-файлы в своём модуле.

### Drupal-lite

Этот раздел специально для тех, кто с друпалом недавно:

1. В статье [Form API #states](https://www.lullabot.com/blog/article/form-api-states) рассказывается, как легко сделать свои формы динамичными без единой Javascipt-строчки.

2. [Пошаговый мануал](http://www.chenhuijing.com/blog/drupal-101-creating-custom-content-with-panels/), как добавить свой собственный текст (custom content) в [Panels](https://www.drupal.org/project/panels).

3. Сложные проверки значений полей можно [настроить прямо из админки с модулем Field Validation](http://www.webwash.net/tutorials/define-custom-validation-using-field-validation-drupal-7).

4. Переходим на сторону добра — отказываемся от Views PHP: [Conditional Views — Sure beats Views PHP for simple variance](https://www.cvillecouncil.us/content/conditional-views-sure-beats-views-php-simple-variance).

5. При записи [обзорного видео](http://codekarate.com/daily-dose-of-drupal/creating-hierarchy-users-drupal-subuser-module) по модулю Subuser Шэйн Томас нашел баг и решил исправить его сам. Подробности в видео [Module Investigator: Fixing an issue in the Drupal Subuser module](http://codekarate.com/daily-dose-of-drupal/module-investigator-fixing-issue-drupal-subuser-module).

### Всё для Drupal-разработчика

Коктейль из материалов для друпалеров среднего уровня и выше:

1. Очередная гигантская компиляция из модулей, статей и тому подобного появилось на Drupal.org. На этот раз она посвящена [созданию сайтов государственных учреждений](https://www.drupal.org/resource-guides/launching-government-website). Архив других компиляций доступен на странице [Resource Guides](https://www.drupal.org/resource-guides). Очень советуем добавить в ваши закладки.

2. Многие поисковые системы поднимают наверх в выдаче сайты, которые работают по HTTPS, а также имеют [мобильную версию](https://seopult.ru/subscribe.html?id=219). Google даже подготовил [официальный гайд](https://developers.google.com/webmasters/mobile-sites/website-software/drupal) по адаптивным темам в Drupal.

3. Не всё решается через модуль Views (и далеко не все списки полезно делать через него). В публикации [Easy Way Out Before Lost inside Views Maze](http://wulei.ca/blog/easy-way-out-lost-inside-views-maze) рассказывается, как можно сделать выборку материалов самостоятельно для отображения блока с ленивой загрузкой через Ajax.

4. Неплохое введение в парадигму Headless Drupal представлено в материале [Headless Drupal. Why & how a RESTful API in Drupal?](http://blog.openlucius.com/en/blog/headless-drupal-why-how-restful-api-drupal)

5. Как портировать модули на форк Drupal 7 под названием [Backdrop CMS](https://backdropcms.org/), читайте в статье [Porting Drupal 7 Modules to Backdrop](https://www.lullabot.com/blog/article/porting-drupal-7-modules-backdrop).

6. Тема безопасности не теряет актуальности. Существует изрядное количество автоматических сканеров уязвимостей сайтов плюс целые базы эксплоитов. Ввести хакеров в заблуждение помогут шаги по сокрытию того факта, что ваш сайт сделан Drupal. В материале [Hiding the fact that your site runs Drupal](http://www.drupalonwindows.com/en/blog/hiding-fact-your-site-runs-drupal) представлен подробный обзор методов достижения этой цели. Дополнительные идеи можно почерпнуть в подборке [Hiding Traits of Drupal](https://github.com/alehkot/drupal-best-practices#hiding-traits-of-drupal).

7. Пакетная обработка больших данных практически всегда предполагает использование очередей. В материале с лаконичным названием [Drupal Queues](http://www.computerminds.co.uk/drupal-code/drupal-queues) показан пример объявления и использования собственной очереди.

8. [The Drupal mail system](http://pronovix.com/blog/drupal-mail-system) — исчерпывающая статья про почтовую подсистему друпала.

9. Если вы задумывались, есть ли что-нибудь похожее на `hook_node_access()`, только для других сущностей, то обязательно прочитайте публикацию [Custom access control for Drupal 7 entities](http://www.webomelette.com/custom-access-control-drupal-7-entities).

10. Капелька драша не повредит нашему дайджесту: [Drush Registry Rebuild](https://www.deeson.co.uk/labs/drush-registry-rebuild) для лечения тех проблем, которые не решаются сбросом кеша.

11. Jeff Geerling проделал огромную работу по популяризации Ansible в Drupal-сообществе, апогеем которой стала [Drupal VM](http://www.drupalvm.com/) = Vagrant + Ansible + Drupal.

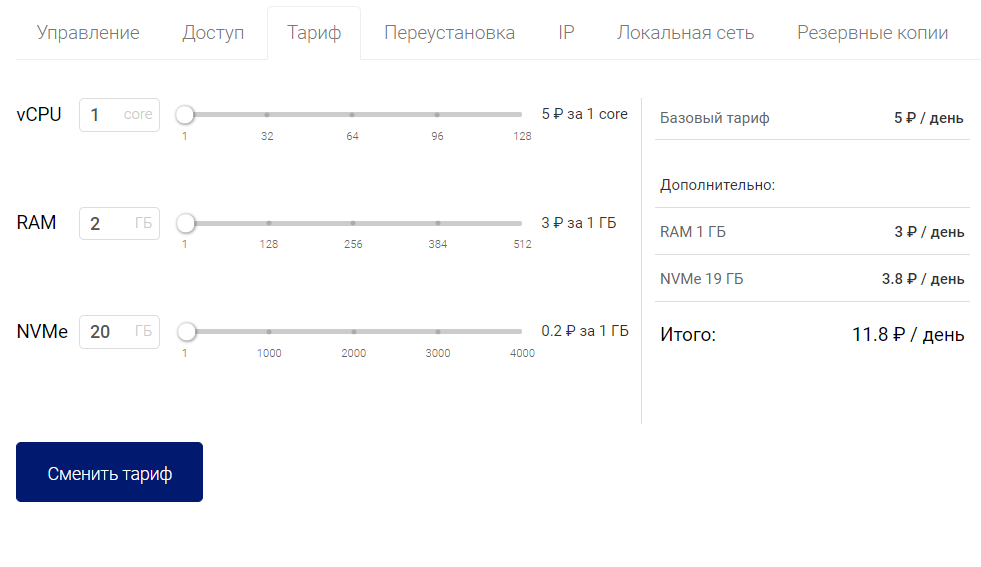

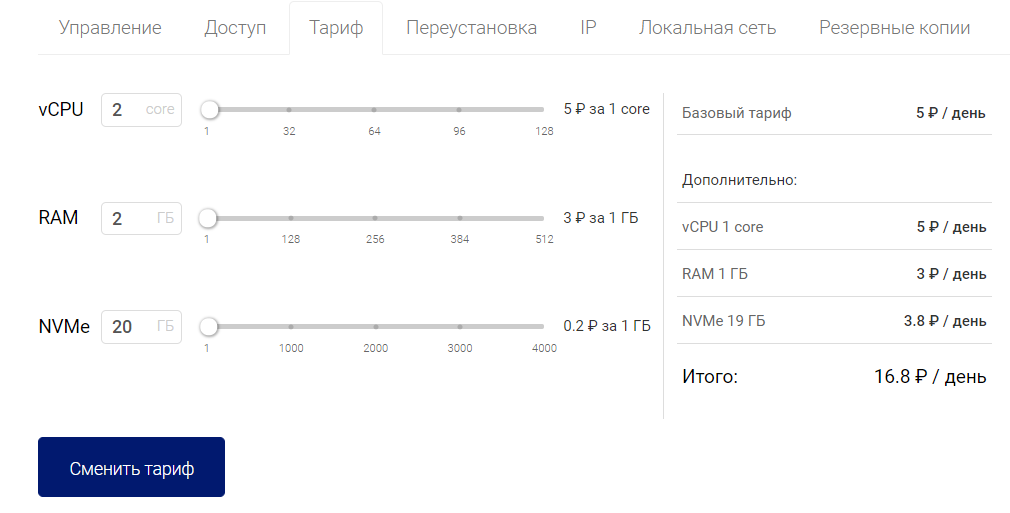

12. Появилось несколько обзоров хостинга Platform.sh: [первые шаги](http://www.sitepoint.com/first-look-platform-sh-development-deployment-saas/) на SitePoint и более [серьёзная статья на примере реального проекта](http://awebfactory.com.ar/node/537).

13. В статье [Drupal Testing Methodologies Are Broken — Here's Why](http://redcrackle.com//blog/drupal-testing-methodologies-are-broken-heres-why) автор интригует скорой публикацией выстраданного фреймворка для интеграционных тестов в Drupal 7, который можно было бы запускать на работающем сайте вместо Simpletest или PHPUnit. Также представлен обзор основных проблем, с которыми сталкиваются разработчики при попытках прикрутить автоматизацию тестов к Drupal.

14. Раз уж мы заговорили про тестирование, стоит упомянуть вводную статью по Behat:[BDD with Behat and Drupal](http://www.appnovation.com/blog/bdd-behat-and-drupal).

15. Луллаботы делятся опытом по использованию популярного Javascript-фреймворка AngularJS в Drupal-проектах: [Wrapping AngularJS modules in Drupal CTools plugins](https://www.lullabot.com/blog/article/wrapping-angularjs-modules-drupal-ctools-plugins).

16. [Углубляемся в query-запросы Solr](http://www.triquanta.nl/blog/what-fq-short-summary-solr-query-fields), чтобы лучше понимать, как это всё вообще работает.

17. В поисках замены Features, серия №2086: встречайте [CINC](https://www.drupal.org/project/cinc) и сразу пример с [созданием представления из кода](http://atendesigngroup.com/blog/how-easily-create-drupal-views-code).

18. Google отключает [Image Charts API](https://developers.google.com/chart/image/) в апреле. По этому поводу [обзор модулей построения графиков](https://www.drupal.org/node/2363985).

### Drupal 8

1. Вышла [9-я бета-версия](https://www.drupal.org/node/2459341) Drupal 8. Критических issue по-прежнему [больше полтинника](https://www.drupal.org/project/issues/search/drupal?project_issue_followers=&status%5B%5D=1&status%5B%5D=13&status%5B%5D=8&status%5B%5D=14&status%5B%5D=4&priorities%5B%5D=400&categories%5B%5D=1&categories%5B%5D=2&version%5B%5D=8.x&issue_tags_op=%3D).

2. Если вы ещё не видели презентацию «[30 Awesome Drupal 8 API Functions](https://www.acquia.com/resources/podcasts/acquia-podcast-187-greatest-hits-2014-161-30-awesome-drupal-8-api-functions)», то отличный шанс сделать это сейчас. Кстати, есть [версия для семёрки](http://brightplumbox.com/30Drupal7API/#/).

3. [Настройка Vagrant для разработки под Drupal 8](https://drupalize.me/blog/201503/tutorial-vagrant-drupal-8-development) с помощью VDD.

4. В статье [Creating Custom Field Formatters in Drupal 8](http://www.sitepoint.com/creating-custom-field-formatters-drupal-8/) рассказывается о том, как создавать новые форматеры полей.

5. Изменения в системе фильтрации текста в восьмёрке, а также подводные камни в виде двойного экранирования рассматриваются в материале [Avoiding Double-Escaped Output in Drupal 8](https://pantheon.io/blog/avoiding-double-escaped-output-drupal-8).

6. В статье [Dependency Injection with Traits in Drupal 8](https://drupalize.me/blog/201503/dependency-injection-traits-drupal-8) автор делится любопытным [опытом портирования одного модуля](https://drupalize.me/blog/201412/adventures-porting-d7-form-module-drupal-8) с Drupal 7 на Drupal 8. По ходу захватывающего странствия встречаются [PHP Traits](http://php.net/manual/en/language.oop5.traits.php), а также [Dependency Injection](https://api.drupal.org/api/drupal/core!modules!system!core.api.php/group/container/8) и [Module Upgrader](https://www.drupal.org/project/drupalmoduleupgrader).

7. В очерке [Alter or Dispatch: Drupal 8 Events versus Alter Hooks](https://www.previousnext.com.au/blog/alter-or-dispatch-drupal-8-events-versus-alter-hooks) сделана попытка указать идеальный способ объявления собственных событий в Drupal 8.

8. Когда вам понадобится Ctools для восьмёрки, вы знаете, где его искать: [The Drupal 8 plugin system — part 4](http://lakshminp-lakshminp.rhcloud.com/the-drupal-8-plugin-system-part-4/).

9. Красивая форма поиска по коммитам в [Drupal 8: Drupal 8 Git Commit Explorer](https://www.eric.pe/terson/understands/drupal-8-by-git-commit).

### Бизнес и сообщество

1. [Drupal 8 Accelerate](https://assoc.drupal.org/d8accelerate).

Программа [грантов по разработке Drupal 8](https://assoc.drupal.org/d8accelerate/awarded) уже наделала много шума. Drupal-ассоциация планирует привлечь как минимум $250k. При этом [половину уже внесли](http://www.phase2technology.com/blog/accelerating-with-drupal-8/) сама ассоциация и 7 крупнейших Drupal-компаний. А вот бы так: делаешь git push на орге, а тебе на счёт автоматически падает $100… Но мы, кажется, отвлеклись :)

2. Новости бизнеса: Mediacurrent, крупнейший игрок Drupal-рынка, [поглощен дизайн-агентством Code and Theory](http://www.mediacurrent.com/blog/mediacurrent-acquired-by-code-and-theory).

3. [Утверждены доклады](https://events.drupal.org/losangeles2015/sessions/accepted) на майский DrupalCon Los Angeles.

4. Сообщество простилось с ушедшим из жизни по причине тяжелой болезни Аароном Винборном. [Почитайте о нём](https://www.drupal.org/node/2444367). Ассоциация [анонсировала премию имени Аарона](https://www.drupal.org/aaron-winborn-award), часть которой будет ежегодно направляться семье Винборнов.

5. Этот человек очень редко высказывается. В этот раз он сделал исключение: Earl Miles, он же [merlinofchaos](https://www.drupal.org/u/merlinofchaos), автор Views и Panels, [о друпале и его сообществе](https://plus.google.com/u/0/+EarlMiles/posts/JiemCwPqECA). (TL;DR: всё нормально и у Ёрла, и у друпала).

6. Две трогательные истории разработчиков из серии «Я и Drupal»: [My journey in Drupal, 4 years on](http://www.paulrowell.com/my-thoughts/my-journey-drupal-4-years), [542 days as a Drupal developer](http://www.chenhuijing.com/blog/542-days-as-a-drupal-developer/). Пусть таких историй будет только больше.

### Интересные модули

1. [Configuration Management](https://www.drupal.org/project/configuration)

Альтернативный [Features](http://drupal.org/project/features) подход для управления конфигурацией рассматривается в статье [Configuration Management, an alternative to Features](http://www.wellnet.it/en/blog/weekly-module-review-2-configuration-management-alternative-features).

2. [Features Builder](https://www.drupal.org/project/features_builder)

Если же вы активно продолжаете использовать модуль Features в разработке, то обратите внимание на материал [Features Builder, problems zero with Features!](http://www.wellnet.it/en/blog/weekly-module-review-3-features-builder-problems-zero-features)

3. [Taxonomy Entity Index](https://www.drupal.org/project/taxonomy_entity_index)

Этот модуль используется для оптимизации производительности сайта при массовом использовании таксономии. На данную тему написана небольшая статья [Drupal 7, Tags, Unpublished Content, and You](http://www.shooflydesign.org/buzz/drupal-7-tags-unpublished-content-and-you).

4. [VoiceCommander](https://www.drupal.org/project/voicecommander)

Голосовые интерфейсы — тренд на протяжении уже многих лет. С этим модулем вы можете проэкзаменовать Web Speech API в друпале.

5. [Openstack Queues](https://www.drupal.org/project/openstack_queues)

Интеграция с движком очередей [Openstack Zaqar](https://wiki.openstack.org/wiki/Zaqar) (альтернатива [Amazon SQS](http://aws.amazon.com/sqs/) с открытым исходных кодом).

6. [Field SQL Lean](https://www.drupal.org/project/field_sql_lean)

Достаточно экстремальный подход к оптимизации, который необратимо изменяет структуру таблиц для хранения значений полей. Очевидно, что с новой структурой не смогут стандартно работать множество модулей Drupal, например Views, тем не менее, полезно знать, что существуют и такие возможности системы.

7. [Views Calc](https://www.drupal.org/project/views_calc)

Этот модуль позволяет вывести строку «Итогов» в таблице. Подсчёт ведётся на стороне БД и поддерживает операции COUNT, SUM, AVG, MIN, MAX. Как пользоваться, [рассказывают в OSTraining](https://www.ostraining.com/blog/drupal/views-calc/).

8. [GA Push](https://www.drupal.org/project/ga_push)

Расширенное API для отправки любых событий в Google Analytics. С его помощью можно, например, [отслеживать ошибки валидации форм](https://vimeo.com/89739132) на вашем сайте.

Над выпуском работали [Олег Кот](mailto:[email protected]) и [Катя Маршалкина](mailto:[email protected]).

Пишете статьи о Drupal на благо сообщества? Дайте нам знать — [[email protected]](mailto:[email protected]).

А ещё мы запускаем Drupal-рассылку. Воспользуйтесь [формой регистрации](http://eepurl.com/bhCjRb) и станьте первыми читателями! | https://habr.com/ru/post/254501/ | null | ru | null |

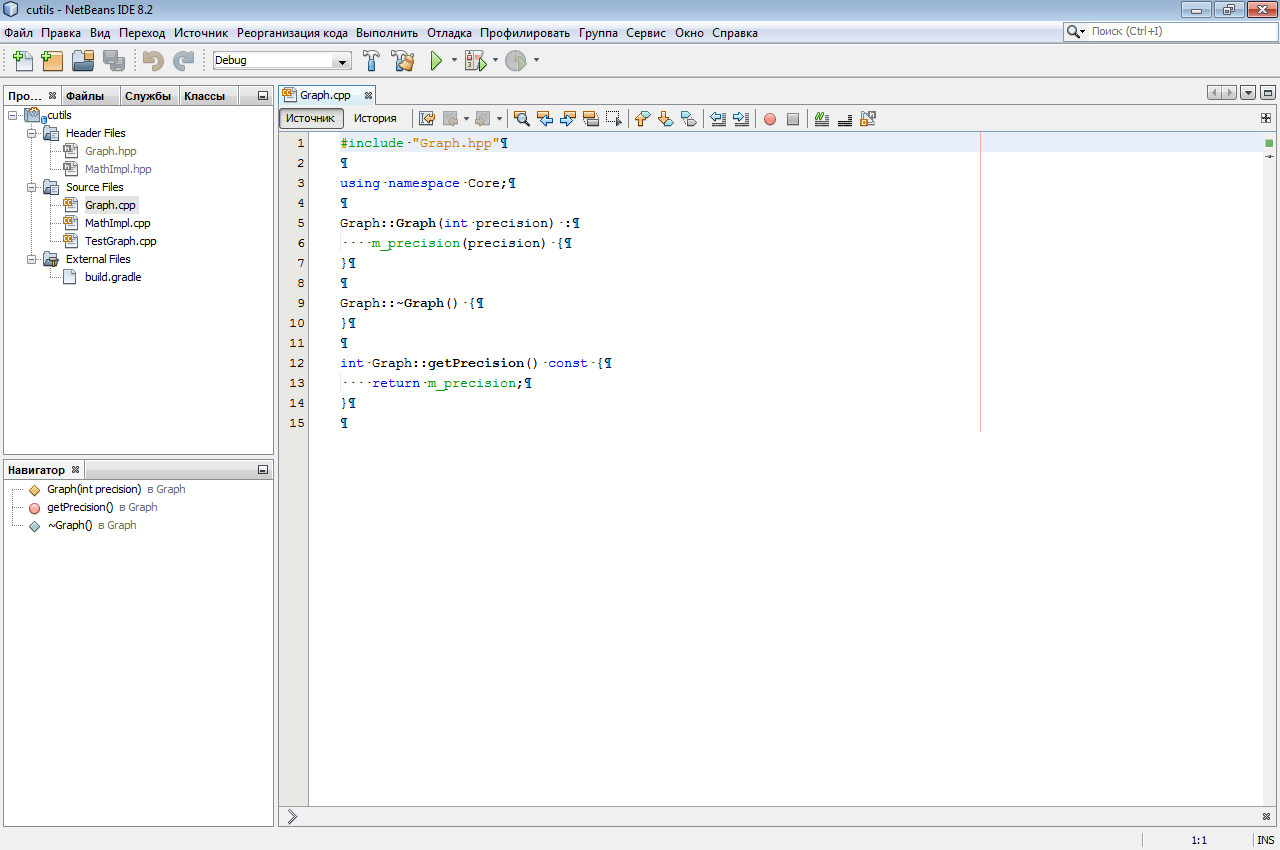

# Пишем свой Gradle плагин для AnnotatedSql

#### Вступление

Привет, коллеги. Давно я не писал ничего на Хабр. Вот, решил исправить это досадное недоразумение.

Не так давно я сменил место работы, и проект, над которым я теперь работаю, использует для сборки Gradle. Более того, проект достаточно развесистый и сложный, и Gradle скрипт в нем весьма непростой. Поэтому я решил, что надо подучить Gradle. Как один из шагов обучения я решил написать свой собственный плагин. Плагин посвящен замечательной библиотеке [annotated-sql](http://habrahabr.ru/post/156283/), созданной моим хорошим товарищем Геннадием [hamsterksu](http://habrahabr.ru/users/hamsterksu/). Я использую эту библиотеку в персональных проектах, поэтому мне нужен удобный способ прикреплять и конфигурировать ее к ним. Библиотека использует процессоры аннотаций, поэтому цель плагина — подружить эти процессоры и gradle сборку.

#### Задача

Перед тем, как приступить к плагину, давайте сначала определим, что мы хотим получить в итоге от плагина.

Библиотека состоит из двух частей — jar с аннотациями, которые мы используем в нашем коде для описания нашей схемы БД и jar с процессорами, который не линкуется в наш код, но используется на этапе компиляции. Наш плагин должен определить, где находятся эти jar's (в идеале, он должен их скачать, но это только после того, как у кого-то из нас дойдут руки их захостить на maven central). После этого он должен настроить процесс компиляции java, чтобы использовать процессоры.

Давайте же сначала рассмотрим, какие изменения мы бы внесли в наш скрипт без плагина, чтобы заставить библиотеку работать.

##### Конфигурация

Поскольку мы не хотим линковать наши процессоры к коду, мы определим отдельную конфигурацию зависимостей, назовем ее asqlapt.

```

configurations {

asqlapt

}

```

и сконфигурируем ее.

```

dependencies {

asqlapt fileTree(dir: 'libs.apt', include: '*.jar')

}

```

здесь мы говорим, что зависимости нашего asqlapt находятся в папке libs.apt нашего проекта.

##### Модификация компиляции

Следующий шаг — вклиниться в компилятор и указать ему на наш процессор. Давайте рассмотрим код, который делает это:

```

android.applicationVariants.all { variant ->

def aptOutput = file("$buildDir/source/apt_generated/$variant.dirName")

variant.javaCompile.doFirst {

aptOutput.mkdirs()

variant.javaCompile.options.compilerArgs += [

'-processorpath', configurations.asqlapt.getAsPath(), '-processor',

'com.annotatedsql.processor.provider.ProviderProcessor,com.annotatedsql.processor.sql.SQLProcessor',

'-s', aptOutput

]

}

}

```

Итак, для каждого варианта сборки андроид приложения мы выполняем следующие шаги:

* Определяем папку, в которую поместятся наши сгенерированные классы.

* Для каждого варианта сборки существует задача javaCompile. Мы можем вклиниться в исполнение этой задачи при помощи метода doFirst. Здесь мы добавляем аргументы компилятору, указываем на путь к процессорам и сами процессоры, а так же папку, куда поместить результат

Вот, в принципе, и все, что нам нужно. Но мы-то хотим оформить это как плагин, не так ли?

#### Создание плагина

Как написано в [документации](http://www.gradle.org/docs/current/userguide/custom_plugins.html), наш плагин дожен находиться в папочке buildSrc в корневом проекте. Создадим эту папочку и build.gradle следующего содержания:

```

apply plugin: 'groovy'

dependencies {

compile gradleApi()

compile localGroovy()

}

```

теперь объявим наш плагин в файле src/main/resources/META-INF/gradle-plugins/annotatedsql.properties следующим образом:

```

implementation-class=com.evilduck.annotatedsql.AnnotatedSqlPlugin

```

С рутиной покончено, теперь к коду. Код плагинов пишется на Groovy.

Создадим наш класс:

```

public class AnnotatedSqlPlugin implements Plugin {

private Project project

public void apply(Project project) {

this.project = project

}

}

```

вот так выглядит заготовка плагина. Начнем выполнять действия в методе apply.

Первое, что мы хотим — добавить конфигурации зависимостей:

```

def setupDefaultAptConfigs() {

project.configurations.create('apt').with {

visible = false

transitive = true

description = 'The apt libraries to be used for annotated sql.'

}

project.configurations.create('annotatedsql').with {

extendsFrom project.configurations.compile

visible = false

transitive = true

description = 'The compile time libraries to be used for annotated sql.'

}

project.dependencies {

apt project.fileTree(dir: "$project.projectDir/libs-apt", include: '*.jar')

annotatedsql project.files("$project.projectDir/libs/sqlannotation-annotations.jar")

}

}

```

этот метод создает две конфигурации — apt и annotatedsql. Первая — для процессоров, вторая — для API. Далее мы инициализируем эти конфигурации значениями по-умолчанию.

Следующий шаг — настройка компилятора:

```

def modifyJavaCompilerArguments() {

project.android.applicationVariants.all { variant ->

def aptOutput = project.file("$project.buildDir/source/$extension.aptOutputDir/$variant.dirName")

variant.javaCompile.doFirst {

aptOutput.mkdirs()

variant.javaCompile.options.compilerArgs += [

'-processorpath', project.configurations.apt.getAsPath(), '-processor',

'com.annotatedsql.processor.provider.ProviderProcessor,com.annotatedsql.processor.sql.SQLProcessor',

'-s', aptOutput

]

}

}

}

```

Тоже ничего нового. Но подождите, что такое extension. Gradle позволяет нам при создании плагинов создавать объекты — расширения. Это простые POGO объекты, хранящие конфигурацию плагина. Самое близкое нам, андроидщикам расширение — android. Да, это как раз тот android обьект, в котором вы конфигурируете свою сборку. Давайте посмотрим, как мы объявили наш extension:

```

class AnnotatedSqlExtension {

public String aptOutputDir

}

```

и в методе apply плагина:

```

extension = project.extensions.create("annotatedsql", AnnotatedSqlExtension)

extension.with {

aptOutputDir = "aptGenerated"

}

```

инициализируем расширение и прикрепляем его к проекту.

Вот, собственно, и весь плагин.

**Полный код**

```

public class AnnotatedSqlPlugin implements Plugin {

private Project project

private AnnotatedSqlExtension extension

public void apply(Project project) {

this.project = project

project.apply plugin: 'android'

extension = project.extensions.create("annotatedsql", AnnotatedSqlExtension)

extension.with {

aptOutputDir = "aptGenerated"

}

setupDefaultAptConfigs()

modifyJavaCompilerArguments()

}

def setupDefaultAptConfigs() {

project.configurations.create('apt').with {

visible = false

transitive = true

description = 'The apt libraries to be used for annotated sql.'

}

project.configurations.create('annotatedsql').with {

extendsFrom project.configurations.compile

visible = false

transitive = true

description = 'The compile time libraries to be used for annotated sql.'

}

project.dependencies {

apt project.fileTree(dir: "${project.projectDir}/libs-apt", include: '\*.jar')

annotatedsql project.files("${project.projectDir}/libs/sqlannotation-annotations.jar")

}

}

def modifyJavaCompilerArguments() {

project.android.applicationVariants.all { variant ->

def aptOutput = project.file("$project.buildDir/source/$extension.aptOutputDir/$variant.dirName")

variant.javaCompile.doFirst {

aptOutput.mkdirs()

variant.javaCompile.options.compilerArgs += [

'-processorpath', project.configurations.apt.getAsPath(), '-processor',

'com.annotatedsql.processor.provider.ProviderProcessor,com.annotatedsql.processor.sql.SQLProcessor',

'-s', aptOutput

]

}

}

}

}

```

Теперь, давайте посмотрим, как мы его используем:

```

buildscript {

repositories {

mavenCentral()

}

dependencies {

classpath 'com.android.tools.build:gradle:0.6.+'

}

}

apply plugin: 'android'

apply plugin: 'annotatedsql'

repositories {

mavenCentral()

}

android {

// наши конфигурации андроид проекта

}

/*

* Если хотим, мы можем изменить aptOutputDir

*/

//annotatedsql {

// aptOutputDir = "customAptOutputDir"

//}

/*

* Если нужно, можем изменить локацию библиотек

*/

//dependencies {

// apt project.fileTree(dir: "${project.projectDir}/libszzz-apt", include: '*.jar')

// annotatedsql project.files("${project.projectDir}/libszzz/sqlannotation-annotations.jar")

//}

```

Как видно, если мы поместили библиотеки в нужное место, все, что нам нужно добавить в скрипт, это

```

apply plugin: 'annotatedsql'

```

Как я уже говорил, в идеале, если разместить jar'ы библиотеки в центральном репозитории, необходимость в ручном добавлении их в проект отпадет совсем. Gradle просто скачает их и положит сам в укромное место. К сожалению, пока репозиториев нет, и это не есть что-то, что я могу контролировать в плагине. Однако, если предположить, что библиотеки были загружены в репозиторий, всё, что нам нужно было бы сделать — это изменить локальные dependencies на удаленные. Что-то вроде:

```

project.dependencies {

apt 'com.hamsterksu.asql:something-version'

annotatedsql 'com.hamstersku.asql:something-else-version'

}

```

В этом случае, все, что нам нужно было бы сделать, это добавить плагин в проект (плагин тоже может быть в репозитории, аналогично android плагину) и применить его:

```

apply plugin: 'annotatedsql'

```

#### Завершение

Напоследок хочу сказать, что это вершина айсберга возможностей Gradle. Тем не менее, надеюсь, что кому-то это поможет начать разбираться в создании плагинов для Gradle, да и Gradle в целом. Лично я, чем больше узнаю, тем сильнее и сильнее влюбляюсь в эту систему сборки.

На этом поспешу распрощаться. Всем спасибо за внимание! | https://habr.com/ru/post/202480/ | null | ru | null |

# Миллион строк плохого кода

*«No pain, no gain», как гласит древняя восточная мудрость. И даже если мудрость не древняя и не восточная, лично для меня самый ценный жизненный опыт чаще всего был и самым болезненным. Недавний пост Дэвида Робинсона — аспиранта, занимающегося программированием в стенах Принстонского университета — посвященный код ревью, не только поднял важный вопрос повседневного быта каждого, кому волей (или неволей) приходится передавать свой опыт другим. Оригинальный текст был относительно «беззубым», однако, пост перестал быть томным после того, как в комментариях появился Джон Кармак.*

Это история о плохом коде, который однажды написал ваш покорный слуга.

На одном из первых курсов университета я писал программу на Java, которая должна была читать файл весом в 6 MB в строку (этим файлом был геном бактерии в формате FASTA). Выглядел мой код следующим образом:

```

BufferedReader reader = new BufferedReader(new FileReader (file));

String line = null;

String text = "";

while( ( line = reader.readLine() ) != null ) {

text = text + line;

}

```

Построение строки при помощи серии конкатенаций подобным образом крайне неэффективно — у меня, без преувеличения, уходило около 40 минут на чтение файла ([с тех пор я узнал несколько способов получше](http://stackoverflow.com/questions/326390/how-to-create-a-java-string-from-the-contents-of-a-file)). Самое главное — после чтения файла весь оставшийся алгоритм в программе отрабатывал секунд за 10. Два дня я так и работал: делал изменения в коде, запускал программу и успевал посмотреть целый эпизод LOST, прежде чем программа завершала выполнение. «Черт, на двенадцатой строчке ошибка! Опять все по-новой...»

После множества повторных запусков я наконец подумал «наверняка *должен* быть лучший способ сделать это». Я выяснил, что можно написать цикл на Perl, который сможет считать геном менее чем за одну секунду (при этом на Perl я умел программировать не лучше, чем на Java — просто повезло). Итак, я сел и написал скрипт на Perl, который читал файл, собирал его в одну строку и выводил ее. Затем я сделал так, что моя программа на Java вызывала скрипт на Perl через командную строку, захватывала вывод и сохраняла его в строку.

Если бы у меня сохранилась эта программа, то я бы напечатал ее исходный код и повесил в рамку на стену, чтобы почаще себе напоминать о том, что никогда и никого не буду ругать за написанный им «плохой» код.

Рассказать об этом случае из моей жизни меня вдохновил свежий комикс с XKCD про “качество кода”:

Комикс кроме как «злым» не назовешь — опытный программист не дает ни одного полезного совета, только проводит гиперболические аналогии. Но что больше всего зацепило мой взгляд, так это ответ пациента — «Хорошо, я почитаю руководство по кодинг стайлу». Отреагирует ли так живой человек, если кто-то будет настолько груб к нему? Разве ответ будет похож не на «Хорошо, это был последний раз когда я показал тебе свой код», или даже «Хорошо, думаю я должен завязать с программированием»?

Проблема присутствует и в научных исследованиях. Есть много причин, по которым ученые публикуют свои статьи без прикладывания к ним кода (и они вполне объяснимы), но первую позицию в их списке обычно занимает смущение: «мой код слишком уродлив для того, чтобы отдавать его кому-то». Те, кто стремятся пристыдить других за код, в этом вопросе не слишком-то помогают!

Известный совет начинающим писателям гласит: «Каждый из нас держит в себе миллион плохих строк. Прежде, чем этот миллион выльется наружу, пытаться написать что-то хорошее бесполезно. Так идите и пишите!». Я вспомнил о нем, когда читал дискуссию, разгоревшуюся по поводу приведенного выше XKCD:

> The only way to write good code is to write tons of shitty code first. Feeling shame about bad code stops you from getting to good code

>

> — Hadley Wickham (@hadleywickham) [17 апреля 2015](https://twitter.com/hadleywickham/status/589068687669243905)

Когда вы, опытный программист, в следующий раз захотите пристыдить кого-нибудь за его код, попробуйте мысленно вернуться к собственному миллиону строк кода. Представьте, что кто-нибудь осудил вас так же, как и я себя выше. Продолжили бы вы просить о помощи? Осилили бы вы свою дорогу в миллион строк?

### Комментарий Джона Кармака

Не надо путать слова «написавший этот код идиот» и «этот код дерьмо» — между ними есть существенная разница. Комикс как раз о последнем. Предполагаю, что сделано это сознательно. Атака на автора вряд ли принесет какую-то пользу, но должна существовать возможность строго критиковать сам код. В реальной жизни, у многих авторов не получается отделять себя от своей работы, однако умение проделывать это — ценный навык.

Предоставленные сами себе, большинство людей демонстрирует непробиваемую способность игнорировать свои недостатки, и это вредит их профессиональному росту. Небольшой стыд часто становится позитивной мотивацией. Мне стыдно за огромное количество из того кода, что я написал за последний год. У меня в голове есть мысли насчет причин, почему все получилось так, как получилось, — некоторые из них представляют собой оправдания, но часть из них — это чистой воды «WTF я думал вообще, когда писал это?». И если вы не чувствуете небольшой вины за ваши последние работы, то, вполне возможно, вам будет полезно, если кто-то укажет вам на проблемы — в том плане, что этот человек сможет пробиться сквозь ваши «защитные механизмы».

Я был бы счастлив, если бы кто-нибудь «зарылся» во весь тот код, что я написал для Oculus Mobile SDK. Уверен, что по большей части этим читателем рано или поздно стану я сам, и по большей части буду только кивать головой и соглашаться с написанным; однако, я уверен, что смогу вынести из этого что-то полезное, и это благотворно повлияет на мою дальнейшую работу.

*>> Вы в Oculus делаете код ревью для каждого коммита?*

Нет. У нас есть некоторые подвижки в этом направлении; мне интересно будет увидеть, что из этого получится. На нас все еще сильно сказывается давление темпа работы над стартапом.

*>> Ваш комментарий к статье выглядит так, будто макака прокатилась по клавиатуре, а вы потом только прошлись для виду автокорректом… ну как, прозвучало не слишком уж полезно, правда? Думаю, что вы путаете излишнюю жесткость с серьезной критикой. Заметили, что моя последняя фраза не такая обидная, и в то же время принесла толку больше, чем первая?*

Обычно тактичные и полезные комментарии работают лучше всего, но бывают случаи, что необходим некоторый минимум «активационной энергии» для того, чтобы комментарий произвел действие на человека.

*>> Делали ли вы ревью кода, написанного другими разработчиками в id в прошлом?*

Неформально, и тогда мне этого хватало. Мне не нравится заниматься ревьюированием кода; возможно, по этой причине я высоко ценю критику.

*Пусть Джон и признается, что отчасти не сторонится в жизни строгих комментариев, ему далеко до Линуса Торвальдса, щедро пересыпающего свои письма личными оскорблениями, а выступления — [фразами в духе](http://arstechnica.com/business/2015/01/15/linus-torvalds-on-why-he-isnt-nice-i-dont-care-about-you/) «Меня не интересуете вы, я беспокоюсь о технологии и ядре — вот что для меня действительно важно» и [утверждениями, что](http://arstechnica.com/information-technology/2013/07/16/linus-torvalds-defends-his-right-to-shame-linux-kernel-developers/) «никто не услышит вас, если вы собираетесь быть мягким».* | https://habr.com/ru/post/256887/ | null | ru | null |

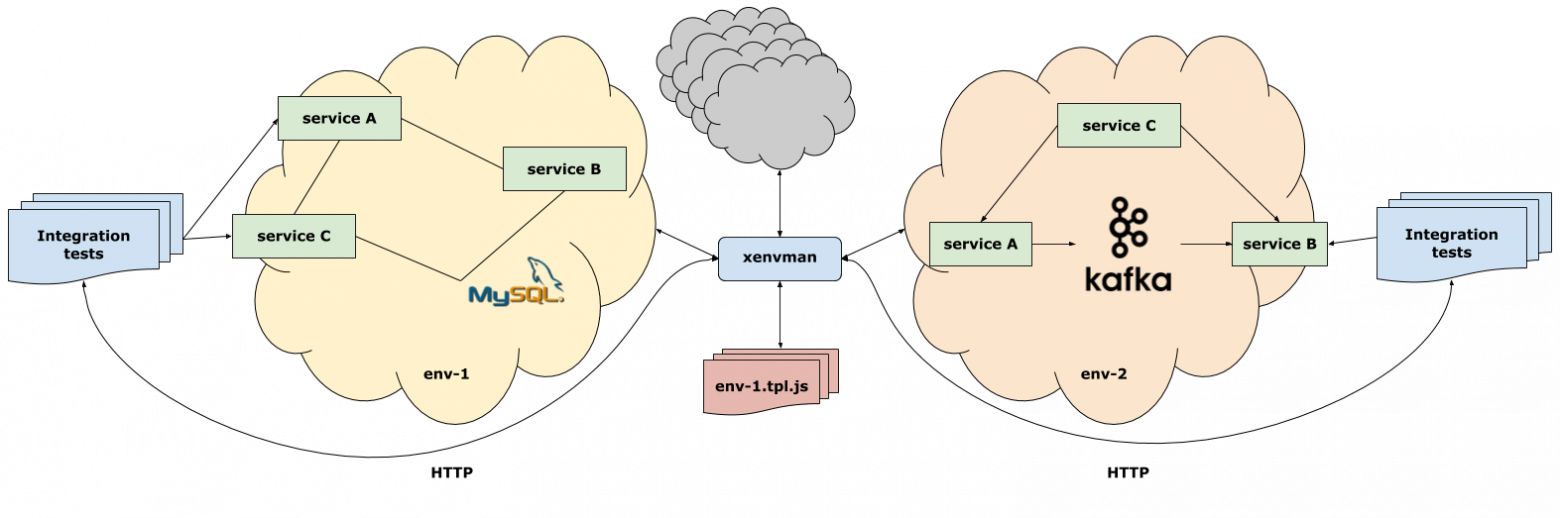

# xenvman: Гибкие окружения для тестирования микросервисов (и не только)

Всем привет!

Я бы хотел немного рассказать о проекте, над которым я работал последние полгода. Проект я делаю в свободное время, но мотивация к его созданию пришла из наблюдений, сделанных на основной работе.

На рабочем проекте мы используем архитектуру микросервисов, и одна из главных проблем, которая проявилась со временем и выросшим количеством этих самых сервисов — это тестирование. Когда некий сервис зависит от пяти-семи других сервисов, плюс ещё какая-нибудь база данных (а то и несколько) в придачу, то тестировать это в "живом", так сказать виде, весьма неудобно. Приходится обкладываться моками со всех сторон так плотно, что самого теста и не разглядеть. Ну или каким-то образом организовывать тестовое окружение, где все зависимости могли бы реально быть запущены.

Собственно для облегчения второго варианта я как раз и сел писать [xenvman](https://github.com/syhpoon/xenvman). Если совсем в двух словах, то это что-то вроде гибрида docker-compose и [test containers](https://www.testcontainers.org/), только без привязки к Java (или любому другому языку) и с возможностью динамически создавать и конфигурировать окружения через HTTP API.

`xenvman` написан на Go и реализован как простой HTTP сервер, что позволяет пользоваться всей доступной функциональностью из любого языка, умеющего разговаривать на этом протоколе.

Основное, что xenvman умеет, это:

* Гибко описывать содержимое окружения с помощью простых скриптов на JavaScript

* Создавать образы “на лету”

* Создавать нужное количество контейнеров и объединять их в единую изолированную сеть

* Пробрасывать внутренние порты окружения наружу, дабы тесты могли достучаться до нужных сервисов даже с других хостов

* Динамически менять состав окружения (останавливать, запускать и добавлять новые контейнеры) на ходу, без остановки работающего окружения.

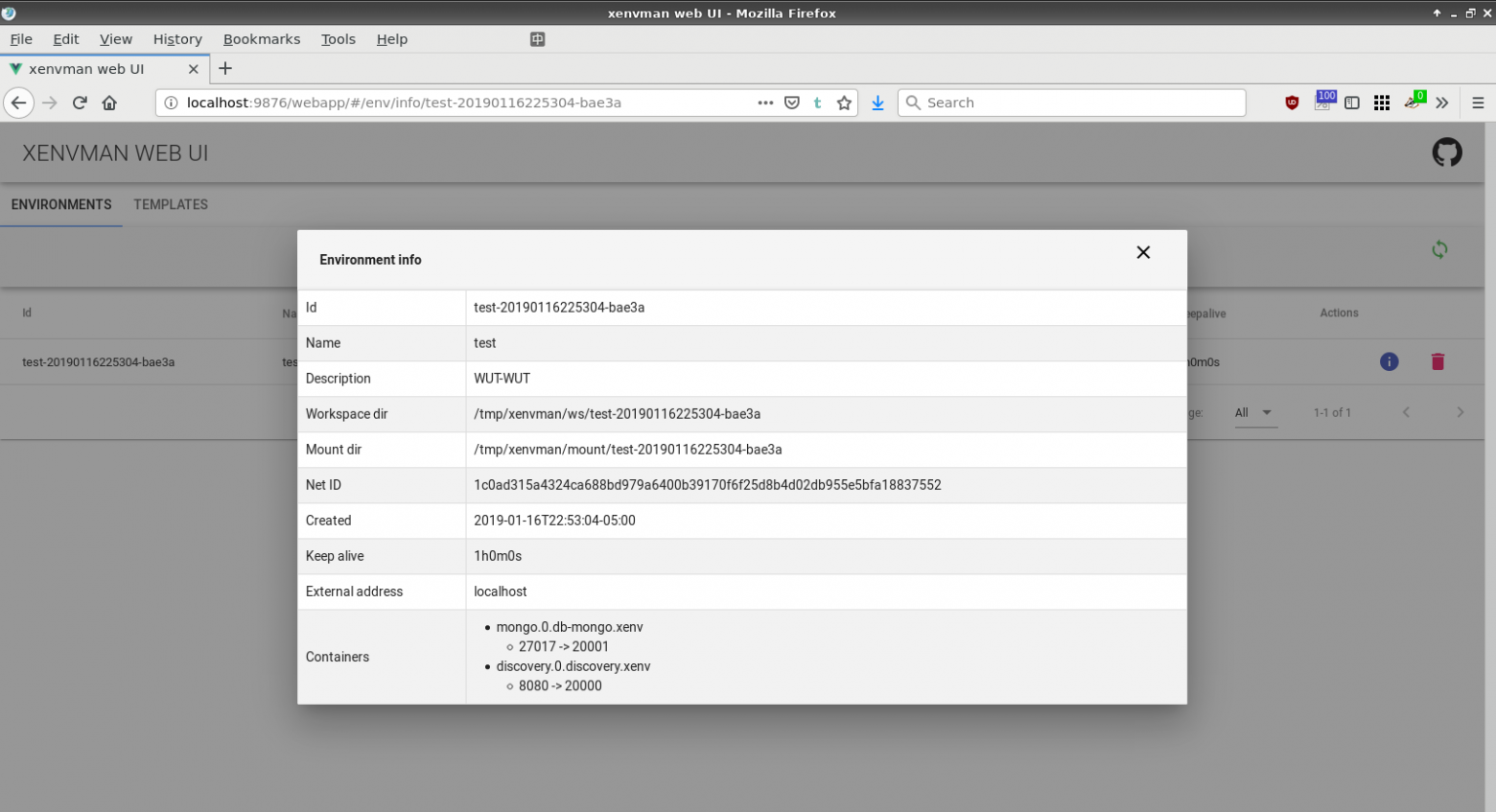

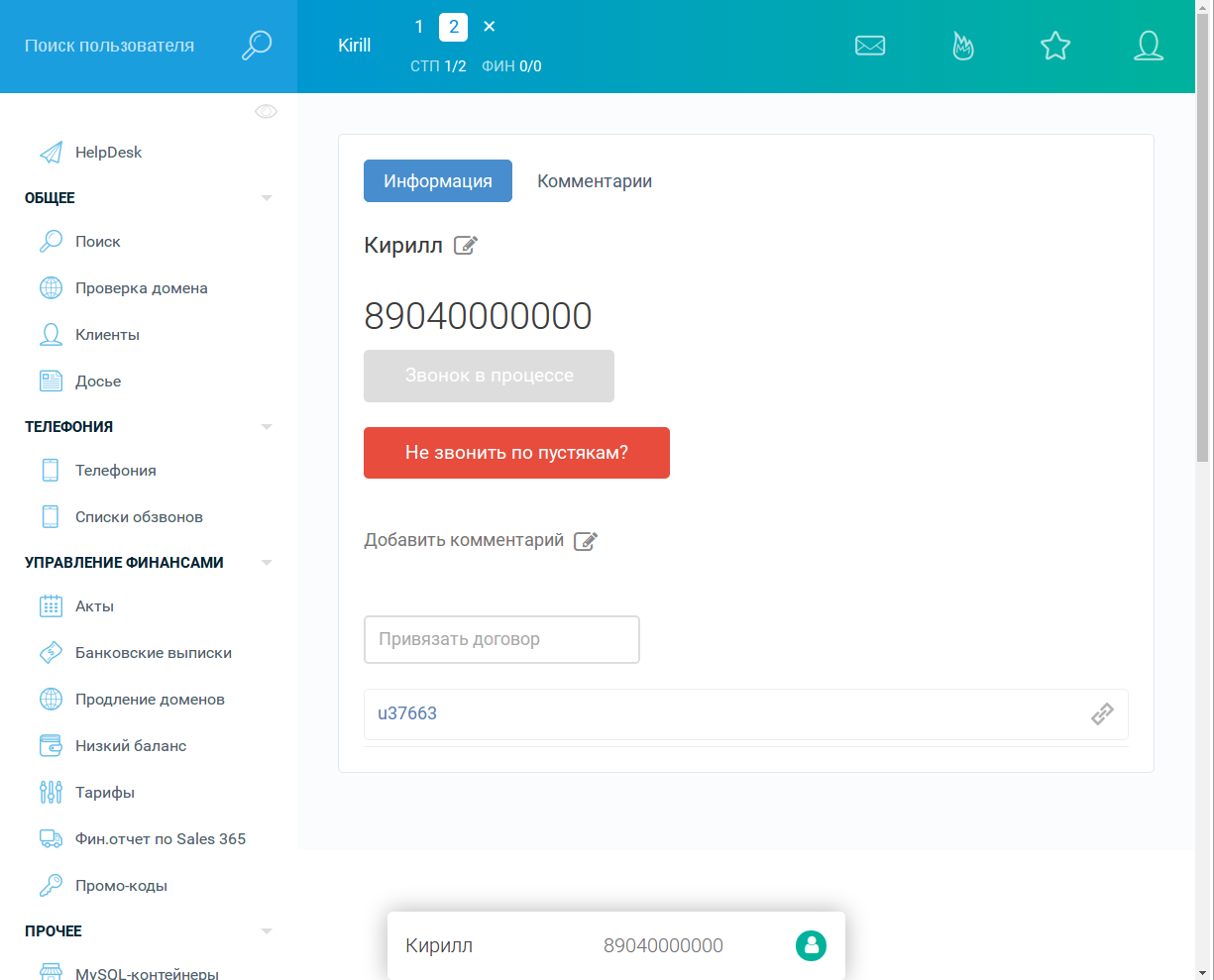

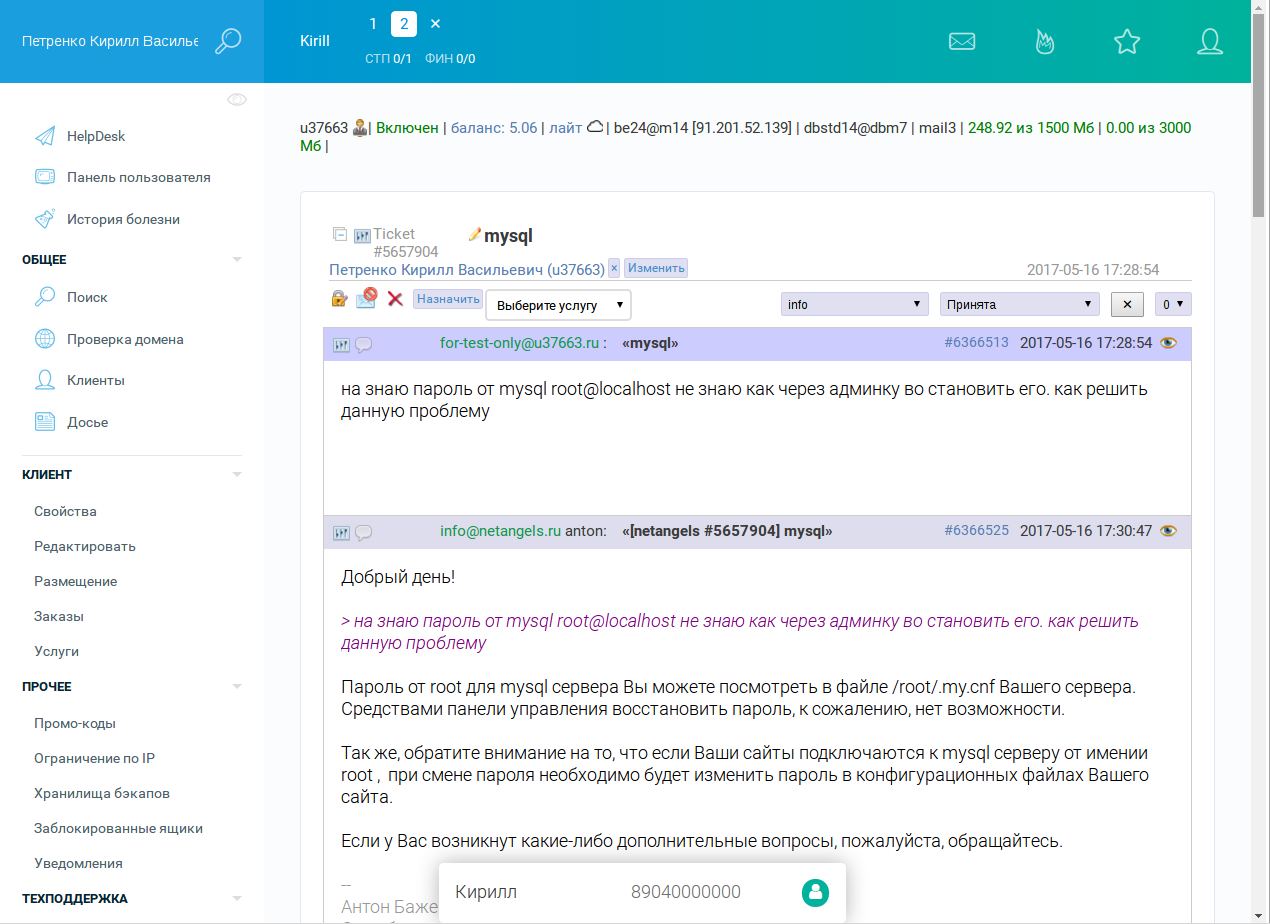

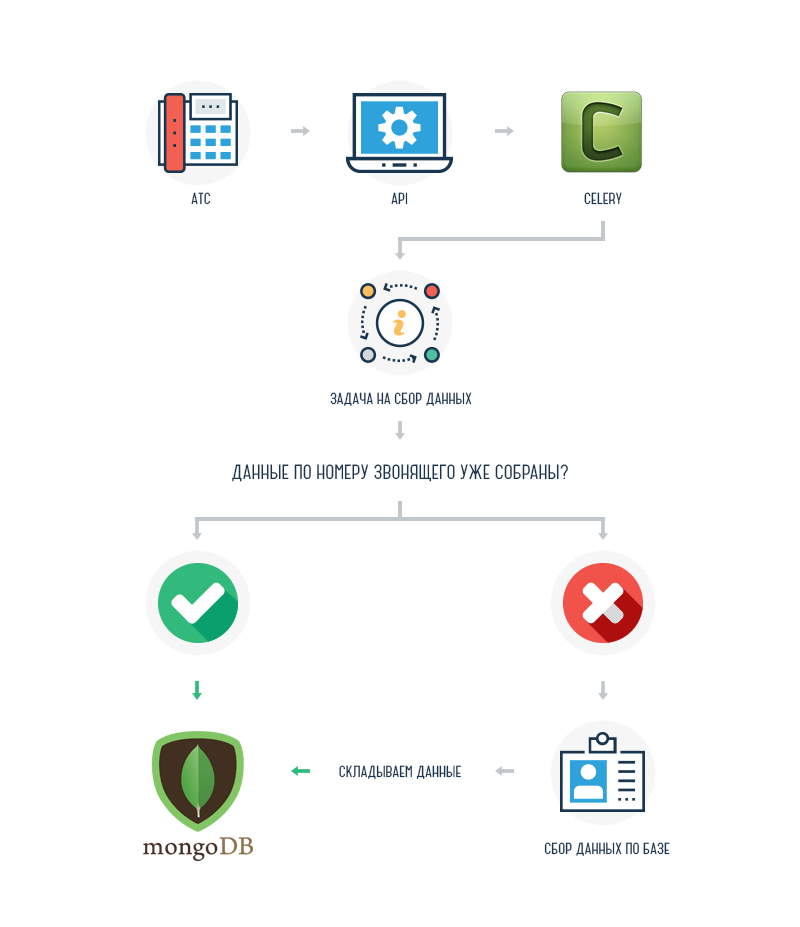

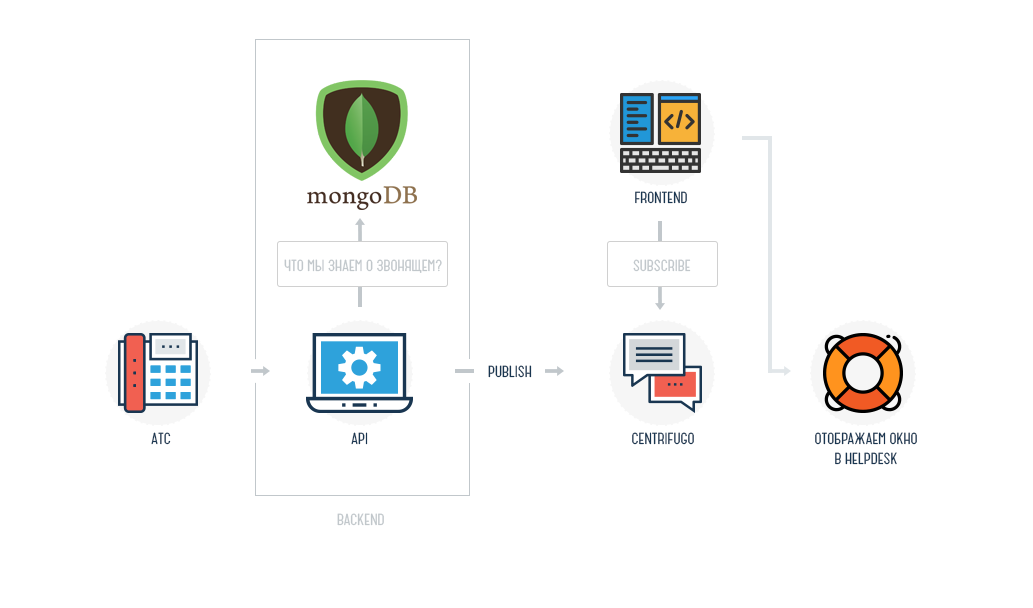

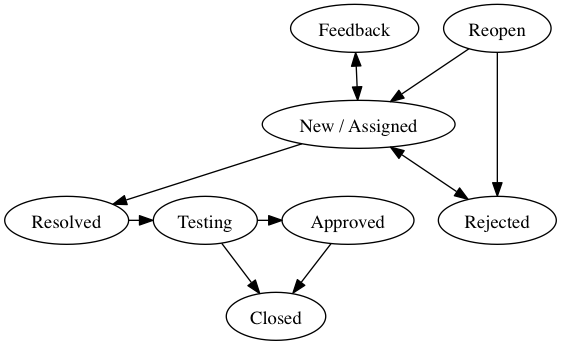

Окружения

---------

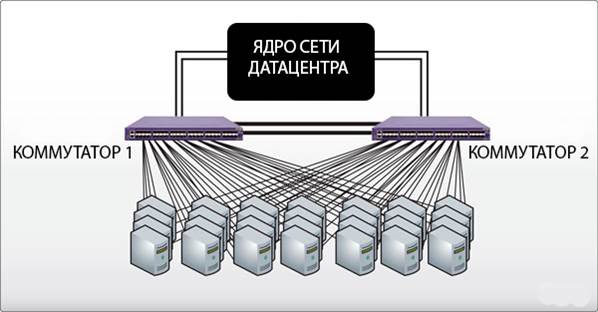

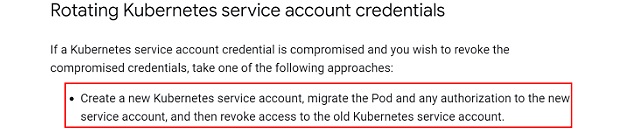

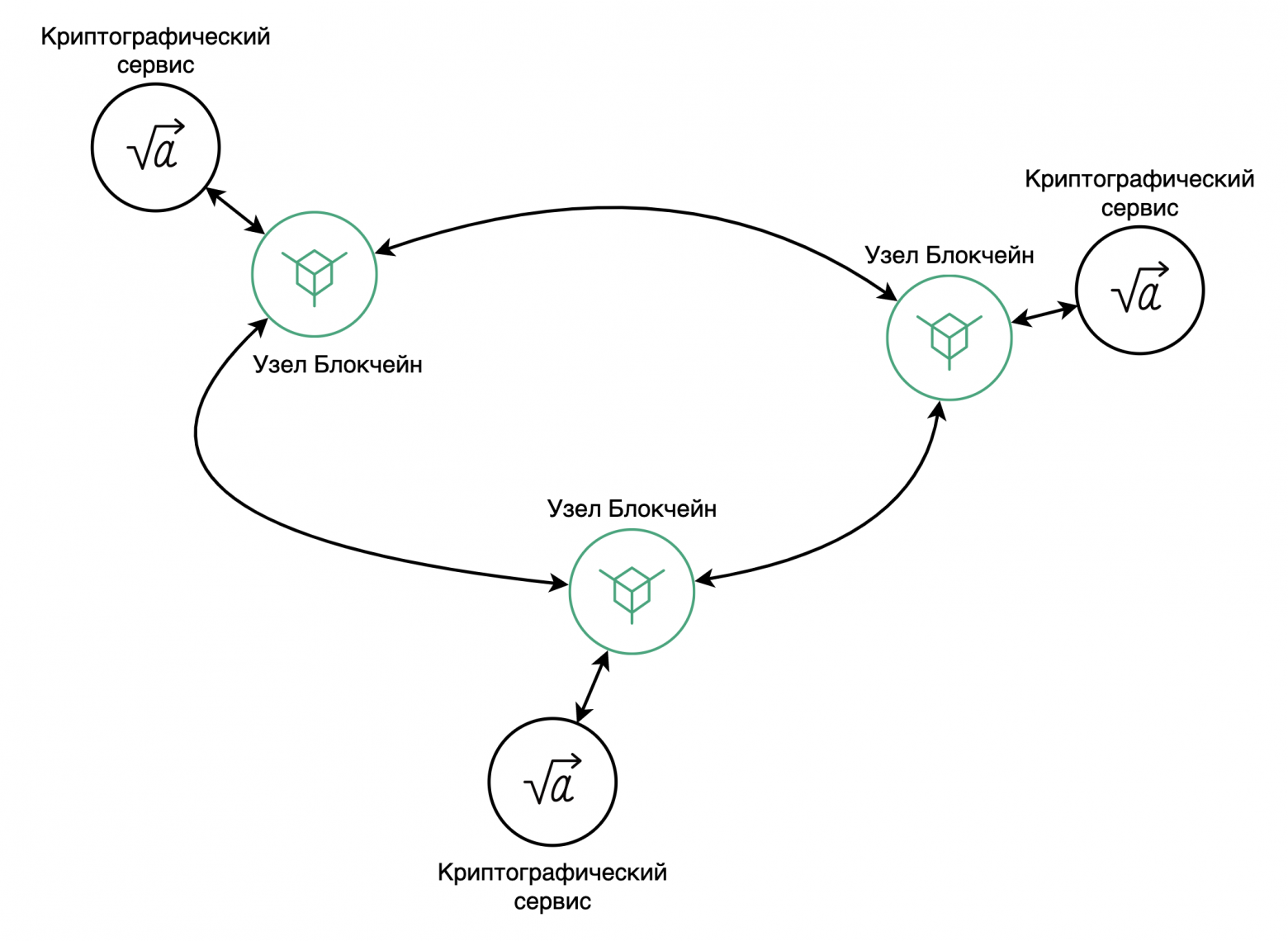

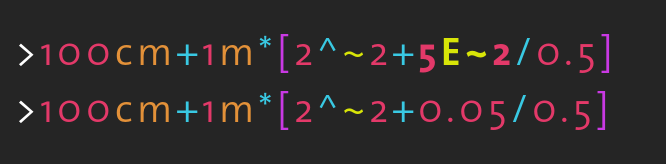

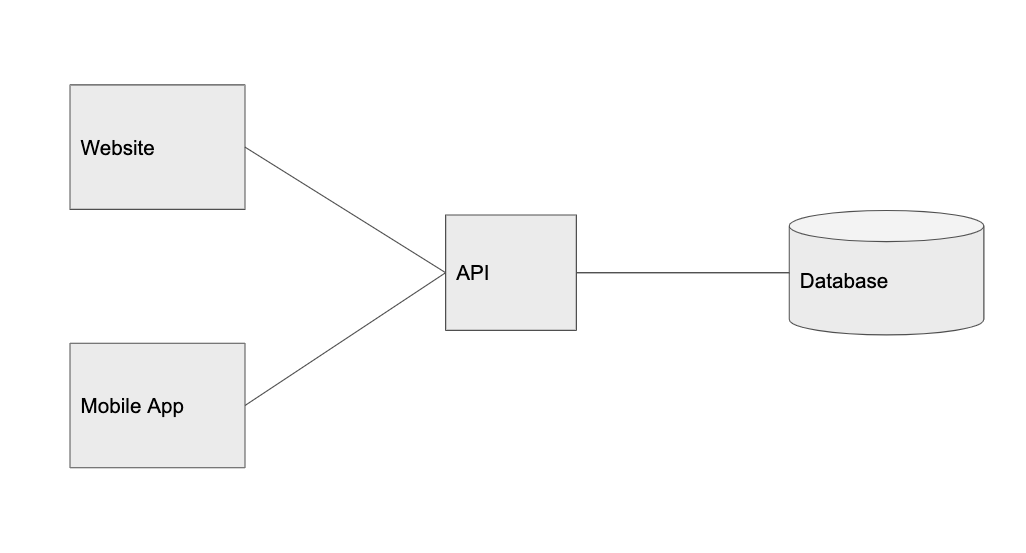

Главным действующим лицом в xenvman является окружение (environment). Это такой-себе изолированный пузырь, в котором запускаются все необходимые зависимости (упакованные в Docker контейнеры) вашего сервиса.

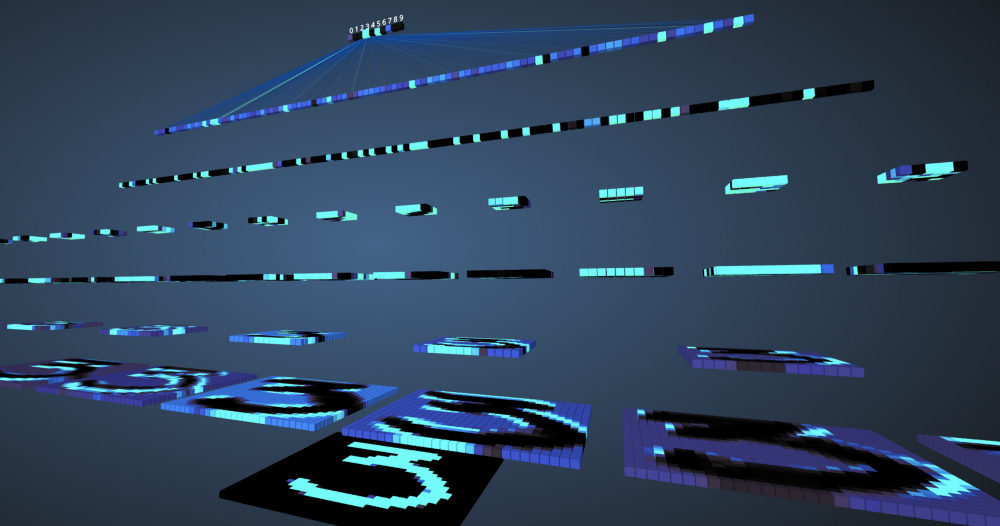

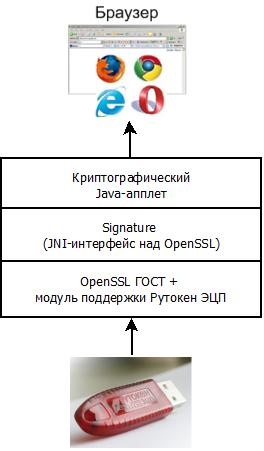

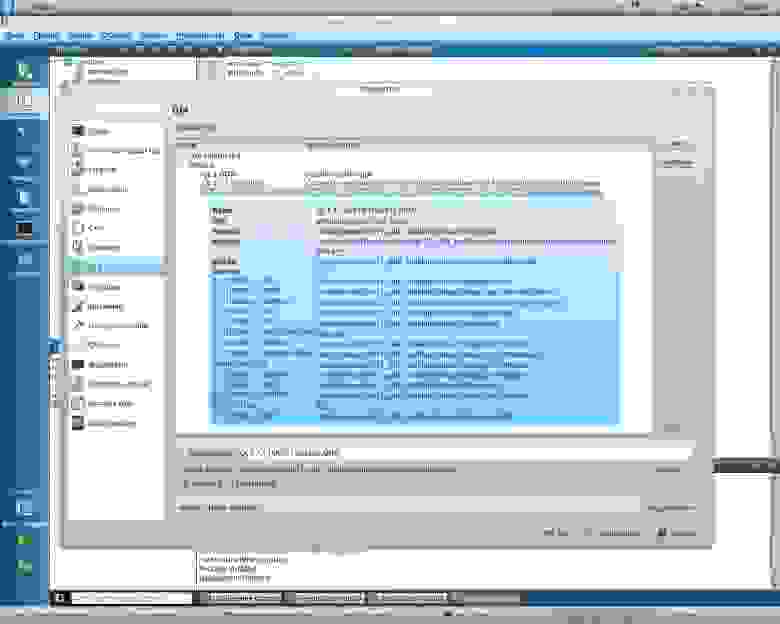

На рисунке выше, показан xenvman сервер и активные окружения, в которых запущены разные сервисы и базы данных. Каждое окружение было создано прямо из кода интеграционных тестов, и будет удалено по их завершению.

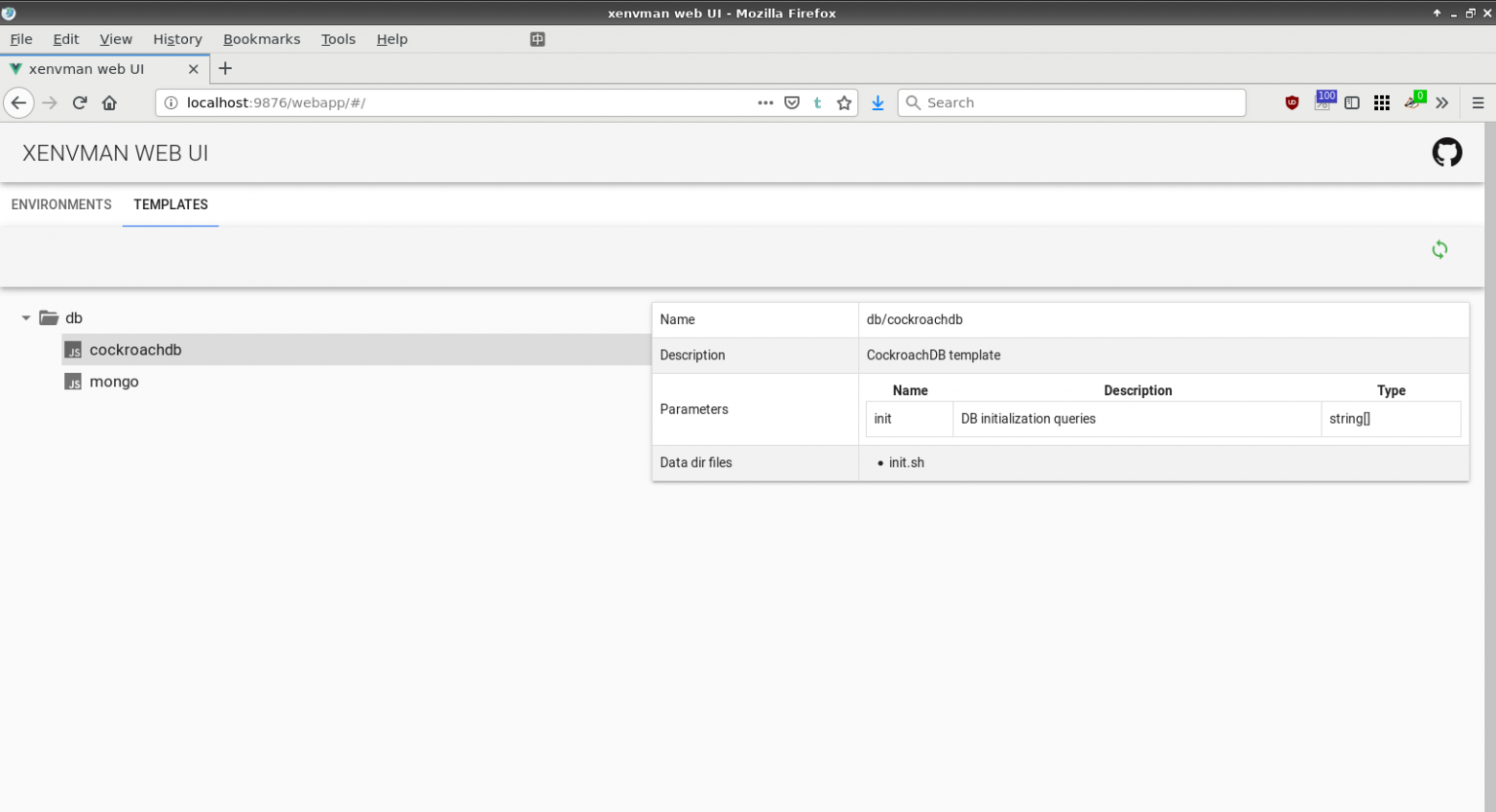

Шаблоны

-------

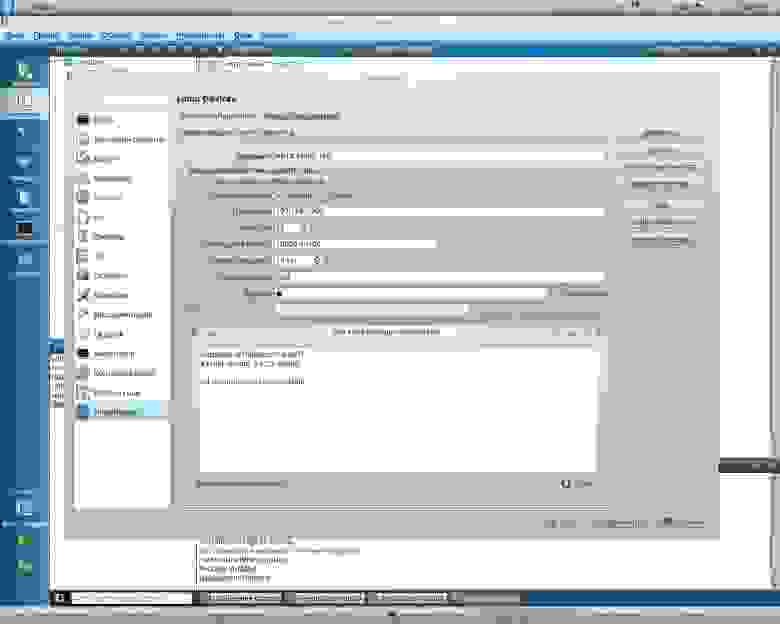

Что непосредственно входит в состав окружения, определяется шаблонами (templates), которые представляют собой небольшие скрипты на JS. xenvman имеет встроенный интерпретатор этого языка, и при получении запроса на создание нового окружения, он просто выполняет указанные шаблоны, каждый из которых добавляет один или более контейнеров в список на выполнение.

JavaScript был выбран для того, чтобы позволить динамически менять/добавлять шаблоны без необходимости пересборки сервера. Кроме того, в шаблонах как правило используются только базовые возможности и типы данных языка (старый добрый ES5, никакого DOM, React и прочей магии), поэтому работа с шаблонами не должна вызвать особых трудностей даже у тех, кто совсем на знает JS.

Шаблоны параметризуемы, то есть мы можем полностью контролировать логику шаблона путём передачи тех или иных параметров в нашем HTTP запросе.

Создание образов “на лету”

--------------------------

Одна из наиболее удобных возможностей xenvman, на мой взгляд, это создание Docker образов прямо по ходу конфигурирования окружения. Зачем это может быть нужно?

Ну вот например у нас на проекте, чтобы получить образ сервиса, нужно закомитить изменения в отдельную ветку, запушить и подождать пока Gitlab CI соберет и зальёт образ.

Если изменился только один сервис, то занять это может 3-5 минут.

А если мы активно пилим новые фичи в наш сервис, или же пытаемся понять почему он не работает, добавляя старый добрый `fmt.Printf` туда-сюда, или ещё как-нибудь часто изменяя код, то даже задержка в 5 минут будет здорово гасить производительность (нашу, как писателей кода). Вместо этого, мы можем просто добавить всю необходимую отладку в код, скомпилировать его локально, и потом просто приложить готовый бинарь в HTTP запрос.

Получив такое добро, шаблон возьмёт этот бинарь и прямо на ходу создаст временный образ, из которого мы уже сможем запустить контейнер как ни в чем не бывало.

На нашем проекте, в основном шаблоне для сервисов, например, мы проверяем присутствует ли бинарь в параметрах, и если да, то собираем образ на ходу, иначе просто скачиваем `latest` версию `dev` ветки. Дальнейший код для создания контейнеров идентичен для обоих вариантов.

Небольшой пример

----------------

Для наглядности, давайте рассмотрим микро-примерчик.

Скажем, пишем мы какой-то чудо-сервер (назовём-ка его — `wut`), которому нужна база данных, чтобы всё там хранить. Ну и в качестве базы, выбрали мы MongoDB. Стало быть для полноценного тестирования нам нужен работающий сервер Mongo. Можно, конечно, установить и запустить его локально, но для простоты и наглядности примера мы предположим, что по какой-то причине это сделать сложно (при других, более сложных конфигурациях в реальных системах это будет больше похоже на правду).

Значит мы попробуем использовать xenvman для того, чтобы создать окружение с запущенным Mongo и нашим `wut` сервером.

Первым делом нам надо создать [базовый каталог](https://github.com/syhpoon/xenvman#Templates), в котором будут храниться все шаблоны:

`$ mkdir xenv-templates && cd xenv-templates`

Дальше создадим два шаблона, один для Mongo, другой для нашего сервера:

`$ touch mongo.tpl.js wut.tpl.js`

### mongo.tpl.js

Откроем `mongo.tpl.js` и запишем туда следующее:

```

function execute(tpl, params) {

var img = tpl.FetchImage(fmt("mongo:%s", params.tag));

var cont = img.NewContainer("mongo");

cont.SetLabel("mongo", "true");

cont.SetPorts(27017);

cont.AddReadinessCheck("net", {

"protocol": "tcp",

"address": '{{.ExternalAddress}}:{{.Self.ExposedPort 27017}}'

});

}

```

В шаблоне должна присутствовать функция *execute()* с двумя параметрами.

Первый — это экземпляр tpl объекта, через который происходит конфигурация окружения. Второй аргумент (params) это просто JSON объект, с помощью которого мы будем параметризовать наш шаблон.

В строке

```

var img = tpl.FetchImage(fmt("mongo:%s", params.tag));

```

мы просим xenvman скачать docker образ `mongo:`, где это версия образа, который мы хотим использовать. В принципе, эта строка эквивалентна команде `docker pull mongo:`, с той лишь разницей, что все функции `tpl` объекта по-сути декларативны, то есть реально образ будет скачан только после того как xenvman выполнит все шаблоны, указанные в конфигурации окружения.

После того, как у нас есть образ, мы можем создать контейнер:

```

var cont = img.NewContainer("mongo");

```

Опять-таки, контейнер моментально не будет создан в этом месте, мы просто декларируем намерение создать его, так сказать.

Далее мы вешаем ярлык на наш контейнер:

```

cont.SetLabel("mongo", "true");

```

Ярлыки используются для того, чтобы контейнеры могли находить друг-друга в окружении, например чтобы вписать IP адрес или имя хоста в конфигурационный файл.

Теперь нам нужно вывесить внутренний порт Mongo (27017) наружу. Это легко делается так:

```

cont.SetPorts(27017);

```

Перед тем, как xenvman отрапортует нам об успешном создании окружения, было бы здорово убедиться, что все сервисы не просто запущены, а уже и готовы принимать запросы. В xenvman для этого имеются [проверки готовности](https://github.com/syhpoon/xenvman#readiness-checks).

Добавим одно такую для нашего mongo контейнера:

```

cont.AddReadinessCheck("net", {

"protocol": "tcp",

"address": '{{.ExternalAddress}}:{{.Self.ExposedPort 27017}}'

});

```

Как мы видим, здесь в строке адреса имеются заглушки, в которые будут динамически подставлены нужные значения прямо перед запуском контейнеров.

Вместо `{{.ExternalAddress}}` будет подставлен внешний адрес хоста, на котором запущен xenvman, а вместо `{{.Self.ExposedPort 27017}}` будет подставлен внешний порт, который был проброшен на внутренний 27017.

Подробнее об интерполяции можно почитать [здесь](https://github.com/syhpoon/xenvman#interpolation).

В итоге всего этого, мы сможем подключаться к Mongo, запущенному в окружении, прямо снаружи, например с хоста, на котором мы запускаем наш тест.

### wut.tpl.js

Так-c, разобравшись с монгой, напишем ещё шаблончик для нашего `wut` сервера.

Так как мы хотим собирать образ на ходу, шаблон будет немного отличаться:

```

function execute(tpl, params) {

var img = tpl.BuildImage("wut-image");

img.CopyDataToWorkspace("Dockerfile");

// Extract server binary

var bin = type.FromBase64("binary", params.binary);

img.AddFileToWorkspace("wut", bin, 0755);

// Create container

var cont = img.NewContainer("wut");

cont.MountData("config.toml", "/config.toml", {"interpolate": true});

cont.SetPorts(params.port);

cont.AddReadinessCheck("http", {

"url": fmt('http://{{.ExternalAddress}}:{{.Self.ExposedPort %v}}/', params.port),

"codes": [200]

});

}

```

Так как здесь мы собираем образ, то мы используем `BuildImage()` вместо `FetchImage()`:

```

var img = tpl.BuildImage("wut-image");

```

Для того, чтобы собрать образ, нам будут нужны несколько файлов:

Dockerfile — собственно инструкция как собирать образ

config.toml — конфигурационный файл для нашего `wut` сервера

С помощью метода `img.CopyDataToWorkspace("Dockerfile");` мы копируем Dockerfile из [каталога данных шаблона](https://github.com/syhpoon/xenvman#data-directory) во [временный рабочий каталог](https://github.com/syhpoon/xenvman#workspace-directory).

Каталог данных — это каталог, в котором мы можем хранить все файлы, необходимые нашему шаблону в работе.

Во временный рабочий каталог мы копируем файлы (с помощью img.CopyDataToWorkspace()), которые попадут в образ.

Далее следует вот такое:

```

// Extract server binary

var bin = type.FromBase64("binary", params.binary);

img.AddFileToWorkspace("wut", bin, 0755);

```

Мы передаём бинарь нашего сервера прямо в параметрах, в закодированном (base64) виде. А в шаблоне мы его просто раскодируем, и получившуюся строку сохраняем в рабочий каталог в виде файла под именем `wut`.

Потом создаем контейнер и монтируем в него конфигурационный файл:

```

var cont = img.NewContainer("wut");

cont.MountData("config.toml", "/config.toml", {"interpolate": true});

```

Вызов `MountData()` означает, что файл `config.toml` из каталога данных будет смонтирован внутрь контейнера под именем `/config.toml`. Флаг `interpolate` указывает xenvman серверу, что перед монтированием в файле следует заменить все имеющиеся там заглушки.

Вот как может выглядеть конфиг:

```

{{with .ContainerWithLabel "mongo" "" -}}

mongo = "{{.Hostname}}/wut"

{{- end}}

```

Тут мы ищем контейнер с ярлыком `mongo`, и подставляем имя его хоста, какое бы оно не было в данном окружении.

После подстановки, файл может выглядеть как:

```

mongo = “mongo.0.mongo.xenv/wut”

```

Далее мы опять вывешиваем порт и заводим проверку готовности, на этот раз HTTP:

```

cont.SetPorts(params.port);

cont.AddReadinessCheck("http", {

"url": fmt('http://{{.ExternalAddress}}:{{.Self.ExposedPort %v}}/', params.port),

"codes": [200]

});

```

На этом наши шаблоны готовы, и мы можем использовать их в коде интеграционных тестов:

```

import "github.com/syhpoon/xenvman/pkg/client"

import "github.com/syhpoon/xenvman/pkg/def"

// Создаём xenvman клиент

cl := client.New(client.Params{})

// Требуем создать для нас окружение

env := cl.MustCreateEnv(&def.InputEnv{

Name: "wut-test",

Description: "Testing Wut",

// Указываем, какие шаблоны добавить в окружение

Templates: []*def.Tpl{

{

Tpl: "wut",

Parameters: def.TplParams{

"binary": client.FileToBase64("wut"),

"port": 5555,

},

},

{

Tpl: "mongo",

Parameters: def.TplParams{"tag": “latest”},

},

},

})

// Завершить окружение после окончания теста

defer env.Terminate()

// Получаем данные по нашему wut контейнеру

wutCont, err := env.GetContainer("wut", 0, "wut")

require.Nil(t, err)

// Тоже самое для монго контейнера

mongoCont, err := env.GetContainer("mongo", 0, "mongo")

require.Nil(t, err)

// Теперь формируем адреса

wutUrl := fmt.Sprintf("http://%s:%d/v1/wut/", env.ExternalAddress, wutCont.Ports[“5555”])

mongoUrl := fmt.Sprintf("%s:%d/wut", env.ExternalAddress, mongoCont.Ports["27017"])

// Всё! Теперь мы можем использовать эти адреса, что подключиться к данным сервисам из нашего теста и делать с ними, что захочется

```

Может показаться, что написание шаблонов будем занимать слишком много времени.

Однако при правильном дизайне, это одноразовая задача, а потом те же самые шаблоны можно переиспользовать ещё и ещё (и даже для разных языков!) просто тонко настраивая их путём передачи тех или иных параметров. Как видно в примере выше, непосредственно код теста очень простой, из-за того, что всю шелуху по настройке окружения мы вынесли в шаблоны.

В этом небольшом примере показаны далеко не все возможности xenvman, более подробное пошаговое руководство доступно [здесь (на англ.)](http://syhpoon.ca/posts/xenvman-tutorial/)

Клиенты

-------

На данный момент имеются клиенты для двух языков:

[Go](https://godoc.org/github.com/syhpoon/xenvman/pkg/client)

[Python](https://github.com/syhpoon/xenvman-python)

Но добавить новые не составит труда, так как предоставляемый API очень и весьма простой.

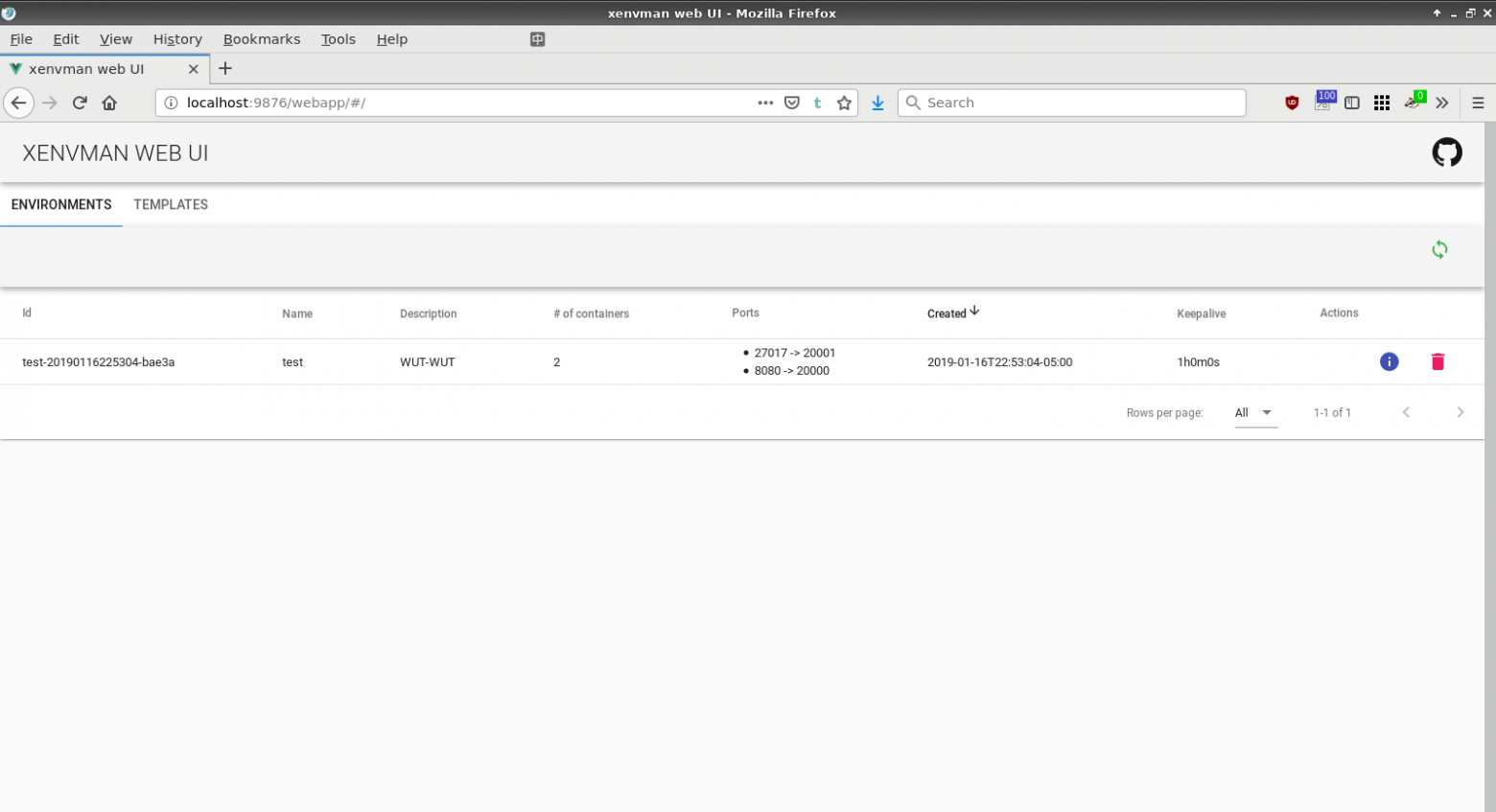

Веб интерфейс

-------------

В версии 2.0.0 был добавлен простенький веб интерфейс, с помощью которого можно управлять окружениями и просматривать доступные шаблоны.

Чем xenvman отличается от docker-compose?

-----------------------------------------

Конечно схожего много, но xenvman мне представляется немного более гибким и динамичным подходом, в сравнении со статической конфигурацией в файле.

Вот главные отличительные особенности, на мой взгляд:

* Абсолютно всё управление осуществляется через HTTP API, посему мы можем создавать окружения из кода любого языка, понимающего HTTP

* Так как xenvman может быть запущен на другом хосте, мы можем использовать все его возможности даже с хоста, на котором не установлен docker.

* Возможность динамического создание образов на лету

* Возможность изменения состава окружения (добавление/останов контейнеров) в процессе его работы

* Уменьшение boilerplate code, улучшение композиции и возможность переиспользования конфигурационного кода за счет использования параметризуемых шаблонов

Ссылки

------

[Github страничка проекта](https://github.com/syhpoon/xenvman)

[Подробный пошаговый пример, на англ.](http://syhpoon.ca/posts/xenvman-tutorial)

Заключение

----------

Вот, собственно и все. В ближайшее время я планирую добавить возможность

вызывать шаблоны из шаблонов и тем самым позволить комбинировать их с большей эффективностью.

Постараюсь ответить на любые вопросы, и буду рад, если кому-нибудь ещё этот проект окажется полезным. | https://habr.com/ru/post/439236/ | null | ru | null |

# Настройка прокси на прошивке Tomato

Начну, пожалуй, с главного — для чего, собственно, нужен мне лично прокси-сервер. У нашего провайдера (думаю как и у всех прочих) есть внутренние ресурсы, доступ на которые возможен только с компьютера, подключенного к этому самому провайдеру. Ранее, я использовал схему: белый IP у компьютера, прокси-сервер (CCProxy) и не выключал компьютер. Идея о том, что на роутере можно поставить прокси-сервер витала давно, так как на роутерах стоит Linux, вопрос был лишь в реализации. Squid слишком тяжел для данной задачи, ведь мне нужно простое и практичное решение и вот недавно, я наткнулся на одну программу — *srelay*, которая осуществляет «проброс» трафика через HTTP и SOCKS прокси.

Итак, теперь приступим к настройке роутера, в моем случае это NETGEAR WNR-3500L-RUS и прошивка Tomato (модификация прошивки не имеет значения). Данная статья рассчитана на продвинутого пользователя и считается. что человек уже умеет обращаться с командной строкой, putty и знает что делает.

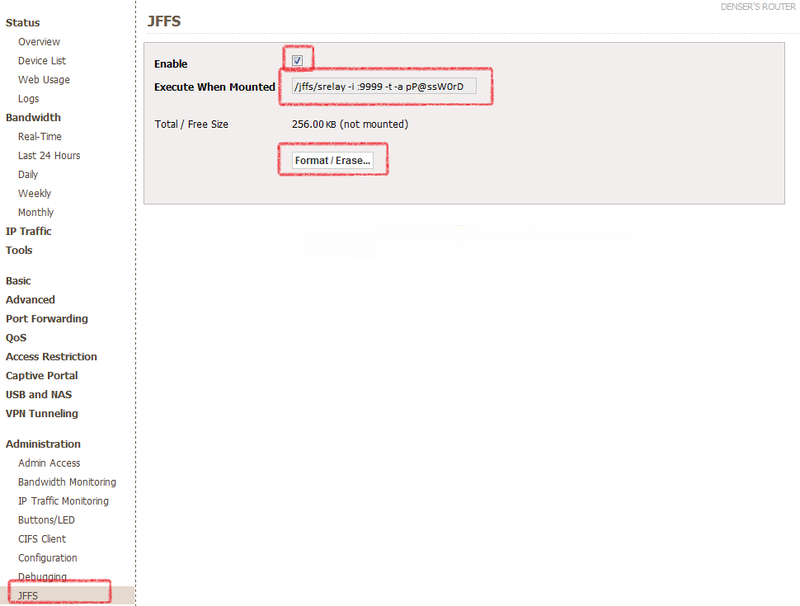

Сперва, необходимо сделать так, чтобы прокси работал всегда и не зависел ни от флешек ни от чего-либо ещё, то есть будем размещать программу в памяти роутера, для этого в разделе Администрирования включаем опцию JFFS — это небольшой раздел, в моем случае 320 кб, на программу для прокси хватит.

Итак, идем в **Administration / JFFS**, включаем галочку **Enable** и нажимаем Format / Erase, ждем некоторое время, и нажимаем **Save**.

Когда раздел JFFS отформатирован и смонтирован, то появится доступ к папке */jffs*, сюда то и поместим программу *srelay*.

Чтобы скачать программу (файл расположен мной на моем же сайте гугла для удобства, уже скомпиленный из optware), выполняем следующий скрипт, можно в разделе **Tools / System**:

`wget "http://sites.google.com/site/denserru/Home/srelay/srelay?attredirects=0&d=1" -O "/jffs/srelay"

chmod +x /jffs/srelay`

Теперь у нас есть программа *srelay* в разделе jffs, который находится в памяти роутера, остается настроить порты, автозапуск программы и её параметры.

Параметры программы можно увидеть по команде:

`root@denser-router:/tmp/home/root# /jffs/srelay -h

srelay 0.4.6 2003/04/13 (Tomo.M)

usage: srelay [options]

options:

-c file config file

-i i/f listen interface IP[:PORT]

-m num max child/thread

-o min idle timeout minutes

-p file pid file

-a np auth methods n: no, p:pass

-u file srelay password file

-f run into foreground

-r resolve client name in log

-s force logging to syslog

-t disable threading

-b avoid BIND port restriction

-v show version and exit

-h show this help and exit`

Нам понадобится следующие из них:

`/jffs/srelay -i :9999 -t -a pP@ssW0rD`

Где 9999 — порт, который будет использоваться для подключения, используйте какой угодно, кроме стандартных. **P@ssW0rD** замените на пароль, который будет использоваться для авторизации(обратите внимание на букву **р** перед паролем), имя пользователя при доступе к прокси — root. Добавляем эту строку в поле **Execute When Mounted**, чтобы программа запускалась при инициализации раздела JFFS с заданными параметрами, а именно:

* работа по протоколам HTTP, SOCKS4 и SOCKS5

* авторизация на порту **9999** пользователь: **root**, пароль: **P@ssW0rD**.

Приблизительно так должно выглядеть в итоге:

Теперь, добавим правило в **Firewall** на открытие порта 9999, для этого переключаемся в раздел **Administration / Scripts**, вкладка **Firewall**, туда добавляем через перенос строки следующее:

`iptables -I INPUT -p tcp --dport 9999 -j ACCEPT`

Выглядеть это будет приблизительно вот так:

Теперь перезагружаем роутер и проверяем работу программы любым доступным методом, например, браузером. Надеюсь вам пригодится эта инструкция как и мне.

Было замечено, что после длительной работы, программа могла закрываться, для этих целей я ставлю программу *monit*, но это тема другой статьи.

Используемые материалы:

1. Исходники самой программы — [socks-relay.sourceforge.net](http://socks-relay.sourceforge.net/)

2. Очерк одного из пользователей — [www.linksysinfo.org/index.php?threads/a-socks-proxy-server-for-tomato.23898](http://www.linksysinfo.org/index.php?threads/a-socks-proxy-server-for-tomato.23898/) | https://habr.com/ru/post/133984/ | null | ru | null |

# Rust и Linux

[](https://habr.com/ru/company/ruvds/blog/670748/)

Во время прошлогодней [Linux Plumbers Conference 2021](https://lpc.events/event/11/) один из мейнтейнеров, [Мигель Охеда](https://ojeda.dev/), задался вопросом: нужен ли сообществу Rust в коде ядра Linux и что нужно для того, чтобы соответствующие патчи были приняты в древе проекта? Комментарии от разработчиков были в основном доброжелательными, но без фанатизма. Лидер проекта Линус Торвальдс сказал, что не против т․ н․ пилотной серии патчей на Rust, с оговоркой, что и остальные разработчики должны рассматривать их в качестве опытной партии.

Тут уместно вспомнить, что ядро Linux вероятно один из самых масштабных проектов с открытым исходным кодом и самый успешный, учитывая пройденный путь за более, чем 30 лет после опубликования версии ядра 0.01. Всё это время разработка велась и ведётся поныне на языке программирования C. Линус Торвальдс без ума от C и не раз высказывался в том духе, что от добра добра не ищут, и все остальные ЯП непригодны для разработки ядра.

---

*Мне нравится разбираться с железом и для этой цели C нет равных.*

> *I like interacting with hardware from a software perspective. And I have yet to see a language that comes even close to C…When I read C, I know what the assembly language will look like.*

*Линус Торвальдс 2012*

---

Быстрый, низкоуровневый и традиционно один из самых востребованных языков программирования, разве C нужны дополнительные подпорки в коде ядра? Что может предложить Rust такого, чтобы вся затея в итоге оправдала себя? Если в двух словах, то всё дело в НП, то есть в неопределённом поведении, характерном для некоторых типичных сценариев в C. Такое поведение зачастую оборачивается ошибками в коде и скрытыми уязвимостями, в то время как Rust *архитектурно* защищён от НП и связанных с ним проблем.

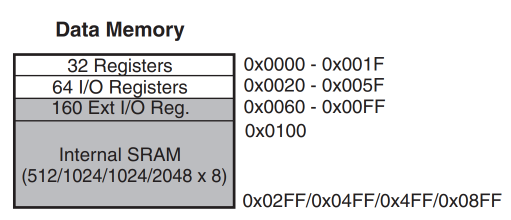

Согласно [последнему рабочему документу](https://www.open-std.org/jtc1/sc22/wg14/www/docs/n2596.pdf) C, неопределённое поведение возникает при использовании ошибочной программной конструкции, или данных, и данный документ для таких сценариев не предъявляет никаких требований. Примером такого рода является поведение при разыменовании нулевого указателя. Такого же поведения можно добиться, если значение первого оператора равно `INT_MIN`, или второго оператора — равно 0.

```

int f(int a, int b) {

return a / b;

}

```

Для того чтобы исправить НП, нужно задать условия выхода.

```

int f(int a, int b) {

if (b == 0)

abort();

if (a == INT_MIN && b == -1)

abort();

return a / b;

}

```

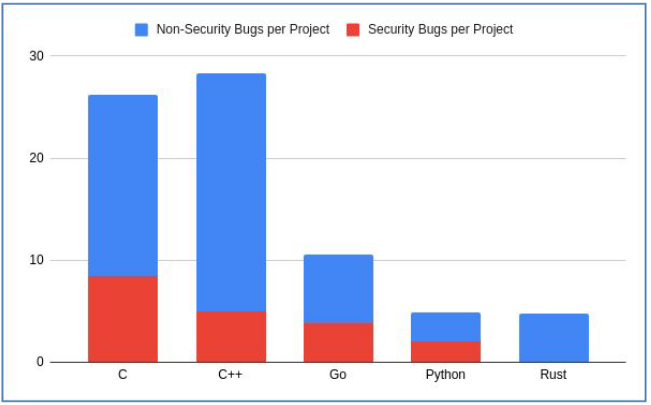

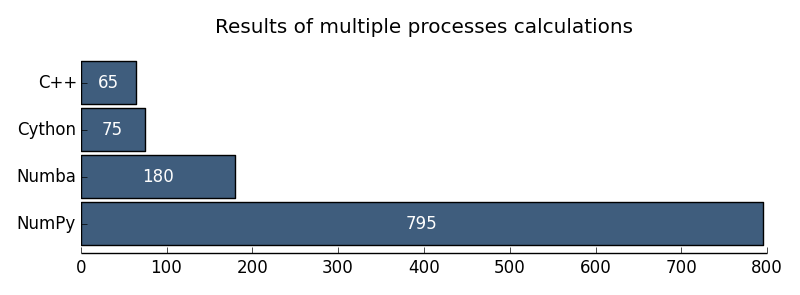

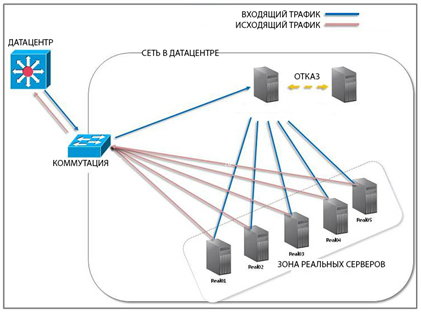

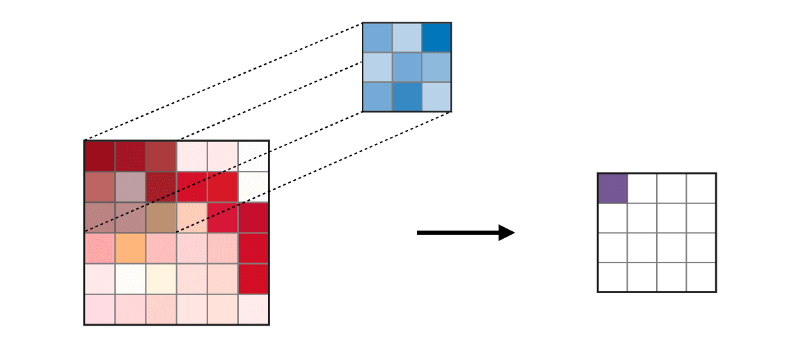

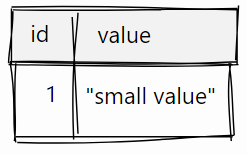

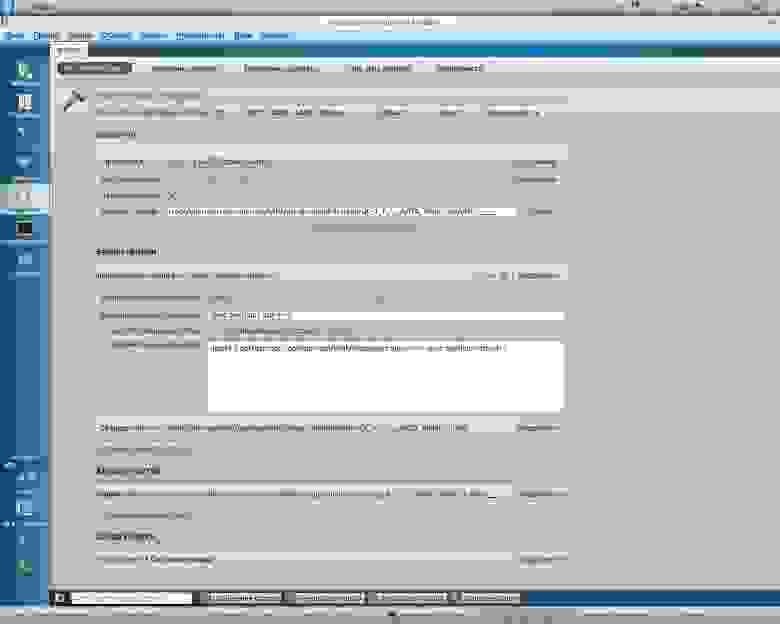

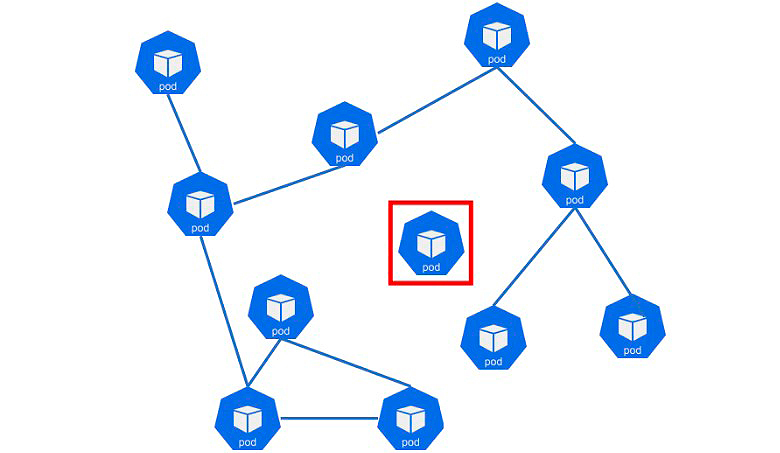

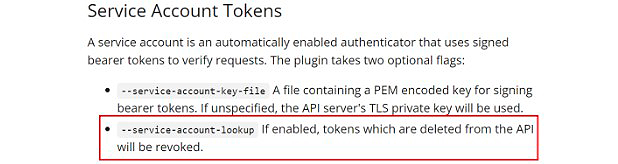

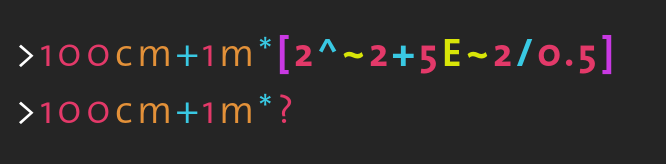

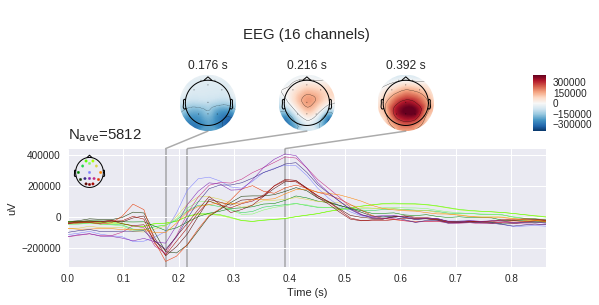

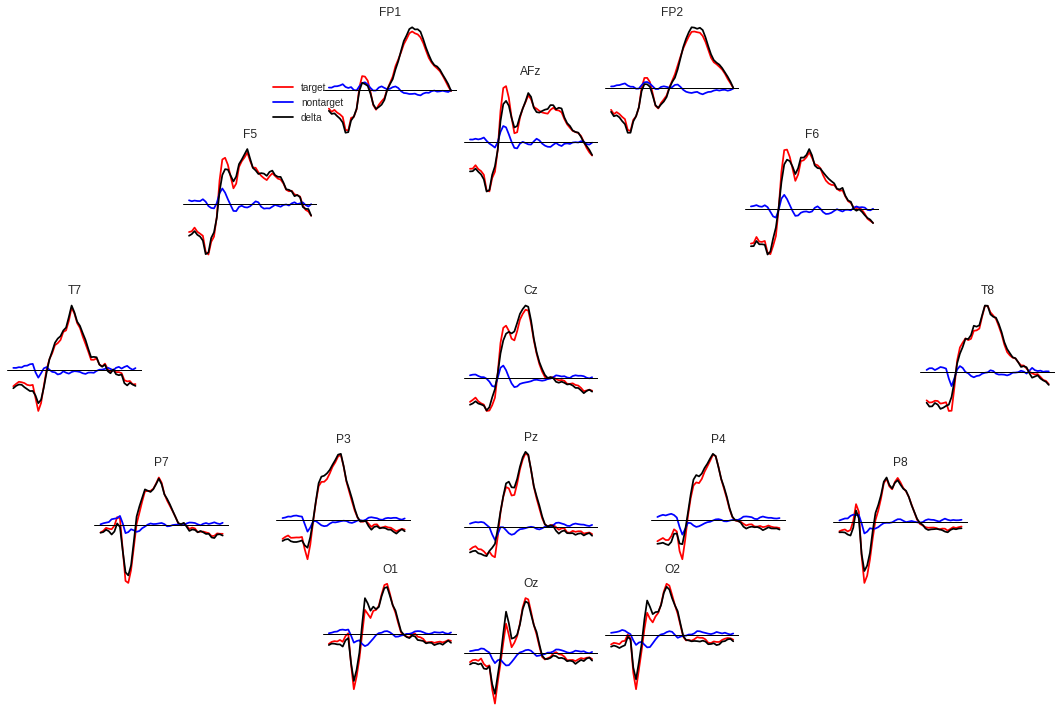

Неопределенное поведение проявляется в нарушениях безопасного использования памяти, например, к ошибкам связанным с переполнением буфера, чтением, или записи за пределами буфера, использование освобождённой памяти (use-after-free) и др. Из недавних примеров можно вспомнить уязвимость записи за пределами буфера [WannaCry](https://www.mandiant.com/resources/wannacry-malware-profile). Туда же следует отнести [Stagefright](https://googleprojectzero.blogspot.com/2015/09/stagefrightened.html) на ОС Android. Анализ 0-day дыр безопасности компании Гугл [показал](https://twitter.com/LazyFishBarrel/status/1129000965741404160), что 80% из них вызваны нарушением безопасного доступа к памяти. Ниже на картинке ещё один результат fuzzing-проверки по разным проектам.

*Figure 1. Соотношение по дырам безопасности в проектах на разных языках программирования.*

Чтобы не быть голословными, рассмотрим на примере:

```

#include

int main(void)

{

int \* const a = malloc(sizeof(int));

if (a == NULL)

abort();

\*a = 42;

free(a);

free(a);

}

```

Несмотря на явную оплошность с двойным освобождением памяти, компилятор не прерывает работу. Таким образом, программа может быть запущена, хоть и завершится с ошибкой.

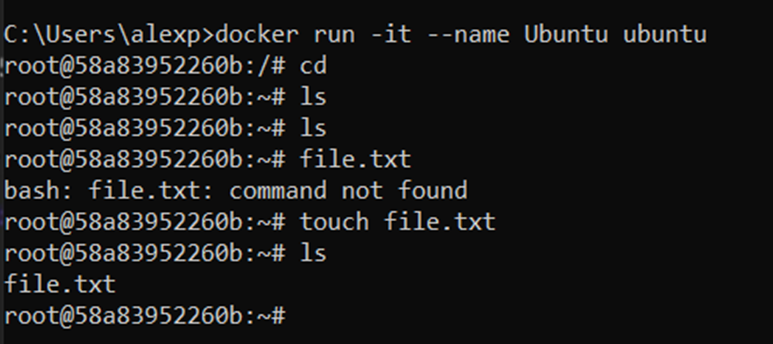

```

|13:59:54|adm@redeye:[~]> gcc -g -Wall -std=c99 -o test test.c

|13:59:59|adm@redeye:[~]> echo $?

0

|14:00:05|adm@redeye:[~]> ./test

free(): double free detected in tcache 2

Aborted

```

Проверим теперь поведение точно такого же кода на Rust.

```

pub fn main() {

let a = Box::new(42);

drop(a);

println!("{}", *a);

}

```

На этапе компиляции программа выдаст ошибку из-за того, что память в переменной была высвобождена. Текст содержит описание и ссылку с кодом ошибки.

```

rustc app.rs

error[E0382]: borrow of moved value: a

--> app.rs:4:17

|

2 | let a = Box::new(42);

| - move occurs because a has type std::boxed::Box, which does not implement the Copy trait

3 | drop(a);

| - value moved here

4 | println!("{}", \*a);

| ^^ value borrowed here after move

error: aborting due to previous error

For more information about this error, try rustc --explain E0382.rustc app.rs

```

Преимущества Rust не ограничиваются безопасным доступом к памяти, есть ряд других полезных свойств, которые могли бы облегчить труд разработчиков ядра Linux. Взять хотя бы инструментарий для управления зависимостями. Много-ли тех, кому по душе сражаться с *include* путями в заголовочных файлах, раз за разом запускать `pkg-config` вручную, либо через макросы *Autotools*, полагаться на то, что пользователь установит нужные версии библиотек? Разве не проще записать всё необходимое в файл `Cargo.toml`, перечислив в нём названия и версии всех зависимостей? При запуске `cargo build` они автоматически подтянутся из реестра пакетов [crates.io](https://crates.io/).

В ядро Linux код попадает не сразу, а после тщательной проверки качества и соответствия внутренним стандартам. Исключения крайне редки, а это подразумевает необходимость часто тестировать программу на наличие возможных ошибок и дефектов. Сложность, или неудобство связанные с тестированием кода напрямую будут сказываться на результате работы. Так уж получилось, что язык С по сегодняшним меркам неважно приспособлен для всестороннего тестирования по ряду причин.

* Немалые трудности представляет обработка сценариев с внутренними статическими функциями. Их можно вызвать лишь в самом файле, где они определены. Для того, чтобы до них добраться извне, нужно писать `#include` директивы, либо же использовать условия `#ifdef`.

* Для того чтобы слинковать часть зависимостей с тестовой программой необходимо творчески редактировать `Makefile`, или `CMakeLists.txt`.

* Нужно выбрать из множества фреймворков какой-то один, либо несколько самых популярных. Придётся их освоить, дабы уметь интегрировать свой проект и запускать автоматические проверки.

И всего этого можно избежать, написав в Rust:

```

#[test]

fn test_foo_prime() {

assert!(foo() == expected_result);

}

```

Вместе с тем, явная ошибка считать, что применение Rust в коде Linux лишено недостатков. **Во-первых**, одним дистиллированно безопасным кодом ядро написать не выйдет, во всяком случае, таковы реалии Linux. Иногда нужно переступить через порог безопасности, например, при статическом считывании и вычислении адресов регистров CPU.

**Во-вторых,** из-за дополнительных рантайм проверок кое-где могут возникнуть проблемы с производительностью и с высокой степенью вероятности это будут именно те редкие фрагменты кода, где сложно соответствовать принятым стандартам безопасности.

И наконец **в третьих** нельзя просто так взять и переписать код на другом ЯП из-за очевидных и неизбежных организационных проблем.

Rust в ядре, как это выглядит?

------------------------------

Так или иначе, Rust получил зелёный свет, пока что в ранге экспериментальной поддержки. Отправной точкой станет использование нового языка программирования при написании драйверов, если этот будет целесообразно. В частности, некоторые [GPIO драйвера](https://lwn.net/Articles/863459/) уже пишут на Rust. Использование Rust в стеке WiFi и Bluetooth драйверов также может пойти на пользу делу по мнению мейнтейнера [kernel.org](http://kernel.org/) Kees Cook.

Если пройти по ссылке, то можно заметить, что код на Rust несколько компактней, но возможно тут немного срезаны углы и принятый стиль разработки Linux нарушен в плане игнорирования длин строк, несоблюдения конвенций наименования переменных и пр. Однако, если приглядеться поближе, есть и более существенные отличия.

```

writeb(pl061->csave_regs.gpio_is, pl061->base + GPIOIS);

writeb(pl061->csave_regs.gpio_ibe, pl061->base + GPIOIBE);

writeb(pl061->csave_regs.gpio_iev, pl061->base + GPIOIEV);

writeb(pl061->csave_regs.gpio_ie, pl061->base + GPIOIE);

```

В этом фрагменте C кода происходит расчёт вручную некоего адреса внутри функции `writeb` и если сравнить с аналогичным фрагментом на Rust, то можно заметить, что там нет лазейки для произвольной записи в память за рамками смещения.

```

pl061.base.writeb(inner.csave_regs.gpio_is, GPIOIS);

pl061.base.writeb(inner.csave_regs.gpio_ibe, GPIOIBE);

pl061.base.writeb(inner.csave_regs.gpio_iev, GPIOIEV);

pl061.base.writeb(inner.csave_regs.gpio_ie, GPIOIE);

```

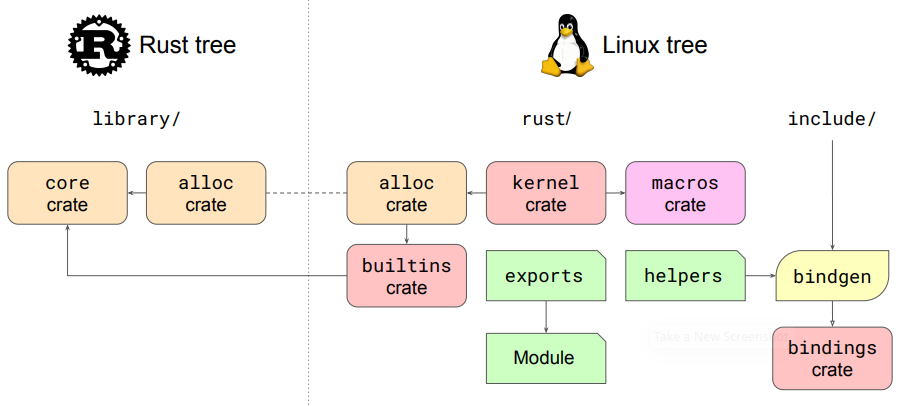

Документация проекта находится [по адресу](https://rust-for-linux.github.io/docs/kernel/) на Гитхабе. Сейчас ссылки на заголовочные `include` файлы C не работают. Rust имеет доступ к условной компиляции на основе конфигурации ядра.

```

#[cfg(CONFIG_X)] // CONFIG_X активен (y or m)

#[cfg(CONFIG_X="y")] // CONFIG_X активен и является встроенным (y)

#[cfg(CONFIG_X="m")] // CONFIG_X активен является модулем (m)

#[cfg(not(CONFIG_X))] // CONFIG_X не активен

```

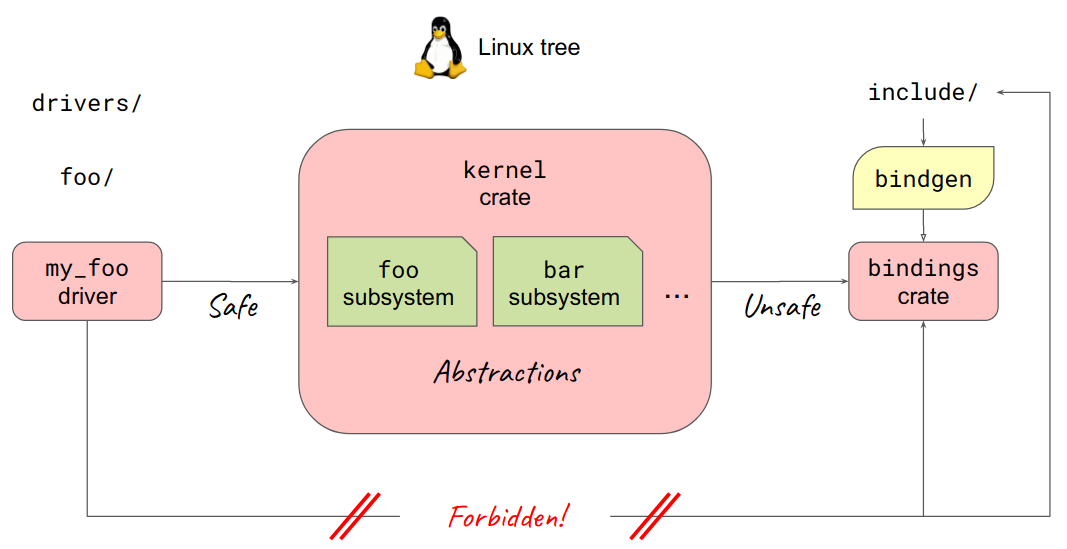

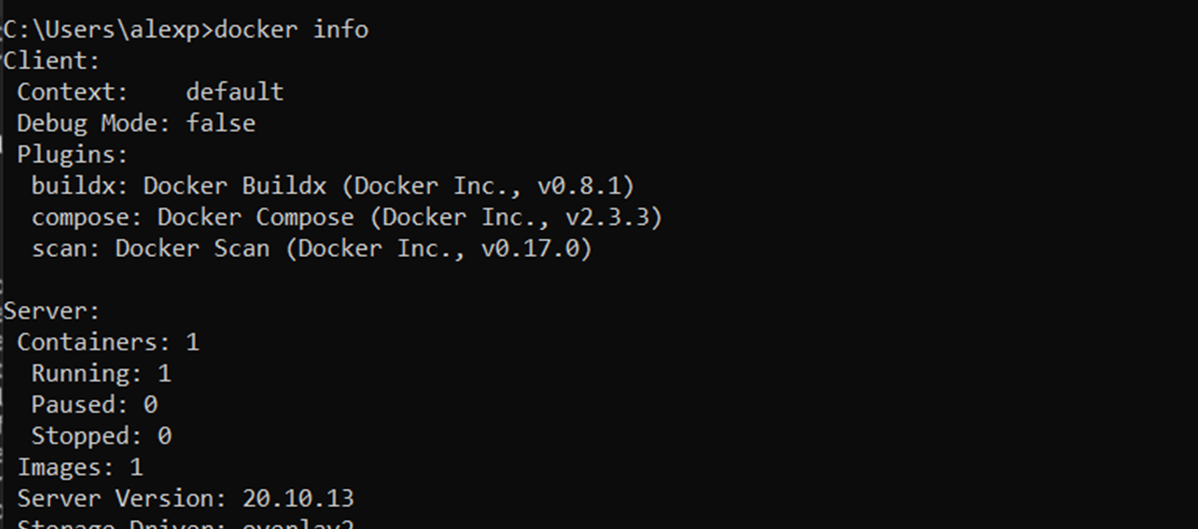

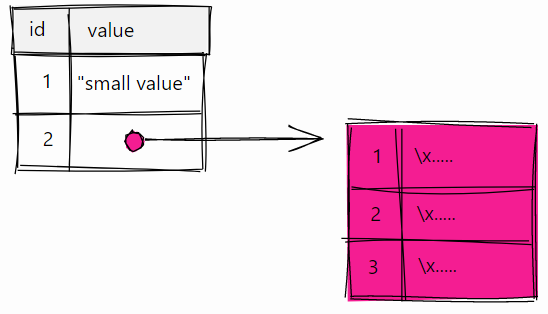

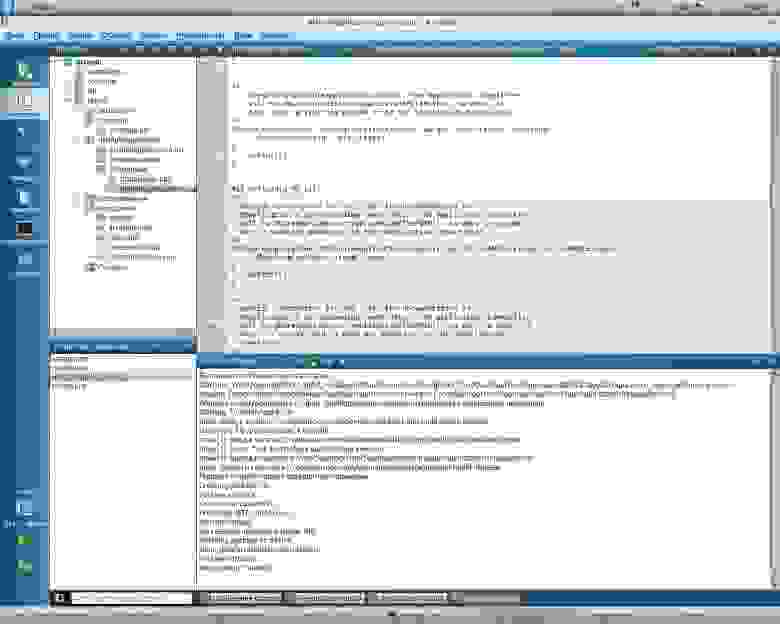

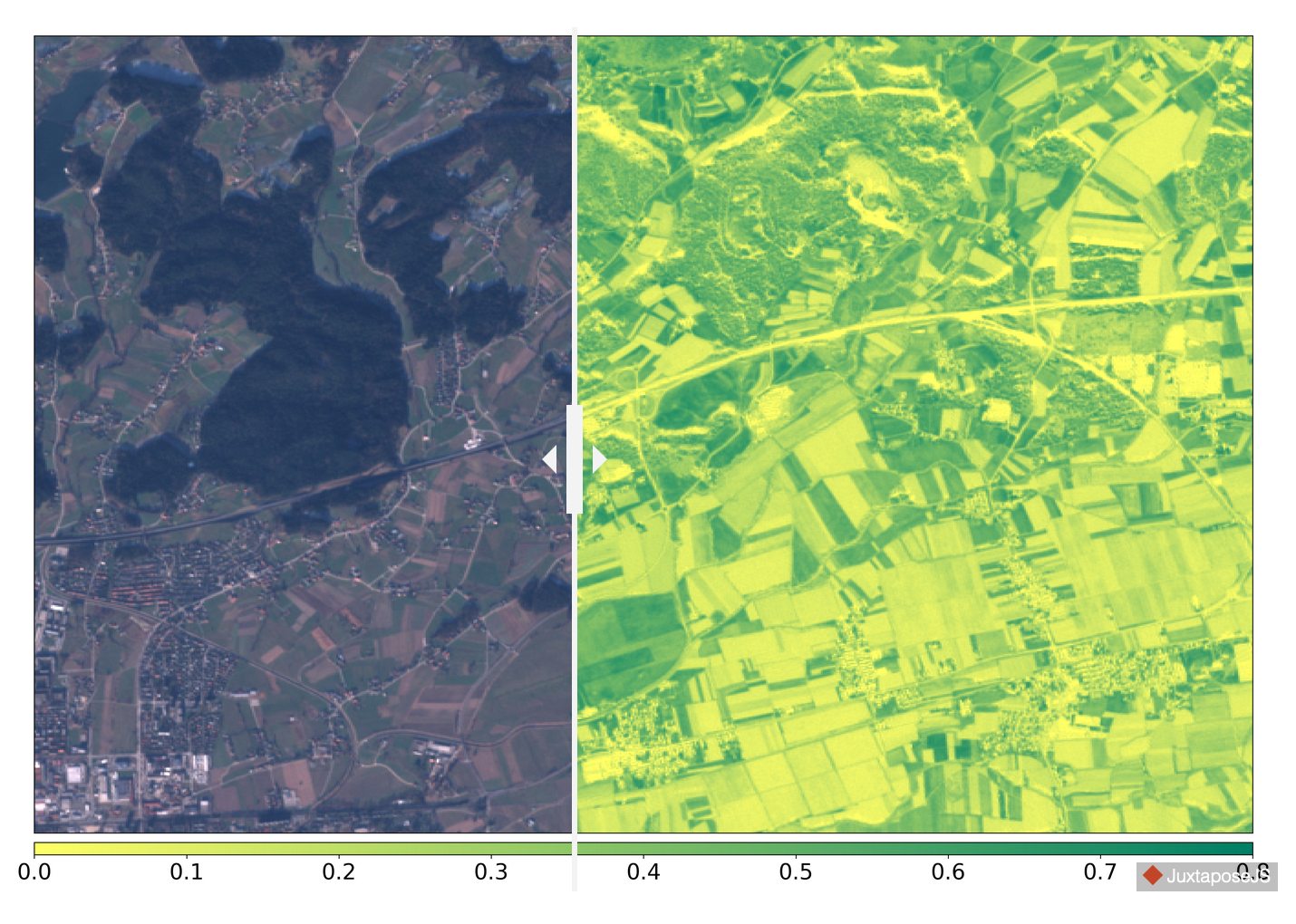

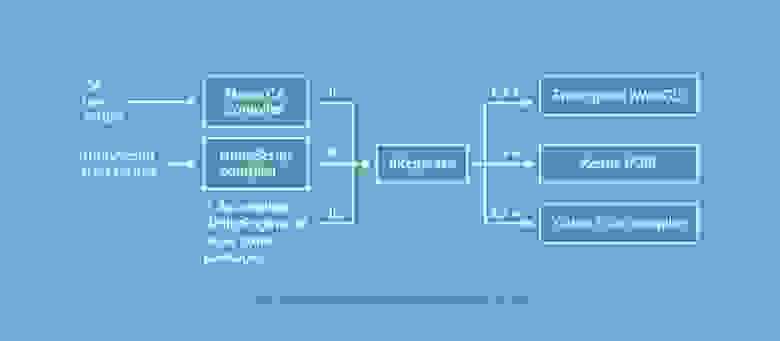

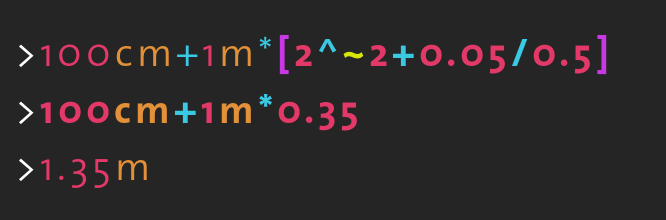

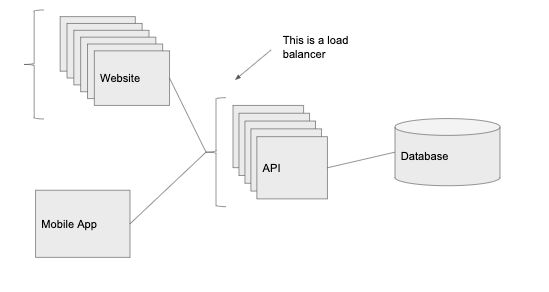

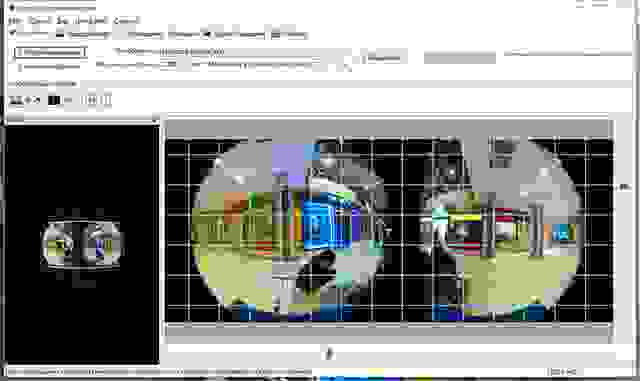

На данный момент интеграция нового языка программирования выглядит так. Название `kernel crate` не должно пугать, это не реализация ядра на Rust, а всего лишь реализация необходимых абстракций. Прикладное средство `bindgen` является по сути парсером, который автоматически создаёт привязки для заголовочных файлов C. `Bindgen` считывает заголовки C и из них пишет соответствующие функции на Rust.

*Figure 2. Rust в структуре каталогов ядра Linux*

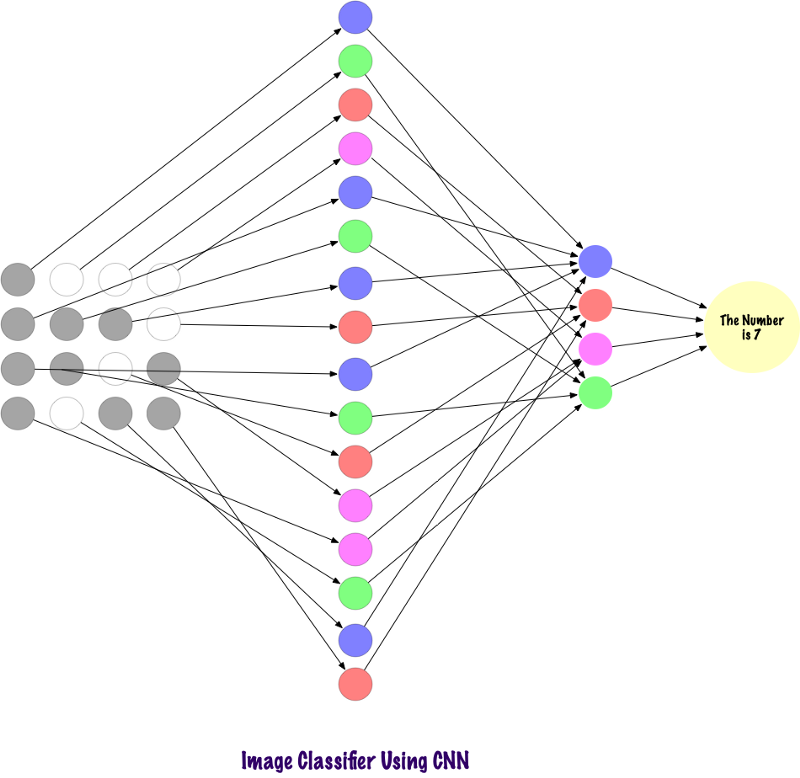

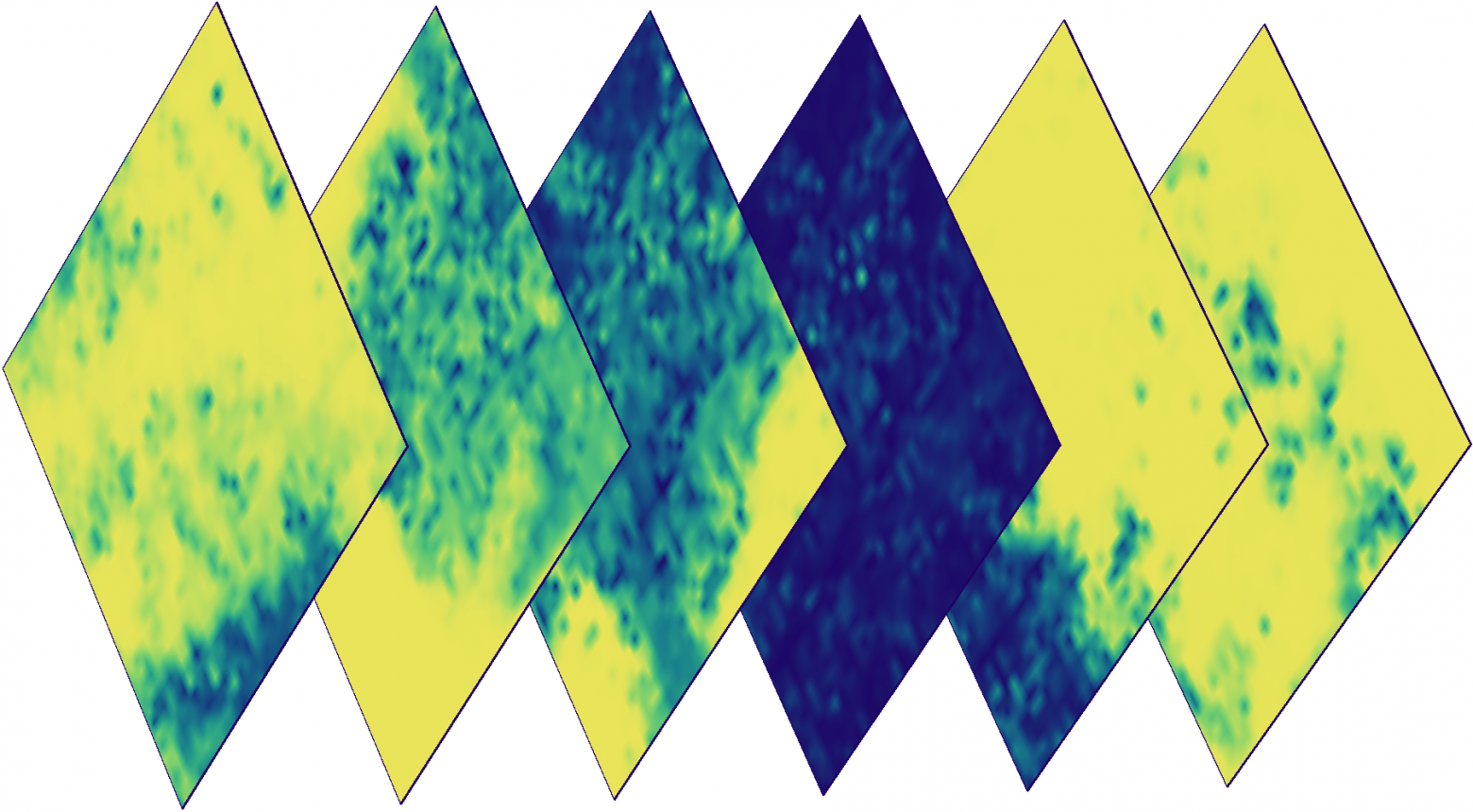

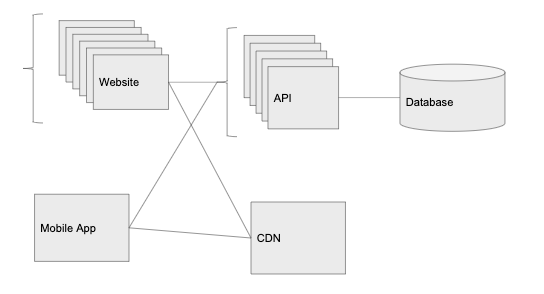

Так выглядит реализация драйверов Linux на Rust. Если идти справа налево, то в начале находится уже знакомый нам обработчик привязок C `bindgen`, правее и за кадром уже чистый и без примесей C код Linux-ядра. Далее следует `kernel crate` с требуемыми абстракциями, впрочем, это может быть какой-нибудь другой *crate*, или даже *crates*. Принципиальный момент заключается в том, что драйвер `my_foo` может использовать только безопасные абстракции из `kernel crate`. Драйвер *не может* напрямую обращаться к C-функциям. Благодаря такой двухступенчатой схеме подсистема обеспечивает безопасность кода Rust в Linux.

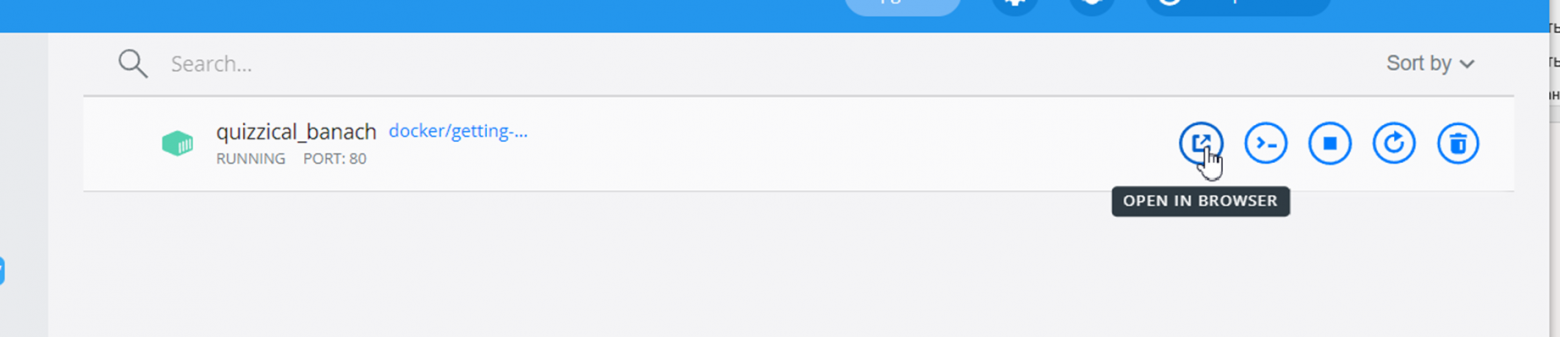

*Figure 3. Принцип работы драйверов Rust*

Поддержка реализована для следующих платформ.

* arm (только armv6);

* arm64;

* powerpc (только ppc64le);

* riscv (только riscv64);

* x86\_64.

7 патчей за 8 месяцев

---------------------

В начале мая Мигель Охеда [представил](https://lwn.net/Articles/894258/) коллегам уже седьмую серию патчей для разработки Rust-драйверов, из которых первая была опубликована без номера версии, в статусе RFC. Таким образом это считается *Patch v6*. Проект получает финансирование со стороны Internet Security Research Group и компании Гугл. Несмотря на экспериментальный статус поддержка Rust уже позволяет разработчикам создавать слои абстракций для различных подсистем, работать над новыми драйверами и модулями. [Список](https://github.com/Rust-for-Linux/linux/issues/2) нестабильных функций и запросов все ещё внушительный, но работа над ним активно ведётся.

В этой серии патчей были следующие изменения.

### ▍ Инфраструктурные обновления

* Инструментарий вместе с библиотекой `alloc` обновлены до версии Rust 1.60.

* Rust имеет такую примечательную функциональность, как [тестируемая документация](https://doc.rust-lang.org/rustdoc/documentation-tests.html). Работает это следующим способом. Программист вставляет в комментарии примеры кода с помощью разметки Markdown, а `rustdoc` умеет их запускать, как обычный тест. Это очень удобно, так как можно показывать, как используется данная функция и одновременно тестировать её.

```

/// /// fn foo() {} /// println!("Hello, World!"); ///

```

До *Patch v6* нельзя было запускать тестируемую документацию с использованием API ядра, с новым патчем это стало возможным. Документация из *kernel crate* во время компиляции преобразуется в *KUnit* тесты и выполняется при загрузке ядра.

* В соответствии с новыми требованиями в тесты не должны завершаться предупреждениями линтера *Clippy*.

* В Rust подсистеме GCC `rustc_codegen_gcc` добавлена новая функциональность по самозагрузке компилятора. Это означает, что его можно использовать для сборки самого компилятора `rustc`. Кроме того, в GCC 12.1 включены исправления, необходимые для `libgccjit`.

### ▍ Абстракции и драйвера

* Начальная поддержка сетевого стека в рамках модуля `net`.

* Методы асинхронного программирования Rust можно использовать в ограниченных средах, включая ядро. В последнем патче появилась поддержка *async* в коде модуля `kasync`. Благодаря этому можно, например, написать асинхронный TCP сокет для ядра.

```

async fn echo_server(stream: TcpStream) -> Result {

let mut buf = [0u8; 1024];

loop {

let n = stream.read(&mut buf).await?;

if n == 0 {

return Ok(());

}

stream.write_all(&buf[..n]).await?;

}

}

```

* Реализована поддержка фильтра сетевых пакетов `net::filter` и связанного с ним образца `rust_netfilter.rs`.

* Добавлен простой мютекс `mutex::Mutex`, не требующий привязки. Это довольно удобно, не смотря на то, что по функционалу мютекс уступает своему аналогу на C.

* Новый механизм блокировки `NoWaitLock`, который в соответствии с названием, никогда не приводит к ситуации ожидания ресурса. Если ресурс занят другим потоком, ядром CPU, то попытка блокировки завершится ошибкой, а не остановкой вызывающего.

* Ещё одна блокировка `RawSpiLock`, на основе C-эквивалента `raw_spinlock_t`, предназначена для фрагментов кода, где приостановка абсолютно недопустима.

* Для тех объектов, по отношению к которым всегда подсчитывается количество ссылок (a. k. a. `always-refcounted`), создан новый тип `ARef`. Его область применения — облегчить определение надстроек существующих C-структур.

### ▍ Дополнительные материалы

* [Rust support](https://lwn.net/Articles/894258/);

* [Шестая версия патчей для ядра Linux с поддержкой языка Rust](https://www.opennet.ru/opennews/art.shtml?num=57153)

* [Rustaceans at the border](https://lwn.net/Articles/889924/);

* [Using Rust for kernel development](https://lwn.net/Articles/870555/);

* [Linux Plumbers Conference 2021](https://lwn.net/Articles/870555/);

[](https://bit.ly/3PT6wqs?utm_source=habr&utm_medium=article&utm_campaign=temujin%0A&utm_content=lsmozhet_li_rust_vystrelit_v_linux?) | https://habr.com/ru/post/670748/ | null | ru | null |

# Дата в копирайтах

Обратил внимание на то, что уже 23 дня, как длиться 2009 год, а на многих сайтах копирайты имеют вид "© 2006—2008", и это в лучшем случае.

Почему бы вместо конечного года не вставить такой вот код:

> `&сopy; 2006—=</font **date("Y");** ?>`

Опубликовано на правах «Мысли вслух» =)

**upd:** Более удобный, как мне кажется, вариант предложил [youROCK](https://geektimes.ru/users/yourock/):

> `&сopy; 2009=</font**(date('Y') != 2009 ? '—' . date('Y') : '')**?>` | https://habr.com/ru/post/50059/ | null | ru | null |

# Разработка приложений для Meego Harmattan

Этот пост участвует в конкурсе [„Умные телефоны за умные посты“.](http://habrahabr.ru/company/Nokia/blog/132522/)

В данной статье хотелось бы поделится с Хабрасообществом своим опытом по разработке софта с использованием QtComponents'ов на примере Meego Harmattan'а. Писать мы будем редактор заметок с синхронизацией средствами Ubuntu One.

Вся разработка будет вестись при помощи scratchbox'а, он имеет некоторые преимущества в сравнении с madde, но работает исключительно в linux системах.

Среди ключевых преимуществ хочется отметить то, что сборка производится в chroot'е и в случае armel для эмуляции используется qemu. Условия максимально приближены к боевым. Это позволяет избежать дополнительной возни с настройкой кросскомпиляции. Дополнительным плюсом является наличие apt-get'а, способного установить все зависимости, необходимые для сборки, что несомненно понадобится при написании приложения сложнее, чем helloworld.

#### Установка и настройка scratchbox'а

Для того, чтобы установить scratchbox нужно скачать и запустить от рута этот [скрипт](http://harmattan-dev.nokia.com/unstable/beta3/harmattan-sdk-setup.py) и в дальнейшем следовать его указаниям.

```

# ./harmattan-sdk-setup.py

```

После установки необходимо перелогинится, чтобы пользователь был успешно добавлен в группу sbox.

Запускать scratchbox мы будем с помощью команды:

```

$ /scratchbox/login

```

Если установщик правильно отработал, то должно появится приглашение примерно следующего содержания:

```

[sbox-HARMATTAN_ARMEL: ~] >

```

Если login ругается, то попробуйте выполнить скрипт run\_me\_first.sh, лежащий в корне scratchbox'а. Нужный таргет можно выбрать с помощью sb\_menu. Остальное руководство по использованию scratchbox'а можно найти [здесь.](http://harmattan-dev.nokia.com/docs/library/html/guide/html/Developer_Library_Alternative_development_environments_Platform_SDK_user_guide_Installing_Harmattan_Platform_SDK.html)

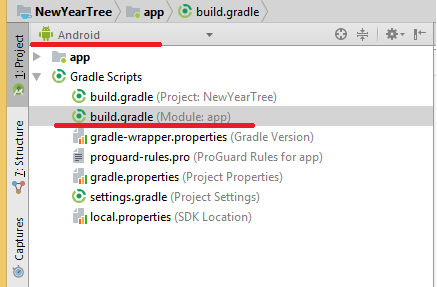

#### Создание cmake проекта

В качестве сборщика я использую не привычный qmake, а более мощный cmake, который умеет искать зависимости, имеет кучу опций настройки и гораздо лучше подходит для кроссплатформенной разработки. В данной статье я не буду сильно углубляться в разбор системы сборки, поэтому для лучшего понимания рекомендую прочесть эту [статью](http://www.devexp.ru/2010/01/cmake-i-qt/).

Единственный минус в том, что cmake не умеет Symbian, поэтому об этой платформе пока можно забыть или же написать вручную специальный проект для сборки именно под эту платформу. Со всеми остальными cmake справляется с легкостью, поэтому в дальнейшем я планирую портировать это приложение на настольные системы и, возможно, на Андроид или даже на iOS.

Проект состоит из некоторого количества зависимых библиотек, которые подключены при помощи git submodule к основному репозиторию, для каждой из них написан свой cmake проект. Все они лежат в каталоге 3rdparty и подключены к основному проекту, поэтому сборка идёт сразу с основными зависимостями, которых нет в репозиториях harmattan'а.

Список 3rdparty библиотек:

* QOauth — реализация протокола Oauth на Qt

* k8json — очень быстрый парсер JSON

* QmlObjectModel — Класс, реализующий модель — список обьектов

Помимо этого есть ещё внешние библиотеки, необходимые для сборки, но присутствующие в основных репах Harmattan'а, к ним относится qca, давайте сразу её установим, а также установим cmake:

```

[sbox-HARMATTAN_ARMEL: ~] > apt-get install libqca2-dev cmake

```

Для того, чтобы её можно было использовать необходимо написать специальный cmake файл, который бы смог найти каталог с заголовочными файлами библиотеки и сам файл библитеки для того, чтобы с ним слинковаться.

```

include(FindLibraryWithDebug)

if(QCA2_INCLUDE_DIR AND QCA2_LIBRARIES)

# in cache already

set(QCA2_FOUND TRUE)

else(QCA2_INCLUDE_DIR AND QCA2_LIBRARIES)

if(NOT WIN32)

find_package(PkgConfig)

pkg_check_modules(PC_QCA2 QUIET qca2)

set(QCA2_DEFINITIONS ${PC_QCA2_CFLAGS_OTHER})

endif(NOT WIN32)

find_library_with_debug(QCA2_LIBRARIES

WIN32_DEBUG_POSTFIX d

NAMES qca

HINTS ${PC_QCA2_LIBDIR} ${PC_QCA2_LIBRARY_DIRS} ${QT_LIBRARY_DIR})

find_path(QCA2_INCLUDE_DIR QtCrypto

HINTS ${PC_QCA2_INCLUDEDIR} ${PC_QCA2_INCLUDE_DIRS} ${QT_INCLUDE_DIR}}

PATH_SUFFIXES QtCrypto)

include(FindPackageHandleStandardArgs)

find_package_handle_standard_args(QCA2 DEFAULT_MSG QCA2_LIBRARIES QCA2_INCLUDE_DIR)

mark_as_advanced(QCA2_INCLUDE_DIR QCA2_LIBRARIES)

endif(QCA2_INCLUDE_DIR AND QCA2_LIBRARIES)

```

В таком же стиле написан поиск большинства зависимостей. Для систем с pgkconfig'ом, к которым относится и Harmattan всё просто и ясно, для систем, где его нет, будем искать в каталоге $QTDIR. В случае, если cmake автоматически не нашел библиотеку, он предложит вручную задать переменные QCA2\_INCLUDE\_DIR QCA2\_LIBRARIES. Такой подход здорово облегчает жизнь на системах, в которых отсутствует менеджер пакетов.

В cmake'е есть переменные, которые позволяют определить платформу, на которой собирается та или иная программа, например:

```

if(WIN32)

....

elseif(APPLE)

...

elseif(LINUX)

...

endif()

```

К сожалению, cmake ничего не знает про Harmattan, самым простым решением является запуск cmake'а с ключем -DHARMATTAN=ON. Теперь у нас определена переменная HARMATTAN, и можно писать подобные вещи:

```

if(HARMATTAN)

add_definitions(-DMEEGO_EDITION_HARMATTAN) #дефайн для компилятора, без него приложение не будет разворачиваться на весь экран.

endif()

```

С помощью этих же переменных можно определять, какая именно реализация GUI будет устанавливаться.

```

if(HARMATTAN)

set(CLIENT_TYPE meego)

message(STATUS "Using meego harmattan client")

else()

set(CLIENT_TYPE desktop)

list(APPEND QML_MODULES QtDesktop)

message(STATUS "Using desktop client")

endif()

set(QML_DIR "${CMAKE_CURRENT_SOURCE_DIR}/qml/${CLIENT_TYPE}")

...

install(DIRECTORY ${QML_DIR} DESTINATION ${SHAREDIR}/qml)

```

Для разработки большую часть времени будет достаточно QtSDK с harmattan quick components и ключа -DHARMATTAN при сборке. В scratchbox'е имеет смысл собирать уже более-менее конечные версии.

#### С++ плагин, реализующий Tomboy notes API

Сам API я решил вынести в отдельный qml модуль, который будет доступен через директиву import. Сделано это для удобства создания множества различных реализаций GUI интерфейса.

Самым сложным в процессе разработки оказалось реализовать авторизацию средствами OAuth, в процессе которой было перебрано несколько различных реализаций библиотек и на данный момент я остановился на QOauth, которая конечно не идеальна, но является вполне рабочей. На [хабре](http://habrahabr.ru/blogs/development/86846/) есть статья с описанием этой библиотеки, поэтому сразу перейдем к решению насущных проблем. Перво-наперво нам нужно получить тот самый вожделенный token.

Дело это не хитрое, просто посылаем запрос на адрес и ждём, когда же нам прилетит запрос на basic авторизацию по https:

```

UbuntuOneApi::UbuntuOneApi(QObject *parent) :

QObject(parent),

m_manager(new QNetworkAccessManager(this)),

m_oauth(new QOAuth::Interface(this))

{

...

connect(m_manager, SIGNAL(authenticationRequired(QNetworkReply*,QAuthenticator*)),

SLOT(onAuthenticationRequired(QNetworkReply*,QAuthenticator*)));

}

...

void UbuntuOneApi::requestToken(const QString &email, const QString &password)

{

m_email = email;

m_password = password;

QUrl url("https://login.ubuntu.com/api/1.0/authentications");

url.addQueryItem(QLatin1String("ws.op"), QLatin1String("authenticate"));

url.addQueryItem(QLatin1String("token_name"), QLatin1Literal("Ubuntu One @ ") % m_machineName);

qDebug() << url.toEncoded();

QNetworkRequest request(url);

QNetworkReply *reply = m_manager->get(request);

reply->setProperty("email", email);

reply->setProperty("password", password);

connect(reply, SIGNAL(finished()), SLOT(onAuthReplyFinished()));

}

...

void UbuntuOneApi::onAuthenticationRequired(QNetworkReply *reply, QAuthenticator *auth)

{

auth->setUser(reply->property("email").toString());

auth->setPassword(reply->property("password").toString());

}

```

Как вы могли заметить, для авторизации используется стандартный для QNetworkAccessManager'а сигнал authenticationRequired, а логин и пароль я просто запоминаю обычными пропертями. Удобно и не засоряет интерфейс лишними деталями.

По завершению в reply должен прийти ответ в json формате, который содержит искомый токен и прочую важную информацию. Тут-то нам и понадобится библиотека k8json.

```

QNetworkReply *reply = static_cast(sender());

QVariantMap response = Json::parse(reply->readAll()).toMap();

if (response.isEmpty()) {

emit authorizationFailed(tr("Unable to recieve token"));

}

m\_token = response.value("token").toByteArray();

m\_tokenSecret = response.value("token\_secret").toByteArray();

m\_oauth->setConsumerKey(response.value("consumer\_key").toByteArray());

m\_oauth->setConsumerSecret(response.value("consumer\_secret").toByteArray());

QUrl url("https://one.ubuntu.com/oauth/sso-finished-so-get-tokens/" + reply->property("email").toString());

connect(get(url), SIGNAL(finished()), SLOT(onConfirmReplyFinished()));

```

Следующим шагом будет отправка подтверждения того факта, что мы получили токен (обратите внимание на последнюю строчку). В результате нам должен прийти ответ ok.

```

void UbuntuOneApi::onConfirmReplyFinished()

{

QNetworkReply *reply = static_cast(sender());

QByteArray data = reply->readAll();

if (data.contains("ok")) {

emit hasTokenChanged();

```