text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Города, инверсии и логистика: разбор задач для QA-инженеров

Друзья, недавно мы опубликовали разбор задач из отборочного контеста на курс [«Автоматическое тестирование веб-сервисов на Go»](https://route256.ozon.ru/qa-engineer). А теперь предлагаем поломать голову над задачами для QA-инженеров: сначала попробуйте найти решение самостоятельно, а потом сравните с нашими вариантами.

Хэш

---

Разработчику складских решений Андрею необходимо создать копию базы данных о заказах и деперсонализировать данные в ней. На вход приходит текстовая строка, содержащая разделённые пробелом *номер заказа, имя, фамилию и стоимость заказа*:

```

order_id first_name second_name price

```

Необходимо написать скрипт на Bash (запуск под Ubuntu 20.04), который выведет те же данные, но с хешированными именем и фамилией. Хешировать необходимо утилитой **sha1sum**.

**Решение**

Утилита sha1sum возвращает два значения: хэш и название файла. Её можно применить к строке, например, командой `echo $string | sha1sum`, однако в таком случае помимо искомой хэш-суммы мы получим ещё записанный через пробел символ «-». Как можно от него избавиться? Один из вариантов — воспользоваться утилитой head с опцией `-c40`, которая оставит первые 40 байт вывода утилиты sha1sum, содержащие искомый хэш, и отбросит остальное.

Финальное решение может выглядеть так:

1. Прочитаем входные данные:

```

read order_id first_name second_name price

```

2. Затем посчитаем хэш и отбросим лишнее:

```

hash1=$(echo $first_name | sha1sum | head -c40)

hash2=$(echo $second_name | sha1sum | head -c40)

```

3. Выведем требуемые данные:

```

echo $order_id $hash1 $hash2 $price

```

Города

------

Света любит путешествовать по новым странам. Собираясь в Бразилию, она опросила всех своих знакомых, в каких городах Бразилии они были. Каждый город Света обозначила отдельным символом и составила из всех ответов друзей длинную текстовую строку. Теперь ей хочется увидеть самый часто посещаемый город. Для этого нужно заменить каждый символ строки, кроме самого частого, на символ «\*».

### Формат входных данных

В единственной строке задана непустая строка из строчных латинских букв, длина которой не превышает 100 символов. Гарантируется, что среди символов строки есть такой, частота которого строго больше частоты остальных символов.

### Формат выходных данных

Выведите искомую строку с заменёнными символами.

**Решение**

Эта задача является чисто технической и сводится к тому, что нужно найти самый часто встречающийся символ в строке, а затем заменить вхождения всех остальных символов на символ «\*».

Для выполнения первой части решения можно использовать, например, ассоциативный массив (`map` или `dict` в зависимости от вашего языка программирования) и посчитать количество вхождений каждого символа, а затем линейным проходом найти максимум. Также можно вспомнить, что все строчные латинские буквы кодируются подряд, а значит можно вычесть из кода символа буквы код буквы «a» и вместо ассоциативного массива использовать обычный длиной 26.

А завершить решение можно обычным линейным проходом по исходной строке и выводом либо самого частого символа, либо «\*».

Инверсии

--------

Антон хочет приобрести велосипед с максимальной выгодой. Выбрав интересную ему модель, продающуюся в разных интернет-магазинах, он хочет научиться прогнозировать будущие изменения стоимости этой модели на разных торговых площадках, чтобы выбрать наиболее благоприятный момент для покупки. Наиболее благоприятным Антон считает момент, после которого с максимальной вероятностью цена уже не будет снижаться. Для этого он решил ежедневно отслеживать динамику цен на выбранных площадках. Через два месяца у него набралось достаточно данных, чтобы высчитать максимальную величину снижения цены (разницу между максимальной и минимальной ценой за период). Собрав накопленные данные в виде нескольких хронологически упорядоченных массивов цен, Антон решил автоматизировать свою работу и найти программное решение поставленной задачи.

Дан массив из  элементов , ,… . Инверсией в массиве называется любая пара индексов , , в которой  и . Назовем величиной инверсии i, j абсолютную разность соответствующих элементов . Требуется найти максимальную по величине инверсию в этом массиве.

### Формат входных данных

В первой строке входных данных содержится одно целое число  — размер массива (). Во второй строке содержатся n целых чисел , ,… , разделённых пробелом — элементы массива ().

### Формат выходных данных

Выведите одно число — максимальную величину инверсии в массиве. Если ни одной инверсии в массиве нет, то выведите 0.

**Решение**

Чтобы найти максимальную по величине инверсию в массиве, найдём для каждого элемента  максимальную по величине инверсию , в которой  и . Если бы ограничения позволяли решать эту задачу за квадратичную асимптотику, то можно было бы просто перебрать все , для которых верно  (только такие индексы  могут составлять инверсию с индексом ), и среди них выбрать индекс, для которого разность  максимальна.

Давайте оптимизируем решение до линейной асимптотики. Заметим, что при фиксированном  разность  будет максимальна при максимальном . То есть мы можем поддерживать максимальное значение в массиве среди элементов  и использовать его в качестве кандидата для вычисления ответа для текущего .

Также не забудем рассмотреть случай, когда в массиве отсутствуют инверсии. Это можно сделать, например, взяв максимум из  и полученного ответа.

Общее поле

----------

Для автоматического поиска похожих товаров в ассортименте маркетплейса Ozon применяются различные методики, среди которых — сравнение по значению характеристик товара. Характеристики для различных товарных групп имеют разную структуру данных, и в общем виде могут быть представлены в формате JSON с произвольной вложенностью полей. На степень похожести товаров в этом случае должны влиять не только значения полей, но и их конкретный путь в структуре JSON. Требуется составить алгоритм, позволяющий оценить степень схожести товаров. Одним из элементов этого алгоритма будет поиск общих полей в двух различных фрагментах JSON.

Вам дано два JSON. Требуется найти в них такое общее поле, у которого будет самая длинная строка, характеризующая путь до него. Если таких строк несколько, то необходимо найти лексикографически наименьшую из них.

### Пояснение к примерам

В первом примере у JSON-ов два общих поля с путём длиной три: `fps` и `a.z`. При этом `a.z` лексикографически меньше.

Во втором примере в первом JSON есть очень длинный путь `a[2].b[0][0]`, однако во втором JSON путь не такой же, а `a[1].b[0][0]`, поэтому это поле не считается общим.

### Формат входных данных

В первой строке задан первый JSON. Во второй строке задан второй JSON. Гарантируется, что длина каждой строки не превышает 3000.

### Формат выходных данных

Выведите максимальный по длине и лексикографически наименьший путь до общего поля данных JSON-ов.

**Решение**

Задача делится на две части: парсинг JSON-а и обход полученной структуры.

В первой части можно пойти трудным путём и самостоятельно написать парсинг, а можно воспользоваться стандартными реализациями. Например, в Python есть модуль json, а в JavaScript объект JSON.

Вторую часть тоже можно решить как минимум двумя способами: сделать параллельный обход двух полученных структур или получить отдельно для каждого JSON-а набор полных путей до полей и затем найти среди них самый длинный и одновременно лексикографически наименьший.

Вот авторское решение задачи на Python:

```

import json

def get_paths(json, prefix, ans):

if type(json) is dict:

for k, v in json.items():

get_paths(v, prefix + '.' + k, ans)

elif type(json) is list:

for i in range(len(json)):

get_paths(json[i], prefix + '[' + str(i) + ']', ans)

else:

ans.append(prefix[1:])

first = json.loads(input())

second = json.loads(input())

ans1 = []

ans2 = []

get_paths(first, '', ans1)

get_paths(second, '', ans2)

intersection_set = set.intersection(set(ans1), set(ans2))

intersection_list = list(intersection_set)

intersection_list = sorted(intersection_list, key=lambda x: (-len(x), x))

print(intersection_list[0])

```

Даты

----

Напишите скрипт, который будет получать на вход `stdin` параметры `d1` и `d2` в формате YYYY-MM-DD, и считать разницу между этими датами в днях. Скрипт проверяется на Bash 5.1.4 (запуск под Ubuntu 20.04).

### Формат входных данных

Две даты через пробел в формате YYYY-MM-DD.

### Формат выходных данных

Одно целое число — разница в днях.

**Решение**

Чтобы решить задачу, необходимо уметь пользоваться функцией `date`, которая позволяет получить из строки дату и преобразить её в формат unix time. Давайте так и поступим, затем найдём разность и переведём её в дни:

1. Считываем даты из входного потока:

```

read s1 s2

d1=`date -d "$s1" "+%Y-%m-%d"`

d2=`date -d "$s2" "+%Y-%m-%d"`

```

2. Переводим даты в unix time:

```

ut1=`date -d "$d1" +%s`

ut2=`date -d "$d2" +%s`

```

3. Считаем разность секунд и переводим в дни:

```

diff=$(($ut1 - $ut2))

diff_days=$(($diff / (60 * 60 * 24)))

```

4. Выводим абсолютное значение разности (можно было бы написать `if`, но такой «чит» выглядит лаконичнее: он переводит значение в строку и удаляет лидирующий минус, если он есть):

```

echo ${diff_days#-}

```

Бонус:

Уже после написания разбора обнаружилось два забавных факта:

1. Во всех тестах вторая дата идёт хронологически позже первой.

2. Формат даты в условии не надо дополнительно парсить, а можно сразу переводить в unix time.

Таким образом, немного упрощённое решение выглядит так:

```

read d1 d2

ut1=`date -d $d1 +%s`

ut2=`date -d $d2 +%s`

diff=$(($ut2 - $ut1))

diff_days=$(($diff / (60 * 60 * 24)))

echo $diff_days

```

Регионы

-------

После начала пандемии значительная часть сотрудников центрального офиса Ozon разъехалась по различным регионам страны. Теперь для того, чтобы оптимально использовать рабочее время при проведении онлайн-встреч, нужно учитывать часовой пояс, в котором проживает каждый сотрудник. Для этого HR-специалисту необходимо собрать данные по смешанным командам (в которых часть сотрудников живёт в Москве, а часть — в других регионах). Данные о сотрудниках хранятся в таблицах:

**local\_employees**

```

id name second_name

1 Андрей Иванов

2 Ольга Смирнова

3 Иван Иванов

```

**remote\_employees**

```

Id first_name second_name region

1 Сергей Кузнецов Казань

2 Илья Фомин Ижевск

3 Анна Сергеевна Казань

4 Артём Сидоров Владимир

```

Напиши запрос, который сгруппирует всех владельцев ПВЗ Ozon в одну таблицу с указанием региона. Для локальных сотрудников нужно указать регион «Москва». Затем отсортировать всё по региону.

Пример ожидаемого ответа:

```

Артём Сидоров Владимир

Илья Фомин Ижевск

Сергей Кузнецов Казань

Анна Сергеева Казань

Андрей Иванов Москва

Ольга Смирнова Москва

Иван Иванов Москва

```

**Решение**

Нужно добавить колонку к local\_employees, а затем объединить получившуюся таблицу с таблицей remote\_employees. Чтобы получить таблицу local\_employees с колонкой региона можно выполнить, например, такой запрос:

```

SELECT

name, second_name, "Москва"

FROM

local_employees

```

Для объединения можно использовать команду `UNION ALL` (команда `UNION` не подойдёт по смыслу). Остаётся только упорядочить итоговую таблицу по региону, что довольно легко сделать. Итоговое решение может выглядеть, например, так:

```

SELECT

first_name, second_name, region

FROM

remote_employees

UNION ALL

SELECT

name, second_name, "Москва"

FROM

local_employees

ORDER BY region

```

Логистика

---------

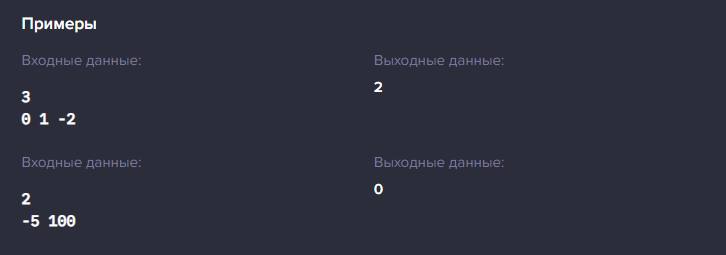

В компании-грузоперевозчике составлен маршрут для грузовика (последовательность посещаемых пунктов погрузки и выгрузки). Но маршрут учитывает только географию местности. Теперь нужно так скорректировать объёмы грузов, которые заказаны в каждой точке, чтобы после каждой операции погрузки или выгрузки объём занятого в кузове места «колебался» вокруг заданного значения (например, вокруг половины от всего объёма кузова). То есть, если в данный момент объём меньше половины, то после посещения следующей точки он должен стать строго больше половины, и наоборот. Обозначим целыми числами величину заказа (в штуках) в каждой точке маршрута. Положительное число означает погрузку в автомобиль, а отрицательное — выгрузку из автомобиля. Предполагается, что в начальной точке грузовик заполнен ровно наполовину. Нужно так скорректировать объёмы заказов на минимально возможные величины, чтобы удовлетворить заданному условию «колебания» занятого объёма. Формально поставленную задачу можно описать следующим образом:

Дан массив из  элементов , ,… . Также определим функцию префиксной суммы .

Вам разрешено делать с массивом следующие операции:

* Увеличить любой элемент массива на единицу.

* Уменьшить любой элемент массива на единицу.

С помощью минимального количества таких операций вам необходимо получить новый массив, для которого любая префиксная сумма  либо положительная, либо отрицательная, и при этом для любого  знак  не должен быть равен знаку .

### Пояснение к примерам

В первом примере можно за две операции получить массив ![$[-1, 2, -2]$](https://habrastorage.org/getpro/habr/formulas/1a4/98b/92a/1a498b92a120d1d2ede9b2535f274e55.svg). Во втором тесте массив уже удовлетворяет необходимые условия.

### Формат входных данных

В первой строке входных данных содержится одно целое число  — размер массива (). Во второй строке содержатся n целых чисел , ,… , разделённые пробелом — элементы массива ().

### Формат выходных данных

Выведите одно число — минимальное количество операций, которые нужно сделать с массивом, чтобы он удовлетворял необходимым условиям.

**Решение**

Если мы зафиксируем финальный знак нулевого элемента, который равен , то знаки остальных префиксных сумм нам уже будут известны. Например, если , то  должны быть положительными, а  — отрицательными.

Пусть мы знаем , а также требуемый знак для . Какое наименьшее количество операций требуется применить к элементу , чтобы сумма

стала нужного знака? Рассмотрим два случая:

1. Если  уже нужного знака, тогда количество требуемых операций равно нулю.

Иначе есть три подслучая:

1. Если , то нужно применить операцию уменьшения  раз, чтобы получить  — это будет минимальное количество операций, так как префиксная сумма  нам не подходит, а сумму  и меньше получать смысла нет: мы сейчас сделаем операций больше, а потом придётся использовать больше операций увеличения, чтобы получить положительное число.

2. Если , то применим  операцию увеличения, чтобы получить .

3. Если же , то достаточно одной операции в зависимости от требуемого знака.

В итоге, для решения задачи предлагаем рассмотреть два случая: когда  и когда ; для каждого из них найти ответ и взять минимальное значение из двух. Получаем решение за линейную асимптотику.

Заключение

----------

Это были задачи из отборочного и основного раунда для поступления на курс «[Автоматическое тестирование веб-сервисов на Go](https://route256.ozon.ru/qa-engineer)». Какие дались вам легче всего, а какие труднее? И расскажите о своих решениях, которые оказались проще или эффективнее наших :) | https://habr.com/ru/post/661557/ | null | ru | null |

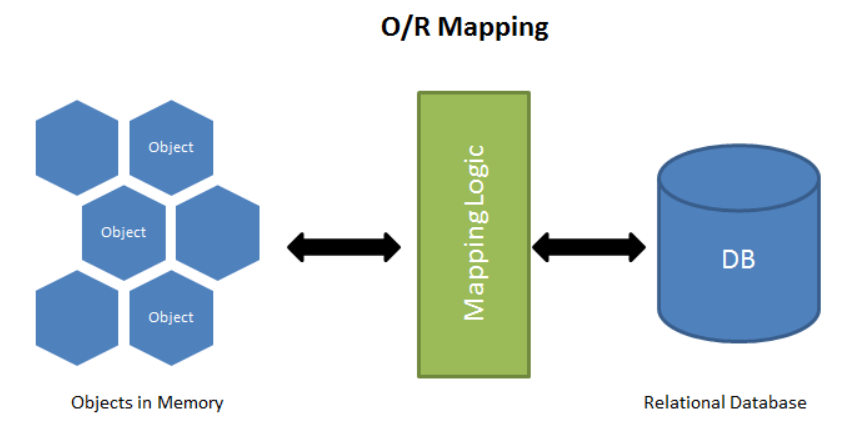

# Идеальный инструмент для работы с СУБД без SQL для Node.js или Все, что вы хотели знать о Sequelize. Часть 1

Представляю вашему вниманию руководство по `Sequelize`.

[`Sequelize`](https://sequelize.org/master/) — это [`ORM`](https://ru.wikipedia.org/wiki/ORM) (Object-Relational Mapping — объектно-реляционное отображение или преобразование) для работы с такими [СУБД](https://ru.wikipedia.org/wiki/%D0%A1%D0%B8%D1%81%D1%82%D0%B5%D0%BC%D0%B0_%D1%83%D0%BF%D1%80%D0%B0%D0%B2%D0%BB%D0%B5%D0%BD%D0%B8%D1%8F_%D0%B1%D0%B0%D0%B7%D0%B0%D0%BC%D0%B8_%D0%B4%D0%B0%D0%BD%D0%BD%D1%8B%D1%85) (системами управления (реляционными) базами данных, Relational Database Management System, RDBMS), как `Postgres`, `MySQL`, `MariaDB`, `SQLite` и `MSSQL`. Это далеко не единственная `ORM` для работы с названными базами данных (далее — БД), но, на мой взгляд, одна из самых продвинутых и, что называется, "battle tested" (проверенных временем).

`ORM` хороши тем, что позволяют взаимодействовать с БД на языке приложения (`JavaScript`), т.е. без использования специально предназначенных для этого языков (`SQL`). Тем не менее, существуют ситуации, когда запрос к БД легче выполнить с помощью `SQL` (или можно выполнить только c помощью него). Поэтому перед изучением настоящего руководства рекомендую бросить хотя бы беглый взгляд на `SQL`. Вот [соответствующая шпаргалка](https://habr.com/ru/company/macloud/blog/564390/).

Это первая из 3 частей руководства, в которой мы поговорим о начале работы с `Sequelize`, основах создания и использования моделей и экземпляров для взаимодействия с БД, выполнении поисковых и других запросов, геттерах, сеттерах и виртуальных (virtual) атрибутах, валидации, ограничениях и необработанных (raw, `SQL`) запросах.

[Вторая часть](https://habr.com/ru/post/566036/).

[Третья часть](https://habr.com/ru/post/567912/).

Я постараюсь быть максимально лаконичным (надеюсь, без ущерба для полноты изложения материала). Я также постараюсь излагать материал максимально простым языком. Большинство примеров, приводимых в руководстве, заимствованы из официальной документации.

Содержание

----------

* [Начало работы](#%D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE-%D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B)

* [Модели](#%D0%BC%D0%BE%D0%B4%D0%B5%D0%BB%D0%B8)

* [Экземпляры](#%D1%8D%D0%BA%D0%B7%D0%B5%D0%BC%D0%BF%D0%BB%D1%8F%D1%80%D1%8B)

* [Основы выполнения запросов](#%D0%BE%D1%81%D0%BD%D0%BE%D0%B2%D1%8B-%D0%B2%D1%8B%D0%BF%D0%BE%D0%BB%D0%BD%D0%B5%D0%BD%D0%B8%D1%8F-%D0%B7%D0%B0%D0%BF%D1%80%D0%BE%D1%81%D0%BE%D0%B2)

* [Поисковые запросы](#%D0%BF%D0%BE%D0%B8%D1%81%D0%BA%D0%BE%D0%B2%D1%8B%D0%B5-%D0%B7%D0%B0%D0%BF%D1%80%D0%BE%D1%81%D1%8B)

* [Геттеры, сеттеры и виртуальные атрибуты](#%D0%B3%D0%B5%D1%82%D1%82%D0%B5%D1%80%D1%8B-%D1%81%D0%B5%D1%82%D1%82%D0%B5%D1%80%D1%8B-%D0%B8-%D0%B2%D0%B8%D1%80%D1%82%D1%83%D0%B0%D0%BB%D1%8C%D0%BD%D1%8B%D0%B5-%D0%B0%D1%82%D1%80%D0%B8%D0%B1%D1%83%D1%82%D1%8B)

* [Валидация и ограничения](#%D0%B2%D0%B0%D0%BB%D0%B8%D0%B4%D0%B0%D1%86%D0%B8%D1%8F-%D0%B8-%D0%BE%D0%B3%D1%80%D0%B0%D0%BD%D0%B8%D1%87%D0%B5%D0%BD%D0%B8%D1%8F)

* [Необработанные запросы](#%D0%BD%D0%B5%D0%BE%D0%B1%D1%80%D0%B0%D0%B1%D0%BE%D1%82%D0%B0%D0%BD%D0%BD%D1%8B%D0%B5-%D0%B7%D0%B0%D0%BF%D1%80%D0%BE%D1%81%D1%8B)

Начало работы

-------------

**Установка**

```

yarn add sequelize

# или

npm i sequelize

```

**Подключение к БД**

```

const { Sequelize } = require('sequelize')

// Вариант 1: передача `URI` для подключения

const sequelize = new Sequelize('sqlite::memory:') // для `sqlite`

const sequelize = new Sequelize('postgres://user:[email protected]:5432/dbname') // для `postgres`

// Вариант 2: передача параметров по отдельности

const sequelize = new Sequelize({

dialect: 'sqlite',

storage: 'path/to/database.sqlite'

})

// Вариант 2: передача параметров по отдельности (для других диалектов)

const sequelize = new Sequelize('database', 'username', 'password', {

host: 'localhost',

dialect: /* 'mysql' | 'mariadb' | 'postgres' | 'mssql' */

})

```

**Проверка подключения**

```

try {

await sequelize.authenticate()

console.log('Соединение с БД было успешно установлено')

} catch (e) {

console.log('Невозможно выполнить подключение к БД: ', e)

}

```

По умолчанию после того, как установки соединения, оно остается открытым. Для его закрытия следует вызвать метод `sequelize.close()`.

**[↥ Наверх](#)**

Модели

------

Модель — это абстракция, представляющая таблицу в БД.

Модель сообщает `Sequelize` несколько вещей о сущности (entity), которую она представляет: название таблицы, то, какие колонки она содержит (и их типы данных) и др.

У каждой модели есть название. Это название не обязательно должно совпадать с названием соответствующей таблицы. Обычно, модели именуются в единственном числе (например, `User`), а таблицы — во множественном (например, `Users`). `Sequelize` выполняет плюрализацию (перевод значения из единственного числа во множественное) автоматически.

Модели могут определяться двумя способами:

* путем вызова `sequelize.define(modelName, attributes, options)`

* путем расширения класса `Model` и вызова `init(attributes, options)`

После определения, модель доступна через `sequelize.model` + название модели.

В качестве примера создадим модель `User` с полями `firstName` и `lastName`.

**`sequelize.define`**

```

const { Sequelize, DataTypes } = require('sequelize')

const sequelize = new Sequelize('sqlite::memory:')

const User = sequelize.define(

'User',

{

// Здесь определяются атрибуты модели

firstName: {

type: DataTypes.STRING,

allowNull: false,

},

lastName: {

type: DataTypes.STRING,

// allowNull по умолчанию имеет значение true

},

},

{

// Здесь определяются другие настройки модели

}

)

// `sequelize.define` возвращает модель

console.log(User === sequelize.models.User) // true

```

**Расширение `Model`**

```

const { Sequelize, DataTypes, Model } = require('sequelize')

const sequelize = new Sequelize('sqlite::memory:')

class User extends Model {}

User.init(

{

// Здесь определяются атрибуты модели

firstName: {

type: DataTypes.STRING,

allowNull: false,

},

lastName: {

type: DataTypes.STRING,

},

},

{

// Здесь определяются другие настройки модели

sequelize, // Экземпляр подключения (обязательно)

modelName: 'User', // Название модели (обязательно)

}

)

console.log(User === sequelize.models.User) // true

```

`sequelize.define` под капотом использует `Model.init`.

В дальнейшем я буду использовать только *первый вариант*.

Автоматическую плюрализацию названия таблицы можно отключить с помощью настройки `freezeTableName`:

```

sequelize.define(

'User',

{

// ...

},

{

freezeTableName: true,

}

)

```

или глобально:

```

const sequelize = new Sequelize('sqlite::memory:', {

define: {

freeTableName: true,

},

})

```

В этом случае таблица будет называться `User`.

Название таблицы может определяться в явном виде:

```

sequelize.define(

'User',

{

// ...

},

{

tableName: 'Employees',

}

)

```

В этом случае таблица будет называться `Employees`.

Синхронизация модели с таблицей:

* `User.sync()` — создает таблицу при отсутствии (существующая таблица остается неизменной)

* `User.sync({ force: true })` — удаляет существующую таблицу и создает новую

* `User.sync({ alter: true })` — приводит таблицу в соответствие с моделью

Пример:

```

// Возвращается промис

await User.sync({ force: true })

console.log('Таблица для модели `User` только что была создана заново!')

```

Синхронизация всех моделей:

```

await sequelize.sync({ force: true })

console.log('Все модели были успешно синхронизированы.')

```

Удаление таблицы:

```

await User.drop()

console.log('Таблица `User` была удалена.')

```

Удаление всех таблиц:

```

await sequelize.drop()

console.log('Все таблицы были удалены.')

```

`Sequelize` принимает настройку `match` с регулярным выражением, позволяющую определять группу синхронизируемых таблиц:

```

// Выполняем синхронизацию только тех моделей, названия которых заканчиваются на `_test`

await sequelize.sync({ force: true, match: /_test$/ })

```

*Обратите внимание*: вместо синхронизации в продакшне следует использовать миграции.

По умолчанию `Sequelize` автоматически добавляет в создаваемую модель поля `createAt` и `updatedAt` с типом `DataTypes.DATE`. Это можно изменить:

```

sequelize.define(

'User',

{

// ...

},

{

timestamps: false,

}

)

```

Названные поля можно отключать по отдельности и переименовывать:

```

sequelize.define(

'User',

{

// ...

},

{

timestamps: true,

// Отключаем `createdAt`

createdAt: false,

// Изменяем название `updatedAt`

updatedAt: 'updateTimestamp',

}

)

```

Если для колонки определяется только тип данных, синтаксис определения атрибута может быть сокращен следующим образом:

```

// до

sequelize.define('User', {

name: {

type: DataTypes.STRING,

},

})

// после

sequelize.define('User', {

name: DataTypes.STRING,

})

```

По умолчанию значением колонки является `NULL`. Это можно изменить с помощью настройки `defaultValue` (определив "дефолтное" значение):

```

sequelize.define('User', {

name: {

type: DataTypes.STRING,

defaultValue: 'John Smith',

},

})

```

В качестве дефолтных могут использоваться специальные значения:

```

sequelize.define('Foo', {

bar: {

type: DataTypes.DATE,

// Текущие дата и время, определяемые в момент создания

defaultValue: Sequelize.NOW,

},

})

```

**Типы данных**

Каждая колонка должна иметь определенный тип данных.

```

// Импорт встроенных типов данных

const { DataTypes } = require('sequelize')

// Строки

DataTypes.STRING // VARCHAR(255)

DataTypes.STRING(1234) // VARCHAR(1234)

DataTypes.STRING.BINARY // VARCHAR BINARY

DataTypes.TEXT // TEXT

DataTypes.TEXT('tiny') // TINYTEXT

DataTypes.CITEXT // CITEXT - только для `PostgreSQL` и `SQLite`

// Логические значения

DataTypes.BOOLEAN // BOOLEAN

// Числа

DataTypes.INTEGER // INTEGER

DataTypes.BIGINT // BIGINT

DataTypes.BIGINT(11) // BIGINT(11)

DataTypes.FLOAT // FLOAT

DataTypes.FLOAT(11) // FLOAT(11)

DataTypes.FLOAT(11, 10) // FLOAT(11, 10)

DataTypes.REAL // REAL - только для `PostgreSQL`

DataTypes.REAL(11) // REAL(11) - только для `PostgreSQL`

DataTypes.REAL(11, 12) // REAL(11,12) - только для `PostgreSQL`

DataTypes.DOUBLE // DOUBLE

DataTypes.DOUBLE(11) // DOUBLE(11)

DataTypes.DOUBLE(11, 10) // DOUBLE(11, 10)

DataTypes.DECIMAL // DECIMAL

DataTypes.DECIMAL(10, 2) // DECIMAL(10, 2)

// только для `MySQL`/`MariaDB`

DataTypes.INTEGER.UNSIGNED

DataTypes.INTEGER.ZEROFILL

DataTypes.INTEGER.UNSIGNED.ZEROFILL

// Даты

DataTypes.DATE // DATETIME для `mysql`/`sqlite`, TIMESTAMP с временной зоной для `postgres`

DataTypes.DATE(6) // DATETIME(6) для `mysql` 5.6.4+

DataTypes.DATEONLY // DATE без времени

// UUID

DataTypes.UUID

```

`UUID` может генерироваться автоматически:

```

{

type: DataTypes.UUID,

defaultValue: Sequelize.UUIDV4

}

```

Другие типы данных:

```

// Диапазоны (только для `postgres`)

DataTypes.RANGE(DataTypes.INTEGER) // int4range

DataTypes.RANGE(DataTypes.BIGINT) // int8range

DataTypes.RANGE(DataTypes.DATE) // tstzrange

DataTypes.RANGE(DataTypes.DATEONLY) // daterange

DataTypes.RANGE(DataTypes.DECIMAL) // numrange

// Буферы

DataTypes.BLOB // BLOB

DataTypes.BLOB('tiny') // TINYBLOB

DataTypes.BLOB('medium') // MEDIUMBLOB

DataTypes.BLOB('long') // LONGBLOB

// Перечисления - могут определяться по-другому (см. ниже)

DataTypes.ENUM('foo', 'bar')

// JSON (только для `sqlite`/`mysql`/`mariadb`/`postres`)

DataTypes.JSON

// JSONB (только для `postgres`)

DataTypes.JSONB

// другие

DataTypes.ARRAY(/* DataTypes.SOMETHING */) // массив DataTypes.SOMETHING. Только для `PostgreSQL`

DataTypes.CIDR // CIDR - только для `PostgreSQL`

DataTypes.INET // INET - только для `PostgreSQL`

DataTypes.MACADDR // MACADDR - только для `PostgreSQL`

DataTypes.GEOMETRY // Пространственная колонка. Только для `PostgreSQL` (с `PostGIS`) или `MySQL`

DataTypes.GEOMETRY('POINT') // Пространственная колонка с геометрическим типом. Только для `PostgreSQL` (с `PostGIS`) или `MySQL`

DataTypes.GEOMETRY('POINT', 4326) // Пространственная колонка с геометрическим типом и `SRID`. Только для `PostgreSQL` (с `PostGIS`) или `MySQL`

```

**Настройки колонки**

```

const { DataTypes, Defferable } = require('sequelize')

sequelize.define('Foo', {

// Поле `flag` логического типа по умолчанию будет иметь значение `true`

flag: { type: DataTypes.BOOLEAN, allowNull: false, defaultValue: true },

// Дефолтным значением поля `myDate` будет текущие дата и время

myDate: { type: DataTypes.DATE, defaultValue: DataTypes.NOW },

// Настройка `allowNull` со значением `false` запрещает запись в колонку нулевых значений (NULL)

title: { type: DataTypes.STRING, allowNull: false },

// Создание двух объектов с одинаковым набором значений, обычно, приводит к возникновению ошибки.

// Значением настройки `unique` может быть строка или булевое значение. В данном случае формируется составной уникальный ключ

uniqueOne: { type: DataTypes.STRING, unique: 'compositeIndex' },

uniqueTwo: { type: DataTypes.INTEGER, unique: 'compositeIndex' },

// `unique` используется для обозначения полей, которые должны содержать только уникальные значения

someUnique: { type: DataTypes.STRING, unique: true },

// Первичные или основные ключи будут подробно рассмотрены далее

identifier: { type: DataTypes.STRING, primaryKey: true },

// Настройка `autoIncrement` может использоваться для создания колонки с автоматически увеличивающимися целыми числами

incrementMe: { type: DataTypes.INTEGER, autoIncrement: true },

// Настройка `field` позволяет кастомизировать название колонки

fieldWithUnderscores: { type: DataTypes.STRING, field: 'field_with_underscores' },

// Внешние ключи также будут подробно рассмотрены далее

bar_id: {

type: DataTypes.INTEGER,

references: {

// ссылка на другую модель

model: Bar,

// название колонки модели-ссылки с первичным ключом

key: 'id',

// в случае с `postres`, можно определять задержку получения внешних ключей

deferrable: Deferrable.INITIALLY_IMMEDIATE

/*

`Deferrable.INITIALLY_IMMEDIATE` - проверка внешних ключей выполняется незамедлительно

`Deferrable.INITIALLY_DEFERRED` - проверка внешних ключей откладывается до конца транзакции

`Deferrable.NOT` - без задержки: это не позволит динамически изменять правила в транзакции

*/

// Комментарии можно добавлять только в `mysql`/`mariadb`/`postres` и `mssql`

commentMe: {

type: DataTypes.STRING,

comment: 'Комментарий'

}

}

}

}, {

// Аналог атрибута `someUnique`

indexes: [{

unique: true,

fields: ['someUnique']

}]

})

```

**[↥ Наверх](#)**

Экземпляры

----------

Наш начальный код будет выглядеть следующим образом:

```

const { Sequelize, DataTypes } = require('sequelize')

const sequelize = new Sequelize('sqlite::memory:')

// Создаем модель для пользователя со следующими атрибутами

const User = sequelize.define('User', {

// имя

name: DataTypes.STRING,

// любимый цвет - по умолчанию зеленый

favouriteColor: {

type: DataTypes.STRING,

defaultValue: 'green',

},

// возраст

age: DataTypes.INTEGER,

// деньги

cash: DataTypes.INTEGER,

})

;(async () => {

// Пересоздаем таблицу в БД

await sequelize.sync({ force: true })

// дальнейший код

})()

```

Создание экземпляра:

```

// Создаем объект

const jane = User.build({ name: 'Jane' })

// и сохраняем его в БД

await jane.save()

// Сокращенный вариант

const jane = await User.create({ name: 'Jane' })

console.log(jane.toJSON())

console.log(JSON.stringify(jane, null, 2))

```

Обновление экземпляра:

```

const john = await User.create({ name: 'John' })

// Вносим изменение

john.name = 'Bob'

// и обновляем соответствующую запись в БД

await john.save()

```

Удаление экземпляра:

```

await john.destroy()

```

"Перезагрузка" экземпляра:

```

const john = await User.create({ name: 'John' })

john.name = 'Bob'

// Перезагрузка экземпляра приводит к сбросу всех полей к дефолтным значениям

await john.reload()

console.log(john.name) // John

```

Сохранение отдельных полей:

```

const john = await User.create({ name: 'John' })

john.name = 'Bob'

john.favouriteColor = 'blue'

// Сохраняем только изменение имени

await john.save({ fields: ['name'] })

await john.reload()

console.log(john.name) // Bob

// Изменение цвета не было зафиксировано

console.log(john.favouriteColor) // green

```

Автоматическое увеличение значения поля:

```

const john = await User.create({ name: 'John', age: 98 })

const incrementResult = await john.increment('age', { by: 2 })

// При увеличении значение на 1, настройку `by` можно опустить - increment('age')

// Обновленный пользователь будет возвращен только в `postres`, в других БД он будет иметь значение `undefined`

```

Автоматическое увеличения значений нескольких полей:

```

const john = await User.create({ name: 'John', age: 98, cash: 1000 })

await john.increment({

age: 2,

cash: 500,

})

```

Также имеется возможность автоматического уменьшения значений полей (`decrement()`).

**[↥ Наверх](#)**

Основы выполнения запросов

--------------------------

Создание экземпляра:

```

const john = await User.create({

firstName: 'John',

lastName: 'Smith',

})

```

Создание экземпляра с определенными полями:

```

const user = await User.create(

{

username: 'John',

isAdmin: true,

},

{

fields: ['username'],

}

)

console.log(user.username) // John

console.log(user.isAdmin) // false

```

Получение экземпляра:

```

// Получение одного (первого) пользователя

const firstUser = await User.find()

// Получение всех пользователей

const allUsers = await User.findAll() // SELECT * FROM ...;

```

Выборка полей:

```

// Получение полей `foo` и `bar`

Model.findAll({

attributes: ['foo', 'bar'],

}) // SELECT foo, bar FROM ...;

// Изменение имени поля `bar` на `baz`

Model.findAll({

attributes: ['foo', ['bar', 'baz'], 'qux'],

}) // SELECT foo, bar AS baz, qux FROM ...;

// Выполнение агрегации

// Синоним `n_hats` является обязательным

Model.findAll({

attributes: [

'foo',

[sequelize.fn('COUNT', sequelize.col('hats')), 'n_hats'],

'bar',

],

}) // SELECT foo, COUNT(hats) AS n_hats, bar FROM ...;

// instance.n_hats

// Сокращение - чтобы не перечислять все атрибуты при агрегации

Model.findAll({

attributes: {

include: [[sequelize.fn('COUNT', sequelize.col('hats')), 'n_hast']],

},

})

// Исключение поля из выборки

Model.findAll({

attributes: {

exclude: ['baz'],

},

})

```

Настройка `where` позволяет выполнять фильтрацию возвращаемых данных. Существует большое количество операторов, которые могут использоваться совместно с `where` через `Op` (см. ниже).

```

// Выполняем поиск поста по идентификатору его автора

// предполагается `Op.eq`

Post.findAll({

where: {

authorId: 2,

},

}) // SELECT * FROM post WHERE authorId = 2;

// Полный вариант

const { Op } = require('sequelize')

Post.findAll({

where: {

authorId: {

[Op.eq]: 2,

},

},

})

// Фильтрация по нескольким полям

// предполагается `Op.and`

Post.findAll({

where: {

authorId: 2,

status: 'active',

},

}) // SELECT * FROM post WHERE authorId = 2 AND status = 'active';

// Полный вариант

Post.findAll({

where: {

[Op.and]: [{ authorId: 2 }, { status: 'active' }],

},

})

// ИЛИ

Post.findAll({

where: {

[Op.or]: [{ authorId: 2 }, { authorId: 3 }],

},

}) // SELECT * FROM post WHERE authorId = 12 OR authorId = 13;

// Одинаковые названия полей можно опускать

Post.destroy({

where: {

authorId: {

[Op.or]: [2, 3],

},

},

}) // DELETE FROM post WHERE authorId = 2 OR authorId = 3;

```

**Операторы**

```

const { Op } = require('sequelize')

Post.findAll({

where: {

[Op.and]: [{ a: 1, b: 2 }], // (a = 1) AND (b = 2)

[Op.or]: [{ a: 1, b: 2 }], // (a = 1) OR (b = 2)

someAttr: {

// Основные

[Op.eq]: 3, // = 3

[Op.ne]: 4, // != 4

[Op.is]: null, // IS NULL

[Op.not]: true, // IS NOT TRUE

[Op.or]: [5, 6], // (someAttr = 5) OR (someAttr = 6)

// Использование диалекта определенной БД (`postgres`, в данном случае)

[Op.col]: 'user.org_id', // = 'user'.'org_id'

// Сравнение чисел

[Op.gt]: 6, // > 6

[Op.gte]: 6, // >= 6

[Op.lt]: 7, // < 7

[Op.lte]: 7, // <= 7

[Op.between]: [8, 10], // BETWEEN 8 AND 10

[Op.notBetween]: [8, 10], // NOT BETWEEN 8 AND 10

// Другие

[Op.all]: sequelize.literal('SELECT 1'), // > ALL (SELECT 1)

[Op.in]: [10, 12], // IN [1, 2]

[Op.notIn]: [10, 12] // NOT IN [1, 2]

[Op.like]: '%foo', // LIKE '%foo'

[Op.notLike]: '%foo', // NOT LIKE '%foo'

[Op.startsWith]: 'foo', // LIKE 'foo%'

[Op.endsWith]: 'foo', // LIKE '%foo'

[Op.substring]: 'foo', // LIKE '%foo%'

[Op.iLike]: '%foo', // ILIKE '%foo' (учет регистра, только для `postgres`)

[Op.notILike]: '%foo', // NOT ILIKE '%foo'

[Op.regexp]: '^[b|a|r]', // REGEXP/~ '^[b|a|r]' (только для `mysql`/`postgres`)

[Op.notRegexp]: '^[b|a|r]', // NOT REGEXP/!~ '^[b|a|r]' (только для `mysql`/`postgres`),

[Op.iRegexp]: '^[b|a|r]', // ~* '^[b|a|r]' (только для `postgres`)

[Op.notIRegexp]: '^[b|a|r]', // !~* '^[b|a|r]' (только для `postgres`)

[Op.any]: [2, 3], // ANY ARRAY[2, 3]::INTEGER (только для `postgres`)

[Op.like]: { [Op.any]: ['foo', 'bar'] } // LIKE ANY ARRAY['foo', 'bar'] (только для `postgres`)

// и т.д.

}

}

})

```

Передача массива в `where` приводит к неявному применению оператора `IN`:

```

Post.findAll({

where: {

id: [1, 2, 3], // id: { [Op.in]: [1, 2, 3] }

},

}) // ... WHERE 'post'.'id' IN (1, 2, 3)

```

Операторы `Op.and`, `Op.or` и `Op.not` могут использоваться для создания сложных операций, связанных с логическими сравнениями:

```

const { Op } = require('sequelize')

Foo.findAll({

where: {

rank: {

[Op.or]: {

[Op.lt]: 1000,

[Op.eq]: null

}

}, // rank < 1000 OR rank IS NULL

{

createdAt: {

[Op.lt]: new Date(),

[Op.gt]: new Date(new Date() - 24 * 60 * 60 * 1000)

}

}, // createdAt < [timestamp] AND createdAt > [timestamp]

{

[Op.or]: [

{

title: {

[Op.like]: 'Foo%'

}

},

{

description: {

[Op.like]: '%foo%'

}

}

]

} // title LIKE 'Foo%' OR description LIKE '%foo%'

}

})

// НЕ

Project.findAll({

where: {

name: 'Some Project',

[Op.not]: [

{ id: [1, 2, 3] },

{

description: {

[Op.like]: 'Awe%'

}

}

]

}

})

/*

SELECT *

FROM 'Projects'

WHERE (

'Projects'.'name' = 'Some Project'

AND NOT (

'Projects'.'id' IN (1, 2, 3)

OR

'Projects'.'description' LIKE 'Awe%'

)

)

*/

```

"Продвинутые" запросы:

```

Post.findAll({

where: sequelize.where(

sequelize.fn('char_length', sequelize.col('content')),

7

),

}) // WHERE char_length('content') = 7

Post.findAll({

where: {

[Op.or]: [

sequelize.where(sequelize.fn('char_length', sequelize.col('content')), 7),

{

content: {

[Op.like]: 'Hello%',

},

},

{

[Op.and]: [

{ status: 'draft' },

sequelize.where(

sequelize.fn('char_length', sequelize.col('content')),

{

[Op.gt]: 8,

}

),

],

},

],

},

})

/*

...

WHERE (

char_length("content") = 7

OR

"post"."content" LIKE 'Hello%'

OR (

"post"."status" = 'draft'

AND

char_length("content") > 8

)

)

*/

```

Длинное получилось лирическое отступление. Двигаемся дальше.

Обновление экземпляра:

```

// Изменяем имя пользователя с `userId = 2`

await User.update(

{

firstName: 'John',

},

{

where: {

userId: 2,

},

}

)

```

Удаление экземпляра:

```

// Удаление пользователя с `id = 2`

await User.destroy({

where: {

userId: 2,

},

})

// Удаление всех пользователей

await User.destroy({

truncate: true,

})

```

Создание нескольких экземпляров одновременно:

```

const users = await User.bulkCreate([{ name: 'John' }, { name: 'Jane' }])

// Настройка `validate` со значением `true` заставляет `Sequelize` выполнять валидацию каждого объекта, создаваемого с помощью `bulkCreate()`

// По умолчанию валидация таких объектов не проводится

const User = sequelize.define('User', {

name: {

type: DataTypes.STRING,

validate: {

len: [2, 10],

},

},

})

await User.bulkCreate([{ name: 'John' }, { name: 'J' }], { validate: true }) // Ошибка!

// Настройка `fields` позволяет определять поля для сохранения

await User.bulkCreate([{ name: 'John' }, { name: 'Jane', age: 30 }], {

fields: ['name'],

}) // Сохраняем только имена пользователей

```

**Сортировка и группировка**

Настройка `order` определяет порядок сортировки возвращаемых объектов:

```

Submodel.findAll({

order: [

// Сортировка по заголовку (по убыванию)

['title', 'DESC'],

// Сортировка по максимальному возврасту

sequelize.fn('max', sequelize.col('age')),

// Тоже самое, но по убыванию

[sequelize.fn('max', sequelize.col('age')), 'DESC'],

// Сортировка по `createdAt` из связанной модели

[Model, 'createdAt', 'DESC'],

// Сортировка по `createdAt` из двух связанных моделей

[Model, AnotherModel, 'createdAt', 'DESC'],

// и т.д.

],

// Сортировка по максимальному возврасту (по убыванию)

order: sequelize.literal('max(age) DESC'),

// Сортировка по максимальному возрасту (по возрастанию - направление сортировки по умолчанию)

order: sequelize.fn('max', sequelize.col('age')),

// Сортировка по возрасту (по возрастанию)

order: sequelize.col('age'),

// Случайная сортировка

order: sequelize.random(),

})

Model.findOne({

order: [

// возвращает `name`

['name'],

// возвращает `'name' DESC`

['name', 'DESC'],

// возвращает `max('age')`

sequelize.fn('max', sequelize.col('age')),

// возвращает `max('age') DESC`

[sequelize.fn('max', sequelize.col('age')), 'DESC'],

// и т.д.

],

})

```

Синтаксис группировки идентичен синтаксису сортировки, за исключением того, что при группировке не указывается направление. Кроме того, синтаксис группировки может быть сокращен до строки:

```

Project.findAll({ group: 'name' }) // GROUP BY name

```

Настройки `limit` и `offset` позволяют ограничивать и/или пропускать определенное количество возвращаемых объектов:

```

// Получаем 10 проектов

Project.findAll({ limit: 10 })

// Пропускаем 5 первых объектов

Project.findAll({ offset: 5 })

// Пропускаем 5 первых объектов и возвращаем 10

Project.findAll({ offset: 5, limit: 10 })

```

`Sequelize` предоставляет несколько полезных утилит:

```

// Определяем число вхождений

console.log(

`В настоящий момент в БД находится ${await Project.count()} проектов.`

)

const amount = await Project.count({

where: {

projectId: {

[Op.gt]: 25,

},

},

})

console.log(

`В настоящий момент в БД находится ${amount} проектов с идентификатором больше 25.`

)

// max, min, sum

// Предположим, что у нас имеется 3 пользователя 20, 30 и 40 лет

await User.max('age') // 40

await User.max('age', { where: { age: { [Op.lt]: 31 } } }) // 30

await User.min('age') // 20

await User.min('age', { where: { age: { [Op.gt]: 21 } } }) // 30

await User.sum('age') // 90

await User.sum('age', { where: { age: { [op.gt]: 21 } } }) // 70

```

**[↥ Наверх](#)**

Поисковые запросы

-----------------

Настройка `raw` со значением `true` отключает "оборачивание" ответа, возвращаемого `SELECT`, в экземпляр модели.

* `findAll()` — возвращает все экземпляры модели

* `findByPk()` — возвращает один экземпляр по первичному ключу

```

const project = await Project.findByPk(123)

```

* `findOne()` — возвращает первый или один экземпляр модели (это зависит от того, указано ли условие для поиска)

```

const project = await Project.findOne({ where: { projectId: 123 } })

```

* `findOrCreate()` — возвращает или создает и возвращает экземпляр, а также логическое значение — индикатор создания экземпляра. Настройка `defaults` используется для определения значений по умолчанию. При ее отсутствии, для заполнения полей используется значение, указанное в условии

```

// Предположим, что у нас имеется пустая БД с моделью `User`, у которой имеются поля `username` и `job`

const [user, created] = await User.findOrCreate({

where: { username: 'John' },

defaults: {

job: 'JavaScript Developer',

},

})

```

* `findAndCountAll()` — комбинация `findAll()` и `count`. Может быть полезным при использовании настроек `limit` и `offset`, когда мы хотим знать точное число записей, совпадающих с запросом. Возвращает объект с двумя свойствами:

+ `count` — количество записей, совпадающих с запросом (целое число)

+ `rows` — массив объектов

```

const { count, rows } = await Project.findAndCountAll({

where: {

title: {

[Op.like]: 'foo%',

},

},

offset: 10,

limit: 5,

})

```

**[↥ Наверх](#)**

Геттеры, сеттеры и виртуальные атрибуты

---------------------------------------

`Sequelize` позволяет определять геттеры и сеттеры для атрибутов моделей, а также *виртуальные атрибуты* — атрибуты, которых не существует в таблице и которые заполняются или наполняются (имеется ввиду популяция) `Serquelize` автоматически. Последние могут использоваться, например, для упрощения кода.

Геттер — это функция `get()`, определенная для колонки:

```

const User = sequelize.define('User', {

username: {

type: DataTypes.STRING,

get() {

const rawValue = this.getDataValue(username)

return rawValue ? rawValue.toUpperCase() : null

},

},

})

```

Геттер вызывается автоматически при чтении поля.

*Обратите внимание*: для получения значения поля в геттере мы использовали метод `getDataValue()`. Если вместо этого указать `this.username`, то мы попадем в бесконечный цикл.

Сеттер — это функция `set()`, определенная для колонки. Она принимает значение для установки:

```

const User = sequelize.define('user', {

username: DataTypes.STRING,

password: {

type: DataTypes.STRING,

set(value) {

// Перед записью в БД пароли следует "хэшировать" с помощью криптографической функции

this.setDataValue('password', hash(value))

},

},

})

```

Сеттер вызывается автоматически при создании экземпляра.

В сеттере можно использовать значения других полей:

```

const User = sequelize.define('User', {

username: DatTypes.STRING,

password: {

type: DataTypes.STRING,

set(value) {

// Используем значение поля `username`

this.setDataValue('password', hash(this.username + value))

},

},

})

```

Геттеры и сеттеры можно использовать совместно. Допустим, что у нас имеется модель `Post` с полем `content` неограниченной длины, и в целях экономии памяти мы решили хранить в БД содержимое поста в сжатом виде. *Обратите внимание*: многие современные БД выполняют сжатие (компрессию) данных автоматически.

```

const { gzipSync, gunzipSync } = require('zlib')

const Post = sequelize.define('post', {

content: {

type: DataTypes.TEXT,

get() {

const storedValue = this.getDataValue('content')

const gzippedBuffer = Buffer.from(storedValue, 'base64')

const unzippedBuffer = gunzipSync(gzippedBuffer)

return unzippedBuffer.toString()

},

set(value) {

const gzippedBuffer = gzipSync(value)

this.setDataValue('content', gzippedBuffer.toString('base64'))

},

},

})

```

Представим, что у нас имеется модель `User` с полями `firstName` и `lastName`, и мы хотим получать полное имя пользователя. Для этого мы можем создать виртуальный атрибут со специальным типом `DataTypes.VIRTUAL`:

```

const User = sequelize.define('user', {

firstName: DataTypes.STRING,

lastName: DataTypes.STRING,

fullName: {

type: DataTypes.VIRTUAL,

get() {

return `${this.firstName} ${this.lastName}`

},

set(value) {

throw new Error('Нельзя этого делать!')

},

},

})

```

В таблице не будет колонки `fullName`, однако мы сможем получать значение этого поля, как если бы оно существовало на самом деле.

**[↥ Наверх](#)**

Валидация и ограничения

-----------------------

Наша моделька будет выглядеть так:

```

const { Sequelize, Op, DataTypes } = require('sequelize')

const sequelize = new Sequelize('sqlite::memory:')

const User = sequelize.define('user', {

username: {

type: DataTypes.STRING,

allowNull: false,

unique: true,

},

hashedPassword: {

type: DataTypes.STRING(64),

is: /^[0-9a-f]{64}$/i,

},

})

```

Отличие между выполнением валидации и применением или наложением органичение на значение поля состоит в следующем:

* валидация выполняется на уровне `Sequelize`; для ее выполнения можно использовать любую функцию, как встроенную, так и кастомную; при провале валидации, SQL-запрос в БД не отправляется;

* ограничение определяется на уровне `SQL`; примером ограничения является настройка `unique`; при провале ограничения, запрос в БД все равно отправляется

В приведенном примере мы ограничили уникальность имени пользователя с помощью настройки `unique`. При попытке записать имя пользователя, которое уже существует в БД, возникнет ошибка `SequelizeUniqueConstraintError`.

По умолчанию колонки таблицы могут быть пустыми (нулевыми). Настройка `allowNull` со значением `false` позволяет это запретить. *Обратите внимание*: без установки данной настройки хотя бы для одного поля, можно будет выполнить такой запрос: `User.create({})`.

Валидаторы позволяют проводить проверку в отношении каждого атрибута модели. Валидация автоматически выполняется при запуске методов `create()`, `update()` и `save()`. Ее также можно запустить вручную с помощью `validate()`.

Как было отмечено ранее, мы можем определять собственные валидаторы или использовать встроенные (предоставляемые библиотекой [`validator.js`](https://github.com/validatorjs/validator.js)).

```

sequelize.define('foo', {

bar: {

type: DataTypes.STRING,

validate: {

is: /^[a-z]+$/i, // определение совпадения с регулярным выражением

not: /^[a-z]+$/i, // определение отсутствия совпадения с регуляркой

isEmail: true,

isUrl: true,

isIP: true,

isIPv4: true,

isIPv6: true,

isAlpha: true,

isAlphanumeric: true,

isNumeric: true,

isInt: true,

isFloat: true,

isDecimal: true,

isLowercase: true,

isUppercase: true,

notNull: true,

isNull: true,

notEmpty: true,

equals: 'определенное значение',

contains: 'foo', // определение наличия подстроки

notContains: 'bar', // определение отсутствия подстроки

notIn: [['foo', 'bar']], // определение того, что значение НЕ является одним из указанных

isIn: [['foo', 'bar']], // определение того, что значение является одним из указанных

len: [2, 10], // длина строки должна составлять от 2 до 10 символов

isUUID: true,

isDate: true,

isAfter: '2021-06-12',

isBefore: '2021-06-15',

max: 65,

min: 18,

isCreditCard: true,

// Примеры кастомных валидаторов

isEven(value) {

if (parseInt(value) % 2 !== 0) {

throw new Error('Разрешены только четные числа!')

}

},

isGreaterThanOtherField(value) {

if (parseInt(value) < parseInt(this.otherField)) {

throw new Error(

`Значение данного поля должно быть больше значения ${otherField}!`

)

}

},

},

},

})

```

Для кастомизации сообщения об ошибке можно использовать объект со свойством `msg`:

```

isInt: {

msg: 'Значение должно быть целым числом!'

}

```

В этом случае для указания аргументов используется свойство `args`:

```

isIn: {

args: [['ru', 'en']],

msg: 'Язык должен быть русским или английским!'

}

```

Для поля, которое может иметь значение `null`, встроенные валидаторы пропускаются. Это означает, что мы, например, можем определить поле, которое либо должно содержать строку длиной 5-10 символов, либо должно быть пустым:

```

const User = sequelize.define('user', {

username: {

type: DataTypes.STRING,

allowNull: true,

validate: {

len: [5, 10],

},

},

})

```

*Обратите внимание*, что для нулевых полей кастомные валидаторы выполняются:

```

const User = sequelize.define('user', {

age: DataTypes.INTEGER,

name: {

type: DataTypes.STRING,

allowNull: true,

validate: {

customValidator(value) {

if (value === null && this.age < 18) {

throw new Error('Нулевые значения разрешены только совершеннолетним!')

}

},

},

},

})

```

Мы можем выполнять валидацию не только отдельных полей, но и модели в целом. В следующем примере мы проверяем наличие или отсутствии как поля `latitude`, так и поля `longitude` (либо должны быть указаны оба поля, либо не должно быть указано ни одного):

```

const Place = sequelize.define(

'place',

{

name: DataTypes.STRING,

address: DataTypes.STRING,

latitude: {

type: DataTypes.INTEGER,

validate: {

min: -90,

max: 90,

},

},

longitude: {

type: DataTypes.INTEGER,

validate: {

min: -180,

max: 180,

},

},

},

{

validate: {

bothCoordsOrNone() {

if (!this.latitude !== !this.longitude) {

throw new Error(

'Либо укажите и долготу, и широту, либо ничего не указывайте!'

)

}

},

},

}

)

```

**[↥ Наверх](#)**

Необработанные запросы

----------------------

`sequelize.query()` позволяет выполнять необработанные `SQL-запросы` (raw queries). По умолчанию данная функция возвращает массив с результатами и объект с метаданными, при этом, содержание последнего зависит от используемого диалекта.

```

const [results, metadata] = await sequelize.query(

"UPDATE users SET username = 'John' WHERE userId = 123"

)

```

Если нам не нужны метаданные, для правильного форматирования результата можно воспользоваться специальными типами запроса (query types):

```

const { QueryTypes } = require('sequelize')

const users = await sequelize.query('SELECT * FROM users', {

// тип запроса - выборка

type: QueryTypes.SELECT,

})

```

Для привязки результатов необработанного запроса к модели используются настройки `model` и, опционально, `mapToModel`:

```

const projects = await sequelize.query('SELECT * FROM projects', {

model: Project,

mapToModel: true,

})

```

Пример использования других настроек:

```

sequelize.query('SELECT 1', {

// "логгирование" - функция или `false`

logging: console.log,

// если `true`, возвращается только первый результат

plain: false,

// если `true`, для выполнения запроса не нужна модель

raw: false,

// тип выполняемого запроса

type: QueryTypes.SELECT,

})

```

Если название атрибута в таблице содержит точки, то результирующий объект может быть преобразован во вложенные объекты с помощью настройки `nest`.

Без `nest: true`:

```

const records = await sequelize.query('SELECT 1 AS `foo.bar.baz`', {

type: QueryTypes.SELECT,

})

console.log(JSON.stringify(records[0], null, 2))

// { 'foo.bar.baz': 1 }

```

С `nest: true`:

```

const records = await sequelize.query('SELECT 1 AS `foo.bar.baz`', {

type: QueryTypes.SELECT,

nest: true,

})

console.log(JSON.stringify(records[0], null, 2))

/*

{

'foo': {

'bar': {

'baz': 1

}

}

}

*/

```

Замены при выполнении запроса могут производиться двумя способами:

* с помощью именованных параметров (начинающихся с `:`)

* с помощью неименованных параметров (представленных `?`)

Заменители (placeholders) передаются в настройку `replacements` в виде массива (для неименованных параметров) или в виде объекта (для именованных параметров):

* если передан массив, `?` заменяется элементами массива в порядке их следования

* если передан объект, `:key` заменяются ключами объекта. При отсутствии в объекте ключей для заменяемых значений, а также в случае, когда ключей в объекте больше, чем заменяемых значений, выбрасывается исключение

```

sequelize.query('SELECT * FROM projects WHERE status = ?', {

replacements: ['active'],

type: QueryTypes.SELECT,

})

sequelize.query('SELECT * FROM projects WHERE status = :status', {

replacements: { status: 'active' },

type: QueryTypes.SELECT,

})

```

Продвинутые примеры замены:

```

// Замена производится при совпадении с любым значением из массива

sequelize.query('SELECT * FROM projects WHERE status IN(:status)', {

replacements: { status: ['active', 'inactive'] },

type: QueryTypes.SELECT,

})

// Замена выполняется для всех пользователей, имена которых начинаются с `J`

sequelize.query('SELECT * FROM users WHERE name LIKE :search_name', {

replacements: { search_name: 'J%' },

type: QueryTypes.SELECT,

})

```

Кроме замены, можно выполнять привязку (bind) параметров. Привязка похожа на замену, но заменители обезвреживаются (escaped) и вставляются в запрос, отправляемый в БД, а связанные параметры отправляются в БД по отдельности. Связанные параметры обозначаются с помощью `$число` или `$строка`:

* если передан массив, `$1` будет указывать на его первый элемент (`bind[0]`)

* если передан объект, `$key` будет указывать на `object['key']`. Каждый ключ объекта должен начинаться с буквы. `$1` является невалидным ключом, даже если существует `object['1']`

* в обоих случаях для сохранения знака `$` может использоваться `$$`

Связанные параметры не могут быть ключевыми словами `SQL`, названиями таблиц или колонок. Они игнорируются внутри текста, заключенного в кавычки. Кроме того, в `postgres` может потребоваться указывать тип связываемого параметра в случае, когда он не может быть выведен на основании контекста — `$1::varchar`.

```

sequelize.query(

'SELECT *, "текст с литеральным $$1 и литеральным $$status" AS t FROM projects WHERE status = $1',

{

bind: ['active'],

type: QueryTypes.SELECT,

}

)

sequelize.query(

'SELECT *, "текст с литеральным $$1 и литеральным $$status" AS t FROM projects WHERE status = $status',

{

bind: { status: 'active' },

type: QueryTypes.SELECT,

}

)

```

**[↥ Наверх](#)**

На этом первая часть руководства завершена. В следующей части мы поговорим о простых и продвинутых ассоциациях (отношениях между моделями), "параноике", нетерпеливой и ленивой загрузке, а также о многом другом.

---

[Аренда VPS/VDS](https://macloud.ru/vps-vds) с быстрыми NVMе-дисками и посуточной оплатой у хостинга Маклауд.

[](https://macloud.ru/vps-vds&utm_source=habr&utm_medium=original&utm_campaign=igor) | https://habr.com/ru/post/565062/ | null | ru | null |

# Второе издание книги «Изучаем Python. Программирование игр, визуализация данных, веб-приложения»

[](https://habrahabr.ru/company/piter/blog/335824/) Привет, Хаброжители! В том году мы делали [обзор](https://habrahabr.ru/company/piter/blog/313510/) книги Эрика Мэтиза. На данный момент вышло новое издание с исправленными опечатками и листингами. Сама книга показывает базовые принципы программирования, знакомит со списками, словарями, классами и циклами, учит создавать программы и тестировать код. Во второй части книги вы начнете использовать знания на практике, работая над тремя крупными проектами: создадите собственную «стрелялку» с нарастающей сложностью уровней, займетесь работой с большими наборами данных и освоите их визуализацию и, наконец, создадите полноценное веб-приложение на базе Django, гарантирующее конфиденциальность пользовательской информации.

Внутри отрывок из книги «Знакомство с Django»

### Знакомство с Django

Современные веб-сайты в действительности представляют собой многофункциональные приложения, достаточно близкие к полноценным приложениям для настольных систем. Python содержит богатый набор инструментов для построения веб-приложений. В этой главе вы научитесь использовать [Django](https://www.djangoproject.com/) для построения проекта Learning Log — сетевой журнальной системы для отслеживания информации, полученной вами по определенной теме.

Мы напишем спецификацию для этого проекта, а затем определим модели для данных, с которыми будет работать приложение. Мы воспользуемся административной системой Django для ввода некоторых начальных данных, а затем научимся писать представления и шаблоны, на базе которых Django будет строить страницы нашего сайта.

Django представляет собой веб-инфраструктуру — набор инструментов для построения интерактивных веб-сайтов. Django может реагировать на запросы страниц, упрощает чтение и запись информации в базы данных, управление пользователями и многие другие операции. В главах 19 и 20 мы доработаем проект Learning Log, а затем развернем его на сервере, чтобы вы (и ваши друзья) могли использовать их.

**Подготовка к созданию проекта**

В начале работы над проектом необходимо описать проект в спецификации. Затем вы создадите виртуальную среду для построения проекта.

**Написание спецификации**

В полной спецификации описываются цели проекта, его функциональность, а также внешний вид и интерфейс пользователя. Как и любой хороший проект или бизнес-план, спецификация должна сосредоточиться на самых важных аспектах и обеспечивать планомерную разработку проекта. Здесь мы не будем писать полную спецификацию, а сформулируем несколько четких целей, которые будут задавать направление процесса разработки. Вот как выглядит спецификация:

*Мы напишем веб-приложение с именем Learning Log, при помощи которого пользователь сможет вести журнал интересующих его тем и создавать записи в журнале во время изучения каждой темы. Домашняя страница Learning Log содержит описание сайта и приглашает пользователя зарегистрироваться либо ввести свои учетные данные. После успешного входа пользователь получает возможность создавать новые темы, добавлять новые записи, читать и редактировать существующие записи.*

Во время изучения нового материала бывает полезно вести журнал того, что вы узнали, — записи пригодятся для контроля и возвращения к необходимой информации. Хорошее приложение повышает эффективность этого процесса.

**Создание виртуальной среды**

Для работы с Django необходимо сначала создать виртуальную среду для работы. Виртуальная среда представляет собой подраздел системы, в котором вы можете устанавливать пакеты в изоляции от всех остальных пакетов Python. Отделение библиотек одного проекта от других проектов принесет пользу при развертывании Learning Log на сервере в главе 20.

Создайте для проекта новый каталог с именем learning\_log, перейдите в этот каталог в терминальном режиме и создайте виртуальную среду. Если вы работаете в Python 3, то сможете создать виртуальную среду следующей командой:

```

learning_log$ python -m venv ll_env

learning_log$

```

Команда запускает модуль venv и использует его для создания виртуальной среды с именем ll\_env. Если этот способ сработал, переходите к разделу «Активизация виртуальной среды» на с. 382. Если что-то не получилось, прочитайте следующий раздел — «Установка virtualenv».

**Установка virtualenv**

Если вы используете более раннюю версию Python или ваша система не настроена для правильного использования модуля venv, установите пакет virtualenv. Установка virtualenv выполняется следующей командой:

```

$ pip install --user virtualenv

```

Возможно, вам придется использовать слегка измененную версию этой команды. (Если вы еще не использовали pip, обратитесь к разделу «Установка пакетов Python с использованием pip» на с. 227.)

ПРИМЕЧАНИЕ

Если вы используете Linux, но и этот способ не сработал, установите virtualenv при помощи менеджера пакетов своей системы. Например, в Ubuntu для установки virtualenv используется команда sudo apt-get install python-virtualenv.

Перейдите в каталог learning\_log в терминальном окне и создайте виртуальную среду следующей командой:

```

learning_log$ virtualenv ll_env

New python executable in ll_env/bin/python

Installing setuptools, pip...done.

learning_log$

```

Если в вашей системе установлено несколько версий Python, укажите версию, которая должна использоваться virtualenv. Например, команда virtualenv ll\_env --python=python3 создаст виртуальную среду, которая использует Python 3.

**Активизация виртуальной среды**

После того как виртуальная среда будет создана, ее необходимо активизировать следующей командой:

```

learning_log$ source ll_env/bin/activate

(1) (ll_env)learning_log$

```

Команда запускает сценарий activate из каталога ll\_env/bin. Когда среда активизируется, ее имя выводится в круглых скобках (1); теперь вы можете устанавливать пакеты в среде и использовать те пакеты, что были установлены ранее. Пакеты, установленные в ll\_env, будут доступны только в то время, пока среда остается активной.

ПРИМЕЧАНИЕ

Если вы работаете в системе Windows, используйте команду ll\_env\Scripts\activate (без слова source) для активизации виртуальной среды.

Чтобы завершить использование виртуальной среды, введите команду deactivate:

```

(ll_env)learning_log$ deactivate

learning_log$

```

Среда также становится неактивной при закрытии терминального окна, в котором она работает.

**Установка Django**

После того как вы создали свою виртуальную среду и активизировали ее, установите Django:

```

(ll_env)learning_log$ pip install Django

Installing collected packages: Django

Successfully installed Django

Cleaning up...

(ll_env)learning_log$

```

Так как вы работаете в виртуальной среде, эта команда выглядит одинаково во всех системах. Использовать флаг --user не нужно, как и использовать более длинные команды вида python -m pip install имя\_пакета.

Помните, что с Django можно работать только в то время, пока среда остается активной.

**Создание проекта в Django**

Не выходя из активной виртуальной среды (пока ll\_env выводится в круглых скобках), введите следующие команды для создания нового проекта:

```

(1) (ll_env)learning_log$ django-admin.py startproject learning_log .

(2) (ll_env)learning_log$ ls

learning_log ll_env manage.py

(3) (ll_env)learning_log$ ls learning_log

__init__.py settings.py urls.py wsgi.py

```

Команда (1) приказывает Django создать новый проект с именем learning\_log. Точка в конце команды создает новый проект со структурой каталогов, которая упрощает развертывание приложения на сервере после завершения разработки.

ПРИМЕЧАНИЕ

Не забывайте про точку, иначе у вас могут возникнуть проблемы с конфигурацией при развертывании приложения. А если вы все же забыли, удалите созданные файлы и папки (кроме ll\_env) и снова выполните команду.

Команда ls (dir в Windows) (2) показывает, что Django создает новый каталог с именем learning\_log. Также создается файл manage.py — короткая программа, которая получает команды и передает их соответствующей части Django для выполнения. Мы используем эти команды для управления такими задачами, как работа с базами данных и запуск серверов.

В каталоге learning\_log находятся четыре файла (3), важнейшими из которых являются файлы settings.py, urls.py и wsgi.py. Файл settings.py определяет то, как Django взаимодействует с вашей системой и управляет вашим проектом. Мы изменим некоторые из существующих настроек и добавим несколько новых настроек в ходе разработки проекта. Файл urls.py сообщает Django, какие страницы следует строить в ответ на запросы браузера. Файл wsgi.py помогает Django предоставлять созданные файлы (имя файла является сокращением от «Web Server Gateway Interface»).

**Создание базы данных**

```

(ll_env)learning_log$ python manage.py migrate

(1)Operations to perform:

Synchronize unmigrated apps: messages, staticfiles

Apply all migrations: contenttypes, sessions, auth, admin

...

Applying sessions.0001_initial... OK

(2)(ll_env)learning_log$ ls

db.sqlite3 learning_log ll_env manage.py

```

Каждое изменение базы данных называется миграцией. Первое выполнение команды migrate приказывает Django проверить, что база данных соответствует текущему состоянию проекта. Когда мы впервые выполняем эту команду в новом проекте с использованием SQLite (вскоре мы расскажем о SQLite более подробно), Django создает новую базу данных за нас. В точке (1) Django сообщает о создании таблиц базы данных, необходимых для хранения информации, используемой в проекте (Synchronize unmigrated apps), а затем проверяет, что структура базы данных соответствует текущему коду (Apply all migrations).

Выполнение команды ls показывает, что Django создает другой файл с именем db.sqlite3 (2). SQLite — база данных, работающая с одним файлом; она идеально подходит для написания простых приложений, потому что вам не нужно особенно следить за управлением базой данных.

**Просмотр проекта**

Убедимся в том, что проект был создан правильно. Введите команду runserver:

```

(ll_env)learning_log$ python manage.py runserver

Performing system checks...

(1) System check identified no issues (0 silenced).

July 15, 2015 - 06:23:51

(2) Django version 1.8.4, using settings 'learning_log.settings'

(3) Starting development server at http://127.0.0.1:8000/

Quit the server with CONTROL-C.

```

Django запускает сервер, чтобы вы могли просмотреть проект в своей системе и проверить, как он работает. Когда вы запрашиваете страницу, вводя URL в браузере, сервер Django отвечает на запрос; для этого он строит соответствующую страницу и отправляет страницу браузеру.

В точке (1) Django проверяет правильность созданного проекта; в точке (2) выводится версия Django и имя используемого файла настроек; в точке (3) возвращается URL-адрес, по которому доступен проект. URL [127.0.0.1](http://127.0.0.1):8000/ означает, что проект ведет прослушивание запросов на порте 8000 локального хоста (localhost), то есть вашего компьютера. Термином «локальный хост» обозначается сервер, который обрабатывает только запросы вашей системы; он не позволяет никому другому просмотреть разрабатываемые страницы.

Теперь откройте браузер и введите URL [localhost](http://localhost):8000/ — или [127.0.0.1](http://127.0.0.1):8000/, если первый адрес не работает. Вы увидите нечто похожее на рис. 18.1 — страницу, которую создает Django, чтобы сообщить вам, что все пока работает правильно. Пока не завершайте работу сервера (но, когда вы захотите прервать ее, это можно сделать нажатием клавиш Ctrl+C).

ПРИМЕЧАНИЕ

Если вы получаете сообщение об ошибке «Порт уже используется», прикажите Django использовать другой порт; для этого введите команду python manage.py runserver 8001 и продолжайте перебирать номера портов по возрастанию, пока не найдете открытый порт.

» Более подробно с книгой можно ознакомиться на [сайте издательства](https://www.piter.com/collection/python/product/izuchaem-python-programmirovanie-igr-vizualizatsiya-dannyh-veb-prilozheniya-2-e-izd)

» [Оглавление](http://storage.piter.com/upload/contents/978544610479/978544610479_X.pdf)

» [Отрывок](http://storage.piter.com/upload/contents/978544610479/978544610479_p.pdf)

Другие книги по теме:

[Автостопом по Python](https://www.piter.com/collection/python/product/avtostopom-po-python)

Авторы: К. Рейтц, Т. Шлюссер. Ссылка на [обзор](https://habrahabr.ru/company/piter/blog/333498/).

[Простой Python. Современный стиль программирования](https://www.piter.com/collection/python/product/prostoy-python-sovremennyy-stil-programmirovaniya)

Автор: Б. Любанович Ссылка на [обзор](https://habrahabr.ru/company/piter/blog/307838/).

[Основы Data Science и Big Data. Python и наука о данных](https://www.piter.com/collection/python/product/osnovy-data-science-i-big-data-python-i-nauka-o-dannyh)

Авторы: Д. Силен, А. Мейсман, М. Али. Ссылка на [обзор](https://habrahabr.ru/company/piter/blog/322194/).

Для Хаброжителей скидка 20% по купону — **Python** | https://habr.com/ru/post/335824/ | null | ru | null |

# Что последует за вебом?

В [первой части](https://habrahabr.ru/post/338880/) я утверждал, что пришло время подумать, как заменить современную веб-платформу для приложений. Причины — её низкая производительность и в принципе нерешаемые проблемы безопасности.

Кое-кто решил, что я пишу слишком в негативном ключе и не обращаю внимания на положительные стороны веба. Так и есть: первая часть была в стиле «Обсудим факт, что мы попали в глубокую яму», а вторая часть — «Как разработать кое-что получше?» Это огромная тема, так что она на самом деле двумя частями не ограничится.

Назовём нашего конкурента вебу NewWeb (э, брендингом можно заняться потом). Для начала нужно понять, почему веб изначально стал успешным. Веб обошёл другие технологии создания приложений с лучшими инструментами для разработки GUI, так что у него явно есть какие-то качества, которые перевешивают недостатки. Если мы не будем соответствовать этим качествам, мы обречены.

*Создание GUI в Matisse, редакторе UI с автоматическим выравниванием и ограничителями. Да здравствует (новый стильный) король?*

Нужно также сконцентрироваться на дешевизне. У веба многочисленные группы разработчиков. Бóльшая часть их работы дублируется или выбрасывается, кое-что можно использовать повторно. Возможна и новая разработка в небольшом объёме… но по большому счёту любую технологию NewWeb придётся собирать из кусочков существующего программного обеспечения. Беднякам не приходится выбирать.

---

Вот мой личный список пяти главных свойств веба:

* Развёртывание и изоляция в песочнице

* Простота в освоении пользователями и разработчиками

* Устранение дихотомии документ/приложение

* Продвинутое оформление и брендинг

* Открытый код и бесплатное использование