text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Где находиться типу: справа или слева?

Как-то увидев очередную статью на Хабре, посвященную для меня совершенно новому и неизведанному языку Go, решил попробовать, что это за зверь и с чем его едят (В основном, конечно, понравился логотип). Конечно, язык имеет много возможностей и достаточно удобен. Но что меня сразу удивило, это отличный от C-подобных языков принцип объявления переменных, а именно тип переменных описывается справа от имени переменной. У меня как человека, практически выросшего на С, это вызывало удивление. Потом я конечно вспомнил Pascal, что там тоже тип переменной был справа. Заинтересовавшись этим вопросом, я попытался разобраться, почему используется тот или иной синтаксис описания типа переменных в этих 2-х языках.

Начнем с описания синтаксиса объявления переменных в С-подобных языках. В С было решено отказаться от отдельного синтаксиса описания переменных и позволить объявлять переменные как выражения:

```

int x;

```

Как мы видим, тип переменной стоит слева, затем имя переменной. Благодаря этому мы максимально приближаем объявление переменной к обычному выражению. Допустим, к такому:

```

int x = 5;

```

Или такому:

```

int x = y*z;

```

В принципе, все просто и понятно, и вполне логично, посмотрим на определение функций в C.

Изначально в C использовался вот такой синтаксис определения функции:

```

int main(argc, argv)

int argc;

char *argv[];

{ /* ... */ }

```

Типы переменных описывались не вместе с именами аргументов, но потом синтаксис заменили на другой:

```

int main(int argc, char *argv[]) { /* ... */ }

```

Здесь все тоже достаточно просто и понятно. Но это удобство начинает испаряться, когда в дело вступают указатели на функции и функции, которые могут принимать указатели на них.

```

int (*fp)(int a, int b);

```

Здесь fp — ссылка на функцию, принимающую 2 аргумента и возвращающая int. В принципе, не сложно, но вот что будет если одним из аргументов будет ссылка на функцию:

```

int (*fp)(int (*ff)(int x, int y), int b)

```

Уже как-то сложновато или вот такой пример:

```

int (*(*fp)(int (*)(int, int), int))(int, int)

```

В нем, если честно, я заблудился.

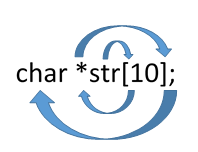

Как видно из описания, при декларировании указателей на функции в языках С есть существенный недостаток в читаемости кода. Теперь посмотрим, какой метод предлагает использовать для чтения определения переменных в С Дэвид Андерсон(David Anderson). Чтение происходит по методу Clockwise/Spiral Rule (часовой стрелке/спирали).

Данный метод имеет 3 правила:

1. Чтение начинается с неизвестного элемента движением по спирали;

2. Обработка выражения по спирали продолжается пока не покроются все символы;

3. Чтение необходимо начинать с круглых скобок.

Пример 1:

Следуя правилу, начинаем с неизвестной str:

* Двигаемся по спирали и первое, что мы видим, это символ ‘[’. Значит, мы имеем дело с массивом

— str массив 10-и элементов;

* Продолжаем движение по спирали и следующий символ это '\*'. Значит, это указатель

— str массив 10-и указателей;

* Продолжая движения по спирали приходим к символу ';', означающий конец выражения. Двигаемся по спирали и находим тип данных char

— str массив 10-и указателей на тип char.

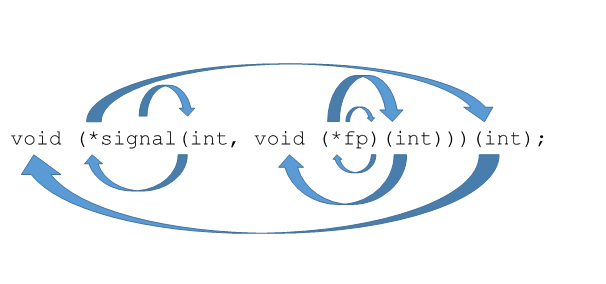

Возьмем пример посложнее

Пример 2:

* Первая неизвестная, которая нам встречается, это signal. Начинаем движение по спирали от нее и видим скобку. Это означает, что:

— signal – это функция которая принимает int и…

* Здесь мы видим вторую неизвестную и пытаемся проанализировать ее. По тому же правилу двигаемся от нее по спирали и видим, что это указатель.

— fp указатель на …

* Продолжаем движение и видим символ ‘(’. Значит:

— fp указатель на функцию, принимающую int и возвращающую…

* Идем по спирали и видим 'void'. Из этого следует, что:

— fp указатель на функцию, принимающую int и ничего не возвращающую;

* Анализ fp закончен и мы возвращаемся к signal

— signal – это функция, которая принимает int и указатель на функцию, принимающую int и ничего не возвращающую;

* Продолжая движение видим символ ‘\*’, что означает

— signal – это функция, которая принимает int и указатель на функцию, принимающую int и ничего не возвращающую, и возвращает указатель на…

* Идем по спирали и мы видим ‘(’, что означает

— signal – это функция, которая принимает int и указатель на функцию, принимающую int и ничего не возвращающую, и возвращает указатель на функцию, принимающую int…

* Делаем последний виток и получаем следующее

— signal – это функция, которая принимает int и указатель на функцию, принимающую int и ничего не возвращающую, и возвращает указатель на функцию, принимающую int и возвращающую void.

Вот так, без особых усилий, предлагает нам читать определение переменных Дэвид Андерсон.

Теперь рассмотрим диаметрально противоположный синтаксис, когда тип переменной находится справа от имени переменной, на примере Go.

В Go переменные читаются слева направо и выглядят вот так:

```

var x int

var p *int

var a [3]int

```

Здесь не нужно применять никаких спиральных методов, читается просто

— переменная *a* — это массив, состоящий из 3-х элементов типа int.

С функциями тоже все достаточно просто:

```

func main(argc int, argv []string) int

```

И данное объявление тоже читается с легкостью слева направо.

Даже сложные функции, принимающие другие функции, вполне читаются слева направо:

```

f func(func(int,int) int, int) int

```

f — функция, принимающая функцию, которая, в свою очередь, принимает в параметрах 2 целых числа и возвращает целое число, и целое число, и возвращающая целое число.

Вот такие имеет отличия определение переменных в языках семейства C и Go. Очевидно, Go явно в этом выигрывает. Но если теперь вспомнить, какие языки выросли из старого доброго С – это С++, C#, Java — все они используют определение переменных такого типа. И они построены на парадигмах ООП и не используют (или практически не используют) передачу указателей на функции, все это нам заменили классы. Недостатки, которые выявляются у определения типа переменной слева, улетучиваются при использовании ООП. | https://habr.com/ru/post/270081/ | null | ru | null |

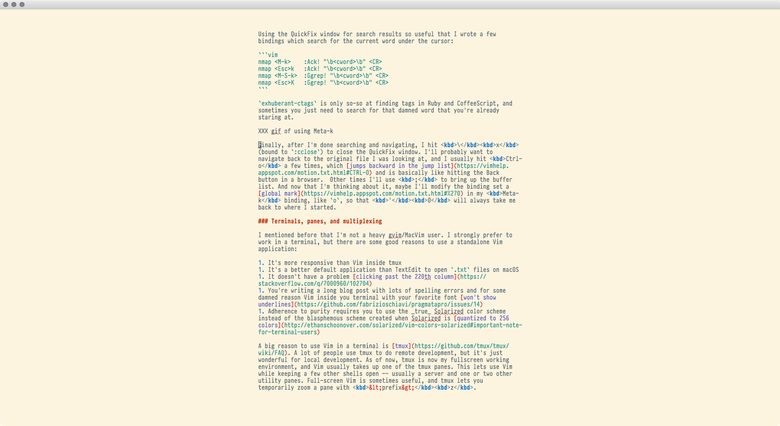

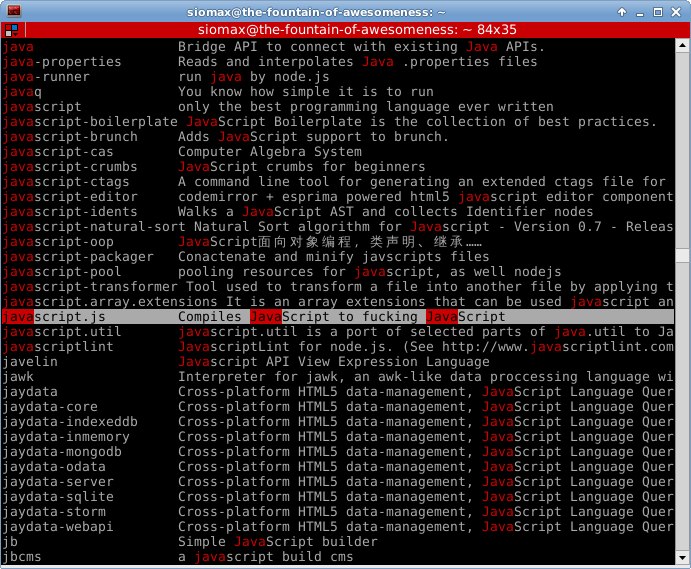

# Var, let или const? Проблемы областей видимости переменных и ES6

Области видимости в JavaScript всегда были непростой темой, особенно в сравнении с более строго организованными языками, такими, как C и Java. В течение многих лет области видимости в JS особенно широко не обсуждались, так как в языке попросту не было средств, которые позволяли бы существенно повлиять на сложившуюся ситуацию. Но в ECMAScript 6 появились некоторые новые возможности, которые позволяют разработчикам лучше контролировать области видимости переменных. Эти возможности в наши дни уже очень хорошо поддерживают браузеры, они вполне доступны для большинства разработчиков. Однако новые ключевые слова для объявления переменных, учитывая ещё и то, что старое ключевое слово `var` никуда не делось, означают не только новые возможности, но и появление новых вопросов. Когда использовать ключевые слова `let` и `const`? Как они себя ведут? В каких ситуациях всё ещё актуально ключевое слово `var`? Материал, перевод которого мы сегодня публикуем, направлен на исследование проблемы областей видимости переменных в JavaScript.

[](https://habr.com/company/ruvds/blog/420359/)

Области видимости переменных: обзор

-----------------------------------

Область видимости переменной — это важная концепция в программировании, которая, правда, может запутать некоторых разработчиков, особенно — новичков. Область видимости переменной — это та часть программы, в которой к этой переменной можно обратиться.

Взгляните на следующий пример:

```

var myVar = 1;

function setMyVar() {

myVar = 2;

}

setMyVar();

console.log(myVar);

```

Что выведет метод `console.log`? Ответ на этот вопрос никого не удивит: он выведет `2`. Переменная `myVar` объявлена за пределами какой-либо функции, что говорит нам о том, что она объявлена в глобальной области видимости. Следовательно, любая функция, объявленная в той же области видимости, сможет обратиться к `myVar`. На самом деле, если речь идёт о коде, выполняемом в браузере, доступ к этой переменной будет даже у функций, объявленных в других файлах, подключённых к странице.

Теперь взглянем на следующий код:

```

function setMyVar() {

var myVar = 2;

}

setMyVar();

console.log(myVar);

```

Внешне его изменения, по сравнению с предыдущим примером, незначительны. А именно, мы всего лишь поместили объявление переменной внутрь функции. Что теперь выведет `console.log`? На самом деле, ничего, так как эта переменная не объявлена и при попытке обратиться к ней будет выведено сообщение о необработанной ошибке `ReferenceError`. Произошло так из-за того, что переменную, с помощью ключевого слова `var`, объявили внутри функции. В результате область видимости этой переменной ограничивается внутренней областью видимости функции. К ней можно обратиться в теле этой функции, с ней могут работать функции, вложенные в эту функцию, но извне она недоступна. Если нам надо, чтобы некоей переменной могли бы пользоваться несколько функций, находящихся на одном уровне, нам надо объявлять эту переменную там же, где объявлены эти функции, то есть — на один уровень выше их внутренних областей видимости.

Вот одно интересное наблюдение: код большинства веб-сайтов и веб-приложений не относится к творчеству какого-то одного программиста. Большинство программных проектов являются результатами командной разработки, и, кроме того, в них используются сторонние библиотеки и фреймворки. Даже если разработкой некоего сайта занимается один программист, обычно он пользуется внешними ресурсами. Из-за этого обычно не рекомендуется объявлять переменные в глобальной области видимости, так как нельзя заранее знать, какие переменные будут объявлять другие разработчики, код которых будет использоваться в проекте. Для того чтобы обойти эту проблему, можно использовать некоторые приёмы, в частности — паттерн «[Модуль](https://alistapart.com/article/the-design-of-code-organizing-javascript)» и [IIFE](https://en.wikipedia.org/wiki/Immediately-invoked_function_expression) при применении объектно-ориентированного подхода к JavaScript-разработке, хотя того же эффекта позволяет достичь инкапсуляция данных и функций в обычных объектах. В целом же можно отметить, что переменные, область видимости которых выходит за пределы той, которая им необходима, обычно представляют собой проблему, с которой надо что-то делать.

Проблема ключевого слова var

----------------------------

Итак, мы разобрались с понятием «область видимости». Теперь перейдём к более сложным вещам. Взгляните на следующий код:

```

function varTest() {

for (var i = 0; i < 3; i++) {

console.log(i);

}

console.log(i);

}

varTest();

```

Что попадёт в консоль после его выполнения? Понятно, что внутри цикла будут выводиться значения увеличивающегося счётчика `i`: `0`, `1` и `2`. После того, как цикл завершается, программа продолжает выполняться. Теперь мы пытаемся обратиться к той же самой переменной-счётчику, которая была объявлена в цикле `for`, за пределами этого цикла. Что из этого выйдет?

В консоль, после обращения к `i` за пределами цикла, попадёт 3, так как ключевое слово `var` действует на уровне функции. Если объявить переменную с использованием `var`, то обратиться к ней в функции можно и после выхода из той конструкции, где она была объявлена.

Это может превратиться в проблему тогда, когда функции усложняются. Рассмотрим следующий пример:

```

function doSomething() {

var myVar = 1;

if (true) {

var myVar = 2;

console.log(myVar);

}

console.log(myVar);

}

doSomething();

```

Что попадёт в консоль теперь? `2` и `2`. Мы объявляем переменную, инициализируем её числом 1, а затем пытаемся переопределить ту же переменную внутри выражения `if`. Так как два эти объявления существуют в одной и той же области видимости, мы не можем объявить новую переменную с тем же именем, даже хотя мы, очевидно, хотим сделать именно это. В результате первая переменная перезаписывается внутри выражения `if`.

Вот в этом-то и заключается самый большой недостаток ключевого слова `var`. Область видимости переменных, объявленных с его использованием, оказывается слишком большой. Это может привести к непреднамеренной перезаписи данных и к другим ошибкам. Большие области видимости часто ведут к появлению неаккуратных программ. В целом, переменная должна иметь область видимости, ограниченную её нуждами, но не превышающую их. Хорошо было бы иметь возможность объявлять переменные, область видимости которых не так велика, как при использовании `var`, что позволило бы, при необходимости, применять более стабильные и лучше защищённые от ошибок программные конструкции. Собственно говоря, такие возможности нам даёт ECMAScript 6.

Новые способы объявления переменных

-----------------------------------

Стандарт ECMAScript 6 (новый набор возможностей JavaScript, известный ещё как ES6 и ES2015) даёт нам два новых способа объявления переменных, отличающихся ограниченной, по сравнению с `var`, областью видимости и имеющих ещё некоторые особенности. Это — ключевые слова `let` и `const`. И то и другое даёт нам так называемую блочную область видимости. Это означает, что область видимости при их использовании может быть ограничена блоком кода, таким, как цикл `for` или выражение `if`. Это даёт разработчику больше гибкости в выборе областей видимости переменных. Рассмотрим новые ключевые слова.

### ▍Использование ключевого слова let

Ключевое слово `let` очень похоже на `var`, основное отличие — ограниченная область видимости переменных, объявляемых с его помощью. Перепишем один из вышеприведённых примеров, заменив `var` на `let`:

```

function doSomething() {

let myVar = 1;

if (true) {

let myVar = 2;

console.log(myVar);

}

console.log(myVar);

}

doSomething();

```

В данном случае в консоль попадут числа `2` и `1`. Происходит это из-за того, что выражение `if` задаёт новую область видимости для переменной, объявленной с помощью ключевого слова `let`. Это приводит к тому, что вторая объявленная переменная — это совершенно самостоятельная сущность, не связанная с первой. С ними можно работать независимо друг от друга. Однако это не значит, что вложенные блоки кода, вроде нашего выражения `if`, полностью отрезаны от переменных, объявленных с помощью ключевого слова `let` в той области видимости, в которой находятся они сами. Взгляните на следующий код:

```

function doSomething() {

let myVar = 1;

if (true) {

console.log(myVar);

}

}

doSomething();

```

В этом примере в консоль попадёт число `1`. У кода, находящегося внутри выражения `if` есть доступ к переменной, которую мы создали за его пределами. Поэтому он и выводит её значение в консоль. А что произойдёт, если попытаться перемешать области видимости? Например, сделать так:

```

function doSomething() {

let myVar = 1;

if (true) {

console.log(myVar);

let myVar = 2;

console.log(myVar);

}

}

doSomething();

```

Может показаться, что первый вызов `console.log` выведет `1`, но на самом деле при попытке выполнить этот код появится ошибка `ReferenceError`, которая сообщает нам о том, что переменная `myVar` для данной области видимости не определена или не инициализирована (текст этой ошибки различается в разных браузерах). В JavaScript существует такое явление, как поднятие переменных в верхнюю часть их области видимости. То есть, если в некоей области видимости объявляют переменную, JavaScript резервирует место для неё ещё до того, как будет выполнена команда её объявления. То, как именно это происходит, различается при использовании `var` и `let`.

Рассмотрим следующий пример:

```

console.log(varTest);

var varTest = 1;

console.log(letTest);

let letTest = 2;

```

В обоих случаях мы пытаемся воспользоваться в переменной до её объявления. Но команды вывода данных в консоль ведут себя по-разному. Первая, использующая переменную, которая позже будет объявлена с помощью ключевого слова `var`, выведет `undefined` — то есть то, что будет записано в эту переменную. Вторая же команда, которая пытается обратиться к переменной, которая позже будет объявлена с помощью ключевого слова `let`, выдаст `ReferenceError` и сообщит нам, что мы пытаемся использовать переменную до её объявления или инициализации. В чём дело?

А дело тут в том, что перед выполнением кода механизмы, ответственные за его выполнение, просматривают этот код, выясняют, будут ли в нём объявляться какие-то переменные, и, если это так, осуществляют их поднятие с резервированием места для них. При этом переменные, объявленные с помощью ключевого слова `var`, инициализируются значением `undefined` в пределах своей области видимости, даже если к ним обращаются до того, как они будут объявлены. Основная проблема тут заключается в том, что значение `undefined` в переменной не всегда указывает на то, что переменной пытаются воспользоваться до её объявления. Взгляните на следующий пример:

```

var var1;

console.log(var1);

console.log(var2);

var var2 = 1;

```

В данном случае, несмотря на то, что `var1` и `var2` объявлены по-разному, оба вызова `console.log` выведут `undefined`. Дело здесь в том, что в переменные, объявленные с помощью `var`, но не инициализированные, автоматически записывается значение `undefined`. При этом, как мы уже говорили, переменные, объявленные с помощью `var`, к которым обращаются до момента их объявления, так же содержат `undefined`. В результате, если в подобном коде что-то пойдёт не так, нельзя будет понять, что именно является источником ошибки — использование неинициализированной переменной или использование переменной до её объявления.

Место для переменных, объявляемых с помощью ключевого слова `let`, резервируется в их блоке, но, до их объявления, они попадают во временную мёртвую зону (TDZ, Temporal Dead Zone). Это приводит к тому, что ими, до их объявления, пользоваться нельзя, а попытка обращения к такой переменной приводит к ошибке. Однако система точно знает причину проблемы и сообщает об этом. Это хорошо видно на данном примере:

```

let var1;

console.log(var1);

console.log(var2);

let var2 = 1;

```

Здесь первый вызов `console.log` выведет `undefined`, а второй вызовет ошибку `ReferenceError`, сообщая нам о том, что переменная пока не объявлена или не инициализирована.

В результате, если при использовании `var` появляется `undefined`, мы не знаем причину подобного поведения программы. Переменная может быть либо объявлена и неинициализирована, либо может быть ещё не объявлена в данной области видимости, но будет объявлена в коде, который расположен ниже команды обращения к ней. При использовании ключевого слова `let` мы можем понять — что именно происходит, а это гораздо полезнее для отладки.

### ▍Использование ключевого слова const

Ключевое слово `const` очень похоже на `let`, но у них есть одно важное различие. Это ключевое слово используется для объявления констант. Значения констант после их инициализации менять нельзя. Нужно отметить, что это относится лишь к значениям примитивных типов, воде строки или числа. Если константа является чем-то более сложным, например — объектом или массивом, внутреннюю структуру подобной сущности модифицировать можно, нельзя лишь заменить её саму на другую. Взгляните на следующий код:

```

let mutableVar = 1;

const immutableVar = 2;

mutableVar = 3;

immutableVar = 4;

```

Этот код будет выполняться вплоть до последней строки. Попытка назначить новое значение константе приведёт к появлению ошибки `TypeError`. Именно так ведут себя константы, но, как уже было сказано, объекты, которыми инициализируют константы, можно менять, они могут подвергаться мутациям, что способно приводить к [неожиданностям](https://alistapart.com/article/why-mutation-can-be-scary).

Возможно вам, как JavaScript-разработчику, интересно, почему иммутабельность переменных — это важно. Константы — это новое явление в JavaScript, в то время как они являются важнейшей частью таких языков, как C или Java. Почему эта концепция так популярна? Дело в том, что использование констант заставляет нас думать о том, как именно работает наш код. В некоторых ситуациях изменение значения переменной может нарушить работу кода, например, если в ней записано число Пи и к ней постоянно обращаются, или если в переменной имеется ссылка на некий HTML-элемент, с которым постоянно нужно работать. Скажем, вот константа, в которую записана ссылка на некую кнопку:

```

const myButton = document.querySelector('#my-button');

```

Если код зависит от ссылки на HTML-элемент, то нам нужно обеспечить неизменность этой ссылки. В результате можно говорить, что ключевое слово `const` идёт не только по пути улучшений в сфере области видимости, но и по пути ограничения возможности модификации значений констант, объявленных с использованием этого ключевого слова. Вспомните, как мы говорили о том, что переменная должна иметь именно такую область видимости, которая ей нужна. Эту мысль можно продолжить, выдвинув рекомендацию, в соответствии с которой у переменной должна быть лишь такая возможность изменяться, которая нужна для правильной работы с ней, и не более того. [Вот](https://zellwk.com/blog/dont-reassign/) хороший материал на тему иммутабельности, из которого можно сделать важный вывод, в соответствии с которым использование иммутабельных переменных заставляет нас тщательнее обдумывать свой код, что ведёт к улучшению чистоты кода и к снижению числа неприятных неожиданностей, возникающих при его работе.

Когда я только начал использовать ключевые слова `let` и `const`, я, в основном, применял `let`, прибегая к `const` лишь тогда, когда запись нового значения в переменную, объявленную с помощью `let`, могла бы навредить программе. Но, всё больше узнавая о программировании, я изменил своё мнение по этому вопросу. Теперь мой основной инструмент — это `const`, а `let` я использую только тогда, когда значение переменной нужно перезаписывать. Это заставляет меня думать о том, действительно ли необходимо менять значение некоей переменной. В большинстве случаев делать этого не нужно.

Нужно ли нам ключевое слово var?

--------------------------------

Ключевые слова `let` и `const` способствуют применению более ответственного подхода к программированию. Существуют ли ситуации, в которых всё ещё нужно ключевое слово `var`? Да, существуют. Есть несколько ситуаций, в которых это ключевое слово нам ещё пригодится. Как следует поразмыслите над тем, о чём мы сейчас поговорим, прежде чем менять `var` на `let` или `const`.

### ▍Уровень поддержки ключевого слова var браузерами

Переменные, объявленные с помощью ключевого слова `var`, отличаются одной очень важной особенностью, отсутствующей у `let` и `const`. А именно, речь идёт о том, что это ключевое слово поддерживают абсолютно все браузеры. Хотя поддержка браузерами [let](https://caniuse.com/#feat=let) и [const](https://caniuse.com/#feat=const) весьма хороша, однако, существует риск того, что ваша программа попадёт в браузер, их не поддерживающий. Для того чтобы понять последствия подобного происшествия, нужно учитывать то, как браузеры обходятся с неподдерживаемым JavaScript-кодом, в противовес, например, тому, как они реагируют на непонятный им CSS-код.

Если браузер не поддерживает какую-то возможность CSS, то это, в основном, ведёт к некоторым искажениям того, что будет выведено на экран. Сайт в браузере, который не поддерживает какие-то из используемых сайтом стилей, будет выглядеть не так, как ожидается, но им, весьма вероятно, можно будет пользоваться. Если же вы используете, например, `let`, а браузер это ключевое слово не поддерживает, то ваш JS-код там просто не будет работать. Не будет — и всё. Учитывая то, что JavaScript является одной из важных составных частей современного веба, это может стать серьёзнейшей проблемой в том случае, если вам надо, чтобы ваши программы работали бы в устаревших браузерах.

Когда говорят о поддержке сайтов браузерами, обычно задаются вопросом о том, в каком браузере сайт будет работать оптимально. Если же речь идёт о сайте, функционал которого основан на использовании `let` и `const`, то похожий вопрос придётся ставить иначе: «В каких браузерах наш сайт работать не будет?». И это — гораздо более серьёзно, чем разговор о том, использовать или нет `display: flex`. Для большинства веб-сайтов число пользователей с устаревшими браузерами не будет достаточно большим, чтобы об этом стоило бы беспокоиться. Однако если речь идёт о чём-то вроде интернет-магазина, или сайтов, владельцы которых покупают рекламу, это может быть весьма важным соображением. Прежде чем использовать новые возможности в подобных проектах, оцените уровень риска.

Если вам нужно поддерживать по-настоящему старые браузеры, но вы хотите при этом использовать `let`, `const` и другие новые возможности ES6, одним из вариантов решения проблемы является применение JavaScript-транспилятора наподобие [Babel](https://babeljs.io/). Транспиляторы обеспечивают перевод нового кода в то, что будет понятно старым браузерам. Применяя Babel, можно писать современный код, использующий самые свежие возможности языка, а затем преобразовывать его в код, который могут выполнять устаревшие браузеры.

Звучит слишком хорошо, чтобы быть правдой? На самом деле, использование транспиляторов таит в себе некоторые неприятные особенности. Так, это значительно увеличивает объём готового кода, если сравнить его с тем, что можно было бы получить, написав его вручную. Как результат, растёт объём файлов. Кроме того, если вы начали использовать некий транспилятор, ваш проект оказывается привязанным к нему. Даже если вы пишете ES6-код, который совершенно правильно обрабатывается Babel, отказ от Babel приведёт к тому, что вам придётся перепроверять весь код, тщательно тестировать его. Если ваш проект работает как часы, эта идея вряд ли понравится тем, кто занимается его разработкой и поддержкой. Тут придётся задаваться некоторыми вопросами. Когда планируется переработать кодовую базу? Когда поддержка чего-то вроде IE8 уже не будет иметь значения? Возможно, ответы на эти вопросы и не повлияют на отказ от транспилятора, но их, в любом случае, надо учитывать, решаясь на столь серьёзный шаг.

### ▍Использование var для решения одной специфической задачи

Есть ещё одна ситуация, в которой ключевое слово `var` может то, чего не могут другие. Это довольно специфическая задача. Рассмотрим следующий код:

```

var myVar = 1;

function myFunction() {

var myVar = 2;

// Внезапно оказалось, что нам нужна переменная myVar из глобальной области видимости!

}

```

Итак, тут мы объявляем переменную `myVar` в глобальной области видимости, но позже теряем к ней доступ, так как объявляем такую же переменную в функции. Вдруг оказывается, что нам нужна и переменная из глобальной области видимости. Подобная ситуация может показаться надуманной, так как первую переменную, например, можно просто передать функции, или можно переименовать одну из них. Но вполне может случиться так, что ни то ни другое вам не доступно. И вот тут нам и пригодятся возможности `var`.

```

var myVar = 1;

function myFunction() {

var myVar = 2;

console.log(myVar); // 2

console.log(window.myVar); // 1

}

```

Когда переменная объявляется в глобальной области видимости с использованием `var`, она автоматически привязывается к глобальному объекту `window`. Ключевые слова `let` и `const` этого не делают. Эта особенность однажды выручила меня в ситуации, когда сборочный скрипт проверял JS-код перед объединением файлов, а ссылка на глобальную переменную в одном из файлов (который, после сборки, был бы объединён с другими) выдавала ошибку, что не давало собрать проект.

Надо отметить, что использование этой возможности ведёт к написанию неаккуратного кода. Чаще всего подобную проблему решают гораздо изящнее, получая в итоге более чистый код и меньшую вероятность возникновения ошибок. Речь идёт о том, что переменные, в виде свойств, записывают в собственный объект:

```

let myGlobalVars = {};

let myVar = 1;

myGlobalVars.myVar = myVar;

function myFunction() {

let myVar = 2;

console.log(myVar); // 2

console.log(myGlobalVars.myVar); // 1

}

```

Безусловно, тут придётся писать больше кода, но этот подход делает код, используемый для решения неких неожиданных проблем, понятнее. В любом случае, бывает так, что рассматриваемая возможность ключевого слова `var` оказывается полезной, хотя, прежде чем прибегать к ней, стоит поискать другой, более понятный, способ решения проблемы.

Итоги

-----

Итак, что выбрать? Как расставить приоритеты? Вот некоторые соображения по этому поводу:

* Вы собираетесь поддерживать IE10 или по-настоящему старые браузеры? Если вы даёте на этот вопрос положительный ответ и не собираетесь пользоваться транспиляторами — отказывайтесь от новых возможностей и используйте `var`.

* Если вы можете позволить себе использование новых возможностей JavaScript, начать стоит с того, чтобы везде, где раньше применялось ключевое слово `var`, использовать `const`. Если где-то нужна возможность перезаписи значения переменной (хотя, если вы попытаетесь переписать свой код, то эта возможность может вам и не понадобиться) — используйте `let`.

Новые ключевые слова `let` и `const`, появившиеся в ECMAScript 6, дают нам больше возможностей по контролю за областью видимости переменных (и констант) в коде веб-сайтов и веб-приложений. Они заставляют нас больше думать о том, как именно работает код, а такие размышления хорошо влияют на то, что у нас получается. Конечно, прежде чем воспользоваться чем-то новым, стоит взвесить все «за» и «против» в применении к конкретной задаче, но, используя `let` и `const`, вы сделаете свои проекты стабильнее и приготовите их к будущему.

**Уважаемые читатели!** Согласны ли вы с рекомендацией, в соответствии с которой ключевое слово `const` стоит сделать основной заменой ключевому слову `var`, прибегая к `let` лишь в тех случаях, когда значение переменной, по объективным причинам, нужно перезаписывать?

[](https://ruvds.com/ru-rub/#order) | https://habr.com/ru/post/420359/ | null | ru | null |

# TagToDo, Да еще одна ToDo-шка

### Мечта

У меня всегда была мечта написать «незабывайку». Множество раз я приступал к этой задаче, но либо желание пропадало на этапе макета, либо друзья говорили: «зачем на еще одина ToDo-шка, их итак миллион». Но желание написать что-то свое не пропадало. И вот на работе выдались относительно спокойные деньки, и я вновь задался темной целью: написать в конце концов свою «незабывайку». А так как я до селе работал только с десктопными приложениями, и в Web не зуб ногой, то решил совместить изучение и давнюю мечту. Учитывая, что основной мой хлеб это .Net + WPF. Я избрал платформой Silverlight. Вроде как и .Net + WPF, но что-то новенькое. Быстро поставил цель, и в идеале я должен был завершить в 5 дней.

### У нас есть цель.

Цель проекта, основная идея: Быстро добавить задачу и навесить (быстро) на нее теги, и чтобы по тегам можно фильтровать! Все. Когда появляется очередная гениальная идея, тыкать ее носом в основную идею. И откладывать. Все идеи как им и положено, крутились в башке, постоянно размножаясь. Но мне удалось им противостоять. В этом мне помог план.

### План таков.

1. Наваять прототип интерфейса за 1 день.

2. Сделать БД и закрыть ее за бизнес-слоем. (1 день)

3. В общем-то накодить и получить первую бету. (1 день)

4. Отстрел багов (2 дня)

План не бог весть какой, но я ему следовал. Прототип был нарисован в программе [Kaxaml](http://www.kaxaml.com) (до сих пор рисую прототипы в виде xaml кода, а не на бумажках или спец. программах), причем там я совершил первую свою ошибку, я рисовал прототип для WPF, а он от Silverlight отличается достаточно сильно. Позднее я довольно много мелочей переправлял, хотя на внешний вид они не повлияли.

### Одежка

Итоговый вид почти не изменился:

Я не дизайнер, поэтому решил просто «слизать» интерфейс с различных мокапов iPhone. Хотя, я не являюсь поклонником(обладателем) этого телефона, но интерфейс мне очень нравится. Подробно этот этап описывать не буду, только основные проблемы. Первая и главная: Silverlight'овский Xaml не есть подмножество WPF-xaml, они жутко отличаются в деталях. На это уже [ссылался](http://wpfslguidance.codeplex.com/Release/ProjectReleases.aspx?ReleaseId=28278) [dotCypress](https://geektimes.ru/users/dotcypress/). Все хитрые анимации я делал через **VisualStateManager**, основная идея его видна, кстати, из названия: организация состояний контрола, и управление переходами между состояниями. Довольно удобно, но не привычно для тех кто игрался с триггерами в WPF.

—

### А где у нас бизнес-логика?

Так как у меня уже есть небольшой хостинг под виндой и БД MS SQL 2008, базу по понятным причинам, я написал там. Хотя, чего я оправдываюсь, я всю жизнь свою работал только с базами от микрософта, и ни капли не жалею об этом. Вся тудушка влезла в одну табличку и 2 хранимые процедуры, одна из которых добавляла тудушку, если ее не было, обновляла если она была, и удаляла, если основной текст ее был пуст (Надо было делать 3 штуки, но тут я схалявил, 3% бизнес-логики БД не убили). Вторая хранимка просто получала список задача. В качестве ID задачи я взял дату ее создания. Памятуя о [статье](http://habrahabr.ru/blogs/refactoring/65432/), бизнес слой полностью перенес в сервис (silverlight enabled service), к которому должна будет обращаться программа, все 97%. Изначально хотел дергать все хранимые процедуры «ручками», но решил себе напомнить замечательный [Rsdn.Framework.Data](http://www.rsdn.ru/article/files/libs/RsdnFrameworkData.xml). Поэтому все было написано через его. Сам класс задачи после навешивания на него атрибутов от Rsdn и WCF выглядел так:

`[DataContract]

public class ToDo {

[MapField("id")]

[DataMember]

public DateTime Id { get; set; }

[MapField("text")]

[DataMember]

public string Text { get; set; }

[MapField("completed")]

[DataMember]

public bool Completed { get; set; }

[MapField("tags")]

[DataMember]

public string Tags { get; set; }

**[MapField("parentid")]

[DataMember]

public DateTime? ParentId { get; set; }**

[IgnoreDataMember]

[MapField("userid")]

public int UserId { get; set; }

}`

ParentId, это намек на ту единственную идею, которая пробила мои защитные барьеры и была реализована позднее. (привет, gmail'у). Как мы видим, класс очень простой, но увешан атрибутами. Атрибуты вида [DataMember], намекают, что эти данные будут уходить Silverlight приложению, а [IgnoreDataMember] — соответственно, что не будут. [MapField(«XXX»)] — это отображение полей класса на поля записи в БД. Признаться, только вот из-за такой магии внутри Rsdn.Framework в свое время я и перешел на c#.

Основной ошибкой на этом этапе было создание своего велосипеда авторизации\регистрации пользователя, хотя есть готовые механизмы ASP.Net и прочего. Почему я не стал ими пользоваться, я не знаю. 80% всего кода и остальные дополнительные таблички были созданы только ради авторизации и регистрации… Я каюсь, но это так.

### Код

Этот этап абсолютно неинтересен, тут обычный C# со своим framework, код пишется легко и быстро. Все здорово. Но как всегда есть и затыки. К примеру, когда «рестайлишь» (создаем новый style) различные элементы, их поведение вполне адекватно и вообще соответствует тому, что ты пишешь, но ListBox имеет досадный баг. Его дочерние элементы никак не хотят занимать всю ширину родителя, а занимают ровно столько, сколько им надо. Грязный [хак](http://silverlight.net/forums/p/18918/70343.aspxl) их победил. Увы, не получилось чистого xaml-решения. Или, например, нету DoubleClick'а, это уже серьезно, но вполне [решаемо](http://silverlight.net/blogs/msnow/archive/2009/01/15/silverlight-tip-of-the-day-82-how-to-implement-double-click.aspx).

### Играем. Тестируем.

Как всегда это самый длинный этап, когда появляется множество гениальных идей, которые надо душить в зародыше. А так же всякие запутки с непонятками, которые надо исправлять. Вот на этом-то этапе мне и подкинули идею «как у Google». Сделать задачи иерархическими. Тут сразу появились хаки с Drag'n'Drop (о Drag'n'Drop в Silverlight я расскажу, если будет интересно, отдельно) и всякие нелогичности. Но вроде все побеждено, я гордо ставлю версию 1.0, и отдаю проект на суд общественности.

### TagTodo. Судим.

Итак, описание чего же у меня получилось. Features.

1. Сохранение задач онлайн, возможность получить к ним доступ из любой точки.

2. На каждую задачу навешиваются теги, по которым потом можно фильтровать. Теги автоматически раскрашиваются, на основе содержимого. Теги можно удалять и таскать.

3. Задачи можно разбить на подзадачи, а те в свою очередь тоже. И располагать задачи в виде иерархии.

4. Весь список можно экспортировать в виде XML.

5. Скорость и простота. Когда вы пишете задачу, отделите от основного текста теги обратным слешем '\'. И по нажатию кнопки enter, задача добавится, а так же появятся набранные теги. Например «Вымыть слона\мойка, слон». Добавится задача «Вымыть слона», с двумя тегами «мойка» и «слон».

6. Чтобы добавить задачу как дочернюю, просто выделите будущего папу и начните имя задачи с обратного слеша '\'. Впрочем, никто потом не помешает сделать то же самое обычным перетаскиванием.

7. Забавный тег «время-деньги». Он будет писать вам сколько же времени прошло с создания этой задачи. (см. картинку выше)

[Заходите](http://pinktown.ru/todo.aspx), поиграйтесь. Вам потребуется Silverlight 3.

**Сразу хочу предупредить**. Экран регистрации довольно нелогичен, сказалось мало времени. Нажав на кнопку регистрации, вы дополнительно к своему имени и паролю сможете ввести почту. При повторном нажатии на эту кнопку — на почту (если все хорошо, логин не занят, почта такая есть и т.п.) уйдет ссылка с подтверждением. Как только вы подтвердите свою почту. Аккаунт будет разблокирован и вы сможете поиграться с тудушкой.

P.S. Мой первый топик на хабре, хотелось обелить ярлык (тег?) «июлята». Получилось или нет — судить вам. Идеи, улучшения приветствуются, хотя и своих полон мозг. | https://habr.com/ru/post/67148/ | null | ru | null |

# macOS и мистический minOS

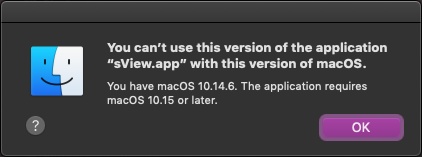

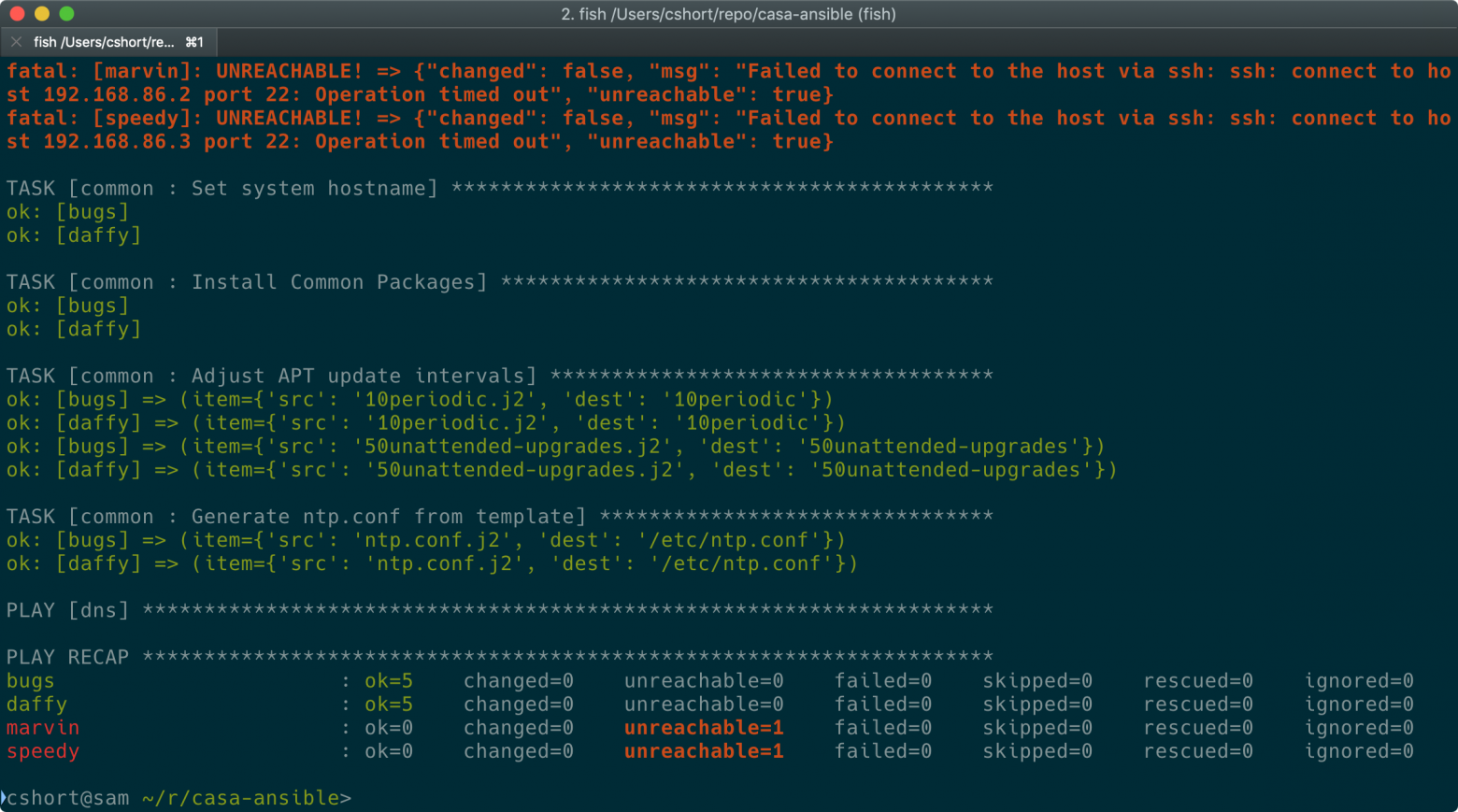

После трёхлетнего перерыва актуальная версия [sView](http://sview.ru/ru/) стала снова доступна на macOS. Релиз sView 20.08 обещал поддержку **macOS 10.10+**, но что-то пошло не так и несколько пользователей обратились со странной проблемой - системы macOS 10.13 и 10.14 отказались запускать приложение с сообщением о необходимости обновиться до macOS 10.15…

Сказать, что ошибка меня озадачила - сильно преуменьшить степень моего негодования, ведь магическая цифра 10.15 нигде не фигурировала ни в скриптах сборки, ни в ресурсах sView! Более того, приложение лично было проверено на более старой версии системы, а именно - на macOS 10.10.

Немного предыстории. В далёком 2011 году вышла первая сборка sView для [OS X 10.6 Snow Leopard](https://ru.wikipedia.org/wiki/Mac_OS_X_Snow_Leopard), и шесть лет именно эта версия системы оставалась минимальным требованием для запуска sView. Поддержка относительно старых версий операционных систем даёт максимальный охват потенциальных пользователей, но требует дополнительных усилий.

Практика разработки Windows, Linux, Android и macOS приложений показывает, что предположения о том, что собранное приложение "вроде должно работать" на всех версиях систем периодически дают сбой, и проблемы совместимости всплывают самым неожиданным образом. В таких случаях возможность проверить работоспособность приложения на разных (в том числе самых старых, формально поддерживаемых) системах становится жизненно необходимой.

Однако старая версия OS X требует такого же ***старого устройства***, так как установить систему на устройство, выпущенное позднее самой системы, зачастую не представляется возможным. Проблему могли бы решить средства виртуализации, однако в случае с macOS дела с ними обстоят не лучшим образом.

Также понадобится и ***подходящий сборочный инструментарий***. В прошлом, сборка приложения для нужной версии OS X требовала наличия нужной версии SDK в XCode. Однако упаковка нескольких SDK в XCode существенно увеличивала размер установки и старые версии SDK быстро исключались из новых версий XCode, осложняя сборку приложений для старых систем.

*Для обеспечения совместимости с OS X 10.6 Snow Leopard, приложение sView долгое время собиралось на OS X той же версии, предустановленной на старом MacBook. При этом несколько версий OS X было установлено на внешний жёсткий диск для тестирования.*

К счастью, со временем разработчики Apple существенно улучшили инструментарий, внедрив версионизацию на уровне заголовочных файлов, опций компилятора и линковщика. Теперь, XCode поставляется всего с одной версией macOS SDK - с самой последней, - но приложение можно собрать с совместимостью с более старыми версиями macOS посредством:

* переменной окружения `MACOSX_DEPLOYMENT_TARGET`(т.е., `export MACOSX_DEPLOYMENT_TARGET=10.10`);

* или флага компилятора`-mmacosx-version-min`(т.е., `EXTRA_CXXFLAGS += -mmacosx-version-min=10.10`).

*В случае CMake соответствующий параметр называется* `CMAKE_OSX_DEPLOYMENT`*, а у qmake -* `QMAKE_MACOSX_DEPLOYMENT_TARGET`*.*

Настройки проекта в XCode 11 позволяют выбрать минимальной платформой даже OS X 10.6, но данный выбор приводит только к ошибкам при сборке и Hello World удалось собрать только при выборе 10.7 или версия новее. Впрочем, OS X 10.6 Snow Leopard вышла в далёком 2009 году - то есть одиннадцать лет назад, - и едва ли имеет активных пользователей. Какую же версию выбрать в качестве минимальной?

**OS X 10.10 Yosemite** была выпущена около 6 лет назад и на 6 релизов "старее" самой актуальной на данный момент macOS 11.0 Big Sur. Трудно представить пользователей более старой OS X с учётом агрессивной политики обновлений Apple. Помимо прочего, OS X 10.10 уже была установлена на моём старом MacBook - слишком старым для разработки, но ещё живом для проверки работоспособности собранного приложения.

*В попытке обновить “старичка” mid-2010 MacBook выяснилось, что свежие версии macOS более не поддерживают такие устройства , а последней совместимой версией оказалась macOS 10.13 High Sierra выпущенная в 2017 году.

Таким образом, Apple лишила свой продукт программных обновлений спустя 7 лет! При этом магазин приложений Apple более не позволяет загрузить старые версии macOS - то есть и обновить OS X 10.10 до macOS 10.13 не получится обычным способом.*

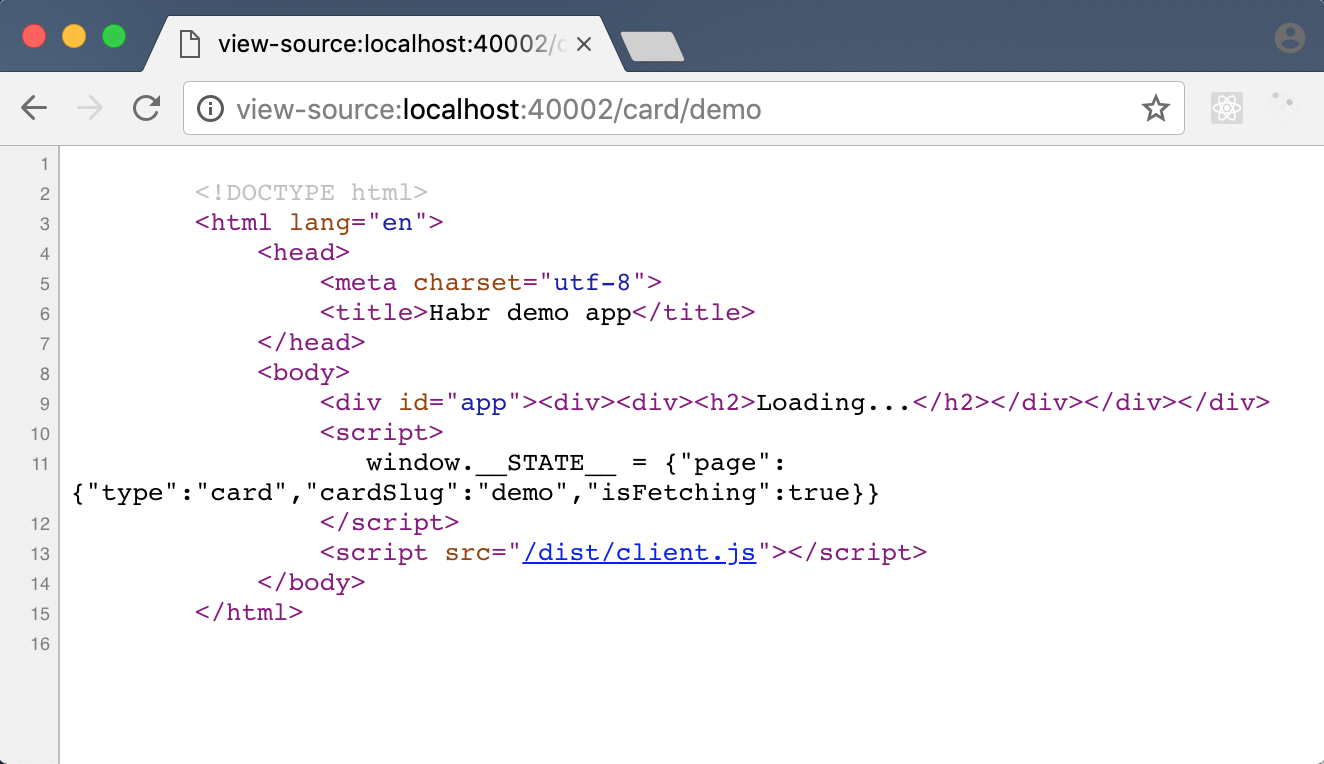

Для [сборки sView](https://github.com/gkv311/sview) на свежем инструментарии в `Makefile` проекта была прописана версия `10.10`, а в `Info.plist` был указан параметр `LSMinimumSystemVersion=10.10`. Сама сборка была осуществлена на macOS 10.15, установленной на относительно свежем Mac mini ‘2018, и протестирована на макбуке с OS X 10.10 - приложение заработало и было опубликовано на сайте!

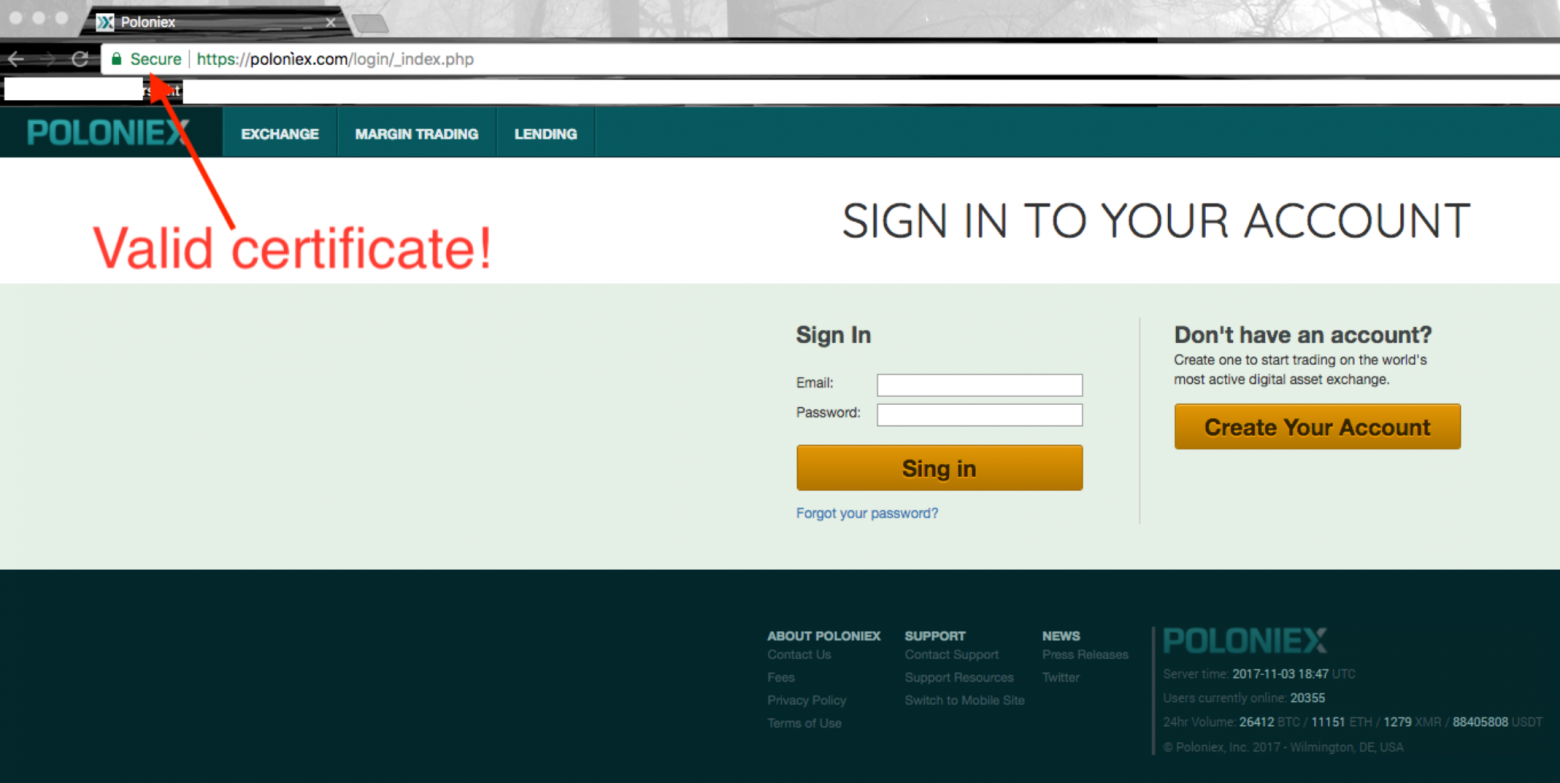

…и тут, как снег на голову, пришли сообщения пользователей об ошибках запуска sView на версиях macOS, *новее*протестированной. Вздор! Откуда система вообще могла взять цифру `10.15`, если `LSMinimumSystemVersion` указывает на `10.10` - а это единственный ранее известный мне источник для подобных сообщений macOS об ошибках?

В слепую локализовать проблему не удавалось - поиски `10.15` в архиве с приложением и в сборочных скриптах ни к чему не привели. Поэтому было найдено временное подопытное устройство с macOS 10.13, выводящее такое же сообщение об ошибке. Удивительно, но запуск исполнительного файла sView из терминала происходил без всяких проблем и ошибок!

Эксперименты показали, что что-то не так непосредственно с исполнительным файлом sView, и в конце концов, утилита `otool -l` выявила источник проблемы:

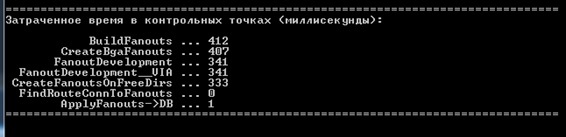

```

Load command 9

cmd LC_BUILD_VERSION

cmdsize 32

platform macos

sdk 10.15

minos 10.15

ntools 1

tool ld

version 450.3

```

Информации о загадочном `minos` нашлось не много в интернете, но удалось выяснить, что данное поле появилось в заголовке [Mach-O](https://ru.wikipedia.org/wiki/Mach-O) исполняемых файлов macOS относительно недавно. Но этого факта оказалось достаточно, чтобы ответить на первый вопрос - как так получилось, что более старая версия OS X 10.10 запускала sView без проблем, а новые macOS 10.13-10.14 выдавали ошибки? Да просто OS X 10.10 ничего не знает о существовании нового поля `minos`!

Оставался последний вопрос - где в процессе сборки приложения закралась ошибка? Изучение пакета sView выявило, что поле `minos` присутствовало только библиотеках и исполняемом файле самого проекта, но не в библиотеках FFmpeg, собранных схожим образом. То есть проблема была явно в `Makefile` проекта. Как оказалось, флаг `-mmacosx-version-min` передавался компилятору через переменную `EXTRA_CXXFLAGS`*,* но не передавался линковщику. Добавление флага в переменную `EXTRA_LDFLAGS` наконец-то решило проблему:

```

TARGET_OS_VERSION = 10.10

EXTRA_CFLAGS += -mmacosx-version-min=$(TARGET_OS_VERSION)

EXTRA_CXXFLAGS += -mmacosx-version-min=$(TARGET_OS_VERSION)

EXTRA_LDFLAGS += -mmacosx-version-min=$(TARGET_OS_VERSION)

```

Оригинальная публикация на английском может быть [найдена здесь](https://unlimited3d.wordpress.com/2020/08/20/minos-mystery-on-macos/).

| https://habr.com/ru/post/534724/ | null | ru | null |

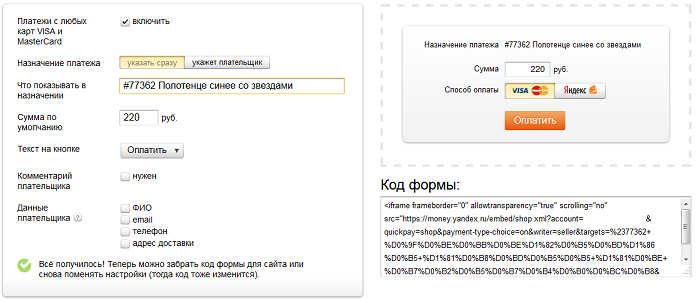

# Некорректная работа API Яндекс.Денег при приеме платежей картой

В прошлые выходные раздался звонок мобильного телефона. Номер незнакомый. Снимаю трубку.

На противоположном конце линии девушка сообщает, что она представляет компанию Яндекс, и что мне высылали электронное письмо с информацией о новом сервисе: теперь можно принимать на сайте платежи не только Яндекс.Деньгами, но и банковскими картами VISA/MasterCard с помощью формы от Яндекса. Я ответил, что письмо не получал (может попало в спам?), но информация интересная, и я обязательно подробнее ознакомлюсь с новыми возможностями сервиса.

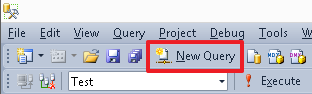

##### Как это работало раньше

На своем сайте получение платежа с помощью Яндекс.Денег сделал примерно года два назад. Для моих целей хватило самой примитивной Формы-принимателя, которую накидал в конструкторе на сайте Я.Денег, вставил в свой на сайт и более не трогал. В форме автоматически подставлялся нужный кошелек, назначение платежа (номер транзакции в моей внутренней базе с кратким описанием) и сумма. Пользователь просто нажимал кнопку «Оплатить», попадал на сайт Яндекс.Денег, где проверял данные формы и вводил платежный пароль. Далее, через HTTP-уведомления получал идентификатор операции (operation\_id) и получал остальные детали платежа через API методом operation-details. Схема довольно простая, и многим наверняка знакомая.

##### Что изменилось сейчас

В конструкторе формочки появилась новая опция: «Платежи с любых карт VISA и MasterCard»

Скорее жму на нее, получаю дополнительный параметр payment-type-choice=on при запросе фрейма, в остальном все остается тоже самое.

Вставляю код получившейся формы для оплаты на сайт, пытаюсь оплатить с карты. Попадаю на сайт Яндекс.Денег, заполняю данные карты. Попадаю на сайт банка (3D-Secure), получаю SMS, ввожу код. Платеж проходит, деньги с карты списаны.

Вот тут начинается самое интересное.

##### Что не работает

Для начала пришло оповещение о платеже на почту. Вместо обычного «Перевод от другого пользователя» и комментария вроде "#77362 Полотенце синее со звездами" или «test1», получаем красиво оформленную бестолковую «квитанцию» вида:

Хм, кто-то заплатил 0.98р. Непонятно кто и непонятно за что.

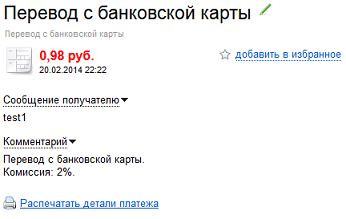

Захожу на сайт Яндекс.Денег, смотрю детали платежа. Там информация о назначении платежа присутствует.

Ага, думаю, информация сохранилась. В письме она не очень-то и нужна, мне нужно забрать ее через API. Но и тут подстерегает неудача. При запросе методом operation-details API возвращает:

`{"details":"","type":"deposition","amount":0.98,"direction":"in","title":"Перевод с банковской карты","datetime":"2014-02-20T18:22:20Z","operation_id":"446xxxxxxxxx16012","status":"success"}`

То есть отсутствует поле «message», как при оплате Яндекс.Деньгами, а поле «details» — пустое.

Пробую оплатить Яндекс.Деньгами через ту же самую форму, все проходит нормально, API возвращает назначение платежа.

`{"message":"test1","details":"test1","sender":"4100xxxxxxxxx36","codepro":false,"type":"incoming-transfer","amount":13.93,"direction":"in","title":"Перевод от 4100xxxxxxxxx36","status":"success","operation_id":"8920xxxxxxxxxxx2025","pattern_id":"p2p", "datetime":"2014-02-18T14:46:08Z"}`

Тут и плательщик обозначен (хотя по сути он мне и не нужен), и назначение платежа. При чем и то и другое аж два раза.

Подумалось, что для платежа картой может стоит указать не только назначение платежа, но и комментарий к платежу? Хорошо, пробуем такую форму.

В ответ получаем «квитанцию» на почту с комментарием (и без назначения). А на сайте можем увидеть и комментарий, и назначение.

На почту

На сайте

А вот через API поле details опять пустое, и message отсутствует.

`{"details":"","type":"deposition","operation_id":"446xxxxxxxxxxxx012", "datetime":"2014-02-20T18:43:35Z", "status":"success", "amount":0.98, "direction":"in", "title":"Перевод с банковской карты"}`

Наличие message в документации заявлено только для p2p переводов, хотя несколько туманное описание, может и не только ([описание метода](http://api.yandex.ru/money/doc/dg/reference/operation-details.xml)). Сообщение так или иначе присутствует, и хранится в базе Яндекса. Но его нельзя прочитать через API.

Возможность оплаты картами безусловно полезная и удобная, но в данном исполнении, нашел ее для себя неприемлемой, и на сайт не выкатил.

Работать может только для получения донейта, и то не целевого, ибо назначение платежа узнать нельзя (разве что распарсив сайт Яндекс.Денег)

##### Когда исправят

Багрепорт в Яндекс отправил еще в воскресенье (16.02.2014), письмо-уведомление получил. Но пока подвижек к устранению никаких. Кидаю для теста каждый день 1 рубль, думаю может исправят молча.

Ну и конечно удивила телефонная реклама в виде настоящей живой девушки (в век повальной автоматизации и роботизации). При этом рекламируемый продукт оказался еще довольно сырым.

P.S. Яндекс.Диск «испортил» мне Windows 7 на двух компьютерах. Обещали исправиться после того случая и более тщательно тестировать продукты. | https://habr.com/ru/post/213377/ | null | ru | null |

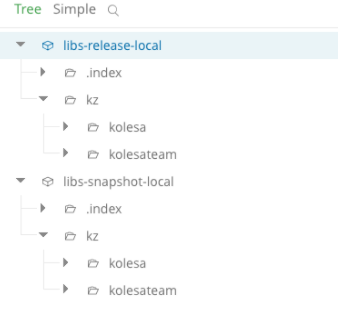

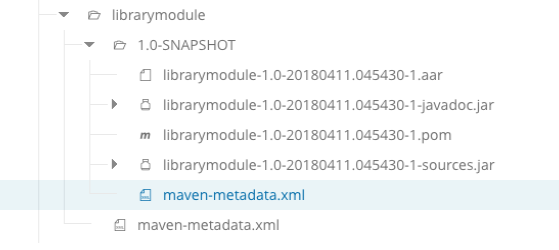

# Модульная разработка Android приложений

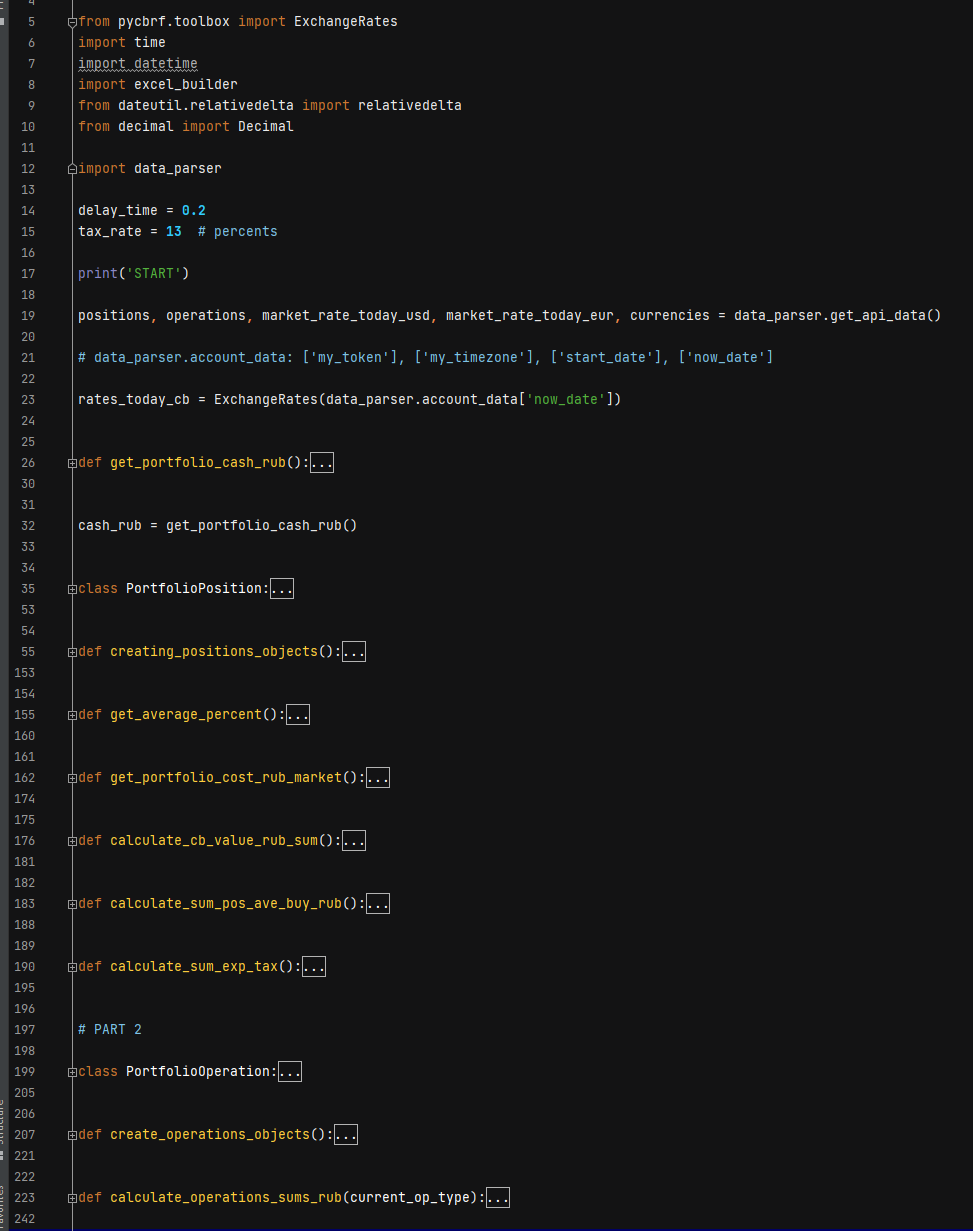

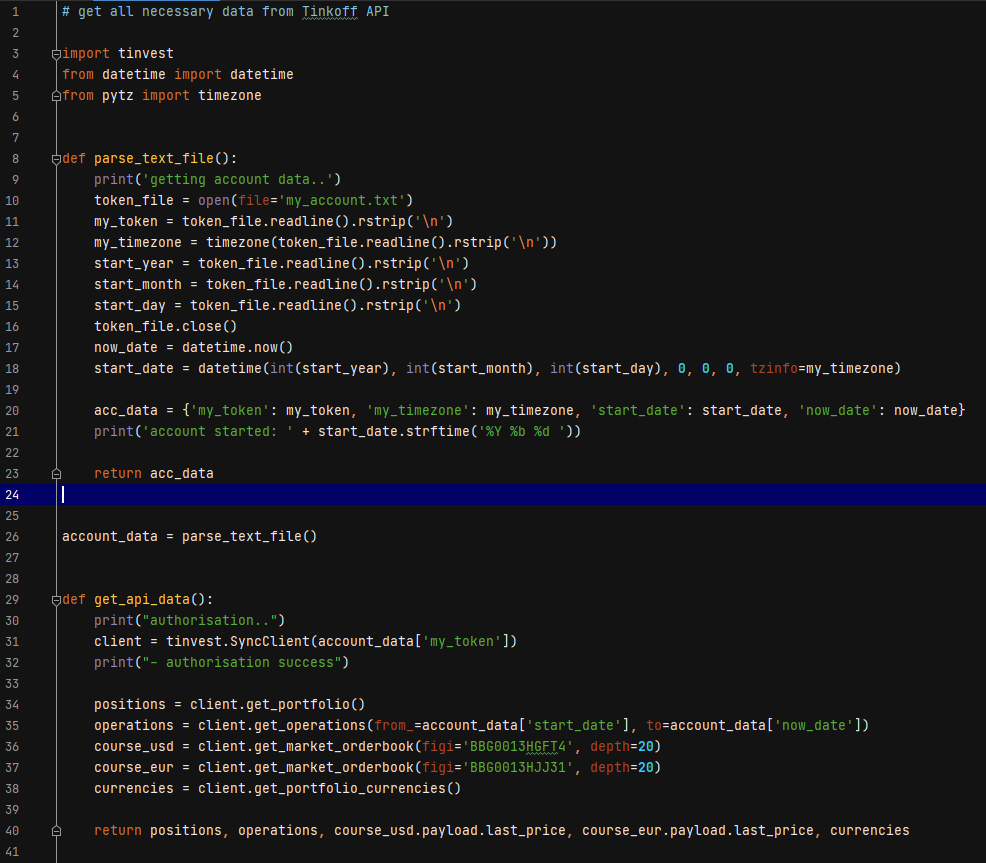

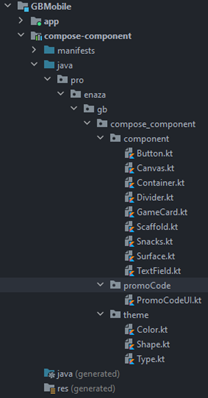

При разработке Android приложений наступают моменты, когда те или иные части кода можно вынести в виде библиотек, чтобы можно было переиспользовать их в разных проектах:

* Модули в проекте, которые часто встречаются. Например, кастомные View

* Когда существующий API неудобный или не позволяет сделать то, что задумали — создаем расширение для этого API

Чаще всего все проблемы были решены задолго до нас, но в нашем случае нужно было вынести часть слоя бизнес-логики и фактически весь слой, отвечающий за данные в 3 наших основных продукта объединенной компании **Колёса Крыша Маркет**. Все наши продукты – [классифайды](https://ru.wiktionary.org/wiki/%D0%BA%D0%BB%D0%B0%D1%81%D1%81%D0%B8%D1%84%D0%B0%D0%B9%D0%B4) про автомобили, недвижимость и прочие товары. Поэтому нами, разработчиками, было решили написать одно решение для всех продуктов компании. К тому же, это облегчило нашу работу.

Попробовали git submodule

-------------------------

Самое простое решение — использовать git submodule. Если кратко объяснить его работу, то к git repository вы прикрепляете ссылку на другой git repository, который должен автоматически клонироваться вместе с родительским. Казалось бы все просто: у нас есть несколько git repository, где хранятся все наши модульные библиотеки и нужно всего лишь указать его в git submodule.

Но как быть с версиями? При обновлении через команду git submodule update стираются изменения в submodule, merge не происходит. Вам придется постоянно обновляться, когда другой разработчик вносит изменение в данном submodule. Вместо этого стоит разрабатывать модули в виде библиотек с jar файлом или Android Archive (aar). По факту, в этих архивах содержатся те же самые файлы, которые могли быть в git submodule, но теперь есть более понятное версионирование вместо истории commit или tag.

Осторожно, не все можно публиковать

-----------------------------------

При публикации библиотек стоить учесть, что они не должны содержать конфиденциальные данные компании. Более того, не будет удобно остальным разработчикам, если в библиотеке будет содержаться код, относящийся к конкретной компании. Следовательно, нам нужен закрытый artifactory для хранения библиотек в закрытом доступе. Есть множество open source решений, но мы используем [JFrog Artifactory](https://jfrog.com/article/private-repositories/).

А если можно публиковать? В таком случае вас ждет светлая дорога в мир open source проектов. Достаточно просто найти открытые web серверы, которые поддерживают gradle, чтобы размещаемые jar и aar файлы подтягивались через dependency в ваших проектах.

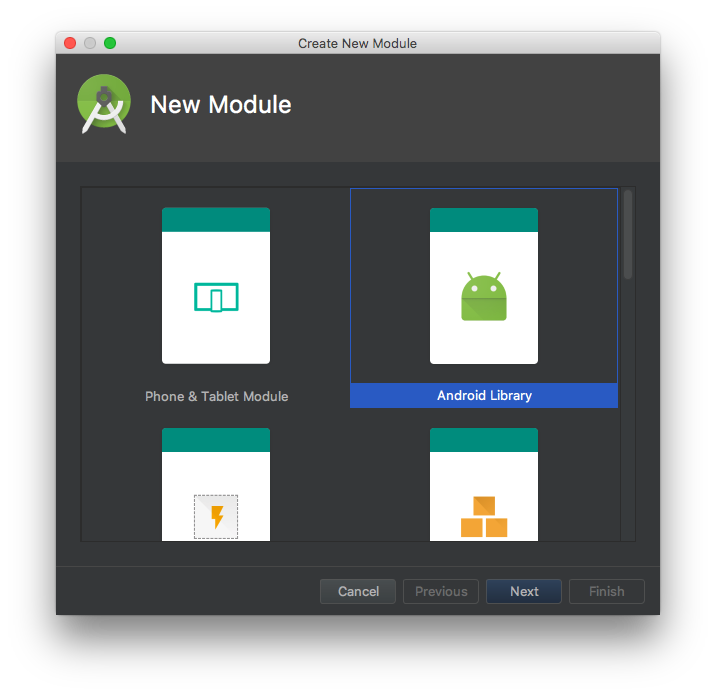

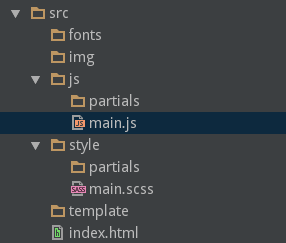

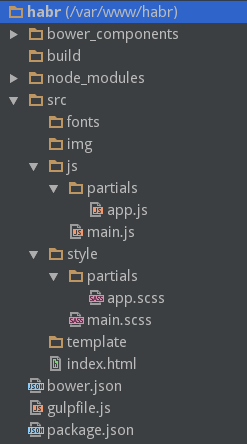

Итак, начинаем создавать модуль

-------------------------------

Начинается все просто — заходим в `File > New > New Module…`

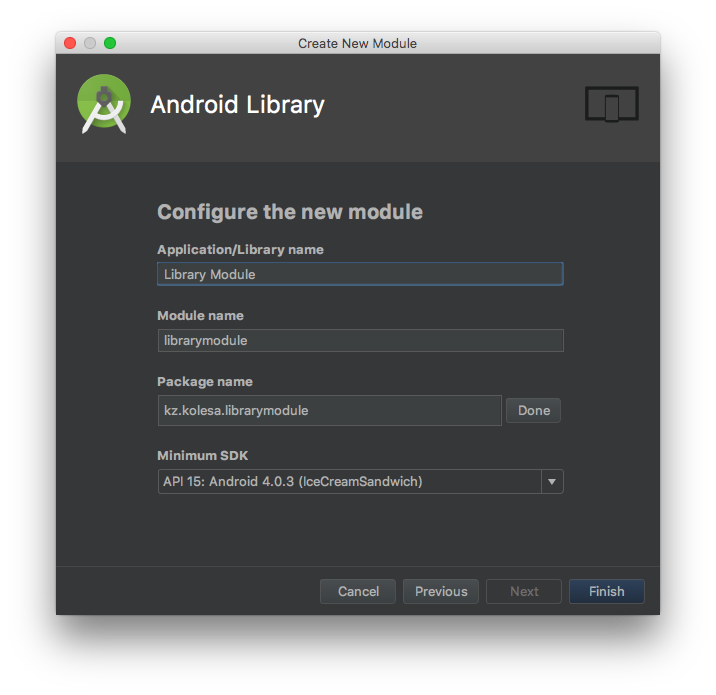

Название библиотеки, которое укажете в этом окне, станет названием бинарника вашей библиотеки.

Создав модуль можете приступить к написанию кода. Если к прилагаемому коду будете писать тесты, остальным членам команды будет понятно, как вашим модулем пользоваться. Еще лучше, если создадите новый sample app module, который работает исключительно с вашим модулем для демонстрации на реальных устройствах. Удобнее, когда вам нужно предварительно протестировать код перед публикацией в artifactory. Для этого достаточно указать зависимость в **build.gradle**. В примерах я буду указывать **librarymodule** в качестве названия модуля.

```

# {module project}/sample-app

dependencies {

implementation project(":librarymodule")

}

```

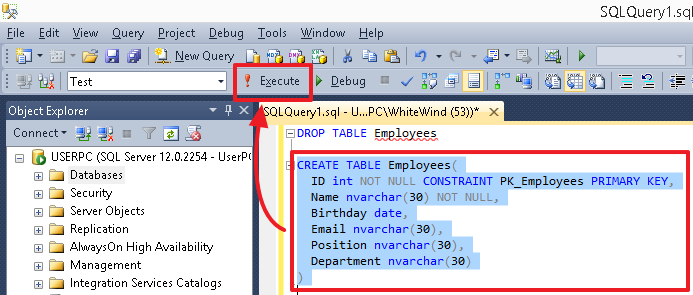

Настраиваем gradle для публикации в artifactory

-----------------------------------------------

Возьмем build скрипт от Chris Banes: [Gradle скрипт для загрузки артифактов в Maven repositories](https://github.com/chrisbanes/gradle-mvn-push)

Конкретно в его случае описывается процесс в maven repository для публичной публикации. Основные настройки абсолютно идентичны: в каждом модуле, который нужно публиковать, вызываем gradle script файл из файла build.gradle модулей и создаем gradle.properties, где будет лежать конфигурационная информация для публикации. Нас интересует возможность публиковать в приватном artifactory

```

# {project}/build.gradle

RELEASE_REPOSITORY_URL={artifactory_url}/release-modules

SNAPSHOT_REPOSITORY_URL={artifactory_url}/snapshot-modules

```

Нам необходимо добавить 2 папки для публикации в artifactory: одну для официального релиза и snapshot для тестовых сборок модулей.

Когда у нас наконец-то настроен конфигурационный файл gradle.properties, мы готовы сделать первую публикацию библиотек в artifactory. В тестовой сборке укажем SNAPSHOT в VERSION\_NAME. Затем выполним команду:

```

./gradlew clean build sdk:uploadArchives

```

Настройка CI окружения

----------------------

Нам удалось вручную опубликовать модули в наш приватный artifactory. В завершениb осталось настроить CI окружение, чтобы мы могли встроить публикацию в наш процесс разработки.

Мы хотим, чтобы только CI мог публиковать в release artifactory, а для остальных добавим свободный доступ на чтение и запись в snapshot. Поэтому внесем изменения в корневом файле gradle.properties, который обычно лежит в `~/.gradle/gradle.properties`. Пропишем {%username%} и {%password%} для доступа при публикации в artifactory. Таким образом у нас будет настроен уровень доступа, без внесения изменений в .gitignore.

```

// ~/.gradle/gradle.properties

artifactory_username=login

artifactory_password=password

```

Добавляем trigger на ветку master, чтобы при merge у нас собралась сборка для публикации в release artifactory. В список задач сборок добавляем запуск тестов, если у нас в модуле они есть. Хорошо будет ещё настроить auto increment версии.

```

# Checkout git repository with modules

# Запускаем тест

./gradlew test

# Собираем архив для публикации

./gradlew librarymodule:build

# Публикация в artifactory

./gradlew libarrymodule:uploadArchives

```

Используем модуль в продукте

----------------------------

Как только CI соберет сборку и зальет ее в artifactory, в проекте можно добавить зависимость этого модуля. Но погодите, нам же нужно добавить еще и url к нашему artifactory, ведь они недоступны в типичном repository как maven

```

# {project}/build.gradle

allprojects {

repositories {

maven { url artifactory_url/release-modules }

maven { url {artifactory_url}/snapshot-modules }

}

}

```

Теперь мы можем использовать его в проекте.

```

# {project}/app/build.gradle

dependencies {

implementation ‘kz.kolesa-team: librarymodule:1.0.0’

}

```

С чем мы столкнулись

--------------------

При подключении Kotlin в наши модули документация для Kotlin файлов не подтягивается. Оказалось, что для этого нужно добавить gradle задачу с [Dokka](https://github.com/Kotlin/dokka).

Если несколько разработчиков указывали идентичные версии для библиотек при публикации, то, естественно, актуальной версией модели оказывалась последняя публикация. В процессе разработки модуля обязали указывать постфикс с идентификатором ticket из Jira. Получается что-то вроде `1.0.1-AAS-1-SNAPSHOT`.

Что в итоге получилось

----------------------

Со временем у нас возросло количество модулей. Мы держали каждый модуль в отдельном git repository. Множество git repository создает большое количество неудобств в процессе разработки, если модуль имеет зависимость от других модулей. В итоге получилось, что для выполнения одной задачи, необходимо было создавать PR в каждом git repository. Не совсем ясно, в каком порядке их нужно тестировать, не учитывая еще постоянное изменение PR, если в одном из PR внесли правки. Поэтому, использовать один git repository для всех модулей на практике оказалось удобнее всего.

Таких модулей у вас может быть множество. Если в том или ином проекте не требуется конкретный модуль, то мы легко можем убрать зависимость, что в итоге нам позволит не писать дублирующие коды в каждом из трех из наших проектов.

Такая модульная разработка внутренних компонентов бизнеса поможет нам повысить скорость доставки фичи до пользователей. В заключении стоит отметить важное преимущество модульной разработки — сборка apk файлов будет занимать намного меньше времени, так как gradle будет пересобирать только ту часть модуля, в которой произошло изменение. | https://habr.com/ru/post/353942/ | null | ru | null |

# VK::App — модуль для создания клиентских приложений в vk.com

Хочу рассказать о своем модуле VK::App для создания клиентских приложений в социальной сети vk.com. Основные возможности модуля:

* Авторизация, основанная на OAuth 2.0, по логину/паролю или cookies.

* Установка прав доступа, которые потребуются приложению.

* Выполнение любых запросов VK API и получение результата в JSON, XML или Perl Object виде.

Модуль использует минимум зависимостей: только LWP и JSON.

Для написания клиентского при приложения вам надо знать **api\_id**. Для этого можно [зарегистрировать](http://vk.com/apps.php?act=add) свое приложение или использовать существующий **api\_id**.

#### Синтаксис

##### Конструкторы

```

#1. Авторизация по логину и паролю

use VK::App;

my $vk = VK::App->new(

# Ваш мобильный телефон или email

login => 'login',

# Пароль

password => 'password',

# api_id приложения

api_id => 'api_id',

# Имя файла в который будут записываться и считываться cookies

#(в данном варианте конструктора это не обязательный параметр)

cookie_file => '/home/user/.vk.com.cookie',

);

#2. Авторизация с помощью cookies файла

use VK::App;

my $vk = VK::App->new(

cookie_file => '/home/user/.vk.com.cookie',

api_id => 'api_id',

);

#3. Дополнительные опции

use VK::App;

my $vk = VK::App->new(

cookie_file => '/home/user/.vk.com.cookie',

api_id => 'api_id',

# Перечисляем через запятую права, которые будут нужны приложению.

# Список всех возможных прав доступа можно посмотреть по ссылке:

# http://vk.com/developers.php?oid=-17680044&p=Application_Access_Rights

scope => 'friends,photos,audio,video,wall,groups,messages,offline',

# Формат данных в котором будут возвращаться ответы на запросы:

# 'JSON', 'XML' или 'Perl' объекты. Значение по умолчанию: 'Perl'.

format => 'Perl',

);

```

##### Примеры запросов

```

# Синтаксис такой:

# my $response = $vk->request($METHOD_NAME,$PARAMETERS);

# Список всех методов:

# http://vk.com/developers.php?oid=-17680044&p=API_Method_Description

#1. Получить uid пользователя по его имени

my $user = $vk->request('getProfiles',{uid=>'genaev',fields=>'uid'});

my $uid = $user->{response}->[0]->{uid};

#2. Получить список треков пользователя по его uid

my $tracks = $vk->request('audio.get',{uid=>$uid});

my $url = $tracks->{response}->[0]->{url}; # прямая ссылка на mp3 первого трека

```

Модуль опубликован на cpan. Более подробная документация и описание всех методов: <https://metacpan.org/module/VK::App>.

#### Зачем нужен еще один велосипед?

Потому что у других велосипедов квадратные колеса! У меня в vk.com есть несколько любимых музыкальных групп и друзей, с которыми наши музыкальные вкусы совпадают. Хотелось иметь актуальную локальную копию музыки этих групп и друзей, чтобы слушать её, например в машине. т.е. иметь возможность автоматической синхронизации. Приложения с GUI я не рассматривал в принципе. Среди консольных подходящих не нашел. Можно было бы поискать реализацию API для других языков программирования (имею опыт работы с Ruby, Python, Java, C), но душа лежит именно к Perl. На cpan.org есть два модуля VK::MP3 и VKontakte::API. VK::MP3 — нормальный модуль, но мои задачи не решает, т.к. занимается только поиском музыки. VKontakte::API — абсолютно не работоспособный. Во-первых он зачем-то требует секретный ключ приложения, что является небезопасным. Во-вторых на запрос getUserSettings он возвращает код +1, что означает фактическое отсутствие [прав доступа](http://vk.com/developers.php?oid=-17680044&p=Application_Rights). В-третьих при использовании третьего варианта конструктора модуль просто падает. По этим причинами и возникла идея написания модуля, о котором здесь идет речь.

#### Планы

Довести до ума мою программу vmd (vkontakte music downloader) ради которой все и затевалось. Выложить её на github, может будет кому-то полезна? Могу собрать из программы статические бинарники под windows, mac, linux (есть купленная версия PDK).

Так получилось, что VK::App — мой первый модуль опубликованный на CPAN. И процесс публикации занял в два-три раза больше времени, чем написание самого модуля. Вроде бы и информации в сети очень много, а четкой последовательности действий не знаешь. Да и есть подводные камни. Я довольно подробно изучил этот вопрос и написал для себя инструкцию, как правильно и быстро собрать дистрибутив модуля для его публикации. Могу её немного причесать и выложить в качестве отдельной статьи на habrahabr.

Буду рад любым фитбекам!

**UPD**

по поводу планов:

пост про vkontakte music downloader — [habrahabr.ru/post/146889](http://habrahabr.ru/post/146889/)

пост про публикацию модулей — [habrahabr.ru/post/146821](http://habrahabr.ru/post/146821/)

кроме того vk.com изменил механизм авторизации по логину и паролю и пришлось менять модуль. Текущая версия VK::App 0.06 — рабочая, все предыдущие не работают. Подозреваю, что модуль VK::MP3 тоже перестал работать. | https://habr.com/ru/post/146598/ | null | ru | null |

# Torrent-файл. Что же у него внутри?

#### Введение

Добрый день.

Использую, как и многие, крупный торрент-трекер — rutracker.org, однако есть одна особенность которая меня раздражает.

Это добавление в список трекеров адреса *ix\*.rutracker.net*, который служит для непонятных мне целей. Однако который часто (у меня — практически всегда) выдаёт ошибки (**502 Bad Gateway** и **0 No Response**). Торрент-клиент (у меня Transmission) помечает торрент сломанным. Что само собой довольно сильно мне мешает. Особенно если учесть особенность Transmission — она задаёт статус торрента по последнему ответу трекера. То есть опрашиваем ix\*, он возвращает ошибку, торрент помечается как Broken, через n минут/секунд опрашивается следующий трекер из списка — *bt\*.rutracker.org* или *retracker.local*, которые возвращают успешный код и торрент снова становится нормальным. Такая чехарда не особо меня радует.

Решение банально — убрать этот нехороший адрес из списка. Однако файлов у меня много, из каждого вручную вырезать совсем не хочется, да и дополнительное действие при добавлении нового торрента выполнять тоже не было никакого желания. Поэтому принял решение разобраться в формате и автоматизировать удаление трекера из списка.

#### Bencode

Именно так называется формат кодирования данных в .torrent-файлах. Больше он почти нигде и не используется, мне попадался он на глаза так же в формате хранения resume-информации в Transmission.

Для большинства актуальных языков написаны библиотеки для работы с этим форматом, но не для C++, да, конечно, есть такая [штука](http://funzix.git.sourceforge.net/git/gitweb.cgi?p=funzix/funzix;a=blob;f=bencode/bencode.c), но это чистый Си и кроме того форма представления мне не показалась удачной, поэтому написал простенький свой велосипед, ибо формат крайне прост.

Описываются 4 типа данных — массив байт, число, список, ассоциативный массив.

Пойдем по порядку:

* Числа задаются в форме **i<последовательность цифр>e**, <последовательность цифр> — это цифры в ascii представлении, то есть 1 задаётся как '1' или 0x31. Заметно что так мы можем задавать огромные числа, которые не влезут ни в long, ни в long long, однако большинство пренебрегают отсутствием лимита и используют 64-битные числа.

* Массив байт — **<длина массива>:<сам массив>**. Длина массива так же формируется неограниченной последовательностью цифр.

* Список — **l<элемeнты списка>e**. Элементом может являться любой из типов данных. В том числе и вложенный список. Конец, как видно из формата, отмечается литералом 'e'.

* Ассоциативный массив — **d<элемeнты массива>e**. Каждый элемент массива выглядит таким образом — **<массив байт><элемент>**. Массив байт — это имя записи в форме из пункта 2. Элемент опять же может быть любым — список, массив, ассоциативный массив, число.

Это всё. Сам файл это последовательность таких записей. Поэтому декодирование крайне просто выполняется:

```

void CTorrentFile::ReadBencElement(ifstream & fin, tree ::pre\_order\_iterator & parent,

string name)

{

BencElement el;

char c = fin.get();

el.name = name;

if (c == 'i')

{

el.type = BencInteger;

fin >> el.integer;

m\_tree.append\_child(parent, el);

} else if (c == 'l')

{

int l = fin.peek();

el.type = BencList;

tree ::pre\_order\_iterator it = m\_tree.append\_child(parent, el);

while (l != 'e')

{

ReadBencElement(fin, it, string(""));

l = fin.peek();

}

fin.seekg(1, ios\_base::cur);

} else if (c == 'd')

{

int l = fin.peek();

el.type = BencDict;

tree ::pre\_order\_iterator it = m\_tree.append\_child(parent, el);

while (l != 'e')

{

string name;

int len;

fin >> len;

fin.seekg(1, ios\_base::cur);

while (len--)

{

char s = fin.get();

name += s;

}

ReadBencElement(fin, it, name);

l = fin.peek();

}

fin.seekg(1, ios\_base::cur);

} else if (c >= '0' && c <= '9')

{

fin.seekg(-1, ios\_base::cur);

int len;

el.type = BencString;

fin >> len;

el.bstr.len = len;

// skip ':'

fin.seekg(1, ios\_base::cur);

el.bstr.byteStr = new char[len + 1];

for (int i = 0; i < len; i++)

{

char s = fin.get();

el.bstr.byteStr[i] = s;

}

el.bstr.byteStr[el.bstr.len] = 0;

m\_tree.append\_child(parent, el);

}

}

```

Кодирование тоже несложно:

```

void CTorrentFile::WriteBencElement(std::ofstream & fout, tree ::sibling\_iterator & el)

{

tree ::sibling\_iterator it;

switch (el->type)

{

case BencInteger:

fout << 'i' << el->integer << 'e';

break;

case BencString:

fout << el->bstr.len << ':';

fout.write(el->bstr.byteStr, el->bstr.len);

break;

case BencList:

fout << 'l';

it = m\_tree.child(el, 0);

for (size\_t i = 0; i < m\_tree.number\_of\_children(el); i++, ++it)

WriteBencElement(fout, it);

fout << 'e';

break;

case BencDict:

fout << 'd';

tree ::sibling\_iterator it = m\_tree.child(el, 0);

for (size\_t i = 0; i < m\_tree.number\_of\_children(el); i++, ++it)

{

fout << it->name.length() << ':' << it->name.c\_str();

WriteBencElement(fout, it);

}

fout << 'e';

break;

}

}

```

#### Структура .torrent-файла.

Как я уже писал выше для кодирования используется Bencode.

Стоит добавить что если массив байт может быть интерпретирован как строка (имена элементов в ассоциативном массиве, просто строковые поля), то используется кодировка utf-8.

Содержимое является одним большим ассоциативным массивом со следующими полями:

* **info** — вложенный ассоциативный массив который собственно и описывает файлы, которые передаёт торрент.

* **announce** — URL для трекера. Наряду с **info** является обязательным полем, всё остальное — опционально.

* **announce-list** — список трекеров, если их несколько. В Bencode-виде — список списков.

* **creation date** — дата создания. UNIX Timestamp.

* **comment** — текстовое описание торрента. rutracker.org хранит здесь ссылку на тему форума.

* **created by** — говорит нам о том, кем создан данный торрент.

Необходимо упомянуть то, что файлы представлены в протоколе кусками. То есть файлы содержащиеся в торренте объединены в единый массив, и затем этот массив разделили на относительно небольшие кусочки. В таком виде данные обрабатывает BitTorrent-протокол.

Ассоциативный массив **info** состоит из:

* **piece length** — размер одного кусочка — 512 килобайт, 1 метр, и так далее. Слишком большое число кусков будет «раздувать» .torrent-файл.

* **pieces** — строка, которая содержит конкатенацию SHA1-хешей, описывающих каждый кусочек. Длина этой строки равна 20 \* количество кусков.

* **name** — рекомендательное имя файла (если файл один) или директории. Увы многие торрент-клиенты воспринимают это как аксиому.

* **length** — если файл один, то будет задано это поле, которое содержит длину файла.

* **files** — если файлов несколько, то появится список ассоциативных массивов.

Формат элементов списка **files**:

* **length** — длина файла.

* **path** — список из строк, которые задают путь. Каждая строка — элемент пути, относительно корневой директории торрента. Для пути *a/b/c/d.jpg* будет 4 строки в данном списке — **['a', 'b', 'c', 'd.jpg']**.

В общем-то это всё.

Нам в данный момент нужно только одно поле — **announce-list**. Пробегаясь по этому списку находим неугодный трекер и вырезаем его:

```

int CTorrentFile::RemoveTracker(const char * mask)

{

int deletedCount = 0;

tree ::pre\_order\_iterator root = m\_tree.child(m\_tree.begin(), 0);

tree ::sibling\_iterator it = m\_tree.child(root, 0);

for (size\_t i = 0; i < m\_tree.number\_of\_children(root); i++, ++it)

{

if (it->type == BencString && !it->name.compare("announce") && it->bstr.len > 0 &&

it->bstr.byteStr)

{

if (wildcardMatch(it->bstr.byteStr, mask))

{

it->bstr.len = 0;

it->bstr.byteStr[0] = 0;

deletedCount++;

}

} else if (it->type == BencList && !it->name.compare("announce-list"))

{

tree ::sibling\_iterator trackerList = m\_tree.child(it, 0);

for (size\_t j = 0; j < it.number\_of\_children(); j++)

{

if (trackerList->type != BencList)

{

++trackerList;

continue;

}

tree ::sibling\_iterator tracker = m\_tree.child(trackerList, 0);

for (size\_t k = 0; k < trackerList.number\_of\_children(); k++)

{

if (tracker->type != BencString || tracker->bstr.len <= 0 ||

!tracker->bstr.byteStr)

{

++tracker;

continue;

}

if (wildcardMatch(tracker->bstr.byteStr, mask))

{

tracker = m\_tree.erase(tracker);

deletedCount++;

} else

++tracker;

}

if (trackerList.number\_of\_children() == 0)

trackerList = m\_tree.erase(trackerList);

else

++trackerList;

}

}

}

return deletedCount;

}

```

Скомпонуем всё в один исходник:

[Скачать](http://dl.dropbox.com/u/11808910/torrentEditor.rar) — кроссплатформенный (win + \*nix), нужен **boost::filesystem**.

Пользоваться просто:

**torrentEditor <имя\_файла> <шаблон>**, где шаблон — это wildcard-строка ('\*' и '?'), для моего случая — *http://ix\*rutracker.net/\**

Если в качестве имени файла подставить имя директории, то будет совершен рекурсивный обход по этой директории и модификация \*.torrent файлов.

Бэкап для *<имя>.torrent* сохраняется в *<имя>.old*.

#### Демоны и watch-directory.

Таким образом мы можем пробежаться по существующим .torrent-файлам и вырезать трекер, однако что делать с новыми файлами?

Я использую удобную штуку — watch directory. Кидаем туда .torrent и клиент обнаружив его в этой папке, сам автоматически добавит его к себе.

Однако мне совсем не хочется предварительно вырезать трекер, а желаю автоматизировать это дело.

Поэтому написал простенький демон, который мониторит собственную watch directory, удаляет трекер и кидает файл в watch directory торрент-клиента.

Для меня как пользователя абсолютно ничего не поменялось, кидаю файлы в ту же папку, получаю на выходе торрент в клиенте.

Демона пишем на Си с использованием замечательной штуки — **inotify**,

```

notifyDesc = inotify_init();

if (notifyDesc < 0)

exit(EXIT_FAILURE);

watchDesc = inotify_add_watch(notifyDesc, argv[1], IN_CREATE);

if (watchDesc < 0)

exit(EXIT_FAILURE);

// endless loop

while (1)

{

processEvents(notifyDesc, argv[2], argv[3], argv[1]);

}

```

Инициализируем модуль с помощью **inotify\_init()**, затем добавляем директорию для слежения **inotify\_add\_watch()**, нас интересует только создание файла, поэтому указываем флажок **IN\_CREATE**. А затем крутим бесконечный цикл слежения за директорией.

```

static void processEvents(int wd, char * moveDir, char * pattern, char * watchDir)

{

#define BUF_SIZE ((sizeof(struct inotify_event) + FILENAME_MAX) * 10)

int len, i = 0;

char buf[BUF_SIZE];

// blocked read, we wake up when directory changed

len = read(wd, buf, BUF_SIZE);

while (i < len)

{

struct inotify_event * ev;

ev = (struct inotify_event *)&buf[i];

processNewFile(ev->name, moveDir, pattern, watchDir);

i += sizeof(struct inotify_event) + ev->len;

}

}

```

Блокирующий вызов **read()** вернёт нам управление как только произойдут нужные нам изменения в одной из директорий, за которыми следим. Таким образом мы абсолютно не грузим процессор во время ожидания.

Сама обработка файла не представляет из себя ничего интересного — пара вызовов **rename()** и один вызов **system()**.

Демонизация тоже стандартна:

```

// create child-process

pid = fork();

// error?

if (pid < 0)

exit(EXIT_FAILURE);

// parent?

if (pid > 0)

exit(EXIT_SUCCESS);

// new session for child

sid = setsid();

if (sid < 0)

exit(EXIT_FAILURE);

// change current directory

if (chdir("/") < 0)

exit(EXIT_FAILURE);

// close opened descriptors

close(STDIN_FILENO);

close(STDOUT_FILENO);

close(STDERR_FILENO);

```

[Исходник](http://dl.dropbox.com/u/11808910/preparetrn.rar). | https://habr.com/ru/post/119753/ | null | ru | null |

# Кластерное хранилище в Proxmox. Часть первая. Fencing

Здравствуйте!

Хочу рассказать о том, как мы используем у себя [Proxmox Virtual Environment](http://www.proxmox.com/products/proxmox-ve).

Я не буду описывать установку и первоначальную настройку — *Proxmox* очень прост и приятен и в установке, и в настройке. Расскажу о том, как мы используем систему в кластерном окружении.

Для полноценной работы кластера необходимо, чтобы управление виртуальной машиной оперативно могли брать на себя разные хосты кластера. Данные виртуалок при этом не должны никуда копироваться. То есть все хосты кластера должны иметь доступ к данным конкретной машины, или, иными словами, все хосты кластера должны работать с единым хранилищем данных, в рамках которого работает конкретный набор виртуальных машин.