text

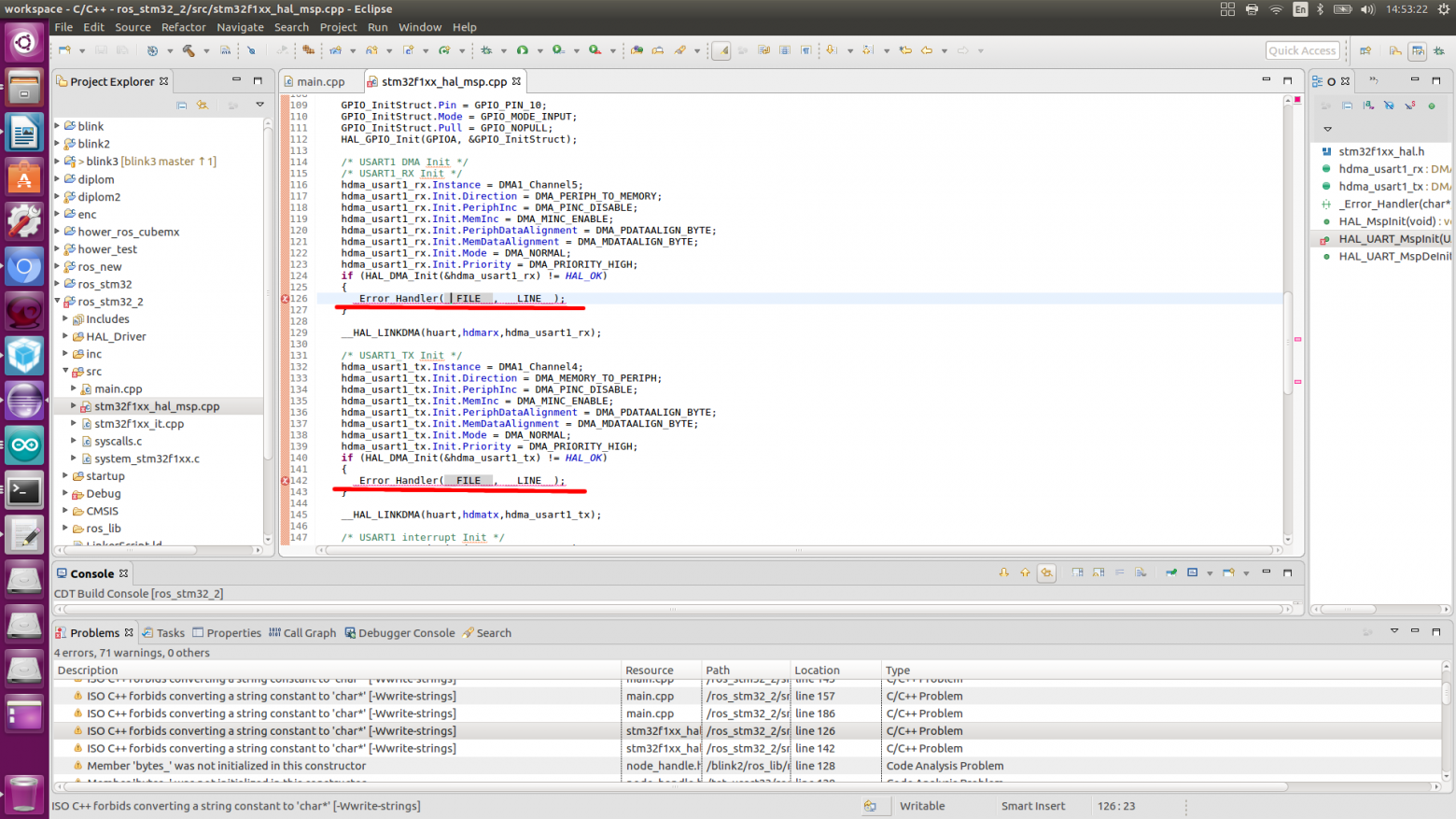

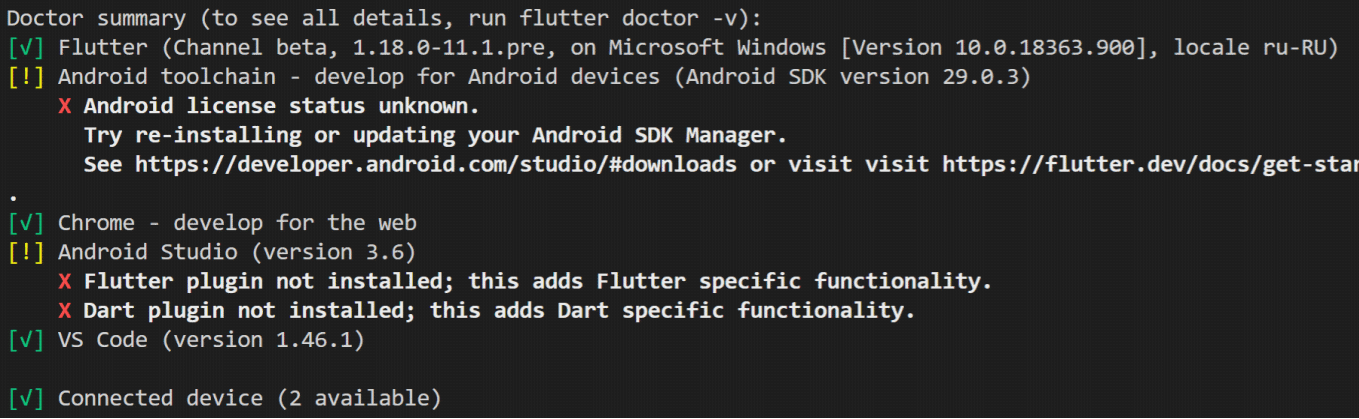

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

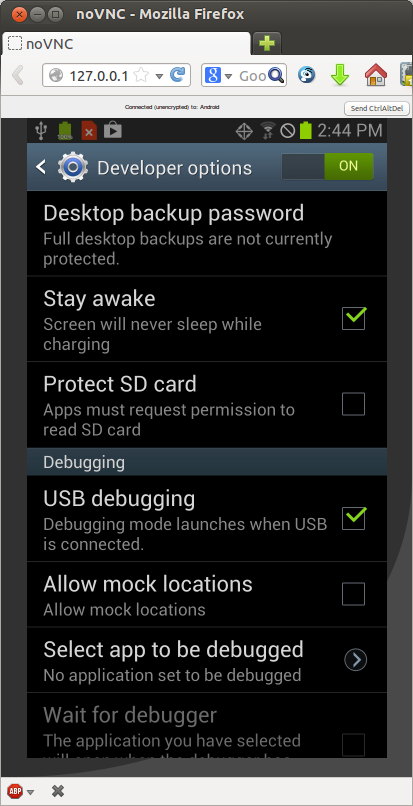

# Создание простой 2D игры на Android

Доброго дня всем!

Когда я писал эту «игру» у меня возникала масса вопросов по поводу зацикливания спрайтов так что бы они появлялись через определенное время, так же были проблемы с обнаружением столкновений двух спрайтов и более, все эти вопросы я сегодня хочу осветить в этом посте так как в интернете я не нашел нормального ответа на мои вопросы и пришлось делать самому. Пост ни на что не претендует, я новичок в разработке игр под android и пишу я для новичков в данной отрасли. Кому стало интересно прошу под кат.

#### Постановка задачи:

Игра должна представлять из себя поле (сцену) на котором располагается ниндзя и призраки. Нинзя должен защищать свою базу от этих призраков стреляя по ним.

Пример такой игры можно посмотреть в [android market'e](https://market.android.com/details?id=com.droidhen.defender&hl=ru). Хотя я сильно замахнулся, у нас будет только похожая идея.

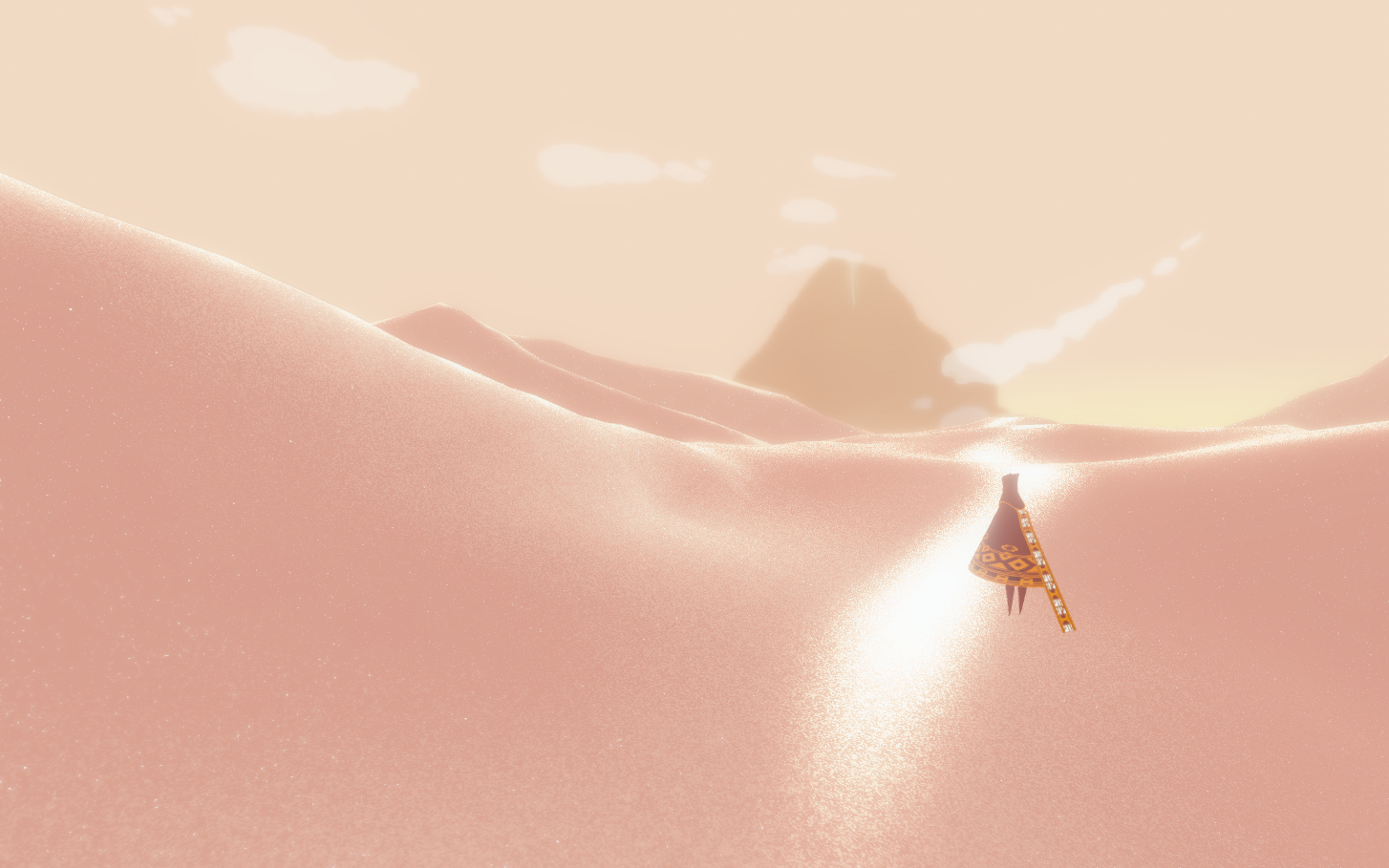

Вот как будет выглядеть игра:

#### Начало разработки

Создаем проект. Запускаем Eclipse — File — Android Project — Defens — Main.java.

Открываем наш файл Main.java и изменяем весь код на код который ниже:

Main.java

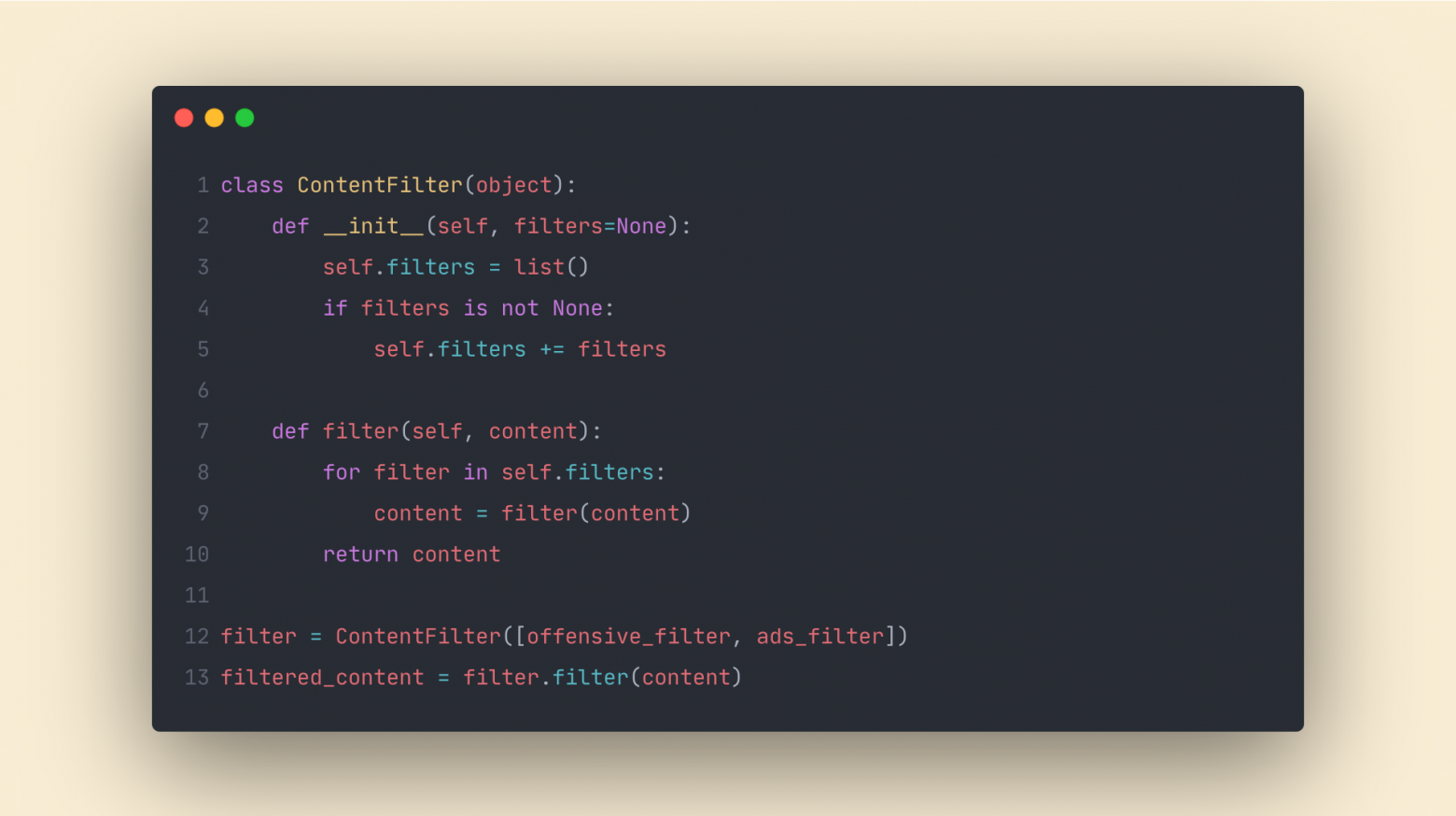

```

public class Main extends Activity {

public void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

// если хотим, чтобы приложение постоянно имело портретную ориентацию

setRequestedOrientation(ActivityInfo.SCREEN_ORIENTATION_LANDSCAPE);

// если хотим, чтобы приложение было полноэкранным

getWindow().addFlags(WindowManager.LayoutParams.FLAG_FULLSCREEN);

// и без заголовка

requestWindowFeature(Window.FEATURE_NO_TITLE);

setContentView(new GameView(this));

}

}

```

Код ниже говорит нашей главной функции что запускать нужно не \*.xml файл темы, а класс который у нас является самой сценой.

```

setContentView(new GameView(this));

```

Дальше Вам нужно создать класс GameView.java который будет служить для нас главным классом на котором будет производится прорисовка всех объектов. Так же в этом классе будет находится и наш поток в котором будет обрабатываться прорисовка объектов в потоке для уменьшения нагрузки игры на процессор. Вот как будет выглядеть класс когда на сцене у нас ничего не происходит:

GameView.java

```

import java.util.ArrayList;

import java.util.Iterator;

import java.util.List;

import java.util.Random;

import towe.def.GameView.GameThread;

import android.content.Context;

import android.graphics.Bitmap;

import android.graphics.BitmapFactory;

import android.graphics.Canvas;

import android.graphics.Color;

import android.view.MotionEvent;

import android.view.SurfaceHolder;

import android.view.SurfaceView;

public class GameView extends SurfaceView

{

/**Объект класса GameLoopThread*/

private GameThread mThread;

public int shotX;

public int shotY;

/**Переменная запускающая поток рисования*/

private boolean running = false;

//-------------Start of GameThread--------------------------------------------------\\

public class GameThread extends Thread

{

/**Объект класса*/

private GameView view;

/**Конструктор класса*/

public GameThread(GameView view)

{

this.view = view;

}

/**Задание состояния потока*/

public void setRunning(boolean run)

{

running = run;

}

/** Действия, выполняемые в потоке */

public void run()

{

while (running)

{

Canvas canvas = null;

try

{

// подготовка Canvas-а

canvas = view.getHolder().lockCanvas();

synchronized (view.getHolder())

{

// собственно рисование

onDraw(canvas);

}

}

catch (Exception e) { }

finally

{

if (canvas != null)

{

view.getHolder().unlockCanvasAndPost(canvas);

}

}

}

}

}

//-------------End of GameThread--------------------------------------------------\\

public GameView(Context context)

{

super(context);

mThread = new GameThread(this);

/*Рисуем все наши объекты и все все все*/

getHolder().addCallback(new SurfaceHolder.Callback()

{

/*** Уничтожение области рисования */

public void surfaceDestroyed(SurfaceHolder holder)

{

boolean retry = true;

mThread.setRunning(false);

while (retry)

{

try

{

// ожидание завершение потока

mThread.join();

retry = false;

}

catch (InterruptedException e) { }

}

}

/** Создание области рисования */

public void surfaceCreated(SurfaceHolder holder)

{

mThread.setRunning(true);

mThread.start();

}

/** Изменение области рисования */

public void surfaceChanged(SurfaceHolder holder, int format, int width, int height)

{

}

});

}

/**Функция рисующая все спрайты и фон*/

protected void onDraw(Canvas canvas) {

canvas.drawColor(Color.WHITE);

}

}

```

Из комментариев надеюсь понятно какая функция что делает. Этот класс является базовым по этому в нем мы будем производиться все действия (функции) которые будут происходить в игре, но для начало нам нужно сделать еще несколько классов Переходи к следующему пункту — создание спрайтов.

#### Создание спрайтов

Спрайты это маленькие картинки в 2D-играх, которые передвигаются. Это могут быть человечки, боеприпасы или даже облака. В этой игре мы будем иметь три различных типа спрайта: Нинзя , призрак , и снаряд .

Сейчас мы будем использовать не анимированные спрайты но в будущем я вставлю спрайты в проэкт, если тянет научиться делать спрайты прошу во [второй урок по созданию игры](http://dajver.blogspot.com/2012/01/android-2.html) под android.

Теперь загрузите эти картинки в папку res/drawable для того, чтобы Eclipse мог увидеть эти картинки и вставить в Ваш проект.

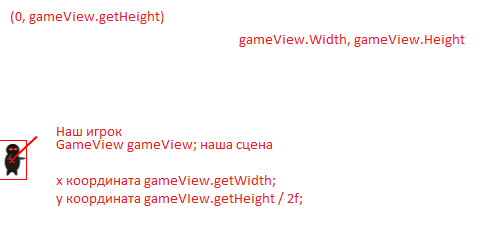

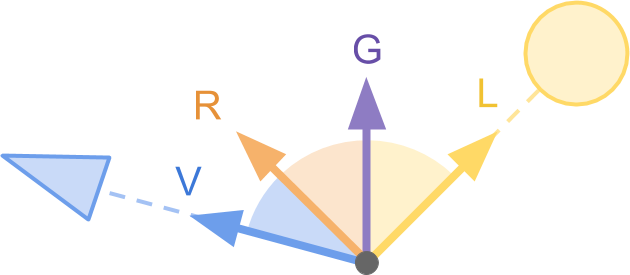

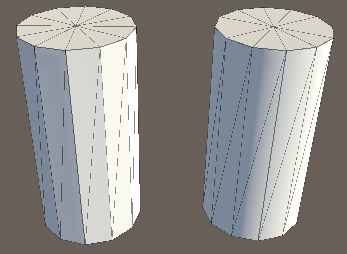

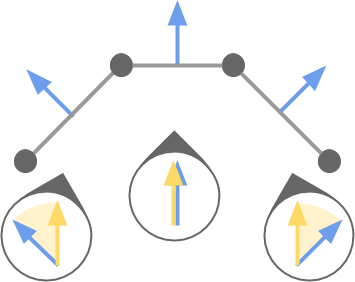

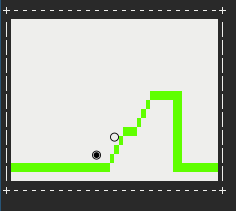

Следующий рисунок должен визуально помочь понять как будет располагаться игрок на экране.

Скучная картинка… Давайте лучше создадим этого самого игрока.

Нам нужно разместить спрайт на экране, как это сделать? Создаем класс Player.java и записываем в него следующее:

Player.java

```

import android.graphics.Bitmap;

import android.graphics.Canvas;

public class Player

{

/**Объект главного класса*/

GameView gameView;

//спрайт

Bitmap bmp;

//х и у координаты рисунка

int x;

int y;

//конструктор

public Player(GameView gameView, Bitmap bmp)

{

this.gameView = gameView;

this.bmp = bmp; //возвращаем рисунок

this.x = 0; //отступ по х нет

this.y = gameView.getHeight() / 2; //делаем по центру

}

//рисуем наш спрайт

public void onDraw(Canvas c)

{

c.drawBitmap(bmp, x, y, null);

}

}

```

Все очень просто и понятно, наш игрок будет стоять на месте и ничего не делать, кроме как стрелять по врагу но стрельба будет реализована в классе пуля (снаряд), который будем делать дальше.

Создаем еще один файл классов и назовем его Bullet.java, этот класс будет определять координаты полета, скорость полета и другие параметры пули. И так, создали файл, и пишем в него следующее:

Bullet.java

```

import android.graphics.Bitmap;

import android.graphics.Canvas;

import android.graphics.Rect;

public class Bullet

{

/**Картинка*/

private Bitmap bmp;

/**Позиция*/

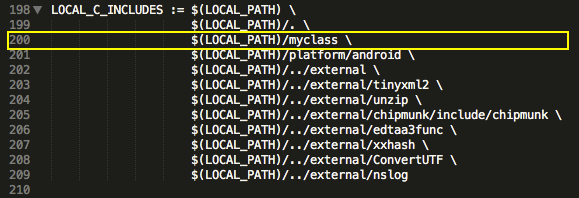

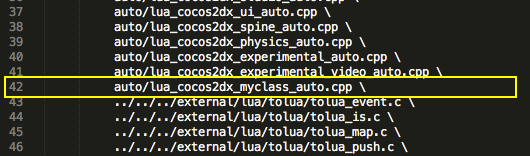

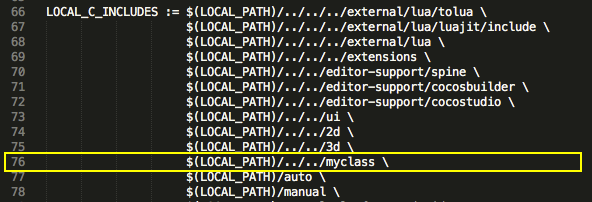

public int x;

public int y;

/**Скорость по Х=15*/

private int mSpeed=25;

public double angle;

/**Ширина*/

public int width;

/**Ввыоста*/

public int height;

public GameView gameView;

/**Конструктор*/

public Bullet(GameView gameView, Bitmap bmp) {

this.gameView=gameView;

this.bmp=bmp;

this.x = 0; //позиция по Х

this.y = 120; //позиция по У

this.width = 27; //ширина снаряда

this.height = 40; //высота снаряда

//угол полета пули в зависипости от координаты косания к экрану

angle = Math.atan((double)(y - gameView.shotY) / (x - gameView.shotX));

}

/**Перемещение объекта, его направление*/

private void update() {

x += mSpeed * Math.cos(angle); //движение по Х со скоростью mSpeed и углу заданном координатой angle

y += mSpeed * Math.sin(angle); // движение по У -//-

}

/**Рисуем наши спрайты*/

public void onDraw(Canvas canvas) {

update(); //говорим что эту функцию нам нужно вызывать для работы класса

canvas.drawBitmap(bmp, x, y, null);

}

}

```

Из комментариев должно быть понятно что пуля выполняет только одно действие — она должна лететь по направлению указанному игроком.

#### Рисуем спрайты на сцене

Для того что бы нарисовать эти два класса которые мы создали, нам нужно отредактировать код в классе GameView.java, добавить несколько методов которые будут возвращать нам наши рисунки. Полностью весь код я писать не буду, буду приводить только код нужных мне методов.

Для начала нам нужно создать объекты классов Bullet и Player для того что бы отобразить их на экране, для этого создадим список пуль, что бы они у нас никогда не заканчивались, и обычный объект класса игрока.

*Шапка GameView*

```

private List ball = new ArrayList();

private Player player;

Bitmap players;

```

Дальше нам нужно присвоить картинки нашим классам, находим конструктор GameView и вставляем в самый конец две строчки:

*GameView.java — Конструктор GameView*

```

players= BitmapFactory.decodeResource(getResources(), R.drawable.player2);

player= new Player(this, guns);

```

И в методе onDraw(Canvas c); делаем видимыми эти спрайты. Проходим по всей коллекции наших элементов сгенерировавшихся в списке.

GameView,java

```

/**Функция рисующая все спрайты и фон*/

protected void onDraw(Canvas canvas) {

canvas.drawColor(Color.WHITE);

Iterator j = ball.iterator();

while(j.hasNext()) {

Bullet b = j.next();

if(b.x >= 1000 || b.x <= 1000) {

b.onDraw(canvas);

} else {

j.remove();

}

}

canvas.drawBitmap(guns, 5, 120, null);

}

```

А для того что бы пули начали вылетать при нажатии на экран, нужно создать метод createSprites(); который будет возвращать наш спрайт.

GameView.java

```

public Bullet createSprite(int resouce) {

Bitmap bmp = BitmapFactory.decodeResource(getResources(), resouce);

return new Bullet(this, bmp);

}

```

Ну и в конце концов создаем еще один метод — onTouch(); который собственно будет отлавливать все касания по экрану и устремлять пулю в ту точку где было нажатия на экран.

GameView.java

```

public boolean onTouchEvent(MotionEvent e)

{

shotX = (int) e.getX();

shotY = (int) e.getY();

if(e.getAction() == MotionEvent.ACTION_DOWN)

ball.add(createSprite(R.drawable.bullet));

return true;

}

```

Если хотите сделать что бы нажатие обрабатывалось не единоразово, т.е. 1 нажатие — 1 пуля, а 1 нажатие — и пока не отпустишь оно будет стрелять, нужно удалить *if(e.getAction() == MotionEvent.ACTION\_DOWN) { }*

и оставить только *ball.add(createSprite(R.drawable.bullet));*.

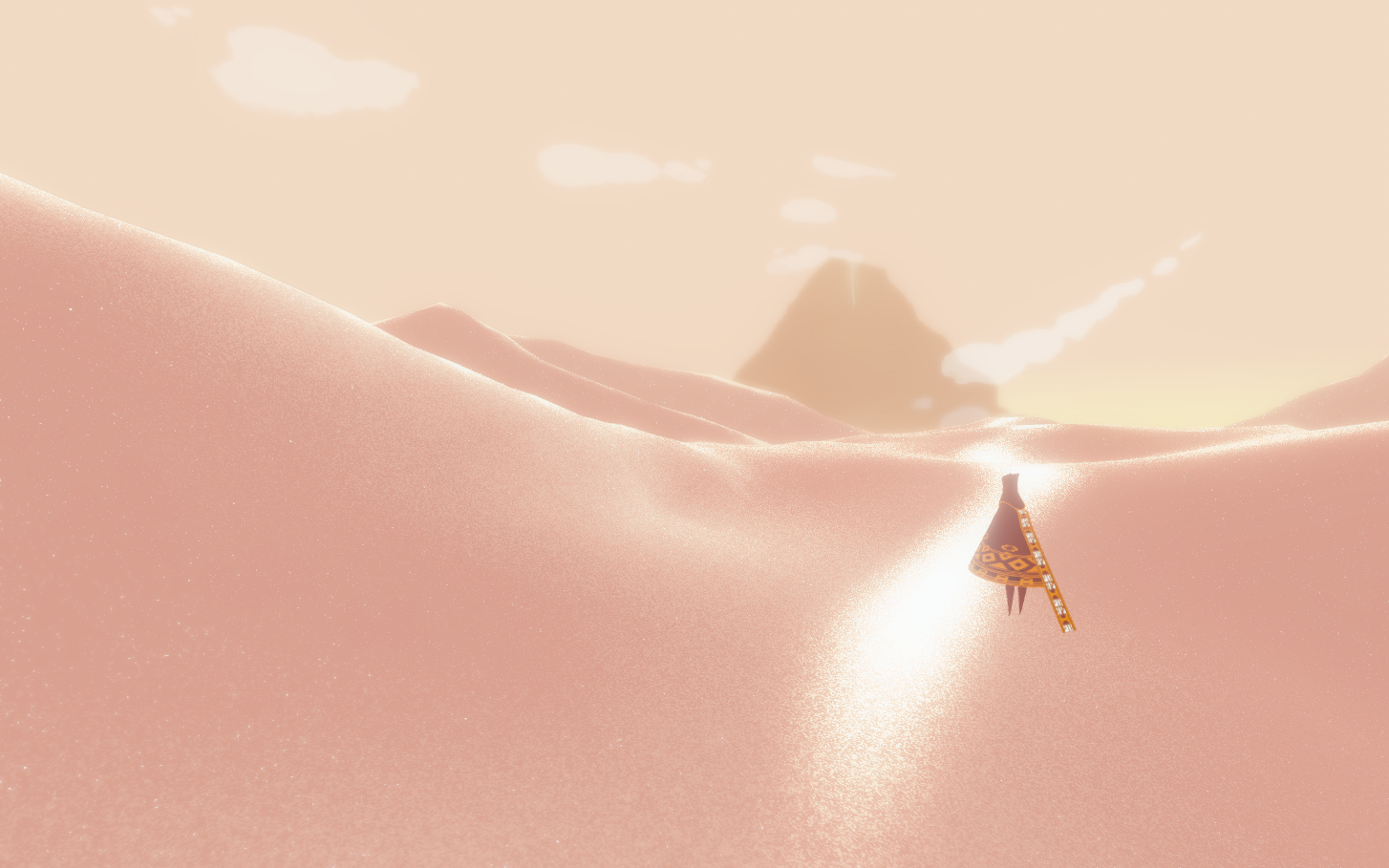

Все, запускаем нашу игру и пробуем стрелять. Должно выйти вот такое:

#### Враги

Для того что бы нам не было скучно играться, нужно создать врагов. Для этого нам придется создать еще один класс который будет называться Enemy.java и который будет уметь отображать и направлять нашего врага на нашу базу. Класс довольно простой по этому смотрим код ниже:

Enemy.java

```

import java.util.Random;

import android.graphics.Bitmap;

import android.graphics.Canvas;

import android.graphics.Rect;

public class Enemy

{

/**Х и У коорданаты*/

public int x;

public int y;

/**Скорость*/

public int speed;

/**Выосота и ширина спрайта*/

public int width;

public int height;

public GameView gameView;

public Bitmap bmp;

/**Конструктор класса*/

public Enemy(GameView gameView, Bitmap bmp){

this.gameView = gameView;

this.bmp = bmp;

Random rnd = new Random();

this.x = 900;

this.y = rnd.nextInt(300);

this.speed = rnd.nextInt(10);

this.width = 9;

this.height = 8;

}

public void update(){

x -= speed;

}

public void onDraw(Canvas c){

update();

c.drawBitmap(bmp, x, y, null);

}

}

```

И так что происходит в этом классе? Рассказываю: мы объявили жизненно важные переменные для нашего врага, высота ширина и координаты. Для размещения их на сцене я использовал класс Random() для того что бы когда они будут появляться на сцене, появлялись на все в одной точке, а в разных точках и на разных координатах. Скорость так же является у нас рандомной что бы каждый враг шел с разной скоростью, скорость у нас начинается с 0 и заканчивается 10, 10 — максимальная скорость которой может достигнуть враг. Двигаться они будут с права налево, для того что бы они не были сразу видны на сцене я закинул их на 900 пикселей за видимость экрана. Так что пока они дойдут можно уже будет подготовиться по полной к атаке.

Дальше нам нужно отобразить врага на сцене, для этого в классе GameView.java делаем следующее:

Создаем список врагов для того что бы они никогда не заканчивались и создаем битмап который будет содержать спрайт:

*Шапка GameView*

```

private List enemy = new ArrayList();

Bitmap enemies;

```

Далее создаем новый поток для задания скорости появления врагов на экране:

*Шапка GameView*

```

private Thread thred = new Thread(this);

```

И имплементируем класс Runuble, вот как должна выглядеть инициализация класса GameView:

```

public class GameView extends SurfaceView implements Runnable

```

Теперь у Вас еклипс требует создать метод run(), создайте его, он будет иметь следующий вид:

*В самом низу класса GameView*

```

public void run() {

while(true) {

Random rnd = new Random();

try {

Thread.sleep(rnd.nextInt(2000));

enemy.add(new Enemy(this, enemies));

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

```

Здесь мы создаем поток который будет создавать спрайт от 0 до 2000 милисекунд или каждые 0, 1 или 2 секунды.

Теперь в конструкторе в самом конце пишем инициализируем наш спрайт с классом для отображения на сцене:

*Конструктор GameView*

```

enemies = BitmapFactory.decodeResource(getResources(), R.drawable.target);

enemy.add(new Enemy(this, enemies));

```

Ну и конечно же нам нужно объявить эти методы в onDraw(); Вот значит и пишем в нем следующее:

*Метод onDraw() в GameView*

```

Iterator i = enemy.iterator();

while(i.hasNext()) {

Enemy e = i.next();

if(e.x >= 1000 || e.x <= 1000) {

e.onDraw(canvas);

} else {

i.remove();

}

}

```

Снова проходим по коллекции врагов с помощью итератора и проверяем — если враг зашел за предел в 1000 пикселей — удаляем его, так как если мы не будем удалять у нас пямять закакается и телефон зависнет, а нам такие проблемы не нужны. Все игра готова для запуска.

Запускаем нашу игру и что мы увидим? А вот что:

Но что я вижу? О нет!!! Пули никак не убивают наших призраков что же делать? А я Вам скажу что делать, нам нужно создать метод который будет образовывать вокруг каждого спрайта — прямоугольник и будет сравнивать их на коллизии. Следующая тема будет об этом.

#### Обнаружение столкновений

И так, у нас есть спрайт, у нас есть сцена, у нас все это даже движется красиво, но какая польза от всего этого когда у нас на сцене ничего не происходит кроме хождения туда сюда этих спрайтов?

С этой функцией я навозился по полной, даже как-то так выходило что психовал и уходил гулять по улице)) Самый трудный метод, хотя выглядеть совершенно безобидно…

Ладно, давайте уже создадим этот метод и не будем много разглагольствовать… Где то в конце класса GameView создаем метод testCollision() и пишем следующий код:

*В самом низу класса GameView.java*

```

/*Проверка на столкновения*/

private void testCollision() {

Iterator b = ball.iterator();

while(b.hasNext()) {

Bullet balls = b.next();

Iterator i = enemy.iterator();

while(i.hasNext()) {

Enemy enemies = i.next();

if ((Math.abs(balls.x - enemies.x) <= (balls.width + enemies.width) / 2f)

&& (Math.abs(balls.y - enemies.y) <= (balls.height + enemies.height) / 2f)) {

i.remove();

b.remove();

}

}

}

}

```

И так, что у нас происходит в этом методе? Мы создаем один итератор и запускаем цикл для просмотра всей коллекции спрайтов, и говорим что каждый следующий спрайт пули будет первым.

Дальше создаем еще один итератор с другим списком спрайтов и снова переопределяем и говорим что каждый следующий спрайт врага будет первым. И создаем оператор ветвления — if() который собственно и проверяет на столкновения наши спрайты. В нем я использовал математическую функцию модуль (abs) которая возвращает мне абсолютное целое от двух прямоугольников.

Внутри ифа происходит сравнения двух прямоугольников Модуль от (Пуля по координате Х минус координата врага по координате Х меньше либо равен ширина пули плюс ширина врага / 2 (делим на два для нахождения центра прямоугольника)) и (Модуль от (Пуля по координате У минус координата врага по координате У меньше либо равен ширина пули плюс ширина врага / 2 (делим на два для нахождения центра прямоугольника)));

И в конце всего, если пуля таки достала до врага — мы удаляем его со сцены с концами.

Ну и для того что бы эта функция стала работать записываем её в метод run() который находится в классе GameThread, ниже нашего метода рисования onDraw().

Вот что у нас получается после запуска приложения: | https://habr.com/ru/post/136802/ | null | ru | null |

# Kubernetes 1.10: обзор основных новшеств

В конце марта состоялся релиз [Kubernetes 1.10](https://kubernetes.io/blog/2018/03/27/kubernetes-1.10-stabilizing-storage-security-networking/). Поддерживая нашу традицию рассказывать подробности о наиболее значимых изменениях в очередном релизе Kubernetes, публикуем этот обзор, подготовленный на основе [CHANGELOG-1.10](https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.10.md), а также многочисленных issues, pull requests и design proposals. Итак, что же нового приносит K8s 1.10?

Хранилища

---------

[**Mount propagation**](https://github.com/jsafrane/community/blob/7a2b2f7d88b50ee7e83dcca79dc96fac96988084/contributors/design-proposals/propagation.md) — возможность контейнеров подключать тома как `rslave`, чтобы примонтированные каталоги хоста были видны внутри контейнера (значение `HostToContainer`), или как `rshared`, чтобы примонтированные каталоги контейнера были видны на хосте (значение `Bidirectional`). Статус — бета-версия ([документация](https://kubernetes.io/docs/concepts/storage/volumes/#mount-propagation) на сайте). Не поддерживается в Windows.

Добавлена возможность создания **локальных постоянных хранилищ** ([Local Persistent Storage](https://github.com/vishh/community/blob/ba62a3f6cb9a301e95c4b64b9052455bdac9a3fe/contributors/design-proposals/local-storage-overview.md#persistent-local-storage)), т.е. `PersistentVolumes` (PVs) теперь могут быть не только сетевыми томами, но и основываться на локально подключённых дисках. Нововведение преследует две цели: а) улучшить производительность (у локальных SSD скорость лучше, чем у сетевых дисков), б) обеспечить возможность использования более дешёвых хранилищ на железных (bare metal) инсталляциях Kubernetes. Эти работы введутся вместе с созданием Ephemeral Local Storage, [ограничения/лимиты](https://github.com/kubernetes/features/issues/361) в котором (впервые представленные в [K8s 1.8](https://habrahabr.ru/company/flant/blog/338230/)) также получили улучшения в очередном релизе — объявлены бета-версией и по умолчанию теперь включены.

Стало доступным (в бета-версии) «**планирование томов с учётом топологии**» *([Topology Aware Volume Scheduling](https://github.com/kubernetes/features/issues/490))*, идея которого сводится к тому, что стандартный планировщик Kubernetes знает (и учитывает) ограничения топологии томов, а в процессе привязки `PersistentVolumeClaims` (PVCs) к PVs учитываются решения планировщика. Реализовано это таким образом, что под теперь может запрашивать PVs, которые должны быть совместимы с другими его ограничениями: требованиями к ресурсам, политиками affinity/anti-affinity. При этом планирование подов, не использующих PVs с ограничениями, должно происходить с прежней производительностью. Подробности — в [design-proposals](https://github.com/msau42/community/blob/6e486a390fc73ff1deb2441abf2c5838e568d438/contributors/design-proposals/storage/volume-topology-scheduling.md).

Среди прочих улучшений в поддержке томов / файловых систем:

* улучшения в Ceph RBD с [возможностью](https://github.com/kubernetes/kubernetes/pull/58916) использования клиента rbd-nbd (на основе популярной библиотеки librbd) в pkg/volume/rbd;

* [поддержка](https://github.com/kubernetes/kubernetes/pull/55866) монтирования Ceph FS через FUSE;

* в плагине для AWS EBS [добавлена](https://github.com/kubernetes/kubernetes/pull/58625) поддержка блочных томов и `volumeMode`, а также поддержка блочных томов [появилась](https://github.com/kubernetes/kubernetes/pull/58710) в плагине GCE PD;

* [возможность](https://github.com/kubernetes/kubernetes/pull/58794) изменения размера тома даже в тех случаях, когда он примонтирован.

Наконец, [были добавлены](https://github.com/kubernetes/features/issues/496) (и объявлены стабильными) **дополнительные метрики**, говорящие о внутреннем состоянии подсистемы хранения в Kubernetes и предназначенные для отладки, а также получения расширенного представления о состоянии кластера. Например, теперь для каждого тома (по `volume_plugin`) можно узнать общее время на операции mount/umount и attach/detach, общее время privision'а и удаления, а также количество томов в `ActualStateofWorld` и `DesiredStateOfWorld`, bound/unbound PVCs и PVs, количество используемых подами PVCs и др. Подробнее — см. [документацию](https://github.com/gnufied/community/blob/1a6217c00d01f4f24efb36bfc942df9592542e46/contributors/design-proposals/storage/additional-volume-metrics.md).

Kubelet, узлы и управление ими

------------------------------

*Kubelet* получил возможность настройки через **версионируемый конфигурационный файл** (вместо традиционного способа с флагами в командной строке), имеющий структуру `KubeletConfiguration`. Чтобы *Kubelet* подхватил конфиг, необходимо запускать его с флагом `--config` (подробности см. в [документации](https://kubernetes.io/docs/tasks/administer-cluster/kubelet-config-file/)). Такой подход называется рекомендуемым, поскольку упрощает разворачивание узлов и управление конфигурациями. Это стало возможным благодаря появлению группы API под названием `kubelet.config.k8s.io`, которая для релиза Kubernetes 1.10 имеет статус бета-версии. Пример конфигурационного файла для *Kubelet*:

```

kind: KubeletConfiguration

apiVersion: kubelet.config.k8s.io/v1beta1

evictionHard:

memory.available: "200Mi"

```

С помощью новой опции в спецификации пода, `shareProcessNamespace` в `PodSpec`, контейнеры теперь могут использовать **общее для пода пространство имён для процессов** *(PID namespace)*. Ранее этой возможности не было из-за отсутствия [необходимой поддержки](https://github.com/moby/moby/pull/22481) в Docker, что привело к появлению дополнительного API, который с тех пор используется некоторыми образами контейнеров… Теперь всё [унифицировали](https://github.com/kubernetes/community/blob/master/contributors/design-proposals/node/pod-pid-namespace.md), сохранив обратную совместимость. Результат реализации — поддержка трёх режимов разделения пространств имён PID в Container Runtime Interface (CRI): для каждого контейнера (т.е. свой namespace у каждого контейнера), для пода (общий namespace для контейнеров пода), для узла. Статус готовности — альфа.

Другое значимое изменение в CRI — появление поддержки **Windows Container Configuration**. До сих пор в CRI можно было конфигурировать только Linux-контейнеры, однако в спецификации исполняемой среды OCI (Open Container Initiative, [Runtime Specification](https://github.com/opencontainers/runtime-spec)) описаны и особенности других платформ — в частности, [Windows](https://github.com/opencontainers/runtime-spec/blob/master/config-windows.md). Теперь в CRI [поддерживаются](https://github.com/JiangtianLi/community/blob/6d08a8213318d63d8ab49fe326afdb6b49037e33/contributors/design-proposals/node/cri-windows.md) ограничения по ресурсам памяти и процессора для Windows-контейнеров (альфа-версия).

Кроме того, статуса бета-версии достигли три разработки Resource Management Working Group:

1. [CPU Manager](https://kubernetes.io/docs/tasks/administer-cluster/cpu-management-policies/) (назначение подам конкретных ядер процессора — подробнее о нём писали в [статье про K8s 1.8](https://habrahabr.ru/company/flant/blog/338230/));

2. [Huge Pages](https://kubernetes.io/docs/tasks/manage-hugepages/scheduling-hugepages/) (возможность использования подами 2Mi и 1Gi Huge Pages, что актуально для приложений, потребляющих большие объёмы памяти);

3. [Device Plugin](https://kubernetes.io/docs/concepts/cluster-administration/device-plugins/) (фреймворк для вендоров, позволяющий объявлять в *kubelet* ресурсы: например, от GPU, NIC, FPGA, InfiniBand и т.п. — без необходимости модифицировать основной код Kubernetes).

**Количество процессов, запущенных в поде**, теперь [можно ограничивать](https://github.com/kubernetes/kubernetes/pull/57973) с помощью параметра `--pod-max-pids` для консольной команды *kubelet*. Реализация имеет статус альфа-версии и требует включения фичи `SupportPodPidsLimit`.

Благодаря тому, что в containerd 1.1 появилась родная поддержка CRI v1alpha2, в Kubernetes 1.10 с containerd 1.1 можно работать напрямую, без необходимости в «посреднике» cri-containerd *(подробнее мы о нём писали в конце [этой статьи](https://habrahabr.ru/company/flant/blog/340010/))*. В CRI-O тоже обновили версию CRI до v1alpha2, а в сам CRI (Container Runtime Interface) добавили поддержку указания GID контейнера в `LinuxSandboxSecurityContext` и в `LinuxContainerSecurityContext` (в дополнение к UID) — поддержка реализована для *dockershim* и имеет статус альфа-версии.

Сеть

----

Опция с использованием CoreDNS вместо *kube-dns* достигла статуса бета-версии. В частности, это [принесло](https://github.com/kubernetes/website/pull/7638/files#diff-e1afcdac8d5e8458274b3c481c5ebcdaR33) возможность **миграции на CoreDNS** при апгрейде с помощью *kubeadm* кластера, использующего *kube-dns*: в этом случае *kubeadm* сгенерирует конфигурацию CoreDNS (т.е. `Corefile`) на основе `ConfigMap` из *kube-dns*.

Традиционно `/etc/resolv.conf` на поде управляется *kubelet*, а данные этого конфига генерируются на основе `pod.dnsPolicy`. В Kubernetes 1.10 (в статусе бета-версии) [представлена](https://github.com/kubernetes/features/issues/504) поддержка **конфигурации `resolv.conf` для пода**. Для этого в `PodSpec` добавлено поле `dnsParams`, которое позволяет переписывать имеющиеся настройки DNS. Подробнее — в [design-proposals](https://github.com/bowei/community/blob/eb79043a77170cc4e340d47f2835de5fb75d0d31/contributors/design-proposals/network/pod-resolv-conf.md). Иллюстрация использования `dnsPolicy: Custom` с `dnsParams`:

```

# Pod spec

apiVersion: v1

kind: Pod

metadata: {"namespace": "ns1", "name": "example"}

spec:

...

dnsPolicy: Custom

dnsParams:

nameservers: ["1.2.3.4"]

search:

- ns1.svc.cluster.local

- my.dns.search.suffix

options:

- name: ndots

value: 2

- name: edns0

```

В *kube-proxy* [добавлена](https://github.com/kubernetes/features/issues/539) опция, позволяющая определять **диапазон IP-адресов для `NodePort`**, т.е. инициировать фильтрацию допустимых значений с помощью `--nodeport-addresses` (со значением по умолчанию `0.0.0.0/0`, т.е. пропускать всё, чему соответствует нынешнее поведение `NodePort`). Предусмотрена [реализация](https://github.com/m1093782566/community/blob/beb68d448e09c307a3ac24146b7165e3fa2bcf02/contributors/design-proposals/network/nodeport-ip-range.md#kube-proxy-implementation-suport) в *kube-proxy* для iptables, Linux userspace, IPVS, Window userspace, winkernel. Статус — альфа-версия.

Аутентификация

--------------

Добавлены новые методы аутентификации (альфа-версия):

1. **внешние клиентские провайдеры**: отвечая на давние запросы пользователей K8s на exec-based plugins, в *kubectl* (client-go) [реализовали](https://github.com/kubernetes/features/issues/541) поддержку [исполняемых плагинов](https://github.com/ericchiang/community/blob/2bfa7e1e624a5c87cbd1d07566e617563e2280fd/contributors/design-proposals/auth/kubectl-exec-plugins.md), которые могут получать аутентификационные данные исполнением произвольной команды и чтением её вывода (плагин GCP тоже может быть настроен на вызов команд, отличных от *gcloud*). Один из вариантов применения — облачные провайдеры смогут создавать собственные системы аутентификации (вместо использования стандартных механизмов Kubernetes);

2. **TokenRequest API** для [получения](https://github.com/mikedanese/community/blob/5f9d2c45bd7dc45367eaae5dafb206609fd14c88/contributors/design-proposals/auth/bound-service-account-tokens.md) токенов JWT (JSON Web Tokens), привязанных к клиентам *(audience)* и времени.

Кроме того, стабильный статус [получила](https://github.com/kubernetes/features/issues/279) возможность ограничения доступа узлов к определённым API (с помощью режима авторизации `Node` и admission-плагина `NodeRestriction`) с целью выдавать им разрешение только на ограниченное число объектов и связанных с ними секретов.

CLI

---

Достигнут прогресс в **переработке вывода**, показываемого командами `kubectl get` и `kubectl describe`. Глобальная задача [инициативы](https://github.com/kubernetes/features/issues/515), получившей в Kubernetes 1.10 статус бета-версии, заключается в том, что получение столбцов для табличного отображения данных должно происходить на стороне сервера (а не клиента), — это делается с целью улучшить пользовательский интерфейс при работе с расширениями. Начавшаяся ранее (в K8s 1.8) работа на серверной стороне доведена до уровня беты, а также [были проведены](https://github.com/kubernetes/kubernetes/issues/58536) основные изменения на стороне клиента.

В *kubectl port-forward* добавлена [возможность](https://github.com/kubernetes/kubernetes/pull/59705) использования имени ресурса для выбора подходящего пода (и флаг `--pod-running-timeout` для ожидания, пока хотя бы один под будет запущен), а также [поддержка](https://github.com/kubernetes/kubernetes/pull/59809) указания сервиса для проброса порта (например: `kubectl port-forward svc/myservice 8443:443`).

Новые сокращённые имена для команд *kubectl*: `cj` вместо `CronJobs`, `crds` — `CustomResourceDefinition`. Например, стала доступна команда `kubectl get crds`.

Другие изменения

----------------

* [API Aggregation](https://github.com/kubernetes/features/issues/263), т.е. агрегация пользовательских apiservers с основным API в Kubernetes, получил стабильный статус и официально готов к использованию в production.

* *Kubelet* и *kube-proxy* теперь [могут запускаться](https://github.com/kubernetes/kubernetes/pull/60144) как родные службы в Windows. Добавлена поддержка Windows Service Control Manager (SCM) и экспериментальная [поддержка изоляции](https://github.com/kubernetes/kubernetes/pull/58751) с Hyper-V для подов с единственным контейнером.

* Функция *Persistent Volume Claim Protection* (`PVCProtection`), «защищающая» от возможного удаления PVCs, которые активно используются подами, переименована в `Storage Protection` и [доведена](https://github.com/kubernetes/kubernetes/pull/59052) до бета-версии.

* Альфа-версия [поддержки Azure](https://github.com/kubernetes/features/issues/514) в *cluster-autoscaler*.

Совместимость

-------------

* Поддерживаемая версия **etcd** — 3.1.12. При этом etcd2 в качестве бэкенда объявлена устаревшей, её поддержка будет удалена в релизе Kubernetes 1.13.

* Проверенные версии **Docker** — от 1.11.2 до 1.13.1 и 17.03.x (не изменились с релиза K8s 1.9).

* Версия **Go** — 1.9.3 (вместо 1.9.2), минимально поддерживаемая — 1.9.1.

* Версия **CNI** — 0.6.0.

P.S.

----

Читайте также в нашем блоге:

* «[Kubernetes 1.9: обзор основных новшеств](https://habrahabr.ru/company/flant/blog/344220/)»;

* «[Четыре релиза 1.0 от CNCF и главные анонсы про Kubernetes с KubeCon 2017](https://habrahabr.ru/company/flant/blog/344098/)»;

* «[Kubernetes 1.8: обзор основных новшеств](https://habrahabr.ru/company/flant/blog/338230/)»;

* «[Docker 17.06 и Kubernetes 1.7: ключевые новшества](https://habrahabr.ru/company/flant/blog/332160/)»;

* «[Инфраструктура с Kubernetes как доступная услуга](https://habrahabr.ru/company/flant/blog/341760/)». | https://habr.com/ru/post/353114/ | null | ru | null |

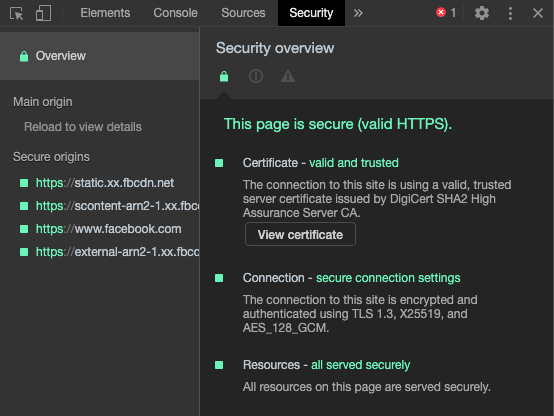

# Атаки на JSON Web Tokens

#### Содержание:

* Что такое JWT?

+ Заголовок

+ Полезная нагрузка

+ Подпись

+ Что такое SECRET\_KEY?

* Атаки на JWT:

+ Базовые атаки:

1. Нет алгоритма

2. Изменяем алгоритм с RS256 на HS256

3. Без проверки подписи

4. Взлом секретного ключа

5. Использование произвольных файлов для проверки

+ Продвинутые атаки:

1. SQL-инъекция

2. Параметр поддельного заголовка

3. Внедрение заголовка ответа HTTP

4. Прочие уязвимости

### Что такое JSON Web Token?

Веб-токен JSON обычно используется для авторизации в клиент-серверных приложениях. JWT состоит из трех элементов:

* Заголовок

* Полезная нагрузка

* Подпись

#### Заголовок

Это объект JSON, который представляет собой метаданные токена. Чаще всего состоит из двух полей:

* Тип токена

* Алгоритм хэширования

[Официальный сайт](https://jwt.io/introduction/) предлагает два алгоритма хэширования:

* «HS256»

* «RS256»

Но на самом деле любой алгоритм с приватным ключом может быть использован.

#### Полезная нагрузка

Это также объект JSON, который используется для хранения такой информации о пользователе, как:

* идентификатор

* имя пользователя

* роль

* время генерации токена и т.д.

#### Подпись

Это наиболее важная часть, поскольку она определяет целостность токена путем подписания заголовка и полезной нагрузки в кодировке Base64-URL, разделенных точкой (.) с секретным ключом. Например, чтобы сгенерировать токен с помощью алгоритма HS256, псевдокод будет таким:

```

// Use Base64-URL algorithm for encoding and concatenate with a dotdata = (base64urlEncode(header) + '.' + base64urlEncode(payload))// Use HS256 algorithm with "SECRET_KEY" string as a secretsignature = HMACSHA256(data , SECRET_KEY)// Complete token

JWT = data + "." + base64UrlEncode(signature)

```

#### Что такое SECRET\_KEY?

Как правило, JWT может быть сгенерирован с помощью двух механизмов шифрования, таких как:

* Симметричное

* Ассиметричное

**Симметричное шифрование:**

Этот механизм требует единственного ключа для создания и проверки JWT.

Например, пользователь "Vasya" сгенерировал JWT с «h1dd1n\_m1ss1g3» в качестве секретного ключа. Любой человек, знающий этот ключ, может с его помощью изменить токен. JWT при этом останется действительным.

*Самый распространенный алгоритм для этого типа — HS256.*

**Асимметричное шифрование:**

Этот механизм требует открытого ключа для проверки и закрытого ключа для подписи.

Например, если "Vasya" использовал это шифрование, то он единственный, кто может создать новый токен, используя закрытый ключ, тогда как "Petya" может только проверить токен с помощью открытого ключа, но не может его изменить.

*Наиболее распространенный алгоритм для этого типа — RS256.*

### Атаки на JWT

Чтобы подделать токен, необходимо иметь правильные ключи (например, секретный ключ для HS256, открытый и закрытый ключи для RS256), но если конфигурация JWT не реализована правильно, то есть много способов обойти элементы управления, которые позволяют изменить токен и получить несанкционированный доступ.

### Базовые атаки

Для выполнения всех этих атак нам понадобиться [JWT\_Tool](https://github.com/ticarpi/jwt_tool/)

#### 1. Нет алгоритма

Если приложению не удается проверить значение заголовка «alg», то мы можем изменить его значение на «none», и таким образом оно исключает необходимость действительной подписи для проверки. Например:

```

// Modified Header of JWT after changing the "alg" parameter{

"alg": "none",

"typ": "JWT"

}

```

**Команда:**

```

python3 jwt_tool.py -X a

```

Здесь jwt\_tool создал различные полезные нагрузки для использования этой уязвимости и обхода всех ограничений, пропустив раздел «Подпись».

#### 2. Изменяем алгоритм с RS256 на HS256

Как было сказано выше, алгоритму RS256 нужен закрытый ключ для подделки данных и соответствующий открытый ключ для проверки подлинности подписи. Но если мы сможем изменить алгоритм подписи с RS256 на HS256, мы заставим приложение использовать только один ключ для выполнения обеих задач, что является нормальным поведением алгоритма HMAC.

Таким образом рабочий процесс будет преобразован из асимметричного в симметричное шифрование. Теперь мы можем подписывать новые токены тем же открытым ключом.

**Команда:**

```

python3 jwt_tool.py -S hs256 -k public.pem

```

В данном случае мы сначала загружаем открытый ключ (public.pem) из приложения, а затем подписываем токен с помощью алгоритма HS256, используя этот ключ. Таким образом, мы можем создавать новые токены и вставлять полезную нагрузку в любое существующее утверждение.

#### 3. Без проверки подписи

Иногда при фаззинге данных в разделе заголовка и полезной нагрузки приложение не возвращает ошибку. Это значит, что подпись не проверяется после того, как она была подписана сервером авторизации. Таким образом, мы можем вставить любую полезную нагрузку в заявку, а токен всегда будет действительным.

**Команда:**

```

python3 jwt_tool.py -I -pc name -pv admin

```

Здесь часть подписи не проверяется, а значит можно смягчить утверждение «имени» в разделе полезной нагрузки, сделав себя «администратором».

#### 4. Взлом секретного ключа

Мы можем получить доступ к файлу SECRET\_KEY с помощью уязвимостей, таких как

* LFI

* XXE

* SSRF

Если это невозможно, то все равно можно провести другие атаки, чтобы проверить, использует ли токен какую-либо слабую секретную строку для шифрования.

*Для этой цели можно использовать расширение BurpSuite под названием JWT Heartbreaker.*

Такое раскрытие поставит под угрозу весь механизм безопасности, поскольку теперь мы можем генерировать произвольные токены с секретным ключом.

Но чтобы убедиться, что полученная нами строка является действительным ключом SECRET\_KEY или нет? Мы можем использовать функцию Crack в jwt\_tool.

**Команда:**

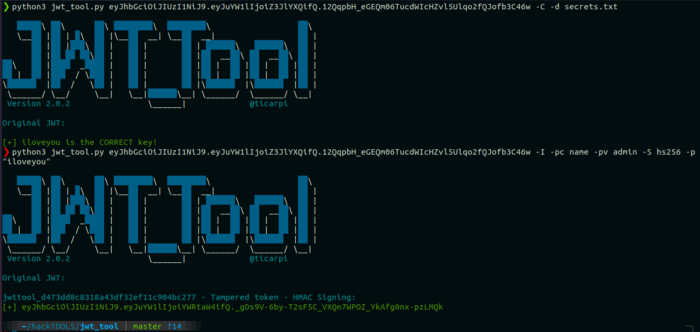

```

python3 jwt_tool.py -C -d secrets.txt

// Use -p flag for a string

```

#### 5. Использование произвольных файлов для проверки

Key ID (kid) – это необязательный заголовок, имеющий строковый тип, который используется для обозначения конкретного ключа, присутствующего в файловой системе или базе данных, а затем использования его содержимого для проверки подписи. Этот параметр полезен, если приложение имеет несколько ключей для подписи токенов, но может быть опасным, если он является инъекционным, поскольку в этом случае злоумышленник может указать на конкретный файл, содержимое которого предсказуемо.

Например, «/dev/null» называется нулевым файлом устройства и всегда ничего не возвращает, поэтому он отлично работает в системах на основе Unix.

**Команда:**

```

python3 jwt_tool.py -I -hc kid -hv "../../dev/null" -S hs256 -p ""

```

В качестве альтернативы можно использовать любой файл, присутствующий в корневом веб-каталоге, например, CSS или JS. Также можно использовать его содержимое для проверки подписи.

**Другое решение проблемы:**

```

python3 jwt_tool.py -I -hc kid -hv "путь / к / файлу" -S hs256 -p "Содержимое файла"

```

### Продвинутые атаки:

#### 1. SQL-инъекция

Эта уязвимость может возникнуть, если любой параметр, который извлекает какое-либо значение из базы данных, не очищается должным образом. Благодаря чему можно решать CTF задачи.

Например, если приложение использует алгоритм RS256, но открытый ключ виден в заявлении «pk» в разделе Payload, тогда можно преобразовать алгоритм подписи в HS256 и создавать новые токены.

**Команда для подсчета количества столбцов:**

```

python3 jwt_tool.py -I -pc name -pv "imparable' ORDER BY 1--" -S hs256 -k public.pem// Increment the value by 1 until an error will occur

```

#### 2. Параметр поддельного заголовка

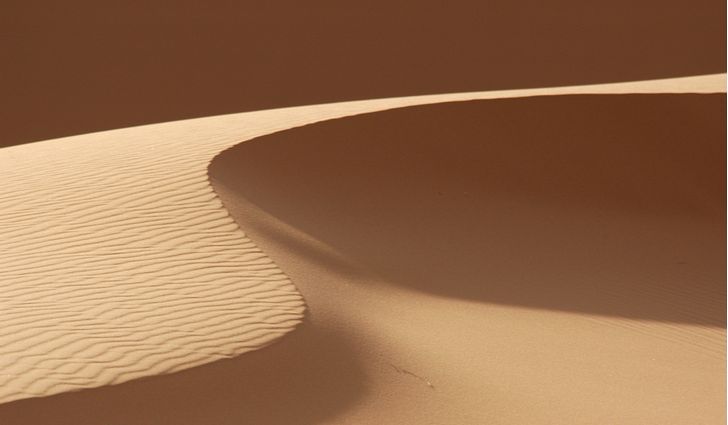

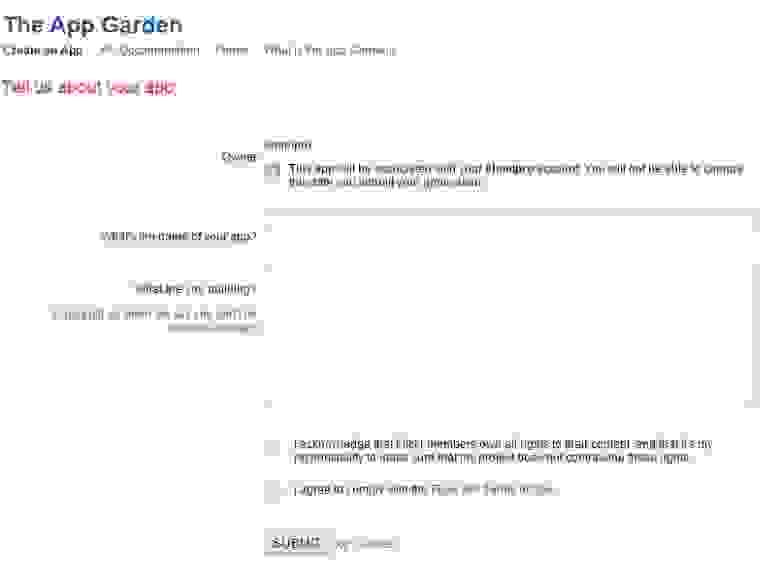

JSON Web Key Set (JWKS) — это набор открытых ключей, которые используются для проверки токена. Вот пример:

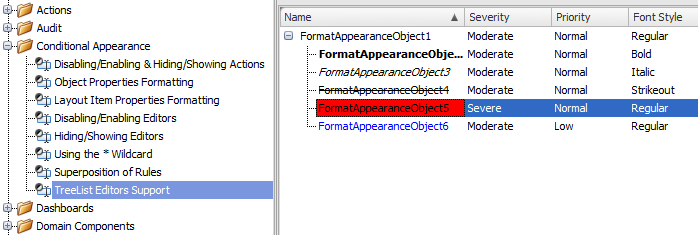

Этот файл хранится на доверенном сервере, приложение может указывать на этот файл через параметры заголовка:

* «jku»

* «x5u»

Но мы можем управлять URL-адресом с помощью таких уловок, как:

* открытый редирект

* добавление символа @ после имени хоста и т. д.

Затем мы можем перенаправить Приложение на наш вредоносный сервер вместо доверенного сервера и генерировать новые токены, так как мы контролируем как открытые, так и закрытые ключи.

**JSON Set URL (jku):**

Этот параметр указывает на набор открытых ключей в формате JSON (атрибуты **n** и **e** в **JWKS**), а «jwt\_tool» автоматически создает файл JWKS с именем «jwttool\_custom\_jwks.json» для этой атаки при первом запуске инструмента после установки.

**Команда:**

```

python3 jwt_tool.py -X s -ju "https://attacker.com/jwttool\_custom\_jwks.json"

```

**X.509 URL (x5u):**

Этот параметр указывает на сертификат открытого ключа X.509 или цепочку сертификатов (атрибут **x5c** в **JWKS**). Вы можете сгенерировать этот сертификат с соответствующим закрытым ключом следующим образом:

```

openssl req -newkey rsa:2048 -nodes -keyout private.pem -x509 -days 365 -out attacker.crt -subj "/C=AU/L=Brisbane/O=CompanyName/CN=pentester"

```

Здесь с использованием OpenSSL сертификат был создан в «attacker.crt», который теперь может быть встроен в файл JWKS с атрибутом «x5c», а его эксплуатация может осуществляться следующим образом:

```

python3 jwt_tool.py -S rs256 -pr private.pem -I -hc x5u -hv "https://attacker.com/custom\_x5u.json"

```

**Встроенные открытые ключи:**

Если сервер встраивает открытые ключи непосредственно в токен с помощью параметров «jwk» (JSON Web Key) или «x5c» (цепочка сертификатов X.509), попробуйте заменить их своими собственными открытыми ключами и подписать токен соответствующим закрытым ключом.

#### 3. Внедрение заголовка ответа HTTP

Предположим, что если приложение ограничивает любой управляемый URL-адрес в параметрах «jku» или «x5c», тогда мы можем использовать уязвимость внедрения заголовка ответа, чтобы добавить встроенный JWKS в ответ HTTP и заставить приложение использовать это для проверки подписи.

#### 4. Прочие уязвимости

Веб-токены JSON – это еще одна форма пользовательского ввода, все параметры в которой должны быть очищены должным образом, иначе это может привести к уязвимостям, таким как:

* LFI

* RCE и другим.

Но это не означает, что приложение по-прежнему безопасно, ведь, если злоумышленник не может подделать JWT, он попытается украсть их с помощью неправильной конфигурации:

* XSS

* CSRF

* CORS и т. д.

Удачных пентестов!

[](https://alexhost.com/ru/dedicated-servers/) | https://habr.com/ru/post/536364/ | null | ru | null |

# На что соглашается человек, когда разрешает все куки

Люди не читают инструкций. Вы почти наверняка не читали лицензионное соглашение Windows, не читали лицензионное соглашение iTunes, не читали условия Linux GPL или любого другого программного обеспечения.

Это нормально. Такова наша природа.

То же самое происходит в интернете. В последнее время благодаря GDPR и другим законам часто приходится видеть всплывающие сообщения, где вас спрашивают разрешения на использование cookies.

Большинство нажимает «Согласиться» — и продолжает жить как ни в чём ни бывало. Никто ведь не читает политику конфиденциальности, верно?

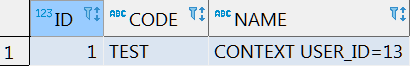

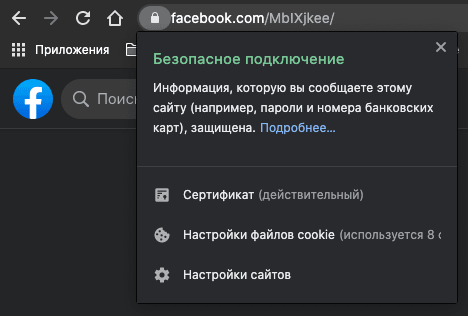

Разработчик Конрад Акунга (Conrad Akunga) [решил разобраться, какие конкретно условия предусмотрены соглашением об использовании](http://www.conradakunga.com/blog/what-do-you-actually-agree-to-when-you-accept-all-cookies/). Для примера он взял новостной сайт Reuters. Это абсолютно произвольный пример, у большинства других сайтов тоже есть свои правила.

Вот эти правила:

>

Обратите внимание на полосу прокрутки. Дальше идёт продолжение.

****Ещё шесть экранов с текстом**

**

Если вкратце, документ информирует пользователя о нескольких вещах:

* Что веб-сайт собирает и обрабатывает данные

* Что для этого он работает с различными партнёрами

* Что сайт хранит некоторые данные на вашем устройстве с помощью файлов cookie

* Что некоторые файлы cookie строго необходимы (определяется сайтом). Их нельзя отключить.

* Некоторые персональные данные могут быть проданы партнёрам для предоставления соответствующего контента

* Вы можете персонализировать рекламу, но не удалить её

Вероятно, все эти запутанные меню компания разработала, чтобы создать некую видимость прозрачности, открытости к диалогу. Но вы всё равно не можете отключить «основные» cookie, поскольку они нужны для работы сайта.

Вы также не можете полностью отключить рекламу. Таким образом, ваш единственный выбор — либо смотреть рекламу, выбранную случайным образом, либо рекламу, которая, по мнению провайдера, может иметь к вам какое-то отношение.

И ещё один пункт о партнёрах, которым продаются ваши персональные данные. Список партнёров общий для всех сайтов, которые сотрудничают с IAB.

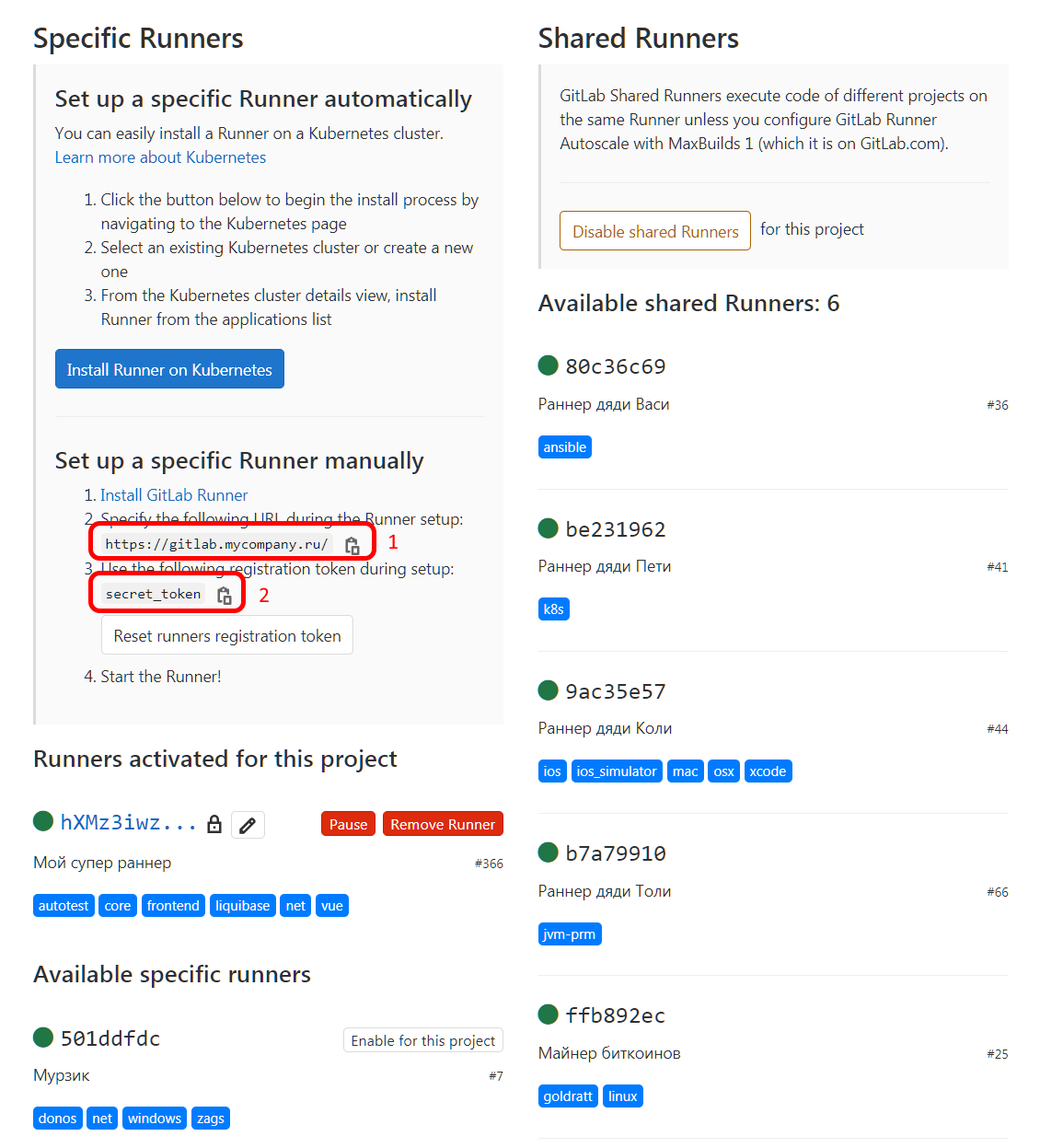

Кто же эти «партнёры»?

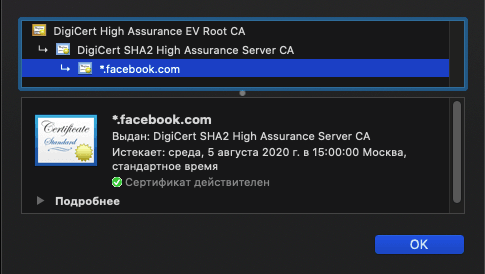

Если нажать на соответствующую кнопку, то появится следующее окно:

>

Обратите внимание, насколько маленький ползунок на полосе прокрутки. Наверное, там их сотни. Под названием каждой компании — ссылка на политику конфиденциальности.

>

Это не одна и та же ссылка, а разные! Каждая из них ведёт на уникальную политику конфиденциальности каждого партнёра. Сколько человек на самом деле пойдёт по этим ссылкам вручную, чтобы прочитать условия? Это просто нереально.

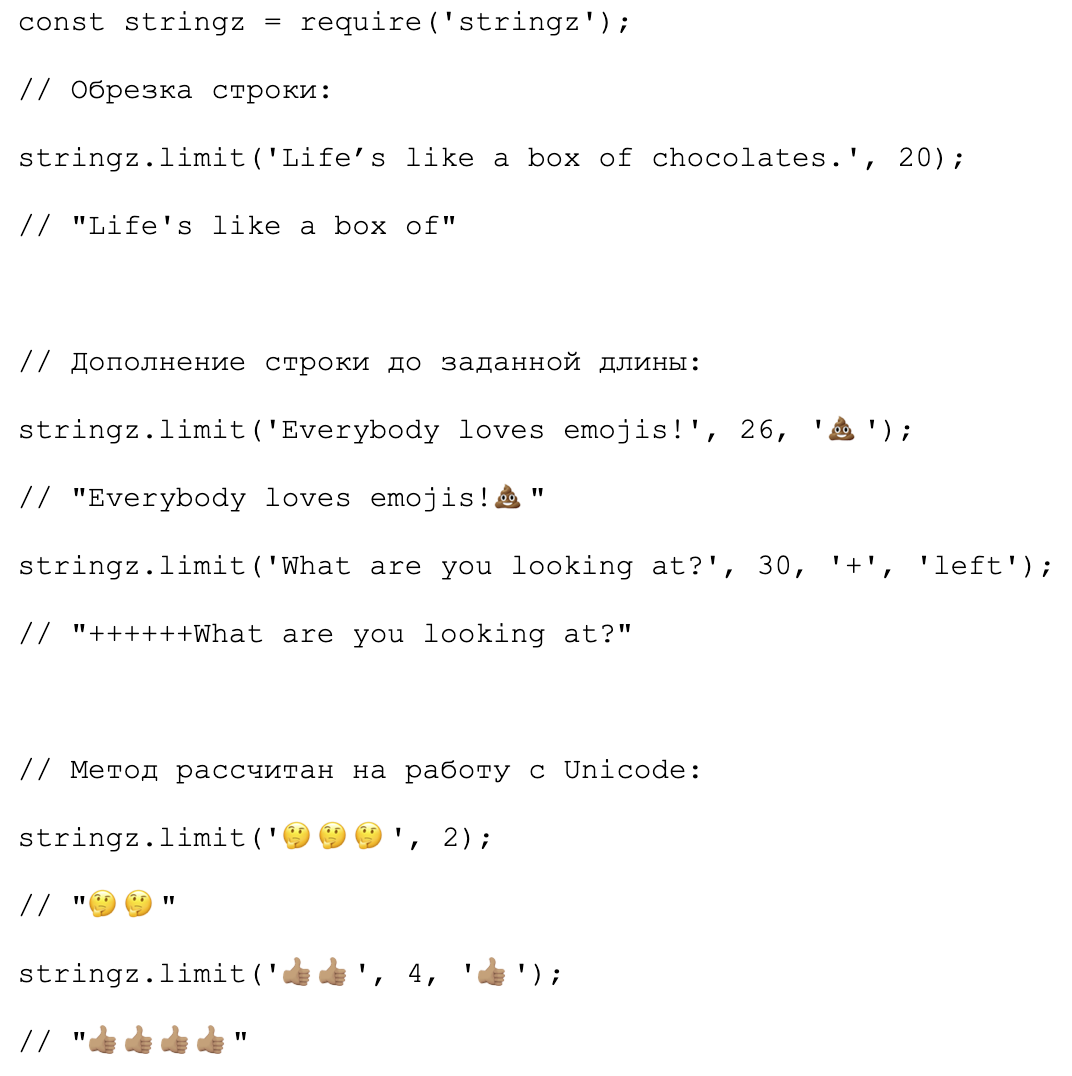

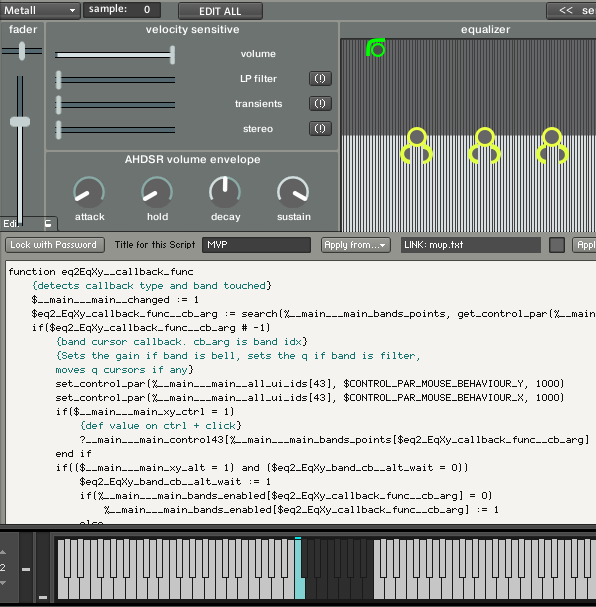

Конрад Акунга воспользовался инструментами разработчика Chrome, чтобы извлечь реальный список партнёров со ссылками на условия конфиденциальности каждого из них.

Скопированный список он вставил в VSCode — и получил огромный файл на 3835 строк, который после форматирования (`Alt + Shift + F`) разбился в чудовище на 54 399 строк.

Конрад написал программку, которая с помощью регулярных выражений извлекает нужные фрагменты данных — названия компаний с URL — и генерирует результат в формате Markdown по шаблону.

```

Log.Logger = new LoggerConfiguration()

.WriteTo.Console()

.CreateLogger();

// Define the regex to extact vendor and url

var reg = new Regex("\"vendor-title\">(?.\*?)<.\*?vendor-privacy-notice\".\*?href=\"(?.\*?)\"",

RegexOptions.Compiled);

// Load the vendors into a string, and replace all newlines with spaces to mitigate

// formatting issues from irregular use of the newline

var vendors = File.ReadAllText("vendors.html").Replace(Environment.NewLine, " ");

// Match against the vendors html file

var matches = reg.Matches(vendors);

Log.Information("There were {num} matches", matches.Count);

// extract the vendor number, name and their url, ordering by the name first.

var vendorInfo = matches.OrderBy(match => match.Groups["company"].Value)

.Select((match, index) =>

new

{

Index = index + 1,

Name = match.Groups["company"].Value,

URL = match.Groups["url"].Value

});

// Create a string builder to progressively build the markdown

var sb = new StringBuilder();

// Append headers

sb.AppendLine($"Listing As At 30 December 2020 08:10 GMT");

sb.AppendLine();

sb.AppendLine("|-|Vendor| URL |");

sb.AppendLine("|---|---|---|");

// Append the vendor details

foreach (var vendor in vendorInfo)

sb.AppendLine($"|{vendor.Index}|{vendor.Name}|[{vendor.URL}]({vendor.URL})|");

// Delete existing markdown file, if present

if (File.Exists("vendors.md"))

File.Delete("vendors.md");

//Write markdown to file

File.WriteAllText("vendors.md", sb.ToString());

```

В результате получился список всех партнёров, и у каждой — свой уникальный документ c условиями конфиденциальности. Вот этот список: [vendors.md](https://raw.githubusercontent.com/conradakunga/BlogCode/master/30%20Dec%202021%20-%20GDPR%20Data%20Vendors/vendors.md).

В нём **647 компаний**.

Очевидно, что *никто* не сможет ознакомиться со всеми этими условиями прежде, чем нажать кнопку «Согласиться», делает вывод автор.

Помните, что эти рекламные провайдеры предоставляют одни и те же услуги разным сайтам. Они однозначно идентифицируют браузер и устройство, поэтому могут анализировать и отслеживать ваши действия на разных сайтах для создания максимально точного профиля. На каждого якобы анонимного пользователя собираются [большие объёмы данных](https://privacyinternational.org/long-read/2433/i-asked-online-tracking-company-all-my-data-and-heres-what-i-found).

Код для парсинга из этой статьи [опубликован на Github](https://github.com/conradakunga/BlogCode/tree/master/30%20Dec%202021%20-%20GDPR%20Data%20Vendors). | https://habr.com/ru/post/544036/ | null | ru | null |

# Python как предельный случай C++. Часть 2/2

Продолжение. Начало в «[Python как предельный случай C++. Часть 1/2](https://habr.com/ru/post/464385/)».

Переменные и типы данных

========================

Теперь, когда мы окончательно разобрались с математикой, давайте определимся, что в нашем языке должны означать переменные.

В С++ у программиста есть выбор: использовать автоматические переменные, размещаемые в стеке, или держать значения в памяти данных программы, помещая в стек только указатели на эти значения. Что, если мы выберем для Python только одну из этих опций?

Разумеется, мы не можем всегда использовать только значения переменных, так как большие структуры данных не поместятся в стек, либо их постоянное перемещение по стеку создаст проблемы с производительностью. Поэтому мы будем использовать в Python только указатели. Это концептуально упростит язык.

Таким образом, выражение

```

a = 3

```

будет означать то, что мы создали в памяти данных программы (так называемой «куче») объект «3» и сделали имя “a” ссылкой на него. А выражение

```

b = a

```

в таком случае будет означать, что мы заставили переменную “b” ссылаться на тот же объект в памяти, на который ссылается “a”, иначе говоря − скопировали указатель.

Если всё является указателем, то сколько списочных типов нам нужно реализовать в нашем языке? Разумеется, только один − список указателей! Вы можете использовать его для хранения целых, строк, других списков, чего угодно − ведь всё это указатели.

Сколько типов хэш-таблиц нам нужно реализовать? (В Python этот тип принято называть «словарём» − `dict`.) Один! Пусть он связывает указатели на ключи с указателями на значения.

Таким образом, нам не нужно реализовывать в нашем языка огромную часть спецификации C++ − шаблоны, поскольку все операции мы производим над объектами, а объекты всегда доступны по указателю. Конечно же, программы, написанные на Python, не обязаны ограничиваться работой с указателями: существуют библиотеки вроде NumPy, при помощи которых учёные работают с массивами данных в памяти, как они бы делали это в Fortran. Но основа языка − выражения вроде “a = 3” − всегда работают с указателями.

Концепция «всё является указателем» также упрощает до предела композицию типов. Хотите список словарей? Просто создайте список и поместите туда словари! Не нужно спрашивать у Python разрешения, не нужно объявлять дополнительные типы, всё работает «из коробки».

А что, если мы хотим использовать составные объекты в качестве ключей? Ключ в словаре должен иметь неизменяемое значение, иначе как искать значения по нему? Списки могут изменяться, поэтому их нельзя использовать в данном качестве. Для подобных ситуаций в Python есть тип данных, который, аналогично списку, является последовательностью объектов, но, в отличие от списка, последовательность эта не изменяется. Этот тип называется кортеж или `tuple` (произносится как «тьюпл» или «тапл»).

Кортежи в Python решают давнюю проблему скриптовых языков. Если вас не впечатляет эта возможность, то вы, наверное, никогда не пытались использовать для серьёзной работы с данными скриптовые языки, в которых в качестве ключа в хэш-таблицах можно использовать только строки или только примитивные типы.

Другая возможность, которую дают нам кортежи − возврат из функции нескольких значений без необходимости объявлять для этого дополнительные типы данных, как это приходится делать в C и C++. Более того, чтобы было проще пользоваться данной возможностью, оператор присваивания был наделён возможностью автоматически распаковывать кортежи в отдельные переменные.

```

def get_address():

...

return host, port

host, port = get_address()

```

У распаковки есть несколько полезных побочных эффектов, например, обмен переменных значениями можно записать так:

```

x, y = y, x

```

Всё является указателем, значит, функции и типы данных могут использоваться как данные. Если вы знакомы с книгой «Паттерны проектирования» за авторством «Банды четырёх», вы должны помнить, какие сложные и запутанные способы она предлагает для того, чтобы параметризовать выбор типа объекта, создаваемого вашей программой во время выполнения. Действительно, во многих языках программирования это сложно сделать! В Python все эти сложности улетучиваются, поскольку мы знаем, что функция может вернуть тип данных, что и функции, и типы данных − это просто ссылки, а ссылки можно хранить, например, в словарях. Это упрощает задачу до предела.

Дэвид Вилер говорил: «Все проблемы в программировании решаются путём создания дополнительного уровня косвенности». Использование ссылок в Python − это тот уровень косвенности, который традиционно применяется для решения множества проблем во многих языках, в том числе и в C++. Но если там он используется явно, и это приводит к усложнению программ, то в Python он используется неявно, единоообразно в отношении данных всех типов, и дружественно к пользователю.

Но если всё является ссылками, то на что ссылаются эти ссылки? В языках вроде C++ есть множество типов. Давайте оставим в Python только один тип данных − объект! Специалисты в области теории типов неодобрительно качают головами, но я считаю, что один исходный тип данных, от которого производятся все остальные типы в языке − это хорошая идея, обеспечивающая единообразность языка и простоту его использования.

Что касается конкретного содержимого памяти, то различные реализации Python (PyPy, Jython или MicroPython) могут управлять памятью по-разному. Но, чтобы лучше понять, как именно реализуется простота и единообразность Python, сформировать правильную ментальную модель, лучше обратиться к эталонной реализации Python на языке C, называемой CPython, которую мы можем загрузить на сайте [python.org](https://python.org/).

```

struct {

struct _typeobject *ob_type;

/* followed by object’s data */

}

```

То, что мы увидим в исходном коде CPython − это структура, которая состоит из указателя на информацию о типе данной переменной и полезной нагрузки, которая определяет конкретное значение переменной.

Как же устроена информация о типе? Снова углубимся в исходный код CPython.

```

struct _typeobject {

/* ... */

getattrfunc tp_getattr;

setattrfunc tp_setattr;

/* ... */

newfunc tp_new;

freefunc tp_free;

/* ... */

binaryfunc nb_add;

binaryfunc nb_subtract;

/* ... */

richcmpfunc tp_richcompare;

/* ... */

}

```

Мы видим указатели на функции, которые обеспечивают выполнение всех операций, которые возможны для данного типа: сложение, вычитание, сравнение, доступ к атрибутам, индексирование, слайсинг и т. д. Эти операции знают, как работать с полезной нагрузкой, которая расположена в памяти ниже указателя на информацию о типе, будь то целое число, строка или объект типа, созданного пользователем.

Это радикальным образом отличается от C и C++, в которых информация о типе ассоциируется с именами, а не со значениями переменных. В Python все имена ассоциированы со ссылками. Значение по ссылке, в свою очередь, имеет тип. В этом и заключается суть динамических языков.

Чтобы реализовать все возможности языка, нам достаточно определить две операции над ссылками. Одна из них наиболее очевидна − это копирование. Когда мы присваиваем значение переменнной, слоту в словаре или атрибуту объекта, мы копируем ссылки. Это простая, быстрая и совершенно безопасная операция: копирование ссылок не изменяет содержимое объекта.

Вторая операция − это вызов функции или метода. Как мы показали выше, программа на Python может взаимодействовать с памятью только посредством методов, реализованных во встроенных объектах. Поэтому она не может вызвать ошибку, связанную с обращением к памяти.

У вас может возникнуть вопрос: если все переменные содержат ссылки, то как я могу защитить от изменений значение пременной, передав её функции как параметр?

```

n = 3

some_function(n)

# Q: I just passed a pointer!

# Could some_function() have changed “3”?

```

Ответ заключается в том, что простые типы в Python являются неизменяемыми: в них попросту не реализован тот метод, который отвечает за изменение их значения. Неизменяемые (иммутабельные) `int`, `float`, `tuple` или `str` обеспечивают в языках типа «всё является указателем» тот же семантический эффект, который в C обеспечивают автоматические переменные.

Унифицированные типы и методы максимально упрощают применение обобщённого программирования, или дженериков. Функции `min()`, `max()`, `sum()` и им подобные являются встроенными, нет нужды их импортировать. И они работают с любыми типами данных, в которых реализованы операции сравнения для `min()` и `max()`, сложения для `sum()` и т. д.

Создание объектов

=================

Мы выяснили в общих чертах, как должны вести себя объекты. Теперь определим, как мы будем их создавать. Это − вопрос синтаксиса языка. C++ поддерживает как минимум три способа создания объекта:

1. Автоматический, объявлением переменной данного класса:

```

my_class c(arg);

```

2. С помощью оператора `new`:

```

my_class *c = new my_class(arg);

```

3. Фабричный, при помощи вызова произвольной функции, возвращающей указатель:

```

my_class *c = my_factory(arg);

```

Как вы уже, наверное, догадались, изучив способ мышления создателей Python на вышеприведённых примерах, теперь мы должны выбрать один из них.

Из той же книги «Банды четырёх» мы узнали, что фабрика − это самый гибкий и универсальный способ создания объектов. Поэтому в Python реализован только этот способ.

Помимо универсальности, этот способ хорош тем, что для его обеспечения не нужно перегружать язык лишним синтаксисом: вызов функции уже реализован в нашем языке, а фабрика − это не что иное, как функция.

Другое правило создания объектов в Python таково: любой тип данных является собственной фабрикой. Конечно, вы можете написать сколько угодно дополнительных, кастомных фабрик (которые будут являться обычными функциями или методами, конечно же), но общее правило останется в силе:

```

# Let’s make type objects

# their own type’s factories!

c = MyClass()

i = int('7')

f = float(length)

s = str(bytes)

```

Все типы являются вызываемыми объектами, и все они возвращают значения своего типа, определяемые аргументами, переданными при вызове.

Таким образом, с использованием только базового синтаксиса языка, могут быть инкапсулированы любые манипуляции при создании объектов, вроде паттернов «Арена» или «Приспособленец», поскольку ещё одна замечательная идея, позаимствованная из C++, заключается в том, что тип сам определяет, как происходит порождение его объектов, как оператор `new` работает для него.

Как насчёт NULL?

================

Обработка пустого указателя добавляет программе сложности, так что мы объявим NULL вне закона. Синтакс Python не даёт возможности создать нулевой указатель. Две элементарные операции над указателями, о которых мы говорили ранее, определены таким образом, что любая переменная указывает на какой-то объект.

Как следствие этого, пользователь не может средствами языка Python создать ошибку, связанную с обращением к памяти, типа ошибки сегментации или выхода за границы буфера. Иными словами, программы на Python не подвержены двум самым опасным типам уязвимостей, которые угрожают безопасности Интернета в течение последних 20 лет.

Вы можете спросить: «Если структура операций над объектами неизменна, как мы видели ранее, то как же пользователи будут создавать собственные классы, с методами и атрибутами, не перечисленными в этой структуре?»

Магия заключена в том, что для пользовательских классов Python имеет очень простую «заготовку» с небольшим числом реализованных методов. Вот самые важные из них:

```

struct _typeobject {

getattrfunc tr_getattr;

setattrfunc tr_setattr;

/* ... */

newfunc tp_new;

/* ... */

}

```

`tp_new()` создаёт для пользовательского класса хэш-таблицу, такую же, как для типа `dict`. `tp_getattr()` извлекает что-то из этой хэш-таблицы, а `tp_setattr()`, наоборот, что-то туда кладёт. Таким образом, способность произвольных классов хранить любые методы и атрибуты обеспечивается не на уровне структур языка C, а уровнем выше − хэш-таблицей. (Разумеется, за исключением некоторых случаев, связанных с оптимизацией производительности.)

Модификаторы доступа

====================

Что же нам делать со всеми теми правилами и концепциями, которые в C++ построены вокруг ключевых слов `private` и `protected`? Python, будучи скриптовым языком, не нуждается в них. У нас уже есть «защищённые» части языка − это данные встроенных типов. Ни при каких условиях Python не позволит программе, например, манипулировать битами числа с плавающей запятой! Этого уровня инкапсуляции вполне достаточно, чтобы поддержать целостность самого языка. Мы, создатели Python, считаем, что целостность языка − это единственный хороший предлог для сокрытия информации. Все остальные структуры и данные пользовательской программы считаются публичными.

Вы можете написать символ подчёркивания (`_`) в начале имени атрибута класса, чтобы предупредить коллегу: на этот атрибут не стоит полагаться. Но в остальном Python выучил уроки начала 90-х: тогда многие верили в то, что основной причиной того, что мы пишем раздутые, нечитаемые и забагованные программы, является недостаток приватных переменных. Думаю, следующие 20 лет убедили всех в индустрии программирования: приватные переменные − это не единственное, и далеко не самое эффективное средство от раздутых и забагованных программ. Поэтому создатели Python решили даже не беспокоиться по поводу приватных переменных, и, как видите, не прогадали.

Управление памятью

==================

Что же происходит с нашими объектами, числами и строками на более низком уровне? Как именно они размещаются в памяти, как CPython обеспечивает совместный доступ к ним, когда и при каких условиях они уничтожаются?

И в этом случае мы выбрали наиболее общий, предсказуемый и производительный способ работы с памятью: со стороны C-программы все наши объекты − это [разделяемые указатели](https://en.cppreference.com/w/cpp/memory/shared_ptr).

С учётом этого знания те структуры данных, которые мы рассмотрели ранее, в части «Переменные и типы данных», должны быть дополнены следующим образом:

```

struct {

Py_ssize_t ob_refcnt;

struct {

struct _typeobject *ob_type;

/* followed by object’s data */

}

}

```

Итак, каждый объект в Python (мы имеем в виду реализацию CPython, разумеется) имеет свой счётчик ссылок. Как только он становится равным нулю, объект может быть удалён.

Механизм подсчёта ссылок не опирается на дополнительные вычисления или фоновые процессы − объект может быть уничтожен мгновенно. Кроме того, он обеспечивает высокую локальность данных: зачастую память снова начинает использоваться сразу после освобождения. Только что уничтоженный объект, скорее всего, недавно использовался, а значит, находился в кэше процессора. Поэтому и только что созданный объект останется в кэше. Эти два фактора − простота и локальность − делают подсчёт ссылок очень производительным способом сборки мусора.

(Из-за того, что объекты в реальных программах нередко ссылаются друг на друга, счётчик ссылок в определённых случаях не может опуститься до нуля, даже когда объекты больше не используются в программе. Поэтому в CPython есть и второй механизм сбора мусора − фоновый, основанный на поколениях объектов. − *прим. перев.*)

Ошибки разработчиков Python

===========================

Мы старались разработать язык, который будет достаточно прост для новичков, но и достаточно привлекателен для профессионалов. При этом нам не удалось избежать ошибок в понимании и использовании инструментов, которые мы сами и создали.

Python 2 из-за инерции мышления, связанной со скриптовыми языками, пытался преобразовывать строковые типы, как делал бы это язык с нестрогой типизацией. Если вы попытаетесь объединить байтовую строку со строкой в Unicode, интерпретатор неявно преобразует байтовую строку в Unicode при помощи той кодовой таблицы, которая имеется в данной системе, и представит результат в Unicode:

```

>>> 'byte string ' + u'unicode string'

u'byte string unicode string'

```

В результате некоторые веб-сайты отлично работали, пока их пользователи использовали английский язык, но выдавали загадочные ошибки при использовании символов других алфавитов.

Эта ошибка проектирования языка была исправлена в Python 3:

```

>>> b'byte string ' + u'unicode string'

TypeError: can't concat bytes to str

```

Похожая ошибка в Python 2 была связана с «наивной» сортировкой списков, состоящих из несравнимых элементов:

```

>>> sorted(['b', 1, 'a', 2])

[1, 2, 'a', 'b']

```

Python 3 в этом случае даёт пользователю понять, что тот пытается сделать что-то не слишком осмысленное:

```

>>> sorted(['b', 1, 'a', 2])

TypeError: unorderable types: int() < str()

```

Злоупотребления

===============

Пользователи и сейчас иногда злоупотребляют динамической природой языка Python, а тогда, в 90-х, когда лучшие практики ещё не были широко известны, это происходило особенно часто:

```

class Address(object):

def __init__(self, host, port):

self.host = host

self.port = port

```

«Но это же неоптимально!» − говорили некоторые, − «Что, если порт не отличается от дефолтного значения? Мы всё равно тратим на его хранение целый атрибут класса!» И в результате получалось что-то вроде

```

class Address(object):

def __init__(self, host, port=None):

self.host = host

if port is not None: # so terrible

self.port = port

```

Так в программе появляются объекты одного типа, с которыми, тем не менее, нельзя работать единообразно, так как одни из них имеют некий атрибут, а другие − нет! И мы не можем прикоснуться к этому атрибуту, не проверив заранее его наличие:

```

# code was forced to use introspection

# (terrible!)

if hasattr(addr, 'port'):

print(addr.port)

```

В настоящее время обилие `hasattr()`, `isinstance()` и прочей интроспекции является верным признаком плохого кода, а лучшей практикой считается делать атрибуты всегда присутствующими в объекте. Это обеспечивает более простой синтаксис при обращении к нему:

```

# today’s best practice:

# every atribute always present

if addr.port is not None:

print(addr.port)

```

Так, ранние эксперименты с динамически добавляемыми и удаляемыми атрибутами завершились, и теперь мы рассматриваем классы в Python примерно так же, как и в C++.

Другой дурной привычкой раннего Python было использование функций, в которых аргумент может иметь совершенно разные типы. Например, вы можете подумать, что для пользователя может быть слишком сложно создавать каждый раз список с именами колонок, и сто́ит разрешить ему передавать их также в виде одной строки, где имена отдельных колонок разделены, скажем, запятой:

```

class Dataframe(object):

def __init__(self, columns):

if isinstance(columns, str):

columns = columns.split(',')

self.columns = columns

```

Но такой подход может породить свои проблемы. Например, что, если пользователь случайно передаст нам строку, которая не предназначена для того, чтобы быть использована как список имён колонок? Или если имя колонки должно содержать запятую?

Также такой код сложнее поддерживать, отлаживать, и особенно тестировать: в тестах может быть предусмотрена проверка только одного из двух поддерживаемых нами типов, но покрытие всё равно составит 100%, и мы не протестируем другой тип.

В итоге мы пришли к тому, что Python даёт пользователю возможность передавать функции аргументы какого угодно типа, но большинство из них в большинстве ситуаций будут использовать функцию так же, как они делали бы это в C: передавать ей аргумент одного типа.

Необходимость использования `eval()` в программе считается явным архитектурным просчётом. Скорее всего, вы просто не сообразили, как сделать то же самое нормальным способом. Но в некоторых случаях − например, если вы пишете программу типа Jupyter notebook или онлайн-песочницу для запуска и тестирования пользовательского кода − использование `eval()` вполне оправдано, и в этом типе задач Python проявляет себя великолепно! Действительно, реализовать нечто подобное на C++ было бы намного сложнее.

Как мы уже показали выше, интроспекция (`getattr()`, `hasattr()`, `isinstance()`) не всегда является хорошим средством для выполнения типичных пользовательских задач. Но эти возможности, тем не менее, встроены в язык, и они просто сверкают в ситуациях, когда наш код должен описывать сам себя: логгирование, тестирование, статическая проверка, отладка!

Эра консолидации

================

В заключение мне хочется отметить следующее: мы живём в такое время, когда лучшие практики разработки на различных языках проявляют тенденцию к консолидации. 20 лет назад я не смог бы даже упомянуть разделяемые указатели в контексте того, что объединяет C++ и Python. А сегодня сообщества, сформировавшиеся вокруг разных языков программирования, свободно обмениваются лучшими практиками. И это изменение произошло в течение девяностых и нулевых.

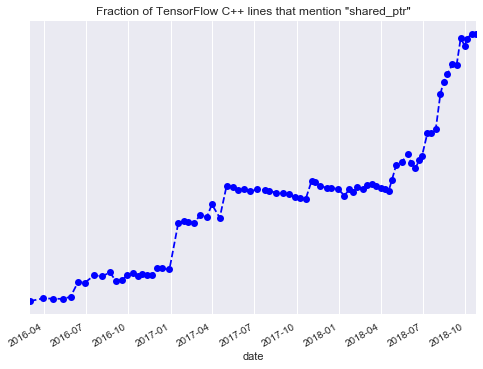

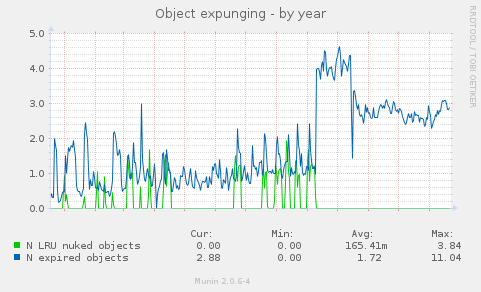

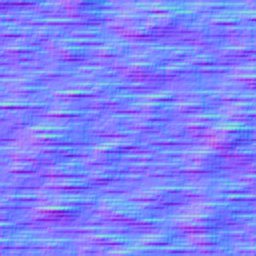

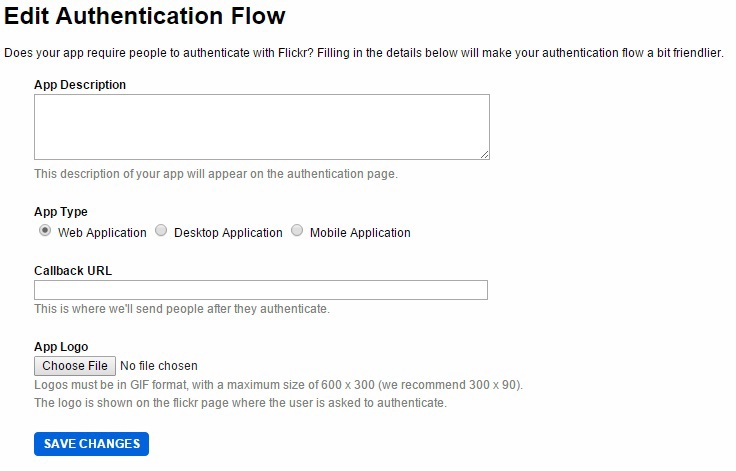

Чтобы получить количественные измерения в подтверждение моей гипотезы, я мониторил использование `shared_ptr` в TensorFlow примерно с 2016 по 2018 год.

TensorFlow − это большой и во многом образцовый C++-проект, но большинство программистов знают его лишь в качестве Python-библиотеки (а C++ − в качестве сборочной системы TensorFlow, наверное).

На диаграмме по вертикали изображено соотношение строк кода TensorFlow, использующих `shared_ptr`, к общему числу строк кода. В лучших традициях Кремниевой долины, этот график направлен строго вверх.

Так куда же направляется современный C++? В начале мы говорили о предельных случаях. Что происходит на графике, который мы видим? Если время стремится к бесконечности, то всё становится разделёнными указателями, и C++ становится Python! | https://habr.com/ru/post/464405/ | null | ru | null |

# Upgrade Viola Jones

В [моём предыдущем топике](http://habrahabr.ru/blogs/algorithm/133826/) я старался показать, как метод Viola Jones работает, с помощью каких технологий и внутренних алгоритмов. В данном посте, дабы не прерывать цепочку, будет также много теории, будет показано *за счет чего* можно улучшить и до того прекрасный метод. Если здесь описать еще и *программную реализацию*, то будет огромное полотно, которое читать будет очень неудобно, и смотреться это никак не будет — решено разбить объем информации на два отдельных поста. Ниже — теория, мало картинок, но много полезного.

### Возникающие проблемы на этапах распознавания эмоций

Человек даже не замечает, как он просто справляется с задачами обнаружения лиц и эмоций при помощи своего зрения. Когда глаз смотрит на окружающие лица людей, предметы, природу, подсознательно не чувствуется, какой объем работы проделывает мозг, чтобы обработать весь поток визуальной информации. Человеку не составит труда найти знакомого человека на фотографии, или отличить ехидную гримассу от улыбки.

Человек пытается *воссоздать и построить* компьютерную систему обнаружения лиц и эмоций — ему это отчасти удается, но каждый раз приходится сталкиваться с большими проблемами при распознавании. Компьютеры в наше время беспрепятственно могут хранить огромные объемы информации, картинки, видео- и аудио файлы. Но отыскать вычислительным системам с такой же легкостью, к примеру, нужную фотографию с определенной эмоцией нужного человека из собственной личной фотогалереи — сложная задача. Решению такой задачи мешают некоторые **факторы**:

* Разный размер искомых объектов, а также масштаб изображений;

* Определяемый объект может находиться где угодно на изображении;

* Совершенно другой объект может быть похож на искомый;

* Предмет, который мы воспринимаем как что-то отдельное, на изображении никак не выделен, и находится на фоне других предметов, сливается с ними;

* Старые и необработанные фотографии — на них всегда присутствуют «отвлекающие» систему царапины, помехи, искажения, а на сканируемых фото нередко появляются разного рода [муары](http://ru.wikipedia.org/wiki/%D0%9C%D1%83%D0%B0%D1%80_%D0%BC%D0%BD%D0%BE%D0%B3%D0%BE%D0%BA%D1%80%D0%B0%D1%81%D0%BE%D1%87%D0%BD%D0%BE%D0%B9_%D0%BF%D0%B5%D1%87%D0%B0%D1%82%D0%B8);

* Не стоит забывать, что во многих алгоритмах распознавания (также и в Виола-Джонс) работа идет с 2D-пространстве непосредственно. Поэтому поворот искомого объекта и изменение угла обзора относительно заданных координатных осей проекции влияют на его проекцию в 2D. Один и тот же объект может давать совершенно разную картинку, в зависимости от поворота или расстояния до него. Искомое лицо может быть повернуто в плоскости изображения. Даже относительно небольшое изменение ориентации лица относительно камеры влечет за собой серьезное изменение изображения лица и о распознании мимики данного лица уже и речи быть не может;

* Качество изображения или кадра: засветы и неправильный [баланс белого](http://ru.wikipedia.org/wiki/%D0%91%D0%B0%D0%BB%D0%B0%D0%BD%D1%81_%D0%B1%D0%B5%D0%BB%D0%BE%D0%B3%D0%BE_%D1%86%D0%B2%D0%B5%D1%82%D0%B0), цветокоррекция и другие параметры безусловно влияют на распознавание объекта;

* Расовая принадлежность людей: цвет кожи, расположение и размеры отдельных распознаваемых признаков;

* Сильное изменение выражения лица. Например, чересчур показное действо может сильно оказать влияние на правильное распознавание определенной эмоции;

* Индивидуальные особенности лица человека, такие как усы, борода, очки, морщины, существенно осложняют автоматическое распознавание;

* Часть лица вообще может быть невидима или обрезана;

* Лица может не быть совсем на фотографии, но машина, как ей кажется, правильно определяет другие объекты за лицо и черты лица и детектирует именно их.

Список можно продолжать еще долго. Но внимание заострено на самых важных моментах, поэтому перечислять все мешающие параметры нет смысла.

### Критерии выбора метода в задаче распознавания эмоций

Сравнение качества распознавания разнообразных методов осложнено многими причинами. Одна из них, и самая весомая – это то, что в большинстве случаев опираться можно только на данные испытаний, предоставляемые самими авторами, так как проведение крупномасштабного исследования по реализации большинства известных методов и сравнения их между собой на едином наборе изображений не представляется возможным:

* необходима универсальная коллекция тестовых данных;

* должны присутствовать одинаковые наборы данных;

* необходимы вычислительная мощность — ресурсы уровня одной лаборатории для этого малы;

* высокая трудоемкость исследования данных алгоритмов;

* на основе информации, предоставляемой авторами методов, также сложно провести корректное сравнение, поскольку проверка методов часто производится на разных наборах изображений, с разной формулировкой условий успешного и неуспешного обнаружения. К тому же проверка для многих методов первой категории производилась на значительно меньших наборах изображений.

*Основные моменты*, влияющие на выбор метода решения задачи, и *условия критериев* выявлены следующие (в процессе разработки интересуют те, которые выделены курсивом, наиболее оптимальные):

• ограничения на лица:

— ограниченный, предопределенный набор людей;

— ограничения на возможную расу людей либо на характерные отличия на лице (к примеру, растительность на лице, очки);

— *отсутствие ограничений*.