text

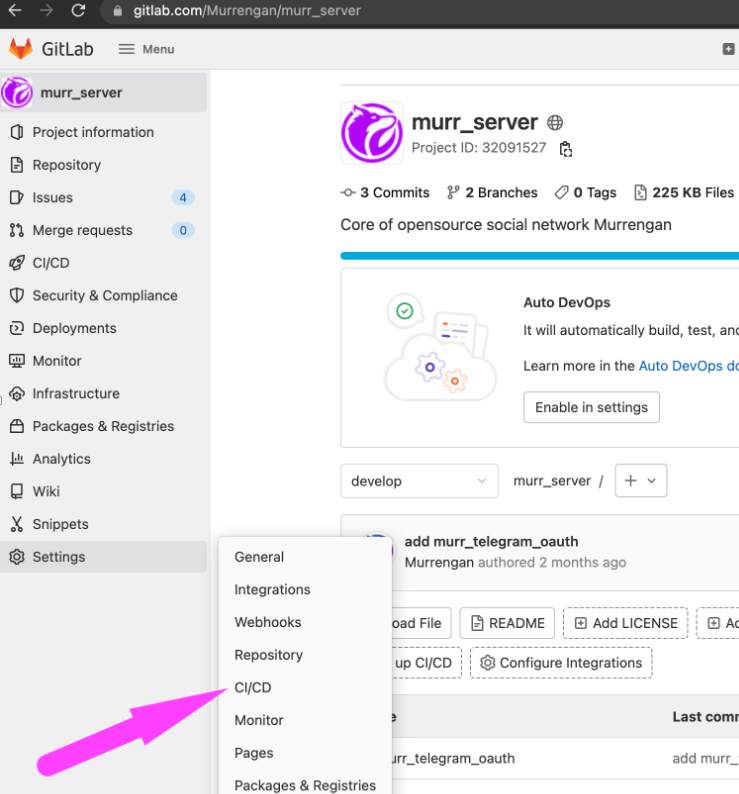

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

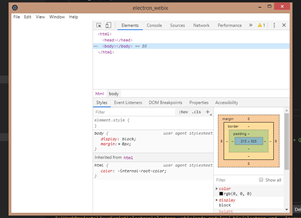

# Чисто-функциональный REST API на Finagle/Finch

История библиотеки [Finch](https://github.com/finagle/finch) началась около года назад «в подвалах» [Конфеттина](http://konfettin.ru/), где мы пытались сделать REST API на [Finagle](http://twitter.github.io/finagle/). Не смотря на то, что finagle-http сам по себе очень хороший инструмент, мы стали ощущать острую нехватку более богатых абстракциий. Кроме того, у нас были особые требования к этим самым абстракциям. Они должны были быть неизменяемыми (immutable), легко композируемыми (composable) и в тоже время очень простыми. Простыми как функции. Так появилась библиотека Finch, которая представляет собой очень тонкий слой функций и типов поверх finagle-http, который делает разработку HTTP (micro|nano)-сервисов на finagle-http более приятной и простой.

Шесть месяцев назад [вышла первая стабильная версия](https://groups.google.com/forum/#!msg/finaglers/HRsfl4st8IQ/JjYZMpM9yIwJ) библиотеки, а буквально на днях [вышла версия 0.5.0](https://github.com/finagle/finch/releases/tag/0.5.0), которую я лично считаю pre-alpha 1.0.0. За это время [6 компаний](https://github.com/finagle/finch#adopters) (три из них еще не в официальном списке: [Mesosphere](http://mesosphere.com/), [Shponic](http://www.sphonic.com/) и [Globo.com](http://globo.com)) начали использовать Finch в production, а некоторые из них даже стали активными контрибьюторами.

Этот пост рассказывает о трех китах на которых построен Finch: `Router`, `RequestReader` и `ResponseBuilder`.

`Router`

--------

Пакет `io.finch.route` реализует route combinators API, который позволяет строить бесконечное количество роутеров, комбинируя их из примитивных роутеров, доступных из коробки. Такой же подход используют [Parser Combinators](http://www.scala-lang.org/api/2.10.2/index.html#scala.util.parsing.combinator.Parsers) и [scodec](https://github.com/scodec/scodec).

В некотором смысле `Router[A]` — это функция `Route => Option[(Route, A)]`. `Router` принимает абстрактный маршрут `Route` и возвращает `Option` от оставшегося маршрута и извлеченное значение типа `A`. Иными словами, `Router` возвращает `Some(...)` в случае успеха (если запрос удалось смаршрутизировать).

Есть всего 4 базовых роутера: `int`, `long`, `string` и `boolean`. Кроме того, есть роутеры, которые не извлекают значение из маршрута, а просто сопоставляют его с образцом (например, роутеры для HTTP методов: `Get`, `Post`).

Следующий пример показывает API для композиции роутеров. Роутер `router` маршрутизирует запросы вида `GET /(users|user)/:id` и извлекает из маршрута целое значение `id`. Обратите внимание на оператор `/` (или `andThen`), c помощью которого мы последовательно композируем два роутера, а также на оператор `|` (или `orElse`), который позволяет композировать два роутера в терминах логического `or`.

```

val router: Router[Int] => Get / ("users" | "user") / int("id")

```

Если роутеру требуется извлечь несколько значений, можно использовать специальный тип `/`.

```

case class Ticket(userId: Int, ticketId: Int)

val r0: Router[Int / Int] = Get / "users" / int / "tickets" / int

val r1: Router[Ticket] = r0 map { case a / b => Ticket(a, b) }

```

Есть специальный тип роутеров, которые извлекают из маршрута сервис (Finagle `Service`). Такие роутеры называются endpoints (на самом деле, `Endpoint[Req, Rep]` — это всего лишь type alias на `Router[Service[Req, Rep]]`). `Endpoint`-ы могут быть неявно (implicitly) конвертированы в Finagle сервисы (`Service`), что позволяет их прозрачно использовать с Finagle HTTP API.

```

val users: Endpoint[HttpRequest, HttpResponse] =

(Get / "users" / long /> GetUser) |

(Post / "users" /> PostUser) |

(Get / "users" /> GetAllUsers)

Httpx.serve(":8081", users)

```

`RequestReader`

---------------

Абстракция `io.finch.request.RequestReader` является ключевой в Finch. Очевидно, что бОльшая часть REST API (без учета бизнес логики) — это чтение и валидация параметров запроса. Этим и занимается `RequestReader`. Как и все в Finch, `RequestReader[A]` — это функция `HttpRequest => Future[A]`. Таким образом, `RequestReader[A]` принимает HTTP запрос и читает из него некоторое значение типа `A`. Результат помещается во `Future`, в первую очередь для того, чтобы представлять этап чтения параметров как дополнительную `Future`-трансформацию (как правило, первую) в data-flow сервиса. Поэтому, если `RequestReader` вернет `Future.exception`, никакие дальнейшие трансформации не будут выполнены. Такое поведение крайне удобно в 99% случаях, когда сервис не должен делать никакую реальную работу если один из его параметров невалиден.

В следующем примере `RequestReader` `title` читает обязательный query-string параметр «title» или возвращает исключение `NotPresent` в случае если парамер отсутствует в запросе.

```

val title: RequestReader[String] = RequiredParam("title")

def hello(name: String) = new Service[HttpRequest, HttpResponse] {

def apply(req: HttpRequest) = for {

t <- title(req)

} yield Ok(s"Hello, $t $name!")

}

```

Пакет `io.finch.request` предоставляет богатый набор встроенных `RequestReader`-ов для чтения различной информации из HTTP запроса: начиная от query-string параметров и заканчивая cookies. Все доступные `RequestReader`-ы делятся на две группы — обязательные (required) и необязательные (optional). Обязательные ридеры читают значение или исключение `NotPresent`, необязательные — `Option[A]`.

```

val firstName: RequestReader[String] = RequiredParam("fname")

val secondName: RequestReader[Option[String]] = OptionalParam("sname")

```

Как и в случае с route combinators, `RequestReader` предоставляет API, с помощью которого можно композировать два ридера в один. Таких API два: monadic (используя `flatMap`) и applicative (используя `~`). В то время как monadic syntax выглядит знакомо, крайне рекомендуется использовать applicative syntax, который позволяет накапливать ошибки, в то время как fail-fast природа монад возвращает только первую из них. Пример ниже показывает оба способа композиции ридеров.

```

case class User(firstName: String, secondName: String)

// the monadic style

val monadicUser: RequestReader[User] = for {

firstName <- RequiredParam("fname")

secondName <- OptionalParam("sname")

} yield User(firstName, secondName.getOrElse(""))

// the applicate style

val applicativeUser: RequestReader[User] =

RequiredParam("fname") ~ OptionalParam("sname") map {

case fname ~ sname => User(fname, sname.getOrElse(""))

}

```

Кроме всего прочего, `RequestReader` позволяет читать из запроса значения типов, отличных от String. Можно конвертировать читаемое значение с помощью метода `RequestReader.as[A]`.

```

case class User(name: String, age: Int)

val user: RequestReader[User] =

RequiredParam("name") ~

OptionalParam("age").as[Int] map {

case name ~ age => User(fname, age.getOrElse(100))

}

```

В основе магии метода `as[A]` лежит implicit параметр типа `DecodeRequest[A]`. Type-class `DecodeRequest[A]` несет информацию о том, как из `String` можно получить тип `A`. В случае ошибки конверсии `RequestReader` прочитает `NotParsed` exception. Из коробки поддерживаются конверсии в типы `Int`, `Long`, `Float`, `Double` и `Boolean`.

Таким же способом реализована поддержка JSON в `RequestReader`: мы можем использовать метод `as[Json]`, если для `Json` есть реализация `DecodeRequest[Json]` в текущей области видимости. В примере ниже `RequestReader` `user` читает пользователя, который сериализован в формате JSON в body HTTP запроса.

```

val user: RequestReader[Json] = RequiredBody.as[Json]

```

С учетом поддержки JSON библиотеки [Jackson](http://jackson.codehaus.org/), чтение JSON объектов с помощью `RequestReader`-а сильно упрощается.

```

import io.finch.jackson._

case class User(name: String, age: Int)

val user: RequestReader[User] = RequiredBody.as[User]

```

Валидация параметров запроса осуществляется с помощью методов `RequestReader.should` и `RequestReader.shouldNot`. Есть два способа валидации: с помощью inline правил и с помощью готовых `ValidationRule`. В примере ниже, ридер `age` читает параметр «age» при условии, что он больше 0 и меньше 120. В противном случае ридер прочитает исключение `NotValid`.

```

val age: RequestReader[Int] = RequiredParam("age").as[Int] should("be > than 0") { _ > 0 } should("be < than 120") { _ < 120 }

```

Пример выше можно переписать в более лаконичном стиле, используя готовые правила из пакета `io.finch.request` и композиторы `or`/`and` из `ValidationRule`.

```

val age: RequestReader[Int] = RequiredParam("age").as[Int] should (beGreaterThan(0) and beLessThan(120))

```

`ResponseBuilder`

-----------------

Пакет `io.finch.response` предоставляет простой API для построения HTTP ответов. Общей практикой считается использовать конкретный `ResponseBuilder`, соответствующий статус-коду ответа, например, `Ok` или `Created`.

```

val response: HttpResponse = Created("User 1 has been created") // plain/text response

```

Важной абстракцией пакета `io.finch.response` является type-class `EncodeResponse[A]`. `ResponseBuilder` способен строить HTTP ответы из любого типа `A`, если для него есть implicit значеие `EncodeResponse[A]` в текущей области видимости. Так реализованна поддержка JSON в `ResponseBuilder`: для каждой поддерживаемой библиотеки есть реализация `EncodeResponse[A]`. Следующий код показывает интеграцию со стандартной JSON реализацией из модуля `finch-json`.

```

import io.finch.json._

val response = Ok(Json.obj("name" -> "John", "id" -> 0)) // application/json response

```

Таким образом, можно расширить функционал `ResponseBuilder`-а, добавив в текущую области видимости implicit значение `EncodeResponse[A]` для нужного типа. Например, для типа `User`.

```

case class User(id: Int, name: String)

implicit val encodeUser = EncodeResponse[User]("applciation/json") { u =>

s"{\"name\" : ${u.name}, \"id\" : ${u.id}}"

}

val response = Ok(User(10, "Bob")) // application/json response

```

Заключение

----------

Finch — очень молодой проект, который определенно не является «серебряной пулей» лишенной «критических недостатков». Это лишь инструмент, который некоторые разработчики считают эффективным для задач, над которыми они работают. Надеюсь, что эта публикация станет отправной точкой для русскоговорящих программистов, решивших использовать/попробовать Finch в своих проектах.

* [Finch на GitHub](https://github.com/finagle/finch)

* [Пост в блоге Finagle](https://finagle.github.io/blog/2014/12/10/rest-apis-with-finch)

* [Демо](https://github.com/finagle/finch/tree/master/demo/src/main/scala/io/finch/demo)

* [User Guide](https://github.com/finagle/finch/blob/master/docs/index.md)

* [Gitter чат](https://gitter.im/finagle/finch) | https://habr.com/ru/post/250591/ | null | ru | null |

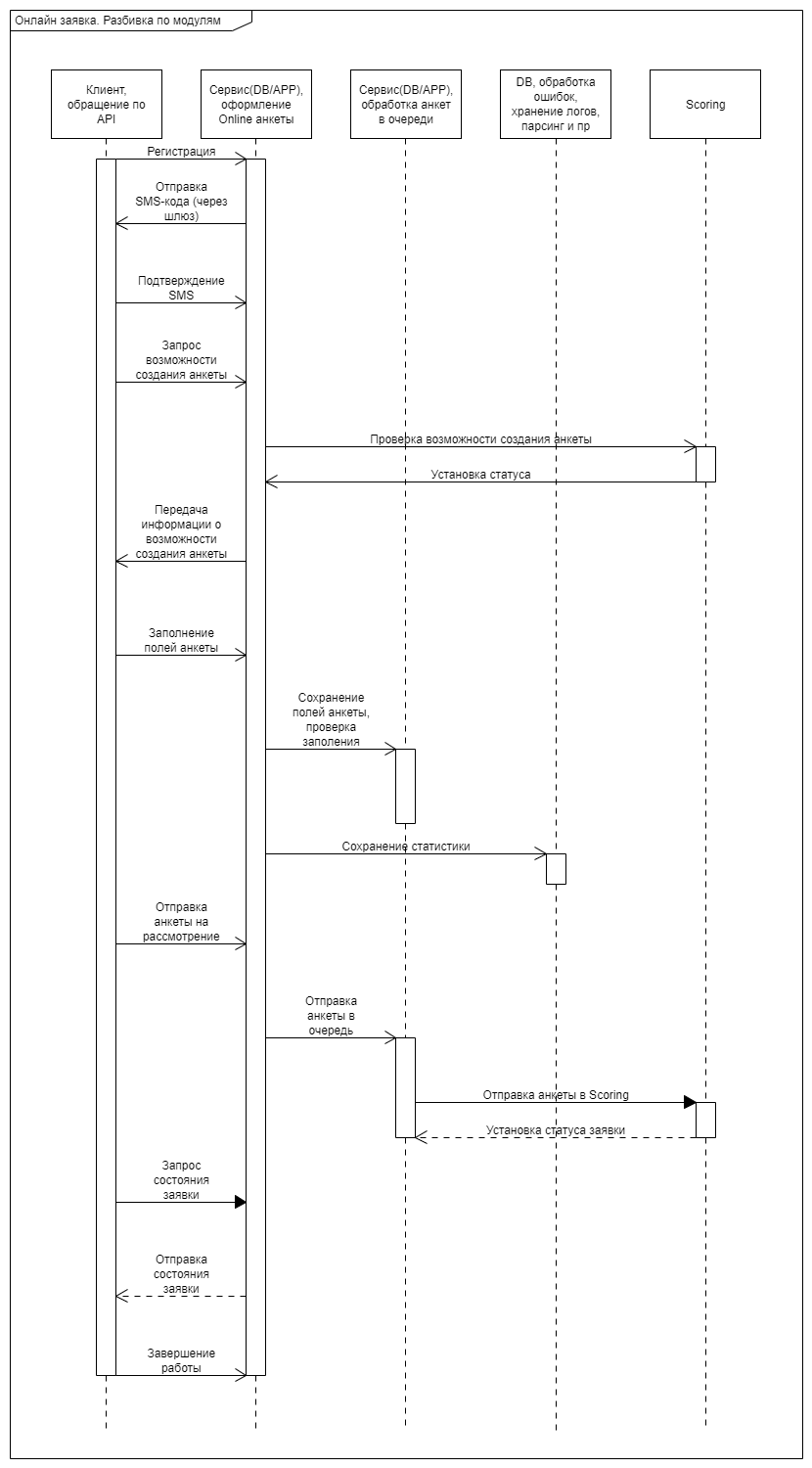

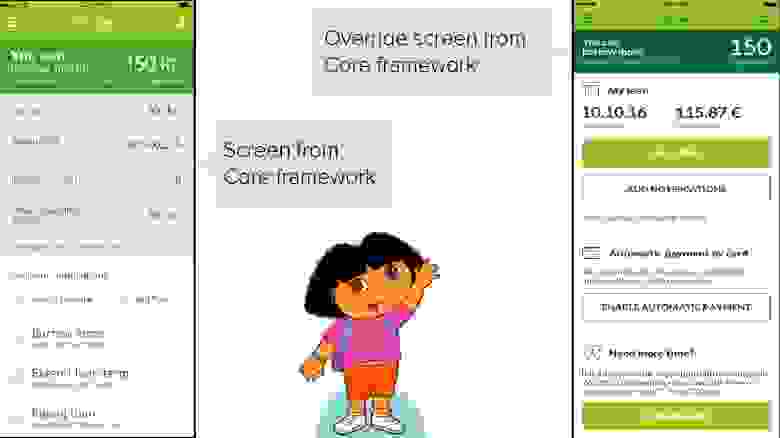

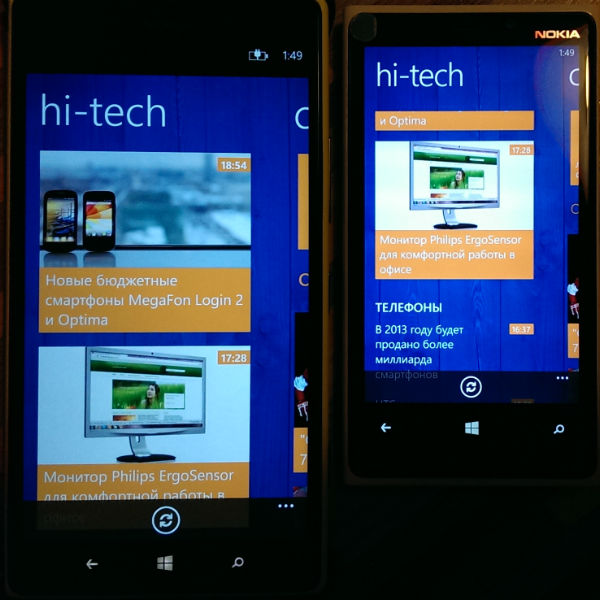

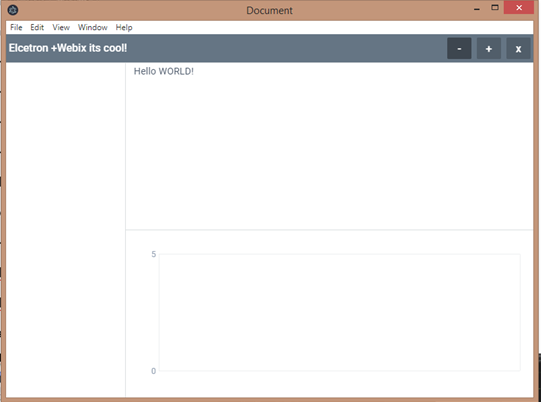

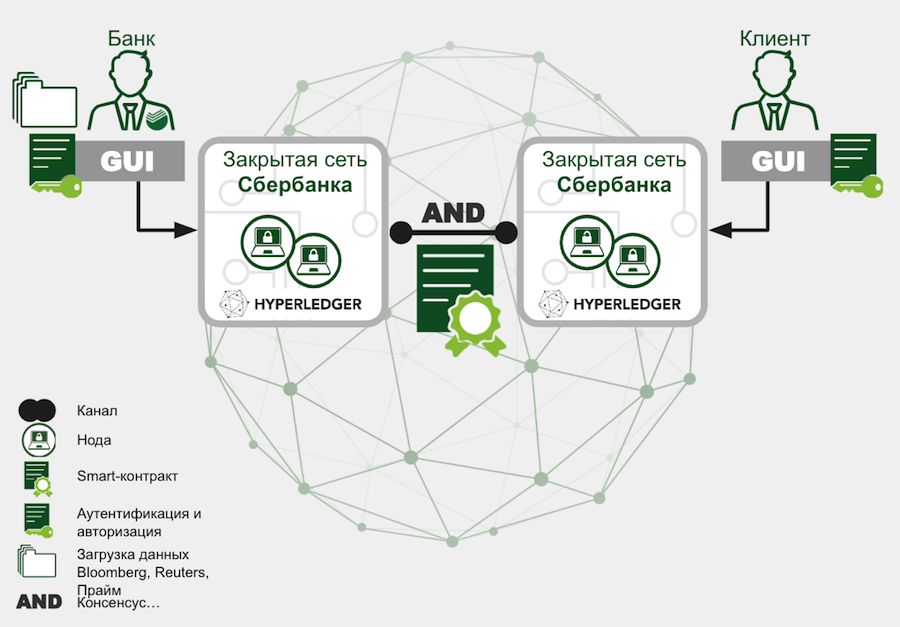

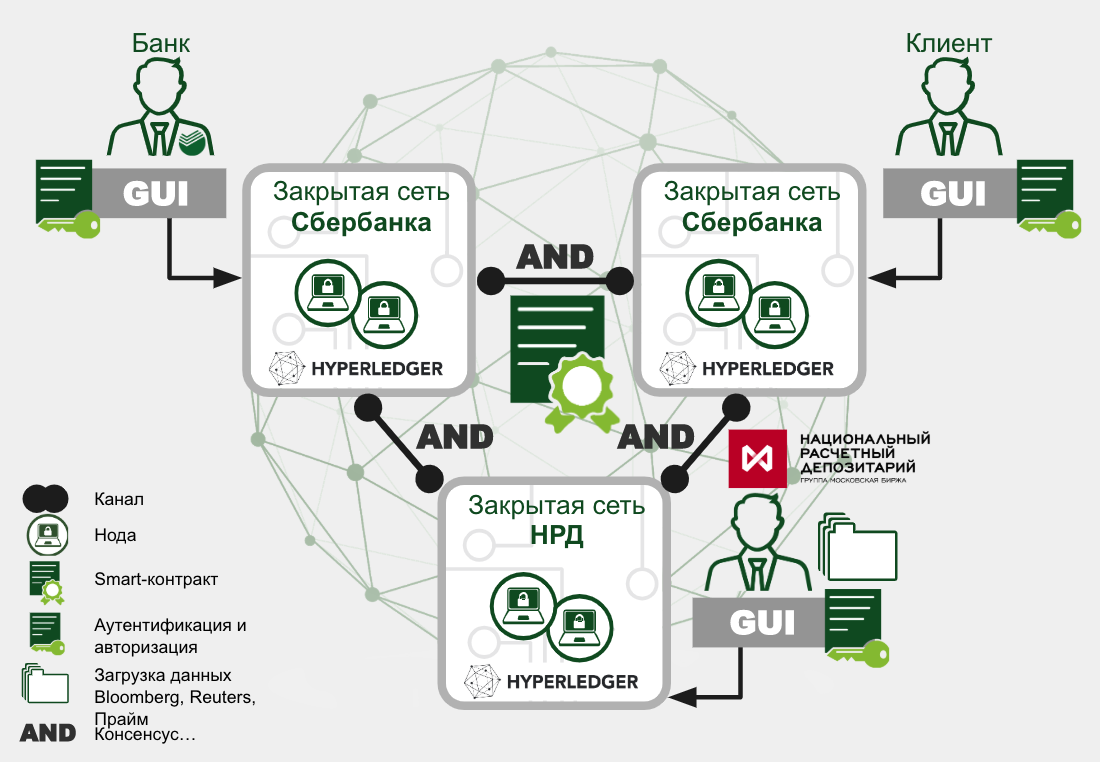

# Как мы создавали первый онлайн-сервис Автокредит

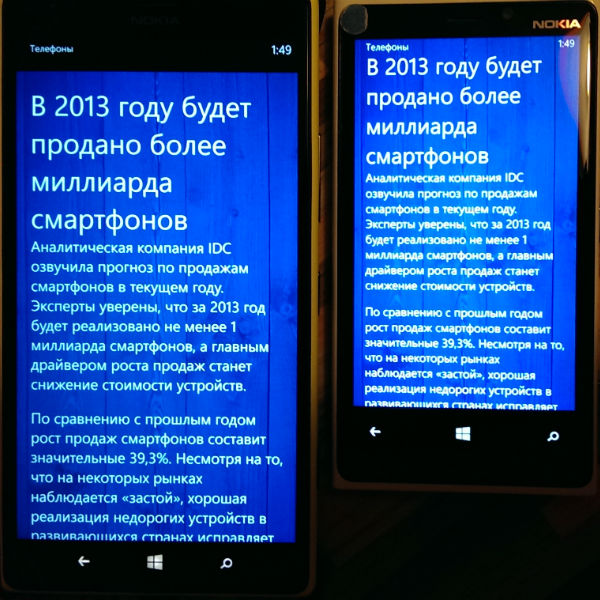

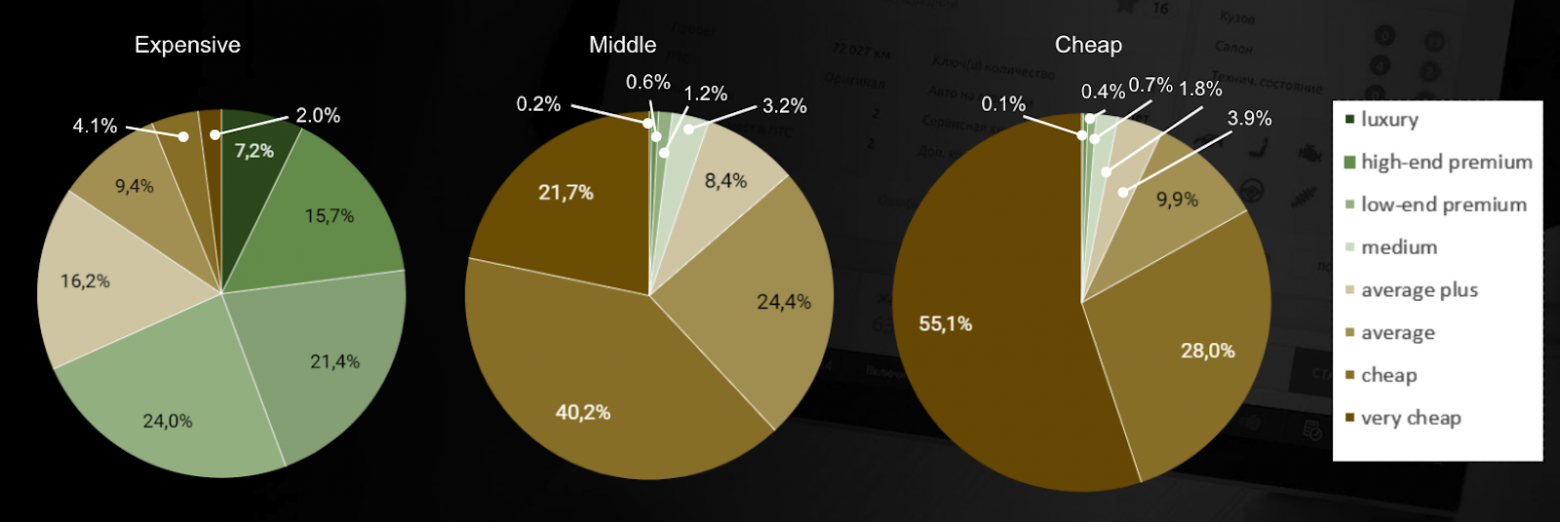

В начале 2018 года на рынке кредитования наметился тренд по активному созданию банками онлайн-решений для клиентов. Появились онлайн-сервисы, облегчающие процесс получения кредитов в таких сегментах, как потребительские товары и ипотека. А вот онлайн-решения для автокредитования еще не было.

Поскольку Русфинанс Банк специализируется на автокредитовании, необходимо было как можно скорее разработать digital-стратегию и запустить удобный сервис, позволяющий клиенту подавать заявку и получать одобрение по кредиту, не выходя из дома.

Готовых ИТ-продуктов, отвечающих нашим потребностям и требованиям, мы не обнаружили, ― в банковской сфере приходится с осторожностью использовать сторонние ИТ-решения, поэтому выбрали путь разработки своими силами.

В этой статье мы расскажем о том, какие требования к сервису мы выдвигали, как превращали MVP в полноценный продукт, а также, как выбирали идеи и их техническую реализацию для более эффективного решения поставленных бизнес-задач.

Функциональные требования

-------------------------

Перед нами стояла амбициозная задача: разработать удобный сервис, позволяющий клиентам Русфинанс Банка получать быстрое решение по кредитной заявке онлайн.

При этом важно было сделать так, чтобы данные по заявке были доступны клиенту в его личном кабинете, и он мог заполнить анкету в модуле с использованием предзаполненных данных.

Чтобы учесть эти и другие важные аспекты мы сформулировали подробные функциональные требования и описали бизнес-процесс (см. схему ниже).

Нашими ключевыми требованиями стали:

1. **Обязательная регистрация по SMS**. Клиент получает доступ к созданию анкеты только после того, как пройдет регистрацию.

2. **Возможность выбора оптимального тарифа**. После заполнения параметров автокредита клиенту подбирается лучшее предложение банка с точки зрения его затрат.

Чуть позже мы расширили наше видение и предложили на выбор клиенту в калькуляторе на сайте три тарифа, оптимальных для получения минимального ежемесячного платежа (ЕП), минимальной ставки, минимального ЕП без КАСКО.

3. **Проверка возможности создания анкеты клиентом**. Решение о приеме заявки от клиента производится на основе данных, введенных им до заполнения анкеты. Отказ от приёма заявки на раннем этапе избавляет от необходимости заполнять анкету, ответ по которой будет отрицательным.

4. **Заведение новой заявки в личном кабинете**. При создании повторной заявки данные в нее автоматически копируются из предыдущей (последней) заявки. Это позволяет экономить время клиента.

5. **Проверки данных в интерфейсах личного кабинета**. Корректность проверки введенных данных реализуется на 3-х уровнях:

* на интерфейсной части ― здесь проверяется правильность формата полей, обязательность заполнения;

* на уровне сервера ― повторяются проверки интерфейсной части, а также, производятся логические проверки, которые не требуют данных технастроек скоринга, которые не переносятся на уровень api (эти проверки производятся при переходе по вкладкам);

* логические проверки скоринга ― результат возвращается скорингом по результатам проверки созданной в нем заявки.

На первых двух уровнях поля с ошибками подсвечиваются, а также, указывается, что именно не так.

6. **SMS-информирование клиентов о решении**. По результатам расчёта онлайн-заявки клиент получает SMS-сообщение с решением. SMS отправляется в случае автоматического одобрения или отказа, т.е. в случаях, если заявка имеет статус «Подтверждена» или «Отказ». При попадании заявки в «серую» зону SMS не отправляется.

7. **Ответ клиенту на сайте**. Помимо ответа по SMS, клиент получает возможность получить ответ на сайте.

Сформулировав и описав все основные функциональные требования, наша команда приступила к их реализации.

Краткое описание бизнес-процесса MVP

------------------------------------

Довольно быстро удалось запустить Фазу 1 продукта ― «преданкета». «Преданкета» отличалась от полноценного онлайн-решения меньшим количеством полей и тем, что решение по кредиту давалось предварительное, а не окончательное. Тем не менее благодаря ее внедрению, мы смогли понять спрос, собрать первые результаты и продолжить работу над полной версией анкеты.

От MVP к полноценному продукту

------------------------------

Разработка полной версии анкеты заняла около года. От предварительной версии она отличалась тем, что:

* на Фазе 1 (предварительная) у клиента запрашивалось меньшее количество полей, не было личного кабинета, решение по анкете принималось предварительное. На этом этапе мы могли точно сказать «НЕТ», если видели признаки мошенничества. Сказать окончательное «ДА» мы могли только после прихода клиента в автосалон.

* на Фазе 2 регистрировался личный кабинет клиента, собиралось больше количество полей, чем в предыдущей Фазе, но в награду за дополнительные усилия клиент сразу получал окончательное решение (конечно, если те данные, которые он указал достоверны и были подтверждены на сделке).

На этапе разработки Фазы 2 (2-й квартал 2018 года) мы приняли решение работать над релизом анкеты по SCRUM. Благодаря выстроенным SCRUM-процессам и готовности руководителей наделять команду полномочиями/ ресурсами нам удалось быстро вывести продукт на рынок.

К концу 2018 года было развернуто полноценное онлайн анкетирование на автокредит без посещения офиса Банка. Тогда же был оформлен первый кредит с клиентом, пришедшим из онлайна.

Бойтесь собственных рассуждений, больше слушайте клиентов

---------------------------------------------------------

С момента появления полноценной онлайн анкеты в банк стали поступать ЛИДы, количество которых пока не отражало целевые показатели.

Необходимо было довести уровень заполняемости анкет до 60% + выдать 500 кредитов за 2019 год.

Мы проводили большое количество внутренних обсуждений, собирали обратную связь от соседних подразделений, шли по пути реализации собственных гипотез.

Как обычно, помогли сами клиенты. Почти одновременно с появлением полноценной анкеты мы реализовали простой функционал сбора обратной связи.

После заполнения анкеты у клиента собиралась обратная связь, задавались вопросы с указанием оценки и комментария: «Все было понятно», «Удобство использования», «Буду рекомендовать друзьям» и «Общий комментарий к анкете».

Ежедневно участники команды получали сводный файл с обратной связью. Раз в 2-3 недели мы анализировали его и делали выводы.

Конечно, в первую очередь нам хотелось просматривать только положительные отзывы, но мы все понимали, что идеальный клиент ― это клиент, дающий критику. Вот здесь нашлись те самые нужные нам идеи и решения, которые были в последствии реализованы на сайте Банка.

В итоге мы:

* «прикрутили» чат с онлайн помощником;

* переименовывали поле «сумму, которую Вы можете выделять на кредит в месяц» и добавили подсказку, как его правильно заполнять, так как клиенты этого не понимали;

* нашли очевидные баги, которые не отловили на этапе теста;

* добавили автозаполнение полей ― на этапе ввода адресов, на этапе выбора работодателя, на этапе указания кем выдан паспорт;

* удалили лишние поля, к примеру, КОД кредитной истории, клиенты не понимали, что от них хотят;

* сделали красивее дизайн анкеты;

* добавили на первый шаг возможность просмотреть короткий 2-х минутный ролик с пояснениями как заполнять анкету;

* сделали возможным подавать повторную заявку, если, к примеру, у клиента прошёл срок действия решения;

* для клиентов группы Росбанк адаптировали автозаполнение полей теми данными, которые уже есть в личном кабинете Группы;

* добавили возможность регистрации Клиента через ЕСИА с автозаполнением полей, доступных в госуслугах;

* реализовали калькулятор, позволяющий на шаге до заполнения анкеты выбирать тариф (при этом клиенту даётся возможность выбора из самого дешевого платежа, самой низкой ставки или тарифа без страховок);

* разместили на сайте банка маркетплейс с возможностью выбора реального автомобиля в наличии или под заказ.

Как нам кажется, устранение багов и новые фичи улучшили картину мира. Мы стали больше получать ЛИДов, а главное появились стабильные продажи.

В начале 2019 года мы оформляли примерно по 10 кредитов в месяц. При этом количество ЛИДов почти по 2 тысячи. В 4 квартале продажи были уже в 5 раз больше. А за 7 месяцев 2020 было продано онлайн кредитов больше, чем за весь 2019 год.

Результаты

----------

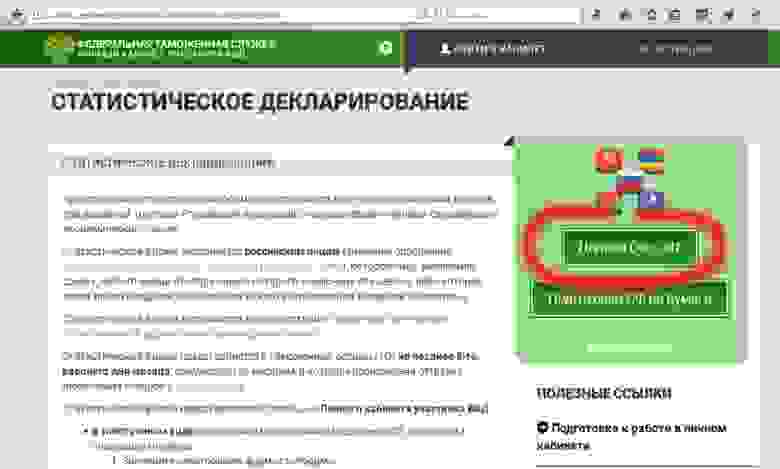

На сайте онлайн-заявка скромно разместилась в основном меню:

Попасть в нее также можно, нажав на кнопку «Подать заявку»:

Анкета имеет лаконичный дизайн:

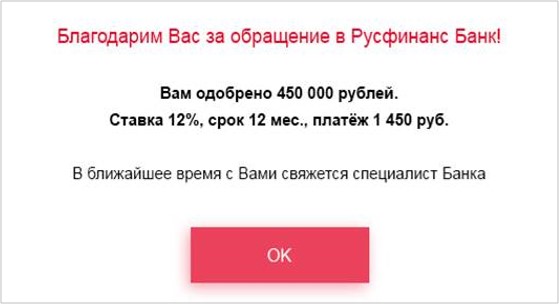

Ответ клиенту после заполнения им заявки мы решили реализовать с использованием фреймворка Angular.

Шаблон компонента отображения сообщения следующий:

```

**{{text}}**

```

Класс компонента отображения сообщения ответа по анкете:

```

import { Component, Input, ViewChild, ViewEncapsulation } from '@angular/core';

import { ModalPopupComponent } from 'src/app/public/modal-popup/modal-popup.component';

import { ModalService } from 'src/app/views/app/modal/modal.service';

@Component({

selector: 'loading-text',

templateUrl: './loading-text.component.html'

})

export class LoadingTextComponent {

@Input() text: string;

@ViewChild('loadingText') loadingText: ModalPopupComponent;

constructor(private modal: ModalService) {}

open = () => {

this.loadingText.open();

};

submit = async () => {

this.loadingText.dismiss('loading-text submit');

};

dismiss = async () => {

this.modal.open('rate');

};

```

Ответ по решению о кредитовании клиент получает на сайте вот в таком виде (пример визуализации ответа, реальные расчеты могут отличаться от указанных):

Теперь, подавая онлайн-заявку и получая быстрый ответ по кредиту, клиенты существенно экономят своё время и нервы.

Однако, мы не останавливаемся на достигнутом и продолжаем работать над новыми фичами. | https://habr.com/ru/post/527326/ | null | ru | null |

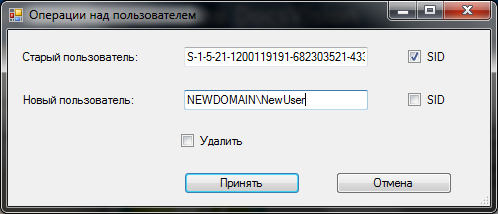

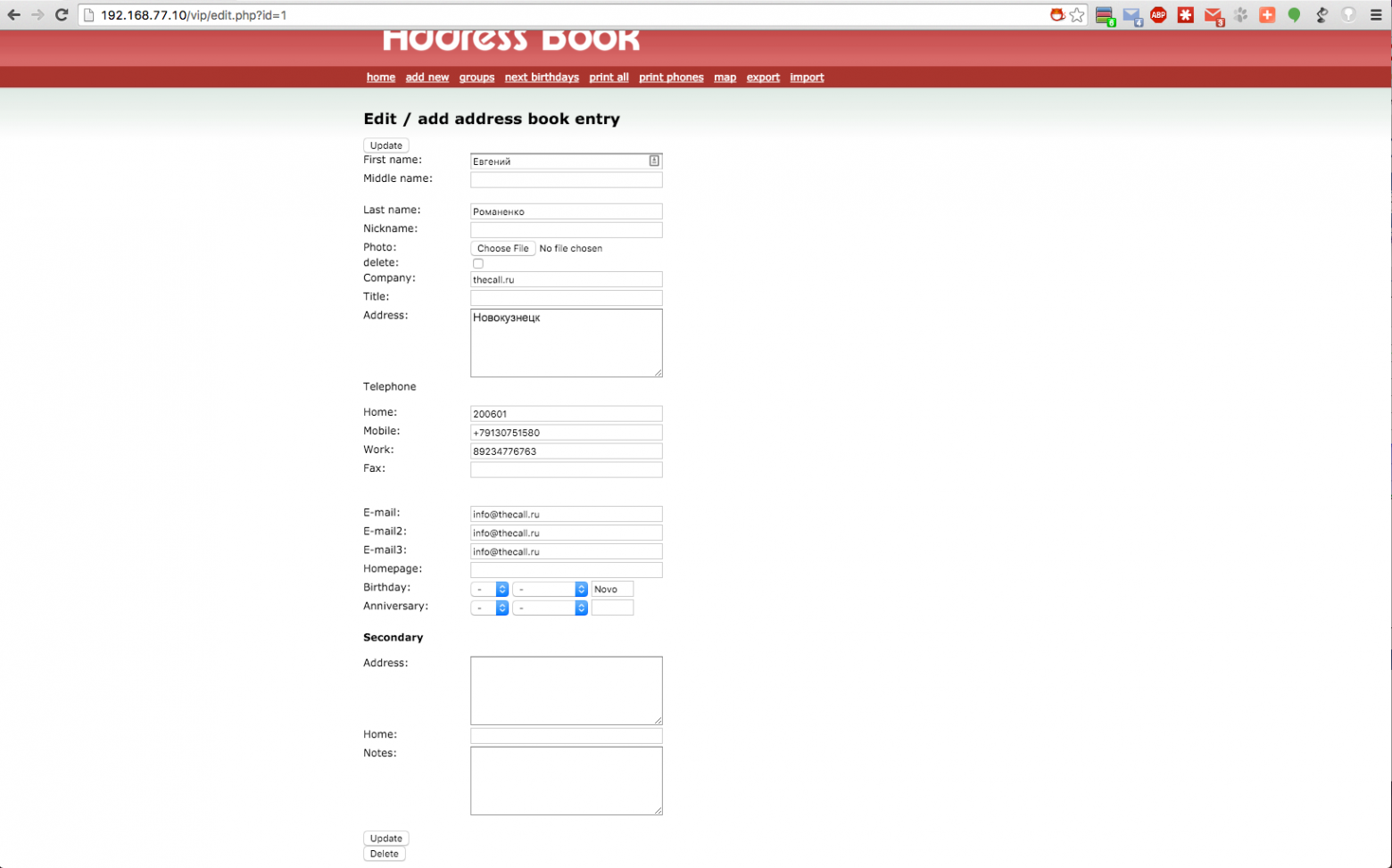

# Автоматизация миграции базы данных DocsVision

#### Преамбула

Казалось бы — если система закрытая, то должны быть удобные инструменты? Ну, или хотя бы API для возможности написания этих удобных инструментов самостоятельно.

К сожалению, обычно все плохо: инструменты есть, но настолько неудобные, что от их наличия — никакого счастья. Приходится выкручиваться.

Итак, дано — система DocsVision (далее DV) версии 4.5 SR1. И, стоит задача переместить базу с одного сервера на другой (скажем, клиенты купили новый). Проблема, которая при этом возникает — ровно одна.

Права на объекты для локальных учетных записей при переносе базы на новое место превратятся в тыкву. А так как стандартные группы DV являются именно локальными — то проблем не избежать.

Кто заинтересован — прошу пожаловать под кат.

#### Стандартные инструменты

Для начала рассмотрим тот инструмент, что нам предлагает для этих целей компания DocsVision.

Он описан по ссылке [dvprofessionals.blogspot.com/2010/03/blog-post\_22.html](http://dvprofessionals.blogspot.com/2010/03/blog-post_22.html)

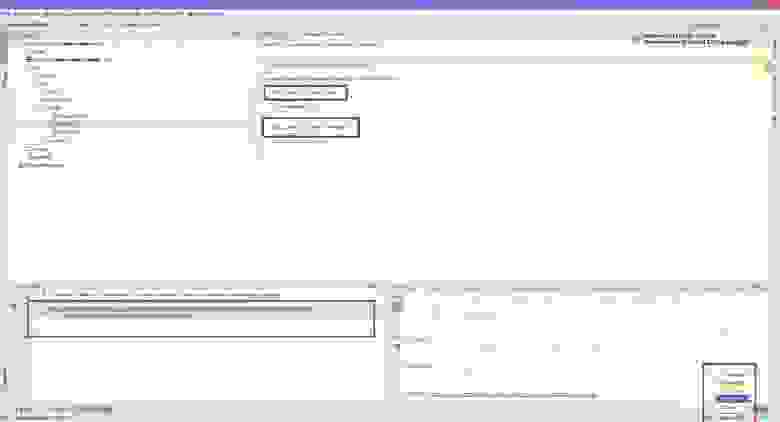

Казалось бы — это то, что нам нужно, но — только на первый взгляд.

Как видно из скриншота — только по одной записи за раз, что даже в случае пары десятков локальных учеток — ну очень неудобно. А, исходя из реального опыта — клиенты без домена встречаются не реже, чем клиенты с доменом. И в этом случае — все пользователи заведены на сервере локально. И руками обрабатывать сотню-другую учеток — ничуть не улыбается.

Поэтому и было принято решение — написать нечто свое.

#### Исследование структуры БД

DocsVision — платформа закрытая и документирована только в рамках предоставленных разработчикам API. Но, кое-какая информация все-таки по интернету гуляет, и ее оказалось достаточно.

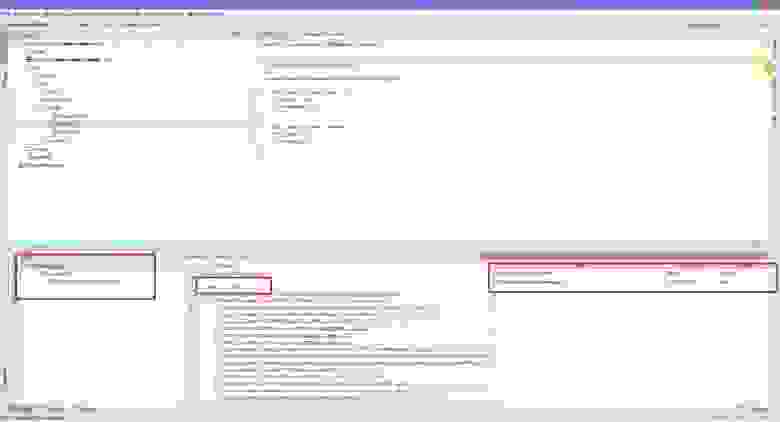

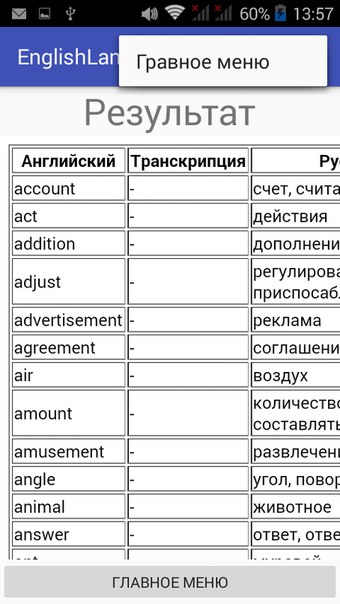

Основными интересующими нас таблицами являются **dvsys\_instances** и **dvsys\_security**. Первая содержит информацию обо всех объектах системы (карточки, папки, справочники, файлы и т.д.), вторая же. не мудрствуя лукаво, хранит описатели безопасности. Структура таблиц приведена ниже.

| | |

| --- | --- |

| image | image |

Связь таблиц осуществляется по полям **dvsys\_instances.SDID** и **dvsys\_security.ID**. Также, необходимо отметить, что количество записей в этих таблицах различается очень сильно, спасибо наследованию прав. Например, у одного из клиентов эти значения составляют 277571 и 6639 соответственно.

Итак, задача поставлена — необходимо пройтись по всем строкам второй таблицы, раскодировать описатели безопасности, заменить старые SID для необходимых записей на новые и, предварительно закодировав, записать обратно. Что ж, приступим.

#### Реализация задуманного

В качестве языка разработки был выбран PowerShell, так как большую часть необходимых задач с его помощью можно решить легко и непринужденно.

Для удобства использования все настройки были вынесены в отдельный файл. К таковым можно отнести таблицу соответствия аккаунтов и настройки доступа к БД.

```

$SIDReplacement = @{

"S-1-5-21-2179127525-659978549-3108502893-1019" = "a31003\akushsky"; #akushsky

"S-1-5-21-2179127525-659978549-3108502893-1016" = "a31003\ASPNET"; #ASPNET

"S-1-5-21-2179127525-659978549-3108502893-1008" = "a31003\DocsVision Administrators"; #DV Administrators

"S-1-5-21-2179127525-659978549-3108502893-1010" = "a31003\DocsVision Power Users"; #DV Power Users

"S-1-5-21-2179127525-659978549-3108502893-1012" = "a31003\DocsVision Users"; #DV Users

"S-1-5-21-2179127525-659978549-3108502893-1026" = "a31003\dobriy"; #DV Editors

}

$SQLServerName = "a31003"

$SQLDatabaseName = "DV-BASE"

```

Мне показалось логичнее запускать скрипт на целевом сервере, поэтому старые учетные записи присутствуют в виде SID-ов (для их получение также можно использовать PowerShell, об этом знает Гугл). А новые — укажем в виде учеток и их SID-ы получим в процессе работы скрипта.

Также, как выяснилось в процессе разработки, PowerShell не умеет создавать экземпляры объектов generic-ков, поэтому из недр Гугла для этого пришлось достать функцию New-GenericObject. Ее код приводить не буду, в конце статьи будет ссылка на репозитарий — все там.

Для удобства, при работе скрипта, в консоль выводится лог, поэтому было решено создать структуру для более удобного накапливания информации.

```

# Struct for log

add-type @"

public struct DVObject {

public string ID;

public string Description;

public string Accounts;

}

"@

```

Для наиболее полного логирования запрос, конечно же, возвращает гораздо больше информации, чем мог бы, но — красота требует жертв.

```

SELECT I.InstanceID, I.Description, S.ID, S.SecurityDesc

FROM [DV-BASE].[dbo].[dvsys_security] S

LEFT JOIN [DV-BASE].[dbo].[dvsys_instances] I

ON I.SDID = S.ID

```

Поэтому, чтобы не обрабатывать один и тот же описатель много раз — идентификаторы записываются.

```

# Replace SDDL in each row only once

$IDList = New-Object System.Collections.Generic.HashSet[Guid]

...

# We need only one SQL-request for each ID

if ($IDList.Contains($row["ID"])) {continue}

else {$isOk = $IDList.Add($row["ID"])}

```

А далее начинается самое интересное:

1. Полученный **SecurityDesc** представляет собой бинарную последовательность символов, закодированную Base64. А, для подмены SID-ов нам необходимо получить SDDL-строку. Описание формата есть на [MSDN](http://msdn.microsoft.com/en-us/library/windows/desktop/aa379567(v=vs.85).aspx). А теперь то же самое, только кодом:

```

# Convert SDDL from Base64 to binary form

$ObjectWithSDDL = ([wmiclass]"Win32_SecurityDescriptorHelper")

.BinarySDToSDDL([System.Convert]::FromBase64String($row["SecurityDesc"]))

$sddl = $ObjectWithSDDL.SDDL

```

2. Далее, вычленяя при помощи регулярки SID-ы из SDDL-строки, проверяем их по таблице соответствия и, в случае совпадения, подменяем.

```

# Match all SIDs and replace

[regex]::Matches($sddl,"(S(-\d+){2,8})") | sort index -desc | % {

if ($SIDReplacement.ContainsKey($_.ToString()))

{

# Translate NT account name to SID

$objUser = New-Object System.Security.Principal.NTAccount($SIDReplacement[$_.ToString()])

$strSID = $objUser.Translate([System.Security.Principal.SecurityIdentifier])

# Replace it in SDDL

$sddl = $sddl.Remove($_.index,$_.length)

$sddl = $sddl.Insert($_.index,$strSID.Value)

# Add to list of current object accounts

$dvobject.Accounts += $SIDReplacement[$_.ToString()]

$dvobject.Accounts += "`n"

# Set replace completed

$replaceComplete = $true

}

}

```

3. Если замена была произведена, то тогда необходимо произвести обратные действия и записать данное изменение в БД:

```

if ($replaceComplete)

{

# Add current info object to list

$DVObjectList.Add($dvobject)

$binarySDDL = ([wmiclass]"Win32_SecurityDescriptorHelper").SDDLToBinarySD($sddl).BinarySD

$ret = [System.Convert]::ToBase64String($binarySDDL)

##### Update database #####

# Update query for currently replaced SDDL

$SqlQuery =

"UPDATE [dbo].[dvsys_security]

SET Hash = '" + $binarySDDL.GetHashCode() + "', SecurityDesc = '" + $ret + "'

WHERE ID = CONVERT(uniqueidentifier, '" + $row["ID"] + "')"

# Attach query to command

$UpdateSqlCmd.CommandText = $SqlQuery

# Execute update query

if ($UpdateSqlCmd.ExecuteNonQuery())

{

Write-host "Update true for ID: " $row["ID"]

}

else

{

Write-host "Update false for ID: " $row["ID"]

}

}

```

Таким образом, получен универсальный механизм для любой миграции — между серверами заказчика, между сервером разработки и заказчиком, да мало ли еще как.

В конце, как и было обещано: [ссылка](https://github.com/akushsky/DVStuff) на репозитарий с описанным кодом. | https://habr.com/ru/post/143281/ | null | ru | null |

# Работа с ngCordova в Cordova приложениях

Всем доброго времени суток.

Есть приложение написанное на ionic и использующее Cordova. Суть приложения — выводить некую информацию с сайта.

Ничего сложного нет. Так же, есть зависимость от интернета. Если есть интернет — отображать свежие данные с сайта, если нет — нужно выводить данные «зашитые» в приложение при релизе. Такое уж было пожелание.

Проблемы возникли, когда нужно было определить наличие интернета на устройстве.

Данная статья не является единственным верным решением задачи. Это лишь моя реализация. Найти более грамотное решение мне не удалось. Потому главная задача моего поста, показать, как проблема была реализована мной, и возможно увидеть, почитать замечания\пожелания\советы других людей. Что поможет как и мне лично, так и другим — в решении подобных проблем.

Приложение состоит из главного экрана, и из двух вариантов второстепенных экранов. При смене роута, и загрузки страницы отрабатывает блок *resolve*, который полностью получает данные, а потом отображает страницу.

```

.config(function($stateProvider, $urlRouterProvider) {

$stateProvider.state('main', {

url: '/',

templateUrl : "views/main.html",

controller : "MainController",

resolve :{

homepageData : function (appService){

return appService.getMainData();

}

...

}

});

...

});

```

В самом начале, для простоты получения информации о состоянии интернета, я использовал обычную переменную в *true | false.*

Все работало отлично. И вот финальный аккорд — нужно узнать есть ли интернет на устройстве или нет. Поскольку опыта разработки в данном направлении у меня нет, а сделать нужно! Я начал гуглить. Нашел библиотеку ngCordova — которая реализует взаимосвязь с API Сordova через привычный angular.js. Эта информация(про интернет) мне нужна на этапе обработки роутов. Но куда бы я не пытался вставить этот код — ничего не получалось. Как говорилось: device not ready.

Вот пример одной из попыток.

```

...

.run(function($ionicPlatform, $rootScope, $cordovaNetwork) {

$ionicPlatform.ready(function() {

if(window.cordova && window.cordova.plugins.Keyboard) {

cordova.plugins.Keyboard.hideKeyboardAccessoryBar(true);

}

if(window.StatusBar) {

StatusBar.styleDefault();

}

//$rootScope.internetAccess = true;

$rootScope.internetAccess = $cordovaNetwork.isOnline();

});

});

```

И как я уже сказал: Error device not ready. Опять в гугл, те решения(для работы с ngCordova) что я находил, были для других плагинов, или не работали вовсе. Попытки сделать на примере других плагинов, ничего не дали.

Решением было дать приложению много обещаний… (: И это сработало. Наобещав золотые горы, оно(приложение) мне поверило и заработало.

Обещания имели вот такой вид:

В resolve:

```

...

resolve :{

homepageData : function (appService, $cordovaNetwork){

return appService.getMainData().then(function(data){

return data;

});

},

....

}

..

```

и функция в service

```

angular.module('myModule').factory('appService', function($q, $http, config_data, $injector, $ionicPlatform) {

var appData = {

getMain : function() {

var defer = $q.defer();

$ionicPlatform.ready(function(){

var cordovaNetwork = $injector.get('$cordovaNetwork');

if(!cordovaNetwork.isOnline()){

defer.resolve($http({ method: 'GET', url: config_data.API_HOST + config_data.JSON_PREFIX + 'main.json' }).success(function(data, status, headers, config) {

return data;

}));

}else{

defer.resolve($http({ method: 'GET', url: 'json/' + config_data.JSON_OFFLINE_PREFIX + 'main.json' }).success(function(data, status, headers, config) {

return data;

}));

}

});

return defer.promise;

},

...

}

return appData;

});

```

Уверен что решение — возможно не самое красивое и правильное, но оно работает. Хочется почитать другие мысли и мнения. | https://habr.com/ru/post/246125/ | null | ru | null |

# Устанавливаем линукс с флешки (конкретно — Debian netinst)

Недавно мне потребовалось установить Debian на старый компьютер найденый в закромах (AMD 650Mhz, 256Mb, 4.3G). Компьютер предназначался для работы в качестве роутера спутникового интернета, о настройке которого я напишу в другой статье.

В компе не было никакого оптического привода, а вытаскивать свой было лень.

Было принято решение ставить с флешки. Я использовал два способа:

**Способ первый — [UNetbootin](http://unetbootin.sourceforge.net/) (универсальный)**

О нем уже [писали на хабре](http://habrahabr.ru/blogs/open_source/37070/).

Вкратце, программа может сама скачивать популярные дистрибутивы, ей можно скормить ISO, или можно скормить сразу ядро с параметрами для вызова. После этого она сама скачает и распакует исошку (если надо), положит на флешку, и добавит загрузчик на флешку. Очень удобно и интуитивно.

Для загрузки с флешки Unetbootin использует загрузчик [syslinux](http://en.wikipedia.org/wiki/Syslinux), с которым все хорошо, кроме того что он не понимает FAT32. Искать как отформатировать 4GB флешку в FAT под виндой мне было лень и я перешел к способу №2.

**Способ второй — boot.img.gz (тестировал только Debian)**

Для второго способа я использовал виртуальную машину с тем же Debian (да, я мог бы отформатировать флешку там, но мысль пошла в другую сторону :) ).

Берем с диска или скачиваем boot.img.gz для своего дистрибутива, после чего делаем так:

`zcat boot.img.gz > /dev/sda`

Вместо /dev/sda ваша USB флешка.

Теперь при загрузке с флешки запустится скрипт который будет искать все ISO на всех доступных ему дисках и предложит выбрать с какого грузится! В моем случае образ был только один и все прошло автомагически :) ~~Возможно, если в ISO будет другой дистрибутив (не Debian) все пойдет так же отлично.~~ (см. update)

Проблеммы: на флешке будет досупно чуть более 160Мb (можно что бы все место было доступно, см. update), поэтому поместить на нее что либо кроме netinst версии дистрибутива не получится, но так как я всегда использую именно его, меня это полностью устраивало.

Как решение проблеммы можно предложить вставить вторую флешку уже с полноценными ISO.

Конец.

**UPDATE:**

[DZhon](https://geektimes.ru/users/dzhon/) — «Надо следить за тем, чтобы совпадали версии debian в boot.img.gz и iso-образе (если один из файлов собран, например, для etch, а второй для sid, то инсталлятор при установке скажет, что не соответствуют версии ядра и модулей к нему и откажется что-либо устанавливать).» © xgu.ru/wiki/Загрузочный\_USB-диск\_с\_Linux

[nshopik](https://geektimes.ru/users/nshopik/) — [www.debian.org/releases/stable/i386/ch04s04.html.en](http://www.debian.org/releases/stable/i386/ch04s04.html.en)

просто набираешь debian usb в гугле и вот эта ссылка на первом месте, рассказывает ваш вариант и альтернативный в котором все пространство флешки доступно | https://habr.com/ru/post/48641/ | null | ru | null |

# Подробнее о протоколе Mail.Ru Агент

На Хабре уже [писали](http://habrahabr.ru/post/136041/) о том, как устроен Mail.Ru Агент. На данный момент официальной документации к протоколу в открытом доступе нет, поэтому приходится исследовать устройство опытным путем. В этой статье я рассмотрю отправление форматированных текстовых сообщений и создание и отправление сообщений в конференцию.

Пара слов о протоколе

---------------------

Сообщения передаются пакетами определенного формата. Первые 44 байта — это заголовок, который выглядит так:

```

struct.pack(

'<7L16s',

magic, # DEAD BEEF, ключевые слова, которые показывают, что это именно MMP протокол

proto, # версия протокола

seq, # порядковый номер сообщения

msg, # тип пакета: сообщение/ запрос на авторизацию/...

dlen, # длина пакета

from_, # адрес отправителя, для исходящего сообщения значение нулевое

fromport, # порт отправителя, для исходящего сообщения тоже нулевое значение

reserved # зарезервированные 16 байт

)

```

Числа здесь передаются в формате UL, который выглядит как 4 байта, записанных справа налево. Таким образом, число 10 будет выглядеть 00 00 00 0A. Так мы будем запаковывать в UL:

```

class MRIMType(object):

def __init__(self, value):

self.value = value

class UL(MRIMType):

def pack(self):

if isinstance(self.value, int):

return struct.pack("

```

Текст передается в формате LPS — строки с заданной длиной (длина задается в виде UL). Мы будем запаковывать в него таким образом:

```

class LPSZ(MRIMType):

def pack(self):

if isinstance(self.value, (list, tuple)): # пакуем списки и тьюплы поэлементно

data = ""

data += UL(self.value).pack()

for element in self.value:

data += element.pack()

return data

elif isinstance(self.value, MRIMType): # пакуем уже запакованные элементы

data = self.value.pack()

return struct.pack("

```

Также нам понадобится упаковывать строки в LPS в других кодировках:

```

class LPSX(MRIMType):

def __init__(self, value, encoding):

super(LPSX, self).__init__(value)

self.encoding = encoding

def pack(self):

encoded_data = self.value.encode(self.encoding)

return struct.pack("

```

Текстовые сообщения с форматированием

-------------------------------------

Посмотрим, как выглядят сообщения. Поле msg в заголовке должно быть заполнено константой 0x1008, в остальном пакет сообщения такой:

```

HEADER

UL(0x80),

LPSA(recipient), # email получателя сообщения

LPSW(body), # собственно, текст сообщения

LPSZ(rtf_part)

```

Последняя составляющая пакета — часть сообщения, связанная с форматированием текста. Если нам не нужно форматирование, rtf\_part должна состоять из пробела. В таком случае Mail.Ru Агент, на который придет это сообщение, будет использовать шрифты, установленные по умолчанию в агенте получателя.

Если мы хотим послать отформатированное сообщение, то последняя часть пакета должна быть LPSZ(rtf\_part), где:

```

rtf_part = pack_rtf(rtf)

def pack_rtf(rtf):

msg = UL(2).pack() + LPSZ(rtf).pack() + LPSZ("\xFF\xFF\xFF\x00").pack()

message = base64.b64encode(msg.encode('zlib'))

return message

```

Последнее слагаемое — цвет фона, при получении сообщения окно чата сменит цвет целиком.

rtf для написания «qwerty» выглядит так:

```

r"{{\rtf1\ansi\ansicpg1252\deff0\deflang1033" \ #поддерживаем русский

r"{{\fonttbl{{\f0\fnil\fcharset204 Tahoma;}}{{\f1\fnil\fcharset0 Tahoma;}}}}\ # шрифты, которыми будем писать. обычно их два

r"{{\colortbl ;\red0\green0\blue0;}} " \ # цвет шрифта

r"\viewkind4\uc1\pard\cf1\f0\fs32 q\f1 werty\f0\par }}" # собственно, текст

```

Можно заметить, что первая буква написана одним шрифтом, а остальные другим. Объяснить такое поведение я не могу, но rtf, сгенерированные Mail.Ru Агент, которые мне удалось получить, выглядели так. rtf, не обладающие таким свойством, остаются валидными. Остальные параметры (язык, таблица шрифтов, русский язык) влияют на валидность rtf.

Остается отметить, что если rtf-часть сообщения не пуста, она придет в сообщении. Если при этом указана текстовая часть сообщения (body), то этот текст мы увидим во всплывающем окне Mail.Ru Агент.

Конференции

-----------

Если для того, чтобы начать чат с другим контактом, нужно просто отправить сообщение, то для того, чтобы начать общаться в конференции, нужно сделать несколько приседаний.

### Создание конференции

Каждая конференция имеет свое уникальное имя, которое выглядит как [email protected], которое мы получаем от сервера в ответ на такое сообщение:

```

HEADER # сообщение с кодом 0x1019

UL(0x80),

LPSW(""),

LPSW(""),

LPSW(chat_name), # название, с которым мы хотим создать чат

LPSW(""),

LPSW(""),

LPSW(""),

LPSZ(LPSZ(LPSZ(packed_recipients))) # трижды запакованный список участников

```

В ответ на это сообщение приходит сообщение от сервера с тем же номером в хедере и айдишником. После получения ответа от сервера можно посылать сообщения в конференцию.

### Отправление сообщений в конференцию

Чтобы отправить сообщение в конференцию, нужно отправить два пакета. Первый пакет не несет смысловой нагрузки, он подготовительный:

```

HEADER # тип пакета -- сообщение (0x1008)

UL(0x200400),

LPSA(chat_alias), #айдишник чата, который мы получили от сервера

LPSZ(" "),

LPSZ("")

```

А теперь, непосредственно, сообщение:

```

HEADER

UL(0x80),

LPSA(chat_alias),

LPSW(body),

LPSZ(rtf_part)

```

Оно выглядит как обычное сообщение с получателем-айдишником конференции.

### Выход из конференции

Данные исследования были нужны мне для реализации автотестов. Я достаточно быстро столкнулась с проблемой — аккаунт может находиться в конечном количестве конференций. Поэтому по окончанию теста нужно покидать конференцию.

```

HEADER # тип сообщения, соответствующий изменению контакта 0x101B

UL(absolute_chat_number), # номер конференции, считая с начала времен.

UL(0x0081),

UL(0xF4244),

LPSZ(chat_alias), # айдишник конференции

LPSW(chat_name), # название конференции

LPSZ(""),

```

Не удалось выяснить, как получить абсолютный номер конференции, но экспериментально выяснено, что идентификация чата происходит не по нему. Поэтому можно указать любое разумное число, например, 42.

Мое исследование далеко от того, чтобы быть полным, поэтому буду рада любым исправлениям и дополнениям. | https://habr.com/ru/post/253303/ | null | ru | null |

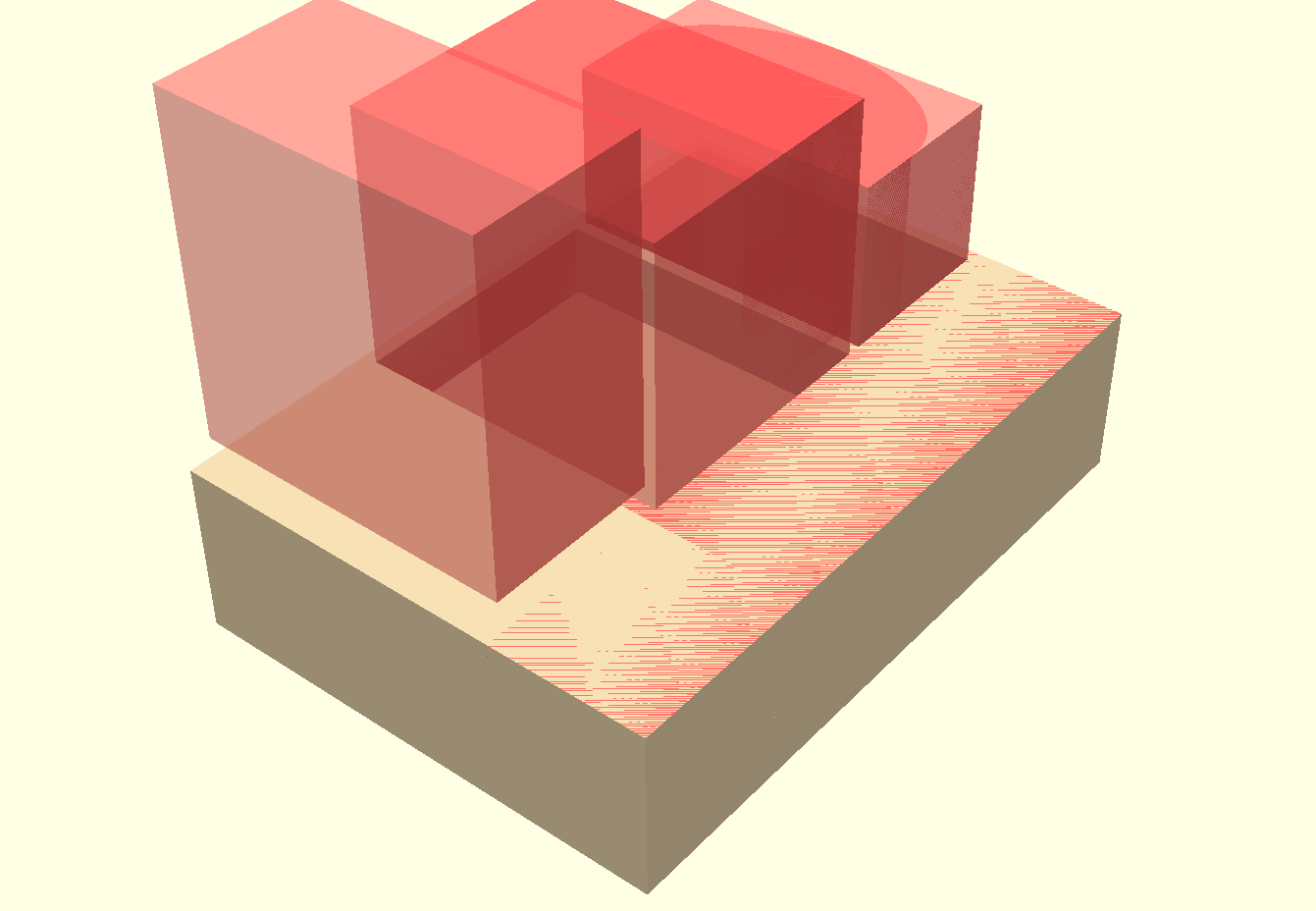

# Метеостанция на Arduino от А до Я. Часть 2

Продолжение. [Предыдущая часть](https://habr.com/post/425901/).

Оглавление:

* [Часть 1. Требования. Выбор железа. Общая схема](https://habr.com/post/425901/)

* [Часть 2. Софт. Центральный блок, железо](https://habr.com/post/425927/)

* [Часть 3. Центральный блок, софт](https://habr.com/post/425953/)

* [Часть 4. Заоконный датчик](https://habr.com/post/425963/)

* [Часть 5. MySQL, PHP, WWW, Android](https://habr.com/post/426019/)

Софт. Выбор компонентов

=======================

Выбор железа и софта тесно взаимосвязан как «курица и яйцо». С чего начать, с железа, с софта? Если у вас хорошее железо, но к нему нет драйверов, библиотек и софта (IDE, утилиты для прошивки и т.п.), то оно бесполезно, и наоборот.

Поэтому рассказываю еще раз про выбор между nRF24L01+ и ESP8266 для связи удаленных датчиков с центральным блоком.

Дело в том, что ESP8266 это не просто тупой WiFi адаптер, он имеет на борту микроконтроллер по мощности и объему памяти *превосходящий* Ардуино. По умолчанию ESP8266 имеет прошивку в виде набора AT команд, в этом случае ESP используется как простой модем. Но есть и более продвинутые прошивки, здесь ESP8266 даже может выступать в роли веб-сервера, ну и конечно же управлять датчиками как и Arduino.

Однако все эти продвинутые прошивки имеют недостатки, которые не позволили (в сумме с железячными вопросами о которых я уже писал) применить ESP8266 в данном проекте:

* все прошивки ещё очень сырые (по состоянию на 2016)

* некоторые готовые небесплатны

* порог вхождения для отладки и внесения изменений гораздо выше, чем у Arduino.

В итоге готовой подходящей продвинутой прошивки я не нашёл, и пока не готов создать свою. ESP8266 чип — обширная и интересная тема.

В свою очередь стандартные AT-прошивки так же имеют минусы:

* они всё ещё сыроваты (по состоянию на 2016)

* мне не удалось найти нормальную библиотеку для Arduino для управления модулем ESP8266 с помощью AT команд, пришлось «колхозить» самому.

С другой стороны радиомодуль nRF24L01+ прост и понятен, для работы с ним есть супер либа [RadioHead](http://www.airspayce.com/mikem/arduino/RadioHead/) и *никаких проблем* с программированием. Библиотека хорошо документирована, что немаловажно.

RadioHead позволяет передавать структуры данных (а не только отдельные числа), что и реализовано в данном проекте. Забегая вперед скажу, RadioHead может **надёжно** передавать данные, с повторами если не дошло с первого раза. Все эти вещи библиотека берет на себя.

Для энергосбережения использую библиотеку [Low Power Library](https://github.com/rocketscream/Low-Power), она проста и содержит только то, что нужно.

Вот кусок кода:

```

// по умолчанию устанавливается 2.402 GHz (канал 2), 2Mbps, 0dBm

rfdata.init();

// передача данных на сервер (с повторами, если потребуется)

rfdata.sendtoWait((uint8_t*)&dhtData, sizeof(dhtData), SERVER_ADDRESS);

// засыпаем

LowPower.powerDown(SLEEP_8S, ADC_OFF, BOD_OFF);`

```

Всё!

В случае же применения ESP8266 в заоконном датчике, я был бы вынужден создавать WiFi точку доступа и каким-то образом передавать данные (где прошивки, где софт?). Либо позволить датчику напрямую слать данные на веб-сервер, а центральный блок (который в этом случае перестаёт играть роль «центрального») учить читать данные оттуда, чтобы их отобразить на табло.

Другими словами я пошёл путем большей автономии от WiFi интернета и PHP + MySQL сервера. Вы можете начать «клепать» метеостанцию уже сейчас не имея доступа в интернет и/или хостинга для сервера, в этом случае ESP8266 вам не нужен, просто добавите его потом.

Для считывания данных с датчиков типа DHT есть библиотека [Adafruit DHT Sensor Library](https://github.com/adafruit/DHT-sensor-library). Работа с ней проста и понятна.

Для датчика давления подходит библиотека [Adafruit BMP085 Unified](https://github.com/adafruit/Adafruit_BMP085_Unified), которая требует наличия библиотеки абстрактного уровня [Adafruit Sensor](https://github.com/adafruit/Adafruit_Sensor).

В составе всех библиотек есть примеры скетчей.

Вот и всё пожалуй с теоретической частью. *«Наши цели ясны, задачи определены. За работу, товарищи!»*

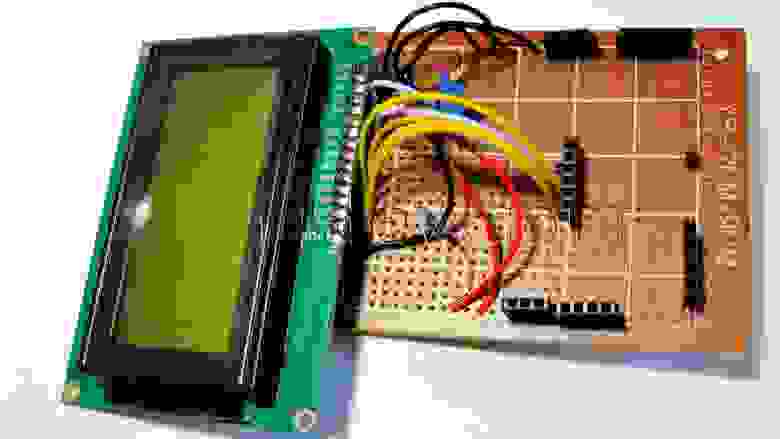

Центральный блок. Железо

========================

Ну наконец-то, после всех заумствований приступаем к сборке!

*Примечание*. Если вы до этого ни разу не собирали метеостанцию (да ладно!), то вы можете начать и не имея всех деталей под рукой. Например, можно начать не имея радиомодуля и/или ESP8266. Датчик барометрического давления BMP180 также может отсутствовать. Добавите потом. Правда в этом случае вам придется самостоятельно закоментировать в скетче те участки кода, которые отвечают за взаимодействие с отсутствующими блоками, но это не так уж и сложно. Я покажу как.

Главное, чтобы хоть что-то собралось и заработало, тогда веселее продолжать.

Как уже говорилось, центральный блок основан на Arduino MEGA. Ещё нам понадобятся:

* датчик температуры и влажности DHT11

* датчик барометрического давления типа BMP180

* WiFi модуль ESP8266

* радиомодуль типа nRF24 2,4 Ггц

* дисплей типа LCD1604 (4 строки по 16 символов), купить можно за $5

* блок питания с выходом 5-12 В постоянного напряжения (я использовал зарядку от мобильного с USB выходом что удобно)

* макетная плата под пайку, паяльник, канифоль, припой либо обычная беспаечная arduino-макетная плата. Лично я паял для надёжности, потому что проект явно был долгоиграющим и не хотелось страдать из-за случайно выдернутого из макетки проводка.

Макетную плату для распайки можно купить от $1. Берите размером побольше, чтобы хватило на все соединения. И ещё раз: перед покупкой читайте описание, а не картинку.

Беспаечную плату можно купить от $2. Берите размером побольше, чтобы хватило на все соединения.

Соединительные провода бывают таких нужных нам типов:

* Dupont кабель «папа-мама» (есть и «папа-папа», «мама-мама»). Это шлейф из нескольких проводов с разными цветами изоляции и коннекторами под штыревые контакты для Arduino. Такими проводами удобно соединять платы и датчики напрямую к Ардуино без использования макетной платы.

* Обычные соединительные провода под беспаечную макетную плату для Ардуино.

* Пучок проводков для пайки.

Первым делом распаял табло LCD-1604. Сначала припаял штырьки к табло, затем разъемы к макетной плате.

Вид снизу.

Паял по наитию без предварительной разводки, поэтому здесь никакой схемы приведено не будет. Делайте как удобнее, хуже не будет. Придерживайтесь только принципа, что чёрный провод — это всегда земля, красный — «плюс» питания, остальные цвета как получится. Получилось так.

Для того чтобы не забыть, где какие разъемы, «покрасил» белым корректором участки платы по соседству и сделал соответствующие надписи. Некрасиво? Зато практично и быстро, это же прототип!

Распиновка и соединение

=======================

Дисплей 16×4 LCD1604

--------------------

Подробнее о дисплее и работе с ним погуглите «Работа с символьными ЖКИ на базе HD44780». Отметим, что нужно внимательно отнестись к полярности подключения питания к ЖК-индикатору и чтобы напряжение питания было в диапазоне +4,5…5,5 В. Невнимательное отношение к этому может привести к выходу индикатора из строя!

| Пин LCD 1604 | Arduino MEGA | Arduino UNO | Описание |

| --- | --- | --- | --- |

| VSS | GND | GND | GND |

| VDD | 5 V | 5 V | 4,7 — 5,3V |

| RS | 22 | 4 | Высокий уровень означает, что сигнал на выходах DB0—DB7 является данными, низкий — командой |

| RW | GND | GND | Определяет направление данных (чтение/запись). Так как операция чтения данных из индикатора обычно бывает невостребованной, то можно установить постоянно на этом входе низкий уровень |

| E | 23 | 5 | Импульс длительностью не менее 500 мс на этом выводе определяет сигнал для чтения/записи данных с выводов DB0-DB7, RS и WR |

| DB4 | 24 | 8 | Входящие/исходящие данные |

| DB5 | 25 | 9 |

| DB6 | 26 | 10 |

| DB7 | 27 | 11 |

| LED A+ | | | +5V или резистор 220 Ом → +5VLED-A |

| LED B- | | | GND |

| V0 | | | GND или подстроечник на 10кОм |

Программная инициализация будет выглядеть так:

```

// Arduino MEGA

LiquidCrystal lcd(22, 23, 24, 25, 26, 27);

// Arduino UNO

LiquidCrystal lcd(4, 5, 8, 9, 10, 11);

```

Температура, влажность DHT11

============================

Подключение датчика температуры и влажности DHT11 (SainSmart). Датчик расположите лицевой стороной вверх, выводы будут описаны слева направо.

| DHT11 | Arduino Mega |

| --- | --- |

| DATA | Digital pin 2 (PWM) (см. ниже DHTPIN) |

| VCC | 3,3—5 В (рекомендуется 5 В, лучше внешнее питание) |

| GND | GND |

Программная инициализация

```

#define DHTPIN 2 // цифровой пин Digital pin 2 (PWM)

#define DHTTYPE DHT11 // см. DHT.h

// инициализация

DHT dht(DHTPIN, DHTTYPE);

```

Барометр BMP180

===============

Подключение датчика атмосферного давления BMP180 (барометр) + температура по интерфейсу I2C/TWI.

| BMP180 | Arduino Mega |

| --- | --- |

| VCC | не подключен |

| GND | GND |

| SCL | 21 (SCL) |

| SDA | 20 (SDA) |

| 3,3 | 3,3 В |

Для UNO: A4 (SDA), A5 (SCL).

```

// инициализация

Adafruit_BMP085_Unified bmp = Adafruit_BMP085_Unified(10085); // sensorID

```

nRF24L01+

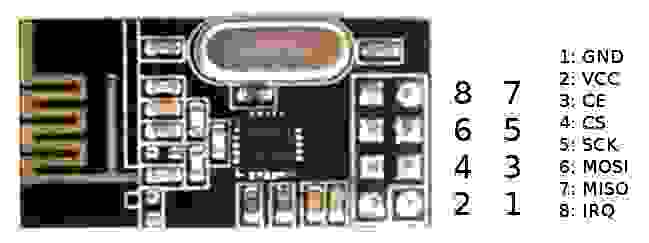

=========

Краткие характеристики:

* Диапазон частот 2,401 — 2,4835 Ггц

* 126 каналов. Нулевой канал начинается с 2400 Мгц и далее с шагом 1 Мгц, например 70 канал находится соответственно на 2470 Мгц. При установке скорости передачи 2Mbps занимается ширина канала в 2 Мгц

* Питание 1,9 — 3,6 В (рекомендуется 3,3 В)

Вот распиновка модуля.

Некоторые советуют сразу же припаять керамический конденсатор 100nF (можно 1µF, 10µF) на выводы питания RF для избежания электрических помех.

Распиновка nRF24L01+ (смотреть сверху платы там где чип, пины должны быть внизу) :

| | | | |

| --- | --- | --- | --- |

| пин **2** 3,3V | пин **4** CSN | пин **6** MOSI | пин **8** IRQ |

| пин **1** GND | пин **3** CE | пин **5** SCK | пин **7** MISO |

Подключение для метеостанции:

| Arduino Mega | nRF24L01+ |

| --- | --- |

| 3,3 В | VCC пин 2 (лучше внешнее питание) |

| пин D8 | CE пин 3 (chip enable in) |

| SS пин D53 | CSN пин 4 (chip select in) |

| SCK пин D52 | SCK пин 5 (SPI clock in) |

| MOSI пин D51 | SDI пин 6 (SPI Data in) |

| MISO пин D50 | SDO пин 7 (SPI data out) |

| IRQ пин 8 (Interrupt output) не подсоединен |

| GND | GND пин 1 (ground in) |

Программирование радиомодуля будет подробно описано в программной части.

ESP8266

=======

Распиновка ESP8266 (смотреть сверху платы там где чипы, пины должны быть внизу):

| | | | |

| --- | --- | --- | --- |

| GND | GPIO2 | GPIO0 | RX |

| TX | CH\_PD | RESET | VCC |

Подключение ESP8266 для метеостанции:

| ESP8266 | Arduino Mega |

| --- | --- |

| TX | 10 пин (SoftwareSerial RX) |

| RX | 11 пин (SoftwareSerial TX) |

| VCC | 3,3 В |

| GND | GND |

| CH\_PD | Через резистор 10К к 3,3 В Arduino |

| GPI0 | Необязательно. Через резистор 10К к 3,3 В Arduino |

| GPI2 | Необязательно. Через резистор 10К к 3,3 В Arduino |

КДПВ

====

Центральный блок в сборе. «Материнскую плату» вырезал из картонной коробки из-под обуви и к ней винтиками на 3 прикрутил всё остальное.

Как видим в этом месте всё питание осуществляется от пинов Ардуино, т.е. к блоку питания напрямую ничего не идёт, и пока мощи хватает.

Вроде всё. Ничего не забыл.

Паяйте, соединяйте. В следующей части будет приведен рабочий скетч для центрального блока и наша метеостанция уже что-то покажет.

| https://habr.com/ru/post/425927/ | null | ru | null |

# Задания для разработчика Яндекс.Музыки для iOS

При заполнении анкеты на должность [разработчика Яндекс.Музыки для iOS](http://company.yandex.ru/job/vacancies/muz_ios.xml) просят выполнить тестовые задания. Задания выложены в открытом виде, никакой просьбы не разглашать задания и не публиковать решения нет.

Приступим.

*Вопрос 1.* В системе авторизации есть следующее ограничение на формат логина: он должен начинаться с латинской буквы, может состоять из латинских букв, цифр, точки и минуса и должен заканчиваться латинской буквой или цифрой. Минимальная длина логина — 1 символ. Максимальная — 20 символов.

Напишите код, проверяющий, соответствует ли входная строка этому правилу.

Используем регулярное выражение. Класс NSRegularExpression появился в iOS 4.0.

```

BOOL loginTester(NSString* login) {

NSError *error = NULL;

NSRegularExpression *regex = [NSRegularExpression

regularExpressionWithPattern:@"\\A[a-zA-Z](([a-zA-Z0-9\\.\\-]{0,18}[a-zA-Z0-9])|[a-zA-Z0-9]){0,1}\\z"

options:NSRegularExpressionCaseInsensitive error:&error];

// Здесь надо бы проверить ошибки, но если регулярное выражение оттестированное и

// не из пользовательского ввода - можно пренебречь.

NSRange rangeOfFirstMatch = [regex rangeOfFirstMatchInString:login options:0 range:NSMakeRange(0, [login length])];

return (BOOL)(rangeOfFirstMatch.location!=NSNotFound);

}

```

[Здесь](http://yadi.sk/d/lvabskzxFZmZS) готовый проект, использующий этот код. Можно потестировать.

Мне кажется, этот вопрос нацелен на то, чтоб отсеять тех, кто боится регулярных выражений.

*Вопрос 2.* Напишите метод, возвращающий N наиболее часто встречающихся слов во входной строке.

Гораздо интересней.

```

-(NSArray*)mostFrequentWordsInString:(NSString*)string count:(NSUInteger)count {

// получаем массив слов.

// такой подход для человеческих языков будет работать хорошо.

// для языков, вроде китайского, или когда язык заранее не известен,

// лучше использовать enumerateSubstringsInRange с опцией NSStringEnumerationByWords

NSMutableCharacterSet *separators = [[NSCharacterSet whitespaceAndNewlineCharacterSet] mutableCopy];

[separators formUnionWithCharacterSet:[NSCharacterSet punctuationCharacterSet]];

NSArray *words = [string componentsSeparatedByCharactersInSet:separators];

NSCountedSet *set = [NSCountedSet setWithArray:words];

// тут бы пригодился enumerateByCount, но его нет.

// будем строить вручную

NSMutableArray *selectedWords = [NSMutableArray arrayWithCapacity:count];

NSMutableArray *countsOfSelectedWords = [NSMutableArray arrayWithCapacity:count];

for (NSString *word in set) {

NSUInteger wordCount = [set countForObject:word];

NSNumber *countOfFirstSelectedWord = [countsOfSelectedWords count] ?

[countsOfSelectedWords objectAtIndex:0] : nil; // в iOS 7 появился firstObject

if ([selectedWords count] < count || wordCount >= [countOfFirstSelectedWord unsignedLongValue]) {

NSNumber *wordCountNSNumber = [NSNumber numberWithUnsignedLong:wordCount];

NSRange range = NSMakeRange(0, [countsOfSelectedWords count]);

NSUInteger indexToInsert = [countsOfSelectedWords indexOfObject:wordCountNSNumber inSortedRange:range

options:NSBinarySearchingInsertionIndex

usingComparator:^(NSNumber *n1, NSNumber *n2)

{

NSUInteger _n1 = [n1 unsignedLongValue];

NSUInteger _n2 = [n2 unsignedLongValue];

if (_n1 == _n2)

return NSOrderedSame;

else if (_n1 < _n2)

return NSOrderedAscending;

else

return NSOrderedDescending;

}];

[selectedWords insertObject:word atIndex:indexToInsert];

[countsOfSelectedWords insertObject:wordCountNSNumber atIndex:indexToInsert];

// если слов уже есть больше чем нужно, удаляем то что с наименьшим повторением

if ([selectedWords count] > count) {

[selectedWords removeObjectAtIndex:0];

[countsOfSelectedWords removeObjectAtIndex:0];

}

}

}

return [selectedWords copy];

// можно было бы сразу вернуть selectedWords,

// но возвращать вместо immutable класса его mutable сабклас нехорошо - может привести к багам

}

// очень интересный метод для юнитестов: правильный результат может быть разным и зависит от порядка слов в строке.

```

Я бы именно такой подход и использовал, если бы мне нужно было решить эту задачу в реальном iOS приложении, при условии, что я понимаю, откуда будут браться входные данные для поиска и предполагаю, что размеры входной строки не будут больше нескольких мегабайт. Вполне разумное допущение для iOS приложения, на мой взгляд. Иначе на входе не было бы строки, а был бы файл. При реально больших входных данных прийдется попотеть над регулярным выражением для перебора слов, чтоб избавиться от одного промежуточного массива. Такое регулярное выражение очень зависит от языка — то что сработает для русского не проканает для китайского. А вот что делать со словами дальше — кроме прямолинейного алгоритма в голову ничего не приходит. Если бы нужно было выбрать одно наиболее часто встречающееся слово — это Fast Majority Voting. Но вся красота этого алгоритма в том, что он работает для выбора одного значения. Модификаций алгоритма для выбора N значений мне не известны. Самому модифицировать не получилось.

*Вопрос 3.* Используя NSURLConnection, напишите метод для асинхронной загрузки текстового документа по HTTP. Приведите пример его использования.

```

-(void)pullTextFromURLString:(NSString*)urlString completion:(void(^)(NSString*text))callBack {

NSURLRequest *request = [NSURLRequest requestWithURL: [NSURL URLWithString:urlString]

cachePolicy:NSURLRequestUseProtocolCachePolicy timeoutInterval:60.0];

[NSURLConnection sendAsynchronousRequest:request

queue:[NSOperationQueue mainQueue]

completionHandler:^(NSURLResponse *response, NSData *data, NSError *error)

{

if (error) {

NSLog(@"Error %@", error.localizedDescription);

} else {

// вообще, не мешало бы определить кодировку, чтоб не было неприятностей

callBack( [[NSString alloc]initWithData:data encoding:NSUTF8StringEncoding] );

}

}];

}

```

Тут все просто. Наверное, как и первый вопрос, этот вопрос на знаю / не знаю.

*Вопрос 4.* Перечислите все проблемы, которые вы видите в приведенном ниже коде. Предложите, как их исправить.

```

NSOperation *operation = [NSBlockOperation blockOperationWithBlock:^{

for (int i = 0; i < 1000; ++i) {

if ([operation isCancelled]) return;

process(data[i]);

}

}];

[queue addOperation:operation];

```

Лично я вижу проблему в том, что переменная operation, «захваченная» блоком при создании блока, еще не проинициализирована до конца. Какое реально значение этой переменной будет в момент «захвата», зависит от того, используется ли этот код в методе класса или в простой функции. Вполне возможно, что сгенерированный код будет вполне работоспособен и так, но мне этот код не ясен. Как выйти из ситуации? Так:

```

NSBlockOperation *operation = [[NSBlockOperation alloc] init];

[operation addExecutionBlock:^{

for (int i = 0; i < 1000; ++i) {

if ([operation isCancelled]) return;

process(data[i]);

}

}];

[queue addOperation:operation];

```

Возможно, достаточно было бы просто добавить модификатор \_\_block в объявление переменной operation. Но так, как в коде выше — наверняка. Некоторые даже создают \_\_weak копию переменной operation и внутри блока используют ее. Хорошо подумав я решил, что в данном конкретном случае, когда известно время жизни переменной operation и блока — это излишне. Ну и я бы подумал, стоит ли использовать NSBlockOperation для таких сложных конструкций. Разумных доводов привести не могу — вопрос личных предпочтений.

Что еще с этим кодом не так? Я не люблю разных магических констант в коде и вместо 1000 использовал бы define, const, sizeof или что-то в этом роде.

В длинных циклах в objective-c нужно помнить об autoreleased переменных и, если такие переменные используются в функции или методе process, а сам этот метод или функция об этом не заботится, нужно завернуть этот вызов в @autoreleasepool {}. Создание нового пула при каждой итерации цикла может оказаться накладным или излишним. Если не используется ARC, можно создавать новый NSAutoreleasePool каждые, допустим, 10 итераций цикла. Если используется ARC, такой возможности нет. Кстати, это, наверное, единственный довод не использовать ARC.

По коду не ясно, меняются ли данные в процессе обработки, обращается ли кто-то еще к этим данным во время обработки из других потоков, какие используются структуры данных, заботится ли сам process о монопольном доступе к данным тогда когда это нужно. Может понадобиться позаботиться о блокировках.

*Вопрос 5.* Есть таблицы:

```

CREATE TABLE tracks (

id INT NOT NULL AUTO_INCREMENT,

name VARCHAR(255) NOT NULL,

PRIMARY KEY (id)

)

```

```

CREATE TABLE track_downloads (

download_id BIGINT(20) NOT NULL AUTO_INCREMENT,

track_id INT NOT NULL,

download_time TIMESTAMP NOT NULL DEFAULT 0,

ip INT NOT NULL,

PRIMARY KEY (download_id)

)

```

Напишите запрос, возвращающий названия треков, скачанных более 1000 раз.

Вот такой запрос справляется с задачей замечательно:

```

select name from tracks where id in

(select track_id from

(select track_id, count(*) as track_download_count from track_downloads

group by track_id order by track_download_count desc)

where track_download_count > 1000)

```

Проверено в sqlite. Предполагаю, что можно сократить на один select, но не знаю как.

Наличие этого вопроса в задании вполне объяснимо — примерно этим приложение и будет заниматься.

Жду критики. | https://habr.com/ru/post/209076/ | null | ru | null |

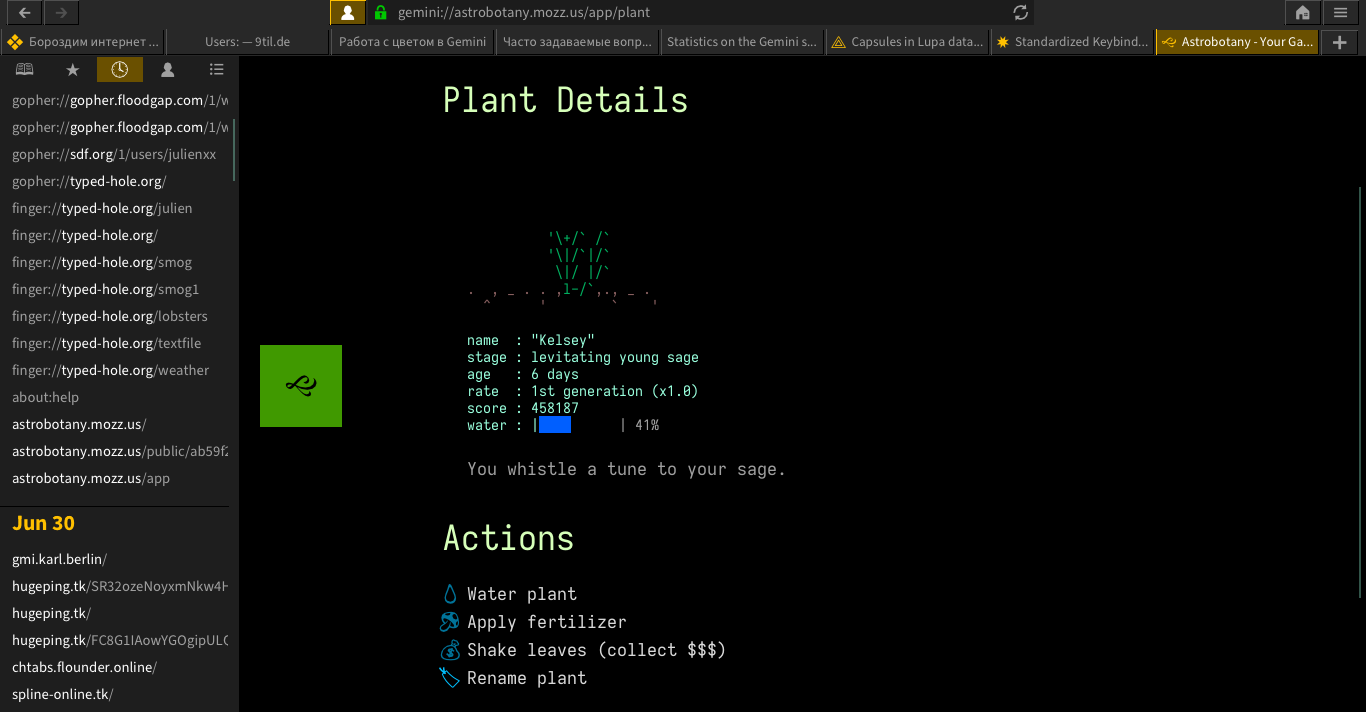

# Долгосрочное хранение данных в Elasticsearch

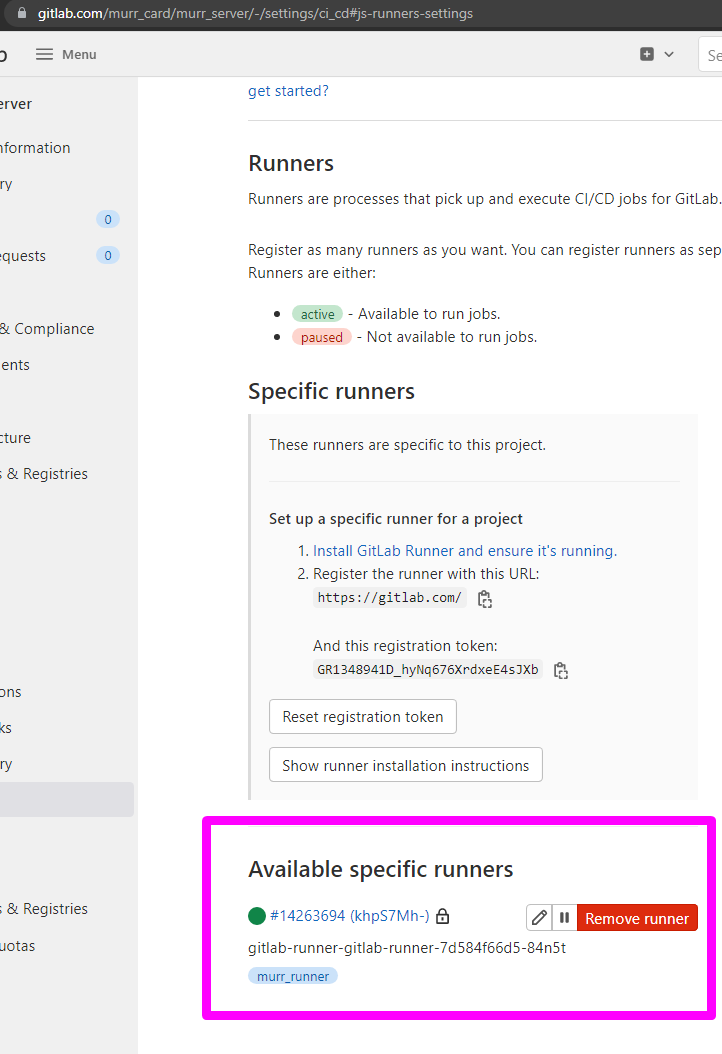

Меня зовут Игорь Сидоренко, я техлид в команде админов, поддерживающих в рабочем состоянии всю инфраструктуру Домклик.

Хочу поделиться своим опытом в настройке распределённого хранения данных в Elasticsearch. Мы рассмотрим, какие настройки на нодах отвечают за распределение шардов, как устроен и работает ILM.

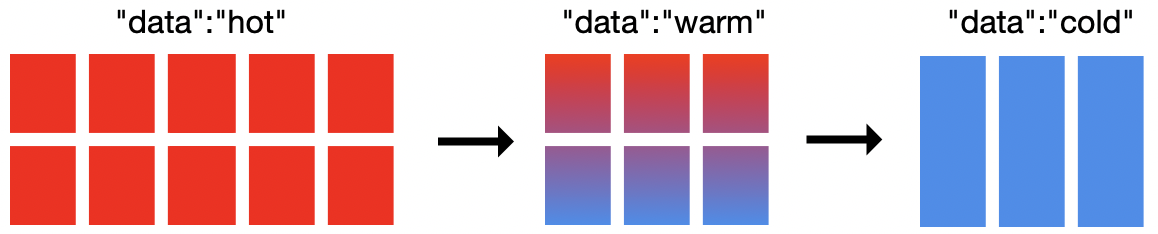

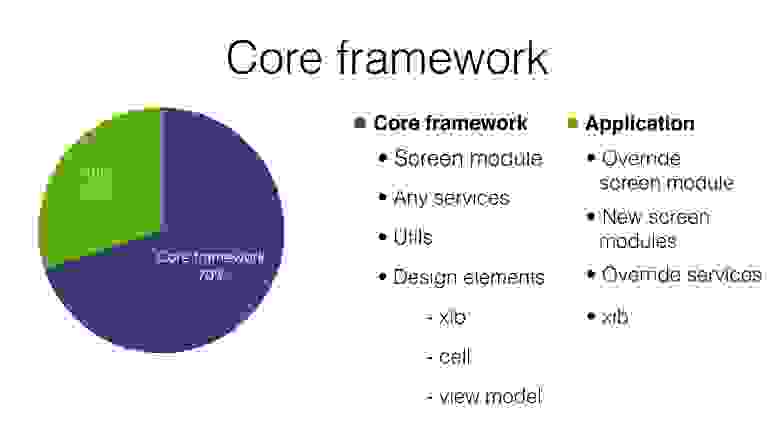

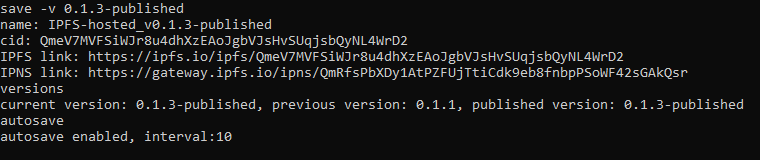

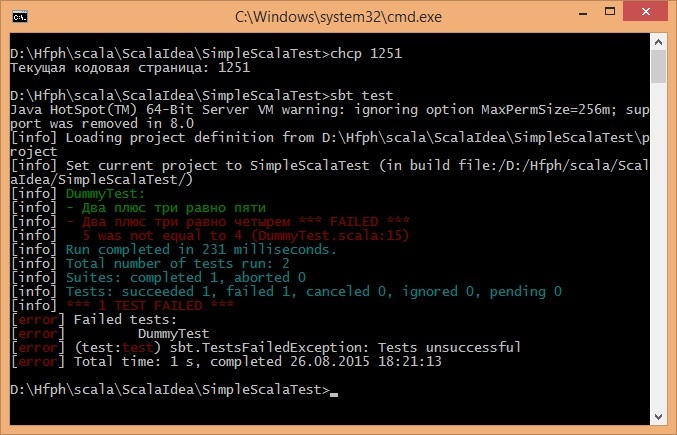

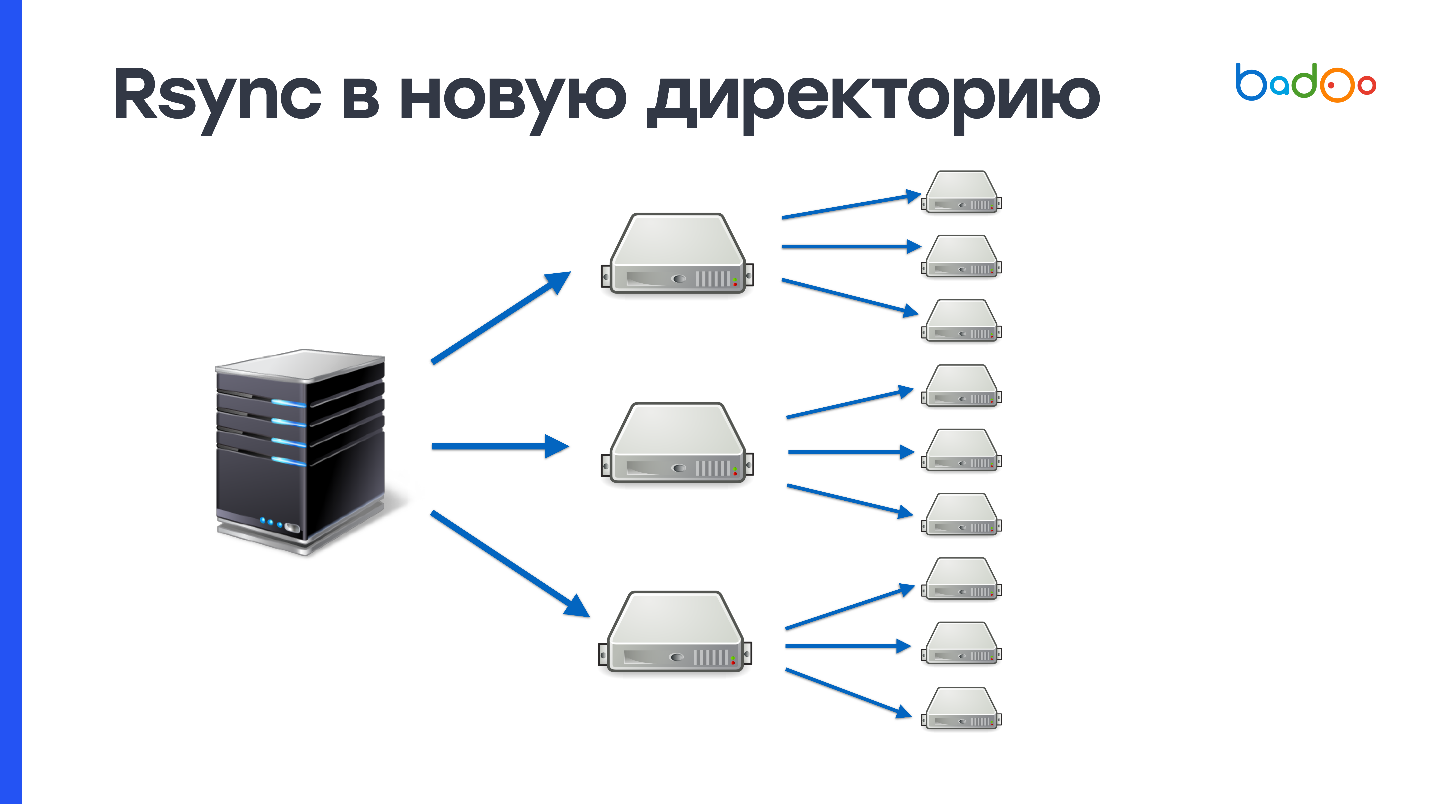

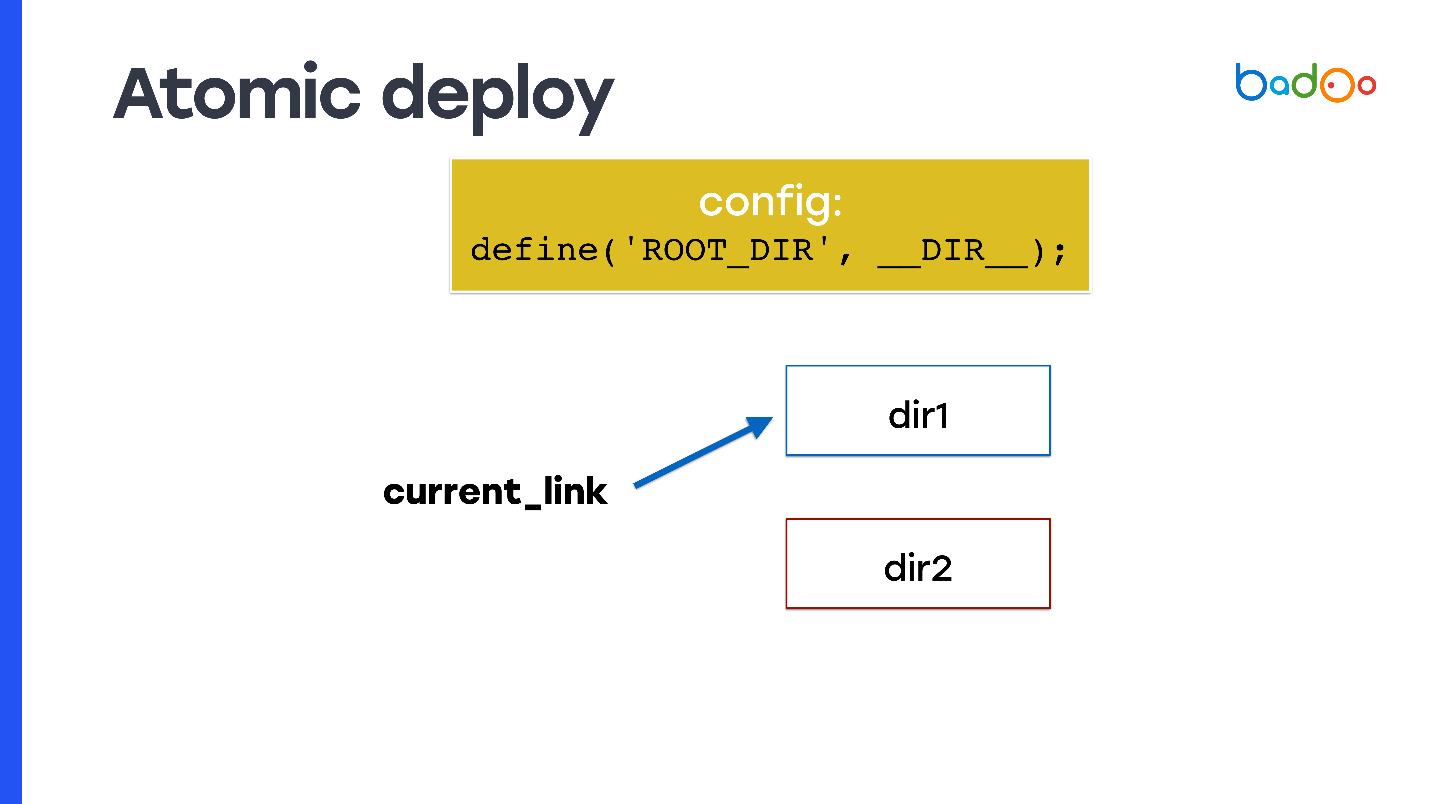

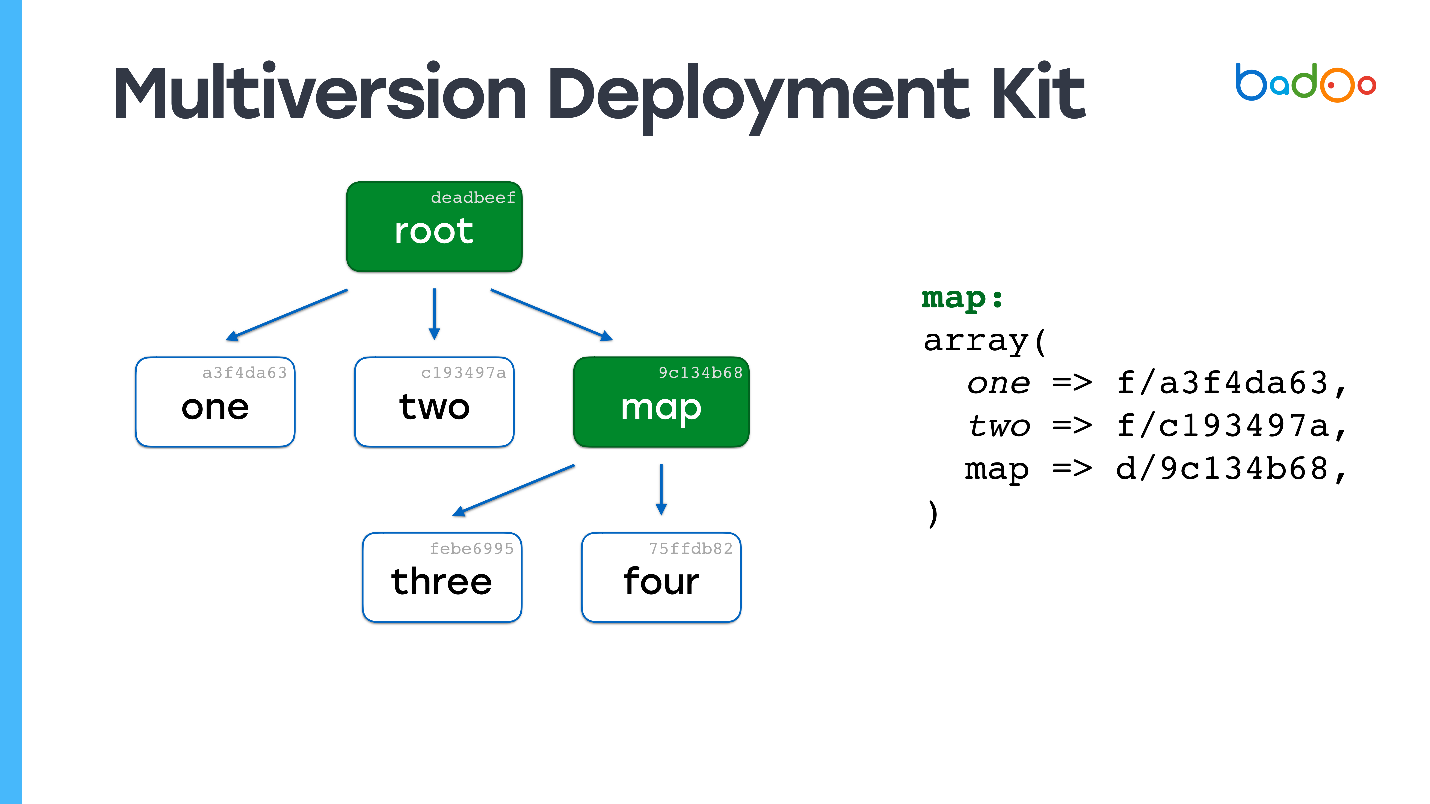

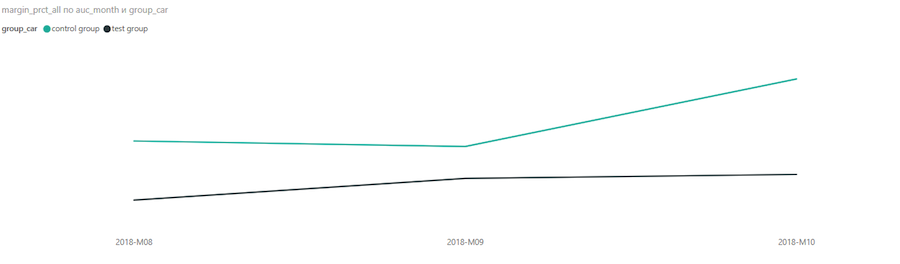

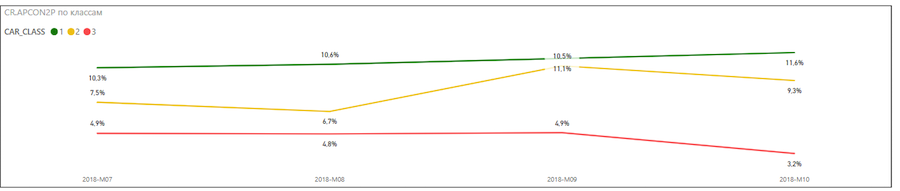

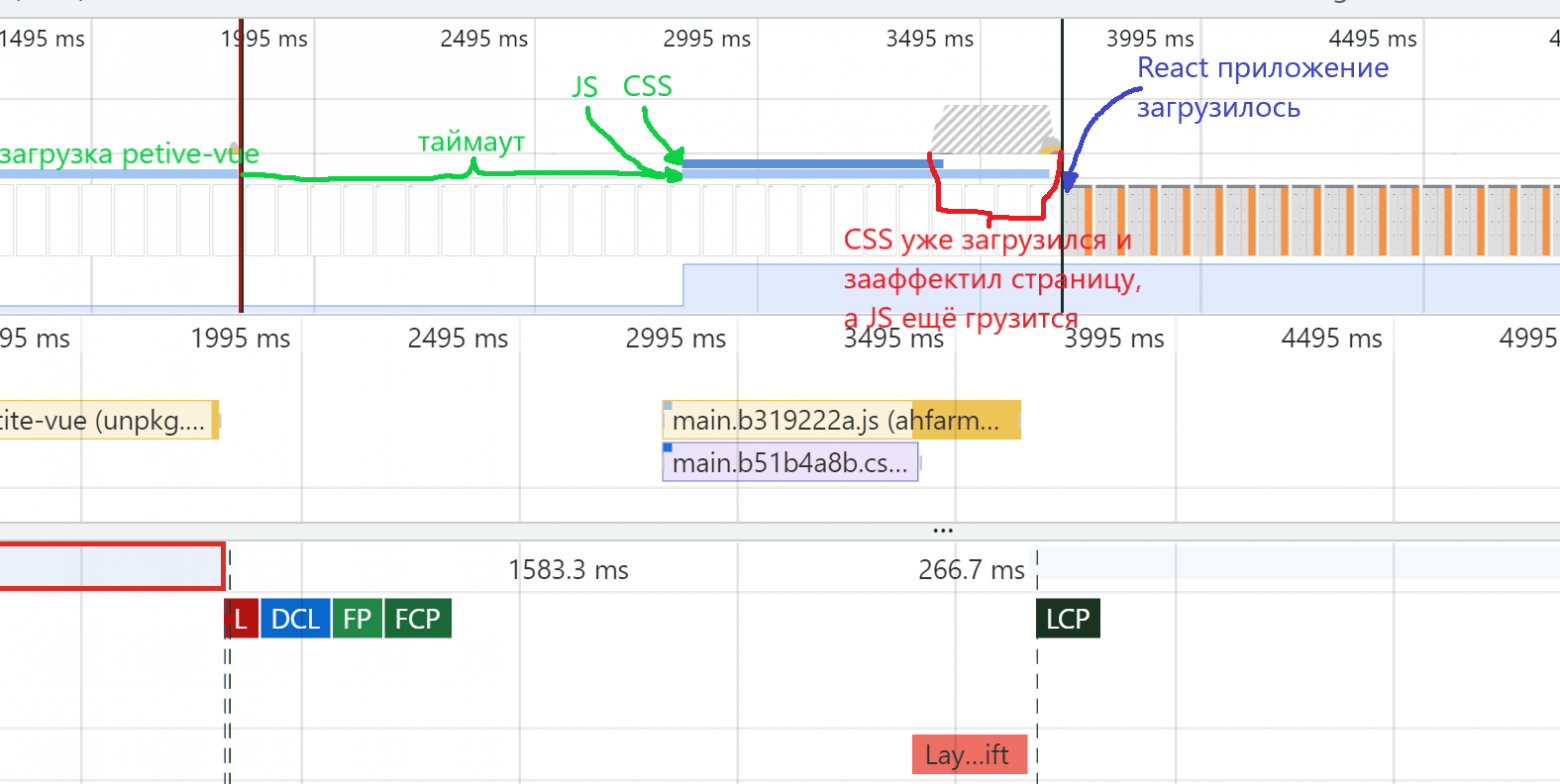

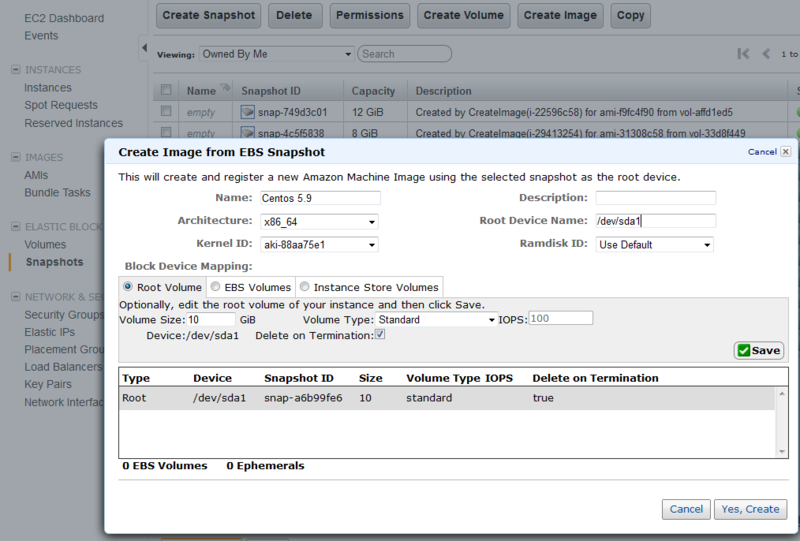

Те, кто работают с логами, так или иначе сталкиваются с проблемой долгосрочного хранение для последующего анализа. В Elasticsearch это особенно актуально, потому что с функциональностью куратора всё было прискорбно. В версии 6.6 появился функционал ILM. Он состоит из 4 фаз:

* Hot — индекс активно обновляется и запрашивается.

* Warm — индекс больше не обновляется, но всё ещё запрашивается.

* Cold — индекс больше не обновляется и редко запрашивается. Информация всё ещё должна быть доступна для поиска, но запросы могут выполняться медленнее.

* Delete — индекс больше не нужен и может быть безопасно удален.

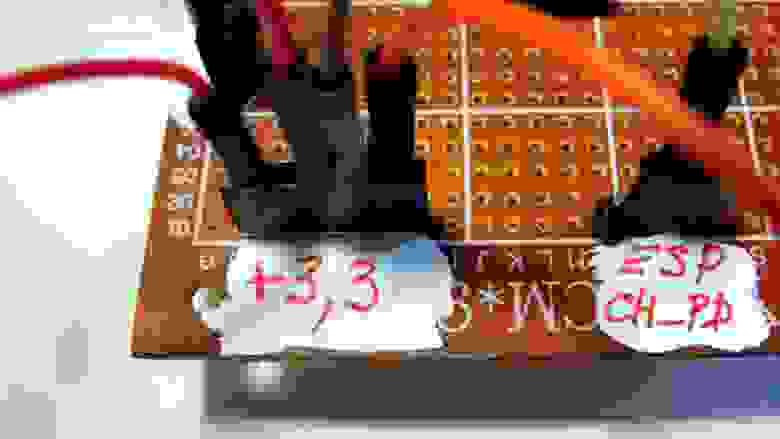

Дано

====

* Elasticsearch Data Hot: 24 процессора, 128 Гб памяти, 1,8 Тб SSD RAID 10 (8 нод).

* Elasticsearch Data Warm: 24 процессора, 64 Гб памяти, 8 Тб NetApp SSD Policy (4 ноды).

* Elasticsearch Data Cold: 8 процессоров, 32 Гб памяти, 128 Тб HDD RAID 10 (4 ноды).

Цель

====

Эти настройки индивидуальны, всё зависит от места на нодах, количества индексов, логов и т.д. У нас это 2-3 Тб данных за сутки.

* 5 дней — фаза Hot (8 основных / 1 реплика).

* 20 дней — фаза Warm ([shrink-индекс](https://www.elastic.co/guide/en/elasticsearch/reference/7.6/indices-shrink-index.html#indices-shrink-index) 4 основных / 1 реплика).

* 90 дней — фаза Cold ([freeze-индекс](https://www.elastic.co/guide/en/elasticsearch/reference/7.6/frozen-indices.html) 4 основных / 1 реплика).

* 120 дней — фаза Delete.

Настройка Elasticsearch

=======================

Для распределения шард по нодам нужен всего один параметр:

* *Hot*-ноды:

```

~]# cat /etc/elasticsearch/elasticsearch.yml | grep attr

# Add custom attributes to the node:

node.attr.box_type: hot

```

* *Warm*-ноды:

```

~]# cat /etc/elasticsearch/elasticsearch.yml | grep attr

# Add custom attributes to the node:

node.attr.box_type: warm

```

* *Cold*-ноды:

```

~]# cat /etc/elasticsearch/elasticsearch.yml | grep attr

# Add custom attributes to the node:

node.attr.box_type: cold

```

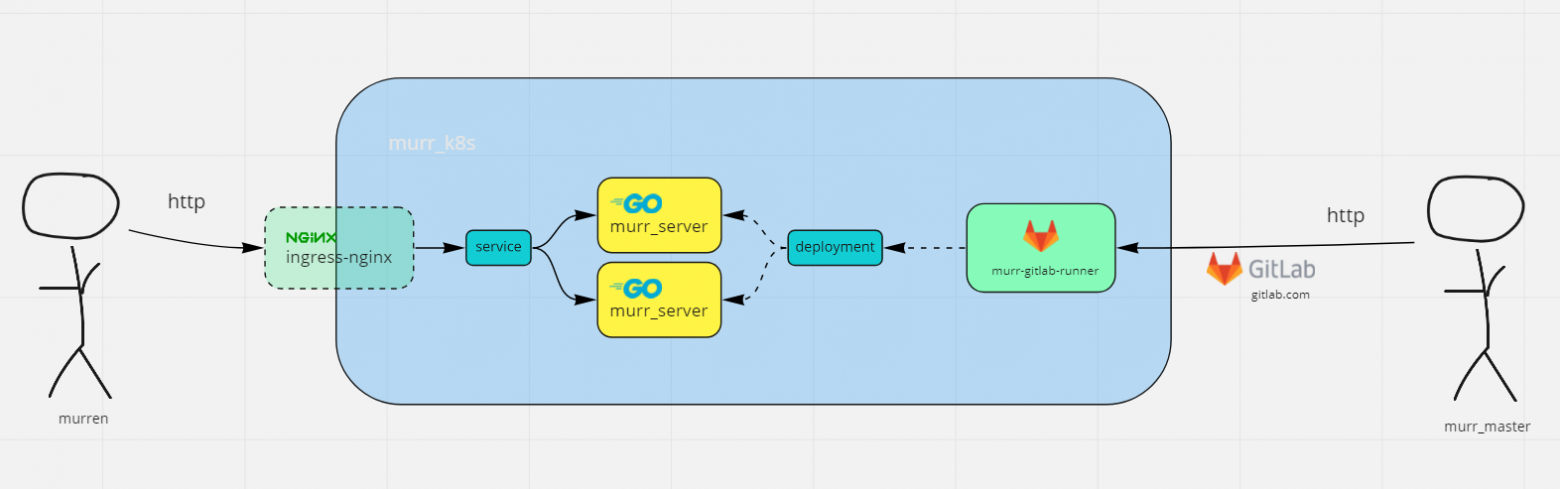

Настройка Logstash

==================

Как это всё работает и как мы реализовали эту функцию? Давайте начнем с попадания логов в Elasticsearch. Есть два способа:

1. Logstash забирает логи из Kafka. Может забрать чистыми или преобразовать на своей стороне.

2. Что-то само пишет в Elasticsearch, например, APM-сервер.

Рассмотрим пример управления индексами через Logstash. Он создает индекс и применяет к нему [шаблон индекса](https://www.elastic.co/guide/en/kibana/master/managing-indices.html) и соответствующий [ILM](https://www.elastic.co/guide/en/elasticsearch/reference/master/index-lifecycle-management-api.html).

**k8s-ingress.conf**

```

input {

kafka {

bootstrap_servers => "node01, node02, node03"

topics => ["ingress-k8s"]

decorate_events => false

codec => "json"

}

}

filter {

ruby {

path => "/etc/logstash/conf.d/k8s-normalize.rb"

}

if [log] =~ "\[warn\]" or [log] =~ "\[error\]" or [log] =~ "\[notice\]" or [log] =~ "\[alert\]" {

grok {

match => { "log" => "%{DATA:[nginx][error][time]} \[%{DATA:[nginx][error][level]}\] %{NUMBER:[nginx][error][pid]}#%{NUMBER:[nginx][error][tid]}: \*%{NUMBER:[nginx][error][connection_id]} %{DATA:[nginx][error][message]}, client: %{IPORHOST:[nginx][error][remote_ip]}, server: %{DATA:[nginx][error][server]}, request: \"%{WORD:[nginx][error][method]} %{DATA:[nginx][error][url]} HTTP/%{NUMBER:[nginx][error][http_version]}\", (?:upstream: \"%{DATA:[nginx][error][upstream][proto]}://%{DATA:[nginx][error][upstream][host]}:%{DATA:[nginx][error][upstream][port]}/%{DATA:[nginx][error][upstream][url]}\", )?host: \"%{DATA:[nginx][error][host]}\"(?:, referrer: \"%{DATA:[nginx][error][referrer]}\")?" }

remove_field => "log"

}

}

else {

grok {

match => { "log" => "%{IPORHOST:[nginx][access][host]} - \[%{IPORHOST:[nginx][access][remote_ip]}\] - %{DATA:[nginx][access][remote_user]} \[%{HTTPDATE:[nginx][access][time]}\] \"%{WORD:[nginx][access][method]} %{DATA:[nginx][access][url]} HTTP/%{NUMBER:[nginx][access][http_version]}\" %{NUMBER:[nginx][access][response_code]} %{NUMBER:[nginx][access][bytes_sent]} \"%{DATA:[nginx][access][referrer]}\" \"%{DATA:[nginx][access][agent]}\" %{NUMBER:[nginx][access][request_lenght]} %{NUMBER:[nginx][access][request_time]} \[%{DATA:[nginx][access][upstream][name]}\] (?:-|%{IPORHOST:[nginx][access][upstream][addr]}:%{NUMBER:[nginx][access][upstream][port]}) (?:-|%{NUMBER:[nginx][access][upstream][response_lenght]}) %{DATA:[nginx][access][upstream][response_time]} %{DATA:[nginx][access][upstream][status]} %{DATA:[nginx][access][request_id]}" }

remove_field => "log"

}

}

}

output {

elasticsearch {

id => "k8s-ingress"

hosts => ["node01", "node02", "node03", "node04", "node05", "node06", "node07", "node08"]

manage_template => true # включаем управление шаблонами

template_name => "k8s-ingress" # имя применяемого шаблона

ilm_enabled => true # включаем управление ILM

ilm_rollover_alias => "k8s-ingress" # alias для записи в индексы, должен быть уникальным

ilm_pattern => "{now/d}-000001" # шаблон для создания индексов, может быть как "{now/d}-000001" так и "000001"

ilm_policy => "k8s-ingress" # политика прикрепляемая к индексу

index => "k8s-ingress-%{+YYYY.MM.dd}" # название создаваемого индекса, может содержать %{+YYYY.MM.dd}, зависит от ilm_pattern

}

}

```

Настройка Kibana

================

Есть базовый шаблон, который применяется ко всем новым индексам. Он задаёт распределение горячих индексов, количество шардов, реплик и т.д. Вес шаблона определяется опцией `order`. Шаблоны с более высоким весом переопределяют уже существующие параметры шаблона или добавляют новые.

**GET \_template/default**

```

{

"default" : {

"order" : -1, # вес шаблона

"version" : 1,

"index_patterns" : [

"*" # применяем ко всем индексам

],

"settings" : {

"index" : {

"codec" : "best_compression", # уровень сжатия

"routing" : {

"allocation" : {

"require" : {

"box_type" : "hot" # распределяем только по горячим нодам

},

"total_shards_per_node" : "8" # максимальное количество шардов на ноду от одного индекса

}

},

"refresh_interval" : "5s", # интервал обновления индекса

"number_of_shards" : "8", # количество шардов

"auto_expand_replicas" : "0-1", # количество реплик на ноду от одного индекса

"number_of_replicas" : "1" # количество реплик

}

},

"mappings" : {

"_meta" : { },

"_source" : { },

"properties" : { }

},

"aliases" : { }

}

}

```

Затем применим маппинг к индексам `k8s-ingress-*` с помощью шаблона с более высоким весом.

**GET \_template/k8s-ingress**

```

{

"k8s-ingress" : {

"order" : 100,

"index_patterns" : [

"k8s-ingress-*"

],

"settings" : {

"index" : {

"lifecycle" : {

"name" : "k8s-ingress",

"rollover_alias" : "k8s-ingress"

},

"codec" : "best_compression",

"routing" : {

"allocation" : {

"require" : {

"box_type" : "hot"

}

}

},

"number_of_shards" : "8",

"number_of_replicas" : "1"

}

},

"mappings" : {

"numeric_detection" : false,

"_meta" : { },

"_source" : { },

"dynamic_templates" : [

{

"all_fields" : {

"mapping" : {

"index" : false,

"type" : "text"

},

"match" : "*"

}

}

],

"date_detection" : false,

"properties" : {

"kubernetes" : {

"type" : "object",

"properties" : {

"container_name" : {

"type" : "keyword"

},

"container_hash" : {

"index" : false,

"type" : "keyword"

},

"host" : {

"type" : "keyword"

},

"annotations" : {

"type" : "object",

"properties" : {

"value" : {

"index" : false,

"type" : "text"

},

"key" : {

"index" : false,

"type" : "keyword"

}

}

},

"docker_id" : {

"index" : false,

"type" : "keyword"

},

"pod_id" : {

"type" : "keyword"

},

"labels" : {

"type" : "object",

"properties" : {

"value" : {

"type" : "keyword"

},

"key" : {

"type" : "keyword"

}

}

},

"namespace_name" : {

"type" : "keyword"

},

"pod_name" : {

"type" : "keyword"

}

}

},

"@timestamp" : {

"type" : "date"

},

"nginx" : {

"type" : "object",

"properties" : {

"access" : {

"type" : "object",

"properties" : {

"agent" : {

"type" : "text"

},

"response_code" : {

"type" : "integer"

},

"upstream" : {

"type" : "object",

"properties" : {

"port" : {

"type" : "keyword"

},

"name" : {

"type" : "keyword"

},

"response_lenght" : {

"type" : "integer"

},

"response_time" : {

"index" : false,

"type" : "text"

},

"addr" : {

"type" : "keyword"

},

"status" : {

"index" : false,

"type" : "text"

}

}

},

"method" : {

"type" : "keyword"

},

"http_version" : {

"type" : "keyword"

},

"bytes_sent" : {

"type" : "integer"

},

"request_lenght" : {

"type" : "integer"

},

"url" : {

"type" : "text",

"fields" : {

"keyword" : {

"type" : "keyword"

}

}

},

"remote_user" : {

"type" : "text"

},

"referrer" : {

"type" : "text"

},

"remote_ip" : {

"type" : "ip"

},

"request_time" : {

"format" : "yyyy/MM/dd HH:mm:ss||yyyy/MM/dd||epoch_millis||dd/MMM/YYYY:H:m:s Z",

"type" : "date"

},

"host" : {

"type" : "keyword"

},

"time" : {

"format" : "yyyy/MM/dd HH:mm:ss||yyyy/MM/dd||epoch_millis||dd/MMM/YYYY:H:m:s Z",

"type" : "date"

}

}

},

"error" : {

"type" : "object",

"properties" : {

"server" : {

"type" : "keyword"

},

"upstream" : {

"type" : "object",

"properties" : {

"port" : {

"type" : "keyword"

},

"proto" : {

"type" : "keyword"

},

"host" : {

"type" : "keyword"

},

"url" : {

"type" : "text",

"fields" : {

"keyword" : {

"type" : "keyword"

}

}

}

}

},

"method" : {

"type" : "keyword"

},

"level" : {

"type" : "keyword"

},

"http_version" : {

"type" : "keyword"

},

"pid" : {

"index" : false,

"type" : "integer"

},

"message" : {

"type" : "text"

},

"tid" : {

"index" : false,

"type" : "keyword"

},

"url" : {

"type" : "text",

"fields" : {

"keyword" : {

"type" : "keyword"

}

}

},

"referrer" : {

"type" : "text"

},

"remote_ip" : {

"type" : "ip"

},

"connection_id" : {

"index" : false,

"type" : "keyword"

},

"host" : {

"type" : "keyword"

},

"time" : {

"format" : "yyyy/MM/dd HH:mm:ss||yyyy/MM/dd||epoch_millis||dd/MMM/YYYY:H:m:s Z",

"type" : "date"

}

}

}

}

},

"log" : {

"type" : "text"

},

"@version" : {

"type" : "text",

"fields" : {

"keyword" : {

"ignore_above" : 256,

"type" : "keyword"

}

}

},

"eventtime" : {

"type" : "float"

}

}

},

"aliases" : { }

}

}

```

После применения всех шаблонов мы применяем ILM-политику и начинаем следить за жизнью индексов.

**GET \_ilm/policy/k8s-ingress**

```

{

"k8s-ingress" : {

"version" : 14,

"modified_date" : "2020-06-11T10:27:01.448Z",

"policy" : {

"phases" : {

"warm" : { # теплая фаза

"min_age" : "5d", # срок жизни индекса после ротации до наступления теплой фазы

"actions" : {

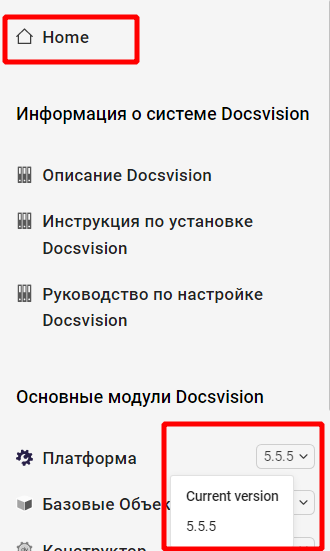

"allocate" : {