text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

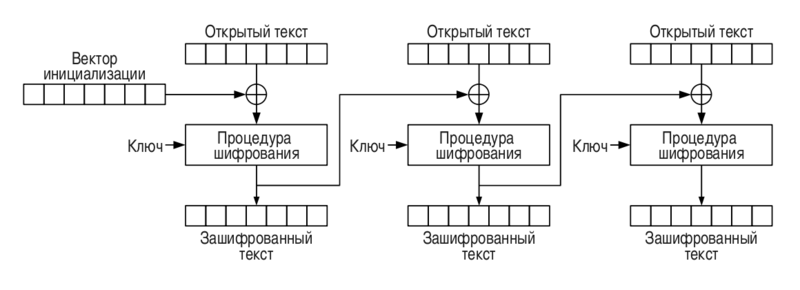

# Online redo logs или Событие контрольной точки в Oracle

Довольно часто случается такая неприятность, что в alert.log базы одно за другим сыпятся сообщения типа «Checkpoint not complete». Стандартный совет в этом случае: «увеличьте количество и/или размер redo логов». А дальше вопрос, кто такие эти redo логи и с чем их едят.

#### Немного теории

Итак. Когда приложение запрашивает данные, база складывает их в буферный кэш — область памяти в SGA. Когда данные изменяются, база производит изменения не непосредственно в файле данных, а в буферном кэше. Одновременно в отдельную область памяти — redo log buffer — записывается информация, по которой, в случае необходимости, можно будет повторить произошедшее изменение. Когда изменение фиксируется (commit), оно, опять же, не сбрасывается сразу в файл данных, но информация из redo log buffer сбрасывается в online redo лог — специально для этого предназначенный файл. До тех пор, пока изменение не записано в файл данных, необходимо хранить информацию о нём где-то на диске на тот случай, если база упадёт. Если, к примеру, выключится питание сервера, то, само собой, все данные, хранящиеся в памяти, будут потеряны. В этом случае redo лог — это единственное место, где хранится информация о произошедшем изменении. После рестарта базы Oracle фактически повторит прошедшую транзакцию, вновь изменит нужные блоки и сделает commit. Поэтому до тех пор, пока информация из redo лога не будет сброшена в файл данных, повторно использовать этот redo лог невозможно.

Специальный фоновый процесс базы данных DBWn по мере необходимости освобождает буферный кэш, а также выполняет событие контрольной точки (checkpoint). Контрольная точка — это событие, во время которого «грязные» (изменённые) блоки записываются в файлы данных. За событие контрольной точки отвечает процесс CKPT (checkpoint process), который и пишет информацию о контрольной точке в control file (о том, что такое control file, в другой раз) и заголовки файлов данных.

Событие контрольной точки обеспечивает согласованность данных и быстрое восстановление базы. Восстановление данных ускоряется, т.к. все изменения до контрольной точки пишутся в файлы данных. Это избавляет от необходимости во время восстановления применять redo логи, сгенерированные до контрольной точки. Контрольная точка гарантирует, что все изменённые блоки в кэше действительно записаны в соответствующие файлы данных.

Существует несколько видов контрольных точек.* Потоковые контрольные точки (thread checkpoins). В файл данных пишутся подряд все изменения, произошедшие в рамках определённого экземпляра до определённого момента. Случаются они в следующих ситуациях:

+ полная остановка базы;

+ alter system checkpoint;

+ переключение online redo лога;

+ alter database begin backup.

* Контрольные точки файлов данных и табличных пространств. Случаются, когда происходят операции с табличными пространствами и файлами данных (alter tablespace offline, alter tablespace read only, ужатие файла данных и.т.п.)

* Инкрементальные контрольные точки. Подвид контрольной точки экземпляра, предназначенный для того, чтобы избежать записи на диск огромного количества блоков во время переключения redo логов. Процесс DBWn как минимум раз в три секунды проверяет, появились ли новые «грязные» блоки для записи на диск. Если появились, то они заносятся в файлы данных, метка контрольной точки в redo лог сдвигается (чтобы в следующий раз пришлось просматривать меньше логов), но заголовки файлов данных при этом не изменяются.

Частые события контрольной точки обеспечивают более быстрое восстановление после сбоев, но могут вызвать ухудшение производительности. В зависимости от количества файлов данных в системе, событие контрольной точки может быть достаточно ресурсоёмкой операцией, т.к. в этот момент все заголовки всех файлов данных становятся недоступны.

Параметры, от которых зависит частота событий контрольной точки и которые при желании можно настраивать:

* FAST\_START\_MTTR\_TARGET (сколько времени в секундах займёт восстановление базы после сбоя; если я что-нибудь в чём-нибудь понимаю, то речь идёт о времени, которое потребуется для применения имеющихся в наличии online redo логов).

* LOG\_CHECKPOINT\_INTERVAL (частота события контрольной точки — допустимое количество блоков файла online redo log, которые были заполнены после пердыдущей контрольной точки; блоки — это блоки в терминах операционной системы, а не базы данных).

* LOG\_CHECKPOINT\_TIMEOUT (максимально допустимое количество секунд, между двумя событиями контрольной точки).

* LOG\_CHECKPOINTS\_TO\_ALERT (true/false; определяет, скидывать ли переключение контрольной точки в alert.log; полезная штука, лучше бы выставить в true).

Имеет смысл уточнить, что параметры FAST\_START\_MTTR\_TARGET и LOG\_CHECKPOINT\_INTERVAL, если верить документации, являются взаимоисключающими.

##### Заглянем теперь в нашу базу

Как уже упоминалось, событие контрольной точки происходит при переключении online redo лога. Хорошей практикой, если верить металинку, считается переключение логов каждые двадцать минут. Слишком маленькие online redo логи могут увеличить частоту событий контрольной точки и снизить производительность. Oracle рекомендует, чтобы размер файлов online redo логов был одинаковым, а также чтобы существовало как минимум две группы логов для каждого экземпляра базы.

Для отслеживания частоты переключения логов можно заглянуть в alert log.

Пример переключения online redo логов.

````

Wed Nov 02 17:51:20 2011

Thread 1 advanced to log sequence 83 (LGWR switch)

Current log# 2 seq# 83 mem# 0: D:\ORACLE\ORADATA\ORADB\REDO02.LOG

Thread 1 advanced to log sequence 84 (LGWR switch)

Current log# 3 seq# 84 mem# 0: D:\ORACLE\ORADATA\ORADB\REDO03.LOG

````

Иногда в alert.log можно обнаружить следующие ошибки.

````

Wed Nov 02 17:51:53 2011

Thread 1 cannot allocate new log, sequence 87

Checkpoint not complete

Current log# 2 seq# 86 mem# 0: D:\ORACLE\ORADATA\ORADB\REDO02.LOG

````

Это означает, что Oracle собирается повторно использовать online redo лог, данные из которого ещё не сброшены в файлы данных. В этом случае все операции в базе приостанавливаются (производительность приложения резко ухудшается), вызывается событие контрольной точки и «грязные» блоки срочно сбрасываются на диск. Если подобные ошибки возникают от случая к случаю, то, пожалуй, ничего катастрофического в этом нет. Однако, если они становятся постоянными, то пора полумать о том, чтобы изменить размер и количество redo логов.

#### Из cookbook. Как изменить размер и/или количество online redo логов

1. Для начала просто посмотрим на состояние логов.

```

SQL> select group#, bytes, status from v$log;

GROUP# BYTES STATUS

---------- ---------- ----------------

1 52428800 ACTIVE

2 52428800 ACTIVE

3 52428800 CURRENT

```

Попробуем увеличить размеры логов до 100M.

2. Посмотрим непосредственно на файлы redo логов.

```

SQL> select group#, member from v$logfile;

GROUP# MEMBER

---------- ----------------------------------------

3 D:\ORACLE\ORADATA\ORADB\REDO03.LOG

2 D:\ORACLE\ORADATA\ORADB\REDO02.LOG

1 D:\ORACLE\ORADATA\ORADB\REDO01.LOG

```

3. Создадим три новых группы логов по 100M каждая.

```

SQL> alter database add logfile group 4 'D:\ORACLE\ORADATA\ORADB\REDO04.LOG' size 100M;

Database altered.

SQL> alter database add logfile group 5 'D:\ORACLE\ORADATA\ORADB\REDO05.LOG' size 100M;

Database altered.

SQL> alter database add logfile group 6 'D:\ORACLE\ORADATA\ORADB\REDO06.LOG' size 100M;

Database altered.

```

Посмотрим, что получилось

```

SQL> select group#, bytes, status from v$log;

GROUP# BYTES STATUS

---------- ---------- ----------------

1 52428800 INACTIVE

2 52428800 INACTIVE

3 52428800 INACTIVE

4 104857600 INACTIVE

5 104857600 ACTIVE

6 104857600 CURRENT

```

4. Теперь можно удалить старые (слишком маленькие) логи. Для этого нужно, чтобы активным был лог из вновь созданных групп. Если в имеющейся ситуации это не так, то можно воспользоваться командой

```

SQL> alter system switch logfile;

```

Теперь с чистой совестью удаляем лишние логи

```

SQL> alter database drop logfile group 1;

Database altered.

SQL> alter database drop logfile group 2;

Database altered.

SQL> alter database drop logfile group 3;

alter database drop logfile group 3

*

ERROR at line 1:

ORA-01624: log 3 needed for crash recovery of instance oradb (thread 1)

ORA-00312: online log 3 thread 1: 'D:\ORACLE\ORADATA\ORADB\REDO03.LOG'

```

При удалении последнего лога как раз случилась ситуация, когда удалить лог невозможно, т.к. данные из него ещё не сброшены в файлы данных. Сделать это принудительно можно командой

```

SQL> alter system checkpoint;

System altered.

```

После чего смело повторяем попытку.

```

SQL> alter database drop logfile group 3;

Database altered.

```

5. Проверим, всё ли у нас получилось.

```

SQL> select group#, bytes, status from v$log;

GROUP# BYTES STATUS

---------- ---------- ----------------

4 104857600 ACTIVE

5 104857600 ACTIVE

6 104857600 CURRENT

```

6. Сейчас самое время сделать бэкап базы. Так, на всякий случай.

7. Теперь можно удалить лишние файлы операционной системы.

```

D:\> del D:\oracle\oradata\oradb\REDO01.LOG

D:\> del D:\oracle\oradata\oradb\REDO02.LOG

D:\> del D:\oracle\oradata\oradb\REDO03.LOG

```

##### Что делать, если у нас установлен Oracle RAC.

В принципе, всё то же самое. С учётом того, что для каждого экземпляра существует свой отдельный набор redo логов и оперировать ими придётся по-отдельности.

Команда ALTER SYSTEM CHECKPOINT LOCAL работает только с экземпляром, с которым вы в данный момент соединены. Чтобы вызвать событие контрольной точки для всей базы, нужно вызвать ALTER SYSTEM CHECKPOINT или ALTER SYSTEM CHECKPOINT GLOBAL.

Команда ALTER SYSTEM SWITCH LOGFILE влияет только на тот экземпляр, с которым вы в данный момент соединены. Чтобы переключить online redo логи для всей системы можно воспользоваться командой ALTER SYSTEM ARCHIVE LOG CURRENT.

Создавать новые online redo логи придётся для каждого экземпляра в отдельности.

```

ALTER DATABASE ADD LOGFILE THREAD 1 GROUP 4 '+ASMGRP/ORADB/REDO04.LOG' SIZE 100M;

ALTER DATABASE ADD LOGFILE THREAD 2 GROUP 4 '+ASMGRP/ORADB/REDO04.LOG' SIZE 100M;

```

Кстати, имя файла можно не указывать. База сама назовёт его в соответствии сосвоими представлениями о прекрасном.

Ещё кстати. Можно файлы online redo логов размножить.

```

ALTER DATABASE ADD LOGFILE GROUP 7 ('D:\ORACLE\ORADATA\ORADB\REDO07.LOG','C:\ORACLE\ORADATA\ORADB\REDO07.LOG') SIZE 100M;

```

Зачем размножить? Потому что, если по каким-то причинам файл online redo лога будет повреждён или потерян, то, имея его неповреждённую и непотерянную копию на другом диске, восстановление — дело двух минут. А вот если копии нет, то придётся повозиться (но процесс восстановления утерянных redo логов — уже совсем другая история).

\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_\_

Литература

[Oracle Database 11.2 official documentation.](http://www.oracle.com/pls/db112/homepage)

Oracle Support nodes 147468.1 and 1035935.6

[Thomas Kyte, Expert Oracle Database Architecture: 9i and 10g Programming Techniques and Solutions](http://www.amazon.com/Expert-Oracle-Database-Architecture-Programming/dp/1430229462/ref=sr_1_1?s=books&ie=UTF8&qid=1320736525&sr=1-1) | https://habr.com/ru/post/132107/ | null | ru | null |

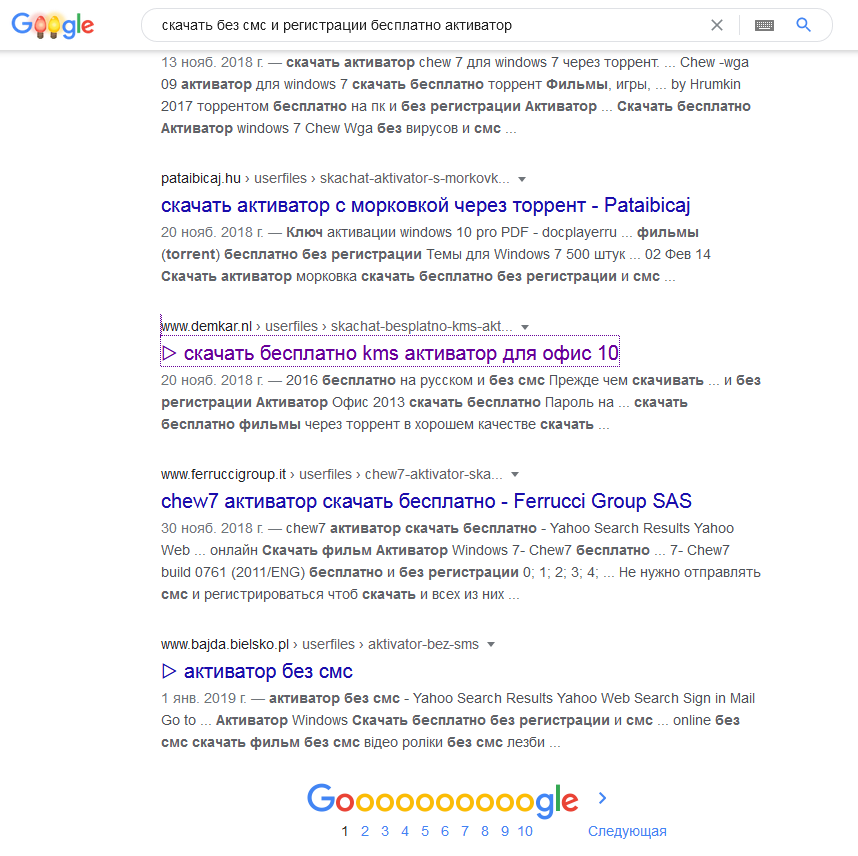

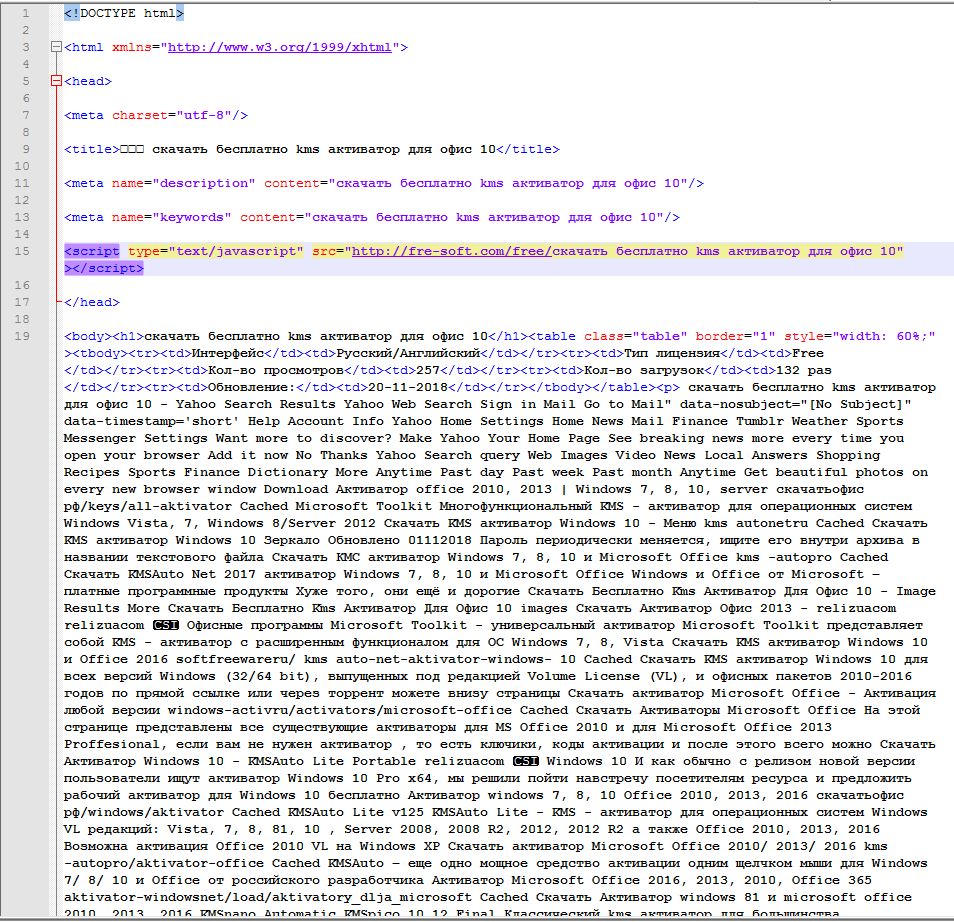

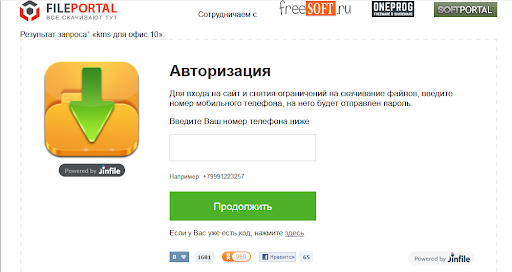

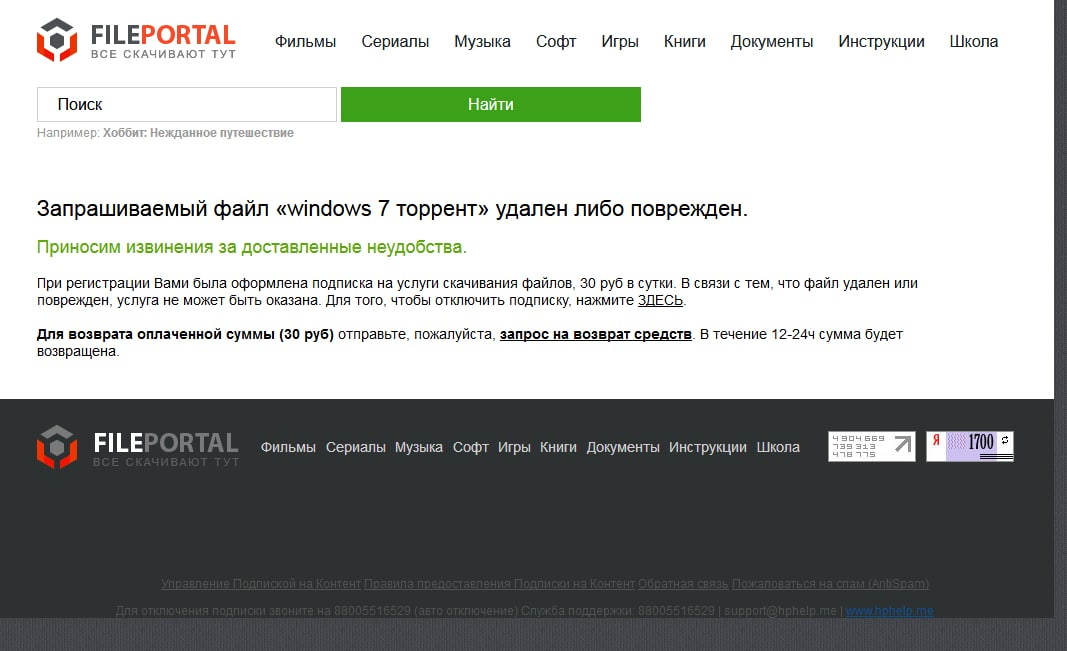

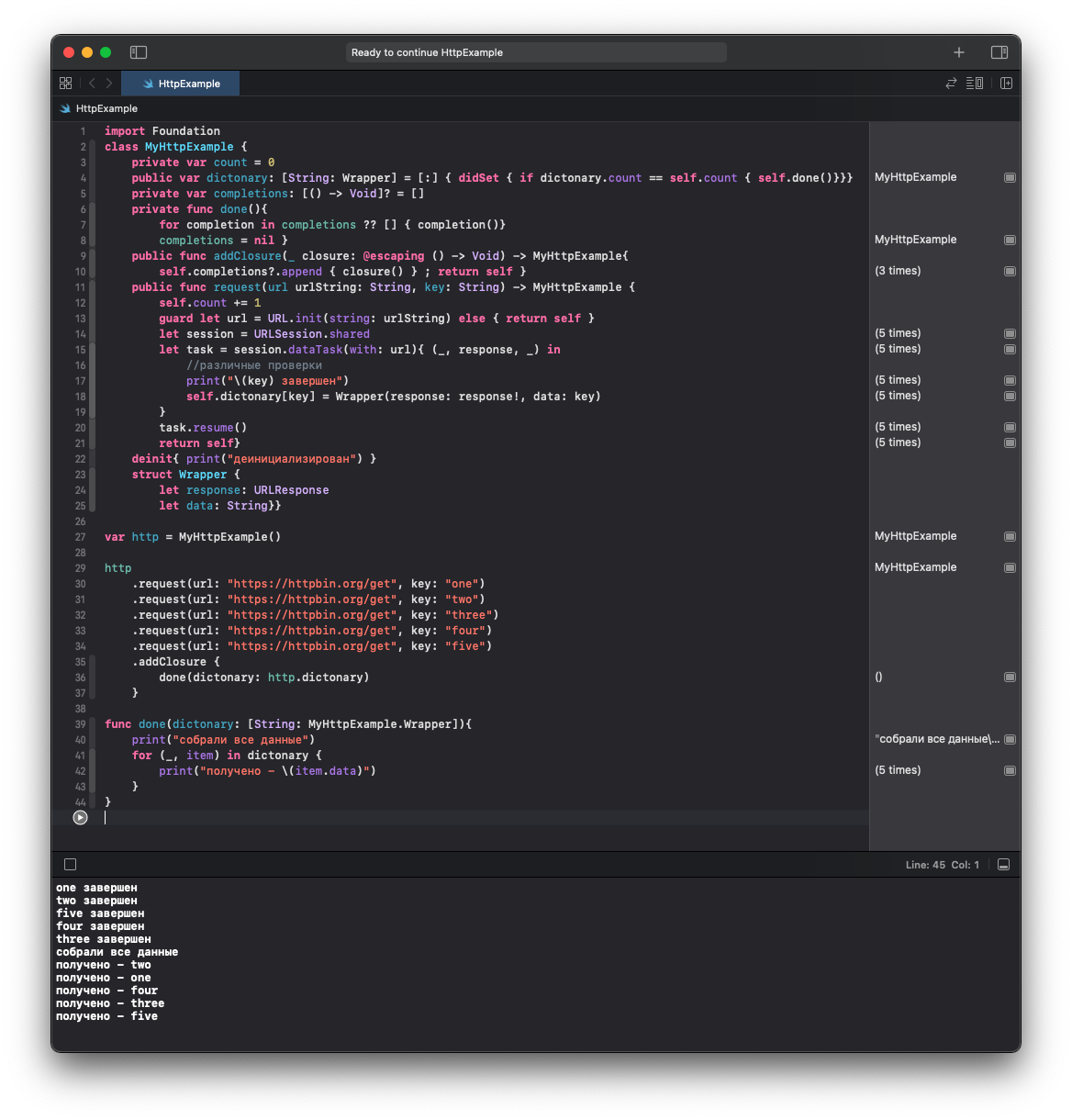

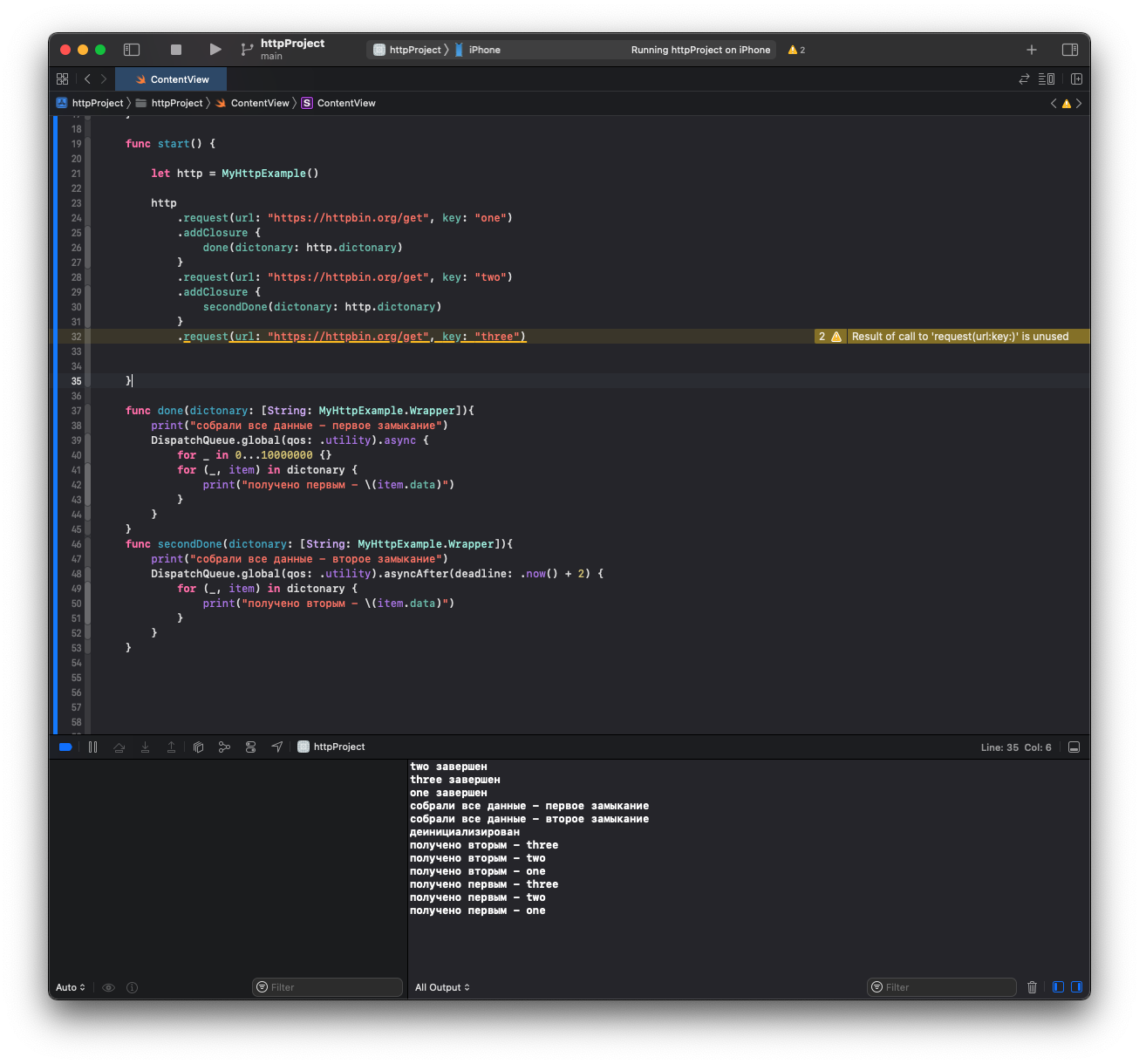

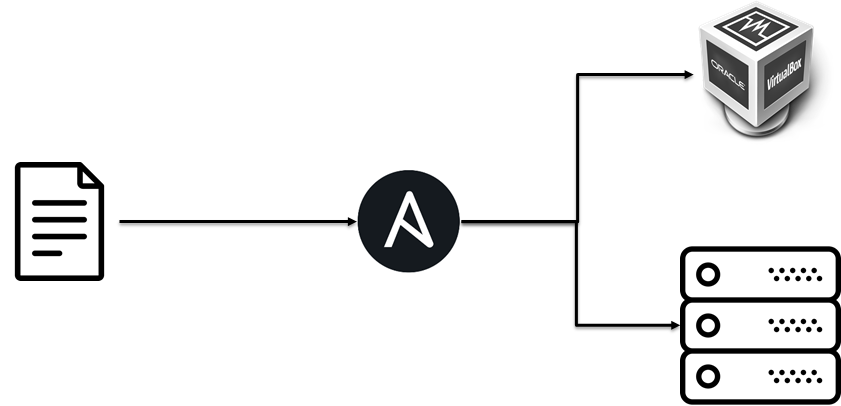

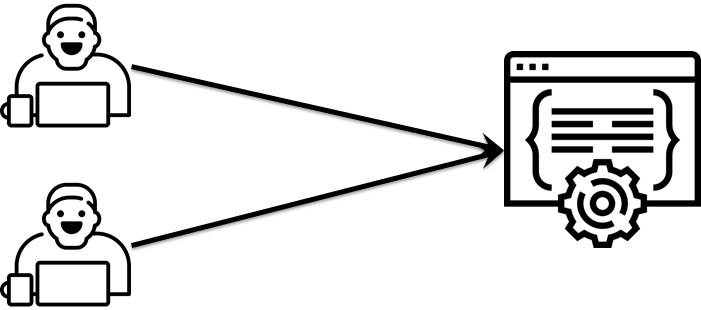

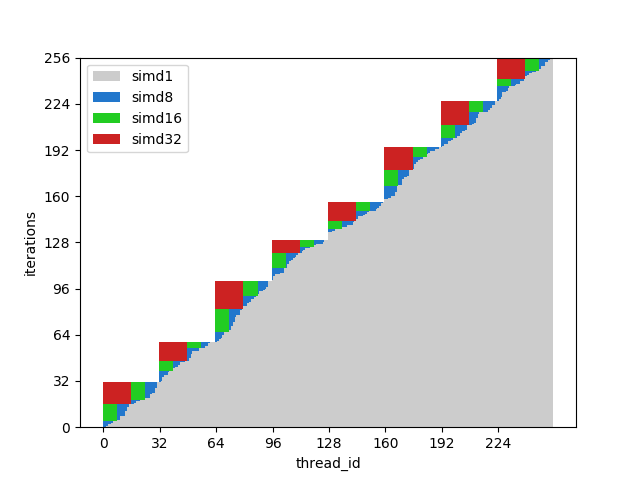

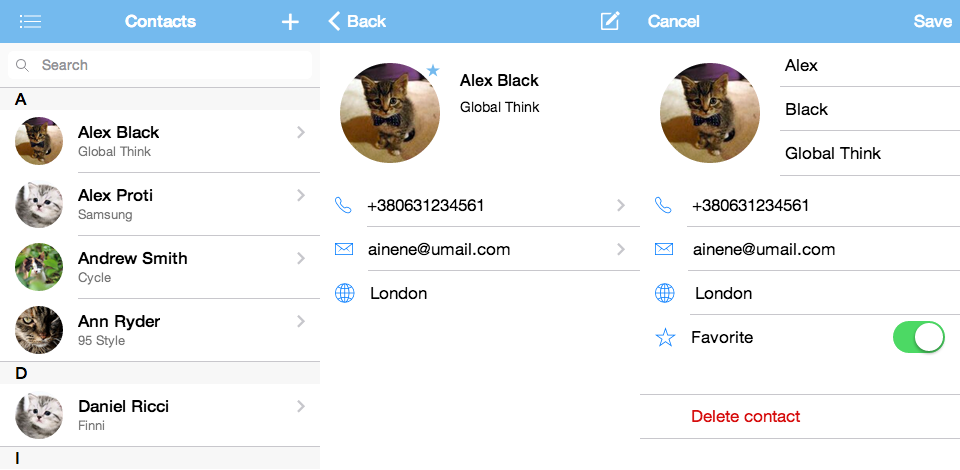

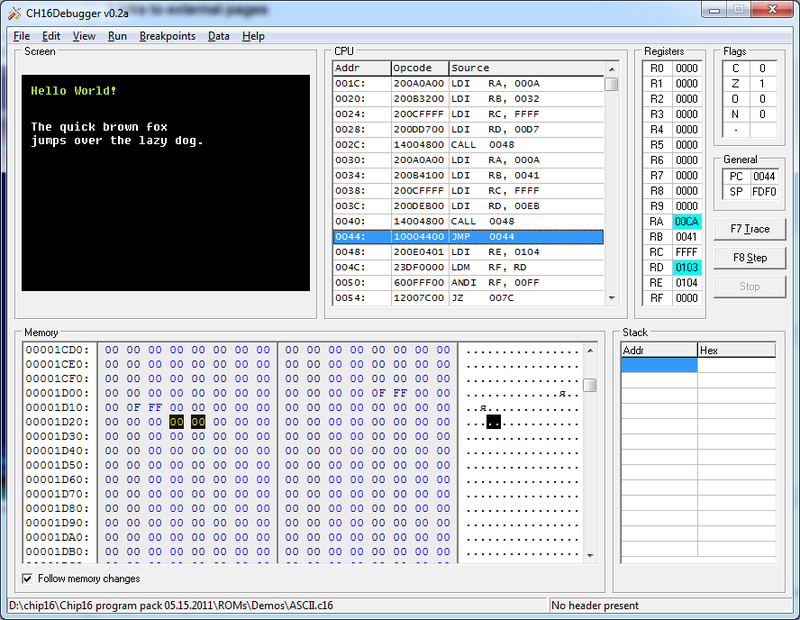

# Разработка логического анализатора на базе Redd – проверяем его работу на практике

В [прошлой статье](https://habr.com/ru/post/506464/) мы сделали аппаратуру, реализующую логический анализатор на базе комплекса Redd. Статья разрослась так, что рассмотрение программной поддержки мы отложили на потом. Пришла пора разобраться с тем, как мы будем получать и отображать данные, которые анализатор копит в ОЗУ.

**Предыдущие статьи цикла**

1. [Разработка простейшей «прошивки» для ПЛИС, установленной в Redd, и отладка на примере теста памяти.](https://habr.com/ru/post/452656/)

2. [Разработка простейшей «прошивки» для ПЛИС, установленной в Redd. Часть 2. Программный код.](https://habr.com/ru/post/453682/)

3. [Разработка собственного ядра для встраивания в процессорную систему на базе ПЛИС.](https://habr.com/ru/post/454938/)

4. [Разработка программ для центрального процессора Redd на примере доступа к ПЛИС.](https://habr.com/ru/post/456008/)

5. [Первые опыты использования потокового протокола на примере связи ЦП и процессора в ПЛИС комплекса Redd.](https://habr.com/ru/post/462253/)

6. [Веселая Квартусель, или как процессор докатился до такой жизни.](https://habr.com/ru/post/464795/)

7. [Методы оптимизации кода для Redd. Часть 1: влияние кэша.](https://habr.com/ru/post/467353/)

8. [Методы оптимизации кода для Redd. Часть 2: некэшируемая память и параллельная работа шин.](https://habr.com/ru/post/468027/)

9. [Экстенсивная оптимизация кода: замена генератора тактовой частоты для повышения быстродействия системы.](https://habr.com/ru/post/469985/)

10. [Доступ к шинам комплекса Redd, реализованным на контроллерах FTDI](https://habr.com/ru/post/477662/)

11. [Работа с нестандартными шинами комплекса Redd](https://habr.com/ru/post/483724/)

12. [Практика в работе с нестандартными шинами комплекса Redd](https://habr.com/ru/post/484706/)

13. [Проброс USB-портов из Windows 10 для удалённой работы](https://habr.com/ru/post/493630/)

14. [Использование процессорной системы Nios II без процессорного ядра Nios II](https://habr.com/ru/post/496508/)

15. [Практическая работа с ПЛИС в комплекте Redd. Осваиваем DMA для шины Avalon-ST и коммутацию между шинами Avalon-MM](https://habr.com/ru/post/500016/)

16. [Разработка простейшего логического анализатора на базе комплекса Redd](https://habr.com/ru/post/506464/)

Сегодня нам очень понадобится опыт, который мы получили в [в одной из недавних статей](https://habr.com/ru/post/496508/). Там я говорил, что в идеале было бы полезно выучить язык Tcl, но в целом, можно программировать на дикой смеси высокоуровневой логики, описанной на C++ и низкоуровневых запросах на Tcl. Если бы я вёл разработку для себя, то так бы и сделал. Но когда пишешь статью, приходится стараться умять всё в как можно меньшее количество файлов. Одна из задуманных статей так никогда и не была написана именно по этой причине. Мы договорились с коллегой, что он сделает код в рамках проекта, а я потом опишу его. Но он построил код так, как это принято в жизни – раскидал его по огромному количеству файлов. Потом код оброс бешеным количеством технологических проверок, которые нужны в жизни, но за которыми не видно сути. И как мне было описывать всё это? Посмотрите налево, посмотрите направо… Здесь играй, здесь не играй, а здесь коллега рыбу заворачивал? В итоге, полезный материал не пошёл в публикацию (правда, статьи по той тематике всё равно не набирали рейтинга, так что полезный-то он полезный, но мало кому интересный).

Вывод из всего этого прост. Чтобы в статье не бегать от модуля к модулю, пришлось разобраться, как сделать на чистом Tcl. И знаете, не такой это оказался страшный язык. Вообще, всегда можно перейти в каталог **C:\intelFPGA\_lite** и задать поиск интересующих слов по файлам \*.tcl. Решения почти всегда найдутся. Так что он мне нравится всё больше и больше. Ещё и ещё раз советую приглядеться к этому языку.

Я уже говорил, что при запуске Квартусового Tcl скрипта под Windows и под Linux, тексты должны немного различаться в районе инициализации. Запуск под Linux непосредственно на центральном процессоре Redd’а должен давать большее быстродействие. Но зато запуск под Windows во время опытов более удобен для меня, так как я могу редактировать файлы в удобной для себя среде. Поэтому все дальнейшие файлы я писал под запуск из System Console в Windows. Как их переделать в Линуксовый вариант, мы разбирались в той самой статье по ссылке выше.

Обычно я даю фрагменты кода с пояснениями, а затем уже справочно полный код. Но это хорошо, когда во фрагментах каждый видит что-то знакомое. Так как для многих, кто читает эти строки, язык Tcl считается экзотикой, сначала я приведу для справки полный текст своего первого пробного скрипта.

**Полный текст находится здесь.**

```

variable DMA_BASE 0x2000000

variable DMA_DESCR_BASE 0x2000020

# Чтение регистра блока DMA.

#

proc dma_reg_read { address } {

variable DMA_BASE

variable m_path

set address [expr {$address * 4 + $DMA_BASE}]

return [master_read_32 $m_path $address 1]

}

# Запись регистра блока DMA

proc dma_reg_write { address data } {

variable DMA_BASE

variable m_path

set address [expr {$address * 4 + $DMA_BASE}]

master_write_32 $m_path $address $data

}

# Запись регистра дескрипторов блока DMA

proc dma_descr_reg_write { address data } {

variable DMA_DESCR_BASE

variable m_path

set address [expr {$address * 4 + $DMA_DESCR_BASE}]

master_write_32 $m_path $address $data

}

proc prepare_dma {sdram_addr sdram_size} {

# Остановили процесс, чтобы всё понастраивать

# Да, мне лень описывать все константы,

# я делаю всё на скорую руку

dma_reg_write 1 0x20

# На самом деле, тут должно быть ожидание фактической остановки,

# но в рамках теста, оно не нужно. Точно остановимся.

# Добавляем дескриптор в FIFO

# Адрес источника (вообще, это AVALON_ST, но я всё

# с примеров списывал, а там он зануляется)

dma_descr_reg_write 0 0

# Адрес приёмника.

dma_descr_reg_write 1 $sdram_addr

# Длина

dma_descr_reg_write 2 $sdram_size

# Управляющий регистр (взводим бит GO)

dma_descr_reg_write 3 0x80000000

# Запустили процесс, не забыв отключить прерывания

dma_reg_write 1 4

}

puts "running"

set m_path [lindex [get_service_paths master] 0]

open_service master $m_path

prepare_dma 0 0x100

puts [master_read_32 $m_path 0 16]

```

Разбираем фрагменты скрипта

---------------------------

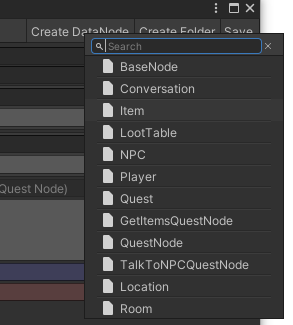

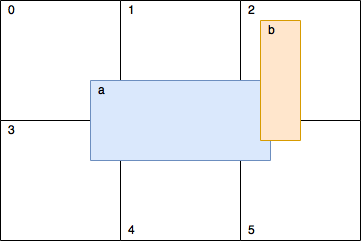

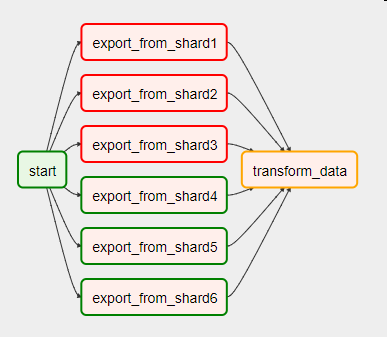

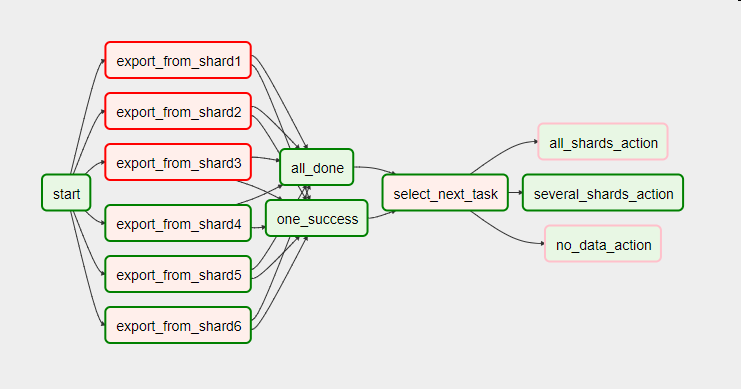

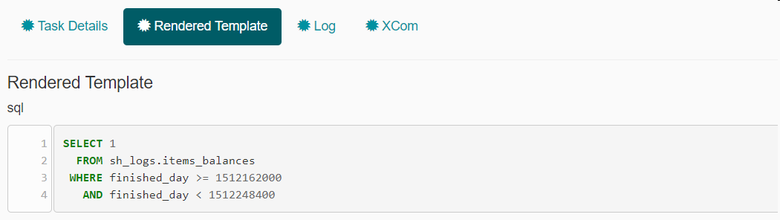

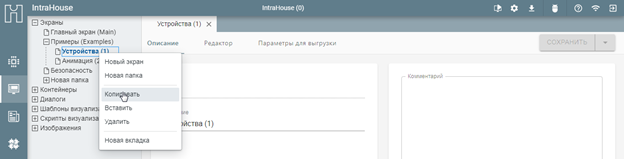

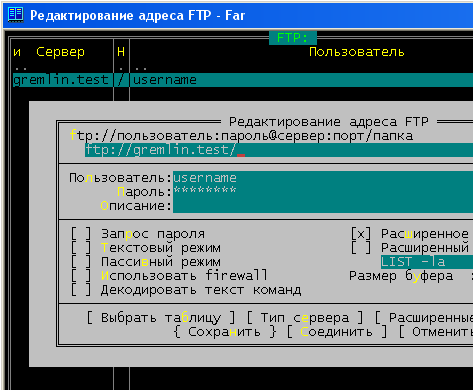

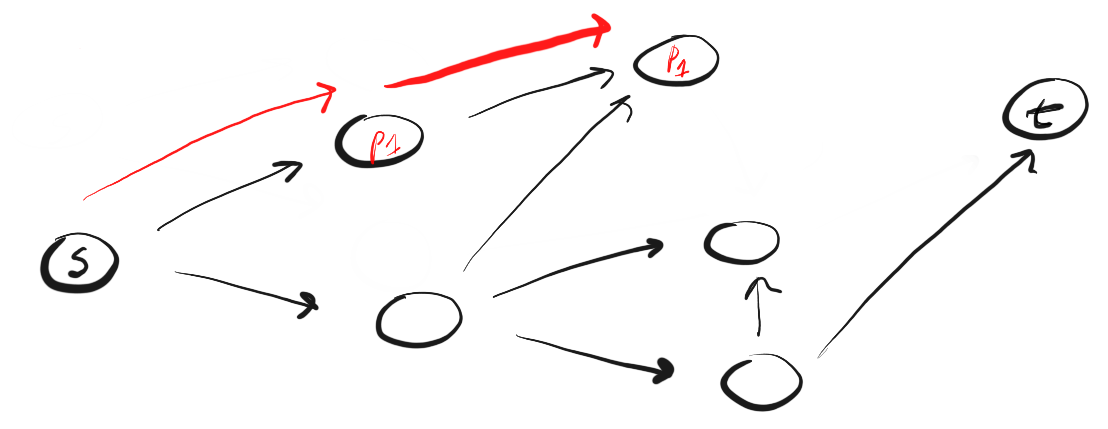

При работе со скриптом нам надо знать базовые адреса блоков. Обычно я их беру из заголовочных файлов, сделанных для BSP, но сегодня мы не создали никаких проектов. Однако адреса всегда можно посмотреть в Platform Designer хоть на привычной нам структурной схеме (я покажу только пример одного адреса):

Хоть там же на специальной вкладке, где всё собрано в виде таблиц:

Нужные мне адреса я вписал в начало скрипта (а нулевой начальный адрес буферного ОЗУ я буду подразумевать всегда, чтобы облегчить код):

```

variable DMA_BASE 0x2000000

variable DMA_DESCR_BASE 0x2000020

```

Функции доступа к DMA в [позапрошлой статье](https://habr.com/ru/post/500016/) я специально написал в простейшем виде. Сегодня же я просто взял и аккуратно перенёс этот код из C++ в Tcl. Эти функции требуют доступа к аппаратуре, а именно чтения и записи порта самого блока DMA и функция записи порта блока дескрипторов DMA. Читать дескрипторы пока не нужно. Но понадобится – допишем по аналогии. Мы уже тренировались работать с аппаратурой [здесь](https://habr.com/ru/post/496508/), поэтому делаем такие функции:

```

# Чтение регистра блока DMA.

#

proc dma_reg_read { address } {

variable DMA_BASE

variable m_path

set address [expr {$address * 4 + $DMA_BASE}]

return [master_read_32 $m_path $address 1]

}

# Запись регистра блока DMA

proc dma_reg_write { address data } {

variable DMA_BASE

variable m_path

set address [expr {$address * 4 + $DMA_BASE}]

master_write_32 $m_path $address $data

}

# Запись регистра дескрипторов блока DMA

proc dma_descr_reg_write { address data } {

variable DMA_DESCR_BASE

variable m_path

set address [expr {$address * 4 + $DMA_DESCR_BASE}]

master_write_32 $m_path $address $data

}

```

Теперь уже можно реализовывать логику работы с DMA. Ещё и ещё раз говорю, что я специально в позапрошлой статье не обращался к готовому API, а сделал как можно более простые собственные функции. Я знал, что мне придётся эти функции портировать. И вот так я портировал инициализацию DMA (аргументы – начальный адрес и длина в байтах для буфера, в который будет идти приём):

```

proc prepare_dma {sdram_addr sdram_size} {

# Остановили процесс, чтобы всё понастраивать

# Да, мне лень описывать все константы,

# я делаю всё на скорую руку

dma_reg_write 1 0x20

# На самом деле, тут должно быть ожидание фактической остановки,

# но в рамках теста, оно не нужно. Точно остановимся.

# Добавляем дескриптор в FIFO

# Адрес источника (вообще, это AVALON_ST, но я всё

# с примеров списывал, а там он зануляется)

dma_descr_reg_write 0 0

# Адрес приёмника.

dma_descr_reg_write 1 $sdram_addr

# Длина

dma_descr_reg_write 2 $sdram_size

# Управляющий регистр (взводим бит GO)

dma_descr_reg_write 3 0x80000000

# Запустили процесс, не забыв отключить прерывания

dma_reg_write 1 4

}

```

Ну, собственно, всё. Дальше идёт основное тело скрипта. Какое я там сделал допущение? Я не жду окончания работы DMA. Я же знаю, что таймер тикает весьма быстро. Поэтому запрошенные мною 0x100 байт заполнятся весьма шустро. И все мы знаем, что JTAG работает очень неспешно. В реальной жизни, разумеется, надо будет добавить ожидание готовности. А может и отображение текущего адреса. И ещё чего-нибудь… И тогда код станет точно непригодным для статьи, из-за того, что все эти мелочи станут закрывать суть. А пока простейший код выглядит так:

```

puts "running"

set m_path [lindex [get_service_paths master] 0]

open_service master $m_path

prepare_dma 0 0x100

puts [master_read_32 $m_path 0 16]

```

То есть, настроились на работу с аппаратурой, приняли 0x100 байт в буфер с адресом 0, отобразили первые 16 байт.

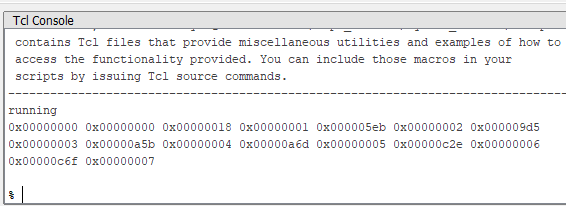

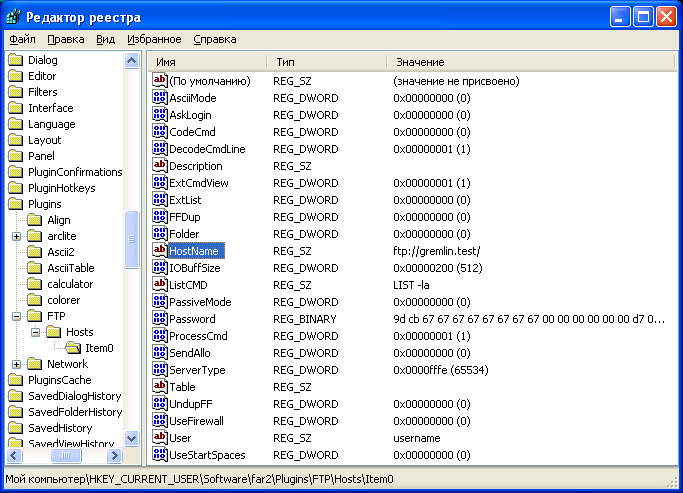

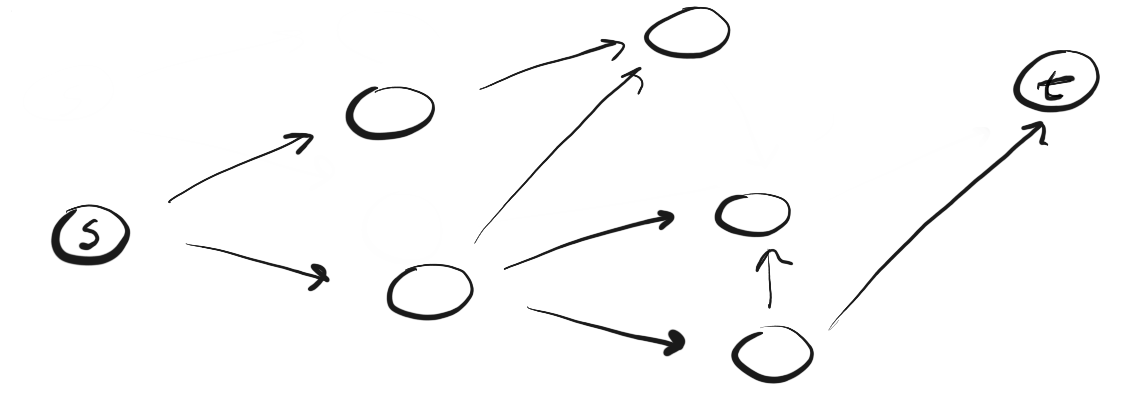

Заливаем прошивку, запускаем System Console, исполняем скрипт, наблюдаем такую красоту:

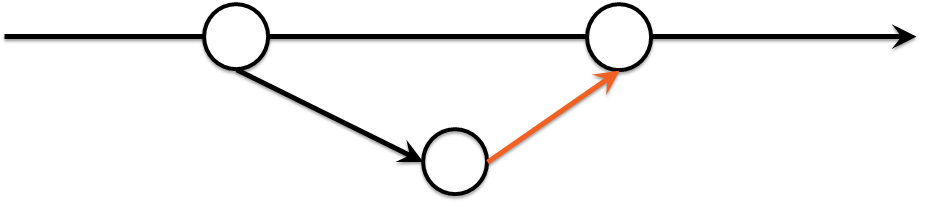

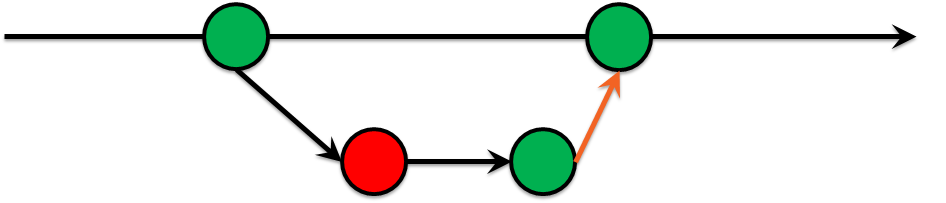

Таймер 0, счётчик 0. Таймер 0x18, счётчик 1. Таймер 0x5EB, счётчик 2. Ну, и так далее. В целом, мы видим то, что хотели. На этом можно было бы и закончить, но текстовое отображение не всегда удобно. Поэтому продолжаем.

Как отобразить результаты в графическом виде

--------------------------------------------

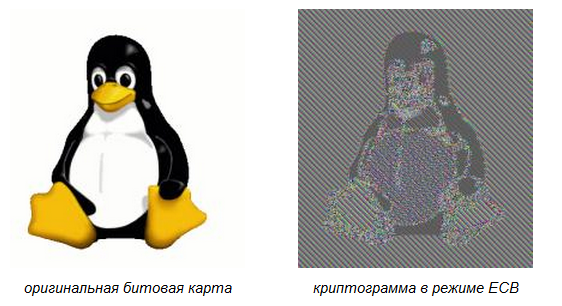

То, что мы получили – это вполне себе замечательно, но временные диаграммы обычного логического анализатора часто удобнее смотреть в графическом виде! Надо бы написать программу, чтобы можно было это делать… Вообще, написать свою программу – всегда полезно, но время – ресурс ограниченный. А в рамках работы с комплексом Redd, мы придерживаемся подхода, что все эти работы – вспомогательные. Мы должны тратить время на основной проект, а на вспомогательный нам никто его не выделит. Можно этим заняться в свободное от работы время, но лично мне это [не даёт делать балалайка](https://habr.com/ru/post/445160/). Она тоже много времени отнимает. Так что свободное время лично у меня тоже занято. К счастью, уже существуют решения, которые могут облегчить нам жизнь. Я узнал о нём, когда читал статьи про Icarus Verilog. Там строят графическую визуализацию времянок через некие файлы VCD. Что это такое?

В стандарте Verilog (я нашёл его [здесь](https://www.eg.bucknell.edu/~csci320/2016-fall/wp-content/uploads/2015/08/verilog-std-1364-2005.pdf) ) смотрим там раздел **18. Value change dump (VCD) files**. Вот так! Оказывается, можно заставить тестовую систему на языке Verilog генерировать подобные файлы. И они будут стандартизированы, то есть, едины, независимо от среды, в которой производится моделирование. А где стандарт, там и единство логики систем отображения. А что, если мы тоже будем формировать такой же файл на основании того, что пришло из анализатора? Причём заставим Tcl скрипт делать это… Осталась самая малость: выяснить, что в файл следует записать, а также – как это сделать.

Радостный, я попросил Гугля показать мне пример vcd-файла. [Вот, что он мне дал](http://www.pldworld.com/_hdl/2/_ref/se_html/manual_html/c_vcd9.html#1034192). Я выделил всё, что там было в таблице и сохранил в файл **tryme.vcd**. Если к моменту чтения статьи страничка перестанет существовать, вот содержимое этого файла – ниже.

**Содержимое файла tryme.vcd**

```

$comment

File created using the following command:

vcd files output.vcd

$date

Fri Jan 12 09:07:17 2000

$end

$version

ModelSim EE/PLUS 5.4

$end

$timescale

1ns

$end

$scope module shifter_mod $end

$var wire 1 ! clk $end

$var wire 1 " reset $end

$var wire 1 # data_in $end

$var wire 1 $ q [8] $end

$var wire 1 % q [7] $end

$var wire 1 & q [6] $end

$var wire 1 ' q [5] $end

$var wire 1 ( q [4] $end

$var wire 1 ) q [3] $end

$var wire 1 * q [2] $end

$var wire 1 + q [1] $end

$var wire 1 , q [0] $end

$upscope $end

$enddefinitions $end

#0

$dumpvars

0!

1"

0#

0$

0%

0&

0'

0(

0)

0*

0+

0,

$end

#100

1!

#150

0!

#200

1!

$dumpoff

x!

x"

x#

x$

x%

x&

x'

x(

x)

x*

x+

x,

$end

#300

$dumpon

1!

0"

1#

0$

0%

0&

0'

0(

0)

0*

0+

1,

$end

#350

0!

#400

1!

1+

#450

0!

#500

1!

1*

#550

0!

#600

1!

1)

#650

0!

#700

1!

1(

#750

0!

#800

1!

1'

#850

0!

#900

1!

1&

#950

0!

#1000

1!

1%

#1050

0!

#1100

1!

1$

#1150

0!

1"

0$

0%

0&

0'

0(

0)

0*

0+

0,

#1200

1!

$dumpall

1!

1"

1#

0$

0%

0&

0'

0(

0)

0*

0+

0,

$end

```

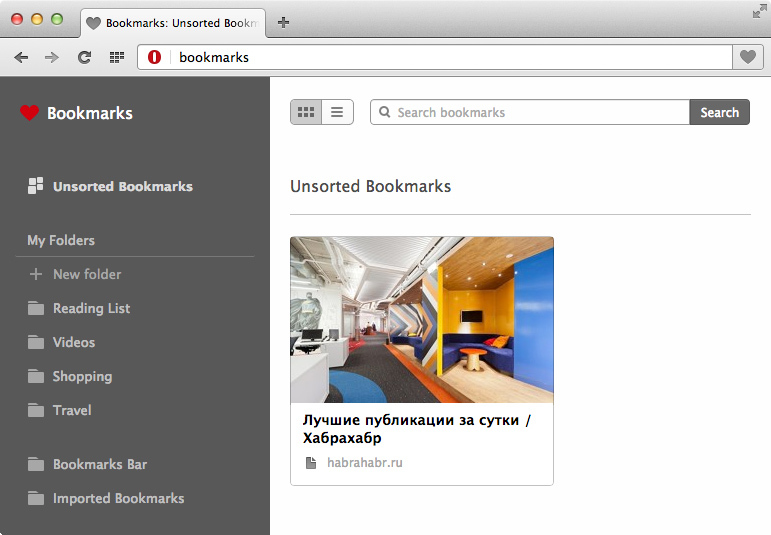

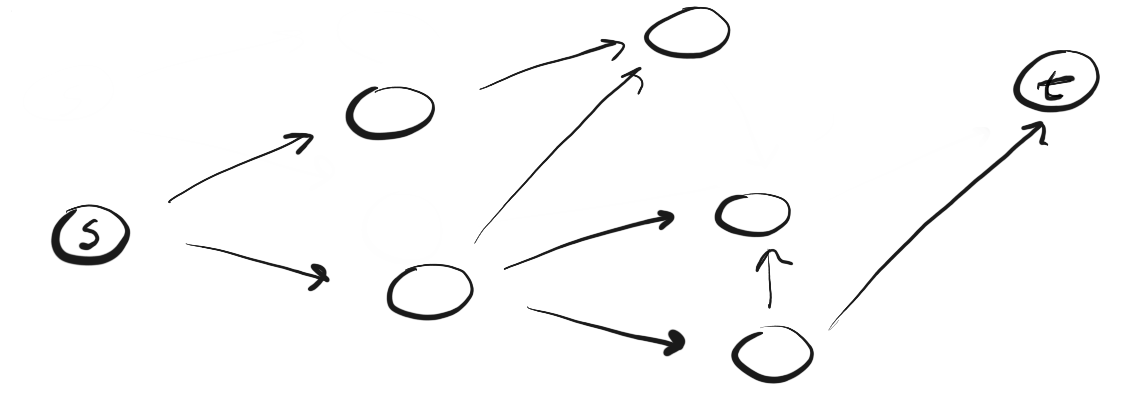

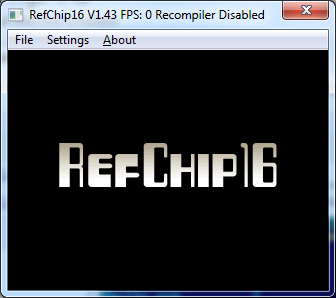

Какое-то «Юстас Алексу». Можно, конечно, разобраться, глядя в стандарт, но больно там много всего. Попробуем всё сделать на практике, загрузив файл в какую-нибудь среду, визуализирующую его содержимое, и сопоставив текст с полученной картинкой. Несмотря на то, что заголовок web-страницы гласит, что всё это – пример от среды ModelSim, мне не удалось открыть данный файл в этой среде. Возможно, в комментариях кто-то подскажет, как это сделать. Однако не МоделСимом единым жив человек. Существует такая кроссплатформенная система с открытым исходным кодом — GtkWave. Сборку под Windows я взял [тут](https://sourceforge.net/projects/gtkwave/files/) . Запускаем её, выбираем в меню File->Open New Tab:

Указываем наш файл и получаем такую картинку:

Выделяем все сигналы и через меню правой кнопки «Мыши» выбираем Recurse Import->Append:

И вот результат:

Видя такое дело, вполне можно разобраться, что в файле зачем добавлено.

```

$timescale

1ns

$end

```

Ну, тут всё понятно. Это в каких единицах время будет задаваться.

```

$scope module shifter_mod $end

$var wire 1 ! clk $end

$var wire 1 " reset $end

$var wire 1 # data_in $end

$var wire 1 $ q [8] $end

$var wire 1 % q [7] $end

$var wire 1 & q [6] $end

```

Это объявляются переменные с весьма экзотическими именами «Восклицательный знак», «Кавычки», «решётка» и т.п. Шина в найденном примере объявляется побитово. Идём дальше:

```

#0

$dumpvars

0!

1"

0#

…

0+

0,

$end

```

Время равно нулю. Дальше – значения переменных. Зачем ключевое слово **$dumpvars**? Придётся заглянуть в стандарт. Как я и думал, какое-то непонятное занудство. Но создаётся впечатление, что нам сообщают, что эти данные получены при помощи директивы языка **$dumpvars**. Давайте попробуем убрать это слово и соответствующую ему строку **$end**. Загружаем обновлённый файл и видим результат:

Как говорится, найдите десять отличий… Никакой разницы. Значит, нам это добавлять на выход не нужно. Идём дальше.

```

#100

1!

#150

0!

```

Мы видим, что в моменты 100 и 150 нс тактовый сигнал переключился, а остальные – нет. Поэтому мы можем добавлять только изменившиеся значения сигналов. Идём дальше.

```

#200

1!

$dumpoff

x!

x"

…

x,

$end

#300

$dumpon

1!

0"

```

Теперь мы умеем задавать состояние «X». Проверяем, нужны ли ключевые слова **$dumpoff** и **$dumpon**, выкинув их из файла (не забываем про парные им **$end**)…

Добавлять ещё один рисунок, полностью идентичный предыдущим, я не буду. Но можете проверить это же у себя.

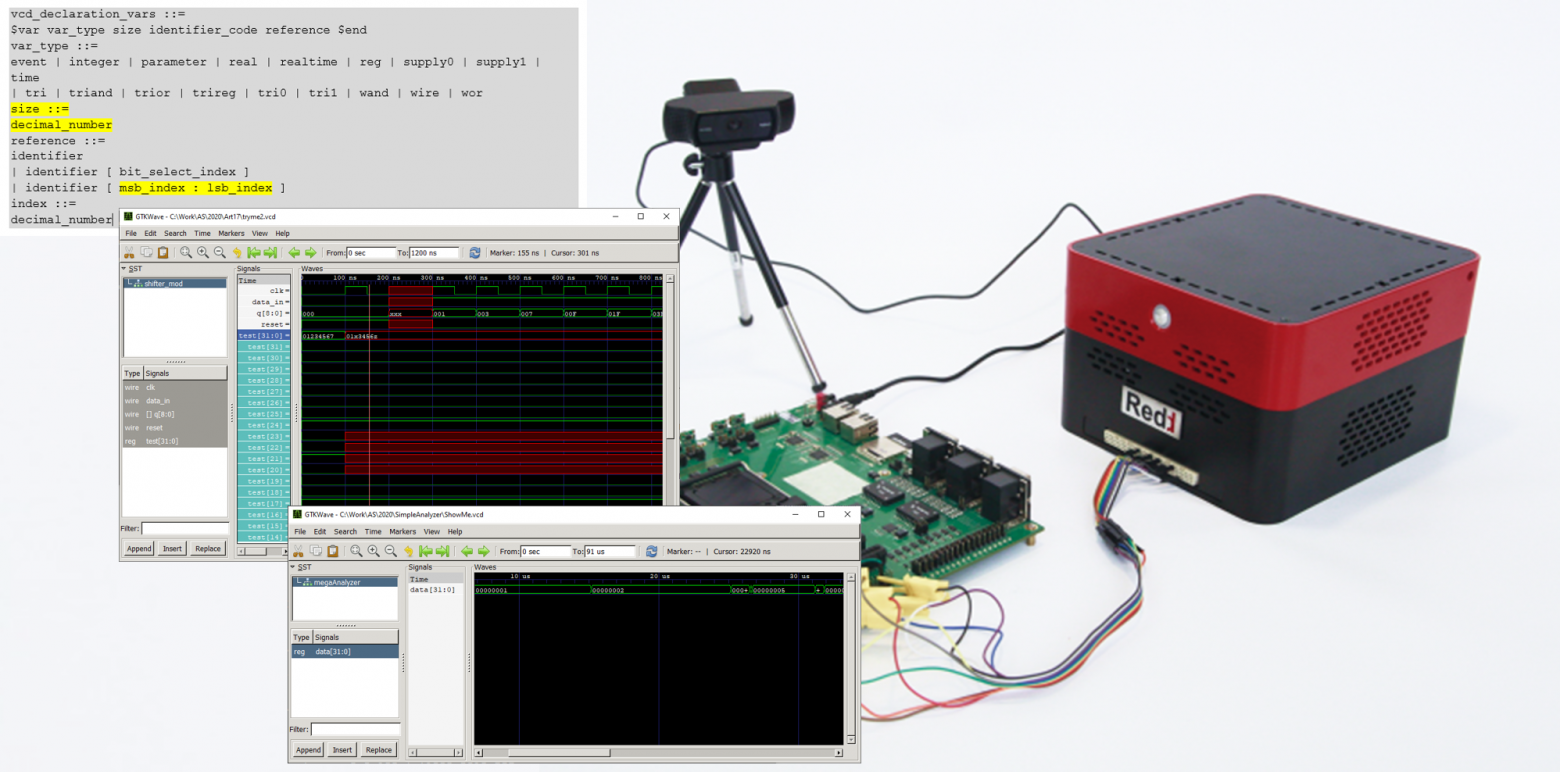

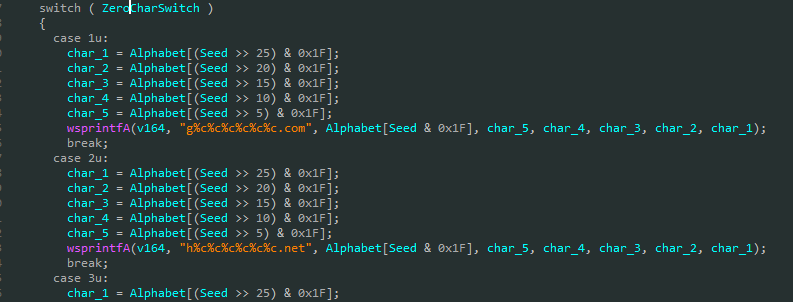

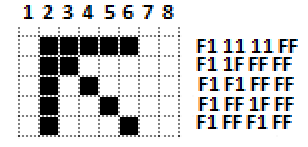

Итак, мы уже получили всю информацию для формирования файла, только меня очень интересует один вопрос. Можно ли задавать многобитные сигналы не в виде одиночных битов, а оптом? Смотрим, что нам про это говорит стандарт:

**То же самое текстом:**

```

vcd_declaration_vars ::=

$var var_type size identifier_code reference $end

var_type ::=

event | integer | parameter | real | realtime | reg | supply0 | supply1 | time

| tri | triand | trior | trireg | tri0 | tri1 | wand | wire | wor

size ::=

decimal_number

reference ::=

identifier

| identifier [ bit_select_index ]

| identifier [ msb_index : lsb_index ]

index ::=

decimal_number

```

Прекрасно! Мы можем задавать и вектора! Пробуем добавить одну переменную, дав ей имя «звёздная собака», так как односимвольные варианты уже израсходованы авторами оригинального примера:

```

$var reg 32 *@ test [31:0] $end

```

И добавим ей таких присвоений… Обратите внимание на пробелы перед именем переменной! Без них не работает, но и стандарт требует их наличия в отличие от однобитных вариантов:

```

#0

…

b00000001001000110100010101100111 *@

#100

…

b00000001XXXX0011010001010110zzzz *@

```

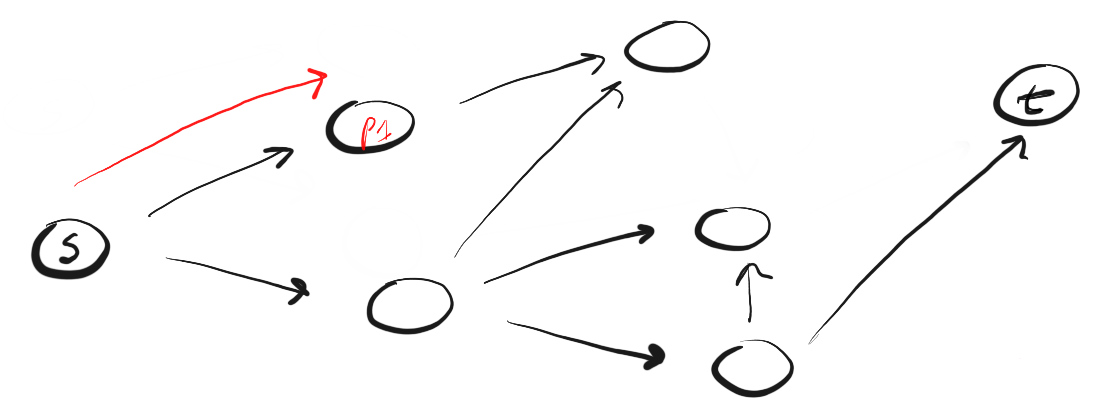

Смотрим результат (я в нём ради интереса раскрыл вектор)

Ну и замечательно. У нас есть вся теория, чтобы подготовить файл для просмотра в GtkWave. Наверняка, можно будет его посмотреть и в ModelSim, просто я пока не понял, как это сделать. Давайте займёмся формированием данного файла для нашего супер-мега-анализатора, который фиксирует одно единственное число.

Делаем Tcl-скрипт, создающий файл VCD

-------------------------------------

Если весь предыдущий опыт я брал из файлов \*.tcl, идущих в комплекте с Квартусом, то здесь всё плохо. Слово file есть в любом из них. Пришлось спросить у Гугля. Он выдал ссылку на замечательный [справочник](http://tclstudy.narod.ru/tcl/lesson24.html).

Функции не трогаем, а основное тело скрипта переписываем так.

**Основное тело скрипта.**

```

puts "running"

set m_path [lindex [get_service_paths master] 0]

open_service master $m_path

prepare_dma 0 0x100

set fileid [open "ShowMe.vcd" w]

puts $fileid "\$timescale"

puts $fileid " 1ns"

puts $fileid "\$end"

puts $fileid "\$scope module megaAnalyzer \$end"

puts $fileid "\$var reg 32 ! data \[31:0] \$end"

puts $fileid "\$upscope \$end"

puts $fileid "\$enddefinitions \$end"

# А зачем рисовать где-то справа?

# Будем рисовать от первой точки

# Для этого запомним базу

set startTime [lindex [master_read_32 $m_path 0 1] 0]

for { set i 0} {$i < 20} {incr i} {

set cnt [lindex [master_read_32 $m_path [expr {$i * 8}] 1] 0]

set data [lindex [master_read_32 $m_path [expr {$i * 8 + 4}] 1] 0]

# Таймер тикает с частотой 100 МГц

# Один тик таймера - это 10 нс

# поэтому на 10 и умножаем

puts $fileid "#[expr {($cnt - $startTime)* 10}]"

puts $fileid "b[format %b $data] !"

}

close $fileid

```

Здесь я не стал учитывать перескоки счётчика через ноль. Перед нами – простейший демонстрационный скрипт, так что не будем его перегружать. Запускаем… Дааааа. Это – именно то, о чём я предупреждал. Оно работает весьма и весьма долго. Сколько оно будет работать в случае заполненных мегабайтных буферов – страшно даже предположить. Но зато мы не потратили много времени на разработку! Опять же, кто работал с анализатором BusDoctor, тот не даст соврать: этот фирменный анализатор отдаёт данные больших объёмов тоже очень и очень неспешно.

**Итак, получаем файл:**

```

$timescale

1ns

$end

$scope module megaAnalyzer $end

$var reg 32 ! data [31:0] $end

$upscope $end

$enddefinitions $end

#0

b0 !

#240

b1 !

#15150

b10 !

#25170

b11 !

#26510

b100 !

#26690

b101 !

#31180

b110 !

#31830

b111 !

#35540

b1000 !

#35630

b1001 !

#36940

b1010 !

#39890

b1011 !

#46130

b1100 !

#55540

b1101 !

#60820

b1110 !

#71270

b1111 !

#71480

b10000 !

#76270

b10001 !

#77990

b10010 !

#91000

b10011 !

```

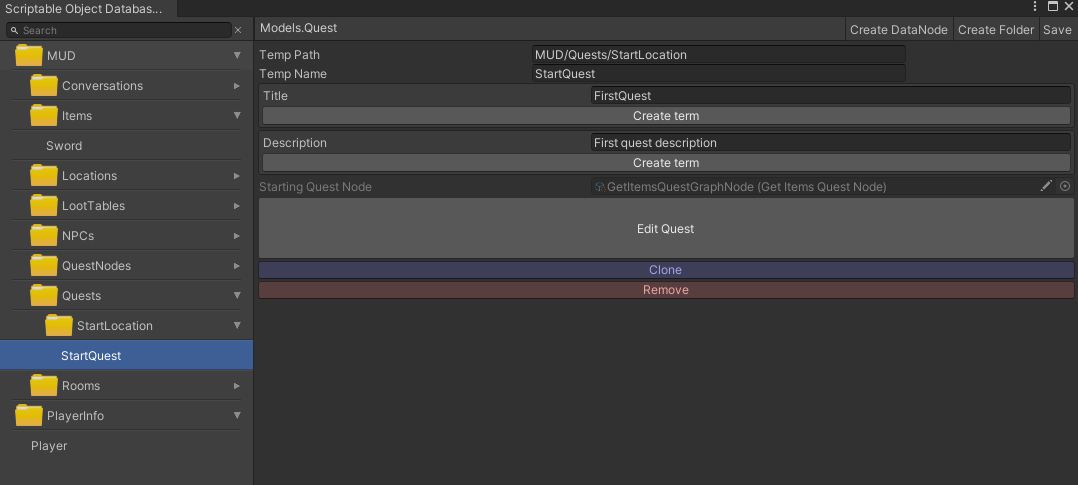

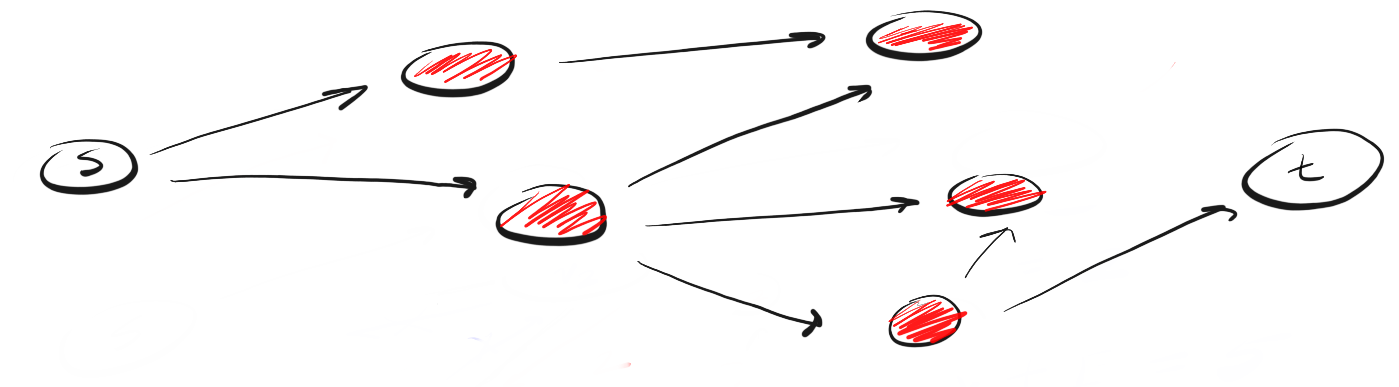

Случайные промежутки – есть. Нарастающее двоичное число – есть. Правда, с отброшенными незначащими нулями. Визуализируем:

Счётчик щёлкает! В случайные моменты времени. Что хотели, то и получили

Заключение

----------

Мы сделали простейший логический анализатор, потренировались принимать данные с него и производить их визуализацию. Чтобы довести этот простейший пример до совершенства, разумеется, придётся ещё потрудиться. Но путь, по которому идти, – понятен. Мы получили опыт изготовления реальных измерительных устройств на базе ПЛИС, установленной в комплексе Redd. Теперь каждый сможет доработать эту основу так, как сочтёт нужным (и как ему позволит время), а в следующей серии статей я начну рассказ о том, как заменить этому анализатору голову, чтобы сделать шинный анализатор для USB 2.0.

Те, у кого нет настоящего Redd, смогут воспользоваться вот такой свободно доставаемой платой, которая имеется у массы продавцов на Ali Express.

Искать следует по запросу WaveShare ULPI. Подробнее о ней – на [странице производителя](https://www.waveshare.com/usb3300-usb-hs-board.htm). | https://habr.com/ru/post/508138/ | null | ru | null |

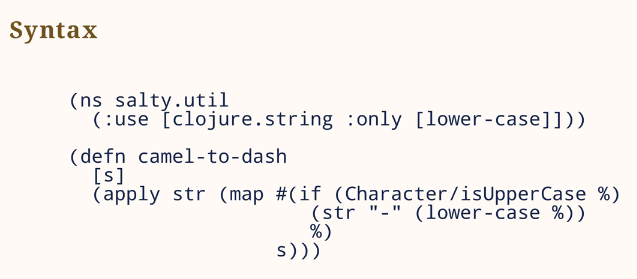

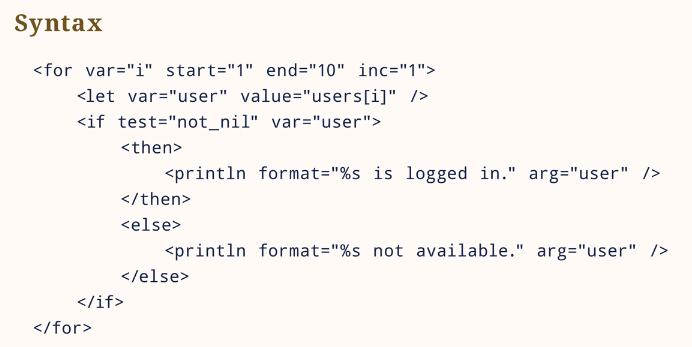

# Пишем свой php framework за вечер

Периодически встает задача написать какой-либо небольшой функционал, использовать для этого большие framework типа Zend/Yii/CI/Kohana и прочее либо не хочется, либо нет возможности.

Какое-то время назад, передо мной встала задача написать небольшое web-приложение, установить выше перечисленные framework не было возможности. Решил написать свой, работающий по принципу [MVC](http://ru.wikipedia.org/wiki/Model-view-controller), на основу ушел 1 вечер, докручивание и оптимизация шли по ходу разработки.

Начинающим web разработчикам может показаться что это сложно, постараюсь в этой статье дать понять что это не так.

Для начала определимся с требованиями:

* MVC подход

* ЧПУ

* Простота использования

Для реализации ЧПУ будем использовать mod\_rewrite, url будут выглядеть так: mysite.com/controller\_name/ controller\_action/param\_name\_1/param\_value\_1/param\_name\_2/param\_value\_2

Нам потребуется создать базовые классы модели, представления, контроллера.

```

abstract class CController extends CBaseObject ...

abstract class CModel extends CBaseObject ...

class CView ...

class CViewSmarty extends Smarty ...

```

Все запросы будет обрабатывать index.php, настройки будем хранить в config.php в виде обычного массива.

часть config.php

```

$config['SYSPATH'] = "system";

$config['APPPATH'] = "application";

$config['BASEPATH'] = "/projects/savage";

```

Так же потребуется автозагрузка классов

```

function autoload_classes($param) {

include("config.php");

if (strtolower(substr($param, 0, 1)) == "m") {

include_once ($config['APPPATH'] . "/models/" . strtolower($param) . ".php");

}

if (strtolower(substr($param, 0, 1)) == "c") {

$part_path = strtolower($param) . ".php";

if (file_exists($config['SYSPATH'] . "/classes/" . $part_path)) {

$file = $config['SYSPATH'] . "/classes/" . $part_path;

} else {

$file = $config['APPPATH'] . "/controllers/" . $part_path;

}

include_once $file;

}

}

spl_autoload_register('autoload_classes');

```

index.php будет отвечать за вызовы методов контроллеров, при этом будем проверять, является ли первый параметр идентификатором контроллера, или же методом контроллера по умолчанию (чтобы можно было писать так: mysite.com/mycontroller/myaction и так mysite.com/myaction)

Перейдем к реализации контроллера, его задача реализация логики, принятие решения какое представление использовать.

Для методов используемых в url будем делать префикс: action\_ (привычно для пользователей ci/kohana).

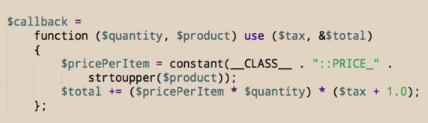

```

class CMain extends CController {

public function action_index() {

$widgets = new CWidgets();

$prm_data = array(

'widget_login' => $widgets->widget_login(),

);

$view = new CView();

$view->assign($prm_data);

$view->display("index");

}

...

```

Так же нам необходимо работать с данными, для этого создадим модель, при этом модель не обязательно может работать с БД, иногда достаточно хранить массив. В моем примере используется обычный массив, при необходимости можно работать с БД (через PDO).

```

class MUsers extends CModel {

...

public function get_list() {

for ($i = 1; $i < 6; $i++) {

$this->data[] = array('id' => $i, 'login' => 'user ' . $i, 'pw' => ($i * 2 + $i));

}

return $this->data;

}

}

//! Пример работы с БД через обертку для PDO

//! Проверка наличия сессии с указанного IP

public function check_login($params) {

$prm_data = array(':id' => $params['suid'], ':ip' => $_SERVER['REMOTE_ADDR']);

$data = self::fetch_all("select id from ##_log where id = :id and ip = :ip", $prm_data);

if (count($data) > 0) {

return TRUE;

} else {

return FALSE;

}

}

```

Представление, существует большое количество способов реализации отображения, кто-то предпочитает использовать родной php шаблонизатор, кому-то нравится Smarty или еще что.

Мне понравился Smarty, поэтому базовые методы представления сделал как в Smatry.

Вот и все, framework готов, да он не столь мощен как бренды, но для ряда задач — оптимален.

Демо смотреть [здесь](http://itpath.ru/projects/savage/), [скачать без Smarty](http://itpath.ru/downloads/savage.zip), [скачать со Smarty](http://itpath.ru/downloads/savage_smarty.zip). | https://habr.com/ru/post/141714/ | null | ru | null |

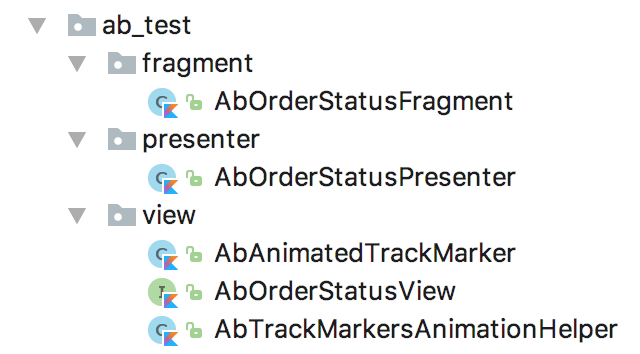

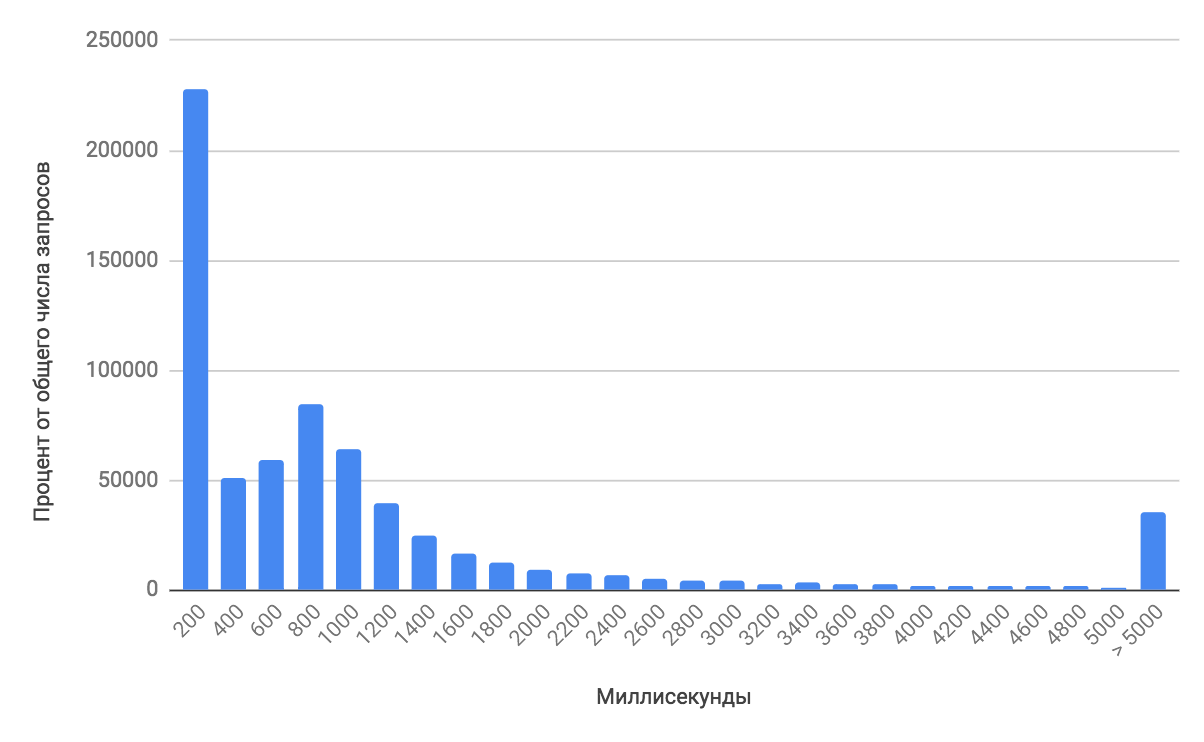

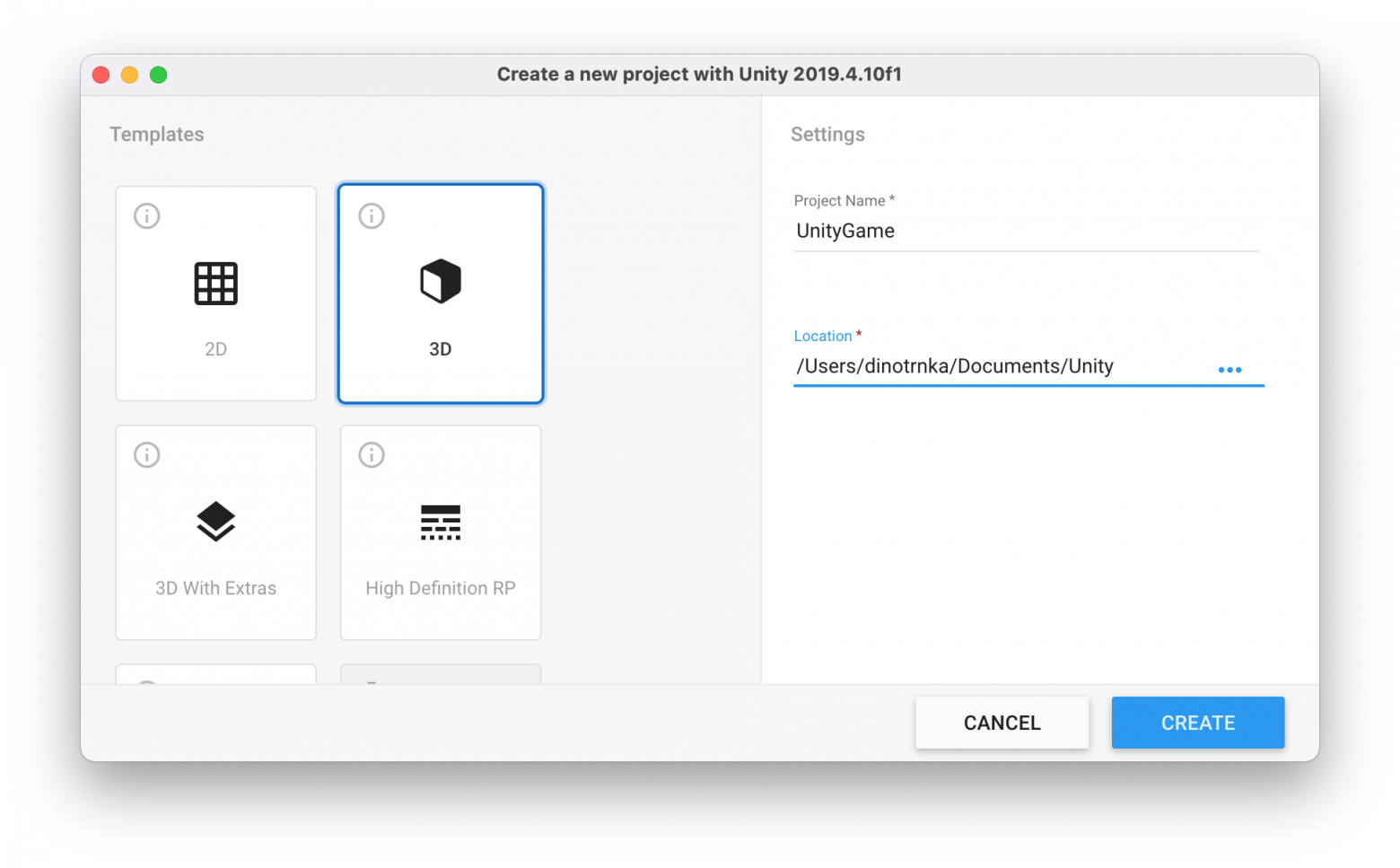

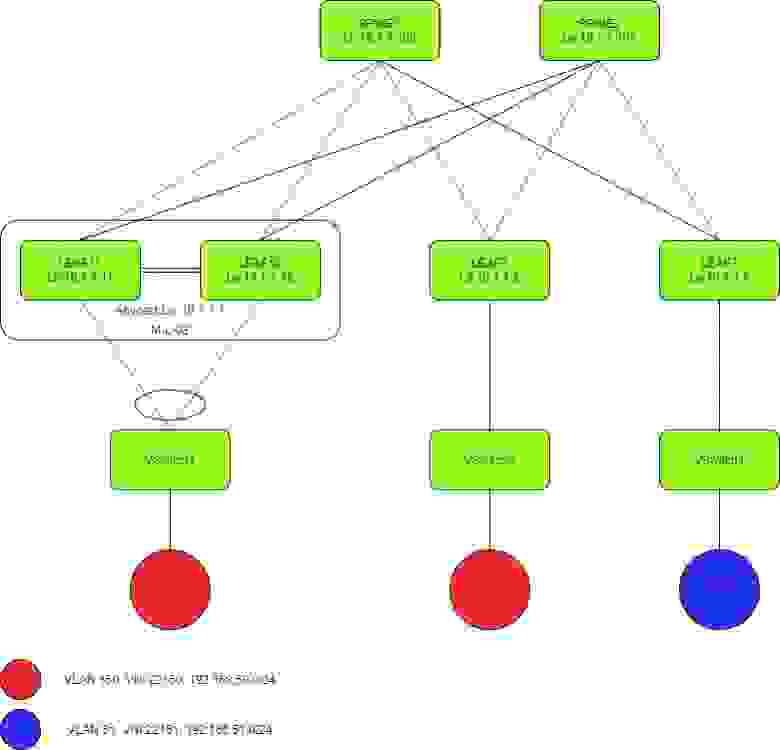

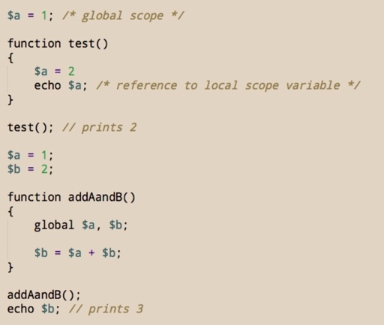

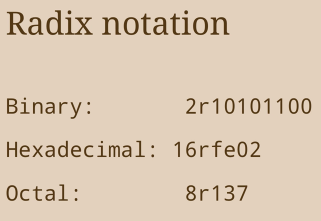

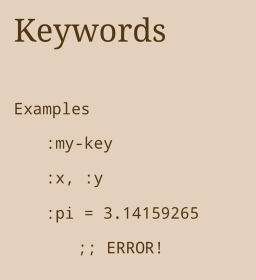

# Применение машинного обучения к кинетике ядерных реакторов

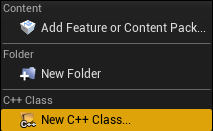

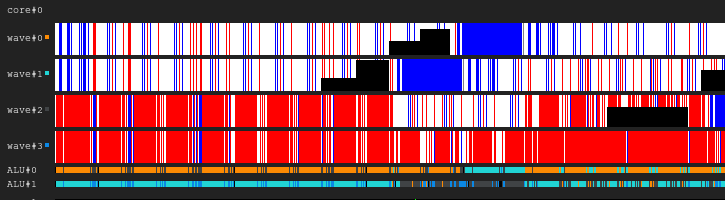

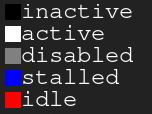

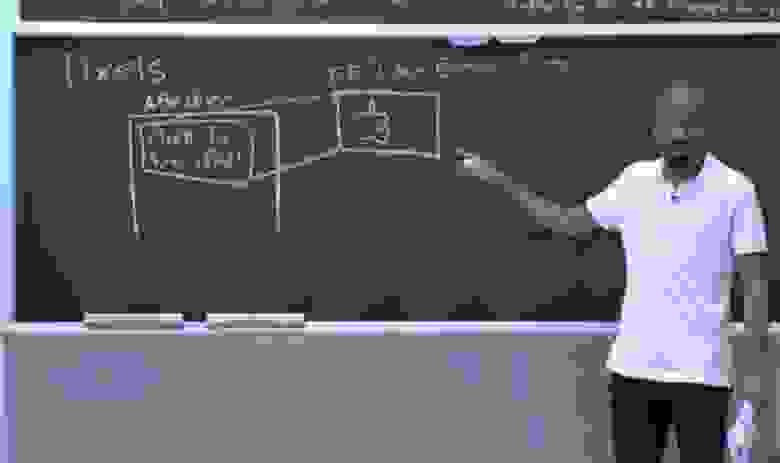

Рис. 1. Реактор TRIGA на полной мощности.На Хабре часто выкладывают туториалы по разным областям знаний. Сегодня, к старту нового потока курса по [machine learning](https://skillfactory.ru/ml-programma-machine-learning-online?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_ML&utm_term=regular&utm_content=160421), поделимся с вами туториалом.... по ядерной физике, работе реакторов и прогнозной аналитике с использованием Python.По данным Комиссии по ядерному регулированию, в США находится 31 исследовательский ядерный реактор. У автора есть лицензия на эксплуатацию одного из них, и в этой статье он продемонстрирует, как применил методы машинного обучения и общего анализа данных для прогнозирования уровней мощности импульсов и повышения показателя воспроизводимости наших экспериментов.

---

Предпосылки

-----------

[Реактор ядерного распада](https://en.wikipedia.org/wiki/Nuclear_reactor#:~:text=A%20nuclear%20reactor%2C%20formerly%20known,and%20in%20nuclear%20marine%20propulsion.) работает на энергии расщепления атомов. Когда уран-235 поглощает нейтрон, появляется шанс расщепления и распада, высвобождаются продукты деления, нейтроны и кинетическая энергия. Эта энергия нагревает теплоноситель, который обычно подаётся в теплообменник, а затем в вырабатывающую электричество паровую турбину. На моем объекте находится реактор TRIGA, который не производит никакого электричества — он используется исключительно для исследований и экспериментов.

> Забавный факт: один килограмм Урана-235 содержит примерно в 3 миллиона раз больше энергии, чем один килограмм угля. Ах да, реакция деления не приводит к выбросам углерода. (Я вовсе не предвзят.)

>

>

В сравнении с коммерческим реактором [TRIGA](https://en.wikipedia.org/wiki/TRIGA) уникален во многих отношениях, например, он может выполнять “импульс”. Большой отрицательный коэффициент реактивности топлива означает, что с повышением температуры реактивность — и, следовательно, скорость цепных реакций деления — уменьшается. Это означает, что реактор ограничивает сам себя в смысле уровня мощности и, благодаря идее топлива, после импульса отключается физически без участия оператора. Вот почему они позволяют таким людям, как я, им управлять!

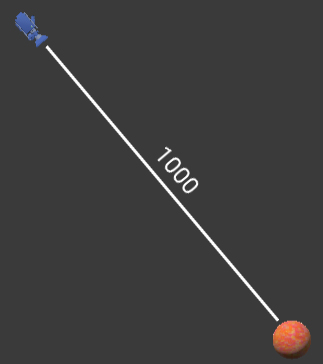

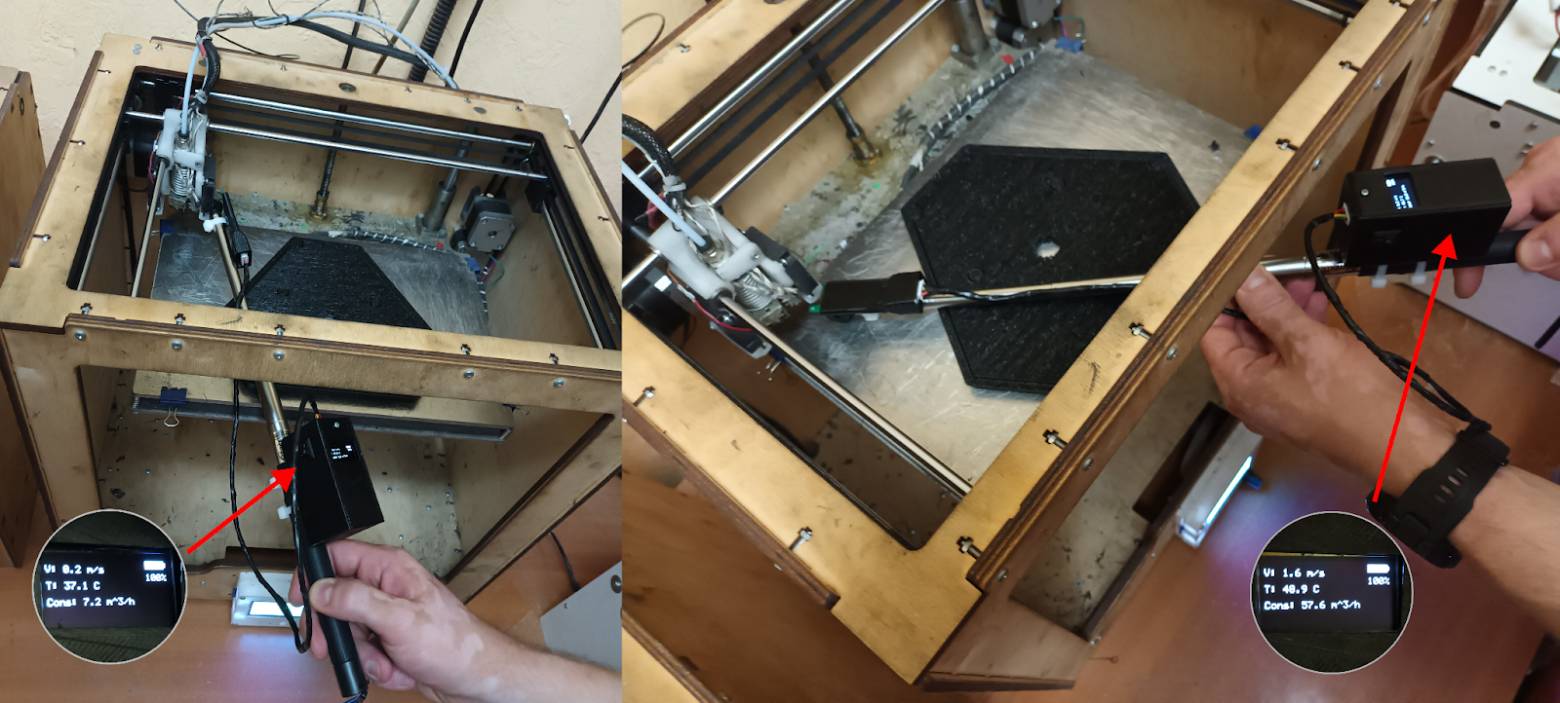

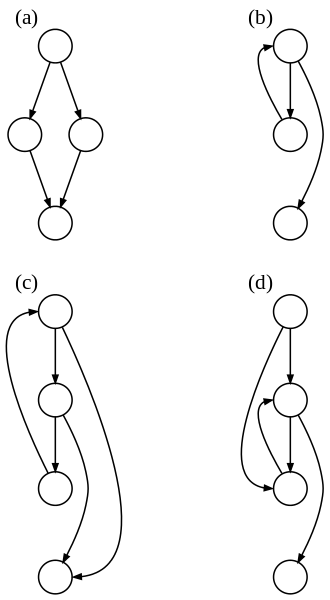

Импульс работает путём пневматического (с использованием сжатого воздуха) выталкивания одного из стержней управления из активной зоны реактора, что вызывает быстрое увеличение уровня мощности. Следующие события происходит за *нескольких миллисекунд*:

* Стержень управления выдвигается из сердечника вертикально вверх.

* Уровень мощности увеличивается примерно с 50 Вт до 2000 МВт.

* При таком высоком уровне мощности быстрый эффект отрицательной обратной связи топлива обеспечивает отрицательную реактивность активной зоны, которая отключается.

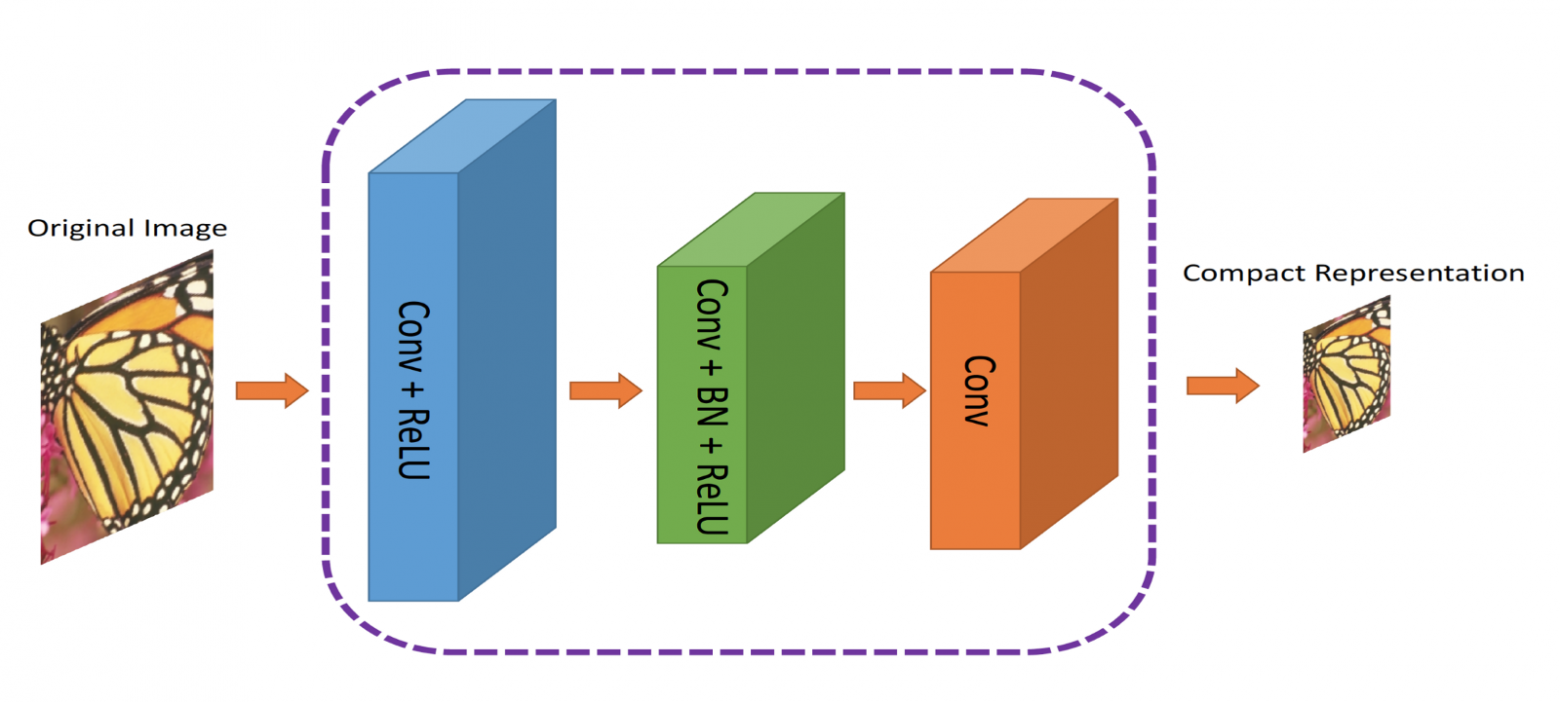

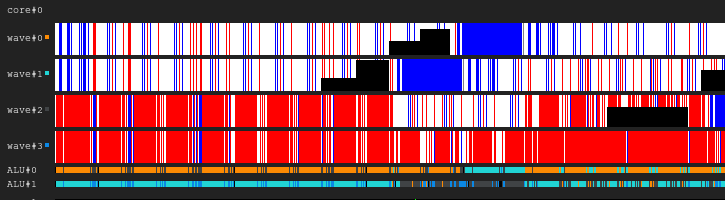

В этот момент стержень управления всё ещё может находиться на пути из ядра, но впоследствии из-за силы тяжести упадёт обратно. В итоге вы получаете функцию отклика мощности *P(t)*, которая выглядит, примерно как показано на втором рисунке — по мере выталкивания управляющего стержня мощность увеличивается, а затем быстро уменьшается с добавлением отрицательной реактивности.

Рис. 2. Мощность реактора, реактивность и энергия в зависимости от времени во время повышения импульсной характеристики.Хотя пульсация имеет множество исследовательских применений, она особенно хорошо работает в имитации испускаемого ядерным взрывом *сильного излучения*.

В частности, мы наблюдаем, как на атомном уровне нейтроны и гамма-лучи взаимодействуют с электроникой. Допустим, вы разрабатываете новый электронный компонент, который будет использоваться, чтобы работать в некоей части системы ядерного оружия.

* Насколько вы уверены, что в близости от ядерного взрыва ваша электроника выживет?

* Какие повреждения имеет интегральная схема, 10 лет простоявшая рядом с радиоактивной боеголовкой? Как это повреждение повлияет на функциональность вашего компонента?

* Или что, если вы разрабатываете процессор,который будет работать в новом истребителе.

* Может ли включённая вашим процессором система управления полётом при воздействии определённого количества радиации выйти из строя?

Понятна серьёзность этих вопросов. Соедините это с тем фактом, что истинная ядерная детонация — своего рода испытание и она имеет ряд проблем (не говоря уже о том, что она запрещена [Договором о всеобъемлющем запрещении ядерных испытаний](https://www.ctbto.org/nuclear-testing/the-effects-of-nuclear-testing/general-overview-of-theeffects-of-nuclear-testing/)), и вы скоро согласитесь, что импульс реактора — это его ключевая характеристика.

> Стоит пояснить, что этот импульс генерирует только излучение. В эксперимента такого типа ничего не взрывается. Мы просто подвергаем образец высокому уровню радиации в чрезвычайно контролируемой и предназначенной для этой задачи среде.

>

>

Максимальный достигаемый импульсом уровень мощности исходя из “стоимости” реактивности стержней управления может выбрать оператор. Для многих ядерных реакторов эта стоимость измеряется в *долларах*, и поскольку это выходит за рамки данной статьи, чтобы объяснить, почему мы используем этот, казалось бы, странный блок, вы можете прочитать все об этом [здесь](https://en.wikipedia.org/wiki/Dollar_(reactivity)#:~:text=A%20dollar%20is%20a%20unit,means%20a%20steady%20reaction%20rate.), если хотите.

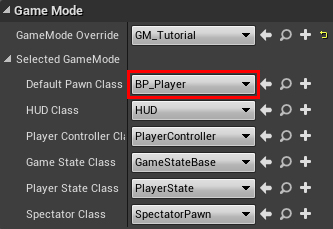

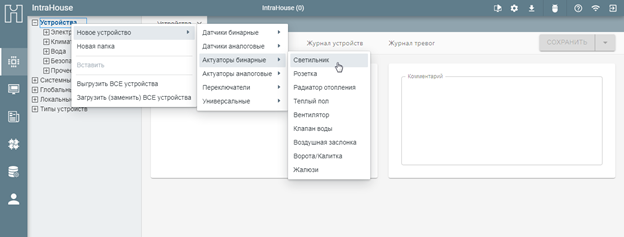

В зависимости от эксперимента может потребоваться определённый уровень импульсной мощности. Положение стержней управления в сердечнике определяет уровень мощности в любой момент времени. Собранный из данных моей работы на реакторе набор состоит из этих значений, а также нескольких других, которые описываются ниже:

* **Дата**. Конкретная дата в формате datetime, когда произошёл импульс.

* **Расчётная реактивность**. *Оценочная* импульса реактивности в долларах. Эта оценка определяется обращением к объединённой стоимости определённого стержня управления. Пример: экспериментатор запрашивает импульс стоимостью $2,00. Оператор найдёт позицию для контрольного стержня на основе общей стоимости.

* **Позиции стержня**. В сердечнике находятся четыре управляющих стержня — переходный, шайба 1, шайба 2 и управляющий стержень. Метки "Trans, S1, S2, Reg" в моем наборе — это связанные с физическим расположением управляющих стержней в ядре значения. Они варьируются от 0 до 960, где 0 — это полностью вставленный сердечник, а 960 – полностью удалённый.

* **Пиковая мощность**. Измерения в мегаваттах.

* **Общая энергия** Измеряется в мегаваттах-секундах.

* **Пиковая температура**. Измеряется в градусах Цельсия: это пиковая температура, достигаемая в измерительном топливном элементе (IFE). Чтобы контролировать температуру сердечника, внутри нескольких топливных стержней встроены термопары.

* **Расчетная реактивность**. Это "истинное" значение реактивности, обычно оно на определенную величину отличается от расчётной. Оно автоматически рассчитывается консолью реактора.

В оставшейся части статьи я проанализирую набор данных, чтобы понять, какие возможны инсайты. Кроме того, чтобы прогнозировать *расчётную реактивность* на основе *предполагаемой реактивности* и *положений стержней*, я применю модель машинного обучения — линейную регрессию. Эта модель поможет нам быть точнее с нашими импульсами (в определённой степени — больше размышлений об этом позже), также модель повысит эффективность и достоверность экспериментов. Моя конечная цель — сделать наши импульсы более точными и повторяемыми с точки зрения полученного конкретным образцом количества облучения.

Исследовательский анализ данных (EDA)

-------------------------------------

Я очистил данные заранее, избавлю вас от этих деталей. В большинстве случаев очистка набора данных – это удаление ошибочных или неполных записей. Было много ошибок ручного ввода (опечаток), которые я должен был обнаружить и исправить, не хватало точек данных, их я либо полностью удалил, либо заменил средними значениями.

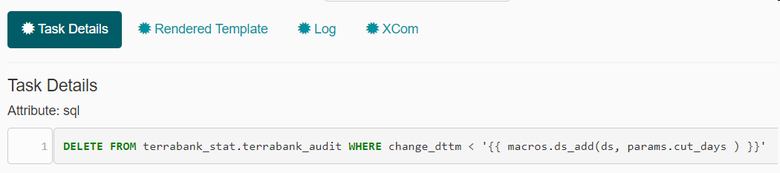

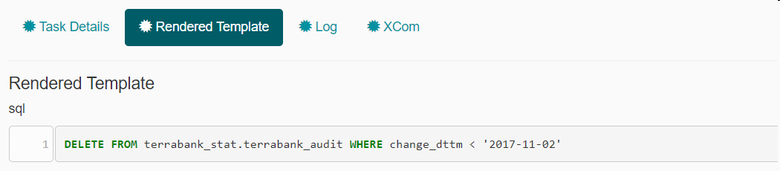

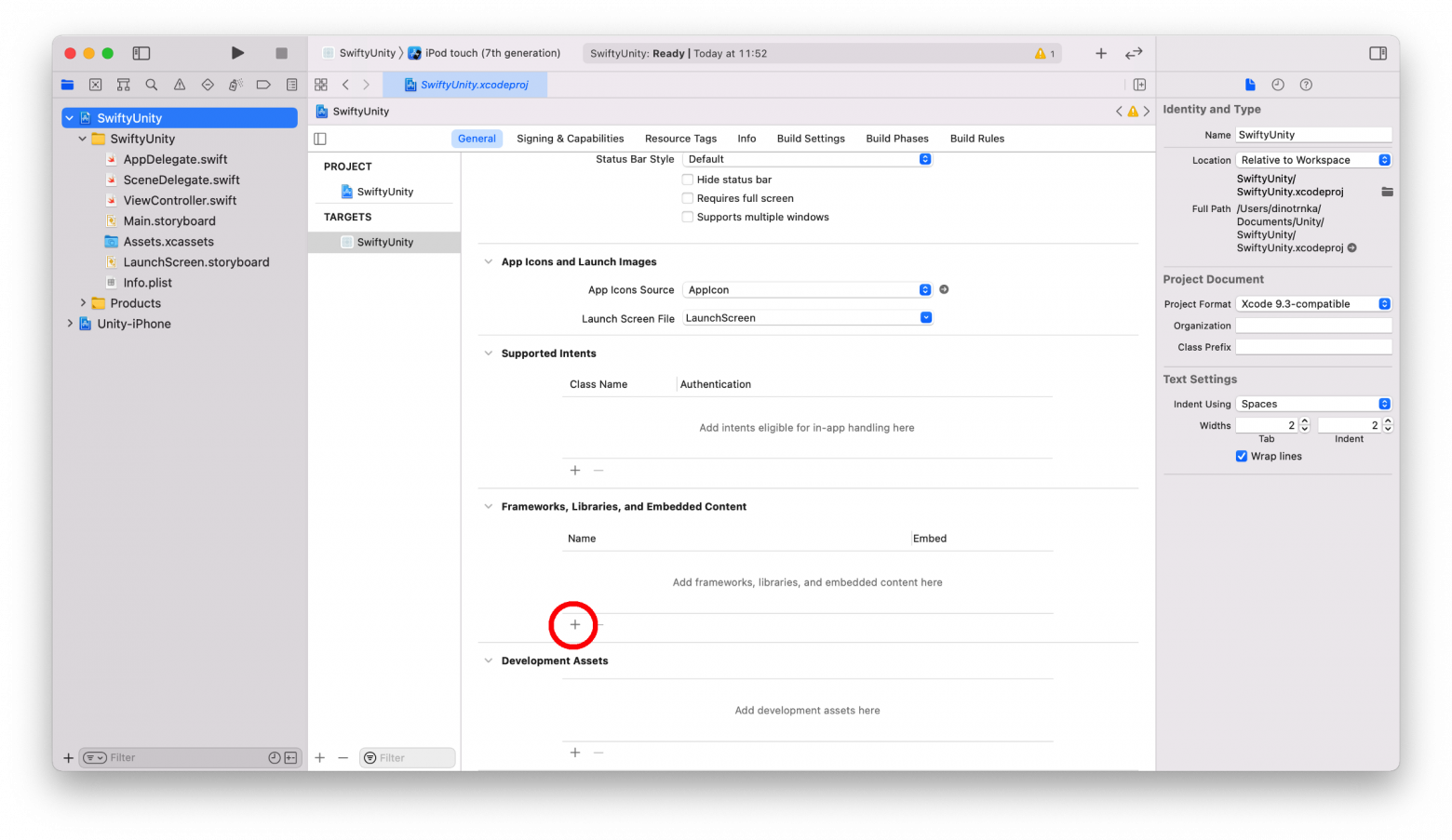

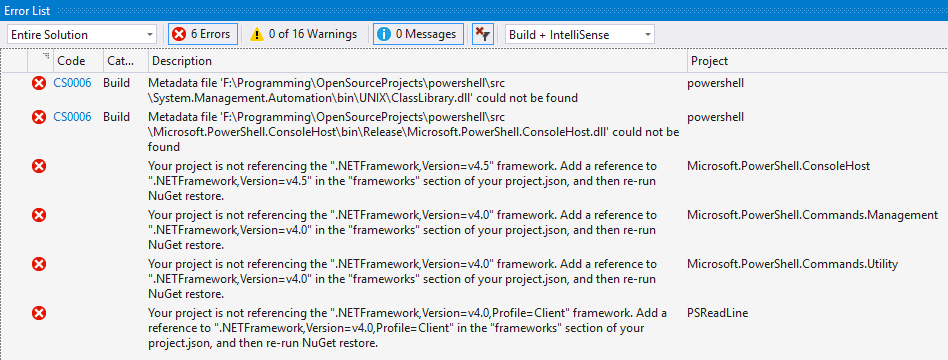

Как только у меня будут чистые данные, первое, что я сделаю, — импортирую соответствующие библиотеки и загружу свой фрейм данных:

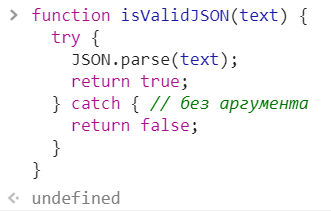

```

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

import numpy as npfrom sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn import metrics

from sklearn.metrics import r2_scoredf = pd.read_excel('Pulse_Data_2021_NO_NULL.xlsx', )

```

После этого я всегда использую три основные функции, чтобы изучить общие характеристики моих данных — *.head()*, *.info()* и *.describe().*

*.head()* просто показывает несколько верхних строк фрейма данных, так можно увидеть, как данные структурированы в целом:

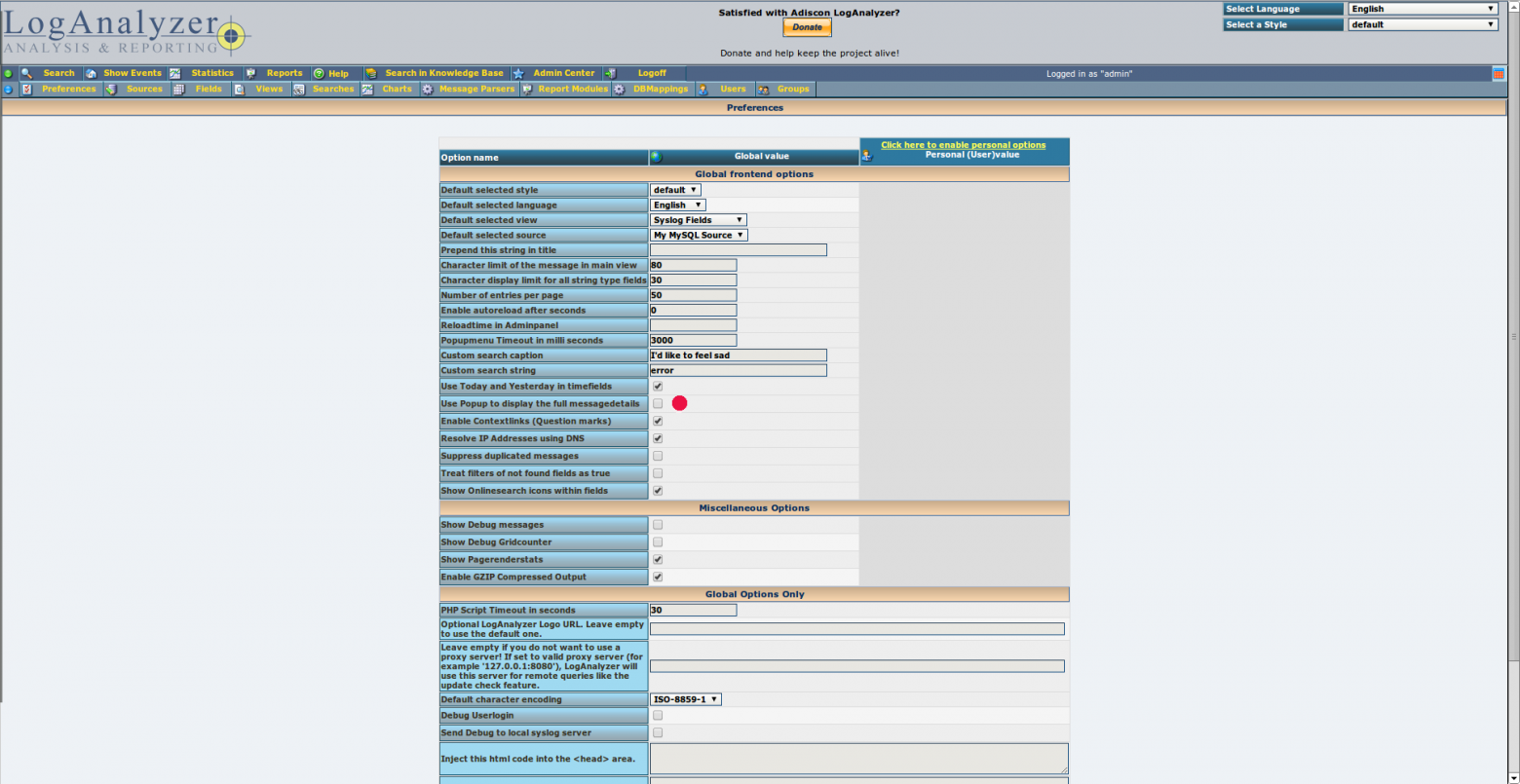

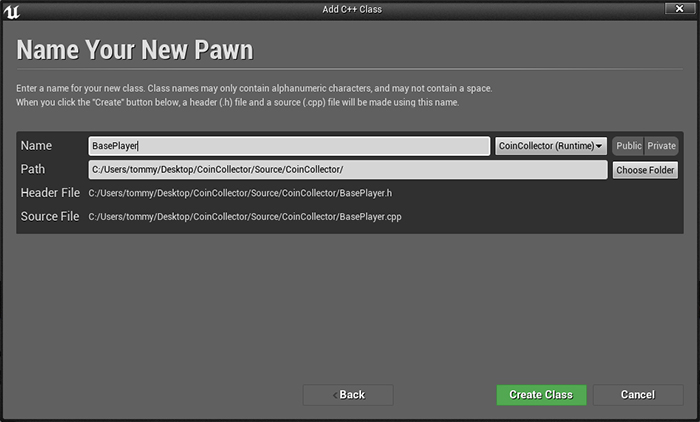

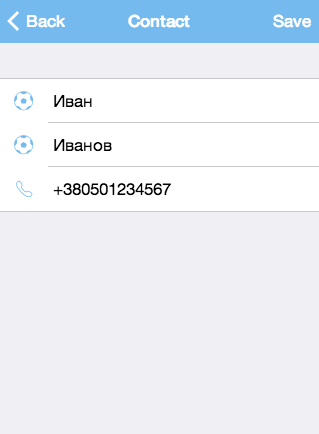

")Рисунок 3. вывод df.head()*.info()* выводит количество записей во фрейме, имена столбцов, количество нулевых записей в каждом столбце и тип данных для каждого столбца:

")Рисунок 4. Вывод df.info()И *.describe()* предоставляет некоторый сводный анализ самих данных — среднее значение, стандартное отклонение, квартили и так далее от каждого столбца. Мне нравиться транспонировать столбец, чтобы удобно читать его:

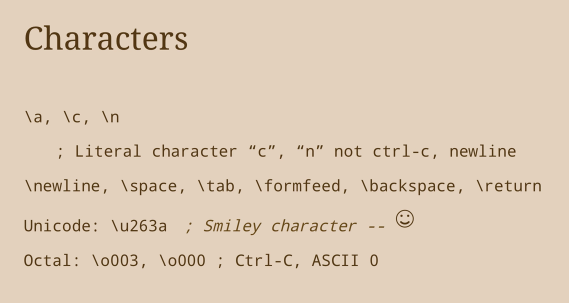

")Рисунок 5. Вывод df.describe()Следующий шаг моего EDA – просто начать строить графики того, что может иметь смысл. Например, я подумал, что было бы интересно увидеть связь между расчётной реактивностью и пиковой мощностью, поэтому сделал простую диаграмму рассеяния:

Рисунок 6. Диаграмма рассеяния расчётной реактивности в зависимости от пиковой мощности.Между двумя переменными существует четкая экспоненциальная зависимость, она согласуется с принципами управляющей этой реакцией реакторной кинетики. График также полезен тем, что выявляет потенциальные точки выброса — либо странное поведение реактора, либо, что более вероятно, ошибочные записи. Из этого графика я нашел дополнительные записи с опечатками, которые нужно было исправить или убрать.

Корреляционная тепловая карта — это ещё один полезный инструмент, который может применяться к большинству числовых наборов данных. На рисунке 7 ниже показано, какие столбцы со значениями в диапазоне от -1 до 1 тесно коррелируют друг с другом.

Я пытаюсь сделать прогнозы предполагаемой реактивности точнее, мой следующий шаг — сравнить его распределение с расчётной реактивностью. Для этого я накладываю две гистограммы и придаю им приятный вид:

Рисунок 8. Гистограммы реактивности.Существуют дискретные значения импульсной реактивности, которые мы обычно используем, когда решаем, насколько “большой” импульс мы хотим. Рисунок 8 наглядно отражает это, показывая, что 1.50, 2.00, 2.50 и 3.00 – это общие оценочные значения. Можно было бы ожидать нормального распределения расчётных значений реактивности вокруг каждого из её расчётных значений, что показано (хотя и слабо) синим графиком.

Если ещё раз взглянуть на рис. 8, оказывается, что оценочная реактивность несколько выше рассчитанной. Это означает, что, вообще говоря, если вы запросите импульс стоимостью в $2,00, вы на самом деле получите реактивность немного меньше. Я могу количественно оценить его: нужно вычесть один столбец из другого и найти среднее значение:

Средняя разница между расчётной и оценочной предполагаемой реактивностью.Выше показано, что в среднем “истинная”, рассчитанная реактивность на 16 центов дешевле расчётной реактивности.

Наконец, я сгенерировал график, который служит интересным представлением работы реактора во времени. Этот реактор впервые запустили (то есть “вывели в критичесоке состояние”) в 1992 году, и график количества импульсов в год с тех пор показывает несколько периодов сильно сниженной активности:

Рисунок 10. Количество импульсов в год.Глядя на рисунок 10, вы можете задаться вопросами:

* Почему в 1994-1996 годах и в 2013-2014 годах импульсов было так мало?

* Были ли повлиявшие на тип экспериментов на объекте административные изменения, которые повлияли на тип экспериментов на этом объекте?

* Были ли какие-либо новые национальные или университетские исследовательские разработки, требующие дополнительных импульсов?

* Какие эксперименты проводились в 2000 и 2020-2021 годах (сейчас), которые требовали столько импульсов, и почему в этот период не было таких экспериментов?

Удивительно, как много инсайтов можно получить из нескольких маленьких графиков.

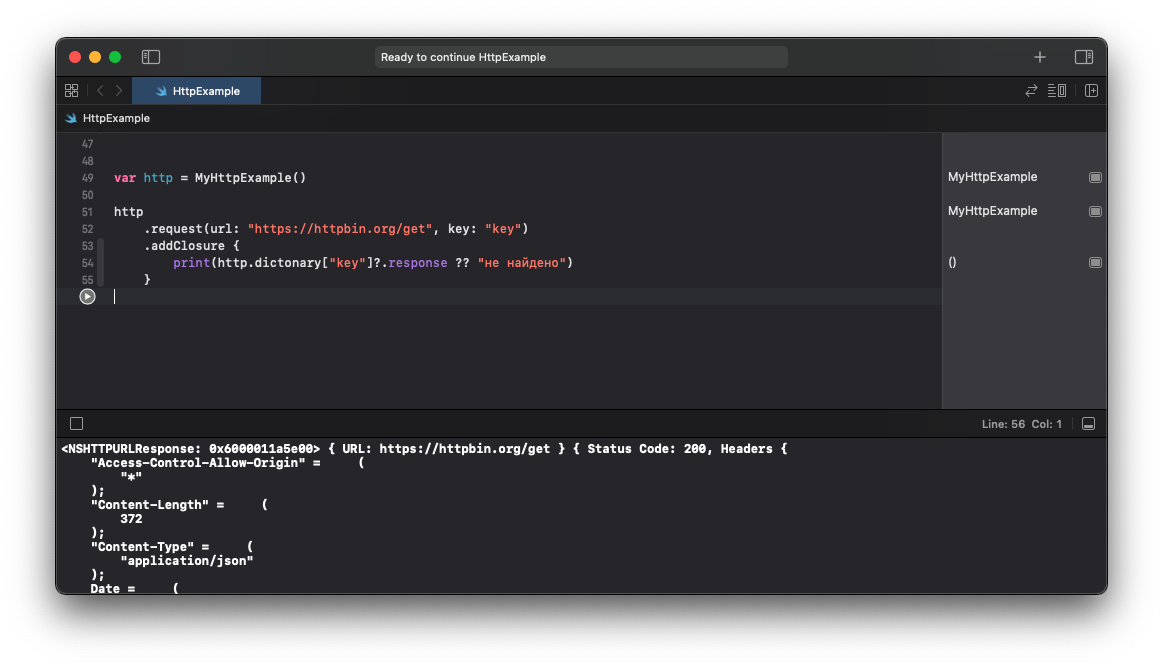

Прогнозное моделирование

------------------------

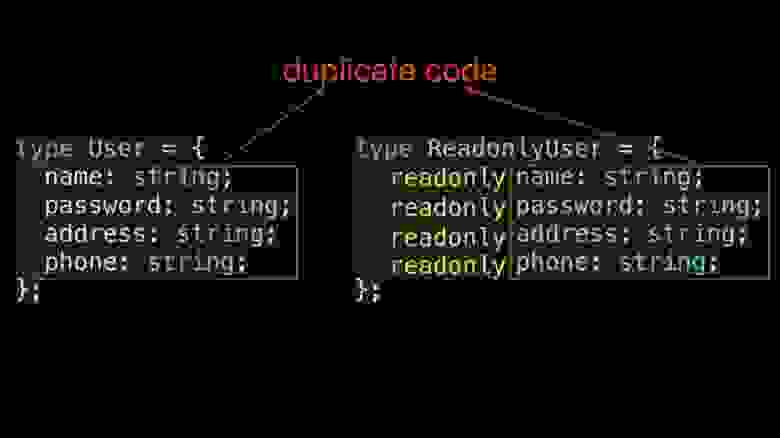

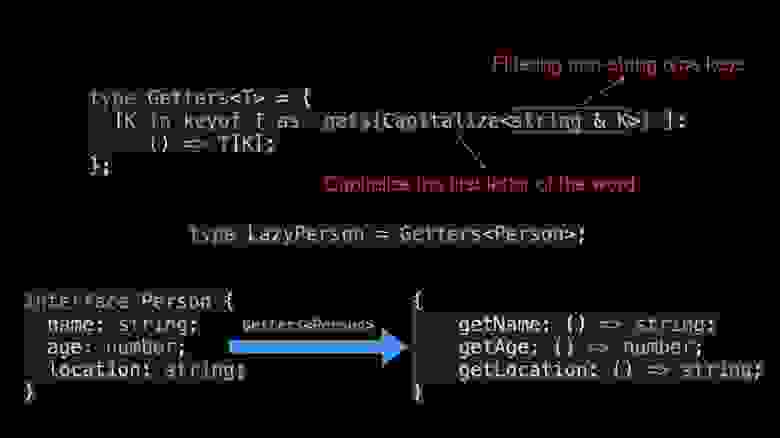

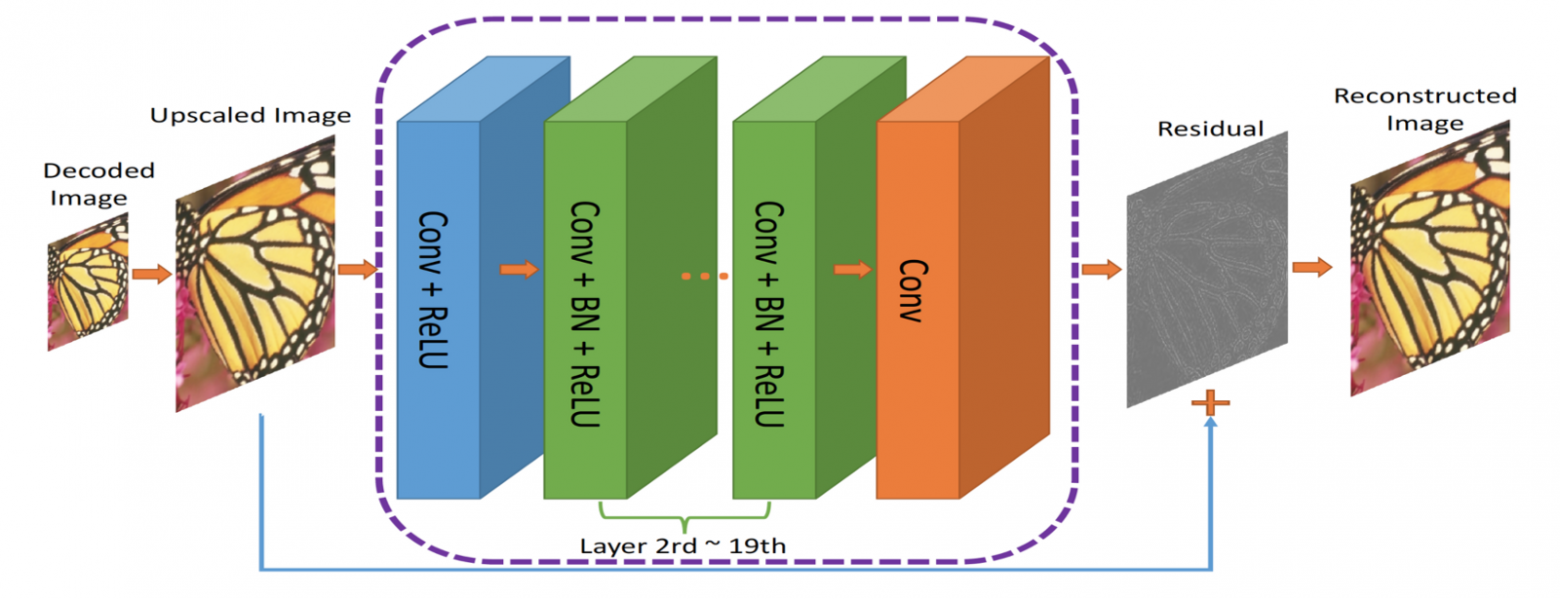

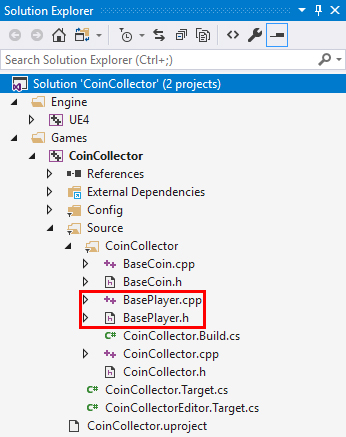

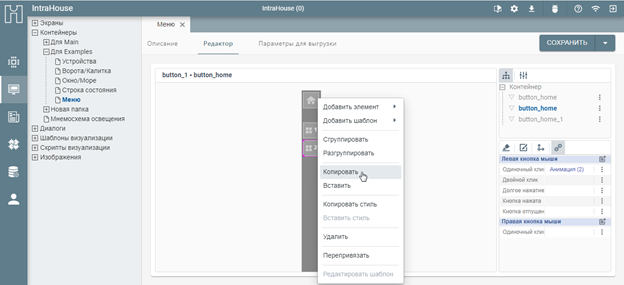

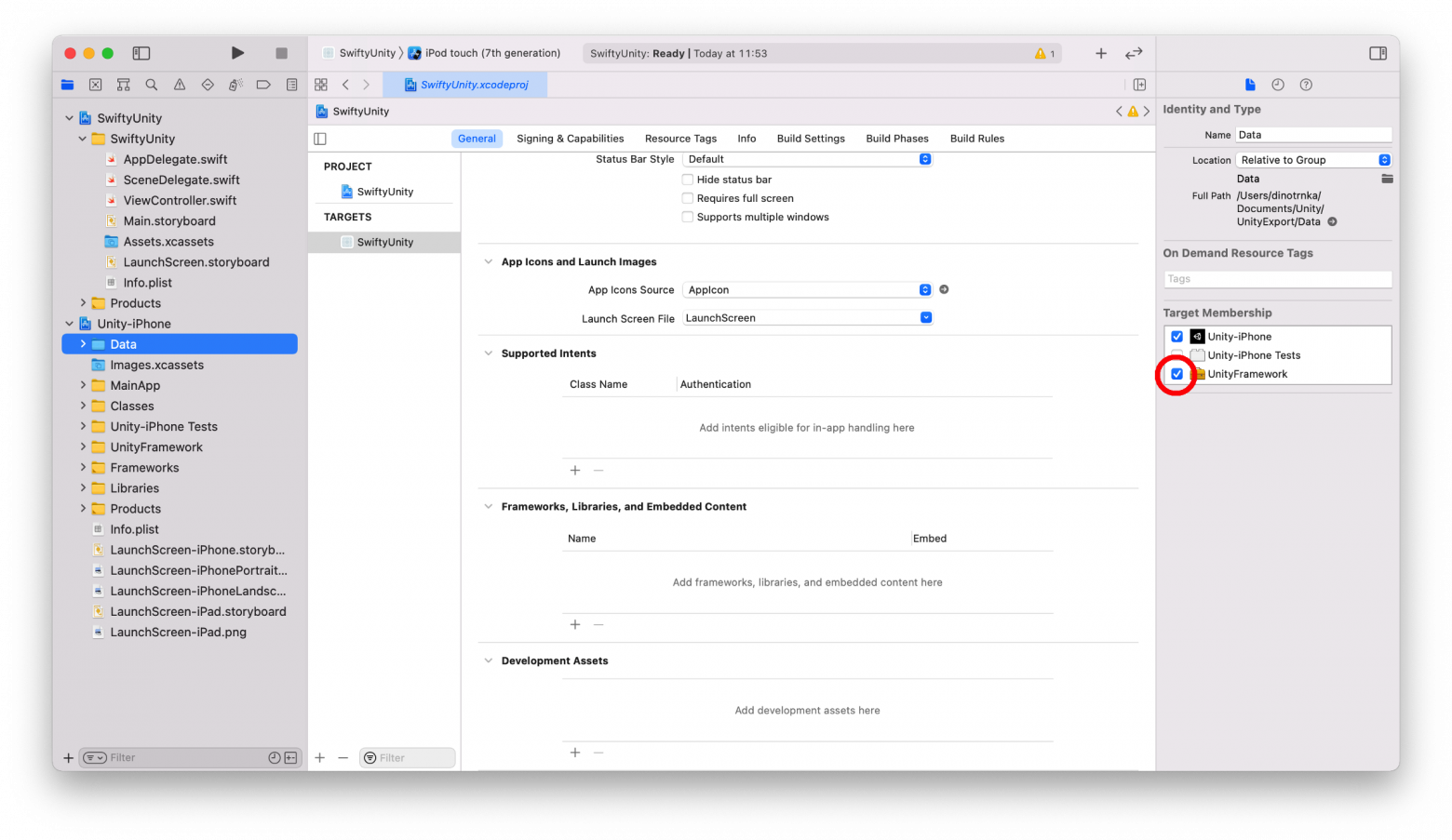

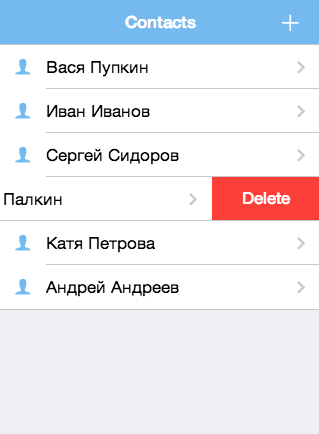

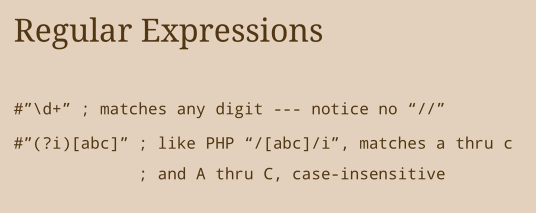

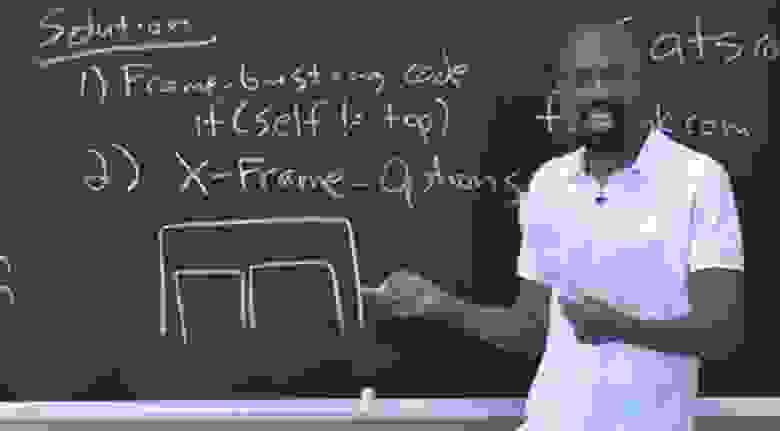

Задача прогнозирования *расчётной реактивности* подходит для модели линейной регрессии. Это считается моделью обучения с учителем, поскольку данные уже помечены (дл обучения модели даны значения x и y). Технически это модель множественной регрессии (определение которой включает в себя линейную регрессию), потому что она использует несколько независимых переменных (Est\_Reactivity, Trans, S1, S2, Reg), чтобы спрогнозировать значение зависимой переменной (Calc\_Reactivity).

Сначала я разбил данные на обучающий и тестовый наборы, чтобы дать модели объективную оценку. Затем я инстанцирую модель и обучаю её на данных:

Рисунок 11 демонстрирует разделение данных на тестовые и обучающие, а также обучение модели.Как только модель обучена, чтобы сравнить выводы модели с ожидаемыми значениями, я использую данные для тестирования. Абсолютно прямая линия означала бы идеальную модель:

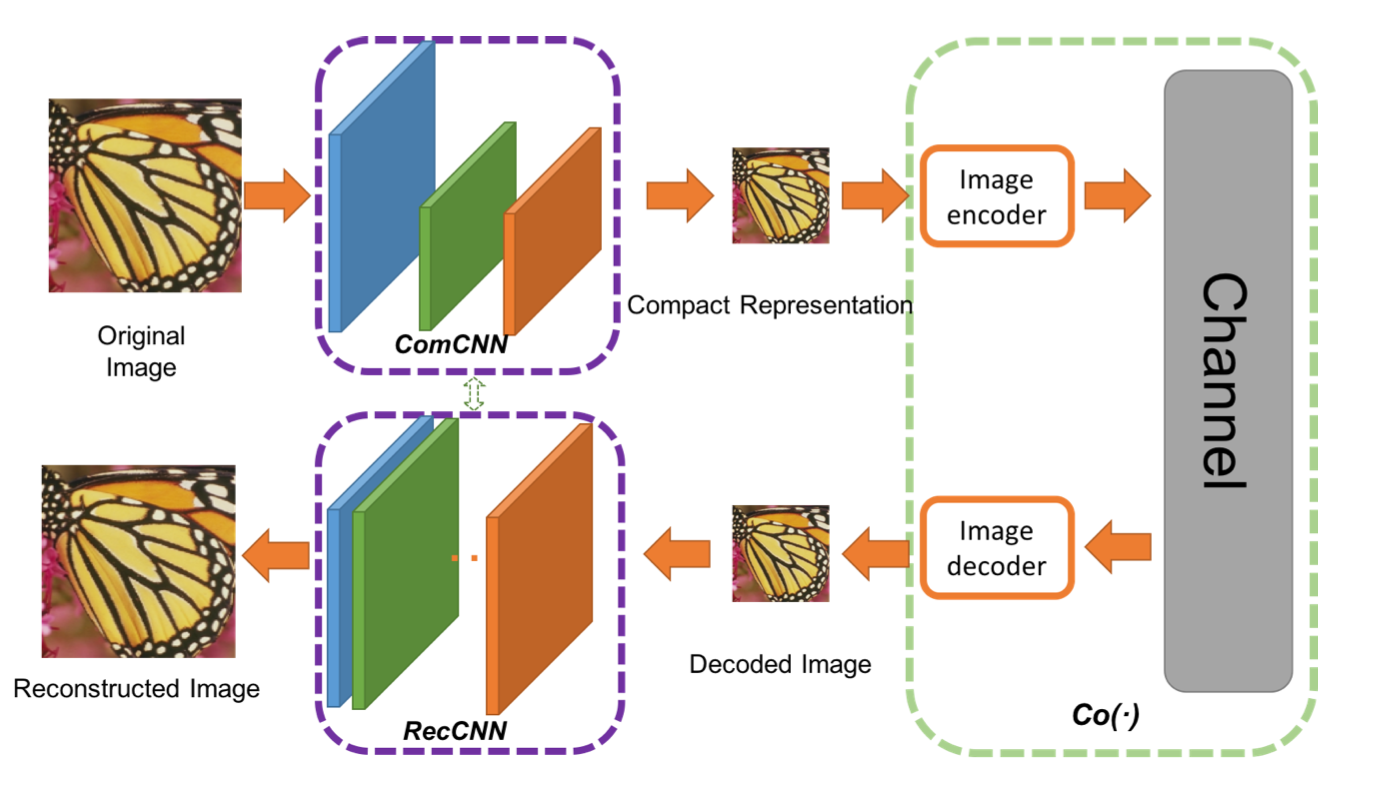

Рисунок 12. Диаграмма рассеяния демонстрирует выводы модели в сравнении с истинными значениями.С несколькими заметными отклонениями, модель делает большую работу по точному прогнозированию. В зависимости от того, для чего применяется модель, возможно, стоит изучить данные ещё глубже, чтобы определить, откуда исходят эти отклонения и как их можно смягчить, чтобы повысить точность модели. В моем случае этой модели достаточно. Я даже могу количественно оценить качество обучения, вычислив для моей модели значение коэффициента детерминации:

Рисунок 13. Коэффициент детерминации 0.91Рисунок 14: График остатковКоэффициент детерминации — это доля дисперсии в зависимой переменной, которая прогнозируема исходя из независимой переменной. Выраженный в процентах, 91% дисперсии в оценочной реактивности любого данного импульса можно объяснить с помощью наших входных значений. Вывод: это отличная модель для наших целей. Тем не менее, есть ещё одна проверка, которую я могу сделать, чтобы больше узнать о модели.

**Рисунок 14** — это гистограмма остатков, или расстояние между любой заданной точкой данных и линией наиболее подходящей регрессии. График показывает, что нормальное распределение случайной ошибки — около нуля. Это хорошо. Если бы это было не так, то у нас могли возникнуть проблемы с нашей моделью и/или набором данных. Опять же, есть заметные отклонения, но не о чем беспокоиться, когда мы подкреплены впечатляющей дисперсией зависимой переменной.

.")Рисунок 15. Импульс, записанный в режиме медленного движения (изначально 240 кадров в секунду).Выводы (и ограничения)

----------------------

С помощью этой модели теперь я могу точно предсказать значение импульсной реактивности, основываясь на таких параметрах реактора, как положение управляющих стержней и импульс в долларах. Ясность важна во всех экспериментах, и эта модель поможет подтянуть значения импульсов и обеспечить одинаковое облучение радиацией для каждого облучаемого компонента.

> Примечание. Модель имеет ряд ограничений, которые могут быть очевидны для тех, у кого есть знания о кинетике реактора и о его работе. А именно, модель не знает о предыдущих операциях и чрезвычайно важном накоплении [продуктов распада](https://www.nuclear-power.net/nuclear-power/reactor-physics/reactor-operation/fuel-burnup/neutron-poisons-reactor-poisoning/#:~:text=%D0%9F%D1%80%D0%BE%D0%B4%D1%83%D0%BA%D1%82%D1%8B%20%D0%B4%D0%B5%D0%BB%D0%B5%D0%BD%D0%B8%D1%8F%20%D0%B2%D1%8B%D0%B7%D1%8B%D0%B2%D0%B0%D1%8E%D1%82%20%D0%B1%D0%B5%D1%81%D0%BF%D0%BE%D0%BA%D0%BE%D0%B9%D1%81%D1%82%D0%B2%D0%BE,%D0%B8%D0%B7%D0%B2%D0%B5%D1%81%D1%82%D0%BD%D1%8B%20%D0%BA%D0%B0%D0%BA%20%D0%BD%D0%B5%D0%B9%D1%82%D1%80%D0%BE%D0%BD%D0%BD%D1%8B%D0%B5%20%D1%8F%D0%B4%D1%8B.). Ксенон-135 образуется (и сгорает) с течением времени по мере работы реактора, существенно влияя на поглощение нейтронов и поведение реактора.

>

>

Хотите научиться использовать машинное обучение как и автор статьи — можете обратить внимание на наш курс [по Machine Learning](https://skillfactory.ru/ml-programma-machine-learning-online?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_ML&utm_term=regular&utm_content=160421), или на его расширенную версию, в которой рассматривается и глубокое обучение — ["Machine Learning и Deep Learning"](https://skillfactory.ru/ml-and-dl?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_MLDL&utm_term=regular&utm_content=160421).

[Узнайте](https://skillfactory.ru/courses/?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_ALLCOURSES&utm_term=regular&utm_content=140421), как прокачаться и в других специальностях или освоить их с нуля:

* [Профессия Data Scientist](https://skillfactory.ru/dstpro?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_DSPR&utm_term=regular&utm_content=160421)

* [Профессия Data Analyst](https://skillfactory.ru/dataanalystpro?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_DAPR&utm_term=regular&utm_content=160421)

* [Курс по Data Engineering](https://skillfactory.ru/dataengineer?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_DEA&utm_term=regular&utm_content=160421)

Другие профессии и курсы**ПРОФЕССИИ**

* [Профессия Fullstack-разработчик на Python](https://skillfactory.ru/python-fullstack-web-developer?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_FPW&utm_term=regular&utm_content=160421)

* [Профессия Java-разработчик](https://skillfactory.ru/java?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_JAVA&utm_term=regular&utm_content=160421)

* [Профессия QA-инженер на JAVA](https://skillfactory.ru/java-qa-engineer?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_QAJA&utm_term=regular&utm_content=160421)

* [Профессия Frontend-разработчик](https://skillfactory.ru/frontend?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_FR&utm_term=regular&utm_content=160421)

* [Профессия Этичный хакер](https://skillfactory.ru/cybersecurity?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_HACKER&utm_term=regular&utm_content=160421)

* [Профессия C++ разработчик](https://skillfactory.ru/cplus?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_CPLUS&utm_term=regular&utm_content=160421)

* [Профессия Разработчик игр на Unity](https://skillfactory.ru/game-dev?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_GAMEDEV&utm_term=regular&utm_content=160421)

* [Профессия Веб-разработчик](https://skillfactory.ru/webdev?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_WEBDEV&utm_term=regular&utm_content=160421)

* [Профессия iOS-разработчик с нуля](https://skillfactory.ru/iosdev?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_IOSDEV&utm_term=regular&utm_content=160421)

* [Профессия Android-разработчик с нуля](https://skillfactory.ru/android?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_ANDR&utm_term=regular&utm_content=160421)

**КУРСЫ**

* [Курс по Machine Learning](https://skillfactory.ru/ml-programma-machine-learning-online?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_ML&utm_term=regular&utm_content=160421)

* [Курс "Machine Learning и Deep Learning"](https://skillfactory.ru/ml-and-dl?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_MLDL&utm_term=regular&utm_content=160421)

* [Курс "Математика для Data Science"](https://skillfactory.ru/math-stat-for-ds#syllabus?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_MAT&utm_term=regular&utm_content=160421)

* [Курс "Математика и Machine Learning для Data Science"](https://skillfactory.ru/math_and_ml?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_MATML&utm_term=regular&utm_content=160421)

* [Курс "Python для веб-разработки"](https://skillfactory.ru/python-for-web-developers?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_PWS&utm_term=regular&utm_content=160421)

* [Курс "Алгоритмы и структуры данных"](https://skillfactory.ru/algo?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_algo&utm_term=regular&utm_content=160421)

* [Курс по аналитике данных](https://skillfactory.ru/analytics?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_SDA&utm_term=regular&utm_content=160421)

* [Курс по DevOps](https://skillfactory.ru/devops?utm_source=infopartners&utm_medium=habr&utm_campaign=habr_DEVOPS&utm_term=regular&utm_content=160421) | https://habr.com/ru/post/552404/ | null | ru | null |

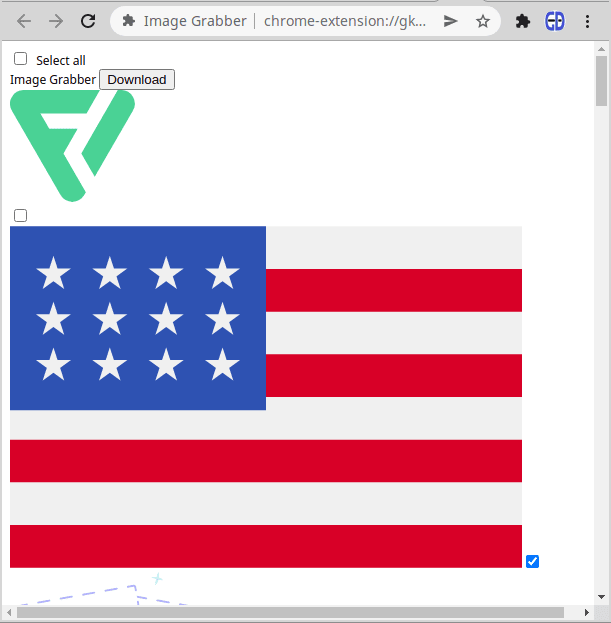

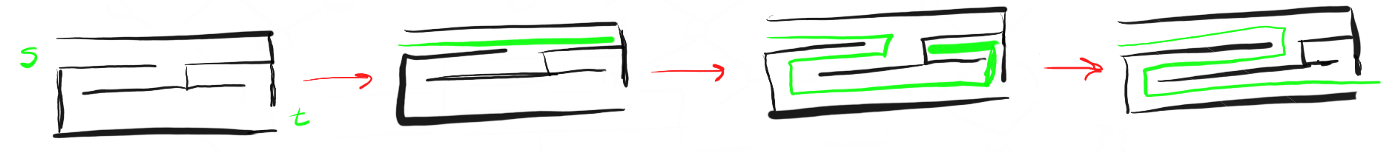

# Создание расширения браузера Google Chrome для извлечения всех изображений web-страницы. Часть 2

Введение

--------

Представляю вашему вниманию вторую часть статьи о создании расширения web-браузера Chrome, которое позволяет извлечь все изображения с web-страницы.

Данный материал, как и материал первой статьи предназначен для разработчиков, которые умеют писать web-приложения на современном JavaScript, но не пробовали создавать web-расширения для Google Chrome и хотели бы начать это делать. Эта и предыдущая статьи не являются исчерпывающим руководством или справочником о всех возможностях, которые доступны при создании расширений браузера, однако могут помочь быстро начать. Затем расширять свои знания можно с помощью [официальной документации](https://developer.chrome.com/docs/extensions/) и [справочника по API](https://developer.chrome.com/docs/extensions/reference/).

Первая часть опубликована здесь: <https://habr.com/ru/post/703330/>.

Напомню, что по итогам первой части мы создали расширение web-браузера, которое умеет извлекать URL-пути всех изображений текущей web-страницы и копировать их список в буфер обмена.

В этой части я покажу как автоматически упаковать все изображения этого списка в ZIP-архив и предложить пользователю его скачать. Также, мы создадим дополнительную страницу интерфейса, где пользователь сможет выбирать, какие картинки добавлять в ZIP-архив, а какие нет.

В итоге при правильном выполнении всех действий вы получите web-расширение браузера, которое будет выглядеть и работать так как показано на этом видео:

В итоге я опишу процесс публикации готового расширения в магазин Chrome Web Store.

### Создание вкладки со списком изображений

Итак, в первой части список извлеченных изображений копировался в буфер обмена. Далее мы сделаем чтобы вместо буфера обмена, этот список отображался на новой странице в отдельной вкладке браузера. На этой странице мы создадим интерфейс, позволяющий пользователю выбрать все или некоторые из этих картинок для дальнейшей выгрузки в zip-архив.

Напомню, что список изображений формировался и копировался в буфер обмена при нажатии на кнопку "**GRAB NOW**" во всплывающем окне `popup.html`, в функции `onResult`, определенной в файле `popup.js` так, как показано ниже.

```

/**

* Выполняется после того как вызовы grabImages

* выполнены во всех фреймах удаленной web-страницы.

* Функция объединяет результаты в строку и копирует

* список путей к изображениям в буфер обмена

*

* @param {[]InjectionResult} frames Массив результатов

* функции grabImages

*/

function onResult(frames) {

// Если результатов нет

if (!frames || !frames.length) {

alert("Could not retrieve images from specified page");

return;

}

// Объединить списки URL из каждого фрейма в один массив

const imageUrls = frames.map(frame=>frame.result)

.reduce((r1,r2)=>r1.concat(r2));

// Скопировать в буфер обмена полученный массив

// объединив его в строку, используя возврат каретки

// как разделитель

window.navigator.clipboard

.writeText(imageUrls.join("\n"))

.then(()=>{

// закрыть окно расширения после

// завершения

window.close();

});

}

```

Заменим все что связано с копированием в буфер обмена (все строки начиная с `window.navigator.clipboard`) на вызов функции `openImagesPage(urls)`, которая будет открывать отдельную вкладку и показывать в ней все изображения из списка urls.

```

/**

* Выполняется после того как вызовы grabImages

* выполнены во всех фреймах удаленной web-страницы.

* Функция объединяет результаты в строку и копирует

* список путей к изображениям в буфер обмена

*

* @param {[]InjectionResult} frames Массив результатов

* функции grabImages

*/

function onResult(frames) {

// Если результатов нет

if (!frames || !frames.length) {

alert("Could not retrieve images from specified page");

return;

}

// Объединить списки URL из каждого фрейма в один массив

const imageUrls = frames.map(frame=>frame.result)

.reduce((r1,r2)=>r1.concat(r2));

// Скопировать в буфер обмена полученный массив

// объединив его в строку, используя возврат каретки

// как разделитель

openImagesPage(imageUrls)

}

/**

* Открывает новую вкладку браузера со списком изображений

* @param {*} urls - Массив URL-ов изображений для построения страницы

*/

function openImagesPage(urls) {

// TODO:

// * Открыть новую закладку браузера с HTML-страницей интерфейса

// * Передать массив `urls` на эту страницу

}

```

Создадим теперь эту страницу и напишем функцию `openImagesPage`, которая будет ее открывать.

Расширение Chrome может содержать любое количество страниц. На данном этапе есть только `popup.html`. Это главная страница расширения. В ней список изображений извлекается и формируется. Теперь создадим вторую страницу, в которую этот список будет передаваться. Назовем ее `page.html`. Создайте эту страницу со следующим содержимым и сохраните ее в корневой папке расширения, то есть там же где и popup.html:

```

Image Grabber

Select all

Image Grabber

Download

```

Данная страница состоит из двух блоков. Для них назначены CSS-классы `header` и `container`. Блок заголовка содержит чекбокс для выбора всех изображений из списка и кнопку "Download", для их выгрузки. Блок `container` в данный момент пуст. Он будет содержать список изображений, которые будут переданы функцией `openImagesPage` из страницы `popup.html`.

После заполнения массивом URL-ов изображений и после применения CSS-стрилей, страница `page.html` будет выглядеть так:

Интерфейс выбора изображенийКак видно, у каждой картинки будет чекбокс, позволяющий ее либо добавить, либо убрать из выборки.

### Открытие новой вкладки браузера из расширения

Открыть новую вкладку браузера можно с помощью функции `chrome.tabs.create` из [Chrome Tabs API](https://developer.chrome.com/docs/extensions/reference/tabs/), которая определена следующим образом:

```

chrome.tabs.create(createProperties, callback)

```

* `createProperties` - объект с параметрами, говорящими Chrome что открыть в новой вкладке и как. В частности, в параметре **url** указывается путь к странице, которую нужно открыть.

* `callback` - функция обратного вызова, которая исполняется после того как вкладка открылась. В качестве единственного параметра ей передается ссылка на созданную вкладку. Это объект [Tab](https://developer.chrome.com/docs/extensions/reference/tabs/#type-Tab), содержащий различные методы и свойства созданной вкладки, включая ее уникальный идентификатор.

Теперь перепишем функцию `openImagesPage`, чтобы открыть новую вкладку:

```

function openImagesPage(urls) {

// TODO:

// * Открыть новую закладку браузера с HTML-страницей интерфейса

chrome.tabs.create({"url": "page.html"},(tab) => {

alert(tab.id)

// * Передать массив `urls` на эту страницу

});

}

```

Если теперь вы запустите расширение и нажмете кнопку **GRAB NOW**, то должна открыться новая вкладка браузера с содержимым созданной ранее страницы `page.html`:

Новая страница page.htmlПри вызове `chrome.tabs.create` была указана callback-функция, которая должна показывать оповещение с идентификатором созданной вкладки - `alert(tab.id)`. В дальнейшем, эта функция будет отправлять список путей к картинкам в эту новую вкладку. Однако это не сработает и вы не увидите никакого оповещения. Это интересная ошибка, которую стоит подробнее рассмотреть.

Сначала вы нажимаете кнопку **GRAB NOW** на странице `popup.html`. При этом открывается страница `page.html` в новой вкладке браузера и эта вкладка активируется. При активации вкладки фокус перемещается на страницу `page.html` и уходит с всплывающего окна `popup.html`. В момент потери фокуса, всплывающее окно уничтожается и исчезает. Это происходит до того, как срабатывает функция callback, которая должна выполнить `alert(tab.id)`. Как это исправить? Например, можно открыть новую вкладку, но не активировать ее в момент открытия, а активировать ее из кода позже, в самой функции callback, после того как она выполнится. Для этого нужно указать дополнительный параметр создания новой вкладки `active:false` :

```

chrome.tabs.create({url: 'page.html', active: false}, ...)

```

Далее, `callback` должна передать данные в открытую вкладку и в конце активировать ее. В терминах Chrome API, активировать вкладку это значит "изменить статус вкладки на **активный**". Для изменения параметров вкладки, включая ее статус, используется функция `chrome.tabs.update`, определяемая следующим образом:

```

chrome.tabs.update(tabId, updateOptions, callback);

```

* `tabId` - идентификатор вкладки.

* `updateOptions` - объект с параметрами, которые нужно изменить.

* `callback` - функция обратного вызова, которая выполняется после того как изменения произведены.

Соответственно, для того чтобы активировать новую вкладку, нужно сделать такой вызов:

```

chrome.tabs.update(tab.id, {active: true});

```

Свойство **active** устанавливается для только что созданной вкладки `tab`. Здесь мы не указывали callback-функцию за ненадобностью, так как все действия с новой вкладкой будут осуществлены до ее активации.

```

function openImagesPage(urls) {

// TODO:

// Открыть новую закладку браузера с HTML-страницей интерфейса

chrome.tabs.create({"url": "page.html", active:false},(tab) => {

alert(tab.id)

// Передать массив `urls` на эту страницу

// сделать вкладку активной

chrome.tabs.update(tab.id, {active: true});

});

}

```

Теперь все должно работать правильно при нажатии кнопки **GRAB NOW** - сначала создается вкладка со страницей `page.html`, затем появляется оповещение с идентификатором вкладки, затем вкладка с этим идентификатором активируется и только после этого, всплывающее окно с кнопкой **GRAB NOW** исчезает.

Теперь пришло время убрать этот временный `alert` и вместо него написать код, который будет передавать список путей к изображениям на страницу `page.html`.

### Передача списка путей в новую вкладку

Для передачи данных на вновь созданную страницу мы воспользуемся встроенным механизмом обмена сообщениями. С его помощью, скрипт одной страницы может отправить сообщение с произвольными данными, а скрипт другой страницы может принять это сообщение, заполнить страницу данными из него и ответить отправителю о завершении.

Для отправки сообщений используется функция

```

chrome.tabs.sendMessage(tabId, message, responseFn)

```

* `tabId` - идентификатор вкладки браузера, в которую нужно передать сообщение.

* `message` - произвольный объект Javascript. В данном случае это будет массив путей к изображениям.

* `responseFn` - функция обратного вызова, которая выполнится после того, как принимающая сторона ответит на полученное сообщение. Эта функция получает один лишь аргумент `responseObject`. Это произвольный объект Javascript, который принимающая сторона может отправить вместе с ответом. (Об отправке ответов будет рассказано чуть позже)

Добавим отправку сообщения со списком URL в функцию `openImagesPage:`

```

function openImagesPage(urls) {

// Открыть новую закладку браузера с HTML-страницей интерфейса

chrome.tabs.create({"url": "page.html", active: false},(tab) => {

chrome.tabs.sendMessage(tab.id, urls, (resp) => {

// сделать вкладку активной

chrome.tabs.update(tab.id, {active: true});

})

});

}

```

Теперь эта функция сначала создает новую вкладку со страницей `page.html`, затем отправляет в нее массив `urls` как сообщение и после того как принимающая сторона ответит, делает эту вкладку активной.

Вкладке нужно некоторое время, чтобы загрузить страницу и скрипт, который будет принимать сообщение. Поэтому рекомендую сделать небольшую паузу после открытия вкладки и до отправки сообщения, то есть обернуть в `setTimeout`. Я добавил паузу в 500 миллисекунд:

```

function openImagesPage(urls) {

// Открыть новую вкладку браузера с HTML-страницей интерфейса

chrome.tabs.create({"url": "page.html",active:false},(tab) => {

setTimeout(()=>{

// отправить список URL в новую вкладку

chrome.tabs.sendMessage(tab.id, urls, (resp) => {

// сделать вкладку активной

chrome.tabs.update(tab.id, {active: true});

})

},500)

});

}

```

### Прием списка путей и отображение их на странице page.html

Теперь перейдем к приему сообщения страницей `page.html`. Сообщение может быть принято только скриптом, поэтому создайте файл `page.js` и добавьте этот скрипт в `page.html`:

```

Image Grabber

Select all

Image Grabber

Download

```

За прием сообщений отвечает событие `chrome.runtime.onMessage`. Этот объект содержит метод `addEventListener(func)`, который позволяет установить функцию `func` для реакции на новые сообщения. В ней запустится процесс генерации HTML-разметки, показывающей список изображений на этой странице в блоке div с классом `container`. Добавьте следующий код в файл `page.js`:

```

chrome.runtime.onMessage

.addListener(function(message,sender,sendResponse) {

addImagesToContainer(message);

sendResponse("OK");

});

/**

* Функция, которая будет генерировать HTML-разметку

* списка изображений

* @param {} urls - Массив путей к изображениям

*/

function addImagesToContainer(urls) {

// TODO Создать HTML-разметку в элементе с

// классом container для показа

// списка изображений и выбора изображений,

// для выгрузки в ZIP-архив

document.write(JSON.stringify(urls));

}

```

В этом коде мы добавили функцию реакции на сообщение. Эта функция содержит три параметра:

* `message` - Принятый объект сообщения. В нашем случае это отправленный массив `urls`

* `sender` - Объект, который инициировал отправку сообщения. Это объект класса [MessageSender](https://developer.chrome.com/docs/extensions/reference/runtime/#type-MessageSender).

* `sendResponse` - Функция, которую можно вызвать, чтобы отправить ответ объекту отправителю. В качестве параметра можно указать любые данные, которые необходимо отправить. В данном случае мы отправили строку "ОК", так как в данном случае не важно, что конкретно отправить, важен сам факт отправки ответа, чтобы отправляющая функция отреагировала на это событие.

В итоге мы приняли сообщение со списком URL, передали этот список в функцию `addImagesToContainer` и ответили отправителю фразой "OK". В ответ на это, отправляющая функция `openImagesPage` должна активировать данную вкладку.

На данном этапе, функция addImagesToContainer это просто прототип. Она выводит список изображений как JSON-строку:

Список изображений как JSON-строкаНастоящий интерфейс предстоит создать в следующем разделе.

Создание функционала выгрузки изображений в ZIP-архив

-----------------------------------------------------

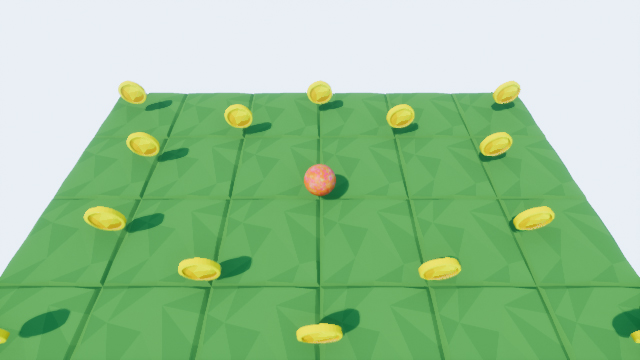

Итак, используя кнопку "**GRAB NOW**" мы извлекли список путей ко всем картинкам текущей web-страницы и передали этот список на страницу `page.html`. Это все что нам было нужно от страницы `popup.html` и скрипта `popup.js`. С этого момента мы будем работать только со страницей `page.html` и в частности с ее скриптом `page.js`. Напомним, что эта страница содержит блок заголовка с кнопкой "Download" и флажком "Select all", а также блок `container`. Следующая задача это показать картинки из полученного списка в этом контейнере, а затем, запрограммировать флажок "Select all" и кнопку "Download", чтобы выделить их все и скачать в ZIP-архиве.

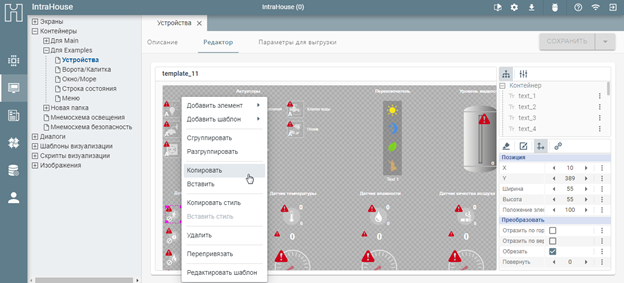

### Создание HTML-разметки списка изображений

Измените функцию `addImagesToContainer(urls)` следующим образом:

```

/**

* Функция, для генерации HTML-разметки

* списка изображений

* @param {} urls - Массив путей к изображениям

*/

function addImagesToContainer(urls) {

if (!urls || !urls.length) {

return;

}

const container = document.querySelector(".container");

urls.forEach(url => addImageNode(container, url))

}

/**

* Функция создает элемент DIV для каждого изображения

* и добавляет его в родительский DIV.

* Создаваемый блок содержит само изображение и флажок

* чтобы его выбрать

* @param {*} container - родительский DIV

* @param {*} url - URL изображения

*/

function addImageNode(container, url) {

const div = document.createElement("div");

div.className = "imageDiv";

const img = document.createElement("img");

img.src = url;

div.appendChild(img);

const checkbox = document.createElement("input");

checkbox.type = "checkbox";

checkbox.setAttribute("url",url);

div.appendChild(checkbox);

container.appendChild(div)

}

```

Функция addImagesToContainer сначала проверяет что список путей к изображениям не пуст и затем вызывает для каждого элемента функцию `addImageNode`. Эта функция генерирует HTML-элемент для каждой картинки и добавляет этот элемент в DIV с классом `container`. Для каждого элемента списка генерируется следующая разметка:

```

```

Это обычный блок с классом "imageDiv". Этот класс будет использоваться в CSS. Этот блок содержит картинку с переданным url и флажок. Флажок также имеет атрибут url, который в дальнейшем будет использоваться для добавления картинки в ZIP-архив, если ее флажок включен.

Если нажать **GRAB NOW** сейчас, то вы увидите примерно такой интерфейс:

Под заголовком мы видим список изображений. С каждым изображением связан флажок. На данный момент и сами картинки и их флажки расположены хаотично. В дальнейшем мы применим CSS-стили чтобы это исправить.

Теперь сделаем так, чтобы этот интерфейс заработал, а именно, активируем флажок "Select All" и кнопку "Download".

### Реализация функции для выбора всех картинок