text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

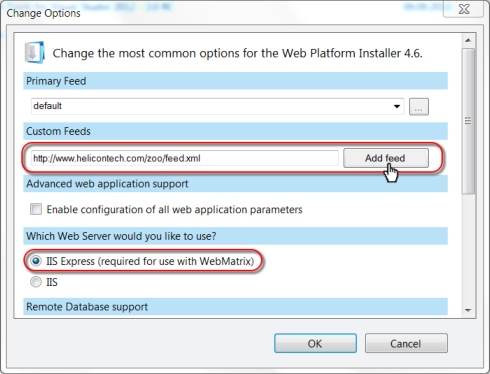

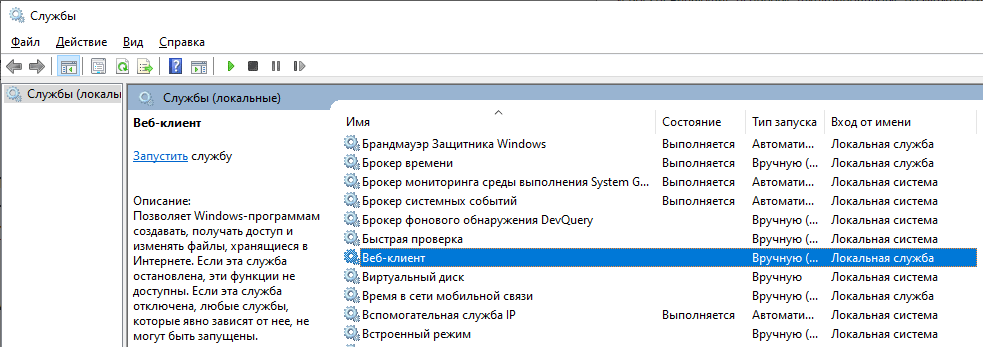

# Установка Битрикс24 на IIS сервер с использованием MSSQL и AD

На днях, встала задача протестировать этот корпоративный портал в коробочной версии. Потратив немало времени и сил, решил описать сей процесс, чтобы сэкономить кому-то лишние усилия.

Начнем с того, что в своей организации у меня «экосистема» ПО построена на базе Windows систем и присутствует большое количество прикладных приложений, написанных под наши задачи и требовалось использование MSSQL для их интеграции. Посему, было решено выделить виртуальную машину с Windows Server для тестирования продукта.

Почитав предлагаемые решения, решил попробовать три варианта:

1. Установка портала на свой IIS сервер с PHP и MSSQL

Первый пункт завершился по началу неудачно: пройдя все шаги настройки по инструкции от разработчиков, в установленном портале не работала половина функций. Как показал анализ и обращение к техподдержке, проблемы была в переопределении URL адресов. Как мне сказали, успешного запуска под IIS пока не получалось. Решил проверить дальше.

2. Установка предлагаемого комплекта с веб-окружением (апач с PHP, mysql и XMPP).

Установка комплекта «по-умолчанию» завелась сразу, но с некоторыми проблемами. Скорость работы была довольно низкой, попытки настроить кэш и сжатие особо не помогли. Переключение в HTTPS не работало, не смотря на отдельно выведенную настройку в консоли. Видимо не зря на официальном сайте стояла приписочка " Пакет «Битрикс: Веб-окружение» рекомендуется использовать только для тестирования ознакомительных версий. Для работы реального проекта рекомендуется BitrixVM".

3. Виртуальная машина битрикс с cent-os.

Некоторые режимы при выборе установки не работали. Пошла только установка демонстрационной версии. Отсутствовал выбор используемой базы данных. В системе не была установлена поддержка MSSQL.

Пришлось вернуться к первому варианту. Помучав то, что есть по этому в интернете выяснил, что правила для переопределения URL прописаны в .htaccess файле и IIS его не понимает.Решил попробовать сконвертировать правила .htaccess в понятный для сервера вид, получив следующую секцию для файла web.config:

```

```

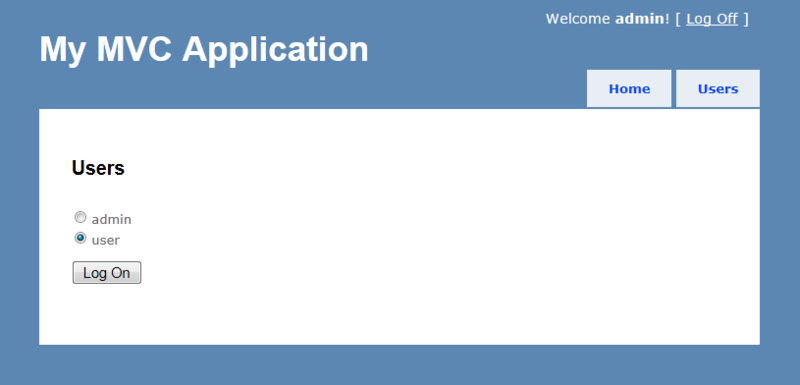

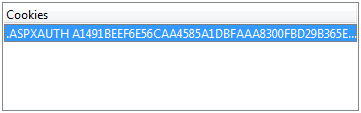

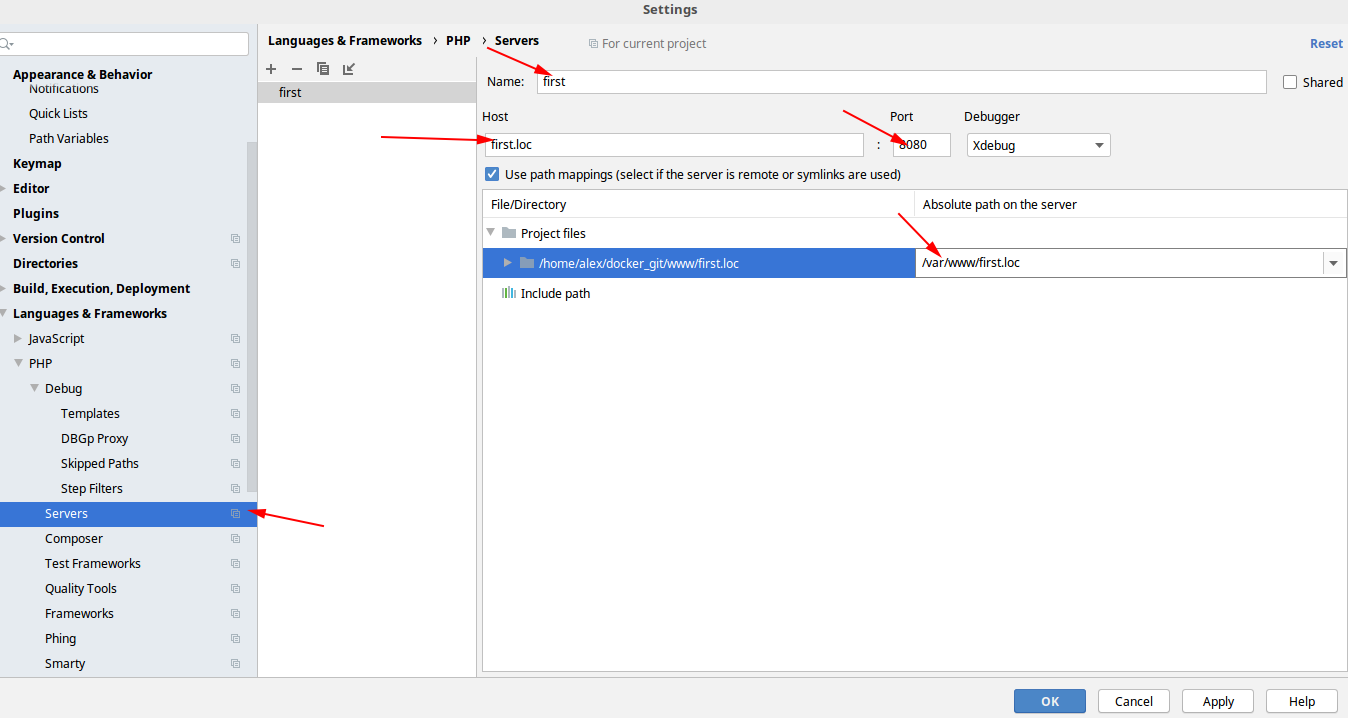

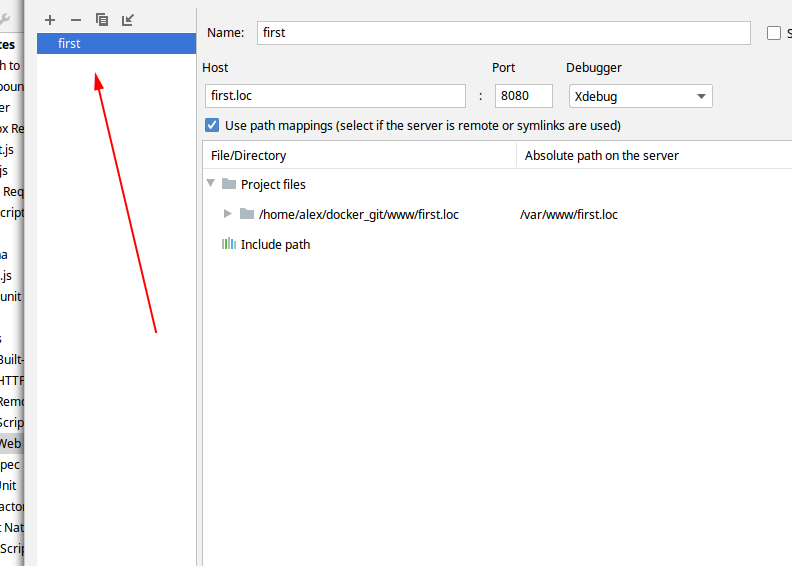

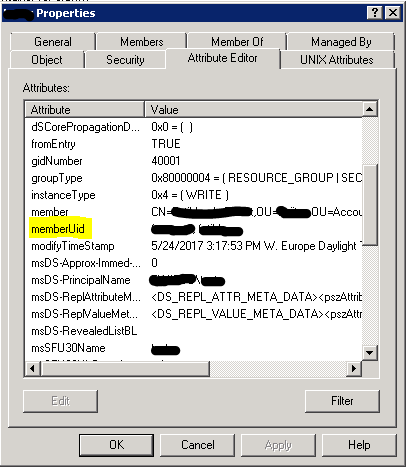

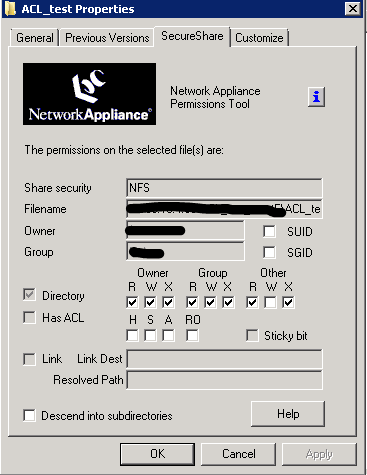

Все недостающие функции вроде как заработали, и можно бы уже порадоваться, но войдя под учеткой из Active Directory отвалился чат. Погрешив на IIS, перелопатил все настройки, но ничего не помогло. И только опытным путем была найдена причина:

мастер настройки портала некорректно создает группы пользователей и у них нет доступа к чату, а иногда и к главной странице.

Для исправления этой проблемы оказалось достаточно заменить группы, к которым добавляется пользователь после авторизации из AD

В правой выделенной части, достаточно заменить группы с префиксом «SITE\_WIZARD:» на подобные группы без этого префикса.

После установки кэша для PHP производительность тоже подтянулась до приемлемого уровня. Для меня осталось решить только проблемы не работающего автообновления и стыковки почтового домена по IMAP, но это уже вопросы к техподдержке, на которые пока ответа не получено. А после, можно и решить вопрос о приобретении. Хотя некий осадочек, от недоработок в установке продукта конечно остался.

Надеюсь это поможет кому-нибудь) | https://habr.com/ru/post/280402/ | null | ru | null |

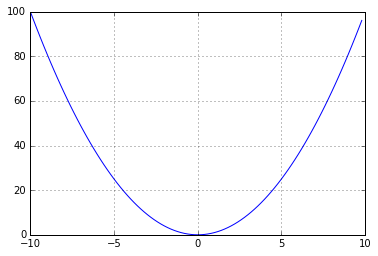

# Алгоритм большинства голосов Бойера — Мура

### Введение

Решал задачки на LeetCode и вот небольшой переводик небольшой [статьи](https://www.geeksforgeeks.org/boyer-moore-majority-voting-algorithm/) про небольшой алгоритм.

Алгоритм голосования Бойера-Мура является одним из самых популярных и оптимальных алгоритмов, который используется для поиска преобладающего элемента среди заданных, который имеет более N / 2 вхождений. Алгоритм выполняет 2 обхода по заданным элементам, что работает при O (N) временной сложности и O (1) пространственной сложности.

```

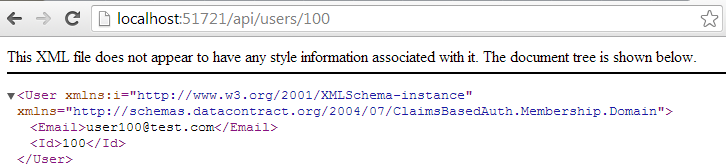

Input :{1,1,1,1,2,3,5}

Output : 1

Input : {1,2,3}

Output : -1

```

Если какой-то элемент встречается больше N/2 раз то отличных от него элементов меньше N/2. Собственно алгоритм на этом и держится.

Для начала выбирается элемент кандидат. Далее для каждого элемента:

* если элемент равен кандидату, количество голосов увеличивается.

* если кандидат и элемент не равны, количество голосов уменьшается.

* если голосов 0, выбирается новый кандидат.

### На словах

По сути, увеличивая или уменьшая количество голосов мы увеличиваем или уменьшаем приоритет определенного кандидата. Это сработает, поскольку правильный кандидат встретится более N/2 раз. Если количество голосов оказалось 0, это означает, что элементов отличных от кандидата, столько-же, сколько и равных ему. Получается текущий кандидат не может быть большинством и мы выбираем следующего кандидата. Окончательный кандидат и будет преобладающим элементом, если такой присутствует. Вторым проходом проверим, что полученный элемент встречается больше N / 2 раз. Если нет то такого элемента нет.

### От слов к коду

```

public static Integer findMajority(int[] nums)

{

int count = 0;

Integer candidate = null;

for (int num : nums) {

// проверяем, если количество голосов 0 меняем кандидата

if (count == 0) {

candidate = num;

}

// если кандидат и число совпали увеличиваем кол-во голосов

// иначе уменьшаем

count += (num == candidate) ? 1 : -1;

}

count = 0;

// считаем количество элементов равных кандидату

// в исходном массиве

for (int num : nums) {

if (num == candidate)

count++;

}

// если кандидат подходит условию возвращаем его

// иначе возвращаем null;

if (count > (nums.length / 2)) return candidate;

else return null;

}

``` | https://habr.com/ru/post/689492/ | null | ru | null |

# Создание Worker-а с другого домена

Worker'ы — ~~внятная~~ реализация многопоточности в JavaScript. На момент сейчас они имеют достаточное количество ограничений. Для ознакомления с ними (как worker'ами, так и ограничениями) можно прочитать [эту статью](http://habrahabr.ru/post/261307/) от хабраюзера [Antelle](http://habrahabr.ru/users/antelle/). Там же есть и ссылки на первоисточники информации для интересующихся.

Сегодня же мне довелось столкнуться другой задачей. А именно: с проблемой создания worker'а из js-файла с другого домена, что на данный момент запрещено его спецификацией.

История началась с создания небольшого расширения Google Chrome для Chess.com, которое использовало стороннюю библиотеку. К несчастью, оказалось, что эта библиотека работает только как worker.

Проблема заключается в том, что у самого Chrome есть определенные ограничения на получение файлов из контекста страницы. Он разрешает внедрение стороннего javascript-кода на страницу, но не более того. А это значит, что код из дополнения может получать worker на страницу только с того домена, на котором он выполнялся. То есть в моем случае: Chess.com. Конечно, можно было бы рассчитывать, что когда-нибудь я получу доступ к боевым серверам Chess.com, но мне бы хотелось, чтобы все заработало уже сегодня. Пришлось гуглить.

К счастью, статья с html5rocks помогла найти решение: создание inline worker'а через Blob. Подробности [здесь](http://www.html5rocks.com/en/tutorials/workers/basics/). Если говорить кратко, то можно создать любую текстовую строку и запихать ее в так называемый Blob — ~~наскальный рисунок~~ модельный прототип сырого внешнего файла.

Например так (взято с html5rocks):

```

var blob = new Blob([

"onmessage = function(e) { postMessage('msg from worker'); }"]);

// Obtain a blob URL reference to our worker 'file'.

var blobURL = window.URL.createObjectURL(blob);

var worker = new Worker(blobURL);

worker.onmessage = function(e) {

// e.data == 'msg from worker'

};

worker.postMessage(); // Start the worker.

```

Здесь мы видим, что создается объект Blob, который в представлении браузера является «как-бы-файлом», и в него записывается исходный текст.

Но если мы можем создать из любого текста Blob, значит, можно загрузить любой текст с другого сайта, а потом запихнуть его в Blob?

Окей, давайте попробуем:

```

$.get("https://example.com/js/worker.js", {},

function (workerCode) {

var blob = new Blob([workerCode], {type : 'javascript/worker'});

var worker = new Worker(window.URL.createObjectURL(blob));

}

);

```

Работает. То есть, фактически, мы можем загрузить любой внешний файл на страницу и запустить его как worker, независимо от принадлежности файлов к одному или нескольким доменам. Нда, вот так день.

Напоследок замечу, что, несмотря на всю сенсационность заголовка, в принципе в этом трюке нет ничего удивительного. То же самое можно проделать и для однопоточного javascript-кода: загрузить его как текст и вызвать через eval. В этом случае остается непонятным лишь неспешное принятие решения о поддержке CORS в Web Workers. | https://habr.com/ru/post/261817/ | null | ru | null |

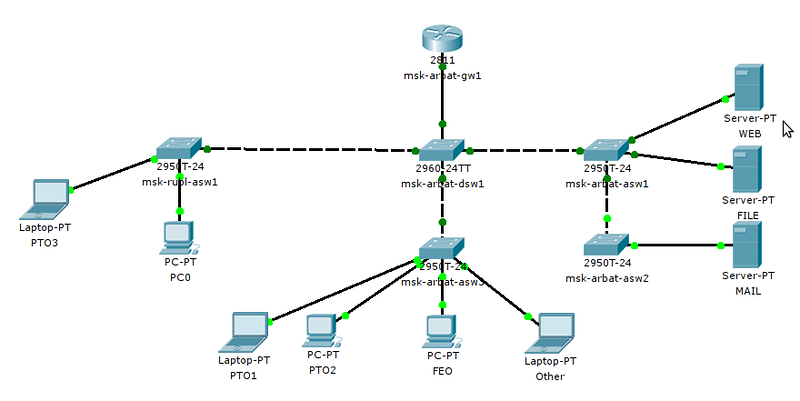

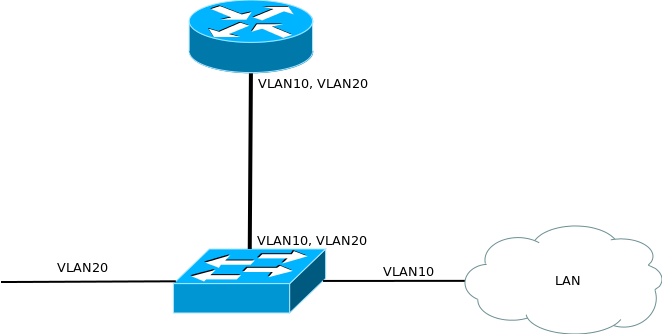

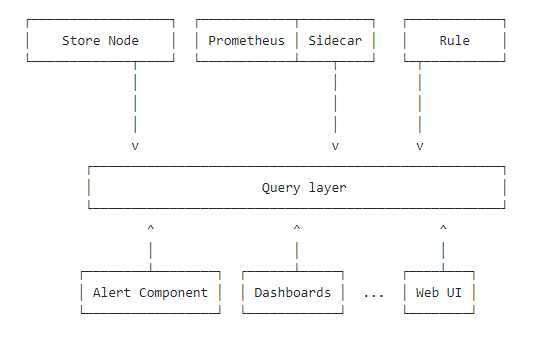

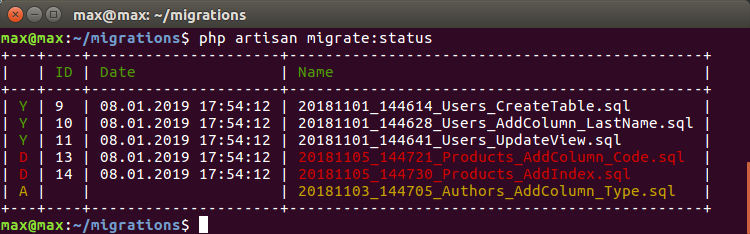

# Инструменты для разработчиков приложений, запускаемых в Kubernetes

Современный подход к эксплуатации решает множество насущных проблем бизнеса. Контейнеры и оркестраторы позволяют легко масштабировать проекты любой сложности, упрощают релизы новых версий, делают их более надежными, но вместе с тем создают и дополнительные проблемы для разработчиков. Программиста, в первую очередь, заботит его код: архитектура, качество, производительность, элегантность, — а не то, как он поедет в Kubernetes и как его тестировать и отлаживать после внесения даже минимальных правок. Посему весьма закономерно и то, что активно развиваются инструменты для Kubernetes, помогающие решать проблемы даже самых «архаичных» разработчиков и позволяя им сосредоточиться на главном.

В этом обзоре представлена краткая информация о некоторых инструментах, которые упрощают жизнь программисту, чей код крутится в pod’ax Kubernetes-кластера.

Простые помощники

-----------------

### Kubectl-debug

* Суть: **добавь свой контейнер в Pod и посмотри, что в нем происходит**.

* [GitHub](https://github.com/aylei/kubectl-debug).

* Краткая статистика GH: 715 звёзд, 54 коммита, 9 контрибьюторов.

* Язык: Go.

* Лицензия: Apache License 2.0.

Этот плагин для kubectl позволяет создать внутри интересующего pod'a дополнительный контейнер, который будет делить пространство имен процессов с остальными контейнерами. В нем можно производить отладку работы pod'а: проверить работу сети, послушать сетевой трафик, сделать strace интересующего процесса и т.п.

Также можно переключиться в контейнер процесса, выполнив `chroot /proc/PID/root` — это бывает очень удобно, когда нужно получить root shell в контейнере, для которого в манифесте выставлен `securityContext.runAs`.

Инструмент прост и эффективен, так что может пригодиться каждому разработчику. Подробнее о нём мы писали в [отдельной статье](https://habr.com/ru/company/flant/blog/436112/).

### Telepresence

* Суть: **перенеси приложение на свой компьютер. Разрабатывай и отлаживай локально**.

* [Сайт](https://www.telepresence.io/); [GitHub](https://github.com/telepresenceio/telepresence).

* Краткая статистика GH: 2131 звезда, 2712 коммитов, 33 контрибьютора.

* Язык: Python.

* Лицензия: Apache License 2.0.

Идея этой оснастки заключается в запуске контейнера с приложением на локальном пользовательском компьютере и проксировании всего трафика из кластера в него и обратно. Такой подход позволяет вести разработку локально, просто изменяя файлы в своей любимой IDE: результаты будут доступны сразу же.

Плюсы локального запуска — удобство правок и моментальный результат, возможность отлаживать приложение привычным способом. Из минусов — требовательность к скорости соединения, что особенно заметно, когда приходится работать с приложением с достаточно высоким RPS и трафиком. Кроме того, у Telepresence есть проблемы с volume mounts в Windows, что может стать решающим ограничителем для разработчиков, привыкшим к этой ОС.

Мы уже делились своим опытом использования Telepresence [здесь](https://habr.com/ru/company/flant/blog/446788/).

### Ksync

* Суть: **почти мгновенная синхронизация кода с контейнером в кластере**.

* [GitHub](https://github.com/vapor-ware/ksync).

* Краткая статистика GH: 555 звёзд, 362 коммита, 11 контрибьюторов.

* Язык: Go.

* Лицензия: Apache License 2.0.

Утилита позволяет синхронизировать содержимое локальной директории с каталогом контейнера, запущенного в кластере. Такой инструмент отлично подойдет для разработчиков на скриптовых языках программирования, основная проблема у которых — доставить код в работающий контейнер. Ksync призван снять эту головную боль.

При однократной инициализации командой `ksync init` в кластере создается DaemonSet, который используется для отслеживания состояния файловой системы выбранного контейнера. На своем локальном компьютере разработчик запускает команду `ksync watch`, которая следит за конфигурациями и запускает [syncthing](https://syncthing.net/), осуществляющую непосредственную синхронизацию файлов с кластером.

Остается проинструктировать ksync, что и с чем синхронизировать. Например, такая команда:

```

ksync create --name=myproject --namespace=test --selector=app=backend --container=php --reload=false /home/user/myproject/ /var/www/myproject/

```

… создаст watcher с именем `myproject`, который будет искать pod с меткой `app=backend` и пытаться синхронизировать локальную директорию `/home/user/myproject/` с каталогом `/var/www/myproject/` у контейнера под названием `php`.

Проблемы и примечания по ksync из нашего опыта:

* На узлах Kubernetes-кластера должна использоваться `overlay2` в качестве storage driver для Docker. Ни с какими другими утилита работать не будет.

* При использовании Windows в качестве ОС клиента возможна некорректная работа watcher'а файловой системы. Данный баг замечен при работе с крупными каталогами — с большим количеством вложенных файлов и директорий. Мы создали [соответствующий issue](https://github.com/syncthing/syncthing/issues/5832) в проекте syncthing, но прогресса по нему пока (с начала июля) нет.

* Используйте файл [`.stignore`](https://docs.syncthing.net/users/ignoring.html) для того, чтобы указать пути или шаблоны файлов, которые не нужно синхронизировать (например, каталоги `app/cache` и `.git`).

* По умолчанию ksync будет перезагружать контейнер при каждом изменении файлов. Для Node.js это удобно, а для PHP — совершенно излишне. Лучше выключить opcache и использовать флаг `--reload=false`.

* Конфигурацию можно всегда исправить в `$HOME/.ksync/ksync.yaml`.

### Squash

* Суть: **отлаживай процессы прямо в кластере**.

* [GitHub](https://github.com/solo-io/squash).

* Краткая статистика GH: 1154 звёзд, 279 коммитов, 23 контрибьютора.

* Язык: Go.

* Лицензия: Apache License 2.0.

Данный инструмент предназначен для отладки процессов непосредственно в pod'ах. Утилита проста и в интерактивном режиме позволяет выбрать нужный отладчик *(см. ниже)* и namespace + pod, в процесс которого нужно вмешаться. В настоящее время поддерживаются:

* delve — для приложений на Go;

* GDB — через target remote + проброс порта;

* проброс порта JDWP для отладки Java-приложений.

Со стороны IDE поддержка есть лишь в VScode (с помощью [расширения](https://marketplace.visualstudio.com/items?itemName=ilevine.squash)), однако в планах на текущий (2019) год значатся Eclipse и Intellij.

Для отладки процессов Squash запускает на узлах кластера привилегированный контейнер, поэтому необходимо сперва ознакомиться с возможностями [безопасного режима](https://squash.solo.io/secure_mode/) во избежание проблем с безопасностью.

Комплексные решения

-------------------

Переходим к тяжелой артиллерии — более «масштабным» проектам, призванным сразу закрыть многие потребности разработчиков.

***NB**: В этом списке, безусловно, есть место и нашей Open Source-утилите [**werf**](https://habr.com/ru/company/flant/blog/333682/) (ранее известной как dapp). Однако мы уже не раз писали и рассказывали о ней, а посему решили не включать в обзор. Для желающих ознакомиться с её возможностями поближе рекомендуем прочитать/послушать доклад «[werf — наш инструмент для CI/CD в Kubernetes](https://habr.com/ru/company/flant/blog/460351/)».*

### DevSpace

* Суть: **для тех, кто хочет начать работать в Kubernetes, но не хочет глубоко залезать в его дебри**.

* [GitHub](https://github.com/devspace-cloud/devspace).

* Краткая статистика GH: 630 звёзд, 1912 коммитов, 13 контрибьюторов.

* Язык: Go.

* Лицензия: Apache License 2.0.

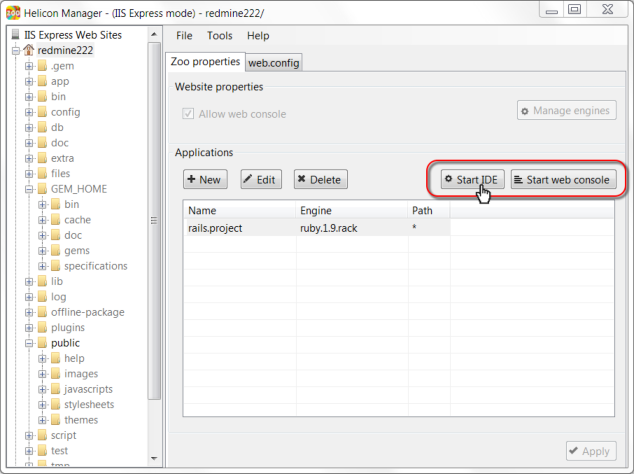

Решение от одноименной компании, предоставляющей managed-кластеры с Kubernetes для командной разработки. Утилита была создана для коммерческих кластеров, однако отлично работает и с любыми другими.

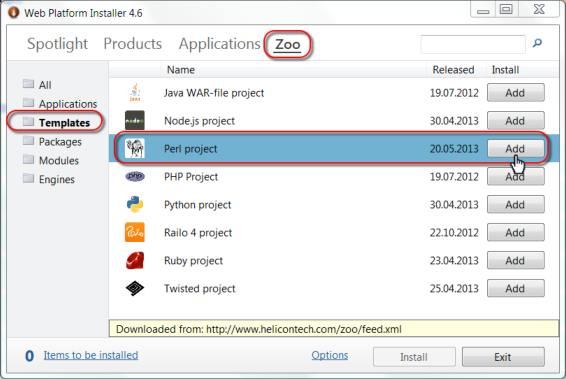

При запуске команды `devspace init` в каталоге с проектом вам предложат (в интерактивном режиме):

* выбрать рабочий Kubernetes-кластер,

* использовать имеющийся `Dockerfile` (или сгенерировать новый) для создания контейнера на его базе,

* выбрать репозиторий для хранения образов контейнеров и т.д.

После всех этих подготовительных действий можно начинать разработку, выполнив команду `devspace dev`. Она соберёт контейнер, загрузит его в репозиторий, выкатит deployment в кластер и запустит проброс портов и синхронизацию контейнера с локальным каталогом.

Опционально будет предложено перейти терминалом в контейнер. Отказываться не стоит, потому как в реальности контейнер стартует с командой sleep, а для реального тестирования приложение требуется запускать вручную.

Наконец, команда `devspace deploy` выкатывает приложение и связанную с ним инфраструктуру в кластер, после чего все начинает функционировать в боевом режиме.

Вся конфигурация проекта хранится в файле `devspace.yaml`. Помимо настроек окружения для разработки в нем же можно найти описание инфраструктуры, похожее на стандартные манифесты Kubernetes, только сильно упрощенные.

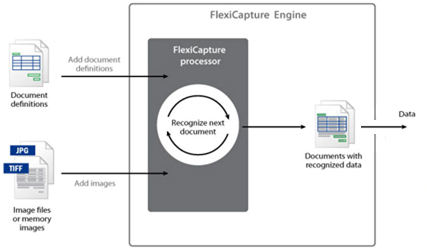

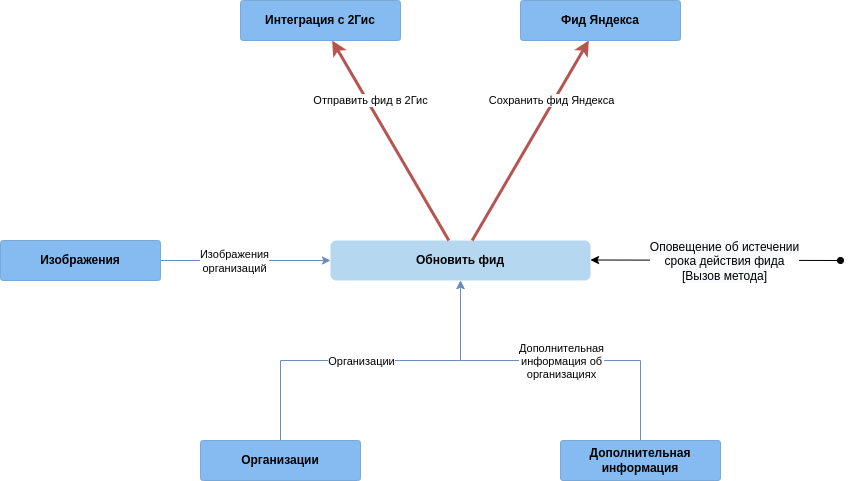

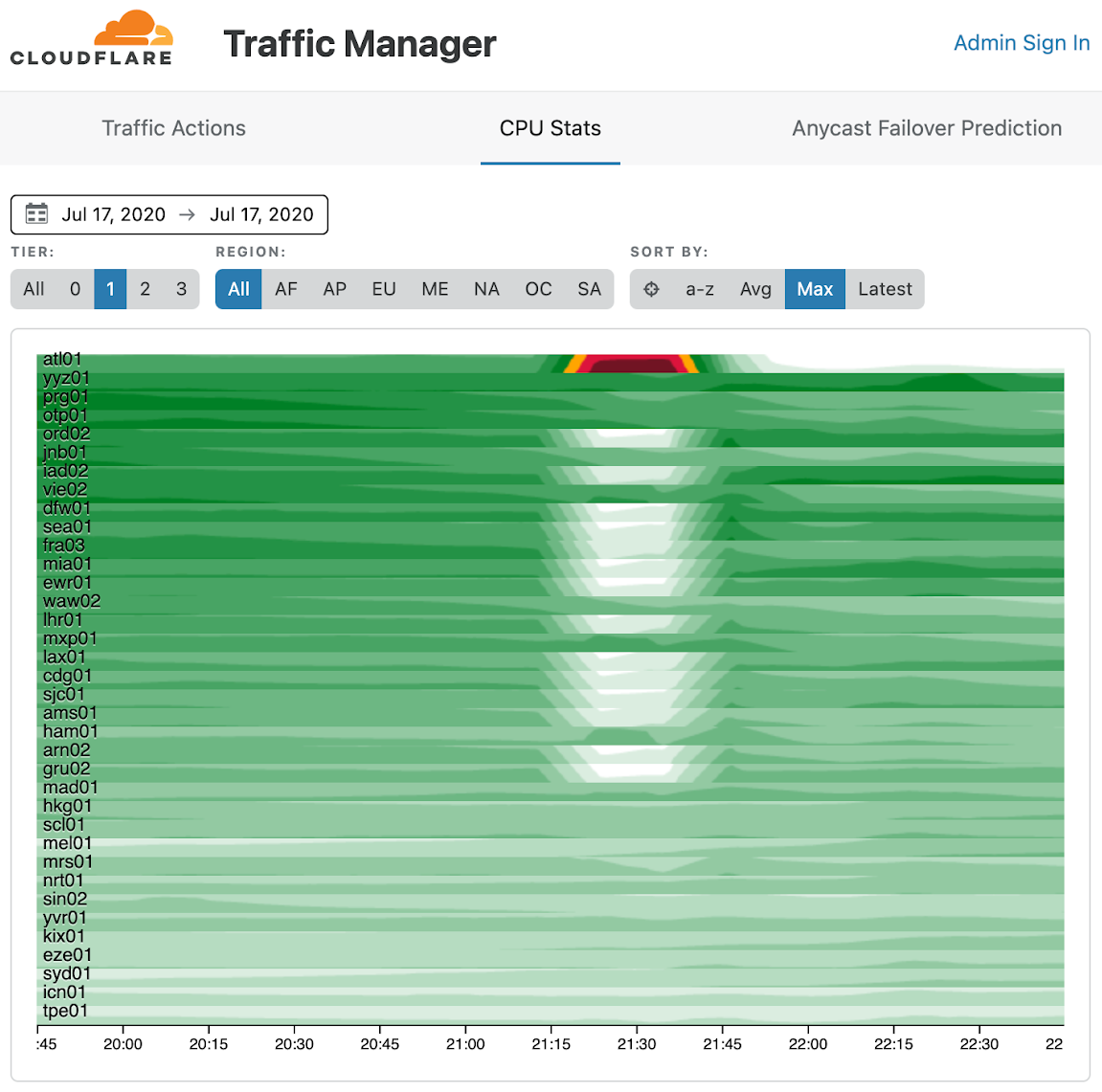

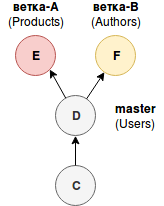

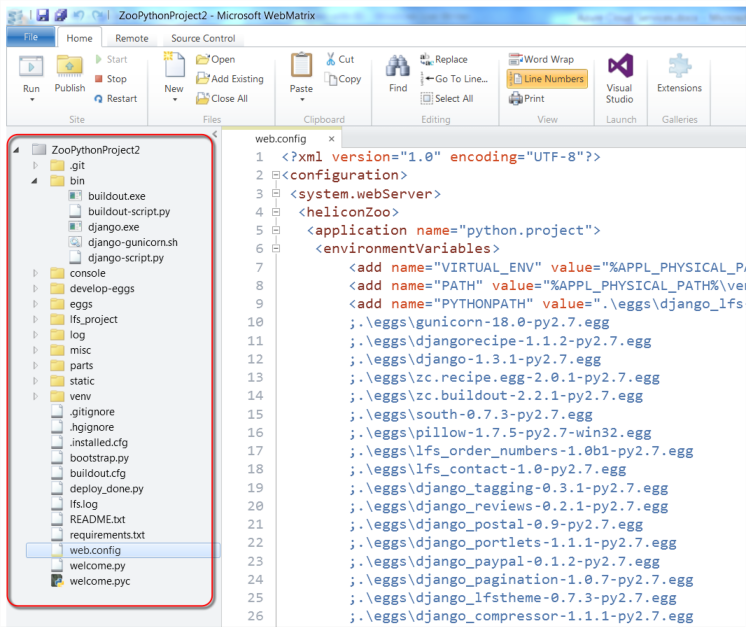

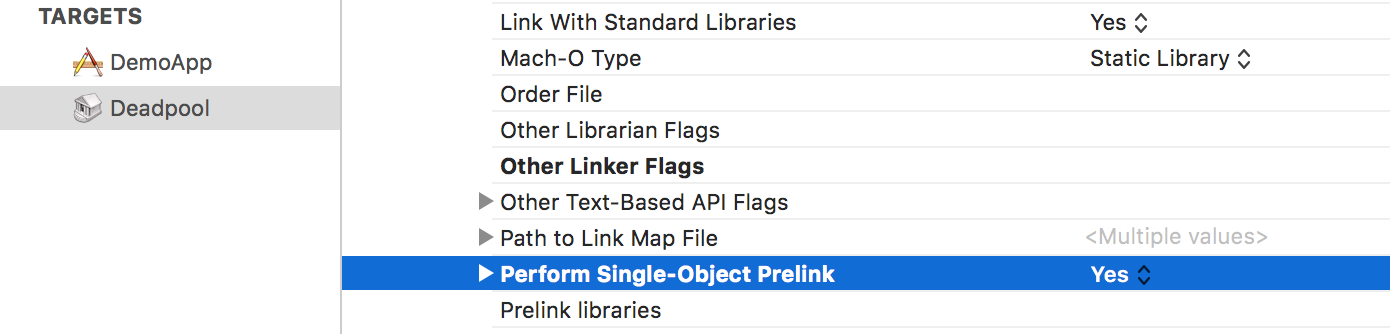

*Архитектура и основные этапы работы с DevSpace*

Кроме того, в проект легко добавить предопределенный компонент (например, СУБД MySQL) или Helm-чарт. Подробнее читайте в [документации](https://devspace.cloud/docs/) — она несложная.

### Skaffold

* [Сайт](https://skaffold.dev/); [GitHub](https://github.com/GoogleContainerTools/skaffold).

* Краткая статистика GH: 7423 звезды, 4173 коммита, 136 контрибьюторов.

* Язык: Go.

* Лицензия: Apache License 2.0.

Эта утилита от Google претендует на то, чтобы покрыть все потребности разработчика, чей код так или иначе будет запускаться в кластере Kubernetes. Начать пользоваться им не так просто, как devspace'ом: никакой интерактивности, определения языка и автосоздания `Dockerfile` здесь вам не предложат.

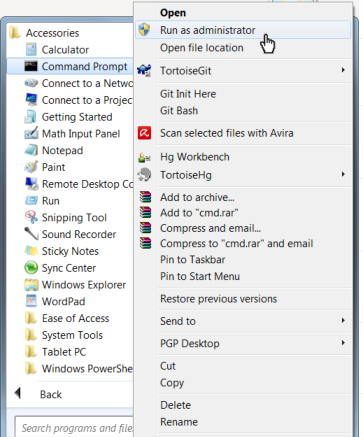

Впрочем, если это не пугает — вот что позволяет делать Skaffold:

* Отслеживать изменения исходного кода.

* Синхронизировать его с контейнером pod'а, если он не требует сборки.

* Собирать контейнеры с кодом, если ЯП — интерпретируемый, или же компилировать артефакты и упаковывать их в контейнеры.

* Получившиеся образы автоматически проверять с помощью [container-structure-test](https://github.com/GoogleContainerTools/container-structure-test).

* Тегировать и загружать образы в Docker Registry.

* Разворачивать приложение в кластере, используя kubectl, Helm или kustomize.

* Делать проброс портов.

* Отлаживать приложения, написанные на Java, Node.js, Python.

Workflow в различных вариациях декларативно описывается в файле `skaffold.yaml`. Для проекта можно также определить несколько профилей, в которых частично или полностью изменять стадии сборки и деплоя. Например, для разработки указать удобный для разработчика базовый образ, а для staging и production — минимальный (+ использовать `securityContext` у контейнеров или же переопределить кластер, в котором приложение будет развернуто).

Сборка Docker-контейнеров может осуществляться локально или удаленно: в [Google Cloud Build](https://cloud.google.com/cloud-build/) или в кластере с помощью [Kaniko](https://github.com/GoogleContainerTools/kaniko). Также поддерживаются Bazel и Jib Maven/Gradle. Для тегирования Skaffold поддерживает множество стратегий: по git commit hash, дате/времени, sha256-сумме исходников и т.п.

Отдельно стоит отметить возможность тестирования контейнеров. Уже упомянутый фреймворк container-structure-test предлагает следующие методы проверки:

* Выполнение команд в контексте контейнера с отслеживанием exit-статусов и проверкой текстового «выхлопа» команды.

* Проверка наличия файлов в контейнере и соответствия атрибутов указанным.

* Контроль содержимого файлов по регулярным выражениям.

* Сверка метаданных образа (`ENV`, `ENTRYPOINT`, `VOLUMES` и т.п.).

* Проверка совместимости лицензий.

Синхронизация файлов с контейнером осуществляется не самым оптимальным способом: Skaffold просто создает архив с исходниками, копирует его и распаковывает в контейнере (должен быть установлен tar). Поэтому, если ваша основная задача — в синхронизации кода, лучше посмотреть в сторону специализированного решения (ksync).

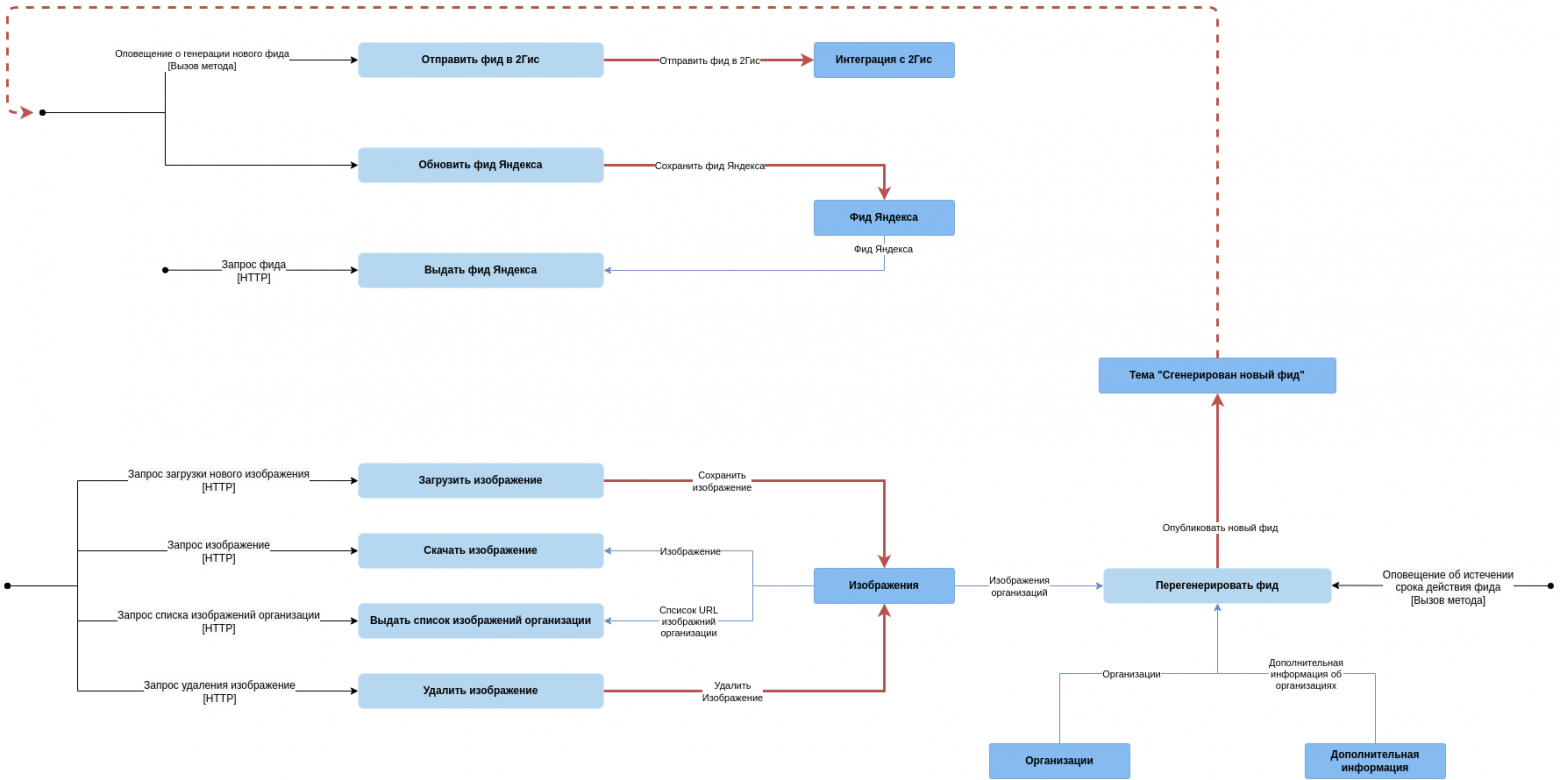

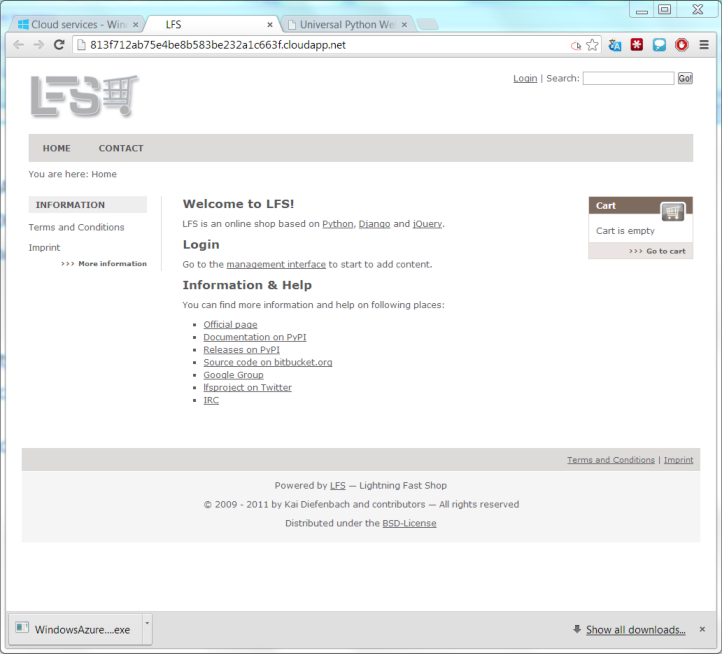

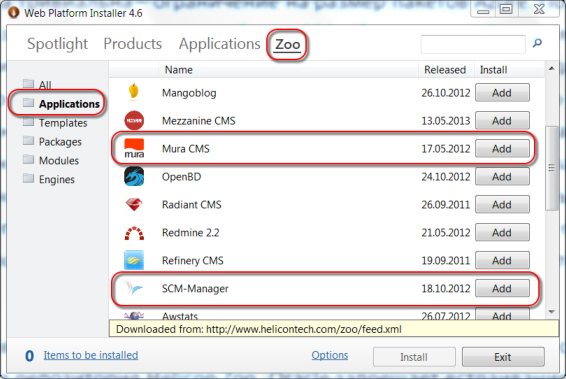

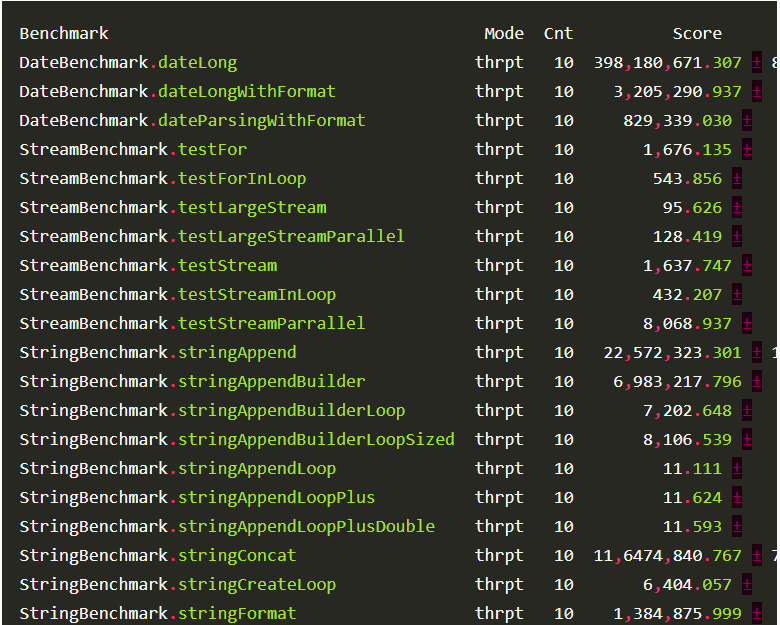

*Основные этапы работы Skaffold*

В целом же инструмент не позволяет абстрагироваться от Kubernetes-манифестов и не имеет какой-либо интерактивности, поэтому может показаться сложным для освоения. Но в этом же и его плюс — большая свобода действий.

### Garden

* [Сайт](https://garden.io/); [GitHub](https://github.com/garden-io/garden).

* Краткая статистика GH: 1063 звезды, 1927 коммитов, 17 контрибьюторов.

* Язык: TypeScript *(планируется разбить проект на несколько компонентов, некоторые из которых будут на Go, а также сделать SDK для создания дополнений на TypeScript/JavaScript и Go)*.

* Лицензия: Apache License 2.0.

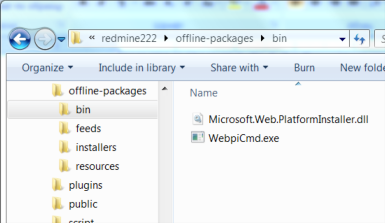

Как и Skaffold, Garden нацелен на автоматизацию процессов доставки кода приложения в K8s-кластер. Для этого сперва необходимо описать структуру проекта в YAML-файле, после чего запустить команду `garden dev`. Она сделает всю магию:

* Соберет контейнеры с различными частями проекта.

* Проведет интеграционные и unit-тесты, если таковые были описаны.

* Выкатит все компоненты проекта в кластер.

* В случае изменения исходного кода — заново запустит весь пайплайн.

Основной упор при использовании этого инструмента делается на совместное использование удаленного кластера командой разработчиков. В этом случае, если какие-то стадии сборки и тестирования уже были сделаны, это значительно ускорит весь процесс, поскольку Garden сможет использовать закэшированные результаты.

Модулем проекта может быть контейнер, Maven-контейнер, Helm-чарт, манифест для `kubectl apply` или даже OpenFaaS-функция. Причем любой из модулей можно подтянуть из удаленного Git-репозитория. Модуль может определять (а может и нет) сервисы, задачи и тесты. Сервисы и задачи могут иметь зависимости, благодаря чему можно определить последовательность деплоя того или иного сервиса, упорядочить запуск заданий и тестов.

Garden предоставляет пользователю красивый dashboard (пока в [экспериментальном состоянии](https://github.com/garden-io/garden/tree/master/dashboard)), в котором отображается граф проекта: компоненты, последовательность сборки, выполнения задач и тестов, их связи и зависимости. Прямо в браузере можно просмотреть и логи всех компонентов проекта, проверить, что выдает тот или иной компонент по HTTP (если, конечно, для него объявлен ресурс ingress).

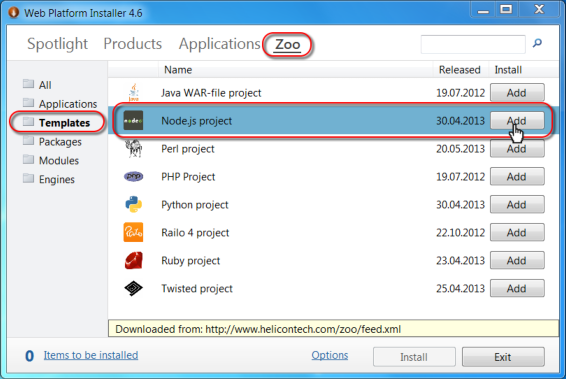

*Панель для Garden*

Есть у этого инструмента и режим hot-reload, который просто синхронизирует изменения скриптов с контейнером в кластере, многократно ускоряя процесс отладки приложения. У Garden хорошая [документация](https://docs.garden.io/) и неплохой [набор примеров](https://github.com/garden-io/garden/tree/master/examples), позволяющих быстро освоиться и начать пользоваться. Кстати, совсем недавно мы публиковали [перевод статьи](https://habr.com/ru/company/flant/blog/459586/) от его авторов.

Заключение

----------

Разумеется, данным списком инструментарий для разработки и отладки приложений в Kubernetes не ограничивается. Существует еще много весьма полезных и практичных утилит, достойных если не отдельной статьи, то — как минимум — упоминания. Расскажите, чем пользуетесь вы, с какими проблемами вам доводилось сталкиваться и как вы их решали!

P.S.

----

Читайте также в нашем блоге:

* «[werf — наш инструмент для CI/CD в Kubernetes (обзор и видео доклада)](https://habr.com/ru/company/flant/blog/460351/)»;

* «[Garden v0.10.0: Вашему ноутбуку не нужен Kubernetes](https://habr.com/ru/company/flant/blog/459586/)»;

* «[Kubernetes tips & tricks: о локальной разработке и Telepresence](https://habr.com/ru/company/flant/blog/446788/)»;

* «[Плагин kubectl-debug для отладки в pod'ах Kubernetes](https://habr.com/ru/company/flant/blog/436112/)». | https://habr.com/ru/post/462707/ | null | ru | null |

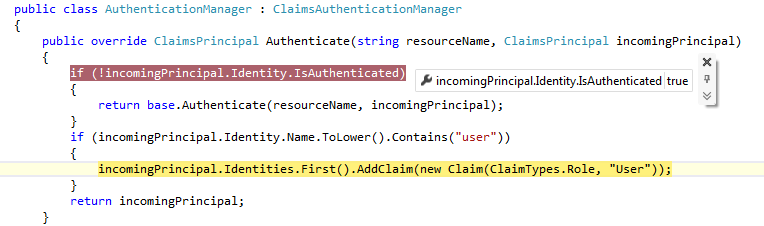

# Безопасный Builder на Scala и Java

Статья о реализации паттерна Builder с проверкой на уровне компиляции, реализованного с помощью параметрического полиморфизма. В ней мы поговорим о том, что такое полиморфизм, каким он бывает. Как устроена магия «оператора» =:= в scala, можно ли повторить ее в java и как используя эти знания реализовать Builder, не допускающий неполной инициализации создаваемого объекта.

Когда в системе возникает сущность с множеством свойств, возникает проблема с ее конструированием. Многословный конструктор или множество setter-ов? Первое выглядит громоздким, второе не безопасно: можно легко упустить вызов метода инициализации важного свойства. Для решения этой проблемы часто прибегают к паттерну Builder.

Паттерн builder решает две задачи: во-первых разделяет алгоритм создания(инициализации) объекта от деталей его(объекта) реализации, во-вторых упрощает сам процесс создания:

```

UrlBuilder()

.withSchema("http")

.withHost("localhost")

.withFile("/")

.build()

```

Остается вопрос: как реализовать builder так, чтобы он не допускал не полной инициализации объекта?

Самым простым решением может показаться проверка всех свойств в методе build. Но такой подход не сможет предостеречь нас от проблем до тех пор, пока они не возникнут в процессе выполнения программы.

Следующее что приходит на ум, это [StepBuilder](https://plugins.jetbrains.com/idea/plugin/8276-stepbuilder-generator) — реализация builder, в которой для каждого нового шага описан свой отдельный класс/интерфейс. Недостатком такого решения является крайняя избыточность реализации.

Несколько иной подход практикуют сторонники scala. Для проверки законченности конфигурирования объекта в scala используется параметрический полиморфизм:

```

trait NotConfigured

trait Configured

class Builder[A] private() {

def configure(): Builder[Configured] = new Builder[Configured]

def build()(implicit ev: Builder[A] =:= Builder[Configured]) = {

println("It's work!")

}

}

object Builder {

def apply(): Builder[NotConfigured] = {

new Builder[NotConfigured]()

}

}

Builder()

.configure() // без вызова этого метода компилятор поругается!

.build()

```

Если при использовании такого builder опустить один метод configure() и вызвать метод build(), компилятор выдаст ошибку:

> `scala> Builder()./*configured()*/.build()

>

> Error:(\_, \_) Cannot prove that Builder[NotConfigured] =:= Builder[Configured].`

Контролем типа в данном примере занимается «оператор» =:=. Запись A =:= B говорит о том, что параметрический (generic) тип A должен быть равен типу B. Мы еще вернемся к данному примеру и разберем магию, с помощью которой компилятор scala отлавливает незавершенное состояние инициализации создаваемого объекта. А пока вернемся в мир более простой и понятной java и вспомним что такое полиморфизм.

В ООП полиморфизм — свойство системы, позволяющее использовать объекты с одинаковым интерфейсом без информации о типе и внутренней структуре объекта. Но то, что мы привыкли называть полиморфизмом в ООП, только частный случай полиморфизма — полиморфизм подтипов. Другим видом полиморфизма является параметрический полиморфизм:

> Параметрический полиморфизм позволяет определять функцию или тип данных обобщённо, так что значения обрабатываются идентично вне зависимости от их типа. Параметрически полиморфная функция использует аргументы на основе поведения, а не значения, апеллируя лишь к необходимым ей свойствам аргументов, что делает её применимой в любом контексте, где тип объекта удовлетворяет заданным требованиям поведения.

Примером может служить функция printNumber(N n). Эта функция выполняется только для аргументов классов-наследников Number. Обратите внимание на то, что компилятор способен проконтролировать соответствие типа переданного аргумента всем ожиданиям параметризированной функции и выдать исключение в случае вызова функции с некорректным аргументом:

> `java> printNumber("123")

>

> Error:(\_, \_) java: method printNumber ... cannot be applied to given types;

>

> required: N

>

> found: java.lang.String

>

> ...`

Это может натолкнуть на мысль о функции build, которая определена только для полностью сконфигурированного экземпляра builder. Но остается открытым вопрос: как объяснить это требование компилятору?

Попытка описать функцию по аналогии с printNumber к успеху не приведет, тк параметрический тип придется указывать при вызове функции и никто не помешает указать там все, что душе угодно:

```

interface NotConfigured {}

interface Configured {}

static class Builder{

static Builder init() {

return new Builder<>();

}

private Builder() {}

public Builder configure() {

return new Builder<>();

}

// первая попытка

public > void build() {

System.out.println("It's work!");

}

public static void main(String[] args) {

Builder.init()

// .configure() // вызов конфигурации опущен,

.>build() // но вызов метода build все еще доступен

}

}

```

Зайдем с другой стороны: потребуем при вызове метода build доказательство того, что текущий экземпляр полностью сконфигурирован:

```

public void build(EqualTypes approve)

...

class EqualTypes {}

```

Теперь чтобы вызвать метод build мы должны передать экземпляр класса EqualTypes такой, в котором тип L равен Configured, а тип R равен типу A, определенному в текущем экземпляре класса Builder.

Пока от такого решения проку мало, достаточно просто опустить тип при создании экземпляра EqualTypes и компилятор позволит нам вызвать функцию build:

```

public static void main(String[] args) {

Builder.init()

// .configure()

.build(new EqualTypes())

}

```

Но если объявить параметризированный фабричный метод такой, который принимал бы некоторый тип T и создавал экземпляр класса EqualTypes:

```

static EqualTypes approve() {

return new EqualTypes();

}

```

и вызывая метода build передавать в него результат работы функции approve, мы получим долгожданный результат: компилятор будет ругаться, если опустить вызов метода configure:

> `java>Builder.init()./*configured()*/.build(approve())

>

> Error:(\_, \_) java: incompatible types: inferred type does not conform to equality constraint(s)

>

> inferred: NotConfigured

>

> equality constraints(s): NotConfigured,Configured`

Дело в том, что к моменту вызова метода build, параметрический тип A класса Builder имеет значение NotConfigured, тк именно с таким значением создается экземпляр в результате вызова метода init. Компилятор не может подобрать такой тип T для функции approve, чтобы он с одной стороны был равен Configured, как того требует метод build, и с другой стороны NotConfigured как параметрический тип A.

Теперь обратите внимание на метод configure — он возвращает такой экземпляр класса Builder, в котором параметрический тип A определен как Configured. Т.е. при правильной последовательности вызова методов компилятор сможет вывести тип T как Configured и вызов метода build пройдет успешно!

> `java>Builder.init().configured().build(approve())

>

> It's work!`

Осталось добиться того, чтобы единственным способом создать экземпляр класса EqualTypes остался метод approve, но это уже задание на дом.

В качестве типа T может выступать более сложный тип, например *Builder*. Сигнатура метода build может быть изменена на несколько более громоздкую:

```

void build(EqualTypes, Builder> approve)

```

Преимущество такого подхода заключается в том, что если понадобится добавить новый обязательный метод, достаточно будет завести для него новый generic параметр.

**Пример UrlBuilder**

```

interface Defined {}

interface Undefined {}

class UrlBuilder {

private String schema = "";

private String host = "";

private int port = -1;

private String file = "/";

static UrlBuilder init() {

return new UrlBuilder<>();

}

private UrlBuilder() {}

private UrlBuilder(String schema, String host, int port, String file) {

this.schema = schema;

this.host = host;

this.port = port;

this.file = file;

}

public UrlBuilder withSchema(String schema) {

return new UrlBuilder<>(schema, host, port, file);

}

public UrlBuilder withHost(String host) {

return new UrlBuilder<>(schema, host, port, file);

}

public UrlBuilder withPort(int port) {

return new UrlBuilder<>(schema, host, port, file);

}

public UrlBuilder withFile(String file) {

return new UrlBuilder<>(schema, host, port, file);

}

public URL build(EqualTypes< UrlBuilder, UrlBuilder> approve) throws MalformedURLException {

return new URL(schema, host, file);

}

public static void main(String[] args) throws MalformedURLException {

UrlBuilder

.init()

.withSchema("http") // пропуск любого

.withHost("localhost") // из этих методов

.withFile("/") // приведет к исключению при компиляции!

.build(EqualTypes.approve());

}

}

```

Вернемся к примеру на scala и посмотрим на то, как устроен «оператор» =:=. Здесь стоит заметить, что в scala допустима [инфиксная форма записи параметров типа](http://www.scala-lang.org/files/archive/spec/2.11/03-types.html#infix-types), что позволяет записать конструкцию вида =:=[A, B] как A =:= B. Да-да! На самом деле =:= — никакой не оператор, это абстрактный класс объявленный в scala.Predef, очень похожий на наш EqualTypes!

```

@implicitNotFound(msg = "Cannot prove that ${From} =:= ${To}.")

sealed abstract class =:=[From, To] extends (From => To) with Serializable

private[this] final val singleton_=:= = new =:=[Any,Any] { def apply(x: Any): Any = x }

object =:= {

implicit def tpEquals[A]: A =:= A = singleton_=:=.asInstanceOf[A =:= A]

}

```

Разница лишь в том, что вызов функции approve (а точнее ее аналога tpEquals) компилятор скалы подставляет автоматически.

Получается, что привычное оперирование типами в scala (*речь идет о применении конструкций `=:=, <:<`*) вполне применимо в java. Но, тем не менее, механизм implicit предусмотренный в scala делает подобное решение более лаконичным и удобным.

Еще одним преимуществом реализации описанного подхода в scala является аннотация `@implicitNotFound`, которая позволяет управлять содержимым исключения при компилировании. Эта аннотация применима к классу, экземпляр которого не может быть найден для неявной подстановки компилятором.

Плохая новость в том, что вы не можете поменять текст ошибки для конструкции =:=, а хорошая — теперь вы можете легко создать собственный аналог с нужным вам сообщением!

```

object ScalaExample extends App {

import ScalaExample.Builder.is

import scala.annotation.implicitNotFound

trait NotConfigured

trait Configured

class Builder[A] private() {

def configure(): Builder[Configured] = new Builder[Configured]

def build()(implicit ev: Builder[A] is Builder[Configured]) = {

println("It's work!")

}

}

object Builder {

@implicitNotFound("Builder is not configured!")

sealed abstract class is[A, B]

private val singleIs = new is[AnyRef, AnyRef] {}

implicit def verifyTypes[A]: A is A = singleIs.asInstanceOf[is[A, A]]

def apply(): Builder[NotConfigured] = {

new Builder[NotConfigured]()

}

}

Builder()

.configure() // без вызова этого метода компилятор поругается:

.build() // Builder is not configured!

}

```

Подводя итог, не могу не отдать должное авторам языка scala: не добавляя специальных конструкций в язык, используя только implicit параметры, разработчикам удалось обогатить языковые конструкции новыми и эффективными решениями, позволяющими гибко оперировать типами.

Что касается Java, развитие языка не стоит на месте, язык меняется в лучшую сторону, вбирая в себя решения и конструкции из других языков. При этом не всегда стоит ждать нововведений от авторов языка, некоторые подходы и решения можно пробовать заимствовать уже сейчас. | https://habr.com/ru/post/323052/ | null | ru | null |

# intv без рекламы

надоела мне реклама на интв, вот и появился на свет такой букмарклет =)

прям складно =), ну да ладно =).

добавляем себе в фавориры вот эту строчку:

`javascript:des=prompt("postfix:");document.location='http://djung.org/tools/getFLV.php?u='+escape(window.location)+'&t='+des+'&v=video';`

у последнего параметра v есть ещё другие опции кроме video

l — получаем ссылки на flv файлы в виде html

t — просто текст с сылками на файлы

kget — чтобы сразу начать качать менеджером закачек kget. | https://habr.com/ru/post/59434/ | null | ru | null |

# Amazon EC2 + PHP-fpm + Nginx

Наступил момент когда я решил перевести свой проект FastCGI, мне не нужна была производительность, не нужна была стабильность или еще какие-то преимущества, которые предоставляет FastCGI. В первую очередь это было желание узнать что то новое, понять как оно работает, и посмотреть все преимущества в деле.

Почитав большое количество информации найденной в интернете, я сделал выбор в пользу php-fpm+Nginx.

Почему именно эта связка, ну во-первых потому что проект написан на php, во-вторых неформальным стандартом в сети является именно она.

Первым делом я перечитал огромную кучу информации, найденной в поисковиках, и везде было практически одно и то же, скачать php, наложить патч php-fpm, make, make install, решение вполне понятное но не совсем правильное для ОС с системами управления пакетами.

Поэтому мной было найдено решение с использованием пакетного менеджера, его я и приведу ниже.

Все манипуляции производились мной на Amazon EC2 micro с установленной ОС Amazon Linux x64, поэтому буду описывать все манипуляции для этой системы. Для других систем все и пакетных менеджеров все практически идентично.

##### Установка компонентов

Установка nginx:

`sudo yum install nginx`

Установка php(мне это не понадобилось т.к. у меня работал Apache+php):

`sudo yum install php`

Установка php-fpm:

`sudo yum install php-fpm`

После установки понадобиться небольшая настройка.

Настройка nginx для работы с php-fpm, файл конфигурации находиться /etc/nginx/nginx.conf:

Вся настройка сводиться к добавления внутрь секции «location» следующего текста. Не забудет так же исправить порт на котором работает сервис если вы так же как и я изначально его будете ставить на систему с уже работающим веб-сервером Apache.

```

location ~ \.php$ {

#root ;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME /var/www/html/$fastcgi_script_name;

include fastcgi_params;

}

```

Для запуска связки в режиме стандартных настроек, ничего менять в файле конфигурации(/etc/php-fpm.conf) не надо. Все параметры конфигурации хорошо описаны в самом файле, так же дополнительно можно посмотреть [тут](http://www.php.net/manual/en/install.fpm.configuration.php).

##### Запуск

Когда настройки завершены переходим к запуску, здесь все еще проще

`sudo service php-fpm start

sudo service nginx start`

Тестирование, сравнение apache+php и nginx+php-fpm, приводить здесь не буду потому что это статья про настройку. Выражу здесь только свое субъективное мнение nginx+php-fpm работает не значительно быстрее apache+php. | https://habr.com/ru/post/134181/ | null | ru | null |

# Способ написания синтаксических анализаторов на c++

В этой статье рассказывается, как писать синтаксические анализаторы с помощью [этой](https://github.com/FeelUsM/common-parse-lib/) небольшой библиотеки на с++.

Обычно, текст на машинном языке состоит из предложений, те — из подпредложений, а те, в свою очередь, из подподпредложений, и так вплоть до символов.

Например, элемент xml состоит из открывающего тега, содержимого и закрывающего тега. —> Открывающий тег состоит из '<', имени тега, возможно пустого списка атрибутов и '>'. —> Закрывающий тег состоит из ''. —> Атрибут состоит из имени, знаков '=', '"', строки символов и снова '"'. —> Содержимое в свою очередь тоже может содержать элементы. —> И т.д. Таким образом, после разбора получается синтаксическое дерево.

Такие языки удобно описывать формой Бэкуса-Наура (БНФ), где каждый нетерминал соответствует некоторому предложению языка. Когда мы пишем программы, мы обычно разбиваем их на функции и подфункции, и раз мы собрались писать синтаксический анализатор, **пусть** каждому нетерминалу БНФ соответствует одна функция нашего анализатора, и пусть каждая такая функция:

* пытается разобрать это предложение с заданной позиции

* возвращает, удалось ли ей это сделать

* возвращает позицию, где закончился разбор или произошла ошибка

* а также, возможно, возвращает некоторые дополнительные данные, которые мы хотим получить в результате разбора

Например для БНФ вида `expr ::= expr1 expr2 expr3` будем писать такую функцию:

```

bool read_expr(char *& p, ....){

if(!read_expr1(p, ....))

return false;

//функция read_expr1() оставляет p там, где завершился разбор expr1

//так что никаких манипуляций с p в данном месте не требуется

if(!read_expr2(p, ....))

return false;

if(!read_expr3(p, ....))

return false;

/*обработку возвращаемых значений добавить по вкусу*/

return true;

}

```

А для предложения БНФ вида `expr ::= expr1 | expr2 | expr3` — функцию:

```

bool read_expr(const char *& p, ....){

const char * l = p;

if(read_expr1(p, ....))

return true;

//p может указывать на точку, где произошла ошибка при разборе expr1

p = l;

if(read_expr2(p, ....))

return true;

p = l;

if(read_expr3(p, ....))

return true;

return false;

/*обработку возвращаемых значений добавить по вкусу*/

}

```

(Кажется это называется синтаксический анализ с возвратами)

Не всякий текст, удовлетворяющий БНФ нам может подходить. Например элемент языка xml может описываться так: `element ::= '<'identifier'>'some_data''` , но это предложение будет действительно элементом, только если идентификаторы совпадают. Такие (или аналогичные) проверки можно легко добавлять в функции разбора.

Терминальные функции могут выглядеть например так:

```

bool read_fix_char(const char *& it, char c){

if(!*it) return false;//конец строки

if(*it!=c) return false;//не тот символ

//в случае неудачи указатель останется на месте

it++; //в случае удачи перейдет к следующему символу

return true;

}

bool read_fix_str(const char * & it, const ch_t * s){

while(*it)//пока не конец строки

if(!*s)

return true;

else if(*it!=*s)

return false;

//в случае неудачи указатель будет указывать на отличающийся символ

else

it++, s++;

if(!*s) return true;

return false;//конец строки оказался раньше ожидаемого

}

```

Пока что мы делали синтаксический анализ строки. Но заметим, что для всех типов вышеперечисленных функций достаточно forward итераторов.

forward stream

==============

Зададимся целью создать класс-поток, предоставляющий forward итераторы, и хранящий в памяти файл не целиком а небольшими кусочками. Тогда, если сделать функции разбора шаблонными, то их можно будет использовать и со строкамии, и с потоками. (Что и сделано в «base\_parse.h» для терминальных (и около того )функций.) Но сначала внесем некоторые разъяснения в идеологию unix «все есть файл»: Бывают файлы располагающиеся на диске — их можно читать несколько раз и с любой позиции (назовем их random-access файлами ). А бывают потоки, перенаправленные из других программ, идущие по сети или от пользователя с клавиатуры (назовем их forward потоками). Такие потоки можно читать только за один проход. (fixme) По этому, что бы можно было работать и с тем и с другим, зададимся целью создать класс-поток, читающий файл за один проход, предоставляющий forward итераторы, и хранящий в памяти файл не целиком а небольшими кусочками.

Для input итераторов такие потоки реализованы очень давно, по сути в себе содержат только один input итератор, и внутри себя содержат один буфер, по которому движется этот итератор, и когда он подходит к концу буфера, в этот буфер загружается следующий кусок файла, а итератор начинает двигаться с начала обновленного буфера.

Forward итераторы отличаются от input итераторов тем, что их можно копировать. Для потока с forward итераторами решением будет список буферов. Как только какой-нибудь итератор выходит за пределы самого правого буфера, в список добавляется новый буфер, и заполняется непосредственно из файла блоком данных. Но постепенно так в память загрузится весь файл, а мы этого не хотим. Сделаем так, чтоб удалялись все буфера, находящиеся левее буфера на котором находится самый левый (отстающий) итератор. Но мы не будем каждому буферу сопоставлять список итераторов, находящихся на нем, а будем сопоставлять всего лишь их количество (подсчет итераторов). Как только какой-нибудь буфер узнает, что на нем осталось 0 итераторов и что он самый левый, тогда удаляется он и все соседние буфера правее него, на которых тоже 0 итераторов.

Получается, каждый итератор должен содержать:

* указатель на символ (который будет возвращаться при разыменовании)

* указатель на конец массива символов в буфере (с ним происходит сравнение при перемещении итератора)

* итератор по списку буферов (для доступа к данным буфера, а через них к данным всего потока).

Когда итератор доходит до границы буфера, он смотрит, есть ли в списке буферов следующий, если его нет — загружает его, на предыдущем буфере уменьшает счетчик итераторов, а на следующем увеличивает. Если на предыдущем буфере осталось 0 итераторов — он удаляется. Если итератор дошел до конца файла — он только отвязывается от предыдущего буфера и переходит в состояние «конец файла». При копировании итератора — увеличивается счетчик итераторов на буфере на котором он находится, а при вызове деструктора итератора — счетчик уменьшается, и, опять же, если на буфере осталось 0 итераторов, то он и соседние справа буфера, на которых тоже 0 итераторов, — удаляются. Детали реализации смотри в [«forward\_stream.h»](https://github.com/FeelUsM/common-parse-lib/blob/master/forward_stream.h).

У таких итераторов есть некоторые особенности использования, отличающие их от обычных итераторов. Так например, перед разрушением(деструктором) потока (хранящего список буферов и некоторую дополнительную информацию) должны быть разрушены все итераторы, т.к. при разрушении они будут обращаться к буферам в не зависимости от того, разрушены ли те в свою очередь или нет. Если мы один раз в результате вызова метода begin() получили первый итератор (и создали первый же буфер), и он ушел на столько, что первый буфер уже удален, мы не сможем снова получить итератор методом begin(). Также (как будет видно из следующего параграфа) у потока нет метода end(). В результате чего мной было принято решение сделать внутренний итератор в потоке, который инициализируется при инициализации всего потока, и ссылку на который можно получить методом iter(). Также при использовании в алгоритмах не стоит лишний раз копировать итераторы, т.к. в памяти хранятся буфера от самого левого до самого правого итератора, и в случае больших файлов это может привести к большому расходу памяти.

В качестве бонуса, есть различные типы буферов: простые (basic\_simple\_buffer), с вычислением строки-столбца по итератору (basic\_adressed\_buffer), планируется сделать буфер, осуществляющий перекодировку между различными кодировками. В связи с чем поток параметризуется типом буфера.

atend()

=======

Конец сишной строки определяется нулевым символом. Это означает, что пока мы движемся по строке, чтобы обнаружить ее конец, нам надо не сравнивать указатель с другим указателем (как это традиционно делается в STL), а надо проверять значение, указываемое нашим указателем. С файлами примерно такая же ситуация: при посимвольном вводе char-ов мы получаем int-ы, и т.к. у них диапозон значений больше, мы опять же тестируем каждый символ на равенство EOF. Масла в огонь добавляет тот факт, что для forward потоков, поступающих в реальном времени, положение конца файла заранее неизвестно.

Эту информацию можно обобщить, сделав функцию atend(it), которая для указателей по строке будет выглядеть так:

```

bool atend(const char * p)

{ return !*p; }

```

А для итераторов по потоку она будет возвращать true, когда итератор указывает на конец файла.

strin

=====

Для интерактивного взаимодействия с пользователем (через stdin) блочная буферизация не подходит, т.к. в блоке чаще всего помещается несколько строк, и после ввода одной строки программа продолжает ожидать ввода от пользователя, т.к. блок все еще не заполнен. Для этого необходима строковая буферизация, когда буфер заполняется символами вплоть до символа перевода строки. В этой библиотеке можно выбрать тип буферизации при помощи выбора типа файла, от которого инициализируется поток (basic\_block\_file\_on\_FILE или string\_file\_on\_FILE).

strin — внутренний итератор потока над stdin'ом со строковой буферизацией.

Для неинтерактивных файлов при создании потока создается итератор, указывающий на первый символ, а значит загружается первый буфер. Для strin'а это не допустимо, т.к. программист может захотеть что-то выполнить или вывести на экран до того как программма перейдет в режим ожидания ввода строки.

По этому строковые файлы при заполнении первого буфера выдают фиктивную строку "\n". Для ее прочтения существует функция start\_read\_line(it), после выполнения которой программа переходит в режим ожидания ввода строки после чего можно произвести синтаксический анализ этой строки, не выводя при этом итераторы за пределы следующего символа '\n'.

Поле анализа прграммист может захотеть опять что-то вывести на экран, и если после этого ему опять понадобятся данные от пользователя, то перед их получением снова следует вызвать start\_read\_line(strin).

Т.о. получается цикл:

```

while(true){

cout << "приглашение" <

```

Конечно это костыль, и можно было бы сделать итераторы, которые требуют загрузки буфера только при разыменовании, но это привело бы к дополнительным проверкам при разименовании и просто усложнению всей системы…

Базовые функции парсинга

========================

Что бы пользователю не приходилось каждый раз заново писать терминальные функции, они в [«base\_parse.h»](https://github.com/FeelUsM/common-parse-lib/blob/master/base_parse.h) уже реализованы. Сейчас они реализованы (кроме обработки плавающих чисел) в общем виде, в дальнейшам планируется специализировать их с использованием строковых функций (таких как strcmp, strstr, strchr, strspn, strcspn) для указателей по строкам и для итераторов по потокам. Также они позволяют пользователю почти не думать о конце файла, и просто задают стиль кода.

Ниже представлена краткая сводка базовых функций парсинга, возвращаемые значиния и статистика их использования при реализации двух тестовых парсеров.

```

size_t n

ch_t c

ch_t * s

func_obj bool is(c) //наподобие bool isspace(c)

span spn //см выше

bispan bspn //см выше

func_obj err pf(it*) //наподобие int read_spc(it*)

func_obj err pf(it*, rez*)

len - кол-во символов, добавлненных в *pstr

. возвращаемое значение в случае реализованность

название аргументы рег.выр. если EOF если не EOF статистика использования

int read_until_eof (it&) .*$ 0 0 1 OK

int read_until_eof (it&, pstr*) .*$ len len OK

int read_fix_length (it&, n) .{n} -1 0 OK

int read_fix_length (it&, n, pstr*) .{n} -(1+len) 0 2 OK

int read_fix_str (it&, s) str -(1+len) 0 или (1+len) 9 OK

int read_fix_char (it&, c) c -1 0 или 1 11 OK

int read_charclass (it&, is) [ ] -1 0 или 1 OK

int read_charclass (it&, spn) [ ] -1 0 или 1 OK

int read_charclass (it&, bspn) [ ] -1 0 или 1 OK

int read_charclass_s (it&, is, pstr*) [ ] -1 0 или 1 OK

int read_charclass_s (it&, spn, pstr*) [ ] -1 0 или 1 1 OK

int read_charclass_s (it&, bspn, pstr*) [ ] -1 0 или 1 5 OK

int read_charclass_c (it&, is, ch*) [ ] -1 0 или 1 OK

int read_charclass_c (it&, spn, ch*) [ ] -1 0 или 1 1 OK

int read_charclass_c (it&, bspn, ch*) [ ] -1 0 или 1 OK

int read_c (it&, ch*) . -1 0 5 OK

int read_while_charclass (it&, is) [ ]* -(1+len) len OK

int read_while_charclass (it&, spn) [ ]* -(1+len) len 2 OK

int read_while_charclass (it&, bspn) [ ]* -(1+len) len OK

int read_while_charclass (it&, is, pstr*) [ ]* -(1+len) len OK

int read_while_charclass (it&, spn, pstr*) [ ]* -(1+len) len OK

int read_while_charclass (it&, bspn, pstr*) [ ]* -(1+len) len 1 OK

int read_until_charclass (it&, is) .*[ ]<- -(1+len) len OK

int read_until_charclass (it&, spn) .*[ ]<- -(1+len) len 1 OK

int read_until_charclass (it&, bspn) .*[ ]<- -(1+len) len OK

int read_until_charclass (it&, is, pstr*) .*[ ]<- -(1+len) len OK

int read_until_charclass (it&, spn, pstr*) .*[ ]<- -(1+len) len 2 OK

int read_until_charclass (it&, bspn, pstr*) .*[ ]<- -(1+len) len OK

int read_until_char (it&, c) .*c -(1+len) len OK

int read_until_char (it&, c, pstr*) .*c -(1+len) len OK

<- - говорит о том, что что после прочтения последнего символа итератор стоит не после него а на нем

int read_until_str (it&, s) .*str -(1+len) len 2 OK

int read_until_str (it&, s, pstr*) .*str -(1+len) len 1 OK

int read_until_pattern (it&, pf) .*( ) -(1+len) len OK

int read_until_pattern (it&, pf, rez*) .*( ) -(1+len) len OK

int read_until_pattern_s (it&, pf, pstr*) .*( ) -(1+len) len OK

int read_until_pattern_s (it&, pf, pstr*, rez*) .*( ) -(1+len) len OK

ch_t c

ch_t * s

func_obj bool is(c) //наподобие bool isspace(c)

span spn //см выше

bispan bspn //см выше

func_obj err pf(it*) //наподобие int read_spc(it*)

func_obj err pf(it*, rez*)

len - кол-во символов, добавлненных в *pstr

. возвращаемое значение в случае реализованность

название аргументы рег.выр. если EOF если не EOF статистика использования

int read_line (it&, s) .*[\r\n]<- -1 или len len OK

int read_line (it&) .*[\r\n]<- -1 или len len 1 OK

int start_read_line (it&) .*(\n|\r\n?) -1 0 или 1 8 OK

<- - говорит о том, что что после прочтения последнего символа итератор стоит не после него а на нем

int read_spc (it&) [:space:] -(1+len) len OK

int read_spcs (it&) [:space:]* -(1+len) len 5 OK

int read_s_fix_str (it&, s) [:space:]*str -(1+len) 0 или len 1 OK

int read_s_fix_char (it&, c) [:space:]*c -1 0 или 1 8 OK

int read_s_charclass (it&, is) [:space:][ ] -1 0 или 1 OK

int read_s_charclass_s (it&, is, pstr*) [:space:][ ] -1 0 или 1 OK

int read_s_charclass_c (it&, is, pc*) [:space:][ ] -1 0 или 1 2 OK

int read_bln (it&) [:blank:] -(1+len) len OK

int read_blns (it&) [:blank:]* -(1+len) len 1 OK

int read_b_fix_str (it&, s) [:blank:]*str -(1+len) 0 или len OK

int read_b_fix_char (it&, c) [:blank:]*c -1 0 или 1 OK

int read_b_charclass (it&, is) [:blank:][ ] -1 0 или 1 OK

int read_b_charclass_s (it&, is, pstr*) [:blank:][ ] -1 0 или 1 OK

int read_b_charclass_c (it&, is, pc*) [:blank:][ ] -1 0 или 1 OK

int_t может быть : long, long long, unsigned long, unsigned long long - для специализаций

[:digit:] ::= [0-"$(($ss-1))"]

sign ::= ('+'|'-')

int ::= spcs[sign]spcs[:digit:]+

. специализация для

. [w]char char16/32 stream_string

. возвращаемое значение в случае реализованность

название аргументы рег.выр. неудача переполнение статистика использования

int read_digit (it&, int ss, int_t*) [:digit:] 1 -1(EOF) 1 OK

int read_uint (it&, int ss, int_t*) [:digit:]+ 1 -1 1 OK

int read_sign_uint (it&, int ss, int_t*) [sign][:digit:]+ 1 -1 OK

int read_sign_s_uint (it&, int ss, int_t*) [sign]spcs[:digit:]+ 1 -1 1 OK

int read_int (it&, int ss, int_t*) spcs[sign]spcs[:digit:]+ 1 -1 1 OK OK

int read_dec (it&, int_t*) int#[:digit:]=[0-9] 1 -1 1 OK OK

int read_hex (it&, int_t*) int#[:digit:]=[:xdigit:] 1 -1 OK OK

int read_oct (it&, int_t*) int#[:digit:]=[0-7] 1 -1 OK OK

int read_bin (it&, int_t*) int#[:digit:]=[01] 1 -1 OK OK

```

Т.к. через имя функции удобно возвращать код ошибки или сообщение об ошибке, что бы текст парсеров выглядел более очевидно, я сделал специальные макросы:

```

#define r_if(expr) if((expr)==0)

#define r_while(expr) while((expr)==0)

#define r_ifnot(expr) if(expr)

#define r_whilenot(expr) while(expr)

/*

r_ifnot(err=read_smth(it))//если что-то не прочитано

return err;

*/

//следующие используются совместно с read_while_sm и read_until

#define rm_if(expr) if((expr)>=0) //типа рег. выр. '.*' * - multiple -> m

#define rm_while(expr) while((expr)>=0)

#define rm_ifnot(expr) if((expr)<0)

#define rm_whilenot(expr) while((expr)<0)

#define rp_if(expr) if((expr)>0) //типа рег. выр. '.+' + - plus -> p

#define rp_while(expr) while((expr)>0)

#define rp_ifnot(expr) if((expr)<=0)

#define rp_whilenot(expr) while((expr)<=0)

/*

rm_if(read_until_char(it,'\n'))//если прочитано 0 или более символов и символ \n

rp_if(read_until_char(it,'\n'))//если прочитано 1 или более символов и символ \n

*/

```

Хотя вполне возможно сделать какой-нибудь класс, хранящий эту информацию и преобразуемый к bool соответствующим образом.

Вообще я противник неконстантных ссылок, и считаю, что аргументы, которые функция должна изменить, должны передаваться в нее по указателю а не по ссылке, что бы при вызове это было видно, но всвязи с тем, что операторы для указателей на что бы то ни было перегружать нельзя, специально для совместимости с operator>>() (парочка таких определена в «strin.h») я итераторы везде передаю по ссылке (а возвращаемые значения по указателю).

На данный момент имеется два примера использования этих функций: [calc.cpp](https://github.com/FeelUsM/common-parse-lib/blob/master/test/calc.cpp) и [winreg.cpp](https://github.com/FeelUsM/common-parse-lib/blob/master/test/winreg.cpp).

---

Таким образом для написания парсера не требуется умения обращаться с другими программами генерации парсеров. Каждый нетерминал БНФ взаимнооднозначно переводится в функцию, которая, конечно, громоздковата по сравнению с описанием в БНФ (это можно в дальнейшем исправить, сделав функцию, делающую разбор по регулярному выражению, аналогично как в ), но зато в нее можно добавить любую проверку и обработку данных. Все это можно делать как со строками, так и с потоками в одинаковой форме. Поток ввода по умолчанию готов к вводу по умолчанию, а операторы >>, аналогичные таким же из стандартной библиотеки, дают возможность использовать эту библиотеку вместо стандартной библиотеки ввода.

Как с помощью forward\_stream делать токенезацию, я попробую рассказать и показать в следующей статье. | https://habr.com/ru/post/266589/ | null | ru | null |

# Как большинство Java проектов выглядят изнутри

Меня зовут Аксёнов Вячеслав, я бэкенд разработчик и в последние годы пишу веб приложения на java/kotlin. За всю свою практику я встречался с различными системами как в продакшене, так и в пет проектах. Некоторые системы имели свои “велосипеды”, но большинство базировались на очень похожих технических решениях.

Основная идея этой статьи описать основные технические задачи, которые ставятся перед современными веб приложениями. А также перечислить те фреймворки и библиотеки, которые чаще всего используются для решения этих задач. Бонусом захватим немного инфраструктуры.

Таким образом новички, которые не знают, чего им ждать от корпоративной разработке или в каком фреймворке подтягивать свои навыки, смогут увидеть картину мира чуть шире и сделать правильный выбор.

### Какие технические задачи бывают?

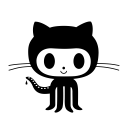

Для начала давайте разберем, какие самые распространенные проблемы и задачи ставятся перед современными веб приложениями. Ниже я привожу список самых популярных задач, с которыми приходится работать разработчику.

* Маршрутизация запросов, построение слоя контроллера.

* Написание сложной и ветвистой бизнес логики.

* Работа с базами данных.

* Работа с транспортом для сообщений.

* Тестирование.

* Статический анализ кода.

* CI/CD.

### Маршрутизация запросов / слой контроллера

Задачи, которые входят в этот слой - это направлять каждый http запрос на тот метод, который займется его обработкой. В это также входит описание модели данных, которая передается на вход, а также сериализация запроса и десериализация ответа.

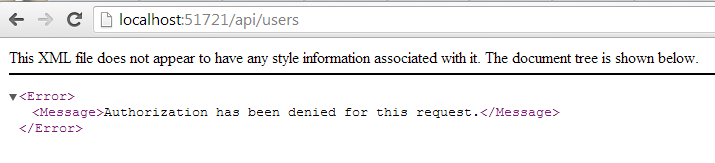

На данный момент самым популярным фреймворком для построения web сервисов является Spring, а именно Spring Boot, который сразу имеет встроенный контейнер сервлетов `tomcat`, либо `netty` - в зависимости от того, какой набор конфигурации выбран.

Так что для описания эндпоинтов вашего приложения вам практически всегда, в 9 из 10 случаев, придется использовать аннотации `@GetMapping` и `@PostMapping`. В том единственном варианте из 10 за маршрутизацию будет отвечать библиотека, которая была написана внутри компании и будет делать то же самое, что и Spring Boot, только “по-своему”.

Раз практически везде используется Spring Boot, то де факто стандартом индустрии для сериализации и десериализации http запросов и ответов является библиотека `Jackson`. Она также входит в зависимости Spring Boot и активно используется внутри.

Чтобы ее использовать, потребуется создать экземпляр `ObjectMapper` и сконфигурировать его, если будет нужно. Имейте в виду, что в Spring Context уже будет инициализированный экземпляр, настроенный, как нужно Spring, так что используйте его осторожно.

Также иногда используют библиотеку от Google - GSON, принципиально она не отличается от `Jackson`.

### Написание сложной и ветвистой бизнес логики.

Выше мы уже выяснили, что стандартом индустрии по разработке web приложений на java является Spring. Это не значит, что вы не сможете встретить условный Javalin или Ktor, так что рассмотрим основную вещь, которую очень любят в Spring и так или иначе реализовывают в любом другом фреймворке. Этим подходом является паттерн dependency injection.

Если коротко, то dependency injection это про то, что вы написали отдельный кирпичик кода - класс и используете его в тех местах, где требуется логика этого кирпичика вместо написания новой.

Так что в любом проекте, в котором вы окажетесь, будет некий контекст, в котором будут храниться эти кирпичики кода, и наличие этого контекста никак не зависит от фреймворка, выбранного для разработки. Скажу по-секрету, что даже когда один из самых прогрессивных Европейских банков отказывается от Spring и разрабатывает веб сервисы на чистой Java, у них все равно есть контекст, в который закладываются все “сервисы”.

### Работа с базой данных.

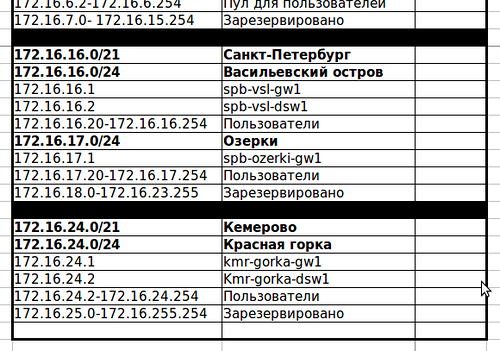

Никакое веб приложение не обходится без использования хранилища данных. Таким хранилищем может быть все что угодно - текстовый файл, кэш redis. Но чаще всего, конечно, используется база данных, опять же стандартом индустрии сейчас являются:

* Postgresql (удобная, производительная, бесплатная).

* Oracle (чуть менее удобная, производительная, имеет вендорный формат.

* MongoDB (очень удобная для стартовой разработки ввиду нереляционности, крайне распространена в облачных решениях).

Для доступа к базе данных нужно иметь возможность открывать соединения, следить за открытыми потоками, выполнять sql запросы, заниматься конвертацией и тд.

В настоящее время большое распространение имеет подход ORM - Object-Relational Mapping. Чтобы покрыть весь спектр задач для хранения информации бд, нужно решать 4 вида операций (тот самый CRUD) - `create, read, update, delete.`

Самые популярные реализации этого подхода заключает в себе фреймворк - `Hibernate`. Он способен генерировать sql запросы в зависимости от кода и сущностей, однако делает это не всегда оптимально.

Также мы не забыли, что стандартом индустрии является Spring Boot, для него также существует реализация ORM работы с бд - `Spring Data JPA`. Она представляет собой обертку над `Hibernate` , с которой можно работать на более высоком уровне абстракций. Она удобно конфигурится и даже позволяет писать запросы без sql вообще. Но если есть потребность написать raw sql и выполнить его, это также можно сделать.

И наконец, самый мощный инструмент, который предоставляет самое лучшее быстродействие, но фактически не реализует ORM идеологию - `jdbcTemplate`. Его суть в выполнении сырых sql запросов. Но если написать поверх него свою логику конвертации и применять его для хранения сущностей в бд по логике ORM, то получится очень быстрый и кастомизируемый инструмент.

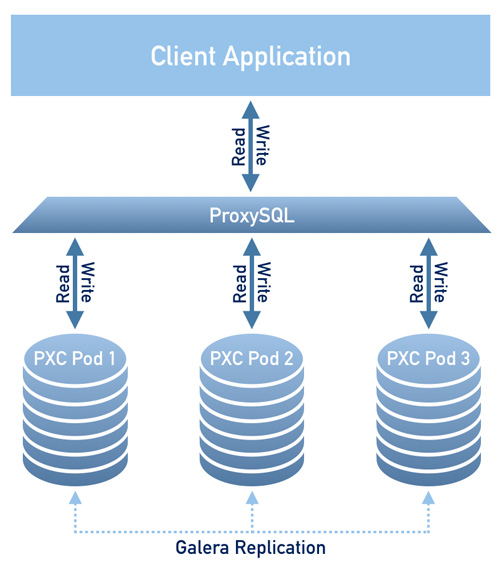

### Работа с транспортом

В качестве транспорта для сообщений используют такие синхронные способы, как http запросы GET/POST. Для них используется либо `RestTemplate`, который входит в список зависимостей Spring Boot, либо более новый и `WebClient`.

Для асинхронных взаимодействий используются брокеры сообщений, самые популярные из которых - rabbitmq и kafka. В этой статье я не буду погружаться в их отличие друг от друга. Остановлюсь на способе интеграции с ними из кода - для этого используются модули Spring Boot, либо самописный “велосипед”, если речь идет про большую компанию. Самые популярные расширения для Spring Boot проекта - это spring-kafka и spring-boot-starter-amqp.

### Тестирование

Тестирование - это неотъемлемая часть любой уважающей себя разработки. В наших реалиях если разработка ведется не сразу в TDD парадигме (Test Driven Development), то внутри команды устанавливается порог кода, который должен быть покрыт тестами.

Тесты пишутся в следующих форматах:

* unit тесты - для тестирования берется отдельный класс или даже его метод.

* интеграционные тесты - тестируется отдельный участок системы вместе с интеграцией с другими элементами. Например интеграционное тестирование процесса в сервисе и его работа с базой данных.

Сторонние библиотеки в тестах нужны для решения задач непосредственно тестирования, а также мокирования (эмуляция ответа какого-то сервиса или интеграции).

Для тестирования чаще всего используют `junit 5`, `TestNG`, `kotest` (kotlin). Для мокирования стандартом java разработки является mockito, для kotlin - `mockk`. Для тестирования Spring Boot приложений используется стартер `spring-boot-starter-test`, который уже включает в себя все необходимые зависимости и умеет строить Spring Context для каждого теста.

Крайне редко бывают настолько сложные и витиеватые процессы, что для тестирования одного сценария нужно вызывать много эндпоинтов одного сервиса. В таком случае нужно быть готовым к тому, что вы столкнетесь с самописными “велосипедами”, такими как отдельное Spring Boot приложение, которое занимается вызовом эндпоинтов и тестированием основного тестируемого приложения.

### Статический анализ

Суть статического анализа кода - это проверка кода на соответствие условиям - отсутствие дублирующего кода, покрытия тестами, соответствие код стайлу и тд.

Как правило для проверок соответствия код стайлу используются такие штуки, как “Линтеры”. По своей природе это те же самые плагины для `gradle`, `maven`. Обычно они запускаются автоматически в ходе настроенного пайплайна. Иногда нужно быть готовым, что нужно вызвать команду, которая отформатирует ваш код по настроенным в линтере правилам.

Для Java самыми популярными линтерами являются - `Checkstyle` и `SonarLint`. Для kotlin - `ktlint`

Для статического анализа, с подсказками и прочими полезными штуками в подавляющем большинстве проектов используется настроенный sonarqube. Для маленьких проектов - codacy или codeclimate. Я бы рекомендовал их использовать даже для пет проектов.

Однако не все проекты имеют выстроенные процессы по поддержанию чистоты кода. Это может происходить в силу различных причин - быстро изменяющийся проект, недостаточное количество времени у команды для выстраивания процессов.

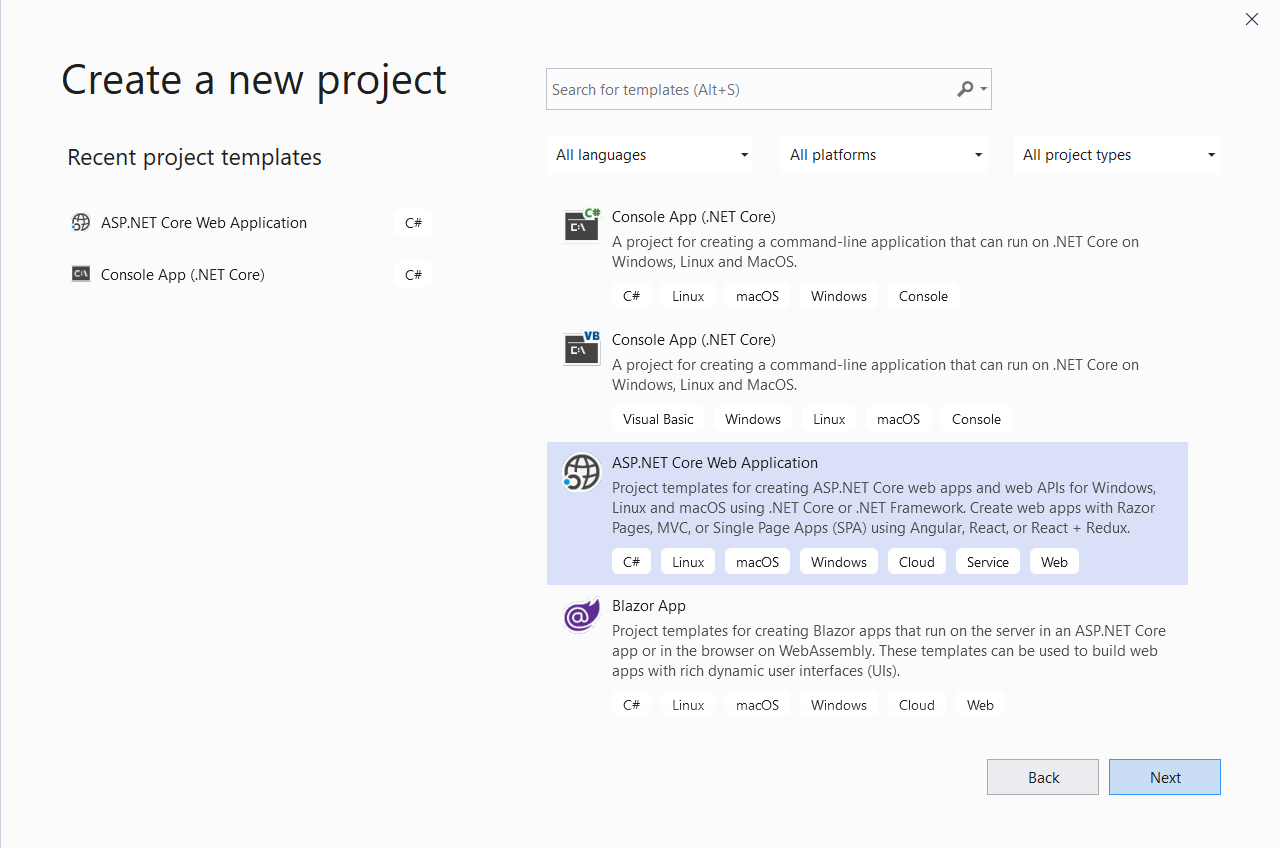

CI/CD - Continuous Integration и Continuous Deployment - это процессы, без которых невозможно представить современную разработку. Можно запаковывать jar файлы руками и руками разворачивать их на серверах, но это увеличивает вероятность ошибок, вызванных человеческим фактором. Чтобы базовые инфраструктурные действия не вызывали большой головной боли, обычно используются скрипты для сборки и деплоя.

Как правило рядовым разработчикам приходится заниматься этим довольно редко, обычно это находится в зоне devops инженеров. Как правило скрипты выполняются в окружении Jenkins, либо Gitlab CI.

Сами скрипты представляют собой набор действий, которые должны быть выполнены для достижения той или иной цели. Самое сложное может быть в том чтобы понять, как связывается код внутри приложения и с деплоем. Для этого используются системы сборки. На данный момент для бэкенда существуют две самые популярные - `maven` и `gradle`. В 9 случаях из 10 это `maven`, он довольно грубый, но функциональный и имеет большое количество плагинов. Также изредка встречается `gradle`, он в свою очередь более свежий, но менее широко распространенный. По функционалу ничем не уступает `maven` в большинстве моментов.

### Вывод.

В этой статье мы рассмотрели основные технические моменты, которые приходится решать бэкенд разработчику в настоящее время. А также основные способы решения задач для каждого из этих технических направлений. Буду рад информации в комментариях о том - с помощью какого инструмента в своем проекте вы решаете задачу и полностью ли вы довольны этим инструментом.

Фото от [Tracy Adams](https://unsplash.com/@tracycodes?utm_source=unsplash&utm_medium=referral&utm_content=creditCopyText) на [Unsplash](https://unsplash.com/s/photos/java?utm_source=unsplash&utm_medium=referral&utm_content=creditCopyText) | https://habr.com/ru/post/659271/ | null | ru | null |

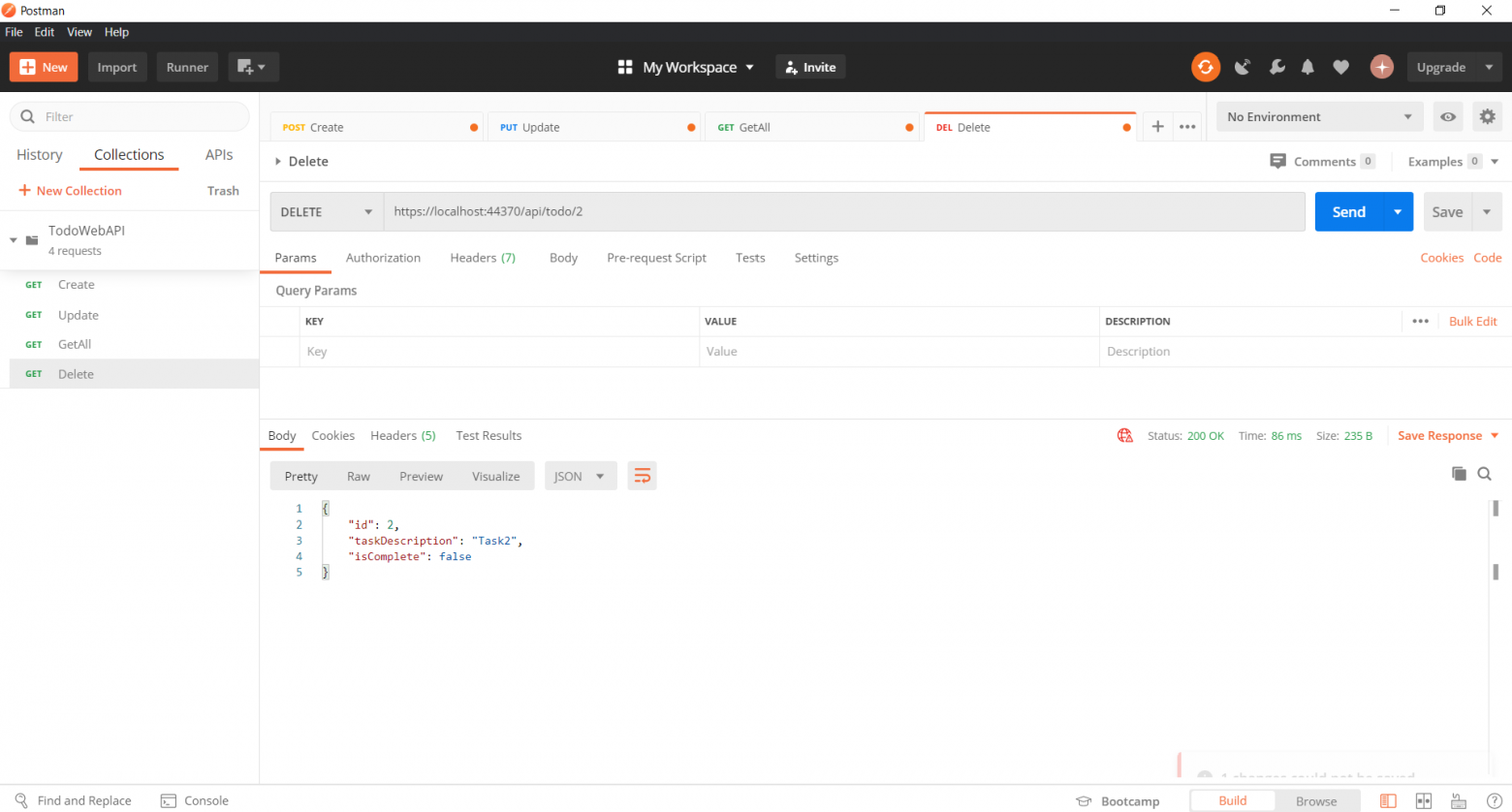

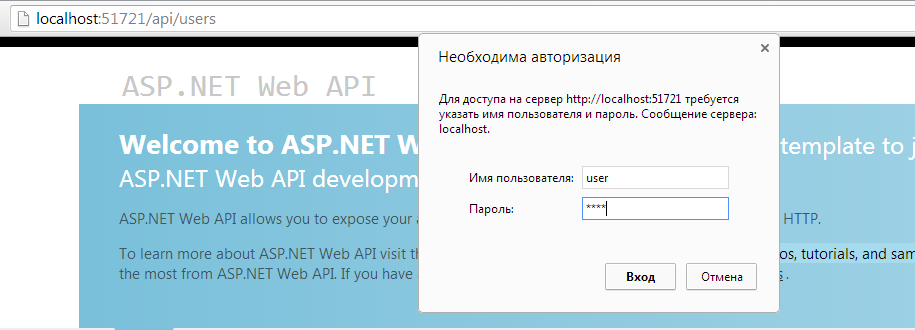

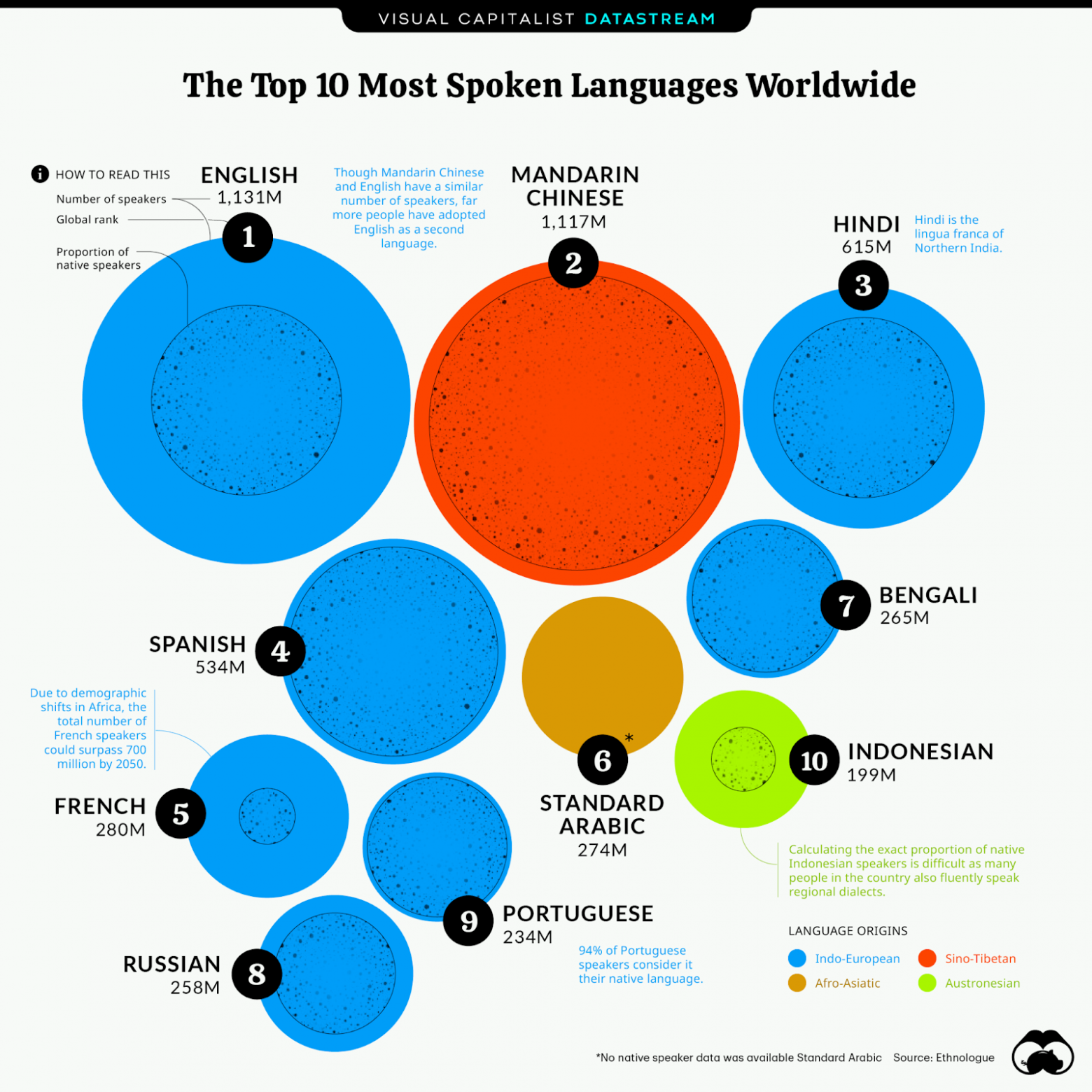

# Библиотека ML Tuning: как подобрать гиперпараметры модели GBTRegressor в PySpark

Привет, Хабр! Меня зовут Никита Морозов, я Data Scientist в Сбере. Сегодня поговорим о том, как при помощи библиотеки ML Tuning осуществить подбор гиперпараметров модели GBTRegressor в PySpark. Зачем всё это нужно? Дело в том, что они используются в машинном обучении для управления процессом обучения модели. Соответственно, подбор оптимальных гиперпараметров — критически важный этап в построении ML‑моделей. Это даёт возможность не только повысить точность, но и бороться с переобучением.

Привычный тюнинг параметров в Python для моделей машинного обучения представляет собой множество техник и способов, например GridSearch, RandomSearch, HyperOpt, Optuna. Но бывают случаи, когда предобработка данных занимает слишком много времени или же объём данных слишком велик, чтобы уместиться в оперативную память одной машины. Для этого на помощь приходит Spark. Подробности — под катом.

Сразу скажу, что статья небольшая, я описываю только то, о чём говорил выше. И да, рассматривать чистку данных и feature engineering в целях экономии времени читателей не буду. Предположим, что данный процесс уже реализован.

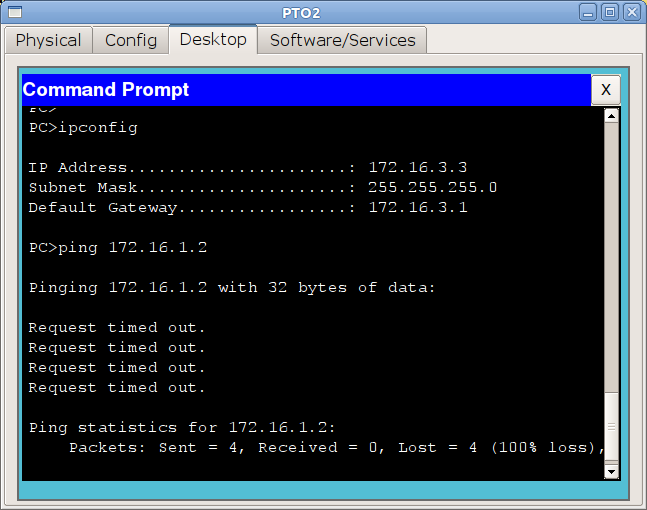

Сразу приступим к основной задаче — рассмотрим, как в Spark работать с моделями машинного обучения на примере GBTRegressor, а главное, как подбирать гиперпараметры. Делать я это буду на всем известном датасете Boston. [Датасет](https://www.cs.toronto.edu/~delve/data/boston/bostonDetail.html) содержит информацию об объектах недвижимости в Бостоне. Его можно скачать из библиотеки sklearn. Объём датасета — (506 X 14).

GBTRegressor — модель градиентного бустинга для задачи регрессии.

Начну с импорта необходимых библиотек:

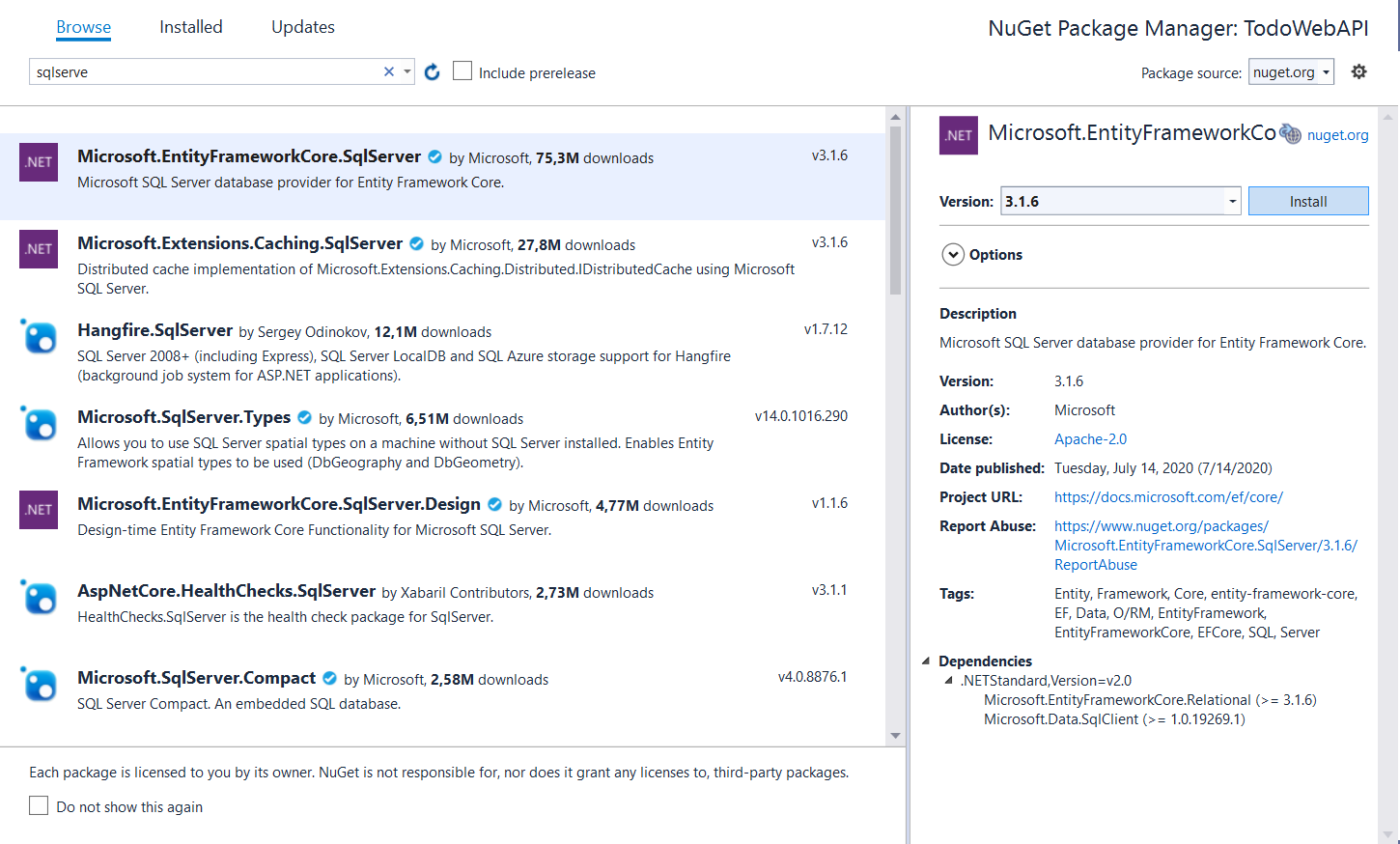

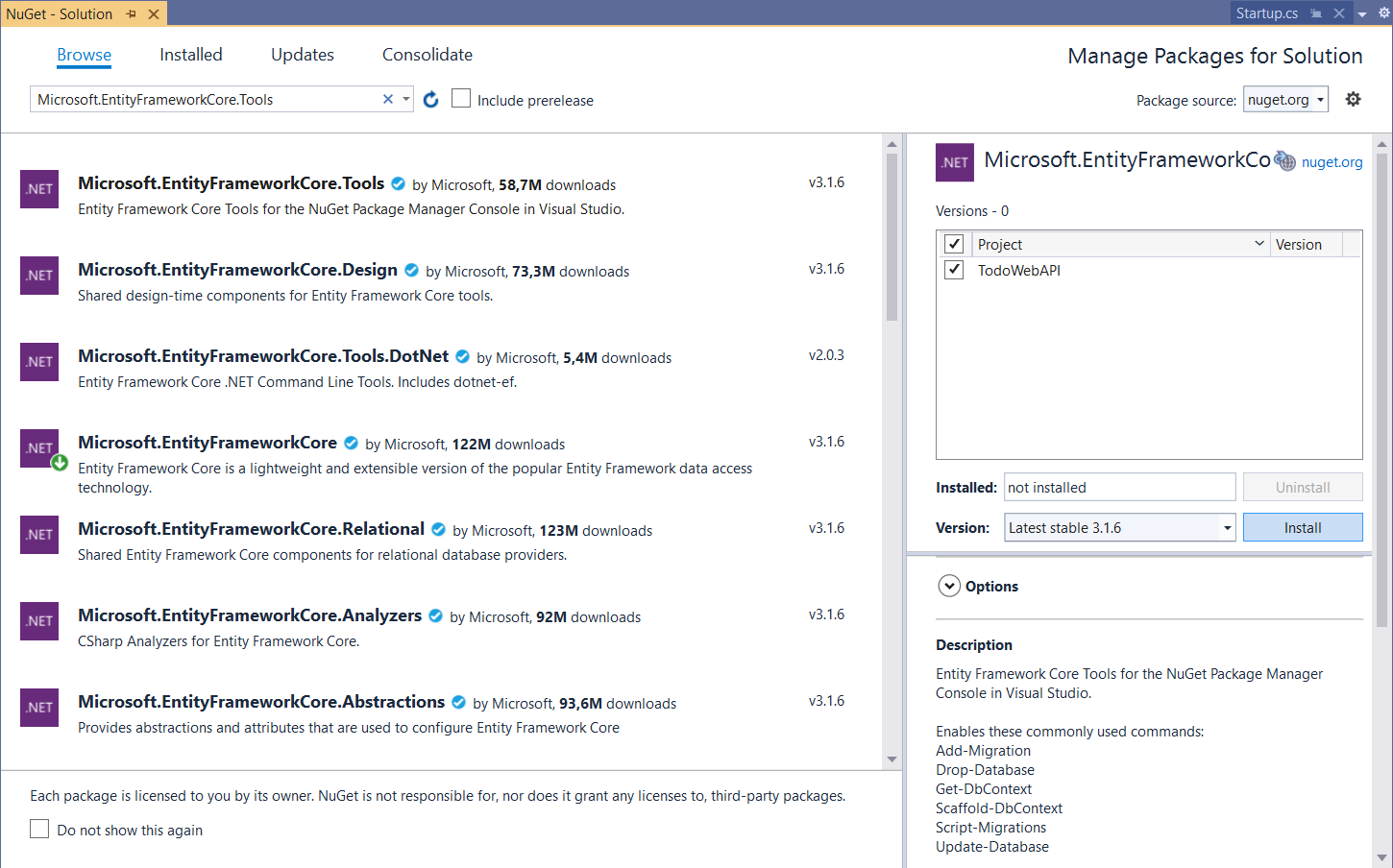

```

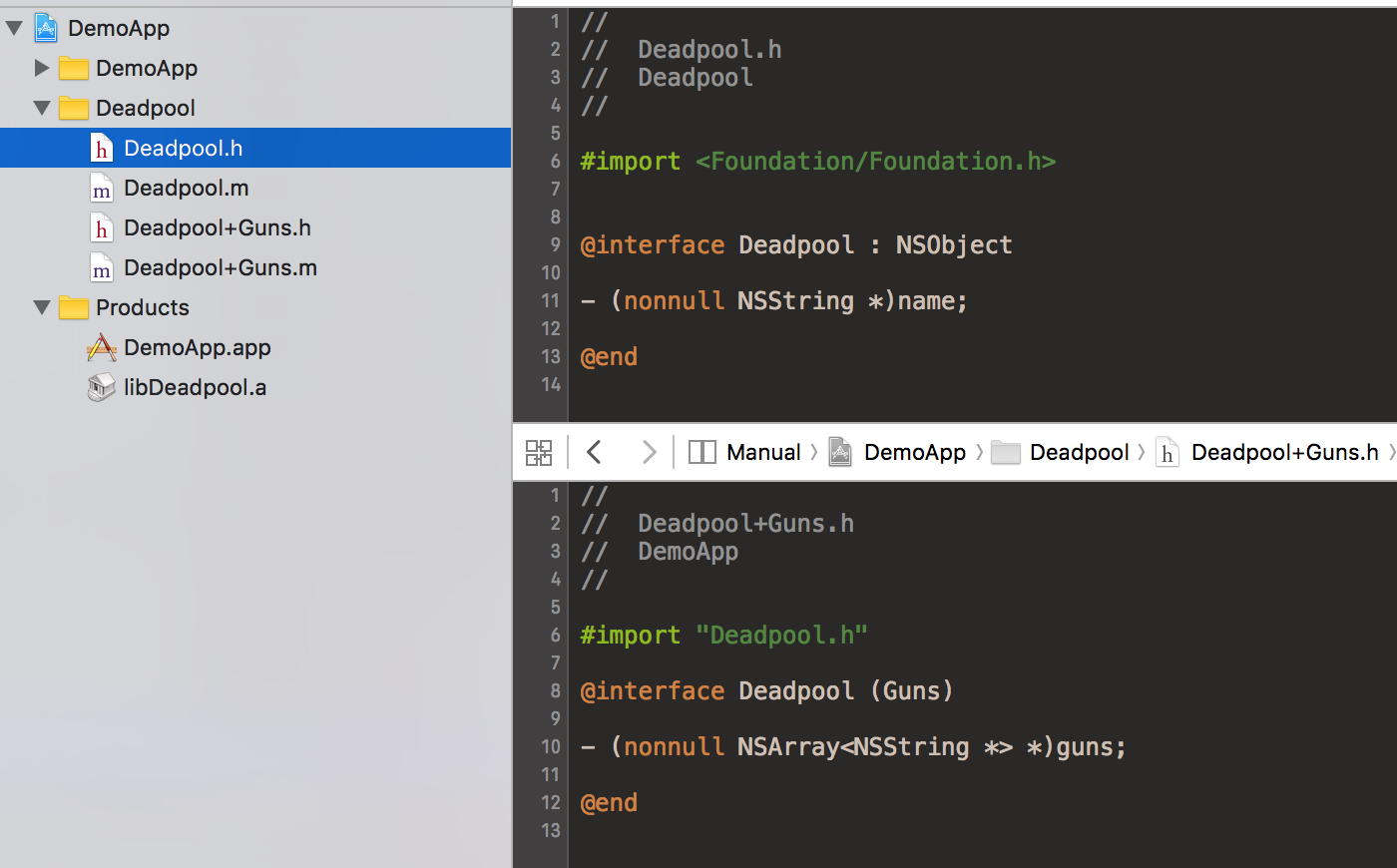

from pyspark.ml.feature import VectorAssembler

from pyspark.ml.regression import GBTRegressor

from pyspark.ml.evaluation import RegressionEvaluator

from pyspark.ml.tuning import CrossValidator, ParamGridBuilder

```

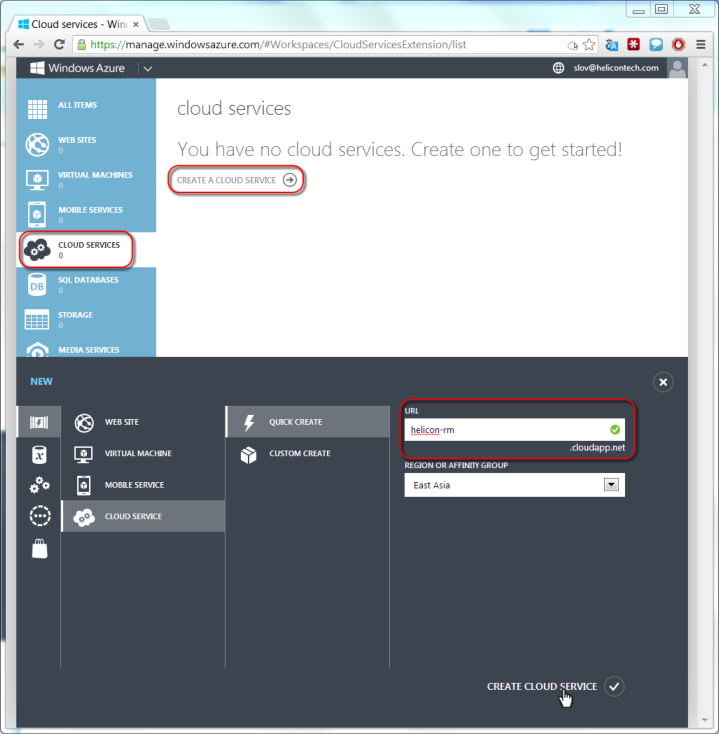

Загружу датасет из sklearn и запишу его в Spark DataFrame:

```

from sklearn.datasets import load_boston

import pandas as pd

boston = load_boston()

boston_df = pd.DataFrame(boston.data, columns = boston.feature_names)

boston_df['TARGET'] = boston.target

boston_df = spark.createDataFrame(boston_df)

```

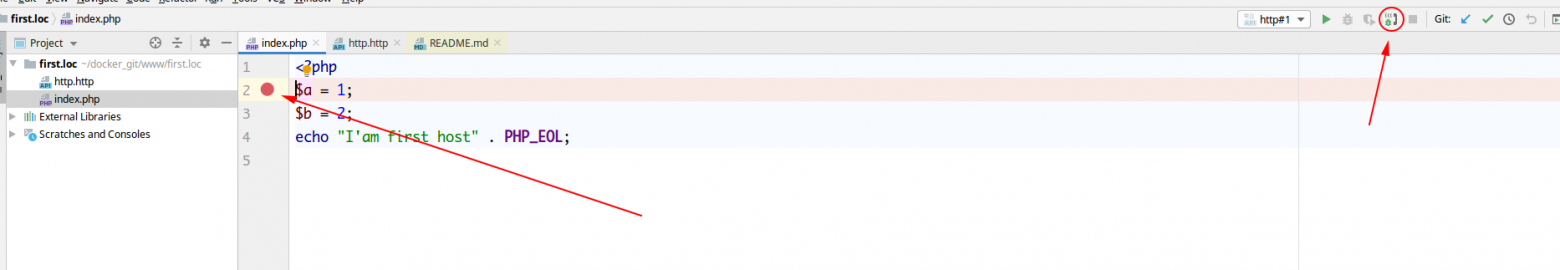

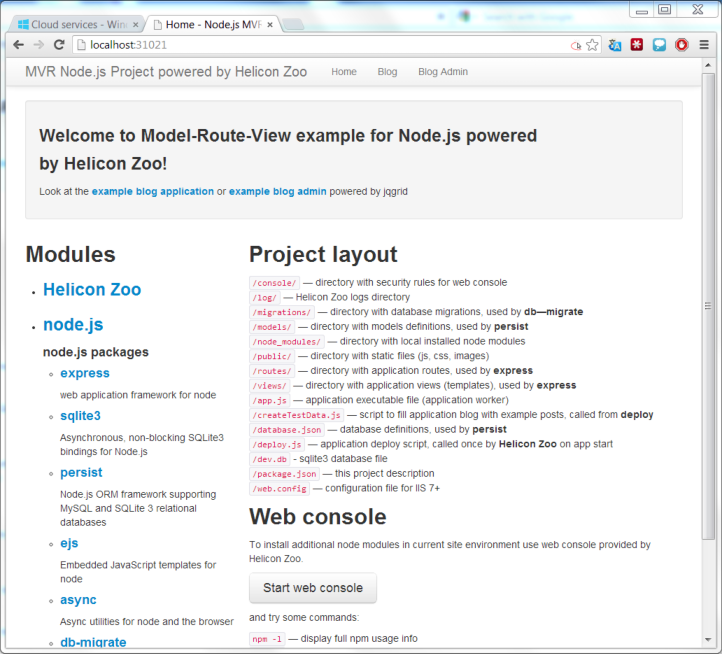

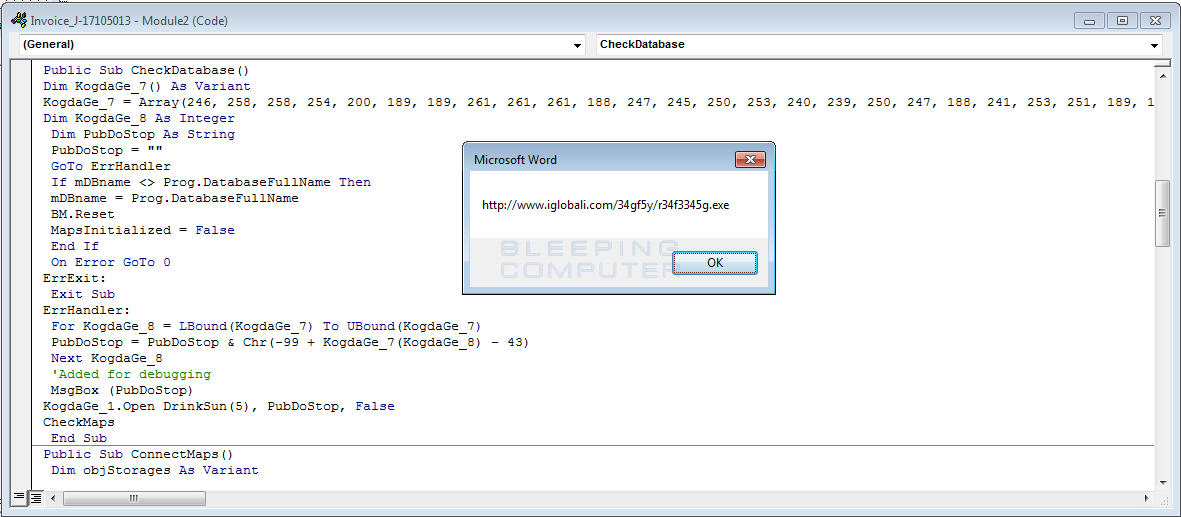

Посмотрю на данные:

Теперь самое время разделить данные на train и test:

```

train, test = boston_df.randomSplit([0.8, 0.2], seed = 12345)

```

Преобразую признаки в единый вектор, а также преобразую датафрейм:

```

vec = VectorAssembler(inputCols=['CRIM', "ZN", "INDUS", "CHAS",

"NOX", "RM", "AGE", "DIS",

"RAD", "TAX","PTRATIO", "B", "LSTAT"],

outputCol='FEATURES')

vector_feature_train = vec.transform(train)

vector_feature_test = vec.transform(test)

```

Инициализирую модель GBTRegressor, явно указав, какая колонка будет отвечать за признаки, а какую колонку будем предсказывать:

```

gbt = GBTRegressor(featuresCol='FEATURES', labelCol='TARGET')

```

Объявлю Evaluator для оценки модели, в качестве метрики выбрав MAE (по умолчанию стоит RMSE):

```

evaluator = RegressionEvaluator(predictionCol='prediction',

labelCol='TARGET',

metricName = 'mae')

```

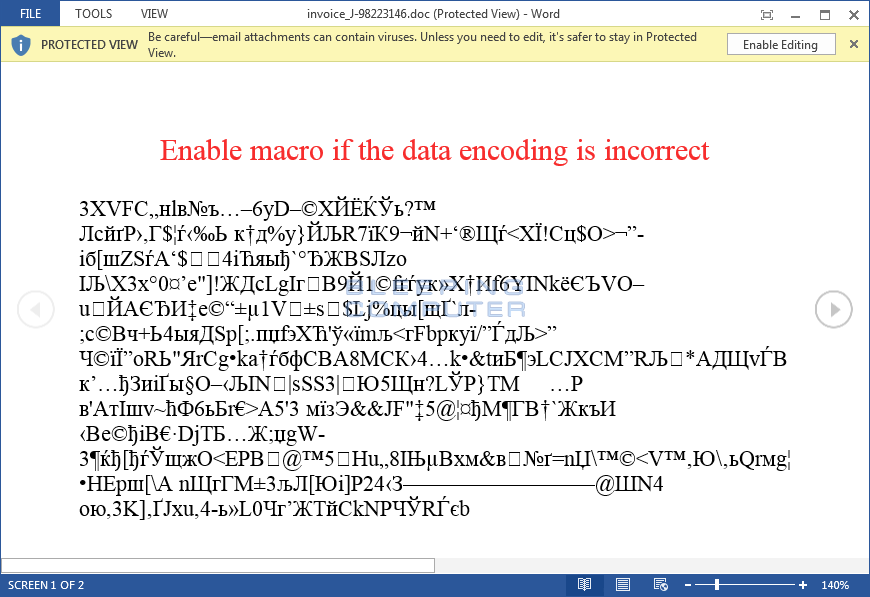

Прежде чем приступать к подбору гиперпараметров, посмотрим на точность модели с дефолтными настройками:

```

gbt_model = gbt.fit(vector_feature_train)

pred = gbt_model.transform(vector_feature_test)

mae = evaluator. evaluate(pred)

print(mae)

```

Запомним значение данной метрики, чтобы проверить, улучшится ли её значение на тестовой выборке после подбора гиперпараметров.

Объявлю сетку параметров, которые требуется подобрать, где MaxDepth — это максимальная глубина дерева, в MaxIter — количество деревьев:

```

paramGrid = ParamGridBuilder() \

.addGrid(gbt.maxIter, [10, 20, 30])\

.addGrid(gbt.maxDepth, [3, 4, 5])\

.build()

```

В GBTRegressor есть и другие параметры, например featureSubsetStrategy — стратегия подбора подмножества признаков, но здесь я рассматриваю сам механизм подбора параметров. С самими параметрами можно ознакомиться в [официальной документации алгоритма GBTRegressor для Spark](https://spark.apache.org/docs/3.3.0/api/python/reference/api/pyspark.ml.regression.GBTRegressor.html).

Значения параметров для подбора можно расширить, скажем, рассмотреть количество итераций не строго 10 или 30, а указать диапазон — [10, 11, 12…30]. Тем самым, возможно, повышаем точность итоговой модели. Но чем больше количество значений перебираемых параметров, тем больше времени займёт процесс самого перебора, особенно на большом объёме данных. Поэтому с количеством параметров и значениями для этих параметров нужно быть осторожным.

Объявлю CrossValidator, в котором укажу алгоритм, сетку параметров, способ оценивания алгоритма и количество фолдов:

```

crossval = CrossValidator(estimator=gbt,

estimatorParamMaps=paramGrid,

evaluator=evaluator,

numFolds=3)

```

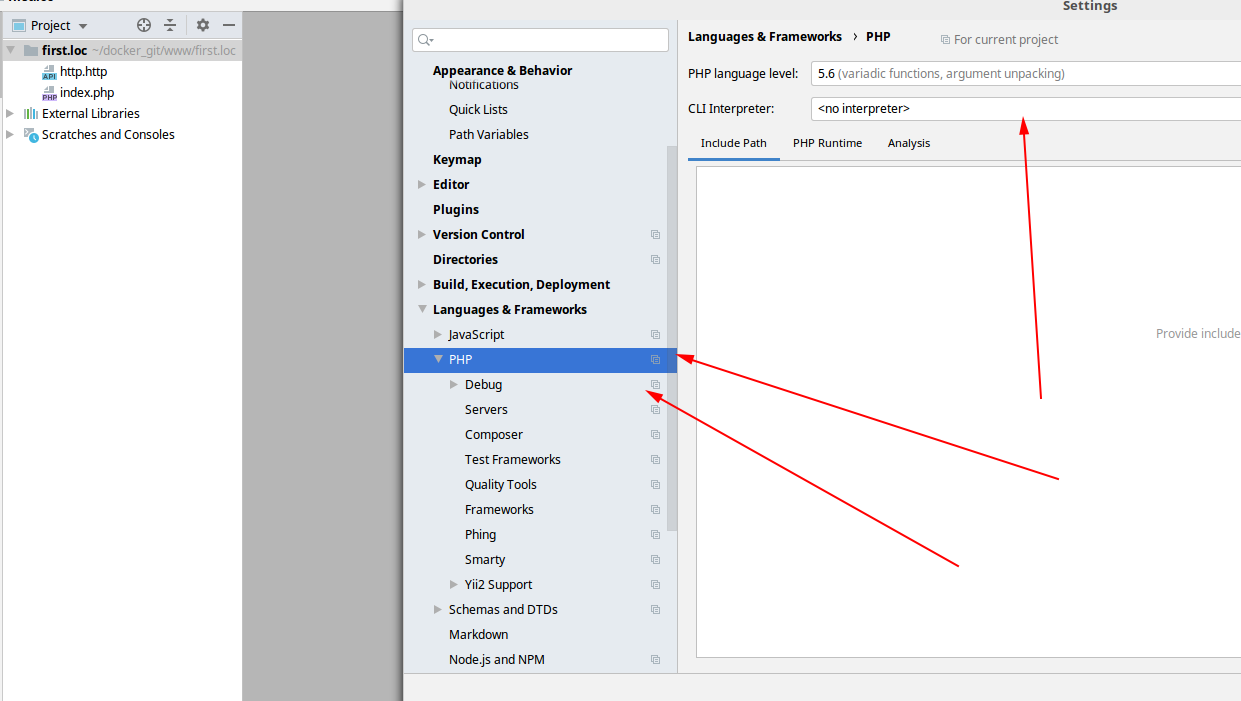

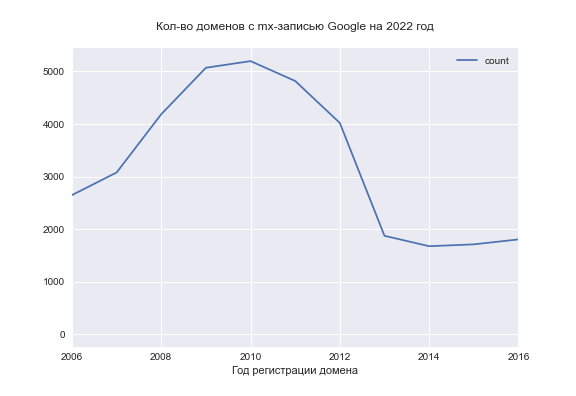

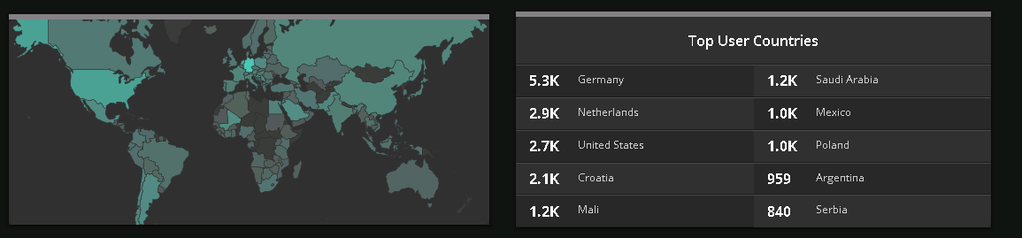

Запустим кросс-валидацию и выведем среднюю метрику на каждую комбинацию параметров:

```

cvModel = crossval.fit(vector_feature_train)

cvModel.avgMetrics

```

Также очень важно посмотреть, при каких параметрах модели была получена лучшая метрика:

```

cvModel.bestModel.extractParamMap()

```

Отсюда можно увидеть, что MaxDepth = 4, а MaxIter = 30.

После получения лучших гиперпараметров уже можно обучить с ними модель, сохранить её и использовать в дальнейших предсказаниях, не затрачивая времени на переобучение модели каждый раз, когда требуется predict.

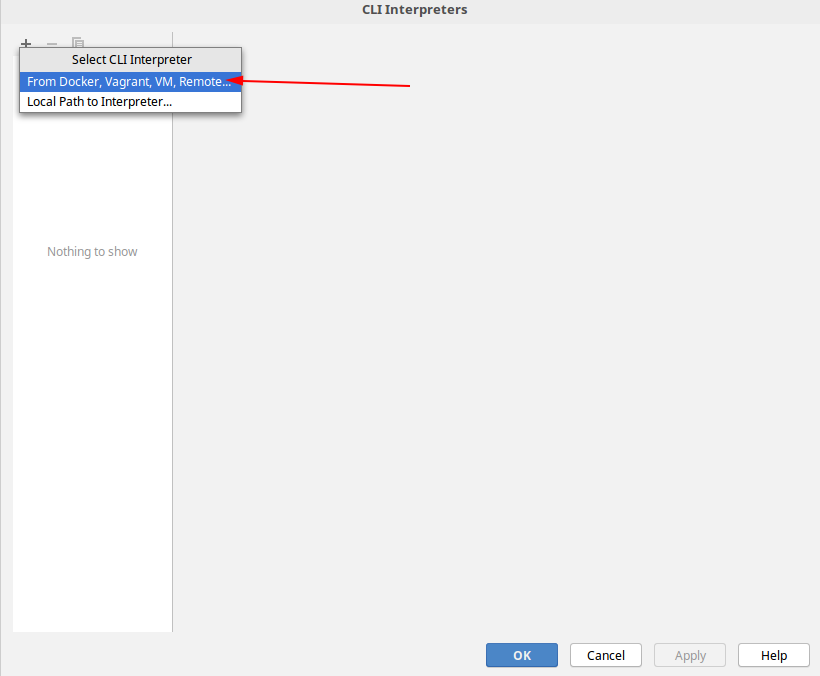

Теперь проверим точность при полученных гиперпараметрах на тестовой выборке:

```

gbt = GBTRegressor(featuresCol='FEATURES', labelCol='TARGET', maxDepth=4, maxIter=30)

gbt_model = gbt.fit(vector_feature_train)

pred = gbt_model.transform(vector_feature_test)

mae = evaluator. evaluate(pred)

print(mae)

```

Всё отлично, метрику удалось улучшить.

Что ещё?

--------

Естественно, это не лучший результат, и можно расширить возможные значения параметров, а также количество самих параметров, чтобы добиться максимально возможной точности. Напомню, что процесс feature engineering был мною пропущен. А ведь он тоже может сильно помочь в получении максимально возможного качества при построении модели. Но цель статьи — показать механизм подбора параметров в Spark ML — выполнена. Остальное — уже дело техники.

И последнее — не забудьте остановить spark-сессию!

Если есть вопросы, задавайте в комментариях. Будет отлично, если кто-то из читателей сможет поделиться собственными кейсами по теме статьи. | https://habr.com/ru/post/715678/ | null | ru | null |

# Ключевое слово this в JavaScript. Полное* руководство

*\* скорее всего, я что-нибудь да упустил, но уверен, в комментариях мне это подскажут*