text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Веб-компоненты в реализации Polymer от Google

Веб-компоненты — это новая эра веб-разработки и почувствовать ее мощь можно уже сегодня при помощи Polymer от Google. Вы можете создавать свои собственные «элементы» (тэги), содержащие шаблон и инкапсулированные стили и логику (js), а так же воспользоваться богатой коллекцией уже готовых элементов.

Что такое Polymer?

------------------

Polymer это библиотека (сами они называют это, набором полифилов и синтаксического сахара) для создания и использования веб-компонент. А веб-компоненты это некий набор стандартов W3C, который в будущем ~~будет поддерживаться~~ [уже поддерживается некоторыми](http://jonrimmer.github.io/are-we-componentized-yet/) браузерами. Если совсем по-простому, то веб-компонента это некий выделенный в отдельный блок кусок html кода с шаблонированием, стилями и логикой. Это позволяет повысить структурированность вашего html кода, повысить читаемость и повторное использование. Один раз написал (или выбрал из [стандартных](http://www.polymer-project.org/docs/elements/)) и используй везде.

> *Если вы думаете, что html5 изменил веб, то подождите и увидите, что сделают Веб-компоненты. © чей-то.*

Проникнуться идеей веб-компонент можно на [webcomponents.org](http://webcomponents.org/). Поковыряться в чужих компонентах можно на [component.kitchen](http://component.kitchen/).

Ну и еще существует большая вероятность, что Polymer-ное виденье будущего станет реальностью, и вы в будущем просто отключите **полифилы** Polymer-а (`platform.js`) и все продолжит работать нативно **(UPD: внес уточнение. Спасибо [nazarpc](https://habrahabr.ru/users/nazarpc/))**. Как мы понимаем, такие компании, как Google и Mozilla (они разрабатывают похожий x-tag) могут менять будущее веба.

Инфраструктура

--------------

Для того, чтобы теорию подкрепить практикой, нам нужна инфраструктура. Самый простой способ создать ее – это [yeoman](http://yeoman.io) и [генератор Polymer](https://github.com/yeoman/generator-polymer) для него (и конечно нужен [Bower](http://bower.io/)). Ниже необходимые команды (уже установленное у вас — пропускайте).

```

npm install -g bower

npm install -g yo

npm install -g generator-polymer

mkdir my-project

cd my-project

yo polymer

```

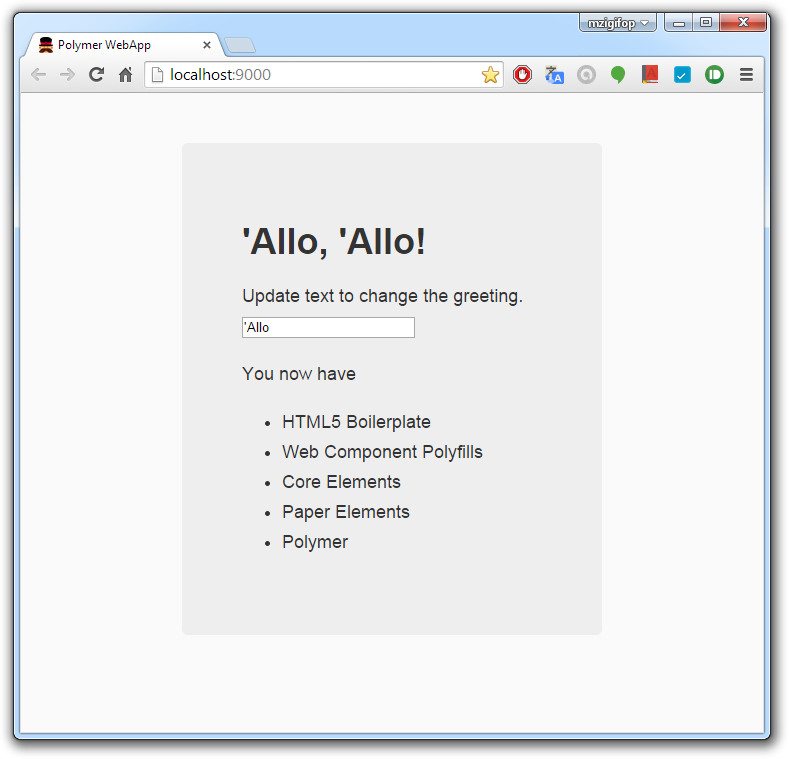

В результате получаем начальный скелет приложения с парой собственных элементов, а также папку со всей коллекцией готовых элементов. Для того, чтобы посмотреть, как это выглядит в работе, нужно запустить сервер.

```

grunt serve

```

После запуска откроется браузер и Вы увидите такую картинку:

Итак, когда инфраструктура налажена, приступим к изучению:

Использование готовых компонент и элементов.

--------------------------------------------

Polymer содержит [две основные коллекции элементов](http://www.polymer-project.org/docs/elements/):

* **Core-elements** – это набор элементов, включающий визуальные элементы (панельки, кнопки, инпуты и пр) и не визуальные элементы (ajax, localstorage и т.д ).

* **Paper-elements** – это набор элементов, реализующий новый [material design](http://www.google.com/design/spec), последнее время широко используемый Google.

Для использования элементов в `index.html` должен быть подключен (у нас уже все подключено) `platform.js`:

```

```

Также нужно импортировать при помощи тега нужные нам элементы до их использования:

```

```

Потом просто вставляете нужные теги в ваш код и все:

```

```

Для API Google есть готовые компоненты, например . Это позволяет легко встраивать сервисы Google в наше приложение. Смотрите список компонент на [googlewebcomponents.github.io](http://googlewebcomponents.github.io/).

По быстрому накидать готовых компонент на страницу, подправить стили и js код, посмотреть, как это все выглядит можно при помощи [Design tool](http://www.polymer-project.org/tools/designer/). С помощью нее можно потом сохранить полученный код как Github Gist.

[Вот](http://youtu.be/djQh8XKRzRg) небольшое видео о работе в этом «редакторе».

Создание элементов

------------------

Это, пожалуй, самая главная фишка веб-компонент и Polymer-а (по крайней мере для меня). Это похоже на директиву Angular, только с нормальным html со стилями и логикой. При чем все это изолированно и работает в своем скопе и ни кто из вне ничего не поломает.

Выглядит это так: (я создам элемент . Начну с пустого `habrauser-card.html` в папке `app/elements`):

```

:host {

display: block;

padding: 10px;

color: {{usercolor}};

}

polyfill-next-selector { content: ':host h3'; }

:host ::content h3 {

margin: 0;

text-decoration: underline;

}

- I am habrauser **{{habrauser}}**

-

Polymer('habrauser-card', {

habrauser: 'DefaultValue',

usercolor: 'green'

});

```

Давайте разберем:

Сначала подключаем `polymer.html` или любую другую компоненту, внутри которой уже есть линк на `polymer.html`.

Затем в тэге определяем наш элемент *(Важно! Имя должно быть обязательно со знаком '–')*. В свойстве `attributes` перечисляем внешние (которые будем использовать при вызове) свойства. Я бы назвал это интерфейсом веб-компоненты. Их еще можно задать через js и свойство `publish:`, но способ задания через аргумент предпочтительнее.

Дальше идет шаблон на языке html (то, что заключено в теги ).

Стили можно писать прямо здесь в тэг | https://habr.com/ru/post/237421/ | null | ru | null |

# Yii 2.0.9

Вышла версия 2.0.9 PHP-фреймворка Yii. Минорный релиз содержит около [60 небольших улучшений и исправлений](https://github.com/yiisoft/yii2/blob/2.0.9/framework/CHANGELOG.md). [Инструкции по установке](http://www.yiiframework.com/download/) можно найти на официальном сайте.

В данной версии есть два изменения, которые, хоть это и маловероятно, могут затронуть ваши приложения. Ознакомьтесь с [UPGRADE.md](https://github.com/yiisoft/yii2/blob/2.0.9/framework/UPGRADE.md).

Спасибо [сообществу Yii](https://github.com/yiisoft/yii2/graphs/contributors) за пулл-реквесты и обсуждения.

Этот релиз вышел благодаря вам!

За разработкой фреймворка можно наблюдать [на GitHub](https://github.com/yiisoft/yii2). Также у нас есть [Twitter](https://twitter.com/yiiframework)

и [Facebook](https://www.facebook.com/groups/yiitalk/).

Далее мы рассмотрим самые интересные улучшения подробней. Полный список изменений и исправлений можно найти в [CHANGELOG](https://github.com/yiisoft/yii2/blob/2.0.9/framework/CHANGELOG.md).

Фильтр action

-------------

`\yii\base\ActionFilter` теперь поддерживает маски для `only` и `except`, что полезно когда

фильтр навешивается на модуль или приложение целиком:

```

return [

'as filter' => [

'class' => 'app\filters\SomeFilter',

'only' => [

'particular/*', // все действия контроллера 'particular'

'*/captcha', // все действия 'captcha' всех контроллеров

],

],

// ...

];

```

Улучшения производительности

----------------------------

* Улучшили производительность перевода сообщений при использовании базы данных. Добавили нужные индексы.

* Схема Oracle теперь считывается быстрее.

Построитель схемы и миграции

----------------------------

Был улучшен построитель схемы, который используется в миграциях. Добавили новый метод `null()` чтобы указывать возможность записи `null` явно. Метод применяется автоматически, если значение по умолчанию — `null`.

```

$type = $this->string(42)->null();

```

Также добавили метод для своего SQL:

```

$type = $this->string(15)->notNull()->append('collate ascii_bin')->append('character set ascii');

```

Синтаксис команды для генерации миграций был немного изменён: `_table` и `_column` теперь обязательны:

```

./yii migrate/create create_user_table

./yii migrate/create add_name_column_to_user_table

```

Провайдеры данных и виджеты

---------------------------

Все улучшения в данном релизе касаются заголовков. В `\yii\data\ArrayDataProvider` добавили свойство `$modelClass`, через которое можно указать модель для получения заголовков полей. В дополнение `\yii\grid\DataColumn`, который определяет поведение для всех столбцов с данными, теперь пытается получить заголовки из `filterModel` грида.

Рефакторинг

-----------

Из интерфейса `ManagerInterface` RBAC выделили `CheckAccessInterface`, который может быть полезен при реализации своей проверки доступа.

`\yii\web\User::loginByCookie()` отрефакторен для большей расширяемости.

Asset-ы

-------

При перечислении файлов в пакетах asset-ов теперь можно задать путь в `null`. В этом случае файлы не регистрируются. Это полезно, например, для регистрации дополнительных файлов для рабочего окружения:

```

namespace common\assets;

use yii\web\AssetBundle;

class ReactAsset extends AssetBundle

{

public $sourcePath = null;

public $js = [

YII_ENV_DEV ? "//fb.me/react-15.0.1.js" : "//fb.me/react-15.0.1.min.js",

YII_ENV_DEV ? "//fb.me/react-dom-15.0.1.js" : "//fb.me/react-dom-15.0.1.min.js",

YII_ENV_DEV ? "//cdnjs.cloudflare.com/ajax/libs/babel-core/5.6.15/browser.js" : null,

];

}

```

Логирование

-----------

`\yii\log\Target::$logVars` теперь можно настроить более тонко:

* `_SESSION` — пишем глобальную переменную сессии. Всё как и было.

* `_SESSION.id` — пишем только `id` из сессии.

* `!_SESSION.secret` — не пишем ключ `secret` из сессии.

Логика такой фильтрации вынесена в `\yii\helpers\ArrayHelper::filter()`. При необходимости можно использовать у себя.

Markdown

--------

Тип синтаксиса по умолчанию для `yii\helpers\Markdown` теперь можно задать через `$defaultFlavor`. | https://habr.com/ru/post/305432/ | null | ru | null |

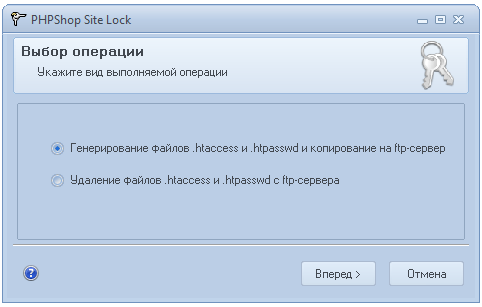

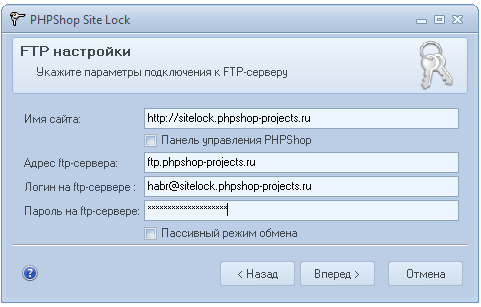

# SiteLock – визуальный генератор пароля для сайтов от PHPShop

Мы часто сталкиваемся с задачей по созданию дополнительного пароля на сайт и панель управления — это дает большую уверенность в сохранности данных, и, конечно, рекомендуем использовать этот метод всем и почаще. Конечно, есть много способов поставить пароль, но все-таки, все они требуют наличия определенных знаний от клиента. Для облегчения жизни клиентам, мы создали **бесплатный визуальный интерфейс генерации паролей — SiteLock, который подходит не только к PHPShop, но и к любым другим CMS**. Сгенерированные пароли, в связке .htaccess + .htpassw, сразу копируются на сайт, через встроенный ftp-менеджер.

#### Какие варианты защиты сайта лучше?

Как известно, самая распространенная дополнительная защита – это [Basic Authentication](http://ru.wikipedia.org/wiki/.htpasswd), она используется на большинстве web-проектов, в роутерах и подобных аппаратах. Таким паролем хорошо защищать сайт от чужих глаз на время его создания и тестирования. Ставить дополнительный пароль рекомендуют [специалисты](http://www.revisium.com/ai/) по поиску и лечению веб-вирусов.

На некоторых хостингах пароль можно выставить через встроенный файловый менеджер (DirectAdmin, cPanel и т.д.). Однако, как показывает практика, хостер обычно советует создавать пароль через SSH, что для обычного пользователя является почти невыполнимой задачей.

В первое время, мы давали клиентам такую инструкцию по установке через FTP и генератора паролей:

* Создать файл .htaccess с содержанием:

```

AuthName "Member's Area"

AuthType Basic

AuthUserFile /home/username/username.ru/.htpasswd

require valid-user

```

* Создать файл /home/username/username.ru/.htpasswd. Для генерации логина и пароля воспользуемся онлайн сервисом [htpasswd-generator](http://www.htaccesstools.com/htpasswd-generator/).

У некоторых пользователей эта инструкция вызывала шок, либо они не могли определить верный путь AuthUserFile, и сайт начинал выдавать 500 ошибку, что отбивало все дальнейшее желание этим заниматься.

Мы решили использовать более дружественный подход по созданию пароля и создали бесплатную утилиту **SiteLock, где, кроме указания ftp-паролей и выбора действия над сайтом, ничего не требуется**.

**SiteLock подойдет не только для PHPShop, его можно использовать для любой CMS**. Sitelock предлагает выбрать папку для паролирования через встроенный ftp-менеджер. После подключения, утилита создаст дерево каталогов сервера. Если сайт на PHPShop, то утилита распознает его автоматически и предлагает создать пароль на папку авторизации панели управления магазином.

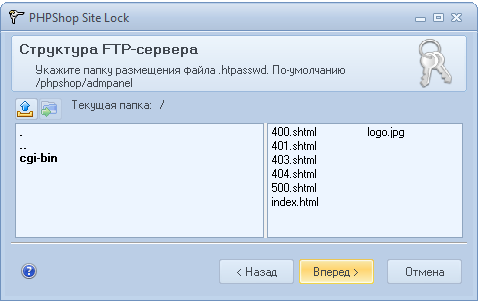

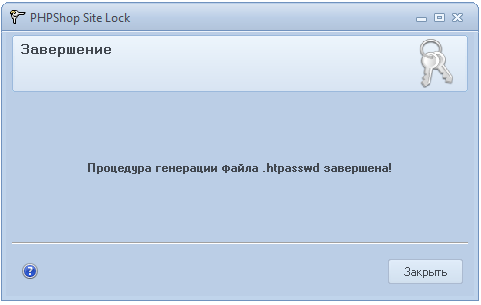

**Скриншоты процесса установки пароля**

SiteLock входит в комплект наших фирменных бесплатных утилит [EasyControl](http://www.phpshop.ru/loads/files/setup.exe).

Про некоторые их них мы уже [писали](http://habrahabr.ru/company/phpshop/blog/).

SiteLock так же доступен отдельно в виде скачиваемого [приложения](http://www.phpshop.ru/loads/files/sitelock.exe) (700 Кб) для использования на сторонних проектах.

Надеемся, что SiteLock будет вам полезен. Пожелания по доработке SiteLock приветствуются. | https://habr.com/ru/post/226003/ | null | ru | null |

# Комитет Госдумы: за лайки и репосты сохранится уголовная ответственность

*Пользователь «Вконтакте» Элина Мамедова из села Чехово (Большая Ялта), которую [обвинили](https://pravo.ru/news/205109/) по 282 статье УК РФ за репосты, сделанные в 2014 и 2015 гг, попросили сдать образец ДНК, слюны и голоса для «базы экстремистов»*

Комитет Госдумы по безопасности и противодействию коррупции [подготовил отрицательное заключение](https://ria.ru/society/20180913/1528500219.html) на проект закона, исключающий уголовную ответственность за репосты в интернете.

За лайки и репосты часто вменяется [статья 282 УК РФ](http://www.consultant.ru/document/cons_doc_LAW_10699/d350878ee36f956a74c2c86830d066eafce20149/) «Возбуждение ненависти либо вражды, а равно унижение человеческого достоинства» (до 5 лет тюремного заключения). Администрация «Вконтакте» помогает устанавливать личности пользователей даже без документально подтверждённого запроса правоохранительных органов.

Десятки пользователей соцсетей уже осуждены по уголовной статье за лайки и репосты. В таких условиях появилась идея вывести данную область из сферы действия уголовного кодекса. Соответствующий законопроект был [опубликован](http://sozd.parliament.gov.ru/bill/495566-7) на сайте системы обеспечения законотворческой деятельности в июне 2018 года. Экспертный совет Госдумы по развитию информационного общества при молодёжном парламенте тоже [предложил изменить меру ответственности за лайки и репосты в социальных сетях](https://www.kommersant.ru/doc/3739330).

Но законопроект и предложения экспертного совета не нашли понимания у коллег. Депутат Госдумы от «Единой России» Сергей Железняк [заявил](https://www.kommersant.ru/doc/3739330), что «нельзя потворствовать манипулированию и информационным войнам», а потому нельзя смягчать наказание за репосты.

«Идея юридически прописана неправильно. Надо по-другому сформулировать, тогда мы поработаем, пообщаемся с экспертами. Проект не поддержан никем», — [сказал](https://ria.ru/society/20180913/1528500219.html) глава комитета Василий Пискарев. Он подчеркнул, что проект о декриминализации лайков и репостов в соцсетях не поддержали правительство РФ и Верховный суд.

«Вконтакте» помогает

====================

Уголовные дела в России чаще всего заводят именно за публикации «Вконтакте». Почему? Это [популярно объясняют](https://t.me/zalayk/13) авторы телеграм-канала [«Ты сядешь за лайк»](https://t.me/zalayk).

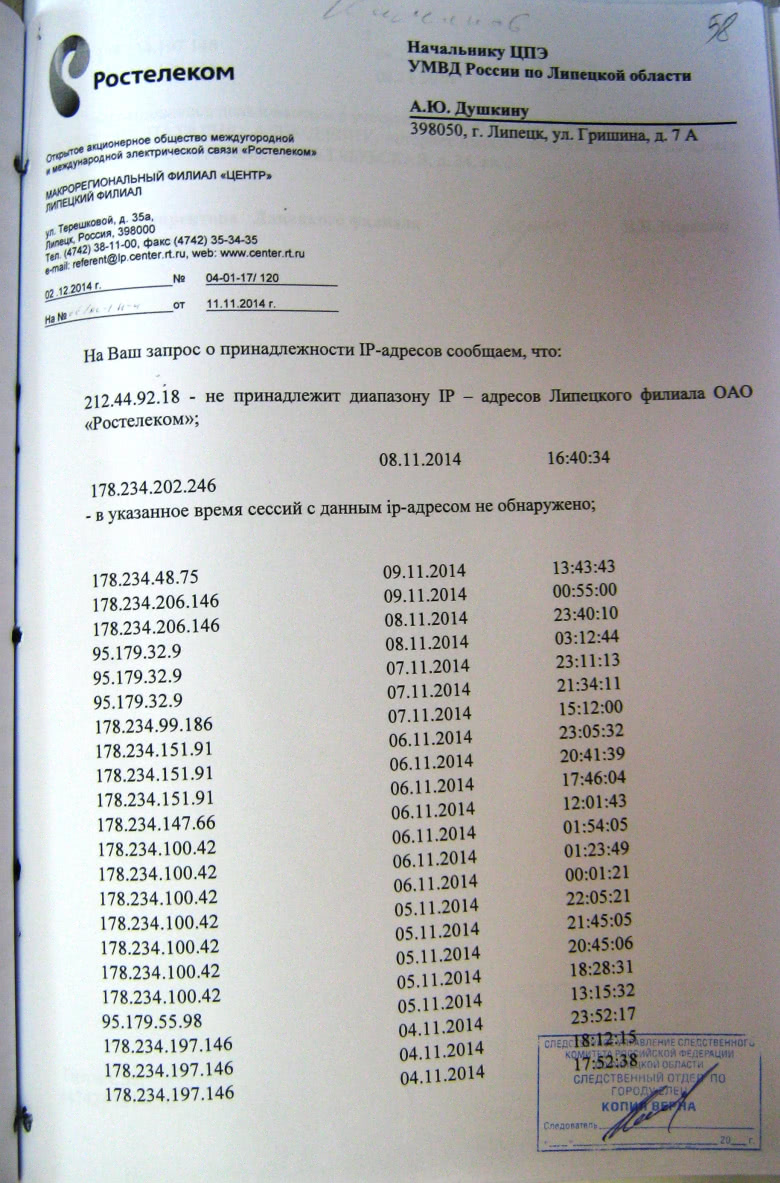

Дело в том, что администрация российского сервиса охотно идёт на контакт и активно помогает правоохранительным органам. Списки IP-адресов и другие конфиденциальные данные иногда высылают даже без официального запроса, просто по желанию, которое сотрудник правоохранительных органов выразил в письме по электронной почте.

Администрация «Вконтакте» сообщает IP-адреса посетителей страницы и телефонный номер, к которым привязана страница любого своего пользователя. После этого делается запрос оператору связи, который обслуживает данный телефонный номер: кто заходил с данного IP на страницу в указанное в ответе от ВКонтакте время. Ответы на эти запросы являются доказательством того, что страница принадлежит конкретному человеку.

[](https://habrastorage.org/webt/sw/hw/fm/swhwfm7e-vlnm4jvyj6x61gzz-8.jpeg)

*Образец ответа «Ростелекома» (оригинал открывается по щелчку)*

И всё — доказательная база собрана. Можно заводить уголовное дело, проводить обыск у подозреваемого и изымать компьютерную технику из квартиры для поиска улик.

*Пользователь «Вконтакте» Мария Мотузная, на которую завели уголовное дело [за публикацию мемов](https://twitter.com/La72La/status/1022767362439827456) про религию. Девушку обвинили в «унижении негроидной расы». Пятое судебное заседание по делу Мотузной [состоится 25 сентября](https://zona.media/online/2018/09/11/motuznaya-4)*

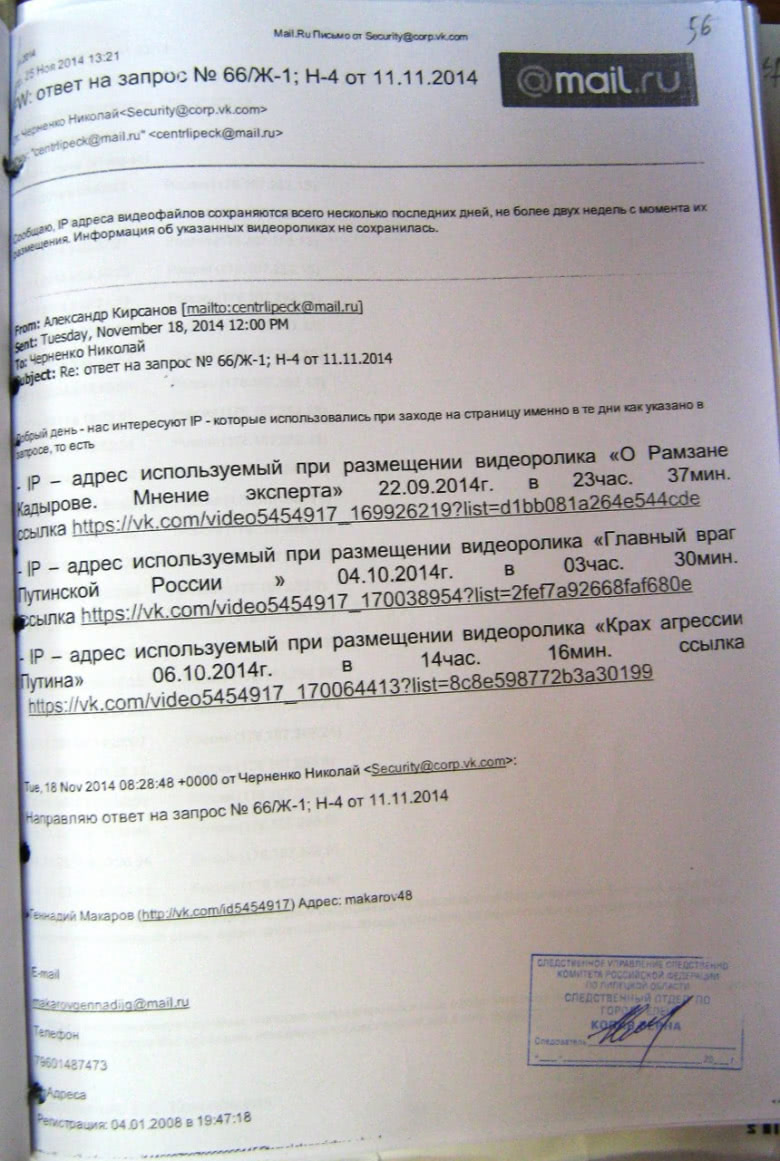

Проблема в том, что по закону ресурсы обязаны отвечать на такие запросы только по решению суда. Но у «Вконтакте» есть специальный почтовый ящик, куда сотрудники любых органов отправляют сканы или даже фотографии запросов, а иногда даже просто текстовые запросы с абсолютно случайных почтовых адресов: «Как вы думаете, что должна сделать законопослушная социальная сеть в ответ на такой запрос? — Правильно, проигнорировать эту филькину грамоту и запросить решение суда. Но ВКонтакте — не просто законопослушная социальная сеть, а очень законопослушная, она дружит с государственными органами. Поэтому ВКонтакте отдаёт информацию вообще на любые письма с запросами. Страшно представить, сколько там фейковых запросов от мамкиных дианонщиков. Да-да, вы правильно поняли — **ВКонтакте помогает сажать своих пользователей**», — пишут авторы канала «Ты сядешь за лайк». Они также опубликовали почтовый ящик для таких запросов (*[email protected]*) и приложили распечатку ответа от администрации социальной сети.

[](https://habrastorage.org/webt/s3/nb/i3/s3nbi3wbkiaodji9ex0xmder4ig.jpeg)

*Пример ответа от сотрудника «Вконтакте» на неофициальный запрос персональных данных, полученный с почтового ящика `@mail.ru` (оригинал открывается по щелчку)*

В последнее время администрация [просит правоохранителей](https://t.me/pchikov/1459) присылать запросы на выдачу конфиденциальных данных по электронной почте хотя бы с официального почтового адреса, а не с `@mail.ru`.

Общественное мнение

===================

По [данным](https://fom.ru/Bezopasnost-i-pravo/14091) фонда «Общественное мнение» (ФОМ), 55% россиян одобряют идею уголовного наказания за публикации в соцсетях, а также считают, что за репосты россиянин должен нести такую же ответственность, как и за свой собственный материал. По мнению респондентов общероссийского опроса, репост является источником распространения информации и он может расшатывать общество и тем самым вредить ему.

После отрицательного заключения профильного комитета перспектива принятия законопроекта о декриминализации лайков и репостов выглядит сомнительной.

> **Предупреждение по просьбе администрации сайта:** «При комментировании этого материала просим соблюдать правила. Пожалуйста, воздержитесь от оскорблений и токсичного поведения. В комментариях работает постмодерация». | https://habr.com/ru/post/423211/ | null | ru | null |

# Компоненты. Тестирование-консоль

[в начало заметок о компонентах](http://habrahabr.ru/post/209350/)

текущая версия vs. v1

---------------------

Компоненты можно тестировать в консоли, как обычные `node.js` модули. К сожалению, к текущей версии в этом случае есть проблемы с использованием зависимостей, например, завязаных на DOM. То есть если я тестирую компоненту к консоли, запуская, скажем node `node mocha ...`, я не могу просто сделать `require` другой компоненты, завязаной на DOM. В любом случае в консоли `require` подхватит модуль node.js, а не компоненту. А в модуле domify node.js нет объекта document. В будущих версиях билдера компонент ситуация изменится. См. <https://github.com/component/component/issues/41>. Пока что для тестирования этих компонент в консоли можно использовать phantom.

В текущей версии приходится использовать (причем в теле компоненты, но только для целей тестирования) что-то вроде (см. `component/router`):

```

try {

var Route = require('route-component');

} catch (err) {

var Route = require('route');

}

```

Я на этом останавливаться не буду, подождем v1. В данном посте сначала посмотрим, как устроено юнит-тестирование компонент на низком уровне, т.е. вручную, потом я напишу об автоматизации этого процесса. О интегральном тестировании js-приложений тоже написано много, я на этом также останавливаться не буду.

Простые же компоненты, не имеющие отличий (кроме обертки) от параллельного node-модуля, такие как, например `component/indexof`, `component/each`, использовать как зависимости можно уже прямо сейчас, mocha-тесты в консоли будут работать.

Код примера доступен по адресу <https://github.com/mbykov/component-testing-example>. Клонируйте и посмотрите его.

юнит vs. интегральные тесты

---------------------------

Что такое интегральный тест понятно — мы тестируем само приложение, в боевой позиции (если отвлечься от stubs & mocks). Мы используем Cucumber, Selenium, Capybara и смотрим, чтобы отклик приложения как целого соответствовал ожиданиям. Юнит-тест — это тест отдельного метода в компоненте. Вызывается *только* данный метод, и если затрагивается что-то еще, то это плохо. Такое вот доморощенное определение. Компоненты, однако, именно так и проектируются. В них есть внутренние функции, недоступные снаружи, и они, естественно, недоступны и для тестирования. И экспортируемые методы, которые мы вполне способны вызвать откуда угодно.

test/test.js

------------

Создадим простейшую компоненту для консольного теста. Пусть нам нужно узнать, скажем, следующую букву. Мы забыли, что идет вслед за `в` — `г` или `д`. Или, скажем, вслед за `ξ` — `η` или `λ`? (Этот «игрушечный» метод годится только для символов без акцентов).

Пусть в компоненте у нас будут два метода, `sym` для преобразования символа, и `word` — для слова. В нем воспользуемся готовой компонентой `component/map` для удобства.

в компоненте должно быть всего лишь

```

var map = require('map-component');

module.exports = nextSym;

function nextSym() {

if (!(this instanceof nextSym)) return new nextSym();

return this;

}

```

и два метода,

```

nextSym.prototype.sym = function(sym){

return String.fromCharCode(sym.charCodeAt(0)+1);

}

nextSym.prototype.word = function(word){

var self = this;

var arr = word.split('');

var res = map(arr, function(sym) {

return self.sym(sym);

})

return res.join('');

}

```

строка if (!(this instanceof example)) return new example() является магическим заклинанием, означающим, что нам не нужно будет писать оператор new при вызове компоненты.

```

$ make

```

package.json, mocha & should

----------------------------

будем использовать фреймворк mocha (кофе мокко) того же автора, [TJ Holowaychuk](http://visionmedia.github.io/mocha/) и [Should Assertion Library](https://github.com/visionmedia/should.js).

Теперь мы используем, по-сути, не компоненты, а node.js, так что создадим файл `package.json`

```

$ npm init

```

в файле `package.json` укажем необходимые нам зависимости

```

"version": "0.0.1",

"dependencies": {

"map-component": "*"

},

"devDependencies": {

"mocha": "*",

"should": "*"

},

```

map-component необходима как пример зависимости для работы компоненты, а mocha и should — для выполнения тестов.

```

$ npm install

```

makefile & test.js

------------------

чтобы не вызывать тесты в консоли руками, в фале Makefile запишем пункт test;

```

test:

@./node_modules/.bin/mocha \

--require should \

--reporter spec

```

mocha по умолчанию ищет тесты в директории test. Создадим файл test.js

```

var nextSym = require('..')();

describe('component console example', function(){

describe('symbol', function() {

it('б before а', function() {

var next = nextSym.sym('а');

next.should.be.equal('б');

})

})

describe('word', function() {

it('shifted qwerty is rxfsuz', function() {

var shifted= nextSym.word('qwerty');

shifted.should.be.equal('rxfsuz');

})

})

})

```

выполняем тест

```

component console example

symbol

✓ б before а

word

✓ shifted qwerty is rxfsuz

2 passing (19ms)

```

Однако компоненты предназначены для работы в браузере. Так что и тестирование в консоли — скорее исключение. Тестирование должно производиться в браузере, и быть удобным. См. след. разделы.

*продолжение следует* | https://habr.com/ru/post/209372/ | null | ru | null |

# Кастомизация каптчи в Zend Framework 2

Компонент *Zend\Captcha* может принимать различные формы, в том числе задавать логические вопросы, генерировать искаженные шрифты, и передавать несколько изображений, установив между ними связь. *Zend\Captcha* имеет целью обеспечить разнообразие серверных решений, которые могут быть использованы либо в автономном режиме либо в сочетании с *Zend\Form* компонентой.

Элемент Captcha имеет более одного поля, которые рендерятся друг за другом. Встроеный генератор изображений каптч (*Zend\Captcha\Image.php*) использует свой собственный хелпер (*Zend\Form\View\Helper\Captcha\Image.php*) для создания изображения. Так-же, в *Zend\Captcha\Image.php* находится метод 'getHelperName'. Этот метод передает имя хелпера для рендеринга изображения каптчи. По умолчанию 'getHelperName' передает 'captcha/image' — экземпляр класса *Zend\Form\View\Helper\Captcha\Image.php*. Если углубиться с помощью дебаггера, можно увидеть, что в свойстве экземпляра *phpRenderer::\_\_helpers*, в *invokablesClasses* располагается хелпер 'captchaimage'. Это и есть *Zend\Form\View\Helper\Captcha\Image.php*, упомянутый ранее. Грубо говоря — вы просто создаете изображение, а всё остальное делает за вас рендерер используя хелпер, хотя такое положение вещей устраивает не всех.

Когда же вы создаете элемент формы Captcha (*Zend\Form\Element\Captcha.php*), вы передаете этому элементу изображение каптчи(*Zend\Captcha\Image.php*). Элемент формы Captcha, в свою очередь, имеет тоже свой хелпер (*Zend\Form\View\Helper\FormCaptcha.php*). В методе render этого хелпера вы увидите, что изображение каптчи (*Zend\Captcha\Image.php*) загружается с помощью ElementInterface:

```

//Zend\Form\View\Helper\FormCaptcha.php

public function render(ElementInterface $element)

{

$captcha = $element->getCaptcha();

```

после чего вызывается хелпер через метод 'getHelperName':

```

$helper = $captcha->getHelperName();

```

В итоге мы получаем экземпляр класса хелпера посредством экземпляра PhpRenderer и возвращаем представление:

```

$helper = $renderer->plugin($helper);

return $helper($element);

```

Нам нужно четко представлять различие между 'элементом формы Captcha и его хелпером' и 'изображением Captcha также со своим хелпером'. Мы передадим 'изображение каптчи' 'элементу формы Captcha', который уже располагает привязанным хелпером. Метод render 'элемента формы Captcha' встроит экземпляр 'изображения Captcha', который мы передали, используя хелпер для генерации изображения и вернет представление. Все, что нужно сделать, это передать 'изображению Captcha' новый хелпер, который отобразит представление так, как нас устроит и переписать *Zend\Captcha\Image.php*, чтоб он получил наш новый хелпер, а не свой по умолчанию.

Перед тем как начать, давайте обратим внимание на несколько деталей:

хелпер *Zend\Form\View\Helper\Captcha\Image.php* для отображения каптчи определяет паттерн как %s%s%s:

```

$pattern = '%s%s%s';

```

Таким образом, первое, что необходимо — наш кастомный хелпер с собственным паттерном. Давайте создадим его в модуле Application:

```

//module\Application\src\Application\View\Helper\Form\Captcha\ViewHelperCaptcha.php

php

namespace Application\View\Helper\Form\Captcha;

use Zend\Form\View\Helper\Captcha\AbstractWord;

use Application\View\Helper\Form\Captcha\CustomCaptcha as CaptchaAdapter;

use Zend\Form\ElementInterface;

use Zend\Form\Exception;

class ViewHelperCaptcha extends AbstractWord

{

/**

* Override

*

* Render the captcha

*

* @param ElementInterface $element

* @throws Exception\DomainException

* @return string

*/

public function render(ElementInterface $element)

{

//Мы можем установить здесь разделитель между изображением и полем ввода.

$this-setSeparator('')

$captcha = $element->getCaptcha();

if ($captcha === null || !$captcha instanceof CaptchaAdapter) {

throw new Exception\DomainException(sprintf(

'%s requires that the element has a "captcha" attribute of type Zend\Captcha\Image; none found',

__METHOD__

));

}

//Как долго будет храниться изображение (по умолчанию 600).

$captcha->setExpiration(10);

//Как часто выполнять очистку файлов(по умолчанию 10). При данной конфигурации старый файл затирается вновь созданным.

$captcha->setGcFreq(1);

$captcha->generate();

$imgAttributes = array(

'width' => $captcha->getWidth(),

'height' => $captcha->getHeight(),

'alt' => $captcha->getImgAlt(),

'src' => $captcha->getImgUrl() . $captcha->getId() . $captcha->getSuffix(),

);

$closingBracket = $this->getInlineClosingBracket();

$img = sprintf(

'![]()createAttributesString($imgAttributes),

$closingBracket

);

$position = $this->getCaptchaPosition();

$separator = $this->getSeparator();

$captchaInput = $this->renderCaptchaInputs($element);

//Наш измененный паттерн

$pattern = '

%s

%s

%s'

if ($position == self::CAPTCHA_PREPEND) {

return sprintf($pattern, $captchaInput, $separator, $img);

}

return sprintf($pattern, $img, $separator, $captchaInput);

}

}

```

Класс нашего хелпера дублирует класс *Zend\Form\View\Helper\Captcha\Image.php* с небольшими изменениями. Наш хелпер не использует *Zend\Captcha\Image.php* для генерации изображения, в отличие от оригинального. Помните, что *Zend\Captcha\Image.php* предоставляет метод 'getHelperName' который возвращает жёстко закодированное имя хелпера 'captcha/image', таким образом, когда форма будет генерировать изображение, она получит для этого не свой хелпер по умолчанию, а только что созданный нами. Что еще нужно, так это передать в phpRenderer наш кастомный хелпер и сгенерировать новое изображение каптчи, которое будет расширять оригинальный класс *Zend\Captcha\Image.php* и перепишет метод 'getHelperName' установив имя хелпера, который мы создали.

Итак, давайте добавим наш класс в конфигурацию хелперов phpRenderer invokables. Реализуем это в module.config.php:

```

//module\Application\config\module.config.php

...

'view_helpers' => array(

'invokables' => array(

'viewhelpercaptcha' => 'Application\View\Helper\Form\Captcha\ViewHelperCaptcha',

),

),

```

Следующим шагом будет создание изображения каптчи, которое возвратит наш хелпер добавленный в конфигурацию модуля как phpRenderer invokables класс. Нет нужды переопределять весь класс *Zend\Captcha\Image.php*, достаточно указать методу 'getHelperName' наш кастомный класс хелпера в качестве параметра. Для этого создадим класс, и назовем его, например, *CustomCaptcha.php* в папке *module\Application\src\Application\View\Helper\Form\Captcha*. Мы собираемся расширить оригинальный класс *Zend\Captcha\Image.php* и переопределить метод 'getHelperName' чтобы он вернул наш хелпер 'viewhelpercaptcha'. Не помешает также переопределить сообщения об ошибках в свойстве $messageTemplates. На ваше усмотрение.

```

//module\Application\src\Application\View\Helper\Form\Captcha\CustomCaptcha.php

php

namespace Application\View\Helper\Form\Captcha;

//Оригинальный класс, который мы расширим.

use Zend\Captcha\Image as CaptchaImage;

//Новая версия класса, в которой мы изменим только необходимое.

class CustomCaptcha extends CaptchaImage

{

protected $messageTemplates = array(

self::MISSING_VALUE = 'Отсутствует значение',

self::MISSING_ID => 'Поле ID отсутствует',

self::BAD_CAPTCHA => 'Неверно введено значение',

public function getHelperName()

{

return 'viewhelpercaptcha';

}

}

```

Последнее, что нам нужно сделать — использовать наше CustomCaptcha изображение в форме. Для этого создадим две папки: одну для шрифта (zf2folder/data/fonts), который понадобится чтобы генерировать слова каптчи, и другую, для хранения файлов изображений каптч (zf2folder/public/img/captcha). Естественно, в папку fonts скопируем шрифт \*.ttf, например arial.ttf.

Для примера можно взять форму из официального туториала:

```

php

namespace Album\Form;

use Zend\Form\Form;

use Application\Form\View\Helper\Captcha\CustomCaptcha;

class AlbumForm extends Form

{

public function __construct($name = null)

{

//Имя формы можно игнорировать

parent::__construct('album');

$this-setAttribute('method', 'post');

//Здесь расположены стандартные элементы

...

//Здесь будем создавать элемент Captcha

$dirdata = './data';

//Создаем новый CustomCaptcha класс

$captchaImage = new CustomCaptcha(array(

'font' => $dirdata . '/fonts/arial.ttf',

'width' => 120,

'height' => 60,

'fsize' => 20,

'wordLen' => 5,

'dotNoiseLevel' => 25,

'lineNoiseLevel' => 2

));

//Назначаем директорию для хранения файлов

$captchaImage->setImgDir('public/img/captcha/');

//Назначаем путь для загрузки файлов каптчи

$captchaImage->setImgUrl('/img/captcha/');

$captchaImage->setImgAlt('Вы человек или робот?');

//Создаем элемент формы Captcha куда добавим нашу CustomCaptcha, созданную выше

$this->add(array(

'type' => 'Zend\Form\Element\Captcha',

'name' => 'captcha',

'options' => array(

'captcha' => $captchaImage,

),

'attributes' => array(

'class' => 'some_class',

)

));

$this->add(array(

'name' => 'submit',

'attributes' => array(

'type' => 'submit',

'value' => 'Go',

'id' => 'submitbutton',

),

));

}

}

```

Добавим в файл вида элемент нашей капчи

```

echo $this->formRow($form->get('captcha')) . PHP_EOL;

```

Изучив структуру html документа, получившегося на выходе, вы увидите, что теперь изображение и поле ввода каптчи обернуты в div-ы. Мы получили более упорядоченный дизайн.

Использованные источники:

[framework.zend.com/manual/2.2/en/modules/zend.captcha.intro.html](http://framework.zend.com/manual/2.2/en/modules/zend.captcha.intro.html)

[framework.zend.com/manual/2.2/en/modules/zend.captcha.operation.html](http://framework.zend.com/manual/2.2/en/modules/zend.captcha.operation.html)

[framework.zend.com/manual/2.2/en/modules/zend.captcha.adapters.html](http://framework.zend.com/manual/2.2/en/modules/zend.captcha.adapters.html)

[framework.zend.com/manual/2.2/en/user-guide/forms-and-actions.html](http://framework.zend.com/manual/2.2/en/user-guide/forms-and-actions.html)

[zendtemple.blogspot.com/2012/12/zend-framework-2-zf2-creating-view.html](http://zendtemple.blogspot.com/2012/12/zend-framework-2-zf2-creating-view.html)

[samsonasik.wordpress.com/2012/09/12/zend-framework-2-using-captcha-image-in-zend-form](http://samsonasik.wordpress.com/2012/09/12/zend-framework-2-using-captcha-image-in-zend-form/) | https://habr.com/ru/post/183232/ | null | ru | null |

# Yii 2.0.6

Состоялся релиз PHP фреймворка Yii версии 2.0.6.

Инструкции по установке и обновлению доступны по адресу <http://www.yiiframework.com/download/>.

Версия 2.0.6 является патч-релизом для ветки 2.0 и содержит [более 70 небольших улучшений и исправлений](https://github.com/yiisoft/yii2/blob/2.0.6/framework/CHANGELOG.md), многочисленные улучшения документации и значительный прогресс с её переводом.

Спасибо всем, кто [участвует в разработке фреймворка](https://github.com/yiisoft/yii2/graphs/contributors). Ваши pull-request-ы, обсуждения и другая помощь незаменимы.

За процессом разработки фреймворка можно следить [поставив звёздочку или нажав кнопку «watch» на GitHub](https://github.com/yiisoft/yii2).

Также можно подписаться на наши [Twitter](https://twitter.com/yiiframework) и [Facebook](https://www.facebook.com/groups/yiitalk/).

Далее представлен небольшой обзор самых интересных нововведений.

Улучшенный синтаксис миграций

-----------------------------

Изначально мы планировали построитель схемы в версии 2.1, но [pana1990](https://github.com/pana1990) и [vaseninm](https://habrahabr.ru/users/vaseninm/) отлично поработали и теперь синтаксис в миграциях стал намного более приятным:

```

$this->createTable('example_table', [

'id' => $this->primaryKey(),

'name' => $this->string(64)->notNull(),

'type' => $this->integer()->notNull()->defaultValue(10),

'description' => $this->text(),

'rule_name' => $this->string(64),

'data' => $this->text(),

'created_at' => $this->datetime()->notNull(),

'updated_at' => $this->datetime(),

]);

```

Обработка ошибок

----------------

В данном релизе довольно много исправлений и улучшений, призванных сделать обработку ошибок ещё более стабильной и полезной:

— Yii теперь отлично справляется с фатальными ошибками HHVM.

— Если `FileCache` не сумел записать в файл, это будет видно в логах.

— `yii\web\ErrorAction` теперь показывает 404, а не пустую страницу в случае прямого перехода по URL.

— Когда `yii migrate` отказывается работать из за отсутствующей директории, путь к ней показывается в ошибке.

— `Json::encode()` и `Json::decode()` лучше обрабатывают ошибки, кидая понятные исключения.

— `ErrorHandler::logException()` теперь логирует весь объект, а не только его строковое представление.

Больше контроля над ActiveForm из JavaScript

--------------------------------------------

Вы можете обновлять ошибки для определённых полей:

```

// добавить ошибку

$('#contact-form').yiiActiveForm('updateAttribute', 'contactform-subject', ["I have an error..."]);

// убрать ошибку

$('#contact-form').yiiActiveForm('updateAttribute', 'contactform-subject', '');

```

Или для всех полей и резюме сразу:

```

$('#contact-form').yiiActiveForm('updateMessages', {

'contactform-subject': ['Really?'],

'contactform-email': ['I don\'t like it!']

}, true);

```

Улучшения `yii message`

-----------------------

Теперь поддерживается создание файлов `.pot`.

Команда теперь отлично переваривает вложенные вызовы:

```

Yii::t('app', 'There are new {messages} for you!', [

'messages' => Html::a(Yii::t('app', 'messages'), ['user/notifications']),

]);

```

Также теперь сортировка происходит даже при отсутствии новых строк, что позволяет получить меньший diff.

Кроме того, была добавлена опция `markUnused`, позволяющая отключить добавление `@@` к неиспользуемым строкам.

Asset-ы

-------

Теперь можно настроить, что публиковать, а что нет:

```

class MyAsset extends AssetBundle

{

public $sourcePath = '@app/assets/js';

public $js = [

'app.js',

];

public $depends = [

'yii\web\YiiAsset',

];

public $publishOptions = [

'except' => '*.ts', // exclude TypeScript sources

// 'only' => '*.js', // include JavaScript only

];

}

```

Можно изменить алгоритм хеширования для имён директорий из `web/assets`. Сделать это можно прямо из конфигурации приложения:

```

return [

// ...

'components' => [

'assetManager' => [

'hashCallback' => function ($path) {

return hash('md4', $path);

}

],

],

];

```

Дополнительные поля в хранилище сессий

--------------------------------------

Теперь вы можете легко хранить дополнительные данные в хранилище сессий. Пока поддерживается только `yii\web\DbSession`, но в будущем поддержка может быть расширена. Для конфигурации надо изменить конфигурацию приложения:

```

return [

// ...

'components' => [

'session' => [

'class' => 'yii\web\DbSession',

'readCallback' => function ($fields) {

return [

'expireDate' => Yii::$app->formatter->asDate($fields['expire']),

];

},

'writeCallback' => function ($session) {

return [

'user_id' => Yii::$app->user->id,

'ip' => $_SERVER['REMOTE_ADDR'],

'is_trusted' => $session->get('is_trusted', false),

];

}

],

],

];

``` | https://habr.com/ru/post/264159/ | null | ru | null |

# Отзывчивые изображения на практике (Часть 3)

Последняя часть истории об отзывчивых изображениях, которую мы начали [здесь](http://habrahabr.ru/company/paysto/blog/244175/) и продолжили [тут](http://habrahabr.ru/company/paysto/blog/244177/), рассказывая о применении srcset и sizes. Сегодня речь пойдет об использовании тега для обертывания изображений.

**Вторая стадия: picture и режиссура**

> srcset для ленивых, picture для безумных

>

> Мэт Маркес

>

>

Итак, для изображений, которые просто нужно масштабировать, мы приводим список наших исходников и их ширину в пикселях в srcset, позволяем браузеру выбирать, какая ширина изображения будет отображаться с помощью sizes, и отпускаем наше безумное желание все контролировать. Но! Иногда нам захочется адаптировать наши изображения, выходя за рамки масштабирования. В таком случае, нам нужно вернуть небольшую часть контроля над подбором исходников. Вводим picture.

У наших детальных изображений большое соотношение сторон – 16:9. На больших экранах они выглядят отлично, но на телефоне они становятся крошечными. Простежка и вышивка, которые нужно показать на детальных изображения, слишком мелкие, чтобы их рассмотреть.

Было бы неплохо, если бы мы могли «увеличивать» изображения на маленьких экранах, представляя их в более плотном и высоком виде.

Такие вещи – подгон контента изображений под отдельные среды – называются «режиссурой». Каждый раз, когда мы обрезаем или иным образом изменяем изображение, чтобы оно соответствовало контрольной точке (вместо изменения размера всего), мы занимаемся режиссурой.

Если мы включаем увеличенные обрезанные изображения в srcset, неизвестно, где они подойдут, а где – нет. С помощью picture и source media мы можем сделать наши желания реальностью: загружать широкие прямоугольные кадры только когда окно шире 36 em. А в небольших окнах всегда загружать квадратные картинки.

```

```

Элемент picture содержит любое количество исходных элементов и один img. Браузер просматривает все исходники изображений, пока не найдет атрибут media, который соответствует текущей среде. Он отправляет srcset подходящего исходника в img, который до сих пор остается тем элементом, который мы «видим» на странице.

Вот более простой пример:

```

```

В окнах с альбомной ориентацией в img подается landscape.jpg. При книжной ориентации (или если браузер не поддерживает picture) img не изменяется, и загружается portrait.jpg.

Это поведение может показаться вам слегка удивительным, если вы привыкли к аудио и видео. В отличие от этих элементов, picture представляет собой невидимую обложку: волшебный span, который задает изображению значение srcset.

Еще один способ кадрирования: img – это не шаг назад. Мы прогрессивно улучшаем img, обертывая его в picture.

На практике это означает, что любые стили, которые мы хотим применить к нашему изображению на экране, необходимо настраивать с учетом img, а не picture. Код picture { width: 100% } ничего не делает. Код picture > img { width: 100% } делает то, что нам нужно.

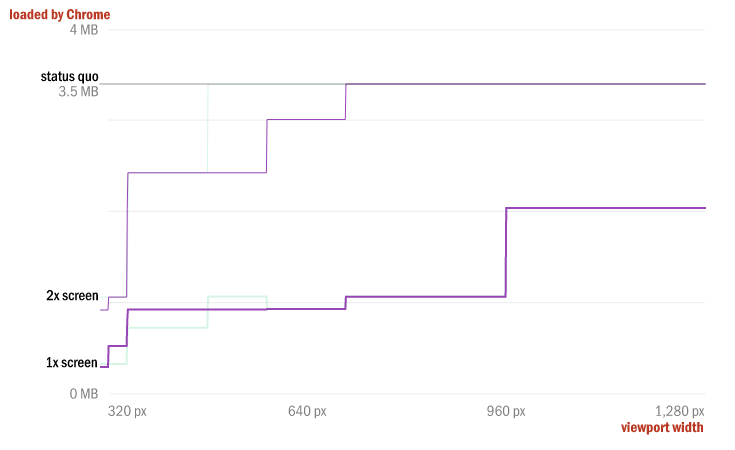

Вот наша страница лоскутных одеял с примененным шаблоном. Вспоминаем, что целью использования picture было предоставить пользователям с небольшими экранами больше (и более полезных) пикселей, и смотрим на то, как развивается производительность:

Неплохо! Мы отправляем немного больше байтов на 1х-экранах. Но по каким-то сложным причинам, имеющим отношение к размерам наших исходных изображений, мы фактически увеличили диапазон размеров экранов, которые ощущают рост производительности на 2х. Экономия на первой стадии изменения страницы остановилась на 480 пикселях для 2х-экранов, но после нашей второй стадии она расширилась вплоть до 700 пикселей.

Теперь наша страница загружается быстрее и лучше выглядит на небольших устройствах. Но мы еще не закончили.

**Третья стадия: делаем несколько форматов с помощью source type**

За 25-летнюю историю интернета в нем доминировали два растровых формата: JPEG и GIF. PNG потребовалось десять мучительных лет, чтобы вступить в этот эксклюзивный клуб. Новые форматы, такие как WebP и JPEG XR, уже стоят на пороге, обещая разработчикам превосходное сжатие и предлагая такие полезные функции, как альфа-каналы и режимы без потерь. Но ввиду одинокого атрибута изображений src, внедрение происходит очень медленно – разработчикам нужна практически универсальная поддержка формата, прежде чем они смогут его использовать. Но не сегодня. picture позволяет легко использовать несколько форматов, следуя той же модели source type, которая установлена для audio и video:

```

```

Если браузер поддерживает атрибут type исходника, он отправит srcset этого исходника в img.

Это довольно простой пример, но когда мы наслаиваем переключение source type поверх нашей существующей страницы лоскутных одеял чтобы, скажем, добавить поддержку WebP, все становится слишком сложным (и повторяющимся):

```

```

Получается слишком много кода для одного изображения. Кроме того, теперь у нас еще и большое количество файлов: целых 12! Три разрешения, два формата и два типа кадрирования на каждое изображение – это реально много. Все, чего мы добились в отношении производительности и функциональности, получается за счет предварительного столкновения со сложностями и дальнейшей возможности сопровождения.

Автоматизация – ваш друг; если подразумевается, что ваша страница будет содержать массивные блоки кода, ссылающиеся на большое количество различных версий изображения, лучше не делать это все вручную.

То же самое с пониманием, что хорошего должно быть понемногу. Я использовал все инструменты из спецификаций на нашем примере. Это почти никогда не будет рассудительным. Огромного увеличения эффективности можно добиться, используя любую из новых функций по отдельности, и вы должны тщательно рассмотреть все сложности их наслоения, прежде чем сохранять и делать все нужное и ненужное.

Но все-таки, давайте посмотрим, что WebP может сделать для наших одеял.

Дополнительные 25-30% экономии свыше того, чего мы уже достигли – не только на нижнем пределе, но и по всему диапазону – это определенно не шутка! Моя методология здесь ни в коем случае не является точной; ваша производительность с WebP может отличаться. Суть в том, что новые форматы, которые обеспечивают значительную выгоду по сравнению с текущим положением JPEG/GIF/PNG, уже существуют и продолжают появляться. Атрибуты picture и source type снижают барьер доступа, навечно расчищая путь для инноваций в области форматов изображений.

**Используем size уже сегодня**

На протяжении многих лет мы знали, что отягощает наши отзывчивые страницы: изображения. Огромные изображения, созданные специально для огромных экранов, которые мы отправляли всем. Мы также знали, как решить эту проблему: отправлять различные исходники разным клиентам. Новая разметка позволяет нам делать именно это. srcset дает возможность предложить несколько версий изображения браузеру, который с помощью атрибута sizes подбирает из пачки наиболее подходящий исходник и загружает его. Атрибуты picture и source позволяют нам вмешаться и взять на себя немного больше контроля, гарантируя, что некоторые исходники будут выбраны, основываясь либо на медиа-запросах, либо на поддержке типа файла.

Вместе эти функции позволяют нам создавать адаптивные, гибкие и отзывчивые изображения. Они позволяют нам отправлять каждому нашему пользователю исходник, созданный специально для его устройства, обеспечивая значительный рост производительности. Вооруженные превосходным полизаполнением и имея понимание будущего, разработчики должны начать использовать такую разметку прямо сейчас!

**Полезные решения Paysto для читателей Хабра:** → [Получите оплату банковской картой прямо сейчас. Без сайта, ИП и ООО.](http://linkcharge.ru/email)

→ [Принимайте оплату от компаний через Интернет. Без сайта, ИП и ООО.](http://linkcharge.ru)

→ [Приём платежей от компаний для Вашего сайта. С документооборотом и обменом оригиналами.](http://linkcharge.ru/api)

→ [Автоматизация продаж и обслуживание сделок с юр.лицами. Без посредника в расчетах.](http://linkcharge.ru/automat) | https://habr.com/ru/post/244241/ | null | ru | null |

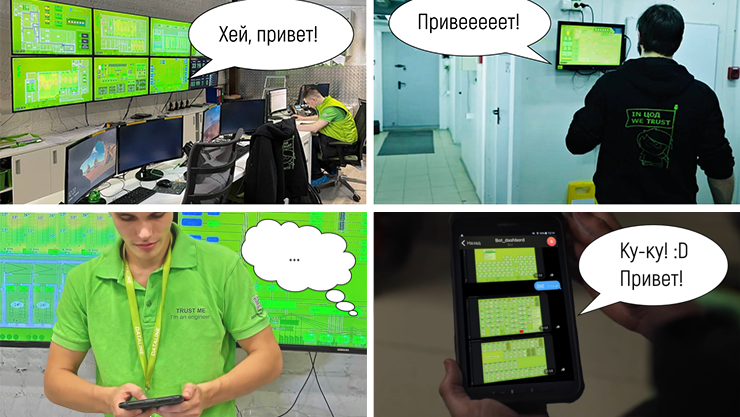

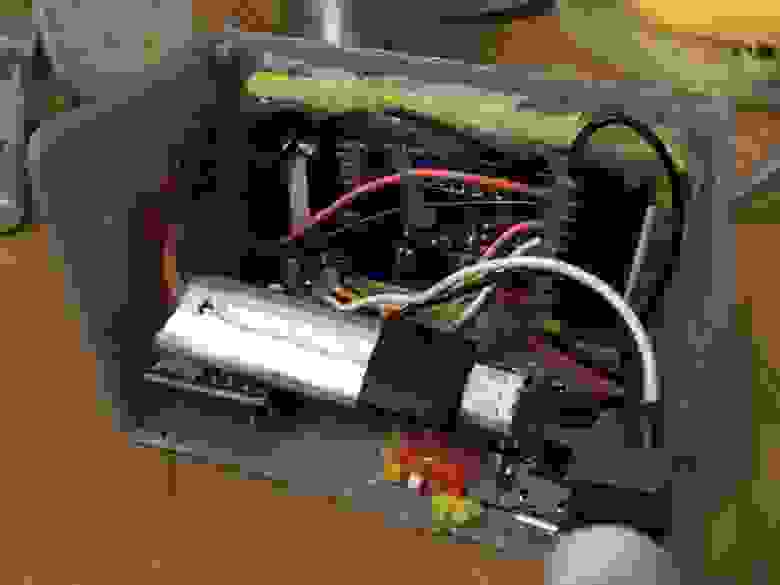

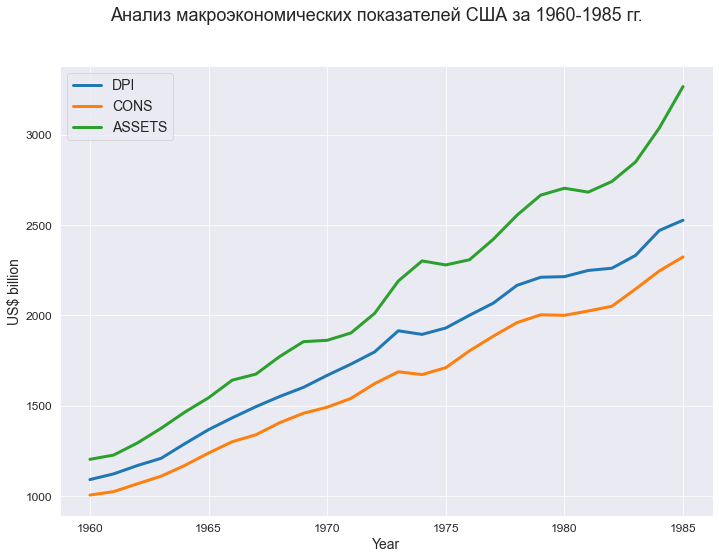

# Кастомизируем дашборды в Grafana для инженеров по холодоснабжению ЦОДа

Система мониторинга инженерной инфраструктуры – это нервная система дата-центра. С ее помощью инженеры вовремя видят неприятные симптомы на графиках и предотвращают проблемы в работе кондиционеров, бесперебойников, сетевых устройств и других элементов инженерных систем.

Наша система мониторинга на базе Nagios развивается вместе с сетью дата-центров, и мы уже много рассказывали о ее работе (например, в этом [цикле](https://uni.dtln.ru/digest/monitoring-inzhenernoy-infrastruktury-v-data-centre-chast-1-osnovnye-momenty)). Но нет предела совершенству, и чем дальше, тем больше хочется улучшить что-то еще: добавить новый “разрез” анализа, взглянуть на оборудование под другим углом.

В этой статье расскажем, как и для каких задач наши инженеры создают кастомные дашборды с помощью графического плагина [FlowCharting](https://grafana.com/grafana/plugins/agenty-flowcharting-panel/) для Grafana.

Что хотелось улучшить в мониторинге

-----------------------------------

Наша система мониторинга работает в более чем 10 дата-центрах и собирает сотни тысяч метрик о работе оборудования. Ее используют сразу несколько групп инженеров с разной специализацией:

* Дежурные инженеры – наша первая линия. Они следят за видеостеной в центре мониторинга, разбирают падающие в систему алерты от оборудования и ИТ-систем, эскалируют их на профильных инженеров.

Наша “дежурка” в OST.* Профильные инженеры из групп холодоснабжения, энергетики, сети и т.д. Они отслеживают показатели здоровья конкретной системы: от нагрузки на оборудование до статистики замены запчастей.

Каждой группе требуются разные данные для разных целей, поэтому для системы мониторинга важна гибкость в представлении информации:

* На видеостену в “дежурке” выносятся ключевые показатели, чтобы инженеры на смене сразу замечали проблемы и быстро принимали решения. Работа дежурных ведется по четким инструкциям, которые оттачивались годами, и следование им отрабатывается чуть ли не поминутно.

При этом инженеры ротируются между объектами. Поэтому отображение информации для видеостен стандартизировано и постоянно совершенствовалось нашей группой разработки (мы уже можем на этом материале написать диссертацию по инженерной психологии :))

* Профильные инженеры “проваливаются” в базу мониторинга глубже. Например, если дежурным достаточно знать статус работы кондиционера и температуру в зале, то инженерам-холодильщикам для своевременного обслуживания понадобятся десятки параметров: давление в контуре, степень открытия клапана, степень загрузки чиллера и т.д.

Такие оперативные данные нужны по каждой конкретной единице оборудования. Выносить их на общую видеостену не имеет смысла – не хватит места, либо дашборд получится таким перегруженным, что его придется читать с лупой.

Профильный инженер может посмотреть необходимую информацию из Nagios у себя на мониторе.

Например, так представлены в базе Nagios параметры одного из кондиционеров.А так выглядит часть параметров одного зала.В принципе, жить и работать с этим можно: есть фильтрация, группировка, – но для восприятия тяжело. От множества одинаковых строчек с мелким текстом устают глаза и “замыливается” взгляд.

Назрела необходимость создать отдельные дашборды для специализированных групп, где каждый инженер может настроить представление под себя.

Сделать это можно было несколькими инструментами:

1. Прикрутить визуализацию с помощью плагинов Nagios. Мы попробовали – нас не устроила сильно ограниченная функциональность.

2. Попросить сделать дашборды нашу группу разработки. Визуализации мониторинга для видеостен создавались так: движок писался на CFML, для конфигов использовался JSON. Для разработки новых дашбордов тоже потребовался бы программист. Чтобы разобраться в узкой инженерной логике, ему пришлось бы плотно пообщаться с каждой группой инженеров, а они у нас обычно сильно загружены “в полях”. Это сильно замедлило бы процесс.

Вдобавок в существующем фронтенде уже есть определенная доля легаси, и важно при изменениях ничего не сломать. К этой системе сложно предоставлять точечный доступ, чтобы не нарушить все зависимости. Поэтому и нельзя было поручить задачу разработчику-аутсорсеру.

Эту визуализацию для видеостены наша группа разработки выполнила с нуля. Самописный дашборд берет данные из Nagios и отображает графически.

3. Найти надстройку, с помощью которой можно делать простые визуализации с понятным UI и минимальным конфигурированием. В этом случае Nagios выступает в роли сборщика данных, а для фронтенда используется стороннее решение с возможностью визуального кодинга/конфигурирования.

Мы остановились на третьем варианте.

Почему Grafana

--------------

В качестве надстройки выбрали [Grafana](https://grafana.com/): мы давно [используем](https://habr.com/ru/company/dataline/blog/569024/) ее для отображения графиков на дашбордах, так что опыт имеется. Это опенсорс (есть платная лицензионная версия Grafana Enterprise, но мы обошлись бесплатной).

В Grafana есть и классические графики, и пайчарты, и тепловые карты.Создать простую визуализацию инженер может сам всего за пару часов. А значит, по трудозатратам выходит очень дешево, можно экспериментировать и не бояться ошибиться.

Из этого следует еще несколько возможностей:

1. В разных ЦОДах можно делать совершенно разные визуализации для разного оборудования. Наши дата-центры проектируются, строятся и эксплуатируются по единым стандартам, мониторинг внедряется по отлаженной схеме, но у каждого ЦОДа есть свои изюминки. Например, мы регулярно тестируем новое оборудование – значит, можно пробовать различные способы за ним наблюдать.

2. Можно проверять гипотезы и чуть ли не А/Б-тесты делать: как быстрее оповестить о проблеме, красной заливкой или мигающей рамкой? А как между собой соотносятся вот эти показатели; что, если отслеживать их вместе вот на таком графике?

Начали мы с усовершенствования мониторинга системы кондиционирования на площадке NORD. Дело было в июне, когда системам холодоснабжения ЦОДов приходится нелегко: летит тополиный пух, который может забиваться в решетки внешних блоков и ухудшать тепло-/воздухообмен. В это время особенно важно следить за параметрами кондиционеров и реагировать, не дожидаясь падения производительности или отказа оборудования.

Мы решили, что возможность видеть на одном экране основные параметры всех кондиционеров ЦОДа придется инженерам холодоснабжения очень кстати. Быстро сделали несколько дашбордов и вывели на мониторы в кабинетах холодильщиков.

Расскажем подробнее о том, как это происходило.

Как выглядит создание дашбордов для ЦОДа

----------------------------------------

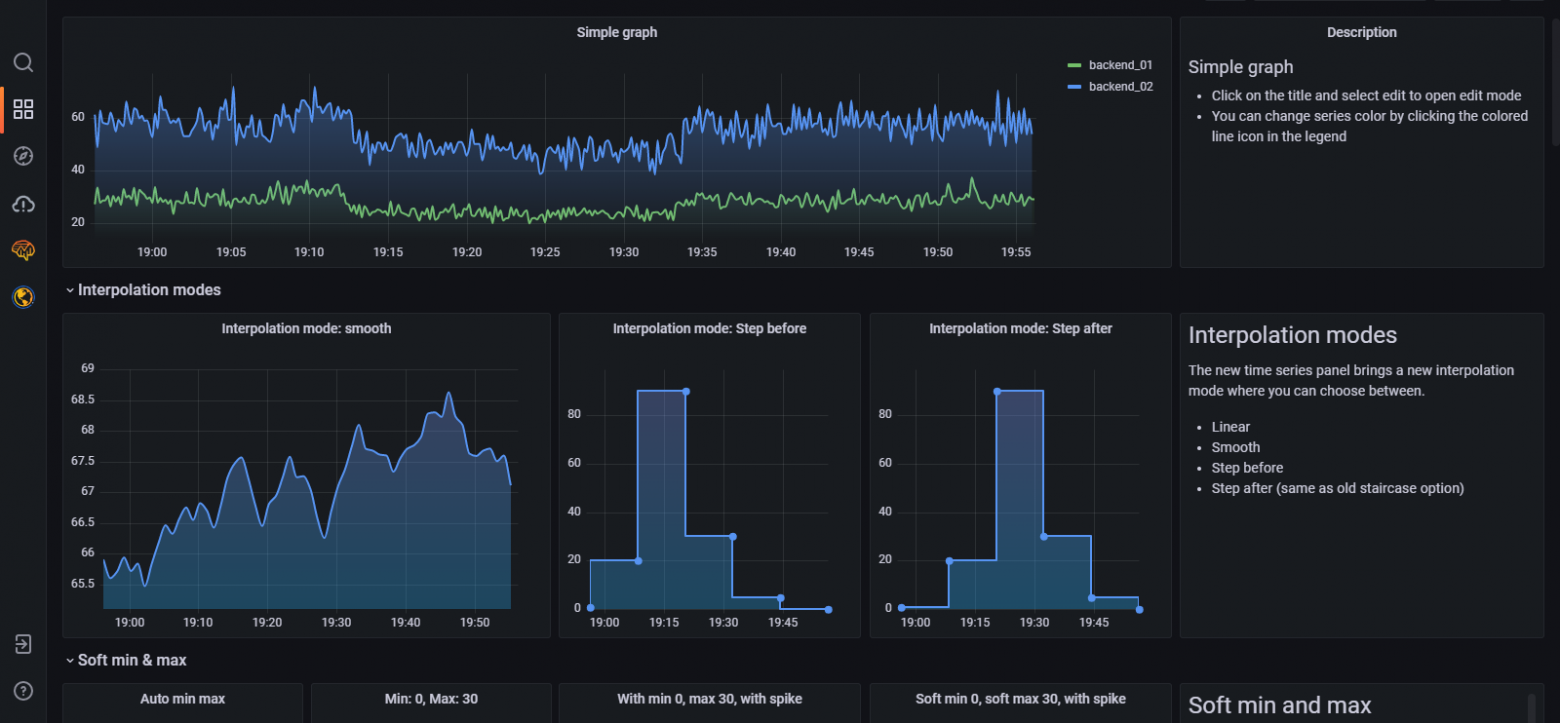

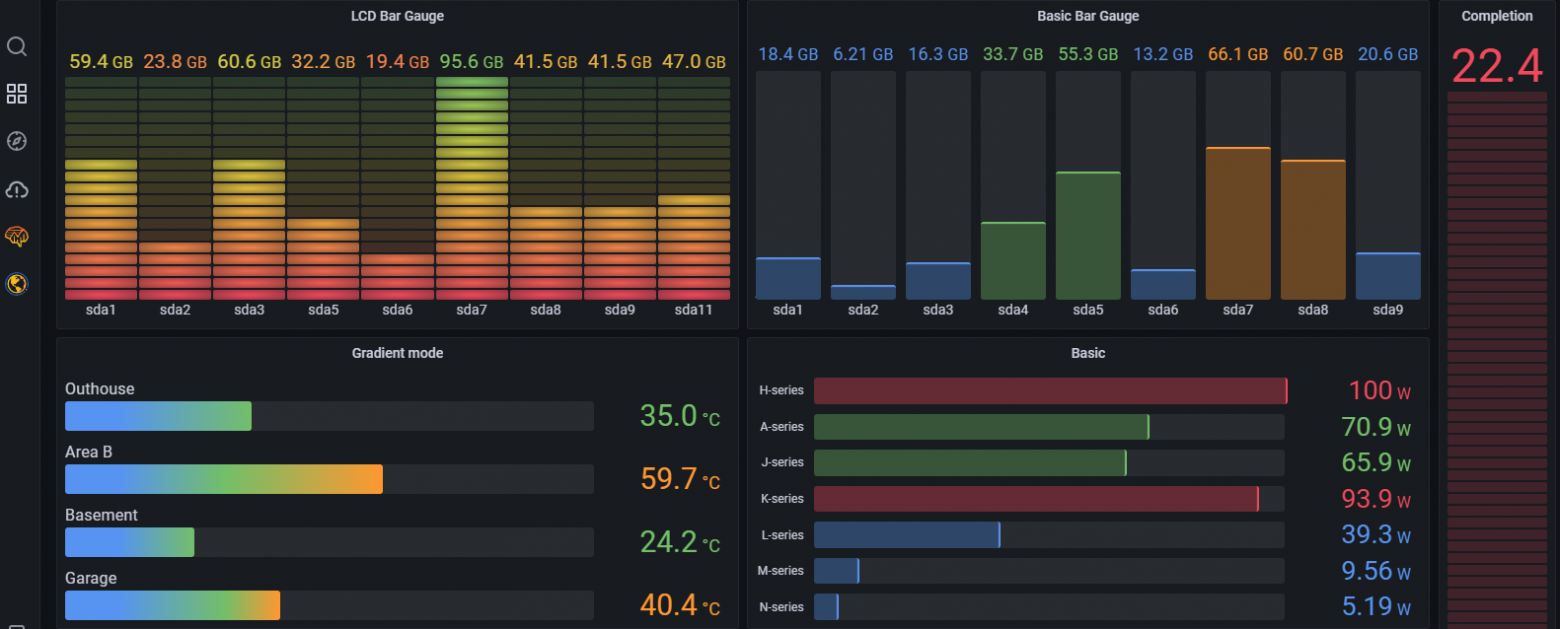

Визуализация метрик в Grafana выглядит так:

Или так:

Или даже так:

Но нам требовалось уместить на один дашборд много метрик, причем отображающих актуальные данные в реальном времени (типовые графики Grafana отображают временные ряды).

Поэтому мы выбрали сторонний плагин [FlowCharting](https://grafana.com/grafana/plugins/agenty-flowcharting-panel/), разработанный специально для рисования в Grafana сложных диаграмм. В качестве графической библиотеки он использует [Draw.io](https://app.diagrams.net/) – еще один бесплатный онлайн-сервис для создания инфографики.

Чтобы избежать риска утечки данных через гипотетически возможные уязвимости в опенсорсном ПО, мы развернули графическую систему во внутренней инфраструктуре DataLine, без доступа во внешнюю сеть.

Вот такой “бутерброд” получился.С помощью Draw.io FlowCharting может создавать самые разные типы диаграмм: от схем программной архитектуры и промышленных процессов до планов этажей в зданиях.

Спектр возможностей для работы с графикой здесь заметно шире, чем в Grafana. Каждому графическому объекту Draw.io автоматически присваивает ID. К этому ID можно привязать данные. В зависимости от данных векторные объекты могут трансформироваться: менять цвет, прозрачность, вращаться и т.д. Можно добавить ссылку. Можно импортировать готовую картинку (например, EPS или JPG) и указать, какие запросы будут взаимодействовать с ней.

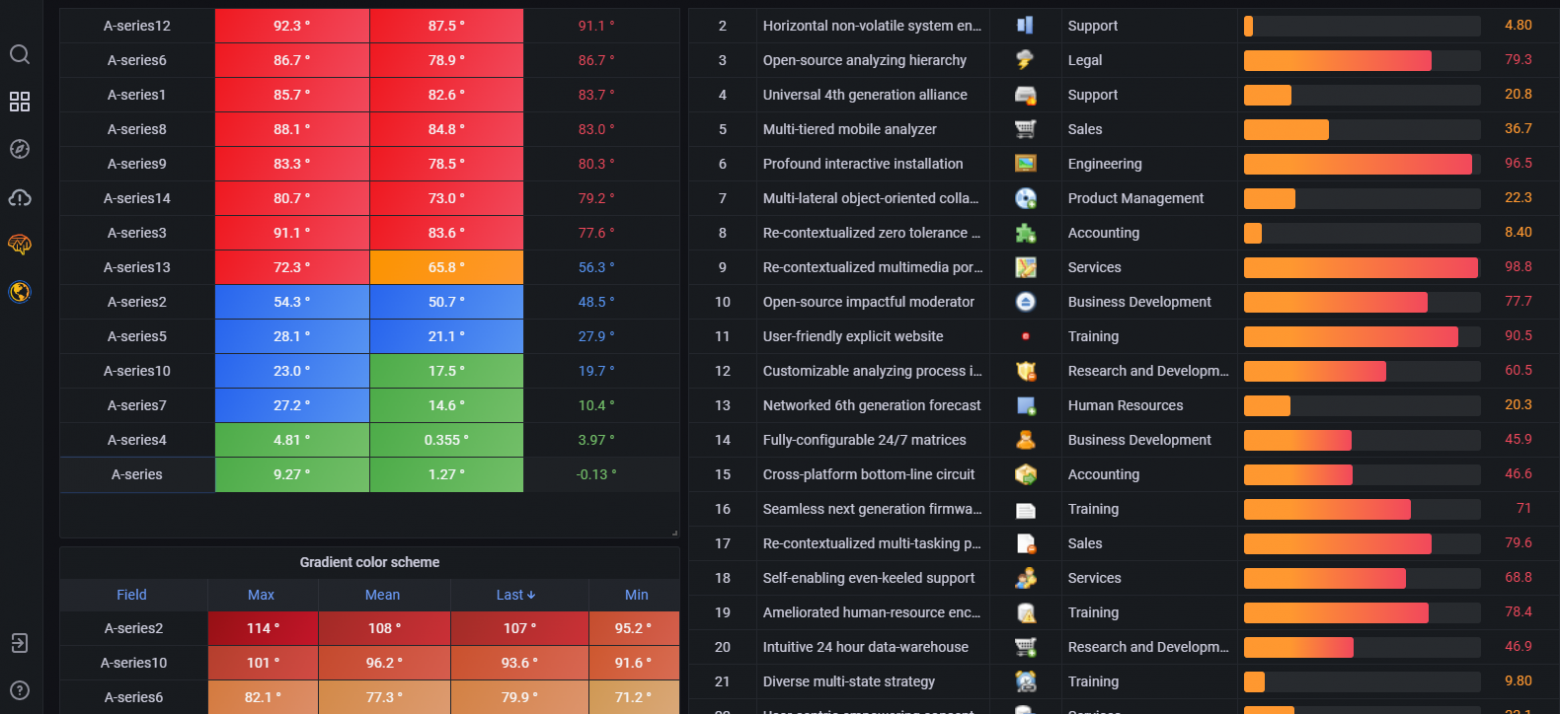

Пример работы с импортированной картинкой: FlowCharting определил фото котика как объект, присвоил ему ID 37 и выделил рамкой.А теперь покажем этапы разработки дашборда для системы охлаждения. Мы взяли конкретный ЦОД, в котором хотелось видеть данные по каждой единице системы кондиционирования: что там с температурой, давлением конденсации и т.д.

1. Для начала хорошо бы представить, какое оборудование у нас есть в ЦОДе и какие показатели по нему мы хотим получать.

Создаем подложку в Draw.io.

2. Выгружаем выбранные данные из базы:

Составляем для этого запросы с помощью редактора.

3. Задаем правила: указываем, какие метрики и куда выводить, при необходимости присваиваем пороговые значения, меняем свойства объектов:

давления в контуре выбираем наиболее красноречивые цвета. Можно еще и красивым градиентом залить.")Для разных пороговых значений (Threshold) давления в контуре выбираем наиболее красноречивые цвета. Можно еще и красивым градиентом залить.Можно настроить события, при которых выбранный объект будет мигать, выделяться рамкой, изменяться в размерах, вращаться и т.д.

4. Готово:

А вот и дашборд.Теперь наблюдатель одновременно видит базовые параметры всех кондиционеров ЦОДа: вкл./выкл. каждого контура, вкл./выкл. компрессоров, давление конденсации и степень открытия ЭТРВ (электронных терморегулирующих вентилей), активные аварии, выход показателей за пороговые значения. Для удобства в правом верхнем углу отображаются данные с метеостанции ЦОДа.

.")Пример работающего дашборда (скрин сделан прошлым летом).Похожий дашборд сделали, чтобы следить за состоянием чиллеров.

Так выглядят данные по всем чиллерам в машзале.Схемы выключенных чиллеров выделяются цветом – становятся серыми. А если происходит авария, на схеме появляется мигающий красный сигнал. Показатели чиллеров отображаются в виде динамических полосок:

Кстати, такое отображение появилось в порядке эксперимента. Но идея так всем понравилась, что мы добавили ее в рабочий вариант.

Параметров у каждого чиллера, конечно, больше основных. Чтобы можно было увидеть их все, мы планируем добавить гиперссылку на каждый чиллер и по ней погружаться на уровень глубже.

Кроме того, в ближайших планах у нас создание похожих дашбордов для дизелей.

Как телеграм-бот помогает холодильщикам

---------------------------------------

Мы не смогли остановиться. Чтобы помочь профильным инженерам “в полях”, где пользоваться ноутбуком и планшетом не всегда удобно, с помощью BotFather создали телеграм-бота, который умеет по запросу отправлять в мессенджер скриншоты наших дашбордов. Фрагмент настройки бота:

```

@bot.message_handler(commands=['nord'])

def start_message(message):

if message.from_user.id not in ids:

bot.send_message(message.chat.id, 'Зарегистрируйся /auth')

else:

img = open('img1.png', 'rb')

bot.send_photo(message.chat.id, img)

img = open('img2.png', 'rb')

bot.send_photo(message.chat.id, img)

img = open('img3.png', 'rb')

bot.send_photo(message.chat.id, img)

```

Мы сами написали специальный скрипт, который ежеминутно скринит выбранные дашборды и сохраняет под заданными именами. Процесс цикличен: названия остаются, сами скрины регулярно меняются на свежие. В папке всегда лежит одинаковое число джипегов. Получив запрос, бот по названию находит в папке нужный файл и отправляет его в мессенджер пользователю.

")Вот так он работает, наш безымянный труженик группы холодоснабжения :)Кстати, этот телеграм-бот – не единственный.

Еще у нас есть, например, боты-напоминалки, которые следят за изменением уставок. Во время ТО часть кондиционеров отключают для проверки и ремонта, а на работающих занижают уставки температур, чтобы в машзале не произошло перегрева. После ТО необходимо вернуть уставкам прежние значения. Теперь, если инженер изменил уставки на кондиционерах, бот напоминает ему, что нужно вернуть все обратно.

Но об этой разработке мы подробно расскажем в следующий раз. | https://habr.com/ru/post/664460/ | null | ru | null |

# Splunk. Введение в анализ машинных данных — часть 2. Обогащение данных из внешних справочников и работа с гео-данными

Мы продолжаем рассказывать и показывать как работает Splunk, в частности говорить о возможностях языка поисковых запросов SPL.

В этой статье на основе [тестовых данных](https://yadi.sk/d/OjbNMbSn3GJUYT) (логи веб сервера) доступных всем желающим для загрузки мы покажем:

* Как обогатить логи информацией из внешних справочников

* Как можно визуализировать географические данные (данные с координатами)

* Как группировать цепочки событий в транзакции и работать с ними

Под катом вы найдете как сами примеры поисковых запросов, так и результат их выполнения. Вы можете [скачать](http://tssolution.ru/splunk/) бесплатную версию Splunk, загрузить [тестовые данные](https://yadi.sk/d/OjbNMbSn3GJUYT) и повторить все на своем локальном компьютере.

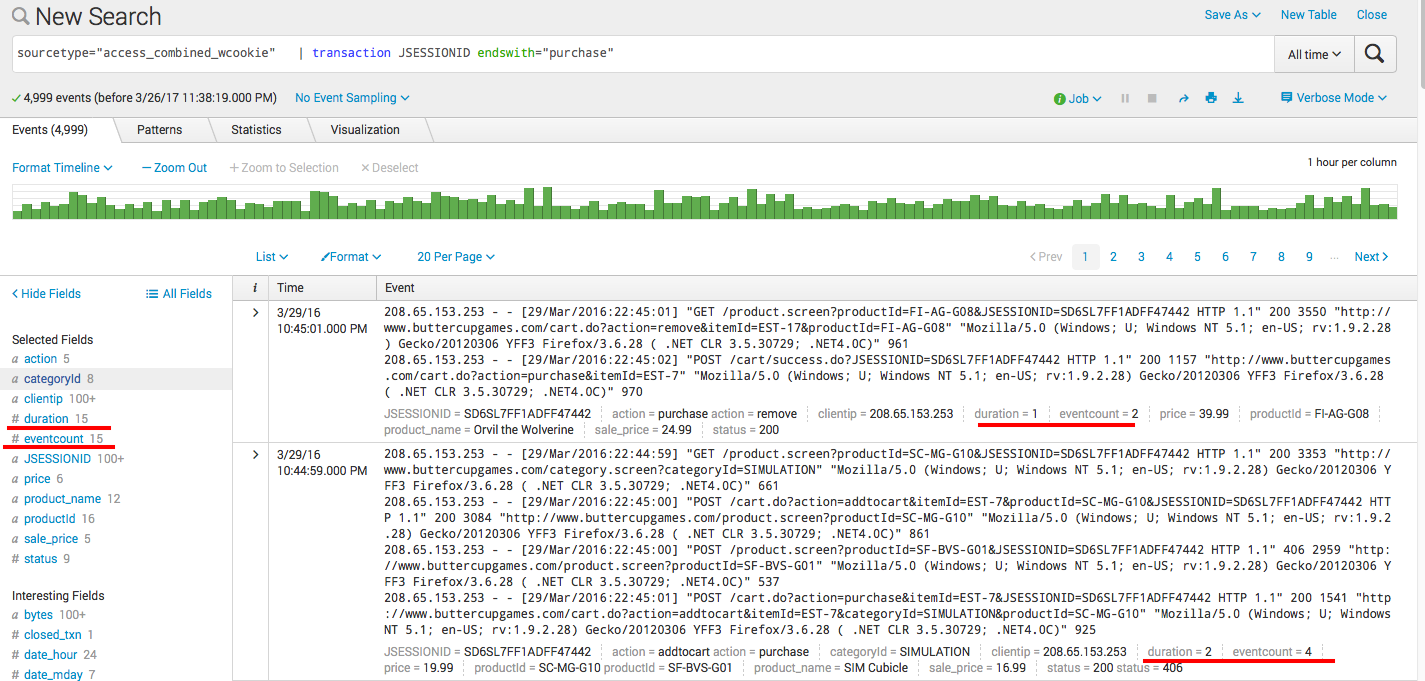

О том как установить Splunk и загрузить тестовые данные мы рассказывали в [предыдущих](https://habrahabr.ru/company/tssolution/blog/324136/) статях нашего блога.

Обогащение данных информацией из внешних справочников

-----------------------------------------------------

Рассмотрим имеющиеся у нас данные.

```

sourcetype=access*

```

Это события access лога, в которых содержится информация о действиях посетителей сайта (по легенде это сайт интернет-магазина компании, занимающейся продажей компьютерных игр). Поэтому в логах у нас есть такие поля, как (наиболее интересные для обработки и запросов):

* action — действия посетителя сайта

* clientip — ip-адресс посетителя сайта

* productId — код продукта

* categoryId — категория продукта

* JSESSIONID — сковозной id сессии

Как мы уже рассказывали в [предыдущем посте](https://habrahabr.ru/company/tssolution/blog/324136/), с помощью Splunk мы можем построить различную аналитику посредством поисковых запросов. Например, мы можем посчитать сколько и каких продуктов покупали, за опредленный временной период:

```

sourcetype=access* action=purchase | stats count by productId | sort -count

```

**Но!** Так как в наших логах кроме productId нет больше никакой информации о продукте, мы не видим что это за товар, сколько он стоит и так далее. Поэтому было бы удобно подгрузить соответствующие поля из внешнего справочника.

В качестве справочника возьмем [простой csv](https://yadi.sk/i/a2SXKomg3GHAb8) файл с интересующей нас информацией о названии продукта и его цене, и загрузим его в Splunk. Сразу скажу, что это самый простой ручной способ обогащения. Понятно, что Splunk может забирать данные из реляционных баз данных, делать запросы к API и прочее.

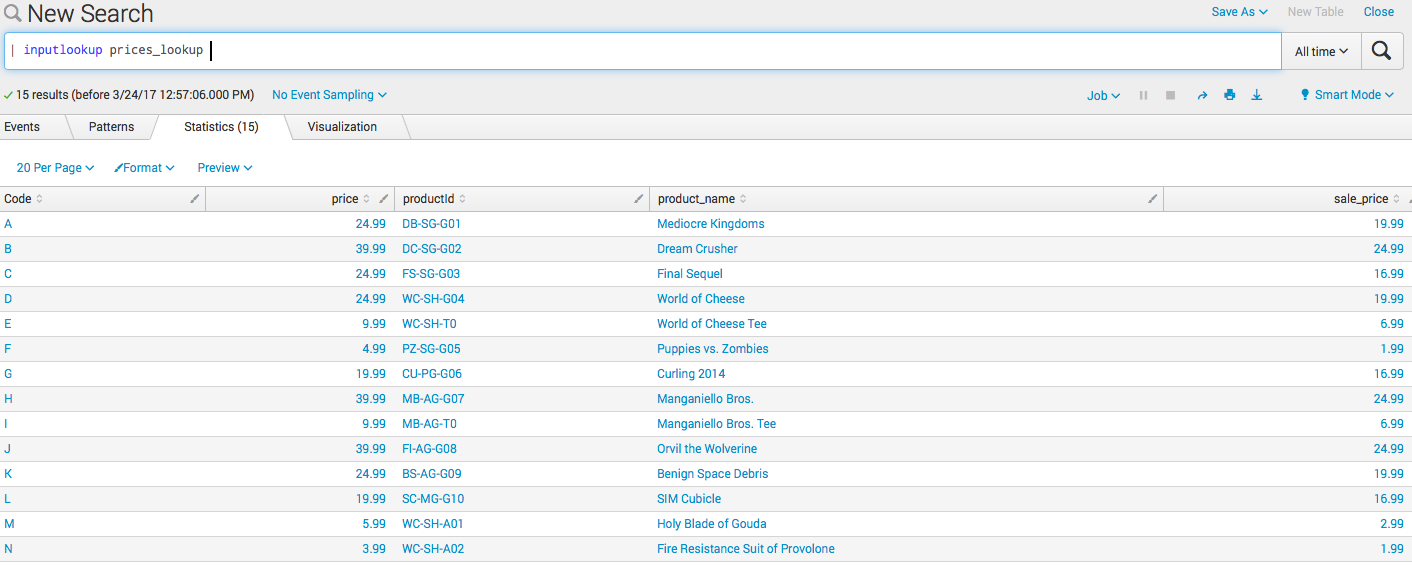

После того как Вы скачали справочник, нужно загрузить его в Splunk и разметить поля. Подробная инструкция [здесь](https://docs.splunk.com/Documentation/Splunk/6.5.2/PivotTutorial/AddlookupfilestoSplunk). Если Вы все сделали правильно, то должны получить следующие результаты поискового запроса:

```

| inputlookup prices_lookup

```

По сути мы просто добавили табличку со справочником в Splunk, теперь давайте сделаем так, чтобы система «дописала» значения этих полей к нашим событиям. Понятно, что она никак не изменит исходные события, а просто логически подтянет поля.

Заходим во вкладку Settings → Lookups → Automatic lookups → New

**Name:** — любое имя

**Lookup table:** prices\_lookup (или как вы нававли Вашу таблицу)

**Sourcetype:** access\_combined\_wcookie

**Lookup input fields:** productId=productId

**Lookup output fields:** price=price, product\_name=product\_name, sale\_price=sale\_price

После чего все сохраняем и меняем *Permissions* на *All Apps* и *Read/Write everyone* как предыдущей инструкции.

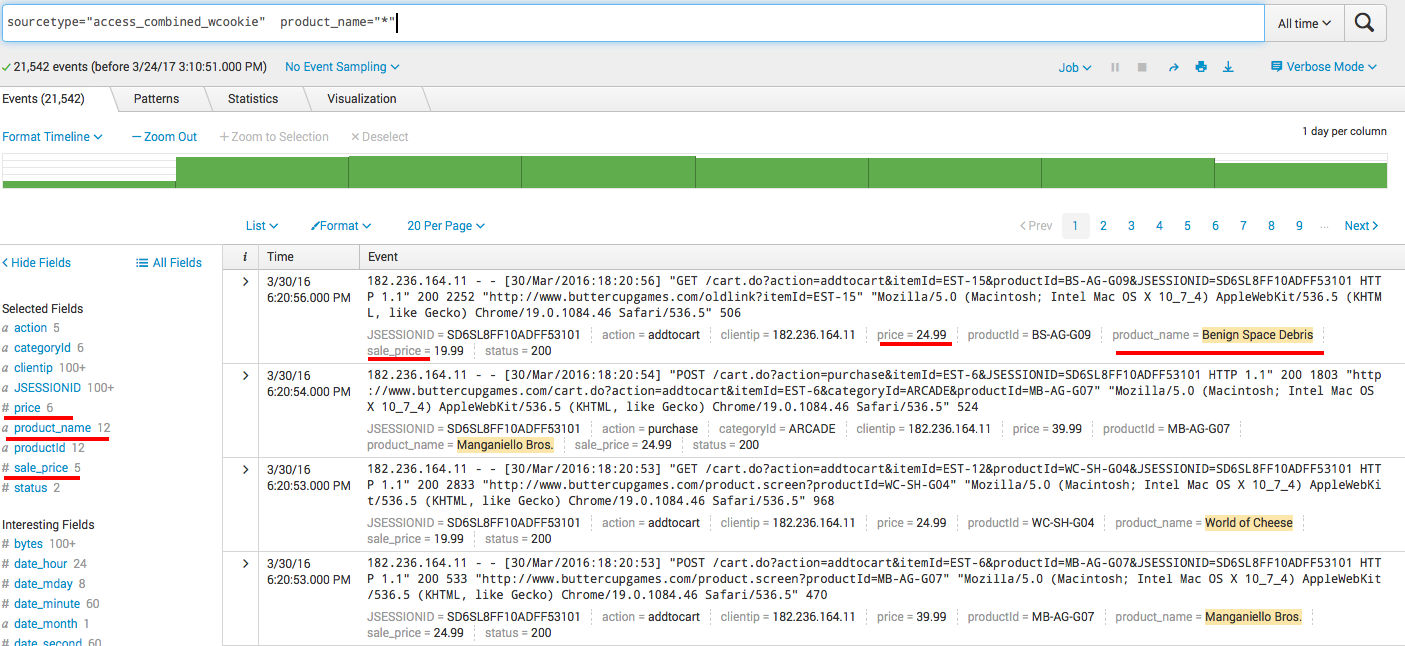

Если все сделано правильно, то теперь при поиске по данному sourcetype должны быть достпны добавленные нами поля (чтобы они отображались снизу каждого события нужно зайти во вкладку *All fields* и выбрать их в качестве *Interesting fields*). Заметьте, что в самих событиях этой информации нет, так как они не изменялись.

```

sourcetype="access_combined_wcookie" product_name="*"

```

Вот теперь результаты наших запросов могут быть куда интереснее. К примеру, мы можем посчитать ту же самую аналитику только уже с привязкой к деньгам и финансовым результатам.

```

sourcetype="access_combined_wcookie" action=purchase

| eval profit=price-sale_price

| stats values(productId) as "Код продукта", values(sale_price) as "Цена покупки", values(price) as "Цена продажи", count as "Количество", sum(profit) as "Итого", by product_name

| sort -"Итого"

| rename product_name as "Наименование"

```

Понятно, что этот пример больше про BI историю. Однако, этот пример с подключением справочников тиражируем и в другие предметные области. К примеру, если говорить про информационную безопасность — мы можем подгружать по CVE коду информацию из баз данных уязвимостей.

И да, совсем забыл! Для удобного редактирования справочников у Splunk есть специальное приложение [Lookup Editor](https://splunkbase.splunk.com/app/1724/), которое можно бесплатно скачать со SplunkBase.

Визуализация данных с географическими координатами

--------------------------------------------------

Иногда бывает очень полезно нанести результаты аналитических запросов на географическую карту. Тут ситуация разделяется на 2 случая: первый — когда в данных уже есть такие поля как широта и долгота (именно благодаря им мы можем нанести что-либо на карту), второй — когда этих полей нет. В нашем примере, то есть в наших данных, как раз второй случай (мы имеем много посетителей интернет магазина из разных мест, но данных об их широте и долготе у нас нет, зато у нас есть их ip-адрес). У Splunk есть встроенный функционал определения широты и долготы (а также города, страны и региона) на основе ip-адреса, команда [iplocation](https://docs.splunk.com/Documentation/Splunk/6.5.2/SearchReference/Iplocation).

```

sourcetype="access_combined_wcookie" | iplocation clientip

```

В результате этого запроса у вас должны появится поля с широтой, долготой, названием города, страны и региона.

Теперь строим какой-нибудь аналитический запрос и наносим на карту. К примеру, посчитаем прибыль по каждому продукту и посмотрим где это покупалось. Для этого используем встроенную функцию [geostats](https://docs.splunk.com/Documentation/Splunk/6.5.2/SearchReference/Geostats).

```

sourcetype="access_combined_wcookie" action=purchase

| iplocation clientip

| eval profit=price-sale_price

| geostats sum(profit) by product_name

```

Также можем воспользоваться другим вариантом визуализации и посмотреть прибыльность в разрезе по странам, для этого используется команда [geom](http://docs.splunk.com/Documentation/Splunk/6.5.2/SearchReference/Geom).

```

sourcetype="access_combined_wcookie" action=purchase

| iplocation clientip

| eval profit=price-sale_price

| stats sum(profit) by Country

| geom geo_countries featureIdField=Country

```

По дефолту, есть маппинг по странам и штатам США, но вы всегда можете сделать свой, на основе широты и долготы и добавить его в Splunk. Например, это могут быть регионы Росиии, или городские округа.

Транзакции или группировка цепочки событий во времени

-----------------------------------------------------

В том случае, когда у нас есть последовательная цепочка событий, например, процесс пересылки электронной почты, какая-нибудь финансовая операция, или как в случае с нашими данными — посещение web сайта, бывает необходимо объединить эти события в транзакции. То есть из группы отдельных событий событий явно выделить цепочку, группируя их по конкретному признаку.

В нашем случае это поле JSESSIONID — уникальный номер сессии пользователя. Для группировки используем команду [transaction](https://docs.splunk.com/Documentation/Splunk/6.5.2/SearchReference/Transaction).

```

sourcetype="access_combined_wcookie" | transaction JSESSIONID endswith="purchase"

```

После чего получаем сгруппированные события, а также новые поля: длительность транзакции, и количество сгруппированных событий.

Теперь можно посчитать, к примеру, статистику по длительности сессий, то есть время за которое посетители решались совершить покупку.

```

sourcetype="access_combined_wcookie" | transaction JSESSIONID endswith="purchase" | search duration>0 | stats min(duration), max(duration), avg(duration)

```

Также можно посчитать количество конкурентных сессий в каждый период времени, для этого есть команда [concurrency](https://docs.splunk.com/Documentation/Splunk/latest/SearchReference/Concurrency).

```

sourcetype="access_combined_wcookie" | transaction JSESSIONID | concurrency duration=duration

```

В результате, создается новое поле *concurrency*, которое и считает конкурентные сессии, но, к сожалению, из-за того что наши данные синтетические у нас в любой момент времени есть только одна конкурентная сессия, поэтому этот пример не очень результативен.

Заключение

----------

Конечно, примеры очень простые, но надеюсь, репрезентативные.

На этом мы заканчиваем данную статью!

Пишите свои вопросы если что-то не заработало или не получилось =)

Еще раз сылки на загрузку [данных](https://yadi.sk/d/OjbNMbSn3GJUYT) и [справочника c ценами](https://yadi.sk/i/a2SXKomg3GHAb8). | https://habr.com/ru/post/324716/ | null | ru | null |

# Re: Командная строка на службе фотографа-линуксоида

Недавно опубликована статья «[Командная строка на службе фотографа-линуксоида](http://habrahabr.ru/blogs/linux/128493/)», где автор пишет о решении разных типовых задач, встающих перед фотографом-линуксоидом, но он рассмотрел явно не всё.

Первая, а точнее, нулевая задача — скопировать изображения. Казалось бы, в ней нет чего-то такого, что бы подлежало оптимизации и автоматизации: всегда можно нажать F5 в mc либо перетащить файлы мышкой или же воспользоваться каким-нибудь менеджером фотографий наподобие digiKam. Можно — но не нужно: слишком много лишних движений. Фотографу-линуксоиду (а точнее, линуксоиду, время от времени занимающемуся фотографией) обычно надо лишь забрать фотографии с карты памяти, аккуратно сложить их на жёсткий диск, рассортировав, например, по времени съёмки и, если лишние буквы раздражают взгляд, убрать их.

Другая задача, о которой говорили в комментариях — пакетное уменьшение фотографий и их подписывание. Один из методов — использовать ImageMagick, к которому доступны различные интерфейсы: как интерфейс командной строки (программы convert, mogrify, montage), так и API для различных языков программирования. В случае с перлом — модуль [Image::Magick](http://search.cpan.org/perldoc?Image::Magick). ImageMagick позволит и уменьшить фотографию, и подписать её.

Я подобные задачи автоматизировал следующим образом:

Перенос фотографий:

```

#!/usr/bin/perl -wl

use strict;

use File::Find;

use File::Path qw(make_path);

use File::Copy;

use Image::ExifTool qw(:Public);

# You can change these variables

my $PATH_SRC = '/media/NIKON/DCIM'; # path to memory card

my $PATH_DST = $ENV{'HOME'} . '/photo'; # path to destination. Don't use ~ for your homedir

my $PRECISION = 2; # 0 for year .. 5 for second

my $MODE = 0644; # for chmod

# Don't touch the rest of file

find( \&wanted, $PATH_SRC );

sub wanted {

return unless /\.jpg/i;

my $new_name = lc $_;

$new_name =~ s/^\D+//;

my $info = ImageInfo( $File::Find::name );

my @date = split /\D+/, $info->{'DateTimeOriginal'};

$#date = $PRECISION;

my $new_dir = join '/', $PATH_DST, @date;

make_path $new_dir

unless -d $new_dir;

my $new_path = "$new_dir/$new_name";

-d $new_dir

and move $File::Find::name, $new_path

and chmod $MODE, $new_path

and print "$File::Find::name => $new_path";

} # sub wanted

```

Уменьшение и подписывание:

```

#!/usr/bin/perl -w

use strict;

use Image::ExifTool ':Public';

use Image::Magick;

use Getopt::Long;

# Constants

my %preferred_fonts = (

'date' => [ qw/ DejaVuSans DejaVu-Sans Bitstream-Vera-Sans BitstreamVeraSans Verdana / ], # Normal width

'name' => [ qw/ DejaVuSansC DejaVu-Sans-Condensed Tahoma / ], # Narrow

'site' => [ qw/ DejaVuSansB BitstreamVeraSansB VerdanaB TahomaB / ], # Bold

);

my $color = '#fff2';

my $gap = 10;

my $name = (getpwuid $>)[6];

$name =~ s/,+$//;

my $prefix = 'small.';

my $site = 'your-site.ru';

my $size = '50%';

# Override with options

GetOptions(

'color:s' => \$color,

'gap:i' => \$gap,

'name:s' => \$name,

'prefix:s' => \$prefix,

'site:s' => \$site,

'size:s' => \$size,

);

# Try to find suitable fonts

my $image = new Image::Magick;

my @available_fonts = $image->QueryFont();

my ( %seen, %fonts );

map { $seen{$_} = 1 } @available_fonts;

while ( my ( $scope, $list ) = each %preferred_fonts ) {

foreach ( @$list ) {

$fonts{ $scope } = $_

and last

if $seen{$_};

} # foreach

} # while

foreach my $file ( @ARGV ) {

my $info = ImageInfo($file, 'CreateDate');

my $date = $$info{'CreateDate'};

my $new_file_name = $file;

$new_file_name =~ s{([^/]+)$}{$prefix$1};

$date =~ s/^(\d{4}):(\d{2}):(\d{2}).*/$3.$2.$1/;

my $p = new Image::Magick or next;

$p->Read( $file );

$p->AutoOrient;

$p->Resize(

'geometry' => $size,

'filter' => 'Lanczos',

'blur' => 0.5,

);

my ( $width, $height ) = $p->Get('width', 'height');

my ( $x, $y ) = ( $width - $gap, $height - $gap );

$p->Set(

'pointsize' => 12,

'fill' => $color,

);

$p->Annotate(

'font' => $fonts{'name'},

'text' => $name,

'rotate' => -90,

'x' => $x,

'y' => $y,

);

$y -= (

$p->QueryFontMetrics(

'font' => $fonts{'name'},

'text' => $name,

)

)[4] + $gap;

$p->Annotate(

'font' => $fonts{'site'},

'text' => $site,

'rotate' => -90,

'x' => $x,

'y' => $y,

);

$y -= (

$p->QueryFontMetrics(

'font' => $fonts{'site'},

'text' => $site,

)

)[4] + $gap;

$p->Annotate(

'font' => $fonts{'date'},

'text' => $date,

'rotate' => -90,

'x' => $x,

'y' => $y,

);

$p->Sharpen(

'radius' => 1,

'sigma' => 2,

);

$p->Write($new_file_name);

print "$file - $date\n";

} # foreach

```

Готовые скрипты и документация к ним выложены на github.com:

* [move-images.pl](https://gist.github.com/483212)

* [resize-mark.pl](https://gist.github.com/600484) | https://habr.com/ru/post/128527/ | null | ru | null |

# PHP-фреймворк Badoo

Код нашего сайта повидал уже не одну версию PHP. Он неоднократно дополнялся, переписывался, модифицировался, рефакторился — в общем, жил и развивался своей жизнью. В это время в мире появлялись и исчезали новые best practice, подходы, фреймворки и тому подобные явления, облегчающие жизнь разработчику и готовые решить все основные проблемы, возникающие в процессе создания веб-сайтов.

В этой статье мы расскажем о нашем пути: как был организован код изначально, какие возникали проблемы и как появился текущий фреймворк.

#### Что было

Проект начали делать еще в 2005 году. Тогда никаких жестких правил по написанию кода и четко структурированного фреймворка не было. Код писали несколько разработчиков, они легко в нем ориентировались и его поддерживали, каждый привносил что-то свое. В то время известные сейчас фреймворки только создавались, поэтому примеров для подражания было мало. Так что можно сказать, что наш фреймворк образовался стихийно.

С архитектурной точки зрения это выглядело так: были объекты страниц, наследуемые от целой иерархии базовых классов, отвечающих за инициализацию окружения, сессии, пользователя и т.п. Каждая страница сама решала, когда, как и что ей выводить, делать редирект и т.п. В иерархии базовых классов было собрано много вспомогательных функций для инициализации и генерации стандартных блоков страниц, проверки пользователей, показа промежуточных промо-страниц и т.п. Со временем большинство из них было переопределено наследниками до неузнаваемости, что в разы усложнило и понимание того, как работает сайт, и саму поддержку кода.