text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

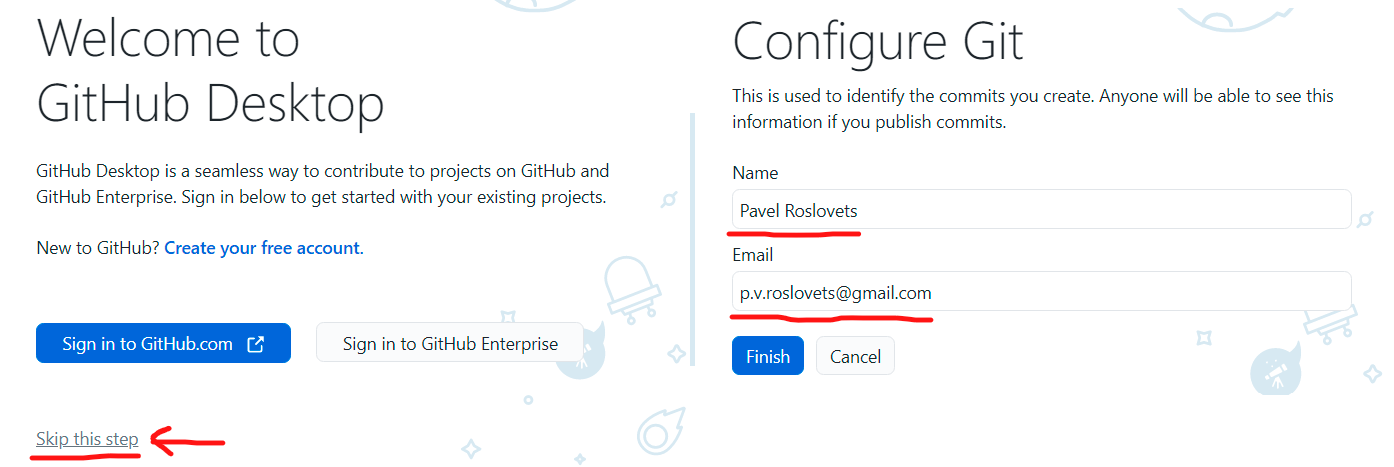

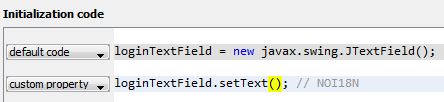

# Как киту съесть Java-приложение и не подавиться

Здравствуйте, уважаемые хабравчане! Сегодня я хотел бы рассказать о том, как «скормить» Java-приложение докеру, как при этом лучше действовать, а чего делать не стоит. Я занимаюсь разработкой на Java более 10 лет, и последние года три провёл в самом тесном общении с Docker, так что у меня сложилось определённое представление о том, что он может и чего не может. Но ведь гипотезы надо проверять на практике, не так ли?

Я представил весь процесс как старую добрую компьютерную игру с тёплым ламповым пиксель-артом.

Начнем мы, как и полагается любой игре, с некоторого брифинга. В качестве вводной возьмем немного рекламы докера.

На сайте [докера](https://www.docker.com/what-docker) можно ознакомиться с рядом рекламных посулов – а именно, с обещанием увеличить скорость разработки и развертывания аж в ***13*** раз и повысить портативность в разработке (в частности, избавиться о сакраментального «работает на моей машине»). Но соответствует ли это реальности?

Сейчас мы попробуем доказать/опровергнуть эти утверждения.

Level 1

-------

Так как мы находимся в игре, то начнем, как и положено, с самого простого уровня.

Какова наша миссия на первом уровне? Наверное, для многих это что-то очень тривиальное и понятное: мы должны «завернуть» в Docker примитивнейшее Java-приложение.

Для этого нам понадобится простой Java-класс, который выводит сакраментальное *Hello JavaMeetup!* Также для того чтобы создать docker-образ нам понадобится [Dockerfile](https://docs.docker.com/engine/reference/builder/). По синтаксису он предельно прост – в качестве базового образа используем **java:8**, добавляем наш Java-класс (команда **ADD**), компилируем его (при помощи команды **RUN**) и указываем команду, которая выполнится при запуске контейнера (команда **CMD**).

**HelloWorld.java**

```

public class HelloWorld {

public static void main (String[] args) {

System.out.println("Hello World!");

}

}

```

**Dockerfile**

```

FROM java:8

ADD HelloWorld.java .

RUN javac HelloWorld.java

CMD ["java", "HelloWorld"]

```

**Docker commands:**

```

$ docker build -t java-app:demo .

$ docker images

$ docker run java-app:demo

```

Чтобы все это дело собрать, нам понадобится, по сути, одна команда – это **docker build**. При сборке указываем имя нашего образа и тег, который мы ему присваиваем (таким образом мы сможем версионировать различные сборки нашего приложения). Далее убедимся, что мы собрали образ, выполнив команду **docker images**. Для того чтобы запустить наше приложение выполним команду **docker run**.

Ура, всё прошло прекрасно, и мы молодцы… Или нет?

Да, миссию мы выполнили. Но баллы с нас снять есть за что. За что, спросите вы, и как избежать подобных промашек в следующий раз?

* Базовый образ докера, который мы использовали, заявлен как нерекомендуемый (deprecated) и не поддерживается [сообществом докера](https://hub.docker.com/_/java/). Даже на [DockerCon17](https://www.youtube.com/watch?v=yHLAaA4gPxw) многим из мира Java EE знакомый Arun Gupta рекомендовал использовать в качестве базового образа openjdk (на что нам также намекают описание и даты обновлений образов <https://hub.docker.com/_/openjdk/> ).

* Для уменьшения размера лучше использовать образы на основе Alpine – образы на основе данного дистрибутива самые легковесные.

* Компилируем при помощи образа jdk, запускаем с помощью jre (бережем место на диске, оно нам еще понадобится).

Вот теперь, можно считать, первый уровень пройден успешно. Поднимаемся на второй.

*[Полезная ссылка для прохождения первого уровня](https://www.tutorialkart.com/docker/docker-Java-application-example/)*

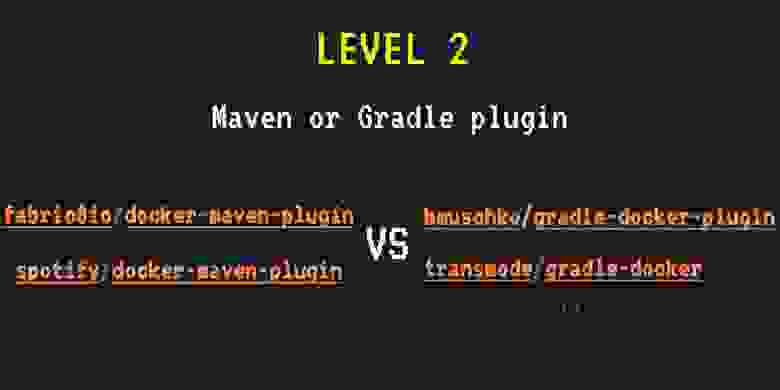

Level 2

-------

Имея дело с Java, мы, скорее всего, будем использовать Maven или Gradle. Поэтому было бы удобно как-то интегрировать наши системы сборки с Docker, чтобы иметь единую среду для сборки проекта и образов докера.

К счастью для нас, большинство плагинов уже написано — как для Maven, так и для Gradle.

Наиболее популярны плагины Maven для Docker [fabric8io](https://github.com/fabric8io/docker-maven-plugin) и [spotify](https://github.com/spotify/docker-maven-plugin). Для Gradle мы можем использовать плагин Бенджамина Мушко – одного из разработчиков Gradle и автора книги «Gradle in Action».

Чтобы подключить докер в систему сборки приложения, в gradle-конфигурации достаточно создать несколько задач, которые будут собирать и запускать наши контейнеры, а также указать некую общую информацию из разряда — какой образ использовать в качестве базового и какое имя дать собранному образу.

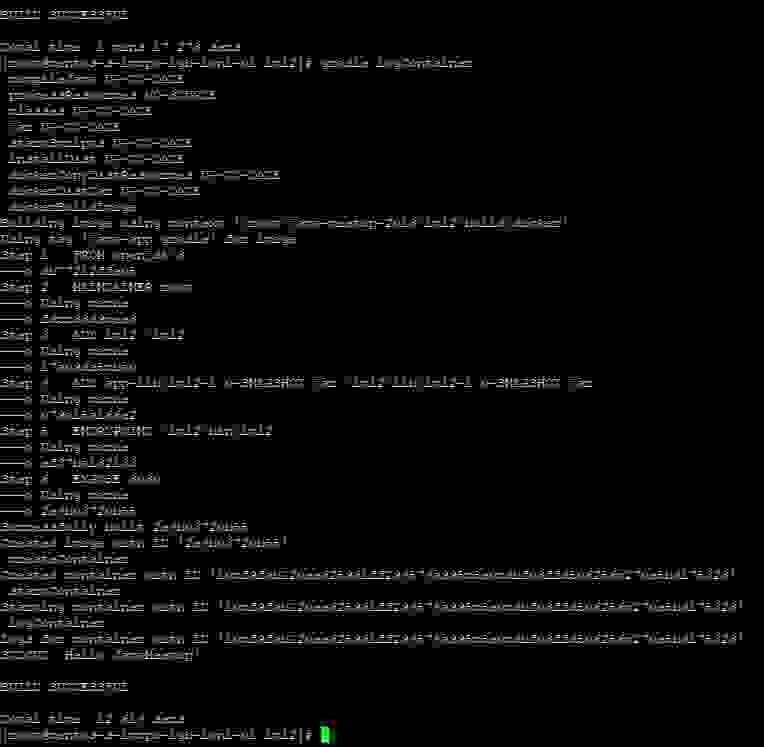

Не будем многословными: возьмём плагин [bmuschko/gradle-docker-plugin](https://github.com/bmuschko/gradle-docker-plugin) и Gradle (поклонники Maven и любители XML, подождите немного!).

Выполним наше первое задание, но теперь с помощью данного плагина. Основные части build.gradle, которые нам понадобятся:

```

docker {

javaApplication {

baseImage = 'openjdk:latest'

tag = 'java-app:gradle'

}

}

task createContainer(type: DockerCreateContainer) {

dependsOn dockerBuildImage

targetImageId { dockerBuildImage.getImageId() }

}

task startContainer(type: DockerStartContainer) {

dependsOn createContainer

targetContainerId { createContainer.getContainerId() }

}

```

Запускаем команду **gradle startContainer** и видим сборку нашего образа и даже запуск контейнера. Но вместо желанного сообщения «Hello JavaMeetup!» получаем уведомление об успешном билде!

Мы где-то ошиблись? Не совсем, просто надо перенаправить вывод нашего контейнера в консоль:

```

task logContainer(type: DockerLogsContainer, dependsOn: startContainer) {

targetContainerId { startContainer.getContainerId() }

follow = true

tailAll = true

onNext {

message -> logger.quiet message.toString()

}

}

```

Запускаем команду **gradle logContainer** и… Ура, заветное сообщение и пройденный уровень.

Вот, собственно говоря, и все. Нам даже не нужен Dockerfile (но лишним он не будет — мало ли, Gradle не окажется под рукой).

Двигаемся дальше!

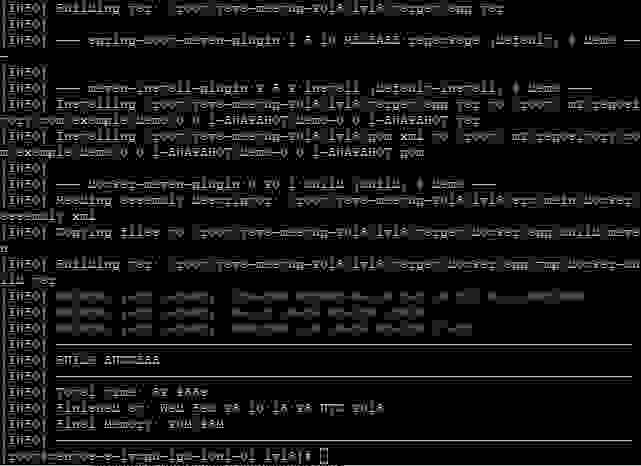

Level 3

-------

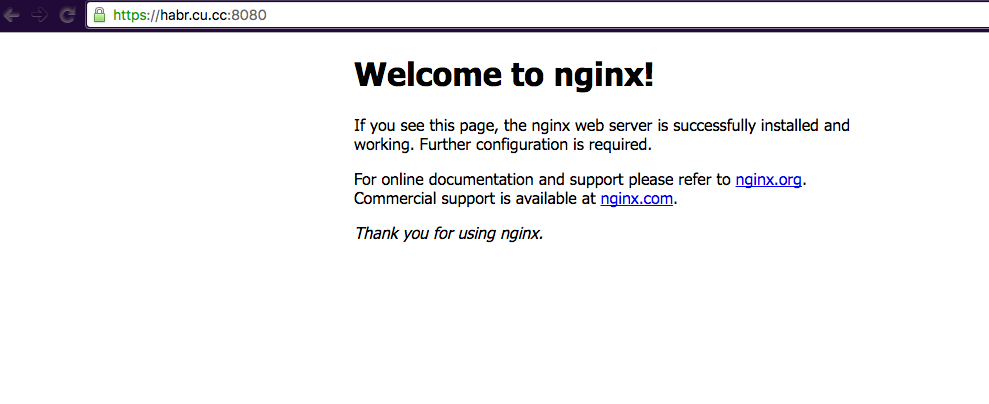

Скорее всего, в реальной жизни наше приложение будет делать что-то похитрее, чем вывод на экран «хелло ворлд». Поэтому на следующем уровне мы узнаем, как запустить сложное приложение – Spring веб-приложение, которое выведет нам какие-нибудь записи из базы.

Для того, чтобы поднять базу и само приложение, мы воспользуемся [Docker Compose](https://docs.docker.com/compose/overview/). Для начала создадим новый файл (очередной новый конфигурационный файл, вздохнете Вы, но нас же это не остановит?) – **docker-compose.yml**. В нем мы просто пропишем сервисы для поднятия образа базы и образа приложения. Docker Compose сам найдёт в текущей директории yml-файл и поднимет или соберет нужные нам контейнеры и образы.

Что бы все это дело запустилось, мы предварительно соберем образ. В [данном примере](https://github.com/alexff91/java-meetup-2018/tree/master/lvl3) использован maven-плагин для Docker(ура, XML!) от fabric8io – поэтому для начала выполним команду **mvn install**:

```

io.fabric8

docker-maven-plugin

0.20.1

app

${project.basedir}/src/main/docker

dir

/app

${project.basedir}/src/main/docker/assembly.xml

build

install

build

```

Подождем пока наш проект и образ докера соберутся, перейдем в директорию с yml файликом и запустим команду **docker-compose up -d**.

Проверим, что оба наши контейнера запущены выполнив команду **docker ps**.

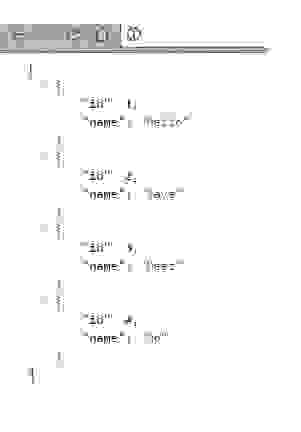

Дабы убедиться, что наше веб-приложение работает и достает что-то из базы, мы можем напрямую что-то изменить в базе, а затем перейти по адресу <http://localhost:8080/> и увидеть желаемые данные.

Все это может показаться сложным, но на самом деле оно предельно просто. Третий уровень пройден. Ну, почти.

У нас есть еще бонусный уровень. На нем мы немножко (совсем чуть-чуть) поиграем в Docker Swarm — а если быть точным, то в [Docker Swarm Mode](https://habrahabr.ru/company/redmadrobot/blog/318866/).

Bonus Level

-----------

Docker Swarm Mode не особенно-то сложен – это просто кластер из машинок, на которых стоит Docker. Для пользователя этот кластер выглядит как одна машина, и все команды работают почти так же, как если бы этого Docker Swarm’a не было.

В swarm-режиме можно запускать несколько экземпляров нашего приложения — для распределения нагрузки, например. Также здесь появляется такая абстракция как стек: с помощью Docker Swarm мы можем деплоить целую связку приложений как единое целое. И, аналогично обычному масштабированию, мы можем разворачивать несколько реплик [стека](https://docs.docker.com/engine/swarm/stack-deploy/).

Docker-команды в swarm mode:

```

$ docker service create --name japp --publish 8080:80 --replicas 3 java-app:demo

$ docker stack deploy -c docker-compose.yml javahelloworld

```

По сути, синтаксис команд предельно прост и напоминает создание обычных контейнеров.

Мы можем так же использовать docker compose:

```

$ docker-compose scale jm-app=3

```

Ну что же, за последние три уровня мы вроде как добились портативности java-приложений. Настало время перейти на последний уровень и попробовать подтвердить или опровергнуть утверждение о том, что Docker делает фразу «работает на моей машине» более не актуальной.

Final Level

-----------

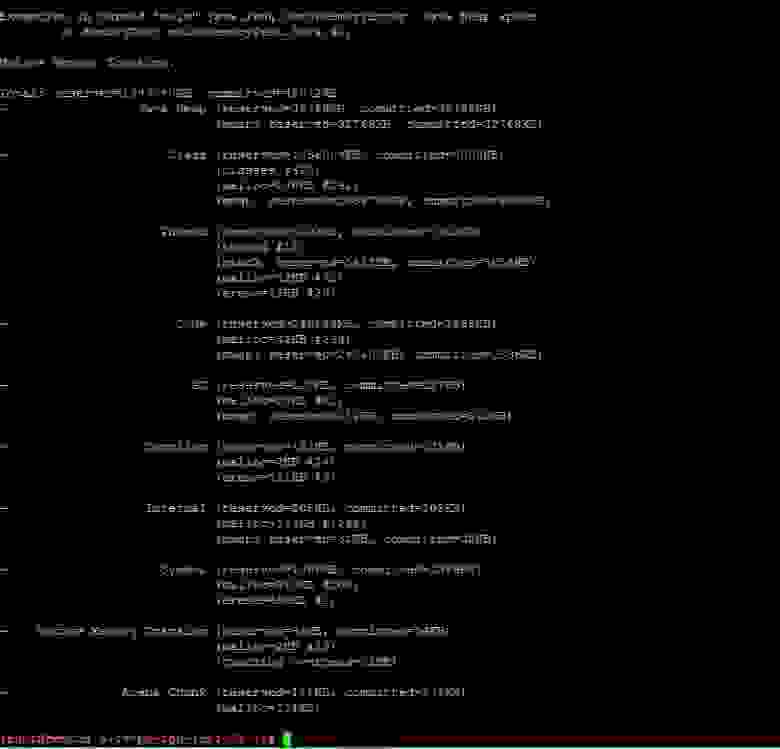

Представим, что у нас тяжеловесное приложение. Либо большое количество микросервисов, которые могут находиться на одной машине. В этом случае Java-приложение (если быть точным, то JVM) непременно схватится с нашим маленьким синим китом в борьбе за ресурсы хостовой машины. Об этом, кстати, хорошо рассказано вот в [этой статье](https://habrahabr.ru/company/ruvds/blog/324756/).

На данном уровне будет меньше всего примеров кода, но будут разные конфигурации запуска докер-контейнера. Основными средствами изоляции процессов и ресурсов, используемыми Docker, являются [cgroups](https://en.wikipedia.org/wiki/Cgroups) и [namespaces](https://en.wikipedia.org/wiki/Linux_namespaces). Но основная проблема заключается в том, что джаве на все это немножко по барабану. Она у нас прожорливая и немного жадная, видит, что ресурсов на самом деле больше, даже если мы задаем ограничения по памяти при создании контейнера с java-приложением при помощи флага — memory. В этом можно убедиться просто выполнив команду free внутри контейнера. Отсюда следует довольно общая рекомендация для Java 8 задавать параметр –Xmx, а параметр –memory делать как минимум в два раза большим, чем –Xmx. Приятная новость с полей Java 9 – там поддержку cgroups добавили.

Промоделировать утечку памяти в джаве довольно просто. Мы просто возьмём уже готовый образ **valentinomiazzo/jvm-memory-test** и будем запускать с различными параметрами размера кучи и --memory для докера.

В первом случае памяти контейнеру у нас выдано меньше, чем java приложению, и мы получаем невнятную ошибку. А хотелось бы получить OutOfMemoryException. Если проинспектировать «убитый» контейнер, то можно заметить, что он был убит [OOMKiller](https://linux-mm.org/OOM_Killer), а это может привести к непредсказуемым последствиям, зависанию java-процесса, неправильному закрытию ресурсов и всяким другим обидным вещам (я встречал даже kernel-panic). Не самое приятное, что может случиться.

Повышаем ставки, даем побольше памяти контейнеру. В этот раз можем словить OutOfMemoryException и после инспектирования убедиться, что OOMKiller наш контейнер не трогал, и от всех вышеперечисленных бед мы избавлены.

Последний уровень пройден, попробуем подытожить.

Resume

------

Итак, что же мы получили в результате, пройдя все уровни нашей игры? Что насчёт обещаний Docker свернуть нам горы?

Портативность не так хороша, как нам хотелось бы, но Java 9 вроде как обещает эти проблемы решить. С повышением гибкости все уже поприятнее: с докером мы получаем воспроизводимую конфигурацию окружения в коде, причём недалеко от основного кода. За такими вещами проще следить, нежели за тем, кто, что и когда подправил, заменил или испортил где-то под рутом. Да и в целом можно добиться неплохого сокращения ресурсов за счет возможности запускать множество контейнеров на одной машине — при тестировании это может быть критично.

То есть, я бы сказал, что для тестирования и/или разработки докер подходит идеально. А вот при работе в production нужно быть осторожнее, поскольку нагрузка в этом случае может оказаться гораздо выше. А получить падение по вине докера – это уж совсем неприятно.

Ну и напоследок — те самые флаги, которые нужны для того, чтобы подружить Java 9 с докером!

Game Over

---------

*Полезные ссылки для прохождения последнего уровня:*

<https://hackernoon.com/crafting-perfect-Java-docker-build-flow-740f71638d63>

<https://jaxenter.com/nobody-puts-Java-container-139373.html>

<https://github.com/valentinomiazzo/docker-jvm-memory-test>

**P.S.** Все упомянутые и приведённые выше примеры можно найти здесь:

[github.com/alexff91/Java-meetup-2018](https://github.com/alexff91/Java-meetup-2018) | https://habr.com/ru/post/350138/ | null | ru | null |

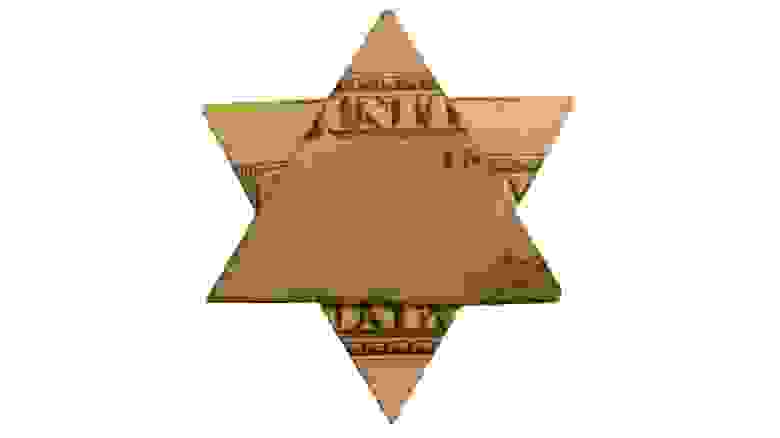

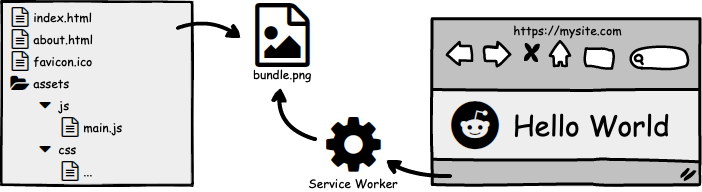

# Учебный проект на Python: интерфейс в 40 строк кода (часть 2)

Демонстрация проекта Python с пользовательским интерфейсом никогда не была такой простой. С помощью Streamlit Framework вы можете создавать браузерный пользовательский интерфейс, используя только код Python. В этой статье мы будем создавать пользовательский интерфейс для программы лабиринта, [подробно описанной в предыдущей статье](https://habr.com/ru/company/skillfactory/blog/509304/).

### Streamlit

Streamlit — это веб-фреймворк, предназначенный для исследователей данных для простого развертывания моделей и визуализаций с использованием Python. Это быстро и минималистично, а также красиво и удобно. Есть встроенные виджеты для пользовательского ввода, такие как загрузка изображений, ползунки, ввод текста и другие знакомые элементы HTML, такие как флажки и переключатели. Всякий раз, когда пользователь взаимодействует с потоковым приложением, сценарий python перезапускается сверху вниз, что важно учитывать при рассмотрении различных состояний вашего приложения.

Вы можете установить Streamlit с помощью pip:

```

pip install streamlit

```

И запустите streamlit в скрипте Python:

```

streamlit run app.py

```

### Варианты использования

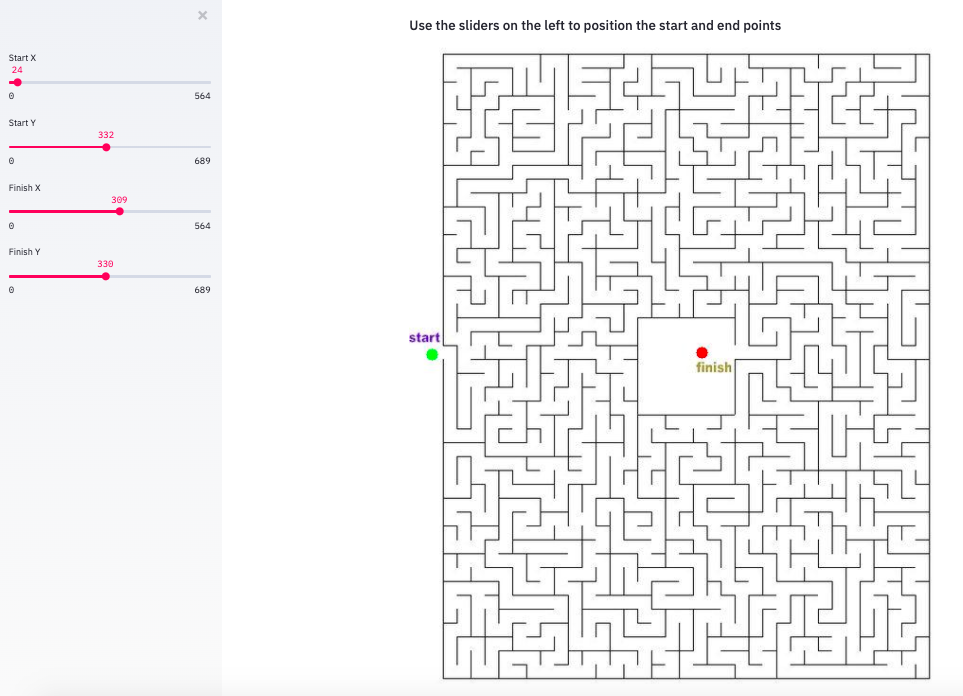

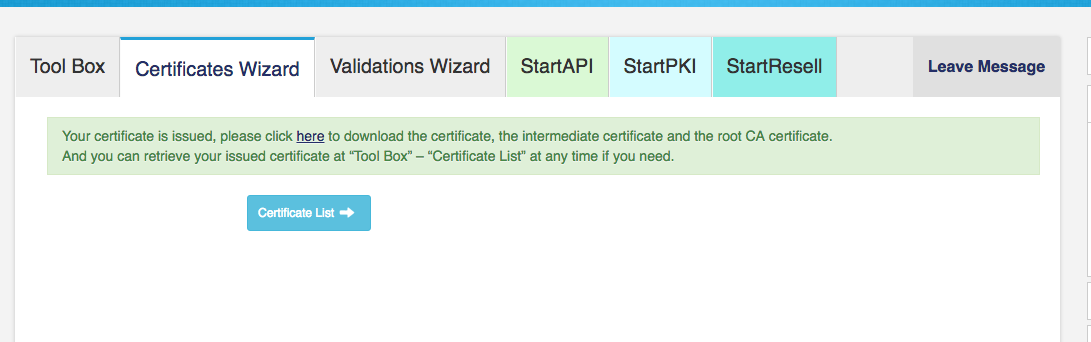

В [предыдущей статье](https://habr.com/ru/company/skillfactory/blog/509304/) мы создали программу на Python, которая будет проходить лабиринт, учитывая файл изображения и начальное/конечное местоположения. Мы хотели бы превратить эту программу в одностраничное веб-приложение, где пользователь может загрузить изображение лабиринта (или использовать изображение лабиринта по умолчанию), настроить начальное и конечное местоположение лабиринта и увидеть пройденный лабиринт.

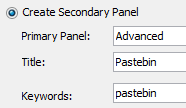

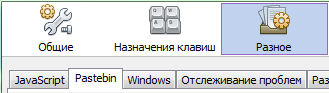

Во-первых, давайте создадим пользовательский интерфейс для загрузчика изображений и возможность использовать изображение по умолчанию. Мы можем добавить вывод текста, используя такие функции, как st.write() или st.title(). Мы храним динамически загруженный файл, используя функцию st.file\_uploader(). Наконец, st.checkbox() вернет логическое значение в зависимости от того, установил ли пользователь флажок.

```

import streamlit as st

import cv2

import matplotlib.pyplot as plt

import numpy as np

import maze

st.title('Maze Solver')

uploaded_file = st.file_uploader("Choose an image", ["jpg","jpeg","png"]) #image uploader

st.write('Or')

use_default_image = st.checkbox('Use default maze')

```

Результат:

Затем мы можем вывести наше изображение по умолчанию или загруженное изображение в пригодный для использования формат изображения OpenCV.

```

if use_default_image:

opencv_image = cv2.imread('maze5.jpg')

elif uploaded_file is not None:

file_bytes = np.asarray(bytearray(uploaded_file.read()), dtype=np.uint8)

opencv_image = cv2.imdecode(file_bytes, 1)

```

Как только изображение загружено, мы хотим показать изображение, размеченное с начальной и конечной точками. Мы будем использовать ползунки, чтобы позволить пользователю переместить эти точки. Функция st.sidebar() добавляет боковую панель на страницу, а st.slider() принимает числово в пределах определенного минимума и максимума. Мы можем определить минимальное и максимальное значения слайдера динамически в зависимости от размера нашего изображения лабиринта.

```

if opencv_image is not None:

st.subheader('Use the sliders on the left to position the start and end points')

start_x = st.sidebar.slider("Start X", value= 24 if use_default_image else 50, min_value=0, max_value=opencv_image.shape[1], key='sx')

start_y = st.sidebar.slider("Start Y", value= 332 if use_default_image else 100, min_value=0, max_value=opencv_image.shape[0], key='sy')

finish_x = st.sidebar.slider("Finish X", value= 309 if use_default_image else 100, min_value=0, max_value=opencv_image.shape[1], key='fx')

finish_y = st.sidebar.slider("Finish Y", value= 330 if use_default_image else 100, min_value=0, max_value=opencv_image.shape[0], key='fy')

marked_image = opencv_image.copy()

circle_thickness=(marked_image.shape[0]+marked_image.shape[0])//2//100 #circle thickness based on img size

cv2.circle(marked_image, (start_x, start_y), circle_thickness, (0,255,0),-1)

cv2.circle(marked_image, (finish_x, finish_y), circle_thickness, (255,0,0),-1)

st.image(marked_image, channels="RGB", width=800)

```

Всякий раз, когда пользователь настраивает ползунки, изображение быстро перерисовывается и точки меняются.

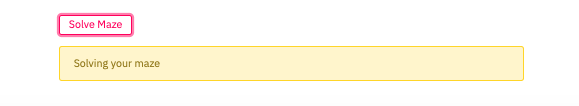

После того, как пользователь определил начальную и конечную позиции, мы хотим кнопку, чтобы решить лабиринт и отобразить решение. Элемент st.spinner () отображается только во время работы его дочернего процесса, а вызов st.image () используется для отображения изображения.

```

if marked_image is not None:

if st.button('Solve Maze'):

with st.spinner('Solving your maze'):

path = maze.find_shortest_path(opencv_image,(start_x, start_y),(finish_x, finish_y))

pathed_image = opencv_image.copy()

path_thickness = (pathed_image.shape[0]+pathed_image.shape[0])//200

maze.drawPath(pathed_image, path, path_thickness)

st.image(pathed_image, channels="RGB", width=800)

```

*Кнопка*

*Вывод решения*

### Вывод

Менее чем в 40 строк кода мы создали простой пользовательский интерфейс для приложения обработки изображений Python. Нам не нужно было писать какой-либо традиционный интерфейсный код. Помимо способности Streamlit переваривать простой код Python, Streamlit интеллектуально перезапускает необходимые части вашего скрипта сверху вниз при каждом взаимодействии пользователя со страницей или при изменении скрипта. Это обеспечивает прямой поток данных и быструю разработку.

Вы можете найти [полный код на Github](https://github.com/maxwellreynolds/Maze/blob/master/ui.py) и первую часть, объясняющую алгоритм решения лабиринта [здесь](https://habr.com/ru/company/skillfactory/blog/509304/). Документация Streamlit, включая важные понятия и дополнительные виджеты находится [здесь](https://docs.streamlit.io/en/stable/).

Узнайте подробности, как получить востребованную профессию с нуля или Level Up по навыкам и зарплате, пройдя платные онлайн-курсы SkillFactory:

* [Курс по Machine Learning](https://skillfactory.ru/ml-programma-machine-learning-online?utm_source=infopartners&utm_medium=habr&utm_campaign=ML&utm_term=regular&utm_content=03072000) (12 недель)

* [Обучение профессии Data Science с нуля](https://skillfactory.ru/data-scientist?utm_source=infopartners&utm_medium=habr&utm_campaign=DST&utm_term=regular&utm_content=03072000) (12 месяцев)

* [Профессия аналитика с любым стартовым уровнем](https://skillfactory.ru/analytics?utm_source=infopartners&utm_medium=habr&utm_campaign=SDA&utm_term=regular&utm_content=03072000) (9 месяцев)

* [Курс «Python для веб-разработки»](https://skillfactory.ru/python-for-web-developers?utm_source=infopartners&utm_medium=habr&utm_campaign=PWS&utm_term=regular&utm_content=03072000) (9 месяцев)

### Читать еще

* [Тренды в Data Scienсe 2020](https://habr.com/ru/company/skillfactory/blog/508450/)

* [Data Science умерла. Да здравствует Business Science](https://habr.com/ru/company/skillfactory/blog/508556/)

* [Крутые Data Scientist не тратят время на статистику](https://habr.com/ru/company/skillfactory/blog/507052/)

* [Как стать Data Scientist без онлайн-курсов](https://habr.com/ru/company/skillfactory/blog/507024/)

* [Шпаргалка по сортировке для Data Science](https://habr.com/ru/company/skillfactory/blog/506888/)

* [Data Science для гуманитариев: что такое «data»](https://habr.com/ru/company/skillfactory/blog/506798/)

* [Data Scienсe на стероидах: знакомство с Decision Intelligence](https://habr.com/ru/company/skillfactory/blog/506790/) | https://habr.com/ru/post/509340/ | null | ru | null |

# Docker Compose: от разработки до продакшена

***Перевод транскрипции подкаста подготовлен в преддверии старта курса [«Администратор Linux»](https://otus.pw/jHmQ/)***

---

Docker Compose — это удивительный инструмент для создания рабочего

окружения для стека, используемого в вашем приложении. Он позволяет вам определять

каждый компонент вашего приложения, следуя четкому и простому синтаксису в [YAML-

файлах](https://en.wikipedia.org/wiki/YAML).

С появлением [docker compose v3](https://docs.docker.com/compose/compose-file/) эти YAML-файлы могут использоваться непосредственно в рабочей среде, при работе с кластером [Docker Swarm](https://docs.docker.com/engine/swarm/).

Но значит ли это, что вы можете использовать один и тот же docker-compose файл в процессе разработки и в продакшен среде? Или использовать этот же файл для стейджинга? Ну, в целом — да, но для такого функционала нам необходимо следующее:

* Интерполяция переменных: использование переменных среды для некоторых

значений, которые изменяются в каждой среде.

* Переопределение конфигурации: возможность определить второй (или любой

другой последующий) docker-compose файл, который что-то изменит относительно

первого, и docker compose позаботится о слиянии обоих файлов.

Различия между файлами для разработки и продакшена

--------------------------------------------------

Во время разработки вы, скорее всего, захотите проверять изменения кода в

режиме реального времени. Для этого, обычно, том с исходным кодом монтируется в

контейнер, в котором находится рантайм для вашего приложения. Но для продакшн-среды

такой способ не подходит.

В продакшене у вас есть кластер с множеством узлов, а том является локальным по

отношению к узлу, на котором работает ваш контейнер (или сервис), поэтому вы не

можете монтировать исходный код без сложных операций, которые включают в себя

синхронизацию кода, сигналы и т. д.

Вместо этого мы, обычно, хотим создать образ с конкретной версией вашего кода.

Его принято помечать соответствующим тегом (можно использовать семантическое

версионирование или другую систему на ваше усмотрение).

Переопределение конфигурации

----------------------------

Учитывая различия и то, что ваши зависимости могут отличаться в сценариях

разработки и продакшена, ясно, что нам потребуются разные конфигурационные файлы.

Docker compose поддерживает объединение различных compose-файлов для

получения окончательной конфигурации. Как это работает можно увидеть на примере:

```

$ cat docker-compose.yml

version: "3.2"

services:

whale:

image: docker/whalesay

command: ["cowsay", "hello!"]

$ docker-compose up

Creating network "composeconfigs_default" with the default driver

Starting composeconfigs_whale_1

Attaching to composeconfigs_whale_1

whale_1 | ________

whale_1 | < hello! >

whale_1 | --------

whale_1 | \

whale_1 | \

whale_1 | \

whale_1 | ## .

whale_1 | ## ## ## ==

whale_1 | ## ## ## ## ===

whale_1 | /""""""""""""""""___/ ===

whale_1 | ~~~ {~~ ~~~~ ~~~ ~~~~ ~~ ~ / ===- ~~~

whale_1 | \______ o __/

whale_1 | \ \ __/

whale_1 | \____\______/

composeconfigs_whale_1 exited with code 0

```

Как было сказано, docker compose поддерживает объединение нескольких compose-

файлов, это позволяет переопределять различные параметры во втором файле. Например:

```

$ cat docker-compose.second.yml

version: "3.2"

services:

whale:

command: ["cowsay", "bye!"]

$ docker-compose -f docker-compose.yml -f docker-compose.second.yml up

Creating composeconfigs_whale_1

Attaching to composeconfigs_whale_1

whale_1 | ______

whale_1 | < bye! >

whale_1 | ------

whale_1 | \

whale_1 | \

whale_1 | \

whale_1 | ## .

whale_1 | ## ## ## ==

whale_1 | ## ## ## ## ===

whale_1 | /""""""""""""""""___/ ===

whale_1 | ~~~ {~~ ~~~~ ~~~ ~~~~ ~~ ~ / ===- ~~~

whale_1 | \______ o __/

whale_1 | \ \ __/

whale_1 | \____\______/

composeconfigs_whale_1 exited with code 0

```

Такой синтаксис не очень удобен в процессе разработки, когда команду

понадобится выполнять множество раз.

К счастью, docker compose автоматически ищет специальный файл с именем

**docker-compose.override.yml** для переопределения значений **docker-compose.yml**. Если

переименовать второй файл, то получится тот же результат, только с помощью изначальной команды:

```

$ mv docker-compose.second.yml docker-compose.override.yml

$ docker-compose up

Starting composeconfigs_whale_1

Attaching to composeconfigs_whale_1

whale_1 | ______

whale_1 | < bye! >

whale_1 | ------

whale_1 | \

whale_1 | \

whale_1 | \

whale_1 | ## .

whale_1 | ## ## ## ==

whale_1 | ## ## ## ## ===

whale_1 | /""""""""""""""""___/ ===

whale_1 | ~~~ {~~ ~~~~ ~~~ ~~~~ ~~ ~ / ===- ~~~

whale_1 | \______ o __/

whale_1 | \ \ __/

whale_1 | \____\______/

composeconfigs_whale_1 exited with code 0

```

Хорошо, так запомнить проще.

#### Интерполяция переменных

Файлы конфигурации поддерживают [интерполяцию

переменных](https://docs.docker.com/compose/compose-file/#variable-substitution) и значения по умолчанию. То есть вы можете сделать следующее:

```

services:

my-service:

build:

context: .

image: private.registry.mine/my-stack/my-service:${MY_SERVICE_VERSION:-latest}

...

```

И если вы выполняете **docker-compose build (или push)** без переменной окружения

**$MY\_SERVICE\_VERSION**, будет использовано значение *latest*, но если вы установите

значение переменной окружения до сборки, оно будет использовано при сборке или пуше

в регистр **private.registry.mine**.

Мои принципы

------------

Подходы, которые удобны для меня, могут пригодиться и вам. Я следую этим

простым правилам:

* Все мои стеки для продакшена, разработки (или других сред) определяются через

файлы docker-compose.

* Файлы конфигурации, необходимые для охвата всех моих сред, максимально

избегают дублирования.

* Мне нужна одна простая команда для работы в каждой среде.

* Основная конфигурация определяется в файле **docker-compose.yml**.

* Переменные среды используются для определения тегов образов или других

переменных, которые могут меняться от среды к среде (стейджинг, интеграция,

продакшен).

* Значения переменных для продакшена используются в качестве значений по

умолчанию, это минимизирует риски в случае запуска стека в продакшене без

установленной переменной окружения.

* Для запуска сервиса в продакшен-среде используется команда **docker stack deploy — compose-file docker-compose.yml --with-registry-auth my-stack-name**.

* Рабочее окружение запускается с помощью команды **docker-compose up -d**.

Давайте посмотрим на простой пример.

```

# docker-compose.yml

...

services:

my-service:

build:

context: .

image: private.registry.mine/my-stack/my-service:${MY_SERVICE_VERSION:-latest}

environment:

API_ENDPOINT: ${API_ENDPOINT:-https://production.my-api.com}

...

```

И

```

# docker-compose.override.yml

...

services:

my-service:

ports: # This is needed for development!

- 80:80

environment:

API_ENDPOINT: https://devel.my-api.com

volumes:

- ./:/project/src

...

```

Я могу использовать **docker-compose (docker-compose up)**, чтобы запустить стек в

режиме разработки с исходным кодом, смонтированным в **/project/src**.

Я могу использовать эти же файлы на продакшене! И я мог бы использовать точно

такой же файл **docker-compose.yml** для стейджинга. Чтобы развернуть это на

продакшен, мне просто нужно собрать и отправить образ с предопределенным тегом

на этапе CI:

```

export MY_SERVICE_VERSION=1.2.3

docker-compose -f docker-compose.yml build

docker-compose -f docker-compose.yml push

```

На продакшене это можно запустить с помощью следующих команд:

```

export MY_SERVICE_VERSION=1.2.3

docker stack deploy my-stack --compose-file docker-compose.yml --with-registry-auth

```

И если вы хотите сделать то же самое на стейдже, необходимо просто определить

необходимые переменные окружения для работы в среде стейджинга:

```

export MY_SERVICE_VERSION=1.2.3

export API_ENDPOINT=http://staging.my-api.com

docker stack deploy my-stack --compose-file docker-compose.yml --with-registry-auth

```

В итоге мы использовали два разных docker-compose файла, которые без

дублирования конфигураций могут использоваться для любой вашей среды!

---

***Узнать подробнее о курсе [«Администратор Linux»](https://otus.pw/jHmQ/)***

--- | https://habr.com/ru/post/512404/ | null | ru | null |

# Решение задания с pwnable.kr 08 — leg, и 10 — shellshock. ARM ассемблер. Уязвимость bash

В данной статье вспомним синтаксис ARM ассемблера, разберемся с уязвимостью shellshock, а также решим 8-е и 10-е задания с сайта [pwnable.kr](https://pwnable.kr/index.php).

**Организационная информация**Специально для тех, кто хочет узнавать что-то новое и развиваться в любой из сфер информационной и компьютерной безопасности, я буду писать и рассказывать о следующих категориях:

* PWN;

* криптография (Crypto);

* cетевые технологии (Network);

* реверс (Reverse Engineering);

* стеганография (Stegano);

* поиск и эксплуатация WEB-уязвимостей.

Вдобавок к этому я поделюсь своим опытом в компьютерной криминалистике, анализе малвари и прошивок, атаках на беспроводные сети и локальные вычислительные сети, проведении пентестов и написании эксплоитов.

Чтобы вы могли узнавать о новых статьях, программном обеспечении и другой информации, я создал [канал в Telegram](https://t.me/RalfHackerChannel) и [группу для обсуждения любых вопросов](https://t.me/RalfHackerPublicChat) в области ИиКБ. Также ваши личные просьбы, вопросы, предложения и рекомендации [рассмотрю лично и отвечу всем](https://t.me/hackerralf8).

Вся информация представлена исключительно в образовательных целях. Автор этого документа не несёт никакой ответственности за любой ущерб, причиненный кому-либо в результате использования знаний и методов, полученных в результате изучения данного документа.

Решение задания leg

-------------------

Нажимаем на первую иконку с подписью leg, и нам говорят, что нужно подключиться по SSH с паролем guest. Так же предоставляют исходный код на C и ассемблере.

Давайте скачаем оба файла и посмортим исходный код на языке C. По ассемблерным вставкам можно сказать, что использует синтаксис ARM. Про ARM ассемблер на Хабре писали [тут](https://habr.com/ru/post/133808/) и [тут](https://habr.com/ru/post/188712/).

В функции main() от пользователя принимается число и сравнивается с суммой результатов трех функций key(). Разберем их по порядку.

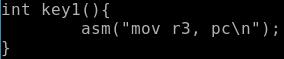

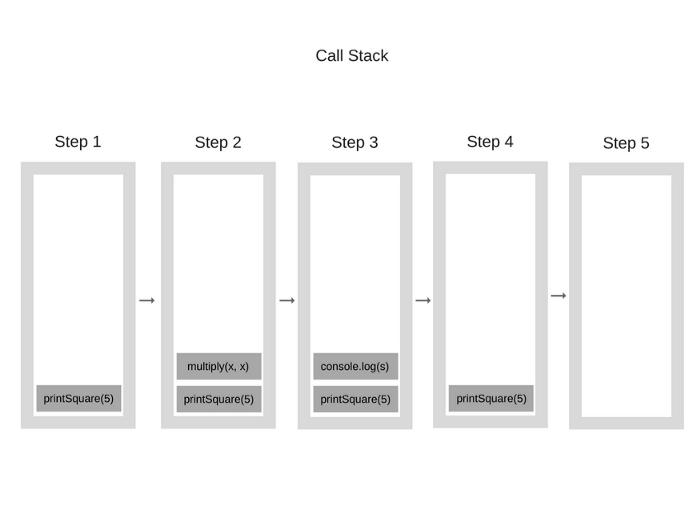

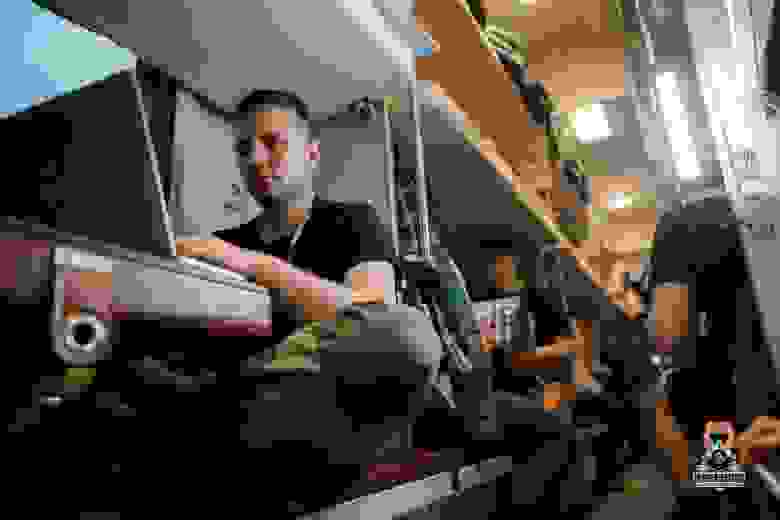

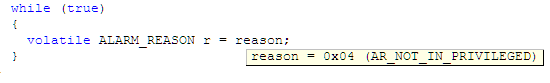

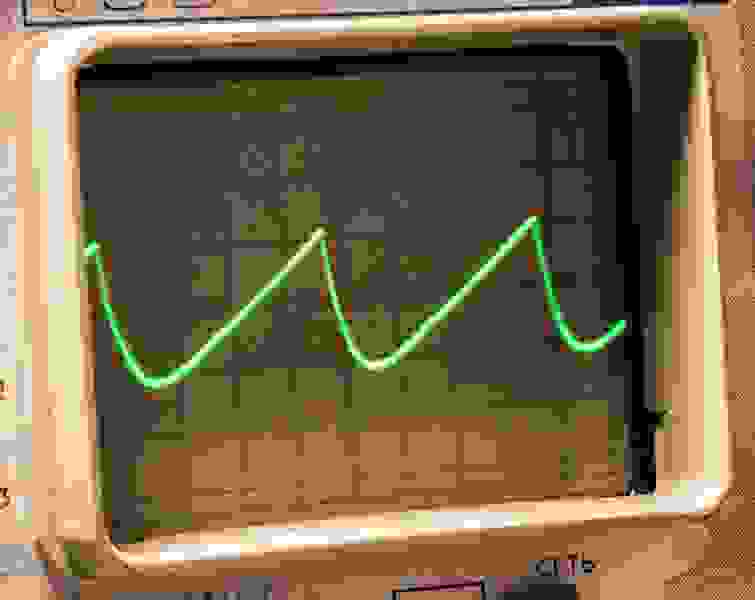

Таким образом в регистр R3 помещается значение из регистра PC. В ARM ассемблере регистр PC содержит адрес следующей инструкции, которая должна быть выполнена. Смотрим дизассемблированный код.

Таким образом, функция key1() вернет значение 0x8ce4. Разберем функцию key2().

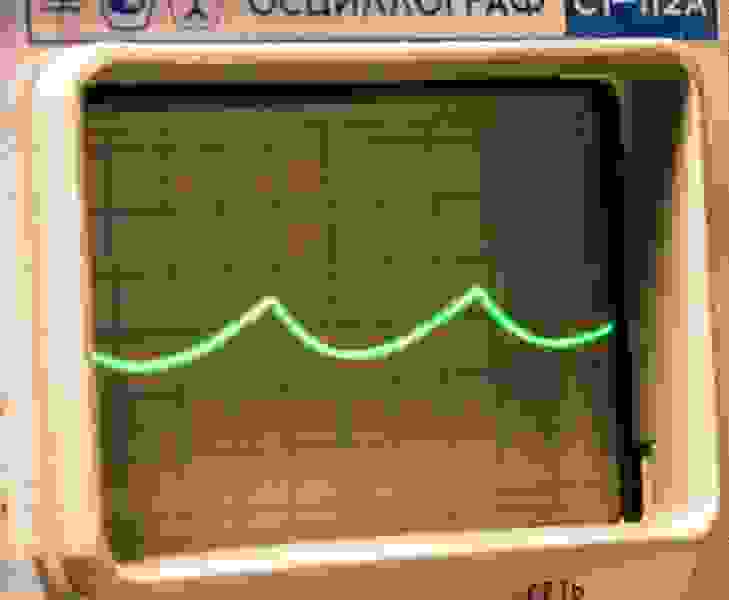

В R3 помещается 0x8d08, которое потом увеличивается на 4 и записывается в регистр R0. То есть key2() вернет 0x8d0c. Рассмотрим key3().

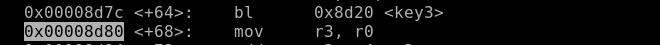

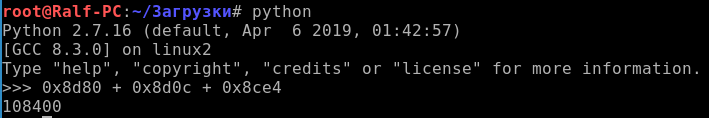

По аналогии с первой функцией делаем вывод, что key3() вернет значение из регистра LR. LR содержит адрес возврата функции. Посмотрим, где вызывается функция и возьмем следующий адрес.

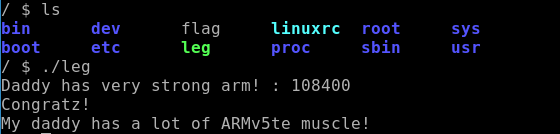

Функция key3() вернет 0x8d80. Подключимся по SSH и введем в программу сумму трех найденных чисел.

Сдаем флаг и получаем два очка.

Shellshock aka Bashdoor

-----------------------

Shellshock (Bashdoor) — программная уязвимость, обнаруженная в программе GNU Bash, которая позволяет исполнять произвольные команды при получении некоторых нестандартных значений переменных окружения. Уязвимость получила номер CVE-2014-6271.

В Unix-подобных операционных системах каждая программа имеет переменными среды. Дочерний процесс наследует у родительского список переменных среды. Кроме переменных среды, bash также поддерживает внутренний список функций — именованных скриптов, которые могут вызываться из исполняемого скрипта. При запуске скриптов из других (родительских) скриптов возможен экспорт значений существующих переменных окружения и определений функций. Определения функций экспортируются путём кодирования их в виде новых переменных окружения специального формата, начинающегося с пустых скобок «()», за которыми следует определение функции в виде строки. Новые экземпляры bash при своем запуске сканируют все переменные среды, детектируя данный формат и преобразовывая его обратно в определение внутренней функции. Таким образом, если злоумышленник имеет возможность подать произвольную переменную среды в запуск bash, то появляется возможность исполнения произвольных команд.

Следующий пример напечатает текст VULN.

```

env x=’() { : ; }; echo “VULN”’ bash -c “echo text”

```

Так как при выполнении команды “echo text” будет загружено определение функции, содержащееся в переменной окружения x, а с ним выполнена команда ‘echo “VULN”’.

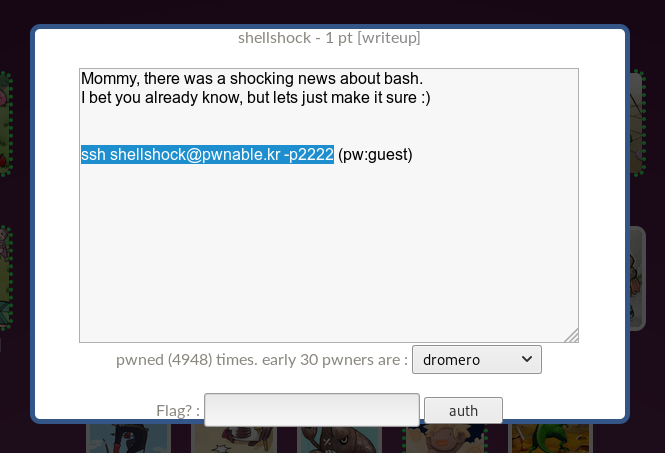

Решение задания shellshock

--------------------------

Нажимаем на первую иконку с подписью shellshock, и нам говорят, что нужно подключиться по SSH с паролем guest.

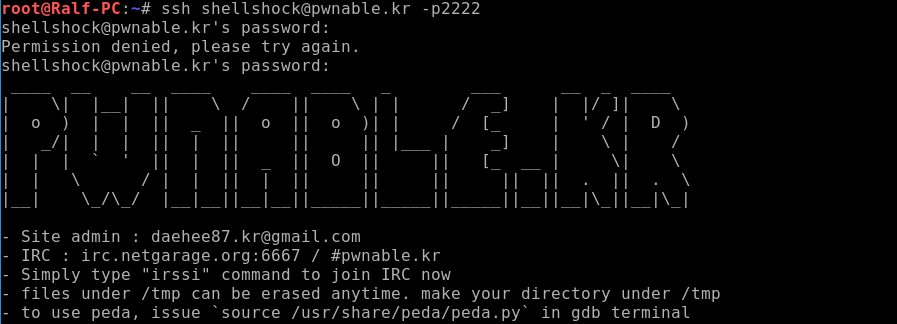

При подключении мы видим соответствующий баннер.

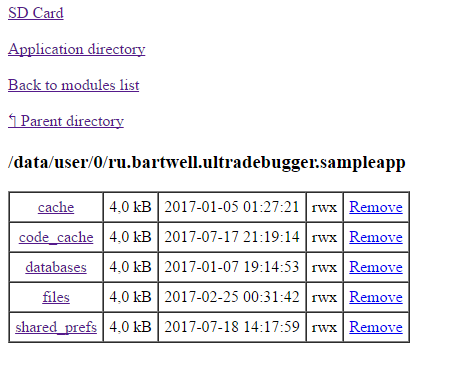

Давайте узнаем, какие файлы есть на сервере, а также какие мы имеем права.

Давай просмотрим исход код.

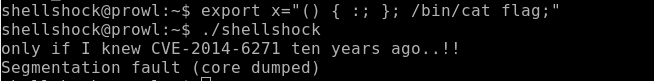

Интерес вызывает строка с вызовом функции system. Исходя из названия, предполагаем, что bash, который находится рядом с программой и вызывается из программы, уязвим. По аналогии с описанной в статье атакой, выполним команду чтения флага.

```

/bin/cat flag

```

Для этого определим функцию в переменной окружения, куда поместим эту команду. А потом запустим программу.

```

export x="() { :; }; /bin/cat flag;"

```

Сдаем флаг и получаем еще одно очко. До встречи в следующей статье.

Мы в телеграм канале: [канал в Telegram](https://t.me/RalfHackerChannel). | https://habr.com/ru/post/461269/ | null | ru | null |

# CSS 3D эффекты

Стивен Виттенс переработал свой сайт Acko.net. Виттенс применил 3D функции CSS 3 и небольшую часть JavaScript для создания ошеломляющего 3D заголовка страницы.

Чтобы увидеть 3D в действии вам надо использовать браузер WebKit (Safari или Chrome) т.к. пока только они поддерживают CSS 3D эффекты. В других браузерах, которые еще не поддерживают 3D эффекты сайт все равно нормально просматривается. Чтобы увидеть полный 3D эффект обязательно прокрутите страницу.

Виттенс в [своем блоге](http://acko.net/blog/making-love-to-webkit/) подробно написал как он создал 3D эффекты и даже сделал 3D редактор, с которым вы можете [поиграть](http://acko.net/editor.html).

Чтобы обойти некоторые ограничения CSS в браузерах Виттенс применил [Three.js](https://github.com/mrdoob/three.js/) — JavaScript 3D библиотека, написана Рикардо Кабелло (его знаменитый проект [Harmony](http://mrdoob.com/projects/harmony/)). Для тех кто заинтересован в исходных кодах некоторых преобразований на Acko.net, Виттенс пообещал выпустить его на GitHub в ближайшее время.

Потестить можно с этим кодом:

```

try{Typekit.load();}catch(e){}

<h1 class="site-name">Habrahabr</h1>

```

~~CSS код в нормальном виде можно взять [здесь](http://acko.net/cache/combo.css), JS [здесь](http://acko.net/cache/combo.js).~~

**UPD:** Перезалил полную версию CSS — [forum.xeksec.com/habr/3d/combo.css](http://forum.xeksec.com/habr/3d/combo.css)

JS — [forum.xeksec.com/habr/3d/combo.js](http://forum.xeksec.com/habr/3d/combo.js) | https://habr.com/ru/post/136475/ | null | ru | null |

# Киллер игорных слотов в браузере своими руками для хабровцев

Здравствуйте!

Я вот заметил, что почти любой софт имеется платный и бесплатный. Но я не видел чтобы был какой-нибудь движок для казино в свободном доступе. Но я это не гуглил, может и имеется. Но что толку если Вы сами не попробовали это сделать? Если не хватает знаний и сил - то дерзайте, покупайте или скачивайте пиратский софт (библиотеку или движок), но мне на разбор чужого детища не хватает сил, да и я никогда таким не занимался. Сейчас уже такое время, что людям трудно даже программу установить на ПК или смартфон, а может разучились и не знают что так можно? Мельчают юзеры, да к тому же печатные машинки сейчас наверное остались только у разработчиков. Везде смартфоны - на андроиде или IOS, но они радуют поддержкой веб-технологий в своих браузерах. Просто открыл сайт и вуаля! Играй не хочу или сёрфь интернет, что-то смотри, читай. Не знаю как сейчас пользователи гаджетов и ПК занимают своё свободное время, как я понял сидят в соцсетях судя по количеству интернет трафика. Но это дело избранных, а тем кому не повезло в жизни ищут как бы заработать. Я кокрас из таких. Насколько я знаю заработать можно своим делом или работая на кого-то. Если рассматривать обычных людей, а не айтишников, то выбор не большой. Смотреть рекламу за копейки, разносить закладки(если понимаете), постить рекламу на всяких сайтах, раскачивать персов в играх на продажу, в случае если ничего не умеете конечно, есть конечно там перепродажа всякой всячины, стать блогером и(или) ютубером, про работу в оффлайне не говорю и наше любимое-вечное: покер и казино. А конкретно слоты - это "однорукий бандит"(запрещены в РФ, если на деньги конечно, да и не только в РФ). Я за всю жизнь играл в них раз, один раз за день когда их запретили в РФ проиграл где-то 3000 рублей ставя на гонку собак.. Это конечно меня разозлило и я решил нанести удар по индустрии. Конечно удар муравьиный, но начало положено.

Немного теории.

Я конечно своими словами.

Игровой автомат - это математическая функция которая возвращает вероятность выигрыша от стоимости хода и бюджета.

Можно даже перефразировать возвращает число у.е. выигрыша в зависимости остался у вас бюджет для получения текущего хода.

То есть, если

Зависит от функции BlackBox, обычно 51 раз выигрывает казино, а 49 раз игрок. Иначе просто разорится крупье. Но бывает, что казино может 100 раз выиграть, а игрок 0. Так что рано радоваться. Конечно если казино грабит игроков, то это сразу заметно и негативный отзыв тут же сделает свое дело. Именно поэтому они меняют адреса(в сети) и добавляют новые "одежды" для слотов, а бывает что и меняют название фирм. Короче дурят как хотят, но что если в сети появятся много сайтов и начнут отъедать у монополистов аудиторию? Конкуренция, что тогда? Если каждому кто захочет склепать сайт например со слотом хотя бы одним, то начнется хаос. Правда тут еще не сильно сделано все. Но я просто хотел привлечь внимание к проблеме. Вернемся к теории, если 0.49\*0.49(умножение вероятностей выигрыша игрока означает вероятность выигрыша игрока подряд для 2х ходов) и так далее

Запомните хотя бы общее правило, предел функции(последовательности) при шагах стремящихся к бесконечности равен 0.(То есть чем дольше играем тем больше проиграем(выигрыш 0)).

```

if(budget - price>=0)

{

step++;

budget -= price;

Win = BlackBox(step,budget,price);

}

else

alert("Пополните счет!");

```

Но этот алгоритм, выше скорее всего остановит Вас раньше.

Теперь рассмотрим проект сам.

Всего 2 играющих символа - буква F и звездочка. Минимальный функционал, по нажатию мышкой или тап с телефона по игровому экрану приведёт к вращению("спину") барабана, через некоторое время он остановится. Во время "спина" происходит смена символов на барабане. Задаются символы генератором случайных чисел. Работает в телефоне(в браузере) и на компьютере. Если у кого IOS, MacOS отпишитесь работает ли?

Не знаю сработает ли медиафайл на странице Хабра, так что продублирую [ссылкой](https://codepen.io/Gremlin_Rage/pen/poPqmxY)

Благодарю за внимание! | https://habr.com/ru/post/665748/ | null | ru | null |

# Работаем с долгими API в ASP.NET Core правильно или тонкости переезда на новую платформу

Microsoft очень постарался, создавая новую платформу для веб-разработки. Новый ASP.NET Core похож на старенький ASP.NET MVC только, быть может, самой MVC-архитектурой. Ушли сложности и привычные вещи из старой платформы, появился встроенный DI и легковесные view-компоненты, HTTP модули и хэндлеры уступили место middleware и т.д. Вкупе с кроссплатформенностью и хорошей производительностью всё это делает платформу очень привлекательной для выбора. В этой статье я расскажу, как мне удалось решить специфическую задачу логирования длительных запросов к сторонним API для повышения удобства анализа инцидентов.

Вместо вступления...

--------------------

В дипломах и диссертациях где-то в начале обычно должна формулироваться проблема. Но то, что я опишу ниже, скорее даже не проблема, а стремление сделать приложение юзабельнее и окружающий мир немножечко прекраснее. Это один из тех моментов в моей жизни, где я спрашиваю себя, а можно ли сделать лучше? А после этого пытаюсь найти способы это сделать. Иногда у меня это получается, иногда я понимаю, что сделать лучше либо невозможно, либо на это стоит затратить столько усилий, что это в конечном итоге потеряет всякий смысл. В конце концов, это ~~не перевернет мир и не решит проблему бедности на планете~~ не то, на что стоит тратить свои силы и время. Но так или иначе, я получаю из этого какой-то опыт, который не может не пригодиться в будущем. В этой статье я опишу то, что мне кажется, у меня получилось сделать лучше.

Формулировка задачи

-------------------

Начну с того, что компания, где я работаю, занимается разработкой высоконагруженных сайтов. Приложения, над которыми на текущий момент мне удалось потрудиться, по своей большей части, являются неким прикрытым авторизацией интерфейсом доступа к внутренним АПИ заказчика. Логики там немного и она распределена примерно в равных пропорциях между frontend'ом и backend'ом. Большинство ключевой бизнес-логики лежит именно в этих АПИ, а сайты, видимые конечному клиенту, являются их консьюмерами.

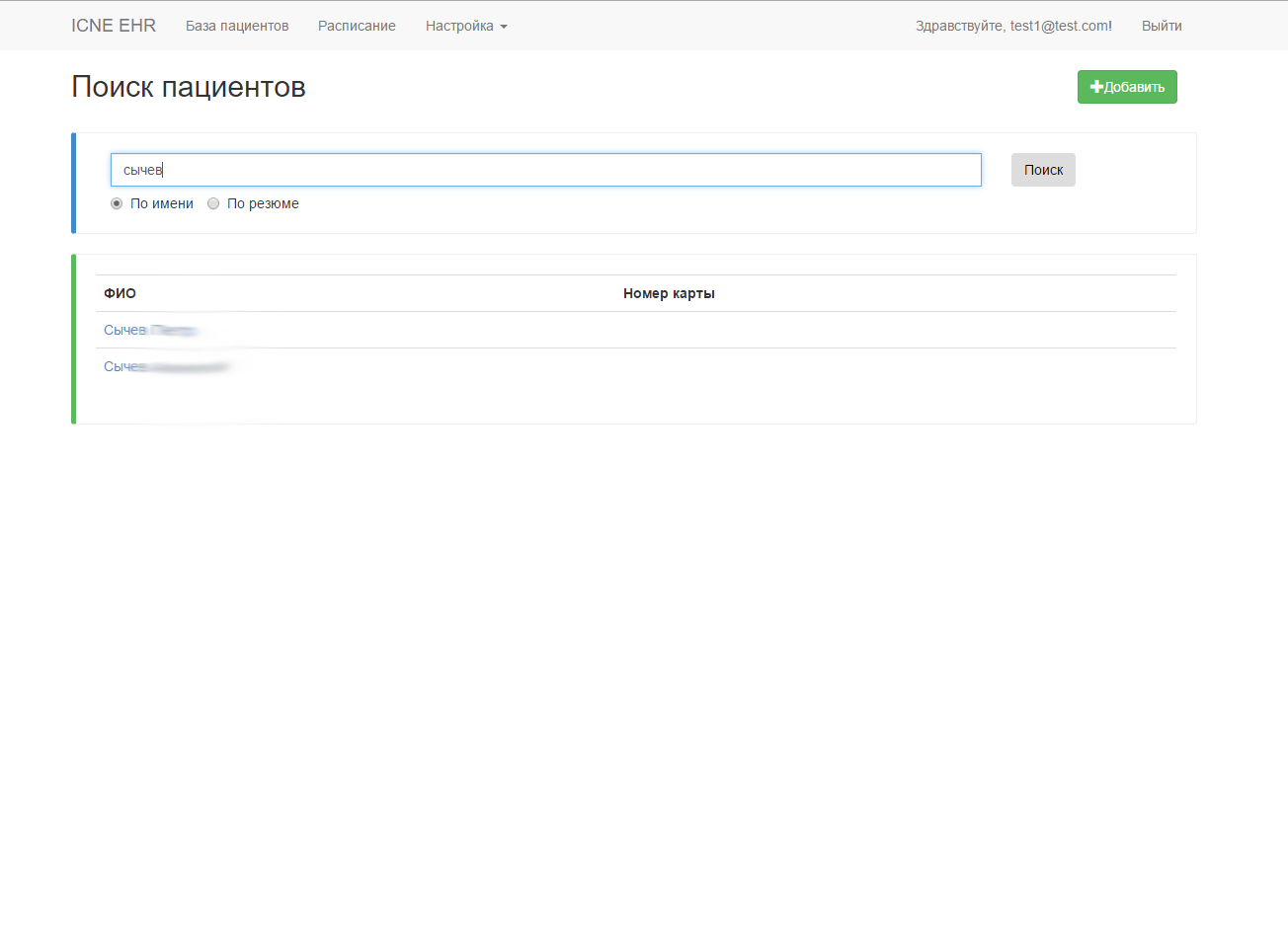

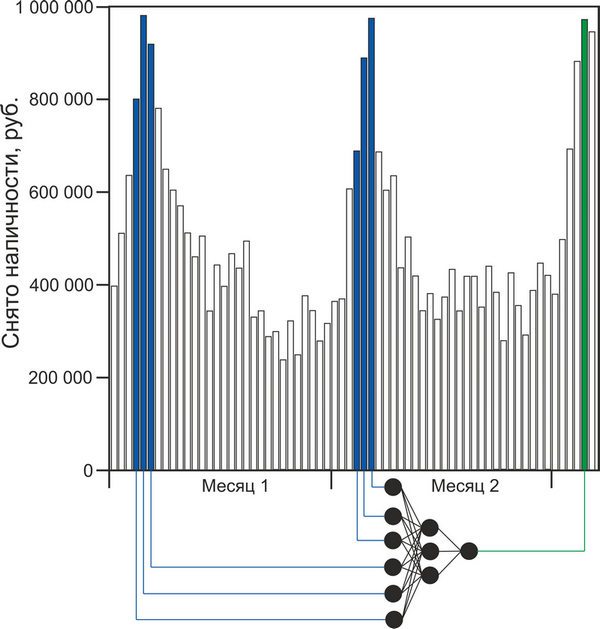

Иногда получается так, что сторонние по отношению к сайту API отвечают на запросы пользователя весьма продолжительное время. Иногда это временный эффект, иногда постоянный. Так как приложения по природе своей — высоконагруженные, нельзя допустить, чтобы запросы пользователя находились в подвисшем состоянии долгое время, иначе это может грозить нам постоянно увеличивающимся количеством открытых сокетов, быстро пополняющуюся очередь не отвеченных запросов на сервере, а ещё — большим количеством клиентов, волнующихся и переживающих, почему их любимый сайт открывается так долго. С API мы ничего сделать не можем. И в связи с этим с очень давних времен у нас на балансировщике было введено ограничение на длительность выполнения запроса, равное 5 секундам. Это в первую очередь накладывает ограничения на архитектуру приложения, так как подразумевает ещё больше асинхронного взаимодействия, вследствие чего решает вышеописанную проблему. Сам сайт открывается быстро, а уже на открытой странице крутятся индикаторы загрузки, которые в конце концов выдадут какой-то результат пользователю. Будет это тем, что пользователь ожидает увидеть, или же ошибкой уже не играет большого значения, и это будет уже совсем другой историей…

**Совсем другая история**[](https://imgbb.com/)

Внимательный читатель заметит: но если ограничение стоит на все запросы, то оно ведь распространяется и на AJAX-запросы тоже. Все правильно. Я вообще не знаю способа отличить AJAX-запрос от обычного перехода на страницу, 100% работающего во всех случаях. Поэтому долгие AJAX-запросы реализуются по следующему принципу: с клиента мы делаем запрос на сервер, сервер создает Task и ассоциирует с ним определенный GUID, затем возвращает этот GUID клиенту, а клиент получает результат по данному GUID, когда он придет на сервер от API. На этом этапе мы почти подобрались к сути моей ~~надуманной проблемы~~ задачи.

Все запросы и ответы к этим API мы должны логировать и хранить для разбора полетов, а из логов мы должны получать максимум полезной информации: вызванный action/controller, IP, URI, логин пользователя и т.д. и т.п. Когда же я в первый раз с помощью NLog'а залогировал свой запрос/ответ в моем ASP.NET Core приложении, то в принципе я не удивился, увидев в ElasticSearch что-то вроде:

`2017-09-23 23:15:53.4287|0|AspNetCoreApp.Services.LongRespondingService|TRACE|/| DoJob method is starting (AspNetCoreApp.Services.LongRespondingService.DoJob:0)| url:http:///`

В то же время в конфигурации NLog все выглядело достаточно правильно и в качестве layout было установлено следующее:

`${longdate}|${event-properties:item=EventId.Id}|${logger}|${uppercase:${level}}|${aspnet-mvc-controller}/${aspnet-mvc-action}| ${message} (${callsite}:${callsite-linenumber})| url:${aspnet-request-url}`

Проблема здесь в том, что ответ от API приходит уже после окончания выполнения запроса клиентом (ему то возвращается всего лишь GUID). Вот тут то я и начал думать о возможных способах решения этой проблемы…

Возможные решения проблемы

--------------------------

Конечно, любую проблему можно устранить несколькими способами. Причем забить на нее — тоже один из приёмов, которым иногда не стоит пренебрегать. Но поговорим всеж-таки о реальных способах решения и их последствиях.

### Передавать ID задачи в метод обращения к API

Наверное, это первое, что только может прийти в голову. Мы генерируем GUID, логируем этот GUID еще до выхода из action'а и передаем его в сервис работы с API.

Проблемы этого подхода — очевидны. Мы должны передавать этот ID в абсолютно все методы обращения к сторонним API. При этом, если мы захотим переиспользовать данный кусочек где-то еще, где такая функциональность не требуется, то нам это очень сильно будет мешать.

Ситуация усугубляется, если перед отдачей данных клиенту, мы хотим их каким-то образом обработать, упростить или агрегировать. Это относится к бизнес-логике и ее следует вынести в отдельный кусочек. Получается, что этот кусочек, который должен оставаться максимально независимым, будет тоже работать с этим идентификатором! Так дела не делаются, поэтому рассмотрим другие способы.

### Сохранить ID задачи в CallContext

Если мы подумаем, какие средства нам предоставляет фрэймворк для этих целей, то первым делом вспомним про CallContext с его LogicalSetData/LogicalGetData. Используя эти методы, можно сохранить ID задачи в CallContext'e, а .NET (лучше сказать, .NET 4.5) сам позаботится о том, чтобы новые потоки автоматически получили доступ к этим же данным. Внутри фрэймворка это реализуется с помощью паттерна, чем-то напоминающего Memento, который должны использовать все методы запуска нового потока/задачи:

```

// Перед запуском задачи делаем snapshot текущего состояния

var ec = ExecutionContext.Capture();

...

// Разворачиваем сохраненный snapshot в новом потоке

ExecutionContext.Run(ec, obj =>

{

// snapshot на этом этапе уже развернут, поэтому здесь вызывается уже пользовательский код

}, state);

```

Теперь когда мы знаем, как сохранить ID, а затем получить его в нашей task'е, мы можем в каждое наше логируемое сообщение, включить этот идентификатор. Можно сделать это непосредственно при вызове метода логирования. Или, чтобы не засорять слой доступа к данным, можно использовать возможности вашего логгера. В NLog, например, есть [Layout Renderers](https://github.com/nlog/nlog/wiki/Layout-Renderers).

Также в крайнем случае можно написать свой логгер. В ASP.NET Core всё логирование осуществляется с помощью специальных интерфейсов, расположенных в пространстве имен Microsoft.Extensions.Logging, которые внедряются в класс посредством DI. Поэтому нам достаточно реализовать два интерфейса: ILogger и ILoggerProvider. Думаю, такой вариант может оказаться полезным, если ваш логгер не поддерживает расширения.

А чтобы все получилось так, как надо, рекомендую ознакомиться со [статьей Stephen'а Cleary](https://blog.stephencleary.com/2013/04/implicit-async-context-asynclocal.html). В ней нет привязки к .NET Core (в 2013 году его просто-напросто еще не было), но что-то полезное для себя там точно можно подчеркнуть.

Недостаток данного подхода в том, что в лог будут попадать сообщения с идентификатором и чтобы получить полную картину нужно будет искать HTTP-запрос с этим же ID. Про производительность я промолчу, так как, даже если и будет какая-та просадка, то по сравнению с другими вещами это будет казаться несоизмеримо малым значением.

### А что, если подумать, почему это не работает?

Как я уже говорил, в лог к нам сыпятся сообщения вида:

`2017-09-23 23:15:53.4287|0|AspNetCoreApp.Services.LongRespondingService|TRACE|/| DoJob method is starting (AspNetCoreApp.Services.LongRespondingService.DoJob:0)| url:http:///`

Т.е. все, что связано с IHttpContext просто зануляется. Оно вроде как и понятно: выполнение запроса то закончилось, поэтому NLog и не может получить данные, т.е. ссылки на HttpContext просто уже нет.

Наконец-то, я решил посмотреть, а как собственно NLog получает ссылку на HttpContext вне контроллера. Так как с SynchronizationContext'ом и HttpContext.Current в .NET Core [было покончено](https://blog.stephencleary.com/2017/03/aspnetcore-synchronization-context.html) (да, это снова Stephen Cleary), значит должен быть какой-то другой способ это сделать.

Поковырявшись в исходниках NLog, я нашел некий [IHttpContextAccessor](https://docs.microsoft.com/ru-ru/dotnet/api/Microsoft.AspNetCore.Http.IHttpContextAccessor?view=aspnetcore-2.0). Жажда понять, что все таки здесь происходит, заставила меня снова залезть в GitHub и посмотреть, что же представляет из себя эта магическая штука с одним свойством. Оказалось, что это просто [абстракция над AsyncLocal](https://github.com/aspnet/HttpAbstractions/blob/rel/2.0.0/src/Microsoft.AspNetCore.Http/HttpContextAccessor.cs), который по сути является новой версией LogicalCallContext (те самые методы LogicalSetData / LogicalGetData). Кстати, для .NET Framework'а так было [не всегда](https://github.com/aspnet/HttpAbstractions/blob/rel/1.1.2/src/Microsoft.AspNetCore.Http/HttpContextAccessor.cs).

После этого я задал себе вопрос: а почему собственно тогда это не работает? Мы запускаем Task стандартным способом, никакого неуправляемого кода тут нет… Запустив дебаггер, чтобы посмотреть, что происходит с HttpContext в момент вызова метода логирования, я увидел, что HttpContext есть, но свойства в нем все обнулены за исключением Request.Scheme, которое в момент вызова равно «http». Вот и получается, что в логе у меня вместо урла — странное "`http:///`".

Итак, получается, что в целях повышения производительности ASP.NET Core где-то внутри себя обнуляет HttpContext'ы и переиспользует их. Видимо, такие тонкости вкупе и позволяют достичь значительного преимущества по сравнению со стареньким ASP.NET MVC.

Что же я мог с этим сделать? Да просто сохранить текущее состояние HttpContext'а! Я написал простой сервис с единственным методом CloneCurrentContext, который я зарегистрировал в DI-контейнере.

**HttpContextPreserver**

```

public class HttpContextPreserver : IHttpContextPreserver

{

private readonly IHttpContextAccessor _httpContextAccessor;

ILogger _logger;

public HttpContextPreserver(IHttpContextAccessor httpContextAccessor, ILogger logger)

{

\_httpContextAccessor = httpContextAccessor;

\_logger = logger;

}

public void CloneCurrentContext()

{

var httpContext = \_httpContextAccessor.HttpContext;

var feature = httpContext.Features.Get();

feature = new HttpRequestFeature()

{

Scheme = feature.Scheme,

Body = feature.Body,

Headers = new HeaderDictionary(feature.Headers.ToDictionary(kvp => kvp.Key, kvp => kvp.Value)),

Method = feature.Method,

Path = feature.Path,

PathBase = feature.PathBase,

Protocol = feature.Protocol,

QueryString = feature.QueryString,

RawTarget = feature.RawTarget

};

var itemsFeature = httpContext.Features.Get();

itemsFeature = new ItemsFeature()

{

Items = itemsFeature?.Items.ToDictionary(kvp => kvp.Key, kvp => kvp.Value)

};

var routingFeature = httpContext.Features.Get();

routingFeature = new RoutingFeature()

{

RouteData = routingFeature.RouteData

};

var connectionFeature = httpContext.Features.Get();

connectionFeature = new HttpConnectionFeature()

{

ConnectionId = connectionFeature?.ConnectionId,

LocalIpAddress = connectionFeature?.LocalIpAddress,

RemoteIpAddress = connectionFeature?.RemoteIpAddress,

};

var collection = new FeatureCollection();

collection.Set(feature);

collection.Set(itemsFeature);

collection.Set(connectionFeature);

collection.Set(routingFeature);

var newContext = new DefaultHttpContext(collection);

\_httpContextAccessor.HttpContext = newContext;

}

}

public interface IHttpContextPreserver

{

void CloneCurrentContext();

}

```

Я не использовал deep cloner, так как это добавило бы тяжелую рефлексию в проект. А нужно это мне всего в одном единственном месте. Поэтому я просто создаю новый HttpContext на базе существующего и копирую в него только то, что будет полезно увидеть в логе при анализе инцидентов (action|controller, url, ip и т.п.). **Копируется не вся информация**.

Теперь запустив приложение, я увидел примерно следующие счастливые строчки:

```

2017-10-08 20:29:25.3015|0|AspNetCoreApp.Services.LongRespondingService|TRACE|Home/Test| DoJob method is starting (AspNetCoreApp.Services.LongRespondingService.DoJob:0)| url:http://localhost/Test/1

2017-10-08 20:29:34.3322|0|AspNetCoreApp.Services.LongRespondingService|TRACE|Home/Test| DoJob method is ending (AspNetCoreApp.Services.LongRespondingService+d\_\_3.MoveNext:0)| url:http://localhost/Test/1

```

А это означало для меня маленькую победу, которой я и делюсь здесь с вами. Кто что об этом думает?

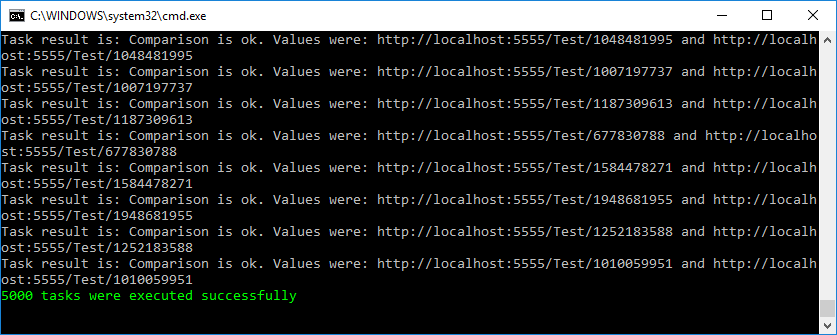

Чтобы удостовериться, что я ничего себе не надумал ложного, я написал маленький функционально-нагрузочный тест, который можно найти в моем репозитории на github'е вместе с сервисом. При запуске 5000 одновременных тасков, тест прошел успешно.

Кстати, благодаря архитектуре ASP.NET Core такие тесты можно писать легко и непринужденно. Нужно всего лишь запустить полноценный сервер внутри теста и обратиться к нему через настоящий сокет:

**Инициализация сервера по URL**

```

protected TestFixture(bool fixHttpContext, string solutionRelativeTargetProjectParentDir)

{

var startupAssembly = typeof(TStartup).Assembly;

var contentRoot = GetProjectPath(solutionRelativeTargetProjectParentDir, startupAssembly);

Console.WriteLine($"Content root: {contentRoot}");

var builder = new WebHostBuilder()

.UseKestrel()

.UseContentRoot(contentRoot)

.ConfigureServices(InitializeServices)

.UseEnvironment(fixHttpContext ? "Good" : "Bad")

.UseStartup(typeof(TStartup))

.UseUrls(BaseAddress);

_host = builder.Build();

_host.Start();

}

```

Еще один довод к использованию ASP.NET Core в своих проектах.

Итоги

-----

Мне очень понравился ASP.NET Core во всех аспектах его реализации. В нем заложена большая гибкость и одновременно лёгкость всей платформы. За счет абстракций для абсолютно всей функциональности можно делать любые вещи и настраивать всю платформу под себя, свою команду и свои методы разработки. Кроссплатформенность пока не доведена до совершенства, но Microsoft к этому стремится, и когда-нибудь (пусть может и не скоро) у них должно это получиться.

[Ссылка на github](https://github.com/Dobby007/aspnetcore-longtask/) | https://habr.com/ru/post/338582/ | null | ru | null |

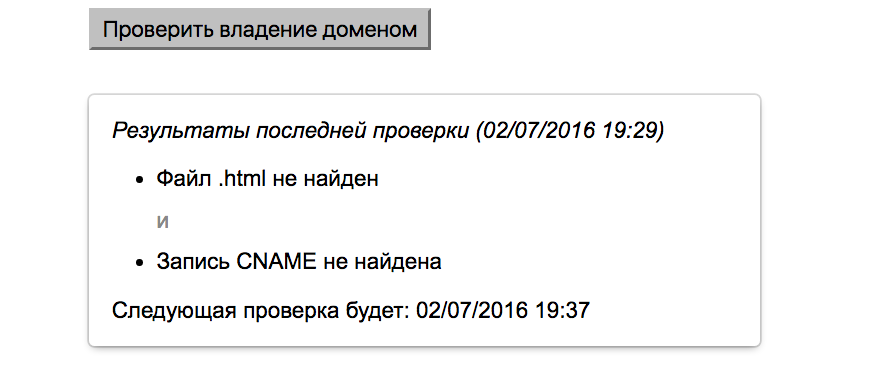

# Время высокой точности: как работать с долями секунды в MySQL и PHP

Однажды я поймал себя на мысли, что при работе со временем в базах данных почти всегда использую время с точностью до секунды просто потому, что я к этому привык и что именно такой вариант описан в документации и огромном количестве примеров. Однако сейчас такой точности достаточно далеко не для всех задач. Современные системы сложны — они могут состоять из множества частей, иметь миллионы пользователей, взаимодействующих с ними, — и во многих случаях удобнее использовать бОльшую точность, поддержка которой уже давно существует.

В этой статье я расскажу про способы использования времени с дробными частями секунды в MySQL и PHP. Она задумывалась как туториал, поэтому материал рассчитан на широкий круг читателей и местами повторяет документацию. Основную ценность должно представлять то, что я собрал в одном тексте всё, что нужно знать для работы с таким временем в MySQL, PHP и фреймворке Yii, а также добавил описания неочевидных проблем, с которыми можно столкнуться.

Я буду использовать термин «время высокой точности». В документации MySQL вы увидите термин “fractional seconds”, но его дословный перевод звучит странно, а другого устоявшегося перевода я не нашёл.

Когда стоит использовать время высокой точности?

------------------------------------------------

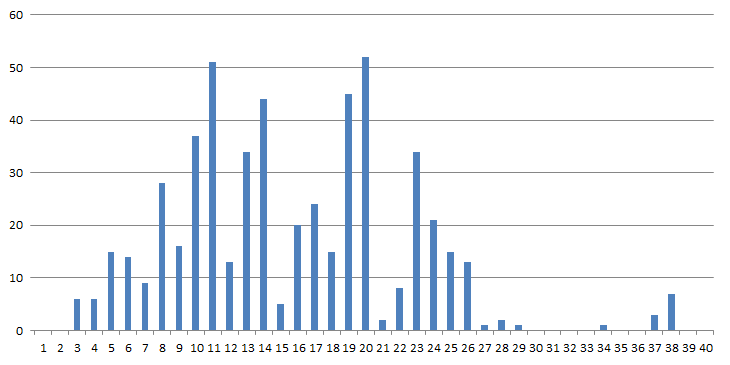

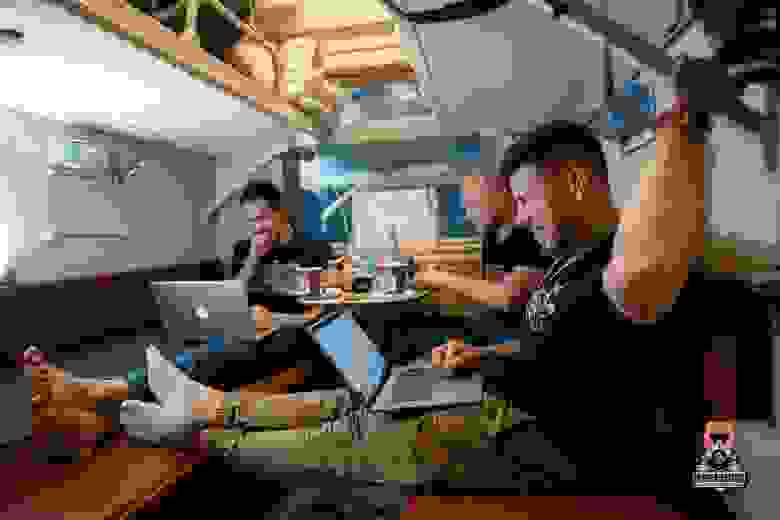

Для затравки покажу скриншот списка входящих писем моего почтового ящика, который хорошо иллюстрирует идею:

Письма представляют собой реакцию одного и того же человека на одно событие. Человек случайно нажал не на ту кнопку, быстро понял это и исправился. В результате мы получили два письма, отправленных примерно в одно и то же время, которые важно правильно отсортировать. Если время отправки совпадает, есть шанс, что письма будут показаны в неправильном порядке и получатель будет сконфужен, так как потом получит не тот результат, на который будет рассчитывать.

Я сталкивался со следующими ситуациями, в которых время высокой точности было бы актуально:

1. Вы хотите замерить время между какими-то операциями. Тут всё очень просто: чем выше точность меток времени на границах интервала, тем выше точность результата. Если вы используете целые секунды, то можете ошибиться на 1 секунду (при попадании на границы секунд). Если же использовать шесть знаков после запятой, то ошибка будет на шесть порядков ниже.

2. У вас есть коллекция, где велика вероятность наличия нескольких объектов с одинаковым временем создания. Примером может служить знакомый всем чат, где список контактов отсортирован по времени последнего сообщения. Если там появляется постраничная навигация, то возникает даже риск потери контактов на границах страниц. Эту проблему можно решить и без времени высокой точности за счёт сортировки и постраничного разбиения по паре полей (время + уникальный идентификатор объекта), но у этого решения есть свои недостатки (как минимум усложнение SQL-запросов, но не только это). Увеличение точности времени поможет снизить вероятность появления проблем и обойтись без усложнения системы.

3. Вам нужно хранить историю изменений какого-то объекта. Особенно важно это в сервисном мире, где модификации могут происходить параллельно и в совершенно разных местах. В качестве примера могу привести работу с фотографиями наших пользователей, где параллельно может осуществляться множество разных операций (пользователь может сделать фотографию приватной или удалить её, она может модерироваться в одной из нескольких систем, обрезаться для использования в качестве фото в чате и т. д.).

Нужно иметь в виду, что нельзя верить полученным значениям на 100% и реальная точность получаемых значений может быть меньше шести знаков после запятой. Это происходит из-за того, что мы можем получить неточное значение времени (особенно при работе в распределённой системе, состоящей из многих серверов), время может неожиданно измениться (например, при синхронизации через NTP или при переводе часов) и т. д. Я не стану здесь останавливаться на всех этих проблемах, но приведу пару статей, где про них можно почитать подробнее:

* [«Заблуждения программистов относительно времени»](https://habr.com/ru/post/146109/) (сама статья очень минималистична, но в дополнение к тезисам из текста можно найти пояснения в комментариях);

* [«Тяжёлое бремя времени»](https://habr.com/ru/company/yandex/blog/463203/).

Работа со временем высокой точности в MySQL

-------------------------------------------

MySQL поддерживает три типа колонок, в которых можно хранить время: `TIME`, `DATETIME` и `TIMESTAMP`. Изначально в них можно было хранить только значения, кратные одной секунде (например, 2019-08-14 19:20:21). В версии 5.6.4, которая вышла в декабре 2011 года, появилась возможность работать и с дробной частью секунды. Для этого при создании колонки нужно указать количество знаков после запятой, которое необходимо хранить в дробной части метки времени. Максимальное количество знаков, которое поддерживается, — шесть, что позволяет хранить время с точностью до микросекунды. При попытке использовать большее количество знаков вы получите ошибку.

Пример:

```

Test> CREATE TABLE `ChatContactsList` (

`chat_id` bigint(20) unsigned NOT NULL AUTO_INCREMENT PRIMARY KEY,

`title` varchar(255) NOT NULL,

`last_message_send_time` timestamp(2) NULL DEFAULT NULL

) ENGINE=InnoDB;

Query OK, 0 rows affected (0.02 sec)

Test> ALTER TABLE `ChatContactsList` MODIFY last_message_send_time TIMESTAMP(9) NOT NULL;

ERROR 1426 (42000): Too-big precision 9 specified for 'last_message_send_time'. Maximum is 6.

Test> ALTER TABLE `ChatContactsList` MODIFY last_message_send_time TIMESTAMP(3) NOT NULL;

Query OK, 0 rows affected (0.09 sec)

Records: 0 Duplicates: 0 Warnings: 0

Test> INSERT INTO ChatContactsList (title, last_message_send_time) VALUES ('Chat #1', NOW());

Query OK, 1 row affected (0.03 sec)

Test> SELECT * FROM ChatContactsList;

+---------+---------+-------------------------+

| chat_id | title | last_message_send_time |

+---------+---------+-------------------------+

| 1 | Chat #1 | 2019-09-22 22:23:15.000 |

+---------+---------+-------------------------+

1 row in set (0.00 sec)

```

В этом примере у метки времени вставленной записи нулевая дробная часть. Это произошло потому, что входящее значение было указано с точностью до секунды. Для решения проблемы нужно, чтобы точность входящего значения была такой же, как у значения в базе данных. Совет кажется очевидным, но он актуален, поскольку подобная проблема может всплыть в реальных приложениях: мы сталкивались с ситуацией, когда значение на входе имело три знака после запятой, а в базе данных хранилось шесть.

Самый простой способ предупредить возникновение этой проблемы — использовать входящие значения с максимальной точностью (до микросекунды). В этом случае при записи данных в таблицу время округлится до требуемой точности. Это абсолютно нормальная ситуация, которая не будет вызывать никаких warning-ов (предупреждений):

```

Test> UPDATE ChatContactsList SET last_message_send_time="2019-09-22 22:23:15.2345" WHERE chat_id=1;

Query OK, 1 row affected (0.00 sec)

Rows matched: 1 Changed: 1 Warnings: 0

Test> SELECT * FROM ChatContactsList;

+---------+---------+-------------------------+

| chat_id | title | last_message_send_time |

+---------+---------+-------------------------+

| 1 | Chat #1 | 2019-09-22 22:23:15.235 |

+---------+---------+-------------------------+

1 row in set (0.00 sec)

```

При использовании автоматической инициализации и автоматического обновления колонок типа TIMESTAMP с помощью конструкции вида `DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP` важно, чтобы значения имели ту же точность, что и сама колонка:

```

Test> ALTER TABLE ChatContactsList ADD COLUMN updated TIMESTAMP(3) DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP;

ERROR 1067 (42000): Invalid default value for 'updated'

Test> ALTER TABLE ChatContactsList ADD COLUMN updated TIMESTAMP(3) DEFAULT CURRENT_TIMESTAMP(6) ON UPDATE CURRENT_TIMESTAMP(6);

ERROR 1067 (42000): Invalid default value for 'updated'

Test> ALTER TABLE ChatContactsList ADD COLUMN updated TIMESTAMP(3) DEFAULT CURRENT_TIMESTAMP(3) ON UPDATE CURRENT_TIMESTAMP(3);

Query OK, 0 rows affected (0.07 sec)

Records: 0 Duplicates: 0 Warnings: 0

Test> UPDATE ChatContactsList SET last_message_send_time='2019-09-22 22:22:22' WHERE chat_id=1;

Query OK, 0 rows affected (0.00 sec)

Rows matched: 1 Changed: 0 Warnings: 0

Test> SELECT * FROM ChatContactsList;

+---------+---------+-------------------------+-------------------------+

| chat_id | title | last_message_send_time | updated |

+---------+---------+-------------------------+-------------------------+

| 1 | Chat #1 | 2019-09-22 22:22:22.000 | 2019-09-22 22:26:39.968 |

+---------+---------+-------------------------+-------------------------+

1 row in set (0.00 sec)

```

Функции MySQL для работы со временем поддерживают работу и с дробной частью единиц измерения. Перечислять их все я не буду (предлагаю посмотреть в документации), но приведу несколько примеров:

```

Test> SELECT NOW(2), NOW(4), NOW(4) + INTERVAL 7.5 SECOND;

+------------------------+--------------------------+------------------------------+

| NOW(2) | NOW(4) | NOW(4) + INTERVAL 7.5 SECOND |

+------------------------+--------------------------+------------------------------+

| 2019-09-22 21:12:23.31 | 2019-09-22 21:12:23.3194 | 2019-09-22 21:12:30.8194 |

+------------------------+--------------------------+------------------------------+

1 row in set (0.00 sec)

Test> SELECT SUBTIME(CURRENT_TIME(6), CURRENT_TIME(3)), CURRENT_TIME(6), CURRENT_TIME(3);

+-------------------------------------------+-----------------+-----------------+

| SUBTIME(CURRENT_TIME(6), CURRENT_TIME(3)) | CURRENT_TIME(6) | CURRENT_TIME(3) |

+-------------------------------------------+-----------------+-----------------+

| 00:00:00.000712 | 21:12:50.793712 | 21:12:50.793 |

+-------------------------------------------+-----------------+-----------------+

1 row in set (0.00 sec)

```

Главная проблема, с которой сопряжено использование дробной части секунд в SQL-запросах, — несогласованность точности при сравнениях (`>`, `<`, `BETWEEN`). С ней можно столкнуться в том случае, если данные в базе имеют одну точность, а в запросах — другую. Вот небольшой пример, иллюстрирующий эту проблему:

```

# На вход подаются шесть знаков в дробной части

Test> INSERT INTO ChatContactsList (title, last_message_send_time) VALUES ('Chat #2', '2019-09-22 21:16:39.123456');

Query OK, 0 row affected (0.00 sec)

Test> SELECT chat_id, title, last_message_send_time FROM ChatContactsList WHERE title='Chat #2';

+---------+---------+-------------------------+

| chat_id | title | last_message_send_time |

+---------+---------+-------------------------+

| 2 | Chat #2 | 2019-09-22 21:16:39.123 | <- Сохраняются только три знака из-за точности, указанной в колонке

+---------+---------+-------------------------+

1 row in set (0.00 sec)

Test> SELECT title, last_message_send_time FROM ChatContactsList WHERE last_message_send_time >= '2019-09-22 21:16:39.123456'; <- Это то же значение, что было в INSERT-е

+---------+-------------------------+

| title | last_message_send_time |

+---------+-------------------------+

| Chat #1 | 2019-09-22 22:22:22.000 |

+---------+-------------------------+

1 row in set (0.00 sec) <- Chat #2 не найден из-за того, что точность в базе ниже, чем точность на входе

```

В данном примере точность значений в запросе выше, чем точность значений в базе, и проблема возникает «на границе сверху». В обратной ситуации (если значение на входе будет иметь точность ниже, чем значение в базе) проблемы не будет — MySQL приведёт значение к нужной точности и в INSERT-е, и в SELECT-е:

```

Test> INSERT INTO ChatContactsList (title, last_message_send_time) VALUES ('Chat #3', '2019-09-03 21:20:19.1');

Query OK, 1 row affected (0.00 sec)

Test> SELECT title, last_message_send_time FROM ChatContactsList WHERE last_message_send_time <= '2019-09-03 21:20:19.1';

+---------+-------------------------+

| title | last_message_send_time |

+---------+-------------------------+

| Chat #3 | 2019-09-03 21:20:19.100 |

+---------+-------------------------+

1 row in set (0.00 sec)

```

Согласованность точности значений всегда стоит держать в голове при работе со временем высокой точности. Если подобные граничные проблемы для вас критичны, то нужно следить за тем, чтобы код и база данных работали с одинаковым количеством знаков после запятой.

**Мысли о выборе точности в колонках с дробными частями секунд**Объём места, занимаемого дробной частью единицы времени, зависит от количества знаков в колонке. Кажется естественным выбирать привычные значения: три или шесть знаков после запятой. Но в случае с тремя знаками не всё так просто. Фактически MySQL использует один байт для хранения двух знаков дробной части:

>

>

> | Fractional Seconds Precision | Storage Required |

> | --- | --- |

> | 0 | 0 bytes |

> | 1, 2 | 1 byte |

> | 3, 4 | 2 bytes |

> | 5, 6 | 3 bytes |

>

>

>

>

>

> [Date and Time Type Storage Requirements](https://dev.mysql.com/doc/refman/8.0/en/storage-requirements.html#data-types-storage-reqs-date-time)

Получается, что если вы выбираете три знака после запятой, то не в полной мере используете занятое место и при тех же накладных расходах могли бы взять четыре знака. Вообще я рекомендую всегда использовать чётное количество знаков и при необходимости «обрезать» ненужные при выводе. Идеальный же вариант — не жадничать и брать шесть знаков после запятой. В худшем случае (при типе DATETIME) эта колонка займёт 8 байт, то есть столько же, сколько целое число в колонке типа BIGINT.

См. также:

* [“Fractional Seconds in Time Values”](https://dev.mysql.com/doc/refman/8.0/en/fractional-seconds.html);

* [“Automatic Initialization and Updating for TIMESTAMP and DATETIME”](https://dev.mysql.com/doc/refman/8.0/en/timestamp-initialization.html);

* [“Date and Time Functions”](https://dev.mysql.com/doc/refman/8.0/en/date-and-time-functions.html).

Работа со временем высокой точности в PHP

-----------------------------------------

Мало иметь время высокой точности в базе данных — нужно уметь работать с ним в коде ваших программ. В этом разделе я расскажу про три основных момента:

1. Получение и форматирование времени: объясню, как получить метку времени перед тем, как положить его в базу данных, получить его оттуда и осуществить какие-то манипуляции.

2. Работа со временем в PDO: покажу на примере, как PHP поддерживает форматирование времени в библиотеке по работе с базой данных.

3. Работа со временем во фреймворках: расскажу про использование времени в миграциях для изменения структуры базы данных.

### Получение и форматирование времени

При работе со временем есть несколько основных операций, которые нужно уметь делать:

* получение текущего момента времени;

* получение момента времени из какой-то отформатированной строки;

* добавление к моменту времени какого-то периода (или вычитание периода);

* получение форматированной строки для момента времени.

В этой части я расскажу, какие возможности для выполнения этих операций есть в PHP.

Первый способ — это работа с **меткой времени как с числом**. В этом случае в PHP-коде мы работаем с численными переменным, которыми оперируем через такие функции, как `time`, `date`, `strtotime`. Этот способ нельзя использовать для работы со временем высокой точности, поскольку во всех этих функциях метки времени представляют собой целое число (а значит, дробная часть в них будет потеряна).

Вот сигнатуры основных таких функций из официальной документации:

> `time ( void ) : int`

>

> <https://www.php.net/manual/ru/function.time.php>

>

>

>

> `strtotime ( string $time [, int $now = time() ] ) : int`

>

> <http://php.net/manual/ru/function.strtotime.php>

>

>

>

> `date ( string $format [, int $timestamp = time() ] ) : string`

>

> <https://php.net/manual/ru/function.date.php>

>

>

>

> `strftime ( string $format [, int $timestamp = time() ] ) : string`

>

> <https://www.php.net/manual/ru/function.strftime.php>

**Любопытный момент про функцию date**Хотя нельзя передать дробную часть секунды на вход этим функциям, в строке шаблона форматирования, передаваемой на вход функции `date`, можно задать символы для отображения милли- и микросекунд. При форматировании на их месте всегда будут возвращаться нули.

| Символ в строке format | Описание | Пример возвращаемого значения |

| --- | --- | --- |

| u | Микросекунды (добавлено в PHP 5.2.2). Учтите, что date() всегда будет возвращать 000000, т.к. она принимает целочисленный параметр, тогда как DateTime::format() поддерживает микросекунды, если DateTime создан с ними. | Например: 654321 |

| v | Миллисекунды (добавлено в PHP 7.0.0). Замечание такое же как и для u. | Например: 654 |

Пример:

```

$now = time();

print date('Y-m-d H:i:s.u', $now);

// 2019-09-11 21:27:18.000000

print date('Y-m-d H:i:s.v', $now);

// 2019-09-11 21:27:18.000

```

Также к этому способу можно отнести функции `microtime` и `hrtime`, которые позволяют получить метку времени с дробной частью для текущего момента. Проблема заключается в том, что нет готового способа форматирования такой метки и получения её из строки определённого формата. Это можно решить, самостоятельно реализовав эти функции, но я не буду рассматривать такой вариант.

> Если вам нужно работать только с таймерами, то хорошим вариантом будет библиотека [HRTime](https://www.php.net/manual/ru/book.hrtime.php), которую я не стану рассматривать подробнее из-за ограниченности её применения. Скажу только, что она позволяет работать со временем с точностью до наносекунды и гарантирует монотонность таймеров, что избавляет от части проблем, с которыми можно столкнуться при работе с другими библиотеками.

Для полноценной работы с дробными частями секунды нужно использовать модуль **DateTime**. С определёнными оговорками он позволяет выполнять все перечисленные ранее операции:

```

// Получение текущего момента времени:

$time = new \DateTimeImmutable();

// Получение момента времени из отформатированной строки:

$time = new \DateTimeImmutable('2019-09-12 21:32:43.908502');

$time = \DateTimeImmutable::createFromFormat('Y-m-d H:i:s.u', '2019-09-12 21:32:43.9085');

// Добавление/вычитание периода:

$period = \DateInterval::createFromDateString('5 seconds');

$timeBefore = $time->add($period);

$timeAfter = $time->sub($period);

// Получение форматированной строки для момента времени:

print $time->format('Y-m-d H:i:s.v'); // '2019-09-12 21:32:43.908'

print $time->format("Y-m-d H:i:s.u"); // '2019-09-12 21:32:43.908502'

```

**Неочевидный момент при использовании `DateTimeImmutable::createFromFormat`**Буква `u` в строке форматирования означает микросекунды, но она корректно работает и в случае с дробными частями меньшей точности. Более того, это единственный способ задать дробные части секунды в строке формата. Пример:

```

$time = \DateTimeImmutable::createFromFormat('Y-m-d H:i:s.u', '2019-09-12 21:32:43.9085');

// => Получаем объект DateTimeImmutable со значением времени 2019-09-12 21:32:43.908500

$time = \DateTimeImmutable::createFromFormat('Y-m-d H:i:s.u', '2019-09-12 21:32:43.90');

// => Получаем объект DateTimeImmutable со значением времени 2019-09-12 21:32:43.900000

$time = \DateTimeImmutable::createFromFormat('Y-m-d H:i:s.u', '2019-09-12 21:32:43');

// => Получаем false

```

Главной проблемой данного модуля является неудобство при работе с интервалами, содержащими дробные секунды (а то и невозможность такой работы). Класс `\DateInterval` хотя и содержит дробную часть секунды с точностью до тех же самых шести знаков после запятой, но инициализировать эту дробную часть можно только через `DateTime::diff`. Конструктор класса DateInterval и фабричный метод `\DateInterval::createFromDateString` умеют работать только с целыми секундами и не позволяют задать дробную часть:

```

// Эта строка выбросит исключение из-за некорректного формата

$buggyPeriod1 = new \DateInterval('PT7.500S');

// Эта строка отработает и вернёт объект периода, но без секунд

$buggyPeriod2 = \DateInterval::createFromDateString('2 minutes 7.5 seconds');