text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

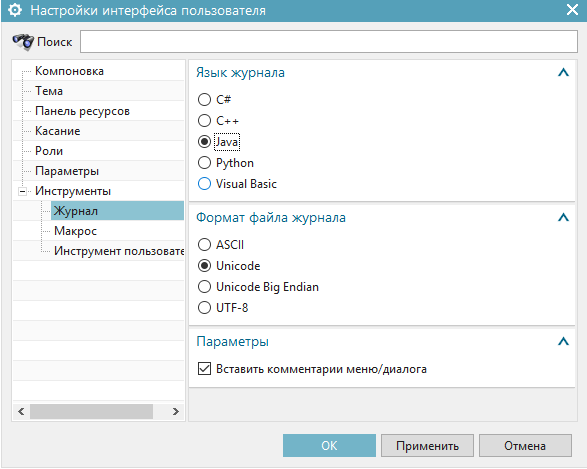

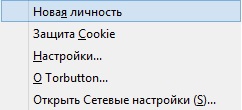

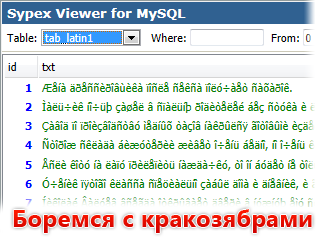

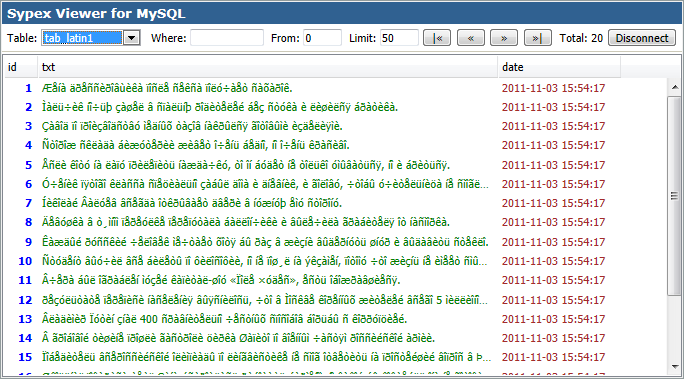

# Сегментация экземпляров с помощью Mask R-CNN

Задача сегментации изображений может решаться в нескольких постановках. Самая распространённая - semantic segmentation с одним классом и фоном, необходимо просто отделить объекты от фона, не различая их между собой. Но часто просто отделения от фона недостаточно, необходимо отделять отдельные образцы друг от друга, например, чтобы оценить размер или расположение каждого отдельного объекта. Как это можно сделать?

Это задача instance segmentation. Её можно решать, как семантическую сегментацию, просто выделяя границы как отдельный класс и присваивая ему больший вес в лоссе. Такое решение подходит для многих ситуаций с простой границей и работает довольно быстро, но может оказаться нестабильным, завестись далеко не “из коробки”. Другой традиционный способ - нахождение объекта через object detection и сегментация внутри найденных ограничивающих рамок. Такой подход, например, используют Mask R-CNN и, с некоторыми модификациями, YOLACT.

Mask R-CNN является наследницей Faster R-CNN, которая используется для выделения ограничивающих рамок. Обе сети дают высокое качество при большом количестве обучающих данных и являются хорошим бейзлайном для большинства задач. Сегодня мы рассмотрим, как можно дообучить модель с torchvision на своих данных и как сделать её инференс.

Полный код можно найти по [ссылке](https://colab.research.google.com/drive/1-epExQsCQUvenJD_c4E4Ji-ZeDteg_z6?usp=sharing#scrollTo=l79ivkwKy357), здесь будут короткие выдержки.

Для начала нужно подготовить датасет. Разметить изображения можно с помощью [VGG](https://www.robots.ox.ac.uk/~vgg/software/via/via.html), он может работать как локально, так и из браузера, отмечать объекты нужно полигонами, а выгрузить результаты в csv, VGG json или COCO json. Затем перегнать аннотации из полигонов в маски с помощью подобного скрипта, [ссылка](https://github.com/comptech-winter-school/coal-composition-control/blob/main/train/converters/vgg_to_mask.py). Итоговая разметка должна быть в формате Penn-Fudan Database. Поскольку процесс разметки трудоёмкий, можно использовать упрощающий трюк - разметить несколько изображений, обучить модель и сделать предразметку ей на необработанных изображения, затем только поправив руками. Пример такого разметчика на основе Mask R-CNN для аннотаций в формате VGG json есть по [ссылке](https://github.com/comptech-winter-school/coal-composition-control/blob/main/train/instance_segmentation/mask_rcnn_annotator.py). Кроме того, некоторые платформы для разметки предоставляют такую услугу.

Можно сразу сохранить маски отдельными файлами, но это может занимать много места, и их загрузка во время обучения может отнимать время, лучше создавать маски прямо во время обучения. Это можно делать так:

```

# маска каждого экземпляра отдельным цветом

mask = get_mask(annotation)

# убираем фон и выделяем номера масок

obj_ids = np.unique(mask)[1:]

# разбиваем общую маску на бинарные

masks = mask == obj_ids[:, None, None]

# переводим в тензор

masks = torch.as_tensor(masks, dtype=torch.uint8)

```

Затем надо сделать стандартные вещи - выбрать оптимизатор и шедулер, изменить количество выходных каналов и backbone, можно настроить и разбиение для anchor boxes. Например, можно настроить модель так:

```

# загружаем предобученную модель

# можно загрузить другой backbone с torchvision, например MobileNetV2

model = torchvision.models.detection.maskrcnn_resnet50_fpn(pretrained=True)

# размер входа для детекторной части

in_features_box = model.roi_heads.box_predictor.cls_score.in_features

# размер входа для сегментационной части

in_features_mask = model.roi_heads.mask_predictor.conv5_mask.in_channels

# выбираем размер для внутреннего представления

# в предикторе для сегментации

hidden_layer = 256

# заменяем последние слои детекции с учётом количества наших классов

# и размера выхода backbone

model.roi_heads.box_predictor = FastRCNNPredictor(in_features_box, num_classes)

# заменяем последние слои для сегментации

model.roi_heads.mask_predictor = MaskRCNNPredictor(in_features_mask, hidden_layer, num_classes)

```

Как применить аугментации? Можно применять их к изначальной маске, полученной из аннотаций, либо использовать аугментации из torchvision когда уже будут созданы bbox’ы и прочее, [вот](https://github.com/pytorch/vision/blob/main/references/detection/transforms.py) доступные для второго варианта. Первый вариант больше подходит для [albumentations](https://albumentations.ai/). В полной версии мы используем случайное отражение по горизонтали (RandomHorizontalFlip) и RandomPhotometricDistort, который включает в себя изменение яркости, контрастности и цветовой гаммы, добавление шума.

Сама тренировка проводится с помощью функции train\_one\_epoch из torchvision.references.detection.engine, там же лежит evaluate для проверки на валидационной выборке. Выводятся стандартные метрики для сегментации и детекции отдельно.

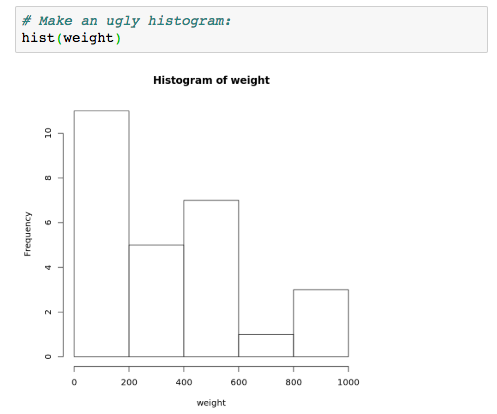

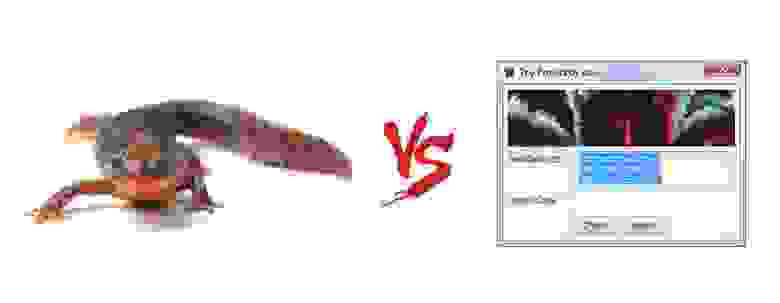

Наконец, перейдём к инференсу. Если запустить сразу, то получится вот такая каша:

Это связано с тем, что сеть для object detection выделяет много лишнего и сегментационная часть обрабатывает пустые регионы. Нужно настроить порог по уверенности для bbox’ов и порог для [non maximum suppression](https://paperswithcode.com/method/non-maximum-suppression).

```

model.roi_heads.score_thresh=0.4

model.roi_heads.nms_thresh=0.3

```

И можно предсказывать!

```

img = transforms.ToTensor()(img)

img = img.to(device)

prediction = model([img])

masks = torch.squeeze(prediction[0]['masks'])

masks = masks > segmentation_th

```

На последнем шаге мы оставляем только те пиксели, уверенность в которых выше порога.

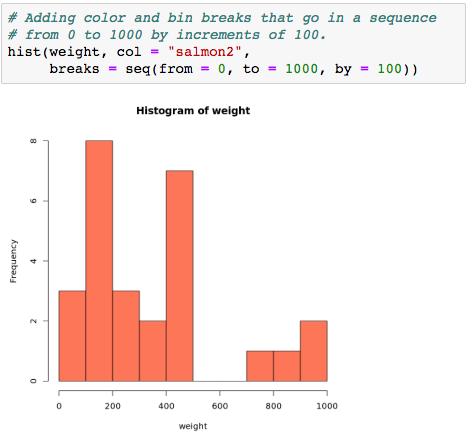

С внесёнными изменениями выглядит намного лучше:

Итак, сегодня мы освоили сегментацию экземпляров с Mask R-CNN. Это не самый быстрый в инференсе и обучении, но стабильный алгоритм, который не боится сливающихся границ, легко настраивается и поддерживается. | https://habr.com/ru/post/665300/ | null | ru | null |

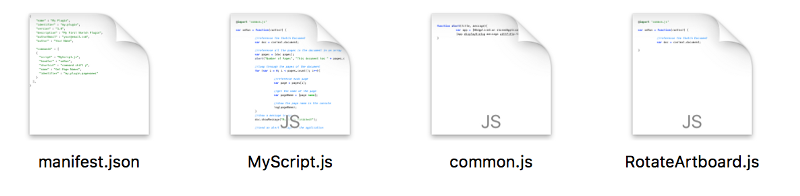

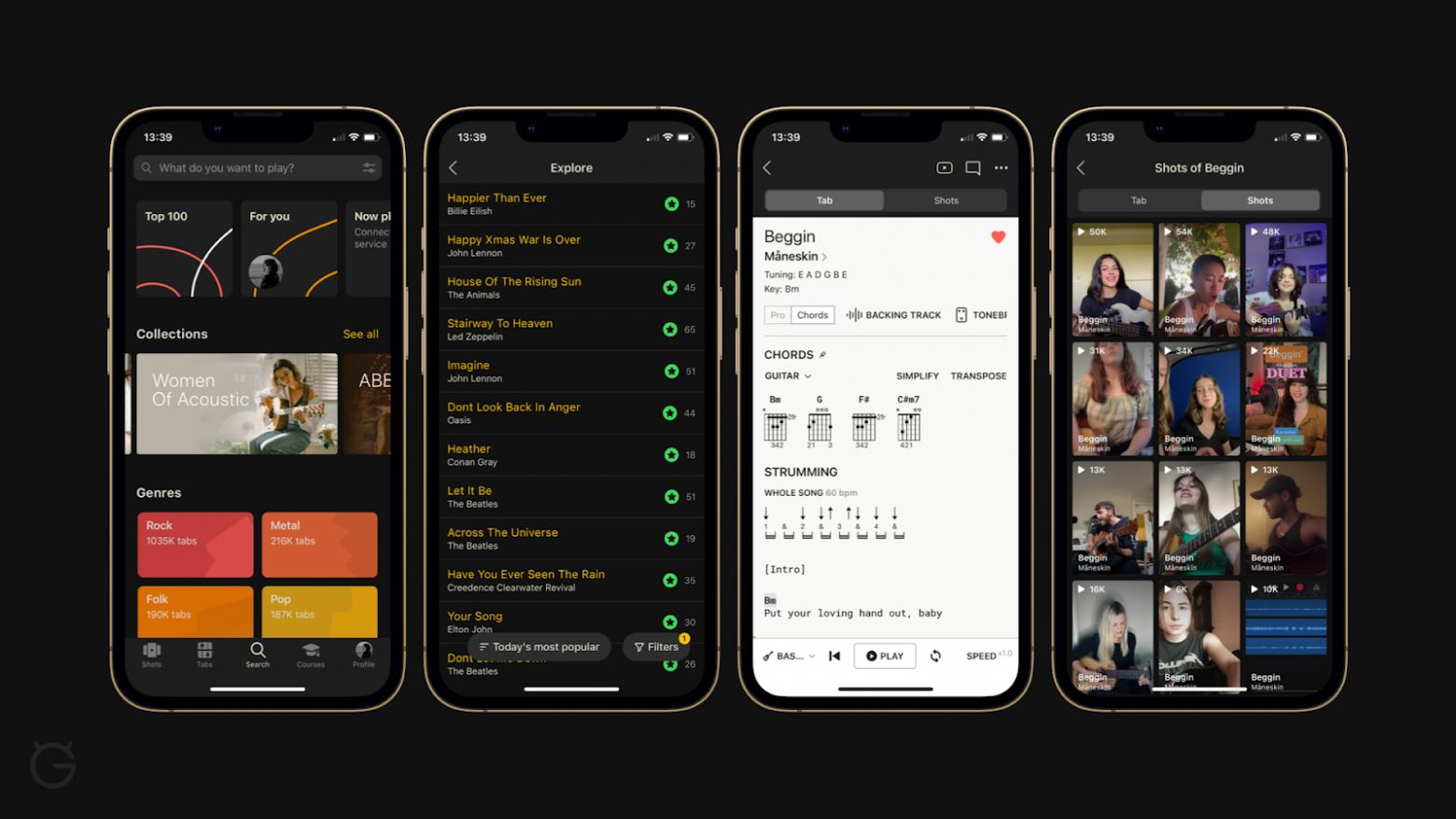

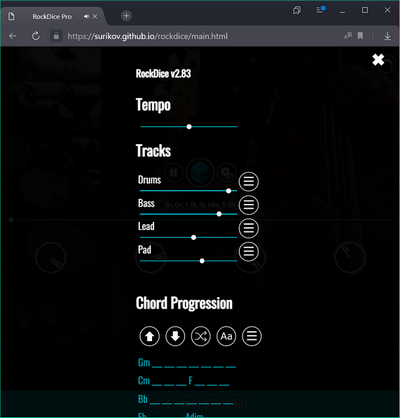

# Каким было автоматизированное рабочее место середины 90-х, и как его повторить на современном компьютере

[](https://habr.com/ru/company/ruvds/blog/707220/)

В настоящее время становится популярным отказываться от интернета, социальных сетей, мессенджеров и прочего. Это называется цифровым детоксом.

Я вам предлагаю совершить нечто подобное, разумеется, ненадолго, и если вам за 40, погрузиться в ностальгические воспоминания. А если вы не представляете, как же люди жили раньше без интернета, то узнать, как выглядело рабочее место программиста или студента в далёкие 90-е годы.

Я хочу, чтобы погружение было максимально приближено к реальности, и считаю, что различные эмуляторы и виртуальные машины очень удобны для изучения, разработки и отладки старого программного обеспечения, но для полного погружения лучше работать с программами без них, на реальном компьютере. Вы, к сожалению, уже не ощутите на себе мерцание и размытость монитора с ЭЛТ, не услышите стук дисковода для гибких дисков, громкое шуршание винчестера, но многие эмоции вы переживёте заново.

Для меня середина 90-х в сфере ИТ неразрывно связана с MS-DOS 6.22.

С появлением ОС Windows постепенно использование MS-DOS и программ для неё сошло на нет. Особенно такая тенденция наметилась с появлением Windows 2000. Уход MS-DOS был обусловлен следующим:

1. MS-DOS не поддерживала файловые системы NTFS и FAT32 (MS-DOS 6.22), которые выгодно отличались от FAT16.

2. Работа с периферийными устройствами усложнялась для пользователя. Если для мыши или CD-ROM проблем не было, то со звуковыми и сетевыми картами, устройствами, использующими USB-интерфейс, дела обстояли хуже. Требовалось множество драйверов или поддержка устройства приложением, и мало что работало из коробки. Иными словами, MS-DOS переставала выполнять функции операционной системы.

3. MS-DOS использовала реальный режим работы процессора, и работать можно было с 640 Кб оперативной памяти. Работа с большими объёмами памяти осуществлялась при помощи так называемых менеджеров памяти.

4. MS-DOS не поддерживала многозадачность. В принципе вы могли запустить несколько резидентных программ, но это по сути не являлось многозадачностью.

Сейчас же, когда хочется поностальгировать, эти недостатки не так важны, так как приятное ощущение тех старых добрых времён всё перевешивает.

Если вам будет что-то непонятно в статье, или вы хотите просто запустить у себя на компьютере программы из статьи, вы можете загрузить готовый образ из [моего репозитория на GitHub](https://github.com/artyomsoft/retro-flash-drive), записать его на флеш-накопитель и запустить компьютер с него.

Какими 90-е остались в моей памяти

----------------------------------

### ▍ Какие были компьютеры

Компьютерная мышь, CD-ROМ-привод, принтер, звуковая карта и колонки являлись роскошью, и у большинства счастливых обладателей персональных компьютеров их не было.

Может потому, что я учился в провинциальном вузе, но в 1996 году IBM-PC-совместимый компьютер был только у одного моего одногруппника, и только к 2001 году компьютеры появились у каждого в моей группе. И то, скорее всего, потому что учились мы на компьютерной специальности.

Так как персонального компьютера практически ни у кого не было, мы видели компьютеры только на практических занятиях, связанных с программированием, и ещё два раза в неделю по два часа после занятий по предварительной записи.

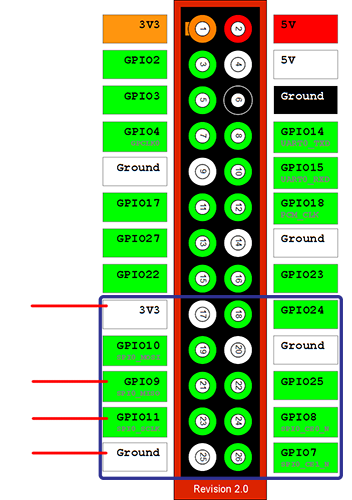

Что же из себя представлял компьютерный класс на моей кафедре в далёком 1996 году в моём вузе? Это около десятка разношёрстных IBM-PC-совместимых компьютеров на базе микропроцессоров Intel 286 и Intel 386, c цветным или монохромным монитором, с винчестером или без, объединённых в локальную сеть.

Было ещё несколько компьютерных классов на вычислительном центре вуза, но там даже не было компьютерной сети. В классах стояли компьютеры (хотя их более правильно назвать ЭВМ) EC 1840. Это такая здоровенная бандура, которая не имеет жёсткого диска, гудит как пылесос и использует в качестве накопителей информации два дисковода на гибких магнитных дисках по 360 Кб каждый.

*Компьютер EC 1840*

Если ты хотел поработать (выполнить задания по программированию) на таком компьютере, то ты должен был отдать свой студенческий билет под залог, а тебе выдавали две дискеты: одну загрузочную дискету 5.25 360 Кб с MS-DOS и Norton Commander и вторую с Turbo Pascal.

### ▍ Какие были сетевые технологии

Некоторые классы были объединены в локальную сеть коаксиальным кабелем с общей пропускной способностью 10 Мбит/c. Эти 10 Мбит делились по-братски на все компьютеры, а это целых два класса по 10 компьютеров. Сеть использовала не привычный нам всем TCP/IP, а протокол от Novel IPX/SPX. Общеинститутской локальной сети не было.

Студентам был предоставлен только доступ на чтение к файловому серверу, где располагались задания на лабораторные работы, документация по программированию, необходимые программы. Персонализированного доступа не было, все студенты и даже преподаватели заходили под обычным юзером.

Высокоскоростного интернета не было вообще, к 1998 году появился канал в 115 Кбит/c на весь институт. Разумеется, что студенты его вообще не видели. Интернет того времени для меня ассоциируется с красными глазами невыспавшегося счастливого одногруппника, которому удалось ночью по dial-up выйти на несколько часов в сеть и даже побеседовать кем-то по ICQ.

### ▍ Что читали и откуда брали информацию

Книг по программированию в библиотеке практически не было. Были какие-то книги по советским компьютерам, был даже трёхтомник Дональда Кнута, но ввиду сложности этого труда он мало чем помогал.

Больше всего помогал опыт работы с компьютером, методички, беседы с одногруппниками после занятий. Помню, с каким восторгом мы слушали студента, который рассказывал, что у его родителей на работе есть персональный компьютер с принтером и Windows 95. Для нас, видевших только MS-DOS 6.22, это было какой-то фантастикой. Также помогали добытые распечатки книжек или интерактивная документация, входящая в комплект поставки IDE Borland Turbo C++ или Borland Turbo Pascal.

### ▍ Какими программами пользовались

Время стёрло из памяти структуру директорий и перечень всего, что было на файловом сервере. Запомнилось только то, что сам часто использовал в то время.

Был текстовый редактор WD, электронные таблицы SuperCalc, IDE для разработки программ: Borland Turbo C++ 3.0, Borland Turbo Pascal 7.0, Borland Turbo Assembler 4.0.

Очень популярны были утилиты от Norton (Symantec). Они отличались очень красивым по тем временам интерфейсом и полезными функциями (дефрагментация диска, проверка диска на битые сектора и лечение, редактирование диска, восстановление удалённых файлов).

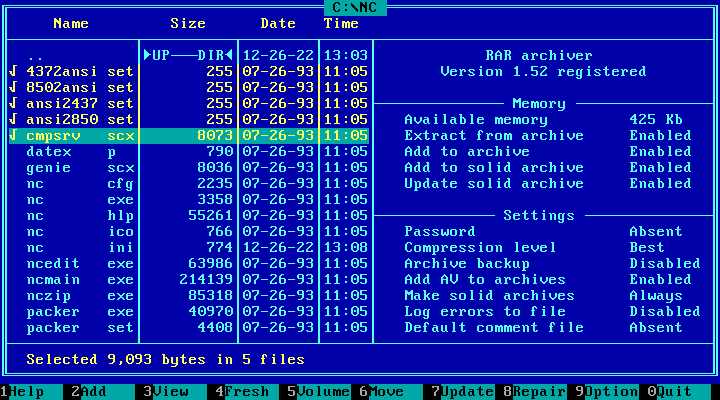

Часто использовались архиваторы. Самым распространённым был RAR.

### ▍ Как играли в компьютерные игры

Игры, естественно, были под запретом даже после занятий, но кого это тогда волновало. Обычно игру приносил какой-нибудь студент на дискете, и в течение часа она, часто вместе с компьютерным вирусом, становилась достоянием группы. Иногда получалось её сохранить на файловом сервере, мы её прятали от администратора всеми возможными способами. Архивировали, изменяли сигнатуру архива в начале файла, переименовывали и прятали в директориях.

С администратором у нас была постоянная необъявленная война — мы изобретали способы, как его можно обмануть, а он — как нам не дать поиграть в любимую игру. Его сообщником была лаборант, которая постоянно следила за тем, чтобы мы не играли на компьютерах. Самый простой способ скрыть факт игры, который был – это нажать кнопку Reset, когда она появлялась на горизонте.

Как только в класс заходила лаборант, все дружно нажимали кнопку Reset, а потом также дружно изучали, что же находится на диске C в программе Volkov Commander.

### ▍ Как экономили каждый байт

В ту эпоху каждый байт был на счету. Чтобы сохранить побольше информации на диск, мы использовали архиваторы, нестандартное форматирование дискет, виртуальные диски со сжатием.

Ещё был интересный способ, которым пользовалась лаборант нашей кафедры, продавая нам дискеты, – это их просверливание. Не буду утверждать, что именно она просверливала, но при выполнении такой операции над дискетой её ёмкость увеличивалась в два раза с 720 Кб до 1.44 Мб. Да, вы не ослышались, нужно было просверлить дискету.

*Советская дискета ёмкостью 720 Кб, которую можно было просверлить*

Дело в том, что контроллер дисковода гибких дисков 3.5 дюйма определял ёмкость дискеты по наличию и расположению отверстия в правом нижнем углу дискеты. Если отверстия не было, то это дискета с ёмкостью 720 Кб, если было, то 1.44 Мб или 2.88 Мб в зависимости от положения. Поэтому при помощи простой дрели можно было увеличить ёмкость дискеты. Понятно, что надёжность записи на такую дискету, как и чтения с неё, была низкая.

### ▍ Какие неприятности случались, и как их устраняли

Часто на дискетах появлялись дефектные сектора, с которых нельзя было прочитать информацию или на которые нельзя было записать информацию. Появлялись они из-за разных причин: некачественная или ветхая дискета, повидавший виды дисковод.

Если на дискете являлся дефектный сектор, то файл, который располагался на этом секторе, становился некорректным. Если это был архив, то он не распаковывался. Боролись мы с этим двумя способами:

1. Записывали две копии своих программ на две разных дискеты. Поэтому у каждого было несколько дискет. Большим шиком была пластиковая прозрачная коробка, в которой мы хранили и носили с собой дискеты.

2. При создании архива выбирали опцию «добавить информацию для восстановления». Помимо компьютерного вируса, который мог непредсказуемо напакостить, очень разочаровывало случайное удаление файла. Для файловой системы FAT было решение в виде программы UnDelete. Главное — нужно было ничего не записывать на диск после удаления, чтобы повысить шансы на восстановление. Однако для сетевого диска таких решений не было. До сих пор помню дипломницу, которая весь вечер набирала файл со своей работой и, уходя домой, случайно его удалила с сетевого диска.

Думаю, у вас тоже осталось много воспоминаний о тех временах. Будет интересно, если вы поделитесь ими в комментариях.

Программное обеспечение 90-х

----------------------------

Назначение программ в 90-х не отличалось от современных программ, существовали те же категории приложений:

1. Офисные приложения.

2. Файловые менеджеры.

3. IDE и компиляторы.

4. Антивирусы.

5. Различные утилиты.

6. Игры.

Разве что не было браузеров. Может, конечно, где-то и были, но распространены не были.

### ▍ Офисные приложения

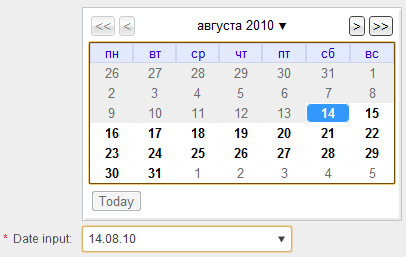

Офисные приложения у нас на кафедре были представлены текстовым редактором WD и электронными таблицами SuperCalc. На них мы и проходили практику на первом курсе. Если WD почти не вызывал вопросов, то SuperCalc по юзабилити немного напоминает редактор Vim (запустить легко, а что-то сделать и выйти с сохранением – нужно знать как, с первого раза не догадаешься).

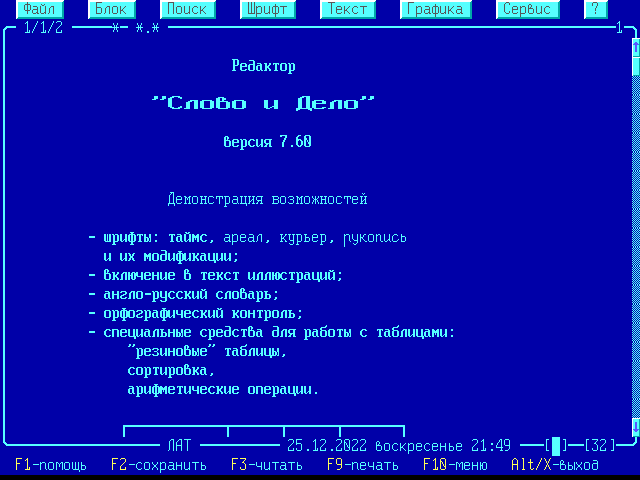

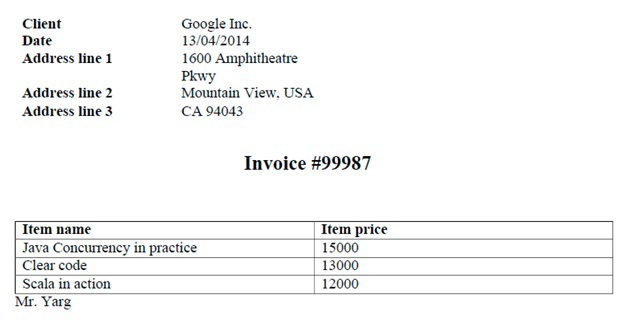

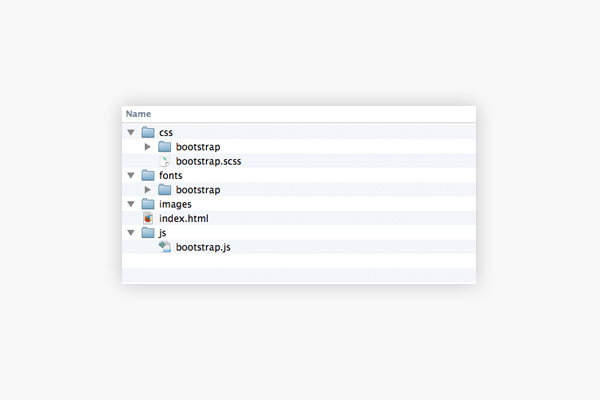

*Текстовый редактор WD*

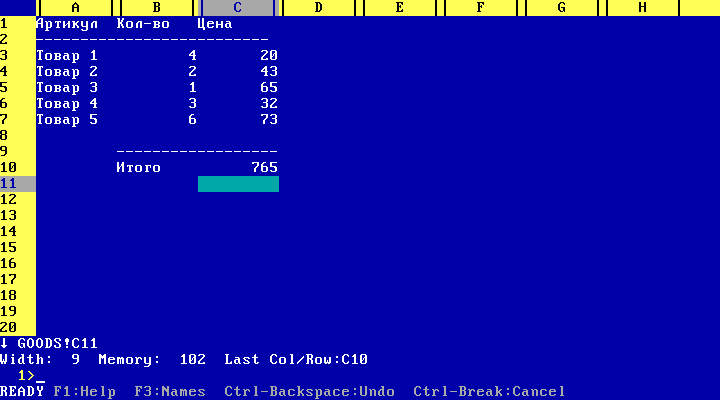

*Электронные таблицы SuperCalc*

### ▍ Файловые менеджеры

Несмотря на то, что мы учили командную строку DOS на предмете «Системное программирование», в основном пользовались файловыми менеджерами.

Я помню три файловых менеджера: Norton Commander, Volkov Commander, DOS Navigator. Первый со вторым можно было легко спутать из-за очень похожего внешнего вида, но как-то модно было использовать Volkov Commander.

DOS Navigator мы использовали только для редактирования больших бинарных файлов (первые два портили файл, если он был большого размера). Такую операцию мы выполняли, когда прятали игры от администратора.

*Файловый менеджер Norton Commander*

### ▍ IDE и компиляторы

Когда мы учились, преподаватели не сильно различали IDE и компиляторы. На некоторых других кафедрах были такие случаи, что преподаватель объяснял студенту причину ошибки компиляции программы тем, что в компьютерном классе поставили новые мониторы.

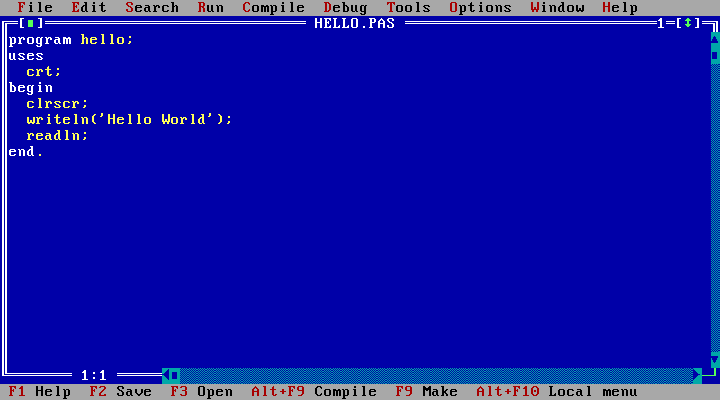

Из IDE было три основных: Borland Turbo Pascal 7.0, Borland Turbo C++ 3.0, Borland Turbo Assembler 4.0, слышали про MASM, но вживую его я не видел, только в книжках.

*IDE Borland Turbo Pascal 7.0*

Интересный случай был с компилятором Turbo Pascal 7.0. Некоторые счастливчики, которые уже купили компьютер и могли делать задания по программированию дома, заметили, что у них почти все программы выдают ошибку деления на 0. Оказалось, что дело было в модуле crt (turbo.tpl), который выдавал такую ошибку, если частота процессора была 200 или более МГц.

### ▍ Антивирусы

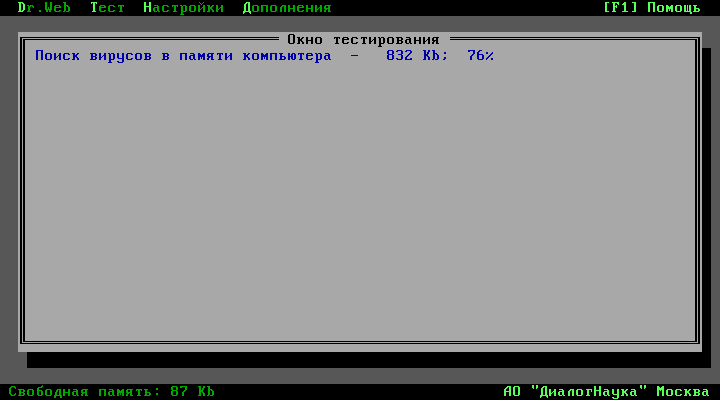

Компьютерные вирусы были всегда. Тот, кто был попродвинутей, соблюдал элементарные средства безопасности: не совал дискету куда ни попадя, а если не нужно было записывать что-то на дискету, то переключатель на ней был в положении защиты от записи. Иногда проверяли свои дискеты на наличие вирусов. Самыми распространёнными были Doctor Web и Norton Antivirus.

*Антивирус Doctor Web*

### ▍ Утилиты

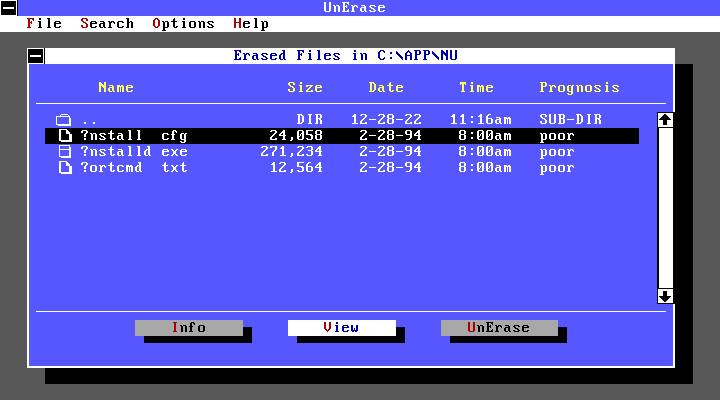

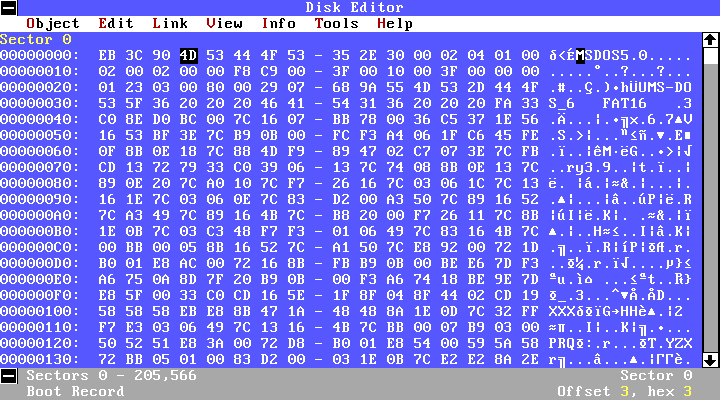

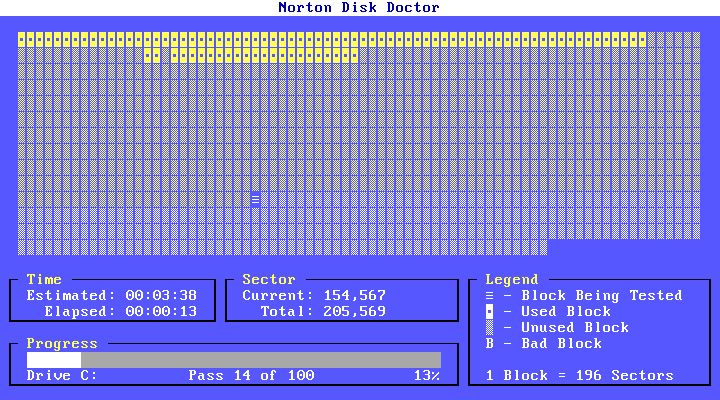

Самой полезной утилитой, наверное, была UnErase из пакета Norton Utilities. Она давала возможность восстановить случайно удалённый файл. Также была интересная утилита DiskEdit, которая позволяла редактировать и просматривать информацию на жёстком диске или дискете на низком уровне (в виде секторов). Для создания архивов использовали rar, реже pkzip/pkunzip. До сих пор помню самый короткий анекдот: «pkunzip.zip».

*Утилита UnErase*

*Утилита DiskEdit*

*Утилита Norton Disk Doctor*

*Архиватор Rar*

### ▍ Игры

Доступных игр было не сильно много, распространялись они на дискетах, CD-ROM диски только появлялись, но мало где можно было прочитать CD-ROM. Наверное, многим запомнилась легендарная Wolfenstein 3D, а потом Doom, Quake, которые уже требовали более мощные по тем меркам компьютеры.

*Игра Wolfenstein 3D*

*Игра Quake*

Были и отечественные игры, которые создавали энтузиасты, например, «Поле чудес». Естественно, игры, как и обычные программы, никто не покупал — их просто доставали у знакомых и обменивались ими. Сложно судить об оригинальности игр в то время. Игра представляла собой нечто видоизменённое (неизвестно кем), и было хорошо, если игра не содержала вируса в своём составе. Но и такие игры были для многих в диковинку и представляли интерес.

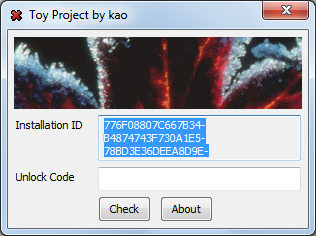

Локализация программ

--------------------

Это было время, когда современные компьютерные технологии только заходили на рынок бывшего СССР. В основном всё программное обеспечение было пиратское и взломанное, если у него предусматривалась защита. Отечественное ПО было, но программы можно было по пальцам пересчитать, по крайней мере у нас: несколько игр и текстовых редакторов, а также KeyRus – резидентная программа, которая позволяла работать с кириллицей.

Программа KeyRus была разработана донецким студентом Дмитрием Гуртяком в 1989 году, к сожалению, рано ушедшем из жизни, но популярность у неё была очень высока, так как в то время использовалась английская версия MS-DOS, которая вообще ничего не знала о кириллице, а программа позволяла очень просто добавить поддержку русского алфавита. Говорят, что была официальная русификация MS-DOS, но я её не видел.

Наверное, из-за нестандартных решений в программе потом у неё были проблемы с работой в Windows NT, да и сейчас в некоторых эмуляторах она не всегда корректно работает.

Воссоздание компьютера из прошлого на современном компьютере

------------------------------------------------------------

В сети много сайтов, которые пытаются сохранить то наследие программ. Например, англоязычные [VentusWare](https://vetusware.com/), [WinWorld](https://winworldpc.com/) или русскоязычный [Old-DOS.ru](http://old-dos.ru/). Я думаю, что вам будет приятно потратить вечер, а может и не один, на их изучение.

После того, как в операционной системе Windows исчезла возможность запускать DOS-программы, самое очевидное решение для запуска старых программ — использовать эмулятор или виртуальную машину, но мы пойдём другим путём – запустим их на современном компьютере в операционной системе MS-DOS 6.22.

Изначально я хотел создать загрузочный ISO с эмуляцией жёсткого диска, но потом от этой идеи отказался, так как флеш-накопитель предоставляет больше возможностей.

Для создания загрузочного флеш-накопителя с DOS мне известны несколько программ:

1. [Rufus](https://rufus.ie) — позволяет, помимо прочего, создать загрузочный накопитель с FreeDOS — современным аналогом MS-DOS, разработка которой прекращена после выхода Windows Me.

2. [RMPrepUSB](https://rmprepusb.com/) — пакет программ, позволяющий записывать различные загрузочные сектора для загрузки ядер MS-DOS и FreeDOS (IO.SYS и KERNEL.SYS), загрузчиков NTLDR (Windows XP), BOOTMGR (Windows Vista, Windows 7), SYSLINUX (простой загрузчик, используемый многими дистрибутивами LINUX для загрузки из BIOS (не UEFI)), проверять работу загрузочного диска в эмуляторе, размечать диск, делать копии разделов, записывать образы разделов на диск.

Разобравшись с вышеперечисленными программами, подготовив необходимые файлы, можно создать загрузочный флеш-накопитель с MS-DOS 6.22 или FreeDOS, но они вам не помогут, если у вас есть образы установочных дискет. Поэтому я решил создать образ флеш-накопителя, используя эмулятор Qemu.

Раньше программы часто не требовали инсталляции — решалось всё простым копированием файлов. Если честно, об установочных дискетах в MS-DOS я узнал уже спустя много лет.

Итак, нам понадобятся:

1. Эмулятор Qemu (только для создания загрузочного флеш-накопителя).

2. Образы инсталляционных дискет MS-DOS 6.22.

3. Программы (образы инсталляционных дискет, директории с программами).

4. Программа для записи образов на флеш-накопитель.

Хотя у меня и получилось запустить многие из программ для MS-DOS 6.22 на своём компьютере, хочу предупредить о сложностях, с которыми вы можете столкнуться.

1. На компьютерах середины 90-х звуковая карта была редкостью, и звук выводился на динамик системного блока. На современных же компьютерах этот динамик может отсутствовать (тогда вы вообще не услышите никакого звука в играх) или эмулироваться звуковой картой (тогда звук может быть искажённым).

2. Некоторые программы, которые напрямую используют порты ввода-вывода, могут не работать.

3. У меня не получилось заставить работать драйвер HIMEM.SYS.

4. DPMI-сервера тех времён, например, для Quake, могут некорректно работать. Я использовал DPMI-сервер с [этого проекта](https://github.com/Baron-von-Riedesel/HX/releases/tag/v2.19).

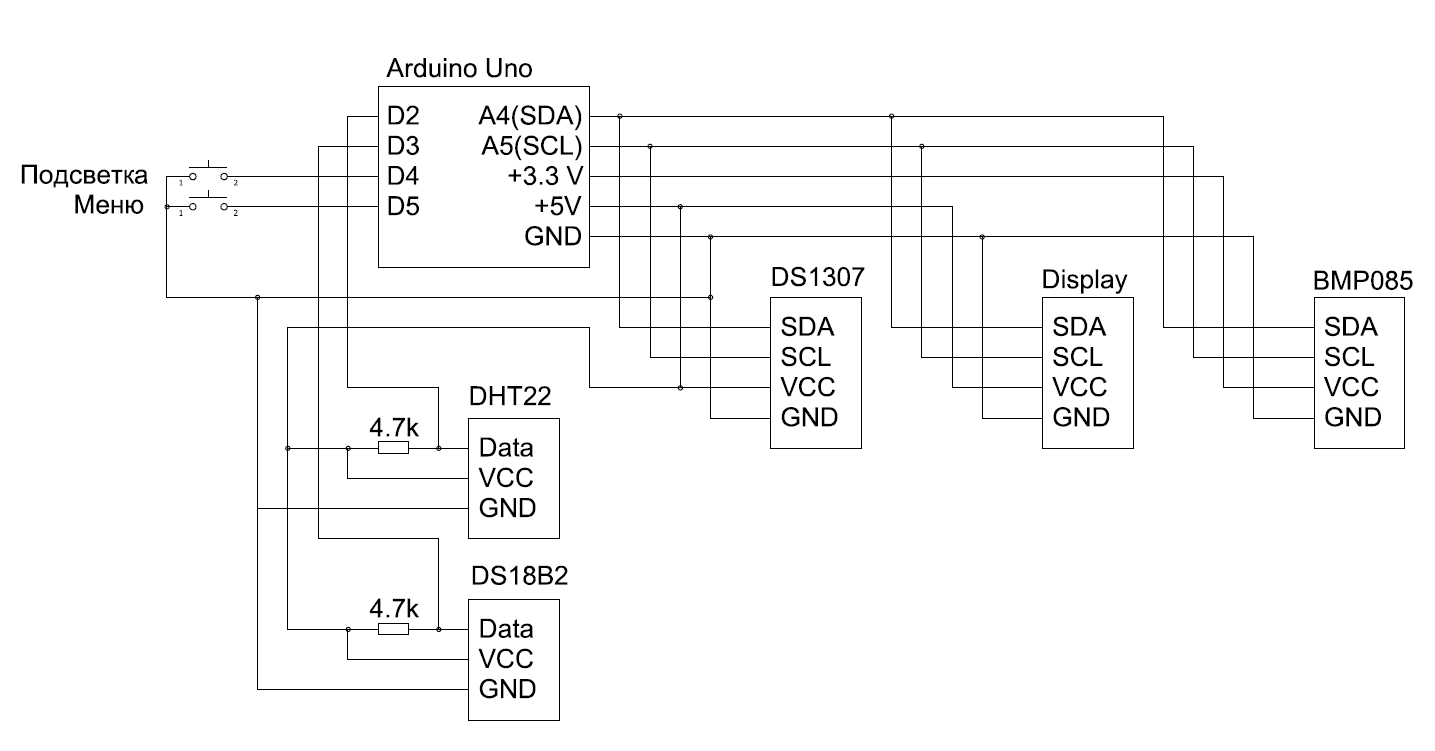

### ▍ Алгоритм создания загрузочного флеш-накопителя с MS-DOS 6.22

1. Подготавливаем директорию, из которой будем устанавливать программы. Я создал в ней две директории (floppy-images и dos-programs), в которые соответственно поместил программы в виде образов инсталляционных дискет и в виде простых файлов.

2. Загружаем и устанавливаем Qemu.

3. Создаём образ жёсткого диска:

```

$ qemu-img create dos.img 500M

```

4. Запускаем qemu:

```

$ qemu-system-i386 -drive file=dos.img,format=raw,media=disk -m 64 -L . -drive file=fat:rw:"dos-programs",format=raw,media=disk -drive file=floppy-images\dos\disk01.img,format=raw,if=floppy

```

5. Следуем инструкциям, которые предлагает нам установщик DOS.

6. Для смены образа дискеты используем Qemu Monitor Console. В графическом режиме эмулятора это Ctrl+Alt+2. Для возврата из неё – Сtrl+Alt+1.

Для просмотра всех дисковых устройств, используемых в эмуляторе:

```

(qemu) info block

```

Для смены образа дискеты:

```

(qemu) change floppy0 <файл образа>

```

Для извлечения образа дискеты:

```

(qemu) eject floppy0

```

7. Чтобы удобнее было работать в MS-DOS 6.22, первым делом устанавливаем Norton Commander:

```

(qemu) change floppy0 floppy-images\nc\disk01.img

```

```

C:\> mkdir C:\APP

C:\> A:

A:\> dir

A:\> install

```

Путь для установки я меняю с C:\NC на C:\APP\NC, чтобы корневая директория была чище. Я не устанавливал просмотрщики NC, вы можете установить.

8. Аналогичным образом устанавливаем Turbo Pascal 7.0, Turbo C++ 3.0, Turbo Assembler 4.0.

9. Остальные программы копируем просто из директории в директорию.

Из всех программ дополнительной настройки требуют только Turbo Pascal 7.0 и Quake.

### ▍ Настройка Turbo Pascal

Как я говорил ранее, Turbo Pascal, а именно его модуль TURBO.TPL, работает некорректно с процессорами с тактовой частотой 200 мегагерц и выше. Поэтому его нужно пропатчить. Я не буду останавливаться, как это сделать, вы это можете прочесть из прилагаемой к нему инструкции.

### ▍ Настройка Quake

Quake сильно выделяется среди компьютерных игр того времени. Для своей работы она требует прилично по тому времени памяти. Работа с памятью более 640 килобайт всегда была сложной в MS-DOS, поэтому на ней у меня игра Quake не запустилась с первого раза.

Почитав немного о DPMI, я понял, что проблему, скорее всего, можно решить, заменив DPMI-сервер на более новый.

Нужно взять файл HDPMI32.EXE из [этого архива](https://github.com/Baron-von-Riedesel/HX/releases/download/v2.19/HXRT219.zip). Для удобства файлы из этого архива я разместил и в моём репозитории в директории dos-programs\APP\HX.

### ▍ Настройка CONFIG.SYS и AUTOEXEC.BAT

В файлах CONFIG.SYS и AUTOEXEC.BAT осуществляется вся нехитрая настойка DOS 6.22. Я их немного изменил, чтобы DOS работал как надо. Содержимое файлов ниже.

Файл config.sys:

```

FILES=30

```

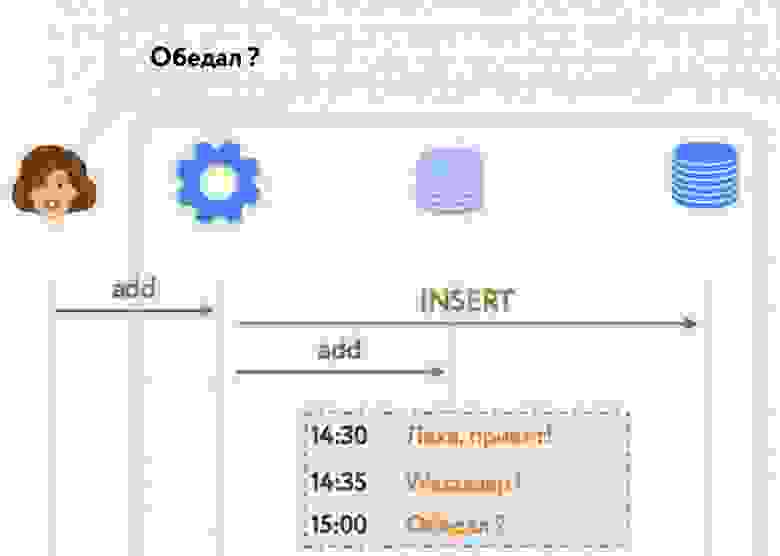

Файл autoexec.bat:

```

@ECHO OFF

PROMPT $p$g

PATH C:\DOS;C:\APP\TC3\BIN;C:\APP\TP7\BIN;C:\APP\TASM4\BIN;

SET TEMP=C:\DOS

C:\APP\KEYRUS\keyrus.com

C:\APP\NC\nc.exe

```

### ▍ Запуск созданного образа на реальном компьютере

1. Закройте Qemu.

2. На флеш-накопитель запишите образ dos.img, используя balenaEtcher или другую программу для записи образов на флеш-накопитель. При записи будут удалены все файлы, которые были на нём ранее, и пространство под файлы будет ограничено 500 Мб (следствие DOS и FAT16). Поэтому вам будет достаточно старого флеш-накопителя на 1 Гб.

3. В BIOS выберите Legacy Mode и отключите Secure Mode.

4. Выполните загрузку с этого флеш-накопителя.

Если вы создадите в Qemu ещё один пустой образ с FAT 16, вы можете использовать его как дополнительный винчестер, и MS-DOS его будет видеть. Единственное условие, вы должны его вставить в разъём до перезагрузки или включения компьютера.

Заключение

----------

Эпоха DOS для меня длилась всего чуть больше года c сентября 1996-го по декабрь 1997-го. Потом в институте заменили компьютеры на более новые — сначала с Windows 3.1, а потом и с Windows NT 4.0. Но запомнилась эта эпоха очень хорошо. Вообще, обучаясь в институте, я видел, как всё быстро меняется в сфере компьютерных технологий. Когда я поступил, были IBM PC 286 и EC 1840, а когда заканчивал, уже были классы с Pentium II 32 Мб.

Надеюсь, если вы были студентом в те далёкие времена, вы ощутили те чувства, которые ощущали тогда. Я считаю, что именно реальный компьютер с DOS 6.22 позволяет лучше всего это ощутить, а не различные эмуляторы и виртуальные машины, или более поздний DOS 7.0, входивший в поставку Windows 95, или ещё более поздний Free DOS.

Если честно, до этой статьи я сам думал, что в DOS 6.22 уже не поработаешь без виртуальной машины или реального компьютера из 90-х, найденного среди хлама в гараже, но оказалось, что я ошибался.

Не все программы и не на всех компьютерах работают как надо. Но если программу можно запустить на более новом компьютере это, с моей точки зрения, говорит о том, что её правильно спроектировали, раз по прошествии 30 лет она продолжает работать и выполнять то, для чего она задумывалась. Некоторые перестают работать потому, что авторы с целью оптимизации использовали недокументированные возможности и нестандартные решения.

Я думаю, что в 90-х годах студент, у которого все эти программы были на винчестере, мог гордиться этим. Я привёл только те программы, с которыми я работал — вы, вероятнее всего, использовали другие программы. Думаю, вы сможете найти и добавить свои программы, которые использовали в то время.

Если вы всё же хотите поиграть в старые DOS-игры в эмуляторе, то можете использовать [DOSBox](https://www.dosbox.com/), но, несмотря на качественную эмуляцию, ощущения всё же будут не те.

В образ я поместил много программ, не сильно экономя пространство, в реальности же жёсткие диски в то время были по 40 мегабайт, и столько информации вы разместить не могли. Приходилось каким-то образом обходить это ограничение. Из дистрибутивов программ удаляли всё, что считали лишним.

Не знаю как вам, но мне приятно ощущать, что какой бы современный компьютер сейчас ни был, он всё равно может работать под управлением MS-DOS 6.22.

Операционная система Windows 95, которая пришла на смену DOS, обладала большими возможностями, но ввиду сложности её запуск на современном железе более затруднительный и требует больших знаний, если он вообще возможен. То же можно сказать и о Windows NT 4.0, Windows 98, Windows ME, Windows 2000, Windows XP. Но это, как говорится, совсем другая история.

> **[Играй в нашу новую игру прямо в Telegram!](https://t.me/ruvds_community/130)**

[](http://ruvds.com/ru-rub?utm_source=habr&utm_medium=article&utm_campaign=artyomsoft&utm_content=kakim_bylo_avtomatizirovannoe_rabochee_mesto_serediny_90-x_i_kak_ego_povtorit_na_sovremennom_kompyutere) | https://habr.com/ru/post/707220/ | null | ru | null |

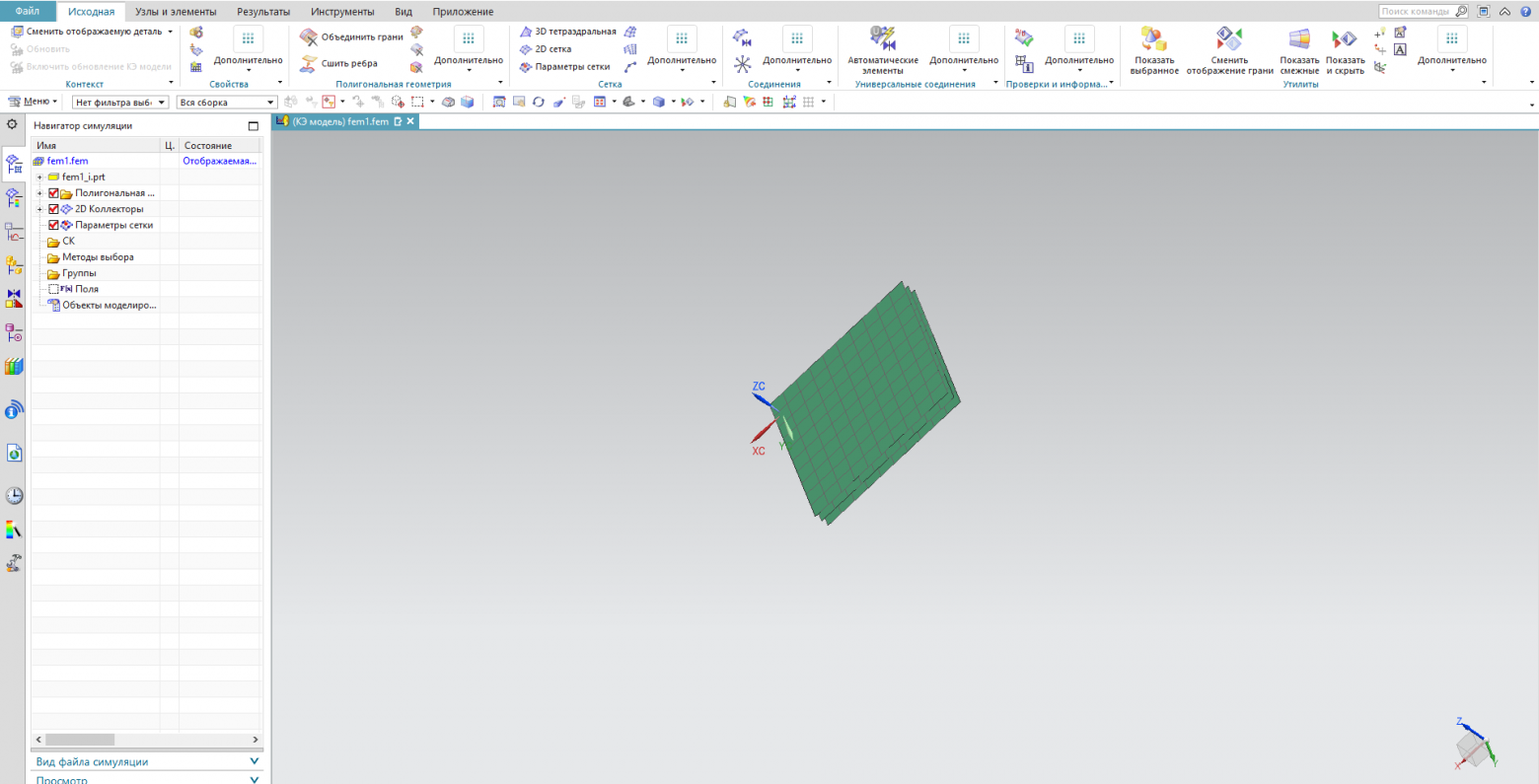

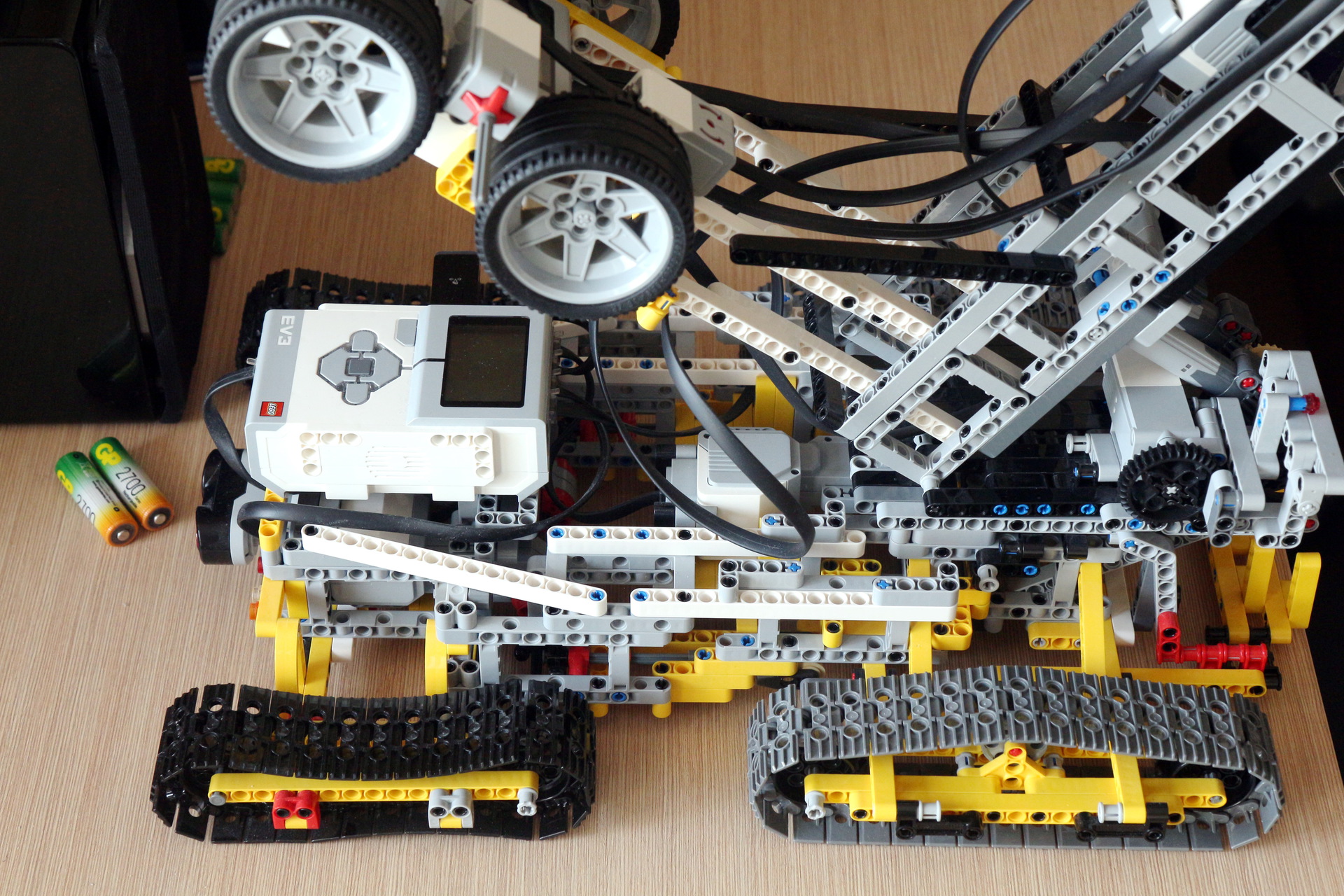

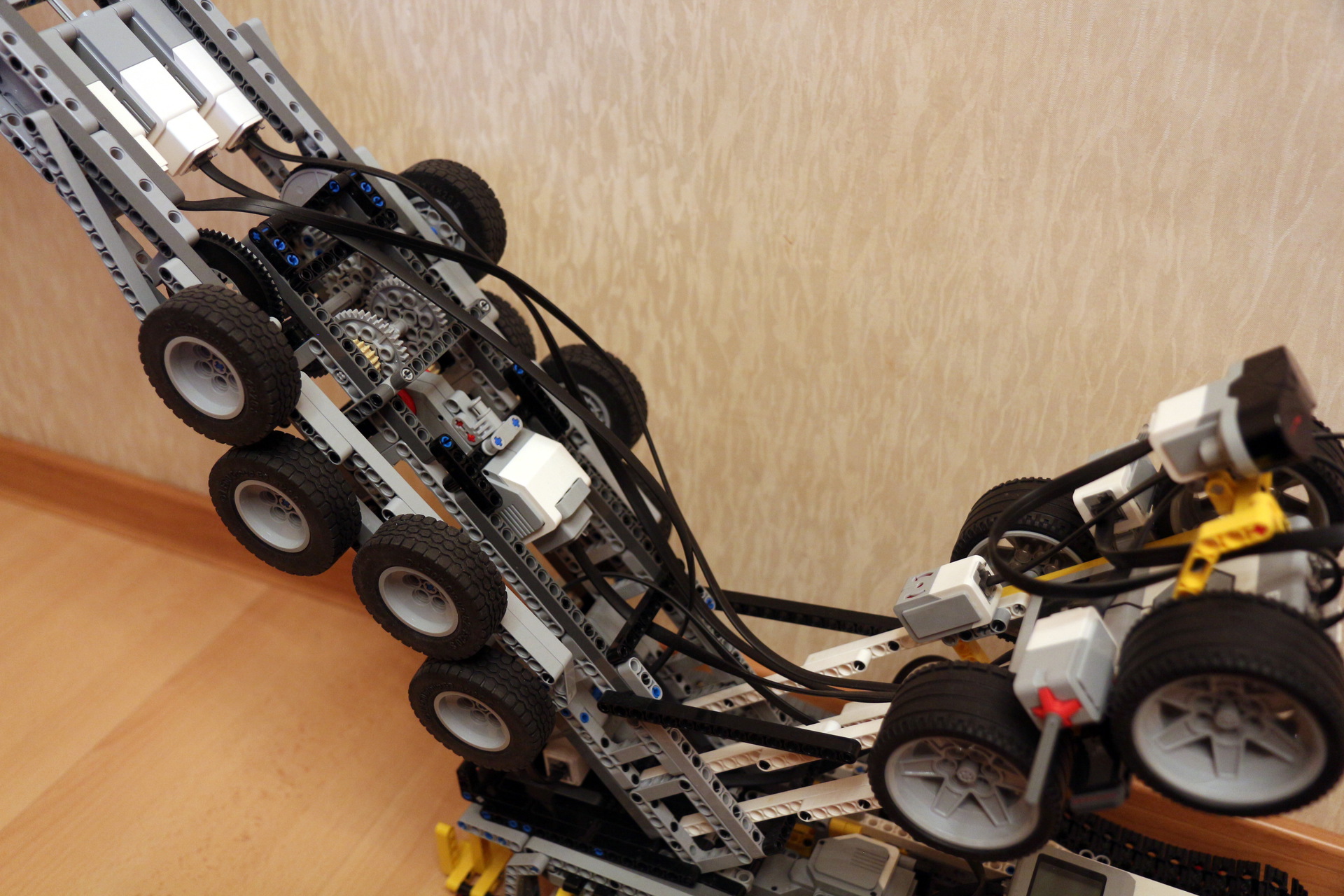

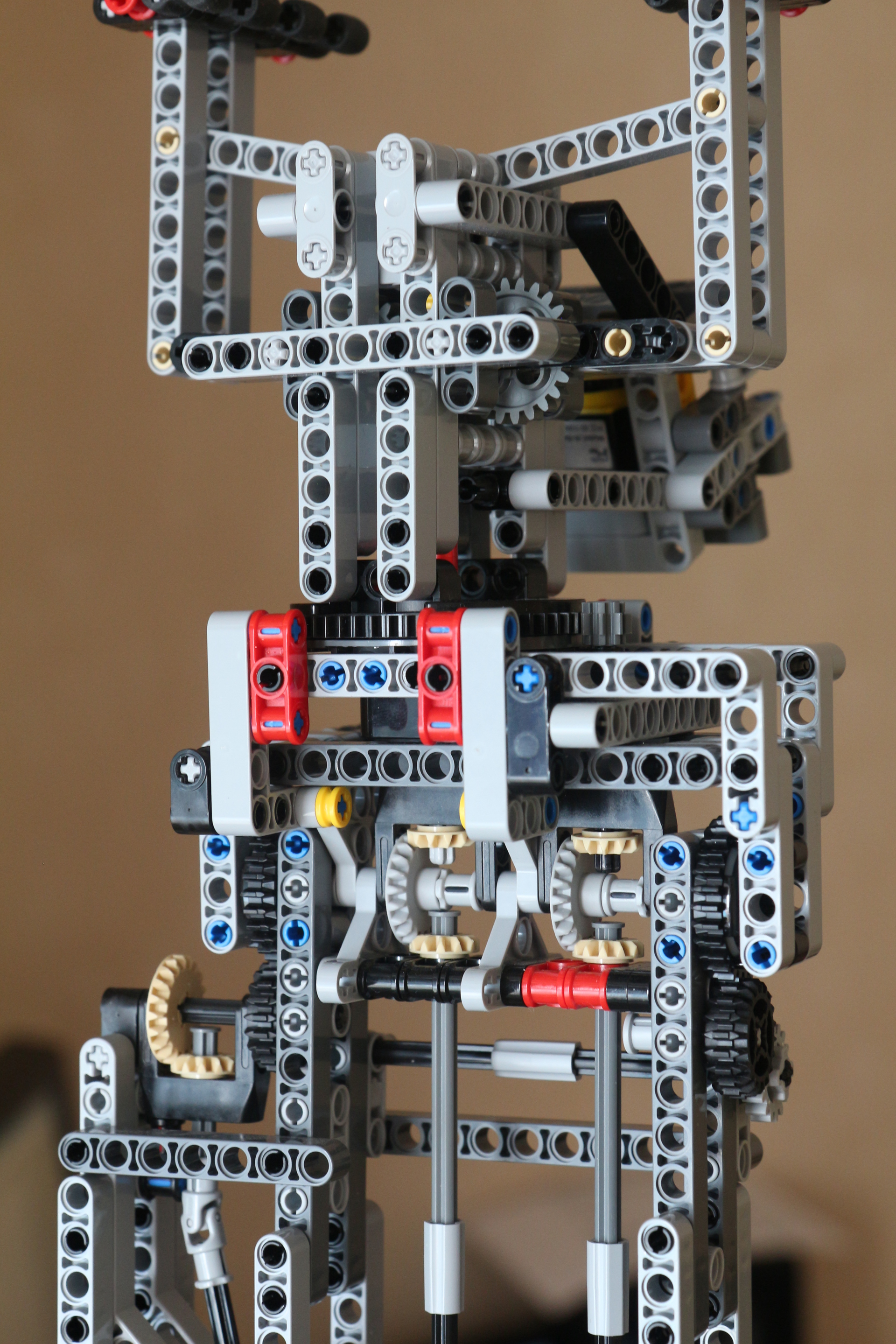

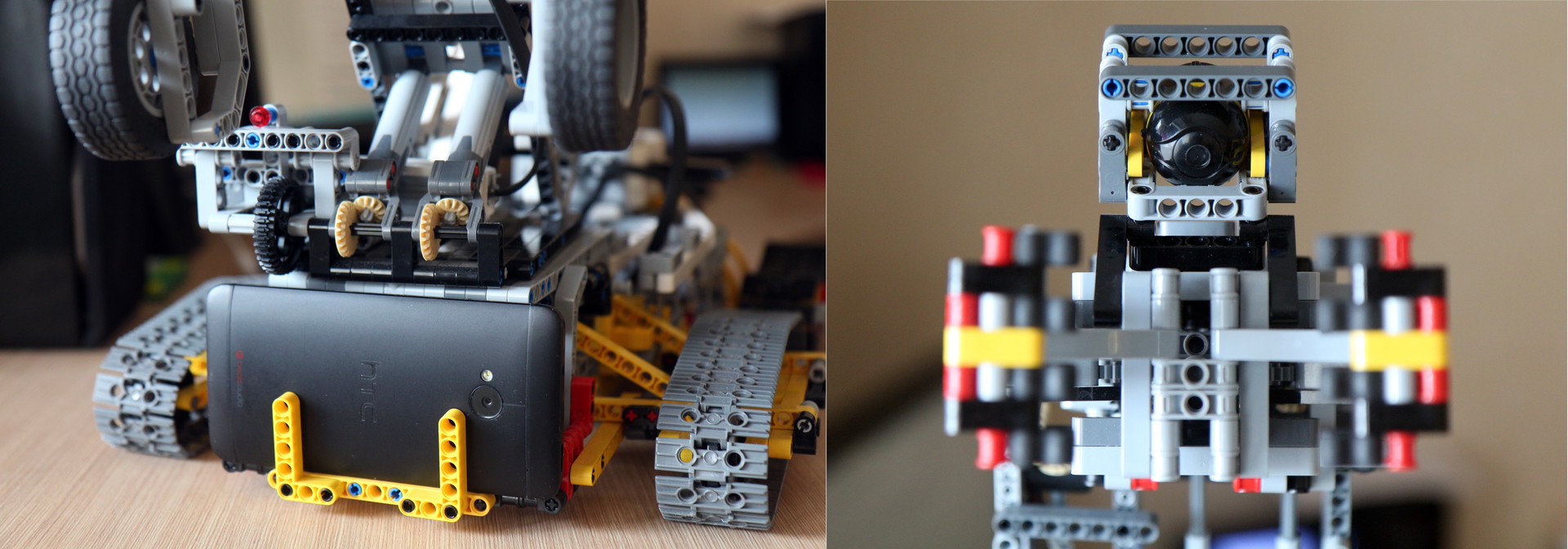

# Физика для мобильного PvP шутера, или как мы из двумерной игру в трёхмерную переделывали

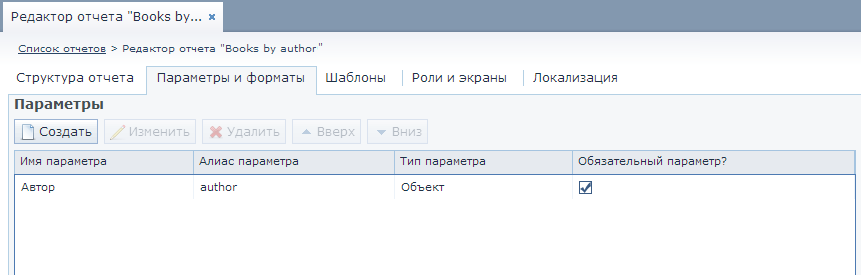

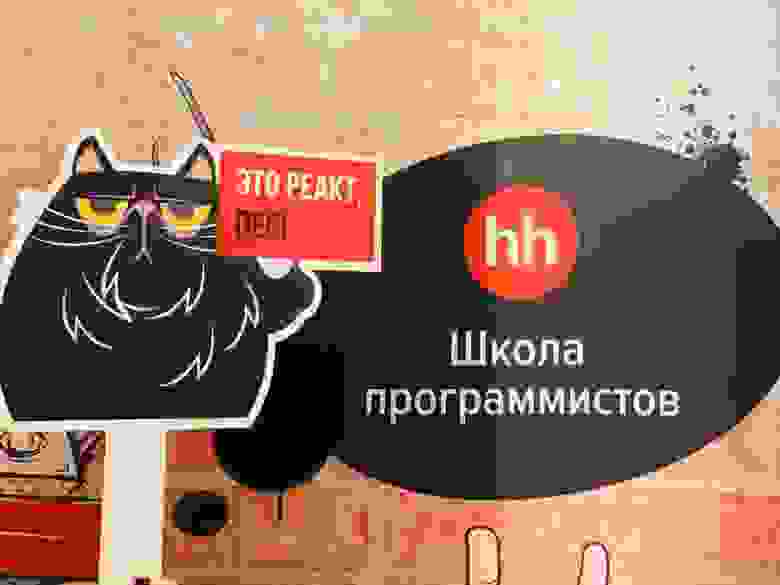

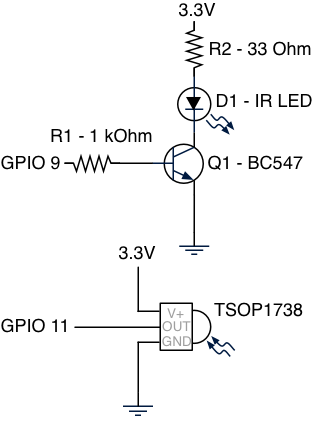

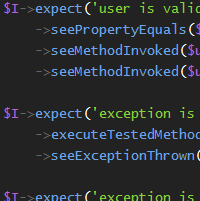

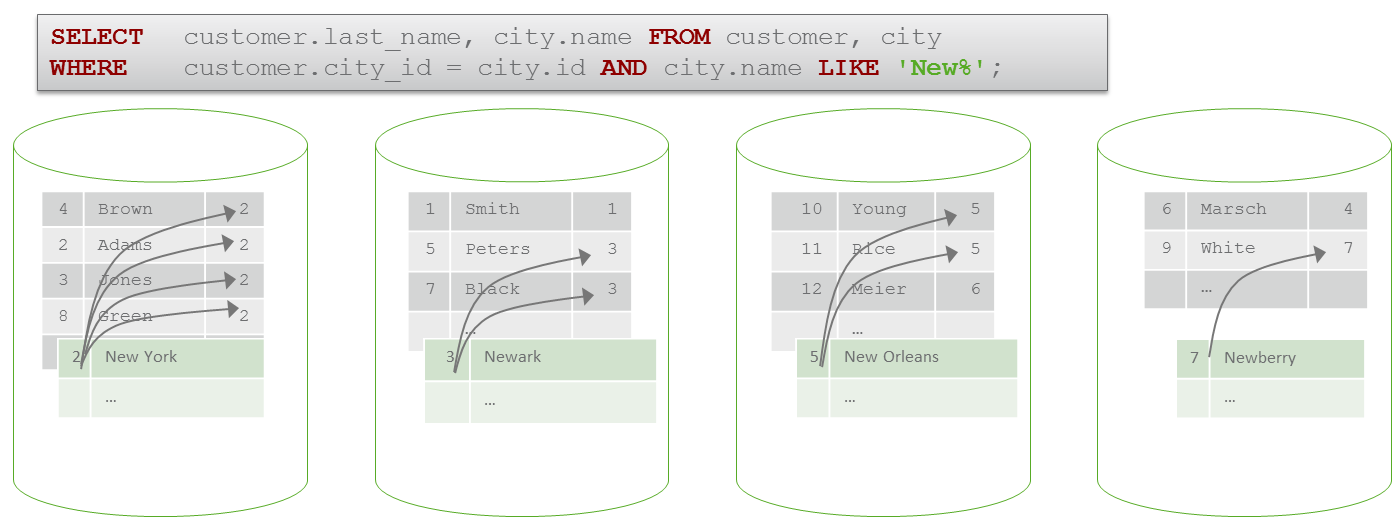

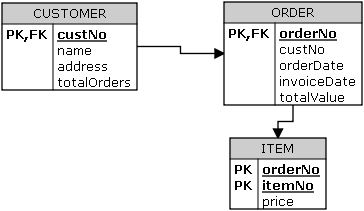

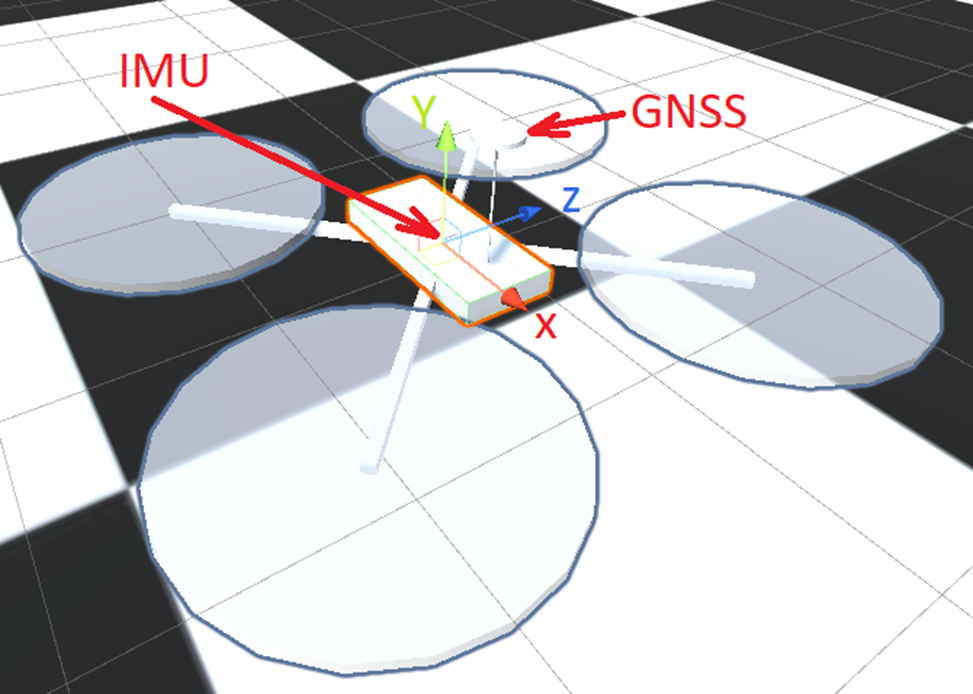

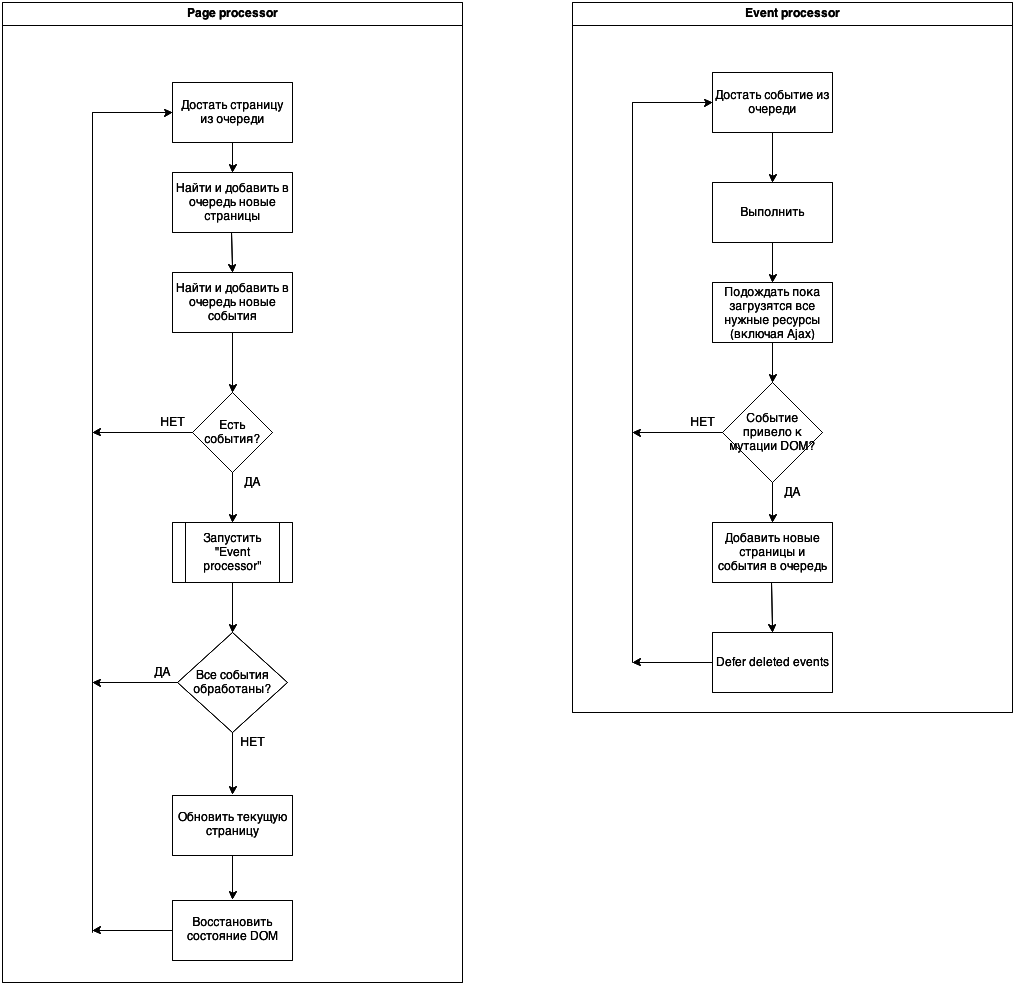

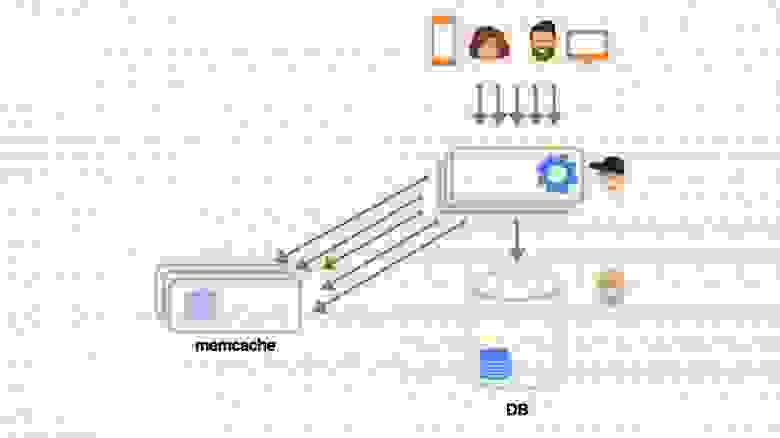

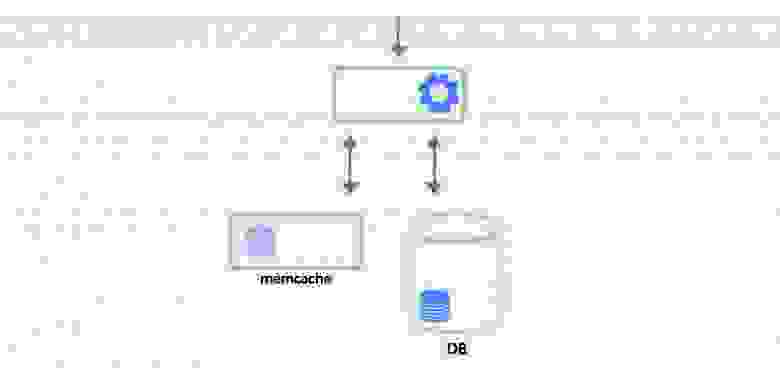

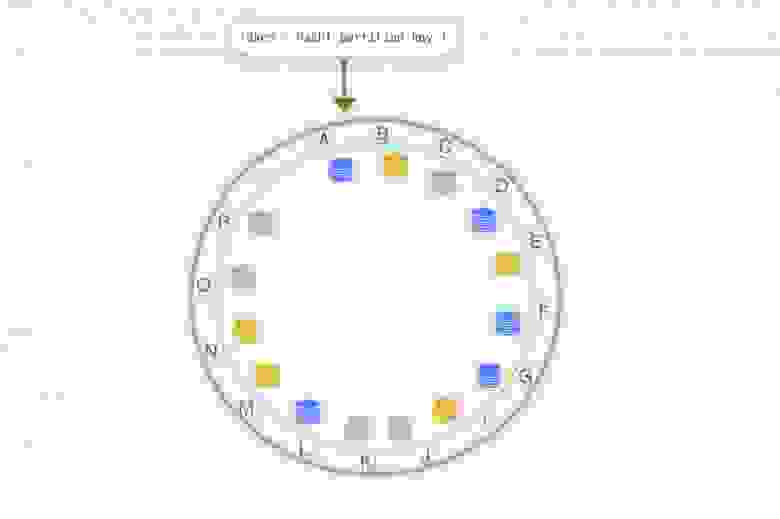

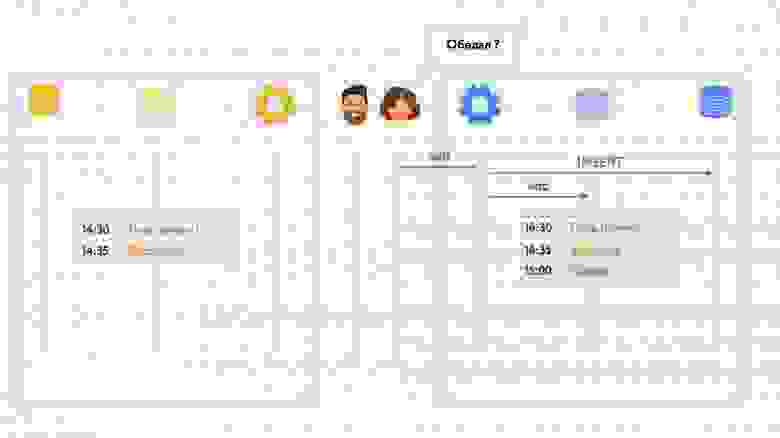

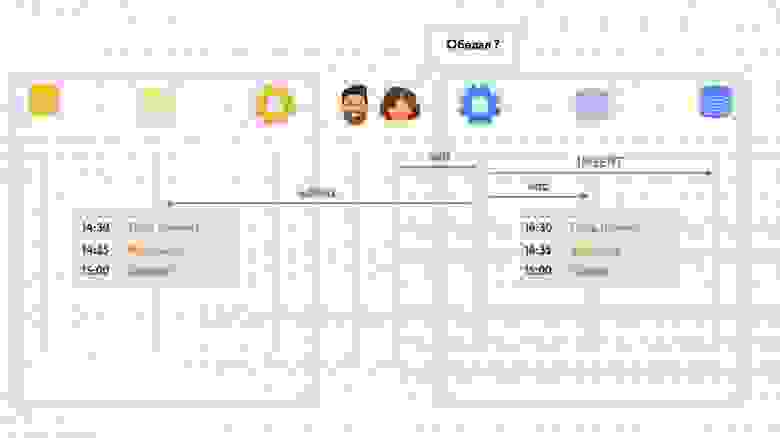

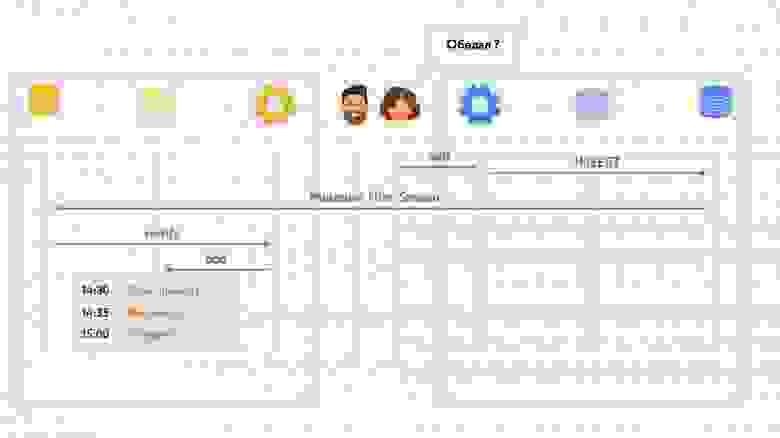

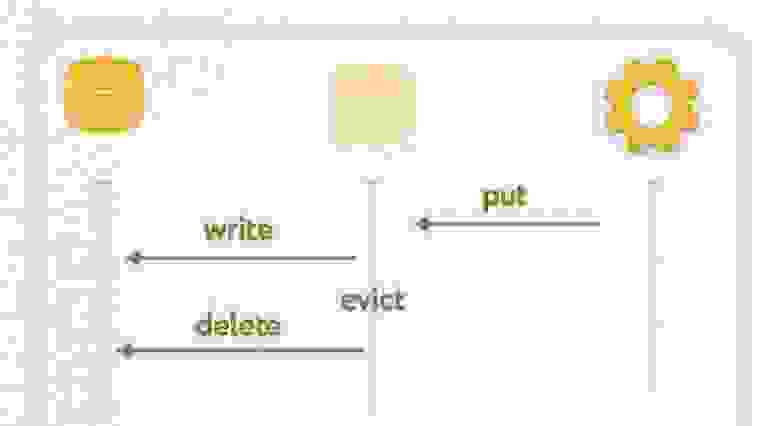

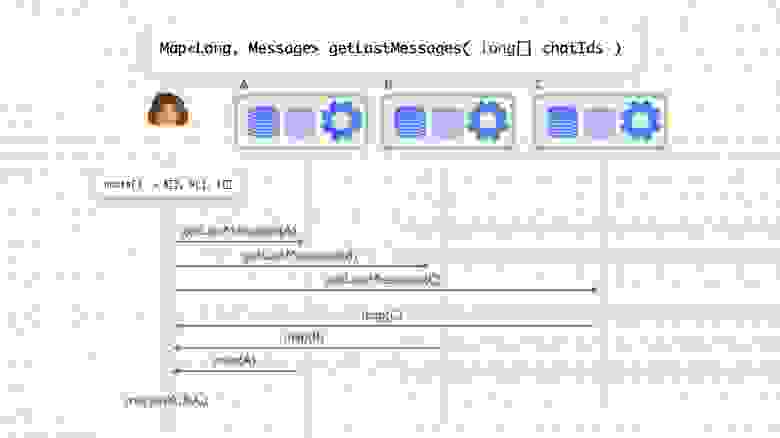

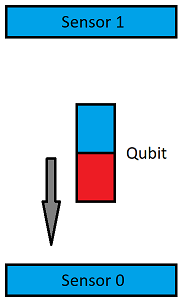

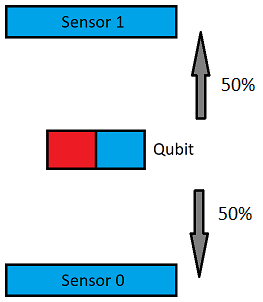

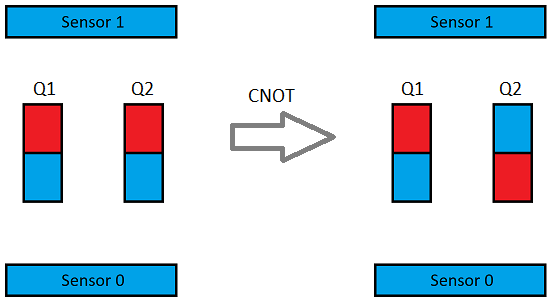

В [предыдущей статье](https://habr.com/ru/company/pixonic/blog/481880/) мой коллега рассказал о том, как мы использовали двумерный физический движок в нашем мобильном мультиплеерном шутере. А теперь я хочу поделиться тем, как мы выкинули всё, что делали до этого, и начали с нуля ― иными словами, как мы перевели нашу игру из 2D-мира в 3D.

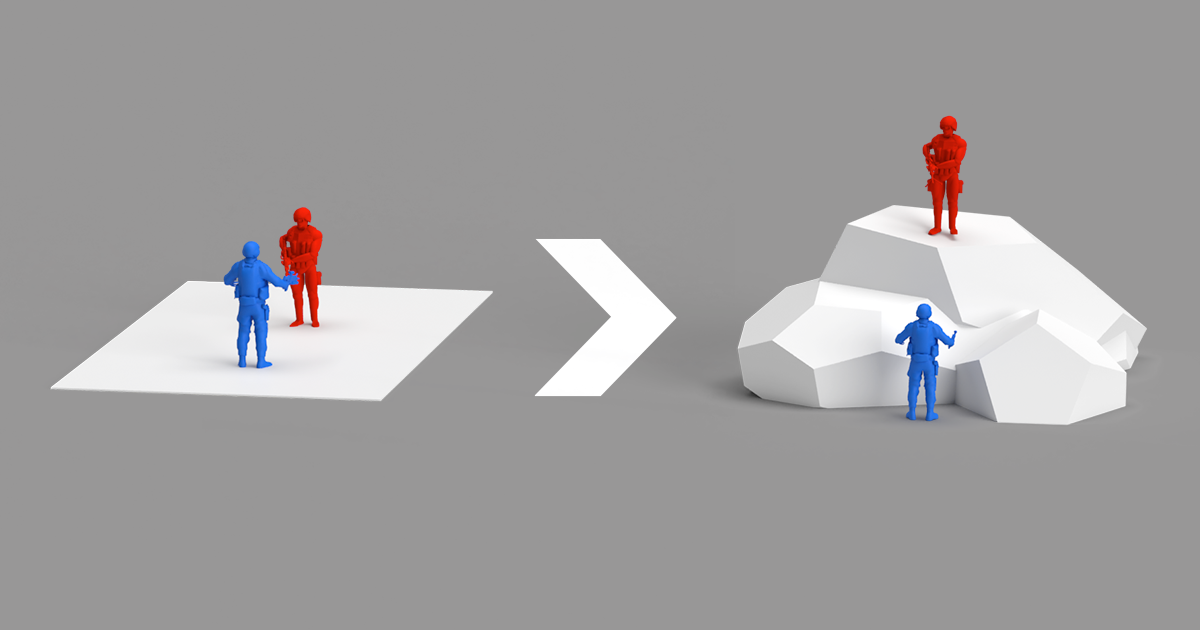

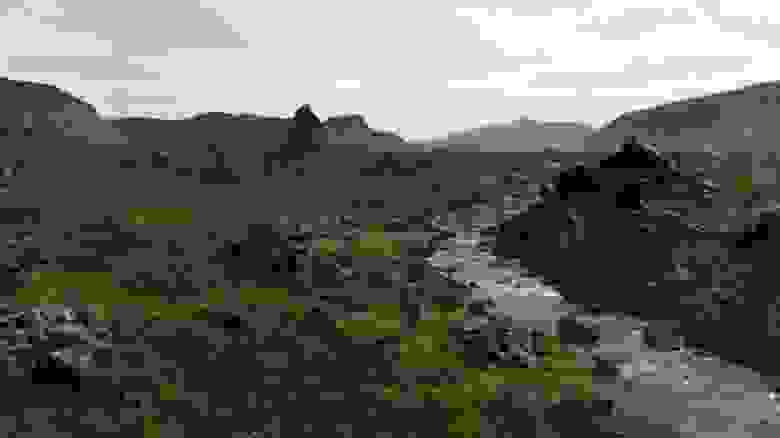

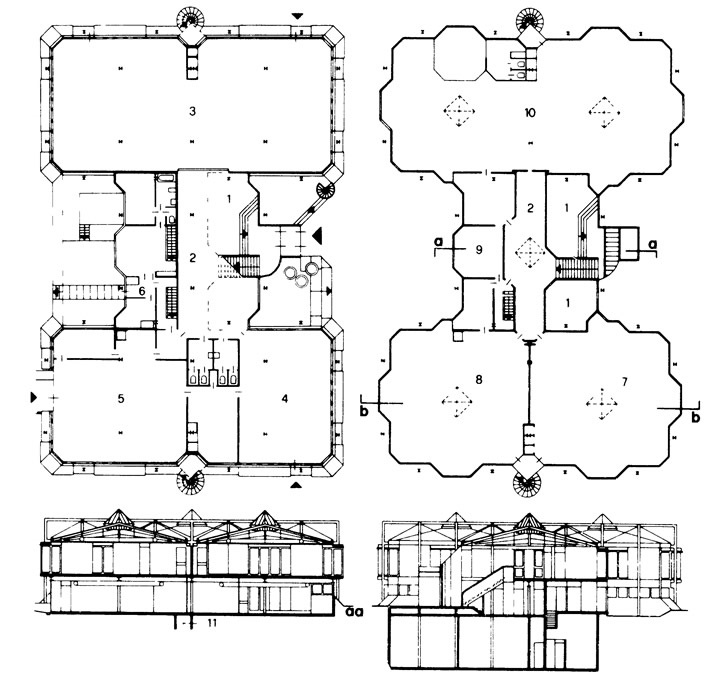

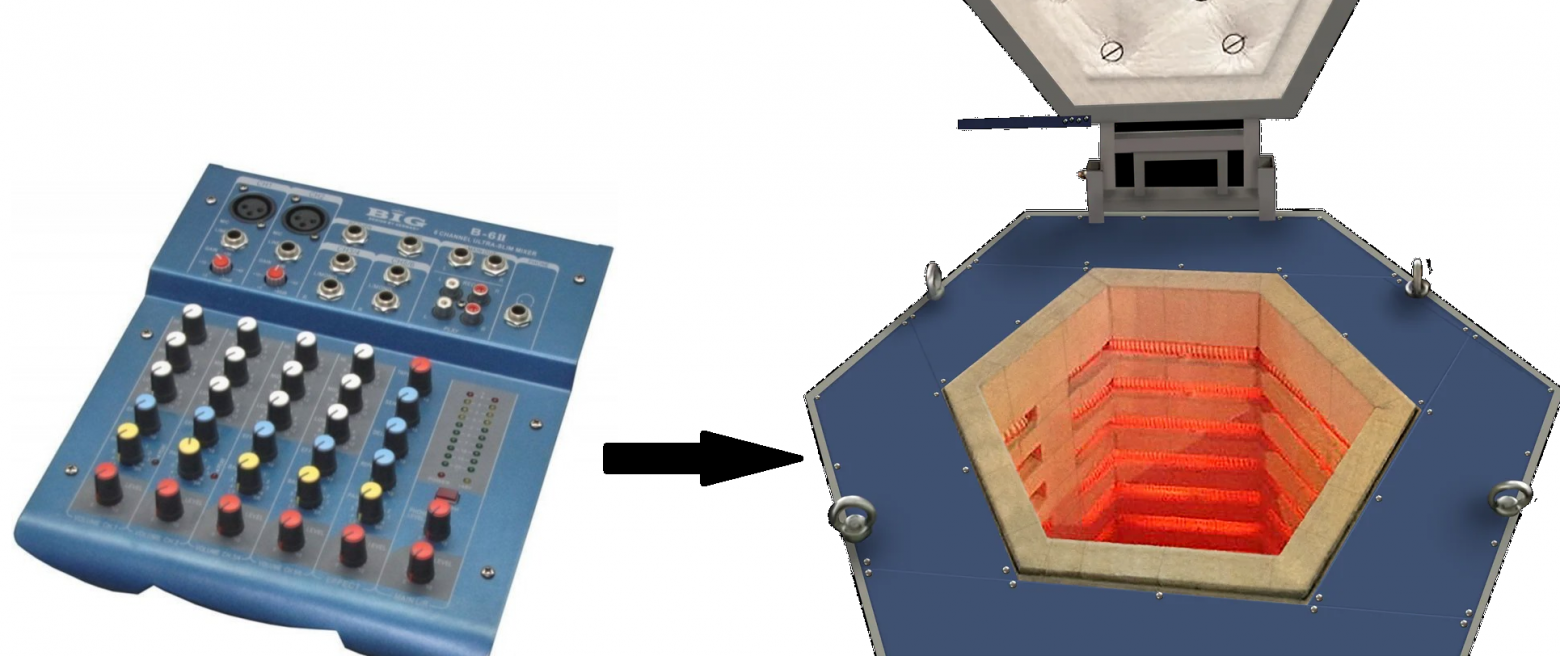

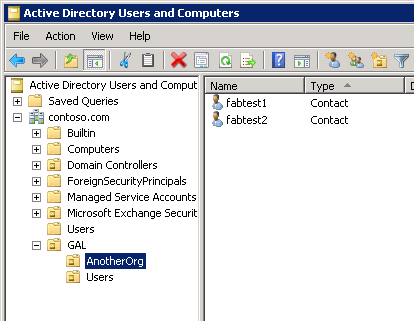

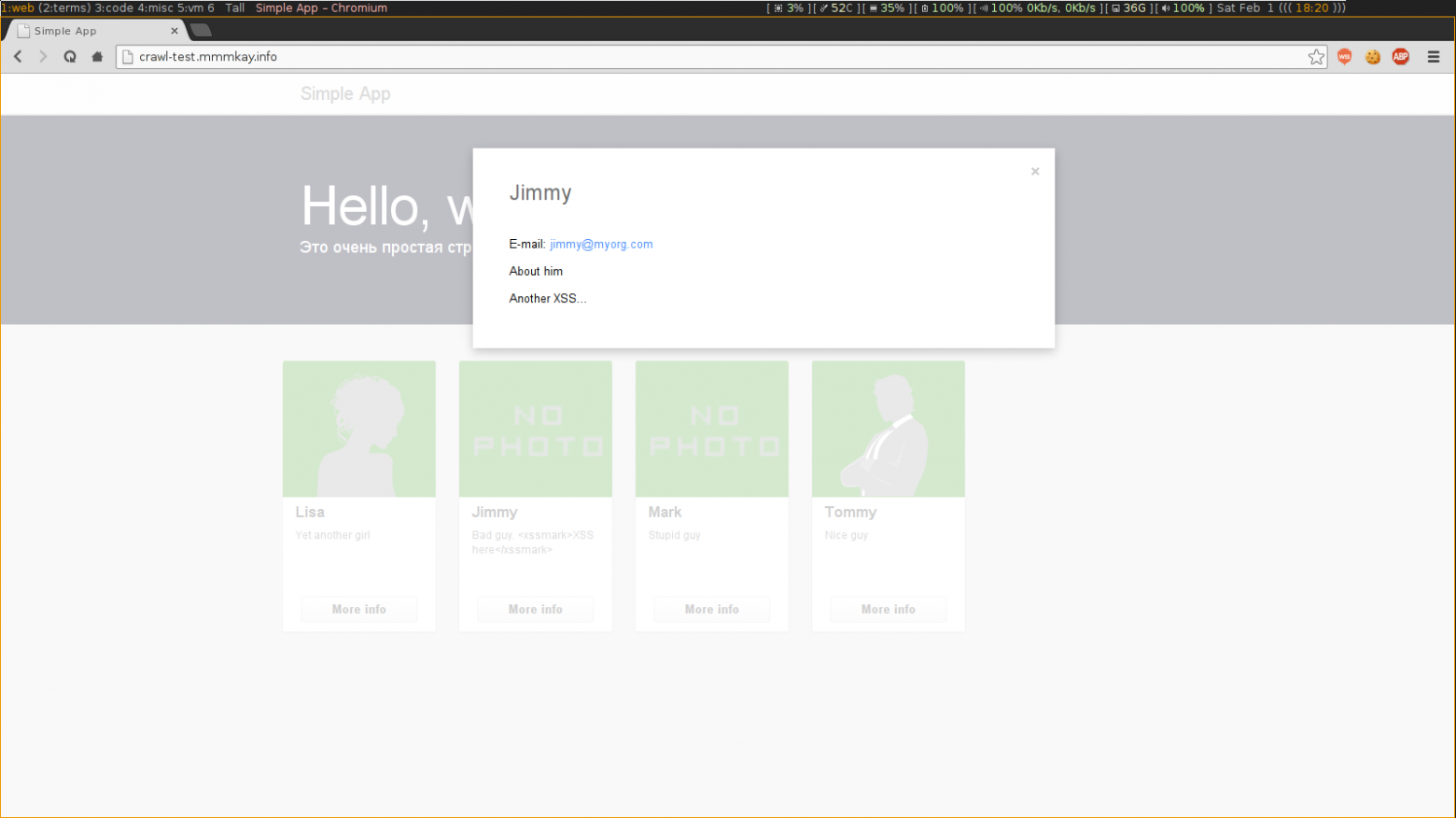

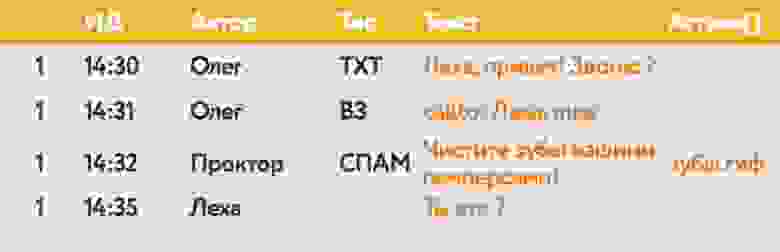

Всё началось с того, что как-то раз к нам в отдел программистов пришли продюсер и ведущий геймдизайнер поставили перед нами челлендж: мобильный PvP Top-Down шутер с перестрелками в замкнутых пространствах надо было переделать в шутер от третьего лица со стрельбой на открытой местности. При этом желательно, чтобы карта выглядела не так:

А так:

Технические требования при этом выглядели следующим образом:

* размер карты ― 100×100 метров;

* перепад высот ― 40 метров;

* поддержка туннелей, мостов;

* стрельба по целям, находящимся на разной высоте;

* коллизии со статической геометрией (коллизии с другими персонажами в игре у нас отсутствуют);

* физика свободного падения с высоты;

* физика броска гранаты.

Забегая вперед, могу сказать, что на последний скриншот наша игра так и не стала похожа: получилось нечто среднее между первым и вторым вариантом.

Вариант первый: слоистая структура

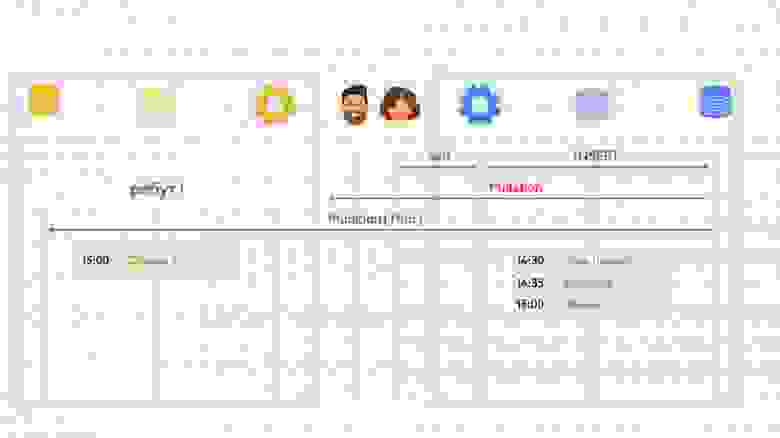

----------------------------------

Первой была предложена идея не менять физический движок, а просто добавить несколько слоев «этажности» уровней. Получалось что-то вроде планов этажей в здании:

При подобном подходе нам не нужно было радикально переделывать ни клиентское, ни серверное приложение, и вообще казалось, что таким образом задача решается довольно просто. Однако при попытке реализовать его мы столкнулись с несколькими критическими проблемами:

1. После уточнения деталей у левел-дизайнеров мы пришли к выводу, что количество «этажей» в такой схеме может оказаться внушительным: часть карт располагается на открытой местности с пологими склонами и холмами.

2. Расчёт попаданий при стрельбе с одного слоя в другой становился нетривиальной задачей. Пример проблемной ситуации изображен на рисунке ниже: здесь игрок 1 может попасть в игрока 3, но не в игрока 2, так как путь выстрела преграждает слой 2, хотя при этом и игрок 2, и игрок 3 находятся на одном слое.

Словом, от идеи разбивать пространство на 2D-слои мы отказались быстро ― и решили, что будем действовать посредством полной замены физического движка.

Что привело нас к необходимости выбрать этот самый движок и встроить его в существующие приложения клиента и сервера.

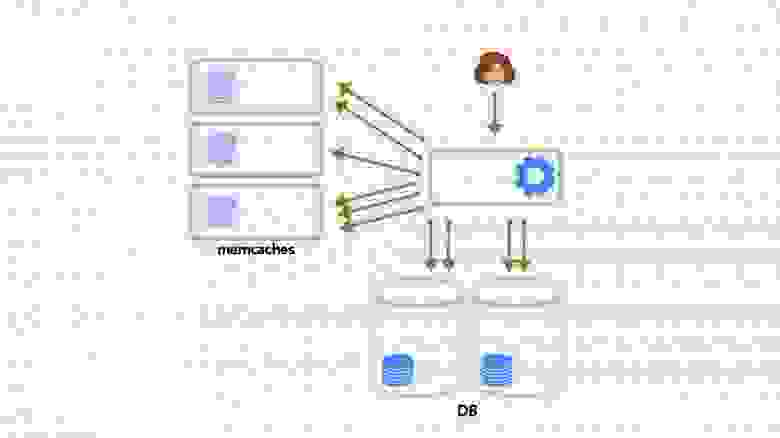

Вариант второй: выбор готовой библиотеки

----------------------------------------

Так как клиент игры у нас написан на Unity, мы решили рассмотреть возможность использования того физического движка, который встроен в Unity по умолчанию ― PhysX. В целом он полностью удовлетворял требованиям наших геймдизайнеров по поддержке 3D-физики в игре, но всё же была и существенная проблема. Заключалась она в том, что наше серверное приложение было написано на C# без использования Unity.

Был вариант использования C++ библиотеки на сервере ― например, того же PhysX, ― но всерьёз мы его не рассматривали: из-за использования нативного кода при таком подходе была высокая вероятность падения серверов. Также смущала низкая производительность Interop операций и уникальность сборки PhysX чисто под Unity, исключающая использование его в другой среде.

Помимо этого, в попытке внедрить эту идею обнаружились и другие проблемы:

* отсутствие поддержки для сборки Unity с IL2CPP на Linux, что оказалось довольно критичным, поскольку в одном из последних релизов мы перевели наши игровые сервера на .Net Core 2.1 и разворачивали их на машинах с Linux;

* отсутствие удобных инструментов для профилирования серверов на Unity;

* низкая производительность приложения на Unity: нам требовался только физический движок, а не весь имеющийся функционал в Unity.

Кроме того, параллельно с нашим проектом в компании разрабатывался ещё один прототип мультиплеерной PvP-игры. Её разработчики использовали Unity-сервера, и мы получили довольно много негативного фидбека касательно предложенного подхода. В частности, одна из претензий заключалась в том, что Unity-сервера сильно «текут», и их приходится перезапускать каждые несколько часов.

Совокупность перечисленных проблем заставила нас отказаться и от этой идеи тоже. Тогда мы решили оставить игровые сервера на .Net Core 2.1 и подобрать вместо VolatilePhysics, использованного нами ранее, другой открытый физический движок, написанный на C#. А именно движок на C# нам потребовался, так как мы опасались непредвиденных крашей при использовании движков, написанных на C++.

В результате для тестов были отобраны следующие движки:

* [Bepu Physic v1](https://github.com/bepu/bepuphysics1);

* [Bepu Physic v2;](https://github.com/bepu/bepuphysics2)

* [Jitter Physic;](https://github.com/mattleibow/jitterphysics)

* [BulletSharp](https://github.com/ValtoLibraries/BulletSharp).

Основными критериями для нас являлись производительность движка, возможность его интеграции в Unity и его поддерживаемость: он не должен был оказаться заброшенным на случай, если мы найдём в нём какие-то баги.

Итак, мы протестировали движки Bepu Physics v1, Bepu Physics v2 и Jitter Physics на производительность, и среди них наиболее производительным показал себя Bepu Physics v2. К тому же, он единственный из этой тройки всё ещё продолжает активно развиваться.

Однако последнему оставшемуся критерию интеграции с Unity Bepu Physics v2 не удовлетворял: эта библиотека использует SIMD-операции и System.Numerics, и поскольку при сборках на мобильные устройства с IL2CPP в Unity нет поддержки SIMD, все преимущества оптимизаций Bepu терялись. Demo-сцена в билде на iOS на iPhone 5S сильно тормозила. Мы не могли использовать это решение на мобильных устройствах.

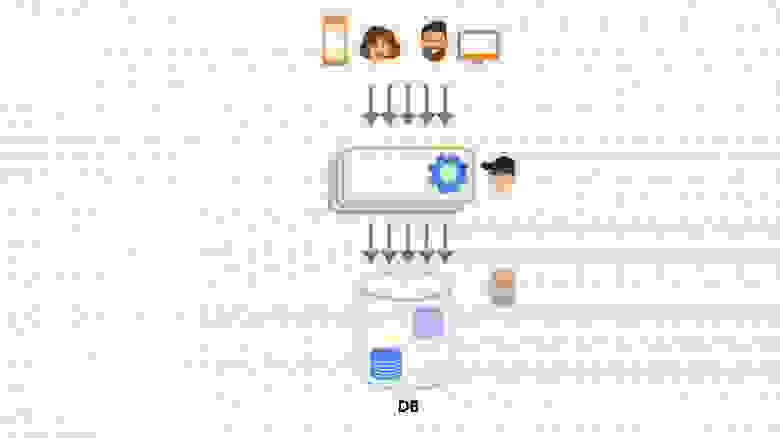

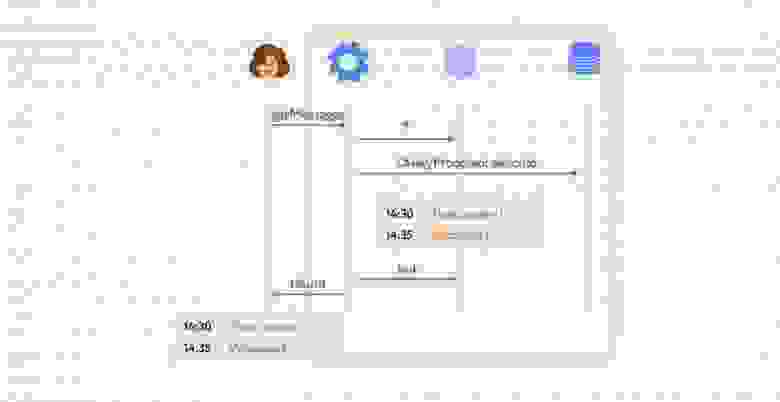

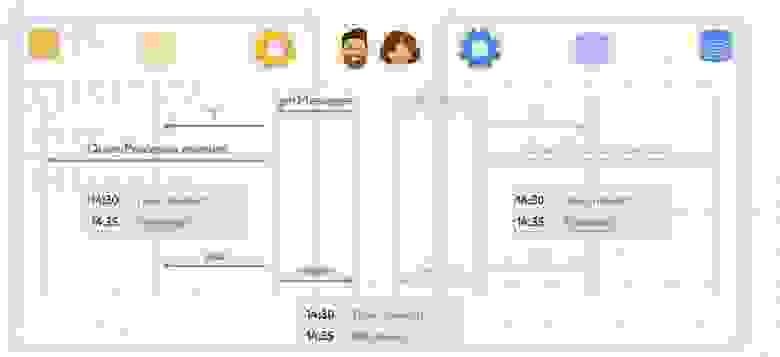

Тут следует пояснить, почему нас вообще интересовало использование физического движка. В одной из своих предыдущих [статей](https://habr.com/ru/company/pixonic/blog/415959/) я рассказывал о том, как у нас реализована сетевая часть игры и как работает локальное предсказание действий игрока. Если вкратце, то на клиенте и на сервере исполняется один и тот же код ― система ECS. Клиент реагирует на действия игрока моментально, не дожидаясь ответа от сервера, ― происходит так называемое предсказание (prediction). Когда с сервера приходит ответ, клиент сверяет предсказанное состояние мира с полученным, и если они не совпадают (misprediction), то на основе ответа с сервера выполняется коррекция (reconciliation) того, что видит игрок.

Основная идея заключается в том, что мы исполняем один и тот же код как на клиенте, так и на сервере, и ситуации с misprediction происходят крайне редко. Однако ни один из найденных нами физических движков на C# не удовлетворял нашим требованиям при работе на мобильных устройствах: например, не мог обеспечить стабильную работу 30 fps на iPhone 5S.

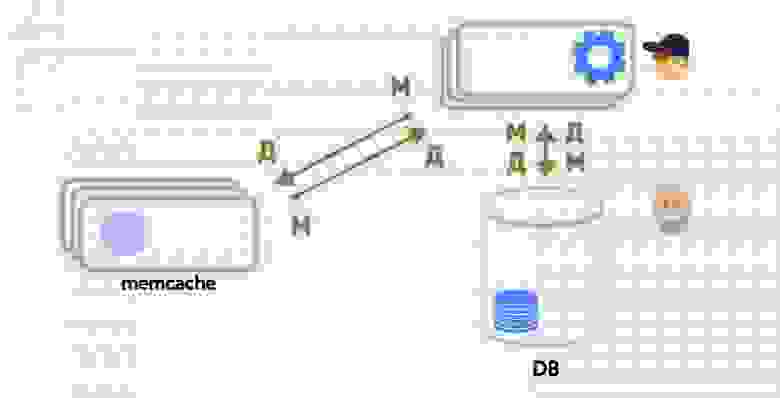

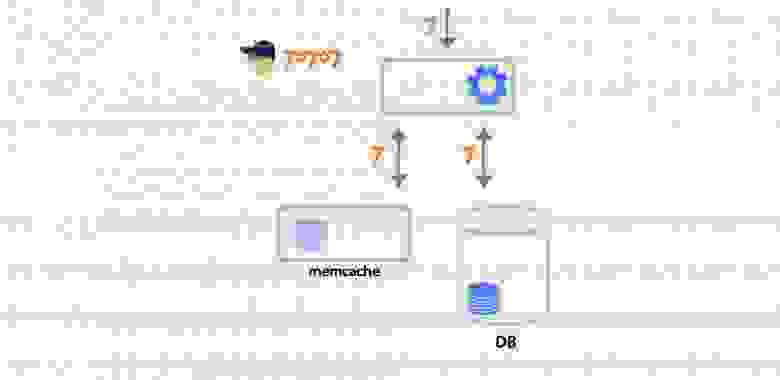

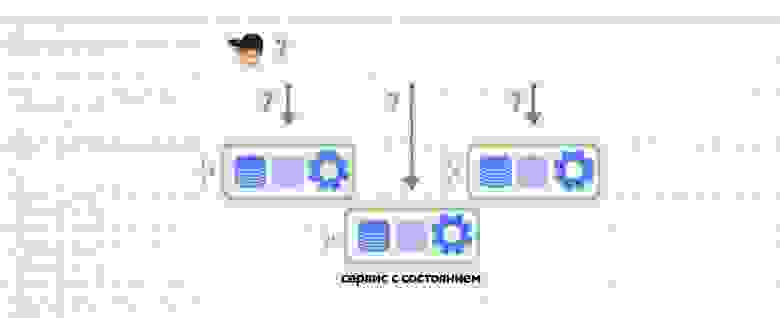

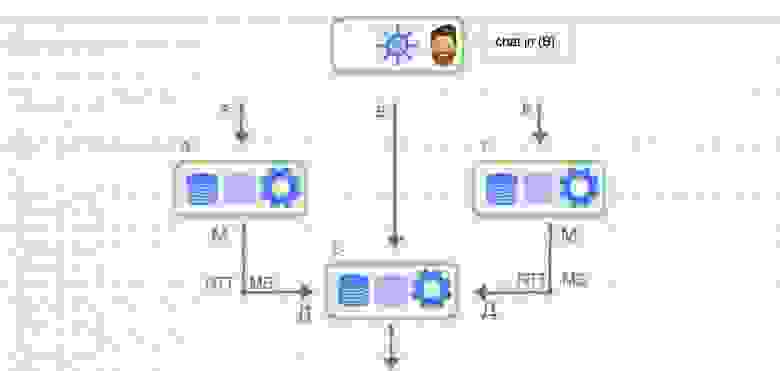

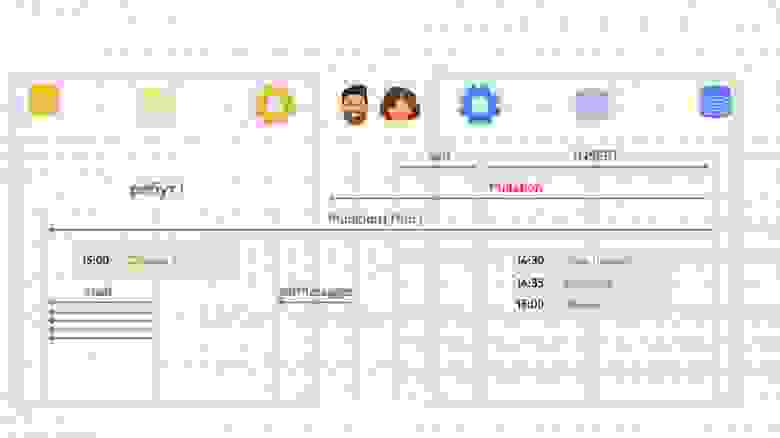

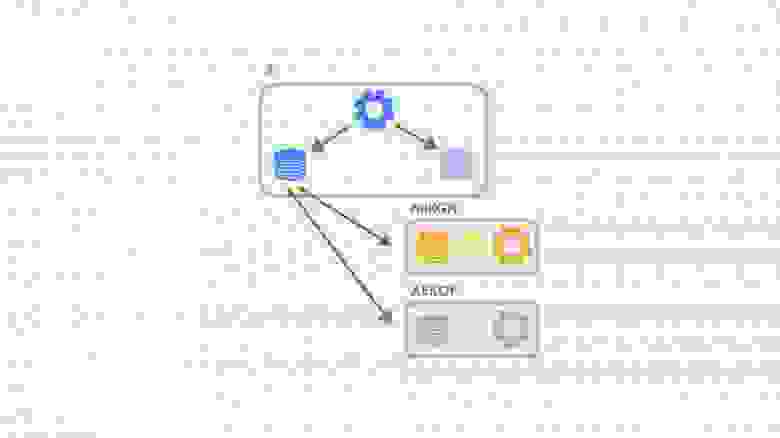

Вариант третий, финальный: два разных движка

--------------------------------------------

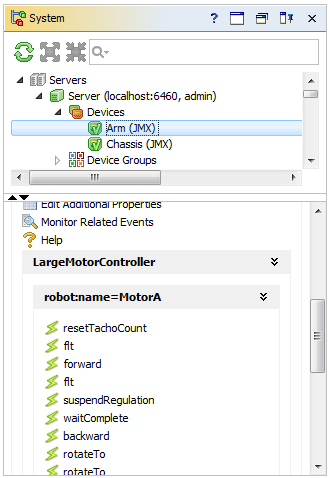

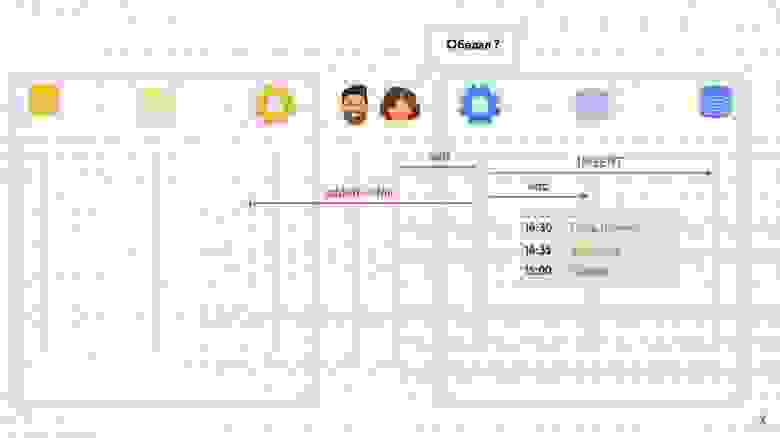

Тогда мы решились на эксперимент: использовать два разных физических движка на клиенте и сервере. Мы посчитали, что в нашем случае это может сработать: у нас в игре довольно простая физика коллизий, к тому же она была реализована нами как отдельная система ECS и не являлась частью физического движка. Всё, что нам требовалось от физического движка ― это возможность делать рейкасты и свипкасты в 3D-пространстве.

В результате мы решили использовать встроенную физику Unity ― PhysX ― на клиенте и Bepu Physics v2 на сервере.

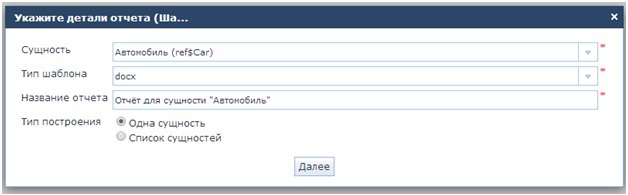

В первую очередь мы выделили интерфейс для использования физического движка:

**Посмотреть код**

```

using System;

using System.Collections.Generic;

using System.Numerics;

namespace Prototype.Common.Physics

{

public interface IPhysicsWorld : IDisposable

{

bool HasBody(uint id);

void SetCurrentSimulationTick(int tick);

void Update();

RayCastHit RayCast(Vector3 origin, Vector3 direction, float distance, CollisionLayer layer,

int ticksBehind = 0, List ignoreIds = null);

RayCastHit SphereCast(Vector3 origin, Vector3 direction, float distance, float radius, CollisionLayer layer, int ticksBehind = 0,

List ignoreIds = null);

RayCastHit CapsuleCast(Vector3 origin, Vector3 direction, float distance, float radius, float height, CollisionLayer layer, int ticksBehind = 0,

List ignoreIds = null);

void CapsuleOverlap(Vector3 origin, float radius, float height, BodyMobilityField bodyMobilityField, CollisionLayer layer, List overlaps, int ticksBehind = 0);

void RemoveOrphanedDynamicBodies(WorldState.TableSet currentWorld);

void UpdateBody(uint id, Vector3 position, float angle);

void CreateStaticCapsule(Vector3 origin, Quaternion rotation, float radius, float height, uint id, CollisionLayer layer);

void CreateDynamicCapsule(Vector3 origin, Quaternion rotation, float radius, float height, uint id, CollisionLayer layer);

void CreateStaticBox(Vector3 origin, Quaternion rotation, Vector3 size, uint id, CollisionLayer layer);

void CreateDynamicBox(Vector3 origin, Quaternion rotation, Vector3 size, uint id, CollisionLayer layer);

}

}

```

На клиенте и сервере были разные реализации этого интерфейса: как уже говорилось, на сервере мы использовали реализацию с Bepu, а на клиенте ― Unity.

Здесь стоит упомянуть о нюансах работы с нашей физикой на сервере.

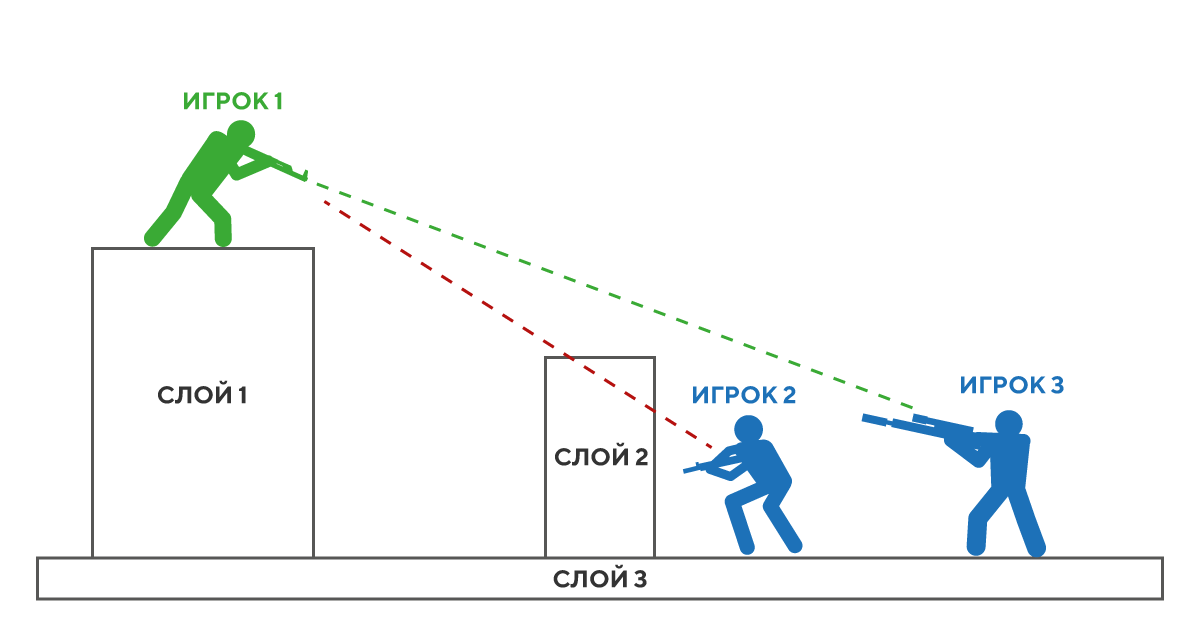

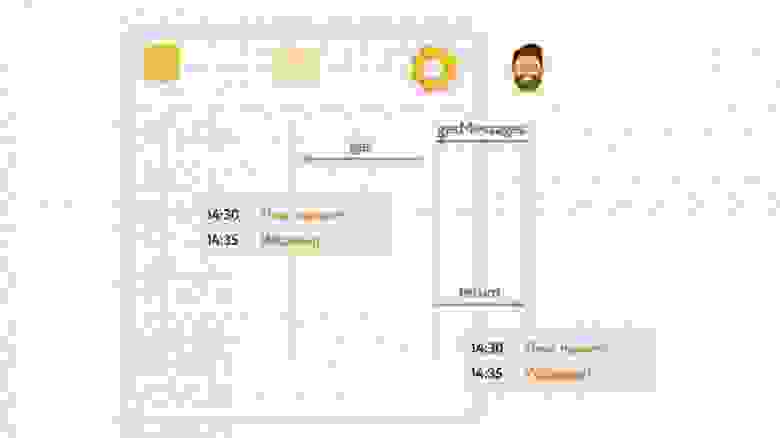

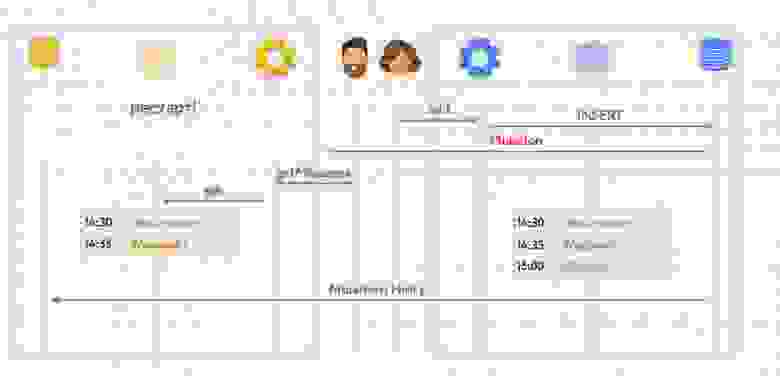

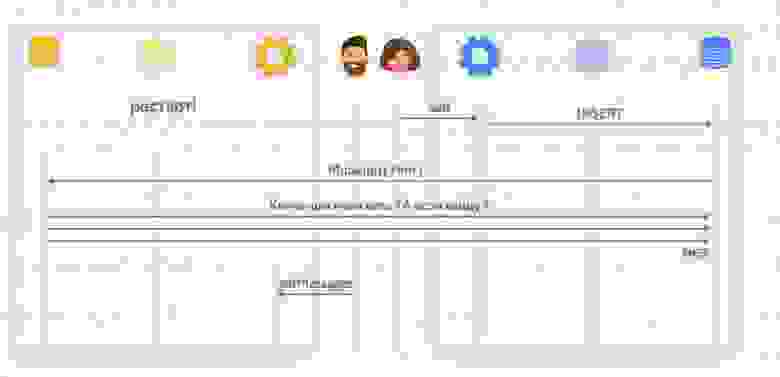

Из-за того, что клиент получает обновления мира с сервера с задержкой (лагом), игрок видит мир немного не таким, каким он представляется на сервере: себя он видит в настоящем, а весь остальной мир — в прошлом. Из-за этого получается, что игрок локально стреляет в цель, которая находится на сервере в другом месте. Так что, поскольку мы используем систему предсказания действий локального игрока, нам необходимо компенсировать лаги при стрельбе на сервере.

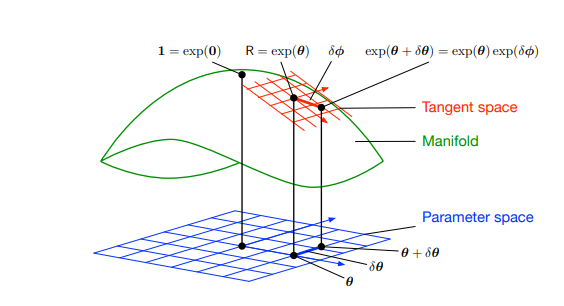

Для того, чтобы их компенсировать, нам необходимо хранить на сервере историю мира за последние N миллисекунд, а также уметь работать с объектами из истории, включая их физику. То есть, наша система должна уметь рассчитывать столкновения, рейкасты и свипкасты «в прошлом». Как правило, физические движки не умеют этого делать, и Bepu с PhysX не исключение. Поэтому нам пришлось реализовать такой функционал самостоятельно.

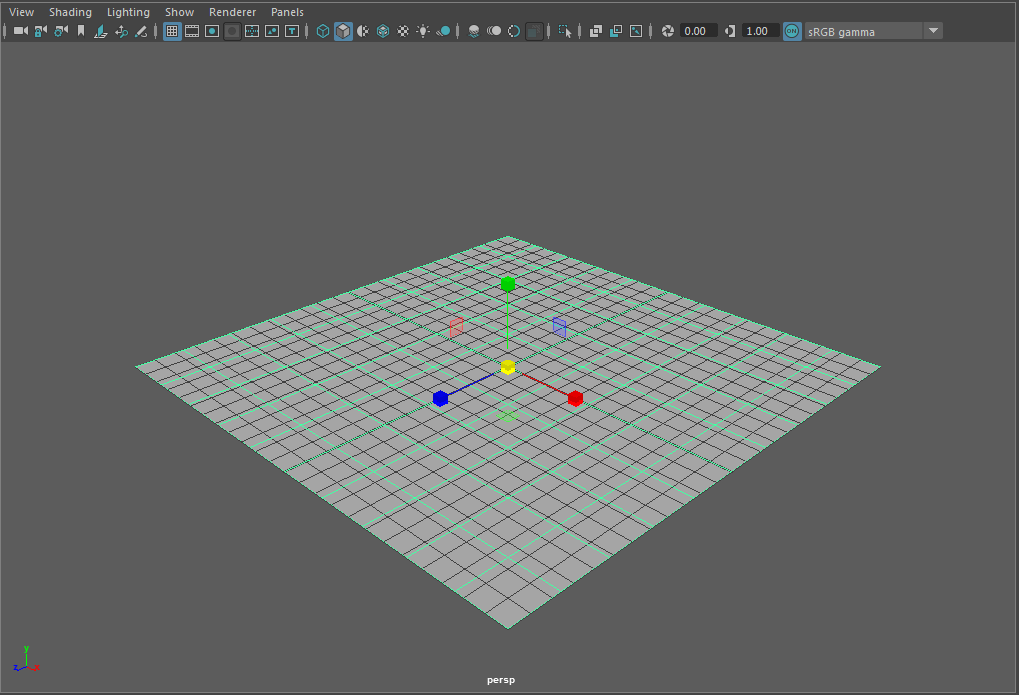

Так как симуляция игры у нас происходит с фиксированной частотой ― 30 тиков в секунду, ― нам нужно было сохранять данные физического мира за каждый тик. Идея заключалась в том чтобы создавать не один экземпляр симуляции в физическом движке, а N ― на каждый тик, хранящийся в истории, ― и использовать циклический буфер этих симуляций для их хранения в истории:

```

private readonly SimulationSlice[] _simulationHistory = new SimulationSlice[PhysicsConfigs.HistoryLength];

public BepupPhysicsWorld()

{

_currentSimulationTick = 1;

for (int i = 0; i < PhysicsConfigs.HistoryLength; i++)

{

_simulationHistory[i] = new SimulationSlice(_bufferPool);

}

}

```

В нашей ECS существует ряд read-write систем, работающих с физикой:

* InitPhysicsWorldSystem;

* SpawnPhysicsDynamicsBodiesSystem;

* DestroyPhysicsDynamicsBodiesSystem;

* UpdatePhysicsTransformsSystem;

* MovePhysicsSystem,

а также ряд read-only систем, таких как система расчёта попаданий выстрелов, взрывов от гранат и т. д.

На каждом тике симуляции мира первой исполняется InitPhysicsWorldSystem, которая устанавливает физическому движку текущий номер тика (SimulationSlice):

```

public void SetCurrentSimulationTick(int tick)

{

var oldTick = tick - 1;

var newSlice = _simulationHistory[tick % PhysicsConfigs.HistoryLength];

var oldSlice = _simulationHistory[oldTick % PhysicsConfigs.HistoryLength];

newSlice.RestoreBodiesFromPreviousTick(oldSlice);

_currentSimulationTick = tick;

}

```

Метод RestoreBodiesFromPreviousTick восстанавливает положение объектов в физическом движке на момент предыдущего тика из данных, хранящихся в истории:

**Посмотреть код**

```

public void RestoreBodiesFromPreviousTick(SimulationSlice previous)

{

var oldStaticCount = previous._staticIds.Count;

// add created static objects

for (int i = 0; i < oldStaticCount; i++)

{

var oldId = previous._staticIds[i];

if (!_staticIds.Contains(oldId))

{

var oldHandler = previous._staticIdToHandler[oldId];

var oldBody = previous._staticHandlerToBody[oldHandler];

if (oldBody.IsCapsule)

{

var handler = CreateStatic(oldBody.Capsule, oldBody.Description.Pose, true, oldId, oldBody.CollisionLayer);

var body = _staticHandlerToBody[handler];

body.Capsule = oldBody.Capsule;

_staticHandlerToBody[handler] = body;

}

else

{

var handler = CreateStatic(oldBody.Box, oldBody.Description.Pose, false, oldId, oldBody.CollisionLayer);

var body = _staticHandlerToBody[handler];

body.Box = oldBody.Box;

_staticHandlerToBody[handler] = body;

}

}

}

// delete not existing dynamic objects

var newDynamicCount = _dynamicIds.Count;

var idsToDel = stackalloc uint[_dynamicIds.Count];

int delIndex = 0;

for (int i = 0; i < newDynamicCount; i++)

{

var newId = _dynamicIds[i];

if (!previous._dynamicIds.Contains(newId))

{

idsToDel[delIndex] = newId;

delIndex++;

}

}

for (int i = 0; i < delIndex; i++)

{

var id = idsToDel[i];

var handler = _dynamicIdToHandler[id];

_simulation.Bodies.Remove(handler);

_dynamicHandlerToBody.Remove(handler);

_dynamicIds.Remove(id);

_dynamicIdToHandler.Remove(id);

}

// add created dynamic objects

var oldDynamicCount = previous._dynamicIds.Count;

for (int i = 0; i < oldDynamicCount; i++)

{

var oldId = previous._dynamicIds[i];

if (!_dynamicIds.Contains(oldId))

{

var oldHandler = previous._dynamicIdToHandler[oldId];

var oldBody = previous._dynamicHandlerToBody[oldHandler];

if (oldBody.IsCapsule)

{

var handler = CreateDynamic(oldBody.Capsule, oldBody.BodyReference.Pose, true, oldId, oldBody.CollisionLayer);

var body = _dynamicHandlerToBody[handler];

body.Capsule = oldBody.Capsule;

_dynamicHandlerToBody[handler] = body;

}

else

{

var handler = CreateDynamic(oldBody.Box, oldBody.BodyReference.Pose, false, oldId, oldBody.CollisionLayer);

var body = _dynamicHandlerToBody[handler];

body.Box = oldBody.Box;

_dynamicHandlerToBody[handler] = body;

}

}

}

}

```

После этого системы SpawnPhysicsDynamicsBodiesSystem и DestroyPhysicsDynamicsBodiesSystem создают или удаляют объекты в физическом движке в соответствии с тем, как они были изменены в прошлом тике ECS. Затем система UpdatePhysicsTransformsSystem обновляет положение всех динамических тел в соответствии с данными в ECS.

Как только данные в ECS и физическом движке оказываются синхронизированы, мы выполняем расчёт движения объектов. Когда все read-write операции оказываются пройдены, в ход вступают read-only системы по расчёту игровой логики (выстрелов, взрывов, тумана войны...)

Полный код реализации SimulationSlice для Bepu Physics:

**Посмотреть код**

```

using System;

using System.Collections.Generic;

using System.Numerics;

using BepuPhysics;

using BepuPhysics.Collidables;

using BepuUtilities.Memory;

using Quaternion = BepuUtilities.Quaternion;

namespace Prototype.Physics

{

public partial class BepupPhysicsWorld

{

private unsafe partial class SimulationSlice : IDisposable

{

private readonly Dictionary \_staticHandlerToBody = new Dictionary();

private readonly Dictionary \_dynamicHandlerToBody = new Dictionary();

private readonly Dictionary \_staticIdToHandler = new Dictionary();

private readonly Dictionary \_dynamicIdToHandler = new Dictionary();

private readonly List \_staticIds = new List();

private readonly List \_dynamicIds = new List();

private readonly BufferPool \_bufferPool;

private readonly Simulation \_simulation;

public SimulationSlice(BufferPool bufferPool)

{

\_bufferPool = bufferPool;

\_simulation = Simulation.Create(\_bufferPool, new NarrowPhaseCallbacks(),

new PoseIntegratorCallbacks(new Vector3(0, -9.81f, 0)));

}

public RayCastHit RayCast(Vector3 origin, Vector3 direction, float distance, CollisionLayer layer, List ignoreIds=null)

{

direction = direction.Normalized();

BepupRayCastHitHandler handler = new BepupRayCastHitHandler(\_staticHandlerToBody, \_dynamicHandlerToBody, layer, ignoreIds);

\_simulation.RayCast(origin, direction, distance, ref handler);

var result = handler.RayCastHit;

if (result.IsValid)

{

var collidableReference = handler.CollidableReference;

if (handler.CollidableReference.Mobility == CollidableMobility.Static)

{

\_simulation.Statics.GetDescription(collidableReference.Handle, out var description);

result.HitEntityId = \_staticHandlerToBody[collidableReference.Handle].Id;

result.CollidableCenter = description.Pose.Position;

}

else

{

\_simulation.Bodies.GetDescription(collidableReference.Handle, out var description);

result.HitEntityId = \_dynamicHandlerToBody[collidableReference.Handle].Id;

result.CollidableCenter = description.Pose.Position;

}

}

return result;

}

public RayCastHit SphereCast(Vector3 origin, Vector3 direction, float distance, float radius, CollisionLayer layer, List ignoreIds = null)

{

direction = direction.Normalized();

SweepCastHitHandler handler = new SweepCastHitHandler(\_staticHandlerToBody, \_dynamicHandlerToBody, layer, ignoreIds);

\_simulation.Sweep(new Sphere(radius), new RigidPose(origin, Quaternion.Identity),

new BodyVelocity(direction.Normalized()),

distance, \_bufferPool, ref handler);

var result = handler.RayCastHit;

if (result.IsValid)

{

var collidableReference = handler.CollidableReference;

if (handler.CollidableReference.Mobility == CollidableMobility.Static)

{

\_simulation.Statics.GetDescription(collidableReference.Handle, out var description);

result.HitEntityId = \_staticHandlerToBody[collidableReference.Handle].Id;

result.CollidableCenter = description.Pose.Position;

}

else

{

var reference = new BodyReference(collidableReference.Handle, \_simulation.Bodies);

result.HitEntityId = \_dynamicHandlerToBody[collidableReference.Handle].Id;

result.CollidableCenter = reference.Pose.Position;

}

}

return result;

}

public RayCastHit CapsuleCast(Vector3 origin, Vector3 direction, float distance, float radius, float height, CollisionLayer layer, List ignoreIds = null)

{

direction = direction.Normalized();

var length = height - 2 \* radius;

SweepCastHitHandler handler = new SweepCastHitHandler(\_staticHandlerToBody, \_dynamicHandlerToBody, layer, ignoreIds);

\_simulation.Sweep(new Capsule(radius, length), new RigidPose(origin, Quaternion.Identity),

new BodyVelocity(direction.Normalized()),

distance, \_bufferPool, ref handler);

var result = handler.RayCastHit;

if (result.IsValid)

{

var collidableReference = handler.CollidableReference;

if (handler.CollidableReference.Mobility == CollidableMobility.Static)

{

\_simulation.Statics.GetDescription(collidableReference.Handle, out var description);

result.HitEntityId = \_staticHandlerToBody[collidableReference.Handle].Id;

result.CollidableCenter = description.Pose.Position;

}

else

{

var reference = new BodyReference(collidableReference.Handle, \_simulation.Bodies);

result.HitEntityId = \_dynamicHandlerToBody[collidableReference.Handle].Id;

result.CollidableCenter = reference.Pose.Position;

}

}

return result;

}

public void CapsuleOverlap(Vector3 origin, float radius, float height, BodyMobilityField bodyMobilityField, CollisionLayer layer, List overlaps)

{

var length = height - 2 \* radius;

var handler = new BepupOverlapHitHandler(

bodyMobilityField,

layer,

\_staticHandlerToBody,

\_dynamicHandlerToBody,

overlaps);

\_simulation.Sweep(

new Capsule(radius, length),

new RigidPose(origin, Quaternion.Identity),

new BodyVelocity(Vector3.Zero),

0,

\_bufferPool,

ref handler);

}

public void CreateDynamicBox(Vector3 origin, Quaternion rotation, Vector3 size, uint id, CollisionLayer layer)

{

var shape = new Box(size.X, size.Y, size.Z);

var pose = new RigidPose()

{

Position = origin,

Orientation = rotation

};

var handler = CreateDynamic(shape, pose, false, id, layer);

var body = \_dynamicHandlerToBody[handler];

body.Box = shape;

\_dynamicHandlerToBody[handler] = body;

}

public void CreateStaticBox(Vector3 origin, Quaternion rotation, Vector3 size, uint id, CollisionLayer layer)

{

var shape = new Box(size.X, size.Y, size.Z);

var pose = new RigidPose()

{

Position = origin,

Orientation = rotation

};

var handler =CreateStatic(shape, pose, false, id, layer);

var body = \_staticHandlerToBody[handler];

body.Box = shape;

\_staticHandlerToBody[handler] = body;

}

public void CreateStaticCapsule(Vector3 origin, Quaternion rotation, float radius, float height, uint id, CollisionLayer layer)

{

var length = height - 2 \* radius;

var shape = new Capsule(radius, length);

var pose = new RigidPose()

{

Position = origin,

Orientation = rotation

};

var handler =CreateStatic(shape, pose, true, id, layer);

var body = \_staticHandlerToBody[handler];

body.Capsule = shape;

\_staticHandlerToBody[handler] = body;

}

public void CreateDynamicCapsule(Vector3 origin, Quaternion rotation, float radius, float height, uint id, CollisionLayer layer)

{

var length = height - 2 \* radius;

var shape = new Capsule(radius, length);

var pose = new RigidPose()

{

Position = origin,

Orientation = rotation

};

var handler = CreateDynamic(shape, pose, true, id, layer);

var body = \_dynamicHandlerToBody[handler];

body.Capsule = shape;

\_dynamicHandlerToBody[handler] = body;

}

private int CreateDynamic(TShape shape, RigidPose pose, bool isCapsule, uint id, CollisionLayer collisionLayer) where TShape : struct, IShape

{

var activity = new BodyActivityDescription()

{

SleepThreshold = -1

};

var collidable = new CollidableDescription()

{

Shape = \_simulation.Shapes.Add(shape),

SpeculativeMargin = 0.1f,

};

var capsuleDescription = BodyDescription.CreateKinematic(pose, collidable, activity);

var handler = \_simulation.Bodies.Add(capsuleDescription);

\_dynamicIds.Add(id);

\_dynamicIdToHandler.Add(id, handler);

\_dynamicHandlerToBody.Add(handler, new DynamicBody

{

BodyReference = new BodyReference(handler, \_simulation.Bodies),

Id = id,

IsCapsule = isCapsule,

CollisionLayer = collisionLayer

});

return handler;

}

private int CreateStatic(TShape shape, RigidPose pose, bool isCapsule, uint id, CollisionLayer collisionLayer) where TShape : struct, IShape

{

var capsuleDescription = new StaticDescription()

{

Pose = pose,

Collidable = new CollidableDescription()

{

Shape = \_simulation.Shapes.Add(shape),

SpeculativeMargin = 0.1f,

}

};

var handler = \_simulation.Statics.Add(capsuleDescription);

\_staticIds.Add(id);

\_staticIdToHandler.Add(id, handler);

\_staticHandlerToBody.Add(handler, new StaticBody

{

Description = capsuleDescription,

Id = id,

IsCapsule = isCapsule,

CollisionLayer = collisionLayer

});

return handler;

}

public void RemoveOrphanedDynamicBodies(TableSet currentWorld)

{

var toDel = stackalloc uint[\_dynamicIds.Count];

var toDelIndex = 0;

foreach (var i in \_dynamicIdToHandler)

{

if (currentWorld.DynamicPhysicsBody.HasCmp(i.Key))

{

continue;

}

toDel[toDelIndex] = i.Key;

toDelIndex++;

}

for (int i = 0; i < toDelIndex; i++)

{

var id = toDel[i];

var handler = \_dynamicIdToHandler[id];

\_simulation.Bodies.Remove(handler);

\_dynamicHandlerToBody.Remove(handler);

\_dynamicIds.Remove(id);

\_dynamicIdToHandler.Remove(id);

}

}

public bool HasBody(uint id)

{

return \_staticIdToHandler.ContainsKey(id) || \_dynamicIdToHandler.ContainsKey(id);

}

public void RestoreBodiesFromPreviousTick(SimulationSlice previous)

{

var oldStaticCount = previous.\_staticIds.Count;

// add created static objects

for (int i = 0; i < oldStaticCount; i++)

{

var oldId = previous.\_staticIds[i];

if (!\_staticIds.Contains(oldId))

{

var oldHandler = previous.\_staticIdToHandler[oldId];

var oldBody = previous.\_staticHandlerToBody[oldHandler];

if (oldBody.IsCapsule)

{

var handler = CreateStatic(oldBody.Capsule, oldBody.Description.Pose, true, oldId, oldBody.CollisionLayer);

var body = \_staticHandlerToBody[handler];

body.Capsule = oldBody.Capsule;

\_staticHandlerToBody[handler] = body;

}

else

{

var handler = CreateStatic(oldBody.Box, oldBody.Description.Pose, false, oldId, oldBody.CollisionLayer);

var body = \_staticHandlerToBody[handler];

body.Box = oldBody.Box;

\_staticHandlerToBody[handler] = body;

}

}

}

// delete not existing dynamic objects

var newDynamicCount = \_dynamicIds.Count;

var idsToDel = stackalloc uint[\_dynamicIds.Count];

int delIndex = 0;

for (int i = 0; i < newDynamicCount; i++)

{

var newId = \_dynamicIds[i];

if (!previous.\_dynamicIds.Contains(newId))

{

idsToDel[delIndex] = newId;

delIndex++;

}

}

for (int i = 0; i < delIndex; i++)

{

var id = idsToDel[i];

var handler = \_dynamicIdToHandler[id];

\_simulation.Bodies.Remove(handler);

\_dynamicHandlerToBody.Remove(handler);

\_dynamicIds.Remove(id);

\_dynamicIdToHandler.Remove(id);

}

// add created dynamic objects

var oldDynamicCount = previous.\_dynamicIds.Count;

for (int i = 0; i < oldDynamicCount; i++)

{

var oldId = previous.\_dynamicIds[i];

if (!\_dynamicIds.Contains(oldId))

{

var oldHandler = previous.\_dynamicIdToHandler[oldId];

var oldBody = previous.\_dynamicHandlerToBody[oldHandler];

if (oldBody.IsCapsule)

{

var handler = CreateDynamic(oldBody.Capsule, oldBody.BodyReference.Pose, true, oldId, oldBody.CollisionLayer);

var body = \_dynamicHandlerToBody[handler];

body.Capsule = oldBody.Capsule;

\_dynamicHandlerToBody[handler] = body;

}

else

{

var handler = CreateDynamic(oldBody.Box, oldBody.BodyReference.Pose, false, oldId, oldBody.CollisionLayer);

var body = \_dynamicHandlerToBody[handler];

body.Box = oldBody.Box;

\_dynamicHandlerToBody[handler] = body;

}

}

}

}

public void Update()

{

\_simulation.Timestep(GameState.TickDurationSec);

}

public void UpdateBody(uint id, Vector3 position, float angle)

{

if (\_staticIdToHandler.TryGetValue(id, out var handler))

{

\_simulation.Statics.GetDescription(handler, out var staticDescription);

staticDescription.Pose.Position = position;

staticDescription.Pose.Orientation = Quaternion.CreateFromAxisAngle(new Vector3(0, 1, 0), angle);

\_simulation.Statics.ApplyDescription(handler, staticDescription);

}

else if(\_dynamicIdToHandler.TryGetValue(id, out handler))

{

BodyReference reference = new BodyReference(handler, \_simulation.Bodies);

reference.Pose.Position = position;

reference.Pose.Orientation = Quaternion.CreateFromAxisAngle(new Vector3(0, 1, 0), angle);

}

}

public void Dispose()

{

\_simulation.Clear();

}

}

public void Dispose()

{

\_bufferPool.Clear();

}

}

}

```

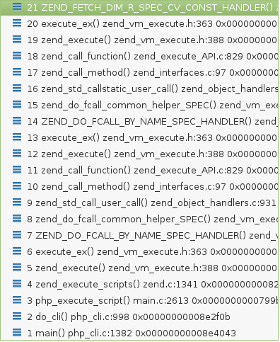

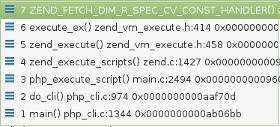

Также, помимо реализации истории на сервере, нам была необходима реализация истории физики на клиенте. В нашем клиенте на Unity есть режим эмуляции сервера ― мы называем его локальной симуляцией, ― в котором вместе с клиентом запускается код сервера. Этот режим у нас используется для быстрого прототипирования игровых фичей.

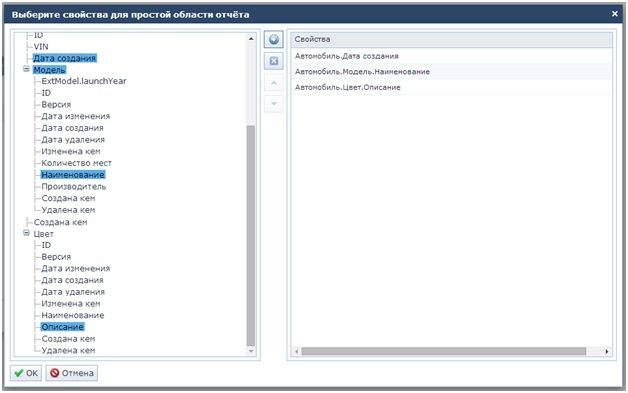

Как и в Bepu, в PhysX нет поддержки истории. Здесь мы использовали ту же идею с использованием нескольких физических симуляций на каждый тик в истории, что и на сервере. Однако Unity накладывает свою специфику на работу с физическими движками. Впрочем, тут следует отметить, что наш проект разрабатывался на Unity 2018.4 (LTS), и какие-то API могут поменяться в более новых версиях, так что таких проблем, как у нас, и не возникнет.

Проблема заключалась в том, что Unity не позволял создать отдельно физическую симуляцию (или, в терминологии PhysX, ― сцену), поэтому каждый тик в истории физики на Unity мы реализовали как отдельную сцену.

Был написан класс-обёртка над такими сценами ― UnityPhysicsHistorySlice:

```

public UnityPhysicsHistorySlice(SphereCastDelegate sphereCastDelegate, OverlapSphereNonAlloc overlapSphere, CapsuleCastDelegate capsuleCast,

OverlapCapsuleNonAlloc overlapCapsule, string name)

{

_scene = SceneManager.CreateScene(name, new CreateSceneParameters()

{

localPhysicsMode = LocalPhysicsMode.Physics3D

});

_physicsScene = _scene.GetPhysicsScene();

_sphereCast = sphereCastDelegate;

_capsuleCast = capsuleCast;

_overlapSphere = overlapSphere;

_overlapCapsule = overlapCapsule;

_boxPool = new PhysicsSceneObjectsPool(\_scene, "box", 0);

\_capsulePool = new PhysicsSceneObjectsPool(\_scene, "sphere", 0);

}

```

Вторая проблема Unity ― вся работа с физикой здесь ведётся через статический класс Physics, API которого не позволяет выполнять рейкасты и свипкасты в конкретной сцене. Этот API работает только с одной ― активной ― сценой. Однако сам движок PhysX позволяет работать с несколькими сценами одновременно, нужно только вызвать правильные методы. К счастью, Unity за интерфейсом класса Physics.cs прятала такие методы, оставалось лишь получить к ним доступ. Сделали мы это так:

**Посмотреть код**

```

MethodInfo raycastMethod = typeof(Physics).GetMethod("Internal_SphereCast",

BindingFlags.NonPublic | BindingFlags.Static);

var sphereCast = (SphereCastDelegate) Delegate.CreateDelegate(typeof(SphereCastDelegate), raycastMethod);

MethodInfo overlapSphereMethod = typeof(Physics).GetMethod("OverlapSphereNonAlloc_Internal",

BindingFlags.NonPublic | BindingFlags.Static);

var overlapSphere = (OverlapSphereNonAlloc) Delegate.CreateDelegate(typeof(OverlapSphereNonAlloc), overlapSphereMethod);

MethodInfo capsuleCastMethod = typeof(Physics).GetMethod("Internal_CapsuleCast",

BindingFlags.NonPublic | BindingFlags.Static);

var capsuleCast = (CapsuleCastDelegate) Delegate.CreateDelegate(typeof(CapsuleCastDelegate), capsuleCastMethod);

MethodInfo overlapCapsuleMethod = typeof(Physics).GetMethod("OverlapCapsuleNonAlloc_Internal",

BindingFlags.NonPublic | BindingFlags.Static);

var overlapCapsule = (OverlapCapsuleNonAlloc) Delegate.CreateDelegate(typeof(OverlapCapsuleNonAlloc), overlapCapsuleMethod);

```

В остальном код реализации UnityPhysicsHistorySlice мало чем отличался от того, что было в BepuSimulationSlice.

Таким образом мы получили две реализации игровой физики: на клиенте и на сервере.

Следующий шаг ― тестирование.

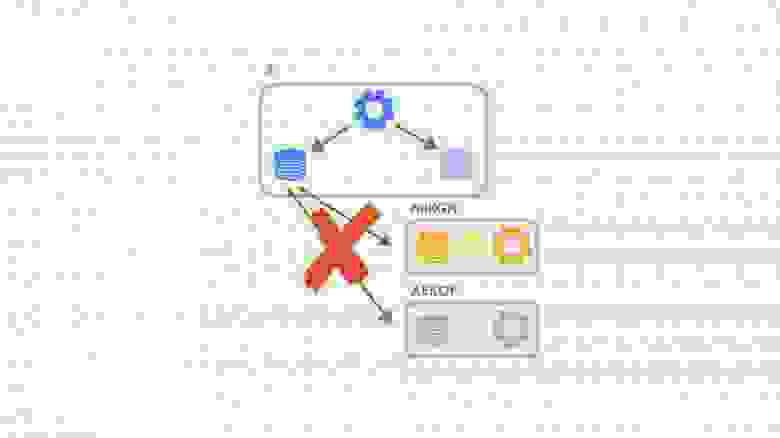

Одним из важнейших показателей «здоровья» нашего клиента является параметр количества расхождений (mispredictions) с сервером. До перехода на разные физические движки этот показатель варьировался в пределах 1-2% ― то есть, за бой длительностью 9000 тиков (или 5 минут) мы ошибались в 90-180 тиках симуляции. Такие результаты мы получали на протяжении нескольких релизов игры в софт-лаунче. После перехода на разные движки мы ожидали сильный рост этого показателя ― возможно, даже в несколько раз, ― ведь теперь мы исполняли разный код на клиенте и сервере, и казалось логичным, что погрешности при расчётах разными алгоритмами будут быстро накапливаться. На практике же оказалось, что параметр расхождений вырос лишь 0.2-0.5% и в среднем стал составлять 2-2,5% за бой, что полностью нас устраивало.

В большинстве движков и технологий, которые мы исследовали, использовался один и тот же код как на клиенте, так и на сервере. Однако наша гипотеза с возможностью применения разных физических движков подтвердилась. Основная причина, по которой показатель расхождений вырос так незначительно, заключалась в том, что передвижение тел в пространстве и столкновения мы рассчитываем сами одной из своих систем ECS. Этот код одинаков как на клиенте, так и на сервере. От физического же движка нам требовался быстрый расчёт рейкастов и свипкастов, и результаты этих операций на практике для двух наших движков отличались не сильно.

Что почитать

------------

В заключение, как обычно, приведём несколько ссылок по теме:

* [Физика для мобильного PvP-шутера, часть 1](https://habr.com/ru/company/pixonic/blog/481880/);

* [Сетевой код для мобильного PvP-шутера](https://habr.com/ru/company/pixonic/blog/415959/);

* [Блог Глена Фидлера о том, как писать сетевой код в играх](https://gafferongames.com);

* [Детерминированая симуляция и сетевой код в игре For Honor](https://www.gdcvault.com/play/1026322/Back-to-the-Future-Working). | https://habr.com/ru/post/485150/ | null | ru | null |

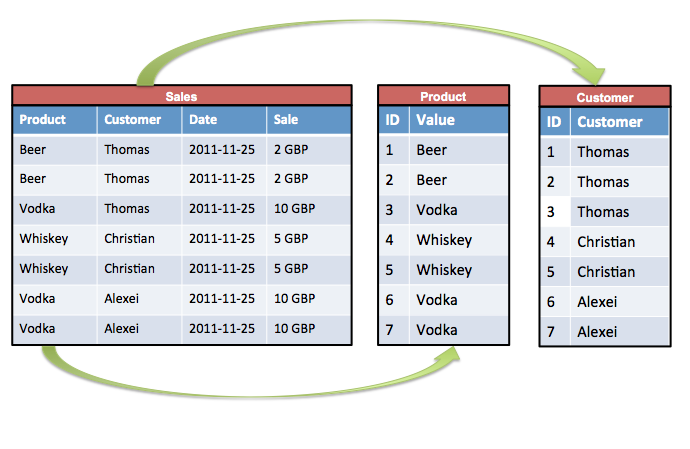

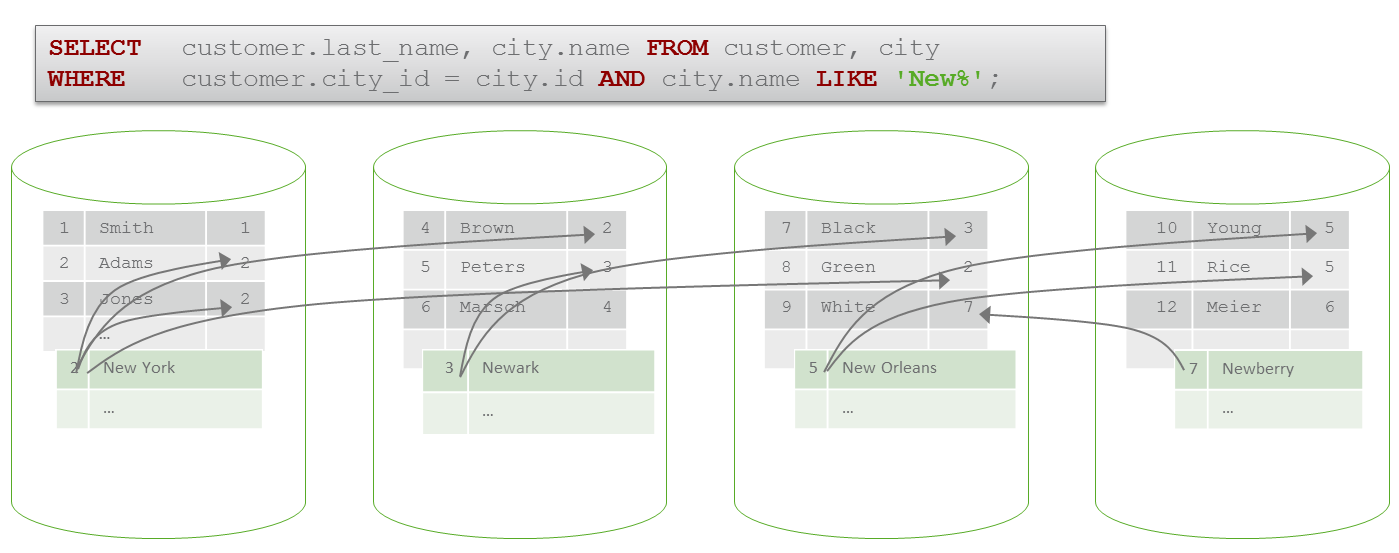

# Правила Трех, Пяти и Ноля

Цель этого поста — познакомить вас с Правилами Трех, Пяти и Ноля и объяснить, какое из них и когда вам следует использовать. В следующем посте мы углубимся в применение Правила Пяти в различных сценариях.

Для начала давайте вспомним один из основополагающих принципов C++ — RAII (Resource Acquisition Is Initialization — “получение ресурса есть инициализация”). Этот принцип заключается в возможности управлять ресурсами, такими как память, с помощью пяти *специальных функций-членов*: конструкторов копирования и перемещения, деструкторов и операторов присваивания. Очень часто, когда кто-либо упоминает RAII, речь идет о деструкторах, детерминированно вызываемых в конце области видимости. Немного иронично, учитывая и без того несуразное название. Но остальные особенности RAII не менее важны. В то время как многие языки просто разделяют свои типы на “значимые” и “ссылочные” (например, C# определяет значимые типы в структурах, а ссылочные — в классах), C++ дает нам куда более широкое пространство для работы с идентификаторами и ресурсами посредством этого набора специальных функций-членов.

Но даже до C++11 ценой этой гибкости была сложность. Некоторые взаимодействия довольно тонкие, и в них легко ошибиться. Поэтому еще в 1991 году [Маршалл Клайн (Marshall Cline) сформулировал “Правило Трех”](http://www.ddj.com/cpp/184401400)— простое эмпирическое правило, применимое для большинства сценариев. Когда C++11 представил move семантику (или семантику перемещения), оно было трансформировано в “Правила Пяти”. Затем [Р. Мартиньо Фернандес (R. Martinho Fernandes) сформулировал “Правило Ноля”](https://web.archive.org/web/20130211035910/http://flamingdangerzone.com/cxx11/2012/08/15/rule-of-zero.html), предполагая, что оно по умолчанию превосходит “Правила Пяти”. Но в чем смысл всех этих правил? И должны ли мы им следовать?

### Как Правило Трех стало Правилом Пяти

Правило Трех предполагает, что если вам нужно определить что-либо из конструктора копирования, оператора присваивания копированием или деструктора, то скорее всего вам нужно определить “все три”. Я взял “все три” в кавычки, потому что этот совет устарел начиная с C++11. Теперь, с move семантикой, у нас появилось две дополнительные специальные функции-члены: конструктор перемещения и оператор присваивания перемещением. Таким образом, Правило Пяти — это просто расширение, которое предполагает, что **если вам нужно определить *что-либо* из этой пятерки, то вам, скорее всего, нужно определить или удалить (или, по крайней мере, рассмотреть такую возможность) *все* *пять***.

(Это утверждение не так строго, как Правило Трех, потому что, если вы не определите операции перемещения, они не будут генерироваться, и вызовы будут обрабатываться через операции копирования. И это не будет ошибкой, но, возможно, это будет вашим большим упущением с точки зрения оптимизации.)

Если вы не компилируете код для более ранней версии, чем C++11, вы должны следовать Правилу Пяти.

В любом случае это правило имеет смысл. Если вам нужно определить пользовательскую специальную функцию-член (не являющуюся конструктором по умолчанию), то обычно это из-за того, что вам нужно непосредственно управлять каким-либо ресурсом. В этом случае вам нужно будет отслеживать, что происходит с ним на каждом этапе его жизненного цикла. Обратите внимание, что существуют различные причины, по которым реализации по умолчанию для специальных функций-членов могут быть запрещены или удалены, и мы рассмотрим их подробнее в следующем посте.

Вот пример, вдохновленный `indirect_value` из [P1950](https://www.open-std.org/jtc1/sc22/wg21/docs/papers/2020/p1950r1.html):

```

template

class IndirectValue {

T\* ptr;

public:

// Инициализация и уничтожение

explicit IndirectValue(T\* ptr ) : ptr(ptr) {}

~IndirectValue() noexcept { if(ptr) delete ptr; }

// Копирование (вместе с деструктором дает нам Правило Трех)

IndirectValue(IndirectValue const& other) : ptr(other.ptr ? new T(\*other.ptr) : nullptr) {}

IndirectValue& operator=(IndirectValue const& other) {

IndirectValue temp(other);

std::swap(ptr, temp.ptr);

return \*this;

}

// Перемещение (добавление этих элементов уже дает нам Правило Пяти)

IndirectValue(IndirectValue&& other) noexcept : ptr(other.ptr) {

other.ptr = nullptr;

}

IndirectValue& operator=(IndirectValue&& other) noexcept {

IndirectValue temp(std::move(other));

std::swap(ptr, temp.ptr);

return \*this;

}

// Остальные методы

};

```

Хочу обратить ваше внимание на то, что для реализации операторов присваивания мы использовали [идиомы копирования и замены (copy-and-swap) и перемещения и замены (move-and-swap)](https://en.wikibooks.org/wiki/More_C%2B%2B_Idioms/Copy-and-swap) в целях предотвращения утечек и автоматической обработки самоприсваивания (мы также могли бы объединить эти два оператора в один, который принимает аргумент по значению, но я хотел продемонстрировать в этом примере обе функции).

Также важно отметить, что оба правила начинаются со слов “если вам необходимо определить какой-либо из…”. Иногда оборотная сторона тоже может представлять интерес. Еще один неявный вывод из этих правил заключается в том, что существуют практические случаи, когда нам вообще не нужно определять какие-либо специальные функции-члены, и все будет работать так, как нужно. Оказывается, это вполне может быть самым важным выводом, но чтобы понять почему, нам нужно немного переформулировать правила. Так на сцену выходит Правило Ноля.

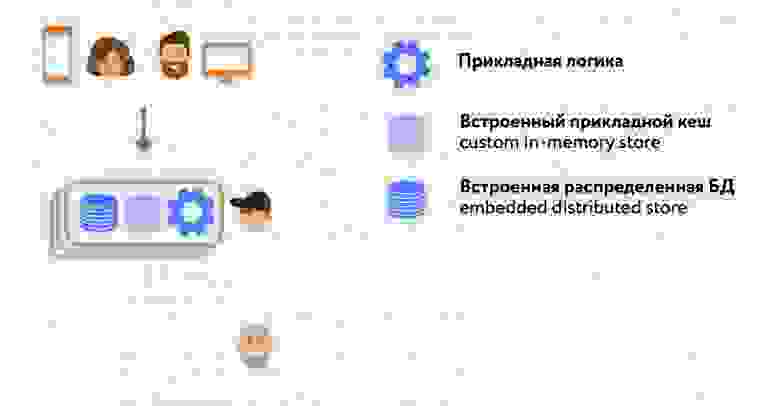

### Правило Ноля

Если ничего из специальных функций-членов не определено пользователем, то (с учетом переменных-членов) компилятор предоставит реализации по умолчанию для каждой из них. **Правило Ноля заключается в том, что тот сценарий, когда *не нужно* определять *ничего* из специальных функций-членов, должен быть *предпочтительным***. Отсюда вытекает два сценария:

1. Ваш класс определяет чисто значимый тип, и любое его состояние состоит из чисто значимых типов (например, примитивов).

2. Любые ресурсы, которые приходится задействовать состояниям вашего класса, управляются классами, которые специализируются исключительно на управлении ресурсами (например, умными указателями, файловыми объектами и т. д.).

Второй сценарий требует немного большего пояснений. Мы можем привести еще одну формулировку, которая заключается в том, что любой класс должен непосредственно управлять *не более чем* одним ресурсом. Поэтому, если вам нужно управлять какой-нибудь памятью, вам следует задействовать уже готовый или написать свой класс, специализированный для управления этой памятью — будь то умный указатель, контейнер на основе массива или что-нибудь еще. Эти типы для управления ресурсами в свою очередь уже будут следовать Правилу Пяти. Но такие классы должны быть довольно редким явлением — стандартная библиотека покрывает наиболее распространенные сценарии своими контейнерами, умными указателями и потоковыми объектами. Класс, который *использует* тип для управления ресурсами, должен “просто делать свою работу”, следуя Правилу Ноля.

Соблюдение этого строгого различия делает ваш код проще, чище и специализированнее, а также делает написание корректного кода немного проще. “Нет такого кода, в котором было бы меньше ошибок, чем в его отсутствии”, поэтому необходимость писать меньше кода (особенно кода для управления ресурсами) – это зачастую очень хорошо.

И даже с этой точки зрения Правило Ноля имеет смысл — и, действительно, анализаторы Sonar рекомендуют вам его в [S493 (*“Правило Ноля” следует соблюдать*)](https://rules.sonarsource.com/cpp/RSPEC-4963).

### Когда и какое правило использовать?

В некотором смысле, Правило Ноля включает в себя Правило Пяти, так что вы можете просто следовать ему. Но самый лучший подход — по умолчанию следовать Правилу Ноля, прибегая к Правилу Пяти, если обнаружили, что вам нужно написать какие-либо специализированные классы, управляющие ресурсами (что само по себе должно происходить достаточно редко). Опять же, это уже оговорено в [S3624 (*когда “Правило Ноля” не применимо, следует следовать “Правилу Пяти”*)](https://rules.sonarsource.com/cpp/RSPEC-3624).

Правило Трех применимо только в том случае, если вы работаете строго с версиями до C++11.

Но действительно ли они охватывают все случаи?

### Когда Правил Трех, Пяти и Ноля недостаточно

Полиморфные базовые классы — распространенный случай, когда применяются вышеуказанные правила, но они кажутся несколько тяжеловесными. Почему? Потому что такие классы должны иметь (по умолчанию) виртуальный деструктор ([S1235 — деструктор *полиморфного базового класса должен быть виртуальным public или не виртуальным*](https://rules.sonarsource.com/cpp/RSPEC-1235) [*protected*](https://rules.sonarsource.com/cpp/RSPEC-1235)). Это не означает, что они должны иметь какие-либо другие специальные функции-члены (на самом деле хорошей практикой является использование в качестве полиморфных базовых классов чистых абстрактных базовых классов) без какой-либо функциональности.

Предоставление публичных операций копирования и перемещения для полиморфных иерархий делает их склонными к сплайсингу, когда разница между статическими и динамическими типами теряется при копировании. Если требуется возможность копирования или перемещения, то они должны осуществляться с помощью виртуальных методов. В этом случае обычно используется виртуальный метод `clone()`. Реализации этих виртуальных методов могут использовать операции копирования и перемещения (в этом случае они могут быть реализованы или заданы по умолчанию как *protected* члены), предотвращая случайное использование извне. В противном случае, что составляет подавляющее большинство сценариев, их следует просто удалить.

```

virtual ~MyBaseClass() = default;

MyBaseClass(MyBaseClass const &) = delete;

MyBaseClass(MyBaseClass &&) = delete;

MyBaseClass operator=(MyBaseClass const &) = delete;

MyBaseClass operator=(MyBaseClass &&) = delete;

```

Реализация или удаление всех специальных функций-членов может стать вполне утомительным занятием, особенно если вы работаете с кодовой базой, в которой много полиморфных базовых классов (хотя в наши дни это довольно редко, по крайней мере, в более современном коде). Один из способов обойти это (фактически единственный способ до C++ 11) это приватное наследование от базового класса, который уже имеет все эти пять определений (или, до C++11, делать “удаленные” функции приватными и нереализованными). Это вполне валидный вариант и, пожалуй, возвращает нас к Правилу Ноля.

Однако оказывается, что все, что нам нужно сделать, это удалить оператор присваивания перемещением. Из-за того, как определяются взаимодействия между специальными функциями-членами, это будет иметь тот же эффект (и, на самом деле, может быть, немного лучше, как мы увидим в следующем посте).

```

virtual ~MyBaseClass() = default;

MyBaseClass operator=(MyBaseClass &&) = delete;

```

Если это кажется странным или немного подозрительным, или если вы хотите больше узнать о применении Правила Пяти в ряде разных случаев, читайте вторую часть этой серии, где мы углубимся во все это, а также в то, как определяются эти взаимодействия.

---

Приглашаем всех желающих на открытое занятие, посвященое многопоточному программированию на C++. На примере такой задачи, как подсчет числа простых чисел, мы рассмотрим, как различные элементы многопоточного программирования на C++ помогут получить более производительное решение. Регистрация на вебинар открыта [по ссылке.](https://otus.pw/I6Z4/) | https://habr.com/ru/post/704492/ | null | ru | null |

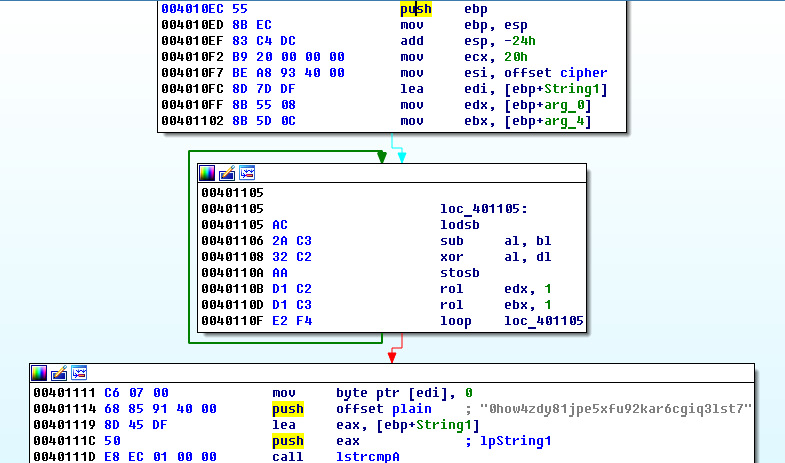

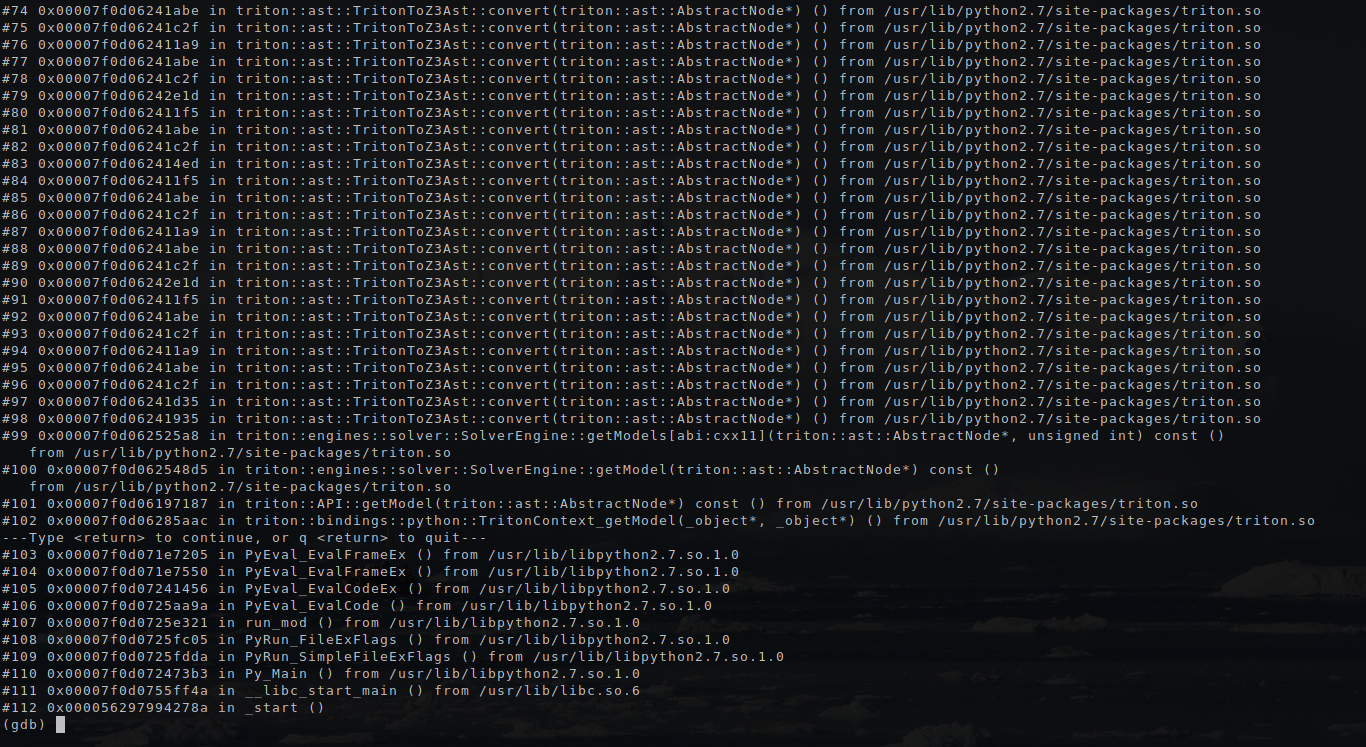

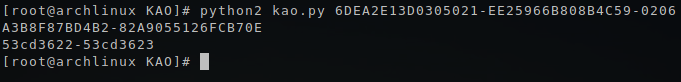

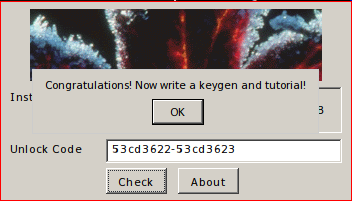

# Хакинг классического Sonic the Hedgehog для Sega