text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Тестирование JavaScript кода с Jest для чайников. Часть 1

Здравствуй, Хабр! Данное руководство является первой частью в запланированном цикле статей про такой замечательный фреймворк для тестирования как Jest. Материал будет полезен новичкам и тем, кто только знакомится с тестированием, и хотел бы изучить этот фреймворк. В первой части мы разберём: как начать работу с jest, как написать простой тест, и какие есть методы для сопоставления проверяемых значение с ожидаемыми. Кому интересно — добро пожаловать под кат!

Что такое Jest?

---------------

Как указано на домашней странице проекта:

> Jest — это восхитительная среда тестирования JavaScript с упором на простоту.

И действительно, Jest очень простой. Он не требует дополнительных настроек, легкий в понимании и применении, а так же имеет довольно хорошую документацию. Отлично подходит для проектов использующих Node, React, Angular, Vue, Babel, TypeScript и не только.

Также он имеет открытый исходный код и поддерживается компанией Facebook.

Установка

---------

Для установки Jest в ваш проект выполните:

```

npm install --save-dev jest

```

Если вы используете yarn:

```

yarn add --dev jest

```

После установки можете обновить секцию scripts вашего package.json:

```

“scripts” : {

“test”: “jest”

}

```

С помощью такого простого вызова мы уже можем запустить наши тесты (на самом деле jest потребует существование хотя бы одного теста).

Также можно установить глобально (но так делать я бы не рекомендовал, так как по мне глобальная установка модулей является плохой практикой):

```

npm install jest --global

```

И соответственно для yarn:

```

yarn global add jest

```

После этого вы можете использовать jest непосредственно из командной строки.

При помощи вызова команды jest --init в корне проекта, ответив на несколько вопросов, вы получите файл с настройками jest.config.js. Или можно добавить конфигурацию прямиком в ваш package.json. Для этого добавьте в корень json ключ «jest» и в соответствующем ему объекте можете добавлять необходимые вам настройки. Сами опции мы разберем позже. На данном этапе в этом нет необходимости, поскольку jest можно использовать «сходу», без дополнительных конфигураций.

Первый тест

-----------

Давайте создадим файл first.test.js и напишем наш первый тест:

```

//first.test.js

test('My first test', () => {

expect(Math.max(1, 5, 10)).toBe(10);

});

```

И запустим наши тесты с помощью npm run test или непосредственно командой jest (если он установлен глобально). После запуска мы увидим отчет о прохождении тестов.

```

**PASS** ./first.test.js

✓ My first test (1 ms)

Test Suites: 1 passed, 1 total

Tests: 1 passed, 1 total

Snapshots: 0 total

Time: 0.618 s, estimated 1 s

```

Давайте «сломаем» наш тест и запустим jest повторно:

```

//first.test.js

test('My first test', () => {

expect(Math.max(1, 5, 10)).toBe(5);

});

```

Как мы видим, теперь наш тест не проходит проверки. Jest отображает подробную информацию о том, где возникла проблема, какой был ожидаемый результат, и что мы получили вместо него.

Теперь давайте разберём код самого теста. Функция *test* используется для создания нового теста. Она принимает три аргумента (в примере мы использовали вызов с двумя аргументами). Первый — строка с названием теста, его jest отобразит в отчете. Второй — функция, которая содержит логику нашего теста. Также можно использовать 3-й аргумент — таймаут. Он является не обязательным, а его значение по умолчанию составляет 5 секунд. Задаётся в миллисекундах. Этот параметр необходим когда мы работаем с асинхронным кодом и возвращаем из функции теста промис. Он указывает как долго jest должен ждать разрешения промиса. По истечению этого времени, если промис не был разрешен — jest будет считать тест не пройденным. Подробнее про работу с асинхронными вызовами будет в следующих частях. Также вместо *test()* можно использовать *it()*. Разницы между такими вызовами нету. *it()* это просто алиас на функцию *test()*.

Внутри функции теста мы сначала вызываем *expect()*. Ему мы передаем значение, которое хотим проверить. В нашем случае, это результат вызова *Math.max(1, 5, 10)*. *expect()* возвращает объект «обертку», у которой есть ряд методов для сопоставления полученного значения с ожидаемым. Один из таких методов мы и использовали — *toBe*.

Давайте разберем основные из этих методов:

* **toBe()** — подходит, если нам надо сравнивать примитивные значения или является ли переданное значение ссылкой на тот же объект, что указан как ожидаемое значение. Сравниваются значения при помощи *Object.is()*. В отличие от === это дает возможность отличать 0 от -0, проверить равенство NaN c NaN.

* **toEqual()** — подойдёт, если нам необходимо сравнить структуру более сложных типов. Он сравнит все поля переданного объекта с ожидаемым. Проверит каждый элемент массива. И сделает это рекурсивно по всей вложенности.

```

test('toEqual with objects', () => {

expect({ foo: 'foo', subObject: { baz: 'baz' } })

.toEqual({ foo: 'foo', subObject: { baz: 'baz' } }); // Ок

expect({ foo: 'foo', subObject: { num: 0 } })

.toEqual({ foo: 'foo', subObject: { baz: 'baz' } }); // А вот так ошибка.

});

test('toEqual with arrays', () => {

expect([11, 19, 5]).toEqual([11, 19, 5]); // Ок

expect([11, 19, 5]).toEqual([11, 19]); // Ошибка

});

```

* **toContain()** — проверят содержит массив или итерируемый объект значение. Для сравнения используется оператор ===.

```

const arr = ['apple', 'orange', 'banana'];

expect(arr).toContain('banana');

expect(new Set(arr)).toContain('banana');

expect('apple, orange, banana').toContain('banana');

```

* **toContainEqual()** — проверяет или содержит массив элемент с ожидаемой структурой.

```

expect([{a: 1}, {b: 2}]).toContainEqual({a: 1});

```

* **toHaveLength()** — проверяет или свойство length у объекта соответствует ожидаемому.

```

expect([1, 2, 3, 4]).toHaveLength(4);

expect('foo').toHaveLength(3);

expect({ length: 1 }).toHaveLength(1);

```

* **toBeNull()** — проверяет на равенство с null.

* **toBeUndefined()** — проверяет на равенство с undefined.

* **toBeDefined()** — противоположность *toBeUndefined*. Проверяет или значение !== undefined.

* **toBeTruthy()** — проверяет или в булевом контексте значение соответствует true. Тоесть любые значения кроме false, null, undefined, 0, NaN и пустых строк.

* **toBeFalsy()** — противоположность *toBeTruthy()*. Проверяет или в булевом контексте значение соответствует false.

* **toBeGreaterThan()** и **toBeGreaterThanOrEqual()** — первый метод проверяет или переданное числовое значение больше, чем ожидаемое >, второй проверяет больше или равно ожидаемому >=.

* **toBeLessThan()** и **toBeLessThanOrEqual()** — противоположность *toBeGreaterThan()* и *toBeGreaterThanOrEqual()*

* **toBeCloseTo()** — удобно использовать для чисел с плавающей запятой, когда вам не важна точность и вы не хотите, чтобы тест зависел от незначительной разницы в дроби. Вторым аргументом можно передать до какого знака после запятой необходима точность при сравнении.

```

const num = 0.1 + 0.2; // 0.30000000000000004

expect(num).toBeCloseTo(0.3);

expect(Math.PI).toBeCloseTo(3.14, 2);

```

* **toMatch()** — проверяет соответствие строки регулярному выражению.

```

expect('Banana').toMatch(/Ba/);

```

* **toThrow()** — используется в случаях, когда надо проверить исключение. Можно проверить как сам факт ошибки, так и проверить на выброс исключения определенного класса, либо по сообщению ошибки, либо по соответствию сообщения регулярному выражению.

```

function funcWithError() {

throw new Error('some error');

}

expect(funcWithError).toThrow();

expect(funcWithError).toThrow(Error);

expect(funcWithError).toThrow('some error');

expect(funcWithError).toThrow(/some/);

```

* **not** — это свойство позволяет сделать проверки на НЕравенство. Оно предоставляет объект, который имеет все методы перечисленные выше, но работать они будут наоборот.

```

expect(true).not.toBe(false);

expect({ foo: 'bar' }).not.toEqual({});

function funcWithoutError() {}

expect(funcWithoutError).not.toThrow();

```

Давайте напишем пару простых тестов. Для начала создадим простой модуль, который будет содержать несколько методов для работы с окружностями.

```

// src/circle.js

const area = (radius) => Math.PI * radius ** 2;

const circumference = (radius) => 2 * Math.PI * radius;

module.exports = { area, circumference };

```

Далее добавим тесты:

```

// tests/circle.test.js

const circle = require('../src/circle');

test('Circle area', () => {

expect(circle.area(5)).toBeCloseTo(78.54);

expect(circle.area()).toBeNaN();

});

test('Circumference', () => {

expect(circle.circumference(11)).toBeCloseTo(69.1, 1);

expect(circle.circumference()).toBeNaN();

});

```

В этих тестах мы проверили результат работы 2-х методов — *area* и *circumference*. При помощи метода *toBeCloseTo* мы сверились с ожидаемым результатом. В первом случае мы проверили или вычисляемая площадь круга с радиусом 5 приблизительно равна 78.54, при этом разница с полученым значением (оно составит 78.53981633974483) не большая и тест будет засчитан. Во втором мы указали, что нас интересует проверка с точностью до 1 знака после запятой. Также мы вызвали наши методы без аргументов и проверили результат с помощью *toBeNaN*. Поскольку результат их выполнения будет NaN, то и тесты будут пройдены успешно.

Разберём ещё один пример. Создадим функцию, которая будет фильтровать массив продуктов по цене:

```

// src/productFilter.js

const byPriceRange = (products, min, max) =>

products.filter(item => item.price >= min && item.price <= max);

module.exports = { byPriceRange };

```

И добавим тест:

```

// tests/product.test.js

const productFilter = require('../src/producFilter');

const products = [

{ name: 'onion', price: 12 },

{ name: 'tomato', price: 26 },

{ name: 'banana', price: 29 },

{ name: 'orange', price: 38 }

];

test('Test product filter by range', () => {

const FROM = 15;

const TO = 30;

const filteredProducts = productFilter.byPriceRange(products, FROM, TO);

expect(filteredProducts).toHaveLength(2);

expect(filteredProducts).toContainEqual({ name: 'tomato', price: 26 });

expect(filteredProducts).toEqual([{ name: 'tomato', price: 26 }, { name: 'banana', price: 29 }]);

expect(filteredProducts[0].price).toBeGreaterThanOrEqual(FROM);

expect(filteredProducts[1].price).toBeLessThanOrEqual(TO);

expect(filteredProducts).not.toContainEqual({ name: 'orange', price: 38 });

});

```

В этом тесте мы проверям результат работы функии *byRangePrice*. Сначала мы проверили соответствие длины полученого массива ожидаемой — 2. Следующая проверка требует, чтобы в массиве находился элемент — { name: 'tomato', price: 26 }. Объект в массиве и объект переданный *toContainEqual* — это два разных объекта, а не ссылка на один и тот же. Но *toContainEqual* сверит каждое свойство. Так как оба объекта идентичные — проверка пройдет успешно. Далее мы используем *toEqual* для провеки структуры всего массива и его элементов. Методы *toBeGreaterThanOrEqual* и *toBeLessThanOrEqual* помогут нам проверить price первого и второго элемента массива. И, наконец, вызов *not.toContainEqual* сделает проверку, не содержится ли в массиве элемент — { name: 'orange', price: 38 }, которого по условию там быть не должно.

В данных примерах мы написали несколько простых тестов используя функции проверки описанные выше. В следующих частях мы разберём работу с асинхронным кодом, функции jest которые не затрагивались в этой части туториала, поговорим о его настройке и многое другое. | https://habr.com/ru/post/502302/ | null | ru | null |

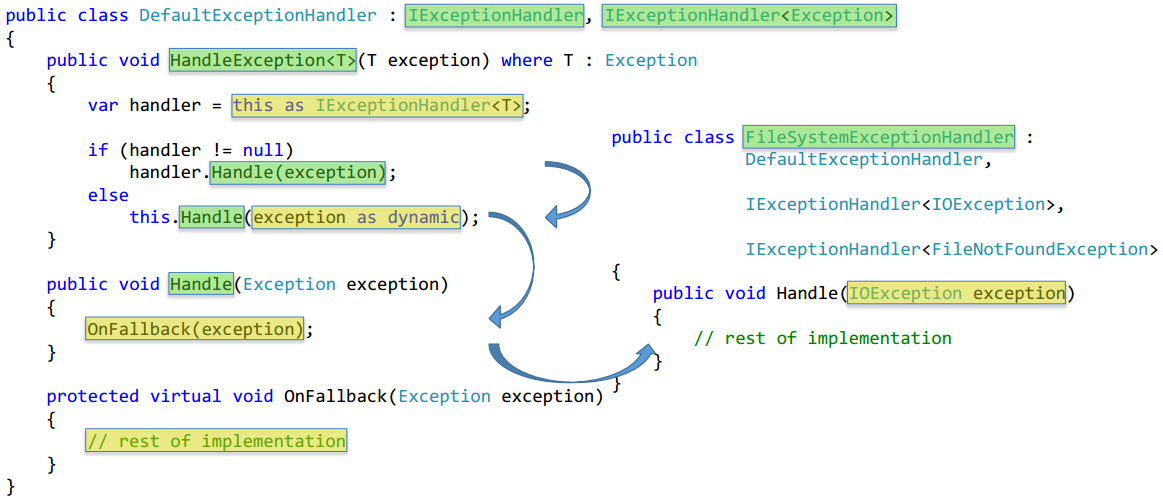

# Как усовершенствовать реализацию Компоновщика в .NET

Каждый прогер наверняка использовал паттерн «Компоновщик», а большинство из нас также сталкивалось с необходимостью реализовать его в своем проекте. И часто так получается, что каждая его реализация налагает особые требования на определяемую бизнес-логику, при этом с точки зрения работы с иерархической структурой мы хотим иметь одинаково широкий набор возможностей: одних методов Add и Remove часто недостаточно, так почему бы не добавить Contains, Clear и с десяток других? А если еще нужны специальные методы обхода поддеревьев через итераторы? И вот такую функциональность хочется иметь для различных независимых иерархий, а также не обременять себя необходимостью определять реализацию таких методов в каждом из множества элементов Composite. Ну и листовые компоненты тоже не помешало бы упростить.

Чуть ниже я предложу свой вариант решения такой проблемы, применительно к возможностям C#.

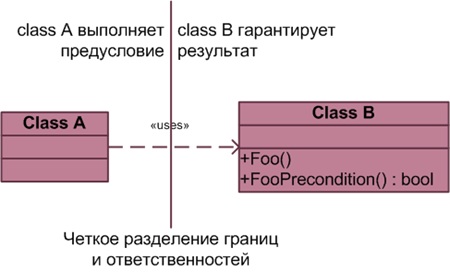

Итак, мы имеем интерфейсный тип Component, который *перегружен двумя областями ответственности*: одна определяет бизнес-логику — то, ради чего и строилась иерархия; вторая обеспечивает прозрачное взаимодействие в иерархии и управляет потомками для композитных элементов. Попробуем одну их них вынести в отдельный интерфейс, к которому можно будет получать доступ по свойству компонента Children (или методу GetChildren). В объекте, который возвращается свойством, будут собраны все операции над коллекцией, включая перечисление, добавление и удаление дочерних элементов, а также все, что нам заблагорассудится.

Мы также определили свойство (метод) IsComposite, чтобы получить быструю и хорошо читаемую проверку на то, является ли элемент композитным или же листовым. Этим свойством можно и не пользоваться: тогда при попытке изменить коллекцию дочерних элементов для листового компонента будет выбрасываться исключение NotSupportedException. Таким образом, мы не теряем *прозрачность интерфейса для всех компонентов* — основное преимущества паттерна «Компоновщик», — и в то же время получаем простой способ определить, могут ли у любого выбранного компонента быть дочерние элементы.

Теперь попробуем определить реализацию интерфейса IComponent, которая была бы хорошо адаптируемой для возможных изменений, и поэтому применимой для построения различных иерархий.

> `using System.Collections.Generic;

>

> using System.Diagnostics.Contracts;

>

> namespace ComponentLibrary

>

> {

>

> [ContractClass(typeof(IComponentContract))]

>

> public interface IComponent<out TComponent, out TChildrenCollection>

>

> where TComponent : IComponent

>

> where TChildrenCollection : class, IEnumerable

>

> {

>

> TChildrenCollection Children { get; }

>

> bool IsComposite { get; }

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

От чего интерфейс реализован как шаблонный и что за параметры-типы он принимает? На самом деле идея очень проста: привнести строгую типизацию туда, где действительные типы еще не известны.

*TComponent* — это всего лишь фактический тип того дочернего интерфейса (или класса в более тесно связанной архитектуре), который вы унаследуете от IComponent, чтобы добавить в него обязанности типа Operation( ).

*TChildrenCollection* — интерфейс коллекции, который вы реализуете, чтобы обращаться к дочерним элементам. В этом интерфейсе должен быть определен как минимум только GetEnumerator( ), через который можно получить итератор коллекции. Дело в том, что иногда не нужно предоставлять методы типа Add( ) и Remove( ), т.к. все элементы могут добавляться в конструкторе, а сама иерархическая структура не должна изменяться после создания. А если вам вдруг понадобятся уведомления об изменении коллекции — передайте ObservableCollection в качестве TChildrenCollection, и дело в шляпе!

В контракте типа мы укажем следующие ограничения на возвращаемое значение свойства Children: 1) возвращаемая коллекция не равна null; 2) ни один из ее элементов не равен null; 3) компонент либо указан как композитный, либо не содержит дочерних элементов. Для краткости код контракта здесь не приводится.

Помните, мы говорили, что хотели бы наделить каждый компонент дополнительным методом, возвращающим итератор, реализующий сложную логику обхода поддерева? Допустим, что мы написали такой итератор ComponentDescendantsEnumerator (его код можно скачать по ссылке в конце статьи), а затем обернули его в класс ComponentDescendantsEnumerable, определяющий IEnumerable. Теперь нужно решить, где разместить методы, возвращающие подобные итераторы? К счастью в C# есть очень полезный механизм — методы-расширения. Давайте попробуем его применить.

> `namespace ComponentLibrary.Extensions

>

> {

>

> public static class ComponentExtensions

>

> {

>

> public static IEnumerable GetDescendants(this T component)

>

> where T : IComponentIEnumerable>

>

> {

>

> // здесь был контракт метода

>

> return new ComponentDescendantsEnumerable(component);

>

> }

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Мы реализуем метод-расширение в отдельном пространстве имен — так мы сможем его вызывать словно метод, принадлежащий интерфейсу IComponent< , >, лишь тогда, когда импортируем это пространство имен.

Далее перед нами еще задача: нужно реализовать способ получения коллекций, которые никогда не содержат элементов, а на все запросы изменения (вроде Add / Remove) выбрасывают NotSupportedException. Сначала сделаем одну такую коллекцию, реализующую ICollection. Однако, если коллекция никогда не изменяется и создается всегда пустой, то нет смысла делать более одной такой коллекции на всю программу (вернее на AppDomain). Идеальный случай, чтобы воспользоваться паттерном «Синглтон»! (реализацию класса Singleton можно узнать в прилагаемых исходниках)

> `sealed internal class ItemsNotSupportedCollection :

>

> Singleton>,

>

> ICollection

>

> {

>

> private ItemsNotSupportedCollection() { }

>

>

>

> public int Count { get { return 0; } }

>

>

>

> public bool IsReadOnly { get { return true; } }

>

>

>

> public bool Contains(T item) { return false; }

>

>

>

> public void CopyTo(T[] array, int arrayIndex) { }

>

>

>

> public void Add(T item) { throw new NotSupportedException(); }

>

>

>

> public void Clear() { throw new NotSupportedException(); }

>

>

>

> public bool Remove(T item) { throw new NotSupportedException(); }

>

>

>

> public IEnumerator GetEnumerator()

>

> {

>

> return ItemsNotSupportedEnumerator.Instance;

>

> }

>

>

>

> IEnumerator IEnumerable.GetEnumerator()

>

> { return this.GetEnumerator(); }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Ради прозрачности используемый класс итератора представляет итератор пустой коллекции, поэтому тоже достаточно одного его экземпляра — вновь синглтон.

> `sealed internal class ItemsNotSupportedEnumerator :

>

> Singleton>,

>

> IEnumerator

>

> {

>

> private ItemsNotSupportedEnumerator() { }

>

>

>

> public T Current { get { return default(T); } }

>

>

>

> public void Dispose() { }

>

>

>

> object IEnumerator.Current { get { return null; } }

>

>

>

> public bool MoveNext() { return false; }

>

>

>

> public void Reset() { throw new NotSupportedException(); }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Осталось только создать статическое свойство, видимое извне сборки и возвращающее доступную только для чтения коллекцию элементов для интерфейса ICollection.

> `public static class ComponentCollections

>

> where TComponent : IComponentIEnumerable>

>

> {

>

> public static ICollection EmptyCollection

>

> {

>

> get

>

> {

>

> // здесь был контракт

>

> return ItemsNotSupportedCollection.Instance;

>

> }

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Пришло время для самого интересного: применение нашей мини-библиотеки для создания конкретной иерархии классов. Допустим надо организовать систему меню, состоящую из: MenuCommand — конкретная команда, и Menu — подменю, которое может содержать другие команды и подменю. Все классы расположены в отдельной сборке. Шестое чувство подсказывает, что паттерн «Компоновщик» пришелся бы здесь кстати.

Сначала определим интерфейс, общий для всех классов иерархии. Внутри интерфейса мы определяем только методы и свойства, требуемые бизнес-логикой нашего меню (в данном случае каждый элемент имеет имя и умеет отображать себя с указанным отступом).

> `namespace MenuLibrary

>

> {

>

> public interface IMenuItem :

>

> IComponent>

>

> {

>

> string Name { get; }

>

> void Display(int indent = 0);

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

В качестве параметра-типа TComponent мы всегда передаем интерфейс компонентов (т.е. этот же IMenuItem), в качестве TChildrenCollection — интерфейс реализуемой коллекции. Мы могли бы для TChildrenCollection создать свой интерфейс, определяющий методы Add, Remove и GetChild (а также GetEnumerator), как и в классическом варианте паттерна. Можно передать например IList, но мы решили, что здесь нам подходит стандартный интерфейс ICollection.

Вот так мы определим листовой компонент MenuCommand:

> `public class MenuCommand : IMenuItem

>

> {

>

> private readonly string name;

>

>

>

> public MenuCommand(string name)

>

> {

>

> // здесь был контракт

>

> this.name = name;

>

> }

>

>

>

> public string Name { get { return this.name; } }

>

>

>

> public void Display(int indent = 0)

>

> {

>

> string indentString = MenuHelper.GetIndentString(indent);

>

> Console.WriteLine("{1}{0} [Command]", this.name, indentString);

>

> }

>

>

>

> public ICollection Children

>

> {

>

> get { return ComponentCollections.EmptyCollection; }

>

> }

>

>

>

> public bool IsComposite { get { return false; } }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Свойство Children возвращает ранее объявленную «синглтоновую» коллекцию для листовых элементов. Теперь объявим композитный компонент Menu.

> `public class Menu : IMenuItem

>

> {

>

> private readonly ICollection children =

>

> new List();

>

>

>

> private readonly string name;

>

>

>

> public Menu(string name)

>

> {

>

> // здесь должен быть контракт

>

> this.name = name;

>

> }

>

>

>

> public string Name { get { return this.name; } }

>

>

>

> public void Display(int indent = 0)

>

> {

>

> string indentString = MenuHelper.GetIndentString(indent);

>

> Console.WriteLine("{1}{0} [Menu]", this.name, indentString);

>

> int childrenIndent = indent + 1;

>

> foreach (IMenuItem child in this.children)

>

> {

>

> child.Display(childrenIndent);

>

> }

>

> }

>

>

>

> public ICollection Children

>

> { get { return this.children; } }

>

>

>

> public bool IsComposite { get { return true; } }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Children неожиданно возвращает использованную стандартную коллекцию List. Это хороший ход, если пользователю нашей иерархии разрешено привести тип объекта Children к List и использовать все дополнительные возможности этого класса. Но если такой расклад недопустим, то надо обернуть List в некий внутренний класс, реализующий только ICollection и недоступный другим сборкам (или даже классам).

Теперь протестируем написанный нами код.

> `using System;

>

> using System.Linq;

>

> using ComponentLibrary.Extensions;

>

> using MenuLibrary;

>

> namespace MenuTest

>

> {

>

> public static class MenuTest

>

> {

>

> public static void Perform()

>

> {

>

> // создаем структуру меню

>

> IMenuItem rootMenu = new Menu("Root");

>

> // ... меню File

>

> IMenuItem fileMenu = new Menu("File");

>

> fileMenu.Children.Add(new MenuCommand("New"));

>

> fileMenu.Children.Add(new MenuCommand("Open"));

>

> // ... меню File->Export

>

> IMenuItem fileExportMenu = new Menu("Export");

>

> fileExportMenu.Children.Add(new MenuCommand("Text Document"));

>

> fileExportMenu.Children.Add(new MenuCommand("Binary Format"));

>

> fileMenu.Children.Add(fileExportMenu);

>

> // ... меню File

>

> fileMenu.Children.Add(new MenuCommand("Exit"));

>

> rootMenu.Children.Add(fileMenu);

>

> // ... меню Edit

>

> IMenuItem editMenu = new Menu("Edit");

>

> editMenu.Children.Add(new MenuCommand("Cut"));

>

> editMenu.Children.Add(new MenuCommand("Copy"));

>

> editMenu.Children.Add(new MenuCommand("Paste"));

>

> rootMenu.Children.Add(editMenu);

>

> // выводим меню на экран

>

> rootMenu.Display();

>

> Console.WriteLine();

>

> // выводим на консоль имена всех составных меню,

>

> // вложенных в Root, начинающихся на буквы "E" или "R"

>

> var compositeMenuNames =

>

> from menu in rootMenu.GetDescendants()

>

> where menu.IsComposite

>

> && (menu.Name.StartsWith("E") || menu.Name.StartsWith("R"))

>

> select menu.Name;

>

> foreach (string menuName in compositeMenuNames)

>

> {

>

> Console.WriteLine(menuName);

>

> }

>

> }

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Обратите внимание на LINQ-запрос к перечислению, возвращаемому методом-расширением GetDescendants(). Взглянем на результат работы.

Вот так все просто. Причем в логике разработанных компонентов все внимание проектировщика сосредоточено на построении бизнес-логики, а не иерархической структуры или классов-контейнеров.

**Ссылка на исходники:** <http://www.fileden.com/files/2011/10/7/3205975/ComponentLibrary.zip>

**P.S.** Если вам что-то показалось не очевидным, либо вы хотели бы посмотреть на вариант реализации иерархии, доступной только для чтения, то можете обратиться к [расширенному варианту](http://sergeyalikin.blogspot.com/2011/10/net.html) этого же поста.

**P.P.S.** Если честно, я надеюсь, что в комментах кто-нибудь предложит лучший вариант реализации Компоновщика, чем у меня.

**UPD** Как правильно заметил [avalter](https://habrahabr.ru/users/avalter/), здесь я всего лишь применил к Компоновщику Extract Interface, Extract Class и использовал NullObject (желательно закончить Extract Class, вынести используемую коллекцию из композитных компонентов и инкапсулировать ее в отдельный класс). В итоге получается не просто Компоновщик, а более гибкая структура.

**Реализовывать каждый раз паттерн таким образом «с нуля» ни в коем случае не советую!** Но можно взять код сборки ComponentLibrary, скопировать ее в свой проект и автоматически получить некоторые преимущества для своей иерархии: готовые Null-Object коллекции для листовых элементов, дополнительные итераторы для обхода структуры, а также контракт на интерфейс IComponent, о котором тут упоминалось вскользь. Т.о. при реализации очередной иерархии, подобной IMenuItem, можно задумываться лишь над логикой методов Display(), если реализованных в ComponentLibrary интерфейсов структур достаточно (иначе определить свои реализации). | https://habr.com/ru/post/130012/ | null | ru | null |

# Javascript примеси для чайников

После того, как с классическим (от слова класс) наследованием в JS стало вроде-бы [все понятно](http://habrahabr.ru/blogs/javascript/131714/), я решил разобраться с реализацией другого способа повторного использвоания кода — примесями. Несмотря на довольно непривычное название, способ этот чертовски прост.

#### 1. Примеси — это, собственно, что ?

Примесь (mixin) — это объект с набором функций, который сам по себе (отдельно от других объектов) не используется.

Вот, например, прекрасная примесь:

```

var Mixin_Babbler =

{

say: function ()

{

console.log("My name is " + this.name + " and i think:'" + this.THOUGHTS + "'");

},

argue: function() { console.log("You're totally wrong"); }

};

```

При попытке вызвать метод say просто так, нас ждет облом, потому что ни *this.name*, ни *this.THOUGHTS* в нашем объекте, почему-то, просто нет.

На самом деле все правильно, чтобы использовать примесь по назначению нам нужен другой объект, и метод, который копирует все свойства переданных ему объектов-примесей в прототип функции конструктора — обычно такой метод называют extend, или mix, или как-нибудь в этом духе:

```

function extend(object)

{

var mixins = Array.prototype.slice.call(arguments, 1);

for (var i = 0; i < mixins.length; ++i)

{

for (var prop in mixins[i])

{

if (typeof object.prototype[prop] === "undefined")

{

object.prototype[prop] = mixins[i][prop];

}

}

}

}

```

#### 2. Ну и как это использовать?

Легко и не напрягаясь — допустим, у нас есть парочка примесей:

```

var Mixin_Babbler =

{

say: function () { console.log("My name is " + this.name + " and i think:'" + this.THOUGHTS + "'"); },

argue: function() { console.log("You're totally wrong"); }

};

var Mixin_BeverageLover =

{

drink: function () { console.log("* drinking " + this.FAVORITE_BEVERAGE + " *"); }

};

```

И, кому-то, возможно, уже знакомая, эволюционная цепочка:

```

function Man(name)

{

this.name = name;

}

Man.prototype =

{

constructor: Man,

THOUGHTS: "I like soccer"

}

extend(Man, Mixin_Babbler);

function Gentleman(name)

{

this.name = name;

}

Gentleman.prototype =

{

constructor: Gentleman,

THOUGHTS: "I like Earl Grey",

FAVORITE_BEVERAGE: "Tea"

}

extend(Gentleman, Mixin_Babbler, Mixin_BeverageLover);

function Programmer(name)

{

this.name = name;

}

Programmer.prototype =

{

constructor: Programmer,

THOUGHTS: "MVC, MVVM, MVP *___* like it!",

FAVORITE_BEVERAGE: "Cofee",

write_good_code: function () { console.log("*writing best code ever*"); this.drink(); }

}

extend(Programmer, Mixin_Babbler, Mixin_BeverageLover);

```

Каждый «класс» теперь не зависит от другого, а весь повторяющийся функционал реализован с помощью примесей.

Теперь стоит все проверить — вдруг заработает:

```

var man = new Man("Bob");

var gentleman = new Gentleman("Bill");

var programmer = new Programmer("Benjamin");

man.say();

man.argue();

gentleman.say();

gentleman.drink();

programmer.say();

programmer.write_good_code();

```

И консоль говорит что таки да, все как надо:

```

My name is Bob and i think:'I like soccer'

*You're totally wrong*

My name is Bill and i think:'I like Earl Grey'

*drinking Tea*

My name is Benjamin and i think:'MVC, MVVM, MVP like *__* it!'

*writing best code ever*

*drinking Cofee*

```

Собственно все. В отличие от «классического» наследования, реализация примесей очень простая и понятная. Существуют конечно некоторые вариации, но так или иначе ядро выглядит именно так.

**UPD.** Как подсказал один очень хороший человек с ником [lalaki](https://habrahabr.ru/users/lalaki/), метод extend можно реализовать немножко по-другому:

```

function extend_2(object)

{

var mixins = Array.prototype.slice.call(arguments, 1);

for (var i = 0; i < mixins.length; ++i)

{

for (var prop in mixins[i])

{

if (typeof object.prototype[prop] === "undefined")

{

bindMethod = function (mixin, prop)

{

return function () { mixin[prop].apply(this, arguments) }

}

object.prototype[prop] = bindMethod(mixins[i], prop);

}

}

}

}

```

С таким подходом можно на лету подменять методы в примеси, и эти изменения сразу будут доступны для всех объектов эту примесь использующих.

Очень-очень маленьким недостатком является то, что не слишком умная подсказка в среде разработки будет всегда показывать что у методов нет аргументов.

Весь код и примеры лежат себе спокойно [вот тут](https://github.com/L0stSoul/Training/tree/master/MixIn) | https://habr.com/ru/post/132340/ | null | ru | null |

# TeamViewer из подручных материалов

Всем привет!

Сегодня хочу рассказать о двух случайно обнаруженных “фичах” известных протоколов, которые позволили сложиться “пазлу” из темы статьи.

И так, у **сотрудника** техподдержки есть необходимость подключаться к рабочему столу **пользователя**, что бы совместно что-то сделать. Раз нет TeamViewer, значить надо использовать что-то похожее, например VNC.Тут же “выплывают” проблемы:

1. компьютер пользователя может быть недоступен для компьютера сотрудника, например, находится в домашней сети за роутером (который так же может быть не доступен из внешних сетей)

2. пользователю нужно не только заранее установить VNC Server на свой компьютер, но и задать (и не забыть:) пароль от него, что бы сообщить его, когда понадобится, сотруднику

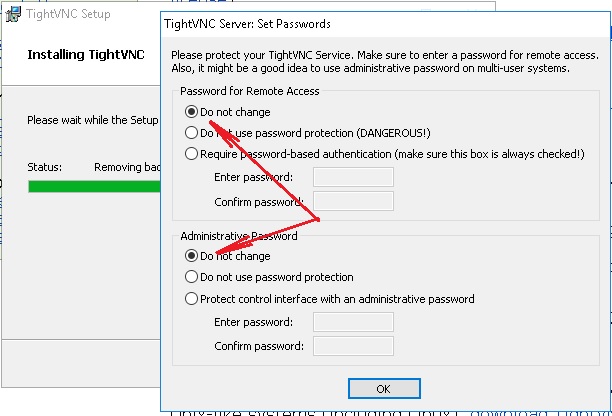

Эти проблемы решает первая “фича” - оказалось, что VNC позволяет организовать подключение “наоборот”, не с клиента на сервер, а с сервера на клиент. В системе Windows пользователь может установить, например, пакет TightVNC оставляя все опции, “по умолчанию”, и, не меняя и не выясняя случайно сгенерированный пароль, который теперь никому не понадобится:

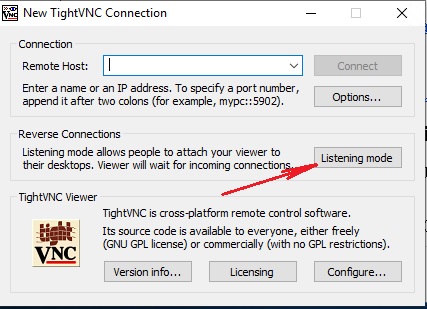

Этот же пакет нужно будет установить сотруднику техподдержки, серверная часть ему не нужна, можно убрать ее из автозагрузки, а понадобится TightVNC Viewer запущенный в Listening mode

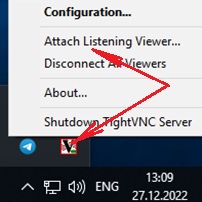

Теперь, по просьбе сотрудника техподдержки, пользователю будет достаточно выбрать меню Attach Listening Viewer

указать "ip\_адрес\_компьютера\_сотрудника\_техподдержки" и нажать на кнопку "Attach"

Если пользователи работают в Linux, то необходимой функциональностью обладает пакет x11vnc, который в debian ориентированных дистрибутивах может быть установлен командой:

```

$ sudo apt install x11vnc

```

Для предоставления своего рабочего стола сотруднику техподдержки пользователю будет достаточно набрать в терминале:

```

$ x11vnc -connect ip_адрес_компьютера_сотрудника_техподдержки

```

Если и сотрудник техподдержки работает в Linux, он может установить пакет tigervnc-viewer

```

$ sudo apt install tigervnc-viewer

```

и, перед оказанием помощи пользователю, запустить в терминале команду:

```

$ vncviewer -listen

```

СТОП! Как это “ip\_адрес\_компьютера\_сотрудника\_техподдержки”? А если (даже наверняка) это такой же “серый” адрес в локальной сети за роутером, как и у сотрудника?

Эту проблему решает вторая “фича” - оказалось что сервис SSH не только позволяет, благодаря опции GatewayPorts yes, установить подключение с компьютера сотрудника к SSH серверу и назначить внешний TCP порт для встречных соединений, которые можно “направить” в VNC viewer, но и сгенерировать этот номер динамически.

Команда будет выглядеть вот так (обратите внимание на 0, там где указывается номер внешнего порта):

```

ssh -R 0:localhost:5500 логин_сотрудника_техподдержки@ip_адрес_ssh_сервера

```

И, да, VNC viewer, в режиме listen, ожидает, по умолчанию, подключения на порту 5500, и теперь его можно ограничить только интерфейсом localhost

Теперь, если “ip\_адрес\_ssh\_сервера” публичный, пользователи смогут предоставить свой рабочий стол, указав вместо “ip\_адреса\_компьютера\_сотрудника\_техподдержки” - “ip\_адрес\_ssh\_сервера:сгенерированный\_номер\_порта”

Некоторой проблемой оказалось “выяснение” назначенного динамического порта, дело в том что в Linux терминале строка:

```

Allocated port NNNNN for remote forward to localhost:5500

```

прекрасно отображается, и сотрудник техподдержки может продиктовать его пользователю, но в Windows, не все SSH клиенты (например PuTTY) это делают, тут могу посоветовать MobaXTerm в нем все как в Linux

В завершении статьи остается только посочувствовать пользователям, которые вместо “каликанья” по “иконке” и сообщения оператору номера подключения в TeamViewer приходится запускать “страшные” программы с непонятными адресами, но мы на работе “боремся” с этим создав bat файл для пользователей Windows и используя Ansible для рабочих станций Linux, после которых на рабочем столе пользователя тоже появляется “иконка”, по которой можно “кликнуть” и ввести там 5 цифр, названных сотрудником техподдержки. Если статья вызовет интерес, можно будет написать продолжение на эту тему.

Еще, из “нехорошего”, трафик между пользовательским VNC и ssh сервером “летит” нешифрованный, тоже в планах поправить в будущем.

Так же, вероятно что MeshCentral или RustDesk окажутся более удобными решениями для тех, кто ищет альтернативу TeamViewer, буду рад почитать статьи на эту тему.

На этом все, всех с Новым годом, всех благ! | https://habr.com/ru/post/709218/ | null | ru | null |

# Пишем современный маршрутизатор на JavaScript

Доброго времени суток, друзья!

Простые одностраничные приложения, основанные на React, Vue или чистом JavaScript, окружают нас повсюду. Хороший «одностраничник» предполагает соответствующий механизм маршрутизации.

Такие библиотеки, как «navigo» или «react-router», приносят большую пользу. Но как они работают? Необходимо ли нам импортировать всю библиотеку? Или достаточно какой-то части, скажем, 10%? В действительности, быстрый и полезный маршрутизатор можно легко написать самому, это займет немного времени, а программа будет состоять менее чем из 100 строчек кода.

### Требования

Наш маршрутизатор должен быть:

* написан на ES6+

* совместим с историей и хешем

* переиспользуемой библиотекой

Обычно в веб приложении используется один экземпляр маршрутизатора, но во многих случаях нам требуется несколько экземпляров, поэтому мы не сможем использовать синглтон (Singleton) в качестве шаблона. Для работы нашему маршрутизатору необходимы следующие свойства:

* маршрутизаторы (routes): список зарегистрированных маршрутизаторов

* режим (mode): хеш или история

* корневой элемент (root): корневой элемент приложения, если мы находимся в режиме использования истории

* конструктор (constructor): основная функция для создания нового экземпляра маршрутизатора

```

class Router {

routes = []

mode = null

root = '/'

constructor(options) {

this.mode = window.history.pushState ? 'history' : 'hash'

if (options.mode) this.mode = options.mode

if (options.root) this.root = options.root

}

}

export default Router

```

### Добавление и удаление маршрутизаторов

Добавление и удаление маршрутизаторов осуществляется через добавление и удаление элементов массива:

```

class Router {

routes = []

mode = null

root = '/'

constructor(options) {

this.mode = window.history.pushState ? 'history' : 'hash'

if (options.mode) this.mode = options.mode

if (options.root) this.root = options.root

}

add = (path, cb) => {

this.routes.push({

path,

cb

})

return this

}

remove = path => {

for (let i = 0; i < this.routes.length; i += 1) {

if (this.routes[i].path === path) {

this.routes.slice(i, 1)

return this

}

}

return this

}

flush = () => {

this.routes = []

return this

}

}

export default Router

```

### Получение текущего пути

Мы должны знать, где находимся в приложении в определенный момент времени.

Для этого нам потребуется обработка обоих режимов (истории и хеша). В первом случае, нам нужно удалить путь к корневому элементу из window.location, во втором — "#". Нам также необходима функция (clearSlash) для удаления всех маршрутизаторов (строки от начала до конца):

```

[...]

clearSlashes = path =>

path

.toString()

.replace(/\/$/, '')

.replace(/^\//, '')

getFragment = () => {

let fragment = ''

if (this.mode === 'history') {

fragment = this.clearSlashes(decodeURI(window.location.pathname + window.location.search))

fragment = fragment.replace(/\?(.*)$/, '')

fragment = this.root !== '/' ? fragment.replace(this.root, '') : fragment

} else {

const match = window.location.href.match(/#(.*)$/)

fragment = match ? match[1] : ''

}

return this.clearSlashes(fragment)

}

}

export default Router

```

### Навигация

Ок, у нас имеется API для добавления и удаления URL. Также у нас имеется возможность получать текущий адрес. Следующий шаг — навигация по маршрутизатору. Работаем со свойством «mode»:

```

[...]

getFragment = () => {

let fragment = ''

if (this.mode === 'history') {

fragment = this.clearSlashes(decodeURI(window.location.pathname + window.location.search))

fragment = fragment.replace(/\?(.*)$/, '')

fragment = this.root !== '/' ? fragment.replace(this.root, '') : fragment

} else {

const match = window.location.href.match(/#(.*)$/)

fragment = match ? match[1] : ''

}

return this.clearSlashes(fragment)

}

navigate = (path = '') => {

if (this.mode === 'history') {

window.history.pushState(null, null, this.root + this.clearSlashes(path))

} else {

window.location.href = `${window.location.href.replace(/#(.*)$/, '')}#${path}`

}

return this

}

}

export default Router

```

### Наблюдаем за изменениями

Теперь нам нужна логика для отслеживания изменений адреса как с помощью ссылки, так и с помощью созданного нами метода «navigate». Также нам необходимо обеспечить рендеринг правильной страницы при первом посещении. Мы могли бы использовать состояние приложения для регистрации изменений, однако в целях изучения сделаем это с помощью setInterval:

```

class Router {

routes = [];

mode = null;

root = "/";

constructor(options) {

this.mode = window.history.pushState ? "history" : "hash";

if (options.mode) this.mode = options.mode;

if (options.root) this.root = options.root;

this.listen();

}

[...]

listen = () => {

clearInterval(this.interval)

this.interval = setInterval(this.interval, 50)

}

interval = () => {

if (this.current === this.getFragment()) return

this.current = this.getFragment()

this.routes.some(route => {

const match = this.current.match(route.path)

if (match) {

match.shift()

route.cb.apply({}, match)

return match

}

return false

})

}

}

export default Router

```

### Заключение

Наша библиотека готова к использованию. Она состоит всего лишь из 84 строчек кода!

Код и пример использования на [Github](https://github.com/thecreazy/create-a-modern-javascript-router).

Благодарю за внимание. | https://habr.com/ru/post/496590/ | null | ru | null |

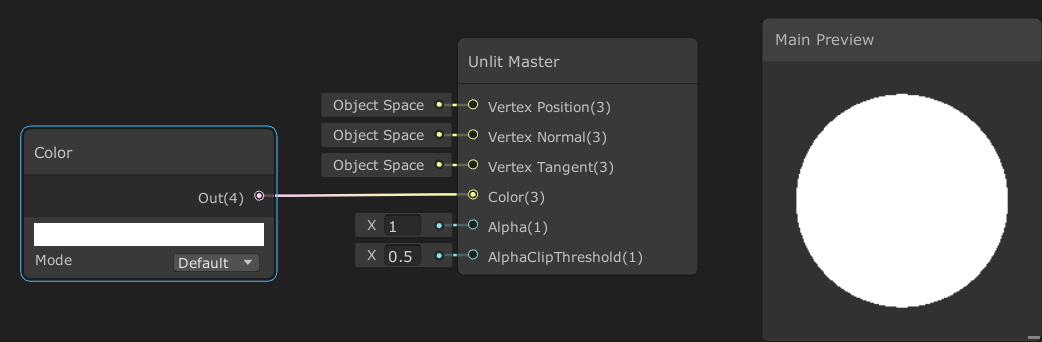

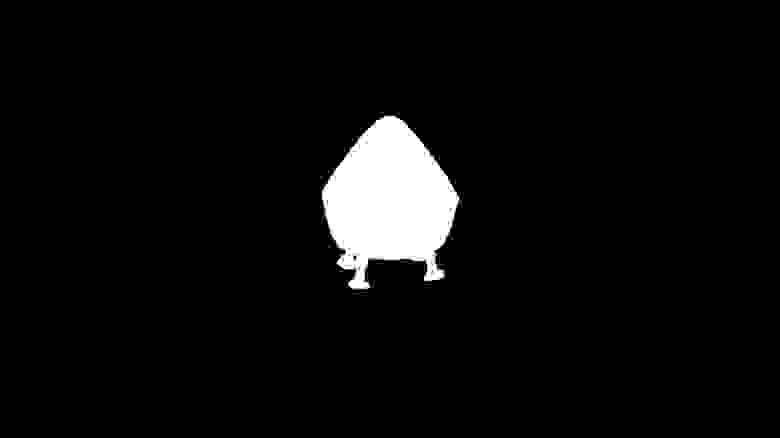

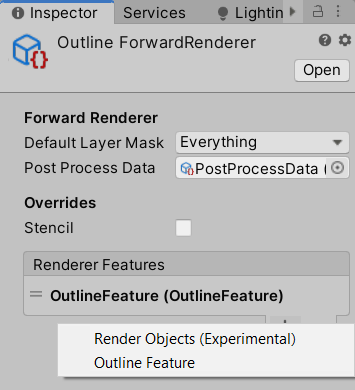

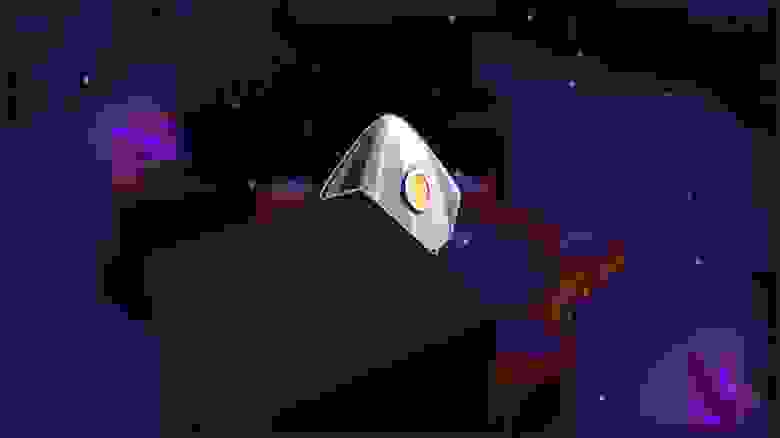

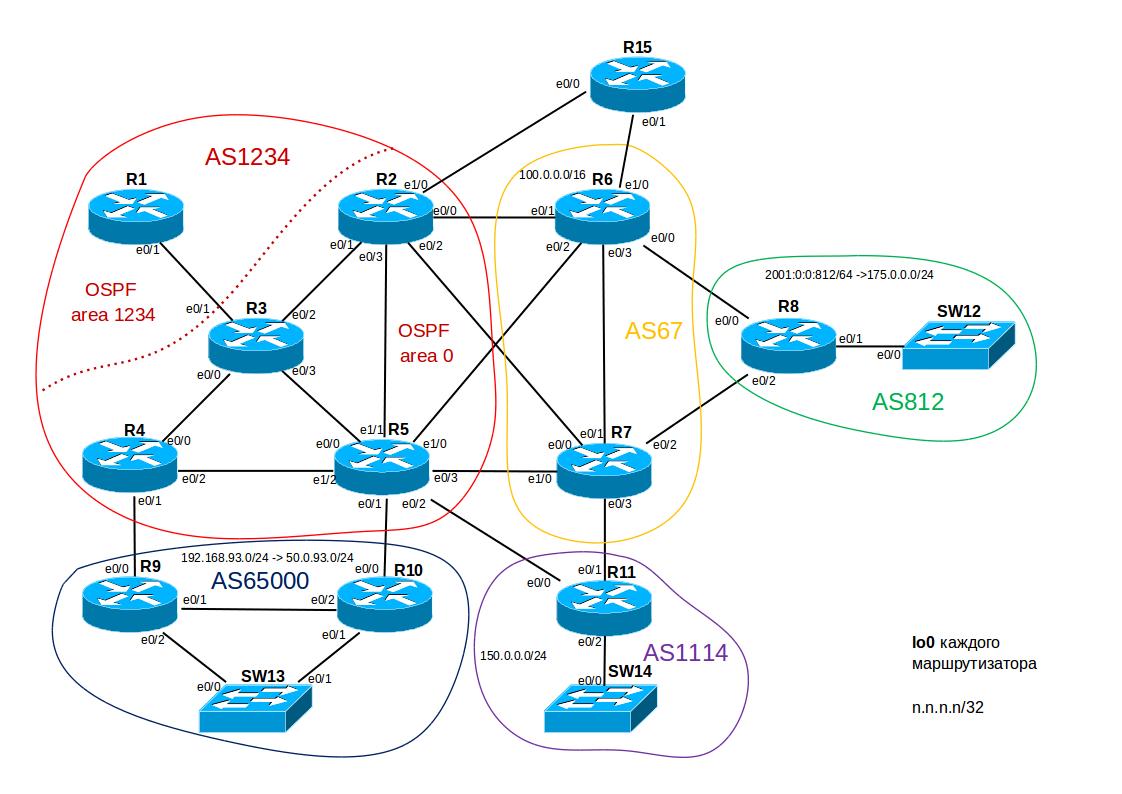

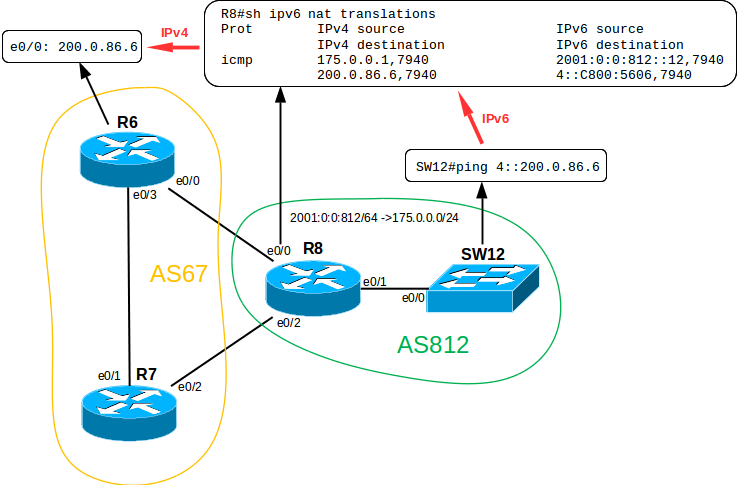

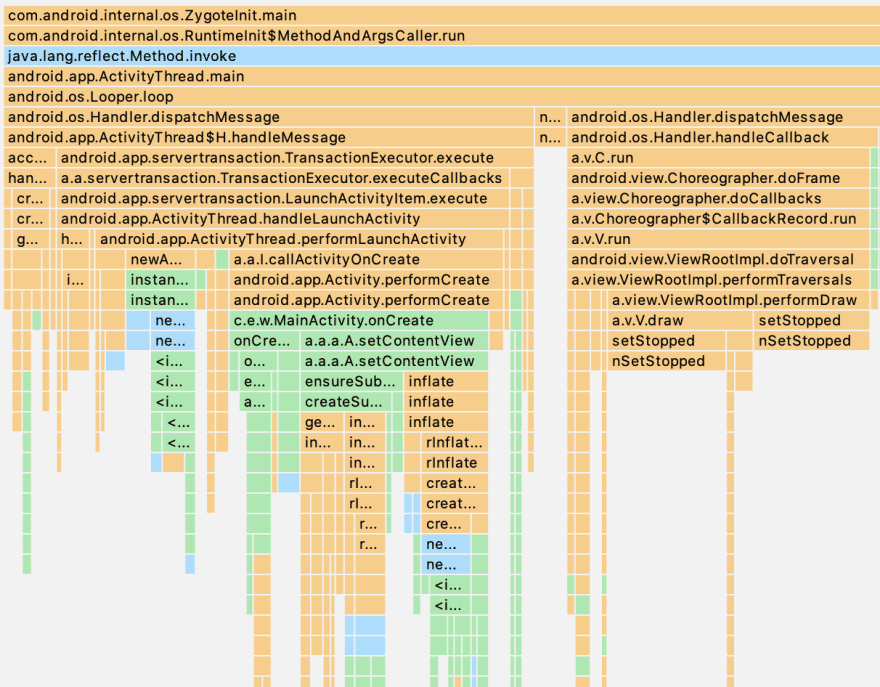

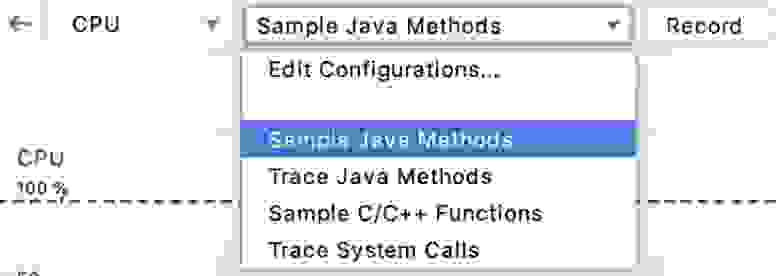

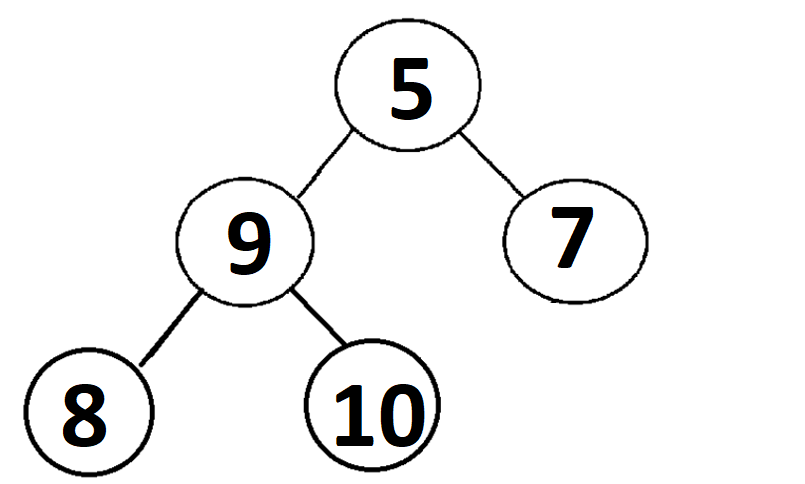

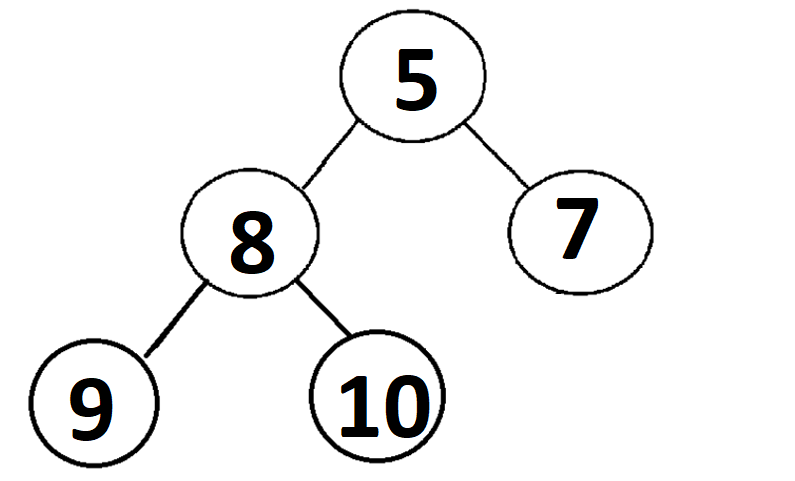

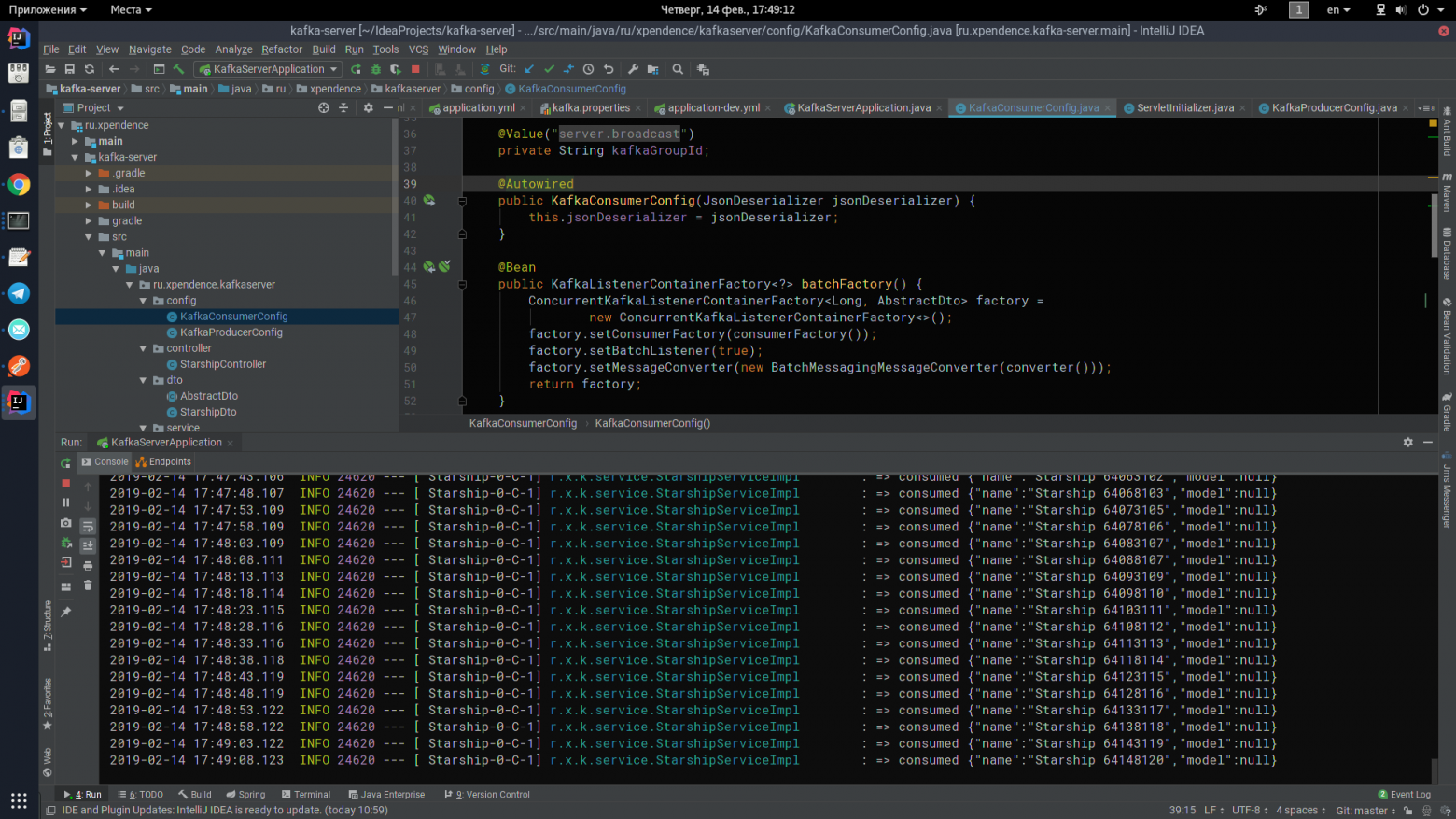

# Создание Outline эффекта в Unity Universal Render Pipeline

В Universal Render Pipeline, создавая свои RendererFeature, можно легко расширить возможности отрисовки. Добавление новых проходов в конвеер рендеринга позволяет создавать различные эффекты. В этой статье, используя ScriptableRendererFeature и ScriptableRenderPass, создадим эффект обводки объекта (Outline) и рассмотрим некоторые особенности его реализации.

Вступление или пару слов о Render Pipeline

------------------------------------------

Scriptable Render Pipeline позволяет управлять отрисовкой графики посредством скриптов на C# и контролировать порядок обработки объектов, света, теней и прочего. Universal Render Pipeline — это готовый Scriptable Render Pipeline, разработанный Unity и предназначенный на замену старому встроенному RP.

Возможности Universal RP можно расширить, создавая и добавляя свои проходы отрисовки ( ScriptableRendererFeature и ScriptableRenderPass ). Об этом и будет текущая статья. Она пригодится тем, кто собирается переходить на Universal RP и, возможно, поможет лучше понимать работу имеющихся ScriptableRenderPass’ов в Universal RP.

При написании этой статьи использовалась Unity 2019.3 и Universal RP 7.1.8.

План действий

-------------

Мы будем разбираться в работе ScriptableRendererFeature и ScriptableRenderPass на примере создания эффекта обводки непрозрачных объектов.

Для этого создадим ScriptableRendererFeature, выполняющую следующие действия:

* отрисовка указанных объектов

* размытие отрисованных объектов

* получение контуров объектов из изображений, полученных на предыдущих проходах

Исходный кадр —

И последовательность результатов, которые мы должны достичь:

В ходе работы мы создадим шейдер, в глобальные свойства которого будут сохраняться результаты первого и второго проходов. Последний проход отобразит результат работы самого шейдера на экран.

**Глобальные свойства**

Это свойства, объявленные в шейдере, но не имеющие определения в блоке Properties. В данном примере нет принципиальной разницы как мы будем задавать текстуры — через глобальные или обычные свойства.

Основная причина использования глобальных свойств — нет необходимости передавать материал каждому проходу. А также отладка становится немного удобнее.

Создаём OutlineFeature

----------------------

ScriptableRendererFeature используется для добавления своих проходов отрисовки (ScriptableRenderPass) в Universal RP. Создадим класс OutlineFeature, наследуемый от ScriptableRenderFeature и реализуем его методы.

```

using UnityEngine;

using UnityEngine.Rendering.Universal;

public class OutlineFeature : ScriptableRendererFeature

{

public override void Create()

{ }

public override void AddRenderPasses(ScriptableRenderer renderer, ref RenderingData renderingData)

{ }

}

```

Метод Create() служит для создания и настройки проходов. А метод AddRenderPasses() для внедрения созданных проходов в очередь отрисовки.

**аргументы AddRenderPasses()**

ScriptableRenderer — текущая стратегия рендеринга по умолчанию для Universal RP. На данный момент в Universal RP реализована только стратегия Forward Rendering.

RenderingData содержит данные для настройки проходов отрисовки — данные об отбраковке, камерах, освещении и прочем.

Теперь приступим к созданию проходов отрисовки, а к текущему классу будем возвращаться после реализации каждого из них.

Render Objects Pass

-------------------

Задача этого прохода — отрисовывать объекты из определенного слоя с заменой материала в глобальное свойство-текстуру шейдера. Это будет упрощенная версия имеющегося в Universal RP прохода RenderObjectsPass, с единственным отличием в цели ( RenderTarget ), куда будет производится отрисовка.

Создадим класс MyRenderObjectsPass, наследуемый от ScriptableRenderPass. Реализуем метод Execute(), который будет содержать всю логику работы прохода, а так же переопределим метод Configure().

```

using UnityEngine.Rendering;

using UnityEngine.Rendering.Universal;

public class MyRenderObjectsPass : ScriptableRenderPass

{

{

public override void Configure(CommandBuffer cmd, RenderTextureDescriptor cameraTextureDescriptor)

{ }

public override void Execute(ScriptableRenderContext context, ref RenderingData renderingData)

{ }

}

}

```

Метод Configure() используется для указания цели рендеринга и создания временных текстур. По умолчанию целью является цель текущей камеры и после выполнения прохода она вновь будет указана по умолчанию. Вызов этого метода осуществляется перед выполнение основой логики прохода.

### Замена цели рендеринга

Объявим RenderTargetHandle для новой цели рендеринга. Используя его, создадим временную текстуру и укажем её как цель. RenderTargetHandle содержит в себе идентификатор используемой временной RenderTexture. А также позволяет получить RenderTargetIdentifier, служащий для идентификации цели рендеринга, которая может быть задана, например как объект RenderTexture, Texture, временная RenderTexture или встроенная (используется камерой при отрисовке кадра).

Объект RenderTargetHandle будет создаваться в OutlineFeature и передаваться нашему проходу при его создании.

```

private RenderTargetHandle _destination;

public MyRenderObjectsPass(RenderTargetHandle destination)

{

_destination = destination;

}

public override void Configure(CommandBuffer cmd, RenderTextureDescriptor cameraTextureDescriptor)

{

cmd.GetTemporaryRT(_destination.id, cameraTextureDescriptor);

}

```

Метод GetTemporaryRT() создаёт временную RenderTexture с заданными параметрами и устанавливает её как глобальное свойство шейдера с указанным именем (имя будет задаваться в фиче).

**Удаление RenderTexture**

ReleaseTemporaryRT() удаляет указанную временную RenderTexture. Это можно сделать в конце метода Execute() или в переопределенном методе FrameCleanup.

После завершения рендеринга, все временные RenderTexture, которые не были освобождены явно, будут удалены.

Для создания временной RenderTexture используем дескриптор текущей камеры, содержащий информацию о размере, формате и прочих параметрах цели камеры.

```

public override void Configure(CommandBuffer cmd, RenderTextureDescriptor cameraTextureDescriptor)

{

cmd.GetTemporaryRT(_destination.id, cameraTextureDescriptor);

ConfigureTarget(_destination.Identifier());

ConfigureClear(ClearFlag.All, Color.clear);

}

```

Указание цели и её очистка должны происходить только в Configure() с использованием методов ConfigureTarget() и ClearTarget().

### Рендер

Подробно рассматривать отрисовку не будем, т.к. это может увести нас далеко и надолго от основной темы. Для отрисовки воспользуемся методом ScriptableRenderContext.DrawRenderers(). Создадим настройки для отрисовки только непрозрачных объектов только из указанных слоёв. Маску слоя будем передавать в конструктор.

```

...

private List \_shaderTagIdList = new List() { new ShaderTagId("UniversalForward") };

private FilteringSettings \_filteringSettings;

private RenderStateBlock \_renderStateBlock;

...

public MyRenderObjectsPass(RenderTargetHandle destination, int layerMask)

{

\_destination = destination;

\_filteringSettings = new FilteringSettings(RenderQueueRange.opaque, layerMask);

\_renderStateBlock = new RenderStateBlock(RenderStateMask.Nothing);

}

public override void Execute(ScriptableRenderContext context, ref RenderingData renderingData)

{

SortingCriteria sortingCriteria = renderingData.cameraData.defaultOpaqueSortFlags;

DrawingSettings drawingSettings = CreateDrawingSettings(\_shaderTagIdList, ref renderingData, sortingCriteria);

context.DrawRenderers(renderingData.cullResults, ref drawingSettings, ref \_filteringSettings, ref \_renderStateBlock);

}

```

**Очень кратко о параметрах**

CullingResults — результаты отбраковки (берём из RenderingData)

FilteringSettings — данные о слоях и типе объектов.

DrawingSettings — настройки отрисовки.

RenderStateBlock — набор значений, используемых для переопределения состояния визуализации (глубины, режимов смешивания и т.п.)

**О готовом RenderObjectsPass в UniversalRP**

Данный метод не универсален, т.к содержит много захардкоженных данных. RenderObjectsPass, реализованный в Universal RP, позволяет более гибко настраивать рендер объектов. Но для примера реализации своей составной RenderFeature практичней использовать что-то более простое :)

### Замена материала

Переопределим используемые материалы при отрисовке, так как нам нужны только контуры объектов.

```

private Material _overrideMaterial;

public MyRenderObjectsPass(RenderTargetHandle destination, int layerMask,, Material overrideMaterial)

{

...

_overrideMaterial = overrideMaterial;

...

}

public override void Execute(ScriptableRenderContext context, ref RenderingData renderingData)

{

...

DrawingSettings drawingSettings = CreateDrawingSettings(_shaderTagIdList, ref renderingData, sortingCriteria);

drawingSettings.overrideMaterial = _overrideMaterial;

...

}

```

### Шейдер для отрисовки

Создадим в ShaderGraph шейдер материала, который будет использоваться при отрисовке объектов в текущем проходе.

### Добавляем проход в OutlineFeature

Вернемся в OutlieFeature. Для начала создадим класс для настроек нашего прохода.

```

public class OutlineFeature : ScriptableRendererFeature

{

[Serializable]

public class RenderSettings

{

public Material OverrideMaterial = null;

public LayerMask LayerMask = 0;

}

...

}

```

Объявим поля для настроек MyRenderPass и имени глобального свойства-текстуры, используемой в качестве цели рендеринга нашим проходом.

```

[SerializeField] private string _renderTextureName;

[SerializeField] private RenderSettings _renderSettings;

```

Создадим идентификатор для свойства-текстуры и экземпляр MyRenderPass.

```

private RenderTargetHandle _renderTexture;

private MyRenderObjectsPass _renderPass;

public override void Create()

{

_renderTexture.Init(_renderTextureName);

_renderPass = new MyRenderObjectsPass(_renderTexture, _renderSettings.LayerMask, _renderSettings.OverrideMaterial);

}

```

В методе AddRendererPass добавляем наш проход в очередь на исполнение.

```

public override void AddRenderPasses(ScriptableRenderer renderer, ref RenderingData renderingData)

{

renderer.EnqueuePass(_renderPass);

}

```

**Забегая вперёд**

Следует также указать когда должен выполняться проход. Но это об этом позже, после реализации всех проходов.

Результат прохода для исходной сцены должен получиться следующий:

**Отладка**

Для отладки удобно использовать Frame Debug для просмотра результатов каждого прохода (Windows-Analysis-FrameDebugger).

Blur Pass

---------

Цель этого прохода — размыть изображение, полученное на предыдущем шаге и установить его в глобальное свойство шейдера.

Для этого несколько раз будем копировать исходную текстуру во временные, с применением к ней шейдера размытия. При этом исходное изображение можно уменьшить в размерах (создать уменьшенную копию), что ускорит расчеты и не повлияет на качестве результата.

Создадим класс BlurPass, наследуемый от ScriptableRenderPass.

```

using UnityEngine.Rendering;

using UnityEngine.Rendering.Universal;

public class BlurPass : ScriptableRenderPass

{

public override void Execute(ScriptableRenderContext context, ref RenderingData renderingData)

{ }

}

```

Заведём переменные под исходную, целевую и временные текстуры (и их ID).

```

private int _tmpBlurRTId1 = Shader.PropertyToID("_TempBlurTexture1");

private int _tmpBlurRTId2 = Shader.PropertyToID("_TempBlurTexture2");

private RenderTargetIdentifier _tmpBlurRT1;

private RenderTargetIdentifier _tmpBlurRT2;

private RenderTargetIdentifier _source;

private RenderTargetHandle _destination;

```

Все ID для RenderTexture задаются через Shader.PropertyID(). Это не означает что где-то обязательно должны существовать такие свойства шейдера.

Добавим поля и под остальные параметры, которые сразу же инициализируем в конструкторе.

```

private int _passesCount;

private int _downSample;

private Material _blurMaterial;

public BlurPass(Material blurMaterial, int downSample, int passesCount)

{

_blurMaterial = blurMaterial;

_downSample = downSample;

_passesCount = passesCount;

}

```

\_blurMaterial — материал с шейдером размытия.

\_downSample — коэффициент для уменьшения размера текстуры

\_passesCount — количество проходов размытия, которое будет применено.

Для создания временных текстур создадим дескриптор со всей необходимой информацией о ней — размере, формате и прочем. Высоту и размер будем масштабировать относительно дескриптора камеры.

```

public override void Configure(CommandBuffer cmd, RenderTextureDescriptor cameraTextureDescriptor)

{

var width = Mathf.Max(1, cameraTextureDescriptor.width >> _downSample);

var height = Mathf.Max(1, cameraTextureDescriptor.height >> _downSample);

var blurTextureDesc = new RenderTextureDescriptor(width, height, RenderTextureFormat.ARGB32, 0, 0);

```

Также создадим идентификаторы и сами временные RenderTexture.

```

_tmpBlurRT1 = new RenderTargetIdentifier(_tmpBlurRTId1);

_tmpBlurRT2 = new RenderTargetIdentifier(_tmpBlurRTId2);

cmd.GetTemporaryRT(_tmpBlurRTId1, blurTextureDesc, FilterMode.Bilinear);

cmd.GetTemporaryRT(_tmpBlurRTId2, blurTextureDesc, FilterMode.Bilinear);

```

Мы снова меняем цель рендеринга, поэтому создадим ещё одну временную текстуру и укажем её как цель.

```

cmd.GetTemporaryRT(_destination.id, blurTextureDesc, FilterMode.Bilinear);

ConfigureTarget(_destination.Identifier());

}

```

### Размытие

Некоторые задачи рендеринга могут быть выполнены с помощью специальных методов ScriptableRenderContext, которые настраивают и добавляют в него команды. Для выполнения других команд потребуется использовать CommandBuffer, который можно получить из пула.

После добавления команд и отправки их на выполнение контексту, буфер нужно будет вернуть обратно в пул.

```

public override void Execute(ScriptableRenderContext context, ref RenderingData renderingData)

{

var cmd = CommandBufferPool.Get("BlurPass");

...

context.ExecuteCommandBuffer(cmd);

CommandBufferPool.Release(cmd);

}

```

Конечная реализация метода Execute() будет следующей.

```

public override void Execute(ScriptableRenderContext context, ref RenderingData renderingData)

{

var cmd = CommandBufferPool.Get("BlurPass");

if (_passesCount > 0)

{

cmd.Blit(_source, _tmpBlurRT1, _blurMaterial, 0);

for (int i = 0; i < _passesCount - 1; i++)

{

cmd.Blit(_tmpBlurRT1, _tmpBlurRT2, _blurMaterial, 0);

var t = _tmpBlurRT1;

_tmpBlurRT1 = _tmpBlurRT2;

_tmpBlurRT2 = t;

}

cmd.Blit(_tmpBlurRT1, _destination.Identifier());

}

else

cmd.Blit(_source, _destination.Identifier());

context.ExecuteCommandBuffer(cmd);

CommandBufferPool.Release(cmd);

}

```

**Blit**

Команда Blit() копирует исходную текстуру в указанную с применением к ней шейдера.

### Шейдер

Для размытия создадим простой шейдер, который будет вычислять цвет пикселя с учётом его ближайших соседей ( среднее значение цвета пяти пикселей ).

**Шейдер размытия**

`Shader "Custom/Blur"

{

Properties

{

_MainTex ("Texture", 2D) = "white" {}

}

SubShader

{

HLSLINCLUDE

#include "Packages/com.unity.render-pipelines.universal/ShaderLibrary/Core.hlsl"

struct Attributes

{

float4 positionOS : POSITION;

float2 uv : TEXCOORD0;

};

struct Varyings

{

float4 positionCS : SV_POSITION;

float2 uv : TEXCOORD0;

};

TEXTURE2D_X(_MainTex);

SAMPLER(sampler_MainTex);

float4 _MainTex_TexelSize;

Varyings Vert(Attributes input)

{

Varyings output;

output.positionCS = TransformObjectToHClip(input.positionOS.xyz);

output.uv = input.uv;

return output;

}

half4 Frag(Varyings input) : SV_Target

{

float2 offset = _MainTex_TexelSize.xy;

float2 uv = UnityStereoTransformScreenSpaceTex(input.uv);

half4 color = SAMPLE_TEXTURE2D_X(_MainTex, sampler_MainTex, input.uv);

color += SAMPLE_TEXTURE2D_X(_MainTex, sampler_MainTex, input.uv + float2(-1, 1) * offset);

color += SAMPLE_TEXTURE2D_X(_MainTex, sampler_MainTex, input.uv + float2( 1, 1) * offset);

color += SAMPLE_TEXTURE2D_X(_MainTex, sampler_MainTex, input.uv + float2( 1,-1) * offset);

color += SAMPLE_TEXTURE2D_X(_MainTex, sampler_MainTex, input.uv + float2(-1,-1) * offset);

return color/5.0;

}

ENDHLSL

Pass

{

HLSLPROGRAM

#pragma vertex Vert

#pragma fragment Frag

ENDHLSL

}

}

}`

**Почему не ShaderGraph?**

Я считаю ShaderGraph однозначно хорошим инструментом, но не когда пытаешься создать граф на 13 дюймовом экране ноутбука используя тачпад :)

### Добавляем проход в OutlineFeature

Порядок действия будет аналогичен добавлению нашего первого прохода. Сначала создадим настройки.

```

[Serializable]

public class BlurSettings

{

public Material BlurMaterial;

public int DownSample = 1;

public int PassesCount = 1;

}

```

Затем поля.

```

[SerializeField] private string _bluredTextureName;

[SerializeField] private BlurSettings _blurSettings;

private RenderTargetHandle _bluredTexture;

private BlurPass _blurPass;

...

public override void Create()

{

_bluredTexture.Init(_bluredTextureName);

_blurPass = new BlurPass(_blurSettings.BlurMaterial, _blurSettings.DownSample, _blurSettings.PassesCount);

}

```

И добавим в очередь на выполнение.

```

public override void AddRenderPasses(ScriptableRenderer renderer, ref RenderingData renderingData)

{

renderer.EnqueuePass(_renderPass);

renderer.EnqueuePass(_blurPass);

}

```

Результат прохода:

Outline Pass

------------

Конечное изображение с обводкой объектов будет получено с помощью шейдера. И результат его работы будет отображаться поверх текущего изображения на экране.

Ниже представлен сразу весь код прохода, т.к. вся логика заключена в двух строках.

```

public class OutlinePass : ScriptableRenderPass

{

private string _profilerTag = "Outline";

private Material _material;

public OutlinePass(Material material)

{

_material = material;

}

public override void Execute(ScriptableRenderContext context, ref RenderingData renderingData)

{

var cmd = CommandBufferPool.Get(_profilerTag);

using (new ProfilingSample(cmd, _profilerTag))

{

var mesh = RenderingUtils.fullscreenMesh;

cmd.DrawMesh(mesh, Matrix4x4.identity, _material, 0, 0);

}

context.ExecuteCommandBuffer(cmd);

CommandBufferPool.Release(cmd);

}

}

```

RenderingUtils.fullscreenMesh возвращает меш размером 1 на 1.

### Шейдер

Создадим шейдер для получения контура. Он должен содержать два глобальных свойства-текстуры. \_OutlineRenderTexture и \_OutlineBluredTexture для изображения указанных объектов и его размытого варианта.

**код шейдера**

```

Shader "Custom/Outline"

{

Properties

{

_Color ("Glow Color", Color ) = ( 1, 1, 1, 1)

_Intensity ("Intensity", Float) = 2

[Enum(UnityEngine.Rendering.BlendMode)] _SrcBlend ("Src Blend", Float) = 1

[Enum(UnityEngine.Rendering.BlendMode)] _DstBlend ("Dst Blend", Float) = 0

}

SubShader

{

HLSLINCLUDE

#include "Packages/com.unity.render-pipelines.universal/ShaderLibrary/Core.hlsl"

struct Attributes

{

float4 positionOS : POSITION;

float2 uv : TEXCOORD0;

};

struct Varyings

{

half4 positionCS : SV_POSITION;

half2 uv : TEXCOORD0;

};

TEXTURE2D_X(_OutlineRenderTexture);

SAMPLER(sampler_OutlineRenderTexture);

TEXTURE2D_X(_OutlineBluredTexture);

SAMPLER(sampler_OutlineBluredTexture);

half4 _Color;

half _Intensity;

Varyings Vertex(Attributes input)

{

Varyings output;

output.positionCS = float4(input.positionOS.xy, 0.0, 1.0);

output.uv = input.uv;

if (_ProjectionParams.x < 0.0)

output.uv.y = 1.0 - output.uv.y;

return output;

}

half4 Fragment(Varyings input) : SV_Target

{

float2 uv = UnityStereoTransformScreenSpaceTex(input.uv);

half4 prepassColor = SAMPLE_TEXTURE2D_X(_OutlineRenderTexture, sampler_OutlineRenderTexture, uv);

half4 bluredColor = SAMPLE_TEXTURE2D_X(_OutlineBluredTexture, sampler_OutlineBluredTexture,uv);

half4 difColor = max( 0, bluredColor - prepassColor);

half4 color = difColor* _Color * _Intensity;

color.a = 1;

return color;

}

ENDHLSL

Pass

{

Blend [_SrcBlend] [_DstBlend]

ZTest Always // всегда рисуем, независимо от текущей глубины в буфере

ZWrite Off // и ничего в него не пишем

Cull Off // рисуем все стороны меша

HLSLPROGRAM

#pragma vertex Vertex

#pragma fragment Fragment

ENDHLSL

}

}

}

```

Так как меш будет отображаться на весь экран, нам не нужно преобразовывать позиции вершин. В некоторых случаях Unity выполняет вертикальный переворот экрана. Чтобы определить это, шейдер проверяет значение \_ProjectionParams.х.

Результат работы шейдера для для двух полученных ранее изображений:

### Добавляем проход в OutlineFeature

Все действия аналогичны предыдущим проходам.

```

[SerializeField] private Material _outlineMaterial;

private OutlinePass _outlinePass;

public override void Create()

{

...

_outlinePass = new OutlinePass(_outlineMaterial);

....

}

public override void AddRenderPasses(ScriptableRenderer renderer, ref RenderingData renderingData)

{

renderer.EnqueuePass(_renderPass);

renderer.EnqueuePass(_blurPass);

renderer.EnqueuePass(_outlinePass);

}

```

RenderPassEvent

---------------

Осталось указать когда будут вызываться созданные проходы. Для этого каждому из них нужно указать параметр renderPassEvent.

**Список событий**

Места в Universal RP, куда могут быть добавлены проходы.

BeforeRendering

BeforeRenderingShadows

AfterRenderingShadows

BeforeRenderingPrepasses

AfterRenderingPrePasses

BeforeRenderingOpaques

AfterRenderingOpaques

BeforeRenderingSkybox

AfterRenderingSkybox

BeforeRenderingTransparents

AfterRenderingTransparents

BeforeRenderingPostProcessing

AfterRenderingPostProcessing

AfterRendering

Создадим соответствующее поле в OutlineFeature.

```

[SerializeField] private RenderPassEvent _renderPassEvent;

```

И укажем его всем созданным проходам.

```

public override void Create()

{

...

_renderPass.renderPassEvent = _renderPassEvent;

_blurPass.renderPassEvent = _renderPassEvent;

_outlinePass.renderPassEvent = _renderPassEvent;

}

```

Настройка

---------

Добавим слой Outline и установим его для объектов, которые хотим обвести.

Создадим и настроим все необходимые ассеты: UniversalRendererPipelineAsset и ForwardRendererData.

Результат

---------

Результат для нашего исходного кадра будет следующим!

Доработка

---------

Сейчас обводка объекта будет видна всегда, даже через другие объекты. Чтобы наш эффект учитывал глубину сцены нужно внести несколько изменений.

### RenderObjectsPass

Указывая цель нашего рендера, мы должны также указать текущий буфер глубины. Создадим соответствующее поле и метод.

```

public class MyRenderObjectsPass : ScriptableRenderPass

{

...

private RenderTargetIdentifier _depth;

public void SetDepthTexture(RenderTargetIdentifier depth)

{ _depth = depth; }

...

}

```

В методе Configure() укажем глубину в настройке цели рендера.

```

public override void Configure(CommandBuffer cmd, RenderTextureDescriptor cameraTextureDescriptor)

{

cmd.GetTemporaryRT(_destination.id, cameraTextureDescriptor);

ConfigureTarget(_destination.Identifier(), _depth);

ConfigureClear(ClearFlag.Color, Color.clear);

}

```

### OutlineFeature

В OutlineFeature передадим MyRenderObjectsPass текущую глубину сцены.

```

public class OutlineFeature : ScriptableRendererFeature

{

...

public override void AddRenderPasses(ScriptableRenderer renderer, ref RenderingData renderingData)

{

var depthTexture = renderer.cameraDepth;

_renderPass.SetDepthTexture(depthTexture);

renderer.EnqueuePass(_renderPass);

renderer.EnqueuePass(_blurPass);

renderer.EnqueuePass(_outlinePass);

}

...

}

```

### UniversalRenderPipelineAsset

В используемом UniversalRenderPipelineAsset поставим галочку напротив пункта DepthTexture.

### Результат

Результат без учета глубины:

Результат с учетом глубины:

Итог

----

ScriptableRendererFeature достаточно удобный инструмент для добавления своих проходов в RP.

В нем можно легко заменять RenderObjectsPass’ы и использовать их в других ScriptableRendererFeature. Не нужно сильно углубляться в реализацию Universal RP и менять его код, чтобы что-то добавить.

P.S.

----

Для того чтобы общий алгоритм работы со ScriptableRendererFeature и ScriptableRenderPass был более понятен, и чтобы статья не сильно разрослась, я намеренно старался создавать код проходов простым, пусть даже в ущерб их универсальности и оптимальности.

Ссылки

------

Исходный код — [ссылка на gitlab](https://gitlab.com/Dimonik333/outline-feature)

Модели и сцена взяты из игры Lander Missions: planet depths

За основу примера была взята следующая реализация обводки — [ссылка на youtube](https://www.youtube.com/watch?v=SMLbbi8oaO8)

Примеры реализации собственных RenderFeature от Unity — [ссылка на github](https://github.com/Unity-Technologies/UniversalRenderingExamples).

Серия уроков по созданию собственного ScriptableRenderPipeline. После прочтения становится ясна общая логика работы RP и шейдеров — [ссылка на туториалы](https://catlikecoding.com/unity/tutorials/custom-srp). | https://habr.com/ru/post/491624/ | null | ru | null |

# Ajax загрузка данных из контейнера

Знаете ли вы, что с помощью jQuery можно загружать не только контент страницы, но и выбранного контейнера на ней? Оказывается можно и делается это следующим образом:

```

$("#area").load("something.html #content");

```

Данный код найдет на странице *something.html* контейнер с id *content*, возьмет его содержимое и загрузит в контейнер с id *area*. Но есть одно но…

И выглядит это но вот таким образом:

```

$("#area").load("something.html #area");

```

Результатом работы такого кода будет такой результат:

```

```

И чем дальше, тем все более вложенным будет этот код.

Решение такое:

```

$("#area").load("something.html #area > *");

```

Демо можно найти [здесь](http://css-tricks.com/examples/AJAXReplaceSamePart/). | https://habr.com/ru/post/112779/ | null | ru | null |

# Реализация кеша с ограничением по числу элементов на Python — решения: простое и посложнее

#### Формулировка задачи

Предположим, что у нас есть необходимость иметь некий сервис, который бы отдавал нам по запросу какую-либо информацию, и отдавал как можно быстрее. Что для этого делает любой нормальный человек? Налаживает кэширование наиболее часто запрашиваемых данных. При этом, если хоть немного задуматься о перспективе, то размеры кэша необходимо ограничивать.

Для простоты реализации в случае Питона сделаем ограничение по числу элементов в кэше (*здесь предполагается, что данные более-менее однородны по размеру, а также учитывается специфика, что определить объём памяти, реально занимаемый каким-либо Питоновским объектом — **весьма** нетривиальная задача, кому интересно, пусть пожалует [сюда](http://packages.python.org/Pympler/asizeof.html)*), а для того, чтобы кэш содержал как можно более часто используемую информацию — построим его по принципу [least recently used](http://en.wikipedia.org/wiki/Cache_algorithms#Least_Recently_Used), т.е. чем более давно запрашивали кусочек информации, тем больше у него шансов «вылететь» из кэша.

О двух решениях (попроще и посложнее) я и расскажу в этой статье.

#### Философское отступление

Я обратил внимание, что зачастую написанный на Питоне код не блещет оптимизациями по потреблению памяти или по скорости (*здесь можно вскользь заметить, что это не только вина программистов-пользователей языка, хорошего инструментария просто нет, или по крайней мере я о таком не знаю (да, я в курсе про cProfile, но он помогает далеко не всегда, например, в нём нет attach-detach; искать же утечки памяти — вообще занятие не для слабонервных, вот если pympler допилят...), если кто подскажет — буду благодарен*). В основном это даже правильно, так как обычно Питон применяют в случае, когда время исполнения программы или потребление памяти не критично, зато критично время написания кода и простота его дальнейшей поддержки, поэтому очевидное, пусть и менее экономичное решение будет удобнее.

Хотя вышесказанное совсем не означает, что любой код на Питоне нужно писать «абы как». Кроме того, иногда производительность и потребление памяти могут стать критичными, даже если код крутится на серверной машине с хорошим процессором и тоннами памяти.

Как раз такой случай (нехватка CPU time) и подвиг меня на исследование этого вопроса и замену одного кэширующего класса другим.

#### Простое решение

Часто говорят — «простое решение — самое верное», хотя в случае с программированием это далеко не всегда так, не правда ли? Однако, если есть задача обеспечения кэша, но нет особых требований к скорости (например, то, что использует этот кэш, само по себе очень медленное, и нет смысла вкладываться в сложную реализацию), то можно обойтись и тривиальными решениями.

##### Реализация

Итак, относительно простое решение:

```

import weakref

class SimpleCache:

def __init__(self, cacheSize):

self.cache = weakref.WeakValueDictionary()

self.cache_LRU = []

self.cacheSize = cacheSize

def __getitem__(self, key):

# no exception catching - let calling code handle them if any

value = self.cache[key]

return self.touchCache(key, value)

def __setitem__(self, key, value):

self.touchCache(key, value)

def touchCache(self, key, value):

self.cache[key] = value

if value in self.cache_LRU:

self.cache_LRU.remove(value)

self.cache_LRU = self.cache_LRU[-(self.cacheSize-1):] + [ value ]

return value

```

##### Использование

Работать с таким кэшем после создания можно, как с обычным dict-ом, но при чтении/записи элемента он будет помещён в конец очереди, а за счёт комбинации WeakValueDictionary() и списка, который хранит не более cacheSize элементов, мы получаем ограничение по количеству сохранённых данных.

Таким образом, после исполнения куска кода

```

cache = SimpleCache(2)

cache[1] = 'a'

cache[2] = 'b'

cache[3] = 'c'

```

в кэше останутся только записи 'b' и 'c' ('a', как самая старая, будет вытеснена).

##### Преимущества и недостатки

Преимущество — относительная простота (около 20 строк кода, после прочтения документации по WeakValueDictionary принцип работы становится понятен).