text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

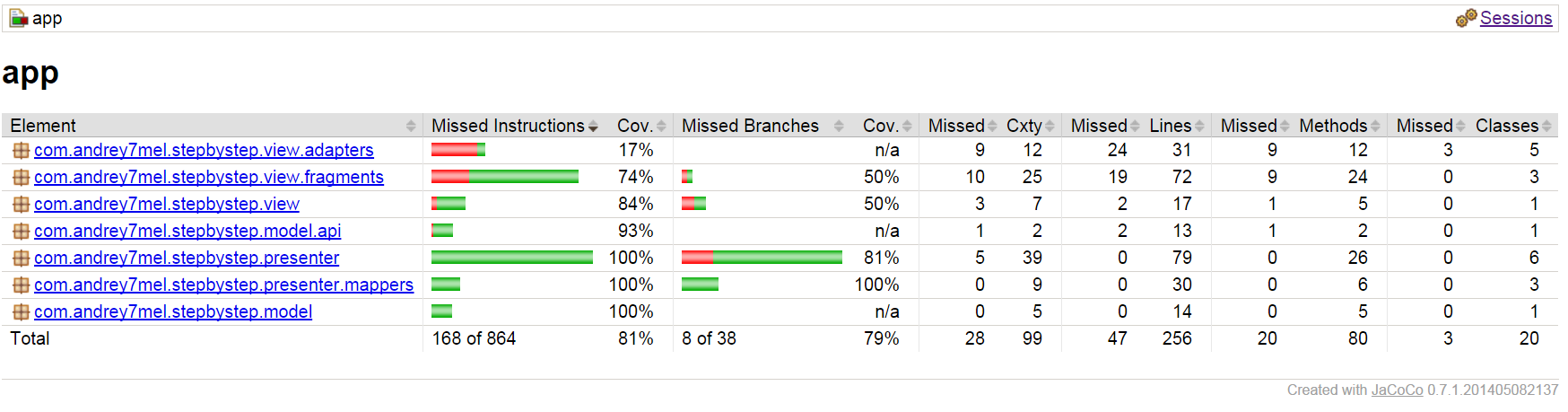

# Unittest и абстрактные тесты

### Вместо вступления

Unittest — наверное самый известный фреймворк для написания тестов в Python. Он очень прост в освоении и его легко начать использовать в вашем проекте. Но ничто не бывает идеальным. В этом посте я хочу рассказать об одной возможности, которой лично мне (думаю, не одному) не хватает в unittest.

### Немного о Unit тестах

Прежде чем обсуждать(и осуждать) тестовый фреймворк, считаю нужным немного поговорить о тестировании в целом. Когда я впервые услышал словосочетание «модульное тестирование», то подумал, что это обязанности какой-то службы по контролю качества, которая проверяет программные модули на соответствие требованиям. Каково же было моё удивление, когда я узнал, что эти самые тесты должны писать программисты. Первое время я не писал тесты… вообще. Ничто не заменит тех ощущений, когда просыпаешься утром и читаешь от пользователя «Программа не работает. С этим срочно надо что-то делать». Сперва мне казалось, что это совершенно обычный процесс, пока не написал первый модульный тест, который нашёл ошибку. Модульные тесты вообще кажутся бесполезными ровно до тех пор, пока не обнаруживают проблемы. Теперь я просто не могу закоммитить новую функцию, не написав на неё тест.

Но тесты служат не только для проверки правильности написания кода. Вот список функций, которые, на мой взгляд, выполняют тесты:

* Обнаружение ошибок в программном коде

* Придание программистам уверенности в том, что их код работает

* Следствие из предыдущего пункта: возможность без опаски вносить изменения в программу

* Тесты — своего рода документация, которая наиболее верно описывает поведение системы

В некотором смысле, тесты повторяют структуру программы. Применимы ли принципы построения программ к тестам? Я считаю, что да — это такая же программа, пусть и проверяющая другую.

### Описание проблемы

В какой-то момент мне пришла идея написать абстрактный тест. Что я подразумеваю под этим? Это такой тест, который сам не выполняется, но объявляет методы, зависящие от параметров, определяемых в наследниках. И тут я обнаружил то, что не могу этого сделать по-человечески в unittest. Вот пример:

```

class SerializerChecker(TestCase):

model = None

serializer = None

def test_fields_creation(self):

props = TestObjectFactory.get_properties_for_model(self.model)

obj = TestObjectFactory.create_test_object_for_model(self.model)

serialized = self.serializer(obj)

self.check_dict(serialized.data, props)

```

Думаю, даже не зная реализацию TestObjectFactory и метода check\_dict понятно, что props — это словарь свойств для объекта, obj — объект, для которого мы проверяем сериализатор. check\_dict проверяет рекурсивно словари на совпадение. Думаю, многие, кто знаком c unittest сразу скажут, что этот тест не соответствует моему определению абстрактного. Почему? Потому что метод test\_fields\_creation выполнится из этого класса, чего нам абсолютно не надо. После некоторого поиска информации, я пришёл к выводу, что самый адекватный вариант — не наследовать SerializerChecker от TestCase, а наследников реализовывать как-то так:

```

class VehicleSerializerTest(SerializerChecker, RecursiveTestCase):

model = Vehicle

serializer = VehicleSerialize

```

RecursiveTestCase — потомок TestCase, который реализует метод check\_dict.

Это решение некрасиво сразу с нескольких позиций:

* В классе SerializerChecker мы должны знать, что потомок должен наследоваться от TestCase. Эта зависимость может создать проблемы для тех, кто незнаком с этим кодом

* Среда разработки упорно считает, что я неправ, так как у SerializerChecker нет метода check\_dict

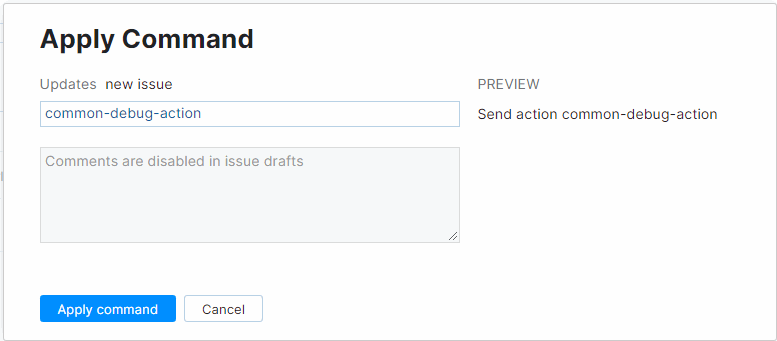

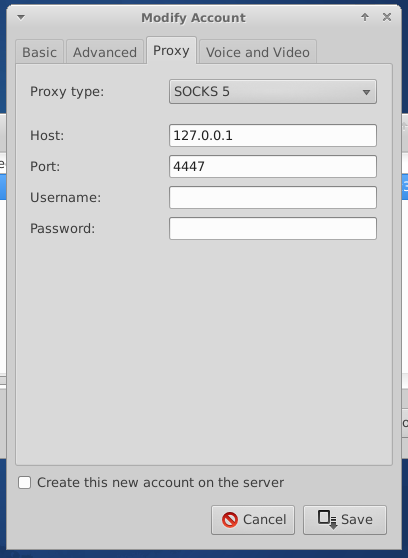

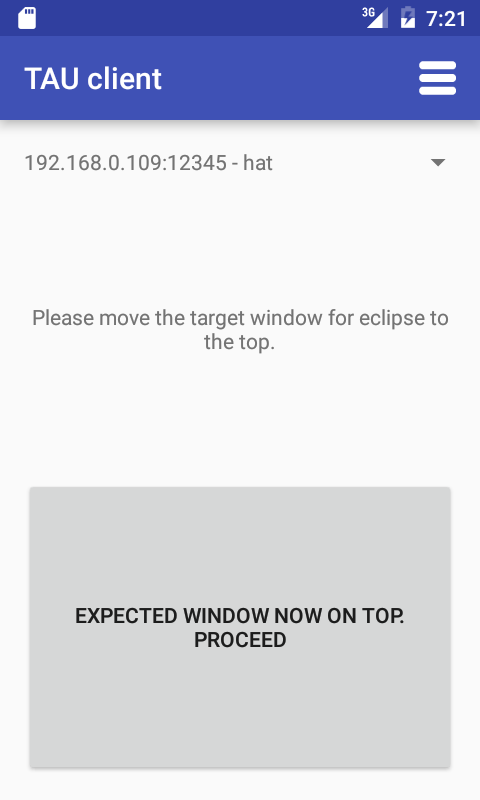

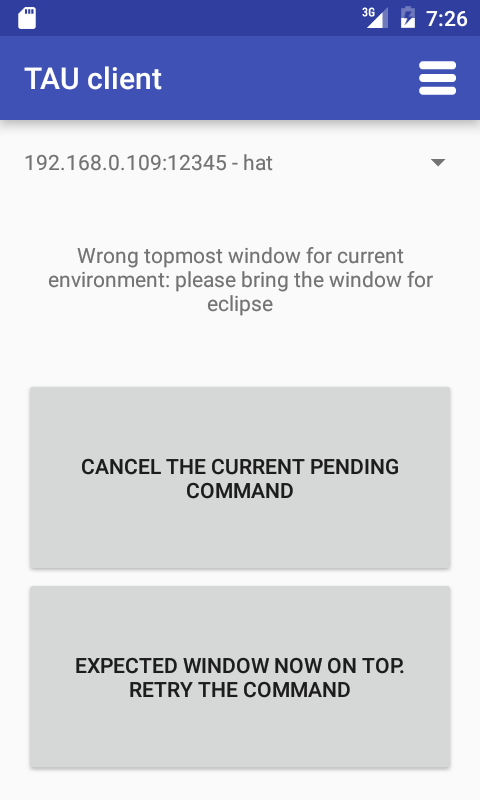

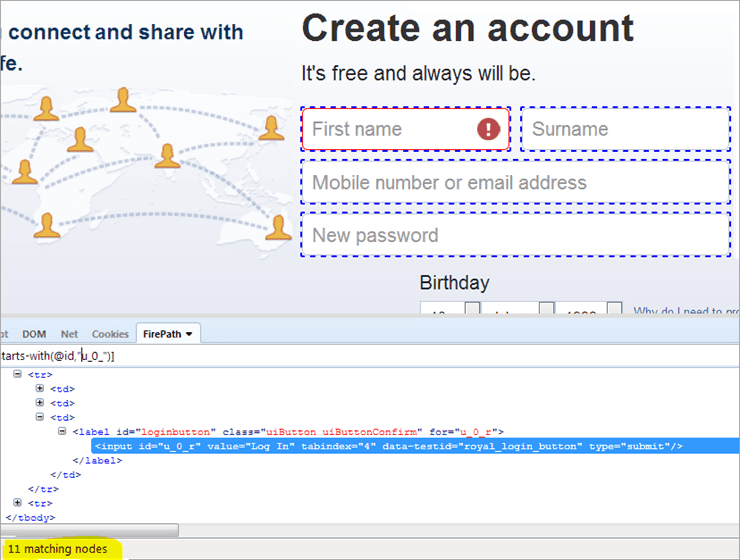

*Ошибка, которую выдаёт среда разработки*

Может показаться, что можно просто добавить заглушку для check\_dict и все проблемы решены:

```

class SerializerChecker:

model = None

serializer = None

def check_dict(self, data, props):

raise NotImplementedError

def test_fields_creation(self):

props = TestObjectFactory.get_properties_for_model(self.model)

obj = TestObjectFactory.create_test_object_for_model(self.model)

serialized = self.serializer(obj)

self.check_dict(serialized.data, props)

```

Но это не является полноценным решением проблемы:

* Мы, по сути, создали интерфейс, который реализует не потомок данного класса, а RecursiveTestCase, что создаёт оправданные вопросы к архитектуре.

* В TestCase много методов assert\*. Неужели нам надо писать заглушку для каждого используемого? Всё ещё кажется хорошим решением?

### Подводя итог

Unittest не предоставляет вменяемой возможности «отключить» класс, отнаследованный от TestCase. Я был бы очень рад, если бы такую функцию добавили в фреймворк. А как вы решаете данную проблему? | https://habr.com/ru/post/447438/ | null | ru | null |

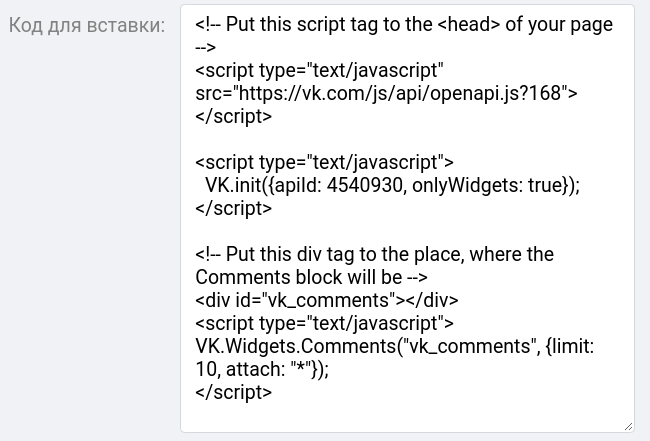

# Проблема с чтением файлов более 1Мб в Android

Добрый день.

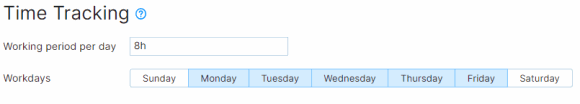

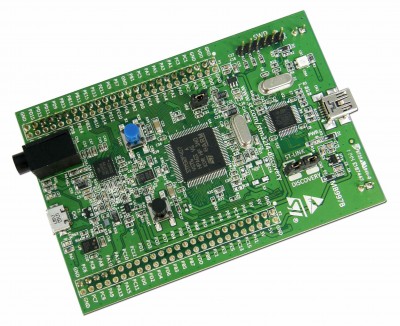

При написании одного приложения для Android столкнулся с проблемой загрузки файлов из директории **assets** размер которых превышает 1Мб.

Допустим, в папке проекта, в **assets** лежит файл **file.dat**, который надо загружать в память и читать данные из него.

Открываем файл, и читаем в buffer 8 первых байт

`AssetManager am = context.getAssets();

InputStream is = am.open("file.dat", AssetManager.ACCESS_BUFFER);

// Read file

is.read(buffer, 0, 8);`

В результате выполнения кода на Android 2.2 и ниже, получаем сообщение в **LogCat**

06-14 17:10:48.554: DEBUG/asset(382): Data exceeds UNCOMPRESS\_DATA\_MAX (1048852 vs 1048576)

и **IOException**

06-14 17:10:48.654: WARN/System.err(698): java.io.IOException

Смотрим исходники андроида. В файле **frameworks/base/include/utils/Asset.h** находится та самая константа **UNCOMPRESS\_DATA\_MAX**

`enum {

/* data larger than this does not get uncompressed into a buffer */

#ifdef HAVE_ANDROID_OS

UNCOMPRESS_DATA_MAX = 1 * 1024 * 1024

#else

UNCOMPRESS_DATA_MAX = 2 * 1024 * 1024

#endif

};`

А в файле **frameworks/base/include/utils/Asset.cpp** происходит проверка на размер файла

`if (mUncompressedLen > UNCOMPRESS_DATA_MAX) {

LOGD("Data exceeds UNCOMPRESS_DATA_MAX (%ld vs %d)\n",

(long) mUncompressedLen, UNCOMPRESS_DATA_MAX);

goto bail;

}`

Как видно из комментария, данные, превышающие по размеру **UNCOMPRESS\_DATA\_MAX** в байтах, не распаковываются в буфер из **.apk** файла.

Решить проблему можно несколькими способами:

**1.** Самый простой — изменить расширение файла **file.dat**, на такое, что этот файл не будет сжиматься при упаковке в **.apk** файл. Список этих расширений определён в **Package.cpp**

`/* these formats are already compressed, or don't compress well */

static const char* kNoCompressExt[] = {

".jpg", ".jpeg", ".png", ".gif",

".wav", ".mp2", ".mp3", ".ogg", ".aac",

".mpg", ".mpeg", ".mid", ".midi", ".smf", ".jet",

".rtttl", ".imy", ".xmf", ".mp4", ".m4a",

".m4v", ".3gp", ".3gpp", ".3g2", ".3gpp2",

".amr", ".awb", ".wma", ".wmv"

};`

Либо, можно вручную скомпилировать проект с помощью **aapt** с опцией "-0", указав расширения файлов, которые не надо сжимать в **.apk**. Если использовать пустую строку, вместо расширения, ни один файл не будет сжат.

Этот способ плох тем, что размер загружаемого пользователем установочного файла из маркета значительно вырастает (на разницу между сжатым и несжатым **file.dat**), а объём файла довольно критичен для мобильных устройств. В моём случае, в **file.dat** хранится текстовая информация, используемая в приложении, в нераспакованном виде занимает немного более 1Мб, а в **.apk** файле сжимается до 40Кб.

Если ваши файлы из **assets** плохо сжимаются в zip (медиа), этот способ отлично подойдёт.

**2.** Второй способ заключается в разбиении **file.dat** на кусочки по 1Мб, например из консоли:

`split file.dat --bytes=1024K`

Получившиеся файлы нужно поместить в **assets**, при первом запуске приложения «склеить» по кусочкам и поместить в директорию с приложением. Данный способ хорошо описан на stackoverflow, его предложил человек под именем Seva Alekseyev, поэтому приведу только ссылку *stackoverflow.com/questions/2860157/load-files-bigger-than-1m-from-assets-folder/3093966#3093966*

В этом случае, ваше приложение будет хранить две копии данных, одни в **.apk** файле, другие, выгруженные в директорию с приложением. Также добавляется немного лишнего кода и необходимость следить за существованием и целостностью «распакованных» данных.

Описанной проблемы для Android 2.3.1 и выше нет.

Конечно, можно придумать ещё что-то, например, загрузка файлов по сети (т.н. кэш), что не всегда надёжно, если пользователь отключил интернет, или генерация файла с нуля, но мне двух вышеописанных методов хватило. | https://habr.com/ru/post/122361/ | null | ru | null |

# Вещи, о которых следует помнить, программируя на Python

Дзэн Питона

-----------

Изучение культуры, которая окружает язык, приближает вас на шаг к лучшим программистам. Если вы всё еще не прочли «Zen of Python», то откройте интерпретатор Python и введите **import this**. Для каждого элемента в списке вы найдете пример [здесь](http://artifex.org/~hblanks/talks/2011/pep20_by_example.html)

Однажды моё внимание привлекло:

**Красивое лучше уродливого**

UPDATE: На [Hacker News](http://news.ycombinator.com/item?id=3996708) было много обсуждений этой статьй. Несколько поправок от них.

Дайте мне функцию, которая принимает список чисел и возвращает только четные числа, деленые на два.

```

#-----------------------------------------------------------------------

halve_evens_only = lambda nums: map(lambda i: i/2, filter(lambda i: not i%2, nums))

#-----------------------------------------------------------------------

def halve_evens_only(nums):

return [i/2 for i in nums if not i % 2]

```

Помните очень простые вещи в Python

-----------------------------------

Обмен значений двух переменных:

```

a, b = b, a

```

Шаговый аргумент для срезов. Например:

```

a = [1,2,3,4,5]

>>> a[::2] # iterate over the whole list in 2-increments

[1,3,5]

```

Частный случай **x[::-1]** является средством выражения **x.reverse()**.

```

>>> a[::-1]

[5,4,3,2,1]

```

UPDATE: Имейте в виду **x.reverse()** переворачивает список, а срезы дают вам возможность делать это:

```

>>> x[::-1]

[5, 4, 3, 2, 1]

>>> x[::-2]

[5, 3, 1]

```

* Не используйте изменяемые типы переменных для значений по умолчанию

```

def function(x, l=[]): # Don't do this

def function(x, l=None): # Way better

if l is None:

l = []

```

UPDATE: Я понимаю что не объяснил почему. Я рекомендую прочитать статью [Fredrik Lundh](http://effbot.org/zone/default-values.htm). Вкратце этот дизайн иногда встречается. «Значения по умолчанию всегда вычисляются тогда, и только тогда, когда **def** заявлена на исполнение.»

* Используйте **iteritems** а не **items**

**iteritems** использует **generators** и следовательно это лучше при работе с очень большими списками.

```

d = {1: "1", 2: "2", 3: "3"}

for key, val in d.items() # builds complete list when called.

for key, val in d.iteritems() # calls values only when requested.

```

Это похоже на **range** и **xrange** когда **xrange** вызывает значения только когда попросят.

UPDATE: Заметьте что **iteritems**, **iterkeys**, **itervalues** удалены из Python 3.x. **dict.keys()**, **dict.items()** и **dict.values()** вернут **views** вместо списка. [docs.python.org/release/3.1.5/whatsnew/3.0.html#views-and-iterators-instead-of-lists](http://docs.python.org/release/3.1.5/whatsnew/3.0.html#views-and-iterators-instead-of-lists)

* Используйте **isinstance** а не **type**

Не делайте:

```

if type(s) == type(""): ...

if type(seq) == list or \

type(seq) == tuple: ...

```

лучше:

```

if isinstance(s, basestring): ...

if isinstance(seq, (list, tuple)): ...

```

Почему не стоит делать так: [stackoverflow.com/a/1549854/504262](http://stackoverflow.com/a/1549854/504262)

Заметьте что я использую **basestring** а не **str**, поскольку вы можете пытаться проверить соответствие **unicode** к **str**. Например:

```

>>> a=u'aaaa'

>>> print isinstance(a, basestring)

True

>>> print isinstance(a, str)

False

```

Это происходит потому что в Python версиях < 3.0 существует два строковых типа: **str** и **unicode**:

```

object

|

|

basestring

/ \

/ \

str unicode

```

* Изучите различные [коллекции](http://docs.python.org/library/collections.html)

Python имеет различные типы контейнеров данных являющихся лучшей альтернативой базовым **list** и **dict** в различных случаях.

~~В большинстве случаев используются эти:~~

UPDATE: Я знаю большинство не использовало этого. Невнимательность с моей стороны. Некоторые могут написать так:

```

freqs = {}

for c in "abracadabra":

try:

freqs[c] += 1

except:

freqs[c] = 1

```

Некоторые могут сказать, лучше было бы:

```

freqs = {}

for c in "abracadabra":

freqs[c] = freqs.get(c, 0) + 1

```

Скорее используйте коллекцию типа **defaultdict**:

```

from collections import defaultdict

freqs = defaultdict(int)

for c in "abracadabra":

freqs[c] += 1

```

**Другие коллекции**

```

namedtuple() # factory function for creating tuple subclasses with named fields

deque # list-like container with fast appends and pops on either end

Counter # dict subclass for counting hashable objects

OrderedDict # dict subclass that remembers the order entries were added

defaultdict # dict subclass that calls a factory function to supply missing values

```

UPDATE: Как отметили в нескольких комментария на Hacker News я мог бы использовать **Counter** вместо **defaultdict**.

```

>>> from collections import Counter

>>> c = Counter("abracadabra")

>>> c['a']

5

```

* Создавая классы в Python задействуйте [magic methods](http://www.rafekettler.com/magicmethods.html)

```

__eq__(self, other) # Defines behavior for the equality operator, ==.

__ne__(self, other) # Defines behavior for the inequality operator, !=.

__lt__(self, other) # Defines behavior for the less-than operator, <.

__gt__(self, other) # Defines behavior for the greater-than operator, >.

__le__(self, other) # Defines behavior for the less-than-or-equal-to operator, <=.

__ge__(self, other) # Defines behavior for the greater-than-or-equal-to operator, >=.

```

Существует ряд других магических методов.

* Условные назначения

```

x = 3 if (y == 1) else 2

```

Этот код делает именно то, как и звучит: «назначить **3** для **x** если **y=1**, иначе назначить **2** для **x**». Вы также можете применить это если у вас есть нечто более сложное:

```

x = 3 if (y == 1) else 2 if (y == -1) else 1

```

Хотя в какой то момент оно идет слишком далеко.

Обратите внимание что вы можете использовать выражение if...else в любом выражение. Например:

```

(func1 if y == 1 else func2)(arg1, arg2)

```

Здесь будет вызываться **func1** если **y=1**, и **func2** в противном случае. В обоих случаях соответствующая функция будет вызываться с аргументами **arg1** and **arg2**.

Аналогично, также справедливо следующее:

```

x = (class1 if y == 1 else class2)(arg1, arg2)

```

где class1 и class2 являются классами.

* Используйте **Ellipsis** когда это необходимо.

UPDATE: Один из комментаторов с Hacker News упоминал: «Использование многоточие для получения всех элементов, является нарушением принципа „Только Один Путь Достижения Цели“. Стандартное обозначение это **[:]**». Я с ним согласен. ЛУчший пример использования в NumPy на [stackoverflow](http://stackoverflow.com/a/118508/504262):

Многоточие используется что бы нарезать многомерные структуры данных.

В данной ситуации это означает, что нужно расширить многомерный срез во всех измерениях.

Пример:

```

>>> from numpy import arange

>>> a = arange(16).reshape(2,2,2,2)

```

Теперь у вас есть 4-х мерная матрица порядка 2x2x2x2. Для того что бы выбрать все первые элементы 4-го измерения, вы можете воспользоваться многоточием:

```

>>> a[..., 0].flatten()

array([ 0, 2, 4, 6, 8, 10, 12, 14])

```

что эквивалентно записи:

```

>>> a[:,:,:,0].flatten()

array([ 0, 2, 4, 6, 8, 10, 12, 14])

```

**Предыдущие предложения.**

При создание класса вы можете использовать **\_\_getitem\_\_** для того что бы ваш объект класса вел себя как словарь. Возьмите этот класс в качестве примера:

```

class MyClass(object):

def __init__(self, a, b, c, d):

self.a, self.b, self.c, self.d = a, b, c, d

def __getitem__(self, item):

return getattr(self, item)

x = MyClass(10, 12, 22, 14)

```

Из-за **\_\_getitem\_\_** вы сможете получить значение **a** объекта **x** как **x['a']**. Вероятно это известный факт.

Этот объект используется для расширения срезов Python [docs.python.org/library/stdtypes.html#bltin-ellipsis-object](http://docs.python.org/library/stdtypes.html#bltin-ellipsis-object) Таким образом если мы добавим:

```

def __getitem__(self, item):

if item is Ellipsis:

return [self.a, self.b, self.c, self.d]

else:

return getattr(self, item)

```

Мы сможем использовать **x[...]** что бы получить список всех элементов.

```

>>> x = MyClass(11, 34, 23, 12)

>>> x[...]

[11, 34, 23, 12]

```

---

P.S

---

Это перевод поста [Satyajit Ranjeev](http://satyajit.ranjeev.in/) – "[A few things to remember while coding in python.](http://satyajit.ranjeev.in/2012/05/17/python-a-few-things-to-remember.html)". ~~Но оформить в хаб переводов не хватило 0.5 кармы, и сохранить черновик не позволяет, поэтому выкладываю как есть.~~ Просьба все замечания по переводу и орфографии присылать в личку, и сильно не пинать =) | https://habr.com/ru/post/144614/ | null | ru | null |

# Игра на пустом месте

#### Игра на пустом месте

Пост о нелегком, но чрезвычайно интересном пути из ниоткуда к готовой игре.

##### Введение

Долгое время с игростроем меня связывала только работа среднестатистическим 3d-художником в филиале одной не шибко известной компании, да вялые попытки вырваться, наконец, на ниву инди-разработки с её неограниченной свободой и баснословными доходами. По крайней мере, именно таким казался мне независимый геймдев по прочтении многочисленных success-stories.

Реальность, однако же, всегда охлаждала мой пыл, напоминая об отсутствующих навыках программирования, управления проектами, умении что-то продавать, опыта разработки хоть чего-нибудь… в сущности, об отсутствии всего, что было необходимо для начала работы над своей собственной игрой. За исключением, пожалуй, владения 3d на некотором уровне.

С деньгами тоже была напряжённая ситуация, поэтому опция «взять — и вложить всем известные $70k в разработку, а на выходе получить готовую конфетку, расхватываемую геймерами как горячие пирожки», для меня тоже оказывалась недоступной.

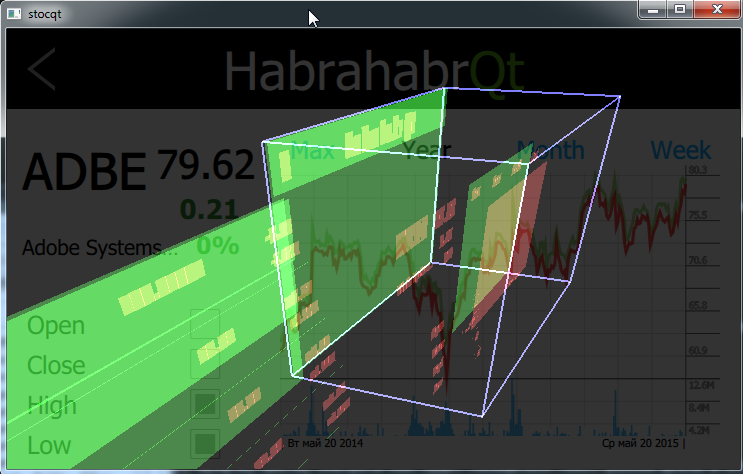

Но в топках энтузиазма вовсю кочегарилось желание. Поэтому было принято решение во что бы то ни стало таки начать (и обязательно закончить!) воплощать в жизнь одну из множества постоянно придумываемых мной идей игры. И вот, в одно прекрасное утро на мой компьютер был неспешно установлен и запущен замечательный инструмент Unity3d, который через несколько секунд уже выжидающе смотрел на меня девственно пустым окном нового проекта.

Следующие месяцы были проведены в невероятно интересной атмосфере изучения огромного количества новой для меня информации и экспериментирования над своим будущим детищем. Об этом процессе я и хотел бы вам рассказать.

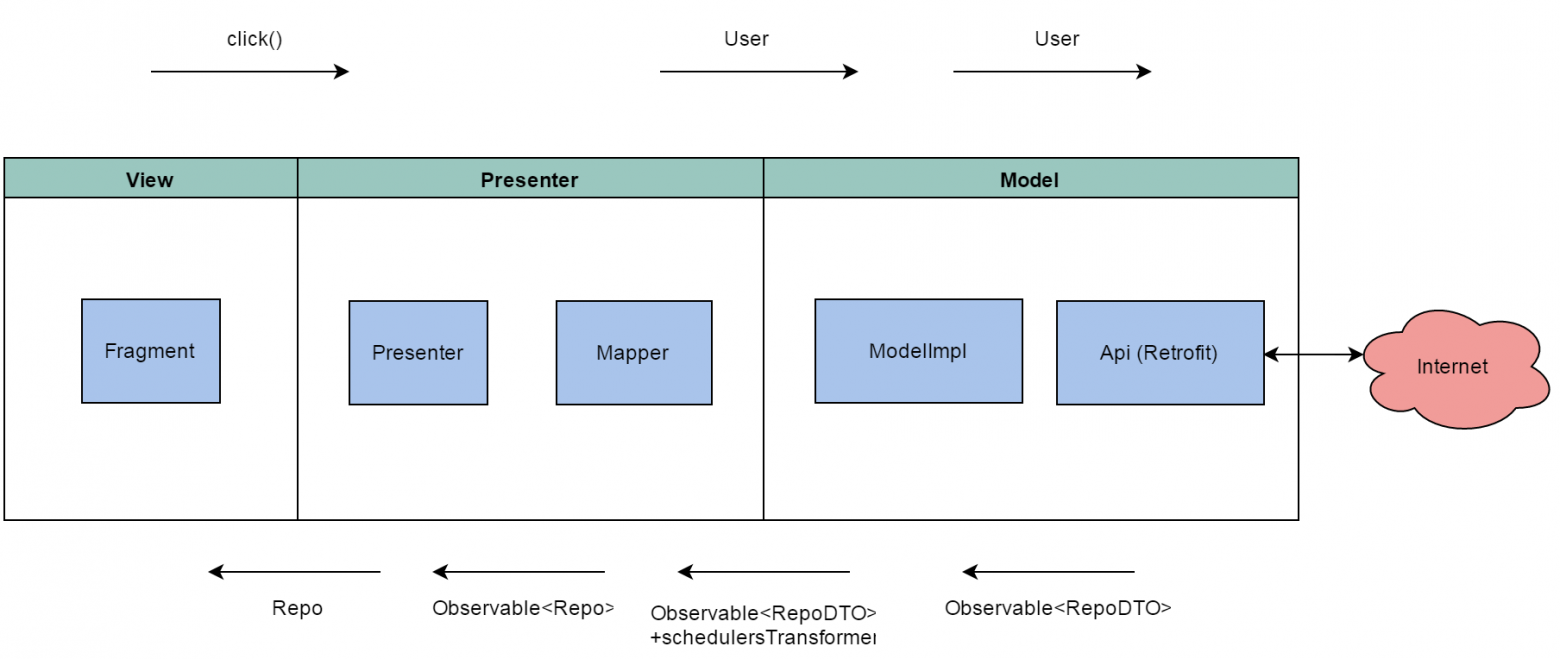

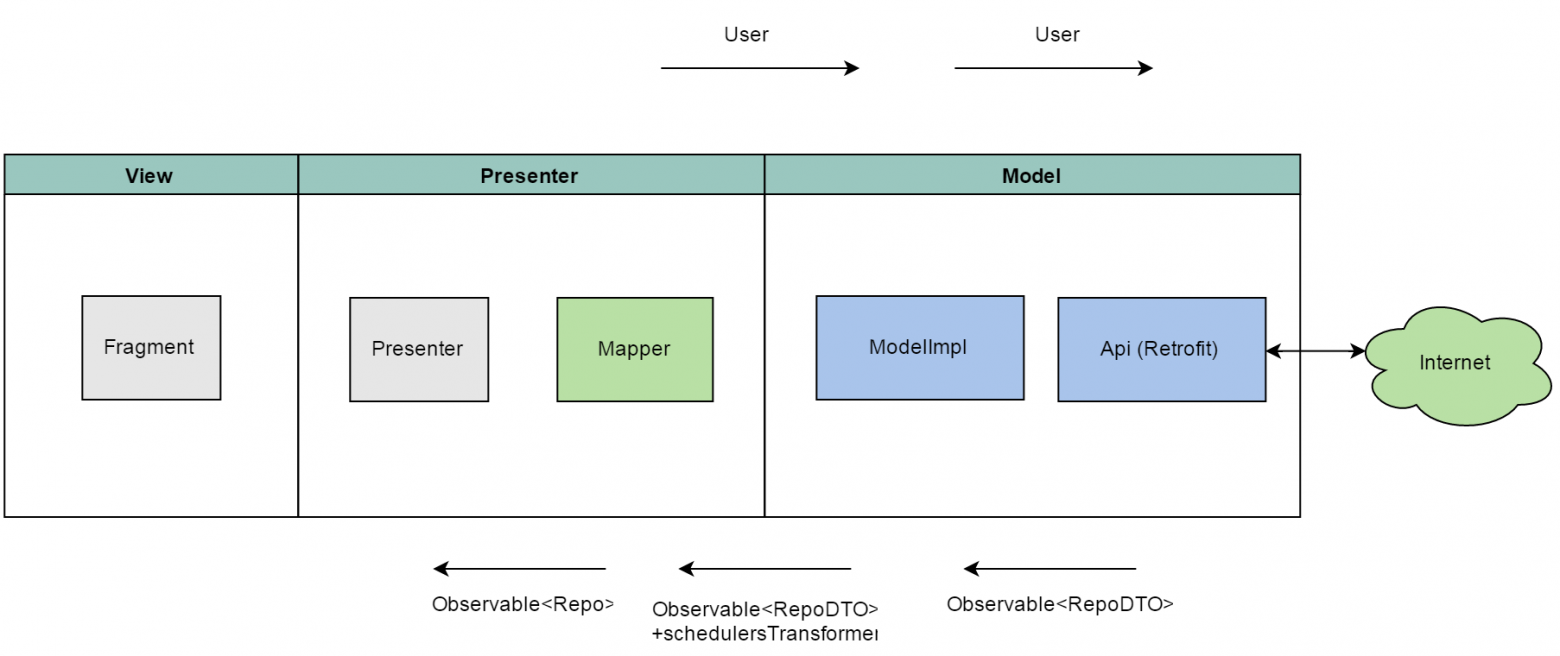

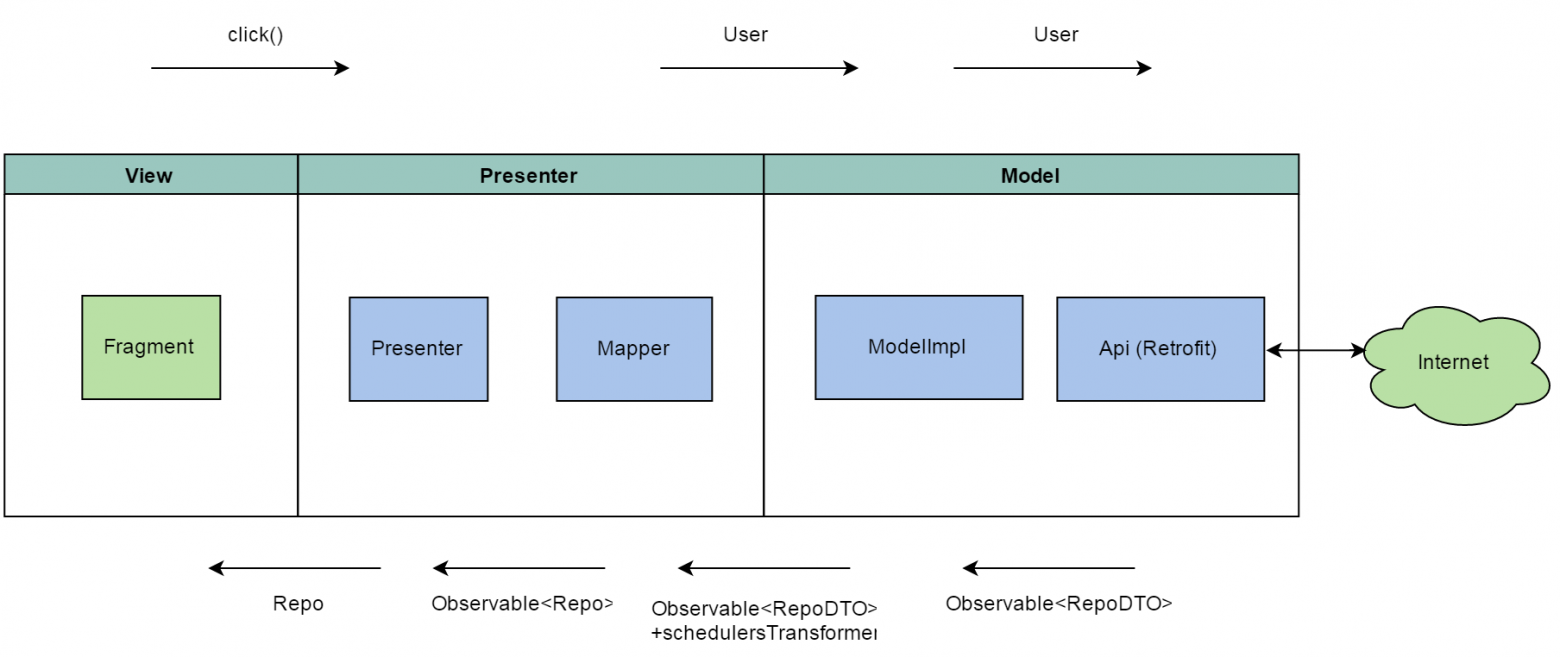

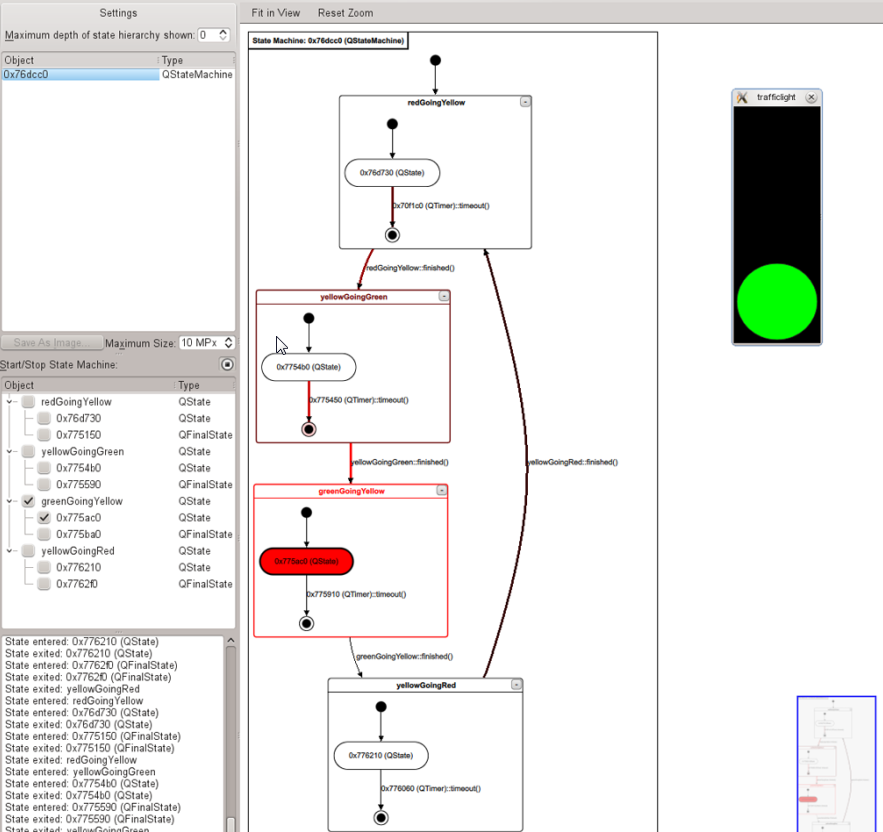

##### Концепт и подготовка прототипа

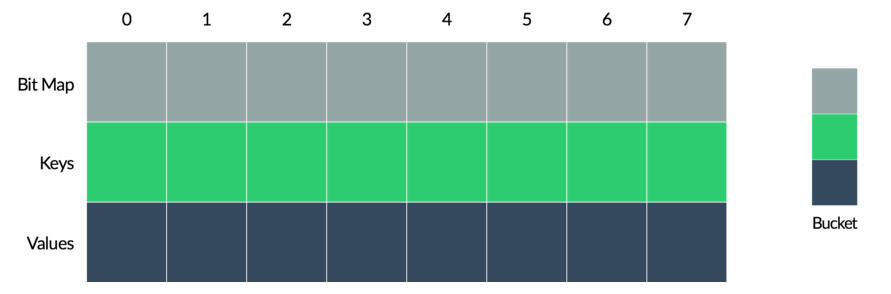

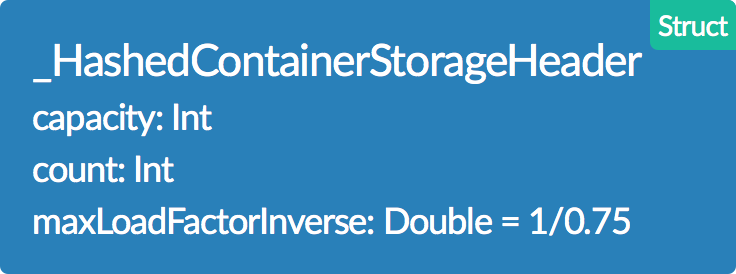

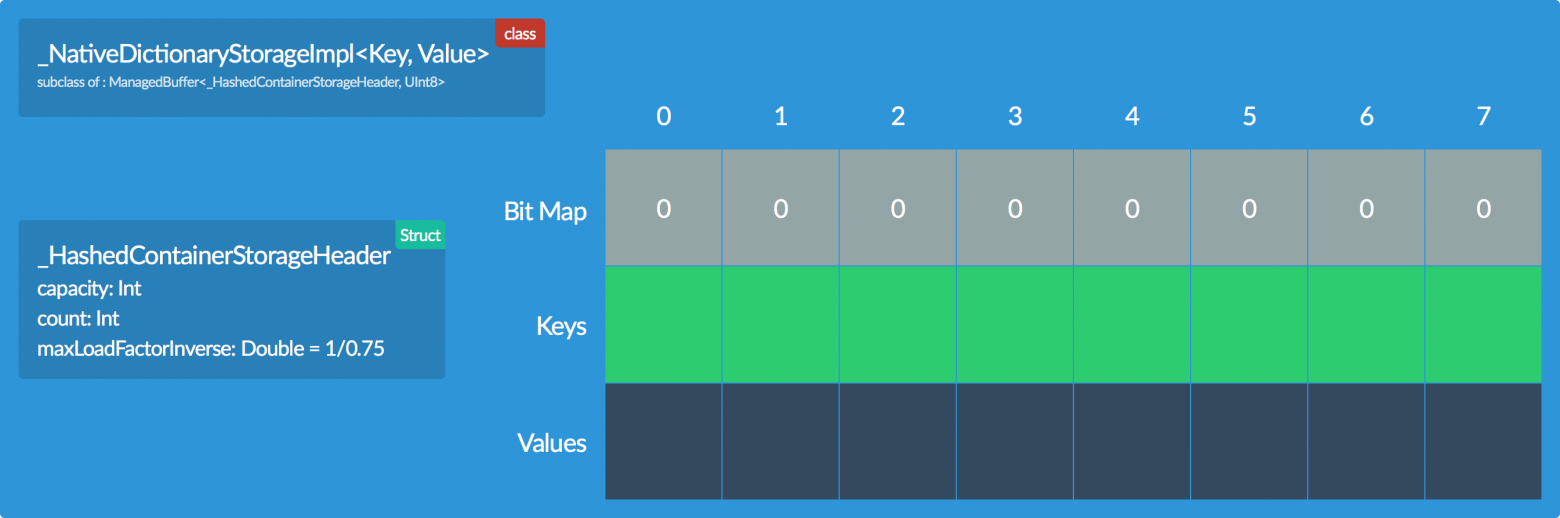

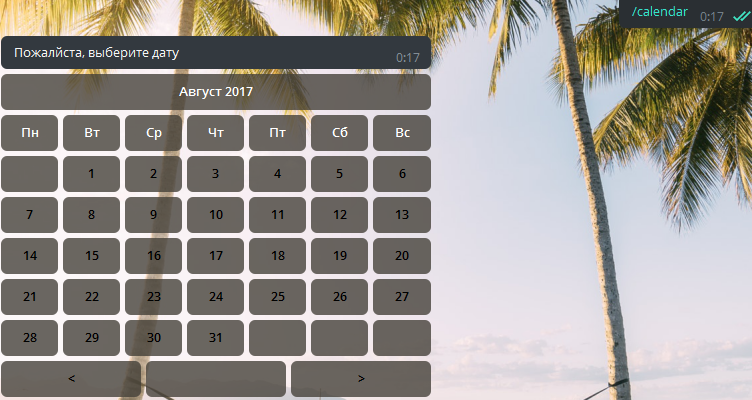

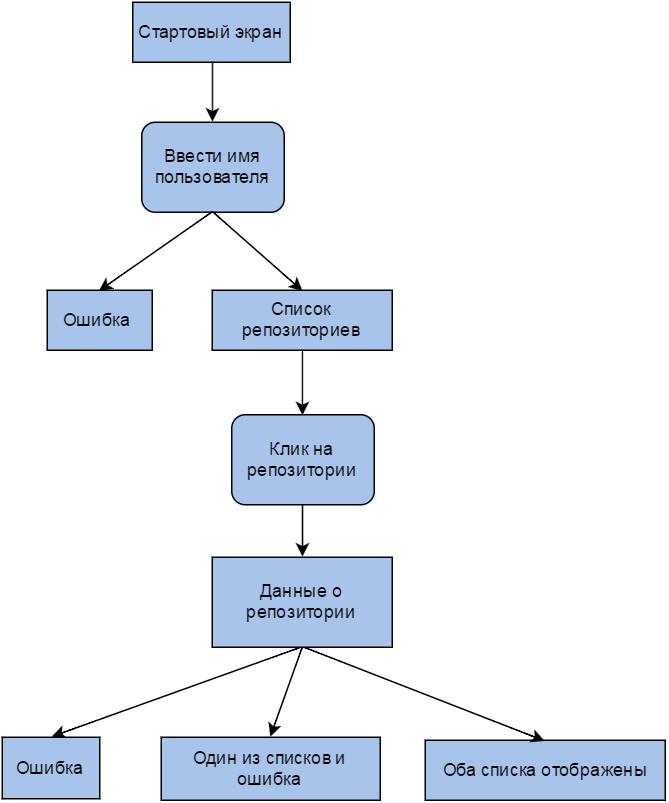

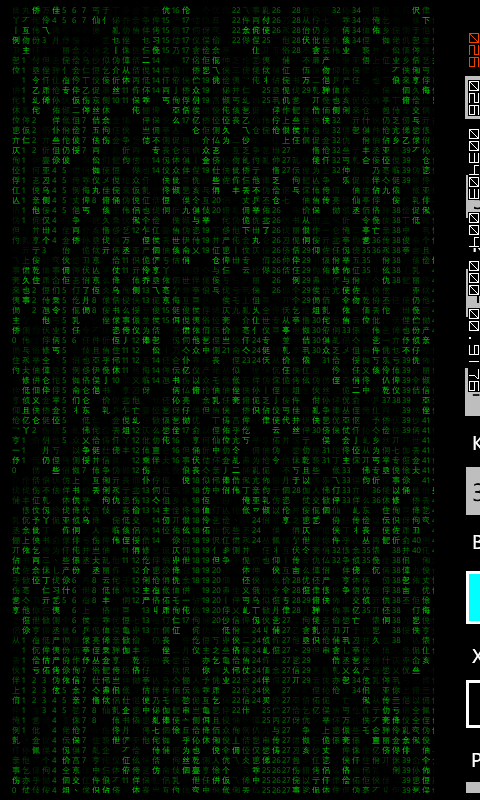

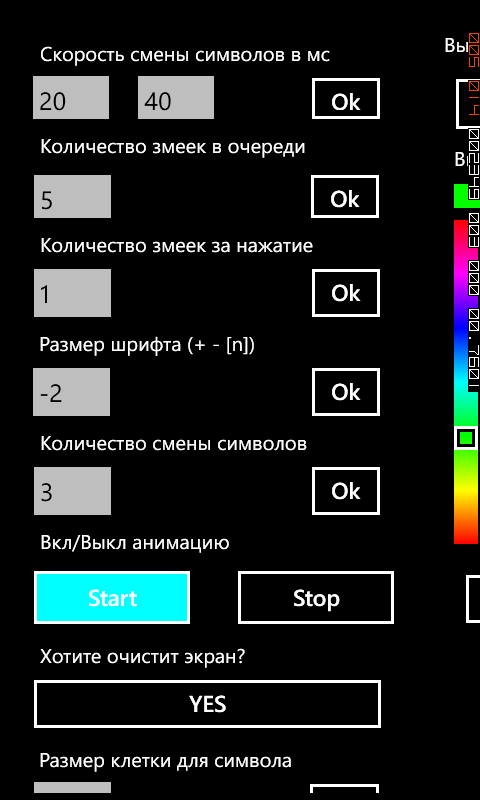

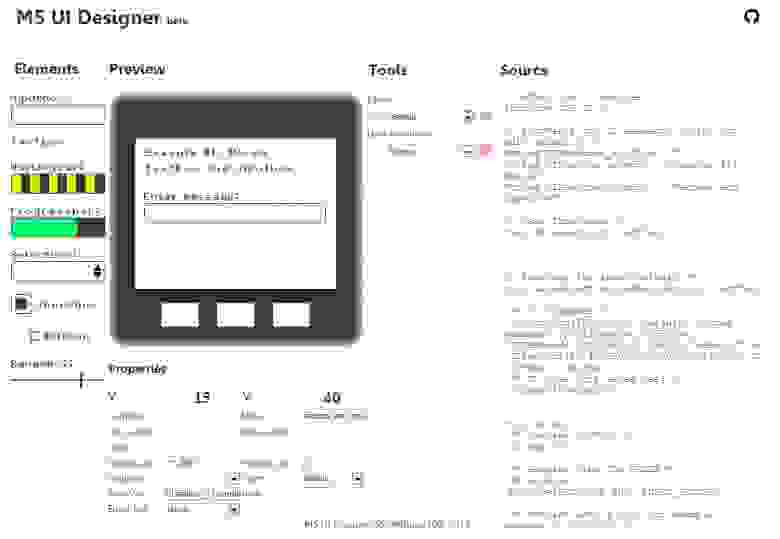

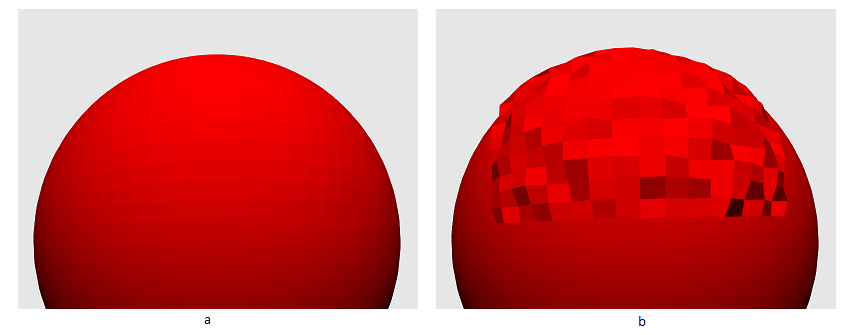

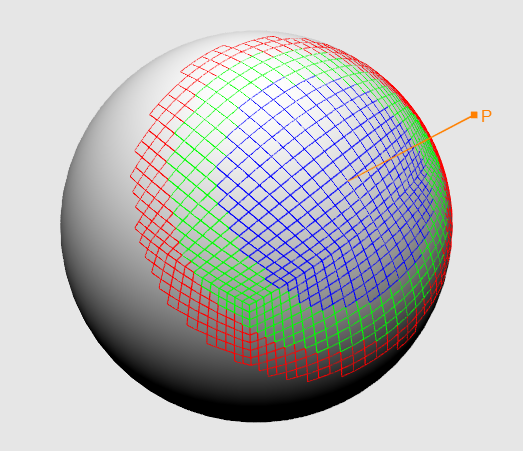

Мне не хотелось браться за что-то большое и сложное. Чем проще, тем лучше — таков был мой девиз. В планах не было вязнуть в непреодолимых задачах и неперелопачиваемых в одиночку объёмах работы. Идея была проста и относительно оригинальна: лабиринт с возможностью прокручивания отдельных квадратных его участков, а-ля plumber game. Поворачивая плитки с участками лабиринта, игрок строит путь к выходу.

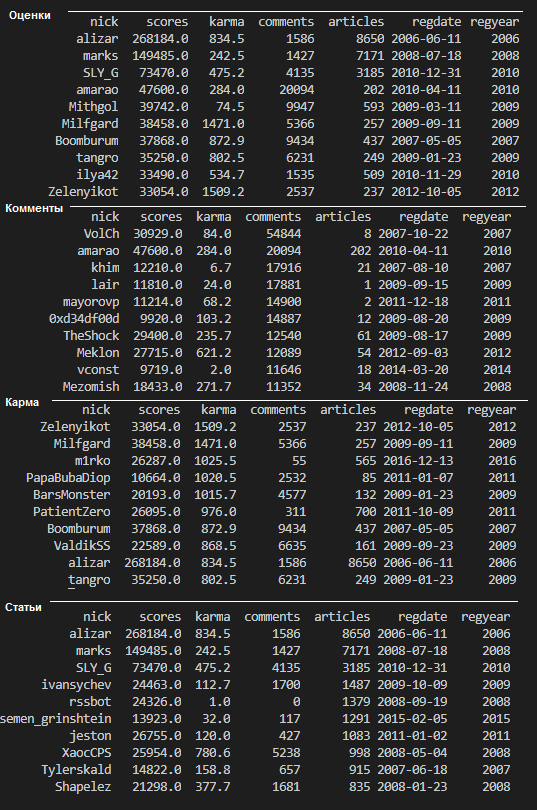

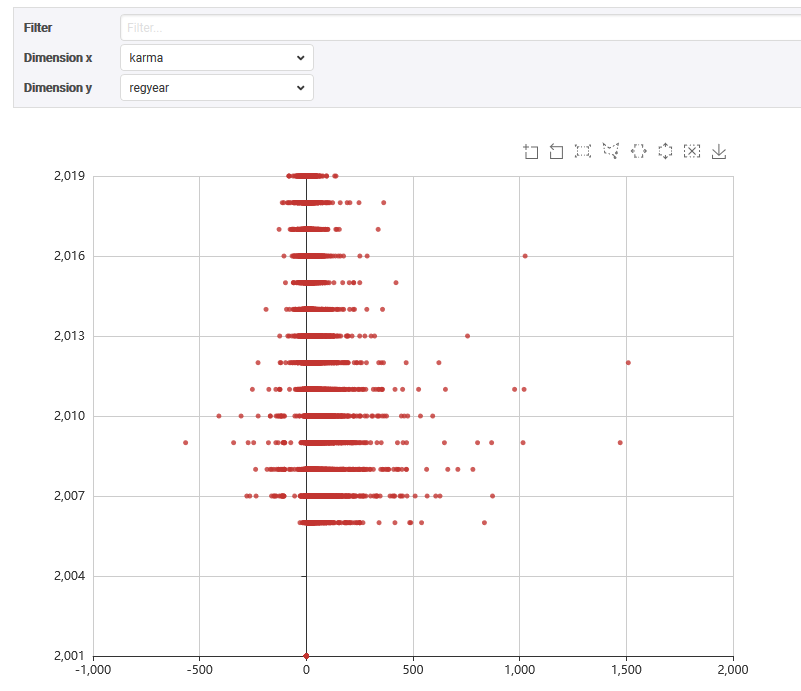

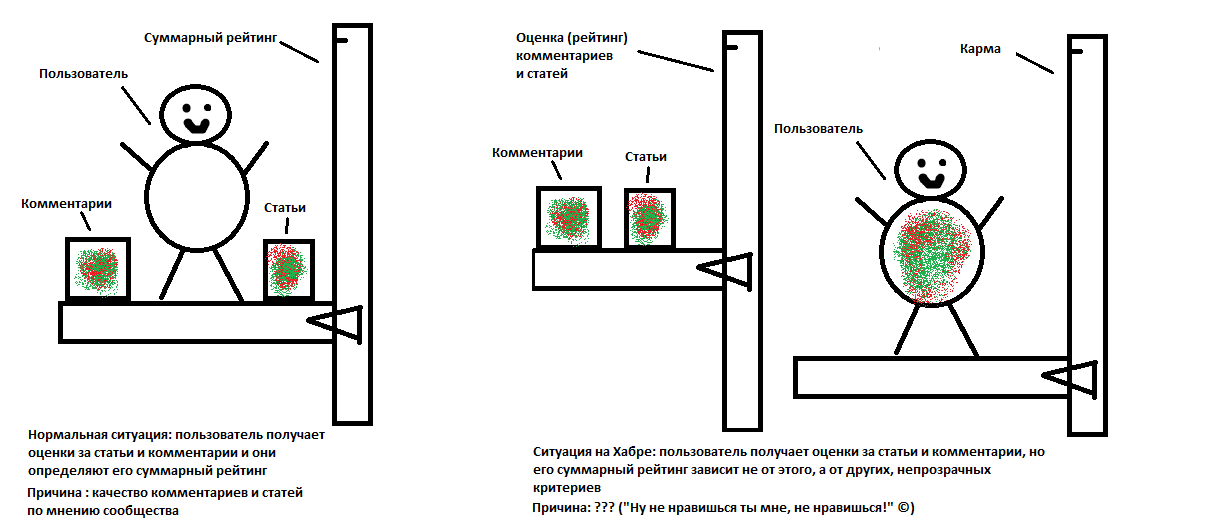

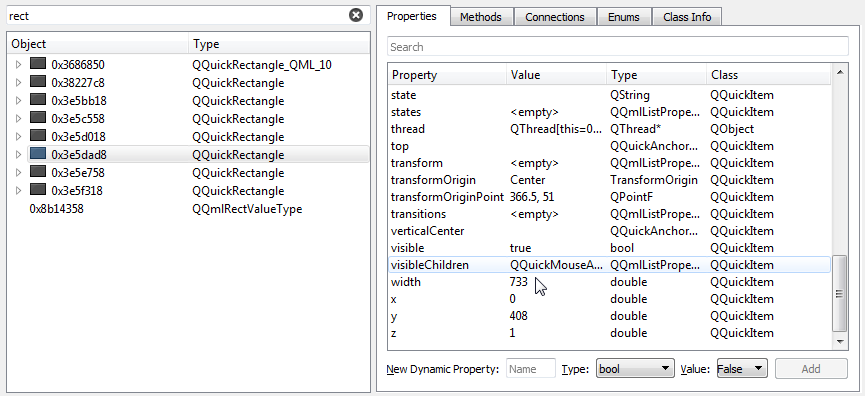

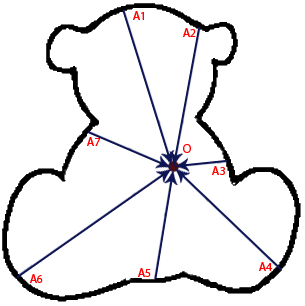

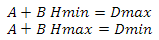

Каждый кусочек (плитка) помимо текстуры представляет из себя нехитрый набор характеристик:

* Плитка всегда имеет сквозной проход

* Плитка может иметь глухие внешние стенки и/или один тупиковый ход

* Имя плитки состоит из четырёх цифр, характеризующих её внешние стенки, начиная с верхней по часовой стрелке. Например, имя **0212** говорит о том, что плитка имеет глухую верхнюю стенку, один тупиковый проход снизу и один сквозной проход, соединяющий левую и правую стороны

* Четыре бита (по одному на каждую сторону), описывающие соединение пройденного пути с рассматриваемой плиткой. Например, **0001** означает, что с левой стороны в плитку упирается пройденный игроком путь

* Массив из четырёх целых чисел, полученный поциферным перемножением предыдущих двух чисел. Элементы этого массива показывают, какие проходы в плитке присоединяются к уже построенному пути

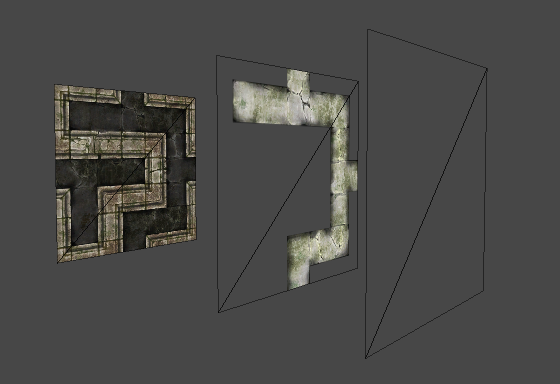

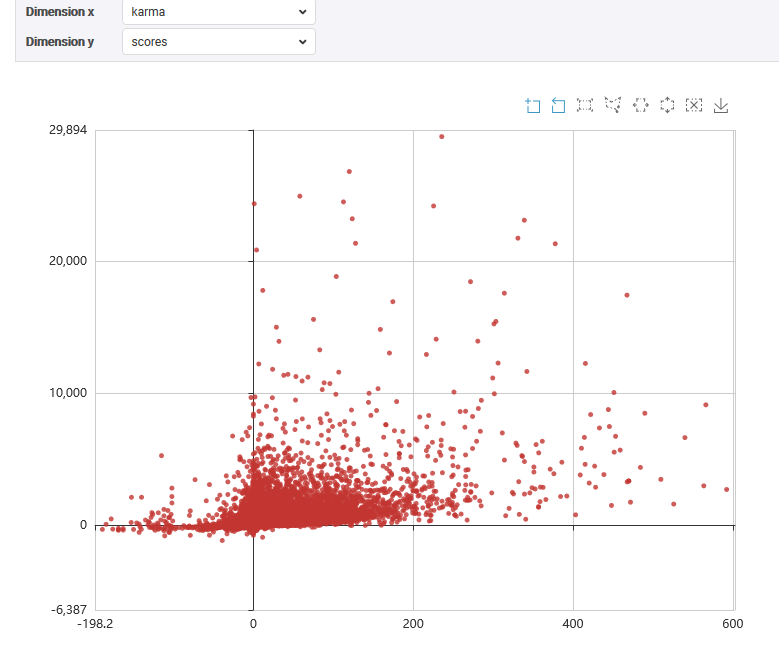

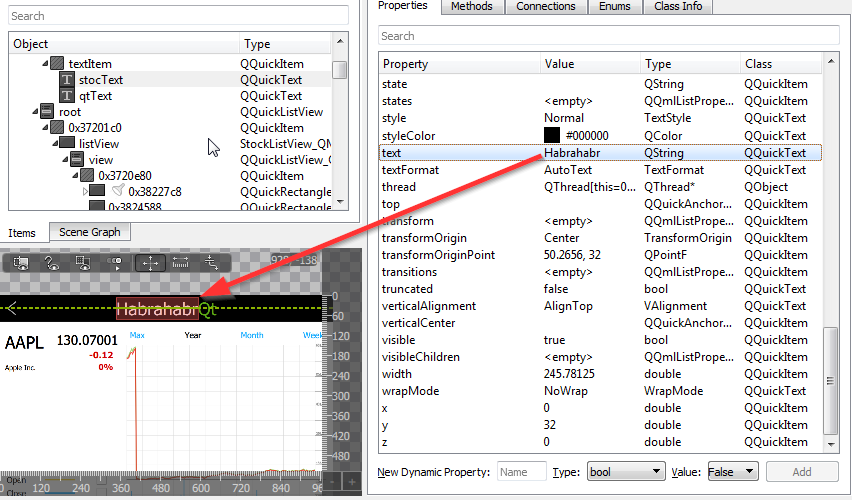

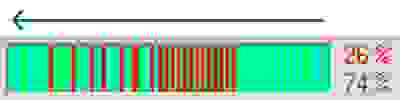

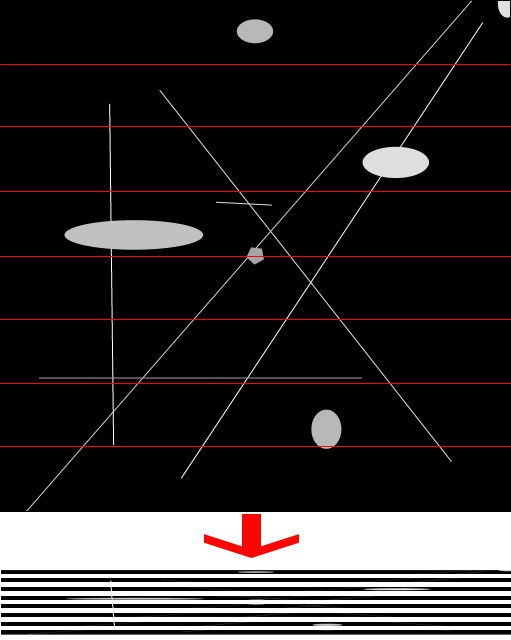

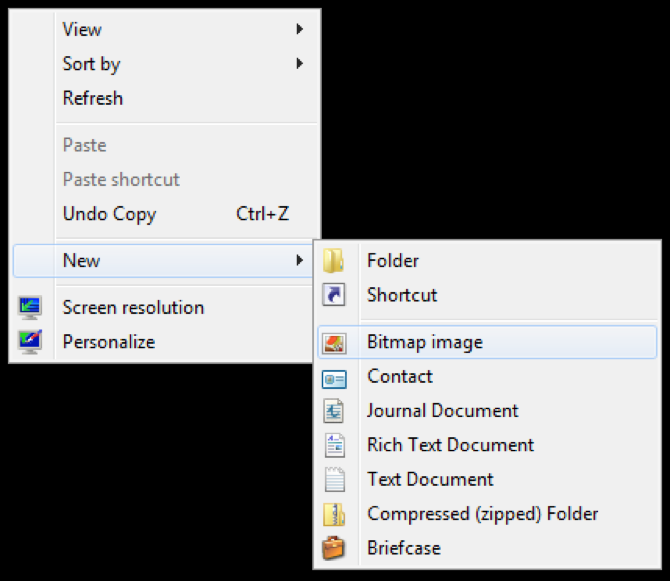

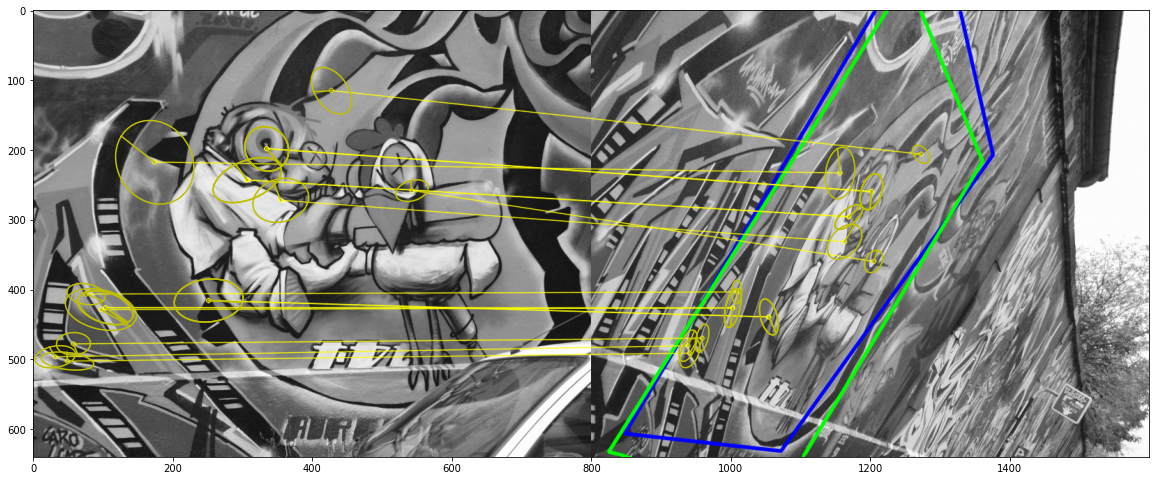

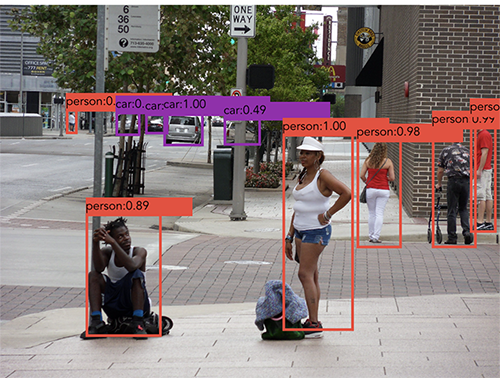

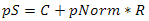

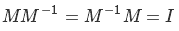

**Схематичные примеры плиток**

Не все плитки, показанные на рисунке, соответствуют правилам, поэтому лишь некоторые из них я использовал в игре

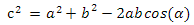

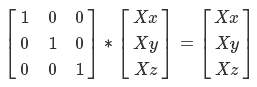

**Как плитки выглядят в игре**

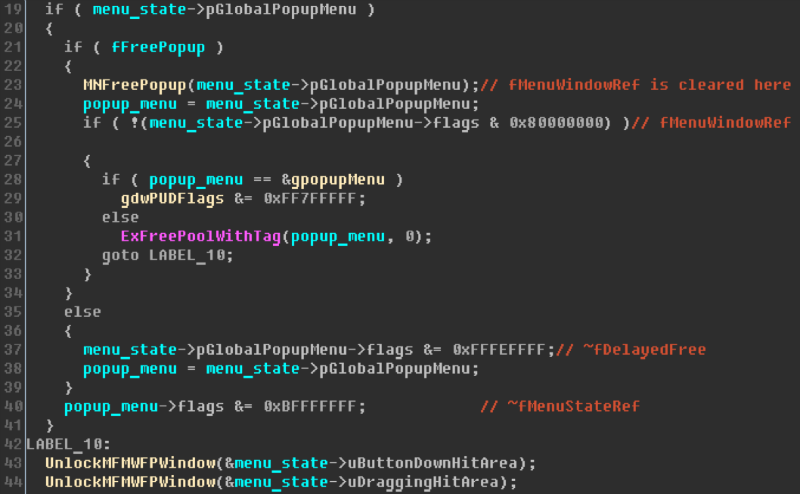

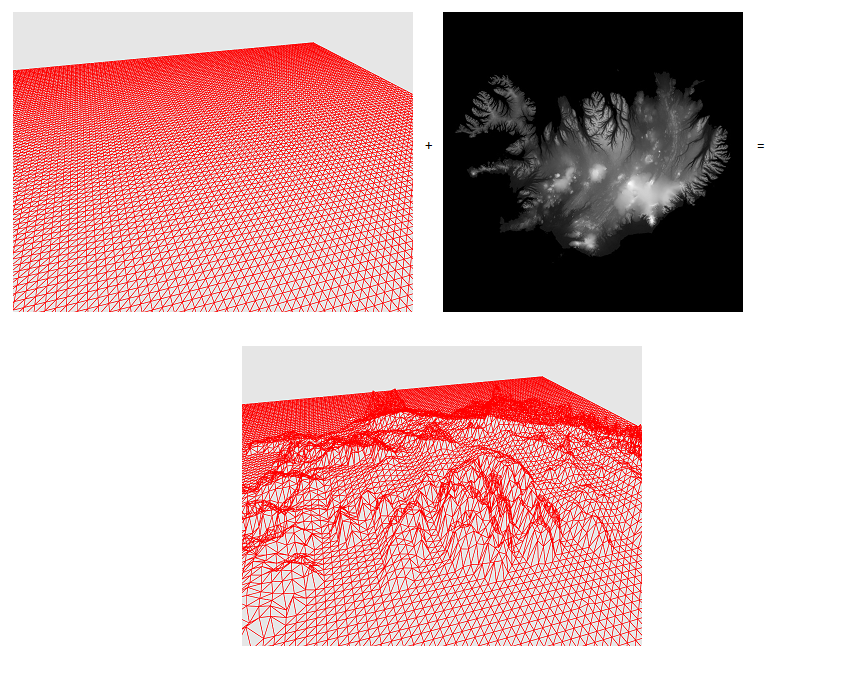

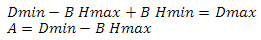

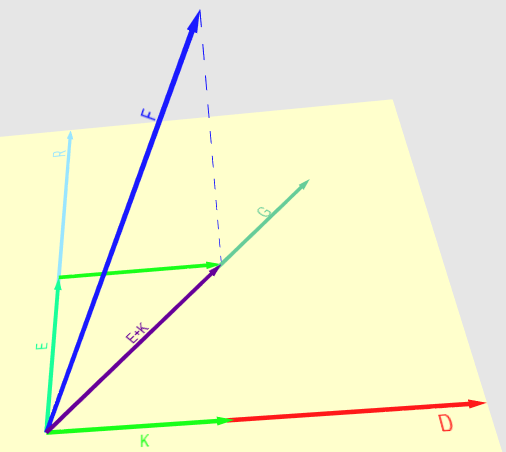

Каждая плиточка в игре представляет собой три квада (четырёхугольника), находящихся один над другим. Самый нижний квад отображает подложку — базовую текстуру стенок и тёмного непройденного пути. Два других квада имеют текстуру пройденных участков плитки, «включающихся», если игрок построил путь через неё. Для наглядности прилагаю картинку:

**Что из себя представляет плитка**

Накладываясь один на другой, квады при прямом изометрическом виде дают картинку готовой плитки

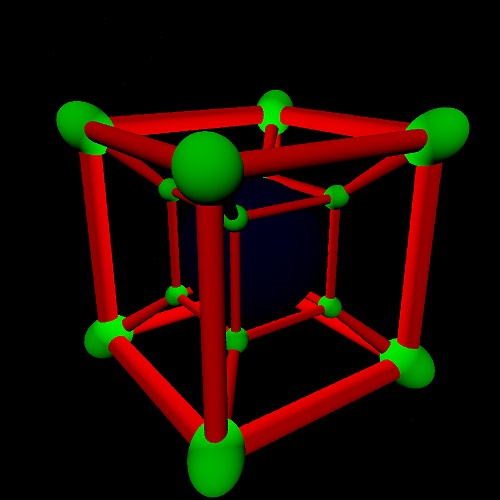

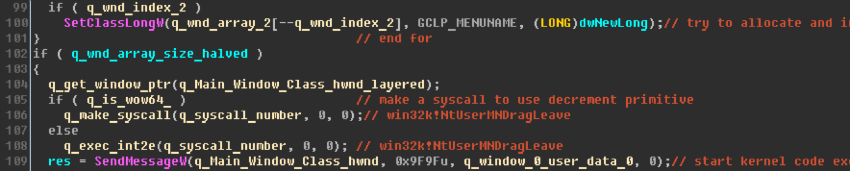

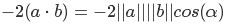

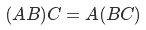

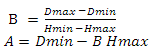

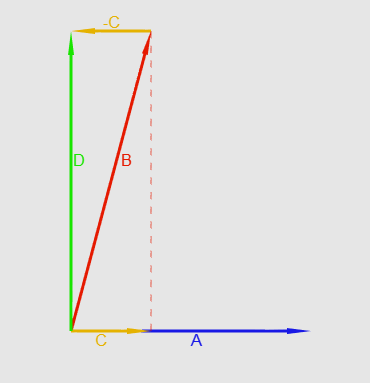

Из таких вот плиток и состоит игровое поле, являющееся двумерным массивом. Первый элемент массива всегда представляет начало лабиринта (`[0, 0]` левая нижняя плитка), последний — конец (`[width – 1, height - 1]` правая верхняя плитка).

**Схематичное игровое поле**

Желтая плитка имеет имя **2210** и массив входов **0001**

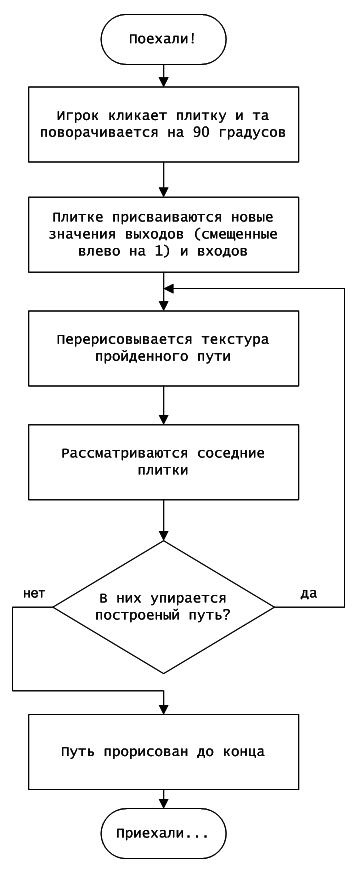

Самое интересное заключалось в том, чтобы придумать и реализовать алгоритм прорисовки построенного пользователем пути. Здесь я тоже не стал мудрствовать лукаво, и в спойлере ниже можно посмотреть, что у меня получилось.

**Упорщенный алгоритм поиска пути**

##### Добавление плюшек и удержание мысли в узде

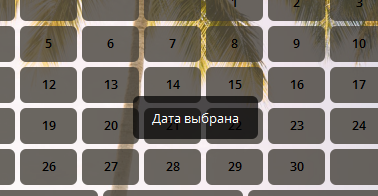

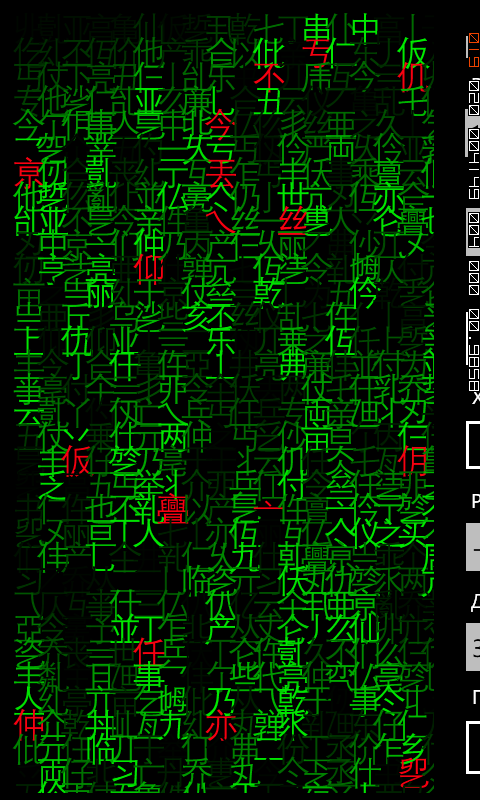

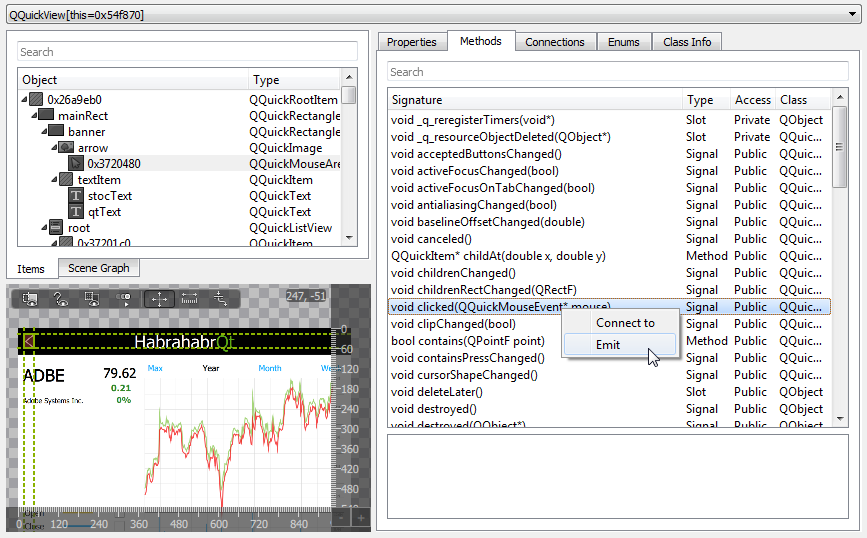

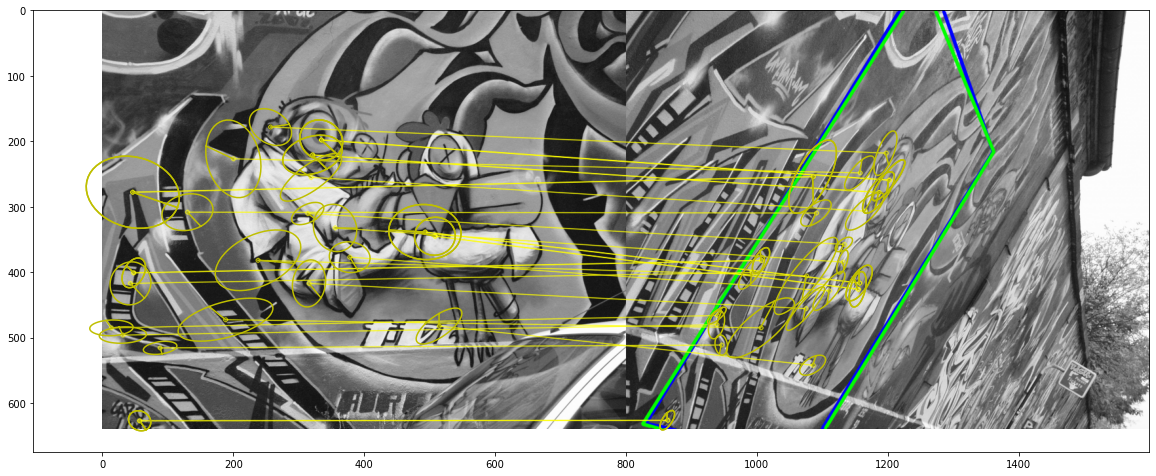

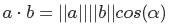

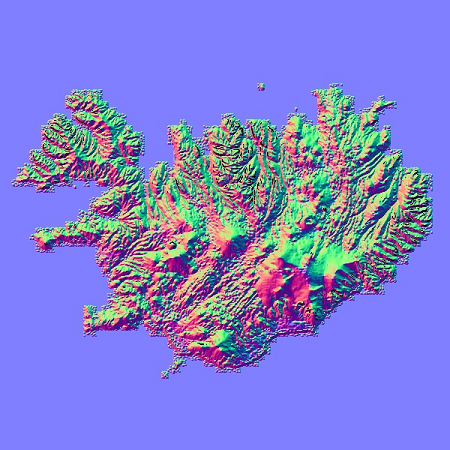

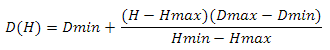

Параллельно допиливанию рабочего прототипа полным ходом шла подготовка текстур. Этот этап для меня был самым простым и ничего особенного из себя не представляет. Я старался выдать максимально приятную глазу картинку, попиксельно выверяя каждый свой шаг. Помучиться пришлось разве что с кастомным шрифтом. Дело в том, что я совершенно не хотел использовать TTF и сконцентрировался исключительно на BitMap fonts. Для использования шрифтов, реализованных текстурой с прозрачностью в альфа-канале, в Unity на данный момент нет удобных бесплатных инструментов. И, так как финансовые траты я с самого начала решил свести к нулю, пришлось шрифт делать руками от начала до конца, включая прорисовку и UV-маппинг каждой буквы. Наградой за унылую монотонную работу мне стал полностью готовый к использованию симпатичный шрифт. Подробнее о том, как я делал шрифт, я писал в [другом посте](http://habrahabr.ru/post/212587/).

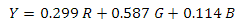

**Шрифт**

Изначально планировалось, что игра будет выполнена в трёх сеттингах с оригинальными особенностями геймплея в каждом из них, содержать кучу разнообразных монстров, оружие для их уничтожения и много чего ещё. Включая даже возможность лишать вереницу бредущих по пустыне путников некоторых материальных ценностей. Но в процессе работы быстро стало понятно, что мне такой объем контента просто не потянуть в одиночку. Поэтому было принято решение ограничиться одним «каменным» сеттингом, сокровищами, разбросанными по разным углам лабиринта, запертыми на замок сундуками/дверьми и ключами к ним. Такой простенький набор вполне вписывался в стратегию «проще — лучше» и требовал совсем не много сил на реализацию

**Предметы в игре**

##### Завершение процесса

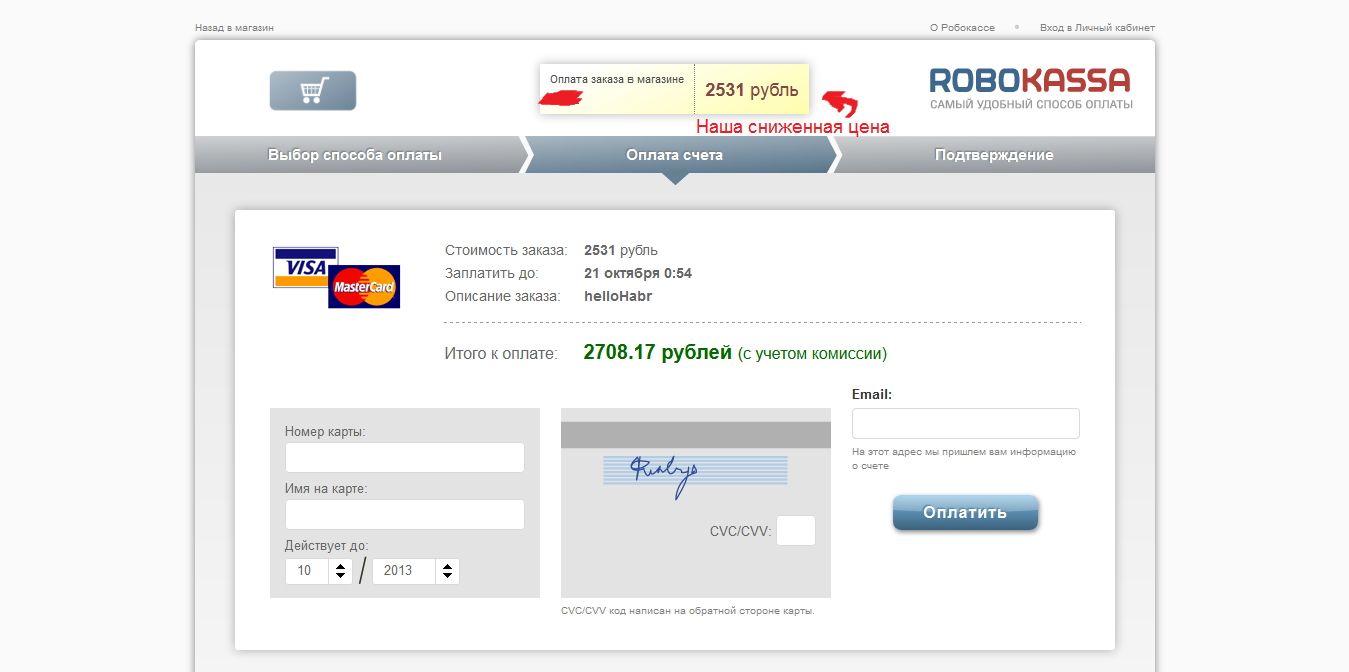

Работа спорилась и, несмотря на то, что я мог уделять проекту лишь свободное от основной работы время, довольно ощутимо подходила к концу. Впору было задуматься о каком-никаком продвижении. Несколько дней поизучав вопрос и прочтя диагональным методом несколько книжек, я снова погрузился в уныние. На повестку выползло понимание, что без приличных затрат на рекламу ни о какой сколь-нибудь интересной прибыли можно даже не думать. Отсутствие денег, в течение всего процесса помогавшее мне оставаться верным правилу «свести затраты на разработку к нулю», не подвело и в этот раз. И на рекламу тратиться не пришлось. Впрочем, на покупку аккаунта продавца Google и домена с хостингом таки пришлось выложить полукруглую сумму в $50.

Еще одним неприятным моментом стала для меня новость, что у меня нет возможности продавать игру в Play Google в связи с отсутствием моей многострадальной страны в соответствующем списке (мне оставили, впрочем, возможность хоть как-то монетизироваться через рекламу в игре).

Но забивать на почти готовый проект смысла уже не было, и остатки сил я бросил на допиливание и вылизывание игры до состояния близкого к идеальному в моём субъективном понимании этого слова. Чем я и занялся. Не за горами был день, когда я с уверенностью мог сказать, что мне удалось осуществить свою мечту.

##### Итоги

И вот, по прошествии полугода со времени старта, игра готова! За месяцы, проведенные в изучении самых различных аспектов игростроя, я получил гигантское количество опыта, научился множеству интересных и увлекательных штук, ~~заработал сколиоз и проблемы со зрением~~, и, главное, получил заряд удовольствия от того, что мне удалось претворить свою мечту в жизнь.

Говорить о популярности игры пока еще слишком рано, равно как и о её интересности для геймеров. Если всё сложится удачно, я посвящу этом отдельный пост.

##### Послесловие

Имеются планы по портированию игры на iOS, если удастся наскрести на аккаунт разработчика Apple. C портом по идее не должно возникнуть трудностей, спасибо могущественному Unity3d. Так же хочется заняться постепенным добавлением новых фич, прощупыванием почвы монетизации через внутриигровые продажи (если я не ошибаюсь, AppStore позволяет совершать валютные операции резидентам Украины), реализацией множества других задумок как в отношении этого проекта, так и относительно новых, которым только предстоит появиться на свет. | https://habr.com/ru/post/212665/ | null | ru | null |

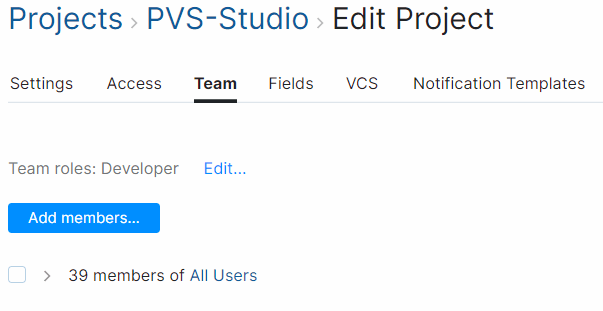

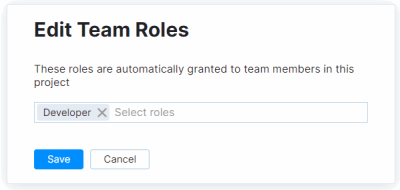

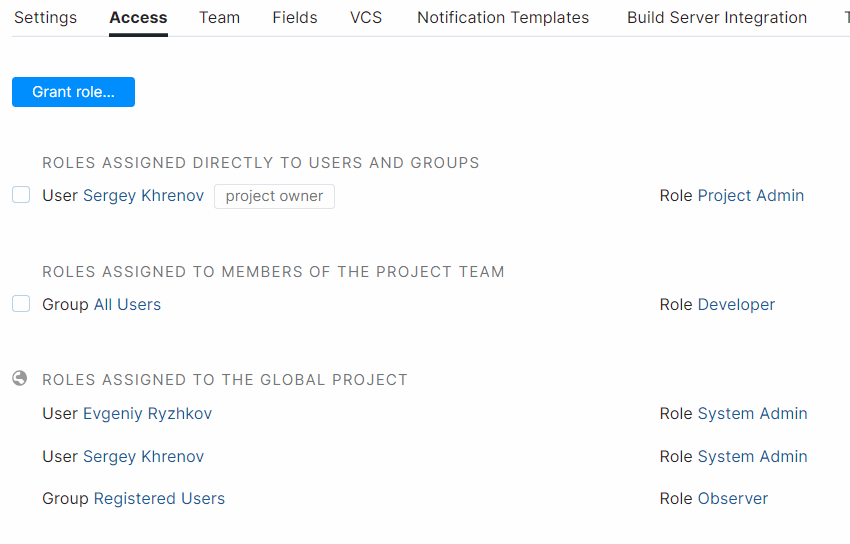

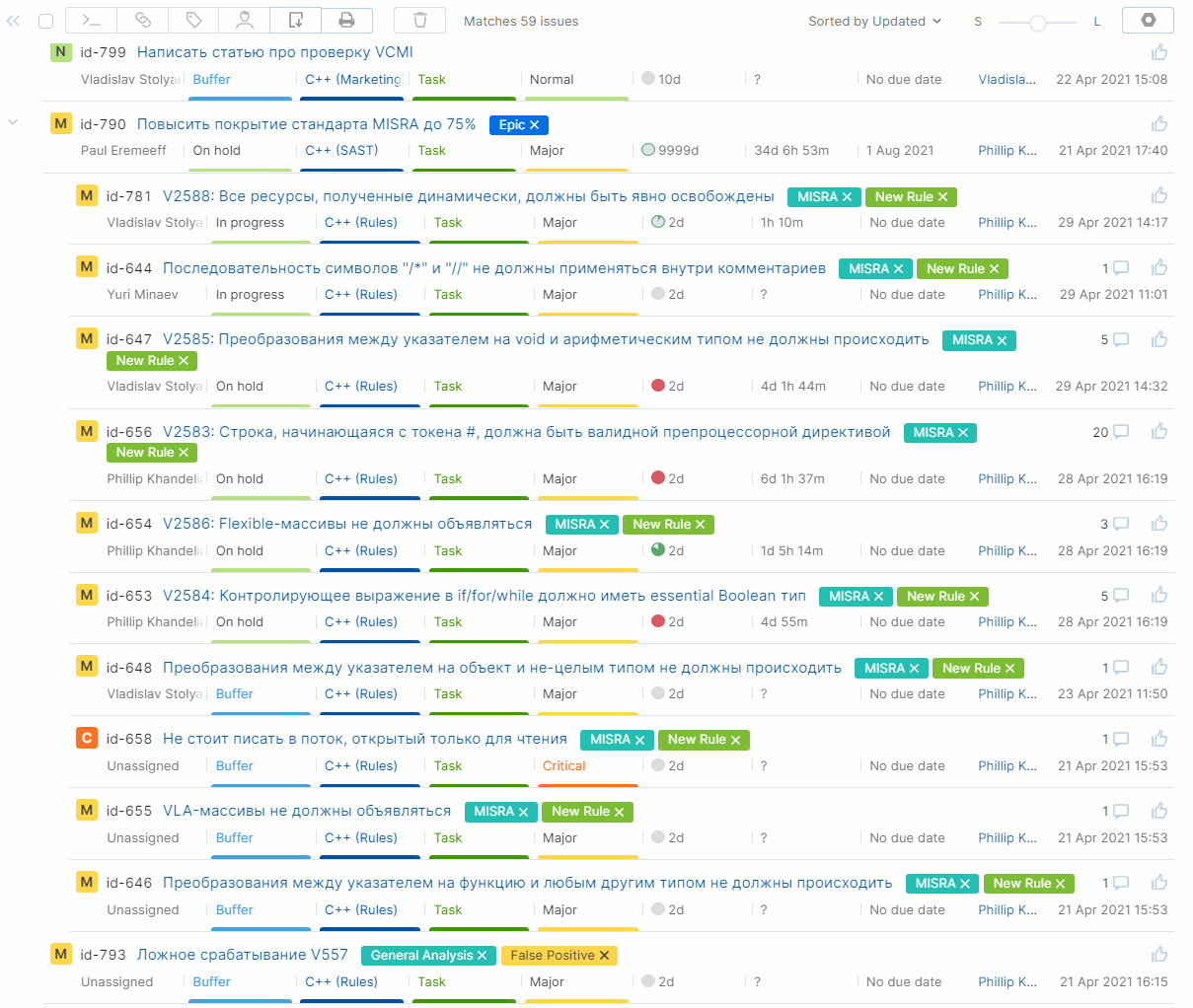

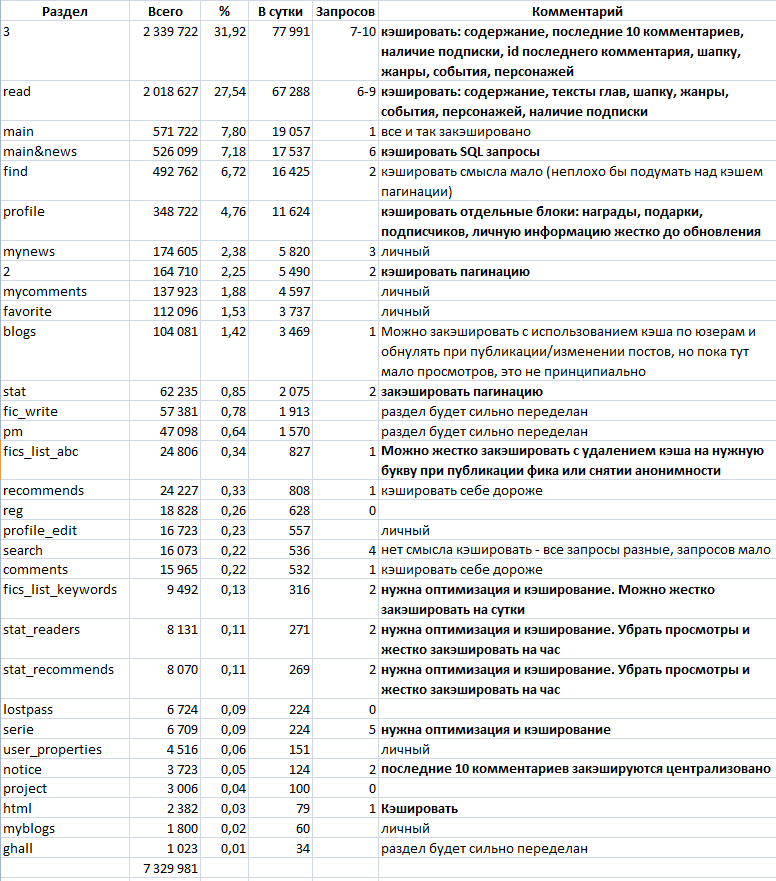

# Проверка проекта LibreOffice

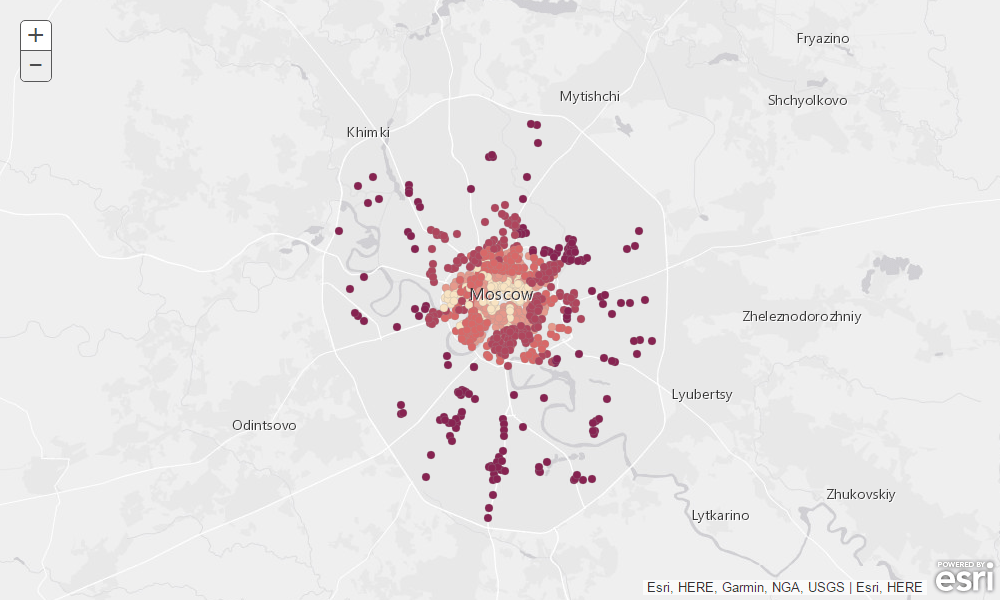

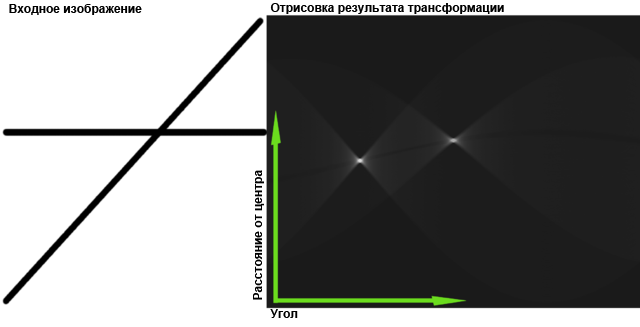

Предлагаем читателю очередную статью о проверке известного open-source проекта. В этот раз мы проверили проект LibreOffice, представляющий собой офисный пакет. В его разработке принимает участие более чем 480 программистов. Код оказался весьма качественным и регулярно проверяемым статическим анализатором Coverity. Но, как и в любом другом большом проекте, были найдены новые ошибки и недочеты, о которых мы и расскажем в статье. Для разнообразия, в этот раз нас будут сопровождать не единороги, а коровы.

[LibreOffice](http://www.viva64.com/go.php?url=1502) — мощный офисный пакет, полностью совместимый с 32/64-битными системами. Переведён более чем на 30 языков мира. Поддерживает большинство популярных операционных систем, включая GNU/Linux, Microsoft Windows и Mac OS X.

LibreOffice бесплатен и имеет открытый исходный код. Написан на языках: Java, Python, C++. Анализу была подвергнута та часть проекта, которая написана на C++ (и немножко на С, [C++/CLI](http://www.viva64.com/go.php?url=1485)). Version: 4.5.0.0.alpha0+ (Git revision: 368367).

Анализ был выполнен с помощью статического анализатора кода [PVS-Studio](http://www.viva64.com/ru/pvs-studio/).

Рассмотрим, какие ошибки были найдены, и что можно с ними сделать. Хочу отметить, что некоторые ошибки могут оказаться не ошибками. Я не знаком с кодом и мог принять за ошибку вполне корректный код. Однако, раз этот код сбил с толку анализатор и меня, значит что-то не так. Этот код пахнет, и хорошо провести его рефакторинг, чтобы снизить вероятность его неправильного понимания в процессе развитии проекта.

Опечатки

--------

Любой код не обходится без опечаток. Многие, конечно, находятся и исправляются на этапе тестирования, но некоторые остаются жить внутри программ на долгое время. Как правило они находятся в редко используемых функциях или не оказывают сильного влияние на работу программы.

Например, встретилась вот такая функция сравнения, которая работает только на одну треть:

```

class SvgGradientEntry

{

....

bool operator==(const SvgGradientEntry& rCompare) const

{

return (getOffset() == rCompare.getOffset()

&& getColor() == getColor()

&& getOpacity() == getOpacity());

}

....

}

```

Предупреждение PVS-Studio: [V501](http://www.viva64.com/ru/d/0090/) There are identical sub-expressions to the left and to the right of the '==' operator: getColor() == getColor() svggradientprimitive2d.hxx 61

Наверное, это ошибка не приносит много вреда. Возможно, этот оператор '==' вообще не используется. Однако, раз анализатор смог найти эту ошибку, он сможет найти и более серьезные сразу после написания нового кода. Поэтому основная ценность статического анализа не в разовых запусках, а в регулярном использовании.

Как можно было бы попробовать избежать такой ошибки? Не знаю. Возможно, если приучить себя более тщательно выравнивать блоки однотипного кода, то ошибка была бы более заметна. Например, функцию можно оформить так:

```

bool operator==(const SvgGradientEntry& rCompare) const

{

return getOffset() == rCompare.getOffset()

&& getColor() == getColor()

&& getOpacity() == getOpacity();

}

```

Теперь стало более заметно, что в правом столбце не хватает «rCompare». Хотя если честно, заметно не очень сильно. Может и не помочь. Человеку свойственно ошибаться. И поэтому статический анализатор бывает хорошим помощником.

А вот пример, где опечатку явно можно было избежать. Кто-то неудачно написал код для обмена значений между двумя переменными.

```

void TabBar::ImplGetColors(....)

{

....

aTempColor = rFaceTextColor;

rFaceTextColor = rSelectTextColor;

rSelectTextColor = rFaceTextColor;

....

}

```

Предупреждение PVS-Studio: [V587](http://www.viva64.com/ru/d/0190/) An odd sequence of assignments of this kind: A = B; B = A;. Check lines: 565, 566. tabbar.cxx 566

В последней строке вместо 'rFaceTextColor' следовало использовать 'aTempColor'.

Не нужно было писать код для обмена значений «вручную». Было бы проще и надёжней воспользоваться стандартной функцией std::swap():

```

swap(rFaceTextColor, rSelectTextColor);

```

Продолжим. От следующей ошибки думаю защититься невозможно. Опечатка в чистом виде:

```

void SAL_CALL Theme::disposing (void)

{

ChangeListeners aListeners;

maChangeListeners.swap(aListeners);

const lang::EventObject aEvent (static_cast(this));

for (ChangeListeners::const\_iterator

iContainer(maChangeListeners.begin()),

iContainerEnd(maChangeListeners.end());

iContainerEnd!=iContainerEnd;

++iContainerEnd)

{

....

}

}

```

Предупреждение PVS-Studio: V501 There are identical sub-expressions to the left and to the right of the '!=' operator: iContainerEnd != iContainerEnd theme.cxx 439

Цикл выполняться не будет, так как условие «iContainerEnd!=iContainerEnd» всегда ложно. Подвело схожие названия итераторов. На самом деле, нужно было написать: «iContainer!=iContainerEnd». Кстати, здесь кажется есть ещё одна ошибка. Странно, что увеличивается итератор «iContainerEnd».

Рассмотрим другой неудачный цикл:

```

static void lcl_FillSubRegionList(....)

{

....

for( IDocumentMarkAccess::const_iterator_t

ppMark = pMarkAccess->getBookmarksBegin(); <<<<----

ppMark != pMarkAccess->getBookmarksBegin(); <<<<----

++ppMark)

{

const ::sw::mark::IMark* pBkmk = ppMark->get();

if( pBkmk->IsExpanded() )

rSubRegions.InsertEntry( pBkmk->GetName() );

}

}

```

Предупреждение PVS-Studio: V625 Consider inspecting the 'for' operator. Initial and final values of the iterator are the same. uiregionsw.cxx 120

Цикл выполняться не будет. В условии итератор 'ppMark' нужно сравнивать с 'pMarkAccess->getBookmarksEnd()'. Идей, как защититься от такой ошибки с помощью правил написания кода, у меня нет. Просто опечатка.

Кстати, иногда ошибка есть, но она никак не влияет на правильное выполнение программы. Сейчас продемонстрирую одну из таких опечаток:

```

bool PolyPolygonEditor::DeletePoints(....)

{

bool bPolyPolyChanged = false;

std::set< sal_uInt16 >::const_reverse_iterator

aIter;( rAbsPoints.rbegin() );

for( aIter = rAbsPoints.rbegin();

aIter != rAbsPoints.rend(); ++aIter )

....

}

```

Предупреждение PVS-Studio: [V530](http://www.viva64.com/ru/d/0119/) The return value of function 'rbegin' is required to be utilized. polypolygoneditor.cxx 38

Ошибка вот здесь: aIter;( rAbsPoints.rbegin() );

Хотели инициализировать итератор. Но случайно вклинилась точка с запятой. Итератор остался неинициализированным. А выражение "(rAbsPoints.rbegin());" болтается в воздухе и ничего не делает.

Спасает ситуацию то, что в цикле итератор всё-таки инициализируется нужным значением. В общем ошибки нет, но лишнее выражение лучше убрать. Кстати, этот цикл был размножен с помощью Copy-Paste, поэтому стоит заглянуть ещё в строку 69 и 129 в этом же файле.

Напоследок опечатка в конструкторе класса:

```

XMLTransformerOOoEventMap_Impl::XMLTransformerOOoEventMap_Impl(

XMLTransformerEventMapEntry *pInit,

XMLTransformerEventMapEntry *pInit2 )

{

if( pInit )

AddMap( pInit );

if( pInit )

AddMap( pInit2 );

}

```

Предупреждение PVS-Studio: V581 The conditional expressions of the 'if' operators situated alongside each other are identical. Check lines: 77, 79. eventoootcontext.cxx 79

Второй оператор 'if' должен проверять указатель 'pInit2'.

Может быть так и задумано, но очень подозрительно

-------------------------------------------------

Есть несколько фрагментов кода, которые кажется содержат опечатки. Но я не уверен. Возможно, так и задумано.

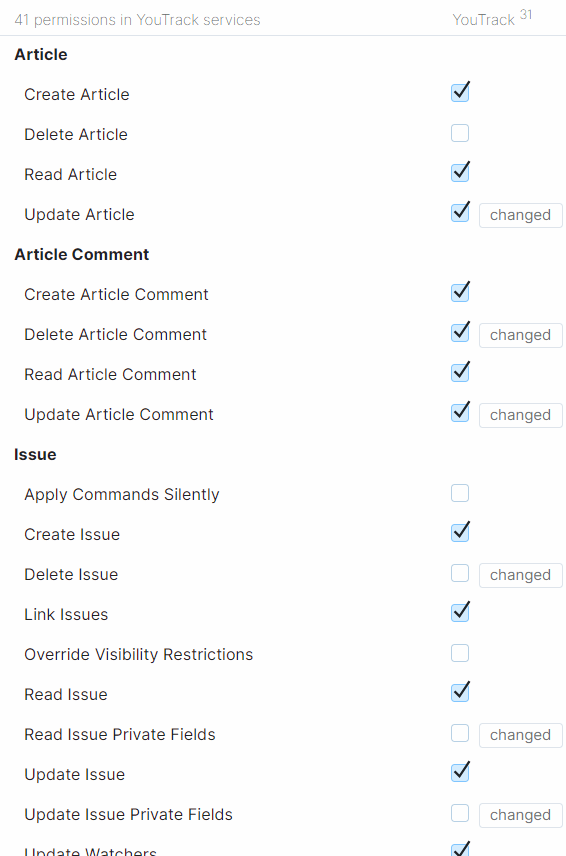

```

class VCL_DLLPUBLIC MouseSettings

{

....

long GetStartDragWidth() const;

long GetStartDragHeight() const;

....

}

bool ImplHandleMouseEvent( .... )

{

....

long nDragW = rMSettings.GetStartDragWidth();

long nDragH = rMSettings.GetStartDragWidth();

....

}

```

Предупреждение: [V656](http://www.viva64.com/ru/d/0277/) Variables 'nDragW', 'nDragH' are initialized through the call to the same function. It's probably an error or un-optimized code. Consider inspecting the 'rMSettings.GetStartDragWidth()' expression. Check lines: 471, 472. winproc.cxx 472

Не понятно, должны инициализироваться переменные nDragW и nDragH одним и тем же значением, или нет. Если да, то не хватает комментария. Или лучше было бы явно написать:

```

long nDragW = rMSettings.GetStartDragWidth();

long nDragH = nDragW;

```

Похожая ситуация:

```

void Edit::ImplDelete(....)

{

....

maSelection.Min() = aSelection.Min();

maSelection.Max() = aSelection.Min();

....

}

```

V656 Variables 'maSelection.Min()', 'maSelection.Max()' are initialized through the call to the same function. It's probably an error or un-optimized code. Consider inspecting the 'aSelection.Min()' expression. Check lines: 756, 757. edit.cxx 757

Для тех, кто работает с проектом здесь всё сразу понятно. Я не работаю, и поэтому не знаю, есть здесь ошибка или нет.

И последний случай. В классе есть три функции:* GetVRP()

* GetVPN()

* GetVUV()

Однако, вот здесь, для инициализации константы 'aVPN' используется функция GetVRP().

```

void ViewContactOfE3dScene::createViewInformation3D(....)

{

....

const basegfx::B3DPoint aVRP(rSceneCamera.GetVRP());

const basegfx::B3DVector aVPN(rSceneCamera.GetVRP()); <<<---

const basegfx::B3DVector aVUV(rSceneCamera.GetVUV());

....

}

```

Предупреждение PVS-Studio: V656 Variables 'aVRP', 'aVPN' are initialized through the call to the same function. It's probably an error or un-optimized code. Consider inspecting the 'rSceneCamera.GetVRP()' expression. Check lines: 177, 178. viewcontactofe3dscene.cxx 178

Анализатор выдал ещё одно предупреждение V656. Я почти уверен, что там настоящая ошибка. Но приводить код не буду, так как он громоздкий. Прошу разработчиков посмотреть вот сюда:* V656 Variables 'oNumOffset1', 'oNumOffset2' are initialized through the call to the same function. It's probably an error or un-optimized code. Check lines: 68, 69. findattr.cxx 69

Copy-Paste

----------

Вынужден признать, что без Copy-Paste программирование временами будет крайне утомительным и скучным занятием. Без Ctrl-C, Ctrl-V программировать не получится, как бы не хотелось запретить эти сочетания клавиш. Поэтому не буду призывать не копировать код. Но призываю всех: копируя код, будьте аккуратны и бдительны!

```

uno::Sequence< OUString >

SwXTextTable::getSupportedServiceNames(void)

{

uno::Sequence< OUString > aRet(4);

OUString* pArr = aRet.getArray();

pArr[0] = "com.sun.star.document.LinkTarget";

pArr[1] = "com.sun.star.text.TextTable";

pArr[2] = "com.sun.star.text.TextContent";

pArr[2] = "com.sun.star.text.TextSortable";

return aRet;

}

```

Предупреждение PVS-Studio: [V519](http://www.viva64.com/ru/d/0108/) The 'pArr[2]' variable is assigned values twice successively. Perhaps this is a mistake. Check lines: 3735, 3736. unotbl.cxx 3736

Классический [эффект последней строки](http://www.viva64.com/ru/b/0260/). Почти уверен, что последняя строчка была получена из предпоследней. Заменили «Content» на «Sortable», а про индекс '2' забыли.

Очень похожий случай:

```

Sequence FirebirdDriver::getSupportedServiceNames\_Static()

{

Sequence< OUString > aSNS( 2 );

aSNS[0] = "com.sun.star.sdbc.Driver";

aSNS[0] = "com.sun.star.sdbcx.Driver";

return aSNS;

}

```

Предупреждение PVS-Studio: V519 The 'aSNS[0]' variable is assigned values twice successively. Perhaps this is a mistake. Check lines: 137, 138. driver.cxx 138

Но самое ужасное, что иногда благодаря Copy-Paste ошибки размножаются. Продемонстрирую это на примере. К сожалению, код будет несколько тяжёл для чтения. Потерпите.

Итак, в программе есть вот такая функция:

```

static bool GetPropertyValue(

::com::sun::star::uno::Any& rAny,

const ::com::sun::star::uno::Reference<

::com::sun::star::beans::XPropertySet > &,

const OUString& rPropertyName,

bool bTestPropertyAvailability = false );

```

Обратите внимание, что последний аргумент 'bTestPropertyAvailability' является необязательным.

Ещё надо сказать, что такое 'sal\_True':

```

#define sal_True ((sal_Bool)1)

```

Теперь собственно ошибка. Посмотрите, как вызывается функция GetPropertyValue():

```

sal_Int32 PPTWriterBase::GetLayoutOffset(....) const

{

::com::sun::star::uno::Any aAny;

sal_Int32 nLayout = 20;

if ( GetPropertyValue(

aAny, rXPropSet, OUString( "Layout" ) ), sal_True )

aAny >>= nLayout;

DBG(printf("GetLayoutOffset %" SAL_PRIdINT32 "\n", nLayout));

return nLayout;

}

```

Предупреждение PVS-Studio: [V639](http://www.viva64.com/ru/d/0257/) Consider inspecting the expression for 'GetPropertyValue' function call. It is possible that one of the closing ')' brackets was positioned incorrectly. pptx-epptbase.cxx 442

Если присмотреться, то выяснится, что одна из закрывающихся круглых скобок стоит не на своём месте. В результате, функция GetPropertyValue() в качестве последнего аргумента получает не 'sal\_True', а значение по умолчанию (равное 'false').

Но это только пол беды. Дополнительно испортилась работа оператора 'if'. Условие выглядит так:

```

if (foo(), sal_True)

```

[Оператор запятая](http://www.viva64.com/go.php?url=1503) возвращает свою правую часть. В результате условие всегда истинно.

Ошибка в этом коде не связана с Copy-Paste. Обыкновенная опечатка. Не там поставлена скобка. Бывает.

Печально то, что эта ошибка была размножена по другим участкам программы. Если в одном месте ошибку исправят, то высока вероятность, что в остальных местах оно останется.

Copy-Paste привёл к появлению этой ошибки ещё в 9 местах:* epptso.cxx 993

* epptso.cxx 3677

* pptx-text.cxx 518

* pptx-text.cxx 524

* pptx-text.cxx 546

* pptx-text.cxx 560

* pptx-text.cxx 566

* pptx-text.cxx 584

* pptx-text.cxx 590

В заключении раздела 3 последних некритических предупреждения. Просто одна лишняя проверка:

```

#define CHECK_N_TRANSLATE( name ) \

else if (sServiceName == SERVICE_PERSISTENT_COMPONENT_##name) \

sToWriteServiceName = SERVICE_##name

void OElementExport::exportServiceNameAttribute()

{

....

CHECK_N_TRANSLATE( FORM ); <<<<----

CHECK_N_TRANSLATE( FORM ); <<<<----

CHECK_N_TRANSLATE( LISTBOX );

CHECK_N_TRANSLATE( COMBOBOX );

CHECK_N_TRANSLATE( RADIOBUTTON );

CHECK_N_TRANSLATE( GROUPBOX );

CHECK_N_TRANSLATE( FIXEDTEXT );

CHECK_N_TRANSLATE( COMMANDBUTTON );

....

}

```

Предупреждение PVS-Studio: [V517](http://www.viva64.com/ru/d/0106/) The use of 'if (A) {...} else if (A) {...}' pattern was detected. There is a probability of logical error presence. Check lines: 177, 178. elementexport.cxx 177

Ничего страшного, но недочёт. Ещё две лишние проверки можно найти здесь:* querydesignview.cxx 3484

* querydesignview.cxx 3486

Храброе использование функции realloc()

---------------------------------------

Функция realloc() используется столь явно небезопасно, что я не рискую назвать это ошибкой. Видимо, это сознательное решение авторов. Раз не удалось выделить память, используя malloc()/realloc(), то пусть программа лучше сразу упадёт. Нечего «брыкаться». Все равно, если программа продолжит работать, вряд ли что из этого хорошего выйдет. Но не честно засчитать выданные анализатором сообщения за ложные срабатывания. Поэтому рассмотрим, что не понравилось анализатору.

Для примера изучим реализацию функции add() в классе FastAttributeList:

```

void FastAttributeList::add(sal_Int32 nToken,

const sal_Char* pValue, size_t nValueLength )

{

maAttributeTokens.push_back( nToken );

sal_Int32 nWritePosition = maAttributeValues.back();

maAttributeValues.push_back( maAttributeValues.back() +

nValueLength + 1 );

if (maAttributeValues.back() > mnChunkLength)

{

mnChunkLength = maAttributeValues.back();

mpChunk = (sal_Char *) realloc( mpChunk, mnChunkLength );

}

strncpy(mpChunk + nWritePosition, pValue, nValueLength);

mpChunk[nWritePosition + nValueLength] = '\0';

}

```

Предупреждение PVS-Studio: [V701](http://www.viva64.com/ru/d/0340/) realloc() possible leak: when realloc() fails in allocating memory, original pointer 'mpChunk' is lost. Consider assigning realloc() to a temporary pointer. fastattribs.cxx 88

Главная беда этого кода в том, что не проверяется результат работы функции realloc(). Безусловно, ситуация, когда не удастся выделить память весьма редка. Но представим — это случилось. Тогда realloc() возвращает NULL. Далее возникнет аварийная ситуация, когда функция strncpy() начнёт копировать данные не пойми куда:

```

mpChunk = (sal_Char *) realloc( mpChunk, mnChunkLength );

}

strncpy(mpChunk + nWritePosition, pValue, nValueLength);

```

Но анализатору не нравится другое. Предположим, что есть какой-то обработчик ошибок. И программа продолжит своё выполнение. Вот только возникает memory leak. В переменную mpChunk будет записан 0, и освободить память уже невозможно. Поясню этот паттерн ошибки чуть подробнее. Многие не задумываются и неправильно используют realloc().

Рассмотрим искусственный пример кода:

```

char *p = (char *)malloc(10);

....

p = (char *)realloc(p, 10000);

```

Если не удастся выделить память, то переменная 'p' будет «испорчена». Теперь нет никакой возможности освободить память, указатель на которую хранился в 'p'.

В таком виде ошибка очевидна. Но на практике такой код встречается достаточно часто. Анализатор выдаёт ещё 8 предупреждений на эту тему, но рассматривать их смысла нет. Все равно LibreOffice считает, что память можно выделить всегда.

Ошибки в логике

---------------

Встретилось ряд забавных ошибок в условиях. Причины, видимо, разные: невнимательность, опечатки, недостаточное знание языка.

```

void ScPivotLayoutTreeListData::PushDataFieldNames(....)

{

....

ScDPLabelData* pLabelData = mpParent->GetLabelData(nColumn);

if (pLabelData == NULL && pLabelData->maName.isEmpty())

continue;

....

}

```

Предупреждение PVS-Studio: [V522](http://www.viva64.com/ru/d/0111/) Dereferencing of the null pointer 'pLabelData' might take place. Check the logical condition. pivotlayouttreelistdata.cxx 157

Логическая ошибка в условии. Если указатель нулевой, то мы его разыменуем. Как я понимаю, здесь следовало использовать оператор ||.

Аналогичная ошибка:

```

void grabFocusFromLimitBox( OQueryController& _rController )

{

....

vcl::Window* pWindow = VCLUnoHelper::GetWindow( xWindow );

if( pWindow || pWindow->HasChildPathFocus() )

{

pWindow->GrabFocusToDocument();

}

....

}

```

Предупреждение PVS-Studio: V522 Dereferencing of the null pointer 'pWindow' might take place. Check the logical condition. querycontroller.cxx 293

Здесь наоборот, вместо '||' следовало написать '&&'.

Теперь чуть более сложное условие:

```

enum SbxDataType {

SbxEMPTY = 0,

SbxNULL = 1,

....

};

void SbModule::GetCodeCompleteDataFromParse(CodeCompleteDataCache& aCache)

{

....

if( (pSymDef->GetType() != SbxEMPTY) ||

(pSymDef->GetType() != SbxNULL) )

....

}

```

Предупреждение PVS-Studio: [V547](http://www.viva64.com/ru/d/0137/) Expression is always true. Probably the '&&' operator should be used here. sbxmod.cxx 1777

Для простоты перепишу выражение:

```

if (type != 0 || type != 1)

```

Условие всегда истинно.

Две похожих ошибки можно найти здесь:* V547 Expression is always true. Probably the '&&' operator should be used here. sbxmod.cxx 1785

* V547 Expression is always false. Probably the '||' operator should be used here. xmlstylesexporthelper.cxx 223

Встретилось два места, где условие является избыточным. Я думаю это ошибки:

```

sal_uInt16 ScRange::ParseCols(....)

{

....

const sal_Unicode* p = rStr.getStr();

....

case formula::FormulaGrammar::CONV_XL_R1C1:

if ((p[0] == 'C' || p[0] != 'c') &&

NULL != (p = lcl_r1c1_get_col(

p, rDetails, &aStart, &ignored )))

{

....

}

```

Предупреждение PVS-Studio: V590 Consider inspecting the 'p[0] == 'C' || p[0] != 'c'' expression. The expression is excessive or contains a misprint. address.cxx 1593

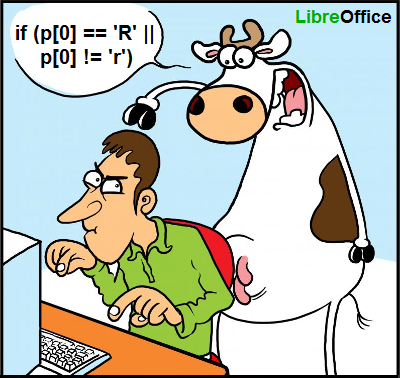

Условие (p[0] == 'C' || p[0] != 'c') можно сократить до (p[0] != 'c'). Уверен, что это ошибка и условие должно быть таким: (p[0] == 'C' || p[0] == 'c').

Идентичная ошибку можно найти в этом же файле чуть ниже:* V590 Consider inspecting the 'p[0] == 'R' || p[0] != 'r'' expression. The expression is excessive or contains a misprint. address.cxx 1652

Пожалуй, к ошибкам в логике можно отнести ситуацию, когда указатель в начале разыменовывается, а потом только проверяется на равенство нулю. Это весьма [распространенная ошибка](http://www.viva64.com/ru/examples/v595/) во всех программах. Обычно она возникает из-за невнимательности в процессе рефакторинга кода.

Типичный пример:

```

IMPL_LINK(....)

{

....

SystemWindow *pSysWin = pWindow->GetSystemWindow();

MenuBar *pMBar = pSysWin->GetMenuBar();

if ( pSysWin && pMBar )

{

AddMenuBarIcon( pSysWin, true );

}

....

}

```

Предупреждение PVS-Studio: V595 The 'pSysWin' pointer was utilized before it was verified against nullptr. Check lines: 738, 739. updatecheckui.cxx 738

Указатель 'pSysWin' разыменовывается в выражении 'pSysWin->GetMenuBar()'. Затем он проверяется на равенство нулю.

Предлагаю создателям LibreOffice также обратить внимание вот на эти места: [LibreOffice-V595.txt](http://www.viva64.com/external-pictures/txt/LibreOffice-V595.txt).

И последняя, на этот раз более запутанная ситуация. Если устали, то можно пропустить это место. Рассмотрим обыкновенно перечисление:

```

enum BRC_Sides

{

WW8_TOP = 0, WW8_LEFT = 1, WW8_BOT = 2,

WW8_RIGHT = 3, WW8_BETW = 4

};

```

Обратите внимание, именованные константы не являются степенью двойки. Это просто числа. В том числе там есть 0.

А работают с этими константами, как будто они представляют степень двойки. Пытаются по маске выбрать и проверить отдельные биты:

```

void SwWW8ImplReader::Read_Border(....)

{

....

if ((nBorder & WW8_LEFT)==WW8_LEFT)

aBox.SetDistance(

(sal_uInt16)aInnerDist.Left(), BOX_LINE_LEFT );

if ((nBorder & WW8_TOP)==WW8_TOP)

aBox.SetDistance(

(sal_uInt16)aInnerDist.Top(), BOX_LINE_TOP );

if ((nBorder & WW8_RIGHT)==WW8_RIGHT)

aBox.SetDistance(

(sal_uInt16)aInnerDist.Right(), BOX_LINE_RIGHT );

if ((nBorder & WW8_BOT)==WW8_BOT)

aBox.SetDistance(

(sal_uInt16)aInnerDist.Bottom(), BOX_LINE_BOTTOM );

....

}

```

Предупреждение PVS-Studio: [V616](http://www.viva64.com/ru/d/0233/) The 'WW8\_TOP' named constant with the value of 0 is used in the bitwise operation. ww8par6.cxx 4742

Это неправильные действия. Например, условие ((nBorder & WW8\_TOP)==WW8\_TOP) всегда истинно. Для пояснения подставлю числа: ((nBorder & 0)==0).

Неправильно сработает проверка и на WW8\_LEFT, если в переменной nBorder будет значение WW8\_RIGHT, равное 3. Подставляем ((3 & 1) == 1). Получается, что WW8\_RIGHT примем за WW8\_LEFT.

Скелет в шкафу

--------------

Анализатор время от времени обнаруживает аномальные места в коде. Это не ошибки, а хитрая задумка. Трогать их смысла нет, но посмотреть может быть интересно. Вот один из таких случаев, где анализатору не понравился аргумент функции free():

```

/* This operator is supposed to be unimplemented, but that now leads

* to compilation and/or linking errors with MSVC2008. (Don't know

* about MSVC2010.) As it can be left unimplemented just fine with

* gcc, presumably it is never called. So do implement it then to

* avoid the compilation and/or linking errors, but make it crash

* intentionally if called.

*/

void SimpleReferenceObject::operator delete[](void * /* pPtr */)

{

free(NULL);

}

```

Техника безопасности

--------------------

Анализатор выявил ряд моментов, которые делают код программы опасным. Опасности разнообразны по своей природе, но я решил их собрать в один раздел.

```

void writeError( const char* errstr )

{

FILE* ferr = getErrorFile( 1 );

if ( ferr != NULL )

{

fprintf( ferr, errstr );

fflush( ferr );

}

}

```

Предупреждение PVS-Studio: [V618](http://www.viva64.com/ru/d/0235/) It's dangerous to call the 'fprintf' function in such a manner, as the line being passed could contain format specification. The example of the safe code: printf("%s", str); unoapploader.c 405

Если в строке 'errstr' встретятся управляющие символы, то произойти может всё, что угодно. Программа может упасть, может записать в файл мусор или произойдёт что-то ещё ([подробности](http://www.viva64.com/ru/b/0129/)).

Правильно будет написать так:

```

fprintf( ferr, "%s", errstr );

```

Ещё два места, где неправильно используется функция printf():* climaker\_app.cxx 261

* climaker\_app.cxx 313

Теперь про опасное использование [dynamic\_cast](http://www.viva64.com/go.php?url=1504).

```

virtual ~LazyFieldmarkDeleter()

{

dynamic_cast

(\*m\_pFieldmark.get()).ReleaseDoc(m\_pDoc);

}

```

Предупреждение PVS-Studio: [V509](http://www.viva64.com/ru/d/0098/) The 'dynamic\_cast' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. docbm.cxx 846

При работе с ссылками, если преобразование невозможно выполнить, оператор dynamic\_cast генерирует исключение std::bad\_cast.

Если в программе возникает исключение, начинается свертывание стека, в ходе которого объекты разрушаются путем вызова деструкторов. Если деструктор объекта, разрушаемого при свертывании стека, бросает еще одно исключение, и это исключение покидает деструктор, библиотека C++ немедленно аварийно завершает программу, вызывая функцию terminate(). Из этого следует, что деструкторы никогда не должны распространять исключения. Исключение, брошенное внутри деструктора, должно быть обработано внутри того же деструктора.

По этой же причине опасно в деструкторы вызывать оператор new. Этот оператор при нехватке памяти сгенерирует исключение std::bad\_alloc. Хорошим тоном будет обернуть его в блок try-catch.

Пример опасного кода:

```

WinMtfOutput::~WinMtfOutput()

{

mpGDIMetaFile->AddAction( new MetaPopAction() );

....

}

```

Предупреждения PVS-Studio: V509 The 'new' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. winmtf.cxx 852

Прочие опасные действия в деструкторе:* V509 The 'dynamic\_cast' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. ndtxt.cxx 4886

* V509 The 'new' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. export.cxx 279

* V509 The 'new' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. getfilenamewrapper.cxx 73

* V509 The 'new' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. e3dsceneupdater.cxx 80

* V509 The 'new' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. accmap.cxx 1683

* V509 The 'new' operator should be located inside the try..catch block, as it could potentially generate an exception. Raising exception inside the destructor is illegal. frmtool.cxx 938

Кстати, раз пошла речь про operator new, то отмечу опасность вот такого кода:

```

extern "C" oslFileHandle

SAL_CALL osl_createFileHandleFromOSHandle(

HANDLE hFile,

sal_uInt32 uFlags)

{

if ( !IsValidHandle(hFile) )

return 0; // EINVAL

FileHandle_Impl * pImpl = new FileHandle_Impl(hFile);

if (pImpl == 0)

{

// cleanup and fail

(void) ::CloseHandle(hFile);

return 0; // ENOMEM

}

....

}

```

Предупреждение PVS-Studio: [V668](http://www.viva64.com/ru/d/0293/) There is no sense in testing the 'pImpl' pointer against null, as the memory was allocated using the 'new' operator. The exception will be generated in the case of memory allocation error. file.cxx 663

Оператор 'new' при нехватке памяти генерирует исключение. Таим образом, проверять указатель, который вернул оператор не имеет смысла. Он всегда не равен 0. При нехватке памяти не будет вызвана функция CloseHandle():

```

FileHandle_Impl * pImpl = new FileHandle_Impl(hFile);

if (pImpl == 0)

{

// cleanup and fail

(void) ::CloseHandle(hFile);

return 0; // ENOMEM

}

```

Я могу ошибаться. Я не знаю проект LibreOffice. Возможно разработчики используют специальный вариант библиотек, в которых оператор 'new' не кидает исключение, а возвращает nullptr. Если это так, то прошу просто не обращать внимание на предупреждения с номером V668. Их можно отключить, чтобы они не мешались.

Если оператор new кидает исключение, то рекомендую просмотреть следующие 126 сообщений: [LibreOffice-V668.txt](http://www.viva64.com/external-pictures/txt/LibreOffice-V668.txt).

Следующая опасность кроется в реализации одной из функций DllMain:

```

BOOL WINAPI DllMain( HINSTANCE hinstDLL,

DWORD fdwReason, LPVOID lpvReserved )

{

....

CreateThread( NULL, 0, ParentMonitorThreadProc,

(LPVOID)dwParentProcessId, 0, &dwThreadId );

....

}

```

Предупреждение PVS-Studio: [V718](http://www.viva64.com/ru/d/0359/) The 'CreateThread' function should not be called from 'DllMain' function. dllentry.c 308

Внутри функции DllMain() нельзя вызывать многие функции, так как это может привести к зависанию приложения или иным ошибкам. Именно к таким функциям относится CreateThread().

Ситуация с DllMain хорошо описана в статье на сайте MSDN: [Dynamic-Link Library Best Practices](http://www.viva64.com/go.php?url=1487).

Этот код может работать, но он опасен и когда-нибудь может подвести.

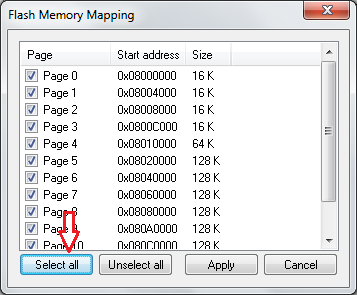

Встретилась ситуация, где функция wcsncpy() может привести к переполнению буфера:

```

typedef struct {

....

WCHAR wszTitle[MAX_COLUMN_NAME_LEN];

WCHAR wszDescription[MAX_COLUMN_DESC_LEN];

} SHCOLUMNINFO, *LPSHCOLUMNINFO;

HRESULT STDMETHODCALLTYPE CColumnInfo::GetColumnInfo(

DWORD dwIndex, SHCOLUMNINFO *psci)

{

....

wcsncpy(psci->wszTitle,

ColumnInfoTable[dwIndex].wszTitle,

(sizeof(psci->wszTitle) - 1));

return S_OK;

}

```

Предупреждение PVS-Studio: [V512](http://www.viva64.com/ru/d/0101/) A call of the 'wcsncpy' function will lead to overflow of the buffer 'psci->wszTitle'. columninfo.cxx 129

Выражение (sizeof(psci->wszTitle) — 1) неверно. Забыли поделить на размер одного символа:

```

(sizeof(psci->wszTitle) / sizeof(psci->wszTitle[0]) - 1)

```

Последний тип ошибки, который мы рассмотрим в этом разделе, являются неработающие вызовы функций memset(). Пример:

```

static void __rtl_digest_updateMD2 (DigestContextMD2 *ctx)

{

....

sal_uInt32 state[48];

....

memset (state, 0, 48 * sizeof(sal_uInt32));

}

```

Предупреждение PVS-Studio: [V597](http://www.viva64.com/ru/d/0208/) The compiler could delete the 'memset' function call, which is used to flush 'state' buffer. The RtlSecureZeroMemory() function should be used to erase the private data. digest.cxx 337

Я уже много раз писал про этот вид ошибки. Поэтому опишу её буквально парой слов, а подробности можно узнать, перейдя по предложенным ссылкам.

Компилятор в праве удалить вызов функции memset(), если после её вызова обнулённая память никак не используется. Именно это здесь и произойдёт. В результате в памяти останутся какие-то приватные данные.

Подробности:1. [V597. The compiler could delete the 'memset' function call, which is used to flush 'Foo' buffer](http://www.viva64.com/ru/d/0208/).

2. [Перезаписывать память — зачем?](http://www.viva64.com/ru/k/0041/)

3. [Zero and forget — caveats of zeroing memory in C](http://www.viva64.com/go.php?url=1028).

Прочие места, где не чистятся приватные данные: [LibreOffice-V597.txt](http://www.viva64.com/external-pictures/txt/LibreOffice-V597.txt).

Всякое разное

-------------

```

Guess::Guess()

{

language_str = DEFAULT_LANGUAGE;

country_str = DEFAULT_COUNTRY;

encoding_str = DEFAULT_ENCODING;

}

Guess::Guess(const char * guess_str)

{

Guess();

....

}

```

Предупреждение PVS-Studio: [V603](http://www.viva64.com/ru/d/0215/) The object was created but it is not being used. If you wish to call constructor, 'this->Guess::Guess(....)' should be used. guess.cxx 56

Программист, написавший этот код, недостаточно хорошо знает язык Си++. Он хотел вызывать один конструктор из другого. Но, на самом деле, он создал временный неименованный объект. Из-за ошибки некоторые поля класса так остаются неинициализированными. [Подробности](http://www.viva64.com/ru/b/0127/).

Ещё один неудачный конструктор: camera3d.cxx 46

```

sal_uInt32 readIdent(....)

{

size_t nItems = rStrings.size();

const sal_Char** pStrings = new const sal_Char*[ nItems+1 ];

....

delete pStrings;

return nRet;

}

```

Предупреждение PVS-Studio: [V611](http://www.viva64.com/ru/d/0226/) The memory was allocated using 'new T[]' operator but was released using the 'delete' operator. Consider inspecting this code. It's probably better to use 'delete [] pStrings;'. profile.hxx 103

Правильно будет: delete [] pStrings;.

Ещё одно предупреждение про неправильное освобождение памяти:* V611 The memory was allocated using 'new T[]' operator but was released using the 'delete' operator. Consider inspecting this code. It's probably better to use 'delete [] pStrings;'. profile.hxx 134

```

static const int kConventionShift = 16;

static const int kFlagMask = ~((~int(0)) << kConventionShift);

```

Предупреждение PVS-Studio: V610 Undefined behavior. Check the shift operator '<<'. The left operand '(~int (0))' is negative. grammar.hxx 56

Имеет место неопределённое поведение из-за сдвига отрицательного значения ([подробности](http://www.viva64.com/ru/b/0142/)).

```

sal_Int32 GetMRest() const {return m_nRest;}

OUString LwpBulletStyleMgr::RegisterBulletStyle(....)

{

....

if (pIndent->GetMRest() > 0.001)

....

}

```

Предупреждение PVS-Studio: [V674](http://www.viva64.com/ru/d/0308/) The '0.001' literal of the 'double' type is compared to a value of the 'long' type. Consider inspecting the 'pIndent->GetMRest() > 0.001' expression. lwpbulletstylemgr.cxx 177

Что-то здесь не так. Нет смысла сравнивать целочисленное значение с 0.001.

Неприятная путаница с типом возвращаемого значения:

```

BOOL SHGetSpecialFolderPath(

HWND hwndOwner,

_Out_ LPTSTR lpszPath,

_In_ int csidl,

_In_ BOOL fCreate

);

#define FAILED(hr) (((HRESULT)(hr)) < 0)

OUString UpdateCheckConfig::getDesktopDirectory()

{

....

if( ! FAILED( SHGetSpecialFolderPathW( .... ) ) )

....

}

```

Предупреждение PVS-Studio: [V716](http://www.viva64.com/ru/d/0357/) Suspicious type conversion: BOOL -> HRESULT. updatecheckconfig.cxx 193

Программист решил, что SHGetSpecialFolderPath() возвращает тип HRESULT. Но, на самом деле, функция возвращает BOOL. Чтобы исправить код, следует убрать из условия макрос FAILED.

Ещё одна такая ошибка: updatecheckconfig.cxx 222

А вот здесь наоборот не хватает макроса FAILED. Так проверять статус типа HRESULT нельзя:

```

bool UniscribeLayout::LayoutText( ImplLayoutArgs& rArgs )

{

....

HRESULT nRC = ScriptItemize(....);

if( !nRC ) // break loop when everything is correctly itemized

break;

....

}

```

Предупреждение PVS-Studio: [V545](http://www.viva64.com/ru/d/0134/) Such conditional expression of 'if' operator is incorrect for the HRESULT type value 'nRC'. The SUCCEEDED or FAILED macro should be used instead. winlayout.cxx 1115

Думаю, здесь следует заменить запятую на точку с запятой:

```

void Reader::ClearTemplate()

{

if( pTemplate )

{

if( 0 == pTemplate->release() )

delete pTemplate,

pTemplate = 0;

}

}

```

Предупреждение PVS-Studio: [V626](http://www.viva64.com/ru/d/0243/) Consider checking for misprints. It's possible that ',' should be replaced by ';'. shellio.cxx 549

Неинтересная мелочь:

```

void TabBar::ImplInit( WinBits nWinStyle )

{

....

mbMirrored = false;

mbMirrored = false;

....

}

```

Предупреждение PVS-Studio: V519 The 'mbMirrored' variable is assigned values twice successively. Perhaps this is a mistake. Check lines: 415, 416. tabbar.cxx 416

И здесь ещё: V519 The 'aParam.mpPreviewFontSet' variable is assigned values twice successively. Perhaps this is a mistake. Check lines: 4561, 4562. output2.cxx 4562

Неправильно магическая константа, обозначающая длину строки:

```

static bool CallRsc2(....)

{

....

if( !rsc_strnicmp( ...., "-fp=", 4 ) ||

!rsc_strnicmp( ...., "-fo=", 4 ) ||

!rsc_strnicmp( ...., "-presponse", 9 ) || <<<<----

!rsc_strnicmp( ...., "-rc", 3 ) ||

!rsc_stricmp( ...., "-+" ) ||

!rsc_stricmp( ...., "-br" ) ||

!rsc_stricmp( ...., "-bz" ) ||

!rsc_stricmp( ...., "-r" ) ||

( '-' != *.... ) )

....

}

```

Предупреждение PVS-Studio: [V666](http://www.viva64.com/ru/d/0291/) Consider inspecting third argument of the function 'rsc\_strnicmp'. It is possible that the value does not correspond with the length of a string which was passed with the second argument. start.cxx 179

Длина строки "-presponse" 10, а не 9 символов.

Странный 'break' внутри цикла:

```

OUString getExtensionFolder(....)

{

....

while (xResultSet->next())

{

title = Reference(

xResultSet, UNO\_QUERY\_THROW )->getString(1 /\* Title \*/ ) ;

break;

}

return title;

}

```

Предупреждение PVS-Studio: [V612](http://www.viva64.com/ru/d/0228/) An unconditional 'break' within a loop. dp\_manager.cxx 100

Ещё три странных цикла:* V612 An unconditional 'break' within a loop. svdfppt.cxx 3260

* V612 An unconditional 'break' within a loop. svdfppt.cxx 3311

* V612 An unconditional 'break' within a loop. personalization.cxx 454

Маловероятное разыменование нулевого указателя:

```

BSTR PromptNew(long hWnd)

{

....

ADOConnection* piTmpConnection = NULL;

::CoInitialize( NULL );

hr = CoCreateInstance(

CLSID_DataLinks,

NULL,

CLSCTX_INPROC_SERVER,

IID_IDataSourceLocator,

(void**)&dlPrompt

);

if( FAILED( hr ) )

{

piTmpConnection->Release();

dlPrompt->Release( );

return connstr;

}

....

}

```

Предупреждение PVS-Studio: V522 Dereferencing of the null pointer 'piTmpConnection' might take place. adodatalinks.cxx 84

Если вдруг функция CoCreateInstance() вернёт статус ошибки, то произойдёт разыменование указателя 'piTmpConnection' который равен NULL.

Микрооптимизации

----------------

Статический анализатор ни в коей мере не может быть заменой инструментам профилирования. Только профилировщик может показать, где стоит оптимизировать вашу программу.

Тем не менее статический анализатор может показать места в коде, которые можно легко улучшить. Не обязательно, что от этого программа будет работать быстрее. Но хуже точно не будет. Пожалуй, речь идёт скорее о хорошем стиле кодирования.

Посмотрим, какие рекомендации выдаёт PVS-Studio касательно микрооптимизаций.

### Передача объектов по ссылке

Если объект, переданный в функцию не изменяется, то эстетично будет передать его по ссылке, а не значению. Конечно, это относится не ко всем объектам. Однако, если, например, мы имеем дело со строками, то нет смысла зря выделять память и копировать содержимое строки.

Пример:

```

string getexe(string exename, bool maybeempty) {

char* cmdbuf;

size_t cmdlen;

_dupenv_s(&cmdbuf, &cmdlen, exename.c_str());

if(!cmdbuf) {

if (maybeempty) {

return string();

}

cout << "Error " << exename << " not defined. "

"Did you forget to source the environment?" << endl;

exit(1);

}

string command(cmdbuf);

free(cmdbuf);

return command;

}

```

Объект 'exename' используется только для чтения. Поэтому анализатор сообщает: [V813](http://www.viva64.com/ru/d/0303) Decreased performance. The 'exename' argument should probably be rendered as a constant reference. wrapper.cxx 18

Объявление функции можно изменить следующим образом:

```

string getexe(const string &exename, bool maybeempty)

```

Передача сложных объектов по константной ссылке обычно более эффективна и позволяет избежать проблемы «срезки». Для тех, кто недостаточно хорошо понимает суть, предлагаю обратиться к 20 правилу «Предпочитайте передачу по ссылке на const передаче по значению» из книги:

Мэйерс С. «Эффективное использование C++. 55 верных способов улучшить структуру и код ваших программ» — М.: ДМК Пресс, 2006. — 300 с.: ил. ISBN 5-94074-304-8

Ещё одной родственной диагностикой является [V801](http://www.viva64.com/ru/d/0135/). Всего, анализатор выдал 465 предупреждений, где на его взгляд можно передавать объект по ссылке: [LibreOffice-V801-V813.txt](http://www.viva64.com/external-pictures/txt/LibreOffice-V801-V813.txt).

### Использование префиксного инкремента

Для итераторов операция префиксного инкремента немного быстрее. Более подробно про это можно прочитать в «Правило 6. Различайте префиксную форму операторов инкремента и декремента» из книги:

Мейерс С. Наиболее эффективное использование С++. 35 новых рекомендаций по улучшению ваших программ и проектов: Пер. с англ. — М.: ДМК Пресс, 2000. — 304 с.: ил. (Серия «Для программистов»). ISBN 5-94074-033-2. ББК 32.973.26-018.1.

Рекомендация может показаться надуманной и, что на практике между 'A++'и '++A' никакой разницы нет. Я изучил этот вопрос, провёл эксперименты и считаю, что эту рекомендацию следует применять ([подробности](http://www.viva64.com/ru/b/0093/)).

Пример кода:

```

typename InterfaceMap::iterator find(const key &rKey) const

{

typename InterfaceMap::iterator iter = m_pMap->begin();

typename InterfaceMap::iterator end = m_pMap->end();

while( iter != end )

{

equalImpl equal;

if( equal( iter->first, rKey ) )

break;

iter++;

}

return iter;

}

```

Предупреждение PVS\_Studio: [V803](http://www.viva64.com/ru/d/0165/) Decreased performance. In case 'iter' is iterator it's more effective to use prefix form of increment. Replace iterator++ with ++iterator. interfacecontainer.h 405

Выражение «iter++» стоит заменить на "++iter". Не знаю, посчитают ли разработчики рациональным потратить на это время. Если решат, что стоит поправить, то вот ещё 257 мест, где можно заменить постфиксный инкремент на префиксный: [LibreOffice-V803.txt](http://www.viva64.com/external-pictures/txt/LibreOffice-V803.txt).

### Проверка, что строка пустая

Чтобы узнать, что строка пустая, необязательно вычислять её длину. Пример неэффективного кода:

```

BOOL GetMsiProp(....)

{

....

char* buff = reinterpret_cast( malloc( nbytes ) );

....

return ( strlen(buff) > 0 );

}

```

Предупреждение PVS-Studio: [V805](http://www.viva64.com/ru/d/0179/) Decreased performance. It is inefficient to identify an empty string by using 'strlen(str) > 0' construct. A more efficient way is to check: str[0] != '\0'. sellang.cxx 49

Неэффективность в том, что нужно перебрать все символы в строке, пока не встретится [терминальный ноль](http://www.viva64.com/ru/t/0088/). Но достаточно проверить только один байт:

```

return buff[0] != '\0';

```

Такой код не очень красив, поэтому лучше будет завести специальную функцию:

```

inline bool IsEmptyStr(const char *s)

{

return s == nullptr || s[0] == '\0';

}

```

Здесь появилась лишняя проверка на равенства указателя нулю. Мне это не очень нравится и можно подумать над другими вариантами. Но всё равно, эта функция будет работать быстрее чем strlen().

Другие неэффективные проверки: [LibreOffice-V805.txt](http://www.viva64.com/external-pictures/txt/LibreOffice-V805.txt).

### Прочее

Есть ещё несколько предупреждений анализатора, которые могут показаться интересными: [LibreOffice-V804\_V811.txt](http://www.viva64.com/external-pictures/txt/LibreOffice-V804_V811.txt).

Количество ложных срабатываний

------------------------------

В статье я упомянул 240 предупреждений, которые мне показались интересными. Всего анализатор выдал около 1500 предупреждений общего плана ([GA](http://www.viva64.com/ru/general-analysis/)) 1 и 2 уровня. Это значит, что анализатор выдаёт много ложных срабатываний? Нет. Большинство предупреждений вполне по делу, но говорить про них в статье нет никакого смысла.

Время от времени мы получаем от наших пользователей положительные отзывы, в которых они говорят: «Анализатор PVS-Studio выдаёт мало ложных срабатываний, что очень удобно». Мы тоже считаем, что ложных срабатываний мало. Но как же так? В статье рассказано только о 16% сообщений. Что всё остальное? Это ложные срабатывания?

Конечно, есть ложные срабатывания. От этого никуда не денешься. Для их подавления есть ряд [механизмов](http://www.viva64.com/ru/d/0021/). Однако, большая часть предупреждений хотя и не выявило ошибку, но указала на код, который плохо пахнет. Попробую пояснить на примерах.

Анализатор выдал **206** предупреждений [V690](http://www.viva64.com/ru/d/0326/) о том, что в классе реализован конструктор копирования, но не реализован оператор присваивания. Вот один из таких классов:

```

class RegistryTypeReader

{

public:

....

inline RegistryTypeReader(const RegistryTypeReader& toCopy);

....

};

inline RegistryTypeReader::RegistryTypeReader(const RegistryTypeReader& toCopy)

: m_pApi(toCopy.m_pApi)

, m_hImpl(toCopy.m_hImpl)

{ m_pApi->acquire(m_hImpl); }

```

С большой вероятностью никакой ошибки нет. Скорее всего, operator = не используется во всех 206 классах. А вдруг используется?

Здесь программисту надо сделать выбор.

Если он считает, что код опасен, то он должен реализовать оператор присваивания или запретить его. Если на его взгляд опасности нет, то он может отключить диагностику V690, и список подозрительных мест сразу похудеет на 206 предупреждений.

Другой пример. Ранее в статье упоминался следующий подозрительный фрагмент:

```

if( pInit )

AddMap( pInit );

if( pInit )

AddMap( pInit2 );

```

Он выявлен с помощью диагностики V581. Но, если честно, я смотрел предупреждения V581 очень поверхностно и мог что-то пропустить. Дело в том, что их ещё 70 штук. И анализатор не виноват. Откуда ему знать, зачем писать вот так:

```

static bool lcl_parseDate(....)

{

bool bSuccess = true;

....

if (bSuccess)

{

++nPos;

}

if (bSuccess)

{

bSuccess =

readDateTimeComponent(string, nPos, nDay, 2, true);

....

}

```

Два раза проверяется 'bSuccess'. Вдруг второй раз следует проверить другую переменную?

Что делать с такими 70 предупреждениями вновь должен решить программист. Если он любит делать несколько одинаковых проверок, чтобы выделить какие-то логические блоки, то анализатор конечно не прав. Нужно отключить диагностику V581 и сразу исчезнут 70 предупреждений.

Если программист не столь уверен в себе, то ему придётся что-то предпринять. Можно отрефакторить код:

```

static bool lcl_parseDate(....)

{

bool bSuccess = true;

....

if (bSuccess)

{

++nPos;

bSuccess =

readDateTimeComponent(string, nPos, nDay, 2, true);

....

}

```

Самое главное, что нет серьезной проблемы с ложными срабатываниями. Если человеку группа предупреждений кажется бессмысленной для его проекта, он просто отключает их и очень сильно сокращает количество предупреждений, которое ему следует изучать. Если, на его взгляд, код следует посмотреть и поправить, то это никакие не ложные срабатывания, а самые настоящие полезные предупреждения.

**Примечание.** Можно начать использовать анализатор, не просматривая сотни или тысячи предупреждений. Можно воспользоваться новым механизмом [разметки сообщений](http://www.viva64.com/ru/d/0345/). Надо скрыть все предупреждения, которые есть и смотреть только на сообщения, которые будут появляются в новом коде. А к ошибкам в старом коде можно будет вернуться в более свободный от срочных дел момент времени.

Заключение

----------

Хотя как всегда в моей статье перечислена масса ошибок, недочетов и ляпов, код LibreOffice весьма качественный. Да и регулярное использование Coverity говорит о серьёзном подходе к разработке. Для проекта такого объёма ошибок весьма мало.