text

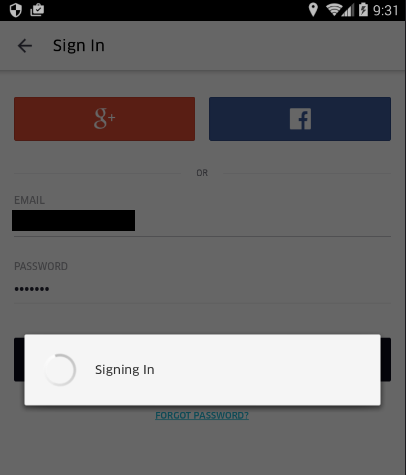

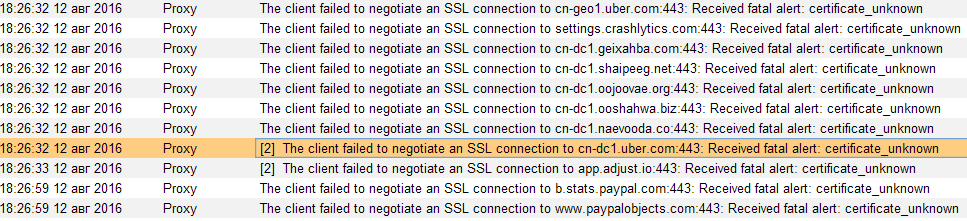

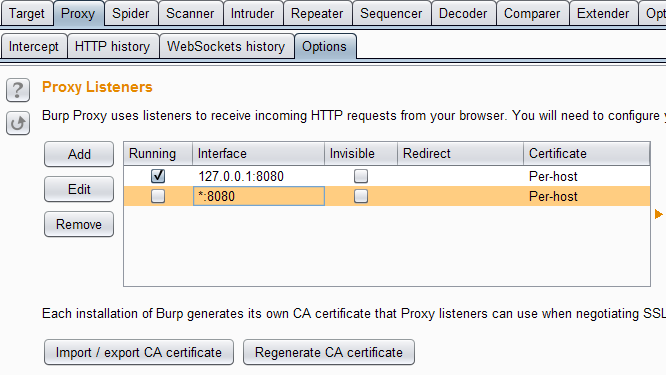

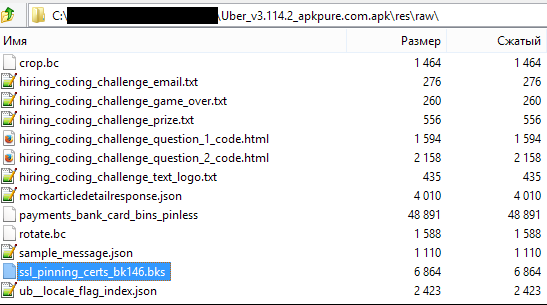

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

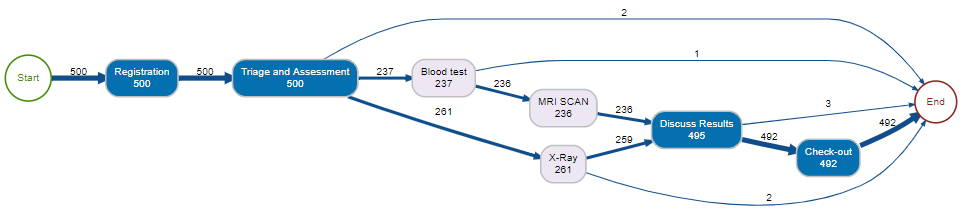

# Terraform, моно-репозитории и compliance as code

***Всем привет. OTUS открыл набор в новую группу по курсу [«Инфраструктурная платформа на основе Kubernetes»](https://otus.pw/McAR/), в связи с этим мы подготовили перевод интересного материала по теме.***

---

Возможно, вы один из тех, кто использует terraform для Infrastructure as a Code, и вам интересно, как использовать его продуктивнее и безопаснее. В общем-то, последнее время, это многих беспокоит. Мы все пишем конфигурацию и код, используя разные инструменты, языки и тратим значительное количество времени на то, чтобы сделать его более читабельным, расширяемым и масштабируемым.

*Может быть, проблема в нас самих?*

Написанный код должен создавать ценность или решать проблему, а также быть пригодным для повторного использования с целью дедупликации. Обычно такого рода дискуссии заканчиваются *“Давайте использовать модули”*. Мы все используем модули terraform, верно? Я мог бы написать множество историй с проблемами из-за чрезмерной модульности, но это совсем другая история, и я не буду.

*Нет, я не буду. Не настаивайте, нет… Ладно, может быть, позже.*

Есть хорошо известная практика — тегировать код при использовании модулей для блокировки root-модуля, чтобы гарантировать его работу даже при изменении кода модуля. Этот подход должен стать командным принципом, при котором соответствующие модули тегируются и используются надлежащим образом.

… но что насчет зависимостей? Что, если у меня **120** модулей в **120** разных репозиториях, и изменение одного модуля влияет на 20 других модулей. Означает ли это, что нам нужно делать **20 + 1** пулл реквестов? Если минимальное количество ревьюеров равно 2, то это означает **21 х 2 = 44** ревью. Серьёзно! Мы просто парализуем команду “изменением одного модуля” и все начнут посылать мемы или гифки Властелина колец, и оставшаяся часть дня будет потеряна.

*Один PR, чтобы уведомить всех, один PR, чтобы собрать всех вместе, сковать и ввергнуть во тьму*

Стоит ли так работать? Должны ли мы уменьшить количество ревьюверов? Или, может, для модулей сделать исключение и не требовать PR, если изменение оказывает большое влияние. Действительно? Вы хотите гулять вслепую в глубоком темном лесу? Или *соберете всех вместе, скуете и ввергнете во тьму*?

Не надо, не меняйте порядок ревью. Если вы считаете, что правильно работать с PR, то придерживайтесь этого. Если у вас есть умные пайплайны или у вас пушат в master, то оставайтесь с этим подходом.

В данном случае проблема не **“как вы работаете”**, а **“какая структура у ваших git-репозиториев”**.

Это похоже на то, что я чувствовал, когда впервые применил предложенное ниже

Вернемся к основам. Каковы общие требования к репозиторию с terraform-модулями?

1. Он должен быть тегирован для того, чтобы не было breaking changes.

2. Любое изменение должно иметь возможность тестирования.

3. Изменения должны проходить взаимное ревью.

Тогда я предлагаю следующее — **НЕ используйте** *микро-репозитории для модулей terraform. Используйте один моно-репозиторий*.

* Вы можете тегировать весь репозиторий, когда есть изменение / требование

* Любое изменение, PR или push можно протестировать

* Любое изменение может пройти через ревью

*У меня есть сила!*

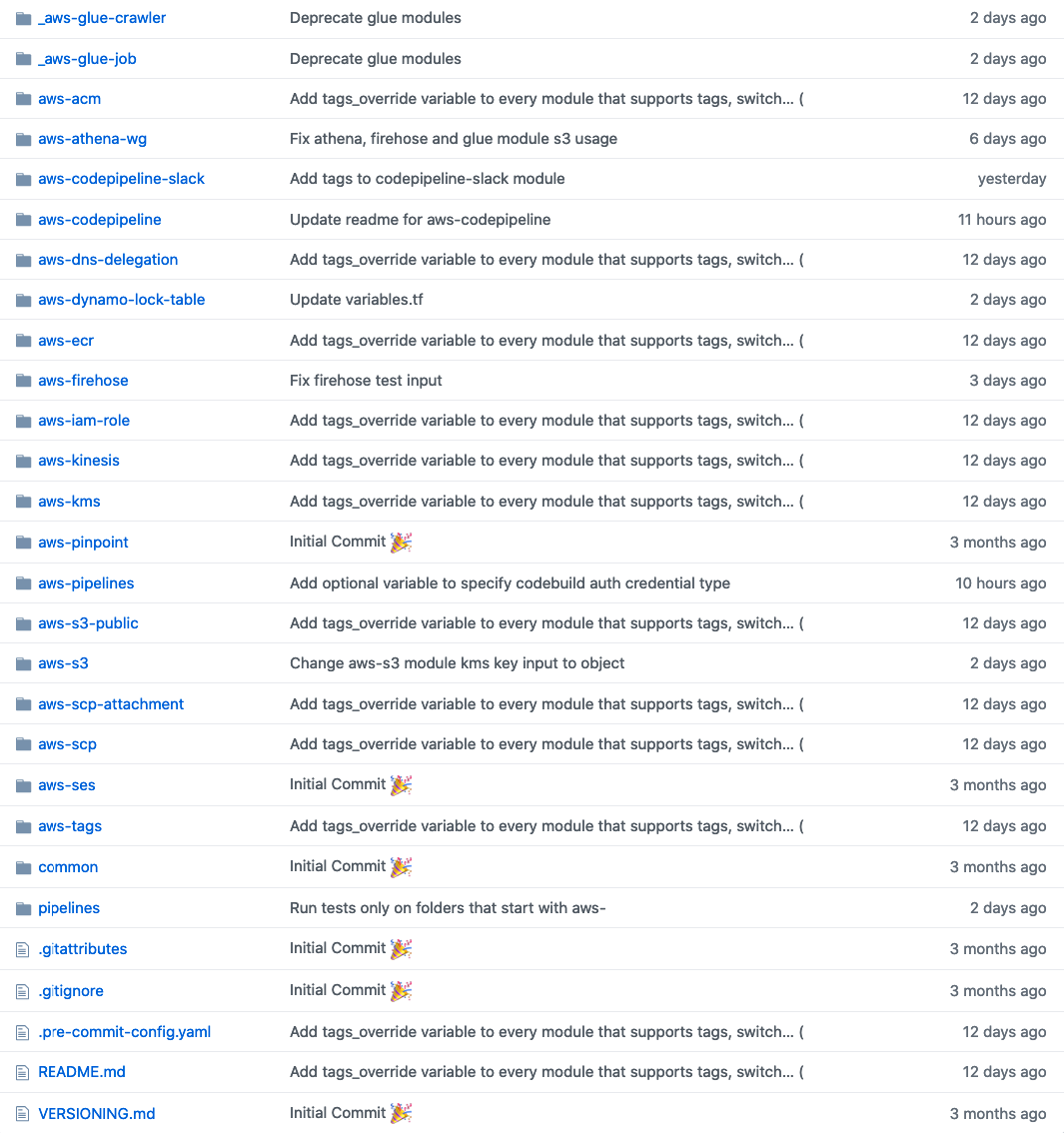

Хорошо, но какая будет структура у этого репозитория? Последние четыре года у меня было много неудач, связанных с этим, и я пришел к выводу, что лучшим решением будет отдельная директория на модуль.

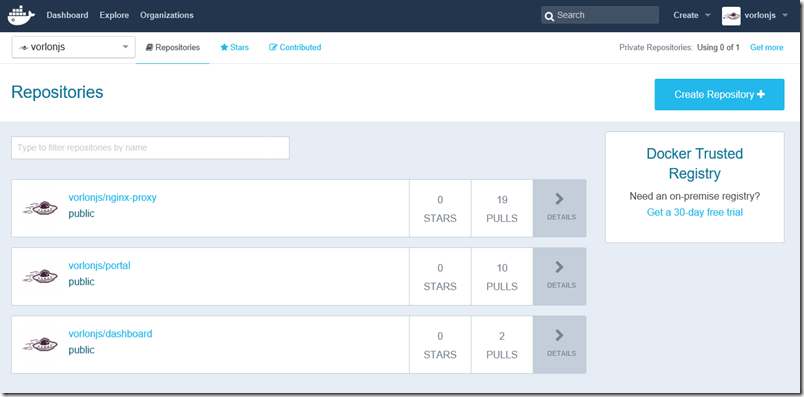

*Пример структуры каталогов для моно-репозитория. Видите изменение tags\_override?*

Таким образом, изменение модуля, которое влияет на 20 других модулей, это всего лишь **1 PR**! Даже если вы добавите 5 ревьюеров к этому PR, то ревью будет очень быстрым по сравнению с микро-репозиториями. Если вы используете Github, то это еще лучше! Вы можете использовать **CODEOWNERS** для модулей, у которых есть мейнтейнеры / владельцы, и любые изменения в этих модулях ДОЛЖНЫ быть одобрены этим владельцем.

Отлично, но как использовать такой модуль, который находится в каталоге моно-репозитория?

Легко:

```

module "from_mono_repo" {

source = "git::ssh://...//.git//"

...

}

module "from\_mono\_repo\_with\_tags" {

source = "git::ssh://....//.git//?ref=1.2.4"

...

}

module "from\_micro\_repo" {

source = "git::ssh://...//.git"

...

}

module "from\_micro\_repo\_with\_tags" {

source = "git::ssh://...//.git?ref=1.2.4"

...

}

```

Какие есть недостатки такого рода структуры? Что ж, если вы попробуете протестировать “каждый модуль” при PR / изменении, то у вас может получиться 1,5 часа CI-пайплайнов. Вам нужно найти измененные модули в PR. Я делаю это так:

```

changed_modules=$(git diff --name-only $(git rev-parse origin/master) HEAD | cut -d "/" -f1 | grep ^aws- | uniq)

```

Есть еще один недостаток: всякий раз, когда вы запускаете “terraform init”, он загружает весь репозиторий в каталог .terraform. Но у меня никогда не было с этим проблем, так как я запускаю свои пайплайны в масштабируемых контейнерах AWS CodeBuild. Если вы используете Jenkins и persistent Jenkins Slaves, то у вас может возникнуть эта проблема.

*Не заставляй нас плакать.*

C моно-репозиторием у вас остаются все преимущества микро-репозиториев, но в качестве бонуса вы снижаете стоимость обслуживания ваших модулей.

*Честно говоря, после работы в таком режиме, предложение использовать микро-репозитории для модулей terraform должно расцениваться как преступление.*

Отлично, а как насчет юнит-тестирования? Вам это действительно нужно? … Вообще, что именно вы понимаете под юнит-тестированием. Вы действительно собираетесь проверять правильно ли создан ресурс AWS? Чья это ответственность: terraform или API, обрабатывающего создание ресурса? Возможно, нам следует больше сосредоточиться на **негативном тестировании и идемпотентности кода**.

Для проверки идемпотентности кода terraform предоставляет отличный параметр, называемый `-detailed-exitcode`. Просто запустите:

```

> terraform plan -detailed-exitcode

```

После этого запускаете `terraform apply` и все. По крайней мере, вы будете уверены в том, что ваш код идемпотентен и не создает новых ресурсов из-за случайной строки или чего-то еще.

Что насчет негативного тестирования? Что, вообще, такое негативное тестирование? На самом деле это не сильно отличается от юнит-тестирования, но вы обращаете внимание на негативные ситуации.

Например, *никому не разрешено создавать незашифрованный и публичный бакет S3*.

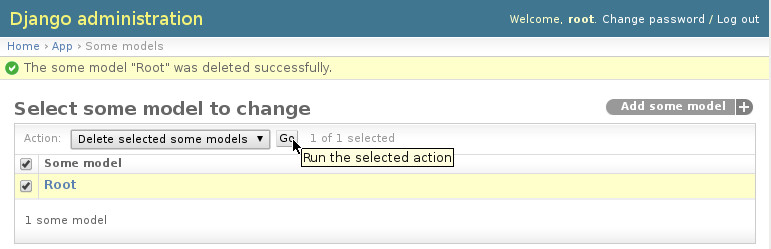

Таким образом, вместо того, чтобы проверять, действительно ли создается S3 бакет, вы, фактически, на основе набора политик, проверяете создает ли ваш код ресурс. Как это сделать? Terraform Enterprise предоставляет отличный инструмент для этого, [Sentinel](https://www.hashicorp.com/sentinel/).

… но есть также альтернативы с открытым исходным кодом. В настоящее время существует множество инструментов для статического анализа HCL-кода. Эти инструменты, основываясь на общих лучших практиках, не позволят вам сделать что-либо нежелательное, но что, если в нем нет нужного вам теста… или, что еще хуже, если ваша ситуация немного отличается. Например, вы хотите разрешить сделать некоторые S3 бакеты публичными на основе некоторых условий, что, на самом деле, будет ошибкой безопасности для этих инструментов.

Здесь появляется [terraform-compliance](https://terraform-compliance.com/). Этот инструмент не только позволит вам написать свои тесты, в которых вы сможете определить ЧТО вы хотите в качестве политики вашей компании, но также поможет вам разделить безопасность и разработку, сдвинув безопасность влево. Звучит довольно противоречиво, не так ли? Нет. Тогда как?

*Лого terraform-compliance*

Прежде всего, terraform-compliance использует Behavior Driven Development (BDD).

```

Feature: Ensure that we have encryption everywhere.

Scenario: Reject if an S3 bucket is not encrypted

Given I have aws_s3_bucket defined

Then it must contain server_side_encryption_configuration

```

*Проверяем включено ли шифрование*

Если вам этого не достаточно то, вы можете написать подробнее:

```

Feature: Ensure that we have encryption everywhere.

Scenario: Reject if an S3 bucket is not encrypted with KMS

Given I have aws_s3_bucket defined

Then it must contain server_side_encryption_configuration

And it must contain rule

And it must contain apply_server_side_encryption_by_default

And it must contain sse_algorithm

And its value must match the "aws:kms" regex

```

*Углубляемся и проверяем, что для шифрования используется KMS*

Код terraform для этого теста:

```

resource "aws_kms_key" "mykey" {

description = "This key is used to encrypt bucket objects"

deletion_window_in_days = 10

}

resource "aws_s3_bucket" "mybucket" {

bucket = "mybucket"

server_side_encryption_configuration {

rule {

apply_server_side_encryption_by_default {

kms_master_key_id = "${aws_kms_key.mykey.arn}"

sse_algorithm = "aws:kms"

}

}

}

}

```

Таким образом, тесты понятны буквально ВСЕМ в вашей организации. Здесь вы можете делегировать написание этих тестов службе безопасности или разработчикам с достаточным знанием безопасности. Этот инструмент также позволяет хранить BDD-файлы в другом репозитории. Это поможет разграничить ответственность, когда изменения в коде и изменения в политиках безопасности, связанных с вашим кодом, будут представлять собой две разные сущности. Это могут быть разные команды с разными жизненными циклами. Удивительно верно? Ну, по крайней мере, для меня это было так.

Для получения дополнительной информации о [terraform-compliance](https://terraform-compliance.com/) посмотрите [эту презентацию](https://www.slideshare.net/EmreErkunt/compliance-as-code-with-terraformcompliance).

Мы решили массу проблем с помощью [terraform-compliance](https://terraform-compliance.com/), особенно там, где службы безопасности достаточно отдалены от команд разработчиков, и могут не понимать, что делают разработчики. Вы уже догадываетесь, что происходит в такого рода организациях. Обычно служба безопасности начинает блокировать все для них подозрительное и строит систему безопасности, основываясь на безопасности периметра. О, Боже…

Во многих ситуациях только использование **terraform** и **terraform-compliance** для команд, которые проектируют (или/и сопровождают) инфраструктуру, помогло посадить эти две разные команды за один стол. Когда ваша служба безопасности начинает что-то разрабатывать с немедленной обратной связью от всех пайплайнов разработки, то у них обычно появляется мотивация делать все больше и больше. Ну, как правило…

Поэтому, при использовании terraform мы структурируем git-репозитории следующим образом:

Конечно, это довольно самоуверенно. Но мне повезло (или не повезло?) поработать с более детализированной структурой в нескольких организациях. К сожалению, все это заканчивалось не очень хорошо. Счастливый конец должен быть скрыт в числе 3.

Дайте мне знать, если у вас есть какие-нибудь истории успеха с микро-репозиториями, мне действительно интересно!

---

*Приглашаем вас на [бесплатный урок](https://otus.pw/McAR/), в рамках которого **мы рассмотрим компоненты будущей инфраструктурной платформы и разберемся, как доставлять наше приложение правильно**.* | https://habr.com/ru/post/496162/ | null | ru | null |

# VDDK errors с человеческим лицом

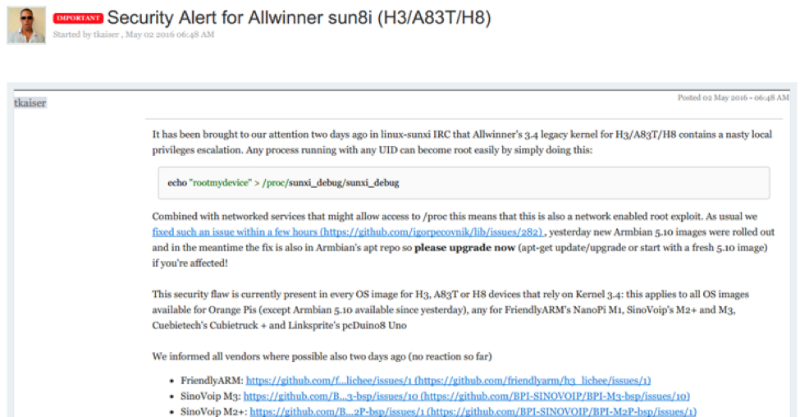

Вся прелесть и ужас VDDK ошибок в том, что, с одной стороны, совершенно точно понятно, где сломалось, а с другой — совершенно непонятно, почему, и как это теперь чинить. Это примерно как RPC call function failed в мире Windows.

Хотя не всё так ужасно, конечно же. Некоторые ошибки имеют совершенно конкретные причины и методы лечения. А некоторые — давно известный список наиболее частых причин и вариантов их исправления.

Наш Veeam Technical Support, конечно же, накапливает в себе подобные знания, и сегодня мы немного подглядим в их записи. Поэтому с превеликим удовольствием представляю вам топ самых частых VDDK errors и методы их устранения.

### VDDK errors. Что это и как они получаются?

Как можно догадаться из названия, это какие-то проблемы на уровне VDDK Api (Virtual Disk Development Kit) — лучшего способа взаимодействия с vSphere инфраструктурой. Не важно, будет это отдельный ESXi хост или развесистый vCenter, но если нам надо что-то записать или считать из нашей инфраструктуры, лучший способ для этого — бесплатно распространяемый VDDK.

Если максимально упростить, то выглядит это взаимодействие примерно так: Veeam сервер хочет, например, что-то прочитать с хоста (или записать) и шлёт ему соответствующий запрос. Создаётся вызов на чтение с указанием, из какого диска, сколько хочется прочитать, с какого оффсета и в какой буфер в памяти. Или записать, аналогично, из указанного буфера. Всё просто.

Но это в идеальном мире.

В реальном же иногда на пути этого простого алгоритма случаются ошибки, из-за которых не получается завершить запрос. И вместо ожидаемого ответа к нам приходит номер ошибки, который тщательно записывается в логи.

Вот о самых частых таких ошибках мы сегодня и поговорим

### Важный дисклеймер!

Не уверен — не делай! Не нажимай и вообще ничего не трогай! Позвонить или написать в саппорт Veeam всегда лучше, чем ставить эксперименты на своём проде. Благо саппорт у нас русскоязычный и технических крайне грамотный.

При малейших сомнениях позвонить и спросить: «У меня вот такая проблема, я нашёл в сети вот такой вариант решения, это поможет мне её решить?» — нормально и правильно. Что не нормально и не правильно, так это будучи не уверенным в своих действиях наворотить дел, а потом просить восстановить всё из руин за пять минут, и чтобы ничего не потерялось.

Да, мы, конечно же, поможем и в этом случае, но лучшая битва — та, которой не было. Поэтому всегда старайтесь критически оценивать свои действия, и всем большого аптайма.

### VDDK error 1: Unknown error

На самом деле по этой ошибке у нас есть целая [КВ статья](https://www.veeam.com/kb1901). И, как она гласит, чаще всего эта ошибка возникает, если у вас установлено слишком много счётчиков производительности — и скачайте патч от VMware, который вам всё поправит.

С одной стороны, даже и комментировать нечего. Вот проблема, вот описание (пусть даже не очень понятное), и, что самое важное — вот вам ещё и ссылка на лекарство. Однако не всё так просто. По нашим наблюдениям, эта ошибка может возникать не только из-за скучной проблемы со счётчиками, но также из-за:

1. Повреждения конкретного VMDK файла. То есть машина ваша вот прямо сейчас работает, но возможно, что скоро перестанет. Или — классический случай — вы её выключите и больше не сможете включить. Словом, приятного вас ожидает мало. Да, есть всякие тулы для проверки целостности и коррекции ошибок, однако это не панацея.

2. Повреждения всего datastore. Тут даже и комментировать ничего не хочется. Надеемся, у вас есть запасной.

3. Проблема с HBA контроллером. Да, проблемы идут по нарастающей. Хорошо если это просто плата сгорела и всё ограничится заменой с проверкой рейда. А если рейд был повреждён и его придётся пересчитывать?

4. И самая безобидная, но тоже причина: ESXi хост периодически теряет связь с vCenter.

Ну хорошо, жути нагнал, скажете вы. А дальше-то что? Как понять, что пора срочно бежать за новыми дисками — или достаточно поставить патчик и выдыхать?

А я вам отвечу — держите набор простейших тестов, которые в случае чего помогут вам принять правильное решение.

* Запускаем Storage vMotion или просто клонируем подозрительную машину на другой датастор, а потом пытаемся запустить бекап. Если клонирование не прошло — однозначно беда где-то в дисковой подсистеме. Режим паранойи на максимум — и проверять всё, от дисков до контроллеров.

Если клонировалось и забекапилось успешно, значит, был повреждён VMDK, т. к. во время клонирования VMware пересоздаёт его содержимое, и теперь там точно нет ошибок.

* Были случаи, когда перезагрузка хоста лечила проблему. Да, это не шутка. «Семь бед — один ресет» всё ещё актуально.

* Если вы уже и перезагрузились, и патч поставили, и машину клонировали, и всё равно ничего не работает — бегом в саппорт VMware.

* Если клонированная машина успешно забекапилась, попробуйте мигрировать её обратно на продакшн сторадж и продолжайте использовать вместо старой. Можно даже делать это ночью на выключенных машинах, чтобы процесс прошёл быстрее и по пути ничего не потерялось.

### VDDK error 2: Value: 0x0000000000000002

Практически всегда идёт рука об руку с VDDK error 1. По нашей статистике, появление ошибки обычно связано с определёнными версиями связки vCenter/ESXi, так что лучший совет здесь — это обновиться хотя бы до версии 6.7. А лучше и 7.0.

Если же не помогло, то переходим к плану Б.

Сама ошибка появляется, когда у ESXi хоста заканчивается память, выделенная под буфер NFC read. По умолчанию, Veeam работает в асинхронном режиме чтения NBD/NFC, что в нормальных условиях может потребовать расширения этого буфера. Но происходит это не всегда. Поэтому для отключения данного режима есть специальный ключик:

```

Name: VMwareDisableAsyncIo

Path: HKEY_LOCAL_MACHINE\SOFTWARE\Veeam\Veeam Backup and Replication

Type: REG_DWORD

Value: 1

```

После его создания надо перезапустить Veeam Backup Service и быть готовым к производительности, просевшей примерно на 10%.

Другой вариант — это зайти со стороны хоста и перезапустить management агентов:

```

/etc/init.d/hostd restart

/etc/init.d/vpxa restart

```

Подробно процедура описана в [КВ от VMware](https://kb.vmware.com/s/article/1003490), так что не будем её переписывать.

И стандартный набор вариантов, которые не будет лишним перебрать в процессе диагностики:

* Мигрировать машины с ошибками на другой хост.

* Попробовать другой Transport mode — HotAdd с виртуальным прокси или DirectSAN.

### VDDK error 3: One of the parameters is invalid

Ошибка, практически всегда случающаяся при использовании Virtual Appliance режима (он же HotAdd mode).

Тут особенно рассказывать нечего, просто дам ссылки на две наших KB, где расписано много вариантов, и даже если вы сразу придёте в саппорт, вас попросят проделать всё там написанное.

[КВ1218](https://www.veeam.com/kb1218) — Общее описание возможных проблем и методы их устранения.

[KB1332](https://www.veeam.com/kb1332) — В случае если ваш Veeam сервер работает как прокси для HotAdd режима

### VDDK error 13: You do not have access rights to this file

И на этот случай у нас имеется [KB2008](https://www.veeam.com/kb2008). Да, там очень много вариантов устранения этой беды, но такая уж ошибка. Однозначно сказать, что именно случилось именно в вашем случае, практически невозможно, поэтому надо брать и перебирать весь список.

Что хочется сказать дополнительно. Очень внимательно относитесь к секции Additional Troubleshooting. Да, там написаны, возможно, слишком очевидные для многих вещи. Но даже такие банальности ускользают от взгляда самых профессиональных профессионалов. Нередки случаи, когда спустя неделю в попытках решить всё самостоятельно они приходят в саппорт только лишь для того, чтобы узнать, что невнимательно прочитали список технических требований, или нечто такое. И обидно, и жалко потраченного времени.

И два совета на все времена:

* Если машина с ролью Veeam proxy была хоть раз клонирована или реплицирована, у её клонов мог сохраниться UUID оригинальной машины. Из-за чего диски временно маунтятся хостом к одной машине, а читать мы их пытаемся с другой. Да, звучит странно, но бывает и такое.

* Если реплицированная машина выключена (а это нормально для реплик — быть выключенными), само собой, все VDDK вызовы и попытки присоединиться будут обречены на провал.

### VDDK error 18000: Cannot connect to the host

В большинстве случаев вина за эту ошибку лежит на баге в самом VDDK. А конкретно виновата библиотека gvmomi.dll. И проявляет он себя только под большой нагрузкой. Например, когда много машин бекапится в параллельном режиме, одна из функций принимает значение 0, и библиотека может схлопнуться. А следом падает всё остальное.

Такая вот печальная история.

Но самое плохое в этой истории — то, что никак не получается точно воспроизвести условия возникновения бага. Это то, что тестировщики называют плавающими багами. Поэтому невозможно точно сказать, сколько именно параллельно обрабатываемых машин вызывает падение.

Однако согласно официальным [release notes](https://www.vmware.com/support/developer/vddk/vddk-602-releasenotes.html) это баг был полностью исправлен. Так что правильный выход из положения — обновить свой хост. Но если по какой-то из причин сделать это невозможно, единственное, чем мы можем помочь — это посоветовать уменьшить количество одновременно обрабатываемых машин.

Больше никак.

### VDDK error 14008: The specified server could not be contacted

Итак, если вас постигла эта беда, то первым делом надо проверять сеть. Скорее всего, сбоит связь между vCenter и Veeam proxy. Смотрим, все ли порты открыты и доступны, все ли DNS имена правильно резолвятся в ожидаемые IP адреса. Причём проверять надо конкретный прокси, задействованный в неудавшейся джобе, а не стоящий рядом точно такой же (бывают случаи).

95% кейсов с этой ошибкой закрываются с пометкой «Проблема с DNS/портами в инфраструктуре клиента».

Поэтому ещё раз призываю вас очень внимательно проверить, везде ли указан верный DNS сервер, нет ли закрытых портов и в какие IP резолвятся FQDN имена.

В старых версиях VDDK была схожая ошибка, возникавшая при использовании недефолтного порта для работы с vCenter, на которую приходились оставшиеся 5%, но сейчас VMware скрыло КВ с её описанием, что, вероятно, означает, что КВ более не релевантна. Но можете поискать её в интернет-архивах по номеру 2108658 (Backup fails when a non-default port is specified for VMware vCenter Server).

### VDDK error 14009: The server refused connection

И последняя ошибка в нашем сегодняшнем топе — The server refused connection. Тут всё абсолютно банально: что-то мешает установить связь между хостом и прокси. В большинстве случаев оказывается виноват фаервол. Но — тонкий момент — не из-за закрытых портов, а из-за вносимых задержек. Так что первым делом проверяем открытость порта 443, а потом смотрим на таймауты.

Если оба варианта ничего не дали — идём в саппорт. Придётся проверять сам хост. Возможно, он просто слишком загружен и не успевает отвечать вовремя, а, возможно, и что-то другое.

И в завершение немного полезных ссылок:

* [Портал](https://www.veeam.com/ru/support.html) нашей орденоносной технической поддержки.

* [Veeam Support Knowledge Base](https://www.veeam.com/kb_search_results.html) | https://habr.com/ru/post/515516/ | null | ru | null |

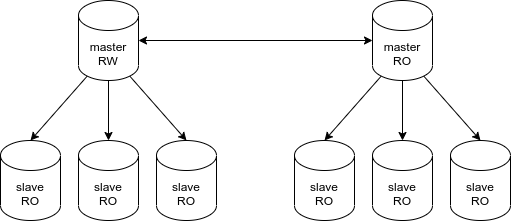

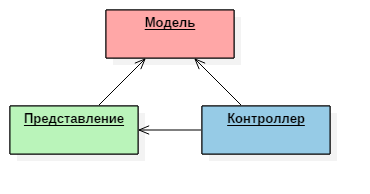

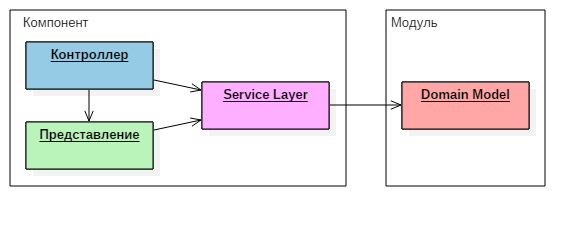

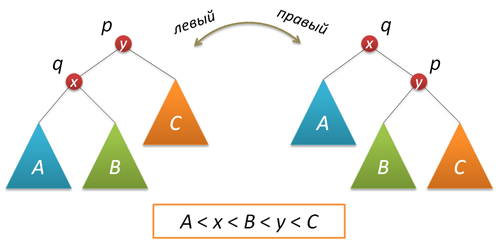

# Dependency Injection в .NET на почтальонах

Наверное, все сталкивались с таким паттерном проектирования, как Inversion of control(IoC, инверсия управления) и его формой - Dependency Injection (DI, внедрение зависимостей). .NET и, в частности, .Net Core предоставляют этот механизм «из коробки». Очень важным моментом является такое понятие, как Lifetime или, время существования зависимости.

**В .NET существует три способа зарегистрировать зависимость:**

* *AddTransient (Временная зависимость)*

* *AddScoped (Зависимость с заданной областью действия)*

* *AddSingleton (Одноэкземплярная зависимость)*

Надо бы разобраться в различиях, поскольку и буквы в вышеописанных способах разные, и вообще, смысл слов тоже от способа к способу отличается. Хорошо, открываем поисковую систему и начинаем искать, в чём собственно различия. Так, везде написано про Asp.Net. Как же понять, как этот механизм работает в общем, отдельно от Asp.Net и запросов?

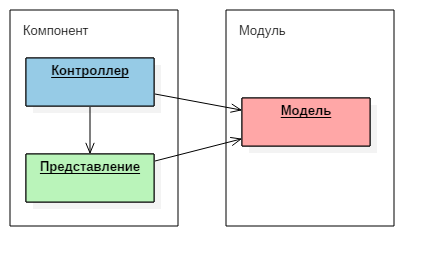

Перед тем, как приступить к рассмотрению различий, давайте немного освежим свои знания о составе механизма внедрения зависимостей, необходимого нам:

* IServiceCollection, представляет собой коллекцию дескрипторов служб

* IServiceProvider, представлет собой контейнер служб .NET

* IServiceScopeFactory, фабрика для создания служб с заданной областью

Все объяснения про различия времени существования разрешенной зависимости сводятся к приведению примеров, построенных на запросах к веб-приложению. Ну, в принципе понятно - новый запрос => новый сервис(за исключением AddSingleton). Что ж, давайте попробуем понять более подробно, в чём же всё-таки различия.

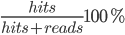

Приведу простой пример на почтальонах. Давайте представим, что мы ждём получения письма. В обязанности почтальона будет входить следующая последовательность действий:

1. *Забрать письмо из отделения.*

2. *Донести письмо до адресата.*

3. *Получить подпись адресата о вручении.*

4. *Вручить письмо адресату.*

Эти действия определим в интерфейсе IPostmanService:

```

using System;

namespace DependencyInjectionConsole.Interfaces

{

public interface IPostmanService

{

void PickUpLetter(string postmanType);

void DeliverLetter(string postmanType);

void GetSignature(string postmanType);

void HandOverLetter(string postmanType);

}

}

```

Также определим расширяющие интерфейс **IPostmanService** интерфейсы **ITransientPostmanService, IScopedPostmanService, ISingletonPostmanService,** для регистрации зависимости разными способами одной и той же реализации **PostmanService:**

```

using DependencyInjectionConsole.Interfaces;

using Microsoft.Extensions.Logging;

using System;

namespace DependencyInjectionConsole.Services

{

public class PostmanService :

ITransientPostmanService,

IScopedPostmanService,

ISingletonPostmanService

{

private readonly string _name;

private readonly string[] _possibleNames = new string[] { "Peter", "Jack", "Bob", "Alex" };

private readonly string[] _possibleLastNames = new string[] { "Brown", "Jackson", "Gibson", "Williams" };

private readonly ILogger \_logger;

public PostmanService(ILogger logger)

{

\_logger = logger;

var rnd = new Random();

\_name = $"{\_possibleNames[rnd.Next(0, \_possibleNames.Length - 1)]} {\_possibleLastNames[rnd.Next(0, \_possibleLastNames.Length - 1)]}";

\_logger.LogInformation($"Hi! My name is {\_name}.");

}

public void DeliverLetter(string postmanType)

{

\_logger.LogInformation($"Postman {\_name} delivered the letter. [{postmanType}]");

}

public void GetSignature(string postmanType)

{

\_logger.LogInformation($"Postman {\_name} got a signature. [{postmanType}]");

}

public void HandOverLetter(string postmanType)

{

\_logger.LogInformation($"Postman {\_name} handed the letter. [{postmanType}]");

}

public void PickUpLetter(string postmanType)

{

\_logger.LogInformation($"Postman {\_name} took the letter. [{postmanType}]");

}

}

}

```

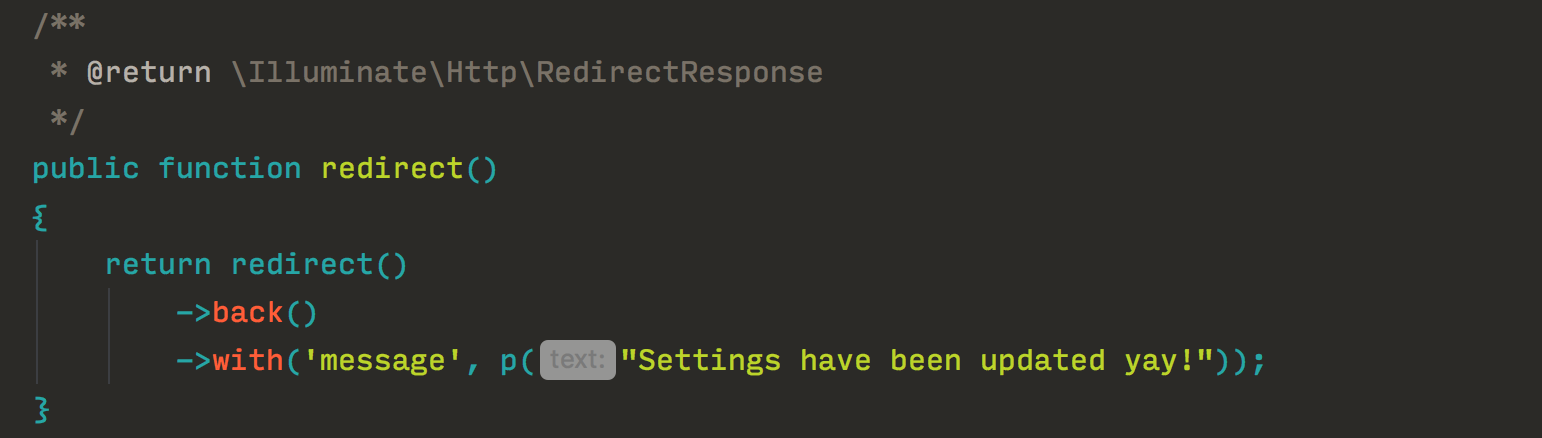

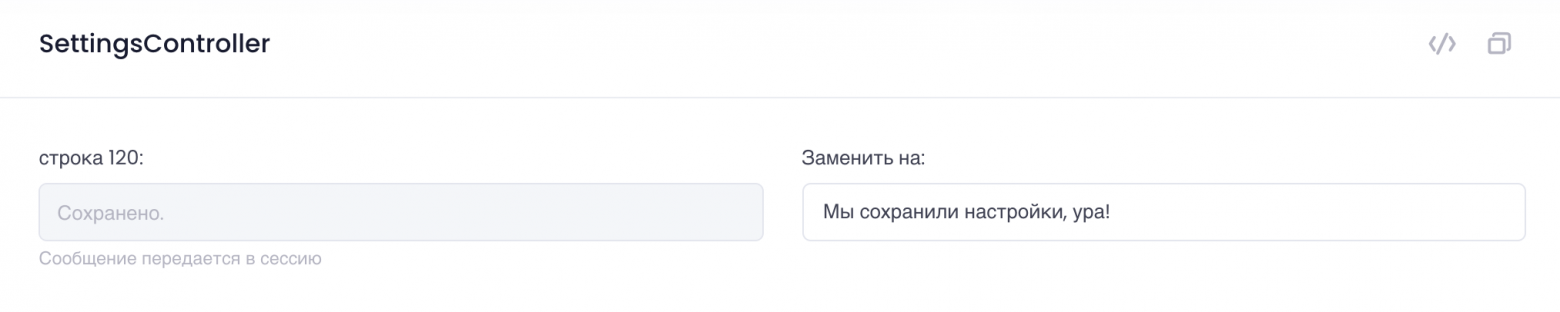

Все ключевые действия почтальона мы будем вызывать через некоего директора **PostmanHandler**, именно ему в конструктор будут внедряться зависимости наших почтальонов:

```

using DependencyInjectionConsole.Interfaces;

using System;

namespace DependencyInjectionConsole

{

public class PostmanHandler

{

private readonly ITransientPostmanService _transientPostman;

private readonly IScopedPostmanService _scopedPostman;

private readonly ISingletonPostmanService _singletonPostman;

public PostmanHandler(ITransientPostmanService transientPostman, IScopedPostmanService scopedPostman, ISingletonPostmanService singletonPostman)

{

_transientPostman = transientPostman;

_scopedPostman = scopedPostman;

_singletonPostman = singletonPostman;

}

public void PickUpLetter()

{

_transientPostman.PickUpLetter(nameof(_transientPostman));

_scopedPostman.PickUpLetter(nameof(_scopedPostman));

_singletonPostman.PickUpLetter(nameof(_singletonPostman));

}

public void DeliverLetter()

{

_transientPostman.DeliverLetter(nameof(_transientPostman));

_scopedPostman.DeliverLetter(nameof(_scopedPostman));

_singletonPostman.DeliverLetter(nameof(_singletonPostman));

}

public void GetSignature()

{

_transientPostman.GetSignature(nameof(_transientPostman));

_scopedPostman.GetSignature(nameof(_scopedPostman));

_singletonPostman.GetSignature(nameof(_singletonPostman));

}

public void HandOverLetter()

{

_transientPostman.HandOverLetter(nameof(_transientPostman));

_scopedPostman.HandOverLetter(nameof(_scopedPostman));

_singletonPostman.HandOverLetter(nameof(_singletonPostman));

}

}

}

```

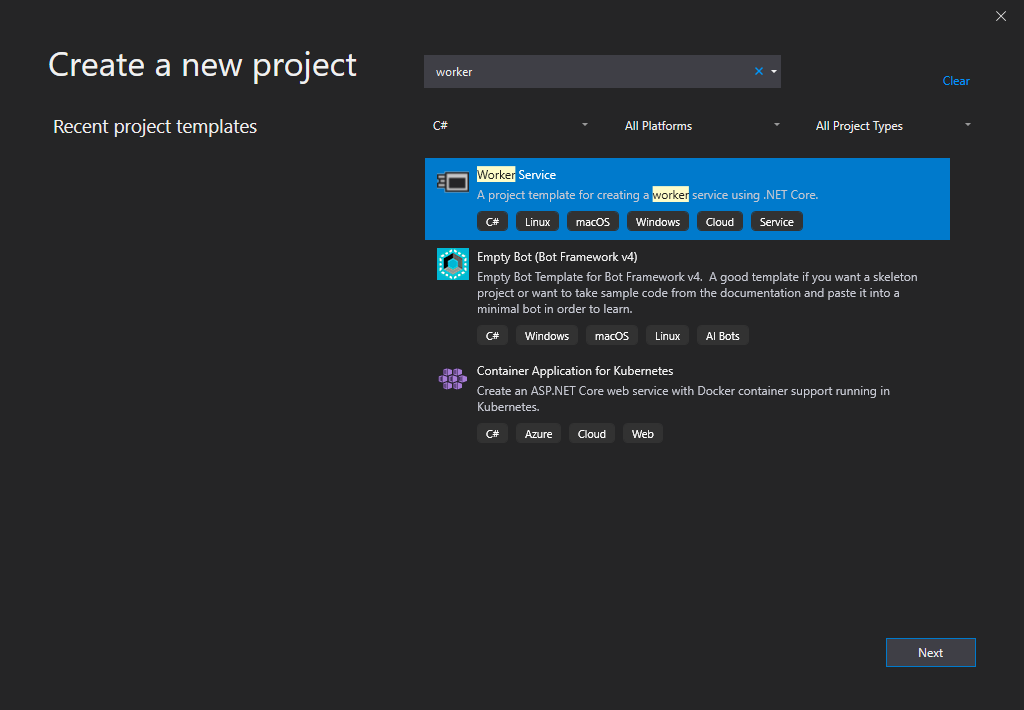

И наконец, определим код в классе **Program:**

```

using DependencyInjectionConsole.Interfaces;

using DependencyInjectionConsole.Services;

using Microsoft.Extensions.DependencyInjection;

using Microsoft.Extensions.Logging;

using System;

namespace DependencyInjectionConsole

{

class Program

{

private static IServiceCollection ConfigureServices()

{

var services = new ServiceCollection();

services.AddTransient();

services.AddScoped();

services.AddSingleton();

services.AddTransient();

services.AddLogging(loggerBuilder =>

{

loggerBuilder.ClearProviders();

loggerBuilder.AddConsole();

});

return services;

}

static void Main(string[] args)

{

PostmanHandler postman;

var services = ConfigureServices();

var serviceProvider = services.BuildServiceProvider();

var scopeFactory = serviceProvider.GetService();

postman = serviceProvider.GetService();

postman.PickUpLetter();

postman = serviceProvider.GetService();

postman.DeliverLetter();

postman = serviceProvider.GetService();

postman.GetSignature();

postman = serviceProvider.GetService();

postman.HandOverLetter();

Console.WriteLine("-----------------Scope changed!---------------------");

using (var scope = scopeFactory.CreateScope())

{

postman = scope.ServiceProvider.GetService();

postman.PickUpLetter();

postman = serviceProvider.GetService();

postman.DeliverLetter();

postman = serviceProvider.GetService();

postman.GetSignature();

postman = serviceProvider.GetService();

postman.HandOverLetter();

}

Console.ReadKey();

}

}

}

```

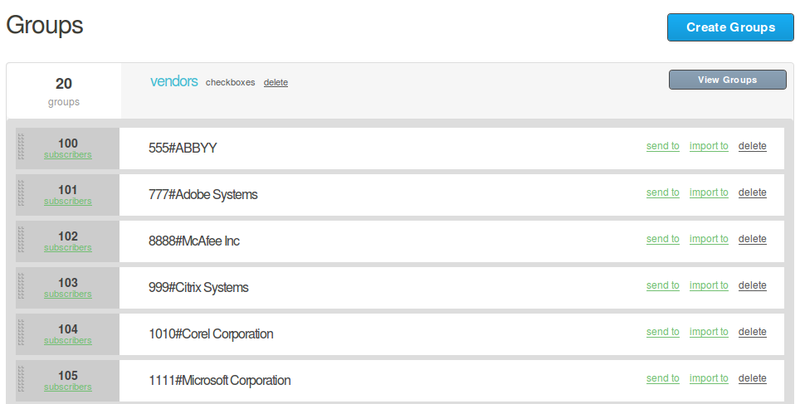

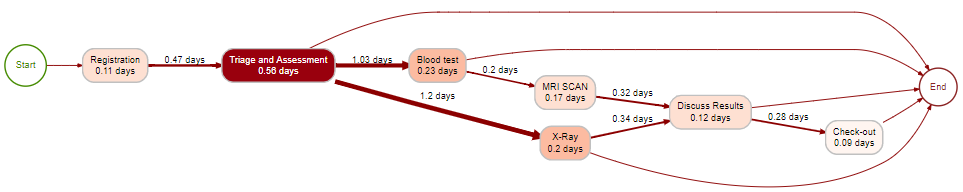

После запуска приложения мы увидим следующий вывод в консоли:

Консольный вывод*Hi! My name is Bob Gibson.

Hi! My name is Jack Jackson.

Hi! My name is Peter Jackson.

Postman Bob Gibson took the letter. [\_transientPostman]

Postman Jack Jackson took the letter. [\_scopedPostman]

Postman Peter Jackson took the letter. [\_singletonPostman]

Hi! My name is Bob Gibson.

Postman Bob Gibson delivered the letter. [\_transientPostman]

Postman Jack Jackson delivered the letter. [\_scopedPostman]

Postman Peter Jackson delivered the letter. [\_singletonPostman]

Hi! My name is Jack Gibson.

Postman Jack Gibson got a signature. [\_transientPostman]

Postman Jack Jackson got a signature. [\_scopedPostman]

Postman Peter Jackson got a signature. [\_singletonPostman]

Hi! My name is Bob Gibson.

Postman Bob Gibson handed the letter. [\_transientPostman]

Postman Jack Jackson handed the letter. [\_scopedPostman]

Postman Peter Jackson handed the letter. [\_singletonPostman]

-----------------Scope changed!---------------------

Hi! My name is Bob Gibson.****Hi! My name is Bob Brown.******(Нас будет интересовать этот момент)*** *Postman Bob Gibson took the letter. [\_transientPostman]

Postman Bob Brown took the letter. [\_scopedPostman]

Postman Peter Jackson took the letter. [\_singletonPostman]

Hi! My name is Peter Jackson.

Postman Peter Jackson delivered the letter. [\_transientPostman]

Postman Jack Jackson delivered the letter. [\_scopedPostman]

Postman Peter Jackson delivered the letter. [\_singletonPostman]

Hi! My name is Bob Jackson.

Postman Bob Jackson got a signature. [\_transientPostman]

Postman Jack Jackson got a signature. [\_scopedPostman]

Postman Peter Jackson got a signature. [\_singletonPostman]

Hi! My name is Peter Brown.

Postman Peter Brown handed the letter. [\_transientPostman]

Postman Jack Jackson handed the letter. [\_scopedPostman]

Postman Peter Jackson handed the letter. [\_singletonPostman]*

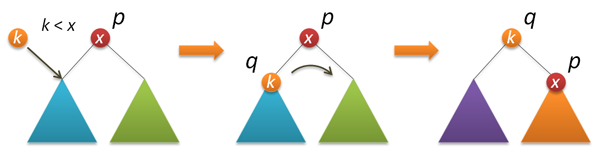

**Пока немного отступим в сторону абстрактного объяснения на почтальонах.**

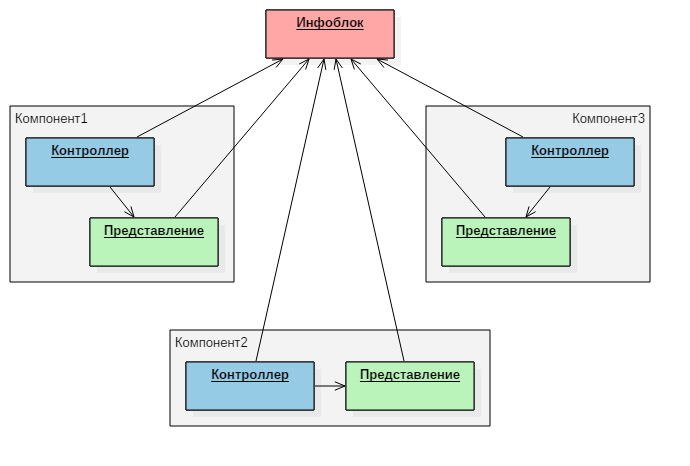

Сначала посмотрим, как всё это будет выглядеть, если отделение почты зарегистрировало нам временного почтальона, т.е. воспользовавшись методом **AddTransient**:

Если перед выполнением каждого действия мы будем получать нового директора, то вместе с ним почтальон тоже будет создаваться новый. И так, каждое действие будет выполнять разный почтальон. Но, если директора мы будем использовать одного – то почтальон будет один.

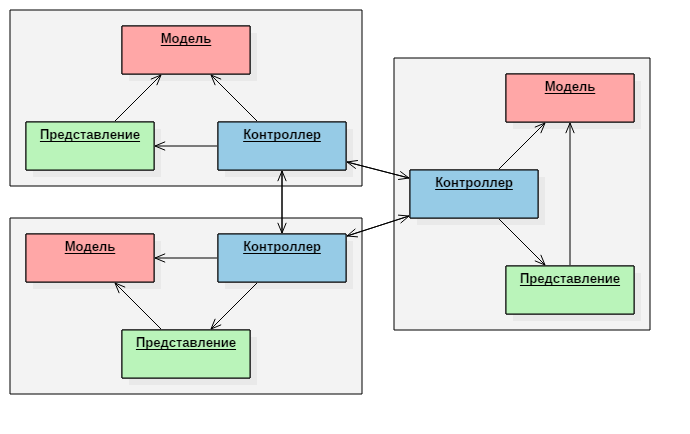

Перейдём к более интересному способу регистрации зависимости – с заданной областью действия, т.е. **AddScoped**:

Нам абсолютно неважно, какой будет директор при выполнении каждого действия – каждый раз новый, или старый. Любой директор всегда будет вызывать одного и того же почтальона. Так будет происходить до тех пор, пока мы находимся в одной области (scope). Как только мы сменим область – почтальон также изменится. Этим и объясняются все примеры, связанные с Asp.Net – при каждом запросе создаётся новая область, в рамках которой выполняется работа.

И последний из способов – одноэкземплярная зависимость, т.е. **AddSingleton**:

Наш директор, как и любой другой знает – нет почтальона лучше, чем зарекомендовавший себя ветеран почтовых войн. При таком способе регистрации зависимости директор всегда будет получать одного и того же почтальона, неважно находимся ли мы в новой области или старой – весь срок жизни приложения наш почтальон будет с нами.

Из консольного вывода мы видим, что наш временный почтальон всегда разный. Наш почтальон с заданной областью меняется лишь единожды - после смены области через **IServiceScopeFactory.CreateScope().** Наш одноэкземплярный почтальон остаётся всегда одним, даже когда мы меняем область.

**Есть одна особенность контейнера зависимостей, о которой разработчик на платформе .NET должен помнить всегда при создании программного продукта.**

Если мы внедряем временную зависимость в зависимость с заданной областью, то она превращается в зависимость с заданной областью.

Например если мы зарегистрируем зависимость PostmanHandler как Scoped:

```

var services = new ServiceCollection();

services.AddTransient();

services.AddScoped();

services.AddSingleton();

//Теперь зависимость нашего директора имеет тип Scoped

services.AddScoped();

services.AddLogging(loggerBuilder =>

{

loggerBuilder.ClearProviders();

loggerBuilder.AddConsole();

});

```

Наш временный почтальон станет почтальоном более постоянным (с заданной областью) и мы увидим от него ***Hi!*** только два раза, первый при старте приложения, второй при смене области.

Если же мы будем внедрять временную или с заданной областью зависимость в зависимость одноэкземплярную, то все они превратятся в зависимости одноэкземплярные.

Давайте зарегистрируем зависимость нашего директора PostmanHandler как Singleton:

```

var services = new ServiceCollection();

services.AddTransient();

services.AddScoped();

services.AddSingleton();

//Теперь зависимость нашего директора имеет тип Singleton

services.AddSingleton();

services.AddLogging(loggerBuilder =>

{

loggerBuilder.ClearProviders();

loggerBuilder.AddConsole();

});

return services;

```

Наши временный и с заданной областью почтальоны станут бесповоротно постоянными (одноэкземплярными) и мы увидим от них ***Hi!*** только единожды - при старте приложения. | https://habr.com/ru/post/595613/ | null | ru | null |

# PHP-Дайджест № 172 (14 – 27 января 2020)

[](https://habr.com/ru/post/485592/)

Свежая подборка со ссылками на новости и материалы. В выпуске: PHP 7.4.2 и другие релизы, Stringable RFC, обзор PHP 8, порция полезных инструментов, 4 ближайших митапа, видеозаписи с конференций, стримы и многое другое.

Приятного чтения!

### Новости и релизы

* [PHP 7.4.2](https://www.php.net/ChangeLog-7.php#7.4.2) — Кроме прочего, в релизе исправлены проблемы с предзагрузкой, а для Windows эта возможность вовсе отключена. Также исправлено много других важных проблем. Если вы откладывали обновление до 7.4 пока «исправят всё баги новой версии», то 7.4.2 уже [достаточно хорош](https://www.reddit.com/r/PHP/comments/esq2sy/php_742_released_this_version_allows_preloading/ffbljzg/?context=3) для использования.

* [PHP 7.3.14](https://www.php.net/ChangeLog-7.php#7.3.14)

* [PHP 7.2.27](https://www.php.net/ChangeLog-7.php#7.2.27)

* [По результатам выборов в PHP-FIG](https://groups.google.com/forum/#!topic/php-fig/M_Np9Gh9Omc) новый core-комитет составят [Korvin Szanto](https://twitter.com/KorvinSzanto), [Enrico Zimuel](https://twitter.com/ezimuel), [Chris Tankersley](https://twitter.com/dragonmantank) и [Massimiliano Arione](https://twitter.com/garakkio) с секретарём [Buster Neece](https://twitter.com/SlvrEagle23).

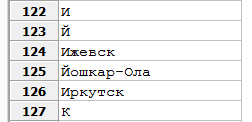

* Ближайшие мероприятия:

• Киев, 29 января: [OroMeetupDev #17: PHP Integrations](https://www.facebook.com/events/537949686930927/)

• Санкт-Петербург, 31 января: [1й BeerPHP-митап](https://t.me/beerphp_spb_news/6)

• Йошкар-Ола, 1 февраля: [Второй PHP Meetup](https://php-yola.timepad.ru/event/1234664/)

• Минск, 6 февраля: [PHP of By #32](https://www.facebook.com/events/132547631122342)

• Москва, 15 февраля:  [Badoo PHP Meetup #4. Легаси](https://habr.com/ru/company/badoo/blog/485732/)

• [PHP Russia 2020](https://phprussia.ru/moscow/2020/) — Конференция пройдёт 13 мая в Инфопространстве (Москва). Приём заявок на доклады открыт и подготовка идёт полным ходом. [Два доклада](https://phprussia.ru/moscow/2020/abstracts) уже приняли и скоро анонсируем ещё одного очень крутого спикера. Билеты можно купить по минимальной цене до 31 января.

• [skyeng/php-communities](https://github.com/skyeng/php-communities) — Открытый список PHP-событий, спикеров и организаторов.

### PHP Internals

* [[RFC] Add Stringable interface](https://wiki.php.net/rfc/stringable) — Предлагается в PHP 8 добавить новый интерфейс `Stringable`, который можно будет добавить к классам, реализующим метод `__toString()`. И тогда использовать объединённый тип string|Stringable где предполагается строка.

```

interface Stringable { public function __toString(): string; }

```

### Инструменты

* [cycle/orm 1.2](https://github.com/cycle/orm) — ORM, которую можно использовать и как DataMapper и в стиле ActiveRecord. В последнем релизе скорость работы увеличена на 33% и судя по [бенчмаркам](https://github.com/adrianmiu/forked-php-orm-benchmark), теперь это одна из самых быстрых ORM.

* [BenMorel/weakmap-polyfill](https://github.com/BenMorel/weakmap-polyfill) — Полифил [WeakMap](https://t.me/phpdigest/104) для PHP 7.4.

* [lisachenko/z-engine](https://github.com/lisachenko/z-engine#abstract-syntax-tree-api) — Экспериментальная библиотека, которая позволяет используя FFI получить доступ к внутренним структурам самого PHP. Добавлены крутые примеры использования, например, [реализация перегрузки операторов на PHP](https://github.com/lisachenko/z-engine#object-extensions-api) и даже [модификация AST](https://github.com/lisachenko/z-engine#modifying-the-abstract-syntax-tree) на лету.

### Symfony

* [История поиска проблем производительности](https://jolicode.com/blog/battle-log-a-deep-dive-in-symfony-stack-in-search-of-optimizations-1-n) в приложении на Symfony, [часть 2](https://jolicode.com/blog/battle-log-a-deep-dive-in-symfony-stack-in-search-of-optimizations-2-n).

* [Выдавайте пользователям конкретные права, а не роли](https://wouterj.nl/2020/01/grant-on-permissions-not-roles).

* [Неделя Symfony #682 (20-26 января 2020)](https://symfony.com/blog/a-week-of-symfony-682-20-26-january-2020)

### Laravel

* [pavel-mironchik/laravel-backup-panel](https://github.com/pavel-mironchik/laravel-backup-panel) — Веб-интерфейс к [spatie/laravel-backup](https://github.com/spatie/laravel-backup). Позволяет в браузере управлять бекапами. Прислал [mironchikpavel](https://twitter.com/mironchikpavel).

* [avto-dev/roadrunner-laravel](https://github.com/avto-dev/roadrunner-laravel) — Новая версия RoadRunner воркера для Laravel. Теперь по умолчанию без пересоздания инстанса приложения и с возможностью расширения, используя событийную систему фреймворка. Прислал [paramtamtam](https://habr.com/ru/users/paramtamtam/).

* [laravelpackage.com](https://laravelpackage.com/) — Подробное руководство по созданию Laravel-пакетов.

* [Об аутентификации и](https://divinglaravel.com/authentication-and-laravel-airlock) [laravel/airlock](https://github.com/laravel/airlock).

* [Контейнеризация Laravel 6 приложения](https://www.digitalocean.com/community/tutorials/containerizing-a-laravel-6-application-for-development-with-docker-compose-on-ubuntu-18-04) для разработки с помощью Docker Compose на Ubuntu 18.04.

* [Список фич ожидающихся в Laravel 7.0](https://protone.media/en/blog/new-features-and-changes-in-the-upcoming-laravel-70-release), который будет представлен на [Laracon Online](https://laracon.net/).

*  [Советы по упрощению контроллеров Laravel](https://laracasts.com/series/guest-spotlight/episodes/5)

*  [Пошаговое руководство по настройке Laravel 6 в Google Cloud Run с непрерывной интеграцией](https://habr.com/ru/company/otus/blog/484738/)

### Yii

*  [Новости Yii 2020, выпуск 1](https://yiiframework.ru/news/257/novosti-yii-2020-vypusk-1) — Обновления Yii 1.1, Yii 2, интересное в Yii 3.

### Zend / Laminas

* [Последний пост в блоге Zend Framework –](https://framework.zend.com/blog/2020-01-24-laminas-launch) [Laminas](https://getlaminas.org/).

### Материалы для обучения

* [PHP в 2020](https://stitcher.io/blog/php-in-2020) — Обзор состояния языка и экосистемы.

* [Состояние PHP 8](https://thephp.website/en/issue/state-of-php-8/) — Когда выйдет и что в него войдёт.

* [Мои настройки PhpStorm после 8 лет использования](https://stefanbauer.me/articles/my-phpstorm-settings-after-8-years-of-use).

* [Бенчмарк (и рекомендации) предзагрузки PHP 7.4](https://developer.happyr.com/php-74-preload) на Symfony приложении от [Tobias Nyholm](https://twitter.com/tobiasnyholm).

* [PHP микро оптимизация: if ($var) VS !empty($var)](https://www.contextualcode.com/Blog/php-micro-optimization.-variable-boolean-cast-vs-!empty) — Немного о том как сравнивать генерируемые опкоды, чтоб понять почему тот или иной код быстрее в PHP.

* [Ещё одна история оптимизации приложения](https://medium.com/pipedrive-engineering/how-two-developers-accelerated-php-monolith-in-pipedrive-df8a18bc2d8a) с помощью Blackfire.io.

* [Как ускорить подсчёт покрытия на Travis на 95%](https://pehapkari.cz/blog/2020/01/06/how-to-speedup-code-coverage-on-travis-by-95-percent) — Использовать в качестве драйвера phpdbg или pcov, а не Xdebug.

*  [Сергей Протько «Солидный код»](https://teletype.in/@hashdev/r1gGcFcP0r) — Расшифровка [доклада с PHP fwdays'17](https://www.youtube.com/watch?v=pu0EXQvoaCc).

*  [Правила работы с динамическими массивами и пользовательскими классами коллекций](https://habr.com/ru/company/mailru/blog/484336/)

*  [Как выглядит zip-архив и что мы с этим можем сделать](https://habr.com/ru/post/471066/), [Часть 2](https://habr.com/ru/post/472966/) — Data Descriptor и сжатие, [Часть 3](https://habr.com/ru/post/484520/) — Практическое применение, [Часть 4](https://habr.com/ru/post/485264/) — Чтение архива.

*  [PHPUnit. «Как мне протестировать мой чёртов контроллер»](https://habr.com/ru/post/485418/), или тестирование для сомневающихся.

*  [Чистые тесты на PHP и PHPUnit](https://habr.com/ru/company/mailru/blog/485124/).

### Аудио/Видео

*  [The Undercover ElePHPant #6](https://tideways.com/profiler/blog/php-shared-nothing-architecture-the-benefits-and-downsides) — О плюсах и минусах shared-nothing архитектуры PHP, а также о серверлесс с [Mathieu Napoli](https://twitter.com/matthieunapoli).

*  [Видеозаписи Laracon AU 2019](https://www.youtube.com/playlist?list=PLEkJYA4gJb78lIOKjZ0tJ9rWszT6uCTJH)

*  [Видеозаписи Scotland PHP 2019](https://www.youtube.com/playlist?list=PLUYKgcymLlHhtiC_h3sRD4hc5CGn3FlIo)

*  [Вводный туториал по Slim Framework](https://www.youtube.com/watch?v=Tr_0F_yRIIU)

*  [Вебинар «Автоматизация тестирования при помощи Codeception»](https://www.youtube.com/watch?v=z112u7gJtq4)

*  [Видеозаписи с SymСode St. Petersburg Meetup #8](https://www.youtube.com/channel/UCIC3R2Vv0YYaSUnHJEK9__g/featured) — Кирилл Смелов (JetBrains) – [Вывод типов в PhpStorm](https://www.youtube.com/watch?v=GgC3BuXKCCc), Антон Жуков (ManyChat) – [Железобетонный бэкенд](https://www.youtube.com/watch?v=PwcuAzS15GA).

### Занимательное

* Расшифровка  [подкастов Тейлора](https://blog.laravel.com/snippets) —  Как в одиночку запустить продукт, если вы разработчик: [Часть 1: Аудитория](https://habr.com/ru/post/483802/), [Часть 2: Поиск идеи](https://habr.com/ru/post/483896/), [Часть 3: Не сдаваться](https://habr.com/ru/post/485510/).

Спасибо за внимание!

Если вы заметили ошибку или неточность — сообщите, пожалуйста, в [личку](https://habrahabr.ru/conversations/pronskiy/).

Вопросы и предложения пишите на [почту](mailto:[email protected]) или в [твиттер](https://twitter.com/pronskiy).

Telegram-канал: **[PHP Digest](https://t.me/phpdigest)**.

[Прислать ссылку](https://bit.ly/php-digest-add-link)

[Поиск ссылок по всем дайджестам](https://pronskiy.com/php-digest/)

← [Предыдущий выпуск: PHP-Дайджест № 172](https://habr.com/ru/post/483684/) | https://habr.com/ru/post/485592/ | null | ru | null |

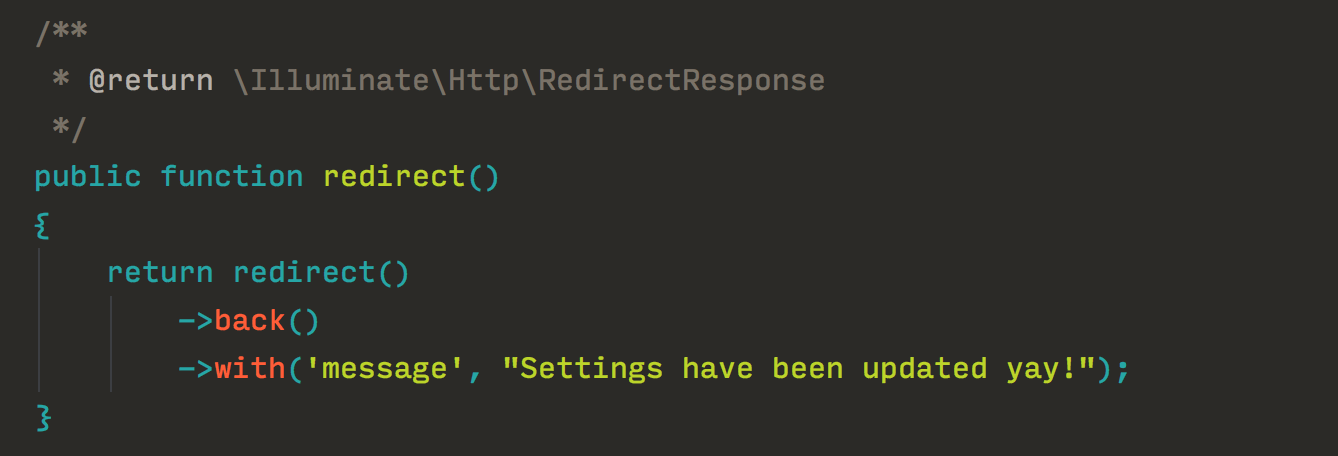

# REST-сервис на Java — это просто

Многим программистам Java-технологии могут показаться монструозными и сложными для понимания. В этой небольшой статье я бы хотел показать, что при желании можно собрать приложение из довольно простых компонентов, не прибегая к мега-фреймворкам.

В качестве примера я выбрал простенький REST-сервис. Для описания ресурсов будет использоваться Jersey. Как бонус, будет показано использование Dependency Injection фреймворка Google Guice. Можно было бы и без него, но я не хочу, что бы пример показался слишком игрушечным и оторванным от жизни. Весь пример я постараюсь уложить в примерно 50 строк в одном файле и не будет использовано ни строчки XML.

Итак, поехали:

1. Опишем простенький класс, который будет предоставлять доступ к некоторой информации. Пусть это будет счетчик вызовов:

> `@Singleton

>

> public static class Counter {

>

> private final AtomicInteger counter = new AtomicInteger(0);

>

> public int getNext() {

>

> return counter.incrementAndGet();

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Аннотация [Singleton](https://habrahabr.ru/users/singleton/) нужна для указания джуйсу, что объект должен быть синглтоном :)

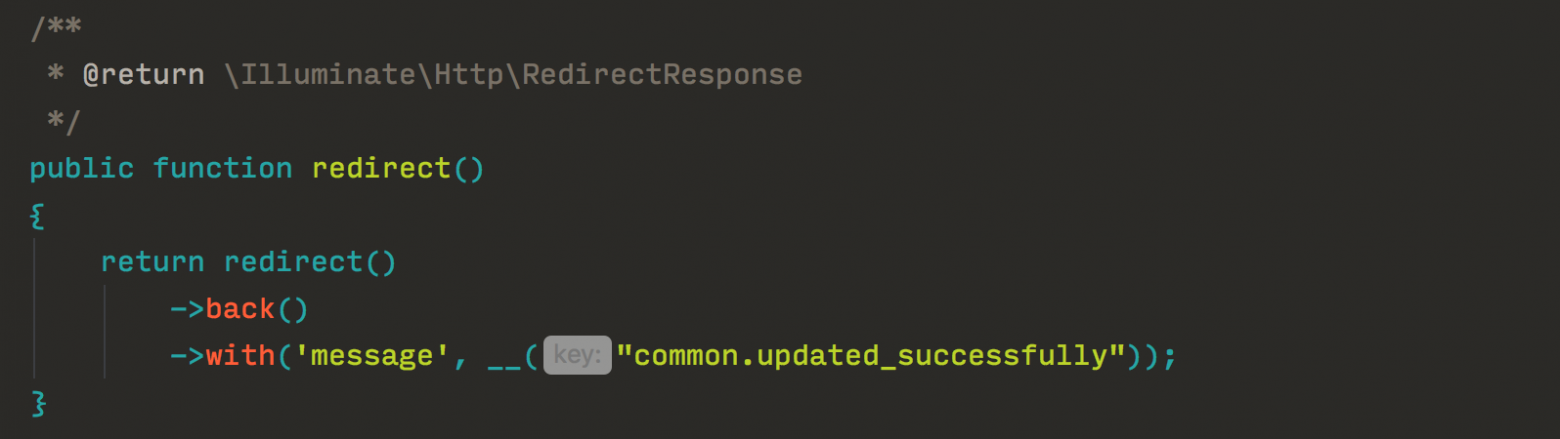

2. Опишем сервис, который будет возращать нам что-то, попутно дергая counter:

> `@Path("/hello")

>

> public static class Resource {

>

>

>

> @Inject Counter counter;

>

>

>

> @GET

>

> public String get() {

>

> return "Hello, User number " + counter.getNext();

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

3. Теперь подружим Jersey и Guice. Я воспользовался готовой интеграцией, она называется jersey-guice. Интеграция осуществляется через сервлет/фильтр GuiceContainer, для использования которого нужно объявить ServletModule из расширения guice-servlet-module и указать, что нужные нам запросы будут обрабатываться GuiceContainer, что позволит объявлять Jersey ресурсы в контексте Guice.

> `public static class Config extends GuiceServletContextListener {

>

> @Override

>

> protected Injector getInjector() {

>

> return Guice.createInjector(new ServletModule(){

>

> @Override

>

> protected void configureServlets() {

>

> bind(Resource.class);

>

> bind(Counter.class);

>

> serve("\*").with(GuiceContainer.class);

>

> }

>

> });

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Там же мы забайндили Counter и Resource.

4. Осталось запустить все это добро, используя сервлет-контейнер. Для этого нам совершенно не обязательно собирать war-ку и деплоить в какой-нибудь Tomcat. Можно воспользоваться встраиваемым контейнером. На ум приходят Jetty и Grizzly. Я выбрал последний. Вот код, который запускает сервер:

> `public static void main(String[] args) throws Exception {

>

> int port = Integer.valueOf(System.getProperty("port"));

>

> GrizzlyWebServer server = new GrizzlyWebServer(port);

>

> ServletAdapter adapter = new ServletAdapter(new DummySevlet());

>

> adapter.addServletListener(Config.class.getName());

>

> adapter.addFilter(new GuiceFilter(), "GuiceFilter", null);

>

> server.addGrizzlyAdapter(adapter, new String[]{ "/" });

>

> server.start();

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Обратите внимание, что пришлось объявить пустой сервлет:

> `@SuppressWarnings("serial")

>

> public static class DummySevlet extends HttpServlet { }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Он нужен, что бы Guice-фильтр сработал. Если не будет ни одного сервлета, Grizzly не будет передавать запрос никаким фильтрам.

Вот пожалуй и все. Далее приведу весь код:

> `public class App {

>

>

>

> @Path("/hello")

>

> public static class Resource {

>

>

>

> @Inject Counter counter;

>

>

>

> @GET

>

> public String get() {

>

> return "Hello, User number " + counter.getNext();

>

> }

>

> }

>

>

>

> @Singleton

>

> public static class Counter {

>

> private final AtomicInteger counter = new AtomicInteger(0);

>

> public int getNext() {

>

> return counter.incrementAndGet();

>

> }

>

> }

>

>

>

> public static class Config extends GuiceServletContextListener {

>

> @Override

>

> protected Injector getInjector() {

>

> return Guice.createInjector(new ServletModule(){

>

> @Override

>

> protected void configureServlets() {

>

> bind(Resource.class);

>

> bind(Counter.class);

>

> serve("\*").with(GuiceContainer.class);

>

> }

>

> });

>

> }

>

> }

>

>

>

> @SuppressWarnings("serial")

>

> public static class DummySevlet extends HttpServlet { }

>

>

>

> public static void main(String[] args) throws Exception {

>

> int port = Integer.valueOf(System.getProperty("port"));

>

> GrizzlyWebServer server = new GrizzlyWebServer(port);

>

> ServletAdapter adapter = new ServletAdapter(new DummySevlet());

>

> adapter.addServletListener(Config.class.getName());

>

> adapter.addFilter(new GuiceFilter(), "GuiceFilter", null);

>

> server.addGrizzlyAdapter(adapter, new String[]{ "/" });

>

> server.start();

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

UPD: [Исходники](http://jersey-guice-demo.googlecode.com/svn/trunk/) | https://habr.com/ru/post/115718/ | null | ru | null |

# Вы знаете, что такое трансдьюсеры

Трансдьюсеры были анонсированы еще в далеком 2014, с тех пор по ним было написано немалое количество статей ([раз](https://habrahabr.ru/post/237613/), [два](https://habrahabr.ru/post/247889/)), но ни после одной статьи я не мог сказать, что понимаю трансдьюсеры кристально ясно. После каждой статьи у меня возникало ощущение, что я приблизительно понимаю что-то сложное, но оно все равно оставалось сложным. А потом однажды в голове что-то щелкнуло: "я ведь уже видел этот паттерн, только он назывался иначе!"

### Задача:

Есть массив scores, содержащий результаты проведенных мною игр в футбол в виде объекта с полями:

* gameID — номер игры;

* my — количество очков у меня;

* others — количество очков у моего противника.

Необходимо найти номера первых двух выигранных мною игр.

Исходные данные для задачи (ответ для таких данных — [1, 3]):

```

const scores = [

{ gameID: 0, my: 1, others: 2 },

{ gameID: 1, my: 2, others: 1 },

{ gameID: 2, my: 0, others: 3 },

{ gameID: 3, my: 3, others: 2 },

{ gameID: 4, my: 3, others: 1 },

{ gameID: 5, my: 0, others: 0 },

{ gameID: 6, my: 4, others: 1 },

]

```

### Решение №1. Императивный цикл

Давайте начнем издалека, вернемся в те далекие дни, когда мы писали обычные императивные циклы и мучились изменяемым состоянием (соглашусь, что в данном примере это не вызывает каких-либо проблем):

```

const result = []

// Пробегаемся по всем играм, пока количество результатов не достигнет двух.

for (let i = 0; i < scores.length && result.length < 2; i++) {

const { gameID, my, others } = scores[i]

if (my > others) {

result.push(gameID)

}

}

```

Тут все довольно просто, красиво и быстро, но императивно и мутабельно. Важно заметить, что лишние итерации не выполняются, цикл завершается сразу после того, как массив с результатами получает нужное количество элементов.

### Решение №2. Array#map и Array#filter

Это уже решение иммутабельное, более выразительное, "современное".

```

const result =

scores

.filter(({ my, others }) => my > others) // выбираем выигрышные

.map(({ gameID }) => gameID) // получаем их номер

.slice(0, 2) // берем первые два

```

Именно так решило бы большинство js-разработчиков в наши дни, полагаю. Но у этого решения есть одна важная проблема: если в предыдущем решении мы делали всего один проход, да и тот не до конца, то сейчас у нас уже аж два полных прохода. Если бы у нас scores содержал миллион элементов, то предикат в filter вызывался бы миллион раз, функция в map применилась бы меньшее, но все равно большое число раз, а в конце мы все равно берем всего лишь два первых элемента. Конечно, преждевременная оптимизация — зло, но это уже ни в какие ворота.

### Решение №3. Свертка

Через свертки можно определить [почти] любую операцию над массивами. В этом решении у нас всего один проход:

```

const result = scores.reduce((result, { my, others, gameID }) => {

// Если игра выиграна и количество результатов меньше двух,

// то добавляем номер в результаты.

if (my > others && result.length < 2) {

return result.concat([gameID])

}

return result

}, [])

```

Это чем-то напоминает решение с циклами, но тут мы передаем промежуточное состояние явно и иммутабельно. Но проблема осталась — вместо двух проходов у нас теперь один, но он все равно полный, то есть при миллионе элементов мы пройдемся по всему миллиону, даже если нужное число результатов мы уже получили, ведь у стандартного reduce нет возможности выйти из цикла через break. Давайте тогда напишем свой reduce, из которого можно выйти, если вернуть reduced-значение (идею позаимствовал из clojure).

```

// Класс-обертка для итогового значения аккумулятора.

class Reduced {

constructor(value) {

this.value = value

}

}

const isReduced = value =>

value instanceof Reduced

const reduced = value =>

isReduced(value) ? value : new Reduced(value)

// Рекурсивная реализация reduce с проверкой аккумулятора на reduced-значение.

const reduce = (reducer, state, array) => {

// Если аккумулятор - reduced-контейнер со значением,

// то распаковываем и возвращаем значение, завершая цикл.

if (isReduced(state)) {

return state.value

}

if (array.length === 0) {

return state

}

// Рекурсивно вызовем reduce для хвоста массива,

// применяя первый элемент к состоянию.

const [x, ...xs] = array

return reduce(reducer, reducer(state, x), xs)

}

const result = reduce((result, { my, others, }) => {

if (my > others) {

if (result.length < 2) {

result = result.concat(gameID)

}

// Завершаем цикл, если набрано нужно число результатов.

if (result.length >= 2) {

result = reduced(result)

}

}

return result

}, [], scores)

```

Ух, теперь-то у нас все быстро (один проход и ровно до тех пор, пока мы не получим нужное количество элементов), но красиво ли? Я считаю, что код выше — страшный: в нем слишком много кода, который не относится к задаче.

### Решение №4. Декомпозиция редьюсера, трансдьюсеры

Редьюсер выше можно разбить на 4 небольших функции, который будут вызываться по цепочке, где одна функция вызывает следующую.

1. `filterWins` фильтрует игры по статусу, то есть пропускает дальше по цепочке только выигранные игры.

2. `mapGameID` достает из игры ее номер.

3. `firstTwo` проверяет количество полученных результатов. Если их меньше двух, то вызывает следующую функцию, получает новые результаты, а потом завершает цикл, если набрано нужное количество.

4. `appendToResult` добавляет номер игры в массив с результатами и возвращает его.

```

// next - следующая функция в цепочке

const filterWins = next => (result, score) =>

// Если игра выигрышная, то передаем ее дальше по цепочке

score.my > score.others

? next(result, score)

: result

const mapGameID = next => (result, { gameID }) =>

// Передаем дальше номер игры

next(result, gameID)

// Эта функция позволяет пропустить через себя ограниченное число элементов.

const firstTwo = next => {

// Мы используем замыкания для добавления локального состояния к нашим редьюсерам.

// n - количество элементов, которые нужно пропустить дальше для добавления в

// массив результатов.

let n = 2

return (result, score) => {

// Если есть свободные места, пропускаем игру дальше и уменьшаем их количество.

if (n > 0) {

result = next(result, score)

n -= 1

}

// Если свободных мест нет, завершаем цикл.

if (n <= 0) {

result = reduced(result)

}

return result

}

}

const appendToResult = (result, gameID) =>

result.concat([gameID])

const result = reduce(

// Последовательно трансформируем редьюсер, применяя наши функции к

// редьюсеру, создавая тем самым цепочку редьюсеров.

filterWins(mapGameID(firstTwo(appendToResult))),

[],

scores,

)

```

Вроде как упростили, разбив на функции, а получилось страшновато. Писать такое каждый раз не очень бы хотелось. Но мы это исправим чуть позже, когда унифицируем код для переиспользования.

Паттерн вам может показаться знакомым, ведь именно так работают middleware. Это и есть middleware. И это и есть трансдьюсеры, потому что трансдьюсеры это и есть middleware. Трансдьюсер — функция, которая принимает один редьюсер и возвращает новый (с дополнительной логикой перед или после вызова редьюсера).

Те, кто слышит понятие `middleware` впервые, могут ознакомится с ним тут: [express.js](http://expressjs.com/ru/guide/using-middleware.html), [laravel](http://laravel.su/docs/5.0/middleware), а так же я пробовал вчера объяснить его своими словами: [мой пост](https://vk.com/home_kana?w=wall-135720595_334)

В данном решении у нас три трансдьюсера: `filterWins`, `mapGameID` и `firstTwo`, и мы их по последовательно применяем к редьюсеру `appendToResult`, создавая все более и более сложный редьюсер.

А теперь давайте унифицируем наши трансдьюсеры:

```

// pred - предикат - функция, которая принимает значение и возвращает true или false.

// Если предикат возвращает true, то пропускаем значение по цепочке дальше, иначе

// возвращаем неизмененный аккумулятор.

const filter = pred => next => (acc, x) =>

pred(x) ? next(acc, x) : acc

// mapper - функция, которая преобразует один элемент в другой.

const map = mapper => next => (acc, x) =>

next(acc, mapper(x))

// Принимает редьюсер и создает новый, который выполнится только n раз.

// После n-ого выполнения цикл завершится.

const take = n => next => (acc, x) => {

if (n > 0) {

acc = next(acc, x)

n -= 1

}

if (n <= 0) {

acc = reduced(acc)

}

return acc

}

```

Заодно переименуем редьюсер:

```

const append = (xs, x) =>

xs.concat([x])

```

А так же добавим хэлпер для композиции функций, чтобы убрать лишние скобки:

```

const compose = (...fns) => x =>

fns.reduceRight((x, fn) => fn(x), x)

```

Добавим хэлпер, который применит транcдьюсер к редьюсеру и вызовет reduce с получившимся редьюсером:

```

const transduce = (transducer, reducer, init, array) =>

reduce(transducer(reducer), init, array)

```

Ну и наконец решим задачу с помощью всех этих функций:

```

const firstTwoWins = compose(

filter(({ my, others }) => my > others),

map(({ gameID }) => gameID),

take(2),

)

const result = transduce(firstTwoWins, append, [], scores)

```

Получилось красивое, быстрое, функциональное, иммутабельное, готовое к переиспользованию решение.

### Вывод:

Трансдьюсеры — очень простой паттерн, который является частным случаем паттерна middleware, который известен намного шире (отсюда и название статьи), основа которого — создание сложных редьюсеров с помощью композиции. А полученные редьюсеры в свою очередь очень универсальны, их можно использовать с обработкой коллекций, стримов, Redux.

Писать весь код для работы с трансдьюсерами каждый раз вручную не придется, ведь трансдьюсеры уже давно реализованы во многих библиотеках для обработки данных (например в `ramda.js` или стандартной библиотеке clojure)

#### Ramda:

```

const scores = [

{ gameID: 0, my: 1, others: 2 },

{ gameID: 1, my: 2, others: 1 },

{ gameID: 2, my: 0, others: 3 },

{ gameID: 3, my: 3, others: 2 },

{ gameID: 4, my: 3, others: 1 },

{ gameID: 5, my: 0, others: 0 },

{ gameID: 6, my: 4, others: 1 },

]

{

const firstTwoWins = compose(

filter(({ my, others }) => my > others),

pluck("gameID"),

take(2),

)

const result = transduce(firstTwoWins, flip(append), [], scores)

}

// Или еще лучше

{

const firstTwoWins = into([], compose(

filter(({ my, others }) => my > others),

pluck("gameID"),

take(2),

))

const result = firstTwoWins(scores)

}

```

#### Clojure:

```

(def scores [{:game-id 0, :my 1, :others 2}

{:game-id 1, :my 2, :others 1}

{:game-id 2, :my 0, :others 3}

{:game-id 3, :my 3, :others 2}

{:game-id 4, :my 3, :others 1}

{:game-id 5, :my 0, :others 0}

{:game-id 6, :my 4, :others 1}])

(defn win? [{:keys [my others]}]

(> my others))

(def first-two-wins

(comp (filter win?)

(map :game-id)

(take 2)))

(def result (transduce first-two-wins conj [] scores)) ;; [1 3]

``` | https://habr.com/ru/post/325388/ | null | ru | null |

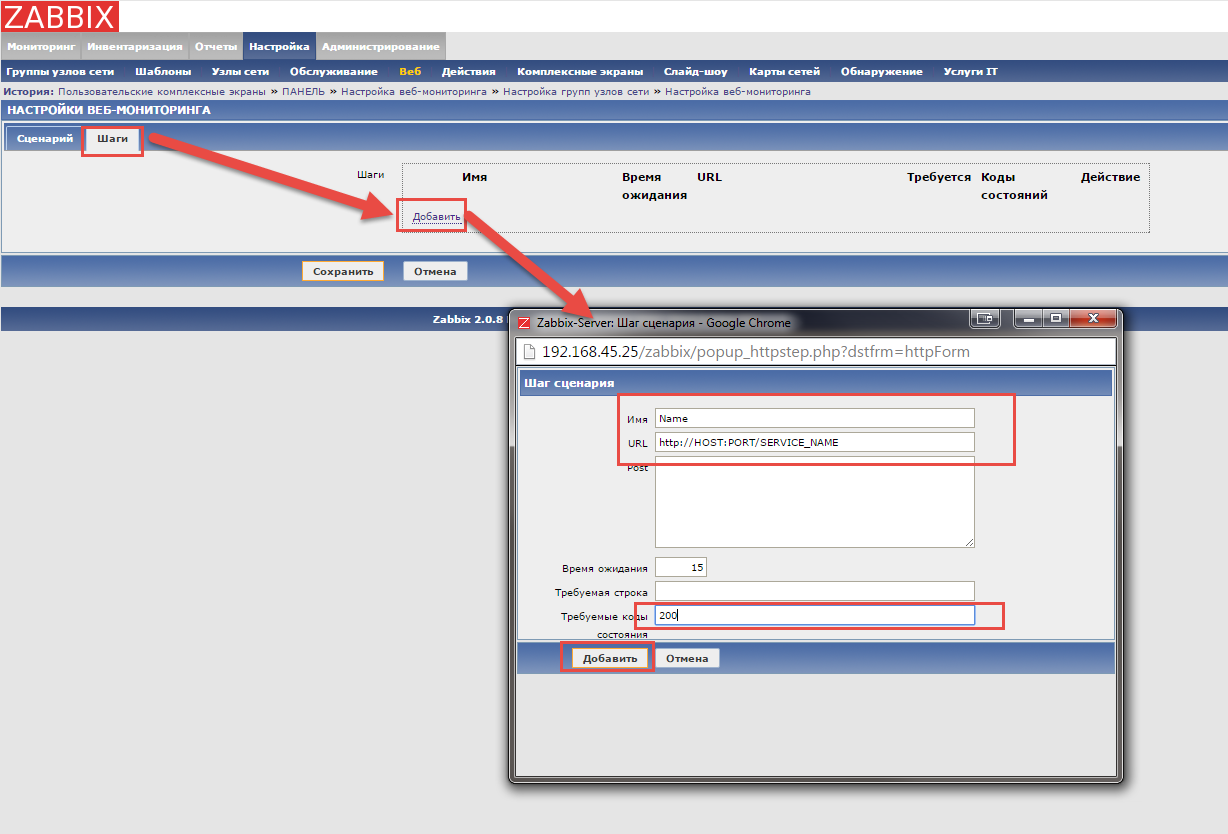

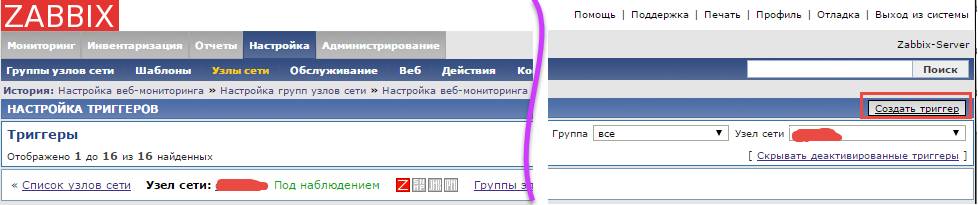

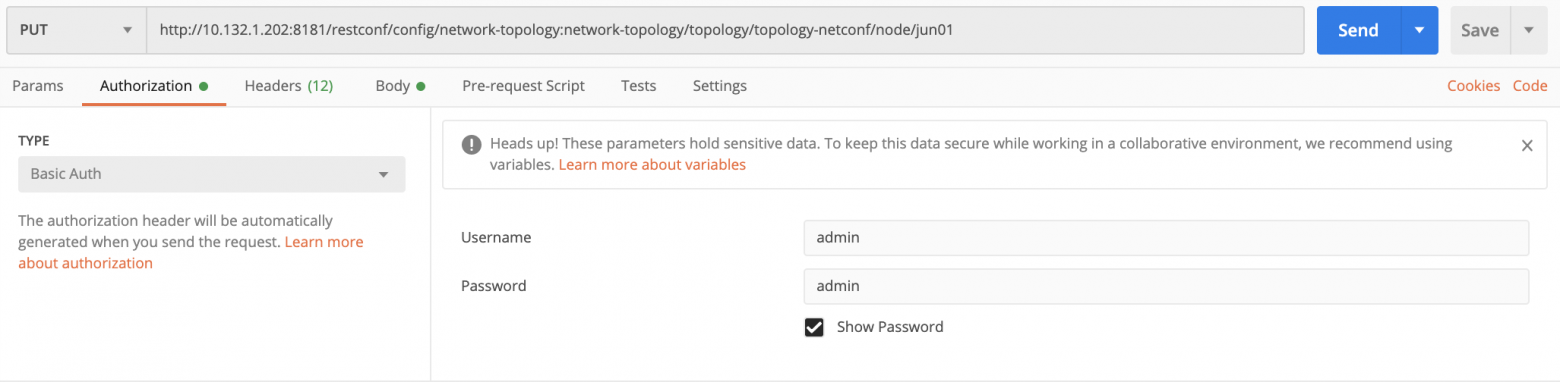

# Подключение периферийных модулей к MIPSfpga, на примере клавиатуры Pmod KYPD

Здравствуйте! Мы одни из победителей [хакатона MIPfpga](https://habrahabr.ru/post/316248/), в этой статье расскажем, как подключать модули в систему на кристалле на основе MIPSfpga на примере клавиатуры Pmod KYPD. Также ознакомим с написанием программы для управления подключенных модулей.

→ Описание клавиатуры найдете [здесь](http://store.digilentinc.com/pmod-kypd-16-button-keypad/)

Pmod KYPD — 16-кнопочная клавиатура с цифрами в шестнадцатеричном формате (0-F). Опрос происходит способом поочередной подачи логического 0 на каждый столбец и считывания состояния строк. Если в момент опроса столбца одна из кнопок в нем нажата, соответствующая строка выдаст логическую 1.

Для начала необходимы исходники MIPSfpga.

→ [Инструкция по скачиванию](http://www.silicon-russia.com/2015/12/11/mipsfpga-download-instructions)

Далее нужно скачать [надстройку MIPSfpga-plus](http://github.com/MIPSfpga/mipsfpga-plus), которая позволяет записывать программы по UARTу.

Описание и инструкции по установке присутствуют, если коротко, то для того, чтобы была возможность просто запустить скрипт и проект собрался, необходимо:

— поместить исходники MIPSfpga в папку

> C:\MIPSfpga;

а MIPSfpga-plus по директории:

> C:\github\mipsfpga-plus;

Далее в папке C:\github\mipsfpga-plus\boards выбрать свою плату, у меня это de0\_cv, и выполнить скрипт make\_project. Проект, который нужно запускать, будет находиться в C:\github\mipsfpga-plus\boards\de0\_cv\project.

Если для вашей платы нет проекта, то можно выбрать наиболее подходящую по количеству логических ячеек и изменить назначения;

— Еще вам понадобятся компилятор, линковщик [Codescape](https://community.imgtec.com/developers/mips/tools/codescape-mips-sdk/download-codescape-mips-sdk-essentials/), а также USB-UART преобразователь, например, pl2303hx или ch340.

> Подключение клавиатуры и USB-UART преобразователя к плате

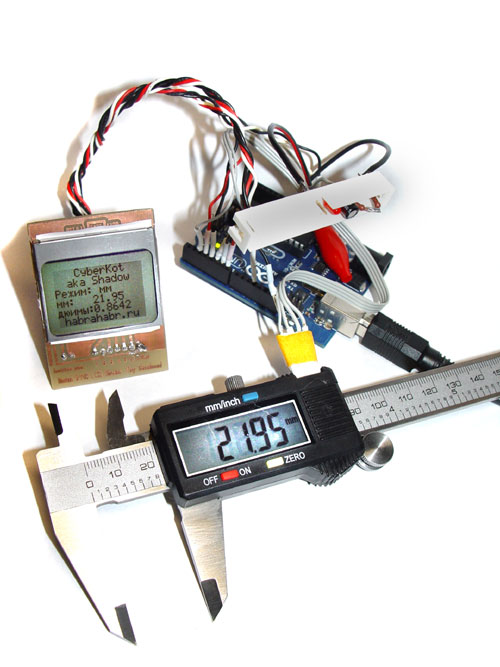

Клавиатура напрямую будет подключена к шине AHB-Lite. Для интеграции клавиатуры в систему мы создали модуль decoder.v. Данный модуль работает по следующему принципу: каждую миллисекунду опрашивается один из столбцов и. если в этот момент была нажата кнопка в этом столбце. то соответствующая строка выдаст логическую 1. Каждой комбинации строка+столбец соответствует цифра от 0 до F. Данная цифра записывается в регистр и по шине передается в память процессора. С помощью программного обеспечения данные с памяти выводятся на индикатор.

**Код модуля**

module decoder(

input i\_row1,

input i\_row2,

input i\_row3,

input i\_row4,

input i\_clk,

input i\_rst\_n,

output [3:0] o\_col,

output [3:0] o\_number);

reg [3:0] col;

reg [31:0] counter;

reg [3:0] number;

parameter ZERO = 8'b11100111; //row, col

parameter ONE = 8'b01110111;

parameter TWO = 8'b01111011;

parameter THREE = 8'b01111101;

parameter FOUR = 8'b10110111;

parameter FIVE = 8'b10111011;

parameter SIX = 8'b10111101;

parameter SEVEN = 8'b11010111;

parameter EIGHT = 8'b11011011;

parameter NINE = 8'b11011101;

parameter TEN = 8'b01111110;

parameter ELEVEN = 8'b10111110;

parameter TWELVE = 8'b11011110;

parameter THIRTEEN = 8'b11101110;

parameter FOURTEEN = 8'b11101101;

parameter FIFTEEN = 8'b11101011;

always @(posedge i\_clk or negedge i\_rst\_n)

begin

if (i\_rst\_n == 1'b0)

begin

col <= 4'b1110;

end

else

begin

if (counter == 31'b111001001110000111000000)

begin

col <= {col [0], col [3:1]};

end

end

end

always @\*

begin

if (i\_rst\_n == 0)

begin

number <= 4'b0;

end

else

begin

case ({i\_row1, i\_row2, i\_row3, i\_row4, col [0], col [1], col [2], col [3]})

ZERO:

begin

number <= 4'b0000;

end

ONE:

begin

number <= 4'b0001;

end

TWO:

begin

number <= 4'b0010;

end

THREE:

begin

number <= 4'b0011;

end

FOUR:

begin

number <= 4'b0100;

end

FIVE:

begin

number <= 4'b0101;

end

SIX:

begin

number <= 4'b0110;

end

SEVEN:

begin

number <= 4'b0111;

end

EIGHT:

begin

number <= 4'b1000;

end

NINE:

begin

number <= 4'b1001;

end

TEN:

begin

number <= 4'b1010;

end

ELEVEN:

begin

number <= 4'b1011;

end

TWELVE:

begin

number <= 4'b1100;

end

THIRTEEN:

begin

number <= 4'b1101;

end

FOURTEEN:

begin

number <= 4'b1110;

end

FIFTEEN:

begin

number <= 4'b1111;

end

default:

begin

number <= number;

end

endcase

end

end

always @(posedge i\_clk or negedge i\_rst\_n)

begin

if (i\_rst\_n == 0)

begin

counter = 31'b0;

end

else

begin

if (counter == 31'b111001001110000111000011)

begin

counter = 31'b0;

end

else

begin

counter = counter + 1'b1;

end

end

end

assign o\_number = number;

assign o\_col = col;

endmodule

Подключаем к проекту файл с описанным выше модулем. В файле верхнего уровня, у нас это de0\_cv.v, добавим следующие строчки:

```

`ifdef MFP_PMOD_KYPD

.KYPD_DATA ( GPIO_0 [35:28] ),

.KEY_0 ( KEY [0] )

`endif

```

Выделим ножки GPIO\_0 [35], GPIO\_0 [34] для питания клавиатуры. В файле mfp\_system.v добавляем входы и выходы:

```

inout [7:0] KYPD_DATA,

input KEY_0

```

В описании модуля mfp\_system добавим:

```

`ifdef MFP_PMOD_KYPD

wire [3:0] KYPD_OUT;

`endif

`ifdef MFP_PMOD_KYPD

decoder decoder

(

.i_clk ( SI_ClkIn ),

.i_rst_n ( KEY_0 ),

.i_row1 ( KYPD_DATA [6] ),

.i_row2 ( KYPD_DATA [4] ),

.i_row3 ( KYPD_DATA [2] ),

.i_row4 ( KYPD_DATA [0] ),

.o_col ( {KYPD_DATA [7],

KYPD_DATA [5],

KYPD_DATA [3],

KYPD_DATA [1]} ),

.o_number ( KYPD_OUT )

);

`endif

```

При создании экземпляра модуля mfp\_ahb\_lite\_matrix\_with\_loader добавим в список входов наши данные:

```

`ifdef MFP_PMOD_KYPD

.KYPD_OUT ( KYPD_OUT ),

`endif

```

В файлах mfp\_ahb\_lite\_matrix\_with\_loader.v, mfp\_ahb\_lite\_matrix.v, mfp\_ahb\_gpio\_slave.v добавляем вход:

```

input [3:0] KYPD_OUT

```

В файле mfp\_ahb\_lite\_matrix\_config.vh, который находится в папке C:\github\mipsfpga-plus, добавляем следующие строчки:

```

`define MFP_PMOD_KYPD_IONUM 4'h5

`define MFP_PMOD_KYPD_ADDR 32'h1f800014

```

Собственно, это и есть адреса, по которым будут доступны регистры. Последним штрихом будет написание программы, которая отображает числа на семисегментном индикаторе.

**Код программы**

#include «mfp\_memory\_mapped\_registers.h»

int main ()

{

int n = 0;

for (;;)

{

MFP\_7\_SEGMENT\_HEX = MFP\_PMOD\_KYPD;

MFP\_GREEN\_LEDS = n++;

}

return 0;

}

Генерируем motorola\_s\_record файл:

```

08_generate_motorola_s_record_file

```

Проверяем к какому СОМ порту подключен USB UART преобразователь:

```

11_check_which_com_port_is_used

```

Изменяем файл 12\_upload\_to\_the\_board\_using\_uart:

```

set a=7

mode com%a% baud=115200 parity=n data=8 stop=1 to=off xon=off odsr=off octs=off dtr=off rts=off idsr=off type program.rec >\.\COM%a%,

```

где а – номер СОМ порта, к которому подключен USB UART преобразователь.

И наконец, загружаем программу:

```

12_upload_to_the_board_using_uart

```

Желаем успеха. | https://habr.com/ru/post/323360/ | null | ru | null |

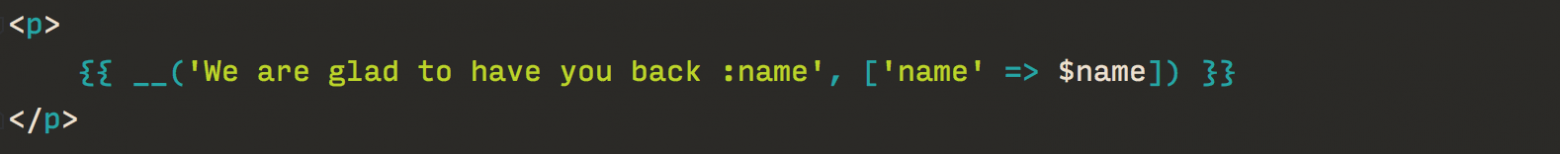

# Никогда не делайте компараторов на базе вычитания

Я обратил внимание, что люди, когда они пишут свой компаратор, очень часто любят сравнению чисел предпочитать их вычитание. Такой подход лаконичен и краток, но к сожалению, не всегда корректно работает, поэтому использовать его нельзя. Я сам когда-то на это попадался, и вижу это настолько часто, что решил написать заметку.

Рассмотрим следующий код:

```

import org.testng.annotations.BeforeMethod;

import org.testng.annotations.Test;

import java.util.Collections;

import java.util.List;

import static java.util.Arrays.*;

import static org.testng.Assert.assertEquals;

public class ComparatorAlgTest {

List list1, list2;

@BeforeMethod

public void init(){

list1 = asList(1,2);

list2 = asList(Integer.MIN\_VALUE, Integer.MAX\_VALUE);

}

void check(String name){

System.out.println(name+" list1 = " + list1);

System.out.println(name+" list2 = " + list2);

assertEquals(list1, asList(1,2) );

assertEquals(list2, asList(Integer.MIN\_VALUE, Integer.MAX\_VALUE) );

}

@Test

public void testWrong() {

Collections.sort(list1, (Integer a, Integer b) -> a-b );

Collections.sort(list2, (Integer a, Integer b) -> a-b );

check("wrong");

}

@Test

public void testFine() {

Collections.sort(list1, (Integer a, Integer b) -> a.equals(b)? 0: a>b ? 1:-1 );

Collections.sort(list2, (Integer a, Integer b) -> a.equals(b)? 0: a>b ? 1:-1 );

check("fine");

}

}

```

Запустив это, можно видеть, что testWrong() заканчивается неудачей, и вместо сортировки по возрастанию мы иногда получаем убывание

`fine list1 = [1, 2]

fine list2 = [-2147483648, 2147483647]

wrong list1 = [1, 2]

wrong list2 = [2147483647, -2147483648]`

На самом деле, пара чисел (Integer.MIN\_VALUE, Integer.MAX\_VALUE) является далеко не единственной комбинацией, при которой subtraction-driven компаратор сработает неверно. Для того, чтобы результат был некорректным, необходимо и достаточно, чтобы при вычитании произошло переполнение. Например, можно подставить asList(-2, Integer.MAX\_VALUE), и subtraction-driven сравнение не сработает тоже. | https://habr.com/ru/post/278329/ | null | ru | null |

# Доступ к свойствам внутри поля Jsonb для Npgsql

PostgreSQL имеет тип данных Jsonb, который позволяет добавлять к стандартной реляционной модели дополнительные свойства с возможностью поиска по ним.

EntityFramework Core с расширением Npgsql умеет вытягивать данные поля в тип `System.String`

Однако для фильтрации по Json свойствам через EF на уровне запросов приходится использовать чистый SQL, что не очень то удобно, так как нужно лезть в маппинг (если он не автоматический), искать названия полей, соответствующих свойствам моделей, поддерживать это именование. Пропадает гибкость, которую нам дает ORM.

Если вас это угнетает, так же как и меня, добро пожаловать под кат.

В конце статьи имеется ссылка на исходники!

### Обозначим задачи

Я, как разработчик, хочу иметь инструмент для доступа к полям Jsonb с целью фильтрации и сортировки по ним, который:

* Будет совместим с **EntityFramework Core 2** (мы используем именно его)

* Не потребует во время работы с ним самому писать SQL

* Будет работать с плоской структурой Json (внутри json есть только json свойства)

Добавлю еще, что есть [Npgsql.Json.NET](https://www.npgsql.org/doc/types/jsonnet.html "Npgsql.Json.NET"), который умеет проецировать Json и Jsonb значения в CLR типы. Если честно, не понимаю, для чего он может понадобиться, ведь раз у нас появилась необходимость в Json поле в реляционной БД, вероятнее всего у нас есть сущности с динамическим набором полей.

### Алгоритм решения задачи

1. Определить метод (или методы), который будет покрывать наши потребности.

2. Создать транслятор, который будет участвовать в генерации SQL кода.

3. Прикрутить все это к Npgsql.

### Решение

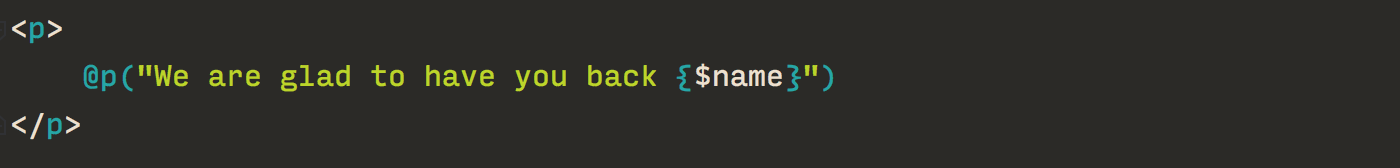

Для начала определим метод. Хочу, чтобы он использовался как то так:

```

context.Entity.Where(x => JsonbMethods.Value(x.JsonbField, "jsonPropertyName") == "value")

```

Следовательно, вот наш метод:

```

public static TSource Value(object jsonbProperty, string jsonbPropertyName)

{

throw new NotSupportedException();

}

```

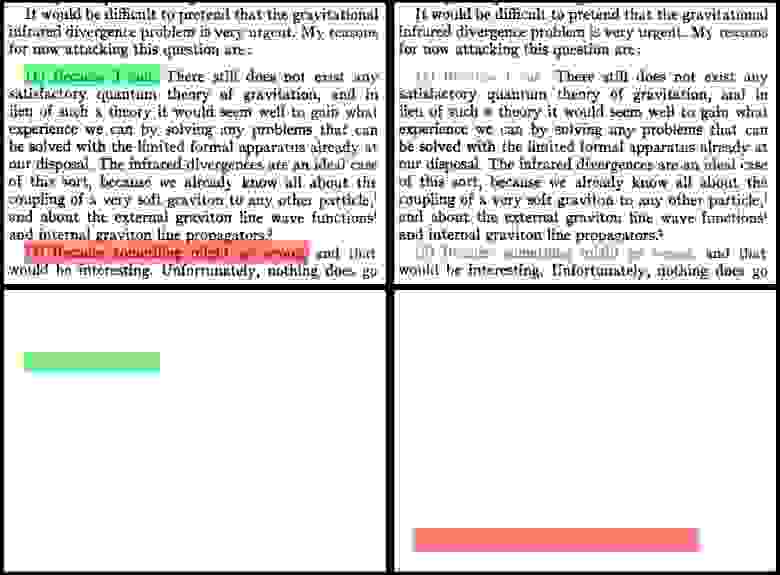

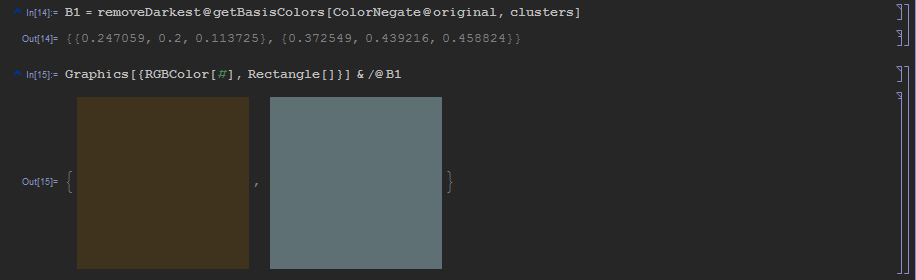

Я несколько часов ковырял исходники EF Core, Npgsql и не только в поисках способов расширить базовый функционал генерации SQL. Добрался [вот до этой статьи](https://habr.com/ru/post/351556/ "вот до этой статьи"), но подход автора по способу подключения транслятора мне не понравился, ведь он переопределяет стандартный инструмент, а значит может конфликтовать с другим похожим инструментом.

В итоге добрался до исходников Net Topology Suite. Все, что мне оттуда потребовалось, это способ подключения транслятора методов.

Но больше всего времени я потратил на то, чтобы сформировать нужный мне фрагмент sql.

Вот требуемый синтаксис

`tableAlias."JsonField"->>"insideProperty"`

Сначала я пробовал в трансляторе возвращать ColumnExpression. Первым параметром при его создании идет имя столбца (string). Я просто состряпал его из параметров, которые мне приходят в метод. Запустил, проверил, ошибка. Оказывается, то, что я передаю в качестве имени, оборачивается в кавычки. В итоге SQLполучился таким `tableAlias.""JsonField"->>"insideProperty""`.