text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Vue 3.0 — первый взгляд

Наконец-то руки дошли попробовать новую версию Vue. Я не собираюсь быть объективным в этой статье, я просто расскажу свои впечатления в процессе работы с новой версией, а также расскажу как её установить и начать работу уже сейчас.

Несмотря на релиз, Vue 3.0 еще не готов для полноценного использования в продакшене. Router и Vuex еще не готовы для работы с новой версией, Vue CLI по умолчанию устанавливает старую версию, не говоря уже о сторонних плагинах и библиотеках, авторы которых не успели их обновить. Вот такой долгожданный и неполноценный релиз мы получили.

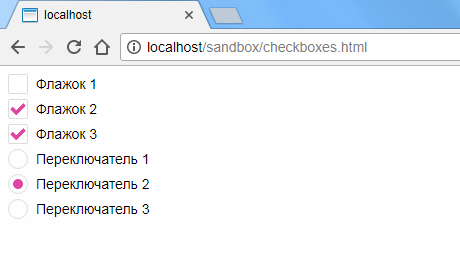

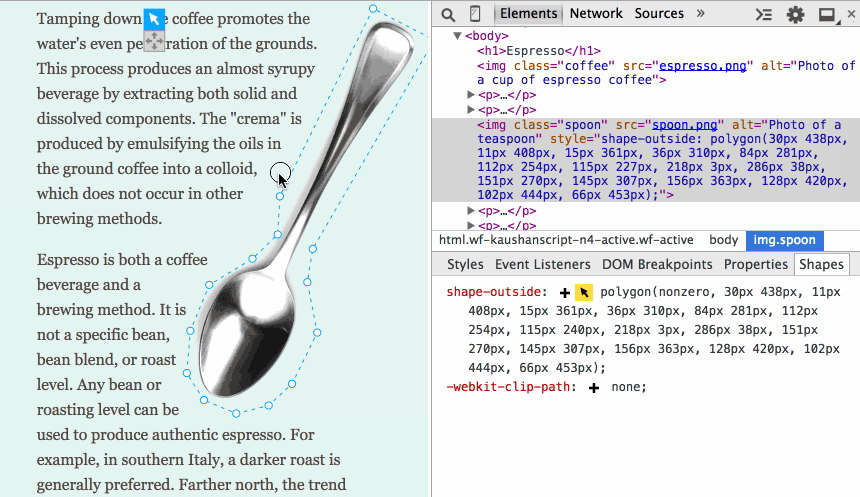

Особенно много вопросов вызывает новый синтаксис, так называемый [Composition API](https://v3.vuejs.org/guide/composition-api-introduction.html), который, к счастью, не заменит полностью привычный и всеми любимый Options API. В пользу новой композиции нам всюду предлагают подобную картинку:

Сравнение фрагментации кода в старом и новом синтаксисеСмахивает на вкусовщину. Мне удобнее написать метод и забыть, что у него внутри, главное - чтобы его имя правильно подсказывало что он делает. Наверное, для стороннего человека будет проще понять скомпонованную логику, и любителям TS зайдет. Что мы точно знаем - это то, что оба подхода останутся навсегда. Так что знать новую компоновку надо. А некогда единое сообщество разделится надвое.

На вопросы "зачем это или другое нововведение" дают один ответ: потому что это есть в React. Такая аргументация не очень вдохновляет, если я хочу, чтобы было как в реакте, я буду писать на реакте.

Давайте перейдем к созданию проекта.

Для тех кто не разобрался с установкой Vue 3, добро пожаловать под спойлер:

Установка Vue 3**Первый вариант** подключения это через npm - набираем в консоли:

```

npm install vue@next

```

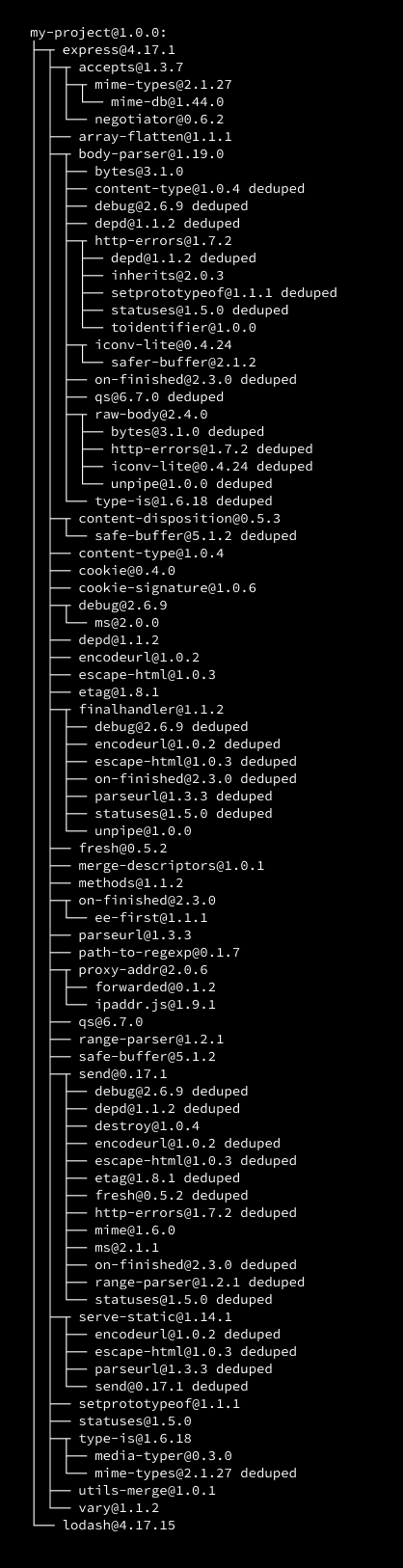

Эта команда просто скачивает пакет в папку `node_modules`. Синтаксис подключения в новой версии изменился, мы не будем его разбирать. Гораздо проще создать проект с помощью Vue CLI.

**Второй вариант:** для начала вам нужно обновить CLI. Снова открываем консоль :

```

npm install -g @vue/cli

```

Почему-то у меня не сработало обновление, тогда я обновил через yarn (да я иногда изменяю Vue с React):

```

yarn global add @vue/cli

```

Не знаю в чем была проблема, в случае чего, обновите через оба менеджера. Чтобы проверить версию, наберите в консоли:

```

vue -V

```

должно показать @vue/cli 4.5.6.

Создаем проект в нужной нам директории:

```

vue create hello-vue

```

Дальше нам предлагают три варианта на выбор. Выбираем вторую строку:

`Default (Vue 3 Preview) ([Vue 3] babel, eslint)`

После того как проект создался, переходим в директорию проекта:

```

cd hello-vue

```

Открываем проект в вашем любимом редакторе кода. Для VScode достаточно набрать в консоли:

```

code .

```

Vue CLi заботливо создал для нас проект. Первое отличие сразу же бросается в глаза. Это файл main.js:

```

import { createApp } from 'vue'

import App from './App.vue'

createApp(App).mount('#app')

```

Теперь наше приложение создается функцией `createApp`, которую необходимо импортировать. Теперь придется импортировать множество вещей. С одной стороны, это кажется лишними манипуляциями, с другой, - не импортированные вещи не войдут в итоговый бандл, а значит уменьшат его вес. В целом, автор фреймворка обещает лучшую производительность.

Удаляем компонент HelloWorld.vue и все содержимое в файле App.vue.

В папке `components` создаем новый файл Card.vue со следующим содержимым:

```

![cat pic]()

{{ catName }}

=============

*{{ text }}*

**{{ website }}**

export default {

name: "Card",

props: {

id: String,

name: String,

text: String,

website: String,

},

computed: {

imgUrl() {

return `https://robohash.org/${this.id}?set=set4&size=180x180`;

},

catName() {

return this.name.replace(/[\_.-]/gi, " ");

},

},

};

```

Компонент карточки получает несколько входящих данных `props`. Некоторые мы хотим изменить перед тем, как использовать их в шаблоне. Например, в имени заменяем все точки, нижние подчеркивания и дефисы на пробелы. Для этого мы привычно используем `computed`. Как этот же компонент будет выглядеть с новым синтаксисом? Для начала импортируем `computed`

```

import { computed } from "vue";

...</code></pre><p>переписываем логику из <code>computed</code>в новую опцию <code>setup </code>вот так:</p><pre><code class="javascript"> setup(props) {

const imgUrl = computed(

() => `https://robohash.org/${props.id}?set=set4&size=180x180`

);

const catName = computed(() => props.name.replace(/[\_.-]/g, " "));

return {

imgUrl,

catName,

};

},</code></pre><p>Setup принимает переменную <code>props</code>, которая содержит все входные параметры.</p><p>Картинки для карточек, нарисованных милых котиков, мы берем с сайта robohash.org. Просто чтобы разбавить наше скучное занятие. А еще добавим ультрамодного неоморфизма в стили:</p><pre><code class="css"><style scoped>

div {

width: 400px;

height: 380px;

position: relative;

background: #ecf0f3;

margin-bottom: 30px;

padding: 30px 5px;

border-radius: 32px;

text-align: center;

cursor: pointer;

font-family: "Montserrat", sans-serif;

font-size: 22px;

font-weight: semibold;

box-shadow: -6px -6px 10px rgba(255, 255, 255, 0.8),

6px 6px 10px rgba(0, 0, 0, 0.2);

color: #6f6cde;

}

</style></code></pre><p>Теперь вернемся к файлу <code>App.vue.</code> Он должен принимать данные для карточек с котиками и создавать карточки. Напишем его сразу на новом синтаксисе:</p><pre><code class="xml"><template>

<div class="container">

<Card

v-for="cat in cats"

:id="cat.id"

:name="cat.username"

:text="cat.company.catchPhrase"

:key="cat.id"

:website="cat.website"

/>

</div>

</template>

<script>

import { ref, onMounted } from "vue";

import Card from "./components/Card";

export default {

name: "App",

components: { Card },

setup() {

const cats = ref([]);

const fetchCats = async () => {

cats.value = await fetch(

"https://jsonplaceholder.typicode.com/users"

).then((response) => response.json());

};

onMounted(fetchCats);

return {

cats,

};

},

};

body {

background: #ecf0f3;

}

.container {

height: 100%;

display: flex;

flex-direction: row;

justify-content: space-around;

align-content: space-around;

flex-wrap: wrap;

padding: 30px 0px;

}

```

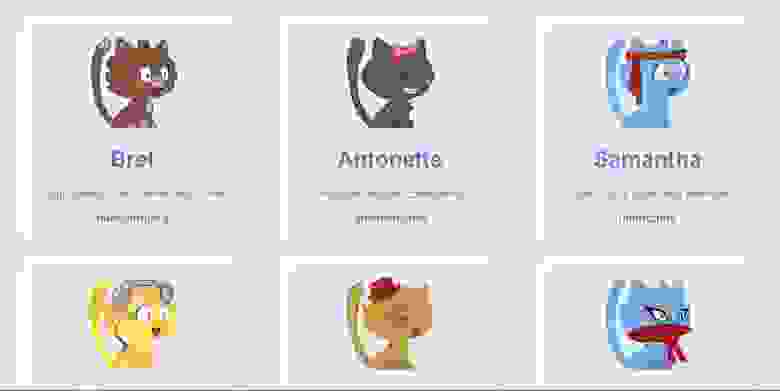

Если вы все сделали правильно, вот что вы должны увидеть в итоге:

Новыми для нас являются две фичи `ref` и `onMounted`

`ref` нужен нам, чтобы создавать реактивную переменную в методе `setup()`. Вот только пользоваться им немного по-другому. `ref` оборачивает наш массив в объект. Это нужно для двусторонней реактивности, ведь простые примитивы джаваскрипт передает как значение, а не как ссылки, в отличие от объектов. Теперь искомый массив доступен через переменную `value` этого объекта, и чтобы присвоить ему новое значение, придется писать вот так:

```

cats.value = data

```

А в шаблоне по прежнему используем просто `cats`

`onMounted` заменяет знакомый `mounted`. Как и все хуки жизненного цикла он будет доступен в setup под тем же именем, только с приставкой `on`. Для каждого метода придется вызывать `onMounted` заново. Напомню, что все эти манипуляции делались с одной целью, чтобы логику получения данных можно было написать вместе.

---

Это только начало знакомства с обновой, для полного погружения курите [мануал](https://v3.vuejs.org/guide/composition-api-introduction.html).

Полный код проекта доступен [здесь](https://github.com/harmyderoman/hello-vue).

Ну и небольшой вывод от меня. Создавать новые проекты и переводить старые(где это возможно) на новую версию фреймворка стоит. Несмотря на некоторые неоднозначные моменты, в ней есть и очевидные плюсы. Пользоваться новым синтаксисом или нет решать вам. | https://habr.com/ru/post/521250/ | null | ru | null |

# Дайджест интересных материалов из мира Drupal #2

Всем привет!

В этом выпуске вас ждут более 30 новостей, материалов, интересных модулей — всё самое интересное и свежее из мира Drupal.

### По-русски

Начнём с материалов на русском языке:

* Хотели прикрутить популярный HTML, CSS-фреймфорк [Boostrap](http://getbootstrap.com/) к своему сайту? Советуем ознакомиться с циклом статей от Angarsky.ru:

+ [Drupal и Bootstrap фреймворк: настройка, использование Sass.](http://www.angarsky.ru/drupal/drupal-bootstrap-framework-nastroyka-sass.html)

+ [Связка из модулей Panels, Views и Bootstrap Framework.](http://www.angarsky.ru/drupal/panels-views-bootstrap-framework.html)

* [Несколько советов по ускорению Drupal](http://habrahabr.ru/post/245763/) от [afi13](https://habrahabr.ru/users/afi13/).

* С момента выхода первого дайджеста в блоге [xandeadx.ru](http://xandeadx.ru/) опубликовано более 10 новых заметок и полезных сниппетов.

* Роман Грачев делится опытом использования [CasperJS для тестирования друпал-проектов](http://netspark.ru/useful/papers/front-end-testirovanie-s-pomoshchyu-capserjs).

* [Опубликованы фото и видео](http://2014.drupalcampmsk.ru/conference/news/2014-12-18) с конференции DrupalCamp MSK 2014.

* В питерском Drupal-сообществе завершился конкурс «[Проекты российских разработчиков](http://drupalspb.org/initiatives/proekty-rossiyskih-razrabotchikov)». Обязательно загляните в комментарии, где перечислены сами модули.

### Всё для Drupal-разработчика

Drupal-новости и статьи со всего мира в нашей основной рубрике:

* «Все технологии будущего имеют одно общее свойство: разработчики первых прототипов сознательно строят системы с возможностью инноваций от будущих пользователей». Возможно и спорное, и слишком строгое утверждение, но может так и объясняется успех Drupal 7? Очень интересный материал ждет вас в статье [Adaptive Architecture: Leave Room to Evolve](https://swsblog.stanford.edu/blog/adaptive-architecture-leave-room-evolve).

* В Drupal'e есть несколько популярных «базовых» тем. Автор статьи объясняет, почему он выбрал Bootstrap: [Which Base Theme We Use (and Why)](http://www.digett.com/blog/12/16/2014/which-base-theme-we-use-and-why).

* Пока не знаете, что такое хуки? [Эта заметка](https://3cwebservices.com/drupal/introduction-drupal-hooks) с примером простого модуля специально для начинающих.

* В Drupal'e, как и в любом полноценном фреймворке, всегда остается место для нетривиальных вещей, подводных камней, граблей, велосипедов и т.п. В этом плане очень интересным являются подборки Gotcha — на этот раз от разработчика Wunderkraut — [Bernt’s Drupal Gotchas](http://www.wunderkraut.com/blog/bernts-drupal-gotchas/2014-01-21).

* Клиент просит у вас [CRM](https://ru.wikipedia.org/wiki/%D0%A1%D0%B8%D1%81%D1%82%D0%B5%D0%BC%D0%B0_%D1%83%D0%BF%D1%80%D0%B0%D0%B2%D0%BB%D0%B5%D0%BD%D0%B8%D1%8F_%D0%B2%D0%B7%D0%B0%D0%B8%D0%BC%D0%BE%D0%BE%D1%82%D0%BD%D0%BE%D1%88%D0%B5%D0%BD%D0%B8%D1%8F%D0%BC%D0%B8_%D1%81_%D0%BA%D0%BB%D0%B8%D0%B5%D0%BD%D1%82%D0%B0%D0%BC%D0%B8)? Вам самим нужна система управления взаимоотношениями с клиентами? Сделайте её на Drupal'e, но не изобретайте велосипед, ведь уже доступно свыше 7 различных решений, которым посвящен [отдельный обзор](http://www.sitepoint.com/7-crm-options-compatible-drupal/).

* Если вы разрабатываете мультиязычный сайт и хотите, чтобы переводились отдельные поля, включая заголовки, а не весь материал целиком, то обязательно ознакомьтесь со статьей [Setup Entity Translation the right way](http://nielsdefeyter.nl/archive/201412/setup-entity-translation-right-way).

* Парсите сторонние сайты? Сталкиваетесь с проблемой подбора регулярных выражений и тому подобного? Попробуйте использовать сервис [Import.IO](https://import.io/). Тем более, что он нормально [интегрируется](http://fourword.fourkitchens.com/article/scraping-websites-drupal-using-feeds-and-importio) с модулем [Feeds](https://www.drupal.org/project/feeds).

* Про гибкий и мощный модуль Views можно говорить бесконечно. В этот раз предлагаем вашему вниманию подробную инструкцию как настроить [хитрый фильтр по типу файла](https://www.ostraining.com/blog/drupal/filter-drupal-file-type/) без единой строчки кода.

Если из админки задачу решить не получается, на помощь приходит Views API. В статье от Appnovation [пример кастомизации встроенного поля](http://www.appnovation.com/blog/how-properly-use-php-drupal-views-fields) с помощью кода.

* «Drupal в активном поиске» — так хотелось озаглавить этот дайджест! :)

1. Отличное [введение в фасетный поиск](https://3cwebservices.com/drupal/creating-faceted-search-view-drupal) (с видео).

2. Серия статей «Apache Solr and Drupal». Уже вышли [первая](http://cheppers.com/blog/apache-solr-and-drupal-part-i-set-up-apache-solr-to-enhance-drupal-search) и [вторая](http://cheppers.com/blog/apache-solr-and-drupal-part-ii-how-to-set-up-drupal-and-solr-to-search-in-attachments) части.

3. [Ещё один мануал по установке Apache Solr](http://www.pixelite.co.nz/article/installing-solr-development/), вариант для разработки.

4. [Интеграция Search API с подходом RESTful](https://medium.com/@e0ipso/restful-drupal-with-search-api-f370050a26bb).

* Изучаете модный AngularJS или только планируете это сделать? Не знаете, как прикрутить его к Drupal'у? Ознакомьтесь с статьей [AngularJS in Drupal Apps](http://www.sitepoint.com/angularjs-drupal-apps/), где создается блок со списком нод и поиском по ним, работающий абсолютно асинхронно.

* Вопросы безопасности на сайтах всегда будут актуальными, тем более, что количество утилит, собирающих уязвимые сайты в полу-автоматическом режиме, постоянно растёт. Статья [Drupal Security Tips for Developers](https://codedrop.com.au/blog/drupal-security-tips-developers) помогает двигаться в правильном направлении.

* В статье [How to improve security on Drupal sites](https://www.drupal.org/node/2368709) приводится ряд способов скрыть факт использования Drupal, чтобы не привлекать внимание автоматических утилит для сканирования на уязвимости.

* Если вы не слышли о концепции Offline-first, то рекомендуем ознакомиться с презентацией [Let's Take Drupal Offline!](http://www.slideshare.net/dickolsson/lets-take-drupal-offline-41650712) Идея, как минимум, любопытная, хоть и мало применимая на данный момент, из коробки.

* Иногда смотришь на стандартные формы редактирования контента в Drupal и понимаешь: «что-то не то». У Юрия Герасимова [есть несколько идей](http://wearepropeople.com/blog/drupal-ux-improvements-when-node-forms-are-a-nuisance), как можно значительно улучшить UX Drupal.

* А знаете ли вы про `user_multiple_role_edit()`? Короткая заметка о том, [как программно задать пользователю роли](http://befused.com/drupal/programmatically-assign-roles-users), к вашим услугам.

* Продолжаем кодерскую тему двумя любопытными библиотеками-хелперами для тех, кто пишет много кода: [Wrappers Delight](http://zengenuity.com/blog/a/201412/decoupling-your-backend-code-drupal-and-improving-your-life-wrappers-delight) и [Distill](https://github.com/patrickocoffeyo/distill).

* Где Drupal, там и Drush. Автор статьи [Advanced Drupal User Management With Drush](http://cheekymonkeymedia.ca/blog/drupal-planet/advanced-drupal-user-management-drush) показал пару примеров работы с пользователями прямо из консоли. Для полного комплекта не хватает только команды [user-login](http://www.drushcommands.com/drush-6x/user/user-login).

* Практически всегда, работая с разными окружениями, например: локальным, стейджинг-сервером, продакшеном, — приходится сталкиваться с тем, что каждое из них использует или свои собственные реквизиты для подключения к базе данных, а также самые разнообразные настройки, что в итоге ведет к надобности иметь один гигантский settings.php-файл или множество различных, например settings-prod.php. Всё бы хорошо, но проблема ещё в том, что локальное окружение у каждого разработчика может быть своё — а это значит, что даже имея локальный файл настроек, допустим settings-local.php, — у каждого будет своя его версия, что приведет к лишним изменениям в git status. У этой проблемы есть решение, и оно рассматривается в статье [Include a local Drupal settings file for environment configuration and overrides](http://www.oliverdavies.co.uk/blog/include-local-drupal-settings-file-environment-configuration-and-overrides).

* Если вы задавались вопросом, как в панелях (Panels) сделать свой собственный «виджет», то рекомендуем прочитать статью [How to Create Ctools Content Types in Drupal 7](http://morpht.com/posts/how-create-ctools-content-types-drupal-7) про создание типов содержимого CTools.

* Вообще, Panels та ещё штучка. Юрий Герасимов [рассказывает в своём блоге](http://ygerasimov.com/control-panes-render-sequence), как можно управлять последовательностью рендеринга панелей из админки и из кода. Век живи, век учись!

* Интересуетесь, как работать с мультимедиа в Drupal? У нас для вас интересная серия статей про модуль Scald: уже вышли [часть 1](http://www.annertech.com/blog/media-management-drupal-websites) (обзор решений) и [часть 2](http://www.annertech.com/blog/drupal-media-management-scald-tutorial) (введение в Scald).

* [Подробный мануал, как подружить модуль Media и YouTube](https://drupalize.me/blog/201412/embed-youtube-videos-media-and-media-internet-sources), написали луллаботы.

* Также мы очень рекомендуем ознакомиться с материалом [Resource Guide: Managing Media in Drupal](https://www.drupal.org/resource-guides/managing-media). В нём представлена компиляция самых известных модулей и практик по этой тематике.

### Бизнес и сообщество

Drupal вне кода:

* Итоги Drupal-года, очень кратко, но очень ёмко: [Six Things We Learned About Drupal in 2014](https://assoc.drupal.org/blog/jsaylor/six-things-we-learned-about-drupal-2014)

* Для ускорения работ над Drupal 8 недавно создали фонд [Drupal Accelerate Fund](https://assoc.drupal.org/d8accelerate) в размере 125000$. Теперь любой человек или организация может обратиться за грантом, в случае если они будут готовы организовать спринт по поддержке ядра системы. Также Dries и Drupal Association [обращаются](http://buytaert.net/announcing-the-drupal-8-accelerate-fund) за помощью к организациям, которые готовы спонсировать в дальнейшем этот фонд. Поставлена амбициозная цель набрать дополнительно 65000$.

* Команда Drupal.org активно работает над тем, чтобы сделать главный Drupal-сайт удобным для всех его пользователей. Для этого Drupal-ассоциация провела серию интервью с разработчиками разного уровня от новичка до мастера. Российское сообщество представляла Катя Маршалкина aka [kalabro](https://habrahabr.ru/users/kalabro/): [Meeting Personas: The Drupal Expert](https://assoc.drupal.org/blog/leighc/meeting-personas-drupal-expert).

* Существует и другое деление Drupal-разработчиков: Site Builder, Themer и Module Develper. В чем разница, читайте в статье [What is a Drupal developer?](http://befused.com/drupal/developer)

* Хотите покодить для Drupal 8, но нет ни наставника, ни подходящего проекта? Подключайтесь к инициативам по переводу сайтов локальных сообществ на Drupal 8: [drupal.ru](https://github.com/DrupalRu/drupal.ru/issues/2) и [drupal.ua](http://drupal.ua/groups/rozrobka-drupalua/drupalua-perekhodyt-na-drupal-8) соответственно.

### Drupal 8

Новости с фронтов разработки следующей версии Drupal:

* Вышла [beta4](https://www.drupal.org/node/2394813).

* [Шпаргалка по конфигурационным yaml-файлам](http://hojtsy.hu/blog/2014-dec-12/drupal-8-configuration-schema-cheat-sheet), в которых теперь хранятся все настройки сайта.

* [Портируем модуль с семёрки на восьмёрку](https://drupalize.me/blog/201412/adventures-porting-d7-form-module-drupal-8) с помощью модуля Drupal Module Upgrader.

* Как известно, Drupal 8 включает в себя некоторое количество PHP компонентов, наверняка знакомых веб-разработчикам из других фреймворков, например Symfony. Kris Vanderwater представляет обзор основных из них:

+ [Composer](https://www.acquia.com/blog/5-php-components-every-drupal-8-developer-should-know-part-1-composer)

+ [Guzzle](https://www.acquia.com/blog/5-php-components-every-drupal-8-developer-should-know-part-2-guzzle) Серия будет продолжена.

* С разработкой Drupal 8 [не всё так просто](http://buytaert.net/scaling-open-source-communities), возможно из-за того, что всё-таки основной фокус системы сместился на движение к enterprise-миру, что естественно повлекло за собой усложнение системы и подняло планку для контрибьюшена. Интересно, в этом плане, смотрится форк от Drupal 7 — [Backdrop CMS](http://us7.campaign-archive1.com/?u=8a016d204af55747c1fef5769&id=4f76bb26b9). Впрочем, [большинство опрошенных](https://drupal8release.zensations.at/) настроены оптимистично на 2015 год.

### Интересные модули

И напоследок несколько модулей, на которые стоит обратить внимание:

* [Taxonomy Term Status](https://www.drupal.org/project/termstatus) позволяет устанавливать статус «опубликовано»/«неопубликовано» для терминов таксономии, совсем как у нод.

* [Default file settings](https://www.drupal.org/project/dfs) для удобного управления дефолтными настройками файловых полей.

* [Classy Panel Styles](https://www.drupal.org/project/classy_panel_styles) для расширенного управления стилями панелей ([видео](http://www.youtube.com/watch?v=5BcD6fVJbYI) и [слайды](http://slides.com/kendalltotten/classy-panel-styles#/)).

* [Views EVI (Exposed Value Injector)](https://www.drupal.org/project/views_evi) — это новый модуль, который позволяет прокидывать аргументы в фильтры.

* [Reroute Email](https://www.drupal.org/project/reroute_email) нужен для перенаправления всей почты на dev-серверах ([статья](http://www.oliverdavies.co.uk/blog/configuring-reroute-email-module)).

* Расширение Drush [Registry Rebuild](https://www.drupal.org/project/registry_rebuild) поможет переместить модуль (даже не выключая его) в другую папку и не увидеть при этом фатальных ошибок PHP.

* Если вы являетесь активным пользователем модуля [Panels](http://drupal.org/project/panels), то наверняка сталкивались с модулем [Fieldable Panels Panes](https://www.drupal.org/project/fieldable_panels_panes), который позволяет прямо при редактировании панели создавать энтити с произвольным набором полей, причем они являются в прямом смысле многоразовыми. Недавно появился модуль [Fieldable Panel Panes Bundles](https://www.drupal.org/project/fpp_bundles), которые позволяет создавать бандлы, по аналогии с типами содержимого.

* В [видео-обзоре на CodeKarate](http://codekarate.com/daily-dose-of-drupal/smart-paging-how-display-node-multiple-pages) подробно разобран модуль [Smart Paging](https://www.drupal.org/project/smart_paging), который используется для постраничного разбиения содержимого ноды по количеству символом, слов или по специальному плейсхолдеру.

Над выпуском работали [Олег Кот](mailto:[email protected]) и [Катя Маршалкина](mailto:[email protected]). Пишите нам с любыми вопросами и предложениями!

Всего наилучшего! До встречи в новом году! | https://habr.com/ru/post/246573/ | null | ru | null |

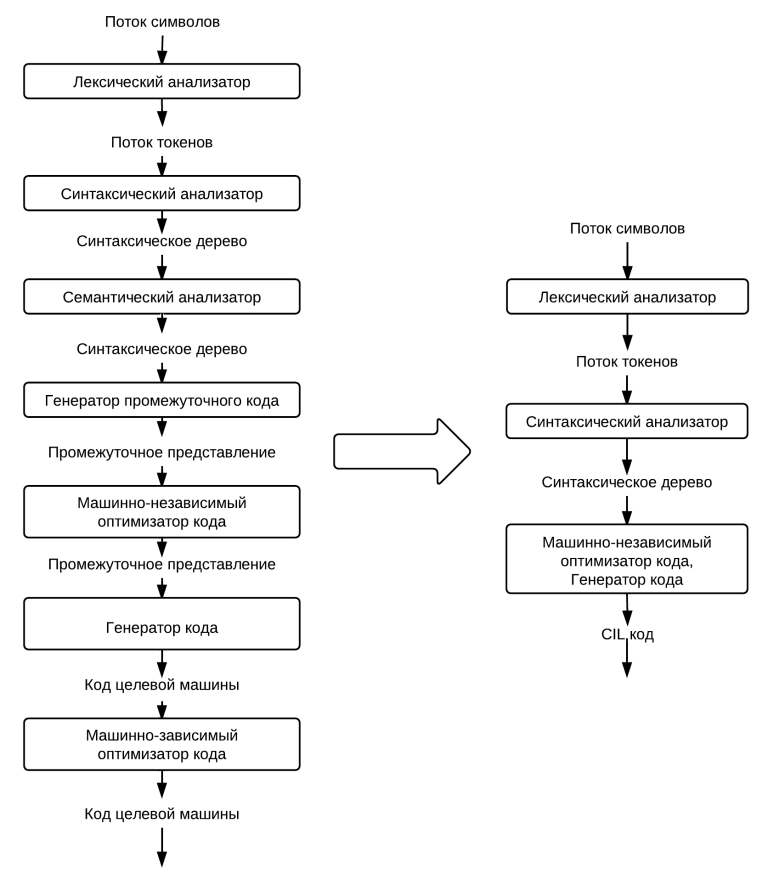

# О Thread и ThreadPool в .NET подробно (часть 1)

Ссылка на Часть 2: "[О Thread и ThreadPool в .NET подробно (часть 2)](https://habr.com/ru/post/654111/)"

Этот текст покрывает ответы на некоторые совсем базовые вопросы и вместе с тем сразу погружает в проблематику получения ответа на вопрос: "как работать лучше? однопоточно, многопоточно или многопоточно, но на ThreadPool?". Ответ на этот вопрос может изначально показаться очень простым и понятным, однако реальность совершенно иная: всё как и везде сильно зависит от ситуации: от типа задачи, от её размера, от прочих условий, которые так просто в голову сами собой не придут.

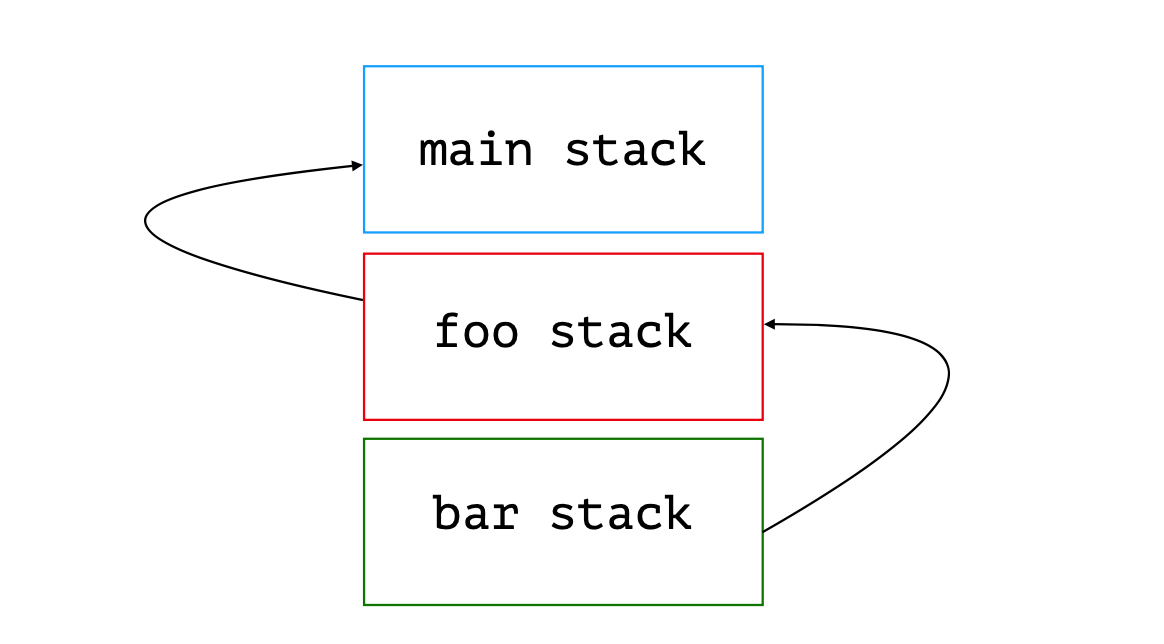

А потому мы пройдёмся в первую очередь по IO-/CPU-bound операциям, стоимости создания потока, базовым основам работы пула потоков (но только основы), а далее -- углубимся в анализ чёрного ящика: от чего зависит производительность пула потоков? Каков объём работы приемлим для того чтобы в него планировать?

Закончим мы главу несколькими, возможно, пугающими выводами об объемах работы, приемлимой для того чтобы обеспечить производительную работу приложения на пуле потоков.

Также отмечу, что материал постепенно переходит от начального уровня сложности 🥤 через ⚠️ средний уровень к ☠️ высокому, о чём вы сможете узнать по пиктограммам.

> 🥤 *Материал начальной сложности*

>

>

Thread

------

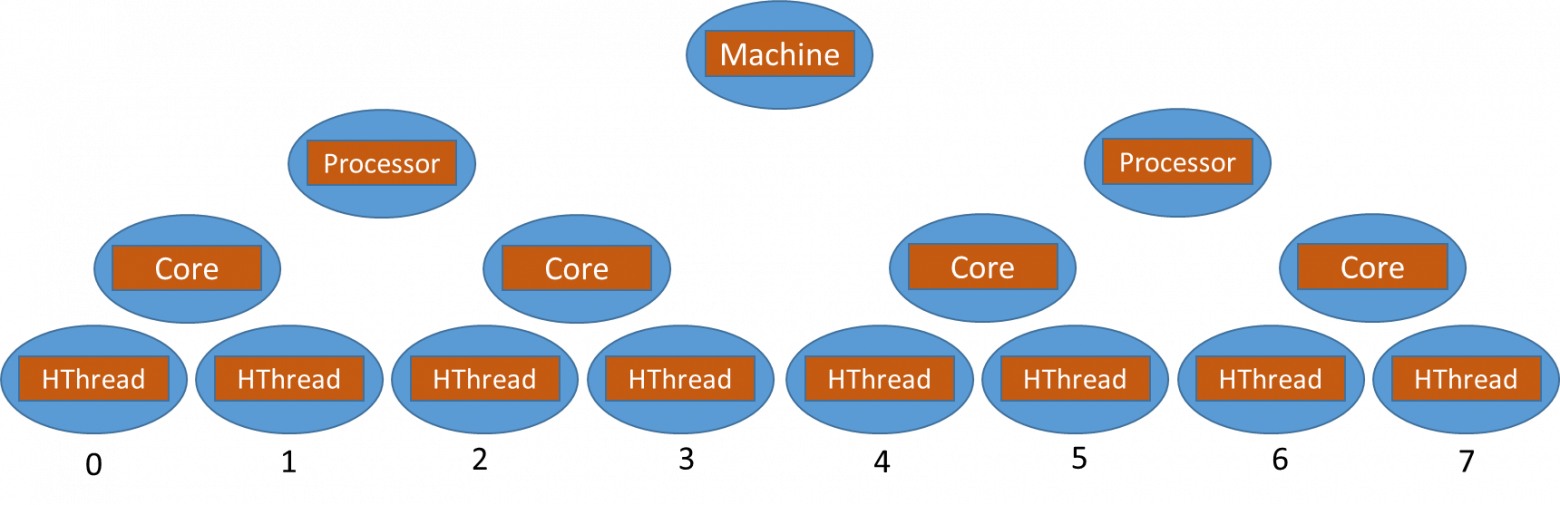

Что такое поток? Проговорим ещё раз. Это некая последовательность команд для процессора, которые он исполняет единым *потоком* параллельно либо псевдопараллельно относительно других *потоков* исполнения кода. Параллельно — потому что код разных потоков может исполняться на разных физических ядрах. Псевдопараллельно — потому что код разных потоков может исполняться на одном физическом ядре. А потому — чтобы эмулировать параллельность в глазах у пользователя они бьются по времени исполнения на очень короткие интервалы и чередутся, создавая иллюзию параллельного исполнения: это можно сравнить с цветной печатью. Если посмотреть на полноцветную печать под лупой (или при помощи камеры смартфона), можно заметить микроточки CMYK (Cyan, Magneta, Yellow, Key). Их можно увидеть только при увеличении, но на расстоянии они образуют единое пятно итогового цвета.

Добиться того, чтобы завладеть ядром процессора монопольно в .NET нет возможности. Да и в ОС нет такого функционала. А это значит, что любой ваш поток будет прерван в абсолютно любом месте: даже по середине операции `a = b;`, когда `b` считали, а `a` ещё не записана просто потому, что помимо вас на том же ярде работает ещё кто-то. И с очень высокой долей вероятности прерваны вы будете на более длительный срок нежели вам отпущено на работу: при большом количестве активных потоков в системе помимо вас на ядре их будет несколько. А значит вы будете по чуть-чуть исполняться в порядке некоторой очереди. Сначала вы, потом все остальные и только потом — снова вы.

Однако, создание потока — это очень дорогая операция. Ведь что такое «создать поток»? Для начала это обращение в операционную систему. Обращение в операционную систему — это преодоление барьера между слоем прикладного ПО и слоем операционной системы. Слои эти обеспечиваются процессором, а стороны барьеров - *кольцами защиты*. Прикладное программное обеспечение имеет кольцо защиты `Ring 3`, тогда как уровень ОС занимает кольцо `Ring 0`. Вызов методов из кольца в кольцо — операция дорогая, а перехода между тем два: из `Ring 3` в `Ring 0` и обратно. Плюс создание стеков потока: один для `Ring 3`, второй — для `Ring 0`. Плюс создание дополнительных структур данных со стороны .NET. В общем чтобы что-то исполнить параллельно чему-то *быстро*, для начала придётся потратить много времени.

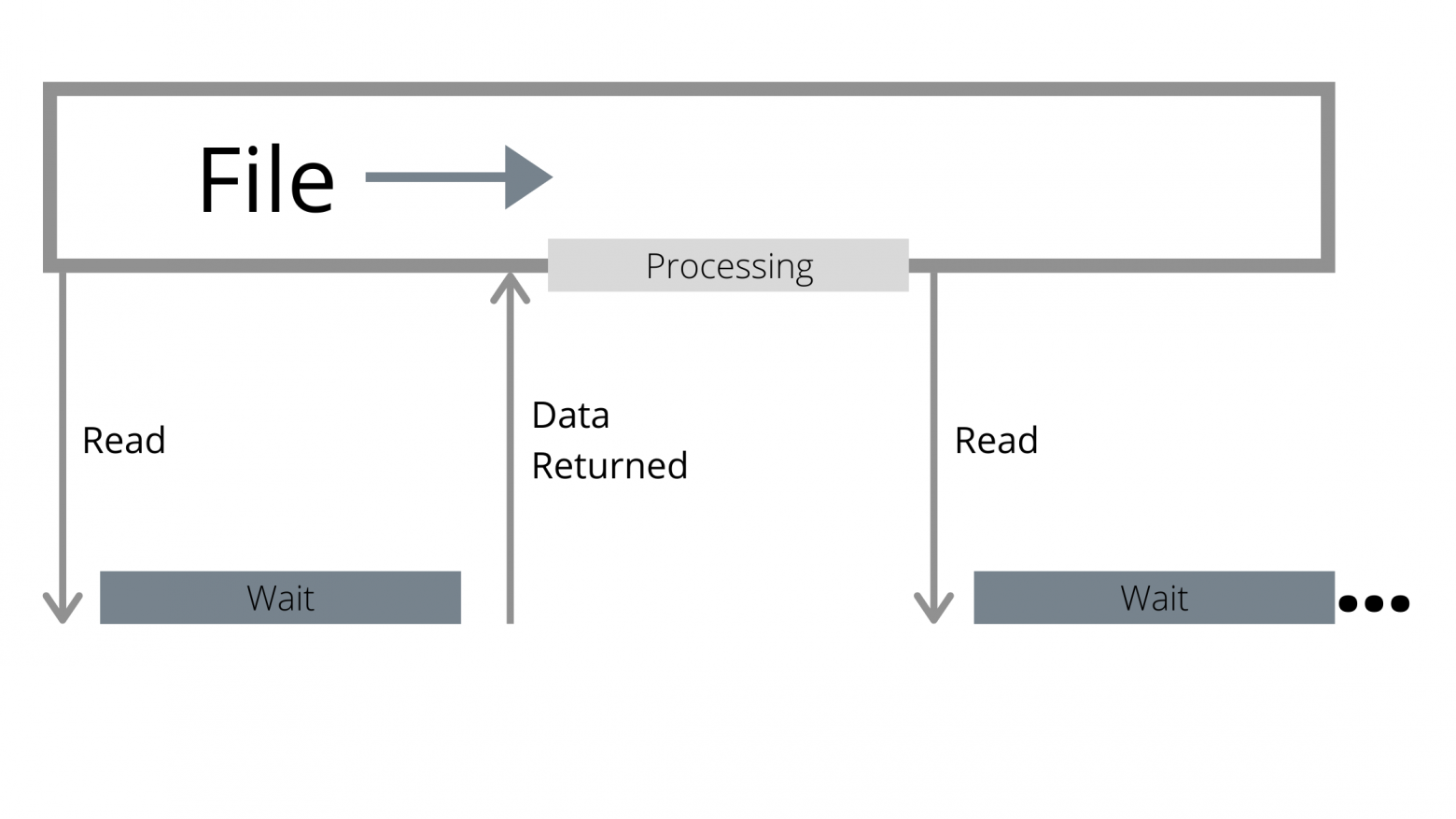

Однако люди заметили, что долгих операций, которые бы исполнялись непрерывно, не уходя в ожидание оборудования, мало. Скорее это выглядит так:

1. *Ожидание сети по вопросу подключения клиента*

2. Проанализировали запрос, сформировали запрос к БД, отправили

3. *Ожидание ответа от сервера БД*

4. Ответ получен, перевели в ответ от сервиса

5. *Отправили ответ*

И пункты (2) и (4) -- не так долго выполняются. Скорее это -- очень короткие по времени исполнения участки кода. А потому стоит задаться вопросом: для чего под них создавать отдельные потоки (тут отсылка к неверному многими трактовании слова *асинхронно* и повсеместной попытки что-то отработать параллельно)? В конце концов цепочка (1) - (5) работает целиком последовательно, а это значит, что в точках (1), (3) и (5) поток исполнения находится в блокировке ожидания оборудования, т.к. ждёт ответа от сетевой карты. Т.е. не участвует в планировании операционной системой и никак не влияет на её производительность. Тогда что, web-серверу надо создать поток под всю цепочку? А если сервер обрабатывает 1000 подключений в секунду? Мы же помним, что один поток создаётся крайне долго. Значит он не сможет работать с такими скоростями если будет создавать под каждый запрос поток. Работать на уже существующих? *Брать потоки в аренду?*

ThreadPool

----------

Именно поэтому и возник пул потоков, ThreadPool. Он решает несколько задач:

* с одной стороны он абстрагирует создание потока: мы этим заниматься не должны

* создав когда-то поток, он исполняет на нём совершенно разные задачи. Вам же не важно, на каком из них исполняться? Главное чтобы был

+ а потому мы более не тратим время на создание потока ОС: мы работаем на уже созданных

+ а потому нагружая ThreadPool своими делегатами мы можем равномерно загрузить ядра CPU работой

* либо ограничивает пропускную способность либо наоборот: даёт возможность работать на все 100% от всех процессорных ядер.

Однако, как мы убедимся позже у любой такой абстракции есть масса нюансов, в которых эта абстракция работает очень плохо и может стать причиной серъёзных проблем. Пул потоков можно использовать не во всех сценариях, а во многих он станет серьёзным "замедлителем" процессов. Однако давайте взглянем на ситуацию под другим углом. Зачастую при объяснении какой-либо темы автором перечисляются функционал и возможности, но совершенно не объясняется "зачем": как будто и так всё понятно. Мы же попробуем пойти другим путём. Давайте попробуем понять ThreadPool.

И если взглянуть на вопрос с той стороны что пул потоков -- это инструмент, то как следствие возникает вопрос: какие задачи должен решать этот инструмент?

### С точки зрения упрощения менеджмента параллелизма

Управлять параллелизмом - задача не из простых. Вернее, конечно же, это сильно зависит от того, что вам необходимо.... Но когда у вас "ничего особенного" не требуется, вручную создавать потоки и гнать через них поток задач станет переусложнением. Тем более что это достаточно рутинная операция. Поэтому наличие стандартного функционала в библиотеке классов выглядит крайне логично.

Единственное, что команда Microsoft сделала неправильно -- что сделала ThreadPool статическим классом без возможности повлиять на реализацию. Это ограничение создало целый пласт недопонимания между разработчиком runtime и конечным разработчиком потому как у последнего нет никакого ощущения, что можно разработать свои пулы потоков и что ими можно пользоваться в рамках текущей реализации. Что есть абстракции над пулами потоков, отдавая которые во внешние алгоритмы вы заставляете их ими пользоваться вместо того чтобы пользоваться стандартным, общим пулом.

Но если закрыть глаза на эти недочёты (к которым мы вернёмся позже), то с точки упрощения менеджмента параллелизма, конечно, пул потоков -- идеальное решение. Ведь в конечном счёте параллельно исполняющийся код -- просто набор множества задач, которым совершенно не важен поток, на котором они работают. Им важно исполняться параллельно друг другу. Вам даже не так важно количество. Вам важно, чтобы CPU расходовался оптимально.

> Пока мы будем рассматривать ThreadPool как *идеальный* пул потоков, который без всяких проблем сопровождает задачу из одного потока в другой

>

>

### С точки зрения IO-/CPU-bound операций

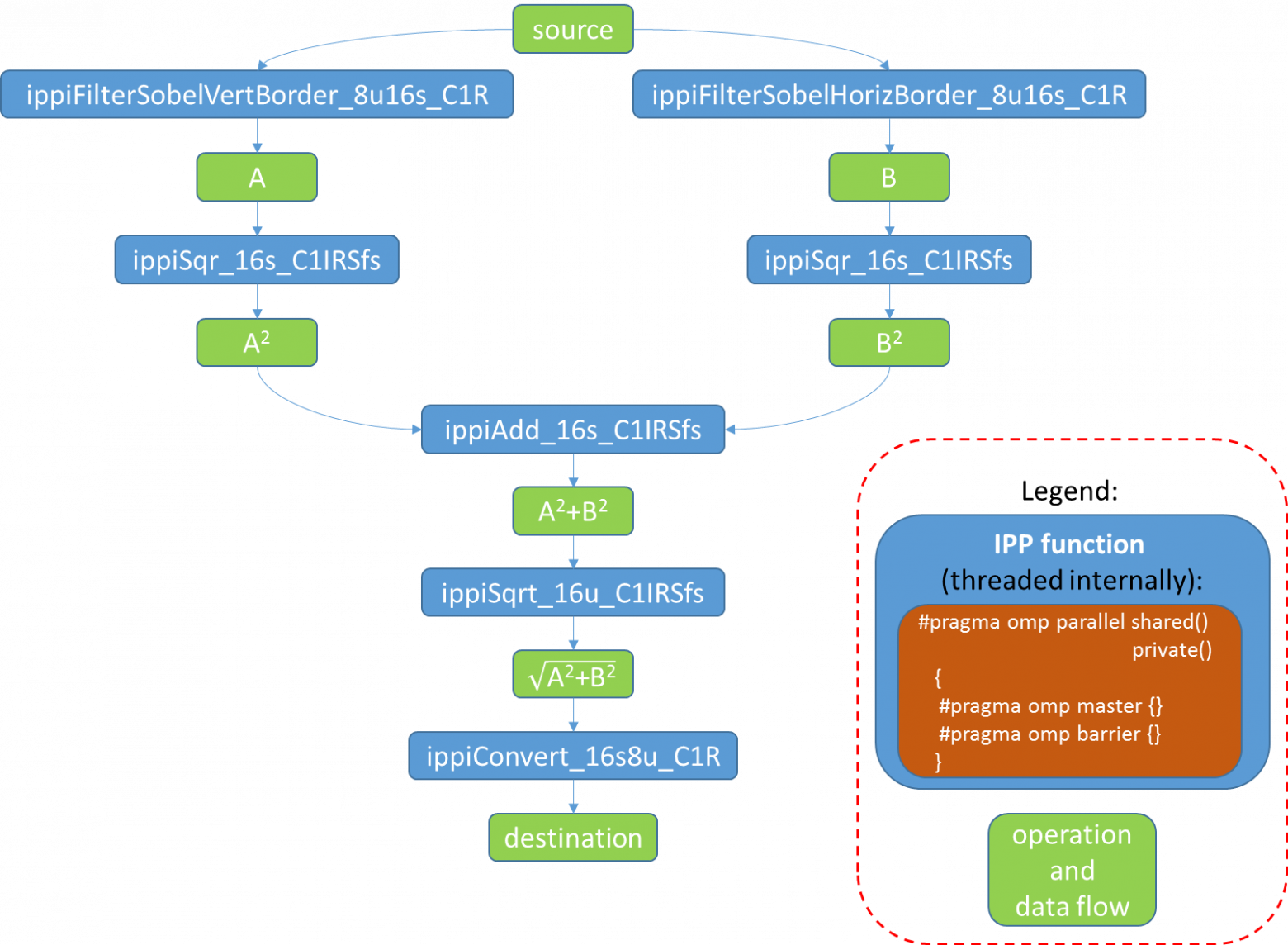

Например, может показаться, что пул потоков создан чтобы решить разделение IO-/CPU-bound операции. И частично это так. Я бы сказал, что пул потоков предоставляет возможность разделения IO-/CPU-bound операций *второго уровня*. В том смысле, что разделение существует и без него и оно находится на более глубоком уровне, на уровне операционной системы.

Для того чтобы "найти" первый слой разделения IO-/CPU-bound операций необходимо вспомнить как работают потоки. Потоки -- это слой виртуализации параллелизма операционной системой. Это значит, что процессор о потоках не знает ничего, о них знает только ОС и всё, что на ней работает. Плюс к этому существуют блокировки, которых почему-то все боятся (спойлер: зря). Блокировка -- это механизм ожидания сигнала от операционной системы что что-то произошло. Например, что отпустили семафор или что отпустили мьютекс. Но ограничивается ли список блокировок примитивами синхронизации? Исходя из знаний рядового .NET разработчика, да. Но на самом деле это не так.

Давайте рассмотрим вызов метода мьютекса, приводящий к состоянию блокировки. Любое взаимодействие с операционной системой приводит к проваливанию в более привилегированное кольцо защиты процессора (`Ring 0` для Windows и `Ring 2` в Linux), или говоря языком прикладного программного обеспечения, в kernel space. Это значит, что при проваливании происходит ряд операций, обеспечивающих сокрытие данных ОС от уровня прикладного программного обеспечения. Все эти операции, естественно, стоят времени. Если говорить о пользователе, времени это стоит не так много, потому что пользователь мыслит медленно. Однако с точки зрения программы это время достаточно заметно. Далее, если речь идёт о блокировке, срабатывает ряд достаточно простых механизмов, которые сначала проверяют состояние блокировки: установлена ли блокировка или нет, и если есть, поток переносится из очереди готовности к исполнению в список ожидания снятия блокировки. Что это значит? Поскольку операционная система руководствуется списком готовых к исполнению потоков при выборе того потока, который будет исполняться на процессоре, заблокированный поток она не заметит и потому не станет тратить на него ресурсы. Его просто нет в планировании. А потому легко сделать вывод, что когда поток встаёт в блокировку, он исчезает из планирования на исполнение и потому если все потоки находятся в блокировке, уровень загруженности процессора будет равен 0%.

Однако только ли примитивы синхронизации обладают такими свойствами? Нет: такими же свойствами обладает подавляющее большинство IO-bound операций. Да, взаимодействие с оборудованием может происходить без IO-bound операций. Простым примером такого поведения может быть отображение памяти какого-то устройства на адресное пространство оперативной памяти. Например, видеокарты: сконфигурировав видеокарту, обращаясь к функциям BIOS на необходимый режим работы (текстовый, графический VESA и проч.), помимо перевода экрана в необходимый режим BIOS должен сконфигурировать взаимодействие видеокарты с прикладным ПО. В случае текстового режима BIOS открывает отображение адресного пространства видеокарты на адресное пространство оперативной памяти, на диапазон 0xB8000 и далее. Записав по этому адресу код символа (конечно же, это будет работать, например, в DOS или если вы решите написать свою операционную систему, но не в Windows), вы моментально увидите его на экране. И это не приведет ни к каким блокировкам: запись будет моментальная.

Однако в случае большинства оборудования (например, сетевая карта, жёсткий диск и прочие) у вас будет одна задержка на синхронную подачу команды на оборудование (без перехода в блокировку, но с переходом в kernel space) и вторая задержка -- на ожидание ответа от оборудования. Большинство таких операций сопровождается постановкой потока в заблокированное состояние. Причиной этому служит разность в скорости работы процессора и оборудования, с которым производится взаимодействие: пока некоторая условная сетевая карта осуществляет посылку пакета и далее -- ожидает получения пакетов с ответом на процессорном ядре можно совершить миллионы, миллиарды операций. А потому пока идёт ответ от оборудования можно сделать много чего ещё и чтобы этого добиться поток переводится в заблокированное состояние и исключается из планирования, предоставив другим потокам возможность использовать для своей работы процессор.

По сути механизм блокировок и есть встроенный в операционную систему механизм разделения IO-/CPU-bound операций. Но решает ли он все задачи разделения?

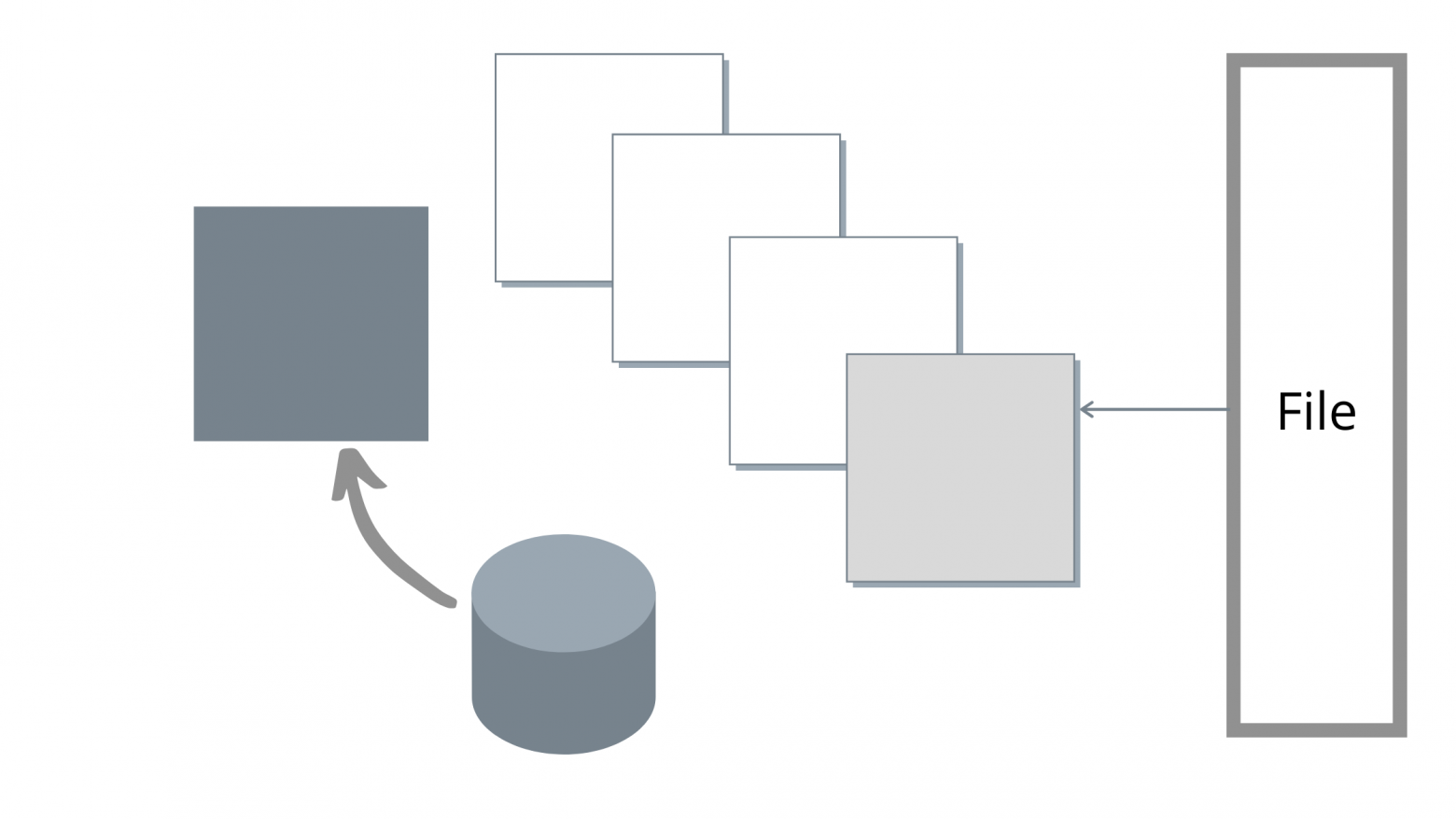

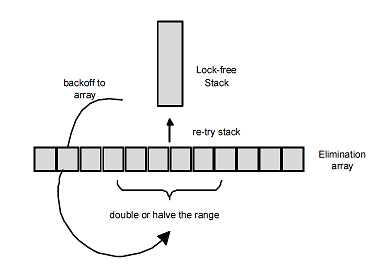

Каждая постановка в блокировку снижает уровень параллелизма с точки зрения IO-bound кода. Т.е., конечно же? операции IO-bound и CPU-bound идут в параллель, но с другой стороны когда некий поток уходит в ожидание, он исчезает из планирования и наше приложение меньше задействует процессор, т.к. с точки зрения только CPU-bound операций мы *теряем* поток исполнения. И уже с точки зрения приложения, а не операционной системы может возникнуть естественное желание занять процессор чем-то ещё. Чтобы это сделать, можно насоздавать потоков и работать на них в параллель, однако это будет достаточно тяжким занятием и потому был придуман следующий очень простой концепт. Создаётся контейнер, который хранит и управляет хранимыми потоками. Этот контейнер, пул потоков, при старте передаёт потоку метод исполнения, который внутри себя в бесконечном цикле разбирает очередь поставленных пулу потоков задач и исполняет их. Какую задачу это решает: программный код построен так, что он, понятно дело исполняется кусочками. Кусочек исполнился, ждём оборудования. Второй кусочек исполнился, ждём оборудования. И так бесконечно. Причем нет же никакой разницы, на каком потоке исполнять вот такие кусочки, верно? А значит их можно отдавать в очередь на исполнение пулу потоков, который будет их разбирать и исполнять.

Но возникает проблема: ожидание от оборудования происходит в потоке, который инициировал это ожидание. Т.е. если мы будем ожидать в пуле потоков, мы снизим его уровень параллелизма. Как это решить? Инженеры из Microsoft создали для этих целей внутри ThreadPool второй пул: пул ожидающих потоков. И когда некий код, работающий в основном пуле решается встать в блокировку, сделать он это должен не тут же, в основном пуле, а специальным образом: перепланировавшись на второй пул (об этом позже).

Работа запланированных к исполнению делегатов (давайте называть вещи своими именами) на нескольких рабочих потоках, а ожидание - на других, предназначенных для "спячки" реализует второй уровень разделения IO-/CPU-bound операций, когда уже приложение, а не операционная система получает механизм максимального занятия работой процессорных ядер. При наличии постоянной работы (нескончаемого списка делегатов в основном пуле CPU-bound операций) приложение может загрузить процессор на все 100%.

### Прикладной уровень

На прикладном уровне объяснения пул потоков работает крайне просто. Существует очередь делегатов, которые переданы пулу потоков на исполнение. Очередь делегатов хранится в широко-известной коллекции `ConcurrentQueue`. Далее, когда вы вызываете `ThreadPool.QueueUserWorkItem(() => Console.WriteLine($"Hello from {Thread.CurrentThread.ManagedThreadId}"))`, то просто помещаете делегат в эту очередь.

ThreadPool внутри себя в зависимости от некоторых метрик, о которых мы поговорим позже создаёт некоторое необходимое ему количество рабочих потоков. Каждый из которых содержит цикл выборки делегатов на исполнение: и запускает их. Если упрощать, внутренний код выглядит примерно так:

```

void ThreadMethod()

{

// ...

while(needToRun)

{

if(_queue.TryDequeue(out var action))

{

action();

}

}

// ...

}

```

Конечно же он сложнее, но общая суть именно такая.

Однако помимо кода, который исполняет процессор (т.н. CPU-bound код) существует также код, приводящий к блокировке исполнения потока: ожиданию ответа от оборудования. Клавиатура, мышь, сеть, диск и прочие сигналы от оборудования. Этот код называется IO-bound. Если мы будем ожидать оборудование на потоках пула, это приведёт к тому, что часть потоков в пуле перестенут быть рабочими на время блокировки. Это как минимум испортит пулу потоков статистики которые он считает и как следствие этого пул начнёт работать сильно медленнее. Пока он поймёт, что ему необходимо расширение, пройдёт много времени. У него появится некий "лаг" между наваливанием нагрузки на пул и срабатыванием кода, расширяющего его. А без блокировок-то он отрабатывал бы очень быстро.

Чтобы избежать таких ситуаций и сохранить возможность "аренды" потоков, ввели второй пул потоков. Для IO-bound операций. А потому в стандартном ThreadPool два пула: один -- для CPU-bound операций и второй -- для IO-bound.

Для нас это значит, что в делегате, работающем в ThreadPool вставать блокировку нельзя. Он для этого не предназначен. Вместо этого необходимо использовать следующий код:

```

ThreadPool.QueueuserWorkItem(

_ => {

// ... 1

// 2

ThreadPool.RegisterWaitForSingleObject(

waitObject, // объект ожидания

(state) => Console.WriteLine($"Hello from {Thread.CurrentThread.ManagedThreadId}"), // 3

null, // объект состояния для передачи в делегат (state)

0, // timeout ожидания объекта состояния (0 = бесконечно)

true); // ждать ли ещё раз при срабатывании waitObject

// (например, если waitObject == AutoResetEvent)

// ... 4

}, null);

);

```

> Тут конечно же стоит помнить о том, что код, который сработает *после* RegisterWaitForSingleObject отработает в лучшем случае параллельно с делегатом, переданным в RegisterWaitForSingleObject, а более вероятно - первее делегата, но в любом случае -- в другом потоке. (1), (2), (3), (4) не будут вызваны последовательно. Последовательно будут вызваны только (1), (2) и (4). А (3) - либо параллельно с (4) либо после.

>

>

В этом случае второй делегат уйдёт на второй пул IO-bound операций, который не влияет на исполнение CPU-bound пула потоков.

#### Оптимальная длительность работы делегатов, количества потоков

Каким может стать оптимальное количество потоков? Ведь работать можно как на двух, так и на 1000 потоках. От чего это зависит?

Пусть у вас есть ряд CPU-bound делегатов. Ну, для весомости их пусть будет миллион. Ну и давайте попробуем ответить на вопрос: на каком количестве потоков их выработка будет максимально быстрой?

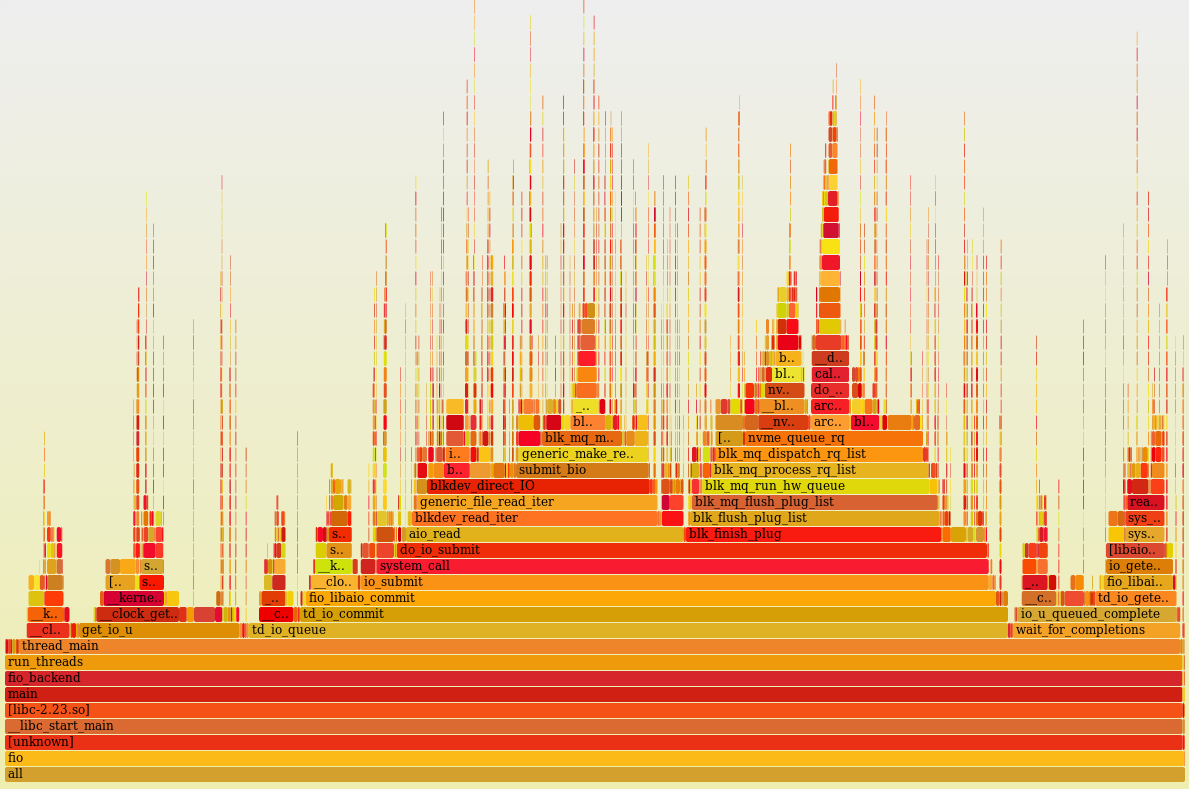

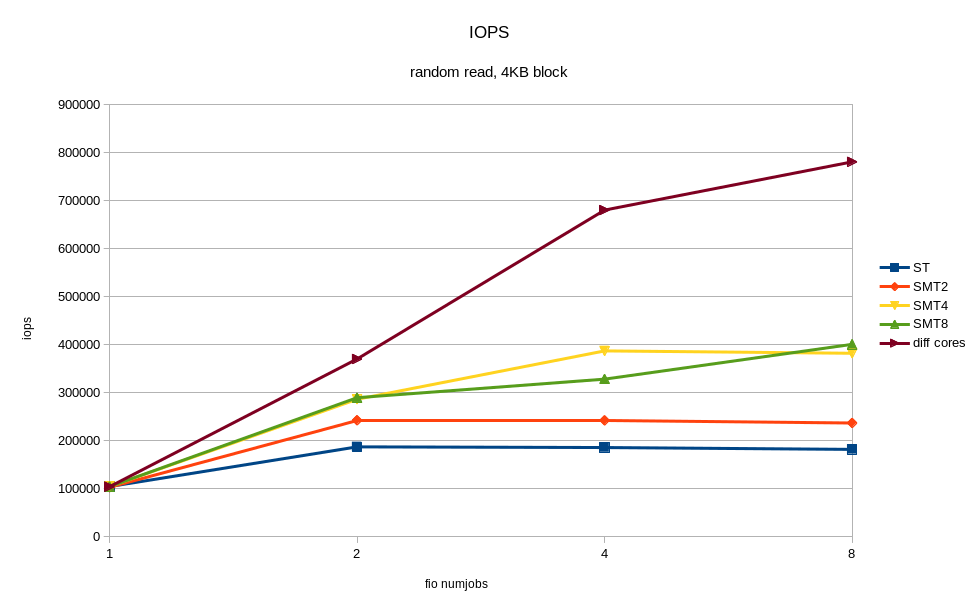

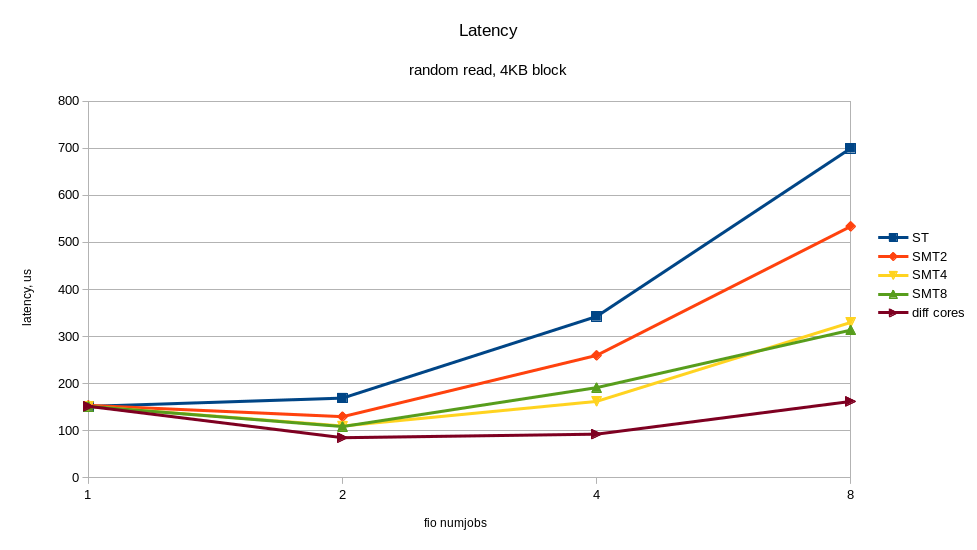

1. Пусть длительность работы каждого делегата заметна: например, 100 мс. Тогда результат будет зависеть от того количества процессорных ядер, на которых идёт исполнение. Давайте поступим как физики и возьмём некоторую идеализированную систему, где кроме нас -- никого нет: ни потоков ОС ни других процессов. Только мы и CPU. Ну и возьмём для примера 2-х ядерный процессор. Во сколько потоков имеет смысл работать CPU-bound коду на 2-х процессорной системе? Очевино, ответ = 2, т.к. если один поток на одном ядре, второй -- на втором, то оба они будут вырабатывать все 100% из каждого ядра ни разу не уходя в блокировку. Станет ли код быстрее, увеличь мы количество потоков в 2 раза? Нет. Если мы добавим два потока, что произойдёт? У каждого ядра появится по второму потоку. Поскольку ядро не резиновое, а железное, частота та же самая, то на выходе на каждом ядре мы будем иметь по два потока, исполняющиеся последовательно друг за другом, по, например, 120 мс. А поскольку время исполнения одинаковое, то фактически первый поток стал работать на 50% от изначальной производительности, отдав 50% второму потоку. Добавь мы ещё по два потока, мы снова поделим между всеми это ядро и каждому достанется по 33,33%. С другой стороны если перестать воспринимать ThreadPool как идеальный и без алгоритмов, а вспомнить, что у него под капотом как минимум ConcurrentQueue, то возникает ещё одна проблема: contention, т.е. состояние спора между потоками за некий ресурс. В нашем случае спор будет идти за смену указателей на голову и хвост очереди внутри ConcurrentQueue. А это в свою очередь *снизит* общую производительность, хоть и практически незаметно: при дистанции в 100 мс очень низка вероятность на разрыв кода методов `Enqueue` и `TryDequeue` системным таймером процессора с последующим переключением планировщиком потоков на поток, который также будет делать `Enqueue` либо `TryDequeue` (contention у них будет происходить с высокой долей вероятности на одинаковых операциях (например, `Enqueue` + `Enqueue`), либо с очень низкой долей вероятности -- на разных).

2. На малой длительности работы делегатов результат мало того, что не становится быстрее, он становится медленнее, чем на 2 потоках, т.к. на малом времени работы увеличивается вероятность одновременной работы методов очереди ConcurrentQueue, что вводит очередь в состояние contention и как результат -- ещё большее снижение производительности. Однако если сравнивать работу на 1 ядре и на нескольких, на нескольких ядрах работа будет быстрее;

3. И последний вариант, который относится к сравнению по времени исполнения делегатов -- когда сами делегаты ну очень короткие. Тогда получится, что при увеличении уровня параллелизма вы наращиваете вероятность состояния contention в очереди ConcurrentQueue. В итоге код, который борется внутри очереди за установку Head и Tail настолько неудачно часто срабатывает, что время contention становится намного больше времени исполнения самих делегатов. А самый лучший вариант их исполнения -- выполнить их последовательно, **в одном потоке**. И это подтверждается тестами: на моём компьютере с 8 ядрами (16 в HyperThreading) код исполняется в 8 раз медленнее, чем на одном ядре.

Другими словами, исполнять CPU-bound код на количестве потоков выше количества ядер не стоит, а в некоторых случаях это даже замедлит приложение, а в совсем вырожденных сценариях лучше бы вообще работать на одном. | https://habr.com/ru/post/654101/ | null | ru | null |

# Plotti.co: самый простой микросервис для мониторинга графиков в реальном времени

Привет, хабравчанин!

В этой заметке речь пойдет о [Plotti.co](http://plotti.co) — адски простом в использовании инструменте, который делает ровно одну вещь, но делает её быстро и хорошо. Речь пойдет об онлайн-рисовании графиков и их обновлении в реальном времени.

Создание живых графиков на лету, как мне кажется, не является той задачей, для решения которой нужно сперва прочесть 10 страниц документации, заплатить за подписку по $20 в месяц, а иногда — и то, и другое сразу. Так нельзя. Не в 2016 году.

В Plotti.co клиентская часть — это SVG-изображение, которое подписывается по EventSource на источник данных от сервера, и обновляет график в соответствии с ними. Интегрируется она в страницу элементарно:

```

```

Да, это всё. Здесь U0N5G5FQigwC — это хеш картинки. Чтобы картинка обновилась во всех браузерах, в которых она сейчас открыта, необходимо просто послать GET-запрос по соответствующему адресу. Например,

```

wget "http://plotti.co/U0N5G5FQigwC?d=1.5,3.6,7.8mbps" -O /dev/null

```

Значения переменных передаются в параметре d и разделяются запятыми. Максимальное число переменных (и, соответственно, линий на графике) — 9; цвет каждого из них фиксирован. Если хочется получить линию какого-то конкретного цвета, можно пропустить нужное число переменных перед ней (например, вот так: `http://plotti.co/U0N5G5FQigwC?d=,,,,,,1.0`).

Проект сделан по принципу «eat your dogfood», так что прямо на заглавной можно посмотреть график текущей загрузки процессора сервера, на котором он крутится. Данные скармливаются в график с помощью нехитрого шелл-скрипта:

```

#!/bin/sh

while true; do

wget -O /dev/null -q http://plotti.co/lock/plottycocpu?d=`mpstat -P ALL 1 1 | awk '/Average:/ && $2 ~ /[0-9]/ {print $3}' | sort -r -g | xargs | sed s/\ /,/g`\%cpuload

done

```

P.S. Проект был написан за два дня силами одного человека и запущен на ARM-сервере от Scaleway за $3 в месяц, и при этом почти пережил нашествие юзеров с [Hacker News](https://news.ycombinator.com/item?id=11290122) позавчера ночью (до 4 тыс одновременных коннектов). Gevent FTW! Дальнейшие исследования показали, что использовать инстанс Xeon у Vultr за $5 в месяц более оправданно.

P.P.S. Проект [опенсорсный](https://github.com/grandrew/plotti.co), приветствуются баг репорты и пулл реквесты!

P.P.P.S. Мопед не мой, а хорошего человека; я пока в основном только свечку держал. | https://habr.com/ru/post/279469/ | null | ru | null |

# Возвращаем авто-логин в Wi-Fi-сеть московского метро в Android

С некоторого времени я стал замечать, что при подключении к московскому метровайфаю на Андроидах перестала вылезать нотификация о том, что необходимо залогиниться. Что было весьма удобно, так как встроенный андроидный HTTP-клиент никогда не показывал мне рекламу, и закрывался сразу же после авторизации, не грузя стартовую страницу wi-fi.ru, также обильно пестрящую рекламой.

Судя по всему, граждане из Максима-Телеком посчитали, что слишком уж много пользователей проплывает мимо их рекламы таким образом и, посчитав себя зело ехидными, точечно разрешили доступ к URL [google.com/generate\_204](http://google.com/generate_204), который и запрашивает HTTP-клиент Dalvik для проверки доступности интернета. Из названия ручки очевидно, что ожидается код 204.

Таким образом, эта проверка стала давать false positive, вынуждая пользователя логиниться через браузер, просматривая рекламу. Беглый поиск по данному вопросу выявил наличие в хранилище настроек Android переменной captive\_portal\_server, которая по умолчанию не установлена, но если записать в нее FQDN какого-нибудь хоста, /generate\_204 будет запрашиваться уже с него. Очевидное решение проблемы тут же напросилось само собой.

На своем сервере я добавил в конфигурацию nginx такие строки:

```

server {

listen 0.0.0.0:80;

location /generate_204 {

return 204;

}

}

```

На Android-устройстве выполнил такую команду (да, минус этого способа — нужен root):

```

root@shamu:/ # settings put global captive_portal_server our-nginx.domain.tld

```

После чего авторизация заработала, как и прежде :) Надеюсь, этот небольшой лайф-хак будет полезен кому-то, кто, как и я, не горит желанием каждый раз просматривать видео-рекламу при входе в сеть.

P.S. Я не упомянул здесь возможность использования различных программ-авторизаторов, работающих в фоновом режиме, так как сам раньше пользовался подобным софтом, и оказалось, что создатели captive-портала активно противодействуют таким мерам, и рано или поздно авторизация перестает работать | https://habr.com/ru/post/268793/ | null | ru | null |

# Современные накопители очень быстры, но плохие API это не учитывают

Почти десять лет я проработал в компании, создающей довольно специализированный продукт — высокопроизводительные системы ввода-вывода. Я имел возможность наблюдать за быстрой и решительной эволюцией технологий хранения данных.

В этом году я сменил работу. Окружённый в новой большой компании инженерами, имевшими опыт в разных сферах работы, я удивился тому, что у каждого из моих коллег, несмотря на выдающийся ум, сложились ложные представления о том, как наилучшим способом использовать современные технологии хранения. Даже если они и были в курсе совершенствования технологий, такие представления приводили к созданию неоптимальных архитектур.

Поразмышляв о причинах этой неувязки, я понял, что в основном устойчивость таких заблуждений вызвана следующим: даже если они проверяли свои предположения при помощи бенчмарков, то данные показывали их (кажущуюся) истинность.

Вот самые распространённые примеры таких заблуждений:

* «Вполне нормально скопировать память здесь и выполнить эти затратные вычисления, потому что это сэкономит нам одну операцию ввода-вывода, которая была бы ещё более затратной».

* «Я проектирую систему, которая должна быть быстрой. Поэтому она должна находиться в памяти».

* «Если мы разобьём эти данные на несколько файлов, то выполнение будет медленным, поскольку возникнут паттерны произвольного ввода-вывода. Нам нужно оптимизировать выполнение под последовательный доступ и осуществлять считывание из одного файла».

* «Прямой ввод-вывод очень медленный. Он подходит только для очень специализированных областей применения. Если у тебя нет собственного кэша, ты обречён».

Однако если изучить [спецификации](https://www.samsung.com/semiconductor/global.semi.static/Ultra-Low_Latency_with_Samsung_Z-NAND_SSD-0.pdf) современных NVMe-устройств, то мы увидим, что даже в потребительском классе это устройства с задержками, измеряемыми в единицах микросекунд, и пропускной способностью в несколько ГБ/с, поддерживающие несколько сотен тысяч произвольных IOPS. Так в чём же нестыковка?

В этой статье я покажу, что несмотря на то, что за прошедшее десятилетие «железо» значительно изменилось, программные API остались прежними или почти не поменялись. Устаревшие API, заполненные копиями памяти, распределением памяти, чрезмерно оптимистичным упреждающим кэшированием при чтении, а также другими всевозможными затратными операциями, мешают нам использовать большинство функций современных устройств.

В процессе написания статьи мне довелось насладиться преимуществами раннего доступа к одному из устройств следующего поколения Optane компании Intel. Хотя они пока ещё не заняли своё место на рынке, эти устройства определённо станут венцом современных тенденций по стремлению ко всё более быстрому оборудованию. Перечисленные в статье показатели были получены на этом устройстве.

В целях экономии времени я буду рассматривать только считывание. Операции записи имеют собственный уникальный спектр тонкостей, а также возможностей совершенствования, которые я рассмотрю в следующей статье.

Мои утверждения

===============

У традиционных API на основе файлов есть три основные проблемы:

* **Они выполняют множество затратных операций, потому что «ввод-вывод — это слишком затратно».**

Когда устаревшим API нужно считать данные, которые не кэшированы в памяти, они генерируют page fault. Потом, когда данные готовы, они генерируют прерывание. Наконец, для традиционного считывания на основе системного вызова требуется дополнительная копия в буфере пользователя, а для операций на основе mmap нужно обновлять распределение виртуальной памяти.

Ни одна из этих операций (page fault, прерывания, копии или распределение виртуальной памяти) не является малозатратной. Однако многие годы назад они всё равно были примерно в сто раз «дешевле», чем затраты на сам ввод-вывод, из-за чего такой подход был приемлемым. Но сегодня это уже не так — задержки устройств приближаются к единицам микросекунд. Такие операции сейчас имеют тот же порядок величин, что и сама операция ввода-вывода.

Приблизительный подсчёт показывает, что в наихудшем случае меньше половины общих затрат на занятость приходится на затраты самого общения с устройством. И это не считая всей пустой траты ресурсов, что приводит нас ко второй проблеме:

* **Увеличение объёмов считывания.**

Я опущу некоторые подробности (например, память, используемую дескрипторами файлов, и различные кэши метаданных в Linux), но если современные NVMe поддерживают множественные параллельные операции, то нет причин полагать, что считывание из нескольких файлов более затратно, чем считывание из одного. Однако определённо важно *общее количество считываемых данных*.

Операционная система считывает данные с *глубиной детализации в страницу*, это означает, что она может считывать минимум по 4 КБ за раз. Это значит, что если нам нужно считать 1 КБ, разделённый на два файла по 512 байта каждый, то мы, по сути, для передачи 1 КБ считываем 8 КБ, впустую тратя 87% операций чтения. На практике, ОС также выполняет упреждающее чтение (по умолчанию на 128 КБ), ожидая, что это сэкономит такты позже, когда вам понадобятся оставшиеся данные. Но если они вам никогда не понадобятся, как это часто бывает в случае произвольного ввода-вывода, то вы просто считываете 256 КБ для передачи 1 КБ, тратя впустую 99% данных.

Если вы решите проверить моё заявление о том, что считывание из нескольких файлов не должно быть фундаментально медленнее считывания из одного файла, то, возможно, докажете собственную правоту, но только потому, что объём считывания значительно увеличивается на величину фактически считываемых данных.

Поскольку проблема заключается в страничном кэше ОС, то что произойдёт, если мы просто откроем файл прямым вводом-выводом, при всех прочих равных условиях? К сожалению, так тоже не будет быстрее. Но в этом и заключается наша третья, и последняя, проблема:

* **Традиционные API не пользуются параллельной обработкой данных**.

Файл рассматривается как последовательный поток байтов, и считывающий не знает, находятся ли данные в памяти, или нет. Традиционные API ждут, пока вы не затронете данные, не находящиеся в памяти, и только потом отдают команду на выполнение операции ввода-вывода. Из-за упреждающего считывания операция ввода-вывода может быть больше, чем затребовал пользователь, но это всё равно только одна операция.

Однако, как бы ни были быстры современные устройства, они по-прежнему медленнее, чем процессор. Пока устройство ожидает возврата операции ввода-вывода, процессор ничего не делает.

*Отсутствие параллельной обработки данных в традиционных API приводит к тому, что процессоры простаивают, ожидая возврата данных операцией ввода-вывода.*

Использование нескольких файлов является шагом в правильном направлении, потому что оно позволяет более эффективно выполнять параллельную обработку: пока один считывающий процесс ожидает, другой может продолжать работу. Но если не быть аккуратным, то можно усугубить одну из предыдущих проблем:

* Работа с несколькими файлами подразумевает наличие нескольких буферов упреждающего считывания, что повышает показатель пустой траты ресурсов при произвольном вводе-выводе.

* В API на основе опроса потоков использование нескольких файлов означает несколько потоков, что увеличивает объём работы, выполняемой на каждую операцию ввода-вывода.

Не говоря уже о том, что во многих ситуациях нам нужно что-то другое, например, у нас может и не быть большого количества файлов.

Путь к более оптимальным API

============================

В прошлом я подробно писал о том, [насколько революционен интерфейс io\_uring](https://www.scylladb.com/2020/05/05/how-io_uring-and-ebpf-will-revolutionize-programming-in-linux/). Но поскольку это довольно низкоуровневый интерфейс, он является только одним фрагментом паззла API. И вот почему:

* Ввод-вывод, выполняемый через io\_uring, всё равно будет страдать от большинства описанных выше проблем, если он использует буферизованные файлы.

* У прямого ввода-вывода есть множество нюансов, а io\_uring, являясь «сырым» интерфейсом, не стремится скрывать эти проблемы (да и не должен этого делать): например, память должна быть правильно выровнена, как и места, из которых выполняется чтение.

* Кроме того, он очень низкоуровневый и «сырой». Чтобы он был полезным, нужно накапливать операции ввода-вывода и управлять ими пакетно. Это требует политик определения моментов, когда это нужно выполнять, а также некого цикла событий, поэтому он будет лучше работать с фреймворком, у которого уже есть вся необходимая функциональность.

Для решения проблемы с API я спроектировал [Glommio](https://www.datadoghq.com/blog/engineering/introducing-glommio/) (ранее известную как Scipio) — библиотеку Rust, ориентированную на прямой ввод-вывод с одним потоком на каждое ядро. Glommio построена на основе io\_uring и поддерживает множество его продвинутых возможностей, позволяющих пользоваться всеми преимуществами прямого ввода-вывода. Ради удобства Glommio поддерживает буферизованные файлы с поддержкой страничного кэша Linux, напоминающей стандартные API Rust (которые мы ниже используем для сравнения), однако основной упор она делает на прямой ввод-вывод (Direct I/O).

В Glommio существует два класса файлов: [файлы с произвольным доступом](https://docs.rs/glommio/0.2.0-alpha/glommio/io/struct.DmaFile.html) и [потоки](https://docs.rs/glommio/0.2.0-alpha/glommio/io/struct.DmaStreamReader.html).

Файлы с произвольным доступом получают в качестве аргумента позицию, то есть хранение seek cursor не требуется. Но важнее всего то, что они не получают в качестве параметра буфер. Вместо этого они используют заранее зарегистрированную буферную область io\_uring для выделения буфера и возврата пользователю. Это означает отсутстие необходимости выделения памяти и копирования буфера пользователя — есть только копия с устройства на буфер glommio, а пользователь получает указатель с подсчётом ссылок на неё. И поскольку мы знаем, что ввод-вывод произвольный, не требуется считывать данных больше, чем было запрошено.

```

pub async fn read_at<'_>(&'_ self, pos: u64, size: usize) -> Result

```

Потоки подразумевают, что вы постепенно пройдёте по всему файлу, поэтому они могут позволить использовать больший размер блоков и упреждающего считывания.

Потоки спроектированы таким образом, чтобы быть похожими на стандартные [AsyncRead](https://docs.rs/futures-lite/1.11.2/futures_lite/io/trait.AsyncReadExt.html) языка Rust, поэтому в них реализовано поведение AsyncRead и они считывают данные в буфер пользователя. Все преимущества сканирования на основе прямого ввода-вывода по-прежнему можно использовать, но теперь существует копия между нашими внутренними буферами упреждающего считывания и буфером пользователя. Это цена, которую приходится платить за удобство пользования стандартным API.

Если вам нужна дополнительная производительность, glommio предоставляет [API для потока](https://docs.rs/glommio/0.2.0-alpha/glommio/io/struct.DmaStreamReader.html#method.get_buffer_aligned), который также обеспечивает доступ к сырым буферам, избавляя от необходимости лишней копии.

```

pub async fn get_buffer_aligned<'_>(

&'_ mut self,

len: u64

) -> Result

```

Тестируем сканы

===============

Для демонстрации этих API у glommio есть [пример программы](https://github.com/DataDog/glommio/blob/master/examples/storage.rs), выполняющий ввод-вывод с различными параметрами с использованием всех этих API (буферизованный, прямой ввод-вывод, произвольный, последовательный) и оценивающий их производительность.

Мы начнём с файла, который примерно в 2,5 раза больше объёма памяти. Для начала просто считаем его последовательно, как обычный буферизованный файл:

> Буферизованный ввод-вывод: отсканировано 53 ГБ за 56 с, 945,14 МБ/с

Вполне неплохо, учитывая, что этот файл не помещается в память, но здесь все преимущества обеспечивает исключительная производительность Intel Optane и бекэнд io\_uring. Эффективность параллельной обработки данных всё равно проявляется при выполнении ввода-вывода и хотя размер страницы ОС составляет 4 КБ, упреждающее считывание позволяет нам эффективно увеличить размер ввода-вывода.

Если бы мы попробовали эмулировать похожие параметры при помощи Direct I/O API (буферы 4 КБ, параллельная обработка одного файла), то результаты бы нас разочаровали, «подтверждая» наши подозрения о том, что прямой ввод-вывод и в самом деле намного медленнее.

> Прямой ввод-вывод: отсканировано 53 ГБ за 115 с, 463,23 МБ/с

Но как мы говорили, файловые потоки прямого ввода-вывода в glommio могут принимать явно заданный параметр упреждающего считывания. Активная glommio может передавать запросы ввода-вывода для позиции с опережением текущего считывания для использования возможностей параллельной обработки данных устройства.

Работа упреждающего считывания в Glommio отличается от принципа упреждающего считывания в ОС: наша цель — использовать параллельную обработку данных, а не просто увеличить размеры ввода-вывода. Вместо того, чтобы потреблять весь буфер упреждающего считывания и только после этого отправлять запрос на новый пакет, glommio отправляет новый запрос сразу после потребления содержимого буфера и всегда старается поддерживать постоянное количество действующих буферов, как показано на рисунке ниже.

В процессе опустошения одного буфера уже запрашивается ещё один буфер. Благодаря этому повышается параллельность обработки.

Как изначально и ожидалось, после правильной реализации параллельной обработки заданием показателя упреждающего считывания, прямой ввод-вывод не только сравнялся с буферизованным вводом-выводом, но и стал на самом деле намного быстрее.

> Прямой ввод-вывод, упреждающее считывание: отсканировано 53 ГБ за 22 с, 2,35 ГБ/с

Эта версия всё ещё использует интерфейсы [AsyncReadExt](https://docs.rs/futures-lite/1.11.2/futures_lite/io/trait.AsyncReadExt.html) языка Rust, что заставляет создавать дополнительную копию из буферов glommio в буферы пользователя.

При помощи [get\_buffer\_aligned](https://docs.rs/glommio/0.2.0-alpha/glommio/io/struct.DmaStreamReader.html#method.get_buffer_aligned) API предоставляет «сырой» доступ к буферу, позволяющему избежать последнего копирования в память. Если мы используем его сейчас для теста считывания, то получим солидную прибавку производительности в 4%.

> Прямой ввод-вывод, API glommio: отсканировано 53 ГБ за 21 с, 2,45 ГБ/с

Последним шагом будет увеличение размера буфера. Поскольку это последовательное сканирование, мы не обязаны ограничиваться размером буфера в 4 КБ; это можно сделать только для сравнения с производительностью страничного кэша ОС.

Давайте подведём итог тому, что происходит внутри glommio и io\_uring при помощи следующего теста:

* каждый запрос ввода-вывода имеет размер 512 КБ,

* многие из них (5) остаются активными для обеспечения параллельной обработки,

* память выделяется и регистрируется предварительно

* в буфер пользователя не выполняется дополнительной копии

* io\_uring переключен в режим опроса, то есть отсутствуют копии в память, прерывания и переключения контекста.

Какими же получились результаты?

> Прямой ввод-вывод, API glommio, большой буфер: отсканировано 53 ГБ за 7 с, 7,29 ГБ/с

Это в семь с лишним раз лучше, чем стандартное решение с буферизацией. Более того, использование памяти никогда не бывает выше, чем заданный показатель упреждающего считывания, умноженный на размер буфера. В нашем примере это 2,5 МБ.

Произвольное считывание

=======================

Сканирование сильно снижает производительность страничного кэша ОС. А как мы справимся с произвольным вводом-выводом? Чтобы проверить это, мы считаем столько, сколько успеем за 20 с, сначала ограничившись первыми 10% доступной памяти (1,65 ГБ)

> Буферизованный ввод-вывод: размер 1,65 ГБ, в течение 20 с, 693870 IOPS

Для прямого ввода-вывода:

> Прямой ввод-вывод: размер 1,65 ГБ, в течение 20 с, 551547 IOPS

Прямой ввод-вывод на 20% медленнее буферизованного считывания. Хотя считывание целиком из памяти по-прежнему быстрее, что никого не должно удивлять, разница далеко не так катастрофична, как можно было ожидать. На самом деле, если помнить, что буферизованная версия хранит 1,65 ГБ резидентной памяти для достижения этого результата, а прямой ввод-вывод использует всего 80 КБ (буферы 20 x 4 КБ), он может даже быть *предпочтительным* для определённых областей применения, в которых память лучше тратить на что-то другое.

Как вам скажет любой инженер по эксплуатации, хороший бенчмарк чтения должен считывать данные настолько, чтобы дойти до накопителя. Ведь, в конце концов, «накопители медленные». Если теперь мы выполним считывание из всего файла, то производительность буферизованного ввода-вывода значительно упадёт (на 65%)

> Буферизованный ввод-вывод: размер 53,69 ГБ, в течение 20 с, 237858 IOPS

При этом прямой ввод-вывод, как и ожидалось, имеет ту же производительность и тот же уровень использования памяти вне зависимости от объёма считываемых данных.

> Прямой ввод-вывод: размер 53,69 ГБ, в течение 20 с, 547479 IOPS

Если сравнивать по более объёмному сканированию, то прямой ввод-вывод в 2,3 раза быстрее, а не медленнее буферизованных файлов.

Выводы

======

Современные NVMe-устройства меняют баланс наилучшей производительности ввода-вывода в приложениях с отслеживанием состояния. Эта тенденция развивалась уже долгое время, но пока её скрывал тот факт, что API (особенно высокоуровневые) не эволюционировали достаточно, чтобы соответствовать тому, что происходит в устройстве, а в последнее время и в слоях ядра Linux. При правильном подборе API прямой ввод-вывод обретает новую жизнь.

Самые новые устройства, например, последнее поколение Intel Optane, просто констатируют этот факт. Всегда найдётся ситуация, когда прямой ввод-вывод может быть лучше стандартного буферизованного ввода-вывода.

При сканировании хорошо продуманные API на основе прямого ввода-вывода просто не имеют равных. И хотя стандартные API на основе буферизованного ввода-вывода были на 20% быстрее при произвольных считываниях целиком помещающихся в памяти данных, за это приходится расплачиваться в 200 раз бОльшим размером используемой памяти, что не всегда является наилучшим решением.

Приложения, которым требуется дополнительная производительность, всё равно могут требовать кэширования части своих результатов, а скоро в glommio будет реализован простой способ интеграции специализированных кэшей для использования с прямым вводом-выводом.

---

#### На правах рекламы

**Эпичные серверы для разработчиков и не только!** [Дешёвые VDS](https://vdsina.ru/cloud-servers?partner=habr189) на базе новейших процессоров AMD EPYC и хранилища на основе NVMe дисков от Intel для размещения проектов любой сложности, от корпоративных сетей и игровых проектов до лендингов и VPN.

[](https://vdsina.ru/cloud-servers?partner=habr189) | https://habr.com/ru/post/530664/ | null | ru | null |

# Неожиданное поведение Garbage Collector'а сессий

На днях я столкнулся с очень интересной проблемой. В системе, с которой я разбирался, использовался механизм ограничения времени жизни сессии. Валидация этого времени перекладывалась на плечи garbage collector'а, который почему-то её выполнял не совсем добросовестно, а то и вовсе не выполнял. Как оказалось, ошибки эти общераспространенных, по этому о тонкостях работы с GC я и хотел бы рассказать.

В php за работу GC для сессий отвечают 3 параметра: **session.gc\_probability**, **session.gc\_divisor** и **session.gc\_maxlifetime**.

Эти параметры говорят о следующем: в **gc\_probability** из **gc\_divisor** запусков session\_start запускается GC, который должен очистить сессии со временем последнего обращения больше, чем **gc\_maxlifetime**.

#### Делаем как все, или пример №1

Попробуем протестировать работу GCна маленьком скрипте:

```

php

ini_set("session.gc_maxlifetime", 1);

session_start();

if (isset($_SESSION['value'])) {

$_SESSION['value'] += 1;

} else {

$_SESSION['value'] = 0;

}

echo $_SESSION['value'];

?

```

Обновим этот файл 10 раз с промежутком секунд по 10-15(можно и больше, важно чтобы промежуток был выше чем 1 секунда). В результате мы получим «неожиданные ответы»:

```

0

1

2

3

...

```

Причина довольно проста и, я бы сказал, очевидна:

gc запустится только в 1 из 1000 запросов, а мы сделали всего 15.

*Примечание: большинство из систем, которые я видел, работали по этому алгоритму и глубже не заходили.*

#### Обойти баг любой ценой, или пример №2

Решение проблемы кажется простым — а что если запуск GC сделать принудительным?

```

php

ini_set("session.gc_maxlifetime", 1);

ini_set("session.gc_divisor", 1);

ini_set("session.gc_probability", 1);

session_start();

if (isset($_SESSION['value'])) {

$_SESSION['value'] += 1;

} else {

$_SESSION['value'] = 0;

}

echo $_SESSION['value'];

?

```

Но поведение этого скрипта становится намного более неожиданным. Давайте попробуем повторить такие же действия, что и для примера №1:

```

0

1

0

1

...

```

#### Разбор полетов, или почему так происходит

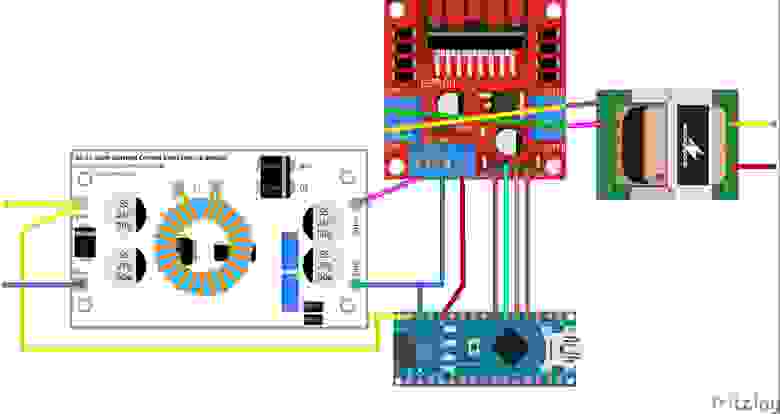

Если мы повесим обработчики, с помощью session\_set\_save\_handler, то с легкостью восстановим порядок загрузки/обработки сессии:

1. open

2. read

3. gc

4. PROGRAM

5. close

Т.е. garbage collector запустился уже после чтения сессии, а значит массив $\_SESSION уже заполнен. Вот отсюда и возникает неожиданная единица во втором примере!

#### Вернемся к 1ому примеру

Как мы теперь видим, сборщик мусора может запустится на 3ем шаге, но что же произойдет если он не запустится? Ведь при стандартных настройках шанс на запуск всего 1 из 1000.

Устаревшая сессия успешно откроется, прочитается, а в конце работы сохранится и время последнего обращения к файлу будет обновлено — в этом случае такая сессия становится почти бесконечной. Но, в тоже время, если наш скрипт использует 1000 разных пользователей, то о «бесконечности» сессии можно забыть, т.к. GC скорее всего запустится у кого либо из пользователей, время жизни начнет работать верно(точнее почти верно). Такое поведение системы неоднозначно и непредсказуемо, а это потенциально приведет к большому количеству трудно отлавливаемых проблем.

#### И что теперь делать, или выходы из ситуации

Самым верным решением, является использования своего механизма валидации сессии. В документации явно сказано что

«session.gc\_maxlifetime задает отсрочку времени в секундах, после которой данные будут рассматриваться как „мусор“ и потенциально будут удалены. Сбор мусора может произойти в течение старта сессии (в зависимости от значений session.gc\_probability и session.gc\_divisor).» Слова «потенциально» и «может», как раз и говорят о том, что gc не предназначен для ограничения времени жизни сессии. В тех местах, где время жизни сессии важно, а возникновение артефактов, как из примера №2 критично, используйте свою валидацию времени жизни.

###### Выход №2, плохой и неправильный

Мы знаем, что установленный «принудительный режим» работы gc отработает на шаге №3 старта сессии. Т.е. фактически после старта устаревшей сессии данные в массиве $\_SESSION присутствуют, а файл уже удален. В таком случае логично попробовать пересоздать сессию, т.е фактически сделать запуск 2 запуска session\_start:

```

php

ini_set("session.gc_maxlifetime", 1);

ini_set("session.gc_divisor", 1);

ini_set("session.gc_probability", 1);

session_start();

if (isset($_SESSION['value'])) {

$_SESSION['value'] += 1;

} else {

$_SESSION['value'] = 0;

}

echo $_SESSION['value'];

session_commit();

session_start();

echo ' '.$_SESSION['value'];

?

```

Результаты работы скрипта будут:

```

0 0

1

0 0

1

...

```

Это поведение ясно из порядка обработки сессии, но(вспомним документацию, да и вообще взглянем адекватно) делать так не стоит.

#### Ура, разобрались — вывод

Меня удивило, что большинство, даже опытных, разработчиков ни разу не задумывались о поведении GC, беззаботно доверяя ему ограничение времени жизни сессии. При том что в документации явно указано, что делать этого не стоит, а название Garbage Collector(не Session Validator, или Session Expire) говорит само за себя. Ну а главный вывод, конечно, заключается в том, что следует тщательно проверять, даже кажущиеся очевидными части системы. Ошибки системных функций или методов иногда являются их неверной трактовкой, а не ошибками как таковыми.

Всем спасибо за то, что дочитали до конца. Надеюсь, что эта статья оказалась для вас полезной. | https://habr.com/ru/post/171151/ | null | ru | null |

# Добавляем анимацию сортировки в jQuery UI

Я понимаю, возможно, есть ощущение, что статья опоздала года этак на 2, сейчас модно писать про es6, react, redux или другие модные в мире фронтенда штуки.

Однако, я думаю, у многих до сих пор есть проекты, которые используют jQuery + jQuery UI. И вот в одном из проектов, используя именно jQuery UI для сортировки элементов списка, мне потребовалась анимация сортировки, которой в jQuery UI «из коробки» нет. Гугление и поиск по stackoverflow привели только к странным решениям через стандартные jquery-ui колбэки, а так как мест, где сортировка использовалась было несколько, такие решения мне не подходили.

К тому же в проекте использовалась библиотека jQuery UI Touch Punch, которая позволяет элегантным образом заставить jQuery UI работать на touch-устройствах, я подумал, почему бы не сделать так же.

Начав разбираться в том, как работает sortable, стало ясно, что при сортировке элементы, перетаскиваемый и на место которого его хотим поставить, просто меняются местами в DOM-дереве. При таком раскладе, из возможных реализаций моей задачи в голову пришла только одна идея.

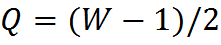

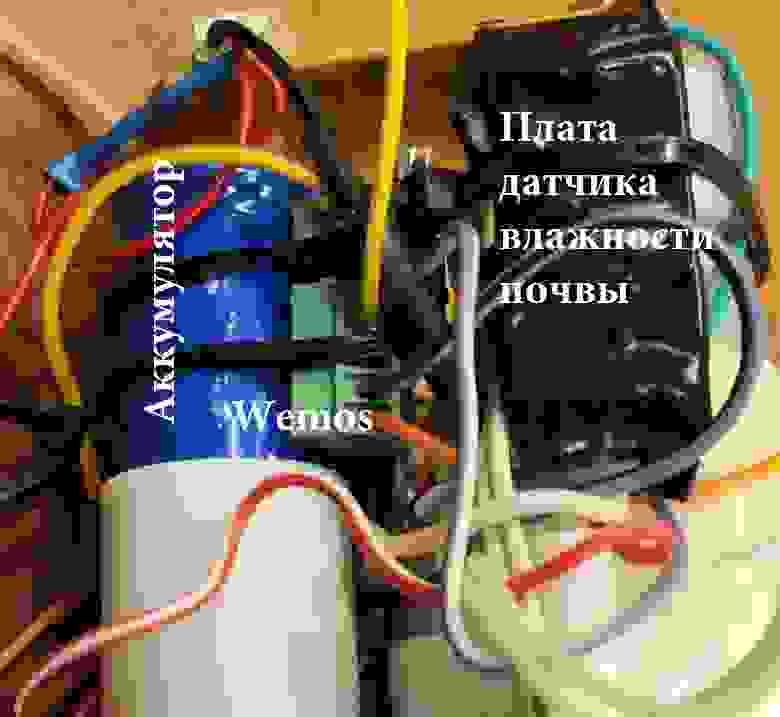

После того, как элемент был перемещен на новое место в DOM-дереве, в зависимости от направления сортировки сместим его в обратную сторону на его высоту (или ширину, в зависимости от оси направления сортировки) и сразу же запустим анимацию. Возможно, на схеме будет чуть понятнее:

Рассмотрим каждый шаг:

1. пользователь начинает перетаскивать **Item 4** на место **Item 3**;

2. срабатывает сортировка родными способами jQuery UI;

3. плагин смещает элемент с помощью трансформации translateY обратно на его старую позицию, не меняя позиции элемента в DOM-дереве;

4. сразу же запускает анимацию через css-transition.

Вуаля, не затрагивая базовую логику виджета sortable мы добавили в него анимацию. Я реализовал это в виде расширения виджета sortable, поэтому чтобы добавить анимацию в уже существующий проект, который использует sortable, нужно просто подключить скрипт и добавить свойство animation в параметры sortable:

```

$('#sortable').sortable({

// ...

// уже существующие параметры

axis: 'y', // обязательно (либо 'x', либо 'y'), иначе будет работать без анимации

animation: 200, // время анимации (0 - не применять анимацию)

});

```

[Исходный код на GitHub](https://github.com/egorshar/jquery-ui-sortable-animation)

[Demo](https://egorshar.github.io/jquery-ui-sortable-animation/ru.html)

**Плюсы:**

* включается одним параметром, даже для давно существующего кода;

* не влияет на логику работы, добавляет только визуальный эффект;

* для браузеров, которые не поддерживают css-transitions будет анимировать с помощью jQuery.animate.

**Ну и, конечно, минусы:**

* работает только при указании свойства axis в параметрах sortable.

На данный момент библиотека решает свои задачи, но неплохо было бы, как минимум, избавиться от обязательности указания свойства axis. Если у вас есть идеи и время — пул-реквесты приветствуются. | https://habr.com/ru/post/273923/ | null | ru | null |

# Учимся правильно бенчмаркать (в том числе итераторы)