text

stringlengths 20

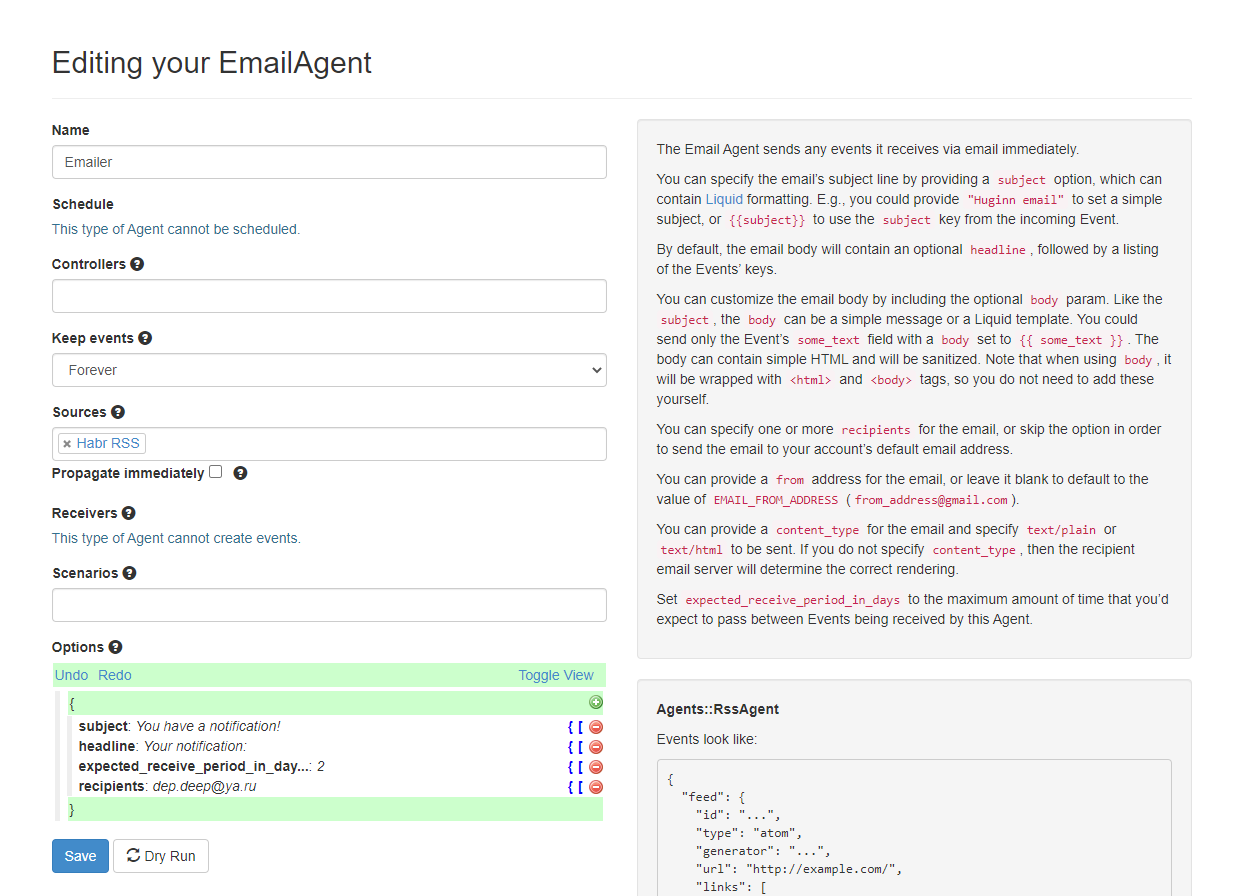

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Особенности профилирования программ на C++

Временами бывает нужно отпрофилировать производительность программы или потребление памяти в программе на C++. К сожалению, зачастую это сделать не так просто как может показаться.

Здесь будут рассмотрены особенности профилирования программ с использованием инструментов **valgrind** и **google perftools**. Материал получился не очень структурированным, это скорее попытка собрать базу знаний «для личных целей», чтобы в будущем не приходилось судорожно вспоминать, «а почему не работает то» или «а как сделать это». Скорее всего, здесь будут затронуты далеко не все неочевидные случаи, если вам есть что добавить, пишите пожалуйста в комментарии.

Все примеры будут запускаться в системе linux.

Профилирование времени выполнения

---------------------------------

### Подготовка

Для разбора особенностей профилирования я буду запускать небольшие программки, как правило состоящие из одного main.cpp файла и одного файла func.cpp вместе с инклудом.

Компилировать их я буду компилятором **g++ 8.3.0**.

Так как профилировать неоптимизированные программы — довольно странное занятие, будем компилировать с опцией **-Ofast**, а для того, чтобы получить debug-символы на выходе, не забудем добавить опцию **-g**. Тем не менее, иногда вместо нормальных имен функций можно увидеть только невнятные адреса вызовов. Это значит, что произошла «рандомизация размещения адресного пространства». Это можно определить, вызывав команду **nm** на бинарнике. Если в большинство адресов выглядят примерно так 00000000000030e0 (большое количество нулей в начале), то скорее всего это оно. В нормальной программе адреса выглядят как 0000000000402fa0. Поэтому нужно добавить опцию **-no-pie**. В результате, полный набор опций будет выглядеть вот так:

**-Ofast -g -no-pie**

Для просмотра результатов будем использовать программу **KCachegrind**, который умеет работать с форматом отчетов **callgrind**

### Callgrind

Первая утилита, которую мы сегодня рассмотрим — **callgrind**. Эта утилита входит в состав инструмента valgrind. Она эмулирует каждую исполняемую инструкцию программы и на основании внутренних метрик о «стоимости» работы каждой инструкции выдает нужное нам заключение. Из-за такого подхода иногда бывает так, что callgrind не может распознать очередую инструкцию и вываливается с ошибкой

*Unrecognised instruction at address*

Единственный выход из такой ситуации — пересмотреть все опции компиляции и попытаться найти мешающую

Давайте для тестирования этого инструмента создадим программу, состоящую из одной shared, и одной static библиотеки (в дальнейшем в других тестах от библиотек откажемся). Каждая библиотека, а также сама программа, будет предоставлять простенькую вычислительную функцию, например, вычисление последовательности Фибоначчи.

**static\_lib**

```

//////////////////

// static_lib.h //

//////////////////

#ifndef SERVER_STATIC_LIB_H

#define SERVER_STATIC_LIB_H

int func_static_lib(int arg);

#endif //SERVER_STATIC_LIB_H

////////////////////

// static_lib.cpp //

///////////////////

#include "static_lib.h"

#include "static_func.h"

#include

int func\_static\_lib(int arg) {

return static\_func(arg);

}

///////////////////

// static\_func.h //

///////////////////

#ifndef TEST\_PROFILER\_STATIC\_FUNC\_H

#define TEST\_PROFILER\_STATIC\_FUNC\_H

int static\_func(int arg);

#endif //TEST\_PROFILER\_STATIC\_FUNC\_H

/////////////////////

// static\_func.cpp //

/////////////////////

#include "static\_func.h"

int static\_func(int arg) {

int fst = 0;

int snd = 1;

for (int i = 0; i < arg; i++) {

int tmp = (fst + snd) % 17769897;

fst = snd;

snd = tmp;

}

return fst;

}

```

**shared\_lib**

```

//////////////////

// shared_lib.h //

//////////////////

#ifndef TEST_PROFILER_SHARED_LIB_H

#define TEST_PROFILER_SHARED_LIB_H

int func_shared_lib(int arg);

#endif //TEST_PROFILER_SHARED_LIB_H

////////////////////

// shared_lib.cpp //

////////////////////

#include "shared_lib.h"

#include "shared_func.h"

int func_shared_lib(int arg) {

return shared_func(arg);

}

///////////////////

// shared_func.h //

///////////////////

#ifndef TEST_PROFILER_SHARED_FUNC_H

#define TEST_PROFILER_SHARED_FUNC_H

int shared_func(int arg);

#endif //TEST_PROFILER_SHARED_FUNC_H

/////////////////////

// shared_func.cpp //

/////////////////////

#include "shared_func.h"

int shared_func(int arg) {

int result = 1;

for (int i = 1; i < arg; i++) {

result = (int)(((long long)result * i) % 19637856977);

}

return result;

}

```

**main**

```

//////////////

// main.cpp //

//////////////

#include

#include "static\_lib.h"

#include "shared\_lib.h"

#include "func.h"

int main(int argc, char \*\*argv) {

if (argc != 2) {

std::cout << "Incorrect args";

return -1;

}

const int arg = std::atoi(argv[1]);

std::cout << "result: " << func\_static\_lib(arg) << " " << func\_shared\_lib(arg) << " " << func(arg);

return 0;

}

////////////

// func.h //

////////////

#ifndef TEST\_PROFILER\_FUNC\_H

#define TEST\_PROFILER\_FUNC\_H

int func(int arg);

#endif //TEST\_PROFILER\_FUNC\_H

//////////////

// func.cpp //

//////////////

#include "func.h"

int func(int arg) {

int fst = 1;

int snd = 1;

for (int i = 0; i < arg; i++) {

int res = (fst + snd + 1) % 19845689;

fst = snd;

snd = res;

}

return fst;

}

```

Компилируем программу, и запускаем valgrind следующим образом:

```

valgrind --tool=callgrind ./test_profiler 100000000

```

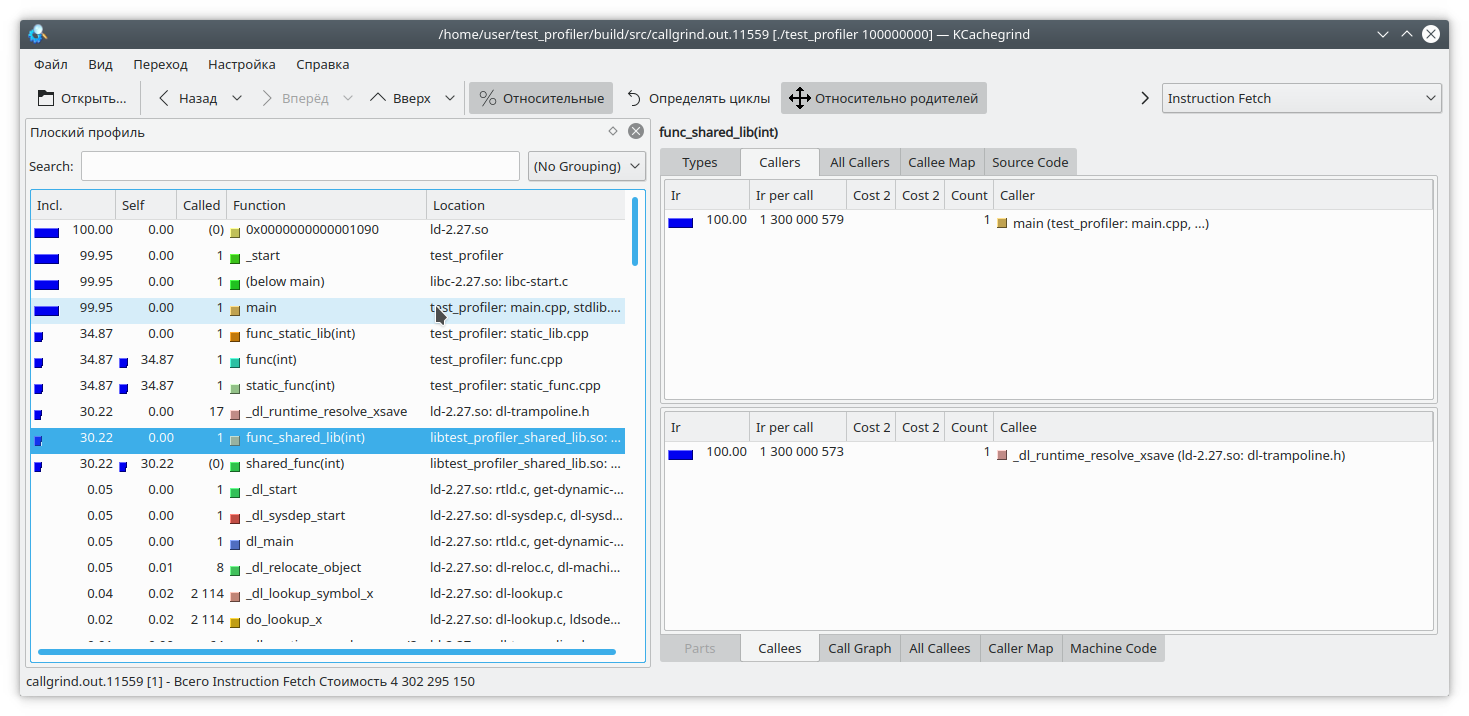

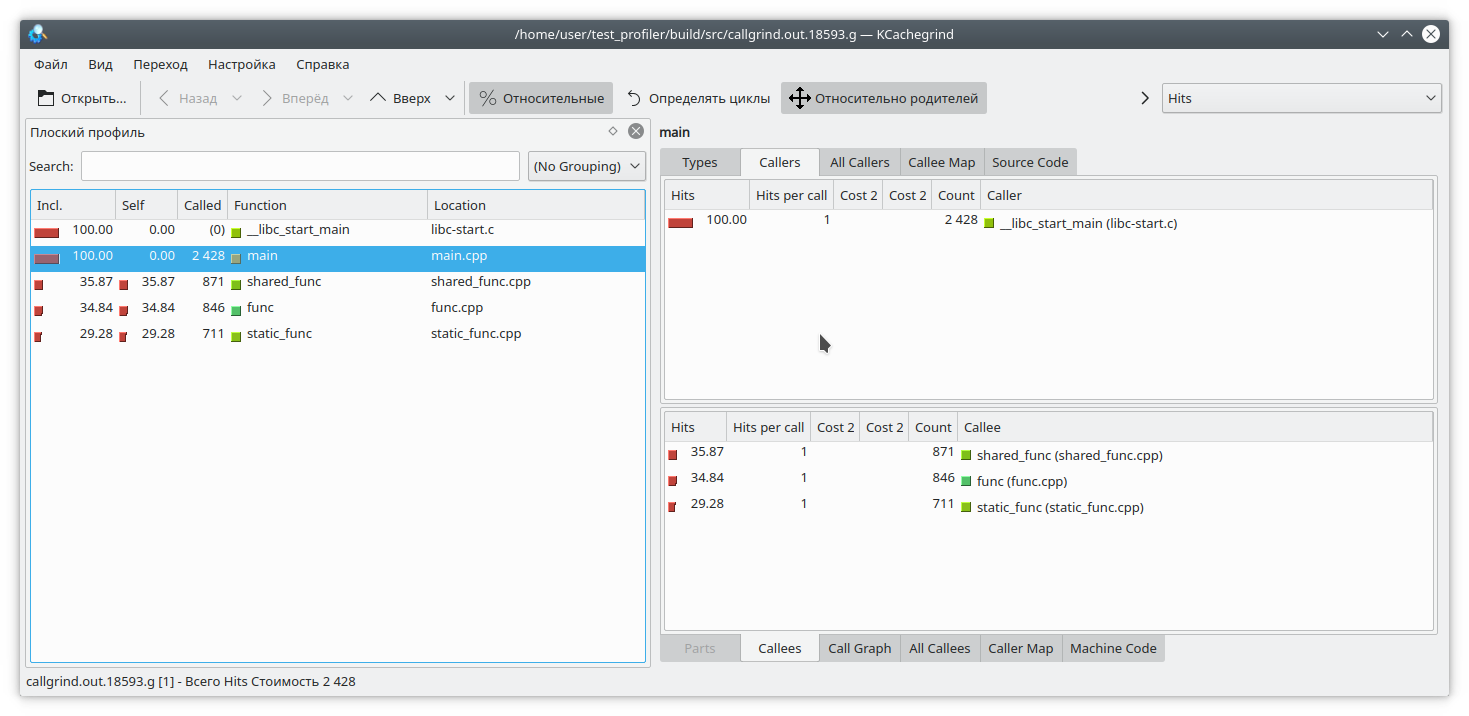

[](https://habrastorage.org/webt/i7/xa/tt/i7xattm3xphucvb3x5ogxlbpv20.png)

Видим, что для статической библиотеки и обычной функции результат похож на ожидаемый. А вот в динамической библиотеке callgrind не смог до конца отрезолвить функцию.

Для того, чтобы это исправить, при запуске программы нужно установить переменную **LD\_BIND\_NOW** в значение 1, вот так:

```

LD_BIND_NOW=1 valgrind --tool=callgrind ./test_profiler 100000000

```

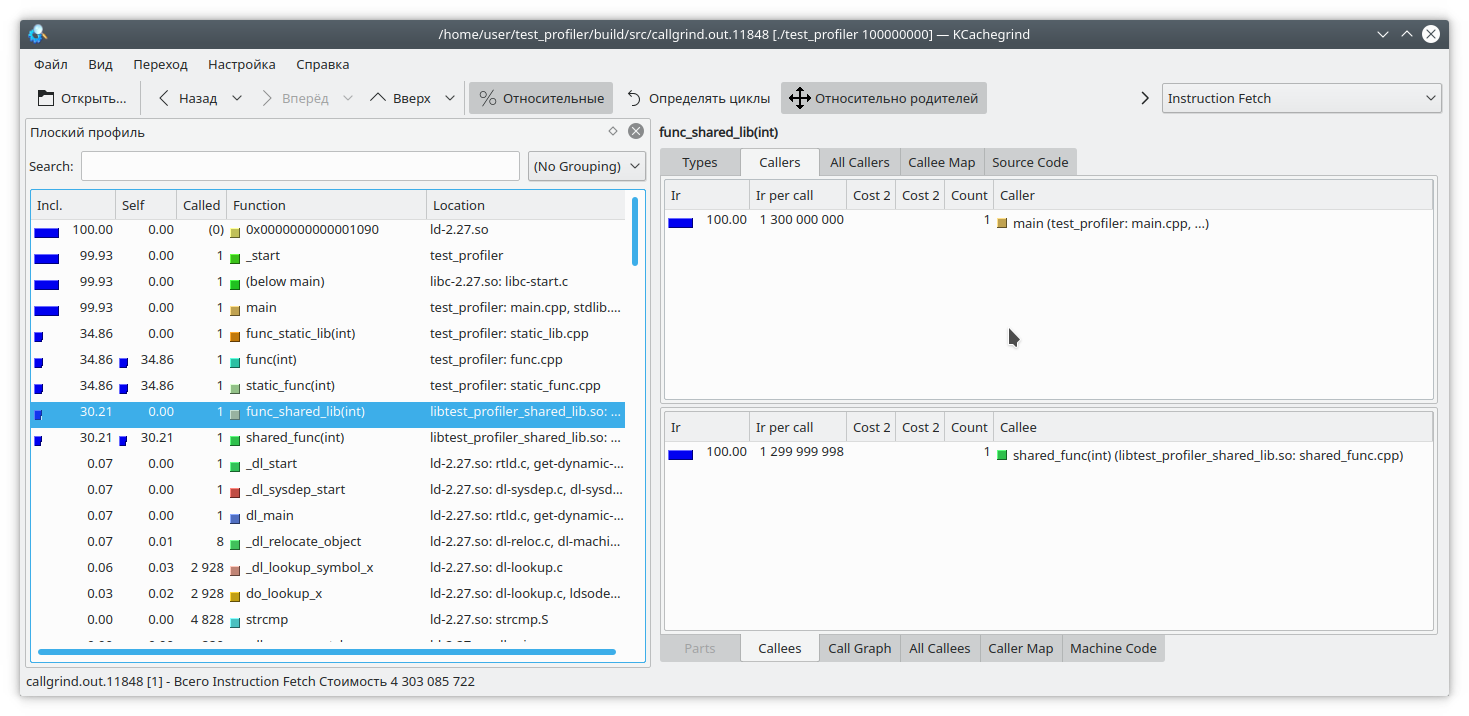

[](https://habrastorage.org/webt/nb/l2/yb/nbl2ybqiy6atyd5cak6evogfbem.png)

И теперь, как видите, все нормально

Следующая проблема callgrind-а, вытекающая из профилирования путем эмуляции инструкций в том, что выполнение программы сильно замедляется. Это может нести в себе неправильную относительную оценку времени выполнения различных частей кода.

Давайте рассмотрим такой код:

```

int func(int arg) {

int fst = 1;

int snd = 1;

std::ofstream file("tmp.txt");

for (int i = 0; i < arg; i++) {

int res = (fst + snd + 1) % 19845689;

std::string r = std::to_string(res);

file << res;

file.flush();

fst = snd;

snd = res + r.size();

}

return fst;

}

```

Здесь я добавил на каждую итерацию цикла запись небольшого количества данных в файл. Так как запись в файл — довольно длительная операция, для противовеса я добавил на каждую итерацию цикла генерацию строки из числа. Очевидно, что в данном случае операция записи в файл занимает больше времени, чем вся остальная логика функции. Но callgrind считает по-другому:

[](https://habrastorage.org/webt/hn/pg/zt/hnpgztqrtptlu7_g0tmr5frgbuy.png)

Также стоит учесть, что callgrind может измерять стоимость работы функции, только когда та работает. Функция не работает — значит, и стоимость не растет. Это усложняет отладку программ, которые время от времени входят в блокировку или работают с блокирующей файловой системой/сетью. Давайте проверим:

```

#include "func.h"

#include

static std::mutex mutex;

int funcImpl(int arg) {

std::lock\_guard lock(mutex);

int fst = 1;

int snd = 1;

for (int i = 0; i < arg; i++) {

int res = (fst + snd + 1) % 19845689;

fst = snd;

snd = res;

}

return fst;

}

int func2(int arg){

return funcImpl(arg);

}

int func(int arg) {

return funcImpl(arg);

}

int main(int argc, char \*\*argv) {

if (argc != 2) {

std::cout << "Incorrect args";

return -1;

}

const int arg = std::atoi(argv[1]);

auto future = std::async(std::launch::async, &func2, arg);

std::cout << "result: " << func(arg) << std::endl;

std::cout << "second result " << future.get() << std::endl;

return 0;

}

```

Здесь мы вложили выполнение функции целиком в lock мьютекса, и вызвали эту функцию из двух разных потоков. Результат callgrind-а вполне предсказуем — он не видит проблемы в захвате мьютекса:

[](https://habrastorage.org/webt/be/eh/nj/beehnjstn0h_kjbjjq2by_randc.png)

Итак, мы рассмотрели некоторые проблемы использования профилировщика callgrind. Давайте перейдем к следующему испытуемому — профилировщику из состава google perftools

### google perftools

В отличие от callgrind, профилировщик от google работает по другому принципу.

Вместо того, чтобы анализировать каждую инструкцию исполняемой программы, он приостанавливает выполнение программы через равные промежутки времени и пытается определить, в какой функции в данный момент находится. В результате, это почти не влияет на производительность запущенного приложения. Но у такого подхода есть и свои слабые стороны.

Давайте для начала попробуем провести профилирование первой программы с двумя библиотеками.

Как правило, для запуска профилирования этой утилитой необходимо предзагрузить библиотеку libprofiler.so, выставить частоту сэмплирования и указать файл для сохранения дампа. К сожалению, профайлер требует, чтобы программа завершалась «своим ходом». Принудительное завершение программы приведет к тому, что дамп отчета просто не создастся. Это неудобно при профилировании долгоживущих программ, которые сами по себе не останавливаются, например демонов. Для обхода этого препятствия я создал такой скрипт:

**gprof.sh**

```

rnd=$RANDOM

if [ $# -eq 0 ]

then

echo "./gprof.sh command args"

echo "Run with variable N_STOP=true if hand stop required"

exit

fi

libprofiler=$( dirname "${BASH_SOURCE[0]}" )

arg=$1

nostop=$N_STOP

profileName=callgrind.out.$rnd.g

gperftoolProfile=./gperftool."$rnd".txt

touch $profileName

echo "Profile name $profileName"

if [[ $nostop = "true" ]]

then

echo "without stop"

trap 'echo trap && kill -12 $PID && sleep 1 && kill -TERM $PID' TERM INT

else

trap 'echo trap && kill -TERM $PID' TERM INT

fi

if [[ $nostop = "true" ]]

then

CPUPROFILESIGNAL=12 CPUPROFILE_FREQUENCY=1000000 CPUPROFILE=$gperftoolProfile LD_PRELOAD=${libprofiler}/libprofiler.so "${@:1}" &

else

CPUPROFILE_FREQUENCY=1000000 CPUPROFILE=$gperftoolProfile LD_PRELOAD=${libprofiler}/libprofiler.so "${@:1}" &

fi

PID=$!

if [[ $nostop = "true" ]]

then

sleep 1

kill -12 $PID

fi

wait $PID

trap - TERM INT

wait $PID

EXIT_STATUS=$?

echo $PWD

${libprofiler}/pprof --callgrind $arg $gperftoolProfile* > $profileName

echo "Profile name $profileName"

rm -f $gperftoolProfile*

```

Эту утилиту нужно запускать, передавая в качестве параметров имя исполняемого файла и список его параметров. Также, предполагается, что рядом со скриптом лежат необходимые ему файлы libprofiler.so и pprof. В случае, если программа долгоживущая и останавливается путем прерывания выполнения, необходимо установить переменную N\_STOP в значение true, например так:

```

N_STOP=true ./gprof.sh ./test_profiler 10000000000

```

В конце работы скрипт сгенерирует отчет в любимом мною формате callgrind.

Итак, давайте запустим нашу программу под этим профилировщиком

```

./gprof.sh ./test_profiler 1000000000

```

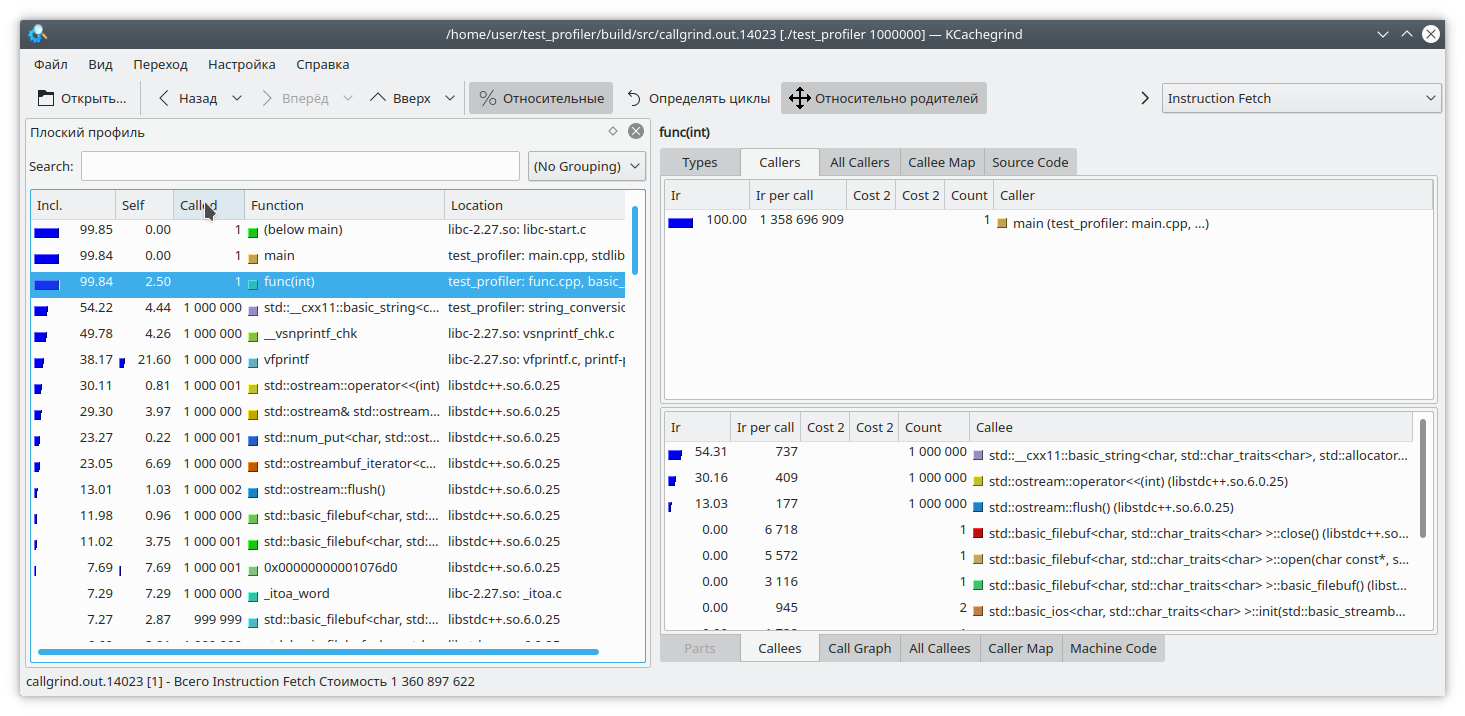

[](https://habrastorage.org/webt/qg/q_/sw/qgq_sw__etaj7mmmrgzvgw_b70c.png)

В принципе, все довольно наглядно.

Как я уже сказал, гугловый профилировщик работает, останавливая выполнение программы и вычисляя текущую функцию. Как же он это делает? Делает он это путем раскрутки стека. А что, если в момент раскрутки стека программа сама раскручивала стек? Ну, очевидно, что ничего хорошего при этом не произойдет. Давайте это проверим. Напишем такую функцию:

```

int runExcept(int res) {

if (res % 13 == 0) {

throw std::string("Exception");

}

return res;

}

int func(int arg) {

int fst = 1;

int snd = 1;

for (int i = 0; i < arg; i++) {

int res = (fst + snd + 1) % 19845689;

try {

res = runExcept(res);

} catch (const std::string &e) {

res = res - 1;

}

fst = snd;

snd = res;

}

return fst;

}

```

И запустим профилирование. Программа довольно быстро зависнет.

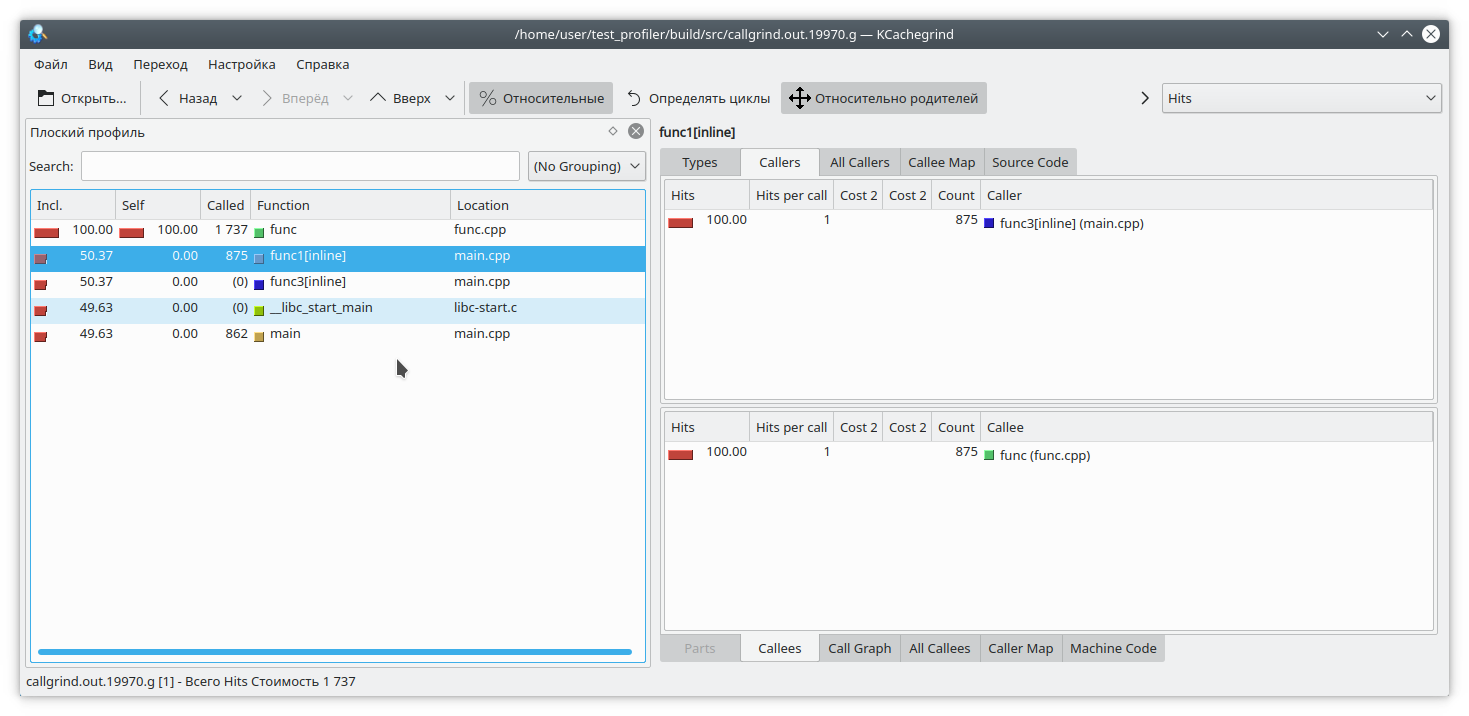

Есть и другая проблема, связанная с особенностью работы профайлера. Предположим, мы сумели раскрутить стек, и теперь нам нужно сопоставить адреса с конкретными функциями программы. Это может быть очень нетривиально, так как в C++ довольно большое количество функций инлайнится. Давайте посмотрим на таком примере:

```

#include "func.h"

static int func1(int arg) {

std::cout << 1 << std::endl;

return func(arg);

}

static int func2(int arg) {

std::cout << 2 << std::endl;

return func(arg);

}

static int func3(int arg) {

std::cout << 3 << std::endl;

if (arg % 2 == 0) {

return func2(arg);

} else {

return func1(arg);

}

}

int main(int argc, char **argv) {

if (argc != 2) {

std::cout << "Incorrect args";

return -1;

}

const int arg = std::atoi(argv[1]);

int arg2 = func3(arg);

int arg3 = func(arg);

std::cout << "result: " << arg2 + arg3;

return 0;

}

```

Очевидно, что если запустить программу например вот так:

```

./gprof.sh ./test_profiler 1000000000

```

то функция func1 никогда не вызовется. Но профайлер считает по-другому:

[](https://habrastorage.org/webt/8-/0o/ny/8-0onyayanqwvdarg94cd92srzc.png)

(К слову, valgrind здесь решил скромно промолчать и не уточнять, из какой конкретной функции пришел вызов).

Профилирование памяти

---------------------

Нередко возникают ситуации, когда память из приложения куда-то «течет». Если это связано с отсутствием очистки ресурсов, то для выявлении проблемы должен помочь Memcheck. Но в современном C++ не так сложно обойтись без ручного управления ресурсами. unique\_ptr, shared\_ptr, vector, map делают манипулирование «голыми» указателями бесмыссленными.

Тем не менее, и в таких приложениях память бывает что течет. Как это происходит? Довольно просто, как правило это чтото вроде «положил значение в долгоживущий map, а удалить забыл». Давайте попробуем отследить эту ситуацию.

Для этого перепишем нашу тестовую функцию таким образом

```

#include "func.h"

#include

#include

#include

static std::deque deque;

static std::map map;

int func(int arg) {

int fst = 1;

int snd = 1;

for (int i = 0; i < arg; i++) {

int res = (fst + snd + 1) % 19845689;

fst = snd;

snd = res;

deque.emplace\_back(std::to\_string(res) + " integer");

map[i] = "integer " + std::to\_string(res);

deque.pop\_front();

if (res % 200 != 0) {

map.erase(i - 1);

}

}

return fst;

}

```

Здесь мы на каждой итерации добавляем в мапу некоторые элементы, и совершенно случайно (правда-правда) забываем их оттуда иногда удалить. Также, для отвода глаз мы немного мучаем std::deque.

Отлавливать утечки памяти мы будем двумя инструментами — **valgrind massif** и **google heapdump**.

### Massif

Запускаем программу такой командой

```

valgrind --tool=massif ./test_profiler 1000000

```

И видим что-то наподобие

**Massif**

```

time=1277949333

mem_heap_B=313518

mem_heap_extra_B=58266

mem_stacks_B=0

heap_tree=detailed

n4: 313518 (heap allocation functions) malloc/new/new[], --alloc-fns, etc.

n1: 195696 0x109A69: func(int) (new_allocator.h:111)

n0: 195696 0x10947A: main (main.cpp:18)

n1: 72704 0x52BA414: ??? (in /usr/lib/x86_64-linux-gnu/libstdc++.so.6.0.25)

n1: 72704 0x4010731: _dl_init (dl-init.c:72)

n1: 72704 0x40010C8: ??? (in /lib/x86_64-linux-gnu/ld-2.27.so)

n1: 72704 0x0: ???

n1: 72704 0x1FFF0000D1: ???

n0: 72704 0x1FFF0000E1: ???

n2: 42966 0x10A7EC: std::__cxx11::basic_string, std::allocator >::\_M\_mutate(unsigned long, unsigned long, char const\*, unsigned long) (new\_allocator.h:111)

n1: 42966 0x10AAD9: std::\_\_cxx11::basic\_string, std::allocator >::\_M\_replace(unsigned long, unsigned long, char const\*, unsigned long) (basic\_string.tcc:466)

n1: 42966 0x1099D4: func(int) (basic\_string.h:1932)

n0: 42966 0x10947A: main (main.cpp:18)

n0: 0 in 2 places, all below massif's threshold (1.00%)

n0: 2152 in 10 places, all below massif's threshold (1.00%)

```

Видно, что massif смог обнаружить утечку в функции, но пока не понятно где. Давайте пересоберем программу с флагом **-fno-inline** и запустим анализ еще раз

**massif**

```

time=3160199549

mem_heap_B=345142

mem_heap_extra_B=65986

mem_stacks_B=0

heap_tree=detailed

n4: 345142 (heap allocation functions) malloc/new/new[], --alloc-fns, etc.

n1: 221616 0x10CDBC: std::_Rb_tree_node, std::allocator > > >\* std::\_Rb\_tree, std::allocator > >, std::\_Select1st, std::allocator > > >, std::less, std::allocator, std::allocator > > > >::\_M\_create\_node, std::tuple<> >(std::piecewise\_construct\_t const&, std::tuple&&, std::tuple<>&&) [clone .isra.81] (stl\_tree.h:653)

n1: 221616 0x10CE0C: std::\_Rb\_tree\_iterator, std::allocator > > > std::\_Rb\_tree, std::allocator > >, std::\_Select1st, std::allocator > > >, std::less, std::allocator, std::allocator > > > >::\_M\_emplace\_hint\_unique, std::tuple<> >(std::\_Rb\_tree\_const\_iterator, std::allocator > > >, std::piecewise\_construct\_t const&, std::tuple&&, std::tuple<>&&) [clone .constprop.87] (stl\_tree.h:2414)

n1: 221616 0x10CF2B: std::map, std::allocator >, std::less, std::allocator, std::allocator > > > >::operator[](int const&) (stl\_map.h:499)

n1: 221616 0x10A7F5: func(int) (func.cpp:20)

n0: 221616 0x109F8E: main (main.cpp:18)

n1: 72704 0x52BA414: ??? (in /usr/lib/x86\_64-linux-gnu/libstdc++.so.6.0.25)

n1: 72704 0x4010731: \_dl\_init (dl-init.c:72)

n1: 72704 0x40010C8: ??? (in /lib/x86\_64-linux-gnu/ld-2.27.so)

n1: 72704 0x0: ???

n1: 72704 0x1FFF0000D1: ???

n0: 72704 0x1FFF0000E1: ???

n2: 48670 0x10B866: std::\_\_cxx11::basic\_string, std::allocator >::\_M\_mutate(unsigned long, unsigned long, char const\*, unsigned long) (basic\_string.tcc:317)

n1: 48639 0x10BB2C: std::\_\_cxx11::basic\_string, std::allocator >::\_M\_replace(unsigned long, unsigned long, char const\*, unsigned long) (basic\_string.tcc:466)

n1: 48639 0x10A643: std::\_\_cxx11::basic\_string, std::allocator > std::operator+, std::allocator >(char const\*, std::\_\_cxx11::basic\_string, std::allocator >&&) [clone .constprop.86] (basic\_string.h:6018)

n1: 48639 0x10A7E5: func(int) (func.cpp:20)

n0: 48639 0x109F8E: main (main.cpp:18)

n0: 31 in 1 place, below massif's threshold (1.00%)

n0: 2152 in 10 places, all below massif's threshold (1.00%)

```

Теперь ясно видно, где утечка — в добавлении элемента map-ы. Massif умеет определять короткоживущие объекты, поэтому манипуляции с std::deque в этом дампе незаметны.

### Heapdump

Для работы google heapdump необходимо прилинковать или предзагрузить библиотеку **tcmalloc**. Эта библиотека подменяет стандартные функции выделения памяти malloc, free,… Также она умеет собирать информацию об использовании этих функций, чем мы и воспользуемся при анализе программы.

Так как этот метод работает очень неторопливо (даже по сравнению с massif-ом), рекомендую сразу отключить при компиляции встраивание функций опцией **-fno-inline**. Итак, пересобираем наше приложение и запускаем с командой

```

HEAPPROFILESIGNAL=23 HEAPPROFILE=./heap ./test_profiler 100000000

```

Здесь предполагается, что библиотека tcmalloc прилинкована к нашему приложению.

Теперь, выжидаем некоторое время, необходимое для образования заметной утечки, и посылаем нашему процессу сигнал 23

```

kill -23

```

В результате появляется файл с именем heap.0001.heap, который мы конвертируем в callgrind формат командой

```

pprof ./test_profiler "./heap.0001.heap" --inuse_space --callgrind > callgrind.out.4

```

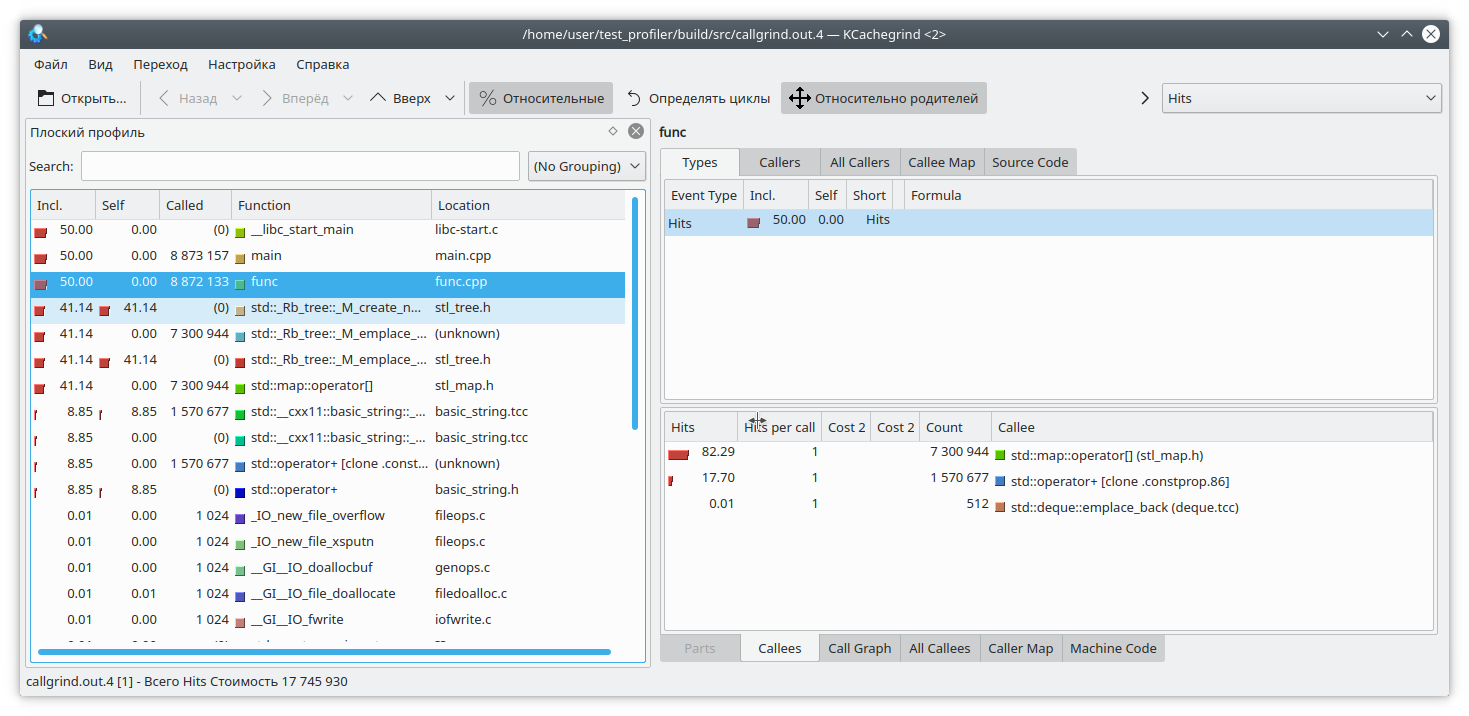

Обратите также внимание на опции pprof-а. Можно выбирать из опций **inuse\_space**, **inuse\_objects**, **alloc\_space**, **alloc\_objects**, которые показывают находящиеся в использование пространство или объекты, или выделенное за все время работы программы пространство и объекты соответственно. Нас интересует опция inuse\_space, которая показывает используемое в настоящее время пространство памяти.

Открываем наш любимый kCacheGrind и видим

[](https://habrastorage.org/webt/of/z2/j8/ofz2j88agvmi4bhfyhigracbn-i.png)

std::map «выел» слишком много памяти. Наверное утечка в нем.

Выводы

------

Профилирование на C++ — очень непростая задача. Здесь нам придется бороться с инлайнингом функций, неподдерживаемыми инструкциями, некорректными результатами и т.д. Не всегда можно доверять результатам работы профилировщика.

Кроме предложенных выше функций, есть и другие инструменты, предназначенные для профилирования — perf, intel VTune и другие. Но и они проявляют некоторые из указанных недочетов. Поэтому не стоит забывать и о «дедушкином» способе профилирования путем замера времени выполнения функций и выводе его в лог.

Также, если у вас есть интересные приемы профилирования кода, прошу выкладывать их в комментариях | https://habr.com/ru/post/482040/ | null | ru | null |

# Установка MacPorts под Mac OS X

[MacPorts](http://www.macports.org/) — система пакетов, при помощи которых довольно просто через терминал загружается, компилируется, устанавливается свободное программное обеспечение, различные библиотеки, а также обновляется MacOS X и Darwin.

Для выполнения всех вышеперечисленных действий, при наличии MacPorts, достаточно в окне терминала ввести

`port install packagename`

где ''packagename'' — имя устанавливаемого [пакета](http://www.macports.org/ports.php).

Но для того, чтобы все так же красиво работало и у вас, необходимо этот самый MacPorts установить.

Не смотря на подробнейшую [инструкцию](http://trac.macports.org/projects/macports/wiki/InstallingMacPorts), я все же столкнулась с некоторыми сложностями в установке данного программного продукта, что и подтолкнуло меня к обобщению прочитанных статей.

Если же вы собираетесь ставить MacPorts из исходников, то эта статья не для вас. Читайте [Installing MacPorts](http://trac.macports.org/projects/macports/wiki/InstallingMacPorts).

XCode

------

Как не удивительно, но для начала вам необходимо будет скачать установочный пакет вовсе не с названием MacPorts, а XCode, без которого MacPorts просто-напросто не установится.

Если у вас новопоставленная Mac OS X, тогда достаточно будет:

> \* скачать соответствующий вашей версии операционной системы установочный пакет [XCode](http://developer.apple.com/tools/xcode/) (для загрузки необходимо бесплатно зарегистрироваться в [Apple Developer Connection](https://connect.apple.com/cgi-bin/WebObjects/MemberSite.woa/101/wo/636HS2WF7yEw3Mo20lZuTSlryca/0.0.17.2.1.3.0.3))

>

> \* запустить установку Xcode Tools и установить данное приложение, используя все настройки по умолчанию

X11

---

В этом и в последующих пунктах советую быть особенно внимательными, т.к. именно при неверной настройке «иксов» у меня все и слетело.

> \* запускаем из ''/Applications/Utilities/X11.app'' (''/Программы/Служебные программы/X11.app'')

>

> \* в меню ''Программы'' выбираем пункт ''Настроить''

>

> \* двойной клик на пункте ''Terminal'', где меняем ''xterm'' на ''xterm -ls''

MacPorts

--------

> \* качаем последнюю версию [MacPorts-1.x.x.dmg](http://svn.macports.org/repository/macports/downloads/)

>

> \* двойной щелчек по MacPorts-1.x.x.pkg

>

> \* устанавливаем с настройками по умолчанию

Shell

-----

Запускаем терминал. Вводим в нем

`ls -a`

и ищем в полученном результате файл под названием ''.profile''

Если таковой отсутствует, тогда попробуем его создать:

`nano .profile`

У нас в терминале появилось окно редактирования файла. Записываем в него строку

`export PATH=/opt/local/bin:/opt/local/sbin:$PATH`

*Внимание:* если у вас Mac OS X 10.4 Tiger или более ранняя версия, тогда в файл следует также добавить следующую строку (ни в коем случае не добавляйте ее, если у вас Mac OS X 10.5 Leopard или выше):

`export DISPLAY=:0.0`

Нажимаем ctrl+O для сохранения файла.

Если такой файл у вас уже есть, тогда проделываем все то же самое, добавляя в файл выше описанные строки.

Что бы все изменения вошли в силу, необходимо перезапустить терминал.

Если все прошло успешно, тогда при вводе в терминале команды

`port`

у вас должно появится примерно следующее:

`MacPorts 1.600

Entering interactive mode... ("help" for help, "quit" to quit)

[Users/username] >`

Первое применение

-----------------

Попробуем обновить MacPorts. Для этого запустим терминал и введем в нем

`sudo port selfupdate`

или, для вывода дополнительной информации в процессе выполнения допишите -d

`sudo port -d selfupdate`

Следует заметить, что данная команда выполняется не очень быстро. Поэтому наберитесь терпения и не нажимайте лишних кнопок.

Примерный результат:

`DEBUG: Rebuilding the MacPorts base system if needed.

DEBUG: Synchronizing ports tree(s)

Synchronizing local ports tree from rsync://rsync.macports.org/

release/ports/

DEBUG: /usr/bin/rsync -rtzv --delete-after

rsync://rsync.macports.org/release/ports/

/opt/local/var/macports/sources/rsync.macports.org/release/ports

receiving file list ... done

...

Downloaded MacPorts base version 1.600

The MacPorts installation is not outdated and so was not updated

DEBUG: Setting ownership to root

selfupdate done!`

Надеюсь у вас все прошло гладко и, что самое главное, все работает.

Ресурсы

-------

1. [MacPorts.org](http://www.macports.org/)

2. [MacPorts Guide](http://guide.macports.org/)

3. [Installing MacPorts](http://trac.macports.org/projects/macports/wiki/InstallingMacPorts)

4. [MacPorts Portfiles](http://www.macports.org/ports.php) | https://habr.com/ru/post/22636/ | null | ru | null |

# Работа с прогресс диалогами

У начинающих работать с андроидом возникают вопросы по поводу создания прогресс диалогов. Моя заметка возможно поможет им.

Создать и запустить диалог можно несколькими способами, но всех их объединяет одно: все изменения видимой части пользовательского интерфейса после создания Activity должны происходить в специальном потоке. Многие об этом забывают и потом удивляются, почему не происходит видимых изменений. Простейший вариант это вызов следующей конструкции:

```

вашаАктивити.runOnUiThread(new Runnable() {

@Override

public void run() {

// Изменение видимой части

}

});

```

или для View:

```

вашеВию.post(new Runnable() {

@Override

public void run() {

// Изменение видимой части

}

});

```

Ваши команды на изменение ставятся в очередь и в определенный момент вызываются Activity. Преимущество есть, хотя на первый взгляд не очевидно. Программа перестает тормозить при каждом изменении интерфейса, все перерисовки проходят как бы фоново, программа не подвисает при исполнении каких то вычислительных задач связанных одновременно с рассчетами/загрузкой и с отображение хода процесса. С другой стороны это немного усложняет код.

Некоторые готовые функции уже запускаются в этом потоке. К таким функциям и относятся вызовы диалогов.

Не используйте создание диалогов напрямую. Для этого есть специальный механизм:

1. Назначьте каждому диалогу свой номер, например **private static final int DIALOG\_KEY = 1**.

2. Создайте диалоги и назначьте их свойства в перезаписываемом методе **onCreateDialog(int id)**.

3. Вызовите диалог на экран при помощи **showDialog(DIALOG\_KEY)** по его номеру.

4. Удалить ставшим ненужным диалог при помощи **dismissDialog(DIALOG\_KEY)**.

#### Вариант 1. Вызов диалога в Activity и прекращение работы диалог при помощи handler.

В приведенном примере вызывается обычный ListView, ему назначается адаптер. При выборе элемента списка появляется диалог загрузки и после окончания загрузки диалог удаляется. Загрузка производится в отдельном потоке для того чтобы ваша activity не зависала на время исполнения загрузки! После окончания загрузки вызывается перехватчик handler для того, чтобы отреагировать и удалить ставшим ненужным диалог загрузки.

```

public class AlphabetView extends Activity {

private static final int DIALOG_LOAD_KEY = 1;

private Activity context;

private Alphabet alphabet;

@Override

public void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.alphabet);

context = this;

alphabet = Main.getAlphabet();

ListView lv = (ListView) findViewById(R.id.ListViewMain);

lv.setAdapter(new ArrayAdapter(this, R.layout.item, alphabet.getNames()));

// Назначаем обработчик нажатий на элементе списка

lv.setOnItemClickListener(new OnItemClickListener() {

public void onItemClick(AdapterView parent, View view, int position, long id) {

final int i = position;

showDialog(DIALOG\_LOAD\_KEY); // Показываем диалог

// Запускаем в отдельном потоке загрузку ваших данных

new Thread(new Runnable() {

public void run() {

Main.loadData(i); // Вызов вашей функции загрузки

handler.sendEmptyMessage(0); // посылаем уведомление об окончании загрузки

}

}).start();

}

});

}

// Это ваш обработчик удаления диалога и к примеру запуск новой Activity

private Handler handler = new Handler() {

@Override

public void handleMessage(Message msg) {

dismissDialog(DIALOG\_LOAD\_KEY); // удаляем диалог

Intent intent = new Intent(context, AuthorsView.class);

startActivity(intent);

}

};

@Override // Здесь вы создаете все диалоги

protected Dialog onCreateDialog(int id) {

switch (id) {

case DIALOG\_LOAD\_KEY: {

ProgressDialog dialog = new ProgressDialog(this);

dialog.setMessage("Загрузка, подождите пожалуйста...");

dialog.setCancelable(true);

return dialog;

}

}

return super.onCreateDialog(id);

}

}

```

#### Вариант 2. Вызов диалога в Activity и прекращение работы диалог без handler.

В данном варианте мы не используем handler. Вместо него мы после создания диалога запускаем в отдельном потоке загрузку, а после окончания загрузки удаляем диалог при помощи вышеописанной **runOnUiThread**.

```

public class AlphabetView extends Activity {

private static final int DIALOG_LOAD_KEY = 1;

private Activity context;

private Alphabet alphabet;

@Override

public void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.alphabet);

context = this;

alphabet = Main.getAlphabet();

ListView lv = (ListView) findViewById(R.id.ListViewMain);

lv.setAdapter(new ArrayAdapter(this, R.layout.item, alphabet.getNames()));

// Назначаем обработчик нажатий на элементе списка

lv.setOnItemClickListener(new OnItemClickListener() {

public void onItemClick(AdapterView parent, View view, int position, long id) {

final int i = position;

showDialog(DIALOG\_LOAD\_KEY); // Показываем диалог

}

});

}

@Override // Здесь вы создаете все диалоги

protected Dialog onCreateDialog(int id) {

switch (id) {

case DIALOG\_LOAD\_KEY: {

final ProgressDialog dialog = new ProgressDialog(this);

dialog.setMessage("Загрузка, подождите пожалуйста...");

dialog.setCancelable(true);

new Thread(new Runnable() {

@Override

public void run() {

Main.loadData(); // Вызов вашей функции загрузки

// Удаление диалога после загрузки

runOnUiThread(new Runnable() {

@Override

public void run() {

dismissDialog(DIALOG\_LOAD\_DATA);

}

});

}

}).start();

return progressDialog;

}

}

return super.onCreateDialog(id);

}

}

```

Возможны также комбинации этих двух вариантов. К примеру в первом варианте возможно вместо hadler также использовать приведенный во втором варианте код:

```

Main.loadData(); // Вызов вашей функции загрузки

// Удаление диалога после загрузки

runOnUiThread(new Runnable() {

@Override

public void run() {

dismissDialog(DIALOG_LOAD_DATA);

}

});

```

#### Вариант 3. Вызов диалога в Activity при помощи AsyncTask.

Иногда удобнее использовать асинхронную задачу AsyncTask. Подробно это описано на [developer.android.com/resources/articles/painless-threading.html](http://developer.android.com/resources/articles/painless-threading.html).

К примеру вы по нажатию вызываете новую асинхронную задачу для загрузки вашего файла:

```

public void onClick(View v) {

new DownloadImageTask().execute("http://example.com/image.png");

}

```

DownloadImageTask расширяет класс AsyncTask в котором есть все методы для нормального отображения диалога. Для инициализации диалога используем функцию onCreateDialog приведенную в примере 1.

```

private class DownloadImageTask extends AsyncTask {

protected Bitmap doInBackground(String... urls) {

return loadImageFromNetwork(urls[0]); // ваша функция загрузки

}

protected void onPreExecute() {

showDialog(DIALOG\_LOAD\_KEY); // Показываем диалог

}

protected void onProgressUpdate() {

// Здесь мы можем обрабатывать ход прогресса загрузки.

}

protected void onPostExecute(Bitmap result) {

dismissDialog(DIALOG\_LOAD\_DATA); // удаляем диалог

}

}

```

Если кто-то предложит еще интересные варианты, буду рад. | https://habr.com/ru/post/111846/ | null | ru | null |

# ESP8266 прошивка, программирование в Arduino IDE

И снова привет [Хабр](http://habr.com/). Этот материал является продолжением моей предыдущей статьи — [ESP8266 и Arduino, подключение, распиновка](https://habr.com/ru/post/390593/), и, должен сказать, что они взаимосвязаны. Я не буду затрагивать темы, которые уже раскрыты.

А сегодня, я поведаю, как же программировать ESP8266 при помощи [Arduino IDE](https://www.arduino.cc/en/Main/Software), так же прошивать другие прошивки, например [NodeMcu](https://github.com/nodemcu/nodemcu-firmware)… Вообщем, этот материал не ограничивается только одной темой Ардуино.

Тема ESP8266 — довольно таки непростая. Но, если работать с этими Wi-Fi модулями в среде разработки [Arduino IDE](https://www.arduino.cc/en/Main/Software) — порог вхождения опускается до приемлемого для обычного ардуинщика уровня. Да и не только ардуинщика, а любого человека, у которого есть желание сварганить что-то по теме [IoT(интернет вещей)](https://geektimes.ru/hub/internet_of_things/), причём не затрачивая много времени читая документацию для микросхемы и изучение API для этих модулей.

Данное видео, полностью дублирует материал, представленный в статье ниже.

Ну что же, мы уже умеем подключать ESP8266 и переводить его в режим программирования, теперь давайте перейдём к чему-то более полезному.

Скажу сразу — один раз запрограммировав модуль в среде разработки ардуино, мы сносим родную прошивку, и у нас пропадёт возможность работать с модулем при помощи AT-команд. Лично мне, от этого, не холодно/не жарко, но если кому-то это будет нужно — ближе к концу статьи я покажу, как обратно прошить в модуль родную прошивку, ну или какой-то загручик типа NodeMcu.

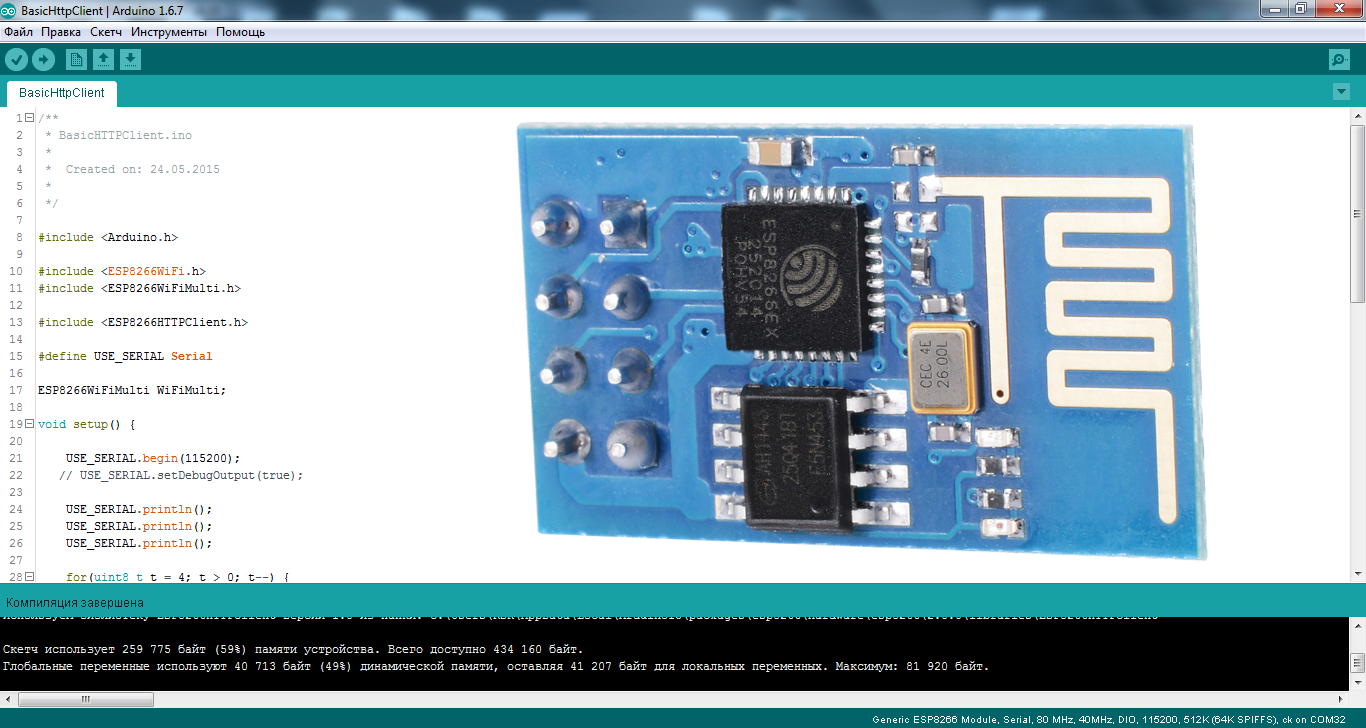

Для начала, на офф.сайте качаем последнюю версию [Arduino IDE](https://www.arduino.cc/en/Main/Software), на данный момент это 1.6.7. Более старые версии типа 1.0.5. не подойдут, потому что банально не имеют нужного функционала, а танцы с бубном нас не интересуют, не так ли?

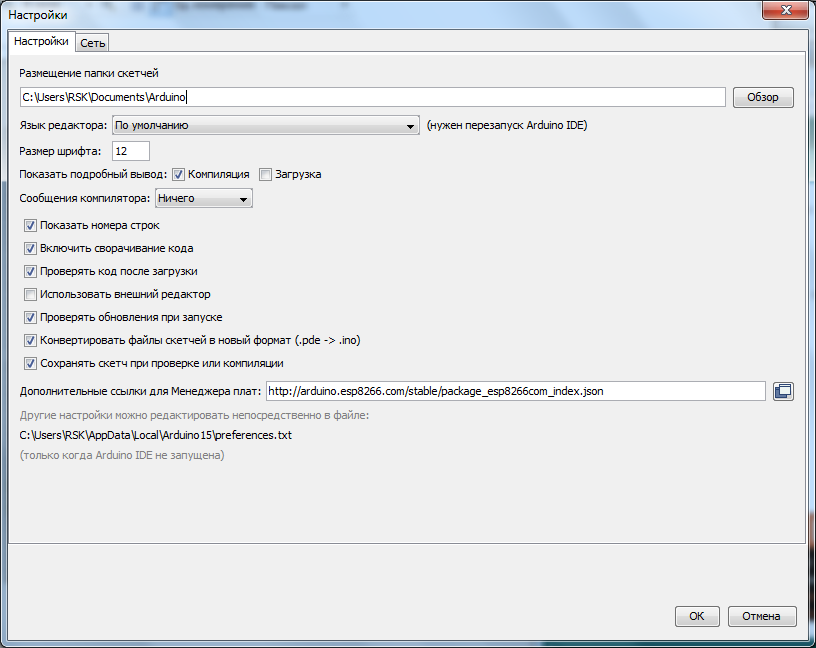

Запускаем среду разработки и тут же идём в Файл/Настройки:

Вставляем ссылку в поле «Дополнительные ссылки для Менеджера плат:» и жмём «OK».

```

http://arduino.esp8266.com/stable/package_esp8266com_index.json

```

Данную ссылку я взял на странице проекта [Arduino core for ESP8266 WiFi chip](https://github.com/esp8266/Arduino#available-versions).

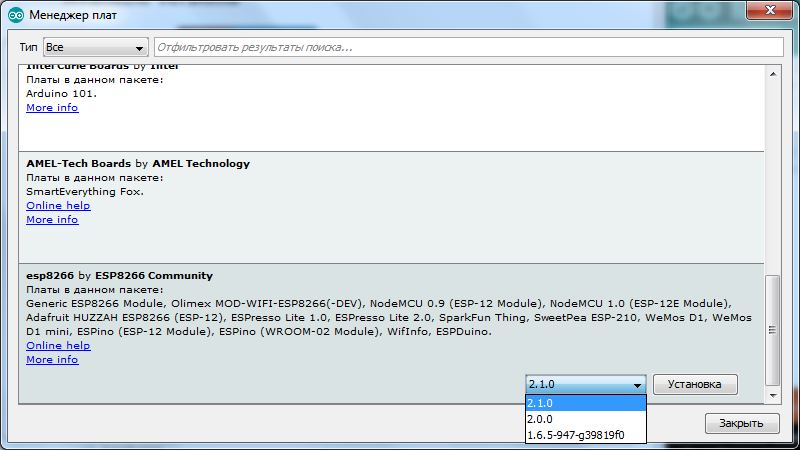

Потом идём Инструменты/Плата:/Менеджер плат...:

Перед нами появится окно менеджера плат, листаем его до самого низа, и если всё сделано правильно мы увидим что-то подобно этому:

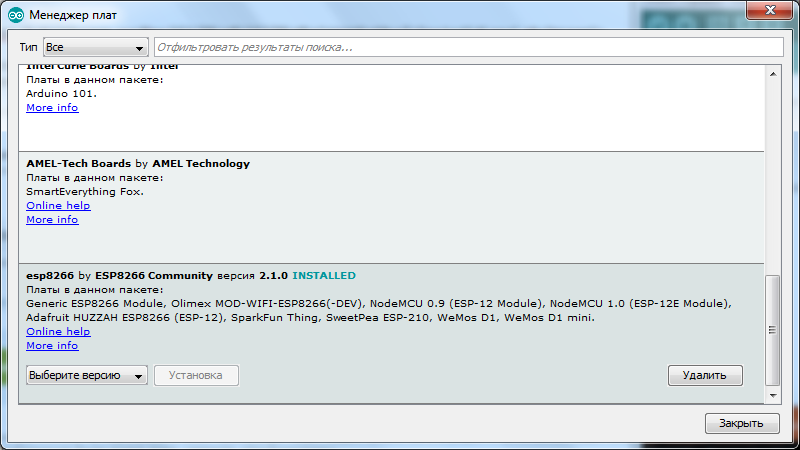

Кликаем курсором по надписи "**esp8266** by **ESP8266 Community**" после этого, у нас появилась кнопка «Установка», выбираете нужную версию, я беру последнюю, на сегодняшний день это 2.1.0. и устанавливаю её. Среда разработки закачает нужные ей файлы(около 150 мегабайт) и напротив надписи "**esp8266** by **ESP8266 Community**" появится «INSTALLED» то есть установлено:

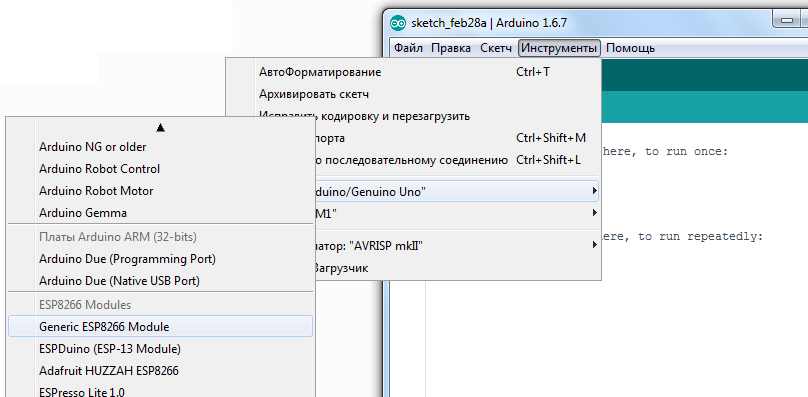

Листаем список плат вниз и видим, что в списке у нас появилось много разных ESP, берём «Generic ESP8266 Module»:

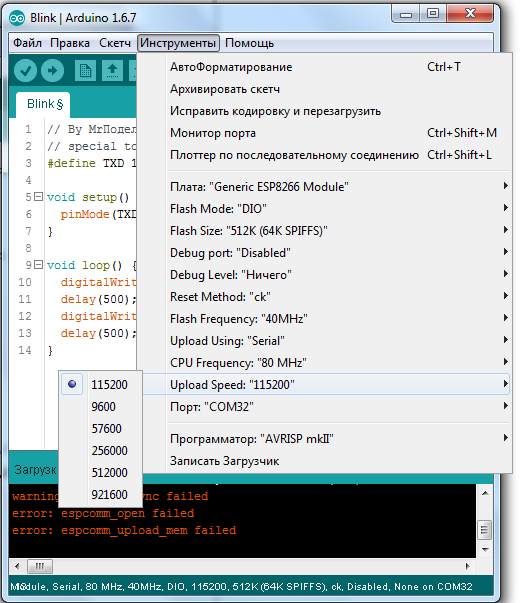

Идём в «Инструменты» и выбираем нужный COM порт(у меня это COM32) [Arduino или USB UART конвертора](https://geektimes.ru/post/271078/), потом ставим Upload Speed:«115200»:

Далее открываем консоль в Arduino IDE, подаём питание на модуль, если всё было сделано правильно, то мы увидим что-то в этом роде:

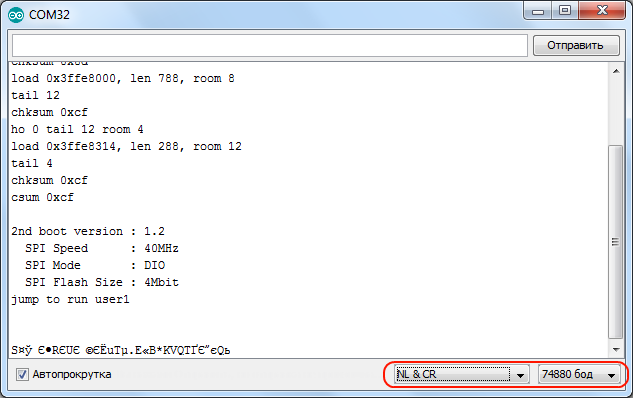

Выставляем скорость 74880 и «NL & CR» и опять же отключаем и подаём питание и он ответит кое какой отладочной информацией:

Заметьте, 74880 — не основная скорость ESP8266, просто он всего лишь на ней отправляет отладочную информацию. Если модуль ничего не отправляет в консоль, тогда возможно что-то подключили не так как надо.

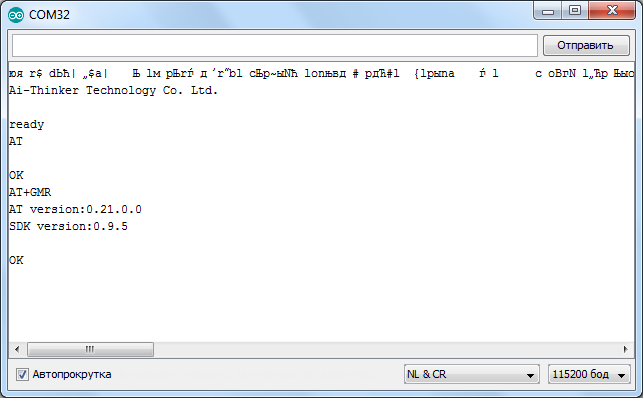

По умолчанию скорость должна быть 115200, но в отдельных случаях может быть и 9600 и другие… Так что попробуйте подобрать.

После подбора нужной скорости отправляем модулю «AT» и он должен ответить что всё «ОК». Команда «AT+GMR» выводит информацию о прошивке.

**Прежде чем начать прошивать ESP8266 в Arduino IDE я советую дочитать статью до конца.**

Теперь давайте попробуем прошить ESP8266 через Arduino IDE. Переводим модуль в режим программирования(как это сделать я писал в [предыдущей статье](https://geektimes.ru/post/271078/)).

Давайте зашьём мигалку штатным светодиодом:

```

// By MrПоделкинЦ youtube.com/RazniePodelki

// special to geektimes.ru/post/271754/

#define TXD 1 // GPIO1/TXD01

void setup() {

pinMode(TXD, OUTPUT);

}

void loop() {

digitalWrite(TXD, HIGH);

delay(1000);

digitalWrite(TXD, LOW);

delay(1000);

}

```

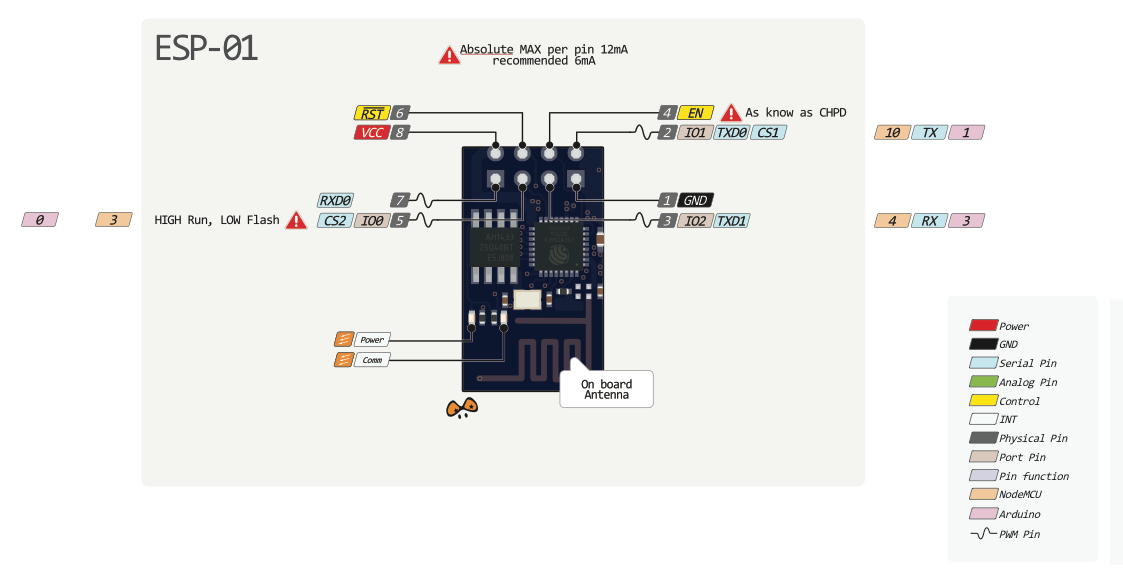

Замигал? Значит всё сделано правильно. Откуда я взял что светодиод подключен на первый пин? В предыдущей статье есть [картинка с распиновкой разных модулей](http://www.pighixxx.com/test/2015/09/esp8266-pinout/), и там есть разметка портов, при использовании загрузчика Arduino(пины отмечены розовым цветом).

Мигание светодиодом это конечно хорошо, но надо бы какой-то веб-сервер заделать или начать управлять светодиодом хотя бы при помощи кнопок в браузере, не так ли? Но об этом я расскажу уже как-нибудь в другой раз.

А теперь **как прошить назад родную прошивку**, да и как вообще прошивать модуль сторонними загрузчиками. Для ESP8266 есть такая программа как [NodeMCU Flasher](https://github.com/nodemcu/nodemcu-flasher), которая изначально предназначена для прошивки загрузчика [NodeMCU](https://github.com/nodemcu/nodemcu-firmware). Но как оказалось, она отлично прошивает и другие прошивки.

Я прикреплю к статье архив с данной программой и прошивкой для удобства, но [тут](https://github.com/nodemcu/nodemcu-flasher) всегда можно скачать новую версию NodeMCU Flasher.

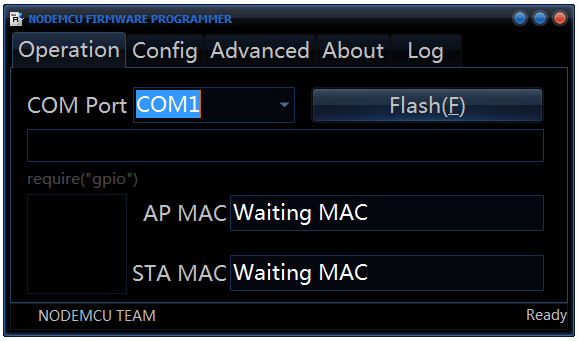

В папке «nodemcu-flasher-master» есть 2 папки Win64 и Win32 и в зависимости от того какая разрядность у вашей ОС выбираем нужную. Дальше в папке Release запускаем «ESP8266Flasher.exe» и видим интерфейс программы:

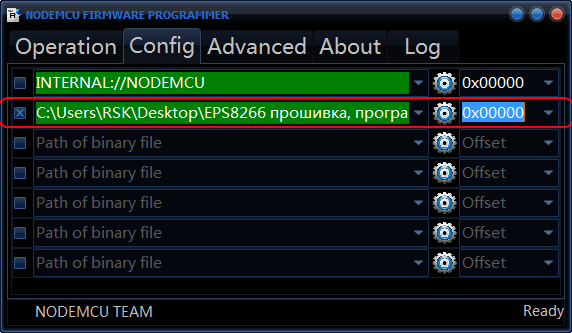

Выбираем нужный COM порт и идём во вкладку «Config», убираем хрестик около «INTERNAL://NODEMCU» и ставим его на один пункт ниже, как на скрине:

(Если захотите прошить загрузчик NodeMCU — убираете хрестик там где его не было, и ставите — где он был, то есть около «INTERNAL://NODEMCU»).

Потом жмём по шестеренке и выбираем где лежит наша прошивка, прошивка как правило в формате \*.bin(в прикреплённом архиве это «v0.9.5.2 AT Firmware.bin» которая лежит в основной папке), и так же выбираем «0x00000» как и выше.

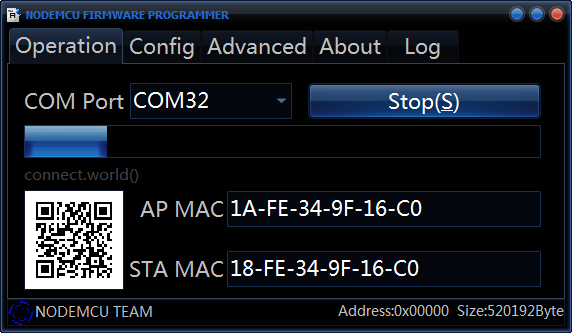

Дальше идём во вкладку «Advanced» и меняем там скорость на 115200, именно эта скорость будет основная и модуль будет отзываться по ней на AT-команды в случае соответствующей прошивки.

Возвращаемся опять на вкладку «Operation» переводим модуль в режим программирования и жмём «Flash»:

Всё, модуль начал прошиваться, после перепрошивки не забываем перезагрузить модуль и вуаля, он прошит нужной нам прошивкой.

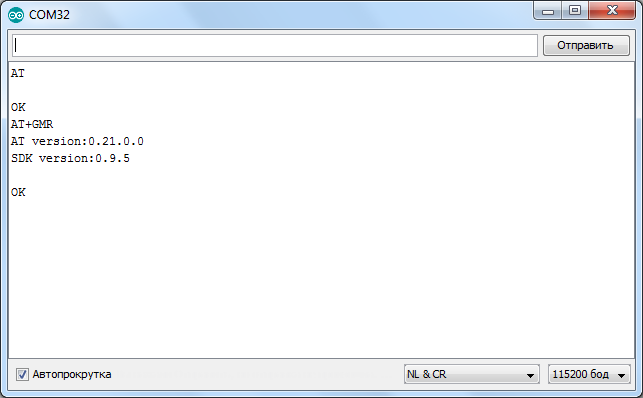

Проверяем AT-командой «AT+GMR» сделали ли мы всё верно:

Как видите всё нормально прошилось.

Ссылки:

[Архив с NodeMCU Flasher, прошивкой и кодом для Arduino IDE](https://vk.com/doc256435878_437314884);

[ESP8266 и Arduino, подключение, распиновка](https://geektimes.ru/post/271078/);

[Свежая версия Arduino IDE всегда лежит тут](https://www.arduino.cc/en/Main/Software);

[NodeMCU Flasher](https://github.com/nodemcu/nodemcu-flasher);

[Русскоязычное сообщество по ESP8266](http://esp8266.ru/);

[Много разных прошивок к ESP8266](http://esp8266.ru/downloads/esp8266-firmware/#wpfb-cat-2);

[Все мои публикации на geektimes](http://geektimes.ru/users/hwman/topics/).

By Сергей ПоделкинЦ ака MrПоделкинЦ.

**P.S.**

Уже на подходе плата на базе esp32:

<http://www.pighixxx.com/test/2015/12/esp32-pinout/>

Которая значительно круче чем esp8266, так что нас скоро ждёт бум, как мне кажется, темы [IoT(интернет вещей)](https://geektimes.ru/hub/internet_of_things/). | https://habr.com/ru/post/371853/ | null | ru | null |

# UI для Firebird на Java

#### Вступление

Год назад потребовалось написать БД в рамках курсовой работы. Особого труда это не вызвало. Выбрал тему, начертил ER-диаграмму, определился с полями таблиц и начал написание. Язык долго не выбирал, на тот момент начинал работать на Java в Eclipse. Выбрал СУБД, мой выбор пал на Firebird. Добавил таблиц через IBExpert и был всем доволен, как только написал UI для пары таблиц понял что можно создавать остальные с помощью копипаста. Код получился ужасный(ООП? не не слышал, так можно это было охарактеризовать), но на тот момент меня все радовало. Прошел год и по воле случая пришлось пересматривать свой код. Это было нечто страшное с непонятной структурой.

Перед собой решил поставить несколько целей:

— простое добавление таблиц

— применить, наконец, ООП

— применить шаблоны проектирования(для обучения)

Также сейчас непонятно почему людям в институте сложно писать простые БД (или лень), в любом случае, хочу показать простоту написания БД и познакомить со своим видением приложения (на мой взгляд очень простым).

#### Начало работы

Для написания БД нам потребуется

— Eclipse IDE for java developers

— Firebird

— Jaybird ( JDBC драйвер, по сути jar библиотека )

— IBExpert ( для добавления таблиц )

Все это можно просто скачать, поэтому вопрос о настройке environment'a пропущу. В этой статье реализую интерфейс для одной таблицы, т.к. остальные таблицы можно будет легко добавить.

#### Написание кода

У нас будет всего одна таблица Ranks с колонками ID и RANK.

Для написания интерфейса выбрал Swing.

Обязанности интерфейса будут такие

— Выбор таблицы

— Вывод\ Обновление таблицы

— Добавление\ Удаление\ Вставка записи

В итоге у нас будет вот такой интерфейс

Архитектуру приложения представляю следующим образом

— главный класс с main(..) (Application)

— соединение с нашей БД (DBHelper)

— общая модель для любой таблицы (AbsTable, Tables)

— базовый класс для всех таблиц(BaseFrame) и классы таблиц наследников (RankFrame)

— класс, создающий компоненты (Components)

— вспомогательный класс для строк, навеяно андроидом (Strings)

##### Написание модели таблицы

Тип наших данных, очевидно, ID — Integer и Rank — String. Названия колонок очевидны.

Заносим данные эти данные в наш класс Tables. Все вновь создаваемые таблицы тоже требуется описать здесь, по заданному шаблону.

```

public class Tables {

public static final Class[] RANKS_TYPE = {

Integer.class,

String.class

};

public static final String[] RANKS_TABLE = {

"ID",

"Rank"

};

}

```

Также создаем класс AbsTable(наследованный от AbstractTableModel), который реализует модель для данных в таблице, нужно переопределить несколько методов базового класса. Реализация простая, принимает данные из класса Tables, для создания матрицы данных. Так можно модель для таблиц в общем виде и избежать бесполезного копирования кода для каждой таблицы.

```

public class AbsTable extends AbstractTableModel {

private List mColumnNames;

private List> mTableData;

private List mColumnTypes;

public AbsTable(Class[] types, String[] columns) {

mColumnTypes = new ArrayList(types.length);

mColumnNames = new ArrayList(columns.length);

for (int i = 0; i < columns.length; ++i) {

mColumnTypes.add(i, types[i]);

mColumnNames.add(columns[i]);

}

}

@Override

public int getColumnCount() {

return mColumnNames.size();

}

@Override

public int getRowCount() {

return mTableData.size();

}

@Override

public Object getValueAt(int row, int column) {

return mTableData.get(row).get(column);

}

public String getColumnName(int column) {

return mColumnNames.get(column);

}

@Override

public boolean isCellEditable(int row, int column) {

return false;

}

@Override

public void setValueAt(Object obj, int row, int column) {

}

@Override

public Class getColumnClass(int col) {

return (Class) mColumnTypes.get(col);

}

public void setTableData(ArrayList> tableData) {

mTableData = tableData;

}

}

```

##### Соединение с БД

Соединение у нас одно, поэтому класс выполнил с помощью Singleton. Создать соединение можно через метод getInstance(), который подключается к БД с заданным логином/ паролем/ путем до файла FDB с помощью метода connect(). Для нашей модели мы будем брать данные с помощь метода getData(String sql). Также когда нам соединение больше не требуется его требуется закрыть, для этого используем метод release().

```

public class DBHelper {

private Connection dbConnection;

private static DBHelper sDBHelper ;

private static final String DRIVER = "org.firebirdsql.jdbc.FBDriver";

private static final String URL = "jdbc:firebirdsql:localhost/3050:C:\\DB\\DB.FDB";

private static final String LOGIN = "SYSDBA";

private static final String PASSWORD = "masterkey";

public static synchronized DBHelper getInstance() {

if (sDBHelper == null) {

sDBHelper = new DBHelper ();

}

return sDBHelper ;

}

private DBHelper () {

}

public void connect() {

try {

Class.forName(DRIVER);

dbConnection = DriverManager.getConnection(URL, LOGIN, PASSWORD);

} catch (ClassNotFoundException ex) {

ex.printStackTrace();

} catch (SQLException e) {

e.printStackTrace();

}

}

public PreparedStatement getPrepareStatement(String sql)

throws SQLException {

return dbConnection.prepareStatement(sql);

}

public synchronized ArrayList> getData(String query) {

ArrayList> dataVector = new ArrayList>();

Statement st = null;

ResultSet rs = null;

try {

st = dbConnection.createStatement();

rs = st.executeQuery(query);

int columns = rs.getMetaData().getColumnCount();

while (rs.next()) {

ArrayList nextRow = new ArrayList(columns);

for (int i = 1; i <= columns; i++) {

nextRow.add(rs.getObject(i));

}

dataVector.add(nextRow);

}

} catch (SQLException e) {

e.printStackTrace();

} finally {

if (rs != null) {

try {

rs.close();

} catch (SQLException e) {

e.printStackTrace();

}

}

if (st != null) {

try {

st.close();

} catch (SQLException e) {

e.printStackTrace();

}

}

}

return dataVector;

}

public void release() {

if (sDBHelper != null) {

sDBHelper = null;

}

if (dbConnection != null) {

try {

dbConnection.close();

} catch (SQLException e) {

e.printStackTrace();

}

}

}

}

```

##### Создание компонент

Нам потребуются такие компоненты как JTable, JScrollPane, JComboBox, JLabel, JTextField, JButton. Сделан класс во избежание бесполезного копирования кода создания компонент при создании таблиц.

```

public class Components {

public static AbsTable createTableModel(Class[] types, String[] col,

String sql) {

AbsTable table = new AbsTable(types, col);

table.setTableData(DBHelper .getInstance().getData(sql));

return table;

}

public static JTable createTable(AbsTable model) {

JTable table = new JTable(model);

table.getColumnModel().getColumn(0).setMaxWidth(50);

return table;

}

public static JScrollPane createScroll(JTable table) {

return new JScrollPane(table);

}

public static JComboBox createCombo(String[] items,

ItemListener listener) {

JComboBox combo = new JComboBox(items);

combo.setEditable(false);

combo.setSelectedIndex(-1);

combo.addItemListener(listener);

return combo;

}

public static JLabel createLabel(String name) {

JLabel label = new JLabel(name);

label.setHorizontalTextPosition(JLabel.LEFT);

label.setIconTextGap(5);

label.setForeground(Color.black);

return label;

}

public static JTextField createEdit(String text) {

JTextField tf= new JTextField(text);

tf.setEditable(true);

tf.setForeground(Color.black);

return tf;

}

public static JButton createButton(String name, ActionListener listener) {

JButton button = new JButton(name);

button.addActionListener(listener);

return button;

}

}

```

##### Вывод таблиц на фрэйм и интерфейс работы с таблицей

Мы уже определили что обязанности интерфейса это вывод таблицы, добавление\обновление\удаление\изменение таблицы. Поэтому создадим базовый абстрактный класс BaseFrame, наследованный от JFrame.

Исходя из обязанностей все таблицы должны обновляться, обеспечивать добавление\удаление\изменение записей, поэтому методы add(), delete(), save(), updateTable делаем абстрактными для всех таблиц. Также в базовом классе должна быть ссылка на соединение(это у нас DBHelper ).

На фрэйме у нас будет

— таблица JTable

— кнопки JButton добавить\сохранить\удалить запись

— скролл JScrollPane для большого числа записей

Все это одинаково для всех создаваемых таблиц поэтому располагается в базовом классе. С класса Components создаем кнопки и назначаем им листенеры(слушатели) действий. Также расширяем базовый класс с помощью интерфейса ListSelectionListener, чтобы ловить события нажатия на ячейки нашей таблицы.

```

abstract class BaseFrame extends JFrame implements ListSelectionListener {

protected JButton mDeleteBtn;

protected JButton mAddBtn;

protected JButton mSaveBtn;

protected JPanel mControlArea;

protected JPanel mEditArea;

protected JScrollPane mScroll;

protected JTable mTable;

protected Container mContainer;

protected AbsTable mTableModel;

protected DBHelper sDBHelper ;

private static final int SIZE_X = 300;

private static final int SIZE_Y = 450;

public BaseFrame(String name) {

super(name);

sDBHelper = DBHelper .getInstance();

sBDHelper.connect();

mAddBtn = Components.createButton(Strings.ADD, new ActionListener() {

@Override

public void actionPerformed(ActionEvent e) {

add();

}

});

mDeleteBtn = Components.createButton(Strings.DELETE,

new ActionListener() {

@Override

public void actionPerformed(ActionEvent e) {

delete();

}

});

mSaveBtn = Components.createButton(Strings.SAVE, new ActionListener() {

@Override

public void actionPerformed(ActionEvent e) {

save();

}

});

setSize(new Dimension(SIZE_X, SIZE_Y));

setVisible(true);

setDefaultCloseOperation(JFrame.DISPOSE_ON_CLOSE);

}

abstract void updateTable();

abstract void add();

abstract void delete();

abstract void save();

}

```

Наконец создаем нашу таблицу. Для её редактирования понадобится 2 JTextField и 2 JLabel. Создаем наши компоненты с помощью класса Component. Добавляем компоненты на фрэйм. Далее требуется переопределить абстрактные методы базового класса для работы с БД(добавление\изменение\удаление записей). Для написания этих методов потребуется немного знания SQL. Не забываем обновлять интерфейс таблицы с помощью переопределенного метода updateTable. Также переопределяем метод valueChanged(..) для обработки нажатия по ячейке.

```

public class RanksFrame extends BaseFrame {

private JLabel mIdLabel;

private JLabel mRankLabel;

private JTextField mIdEdit;

private JTextField mRankEdit;

public RanksFrame() {

super(Strings.RANK);

mContainer = getContentPane();

mTableModel = Components.createTableModel(Tables.RANKS_TYPE,

Tables.RANKS_TABLE, "SELECT * FROM RANKS ORDER BY ID");

mTable = Components.createTable(mTableModel);

mScroll = Components.createScroll(mTable);

mIdLabel = Components.createLabel(Strings.ID);

mIdEdit = Components.createEdit("");

mRankLabel = Components.createLabel(Strings.RANK);

mRankEdit = Components.createEdit("");

mTable.getSelectionModel().addListSelectionListener(this);

mControlArea = new JPanel(new GridLayout(1, 3));

mEditArea = new JPanel(new GridLayout(2, 2));

mEditArea.add(mIdLabel);

mEditArea.add(mIdEdit);

mEditArea.add(mRankLabel);

mEditArea.add(mRankEdit);

mControlArea.add(mSaveBtn);

mControlArea.add(mDeleteBtn);

mControlArea.add(mAddBtn);

mContainer.add(mScroll);

mContainer.add(mEditArea);

mContainer.add(mControlArea);

mContainer.setLayout(new BoxLayout(mContainer, BoxLayout.Y_AXIS));

}

@Override

public void updateTable() {

SwingUtilities.invokeLater(new Runnable() {

public void run() {

mTableModel.setTableData(sBDHelper

.getData("SELECT * FROM RANKS ORDER BY ID"));

mTable.updateUI();

mRankEdit.setText(null);

mIdEdit.setText(null);

}

});

}

@Override

public void add() {

PreparedStatement ps = null;

try {

ps = sBDHelper

.getPrepareStatement("INSERT INTO RANKS (ID,RANK) VALUES(?,?)");

ps.setString(1, mIdEdit.getText());

ps.setString(2, mRankEdit.getText());

ps.executeUpdate();

} catch (SQLException r) {

r.printStackTrace();

} finally {

if (ps != null) {

try {

ps.close();

} catch (SQLException e) {

e.printStackTrace();

}

}

updateTable();

}

}

@Override

public void delete() {

PreparedStatement ps = null;

try {

ps = sBDHelper.getPrepareStatement("DELETE FROM RANKS WHERE ID=?");

ps.setString(1, mIdEdit.getText());

ps.executeUpdate();

} catch (SQLException r) {

r.printStackTrace();

} finally {

if (ps != null) {

try {

ps.close();

} catch (SQLException e) {

e.printStackTrace();

}

}

updateTable();

}

}

@Override

public void save() {

PreparedStatement ps = null;

try {

ps = sBDHelper

.getPrepareStatement("UPDATE RANKS SET RANK=? WHERE ID=?");

ps.setString(1, mRankEdit.getText());

ps.setString(2, mIdEdit.getText());

ps.executeUpdate();

} catch (SQLException r) {

r.printStackTrace();

} finally {

if (ps != null) {

try {

ps.close();

} catch (SQLException e) {

e.printStackTrace();

}

}

updateTable();

}

}

@Override

public void valueChanged(ListSelectionEvent e) {

mIdEdit.setText(mTable.getModel()

.getValueAt(mTable.getSelectedRow(), 0).toString());

mRankEdit.setText(mTable.getModel()

.getValueAt(mTable.getSelectedRow(), 1).toString());

}

}

```

##### Конец близок, интерфейс выбора таблицы

Пишем код главного окна БД. Интерфейс выбора выглядит как JComboBox с названиями таблиц mTables. По нажатию срабатывает switch к выбранной таблицы, здесь нужно будет добавлять все наши таблицы для их создания. Ох, наконец, для обработки закрытия нашего приложения используем интерфейс WindowListener(написал только метод который использую, остальные выкинул ибо итак много кода), при закрытии закрываем соединение.

```

public class Application extends JFrame implements WindowListener {

private String[] mTables = { "Ranks" };

private static final int RANKS = 0;

private JComboBox mComboMenu;

public Application() throws SQLException {

super(Strings.DB\_NAME);

mComboMenu = Components.createCombo(mTables,

new ItemListener() {

@Override

public void itemStateChanged(ItemEvent evt) {

switch (mComboMenu.getSelectedIndex()) {

case RANKS:

new RanksFrame();

break;

}

SwingUtilities.invokeLater(new Runnable() {

public void run() {

mComboMenu.setSelectedIndex(-1);

}

});

}

});

Container container = getContentPane();

container.add(mComboMenu);

container.setLayout(new BoxLayout(container, BoxLayout.Y\_AXIS));

setDefaultCloseOperation(JFrame.EXIT\_ON\_CLOSE);

setSize(400, 80);

setResizable(false);

setVisible(true);

addWindowListener(this);

}

public static void main(String[] args) throws SQLException {

new Application();

}

@Override

public void windowClosing(WindowEvent arg0) {

DBHelper .getInstance().release();

}

}

```

#### Заключение

Надеюсь не утомил, статья носит обучающий характер, поэтому надеюсь написание/создание таблиц БД после прочтения данной статьи облегчится. Также преследую призрачную надежду того, что студенты, наконец, сядут и напишут сами базу данных.

P.S. Надеюсь мой рефакторинг удался и все выглядит просто и наглядно. Критика приветствуется, особенно по шаблонам проектирования.

upd:

Vector -> ArrayList спасибо javax

За множество недочетов спасибо gvsmirnov и aleksandy | https://habr.com/ru/post/145531/ | null | ru | null |

# Используем статические ссылки на свойства объектов при помощи лямбд

Так уж исторически сложилось, что в Java для свойств объектов (properties) не предусмотрено никакой физической сущности. Свойства в Java — это некоторые соглашения в именовании полей и методов доступа к ним (аксессоров). И, хотя наличие физических свойств в языке упростило бы множество кейсов (начиная от глупой генерации геттеров-сеттеров), судя по всему, в ближайшем будущем в Java ситуация не изменится.

Тем не менее, разрабатывая многослойные бизнес приложения и используя различные фреймворки для меппинга и связки (binding) данных, часто бывает необходимо передать ссылку на свойство объекта. Рассмотрим какие для этого есть варианты.

Использовать имя свойства

-------------------------

Пока что единственным общепринятым способом сослаться на свойство объекта является строка с его именем. Низлежащая библиотека использует reflection или introspection для поиска методов-аксессоров и доступа к полям. Для ссылки ко вложенным объектам как правило используется следующая нотация:

```

person.contact.address.city

```

Проблема такого способа — отсутствие всяческого контроля над написанием имени и типом свойства со всеми вытекающими:

* Нет контроля ошибок на стадии компиляции. Можно ошибиться в имени, можно применить не к тому классу, не контролируется тип свойства. Приходится дополнительно писать достаточно глупые тесты.

* Нет поддержки со стороны IDE. Сильно утомляет, когда мепите 200+ полей. Хорошо если в наличии для этого есть джун, которому можно все сбагрить.

* Сложный рефакторинг кода. Поменяйте название поля, и сразу много что отвалится. Хорошие IDE выведут еще стопицот мест, где встречается похожее слово.

* Поддержка и анализ кода. Хотим посмотреть, где используется свойство, но “Find Usages” не покажет строки.

В итоге мы все же хотим иметь статическую типобезопасную ссылку на свойство. Наилучшим кандидатом на эту роль будет геттер, потому как:

* Привязан к конкретному классу

* Содержит имя свойства

* Имеет тип

Каким образом можно сослаться на геттер?

Проксирование

-------------

Одним из интересных способов является проксирование (или мокирование) объектов для перехвата цепочки вызовов геттеров, который используется в некоторых библиотеках: [Mockito](https://site.mockito.org/), [QueryDSL](http://querydsl.com/), [BeanPath](https://github.com/CUSTIS-public/beanpath). По поводу последней на Хабре [была статья](https://habr.com/ru/company/custis/blog/243803/) от автора.

Идея достаточно проста, но нетривиальна в реализации (пример из упомянутой статьи).

```

Account account = root(Account.class);

tableBuilder.addColumn( $( account.getCustomer().getName() ) );

```

При помощи динамической кодогенерации создается специальный прокси-класс, который наследуется от класса бина и перехватывает все вызовы геттеров в цепочке, конструируя путь в ThreadLocal-переменной. При этом вызова настоящих геттеров объекта не происходит.

В данной статье мы рассмотрим альтернативный способ.

Ссылки на методы

----------------

С появлением Java 8 пришли лямбды и возможность использовать ссылки на методы. Поэтому натурально было бы иметь что-то вроде:

```

Person person = …

assertEquals("name", $(Person::getName).getPath());

```

Метод $ принимает следующую лямбду в которой передается ссылка на геттер:

```

public interface MethodReferenceLambda extends Function, Serializable {}

...

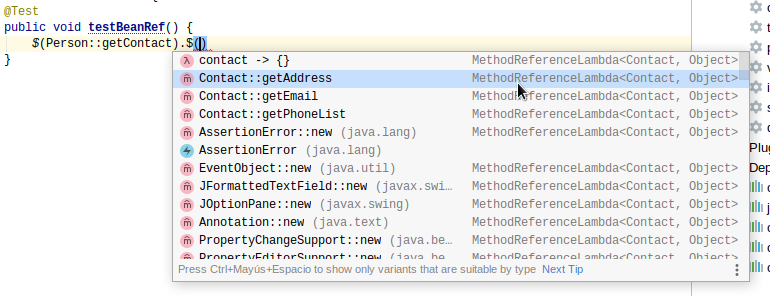

public static BeanProperty $(MethodReferenceLambda methodReferenceLambda)

```

Проблема в том, что благодаря стиранию типов, нет никакой возможности в рантайме получить типы BEAN и TYPE, а также отсутствует любая информация об имени геттера: метод, который вызывается “снаружи” — это Function.apply().

Тем не менее существует определенный трюк — это использование сериализованной лямбды.

```

MethodReferenceLambda lambda = Person::getName();

Method writeMethod = lambda.getClass().getDeclaredMethod("writeReplace");

writeMethod.setAccessible(true);

SerializedLambda serLambda = (SerializedLambda) writeMethod.invoke(lambda);

String className = serLambda.getImplClass().replaceAll("/", ".");

String methodName = serLambda.getImplMethodName();

```

Класс SerializedLambda содержит всю необходимую информацию о вызываемом классе и методе. Дальше дело техники.

Поскольку я много работаю со структурами данных, этот метод сподвиг меня на написание небольшой библиотечки для статического доступа к свойствам.

Библиотека BeanRef

------------------

Использование библиотеки выглядит это примерно так:

```

Person person = ...

// цепочечная ссылка вложенное свойство

final BeanPath personCityProperty =

$(Person::getContact).$(Contact::getAddress).$(Address::getCity);

assertEquals("contact.address.city", personCityProperty.getPath());

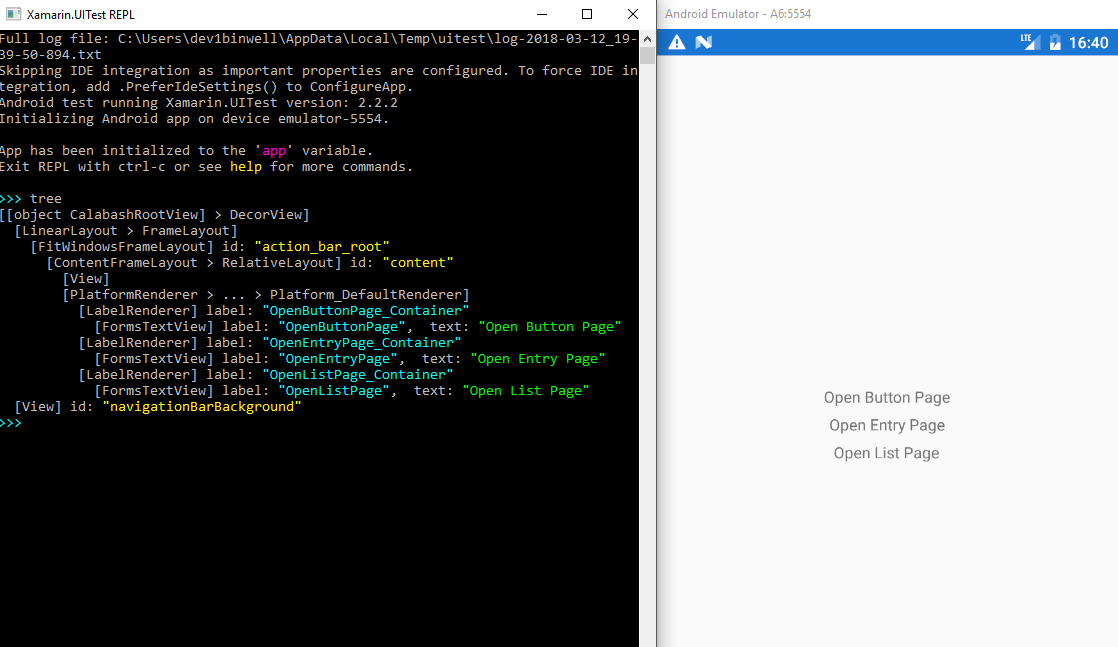

```

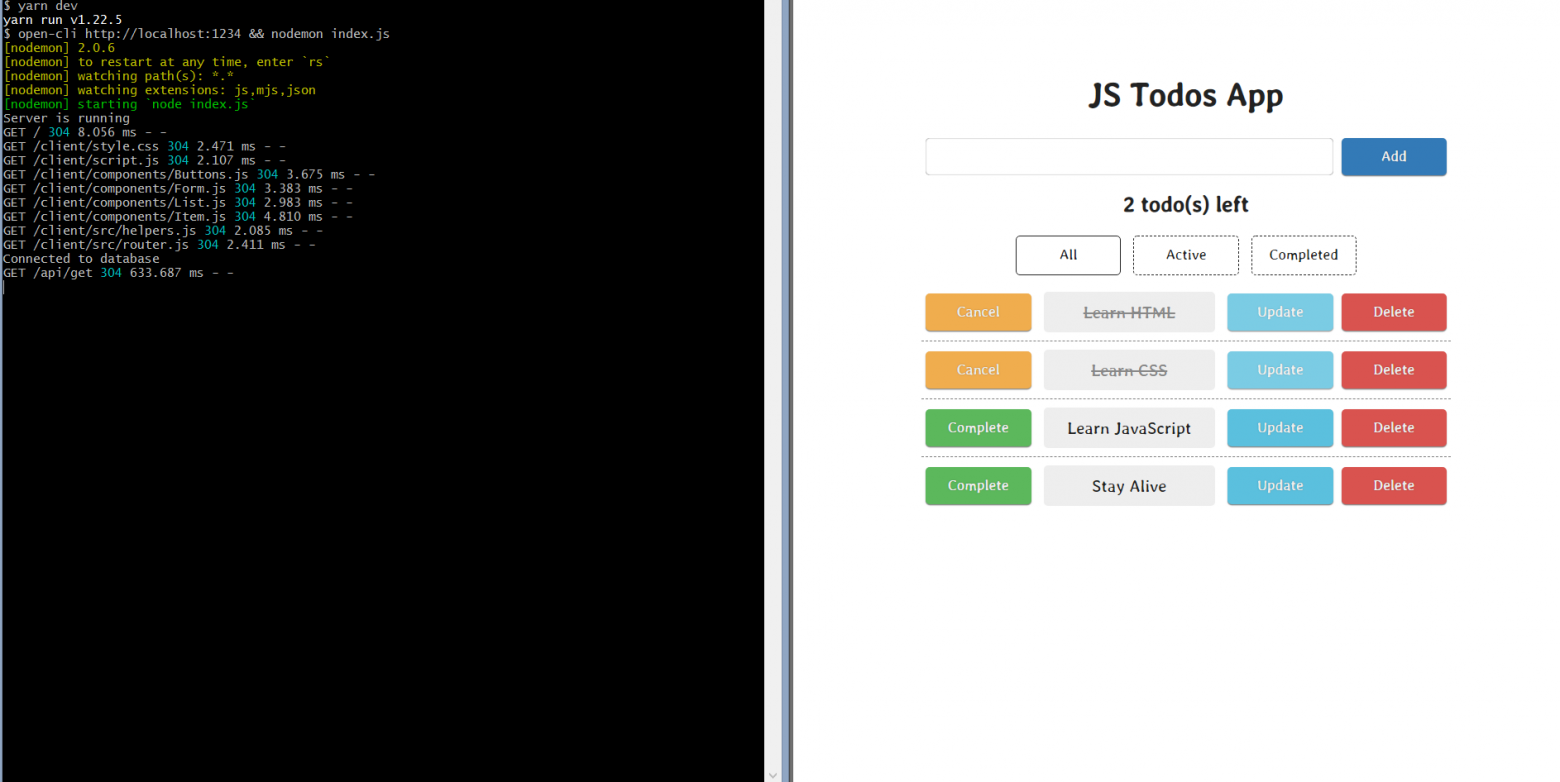

и не требует магии кодогенерации и сторонних зависимостей. Вместо цепочки геттеров используется цепочка лямбд со ссылкой на геттеры. При этом соблюдается типобезопасность и достаточно неплохо работает IDE-шное автодополнение:

Можно использовать имя геттера как в стандартной нотации (getXXX()/isXXX()), так и нестандартной (xxx()). Библиотека попытается найти соответствующий сеттер, и, если он отсутствует, то свойство объявляется read-only.

Для ускорения производительности отрезольвенные свойства кэшируются, и при повторном вызове с той же лямбдой выдается уже сохраненный результат.

Помимо имени свойства/пути при помощи объекта BeanPath можно получить доступ к значению свойства объекта:

```

Person person = ...

final BeanPath personCityProperty =

$(Person::getContact).$(Contact::getAddress).$(Address::getCity);

String personCity = personCityProperty.get(person);

```

При этом если промежуточный объект в цепочке null, то соответствующий вызов вернет также null вместо NPE. Это сильно упростит код, не требуя ставить проверки.

Через BeanPath также можно менять значение свойства объекта, если оно не read-only:

```

personCityProperty.set(person, “Madrid”);

```

Следуя той же идее — как можно меньше NPE — в этом случае если один из промежуточных объектов в цепочке null, то библиотека попытается автоматически его создать и сохранить в поле. Для этого соответствующее свойство должно быть writeable, а класс объекта иметь публичный конструктор без параметров.

В качестве экспериментальной фичи предлагается возможность работы с коллекциями. Для некоторых особых случаев иногда приходится конструировать пути, ссылаясь на объекты внутри коллекции. Для этого предусмотрен метод $$, который конструирует ссылку на последний элемент коллекции (считая его единственным).

```

final BeanPath personPhonePath =

$(Person::getContact).$$(Contact::getPhoneList).$(Phone::getPhone);

assertEquals("contact.phoneList.phone", personPhonePath.getPath());

assertEquals(personPhonePath.get(person), person.getContact().getPhoneList()

.get(person.getContact().getPhoneList().size()-1).getPhone());

```

Проект хостится тут: <https://github.com/throwable/beanref>, бинарники доступны из maven-репозитория jcenter.

Полезняшки

----------

[java.beans.Introspector](https://docs.oracle.com/javase/9/docs/api/java/beans/package-summary.html)

Класс Introspector из стандартной RT джавы позволяет резольвить свойства бинов.

[Apache Commons BeanUtils](https://commons.apache.org/proper/commons-beanutils/javadocs/v1.8.3/apidocs/org/apache/commons/beanutils/package-summary.html)

Наиболее полная библиотека для работы с Java Beans.

[BeanPath](https://github.com/CUSTIS-public/beanpath)

Упомянутая библиотека, которая делает то же самое через проксирование.

[Objenesis](http://objenesis.org/)

Инстанциируем объект любого класса с любым набором конструкторов.

[QueryDSL Aliases](http://www.querydsl.com/static/querydsl/2.1.0/reference/html/ch03s04.html)

Использование проксированных классов для задания критериев в QueryDSL

[Jinq](http://www.jinq.org/)

Интереснейшая библиотека, которая использует лямбды для задания критериев в JPA. Много магии: проксирование, сериализация лямбд, интерпретация байткода. | https://habr.com/ru/post/469181/ | null | ru | null |

# «Боты должны работать, разработчики должны думать»: пишем Github App на Node.js

Разработчик — натура творческая. У него нет времени на рутинные задачи, о которых может позаботиться машина. Поэтому все, что можно автоматизировать, должно быть автоматизировано.

Привет! Меня зовут Никита. Я разработчик [Taiga UI](https://github.com/Tinkoff/taiga-ui), библиотеки Angular-компонентов, которая активно используется в нашей компании «Тинькофф». Я расскажу про решение одной из таких рутинных задач на нашем проекте с помощью написания с нуля своего [Github App](https://docs.github.com/en/developers/apps/getting-started-with-apps/about-apps#about-github-apps) на Node.js.

Постановка проблемы

-------------------

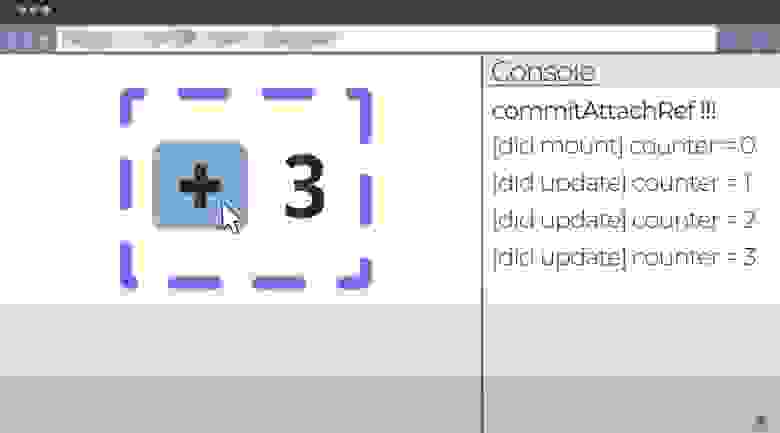

На проекте мы активно пишем скриншотные тесты с использованием фреймворка [Cypress](https://www.cypress.io/).

После внесения правок в код и открытия Pull Request в CI начинается Github Workflow на запуск всех тестов, которые и спасают наш будущий релиз от внесения багов в компоненты UI Kit. Как только какой-либо тест падает, все скриншоты прикрепляются архивом как артефакты к данному workflow, которые разработчик может скачать и изучить. К сожалению, мы живем не в идеальном мире, где не допускаем ошибок, и тесты периодически падают. Когда тестов слишком много, такое, казалось бы, простое действие, как скачивание архива и поиск скриншотов с различиями состояний «до»/«после», становится изнурительным занятием. А как было бы круто, если бы была возможность упростить этот процесс!

В Cypress для этого есть официальный платный инструмент — [Dashboard](https://www.cypress.io/dashboard/). Но тарифы, которые там предлагаются, выглядят чрезмерно дорогими для наших нужд.

Есть альтернативное неофициальное решение, которое успело набрать популярность, — [Sorry Cypress](https://sorry-cypress.dev/). Его авторы предлагают свой вариант Dashboard, но уже с более низкими ценами или с возможностью хостинга всей инфраструктуры на свои сервера. Этот неофициальный вариант уже кажется более приемлемым. Но мы решили написать простенький Github-бот.

Как работают Github Apps

------------------------

Если сильно упрощать, то Github App — это набор функций-колбэков, которые вызываются при срабатывании нужного события (webhook-event) в репозитории. Список всех доступных событий представлен [на странице Github Docs](https://docs.github.com/en/developers/webhooks-and-events/webhooks/webhook-events-and-payloads). Сами функции-колбэки обычно внутри себя дергают API Github, которые и приводят к созданию в репозитории новых комментариев, веток, файлов и т. п.

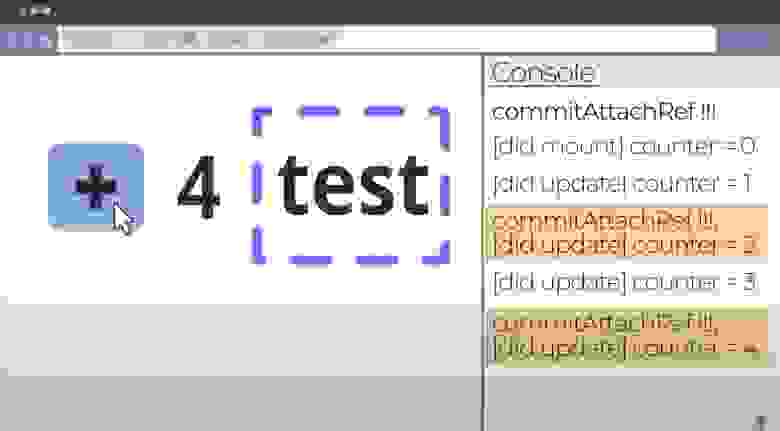

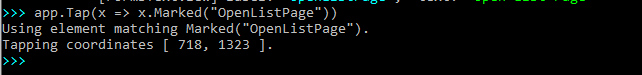

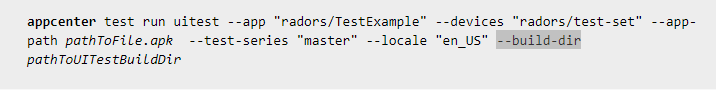

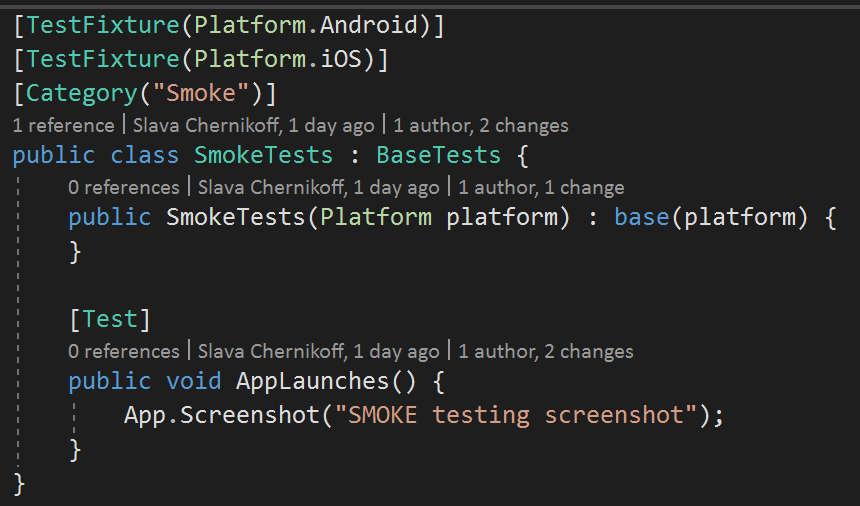

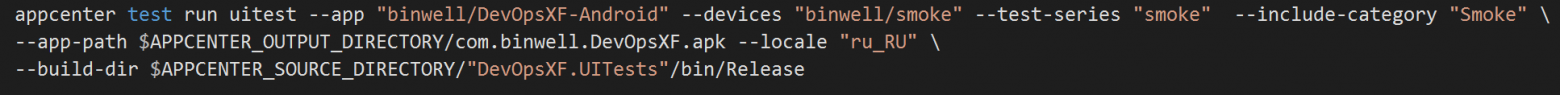

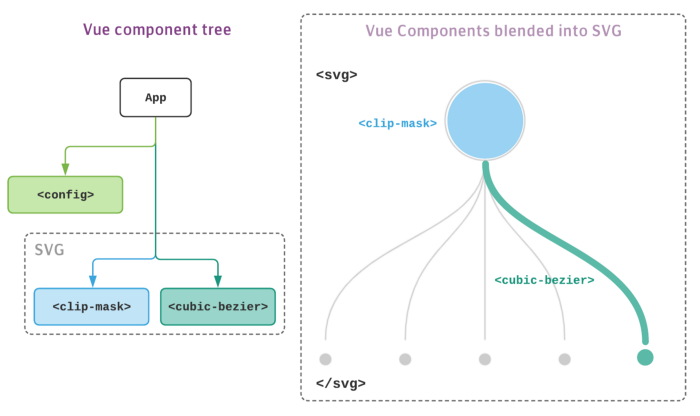

Всю работу с прослушиванием нужных событий и отправкой нужных API-запросов можно выполнять и на нативном js. Но гораздо проще это сделать с помощью уже готовых популярных решений, предоставляющих некоторое абстрагирование от всего этого. Мы воспользуемся фреймворком [Probot](https://probot.github.io/), созданным для написания Github-приложений.

Процесс инициализации нового приложения через cli-команды и шаги его запуска хорошо описаны [на официальной странице фреймворка](https://probot.github.io/docs/development/#generating-a-new-app), разбирать мы их не будем. При создании приложения рекомендуем выбирать шаблон, написанный на Typescript: строгая типизация позволит вам избежать некоторых ошибок (о том, как можно выжать максимум из возможностей данного языка, читайте [в этой статье](https://habr.com/ru/company/tinkoff/blog/521262/)). При создании текущего приложения мы также будем использовать шаблон с Typescript.

Прослушиваем события репозитория

--------------------------------

Нашему боту достаточно прослушивать только три типа событий: когда workflow начинается и завершается, а также когда PR закрывается. Открываем в сгенерированном приложении `index.ts` файл и добавляем следующий код:

```

import {Probot} from 'probot';

export = (app: Probot) => {

app.on('workflow_run.requested', async context => {

// ...

});

app.on('workflow_run.completed', async context => {

// ...

});

app.on('pull_request.closed', async context => {

// ...

});

};

```

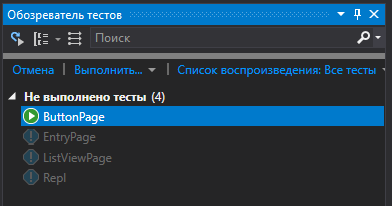

Примечание: не забываем в Github на странице настроек приложения дать боту права на прослушивание событий `workflow_run` и `pull_request`.

В коде видно, что каждая функция, пробрасываемая как колбэк на события репозитория, принимает аргумент `context`.

Этот контекст содержит множество полезной информации о «прослушиваемом» событии. Например, так будет выглядеть утилита-селектор для получения имени workflow, который вызвал данный webhook-event:

```

import {Context} from 'probot/lib/context';

import {

EventPayloads

} from '@octokit/webhooks/dist-types/generated/event-payloads';

type WorkflowRunContext = Context;

export const getWorkflowName = (context: WorkflowRunContext): string =>

context.payload.workflow?.name || '';

```

Также внутри `context.payload` содержится нужная нам информация: id workflow, название ветки, на которой сработал данный workflow, номер открытого pull request и множество другой информации.

Используем Github API

---------------------

Фреймворк Probot внутри себя использует [Node.js-модуль '@octokit/rest'](https://github.com/octokit/rest.js#readme). Чтобы получить доступ к REST-API-методам Github, достаточно обратиться к `context.octokit…`. Весь перечень доступных действий [смотрите здесь](https://octokit.github.io/rest.js/).

Нашему боту для создания комментариев к PR нужны следующие методы:

1. `context.octokit.issues.createComment` (создать новый комментарий к PR).

2. `context.octokit.rest.issues.updateComment` (отредактировать контент уже существующего комментария к PR).

Пусть вас не смущает, что мы используем методы из объекта `issue`. Pull request — это issue, содержащий код. Поэтому все методы, применимые к issue, применимы и к pull requests.

Для загрузки артефактов со скриншотами упавших тестов мы используем методы:

1. `context.octokit.actions.listWorkflowRunArtifacts` (перечень метаинформации о доступных артефактах данного workflow).

2. `context.octokit.actions.downloadArtifact` (загрузка архивов-артефактов по их id).

Итак, у нас есть файлы со скриншотами, и мы знаем, как создавать комментарии. Комментарии понимают Markdown-синтаксис, а в данный формат можно вставлять изображения как base64-строки. Кажется, что еще полшага — и все будет готово… но нет. Markdown, который использует Github, не поддерживает возможность вставить таким образом изображения: только по ссылке из внешнего источника.

Но и эту проблему можно решить: можно загрузить нужный файл (который мы планируем прикрепить к отчету об упавших тестах) на отдельную ветку репозитория и получить доступ к этому изображению через `https://raw.githubusercontent.com/...`. Код для решения данной проблемы будет следующий:

```

const GITHUB_CDN_DOMAIN = 'https://raw.githubusercontent.com';

const getFile = async (path: string, branch?: string) => {

return context.octokit.repos.getContent({

...context.repo(),

path,

ref: branch

}).catch(() => null);

}

// returns url to uploaded file

const uploadFile = async ({file, path, branch, commitMessage}: {

file: Buffer,

path: string,

commitMessage: string,

branch: string

}): Promise => {

const {repo, owner} = context.repo();

const content = file.toString('base64');

const oldFileVersion = await getFile(path, branch);

const sha = oldFileVersion && 'sha' in oldFileVersion.data

? oldFileVersion.data.sha

: undefined

const fileUrl = `${GITHUB\_CDN\_DOMAIN}/${owner}/${repo}/${branch}/${path}`;

return context.octokit.repos

.createOrUpdateFileContents({

owner,

repo,

content,

path,

branch,

sha,

message: commitMessage,

})

.then(() => fileUrl);

}

// returns urls to uploaded images

const uploadImages = async (

images: Buffer[],

pr: number,

workflowId: number,

i: number

): Promise => {

const {repo, owner} = context.repo();

const path = `\_\_bot-screens/${owner}-${repo}-${pr}/${workflowId}-${i}.png`;

return Promise.all(images.map(

(file, index) => uploadFile({

file,

path,

commitMessage: 'chore: upload images of failed screenshot tests',

branch: 'screenshot-bot-storage',

})

));

}

```

После закрытия PR загруженные изображения всегда можно удалить. И для всех этих действий также есть свои методы в библиотеке [@octokit/rest](https://github.com/octokit/rest.js#readme).

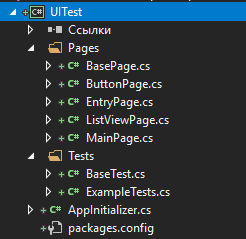

Деплой готового кода

--------------------