text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Как автоматизировать безопасный декодинг массивов в Swift с @propertyWrapper

Привет! На связи Влад, iOS-разработчик из Ozon. Сегодня я поделюсь с вами, возможно, не самым очевидным способом использования propertyWrappers. Обёртки позволяют добавлять дополнительную логику свойствам. В одну из них мы спрятали описание безопасного декодинга массивов, и теперь нам достаточно пометить свойство как @SafeDecode — и всё начинает работает автоматически. О том, как они работают и как их завести у себя, читайте дальше.

### Что такое безопасный декодинг

Для тех, кто сталкивается с безопасным декодингом впервые, поясню: безопасный декодинг массива — это декодинг, при котором в декодируемом массиве может содержаться элемент, не соответствующий ожидаемому формату; при этом в результате мы получим все элементы массива, которые смогли распарсить.

Например, у нас есть структура:

```

struct Article {

let title: String // обязательное поле

let subtitle: String? // не обязательное поле

}

```

И мы пытаемся распарсить такой массив данных:

```

[

{

"title": "Title1",

"subtitle": "Subtitle1"

},

{

// В этом элементе нет: "title": "Title1",

"subtitle": "Subtitle1"

}

]

```

```

do {

let articles = try JSONDecoder().decode([Article].self, from: jsonData)

} catch {

print(error)

// Мы получим ошибку: "No value associated with key title (\"title\")."

// Потому что во втором элементе нет title, из-за этого

// весь массив не распарсится

}

```

Чтобы всё-таки получить все остальные элементы, мы используем propertyWrapper. Он содержит внутри логику, которая фильтрует ошибки и возвращает полученные значения.

### Для тех, кто ещё не работал с propertyWrapper

Если вы уже знаете, как работает обёртка свойств, смело переходите к следующему разделу. Или можете освежить знания.

PropertyWrapper — это обёртка, позволяющая добавлять дополнительную логику самому свойству. То есть, например, мы можем сделать так, чтобы все слова в строке начинались с заглавной буквы или чтобы числа в переменной были всегда меньше 12. И всё это — всего одной строкой.

Давайте попробуем.

Для начала сделаем основу propertyWrapper:

```

@propertyWrapper

struct Example {

public var wrappedValue: Any

public init(wrappedValue: Any) {

self.wrappedValue = wrappedValue

}

}

```

Она состоит из маркировки `@propertyWrapper` и обязательного свойства wrappedValue.

Эту обёртку уже можно использовать:

```

struct Numbers {

@Example let value: Any

}

```

Но она пока что ничего не делает.

Посмотрим, как выглядит propertyWrapper, который будет устанавливать в свойство только положительные числа с помощью `abs()`:

```

@propertyWrapper

struct Abs {

private var number: Int = 0

var wrappedValue: Int {

get { number }

set { number = abs(newValue) }

}

}

```

Вся логика работы у нас спрятана в одной строке: `number = abs(newValue)`. Чтобы сделать из этой обёртки что-то новое, достаточно поменять только эту строку.

Также у нас нет `init(wrappedValue: Any)`, как в основе, потому что мы сразу задали значение для number. Если этого не сделать, придётся дописать `init()`.

Пример использования:

```

struct Number {

@Abs var nonNegativeNumber: Int

}

var number = Number()

number.nonNegativeNumber = -1

print(number.nonNegativeNumber) // 1

number.nonNegativeNumber = -77

print(number.nonNegativeNumber) // 77

```

Теперь любое число, установленное в nonNegativeNumber, будет положительным благодаря обёртке `@Abs`.

Давайте посмотрим, как ещё можно сделать эту же обёртку. Мы можем вместо приватного number сделать всё в wrappedValue, для этого нам понадобится наблюдатель свойства `didSet {}`:

```

@propertyWrapper

struct Abs {

var wrappedValue: Int {

didSet { wrappedValue = abs(wrappedValue) }

}

init(wrappedValue: Int) {

self.wrappedValue = abs(wrappedValue)

}

}

```

Результат будет тот же:

```

struct Number {

@Abs var nonNegativeNumber: Int

}

var number = Number()

number.nonNegativeNumber = -15

print(number.nonNegativeNumber) // 15

number.nonNegativeNumber = -40

print(number.nonNegativeNumber) // 40

```

А теперь рассмотрим пример, в котором propertyWrapper будет удалять цифры из конца строки:

```

@propertyWrapper

struct WithoutDecimalDigits {

var wrappedValue: String {

didSet { wrappedValue = wrappedValue.trimmingCharacters(in: .decimalDigits) }

}

init(wrappedValue: String) {

self.wrappedValue = wrappedValue.trimmingCharacters(in: .decimalDigits)

}

}

```

Вся логика работы содержится в `didSet{}`. При таком подходе нам обязательно нужно установить значение wrappedValue через `init()`. Это связано с тем, что наблюдатели свойств начинают работать только после установки значения в объект. Проще говоря, блок `didSet{}` заработает только после установки значения wrappedValue в `init()`.

Реализация:

```

struct Example {

@WithoutDecimalDigits var value: String

}

let exampleString = Example(value: "Hello 123")

print(exampleString.value) // "Hello "

```

Теперь наша обёртка удаляет все цифры из строки.

Зная эти основы, можно делать удобные propertyWrappers для своего проекта. Но использовать их нужно с осторожностью. Если скрыть внутри сложную логику, то, в будущем, можно случайно добавить неочевидное поведение.

Как безопасно декодировать массив с propertyWrapper

---------------------------------------------------

Обёртки очень легко использовать:

```

struct Example: Decodable {

@SafeArray let articlesArray: [Article]

}

```

Мы помечаем декодируемый массив как `@SafeArray` — и в нём будут все элементы, которые можно получить.

Чтобы propertyWrapper заработал, нужно сделать две вещи:

1. Подготовить новый тип `Throwable`, который может содержать либо значение, либо ошибку.

2. Написать расширение для SingleValueDecodingContainer.

Делаем тип, он будет очень простым:

```

enum Throwable: Decodable {

case success(T)

case failure(Error)

init(from decoder: Decoder) throws {

do {

let decoded = try T(from: decoder)

self = .success(decoded)

} catch let error {

self = .failure(error)

}

}

}

```

А теперь сделаем расширение.

**Шаг 1.** Подготавливаем расширение:

```

extension SingleValueDecodingContainer {

func safelyDecodeArray() throws -> [T] where T: Decodable {

}

}

```

**Шаг 2.** Добавляем декодинг массива:

```

extension SingleValueDecodingContainer {

func safelyDecodeArray() throws -> [T] where T: Decodable {

let decodedArray = (try? decode([Throwable].self)) ?? []

}

}

```

**Шаг 3.** Фильтруем и возвращаем декодируемый массив:

```

extension SingleValueDecodingContainer {

func safelyDecodeArray() throws -> [T] where T: Decodable {

let decodedArray = (try? decode([Throwable].self)) ?? []

let filtredArray = decodedArray.compactMap { result -> T? in

switch result {

case let .success(value):

return value

case .failure(\_):

return nil

}

}

return filtredArray

}

}

```

В результате декодинга `safelyDecodeArray` вернёт либо все полученные элементы, либо пустой массив.

Следующие два шага — для тех, кто хочет добавить обработку ошибок и проверку на пустой массив; если вы хотите сразу перейти к реализации propertyWrapper, их можно пропустить.

**Шаг 4.** Добавляем проверку и возвращаем ошибку, если после фильтрации получился пустой массив:

```

extension SingleValueDecodingContainer {

func safelyDecodeArray() throws -> [T] where T: Decodable {

...

if filtredArray.isEmpty {

throw DecodingError.dataCorruptedError(in: self, debugDescription: "Empty array of elements is not allowed")

}

return filtredArray

}

}

```

**Шаг 5.**Добавляем возможность выводить все полученные ошибки через callback:

```

extension SingleValueDecodingContainer {

// 1. Добавим callback для вывода описания ошибок onItemError: (([String: Any]) -> Void)?

func safelyDecodeArray(onItemError: (([String: Any]) -> Void)?) throws -> [T] where T: Decodable {

let decodedArray = (try? decode([Throwable].self)) ?? []

// 2. Чтобы иметь доступ к индексу элемента, добавим enumerated() и index

let filtredArray = decodedArray.enumerated().compactMap { index, result -> T? in

switch result {

case let .success(value):

return value

// 3. Добавим errorInfo и его передачу через callback

case let .failure(error):

var errorInfo = [String: Any]()

errorInfo["error"] = error

errorInfo["index"] = index

onItemError?(errorInfo)

return nil

}

}

if filtredArray.isEmpty {

throw DecodingError.dataCorruptedError(in: self, debugDescription: "Empty array of elements is not allowed")

}

return filtredArray

}

}

```

Теперь у нас есть возможность использовать вывод описания ошибок декодинга в нашем propertyWrapper.

**Финальный шаг.** Реализуем propertyWrapper:

```

@propertyWrapper

public struct SafeArray: Decodable {

public let wrappedValue: [T]

public init(wrappedValue: [T]) {

self.wrappedValue = wrappedValue

}

public init(from decoder: Decoder) throws {

let container = try decoder.singleValueContainer()

wrappedValue = try container.safelyDecodeArray()

}

}

```

Это всё, что нужно сделать, чтобы использовать обёртку для безопасного декодинга массивов. Теперь можно помечать массивы как `SafeArray` — и всё заработает автоматически.

Код из статьи целиком вы найдёте в последнем разделе.

Дополнительные propertyWrappers

-------------------------------

В примере мы парсили массив в константу. Если нам нужно менять массив после парсинга, достаточно заменить в обёртке `let` на `var`, потому что обёрнутое свойство должно быть таким же, как wrappedValue:

```

@propertyWrapper

public struct SafeMutableArray: Decodable {

public var wrappedValue: [T]

...

}

```

Тогда свойство тоже можно будет сделать переменной:

```

struct Example: Decodable {

@SafeMutableArray var articlesArray: [Article]

}

```

Если нам нужно получить опциональный массив, необходимо добавить опциональность и для wrappedValue:

```

@propertyWrapper

public struct SafeOptionalArray: Decodable {

public let wrappedValue: [T]?

public init(wrappedValue: [T]?) {

self.wrappedValue = wrappedValue

}

public init(from decoder: Decoder) throws {

let container = try decoder.singleValueContainer()

wrappedValue = try? container.safelyDecodeArray()

}

}

```

Чтобы после декодинга опциональный массив можно было изменить, достаточно снова заменить `let wrappedValue` на `var wrappedValue`.

### Вместо вывода

Это был, на мой взгляд, не самый очевидный способ декодирования данных в Swift, однако это ещё не все возможности property Wrapper.

Так как обёртки используются в структурах и классах, то их можно попробовать использовать в любом месте приложения, добавляя любую нужную логику, которую можно уместить.

Но всегда помните о том, что большая сила влечёт за собой и большую ответственность: если оставить внутри обёртки сложную логику, то она может аукнуться неочевидным поведением обёрнутого свойства. Применяйте инструмент там, где это действительно необходимо и к месту.

Код из статьи

```

@propertyWrapper

public struct SafeArray: Decodable {

public let wrappedValue: [T]

public init(wrappedValue: [T]) {

self.wrappedValue = wrappedValue

}

public init(from decoder: Decoder) throws {

let container = try decoder.singleValueContainer()

wrappedValue = try container.safelyDecodeArray(onItemError: nil)

}

}

extension SingleValueDecodingContainer {

func safelyDecodeArray(onItemError: (([String: Any]) -> Void)?)

throws -> [T] where T: Decodable {

let decodedArray = (try? decode([Throwable].self)) ?? []

let filtredArray = decodedArray.enumerated().compactMap { index, result -> T? in

switch result {

case let .success(value):

return value

case let .failure(error):

var errorInfo = [String: Any]()

errorInfo["error"] = error

errorInfo["index"] = index

onItemError?(errorInfo)

return nil

}

}

if filtredArray.isEmpty {

throw DecodingError.dataCorruptedError(in: self, debugDescription: "Empty array of elements is not allowed")

}

return filtredArray

}

}

enum Throwable: Decodable {

case success(T)

case failure(Error)

init(from decoder: Decoder) throws {

do {

let decoded = try T(from: decoder)

self = .success(decoded)

} catch let error {

self = .failure(error)

}

}

}

``` | https://habr.com/ru/post/571006/ | null | ru | null |

# Получение статистики и скриншотов видеоролика посредством php5-ffmpeg

Продолжаем делать ютуб [habrahabr.ru/post/171225](http://habrahabr.ru/post/171225/)

*Открытый вопрос — с уходом ffmpeg из Ubuntu, что придет на замену модулю php5-ffmpeg? Сообщите в комментариях, если вам что-то известно.*

Под катом небольшая функция, написанная на PHP5, использующая модуль php5-ffmpeg, извлекающая скриншоты и статистику из видео.

Установка модуля php5-ffmpeg в Ubuntu

```

sudo apt-get install php5-ffmpeg

```

Функция принимает параметры

$video — полный серверный путь до (загруженного) видеоролика

$screens\_path — передать полный серверный путь, чтобы сделать скриншоты

$screens\_count — количество скриншотов

```

function movie_progress($video,$screens_path = FALSE,$screens_count = 10)

{

$movie = new ffmpeg_movie($video);

if ( ! $movie)

{

return;

}

$frame_count = $movie->getFrameCount();

// получаем скриншоты

$screens = FALSE;

if ($screens_path)

{

// определяем интервал, через который будем извлекать скрины

$step = floor($frame_count / ($screens_count));

$screens = array();

// извлекаем скриншоты, и складываем пути в массив

for ($i = $step; $i < $frame_count; $i += $step)

{

$filename = $path.md5(rand()).'.png';

$frame = $movie->getFrame($i);

$image = $frame->toGDImage();

imagepng($image,$filename);

if (is_file($filename))

{

$screens[] = $filename;

}

}

}

// возвращаем статистику и список скринов

return array(

'width' => $movie->getFrameWidth(), // ширина в пикселях

'height' => $movie->getFrameHeight(), // высота в пикселях

'frame_count' => $frame_count, // количество фреймов

'bitrate' => $movie->getBitRate(), // битрейт

'video_bitrate' => $movie->getVideoBitRate(),

'video_codec' => $movie->getVideoCodec(),

'audio_codec' => $movie->getAudioCodec(),

'screens' => $screens, // массив со скриншотами

);

}

```

Можно модифицировать любым образом, по вашему усмотрению.

Методы $movie->getAuthor(), $movie->getCopyright(), $movie->getArtist(), $movie->getGenre() и подобные по неизвестным мне причинам приводят к фатальной ошибке, не отлавливаемой средствами PHP.

Документация на модуль [ffmpeg-php.sourceforge.net/doc/api/index.php](http://ffmpeg-php.sourceforge.net/doc/api/index.php)

Конвертация формата и наложение ватермарка [habrahabr.ru/post/171225](http://habrahabr.ru/post/171225/) | https://habr.com/ru/post/171239/ | null | ru | null |

# Автоматизируем десктопный GUI на Python + pywinauto: как подружиться c MS UI Automation

Python библиотека [pywinauto](https://github.com/pywinauto/pywinauto) — это open source проект по автоматизации десктопных GUI приложений на Windows. За последние два года в ней появились новые крупные фичи:

* Поддержка технологии MS UI Automation. Интерфейс прежний, и теперь поддерживаются: WinForms, WPF, Qt5, Windows Store (UWP) и так далее — почти все, что есть на Windows.

* Система бэкендов/плагинов (сейчас их двое под капотом: дефолтный `"win32"` и новый `"uia"`). Дальше плавно двигаемся в сторону кросс-платформенности.

* Win32 хуки для мыши и клавиатуры (hot keys в духе pyHook).

Также сделаем небольшой обзор того, что есть в open source для десктопной автоматизации (без претензий на серьезное сравнение).

Эта статья — частично расшифровка доклада с конференции SQA Days 20 в Минске ([видеозапись](https://www.youtube.com/watch?v=S__GZvPuyNw) и [слайды](https://www.slideshare.net/VLDCORP/gui-69866193)), частично русская версия [Getting Started Guide](https://pywinauto.readthedocs.io/en/latest/getting_started.html) для pywinauto.

* Основные подходы

+ [Координатный метод](/post/323962#koordinatnyy-metod)

+ [Распознавание эталонных изображений](/post/323962#raspoznavanie-etalonnyh-izobrazheniy)

+ [Accessibility технологии](/post/323962#accessibility-tehnologii)

* Основные десктопные accessibility технологии

+ [Старый добрый Win32 API](/post/323962#staryy-dobryy-win32-api)

+ [Microsoft UI Automation](/post/323962#microsoft-ui-automation)

+ [AT-SPI (Linux)](/post/323962#at-spi)

+ [Apple Accessibility API](/post/323962#apple-accessibility-api)

* [Как начать работать с pywinauto](/post/323962#kak-nachat-rabotat-s-pywinauto)

+ [Входные точки для автоматизации](/post/323962#vhodnye-tochki-dlya-avtomatizacii)

+ [Спецификации окон/элементов](/post/323962#specifikacii-okonelementov)

+ [Магия доступа по атрибуту и по ключу](/post/323962#magiya-dostupa-po-atributu-i-po-klyuchu)

+ [Пять правил для магических имен](/post/323962/#pyat-pravil-dlya-magicheskih-imen)

Начнём с краткого обзора опен сорса в этой области. Для десктопных GUI приложений всё несколько сложнее, чем для веба, у которого есть Selenium. Вот основные подходы:

### Координатный метод

Хардкодим точки кликов, надеемся на удачные попадания.

[+] Кросс-платформенный, легко реализуемый.

[+] Легко сделать "record-replay" запись тестов.

[-] Самый нестабильный к изменению разрешения экрана, темы, шрифтов, размеров окон и т.п.

[-] Нужны огромные усилия на поддержку, часто проще перегенерить тесты с нуля или тестировать вручную.

[-] Автоматизирует только действия, для верификации и извлечения данных есть другие методы.

Инструменты (кросс-платформенные): [autopy](https://github.com/msanders/autopy), [PyAutoGUI](https://github.com/asweigart/pyautogui), [PyUserInput](https://github.com/SavinaRoja/PyUserInput) и многие другие. Как правило, более сложные инструменты включают в себя эту функциональность (не всегда кросс-платформенно).

Стоит сказать, что координатный метод может дополнять остальные подходы. Например, для кастомной графики можно кликать по относительным координатам (от левого верхнего угла окна/элемента, а не всего экрана) — обычно это достаточно надежно, особенно если учитывать длину/ширину всего элемента (тогда и разное разрешение экрана не помешает).

Другой вариант: выделять для тестов только одну машину со стабильными настройками (не кросс-платформенно, но в каких-то случаях годится).

### Распознавание эталонных изображений

[+] Кросс-платформенный

[+-] Относительно надежный (лучше, чем координатный метод), но всё же требует хитростей.

[-+] Относительно медленный, т.к. требует ресурсов CPU для алгоритмов распознавания.

[-] О распознавании текста (OCR), как правило, речи не идёт => нельзя достать текстовые данные. Насколько мне известно, существующие OCR решения не слишком надежны для этого типа задач, и широкого применения не имеют (welcome в комменты, если это уже не так).

Инструменты: [Sikuli](https://github.com/sikuli/sikuli), [Lackey](https://github.com/glitchassassin/lackey) (Sikuli-совместимый, на чистом Python), [PyAutoGUI](https://github.com/asweigart/pyautogui).

### Accessibility технологии

[+] Самый надежный метод, т.к. позволяет искать по тексту, независимо от того, как он отрисован системой или фреймворком.

[+] Позволяет извлекать текстовые данные => проще верифицировать результаты тестов.

[+] Как правило, самый быстрый, т.к. почти не расходует ресурсы CPU.

[-] Тяжело сделать кросс-платформенный инструмент: абсолютно все open-source библиотеки поддерживают одну-две accessibility технологии. Windows/Linux/MacOS целиком не поддерживает никто, кроме платных типа TestComplete, UFT или Squish.

[-] Не всегда такая технология в принципе доступна. Например, тестирование загрузочного экрана внутри VirtualBox'а — тут без распознавания изображений не обойтись. Но во многих классических случаях все-таки accessibility подход применим. О нем дальше и пойдет речь.

Инструменты: [TestStack.White](https://github.com/TestStack/White) на C#, [Winium.Desktop](https://github.com/2gis/Winium.Desktop) на C# (Selenium совместимый), [MS WinAppDriver](https://github.com/Microsoft/WinAppDriver) на C# (Appium совместимый), [pywinauto](https://github.com/pywinauto/pywinauto), [pyatom](https://github.com/pyatom/pyatom) (совместим с LDTP), [Python-UIAutomation-for-Windows](https://github.com/yinkaisheng/Python-UIAutomation-for-Windows), [RAutomation](https://github.com/jarmo/RAutomation) на Ruby, [LDTP](https://ldtp.freedesktop.org/wiki/) (Linux Desktop Testing Project) и его Windows версия [Cobra](https://github.com/ldtp/cobra).

LDTP — пожалуй, единственный кросс-платформенный open-source инструмент (точнее семейство библиотек) на основе accessibility технологий. Однако он не слишком популярен. Сам не пользовался им, но по отзывам интерфейс у него не самый удобный. Если есть позитивные отзывы, прошу поделиться в комментах.

### Тестовый backdoor (a.k.a. внутренний велосипед)

Для кросс-платформенных приложений сами разработчики часто делают внутренний механизм для обеспечения testability. Например, создают служебный TCP сервер в приложении, тесты к нему подключаются и посылают текстовые команды: на что нажать, откуда взять данные и т.п. Надежно, но не универсально.

Основные десктопные accessibility технологии

--------------------------------------------

### Старый добрый Win32 API

Большинство Windows приложений, написанных до выхода WPF и затем Windows Store, построены так или иначе на Win32 API. А именно, MFC, WTL, C++ Builder, Delphi, VB6 — все эти инструменты используют Win32 API. Даже Windows Forms — в значительной степени Win32 API совместимые.

Инструменты: [AutoIt](https://www.autoitscript.com/site/autoit/) (похож на VB) и Python обертка [pyautoit](https://github.com/jacexh/pyautoit), [AutoHotkey](https://github.com/Lexikos/AutoHotkey_L/) (собственный язык, есть IDispatch COM интерфейс), [pywinauto](https://github.com/pywinauto/pywinauto) (Python), [RAutomation](https://github.com/jarmo/RAutomation) (Ruby), [win32-autogui](https://github.com/robertwahler/win32-autogui) (Ruby).

### Microsoft UI Automation

Главный плюс: технология MS UI Automation поддерживает подавляющее большинство GUI приложений на Windows за редкими исключениями. Проблема: она не сильно легче в изучении, чем Win32 API. Иначе никто бы не делал оберток над ней.

Фактически это набор custom COM интерфейсов (в основном, **UIAutomationCore.dll**), а также имеет .NET оболочку в виде `namespace System.Windows.Automation`. Она, кстати, имеет привнесенный баг, из-за которого некоторые UI элементы могут быть пропущены. Поэтому лучше использовать UIAutomationCore.dll напрямую (если слышали про UiaComWrapper на C#, то это оно).

Разновидности COM интерфейсов:

(1) Базовый IUknown — "the root of all evil". Самый низкоуровневый, ни разу не user-friendly.

(2) IDispatch и производные (например, `Excel.Application`), которые можно использовать в Python с помощью пакета win32com.client (входит в pyWin32). Самый удобный и красивый вариант.

(3) Custom интерфейсы, с которыми умеет работать сторонний Python пакет [comtypes](https://github.com/enthought/comtypes).

Инструменты: [TestStack.White](https://github.com/TestStack/White) на C#, [pywinauto](https://github.com/pywinauto/pywinauto) 0.6.0+, [Winium.Desktop](https://github.com/2gis/Winium.Desktop) на C#, [Python-UIAutomation-for-Windows](https://github.com/yinkaisheng/Python-UIAutomation-for-Windows) (у них исходный код сишных оберток над UIAutomationCore.dll не раскрыт), [RAutomation](https://github.com/jarmo/RAutomation) на Ruby.

### AT-SPI

Несмотря на то, что почти все оси семейства Linux построены на X Window System (в Fedora 25 "иксы" поменяли на Wayland), "иксы" позволяют оперировать только окнами верхнего уровня и мышью/клавиатурой. Для детального разбора по кнопкам, лист боксам и так далее — существует технология AT-SPI. У самых популярных оконных менеджеров есть так называемый AT-SPI registry демон, который и обеспечивает для приложений автоматизируемый GUI (как минимум поддерживаются Qt и GTK).

Инструменты: [pyatspi2](https://github.com/GNOME/pyatspi2).

pyatspi2, на мой взгляд, содержит слишком много зависимостей типа того же PyGObject. Сама технология доступна в виде обычной динамической библиотеки `libatspi.so`. К ней имеется [Reference Manual](https://developer.gnome.org/libatspi/). Для библиотеки pywinauto планируем реализовать поддержку AT-SPI имеено так: через загрузку libatspi.so и модуль ctypes. Есть небольшая проблема только в использовании нужной версии, ведь для GTK+ и Qt приложений они немного разные. Вероятный выпуск pywinauto 0.7.0 с полноценной поддержкой Linux можно ожидать в первой половине 2018-го.

### Apple Accessibility API

На MacOS есть собственный язык автоматизации AppleScript. Для реализации чего-то подобного на Python, разумеется, нужно использовать функции из ObjectiveC. Начиная, кажется, еще с MacOS 10.6 в предустановленный питон включается пакет pyobjc. Это также облегчит список зависимостей для будущей поддержки в pywinauto.

Инструменты: Кроме языка Apple Script, стоит обратить внимание на [ATOMac](https://github.com/pyatom/pyatom), он же pyatom. Он совместим по интерфейсу с LDTP, но также является самостоятельной библиотекой. На нем есть [пример автоматизации iTunes на macOs](https://github.com/vasily-v-ryabov/ui-automation-course/blob/master/10_Golodyaev/AppleID.py), написанный моим студентом. Есть известная проблема: не работают гибкие тайминги (методы `waitFor*`). Но, в целом, неплохая вещь.

---

**Как начать работать с pywinauto**

-----------------------------------

Первым делом стоит вооружиться инспектором GUI объектов (то, что называют Spy tool). Он поможет изучить приложение изнутри: как устроена иерархия элементов, какие свойства доступны. Самые известные инспекторы объектов:

* **Spy++** — входит в поставку Visual Studio, включая Express или Community Edition. Использует Win32 API. Также известен его клон **AutoIt Window Info**.

* **Inspect.exe** — входит в Windows SDK. Если он у вас установлен, то на 64-битной Windows можно найти его в папке `C:\Program Files (x86)\Windows Kits\\bin\x64`. В самом инспекторе нужно выбрать режим **UI Automation** вместо MS AA (Active Accessibility, предок UI Automation).

Просветив приложение насквозь, выбираем бэкенд, который будем использовать. Достаточно указать имя бэкенда при создании объекта Application.

* **backend="win32"** — пока используется по умолчанию, хорошо работает с MFC, WTL, VB6 и другими legacy приложениями.

* **backend="uia"** — новый бэкенд для MS UI Automation: идеально работает с WPF и WinForms; также хорош для Delphi и Windows Store приложений; работает с Qt5 и некоторыми Java приложениями. И вообще, если Inspect.exe видит элементы и их свойства, значит этот бэкенд подходит. В принципе, большинство браузеров тоже поддерживает UI Automation (Mozilla по умолчанию, а Хрому при запуске нужно скормить ключ командной строки `--force-renderer-accessibility`, чтобы увидеть элементы на страницах в Inspect.exe). Конечно, конкуренция с Selenium в этой области навряд ли возможна. Просто еще один способ работать с браузером (может пригодиться для кросс-продуктового сценария).

### Входные точки для автоматизации

Приложение достаточно изучено. Пора создать объект Application и запустить его или присоединиться к уже запущенному. Это не просто клон стандартного класса `subprocess.Popen`, а именно вводный объект, который ограничивает все ваши действия границами процесса. Это очень полезно, если запущено несколько экземпляров приложения, а остальные трогать не хочется.

```

from pywinauto.application import Application

app = Application(backend="uia").start('notepad.exe')

# Опишем окно, которое хотим найти в процессе Notepad.exe

dlg_spec = app.UntitledNotepad

# ждем пока окно реально появится

actionable_dlg = dlg_spec.wait('visible')

```

Если хочется управлять сразу несколькими приложениями, вам поможет класс `Desktop`. Например, в калькуляторе на Win10 иерархия элементов размазана аж по нескольким процессам (не только `calc.exe`). Так что без объекта `Desktop` не обойтись.

```

from subprocess import Popen

from pywinauto import Desktop

Popen('calc.exe', shell=True)

dlg = Desktop(backend="uia").Calculator

dlg.wait('visible')

```

Корневой объект (`Application` или `Desktop`) — это единственное место, где нужно указывать бэкенд. Все остальное прозрачно ложится в концепцию "спецификация->враппер", о которой дальше.

### Спецификации окон/элементов

Это основная концепция, на которой строится интерфейс pywinauto. Вы можете описать окно/элемент приближенно или более детально, даже если оно еще не существует или уже закрыто. Спецификация окна (объект *WindowSpecification*) хранит в себе критерии, по которым нужно искать реальное окно или элемент.

Пример детальной спецификации окна:

```

>>> dlg_spec = app.window(title='Untitled - Notepad')

>>> dlg_spec

>>> dlg\_spec.wrapper\_object()

```

Сам поиск окна происходит по вызову метода `.wrapper_object()`. Он возвращает некий "враппер" для реального окна/элемента или кидает `ElementNotFoundError` (иногда `ElementAmbiguousError`, если найдено несколько элементов, то есть требуется уточнить критерий поиска). Этот "враппер" уже умеет делать какие-то действия с элементом или получать данные из него.

Python может скрывать вызов `.wrapper_object()`, так что финальный код становится короче. Рекомендуем использовать его только для отладки. Следующие две строки делают абсолютно одно и то же:

```

dlg_spec.wrapper_object().minimize() # debugging

dlg_spec.minimize() # production

```

Есть множество критериев поиска для спецификации окна. Вот лишь несколько примеров:

```

# могут иметь несколько уровней

app.window(title_re='.* - Notepad$').window(class_name='Edit')

# можно комбинировать критерии (как AND) и не ограничиваться одним процессом приложения

dlg = Desktop(backend="uia").Calculator

dlg.window(auto_id='num8Button', control_type='Button')

```

Список всех возможных критериев есть в доках функции [pywinauto.findwindows.find\_elements(...)](https://pywinauto.readthedocs.io/en/latest/code/pywinauto.findwindows.html#pywinauto.findwindows.find_elements).

### Магия доступа по атрибуту и по ключу

Python упрощает создание спецификаций окна и распознает атрибуты объекта динамически (внутри переопределен метод `__getattribute__`). Разумеется, на имя атрибута накладываются такие же ограничения, как и на имя любой переменной (нельзя вставлять пробелы, запятые и прочие спецсимволы). К счастью, pywinauto использует так называемый "best match" алгоритм поиска, который устойчив к опечаткам и небольшим вариациям.

```

app.UntitledNotepad

# то же самое, что

app.window(best_match='UntitledNotepad')

```

Если все-таки нужны Unicode строки (например, для русского языка), пробелы и т.п., можно делать доступ по ключу (как будто это обычный словарь):

```

app['Untitled - Notepad']

# то же самое, что

app.window(best_match='Untitled - Notepad')

```

### Пять правил для магических имен

Как узнать эталонные магические имена? Те, которые присваиваются элементу перед поиском. Если вы указали имя, достаточно похожее на эталон, значит элемент будет найден.

1. По заголовку (текст, имя): `app.Properties.OK.click()`

2. По тексту и по типу элемента: `app.Properties.OKButton.click()`

3. По типу и по номеру: `app.Properties.Button3.click()` (имена `Button0` и `Button1` привязаны к первому найденному элементу, `Button2` — ко второму, и дальше уже по порядку — так исторически сложилось)

4. По статическому тексту (слева или сверху) и по типу: `app.OpenDialog.FileNameEdit.set_text("")` (полезно для элементов с динамическим текстом)

5. По типу и по тексту внутри: `app.Properties.TabControlSharing.select("General")`

Обычно два-три правила применяются одновременно, редко больше. Чтобы проверить, какие конкретно имена доступны для каждого элемента, можно использовать метод **print\_control\_identifiers()**. Он может печатать дерево элементов как на экран, так и в файл. Для каждого элемента печатаются его эталонные магические имена. Также можно скопипастить оттуда более детальные спецификации дочерних элементов. Результат в скрипте будет выглядеть так:

```

app.Properties.child_window(title="Contains:", auto_id="13087", control_type="Edit")

```

**Само дерево элементов - обычно довольно большая портянка.**

```

>>> app.Properties.print_control_identifiers()

Control Identifiers:

Dialog - 'Windows NT Properties' (L688, T518, R1065, B1006)

[u'Windows NT PropertiesDialog', u'Dialog', u'Windows NT Properties']

child_window(title="Windows NT Properties", control_type="Window")

|

| Image - '' (L717, T589, R749, B622)

| [u'', u'0', u'Image1', u'Image0', 'Image', u'1']

| child_window(auto_id="13057", control_type="Image")

|

| Image - '' (L717, T630, R1035, B632)

| ['Image2', u'2']

| child_window(auto_id="13095", control_type="Image")

|

| Edit - 'Folder name:' (L790, T596, R1036, B619)

| [u'3', 'Edit', u'Edit1', u'Edit0']

| child_window(title="Folder name:", auto_id="13156", control_type="Edit")

|

| Static - 'Type:' (L717, T643, R780, B658)

| [u'Type:Static', u'Static', u'Static1', u'Static0', u'Type:']

| child_window(title="Type:", auto_id="13080", control_type="Text")

|

| Edit - 'Type:' (L790, T643, R1036, B666)

| [u'4', 'Edit2', u'Type:Edit']

| child_window(title="Type:", auto_id="13059", control_type="Edit")

|

| Static - 'Location:' (L717, T669, R780, B684)

| [u'Location:Static', u'Location:', u'Static2']

| child_window(title="Location:", auto_id="13089", control_type="Text")

|

| Edit - 'Location:' (L790, T669, R1036, B692)

| ['Edit3', u'Location:Edit', u'5']

| child_window(title="Location:", auto_id="13065", control_type="Edit")

|

| Static - 'Size:' (L717, T695, R780, B710)

| [u'Size:Static', u'Size:', u'Static3']

| child_window(title="Size:", auto_id="13081", control_type="Text")

|

| Edit - 'Size:' (L790, T695, R1036, B718)

| ['Edit4', u'6', u'Size:Edit']

| child_window(title="Size:", auto_id="13064", control_type="Edit")

|

| Static - 'Size on disk:' (L717, T721, R780, B736)

| [u'Size on disk:', u'Size on disk:Static', u'Static4']

| child_window(title="Size on disk:", auto_id="13107", control_type="Text")

|

| Edit - 'Size on disk:' (L790, T721, R1036, B744)

| ['Edit5', u'7', u'Size on disk:Edit']

| child_window(title="Size on disk:", auto_id="13106", control_type="Edit")

|

| Static - 'Contains:' (L717, T747, R780, B762)

| [u'Contains:1', u'Contains:0', u'Contains:Static', u'Static5', u'Contains:']

| child_window(title="Contains:", auto_id="13088", control_type="Text")

|

| Edit - 'Contains:' (L790, T747, R1036, B770)

| [u'8', 'Edit6', u'Contains:Edit']

| child_window(title="Contains:", auto_id="13087", control_type="Edit")

|

| Image - 'Contains:' (L717, T773, R1035, B775)

| [u'Contains:Image', 'Image3', u'Contains:2']

| child_window(title="Contains:", auto_id="13096", control_type="Image")

|

| Static - 'Created:' (L717, T786, R780, B801)

| [u'Created:', u'Created:Static', u'Static6', u'Created:1', u'Created:0']

| child_window(title="Created:", auto_id="13092", control_type="Text")

|

| Edit - 'Created:' (L790, T786, R1036, B809)

| [u'Created:Edit', 'Edit7', u'9']

| child_window(title="Created:", auto_id="13072", control_type="Edit")

|

| Image - 'Created:' (L717, T812, R1035, B814)

| [u'Created:Image', 'Image4', u'Created:2']

| child_window(title="Created:", auto_id="13097", control_type="Image")

|

| Static - 'Attributes:' (L717, T825, R780, B840)

| [u'Attributes:Static', u'Static7', u'Attributes:']

| child_window(title="Attributes:", auto_id="13091", control_type="Text")

|

| CheckBox - 'Read-only (Only applies to files in folder)' (L790, T825, R1035, B841)

| [u'CheckBox0', u'CheckBox1', 'CheckBox', u'Read-only (Only applies to files in folder)CheckBox', u'Read-only (Only applies to files in folder)']

| child_window(title="Read-only (Only applies to files in folder)", auto_id="13075", control_type="CheckBox")

|

| CheckBox - 'Hidden' (L790, T848, R865, B864)

| ['CheckBox2', u'HiddenCheckBox', u'Hidden']

| child_window(title="Hidden", auto_id="13076", control_type="CheckBox")

|

| Button - 'Advanced...' (L930, T845, R1035, B868)

| [u'Advanced...', u'Advanced...Button', 'Button', u'Button1', u'Button0']

| child_window(title="Advanced...", auto_id="13154", control_type="Button")

|

| Button - 'OK' (L814, T968, R889, B991)

| ['Button2', u'OK', u'OKButton']

| child_window(title="OK", auto_id="1", control_type="Button")

|

| Button - 'Cancel' (L895, T968, R970, B991)

| ['Button3', u'CancelButton', u'Cancel']

| child_window(title="Cancel", auto_id="2", control_type="Button")

|

| Button - 'Apply' (L976, T968, R1051, B991)

| ['Button4', u'ApplyButton', u'Apply']

| child_window(title="Apply", auto_id="12321", control_type="Button")

|

| TabControl - '' (L702, T556, R1051, B962)

| [u'10', u'TabControlSharing', u'TabControlPrevious Versions', u'TabControlSecurity', u'TabControl', u'TabControlCustomize']

| child_window(auto_id="12320", control_type="Tab")

| |

| | TabItem - 'General' (L704, T558, R753, B576)

| | [u'GeneralTabItem', 'TabItem', u'General', u'TabItem0', u'TabItem1']

| | child_window(title="General", control_type="TabItem")

| |

| | TabItem - 'Sharing' (L753, T558, R801, B576)

| | [u'Sharing', u'SharingTabItem', 'TabItem2']

| | child_window(title="Sharing", control_type="TabItem")

| |

| | TabItem - 'Security' (L801, T558, R851, B576)

| | [u'Security', 'TabItem3', u'SecurityTabItem']

| | child_window(title="Security", control_type="TabItem")

| |

| | TabItem - 'Previous Versions' (L851, T558, R947, B576)

| | [u'Previous VersionsTabItem', u'Previous Versions', 'TabItem4']

| | child_window(title="Previous Versions", control_type="TabItem")

| |

| | TabItem - 'Customize' (L947, T558, R1007, B576)

| | [u'CustomizeTabItem', 'TabItem5', u'Customize']

| | child_window(title="Customize", control_type="TabItem")

|

| TitleBar - 'None' (L712, T521, R1057, B549)

| ['TitleBar', u'11']

| |

| | Menu - 'System' (L696, T526, R718, B548)

| | [u'System0', u'System', u'System1', u'Menu', u'SystemMenu']

| | child_window(title="System", auto_id="MenuBar", control_type="MenuBar")

| | |

| | | MenuItem - 'System' (L696, T526, R718, B548)

| | | [u'System2', u'MenuItem', u'SystemMenuItem']

| | | child_window(title="System", control_type="MenuItem")

| |

| | Button - 'Close' (L1024, T519, R1058, B549)

| | [u'CloseButton', u'Close', 'Button5']

| | child_window(title="Close", control_type="Button")

```

В некоторых случаях печать всего дерева может тормозить (например, в iTunes на одной вкладке аж три тысячи элементов!), но можно использовать параметр `depth` (глубина): `depth=1` — сам элемент, `depth=2` — только непосредственные дети, и так далее. Его же можно указывать в спецификациях при создании `child_window`.

### Примеры

Мы постоянно пополняем [список примеров в репозитории](https://github.com/pywinauto/pywinauto/tree/master/examples). Из свежих стоит отметить автоматизацию сетевого анализатора WireShark (это хороший пример Qt5 приложения; хотя эту задачу можно решать и без GUI, ведь есть `scapy.Sniffer` из питоновского пакета [scapy](https://github.com/secdev/scapy)). Также есть пример автоматизации MS Paint с его Ribbon тулбаром.

Еще один отличный пример, написанный моим студентом: [перетаскивание файла из explorer.exe на Chrome страницу для Google Drive](https://github.com/vasily-v-ryabov/ui-automation-course/tree/master/02_google_drive_Murashov) (он перекочует в главный репозиторий чуть позже).

И, конечно, пример подписки на события клавиатуры (hot keys) и мыши:

[hook\_and\_listen.py](https://github.com/pywinauto/pywinauto/blob/master/examples/hook_and_listen.py).

### Благодарности

Отдельное спасибо — тем, кто постоянно помогает развивать проект. Для меня и [Валентина](https://github.com/airelil) это постоянное хобби. Двое моих студентов из ННГУ недавно защитили дипломы бакалавра по этой теме. [Александр](https://github.com/cetygamer) внес большой вклад в поддержку MS UI Automation и недавно начал делать автоматический генератор кода по принципу "запись-воспроизведение" на основе текстовых свойств (это самая сложная фича), пока только для "uia" бэкенда. [Иван](https://github.com/MagazinnikIvan) разрабатывает новый бэкенд под Linux на основе AT-SPI (модули `mouse` и `keyboard` на основе [python-xlib](https://github.com/python-xlib/python-xlib) — уже в релизах 0.6.x).

Поскольку я довольно давно читаю спецкурс по автоматизации на Python, часть студентов-магистров выполняют домашние задания, реализуя небольшие фичи или примеры автоматизации. Некоторые ключевые вещи на стадии исследований тоже когда-то раскопали именно студенты. Хотя иногда за качеством кода приходится строго следить. В этом сильно помогают статические анализаторы (QuantifiedCode, Codacy и Landscape) и автоматические тесты в облаке (сервис AppVeyor) с покрытием кода в районе 95%.

Также спасибо всем, кто оставляет отзывы, заводит баги и присылает пулл реквесты!

### Дополнительные ресурсы

За вопросами мы следим по [тегу на StackOverflow](https://stackoverflow.com/questions/tagged/pywinauto) (недавно появился [тег в русской версии SO](https://ru.stackoverflow.com/questions/tagged/pywinauto)) и [по ключевому слову на Тостере](https://toster.ru/search?q=pywinauto). Есть [русскоязычный чат в Gitter'е](https://gitter.im/pywinauto-russian-users/Lobby).

Каждый месяц обновляем [рейтинг open-source библиотек для GUI тестирования](https://github.com/pywinauto/pywinauto/wiki/UI-Automation-tools-ratings). По количеству звезд на гитхабе быстрее растут только Autohotkey (у них очень большое сообщество и длинная история) и PyAutoGUI (во многом благодаря популярности книг ее автора Al Sweigart: "Automate the Boring Stuff with Python" и других). | https://habr.com/ru/post/323962/ | null | ru | null |

# Две скрытые кайфовые фичи Windows Admin Center: как найти, настроить и использовать

Недавно я шерстил Хабр и встретил комментарий от [Inskin](https://habr.com/ru/users/inskin/):

Я впервые познакомился в Windows Admin Center, когда в нем был только счетчик управления файлами и больше ничего. Сейчас все инструменты из RSAT потихоньку переезжают в Windows Admin Center.

Пока я не видел ни одного толковой русской статьи про настройку Windows Admin Center и решил написать ее сам. Под катом подробный обзор, две скрытые кайфовые фишки WAC, а также инструкции по установке и настройке.

Какие фичи реализованы на текущий момент?

-----------------------------------------

Чуть больше года назад WAС был практически неюзабельным, в превью версии был только красивый дашборд и управление процессами.

Теперь, можно делать полноценный деплой новых серверов прямо из браузера.

1. Диспетчер задач

2. Управление сертификатами

3. Управление устройствами

4. Просмотр событий

5. Проводник

6. Брандмауэр

7. Установка и удаление программ и служб и ролей

8. Regedit

9. Планировщик задач

А еще WAC может служить шлюзом для WinRM и RDP.

Кстати, для подключения, Windows Admin Center использует WinRM и общий runspace вместе с WSMan’ом, поэтому, если у вас подключены сетевые диски, то подключаться к серверам что хостят эти диски можно будет без ввода логина и пароля.

Попробуйте сделать Enter-PSSession без указания Credentials, если команда не попросит логин или пароль, то значит можно будет войти и через WAC без ввода логина и пароля.

Что вы могли упустить:

----------------------

Часть функционала все еще скрыта за плагинами, поэтому, вы могли упустить две очень крутые фишки и одну не очень крутую.

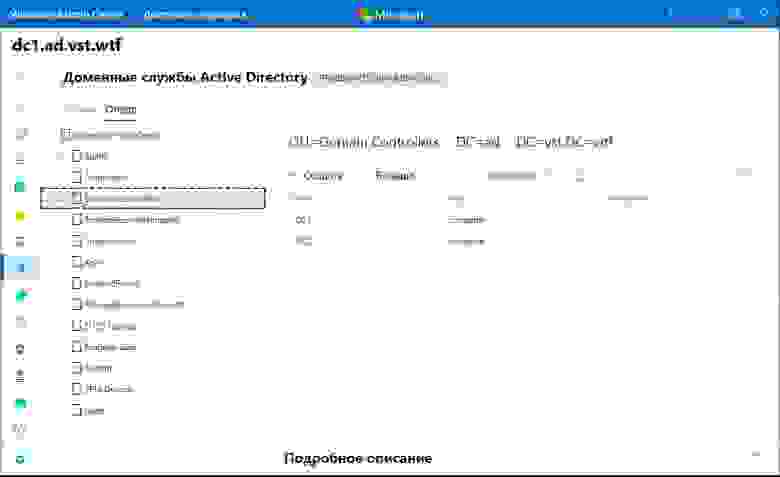

### Управление AD (превью):

Органы управления Active Directory тут похожи на что-то между ADAC и ADDC. Хорошо, что они переосмыслили интерфейс, в целом это выглядит даже удобнее, чем через RSAT. В еще одном вопросе можно целиком перейти на WAC.

### Управление DNS (превью):

В WAC переехал полностью функционал управления DNS. Создание новых зон, PTR записей, теперь все это доступно через Windows Admin Center.

### Управление Windows Defender (превью):

Пока что можно только управлять сканированием и отключать защиту в реальном времени. Отсутствуют все пункты защитника, плюс нельзя управлять защитой от программ-шантажистов.

Установка на Windows Server / Windows 10

----------------------------------------

По моему мнению, самая правильная установка это – установка на локальный компьютер. Сначала нужно скачать установочный файл по ссылке:

<http://aka.ms/WACDownload>

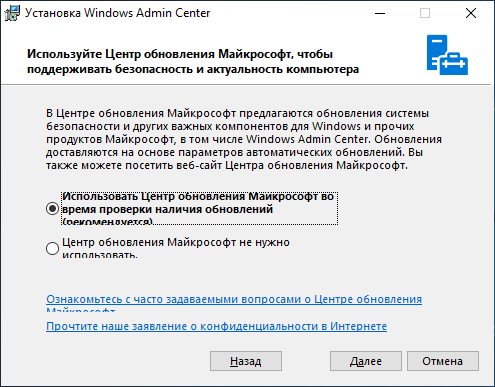

Установка очень проста, «далее, далее, готово», но пару рекомендаций дать нужно. Обязательно выберите пункт об автоматическом обновлении WAC, гарантирую, вам это пригодится, но по непонятным причинам, этот пункт по умолчанию снят.

WinRM работает по HTTP протоколу, поэтому, чтобы Windows Admin Center не подключался к удаленным серверам по HTTP обязательно включите этот пункт. Он тоже снят по умолчанию.

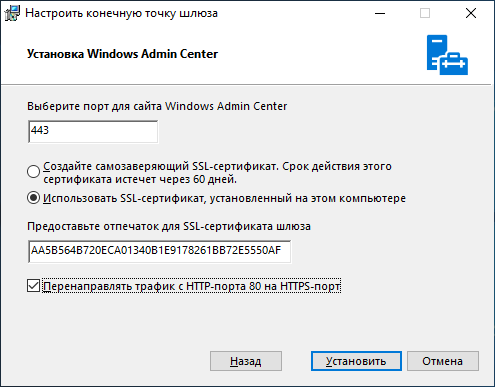

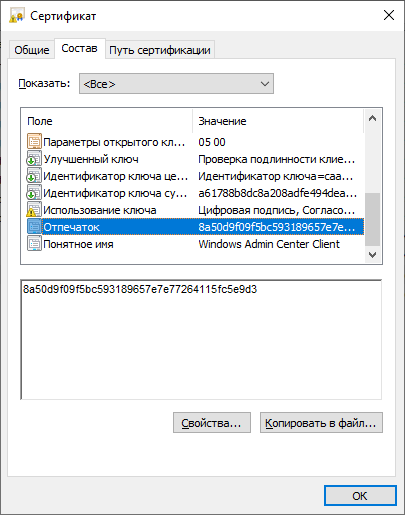

Если вы используете WAC на домашней системе, рекомендую оставить самоподписанный сертификат. Он автоматически добавляется в доверенные и не доставляет неудобств, но если у вас есть свой собственный сертификат и вы хотите использовать его, то впишите его отпечаток в графу, как показано ниже:

Можно перейти в certmgr → Личное → Сертификаты, перейти в свойства сертификата и найти его отпечаток.

Тоже самое с помощью PowerShell:

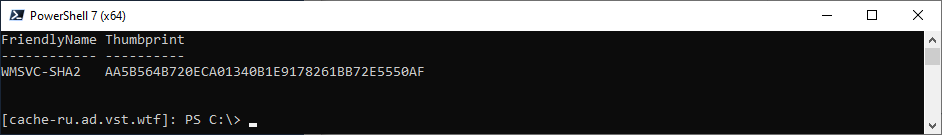

```

Get-ChildItem -Path Cert:LocalMachine\MY | Select-Object FriendlyName, Thumbprint

```

Установка на Server Core

------------------------

*[VPS с Windows Server Core](https://ruvds.com/ru-rub/marketplace#order) можно взять прямо из маркетплейса*

Чтобы использовать Windows Admin Center в качестве управляющего узла, обязательно нужна Active Directory. Войти в Windows Admin Center развернутую на Server Core можно только под административной ролью в AD.

Скачиваем WAC:

```

Start-BitsTransfer -Source http://aka.ms/WACDownload

-Destination C:\Users\Administrator\Downloads\wac.msi

```

Устанавливаем с самоподписанным сертификатом:

```

Start-Process -FilePath "C:\Users\Administrator\Downloads\wac.msi" -ArgumentList " /qn SSL_CERTIFICATE_OPTION=generate"

```

Если у вас есть купленный сертификат или серитфикат от Let’s Encrypt, установленный в системной хранилище сертификатов, то впишите его Thumbprint в аргументы установщика.

Получить отпечаток сертификата можно вот так:

```

Get-ChildItem -Path Cert:LocalMachine\MY | Select-Object FriendlyName, Thumbprint

```

Вписать отпечаток нужно после SME\_THUMBPRINT, как в примере:

```

Start-Process -FilePath "C:\Users\Administrator\Downloads\wac.msi" -ArgumentList " /qn SME_THUMBPRINT=AA5B564B720ECA01340B1E9178261BB72E5550AF SSL_CERTIFICATE_OPTION=installed"

```

Чтобы изменить сертификат, нужно будет еще раз запустить установщик, вписав в отпечаток нового сертификата.

Выводы

------

С каждой новой версией Windows Admin Center становится все функциональнее и функциональнее.

До полного счастья нужно разве что доделать все диспетчеры связанные с AD, добавить поддержку RRAS, IIS, перенести целиком проводник вместе с нормальным управлением SMB и Bitlocker, управление групповыми политиками и нормальный Windows Defender, и чтобы все диспетчеры, которые работают с файлами умели открывать и выбирать пути с диска машины, к которой ты подключен. А еще чтобы когда ты закрываешь WAC, нужно чтобы он закрывал PSSession и освобождал память на сервере, еще неплохо было бы, чтобы можно было ставить на Server Core без обязательного наличия AD, а когда закончат, можно перейти к MS SQL Server.

А в целом очень даже неплохо, очень рекомендую ознакомиться.

[](http://ruvds.com/ru-rub?utm_source=habr&utm_medium=article&utm_campaign=machehin&utm_content=wac-ustanovka-nastroika#order) | https://habr.com/ru/post/538080/ | null | ru | null |

# Простой Dependency Injection в Node.js

Прочитав несколько статей на тему DI мне захотелось использовать его в Node.js; после недолгих поисков оказалось, что модулей для этого не так много, из них самый интересный — [di.js](https://github.com/angular/di.js/) от Angular, но он мне не подошел и я решил написать свой.

#### Почему не di.js?

* он написан с использованием ES6, т.е. нуждается в предварительной компиляции в ES5, а так как он использует декораторы, то и ваш код должен быть скомпилирован в ES5

* давно не поддерживается

* использует старый компилятор (es6-shim)

* нет возможности создавать несколько инстансов одного класса

#### Пишем свою реализацию

Самой интересной в написании модуля оказалась задача динамической передачи в конструктор аргументов.

Наиболее очевидное решение — использовать *apply*, но это не сработает, так как он взаимодействует с методами, а не конструкторами.

Для нашей цели можно воспользоваться [spread operator](https://developer.mozilla.org/ru/docs/Web/JavaScript/Reference/Operators/Spread_operator):

```

class Test {

constructor(a, b) {

}

}

let args = [1, 2]

let test = new Test(...args)

```

В остальном реализация довольно скучна и не содержит ничего интересного.

#### Используем модуль

Я решил отказаться от декораторов di.js в пользу конфиг-файла. Допустим, мы описываем архитектуру компьютера, тогда в конфиге нам нужно описать наши классы, пути к ним и их аргументы:

```

{

"Computer": {

"class": "./Computer.js", // Путь к классу

"args": ["RAM", "HDD", "CPU", "GPU"] // Зависимости

},

"RAM": {

"class": "./RAM.js",

"args": []

},

"HDD": {

"class": "./HDD.js",

"args": []

},

"CPU": {

"class": "./CPU.js",

"args": ["RAM"]

},

"GPU": {

"class": "./GPU.js",

"args": []

}

}

```

Класс *Computer*, как и все остальные, довольно простой:

```

'use strict'

class Computer {

constructor(ram, hdd, cpu, gpu) {

this._cpu = cpu

this._gpu = gpu

this._hdd = hdd

this._ram = ram

}

}

module.exports = Computer

```

Теперь в точке входа нашего приложения используем модуль:

```

const Injector = require('razr')(__dirname, './path/to/your/config.json') // передаем текущий путь и путь к конфигу

const computer = Injector.get('Computer') // тут мы молучим инстанс Computer

```

Стоит заметить, что в конфиг-файле нужно указывать пути к классам относительно точки входа приложения.

На этом все. Спасибо всем, кто дочитал. А вот ссылочка на GitHub — <https://github.com/Naltox/razr> и NPM — <http://npmjs.com/package/razr> | https://habr.com/ru/post/306276/ | null | ru | null |

# InterSystems iKnow. Часть вторая. Создание простого домена

Это продолжение моего рассказа про Natural Language Processing технологию Intersystems iKnow, начало [здесь](http://habrahabr.ru/company/intersystems/blog/243217/). Во второй части вы найдете описание практической работы с iKnow. Мы создадим домен, настроим его, загрузим текст. Затем, посмотрим и проанализируем результаты. Подробнее об этом под катом…

Начнем с создания домена. Домен в iKnow можно сравнить с областью в Caché или с почтовым ящиком в подъезде вашего дома. Это некоторый контейнер, куда загружаются тексты. Кроме текстов там хранится инструментарий, необходимый для их анализа, например, конфигурации, лоадеры, листеры, словари и т.д.

Существует два способа создания доменов. Один из них – использование класса [%iKnow.Domain](http://docs.intersystems.com/cache20141/csp/documatic/%25CSP.Documatic.cls?APP=1&LIBRARY=%25SYS&CLASSNAME=%25iKnow.Domain). При использовании этого подхода необходимо вручную писать код создания как самого домена, так и всех объектов внутри него. Этот процесс достаточно сложен, требует времени и опыта работы с iKnow, однако, позволяет реализовывать сложные iKnow-приложения с постпроцессингом проиндексированных данных.

Есть альтернативный способ, основанный на использовании класса [%iKnow.DomainDefinition](http://docs.intersystems.com/cache20141/csp/documatic/%25CSP.Documatic.cls?APP=1&LIBRARY=%25SYS&CLASSNAME=%25iKnow.DomainDefinition), который подходит для быстрого прототипирования. Он позволяет создать домен декларативным путем через описание его структуры в XML представлении. А сам объект домена создается автоматически при компиляции класса. Данный метод проще, компактней, позволяет быстрее сформировать новый домен с нуля. В этой статье я опишу второй способ работы и приведу примеры кода.

Замечание. Я создаю и тестирую код в версии Caché 2015.2 Field Test. Принципиальное отличие от предыдущих версий заключается в поддержке стемминга и лемматизации. В связи с этим будет встречаться отличие в ряде настроек, но об этом позже. Итак, приступим.

**Шаг нулевой. Постановка задачи**

Прежде чем начать писать код, я сформулирую задачу, которую буду решать. Мы напишем простейший агрегатор новостей. Для этого создадим домен в iKnow, который будет загружать статьи из RSS лент, а затем научим его разделять эти статьи по темам. Категории новостей предлагаю взять такие: “политика”, “экономика”, “спорт” и, к примеру, “угроза из космоса”.

**Шаг первый. Создание домена**

Создаем домен с помощью DomainDefinition. Для этого достаточно скомпилировать такой класс:

```

Class HabrDomain.News Extends %iKnow.DomainDefinition

{

XData Domain {XMLNamespace =TEST]

{

}

}

```

Хочу отметить, что сам домен совершенно пустой, и создается как объект сразу после компиляции класса HabrDomain.News. Для того, чтобы в этом убедиться запустите команду

*do $system.iKnow.ListDomains()*

в терминале. Вы увидите, что сформирован домен NewsAggregator, c ID равным 1 (ID может отличаться, если вы уже создавали домены), без загруженных текстов (# of sources равно 0).

**Шаг второй. Настройка домена**

Под настройкой домена можно понимать весьма широкий круг действий, но сейчас речь пойдет о конфигурации домена. Конфигурация используется только при загрузке документов в домен и отвечает за то, как iKnow будет обрабатывать текст. Конфигурация создается как объект, поэтому её можно однажды создать, а потом многократно повторно использовать для разных доменов данной области. Теоретически, конфигурация не является обязательной, и все настройки могут быть заменены некими значениями “по умолчанию”, но, в этом случае, про работу с русскими текстами лучше сразу забыть.

Для описания конфигурации в DomainDefinition добавляем строку внутри тэгов Domain:

```

```

Согласно этой строке, мы создали конфигурацию с именем “Russian”, которая будет использовать для анализа текстов семантическую модель русского языка, при этом механизмы автоматического определения языка текстовых документов будут отключены. Параметр “stemming” со значением “DEFAULT” является обязательным (но не достаточным) условием для того, чтобы при анализе текста подключилась русская лемматизация.

Для завершения настройки стемминга добавим следом за конфигурацией еще одну строку:

```

```

**Шаг третий. Создание полей для метаданных**

Когда мы будем загружать статьи в наш домен, то загружаться будут не только тексты. Из RSS-лент можно получить еще много полезной информации, которую мы потом сможем использовать. Для хранения этих данных сконфигурируем поля метаинформации. Для этого добавим в блок XData класса следующие строки:

```

```

Таким образом, мы описали 5 полей. PubDate будет хранить дату публикации статьи, Title – её заголовок, Link – ссылку на полный текст. В поле Agency мы будем загружать имя ресурса, из которого мы загрузили статью, а в Country – территориальную принадлежность источника.

**Шаг четвертый. Описываем источники, откуда будем загружать статьи**

При постановке задачи мы договорились, что тексты будут загружаться из RSS-лент. В качестве примера я возьму ленту <http://static.feed.rbc.ru/rbc/internal/rss.rbc.ru/rbc.ru/mainnews.rss> rbc.ru, где публикуются новости из всех разделов. Чтобы указать iKnow работать с этим ресурсом, добавим код:

```

```

Теперь подробнее опишу поля данной записи. serverName – это имя сервера и первая часть ссылки на RSS-ленту, заканчивающаяся именем домена верхнего уровня (в нашем случае .ru). Вторая часть ссылки прописывается в параметр url. Обратите внимание, что начинается url всегда с “/”. Из каждой публикации мы будем загружать два текстовых поля – заголовок и текст (под текстом я понимаю тело статьи, которая публикуется в ленте; чаще всего это краткое вступление, а не полноценный материал)

Далее конвертер. Он в нашем случае стандартный %iKnow.Source.Converter.Html, а его назначение – удалить из загружаемого текста все html теги, чтобы получить чистый текст.

И, наконец, описываем загрузку метаданных. Чуть выше мы создали 5 полей, три из которых iKnow заполняет автоматически, это – дата публикации, заголовок и ссылка на полный текст статьи. Два оставшихся поля будут заполняться отсюда. В поле “Agency” будет писаться “RBC”, а в “Country” – “Russia”.

**Шаг пятый. Словари**

Одним из преимуществ технологии iKnow является то, что для базового анализа текста не используются словари, а используется компактная и быстрая семантическая языковая модель. Но есть ряд задач, в которых словари нам все-таки понадобятся. Одна из них – matching – отнесение статей к темам (например, статьи о спорте, о политике, об экономике или угрозе инопланетного вторжения). Иными словами, при описании домена мы можем задать термины, при упоминании которых в тексте статья будет отнесена к той или иной категории. Добавляем в класс такой код:

```

```

В разделе matching содержится набор словарей . Каждый словарь описывает свою категорию, термины в которой разделены на предметы (подкатегории) и термины . Целью этой статьи является простая демонстрация возможностей и механизмов iKnow, в то время как для серьезной задачи словари должны также быть серьезными и весьма объемными.

**Шаг шестой. Запуск**

Теперь наш домен полностью описан. **полный текст класса:**

```

Class HabrDomain.News Extends %iKnow.DomainDefinition

{

XData Domain [ XMLNamespace = TEST ]

{

}

ClassMethod DeleteDomain(DomainName As %String) As %Status

{

set tSC = ##class(%iKnow.Domain).%OpenId(..%GetDomainId()).DropData(1, 1, 1, 1, 1)

quit:$$$ISERR(tSC) tSC

quit ##class(%iKnow.Domain).%DeleteId(..%GetDomainId())

}

}

```

Несколько слов про метод DeleteDomain, который я добавил к коду. Созданный домен существует как объект класса %iKnowDomain, но удалить его можно только внутренними методами класса HabrDomain.News, поскольку именно он управляет доменом.

Наконец, мы можем запустить расчет.

*do ##class(HabrDomain.News).%Build()*

В результате в созданный при компиляции домен NewsAggregator будут добавлены статьи из указанных нами источников. Кроме того данные будут проанализированы на предмет вхождения в них маркеров из словаря Matching.

**Шаг седьмой. Просмотр результатов**

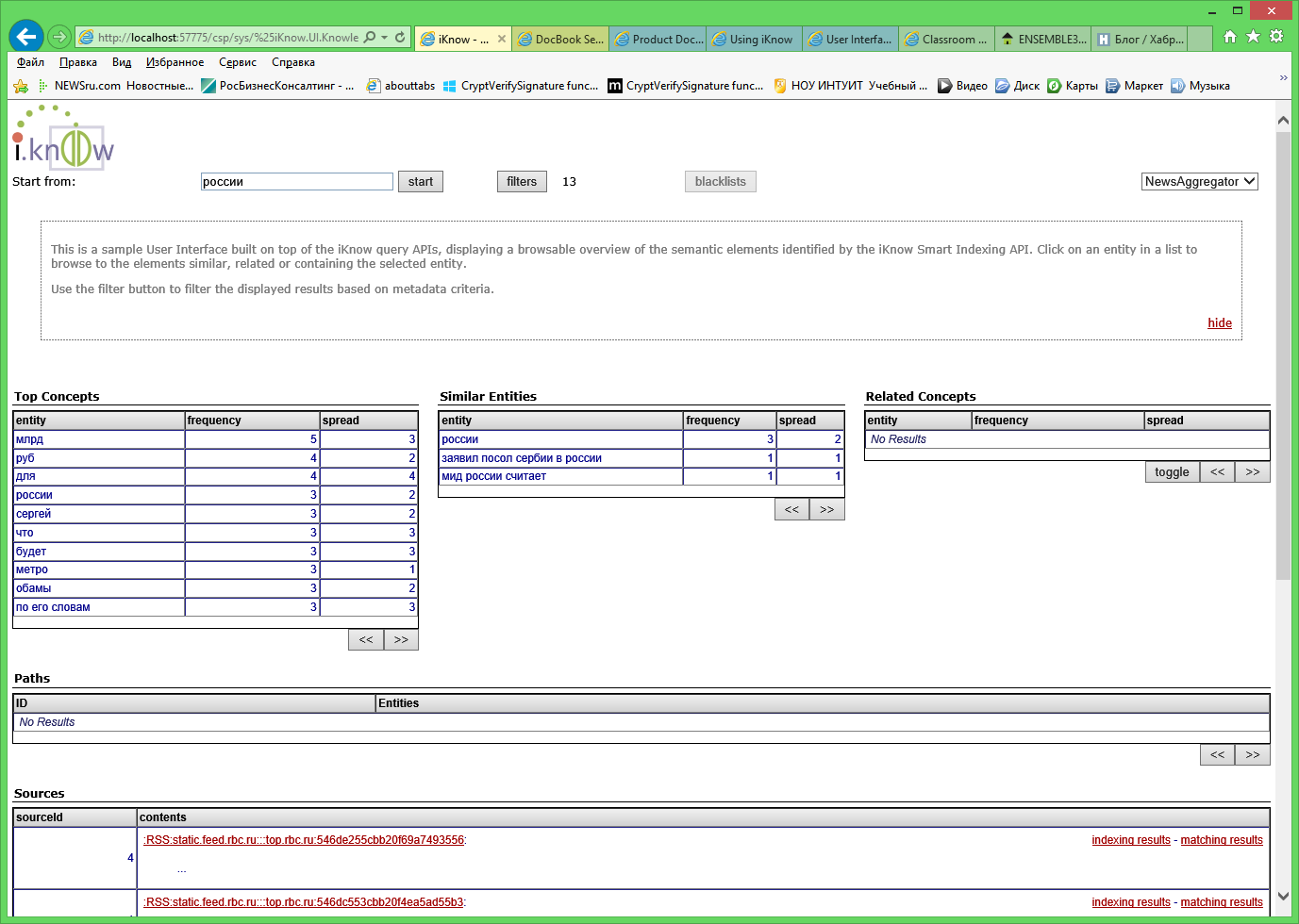

Для просмотра результатов удобнее всего воспользоваться одним из существующих UI, например [Knowledge Portal](http://docs.intersystems.com/cache20141/csp/docbook/DocBook.UI.Page.cls?KEY=GIKNOW_userinterfaces#GIKNOW_userinterfaces_kportal), Indexing Results и Matching Results.

Рисунок 1. Knowledge Portal.

Knowledge Portal позволяет провести первичный анализ результатов работы iKnow. Здесь можно выбрать любой из созданных доменов, в нашем случае это NewsAggregator. Таблица “Top concepts” показывает частоту упоминания тех или иных концептов, при этом frequency – это число упоминаний концепта, а spread – число статей, в которых концепт присутствует. Если мы выберем любой концепт в этой таблице (сейчас выбран концепт “России”, Рисунок 1), то обновится содержимое таблиц “Similar Entities”, “Related Concepts”, “Paths”, “Sources”.

Таблица “Similar Concepts” выводит похожие концепты. В нашем случае похожими будут те концепты, где встречается слово “Россия”, но будут присутствовать дополнительные термины (например “посол Сербии в России”). Таблица “Related Concepts”, в нашем случае она получилось пустой из-за малого количества загруженных статей, будет содержать список концептов, которые наиболее часто упоминаются связанными с выбранным. Ниже в примере такие концепты выделены курсивом.

* [*Инфляция*] в [России]

* [*дефицит торгового баланса евросоюза*] с [россией]

* [россия] оставляет [*право*] на [ответные меры]

Еще одной очень интересной таблицей является “Sources”. Отсюда можно открывать просмотр текста статьи, результаты индексирования и категоризации. С просмотром текста всё весьма просто. Единственный параметр, который можно выбирать в диалоговом окне – это количество выводимых предложений. Так, например, если мы установим 1, то iKnow покажет единственное, наиболее важное, по её мнению, предложение в статье.

Рисунок 2. Indexing Results.

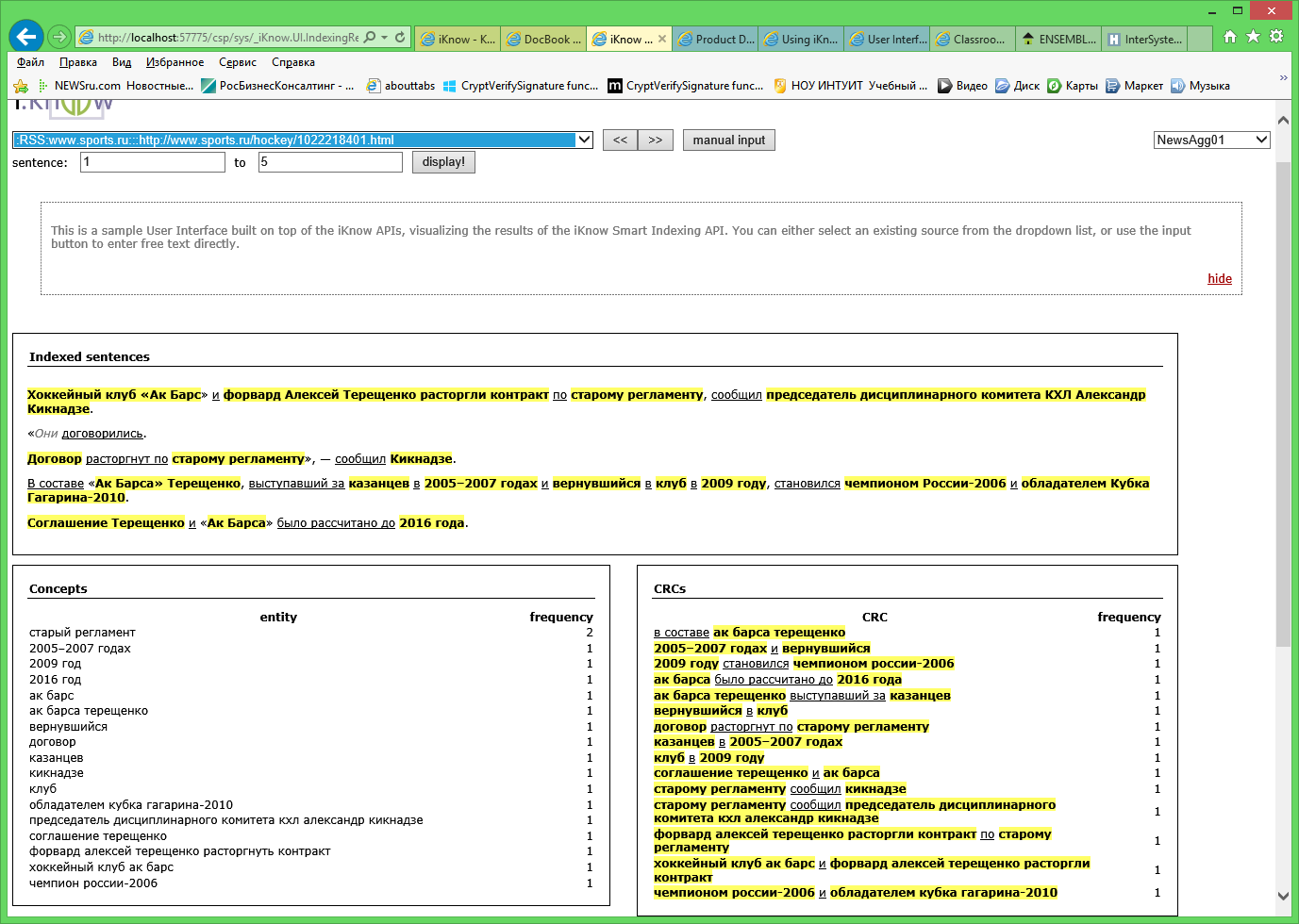

Окно Indexing Results позволяет анализировать результаты индексирования. Здесь цветом выделяются концепты, подчеркнутым курсивом – связи, и серым курсивом – незначащие слова. Как правило, данное окно используется для проверки правильности настроек домена по результатам индексирования, но также оно очень удобно для чтения текстов статей (например, при составлении словарей).

Рисунок 3. Matching Results.

Наконец, третье доступное окно – Matching Results. Здесь можно видеть результаты категоризации статей по словарям, которые мы добавляли в описание домена. Выделенный рыжим цветом концепт в тексте означает, что он в точности соответствует термину из словаря. Если рыжим выделено только обрамление концепта – он является похожим на словарный.

Пришло время подвести итог. Мы научились создавать простейший агрегатор новостей. Для этого с помощью класса %iKnow.DomainDefinition был сформирован домен. В этом домене была создана конфигурация, поддерживающая русский язык и инструмент лемматизации. Были добавлены источники в виде RSS лент. И, наконец, мы создали словари для категоризации. После этого запустили построение домена и, с помощью стандартного UI, проанализировали результаты.

В статье показан пример создания домена iKnow на примере анализа новостей из RSS ленты. Для создания домена использовался класс %iKnow.DomainDefinition. Создана конфигурация домена с поддержкой русского языка и лемматизации, добавлен источник RSS ленты, создан простейший словарь для категоризации статей.

Класс DomainDefinition прекрасно подходит для быстрого создания доменов и прототипирования с использованием iKnow. В реальных приложениях словари терминов для категоризации и сантимент-анализа насчитывают сотни, а то и тысячи слов. Для таких проектов используется класс %iKnow.Domain, который позволяет выполнять также другие интересные задачи. Об этом речь пойдет в моей следующей статье. | https://habr.com/ru/post/244697/ | null | ru | null |

# Советский номерной знак и колмогоровская сложность

Физик Лев Ландау играл в ментальную игру с советскими номерами[[1](https://doi.org/10.1007/s00283-017-9743-9)]. Таблички имели форму двух цифр, тире, еще двух цифр и некоторых букв.

### Правила игры

Его игра заключалась в том, чтобы применять математические операторы к числам по обе стороны от тире, чтобы тире можно было заменить на знак равенства. Например, если взять номерной знак 44-74, одним из решений будет

**4! + 4 = 7 \* 4**

Обратите внимание, что мы можем вставить операторы, такие как **!**, **+** и **\***, но не добавляя цифр.

Есть ли решение для каждого возможного номерного знака? Это зависит от того, какие операторы вы разрешаете использовать.

Вы можете тривиализировать игру, применив операцию дробной части { x } к обеим сторонам, поскольку дробная часть целого числа равна нулю. Вы можете запретить оператор дробной части на том основании, что это явно не математическая операция старшей школы, или просто запретить ее, потому что она делает игру неинтересной.

> [](https://www.edsd.ru/ "EDISON Software - web-development")

>

> Компания EDISON время от времени тоже участвует в научных изысканиях, в частности, для Томского государственного университета проведена [автоматизация измерений с помощью экспертных систем](https://www.edsd.ru/ru/proekty/avtomatizaciya_izmereniy).

>

>

>

>

>

> Мы создали ПО для отечественного микротомографа. В основном, использовали C++ и CUDA. Если необходимо, то пишем [программы на языке Python](https://www.edsd.ru/ru/portfolio/tehnologiya/python), нынче популярном в научной среде.

>

>

### Универсальное решение

Оказывается, есть универсальное решение, начиная с наблюдения, что

√ ( n + 1) = sec arctan √ n.

Если одна сторона больше другой на один, формула выше дает немедленное решение. Например, решение для номерного знака 89-88 будет

√89 = sec arctan√88.

Если разница больше, формула может применяться неоднократно. Например, мы могли бы применить формулу дважды, чтобы получить

√ ( n + 2) = sec arctan√ ( n + 1) = sec arctan sec arctan√ n

и поэтому возможное решение для 35-37 является

sec arctan sec arctan √35 = √37.

### Колмогоровская сложность

Учитывая, что решение всегда возможно, мы можем сделать игру более интересной, находя самое простое решение. У нас есть интуитивное представление о том, что это значит. С нашим примером 44-74, первое решение

4! + 4 = 7 \* 4

проще, чем универсальное решение

sec arctan sec arctan… √44 = √74

что потребовало бы применения секансов и арктангенсов 30 раз.

Колмогоровская сложность объекта — это длина самой короткой компьютерной программы для создания объекта. Мы могли бы вычислить колмогоровскую сложность функций, применяемых к цифрам на каждой стороне, чтобы измерить, насколько сложным является решение.

Чтобы выяснить это, нам нужно указать, какой у нас язык программирования, и это не так просто, как кажется. Если мы думаем о математической нотации как о языке программирования, хотим ли мы считать! как один символ и arctan как 6 символов? Это не кажется правильным. Если бы мы написали «arctan» как «atn», мы бы использовали меньше символов, не создавая другого решения.

### Сложность кода Python

Чтобы сделать вещи более объективными, мы могли бы рассмотреть длину реальных компьютерных программ, а не представлять математическую нотацию как язык программирования. Скажем, мы выбрали Python. Тогда вот пара функций, которые вычисляют наши два решения для номерного знака 44-74.

```

from math import sqrt, cos, atan

def f():

sec = lambda x: 1/cos(x)

y = sqrt(44)

for _ in range(30):

y = sec(atan(y))

return y

def g():

return sqrt(77)

```

Мы могли бы измерить сложность наших функций f и g подсчитывая количество символов в каждой. Но все еще есть трудности.

А как насчет импорта? Его длина должна считаться с f потому что он использует все импортированные операторы, но g использовал более короткий оператор, который только импортировал sqrt. Более фундаментально, мы обманываем, даже импортируя библиотеку?

Кроме того, две вышеупомянутые функции не дают точно такой же результат из-за ограниченной точности. Мы можем представить, что наши импортированные функции бесконечно точны, но тогда мы на самом деле не используем Python, а скорее идеализированную версию Python.

А как насчет цикла? Это ввело новые цифры, 3 и 0, и поэтому нарушает правила игры Ландау. Так следует ли нам развернуть цикл, прежде чем вычислять сложность?

### Мысленный эксперимент

Сложность по Колмогорову — очень полезная концепция, но это скорее мысленный эксперимент, чем то, что вы можете вычислить практически. Мы можем представить себе самую короткую программу для вычисления чего-либо, но мы редко можем знать, что мы действительно нашли такую программу. Все, что мы можем знать на практике, это верхние границы.

Теоретически вы можете перечислить все машины Тьюринга заданной длины или все программы Python заданной длины и найти самую короткую, которая выполняет данную задачу, но список растет экспоненциально с увеличением длины.

Тем не менее, можно рассчитать продолжительность конкретных программ, если мы имеем дело с некоторыми из упомянутых выше сложностей. Мы могли бы сделать игру Ландау игрой для двоих, посмотрев, кто может предложить более простое решение за фиксированный промежуток времени.

### Вернемся к Ландау

Если мы допустим синус и степень в нашем наборе операторов, то у Б.С. Горобец есть универсальное решение. Для n ≥ 6, n! кратный 360, и так

sin( n !) ° = 0.

И если n меньше 6, его двузначное представление начинается с нуля, поэтому мы можем умножить цифры, чтобы получить ноль.

Если мы запрещаем трансцендентные функции, мы блокируем трюк Горобец и у нас есть функции, длину которых мы можем объективно измерить на языке программирования. | https://habr.com/ru/post/439296/ | null | ru | null |

# Декораторы, о которых вам не расскажут

*От переводчика: мне понравился подход к объяснению декораторов, описанный в этой статье, а так как других вариантов перевода я не нашёл, я решил поделиться этим с аудиторией Хабра. Надеюсь что этот текст будет полезен как новичкам, так и опытным программистам.*

Если вы программируете на языке Python, вы должны были слышать о декораторах, однако существует много людей, которые либо не знакомы с ними, либо, что еще хуже, знакомы с ними (использовали так или иначе), но так и не поняли их суть.

Если вы относитесь к последней категории, вы наверняка слышали: «Декораторы — это просто, это функции, которые принимают функции и возвращают другие функции!». Наверняка вы читали статьи в блогах о декораторах, которые добавляют что-то к результату функции или что-то выводят в консоль при ее вызове, или реализуют кэширование — как будто это настолько непреодолимые проблемы, что их можно решить только с помощью декораторов. Если вы пишете на Flask, вы наверняка использовали `@app.route` особо не задумываясь, что он на самом деле делает.

Короче говоря, вы знаете, что декораторы существуют, используете их, но не уверены *точно* для чего они нужны и почему они такие, какие есть. Практика приводит к совершенству, но бездумное следование инструкциям ведёт к апатии. Так человек, который совершенно не интересуется классикой, но которого учили игре на скрипке только как инструменте классической музыки, не станет виртуозом, не открыв для себя скрипку с других сторон.

Цель этого краткого руководства — развеять мифы, которые вы слышали о декораторах, и показать вам другие их стороны, о которых вы и не подозревали.

#### Обязательное напоминание

Закон штата требует, чтобы перед тем, как мы продолжим, я напомнил вам основные принципы работы декораторов.

#### Функции в Python

Первое, что вы должны понять: все функции в Python — это [объекты первого класса](https://ru.wikipedia.org/wiki/%D0%9E%D0%B1%D1%8A%D0%B5%D0%BA%D1%82_%D0%BF%D0%B5%D1%80%D0%B2%D0%BE%D0%B3%D0%BE_%D0%BA%D0%BB%D0%B0%D1%81%D1%81%D0%B0), то есть такие же объекты, как и любые другие.

У них есть атрибуты:

```

def f():

"""Print something to standard out."""

print('something')

print(dir(f))

# ['__call__', '__class__', '__closure__', '__code__', '__defaults__',

# '__delattr__', '__dict__', '__doc__', '__format__', '__get__',

# '__getattribute__', '__globals__', '__hash__', '__init__',

# '__module__', '__name__', '__new__', '__reduce__', '__reduce_ex__',

# '__repr__', '__setattr__', '__sizeof__', '__str__', '__subclasshook__',

# 'func_closure', 'func_code', 'func_defaults', 'func_dict', 'func_doc',

# 'func_globals', 'func_name']

```

Вы можете присваивать их в качестве значений переменных:

```

g = f

g()

# something

```

Можете использовать их в качестве аргументов других функций:

```

def func_name(function):

return function.__name__

func_name(f)

# 'f'

```

Можете добавлять их внутрь структур данных:

```

function_collection = [f, g]

for function in function_collection:

function()

# something

# something

```

Декоратор — это объект и вы можете делать с ним то что и с любым другим объектом.

#### Декораторы

Декораторы часто описывают как «функции которые принимают функции на вход и возвращают другие функции». Однако, в этом нет ни единого истинного слова. Что истинно, так это:

* Декораторы применяются один раз, в момент создания функции.

* Аннотация функции `x` декоратором `@d` эквивалентна созданию функции `x` и затем немедленному переопределению `x = d(x)`.

* Декорирование функции последовательно двумя декораторами `@d` и `@e` эквивалентно: `x = d(e(x))` после создания функции.

Второй из этих принципов продемонстрирован здесь:

```

def print_when_called(function):

def new_function(*args, **kwargs):

print("{} was called".format(function.__name__))

return function(*args, **kwargs)

return new_function

def one():

return 1

one = print_when_called(one)

@print_when_called

def one_():

return 1

[one(), one_(), one(), one_()]

# one was called

# one_ was called

# one was called

# one_ was called

# [1, 1, 1, 1]

```

Сразу же уточню: хотя я только что сказал, что декораторы применяются во время создания функции, сообщения в приведенном выше примере печатаются во время вызова функции. Это происходит потому, что `print_when_called` возвращает `new_function`, которая сама печатает сообщения перед вызовом `one` или `one_`. Посмотрите другой пример:

```

def print_when_applied(function):

print("print_when_applied was applied to {}".format(function.__name__))

return function

@print_when_applied

def never_called():

import os

os.system('rm -rf /')

# print_when_applied was applied to never_called

```

`never_called`, никогда не вызывается, но сообщение из декоратора `print_when_applied` все равно выводится.

А так можно продемонстрировать порядок применения декораторов, глядите внимательно на имена функций:

```

@print_when_applied

@print_when_called

def this_name_will_be_printed_when_called_but_not_at_definition_time():

pass

this_name_will_be_printed_when_called_but_not_at_definition_time()

# print_when_applied was applied to new_function

# this_name_will_be_printed_when_called_but_not_at_definition_time was called

```

`print_when_called` возвращает функцию с именем `new_function`, и именно к ней обращается `print_when_applied`.

### Мифы о декораторах

Чтобы по-настоящему понять потенциал декораторов, недостаточно узнать то, чего вы еще не знаете, надо забыть то, что вы уже знаете.

#### Миф первый: декоратор возвращает функцию

Ранее я утверждал, что применение декоратора `d` к функции `x` - это то же самое, что создать `x`, и потом сделать `x = d(x)`.

Но кто сказал, что `d` должен возвращать функцию? На самом деле, `func_name` (которую я определил ранее) возвращает строку, но прекрасно работает как декоратор.

```

@func_name

def a_named_function():

return

a_named_function

'a_named_function'

```

Почему это так важно? Это означает, что функции могут быть не просто вызываемыми объектами, а небольшими изолированными областями для выполнения... всего, что вы захотите. Например, если вы хотите обработать список, вы можете сделать следующее:

```

def process_list(list_):

def decorator(function):

return function(list_)

return decorator

unprocessed_list = [0, 1, 2, 3]

special_var = "don't touch me please"

@process_list(unprocessed_list)

def processed_list(items):

special_var = 1

return [item for item in items if item > special_var]

(processed_list, special_var)