text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Отправка e-mail сообщения в среде разработки 3CX Call Flow Designer

Введение

--------

В этом статье мы расскажем, как отправить e-mail сообщение из [3CX Call Flow Designer](https://www.3cx.com/phone-system/call-flow-designer/), используя компонент Email Sender. Приложение записывает голос позвонившего абонента в WAV файл и отсылает его как e-mail вложение.

Вы можете использовать этот компонент, например, для уведомления о заказе товара через голосовое меню 3CX, и в других ситуациях, когда голосовое взаимодействие пользователя с системой должно сопровождаться отправкой e-mail.

Напомним, что в предыдущих статьях мы рассмотрели создание [CFD приложения для исходящего обзвона](https://habrahabr.ru/company/3cx/blog/336528/) (по завершении обзвона можно отсылать отчет, используя компонент Email Sender), [работу CFD с базами данных](https://habrahabr.ru/company/3cx/blog/334472/) (которые также можно использовать для получения номера абонента) и [маршрутизацию входящих вызовов в зависимости от времени суток](https://habrahabr.ru/company/3cx/blog/333958/) (которую можно комбинировать с исходящим обзвоном)

Обратите внимание — среда разработки 3CX CFD поставляется бесплатно. Но голосовые приложения будут выполняться только на [3CX редакции Pro и Enterprise](https://www.3cx.ru/ip-pbx/edition-comparison/). Скачать CFD можно [отсюда](http://downloads.3cx.com/downloads/3CXCallFlowDesigner.exe).

Демо-проект этого голосового приложения поставляется вместе с дистрибутивом 3CX CFD и находится в папке **Documents\3CX Call Flow Designer Demos**. В демо-приложении для начала работы достаточно указать параметры вашего SMTP сервера.

Создание проекта

----------------

Для создания проекта CFD перейдите в **File → New → Project**, укажите папку размещения проекта и его имя, например, **EMailDemo**.

Запись сообщения пользователя в файл

------------------------------------

Для начала запишем сообщение абонента в файл. Этот файл и будет затем отослан на e-mail. Для этого используется компонент **Record**.

1. Перетащите компонент **Record** в основное окно среды разработки (в голосовое приложение **Main**). Перейдите в окно свойств и переименуйте компонент в **recordYourMessage**.

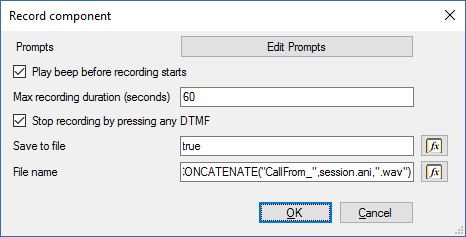

2. Дважды кликните на компоненте и в открывшимся окне установите следующие параметры:

```

CONCATENATE("CallFrom_",session.ani,".wav")

```

Отправка записанного сообщения на e-mail

----------------------------------------

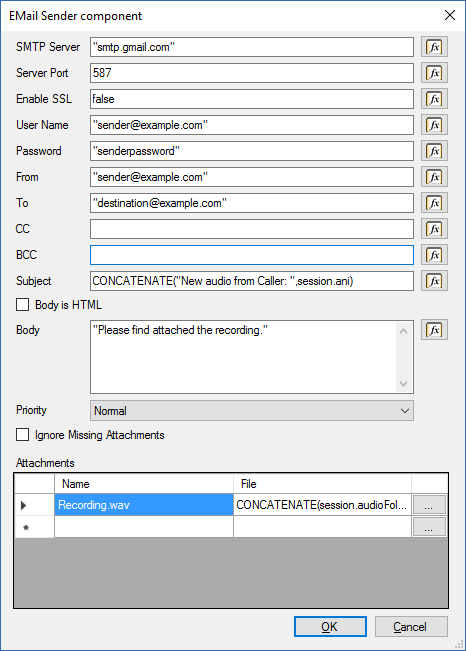

Теперь отправим записанный аудиофайл в виде e-mail вложения. Для этого добавим компонент **E-Mail Sender** в ветвление **Audio Recorded** компонента **Record** и настроим его как показано ниже:

Обратите внимание, что в тех параметрах, где указываются выражения (поля имеют кнопку **Fx** справа), любая указанная константа должна заключаться в кавычки, поскольку в этих полях также могут находится переменные или результаты выражения.

Для параметра **Subject** мы используем выражение, которое добавляет номер позвонившего абонента.

Список вложений **Attachments** содержит описания файлов, состоящие из двух столбцов:

* **Name** — имя файла, которое увидит получатель e-mail сообщения. Укажем здесь **Recording.wav**, чтобы во вложении приходил файл только с этим именем.

* **File** — выражение, которое указывает на физический файл записи, который нужно вложить в письмо. Однако здесь мы должны дополнить выражение, генерирующее имя файла (которое использовалось в предыдущем шаге). В предыдущем шаге в компоненте **Record** использовался относительный путь к файлу — указывалось только имя. Файл создавался в каталоге аудиофайлов данного проекта. Компоненту **Email Sender** следует передать полный путь к файлу, поэтому выражение дополняется переменной **session.audioFolder**:

```

CONCATENATE(session.audioFolder,"/CallFrom_",session.ani,".wav")

```

Теперь голосовое приложение корректно найдет и вложит аудиофайл.

Компиляция и установка приложения на сервер 3CX

-----------------------------------------------

Голосовое приложение готово! Теперь его следует скомпилировать и загрузить на сервер 3CX. Для этого:

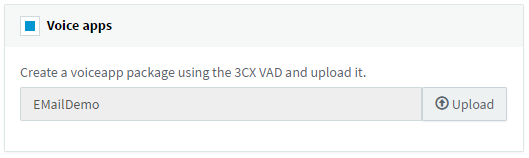

* Перейдите в меню **Build → Build All**, и CFD создаст файл **EMailDemo.tcxvoiceapp**.

* Перейдите в интерфейс управления 3CX, в раздел **Очереди вызовов**. Создайте новую Очередь вызовов, укажите название и добавочный номер Очереди, а затем установите опцию **Голосовые приложения** и загрузите скомпилированный файл.

* Сохраните изменения в Очереди вызовов. Голосовое приложение готово к использованию.

| https://habr.com/ru/post/337096/ | null | ru | null |

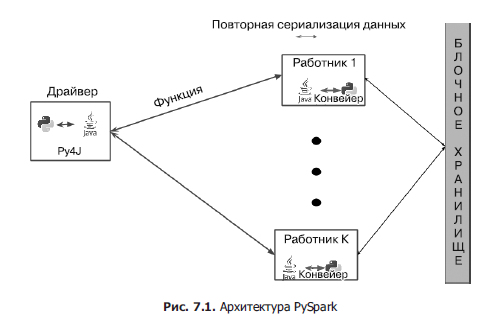

# Итерируемый объект, итератор и генератор

Привет, уважаемые читатели Хабрахабра. В этой статье попробуем разобраться что такое итерируемый объект, итератор и генератор. Рассмотрим как они реализованы и используются. Примеры написан на Python, но итераторы и генераторы, на мой взгляд, фундаментальные понятия, которые были актуальны 20 лет назад и еще более актуальны сейчас, при этом за это время фактически не изменились.

Итераторы

---------

Для начала вспомним, что из себя представляет паттерн «Итератор(Iterator)».

Назначение:

* для доступа к содержимому агрегированных объектов без раскрытия их внутреннего представления;

* для поддержки нескольких активных обходов одного и того же агрегированного объекта (желательно, но не обязательно);

* для предоставления единообразного интерфейса с целью обхода различных агрегированных структур.

В итоге мы получаем разделение ответственности: клиенты получают возможность работать с разными коллекциями унифицированным образом, а коллекции становятся проще за счет того, что делегируют перебор своих элементам другой сущности.

Существуют два вида итераторов, *внешний* и *внутренний*.

*Внешний итератор* — это классический (pull-based) итератор, когда процессом обхода явно управляет клиент путем вызова метода Next.

*Внутренний итератор* — это push-based-итератор, которому передается callback функция, и он сам уведомляет клиента о получении следующего элемента.

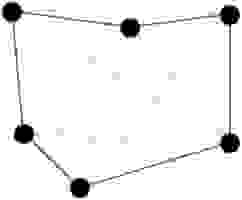

Классическая диаграмма паттерна “Итератор”, как она описана в небезызвестной книги «банды четырех»:

*Aggregate* — составной объект, по которому может перемещаться итератор;

*Iterator* — определяет интерфейс итератора;

*ConcreteAggregate* — конкретная реализация агрегата;

*ConcreteIterator* — конкретная реализация итератора для определенного агрегата;

*Client* — использует объект Aggregate и итератор для его обхода.

### Пробуем реализовать на Python классический итератор

Абстрактные классы:

```

class Aggregate(abc.ABC):

@abc.abstractmethod

def iterator(self):

"""

Возвращает итератор

"""

pass

class Iterator(abc.ABC):

def __init__(self, collection, cursor):

self._collection = collection

self._cursor = cursor

@abc.abstractmethod

def first(self):

"""

Возвращает итератор к началу агрегата.

Так же называют reset

"""

pass

@abc.abstractmethod

def next(self):

"""

Переходит на следующий элемент агрегата.

Вызывает ошибку StopIteration, если достигнут конец последовательности.

"""

pass

@abc.abstractmethod

def current(self):

"""

Возвращает текущий элемент

"""

pass

```

Конкретная реализация итератора для списка:

```

class ListIterator(Iterator):

def __init__(self, collection, cursor):

"""

:param collection: список

:param cursor: индекс с которого начнется перебор коллекции.

так же должна быть проверка -1 >= cursor < len(collection)

"""

super().__init__(collection, cursor)

def first(self):

"""

Начальное значение курсора -1.

Так как в нашей реализации сначала необходимо вызвать next

который сдвинет курсор на 1.

"""

self._cursor = -1

def next(self):

"""

Если курсор указывает на послений элемент, то вызываем StopIteration,

иначе сдвигаем курсор на 1

"""

if self._cursor + 1 >= len(self._collection):

raise StopIteration()

self._cursor += 1

def current(self):

"""

Возвращаяем текущий элемент

"""

return self._collection[self._cursor]

```

Конкретная реализация агрегата:

```

class ListCollection(Aggregate):

def __init__(self, collection):

self._collection = list(collection)

def iterator(self):

return ListIterator(self._collection, -1)

```

Теперь мы можем создать объект коллекции и обойти все ее элементы с помощью итератора:

```

collection = (1, 2, 5, 6, 8)

aggregate = ListCollection(collection)

itr = aggregate.iterator()

# обход коллекции

while True:

try:

itr.next()

except StopIteration:

break

print(itr.current())

```

А так как мы реализовали метод first, который сбрасывает итератор в начальное состояние, то можно воспользоваться этим же итератором еще раз:

```

# возвращаем итератор в исходное состояние

itr.first()

while True:

try:

itr.next()

except StopIteration:

break

print(itr.current())

```

Реализации могут быть разные, но основная идея в том, что итератор может обходить различные структуры, вектора, деревья, хеш-таблицы и много другое, при этом имея снаружи одинаковый интерфейс.

### Протокол итерирования в Python

В книге «банды четырех» о реализации итератора написано:

*Минимальный интерфейс класса Iterator состоит из операций First, Next, IsDone и CurrentItem.* ~~Но если очень хочется, то~~ *этот интерфейс можно упростить, объединив операции Next, IsDone и CurrentItem в одну, которая будет переходить к следующему объекту и возвращать его. Если обход завершен, то эта операция вернет специальное значения(например, 0), обозначающее конец итерации.*

Именно так и реализовано в Python, но вместо специального значения, о конце итерации говорит StopIteration. *Проще просить прощения, чем разрешения.*

Сначала важно определиться с терминами.

Рассмотрим *итерируемый объект* (Iterable). В стандартной библиотеке он объявлен как абстрактный класс collections.abc.Iterable:

```

class Iterable(metaclass=ABCMeta):

__slots__ = ()

@abstractmethod

def __iter__(self):

while False:

yield None

@classmethod

def __subclasshook__(cls, C):

if cls is Iterable:

return _check_methods(C, "__iter__")

return NotImplemented

```

У него есть абстрактный метод \_\_iter\_\_ который должен вернуть объект итератора. И метод \_\_subclasshook\_\_ который проверяет наличие у класса метод \_\_iter\_\_. Таким образом, получается, что *итерируемый объект* это любой объект который реализует метод \_\_iter\_\_

```

class SomeIterable1(collections.abc.Iterable):

def __iter__(self):

pass

class SomeIterable2:

def __iter__(self):

pass

print(isinstance(SomeIterable1(), collections.abc.Iterable))

# True

print(isinstance(SomeIterable2(), collections.abc.Iterable))

# True

```

Но есть один момент, это функция iter(). Именно эту функцией использует например цикл for для получения итератора. Функция iter() в первую очередь для получения итератора из объекта, вызывает его метод \_\_iter\_\_. Если метод не реализован, то она проверяет наличие метода \_\_getitem\_\_ и если он реализован, то на его основе создается итератор. \_\_getitem\_\_ должен принимать индекс с нуля. Если не реализован ни один из этих методов, тогда будет вызвано исключение TypeError.

```

from string import ascii_letters

class SomeIterable3:

def __getitem__(self, key):

return ascii_letters[key]

for item in SomeIterable3():

print(item)

```

Итого, **итерируемый объект** — это любой объект, от которого встроенная функция iter() может получить итератор. Последовательности(abc.Sequence) всегда итерируемые, поскольку они реализуют метод \_\_getitem\_\_

Теперь посмотрим, что с итераторами в Python. Они представлены абстрактным классом collections.abc.Iterator:

```

class Iterator(Iterable):

__slots__ = ()

@abstractmethod

def __next__(self):

'Return the next item from the iterator. When exhausted, raise StopIteration'

raise StopIteration

def __iter__(self):

return self

@classmethod

def __subclasshook__(cls, C):

if cls is Iterator:

return _check_methods(C, '__iter__', '__next__')

return NotImplemented

```

*\_\_next\_\_* Возвращает следующий доступный элемент и вызывает исключение StopIteration, когда элементов не осталось.

*\_\_iter\_\_* Возвращает self. Это позволяет использовать итератор там, где ожидается итерируемых объект, например for.

*\_\_subclasshook\_\_* Проверяет наличие у класса метода \_\_iter\_\_ и \_\_next\_\_

Итого, **итератор в python** — это любой объект, реализующий метод \_\_next\_\_ без аргументов, который должен вернуть следующий элемент или ошибку StopIteration. Также он реализует метод \_\_iter\_\_ и поэтому сам является *итерируемым объектом*.

Таким образом можно реализовать итерируемый объект на основе списка и его итератор:

```

class ListIterator(collections.abc.Iterator):

def __init__(self, collection, cursor):

self._collection = collection

self._cursor = cursor

def __next__(self):

if self._cursor + 1 >= len(self._collection):

raise StopIteration()

self._cursor += 1

return self._collection[self._cursor]

class ListCollection(collections.abc.Iterable):

def __init__(self, collection):

self._collection = collection

def __iter__(self):

return ListIterator(self._collection, -1)

```

Варианты работы:

```

collection = [1, 2, 5, 6, 8]

aggregate = ListCollection(collection)

for item in aggregate:

print(item)

print("*" * 50)

itr = iter(aggregate)

while True:

try:

print(next(itr))

except StopIteration:

break

```

Функция next() вызывает метод \_\_next\_\_. Ей можно передать второй аргумент который она будет возвращать по окончанию итерации вместо ошибки StopIteration.

```

itr = iter(aggregate)

while True:

item = next(itr, None)

if item is None:

break

print(item)

```

Прежде чем переходить к генераторам, рассмотрим еще одну возможность встроенной функции *iter()*. Ее можно вызывать с двумя аргументами, что позволит создать из *вызываемого объекта*(функция или класс с реализованным методом \_\_call\_\_) итератор. Первый аргумент должен быть вызываемым объектом, а второй — неким ограничителем. Вызываемый объект вызывается на каждой итерации и итерирование завершается, когда возбуждается исключение StopIteration или возвращается значения ограничителя.

Например, из функции которая произвольно возвращает 1-6, можно сделать итератор, который будет возвращать значения пока не «выпадет» 6:

```

from random import randint

def d6():

return randint(1, 6)

for roll in iter(d6, 6):

print(roll)

```

**Другие примеры**

Небольшой класс ProgrammingLanguages, у которого есть кортеж c языками программирования, конструктор принимает начальное значения индекса по названию языка и функция \_\_call\_\_ которая перебирает кортеж.

```

class ProgrammingLanguages:

_name = ("Python", "Golang", "C#", "C", "C++", "Java", "SQL", "JS")

def __init__(self, first=None):

self.index = (-1 if first is None else

ProgrammingLanguages._name.index(first) - 1)

def __call__(self):

self.index += 1

if self.index < len(ProgrammingLanguages._name):

return ProgrammingLanguages._name[self.index]

raise StopIteration

```

Можем перебрать все языки начиная с C# и до последнего:

```

for lang in iter(ProgrammingLanguages("C#"), None):

print(lang)

```

C первого до C:

```

pl = ProgrammingLanguages()

for lang in iter(pl, "C"):

print(lang)

```

Еще один пример:

```

# читаем файл до пустой строки

with open('mydata.txt') as fp:

for line in iter(fp.readline, ''):

print(line)

```

Генераторы

----------

С точки зрения реализации, генератор в Python — это языковая конструкция, которую можно реализовать двумя способами: как функция с ключевым словом *yield* или как генераторное выражение. В результате вызова функции или вычисления выражения, получаем объект-генератор типа types.*GeneratorType*.

В объекте-генераторе определены методы \_\_next\_\_ и \_\_iter\_\_, то есть реализован протокол итератора, с этой точки зрения, в Python любой генератор является итератором.

Концептуально, итератор — это механизм поэлементного обхода данных, а генератор позволяет отложено создавать результат при итерации. Генератор может создавать результат на основе какого то алгоритма или брать элементы из источника данных(коллекция, файлы, сетевое подключения и пр) и изменять их.

Ярким пример являются функции range и enumerate:

*range* генерирует ограниченную арифметическую прогрессию целых чисел, не используя никакой источник данных.

*enumerate* генерирует двухэлементные кортежи с индексом и одним элементом из итерируемого объекта.

### Yield

Для начало напишем простой генератор не используя объект-генератор. Это генератор чисел Фибоначчи:

```

class FibonacciGenerator:

def __init__(self):

self.prev = 0

self.cur = 1

def __next__(self):

result = self.prev

self.prev, self.cur = self.cur, self.prev + self.cur

return result

def __iter__(self):

return self

for i in FibonacciGenerator():

print(i)

if i > 100:

break

```

Но используя ключевое слово *yield* можно сильно упростить реализацию:

```

def fibonacci():

prev, cur = 0, 1

while True:

yield prev

prev, cur = cur, prev + cur

for i in fibonacci():

print(i)

if i > 100:

break

```

Любая функция в Python, в теле которой встречается ключевое слово *yield*, называется *генераторной функцией* — при вызове она возвращает *объект-генератор*.

*Объект-генератор* реализует интерфейс итератора, соответственно с этим объектом можно работать, как с любым другим *итерируемым объектом*.

```

fib = fibonacci()

print(next(fib))

# 0

print(next(fib))

# 1

for num, fib in enumerate(fibonacci()):

print('{0}: {1}'.format(num, fib))

if num > 9:

break

# 0: 0

# 1: 1

# 2: 1

...

```

Рассмотрим работу yield:

```

def gen_fun():

print('block 1')

yield 1

print('block 2')

yield 2

print('end')

for i in gen_fun():

print(i)

# block 1

# 1

# block 2

# 2

# end

```

1. при вызове функции gen\_fun создается *объект-генератор*

2. for вызывает iter() с этим объектом и получает итератор этого генератора

3. в цикле вызывает функция next() с этим итератором пока не будет получено исключение StopIteration

4. при каждом вызове next выполнение в функции начинается с того места где было завершено в последний раз и продолжается до следующего *yield*

Происходит приблизительно следующее. Генераторная функция разбивается на части:

```

def gen_fun_1():

print('block 1')

return 1

def gen_fun_2():

print('block 2')

return 2

def gen_fun_3():

print('end')

def gen_fun_end():

raise StopIteration

```

Создается стейт-машина в которой при каждом вызове \_\_next\_\_ меняется состояния и в зависимости от него вызывается тот или иной кусок кода. Если в функции yield в цикле, то соответственно состояние стейт-машины зацикливается пока не будет выполнено условие.

Свой вариант range:

```

def cool_range(start, stop, inc):

x = start

while x < stop:

yield x

x += inc

for n in cool_range(1, 5, 0.5):

print(n)

# 1

# 1.5

# ...

# 4.5

print(list(cool_range(0, 2, 0.5)))

# [0, 0.5, 1.0, 1.5]

```

### Генераторное выражение (generator expression)

Если кратко, то синтаксически более короткий способ создать генератор, не определяя и не вызывая функцию. А так как это выражение, то у него есть и ряд ограничений. В основном удобно использовать для генерации коллекций, их несложных преобразований и применений на них условий.

В языках программирования есть такие понятия, как *ленивые/отложенные вычисления(lazy evaluation)* и *жадные вычисления(eager/greedy evaluation)*. Генераторы можно считать отложенным вычислением, в этом смысле списковое включение(list comprehension) очень похожи на генераторное выражение, но являются разными подходами.

```

(i for i in range(10000000))

[i for i in range(10000000)]

```

Первый вариант работает схожим с нашей функцией cool\_range образом и может генерировать без проблем любой диапазон. А вот второй вариант создаст сразу целый список, со всеми вытекающими от сюда проблемами.

### Yield from

Для обхода ограниченно вложенных структур, традиционный подход использовать вложенные циклы. Тот же подход можно использовать когда генераторная функция должна отдавать значения, порождаемые другим генератором.

Функция похожая на itertools.chain:

```

def chain(*iterables):

for it in iterables:

for i in it:

yield i

g = chain([1, 2, 3], {'A', 'B', 'C'}, '...')

print(list(g))

# [1, 2, 3, 'A', 'B', 'C', '.', '.', '.']

```

Но вложенные циклы можно убрать, добавив конструкцию yield from:

```

def chain(*iterables):

for it in iterables:

yield from it

g = chain([1, 2, 3], {'A', 'B', 'C'}, '...')

print(list(g))

# [1, 2, 3, 'A', 'B', 'C', '.', '.', '.']

```

Основная польза yield from в создании прямого канала между внутренним генератором и клиентом внешнего генератора. Но это уже больше тема про *сопрограммы(coroutines)*, которые заслуживают отдельной статьи. Там же можно обсудить методы генератора: close(), throw() и send().

И в заключении еще один пример. Функция принимающая итерируемый объект, с любым уровнем вложенности другими итерируемыми объектами, и формирующая плоскую последовательность:

```

from collections import Iterable

def flatten(items, ignore_types=(str, bytes)):

"""

str, bytes - являются итерируемыми объектами,

но их хотим возвращать целыми

"""

for x in items:

if isinstance(x, Iterable) and not isinstance(x, ignore_types):

yield from flatten(x)

else:

yield x

items = [1, 2, [3, 4, [5, 6], 7], 8, ('A', {'B', 'C'})]

for x in flatten(items):

print(x)

# 1

# 2

# 3

# 4

# 5

# 6

# 7

# 8

# A

# C

# B

```

На сегодня все. Спасибо! | https://habr.com/ru/post/337314/ | null | ru | null |

# Обзор системы мониторинга приложений Instana

Сегодня я расскажу, что из себя представляет [Instana](https://www.instana.com/), и чем эта система мониторинга (СМ) отличается от других.

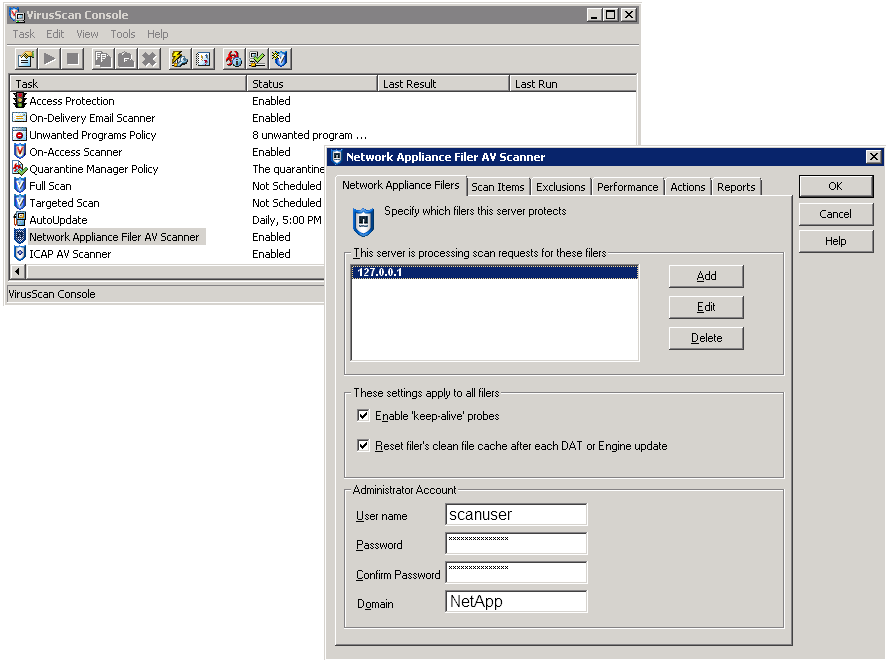

Система состоит из **Instana Backend** (сервер с веб-интерфейсом и хранилищем собранных данными) и **Instana Agent** (агент, который устанавливается на целевые хосты для мониторинга приложений). В качестве БД для хранения данных по метрикам используется [Cassandra](http://cassandra.apache.org/). Кроме On-premise установки, есть облачная версия. Обзор посвящен опыту использования первого варианта.

### Установка

Технические детали и ссылки на документацию — под спойлером.

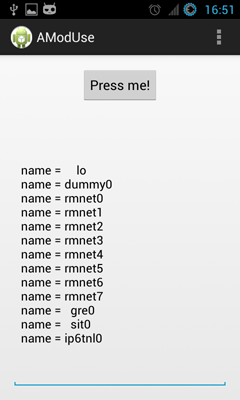

**Подробности установки**### Подготовка

Перед началом установки необходимо убедиться, что у вас открыт доступ к [репозиториям Instana](https://instana.atlassian.net/wiki/display/DOCS/Outbound+Network+Access+Requirements), так как большинство компонентов загружают необходимые пакеты и артефакты при запуске. Это касается и агента Instana. Его дистрибутив содержит только ядро агента: во время установки агент обнаруживает компоненты на целевом сервере и скачивает пакеты, необходимые для мониторинга этих компонентов. Вы можете использовать ваш внутренний репозиторий в режиме прокси (например, [Sonartype Nexus](https://instana.atlassian.net/wiki/display/DOCS/Using+on-premises+agent+repository)).

Выберите операционку — на данный момент для установки бэкенд-сервера поддерживаются:

* SLES: >= 12

* Ubuntu: >= 16.04

* Debian: >= 8

* RedHat Enterprise Linux >= 7.2

* CentOS >= 7

Требования к версиям ОС обусловлены тем, что ПО Instana работает на [Docker](https://www.docker.com/) >= 1.10.

ПО платное, поэтому вам также понадобится [ключ активации для Backend и Agent](https://instana.atlassian.net/wiki/display/DOCS/On+Premises).

### Установка Backend

Мы используем CentOS 7, установка прошла четко по [инструкции](https://instana.atlassian.net/wiki/display/DOCS/Installation).

Добавляем запись о репозитории (используется логин/пароль, выделенный вендором):

```

sudo tee /etc/yum.repos.d/instana.repo <<-EOF

[instanarepo]

name=Instana Repository

baseurl=https://:@package-repository.instana.io/backend/rhel7

enabled=1

gpgcheck=1

gpgkey=https://:@package-repository.instana.io/instana.gpg

EOF

```

После чего запускаем установку пакета через yum:

```

yum install instana-backend

```

После окончания установки не торопитесь запускать, сперва надо скопировать и поправить [конфиг для Instana Backend](https://instana.atlassian.net/wiki/display/DOCS/Installation#Installation-Configuration):

```

cd /etc/instana-backend

cp instana.settings.template instana.settings

```

Нам понадобилось закомментировать строчку в /etc/sudoers с помощью команды visudo, чтобы произвести запуск из под root с помощью sudo:

```

#Defaults requiretty

```

Логинимся в репозиторий Instana:

```

docker login -u ”$INSTANA_REPO_USER” -p “$INSTANA_REPO_PASSWORD” registry-

public.instana.io

```

Добавляем запуск бэкенда в автозагрузку:

```

systemctl enable instana-backend.service

```

Всё, теперь можно запускать:

```

systemctl start instana-backend

```

После этого начнут загружаться необходимые пакеты из репозитория, это займет время. В конце должна появиться радостная надпись:

```

All done :)

```

### Установка агента

На данный момент поддерживаются следующие операционки:

* Linux 32 / 64 bit

* Windows 32 / 64 bit

* Mac OS 64 bit

Для запуска агента необходимо установить [JDK 8](http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html) (не JRE !). Переменная среды JAVA\_HOME должна содержать корректный путь к установленному JDK.

Заходим в веб-интерфейс Instana Backend и скачиваем дистрибутив под нужную операционку:

[](https://habrastorage.org/files/a57/487/dcb/a57487dcbbdb46e596df5ac7d40d4be7.png)

Также можно скачать дистрибутивы напрямую на [сайте вендора](https://instana.atlassian.net/wiki/display/DOCS/Agent+Installation).

Например, на Linux установка агента заключается в копировании и распаковке архива. Перед запуском необходимо поправить [конфиг агента](https://instana.atlassian.net/wiki/display/DOCS/Agent+Proxy+Setup) и указать данные вашего репозитория. Теперь можно запустить агента:

```

/instana-agent/bin/start

```

После запуска можно проверить статус агента командой:

```

/instana-agent/bin/status

```

При необходимости остановить агента можно командой:

```

/instana-agent/bin/stop

```

Текущий лог агента лежит здесь:

```

/instana-agent/data/log/agent.log

```

Чтобы все хосты у вас на карте были разбиты на зоны (как на картинке ниже), искались по тегам, необходимо внести правки в конфиг агента на хосте и перезапустить агента. Всё это подробно описано в [документации](https://instana.atlassian.net/wiki/display/DOCS/Agent+Configuration). Кстати, для начала можно установить агента на сам сервер Backend Instana.

Агента также можно [установить в контейнере](https://instana.atlassian.net/wiki/pages/viewpage.action?pageId=1179728).

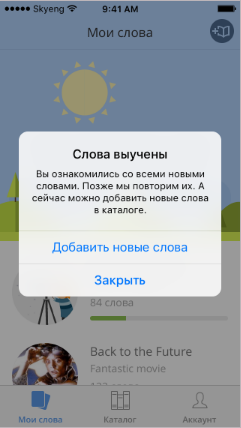

### Использование

Несмотря на то, что интерфейс системы очень интуитивный, советую прочитать соответствующую [документацию](https://instana.atlassian.net/wiki/display/DOCS/Getting+Started), встречаются неочевидные моменты.

Например, чтобы посмотреть подробности того или иного параметра необходимо кликнуть на нем (для меня строка таблицы была неочевидным местом клика):

[](https://habrastorage.org/files/fa1/a52/c27/fa1a52c2721d409db155bc17d671c56b.png)

Откроется соответствующий график:

[](https://habrastorage.org/files/cc3/e1b/201/cc3e1b2014824845b3dea5a3960d62ef.png)

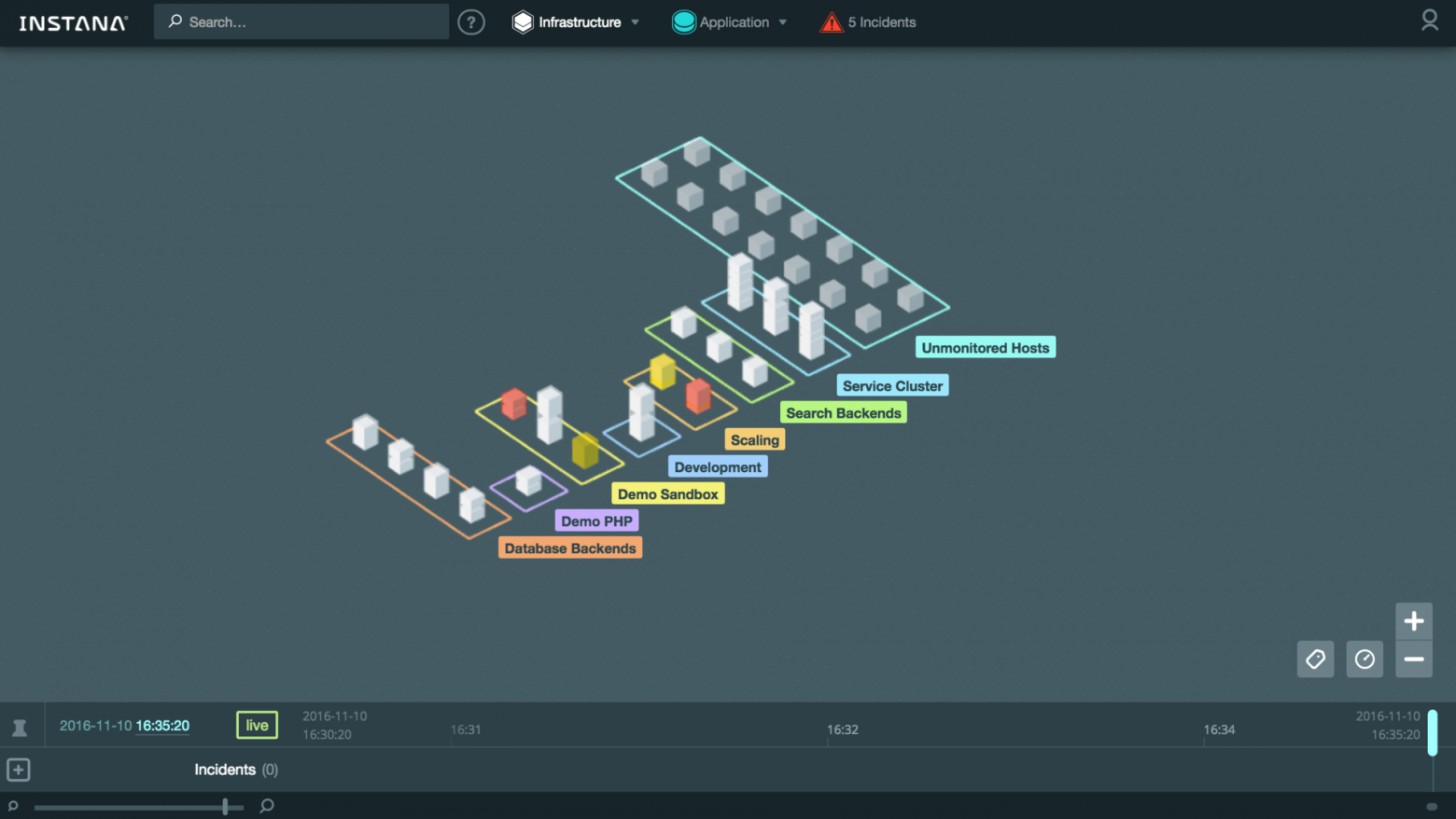

Инфраструктурная карта ([Infrastructure Map](https://instana.atlassian.net/wiki/display/DOCS/Infrastructure+View)):

[](https://habrastorage.org/files/afa/b6a/068/afab6a068bd34f8382506f2c1dc5cde5.png)

Можно включить отображение значений системной метрики (ЦПУ, память) прямо на карте:

[](https://habrastorage.org/files/308/341/00c/30834100c8354922b56c0094ab7b5d09.gif)

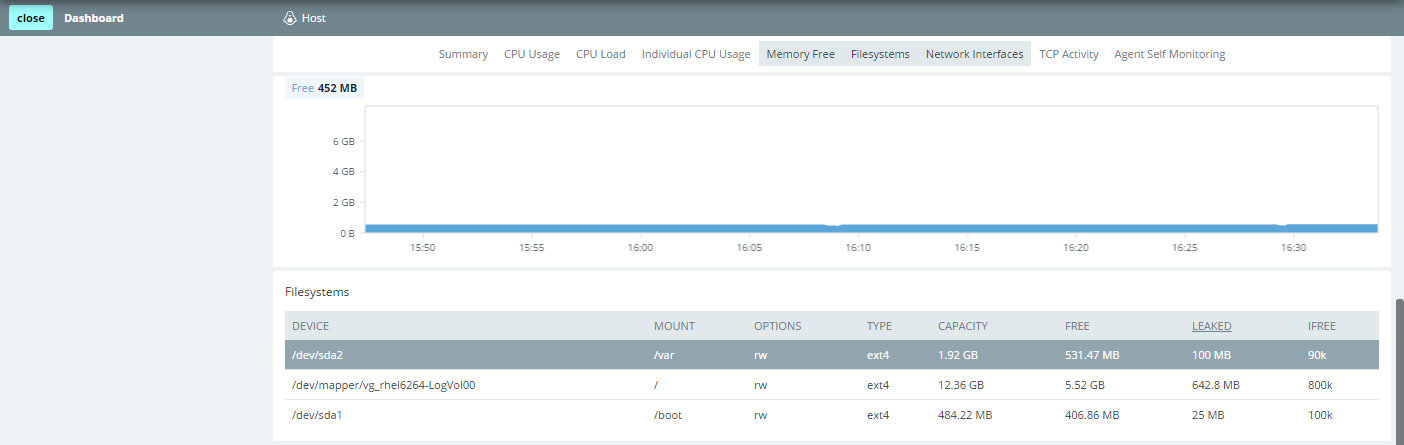

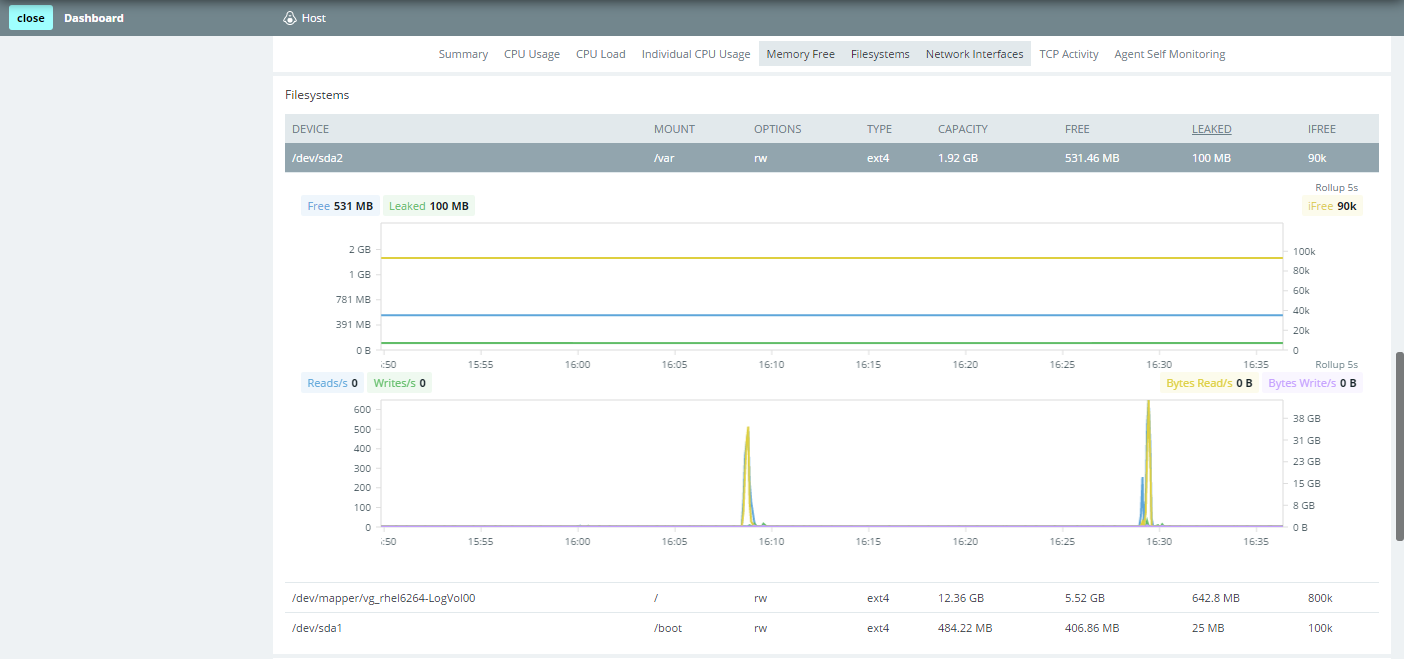

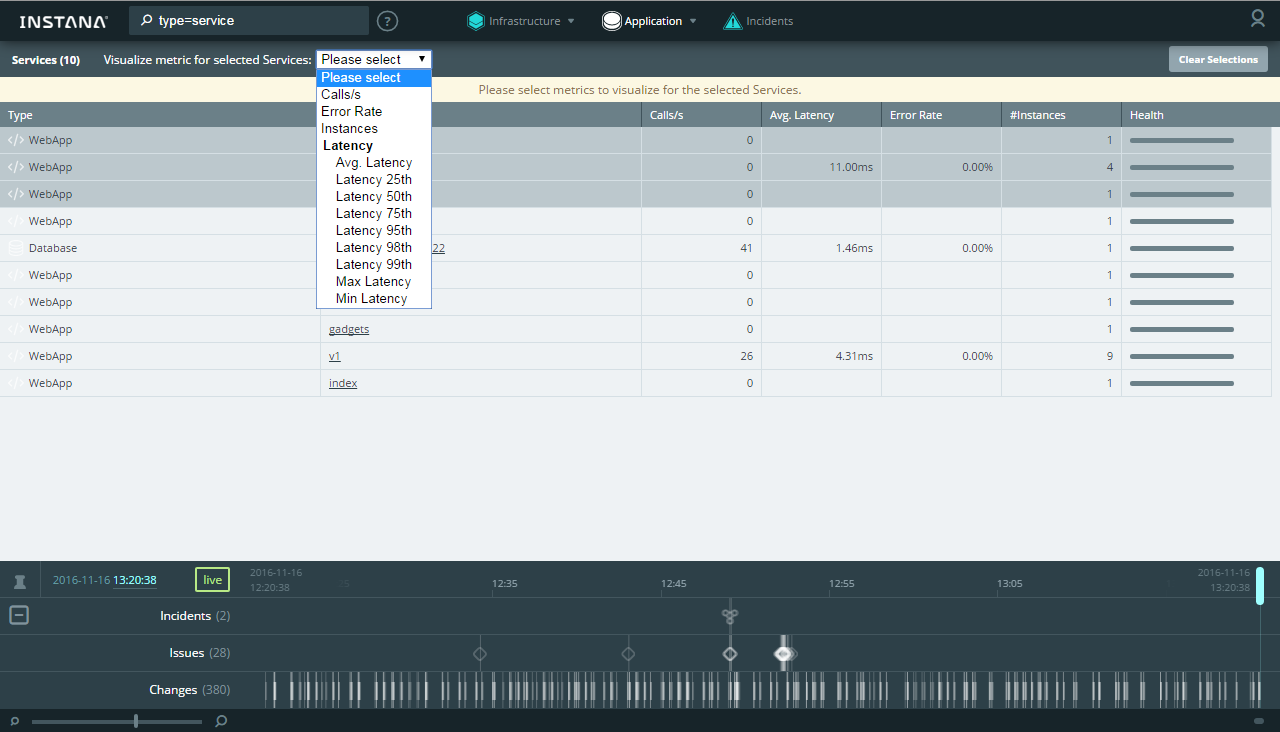

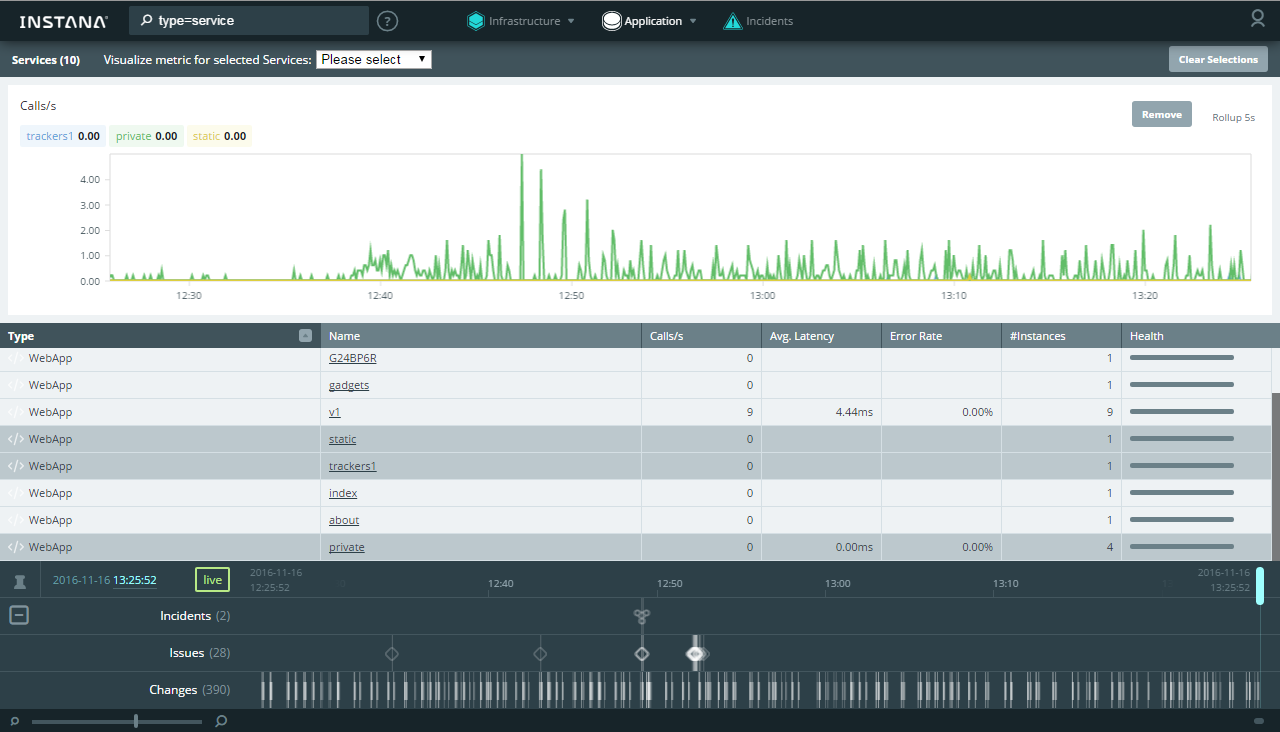

В новой версии добавилась таблица сравнения. Она позволяет сразу увидеть текущее значение основных системных метрик по всем хостам. К тому же можно быстро выделить нужные хосты и проанализировать произвольную метрику на сводном графике:

[](https://habrastorage.org/files/fa0/4f0/c61/fa04f0c613984f59b757e88c9c88ff3c.gif)

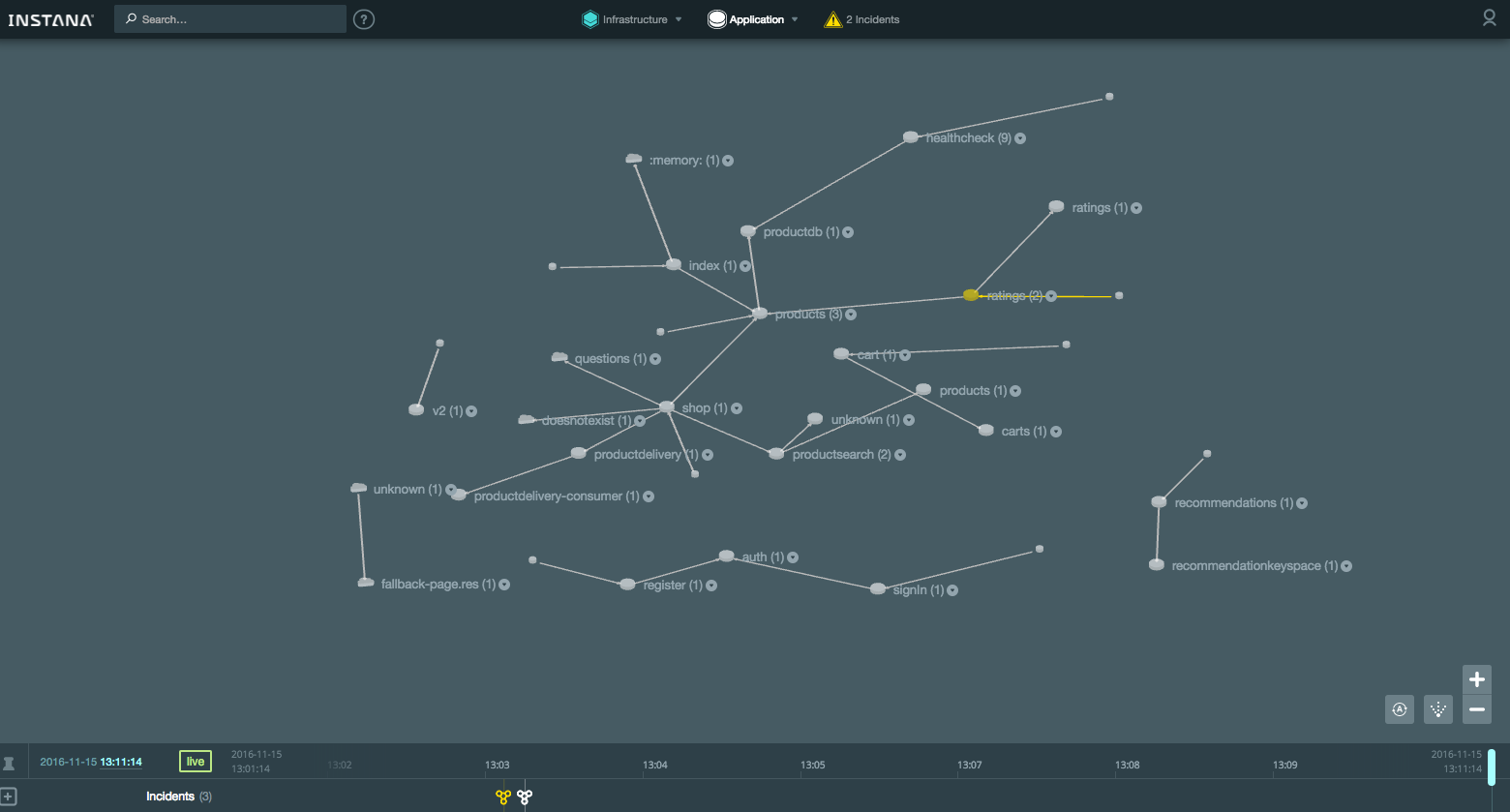

Карта приложения ([Application Map](https://instana.atlassian.net/wiki/display/DOCS/Application+Map)):

[](https://habrastorage.org/files/210/c34/082/210c34082aaf4e55a266dc57a31ad981.png)

В новой версии добавилась таблица сравнения для компонентов приложения, где также можно выбрать компоненты и проанализировать их на сводном графике:

[](https://habrastorage.org/files/95a/59f/183/95a59f183067449fbded1933df05657f.png)

[](https://habrastorage.org/files/1ef/719/1f8/1ef7191f8f7d44ba9a794944c3e4aae1.png)

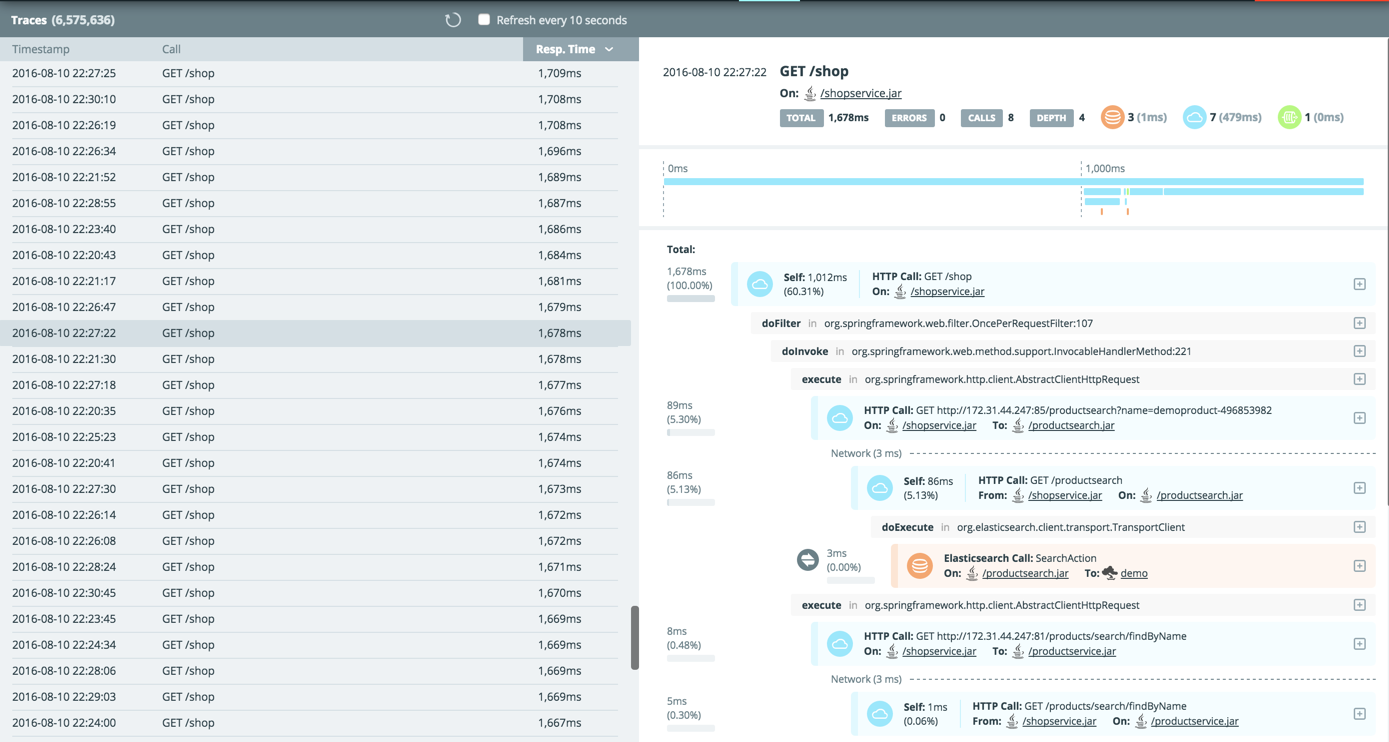

Все транзакции доступны для анализа в [Trace view](https://instana.atlassian.net/wiki/display/DOCS/Trace+View), где таблица сортируется по любому столбцу (можно, например, быстро найти самую длительную транзакцию):

[](https://habrastorage.org/files/e90/23e/c39/e9023ec3933c4986a23b44c153a11baa.png)

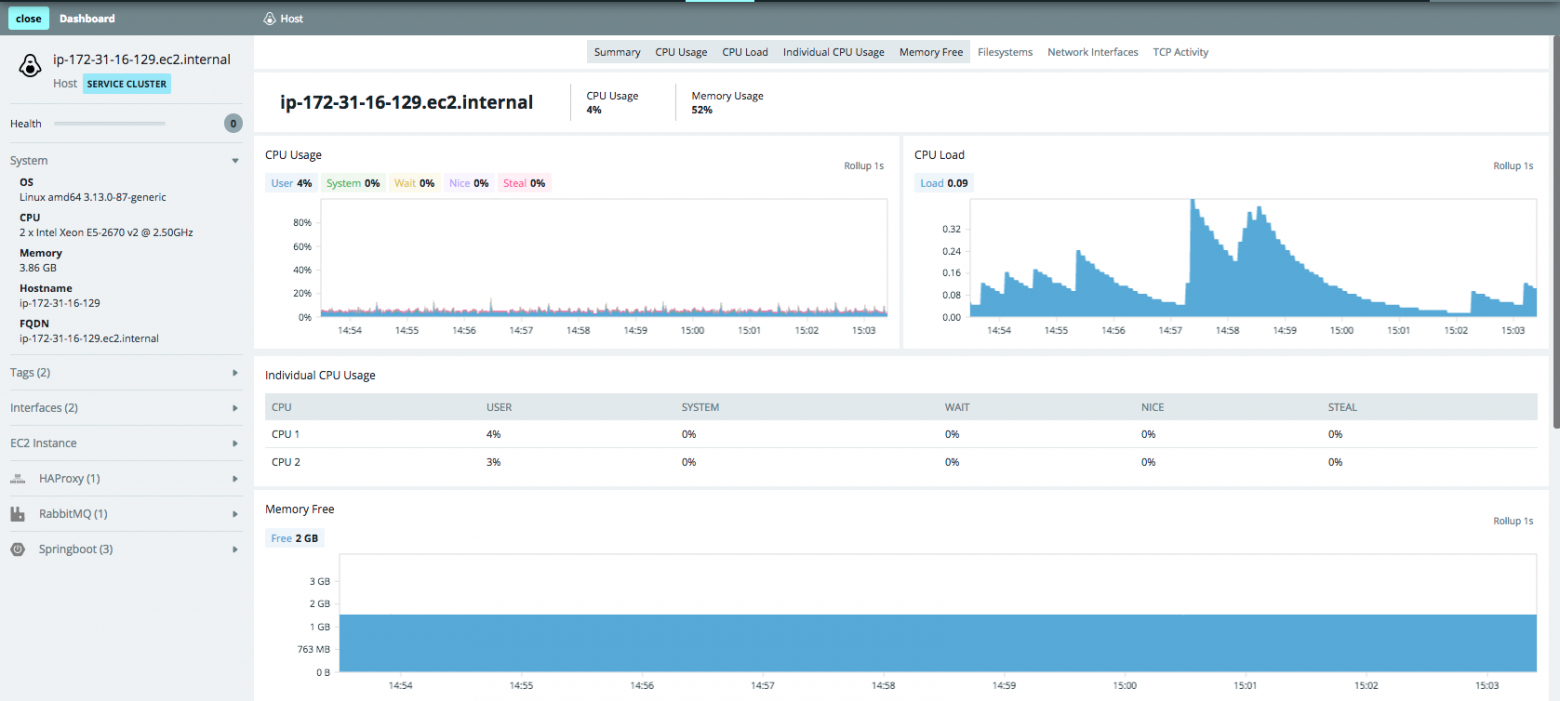

Из любого представления вы можете открыть дашборд, в котором найдете графики и значения метрик по хосту и компонентам на нем:

[](https://habrastorage.org/files/2c3/984/4f2/2c39844f2cb043f7b5d27be9ca8e75f4.png)

Есть поиск по именам хостов, компонентам, трассировке, тегам, зонам — поддерживаются маски (\*) и объединения (AND/OR):

[](https://habrastorage.org/files/271/3cc/62d/2713cc62d9bb4d9a8bea4d0db9c5045b.gif)

Отличительной особенностью, которой на данный момент нет ни у одной другой СМ, является работа с историческими данными в режиме [Timeshift](https://www.instana.com/blog/introducing-timeshift-application-monitoring/). При прокрутке шкалы времени (Timeline) видим не только все события за прошедшее время, но и как выглядела карта (физическая/логическая) в прошлом. Например, видно что на сервере перестал работать Tomcat, как это повлияло на взаимодействия компонентов приложения, как раньше выглядела инфраструктурная карта и карта компонентов приложения. В таком же ключе можно смотреть транзакции (вкладка Application → [Trace](https://instana.atlassian.net/wiki/display/DOCS/Trace+View)).

[](https://habrastorage.org/files/a3d/60a/8ba/a3d60a8ba21343529a7f33b22fbc9ecd.png)

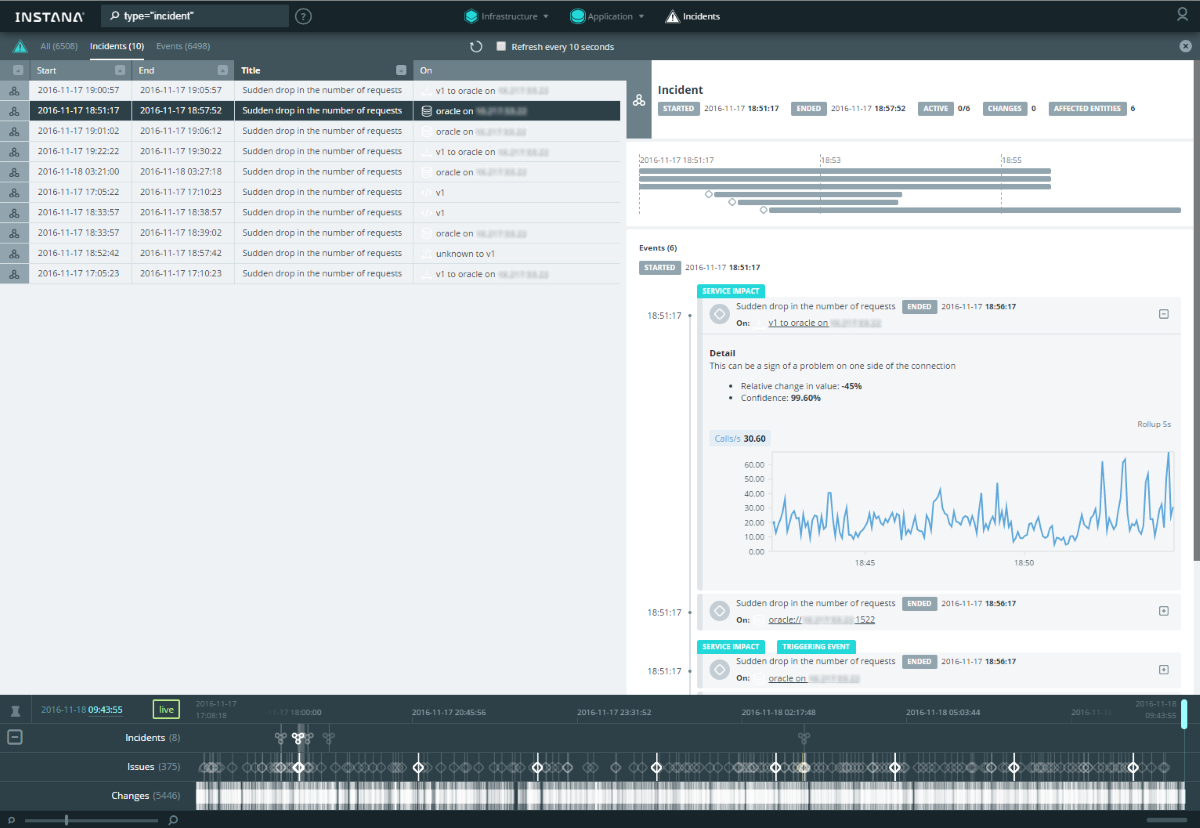

В новой версии бэкенда все события собраны в отдельной вкладке Incidents, где можно отсортировать таблицу по столбцам и анализировать детали:

[](https://habrastorage.org/files/d29/606/ef3/d29606ef3947434f88339aff7e5c36ed.png)

По ссылкам в деталях можно сразу перейти на подробный дашборд соответствующего компонента.

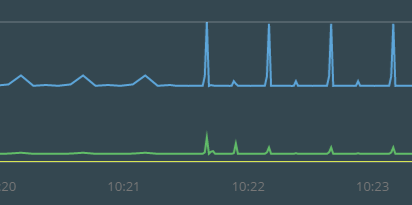

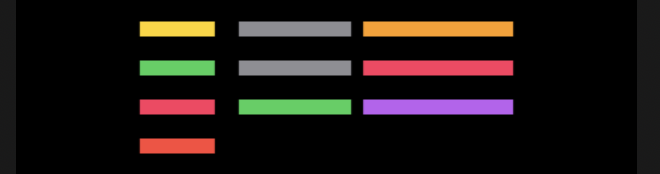

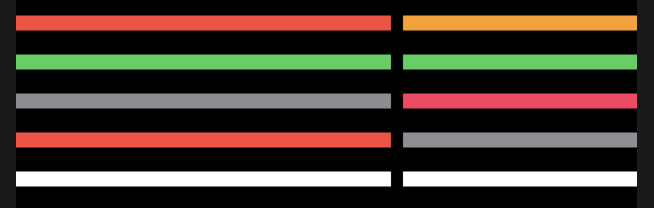

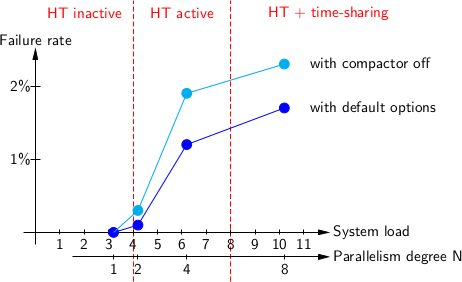

В отличие от классического инфраструктурного мониторинга (доступность хоста, уровень утилизации ЦПУ, доступность HTTP-страницы и т.п.), мониторинг приложений предъявляет более серьезные требования к частоте и детализации (гранулярности) собираемых данных. Чем чаще получаем значение той или иной метрики, тем лучше, особенно это касается транзакционного мониторинга. Это связано с тем, что проблемы при работе приложения могут быть очень непродолжительными, а последствия при этом вполне ощутимыми. Для сравнения графики с различной гранулярностью (1 минута vs 5 секунд):

Сразу понятно, что недостаточно подробные данные в ряде случаев не позволят обнаружить проблему. Данная система позволяет собирать данные с частотой [вплоть до 1 секунды](https://www.instana.com/blog/monitoring-needs-immediate-accurate/). Для уменьшения объема исторических данных они агрегируются относительно давности — чем дальше, тем ниже гранулярность: **1 секунда** (live-данные хранятся 10 минут) → **5 секунд** (хранятся 1 день) → **1 минута** (хранятся 31 день) → **5 минут** (хранятся 3 месяца) → **1 час** (хранятся 1 год, но можно увеличить).

Очень полезен [автоматический поиск (Automatic Discovering) компонентов](https://www.instana.com/blog/auto-change-detection-improves-root-cause-determination/): если на хосте установлен агент Instana, в СМ автоматически появятся все известные ей компоненты и сервисы. Это особенно важно, когда ваше приложение построено на [микросервисах](https://www.instana.com/blog/monitoring-microservices-part-i-discovery-putting-the-puzzle-together/):

[Список поддерживаемых технологий](https://www.instana.com/product/) включает практически всё, что сейчас популярно. Естественно, можно [смотреть транзакции](https://instana.atlassian.net/wiki/display/DOCS/Trace+View) и анализировать работу приложения на уровне вызова метода (в документации есть [подробности механизма трассировки](https://instana.atlassian.net/wiki/display/DOCS/Tracing)).

Важный критерий при выборе СМ для нас — поддержка [Scala](https://ru.wikipedia.org/wiki/Scala_(%D1%8F%D0%B7%D1%8B%D0%BA_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F)), это редкость для СМ приложений. Может показаться, что для СМ достаточно поддержки Java — и глубокий мониторинг приложения ([инструментирование](https://ru.wikipedia.org/wiki/%D0%98%D0%BD%D1%81%D1%82%D1%80%D1%83%D0%BC%D0%B5%D0%BD%D1%82%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5_(%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5))) в кармане. Но на поверку оказывается, что это не так: без поддержки Scala на мониторинге будет видна трассировка только одного вызова JVM. Поэтому даже [самые известные игроки на рынке APM](https://habrastorage.org/files/13a/05f/dc7/13a05fdc74e7493186f8376736777f0c.png) на сегодняшний день отстают в этом плане.

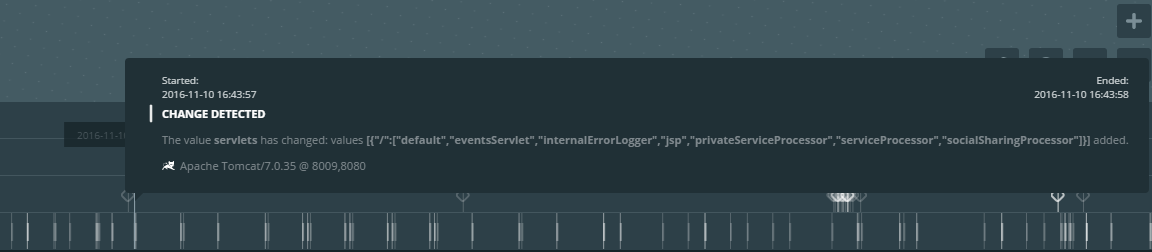

Система видит [изменения компонентов по принципу дельты](https://www.instana.com/blog/auto-change-detection-improves-root-cause-determination/):

[](https://habrastorage.org/files/e02/2f2/8d2/e022f28d297743f9ac04391b859f0f92.png)

Кроме того система способна в онлайн-режиме отображать состояние взаимодействия между компонентами (частота перемещения точек на связях показывает насколько быстро идет обмен данными):

[](https://habrastorage.org/files/bca/1f1/5e2/bca1f15e23e3482fa217ea3666e04617.gif)

Для оповещения «из коробки» доступны следующие варианты интеграций:

* Email

* OpsGenie

* PagerDuty

* Slack

* Webhook

Продукт [активно развивается](https://instana.atlassian.net/wiki/display/DOCS/Release+Notes), но уже сейчас выглядит удобным инструментом для поиска проблем с приложением как на стадии тестирования/отладки, так и для оперативного мониторинга.

### Ссылки

В статье использованы материалы:

* [Сайт Instana](https://www.instana.com/)

* [Документация Instana](https://instana.atlassian.net/wiki/spaces/DOCS)

* [Канал Instana на Youtube](https://www.youtube.com/channel/UC_AAMzr7IEz8F08qzS9hMwQ) | https://habr.com/ru/post/317254/ | null | ru | null |

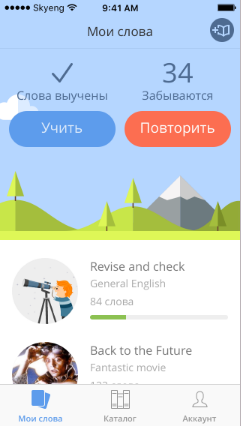

# Почему ты не учишь английский язык?

Часто ли вы натыкались в вакансиях на слова "English B2" / "Intermediate English" / "Английский на уровне чтения документации" и задавались ли вы вопросом, почему это резко стало так важно? Сейчас действительно наблюдается тенденция, что больше и больше компаний выделяют английский язык как требуемый навык, несмотря на то что команда полностью русскоговорящая и с иностранными заказчиками не работает.

С учетом того образования, которое есть сейчас в российских школах, на выходе довольно много людей плохо знают английский. И даже видя интерес компаний к знанию английского от соискателя, они откладывают изучение языка в долгий ящик из-за некоторых заблуждений, которые сейчас распространены.

Сегодня я как раз хочу поговорить об этом. Эта статья будет интересна тем людям, кто задумывается, стоит ли сейчас тратить время на изучение английского.

> Это вторая часть из цикла статей об основных проблемах, с которыми могут столкнуться новички на старте карьеры. Первая часть находится [здесь](https://habr.com/ru/sandbox/153134/). Там можно почитать про "ожидание / реальность" работы разработчика.

>

>

---

#### Я смогу выучить, когда он мне понадобится

Если ты, дорогой читатель, узнал в этих словах себя, не совершай ту же ошибку, что многие из нас сделали. Изучение английского требует ежедневного труда, не получится выучить его за неделю и сразу читать техническую документацию.

Да, тебе не нужно знать многие грамматический конструкции, и не так уж надо уметь говорить на языке, но документация написана сложным техническим языком с использованием специфических терминов. Если ты изначально не привыкнешь что массив - это *array*, а переменная - это *variable*, то потом будет тяжело покрывать весь этот объем слов, и ты просто будешь спотыкаться на каждом слове в какой-нибудь статье.

Да и в работе момент, когда "*понадобится*" наступит очень быстро. Когда будут возникать какие-то теоретические вопросы, тебе могут скинуть англоязычную статью или часть документации, который тебе придется как-то читать. Но без знаний и практики конечно это будет медленнее, чем могло бы быть.

#### Большинство вещей, которые мне могут понадобиться, уже переведены на русский язык

Это очень яркое заблуждение, которое рассыпается с началом практики. Начнем с того, что маленькие публичные пакеты предоставляют информацию на английском. Только крупные, популярные библиотеки могут быть переведены на несколько языков.

Часто сервисы прибегают к помощи любительского перевода, то есть сообщество просто из благих побуждений хочет помочь с переводом. Из-за этого он может быть не полный или не актуальный. Приведу несколько примеров из практики, с которыми я сталкивалась.

*MDN - один из самых популярных ресурсов для чтения документации по JavaScript*

Давайте зайдем на [статью](https://developer.mozilla.org/ru/docs/Web/API/Window/scroll) по методу `window.scroll`, она довольно часто используется для прокрутки.

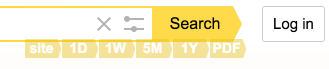

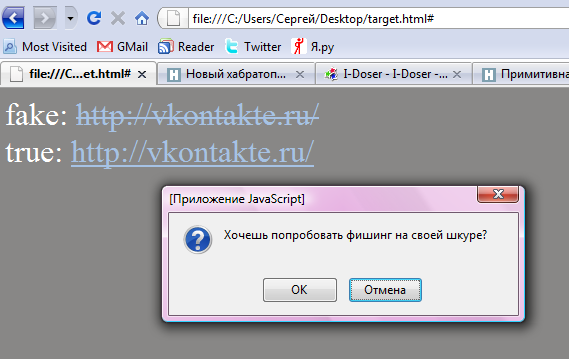

Русская версияОбратите внимание на пераметрыАнглийская версияПараметры уже немного другие или мне кажется?В английской версии мы неожиданно узнаем, что можно передавать не только координаты, но и объект с опциями. Что тоже интересно, но этого нет на скриншотах, что в русской версии нет таблицы с поддержкой от браузеров, а в английской есть, и конкретно для этой функции она весьма важна.

*Nuxt - SSR фреймворк для Vue*

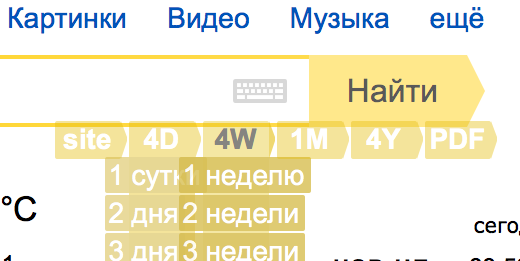

У Vue замечательная документация, которая действительно хорошо переведена. Чего не скажешь о Nuxt. Если сейчас переключить на русский, то вы можете увидеть подобную картину:

Давайте же попробуем почитатьНу в общем-то все понятноЭто на самом деле лучшее, что они могли сделать, потому что до этого был русский перевод, но он был настолько не актуальный, что примеры из него просто не работали, а половины информации там не было вообще.

Английский - это международный язык разработки, самая актуальная и верная информация будет именно на нем.

#### Русских разработчиков так много, что я смогу найти ответ на любой вопрос

Когда что-то не получается, человек идет задавать вопросы гуглу. Кто знает английский язык, тот задаст на английском, а кто не знает - будет задавать на русском. Как вы думаете, кто быстрее найдет ответ?

Большая часть вопросов на том же stackoverflow написана на английском, большая часть issues в пакетах на github написана на английском. Как я уже говорила выше, этот язык - международный в плане разработки, а значит, задавая вопрос на английском, вы получаете доступ к мировой базе информации, большему количеству кейсов и огромному количеству ответов и решений.

#### Я буду работать с русскоговорящими людьми, зачем мне понадобиться английский

Есть стандарты того, что код оформляется на английском языке. То есть названия переменных - это не русская транскрипция, а английские слова. Комментарии к коду часто пишут на английском. Грубо говоря, если ты видишь переменную `width`, ты быстро понимаешь, что это связано с шириной. Человек же не знакомый с этим языком, будет дольше по времени читать программу.

Работа с git тоже часто происходит именно на английском: те же названия веток и коммиты. И даже если ты не используешь иностранный язык, другой человек в команде может, и читая историю коммитов не получится быстро сориентироваться.

---

Надеюсь я убедила вас, что английский надо начинать учить как можно раньше и развеяла ваши заблуждения, если они у вас были. | https://habr.com/ru/post/552276/ | null | ru | null |

# Proof-of-Proof-of-Work на пальцах. На пути к разумному блокчейну

Блокчейн-протоколы должны обеспечивать консенсус среди нод децентрализованной системы. Пожалуй, самым известным алгоритмом консенсуса можно считать «тормозунутый, но надежный, потому что тормознутый» алгоритм Proof-of-Work: каждая нода, имея набор новых транзакций перебирает некоторое число nonce, являющееся полем блока. Блок считается валидным, если валидны все транзакции внутри него и хэш-функция от заголовка блока имеет некоторую общепринятую особенность (например, количество нулей в начале, как в Bitcoin):

**```

Hash( Block{transaction,nonce,…} ) = 000001001...

```**

Как известно, блокчейн — это цепочка блоков. Цепочкой он является потому, что внутри каждого блока записан id (как правило хэш от заголовка) предыдущего блока. Для последующих рассуждений блокчейн в упрощенном виде можно представить так:

В процессе синхронизации ноды с другими нодами, ей необходимо осуществить валидацию всех блоков, которые ей прислали соседи – проверить хэши и транзакции всех новых блоков, а в случае первого подлючения, до самого первого блока (genesis -block). Нетрудно предположить, что это достаточно длительный и затратный процесс…

Есть вариант запросить у соседних нод несколько последних блоков и, доверившись, принять их как валидные. Но этот вариант не соответствует духу безопасности в «среде, где никто никому не доверяет»

### PoPoW-ноды.

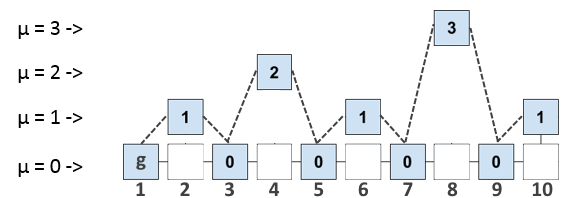

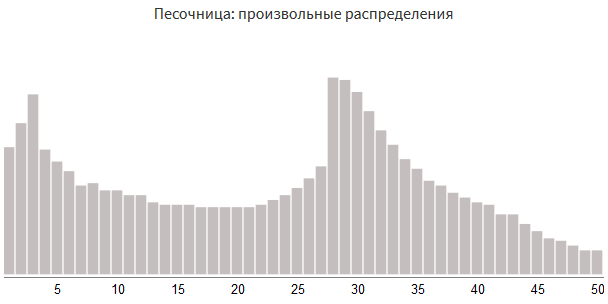

Хэш-функция от заголовка блока является его id. Как было сказано ранее, в сети Bitcoin, как и во многих других сетях, особенностью, по которой определяется валидность блока, является число нулей в начале записи id. Это известное и общее для всех майнеров число нулей, называют сложностью майнинга T (mining target). Валидный хэш с T нулями в начале может иметь больше нулей в начале, чем Т. Конкретнее, половина блоков будет иметь только T нулей в начале; половина блоков будет иметь T+1 нуль в начале; четверть блоков T+2 нулей и.т.д. Например так может выглядеть набор валидных блоков для T = 5:

```

000000101… (6 нулей)

000001110… (5 нулей)

000001111… (5 нулей)

000000010… (7 нулей)

000000101… (6 нулей)

000001110… (5 нулей)

000001111… (5 нулей)

```

Количество нулей, превышающее T в id блока назовем уровнем µ, а блоки с уровнем µ будем называть µ — суперблоками. Если блок является µ — суперблоком, то он так же является и

(µ -1)-суперблоком. Таким образом, пока ничего не изменяя, а лишь оперируя введенным параметром µ, можем представить цепочку блоков в следующем µ-уровневом виде:

Блоки пронумерованы для простоты описания, нумерация не несет смысловой нагрузки.

Теперь подумаем, как мы можем это использовать. Если в заголовок каждого блока записывать не только id предыдущего блока, но и id всех последних блоков на каждом уровне, то мы позволяем каждому блоку ссылаться на более «древние» блоки, чем предыдущий. Набор всех последних на каждом уровне блоков будем называть interlink (множественная ссылка). Например, Interlink для блока 8 выглядит так:

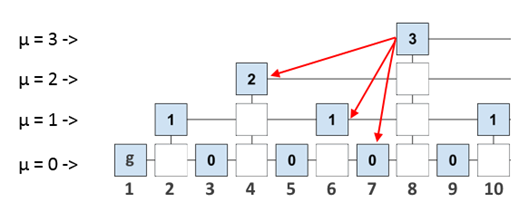

Что нам это дает? Допустим, мы подключили новую ноду и теперь хотим безопасно синхронизировать её. Как мы уже сказали, для полноценной валидации нового блока, ноде нужно «прошагать» до genesis – блока по всему блокчейну. Однако, если мы будем иметь в валидируемом блоке ссылки на некоторые «опорные» блоки, то сможем «прошагать» до genesis – блока, запросив у других нод не весь блокчейн, а лишь некоторое доказательство (proof), которое будет содержать короткий маршрут до самого первого блока. Сам маршрут будет являться валидной подцепочкой самого блокчейна, так как блоки подцепочки последовательно ссылаются друг на друга.

Доказательство – это набор заголовков нескольких предыдущих блоков. Строго говоря, доказательство содержит не только «короткий маршрут», но и ещё несколько заголовков других блоков. Это сделано для верификации доказательства (verify) по задаваемым параметрам безопасности m, k и др. (подробное описание приводится в оригинальной статье, ссылка в конце).

Нода, которая не хранит весь блокчейн, а лишь запрашивает proof у full-нод, хранящих всю историю, называется PoPoW – нодой. Теоретически такую ноду можно развернуть на маломощном компьютере, смартфоне.

Алгорим работы PoPoW-протокола следующий:

1. PoPoW-нода запрашивает доказательство для блока у full – ноды.

2. Full – нода (proover) формирует доказательство и отправляет его.

3. PoPoW-нода (verifier) проверяет доказательство, сопоставляет с доказательствами других нод и делает заключение о валидности блока.

Также стоит отметить, что сложность создания PoPoW доказательства не уступает сложности создания полной цепочки из валидных заголовков (хэш функция заголовка содержит Interlink, поэтому «подделывать» блоки нечестной ноде пришлось бы с учетом µ-уровневой иерархичности). Поэтому использование для валидации блока PoPoW доказательства не влечет потери безопасности.

### NiPoWPoW – алгоритм

Алгорим NiPoPoW – Non-Interactive Proof-of-Proof-of-Work – включает в себя усовершенствованные формирование и проверку доказательств, он устойчив к некоторым атакам, которым подвержен PoPoW. Ссылка на оригинальную статью от авторов так же в конце.

### Для чего все это нужно?

С помощью этих алгоритмов решаются две актуальные проблемы: эффективная верификация транзакции и эффективное доказательство для сайдчейнов (Sidechains).

В первом случае этот алгоритм позволяет подключать к сети «легкие» ноды, которые смогут быстро синхронизироваться с сетью.

Во втором случае алгоритм позволяет хранить и ссылаться на события, произошедшие в других блокчейн-сетях, что полезно для клиентов и кошельков, работающих с несколькими блокчейнами. PoPoW-доказательство достаточно короткое для того, чтобы можно было поместить его в транзакцию. Например, можно писать смарт-контракты в блокчейне A, которые опираются на какие-то события в блокчейне Б.

Данный обзор составлен на свежую голову после участия в хакатоне [Unblock Hackathon](https://binarydistrict.com/ru/courses/blockchain-hackathon/), где одним из заданий было реализовать данный протокол. Авторами задания были партнеры хакатона из [Ergo platform](https://ergoplatform.org/), внутри которой используется этот алгоритм.

Текст подготовлен на основе оригинальных статей

PoPoW: [Proofs of Proofs of Work with Sublinear Complexity. Aggelos Kiayias, Nikolaos Lamprou, and Aikaterini-Panagiota Stouka](http://fc16.ifca.ai/bitcoin/papers/KLS16.pdf)

NiPoPoW: [Non-Interactive Proofs of Proof-of-Work. Aggelos Kiayias, Andrew Miller and Dionysis Zindros](https://eprint.iacr.org/2017/963.pdf) | https://habr.com/ru/post/353160/ | null | ru | null |

# Как запустить несколько пайплайнов с помощью GitLab CI/CD

Запуск и визуализация пайплайнов при настройке GitLab CI/CD для нескольких проектов.

Непрерывная интеграция (CI) — это практика автоматизации сборки и тестирования кода до его слияния с основной веткой. Она позволяет разработчикам вливать код довольно часто и рано, снижая при этом риск внесения новых ошибок в главный репозиторий исходного кода.

Хотя CI проверяет, что новый код не сломается при интеграции с другим кодом в том же репо, прохождение всех тестов на этом репо — это только первый шаг. После запуска CI в коде важно развернуть и запустить тесты в реальной среде. Переход от CI к непрерывной доставке и деплою (CD) является следующим шагом к “взрослому” DevOps. Развертывание и последующее повторное тестирование позволяют тестировать код одного проекта вместе с другими компонентами и сервисами, которые, возможно, управляются другими проектами.

Зачем мне нужно убедиться, что мой код работает с другими компонентами?

-----------------------------------------------------------------------

Хорошим примером может служить архитектура микросервисов. Обычно микросервисы управляются в разных [проектах](https://docs.gitlab.com/ee/user/project/), где каждый микросервис имеет свой собственный репозиторий с пайплайном. Кроме того, очень часто каждая команда разработчиков несёт ответственность за отдельные микросервисы и конфигурации пайплайнов. Как программист, вы возможно захотите убедиться, что изменения в вашем коде не нарушают функциональность зависимых от него микросервисов. Поэтому вы можете запускать тесты на них дополнительно к тестам для вашего проекта.

Пайплайн кросс-проекта

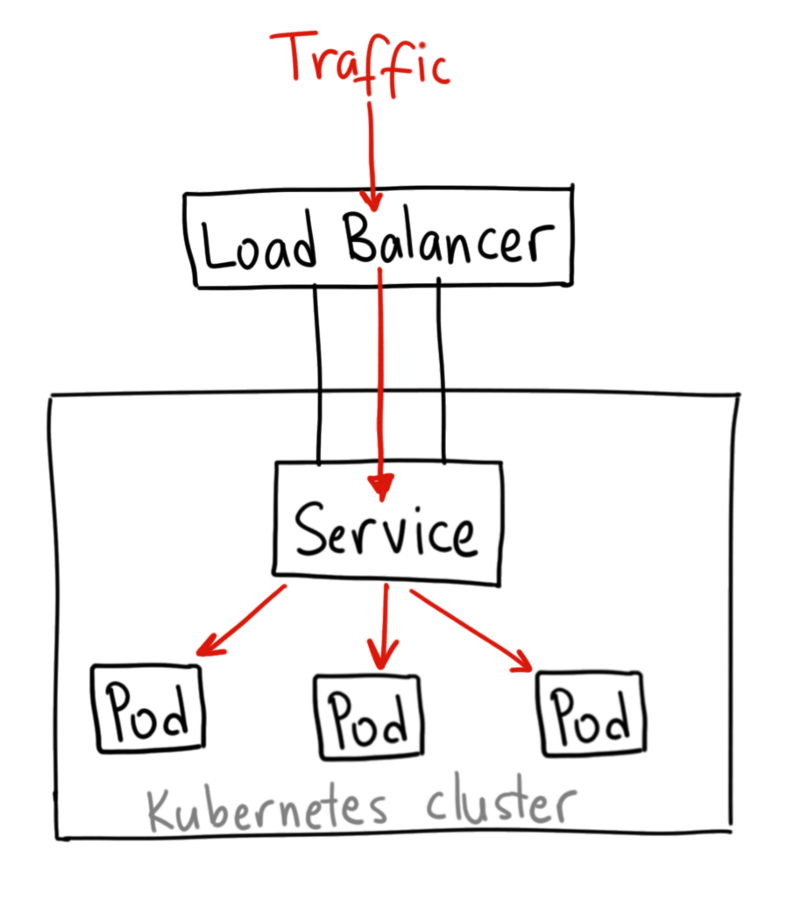

----------------------

При запуске пайплайна проекта, вам также нужно будет запустить кросс-проектные пайплайны, которые в конечном итоге развернут и протестируют последнюю версию всех зависимых микросервисов. Для достижения этой цели вам нужен простой, гибкий и удобный способ запуска других пайплайнов в рамках CI вашего проекта. GitLab CI/CD предлагает легкий путь запуска кросс-проектного пайплайна путем добавления специального задания в файл конфигурации CI.

GitLab CI/CD конфигурационный файл

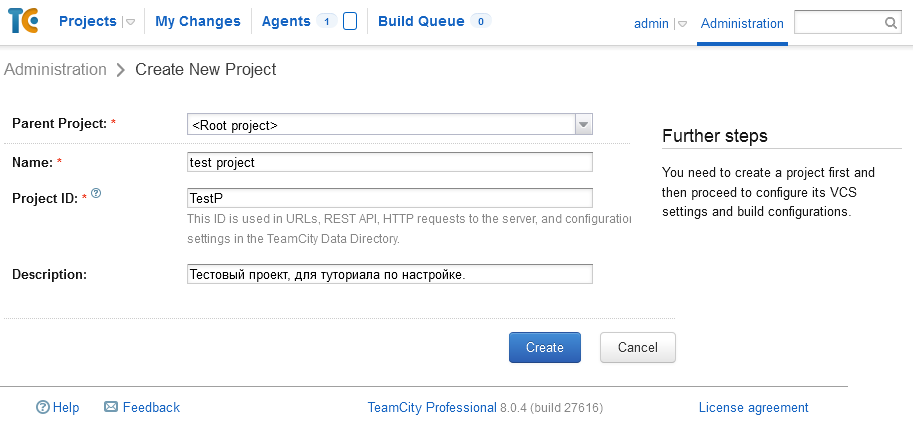

----------------------------------

В GitLab CI/CD пайплайны, а также задания (jobs) и этапы их компонентов определяются в файле `.gitlab-ci.yml`для каждого проекта. Файл является частью репозитория проекта. Он полностью версионный, и разработчики могут редактировать его с помощью любой IDE по своему выбору. Им не нужно просить системного администратора или команду DevOps вносить изменения в конфигурацию пайплайна, поскольку могут делать это сами. Файл `.gitlab-ci.yml` определяет структуру и порядок пайплайнов, и решает, что надо выполнять с помощью [GitLab Runner](https://docs.gitlab.com/runner/) (агент, который запускает задания), и какие решения следует принимать при возникновении определенных условий, например, когда процесс завершается успешно или выходит из строя.

Добавление job для запуска кросс-проектного пайплайна

-----------------------------------------------------

Начиная с GitLab 11.8, GitLab предоставляет новый синтаксис конфигурации CI/CD для запуска кросс-проектных пайплайнов, его можно найти в [правилах конфигурации пайплайна](https://docs.gitlab.com/ee/ci/yaml/README.html). Следующий код иллюстрирует настройку bridge job для запуска нисходящего пайплайна:

```

// job1 это job в восходящем проекте

deploy:

stage: Deploy

script: this is my script

// job2 это bridge job в восходящем проекте, который запускает кросс-проектный пайплайн

Android:

stage: Trigger-cross-projects

trigger: mobile/android

```

В приведенном выше примере, как только deploy job (задача развертывания) на этапе деплоя выполнится успешно, запустится задание для Android bridge. Его первоначальный статус будет в ожидании. GitLab создаст нисходящий пайплайн в проекте mobile/android, и, как только он будет создан, Android job выполнится успешно. В этом случае mobile/android является полным путем к этому проекту.

Пользователь, создавший вышестоящий пайплайн, должен иметь права доступа к нижестоящему проекту (в данном случае mobile / android). Если нижестоящий проект не может быть найден или у пользователя нет прав доступа для создания там пайплайна, Android job получит статус failed.

Обзор графиков от восходящего до нижестоящего пайплайна

-------------------------------------------------------

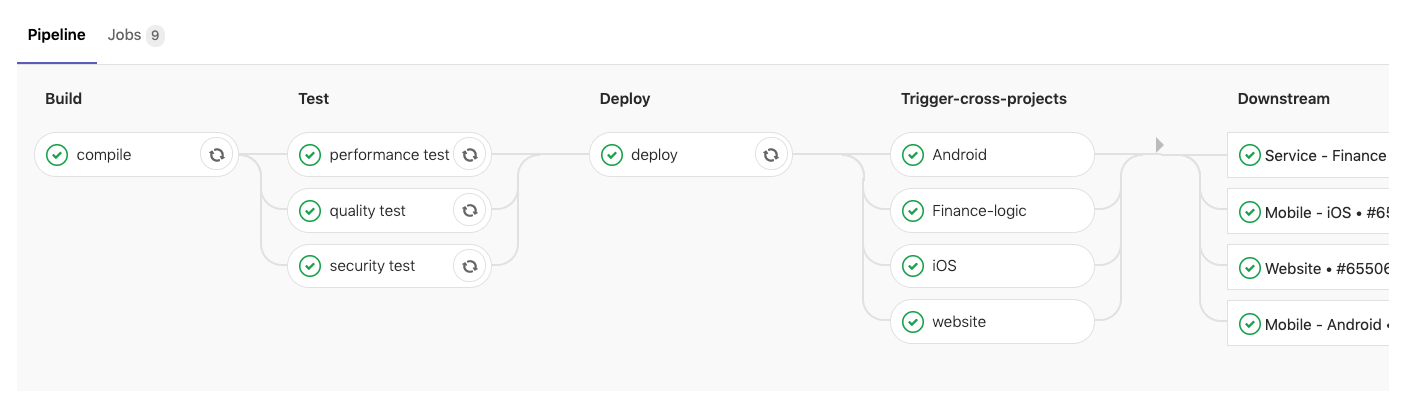

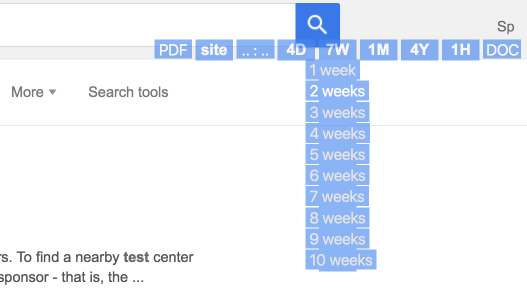

GitLab CI/CD позволяет визуализировать конфигурацию пайплайна. На приведенном ниже рисунке этапы сборки, тестирования и деплоя являются частями восходящего (upstream) проекта. Как только deploy job выполнено успешно, четыре кросс-проекта будут запущены параллельно, и вы сможете перейти к ним, щелкнув на одну из нисходящих (downstream) job.

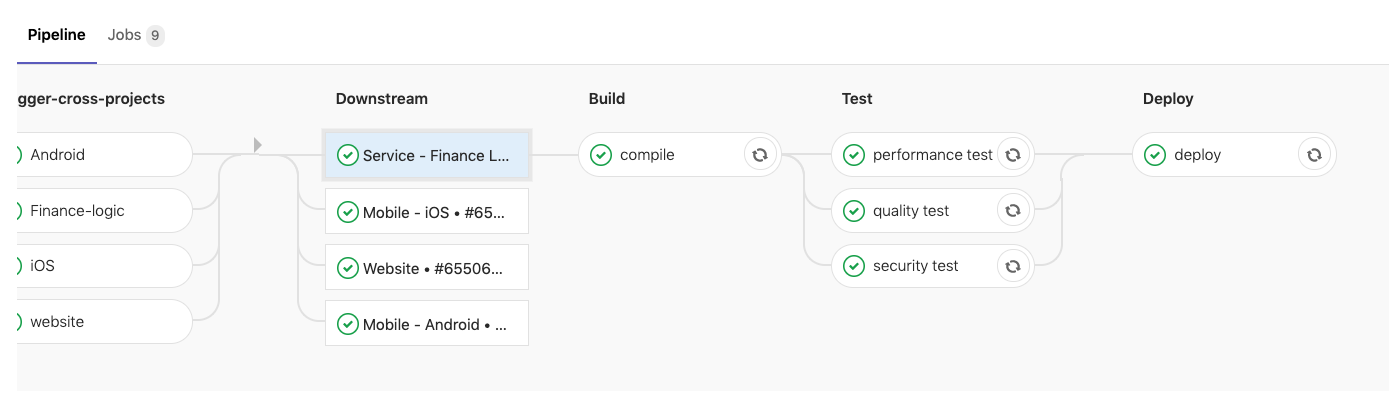

На приведенном ниже рисунке виден нисходящий пайплайн «Сервис — Финансы». Теперь можно прокрутить влево к восходящему пайплайну, прокрутить вправо назад к нисходящему или выбрать другой нисходящий пайплайн.

Определение ветки нижестоящего пайплайна

----------------------------------------

Можно указать имя ветки, которое будет использовать нисходящий пайплайн:

```

trigger:

project: mobile/android

branch: stable-11-2

```

Используйте ключевое слово проекта, чтобы указать полный путь к нисходящему проекту. Используйте ключевое слово branch, чтобы определить имя ветки. GitLab будет использовать коммит, который в данный момент находится в HEAD ветки при создании нисходящего пайплайна.

Передача переменных в нисходящий пайплайн

-----------------------------------------

Когда-нибудь вам возможно захочется передать переменные в нисходящий пайплайн. Вы можете сделать это с помощью ключевых слов для переменных, как и при определении обычной job.

```

Android:

variable:

ENVIRONMENT: ‘This is the variable value for the downstream pipeline’

stage: Trigger-cross-projects

trigger: mobile/android

```

Переменная ENVIRONMENT будет передаваться каждой job, определенной в нисходящем пайплайне. Она будет доступна в качестве переменной среды каждый раз, когда GitLab Runner выбирает job.

Итого о кросс-проектном пайплайне

---------------------------------

Файл `.gitlab-ci.yml`определяет порядок этапов CI/CD, какие задания выполнять и при каких условиях запускать или пропускать выполнение задания. Добавление 'bridge job' с ключевым словом `trigger` в этот файл можно использовать для запуска кросс-проектных пайплайнов. Мы можем передавать параметры заданиям в нисходящих пайплайнах и даже определять ветку, которую будет использовать нисходящий пайплайн.

Пайплайны могут быть сложными структурами с множеством последовательных и параллельных задач, и, как мы только что узнали, иногда они могут запускать нисходящие пайплайны. Чтобы упростить понимание потока пайплайна, включая нисходящие пайплайны, в GitLab есть графики пайплайнов для просмотра пайплайнов и их статусов.

### Также читайте другие статьи в нашем блоге:

* [/etc/resolv.conf для Kubernetes pods, опция ndots:5, как это может негативно сказаться на производительности приложения](https://habr.com/ru/company/nixys/blog/464371/)

* [Разбираемся с пакетом Context в Golang](https://habr.com/ru/company/nixys/blog/461723/)

* [Три простых приема для уменьшения Docker-образов](https://habr.com/ru/company/nixys/blog/437372/)

* [Бэкапы Stateful в Kubernetes](https://habr.com/ru/company/nixys/blog/426543/)

* [Резервное копирование большого количества разнородных web-проектов](https://habr.com/ru/company/nixys/blog/424717/)

* [Telegram-бот для Redmine. Как упростить жизнь себе и людям](https://habr.com/ru/company/nixys/blog/347526/) | https://habr.com/ru/post/467107/ | null | ru | null |

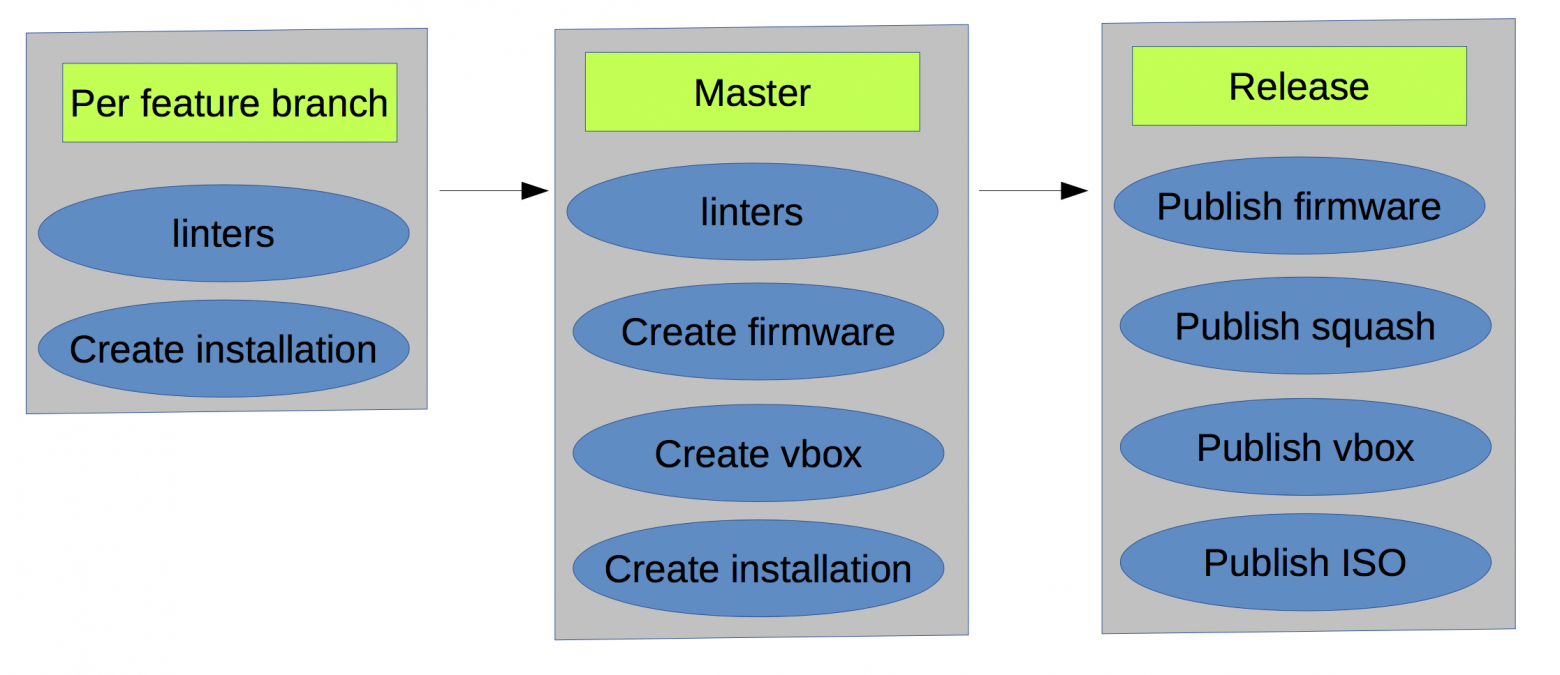

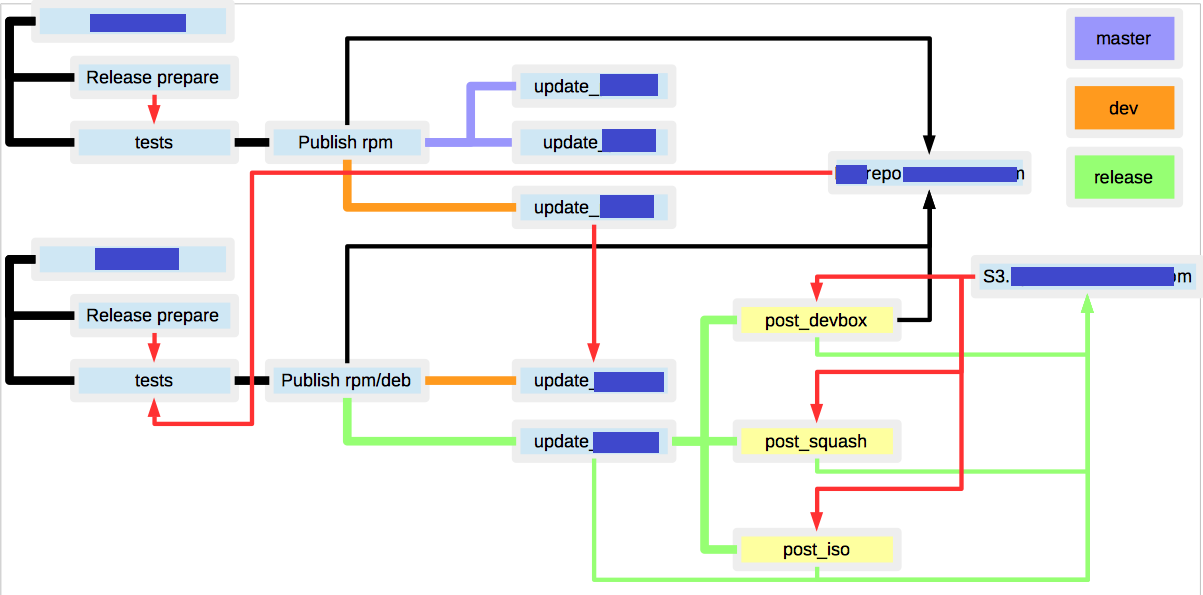

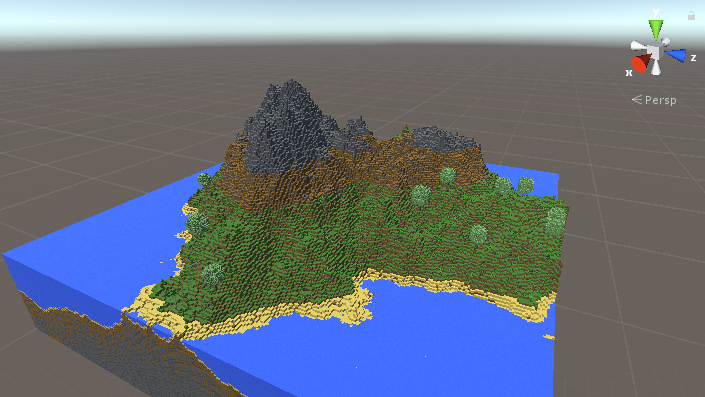

# Как наломать велосипедов поверх костылей при тестировании своего дистрибутива

Диспозиция

==========

Представим на минуту, вы разрабатываете программно-аппаратный комплекс, который базируется на своем дистрибутиве, состоит из множества серверов, обладает кучей логики и в конечном счете это все должно накатываться на вполне реальное железо. Если вы впустите бяку, пользователи вас по головке не погладят. Всплывают три извечных вопроса: что делать? как быть? и кто виноват?

Далее по тексту будет история, как начать стабильно релизиться и как к этому пришли. Чтобы не растягивать статью, не буду говорить про модульное, ручное тестирование и все стадии выкатывания на продуктив.

Сначала было MVP

================

Сложно сделать сразу всё и правильно, особенно, когда конечная цель точно не известна. Первоначальный деплой на стадии MVP выглядел примерно так: никак.

```

make dist

for i in a b c ; do

scp ./result.tar.gz $i:~/

ssh $i "tar -zxvf result.tar.gz"

ssh $i "make -C ~/resutl install"

done

```

Скрипт конечно упрощен донельзя для передачи сути, что CI нет. С машины разработчика на честном слове собрали и залили на тестовую среду для показа. На данном этапе тайное знание настройки серверов сидело в головах разработчиков и немного в документации.

Проблема в том, что есть тайное знание как заливать.

Фигак-Фигак и на staging

========================

Исторически сложилось, что teamcity использовался на множестве проектов, да и gitlab CI еще тогда не было. Teamcity был выбран за основу CI на проекте.

Разово создали виртуальную машину, внутри нее запускались "тесты"

```

make install && ./libs/run_all_tests.sh

make dist

make srpm

rpmbuild -ba SPECS/xxx-base.spec

make publish

```

тесты сводились к следующему:

1. в полуруками предподготовленном окружении установить набор утилит

2. проверить их работу

3. если ок — то опубликовать rpm

4. в полуручном режиме сходить на staging и накатить новую версию

Стало лучше:

* теперь в мастере лежит что-то проверенное

* знаем что в каком-то окружение работает

* отлавливаем детские ошибки

Но чувствуете боль?

* проблемы с зависимостям (часть пакетов пересобрана)

* окружение для разработки каждый разворачивает как умеет

* тесты гоняются в каком-то непонятном окружении

* сборка дистрибутива, настройка инсталляции и тесты — три разные несвязные вещи

Делаем мир чуточку лучше

========================

Такая схема прожила какое-то время, но мы ведь на то и инженеры, чтобы решать проблемы и делать мир лучше.

* Зависимости всего дистрибутива вынесены в метапакет

* Был создан шаблон виртуальной машины используя средства vagrant

* Bash скрипты создания инсталляций переписаны на ansible

* Создана библиотека для интеграционного тестирования, чтобы проверять что система работает в целом правильно

* Часть сценариев покрыта через serverspec

Это позволило:

* Сделать идентичным окружение разработки/тестирования

* Держать код развертывания вместе с кодом приложения

* Ускорить включение в процесс новых разработчиков

Такая схема прожила весьма долго, т.к. за приемлемое время (30-60 минут на билд) позволяла отлавливать множество ошибок, не доводя их до ручного тестирования. Но осадочек был, что при обновление ядра или при откате какого-то пакета всё шло наперекосяк, и где-то начинал грустить щенок.

Становится жарко

================

По ходу пьесы появлялись различные проблемы, которые потянут на отдельную статью:

1. Прогон интеграционных тестов со временем стал затягиваться, т.к. шаблон виртуальной машины стал отставать от актуальных версий пакетов. Пару месяцев пересобирали в полуручном режиме. В итоге сделали, чтобы при выпуске релиза:

* автоматом собирался vmdk

* vmdk прицеплялся к виртуальной машине

* полученная VM паковалась и заливалась в s3 (кстати, кто знает как vagrant подружить с s3?)

2. При одобрении мерджа не виден статус билда — переехали на gitlab ci. Обошлись малой кровью — пришлось отказаться от тригера некоторых билдов по регулярке тэга, в остальном рады.

3. Раз в неделю была рутина по выпуску релиза — автоматизировали:

* Инкремент версии релиза

* Генерация release notes по закрытым задачам

* Обновление changelog

* Создание merge requests

* Создание нового milestone

4. Чтобы ускорить билды — часть шагов была вынесена в docker, как то: линтеры, нотификации, сборка документации, часть тестов итд итп

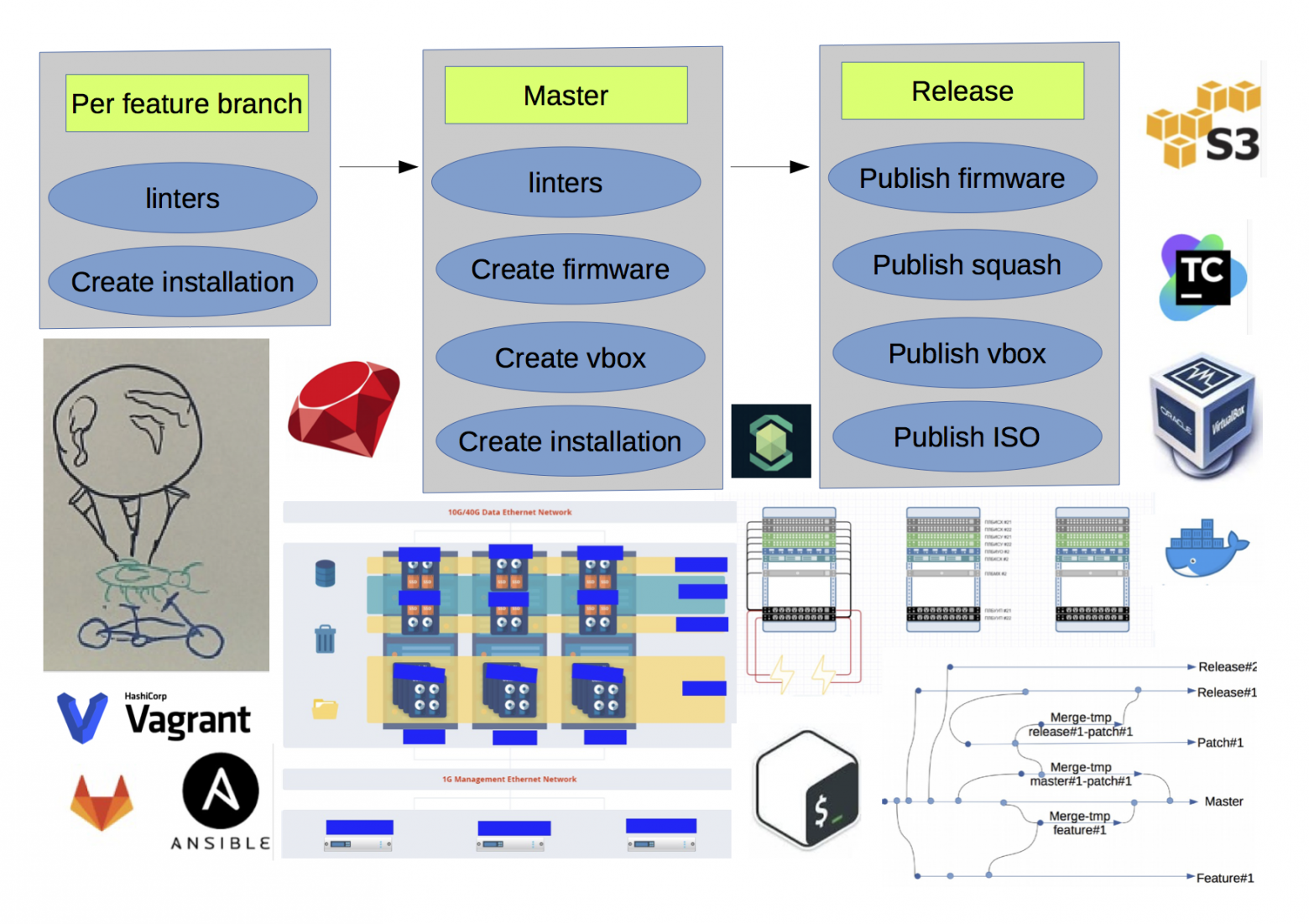

Несколько упростив, конечная схема получилась такая(красным обозначены неочевидные связи между билдами):

1. множество RPM/DEB репозиториев под разрабатываемые пакеты

2. S3 хранилище для хранения артефактов(firmware, squash, iso, VM templates)

3. если по одному и тому же бранчу запустить сборку дистрибутива, то результат может получится различным, т.к. зависимости между пакетами прописаны не жестко, и состояние репозиториев могло измениться

4. множество неочевидных связей между билдами

Это позволило:

* Выпускать приватный релиз раз в неделю

* Повысить скорость разработки за счет уменьшения кол-ва конфликтов и увеличения прогонов тестов

Заключение

==========

Сложно полученный результат назвать идеальным, но с другой стороны готовых решений для задач такого рода не встречал. Основные посылы из этого опуса:

* дорога в тысячу ли начинается с первого шага (с)

* есть боль — уменьшайте ее.

**UPD:** [English version](http://www.goncharov.xyz/it/how-to-test-custom-os-distr.html) | https://habr.com/ru/post/342216/ | null | ru | null |

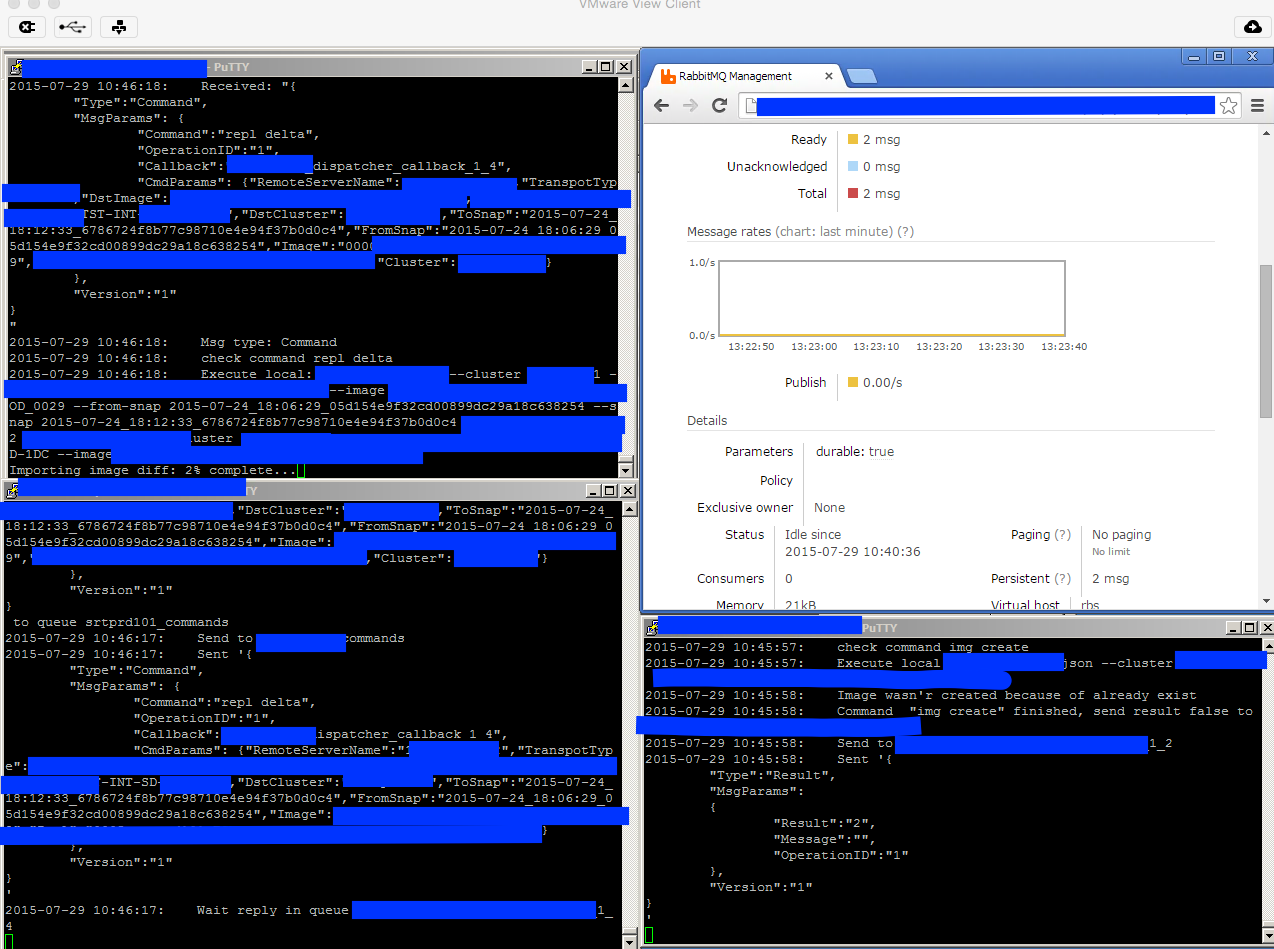

# Я бы сделал лучше

Студия Лебедева порадовала нас новым творением — обновился интернет-магазин Техносилы. Все мило и, как обычно в последнее время у Лебедева, лаконично, но…

Что мы видим на первой же странице:

Названия товаров не помещаются и просто обрезаются свойством `overflow: hidden`

Не очень красиво, я бы сказал. Но ведь есть же замечательное, но крайне редко используемое (мне ни разу не попадалось на глаза его использование) свойство `text-overflow: ellipsis`. Что удивительно, его (это свойство) поддерживает дружное семейство браузеров по имени Internet Explorer. Это свойство имеет два (согласно с [сайтом MS](http://msdn.microsoft.com/en-us/library/ms531174%28VS.85%29.aspx)) значения: `clip` (по умолчанию) и `ellipsis`, что в сочетании со свойством `overflow: hidden` дает замечательный результат: текст, который не помещается в каком-либо элементе обрезается с заменой последних символов на многоточие!!! Получается очень аккуратно и симпатично.

[Как это выглядит.](http://starhack.ru/ya-by-sdelal-luchshe/)

Некоторые браузеры, в частности Opera, требуют своего префикса для этого свойства. MSDN рекомендует так же использовать префикс -ms для ИЕ8, но понимает это свойство и без него

Проверил, что Хром 2 и Сафари 4 понимают без префиксов, а ФайрФокс 3 не понимает вовсе

Но если не использовать это свойство, то хотя бы снабдить заголовок соответствующей всплывающей подсказкой, хотя бы в виде title | https://habr.com/ru/post/55587/ | null | ru | null |

# SQL или NoSQL — вот в чём вопрос

Все мы знаем, что в мире технологий баз данных существует два основных направления: SQL и NoSQL, реляционные и нереляционные базы данных. Различия между ними заключаются в том, как они спроектированы, какие типы данных поддерживают, как хранят информацию.

Реляционные БД хранят структурированные данные, которые обычно представляют объекты реального мира. Скажем, это могут быть сведения о человеке, или о содержимом корзины для товаров в магазине, сгруппированные в таблицах, формат которых задан на этапе проектирования хранилища.

Нереляционные БД устроены иначе. Например, документо-ориентированные базы хранят информацию в виде иерархических структур данных. Речь может идти об объектах с произвольным набором атрибутов. То, что в реляционной БД будет разбито на несколько взаимосвязанных таблиц, в нереляционной может храниться в виде целостной сущности.

Внутреннее устройство различных систем управления базами данных влияет на особенности работы с ними. Например, нереляционные базы лучше поддаются масштабированию.

[](https://habrahabr.ru/company/ruvds/blog/324936/)

Какую технологию выбрать? Ответ на этот вопрос зависит от особенностей проекта, о котором идёт речь.

О выборе SQL-баз данных

-----------------------

Не существует баз данных, которые подойдут абсолютно всем. Именно поэтому многие компании используют и реляционные, и нереляционные БД для решения различных задач. Хотя NoSQL-базы стали популярными благодаря быстродействию и хорошей масштабируемости, в некоторых ситуациях предпочтительными могут оказаться структурированные SQL-хранилища. Вот две причины, которые могут послужить поводом для выбора SQL-базы:

1. Необходимость соответствия базы данных требованиям ACID (Atomicity, Consistency, Isolation, Durability — атомарность, непротиворечивость, изолированность, долговечность). Это позволяет уменьшить вероятность неожиданного поведения системы и обеспечить целостность базы данных. Достигается подобное путём жёсткого определения того, как именно транзакции взаимодействуют с базой данных. Это отличается от подхода, используемого в NoSQL-базах, которые ставят во главу угла гибкость и скорость, а не 100% целостность данных.

2. Данные, с которыми вы работаете, структурированы, при этом структура не подвержена частым изменением. Если ваша организация не находится в стадии экспоненциального роста, вероятно, не найдётся убедительных причин использовать БД, которая позволяет достаточно вольно обращаться с типами данных и нацелена на обработку огромных объёмов информации.

О выборе NoSQL-баз данных

-------------------------

Если есть подозрения, что база данных может стать узким местом некоего проекта, основанного на работе с большими объёмами информации, стоит посмотреть в сторону NoSQL-баз, которые позволяют то, чего не умеют реляционные БД.

Вот возможности, которые стали причиной популярности таких NoSQL баз данных, как MongoDB, CouchDB, Cassandra, HBase:

1. Хранение больших объёмов неструктурированной информации. База данных NoSQL не накладывает ограничений на типы хранимых данных. Более того, при необходимости в процессе работы можно добавлять новые типы данных.

2. Использование облачных вычислений и хранилищ. Облачные хранилища — отличное решение, но они требуют, чтобы данные можно было легко распределить между несколькими серверами для обеспечения масштабирования. Использование, для тестирования и разработки, локального оборудования, а затем перенос системы в облако, где она и работает — это именно то, для чего созданы NoSQL базы данных.

3. Быстрая разработка. Если вы разрабатываете систему, используя agile-методы, применение реляционной БД способно замедлить работу. NoSQL базы данных не нуждаются в том же объёме подготовительных действий, которые обычно нужны для реляционных баз.

В следующем разделе рассмотрим некоторые различия между технологиями SQL и NoSQL. А именно, сначала взглянем на простой пример, показывающий фундаментальное различие двух подходов к организации баз данных, потом поговорим о масштабируемости и индексации данных. А в итоге остановимся на примере большой CRM-системы, нуждающейся в высокой производительности хранилища данных.

SQL и NoSQL

-----------

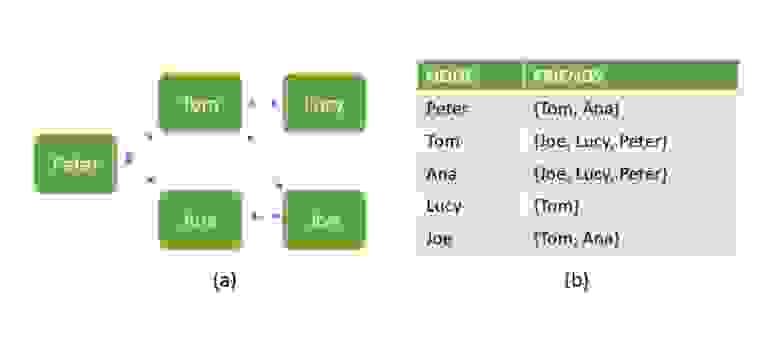

Начнём с некоторых ключевых концепций реляционных и нереляционных баз данных. Ниже показана база данных, содержащая сведения о взаимоотношениях людей. Вариант **a** — это бессхемная структура, построенная в виде графа, характерная для NoSQL-решений. Вариант **b** показывает, как те же данные можно представить в структурированном виде, типичном для SQL.

*Два варианта представления данных*

Бессхемность означает, что два документа в структуре данных NoSQL не должны иметь одинаковые поля и могут хранить данные разных типов. Вот, например, массив объектов, набор полей которых не совпадает.

```

var cars = [

{ Model: "BMW", Color: "Red", Manufactured: 2016 },

{ Model: "Mercedes", Type: "Coupe", Color: "Black", Manufactured: "1-1-2017" }

];

```

При реляционном подходе данные надо хранить в заранее спроектированной структуре, из которой эти данные потом можно извлекать. Например, используя оператор `JOIN`при выборке из двух таблиц:

```

SELECT Orders.OrderID, Customers.Name, Orders.Date

FROM Orders

INNER JOIN Customers

ON Orders.CustID = Customers.CustID

```

Как более продвинутый пример, для демонстрации того, когда SQL предпочтительнее NoSQL, рассмотрим особенности применения в NoSQL-базах алгоритмов [уплотнения](http://web.engr.illinois.edu/~sgupta49/papers/compaction.pdf). Проблема заключается в том, что в некоторых NoSQL-базах (например, в CouchDB и HBase) постоянно приходится формировать так называемые `sstables` — строковые таблицы в формате ключ-значение, отсортированные по ключу. В такие таблицы, которые сохраняются на диск, данные попадают из таблиц, хранящихся в памяти, при их переполнении и в других ситуациях. При интенсивной работе с базой создание таблиц, со временем, приводит к тому, что подсистема ввода-вывода устройства хранения данных становится узким местом для операций чтения данных. Как результат, чтение в NoSQL-базе происходит медленнее, чем запись, что сводит на нет одно из главных преимуществ нереляционных баз данных. Именно для того, чтобы уменьшить этот эффект, системы NoSQL используют, в фоновом режиме, алгоритмы уплотнения данных, пытаясь объединить множество таблиц в одну. Но и сама по себе эта операция весьма ресурсоёмка, система работает под повышенной нагрузкой.

### Масштабируемость

Одно из основных различий рассматриваемых технологий заключается в том, что NoSQL-базы лучше поддаются масштабированию. Например, в MongoDB имеется встроенная поддержка репликации и шардинга (горизонтального разделения данных) для обеспечения масштабируемости. Хотя масштабирование поддерживается и в SQL-базах, это требует гораздо больших затрат человеческих и аппаратных ресурсов.

| | | | |

| --- | --- | --- | --- |

| **Тип хранилища данных** | **Сценарий использования** | **Пример** | **Рекомендации** |

| Хранилище типа ключ-значение | Подходит для простых приложений, с одним типом объектов, в ситуациях, когда поиск объектов выполняют лишь по одному атрибуту. | Интерактивное обновление домашней страницы пользователя в Facebook. | Рекомендовано знакомство с технологией memcached.

Если приходится искать объекты по нескольким атрибутам, рассмотрите вариант перехода к хранилищу, ориентированному на документы. |

| Хранилище, ориентированное на документы | Подходит для хранения объектов различных типов. | Транспортное приложение, оперирующее данными о водителях и автомобилях, работая с которым надо искать объекты по разным полям, например — имя или дата рождения водителя, номер прав, транспортное средство, которым он владеет. | Подходит для приложений, в ходе работы с которыми допускается реализация принципа «согласованность в конечном счёте» с ограниченными атомарностью и изоляцией. Рекомендуется применять механизм кворумного чтения для обеспечения своевременной атомарной непротиворечивости. |

| Система хранения данных с расширяемыми записями | Более высокая пропускная способность и лучшие возможности параллельной обработки данных ценой слегка более высокой сложности, нежели у хранилищ, ориентированных на документы. | Приложения, похожие на eBay. Вертикальное и горизонтальное разделение данных для хранения информации клиентов. | Для упрощения разделения данных используются HBase или Hypertable. |

| Масштабируемая RDBMS | Использование семантики ACID освобождает программистов от необходимости работать на достаточно низком уровне, а именно, отвечать за блокировки и непротиворечивость данных, обрабатывать устаревшие данные, коллизии. | Приложения, которым не требуются обновления или слияния данных, охватывающие множество узлов. | Стоит обратить внимание на такие системы, как MySQL Cluster, VoltDB, Clustrix, ориентированные на улучшенное масштабирование. |

Более подробное сравнение SQL и NoSQL можно найти в [этом](http://www.cattell.net/datastores/Datastores.pdf) материале. Вот его основные положения. А именно, были проведены испытания трёх основных характеристик систем: параллельная обработка данных, работа с хранилищами информации, репликация данных. Возможности параллельной обработки оценивались путём анализа механизмов блокировки, управления параллельным доступом на основе многоверсионности, и ACID. Тестирование хранилищ охватывало и физические носители, и хранилища использующие оперативную память. Репликацию испытывали в синхронном и асинхронном режимах.

Используя данные, полученные в ходе испытаний, авторы делают выводы о том, что SQL-базы с возможностью кластеризации показали многообещающие результаты производительности в расчёте на один узел, и, кроме того, обладают способностью масштабируемости, что даёт системам RDBMS преимущество перед NoSQL за счёт полного соответствия принципам ACID.

### Индексация

В системах RDBMS индексация используется для ускорения операций извлечения данных из баз. Отсутствие индекса означает, что таблица должна быть просмотрена целиком для того, чтобы выполнить запрос на чтение.

И в SQL, и в NoSQL-базах индексы служат одной и той же цели — ускорить и оптимизировать извлечение данных. Но то, как именно они работают — различается из-за разных архитектур баз данных и особенностей хранения информации в базе. В то время, как SQL-индексы представлены в виде B-деревьев, которые отражают иерархическую структуру реляционных данных, в NoSQL базах данных они указывают на документы, или на части документов, между которыми, в основном, нет никаких отношений. [Вот](http://sql-vs-nosql.blogspot.co.il/2013/11/indexes-comparison-mongodb-vs-mssqlserver.html) подробный материал на эту тему.

### CRM-системы

CRM-приложения — это один из лучших примеров систем, для которых характерны огромные объёмы ежедневно обрабатываемых данных и очень большое количество транзакций. Все разработчики таких приложений используют и SQL, и NoSQL базы данных. И, хотя большая часть данных транзакций всё ещё хранится в SQL-базах, применение находят общедоступные системы класса DBaaS (data-base-as-a-service, база данных как сервис), наподобие AWS DynamoDB и Azure DocumentDB, в результате, серьёзная нагрузка по обработке данных может быть перенесена в облачные NoSQL-базы.

В то время, как использование подобных служб освобождает разработчика от решения задач по обслуживанию хранилищ, это, кроме того, область, где NoSQL базы применяются для того, для чего они, в основном, и были созданы, например, для глубинного анализа данных. Объёмы информации, хранимой в огромных CRM-системах финансовых и телекоммуникационных компаний, было бы практически невозможно проанализировать, используя инструменты вроде SAS или R. Это потребовало бы огромных аппаратных ресурсов.

Главное преимущество таких систем — использование [неструктурированных](http://panoply.io/blog/how-data-structures-impact-the-data-warehouse/) данных, похожих на документы. Такие данные могут подаваться на вход статистических моделей, которые дают компаниям возможность выполнять различные виды анализа. CRM-приложения, кроме того, являются весьма удачным примером, в котором две системы баз данных выступают не конкурентами, а существуют в гармонии, играя каждая свою роль в большой архитектуре управления данными.

Итоги

-----

Занимаясь поиском системы управления базами данных, можно выбрать одну технологию, а позже, уточнив требования, переключиться на что-то другое. Однако, разумное планирование позволит сэкономить немало времени и средств.

Вот признаки проектов, для которых идеально подойдут SQL-базы:

* Имеются логические требования к данным, которые могут быть определены заранее.

* Очень важна целостность данных.

* Нужна основанная на устоявшихся стандартах, хорошо зарекомендовавшая себя технология, используя которую можно рассчитывать на большой опыт разработчиков и техническую поддержку.

А вот свойства проектов, для которых подойдёт что-то из сферы NoSQL:

* Требования к данным нечёткие, неопределённые, или развивающиеся с развитием проекта.

* Цель проекта может корректироваться со временем, при этом важна возможность немедленного начала разработки.

* Одни из основных требований к базе данных — скорость обработки данных и масштабируемость.

В итоге хочется сказать, что в современном мире нет противостояния между реляционными и нереляционными базами данных. Вместо этого стоит говорить об их совместном использовании для решения задач, на которых та или иная технология показывает себя лучше всего. Кроме того, всё сильнее наблюдается интеграция этих технологий друг в друга. Например, Microsoft, Oracle и Teradata сейчас предлагают некоторые формы интеграции с Hadoop для подключения аналитических инструментов, основанных на SQL, к миру неструктурированных больших данных.

Уважаемые читатели, а вам приходилось выбирать системы управления базами данных для собственных проектов? Если да — поделитесь пожалуйста опытом, расскажите, что и почему вы в итоге выбрали. | https://habr.com/ru/post/324936/ | null | ru | null |

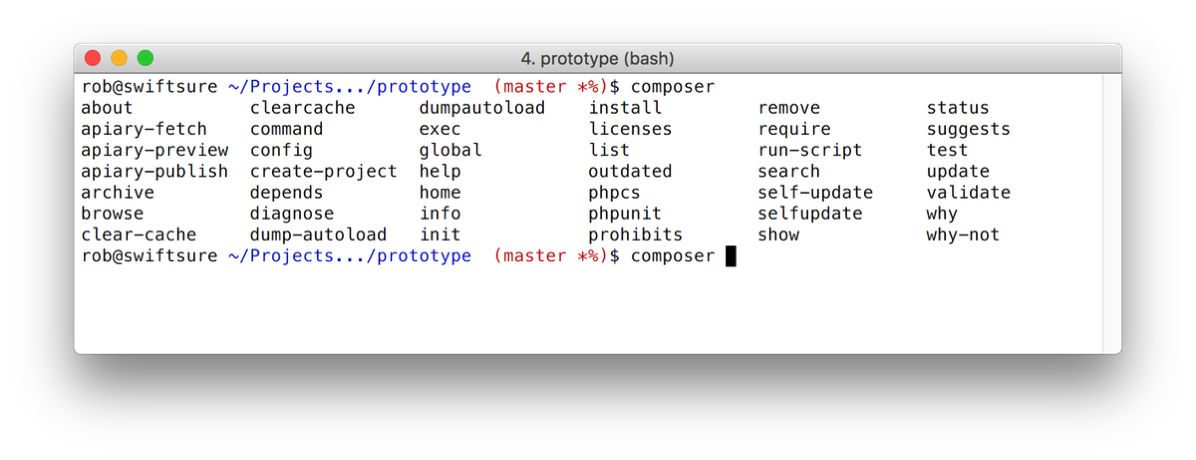

# composer и автодополнение командной строки

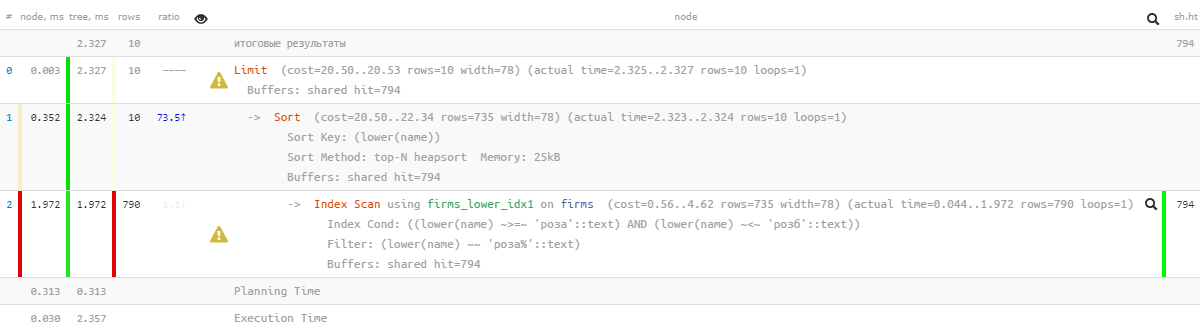

Так как я все больше и больше добавляю свои скрипты в файлы `composer.json`, было бы полезно иметь автозаполнение для команды `composer` в `bash`. Мой вопрос в Твиттере не дал немедленного решения, и, поскольку я уже делал нечто подобное для [`Phing`](https://akrabat.com/autocomplete-phing-targets-on-the-command-line/), я закатал рукава и написал своё решение.