text

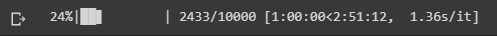

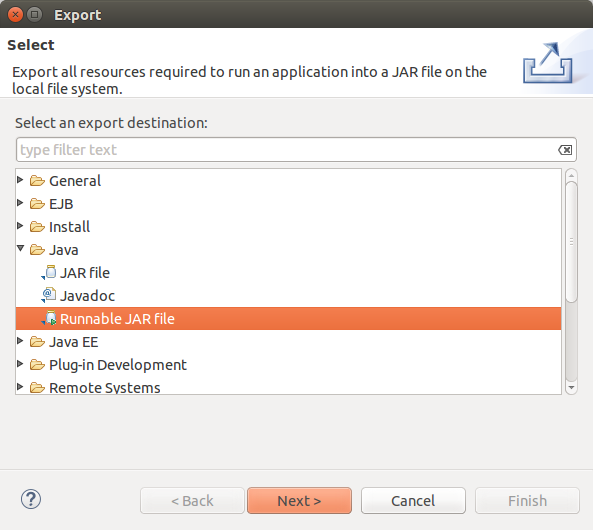

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

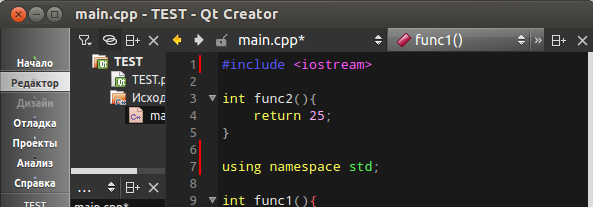

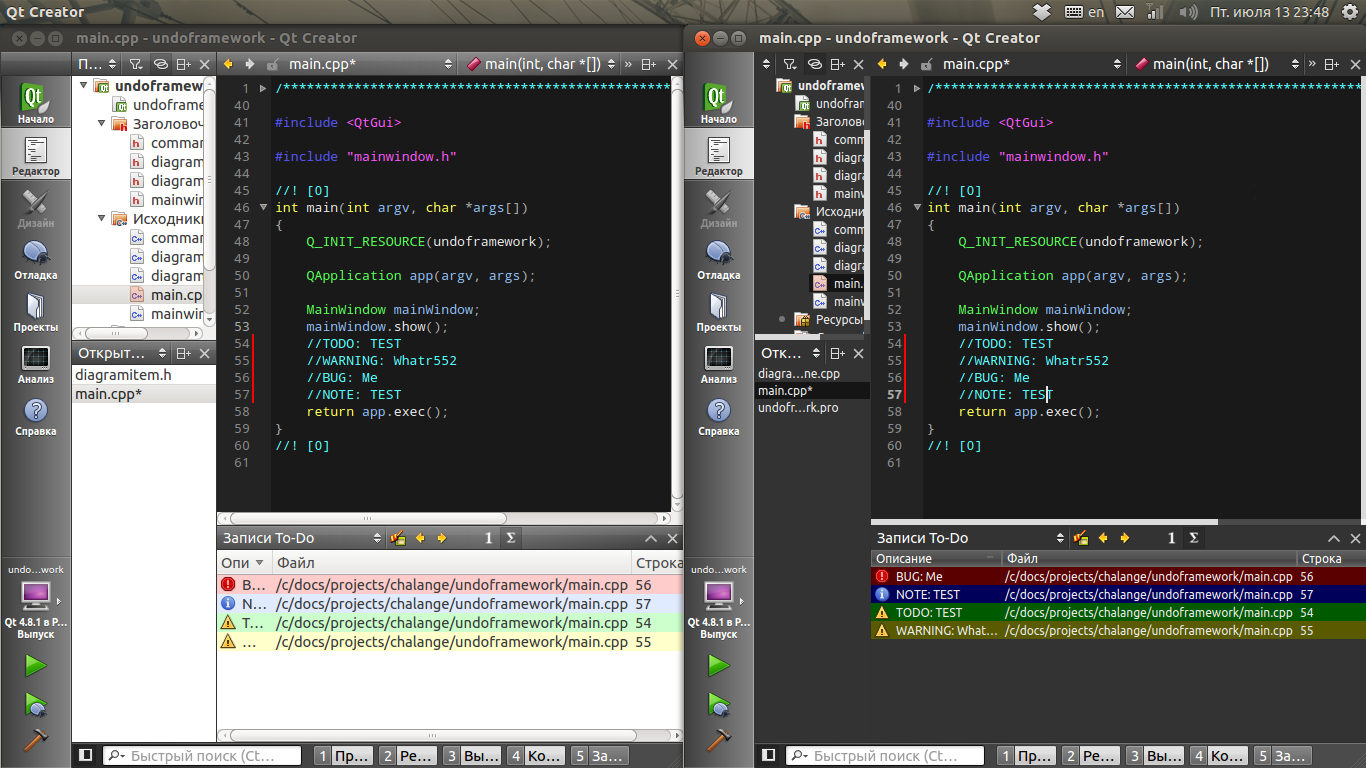

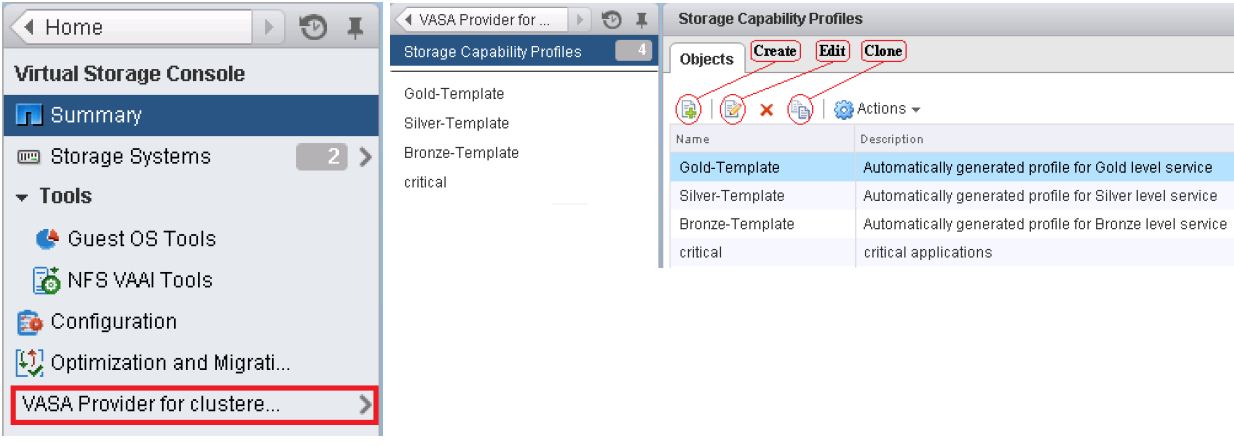

# Редизайн Qt Creator своими руками

Многие из тех кто занимаются разработкой на C++/Qt знакомы с такой средой как Qt Creator, создатели которой потрудились над дизайном не меньше чем над функциональностью. Но меня, как любителя темных цветовых схем и плоского минимализма, всегда не устраивали светлый фон панелек и градиентные заголовки.

Казалось бы, открытый исходный код — бери да меняй, но неопытность и лень останавливали меня, пока я не узнал про такую вещь как Qt Style Sheets, позволяющюю описать вид виджетов в формате css.

Заранее предупреждаю: Приведенное ниже пускай и не очень грязный, но хак. Конечно он наврятли откроет дыру в безопасности, украдет ваши пароли и отошлет их Пражским хакерам, но возможны разнообразные артефакты в интерфейсе.

Подготовка среды

================

UPD: Ничего патчить ненадо Вместо этого по совету [cyberbobs](https://habrahabr.ru/users/cyberbobs/) достаточно запускать QtCreator с параметром -stylesheet=stylesheet.css, поэтому сразу переходим к перерисовке, но если очень хочется

**то продолжайте**Для начала берем [исходный код](http://get.qt.nokia.com/qtcreator/qt-creator-2.5.0-src.tar.gz) среды. Распаковываем и добавляем в конструктор `MainWindow::MainWindow()` расположенный примерно в `./src/plugins/coreplugin/mainwindow.cpp:199` свой костыль, снабдив его опознавательными знаками, чтоб в случае чего можно было быстро найти ~~и уничтожить~~:

```

//$$MARKER

//HACK: Injecting css to change appearance

//Получаем путь к папке с файлами приложения

//В Linux: /home/shed/.local/share/data/Nokia/QtCreator

//В Windows: C:\Document and Settings\user\Local Settings\Application Data

QString csspath = QDesktopServices::storageLocation(QDesktopServices::DataLocation)+"/stylesheet.css";

QFile css(csspath);

if (css.open(QIODevice::ReadOnly | QIODevice::Text)){

qDebug() << "NOTE: stylesheet loaded from" << csspath;

QString style = QTextStream(&css).readAll();

qApp->setStyleSheet(style);

} else {

qDebug() << "NOTE: stylesheet not found in " << csspath;

}

//$$MARKEREND

```

ленивые могут взять измененный [файл](https://dl.dropbox.com/u/54323116/habr/01/attach/mainwindow.cpp) для последней стабильной версии 2.5.0

затем

`qmake && make && ./bin/qtcreator`

если все прошло гладко на выходе получаем

`NOTE: stylesheet not found in <путь-к-таблице-стилей>/stylesheet.css`

теперь создаем этот самый stylesheet.css и пишем туда для проверки

```

background: blue; color: red;

```

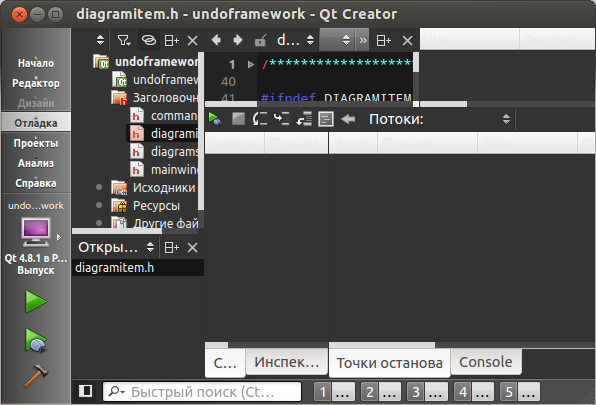

перезапускаем qtcreator (для экономии нервов следовало бы настроить редактор на запуск qtcreator одним нажатием) и видим такую феерию:

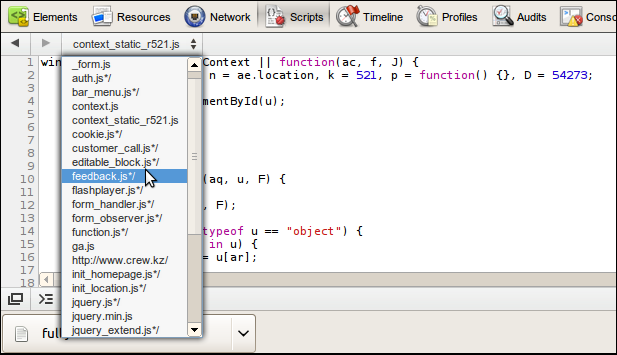

Как и следовало, setStyle покрасил все в синий, но появилось два отщепенца: список классов и методов текущего документа и переключатели панелей вывода. У меня есть два предположения почему так: либо эти элементы не являются потомками QWidget, что врятли, либо они используют свой способ отрисовки обходящий систему стилей Qt, что вполне возможно, учитывая их нестандартный вид.

Перерисовка

===========

Как известно таблица стилей представляет собой набор записей вида:

```

<Селектор>[, <Селектор>, ...] {

<Параметр>: <Значение>;

<Параметр>: <Значение>;

...

<Параметр>: <Значение>;

}

```

Если вы никогда раньше не писали ничего подобного, несколько уроков из любого [тьюторала](http://ru.html.net/tutorials/css/) дадут вам представление о том что будет происходить ниже. Позже стоит прочесть [документацию](http://doc.crossplatform.ru/qt/4.5.0/stylesheet-reference.html) по Qt Style Sheet и [примеры](http://doc.crossplatform.ru/qt/4.5.0/stylesheet-examples.html#customizing-qheaderview).

Селекторы

---------

В демонологии чтобы вызвать демона нужно знать его имя, в нашем случае для составления селектора нужно знать название класса, objectName или значение любого свойства, заданного с использованием Q\_PROPERTY() и setProperty().

Qt потдерживает все [СSS2-селекторы](http://www.w3.org/TR/CSS2/Селектор.html#q1). Самые полезные согласно документации:

| | | |

| --- | --- | --- |

| Универсальный селектор | \* | Соответствует всем виджетам. |

| Селектор типа | QPushButton | Соответствует экземплярам класса QPushButton и его подклассов. |

| Селектор свойства | QPushButton[flat=«false»] | Соответствуют экземплярам класса QPushButton, которые не являются плоскими (flat). Можно использовать этот селектор для проверки любого свойства Qt, заданного с использованием Q\_PROPERTY().

Вместо = вы можете также использовать ~= для проверки содержит ли свойство Qt типа QStringList заданную строку QString. |

| Селектора класса | .QPushButton | Соответствует экземплярам класса QPushButton, но не его подклассов.

Эквивалентно выражению \*[class~=«QPushButton»]. |

| Селектор идентификатора (ID) | QPushButton#okButton | Соответствует всем экземплярам класса QPushButton, чье objectName равно okButton. |

| Селектор потомков | QDialog QPushButton | Соответствует всем экземплярам класса QPushButton, которые являются наследниками класса QDialog (дочерними, внучатыми и т.д.). |

| Селектор дочерних элементов | QDialog > QPushButton | Соответствует всем экземплярам класса QPushButton, являющихся непосредственными потомками QDialog. |

Нас пока интересует только селектор типа, более гибким и правильным было бы использование свойств, но это требует вмешательства в код.

Теперь давайте поиграем в дизайнеров.

Напомню, мы хотели сделать темный фон у панелей. Для этого нам нужно выбрать селектор. Что мы обычно видим в этих панельках? Деревья в «Проекты», «Обзор Классов», «Иерархия типов» и «Контур» (в девичестве «Outline»), списки в «Файловая Система», «Открытые Документы» и «Закладки» и таблицы в панелях отладки, т.е. стандартные QListView, QTreeView и QTableVeiw имя которым **QAbstractItemView**.

Поэтому напишем в наш stylesheet.css следующее:

```

QAbstractItemView {

color: #EAEAEA;

background: #232323;

font-size: 9pt;

}

```

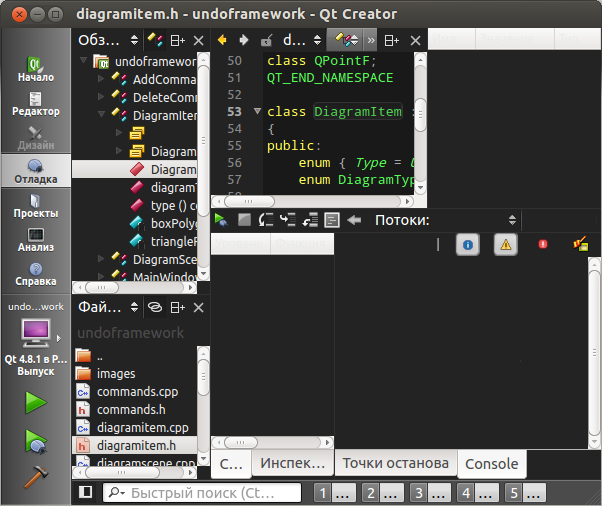

Запускаем, уменьшаем размеры окна до минимума чтоб вылезло побольше всяких элементов и видим:

Мы получили что хотели, но наши (пусть и нелюбимые) панельки потеряли свой вид, и причем без нашей команды. Если кто пробегался глазами по MainWindow::MainWindow() возможно заметил неприметную строчку `qApp->setStyle(new ManhattanStyle(baseName));`, особо настойчивые могли щелкнуть по ManhattanStyle и заметить что он наследуеться от QProxyStyle т.е. именно он переопределяет рисовку у наших панелек. И именно он уходит за кулисы как только мы задаем стиль.

Предчуствуя кучу мелкой работы по наведению красоты в этих поблекших кнопках я решил не мелочиться, и вбухал помимо QAbstractItemView еще и **QMainWindow** — отца всех виджетов:

```

QAbstractItemView, QMainWindow {

color: #EAEAEA;

background: #232323;

font-size: 9pt;

}

```

Запускаем:

Почти то что надо. Остается омрачить белые пятна табов, хедеров и скролбаров.

Субэлементы и состояния

-----------------------

Как и СCS2, Qt Style Sheet поддерживает субэлементы и состояния, т.е. запись селектора в виде:

```

<Селектор>::<Субэлемент>:<Состояние>

```

Например `QScrollBar::left-arrow:horizontal` выбирает все левые стрелки гоизонтальных полос прокрутки.

Рассмотрим как это работает на наших белых пятнах.

### Оформляем QTreeView и QAbstractItemView

Для начала изменим облик выделенного элемента в QAbstractItemView на более темный с помощью:

```

QAbstractItemView::item:selected {

color: #EAEAEA;

background-color: #151515;

}

```

Сравниваем:

Теперь разберемся с **QTreeView**.

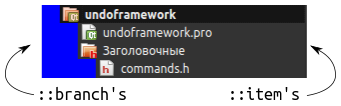

Каждая его строчка состоит из одного субэлемента ::item и одного или нескольких ::branch:

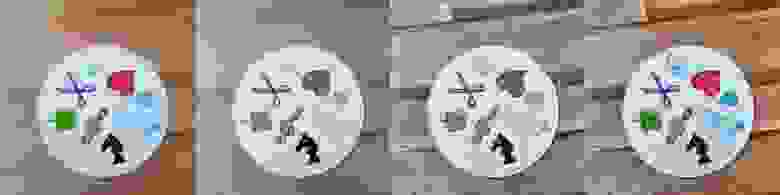

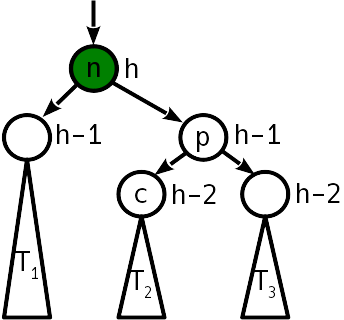

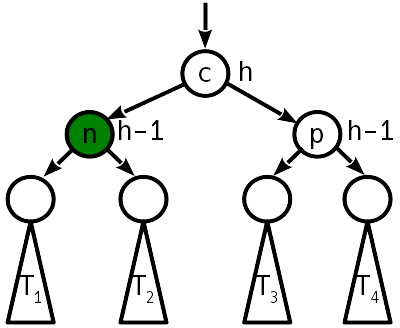

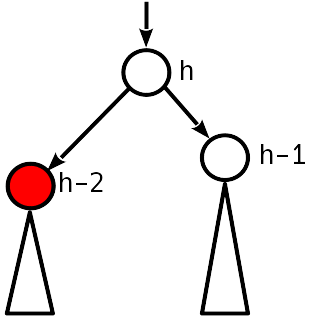

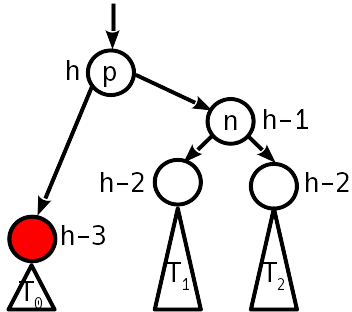

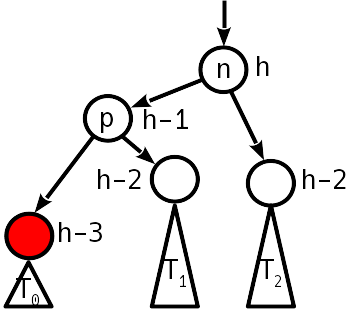

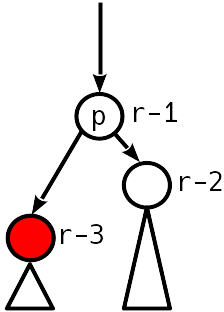

::branch помимо стандартных состояний поддерживает еще 4:

\*Синие — элементы с искомым состоянием

| | | | |

| --- | --- | --- | --- |

| | | | |

| `:open` | `:adjoins-item` | `:has-children` | `:has-subling` |

Подумав, я решил забыть про надоевшие стрелочки и сделать напротив сгрупированных элементов маленькую серенькую точку. Стало быть нам нужны `:closed:adjoins-item:has-children`. Подергав параметры получаем чтото вроде:

```

QTreeView::branch:closed:adjoins-item:has-children {

background: solid #777777;

margin: 6px;

height: 6px;

width: 6px;

border-radius: 3px;

}

```

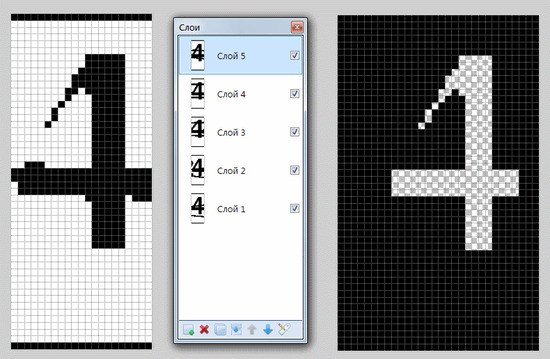

Если же вы любите стрелочки, вам должна понравиться конструкция url(filename), которая переданная в image: или border-image: установит в качестве фона или границы изображение, хранящееся на жестком диске либо в системе ресурсов Qt.

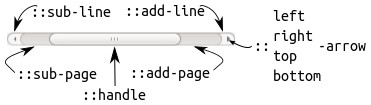

### Изменяем QScrollBar

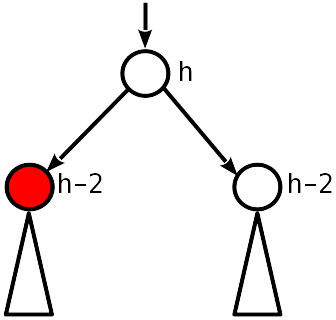

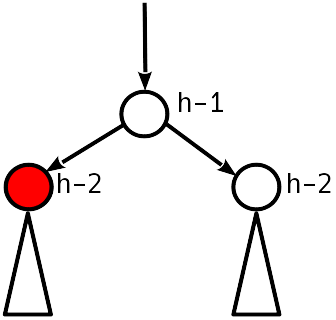

В глазах Qt Style Sheets, стандартная полоса прокрутки состоит из следующих субэлементов:

Цинично превращаем это трехмерное великолепие в унылую серо-серую полоску, а кнопки вместе со стрелочками отправляем на награждение премии «Ненужно 2012» следующими строками:

```

QScrollBar {

border: none;

background: #494949;

height: 6px;

width: 6px;

margin: 0px;

}

QScrollBar::handle {

background: #DBDBDB;

min-width: 20px;

min-height: 20px;

}

QScrollBar::add-line, QScrollBar::sub-line {

background: none;

border: none;

}

QScrollBar::add-page, QScrollBar::sub-page {

background: none;

}

```

Получаем:

### Модифицируем QTabBar

Без лишних слов приступаем к переделке ~~нашей гостинной~~ вкладок. Уж кого, а этот виджет разработчики не обделили:

* Субэлементы: ::tear (разделитель вкладок) и ::scroller (кнопка прокрутки)

* Целая россыпь дополнительных состояний вкладок: :only-one, :first, :last, :middle, :previous--selected, :next-selected, :selected, назначения которых я надеюсь понятны из названий.

* Псевдо-состояния :top, :left, :right, :bottom зависимые от ориентации панели.

* Отрицательные поля которые можно использовать для создания перекрытий

Есть где разгуляться фантазии.

Следует помнить лишь одно, QTabBar лежит на QTabWidget, поэтому фон стоит изменять через виджет, а свойства вкладок уже через панель. Но мы люди неприхотливые, к тому же о фоне у нас позаботился QMainWindow, поэтому мы ляпаем тоненькие неприметные вкладки строками:

```

QMainWindow,

QAbstractItemView,

QTreeView::branch,

QTabBar::tab

{

...

QTabBar::tab:selected {

font: bold;

border-color: #9B9B9B;

border-bottom-color: #C2C7CB;

}

QTabBar::tab:!selected {

margin-top: 2px;

}

```

### Изменяем QHeaderView

Для тех кто не знал, все эти заголовки таблиц в Qt это и есть QHeaderView. У него один субэлемент ::section который обладает теми же состояниями что и QTabBar::tab.

На этот раз я решил отступиться от традиции и сделать градиентную заливку (да здесь и так можно). Для этого используются конструкции qlineargradient, qradialgradient, qconicalgradient. Градиенты указываются в режиме ограничивающего прямоугольника объекта (Object Bounding Mode). Представьте себе прямоугольник, в котором визуализируется градиент, верхний левый угол которого находится в (0, 0), а нижний правый угол — в (1, 1). Параметры градиента в этом случае указываются как доля между 0 и 1. Эти значения экстраполируются на реальные координаты прямоугольника во время выполнения. Возможно задание значений, которые лежат вне ограничивающего прямоугольника (например, -0.6 или 1.8).

Я использовал следующее оформление:

```

QHeaderView::section {

background-color: qlineargradient(x1:0, y1:0, x2:0, y2:1,

stop:0 #616161, stop: 0.5 #505050,

stop: 0.6 #434343, stop:1 #656565);

color: white;

padding-left: 4px;

border: 1px solid #6c6c6c;

}

```

То чего мы и добивались.

### Уговариваем упрямую панельку

Осталась только одна маленькая проблемка:

Этот отщепеныш остался абсолютно равнодушен к нашим стараниям, более того он оставался равнодушен даже когда мы в качестве селектора указали прадедушку QWidget'а. Несмотря на это, я все же перебирал разные селекторы. Впервые удалось пронять ее селекторами с QComboBox и QLabel:

```

QComboBox, QComboBox::drop-down {

color: #EAEAEA;

background: #232323;

font-size: 9pt;

border: none;

padding: 1px 18px 1px 3px;

min-width: 6em;

}

QLabel {

border-style: solid;

color: #EAEAEA;

background: #232323;

font-size: 9pt;

}

```

Минусы на лицо. Мало неумолимой никакими border-style рамки вокруг отщепеныша, так еще и тяжелая наследственнасть просочилась везде куда ненадо.

Тут как кстати, проявились капли здравого смысла. Дети, что такое тоненькое, в верху окна с кнопочками в ряд? Конечно же это QToolBar!

Пробуем:

```

QToolBar {

border-style: solid;

border-style: outset;

color: #EAEAEA;

background: #333333;

font-size: 9pt;

}

```

Бинго! Пропали все следы тяжелой болезни и отщепенец послушно влился в общий вид.

Итоги

=====

[stylesheet.css](https://dl.dropbox.com/u/54323116/habr/01/attach/stylesheet.css)

TODO:

=====

Правильнее было бы не кодировать цвета, а брать их из палитры, которая в лучшем случае могла бы заполняться согласно цветовой схеме редактора. Кроме того можно было бы оформить все это в виде корректного дополнения и добавить свою страницу настройки с выбором стиля, и возможно редактором. Ну самое желанное это конечно же похудеть удобную но толстую боковую панелька. убрав текст и получить доступ к ее оформлению из нашего css файла, но это требует более глубокого вмешательства в код да и вообще совсем другая история. | https://habr.com/ru/post/152367/ | null | ru | null |

# Blazor + MVVM = Silverlight наносит ответный удар, потому что древнее зло непобедимо

Привет, Хабр!

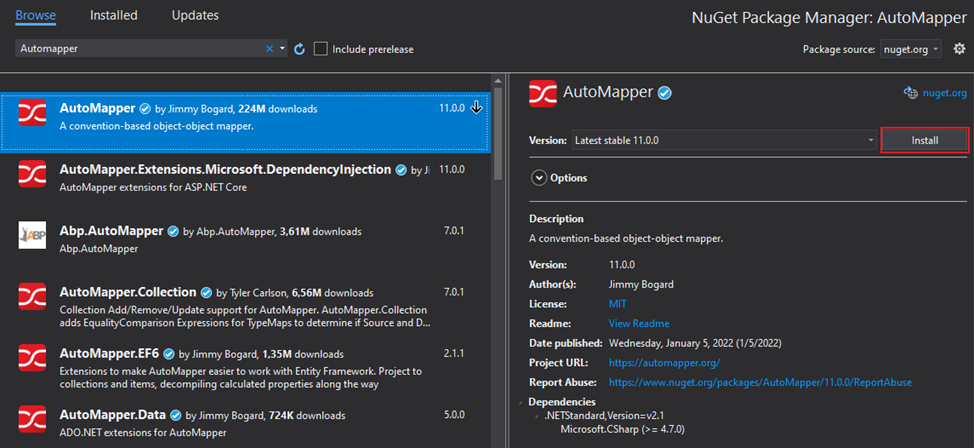

Таки да, скоро выходит net core 3.0 и там будет шаблон проекта с Blazor как один из дефолтных. Название у фреймворка, по-моему, похоже на название какого-нибудь покемона. Блазор вступает в бой! Решил я значит глянуть что за зверь такой и с чем его едят поэтому сделал на нем Todo лист. Ну и на Vue.js тоже, для сравнения с сабжем потому что по моему они похожи система компонентов в обоих и реактивность и вот это все. Больше тудушек богу тудушек! По факту это Гайд для юных, не окрепших умов которым лень TypeScript или JavaScript учить а кнопочки и инпуты на сайте сделать хочется. Как в том меме -«Технарь хотел написать книгу но получилась инструкция». Кому интересны мои похождения в фронт энде или узнать что за Blazor такой добро пожаловать под кат.

Введение

--------

Была когда-то у Майкрософт идея работы C# в браузере и звали эту идею Силверлайт. Не взлетело. Эти ваши тырнеты были тогда другие как собственно и браузеры. Почему я думаю что сейчас взлетит? Потому что сейчас веб ассембли есть во всех современных браузерах по дефолту. Нет необходимости в установке отдельного расширения. Другая проблема размеры приложения. Если на Vue.js SPA весит 1.7 мегабайт, то точно такое же на Blazor 21 мегабайт. Сейчас интернет быстрее и надежнее стал чем во времена Сильверлайта да и скачивать приложение надо один раз, а дальше там кеш и все дела. Вообще Blazor мне показался очень похожим на Vue.js. И так, как дань уважения Silverligtht, WPF и UWP да и просто потому что у шарпистов так принято я решил использовать паттерн MVVM для своего проекта. Так для справки — Я вообще бекэндшик и мне Blazor понравился. Слабонервных предупреждаю — Дизайн и верстка в моих примерах ужасные, а в проекте с Vue.js опытный фронтэндшик может узреть много говнокода. Ну и с орфографией и пунктуацией дела тоже так себе.

Ссылки

------

[Пример Todo на Vue + Vuex](https://gitlab.com/VictorWinbringer/vuetodo)

[Пример Todo на Blazor](https://gitlab.com/VictorWinbringer/blazorexample)

Модели размещения

-----------------

1. На стороне клиента. Стандартное SPA которое можно раздавать различными способами. В моем примере я использовал шаблон в котором файлы приложения отдает браузеру сервер на asp.net core. Минус этого подхода в тех самых 21 мегабайтах которые нужно скачать браузеру.

2. На стороне сервера. Все происходит на сервере, а клиенту через сокеты передается готовый DOM. Браузеру вообще почти ничего не надо скачивать в начале, но зато вместо этого постоянно по кускам скачивать обновленный DOM. Ну и вся нагрузка по клиентскому коду внезапно взваливается на сервер.

Мне лично первый вариант больше нравиться и его можно использовать во всех тех случаях когда вам не нужно беспокоиться о конверсии пользователей. Например это какая-то внутренняя информационная система компании или специализированное B2B решение потому что Blazor долго скачивается в первый раз. Если ваши пользователи постоянно заходят в ваше приложение, то они не заметят никакой разницы с JS версией. Если пользователь заходит по рекламной ссылке просто глянуть что там за сайт какой-то скорее всего он не будет долго ждать пока сайт загрузиться и просто уйдет. В этом случае лучше использовать второй вариант размещения т.e. Server Side Blazor.

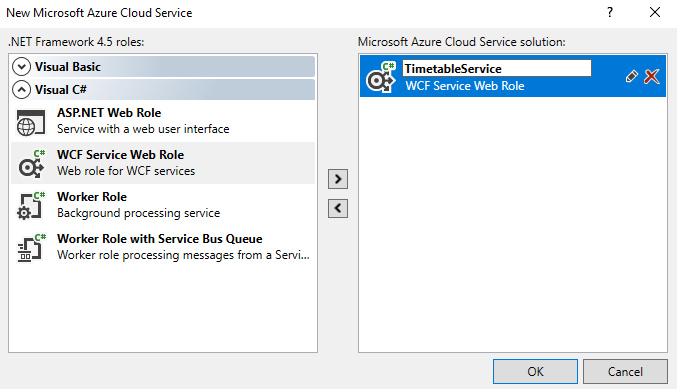

Создание проекта

----------------

Скачайте net core 3.0 [dotnet.microsoft.com/download/dotnet-core/3.0](https://dotnet.microsoft.com/download/dotnet-core/3.0)

Выполните в терминале команду которая загрузить вам необходимые шаблоны.

```

dotnet new -i Microsoft.AspNetCore.Blazor.Templates

```

Для создания Server Side

```

dotnet new blazorserverside -o MyWebApp

```

Для Client Side файлики которого будет раздавать сервер asp.net core

```

dotnet new blazorhosted -o MyWebApp

```

Если вам захотелось экзотики и вдруг решили не использовать в качестве сервера asp.net core а что-то другое (А оно вам надо вообще?) можете создать только клиент без сервера вот такой командой.

```

dotnet new blazor -o MyWebApp

```

Биндинги

--------

Поддерживается односторонняя привязка и двусторонняя. Таки да, не надо никаких OnPropertichanged как в WPF. При изменении Вью Модели разметка меняется автоматически.

```

One way binding:

Two way binding:

Two way binding и смена события при которов будет меняться поле Text на событие oninput:

//ViewModel

@code{

string Text;

async Task InpuValueChanged()

{

Console.WriteLine("Input value changed");

}

}

```

И так, тут у нас есть ViewModel (анонимная) у которой есть поле Text.

В первом инпуте через «value=@Text» мы сделали одностороннюю привязку. Теперь когда мы изменим Text в коде тут же изменится текст внутри input. Только вот чтобы мы не печатали в нашем инпуте это никак не повлияет на нашу VM. Во втором input через "@bind=@Text" мы сделали двухстороннюю привязку. Теперь если мы напишем что-то новое в нашем input тут же поменяется наша VM, и обратное тоже верно т.е. если мы поменяем поле Text в коде то наш input тут же отобразит новое значение. Тут есть одно НО — по дефолту изменения привязаны к событию onchange нашего input поэтому VM поменяться только тогда когда мы завершим ввод. В третьем input "@bind:event=«oninput»" мы изменили событие для передачи данных VM на oninput теперь каждый раз когда мы печатаем какой-нибудь символ новое значение тут же передается нашей VM. Так же для DateTime можно указать формат например так.

View Model

-----------

Можно ее делать анонимкой тогда ее нужно помешать внутри блока "@code {}"

```

@page "/todo"

Привет @UserName

@code{

public string UserName{get; set;}

}

```

или можно вынести ее в отдельный файл. Тогда ее надо наследовать от ComponentBase и в начале страницы указать ссылку на нашу VM c помошью "@inherits"

Например

TodoViewModel.cs:

```

public class TodoViewModel: ComponentBase{

public string UserName{get; set;}

}

```

Todo.razor:

```

@page "/todo"

@inherits MyWebApp.ViewModels.TodoViewModel

Привет @UserName

```

Маршрутизация

-------------

Маршруты на которые будет реагировать страница указываются в ее начале с помощью "@page". Причем их может быть несколько. Будет выбран первый точно соответствующий в порядке сверху вниз. Например:

```

@page "/todo"

@page "/todo/delete"

Hello!

=======

```

Эта страница будет открываться по адресу "/todo" или «todo/delete»

Лайауты

-------

В общем-то сюда обычно помещают одинаковые для нескольких страниц вещи. Вроде сайдбара и прочего.

Для того чтобы использовать лайаут во первых, нужно его создать. Он должен наследоваться от LayotComponentBase с помощью "@inherits". Например

```

@inherits LayoutComponentBase

[About](http://blazor.net)

@Body

```

Во-вторых, его нужно импортировать. Для этого в директории со страницами которые его будут использовать нужно создать файл \_imports.razor потом добавить в этот файл строчку "@layout"

```

@layout MainLayout

@using System

```

В третьих можно у страницы указать какой именно лайаут она использует напрямую

```

@layout MainLayout

@page "/todo"

@inherits BlazorApp.Client.Presentation.TodoViewModel

### Todo

```

Вообще \_imports.razor и using в нем действуют на все страницы которые находятся с ним в одной папке.

Параметры маршрутов

-------------------

Во первых — указать параметр и его тип в фигурных скобках в нашем маршруте (регистра независим). Поддерживаются стандартные типы дотнет. Таки да, опциональных параметров нет т.е. значение нужно передавать всегда.

Само значение можно получить создав у нашей ViewModel свойство с именем таким же как у параметра и с атрибутом [Parameter] БТВ — забегая в перед — данные и события в дочерние компоненты из родительских передаются тоже с помощью атрибута [Parameter] так же есть каскадные параметры. Они передаются от родительского компонента всем его дочерним компонентам и их дочерним компонентам. Они используются в основном для стилей а стили лучше все же просто делать в CSS поэтому ну его нафиг.

```

@page "/todo/delete/{id:guid}"

Hello!

=======

@code{

[Parameter]

public Guid Id { get; set; }

}

```

DI

--

Все регистрируется в Startup.cs, как в обычном asp.net core приложении. Тут ничего нового. А вот внедрение зависимостей для нашей VM таки происходит через публичные свойства а не через конструктор. Свойство просто нужно декорировать атрибутом [Inject]

```

public class DeleteTodoViewModel : ComponentBase

{

[Parameter]

private Guid Id { get; set; }

[Inject]

public ICommandDispatcher CommandDispatcher { get; set; }

```

По умолчанию есть уже подключенных 3 сервиса. HttpClient — ну вы знаете зачем он. IJSRuntime — вызов JS кода из C#. IUriHelper — с помощью не его можно делать переадресацию на другие страницы.

Пример приложения

-----------------

### Компонет таблицы Todo

TodoTableComponent.razor:

```

//1)

Задача выполнена | Название | Дата создания | Действия |

//2)

@foreach (var item in Items)

{

//3)

|ClickRow(item.Id)) class="@(item.Id == Current?"table-primary":null)">

| @item.Name | @item.Created.ToString("dd.MM.yyyy HH:mm:ss") | [Удалить](/todo/delete/@item.Id) |

}

@code {

//4)

[Parameter]

private List Items { get; set; }

[Parameter]

private EventCallback OnClick { get; set; }

[Parameter]

private Guid Current { get; set; }

private async Task ClickRow(Guid id)

{

//5

await OnClick.InvokeAsync(CreateArgs(id));

}

private ClickTodoEventArgs CreateArgs(Guid id)

{

return new ClickTodoEventArgs { Id = id };

}

//6)

public class ClickTodoEventArgs : UIMouseEventArgs

{

public Guid Id { get; set; }

}

}

```

1. Так как это компонент нам тут не нужны "@page" и "@layout" потому что он не будет участвовать в маршрутизации а лайаут он будет использовать от родительского компонента

2. С символа @ начинается C# код. Собственно так же как и в Razor

3. ```

@onclick=@(()=>ClickRow(item.Id))

```

Привязывает событие нажатия на строку к методу ClickRow нашей ViewModel

4. Указываем какие параметры будут передаваться из родительского компонента или страницы в наш с помощью атрибута [Parameter]

5. Вызываем функцию обратного вызова которую получили из родительского компонента. Так родительский компонент узнает что в дочернем произошло какое-то событие. Функции можно передавать только завернутыми в EventCallback<> параметризованный EventArgs. Возможный список EventArgs можно посмотреть тут — [docs.microsoft.com/ru-ru/aspnet/core/blazor/components?view=aspnetcore-3.0#event-handling](https://docs.microsoft.com/ru-ru/aspnet/core/blazor/components?view=aspnetcore-3.0#event-handling)

6. Так как список возможных типов EventArgs ограничен а нам нужно передать дополнительное свойство Id в обработчик события на стороне родительского компонента то мы создаем свой собственный класс параметра унаследованный от базового и передаем уже его в событие. Таки да — в родительский компонент, в функцию обработчик события прилетит обычный UIMouseEventArgs и его нужно будет привести к нашему типу например с помощью оператора as

Пример использования:

### Страница для удаления Todo

Наша ViewModel aka VM — DeleteTodoViewModel.cs:

```

public class DeleteTodoViewModel : ComponentBase

{

//1)

[Parameter]

private Guid Id { get; set; }

//2)

[Inject]

public ICommandDispatcher CommandDispatcher { get; set; }

[Inject]

public IQueryDispatcher QueryDispatcher { get; set; }

[Inject]

public IUriHelper UriHelper { get; set; }

//3)

public TodoDto Todo { get; set; }

protected override async Task OnInitAsync()

{

var todo = await QueryDispatcher.Execute(new GetById(Id));

if (todo != null)

Todo = new TodoDto { Id = todo.Id, IsComplite = todo.IsComplite, Name = todo.Name, Created = todo.Created };

await base.OnInitAsync();

}

//4)

public async Task Delete()

{

if (Todo != null)

await CommandDispatcher.Execute(new Remove(Todo.Id));

Todo = null;

//5)

UriHelper.NavigateTo("/todo");

}

}

```

1. Параметр маршрута "/todo/delete/{id:guid}" сюда передаться Guid если мы перейдем например по адресу localhost/todo/delete/ae434aae44...

2. Инжектим сервисы из DI контейнера в нашу VM.

3. Просто свойство нашей VM. Ее значение мы устанавливаем сами, какое хотим.

4. Это метод вызывается автоматически при инициализации страницы. Тут мы устанавливаем нужные значения для свойств нашей VM

5. Метод нашей VM. Мы можем привязать его например к событию нажатия какой нибудь кнопки нашей View

6. Переход на другую страницу которая находиться по адресу "/todo" т.е. у нее в начале есть строчка "@page "/todo""

Наша View — DeleteTodo.razor:

```

//1)

@page "/todo/delete/{id:guid}"

@using BlazorApp.Client.TodoModule.Presentation

@using BlazorApp.Client.Shared;

//2)

@layout MainLayout

//3)

@inherits DeleteTodoViewModel

### Удалить Todo

@if (Todo != null)

{

@Todo.Name

//4)

Удалить

}

else

{

*Такой Todo не найден*

}

```

1. Указываем что эта страна будет доступна по адресу {корневой адрес нашего сайта} +"/todo/delete/"+{какой то Guid}. Например [localhost/todo/delete/ae434aae44](http://localhost/todo/delete/ae434aae44)...

2. Указываем что наша страница будет рендериться внутри MainLayout.razor

3. Указываем что наша страница будет использовать свойства и методы класса DeleteTodoViewModel

4. Узказываем что при нажатии на эту кнопку будет вызываться метод Delete() нашей VM

### Главная страница Todo

TodoViewModel.cs:

```

public class TodoViewModel : ComponentBase

{

[Inject]

public ICommandDispatcher CommandDispatcher { get; set; }

[Inject]

public IQueryDispatcher QueryDispatcher { get; set; }

//1)

[Required(ErrorMessage = "Введите название Todo")]

public string NewTodo { get; set; }

public List Items { get; set; }

public TodoDto Selected { get; set; }

protected override async Task OnInitAsync()

{

await LoadTodos();

await base.OnInitAsync();

}

public async Task Create()

{

await CommandDispatcher.Execute(new Add(NewTodo));

await LoadTodos();

NewTodo = string.Empty;

}

//2)

public async Task Select(UIMouseEventArgs args)

{

//3)

var e = args as TodoTableComponent.ClickTodoEventArgs;

if (e == null)

return;

var todo = await QueryDispatcher.Execute(new GetById(e.Id));

if (todo == null)

{

Selected = null;

return;

}

Selected = new TodoDto { Id = todo.Id, IsComplite = todo.IsComplite, Name = todo.Name, Created = todo.Created };

}

public void CanselEdit()

{

Selected = null;

}

public async Task Update()

{

await CommandDispatcher.Execute(new Update(Selected.Id, Selected.Name, Selected.IsComplite));

Selected = null;

await LoadTodos();

}

private async Task LoadTodos()

{

var todos = await QueryDispatcher.Execute>(new GetAll());

Items = todos.Select(t => new TodoDto { Id = t.Id, IsComplite = t.IsComplite, Name = t.Name, Created = t.Created })

.ToList();

}

}

```

1. Поддерживаются стандартные атрибуты валидации из System.ComponentModel.DataAnnotations. Конкретно тут мы указываем что это поле обязательное и тот текст который будет отображаться если пользователь не укажет значение в том input который будет связан с этим полем.

2. Метод для обработки события с параметром. Этот метод будет обрабатывать событие из дочернего компонента

3. Приводем аргумент к типу который мы создали в дочернем компоненте

Todo.razor:

```

@layout MainLayout

@page "/todo"

@inherits BlazorApp.Client.Presentation.TodoViewModel

### Todo

#### Список

@if (Items == null)

{

*Загрузка...*

}

else if (Items.Count == 0)

{

*Нет задач для отображения. Пожалуйсте добавте какую нибудь.*

}

else

{

//1)

}

#### Создать Todo

@if (Items != null)

{

//2)

//3)

//4)

//5)

//6)

//7)

Создать

}

#### Редактировать Todo

@if (Items != null)

{

@if (Selected != null)

{

Сохранить

Отмена

}

else

{

*Кликните на задаче чтобы ее редактировать*

}

}

```

1. Вызываем дочерний компонент и передаем ему в качестве параметров свойства и методы нашей VM.

2. Встроенный компонент формы с валидацией данных. Указываем в нем что в качеств е модели он будет использовать нашу VM и при отправке валидных данных он будет вызывать ее метод Create()

3. Валидация будет выполняться с помощью атрибутов модели вроде [Requared] и т.п.

4. Здесь буду отображаться общие ошибки валицадии

5. Создаст input с валидацией. Список возможных тегов — InputText, InputTextArea, InputSelect, InputNumber, InputCheckbox, InputDate

6. Здесь будут отображаться ошибки валидации для свойства public string NewTodo{get;set;}

7. При нажатии на эту кнопку будет вызываться событие OnValidSubmit нашей формы

### Файл Startup.cs

Тут мы регистрируем наши сервисы

```

public class Startup

{

public void ConfigureServices(IServiceCollection services)

{

//Добавляем LocalStorage и SessionStorage как синглтоны чтобы сохранять данные на

//стороне клиента в браузере

// Тут нужно подключить черед Nuget пакет Blazor.Extensions.Storage

services.AddStorage();

services.AddSingleton();

services.AddSingleton();

services.AddSingleton();

services.AddSingleton>, GetAllHandler>();

services.AddSingleton, GetByIdHandler>();

services.AddSingleton, AddHandler>();

services.AddSingleton, RemoveHandler>();

services.AddSingleton, UpdateHandler>();

}

public void Configure(IComponentsApplicationBuilder app)

{

//Указываем что корневым компонентом нашего приложения будет App.razor

// и его содержимое будет помещаться внутри тега

app.AddComponent("app");

}

}

```

Эпилог

------

Эта статься была написана, чтобы разыграть аппетит и подтолкнуть к дальнейшему изучению Blazor. Надеюсь, поставленной цели я достиг. Ну а чтобы изучить его получше, рекомендую почитать [официальное руководство от Майкрософт](https://docs.microsoft.com/ru-ru/aspnet/core/blazor/?view=aspnetcore-3.0).

Благодарности

-------------

Спасибо [AndreyNikolin](https://habr.com/ru/users/andreynikolin/), [win32nipuh](https://habr.com/ru/users/win32nipuh/), [SemenPV](https://habr.com/ru/users/semenpv/) за найденные орфографические и грамматические ошибки в тексте. | https://habr.com/ru/post/463197/ | null | ru | null |

# Капча, частный случай: рвём нейронную сеть тридцатью строками кода

Уже не помню, как я наткнулся на статью [habr.com/ru/post/464337](https://habr.com/ru/post/464337/), но она запала мне в мозг и не давала покоя вплоть до минувшего дня. Несколько раз я пытался понять происходящее, пару раз пытался заставить это работать, но безрезультатно: я совершенно ничего не понимаю в нейронных сетях и даже программирую не как настоящий программист.

Наконец, несколько дней назад я осилил запуск питона и решил, [а почему бы и не да](https://youtu.be/kLezFlhQook?t=107) и всё такое. Забыв всё, что я прочитал в упомянутой статье, пошёл своим путём.

Вспоминая несметное количество решённых капч, я предположил, что можно решать их банальным сравнением с маской, что и подтвердилось впоследствии.

Во-первых, вручную собрал тестовые капчи (83 штуки) и дал им очевидные имена. Скриптом превратил их в битовые изображения.

Цифры в капчах бывают двух размеров по высоте с разницей в 1 пиксель и трёх-четырёх начертаний по ширине. Базовая линия всех символов во всех капчах одинаковая. Всё это разнообразие, как оказалось, имеет некую общую маску, сравнение с которой однозначно идентифицирует цифру. Вырезал по нескольку (сначала – по 5, потом добавлял ещё по 1-2; с «4» провозился дольше остальных) одинаковых цифр из разных капч. В paint.net наложил их друг на друга и получил общую для всех начертаний каждой цифры маску.

Единственную проблему обнаружил позднее, уже при массовой обработке, но успешно её обошёл

**при помощи костыля**

Первоначально, распознавание шло по порядку — по исходному образу прогонялась маска «1», потом «2» и т.д. до «9». Оказалось, что в некоторых случаях, когда толстая линия шума накладывается на ножку «4», то одинаково успешно распознаются и «4», и «1». Пришлось, во-первых, изменить порядок применения масок с «123456789» на «423156789» и во-вторых, при успешном распознавании «4» заливать это место белым, чтобы гарантированно исключить «1».

Кроме этого небольшого недоразумения шум совершенно не мешает. Итогом этого этапа стал набор из 9 масок. Два вложенных цикла и вуаля! – все мои 83 капчи распознаются на ура!

Дальше встал вопрос: где взять большой набор капч для проверки. И я скачал «29 000 капч» из упомянутой статьи.

**Однако, это оказалось пустой тратой времени.**

Во-первых (точнее, во-вторых, т.к. я обнаружил уже позднее), там присутствуют идентичные файлы: один и тот же файл сохранён под разными именами: 6503 раза, 5420 раз, 760 и т.д. – т.е. всего уникальных файлов 14882, что, впрочем, тоже немало.

Во-вторых, а на самом деле – во-первых, – это не настоящие капчи. Сайт отдаёт картинку в формате PNG, а в наборе – JPG, причём крайне плохого качества, причём со сдвигом. Могу предположить, что именно такова была цель автора – статья же недаром называется «”зашумленная” капча».

Так что пришлось расчехлить гугл и самостоятельно намайнить идеальных капч: за ночь набралось 3224 файла, в том числе 49 абсолютно пустых, как выяснилось позднее. Cпасибо Ганеше за [код](https://gist.github.com/spirkaa/4c3b8ad8fd34324bd307#gistcomment-3157744).

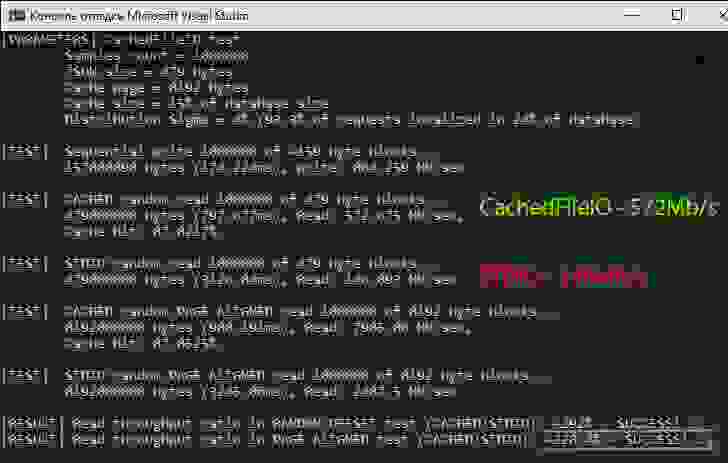

Собственно распознавание капчи укладывается в 26 строк скучного кода на питоне. Из внешних модулей нужен только PIL. Скорость работы – примерно 1000 капч в минуту (одна тысяча капч в минуту) на стареньком Core 2 «четыре ядра четыре гига». На более приличном восьмипоточном i5 заметно быстрее, хотя дело, конечно, не в потоках. Распознавание 100% или очень к тому близко: выборочная проверка не показала ошибок.

Конечно, всё это не интересно в смысле нейронных сетей и прочих блокчейнов, но имеет совершенно определённое преимущество перед предложенным ранее вариантом: скорость и точность. Так же верно и то, что любое изменение параметров капчи – гарнитуры или размера шрифта, вид шума и т.д. – приведёт к полной неработоспособности моего решения.

[Скачать архив с капчами с Яндекс.Диска (14МБ).](https://yadi.sk/d/7Lno4LQ_-Vqytw)

**Исходный код**

```

from PIL import Image, ImageTk

def recognize(filepath):

Zlist = [] # [(x1, z1), (x2, z2), (x3, z3), etc.] - position and digit

captcha = ""

originalimage = Image.open(filepath).convert('L').point(lambda x : 255 if x > 20 else 0, mode='1').convert('1').convert('RGBA')

if originalimage.getextrema() == ((0, 0), (0, 0), (0, 0), (255, 255)):

return("empty image")

for z in [4, 2, 3, 1, 5, 6, 7, 8, 9]: # reorder to exclude false 1 on 4

mask = Image.open('mask' + str(z) + '.png').convert('RGBA')

previ = 0

for i in range(15, 120): # no digit in left part

resultimage = Image.alpha_composite(originalimage.crop((i, 0, i + 30, 0 + 50)), mask)

if resultimage.getextrema() == ((0, 0), (0, 0), (0, 0), (255, 255)):

if z == 4: # delete 4 to exclude false 1 on 4

maskx = Image.open('mask4x.png').convert('RGBA')

originalimage.paste(Image.alpha_composite(originalimage.crop((i, 0, i + 30, 0 + 50)), maskx), (i, 0))

if previ == 0 or i > previ + 15: #no digit closer then 15 px

Zlist.append((i, z))

if len(Zlist) == 5:

Zlist.sort()

for z in Zlist:

captcha = captcha + str(z[1])

return(captcha)

previ = i

i = i + 15 #skip a little

Zlist.sort()

return(str(Zlist)) #if less then 5 digits recognized

def main():

captcha = recognize(entry.path)

#----------------------------------------------#

# в архиве полный код для массовой обработки #

#----------------------------------------------#

main()

```

Дополнение от 13.02.2020.

Ради чего всё затевалось? Не ради же спортивного распознавания сохранённых картинок? Нет, всё это было исключительно в прагматических целях.

[Готовое решение для работы.](https://github.com/0-6-1-7/rosreestr) — локальный http-сервер распознавания плюс расширение для Chrome.

Пока единственное, что оно умеет (я надеюсь, что умеет) — автоматически вставлять капчу в нужное место. В планах:

— очистить интерфейс сайта, оставив необходимый минимум;

— автоматизировать обновление капчи при просмотре сведений, т.к. одна капча даёт возможность открыть всего 4 объекта.

— загружать сразу все готовые выписки, а не по одной.

Дополнение от 05.03.2020.

[Готовое решение для работы.](https://github.com/0-6-1-7/rosreestr) — локальный http-сервер распознавания плюс расширение для Chrome.

Обновил расширение для Chrome. Теперь оно умеет, помимо автоподставновки капчи,

1. при открытии страниц с информацией об объектах недвижимости разворачивать сведения о правах;

2. собирать информацию с этих страниц для последующей обработки.

Скриншот в комментарии [habr.com/post/488018/#comment\_21360646](https://habr.com/post/488018/#comment_21360646)

Дополнение от 17.04.2020.

[Бот для заказа выписок по списку](https://github.com/0-6-1-7/rosreestr/tree/master/EGRN%20bot) — в связи с ограничением на частоту заказа выписок — 1 выписка за 5 минут. Скриншот в [комментарии](https://habr.com/ru/post/488018/#comment_21510362) | https://habr.com/ru/post/488018/ | null | ru | null |

# Первое знакомство с архитектурой коллекционной карточной игры «Last Argument»

Добрый день!

Меня зовут Сергей, я независимый разработчик игр. В сентябре 2014 года я поставил перед собой цель — реализовать игру во многом схожую с Hearthstone. Я долго размышлял перед тем, как взяться за этот проект: по силам ли мне это?! В тот момент задача казалась неподъемной для одного разработчика. Из титров к оригинальной игре было очевидно, что над ней трудятся не менее десяти человек, кроме того у Blizzard, есть уже сложившееся комьюнити и достаточно денег на маркетинг. Сама игра реализована по мотивам уже существующего игрового мира, что также несколько упрощает разработку самим близардам. Ничего из вышеописанных сопутствующих условий у меня нет и потому меня до сих пор преследуют сомнения относительно ожидаемого успеха от данной инициативы. Тем не менее, я все таки взялся за этот проект — прежде всего потому, что мне нравятся коллекционный карточные игры и сама работа над подобной игрой приносит мне удовольствие. Я решил, что этот проект, так или иначе, даст мне возможность получить практический опыт в разработке подобных игр. Даже если с первой попытки мне не удастся трансформировать это в какое-то коммерчески успешное предприятие, общий совокупный опыт, полученный в ходе работы над этим проектом, даст мне возможность, в будущем, экспериментировать в этом жанре и, в конечном счете, я так или иначе все равно нащупаю ту оригинальную механику и сеттинг, которые позволят создать собственную игровую студию, специализирующуюся на разработке оригинальных коллекционных карточных игр.

В настоящий момент я работаю над игрой уже восьмой месяц и хотел бы этой публикацией начать цикл статей, который открывает некоторые нюансы того, как работают коллекционные карточные игры в принципе. Наверное, для многих опытных разработчиков эти статьи вряд ли смогут рассказать что-то принципиально новое; и все же, я надеюсь, что если вы никогда ранее не сталкивались с подобными играми — у вас проснется дополнительный интерес к ним и, возможно, вы начнете разрабатывать свою игру или, может быть, присоединитесь к данному проекту.

В своей работе я использую python 3.3, django, redis и tornado для серверной части проекта action script + robotlegs для клиентской. Я не исключаю того, что в ближайшем будущем я также начну писать клиент на С++ под Unreal Engine 4. До последнего времени я был сфокусирован на работе непосредственно над кодом, обеспечивающим игровую механику и потому на данном этапе для меня было не слишком важно, какую технологию использовать для написания клиентской части игры. Я просто выбрал то, что лучше знал.

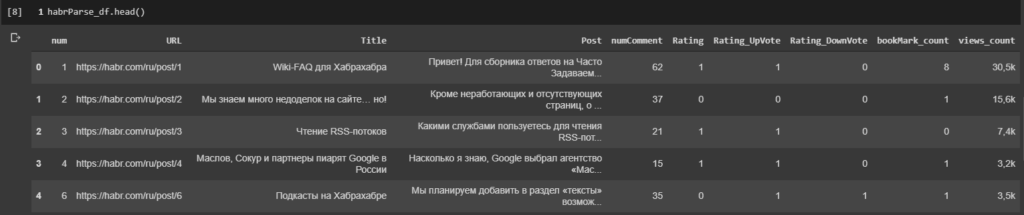

Django используется для административной панели, которая позволяет настраивать эффекты при розыгрыше тех или иных карт, а также работает с запросами касающимися создания новых карт самих игроков и создания определенной колоды из того набора, который открыт у игрока. Сами матчи не используют базу данных — вместо этого они просто кешируют собственную модель в redis. Бой между двумя реальными игроками осуществляется через приложение tornado, использующее постоянное сокетное соединение между двумя клиентами.

Совсем коротко архитектура игры выглядит так:

У клиентов есть как сервисы для установления контакта с торнадо приложением в рамках какого-то конкретного матча, так и отдельные сервисы, касающиеся коллекции карт. Совершая те или иные ходы, один из клиентов информирует об этом сервер, на основании полученных данных сервер анализирует сделанное игроком действие и формирует игровой сценарий, который отправляет обратно обоим клиентам. Получив от сервера игровой сценарий, клиент отдает его команде, отвечающей за его проигрывание. В целом, плавное и комплексное проигрывание всех игровых событий происходит за счет двух рекурсивных функций: одна функция находится на сервере, она анализирует настройки той или иной карты, проходит по всем переменным конкретного эффекта и формирует массив игровых действий; вторая рекурсивная функция клиентская, последовательно проигрывает каждое игровое действие, обнаруженное в игровом сценарии.

Вероятно, я еще напишу отдельную статью о том, что представляют собой настройки той или иной карты. Сегодня я ограничусь лишь одним поверхностным примером, того как это может выглядеть в реальном матче: предположим, у игрока на руках есть карта с простой способностью «Провокация». Эта защитная способность вынуждает сначала атаковать существо со способностью «Провокация» и только после его смерти уже других существ и героя противника.

Изначально один из игроков оповещает сервер о том что разыграна та или иная карта. По индексу карты сервер определяет набор ее настроек и отдает настройки карты особому игровому реактору. Игровой реактор пропускает все настройки карты через свою рекурсивную функцию и возвращает уже готовый игровой сценарий. Конкретно способность «Провокация» срабатывает таким образом. Сама карта хранит описание способности в константах:

* EtitudeType (Вид способности)

* EtitudePeriod (Момент срабатывания способности)

* EtitudeLevel (Уровень влияния способности)

В нашем случае реактор будет пропускать все способности через период EtitudePeriod.SELF\_PLACED. Это значит, что он пытается найти способность, которую необходимо активировать сразу же, как только фишка оказалась на поле. Как только он обнаружит эту способность, по уровню влияния он сможет понять, к кому нужно будет применить эту способность. В данном случае по константе EtitudeLevel.SELF он поймет, что способность нужно применить к самому существу, спровоцировавшему срабатывание этой способности. На третьем этапе рекурсивная функция установит тип способности EtitudeType.Provocation, далее реактор изменит характеристики этого существа в своей модели и сформирует игровой сценарий, указав индекс существа и способность, которую необходимо применить к этому существу. Сформированный сценарий реактор вернет торнадо приложению, а тот в свою очередь отдаст его своим соединениям.

Немного кода для полноты картины:

```

# match.py

def place_unit (self, index, attachment)

unit = self.get_unit(index, attachment)

scenario = []

reactor = new Reactor(scenario)

scenario = reactor.place_unit(unit)

return scenario

```

```

# reactor.py

def place_unit (self, unit)

self.initiator = unit

self.etitudes = initiator.etitudes[:]

self.activate(EtitudePeriod.SELF_PLACED)

return self.scenario

def activate(self, period):

if len(self.etitudes):

etitude = self.etitudes[0]

del self.etitudes[0]

if period == etitude.period:

targets = self.get_targets(etitude.level)

# some other etitudes ...

if etitude.type == EtitudeType.PROVOCATION:

for target in targets:

target.provocation = True

action = {}

action['type'] = 'provocation'

action['target'] = {'index':target.index}

self.scenario.append(action)

self.activate(period)

```

На клиенте аналогичная рекурсивная функция перебирает компоненты игрового сценария, по индексу определяет, какой именно элемент (карта, существо) будет трансформирован и визуализирует тот или иной эффект в зависимости от его типа.

В общем, это все, что я хотел рассказать в своей вводной части. Благодарю за внимание! | https://habr.com/ru/post/256889/ | null | ru | null |

# Удаленное включение по Mac-адресу C# (Wake On Lan)

В этой статье я хотел бы поделиться небольшим опытом удаленного включения компьютера. Эта тема, пожалуй, многим известна, но хотелось бы еще раз уделить внимание данной технологии. Свою статью я разделю на две части:

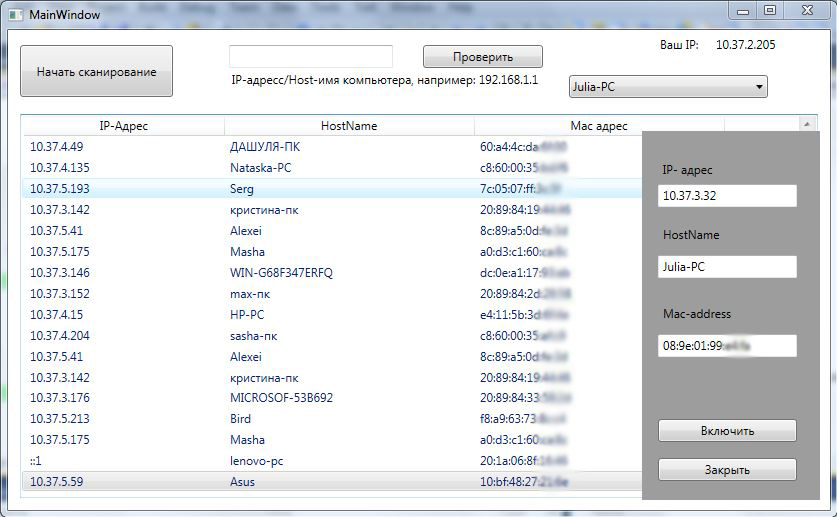

* Сканирование локальной сети, получение IP-адреса, HostName, Mac-address;

* Создание "[magic packet](https://ru.wikipedia.org/wiki/Wake-on-LAN#Magic_packet)" и отправка.

Вот так примерно выглядит созданная программа:

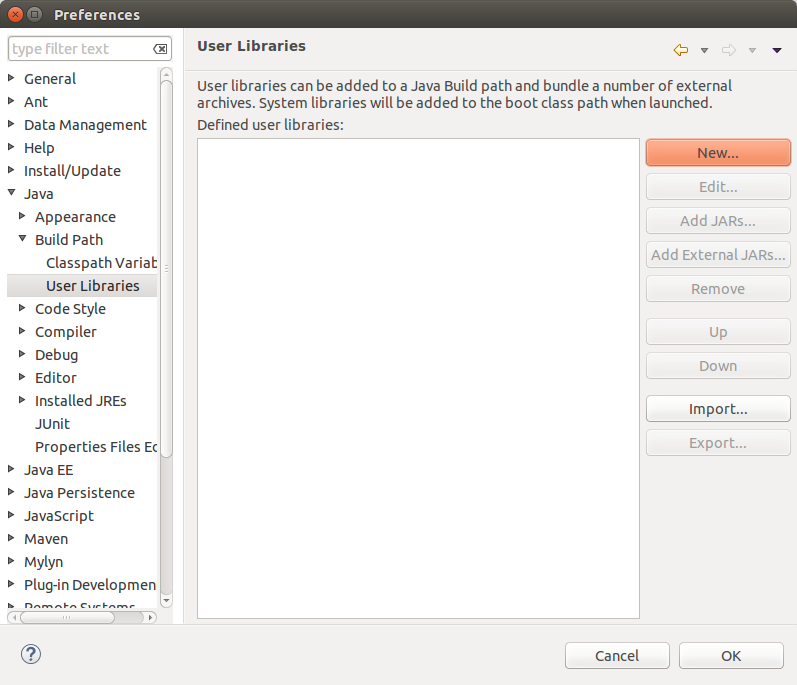

Итак, приступим к выполнению первого пункта.

#### 1. Сканирование локальной сети: получение IP-адреса, HostName, Mac-address

В настоящее время существует множество программ, которые реализуют данный пункт. В этой статье я напишу пример кода, который будет выполнять поставленную задачу.

Создадим новый проект в Visual Studio WPF C#. Для начала создадим основной элемент- это ListView, где будет выводится полученная информация.

*Код XAML*

```

```

*Код C#*

```

class TableHost

{

public string ipAdress { get; set; }

public string nameComputer { get; set; }

public string MacAdress { get; set; }

}

```

Следующим действием узнаем свой IP-адрес и приступим к сканировании локальной сети. Код простой, даже для новичка он не вызовет особых трудностей.

*Код C#*

```

// Получение ip-адреса.

System.Net.IPAddress ip = System.Net.Dns.GetHostByName(host).AddressList[0];

private void button2_Click(object sender, RoutedEventArgs e)

{

int i = int.Parse(ipToString[0]);

int j = int.Parse(ipToString[1]);

{

for(int k = 0;k<6;k++)

{

for (int m = 0; m < 254; m++)

{

//Запускаем проверку в новом потоке

Thread _thread = new Thread(() => GetInform(string.Format("{0}.{1}.{2}.{3}", i.ToString(), j.ToString(), k.ToString(), m.ToString())));

_thread.Start();

}

}

}

}

private void GetInform(string textName)

{

string IP_Address = "";

string HostName = "";

string MacAddress = "";

try

{

//Проверяем существует ли IP

entry = Dns.GetHostEntry(textName);

foreach (IPAddress a in entry.AddressList)

{

IP_Address = a.ToString();

break;

}

//Получаем HostName

HostName = entry.HostName;

//Получаем Mac-address

IPAddress dst = IPAddress.Parse(textName);

byte[] macAddr = new byte[6];

uint macAddrLen = (uint)macAddr.Length;

if (SendARP(BitConverter.ToInt32(dst.GetAddressBytes(), 0), 0, macAddr, ref macAddrLen) != 0)

throw new InvalidOperationException("SendARP failed.");

string[] str = new string[(int)macAddrLen];

for (int i = 0; i < macAddrLen; i++)

str[i] = macAddr[i].ToString("x2");

MacAddress = string.Join(":", str);

//Далее, если всё успешно, добавляем все данные в список, после чего выводим всё в ListView

Dispatcher.Invoke(new Action(() =>

{

_host.Add(new TableHost() { ipAdress = IP_Address, nameComputer = HostName, MacAdress = MacAddress });

listView1.ItemsSource = null;

listView1.ItemsSource = _host;

}));

}

catch { }

}

```

Теперь мы имеем всё, что нам необходимо. Приступаем к следующему этапу.

#### 2. Создание «magic packet» и отправка

С определением вы можете ознакомится [здесь](https://ru.wikipedia.org/wiki/Wake-on-LAN#Magic_packet). Этот этап, как вы сами понимаете, будет работать только с выключенным компьютером, так что нам необходимо будет сохранить всю информацию. Полный код я напишу в конце статьи.

Код на самом деле не такой то уж и страшный, деятельность этого пункта можно разделить на два этапа: создание пакета и его отправка.

*Код C#*

```

[DllImport("iphlpapi.dll", ExactSpelling = true)]

public static extern int SendARP(int destIp, int srcIP, byte[] macAddr, ref uint physicalAddrLen);

private void WakeFunction(string MAC_ADDRESS)

{

WOLClass client = new WOLClass();

client.Connect(new IPAddress(0xffffffff), 0x2fff);

client.SetClientToBrodcastMode();

int counter = 0;

//буфер для отправки

byte[] bytes = new byte[1024];

//Первые 6 бит 0xFF

for (int y = 0; y < 6; y++)

bytes[counter++] = 0xFF;

//Повторим MAC адрес 16 раз

for (int y = 0; y < 16; y++)

{

int i = 0;

for (int z = 0; z < 6; z++)

{

bytes[counter++] = byte.Parse(MAC_ADDRESS.Substring(i, 2), NumberStyles.HexNumber);

i += 2;

}

}

//Отправляем полученный магический пакет

int reterned_value = client.Send(bytes, 1024);

}

public class WOLClass : UdpClient

{

public WOLClass()

: base()

{ }

//Установим broadcast для отправки сообщений

public void SetClientToBrodcastMode()

{

if (this.Active)

this.Client.SetSocketOption(SocketOptionLevel.Socket,SocketOptionName.Broadcast, 0);

}

}

```

Вот, наверное, и всё, я постарался пробежаться по основным моментам несложной, но очень интересной программы. Для статьи я наполнил эту программу еще некоторым функционалом, чтобы как-то разнообразить ее. Если кого то заинтересует — здесь есть, что взять для себя. Ниже представлен весь код:

**Код XAML**

```

IP-адресс/Host-имя компьютера,

например: 192.168.1.1

```

**код C#**

```

using System;

using System.Collections.Generic;

using System.Linq;

using System.Text;

using System.Windows;

using System.Windows.Controls;

using System.Windows.Data;

using System.Windows.Documents;

using System.Windows.Input;

using System.Windows.Media;

using System.Windows.Media.Imaging;

using System.Windows.Navigation;

using System.Windows.Shapes;

using System.Net;

using System.Runtime.InteropServices;

using System.Threading;

using System.Net.Sockets;

using System.Globalization;

using System.IO;

namespace Network

{

///

/// Interaction logic for MainWindow.xaml

///

public partial class MainWindow : Window

{

[DllImport("iphlpapi.dll", ExactSpelling = true)]

public static extern int SendARP(int destIp, int srcIP, byte[] macAddr, ref uint physicalAddrLen);

List \_host = new List();

string hostname = "";

IPHostEntry entry ;

string[] ipToString = new string[4];

public MainWindow()

{

InitializeComponent();

//string[] first = adress.ToString().Split('.');

//string[] second = IPAddress.Parse("192.168.1.0").ToString().Split('.');

// Получение имени компьютера.

String host = System.Net.Dns.GetHostName();

// Получение ip-адреса.

System.Net.IPAddress ip = System.Net.Dns.GetHostByName(host).AddressList[0];

// Показ адреса в label'е.

label3.Content = ip.ToString();

ipToString = ip.ToString().Split('.');

ADd();

}

string[] ipadressText;

string[] hostnameText;

string[] macaddressText;

private void ADd()

{

string[] str = File.ReadAllLines("IPMAC.txt");

ipadressText = new string[str.Length];

hostnameText = new string[str.Length];

macaddressText = new string[str.Length];

for (int i = 0; i < str.Length; i++)

{

string[] s = str[i].Split('#');

ipadressText[i] = s[0];

hostnameText[i] = s[1];

macaddressText[i] = s[2];

comboBox1.Items.Add(s[1]);

}

}

private void WakeFunction(string MAC\_ADDRESS)

{

WOLClass client = new WOLClass();

client.Connect(new IPAddress(0xffffffff), 0x2fff);

client.SetClientToBrodcastMode();

int counter = 0;

//буффер для отправки

byte[] bytes = new byte[1024];

//Первые 6 бит 0xFF

for (int y = 0; y < 6; y++)

bytes[counter++] = 0xFF;

//Повторим MAC адрес 16 раз

for (int y = 0; y < 16; y++)

{

int i = 0;

for (int z = 0; z < 6; z++)

{

bytes[counter++] = byte.Parse(MAC\_ADDRESS.Substring(i, 2), NumberStyles.HexNumber);

i += 2;

}

}

//Отправляем полученый магический пакет

int reterned\_value = client.Send(bytes, 1024);

}

private void GetInform(string textName)

{

string IP\_Address = "";

string HostName = "";

string MacAddress = "";

try

{

//Проверяем существует ли IP

entry = Dns.GetHostEntry(textName);

foreach (IPAddress a in entry.AddressList)

{

IP\_Address = a.ToString();

break;

}

//Получаем HostName

HostName = entry.HostName;

//Получаем Mac-address

IPAddress dst = IPAddress.Parse(textName);

byte[] macAddr = new byte[6];

uint macAddrLen = (uint)macAddr.Length;

if (SendARP(BitConverter.ToInt32(dst.GetAddressBytes(), 0), 0, macAddr, ref macAddrLen) != 0)

throw new InvalidOperationException("SendARP failed.");

string[] str = new string[(int)macAddrLen];

for (int i = 0; i < macAddrLen; i++)

str[i] = macAddr[i].ToString("x2");

MacAddress = string.Join(":", str);

//Далее, если всё успешно, добавляем все данные в список, после чего выводим всё в ListView

Dispatcher.Invoke(new Action(() =>

{

\_host.Add(new TableHost() { ipAdress = IP\_Address, nameComputer = HostName, MacAdress = MacAddress });

listView1.ItemsSource = null;

listView1.ItemsSource = \_host;

}));

}

catch { }

}

private void button1\_Click(object sender, RoutedEventArgs e)

{

//string message = "";

//Print(GetIP(textBox1.Text), GetHostName(textBox1.Text), GetMac(message));

}

private void button2\_Click(object sender, RoutedEventArgs e)

{

int i = int.Parse(ipToString[0]);

int j = int.Parse(ipToString[1]);

{

for(int k = 0;k<6;k++)

{

for (int m = 0; m < 254; m++)

{

Thread \_thread = new Thread(() => GetInform(string.Format("{0}.{1}.{2}.{3}", i.ToString(), j.ToString(), k.ToString(), m.ToString())));

\_thread.Start();

}

}

}

}

private void PowerOn\_Click(object sender, RoutedEventArgs e)

{

try

{

WakeFunction(\_host[listView1.SelectedIndex].MacAdress.ToString().Replace(":", ""));

MessageBox.Show("Операция выполнена успешно!", "Внимание!", MessageBoxButton.OK, MessageBoxImage.Information);

}

catch { MessageBox.Show("Запрос некорретный!","Внимание!Ошибка!",MessageBoxButton.OK,MessageBoxImage.Error); }

}

private void ClearList\_Click(object sender, RoutedEventArgs e)

{

\_host.Clear();

listView1.Items.Refresh();

}

private void copyIP\_Click(object sender, RoutedEventArgs e)

{

Clipboard.SetText(\_host[listView1.SelectedIndex].ipAdress.ToString());

}

private void copyName\_Click(object sender, RoutedEventArgs e)

{

Clipboard.SetText(\_host[listView1.SelectedIndex].nameComputer.ToString());

}

private void copyMacAddress\_Click(object sender, RoutedEventArgs e)

{

Clipboard.SetText(\_host[listView1.SelectedIndex].MacAdress.ToString());

}

private void button1\_Click\_1(object sender, RoutedEventArgs e)

{

GetInform(textBox1.Text);

}

private void Window\_Closing(object sender, System.ComponentModel.CancelEventArgs e)

{

StreamWriter write = new StreamWriter(@"C:\Users\\*\*\*\IPMAC.txt", true);

for (int index = 0; index < \_host.Count; index++)

{

if (!macaddressText.Contains(\_host[index].MacAdress))

write.WriteLine(\_host[index].ipAdress + "#" + \_host[index].nameComputer + "#" + \_host[index].MacAdress);

}

write.Close();

}

void P()

{

for (double i = -192; i < 10; i += 0.004)

{

Dispatcher.Invoke(new Action(() =>

{

rectangle1.Margin = new Thickness(0, 101, i, 10);

}));

}//12,0,12,1

}

private void comboBox1\_SelectionChanged(object sender, SelectionChangedEventArgs e)

{

//ii = rectangle1.Width;

textBox2.Text = ipadressText[comboBox1.SelectedIndex];

textBox3.Text = comboBox1.SelectedItem.ToString();

textBox4.Text = macaddressText[comboBox1.SelectedIndex];

Thread thread = new Thread(P);

thread.Start();

}

private void button3\_Click(object sender, RoutedEventArgs e)

{

try

{

WakeFunction(textBox4.Text.Replace(":", ""));

MessageBox.Show("Операция выполнена успешно!", "Внимание!", MessageBoxButton.OK, MessageBoxImage.Information);

}

catch { MessageBox.Show("Запрос некорретный!", "Внимание!Ошибка!", MessageBoxButton.OK, MessageBoxImage.Error); }

}

private void button4\_Click(object sender, RoutedEventArgs e)

{

Thread thread = new Thread(CLose);

thread.Start();

}

void CLose()

{

for (double i = 9; i > -193; i -= 0.004)

{

Dispatcher.Invoke(new Action(() =>

{

rectangle1.Margin = new Thickness(0, 101, i, 10);

}));

}//12,0,12,1

}

}

class TableHost

{

public string ipAdress { get; set; }

public string nameComputer { get; set; }

public string MacAdress { get; set; }

}

public class WOLClass : UdpClient

{

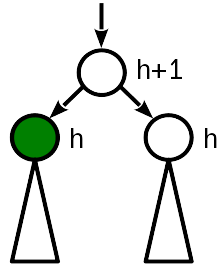

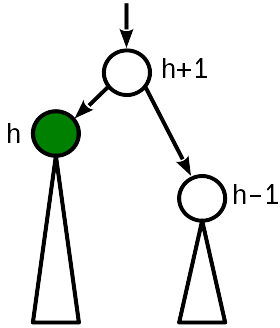

public WOLClass()

: base()

{ }

//Установим broadcast для отправки сообщений

public void SetClientToBrodcastMode()

{

if (this.Active)

this.Client.SetSocketOption(SocketOptionLevel.Socket,SocketOptionName.Broadcast, 0);

}

}

}

``` | https://habr.com/ru/post/262699/ | null | ru | null |

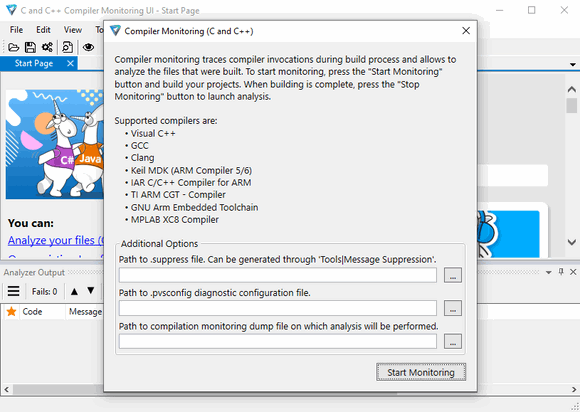

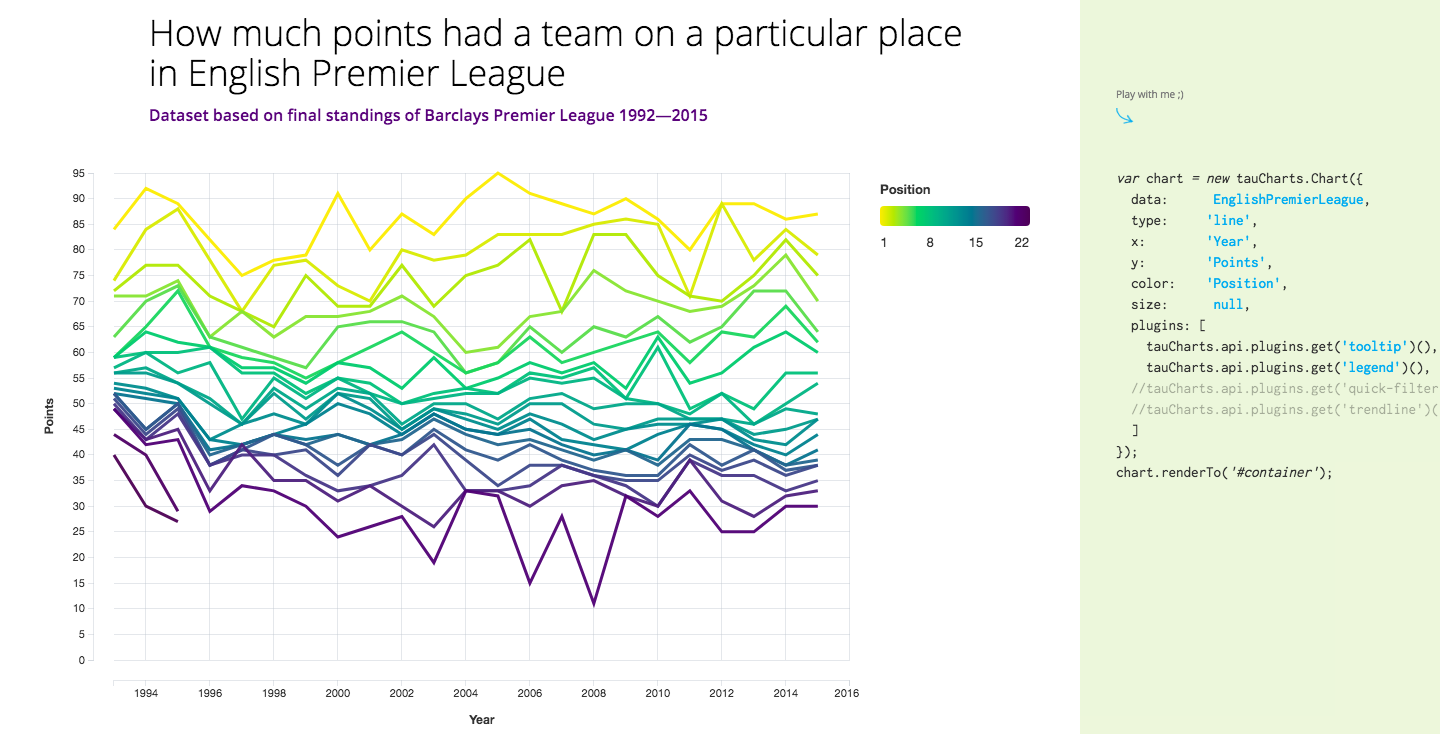

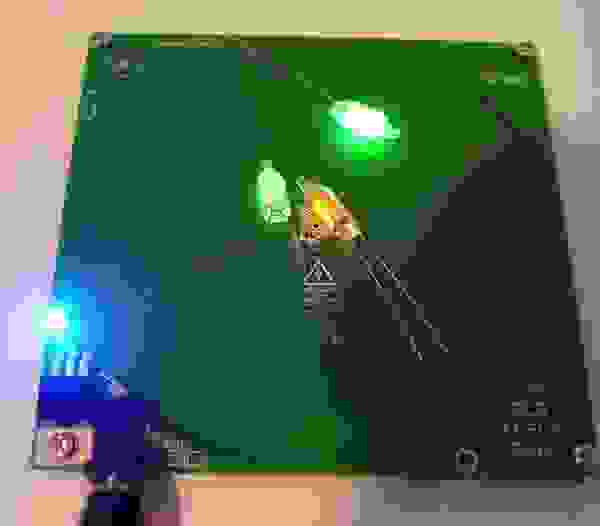

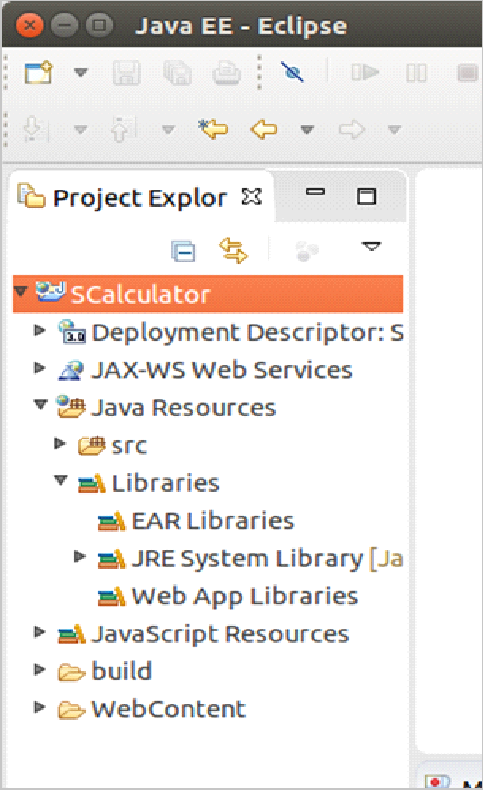

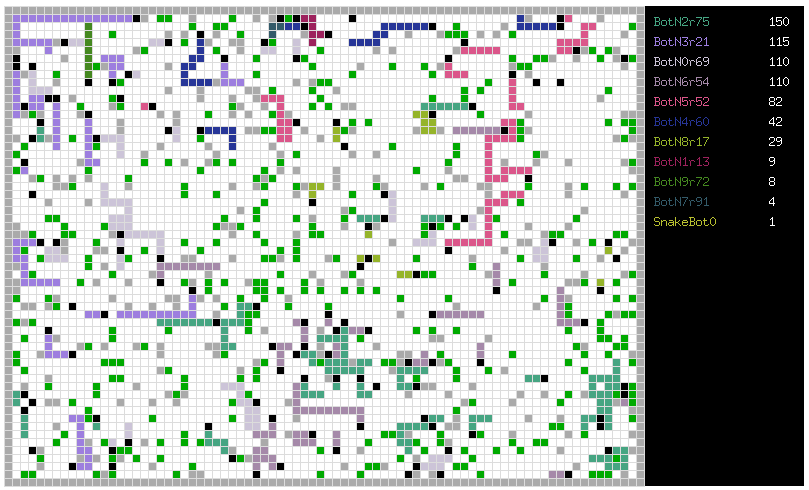

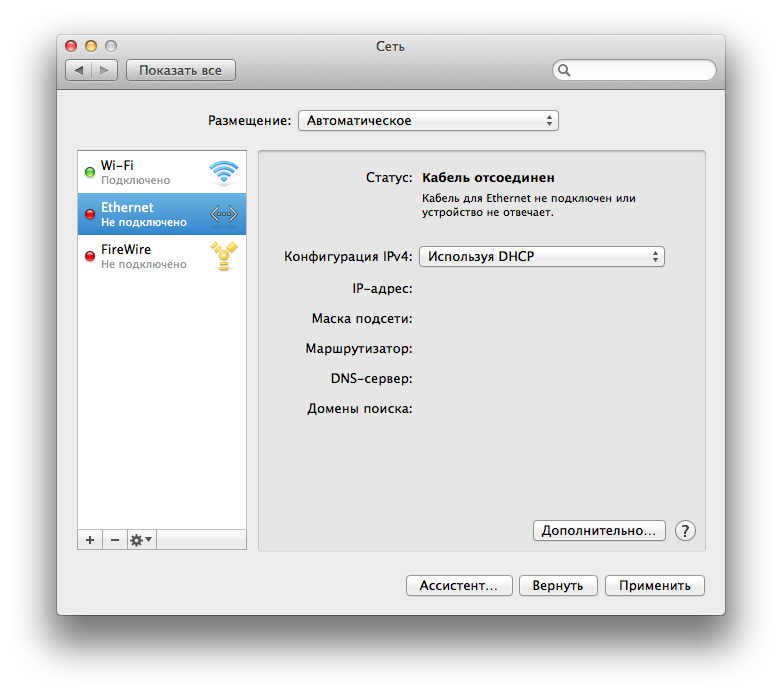

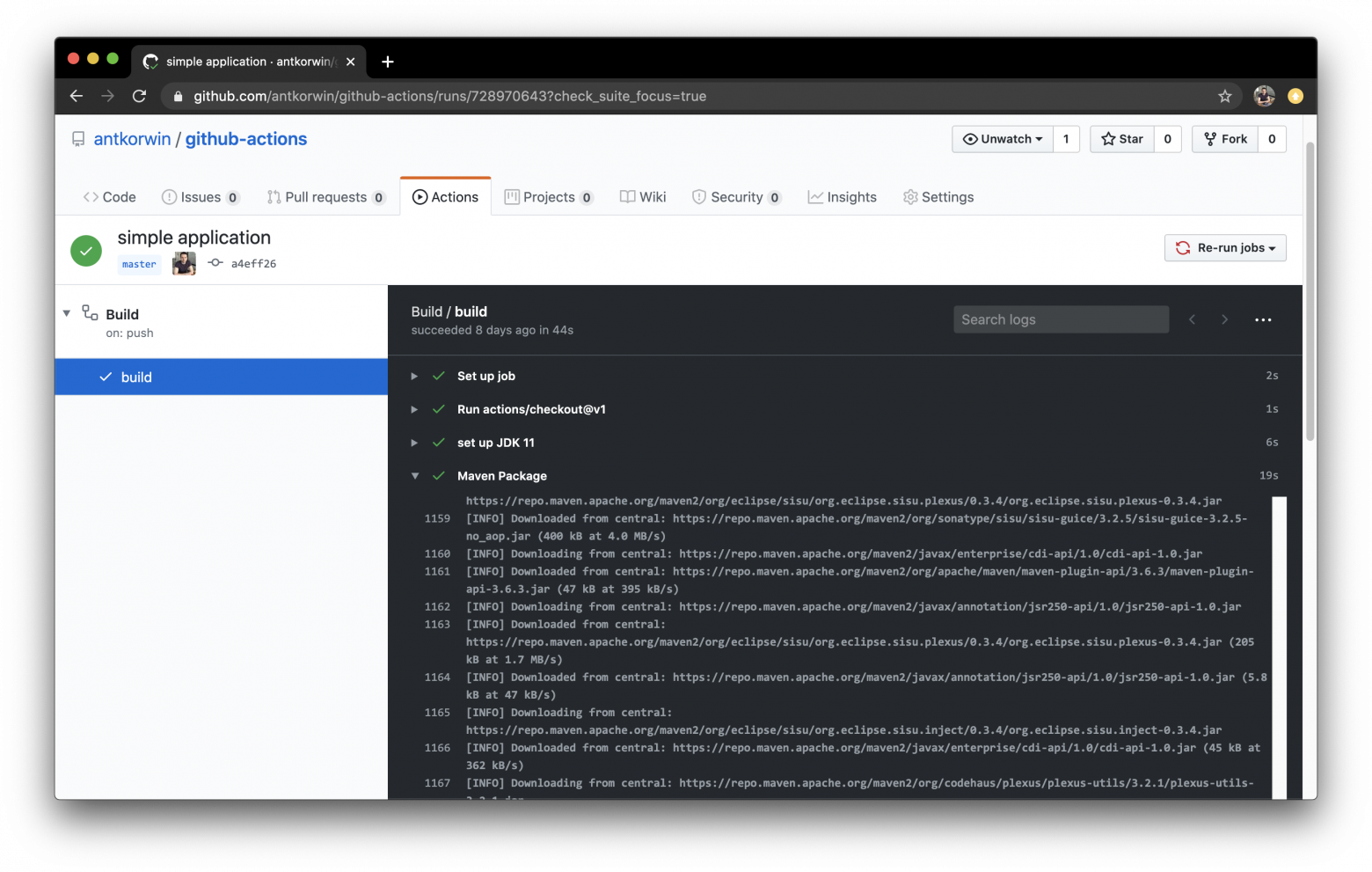

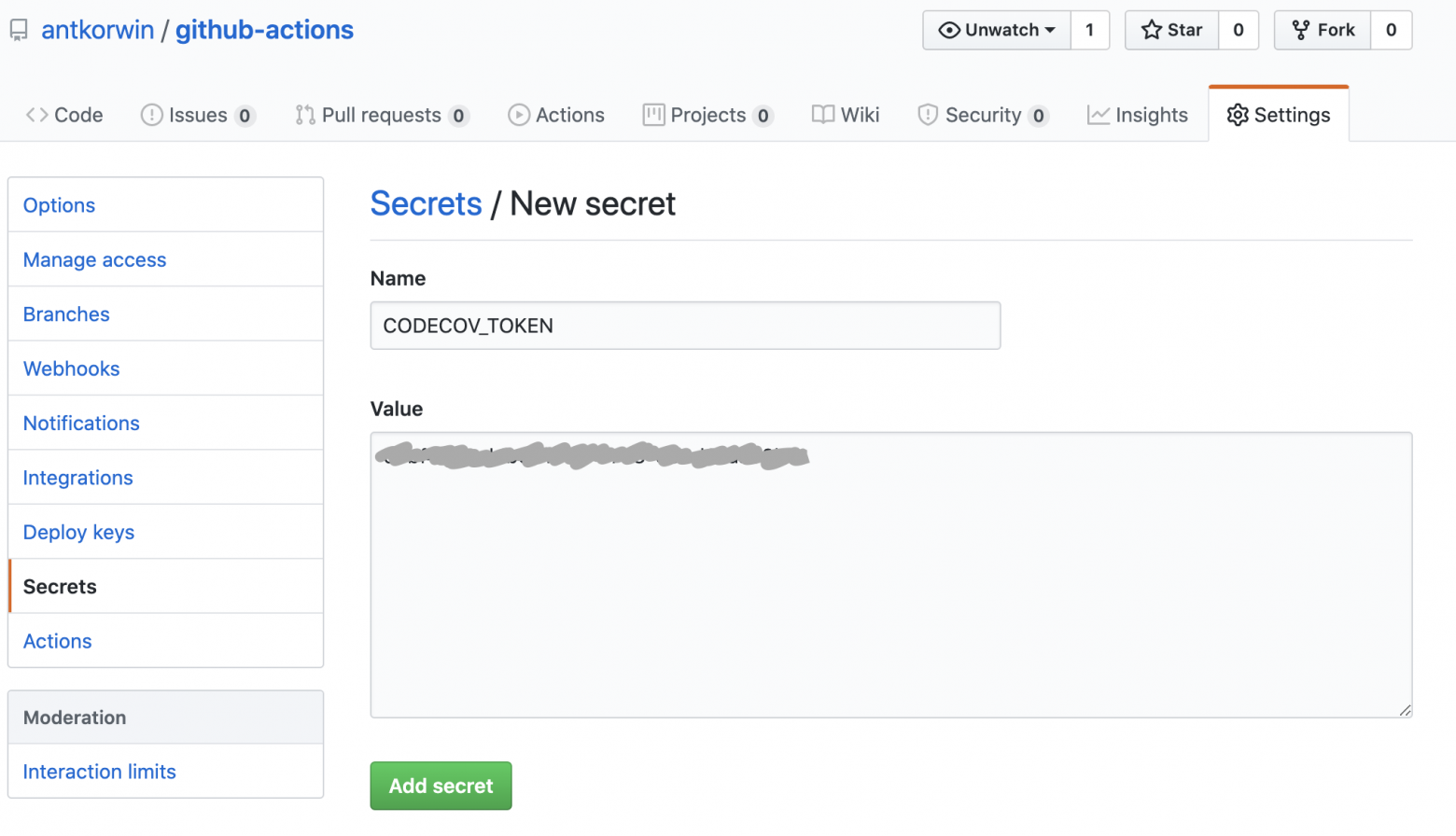

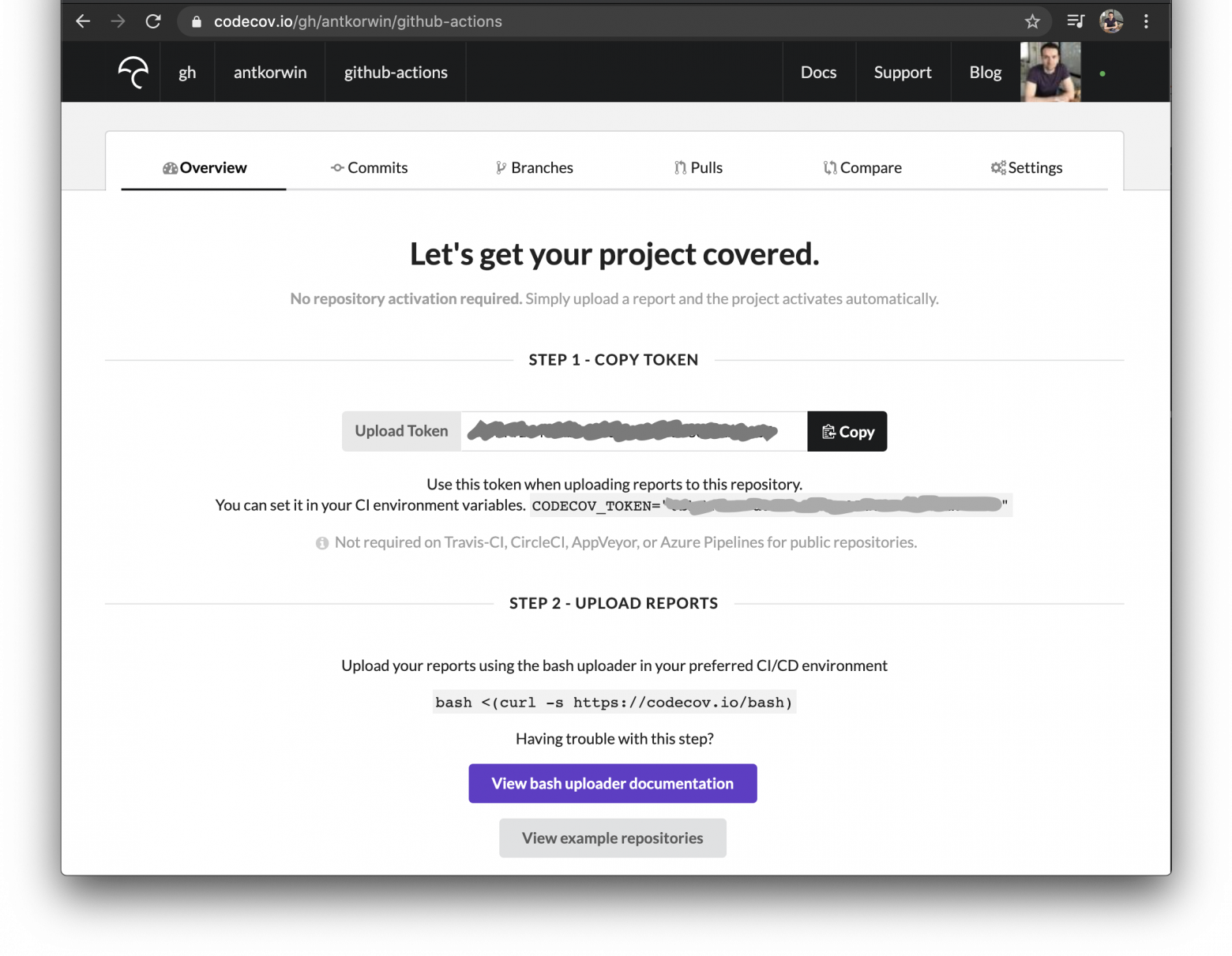

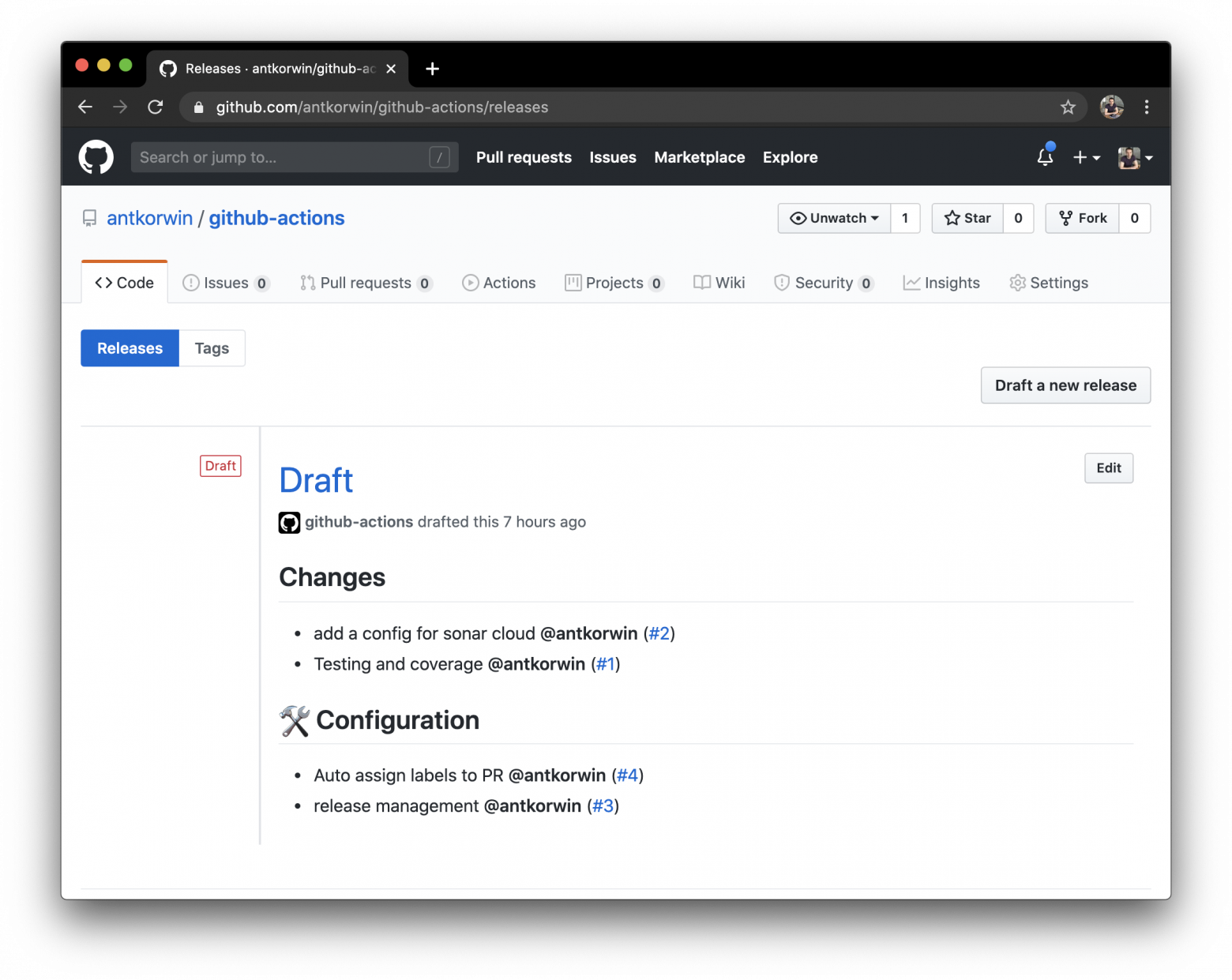

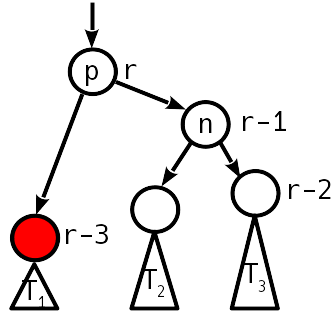

# Полигоны Another World: Sega Genesis

Перевод [пятой статьи из серии от Fabien Sanglard](https://fabiensanglard.net/another_world_polygons_Genesis/index.html), в этот раз про [порт Another World на Sega Genesis](https://suvitruf.ru/2020/05/16/7860/another_world_polygons_genesis/).

Разработка MegaDrive/Genesis началась сразу после того, как Sega выпустила свою Master System в 1987 году. В то время целью Sega было создание чего-то, что превосходит PC Engine от NEC и Famicom от Nintendo.

Серия статей

------------

1. [Полигоны Another World](https://habr.com/ru/post/482872/).

2. [Полигоны Another World: Amiga 500](https://habr.com/ru/post/483140/).

3. [Полигоны Another World: Atari ST](https://habr.com/ru/post/484656/).

4. [Полигоны Another World: IBM PC](https://habr.com/ru/post/492298/).

5. Полигоны Another World: Sega Genesis.

История

-------

Под руководством Масами Исикавы команде потребовался всего год на создание 16-битной системы. Консоль, запущенная 29 октября 1988 года в Японии, не очень хорошо себя зарекомендовала, за первый год было продано 400 000 устройств. Несмотря на выпуск многочисленных периферийных устройств и опережние NES на целое поколение, MegaDrive не нашёл своей аудитории.

Выпуск в США (январь 1989 г.) и Европе (сентябрь 1990 г.) был не самым удачным[[1]](#Sega_Mega_Drive_launch). Спасение пришло в середине 1990 года, когда Том Калинске стал генеральным директором Sega America. Снижение цен, самоотверженная команда разработчиков из США, агрессивная рекламная кампания на телевидении («Genesis does what Nintendon't») и замена входящей в комплект игры Altered Beast на Sonic the Hedgehog вывели Genesis на вершину хит-парадов.

В сочетании с поздним Nintendo SNES и проблемной NEC TurboGrafx-16, Sega в январе 1992 года контролировала 65% рынка 16-битных консолей и по продажам превосходила Nintendo четыре рождественских сезона подряд с 1990 по 1994 год. Продано было 39,7 миллиона единиц по всему миру[[2]](#mega_drive_sales_figures_update).

Архитектура

-----------

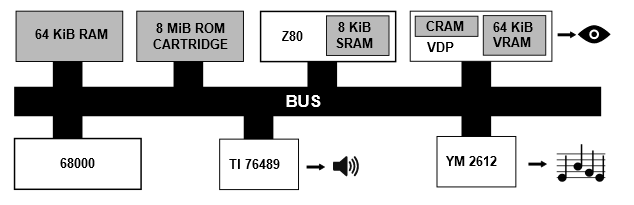

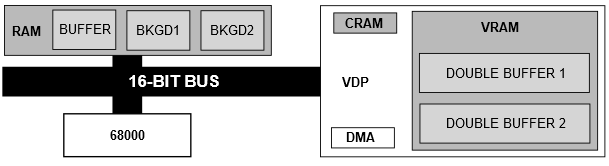

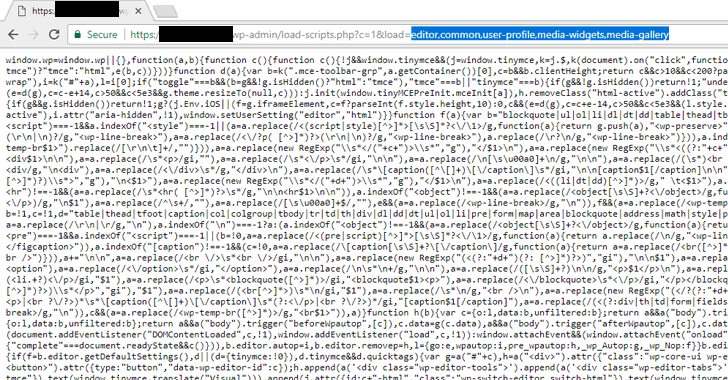

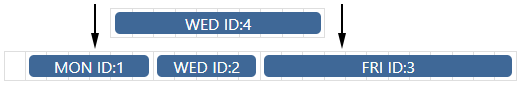

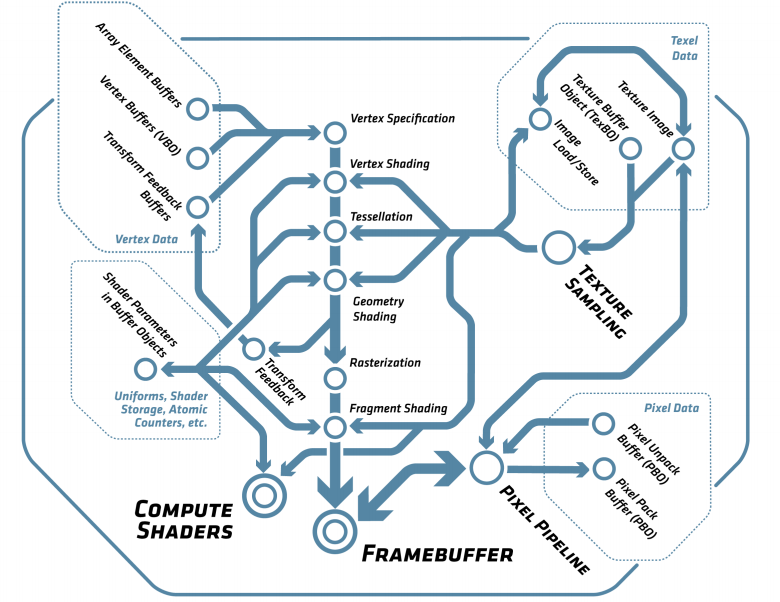

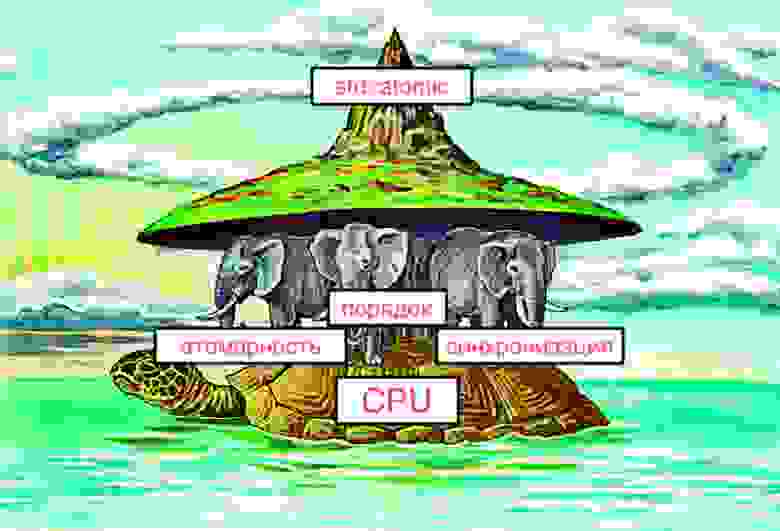

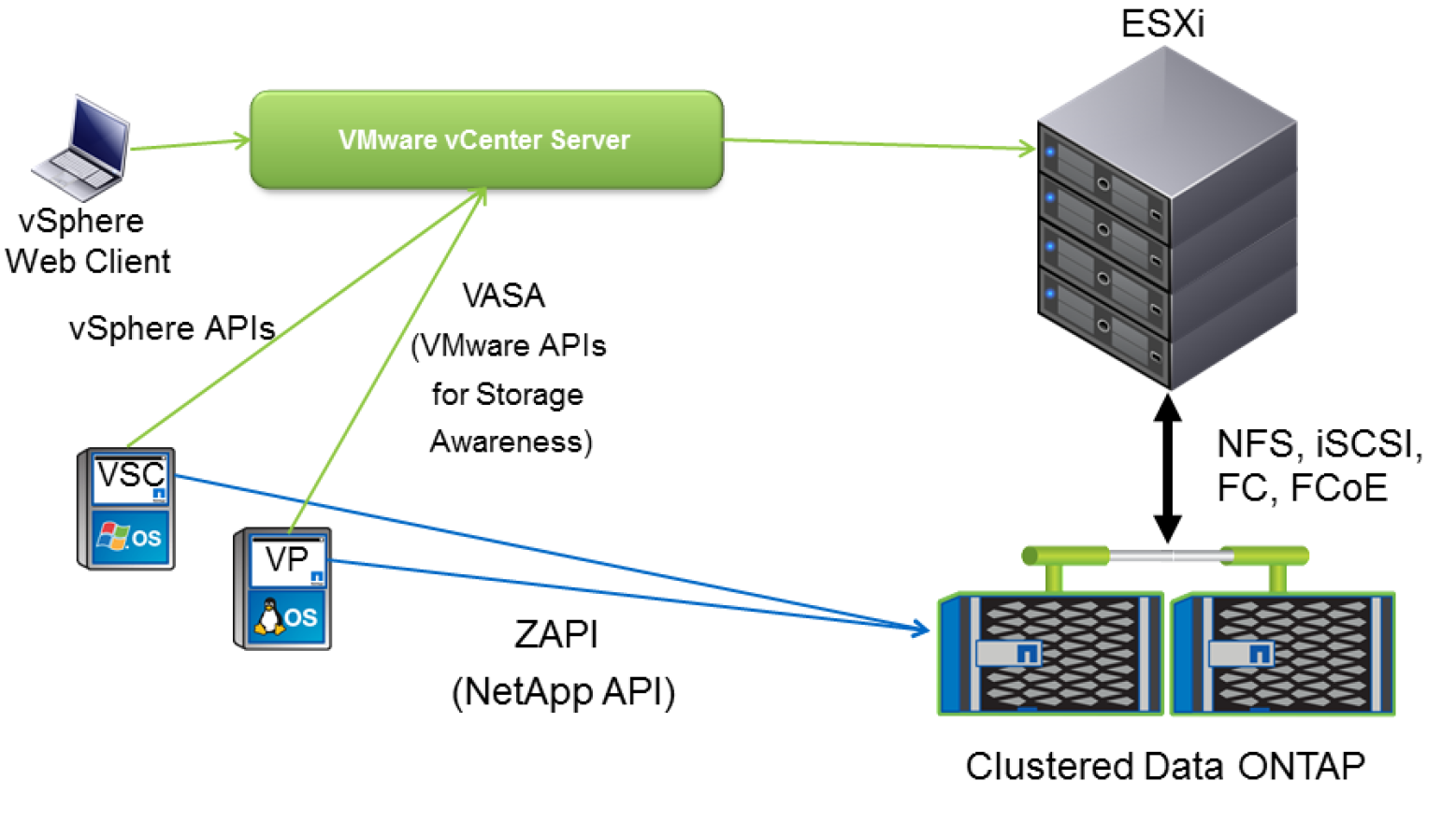

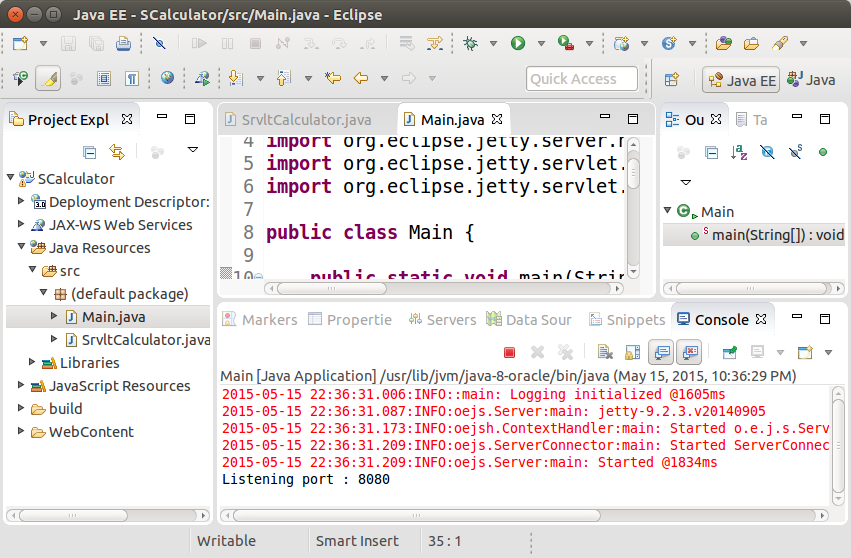

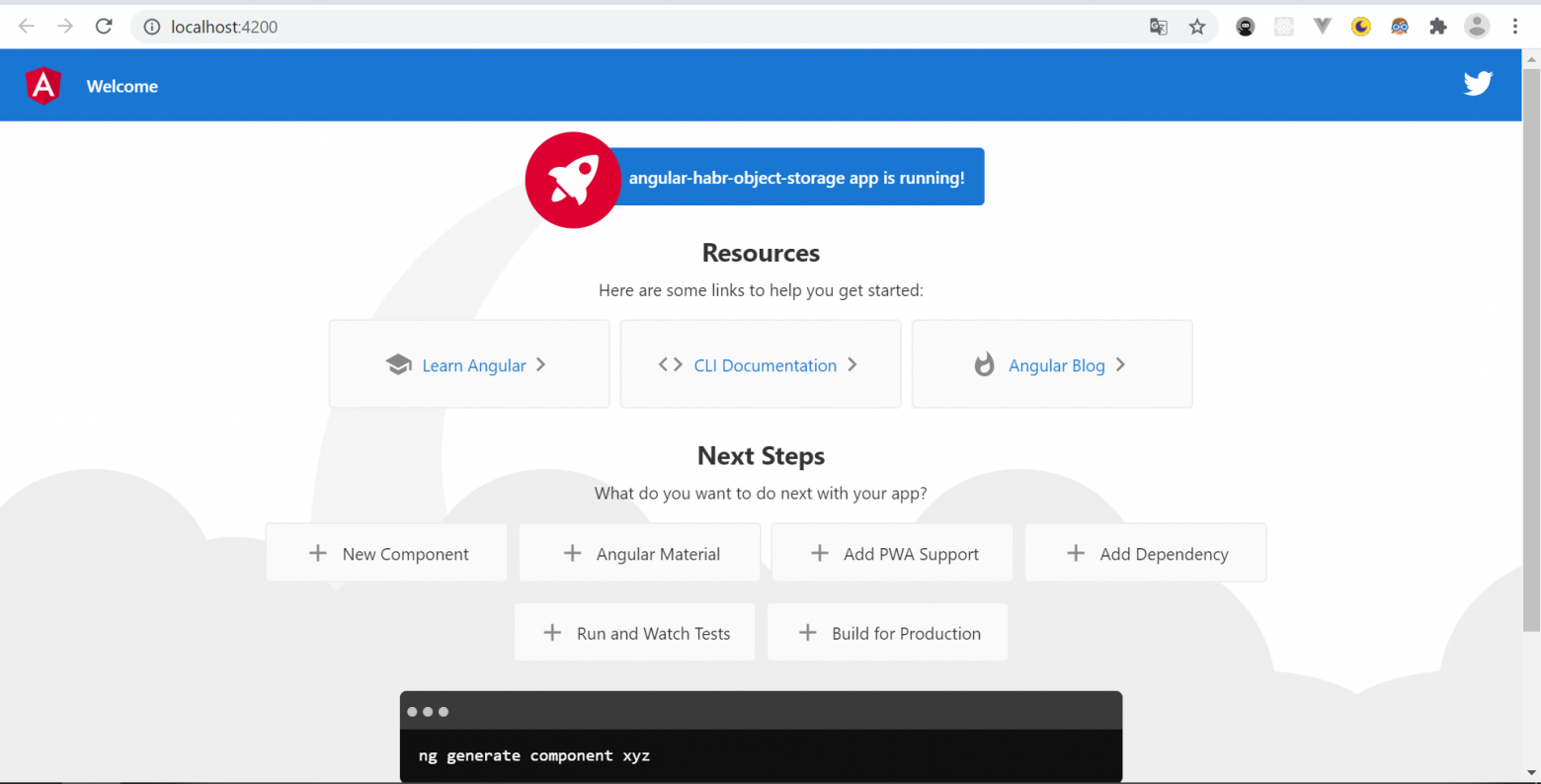

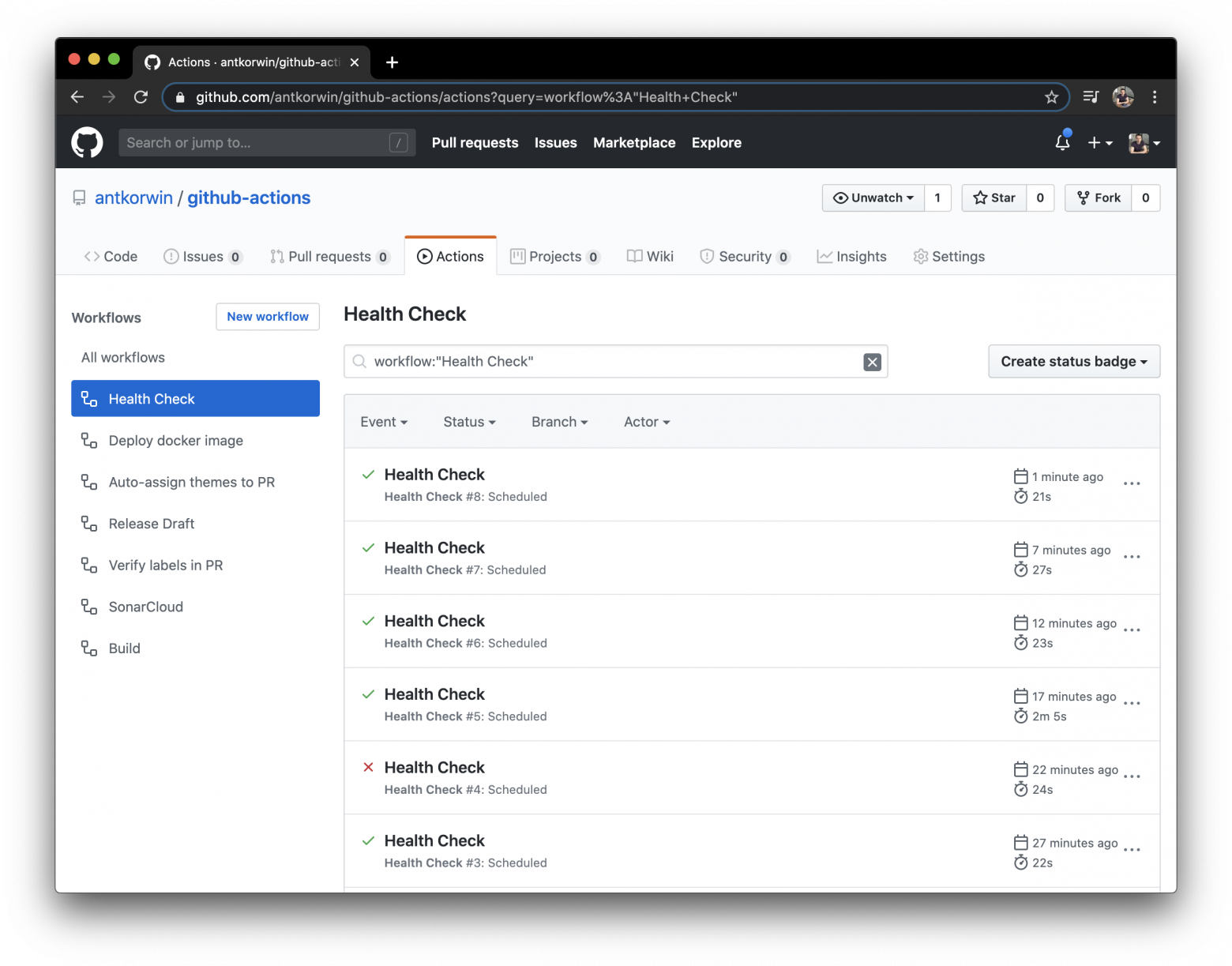

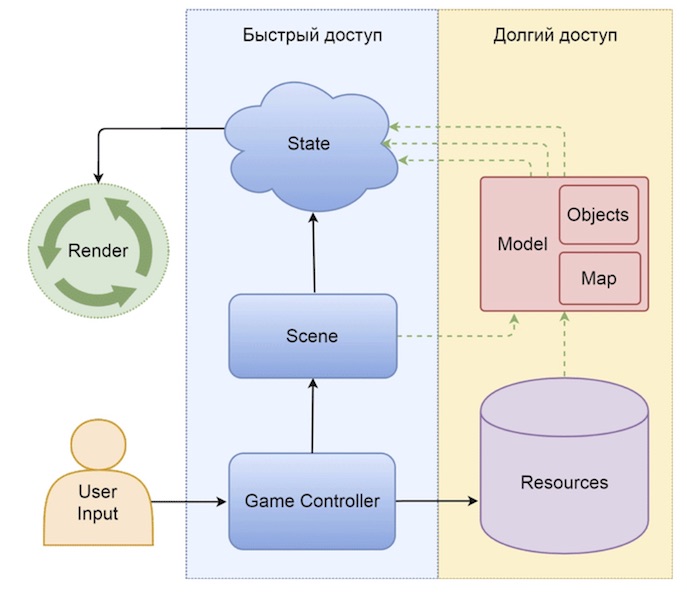

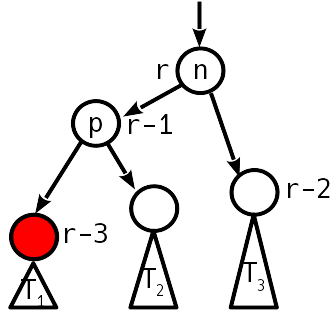

Если рассматривать с технической стороны, то Genesis имеет впечатляющую Motorola 68000 (7,61 МГц), до 8 МБ ПЗУ, 64 КБ ОЗУ, 64 КБ видеопамяти, видео процессор ASIC (13 МГц) и Z-80 (3,58 МГц) с 8 КБ для аудио управления TI 76489 и YM 2612.

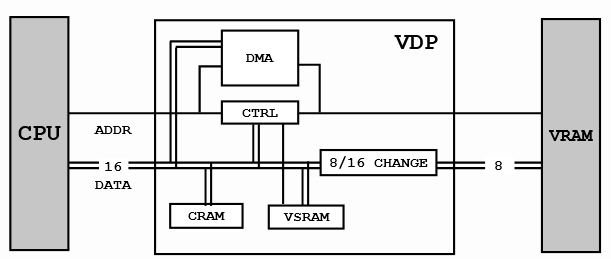

Видео система

-------------

Компонент, отвечающий за генерацию видеосигнала, называется VDP (Video Display Processor). Он управляет VRAM и CRAM, где хранятся палитры.

Обратите внимание, что процессор 68000 не может адресовать VRAM, он может «общаться» только с VDP через регистры, замапленные в RAM. Передача данных обычно осуществляется с помощью DMA видео процессора, который имеет доступ к RAM и VRAM. VDP также имеет регистры для разрешения VRAM операций чтения/записи, но они довольно медленные.

> 68000 останавливается во время DMA передачи, но Z-80 может продолжать работать до тех пор, пока нет необходимости в доступе к ОЗУ.

>

>

>

> DMA довольно быстр во время BLANK и работает в два раза быстрее, чем цикл 68000. Это так же быстро, как 68000 во время активного сканирования.

>

>

>

> **— Genesis Developer Manual**

Цветовая система похожа на Atari ST с 3 битами на канал, в сумме 9 бит на цвет.

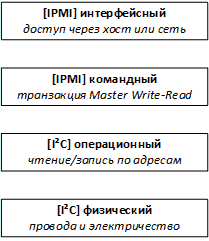

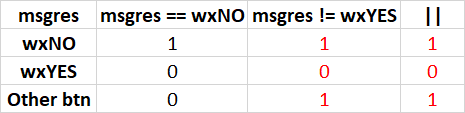

| | |

| --- | --- |

| | |

Видео процессор (VDP)

---------------------

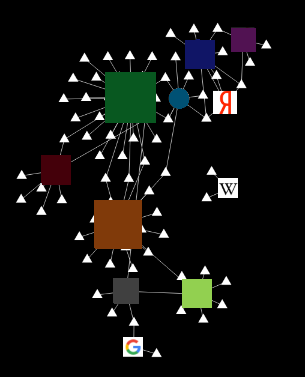

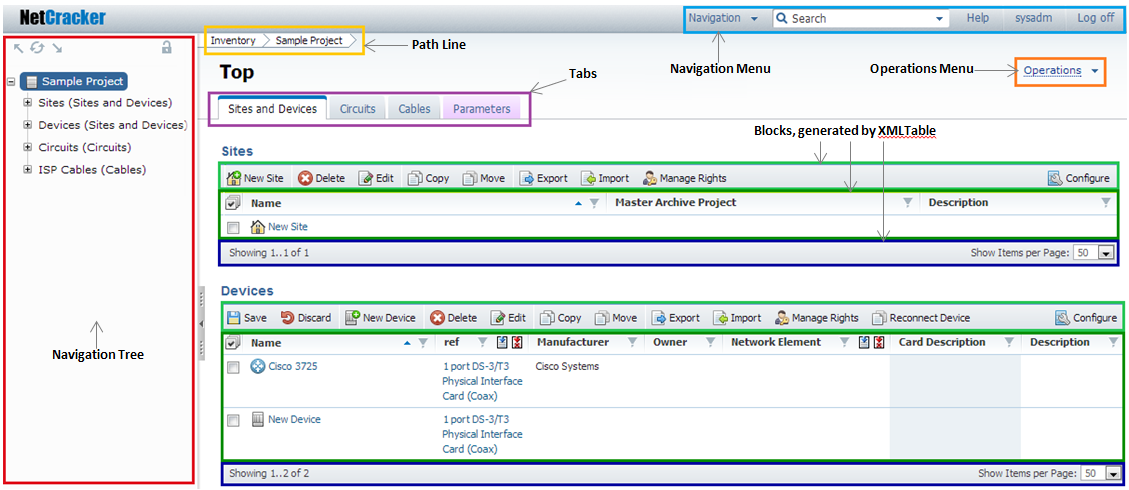

VDP является графическим ядром ASIC системы. Он основан на спрайтовом движке, что означает отсутствие кадрового буфера. Он работает с четырьмя слоями[[3]](#Genesis_Software_Manual), называемыми Scroll B, Scroll A, Windows и Sprites.

Scroll A и Scroll B являются скролфилдами. Они могут быть больше экрана и перемещаться независимо друг от друга, чтобы создать эффект параллакса. Scroll A также может быть использована в качестве «Window», которое нельзя прокручивать и поэтому хорошо подходит для отображения HUD элементов.

Все элементы слоёв используют 4-битные индексы в палитре своих слоёв (следовательно, всего четыре палитры). Индекс палитры 0 всегда считается прозрачным во всех четырех палитрах. Это даёт 15 цветов на слой[[4]](#HBLANK_comment). Все палитры хранятся в 128 байтах, называемых CRAM.

Когда VDP генерирует строки развёртки для телевизора, для каждого пикселя система приоритета сообщает, в каком порядке следует выбирать слои. Нет поддержки смешивания (прозрачности) между слоями, но прозрачность может быть достигнута (используя индекс 0). Если упростить, удобной аналогией для понимания приоритета будет Z-компонента со Scroll B, находящимся сзади, и Sprite, находящимся впереди. Пока VDP попадает в прозрачные пиксели, он продолжает переходить на следующий уровень.

Слои

----

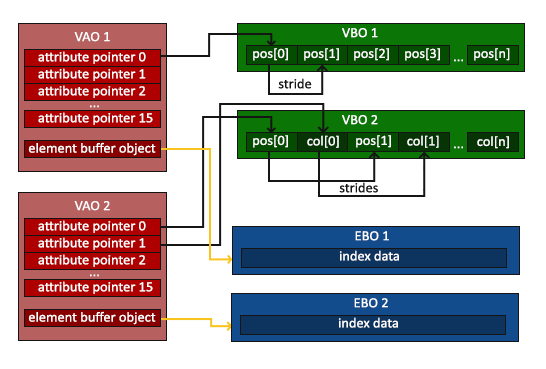

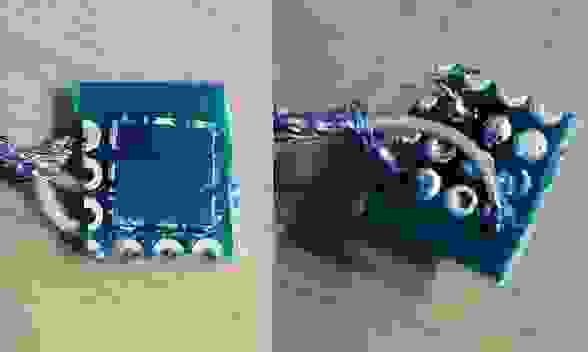

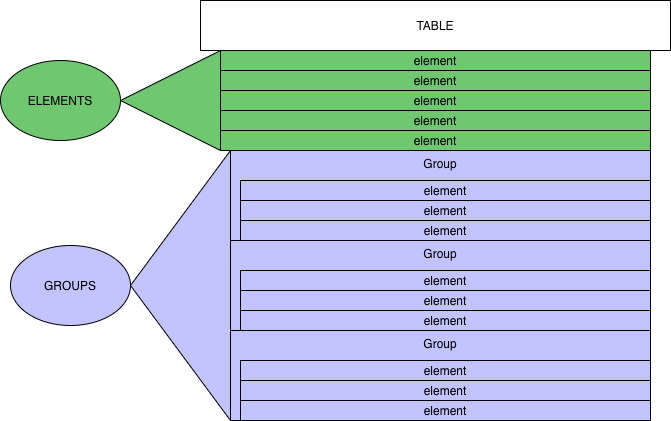

Скроллфилды состоят из ячеек размером 8x8. Слой ячейки состоит из 32 байтов, представленных в виде 8 линий полубайтов.

`Ячейка VRAM (64 полубайт):

==========================

WORD | WORD | WORD | WORD |

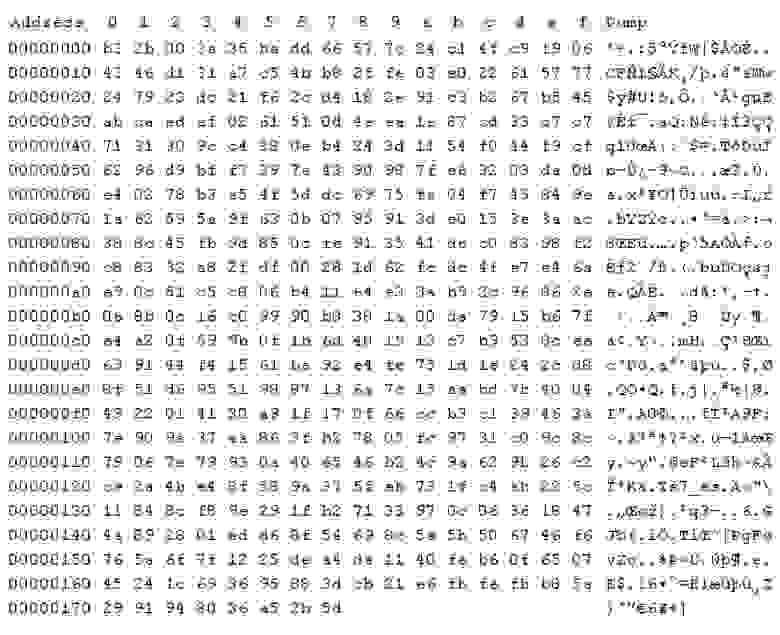

-----------------------------------------------------

BYTE | BYTE | BYTE | BYTE | BYTE | BYTE | BYTE | BYTE

-----------------------------------------------------

0 0 F F F F 0 0 0 F 0 0 0 0 F 0

F 0 F 0 F 0 0 F F 0 F 0 F 0 0 F

F 0 0 0 0 F 0 F F 0 F F F 0 0 F

0 F 0 0 0 0 F 0 0 0 F F F F 0 0

Экран (8 строк по 8 пикселей):

=============================

0 0 F F F F 0 0

0 F 0 0 0 0 F 0

F 0 F 0 F 0 0 F

F 0 F 0 F 0 0 F

F 0 0 0 0 F 0 F

F 0 F F F 0 0 F

0 F 0 0 0 0 F 0

0 0 F F F X 0 0`

Содержимое скроллфилда задаётся записями в его «таблице имён»[[5]](#VDP_Planes_Nametables).

Слой спрайтов может отображать до 80 спрайтов независимо от содержимого двух скроллов. Спрайты могут быть больше, чем Ячейки, от 8х8 до 32х32. Свойства (положение в виртуальном пространстве 512x512, приоритет и многое другое) спрайта задаются записью в «таблице спрайтов»[[6]](#VDP_Sprite_Table).

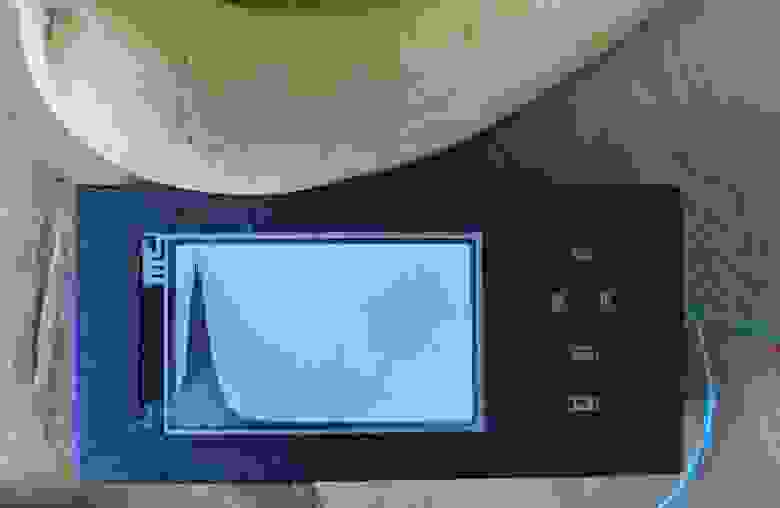

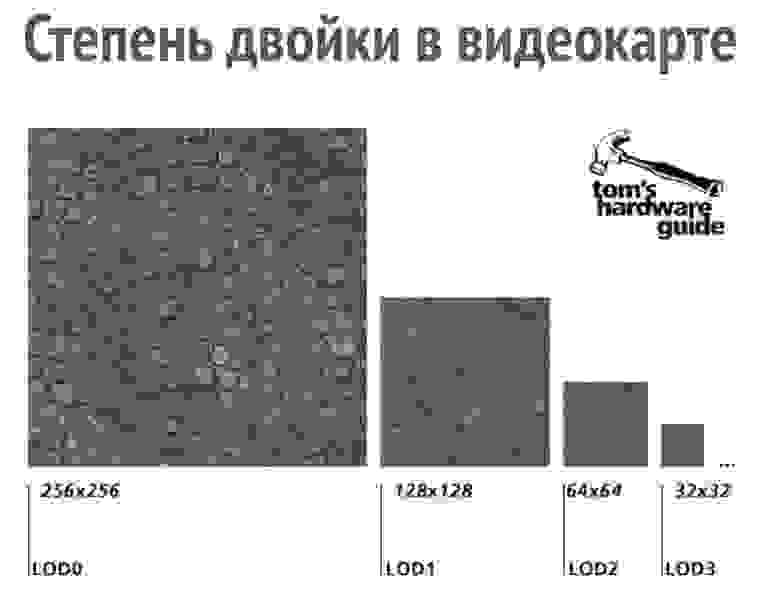

Доступно два режима: «H32» с ячейками 32x28 (256x224 пикселей) и «H40» с ячейками 40x28 (320x224 пикселей).

NTSC vs PAL

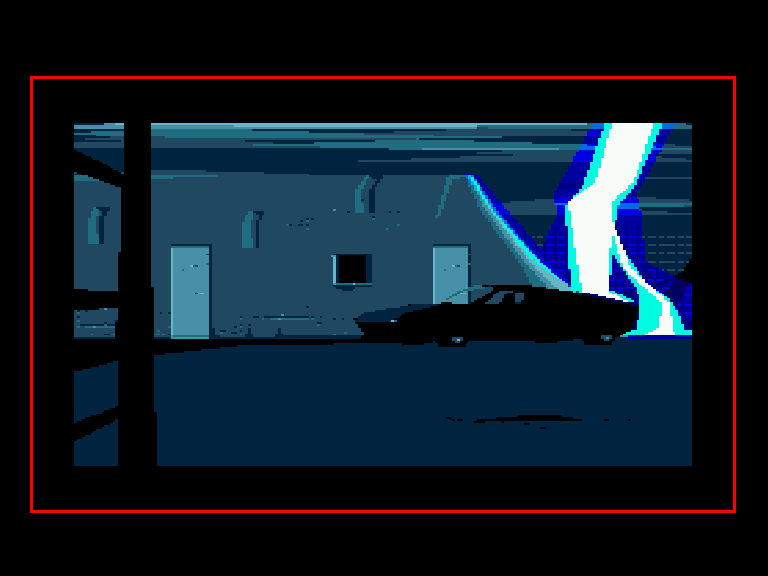

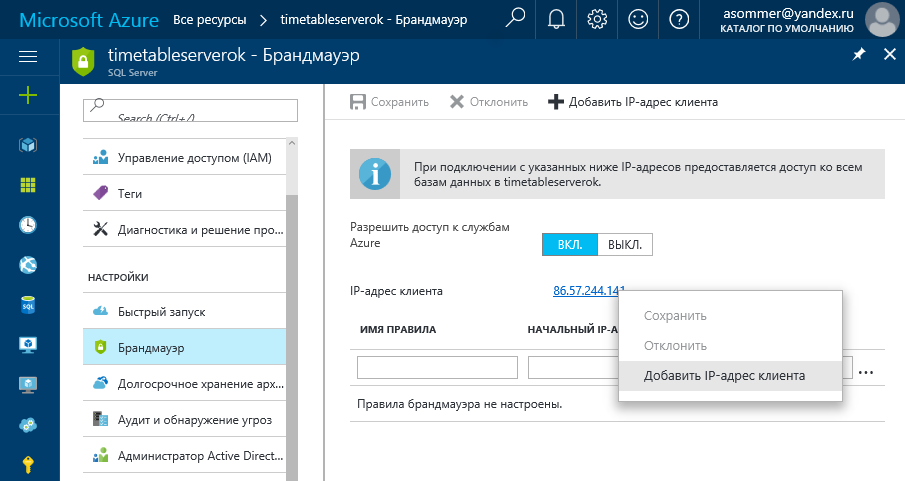

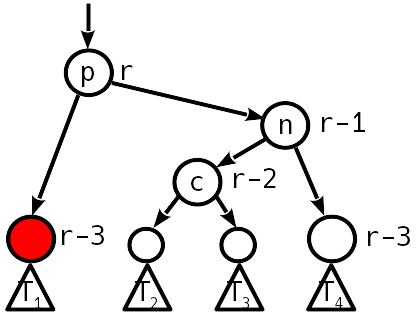

-----------

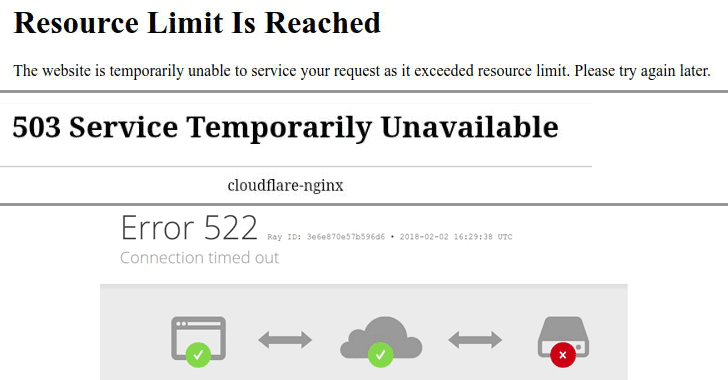

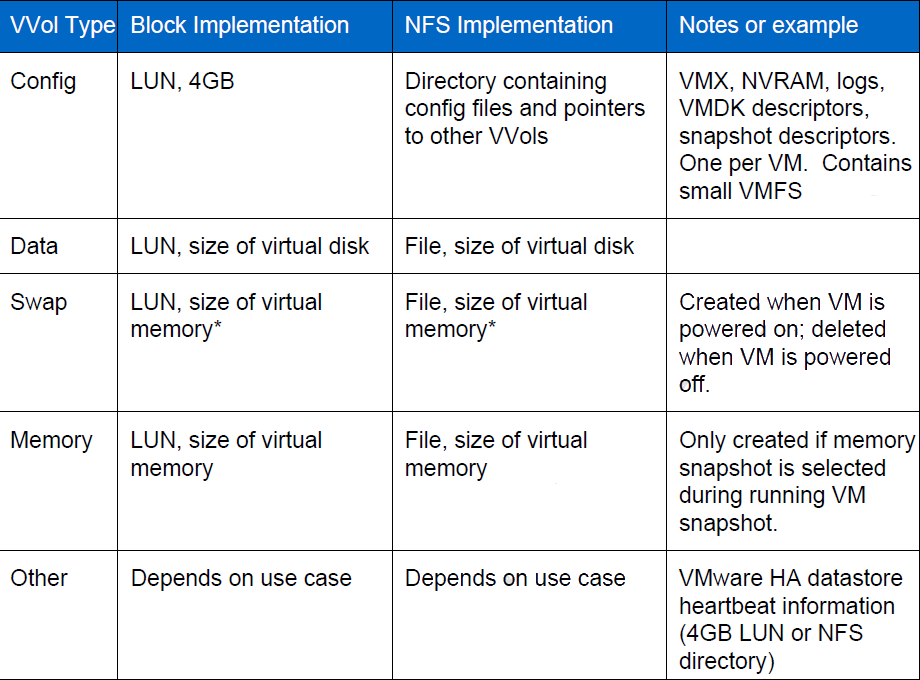

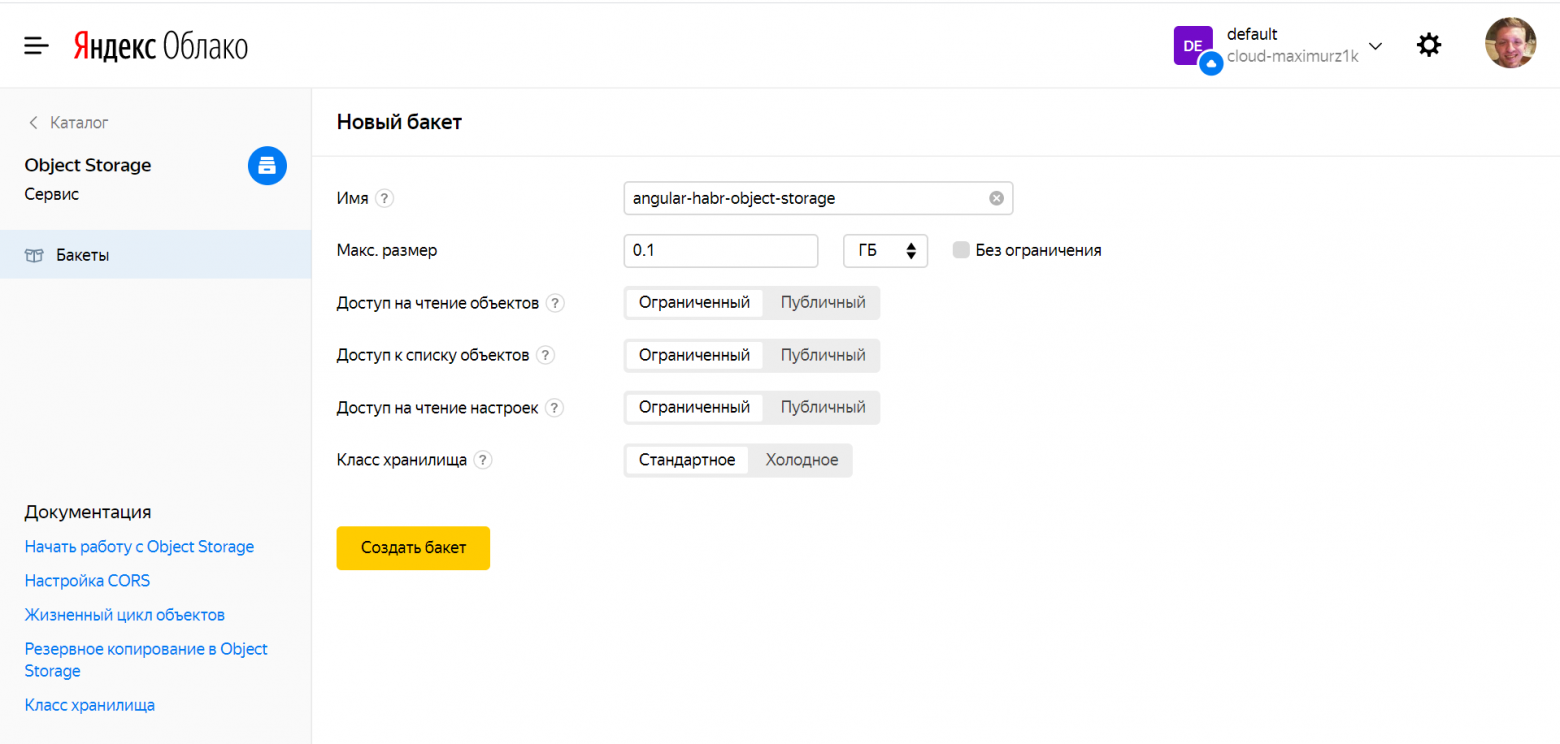

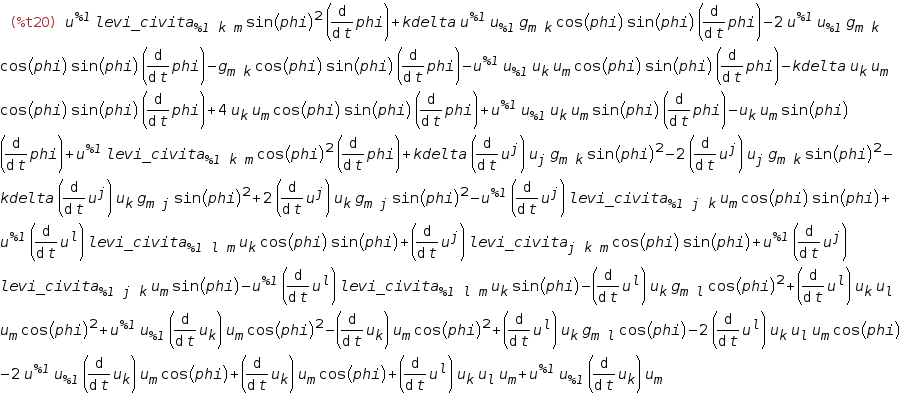

Есть разница между американскими телевизорами и европейскими телевизорами. PAL имеет 576 видимых линий, в то время как NTSC имеет 486 видимых линий. Genesis решил это, предоставив режим PAL с 30 горизонтальными ячейками (на две больше, чем в NTSC 28). Дополнительные ячейки позволили избежать больших чёрных полос сверху и снизу экрана. Однако это было значительным бременем для разработчика, и вроде как они никогда особо не парились на этот счёт.

| | |

| --- | --- |

| | |

Чтобы ещё подлить масла в огонь — ранние игры на MegaDrive, такие как Sonic The Hedgehog, работали на 17% медленнее на европейских консолях (даже музыка была медленнее). Разработчики в Японии и США не следовали передовым методам и полагали, что сигнал VBLANK, используемый для измерения времени, запускается каждые 16 мс. Поскольку PAL обновляется с частотой 50 Гц, а NTSC обновляется с частотой 60 Гц, VBLANK в Европе срабатывает раз в 20 мс, а не 16.

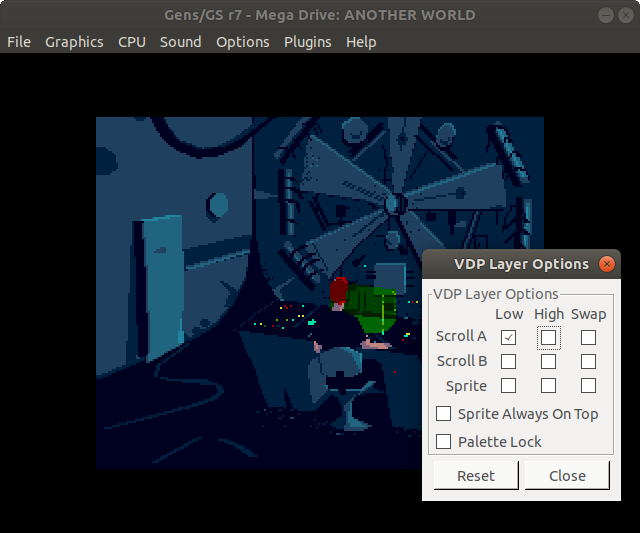

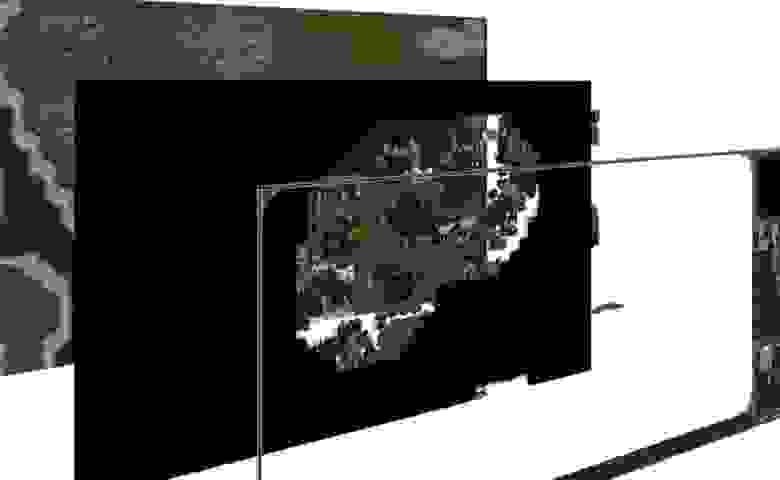

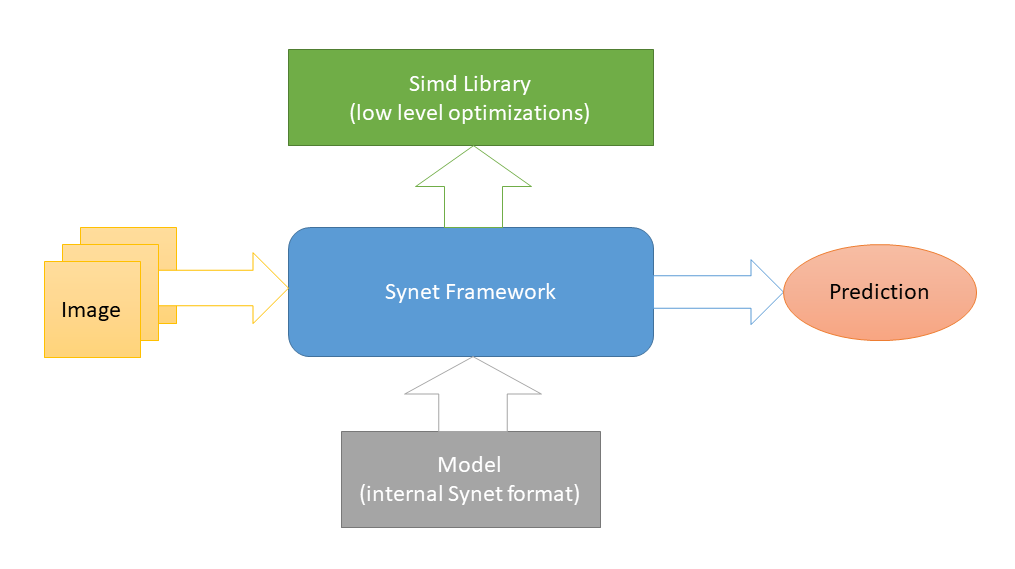

Another World на Genesis

------------------------

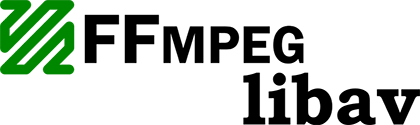

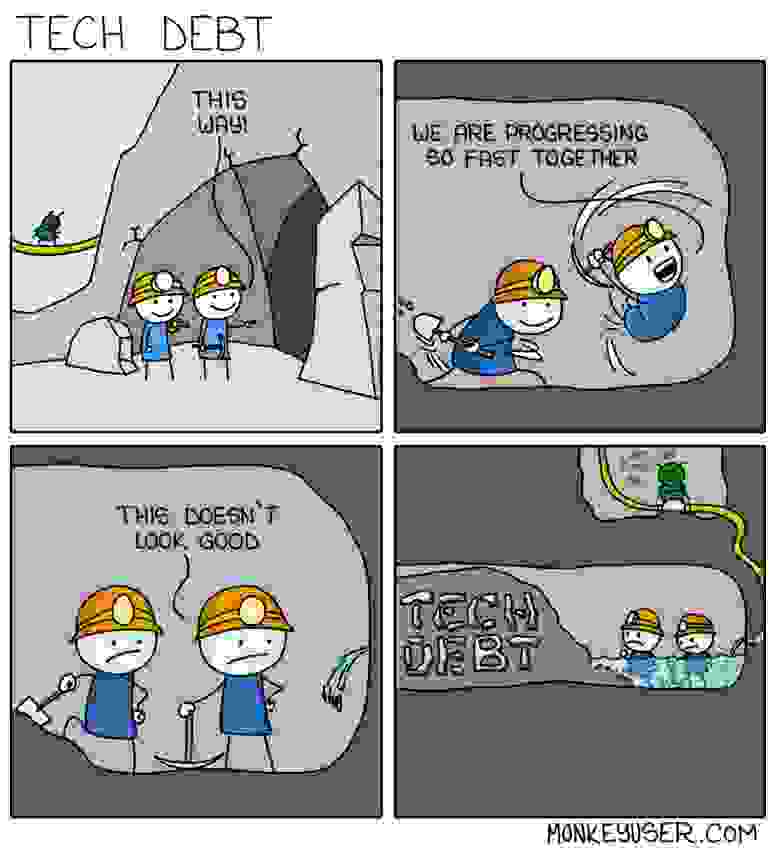

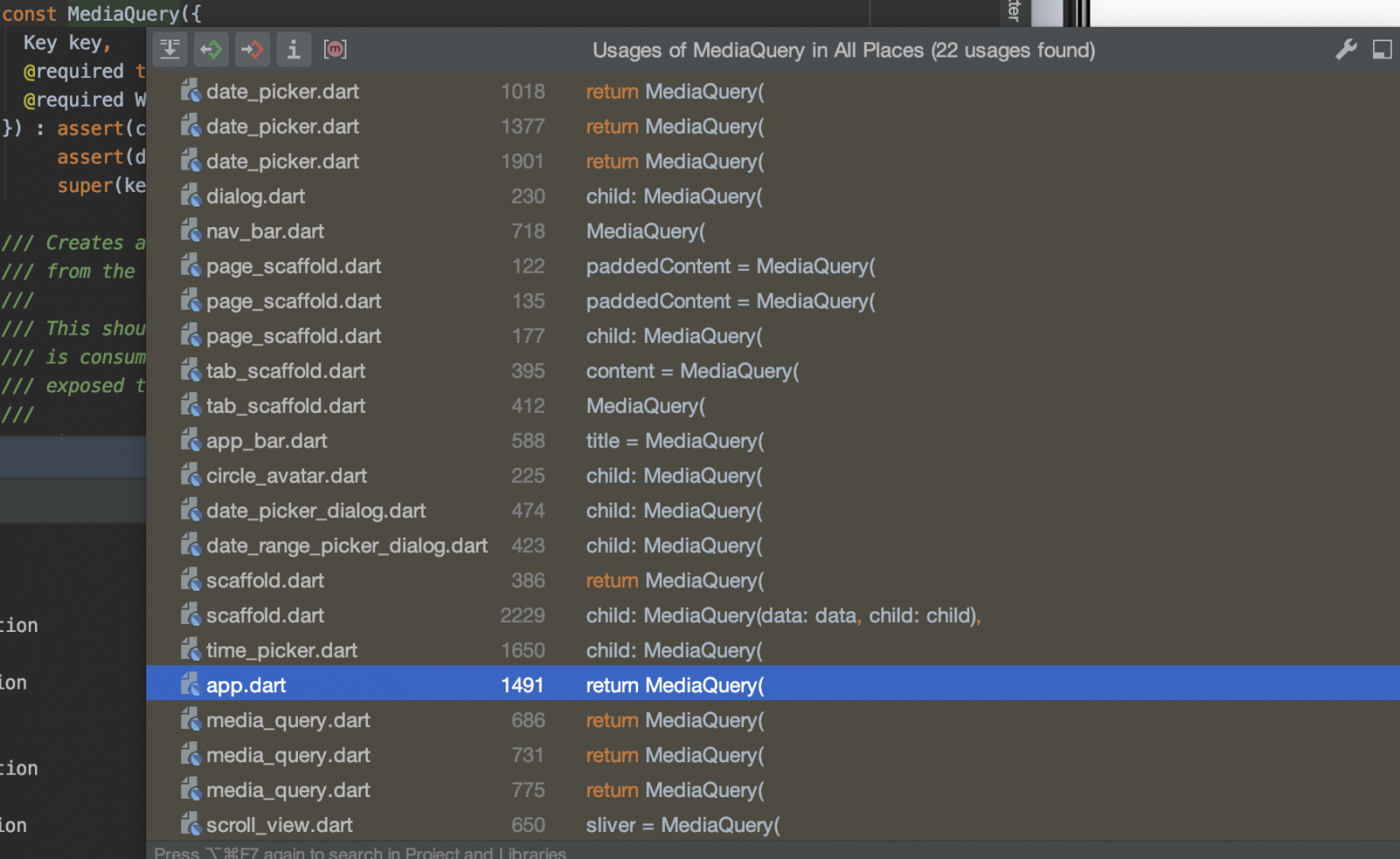

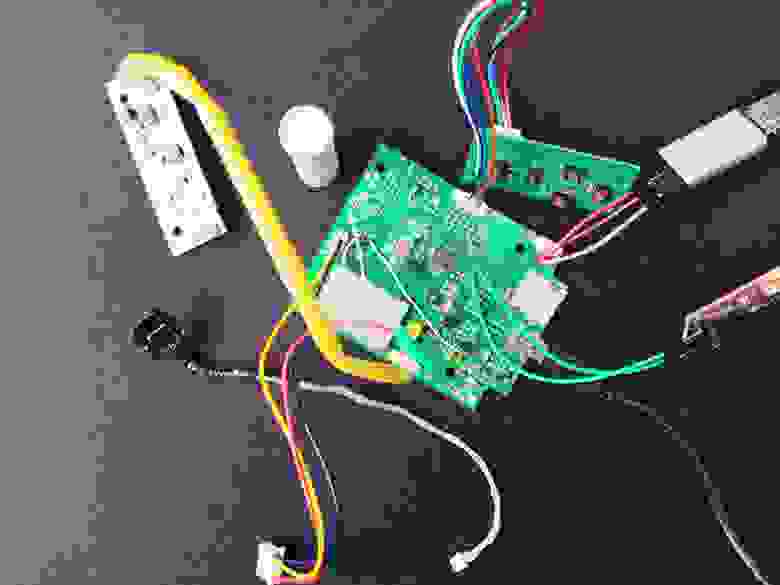

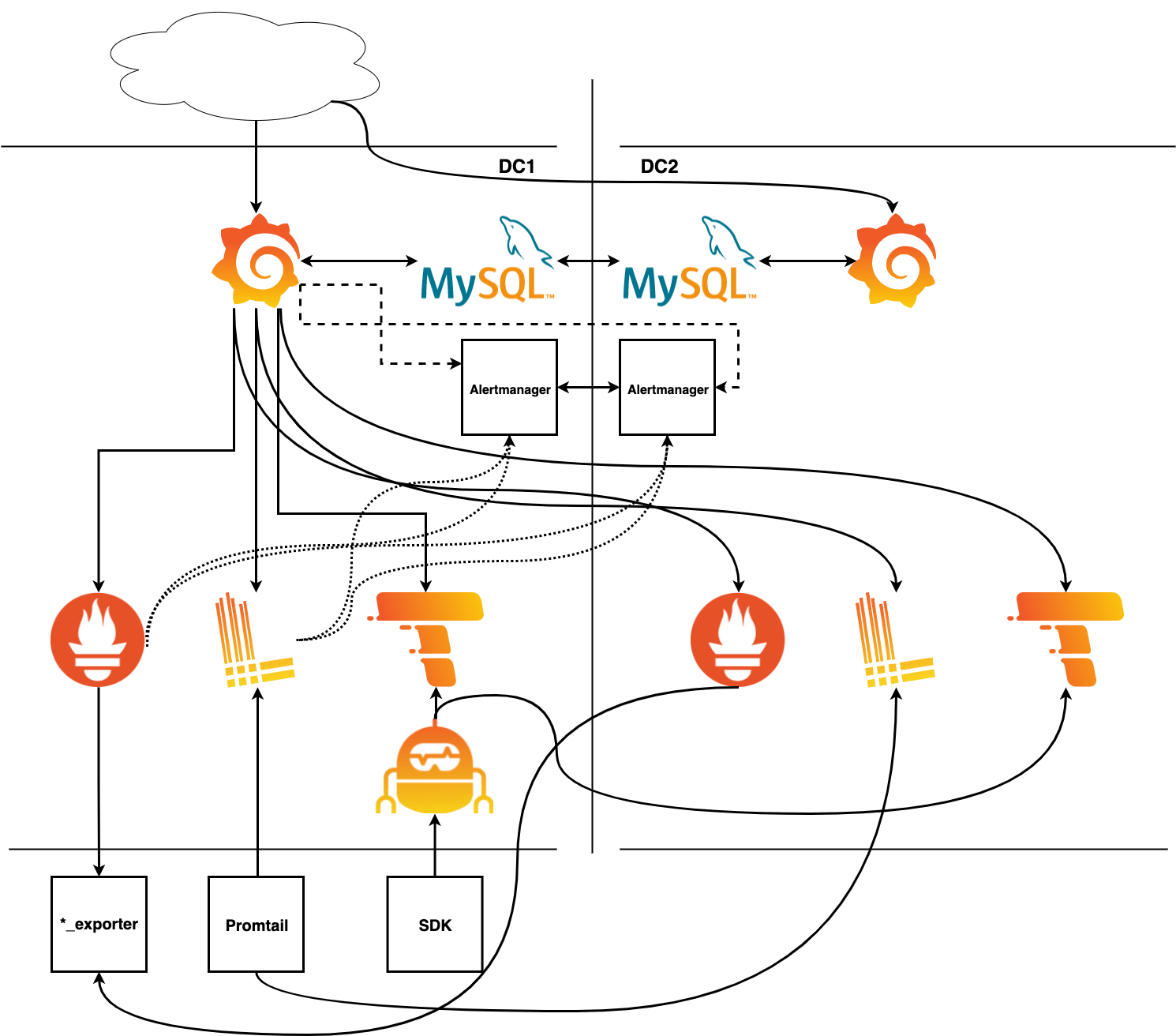

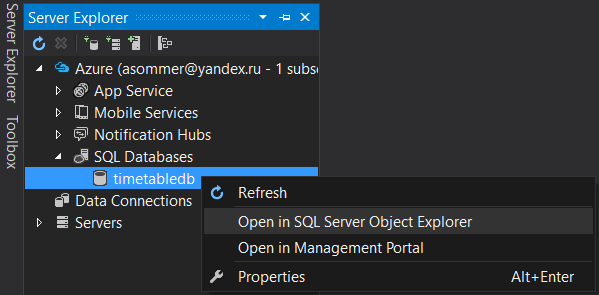

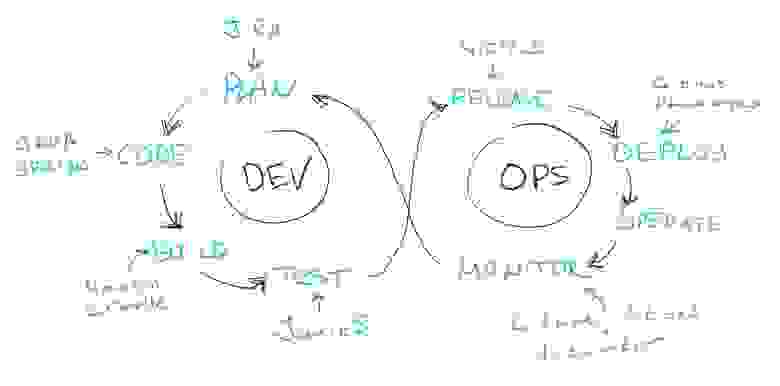

Порт на Genesis — первый, рассмотренный в этой серии, сделанный не Delphine Software. Interplay позаботилась о многих портах помимо Genesis, включая Macintosh, Super Nintendo и даже Apple IIGS.

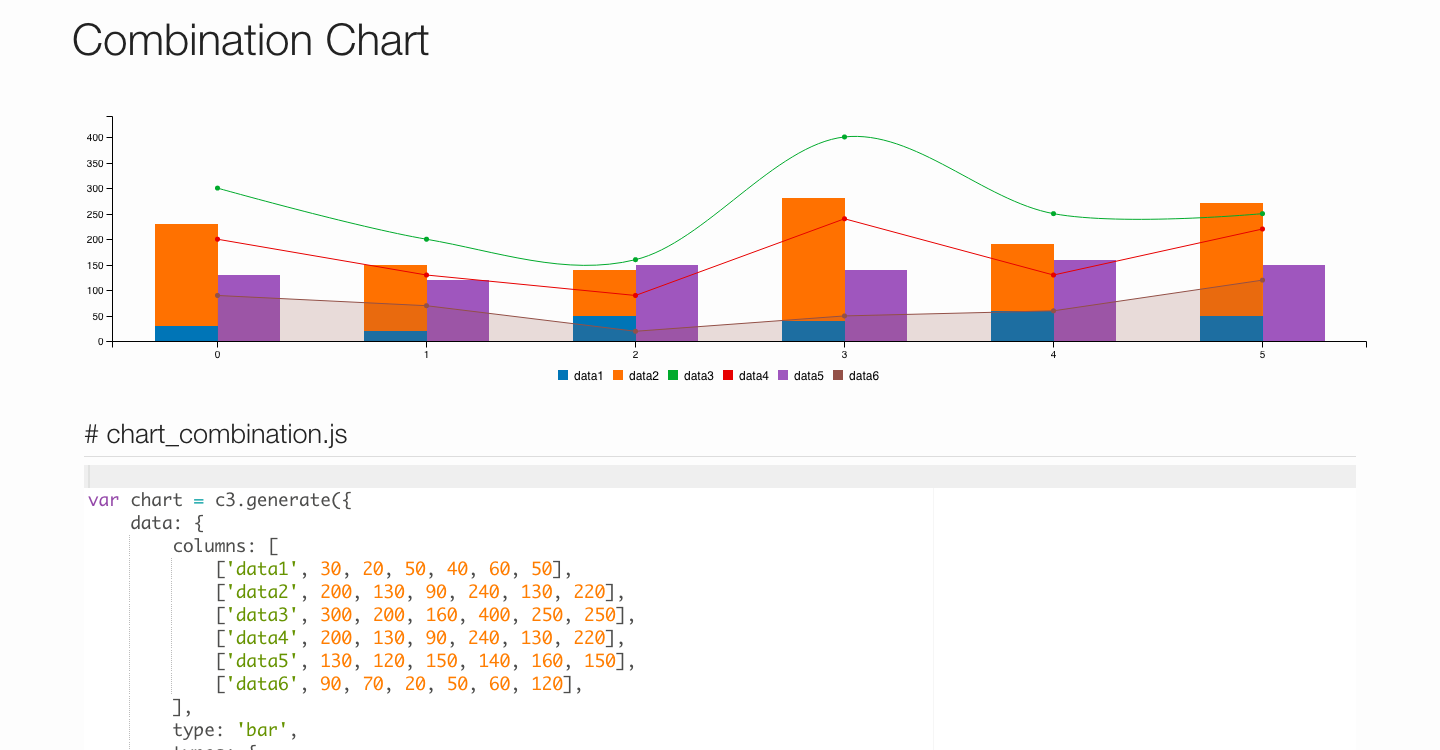

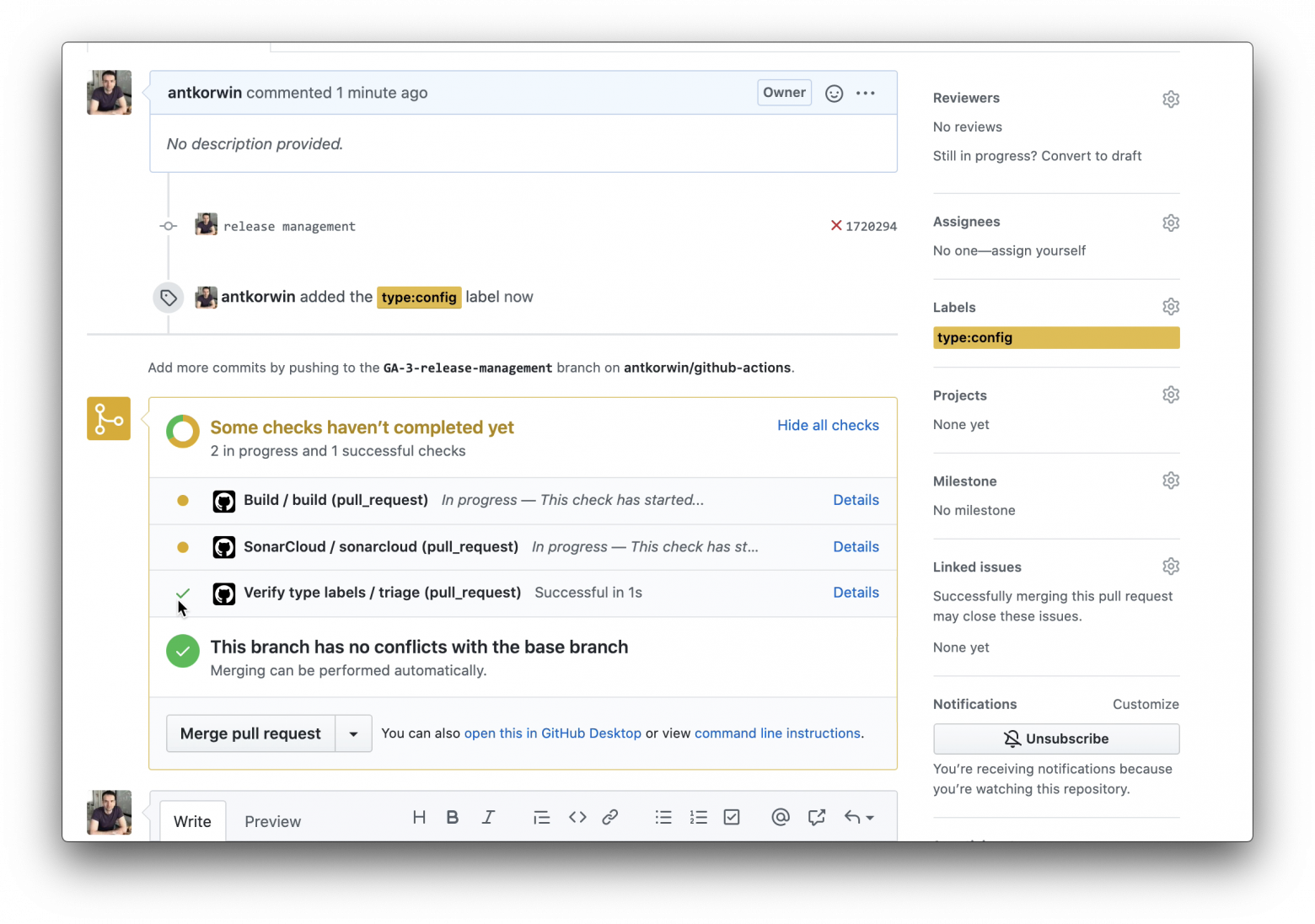

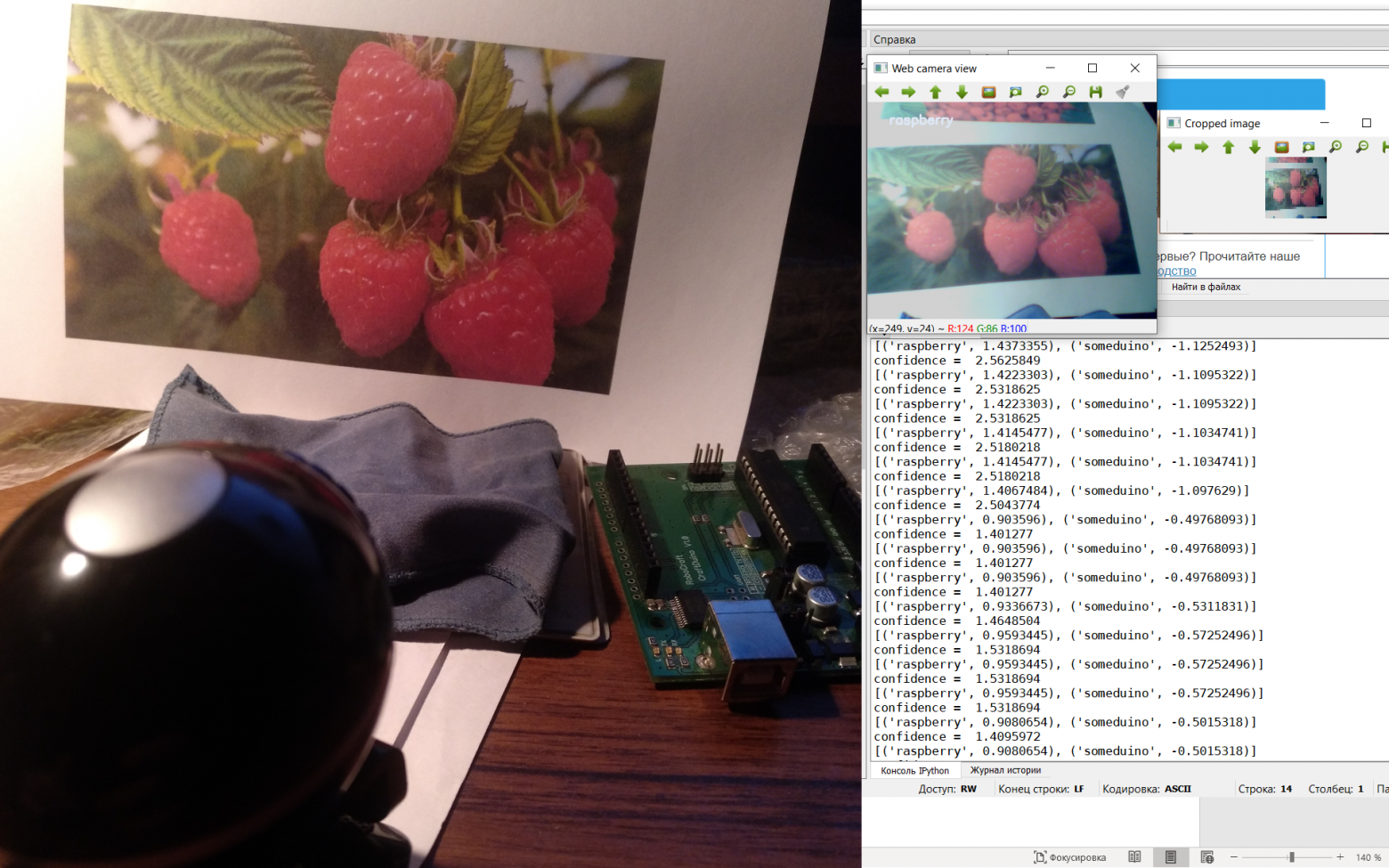

Задача портирования на Sega легла на Майкла Бертона, а Ребекка Хейнеман позаботилась о трёх других платформах. Поскольку Genesis основан на 68000, большая часть кода из Atari ST версии могла быть повторно использована для реализации виртуальной машины.

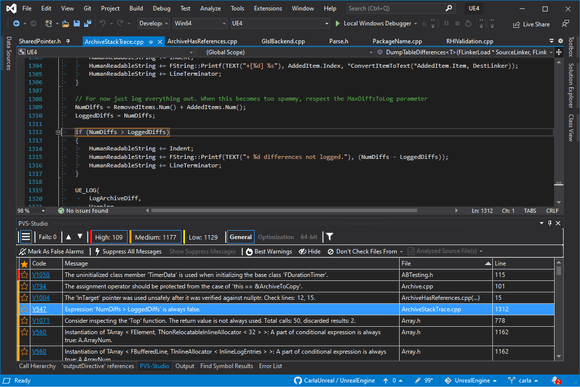

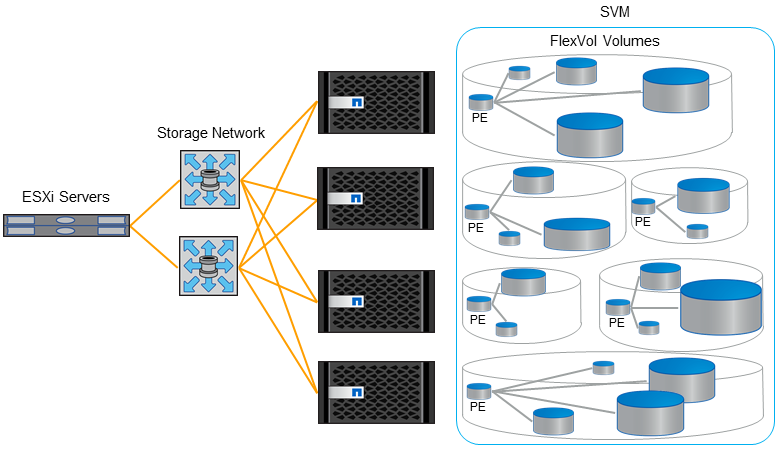

Для североамериканского релиза Interplay был обеспокоен тем, что клиенты будут путать игру с TV сериалом[[7]](#Wikipedia_Another_World_TV_Series). Игра была переименована в Out Of This World. Забавно, что сериал под названием Out Of This World вышел в 1991 году[[8]](#Wikipedia_Out_of_This_World_TV_Series), но уже было поздно снова менять название игры.

В Interplay также были обеспокоены тем, что игровая упаковка была слишком красивой, поэтому они исправили ошибку.

| | |

| --- | --- |

| | |

Майкл не сразу ответил на запросы по электронной почте, поэтому остальная часть этой статьи основана на наблюдениях, сделанных с эмуляторами GenS и Exodus, а также на результатах дизасемблирования.

Невозможная структура

---------------------

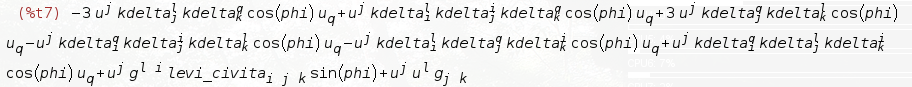

Руководство по программному обеспечению Genesis[[9]](#Genesis_Software_Manual_2) — это чудо, которое содержит даже тщательного документированные тайминги DMA. Изучив его, Фабьен надеялся увидеть, что VDP широко используется, поскольку он выделяется двумя вещами, в которых Another World нуждается больше всего.

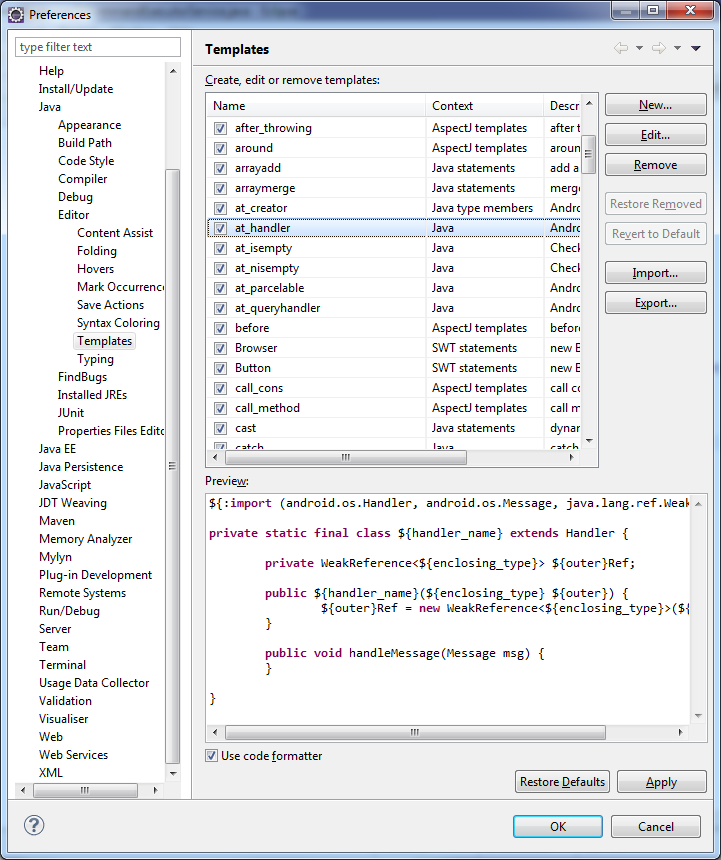

VDP мог бы использовать DMA FILL[[10]](#VDP_DMA_FILL) для отрисовки полигонов, как Amiga Blitter. Функция DMA COPY[[11]](#VDP_DMA_COPY) идеально подходила для реализации опкода VM COPY. К сожалению, некоторые детали не сработали.

Во-первых, необходим огромный объём VRAM. Размещение всех четырёх кадровых буферов 320x200 в VRAM — это слишком много для 64 КБ. Это не было концом, поскольку кадровый буфер мог быть упакован, а разрешение снижено, чтобы уменьшить потребление видеопамяти.

Во-вторых, операции записи DMA FILL выполняются с 16-битной гранулярностью, которая быстра, но когда требовался отдельный ниббл, чтение из VRAM с регистрами VDP, установка маски и обратная запись снизили бы частоту кадров.

Наконец, слой ячеек несовместим с тем, как работает DMA FILL. Для Another World необходимо записывать длинные строки пикселей, но линия разбита на два слова (4 байта) с шагом 28 байтов. Поскольку у DMA FILL нету шага, для этого потребовалось бы много запросов, и издержки убили бы частоту кадров.

Эта невозможная конструкция была подтверждена отслеживанием VDP регистров #17[[12]](#VDP_Registers) в эмуляторе Exodus, который показал, что DMA COPY и DMA FILL никогда не использовались.

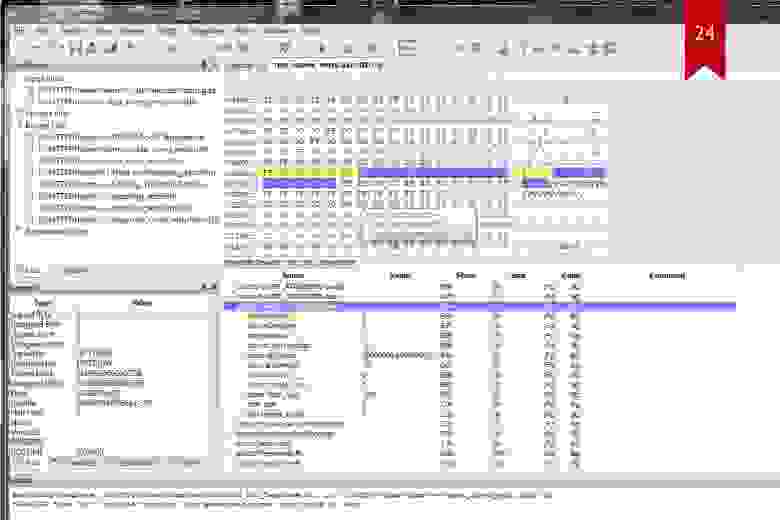

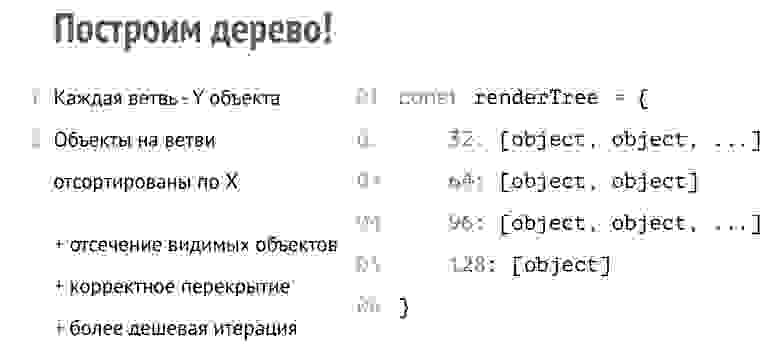

Архитектура Another World на Genesis

------------------------------------

Не имея возможности построить движок, основанный на рендеринге VDP, в свою VRAM, Another World пошёл по тяжёлому для 68000 пути, подобному тому, что мы видели на Atari ST.

Три кадровых буфера, два BKGD и «рабочий» буфер хранятся в оперативной памяти. Там 68000 выполняет все операции рендеринга и копирования.

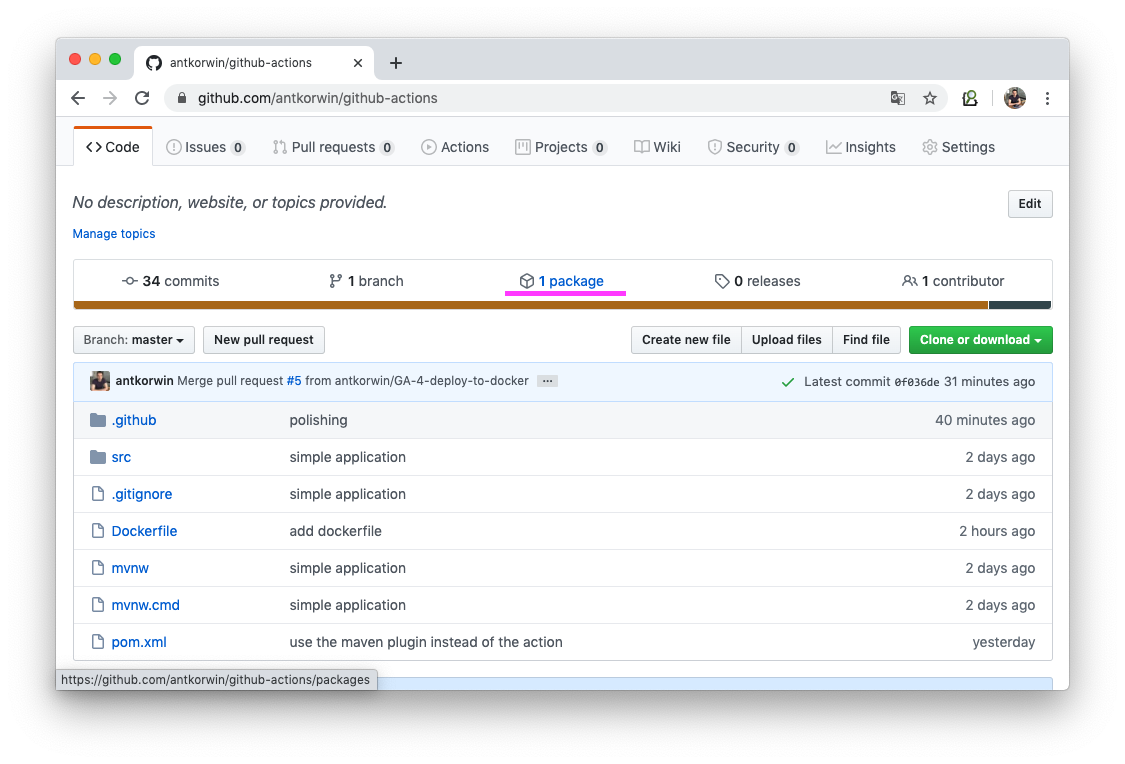

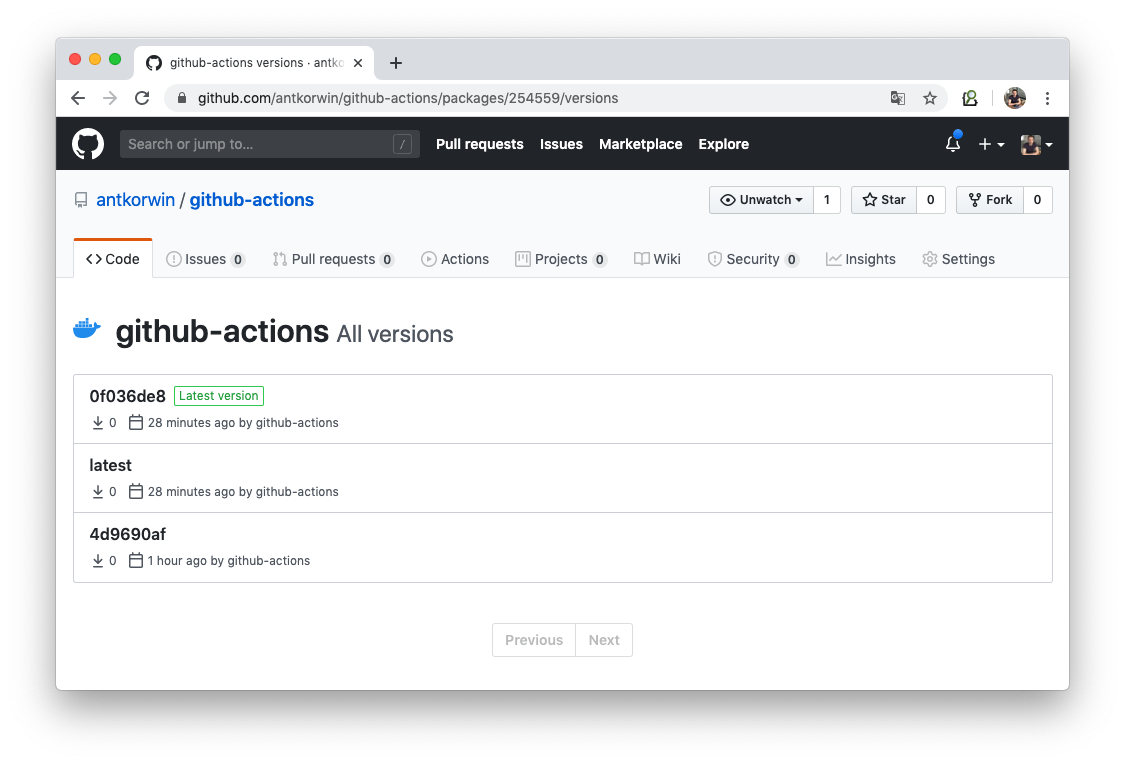

Как только кадр завершен, он записывается DMA в неиспользуемый двойной буфер в VRAM. На следующем VBLANK «активный» буфер VRAM флипается.

Все слои отключены, кроме Scroll A, если верить Gens. Оригинальный Scroll A изменяется в зависимости от того, какой из двойных буферов был записан последним.

По сравнению с Atari ST единственная оптимизация, по-видимому, заключается в реализации COPY, которая теперь использует инструкцию movem. Прирост производительности неясен (5%?).

Без фреймбуфера

---------------

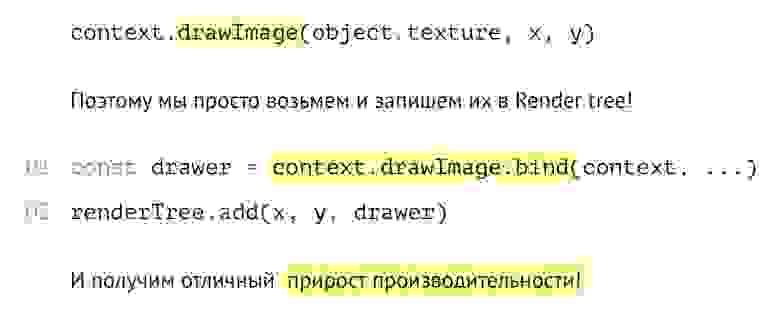

В VAM VRAM нет кадровых буферов для отрисовки, но есть способ обойти это, покрывая весь экран Ячейками и переводя координаты пространства экрана в координаты Ячейки.

Для pixel perfect порта можно использовать режим H40 для получения разрешения 320x224 пикселей. Удаление трёх линий Ячеек привело бы к разрешению 320х200, что и было необходимо.

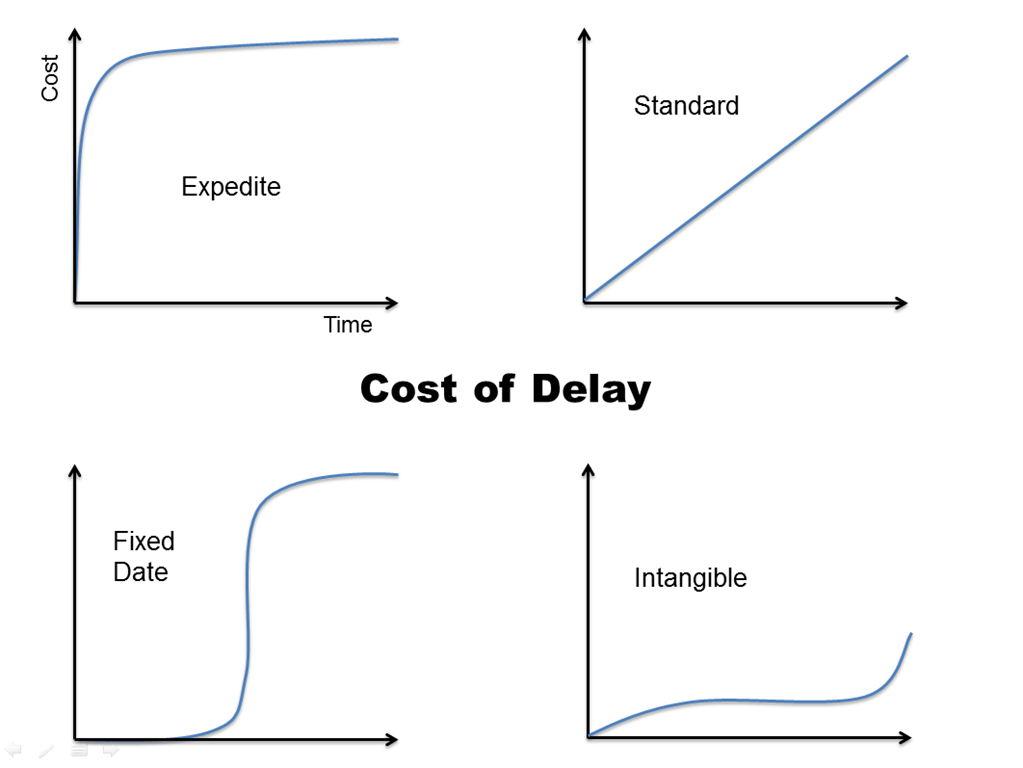

При 320x200 кадровый буфер будет иметь размер 320 \* 300/2 = 32 000 байт. Если мы посмотрим на полосу пропускания VDP DMA[[13]](#MegaDrive_DMA_Bandwidth), то увидим, что для NTSC системы потребуется 32000/11556 = 2,7 кадра, а на PAL системе 32000/21654 = 1,4 кадра.

`Пропускная способность DMA, байт/фрейм:

===============================

Частота Разрешение On VBLANK On Active Display Total

--------------------------------------------------------------------------

60 Hz 256 x 224 6118 3584 9702

320 x 224 7524 4032 11556

50 Hz 256 x 224 14329 3584 17913

320 x 224 17622 4032 21654

256 x 240 11753 3840 15593

320 x 240 14454 4320 18774`

**На заметку:** обратите внимание на то, что система PAL превосходит NTSC, когда речь идет о передаче из ОЗУ в VRAM. Именно поэтому большинство демо-групп работают с PAL MegaDrive вместо NTSC Genesis.

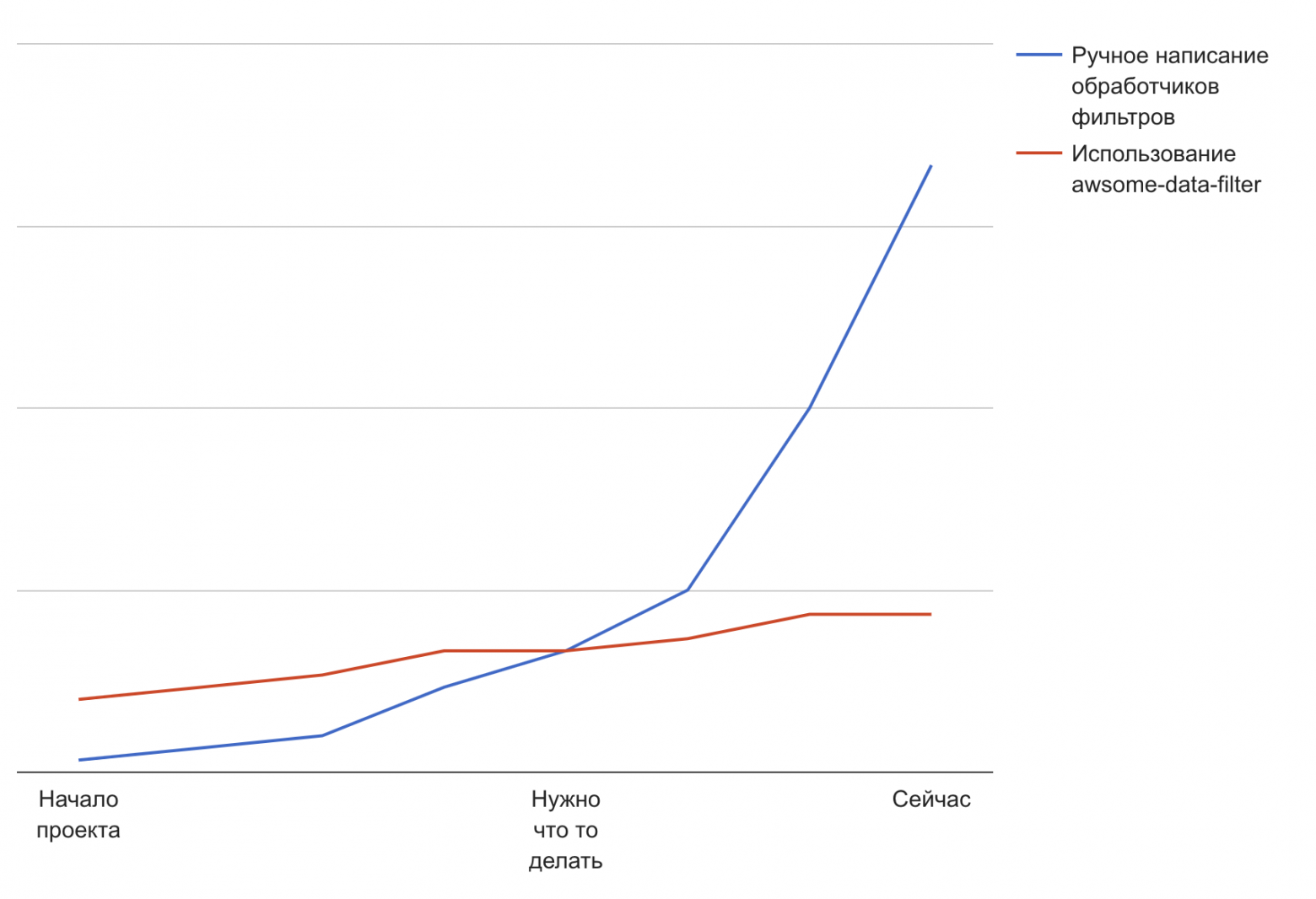

Если посмотреть на диаграмму и учесть игровую логику виртуальной машины и рендеринг полигонов поверх передачи из RAM в VRAM, мы увидим, что игра будет выдавать лишь 12-15 кадров в секунду на NTSC, что было неприемлемо.

`Framerate for # missed VSYNCs:

==============================

Missed VSYNCs : 0 1 2 3 4 5 6 7

-------------------------------------------------------

NTSC Framerate : 60 30 20 15 12 10 8 7

PAL Framerate : 50 25 16 12 10 8 7 6`

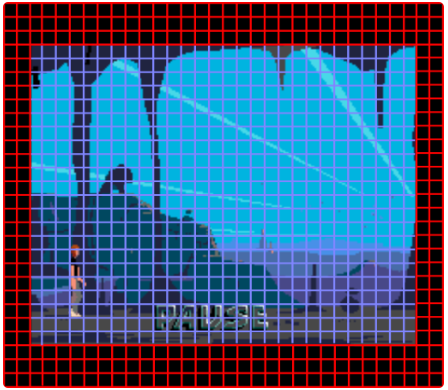

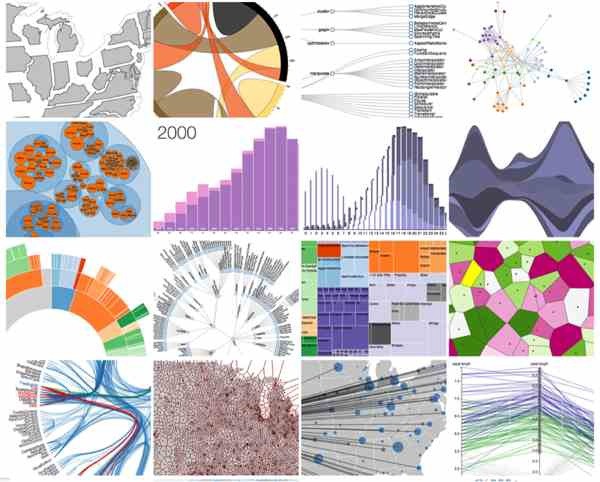

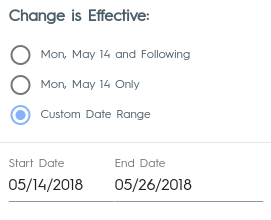

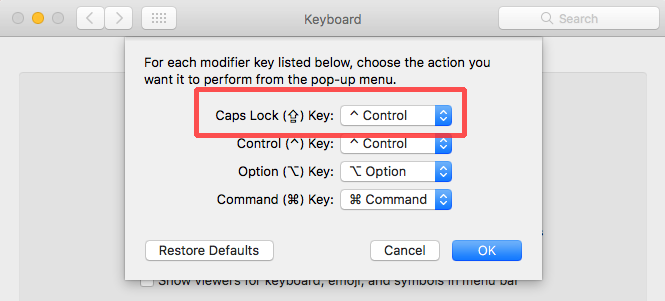

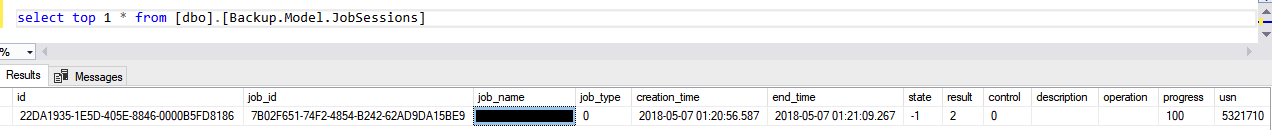

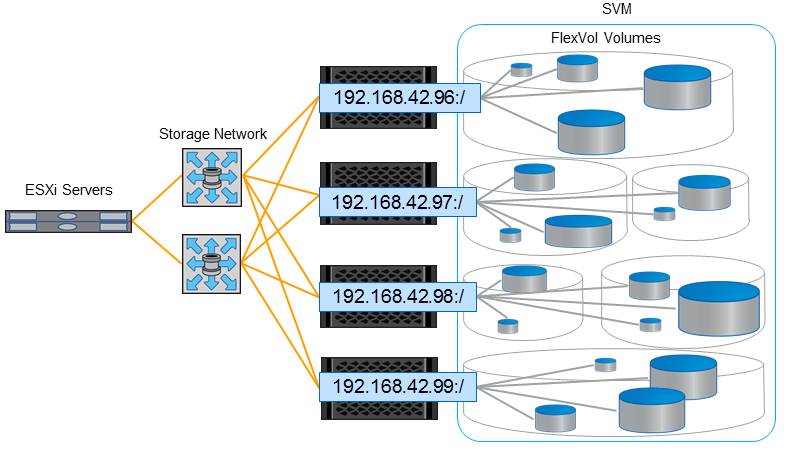

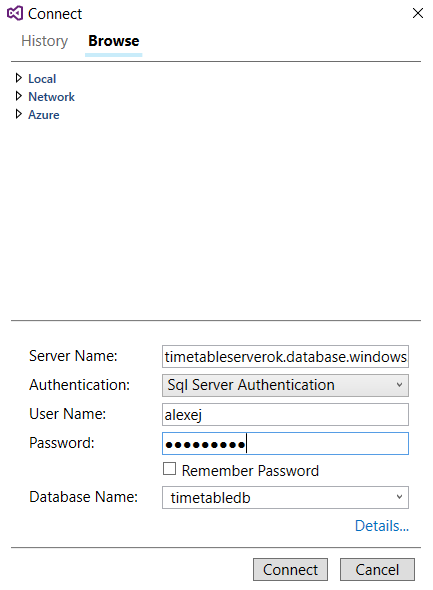

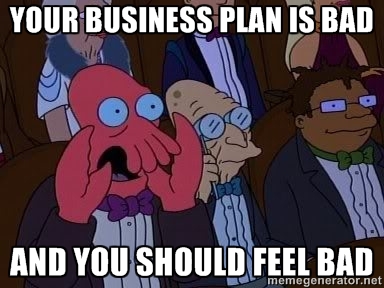

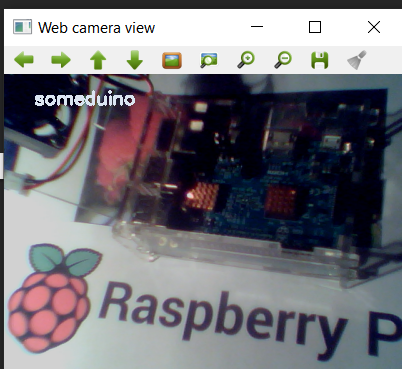

Чтобы уменьшить нагрузку на полосу пропускания, VDP устанавливается в режиме «H32» с разрешением 32х28. Некоторые столбцы и строки настроены на использование Чёрной ячейки и никогда больше не используются. Эти дополнительные чёрные ячейки еще больше снижают разрешение, а также сохраняют соотношение сторон, равное 1:3.

Только 28x22 Ячейки активно отрисовываются, что даёт разрешение 224x176 и кадровый буфер 224 \* 176/2 = 19,712 байт.

Это более низкое разрешение ускорило выполнение опкодов копирования, заполнения и отрисовки полигонов, а также снизило стоимость переноса из RAM в VRAM. В системе NTSC 19,712 / 9702 = 2 пропущенных кадра. Добавьте ещё один для отрисовки/копирования/заполнения, и вы получите 15-12 кадров в секунду, что, кажется, подтверждается реальными кадрами[[14]](#Out_of_This_World_on_US_Model_2_Sega_Genesis_through_S_Video).

В системе PAL стоимость передачи составляет 19712/17913 = 1,1 кадра. Это, вероятно, привело к пропуску 2 vsync и лучшей частоте кадров, чем на NTSC, близкой к 16-12fps.

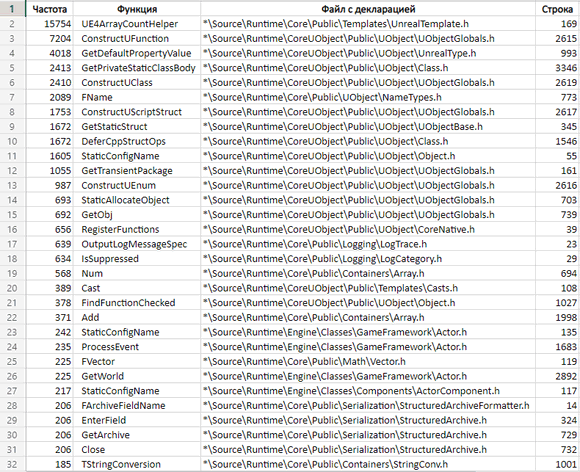

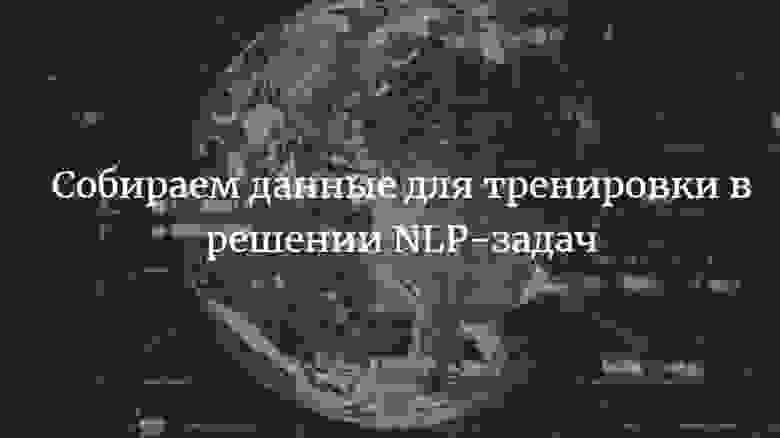

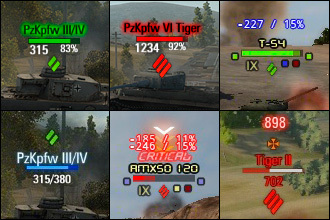

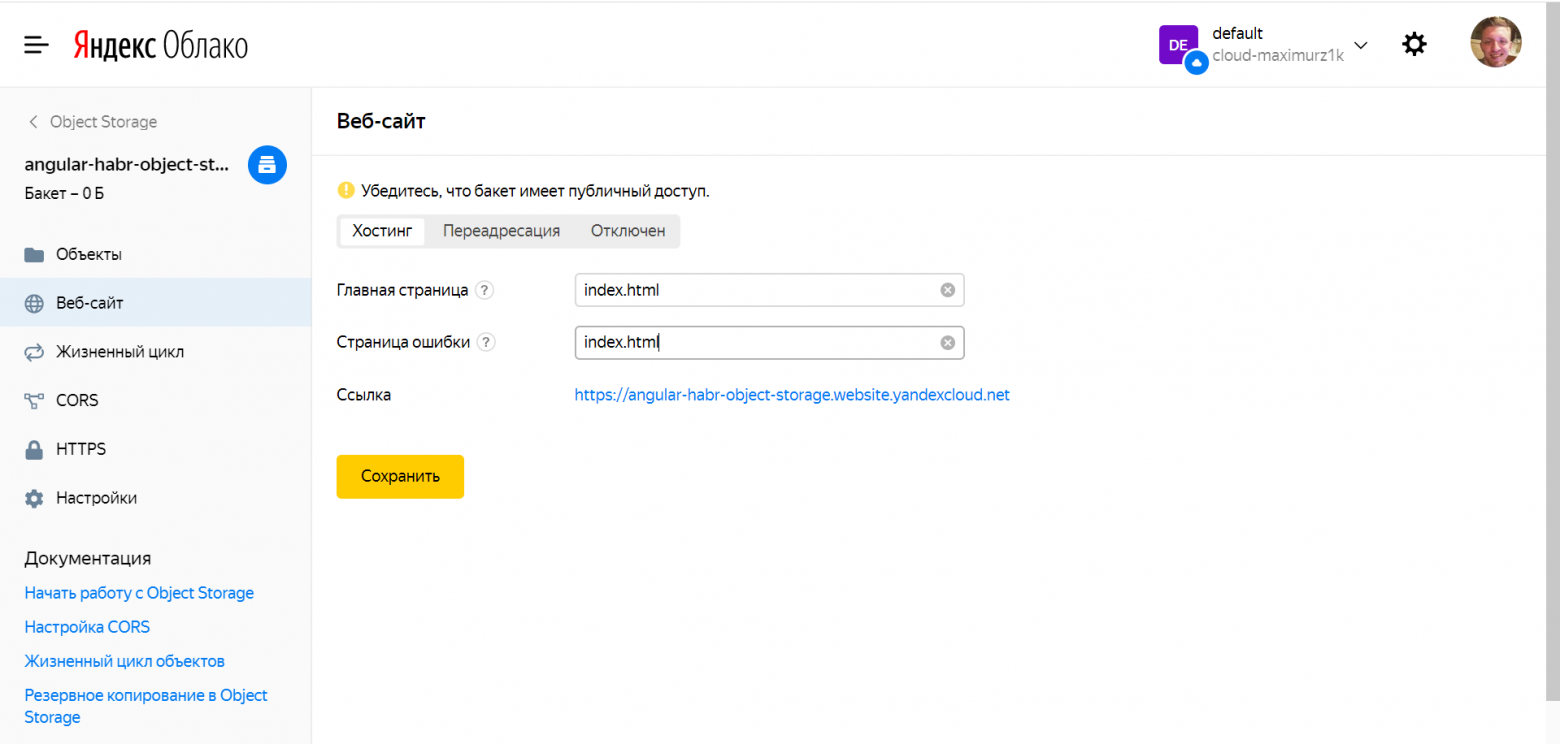

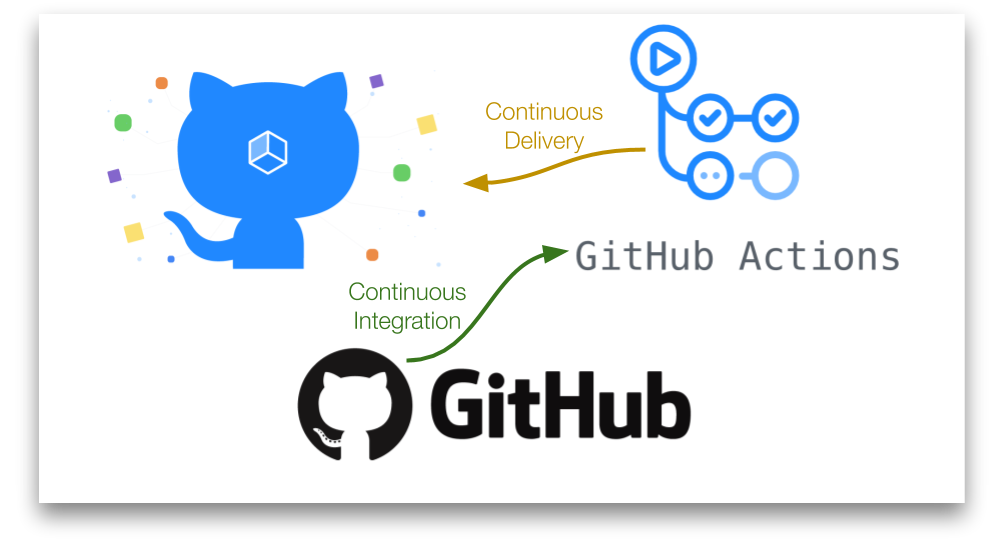

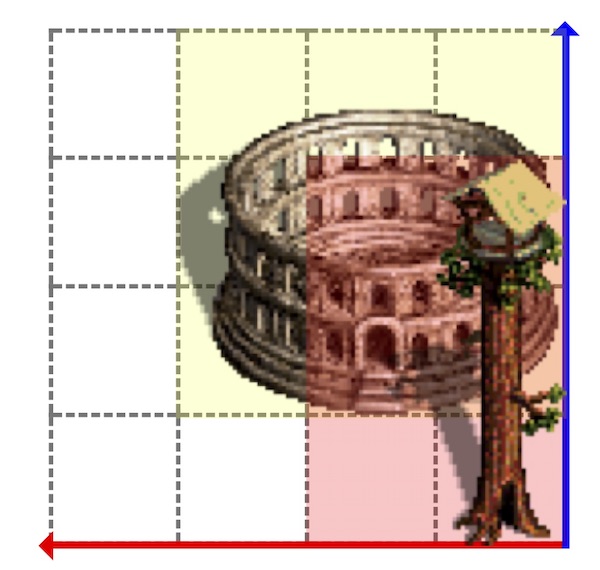

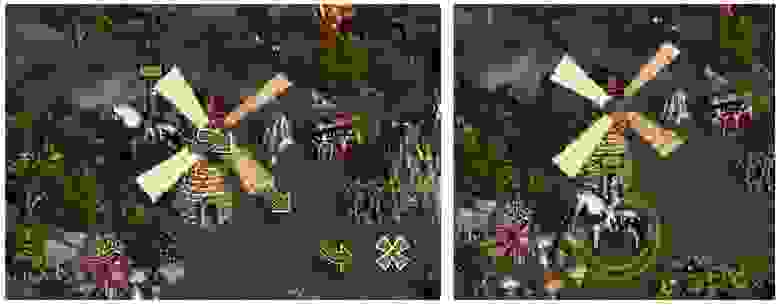

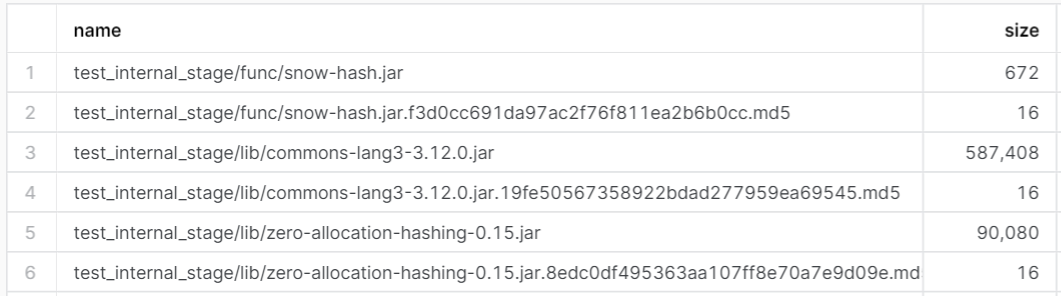

| | |

| --- | --- |

| | |

Обратите внимание на дополнительные черты лица и то, как Лестер выглядит более обеспокоенным. Снизу виден клиппинг (правая рука Лестера). Разница в глубине цвета заметна, но это не проблема.

Поговорим о цвете

-----------------

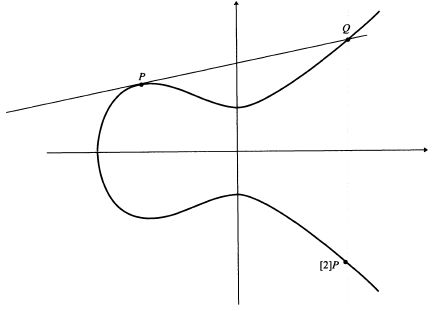

Кое-что могло заинтересовать вас ранее при описании видеосистемы — VDP поддерживает прозрачность для каждого пикселя. Это достигается тем, что нулевой индекс цвета на всех слоях рассматривается как прозрачный. Это эффективно уменьшает количество цветов, доступных на слой, до 15. Но Another World нуждается в 16. Это проблема.

Фабьен представлял себе решение в использовании Плоскость B и заполнении повторяющейся ячейкой с цветовым индексом 0x01. При загрузке палитры цвет 0 из плоскости A также копируется в палитру плоскости B по индексу 0x01. Затем воспроизведение может продолжаться как обычно. Поскольку плоскость B отстаёт от плоскости A, любой цвет, установленный на 0x0, вместо этого будет установлен на 0x1 плоскости B.

Но оказалось, что ничего из этого не было нужно. Запустив игру на Exodus и глядя на палитры в реальном времени, Фабьен заметил, что все палитры используют один и тот же чёрный цвет с индексом 0. Всё, что нужно было сделать разработчику, это установить BACKGROUND COLOR (цвет, который используется, когда все слои прозрачны) чёрным и покончить с этим.

Итог

----

Это был, без сомнения, самый сложный из изученных портов. Несмотря на мощный процессор и VDP, MegaDrive, похоже, проседал во время передачи RAM/VRAM, которая, честно говоря, никогда не была рассчитана на вывод в полноэкранном режиме.

Возможно, что-то можно было бы сделать с системой кэширования Ячеек, чтобы передавать только грязные данные, чтобы уменьшить объём передаваемых данных, но, скорее всего, разработчику попросту не дали достаточно времени для порта.

Более низкое разрешение не особо заметно, но ячейки, преднамеренно оставленные чёрными, добавили полосы. В системе NTSC это было не слишком большой проблемой, но на телевизоре PAL чёрные ячейки кадрового буфера ещё больше добавили к «естественным» чёрным полосам.

Парились ли по этому поводу игроки того времени? Вряд ли. StarFox на SNES имеет ту же частоту кадров/дополнительные чёрные полосы, но всё равно запомнилась как отличная игра. Фабьен верит, что это справедливо и для Out of This World/Another world на Genesis/MegaDrive.

Ссылки

------

1. [Wikipedia: Sega Genesis, Запуск](https://ru.wikipedia.org/wiki/Sega_Mega_Drive#%D0%97%D0%B0%D0%BF%D1%83%D1%81%D0%BA).

2. [Продажи Mega Drive](http://segatastic.blogspot.com/2009/12/mega-drive-sales-figures-update.html).

3. [Genesis Software Manual: VDP 315-5313](https://suvitruf.ru/wp-content/uploads/2020/05/GenesisSoftwareManual.pdf).

4. Существует много приёмов для отображения большего количества цветов, таких как изменение палитры в HBLANK или потоковая передача цветов в BACKGROUND REGISTER, но они здесь не актуальны.

5. [VDP, таблицы имён](https://segaretro.org/Sega_Mega_Drive/Planes#Nametables).

6. [VDP, таблица спрайтов](https://segaretro.org/Sega_Mega_Drive/Sprites)