text

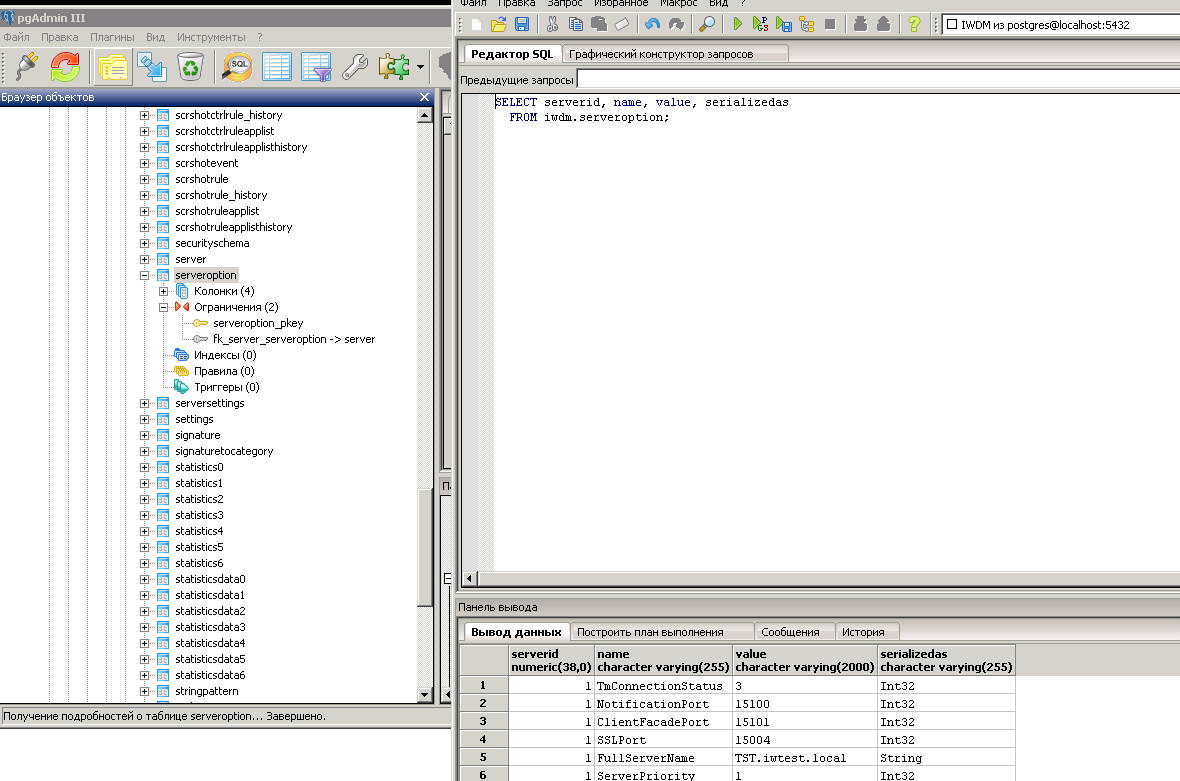

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# О сравнении объектов по значению — 4, или Inheritance & Equality operators

#### В [предыдущей публикации](https://habrahabr.ru/post/315168/) мы получили вариант реализации сравнения объектов по значению для платформы [.NET](https://www.microsoft.com/net), на примере класса Person, включающий:

* перекрытие методов [Object.GetHashCode()](https://msdn.microsoft.com/library/system.object.gethashcode.aspx), [Object.Equals(Object)](https://msdn.microsoft.com/library/bsc2ak47.aspx);

* реализацию интерфейса [IEquatable (Of T)](https://msdn.microsoft.com/library/ms131187.aspx);

* реализацию Type-specific статических метода Equals(Person, Person) и операторов ==(Person, Person), !=(Person, Person).

Каждый из способов сравнения для любой одной и той же пары объектов возвращает один и тот же результат:

**Пример кода**

```

Person p1 = new Person("John", "Smith", new DateTime(1990, 1, 1));

Person p2 = new Person("John", "Smith", new DateTime(1990, 1, 1));

//Person p2 = new Person("Robert", "Smith", new DateTime(1991, 1, 1));

object o1 = p1;

object o2 = p2;

bool isSamePerson;

isSamePerson = o1.Equals(o2);

isSamePerson = p1.Equals(p2);

isSamePerson = object.Equals(o1, o2);

isSamePerson = Person.Equals(p1, p2);

isSamePerson = p1 == p2;

isSamePerson = !(p1 == p2);

```

При этом, каждый из способов сравнения является коммутативным:

x.Equals(y) возвращает тот же результат, что и y.Equals(x), и т.д.

Таким образом, клиентский код может сравнивать объекты любым способом — результат сравнения будет детерминирован.

#### Однако, требует раскрытия вопрос:

Как именно обеспечивается детерминированность результата при реализации статических методов и операторов сравнения в случае наследования — с учетом того, что статические методы и операторы не обладают полиморфным поведением.

Для наглядности приведем класс Person из [предыдущей публикации](https://habrahabr.ru/post/315168/):

**class Person**

```

using System;

namespace HelloEquatable

{

public class Person : IEquatable

{

protected static int GetHashCodeHelper(int[] subCodes)

{

if ((object)subCodes == null || subCodes.Length == 0)

return 0;

int result = subCodes[0];

for (int i = 1; i < subCodes.Length; i++)

result = unchecked(result \* 397) ^ subCodes[i];

return result;

}

protected static string NormalizeName(string name) => name?.Trim() ?? string.Empty;

protected static DateTime? NormalizeDate(DateTime? date) => date?.Date;

public string FirstName { get; }

public string LastName { get; }

public DateTime? BirthDate { get; }

public Person(string firstName, string lastName, DateTime? birthDate)

{

this.FirstName = NormalizeName(firstName);

this.LastName = NormalizeName(lastName);

this.BirthDate = NormalizeDate(birthDate);

}

public override int GetHashCode() => GetHashCodeHelper(

new int[]

{

this.FirstName.GetHashCode(),

this.LastName.GetHashCode(),

this.BirthDate.GetHashCode()

}

);

protected static bool EqualsHelper(Person first, Person second) =>

first.BirthDate == second.BirthDate &&

first.FirstName == second.FirstName &&

first.LastName == second.LastName;

public virtual bool Equals(Person other)

{

//if ((object)this == null)

// throw new InvalidOperationException("This is null.");

if ((object)this == (object)other)

return true;

if ((object)other == null)

return false;

if (this.GetType() != other.GetType())

return false;

return EqualsHelper(this, other);

}

public override bool Equals(object obj) => this.Equals(obj as Person);

public static bool Equals(Person first, Person second) =>

first?.Equals(second) ?? (object)first == (object)second;

public static bool operator ==(Person first, Person second) => Equals(first, second);

public static bool operator !=(Person first, Person second) => !Equals(first, second);

}

}

```

#### И создадим класс-наследник PersonEx:

**class PersonEx**

```

using System;

namespace HelloEquatable

{

public class PersonEx : Person, IEquatable

{

public string MiddleName { get; }

public PersonEx(

string firstName, string middleName, string lastName, DateTime? birthDate

) : base(firstName, lastName, birthDate)

{

this.MiddleName = NormalizeName(middleName);

}

public override int GetHashCode() => GetHashCodeHelper(

new int[]

{

base.GetHashCode(),

this.MiddleName.GetHashCode()

}

);

protected static bool EqualsHelper(PersonEx first, PersonEx second) =>

EqualsHelper((Person)first, (Person)second) &&

first.MiddleName == second.MiddleName;

public virtual bool Equals(PersonEx other)

{

//if ((object)this == null)

// throw new InvalidOperationException("This is null.");

if ((object)this == (object)other)

return true;

if ((object)other == null)

return false;

if (this.GetType() != other.GetType())

return false;

return EqualsHelper(this, other);

}

public override bool Equals(Person other) => this.Equals(other as PersonEx);

// Optional overloadings:

public override bool Equals(object obj) => this.Equals(obj as PersonEx);

public static bool Equals(PersonEx first, PersonEx second) =>

first?.Equals(second) ?? (object)first == (object)second;

public static bool operator ==(PersonEx first, PersonEx second) => Equals(first, second);

public static bool operator !=(PersonEx first, PersonEx second) => !Equals(first, second);

}

}

```

#### В классе-наследнике появилось еще одно ключевое свойство MiddleName. Поэтому первым делом необходимо:

* Реализовать интерфейс IEquatable(Of PersonEx).

* Реализовать метод PersonEx.Equals(Person), перекрыв унаследованный метод Person.Equals(Person) (стоит обратить внимание, что последний изначально был объявлен виртуальным для учета возможности наследования) и попытавшись привести объект типа Person к типу PersonEx.

(В противном случае, сравнение объектов, у которых равны все ключевые поля, кроме MiddleName, возвратит результат "объекты равны", что неверно с предметной точки зрения.)

При этом:

* Реализация метода PersonEx.Equals(PersonEx) аналогична реализации метода Person.Equals(Person).

* Реализация метода PersonEx.Equals(Person) аналогична реализации метода Person.Equals(Object).

* Реализация статического protected-метода EqualsHelper(PersonEx, PersonEx) аналогична реализации метода EqualsHelper(Person, Person); для повторного использования кода, последний используется в первом методе.

#### Далее реализован метод PersonEx.Equals(Object), перекрывающий унаследованный метод Equals(Object), и представляющий собой вызов метода PersonEx.Equals(PersonEx), с приведением входящего объекта к типу PersonEx с помощью оператора [as](https://msdn.microsoft.com/library/cscsdfbt.aspx).

Стоит отметить, что реализация PersonEx.Equals(Object) не является обязательной, т.к. в случае ее отсутствия и вызова клиентским кодом метода Equals(Object) вызвался бы унаследованный метод Person.Equals(Object), который внутри себя вызывает *виртуальный* метод PersonEx.Equals(Person), приводящий к вызову PersonEx.Equals(PersonEx).

Однако, метод PersonEx.Equals(Object) реализован для "полноты" кода и большего быстродействия (за счет минимизации количества приведений типов и промежуточных вызовов методов).

#### Другими словами, создавая класс PersonEx и наследуя класс Person, мы поступали таким же образом, как при создании класса Person и наследовании класса [Object](https://msdn.microsoft.com/library/system.object.aspx).

Теперь, какой бы метод у объекта класса PersonEx мы не вызывали:

Equals(PersonEx), Equals(Person), Equals(object),

для любой одной и той же пары объектов будет возвращаться один и тот же результат (при смене операндов местами так же будет возвращаться тот же самый результат).

Обеспечить такое поведение позволяет полиморфизм.

#### Также мы реализовали в классе PersonEx статический метод PersonEx.Equals(PersonEx, PersonEx) и соответствующие ему операторы сравнения PersonEx.==(PersonEx, PersonEx) и PersonEx.!=(PersonEx, PersonEx), также действуя таким же образом, как и при при создании класса Person.

Использование метода PersonEx.Equals(PersonEx, PersonEx) или операторов PersonEx.==(PersonEx, PersonEx) и PersonEx.!=(PersonEx, PersonEx) для любой одной и той же пары объектов даст тот же результат, что и использование экземплярных методов Equals класса PersonEx.

#### А вот дальше становится интереснее.

Класс PersonEx "унаследовал" от класса Person статический метод Equals(Person, Person) и соответствующие ему операторы сравнения ==(Person, Person) и !=(Person, Person).

#### Какой результат будет получен, если выполнить следующий код?

**Код**

```

bool isSamePerson;

PersonEx pex1 = new PersonEx("John", "Teddy", "Smith", new DateTime(1990, 1, 1));

PersonEx pex2 = new PersonEx("John", "Bobby", "Smith", new DateTime(1990, 1, 1));

//PersonEx pex2 = new PersonEx("John", "Teddy", "Smith", new DateTime(1990, 1, 1));

Person p1 = pex1;

Person p2 = pex2;

isSamePerson = Person.Equals(pex1, pex2);

isSamePerson = PersonEx.Equals(p1, p2);

isSamePerson = pex1 == pex2;

isSamePerson = p1 == p2;

```

Несмотря на то, что метод Equals(Person, Person) и операторы сравнения ==(Person, Person) и !=(Person, Person) — статические, результат всегда будет тем же самым, что и при вызове метода Equals(PersonEx, PersonEx), операторов ==(PersonEx, PersonEx) и !=(PersonEx, PersonEx), или любого из экземплярных виртуальных методов Equals.

#### Именно для получения такого полиморфного поведения, статические методы Equals и операторы сравнения "==" и "!=", на каждом из этапов наследования реализуются с помощью экземплярного виртуального метода Equals.

Более того, реализация в классе PersonEx метода Equals(PersonEx, PersonEx) и операторов ==(PersonEx, PersonEx) и !=(PersonEx, PersonEx), так же, как и для метода PersonEx.Equals(Object), является опциональной.

Метод Equals(PersonEx, PersonEx) и операторы ==(PersonEx, PersonEx) и !=(PersonEx, PersonEx) реализованы для "полноты" кода и большего быстродействия (за счет минимизации количества приведений типов и промежуточных вызовов методов).

Единственным нестройным моментом в "полиморфности" статических Equals, "==" и "!=" является то, что если два объекта типа Person или PersonEx привести к типу [object](https://msdn.microsoft.com/library/9kkx3h3c.aspx), то сравнение объектов с помощью операторов [==](https://msdn.microsoft.com/library/53k8ybth.aspx) и [!=](https://msdn.microsoft.com/library/3tz250sf.aspx) будет произведено по ссылке, а с помощью метода [Object.Equals(Object, Object)](https://msdn.microsoft.com/library/w4hkze5k.aspx) — по значению. Но это — "by design" платформы.

#### В [продолжении](https://habrahabr.ru/post/315622/) рассмотрим особенности реализации сравнения по значению для объектов — экземпляров [*структур*](https://msdn.microsoft.com/library/ah19swz4.aspx), а также поговорим о кейсах, когда действительно целесообразно реализовывать для своих типов сравнение объектов по значению, и как это делать, в т.ч. с предметной точки зрения. | https://habr.com/ru/post/315258/ | null | ru | null |

# Разумное АОП для поклонников IOC-контейнеров

Я очень не люблю boilerplate. Такой код скучно писать, уныло сопровождать и модифицировать. Совсем мне не нравится, когда тот самый bolierplate перемешан с бизнес-логикой приложения. Очень хорошо проблему описал [krestjaninoff](https://habrahabr.ru/users/krestjaninoff/) еще [5 лет назад](https://habrahabr.ru/post/114649/). *Если вы не знакомы с парадигмой AOP, прочитайте материал по ссылке, он раскрывает тему*.

Как на момент прочтения этой статьи, так и сейчас меня не устраивают ни [PostSharp](https://www.postsharp.net/) ни Spring. Зато за прошедшее время в .NET появились другие инструменты, позволяющие вытащить «левый» код из бизнес-логики, оформить его отдельными переиспользуемыми модулями и описать декларативно, не скатываясь при этом в переписывание результирующего IL и прочую содомию.

Речь пойдет о проекте [Castle.DynamicProxy](http://www.castleproject.org/projects/dynamicproxy) и его применении в разработке корпоративных приложений. Я позаимствую пример у [krestjaninoff](https://habrahabr.ru/users/krestjaninoff/), потому что аналогичный код я вижу с завидной регулярностью, и он доставляет мне много хлопот.

```

public BookDTO getBook(Integer bookId) throws ServiceException, AuthException {

if (!SecurityContext.getUser().hasRight("GetBook"))

throw new AuthException("Permission Denied");

LOG.debug("Call method getBook with id " + bookId);

BookDTO book = null;

String cacheKey = "getBook:" + bookId;

try {

if (cache.contains(cacheKey)) {

book = (BookDTO) cache.get(cacheKey);

} else {

book = bookDAO.readBook(bookId);

cache.put(cacheKey, book);

}

} catch(SQLException e) {

throw new ServiceException(e);

}

LOG.debug("Book info is: " + book.toString());

return book;

}

```

Итак, в примере выше одна «полезная» операция – чтение книги из БД по Id. В нагрузку метод получил:

* проверку авторизации

* кеширование

* обработку исключений

* логирование

Справедливости ради стоит заметить, что проверку авторизации и прав доступа, кеширование уже мог бы обеспечить ASP.NET с помощью атрибутов *[Authorize]* и *[OutputCache]*, однако по условию это «сферический web-сервис в вакууме» (к тому же написанный на Java), поэтому требования к нему неизвестны, как, впрочем, неизвестно используется ли ASP.NET, WCF или корпоративный фреймворк.

### Задача

* переместить вспомогательный код в подходящее место

* сделать его (код) переиспользуемым для других служб

В мире АОП есть специальный термин, для решаемой нами задачи: [cross-cutting concerns](http://stackoverflow.com/questions/23700540/cross-cutting-concern-example). Выделяются *base concerns* – основную функциональность системы, например, бизнес-логику и *cross-cutting concerns* – второстепенную функциональность (логирование, проверка прав доступа, обработка ошибок и т.д.), необходимая тем не менее повсеместно в коде приложения.

Наиболее часто мне встречается и прекрасно иллюстрирует ситуацию *cross-cutting concern* такого вида:

```

dbContext.InTransaction(x => {

//...

}, onFailure: e => {success: false, message: e.Message});

```

В нем уродливо абсолютно все, начиная от возрастающего code nesting, заканчивая перекладыванием функций проектировщика системы на прикладного программиста: нет никакой гарантии, что транзакции будут вызваны везде где нужно, непонятно как управлять уровнем изоляции транзакций и вложенными транзакциями и этот код будет скопирован сто тысяч раз где надо и не надо.

### Решение

Castle.DynamicProxy предоставляет простое API для создания proxy-объектов на лету с возможностью доопределить то, чего нам не хватает. Этот подход используется в популярных изоляционных фреймворках: [Moq](https://github.com/moq/moq4) и [Rhino Mocks](https://hibernatingrhinos.com/oss/rhino-mocks). Нам доступно [два варианта](https://github.com/castleproject/Core/blob/master/docs/dynamicproxy-kinds-of-proxy-objects.md):

1. создание прокси по интерфейсной ссылке (в этом случае будет использоваться композиция)

2. создание прокси для класса (будет создан наследник)

Основное отличие для нас будет заключаться в том, что для модификации методов класса, они должны быть объявлены доступными (*public* или *protected*) и виртуальными. Механизм аналогичен *Lazy Loading* у в *Nhibernate* или *EF*. Для обогащения функциональности в Castle.DynamicProxy используются «перехватчики» (*Interceptor*). Например, чтобы обеспечить транзакционностью все службы приложения можно написать *Interceptor* вроде такого:

```

public class TransactionScoper : IInterceptor

{

public void Intercept(IInvocation invocation)

{

using (var tr = new TransactionScope())

{

invocation.Proceed();

tr.Complete();

}

}

}

```

И создать прокси:

```

var generator = new ProxyGenerator();

var foo = new Foo();

var fooInterfaceProxyWithCallLogerInterceptor

= generator.CreateInterfaceProxyWithTarget(foo, TransactionScoper);

```

Или с [использованием контейнера](http://docs.autofac.org/en/latest/advanced/interceptors.html):

```

var builder = new ContainerBuilder();

builder.Register(c => new TransactionScoper());

builder.RegisterType()

.As()

.InterceptedBy(typeof(TransactionScoper));

var container = builder.Build();

var willBeIntercepted = container.Resolve();

```

Аналогичным образом можно добавить обработку ошибок

```

public class ErrorHandler : IInterceptor

{

public readonly TextWriter Output;

public ErrorHandler(TextWriter output)

{

Output = output;

}

public void Intercept(IInvocation invocation)

{

try

{

Output.WriteLine($"Method {0} enters in try/catch block", invoca-tion.Method.Name);

invocation.Proceed();

Output.WriteLine("End of try/catch block");

}

catch (Exception ex)

{

Output.WriteLine("Exception: " + ex.Message);

throw new ValidationException("Sorry, Unhandaled exception occured", ex);

}

}

}

public class ValidationException : Exception

{

public ValidationException(string message, Exception innerException)

:base(message, innerException)

{ }

}

```

Или логирование:

```

public class CallLogger : IInterceptor

{

public readonly TextWriter Output;

public CallLogger(TextWriter output)

{

Output = output;

}

public void Intercept(IInvocation invocation)

{

Output.WriteLine("Calling method {0} with parameters {1}.",

invocation.Method.Name,

string.Join(", ", invocation.Arguments.Select(a => (a ?? "").ToString()).ToArray()));

invocation.Proceed();

Output.WriteLine("Done: result was {0}.", invocation.ReturnValue);

}

}

```

Кеширование и многие другие операции. Отличительной особенностью данного подхода от реализации паттерна «декоратор» средствами ООП является возможность добавлять вспомогательную функциональность к любым типам без необходимости создавать наследников. Подход также решает проблему множественного наследования. Мы спокойно может добавить более одного перехватчика на каждый тип:

```

var fooInterfaceProxyWith2Interceptors

= generator.CreateInterfaceProxyWithTarget(Foo, CallLogger, ErrorHandler);

```

Еще одной сильной стороной данного подхода является выделение сквозной функциональности из слоя бизнес-логики и лучшее отделение инфраструктурного кода от домена приложения.

Если в процессе регистрации нельзя точно сказать какие службы нужно проксировать, а какие – нет, то можно использовать атрибуты для получения информации в runtime (хотя этот подход и может привести к некоторым проблемам):

```

public abstract class AttributeBased : IInterceptor

where T:Attribute

{

public void Intercept(IInvocation invocation)

{

var attrs = invocation.Method

.GetCustomAttributes(typeof(T), true)

.Cast()

.ToArray();

if (!attrs.Any())

{

invocation.Proceed();

}

else

{

Intercept(invocation, attrs);

}

}

protected abstract void Intercept(IInvocation invocation, params T[] attr);

}

```

Можно даже воспользоваться [готовым решением](https://habrahabr.ru/post/246469/).

Минусы

------

Я вижу четыре объективных минуса данного подхода:

1. Не интуитивность

2. Пересечение с инфраструктурным кодом других фреймворков

3. Зависимость от IOC-контейнера

4. Производительность

#### Не интуитивность

Проще всего разобраться с таким структурированием кода людям, знакомым с концепциями функционального программирования. С изрязным количеством оговорок подход можно назвать напоминающим «[композицию](https://habrahabr.ru/post/246009/)». Криво спроектированные перехватчики могут быть причиной изрядного количества не очевидных багов и проблем с производительностью.

#### Пересечение с инфраструктурным кодом других фреймворков

Как я говорил в начале, атрибуты *Authorize* и *OutputCache* уже есть в ASP.NET. В определенном смысле мы занимаемся велосипедостроительством. Подход больше подходит командам, для которых важно абстрагирование от конечной инфраструктуры выполнения. Кроме этого подход работает и в контексте частичного применения, а не «все или ничего». Никто не заставляется нас заново реализовывать проверку авторизации в AOP-стиле, если это не требуется.

#### Зависимость от IOC-контейнера

Для сервисного слоя минус практически отсутствует, если вы практикуете IOC/DI. В 99% случаев службы будут получены с помощью IOC-контейнера. Создание Entity и Dto обычно происходит явно, с помощью оператора new или маппера. Думаю, что это правильное положение вещей и не вижу применения перехватчиков на уровне создания Entity или Dto. Я видел несколько примеров применения перехватчиков для заполнения служебных полей в *Entity*, но со временем от этого подхода всегда отказывались. Гораздо лучше, чтобы объект сам заботился о сохранности своего [инварианта](https://habrahabr.ru/post/259829/).

#### Производительность

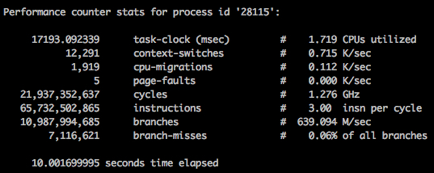

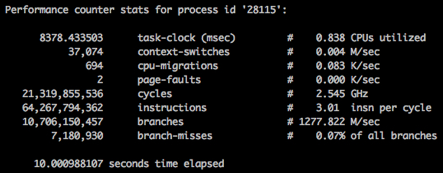

Три предыдущих пункта я привел скорее для точности, чем из прагматических соображений. Я скорее отношу их к границам применимости подхода, а не к настоящим проблемам. По поводу производительности я не был столь уверен, поэтому решил сделать серию бенчмарков c помощью [BenchmarkDotNet](https://github.com/PerfDotNet/BenchmarkDotNet). С фантазией у меня было не очень, поэтому измерялось время получения случайного числа:

```

public class Foo : IFoo

{

private static readonly Random Rnd = new Random();

public double GetRandomNumber() => Rnd.Next();

}

public class Foo : IFoo

{

private static readonly Random Rnd = new Random();

public double GetRandomNumber() => Rnd.Next();

}

```

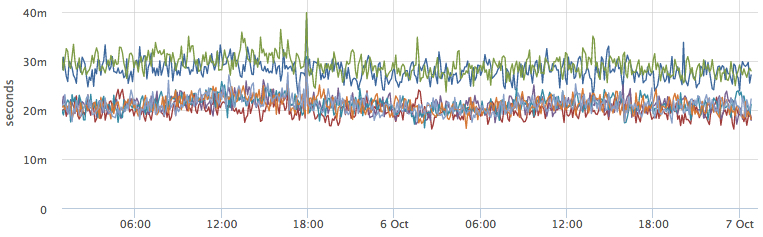

Исходники бенчмарков и примеры кода [доступны на github](https://github.com/max-arshinov/Castle.DynamicProxy.Benchmarks). Очевидно, что за магию с рефлексией и динамической компиляцией приходится платить:

1. Временем создания объекта: ~2,000 ns. Не принципиально, если службы создаются один раз, а за лайфтайм «протухающих» зависимостей, таких как контекст бд отвечает другой объект

2. Временем выполнения операций: так-же примерно ~1,000 лишних наносекунд внутри Castle.DynamicProxy используется Reflection со всеми вытекающими последствиями.

В абсолютных значениях это довольно много, однако если код выполняется дольше 50 ns, например, происходит запись в БД или запрос по сети, то ситуация выглядит иначе:

```

public class Bus : Bar

{

public override double GetRandomNumber()

{

Thread.Sleep(100);

return base.GetRandomNumber();

}

}

```

```

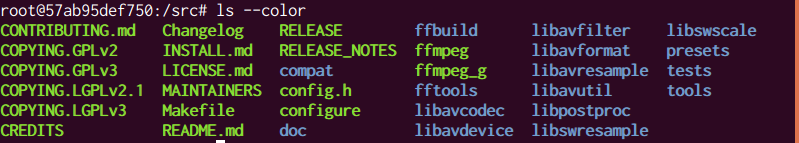

Host Process Environment Information:

BenchmarkDotNet=v0.9.8.0

OS=Microsoft Windows NT 6.2.9200.0

Processor=Intel(R) Core(TM) i7-4710HQ CPU 2.50GHz, ProcessorCount=8

Frequency=2435775 ticks, Resolution=410.5470 ns, Timer=TSC

CLR=MS.NET 4.0.30319.42000, Arch=64-bit RELEASE [RyuJIT]

GC=Concurrent Workstation

JitModules=clrjit-v4.6.1080.0

```

```

Type=InterceptorBenchmarks Mode=Throughput GarbageCollection=Concurrent Workstation

LaunchCount=1 WarmupCount=3 TargetCount=3

```

| Method | Median | StdDev |

| --- | --- | --- |

| CreateInstance | 0.0000 ns | 0.0000 ns |

| CreateClassProxy | 1,972.0032 ns | 8.5611 ns |

| CreateClassProxyWithTarget | 2,246.4208 ns | 5.3436 ns |

| CreateInterfaceProxyWithTarget | 2,063.6905 ns | 41.9450 ns |

| CreateInterfaceProxyWithoutTarget | 2,105.9238 ns | 4.9295 ns |

| Foo\_GetRandomNumber | 11.0409 ns | 0.1306 ns |

| Foo\_InterfaceProxyGetRandomNumber | 51.6061 ns | 0.2764 ns |

| FooClassProxy\_GetRandomNumber | 9.0125 ns | 0.1766 ns |

| BarClassProxy\_GetRandomNumber | 44.8110 ns | 0.4770 ns |

| FooInterfaceProxyWithCallLoggerInterceptor\_GetRandomNumber | 1,756.8129 ns | 75.4694 ns |

| BarClassProxyWithCallLoggerInterceptor\_GetRandomNumber | 1,714.5871 ns | 25.2403 ns |

| FooInterfaceProxyWith2Interceptors\_GetRandomNumber | 2,636.1626 ns | 20.0195 ns |

| BarClassProxyWith2Interceptors\_GetRandomNumber | 2,603.6707 ns | 4.6360 ns |

| **Bus\_GetRandomNumber** | **100,471,410.5375 ns** | **113,713.1684 ns** |

| **BusInterfaceProxyWith2Interceptors\_GetRandomNumber** | **100,539,356.0575 ns** | **89,725.5474 ns** |

| CallLogger\_Intercept | 3,841.4488 ns | 26.3829 ns |

| WriteLine | 859.0076 ns | 34.1630 ns |

Думаю, если заменить *Reflection* на закешированные *LambdaExpression* можно добиться того, что разницы в производительности не будет совсем, но для этого нужно переписать DynamicProxy, добавить поддержку в популярные контейнеры (сейчас перехватчики точно поддерживаются из коробки [Autofac](http://docs.autofac.org/en/latest/advanced/interceptors.html) и [Castle.Windsor](https://github.com/castleproject/Windsor/blob/master/docs/interceptors.md), про остальные не знаю). Сомневаюсь, что это произойдет в ближайшее время.

Поэтому, если в среднем ваши операции выполняются не менее чем 100 ms и три предыдущих минуса вас не пугают, «контейнерное AOP» в C# уже production-ready. | https://habr.com/ru/post/305360/ | null | ru | null |

# YOLO и другие отвязные методологии

YOLO

====

Позвольте поведать вам о совершенно новой методологии, которая радикально изменит ваши подходы в программировании. Итак, прервитесь ненадолго от своего стройного и прямолинейного кода и откройте для себя мир альтернативных IT-методологий.

Вообразите наше восхищение, когда манифест этой новаторской новой методологии попал в наши новостные ленты. Пророк `YDD`, она же `YOLO Driven Development` *Todor Grudev* высек в камне ([на GitHub](https://gist.githubusercontent.com/mariozig/5025613/raw/yolo)) 17 заповедей `YDD`. `YOLO` буквально означает — *You Only Live Once*, или по-русски: `ВЖОР` — *Вы Живете Один Раз*.

Узрите же постулаты `YDD` !

```

# Не рефактори, это плохая практика. ВЖОР

# Не понимать, почему или как что-либо работает - это всегда хорошо. ВЖОР

# Никогда не тестируй собственный код, просто проси других. ВЖОР

# Никто не собирается читать твой код, так что не комментируй его вообще. ВЖОР

# Зачем делать что-то простыми способами, когда можно каждый раз переизобрести велосипед? Готовые и удобные решения для лошков.

# Не изучайте документацию. ВЖОР.

# Не тратье время на постигание кусочков кода. ВЖОР.

# Не пишите спецификации. Хорошо вяжется с методологией YDD.

# Не соблюдайте правила именования. ВЖОР

# Платить за онлайновые обучающие курсы всегда лучше чем обычный поиск и чтение материала. ВЖОР

# Всегда используйте продакшн в качестве любых других окружений. ВЖОР

# Никогда не описывайте то, что вы пытаетесь сделать, просто задавайте хаотичные случайные вопросы по теме как это делается. ВЖОР

# Не делайте отступы. ВЖОР

# Системы контроля версий для слюнтяев. ВЖОР.

# Разработка на системе близкой к системе развертывания - это для слюнтяев. ВЖОР.

# Я обычно не тестирую свой код. Но когда тестирую, я делаю это на продакшне. ВЖОР.

# Настоящие мужики деплоят посредством ftp. ВЖОР.

```

Забудьте все эти древние языческие традиции `TDD` и `BDD`. Новая методология каждый день уберегает вас от надоедливых консультантов! Пользователь [Ruby.zigzo](http://ruby.zigzo.com/2013/02/24/ydd-guidelines-yolo-driven-development/) подытоживает данный `YDD` манифест следующим образом:

```

Конечно же это шутка. Не следуйте приведенным здесь рекомендациям.. или следуйте!

YOLO!

```

Однако, простой поиск на **GitHub** формулировки *"потому что ВЖОР"* выдает свыше **600** результатов, доказывающих, что многие разработчики уже начали применять `ВЖОР`-подходы:

```

(map(lambda __suchwoow:\

map(lambda __because___yolo__:\

__lololol_.__setitem__(( (__because___yolo__)) , (0)),

range(2*(__suchwoow), ((very_math)), __suchwoow

```

Ну уж нет!

==========

Итак, `ВЖОР` — это не ваш метод? Что ж, вот ряд других бодрящих IT методологий, которые можно взять на вооружение.

Голубиная Методология

---------------------

Влетает ваш начальник, гадит на всё вокруг, затем улетает.

ADD (Asshole Driven Development)

--------------------------------

`ADD`, по-русски, `РЧМ` — Разработка Через Чудака.

Старая добрая метода, основные принципы которой — это команды, в которых есть величаший **Ч**удак, который принимает все самые ответственные решения. Разумеется, мудрость, процессы и логика не завезены по-умолчанию.

NDAD (No Developers Allowed in Decisions)

-----------------------------------------

`NDAD` — Разработчикам Не Дано Принимать Решения.

Разработчикам всех видов и мастей строго воспрещается принимать какие-либо решения касательно проектов, начиная от дизайна бек-енда заканчивая сроками, потому что среднее управленческое звено и топ-менеджмент четко знают, чего они хотят, как это будет сделано и как много времени займет реализация.

FDD (Fear Driven Development)

-----------------------------

`FDD` — Разработка Через Устрашение

[Аналитический паралич](https://ru.wikipedia.org/wiki/%D0%90%D0%BD%D0%B0%D0%BB%D0%B8%D1%82%D0%B8%D1%87%D0%B5%D1%81%D0%BA%D0%B8%D0%B9_%D0%BF%D0%B0%D1%80%D0%B0%D0%BB%D0%B8%D1%87), который может замедлить весь проект, так как разработчики боятся ошибиться, поломать сборку или внести баги. Источники беспокойства разработчика могут быть связаны с затруднениями в обмене информацией или указанием команде на то, что незаменимых людей нет.

CYAE (Cover Your Ass Engineering)

---------------------------------

`CYAE` — по-русски, `МХСКИ` — Моя-Хата-С-Краю Инженерия.

Данную методологию красноречиво описал за нас [Scott Berkun](http://scottberkun.com): основной движущей силой персональных усилий является стремление сделать так, что когда дерьмо полетит на вентилятор, вы не окажетесь крайним.

Пожалуйста, поделитесь в комментариях своими избранными и любопытными методологиями разработки, а также курьезными случаями или историями о коллегах-апологетах "продвинутых подходов".

От переводчика

==============

Пара примечаний и моментов:

1. Очевидно, YOLO уходит корнями в [одноименный мем](https://memepedia.ru/yolo/), где фраза **YOLO** по сути оправдывала любой безрассудный или очень нелогичный и дурацкий поступок и поведение.

2. `YOLO`-методология может прекрасно проявить себя в сочетании c `YOBA`-методологией. Попробуйте и поделитесь опытом! | https://habr.com/ru/post/436242/ | null | ru | null |

# PHP дженерики уже сегодня (ну, почти)

Если спросить PHP-разработчиков, какую возможность они хотят увидеть в PHP, большинство назовет дженерики.

Поддержка дженериков на уровне языка была бы наилучшим решением. Но, реализовать их [сложно](https://www.youtube.com/watch?v=teKnckg5x7I&feature=youtu.be&t=1121). Мы надеемся, что однажды нативная поддержка станет частью языка, но, вероятно, этого придется ждать несколько лет.

Данная статья покажет, как, используя существующие инструменты, в некоторых случаях с минимальными модификациями, мы можем получить мощь дженериков в PHP уже сейчас.

> От переводчика: Я умышленно использую кальку с английского "дженерики", т.к. ни разу в общении не слышал, чтобы кто-то называл это "обобщенным программированием".

Содержание:

-----------

* [Что такое дженерики](#what-are-generics)

* [Как внедрить дженерики без поддержки языка](#how-to-implement-generics-without-language-level-support)

* [Стандартизация](#agreeing-on-a-standard)

* [Поддержка инструментами](#tool-support)

* [Поддержка стороннего кода](#third-party-code-support)

* [Дальнейшие шаги](#next-steps)

* [Ограничения](#limitations)

* [Почему бы вам просто не добавить дженерики в язык?](#why-dont-you-just-add-generics-to-the-language)

* [Что, если мне не нужны дженерики?](#what-if-i-dont-want-generics)

Что такое дженерики

-------------------

Данный раздел покрывает краткое введение в [дженерики](https://ru.wikipedia.org/wiki/%D0%9E%D0%B1%D0%BE%D0%B1%D1%89%D1%91%D0%BD%D0%BD%D0%BE%D0%B5_%D0%BF%D1%80%D0%BE%D0%B3%D1%80%D0%B0%D0%BC%D0%BC%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5).

Ссылки для чтения:

* [RFC](https://wiki.php.net/rfc/generics) на добавление PHP дженериков

* Поддержка дженериков в [Phan](https://github.com/phan/phan/wiki/Generic-Types)

* Дженерики и [шаблоны](https://psalm.dev/docs/templated_annotations/) в Psalm

### Простейший пример

Так как на данный момент невозможно определить дженерики на уровне языка, нам придется воспользоваться другой прекрасной возможностью — определить их в докблоках.

Мы уже используем этот вариант во множестве проектов. Взгляните на этот пример:

```

/**

* @param string[] $names

* @return User[]

*/

function createUsers(iterable $names): array { ... }

```

В коде выше мы делаем то, что возможно на уровне языка. Мы определили параметр `$names` как нечто, что может быть перечислено. Также мы указали, что функция вернет массив. PHP выбросит `TypeError`, если типы параметров и возвращаемое значение не соответствуют.

Докблок улучшает понимание кода. `$names` должны быть строками, а функция обязана вернуть массив объектов `User`. Сам по себе PHP не делает таких проверок. А вот IDE, такие как PhpStorm, понимают эту нотацию и предупреждают разработчика о том, что дополнительный контракт не соблюден. В добавок к этому, инструменты статического анализа, такие как Psalm, PHPStan и Phan могут валидировать корректность переданных данных в функцию и из неё.

### Дженерики для определения ключей и значений перечисляемых типов

Выше приведен самый простой пример дженерика. Более сложные способы включают возможность указания типа его ключей, наравне с типом значений. Ниже один из способов такого описания:

```

/**

* @return array

\*/

function getUsers(): array { ... }

```

Здесь сказано, что массив возвращаемых функцией `getUsers` имеет строковые ключи и значения типа `User`.

Статические анализаторы, такие как Psalm, PHPStan и Phan понимают данную аннотацию и учтут ее при проверке.

Рассмотрим следующий код:

```

/**

* @return array

\*/

function getUsers(): array { ... }

function showAge(int $age): void { ... }

foreach(getUsers() as $name => $user) {

showAge($name);

}

```

Статические анализаторы выбросят предупреждение на вызове `showAge` с ошибкой, наподобие такой: `Argument 1 of showAge expects int, string provided`.

К сожалению, на момент написания статьи PhpStorm этого не умеет.

### Более сложные дженерики

Продолжим углубляться в тему дженериков. Рассмотрим объект, представляющий собой [стек](https://ru.wikipedia.org/wiki/%D0%A1%D1%82%D0%B5%D0%BA) :

```

class Stack

{

public function push($item): void { ... }

public function pop() { ... }

}

```

Стек может принимать любой тип объекта. Но что, если мы хотим ограничить стек только объектами типа `User`?

Psalm и Phan поддерживают следующие аннотации:

```

/**

* @template T

*/

class Stack

{

/**

* @param T $item

*/

public function push($item): void;

/**

* @return T

*/

public function pop();

}

```

Докблок используется для передачи дополнительной информации о типах, например:

```

/** @var Stack $userStack \*/

$stack = new Stack();

Means that $userStack must only contain Users.

```

Psalm, при анализе следующего кода:

```

$userStack->push(new User());

$userStack->push("hello");

```

Будет жаловаться на 2 строку с ошибкой `Argument 1 of Stack::push expects User, string(hello) provided.`

На данный момент PhpStorm не поддерживает данную аннотацию.

На самом деле, мы покрыли только часть информации о дженериках, но на данный момент этого достаточно.

Как внедрить дженерики без поддержки языка

------------------------------------------

Необходимо выполнить следующие действия:

* На уровне сообщества определите стандарты дженериков в докблоках (например, новый PSR, либо возврат назад, к PSR-5)

* Добавьте докблок-аннотации в код

* Используйте IDE, понимающие эти обозначения, чтобы проводить статический анализ в режиме реального времени, с целью поиска несоответствий.

* Используйте инструменты статического анализа (такие как Psalm) как один из шагов CI, чтобы отловить ошибки.

* Определите метод для передачи информации о типах в сторонних библиотеках.

Стандартизация

--------------

На данный момент, сообщество PHP уже неофициально приняло данный формат дженериков (они поддерживаются большинством инструментов и их значение понятно большинству):

```

/**

* @return User[]

*/

function getUsers(): array { ... }

```

Тем не менее, у нас есть проблемы с простыми примерами, вроде такого:

```

/**

* @return array

\*/

function getUsers(): array { ... }

```

Psalm его понимает, и знает, какой тип у ключа и значения возвращаемого массива.

На момент написания статьи, PhpStorm этого не понимает. Используя данную запись я упускаю мощь статического анализа в реальном времени, предлагаемую PhpStorm-ом.

Рассмотрим код ниже. PhpStorm не понимает, что `$user` имеет тип `User`, а `$name` — строковой:

```

foreach(getUsers() as $name => $user) {

...

}

```

Если бы я выбрал Psalm как инструмент статического анализа, я бы мог написать следующее:

```

/**

* @return User[]

* @psalm-return array

\*/

function getUsers(): array { ... }

```

Psalm все это понимает.

PhpStorm знает, что переменная `$user` относится к типу `User`. Но, он все еще не понимает, что ключ массива относится к строке. Phan и PHPStan не понимают специфичные аннотации psalm. Максимум, который они понимают в данном коде такой же, как в PhpStorm: the type of `$user`

Вы можете утверждать, что PhpStorm'у просто стоит принять соглашение `array`. Я с вами не соглашусь, т.к. считаю, что это диктование стандартов — задача языка и сообщества, а инструменты лишь должны им следовать.

Я предполагаю, что описанное выше соглашение будет тепло встречено большей частью PHP-сообщества. Той, которую интересуют дженерики. Тем не менее, все становится гораздо сложнее, когда речь идет о шаблонах. В настоящее время ни PHPStan, ни PhpStorm не поддерживают шаблоны. В отличие от Psalm и Phan. Их назначение схоже, но если вы копнете глубже, то поймете, что реализации немного отличаются.

Каждый из представленных вариантов является своего рода компромиссом.

Проще говоря, есть потребность в соглашении о формате записи дженериков:

* Они улучшают жизнь разработчиков. Разработчики могут добавить дженерики в свой код и получить от этого пользу.

* Разработчики могут использовать инструменты, которые им больше нравятся и переключаться между ними (инструментами) по мере необходимости.

* Создатели инструментов могут создавать эти самые инструменты, понимая пользу для сообщества и не опасаясь того, что что-то изменится, или что их обвинят в "неправильном подходе".

Поддержка инструментами

-----------------------

Psalm имеет всю необходимую функциональность для проверки дженериков. Phan вроде как, тоже.

Я уверен, что PhpStorm внедрит дженерики как только в сообществе появится соглашении о едином формате.

Поддержка стороннего кода

-------------------------

Завершающая часть головоломки дженериков — это добавление поддержки сторонних библиотек.

Надеюсь, как только стандарт определения дженериков появится, большинство библиотек внедрят его. Тем не менее, это произойдет не сразу. Часть библиотек используются, но не имеют активной поддержки. При использовании статических анализаторов для валидации типов в дженериках важно, чтобы были определены все функции, которые принимают или возвращают эти дженерики.

Что произойдет, если ваш проект будет опираться на работу сторонних библиотек, не имеющих поддержку дженериков?

К счастью, данная проблема уже решена, и решением этим являются функции-заглушки. Psalm, [Phan](https://github.com/phan/phan/wiki/How-To-Use-Stubs) и [PhpStorm](https://github.com/JetBrains/phpstorm-stubs/tree/master/standard) поддерживают заглушки.

Заглушки — это обычные файлы, содержащие сигнатуры функций и методов, но не реализующие их. Добавляя докблоки в заглушки, инструменты статического анализа получают необходимую им дополнительную информацию. Например, если у вас имеется класс стека без тайпхинтов и дженериков, вроде такого.

```

class Stack

{

public function push($item)

{

/* some implementation */

}

public function pop()

{

/* some implementation */

}

}

```

Вы можете создать файл-заглушку, имеющую идентичные методы, но с добавлением докблоков и без реализации функций.

```

/**

* @template T

*/

class Stack

{

/**

* @param T $item

* @return void

*/

public function push($item);

/**

* @return T

*/

public function pop();

}

```

Когда статический анализатор видит класс стека, он берет информацию о типах из заглушки, а не из реального кода.

Возможность просто делиться кодом заглушек (например, через composer) была бы крайне полезна, т.к. позволяла бы делиться проделанной работой.

Дальнейшие шаги

---------------

Сообществу нужно отойти от соглашений и определить стандарты.

Может быть, лучшим вариантом будет PSR про дженерики?

Или, может быть, создатели основных статических анализаторов, PhpStorm, других IDE и кто-либо из людей, причастных к разработке PHP (для контроля) могли бы разработать стандарт, которым бы пользовались все.

Как только стандарт появится, все смогут помочь с добавлением дженериков в существующие библиотеки и проекты, создавая Pull Request'ы. А там, где это невозможно, разработчики могут писать и обмениваться заглушками.

Когда все будет сделано, мы сможем пользоваться инструментами вроде PhpStorm для проверки дженериков в режиме реального времени, пока пишем код. Мы можем использовать инструменты статического анализа как часть нашего CI в качестве гарантии безопасности.

Кроме того, дженерики могут быть реализованы и в PHP (ну, почти).

Ограничения

-----------

Есть ряд ограничений. PHP — это динамичный язык, который позволяет делать много "магических" вещей, например [таких](https://www.youtube.com/watch?v=RfXO5Y-QqPo). Если вы используете слишком много магии PHP, может случиться так, что статические анализаторы не смогут точно извлечь все типы в системе. Если какие-либо типы неизвестны, то инструменты не смогут во всех случаях корректно использовать дженерики.

Тем не менее, основное применение подобного анализа — проверка вашей бизнес-логики. Если вы пишете чистый код, то не стоит использовать слишком много магии.

Почему бы вам просто не добавить дженерики в язык?

--------------------------------------------------

Это было бы наилучшим вариантом. У PHP открытый исходный код, и никто не мешает вам склонировать исходники и реализовать дженерики!

Что, если мне не нужны дженерики?

---------------------------------

Просто игнорируйте все вышесказанное. Одно из главных преимуществ PHP в том, что он гибок в выборе подходящего уровня сложности реализации в зависимости от того, что вы создаете. С одноразовым кодом не нужно думать о таких вещах, как тайпхинтинг. А вот в больших проектах стоит использовать такие возможности.

> Спасибо всем дочитавшим до этого места. Буду рад вашим замечаниям в ЛС.

>

>

>

> **UPD**: [ghost404](https://habr.com/ru/users/ghost404/) в комментариях отметил, что *PHPStan с версии 0.12.x понимает psalm аннотации и поддерживает дженерики* | https://habr.com/ru/post/456466/ | null | ru | null |

# (Архив) Matreshka.js — MK.Object

**Статья устарела. В [новой документации](http://ru.matreshka.io/) содержится самая актуальная информация из этого поста. См. [Matreshka.Object](http://ru.matreshka.io/#Matreshka.Object).**

* [Введение](http://habrahabr.ru/post/196146/)

* [Наследование](http://habrahabr.ru/post/200078/)

* **MK.Object**

* [MK.Array](http://habrahabr.ru/post/198212/)

* [Matreshka.js v0.1](http://habrahabr.ru/post/217241/)

* [Matreshka.js v0.2](http://habrahabr.ru/post/231333/)

* [Реализация TodoMVC](http://habrahabr.ru/post/231347/)

В предыдущих статьях мы познакомились с общими принципами Матрешки: привязка элементов, события, наследование. В конце предыдущей статьи я задал себе вопрос: «Как разграничить состояние приложения (показать ли пользователю пароль) и данные приложения (логин, пароль, «запомнить меня»)».

Класс, который нам в этом поможет, называется `MK.Object`, который наследуется от класса `Matreshka`. Идея проста: у нас есть множество ключей, отвечающих за данные в экземпляре класса и мы считаем, что остальные свойства отвечают лишь за состояние приложения и не являются бизнес моделью.

**Как устроено множество ключей**За множество ключей отвечает псевдоприватное свойство `._keys`, которое является объектом со значениями, которые нам безразличны. Массив бы нам не подошел, потому что, перед добавлением нового ключа надо было бы проверять, есть ли ключ в массиве, а при удалении, пришлось бы узнавать индекс, затем сдвигать следующие элементы. В случае объекта, мы получаем полноценное множество строк, для добавления нового ключа не нужно проверять его наличие, а для удаления требуется лишь вызов оператора `delete`.

Для того, чтоб установить свойство, которое отвечает за данные, используется метод `.jset`:

```

var mkObject = new MK.Object();

mkObject.jset( 'a', 1 );

console.log( mkObject.toJSON() ); // { a: 1 }

```

Документация к **.jset**: [finom.github.io/matreshka/docs/Matreshka.Object.html#jset](http://finom.github.io/matreshka/docs/Matreshka.Object.html#jset)

Документация к **.toJSON**: [finom.github.io/matreshka/docs/Matreshka.Object.html#toJSON](http://finom.github.io/matreshka/docs/Matreshka.Object.html#toJSON)

Теперь можем работать с новым свойством как обычно:

```

var mkObject = new MK.Object();

mkObject.jset( 'a', 1 );

mkObject.a = 2;

console.log( mkObject.toJSON() ); // { a: 2 }

```

В том числе, мы можем использовать унаследованные от класса `Matreshka` методы:

```

mkObject.bindNode( 'a', '.my-element' );

mkObject.on( 'change:a', handler );

```

Если мы установим свойство, не добавив его ключ в множество ключей, в результате работы метода `.toJSON` мы не увидим этого свойства:

```

var mkObject = new MK.Object();

mkObject.jset( 'a', 1 );

mkObject.b = 3;

console.log( mkObject.toJSON() ); // { a: 1 }

```

Можно добавить ключи в список ключей, используя метод `.addJSONKeys`

Дока: [finom.github.io/matreshka/docs/Matreshka.Object.html#addJSONKeys](http://finom.github.io/matreshka/docs/Matreshka.Object.html#addJSONKeys)

```

mkObject.addJSONKeys( 'b', 'c' );

```

Здесь следует важное правило: если вы не уверены наверняка, какие свойства должны попадать в результат работы функции `.toJSON`, всегда используйте `.jset` вместо обычного присваивания. Если ключи известны, то, лично я, предпочитаю всегда задавать данные по умолчанию:

```

var MyClass = Class({

'extends': MK.Object,

constructor: function( data ) {

this

.initMK()

.jset({ // данные по умолчанию

a: 1,

b: 2,

c: 3

})

.set( data ) // кастомные данные (data - обычный объект с данными)

;

}

});

```

Обратите внимание на вызов `.initMK`. Здесь он инициализирует не только объекты событий и «специальных» свойств, но и объект-множество ключей. Кроме этого, он добавляет необходимые обработчики событий вызывая событие `"modify"` при изменении данных. Пример:

```

var mkObject = new MK.Object();

mkObject.jset({

a: 1,

b: 2

});

mkObject.c = 3;

mkObject.on( 'modify', function() {

alert( 'Data is changed' );

});

mkObject.a = 4; // вызывает обработчик

mkObject.b = 5; // вызывает обработчик

mkObject.c = 6; // обработчик не вызывается, так как ключ "c" не обозначен, как данные

```

Если передать классу аргумент в виде объекта, он интерпретирует его, как данные:

```

var mkObject = new MK.Object({ a: 1, b: 2 });

// то же самое, что и

var mkObject = new MK.Object();

mkObject.jset({ a: 1, b: 2 });

```

Перебрать данные можно с помощью метода `.each`:

```

var mkObject = new MK.Object();

mkObject.jset({

a: 1,

b: 2

});

mkObject.c = 3;

mkObject.each( function( item, key ) {

console.log( key );

}); // выведет 'a', 'b'

```

Дока: [finom.github.io/matreshka/docs/Matreshka.Object.html#each](http://finom.github.io/matreshka/docs/Matreshka.Object.html#each)

Проверить, есть ли в объекте какое-нибудь свойство можно с помощью метода `.hasOwnProperty`

```

var mkObject = new MK.Object();

mkObject.jset( 'a', 1 );

mkObject.b = 2;

alert( mkObject.hasOwnProperty( 'a' ) ); // true

alert( mkObject.hasOwnProperty( 'b' ) ); // false ('b' не является данными)

```

Это позволяет юзать конструкцию `for..in`, как для обычного объекта:

```

for( var i in mk ) if( mk.hasOwnProperty( i ) ) {

doSomething(i, mk[i])

}

```

**UPD**: Не работает в восьмом осле из-за ограничений `Object.defineProperty`

Есть еще ряд методов, имена которых говорят сами за себя:

[`.keyOf`](http://finom.github.io/matreshka/docs/Matreshka.Object.html#keyOf), который ищет ключ по значению и возвращает ключ (аналог `.indexOf` для массива).

[`.keys`](http://finom.github.io/matreshka/docs/Matreshka.Object.html#keys), возвращающий массив ключей.

[`.removeJSONKeys`](http://finom.github.io/matreshka/docs/Matreshka.Object.html#removeJSONKeys), удаляющий ключи из множества ключей, отвечающих за данные.

Взгляните на измененный пример из предыдущей статьи: [jsbin.com/disigiza/1/edit](http://jsbin.com/disigiza/1/edit)

В конструкторе мы задаём данные по умолчанию:

```

...

constructor: function () {

this

.initMK()

.jset({ // вот здесь

userName: '',

password: '',

rememberMe: true

})

.bindings()

.events();

},

...

```

А затем, вместо того, чтоб вручную конструировать объект, который должен быть послан на сервер, мы вызываем метод `.toJSON`:

```

...

login: function () {

if (this.isValid) {

alert( JSON.stringify( this.toJSON() ) );

}

return this;

}

...

```

#### В завершение

Теперь мы знаем, как отделить данные Матрешки от состояний, которые не интересны бекенду. Замечательно. Но что, если нам нужно множество данных? Что-то типа массива или коллекции из Backbone.js. Решение — класс `MK.Array`, о котором я расскажу в следующей статье.

Спасибо, что прочли статью до конца. Всем добра и хорошего кодинга. | https://habr.com/ru/post/196886/ | null | ru | null |

# Зачем в npm 7 оставили поддержку package-lock.json?

Мне, с того момента, как мы объявили о том, что в npm 7 будут поддерживаться файлы `yarn.lock`, несколько раз задавали один и тот же вопрос. Он звучал так: «Зачем тогда оставлять поддержку `package-lock.json`? Почему бы не использовать только `yarn.lock`?».

[](https://habr.com/ru/company/ruvds/blog/509196/)

Краткий ответ на этот вопрос выглядит так: «Потому что `yarn.lock` не полностью удовлетворяет нуждам npm. Если полагаться исключительно на него, это ухудшит возможности npm по формированию оптимальных схем установки пакетов и возможности по добавлению в проект нового функционала». Ответ более подробный представлен в данном материале.

Базовая структура файла yarn.lock

---------------------------------

Файл `yarn.lock` представляет собой описание соответствия спецификаторов зависимостей пакетов и метаданных, описывающих разрешение этих зависимостей. Например:

```

[email protected]:

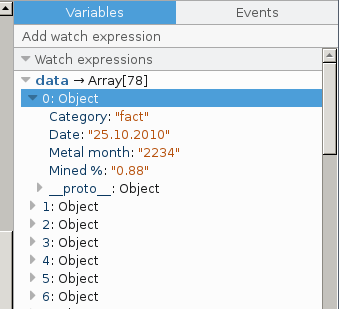

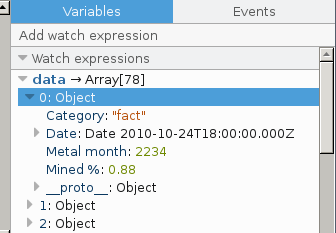

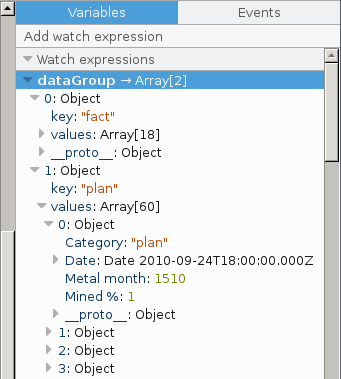

version "1.0.2"

resolved "https://registry.yarnpkg.com/mkdirp/-/mkdirp-1.0.2.tgz#5ccd93437619ca7050b538573fc918327eba98fb"

integrity sha512-N2REVrJ/X/jGPfit2d7zea2J1pf7EAR5chIUcfHffAZ7gmlam5U65sAm76+o4ntQbSRdTjYf7qZz3chuHlwXEA==

```

В этом фрагменте сообщается следующее: «Любая зависимость от `[email protected]` должна разрешаться именно в то, что указано здесь». Если несколько пакетов зависят от `[email protected]`, то все эти зависимости будут разрешены одинаково.

В npm 7, если в проекте существует файл `yarn.lock`, npm будет пользоваться содержащимися в нём метаданными. Значения полей `resolved` сообщат npm о том, откуда ему нужно загружать пакеты, а значения полей `integrity` будут использоваться для проверки того, что получено, на предмет соответствия этого тому, что ожидалось получить. Если пакеты добавляются в проект или удаляются из него, соответствующим образом обновляется содержимое `yarn.lock`.

Npm при этом, как и прежде, создаёт файл `package-lock.json`. Если в проекте присутствует этот файл, он будет использоваться как авторитетный источник сведений о структуре (форме) дерева зависимостей.

Вопрос тут заключается в следующем: «Если `yarn.lock` достаточно хорош для менеджера пакетов Yarn — почему npm не может просто использовать этот файл?».

Детерминированные результаты установки зависимостей

---------------------------------------------------

Результаты установки пакетов с помощью Yarn гарантированно будут одними и теми же при использовании одного и того же файла `yarn.lock` и одной и той же версии Yarn. Применение различных версий Yarn может привести к тому, что файлы пакетов на диске будут расположены по-разному.

Файл `yarn.lock` гарантирует детерминированное разрешение зависимостей. Например, если `[email protected]` разрешается в `[email protected]`, то, учитывая использование одного и того же файла `yarn.lock`, это будет происходить всегда, во всех версиях Yarn. Но это (как минимум, само по себе) не эквивалентно гарантии детерминированности структуры дерева зависимостей!

Рассмотрим следующий граф зависимостей:

```

root -> (foo@1, bar@1)

foo -> (baz@1)

bar -> (baz@2)

```

Вот пара схем деревьев зависимостей, каждое из которых можно признать корректным.

Дерево №1:

```

root

+-- foo

+-- bar

| +-- baz@2

+-- baz@1

```

Дерево №2:

```

+-- foo

| +-- baz@1

+-- bar

+-- baz@2

```

Файл `yarn.lock` не может сообщить нам о том, какое именно дерево зависимостей нужно использовать. Если в пакете `root` будет выполнена команда `require(«baz»)` (что некорректно, так как эта зависимость не отражена в дереве зависимостей), файл `yarn.lock` не гарантирует правильного выполнения этой операции. Это — форма детерминизма, которую может дать файл `package-lock.json`, но не `yarn.lock`.

На практике, конечно, так как у Yarn, в файле `yarn.lock`, есть вся информация, необходимая для того чтобы выбрать подходящую версию зависимости, выбор является детерминированным до тех пор, пока все используют одну и ту же версию Yarn. Это означает, что выбор версии всегда делается одним и тем же образом. Код не меняется до тех пор, пока кто-нибудь его не изменит. Надо отметить, что Yarn достаточно интеллектуален для того, чтобы, при создании дерева зависимостей, не зависеть от расхождений, касающихся времени загрузки манифеста пакета. Иначе детерминированность результатов гарантировать было бы нельзя.

Так как это определяется особенностями алгоритмов Yarn, а не структурами данных, имеющимися на диске (не идентифицирующих алгоритм, который будет использован), эта гарантия детерминизма, в своей основе, слабее, чем гарантия, которую даёт `package-lock.json`, содержащий полное описание структуры дерева зависимостей, хранящегося на диске.

Другими словами, на то, как именно Yarn строит дерево зависимостей, влияют файл `yarn.lock` и реализация самого Yarn. А в npm на то, каким будет дерево зависимостей, влияет только файл `package-lock.json`. Благодаря этому структуру проекта, описанную в `package-lock.json`, становится сложнее случайно нарушить, пользуясь разными версиями npm. А если же в файл будут внесены изменения (может быть — по ошибке, или намеренно), эти изменения будут хорошо заметны в файле при добавлении его изменённой версии в репозиторий проекта, в котором используется система контроля версий.

Вложенные зависимости и дедупликация зависимостей

-------------------------------------------------

Более того, существует целый класс ситуаций, предусматривающих работу с вложенными зависимостями и дедупликацию зависимостей, когда файл `yarn.lock` не способен точно отразить результат разрешения зависимостей, который будет, на практике, использоваться npm. Причём, это справедливо даже для тех случаев, когда npm использует `yarn.lock` в качестве источника метаданных. В то время как npm использует `yarn.lock` как надёжный источник информации, npm не рассматривает этот файл в роли авторитетного источника сведений об ограничениях, накладываемых на версии зависимостей.

В некоторых случаях Yarn формирует дерево зависимостей с очень высоким уровнем дублирования пакетов, а нам это ни к чему. В результате оказывается, что точное следование алгоритму Yarn в подобных случаях — это далеко не идеальное решение.

Рассмотрим следующий граф зависимостей:

```

root -> ([email protected], [email protected], [email protected])

[email protected] -> ()

[email protected] -> ()

[email protected] -> ([email protected], [email protected])

[email protected] -> ()

[email protected] -> ([email protected])

```

Проект `root` зависит от версий `1.x` пакетов `x`, `y` и `z`. Пакет `y` зависит от `[email protected]` и от `[email protected]`. У пакета `z` версии 1 нет зависимостей, но этот же пакет версии 2 зависит от `[email protected]`.

На основе этих сведений npm формирует следующее дерево зависимостей:

```

root ([email protected], [email protected], [email protected]) <-- здесь зависимость [email protected]

+-- x 1.2.0 <-- [email protected] разрешается в 1.2.0

+-- y ([email protected], [email protected])

| +-- x 1.1.0 <-- [email protected] разрешается в 1.1.0

| +-- z 2.0.0 ([email protected]) <-- здесь зависимость [email protected]

+-- z 1.0.0

```

Пакет `[email protected]` зависит от `[email protected]`, то же самое можно сказать и о `root`. Файл `yarn.lock` сопоставляет `[email protected]` c `1.2.0`. Однако зависимость пакета `z`, где тоже указано `[email protected]`, вместо этого, будет разрешена в `[email protected]`.

В результате, даже хотя зависимость `[email protected]` описана в `yarn.lock`, где указано, что она должна разрешаться в версию пакета `1.2.0`, имеется второй результат разрешения `[email protected]` в пакет версии `1.1.0`.

Если запустить npm с флагом `--prefer-dedupe`, то система пойдёт на шаг дальше и установит лишь один экземпляр зависимости `x`, что приведёт к формированию следующего дерева зависимостей:

```

root ([email protected], [email protected], [email protected])

+-- x 1.1.0 <-- [email protected] для всех зависимостей разрешается в версию 1.1.0

+-- y ([email protected], [email protected])

| +-- z 2.0.0 ([email protected])

+-- z 1.0.0

```

Это минимизирует дублирование зависимостей, получившееся дерево зависимостей фиксируется в файле `package-lock.json`.

Так как файл `yarn.lock` фиксирует лишь порядок разрешения зависимостей, а не результирующее дерево пакетов, Yarn сформирует такое дерево зависимостей:

```

root ([email protected], [email protected], [email protected]) <-- здесь зависимость [email protected]

+-- x 1.2.0 <-- [email protected] разрешается в 1.2.0

+-- y ([email protected], [email protected])

| +-- x 1.1.0 <-- [email protected] разрешается в 1.1.0

| +-- z 2.0.0 ([email protected]) <-- [email protected] тут бы подошёл, но...

| +-- x 1.2.0 <-- Yarn создаёт дубликат ради выполнения того, что описано в yarn.lock

+-- z 1.0.0

```

Пакет `x`, при использовании Yarn, появляется в дереве зависимостей три раза. При применении npm без дополнительных настроек — 2 раза. А при использовании флага `--prefer-dedupe` — лишь один раз (хотя тогда в дереве зависимостей оказывается не самая новая и не самая лучшая версия пакета).

Все три получившихся дерева зависимостей можно признать корректными в том смысле, что каждый пакет получит те версии зависимостей, которые соответствуют заявленным требованиям. Но нам не хотелось бы создавать деревья пакетов, в которых слишком много дубликатов. Подумайте о том, что будет, если `x` — это большой пакет, у которого есть много собственных зависимостей!

В результате имеется единственный способ, используя который, npm может оптимизировать дерево пакетов, поддерживая, в то же время, создание детерминированных и воспроизводимых деревьев зависимостей. Этот способ заключается в применении lock-файла, принцип формирования и использования которого на фундаментальном уровне отличается от `yarn.lock`.

Фиксация результатов реализации намерений пользователя

------------------------------------------------------

Как уже было сказано, в npm 7 пользователь может использовать флаг `--prefer-dedupe` для того чтобы был бы применён алгоритм генерирования дерева зависимостей, при выполнении которого приоритет отдаётся дедупликации зависимостей, а не стремлению всегда устанавливать самые свежие версии пакетов. Применение флага `--prefer-dedupe` обычно идеально подходит в ситуациях, когда дублирование пакетов нужно свести к минимуму.

Если используется этот флаг, то итоговое дерево для вышеприведённого примера будет выглядеть так:

```

root ([email protected], [email protected], [email protected]) <-- здесь зависимость [email protected]

+-- x 1.1.0 <-- [email protected] разрешается в 1.1.0 во всех случаях

+-- y ([email protected], [email protected])

| +-- z 2.0.0 ([email protected]) <-- здесь зависимость [email protected]

+-- z 1.0.0

```

В данном случае npm видит, что даже хотя `[email protected]` — это самая свежая версия пакета, удовлетворяющая требованию `[email protected]`, вместо неё вполне можно выбрать `[email protected]`. Выбор этой версии приведёт к меньшему уровню дублирования пакетов в дереве зависимостей.

Если не фиксировать структуру дерева зависимостей в lock-файле, то каждому программисту, работающему над проектом в команде, пришлось бы настраивать свою рабочую среду точно так же, как её настраивают остальные члены команды. Только это позволит ему получить тот же результат, что и остальные. Если «реализация» механизма построения дерева зависимостей может быть изменена подобным способом, это даёт пользователям npm серьёзные возможности по оптимизации зависимостей в расчёте на собственные специфические нужды. Но, если результаты создания дерева зависят от реализации системы, это делает невозможным создание детерминированных деревьев зависимостей. Именно к этому приводит использование файла `yarn.lock`.

Вот ещё несколько примеров того, как дополнительные настройки npm способны приводить к созданию отличающихся друг от друга деревьев зависимостей:

* `--legacy-peer-deps`, флаг, который заставляет npm полностью игнорировать `peerDependencies`.

* `--legacy-bundling`, флаг, говорящий npm о том, что он не должен даже пытаться сделать дерево зависимостей более «плоским».

* `--global-style`, флаг, благодаря которому всех транзитивные зависимости устанавливаются в виде вложенных зависимостей, в папках зависимостей более высокого уровня.

Захват и фиксация результатов разрешения зависимостей и расчёт на то, что при формировании дерева зависимостей будет использован один и тот же алгоритм, не работают в условиях, когда мы даём пользователям возможность настраивать механизм построения дерева зависимостей.

Фиксация же структуры готового дерева зависимостей позволяет нам давать в распоряжение пользователей подобные возможности и при этом не нарушать процесс построения детерминированных и воспроизводимых деревьев зависимостей.

Производительность и полнота данных

-----------------------------------

Файл `package-lock.json` приносит пользу не только тогда, когда нужно обеспечить детерминированность и воспроизводимость деревьев зависимостей. Мы, кроме того, полагаемся на этот файл для отслеживания и хранения метаданных пакетов, значительно экономя время, которое иначе, с использованием только `package.json`, ушло бы на работу с реестром npm. Так как возможности файла `yarn.lock` сильно ограничены, в нём нет метаданных, которые нам нужно постоянно загружать.

В npm 7 файл `package-lock.json` содержит всё, что нужно npm для полного построения дерева зависимостей проекта. В npm 6 эти данные хранятся не так удобно, поэтому, когда мы сталкиваемся со старым lock-файлом, нам приходится нагружать систему дополнительной работой, но это делается, для одного проекта, лишь один раз.

В результате, даже если в `yarn.lock` и были записаны сведения о структуре дерева зависимостей, нам приходится использовать другой файл для хранения дополнительных метаданных.

Будущие возможности

-------------------

То, о чём мы тут говорили, может серьёзно измениться, если учитывать различные новые подходы к размещению зависимостей на дисках. Это — pnpm, yarn 2/berry и PnP Yarn.

Мы, работая над npm 8, собираемся исследовать подход к формированию деревьев зависимостей, основанный на виртуальной файловой системе. Эта идея смоделирована в Tink, работоспособность концепции подтверждена в 2019 году. Мы, кроме того, обсуждаем идею перехода на что-то вроде структуры, используемой pnpm, хотя это, в некотором смысле, даже более масштабное кардинальное изменение, чем использование виртуальной файловой системы.

Если все зависимости находятся в некоем центральном хранилище, а вложенные зависимости представлены лишь символьными ссылками или виртуальной файловой системой, тогда моделирование структуры дерева зависимостей было бы для нас не таким важным вопросом. Но нам всё ещё нужно больше метаданных, чем способен предоставить файл `yarn.lock`. В результате больше смысла имеет обновление и рационализация существующего формата файла `package-lock.json`, а не полный переход на `yarn.lock`.

Это — не статья, которую можно было бы назвать «О вреде yarn.lock»

------------------------------------------------------------------

Мне хотелось бы особо отметить то, что, судя по тому, что я знаю, Yarn надёжно создаёт корректные деревья зависимостей проектов. И, для определённой версии Yarn (на момент написания материала это относится ко всем свежим версиям Yarn), эти деревья являются, как и при использовании npm, полностью детерминированными.

Файла `yarn.lock` достаточно для создания детерминированных деревьев зависимостей с использованием одной и той же версии Yarn. Но мы не можем полагаться на механизмы, зависящие от реализации менеджера пакетов, учитывая использование подобных механизмов во многих инструментах. Это ещё более справедливо, если учесть то, что реализация формата файла `yarn.lock` нигде формально не документирована. (Это — не проблема, уникальная для Yarn, в npm сложилась такая же ситуация. Документирование форматов файлов — это довольно серьёзная работа.)

Лучший способ обеспечения надёжности построения строго детерминированных деревьев зависимостей, это, в долгосрочной перспективе, фиксация результатов разрешения зависимостей. При этом не стоит полагаться на веру в то, что будущие реализации менеджера пакетов будут, при разрешении зависимостей, идти тем же путём, что и предыдущие реализации. Подобный подход ограничивает наши возможности по конструированию оптимизированных деревьев зависимостей.

Отклонения от изначально зафиксированной структуры дерева зависимостей должны быть результатом явно выраженного желания пользователя. Такие отклонения должны сами себя документировать, внося изменения в зафиксированные ранее данные о структуре дерева зависимостей.

Только `package-lock.json`, или механизм, подобный этому файлу, способен дать npm такие возможности.

**Каким менеджером пакетов вы пользуетесь в своих JavaScript-проектах?**

[](http://ruvds.com/ru-rub?utm_source=habr&utm_medium=perevod&utm_campaign=npm-package-lock) | https://habr.com/ru/post/509196/ | null | ru | null |

# Конституция РФ в виде сервиса ежедневных напоминаний

Вчера в отечестве прошел день Конституции, нашего основополагающего закона. У Конституции юбилей, ей 20 лет.

[Описание из вики](http://ru.wikipedia.org/wiki/%CA%EE%ED%F1%F2%E8%F2%F3%F6%E8%FF):

*Конститу́ция (от лат. constitutio — «устройство») — основной закон государства

Нормативный правовой акт высшей юридической силы государства или государственно-территориального содружества в межгосударственных объединениях, закрепляющий основы политической, экономической и правовой систем данного государства или содружества, основы правового статуса государства и личности, их права и обязанности.

Конституция в материальном смысле — совокупность правовых норм, определяющих высшие органы государства, порядок их формирования и функционирования, их взаимные отношения и компетенцию, а также принципиальное положение индивида по отношению к государственной власти.*

К этому основному закону прилагается очень важное постановление Верховного суда, о том, что Конституция является непосредственно действующей и применяется перед любым другим законом.

**постановление**[Постановление Пленума Верховного Суда РФ от 31 октября 1995 г. N 8](http://www.constitution.ru/decisions/10003328/10003328.htm)

Закрепленное в Конституции Российской Федерации положение о высшей юридической силе и прямом действии Конституции означает, что все конституционные нормы имеют верховенство над законами и подзаконными актами, в силу чего суды при разбирательстве конкретных судебных дел должны руководствоваться Конституцией Российской Федерации.

В целях единообразного применения судами конституционных норм при осуществлении правосудия Пленум Верховного Суда Российской Федерации постановляет дать следующие разъяснения:

1. В соответствии со ст. 18 Конституции Российской Федерации права и свободы человека и гражданина являются непосредственно действующими. Они определяют смысл, содержание и применение законов, деятельность законодательной и исполнительной власти, местного самоуправления и обеспечиваются правосудием.

Учитывая это конституционное положение, а также положение ч. 1 ст. 46 Конституции Российской Федерации, гарантирующей каждому право на судебную защиту его прав и свобод, суды обязаны обеспечить надлежащую защиту прав и свобод человека и гражданина путем своевременного и правильного рассмотрения дел.

2. Согласно ч. 1 ст. 15 Конституции Российской Федерации, Конституция имеет высшую юридическую силу, прямое действие и применяется на всей территории Российской Федерации. В соответствии с этим конституционным положением судам при рассмотрении дел следует оценивать содержание закона или иного нормативного правового акта, регулирующего рассматриваемые судом правоотношения, и во всех необходимых случаях применять Конституцию Российской Федерации в качестве акта прямого действия.

Суд, разрешая дело, применяет непосредственно Конституцию, в частности:

а) когда закрепленные нормой Конституции положения, исходя из ее смысла, не требуют дополнительной регламентации и не содержат указания на возможность ее применения при условии принятия федерального закона, регулирующего права, свободы, обязанности человека и гражданина и другие положения;

б) когда суд придет к выводу, что федеральный закон, действовавший на территории Российской Федерации до вступления в силу Конституции Российской Федерации, противоречит ей;

в) когда суд придет к убеждению, что федеральный закон, принятый после вступления в силу Конституции Российской Федерации, находится в противоречии с соответствующими положениями Конституции;

г) когда закон либо иной нормативный правовой акт, принятый субъектом Российской Федерации по предметам совместного ведения Российской Федерации и субъектов Российской Федерации, противоречит Конституции Российской Федерации, а федеральный закон, который должен регулировать рассматриваемые судом правоотношения, отсутствует.

Конституция у нас довольно неплохая, в ней прописаны очень интересные и полезные для граждан вещи. К сожалению, по различным причинам, постановление Верховного суда и вместе с ним Конституция почти не применяется в судах. Знакомый адвокат на мой вопрос, почему это происходит, ответил в двух словах: «Россия не является правовым государством». Это расстраивает, но это реальность.

Часть этой реальности в том, что наши сограждане очень плохо знают свой основной закон, то, что по идее должно нас всех объединять, вот [недавний опрос Левада-центра](http://www.levada.ru/10-12-2013/rossiyane-o-konstitutsii), две трети страны никогда не читали его или ничего не помнят, а уверенным знанием могут похвастаться лишь 11%. Мне кажется, что если большее количество людей будет знать Конституцию — то и страна будет потихоньку меняться в лучшую сторону (Конституция сейчас значительно лучше современных федеральных законов).

Несколько месяцев назад мне пришла в голову идея сделать сервис в социальных сетях, который раз в сутки выдает произвольную цитату из Конституции. Быть программистом очень хорошо, все что нужно для реализации своих идей — руки и мозг. Делал я это в том числе для себя самого, чтобы иметь возможность постоянно помнить о тех идеалах, к которым надо стремиться. Я взял первые 65 статей, это главы 1 и 2, наиболее общие вещи, дальше уже идут особенности устройства федеральной власти и местного самоуправления.

В качестве бонуса прикладываю [текстовый файл со всеми статьями](http://kulikovtasks.appspot.com/json/constitution.txt), который я где-то нашел, и [json](http://kulikovtasks.appspot.com/json/constitution.json), который представляет из себя массив, включающий вложенные массивы с полями номера главы, статьи, пункта статьи и, собственно, текста пункта.

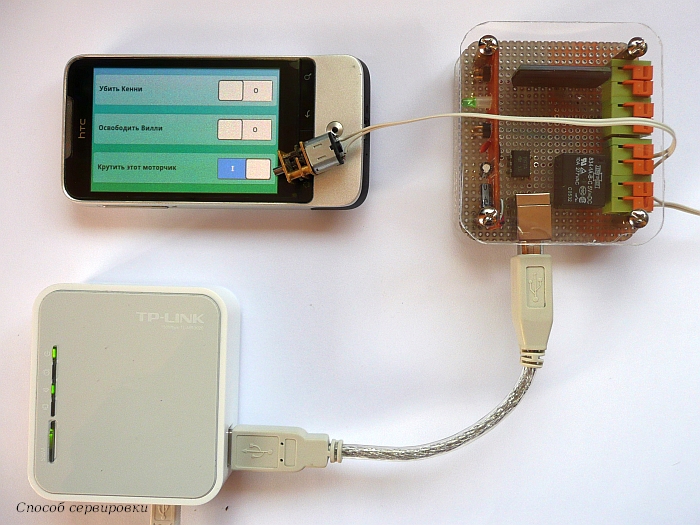

Сама реализация сделана через Google App Engine, посредством [cron-заданий](https://developers.google.com/appengine/docs/python/config/cron?hl=ru). Каждый день в 9 утра запускается задание, скрипт берет произвольную статью и публикует её в фейсбук и в ВК.

```

def vk_post(message): # VK

values = {

'owner_id' : -56504425,

'access_token' : '11111111111111111111111111111111111111111',

'from_group' : 1,

'message': message

}

method = 'wall.post'

url = 'https://api.vk.com/method/%s' % method

data = urllib.urlencode(values)

req = urllib2.Request(url, data)

response = urllib2.urlopen(req)

the_page = response.read()

def fb_post(message): # FB

url = 'https://graph.facebook.com/me/feed'

values = {

'access_token' : '111111111111111111111111111111111111111',

'message': message

}

data = urllib.urlencode(values)

req = urllib2.Request(url, data)

response = urllib2.urlopen(req)

the_page = response.read()

```

Пересылка в твиттер идет уже через автопост контакта, сделать так пришлось, потому что статьи часто длиннее 140 символов, а так автопост удобно оставляет ссылку на основной пост в ВК с полным текстом. Попытался добавить публикацию в Одноклассники, но не смог разобраться с API :)

Подписаться на ежедневные откровения из конституции можно тут:

[www.facebook.com/constitutionRF](https://www.facebook.com/constitutionRF)

[vk.com/constitutionrf](http://vk.com/constitutionrf)

[twitter.com/RFConstitution](https://twitter.com/RFConstitution) | https://habr.com/ru/post/206006/ | null | ru | null |

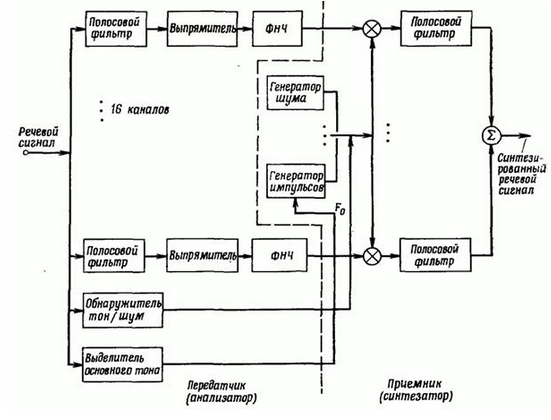

# Синтезатор речи «для роботов» с нуля

Давным-давно посетила меня идея создать синтезатор речи с «голосом робота», как, например, в песне Die Roboter группы Kraftwerk. Поиски информации по «голосу робота» привели к историческому факту, что подобное звучание синтетической речи характерно для вокодеров, которые используются для сжатия речи (2400 — 9600 бит/c). Голос человека, синтезированный вокодером, отдает металлическим звучанием и становится похожим на тот самый «голос робота». Музыкантам понравился данный эффект искажения речи, и они стали активно его использовать в своем творчестве.

Поиски информации по реализации вокодера вывели меня на книгу [«Теория и применение цифровой обработки сигналов»](http://scask.ru/book_r_cos.php), где расписано почти все, что необходимо для создания собственного синтезатора речи на основе вокодера.

#### Небольшое замечание касательно выбора способа реализации синтеза речи