text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Поисковое API для PHP (Flash, Java и других)

**Задача:** организовать поиск по всему сайту затратив как можно меньше усилий и оформить результаты в своем стиле.

**Рассуждение**

Есть различные серверные системы для организации полнотекстового поиска индексируя сайт, индексирую базу данных. Но их надо устанавливать на своем сервере, настраивать, а некоторые из них еще и платные.

В какой-то момент решил воспользоваться Google Ajax Search API через JavaScript, но тут вид результатов менять достаточно сложно, да и еще надо делать запросы в другой домен при помощи javascript.

**Решение**

В итоге набрел на странице [Google AJAX Search API](http://code.google.com/intl/ru-RU/apis/ajaxsearch/documentation/) в раздел [Code Snippets](http://code.google.com/intl/ru-RU/apis/ajaxsearch/documentation/#fonje_snippets) и все стало просто: немного кода на php и полнотекстовый поиск по любому сайту готов.

#### PHP

Приведен слегка упрощенный фрагмент кода. Конечно, хорошо бы сделать проверку на доступность сервера ajax.googleapis.com в данный момент.

> `php<br/

> //Получаем настройки поискового запроса

>

> $data = MyDB::get() -> selectOne('\*',self::TABLE,'`id\_mod` = '.$this->id\_mod);

>

>

>

> //На каком сайте ищем?

>

> $sireUrl = $data['url'];

>

>

>

> //Данные полученные от пользователя

>

> $sigs = array(

>

> 'q' => array('type' => 'string', 'required' => false),

>

> 'start' => array('type' => 'integer', 'required' => false)

>

> );

>

> $reqData = SpeData::sanitize\_vars($this->queryArray, $sigs, 'RequestException');

>

> $q = urlencode($reqData['q'].' site:'.$sireUrl);

>

> $start = empty($reqData['start']) ? 0 : $reqData['start'];

>

>

>

> //Отправляем запрос гуглу, собственно это основаня часть :)

>

> $ch = curl\_init();

>

> curl\_setopt($ch, CURLOPT\_URL, "http://ajax.googleapis.com/ajax/services/search/web?v=1.0&q=$q&rsz=large&hl=ru&start=$start");

>

> curl\_setopt($ch, CURLOPT\_RETURNTRANSFER, 1);

>

> curl\_setopt($ch, CURLOPT\_REFERER, "http://$sireUrl/");

>

> $body = curl\_exec($ch);

>

> curl\_close($ch);

>

>

>

> //Ответ получили, в принципе, зада выполнена :)

>

> $json = json\_decode($body);

>

> //На этом этапе можно сделать print\_r($json) и все станет понятно

>

> //Но что бы в smarty было проще разобрать результаты, можно преобразовать его в следующий вид

>

>

>

> $search = array();

>

>

>

> //Результаты поиска

>

> if (count($json -> responseData -> results) == 0) { //если ничего не найдено

>

> $search['result'] = false;

>

> } else {

>

> foreach ($json -> responseData -> results as $v) {

>

> $search['result'][] = array(

>

> 'GsearchResultClass' => $v -> GsearchResultClass,

>

> 'unescapedUrl' => $v -> unescapedUrl,

>

> 'url' => $v -> url,

>

> 'visibleUrl' => $v -> visibleUrl,

>

> 'cacheUrl' => $v -> cacheUrl,

>

> 'title' => $v -> title, //заголовок найденого документа (индексируется ведь не только html-странички)

>

> 'titleNoFormatting' => $v -> titleNoFormatting,

>

> 'content' => $v -> content //выдержка из текста документа

>

> );

>

> }

>

> }

>

>

>

> //Список ссылок на остальные результаты поиска

>

> if (count($json -> responseData -> results) == 0) { //если ничего не найдено

>

> $search['pages'] = false;

>

> } else {

>

> $url = 'http://'.$\_SERVER['HTTP\_HOST'].$\_SERVER['REDIRECT\_URL'].'?q='.$reqData['q'];

>

> foreach ($json -> responseData -> cursor -> pages as $v) {

>

> $search['pages'][] = array(

>

> 'start' => $v -> start,

>

> 'startUrl' => $url.'&start='.$v -> start,

>

> 'label' => $v -> label

>

> );

>

> }

>

> }

>

>

>

> //Общая информация о результатах поиска

>

> $currentPageIndex = $json -> responseData -> cursor -> currentPageIndex;

>

> $search['info'] = array(

>

> 'q' => $reqData['q'],

>

> 'estimatedResultCount' => $json -> responseData -> cursor -> estimatedResultCount,

>

> 'moreResultsUrl' => $json -> responseData -> cursor -> moreResultsUrl,

>

> 'currentPageIndex' => $currentPageIndex,

>

> 'currentLabel' => $currentPageIndex + 1,

>

> 'startResult' => $currentPageIndex \* 8 + 1,

>

> 'endResult' => ($currentPageIndex \* 8 + 1) + count($search['result']),

>

> 'next' => (count($search['pages']) > $currentPageIndex + 1) ? $search['pages'][$currentPageIndex + 1]['startUrl'] : false,

>

> 'prev' => ($currentPageIndex) ? $search['pages'][$currentPageIndex - 1]['startUrl'] : false

>

> );

>

>

>

>

>

> //Все готово

>

> MySmarty::get() -> assign('search', $search);

>

>

>

> ?>

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

#### SMARTY

Использую ограничители «{{» и «}}» что бы отличать smarty от javascript

> `{{if !$search.result}}

>

> По запросу **{{$search.info.q}}** ничего не найдено или в данным момент поисковый сервис недоступен.

>

> {{else}}

>

> Результаты **{{$search.info.startResult}} - {{$search.info.endResult}}** из примерно **{{$search.info.estimatedResultCount}}** для **{{$search.info.q}}**

>

>

>

>

>

>

>

>

>

> {{section name=i loop=$search.result}}

>

> ["{{$search.result[i].url}}"](<font)>{{$search.result[i].title}}

>

>

> {{$search.result[i].content}}

>

>

>

>

>

>

>

>

>

> {{/section}}

>

>

>

>

>

>

>

>

> {{if $search.info.prev}}

>

> ["{{$search.info.prev}}">Предыдущая](<font)

>

> {{/if}}

>

>

>

>

>

> {{section name=i loop=$search.pages}}

>

> {{if $search.info.currentLabel == $search.pages[i].label}}

>

> {{$search.pages[i].label}}

>

> {{else}}

>

> ["{{$search.pages[i].startUrl}}">{{$search.pages[i].label}}](<font)

>

> {{/if}}

>

> {{/section}}

>

>

>

> {{if $search.info.next}}

>

> ["{{$search.info.next}}">Следующая](<font)

>

> {{/if}}

>

>

>

> {{/if}}

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Вот и получили хороший поиск по любого рода данным (html,doc,pdf и остальные документы по которым ищет google).

Так же есть удобный инструмент для тестов [Google Ajax Api Playground](http://code.google.com/apis/ajax/playground/ "Google Ajax Api Playground").

Хабралюди, если вы в курсе, подскажите пожалуйста, как обстоят дела с соглашениями об использовании этого поискового API. Должен ли я на страничке с результатами указывать что пользуюсь поиском google, или делать еще что-либо подобное?

Спасибо за внимание.

P.S. Это мой первый пост на хабре, если что-то сделал не так скажите, исправлю :) | https://habr.com/ru/post/54012/ | null | ru | null |

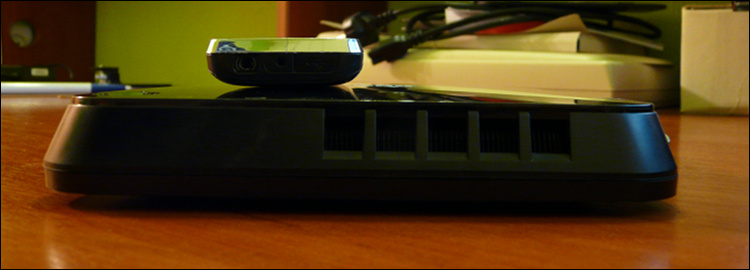

# Почему маршрутизатор отказывается пустить вас телнетом

**Вступление**

С оборудованием Cisco я работаю уже несколько лет, но с подобной проблемой столкнулся впервые. Хотя может и не впервые :). Точно сказать не могу, так как всякого рода траблов и непоняток было много, из-за того что я настраивал в работу и изучал их одновременно. Но раньше скорее всего все решалось обычным хардрезетом, теперь же я разобрался в чем дело.

**Что было поводом?**

В один прекрасный день мне понадобилось зайти удаленно на один из роутеров Cisco, чтобы посмотреть вывод sh ver. Обычно я захожу со своей машины с OS Windows посредством Putty. Как обычно окно терминала открылось, и…, не выдав никакой текстовой информации с велкомом и приглашением к логину, сразу же закрылось без объяснения причин.

Попробовал с линуксового сервера:

`[valent@linux ~]$ telnet 10.15.xxx.yy

Trying 10.15.xxx.yy...

telnet: connect to address 10.15.xxx.yy: Connection refused

telnet: Unable to connect to remote host: Connection refused`

Попробовав еще несколько раз с тем же результатом с других хостов я решил немного

~~попинать головой стену~~ подумать :)

И вот что обнаружилось и придумалось.

Так как фаервола и ACL от меня в сторону роутера не было, да и я заходил на роутер перед этим много раз на прошлой неделе, настраивая тоннель, то я сделал вывод, что закончились свободные **vty line**. Конечно, дошел к этому выводу я не так быстро и сразу, были разные предположения, но помогло то, что глюков в циске я еще не встречал, роутер по информации маршрутизации и cdp работал, в чудеса особо не верю, заходил на роутер буквально пару дней назад и еще помню примерно конфиг, плюс на днях читал блог одного цисковода, где он как раз тюннинговал эти самые **vty line**.

**Что было сделано?**

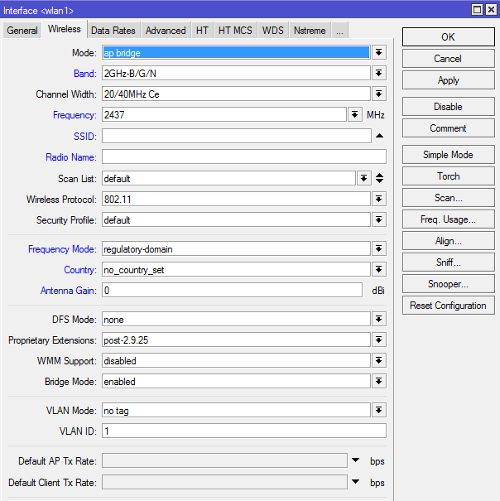

На прошлой неделе я настраивал на этом роутере (к слову сказать Cisco 1841) тоннель через партнерские сети к другому такому же роутеру. Что бы окно терминала не закрывалось из-за бездействия при выводе дебага, в настройках **line vty** я установил параметр **exec-timeout 0 0** (время бездействия в 0 минут 0 секунд, то есть сессия будет висеть практически вечно).

В процессе настройки несколько раз выходил нештатно, то есть просто закрывал окно терминала. В итоге все мои telnet-сессии остались открытыми и занятыми и когда я попытался очередной раз зателнетится на роутер — меня не пустило.

Повезло только то, что был еще открыт доступ по http протоколу и это помогло диагностировать и решить проблему.

**Что нужно сделать ?**

Нужно посмотреть сводный статус TCP-соединений:

`cisco#show tcp brief

TCB Local Address Foreign Address (state)

8173B78C 10.15.xxx.yy.23 10.15.aa.bb.2530 ESTAB

...

80CCEB24 10.15.xxx.yy.23 10.15.aa.bb.4427 ESTAB`

Первая колонка — это TCB адрес (Transmission Control Block адрес установленого TCP-соединения). По аналогии с \*nix, можно сказать что это PID процесса, который можно убить:

`router#clear tcp tcb 8173B78C

[confirm]`

для подтверждения нажав «y» мы убиваем данную сессию.

Таким образом, сняв TCP-сессии, я освободил vty линии и смог зайти телнетом на роутер.

Хочу заметить еще, что более подробно о TCP-соединении можно узнать, если ввести команду:

`show tcp tcb [TCB address]`

Например:

`router#show tcp tcb 80CCF254

Connection state is ESTAB, I/O status: 1, unread input bytes: 1

Local host: 10.15.xxx.yy, Local port: 23

Foreign host: 10.15.aa.bb, Foreign port: 1840

Enqueued packets for retransmit: 1, input: 0 mis-ordered: 0 (0 bytes)

Event Timers (current time is 0x374828A8):

Timer Starts Wakeups Next

Retrans 123 7 0x374829CB

TimeWait 0 0 0x0

AckHold 128 11 0x0

SendWnd 0 0 0x0

KeepAlive 0 0 0x0

GiveUp 0 0 0x0

PmtuAger 0 0 0x0

DeadWait 0 0 0x0

iss: 2866020113 snduna: 2866027408 sndnxt: 2866027946 sndwnd: 65097

irs: 672352072 rcvnxt: 672352285 rcvwnd: 3916 delrcvwnd: 212

SRTT: 302 ms, RTTO: 319 ms, RTV: 17 ms, KRTT: 0 ms

minRTT: 156 ms, maxRTT: 564 ms, ACK hold: 200 ms

Flags: passive open, higher precedence, retransmission timeout

Datagrams (max data segment is 536 bytes):

Rcvd: 248 (out of order: 0), with data: 137, total data bytes: 212

Sent: 166 (retransmit: 7, fastretransmit: 0), with data: 154, total data bytes: 8368`

P.S. Хабр читаю уже давно, часто есть желание прокоментировать тот или иной пост. И вот, документируя вышеизложеное в свой вики, я подумал что может быть это будет интересно и еще кому-то.

Пользуясь представленой возможностью, хочу заметить, что это мой первый пост на хабре и, надеюсь, что не последний :)

P.S.S. Сегодня нашел на опеннете то же решение, но опубликованое в 2004 году — <http://www.opennet.ru/tips/info/720.shtml>. Хочу отметить, что мой пост — не плагиат, а 100% самостоятельная работа. | https://habr.com/ru/post/82694/ | null | ru | null |

# Однопоточный JavaScript и многопоточная Java: что быстрее?

Асинхронное выполнение на Java и JavaScript

-------------------------------------------

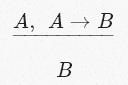

При необходимости в JavaScript можно запускать дополнительные потоки. Но обычно в Node.js или в браузерах весь код на JavaScript выполняется в одном потоке. В браузерах [один и тот же поток рендерит содержимое веб-страницы на экран](https://medium.com/geekculture/requestanimationframe-not-for-animation-a-key-tool-illustrated-and-explained-7cd987f07697). По сути, один поток выполнения занимается всеми задачами, потому что приложения JavaScript пользуются преимуществами асинхронного выполнения. Для асинхронного выполнения задача помещается в очередь задач. Задачи из очереди одна за другой выполняются единственным потоком. Например, вторая строка кода выполняет планирование асинхронной задачи, которая запускается после завершения текущей задачи:

```

console.log("1");

setTimeout(()=>console.log("2"));

console.log("3");

```

Результатом работы кода будет `1 3 2`.

В Java API под асинхронным выполнением обычно подразумевается, что задача выполняется в новом выделенном потоке. Например, представленный ниже код при помощи метода supplyAsync() планирует асинхронную задачу:

```

System.out.println("current thread: " + Thread.currentThread().getName());

var future = CompletableFuture.supplyAsync(() -> Thread.currentThread().getName());

System.out.println("current thread: " + Thread.currentThread().getName());

System.out.println("task thread: " + future.get());

```

Результат работы программы показывает, что текущий поток создал новый поток для выполнения задачи:

```

current thread: main

current thread: main

task thread: ForkJoinPool.commonPool-worker-1

```

Проблема множественных потоков заключается в том, что Java runtime не может создавать бесконечное их количество. Когда все запущенные потоки ожидают, а новые потоки создать нельзя, приложение тоже ничего не будет делать. Чуть ниже я проиллюстрирую этот случай, но сначала мне бы хотелось упомянуть менее серьёзный, но более распространённый пример.

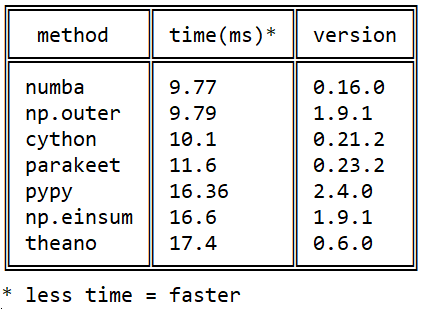

Сравнение производительности многопоточных и однопоточных приложений

--------------------------------------------------------------------

Теоретически многопоточные приложения должны быть более производительными, чем однопоточные, но на практике это не всегда так. Возьмём в качестве примера основной способ применения Java — серверы приложений Java. В логе видно, что HTTP-запросы обрабатывает множество параллельных потоков с собственными именами. Но если развёрнутое веб-приложение выполняет операции ввода-вывода, то многопоточность по большей мере теряет смысл, поскольку доступ к файловой системе — это узкое «бутылочное горлышко». Десять потоков не могут быть производительнее одного потока, вынужденного ждать содержимого от файловой системы. Например, [Java-сервер Tomcat при передаче статичных файлов проявляет себя не лучше, чем один инстанс Node.js](https://medium.com/codex/what-is-faster-tomcat-or-node-js-with-express-602a829b49b6).

Когда многопоточная Java работает медленнее, чем однопоточный JavaScript

------------------------------------------------------------------------

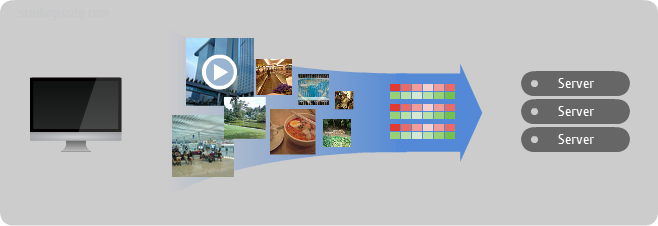

Давайте попробуем скачать содержимое примерно ста случайных URL. При этом воспользуемся возможностью и сравним производительность древнего `HttpURLConnection` и современного `HttpClient`.

Представленный ниже код извлекает все абсолютные ссылки с <https://www.bbc.com/news/world> (около 100 URL), загружает их содержимое, а затем выводит общее время, потраченное на параллельное получение содержимого:

```

public abstract class Runner {

abstract CompletableFuture> requestManyUrls(List urls) throws Exception;

void run() throws Exception {

var urls = getUrlsFromUrl("https://www.bbc.com/news/world");

var start = System.currentTimeMillis();

var contents = requestManyUrls(urls).get();

var time = System.currentTimeMillis() - start;

var totalLength = contents.stream()

.mapToInt(o -> o.txt().length())

.reduce((a, b) -> a + b).getAsInt();

System.out.println("fetched " + totalLength + " bytes from " + urls.size() + " urls in " + time + " ms");

}

}

```

Также код выводит общий размер загруженного содержимого, чтобы убедиться, что разные способы загружают один и тот же контент. Самое важное для нас в коде — это измерение времени, необходимого для параллельного выполнения множества HTTP-запросов.

`UrlTxt` — это просто запись с двумя полями:

```

public record UrlTxt(String url,String txt) {}

```

Метод `getUrlsFromUrl()` извлекает абсолютные URL из содержимого <https://www.bbc.com/news/world>:

```

public static List getUrlsFromUrl(String url) throws Exception {

return Pattern.compile("href=\"(https:[^\"]+)\"")

.matcher(get(url))

.results()

.map(r -> r.group(1))

.collect(Collectors.toList());

}

```

Параллельные HTTP-запросы при помощи древнего HttpURLConnection

---------------------------------------------------------------

Для получения содержимого URL используется обычный код:

```

public static String get(String url) throws Exception {

var con = (HttpURLConnection) new URL(url).openConnection();

con.setInstanceFollowRedirects(false);

if (con.getResponseCode() == HttpURLConnection.HTTP_NOT_FOUND) {

return ""; // 404 throws FileNotFoundException

}

try ( BufferedReader in = new BufferedReader(new InputStreamReader(con.getInputStream()))) {

var response = new StringBuilder();

String line;

while ((line = in.readLine()) != null) {

response.append(line);

}

return response.toString();

}

}

```

`get()` используется в подклассе общего родителя `Runner`. Чтобы использовать `get()` асинхронным образом, я применяю метод-адаптер `load()`. Кстати, обратите внимание на раздражающее ограничение стандартных функциональных интерфейсов — они не выдают исключений и реализующий их код часто необходимо оборачивать в некрасивые блоки `try catch`.

```

public class URLRequests extends Runner {

CompletableFuture load(String url) {

return CompletableFuture.supplyAsync(() -> {

try {

return new UrlTxt(url, get(url));

} catch (Exception e) {

throw new IllegalStateException(e);

}

});

}

@Override

CompletableFuture> requestManyUrls(List urls) throws InterruptedException, ExecutionException {

CompletableFuture[] requests = urls

.stream().map(url -> load(url)).toArray(i -> new CompletableFuture[i]);

return CompletableFuture.allOf(requests)

.thenApply(v -> {

return Stream.of(requests)

.map(future -> future.join())

.collect(Collectors.toList());

});

}

public static void main(String[] args) Exception {

new URLRequests().run();

}

}

```

Функциональный код в requestManyUrls() адаптирован из самого современного [рецепта по созданию параллельных запросов](https://openjdk.java.net/groups/net/httpclient/recipes.html).

Результат работы кода:

```

fetched 39517285 bytes from 105 urls in 6211 ms

```

Если повторно запустить тот же код, общий размер будет близким, но не точно таким же. Предполагаю, что содержимое некоторых ссылок динамично.

Параллельные HTTP-запросы при помощи современного HttpClient

------------------------------------------------------------

Похоже, в настоящее время `HttpClient` — это лучший класс Java для создания HTTP-запросов. Кажется, он даже поддерживает HTTP/2, потому что иногда выдаёт ошибку HTTP/2 `GOAWAY`.

```

public class HttpClientRequests extends Runner {

@Override

public CompletableFuture> requestManyUrls(List urls) throws InterruptedException, ExecutionException {

HttpClient client = HttpClient.newHttpClient();

CompletableFuture>[] requests = urls.stream()

.map(url -> URI.create(url))

.map(uri -> HttpRequest.newBuilder(uri))

.map(reqBuilder -> reqBuilder.build())

.map(request -> client.sendAsync(request, BodyHandlers.ofString()))

.toArray(i -> new CompletableFuture[i]);

return CompletableFuture.allOf(requests)

.thenApply(v -> {

return Stream.of(requests)

.map(future -> future.join())

.map(response -> new UrlTxt(response.uri().toString(), response.body()))

.collect(Collectors.toList());

});

}

public static void main(String[] args) throws Exception {

new HttpClientRequests().run();

}

}

```

Огромный код с современным `HttpClient` выглядит пугающе, но по сравнению с предыдущим результатом в 6211 мс его работа радует:

```

fetched 39983157 bytes from 105 urls in 4910 ms

```

Параллельные HTTP-запросы на Node.js

------------------------------------

В браузере JavaScript не может скачивать содержимое с других хостов, если целевой хост этого не разрешил. Это мера безопасности. Сайт *bbc.com* не разрешает другим хостам получать его содержимое. Поэтому я использую только Node.js.

Посмотрите, насколько прост полный аналог предыдущего кода на JavaScript:

```

import fetch from 'node-fetch';

const re = /href=\"(https:[^\"]+)\"/g;

function extractLinks(txt) {

return Array.from(txt.matchAll(re), ar => ar[1]);

}

function load(url) {

return fetch(url,{redirect:"manual"})

.then(res => res.text().then(txt => ({ url, txt })));

}

load("https://www.bbc.com/news/world")

.then(({ txt }) => extractLinks(txt))

.then(urls => {

const start = Date.now();

Promise.all(urls.map(url => load(url)))

.then(contents => {

const time= Date.now() - start ;

const totalLength = contents.reduce((total, { url, txt }) => total + txt.length , 0);

console.log("fetched " + totalLength + " bytes from " + urls.length + " urls in " + time + " ms");

});

});

```

Что бы вы ни писали на JavaScript, преимущество очевидно — чем меньше клавиш мы нажимаете, тем меньше тратите времени и тем меньше вероятность внести баги. Однако так думают не все. Многие любят преобразовывать JavaScript в Java-подобный код под названием TypeScript.

Результат работы файла на JavaScript:

```

fetched 39492499 bytes from 105 urls in 1744 ms

```

Почему разница между Java и JavaScript почти трёхкратная?

---------------------------------------------------------

Код на JavaScript сначала выполняет один за другим 105 HTTP-запросов. Когда приходит ответ, движок JavaScript помещает в очередь задач небольшой обратный вызов. После получения всех ответов единственный поток по очереди обрабатывает их.

В Java это работает совершенно иначе. Создаётся множество потоков, каждый из которых отправляет один HTTP-запрос. После создания некого оптимального количества потоков стандартный оптимальный внутренний пул потоков больше не может создавать потоки. Несколько созданных потоков ждут ответов. Код ничего не делает. После поступления ответов создаются новые потоки для отправки новых запросов. И этот процесс повторяется, пока не будут отправлены все запросы. По сути, мой пример кода на Java (4910–1744)/4910=64% от общего времени не делает ничего, кроме как ждёт HTTP-откликов. Ситуация такая же, как и с вводом-выводом в серверах приложений Java, но для Интернет-содержимого время ожидания больше.

Если вы знаете, как реализовать более эффективные параллельные HTTP-запросы на Java, то напишите комментарий.

Исходный код можно скачать с <https://github.com/marianc000/concurrentHTTPRequests>.

[](https://cloud.timeweb.com/?utm_source=habr&utm_medium=banner&utm_campaign=cloud&utm_content=direct&utm_term=low) | https://habr.com/ru/post/592017/ | null | ru | null |

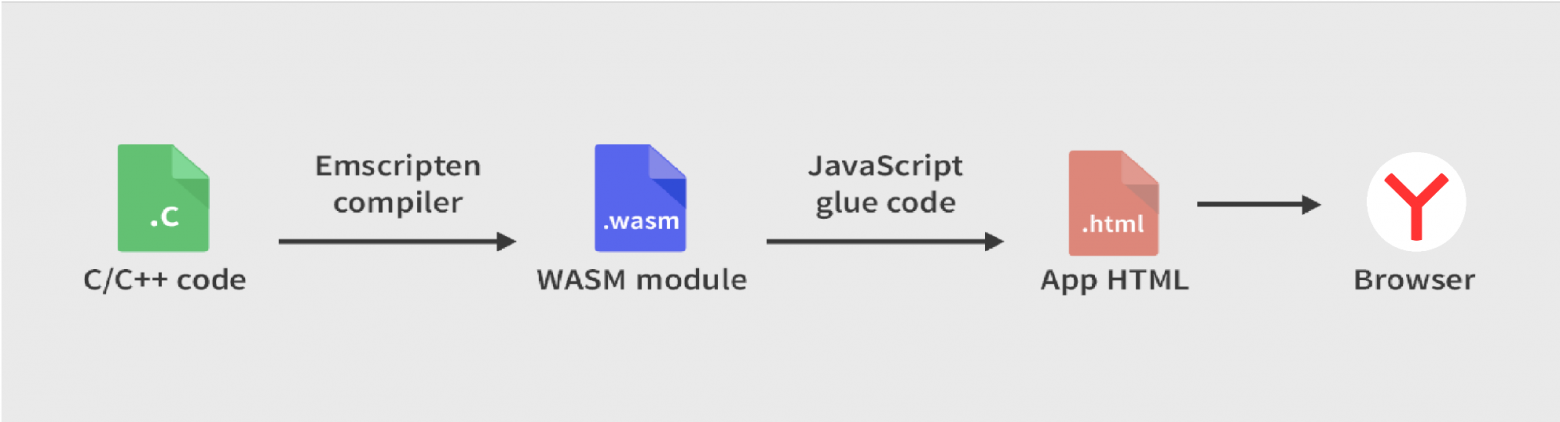

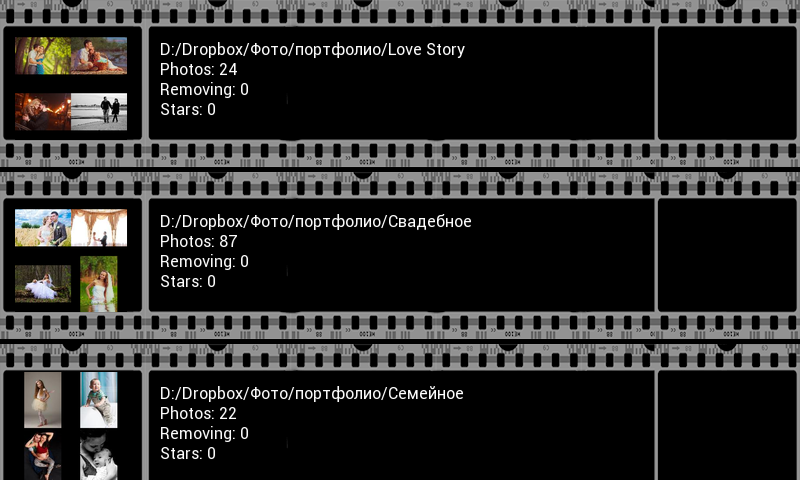

# Linux контейнер для .NET Framework приложения (когда сложно уйти на .Net Core)

Здравствуй, Хабр.

Хочу поделиться с миром достаточно нетипичной, по крайней мере для меня, задачкой и её решением, которое мне кажется вполне приемлемым. Описанное ниже, возможно, не является идеальным выходом из ситуации, но это работает, и работает так, как задумывалось.

#### Завязка и предпосылки

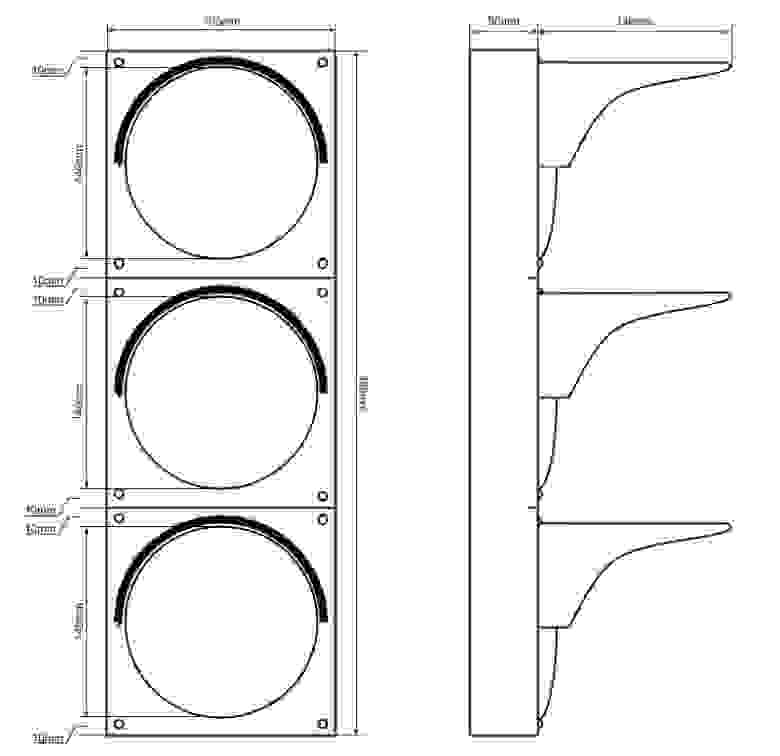

Появилась по работе задача: нужно на сайт вынести 3D-превьюшки BIM-моделей разного оборудования, материалов, объектов. Нужно что-то легковесное, несложное.

На сайте модели этих объектов хранятся и доступны для скачивания в проприетарных форматах различных [САПР](https://ru.wikipedia.org/wiki/%D0%A1%D0%B8%D1%81%D1%82%D0%B5%D0%BC%D0%B0_%D0%B0%D0%B2%D1%82%D0%BE%D0%BC%D0%B0%D1%82%D0%B8%D0%B7%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%BD%D0%BE%D0%B3%D0%BE_%D0%BF%D1%80%D0%BE%D0%B5%D0%BA%D1%82%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F) и в виде открытых форматов 3D-моделей. Среди них есть и формат [**IFC**](https://ru.wikipedia.org/wiki/Industry_Foundation_Classes). Его-то я и буду использовать, как исходник для решения этого задания.

#### Один из вариантов исполнения и его особенности

Формально можно было бы ограничиться написанием какого-нибудь конвертера \*.ifc во что-то для отображения на web-странице. С этого я и начал.

Для подобного преобразования был избран замечательный тулкит — [**xBIM Toolkit**](https://docs.xbim.net/index.html).

В примерах использования этого инструмента просто и доходчиво [*описано*](https://docs.xbim.net/examples/creating-wexbim-file.html), как работать с IFC и специализированным для web-форматом \*.wexBIM.

**Сначала конвертируем \*.ifc в \*.wexBIM:**

```

using System.IO;

using Xbim.Ifc;

using Xbim.ModelGeometry.Scene;

namespace CreateWexBIM

{

class Program

{

public static void Main()

{

const string fileName = "SampleHouse.ifc";

using (var model = IfcStore.Open(fileName))

{

var context = new Xbim3DModelContext(model);

context.CreateContext();

var wexBimFilename = Path.ChangeExtension(fileName, "wexBIM");

using (var wexBiMfile = File.Create(wexBimFilename))

{

using (var wexBimBinaryWriter = new BinaryWriter(wexBiMfile))

{

model.SaveAsWexBim(wexBimBinaryWriter);

wexBimBinaryWriter.Close();

}

wexBiMfile.Close();

}

}

}

}

}

```

Далее полученный файл используется в «плеере» [**xBIM WeXplorer**](http://docs.xbim.net/XbimWebUI/).

**Пример встраивания \*.wexBIM в страницу:**

```

Hello building!

var viewer = new xViewer('viewer');

viewer.load('data/SampleHouse.wexbim');

viewer.start();

```

Что ж, поехали. Беру [nuget'ы](https://www.nuget.org/packages?q=xbim) от xBIM. Пишу консольное приложение, которое на вход принимает пачку путей к \*.ifc-файлам, рядом с ними складывает пачку \*.wexBIM-файлов. Всё, можно выкладывать на сайт.

Но как-то это простенько… Хочется, чтобы эта программа стала неким сервисом, который по событию загрузки \*.ifc на портал, сразу создаёт необходимый \*.wexBIM, и он сразу отображается в подготовленном контейнере.

Ок, формирую новые требования:

1. пусть задания на конвертацию приходят от нашего [RabbitMQ](https://www.rabbitmq.com/);

2. сами задания хочу видеть в виде бинарного сообщения, которое на самом деле будет готовым для десериализации классом, описанным в [protobuf](https://ru.wikipedia.org/wiki/Protocol_Buffers)-файле;

3. задание будет содержать ссылку для скачивания исходного \*.ifc-файла с нашего [Minio](https://min.io/);

4. задание также будет сообщать мне, в какой bucket в Minio складывать результат;

5. пусть само приложение будет собрано под .net core 3.1 и работет внутри Linux docker-контейнера на нашей «docker-ферме»;

#### Первые сложности и условности

Описывать подробно первые 4 пункта реализации не стану. Возможно позже.

Заставил приложение слушать очередь заданий и отсылать сообщение с результатом в очередь из [CorrelationId](https://www.rabbitmq.com/tutorials/tutorial-six-dotnet.html) сообщения-задания. Прикрутил генерированные классы запрос/ответ из protobuf. Научил скачивать/загружать файлы в [minio](https://docs.min.io/docs/minio-client-complete-guide.html).

Всё это делаю в проекте консольного приложения. В настройках проекта:

```

netcoreapp3.1

```

И на моей машине с Windows 10 всё вполне отлаживается и работает. Но при попытке запустить приложение в [WSL](https://ru.wikipedia.org/wiki/Windows_Subsystem_for_Linux) ловлю ошибку **System.IO.FileLoadException**:

**Полная информация по ошибке:**

```

{

"Type": "System.IO.FileLoadException",

"Message": "Failed to load Xbim.Geometry.Engine64.dll",

"TargetSite": "Void .ctor(Microsoft.Extensions.Logging.ILogger`1[Xbim.Geometry.Engine.Interop.XbimGeometryEngine])",

"StackTrace": " at Xbim.Geometry.Engine.Interop.XbimGeometryEngine..ctor(ILogger`1 logger)\r\n at Xbim.Geometry.Engine.Interop.XbimGeometryEngine..ctor()\r\n at Xbim.ModelGeometry.Scene.Xbim3DModelContext.get_Engine()\r\n at Xbim.ModelGeometry.Scene.Xbim3DModelContext.CreateContext(ReportProgressDelegate progDelegate, Boolean adjustWcs)\r\n at My.Converter.ConvertIfc.CreateWebIfc(String ifcFileFullPath, String wexBIMFolder)",

"Data": {},

"InnerException": {

"Type": "System.IO.FileNotFoundException",

"Message": "Could not load file or assembly 'Xbim.Geometry.Engine.dll, Culture=neutral, PublicKeyToken=null'. The system cannot find the file specified.",

"FileName": "Xbim.Geometry.Engine.dll, Culture=neutral, PublicKeyToken=null",

"FusionLog": "",

"TargetSite": "System.Reflection.RuntimeAssembly nLoad(System.Reflection.AssemblyName, System.String, System.Reflection.RuntimeAssembly, System.Threading.StackCrawlMark ByRef, Boolean, System.Runtime.Loader.AssemblyLoadContext)",

"StackTrace": " at System.Reflection.RuntimeAssembly.nLoad(AssemblyName fileName, String codeBase, RuntimeAssembly assemblyContext, StackCrawlMark& stackMark, Boolean throwOnFileNotFound, AssemblyLoadContext assemblyLoadContext)\r\n at System.Reflection.RuntimeAssembly.InternalLoadAssemblyName(AssemblyName assemblyRef, StackCrawlMark& stackMark, AssemblyLoadContext assemblyLoadContext)\r\n at System.Reflection.Assembly.Load(String assemblyString)\r\n at Xbim.Geometry.Engine.Interop.XbimGeometryEngine..ctor(ILogger`1 logger)",

"Data": {},

"Source": "System.Private.CoreLib",

"HResult": -2147024894

},

"Source": "Xbim.Geometry.Engine.Interop",

"HResult": -2146232799

}

```

Сеанс активного гугления и вдумчивого чтения показал мне, что я крайне невнимателен:

> Recently at work, we were evaluating a few options to render building models in the browser. Building Information Modeling (BIM) in interoperability scenarios is done via Industry Foundation Classes, mostly in the STEP Physical File format. The schema is quite huge and complex with all the things you have to consider, so we were glad to find the xBim open source project on GitHub. They've got both projects to visualize building models in the browser with WebGL as well as conversion tools to create the binary-formatted geometry mesh. To achieve that, native C++ libraries are dynamically loaded (so no .Net Core compatibility) which must be present in the bin folder. The C++ libraries are expected either in the same folder as the application binaries or in a x64 (or x86, respectively) sub folder (See [here](https://github.com/xBimTeam/XbimGeometry/blob/master/Xbim.Geometry.Engine.Interop/XbimCustomAssemblyResolver.cs) for more details). In regular projects, the xBim.Geometry NuGet package adds a build task to copy the dlls into the build output folder, but this doesn't work with the new tooling. You can, however, get it to work in Visual Studio 2015 by taking care of supplying the interop dlls yourself.

И подобные трудности не у одного меня. Многим хочется [xBIM под .Net Core](https://github.com/xBimTeam/XbimEssentials/issues/213).

Не критично, но многое меняет… Всё упирается в невозможность нормально загрузить *Xbim.Geometry.Engine64.dll*. Нужно иметь на машине **[vc\_redist.x64.exe](https://support.microsoft.com/ru-ru/help/2977003/the-latest-supported-visual-c-downloads)**. Какие у меня варианты?

Первое, что подумалось: «А может виндовый контейнер с полным .Net Framework использовать?

Доставить Microsoft Visual C++ Redistributable for Visual Studio 2015, 2017 and 2019 в этот контейнер, и всё будет ок?» Я это попробовал:

**Испытательный Windows-образ для docker:**

Сменил .Net Core на:

```

net47

```

Dockerfile:

```

FROM microsoft/dotnet-framework:4.7

WORKDIR /bimlibconverter

COPY lib/VC_redist.x64.exe /VC_redist.x64.exe

RUN C:\VC_redist.x64.exe /quiet /install

COPY bin/Release .

ENTRYPOINT ["MyConverter.exe"]

```

Что ж, это сработало… It's alive! Но. А как же наша хостовая Linux-машина с docker? Не получится на неё загнать контейнер с образом на [Windows Server Core](https://hub.docker.com/_/microsoft-dotnet-framework-runtime/). Надо выкручиваться…

#### Компромисс и развязка

Очередной поиск в Сети вывел меня на [статью](https://medium.com/better-programming/how-to-run-any-windows-cli-app-in-a-linux-docker-container-318cd49bdd25). В ней автор требует от реализации похожего:

> To make things worse:

>

> All binaries are 32-bits (x86).

>

> Some require visual C++ redistributable runtime components.

>

> Some require the .NET runtime.

>

> Some need a windowing system, even though we only use the command-line interface (CLI).

В посте описывается потенциальная возможность запуска Windows-приложений в wine в Linux-контейнере. Любопытно, решил я.

После некоторых проб, багов и дополнений был получен Dockerfile:

**Docker образ на основе Ubuntu с Wine, .Net Framework и vcredist на борту:**

```

FROM ubuntu:latest

#Добавляем поддержку x86

RUN dpkg --add-architecture i386 \

&& apt-get update \

#Ставим некоторые необходимые пакеты

&& apt-get install -qfy --install-recommends \

software-properties-common \

gnupg2 \

wget \

xvfb \

cabextract \

#Добавляем репозитарий Wine

&& wget -nv https://dl.winehq.org/wine-builds/winehq.key \

&& apt-key add winehq.key \

&& apt-add-repository 'deb https://dl.winehq.org/wine-builds/ubuntu/ bionic main' \

#Дополнительный репозитарий для корректной установки Wine

&& add-apt-repository ppa:cybermax-dexter/sdl2-backport \

#Ставим сам Wine

&& apt-get install -qfy --install-recommends \

winehq-staging \

winbind \

#Подчищаем лишнее

&& apt-get -y clean \

&& rm -rf \

/var/lib/apt/lists/* \

/usr/share/doc \

/usr/share/doc-base \

/usr/share/man \

/usr/share/locale \

/usr/share/zoneinfo

#Переменные окружения для старта Wine

ENV WINEDEBUG=fixme-all

ENV WINEPREFIX=/root/.net

ENV WINEARCH=win64

#Пуск конфигурирования Wine

RUN winecfg \

#Скачиваем winetricks, без них .Net Framework не заведётся

&& wget https://raw.githubusercontent.com/Winetricks/winetricks/master/src/winetricks \

-O /usr/local/bin/winetricks \

&& chmod +x /usr/local/bin/winetricks \

#Подчищаем лишнее

&& apt-get -y clean \

&& rm -rf \

/var/lib/apt/lists/* \

/usr/share/doc \

/usr/share/doc-base \

/usr/share/man \

/usr/share/locale \

/usr/share/zoneinfo \

#Запуск Wine с необходимыми дополнениями

&& wineboot -u && winetricks -q dotnet472 && xvfb-run winetricks -q vcrun2015

WORKDIR /root/.net/drive_c/myconverter/

#Копируем наше приложение

COPY /bin/Release/ /root/.net/drive_c/myconverter/

ENTRYPOINT ["wine", "MyConverter.exe"]

```

UPD: немного изменил файл для сборки более компактного образа. Спасибо комментарию [rueler](https://habr.com/ru/users/rueler/)

Build идёт небыстро, но заканчивается удачно. Пробую, проверяю. Работает!

#### Итоги, выводы, размышления

Это сработало. На выходе получаем Linux-образ для docker-контейнера. Он «пухловат» (~5.2Гб), но вполне быстро стартует и внутри работает консольное Windows-приложени на .Net Framework 4.7, которое слушает RabbitMQ, пишет логи в [Graylog](https://www.graylog.org/), скачивает и загружает файлы на/в Minio. Обновлять само приложение буду по remote docker API.

Решение утилитарной выделенной задачи реализовано. Возможно, и скорее всего, не универсальное. Но меня в принципе устроило. Может быть кому-то тоже пригодится.

Спасибо, что прочли. На Хабр пишу впервые. Увидимся в комментариях. | https://habr.com/ru/post/498396/ | null | ru | null |

# Thymeleaf + Spring WebFlux + Spring Security

Thymeleaf появился довольно давно, как минимум 10 лет назад, но он до сих пор весьма популярен и активно поддерживается. Шаблоны Thymeleaf удобны тем, что при простом открытии в браузере они выглядят как обычные HTML-страницы и их можно использовать как статический прототип приложения.

В этой статье рассмотрим, как создать простое приложение Spring WebFlux с Thymeleaf, аутентификацией Okta OIDC, защитой от CSRF-атак и контролем полномочий.

Будем использовать следующие фреймворки и инструменты:

* [HTTPie 3.0.2](https://httpie.io/)

* [Java 11](https://jdk.java.net/java-se-ri/11)

* [Okta CLI 0.10.0](https://cli.okta.com/)

### Что такое Thymeleaf?

Thymeleaf — это опенсорсный серверный шаблонизатор для различных типов приложений как веб, так и других, созданный Даниэлем Фернандесом (Daniel Fernández). Шаблоны похожи на HTML и могут использоваться со Spring MVC, Spring Security и другими популярными фреймворками. В том числе есть интеграция со Spring WebFlux, но на данный момент об этом довольно мало информации. Thymeleaf-стартер выполняет [автоматическую настройку](https://docs.spring.io/spring-framework/docs/current/reference/html/web-reactive.html#webflux-view-thymeleaf) template engine, template resolver и reactive view resolver.

Возможности Thymeleaf включают в себя:

* Работу с фрагментами: рендеринг только части шаблона. Может использоваться при обновлении части страницы при ответе на AJAX-запросы. Также есть механизм "компонент": фрагменты могут включаться в несколько разных шаблонов.

* Обработку форм с использованием объектов-моделей, содержащих поля формы.

* Рендеринг переменных и внешних текстовых сообщений с помощью языка выражений Thymeleaf [Standard Expression Syntax](https://www.thymeleaf.org/doc/tutorials/3.0/usingthymeleaf.html#standard-expression-syntax).

* Наличие циклов и условных конструкций.

### Spring WebFlux-приложение с Thymeleaf

Мы напишем простое монолитное реактивное приложение на Spring Boot с Thymeleaf. Заготовку приложения можно создать через веб-интерфейс [Spring Initializr](https://start.spring.io/) или с помощью следующей команды HTTPie:

```

https -d start.spring.io/starter.zip bootVersion==2.6.4 \

baseDir==thymeleaf-security \

groupId==com.okta.developer.thymeleaf-security \

artifactId==thymeleaf-security \

name==thymeleaf-security \

packageName==com.okta.developer.demo \

javaVersion==11 \

dependencies==webflux,okta,thymeleaf,devtools

```

У нас будет Maven-проект. Распакуйте его и добавьте пару зависимостей: `thymeleaf-extras-springsecurity5` для поддержки Spring Security в шаблонах и `spring-security-test` для тестов.

```

org.thymeleaf.extras

thymeleaf-extras-springsecurity5

3.0.4.RELEASE

org.springframework.security

spring-security-test

test

```

### Аутентификация с помощью OpenID Connect

Вам понадобится бесплатный аккаунт разработчика Okta. Установите [Okta CLI](https://cli.okta.com/) и запустите `okta register` для создания нового аккаунта. Если у вас уже есть учетная запись, то используйте `okta login`. Для создания нового приложения выполните `okta apps create`.

Имя приложения (Application name) можете оставить по умолчанию или изменить по вашему усмотрению. Тип приложения (Type of Application) выберите **Web**. Framework of Application — **Okta Spring Boot Starter**. Значение Redirect URI оставьте по умолчанию: перенаправление входа (Login Redirect) на `http://localhost:8080/login/oauth2/code/okta` и выхода (Logout Redirect) на `http://localhost:8080`.

Okta CLI создаст OIDC Web App в вашей Okta Org, добавит указанные вами URI перенаправления и предоставит доступ группе Everyone. После завершения должно появиться сообщение, похожее на это:

```

Okta application configuration has been written to:

/path/to/app/src/main/resources/application.properties

```

Реквизиты доступа вашего приложения будут в файле `src/main/resources/application.properties`.

```

okta.oauth2.issuer=https://dev-133337.okta.com/oauth2/default

okta.oauth2.client-id=0oab8eb55Kb9jdMIr5d6

okta.oauth2.client-secret=NEVER-SHOW-SECRETS

```

Для создания приложения вы также можете использовать Okta Admin Console. Подробнее об этом см. раздел [Create a Spring Boot App](https://developer.okta.com/docs/guides/sign-into-web-app/springboot/create-okta-application/) в документации.

Давайте переименуем `application.properties` в `application.yml` и добавим следующие параметры:

```

spring:

thymeleaf:

prefix: file:src/main/resources/templates/

security:

oauth2:

client:

provider:

okta:

user-name-attribute: email

okta:

oauth2:

issuer: https://{yourOktaDomain}/oauth2/default

client-id: {clientId}

client-secret: {clientSecret}

scopes:

- email

- openid

```

Обратите внимание, что нам пока не нужен scope `profile`. Для запросов OpenID Connect [обязателен только openid](https://openid.net/specs/openid-connect-basic-1_0.html#Scopes). Свойство `thymeleaf.prefix` разрешает горячую перезагрузку шаблонов, если в проект подключена зависимость `spring-boot-devtools`.

### Шаблоны Thymeleaf

Для шаблонов создайте папку `src/main/resources/templates` и в ней файл `home.html` со следующим содержимым:

```

User Details

Okta Hosted Login + Spring Boot Example

---------------------------------------

Hello!

If you're viewing this page then you have successfully configured and started this example server.

This example shows you how to use the [Okta Spring Boot

Starter](https://github.com/okta/okta-spring-boot) to add the [Authorization

Code Flow](https://developer.okta.com/docs/guides/implement-grant-type/authcode/main/) to your application.

When you click the login button below, you will be redirected to the login page on your Okta org. After you

authenticate, you will be returned to this application.

Welcome home, Joe Coder!

You have successfully authenticated against your Okta org, and have been redirected back to this

application.

Sign In

```

В приведенном выше шаблоне закомментированный тег позволяет включить фрагменты верхнего и нижнего колонтитулов, определенных в `header.html` и `footer.html`. Они содержат зависимости Bootstrap для оформления шаблонов. Также вместо будет вставлен фрагмент меню.

Условные выражения `th:if` и `th:unless` используются для проверки статуса аутентификации. Если пользователь не аутентифицирован, будет отображаться кнопка "**Sign In**". Иначе — приветствие с именем пользователя.

Далее создайте шаблон head.html:

```

Nothing to see here, move along.

```

И `footer.html`:

```

Nothing to see here, move along.

```

А также шаблон `menu.html` фрагмента меню:

```

* Home

Logout

```

### Контроллер

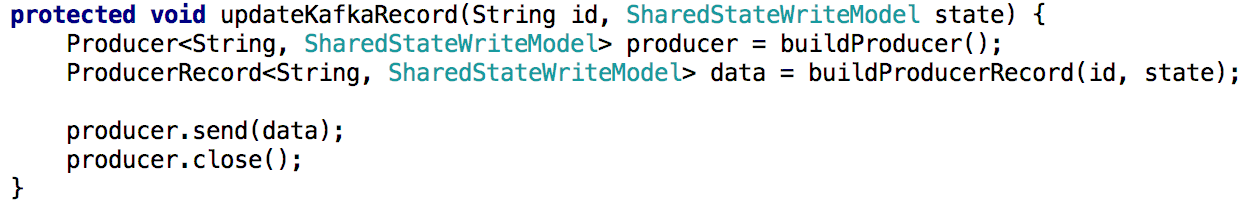

Для доступа к странице `home` потребуется контроллер. Создайте в пакете `com.okta.developer.demo` класс `HomeController` со следующим содержимым:

```

package com.okta.developer.demo;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.security.core.Authentication;

import org.springframework.stereotype.Controller;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.reactive.result.view.Rendering;

import reactor.core.publisher.Mono;

import java.util.List;

import java.util.stream.Collectors;

@Controller

public class HomeController {

private static Logger logger = LoggerFactory.getLogger(HomeController.class);

@GetMapping("/")

public Mono home(Authentication authentication) {

List authorities = authentication.getAuthorities()

.stream()

.map(scope -> scope.toString())

.collect(Collectors.toList());

return Mono.just(Rendering.view("home").modelAttribute("authorities", authorities).build());

}

}

```

Этот контроллер отображает представление `home` и заполняет в атрибуте модели полномочия (authorities) для дальнейшей проверки прав доступа.

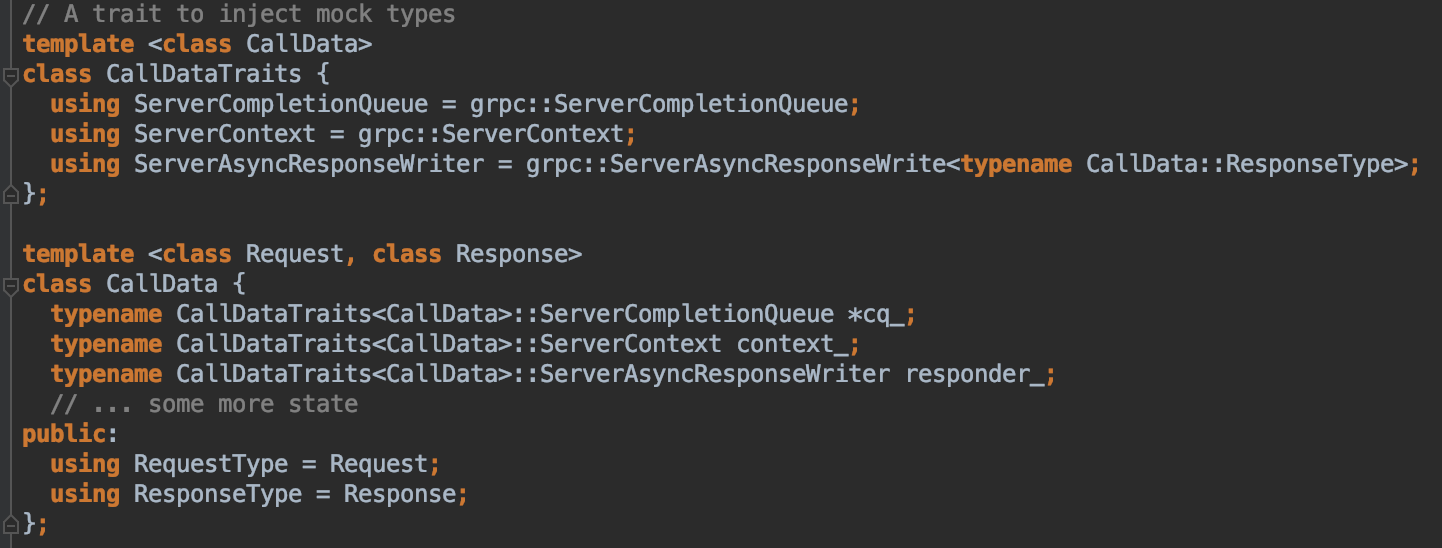

### Настройка безопасности

Okta-стартер по умолчанию настроен на аутентифицированный доступ ко всем страницам. Нам это нужно немного подправить, поэтому добавьте класс `SecurityConfiguration` в тот же пакет, что и раньше.

```

package com.okta.developer.demo;

import org.springframework.context.annotation.Bean;

import org.springframework.security.config.annotation.method.configuration.EnableReactiveMethodSecurity;

import org.springframework.security.config.annotation.web.reactive.EnableWebFluxSecurity;

import org.springframework.security.config.web.server.ServerHttpSecurity;

import org.springframework.security.web.server.SecurityWebFilterChain;

import org.springframework.security.web.server.authentication.logout.RedirectServerLogoutSuccessHandler;

import org.springframework.security.web.server.authentication.logout.ServerLogoutSuccessHandler;

import java.net.URI;

@EnableWebFluxSecurity

@EnableReactiveMethodSecurity

public class SecurityConfiguration {

@Bean

public ServerLogoutSuccessHandler logoutSuccessHandler(){

RedirectServerLogoutSuccessHandler handler = new RedirectServerLogoutSuccessHandler();

handler.setLogoutSuccessUrl(URI.create("/"));

return handler;

}

@Bean

public SecurityWebFilterChain securityWebFilterChain(ServerHttpSecurity http) {

http

.authorizeExchange().pathMatchers("/").permitAll().and().anonymous()

.and().authorizeExchange().anyExchange().authenticated()

.and().oauth2Client()

.and().oauth2Login()

.and().logout().logoutSuccessHandler(logoutSuccessHandler());

return http.build();

}

}

```

Здесь мы разрешаем анонимный доступ всем пользователям к корневой странице (/), чтобы они могли залогиниться.

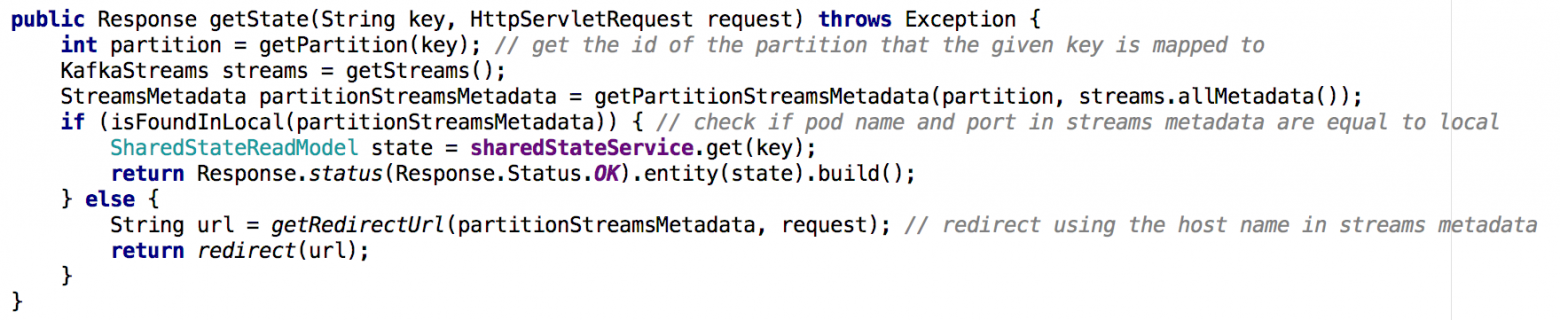

### Запуск приложения

Запустите приложение с помощью Maven:

`./mvnw spring-boot:run`

Перейдите по адресу <http://localhost:8080> — вы увидите страницу home и кнопку "**Sign In**". Нажмите кнопку и залогиньтесь, используя учетные данные Okta. После успешного входа вы должны быть перенаправлены на страницу home и увидеть содержимое для аутентифицированных пользователей.

### Защита контента с помощью авторизации

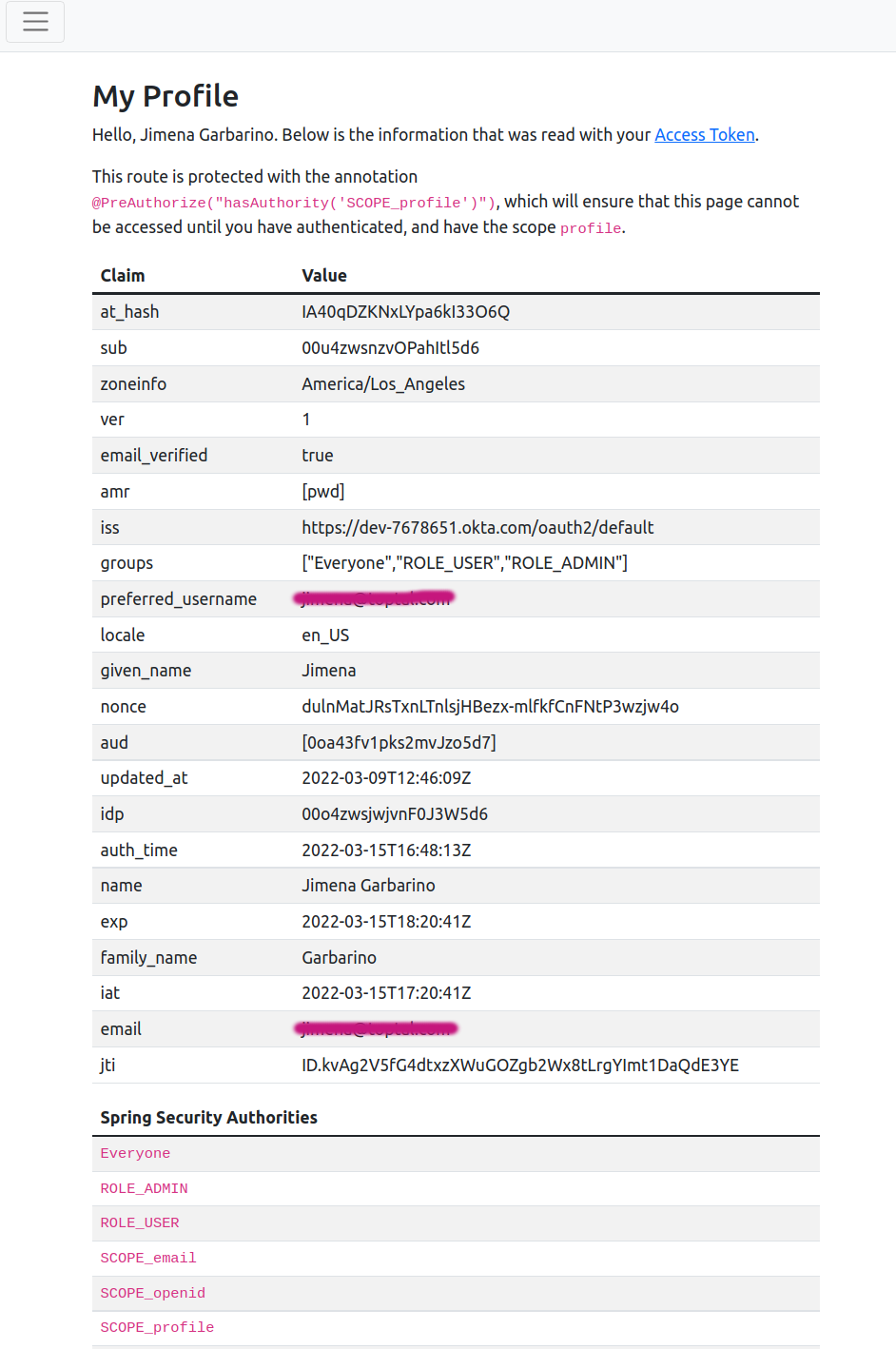

Далее добавим шаблон `userProfile.html`, который будет отображать информацию о `claim`, содержащихся в ID токене, возвращенном Okta, а также полномочия (authorities), полученные Spring Security от токена.

```

User Details

My Profile

----------

Hello, Joe Coder. Below is the

information that was read with your [ID Token](https://developer.okta.com/docs/api/resources/oidc.html#get-user-information).

This route is protected with the annotation `@PreAuthorize("hasAuthority('SCOPE_profile')")`,

which will ensure that this page cannot be accessed until you have authenticated, and have the scope `profile`.

| Claim | Value |

| --- | --- |

| Key | Value |

| Spring Security Authorities |

| --- |

| `Authority` |

```

Настраиваем в `HomeController` маппинг:

```

@GetMapping("/profile")

@PreAuthorize("hasAuthority('SCOPE_profile')")

public Mono userDetails(OAuth2AuthenticationToken authentication) {

return Mono.just(Rendering.view("userProfile")

.modelAttribute("details", authentication.getPrincipal().getAttributes())

.build());

}

```

Аннотация `@PreAuthorize` позволяет определить правила авторизации с помощью SpEL (Spring Expression Language). Правила проверяются перед выполнением метода. В данном случае только пользователи с полномочиями `SCOPE_profile` смогут обратиться к странице `userProfile`. Это защита на стороне сервера.

На клиентской стороне добавьте в шаблоне `home.html` ссылку для доступа к странице `userProfile` после "You successfully …". Ссылка будет отображаться только для пользователей с полномочиями (authority) `SCOPE_profile`.

```

You have successfully authenticated against your Okta org, and have been redirected back to this application.

Visit the My Profile page in this application to view the information retrieved with your OAuth Access Token.

```

Обратите внимание, что условие авторизации реализовано именно таким образом, так как выражения вроде `${#authorization.expression('hasRole(''SCOPE_profile'')')}` не работают в WebFlux из-за отсутствия поддержки в реактивном Spring Security (Spring Security 5.6). Поддерживается только минимальный набор выражений для проверки безопасности: `[isAuthenticated(), isFullyAuthenticated(), isAnonymous(), isRememberMe()]`.

Запустите приложение еще раз. После входа в систему вы не увидите новую ссылку, но если перейдете по адресу `http://localhost:8080/profile`, то получите HTTP ERROR 403 Forbidden — доступ запрещен. Это связано с тем, что в `application.yml` мы настроили только получение scope для `email` и `openid`, а profile не возвращается в токене доступа (access token). Добавьте отсутствующий scope в `application.yml`, перезапустите. Теперь представление `userProfile` должно стать доступно:

Как видите, Spring Security назначает группы, содержащиеся в `claim`, а также запрошенные scope в качестве полномочий (authorities). У scope префикс `SCOPE_`. При создании приложения через Okta CLI по умолчанию создаются группы `ROLE_ADMIN` и `ROLE_USER`, и ваша учетная запись включается в эти группы.

Защита от CSRF-атак

-------------------

Атака CSRF (Cross-site request forgery, межсайтовая подделка запроса) позволяет отправить данные с формы на странице злоумышленника на сайт-жертву, на котором пользователь уже аутентифицирован, и выполнить от лица пользователя вредоносные действия.

Защита от CSRF в Spring Security включена по умолчанию как для сервлет-приложений, так и для WebFlux. Основной способ защиты — [Synchronizer Token Pattern](https://docs.spring.io/spring-security/reference/features/exploits/csrf.html#csrf-protection-stp). В каждый HTTP-запрос помещается случайно сгенерированное значение — CSRF-токен. Токен должен находиться в части запроса, которая не заполняется браузером автоматически. Например, для этого можно использовать HTTP-параметр или заголовок.

Давайте проверим защиту от CSRF, создав простое приложение для проведения опросов. Создайте шаблон `quiz.html` со следующим содержимым:

```

Thymeleaf Quiz

Select the right answer

-----------------------

*

### What is Thymeleaf?

**A.** A server-side Java template engine

**B.** A markup language

**C.** A web framework

Your CSRF token is:

Submit

```

Токен CSRF доступен в качестве атрибута запроса, в учебных целях отобразим его в шаблоне `quiz.html`.

Также добавьте шаблон `result.html` для отображения результата опроса:

```

Thymeleaf Quiz Submission

#### Your selected answer is

Good Job!

It is not the right answer

Try again!

```

Далее класс `QuizSubmission` для хранения ответа:

```

package com.okta.developer.demo;

public class QuizSubmission {

private String answer;

public String getAnswer() {

return answer;

}

public void setAnswer(String answer) {

this.answer = answer;

}

}

```

И контроллер `QuizController` для отображения опроса и обработки данных формы:

```

package com.okta.developer.demo;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.http.MediaType;

import org.springframework.security.access.prepost.PreAuthorize;

import org.springframework.stereotype.Controller;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.reactive.result.view.Rendering;

import reactor.core.publisher.Mono;

@Controller

public class QuizController {

private static Logger logger = LoggerFactory.getLogger(QuizController.class);

@GetMapping("/quiz")

@PreAuthorize("hasAuthority('SCOPE_quiz')")

public Mono showQuiz() {

return Mono.just(Rendering.view("quiz").modelAttribute("quiz", new QuizSubmission()).build());

}

@PostMapping(path = "/quiz", consumes = {MediaType.APPLICATION\_FORM\_URLENCODED\_VALUE})

@PreAuthorize("hasAuthority('SCOPE\_quiz')")

public Mono saveQuiz(QuizSubmission quizSubmission) {

return Mono.just(Rendering.view("result").modelAttribute("quiz", quizSubmission).build());

}

}

```

В новом контроллере и шаблонах доступ к опросу разрешен только пользователям с полномочиями `SCOPE_quiz`. Добавьте защищенную ссылку в шаблон `home.html` после ссылки на профиль:

```

You have successfully authenticated against your Okta org, and have been redirected back to this application.

Visit the My Profile page in this application to view the information retrieved with your OAuth Access Token.

Visit the Thymeleaf Quiz to test Cross-Site Request Forgery (CSRF) protection.

```

Перед повторным запуском приложения давайте проверим защиту от CSRF с помощью теста. Создайте `QuizControllerTest` в `src/test/java` в пакете `com.okta.developer.demo`:

```

package com.okta.developer.demo;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.autoconfigure.web.reactive.WebFluxTest;

import org.springframework.http.MediaType;

import org.springframework.test.web.reactive.server.WebTestClient;

import static org.springframework.security.test.web.reactive.server.SecurityMockServerConfigurers.csrf;

import static org.springframework.security.test.web.reactive.server.SecurityMockServerConfigurers.mockOidcLogin;

@WebFluxTest

public class QuizControllerTest {

@Autowired

private WebTestClient client;

@Test

void testPostQuiz_noCSRFToken() throws Exception {

QuizSubmission quizSubmission = new QuizSubmission();

this.client.mutateWith(mockOidcLogin())

.post().uri("/quiz")

.exchange()

.expectStatus().isForbidden()

.expectBody().returnResult()

.toString().contains("An expected CSRF token cannot be found");

}

@Test

void testPostQuiz() throws Exception {

this.client.mutateWith(csrf()).mutateWith(mockOidcLogin())

.post().uri("/quiz")

.contentType(MediaType.APPLICATION_FORM_URLENCODED)

.exchange().expectStatus().isOk();

}

@Test

void testGetQuiz_noAuth() throws Exception {

this.client.get().uri("/quiz").exchange().expectStatus().is3xxRedirection();

}

@Test

void testGetQuiz() throws Exception {

this.client.mutateWith(mockOidcLogin())

.get().uri("/quiz").exchange().expectStatus().isOk();

}

}

```

Тест `testPostQuiz_noCSRFToken()` проверяет, что опрос не может быть отправлен без CSRF-токена, даже если пользователь залогинен. Второй тест `testPostQuiz()` — токен CSRF добавляется к фиктивному запросу с помощью `mutateWith(csrf())`. Здесь ожидаемый статус ответа — HTTP 200 OK. Третий тест `testGetQuiz_noAuth()` проверяет, что запрос будет перенаправлен (в форму входа Okta), если пользователь не аутентифицирован. И последний тест `testGetQuiz()` проверяет, что можно получить доступ к опросу, если пользователь аутентифицирован с помощью OIDC.

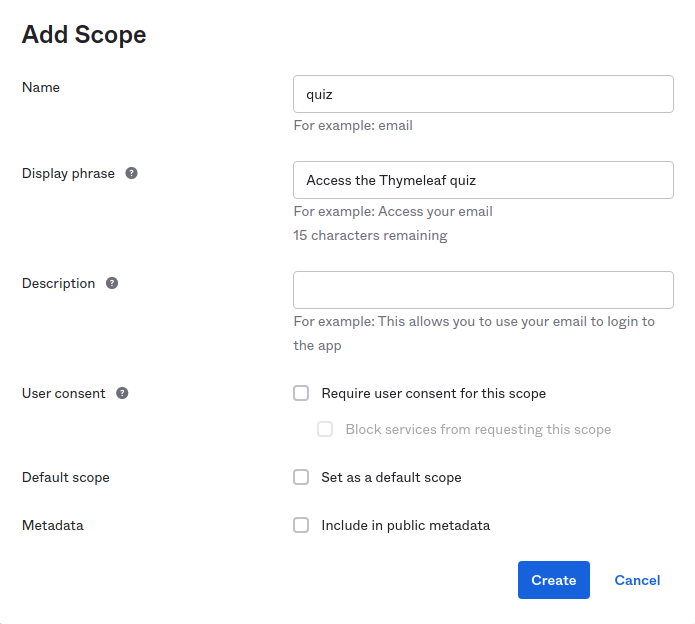

Поскольку `quiz` не является стандартным scope или scope, определенным в Okta, вам необходимо определить ее для default-сервера авторизации перед запуском приложения. Перейдите в Okta Admin Console в меню **Security > API**, выберите сервер авторизации default. На вкладке **Scopes** нажмите **Add Scope**. Введите имя (Name) quiz и описание (Display phrase). Остальные поля оставьте со значениями по умолчанию и нажмите **Create**. Теперь при логине через OIDC можно требовать scope `quiz`.

Запустите приложение, не добавляя scope `quiz` в `application.yml`, и войдите в систему — вы не должны видеть ссылку на тест. Если выполнить GET-запрос по адресу `http://localhost:8080/quiz`, то ответ будет 403 Forbidden.

Теперь добавьте `quiz` в список scopes в конфигурации Okta в `application.yml`. Окончательная конфигурация должна выглядеть следующим образом:

```

spring:

security:

oauth2:

client:

provider:

okta:

user-name-attribute: email

okta:

oauth2:

issuer: https://{yourOktaDomain}/oauth2/default

client-id: {clientId}

client-secret: {clientSecret}

scopes:

- email

- openid

- profile

- quiz

```

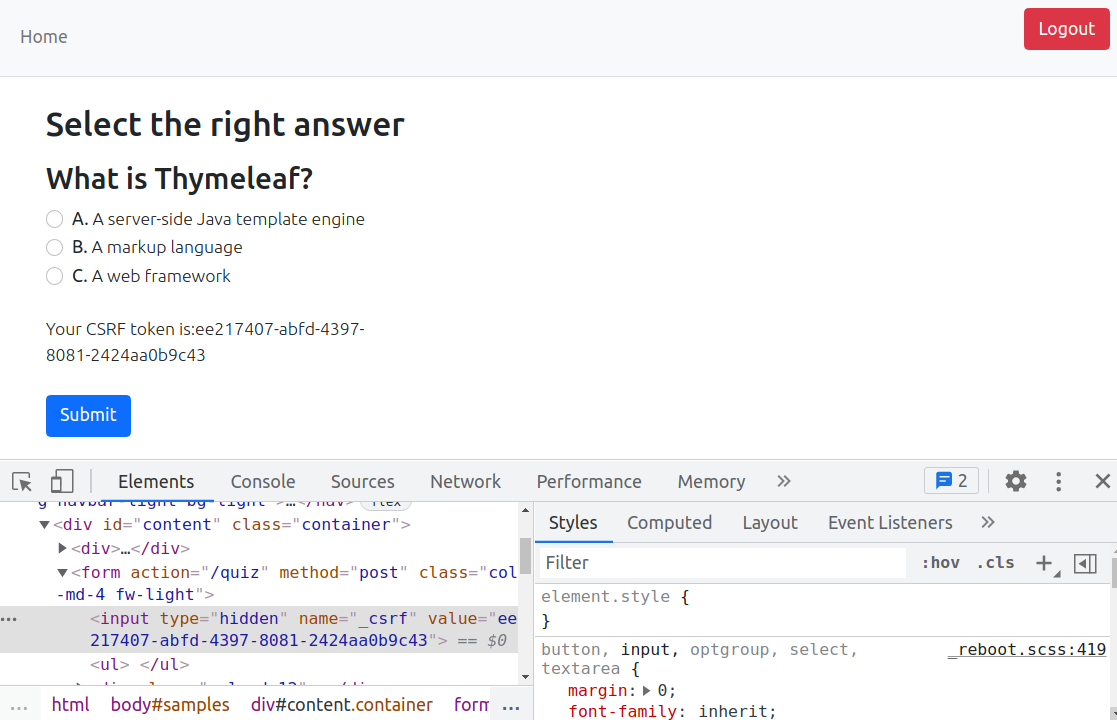

Запустите приложение еще раз. Вы должны увидеть ссылку "Visit the **Thymeleaf Quiz** to test Cross-Site Request Forgery (CSRF) protection". Нажмите на ссылку — вы перейдете на страницу с quiz:

Spring Security добавляет CSRF-токен в форму в виде скрытого атрибута .

Можно выполнить POST-запрос с помощью HTTPie и убедиться еще раз, что CSRF-защита работает.

```

$ http POST http://localhost:8080/

HTTP/1.1 403 Forbidden

Cache-Control: no-cache, no-store, max-age=0, must-revalidate

Content-Type: text/plain

Expires: 0

Pragma: no-cache

Referrer-Policy: no-referrer

X-Content-Type-Options: nosniff

X-Frame-Options: DENY

X-XSS-Protection: 1 ; mode=block

content-length: 38

An expected CSRF token cannot be found

```

Интересный факт — CSRF-защита приоритетнее аутентификации в цепочке фильтров Spring Security.

#### Больше о Spring Boot и Spring Security

Надеюсь, вам понравилось это краткое введение в Thymeleaf и вы узнали, как защитить контент и реализовать авторизацию на стороне сервера с помощью Spring Security. Вы также убедились, насколько быстро и легко интегрировать OIDC-аутентификацию с помощью Okta. Узнать больше о Spring Boot Security и OIDC вы можете в следующих статьях:

* [Learn How to Build a Single-Page App with Vue and Spring Boot](https://developer.okta.com/blog/2021/10/04/spring-boot-spa)

* [Kubernetes to the Cloud with Spring Boot and JHipster](https://developer.okta.com/blog/2021/06/01/kubernetes-spring-boot-jhipster)

* [Spring Native in Action with the Okta Spring Boot Starter](https://developer.okta.com/blog/2021/09/16/spring-native-okta-starter)

Исходный код из статьи вы можете найти на [GitHub](https://github.com/oktadev/okta-thymeleaf-security-example).

---

Всех, дочитавших статью до конца, приглашаем на открытое занятие «Validation Framework в Spring». На занятии рассмотрим, как валидировать различные объекты с использованием javax.validation, в Spring проектах с особенностями. Регистрация — [по ссылке](https://otus.pw/0bg6/). | https://habr.com/ru/post/665952/ | null | ru | null |

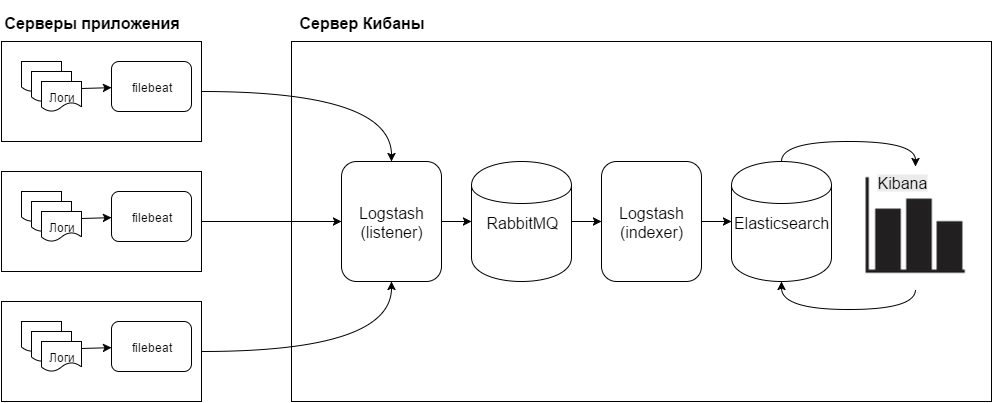

# Управление распределенной командой в режиме многопроектности (обзор и видео доклада)

23-24 сентября в Санкт-Петербурге проходила конференция [Saint TeamLead Conf 2019](https://teamleadconf.ru/spb/2019). «Флант» принял в ней активное участие: Игорь Цупко (наш директор по неизвестному) провел митап, на котором участники разобрались в способах поиска и выявления тайных знаний внутри организации, а Сергей Гончарук (менеджер проектов) выступил с докладом «Управление распределенной командой в режиме многопроектности». По традиции, мы публикуем обзор доклада и [его видео](https://www.youtube.com/watch?v=iZ4ornp2XwI&list=PL1mJ-PkCYnmB9vljnjxCMP3dlxQY3Dfcq) (~37 минут).

«Распределенная команда» и «многопроектность»

---------------------------------------------

Под распределенной командой разные компании понимают очень разные вещи — например, филиальную сеть или офис и удаленных работников… Но в нашем случае офиса в его «настоящем» понимании вообще нет.

Сейчас у нас работает более 80 сотрудников, которые живут в более чем 20 городах России и не только. Большинство из нас видит друг друга «в живую» только 2 дня в году, на дне рождения «Фланта».

В остальное время мы живем в Москве, Самаре, Тюмени, Нижнем Новгороде или любом другом городе, работаем под пение птиц или запах кофе. Вместо аренды места, инвестируем деньги во что-то действительно полезное. И так как все работают удаленно, у нас нет деления на «филиалы» или «касты».

А главное — мы нанимаем лучших, несмотря ни на какие границы! Вот что значит «распределенность» в нашем понимании.

Давайте теперь разберемся с многопроектностью, но для начала важно немного погрузиться в устройство «Фланта».

Мы инженерная компания, у нас много инженеров. Пять-семь инженеров под управлением тимлида и менеджера составляют команду. Таких команд несколько, и у каждой команды есть свой набор из проектов.

Проект для нас — это инфраструктура клиента для одного продукта либо одной команды разработки. То есть у проекта есть четкие границы, но нет ограничений по росту и развитию!

У каждого проекта есть свои потребности, которые нужно как-то донести до команды

Это делает менеджер. Таковы основы «многопроектности».

Теперь, когда у нас есть общее понимание терминов из названия доклада, вопрос: что нужно, чтобы в таких условиях всё не просто работало, а работало хорошо?

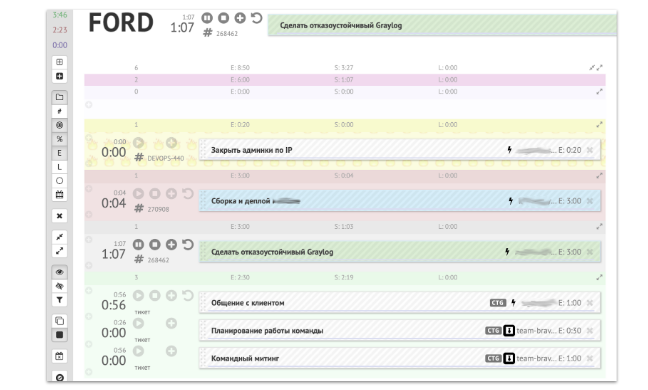

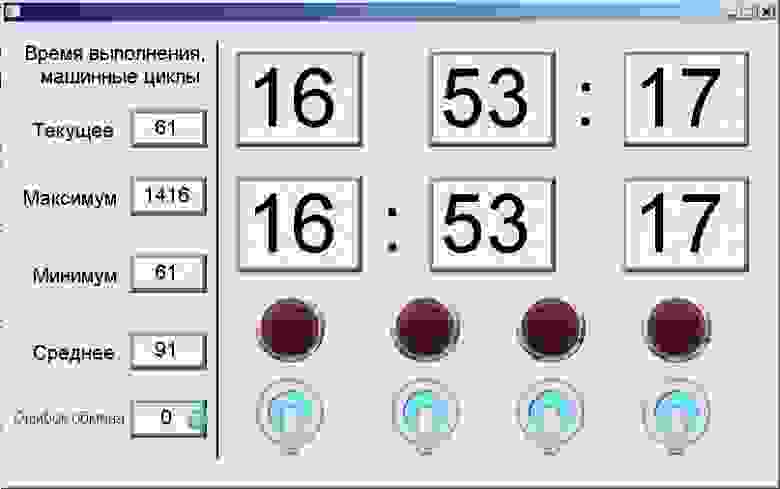

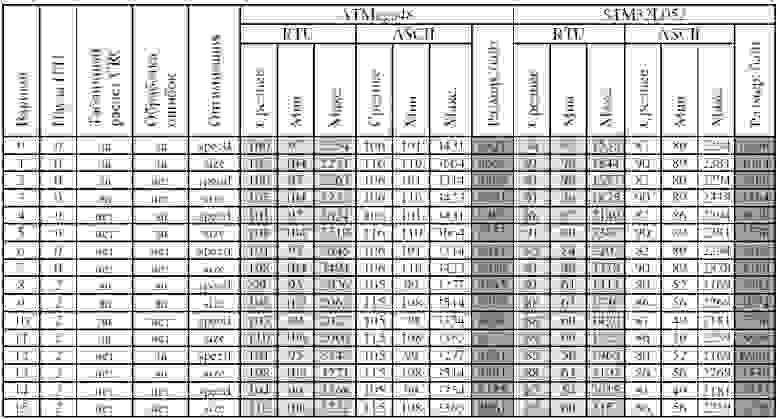

За решение этого вопроса отвечает менеджер команды. Быть «переводчиком» с клиентского на инженерный — это одна из его ключевых компетенций. Вторая — организация конструктивного общения внутри команды и с клиентами. А третья базовая компетенция — нахождение баланса между потоком дел и реальными возможностями инженеров:

Разберем подробнее каждую компетенцию.

1. Трансляция ожиданий

----------------------

Даже у одного и того же клиента могут быть противоречивые ожидания. Например, бизнес клиента требует, чтобы приносящий деньги production был стабилен. И к тому же, постоянно пополнялся новыми функциями, которые помогают увеличить выручку.

Ну, а если уж и случится какая-то авария (бизнес готов к тому, что аварии бывают), то она будет устранена в максимально короткий срок. Звучит очень предсказуемо, не так ли?

Но у этого же клиента есть и разработчики. И их ожидания, оказывается, совсем иные! Для разработчиков dev важнее production’а (ведь на них тоже давит бизнес), а еще они ждут, что любая их просьба будет услышана и сделана прямо сейчас (обычно это описывается фразой «ведь там дел на 5 минут»).

Единственное, что объединяет и бизнес и разработчиков в требованиях, — и те, и другие ожидают, что плановые задачи будут сделаны точно и в обещанные сроки.

Посмотрим на картину в целом… Да тут же полно взаимоисключающих параграфов!

* Добавление новых фич всегда добавляет и новые точки отказа. Бабах! И production работает нестабильно после пятничного релиза.

* Наши инженеры максимально оперативно выполняли в течение дня всё, о чем просят разработчики, а плановые задачи так и остались нетронутыми из-за этого.

* Или вот такая история: стабильности какого окружения уделить больше внимания? Мы стабилизировали dev, выделив на это ресурсы, но у нас после очередного выката начал падать production!

* Частый кейс: сломался production и вся команда ушла его чинить. При этом, конечно, нет продвижения по плановым задачам, и даже разработчики из Индии в чате уже перешли на русский мат, потому что не могут дождаться ответа.

И мы понимаем, что сами требования противоречивы, а значит — напрямую транслировать их невозможно.

2. Коммуникации

---------------

В трансляции ожиданий действительно есть проблемы. Хорошо, может быть, тогда хотя бы с коммуникациями все проще?

Для общения между собой и с клиентами мы используем Slack для текста и Google Meet для митингов и случаев, когда сказать проще, чем написать. Но в чате мы часто получаем сообщения, которые не несут в себе полезного смысла или содержат столько ошибок, что смысл распознать сложно!

Почему мы обращаем на это внимание? Дело в том, что, например, только за июль 2019 года мы получили 1993 обращения от клиентов в Slack, требующих обязательной реакции. И, естественно, с ростом количества клиентов есть и устойчивый тренд по росту количества таких обращений. Около 165 инженеро-часов мы потратили в июле на реакцию на такие обращения. А ведь по каждому обращению требовалось еще и что-то сделать!

Нам очень жаль, когда время инженеров, которое могло бы быть инвестировано в плановые задачи, реакцию на другие обращения или даже на починку аварий, тратится впустую.

Проблема в чатах очевидна, но у видеоконференций наверняка нет проблем?

Мы говорили выше, что используем Google Meet для ежедневных командных митингов, а остальное время делаем задачи, которые разобрали на митинге. Каждый день мы тратим на митинги порядка часа. Мы стараемся тратить на непосредственную работу не менее семи часов в день, то есть на выполнение задач остается 6 часов. Но у нас очень разные по длительности задачи.

Вот и получается, что за час митинга мы могли бы завершить несколько небольших, но, вероятно, важных для наших клиентов задач. И нам надо понять, действительно ли нужны часовые митинги или все же лучше пойти и поработать это время?

Если попробовать собрать проблемы коммуникаций вместе, получаем, что чат генерирует бесполезные прерывания и регулярные митинги «отъедают» рабочее время.

Эффективные коммуникации не выстраиваются сами по себе.

3. Планирование

---------------

Что ж, нам надо решать проблемы в коммуникациях и трансляции ожиданий, но в планировании, наверное, нет никаких подводных камней? Давайте разберемся.

Каждый день создается большое количество новых задач. Хотелось бы, чтобы мы закрывали задачи так же быстро, как они растут. Но в жизни идеал редко бывает достижим. Во-первых, в инфраструктуре иногда что-нибудь да ломается. Во-вторых, всегда есть какие-то мелкие дела, которые проще сделать сразу. В-третьих, есть задачи, о решении которых мы договорились на командном митинге:

А иногда случается так, что из-за аварий и дерганий по мелочам до плановых вообще не удается добраться! При этом новые задачи не перестают прибывать — все обещанные сроки срываются.

Наш рецепт

----------

Но на все проблемы с трансляцией ожиданий, с коммуникациями и планированием, методом набивания шишек удалось получить, как нам кажется, правильный ответ.

Одним из ключевых бизнес-процессов, затрагивающих все три базовые компетенции, является командный митинг. И у нас появилось предположение, что если сделать командный митинг эффективным мы сможем достигнуть 80% результата двадцатью процентами усилий? Мы проверили эту теорию.

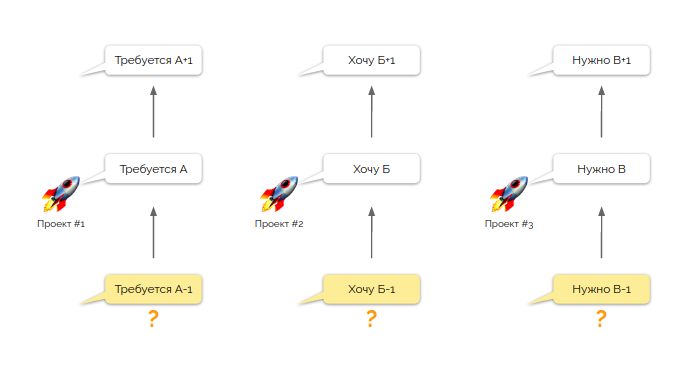

Как вы помните, у нас есть команда, обслуживающая свой набор проектов. И у нее есть некий перечень требований от этих проектов. Но каждое требование, как правило, лишь одно в цепочке взаимосвязанных задач. И так в каждом проекте! И прежде, чем взять в работу новую задачу, нам надо понимать, сделали ли мы предыдущий этап?

Вчера задачу А-1 выполнял Егор, задачу Б-1 — Семен, а задачу В-1 — Жанна. Но как нам погрузить всех инженеров во все проекты настолько глубоко, чтобы Егору удалось успешно справиться с задачей Б, а Семёну — с двумя небольшими задачами А и В. «Зачем все эти сложности?» — спросите вы. Да дело в том, что Жанна сегодня в отпуске и плановых задач выполнять не будет!

В нашем фокусе внимания много подобных задач. В среднем в каждую команду мы получаем около 25 новых задач каждый рабочий день. И так как задач много, связи между ними запутаны и нет понимания, выполнены ли все задачи предыдущего дня. Для того, чтобы распутывать все это, нужен командный митинг, причем каждый рабочий день, иначе мы не сможем управлять этим потоком.

Учитывая объемы потока, к митингу стоит заранее подготовиться. Мы на подготовке без инженеров не сможем понять, какие именно задачи сделаны полностью, а какие — нет. И, конечно, не сможем передать знания от инженера к инженеру. Но нам однозначно по силам определить приоритеты взятия новых задач в работу.

Приоритезация задач

-------------------

На чем мы основываемся при приоритезации задач? Во-первых, у нас есть стратегические договоренности с клиентом о целях, которые нужно достичь. Во-вторых, раз в неделю мы уточняем тактические планы на online-встрече с заказчиком. Потребности клиента при подготовке как раз отстаивает менеджер, а техническую необходимость и порядок выполнения той или иной задачи — тимлид команды. Именно так, на основании **паритета мнений тимлида и менеджера**, формируется список задач на день.

Культура проведения командных митингов

--------------------------------------

Как только список задач на день определили, чтобы уточнить, что сделано, и погрузить в подробности коллег, начинаем командный митинг, на котором каждый инженер должен подробно рассказать, что он сделал вчера, а вся команда — услышать и, главное, понять произошедшие изменения. Но это проще сказать, чем сделать.

Мы ввели ряд культурных особенностей проведения митинга, которые позволили достигнуть требуемого результата:

В начале митинга, пока все собираются, мы тратим 10-15 минут на разговоры о жизни. О новостях и событиях, не связанных с работой, об увлечениях коллег. Так инженеры, которые находятся в разных городах и почти не видятся, становятся приятелями или даже друзьями. И **эти 10-15 минут в день помогают команде быть более сплоченной**.

После тимбилдинг-беседы приступаем к содержательной части. Вернемся немного назад.

Помните вот эту иллюстрацию? Дело в том, что ни Семен, ни Егор до начала митинга не знают, какие задачи и в каких проектах они будут выполнять сегодня. По целому ряду причин: отпуска, командировки, болезнь, дежурства и т.п. — задача может менять исполнителей изо дня в день, пока не будет полностью решена. И каждый инженер понимает, что сегодня задача может быть назначена и на него, то есть все инженеры уже изначально **заинтересованы вникнуть в подробности каждой задачи**.

Мы разбираем на митинге всей командой возникшие блокировки. Мы настаиваем, чтобы в решении проблемы докладчика приняла участие вся команда. Так мы **мотивируем погружаться в задачи и решать их вместе**.

Если команда работает в офисе, неформальное общение часто происходит «у кулера». Но и в распределенной команде потребность в таком общении существует. Именно поэтому во время обсуждения задач разговор зачастую утекает куда-то не туда. Но мы пресекаем любые отвлечения. Как именно? Нам это удается довольно легко: ведь для отвлеченных разговоров есть специально выделенное время, а сейчас — время работы. Поэтому даже обычного устного «давайте по делу» хватает, чтобы все вернулись к деловой повестке. Пресекая отвлечения в процессе разбора задач, мы **настраиваем команду на рабочий лад**.

Мы стараемся контролировать время доклада каждого инженера. Порой для погружения в детали нам нужен длинный и подробный рассказ о задаче. Тем не менее, в большинстве случаев, мы **стараемся не растянуть митинг**.

Эффективные митинги — серебряная пуля?

--------------------------------------

Благодаря подготовке к митингу на основе паритета мнений тимлида и менеджера и нашим культурным особенностям проведения митинга мы действительно сделали их эффективными. Но получилось ли закрыть 80% по всем компетенциям? Не совсем.

Мы хорошо поработали с трансляцией ожиданий, но в коммуникациях все еще проблемы с неинформативными сообщениями в чатах, а в планировании остались прерывания, которые не дают эффективно делать плановые задачи.

Да, но ведь и неинформативные сообщения в чате — тоже прерывания. И нам необходимо найти механизм, который поможет нам эффективно обрабатывать прерывания всех видов.

Борьба с прерываниями

---------------------

Мы подумали, а что, если у нас будет отдельный человек, который будет «закрывать» собой команду, работающую над плановыми заданиями от потока прерываний?

Идея не новая и в общем хорошая, но кто именно будет это делать? Мы рассматривали два варианта: поиск и найм такой службы или использование уже имеющихся инженеров. Поиск новых людей требовал времени и финансовых ресурсов, а существующие инженеры уже были «проверены в бою» и погружены во все проекты команды. Поэтому вариант с наймом новых людей был отвергнут.

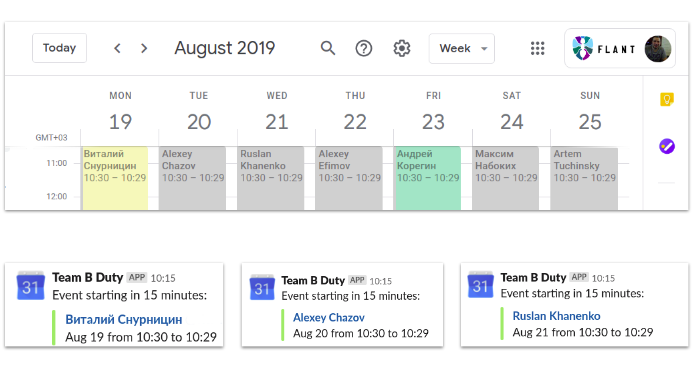

Осталось определиться с вопросом, как организовать такую службу из текущих инженеров. Тут решение было на поверхности: просто применили дежурства по графику, с ротацией инженеров из команды. Само расписание дежурств мы ведем в Google Calendar, плюс настроили уведомления в Slack о том, кто дежурит сегодня.

Казалось бы, все теперь должно быть отлично? Ура? Нет, на самом деле осталась проблема. Помните, чуть раньше мы говорили, что только в Slack получаем почти 2000 обращений в месяц, а это около 16 обращений в день в каждую команду. Но кроме Slack дежурный должен будет обработать сообщения и от систем мониторинга, а в день это:

* 112 — от Prometheus;

* 16 — от okmeter;

* 25 — от систем внешнего blackbox-мониторинга;

* 14 — от различных кастомных скриптов;

* и даже 2 телефонных звонка от клиентов.

Это же 198 прерываний каждый день из разных источников! Но на самом деле источников еще больше:

* Prometheus есть почти у каждого клиента;

* и Okmeter установлен у каждого клиента;

* а вот кастомных скриптов даже у одного клиента может быть сколько угодно…

Чтобы без волшебства и суперспособностей с этим справился любой инженер из команды, мы собрали алерты от всех источников прерываний в одном месте. Этот инструмент мы назвали Madison, а каждое сообщение в него — Инцидентом.

Но Madison лишь собирает инциденты и хранит состояние о них. Нам же нужно понимать, какой инцидент брать в работу первым, то есть произвести триаж, иметь четкий порядок обработки и эскалации, чтобы легко выполнить его в стрессовой ситуации.

Мы создали и такой инструмент — назвали его Polk:

Polk — это рабочее место дежурного инженера. Он позволяет дежурному фокусироваться только на инцидентах, не отвлекаясь на плановые задачи, получать инциденты из всех источников в одном месте, помогает с определением критичности инцидента по заранее определенному Severity, имеет набор четко описанных статусов и алгоритм обработки, определяющий движение по этим статусам.

Технические и культурные особенности общения в чатах

----------------------------------------------------

Отлично: теперь дежурный, снабженный таким мощным инструментом, действительно закрывает команду от прерываний. Но даже с таким инструментарием дежурство выматывает, а бесполезные прерывания только подливают масло в огонь.

Для борьбы с бесполезными прерываниями в чате мы можем применить небольшой набор технических средств, но основное решение этой проблемы точно лежит в культурной плоскости.

С технической точки зрения в Slack мы разделили информацию по проектам, создав раздельно канал для общения с представителями заказчиков, и по каждому проекту — канал для обсуждения инженерами работ по нему. Еще мы написали бота `@flant`, при обращении к которому в Polk автоматически создается инцидент, который обрабатывает дежурный.

Кроме того, мы рекомендовали клиентам использовать `@flant`, а `@channel` (событие, оповещающее всех участников канала) и `@here` (событие, оповещающее всех участников канала, находящихся online) использовать только в тех редких и исключительных случаях, когда без них действительно нельзя обойтись (например, когда бот `@flant` недоступен).

В первый день нашего сотрудничества с клиентом мы размещаем в канале подробную инструкцию по взаимодействию. И на первой же регулярной встрече обязательно обсуждаем взаимодействие, в том числе и разницу между `@channel`, `@here` и `@flant`.

В частности, мы акцентируем внимание на том, что обращение к `@flant` для нас, в первую очередь, это действие с обязательной реакцией, а `@channel` и `@here` для большей части команды — просто прерывание, которое к тому же безадресно и может быть проигнорировано, отвлекая при этом всю команду от решения плановых задач, в том числе по данному проекту.

Но в чат приходят новые коллеги со стороны клиентов, которые не знают о боте. Другие просто забывают. Если так происходит, мы мягко напоминаем о его существовании.

Для общения же между инженерами мы используем те же правила для `@channel`

и `@here`: не использовать их без крайней необходимости. И еще, мы настаиваем на придерживании правила «Не говори просто „привет“ в чате — сразу сформулируй мысль». Это правило обязательно к прочтению всеми новичками. Тем, кто его забыл, об этом обязательно напомнят — если потребуется, развернуто.

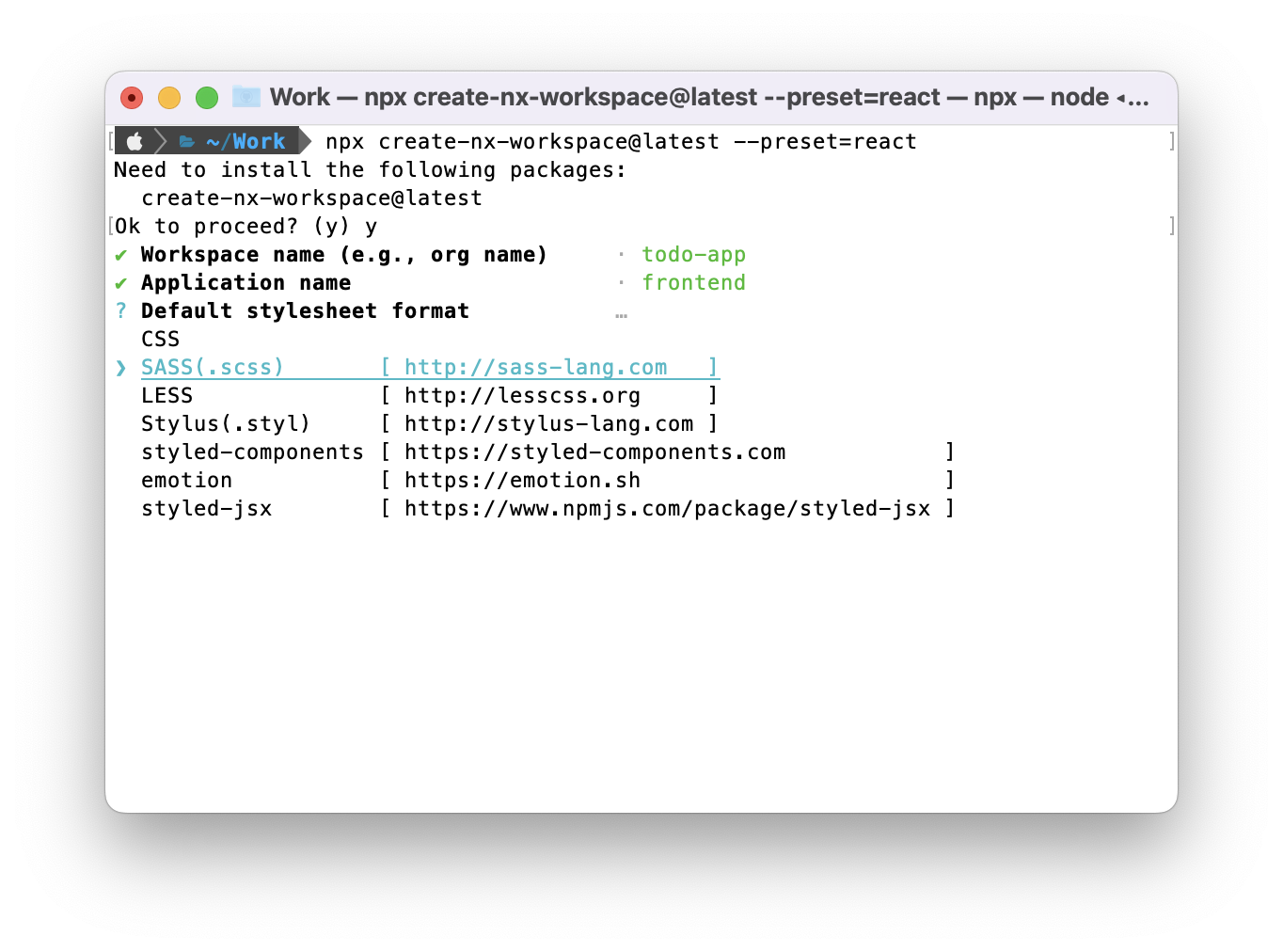

Итого: с введением дежурств и исправлением проблем общения в чате мы справились и с большей частью бесполезных прерываний и с влиянием прерываний на выполнение плановых задач.