text

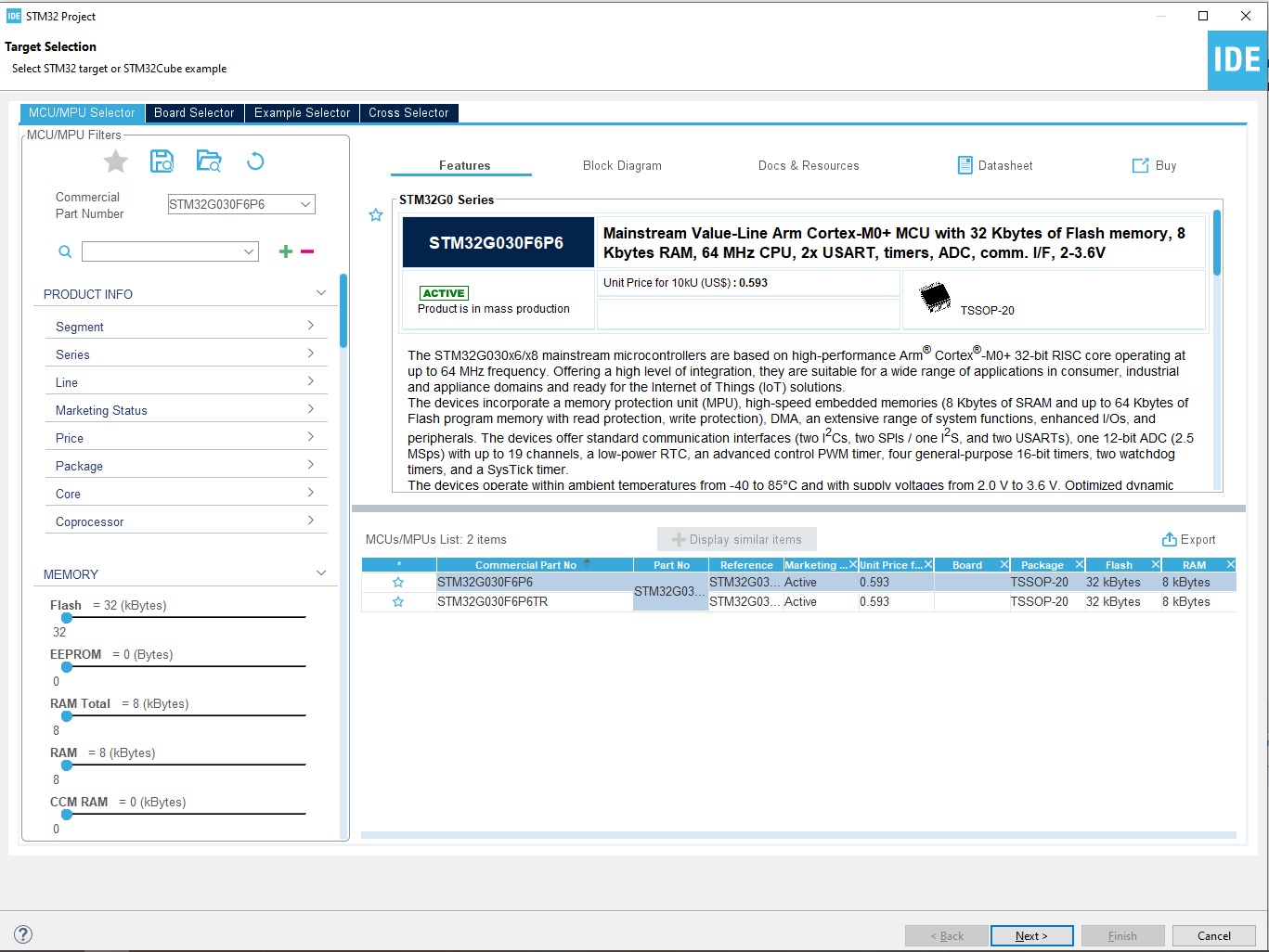

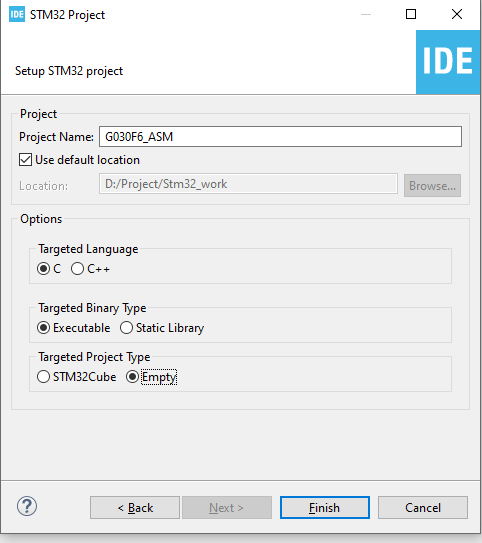

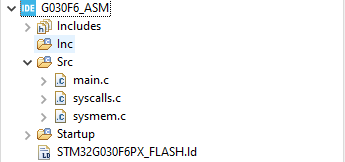

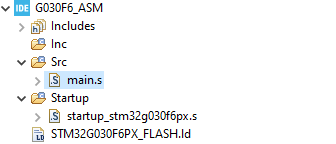

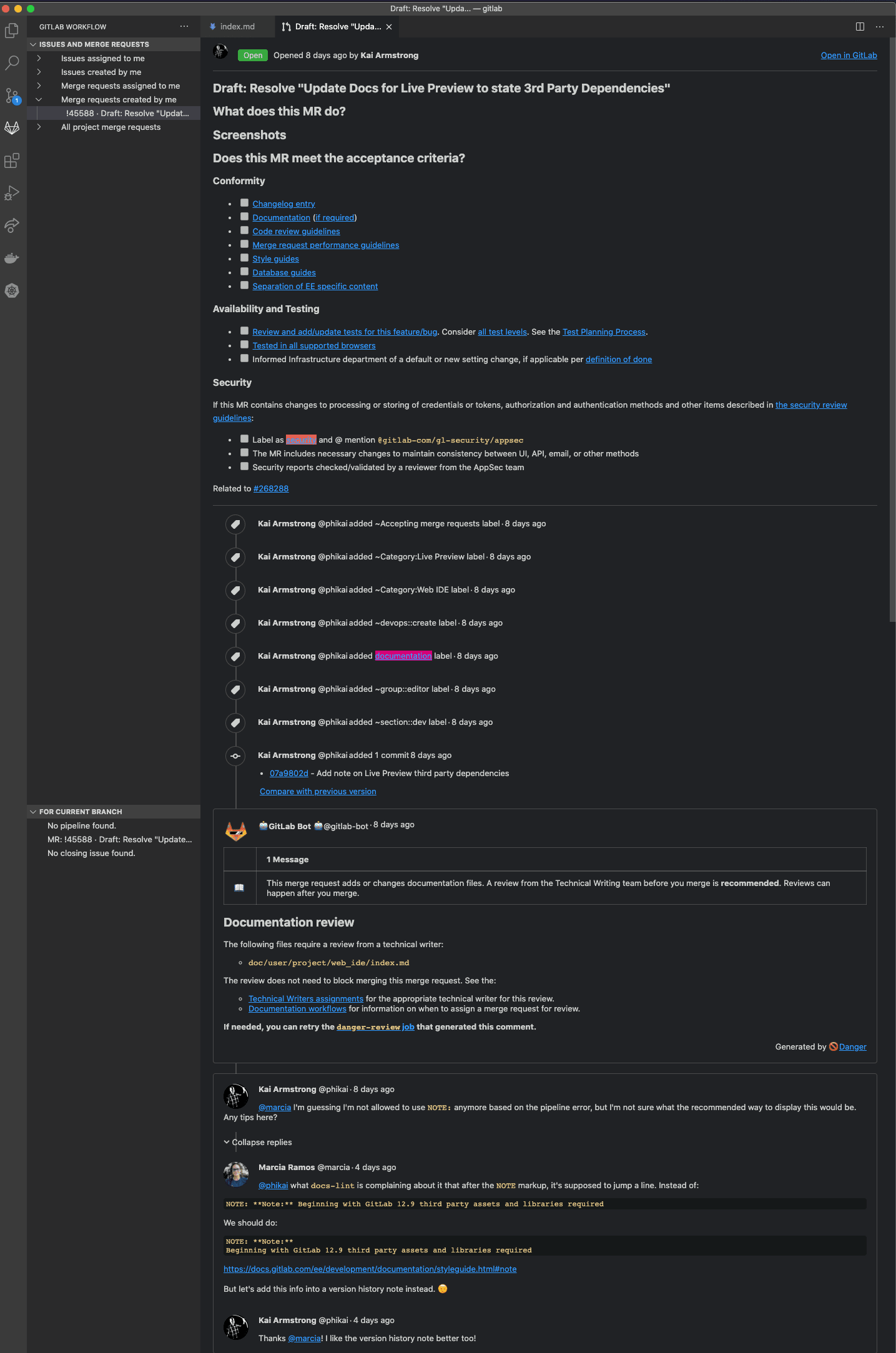

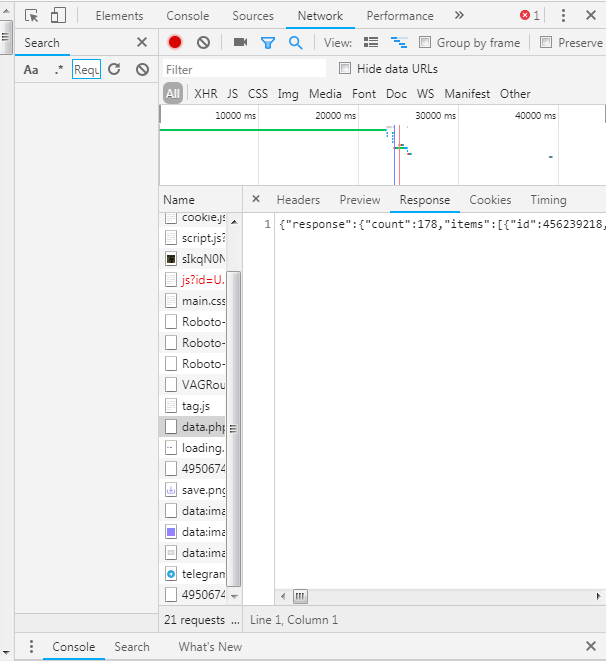

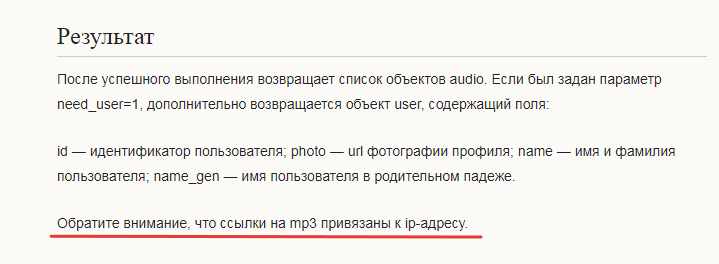

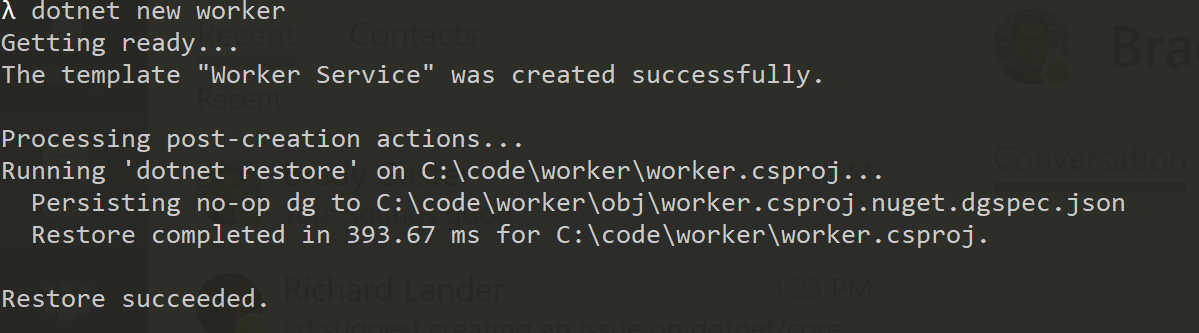

stringlengths 20

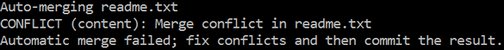

1.01M

| url

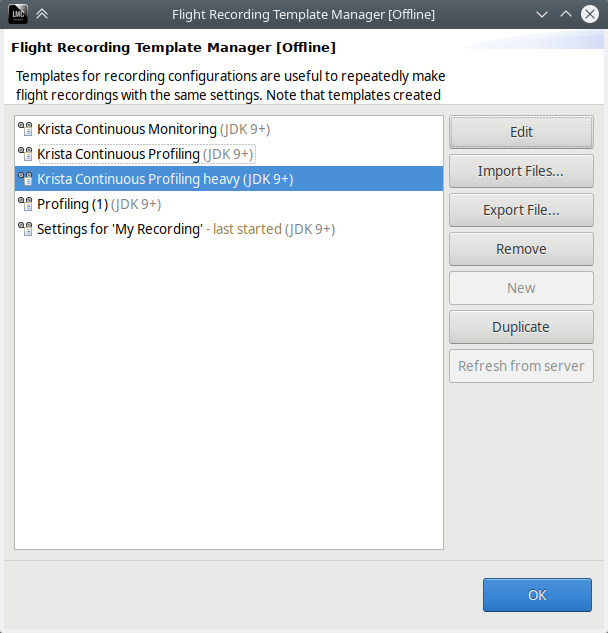

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

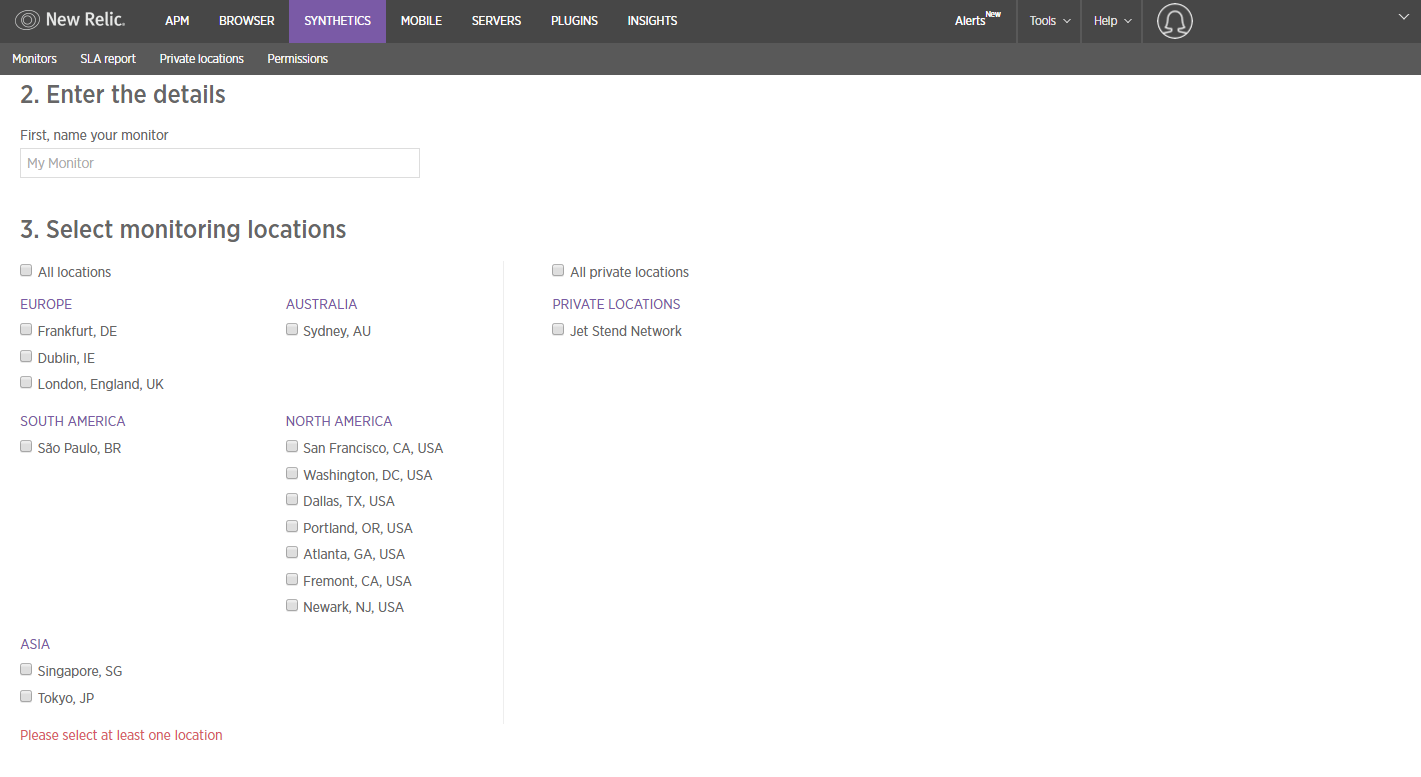

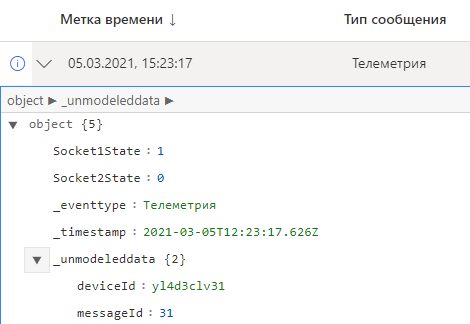

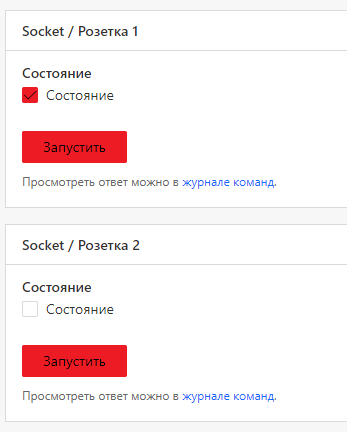

# Анализ трафика приложений на Android Emulator. Причем здесь Root?

Привет! Я думаю, что наберется немало людей, перед которыми стоят интересные задачи по работе с приложениями. Например - анализ трафика для, разумеется, тестирования этих самых приложений! Вам выпало нелегкое бремя - необходимо отдебажить продовую сборку чего-либо и вы начинаете свои поиски решений проблем. А проблем у вас на этом пути будет много. О том, как их можно решить я и пишу.

Классический путь начинается с установки какого-нибудь Charles, настройки в нем proxy-сервера и попытки слушать трафик, однако мы быстро натыкаемся на проблему - все адекватные современные приложения используют HTTPS, а поэтому - на ваше устройство придется установить сертификат, который и позволит слушать трафик. Тут то и начинается самое интересное...

Давайте создадим чек-лист, на который будем ориентироваться в процессе:

* ⚑ Предварительные подготовления, позволяющие начать установку эмулятора

* ⚑ Вы находитесь здесь

* ⚐ Установка эмулятора

* ⚐ Установка сертификата для MITM

* ⚐ Проверка работоспособности прослушки трафика

* ⚐ Разочарование

* ⚐ Получение root-доступа

* ⚐ Перенос сертификата в системное хранилище

* ⚐ Разочарование(?)

* ⚐ SSL Unpinning

* ⚐ Profit!!!

### Установка Android Emulator

Я не буду описывать всю процедуру установки, надеюсь, вы сможете сделать [все](https://developer.android.com/studio/run/emulator) подготовительные [действия](https://developer.android.com/studio), чтобы оказаться в ситуации, когда вам осталось лишь выбрать определенный тип OS в эмуляторе, а все предыдущие шаги уже выполнены.

Итак:

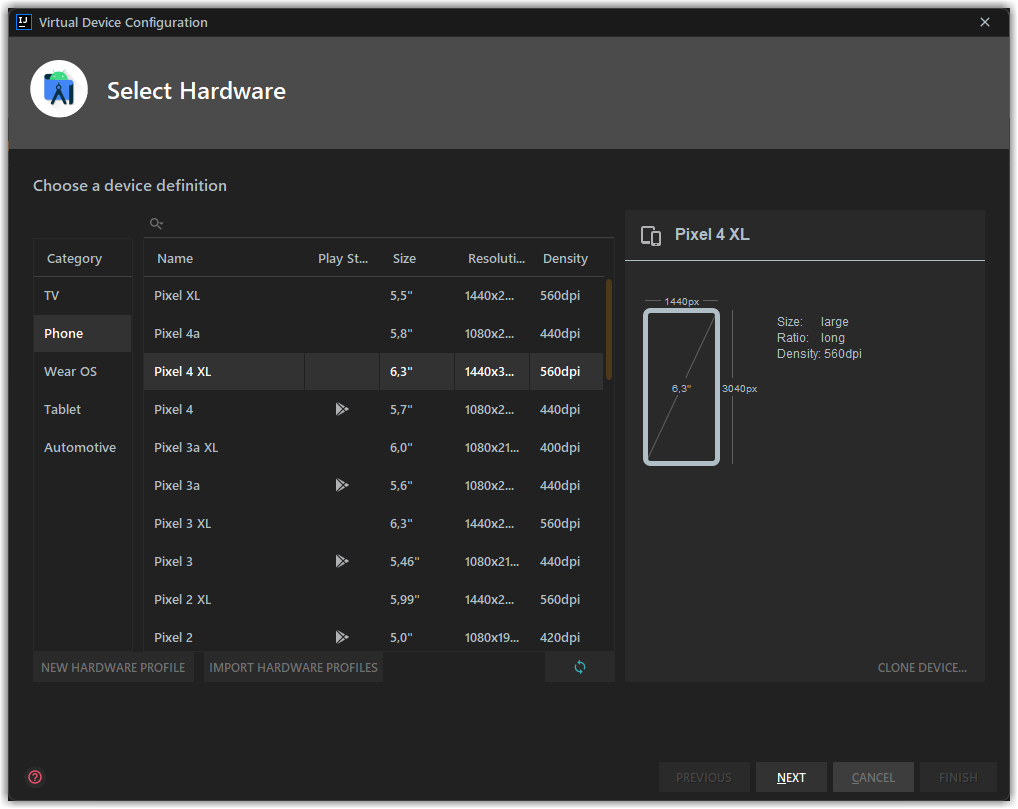

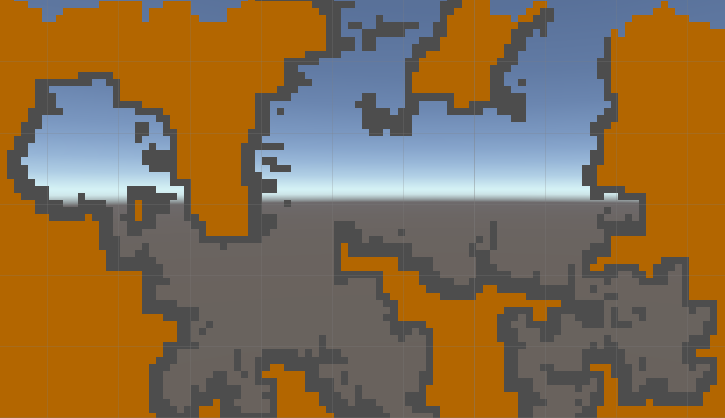

1. Выбираем любой подходящий вариант, с важной оговоркой - это должна быть сборка без Google Play, но с Google Play Services (далее будет видно). Соответственно - выбираем устройство без треугольника

2. Выбираем любой интересующий образ в котором есть Google Play APIs

3. Устанавливаем параметр Cold Boot

Готово!

* ⚑ Установка эмулятора

### Установка сертификата для proxy-sniffer

Для прослушки трафика я буду пользоваться Fiddler Everywhere. И покажу порядок настройки данной софтины, согласно которому мы закроем еще один пункт нашей дорожной карты.

*Тут я сделаю небольшое лирическое отступление - данная программа платная, да и еще по подписке, и стоить будет, в лучшем случае - 10$ в месяц. Но, у вас будет триал в 30 дней, после которого нужно больше золота, поэтому можно использовать любой другой инструмент. Сам я пытался заюзать Postman - в нем тоже есть proxy-tooling, однако, корневые сертификаты, которые генерирует Postman, не пригодны для установки в Android 10 / 11. Однако, служба поддержки уже бдит, и, надеюсь, за отведенные 30 дней триала все заработает как надо (в Postman) и вы сможете пользоваться наиболее удобным (с моей точки зрения) инструментом для решения данной задачи. Когда это случится - я дополню данную статью. А теперь возвращаемся к процессу установки сертификата на устройство (эмулятор).*

Нам необходимо раскрыть пункт **Advanced Settings** в настройках Fiddler, и экспортировать корневой сертификат. В данный момент я пользователь Windows и на данной ОС он окажется на рабочем столе, подсказка об этом показывается по наведению на значок вопроса.

После экспорта сертификата, плавным движением кистей рук, переносим его на запущенный эмулятор - файл окажется в папке `.../Downloads`. После чего можно сразу идти в настройки и устанавливать наш серт:

Отлично! Можем поставить галочку у еще одного пункта:

* ⚑ Установка сертификата для MITM

### Проверяем, все ли ок

Самое время проверить, принесли ли наши усилия хоть какие-то полезные плоды. Подопытным кроликом сегодняшнего эксперимента будет приложение **Reddit** и первое, что мы увидим, если попытаемся загрузить посты:

Пустота.

А также бесконечное количество попыток SSL-handshake в Fiddler. Кажется, пора поставить прочерк сразу напротив двух пунктов нашей дорожной карты:

* ⚑ Проверка работоспособности прослушки трафика

* ⚑ Разочарование

* ### Я есть root

Мне кажется, что наступил момент рассказать, для чего нам вообще рут? Все дело в том пресловутом изменении Android 7, после которого пользовательские сертификаты перестали быть доверенными. Посему - нам необходимо сделать что-то с нашим установленным сертификатом, чтобы мы смогли использовать его для изучения трафика нашего ~~рабочего~~ приложения. И сделать это можно, только если ваш девайс рутован. Тут же заключается и причина использования эмулятора, да и связанные с этим особенности: без эмулятора вам придется иметь постоянно рутованное устройство, если это отдельный выделенный смартфон - то проблем с этим особенно и нет (ну, кроме зарядки, постепенного устаревания и ограничений конкретной модели), однако, если у вас свой личный аппарат - то минусы от root могут быть существенными - не работающая система безопасности, сломанный Google Pay или отвалившиеся камеры... Ну и помимо всего прочего - эмулятор позволяет легко изменить версию Android (правда, придется повторить все действия, перечисленные тут, но у вас уже будет эта статья, а я вот это все пишу её не имея).

А теперь приступим. Благодаря прекраснейшему [проекту](https://github.com/newbit1/rootAVD) весь процесс сводится к запуску всего лишь одного скрипта, с небольшими подготовительными работами. Также, обращайте внимание на то, что выводится в консоль и если вы пользуетесь Windows - то запускайте не `.sh`, а `.bat`. Возможно, WSL будет тут как раз кстати, но моя система, скажем так, с некоторыми особенностями, которые WSL использовать не позволяют (если вы знаете, как завести на Ryzen 5000-серии и WSL и Android Emulator - то прошу написать об этом комментарий).

А вот и сами работы:

```

./rootAVD.sh ~/Library/Android/sdk/system-images/android-30/google_apis/x86_64/ramdisk.img

```

Плюс, нужно перезагрузить эмулятор. Ну и, у пользователей Windows путь до образа будет примерно таким:

```

C:\Users\Me\AppData\Local\Android\Sdk\system-images\android-30\google_apis\x86_64\ramdisk.img

```

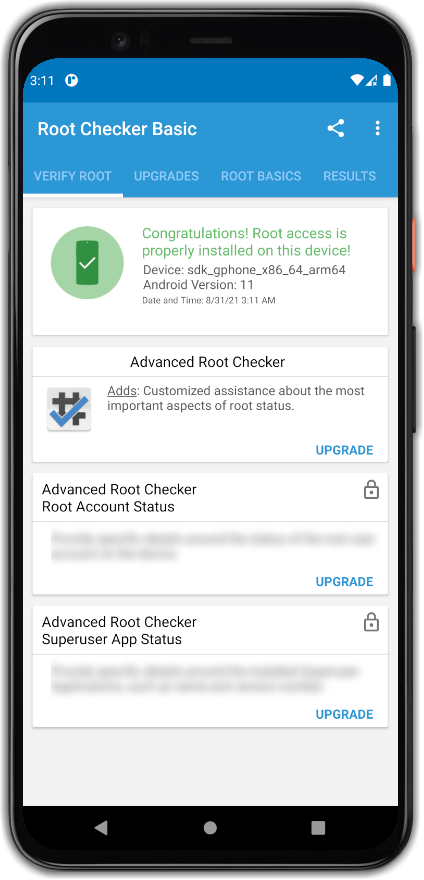

На выходе мы получаем рут, который сохраняется при перезагрузке эмулятора, но wipe делать не стоит.

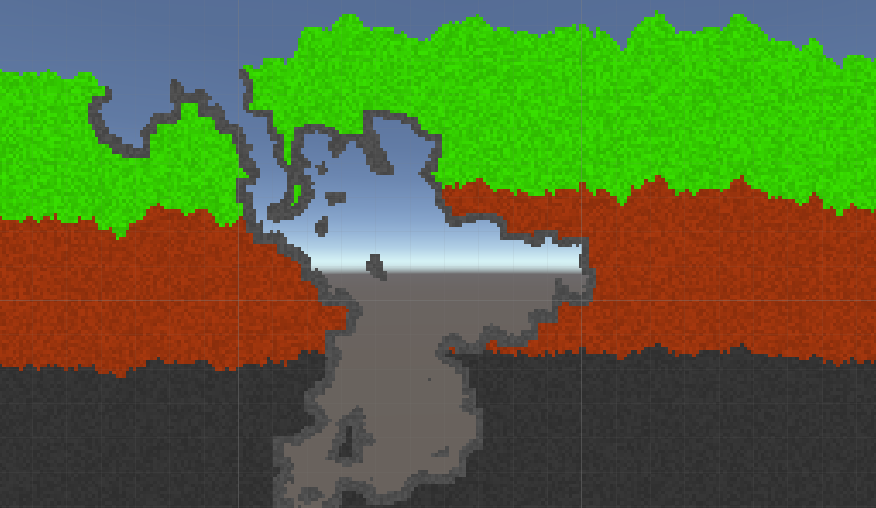

Ставим галку:

+ ⚑ Получение root-доступа### Делаем сертификат доверенным

Для этого нам понадобится перенести его в хранилище доверенных сертификатов. Тут рут нам и нужен (не только тут, но это позже).

Для этого мы запускаем цепочку следующих команд:

```

adb shell

su

mkdir -m 700 /data/certs

cp /system/etc/security/cacerts/* /data/certs/

mount -t tmpfs tmpfs /system/etc/security/cacerts

cp /data/misc/user/0/cacerts-added/* /system/etc/security/cacerts/

mv /data/certs/* /system/etc/security/cacerts/

chown root:root /system/etc/security/cacerts/*

chmod 644 /system/etc/security/cacerts/*

chcon u:object_r:system_file:s0 /system/etc/security/cacerts/*

```

После чего наблюдаем следующую картинку в системных сертификатах:

Наш сертификат стал системным, поэтому закроем еще один пункт:

+ ⚑ Перенос сертификата в системное хранилищеИ давайте сразу проверим наше приложение:

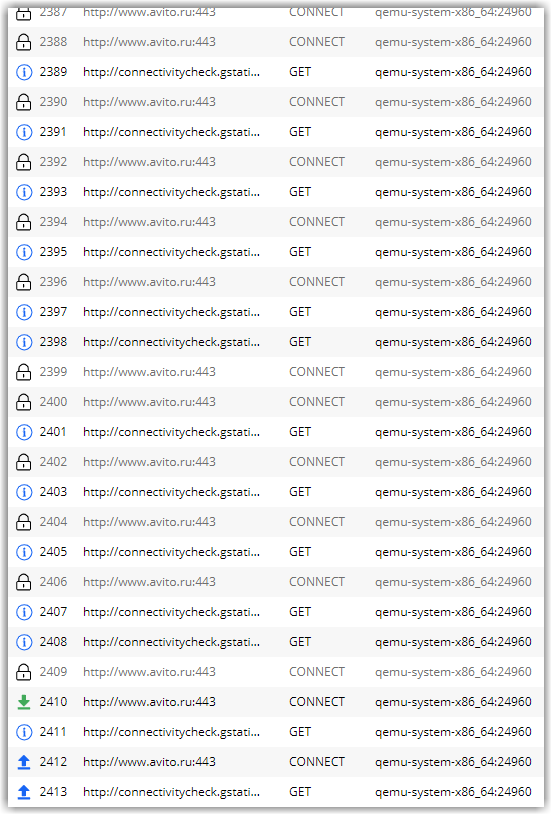

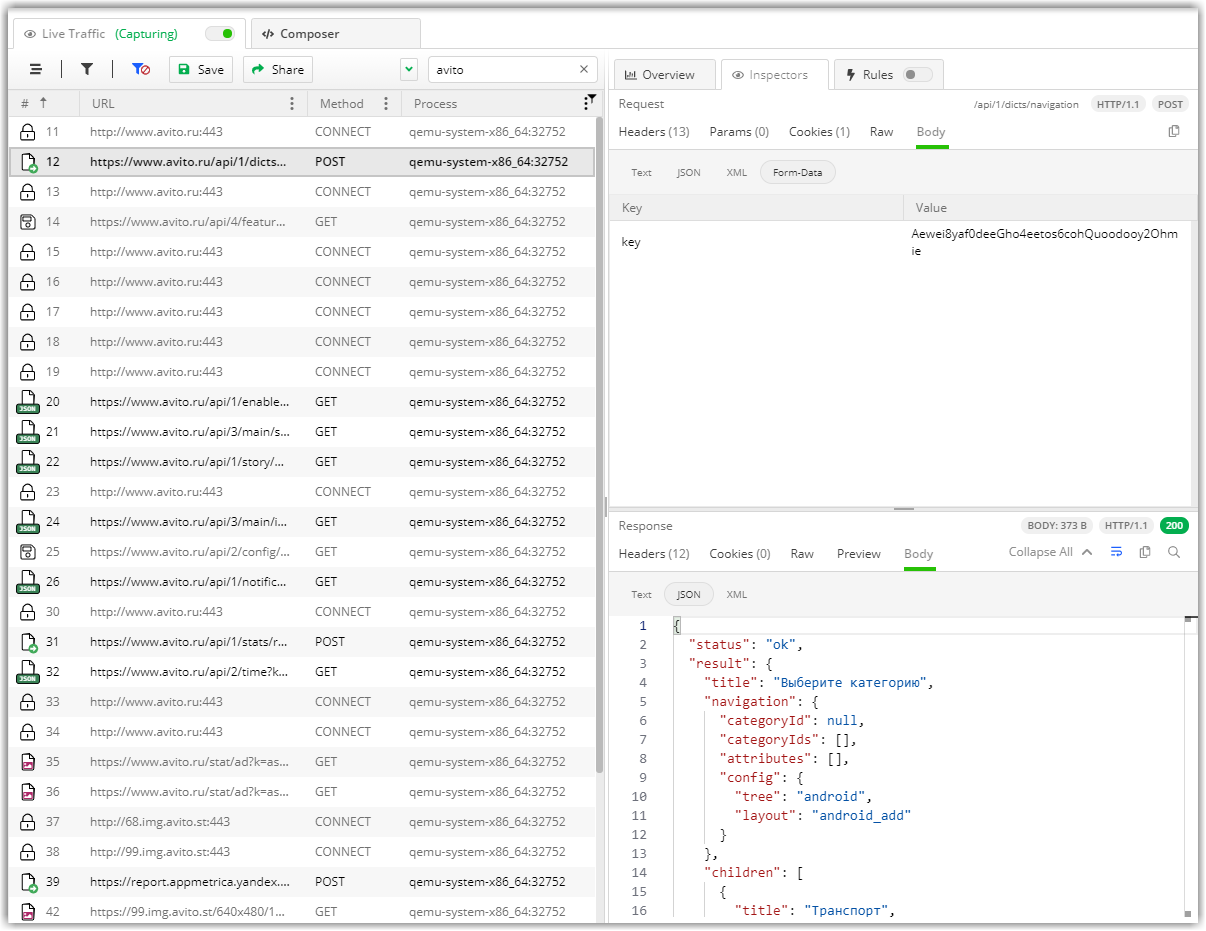

Отлично! Теперь мы можем слушать HTTPS-трафик любых (ли?) приложений с эмулятора. Давайте, чтобы закрепить результат, попробуем еще одно приложение - **Avito** (как говорили Ник и Майк - это крепкий орешек).

Кажется, тут что-то пошло не так. Впрочем вы и так все знаете, так как видели гигантский спойлер в самом начале, поэтому ставим еще одну галку:

+ ⚑ Разочарование!### SSL-Unpinning

На данную тему есть множество решений, но, как правило, все они крутятся вокруг одной идеи - пересборки приложения, которое вы хотите изучить. Данный подход весьма громоздкий, сложный и может сподвигнуть к прокрастинации, поэтому нужно что-то такое, что позволит сделать все намного проще и универсальнее. И рецепт этого чего-то прямо тут, бесплатно и без СМС:

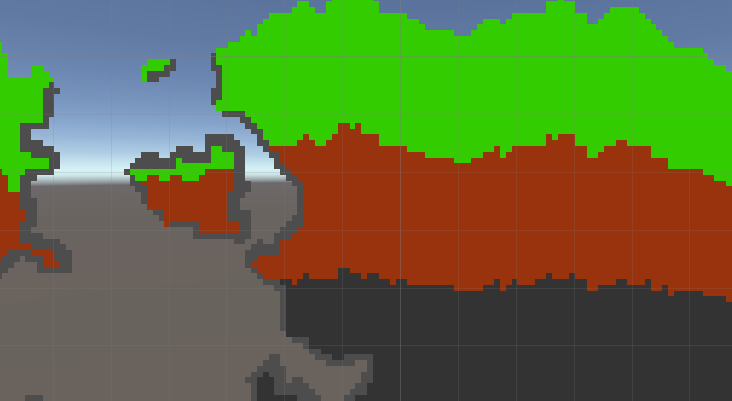

1. Благодаря наличию root установим Xposed

2. Благодаря Xposed установим модуль для отвязки SSL-привязки

3. Profit!!! (два пункта тут смотрелись бы уныло)А теперь давайте по порядку.

**Установка Xposed**

С учетом нашего изначального плана слушать всё и вся на эмуляторе на этом шаге появляются некоторые сложности - нужно подобрать удачную комбинацию программных решений, которые будут работать и на эмуляторе. Благодаря этой статье вам совершенно точно не придется тратить несколько часов на поиски этих решений и будет достаточно следовать простой инструкции:

1. Скачиваем [последнюю](https://github.com/RikkaApps/Riru/releases) версию Magisk-модуля с интересным названием Riru и устанавливаем его посредством Magisk

2. Закрываем эмулятор, а затем снова запускаем (данный шаг эмулирует перезагрузку, которая у меня, по каким-то причинам, не работает, если работает у вас - может быть достаточно и её)

3. Находим в репозитории Magisk модуль с названием `Riru - LSPosed` и устанавливаем его

4. Снова ребутим эмулятор

5. Открываем приложение LSPosed, в котором необходимо установить уже Xposed-модуль SSLUnpinning

6. Переключаем все галки в настройках данного модуля у всех приложений, которые хотим слушать и активируем сам модуль

7. Ребутим эмуляторПосле этого вы оказались в ситуации, когда у вас есть эмулятор с:

+ Полноценным рутом (Magisk)

+ Установленным MITM-сертификатом в User-space

+ Установленным Xposed (LSPosed)

+ Установленным модулем для SSL-UnpinningВ процессе имея следующий набор картинок:

Можно честно поставить галку:

+ ⚑ SSL UnpinningНастал час проверить, работает ли этот паровоз:

Работает! Ник и Майк ошиблись! Можем ставить и последнюю галку:

+ ⚑ Profit!!!Какие есть нюансы? Во первых - при каждом включении эмулятора будет необходимо снова делать сертификаты доверенными (в принципе, после всех этих процедур можно отключить Cold Boot, и тогда не придется, но рано или вам придется перезагрузить эмулятор "жестко", и тогда потребуется поработать и с сертификатами). Возможно, тут есть постоянное решение или это можно, на худой конец, автоматизировать, но я устал. Во вторых - не все приложения в принципе хотят запускаться на эмуляторе. Самый надежный вариант - иметь набор выделенных телефонов на разных версиях Android, все из которых будут иметь весь арсенал инструментов из данного мануала (с небольшими изменениями), но он не всегда возможен.

Под конец - я еще раз продублирую всю инструкцию по пунктам, чтобы был понятен сам алгоритм:

+ Делаем приготовления (ставим Android Studio), чтобы иметь возможность установить / запустить эмулятор

+ Устанавливаем эмулятор с параметрами, определенными выше

+ Устанавливаем интересующие нас приложения на эмулятор методом перетаскивания курсором и убеждаемся, что они в принципе работают и все это будет не зря

+ Получаем root (Magisk) посредством инструкции, указанной выше

+ Перезагружаем эмулятор

+ Устанавливаем Riru

+ Перезагружаем эмулятор

+ Устанавливаем LSPosed

+ Перезагружаем эмулятор

+ Устанавливаем Xposed-модуль SSLUnpinning

+ Ставим все галки в модуле у интересующих нас приложений и у самого модуля (включаем его)

+ Закрываем эмулятор

+ Выключаем Cold Boot

+ Включаем эмулятор

+ Устанавливаем MITM CA-сертификат в User-space (считай - просто устанавливаем)

+ Делаем сертификат доверенным по инструкции выше

+ Настраиваем Proxy на эмуляторе согласно параметрам, указанным выше, или вашим собственным (в зависимости от того, каким инструментом для анализа трафика вы собираетесь пользоваться)

+ Анализируем работу приложенияЕсли будете устанавливать дополнительные приложения на эмулятор - то необходимо проставить галки напротив них в SSLUnpinning (через LSPosed) и жестко перезагрузить эмулятор, с последующим фиксом сертификатов после перезагрузки. На этом, собственно, все, до новых встреч! | https://habr.com/ru/post/575460/ | null | ru | null |

# Настройка ISCSI initiator в linux

Abstract: как работает open-iscsi (ISCSI initiator в linux), как его настраивать и чуть-чуть про сам протокол ISCSI.

Лирика: В интернете есть множество статей довольно хорошо объясняющих, как настроить ISCSI target, однако, почему-то, практически нет статей про работу с инициатором. Не смотря на то, что target технически сложнее, административной возни с initiator больше — тут больше запутанных концепций и не очень очевидные принципы работы.

ISCSI

=====

Перед тем, как рассказать про ISCSI — несколько слов о разных типах удалённого доступа к информации в современных сетях.

NAS vs SAN

----------

Существует два метода доступа к данным, находящимся на другом компьютере: файловый (когда у удалённого компьютера запрашивают файл, а какими файловыми системами это сделано — никого не волнует), характерные представители NFS, CIFS (SMB); и блочный — когда у удалённого компьютера запрашивают блоки с дискового носителя (аналогично тому, как их читают с жёсткого диска). В этом случае запрашивающая сторона сама себе делает на блочном устройстве файловую систему, а сервер, отдающий блочное устройство, знать не знает про файловые системы на нём. Первый метод называют NAS (network attached storage), а второй — SAN (storage area network). Названия вообще указывают на другие признаки (SAN подразумевает выделенную сеть до хранилищ), но так сложилось, что NAS — это файлы, а SAN — это блочные устройства по сети. И хотя все (?) понимают, что это неправильные названия, чем дальше, тем больше они закрепляются.

scsi over tcp

-------------

Одним из протоколов доступа к блочным устройствам является iscsi. Буква 'i' в названии относится не к продукции эппл, а к Internet ~~Explorer~~. По своей сути это 'scsi over tcp'. Сам протокол SCSI (без буквы 'i') — это весьма сложная конструкция, поскольку он может работать через разные физические среды (например, UWSCSI — параллельная шина, SAS — последовательная — но протокол у них один и тот же). Этот протокол позволяет делать куда больше, чем просто «подтыкать диски к компьютеру» (как это придумано в SATA), например, он поддерживает имена устройств, наличие нескольких линков между блочным устройством и потребителем, поддержку коммутации (ага, SAS-коммутатор, такие даже есть в природе), подключение нескольких потребителей к одному блочному устройству и т.д. Другими словами, этот протокол просто просился в качестве основы для сетевого блочного устройства.

Терминология

------------

В мире SCSI приняты следующие термины:

**target** — тот, кто предоставляет блочное устройство. Ближайший аналог из обычного компьютерного мира — сервер.

**initiator** — клиент, тот, кто пользуется блочным устройством. Аналог клиента.

**WWID** — уникальный идентификатор устройства, его имя. Аналог DNS-имени.

**LUN** — номер «кусочка» диска, к которому идёт обращение. Ближайший аналог — раздел на жёстком диске.

ISCSI приносит следующие изменения: WWID исчезает, на его место приходит понятие IQN (iSCSI Qualified Name) — то есть чистой воды имя, сходное до степени смешения с DNS (с небольшими отличиями). Вот пример IQN: iqn.2011-09.test:name.

IETD и open-iscsi (сервер и клиент под линукс) приносят ещё одну очень важную концепцию, о которой чаще всего не пишут в руководствах по iscsi — portal. Portal — это, если грубо говорить, несколько target'ов, которые анонсируются одним сервером. Аналогии с www нет, но если бы веб-сервер можно было попросить перечислить все свои virtualhosts, то это было бы оно. portal указывает список target'ов и доступные IP, по которым можно обращаться (да-да, iscsi поддерживает несколько маршрутов от initiator к target).

target

======

Статья не про target, так что даю очень краткое описание того, что делает target. Он берёт блочное устройство, пришлёпывает к нему имя и LUN и публикет его у себя на портале, после чего позволяет всем желающим (авторизация по вкусу) обращаться к нему.

Вот пример простенького файла конфигурации, думаю, из него будет понятно что делает target (файл конфигурации на примере IET):

```

Target iqn.2011-09.example:data

IncomingUser username Pa$$w0rd

Lun 0 Path=/dev/md1

```

(сложный от простого отличается только опциями экспорта). Таким образом, если у нас есть target, то мы хотим его подключить. И тут начинается сложное, потому что у initiator'а своя логика, он совсем не похож на тривиальное mount для nfs.

Initiator

=========

В качестве инициатора используется open-iscsi. Итак, самое важное — у него есть *режимы работы* и *состояние*. Если мы дадим команду не в том режиме или не учтём состояние, результат будет крайне обескураживающий.

Итак, режимы работы:* Поиск target'ов (discovery)

* Подключение к target'у

* Работа с подключенным target'ом

Из этого списка вполне понятен жизненный цикл — сначала найти, потом подключиться, потом отключиться, потом снова подключиться. Open-iscsi держит сессию открытой, даже если блочное устройство не используется. Более того, он держит сессию открытой (до определённых пределов, конечно), даже если сервер ушёл в перезагрузку. Сессия iscsi — это не то же самое, что открытое TCP-соединение, iscsi может прозрачно переподключаться к target'у. Отключение/подключение — операции, которыми управляют «снаружи» (либо из другого ПО, либо руками).

Немного о состоянии. После discovery open-iscsi *запоминает* все найденные target'ы (они хранятся в /etc/iscsi/), другими словами, discovery — операция постоянная, совсем НЕ соответствующая, например, dns resolving). Найденные target можно удалить руками (кстати, частая ошибка — когда у open-iscsi, в результате экспериментов и настройки, пачка найденных target'ов, при попытке логина в которые выползает множество ошибок из-за того, что половина target'ов — старые строчки конфига, которые уже давно не существуют на сервере, но помнятся open-iscsi). Более того, open-iscsi позволяет менять настройки запомненного target'а — и эта «память» влияет на дальнейшую работу с target'ами даже после перезагрузки/перезапуска демона.

Блочное устройство

==================

Второй вопрос, который многих мучает по-началу — куда оно попадает после подключения? open-iscsi создаёт хоть и сетевое, но БЛОЧНОЕ устройство класса SCSI (не зря же оно «я сказя»), то есть получает букву в семействе /dev/sd, например, /dev/sdc. Используется первая свободная буква, т.к. для всей остальной системы это блочное устройство — типичный жёсткий диск, ничем не отличающийся от подключенного через usb-sata или просто напрямую к sata.

Это часто вызывает панику «как я могу узнать имя блочного устройства?». Оно выводится в подробном выводе iscsiadm (# iscsiadm -m session -P 3).

Авторизация

===========

В отличие от SAS/UWSCSI, ISCSI доступно для подключения кому попало. Для защиты от таких, есть логин и пароль (chap), и их передача iscsiadm'у — ещё одна головная боль для начинающих пользователей. Она может осуществляться двумя путями — изменением свойств уже найденного ранее target'а и прописываем логина/пароля в файле конфигурации open-iscsi.

Причина подобных сложностей — в том, что пароль и процесс логина — это атрибуты не пользователя, а системы. ISCSI — это дешёвая версия FC-инфраструктуры, и понятие «пользователь» в контексте человека за клавиатурой тут неприменимо. Если у вас sql-база лежит на блочном устройстве iscsi, то разумеется, вам будет хотеться, чтобы sql-сервер запускался сам, а не после минутки персонального внимания оператора.

Файл конфигурации

=================

Это очень важный файл, потому что помимо логина/пароля он описывает ещё поведение open-iscsi при нахождении ошибок. Он может отдавать ошибку «назад» не сразу, а с некоторой паузой (например, минут в пять, чего достаточно для перезагрузки сервера с данными). Так же там контролируется процесс логина (сколько раз пробовать, сколько ждать между попытками) и всякий тонкий тюнинг самого процесса работы. Заметим, эти параметры довольно важны для работы и вам нужно обязательно понимать, как поведёт ваш iscsi если вынуть сетевой шнурок на 10-20с, например.

Краткий справочник

==================

Я не очень люблю цитировать легконаходимые маны и строчки, так что приведу типовой сценарий употребения iscsi:

сначала мы находим нужные нам target, для этого мы должны знать IP/dns-имя инициатора: `iscsiadm -m discovery -t st -p 192.168.0.1` -t st — это команда send targets.

`iscsiadm -m node` (список найденного для логина)

`iscsiadm -m node -l -T iqn.2011-09.example:data` (залогиниться, то есть подключиться и создать блочное устройство).

`iscsiadm -m session` (вывести список того, к чему подключились)

`iscsiadm -m session -P3` (вывести его же, но подробнее — в самом конце вывода будет указание на то, какое блочное устройство какому target'у принадлежит).

`iscsiadm - m session -u -T iqn.2011-09.example:data` (вылогиниться из конкретной )

`iscsiadm -m node -l` (залогиниться во все обнаруженные target'ы)

`iscsiadm -m node -u` (вылогиниться из всех target'ов)

`iscsiadm -m node --op delete -T iqn.2011-09.example:data` (удалить target из обнаруженных).

mulitpath

=========

Ещё один вопрос, важный в серьёзных решениях — поддержка нескольких маршрутов к источнику. Прелесть iscsi — в использовании обычного ip, который может быть обычным образом обработан, как и любой другой трафик (хотя на практике обычно его не маршрутизируют, а только коммутируют — слишком уж великая там нагрузка). Так вот, iscsi поддерживает multipath в режиме «не сопротивляться». Сам по себе open-iscsi не умеет подключаться к нескольким IP одного target'а. Если его подключить к нескольким IP одного target'а, то это приведёт к появлению нескольких блочных устройств.

Однако, решение есть — это multipathd, который находит диски с одинаковым идентифиатором и обрабатывает их как положено в multipath, с настраиваемыми политиками. Эта статья не про multipath, так что подробно объяснять таинство процесса я не буду, однако, вот некоторые важные моменты:

1. При использовании multipath следует ставить маленькие таймауты — переключение между сбойными путями должно происходить достаточно быстро

2. В условиях более-менее быстрого канала (10G и выше, во многих случаях гигабит) следует избегать параллелизма нагрузки, так как теряется возможность использовать bio coalesing, что в некоторых типах нагрузки может неприятно ударить по target'у. | https://habr.com/ru/post/97529/ | null | ru | null |

# Поиск в пространстве стратегий. AI водитель

Выкладываю отчёт о своём эксперименте в области машинного обучения. В этот раз темой эксперимента было создание AI для управления моделькой автомобиля.

Как написано на [умных сайтах](http://www.machinelearning.ru/wiki/index.php?title=%D0%9E%D0%B1%D1%83%D1%87%D0%B5%D0%BD%D0%B8%D0%B5_%D1%81_%D0%BF%D0%BE%D0%B4%D0%BA%D1%80%D0%B5%D0%BF%D0%BB%D0%B5%D0%BD%D0%B8%D0%B5%D0%BC), существует два основных способа сделать, чтобы объект управления максимизировал некую функцию оценки:

1) Запрограммировать обучение с подкреплением (привет собакам Павлова)

2) Провести прямой поиск в пространстве стратегий

Я решил выбрать второй вариант.

AI-водитель

------------

В качестве модельной задачи я выбрал подзадачу из одного чемпионата по ИИ (когда я её решал впервые, я ещё не умел machine learning).

Есть объект. Он может поворачиваться вправо-влево и ускоряться вперёд-назад (вперёд – побыстрее, назад – помедленнее). Как быстрее всего добраться этим объектом из пункта А в пункт Б?

**Программный код симуляции на Matlab**

```

function q = evaluateNN(input,nn)

unit.angle=0;

unit.x=0;

unit.y=0;

trg.x=input(1);

trg.y=input(2);

q=0;

rmin=1e100;

for i=1:20 %машина "живёт" 20 тактов

%работа сенсоров

tangle=180*atan2(-unit.y+trg.y,-unit.x+trg.x)/3.141-unit.angle;

if(tangle>180)

tangle=tangle-360;

end;

if(tangle<-180)

tangle=tangle+360;

end;

r=sqrt((unit.y-trg.y)^2+(unit.x-trg.x)^2);

%принятие решений

answArr=fastSim(nn,[tangle;r]);

answArr(1)=(10+(-2))/2+ answArr(1)*(10-(-2))/2;

answArr(2)=(30+(-30))/2+ answArr(2)*(30-(-30))/2;

%механика

vx=answArr(1)*cos(3.141*unit.angle/180);

vy=answArr(1)*sin(3.141*unit.angle/180);

unit.x=unit.x+vx;

unit.y=unit.y+vy;

unit.angle=unit.angle+answArr(2);

%да, машина у нас довольно простенькая.

if(r0)

q=0;

end;

end

```

Вообще-то задачу можно решить, записав дифференциальное уравнение движения и решив его… Но я в диффурах не силён. Поэтому регулярно сталкивался с такими проблемами:

Юнит повёрнут к цели спиной. Ему лучше развернуться и доехать, или доехать задним ходом?

Юнит повёрнут к цели под 70 градусов. Мне лучше ускоряться и одновременно поворачивать, или сначала повернуть, а потом ускоряться? Как выбрать порог, отделяющий одну стратегию от другой?

Теперь, когда у меня есть эффективный оптимизирующий алгоритм и скоростные нейросети, я решил задачу перебором стратегий. То есть я представил нашу задачу как функцию, где входные величины — это веса и сдвиги нейронов, а выходная величина — это численная оценка эффективности данной стратегии (эта численная оценка называется функцией качества или метрикой качества).

Входные данные нейросети:

1) Направление на цель (от -180 до 180 градусов)

2) Расстояние до цели

3) Курсовая скорость объекта управления

4) Боковая скорость объекта управления

Курсовая и боковая скорости – это вот эти штуки:

Выходные величины – положение руля (от -30 до +30 градусов за такт) и ускорение от движка (от -2 до +10 клеток/ход за ход).

В качестве функции качества в единичном испытании я выбрал q=(-минимальное расстояние до цели). Q всегда отрицательна, но чем больше Q, тем выше мы оцениваем качество алгоритма. Так как испытаний я провожу несколько, надо вывести из них какую-то единую метрику качества.

Я взял в качестве метрики наихудшее значение качества по всем испытаниям — то есть бот стремиться улучшить не средний, а худший из результатов. Я так сделал, чтобы AI не стремился оптимизировать результаты одних испытаний в ущерб результатам других испытаний.

Моя нейросеть состояла из 2 слоёв по 7 нейронов каждый, функция активации каждого нейрона – арктангенс.

Несколько минут обучения и…

AI стал наводиться на цель вот так. Красная стрелочка – это ориентация машины. То есть бот давал задний ход, одновременно разворачивался, а затем переходил с заднего хода на передний. При этом цели он достигал быстрее, чем стратегия «сначала хотя бы частично развернуться, потом ехать» и чем стратегия «ехать задом».

AI-собиратель

-------------

Немного меняем постановку задачи. Всё та же плоскость, всё те же возможности ускоряться/поворачивать (на этот раз ускорение от -3 до 7, а поворот от -30 до 30 градусов за ход). Каждое испытание ограничено 100 ходами.

Но теперь целей несколько. Каждая цель неподвижна. AI видит их таким образом:

Нейросети доступен угол обзора в 200 градусов, который разбит на 9 равных секторов (22 градуса каждый). Если в один из секторов попадает цель, то на соответствующий сенсор нейросети попадает число, равное расстоянию до цели. Если цели в секторе нет, то на сенсор попадает число 1000 (практически все расстояния в симуляции меньше этого числа).

Если управляемый объект подъезжает к цели на расстояние 10 или меньше, цель уничтожается, а AI получает 10 очков (типа съел цель).

Начальные координаты объекта управления нулевые (0,0). Координаты целей в первом испытании такие:

[50,100] [10,30] [100,-120] [60,75]

Это типичные координаты. Всего испытаний 6, и координаты примерно такого порядка. Целей всегда 4.

Ставлю ИИ на обучение. ИИ безуспешно пытается обучиться в течение нескольких часов. Он в среднем захватывает одну цель за испытание (даже чуть меньше). Полагаю, проблема в том, что функция зависимости награды от коэффициентов кусочно-постоянная.

В таких случаях мой оптимизатор работает довольно плохо (да и эволюция в таких случаях не особенно справляется).

Поэтому я совершаю небольшое читерство. Я делаю, чтобы каждый ход AI получал число очков, обратно пропорциональное расстоянию до каждой из неподобранных целей. Он получает по 0.1/r очков за каждую цель. То есть на расстоянии в 10 он будет получать 0.001 очко за цель, а «съедание» этой цели будет давать 10 очков. Число очков, получаемое AI, меняется очень слабо, но функция становится кусочно-переменной, то есть у неё появляется ненулевая производная.

**Исходный код симуляции с водителем, находящим ключевые точки**

```

function q = evaluateNN(input,nn)

unit.angle=0;

unit.x=0;

unit.y=0;

unit.vx=0;

unit.vy=0;

trg=[];

trg(1).x=input(1);

trg(1).y=input(2);

trg(1).pickable=1;

trg(2).x=input(3);

trg(2).y=input(4);

trg(2).pickable=1;

trg(3).x=input(5);

trg(3).y=input(6);

trg(3).pickable=1;

trg(4).x=input(7);

trg(4).y=input(8);

trg(4).pickable=1;

tsz=size(trg);

tangle=[];

r=[];

sensor=[];

sensorMax=5;

sensorBound=70;

sectorSize=2*sensorBound/sensorMax;

q=-100;

rmin=1e100;

for i=1:200

%работа сенсоров

for j=1:sensorMax

sensor(j)=1e4;

end;

for j=1:tsz(2)

tangle(j)=180*atan2(-unit.y+trg(j).y,-unit.x+trg(j).x)/3.141-unit.angle;

if(tangle>180)

tangle=tangle-360;

end;

if(tangle<-180)

tangle=tangle+360;

end;

r(j)=sqrt((unit.y-trg(j).y)^2+(unit.x-trg(j).x)^2);

if(tangle(j)>-sensorBound && tangle(j)r(j))

sensor(index)=r(j);

end;

end;

%даём подкрепление за подбор награды

if(r(j)<10 && trg(j).pickable==1)

%picked up

q=q+10;

trg(j).pickable=0;

end;

%даём подкрепление за близость к награде

if(r(j)<50 && trg(j).pickable==1)

q=q+1/r(j);

end;

end;

%сенсоры скорости: боковой и курсовой

vangle=180\*atan2(unit.vy,unit.vx)/3.141;

vr=unit.vy\*sin(3.141\*unit.angle/180)+unit.vx\*cos(3.141\*unit.angle/180);%v-radial. Scalar multing

vb=-unit.vx\*sin(3.141\*unit.angle/180)+unit.vy\*cos(3.141\*unit.angle/180);%v-back. vx\*(-y)+vy\*x

%принятие решений

answArr=fastSim(nn,[sensor'';vr;vb]);

answArr(1)=(4+(-1))/2+ answArr(1)\*(4-(-1))/2;

answArr(2)=(30+(-30))/2+ answArr(2)\*(30-(-30))/2;

%механическая модель

ax=answArr(1)\*cos(3.141\*unit.angle/180);

ay=answArr(1)\*sin(3.141\*unit.angle/180);

unit.vx=unit.vx+ax;

unit.vy=unit.vy+ay;

unit.x=unit.x+unit.vx;

unit.y=unit.y+unit.vy;

unit.angle=unit.angle+answArr(2);

end;

if(q>0)

q=0;

end;

end

```

При этом результаты нескольких испытаний я объединял следующим образом: я брал средний результат и наихудший, и брал от них среднее.

```

nnlocal=ktonn(nn,k);

arr=[1,2,3,4,1,2,3,4];

input=[[50,100,10,30,100,-120,60,75];[-50,50,-100,100,10,0,20,-90];[100,-60,-100,15,20,0,15,4];[-100,-10,-25,15,60,-5,-80,10];[-10,-70,0,-40,0,40,20,22]; [20,-100,-20,22,-30,0,100,-10];];

for (i=1:6)

nncopy=nnlocal;

val=evaluateNN(input(i,:),nncopy);

sum_=sum_+val;

arr(i)=val;

countOfPoints=countOfPoints+1;

end;

q=sum_/countOfPoints- sum(abs(k))*0.00001;

```

Работа пошла бодрее. Несколько десятков минут – и вуаля:

Так мы проходим 1-ое испытание. Все цели (синие крестики) успешно захвачены.

Так мы проходим 2-ое испытание. Захвачено 3 цели (для захвата той первой цели пришлось чуть проехать вперёд, а затем развернуться. Крупным планом это выглядит так:

В 3-ем испытании тоже 4 из 4:

И в 4-ом:

И в 5-ом:

А вот в 6-ом у нас уже 3 из 4.

Зададим теперь новые испытания – такие, которых не было в обучающей выборке (проведём кроссвалидацию).

3 из 4! Признаться, я до последнего сомневался, что AI сможет перенести опыт обучающей выборки на тестовую.

Отработал 3 цели, и мимо одной чуть-чуть промазал.

Ну а тут AI совсем облажался. Отработал 2 цели из 4.

Вывод

-----

Отчёт об эксперименте должен заканчиваться выводами. Выводы следующие:

1) Обучение методом перебора пространства стратегий — многообещающая методика. Но она требовательна к оптимизатору — я применял довольно замороченный алгоритм для подбора параметров.

2) Кусочно-постоянная функция качества — это зло. Если у функции нет чего-то, хоть отдалённо напоминающего производную, её очень тяжело будет оптимизировать.

3) 2 слоя по 7 нейронов — это достаточно, чтобы сделать простенький автопилот. Обычно 14 нейронов — это пшик, из которого не собрать никакую полезную функцию.

Буду благодарен за комментарии, товарищи!

Если статья понравится, я расскажу, как делал аналогичный AI для игры типа Mortal Kombat. | https://habr.com/ru/post/323424/ | null | ru | null |

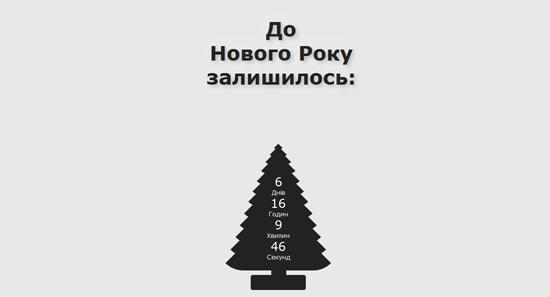

# Создаем новогоднюю ёлку-таймер при помощи CSS3

Буквально неделю назад я загорелся идеей, максимально использовать для создания своих сайтов CSS3. И так как в последнее время меня мучает бессонница, я стал развивать эти навыки. Расслабляясь и смотря очередное видео, я пропитался новогодним настроением и решил сделать новогоднюю елку на CSS. Идея была в том, что все должно быть максимально простым, классическим и без использования картинок. В то время когда я делал елку, я решил сделать еще и таймер обратного отсчета к Новому году. На все это я потратил не очень много времени и масса удовольствия была мне обеспечена.

Итак, приступим.

HTML-код будет предельно простой:

```

До Нового Року залишилось...

$(function () {

var austDay = new Date(2011, 1, 1, 00, 00, 00) ;

austDay = new Date(austDay.getFullYear() + 1, 1 - 1, 1);

$('#defaultCountdown').countdown({until: austDay});

$('#year').text(austDay.getFullYear());

});

До

Нового Року

залишилось:

```

**Пишем стили**

Для начала мы создадим фон для нашей елки:

```

body {

background: #E8E8E8;

}

```

Для создания елки я использовал легкую схему из двенадцати треугольников, ножки, и подставки — придавая им соответствующие стили.

Получилось следующее:

```

.fir-tree {

position: absolute;

top: 80%;

left: 45%;

width: 100px;

height: 30px;

background: #222222;

-moz-border-radius: 4px;

-webkit-border-radius: 4px;

border-radius: 4px;

}

.fir-tree .conf-stem {

position: absolute;

top: 0%;

left: 10%;

width: 100px;

height: 30px;

background: #222222;

-moz-border-radius: 4px;

-webkit-border-radius: 4px;

border-radius: 4px;

}

.fir-tree .stem {

position: absolute;

top: -120%;

left: 41%;

width: 30px;

height: 60px;

background: #222222;

}

.fir-tree .a {

position: inherit;

top: -430%;

left: -65%;

width:0;

height: 0;

border-left: 120px solid transparent;

border-right: 120px solid transparent;

border-bottom: 120px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .b {

position: inherit;

top: -485%;

left: -55%;

width:0;

height: 0;

border-left: 110px solid transparent;

border-right: 110px solid transparent;

border-bottom: 110px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .c {

position: inherit;

top: -535%;

left: -45%;

width:0;

height: 0;

border-left: 100px solid transparent;

border-right: 100px solid transparent;

border-bottom: 100px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .d {

position: inherit;

top: -585%;

left: -35%;

width:0;

height: 0;

border-left: 90px solid transparent;

border-right: 90px solid transparent;

border-bottom: 90px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .e {

position: inherit;

top: -635%;

left: -25%;

width:0;

height: 0;

border-left: 80px solid transparent;

border-right: 80px solid transparent;

border-bottom: 80px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .f {

position: inherit;

top: -685%;

left: -15%;

width:0;

height: 0;

border-left: 70px solid transparent;

border-right: 70px solid transparent;

border-bottom: 70px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .g {

position: inherit;

top: -725%;

left: -5%;

width:0;

height: 0;

border-left: 60px solid transparent;

border-right: 60px solid transparent;

border-bottom: 60px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .h {

position: inherit;

top: -765%;

left: 5%;

width:0;

height: 0;

border-left: 50px solid transparent;

border-right: 50px solid transparent;

border-bottom: 50px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .i {

position: inherit;

top: -805%;

left: 15%;

width:0;

height: 0;

border-left: 40px solid transparent;

border-right: 40px solid transparent;

border-bottom: 40px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .j {

position: inherit;

top: -835%;

left: 25%;

width:0;

height: 0;

border-left: 30px solid transparent;

border-right: 30px solid transparent;

border-bottom: 30px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .k {

position: inherit;

top: -855%;

left: 35%;

width:0;

height: 0;

border-left: 20px solid transparent;

border-right: 20px solid transparent;

border-bottom: 20px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

.fir-tree .l {

position: inherit;

top: -872%;

left: 45%;

width:0;

height: 0;

border-left: 10px solid transparent;

border-right: 10px solid transparent;

border-bottom: 10px solid #222222;

/* Only FF, Safari, Chrome (I don't use this in IE and Opera because this function doesn't work correctly) */

-moz-border-radius: 50px;

-webkit-border-radius: 50px;

}

```

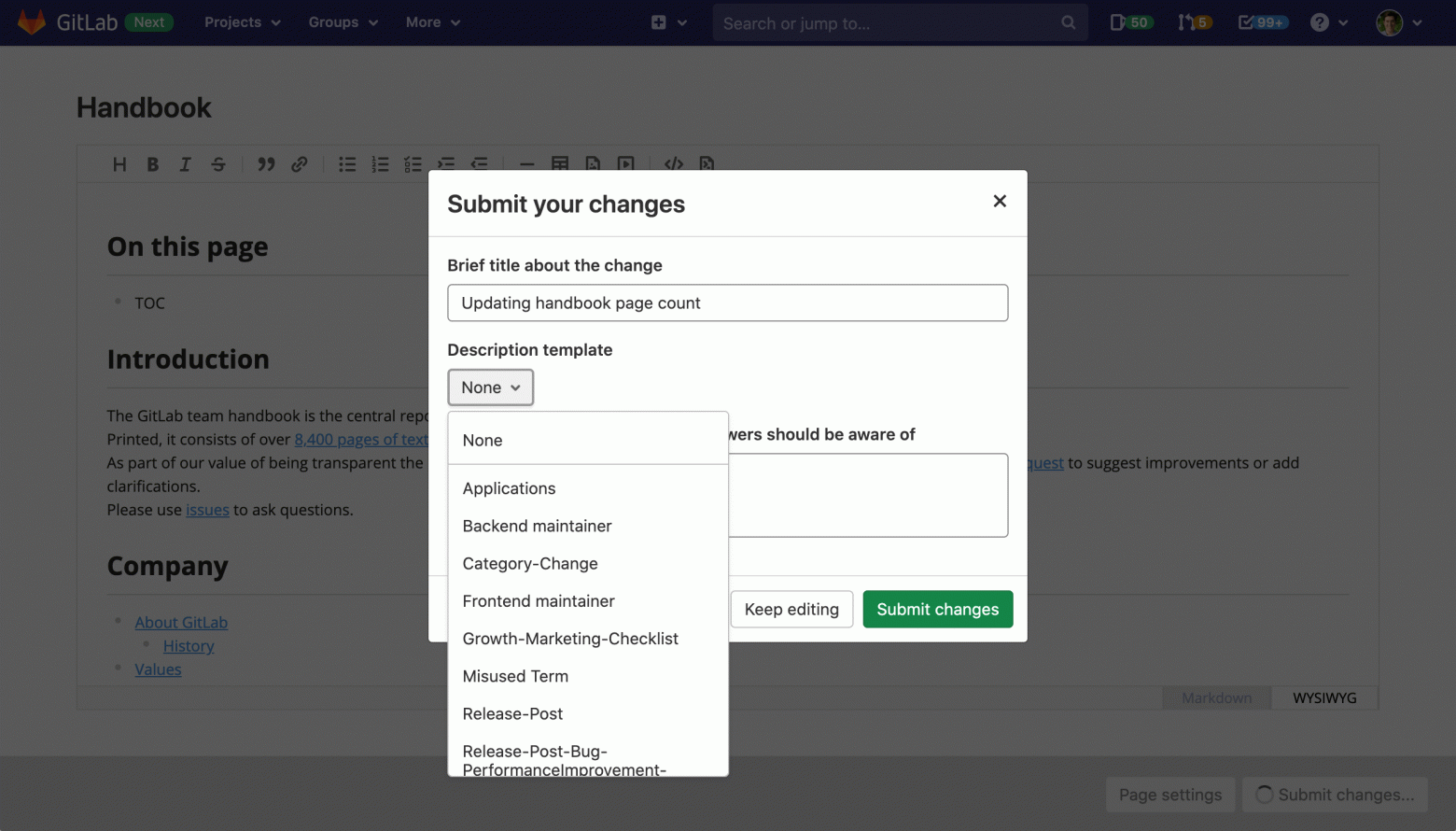

Елка у нас уже есть и теперь нужно сделать таймер. Для его создания я выбрал плагин для JS под названием [Countdown](http://keith-wood.name/countdown.html).

Что бы сделать обратный отсчет, я использовал такой шаблонный код:

```

$(function () {

var austDay = new Date(2011, 1, 1, 00, 00, 00) ;

austDay = new Date(austDay.getFullYear() + 1, 12 - 1, 32);

$('#defaultCountdown').countdown({until: austDay});

$('#year').text(austDay.getFullYear());

});

```

Для плагина конечно же можно добавить стили по вкусу, вот мои:

```

.countdown_show1 .countdown_section {

width: 200%;

}

.countdown_show2 .countdown_section {

width: 100%;

}

.countdown_show3 .countdown_section {

width: 100%;

}

.countdown_show4 .countdown_section {

width: 100%;

}

.countdown_show5 .countdown_section {

width: 100%;

}

.countdown_show6 .countdown_section {

width: 100%;

}

.countdown_show7 .countdown_section {

width: 60%;

}

.countdown_section {

display: block;

float: left;

font-size: 80%;

text-align: center;

}

.countdown_amount {

font-size: 200%;

}

.countdown_descr {

display: block;

width: 100%;

}

```

Полноценная елка у нас уже есть, осталось лишь сделать надпись. Для надписи можно использовать какой-нибудь красивый шрифт, но в данном примере я решил удержаться и следовать простоте.

```

.text {

position: absolute;

top: -800%;

left: -430%;

font-size: 40px;

color: #222222;

font-family: Verdana, Arial;

text-align: center;

font-weight:bold;

text-shadow: 4px 4px 7px rgba(0,0,0,0.2),

0px -6px 38px rgba(255,255,255,0.3);

}

```

И вот что у нас в результате получилось:

[Демонстрация](http://holovko.org.ua/newyear/)

**Заключение**

Итак, у нас получился красивый таймер в виде елки. Все довольно просто и красиво.

С наступающим! | https://habr.com/ru/post/135238/ | null | ru | null |

# Создание модулей с учётом новой структуры Joomla 4

Joomla 4 "под капотом" претерпела немало изменений относительно предыдущих версий. Её кодовую базу сообщество разработчиков регулярно подтягивают до современных реалий, вводя актуальные технологии в ядро CMS. Так, например, если раньше загрузка классов была вариациями на тему include, то в Joomla 4 появился лоадер, приведённый к PSR-4. Ядро CMS переводится на концепцию сервис-провайдеров, внедрены DI-контейнеры, переработанная система событий для плагинов позволила [увеличить производительность при генерации страниц более чем в два раза.](https://github.com/joomla/joomla-cms/discussions/38407#discussioncomment-3472706) Эти изменения влекут за собой изменения в структуре компонентов, модулей и плагинов.

В данной статье пойдёт речь о том, как создать модуль для Joomla 4 с новой структурой файлов и классов. К слову сказать, legacy ещё работает и многие расширения, созданные по канонам Joomla 3 (а не работавшие на Joomla 3, но написанные по канонам Joomla 1.5) ещё долго будут работать на Joomla 4.

Отступление

-----------

Я предполагаю, что часть читателей имеет опыт работы с Joomla, но не имеет опыта создания модулей, поэтому постараюсь описать создание модуля как можно подробнее. Статья имеет сугубо прикладной характер, без погружения в теорию ООП и его реализацию в Joomla. Основная цель - подсказать что "делать руками", когда поставлена определённая задача.

Рассказывать о создании модуля я буду на примере своего модуля **WT Yandex map items** - [модуля вывода материалов Joomla на Яндекс.карты](https://web-tolk.ru/dev/joomla-modules/wt-yandex-map-items.html) по координатам из пользовательских полей, который создавался под проект на Joomla 4, поэтому названия файлов, классов и namespace будут содержать название именно этого модуля. При создании своего модуля, естественно, нужно изменить их на свои.

Файловая структура модуля Joomla 3 vs Joomla 4 и распределение функционала

--------------------------------------------------------------------------

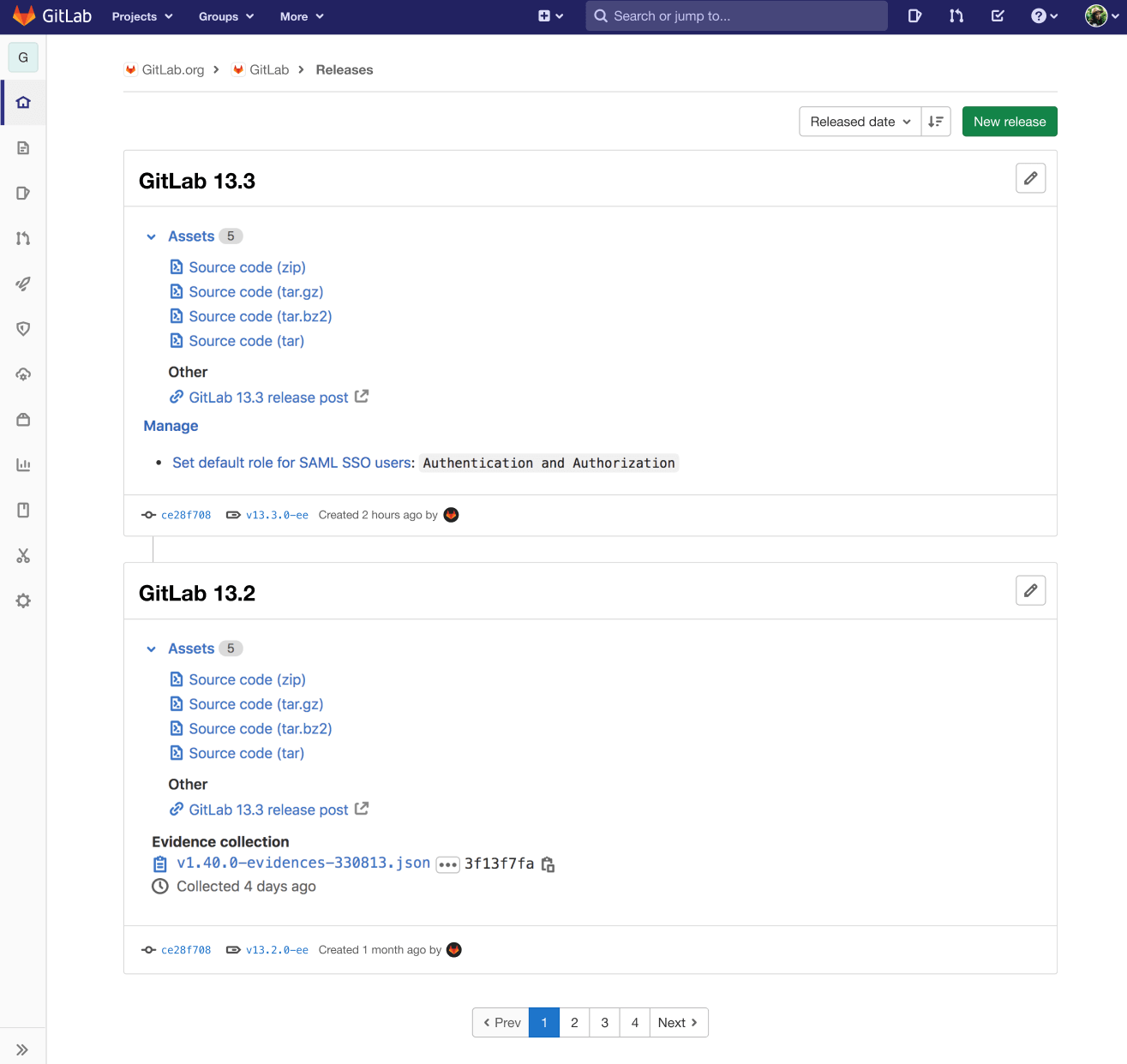

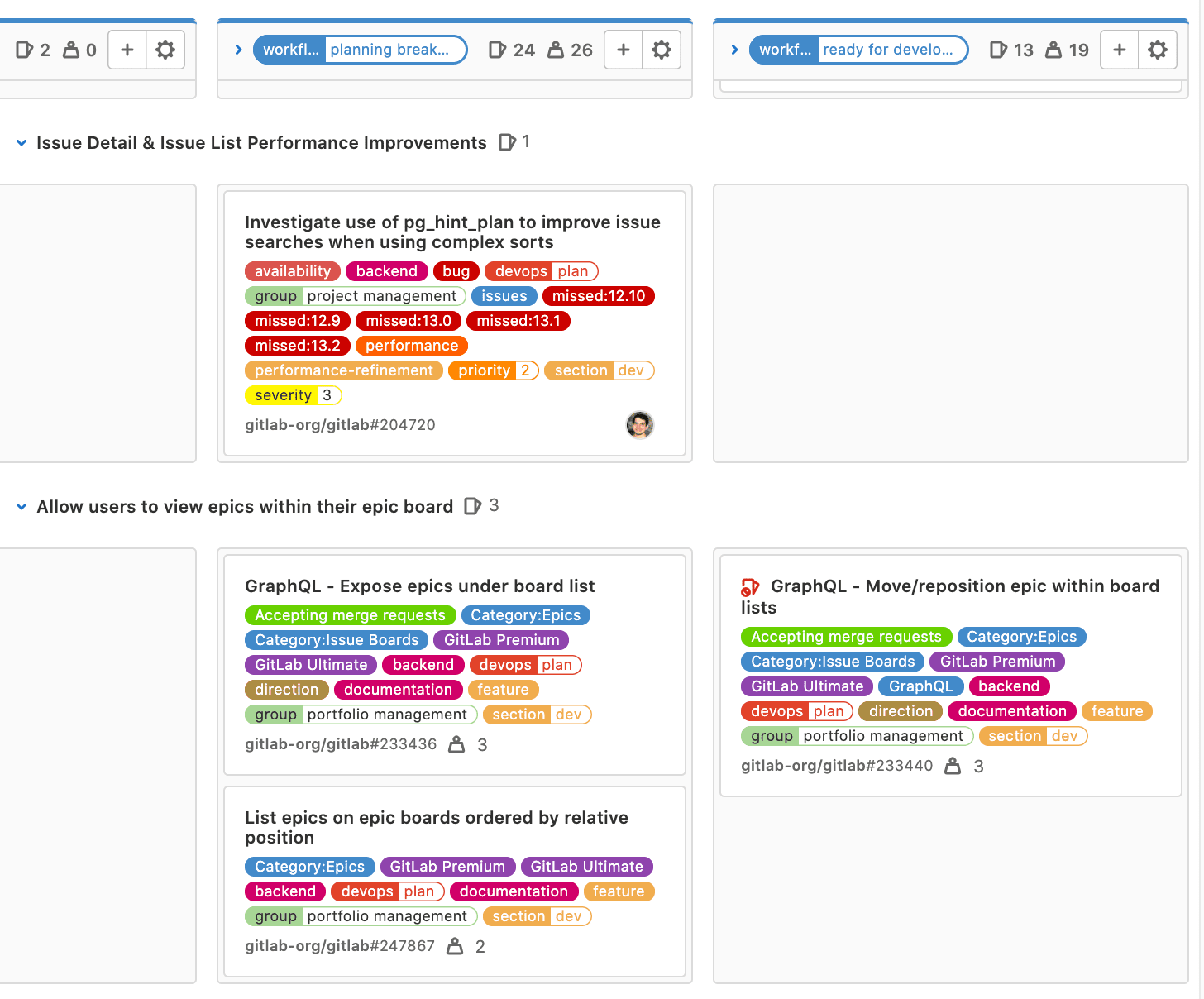

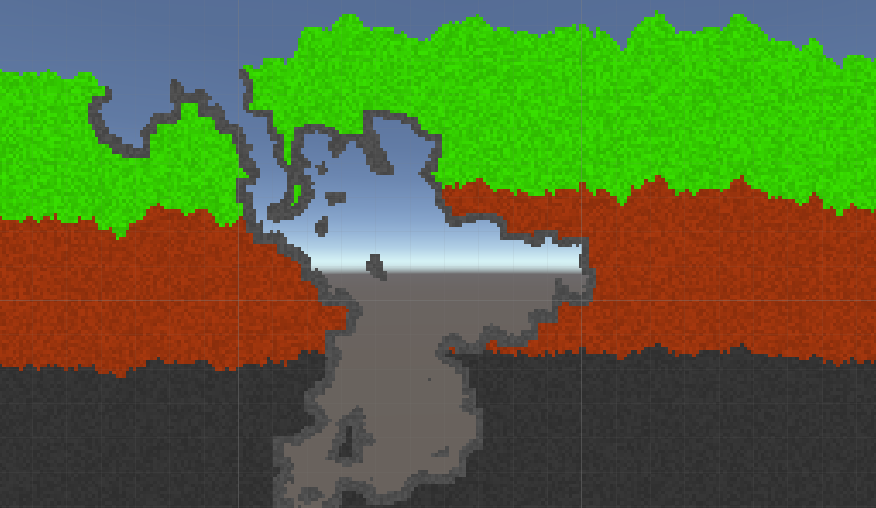

### Было (Joomla 3)

Старая файловая структура модуля Joomla 3Для создания модуля было необходимо как минимум 3 файла:

* **mod\_wtyandexmapitems.xml** - описание модуля для установщика расширений Joomla (системное имя, дата, версия, сайт разработчика и т.д.), параметры конфигурации, сервер обновлений и т.д.

* **mod\_wtyandexmapitems.php** - "точка входа" в модуль. С этого файла начинается работа Вашего кода.

* **tmpl/default.php** - макет вывода для модуля. Здесь находится HTML-вёрстка Вашего модуля. При необходимости, можно скопировать и переименовать этот файл, изменить вывод HTML по своему вкусу и выбрать в настройках свой новый макет вывода.

Этот же способ позволяет выполнять любой свой PHP-код в нужном месте и в нужное время.

Именно такую структуру мы видим в одном из простейших модулей Joomla - mod\_custom - "HTML-код".

Файловая структура модуля типа HTML-код в Joomla 3.#### Хелпер (helper) модуля Joomla

Если наш модуль делает что-то более сложное, чем просто вывод значений из настроек модуля, например:

* отображает список новых статей на сайте;

* показывает карусель товаров из компонента интернет-магазина;

* выводит популярные комментарии или фотографии из фото-галереи ;

* подтягивает данные модуля по ajax (ajax-корзина товаров, к примеру).

то все функции, выполняющие эту работу, помещаются в хелпер модуля. В Joomla 3 он помещался в файл helper.php, находящийся рядом с основным php-файлом. Подключение хелпера было в "точке входа" с помощью `JLoader::register('ModWtyandexmapitemsHelper', __DIR__ . '/helper.php');`

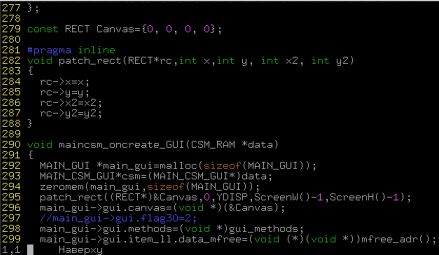

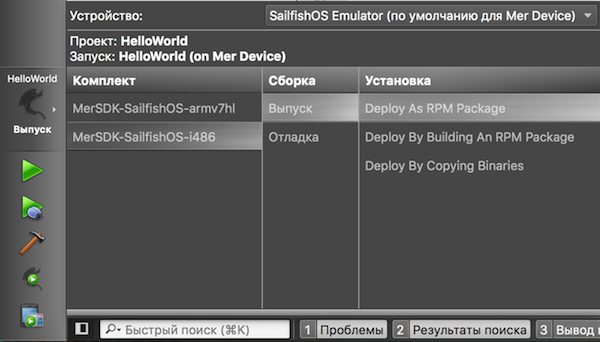

### Стало (Joomla 4)

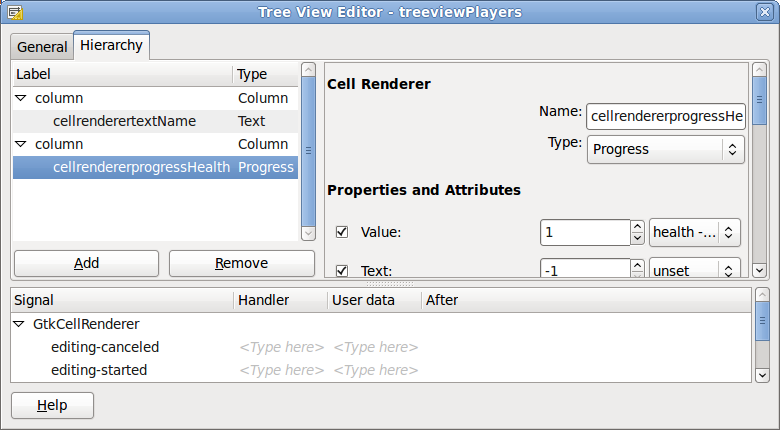

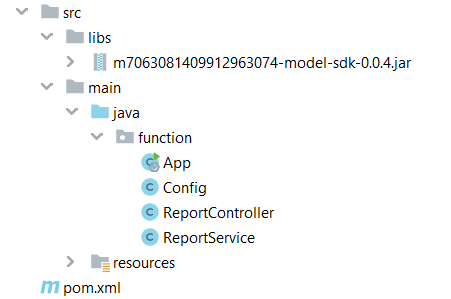

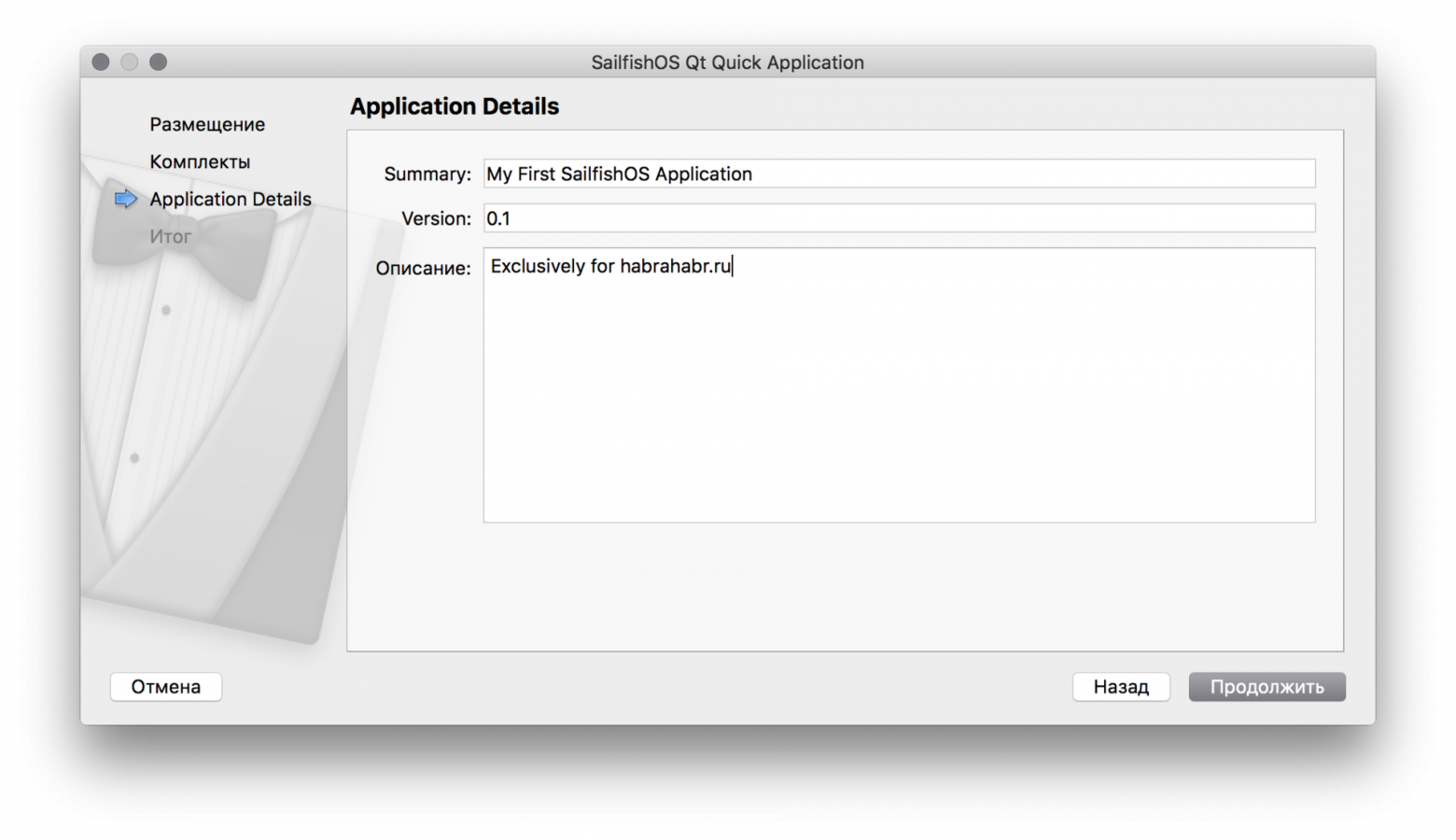

Новая файловая структура модуля для Joomla 4Для создания модуля в Joomla 4 нужны следующие файлы (с меньшим количеством можно поэкспериментировать спортивного интереса ради):

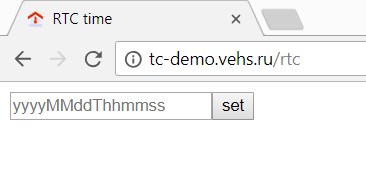

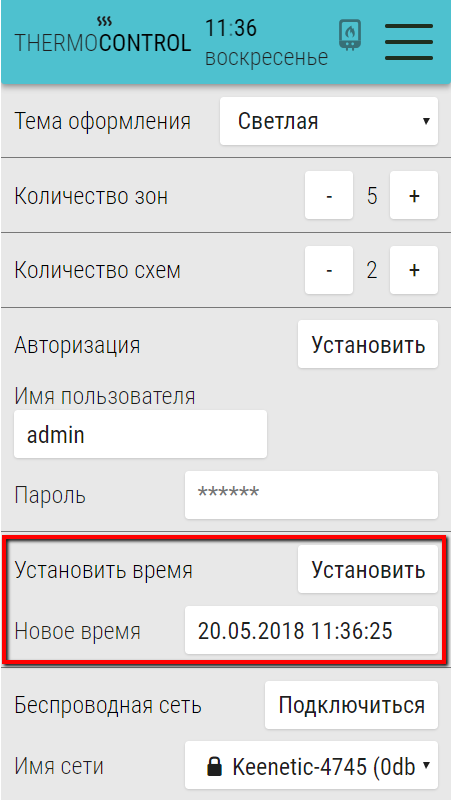

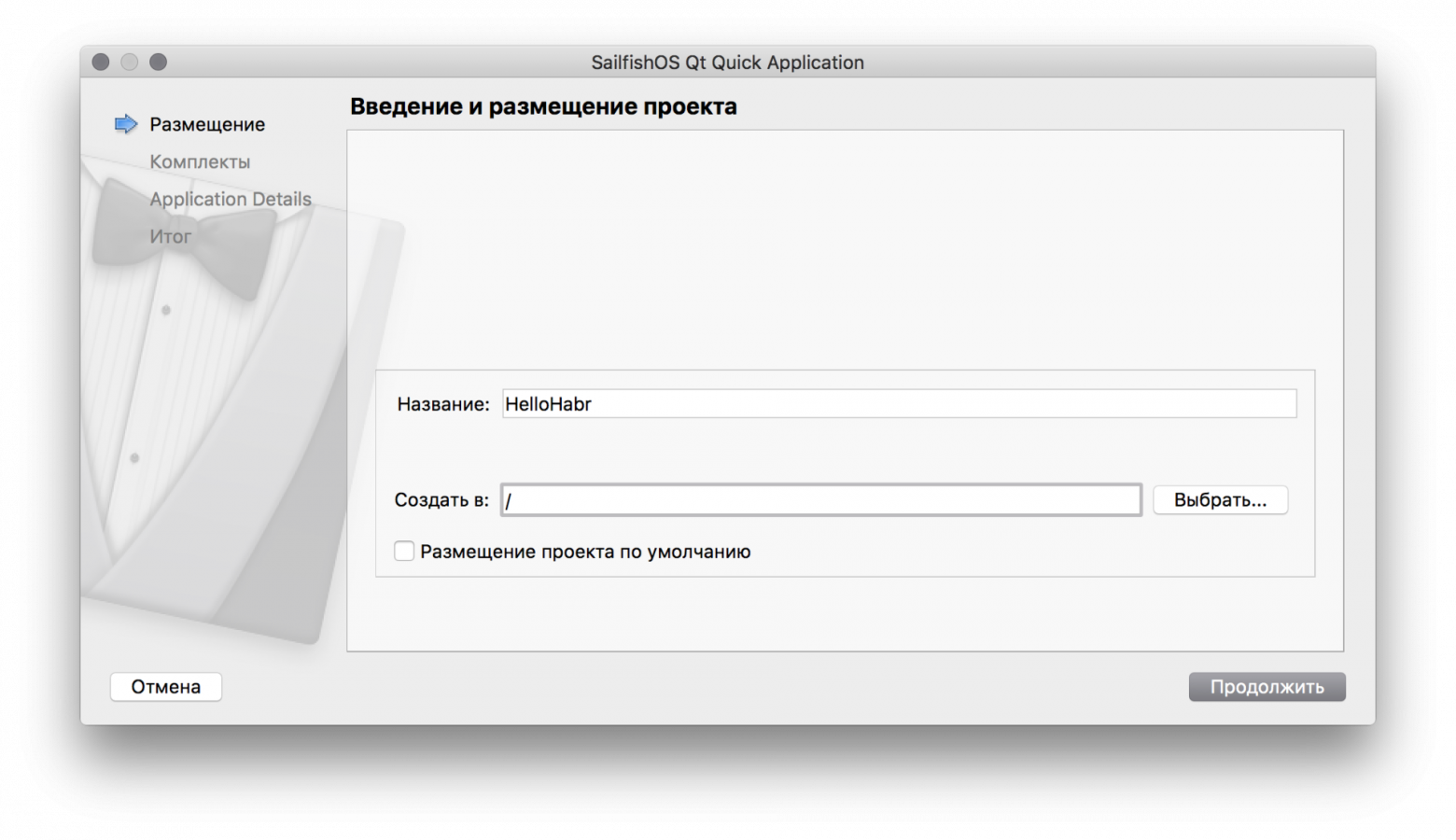

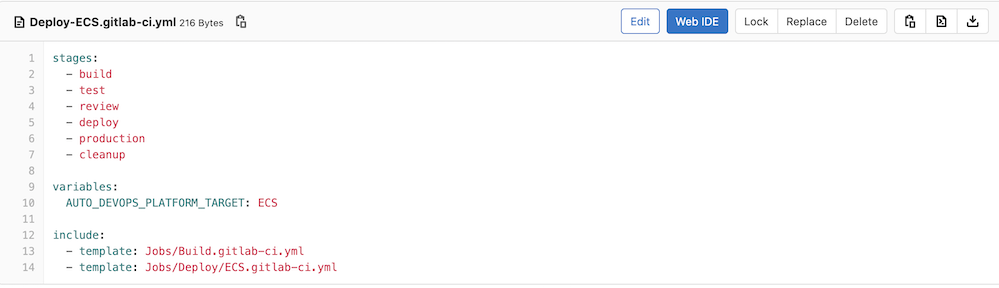

#### Файл mod\_wtyandexmapitems.xml

Этот файл содержит описание модуля для установщика расширений Joomla (системное имя, дата, версия, сайт разработчика и т.д.), параметры конфигурации, сервер обновлений, **а также** **задаёт Namespace модуля и директории для автозагрузки классов**.

Namespace Joomla\Module\Wtyandexmapitems начинается в modules/mod\_wtyandexmapitems/src

```

xml version="1.0" encoding="utf-8"?

MOD\_WTYANDEXMAPITEMS

Sergey Tolkachyov

13/09/2022

(C) 2022 Sergey Tolkachyov.

GNU General Public License version 2 or later

[email protected]

https://web-tolk.ru

1.0.0

MOD\_WTYANDEXMAPITEMS\_DESC

Joomla\Module\Wtyandexmapitems

src

language

services

tmpl

language/en-GB/mod\_wtyandexmapitems.ini

language/en-GB/mod\_wtyandexmapitems.sys.ini

language/ru-RU/mod\_wtyandexmapitems.ini

language/ru-RU/mod\_wtyandexmapitems.sys.ini

```

**Также обратите внимание**, что для корректной установки и работы модуля нужно указывать атрибут `module="mod_wtyandexmapitems"` в xml-манифесте. Если в Joomla 3 этот атрибут указывался для файла "точки входа" (`mod\_wtyandexmapitems.php`), то сейчас он указывается для папки `src` модуля - `src` .

Ещё одно **нововведение связано с языковыми файлами**: теперь в именах файлов не обязательно дублировать префикс языка - "ru-RU.mod\_wtyandexmapitems.ini". Достаточно того, что файл лежит в папке "ru-RU".

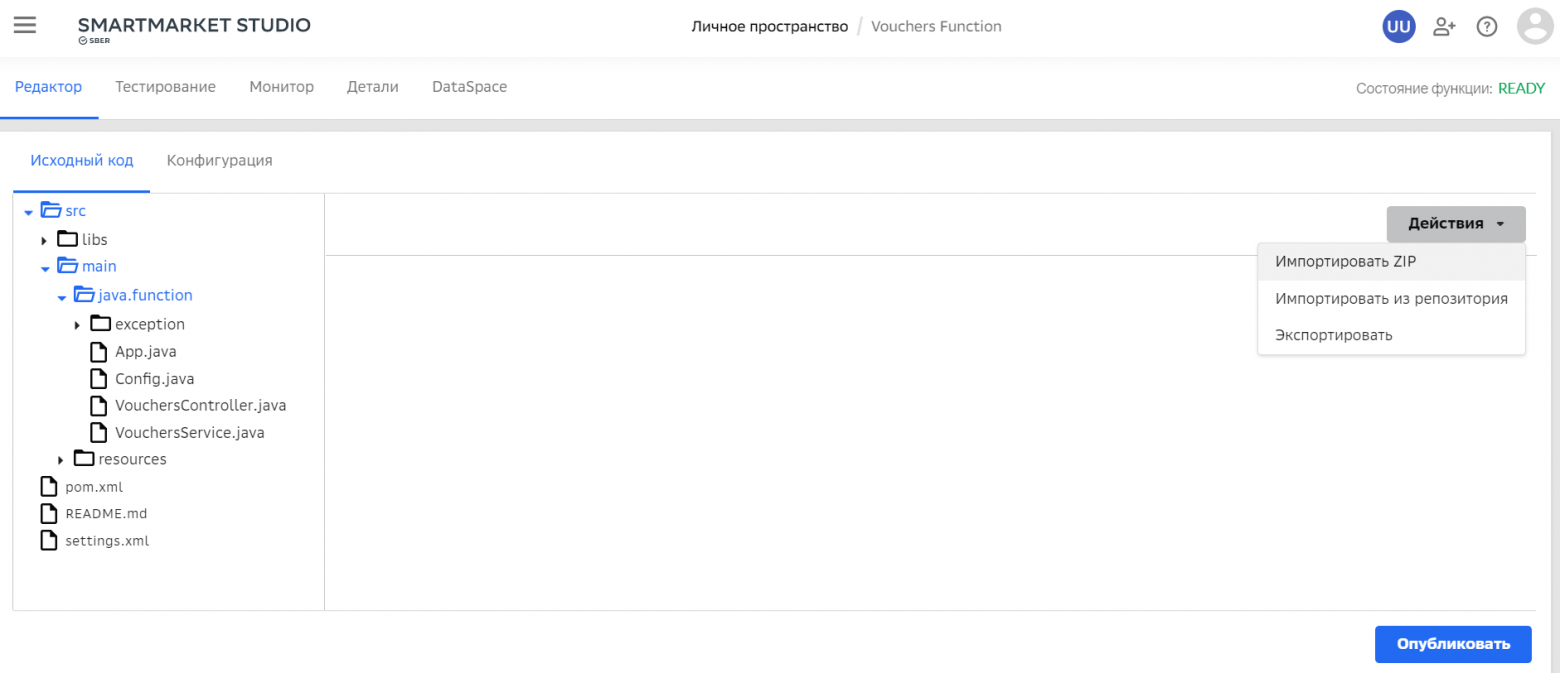

#### Файл services/provider.php

Файл - сервис-провайдер Вашего модуля. Он сообщает Joomla, что Ваш модуль существует и регистрирует namespace модуля в глобальном пространстве имён.

```

php

/**

* @package WT Yandex Map items

*

* @copyright (C) 2022 Sergey Tolkachyov

* @link https://web-tolk.ru

* @license GNU General Public License version 2 or later

*/

defined('_JEXEC') or die;

use Joomla\CMS\Extension\Service\Provider\HelperFactory;

use Joomla\CMS\Extension\Service\Provider\Module;

use Joomla\CMS\Extension\Service\Provider\ModuleDispatcherFactory;

use Joomla\DI\Container;

use Joomla\DI\ServiceProviderInterface;

/**

* The WT Yandex map items module service provider.

*

* @since 1.0.0

*/

return new class implements ServiceProviderInterface

{

/**

* Registers the service provider with a DI container.

*

* @param Container $container The DI container.

*

* @return void

*

* @since 4.0.0

*/

public function register(Container $container)

{

// Основной namespace модуля

$container-registerServiceProvider(new ModuleDispatcherFactory('\\Joomla\\Module\\Wtyandexmapitems'));

// Namespace модуля для хелпера

$container->registerServiceProvider(new HelperFactory('\\Joomla\\Module\\Wtyandexmapitems\\Site\\Helper'));

// Namespace модуля для своих типов полей

$container->registerServiceProvider(new HelperFactory('\\Joomla\\Module\\Wtyandexmapitems\\Site\\Fields'));

$container->registerServiceProvider(new Module);

}

};

```

Некоторые модули для Joomla могут быть довольно сложными, использовать дополнительные PHP-библиотеки и SDK, поэтому в папке `src` модуля могут быть самые разные Namespace, которые можно зарегистрировать в сервис-провайдере, дабы они были доступны глобально. Однако, я предпочитаю библиотеки оформлять отдельными расширениями Joomla и устанавливать их в папку libraries в корне сайта, а обращаться к ним уже по namespace. Это удобно для тех случаев, когда не одно Ваше расширение использует данную библиотеку, а несколько. В таком случае для библиотеки потребуется системный плагин, регистрирующий её namespace в глобальном пространстве имён.

Берём на заметку, что в Namespace указывается "клиент" модуля - "Site" или "Administrator".

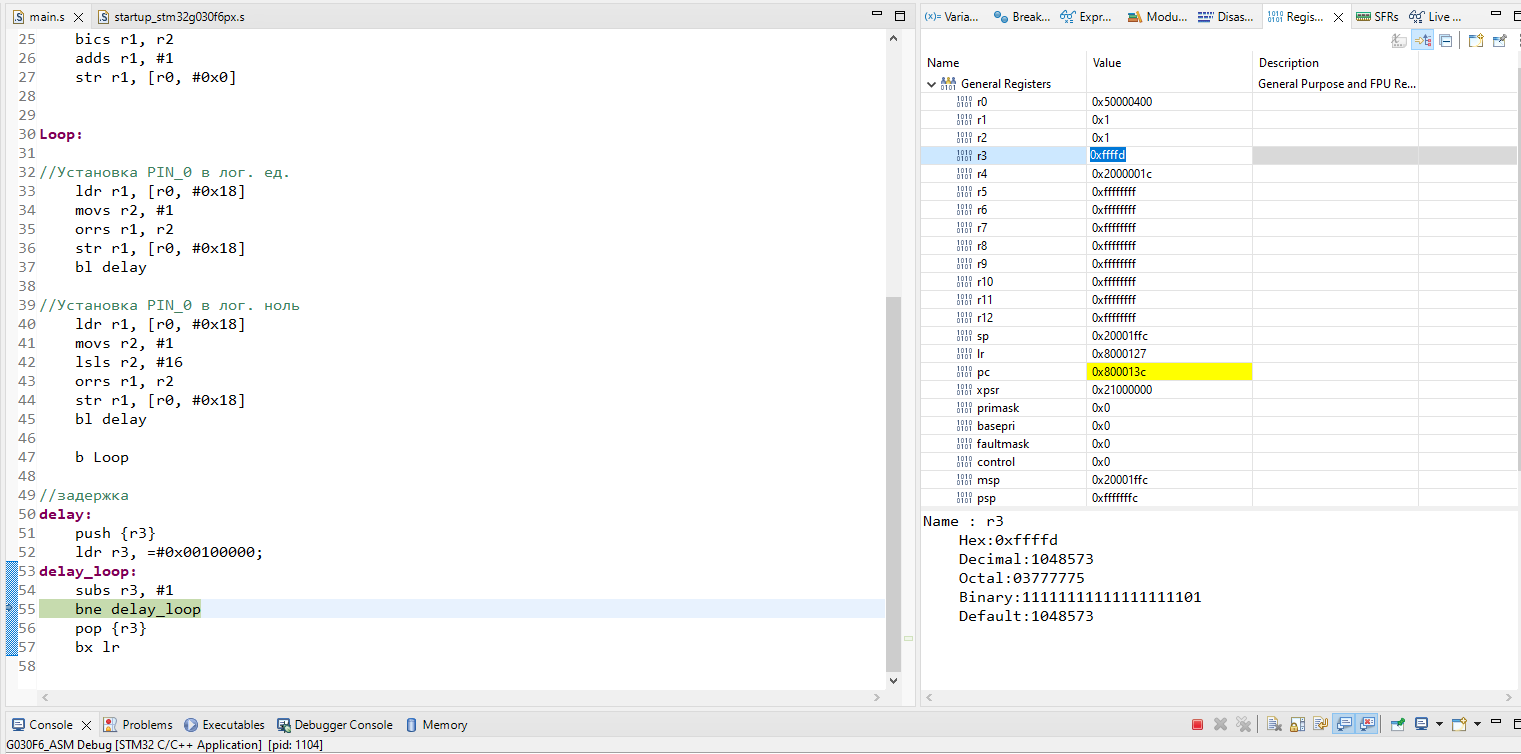

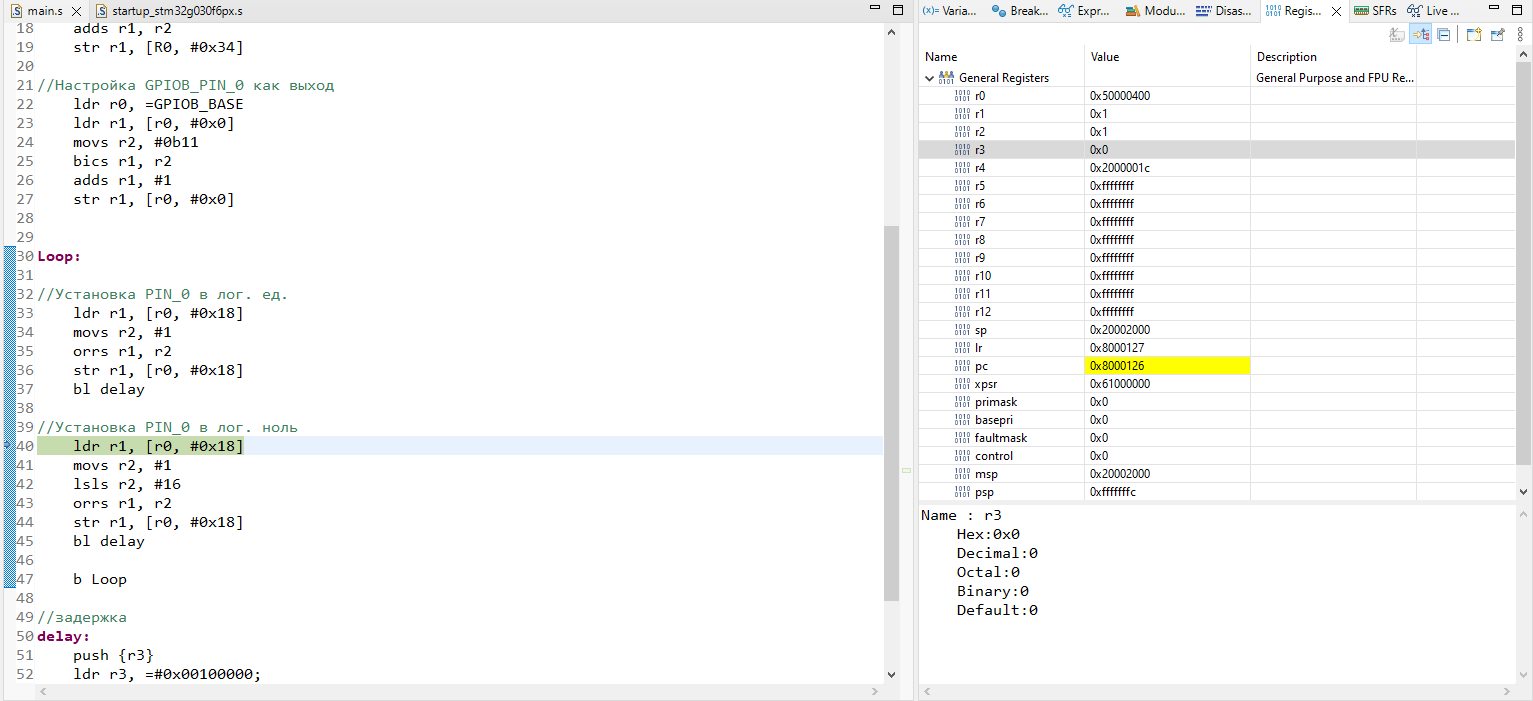

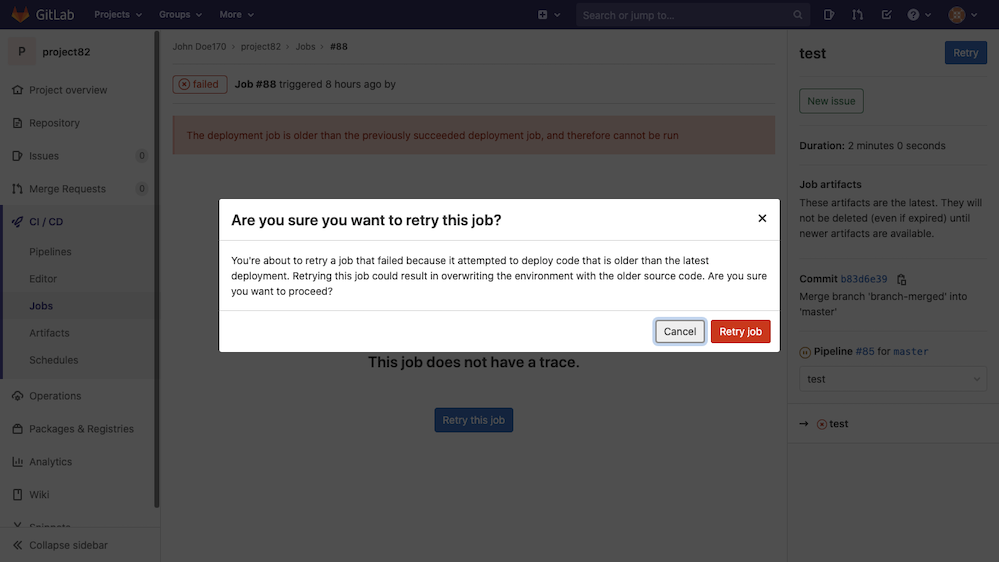

#### Файл src/Dispatcher/Dispatcher.php

Этот файл используется для того, чтобы передать данные из хелпера модуля в макет (layout).

```

php

/**

* @package WT Yandex Map items

*

* @copyright (C) 2022 Sergey Tolkachyov

* @link https://web-tolk.ru

* @license GNU General Public License version 2 or later

*/

namespace Joomla\Module\Wtyandexmapitems\Site\Dispatcher;

\defined('JPATH_PLATFORM') or die;

use Joomla\CMS\Application\CMSApplicationInterface;

use Joomla\CMS\Dispatcher\AbstractModuleDispatcher;

use Joomla\CMS\Extension\ModuleInterface;

use Joomla\Input\Input;

use Joomla\Module\Wtyandexmapitems\Site\Helper\WtyandexmapitemsHelper;

use Joomla\Registry\Registry;

/**

* Dispatcher class for mod_wtyandexmapitems

*

* @since 1.0.0

*/

class Dispatcher extends AbstractModuleDispatcher

{

/**

* The module extension. Used to fetch the module helper.

*

* @var ModuleInterface|null

* @since 1.0.0

*/

private $moduleExtension;

public function __construct(\stdClass $module, CMSApplicationInterface $app, Input $input)

{

parent::__construct($module, $app, $input);

$this-moduleExtension = $this->app->bootModule('mod_wtyandexmapitems', 'site');

}

/**

* Returns the layout data.

*

* @return array

*

* @since 1.0.0

*/

protected function getLayoutData()

{

$data = parent::getLayoutData();

// Вариант использования хелпера через Namespace

$data['placemarks'] = (new WtyandexmapitemsHelper)->getPlacemarks($data['params'], $this->getApplication());

// ИЛИ

// Вариант использования хелпера через $this->moduleExtension,

// который мы загрузили в конструкторе класса

$helper = $this->moduleExtension->getHelper('WtyandexmapitemsHelper');

// ИЛИ

// Вариант использования хелпера напрямую из этого метода,

// не загружая модуль в $this->moduleExtension.

// Тогда строка $this->moduleExtension в __construct() не нужна.

$helper = $this->app->bootModule('mod_wtyandexmapitems', 'Site')->getHelper('WtyandexmapitemsHelper');

$data['placemarks'] = $helper->getPlacemarks($data['params'], $this->getApplication());

return $data;

}

}

```

Особый интерес для нас представляет функция `getLayoutData()`, так как именно в ней мы обращаемся к методам нашего хелпера модуля и помещаем полученные данные в массив `$data`. Ключ массива `$data` может быть любым и может быть не единственным. Можно провести параллель с Model в MVC, когда мы из разных мест собираем данные и передаём их для отображения.

В хелпере модуля можно собрать один результирующий массив данных и в диспетчере передать на рендер только его (обратившись только к одному методу хелпера - точке входа в хелпер). А можно обращаться к разным методам хелпера в диспетчере, присваивая данные разным элементам массива `$data`. Подход к реализации Вы выбираете сами, распределяя функционал между этими двумя файлами.

#### Файл src/Helper/WtyandexmapitemsHelper.php

Хелпер модуля. Имя файла = имя модуля без суффикса "mod\_" + Helper (с заглавной буквы).

Namespace хелпера **-** `Joomla\Module\Wtyandexmapitems\Site\Helper`. Вместо "Site" может быть "Administrator", если у Вас модуль для панели администратора, например для дашбордов Joomla 4. Имя класса совпадает с именем файла. Внутри - нужные Вам функции.

```

php

/**

* @package WT Yandex Map items

*

* @copyright (C) 2022 Sergey Tolkachyov

* @link https://web-tolk.ru

* @license GNU General Public License version 2 or later

*/

namespace Joomla\Module\Wtyandexmapitems\Site\Helper;

use Joomla\CMS\Access\Access;

use Joomla\CMS\Component\ComponentHelper;

use Joomla\CMS\Factory;

use Joomla\CMS\Helper\ModuleHelper;

use Joomla\CMS\HTML\HTMLHelper;

use Joomla\CMS\Language\Text;

use Joomla\CMS\Layout\FileLayout;

use Joomla\CMS\Router\Route;

use Joomla\CMS\Uri\Uri;

use Joomla\Component\Content\Site\Helper\RouteHelper;

use Joomla\Component\Fields\Administrator\Helper\FieldsHelper;

use Joomla\Registry\Registry;

\defined('_JEXEC') or die;

/**

* Helper for mod_wtyandexmapitems

*

* @since 1.0

*/

class WtyandexmapitemsHelper

{

public function getPlacemarks($params, $app):array

{

/**

* Этот метод мы вызывали в файле

* src/Dispatcher/Dispatcher.php

* в строке

* $data['placemarks'] = (new WtyandexmapitemsHelper)-getPlacemarks($data['params'], $this->getApplication());

*/

}

}

```

В данном случае в методе `getPlacemarks()` я получаю с помощью нескольких методов список материалов Joomla 4, их пользовательские поля, выбираю (сообразно настройкам модуля) поле, в котором хранятся координаты, а затем собираю массив со структурой, необходимой для Яндекс карт.

#### Работа с Ajax в модулях Joomla 4

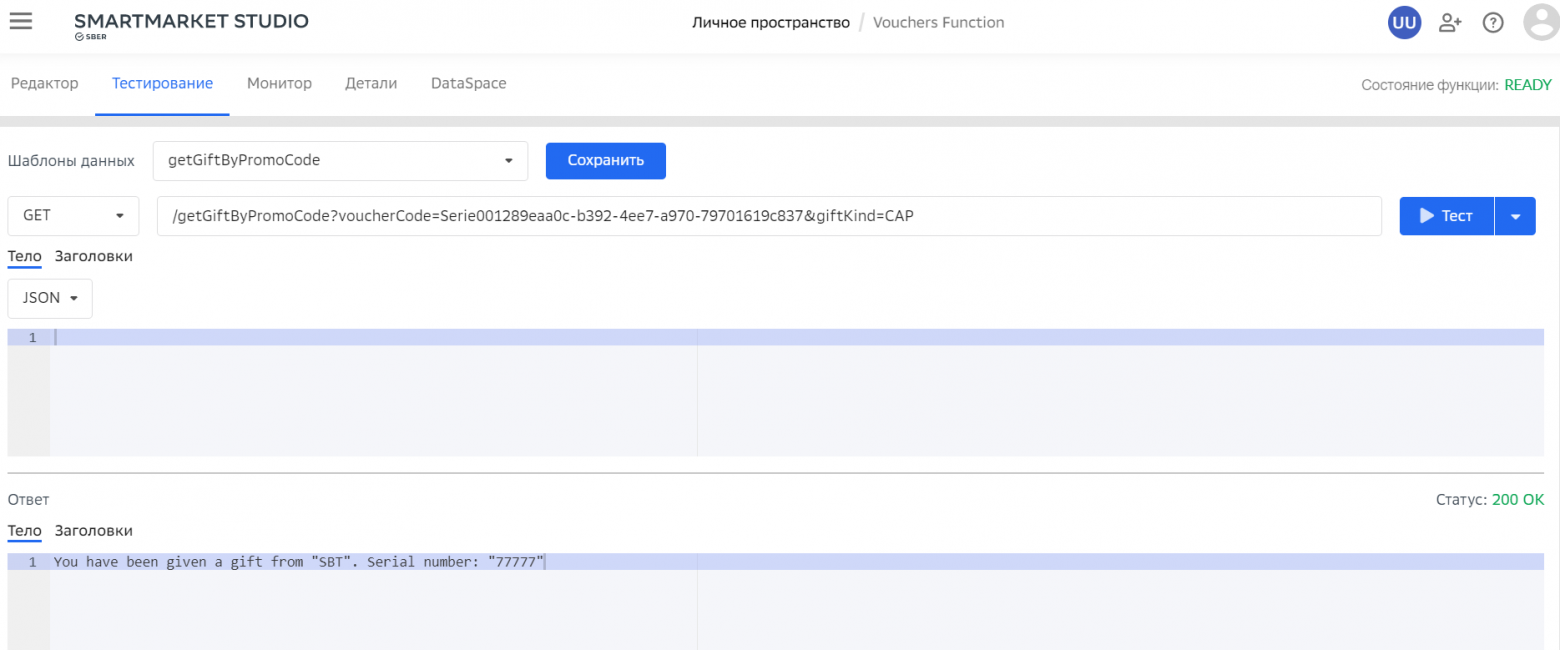

Если Вашему модулю есть что отдать по ajax на фронт, то для этого нужно в хелпере модуля создать метод `getAjax()`.В нашем случае на Яндекс.карты будет загружаться более 100 меток с текстами и картинками. Поэтому целесообразнее получать эти данные по ajax.

Согласно [документации Joomla по использованию ajax](https://docs.joomla.org/Using_Joomla_Ajax_Interface) Вы можете в запросе указывать конкретный метод хелпера. В таком случае имя метода должно заканчиваться на "Ajax": например `method=mySuperAwesomeMethodToTrigger` вызовет метод `mySuperAwesomeMethodToTriggerAjax` модуля.

Пример ajax-запроса, реализованного нативными средствами Joomla ([статья-мануал на Хабре](https://habr.com/ru/post/588651/)).

```

Joomla.request({

url: window.location.origin + "/index.php?option=com_ajax&module=wtyandexmapitems&format=raw",

onSuccess: function (response, xhr){

if (response !== ""){

let placemarks = JSON.parse(response);

console.log(placemarks);

objectManager.add(placemarks);

myMap' . $module->id . '.geoObjects.add(objectManager);

}

}

});

}

```

#### Файл tmpl/default.php - макет вывода в Joomla

Здесь по-прежнему находится HTML-вёрстка Вашего модуля. Его по-прежнему можно скопировать в ту же папку или в папку с Вашим шаблоном (сделать переопределение), переименовать и изменить вывод HTML, не отказывая себе в самых страшных извращениях и при этом не опасаясь того, что Ваши изменения будут затёрты при обновлении движка.

В файлах макетов вывода, как правило, находится цикл вывода данных foreach.

В Joomla 3 нередко можно было встретить следующую конструкцию:

```

// Файл "точка входа" модуля mod_menu.php

// $list - массив с пунктами меню, которые передаются в макет вывода

$list = ModMenuHelper::getList($params);

```

```

// Файл tmpl/default.php - макет вывода модуля mod_menu

// $list - массив с пунктами меню, которые передаются в макет вывода

foreach ($list as $i => &$item){

// здесь работа по отображению HTML меню, с учетом настроек модуля и данных в массиве

}

```

В Joomla 4 в принципе осталось то же самое, за небольшими изменениями:

* данные мы получаем из хелпера и передаём не в "точке входа" (которой теперь нет по определению), а в файле `src/Dispatcher/Dispatcher.php`. **Те самые** `$data['placemarks']` **в макете вывода становятся просто** `$placemarks`**.**

* "рядом" с Вашими переменными передаются следующие:

+ `$module` - объект модуля. Оттуда Вы можете взять id модуля (`$module->id`), заголовок модуля, его позицию и т.д.

+ `$app` - объект приложения. Это значит, что Вам не нужно самостоятельно вызывать `Joomla\CMS\Factory::getApplication()`. Он уже есть для Вашего удобства.

+ `$input` - также в макете модуля теперь сразу доступен объект Input (через него мы получаем GET, POST параметры, SERVER и т.д.), который раньше приходилось вызывать самостоятельно.

+ `$params` - параметры модуля. Получаем их как раньше: `$params->get('param_name' , 'default_value_if_value_is_empty')`. Эти параметры мы собираем с помощью различных типов полей Joomla в xml-манифесте модуля.

+ `$template` - параметры настроек стиля текущего шаблона. У шаблонов Joomla есть templateDetails.xml, в которых можно задавать различные параметры шаблона: логотипы, шрифты, пользовательские скрипты в и и всё, что душе угодно. Теперь в модуле Вы имеете возможность без лишних шевелений получить доступ к этим параметрам. Однако, стоит помнить, что многие студийные шаблоны (JoomShaper Helix и иже с ними) не используют стандартное место хранение параметров, поэтому там может оказаться пусто.

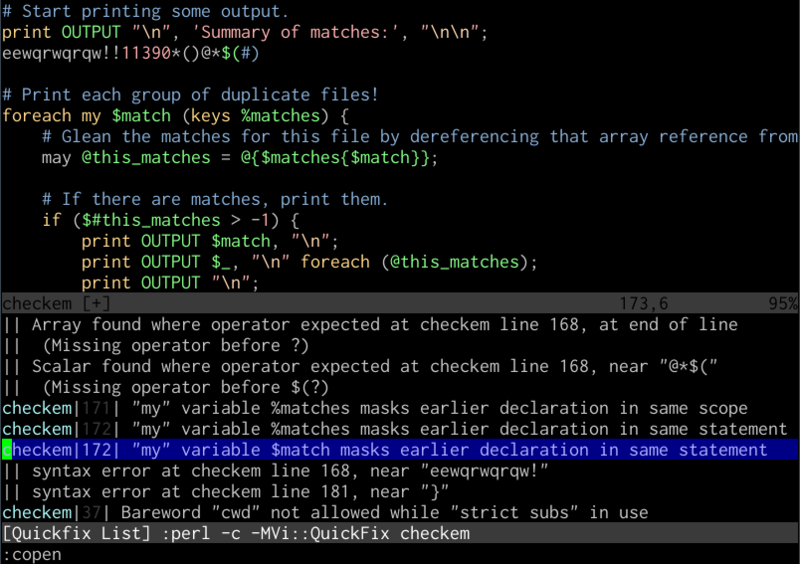

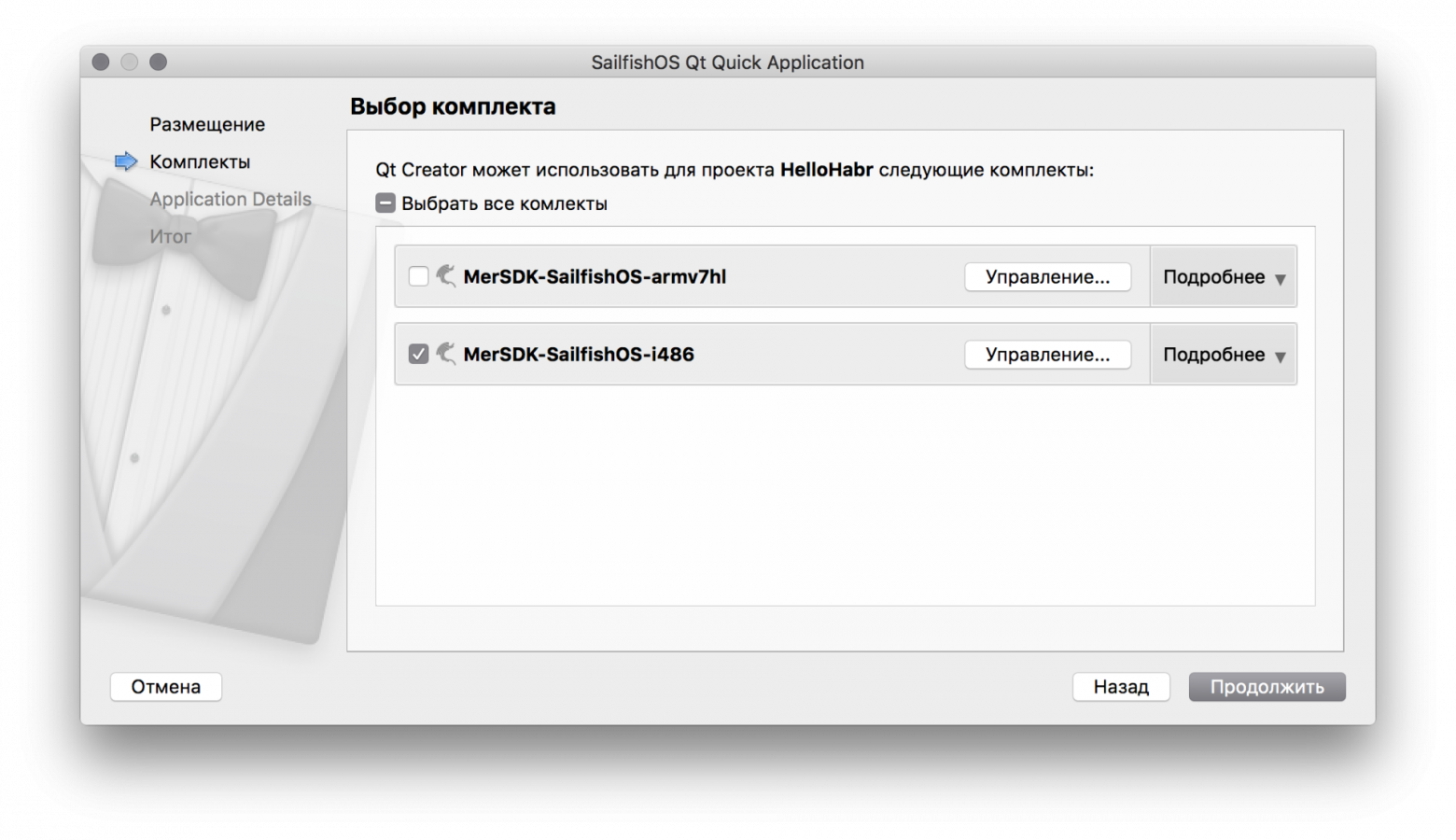

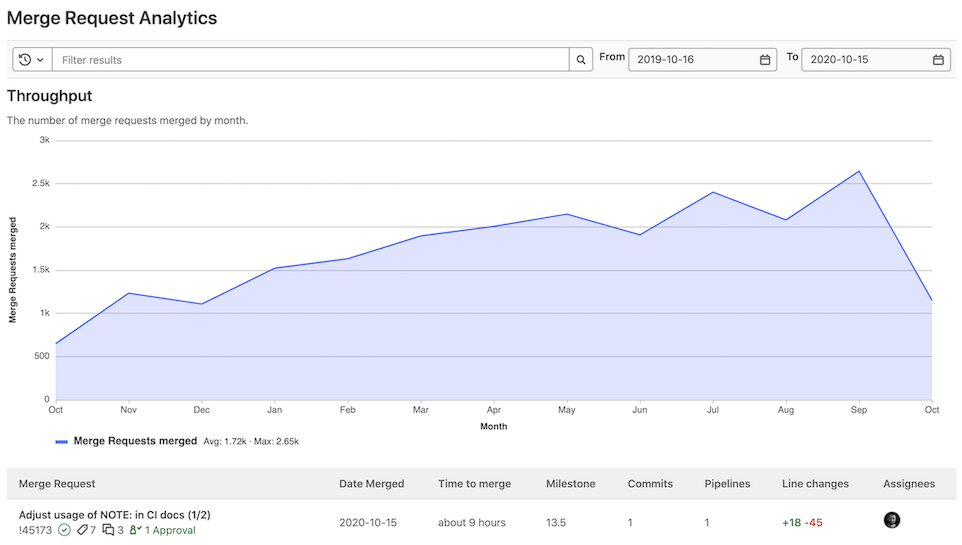

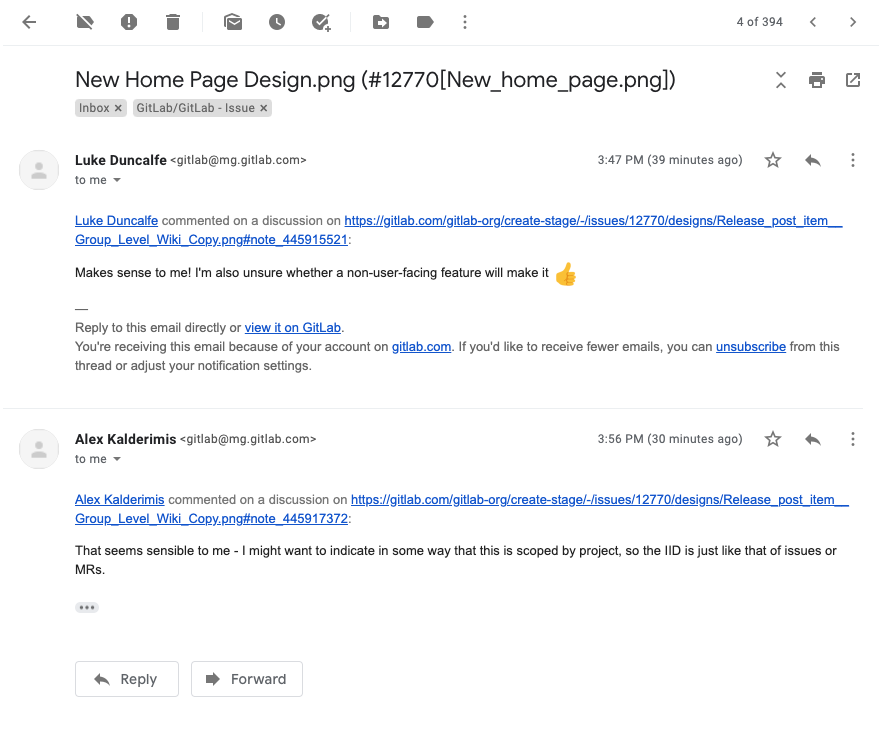

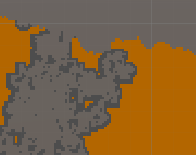

Свои типы полей Joomla для модуля

---------------------------------

Как и в Joomla 3, в Joomla 4, если Вам не хватает [стандартных типов полей](https://docs.joomla.org/Standard_form_field_types), у Вас есть возможность создавать свои типы полей. Это могут быть нестандартные выборки из базы данных, получение значений списка из сторонних сервисов по API и т.д.

Возможность создавать свои пользовательские типы полей открывает широкие возможности Joomla. Наглядный пример:

### Joomla 3

В Joomla 3 Вам надо было указать свой тип поля и назначить атрибут `addfieldpath` родительскому или напрямую . Например

Php-файл поля находится в папке с модулем `modules/mod_wtyandexmapitems/fields`.

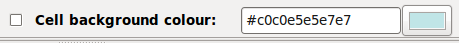

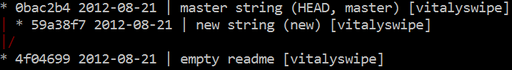

### Joomla 4

В Joomla 4 атрибут `addfieldpath` не работает. Вместо него используется атрибут `addfieldprefix`, в котором нужно указать **namespace для пользовательских полей модуля**.

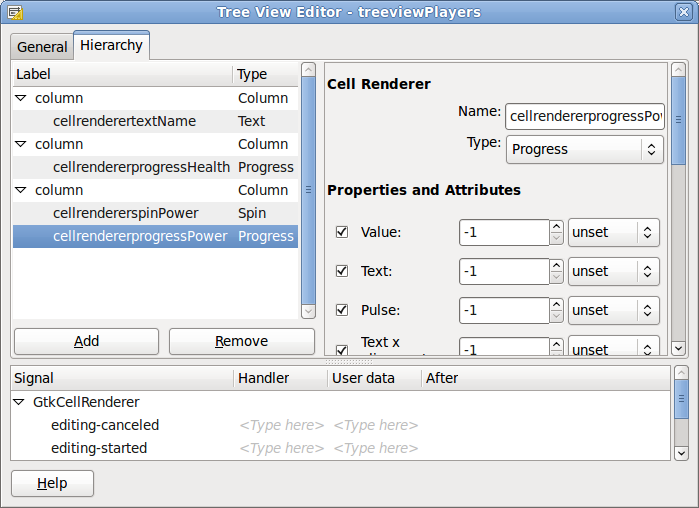

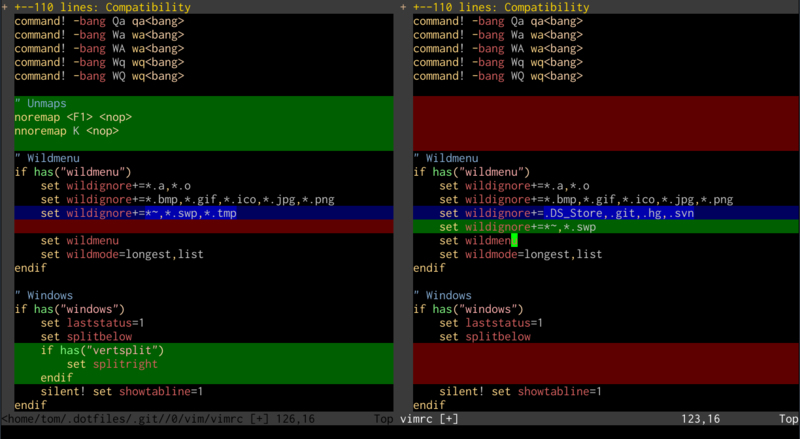

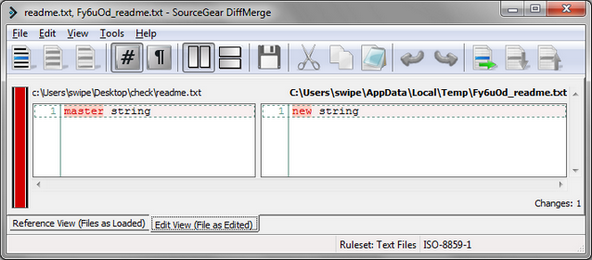

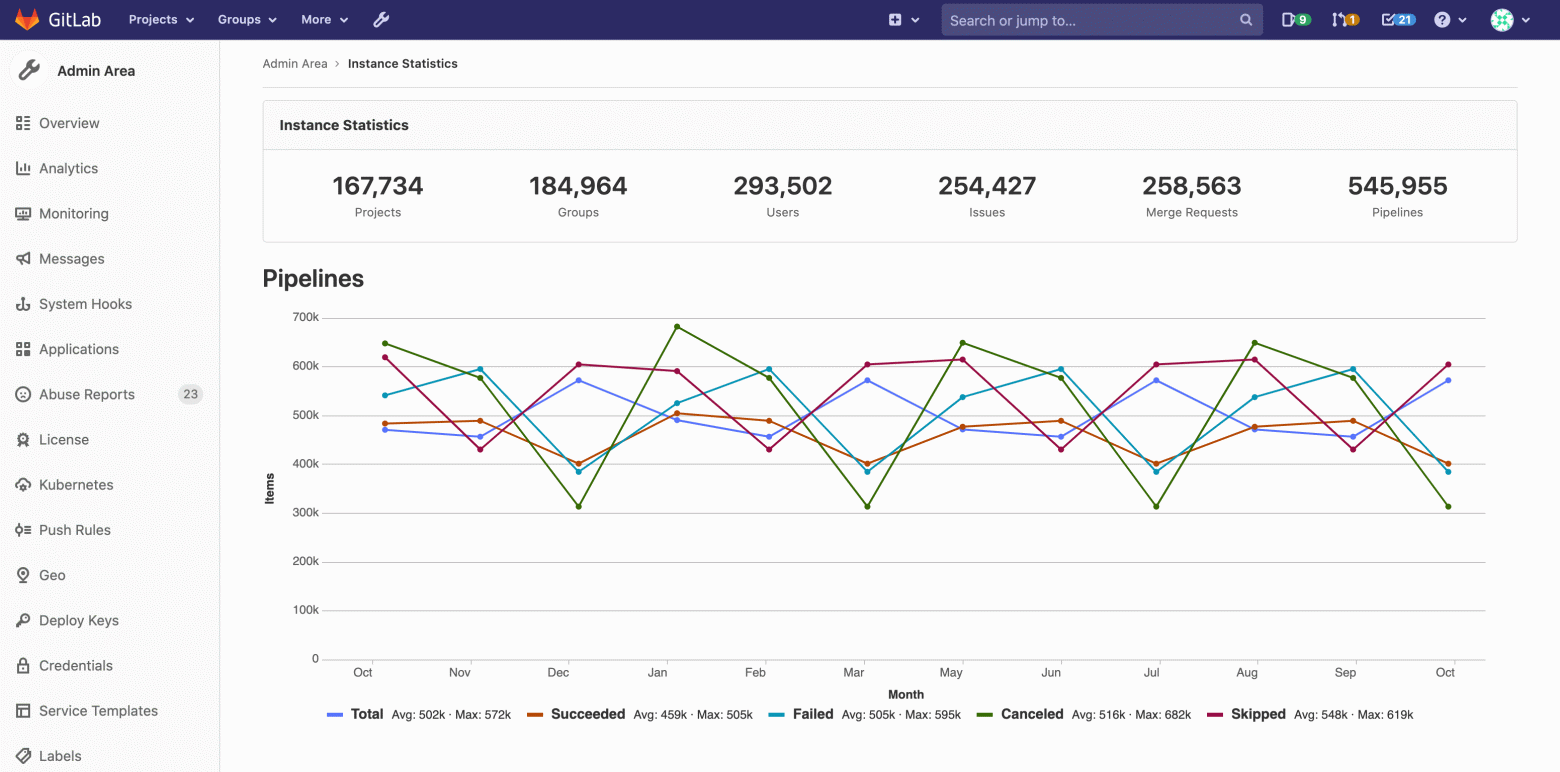

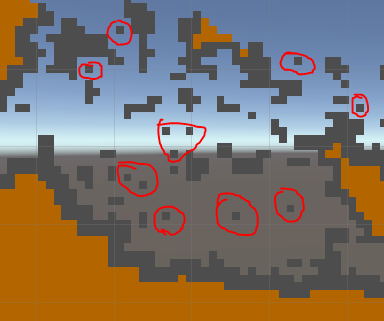

Собственные типы полей в Joomla 4Поля мы складываем в `src/Fields`. У файлов полей должен быть namespace `namespace Joomla\Module\Wtyandexmapitems\Site\Fields`. Я использую собственный тип поля, расширяющий тип поля spacer (пробел), для вывода своего логотипа, версии модуля, ссылки на сайт и иногда дополнительной информации.

Вариант использования пользовательского типа поля в Joomla 4А вот пример использования в Joomla 3. Плагин для двухсторонней интеграции Joomla с CRM Битрикс 24 в настройках показывает информацию об аккаунте, из-под которого создан вебхук на стороне Битрикс 24. Если информация отображается, значит плагин настроен верно.

Вариант использования пользовательского типа поля в Joomla 3А здесь в настройках плагина отображается список стадий лида (или сделки), получаемый по API из CRM Битрикс 24. Это так же реализовано с помощью пользовательских типов полей (пример из версии для Joomla 3).

Получение данных для поля из API стороннего сервиса в Joomla 3Гибридный вариант модуля

------------------------

Если у Вас совсем нет времени, а завести "со шморгалкой" старый модуль на Joomla 4 всё-таки надо, поддерживается (пока что) как старый, так и гибридный вариант структуры модуля.

1. **Пока что можно обойтись без сервис-провайдера.** Вообще. Тогда нужен файл "точки входа" `mod_wtyandexmapitems.php` и соответствующая строка в xml-манифесте модуля.

2. **Пока что можно обойтись без папки src**. И подключать хелпер по старинке через `JLoader::register('ModWtyandexmapitemsHelper', __DIR__ . '/helper.php')`. Соответственно файл helper.php должен лежать рядом с "точкой входа" в модуль.

3. **Можно переместить хелпер в папку** `src`, переименовать файл, назначить ему namespace (и в xml-манифесте модуля тоже) и использовать в "точке входа" просто `use Joomla\Module\Wtyandexmapitems\Site\Helper\WtyandexmapitemsHelper` - namespace хелпера. На момент написания статьи большая часть даже стандартных модулей Joomla переделана именно так, с частичным сохранением старой структуры. Полностью новым канонам пока что соответствует лишь модуль панели управления `mod_quickicon` - иконок быстрого доступа.

Полезные дополнения

-------------------

### Об использовании \Joomla\CMS\Factory

Из статьи [Распространенные ошибки при написании плагинов Joomla 4](https://habr.com/ru/post/677262/)

Вы должны использовать ТОЛЬКО ДВА метода `\Joomla\CMS\Factory` в Joomla 4:

* `getContainer()` - возвращает контейнер внедрения зависимостей Joomla (DI Container, иногда сокращенно DIC).

* `getApplication()` - возвращает текущий объект приложения Joomla, обрабатывающий запрос.

Всё. Больше ничего другого использовать не нужно! Всё остальное предоставляется либо через DI-контейнер, либо через сам объект приложения.

Чтобы получить документ приложения используйте `\Joomla\CMS\Factory::getApplication()->getDocument()`.

### Правильное подключение CSS и JS в Joomla 4

1. Статья [Как правильно подключать JavaScript и CSS в Joomla 4](https://jpath.ru/docs/output/js-css/kak-pravilno-podklyuchat-javascript-i-css-v-joomla-4)

2. Статья на хабре [Использование WebAssetsManager Joomla 4 и добавление собственных пресетов с помощью плагина](https://habr.com/ru/post/672020/). Мы помним, что все CSS и JS файлы должны лежать в папке `media`. Подробнее в статьях.

### Замена для популярных, но устаревших методов

Многие из этих методов работали ещё со времен Joomla 1.5 (с 2008 года!).

* `JRequest::getUri()` заменяем на $uri = `Joomla\CMS\Uri::getInstance()` и читаем документацию к нему.

* методы `JRequest::getCmd` и аналогичные перекочевали в `Joomla\Input\Input` или (что проще) `$app->getInput()`. Пока что поддерживается устаревший синтаксис `$app->input`, но в Joomla 5 (выйдет осенью 2023 года) он может быть удалён ([план выпуска релизов и принципы удаления устаревшего кода в Joomla](https://habr.com/ru/news/t/686224/)).

* `$app->isAdmin()` и `$app->isSite()` стали `$app->isClient('Site')` и `$app->isClient('Administrator')`.

* **Подключение к базе данных:** вместо `JFactory::getDbo()` (или `Joomla\CMS\Factory::getDbo`) используем `$app->getContainer()->get('DatabaseDriver')` ('DatabaseDriver' регистрозависимый).

* **Получение объекта пользователя:** вместо `JFactory::getUser()` (или `Joomla\CMS\Factory::getUser()`*)* используем `$app->getIdentity()`

Заключение

----------

Буду рад, если статья окажется полезной для разработчиков. Также буду признателен замечаниям и исправлениям, если таковые имеются у читателей.

### Полезные ресурсы

#### Ресурсы сообщества:

* [форум русской поддержки Joomla](https://joomlaforum.ru/).

* [интернет-портал Joomla-сообщества](https://joomlaportal.ru/).

* <https://vc.ru/s/1146097-joomla> - Сообщество Joomla на VC.

#### Telegram:

* [Чат сообщества «Joomla! по-русски»](https://t.me/joomlaru).

* [Joomla для профессионалов, разработчики Joomla](https://t.me/projoomla).

* [Новости о Joomla! и веб-разработке по-русски](https://t.me/joomlafeed).

* [Вакансии и предложения работы по Joomla](https://t.me/joomla_jobs): фуллтайм, частичная занятость и разовые подработки. Размещение вакансий [здесь](https://jpath.ru/jobs/add).

* [Англоязычный чат сообщества](https://t.me/joomlatalks).

* [Новости Joomla! по-английски](https://t.me/joomlahub) | https://habr.com/ru/post/684534/ | null | ru | null |

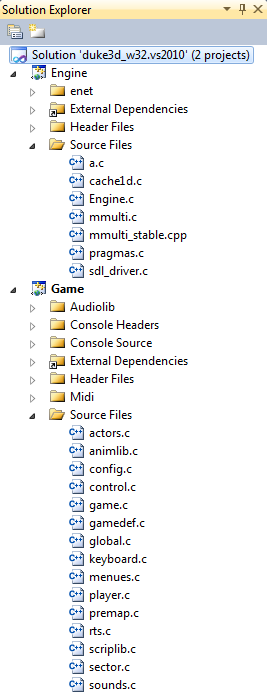

# Анализ исходного кода Duke Nukem 3D: Часть 1

Уйдя с работы в Amazon, я провёл много времени за чтением отличного исходного кода.

[Разобравшись](http://fabiensanglard.net/doomIphone/doomClassicRenderer.php) [с](http://fabiensanglard.net/quakeSource/index.php) [невероятно](http://fabiensanglard.net/wolf3d/index.php) [замечательным](http://fabiensanglard.net/quake3/index.php) [кодом](http://fabiensanglard.net/quake2/index.php) [idSoftware](http://fabiensanglard.net/doom3/index.php), я принялся за одну из [лучших игр всех времён](http://en.wikipedia.org/wiki/List_of_best-selling_PC_video_games): Duke Nukem 3D и за её движок под названием "*Build*".

Это оказался трудный опыт: сам движок имеет большую важность и высоко ценится за свою скорость, стабильность и потребление памяти, но мой энтузиазм столкнулся с исходным кодом, противоречивым в отношении упорядоченности, соблюдения рекомендаций и комментариев/документации. Читая код, я многое узнал о унаследованном коде и о том, что позволяет программному обеспечению жить долго.

Как обычно, я переработал [свои заметки](http://fabiensanglard.net/duke3d/notes.txt) в статью. Надеюсь, она вдохновит вас на чтение исходного кода и совершенствование своих навыков.

Хочу поблагодарить **Кена Силвермана (Ken Silverman)** за вычитку этой статьи: его терпеливость и добросовестные ответы на мои письма были важны для меня.

Происхождение

-------------

Duke Nukem 3D — не одна, а **две** базы кода:

* Движок *Build*: обеспечивает рендеринг, работу с сетью, файловой системой и службы кэширования.

* Игровой модуль: использует службы *Build* для создания игры.

Зачем нужно было такое разделение? Потому что в 1993 году, когда началась разработка, только у немногих людей были навыки и рвение, необходимые для создания хорошего 3D-движка. Когда 3D Realms решила написать игру, которая станет конкурентом *Doom*, ей нужно было найти мощную технологию. И в этот момент на сцене появляется Кен Силверман.

Согласно его [хорошо документированному веб-сайту](http://advsys.net/ken/build.htm) и [интервью](http://www.3drealms.com/news/2006/02/the_apogee_legacy_8.html), Кен (в то время ему было 18 лет) написал дома 3D-движок и отправил демо в 3D Realms для оценки. Они посчитали его навыки многообещающими, и заключили соглашение:

Силверман напишет новый движок для 3D Realms, но сохранит за собой исходный код.

Он предоставит только двоичную статическую библиотеку (`Engine.OBJ`) с файлом заголовка `Engine.h`. Со своей стороны, команда 3D Realms возьмёт на себя работу над игровым модулем (`Game.OBJ`) и выпустит финальный исполняемый `DUKE3D.EXE`.

К сожалению, исходный код обеих частей игры не был открыт одновременно:

* Исходный код движка был выпущен Кеном Силверманом 20 июня 2000 года.

* Исходный код игрового модуля был выпущен 3D Realms 1 апреля 2003 года.

В результате полный исходный код стал доступен только через 7 лет после выпуска игры.

**Интересный факт:** название движка "*Build*" было выбрано Кеном Силверманом при создании каталога для нового движка. Он воспользовался [тезаурусом, чтобы найти синонимы к слову «Construction»](http://advsys.net/ken/build.htm).

Первый контакт

--------------

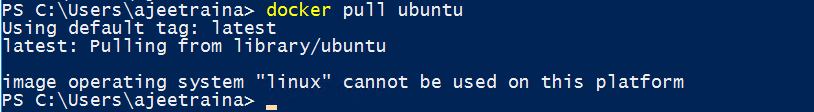

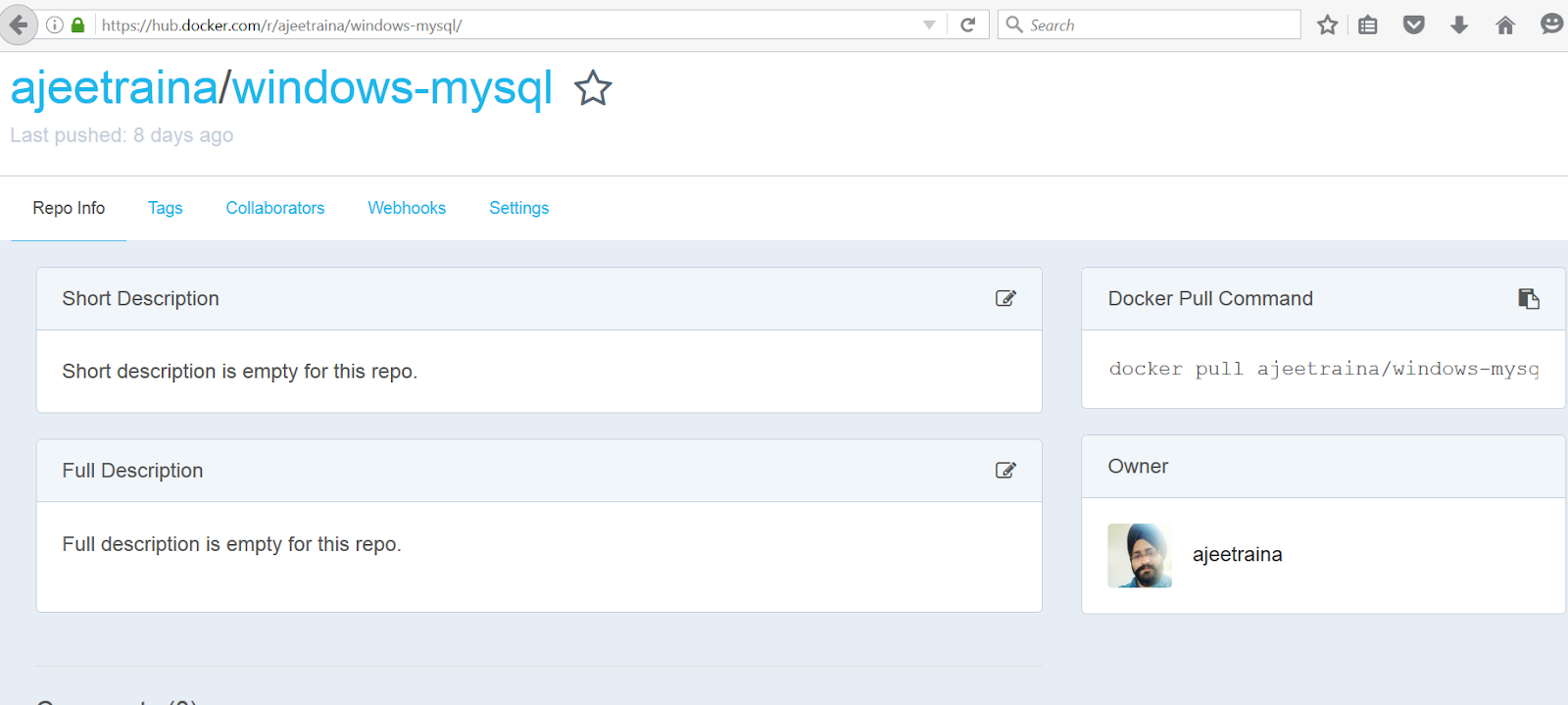

Поскольку исходный код выпущен давным-давно (он был предназначен для компилятора Watcom C/C++ и систем DOS), я попытался найти что-то похожее на [Chocolate doom](http://www.chocolate-doom.org/wiki/index.php/Chocolate_Doom): порт, точно воспроизводящий игровой процесс Duke Nukem 3D, таким, каким он был в 90-х, и беспроблемно компилирующийся на современных системах.

Выяснилось, что сообщество исходного кода Duke Nukem уже не слишком активно: многие порты снова устарели, некоторые созданы для MacOS 9 PowerPC. До сих пор поддерживается только один ([EDuke32](http://eduke32.com/)), но он слишком сильно эволюционировал по сравнению с оригинальным кодом.

В результате я начал работать с [xDuke](http://vision.gel.ulaval.ca/~klein/duke3d/), хотя он и не компилировался на Linux и Mac OS X (что исключило использование XCode: отличного IDE для чтения кода и профайлинга).

xDuke, сделанный на Visual Studio, точно воспроизводит оригинальный код. Он содержит два проекта: Engine и Game. Проект «Engine» компилируется в статическую библиотеку (`Engine.lib`), а проект «Game» (содержащий метод `main`) связывается с ним для генерирования `duke3D.exe`.

При открытии VS исходники движка выглядят довольно неприветливо из-за сложных имён файлов (`a.c`, `cache1d.c`). Файлы эти содержат нечто враждебное глазу и мозгу. Вот один из множества примеров в файле [Engine.c (строка 693)](https://github.com/fabiensanglard/vanilla_duke3D/blob/master/SRC/ENGINE.C#L1280):

```

if ((globalorientation&0x10) > 0) globalx1 = -globalx1, globaly1 = -globaly1, globalxpanning = -globalxpanning;

if ((globalorientation&0x20) > 0) globalx2 = -globalx2, globaly2 = -globaly2, globalypanning = -globalypanning;

globalx1 <<= globalxshift; globaly1 <<= globalxshift;

globalx2 <<= globalyshift; globaly2 <<= globalyshift;

globalxpanning <<= globalxshift; globalypanning <<= globalyshift;

globalxpanning += (((long)sec->ceilingxpanning)<<24);

globalypanning += (((long)sec->ceilingypanning)<<24);

globaly1 = (-globalx1-globaly1)*halfxdimen;

globalx2 = (globalx2-globaly2)*halfxdimen;

```

**Примечание:** если имя файла/переменной содержит цифру, то это, вполне возможно, не очень хорошее имя!

**Интересный факт:** последняя часть кода `game.c` содержит [черновик сценария Duke V](https://github.com/fabiensanglard/chocolate_duke3D/blob/master/Game/src/game.c#L10795)!

**Примечание:** порт xDuke использует SDL, но преимущество кроссплатформенного API утеряно из-за таймеров WIN32 (`QueryPerformanceFrequency`). Похоже, что использованный SDL Timer слишком неточен для эмуляции частоты 120 Гц в DOS.

Сборка

------

Разобравшись с SDL и расположением заголовком/библиотек DirectX, можно собрать код за один щелчок. Это очень приятно. Последнее, что осталось — достать файл ресурсов `DUKE3D.GRP`, и игра запустится… ну, или типа того. Похоже, у SDL есть какие-то проблемы с палитрой в Vista/Windows 7:

Запуск в оконном режиме (или лучше в Windows 8) кажется решает проблему:

Погружение в процесс

--------------------

Теперь игра работает. За несколько секунд *Build* предстаёт во всё своём блеске, демонстрируя:

* Наклонные потолки

* Реалистичное окружение

* Возможность свободного падения

* Ощущение истинного 3D.

Последний пункт, наверно, больше всего повлиял на игроков в 1996 году. Уровень погружения был непревзойдённым. Даже когда технология достигла своего предела из-за двухмерных карт, Тодд Реплогл (Todd Replogle) и Аллен Блум (Allen Blum) реализовали «эффекторы секторов» позволявшие телепортировать игрока и усиливавшие ощущение погружения в трёхмерный мир. Эта функция используется в легендарной карте «L.A Meltdown»:

Когда игрок запрыгивает в вентиляционную шахту:

Срабатывают эффекторы секторов и перед «приземлением» телепортируют игрока совершенно в другое место карты:

Хорошие игры медленно стареют, и Duke Nukem не стала исключением: двадцать лет спустя в неё всё ещё невероятно интересно играть. А теперь мы ещё и можем изучить её исходники!

Обзор библиотеки движка

-----------------------

Код движка находится в одном файле из 8503 строк и с 10 основными функциями (`Engine.c`) и в двух дополнительных файлах:

* `cache1.c`: содержит виртуальную файловую систему (sic!) и процедуры системы кэширования.

* `a.c`: реализация на C воссозданного обратной разработкой кода, который был высокооптимизированным x86-ассемблером. Код работает, но читать его — огромная мука!

Три модуля трансляции и несколько функций составляют высокоуровневую архитектуру, которую сложно понять. К сожалению, это не единственные сложности, с которыми придётся столкнуться читателю.

Внутренностям движка *Build* я посвятил целый раздел (см. ниже).

### Обзор игрового модуля

Игровой модуль целиком построен поверх модуля движка, системные вызовы операционной системы используются процессом. Всё в игре выполняется через *Build* (отрисовка, загрузка ресурсов, файловая система, система кэширования и т.д.). Единственное исключение — звуки и музыка, они полностью относятся к *Game*.

Поскольку меня больше интересовал движок, особо я здесь не разбирался. Но в этом модуле видно больше опыта и организации: 15 файлов делят исходный код на понятные модули. В нём даже есть `types.h` (инициатор `stdint.h`) для улучшения портируемости.

Пара интересных моментов:

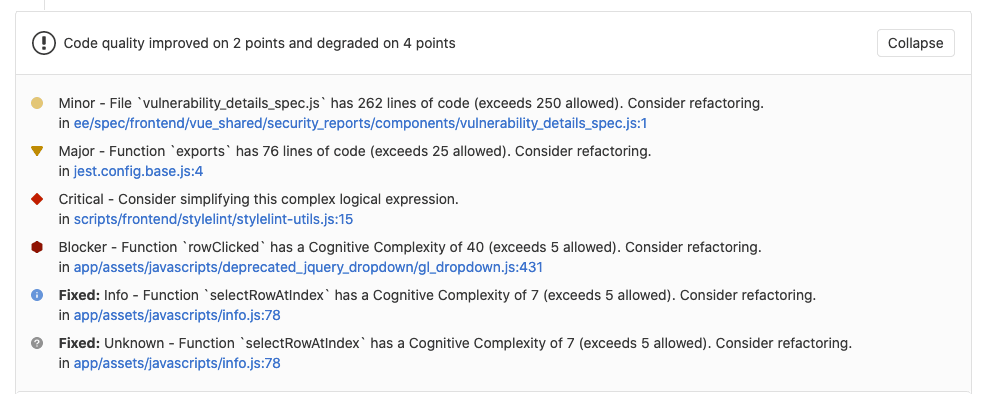

* `game.c` — это монстр из 11 026 строк кода.

* В `menu.c` есть 3000 строк со «switch case».

* Большинство методов имеют параметры «void» и возвращают «void». Всё выполняется через глобальные переменные.

* В наименованиях методов не используется camelCase или префикс NAMESPACE.

* В модуле есть хороший парсер/лексический анализатор, хотя и **значения токенов** [передаются через десятичные](https://github.com/fabiensanglard/chocolate_duke3D/blob/master/Game/src/gamedef.c#L459) значения вместо [`#define`](https://github.com/fabiensanglard/chocolate_duke3D/blob/master/Game/src/gamedef.c#L52).

В целом эту часть кода легко читать и понимать.

### Унаследованный исходный код

Глядя на бесконечное количество портов, порождённых Doom/Quake, я всегда удивлялся, почему так мало портов Duke Nukem 3D. Тот же вопрос возник, когда движок был портирован под OpenGL только после того, как Кен Силверман решил заняться этим самостоятельно.

Теперь, когда я посмотрел на код, рискну объяснить это во второй части этой статьи

### Chocolate Duke Nukem 3D

Я обожаю этот движок и люблю игру, поэтому не мог оставить всё как есть: я создал [Chocolate Duke Nukem 3D](https://github.com/fabiensanglard/chocolate_duke3D), порт «ванильного» исходного кода, пытаясь достичь таким образом двух целей:

* Обучение: простота чтения/понимания и удобство портирования.

* Достоверность: игровой процесс должен быть похожим на тот, который мы видели в 1996 году на наших 486-х.

Надеюсь, эта инициатива поможет унаследовать код. Самые важные модификации будут описаны во второй части статьи.

Внутренности движка Build

=========================

[*Build*](http://en.wikipedia.org/wiki/Build_engine) использовался в Duke Nukem 3D и многих других успешных играх, таких как [Shadow Warrior](http://en.wikipedia.org/wiki/Shadow_Warrior) и [Blood](http://en.wikipedia.org/wiki/Blood_(video_game)). В момент выпуска 29 января 1996 года он уничтожил движок *Doom* инновационными возможностями:

* Разрушаемым окружением

* Наклонными полами и потолками

* Зеркалами

* Возможностью смотреть вверх и вниз

* Способностью летать, ползать и плавать под водой

* [Воксельными объектами](http://fd.fabiensanglard.net/duke3d/blood_voxels.png) (появились позже в «Blood»)

* Настоящим погружением в 3D (благодаря телепортам).

Корону у него отнял в июне 1996 года Quake, запущенный на мощных «Пентиумах»… но в течение нескольких лет *Build* обеспечивал высокое качество, свободу дизайнеров и, что важнее всего, хорошую скорость на большинстве компьютеров того времени.

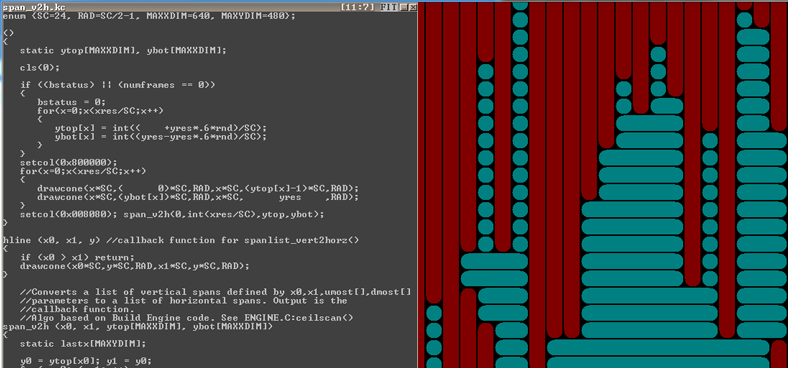

Важнейшая концепция: система порталов

-------------------------------------

Большинство 3D-движков разделяло игровые карты с помощью двоичного разбиения пространства (Binary Space Partition) или октодерева (Octree). Doom, например, предварительно обрабатывал каждую карту затратным по времени методом (до 30 минут), в результате чего получалось BSP-дерево, позволявшее:

* Сортировать стены

* Определять положение

* Обнаруживать столкновения.

Но в угоду скорости приходилось идти на уступки: стены **не могли передвигаться**. *Build* снял это ограничение, он не обрабатывал предварительно карты, а вместо этого использовал **систему порталов**:

На этой карте гейм-дизайнер нарисовал 5 секторов (сверху) и соединил их вместе, пометив стены как порталы (снизу).

В результате база данных мира *Build* стала до смешного простой: один массив для секторов и один массив для стен.

```

Секторы (5 записей): Стены (29 записей) :

============================ ==========================================

0| startWall: 0 numWalls: 6 0| Point=[x,y], nextsector = -1 // Стена в секторе 0

1| startWall: 6 numWalls: 8 ..| // Стена в секторе 0

2| startWall: 14 numWalls: 4 ..| // Стена в секторе 0

3| startWall: 18 numWalls: 3 3| Point=[x,y], nextsector = 1 // Портал из сектора 0 в сектор 1

4| startWall: 21 numWalls: 8 ..| // Стена для сектора 0

============================ ..| // Стена для сектора 0

..|

Первая стена сектора 1 >> 6| Point=[x,y], nextsector = -1

7| Point=[x,y], nextsector = -1

8| Point=[x,y], nextsector = -1

9| Point=[x,y], nextsector = 2 //Портал из сектора 1 в сектор 2

10| Point=[x,y], nextsector = -1

11| Point=[x,y], nextsector = 0 //Портал из сектора 1 в сектор 0

12| Point=[x,y], nextsector = -1

Последняя стена сектора 1 >> 13| Point=[x,y], nextsector = -1

..|

28| Point=[x,y], nextsector = -1

===========================================

```