text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# «Распределение в запросе» или «избавляемся от перебора»

**Хороший перебор — это отсутствие перебора. Рассмотрим пример замены полного перебора запросом.**

В свое время, года 3 назад, возникла необходимость оптимизации конфигурации 1С и устранения ее узких мест в одной компании. Одним из таких узких мест оказался, казалось бы, безобидный, механизм распределения товаров в реализации по сериям. Суть в том, что строк распределялось достаточно много и было это очень медленно. Не миллионы за раз, конечно, но на это самое распределение для одного документа могло уходить до минуты.

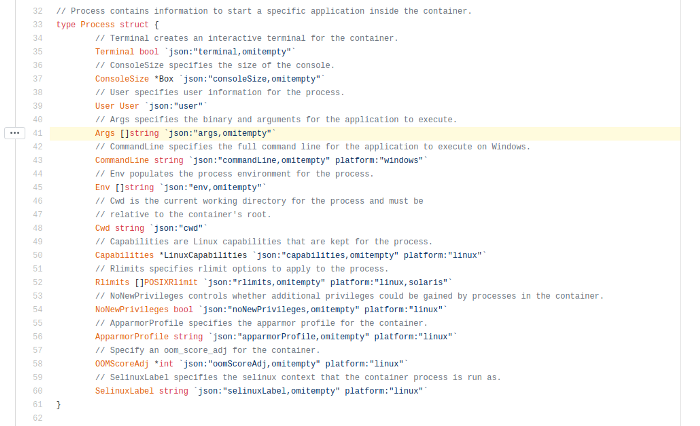

Запрос специально привожу на T-SQL, т.к. думаю, что Хабравцам это будет ближе.

В общем от этого дела становилось всем очень грустно, т.к. параллельно бухгалтера препроводили документы, другие операторы тоже формировали документы отгрузки и когда отгружали «большого» клиента – жизнь на некоторое время замирала.

К слову сказать, размер базы 1С за 2-3 года на тот момент составлял ~500 Гб, заказов от одного клиента за день могло прийти десяток-другой, а в некоторых из них строк могло быть более 1000, в общем «Реализация товаров и услуг» на 1000 строк — это не было ничем сверхъестественным. Реиндексация, обновление статистики, шринк и другие необходимые процедуры проводились регулярно, но сейчас речь не об этом. Вернемся к нашему объекту оптимизации. На тот момент механизм распределения был до банального прост:

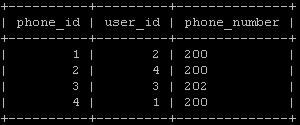

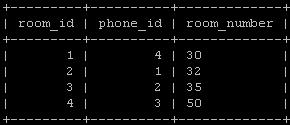

1. Запросом получали остатки по сериям (Номенклатура – Серия – Количество).

2. Другим запросом получали таблицу товаров к отгрузке (Номенклатура – Заказ покупателя – Количество).

3. Проходил обыкновенный перебор для каждой номенклатуры по принципу «**Пока** **КоличествоКРаспределению** > 0 **Цикл** ……… ».

Т.к. я всегда придерживался позиции, что сам факт перебора на больших объемах данных – это уже само по себе узкое место, то возможность «улучшения» алгоритма перебора я даже рассматривать не планировал. Нужна была альтернатива. Также на тот момент я уже давно набил руку в оптимизации сложных запросов и укрепился в выводе, что нет ни одной задачи, которую нельзя было бы решить исключительно запросом и точно знал, что качественный запрос (пакет запросов) в 99% случаев окажется самым эффективным решением, чем какая-либо пост-обработка результатов запроса. Вопрос оставался только в нахождении этого решения).

Выходил я на перекур с достаточно тривиальным условием задачи (распределить количество по измерениям одной таблицы на количество по измерениям из другой) и 2-мя тезисами:

* Мы имеем 2 таблицы, которые и так собираются запросом.

* SQL не знает никакого «Распределить». SQL знает только «больше», «меньше», «равно» (утрированно). Надо дать ему некий параметр для сравнения. Числовой параметр, по которому будет понятно какое количество **еще** можно распределить в условную строку.

И в этот самый момент, когда я мысленно проговаривал второй тезис, слово «**еще**» и натолкнуло меня на решение. Далее, рисуя палочкой на снегу, я не успел докурить, как уже побежал пробовать свою гипотезу в консоли запросов.

Рассмотрим ниже простой пример:

У нас есть складские ячейки с количеством вмещаемого в них товара с одной стороны (A, B, C, D) и сам товар (X, Y, Z), который необходимо «как-то» разложить по этим ячейкам, но так, чтоб в ячейку не положили больше товара, чем может быть в ней места.

> A – 10 мест

>

> B – 1 место

>

> C – 5 мест

>

> D – 8 мест

>

>

>

> X – 13 шт

>

> Y – 1 шт

>

> Z – 4 шт

Результатом должна стать таблица распределения:

> A-X-10

>

> B-X-1

>

> C-X-2

>

> C-Y-1

>

> C-Z-2

>

> D-Z-2

Для этого нам надо определить порядок распределения, сделать это оказалось до банального просто:

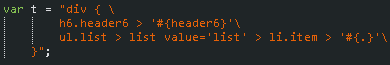

```

select

t1.Cell,

t1.Qty,

ISNULL(sum(t2.Qty),0)+1 as OrderBottom,

ISNULL(sum(t2.Qty),0)+t1.Qty as OrderTop

into OrderedCells

from Cells as t1

left join Cells as t2

on t1.Cell > t2.Cell

Group by

t1.Cell,

t1.Qty

```

Кстати, здесь же можно учесть и порядок распределения, если, например, в какие-то ячейки товар надо класть в первую очередь. Решается изменением условия в соединении.

Тоже самое и с товарами:

```

select

t1.Goods,

t1.Qty,

ISNULL(sum(t2.Qty),0)+1 as OrderBottom,

ISNULL(sum(t2.Qty),0)+t1.Qty as OrderTop

into OrderedGoods

from Goods as t1

left join Goods as t2

on t1.Goods > t2.Goods

Group by

t1.Goods,

t1.Qty

```

Для простоты понимания разложу все эти позиции поштучно в таблице и наложу одну на другую в порядке распределения:

Нам просто нужно написать граничные условия. А теперь осталось просто соединить эти таблицы и получим наш результат:

```

select

OrderedCells.Cell,

OrderedGoods.Goods,

case when OrderedGoods.OrderTop < OrderedCells.OrderTop

then OrderedGoods.OrderTop

else OrderedCells.OrderTop

end - case when OrderedGoods.OrderBottom > OrderedCells.OrderBottom

then OrderedGoods.OrderBottom

else OrderedCells.OrderBottom

end + 1 as Qty

from

OrderedCells

inner join OrderedGoods

on OrderedCells.OrderBottom <= OrderedGoods.OrderTop

and OrderedCells.OrderTop >= OrderedGoods.OrderBottom

```

Сразу оговорюсь, что в запросе умышленно добавлено большее количество полей, чем надо. Можно было бы обойтись и одной границей распределения (нарастающим итогом) и не делать «+1», но как мне показалось – в таком виде это более наглядно для понимания. Оптимизацию запросов мы в этой теме не рассматриваем, поэтому и индексы здесь тоже не описаны. Ну а более сложные алгоритмы распределения (по нескольким измерениям, например) решаются только изменением условий соединения и проверки границ.

Вот и все. В итоге вместо минут ожидания на тех же объемах данных этот запрос выполнялся считанные миллисекунды.

Прошу простить за обилие лирики в этой статье. Хотелось дать не математическое решение узкой задачи, а поделиться концептуальным подходом к решению подобных задач, именно ходом своих мыслей. | https://habr.com/ru/post/318240/ | null | ru | null |

# 12 возможностей ES10 в 12 простых примерах

*Перед вами перевод статьи из блога [Carlos Caballero](https://medium.com/better-programming/twelve-es10-features-in-twelve-simple-examples-6e8cc109f3d3) на сайте Medium.com. Автор расскажет нам о функциях, которые появились в версии ES10 2019 года.*

[ES10](https://www.ecma-international.org/ecma-262/10.0/index.html#Title) — это версия [ECMAScript](https://www.ecma-international.org/publications/standards/Ecma-262.htm), актуальная для 2019 года. Она содержит не так много нововведений, как версия [ES6](http://es6-features.org/#Constants), выпущенная в 2015 году, однако в нее включили несколько полезных функций.

В этой статье функции, представленные в ES10, описываются в виде примеров простого кода. Вы сможете быстро их понять без подробного разъяснения. Конечно же, для этого понадобятся базовые знания JavaScript.

Новыми функциями JavaScript в ES2019 являются:

* `Array#{flat,flatMap}`

* `Object.fromEntries`

* `String#{trimStart,trimEnd}`

* `Symbol#description`

* необязательная привязка `try { } catch {} //`

* JSON ⊂ ECMAScript

* хорошо сформированный `JSON.stringify`

* устойчивый `Array#sort`

* обновленная Function#toString

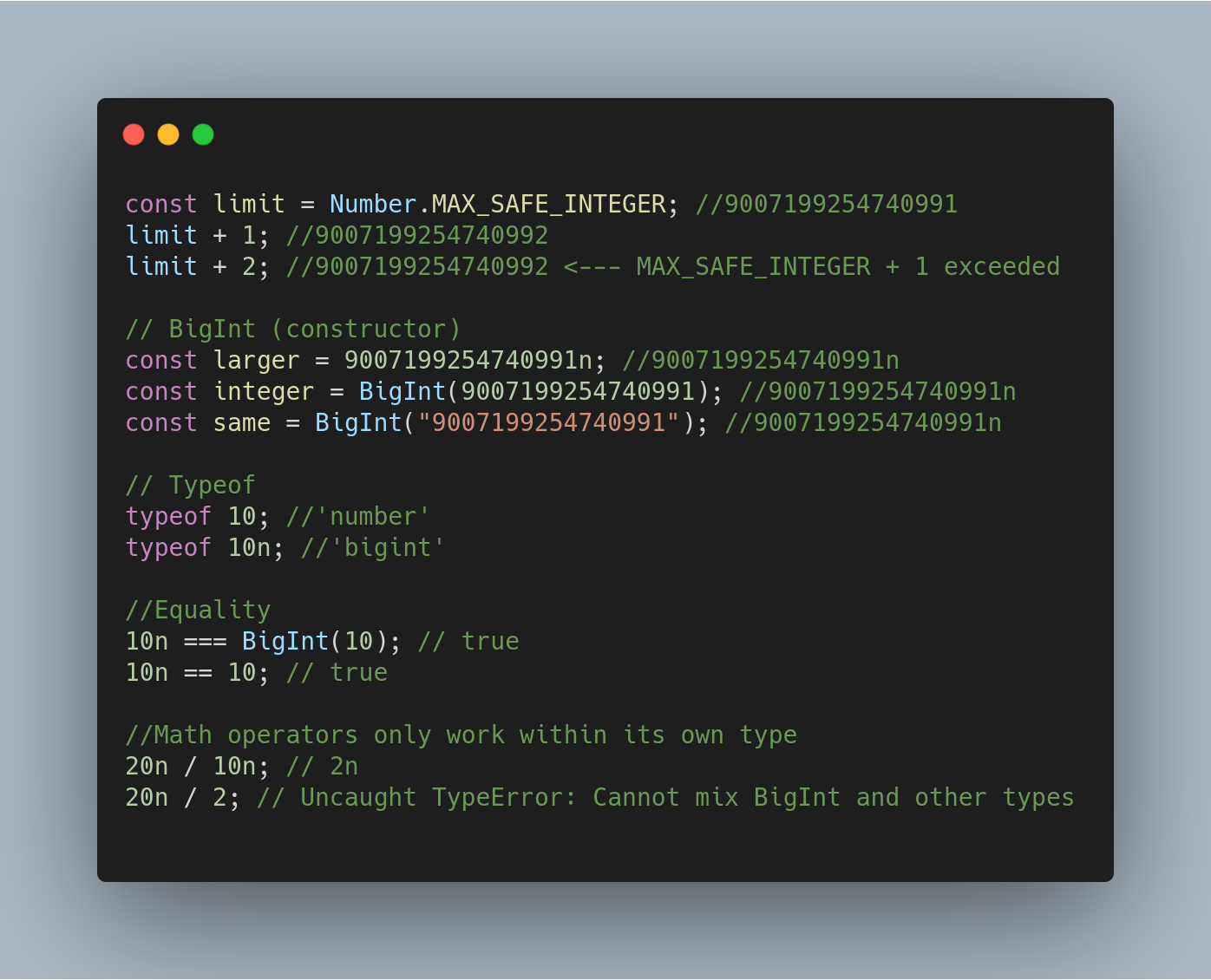

* `BigInt` — простой тип (3 стадия)

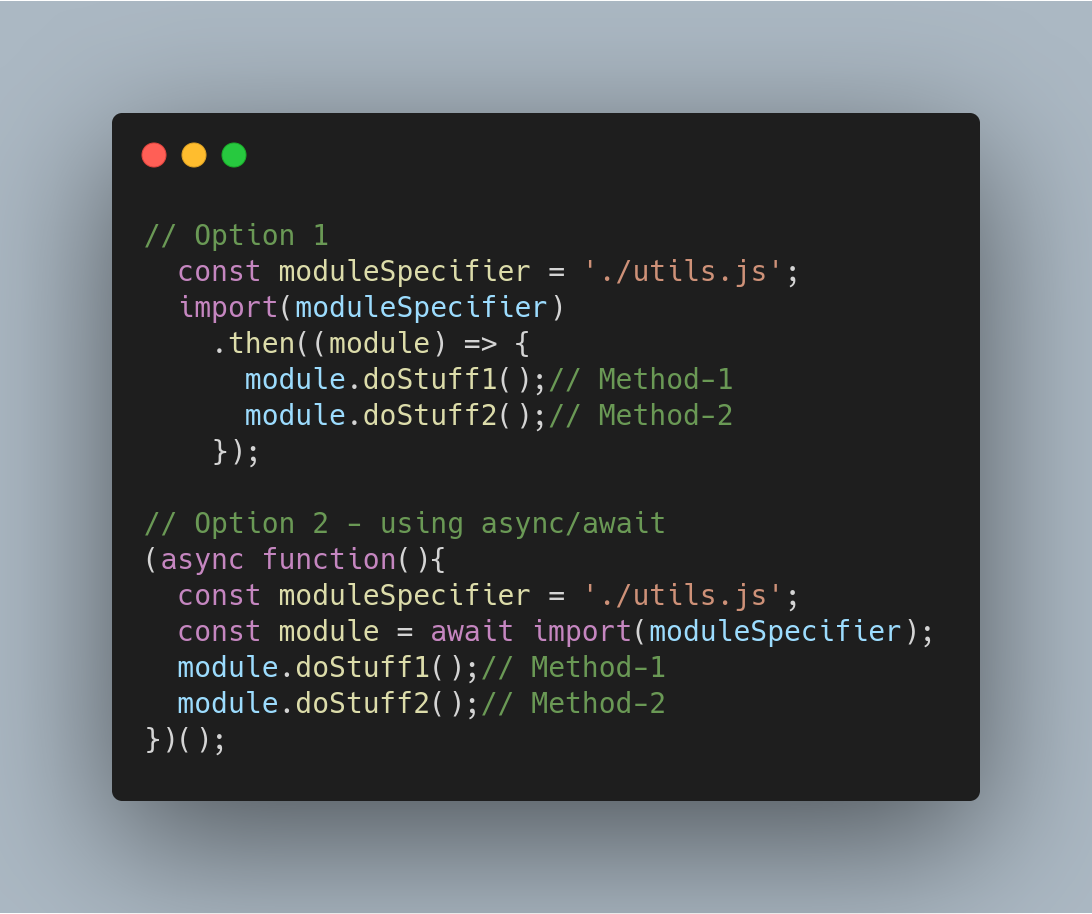

* динамический импорт (3 стадия)

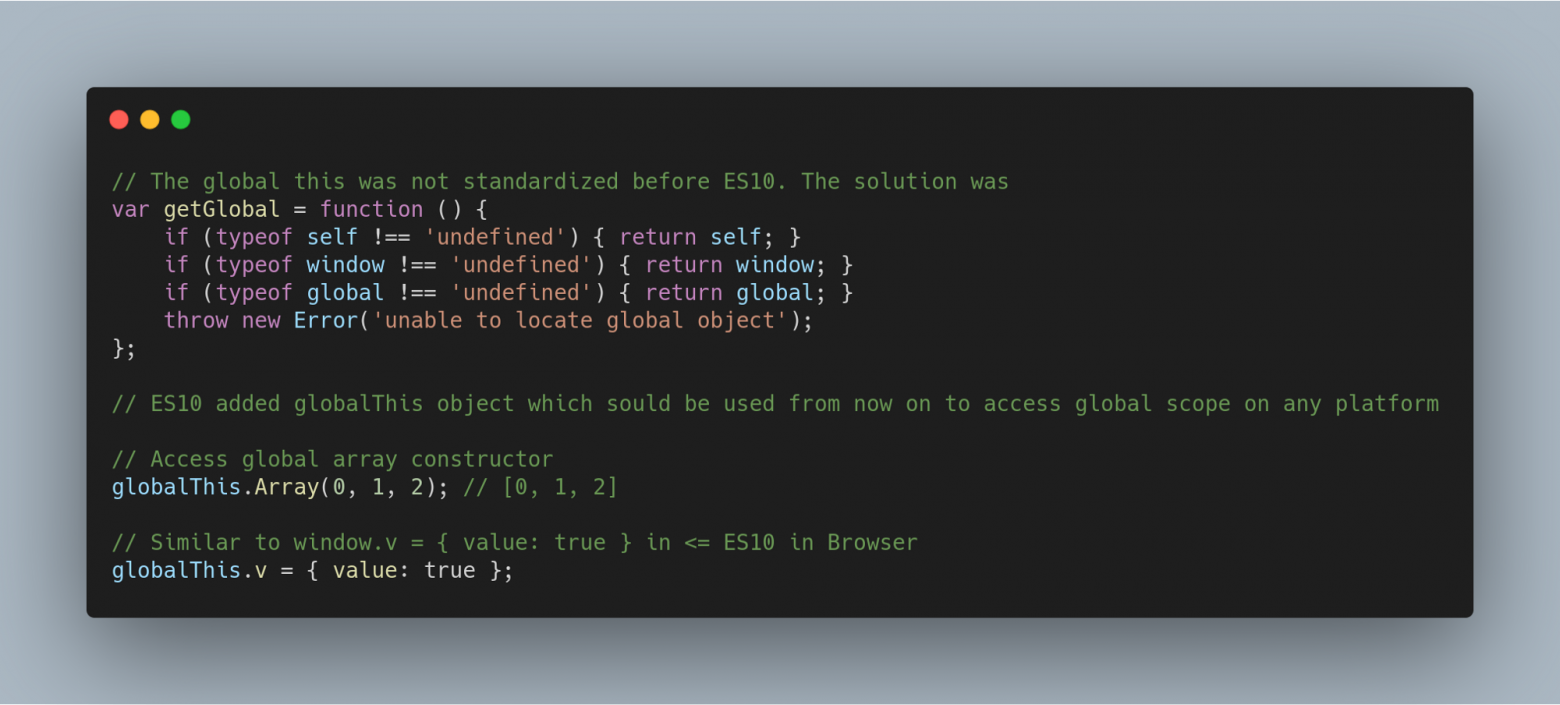

* стандартизированный объект `global This` (3 стадия).

### Array.flat() и Array.flatMap()

Существует два новых метода `Array`:

* Метод `Array.flat()` возвращает новый массив, в котором все элементы вложенных подмассивов были рекурсивно подняты на указанный уровень depth.

* Метод `Array.flatMap()` сначала применяет функцию к каждому элементу, а затем преобразует полученный результат в плоскую структуру и помещает в новый массив. Это идентично функции `map()` с последующим применением функции `flat()` с параметром depth, равным 1, но `flatMap()` чаще более эффективен, поскольку совмещает в себе оба подхода в одном методе.

### Object.fromEntries()

Преобразует список кода и пары значений в объект.

### String.prototype.matchAll

При сопоставлении строки с регулярным выражением метод `matchAll()` возвращает итератор по всем результатам, включая группы захвата.

### String.trimStart() and String.trimEnd()

Появилось два новых метода `String` для удаления пробелов из строки:

* Метод `trimStart()` удаляет пробел в начале строки.

* Метод `trimEnd()` удаляет пробел в конце строки.

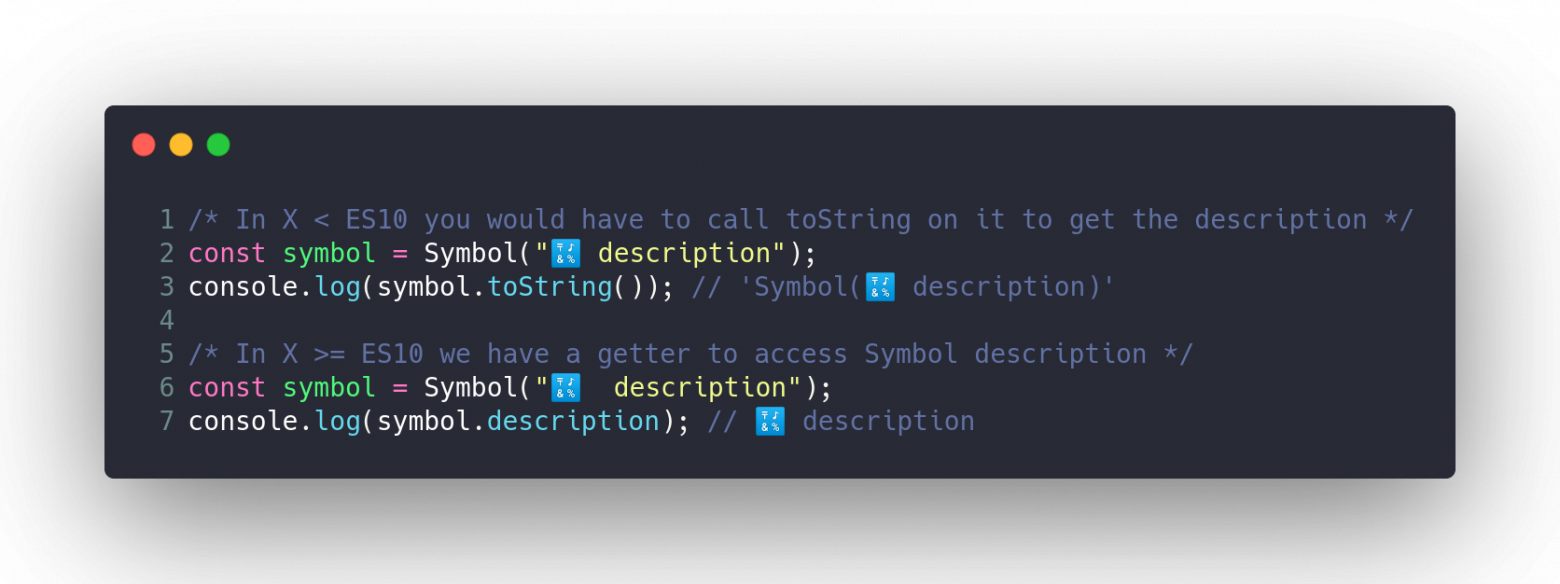

### Symbol.Description

Добавлен новый вариант получения описания `Symbol`. Теперь, создавая `Symbol`, вы можете добавить строку в качестве описания — в ES10 есть доступ к этому показателю.

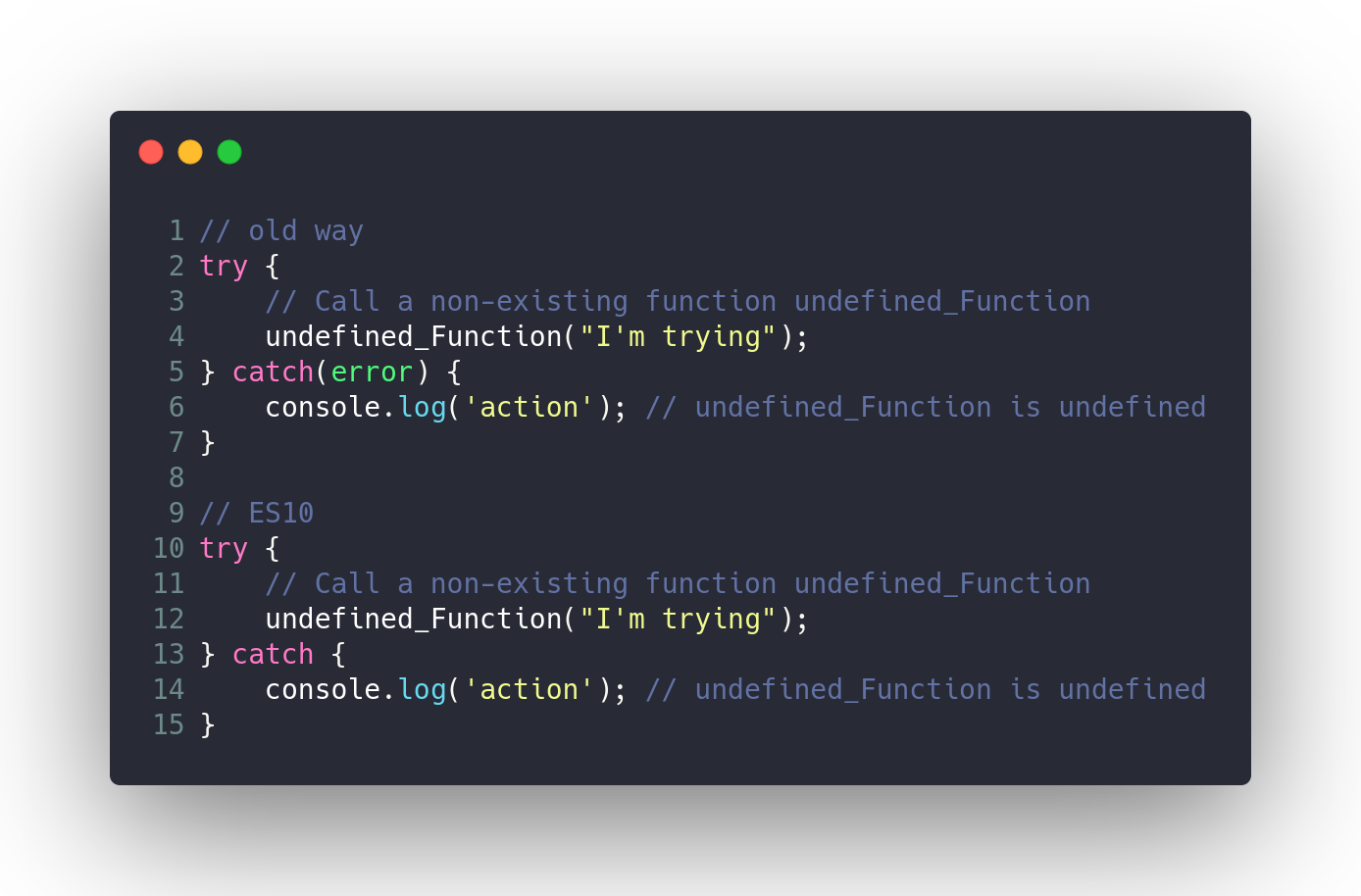

### Необязательная привязка `try/catch`

Раньше выражение `catch` из конструкции `try/catch` нуждалось в переменной. Сегодня разработчики могут использовать `try/catch` без создания ненужной привязки.

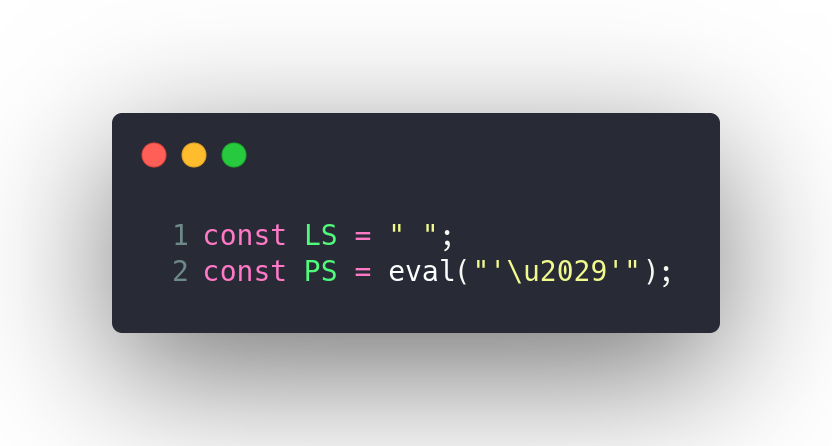

### JSON ⊂ ECMAScript

Символы неэкранированного разделителя строк `U+2028` и разделителя абзацев `U+2029` не были представлены в предыдущих версиях ECMAScript.

* U+2028 — разделитель абзацев.

* U+2029 — разделитель строк.

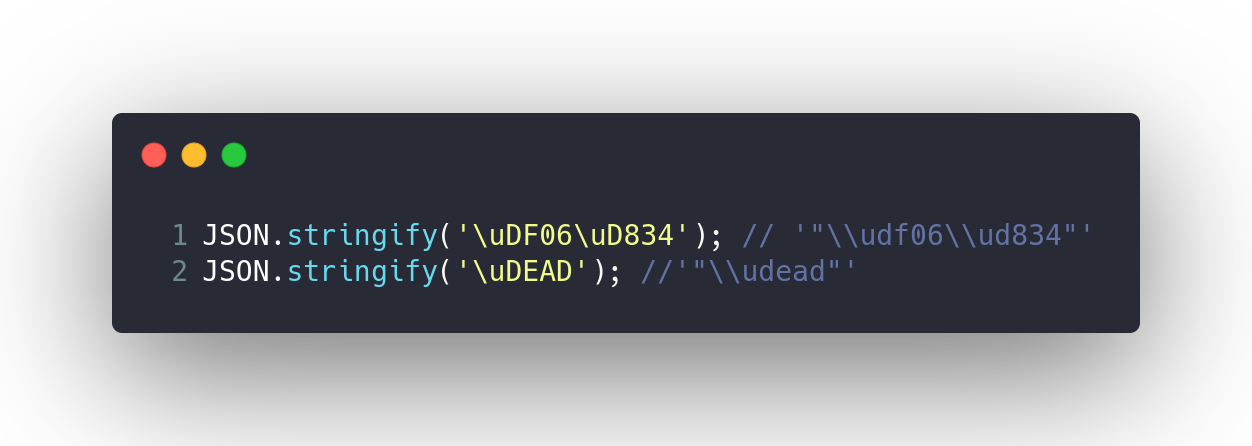

### Хорошо сформированный JSON.stringify()

`JSON.stringify()` может возвращать символы между `U+D800` и `U+DFFF` в качестве значений, для которых не существует эквивалента символов UTF-8. Однако формату JSON необходимо кодирование UTF-8. Было предложено решение представить непарные суррогатные кодовые точки в качестве экранированных последовательностей JSON вместо того, чтобы оставить их одиночными кодовыми единицами UTF-16.

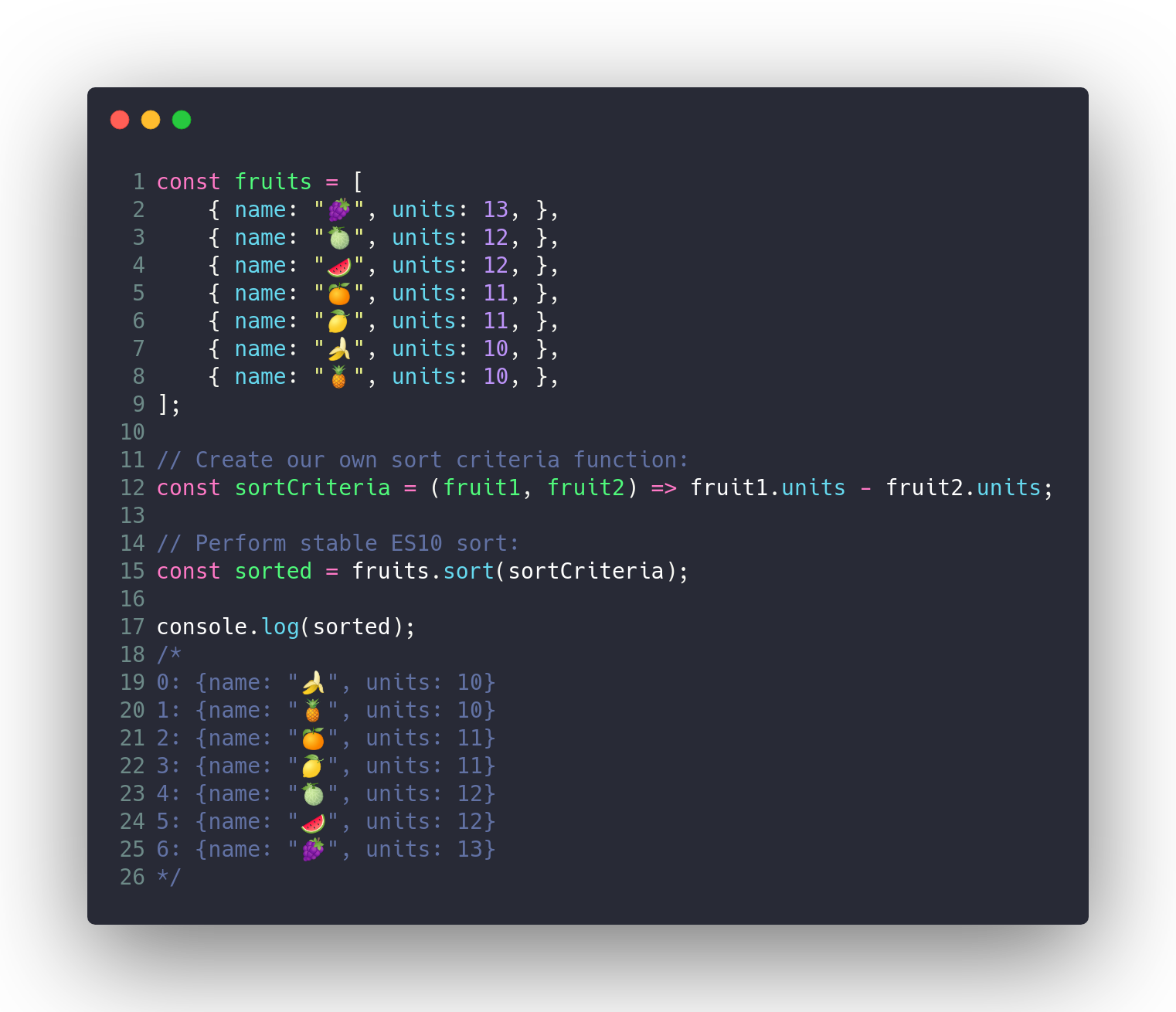

### Устойчивый Array.prototype.sort()

В предыдущей реализации движка V8 использовался нестабильный алгоритм быстрой сортировки для массивов, содержащих более 10 элементов.

*Алгоритм стабильной сортировки* — это алгоритм сортировки, при котором два объекта с одинаковыми ключами остаются в том же порядке, в котором они были до сортировки.

### Обновленная Function.toString()

Метод `toString()` возвращает строковое представление исходного кода функции. В ES6 при вызове `toString()` для функции он мог возвращать разный результат в зависимости от конкретной реализации движка ECMAScript. По возможности возвращался исходный код, в противном случае — стандартизированная заглушка.

### BigInt — целые числа произвольной длины

`BigInt` — это 7-й примитивный тип, целое число произвольной длины. Переменные данного типа могут состоять из 253 числовых знаков, они не ограничены числовым значением `9007199254740992`.

### Динамический импорт

Динамический `import()` возвращает промис для объекта пространства имен запрашиваемого модуля. Следовательно, теперь импорт можно назначить переменной, используя `async/await`.

### Стандартизированный объект globalThis

Объект `globalThis` не был стандартизирован до появления ES10. В коде готового приложения его приходилось приводить к стандарту для различных платформ самостоятельно, прописывая нечто громоздкое, например:

### Заключение

JavaScript является живым языком, что очень благоприятно для веб-программирования. Мы наблюдаем его динамичное развитие с момента появления ES6 в 2015 году. В этой статье мы осветили функции, которые появились в версии ES10 2019 года. Также были представлены некоторые функции, которые обретут стабильность в ES11 (2020), поскольку они находятся в 3 стадии внедрения и, вероятно, в итоге будут стандартизированы для следующего выпуска.

Многие из этих функций могут оказаться ненужными для создания вашего веб-приложения. Однако все они дают возможность обойтись без хитроумных приемов или написания большого количества кода там, где это требовалось раньше. | https://habr.com/ru/post/471142/ | null | ru | null |

# Передача даты с формы в базу

**Дано**

Angular, PrimeNG, Spring Boot, JDBC, PostgreSQL

**Надо**

Передавать дату с формы в базу и обратно

#### Подготовка

```

create database test_date;

```

```

CREATE TABLE test_table (

test_date date NULL,

test_timestamp timestamp NULL,

test_timestamptz timestamptz NULL,

id serial2,

CONSTRAINT test_table_pk PRIMARY KEY (id)

);

```

java.util.Date

--------------

### Решение 1

Надо сохранять только дату без времени. Использую колонку с типом `date`.

Выбираю на форме дату `2020-12-22`. На сервер отправится `2020-12-21T21:00:00.000Z`. Это текущее время по `UTC`, так как браузер в зоне +3. Java сделает запрос

```

statement.setObject(1, entity.getTestDate(), Types.DATE)

```

```

insert into test_table (test_date) values ('2020-12-22 +03')

```

Java отбрасывает время и передает автоматически таймзону (по умолчанию зона сервера или `-Duser.timezone=Europe/Moscow`). Postgres не учитывает зону для типа данных `date`. Будет сохранено `2020-12-22`. При чтении из базы вернется эта же дата. В Json попадет

```

{ "testDate": "2020-12-22" }

```

Браузер прочитает такой формат, как начало дня по UTC.

```

new Date('2020-12-22')

new Date('2020-12-22T00:00:00.000+00:00')

Tue Dec 22 2020 03:00:00 GMT+0300 (Moscow Standard Time)

```

Т.е на форме отображается `2020-12-22 03:00` или просто без времени `2020-12-22`. Все верно.

Я встречал ситуацию , когда Chrome и Firefox интерпретировали дату без времени по-разному. Кто-то как начало дня по локальному времени. В данный момент такое не воспроизводится на обновленных версиях. Документация говорит, что сейчас такой формат стандартизирован. Но если строка отличается от формата `2020-12-22T00:00:00.000+00:00`, то поведение не гарантировано.

Ошибка всплывет только если начнет тестировать пользователь, который восточнее часового пояса сервера. Например Europe/Samara (+4). Выберет на форме `2020-12-22`. На сервер отправится `2020-12-21T20:00:00.000Z` (2020-12-22 00:00 +4). Сервер (работает в зоне +3) переведет это в `2020-12-21T23:00:00.000+03:00`, отбросит время и сохранит как

```

insert into test_table (test_date) values ('2020-12-21 +03')

```

При чтении сервер отдаст `2020-12-21`, что превратится в `2020-12-21 04:00`. На форме видим `2020-12-21`. Ошибка.

### Решение 2

При сохранении в БД указать временную зону пользователя, а не зону сервера.

```

statement.setDate(1, new java.sql.Date(entity.getTestDate().getTime()),

Calendar.getInstance(TimeZone.getTimeZone(userZoneId)));

```

Получить её можно отдельным параметром в запросе. Для этого в JS можно выполнить.

```

Intl.DateTimeFormat().resolvedOptions().timeZone;

```

Можно попробовать с полифилом новый API `Temporal.now().timeZone().id`. Этот параметр должен содержать зону по умолчанию. На старых браузерах может не работать или возвращать неправильную зону.

Запрос на сервер:

```

{"testDate":"2020-12-21T20:00:00.000Z","zoneId":"Europe/Samara"}

```

Сохранение:

```

insert into test_table (test_date) values ('2020-12-22 +04')

```

Зная зону, драйвер преобразовал `2020-12-21T23:00:00.000+03:00` в `2020-12-22T00:00:00.000+04:00`, и сформировал строку `2020-12-22 +04`. При чтении получится `2020-12-22` -> `2020-12-22 04:00:00`. На форме видим `2020-12-22`. Все верно.

Теперь протестируем ситуацию, когда пользователь к западу от UTC. Например America/Chicago (-6). Сохранится выбранная дата `2020-12-22`. При чтении сервер отдаст её обратно, но она превратится в `2020-12-21 18:00` по местному времени пользователя и отобразится как `2020-12-21`.

### Решение 3

Надо , чтобы сервер отдавал дату с временем `2020-12-22T00:00:00.000` и без зоны, тогда это будет преобразовано браузером в начало дня по местному времени. Для этого сделаю сериалайзер даты

```

import java.text.SimpleDateFormat;

import com.fasterxml.jackson.core.JsonGenerator;

import com.fasterxml.jackson.databind.JsonSerializer;

import com.fasterxml.jackson.databind.SerializerProvider;

public class DateSerializer extends JsonSerializer {

private final static SimpleDateFormat format = new SimpleDateFormat("yyyy-MM-dd'T'HH:mm:ss");

@Override

public void serialize(Date value, JsonGenerator gen, SerializerProvider serializers) throws IOException {

gen.writeString(format.format(value));

}

}

```

Теперь все верно. Выбранная пользователем дата сохраняется в БД правильно. И возвращается на форму правильно. Проверено на разных таймзонах. Можно на прод.

С прода приходит баг. Пользователи видят неправильную дату. И смещение не на один день, а вообще не та дата.

### Решение 4

Метод `java.text.SimpleDateFormat.format()` не потокобезопасный. А я создал его один раз на все приложение. Надо для каждой сериализации делать свой экземпляр.

```

private static final String format = "yyyy-MM-dd'T'HH:mm:ss";

@Override

public void serialize(Date value, JsonGenerator gen, SerializerProvider serializers) throws IOException {

gen.writeString(new SimpleDateFormat(format).format(value));

}

```

Получился сервис со странным интерфейсом для сохранения даты. В другом клиенте придется передавать не только дату, но и рассчитывать время и передавать зону, для которой это время рассчитано. Если я захочу сохранить `2020-12-22`, то мне надо сначала определится с зоной. Если это +3, то надо передавать

```

{"testDate":"2020-12-21T21:00:00.000Z","zoneId":"Europe/Moscow"}

```

или

```

{"testDate":"2020-12-22T00:00:00.000+03:00","zoneId":"Europe/Moscow"}

```

В последнем варианте вообще получилось дублирование нужной информации о смещении. Надо убрать из запроса зону и оставить дату в формате `2020-12-22`. Если придет `2020-12-21T21:00:00.000Z`, то игнорировать время с зоной - сохранять как `2020-12-21`). Возвращаться результат должен тоже без времени.

### Решение 5

Убираю свой сериалайзер из java. На фронте надо обработать `2020-12-22` без времени, чтобы это было начало дня по локальному времени.

```

const ymd: string[] = obj.testDate.split('-');

const date: Date = new Date(ymd);

```

Это удобно и оно работает в Chrome и Firefox. Но конструктор с параметром `Array` не описан в стандарте. Поэтому параметр будет преобразован в строку и передан в `Date.parse()`. А этот метод стандартно работает только для `2020-12-22`.

Поэтому напишу по стандарту

```

const ymd: number[] = obj.testDate.split('-').map((s: string) => Number(s));

const date: Date = new Date(ymd[0], ymd[1] - 1, ymd[2])

```

Следующим шагом надо отбрасывать время при сохранении. Это уже делает JDBC. Но это вызывает ошибку для пользователей с востока. Так как время отбрасывается от даты по серверному времени. Поэтому время надо отбрасывать до конвертации строки в дату по серверному времени. Тут появляется ещё проблема: браузер отправляет дату, как начало дня по времени UTC. Т.е код надо писать ещё перед отправкой на фронте.

```

public saveEntity(entity: TestEntity): Observable {

const date: Date = entity.testDate;

const testDate: string = [date.getFullYear(), date.getMonth() + 1, date.getDate()]

.map(n => String(n).padStart(2, '0')).join('-');

const body: any = Object.assign({}, entity, {testDate});

return this.http.post(CONTROLLER, body);

}

```

Такой вариант работает, для пользователей из всех зон работает. И не надо ничего программировать на сервере.

Потом на проекте появляется разработчик из Чикаго. И тестирует приложение у себя. На сервер отправляется `2020-12-22`. Сервер превращает это в `2020-12-21 18:00:00` по местному времени. И сохраняет

```

insert into test_table (test_date) values ('2020-12-21 -06')

```

Ошибка. Решение работает только для сервера к востоку от UTC.

### Решение 6

Самое простое решение - захардкодить зону приложения.

```

System.setProperty("user.timezone", "UTC")

```

Но не совсем правильное. Что делать, если в приложении уже куча логики зависит от того, что сервер находится где-то по местному времени на западе? Проблема в том, что Jackson воспринимает полученную дату как начало дня по UTC. A я хотел, чтобы дата была началом дня для сервера.Тогда надо захардкодить эту зону и указать Jackson, что для конвертации надо использовать зону сервера.

```

public static final String APP_TIMEZONE = "America/Chicago";

public static void main(String[] args) {

System.setProperty("user.timezone", APP_TIMEZONE);

SpringApplication.run(TestDateApplication.class, args);

}

```

```

import com.fasterxml.jackson.annotation.JsonFormat;

public class TestEntity {

@JsonFormat(timezone = TestDateApplication.APP_TIMEZONE,

pattern = "yyyy-MM-dd")

private Date testDate;

```

Так как браузер теперь передает только дату без времени. То можно ограничить интерфейс и не позволять формат с временем. Если кто-то начнет передавать время, значит возможна ошибка с временными зонами.

### Решение 7

Jackson пропускает такие даты, не учитывая время. Поэтому надо писать свой десериалайзер. Он будет выбрасывать исключение, если строка длиннее заданного формата.

```

import java.io.IOException;

import java.text.ParseException;

import java.text.SimpleDateFormat;

import java.util.Date;

import com.fasterxml.jackson.core.JsonParser;

import com.fasterxml.jackson.core.JsonProcessingException;

import com.fasterxml.jackson.core.JsonToken;

import com.fasterxml.jackson.databind.DeserializationContext;

import com.fasterxml.jackson.databind.JsonDeserializer;

import com.fasterxml.jackson.databind.exc.InvalidFormatException;

public class DateDeserializer extends JsonDeserializer {

private static final String format = "yyyy-MM-dd";

@Override

public Date deserialize(JsonParser p, DeserializationContext ctxt)

throws IOException, JsonProcessingException {

if (p.hasToken(JsonToken.VALUE\_STRING)) {

String text = p.getText().trim();

if (text.length() != format.length()) {

throw new InvalidFormatException(p, "Wrong date", text, Date.class);

}

try {

Date result = new SimpleDateFormat(format).parse(text);

return result;

} catch (ParseException e) {

throw new InvalidFormatException(p, "Wrong date", text, Date.class);

}

}

return (Date) ctxt.handleUnexpectedToken(Date.class, p);

}

}

```

Если сохранить дату на востоке, а открыть на западе, то она будет одинакова. Но на западе может быть еще только вчера. Это может быть принято за ошибку. Зависит от задачи. Если речь о дате рождения, то ошибки нет. Если о дате публикации новости, то читатель на западе увидит новость из будущего. Это может выглядеть странно.

### Решение 8

Для такого случая придется сохранять время вместе с датой. От времени зависит, одинаковая дата для разных часовых поясов в это время или разная. Для сохранения можно использовать два типа: `timestamp` или `timestamp with time zone`. Зону мне хранить, вроде бы, не надо, поэтому сделаю `timestamp`.

```

private static final String COLUMN_LABEL = "test_timestamp";

entity.setTestDate(rs.getTimestamp(COLUMN_LABEL));

statement.setTimestamp(1, new Timestamp(entity.getTestDate().getTime()));

```

С фронта поступит дата `2020-12-21T20:00:00.000Z`. Будет передана в базу как

```

insert into test_table (test_timestamptz) values ('2020-12-21 14:00:00-06')

```

И сохранена в базе как время `2020-12-21 14:00:00`. На фронт придет время с указанием зоны `2020-12-21T20:00:00.000+00:00` и будет показано локальное время. Работает.

Беда придет, если изменится таймзона сервера. Время в базе сохранено по зоне сервера. При чтении на сервере с другой таймзоной будет неправильное время. Из `2020-12-21 14:00:00` на сервере `Europe/Moscow` получится `2020-12-21T11:00:00.000+00:00`. А должно было быть `2020-12-21T20:00:00.000+00:00`.

### Решение 9

Либо сервер должен быть всегда в одной зоне. Либо надо хранить даты в одной зоне и явно это указывать. Так как сервер был раньше в `America/Chicago` и время сохранено в такой зоне, то я укажу эту зону

```

private static final String COLUMN_TIMEZONE = "America/Chicago";

entity.setTestDate(rs.getTimestamp(COLUMN_LABEL,

Calendar.getInstance(TimeZone.getTimeZone(COLUMN_TIMEZONE))));

statement.setTimestamp(1, new Timestamp(entity.getTestDate().getTime()),

Calendar.getInstance(TimeZone.getTimeZone(COLUMN_TIMEZONE)));

```

Чтобы было легче дебажить, лучше сделать зону `UTC`. И в базе перевести время на `UTC`.

```

update test_table

set test_timestamp =

(test_timestamp at time zone 'America/Chicago') at time zone 'UTC';

```

```

private static final String COLUMN_TIMEZONE = "UTC";

```

С фронта поступит дата `2020-12-21T20:00:00.000Z`. Будет передана в базу как

```

insert into test_table (test_timestamp) values ('2020-12-21 20:00:00+00')

```

И сохранена в базе как время `2020-12-21 20:00:00`. При чтении сервер получит `2020-12-21 14:00:00` по своему времени (-6). На фронт придет время с указанием зоны `2020-12-21T20:00:00.000+00:00` и будет показано локальное время.

### Решение 10

Получилось тоже самое, что можно было сделать сразу, используя `timestamp with time zone`. Данный тип не хранит зону. Он хранит время для зоны `UTC` и автоматически конвертирует его во время для другой зоны. Поэтому код можно переписать без указания зоны при сохранении и чтении.

```

private static final String COLUMN_LABEL = "test_timestamptz";

entity.setTestDate(rs.getTimestamp(COLUMN_LABEL));

statement.setTimestamp(1, new Timestamp(entity.getTestDate().getTime()));

```

С фронта поступит дата `2020-12-21T20:00:00.000Z`. Будет передана в базу как

```

insert into test_table (test_timestamptz) values ('2020-12-21 14:00:00-06')

```

И сохранена в базе независимо от зоны сервера как время `2020-12-21T20:00:00.000Z`. При чтении сервер получит `2020-12-21 14:00:00` по своему времени. На фронт придет время с указанием зоны `2020-12-21T20:00:00.000+00:00` и будет показано локальное время.

### Решение 11

Надо чтобы время показывалось всегда то, что ввели, и не зависело от временной зоны браузера или сервера. Для передачи по сети буду использовать формат без указания зоны. Для хранения буду использовать колонку `timestamp`.

```

public saveEntity(entity: TestEntity): Observable {

const date: Date = entity.testDate;

const testDate: string = [date.getFullYear(), date.getMonth() + 1, date.getDate()]

.map(n => String(n).padStart(2, '0')).join('-')

+ 'T' + [date.getHours(), date.getMinutes(), date.getSeconds()]

.map(n => String(n).padStart(2, '0')).join(':');

const body: any = Object.assign({}, entity, {testDate});

return this.http.post(CONTROLLER, body);

}

```

```

@JsonDeserialize(using = DateDeserializer.class)

@JsonFormat(pattern = "yyyy-MM-dd'T'HH:mm:ss", timezone = TestDateApplication.APP_TIMEZONE)

private Date testDate;

```

В десериалайзере:

```

Date result = new SimpleDateFormat("yyyy-MM-dd'T'HH:mm:ss").parse(text);

```

При выборе на форме `2020-12-22 14:14` отправится `2020-12-22T14:14:00`. Это воспринимается как локальное время. И будет отправлено в базу.

```

insert into test_table (test_timestamp) values ('2020-12-22 14:14:00+04')

```

Так как тип колонки `timestamp without time zone`, то переданная зона просто будет отброшена, и дополнительной конвертации не будет. При чтении все также. Отобразится тоже, что сохраняли, в любом часовом поясе.

```

new Date('2020-12-22T14:14:00')

Tue Dec 22 2020 14:14:00 GMT-0600 (Central Standard Time)

```

Time API

--------

### Решение 1

Сохраняю только дату. Колонка `date`. Тип поля DTO `LocalDate`.

```

private LocalDate testDate;

statement.setObject(1, entity.getTestDate(), Types.DATE);

entity.setTestDate(rs.getObject("test_date", LocalDate.class));

```

Выберу на форме `2020-12-22`. От браузера придет `2020-12-21T21:00:00.000Z`. Jackson превратит это в `LocalDateTime` для зоны `UTC` и отбросит время.

```

insert into test_table (test_date) values ('2020-12-21'::date)

```

В браузер вернется `2020-12-21`. Неверно.

```

new Date('2020-12-21')

Mon Dec 21 2020 03:00:00 GMT+0300 (Moscow Standard Time)

```

### Решение 2

Надо делать десериализацию с таймзоной сервера.

```

public LocalDate deserialize(JsonParser p, DeserializationContext ctxt)

throws IOException, JsonProcessingException {

if (p.hasToken(JsonToken.VALUE_STRING)) {

String text = p.getText().trim();

try {

DateTimeFormatter formatter = new DateTimeFormatterBuilder()

.append(DateTimeFormatter.ISO_LOCAL_DATE_TIME)

.appendZoneId()

.toFormatter();

LocalDate result = ZonedDateTime.parse(text, formatter)

.withZoneSameInstant(ZoneId.systemDefault())

.toLocalDate();

return result;

} catch (Exception e) {

throw new InvalidFormatException(p, "Wrong date", text, Date.class);

}

}

return (LocalDate) ctxt.handleUnexpectedToken(LocalDate.class, p);

}

```

Теперь сохраняется введенная дата.

```

insert into test_table (test_date) values ('2020-12-22'::date)

```

Но это не будет работать для пользователя восточнее сервера.

### Решение 3

Можно пойти путем передачи зоны пользователя. Тогда надо сменить тип поля на тип с временем: `LocalDateTime`.

```

String zoneId = entity.getZoneId();

statement.setObject(1,

ZonedDateTime.of(entity.getTestDate(), ZoneId.systemDefault())

.withZoneSameInstant(ZoneId.of(zoneId))

.toLocalDate(),

Types.DATE);

entity.setTestDate(

LocalDateTime.of(rs.getObject(COLUMN_LABEL, LocalDate.class), LocalTime.MIN));

```

Обратно с сервера вернется дата уже с временем `2021-12-22T00:00:00`. Поэтому это решение будет работать и для пользователей с запада от UTC.

### Решение 4

Если формировать дату без времени на фронте, то на сервере можно оставить только поле с типом `LocalDate`. И больше не делать дополнительных конвертаций.

```

statement.setObject(1, entity.getTestDate(), Types.DATE);

entity.setTestDate(rs.getObject(COLUMN_LABEL, LocalDate.class));

```

Это решение работает, если даже переместить сервер в другую зону.

Чтобы предотвратить ошибку из-за передачи даты в формате ISO по времени UTC, достаточно указать формат. На дополнительные символы будет ругаться.

```

@JsonFormat(pattern = "yyyy-MM-dd")

private LocalDate testDate;

```

### Решение 5

Чтобы сохранить время можно использовать `LocalDateTime`. Но для конвертации строки `2020-12-21T20:00:00.000Z` в локальное время нужен десериалайзер с использованием `ZoneDateTime`. Поэтому буду использовать сразу его.

```

statement.setObject(1,

entity.getTestDate()

.withZoneSameInstant(ZoneId.systemDefault())

.toLocalDateTime(),

Types.TIMESTAMP);

entity.setTestDate(

ZonedDateTime.of(

rs.getObject(COLUMN_LABEL, LocalDateTime.class),

ZoneId.systemDefault()

)

);

```

При изменении зоны сервера даты поедут.

### Решение 6

Укажу явно зону `UTC` для хранения времени.

```

private static final String COLUMN_TIMEZONE = "UTC";

statement.setObject(1,

entity.getTestDate()

.withZoneSameInstant(ZoneId.of(COLUMN_TIMEZONE))

.toLocalDateTime(),

Types.TIMESTAMP);

entity.setTestDate(

ZonedDateTime.of(

rs.getObject(COLUMN_LABEL, LocalDateTime.class),

ZoneId.of(COLUMN_TIMEZONE)

)

);

```

### Решение 7

Теперь можно перейти на тип колонки `timestamptz`.

Чтобы сохранить `ZonedDateTime` в такую колонку, можно использовать `LocalDateTime`, но обязательно сконвертировав в зону сервера. Потому что JDBC сам добавит в запрос смещение на основе зоны сервера. Postgres его учтет для конвертации в UTC.

```

statement.setObject(1,

entity.getTestDate()

.withZoneSameInstant(ZoneId.systemDefault())

.toLocalDateTime());

```

```

insert into test_table (test_timestamptz) values ('2020-12-21 23:30:00+03'::timestamp)

```

Можно сохранять `OffsetDateTime`. Тогда будет передано то, что пришло из браузера.

```

statement.setObject(1, entity.getTestDate().toOffsetDateTime());

```

```

insert into test_table (test_timestamptz)

values ('2020-12-21 20:30:00+00'::timestamp with time zone)

```

Читать из базы драйвер позволяет только в `OffsetDateTime`.

```

entity.setTestDate(

rs.getObject(COLUMN_LABEL, OffsetDateTime.class).toZonedDateTime()

);

```

Поэтому поле DTO можно сразу переделать в `OffsetDateTime`.

### Решение 8

Для сохранение выбранного времени и отображения его независимо от зоны браузера достаточно передавать на сервер локальное время.

```

public saveEntity(entity: TestEntity): Observable {

const date: Date = entity.testDate;

const testDate: string =

[date.getFullYear(), date.getMonth() + 1, date.getDate()]

.map(n => String(n).padStart(2, '0')).join('-')

+ 'T'

+ [date.getHours(), date.getMinutes(), date.getSeconds()]

.map(n => String(n).padStart(2, '0')).join(':');

const body: any = Object.assign({}, entity, {testDate});

return this.http.post(CONTROLLER, body);

}

```

На сервере использовать `LocalDateTime` и `timestamp`. Дополнительная настройка Jackson не нужна. При передаче времени с зоной он будет ругаться.

```

statement.setObject(1, entity.getTestDate());

entity.setTestDate(rs.getObject(COLUMN_LABEL, LocalDateTime.class));

```

Заключение

----------

Чтобы избежать некоторых ошибок, надо изначально договорится о некоторых вещах. Формат даты в запросе и ответе. Зона, в которой будет запущен сервер. Зона, в которой хранится время.

Дополнительные ошибки могут появится, из-за устаревшей tzdata. PostgreSQL имеет свою tzdata. Если есть колонки `timestamptz`, то эта база используется. Надо обновлять минорные релизы. PostgreSQL может быть собран с флагом `with-system-tzdata`. Тогда надо обновлять системные зоны. Java имеет свою tzdata. Надо тоже обновлять. Можно отдельно от всей jre. Joda-time имеет свою tzdata.

Все решения доступны в [репозитории](https://github.com/Qwertovsky/test_date/commits/). Там две ветки. | https://habr.com/ru/post/536016/ | null | ru | null |

# Передача анонимных объектов в View

Идея состоит в том чтобы пользоваться моделью с новым более удобным dynamic синтаксисом. Главное ограничение тут в том, что нельзя просто передать анонимный объект как модель, потому что анонимные типы имеют модификатор доступа internal.

Предположим, что мы пытаемся написать этот код в контроллере:

> `public class HomeController : Controller

>

> {

>

> public ActionResult Index()

>

> {

>

> return View(

>

> new

>

> {

>

> Message = "Welcome to ASP.NET MVC!",

>

> Date = DateTime.Now

>

> });

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Обратите внимание, что мы передаем анонимный объект в модель. Главная причина этого — это избежать создание необходимого внешнего ViewModel типа. Очевидно, что это несколько спорный момент, но оно должно выглядеть проще чем такая альтернатива:

> `ViewData["Message"] = "Welcome to ASP.NET MVC!";

>

> ViewData["Date"] = DateTime.Now;

>

> return View();

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Затем мы изменяем View таким образом, чтобы он имел

> `Inherits="System.Web.Mvc.ViewPage"

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

В идеале это должно позволить нам написать что-то типа этого:

> `<asp:Content ID="indexContent" ContentPlaceHolderID="MainContent" runat="server">

>

> <h2><%= Model.Message %>h2>

>

> <p>

>

> The date is <%= Model.Date %>

>

> p>

>

> asp:Content>

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Но по умолчанию dynamic binder не даст нам сделать это!

К сожалению, если вы попытаетесь запустить этот код, то будет:

**error: Microsoft.CSharp.RuntimeBinder.RuntimeBinderException: '<>f\_\_AnonymousType1.Message' is inaccessible due to its protection level**

Причина этого анонимный тип в контроллере является internal, так что он может быть доступен только из той сборки в которой он определен. Так как view компилируется отдельно, dynamic binder жалуется, что не может выйти за пределы этой сборки. Но достаточно просто можно написать свой DynamicObject, который связывает через private reflection.

Здесь мы собираеся написать не только свой DynamicObject, но также свой DynamicViewPage, который использует его. Вот полная реализация:

> `public class DynamicViewPage : ViewPage {

>

> // Скрываем модель класса предка и заменяем его на dynamic

>

> public new dynamic Model { get; private set; }

>

>

>

> protected override void SetViewData(ViewDataDictionary viewData) {

>

> base.SetViewData(viewData);

>

>

>

> // Создаем динамический объект, который использует private рефлексию над объектом модели

>

> Model = new ReflectionDynamicObject() { RealObject = ViewData.Model };

>

> }

>

>

>

> class ReflectionDynamicObject : DynamicObject {

>

> internal object RealObject { get; set; }

>

>

>

> public override bool TryGetMember(GetMemberBinder binder, out object result) {

>

> // Возвращаем значение свойства

>

> result = RealObject.GetType().InvokeMember(

>

> binder.Name,

>

> BindingFlags.GetProperty | BindingFlags.Instance | BindingFlags.Public | BindingFlags.NonPublic,

>

> null,

>

> RealObject,

>

> null);

>

>

>

> // Всегда возвращаем true, так как InvokeMember вызовет исключение, если что-то пойдет не так

>

> return true;

>

> }

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Как вы видите здесь все просто. Все что нам нужно это узнать значение свойства используя private reflection. Вот и все, осталось только использовать это как наш базовый класс для View.

**<%@ Page Language=«C#» MasterPageFile="~/Views/Shared/Site.Master" Inherits=«MvcHelpers.DynamicViewPage» %>** | https://habr.com/ru/post/79363/ | null | ru | null |

# От UI-kit до дизайн-системы

*Опыт онлайн-кинотеатра Иви*

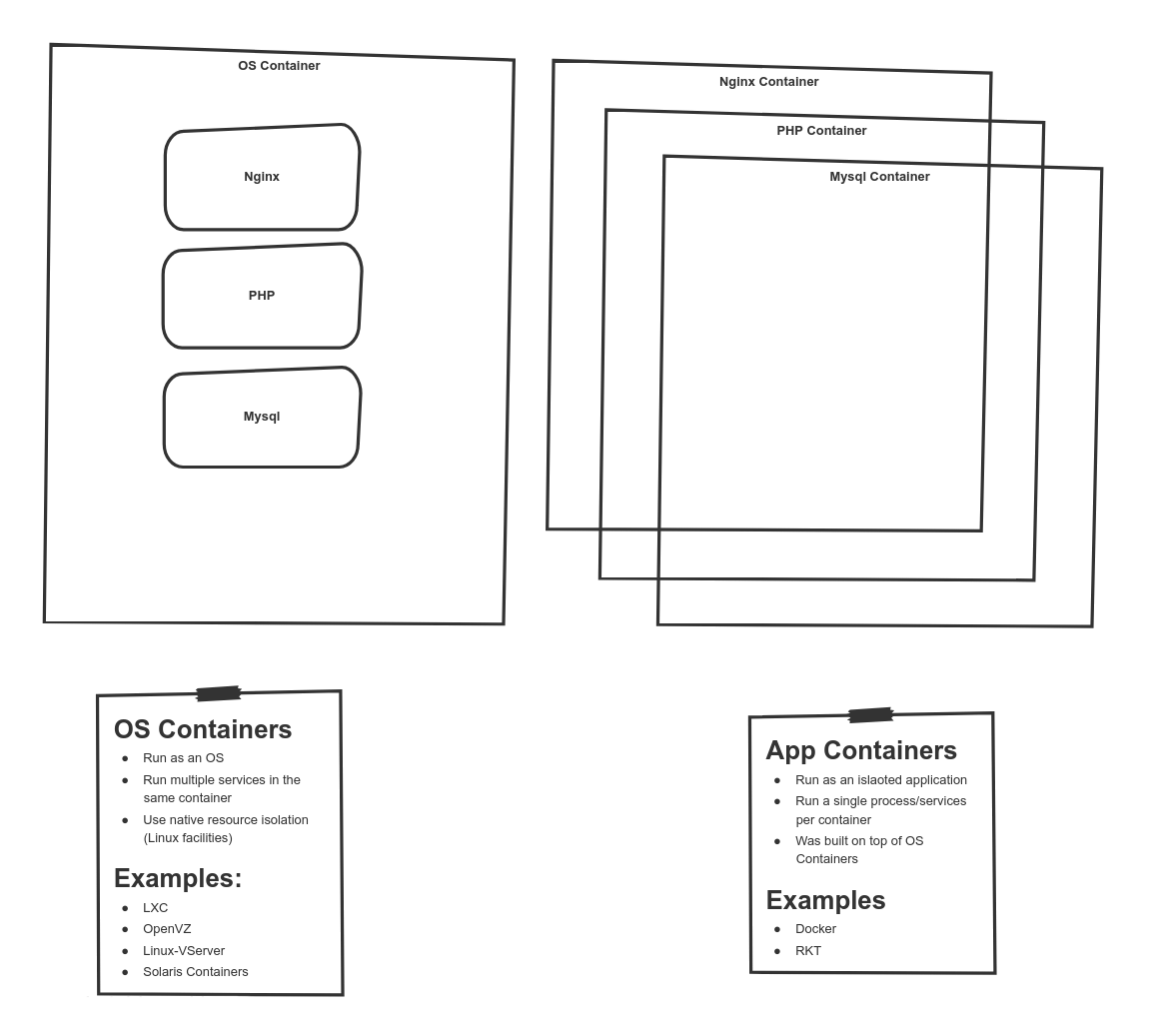

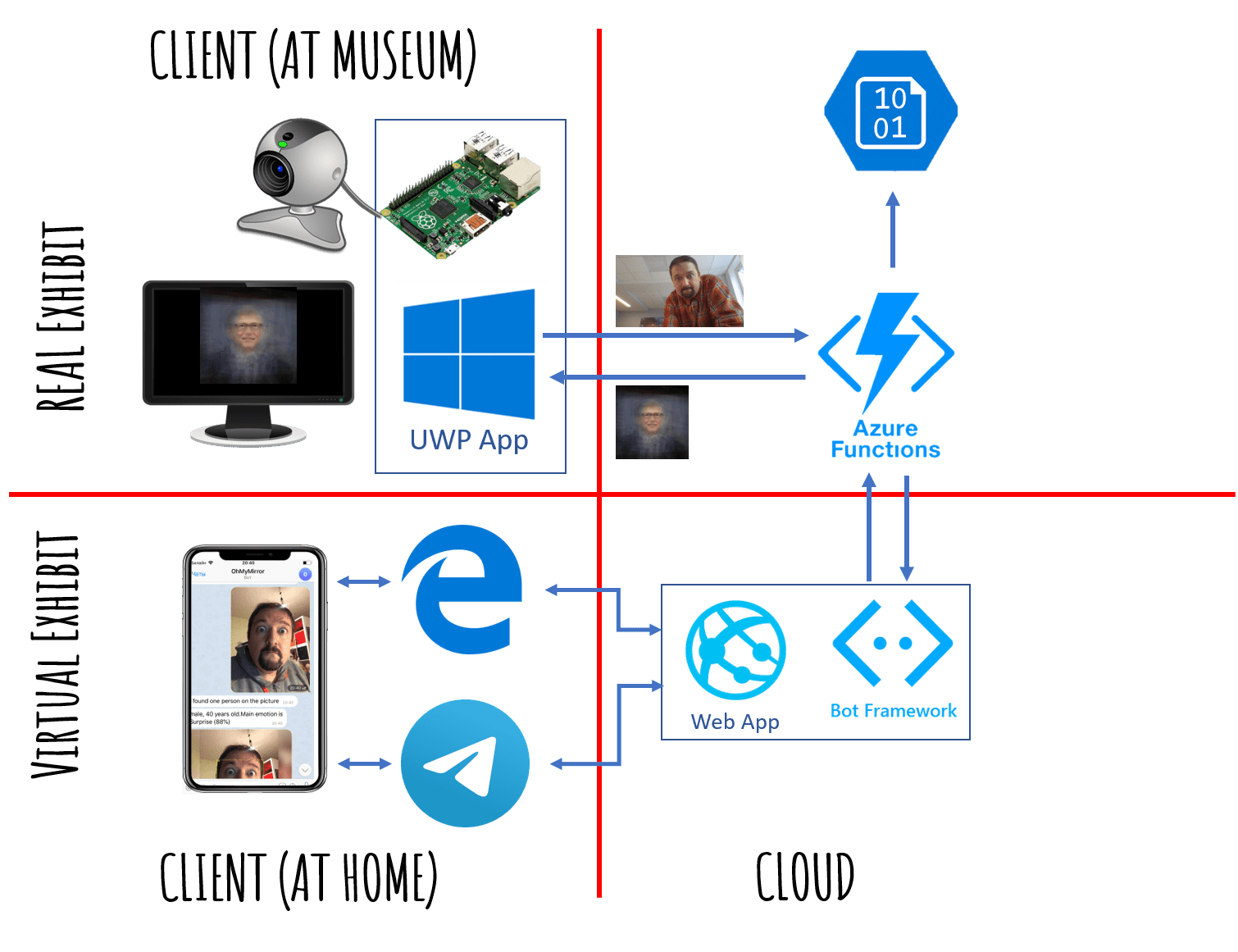

Когда в начале 2017 года мы впервые задумались о создании собственной системы доставки дизайна в код, об этом уже многие говорили и кто-то даже делал. Однако, об опыте построения кроссплатформенных дизайн-систем и по сей день мало что известно, а понятных и проверенных рецептов, описывающих технологии и способы подобной трансформации процесса имплементации дизайна в уже работающий продукт как не было, так и нет. Да и под «компонентами в коде» часто понимают очень разные вещи.

[](https://habr.com/ru/company/ivi/blog/456854/)

Меж тем компания год от года удваивала штат — нужно было масштабировать отдел дизайна и оптимизировать процессы создания и передачи макетов в разработку. Умножаем всё это на «зоопарк» платформ, которые нужно поддерживать, и получаем подобие вавилонского столпотворения, которое просто не способно «нормально делать» и приносить доход. Развитие платформ часто шло параллельно, и один и тот же функционал мог выходить на разных платформах с лагом в несколько месяцев.

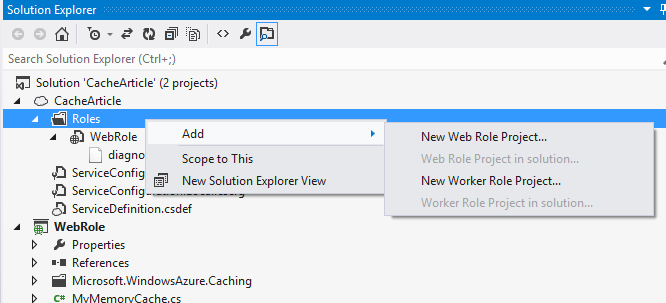

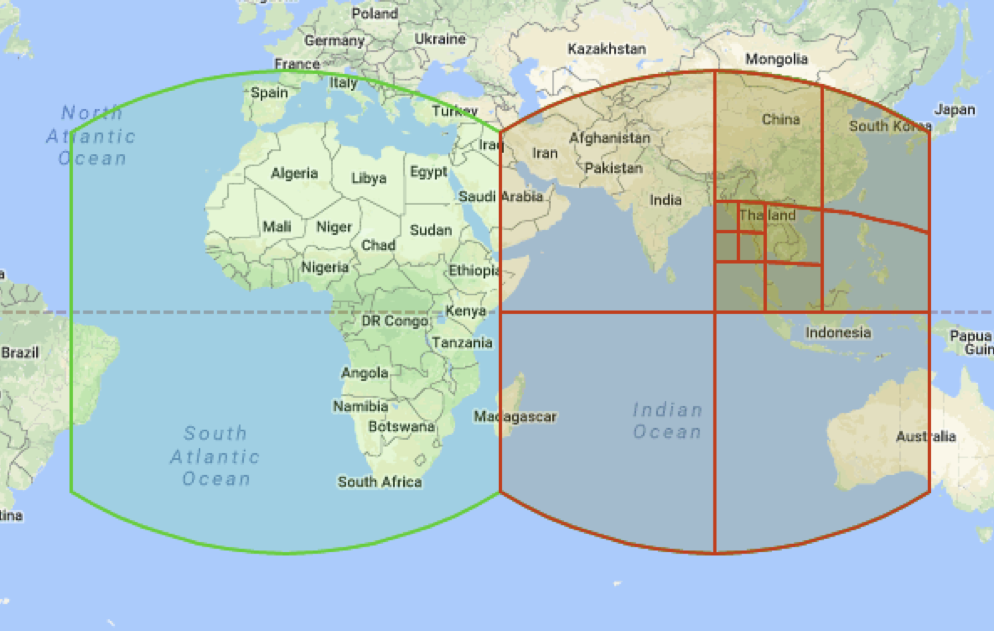

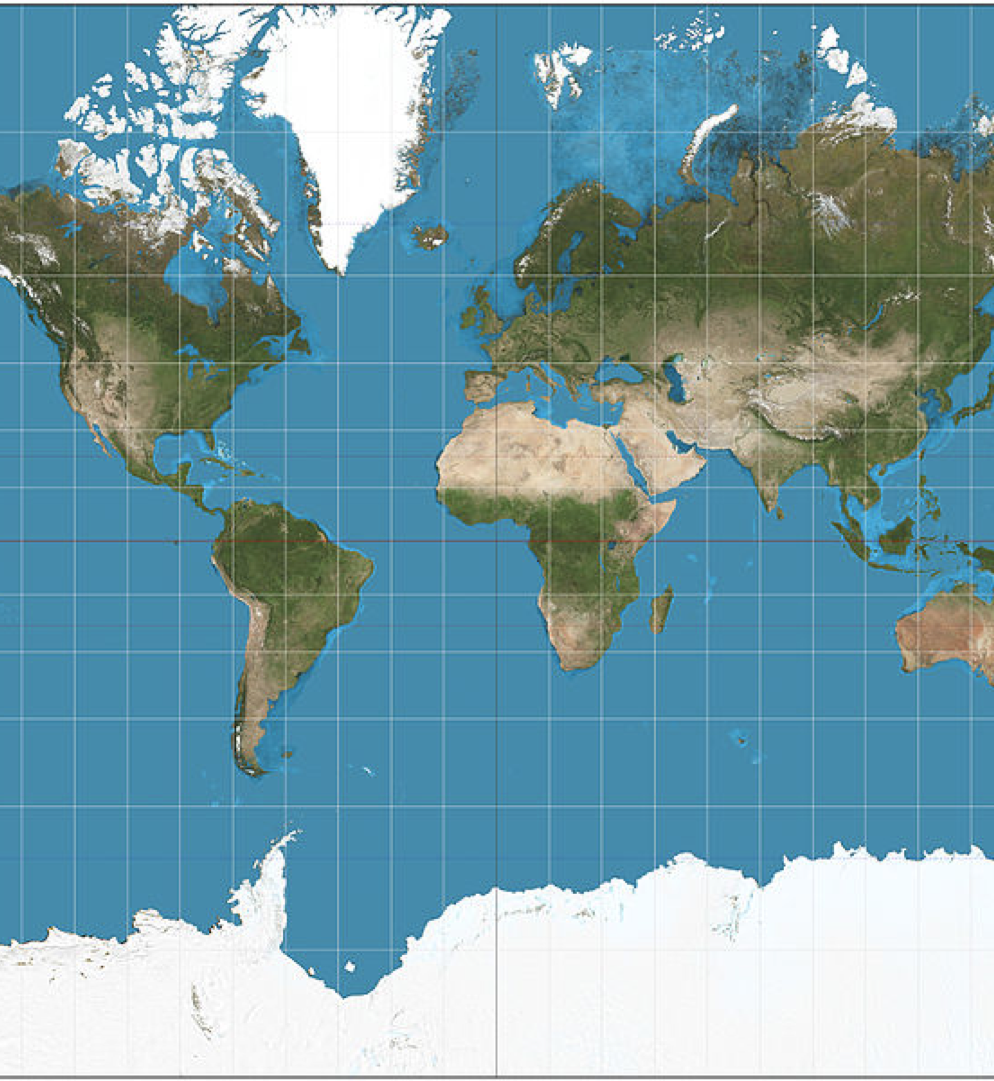

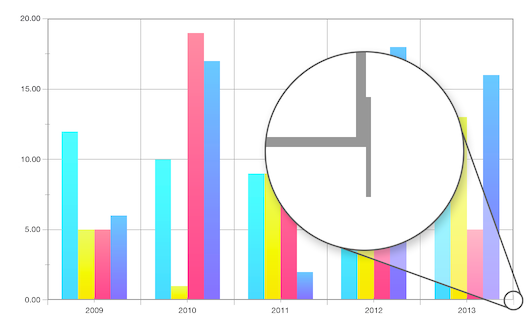

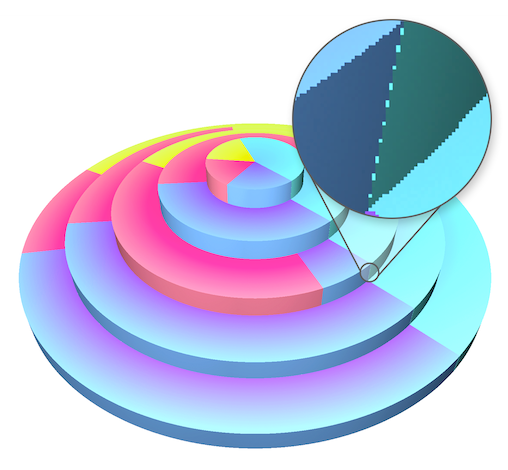

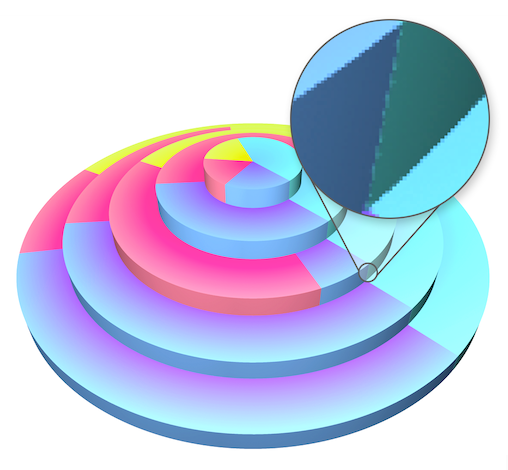

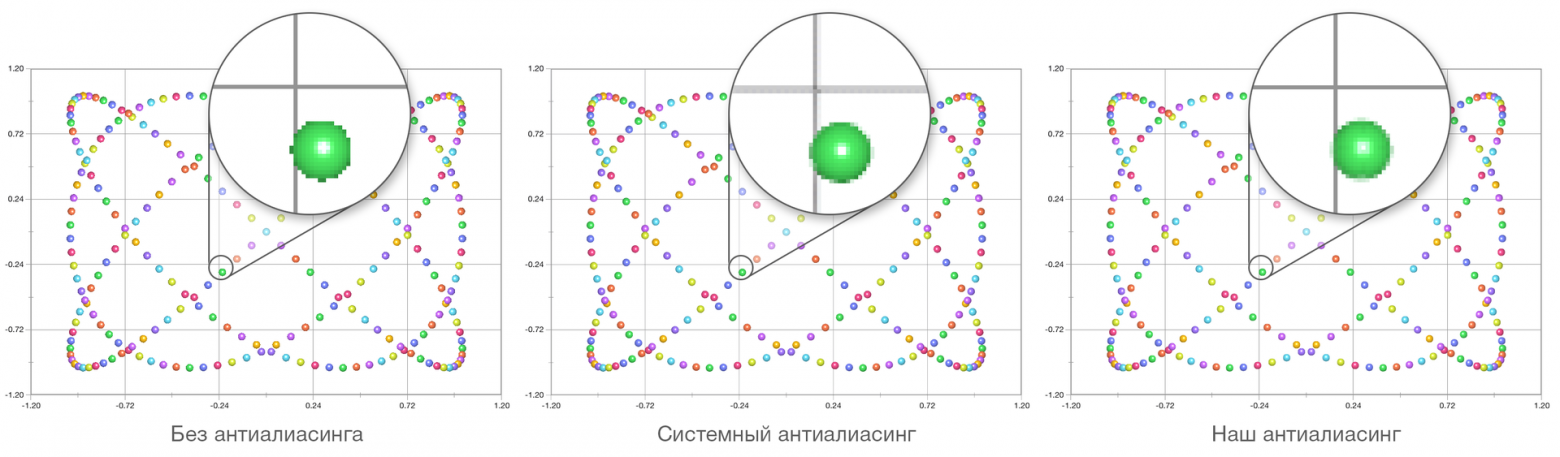

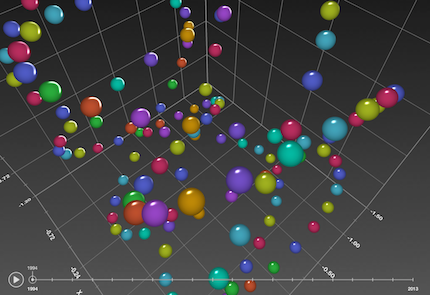

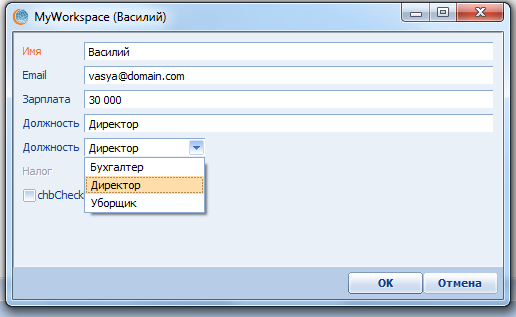

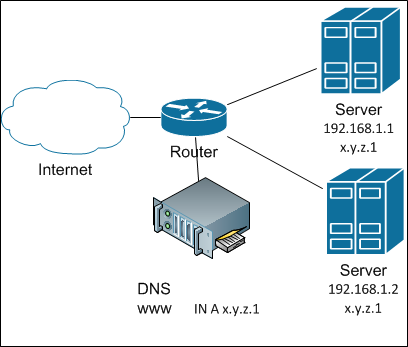

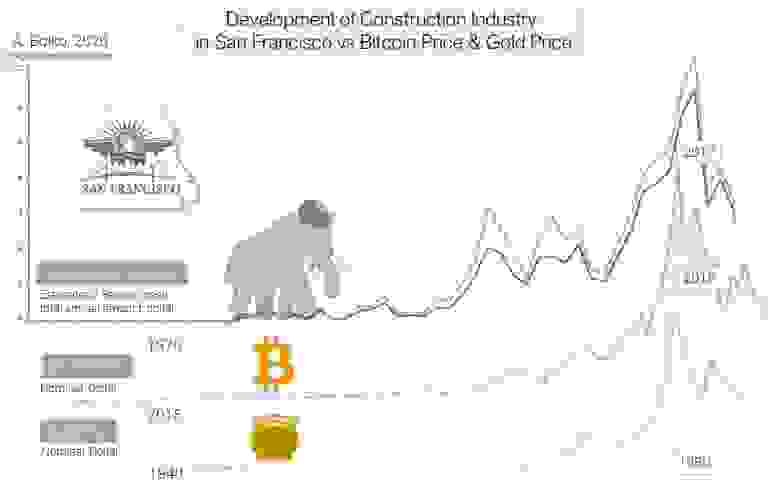

*Отдельные наборы макетов для каждой платформы*

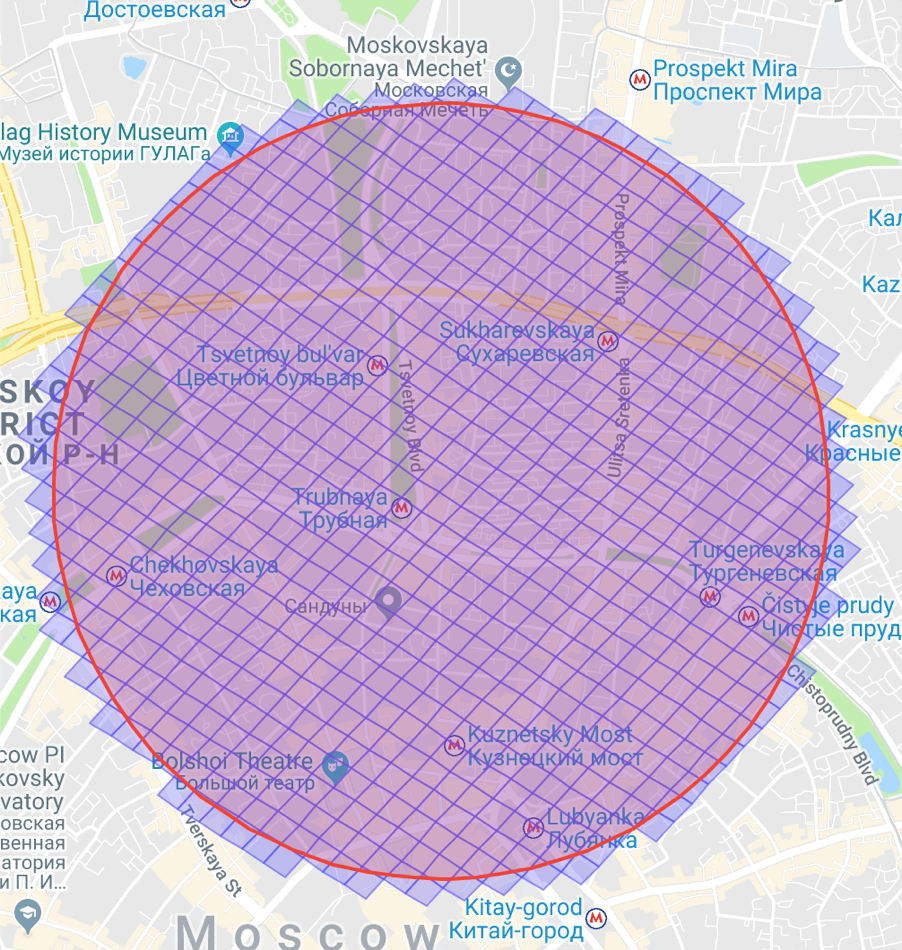

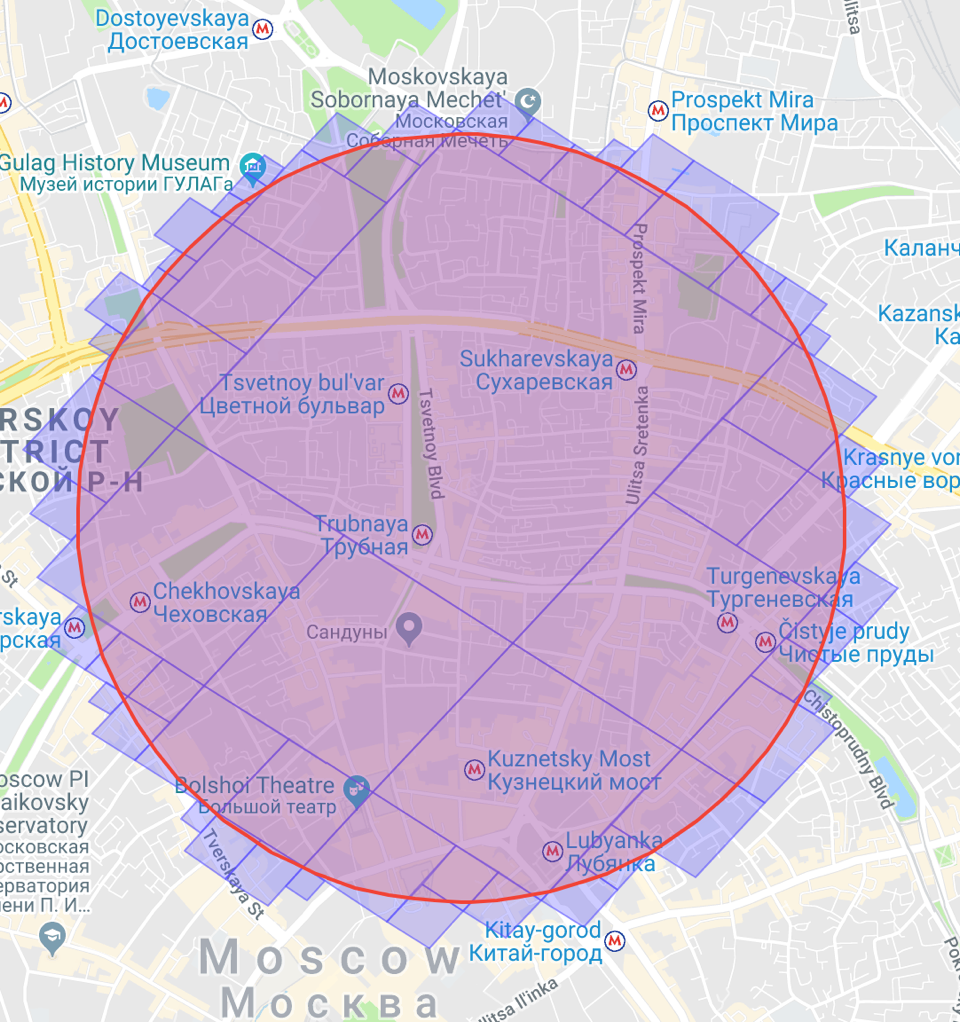

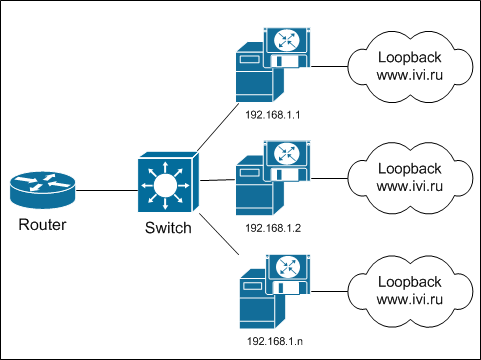

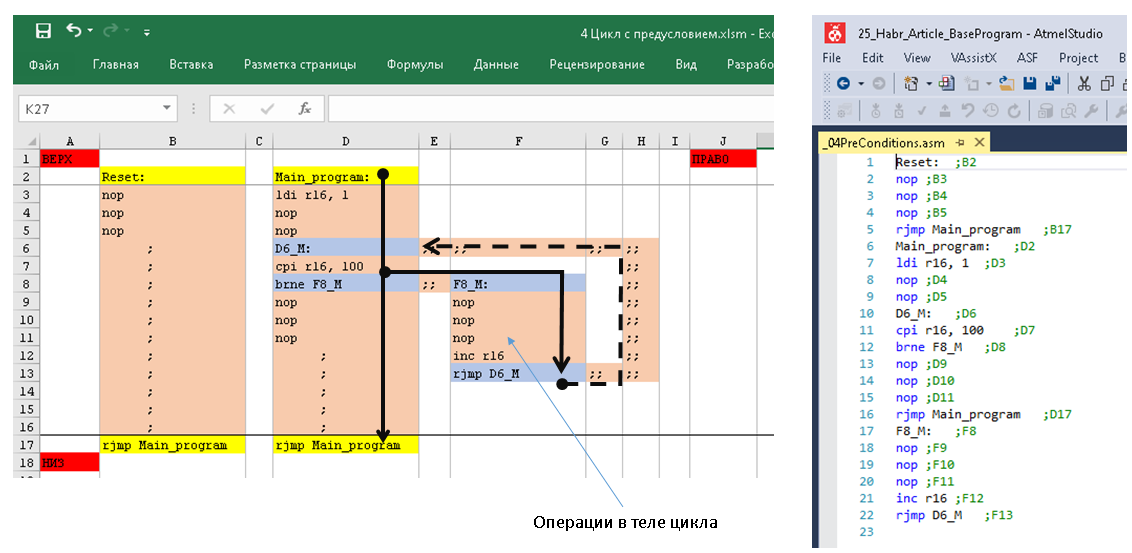

Традиционно, мы начали с проблем, которые помогла бы решить дизайн-система и сформулировали требования к её проектированию. Помимо создания единого визуального языка, увеличения скорости макетирования и разработки, повышения качества продукта в целом, было жизненно необходимо максимально унифицировать дизайн. Это нужно для того, чтобы развитие функционала стало возможным сразу на всех наших платформах одновременно: Web, iOS, Android, Smart TV, tvOS, Android TV, Windows 10, xBox One, PS4, Roku — не прорабатывая при этом каждую из них в отдельности. И это у нас получилось!

Дизайн → данные

---------------

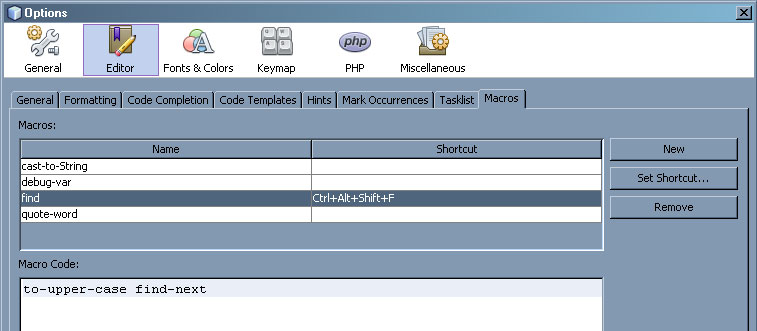

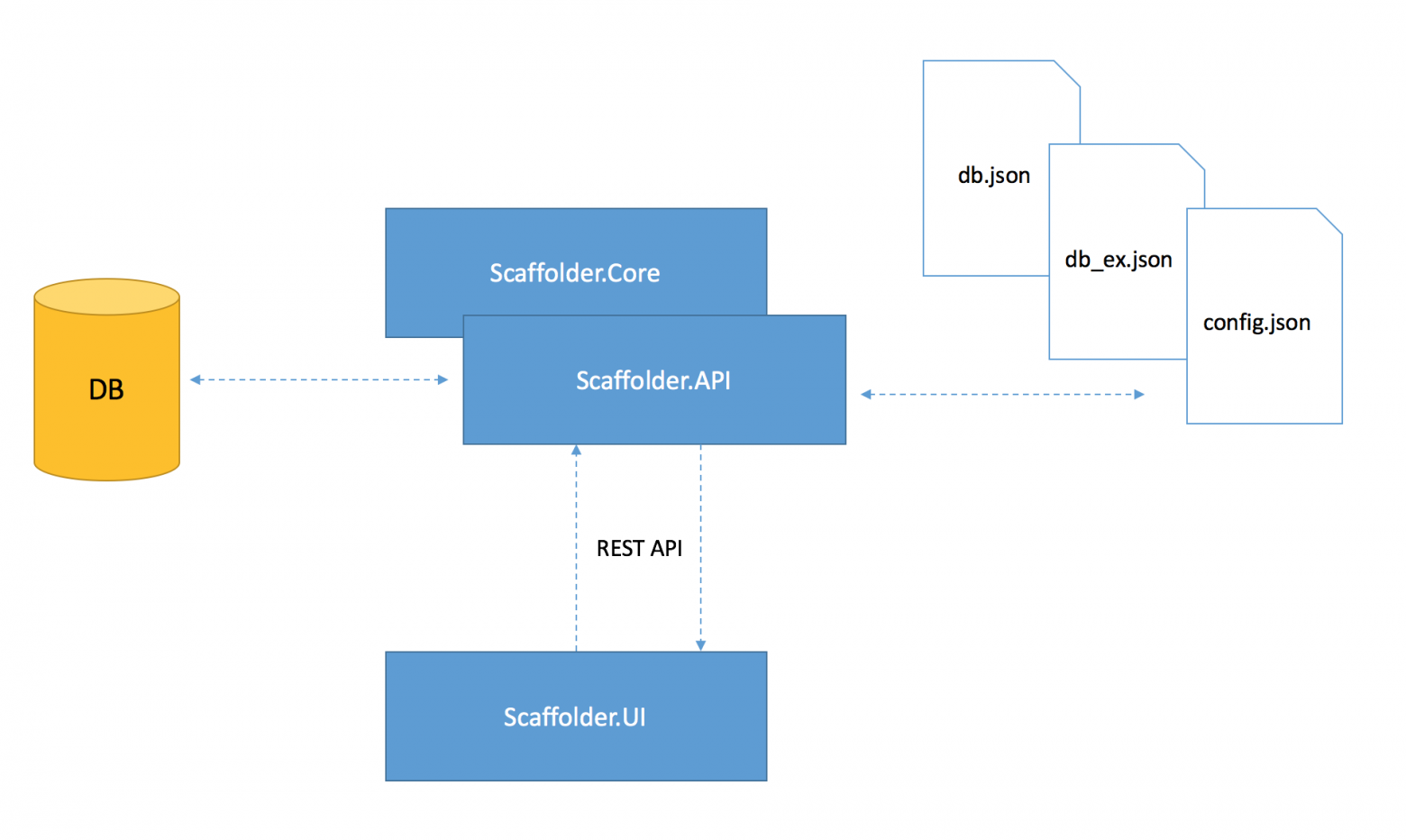

Когда принципиальные договорённости отделов продукта и разработки были достигнуты, мы сели за подбор технологического стека и проработку деталей всего процесса — от макета до релиза. Чтобы полностью автоматизировать процесс передачи дизайна в разработку поисследовали вариант с парсером параметров компонентов прямо из Sketch-файлов с макетами. Оказалось, что находить нужные нам куски кода и извлекать нужные нам параметры — затея сложная и опасная. Во-первых, дизайнерам придётся быть крайне аккуратными в именовании всех слоёв исходника, во-вторых, это работает только для самых простых компонентов, а в-третьих, зависимость от чужой технологии и структуры кода исходного Sketch-макета ставит под угрозу будущее всего проекта. Мы решили отказаться от автоматизации на этом участке. Так в команде дизайн-системы появился первый человек, на вход которому подаются дизайн-макеты, а на выходе — данные, описывающие все параметры компонентов и иерархически упорядоченные по методологии атомарного дизайна.

Дело оставалось за малым: где и как хранить данные, как передавать в разработку и как интерпретировать в разработке на всех поддерживаемых нами платформах. Вечер переставал быть томным… Итогом регулярных встреч рабочей группы, состоящей из дизайнеров и тимлидов от каждой платформы стали договорённости о нижеследующем.

Вручную разбираем визуал на элементы-атомы: шрифты, цвета, прозрачности, отступы, скругления, иконки, картинки и длительности для анимаций. И собираем из этого кнопки, инпуты, чекбоксы, виджеты банковских карт и т. д. Стилям любого из уровней, кроме пиктограмм присваиваем несемантические имена, например названия городов, имена нимф, покемонов, марки автомобилей… Тут условие одно — список не должен исчерпаться раньше, чем закончатся стили — шоу маст гоу он! Семантикой же не стоит увлекаться, чтобы не пришлось добавлять среднюю кнопку между «small» и «medium», например.

Визуальный язык

---------------

Разработчики ушли думать, как хранить и передавать данные, чтобы это подходило всем платформам, а дизайну предстояло спроектировать элементы интерфейса, способные одинаково хорошо выглядеть и эффективно работать на всём парке поддерживаемых устройств.

Ранее мы уже успели «обкатать» большинство элементов дизайна в приложении под Windows 10, которое на тот момент являлось для нас новой платформой, то есть требовалась отрисовка и разработка «с нуля». Рисуя его, мы смогли подготовить и проверить большинство компонентов и понять, какие из них должны были войти в будущую дизайн-систему Иви. Без такой «песочницы» подобный опыт можно было получить только большим числом итераций на уже работающих платформах, а на это потребовалось бы больше года.

Переиспользование одинаковых компонентов на разных платформах уменьшает количество макетов и массив данных дизайн-системы в разы, поэтому дизайну предстояло решить ещё одну задачу, ранее не описанную в практиках продуктового дизайна и разработки — как, например кнопку для телефонов и планшетов переиспользовать на телевизорах? И как в принципе быть с размерами шрифтов и элементов на таких разных платформах?

Очевидно, требовалось спроектировать кроссплатформенную модульную сетку, которая будет задавать нужные нам размеры текста и элементов для каждой конкретной платформы. За точку отсчёта для сетки мы выбрали размер и количество постеров фильмов, которые хотим видеть на том или ином экране и, исходя из этого сформулировали правило построения колонок сетки, при условии — ширина одной колонки равна ширине постера.

Теперь нужно привести к одному размеру макета все большие экраны и вписать их в общую сетку. Apple TV и Roku разрабатываются в размер 1920x1080, Android TV — 960x540, Smart TV, в зависимости от вендора бывают такими же, а бывают 1280x720. Когда приложение рендерится и отображается на экранах Full HD, 960 умножается на 2, 1280 на 1,33, а 1920 выводится как есть.

Опуская скучные подробности, мы пришли к тому, что вообще все экраны, включая телеэкраны с точки зрения элементов и их размеров покрываются одним дизайн-макетом, а все телеэкраны являются частным случаем общей кроссплатформенной сетки, и состоят из пяти или шести колонок, как средний планшет или десктоп. Кому интересны подробности, го в комменты.

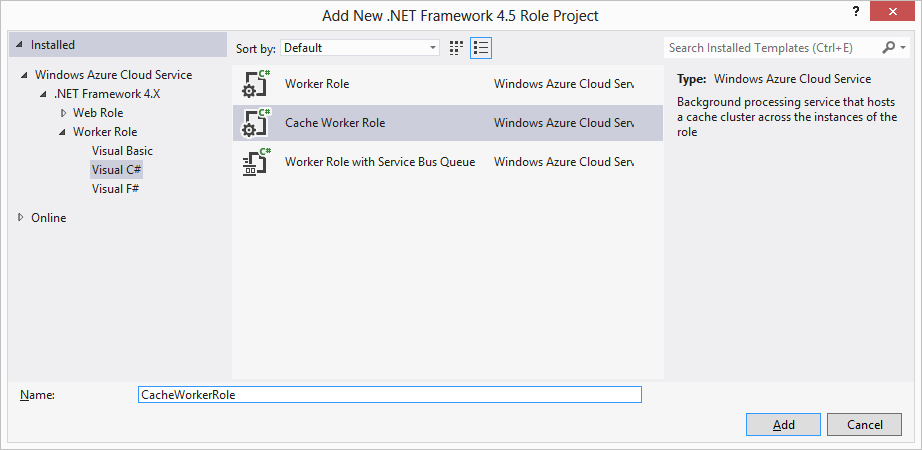

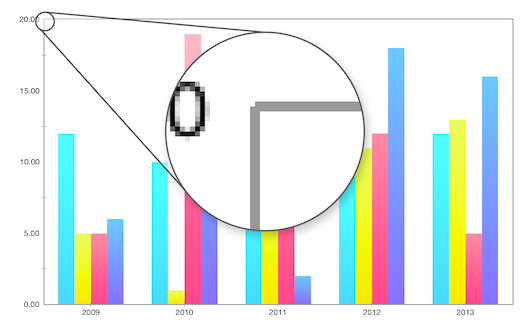

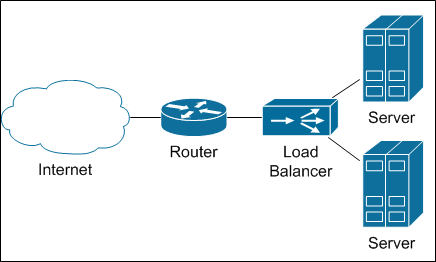

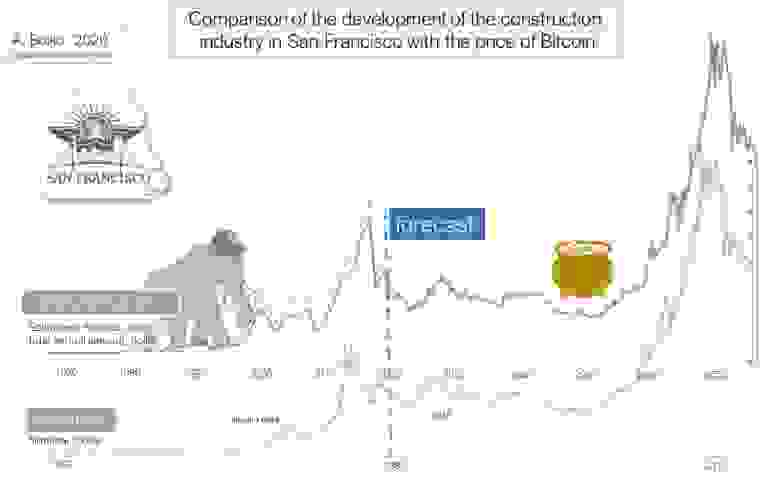

*Единый UI для всех платформ*

Теперь для отрисовки новой фичи нам не нужно рисовать макеты под каждую из платформ, плюс варианты адаптивности для каждой из них. Достаточно показать один макет и его адаптивность для всех платформ и устройств любой ширины: телефоны — 320–599, всё остальное — 600–1280.

Данные → разработка

-------------------

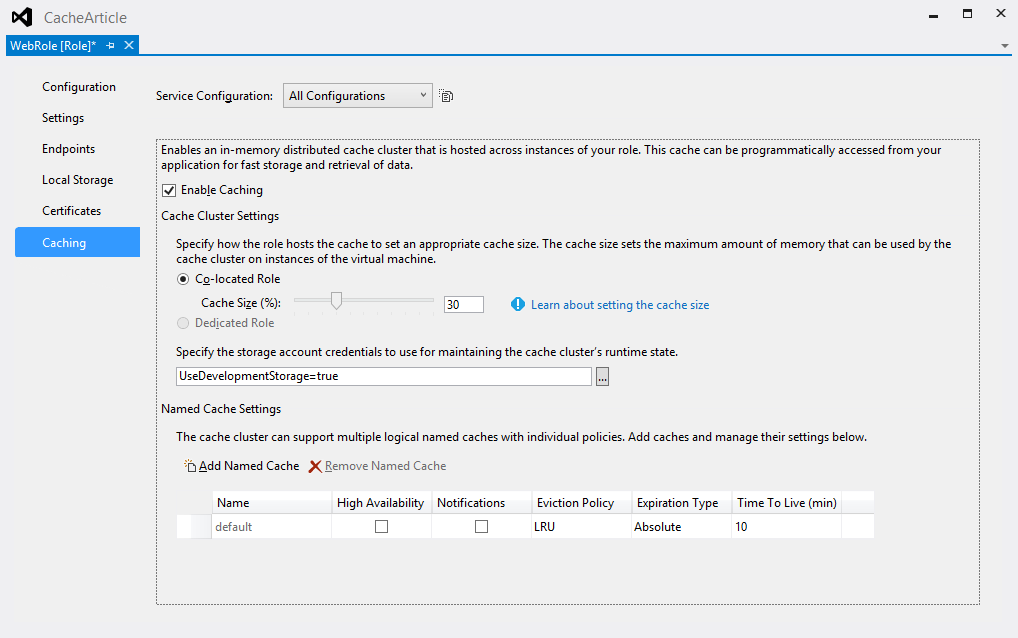

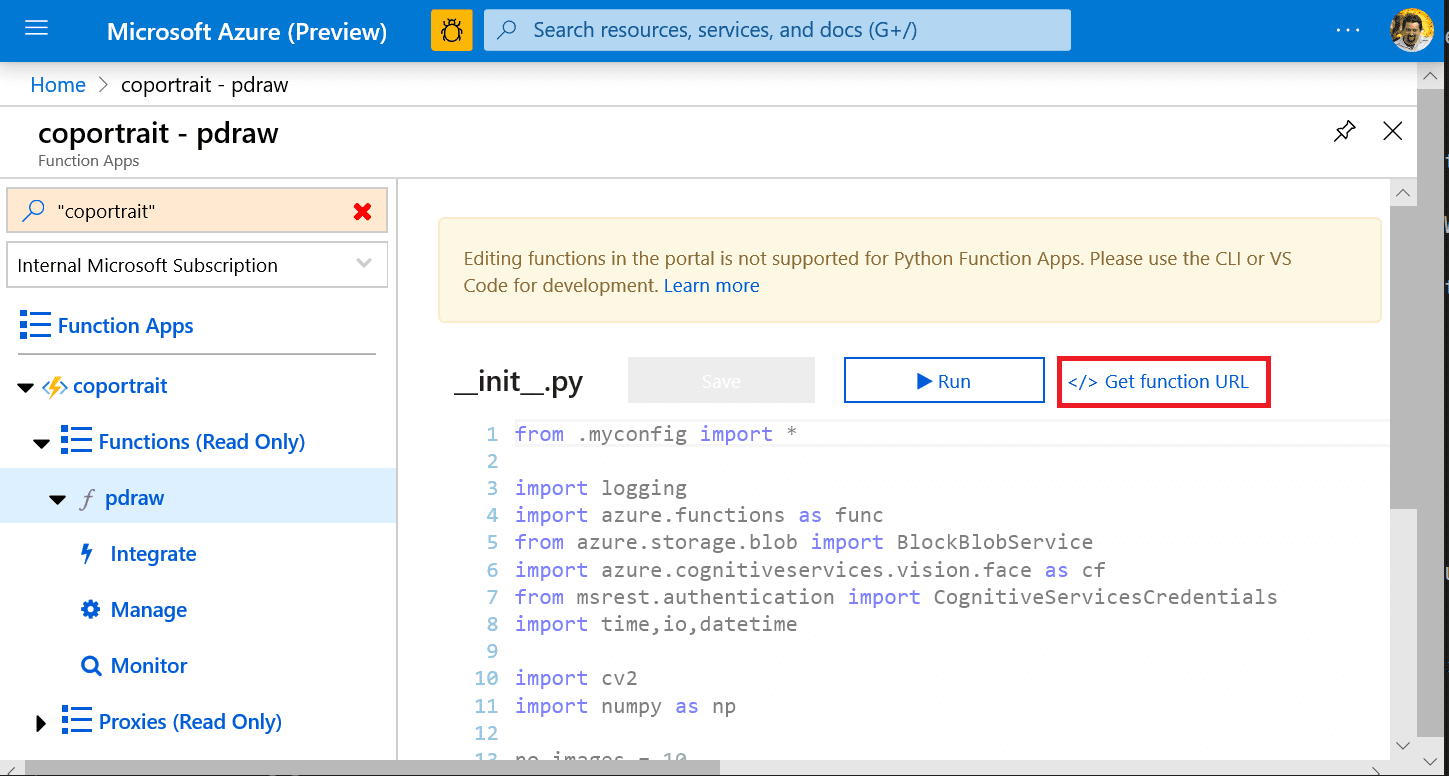

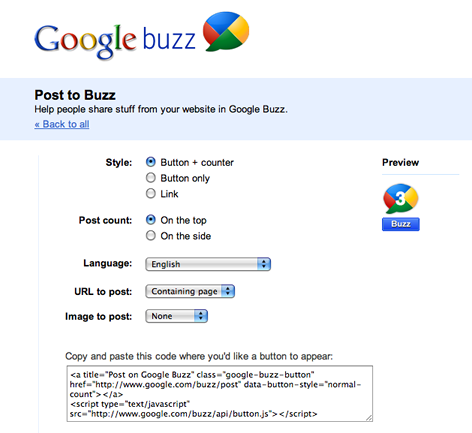

Конечно, как бы нам ни хотелось прийти к абсолютно унифицированному дизайну, каждая платформа имеет свои уникальные особенности. Несмотря на то, что и веб, и Smart TV используют стек ReactJS + TypeScript, приложение для Smart TV запускается на устаревших WebKit- и Presto-клиентах, и потому не может использовать общие стили с вебом. А email-рассылки и вовсе вынуждены работать с табличной вёрсткой. При этом ни одна из не-html-платформ не использует и не планирует использовать React Native или какие-то её аналоги, опасаясь ухудшения производительности, так как у нас слишком много кастомных лэйаутов, коллекций со сложной логикой обновления, изображений и видео. Поэтому для нас не подходит распространённая схема — поставлять готовые CSS-стили или React-компоненты. Поэтому мы решили передавать данные в формате JSON, описывая значения в абстрактном декларативном виде.

> Так свойство `rounding: 8` приложение Windows 10 преобразует в `CornerRadius="8"`, веб — `border-radius: 8px`, Android — `android:radius="8dp"`, iOS — `self.layer.cornerRadius = 8.0`.

>

> Cвойство `offsetTop: 12` один и тот же веб-клиент в разных случаях может интерпретировать как `top`, `margin-top`, `padding-top` или `transform`

Декларативность описания также предполагает, что если платформа технически не может использовать какое-либо свойство или его значение, она может его проигнорировать. С точки зрения терминологии мы сделали некое подобие языка эсперанто: что-то взяли из Android, что-то из SVG, что-то из CSS.

В случае если на той или иной платформе потребуется отображать элементы как-то иначе, мы реализовали возможность передачи соответствующей генерации данных в виде отдельного JSON-файла. Например, состояние «в фокусе» для Smart TV, диктует изменение позиции текста под постером, значит для этой платформы данный компонент в значении свойства «отступ» будет содержать необходимые ей 8 поинтов отступа. Хоть это и усложняет инфраструктуру дизайн-системы, зато даёт дополнительную степень свободы, оставляя нам возможность самим управлять визуальной «непохожестью» платформ, а не быть заложниками нами же созданной архитектуры.

Пиктограммы

-----------

Иконографика в цифровом продукте — это всегда объёмный и не самый простой подпроект, часто имеющий отдельного дизайнера. Глифов всегда много, каждый из них имеет несколько размеров и цветов, к тому же платформам они нужны, как правило в разных форматах. В общем, не было повода не завести всё это в дизайн-систему.

Глифы загружаются в векторном SVG-формате, а значения цветов автоматически заменяются переменными. Приложения-клиенты могут получать их уже готовыми к использованию — в любом формате и цвете.

Предпросмотр

------------

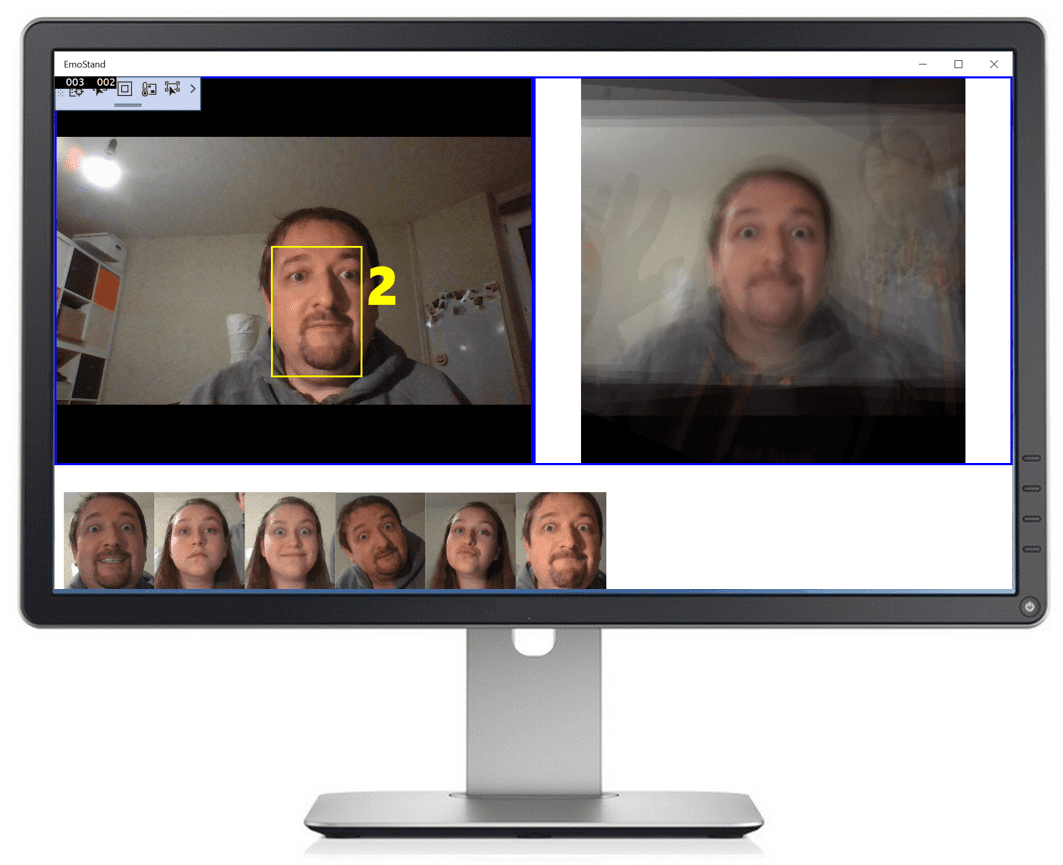

Поверх JSON’а с данными мы написали инструмент для предпросмотра компонентов — JS-приложение, на лету пропускающее JSON-данные через свои генераторы разметки и стилей, и отображающее в браузере различные вариации каждого из компонентов. По сути, предпросмотр является точно таким же клиентом, как и платформенные приложения, и работает с теми же данными.

Понять, как работает тот или иной компонент, проще всего путём взаимодействия с ним. Поэтому мы не стали использовать инструменты, подобные Storybook, а сделали интерактивный предпросмотр — можно пощупать, понаводить, покликать… При добавлении в дизайн-систему нового компонента он появляется в предпросмотре, чтобы платформам было на что ориентироваться при его внедрении.

Документация

------------

На основе тех данных, которые в виде JSON поставляются платформам, автоматически формируется документация по компонентам. Описывается перечень свойств и возможные типы значений в каждом из них. После автогенерации информацию можно уточнить в ручном режиме, добавить текстовое описание. Предпросмотр и документация снабжены перекрёстными ссылками друг на друга на уровне каждого компонента, а вся информация, попадающая в документацию, доступна разработчикам в виде дополнительных JSON-файлов.

Депрекатор

----------

Ещё одной необходимостью стала возможность со временем заменять и обновлять уже существующие компоненты. Дизайн-система научилась сообщать разработчикам, какие свойства или даже целые компоненты использовать нельзя и удалять их, как только они перестают использоваться на всех платформах. Пока в этом процессе ещё много «ручного» труда, но мы не стоим на месте.

Клиентская разработка

---------------------

Несомненно, самым масштабным по сложности этапом стала интерпретация данных дизайн-системы в коде всех поддерживаемых нами платформ. Если, например, модульные сетки на вебе не являются чем-то новым, то разработчики нативных мобильных приложений под iOS и Android изрядно попотели, прежде чем придумали, как с этим жить.

Для верстки экранов iOS-приложения мы используем два базовых механизма, которые предоставляет iviUIKit: cвободная компоновка элементов и компоновка коллекций элементов. Мы используем VIPER, и всё взаимодействие с iviUIKit сосредоточено во View, а большая часть взаимодействия с Apple UIKit сосредоточена в iviUIKit. Размеры и расположение элементов задаётся в терминах колонок и синтаксических конструкций, работающих поверх нативных констрейнтов iOS SDK, делающих их более прикладными. Особенно это упростило нам жизнь при работе с UICollectionView. Мы написали несколько настраиваемых обёрток для лэйаутов, в том числе довольно сложных. Клиентского кода получилось минимум и он стал декларативным.

Для генерации стилей в проекте Android мы используем Gradle, превращая данные дизайн-системы в стили формата XML. При этом у нас есть несколько генераторов различного уровня:

* **Базовые**. Парсят данные примитивов для генераторов более высокого уровня.

* **Ресурсные**. Скачивают картинки, иконки, и прочую графику.

* **Компонентные**. Пишутся для каждого компонента, где описано какие свойства и как перевести в стили.

Релизы приложений

-----------------

После того, как дизайнеры нарисовали новый компонент или переработали существующий, эти изменения попадают в дизайн-систему. Разработчики каждой из платформ дорабатывают свою кодогенерацию, обеспечивая поддержку изменений. После этого его можно использовать в реализации нового функционала, где этот компонент необходим. Таким образом, взаимодействие с дизайн-системой происходит не в реальном времени, а только в момент сборки новых релизов. Такой подход также позволяет лучше контролировать процесс передачи данных и гарантирует работоспособность кода в проектах клиентской разработки.

Итоги

-----

Скоро год как дизайн-система стала частью инфраструктуры, обслуживающей развитие онлайн-кинотеатра Иви, и уже можно делать кое-какие выводы:

* Это большой и сложный в реализации проект, требующий постоянных выделенных ресурсов.

* Это позволило нам создать свой уникальный кроссплатформенный визуальный язык, отвечающий задачам сервиса онлайн видео.

* У нас больше нет визуально и функционально отстающих платформ.

Предпросмотр компонентов дизайн-системы Иви — [design.ivi.ru](http://design.ivi.ru) | https://habr.com/ru/post/456854/ | null | ru | null |

# Практика в работе с нестандартными шинами комплекса Redd

В [прошлой статье](https://habr.com/ru/post/483724/) мы рассмотрели теорию по управлению тысячей мелочей в комплексе Redd, но чтобы не раздувать объём, отложили практику на следующий раз. Пришла пора провести практические опыты. Те же, кто не пользуется комплексом Redd, тоже смогут найти в этой статье полезные знания, а именно — методику подачи Vendor команд в USB накопители из ОС Linux, ведь как уже говорилось, контроллер STM32 в комплексе выполняет функцию SD-ридера, то есть — накопителя.

**Предыдущие статьи цикла**1. [Разработка простейшей «прошивки» для ПЛИС, установленной в Redd, и отладка на примере теста памяти.](https://habr.com/ru/post/452656/)

2. [Разработка простейшей «прошивки» для ПЛИС, установленной в Redd. Часть 2. Программный код.](https://habr.com/ru/post/453682/)

3. [Разработка собственного ядра для встраивания в процессорную систему на базе ПЛИС.](https://habr.com/ru/post/454938/)

4. [Разработка программ для центрального процессора Redd на примере доступа к ПЛИС.](https://habr.com/ru/post/456008/)

5. [Первые опыты использования потокового протокола на примере связи ЦП и процессора в ПЛИС комплекса Redd.](https://habr.com/ru/post/462253/)

6. [Веселая Квартусель, или как процессор докатился до такой жизни.](https://habr.com/ru/post/464795/)

7. [Методы оптимизации кода для Redd. Часть 1: влияние кэша.](https://habr.com/ru/post/467353/)

8. [Методы оптимизации кода для Redd. Часть 2: некэшируемая память и параллельная работа шин.](https://habr.com/ru/post/468027/)

9. [Экстенсивная оптимизация кода: замена генератора тактовой частоты для повышения быстродействия системы.](https://habr.com/ru/post/469985/)

10. [Доступ к шинам комплекса Redd, реализованным на контроллерах FTDI](https://habr.com/ru/post/477662/)

11. [Работа с нестандартными шинами комплекса Redd](https://habr.com/ru/post/483724/)

Классификация накопителей по системам команд

--------------------------------------------

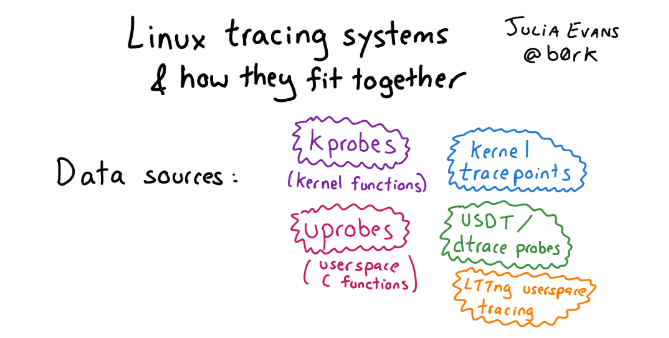

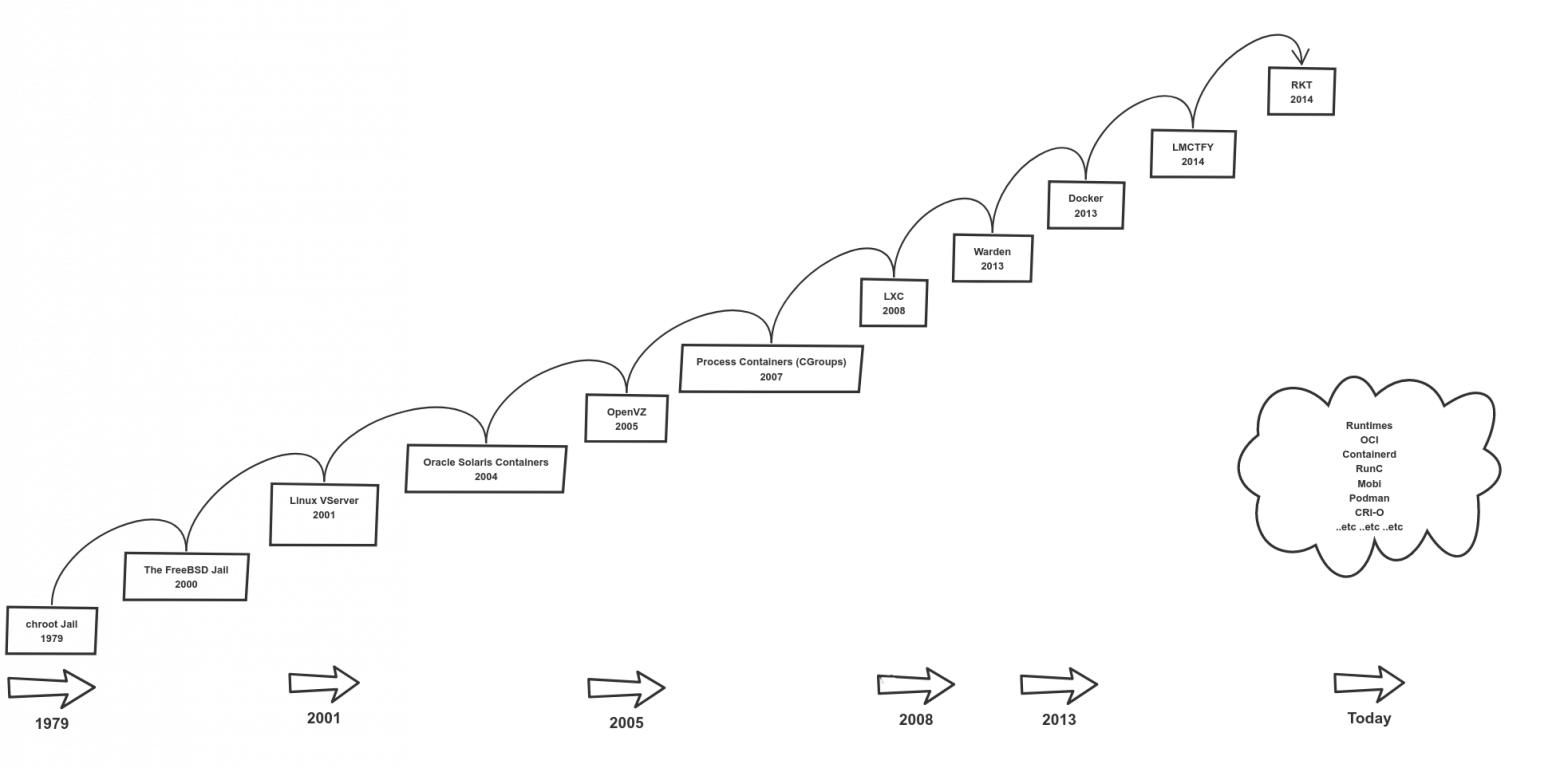

При работе с накопителями следует различать физический интерфейс и систему команд. В частности, накопители CD/DVD/BD и прочая оптика. Традиционно они подключаются к кабелю SATA (ранее — IDE). Но конкретно по этому проводу во время работы бегают только команды PACKET, в блоке данных которых размещаются команды, закодированные по совершенно иному принципу (скоро мы узнаем, по какому). Поэтому сейчас мы будем говорить не столько о проводах, сколько о командах, которые в них бегают. Мне известно три распространённых системы команд для работы с накопителями.

* MMC. Её понимают SD-карты. Честно говоря, для меня это самая загадочная система команд. Как их подавать, вроде, ясно, но как управлять накопителем, не вчитываясь внимательно в документ, содержащий массу графов переходов, — я вечно путаюсь. К счастью, сегодня нас это не тревожит, так как хоть мы и работаем с SD-картой, но работу с ней осуществляет контроллер STM32 в режиме «чёрного ящика».

* ATA. Исходно эти команды бегали по шине IDE, затем — по SATA. Замечательная система команд, но сегодня мы также лишь упомянем, что она существует.

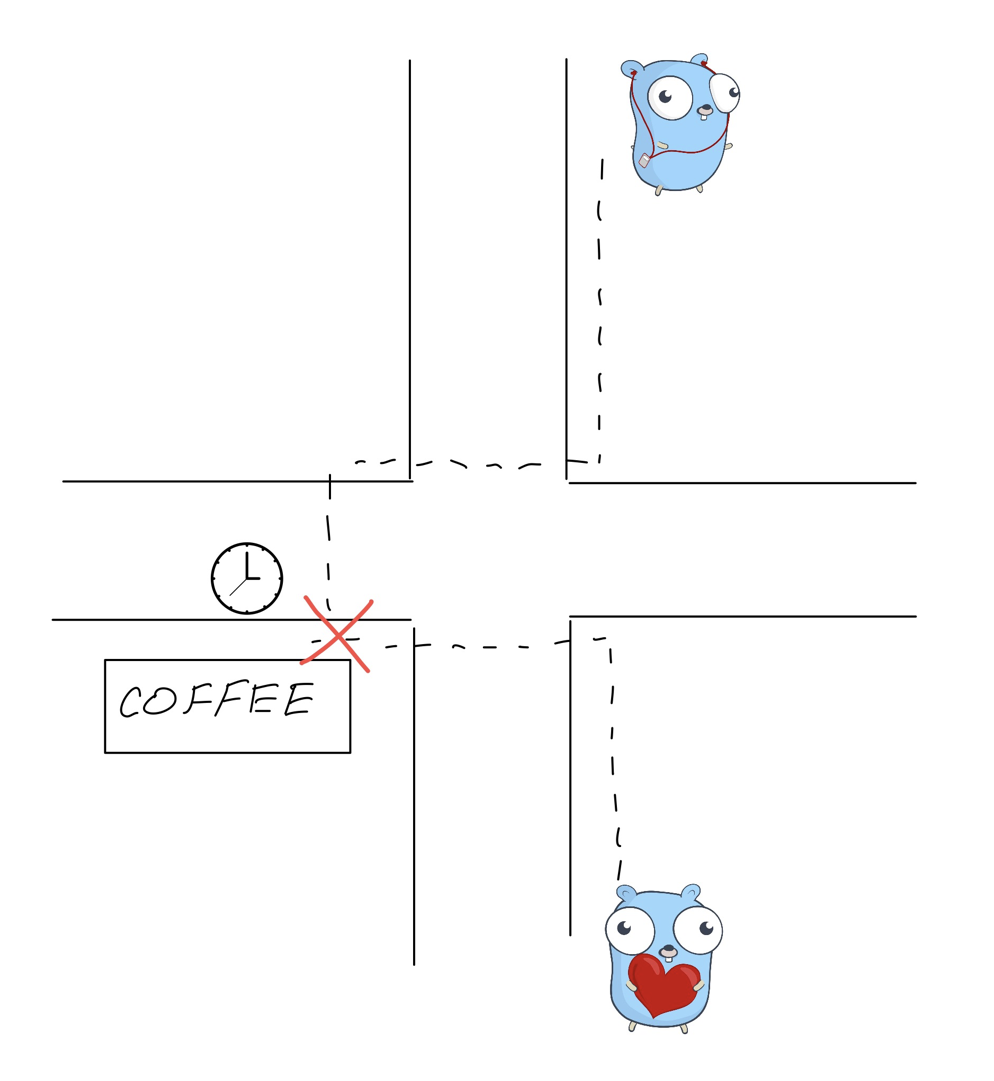

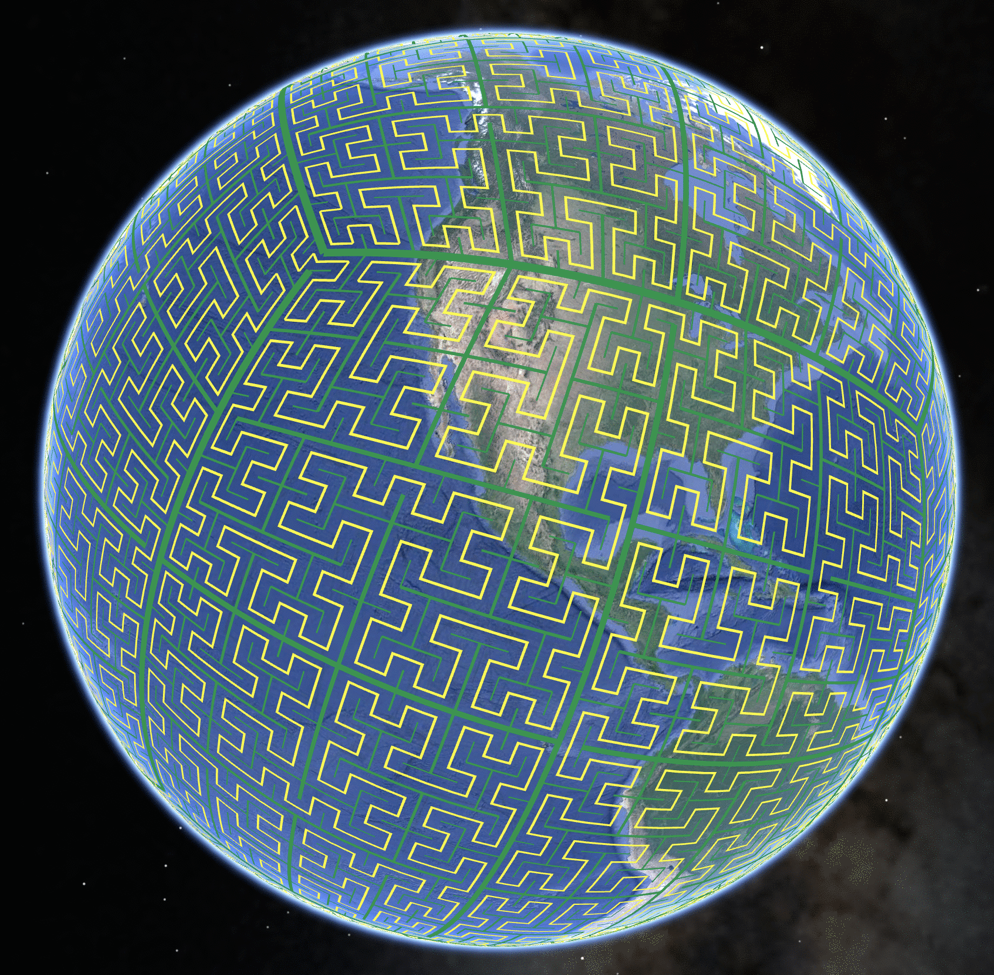

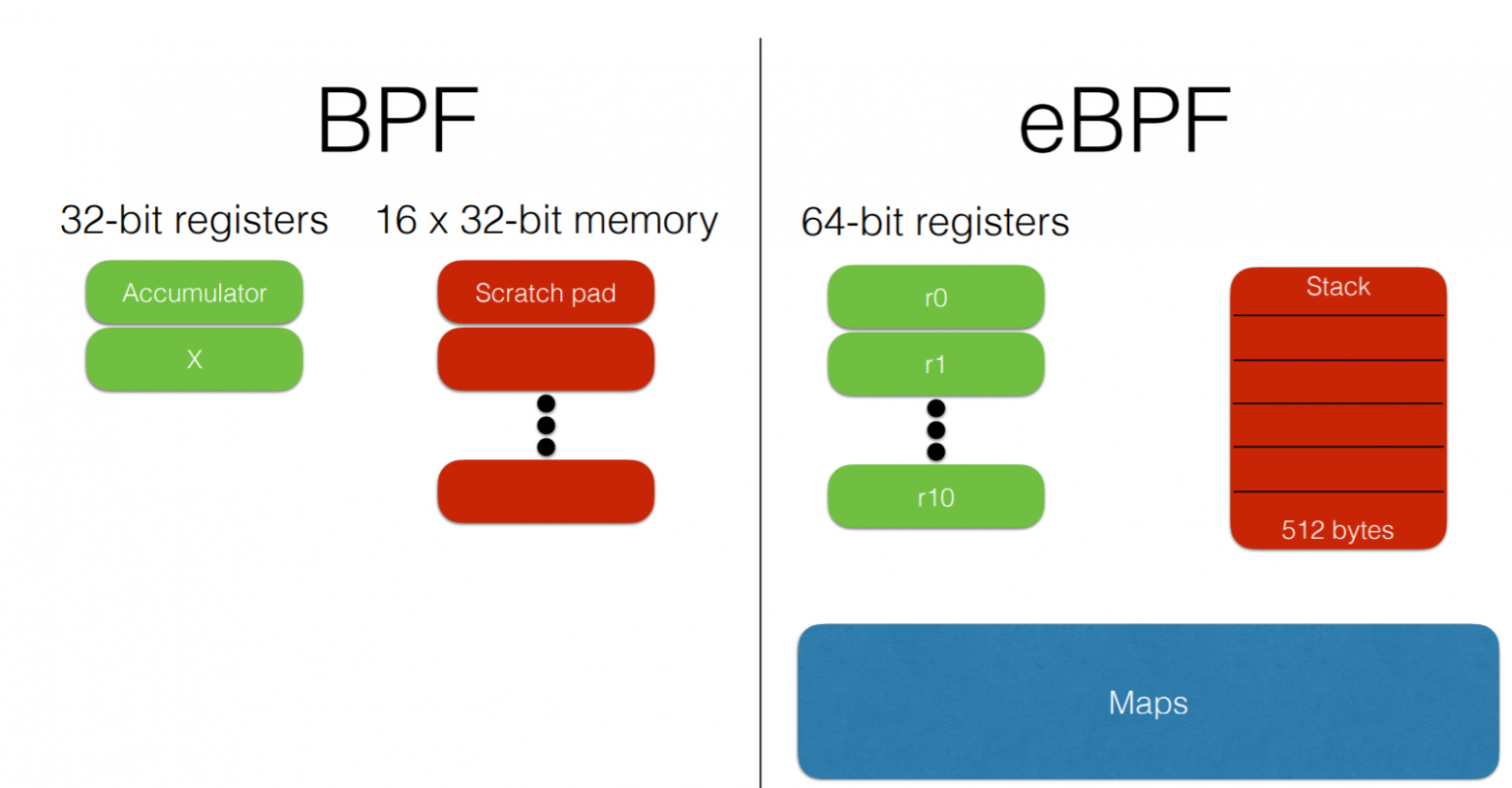

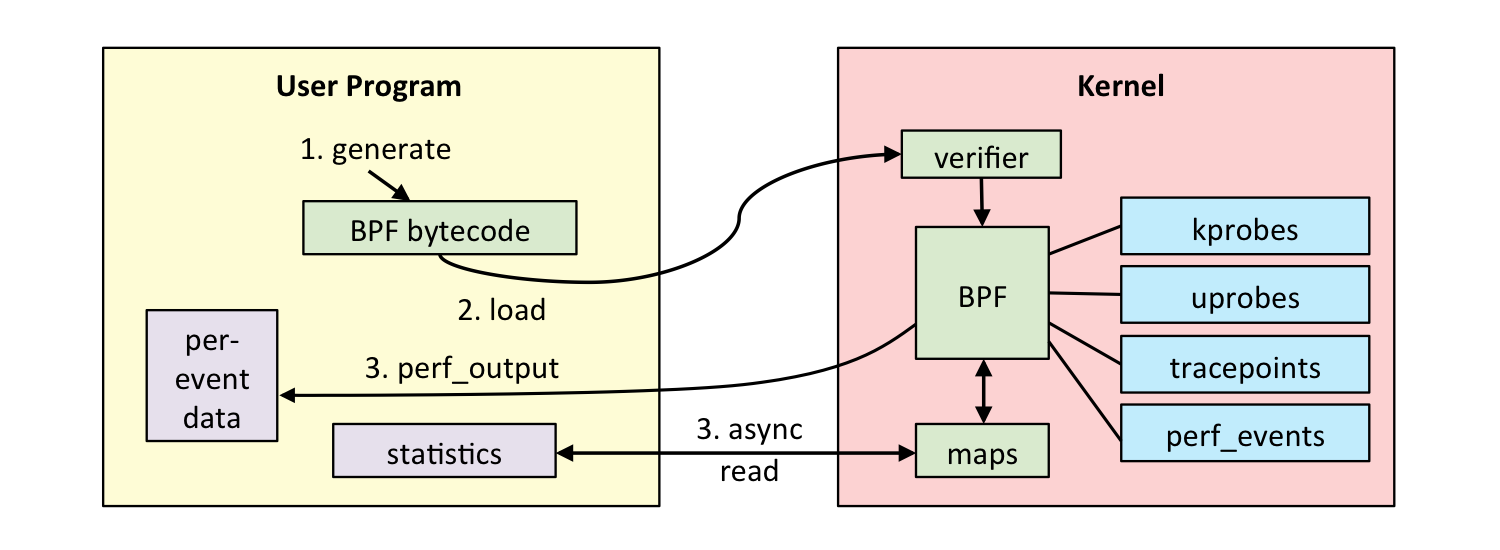

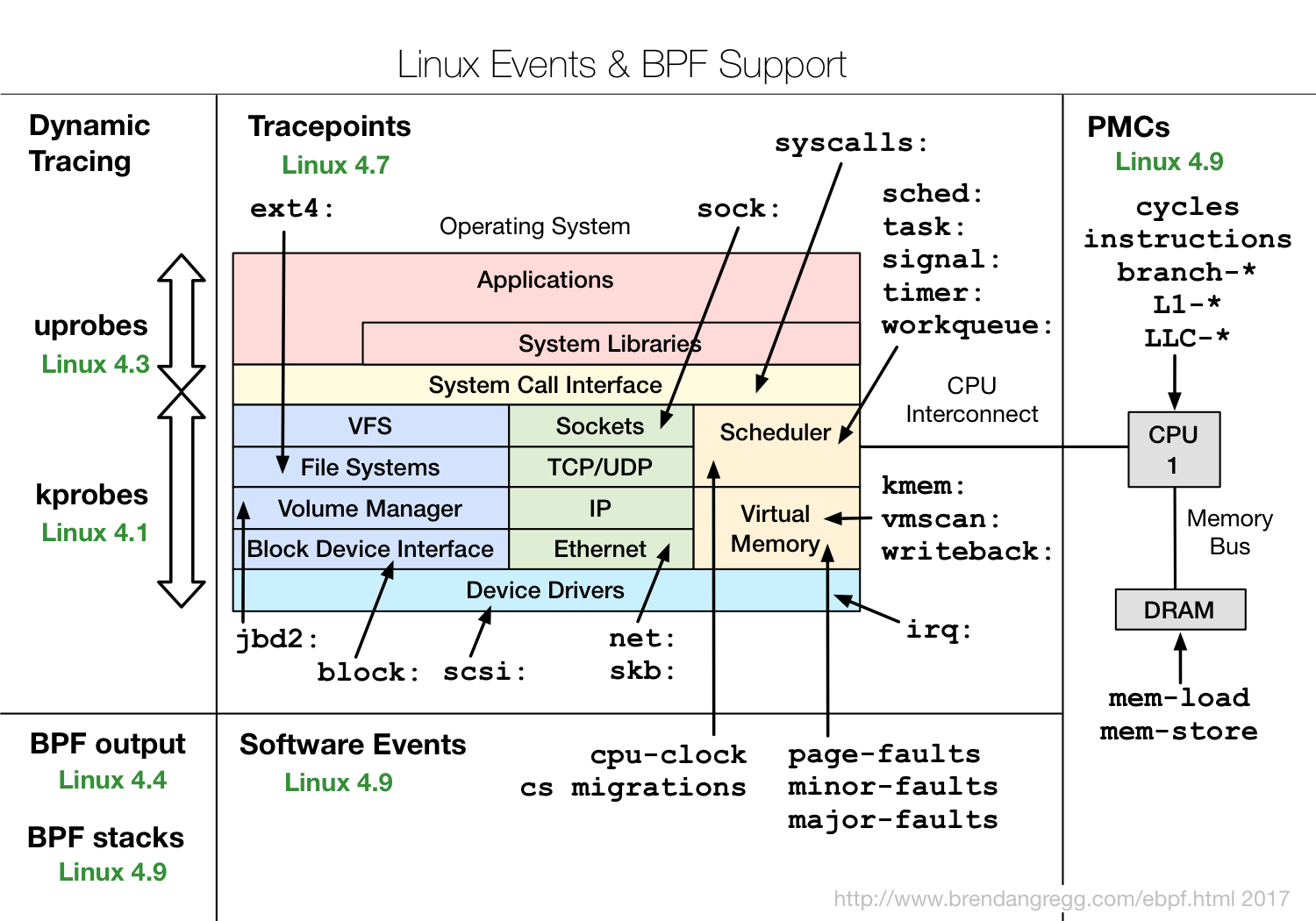

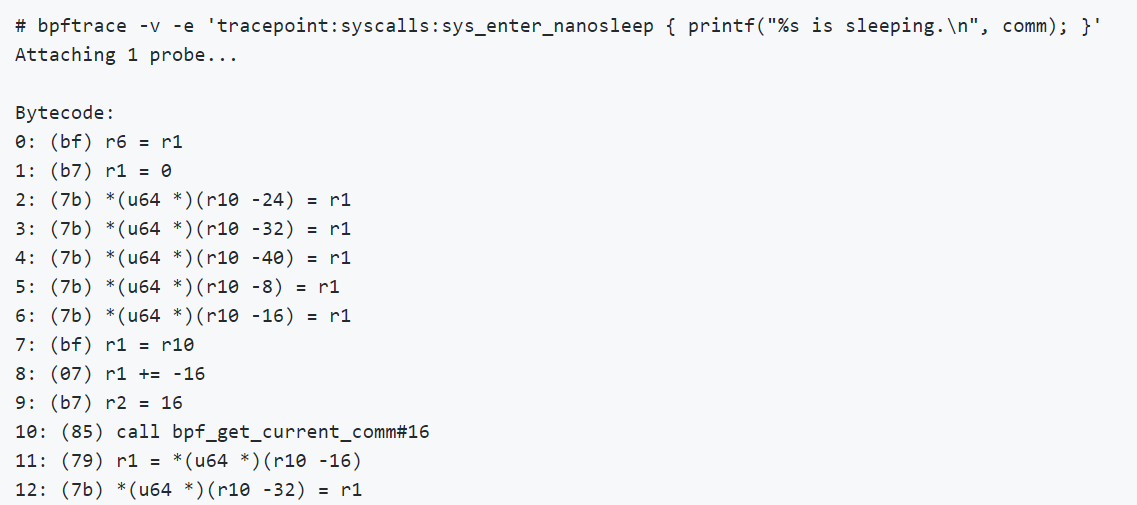

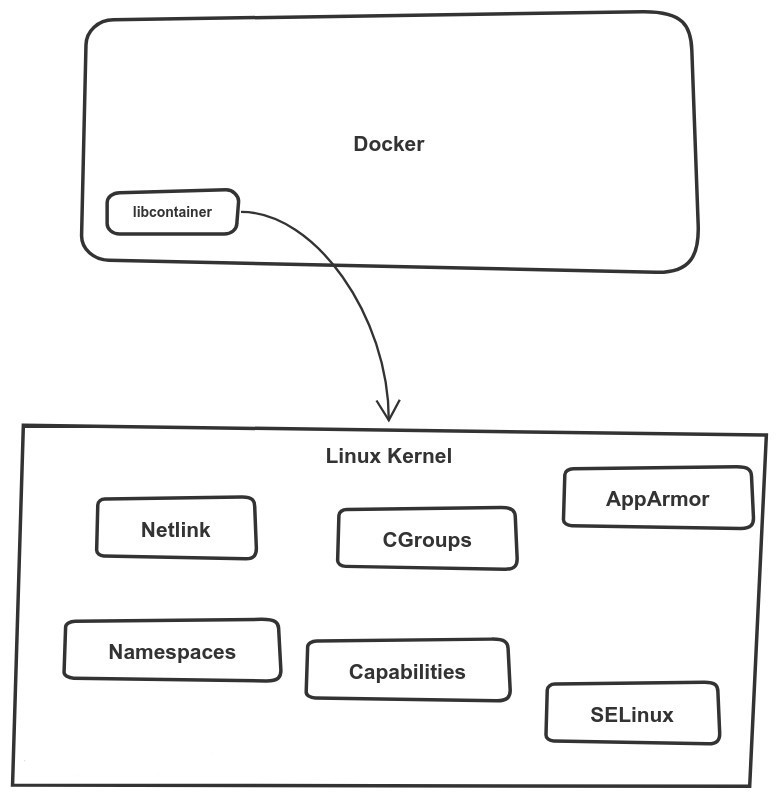

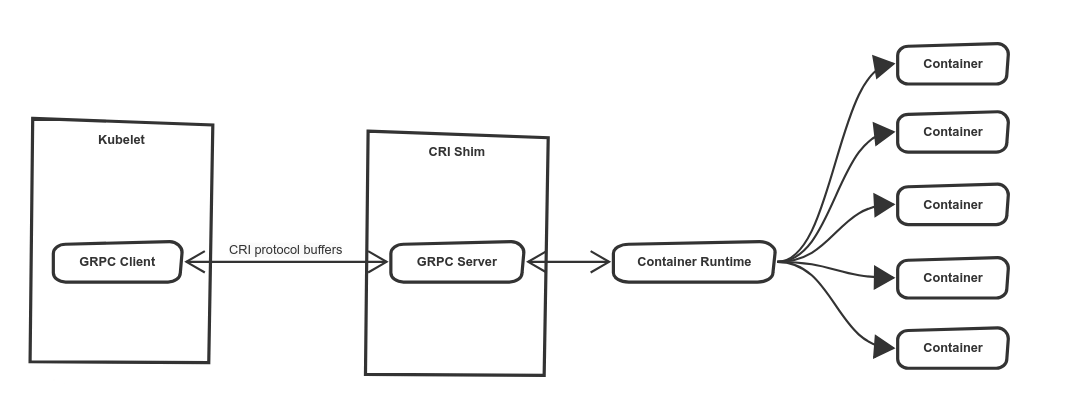

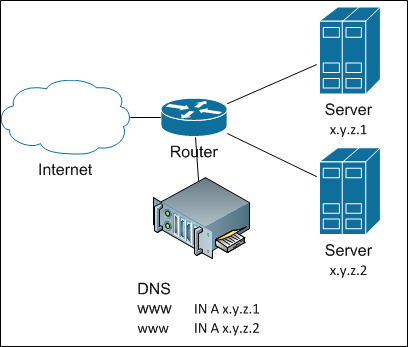

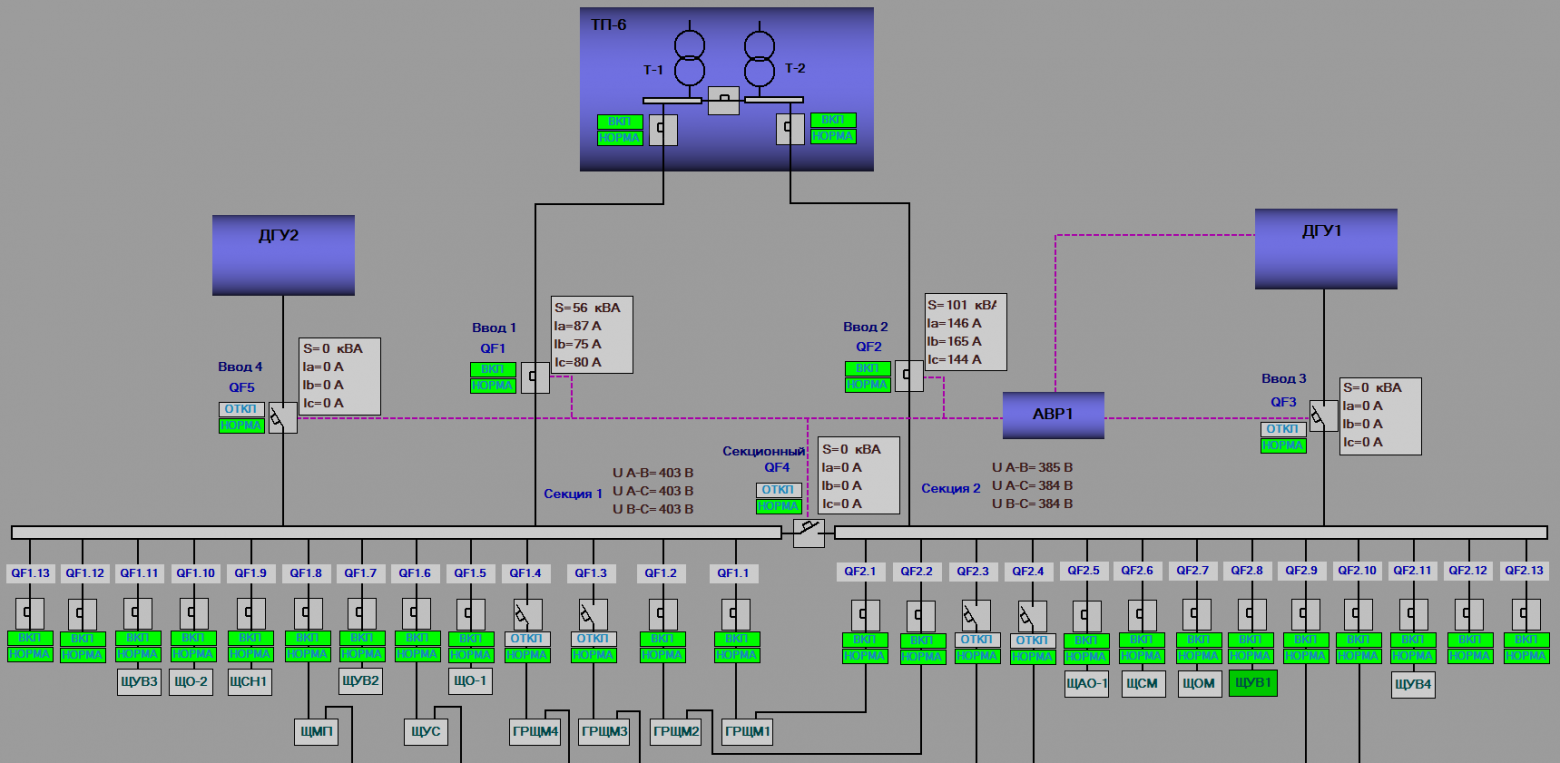

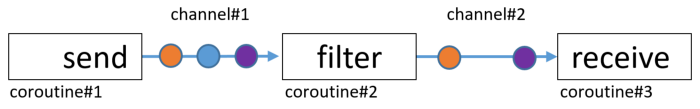

* SCSI. Эта система команд используется у широкого спектра устройств. Рассмотрим её применение в накопителях. Там сегодня SCSI-команды бегают, в первую очередь, по проводам шины SAS (кстати, сейчас в моду входят даже SSD с интерфейсом SAS). Как ни странно, оптические накопители, физически подключённые к шине SATA, также работают через SCSI-команды. По шине USB при работе по стандарту Mass Storage Device, также команды идут в формате SCSI. Микроконтроллер STM32 подключён к комплексу Redd через шину USB, то есть, в нашем случае, команды проходят по следующему пути:

От PC до контроллера, по шине USB, команды идут в формате SCSI. Контроллер перекодирует команды по правилу MMC и отправляет их по шине SDIO. Но нам предстоит писать программу для PC, поэтому от нас команды уходят именно в формате SCSI. Их готовит драйвер устройства Mass Storage Device, с которым мы общаемся через драйвер файловой системы. Можно ли к этим запросам подмешивать запросы к прочим устройствам? Давайте разбираться.

Детали системы команд SCSI

--------------------------

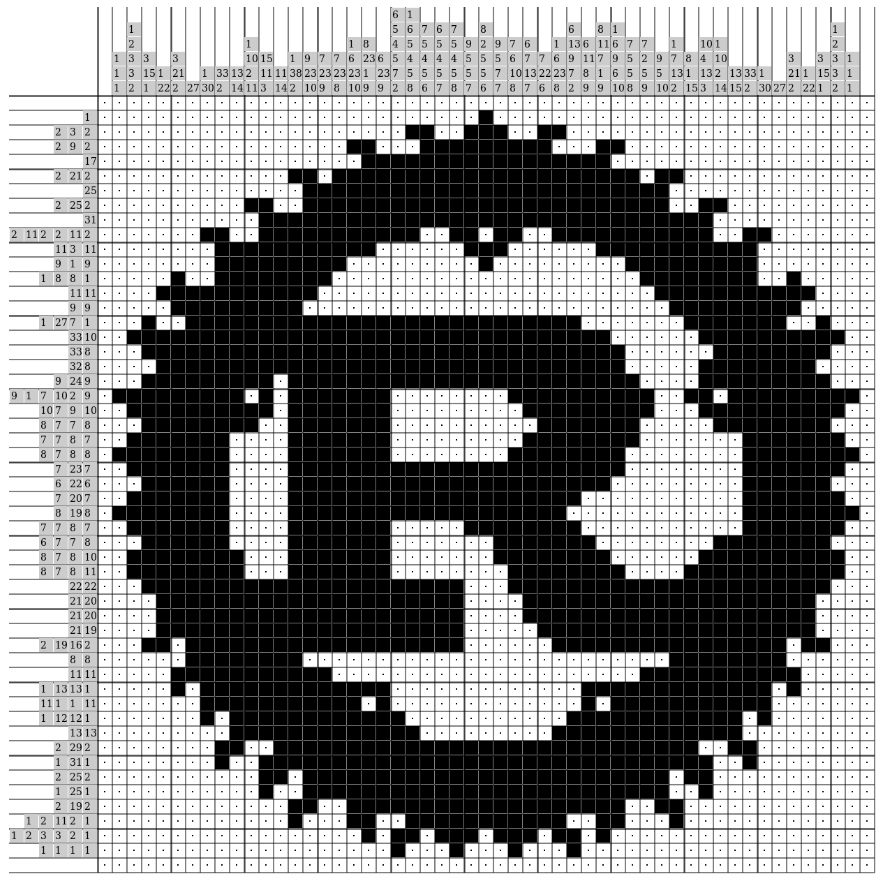

Если подходить к делу формально, то описание стандарта SCSI имеется на сайте t10.org, но будем реалистами. Никто добровольно читать его не станет. Точнее, не его, а их: там лежит целый ворох открытых документов и гора закрытых.Только крайняя необходимость заставит погрузиться в тот сложный язык, которым написан стандарт (это, кстати, касается и стандарта ATA на t13.org). Намного проще читать документацию на реальные накопители. Она написана более живым языком, а ещё из неё вырезаны гипотетические, но реально не используемые части. При подготовке статьи я наткнулся на довольно новый (2016 года) документ **SCSI Commands Reference Manual** фирмы Seagate (прямая ссылка [www.seagate.com/files/staticfiles/support/docs/manual/Interface%20manuals/100293068j.pdf](https://www.seagate.com/files/staticfiles/support/docs/manual/Interface%20manuals/100293068j.pdf) но, как всегда, я не знаю, сколько она проживёт). Думаю, если кто-то хочет освоить эту систему команд, ему лучше начать именно с этого документа. Помним только, что SD-ридеры реализуют ещё более мелкое подмножество команд из того описания.

Если же говорить совсем коротко, то в накопитель уходит командный блок, имеющий длину от 6 до 16 байт. К командному блоку может быть прикреплён блок данных либо от PC к накопителю, либо от накопителя к PC (стандарт SCSI допускает и двунаправленный обмен, но для Mass Storage Device через USB допускается только один блок, а значит, направление — только одно). В блоке команд первый байт — это всегда код команды. Остальные байты — её аргументы. Правила заполнения аргументов описываются исключительно деталями реализации команды.

Сначала я вставил в статью массу примеров, но потом понял, что они затрудняют чтение. Поэтому всем желающим я предлагаю сравнить поля команды READ CAPACITY (10) из таблицы 119 Сигейтовского документа и поля команды READ(10) из таблицы 97 того же документа (ссылку см. выше). Кто не нашёл никакой связи — не пугайтесь. Именно это я и хотел показать. Кроме поля «команда» в нулевом байте, назначение всех полей зависит исключительно от специфики конкретной команды. Всегда надо открывать документ и изучать назначение остальных полей в нём.

Итак:

* Для общения с накопителем следует сформировать блок команды длиной от 6 до 16 байт (зависит от формата команды, точное число указывается в документации на неё).

* Самым важным является нулевой байт блока: именно он задаёт код команды.

* Остальные байты блока не имеют чёткого назначения. Чтобы понять, как их заполнять, следует открыть документацию на конкретную команду.

* К команде может быть прикреплён блок данных, которые передаются в накопитель или из накопителя.

Собственно, всё. Мы изучили правила подачи SCSI-команд. Теперь мы можем их подавать, была бы на них документация. Но как это сделать на уровне операционной системы?

Подача SCSI команд в ОС Linux

-----------------------------

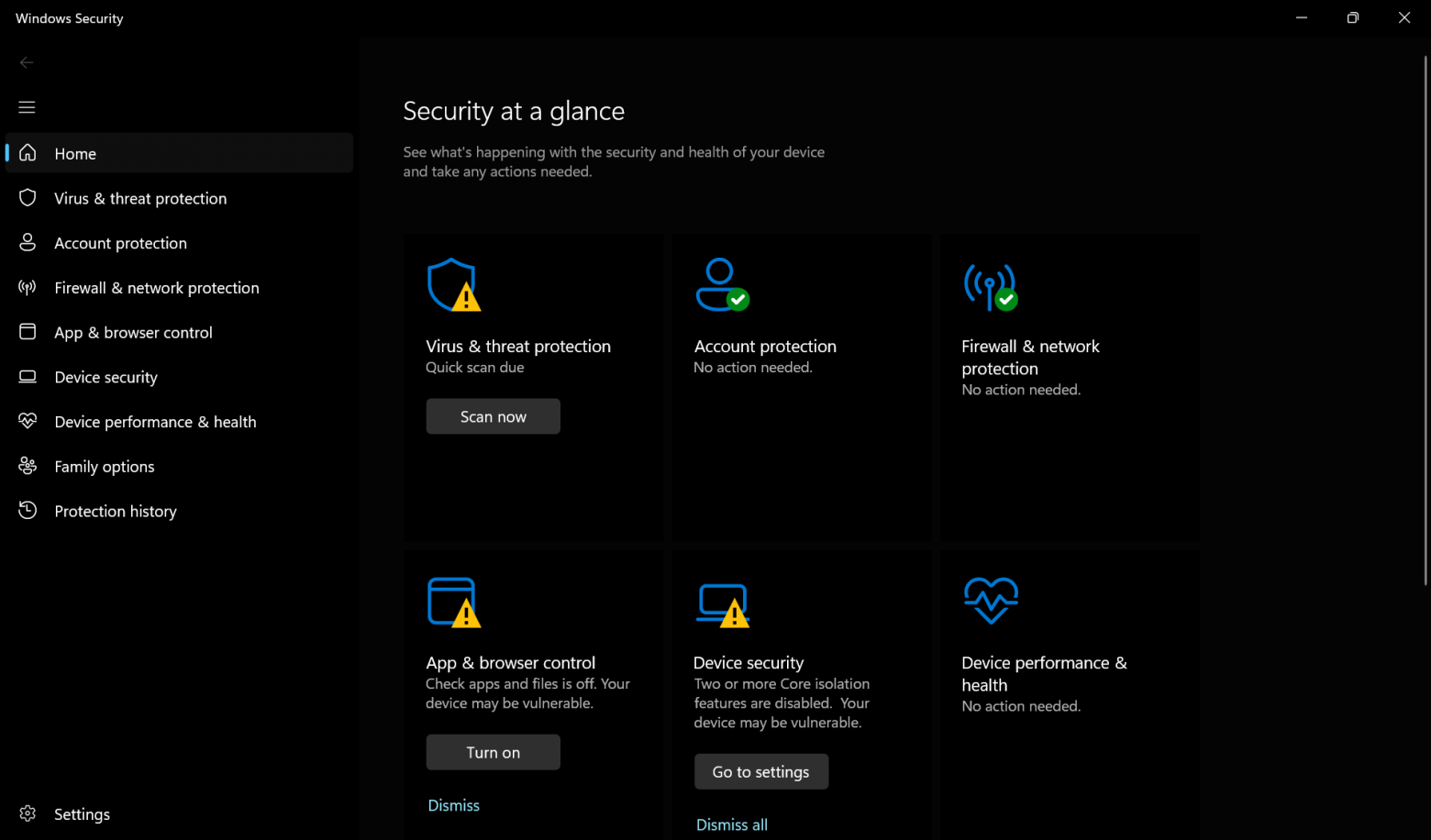

### Поиск целевого устройства

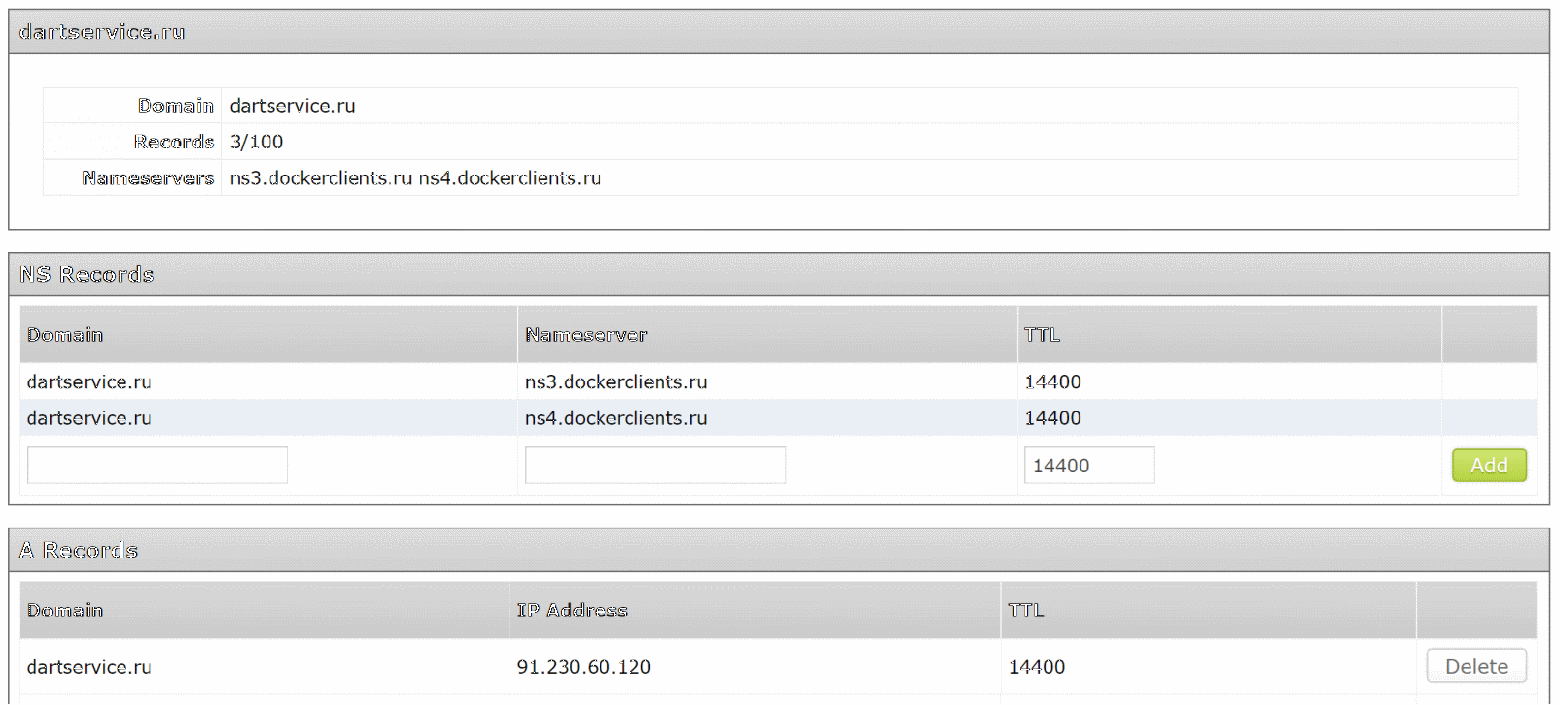

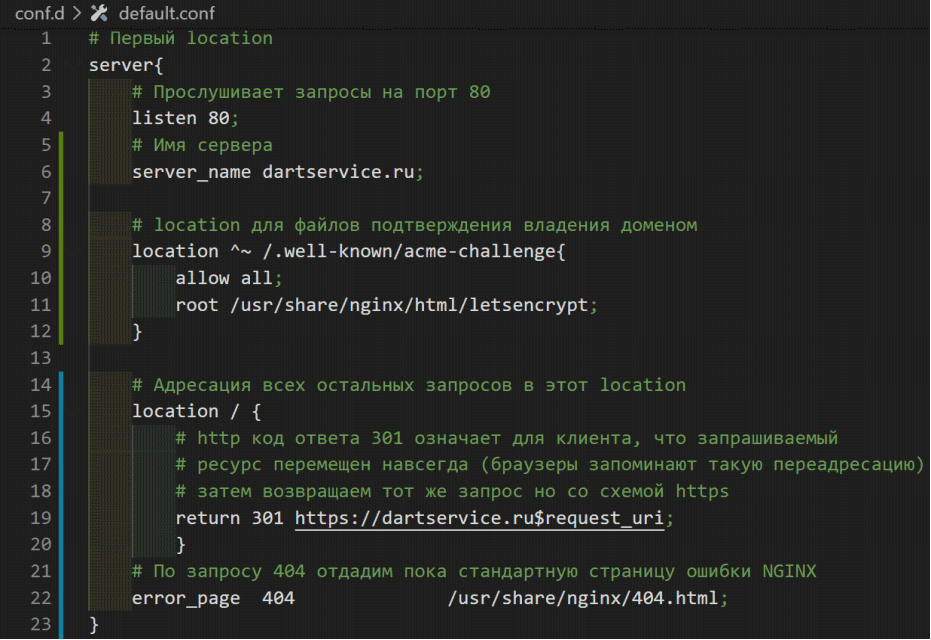

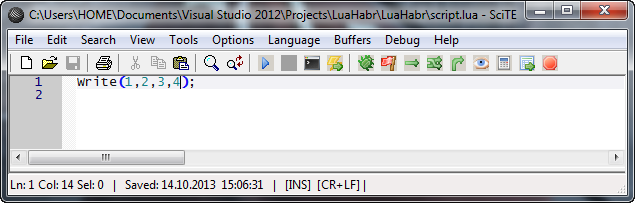

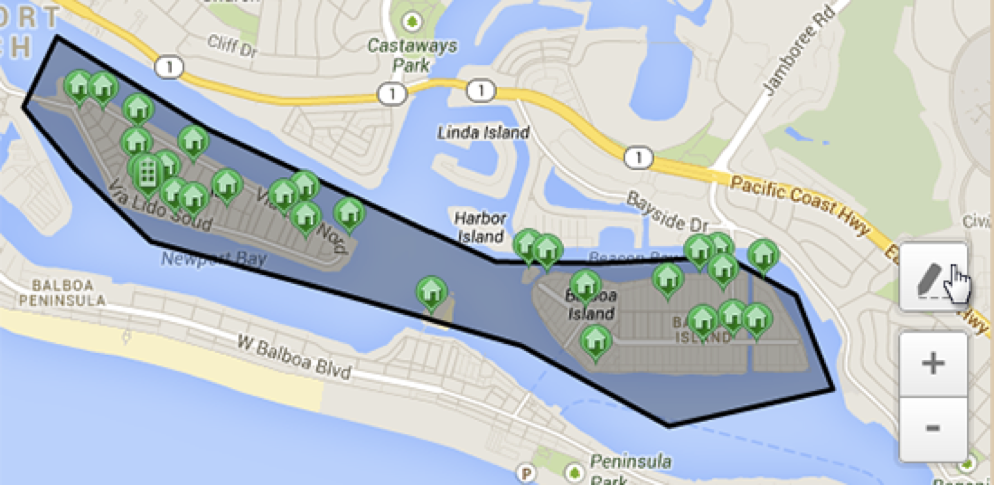

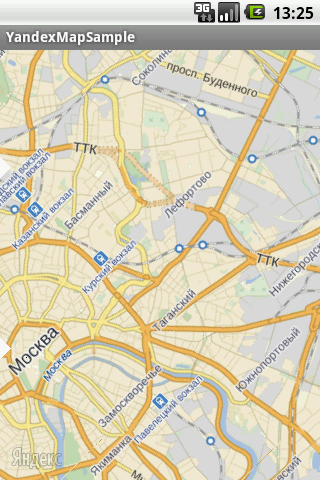

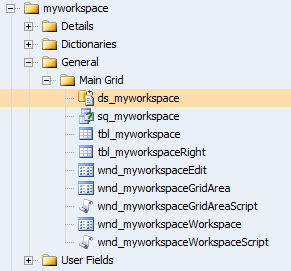

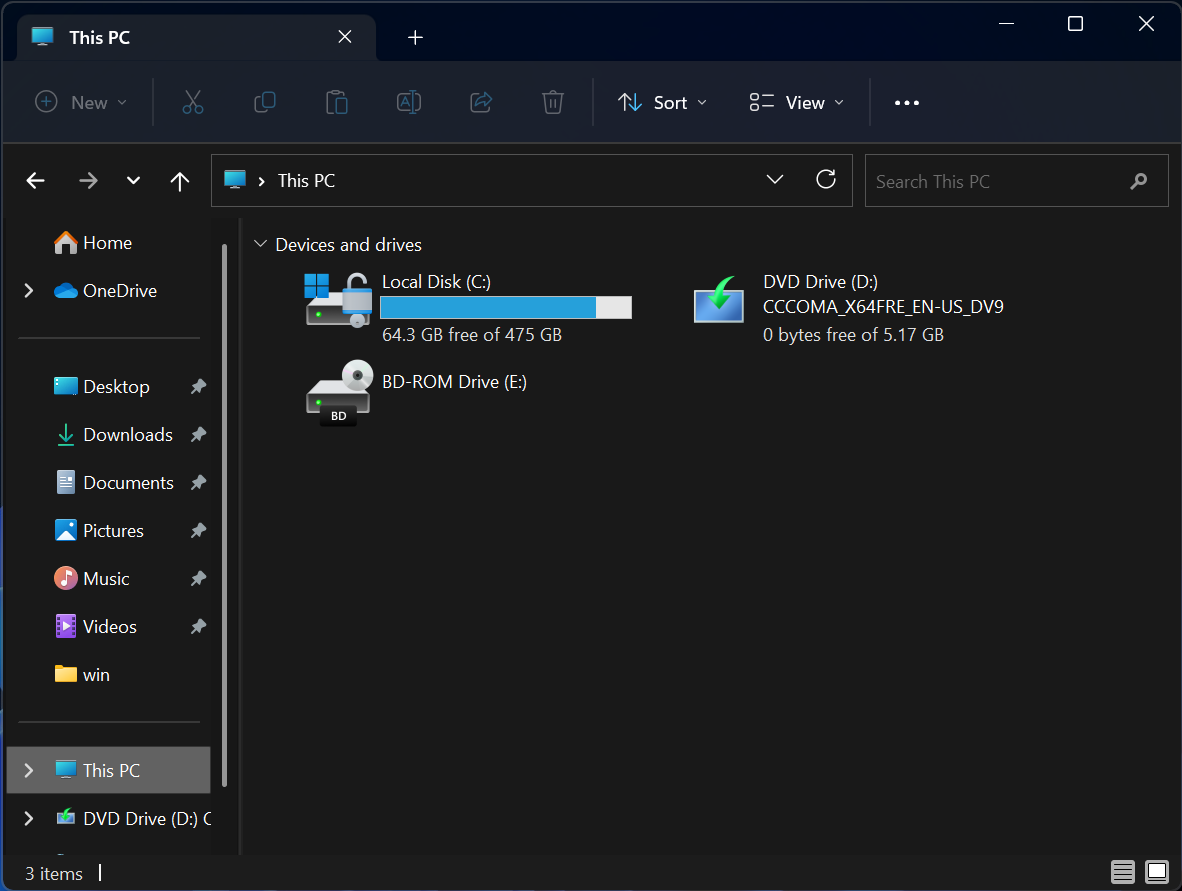

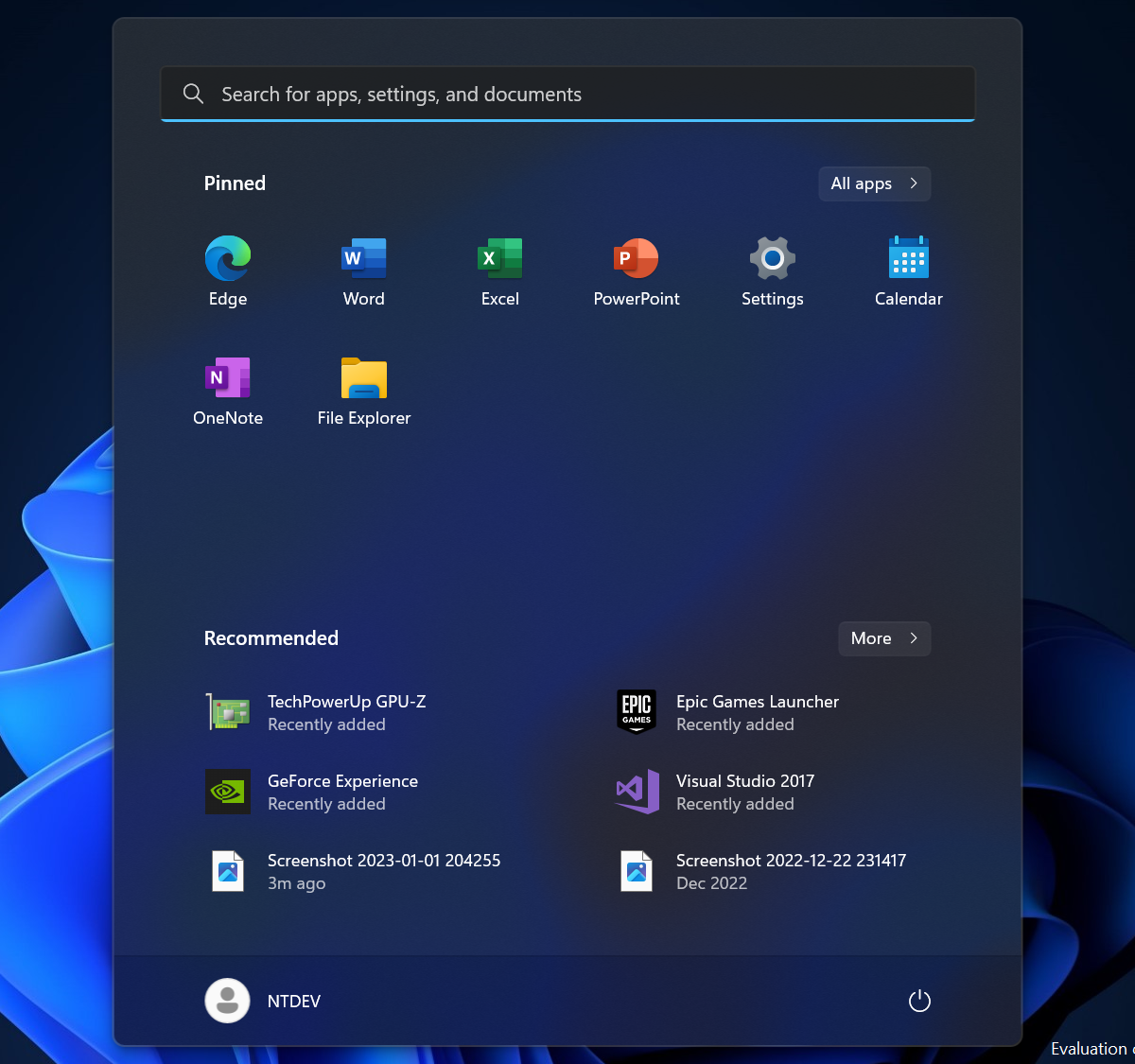

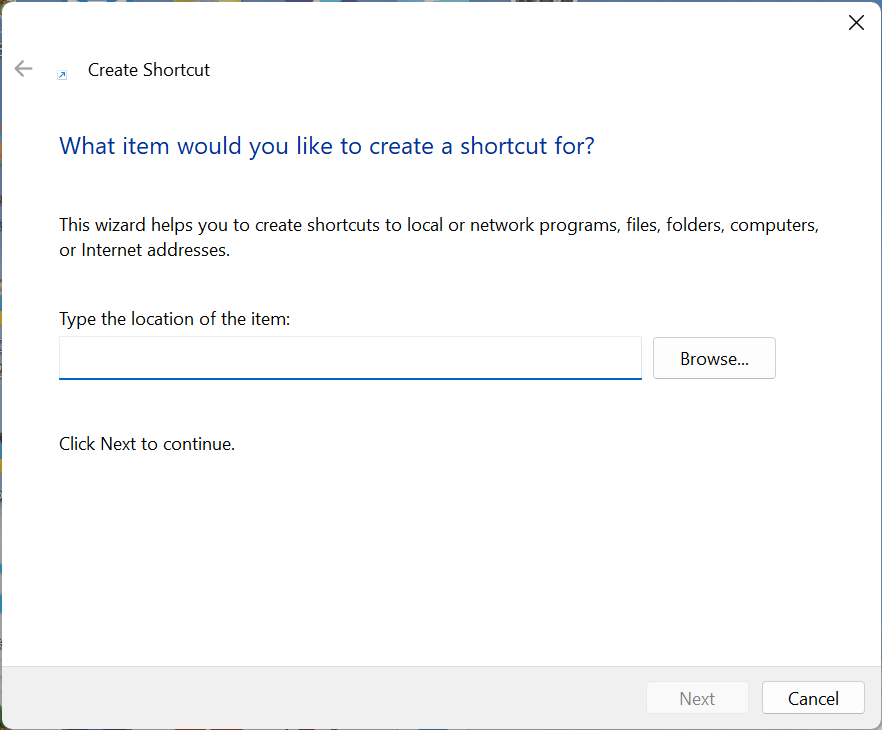

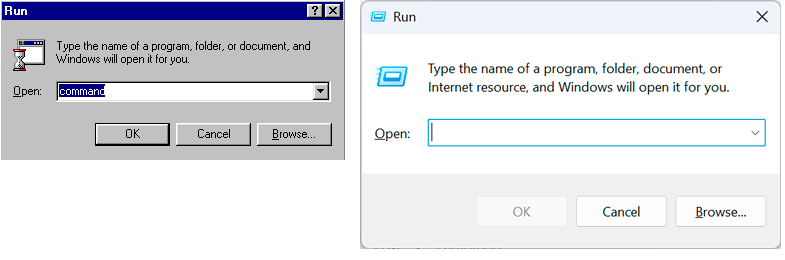

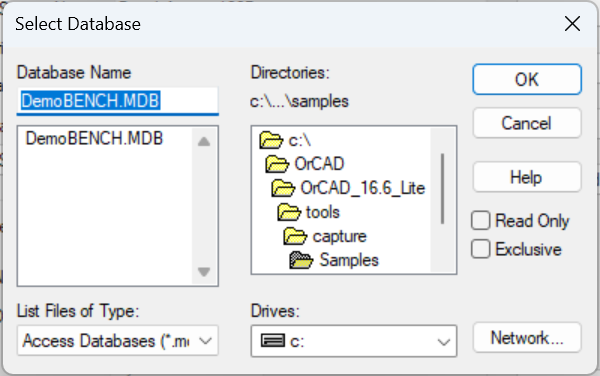

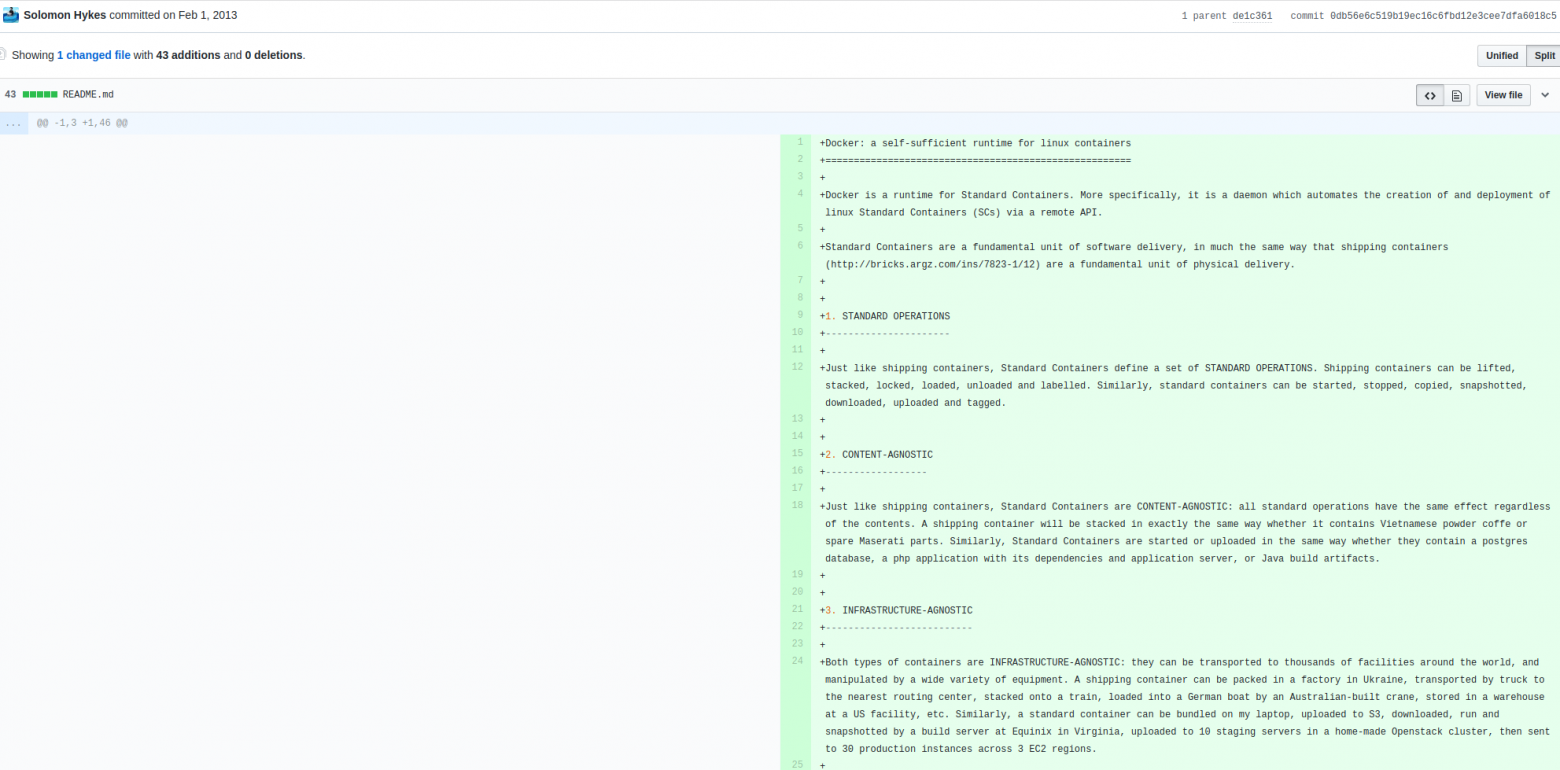

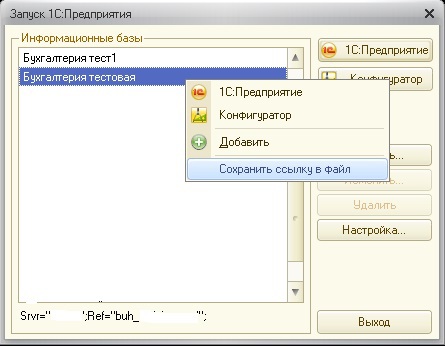

Для подачи команд следует открыть дисковое устройство. Давайте найдём его имя. Для этого мы пойдём абсолютно тем же путём, каким шли в [статье про последовательные порты](https://habr.com/ru/post/477662/). Посмотрим список «файлов» в каталоге **/dev** (помним, что в Linux устройства также показываются в виде файлов и их список отображается той же командой **ls**).

Сегодня обращаем внимание на виртуальный каталог **disk**:

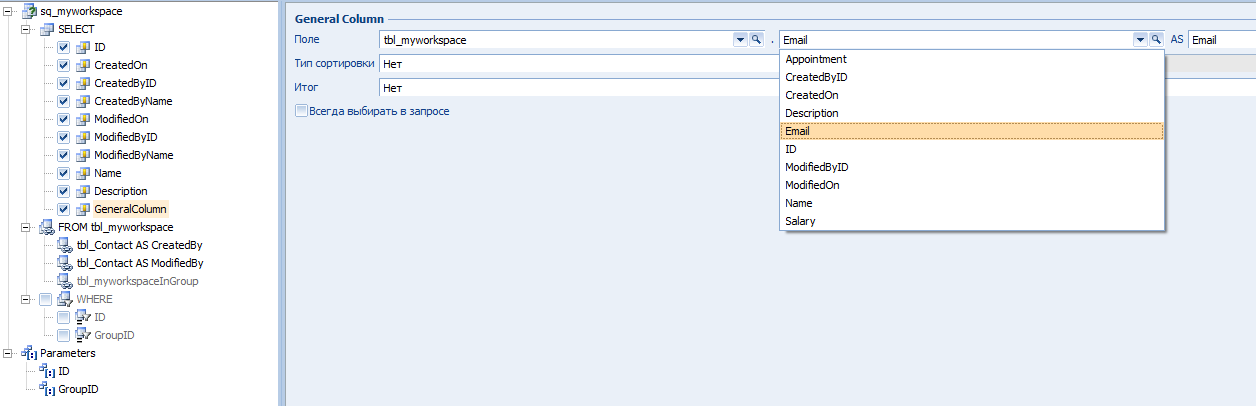

Смотрим его содержимое:

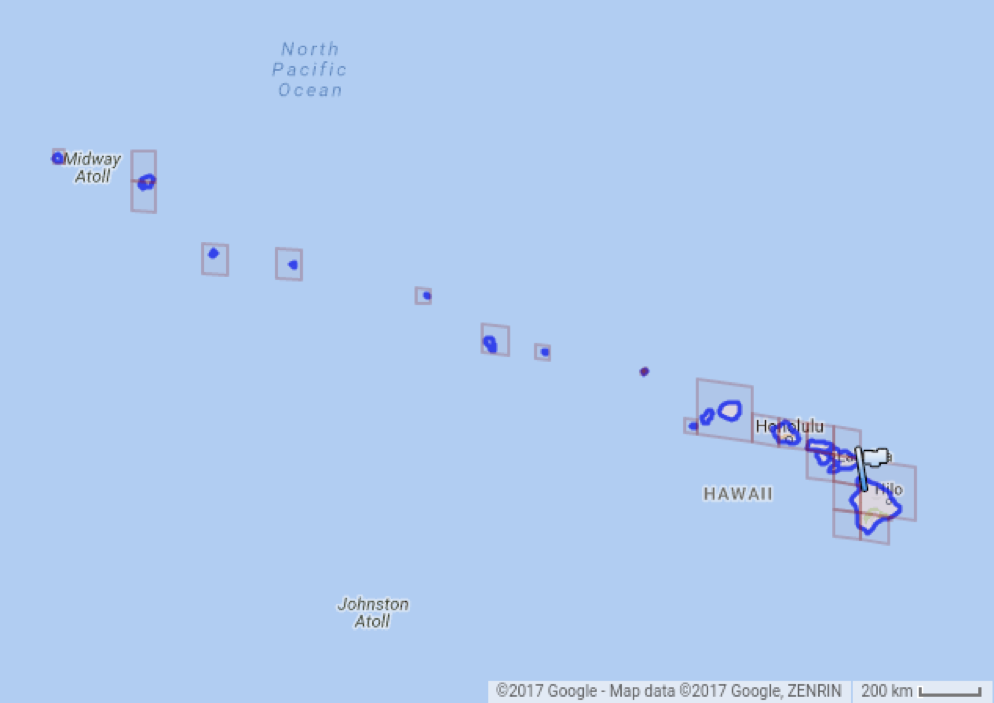

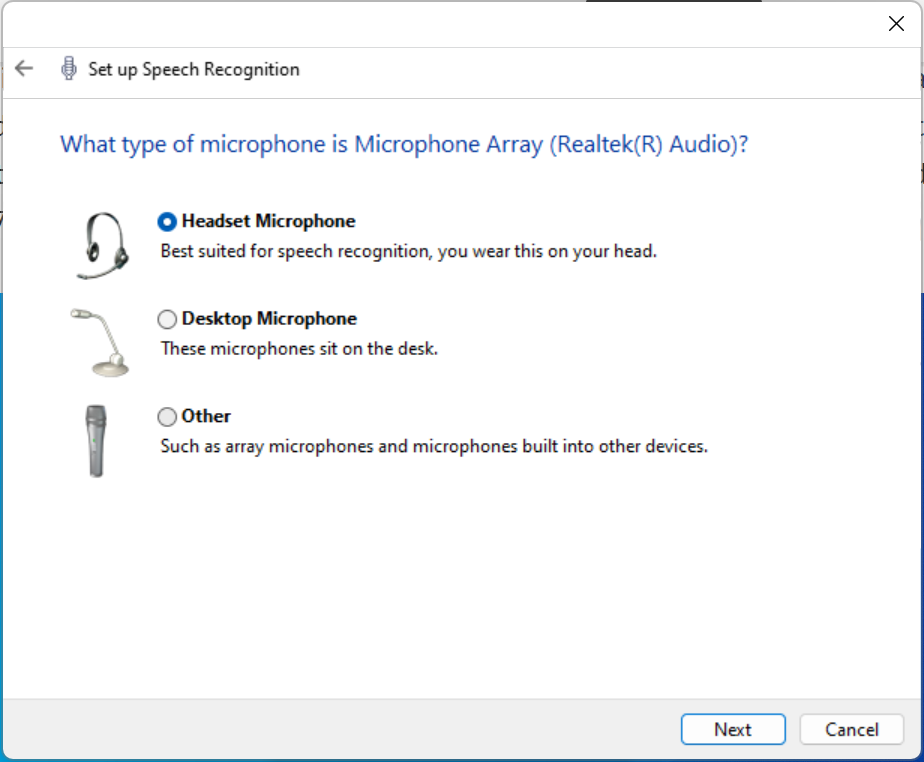

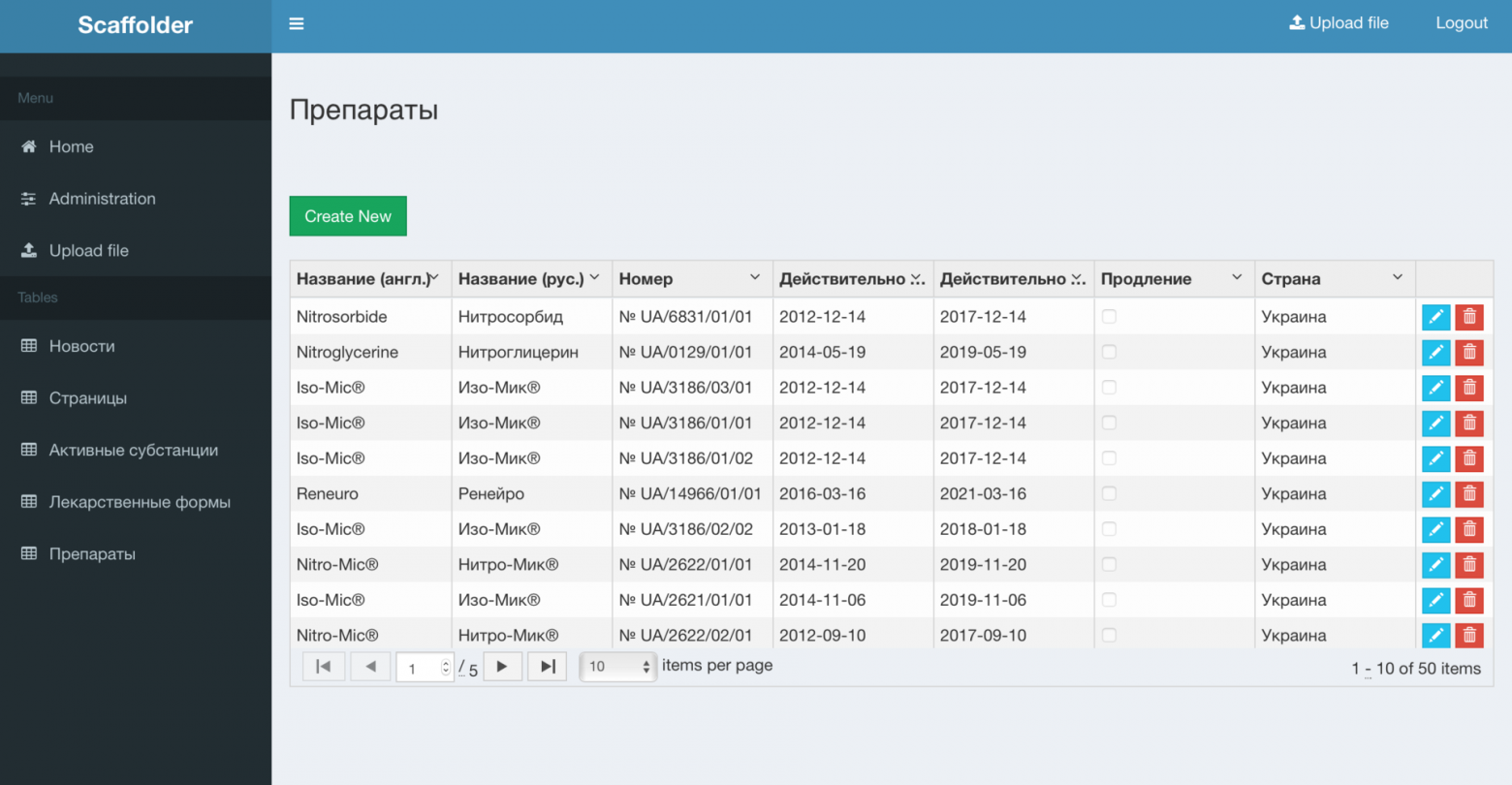

Знакомый набор вложенных каталогов! Пробуем рассмотреть каталог **by-id**, применив уже знакомый нам по статье про последовательные порты ключ **–l** команды **ls**:

Выделенные слова говорят сами за себя. Это накопитель, содержащий внутреннюю SDшку комплекса Redd. Отлично! Теперь мы знаем, что устройству **MIR\_Redd\_Internal\_SD** соответствует устройства **/dev/sdb и /dev/sdb1**. То, которое без цифры, — это сам накопитель, работать мы будем именно с ним, а с цифрой — это файловая система, размещённая на вставленном в него носителе. В терминах работы с SD-картой, **/dev/sdb** — это ридер, а **/dev/sdb1** — файловая система на вставленной в него карточке.

### Функция операционной системы для подачи команд

Обычно в любой ОС все нестандартные вещи с устройствами делаются через прямые запросы к драйверу. В Linux для посылки таких запросов имеется функция **ioctl()**. Не исключение и наш случай. В качестве аргумента передаём запрос **SG\_IO**, описанный в заголовочном файле **sg.h**. Там же описана и структура **sg\_io\_hdr\_t**, содержащая параметры запроса. Полностью структуру приводить я не стану, так как далеко не все её поля подлежат заполнению. Приведу только наиболее важные из них:

```

typedef struct sg_io_hdr

{

int interface_id; /* [i] 'S' for SCSI generic (required) */

int dxfer_direction; /* [i] data transfer direction */

unsigned char cmd_len; /* [i] SCSI command length ( <= 16 bytes) */

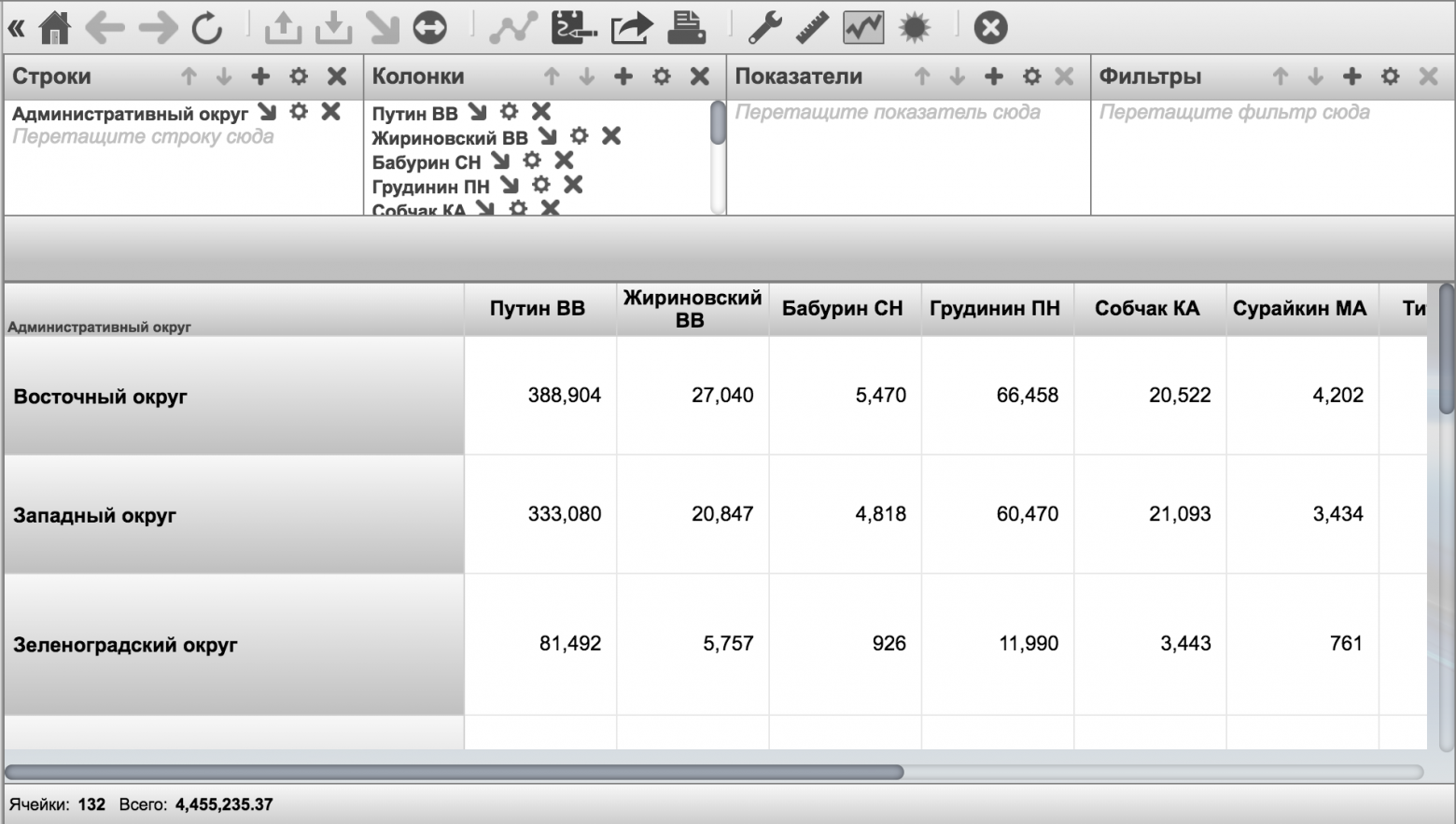

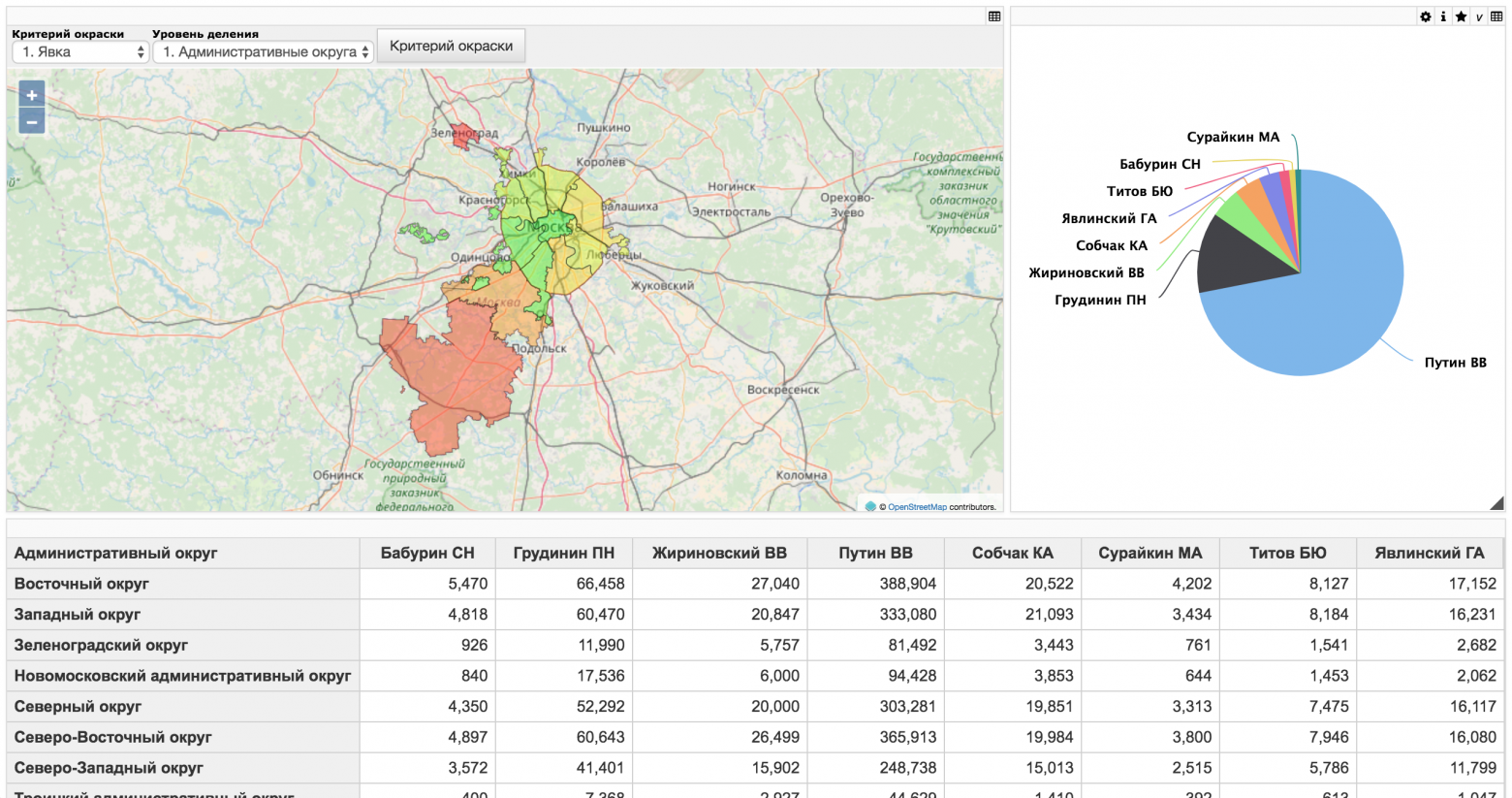

unsigned char mx_sb_len; /* [i] max length to write to sbp */

unsigned short int iovec_count; /* [i] 0 implies no scatter gather */

unsigned int dxfer_len; /* [i] byte count of data transfer */

void * dxferp; /* [i], [*io] points to data transfer memory

or scatter gather list */

unsigned char * cmdp; /* [i], [*i] points to command to perform */

unsigned char * sbp; /* [i], [*o] points to sense_buffer memory */

unsigned int timeout; /* [i] MAX_UINT->no timeout (unit: millisec) */

```

Описывать те поля, которые хорошо документированы в комментариях (**interface\_id, dxfer\_direction, timeout**) нет смысла. Статья и так разрастается.

Поле **cmd\_len** содержит число байтов в блоке команды, а **cmdp** — указатель на этот блок. Без команды обойтись нельзя, поэтому число байтов должна быть не нулевым (от 6 до 16).

Данные же опциональны. Если они есть, то длина выделенного буфера задаётся в поле **dxfer\_len**, а указатель на него — в поле **dxferp**. Накопитель может физически передать меньше данных, чем указан размер буфера. Направление передачи задаётся в поле **dxfer\_direction**. Допустимые для USB Mass Storage Device значения: **SG\_DXFER\_NONE, SG\_DXFER\_TO\_DEV, SG\_DXFER\_FROM\_DEV**. В заголовочном файле есть ещё одно, но стандарт Mass Storage Device не позволяет реализовать это физически.

Также можно запросить возврат расширенного кода ошибки (**SENSE**). Что это такое, можно прочитать в Сигейтовском документе, раздел 2.4. Длина выделенного буфера указывается в поле **mx\_sb\_len**, а указатель на сам буфер — в поле **sbp**.

Как видим, в этой структуре заполняется всё то, о чём я говорил выше (плюс даётся возможность получить расширенные сведения об ошибке). Подробнее про работу с запросом **SG\_IO** можно прочитать здесь: [sg.danny.cz/sg/sg\_io.html](http://sg.danny.cz/sg/sg_io.html)

### Посылаем стандартную команду в накопитель

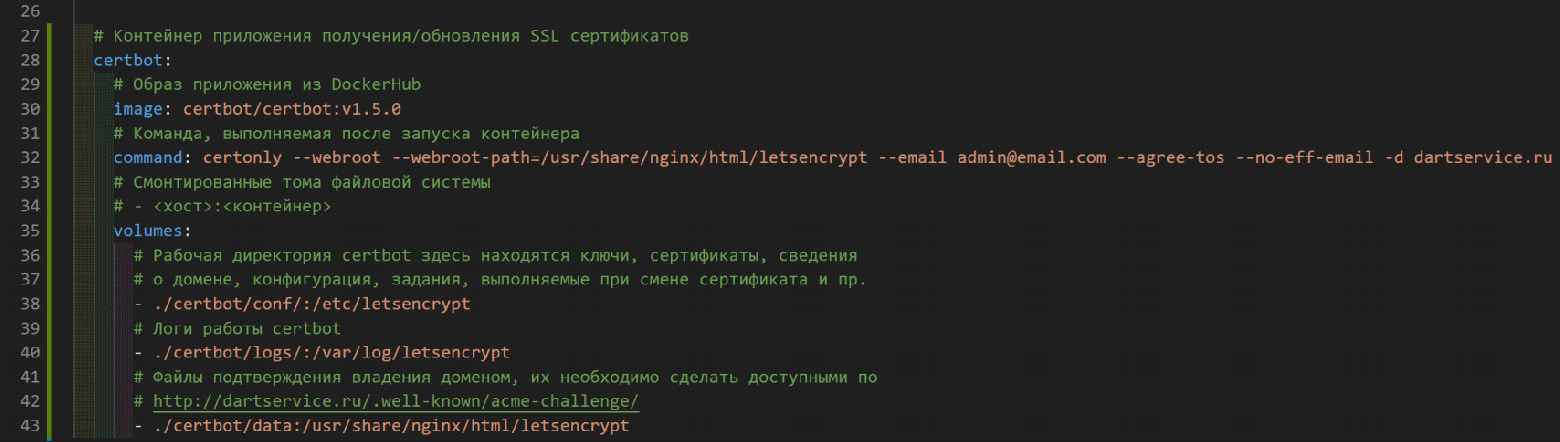

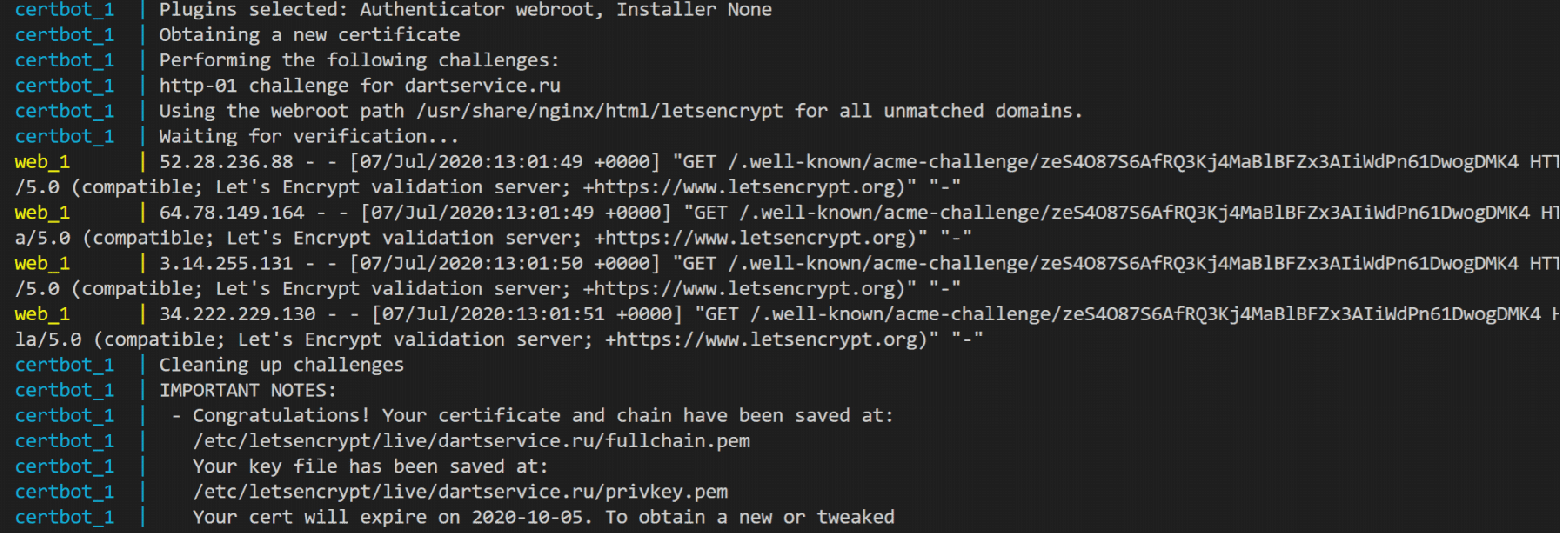

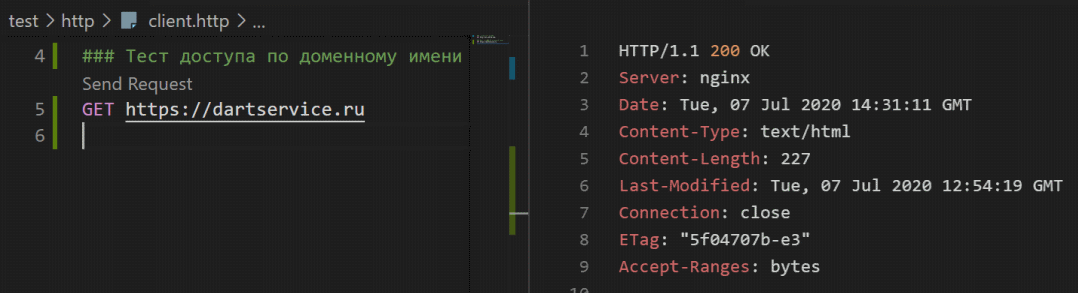

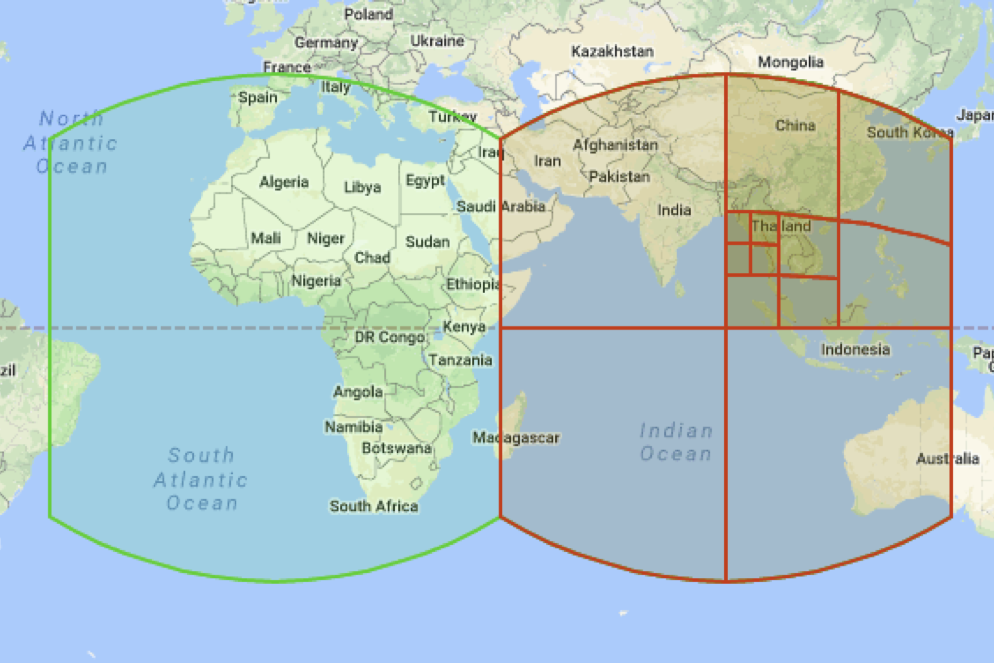

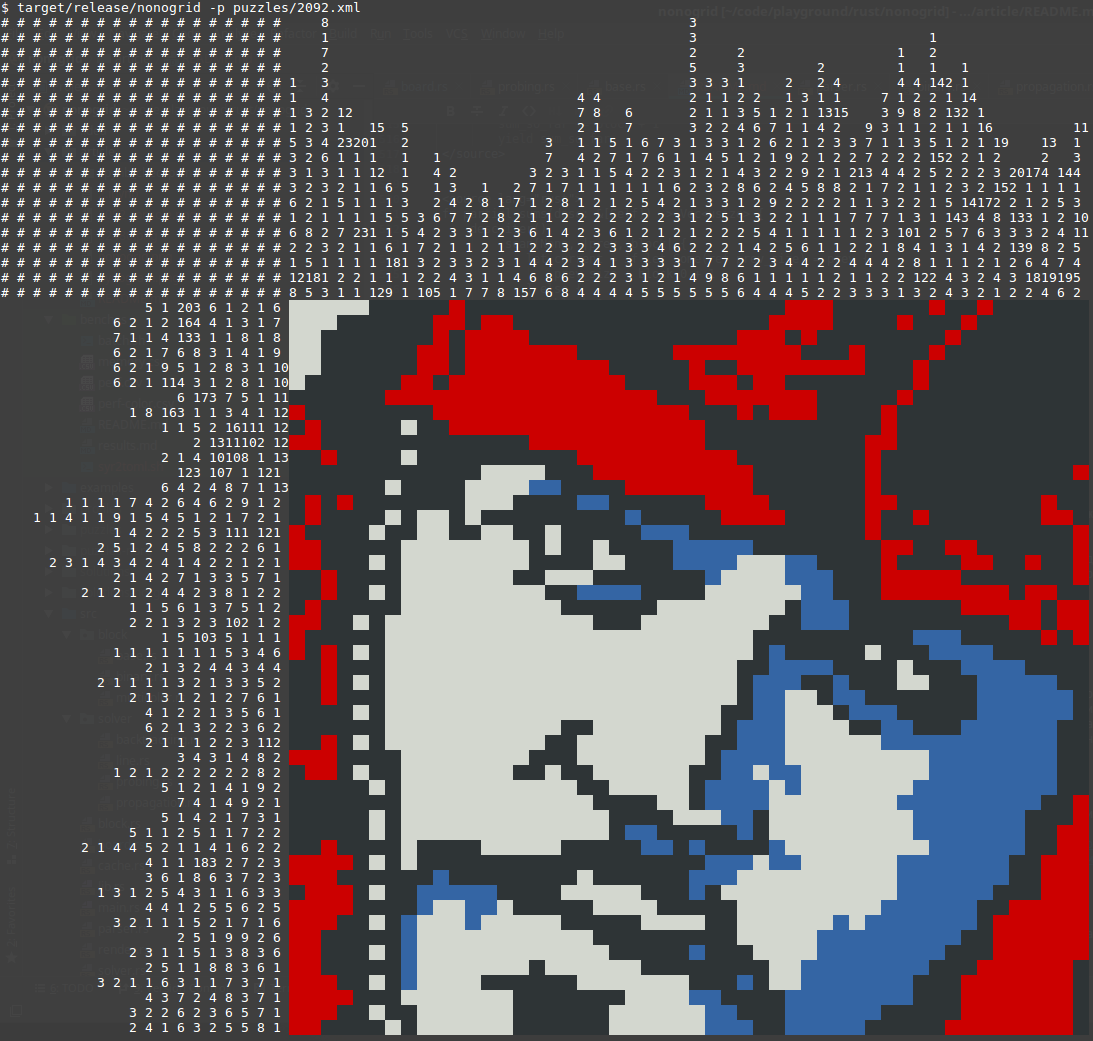

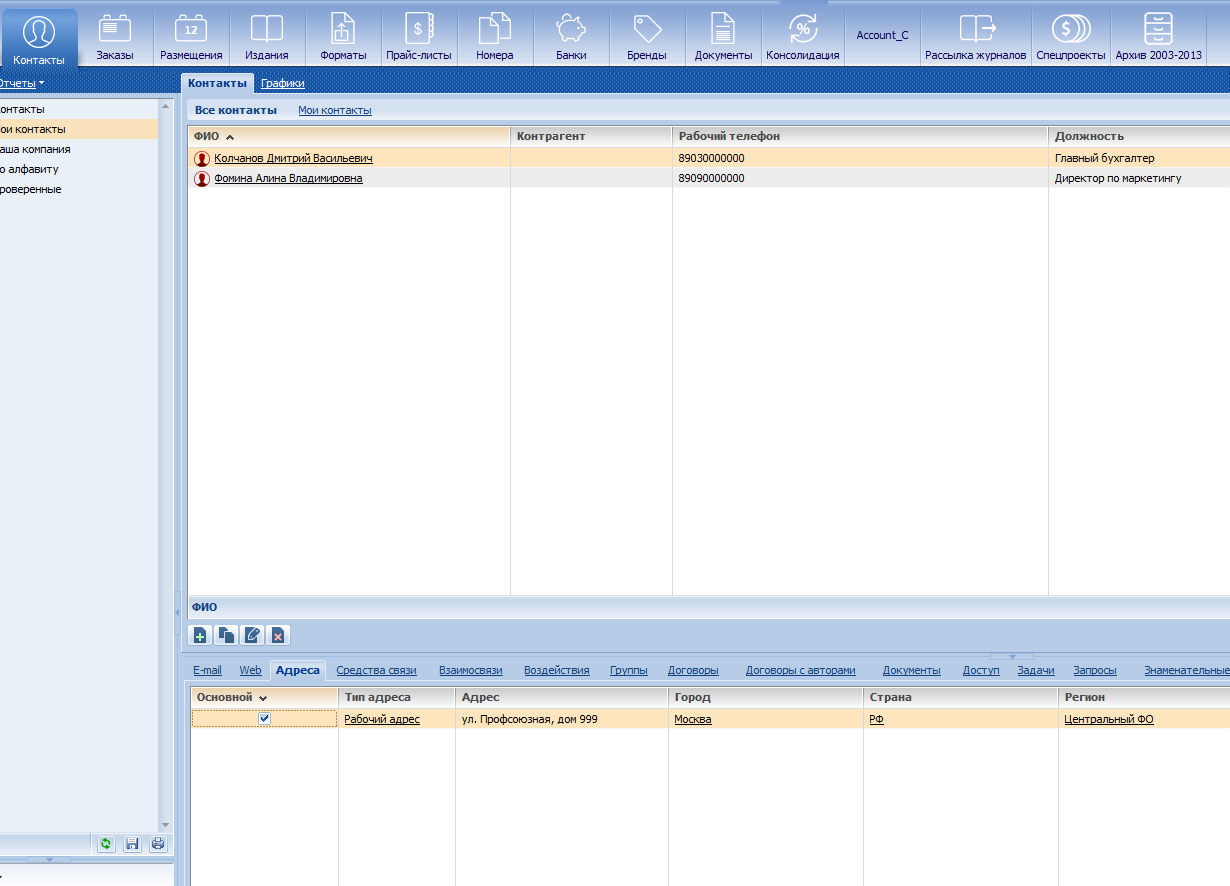

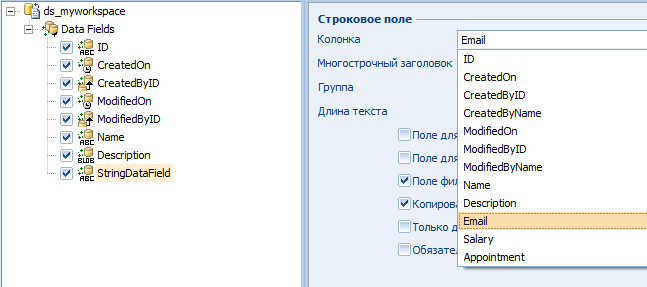

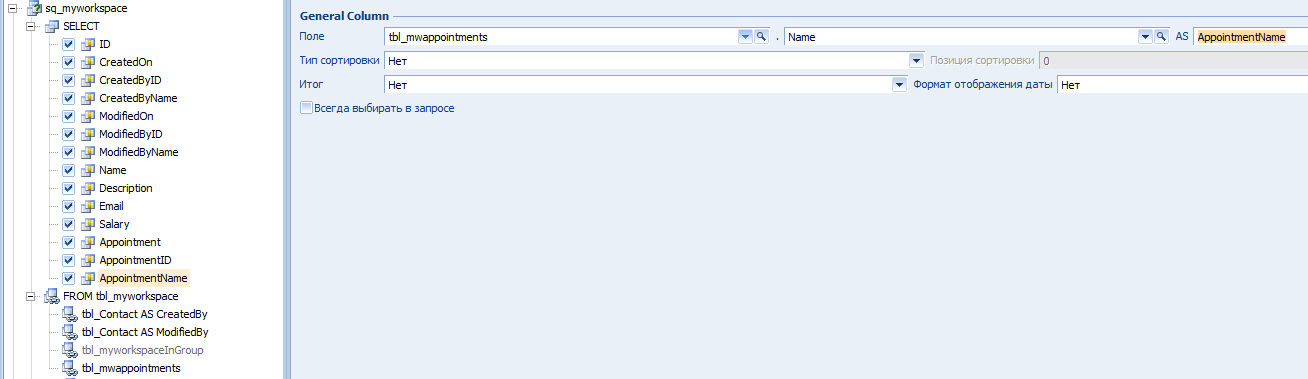

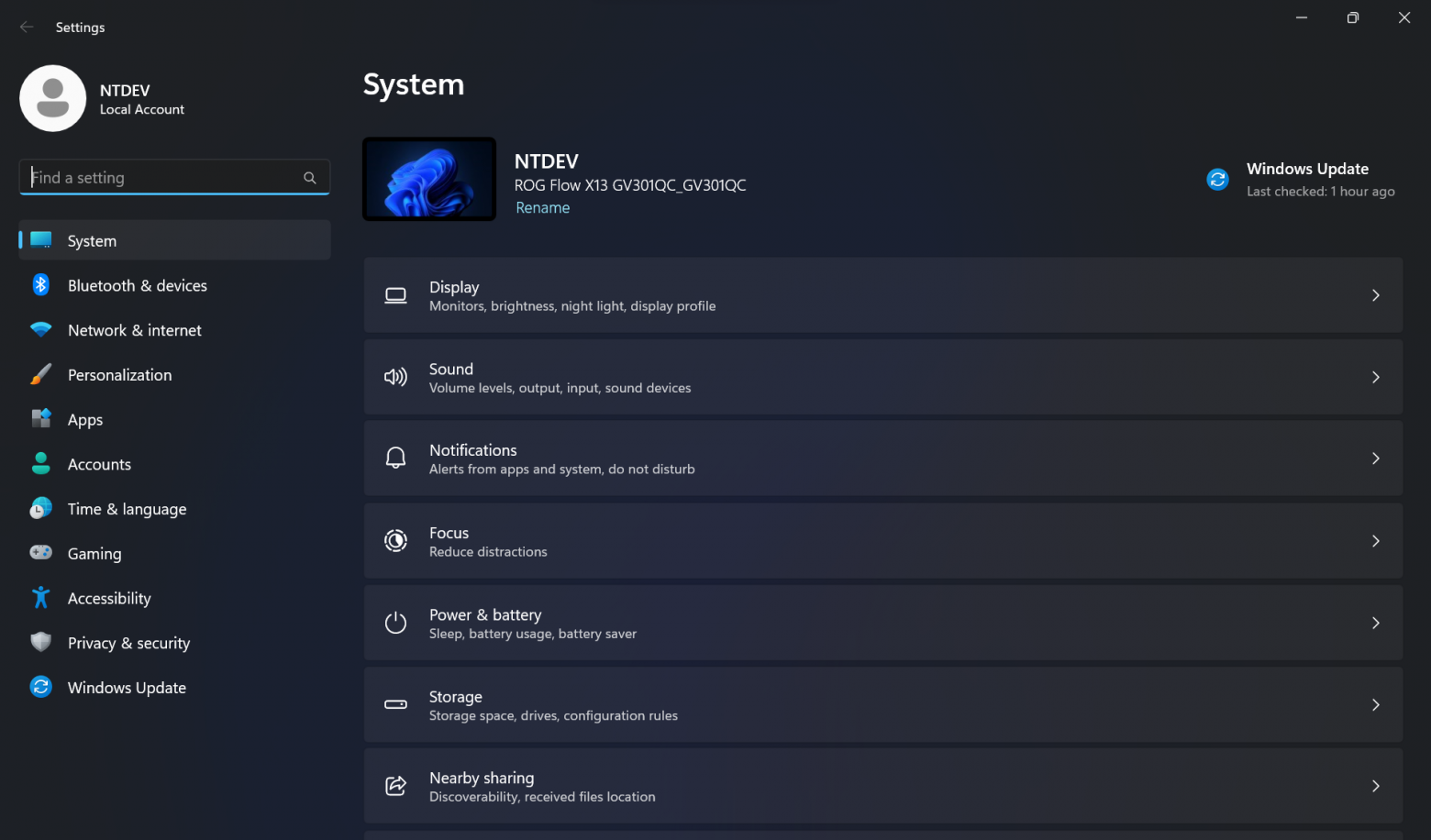

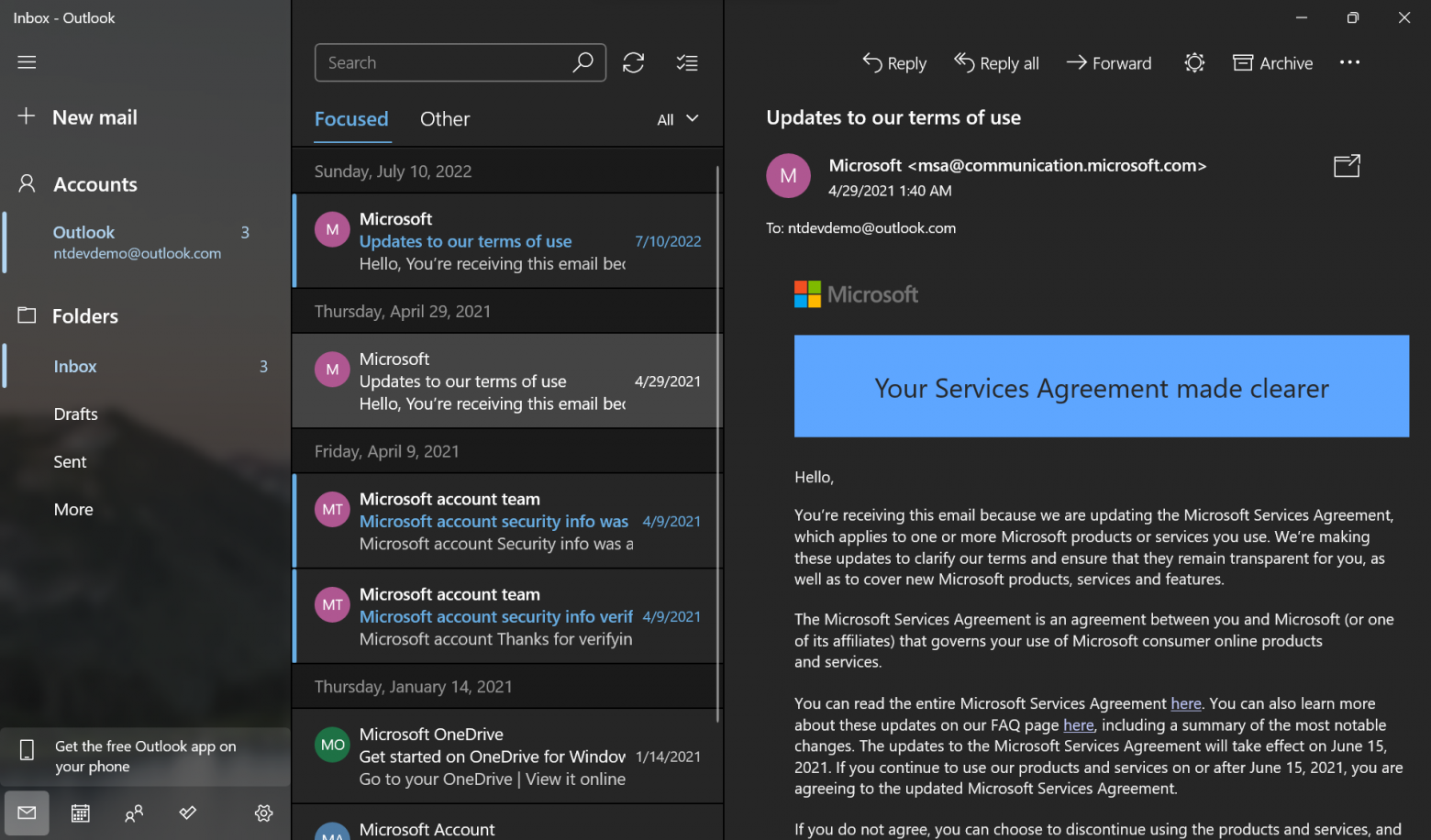

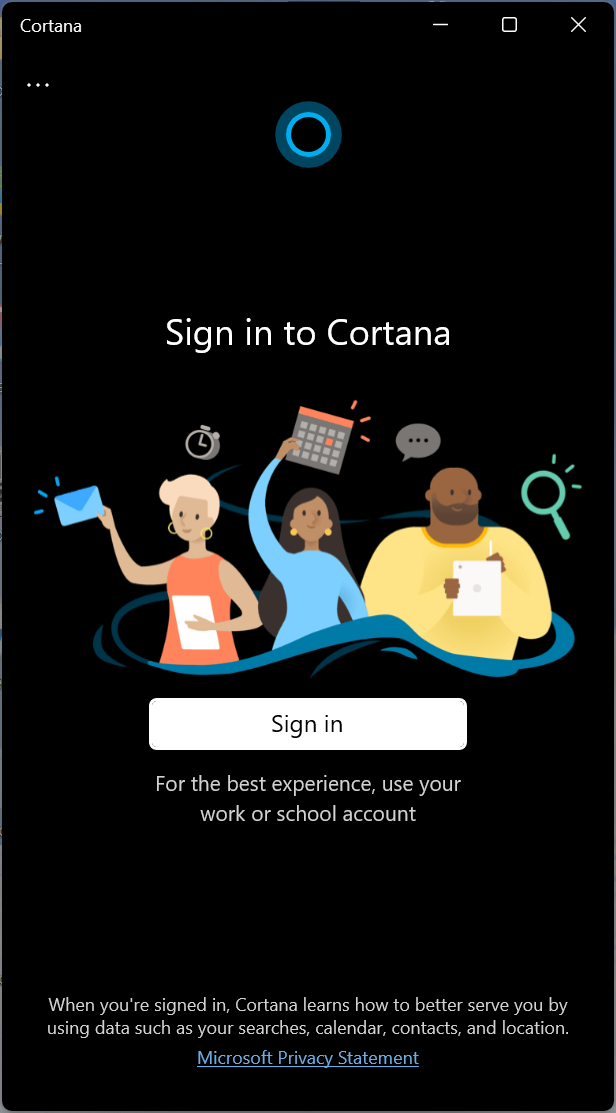

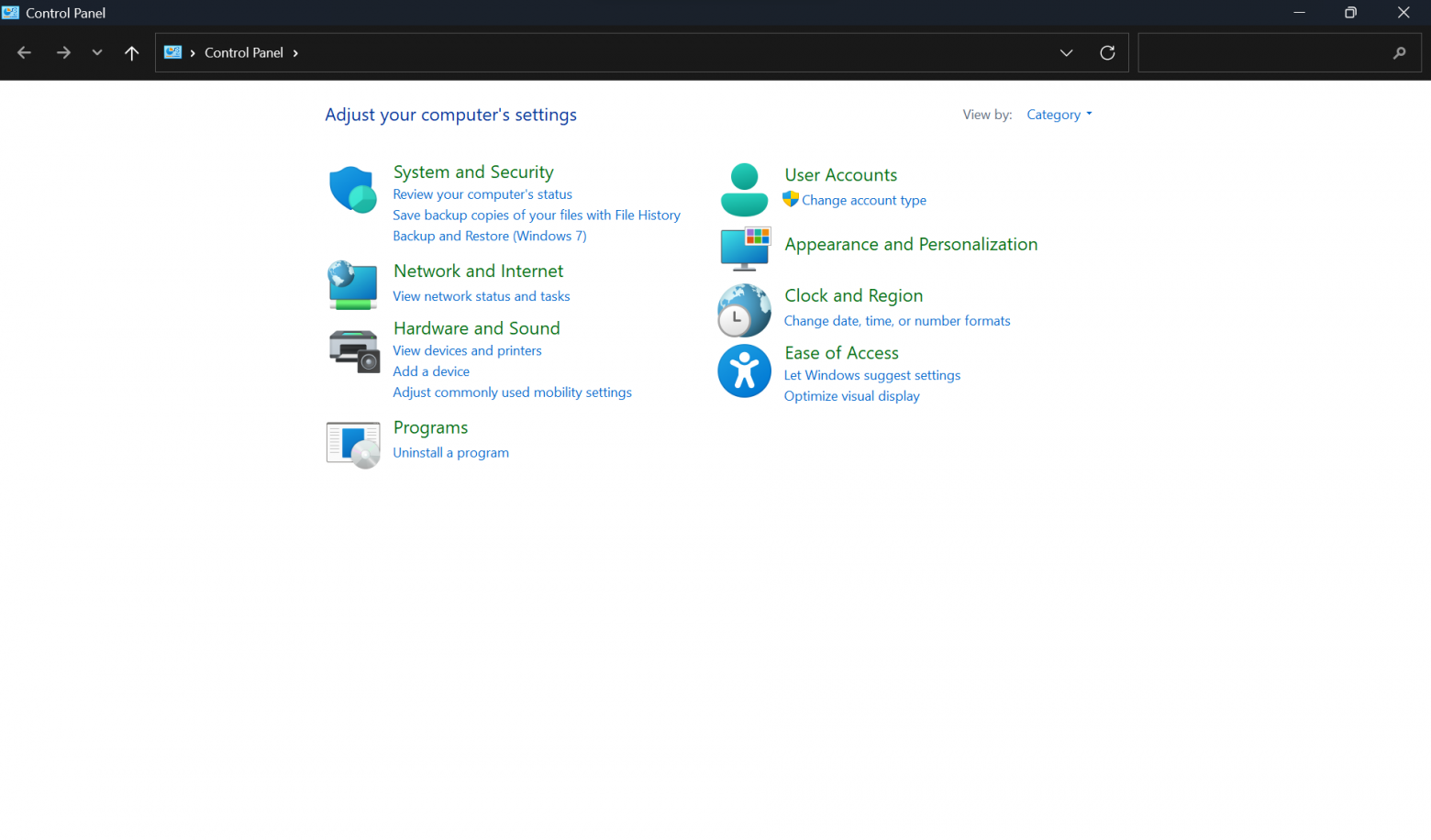

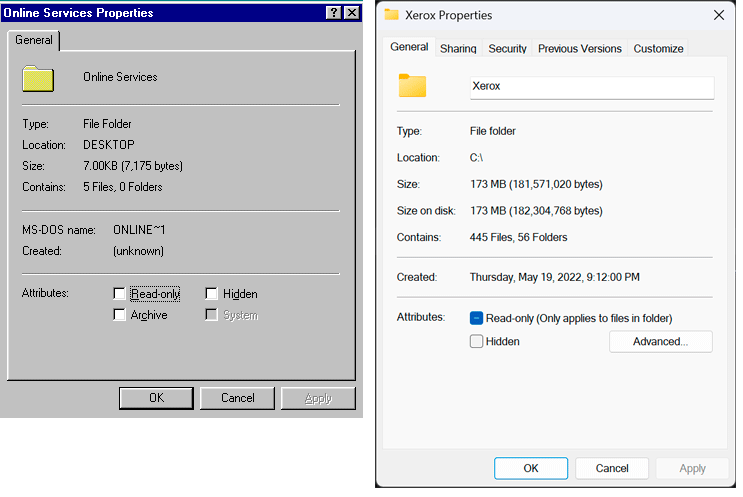

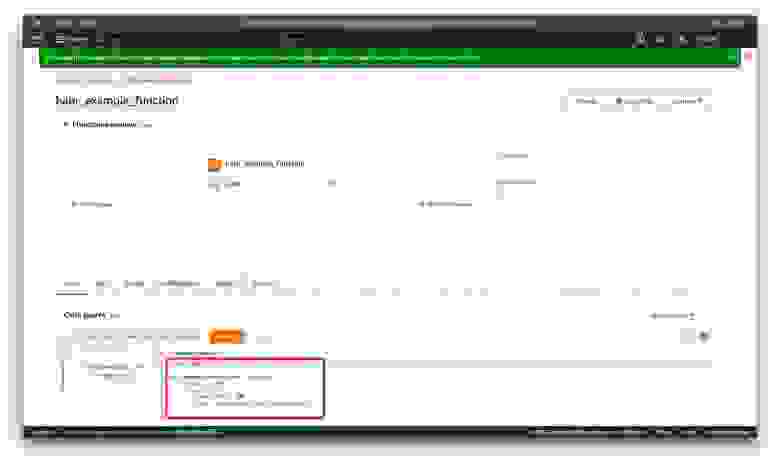

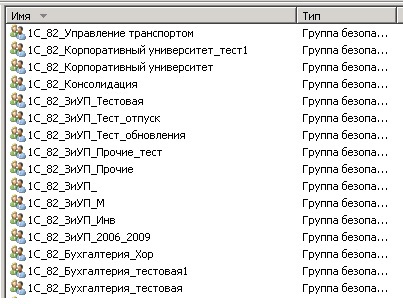

Ну что ж, мы выяснили формат команды, мы выяснили, в какое устройство её посылать, мы выяснили, какую функцию для этого вызывать. Давайте попробуем послать какую-нибудь стандартную команду в наше устройство. Пусть это будет команда получения имени накопителя. Вот так она описана в Сигейтовском документе:

Обратите внимание, что согласно SCSI-идеологии, все поля в стандартных командах заполняются в нотации Big Endian, то есть, старшим байтом вперёд. Поэтому поле с длиной буфера мы заполняем не в формате «0x80, 0x00», а наоборот – «0x00, 0x80». Но это – в стандартных командах. В нестандартных возможно всё, всегда надо сверяться с описанием. Собственно, только код команды (**12h**) и длину мы и должны заполнить. Страницу мы будем запрашивать нулевую, а остальные поля или зарезервированы, или устарели, или по умолчанию нулевые. Так что все их заполняем нулями.

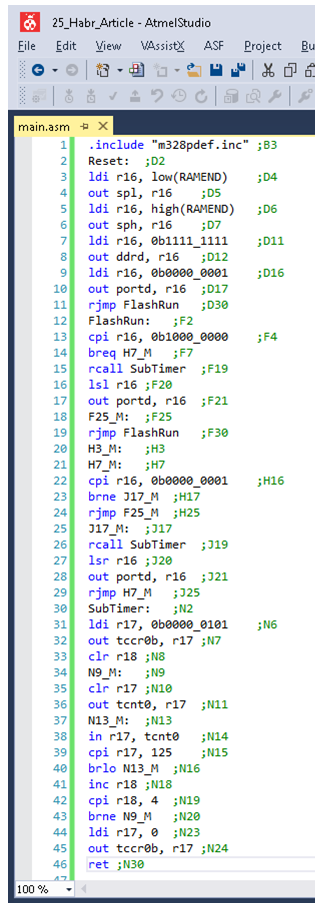

**Делаем программку, которая подаёт эту команду:**

```

#include

#include

#include

#include // open

#include // close

#include

#include

#include

int main()

{

printf("hello from SdAccessTest!\n");

int s\_fd = open("/dev/sdb", O\_NONBLOCK | O\_RDWR);

if (s\_fd < 0)

{

printf("Cannot open file\n");

return -1;

}

sg\_io\_hdr\_t header;

memset(&header, 0, sizeof(header));

uint8\_t cmd12h[] = { 0x12,0x00,0x00,0x00,0x80,0x00};

uint8\_t data[0x80];

uint8\_t sense[0x80];

header.interface\_id = 'S'; // Обязательно 'S'

// Команда

header.cmd\_len = sizeof(cmd12h);

header.cmdp = cmd12h;

// Данные

header.dxfer\_len = sizeof(data);

header.dxferp = data;

header.dxfer\_direction = SG\_DXFER\_TO\_FROM\_DEV;

// Технологическая информация о результате

header.mx\_sb\_len = sizeof(sense);

header.sbp = sense;

//Таймаут

header.timeout = 100; // 100 мс

int res = ioctl(s\_fd, SG\_IO, &header);

close(s\_fd);

return 0;

}

```

Как такие программы запускать на удалённом устройства Redd, мы уже рассматривали в одной из [предыдущих статей](https://habr.com/ru/post/456008/). Правда, запустив её первый раз, я сразу получил ошибку вызова функции **open()**. Оказалось, что у пользователя по умолчанию не хватает прав для открытия дисковых устройств. Какой из меня специалист по Линуксу, я много раз писал, но в сети мне удалось найти, что для решения этой беды можно изменить права доступа к устройству, подав команду:

**sudo chmod 666 /dev/sdb**

Однако мой начальник (а вот он — большой специалист по этой ОС) позже отметил, что решение действует до перезагрузки операционной системы. Чтобы получить права наверняка, надо добавить пользователя в группу **disk**.

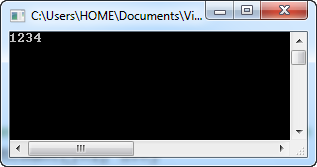

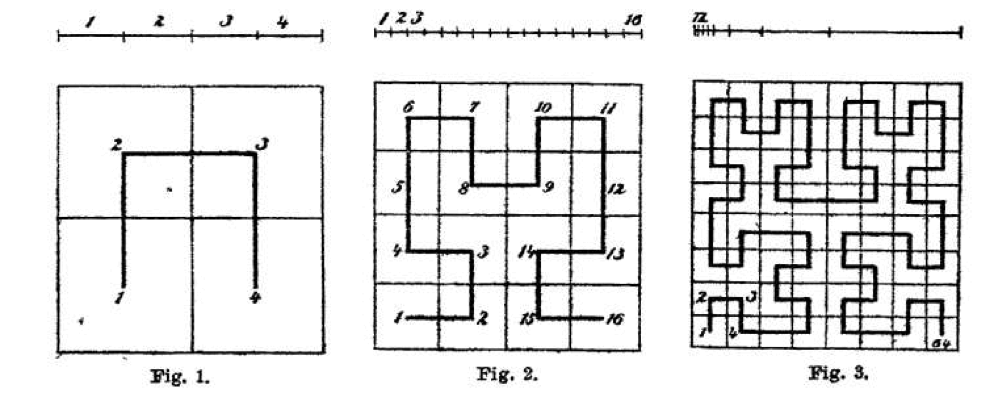

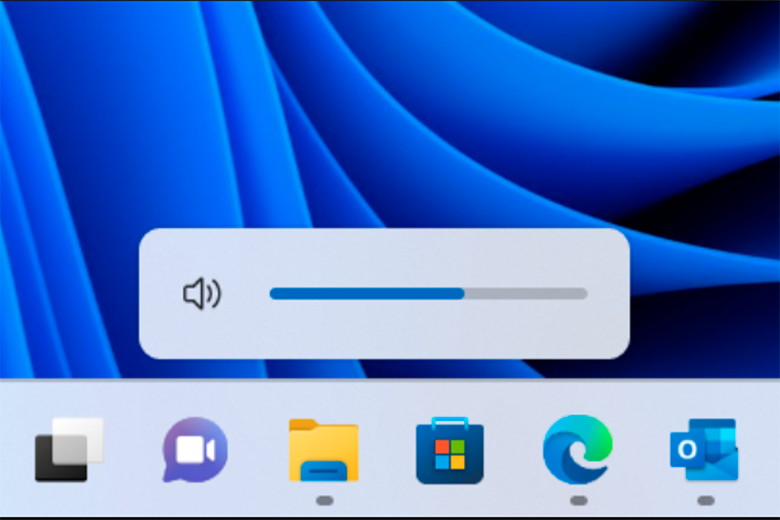

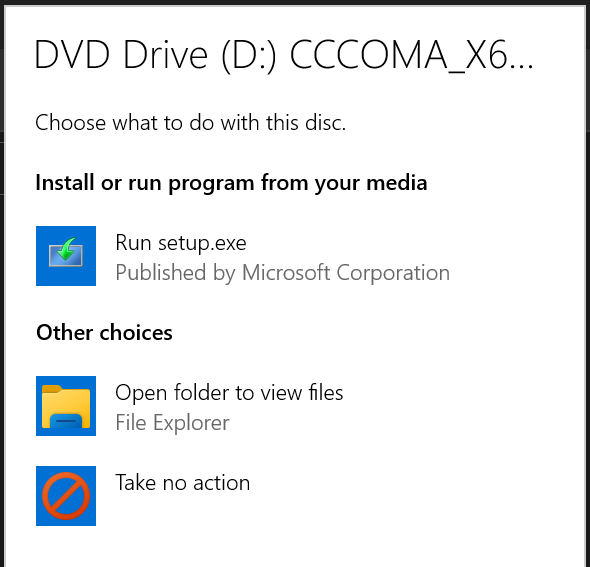

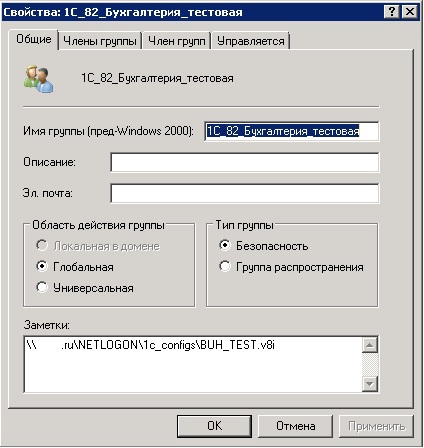

Каким бы из этих двух путей мы ни пошли, но после того, как всё заработало, ставим точку останова на строку **close(s\_fd);** и осматриваем результаты к моменту её достижения в среде разработки (так как программа — даже не однодневка, а значит — некогда нам тратить силы и время на вставку отображалок, если нам всё может показать среда разработки). Значение переменной **res** равно нулю. Значит, команда отработала без ошибок.

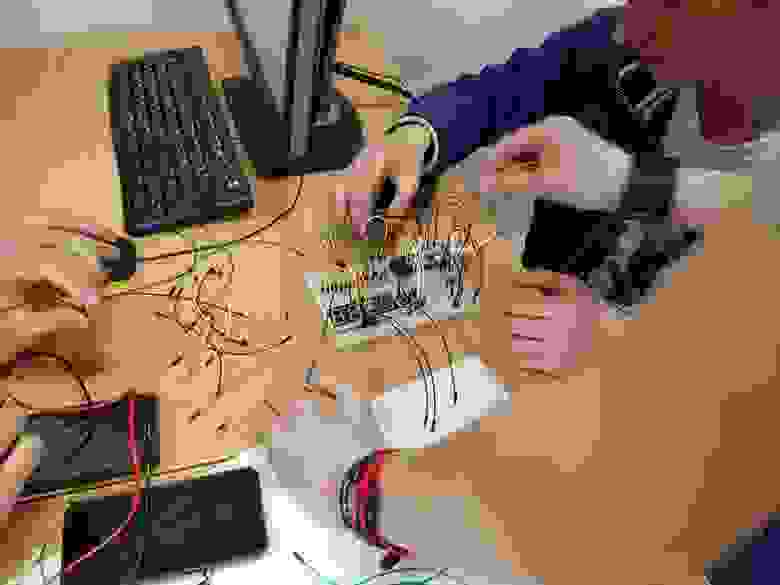

Что пришло в буфер? Когда я ввёл в адрес для дампа слово **data**, мне сказали, что не могут вычислить значение, пришлось вводить **&data**. Странно, ведь **data** – это указатель, при отладке под Windows всё работает, но просто отмечаю этот факт, работает так: смотрим на результат, полученный так:

Всё верно, нам вернули имя и ревизию накопителя. Подробнее с форматом полученной структуры можно ознакомиться в Сигейтовском документе (раздел 3.6.2, таблица 59). Буфер **sense** не заполнился, но и описание IOCTL запроса говорит, что он заполняется, только когда возникла ошибка, возвращающая что-то в этом буфере. Дословно: **Sense data (only used when 'status' is CHECK CONDITION or (driver\_status & DRIVER\_SENSE) is true)**.

Формат нестандартной команды для накопителя Redd Internal SD

------------------------------------------------------------

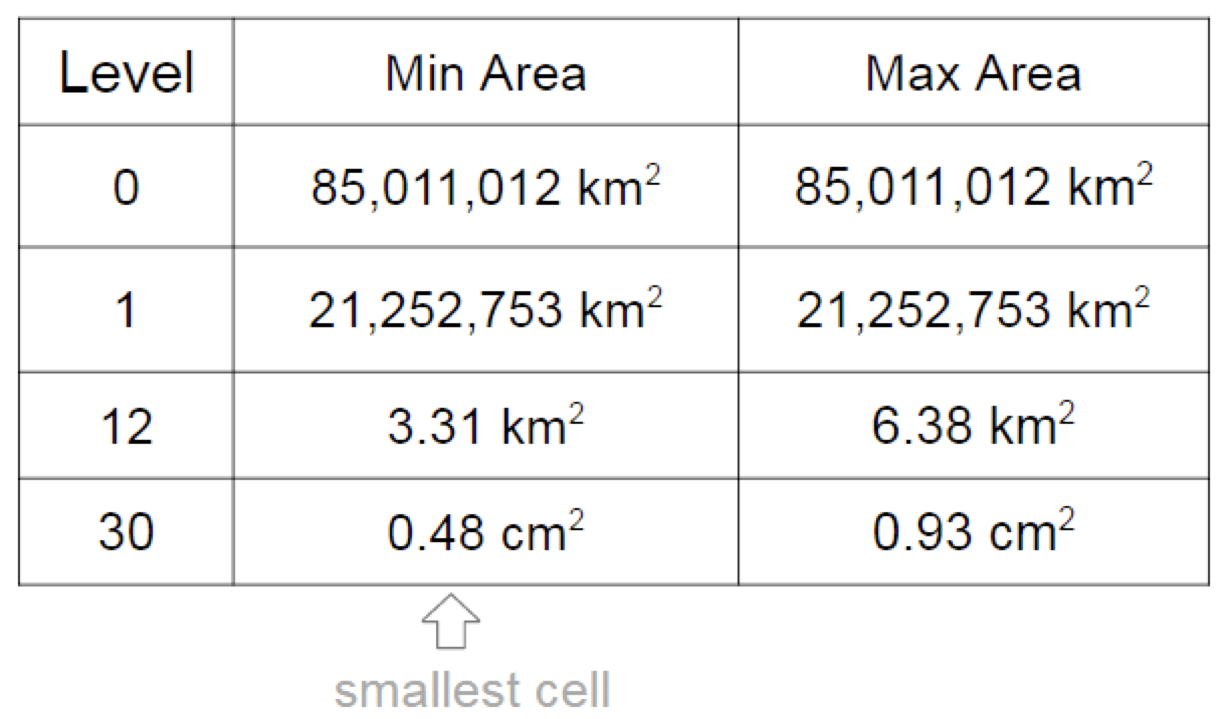

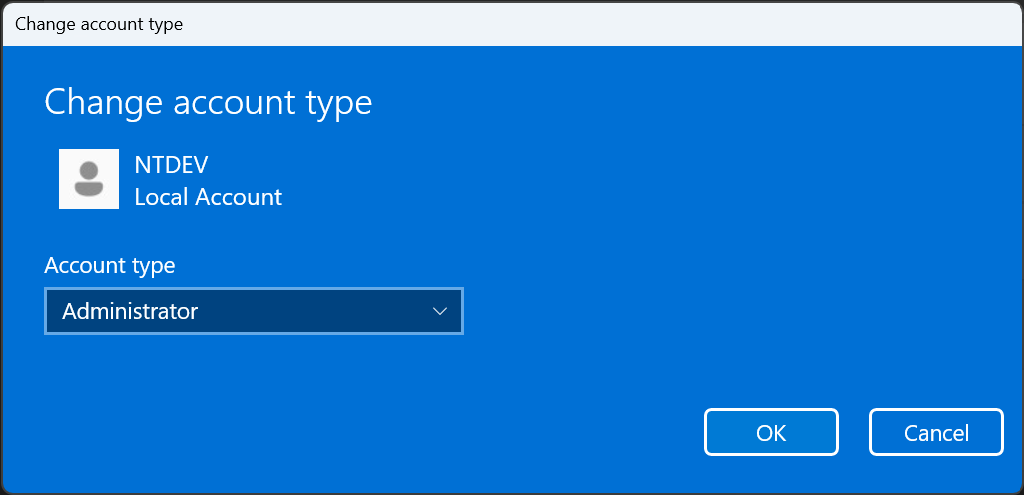

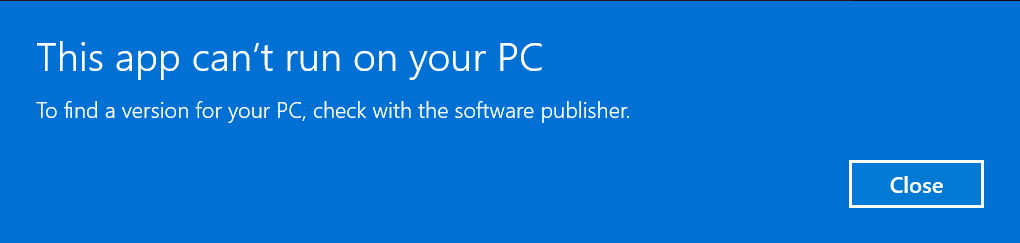

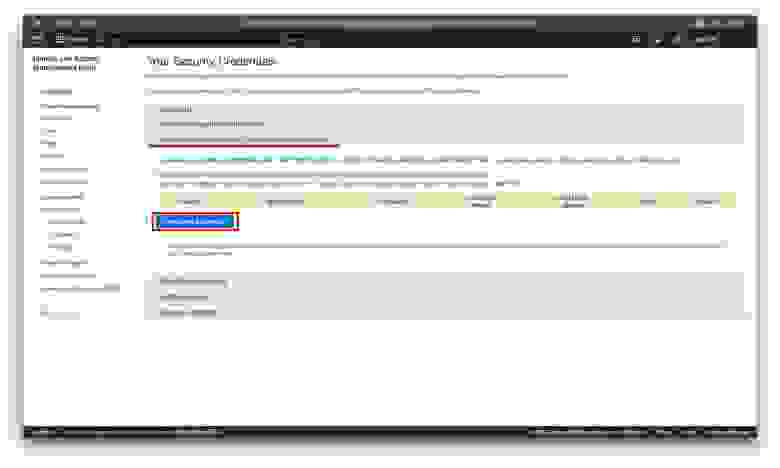

Теперь, когда мы не только изучили сухое описание стандарта, но и попробовали всё на практике, прочувствовав, что такое блок команды, уже можно показать формат команды, при помощи которой можно вызывать нестандартные функции, «прошитые» в контроллер STM32 на плате комплекса. Код команды я выбрал из начала диапазона **Vendor Specific** команд. Он равен 0xC0. Традиционно, в описаниях SCSI команд, пишут **C0h**. Длина команды всегда равна 10 байтам. Формат команды унифицирован и представлен в таблице ниже.

| | |

| --- | --- |

| **Байт** | **Назначение** |

| 0 | Код команды C0h |

| 1 | Код подкоманды |

| 2 | Аргумент arg1. Задаётся в нотации Little Endian (младшим байтом вперёд) |

| 3 |

| 4 |

| 5 |

| 6 | Аргумент arg2. Задаётся в нотации Little Endian (младшим байтом вперёд) |

| 7 |

| 8 |

| 9 |

Как видно, аргументы задаются в нотации Little Endian. Это позволит описать команду в виде структуры и обращаться к её полям напрямую, не прибегая к функции перестановки байт. Проблем выравнивания (двойные слова в структуре имеют смещения, не кратные четырём) на архитектурах x86 и x64 не стоит.

Коды подкоманд описаны следующим перечислением:

```

enum vendorSubCommands

{

subCmdSdEnable = 0, // 00 Switch SD card to PC or Outside

subCmdSdPower, // 01 Switch Power of SD card On/Off

subCmdSdReinit, // 02 Reinitialize SD card (for example, after Power Cycle)

subCmdSpiFlashEnable, // 03 Switch SPI Flash to PC or Outside

subCmdSpiFlashWritePage, // 04 Write Page to SPI Flash

subCmdSpiFlashReadPage, // 05 Read Page from SPI Flash

subCmdSpiFlashErasePage,// 06 Erase Pages on SPI Flash (4K block)

subCmdRelaysOn, // 07 Switch relays On by mask

subCmdRelaysOff, // 08 Switch relays off by mask

subCmdRelaysSet, // 09 Set state of all relays by data

subCmdFT4222_1_Reset, // 0A Activate Reset State or switch chip to normal mode

subCmdFT4222_2_Reset, // 0B Activate Reset State or switch chip to normal mode

subCmdFT4222_3_Reset, // 0C Activate Reset State or switch chip to normal mode

subCmdFT4232_Reset, // 0D Activate Reset State or switch chip to normal mode

subCmdFT2232_Reset, // 0E Activate Reset State or switch chip to normal mode

subCmdMAX3421_Reset, // 0F Activate Reset State or switch chip to normal mode

subCmdFT4222_1_Cfg, // 10 Write to CFG pins of FT4222_1

subCmdFT4222_2_Cfg, // 11 Write to CFG pins of FT4222_2

subCmdFT4222_3_Cfg, // 12 Write to CFG pins of FT4222_3

};

```

Их можно разбить на группы.

### Переключение устройств на внутренний и внешний режимы

Команды **subCmdSdEnable** и **subCmdSpiFlashEnable** коммутируют SD-карту и SPI-флэш соответственно. В параметре **arg1** передаётся одно из следующих значений:

```

enum enableMode

{

enableModeToPC = 0,

enableModeOutside

};

```

По умолчанию, оба устройства подключены к PC.

### Коммутация питания

Протокол SDIO требует достаточно больших манипуляций при инициализации. Иногда бывает полезно сбросить SD-карту к начальному состоянию (например, при переключении её линий на внешний разъём). Для этого надо отключить, затем — включить её питание. Это можно сделать при помощи команды **subCmdSdPower**. В аргументе **arg1** передаётся одно из следующих значений: 0 — выключение питания, 1 — включение. Не забудьте дать время на разрядку конденсаторов на линии питания.

После включения питания, карту, если она подключена к PC, следует переинициализировать. Для этого используйте команду **subCmdSdReinit** (у неё нет аргументов).

### Работа с SPI флэшкой

Если SD-карта подключается к системе как полноценный накопитель, микросхеме SPI Flash доступ в текущей версии сделан достаточно ограничено. Можно обращаться только к отдельным её страницам (256 байт) и только по одной. Объём памяти в микросхеме таков, что даже при работе по странице всё равно много времени процесс не займёт, но зато такой подход существенно упрощает «прошивку» микроконтроллера.

Команда **subCmdSpiFlashReadPage** считывает страницу. Адрес задаётся в параметре arg1, число страниц на передачу — в параметре arg2. Но в текущей версии число страниц должно быть равно единице. Команда вернёт 256 байт данных.

Зеркальная для неё — команда **subCmdSpiFlashWritePage**. Аргументы для неё заполняются по тому же принципу. Направление передачи данных — к устройству.

Особенностью флэш-памяти является то, что при записи можно заменять только единичные биты на нулевые. Чтобы вернуть их в единичное значение, страницы следует стереть. Для этого имеется команда **subCmdSpiFlashErasePage**. Правда, из-за особенностей применённой микросхемы, стирается не одиночная страница, адрес которой задан в параметре **arg1**, а блок размером 4 килобайта, содержащий её.

### Управление твердотельными реле

В комплексе установлено шесть твердотельных реле. Для управления ими имеется три команды.

**subCmdRelaysSet** — устанавливает значение всех шести реле одновременно. В параметре **arg1** передаётся значение, каждый бит которого соответствует своему реле (нулевой бит — реле с индексом 0, первый — с индексом 1 и т. д.). Единичное значение бита приводит к замыканию реле, нулевое — к размыканию.

Такой метод работы хорош, когда все реле работают, как единая группа. Если же они работают независимо друг от друга, при таком подходе приходится заводить буферную переменную, которая хранит значение состояний всех реле. Если же разными реле управляют разные программы, проблема хранения сводного значения становится крайне острой. В этом случае можно воспользоваться двумя другими командами:

**subCmdRelaysOn** — включает выбранные реле по маске. Те реле, которым соответствуют единичные биты в аргументе **arg1**, будут включены. Реле же, которым соответствуют нули в маске, сохранят своё текущее состояние.

Зеркальная ей команда **subCmdRelaysOff** выключит выбранные реле по маске. Те реле, которым соответствуют единичные биты в аргументе **arg1**, будут выключены. Реле же, которым соответствуют нули в маске, сохранят своё текущее состояние.

### Сброс контроллеров FTDI и Maxim

Для подачи сигналов сброса на микросхемы FTDI и Maxim, используется группа команд **subCmdFT4222\_1\_Reset**, **subCmdFT4222\_2\_Reset**, **subCmdFT4222\_3\_Reset**, **subCmdFT4232\_Reset**, **subCmdFT2232\_Reset** и **subCmdMAX3421\_Reset**. Из их имён видно, сигналами сброса каких микросхем они управляют. Мостов FT4222, как мы рассматривали ранее, в схеме два (их индексы 1 и 2), ещё один мост FT4222 передаёт данные в микросхему MAX3421, которую мы будем рассматривать в следующей статье.

В параметре **arg1** передаётся одно из следующих значений:

```

enum ResetState

{

resetStateActive =0,

resetStateNormalOperation

};

```

По умолчанию, все мосты находятся в нормальном рабочем состоянии. Как уже отмечалось в [прошлой статье](https://habr.com/ru/post/483724/), мы пока сами не уверены, понадобится ли эта функциональность, но когда нет прямого доступа к устройству — лучше иметь возможность дистанционно сбрасывать всё и вся.

### Переключение конфигурационных линий микросхем FT4222

Микросхемы FT4222 имеют четыре режима. Вряд ли кому-то понадобится режим, отличный от «00», но если вдруг понадобится — для переключения можно использовать команды **subCmdFT4222\_1\_Cfg**, **subCmdFT4222\_2\_Cfg** и **subCmdFT4222\_3\_Cfg** для первой, второй и третьей микросхем. Значение линий CFG0 и CFG1 задаётся в младших двух битах параметра **arg1**.

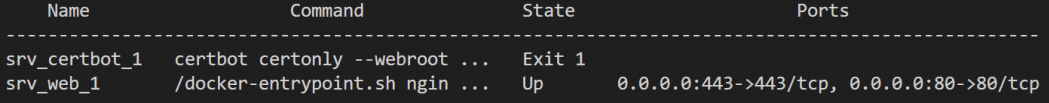

Практический опыт подачи команды в контроллер STM32

---------------------------------------------------

Для проверки полученного теоретического материала на практике попробуем переключить SD-карту наружу. Для этого надо подать команду **subCmdSdEnable**, имеющую код 0x00 с аргументом **enableModeOutside**, имеющим код 0x01. Прекрасно. Переписываем программу из прошлого опыта следующим образом.

**Переписанная программа:**

```

#include

#include

#include

#include // open

#include // close

#include

#include

#include

int main()

{

printf("hello from SdAccessTest!\n");

int s\_fd = open("/dev/sdb", O\_NONBLOCK | O\_RDWR);

if (s\_fd < 0)

{

printf("Cannot open file\n");

return -1;

}

sg\_io\_hdr\_t header;

memset(&header, 0, sizeof(header));

uint8\_t cmdSdToOutside[] = { 0xC0,0x00,0x01,0x00,0x00,0x00,0x00,0x00,0x00,0x00 };

uint8\_t cmdSdToPC[] = { 0xC0,0x00,0x00,0x00,0x00,0x00,0x00,0x00,0x00,0x00 };

uint8\_t sense[32];

memset(sense, 0, sizeof(sense));

header.interface\_id = 'S'; // Обязательно 'S'

// Команда

header.cmd\_len = sizeof(cmdSdToOutside);

header.cmdp = cmdSdToOutside;

// Данные (их нет)

header.dxfer\_len = 0;

header.dxferp = 0;

header.dxfer\_direction = SG\_DXFER\_NONE;

// Технологическая информация о результате

header.mx\_sb\_len = sizeof(sense);

header.sbp = sense;

//Таймаут

header.timeout = 100; // 100 мс

int res = ioctl(s\_fd, SG\_IO, &header);

// Включаем обратно

header.cmdp = cmdSdToPC;

res = ioctl(s\_fd, SG\_IO, &header);

close(s\_fd);

return 0;

}

```

Мы изменили длину команды до десяти байт и убрали блок данных. Ну, и записали код команды с аргументами, согласно требованиям. В остальном, всё осталось то же самое. Запускаем… И… Ничего не работает. Функция **ioctl()** возвращает ошибку. Причина описана в документе на команду **SG\_IO**. Дело в том, что мы подаём Vendor Specific команду **C0h**, а про них там сказано дословно следующее:

> Any other SCSI command (opcode) not mentioned for the sg driver needs O\_RDWR. Any other SCSI command (opcode) not mentioned for the block layer SG\_IO ioctl needs a user with CAP\_SYS\_RAWIO capability.