text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Perst — высокопроизводительная ООБД

Perst — An open source, object-oriented embedded database

---------------------------------------------------------

Высокопроизводительная объектно-ориентированная [встраиваемая](http://ru.wikipedia.org/wiki/%D0%A1%D0%B8%D1%81%D1%82%D0%B5%D0%BC%D0%B0_%D1%83%D0%BF%D1%80%D0%B0%D0%B2%D0%BB%D0%B5%D0%BD%D0%B8%D1%8F_%D0%B1%D0%B0%D0%B7%D0%B0%D0%BC%D0%B8_%D0%B4%D0%B0%D0%BD%D0%BD%D1%8B%D1%85) база данных от компании McObject.

### Поддерживаемые платформы

* J2SE 1.4 and выше

* Android (Open Handset Alliance)

* J2ME MIDP 2.0/CLDC 1.1

* .NET Framework (1.0, 2.0, 3.0, 3.5)

* .NET Compact Framework (1.0, 2.0)

* Mono

### Основные возможности

* Хранит данные непосредственно в объектах Java и .NET, исключая время на преобразование необходимое реляционным и объектно-ориентированным БД

* Компактная (сборка для .NET весит всего чуть больше 500 кб)

* Поддержка транзакций

* Легко используемые инструменты разработки (ниже приведен код, по которому вы сможете это оценить)

* Есть возможность использовать SQL-подобный язык запросов (для .NET 3.5 можно использовать LINQ)

* Экспорт в XML

* Репликация

* Полнотекстовый индекс (скорость индексации конечно не сравниться со Sphinx или Lucene, но все же для некоторых задач сгодиться)

* Шифрование базы при помощи алгоритма RC4

* Быстрая система восстановление БД после сбоев (без использования log-файлов)

* *с остальными возможностями вы можете ознакомиться на странице* [спецификации Perst](http://www.mcobject.com/perst_database_spec)

### Лицензия

Двойная: либо GNU General Public License version 2, либо если вас не устраивает GNU GPL v2 есть коммерческая.

### Быстродействие

На официальном сайте выложены тесты от двух компаний PolePosition и TestIndex. PolePosition производит сравнение Perst с db4o, о которой не раз [упоминали](http://habrahabr.ru/search/?q=db4o) на Хабре. Результат, как вы наверно догадались, Perst быстрее. Такой же результат сообщает нам TestIndex, проводившая тестирование на эмуляторе Android и смартфоне T-Mobile G1 сравнивая Perst c SQLite. Pdf-ки с графиками можно скачать с [официального сайта](http://www.mcobject.com/perst_eval).

### Пример на С#

Тут действительно все просто — все объеты (классы), которые необходимо хранить в базе данных Perst наследуются **от класса Persistent**. Создадим класс простой класс данных:

> `1. ///

> 2. /// Класс для хранения данных.

> 3. ///

> 4. class MyData : Persistent

> 5. {

> 6. public int intKey;

> 7. public string strData;

> 8. }

> \* This source code was highlighted with Source Code Highlighter.`

Теперь нам необходимо создать класс который будет создавать нужные нам индексы, а также являться корневым элементом базы данных.

> `1. ///

> 2. /// Корневой элемент базы данных.

> 3. ///

> 4. class MyRoot : Persistent

> 5. {

> 6. ///

> 7. /// Индекс по полю intKey в класе MyData.

> 8. ///

> 9. public FieldIndex<int, MyData> intKeyIndex;

> 10.

> 11. public MyRoot(Storage db)

> 12. : base(db)

> 13. {

> 14. intKeyIndex = db.CreateFieldIndex<int, MyData>("intKey", false); // False обозначает неуникальность ключа.

> 15. }

> 16. public MyRoot()

> 17. {

> 18. }

> 19. }

> \* This source code was highlighted with Source Code Highlighter.`

Ну, а теперь там осталось только подключиться к базе и работать с ней. Заодно проведем тестирование быстродействия.

> `1. class Program

> 2. {

> 3. static void Main(string[] args)

> 4. {

> 5. DateTime t1;

> 6. DateTime t2;

> 7. Storage db = StorageFactory.Instance.CreateStorage();

> 8. MyRoot Root;

> 9. MyData Obj;

> 10. MyData[] ObjList;

> 11.

> 12. // Выделим Perst 10Мб оперативной памяти для работы с базой, что бы немного снизить нагрузки на диск и

> 13. // увеличить скорость.

> 14. db.Open("MyDB.pdb", 10 \* 1024 \* 1024, "My\_SecreT\_k3y");

> 15. // Если в базе еще нет корневого элемента, создадим его.

> 16. if (db.Root == null)

> 17. {

> 18. db.Root = new MyRoot(db);

> 19. }

> 20. Root = (MyRoot)db.Root;

> 21.

> 22. // Добавим объект MyData в базу.

> 23.

> 24. t1 = DateTime.Now;

> 25. for (int i = 0; i < 100000; i++)

> 26. {

> 27. Obj = new MyData();

> 28. Obj.intKey = i;

> 29. Obj.strData = "Привет, мир!!!";

> 30. Root.intKeyIndex.Put(Obj);

> 31. }

> 32. t2 = DateTime.Now;

> 33. Console.WriteLine((t2 - t1).TotalMilliseconds.ToString() + " ms");

> 34.

> 35. // Теперь попробуем его получить.

> 36. //Т.к. мы создали индекс с неуникальным ключом, то воcпользуемся перегруженой функцией Get(from, till).

> 37. ObjList = Root.intKeyIndex.Get(1000, 1000);

> 38. foreach (MyData Obj1 in ObjList)

> 39. {

> 40. Console.WriteLine(Obj1.strData);

> 41. }

> 42.

> 43. db.Close();

> 44. }

> 45. }

> \* This source code was highlighted with Source Code Highlighter.`

На моем ноуте создание 100000 объектов выполняется за 2.4сек, т.е. ~42к записей в сек.

### Вывод

Perst действительно быстрая и компактная ООБД, которая подойдет не только для вашего приложения для PC, но и для мобильных устройств.

*Но можно ли ее применить на сайтах спросите вы?* Ответ будет таков: в туториале заявлена поддержка мульти-клиентского приложения, используя для этого ThreadTransaction и свойство БД perst.multiclient.support, но мне так и не удалось добиться высокой производительности (10 потоков создают по 10 записей выполнялось 21сек). Скорее всего я что, то не так делаю?! В любом случае исходники я выложу, что вы смогли меня поправить и сами потестировать.

### Ссылки

1. [Официальный сайт](http://www.mcobject.com/perst/)

2. [Страница загрузки](http://www.mcobject.com/perst_eval)

3. [Исходники примеров на VB.NET](http://narod.ru/disk/19162576000/PerstTest.7z.html)

4. [Исходники примеров на C#](http://narod.ru/disk/19168315000/PerstLoadTestCsharp.7z.html) | https://habr.com/ru/post/89150/ | null | ru | null |

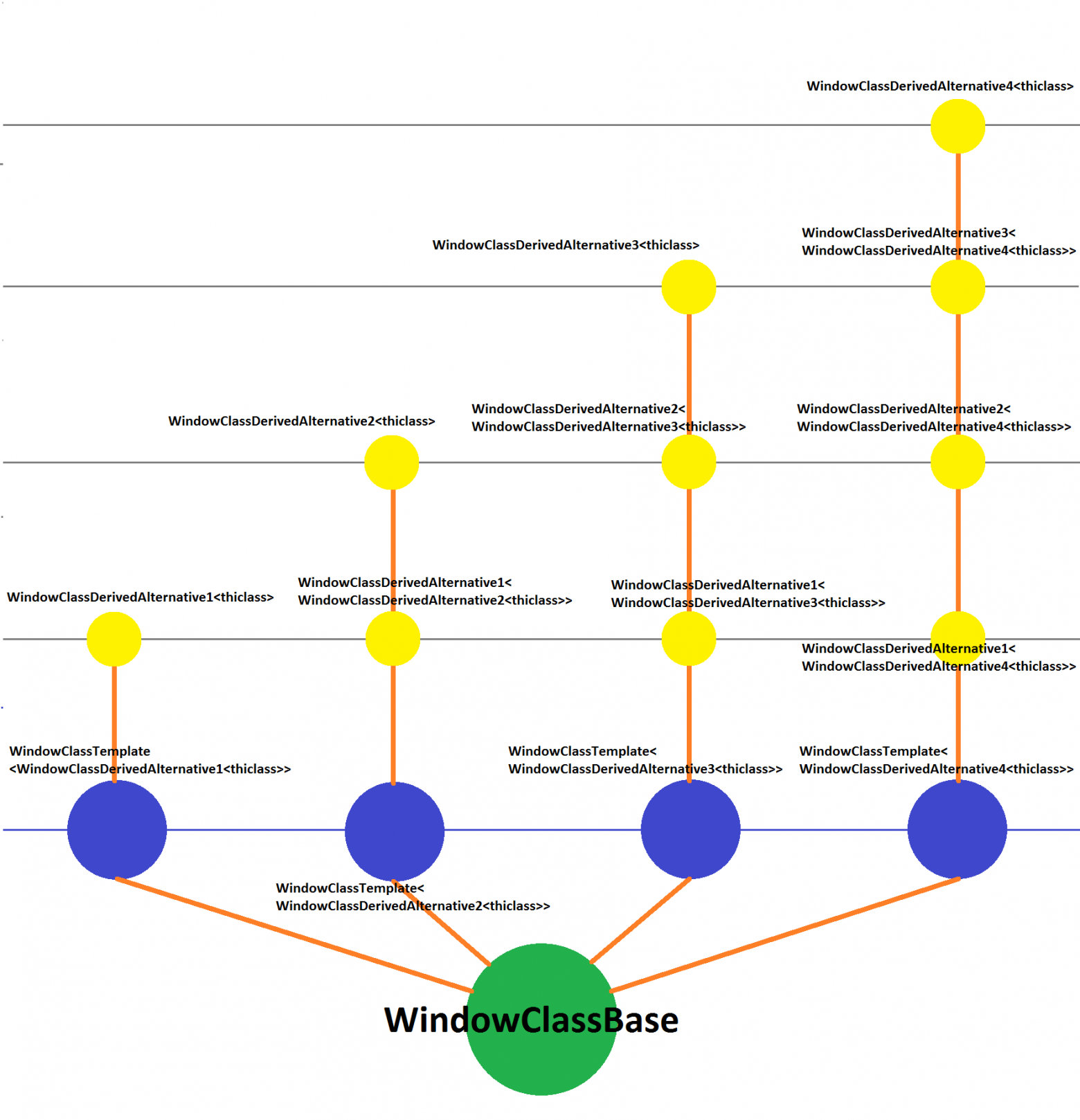

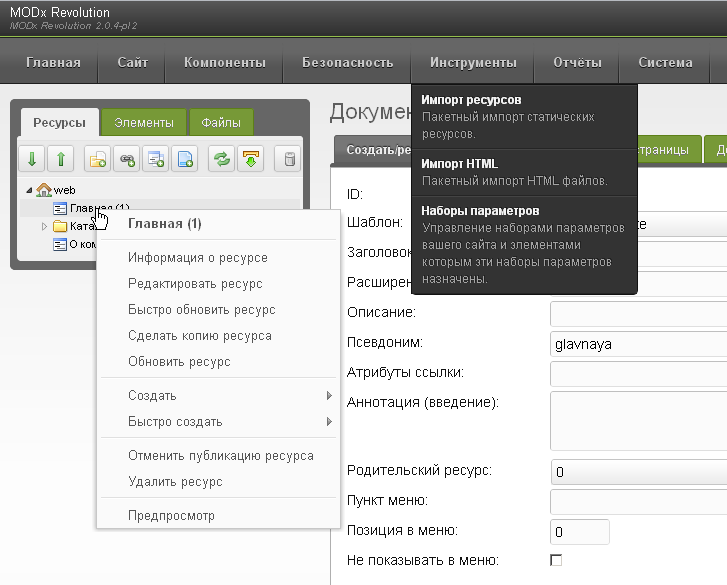

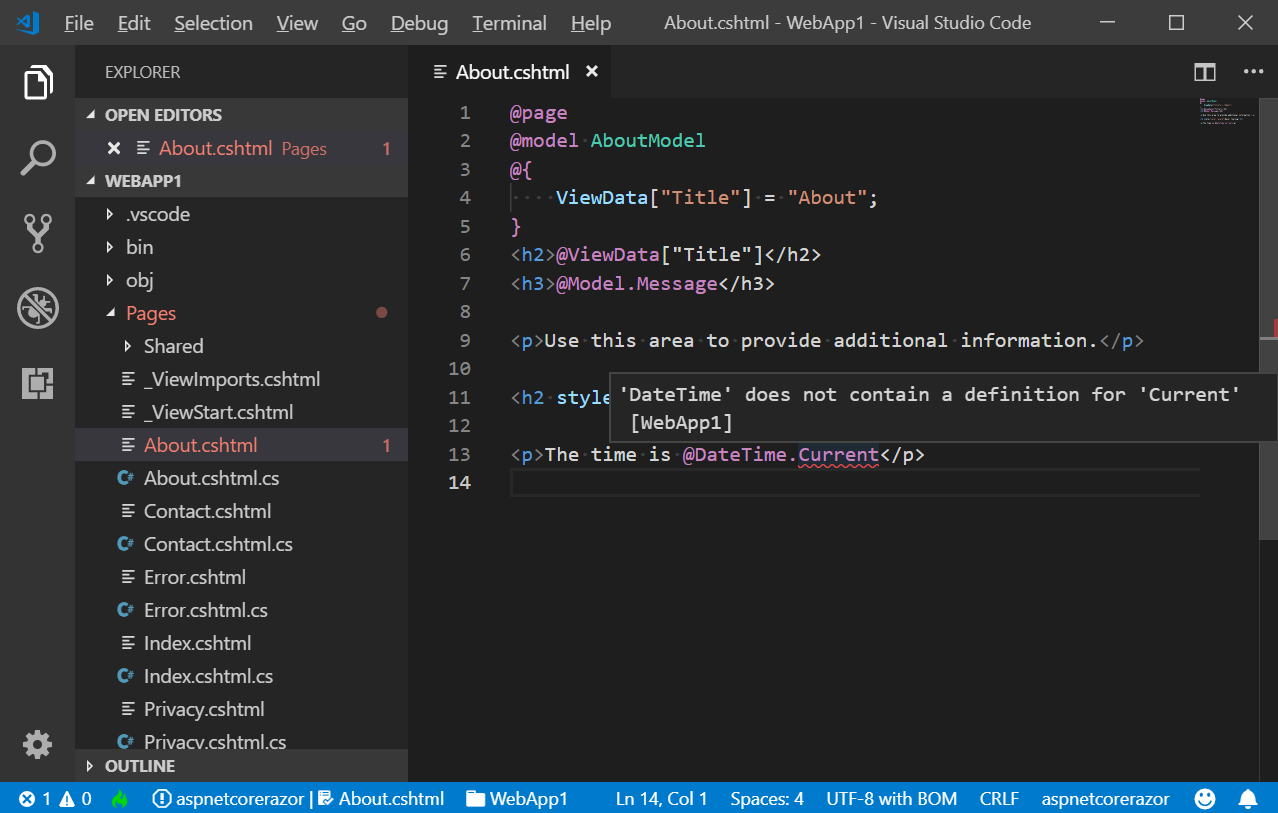

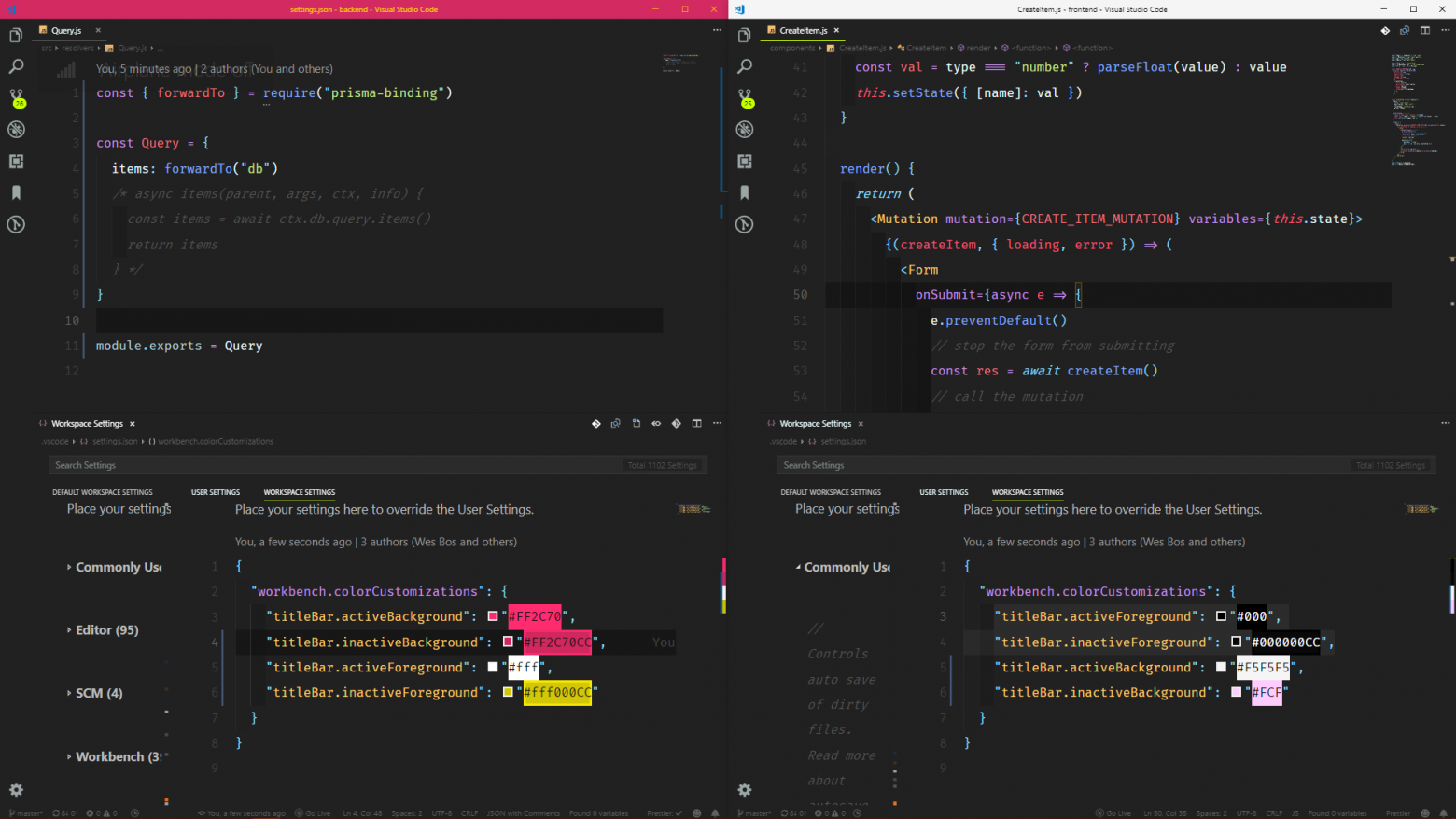

# Я не могу спроектировать архитектуру своего интернет-магазина или как я пишу «под клиента»

Эта статья будет в форме вопроса. Я опишу свою проблему, с которой столкнулся при написании сайта.

Начнем! Вы уже, возможно, знаете меня, а если нет, то советую прочитать про меня [тут](https://habr.com/en/post/553322/), и [тут](https://habr.com/en/post/576954/).

Как я написал свой интернет-магазин

-----------------------------------

До магазина, я писал программу для учёта зарплаты для сети магазинов мяса, которые работают с моим папой. Программка была самая простая, которая может быть. Писал на WinForms.

После этого я пытался переписать папину программу для автоматизации магазинов. Писал на WPF. Много чему научился, получил огромный опыт, но конечно же не написал и 1% того, что нужно было.

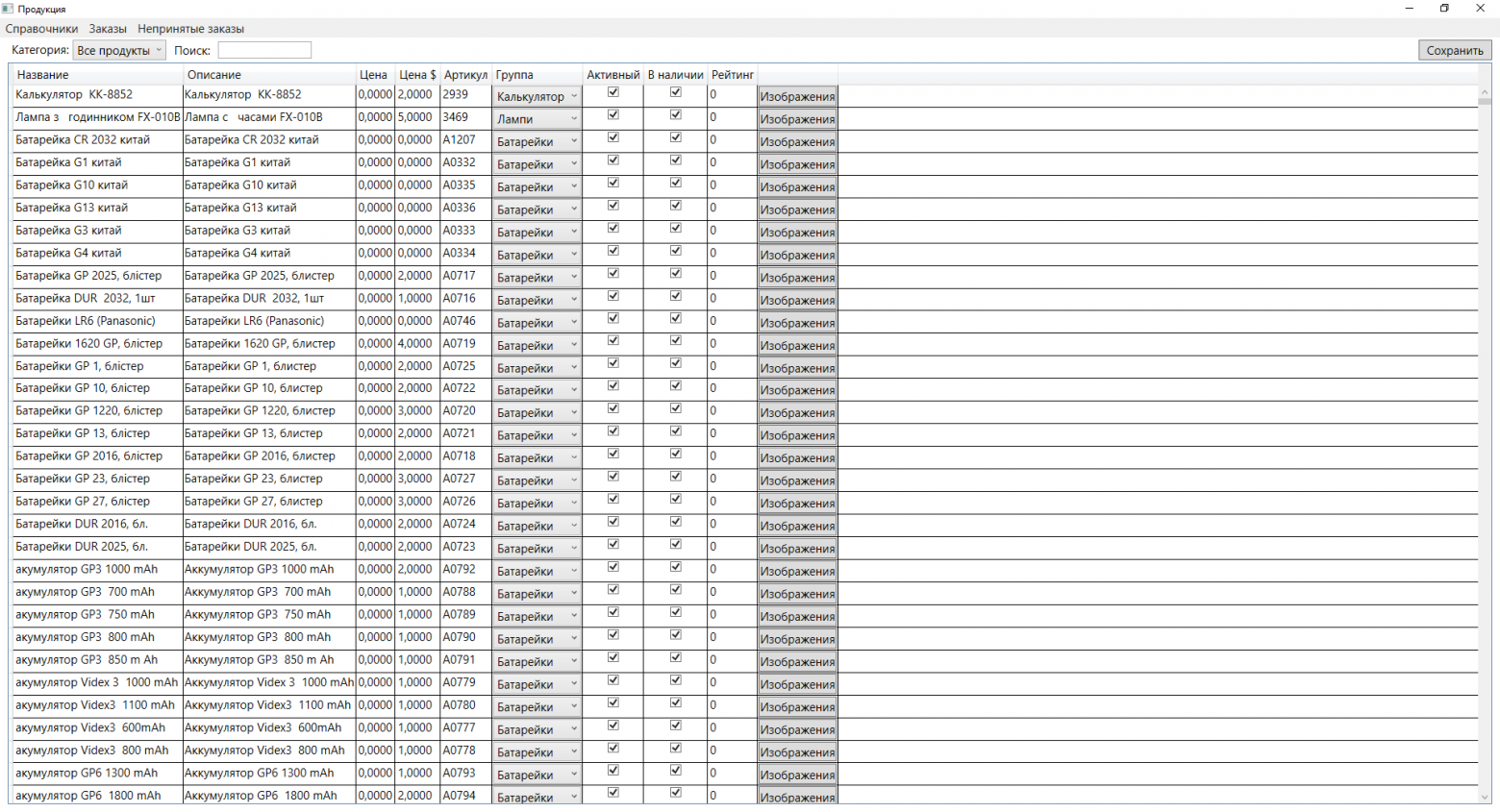

Потом тем же магазинам мяса захотелось интернет-магазин. Я и предложил написать. Потом захотел ещё один клиент, ещё один, и ещё.. Сейчас пишу магазин электротоваров.

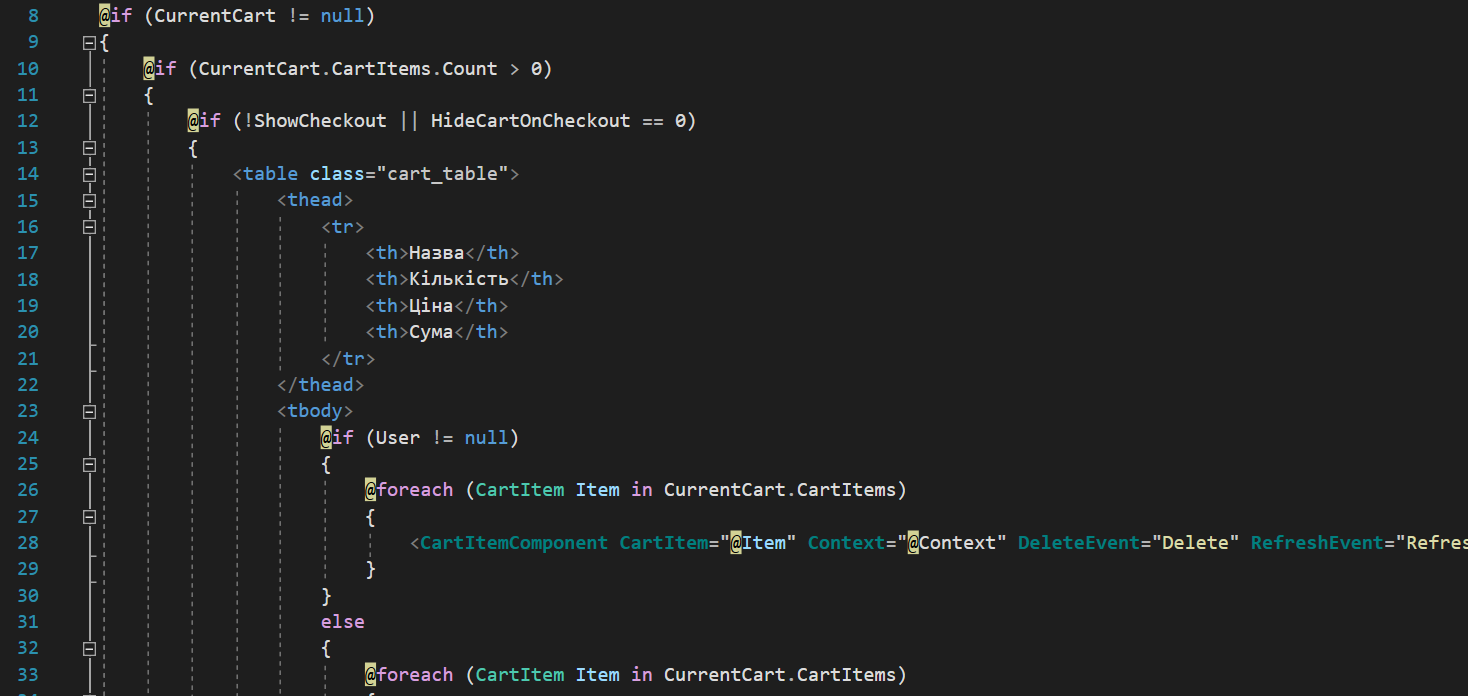

Короче говоря, мой интернет-магазин написан на Blazor.

Когда я обещал написать его, я в душе не знал, что такое ASP.NET Core(Blazor). C# знал 2 месяца. Умел верстать сайты, немного знал CMS, немного умел работать с базами данных.

Также мне нужно было написать админку, где можно менять цены на продукты, добавлять категории и много чего еще. Ещё, на сайте автоматически заказ отправлялся на магазин по адресу в папину программу. Нужно было сделать возможность поменять магазин, который обслуживает заказ.

Решил для админки написать приложение на WPF, так как уже знал его, а на самом сайте мне тогда было сложно сделать.

Когда я писал для одного клиента, то было ещё все хорошо. Но уже скоро стали появляться проблемы.

Вот, например: для сети магазинов я делал справочник магазинов, где можно указывать название, загружать картинки, написать адрес и прочее. Это потом было отображено на старице на сайте. И также к этим магазинам нужно было привязать адреса, которые обслуживает точка.

Второй клиент был с одним магазином, и, естественно, зачем ему нужен справочник магазинов? Что делать?

Настройки - всему голова!

-------------------------

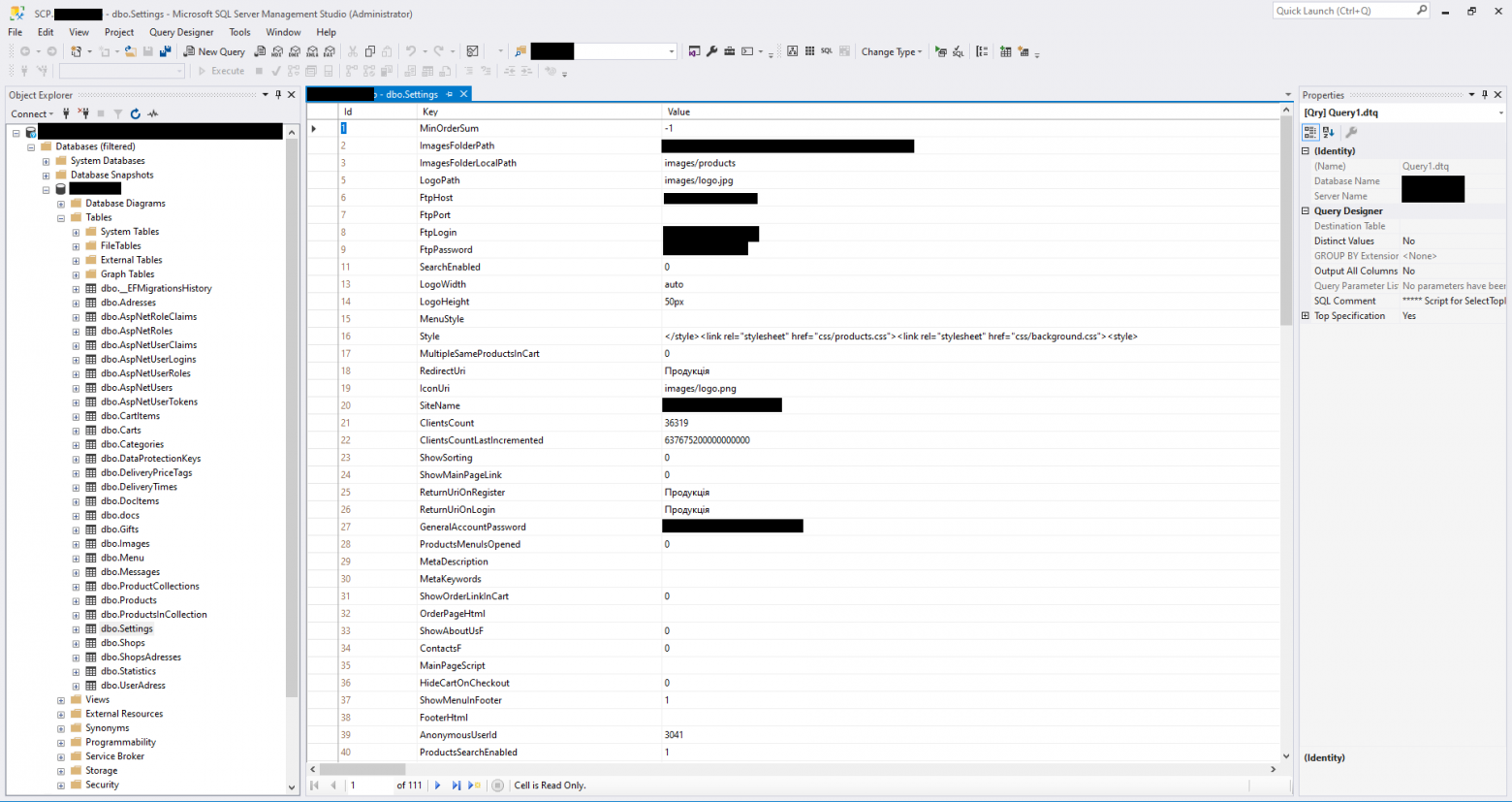

Да, я просто создавал настройку. Называл её, например, `ShowShopsInMenuDesktop`. Хранил в виде key-value в таблице.

Такая же ситуация и на сайте. Для этого, кстати, и приставка Desktop к настройке.

Таких настроек у меня сейчас уже 111!

Я путаюсь в них, что-то, в них, поменять - достаточно проблематичная задача.

Почему так много? Очень много деталей, которые нужно настраивать, и их количество только увеличивается.

Как я пишу «под клиента»

------------------------

Ну 200 настроек, и что с того? Сложность даже не в настройках, а в коде, где их нужно проверять.

Очень, очень много if-ов! Один if вложенный в if, который вложен ещё в один if!

Это сильно усложняет код. Писать и самое главное - понимать практически невозможно.

Как я это пытаюсь решить

------------------------

Я нашёл решение, которым пользуюсь постоянно, и которое хоть как-то спасает меня.

Решение такое: Если много проверок и настроек - вынеси это в базу в нужном виде и генерируй в программе из базы.

Есть у меня меню. Можно задавать настройки для каждого пункта типа `ShowItemInMenu`, а можно просто хранить пункты меню в таблице Menu и генерировать меню из базы.

Гибкости больше, все удобно и не засоряет настройки. Прекрасно!

Почему это не работает

----------------------

Да, большинство настроек можно убрать и переместить в другую таблицу в нужном виде.

Но что делать, если это настройка, которая меняет алгоритм работы программы или настройка, которую нельзя никуда вынести.

У меня есть настройка `CanUserBuyProducts`. Она отвечает за то, что человек может купить продукт, добавить его в корзину. Если она выключена, то пользователь сможет только смотреть продукты. Мое решение здесь не работает. И таких настроек тоже очень много, и даже если максимально вынести все правильно в базу, то проблема все равно останется.

И, вишенка на торте - разметка и стили. Менять разметку и стили компонента - обычное дело для меня. Каждый клиент хочет по-своему.

Поэтому стили у меня хранятся в css файлах, которые я могу менять. Никакого Sass, PostCSS и прочих предпроцессоров, только чистый CSS, только хардкор! Ладно, шутка)) Люблю чистый CSS.

Но хранение css в файлах лишает меня многих возможностей. Например, бандлинг.

А что с шаблоном компонента? А ничего... Добавляю десятки настроек, чтобы сделать элементарную вещь.

С приложением WPF еще сложнее. Настройка нужна на каждую мелочь. Нужно сделать фон отчета красным? Настройка! Убрать кнопку? Настройка!

Генерировать и хранить всю форму в базе со всеми параметрами и элементами на ней - это уже перебор, просто бред.

И что же делать?

----------------

Я провел месяцы в размышлениях и поисках решения. Но пока "стек" решений у меня остается прежним.

Писать отдельный сайт каждому клиенту каждый со своими багами и проблемами? Нет, спасибо.

Может сделать отдельную ветку каждому клиенту, а потом сливать их? Еще хуже!

Единственная статья на Хабре, которая поднимает похожий вопрос - это [«Как мы дорабатываем продукт под конкретного клиента»](https://habr.com/en/company/lsfusion/blog/461983/) от LsFusion. Я других не нашел.

В их статье они пришли к решению - модульность. Круто, они написали свой собственный язык программирования, а мне-то что делать?

Я думаю, что такая проблема возникает у многих. Как ее решить, вот в чем вопрос?

Ссылки на Github проект:

[ShopWeb](https://github.com/arthurlomakin11/ShopWeb) - сам сайт

[ShopWebData](https://github.com/arthurlomakin11/ShopWebData) - сущности

[ShopWebApp](https://github.com/arthurlomakin11/ShopWebApp) - приложение | https://habr.com/ru/post/578648/ | null | ru | null |

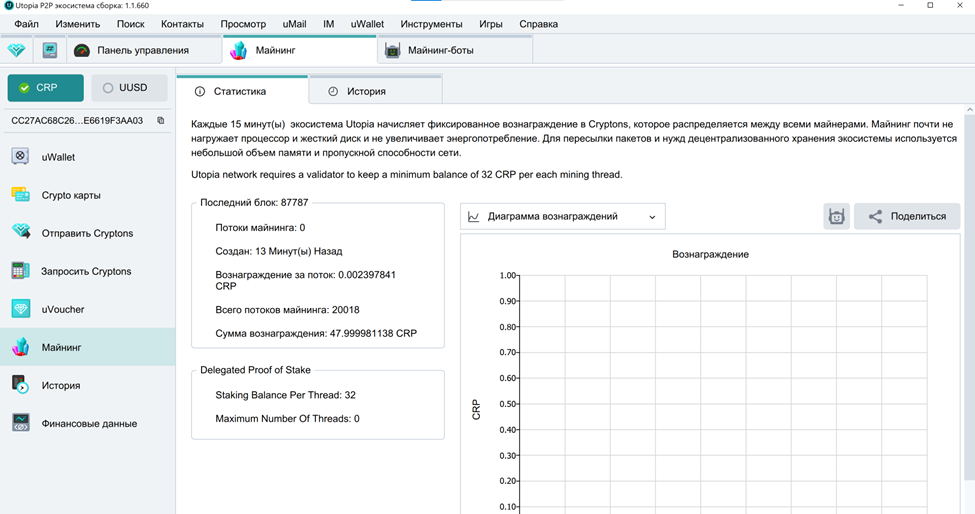

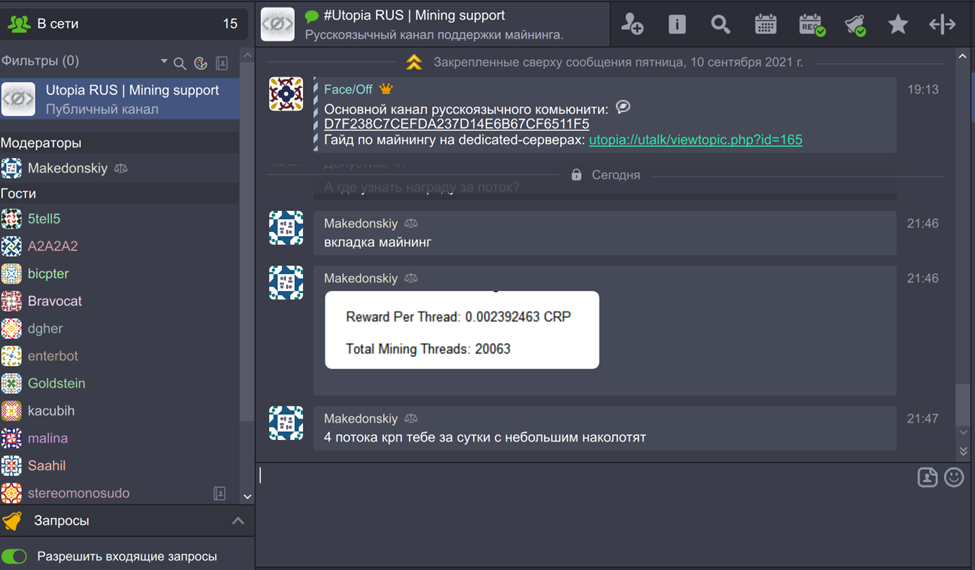

# Первый опыт майнинга

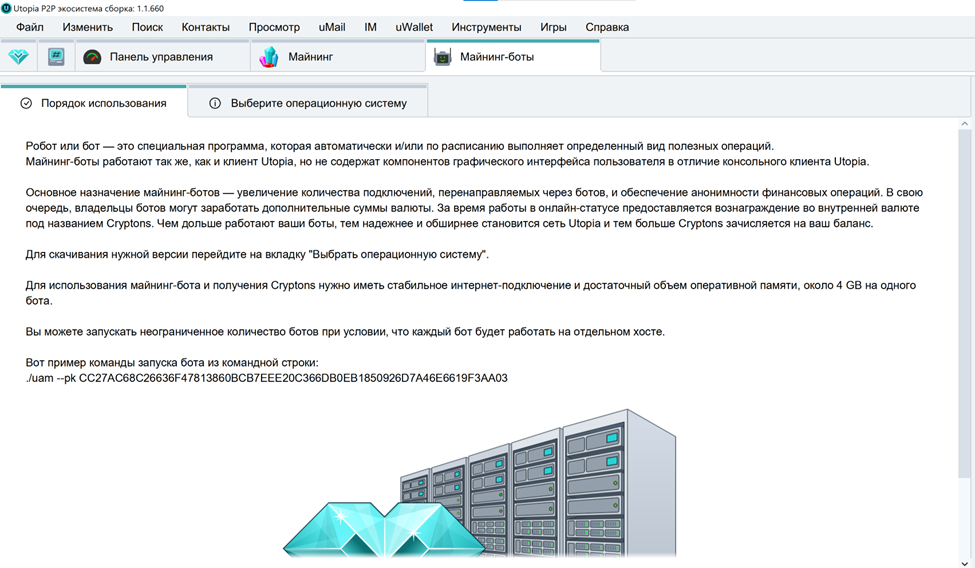

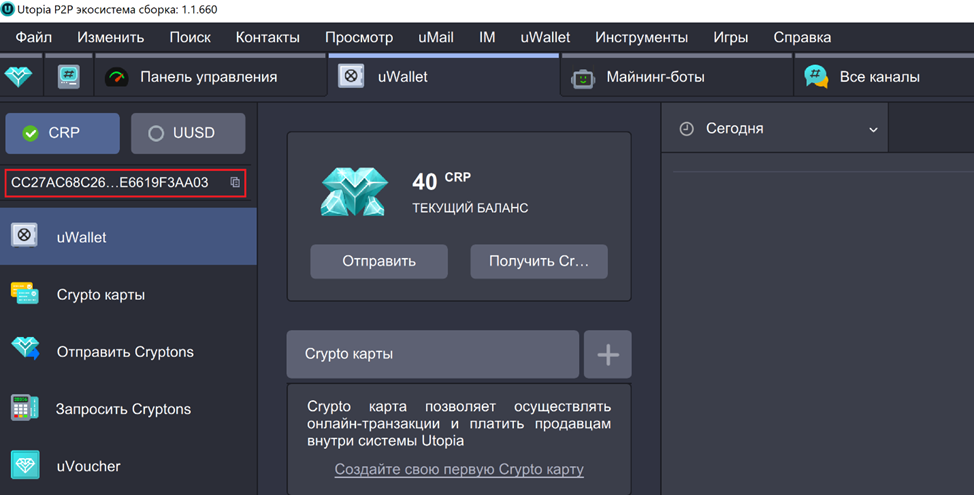

Недавно я написал про p2p-экосистему, чем вызвал бурную и интересную реакцию в комментариях. Поэтому решил продолжить.

В экосистеме есть возможность покупки-продажи товаров и услуг – при этом все транзакции анонимны. Есть специальные Crypto-карты даже имя аккаунта не будет видно продавцу. Поэтому первое, что пришло в голову при использовании – запустить майнинг, намайнить местных криптонов и что-то на них купить.

Но тут пришлось столкнуться с препятствиями в виде повышенной сложности запуска этого процесса. Пришлось немного поколдовать с виртуальной машиной.

### Процесс настройки майнинга

Майнинг-боты Utopia работают только под Linux и не на компьютере, на котором вы установили Utopia. Согласно требованиям экосистемы, для этого нужно поднимать либо VPS, либо выделенный сервер.

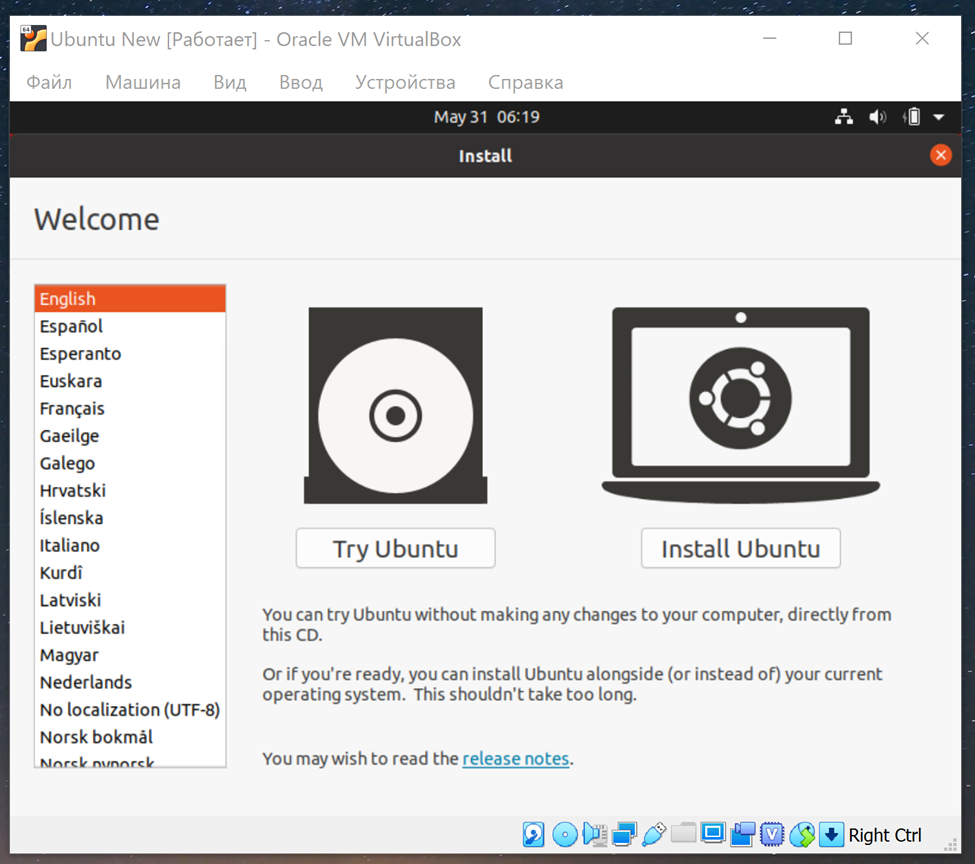

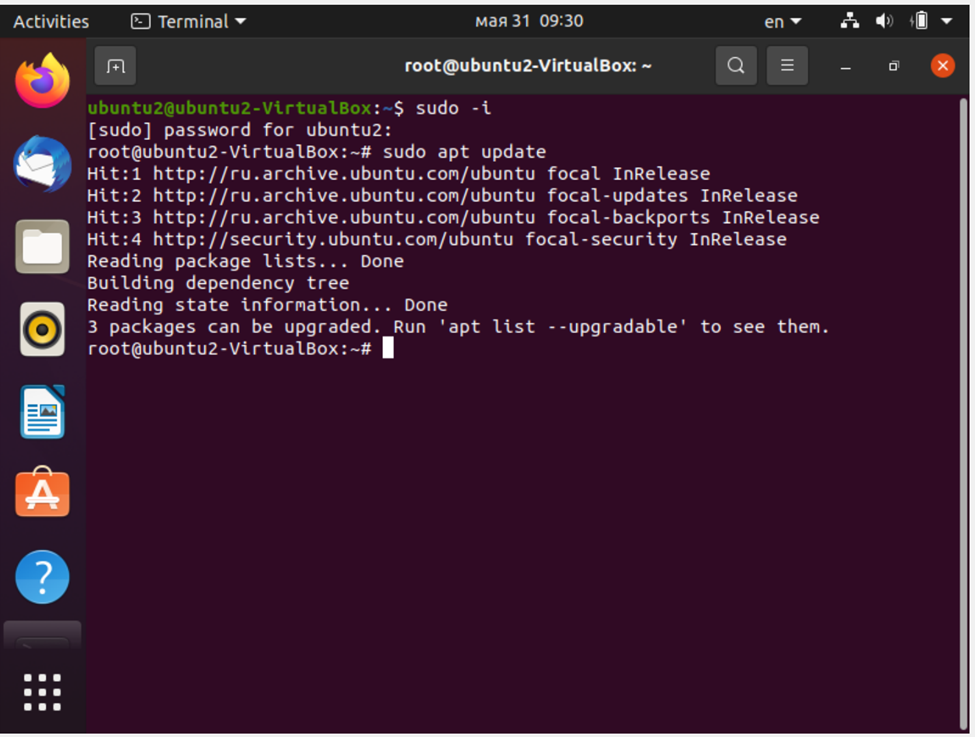

Но я решил проверить, можно ли запустить бота на том же компьютере (чтобы не вставать к другому). Причём на компьютере, где стоит Windows. Для этого я использовал Virtualbox.

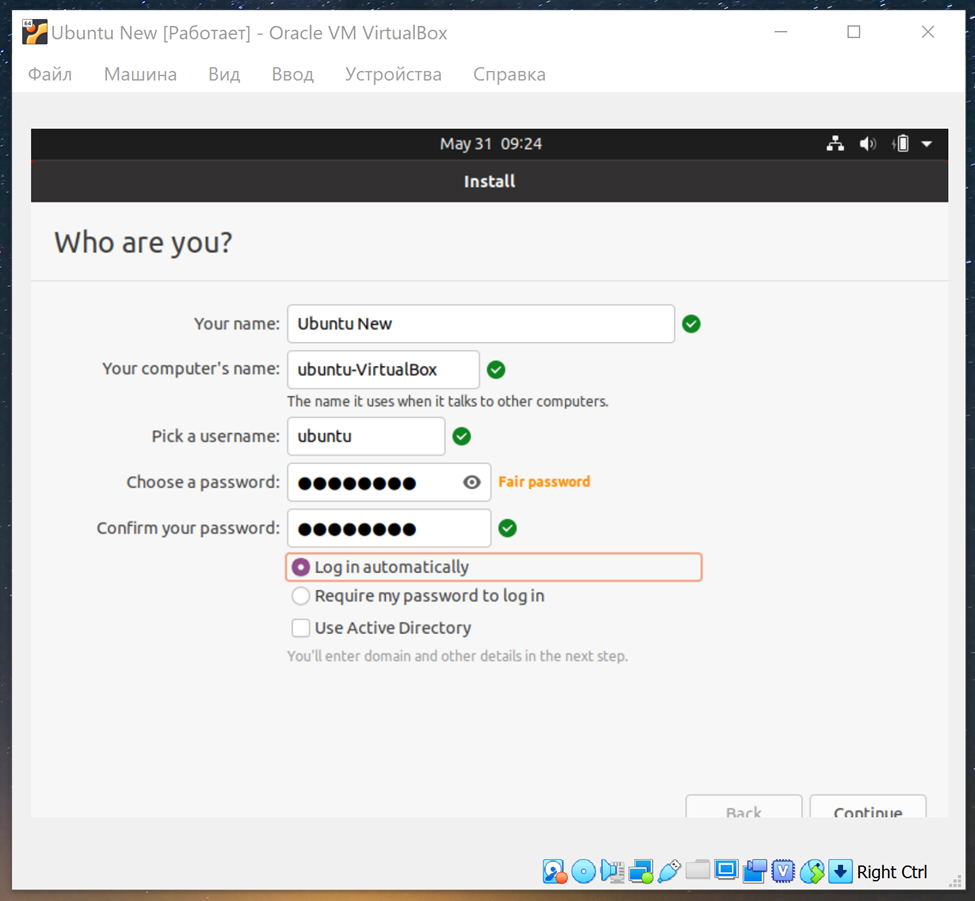

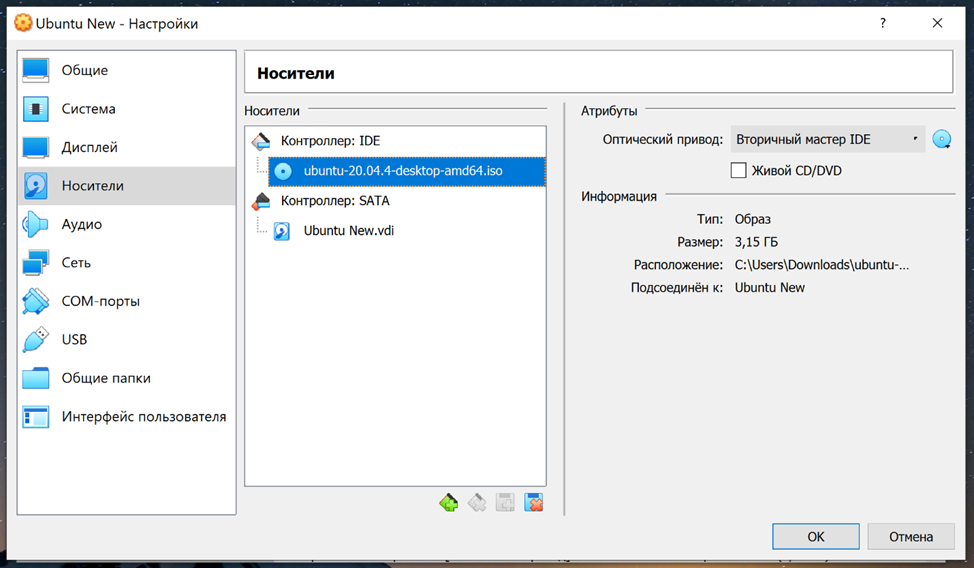

**Шаг 1.**

Скачиваем Virtualbox с сайта [Oracle VM VirtualBox](https://www.virtualbox.org/) – версию для Windows. Устанавливаем.

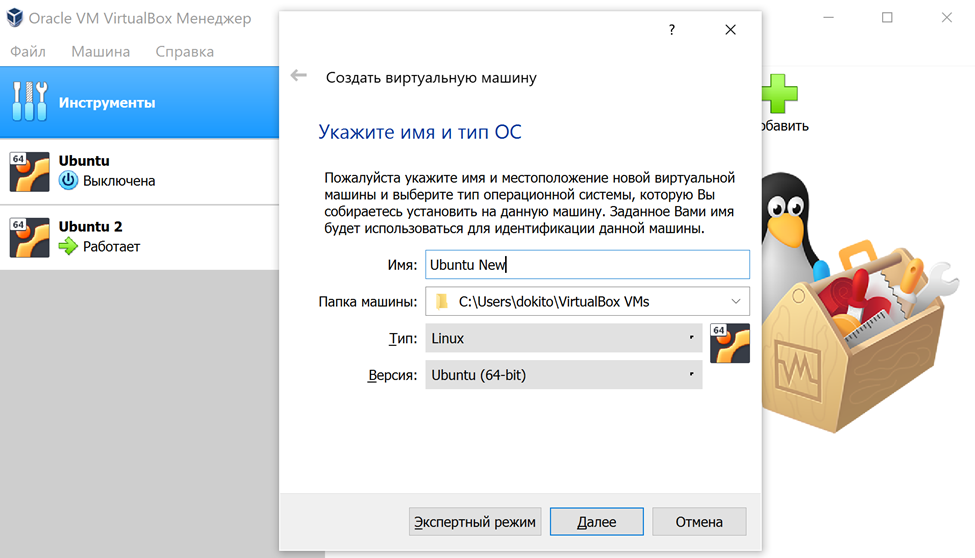

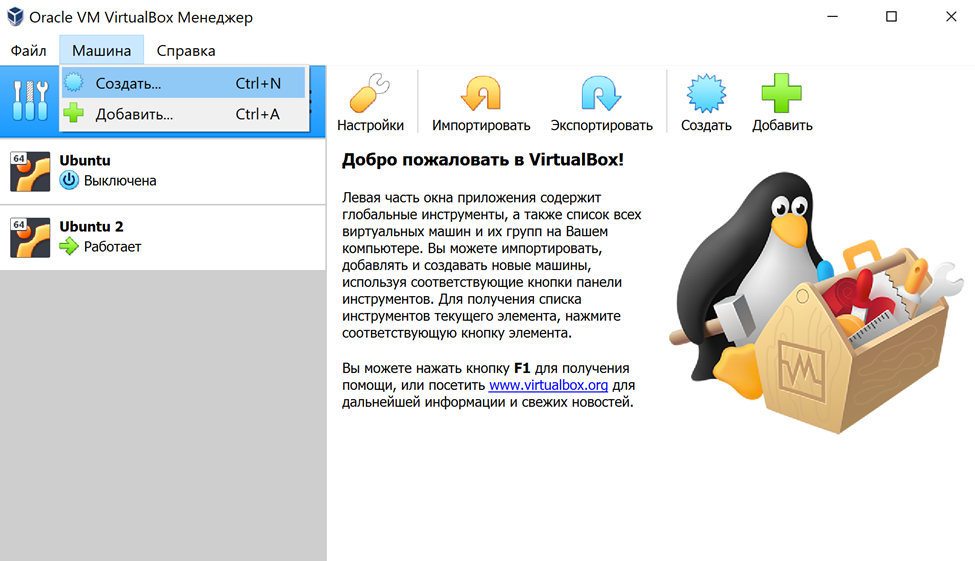

Создаём новую машину. Если написать имя Ubuntu – то программа автоматом подставляет тип операционной системы.

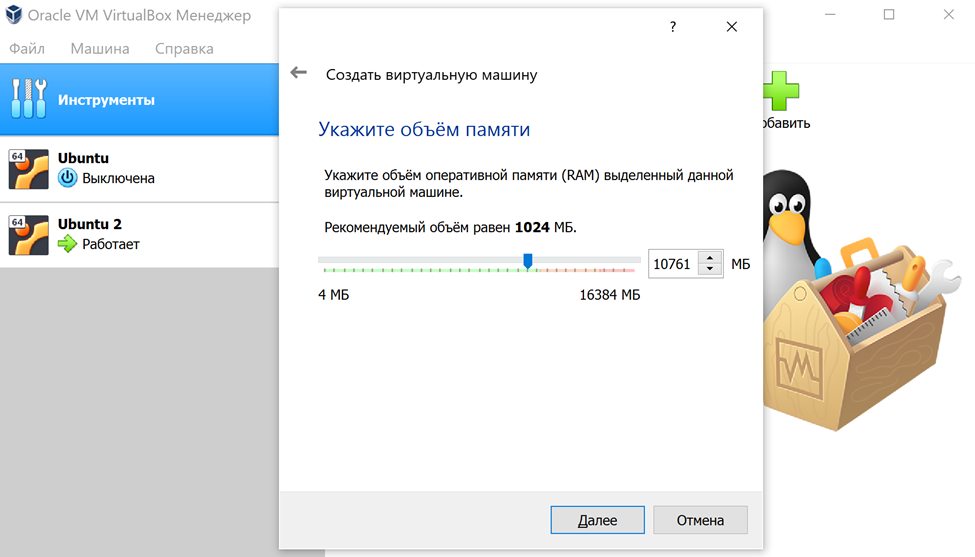

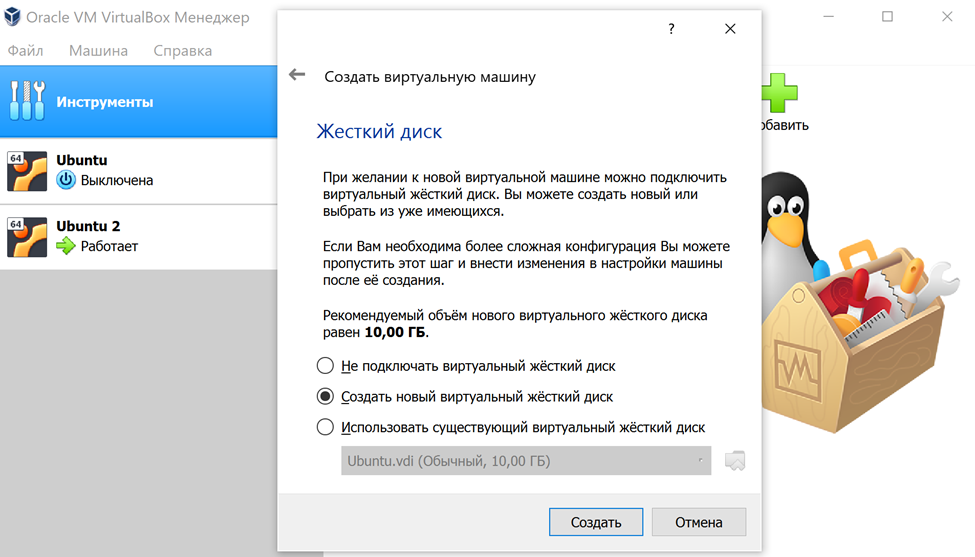

При указании объёма оперативной памяти для виртуальной машины нужно учесть, что одному боту требуется 4 гигабайта. Поэтому берём с сильным запасом. Я выделил более 10 ГБ.

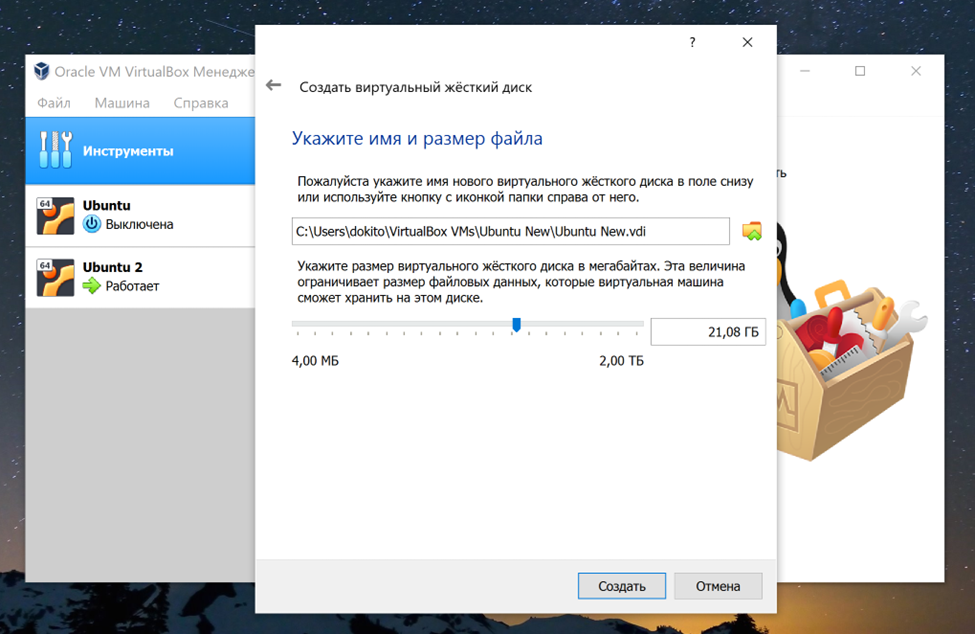

Создаём новый жёсткий диск. 10 ГБ – слишком мало, сама система займёт 9,5 из них. Поэтому ставим от 20 гигабайт.

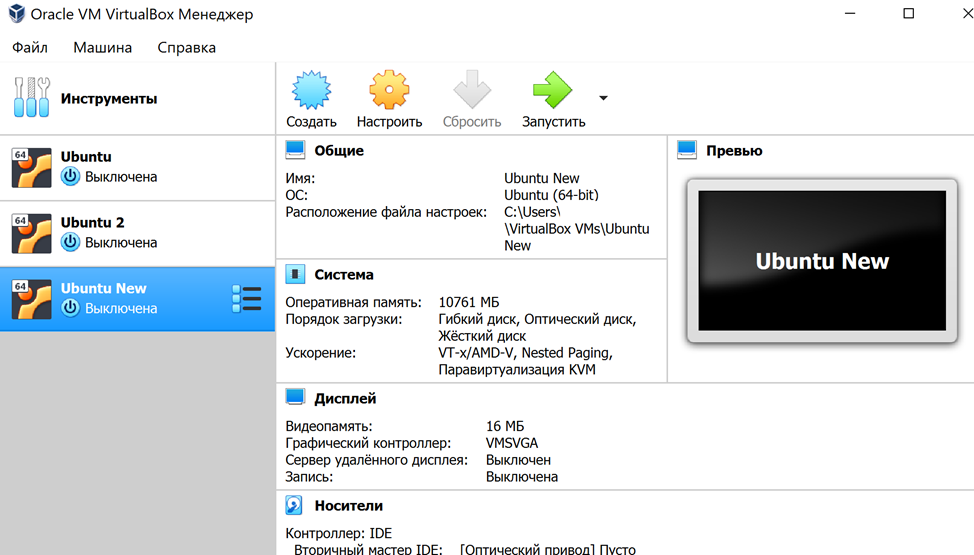

Виртуальная машина создана.

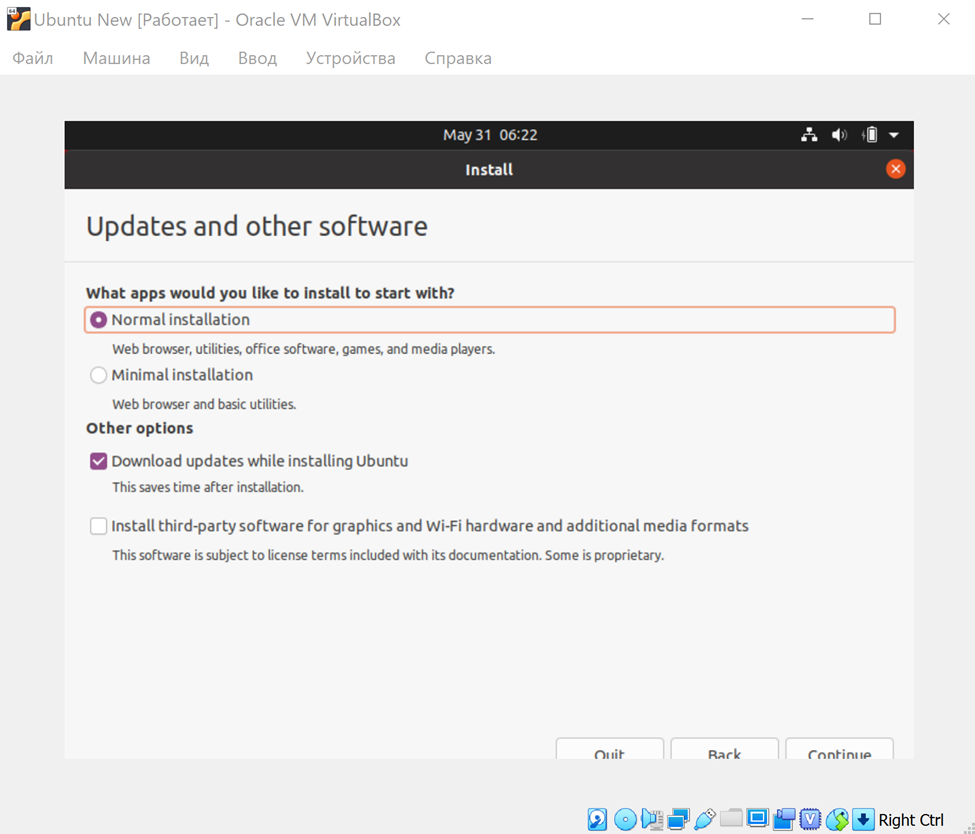

**Шаг 2.**

Переходим к следующему шагу – на виртуальную машину нам нужно поставить Ubuntu. Скачиваем [Ubuntu](https://ubuntu.ru/get) и устанавливаем.

Для этого идём в настройки, и в «носителях» выбираем образ Ubuntu, который только что скачали. Запускаем машину – и начинаем установку.

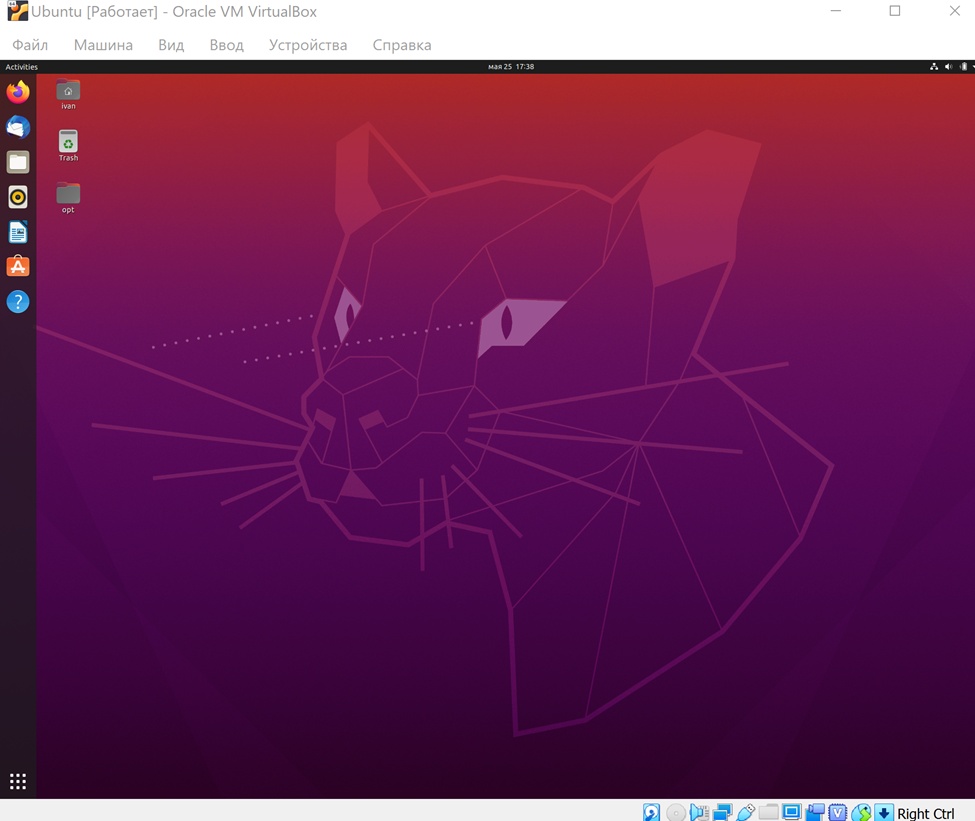

**Шаг 3.**

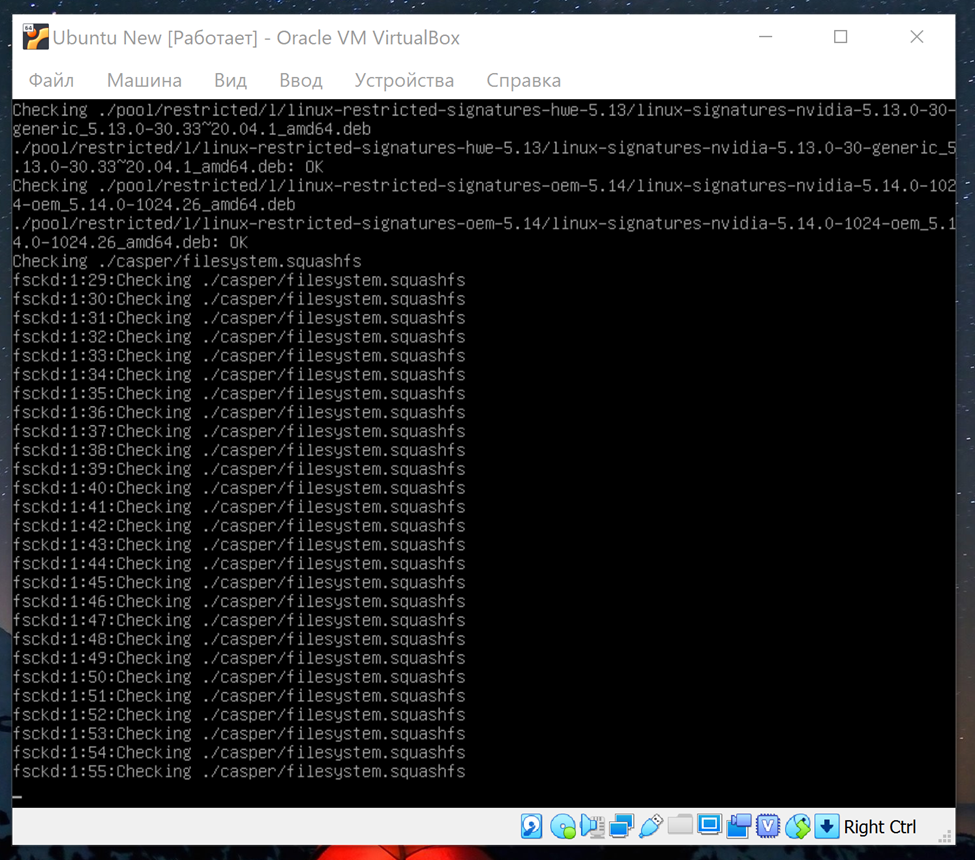

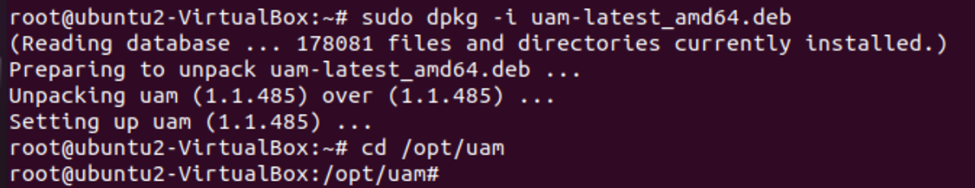

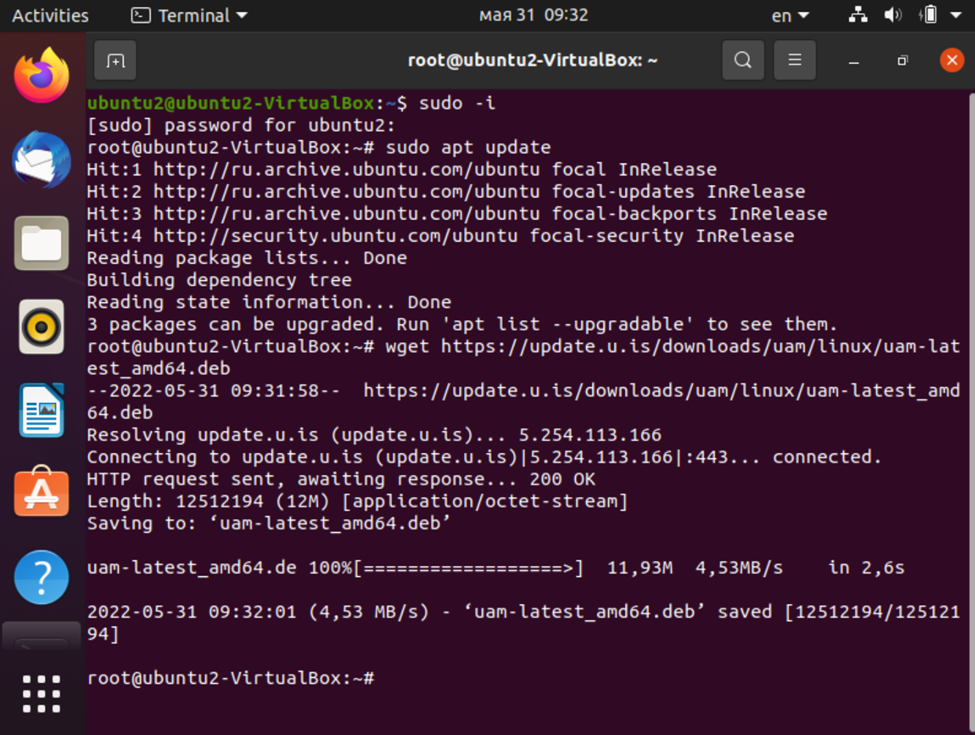

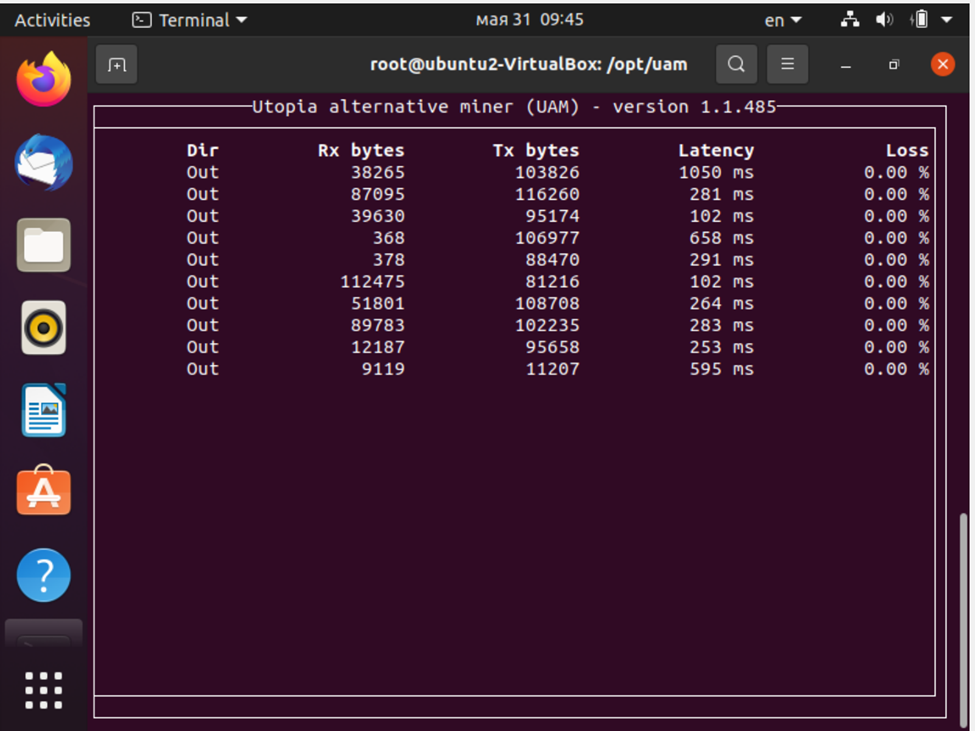

Время запускать майнинг-бота. Для этого нужно скачать обновления, скачать бота, открыть папку с ним и запустить, добавив ключ аккаунта. Но перед этим – назначить себя root.

Команды:

```

sudo -i

sudo apt update

wget https://update.u.is/downloads/uam/linux/uam-latest_amd64.deb

sudo dpkg -i uam-latest_amd64.deb

cd /opt/uam

./uam — pk КЛЮЧ

```

После того, как мы распаковали майнинг-бота, нужно его запустить. Для этого потребуется ключ – Public Key в экосистеме Utopia. Он находится в uWallet – слева сверху.

Ввести ключ нужно командой:

```

./uam --pk КЛЮЧ

```

Итог: бот запущен.

Кстати, по поводу майнинга: в комментариях и разборах видел предположение, что «Utopia может в теории использовать ваши мощности, чтобы вы майнили Bitcoin, а получали за это криптоны». На самом деле, это невозможно – потому что в майнинге криптонов вообще не участвует графическое вычисление.

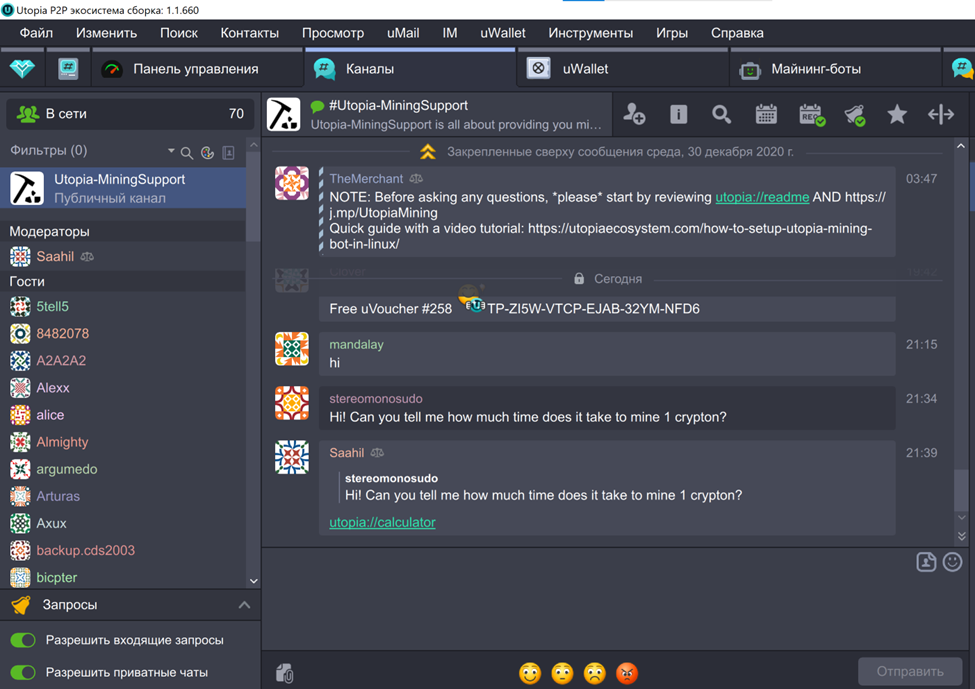

Сколько времени нужно, чтобы намайнить один криптон – об этом я спросил в каналах, связанных с майнингом, в экосистеме. Меня отправили на сайт калькулятора во встроенном браузере.

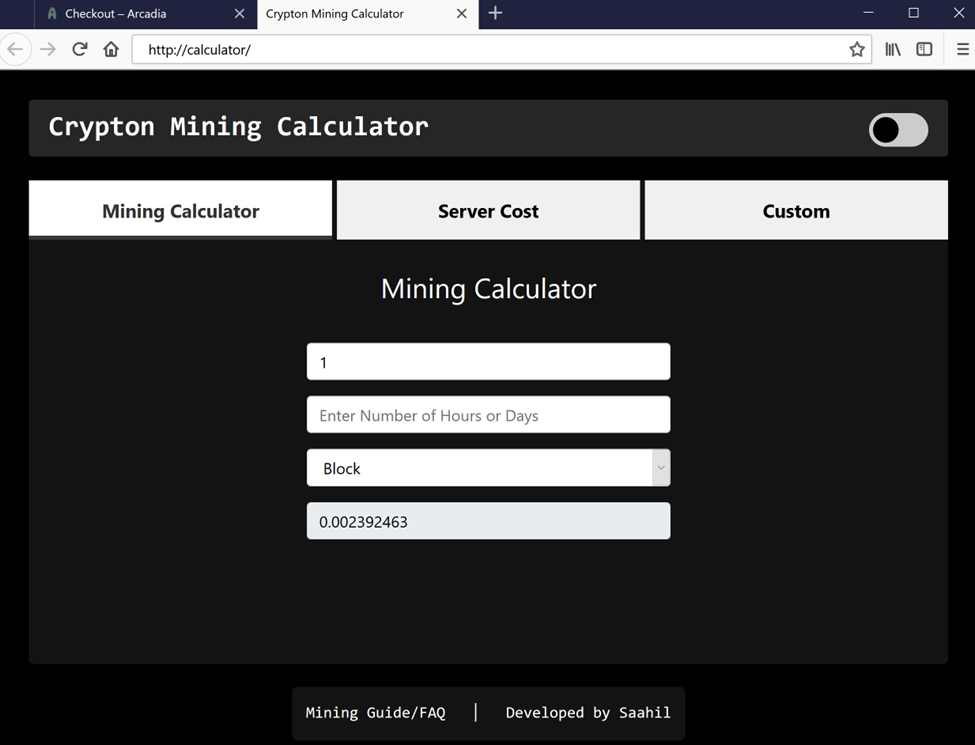

Как оказалось, этот калькулятор сделал тот же пользователь, что дал на него ссылку. Но возникла проблема: калькулятор просит ввести «количество часов или дней» для расчёта. А результат выдаёт один. То есть неясно, за 24 часа он считает или за 24 дня.

Поэтому пришлось пойти другим путём. Во вкладке майнинга есть показатель – стоимость за один поток. Начисление происходит каждые 15 минут. Таким образом, если взять показатель потока, умножить его на 96, то получим, сколько он даст за сутки. То есть при 0,002 за поток в сутки получаем 0,2208.

При запуске четырёх ботов – увеличиваем до 0,88 – то есть, как подсказали в одном из топиков, сделать один криптон с помощью четырёх майнинг-ботов можно за сутки с небольшим.

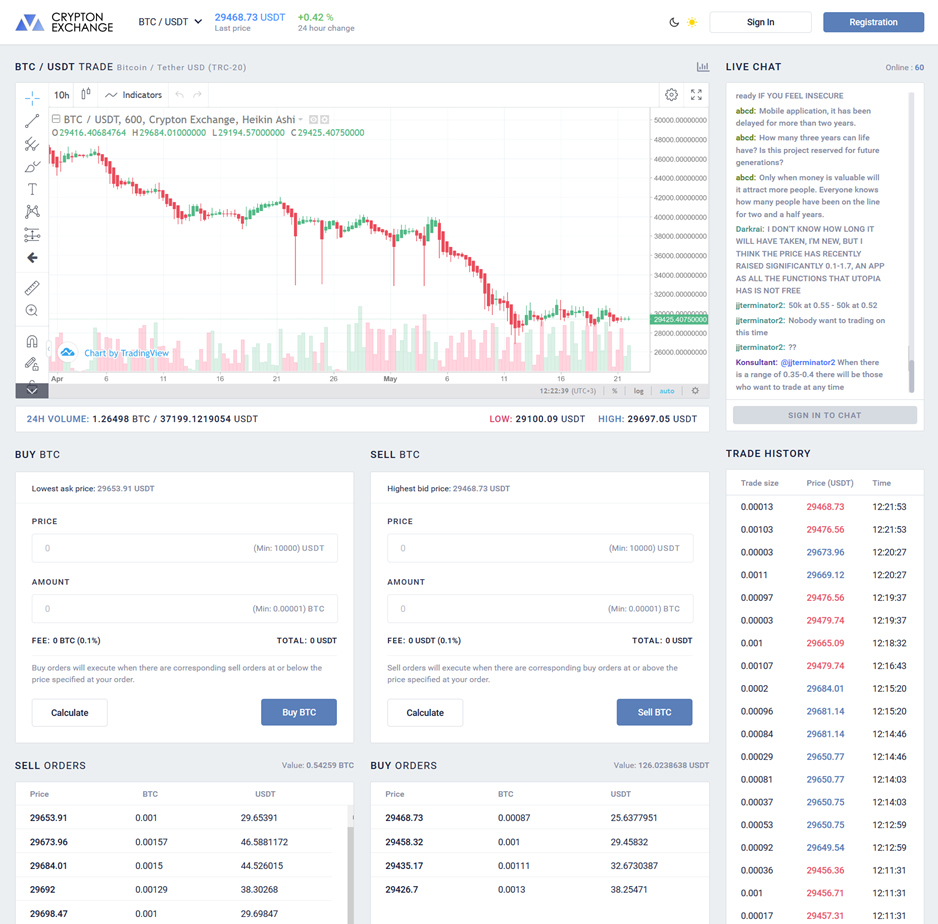

### Итог: как использовать криптоны

Теперь вопрос, зачем, собственно, криптоны нужны в экосистеме, что с ними можно делать.

В экосистеме Utopia действует биржа. Попасть в неё можно по адресу [crp](http://crp/) во встроенном браузере Idyll. Или по адресу crp.is – в обычном браузере.

На данный момент для продажи и покупки на бирже доступны. Сейчас идёт голосование за то, какие новые криптовалюты появятся.

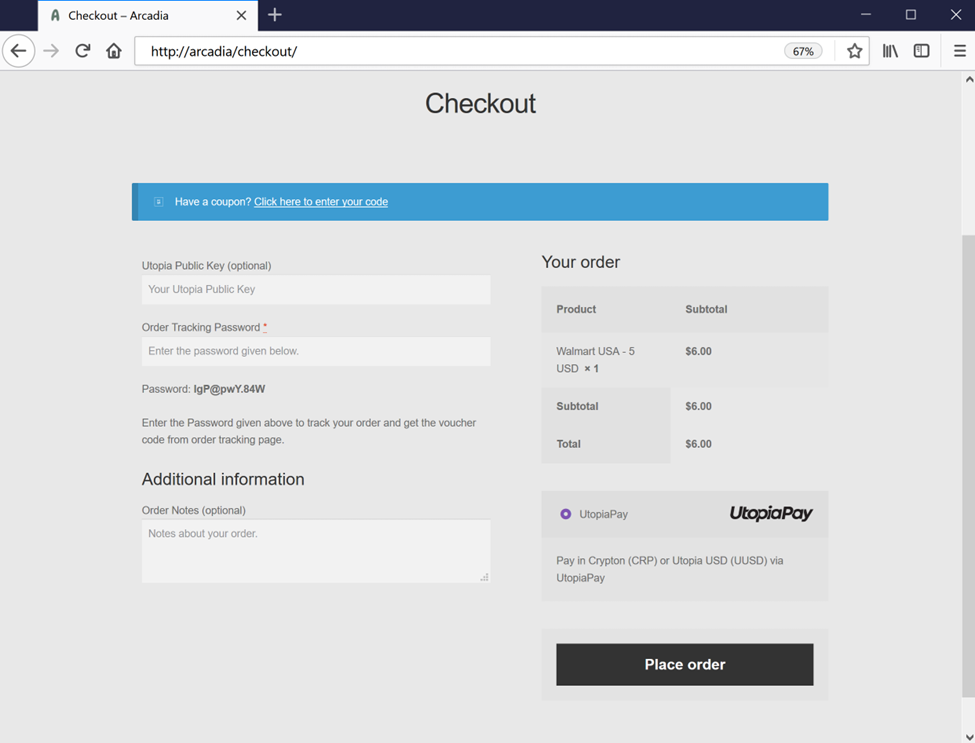

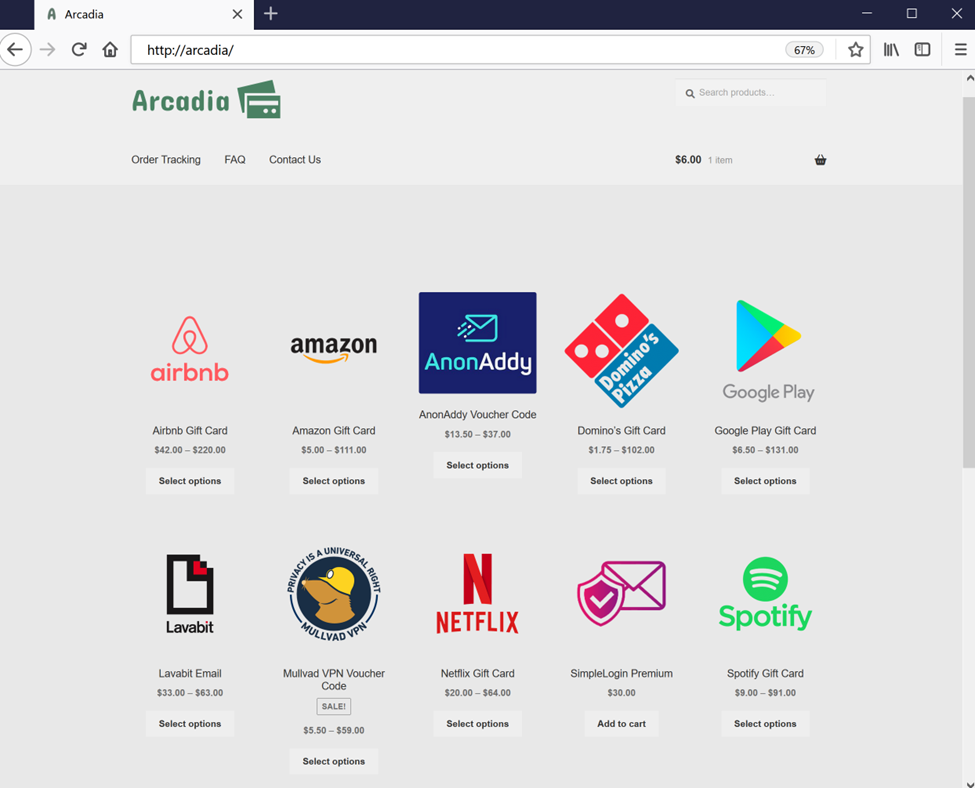

Также деньги можно потратить на подарочные карты в ряде магазинов – через сайт Arcadia во встроенном браузере. Здесь есть Google Play, Twitch, Amazon и так далее.

Также за криптоны можно купить себе доменное имя. Оно, кстати, покупается навечно. Я собираюсь попробовать создать сайт именно в Utopia – постараюсь разобраться, как это работает. И да – чтобы поддержать авторов сайтов можно отправлять им валюту. Поэтому напишу подробности, когда смогу создать новую страницу. | https://habr.com/ru/post/669494/ | null | ru | null |

# Машина опорных векторов в 30 строчек

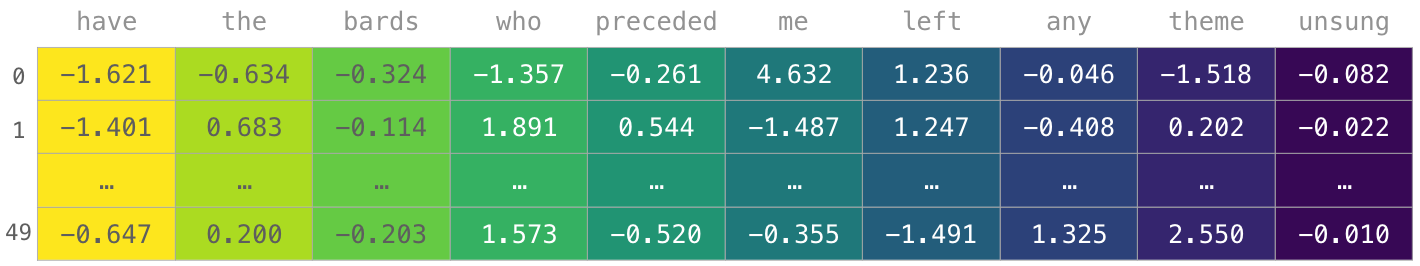

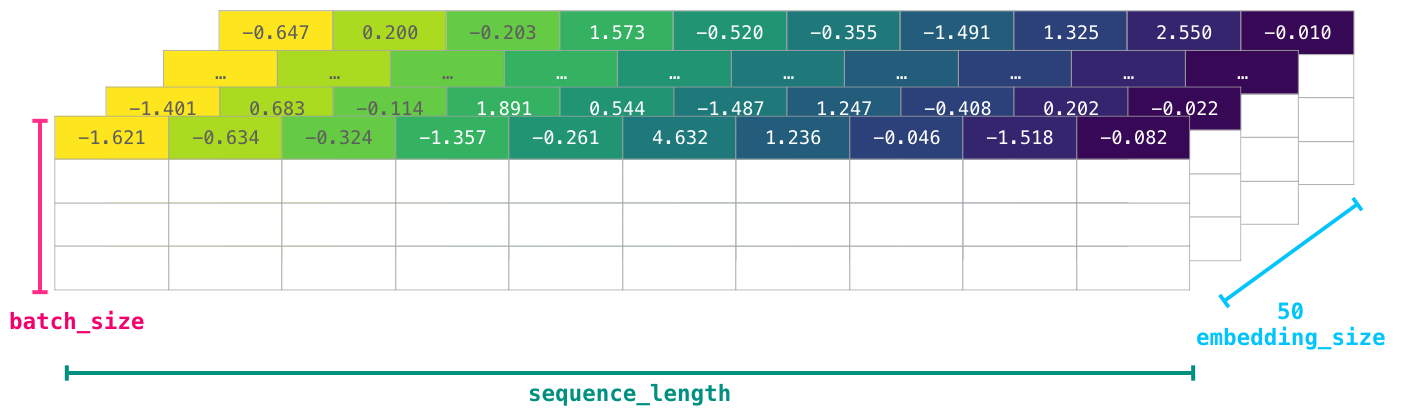

В этой статье я расскажу как написать свою очень простую машину опорных векторов без scikit-learn или других библиотек с готовой реализацией всего в 30 строчек на Python. Если вам хотелось разобраться в алгоритме SMO, но он показался слишком сложным, то эта статья может быть вам полезна.

Невозможно объяснить, что такое ~~Матрица~~ машина опорных векторов… Ты должен увидеть это сам.

Узнав, что на Хабре есть возможность вставлять медиаэлементы, я создал небольшое демо (если вдруг не сработает — можно ещё попытать счастья с версией на гитхабе [[1]](#git_demo)). Поместите на плоскость (пространство двух фич  и ) несколько красных и синих точек (это наш датасет) и машина произведёт классификацию (каждая точка фона закрашивается в зависимости от того, куда был бы классифицирован соответствующий запрос). Подвигайте точки, поменяйте ядро (советую попробовать Radial Basis Functions) и твёрдость границы (константа ). Мои извинения за ужасный код на JS — писал на нём всего несколько раз в жизни, чтобы разобраться в алгоритме используйте код на Python далее в статье.

Содержание

----------

* В [следующем разделе](#secSVM) я бегло опишу математическую постановку задачи обучения машины опорных векторов, к какой задаче оптимизации она сводится, а также некоторые гиперпараметры, позволяющие регулировать работу алгоритма. Этот материал лишь подводящий к нашей конечной цели и нужен чтобы вспомнить ключевые факты, если такое напоминание не требуется — можете его пропустить без ущерба для понимания дальнейших частей. Если же вы ранее не сталкивались с машинами опорных векторов, то понадобиться куда более полное изложение — обратите внимание на соответствующую лекцию уже ставшего классикой курса Воронцова [[2]](#woron) или на десятую лекцию курса [[3]](#gitrepo), в которую, кстати, входит представленный ниже метод.

* В разделе [«Алгоритм SMO»](#secSMO) я подробно расскажу как решить поставленную задачу минимизации упрощенным методом SMO и в чём, собственно, состоит упрощение. Будут выкладки, но их объём гораздо меньше, чем в тех подходах к SMO, что доводилось видеть мне.

* Наконец, в разделе [«Реализация»](#secImplementation) будет представлен код классификатора на Python и схема обучения в псевдокоде.

* Узнать насколько алгоритм удался можно в разделе [«Сравнение с sklearn.svc.svm»](#secComparison) — там приведено визуальное сравнение для небольших датасетов в 2D и confusion matrix для двух классов из MNIST.

* А в [«Заключении»](#secConclusion) что-нибудь да заключим.

Машина опорных векторов

-----------------------

Машина опорных векторов — метод машинного обучения (обучение с учителем) для решения задач классификации, регрессии, детектирования аномалий и т.д. Мы рассмотрим ее на примере задачи бинарной классификации. Наша обучающая выборка — набор векторов фич , отнесенных к одному из двух классов . Запрос на классификацию — вектор , которому мы должны приписать класс  или .

В простейшем случае классы обучающей выборки можно разделить проведя всего одну прямую как на рисунке (для большего числа фич это была бы гиперплоскость). Теперь, когда придёт запрос на классификацию некоторой точки , разумно отнести её к тому классу, на чьей стороне она окажется.

Как выбрать лучшую прямую? Интуитивно хочется, чтобы прямая проходила посередине между классами. Для этого записывают уравнение прямой как  и масштабируют параметры так, чтобы ближайшие к прямой точки датасета удовлетворяли  (плюс или минус в зависимости от класса) — эти точки и называют *опорными векторами*.

В таком случае расстояние между граничными точками классов равно . Очевидно, мы хотим максимизировать эту величину, чтобы как можно более качественно отделить классы. Последнее эквивалентно минимизации , полностью задача оптимизации записывается

Если её решить, то классификация по запросу  производится так

Это и есть простейшая машина опорных векторов.

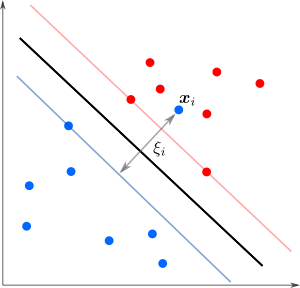

А что делать в случае когда точки разных классов взаимно проникают как на рисунке?

Мы уже не можем решить предыдущую задачу оптимизации — не существует параметров удовлетворяющих тем условиям. Тогда можно разрешить точкам нарушать границу на величину , но также желательно, чтобы таких нарушителей было как можно меньше. Этого можно достичь с помощью модификации целевой функции дополнительным слагаемым (регуляризация ):

а процедура классификации будет производиться как прежде. Здесь гиперпараметр  отвечает за силу регуляризации, то есть определяет, насколько строго мы требуем от точек соблюдать границу: чем больше  — тем больше  будет обращаться в ноль и тем меньше точек будут нарушать границу. Опорными векторами в таком случае называют точки, для которых .

А что если обучающая выборка напоминает логотип группы The Who и точки ни за что нельзя разделить прямой?

Здесь нам поможет остроумная техника — *трюк с ядром* [[4]](#kernel). Однако, чтобы ее применить, нужно перейти к так называемой *двойственной* (или *дуальной*) задаче Лагранжа. Детальное ее описание можно посмотреть в Википедии [[5]](#wiki_opt) или в шестой лекции курса [[3]](#gitrepo). Переменные, в которых решается новая задача, называют *дуальными* или *множителями Лагранжа*. Дуальная задача часто проще изначальной и обладает хорошими дополнительными свойствами, например, она вогнута даже если изначальная задача невыпуклая. Хотя ее решение не всегда совпадает с решением изначальной задачи (разрыв двойственности), но есть ряд теорем, которые при определённых условиях гарантируют такое совпадение (сильная двойственность). И это как раз наш случай, так что можно смело перейти к двойственной задаче

где  — дуальные переменные. После решения задачи максимизации требуется ещё посчитать параметр , который не вошёл в двойственную задачу, но нужен для классификатора

![$ b = \mathbb{E}_{k,\xi_k \neq 0}\left[y_k - \sum_i \lambda_i y_i (\boldsymbol{x}_i \cdot \boldsymbol{x}_k)\right]. $](https://habrastorage.org/getpro/habr/formulas/904/d3c/4ef/904d3c4efd77155c3d1185166aa743d8.svg)

Классификатор можно (и нужно) переписать в терминах дуальных переменных

В чём преимущество этой записи? Обратите внимание, что все векторы из обучающей выборки входят сюда исключительно в виде скалярных произведений . Можно сначала отобразить точки на поверхность в пространстве большей размерности, и только затем вычислить скалярное произведение образов в новом пространстве. Зачем это делать видно из рисунка.

При удачном отображении образы точек разделяются гиперплоскостью! На самом деле, всё ещё лучше: отображать-то и не нужно, ведь нас интересует только скалярное произведение, а не конкретные координаты точек. Так что всю процедуру можно эмулировать, заменив скалярное произведение функцией , которую называют *ядром*. Конечно, быть ядром может не любая функция — должно хотя бы гипотетически существовать отображение , такое что . Необходимые условия определяет теорема Мерсера [[6]](#merser). В реализации на Python будут представлены линейное (), полиномиальное () ядра и ядро радиальных базисных функций (). Как видно из примеров, ядра могут привносить свои специфические гиперпараметры в алгоритм, что тоже будет влиять на его работу.

Возможно, вы видели видео, где действие гравитации поясняют на примере натянутой резиновой пленки в форме воронки [[7]](#video). Это работает, так как движение точки по искривленной поверхности в пространстве большой размерности эквивалентно движению её образа в пространстве меньшей размерности, если снабдить его нетривиальной метрикой. Фактически, ядро искривляет пространство.

Алгоритм SMO

------------

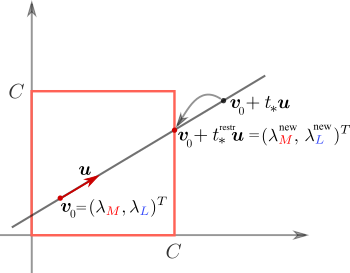

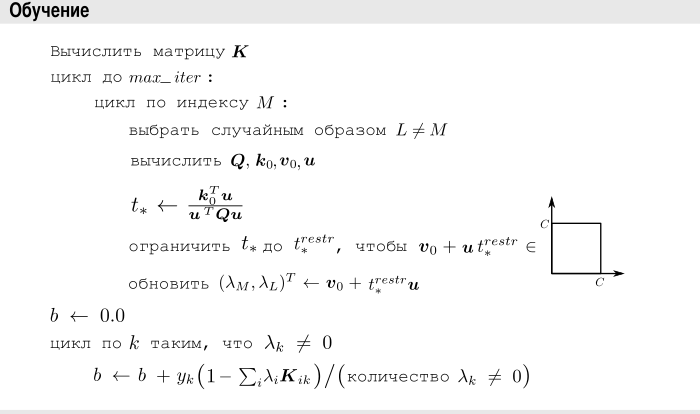

Итак, мы у цели, осталось решить дуальную задачу, поставленную в предыдущем разделе

после чего найти параметр

![$ b = \mathbb{E}_{k,\xi_k \neq 0}[y_k - \sum_i \lambda_i y_i K(\boldsymbol{x}_i; \boldsymbol{x}_k)], \tag{1} $](https://habrastorage.org/getpro/habr/formulas/c0d/479/821/c0d479821cb4f0f2b33fbb7664ff4a5c.svg)

а классификатор примет следующий вид

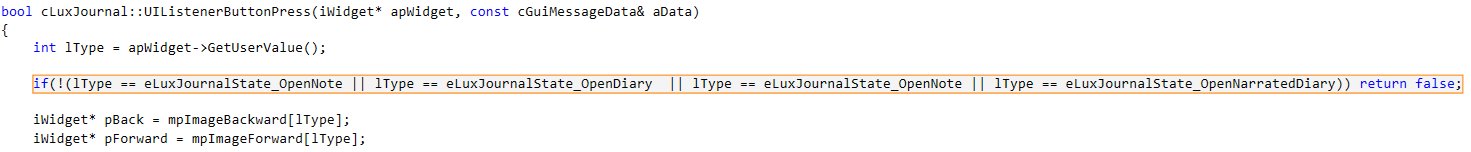

Алгоритм SMO (Sequential minimal optimization, [[8]](#wiki_smo)) решения дуальной задачи заключается в следующем. В цикле при помощи сложной эвристики ([[9]](#platt)) выбирается пара дуальных переменных $inline$\lambda\_\M$inline$ и , а затем по ним минимизируется целевая функция, с условием постоянства суммы $inline$y\_\M\lambda\_\M + y\_\L\lambda\_\L$inline$ и ограничений $inline$0 \leq \lambda\_\M \leq C$inline$, $inline$0 \leq \lambda\_\L \leq C$inline$ (настройка жёсткости границы). Условие на сумму сохраняет сумму всех  неизменной (ведь остальные лямбды мы не трогали). Алгоритм останавливается, когда обнаруживает достаточно хорошее соблюдение так называемых *условий ККТ* (Каруша-Куна-Такера [[10]](#wiki_kkt)).

Я собираюсь сделать несколько упрощений.

* Откажусь от сложной эвристики выбора индексов (так сделано в курсе Стэнфордского университета [[11]](#stanford)) и буду итерировать по одному индексу, а второй — выбирать случайным образом.

* Откажусь от проверки ККТ и буду выполнять наперёд заданное число итераций.

* В самой процедуре оптимизации, в отличии от классической работы [[9]](#platt) или стэнфордского подхода [[11]](#stanford), воспользуюсь векторным уравнением прямой. Это существенно упростит выкладки (сравните объём [[12]](#rgarticle) и [[13]](#fullderiv)).

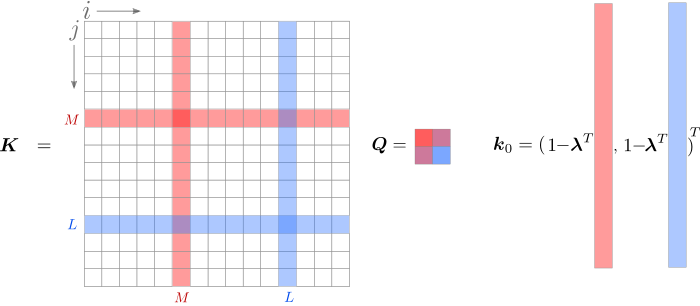

Теперь к деталям. Информацию из обучающей выборки можно записать в виде матрицы

В дальнейшем я буду использовать обозначение с двумя индексами (), чтобы обратиться к элементу матрицы и с одним индексом () для обозначения вектора-столбца матрицы. Дуальные переменные соберём в вектор-столбец . Нас интересует

Допустим, на текущей итерации мы хотим максимизировать целевую функцию по индексам $inline$\L$inline$ и $inline$\M$inline$. Мы будем брать производные, поэтому удобно выделить слагаемые, содержащие индексы  и $inline$\M$inline$. Это просто сделать в части с суммой , а вот квадратичная форма потребует несколько преобразований.

При расчёте  суммирование производится по двум индексам, пускай  и . Выделим цветом пары индексов, содержащие $inline$\L$inline$ или $inline$\M$inline$.

Перепишем задачу, объединив всё, что не содержит  или $inline$\lambda\_\M$inline$. Чтобы было легче следить за индексами, обратите внимание на  на изображении.

$$display$$ \begin{aligned} \mathscr{L} &= \lambda\_\M + \lambda\_\L - \sum\_{j} \lambda\_\M \lambda\_j K\_{\M,j} - \sum\_{i} \lambda\_\L \lambda\_i K\_{\L,i} + \text{const} + \\ {\text{компенсация}\atop\text{двойного подсчета}} \rightarrow\qquad &+ \frac{1}{2}\lambda\_\M^2 K\_{\M,\M} + \lambda\_\M \lambda\_\L K\_{\M,\L} + \frac{1}{2}\lambda\_\L^2 K\_{\L,\L} = \\ &= \lambda\_\M \left(1-\sum\_{j} \lambda\_j K\_{\M,j}\right) + \lambda\_\L \left(1-\sum\_{i} \lambda\_i K\_{\L,i}\right)+\\ &+\frac{1}{2}\left(\lambda\_\M^2 K\_{\M,\M} + 2 \lambda\_\M \lambda\_\L K\_{\M,\L}+\lambda\_\L^2 K\_{\L,\L} \right) + \text{const} = \\ &=\boldsymbol{k}^T\_0 \boldsymbol{v}\_0 + \frac{1}{2}\boldsymbol{v}^{\,T}\_0 \, \boldsymbol{Q} \, \boldsymbol{v}\_0 + \text{const}, \end{aligned} $$display$$

где  обозначает слагаемые, не зависящие от $inline$\lambda\_\L$inline$ или $inline$\lambda\_\M$inline$. В последней строке я использовал обозначения

$$display$$ \begin{align} \boldsymbol{v}\_0 &= (\lambda\_\M, \lambda\_\L)^T, \tag{4a}\\ \boldsymbol{k}\_0 &= \left(1 - \boldsymbol{\lambda}^T\boldsymbol{K}\_{\M}, 1 - \boldsymbol{\lambda}^T\boldsymbol{K}\_{\L}\right)^T, \tag{4b}\\ \boldsymbol{Q} &= \begin{pmatrix} K\_{\M,\M} & K\_{\M,\L} \\ K\_{\L,\M} & K\_{\L,\L} \\ \end{pmatrix},\tag{4c}\\ \boldsymbol{u} &= (-y\_\L, y\_\M)^T. \tag{4d} \end{align} $$display$$

Обратите внимание, что  не зависит ни от $inline$\lambda\_\L$inline$, ни от $inline$\lambda\_\M$inline$

$$display$$ \boldsymbol{k}\_0 = \begin{pmatrix} 1 - \lambda\_\M K\_{\M,\M} - \lambda\_\L K\_{\M,\L} - \sum\_{i \neq \M,\L} \lambda\_i K\_{\M,i}\\ 1 - \lambda\_\M K\_{\L,\M} - \lambda\_\L K\_{\L,\L} - \sum\_{i \neq \M,\L} \lambda\_i K\_{\L,i}\\ \end{pmatrix} = \begin{pmatrix} 1 - \sum\_{i \neq \M,\L} \lambda\_i K\_{\M,i}\\ 1 - \sum\_{i \neq \M,\L} \lambda\_i K\_{\L,i}\\ \end{pmatrix} - \boldsymbol{Q} \boldsymbol{v}\_0. $$display$$

Ядро — симметрично, поэтому  и можно записать

Мы хотим выполнить максимизацию так, чтобы $inline$y\_\L\lambda\_\L + y\_\M\lambda\_\M$inline$ осталось постоянным. Для этого новые значения должны лежать на прямой

$$display$$ (\lambda\_\M^\text{new}, \lambda\_\L^\text{new})^T = \boldsymbol{v}(t) = \boldsymbol{v}\_0 + t \boldsymbol{u}. $$display$$

Несложно убедиться, что для любого

$$display$$ y\_\M\lambda\_\M^\text{new} + y\_\L\lambda\_\L^\text{new} = y\_\M \lambda\_\M + y\_\L \lambda\_\L + t (-y\_\M y\_\L + y\_\L y\_\M) = y\_\M\lambda\_\M + y\_\L\lambda\_\L. $$display$$

В таком случае мы должны максимизировать

что легко сделать взяв производную

Приравнивая производную к нулю, получим

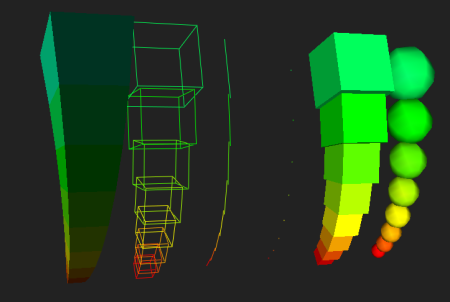

И ещё одно: возможно мы заберёмся дальше чем нужно и окажемся вне квадрата как на картинке. Тогда нужно сделать шаг назад и вернуться на его границу

$$display$$ (\lambda\_\M^\text{new}, \lambda\_\L^\text{new}) = \boldsymbol{v}\_0 + t\_\*^{\text{restr}} \boldsymbol{u}. $$display$$

На этом итерация завершается и выбираются новые индексы.

Реализация

----------

Принципиальную схему обучения упрощённой машины опорных векторов можно записать как

Давайте посмотрим на код на реальном языке программирования. Если вы не любите код в статьях, можете изучить его на гитхабе [[14]](#smo_repo).

**Исходный код упрощённой машины опорных векторов**

```

import numpy as np

class SVM:

def __init__(self, kernel='linear', C=10000.0, max_iter=100000, degree=3, gamma=1):

self.kernel = {'poly' : lambda x,y: np.dot(x, y.T)**degree,

'rbf': lambda x,y: np.exp(-gamma*np.sum((y-x[:,np.newaxis])**2,axis=-1)),

'linear': lambda x,y: np.dot(x, y.T)}[kernel]

self.C = C

self.max_iter = max_iter

# ограничение параметра t, чтобы новые лямбды не покидали границ квадрата

def restrict_to_square(self, t, v0, u):

t = (np.clip(v0 + t*u, 0, self.C) - v0)[1]/u[1]

return (np.clip(v0 + t*u, 0, self.C) - v0)[0]/u[0]

def fit(self, X, y):

self.X = X.copy()

# преобразование классов 0,1 в -1,+1; для лучшей совместимости с sklearn

self.y = y * 2 - 1

self.lambdas = np.zeros_like(self.y, dtype=float)

# формула (3)

self.K = self.kernel(self.X, self.X) * self.y[:,np.newaxis] * self.y

# выполняем self.max_iter итераций

for _ in range(self.max_iter):

# проходим по всем лямбда

for idxM in range(len(self.lambdas)):

# idxL выбираем случайно

idxL = np.random.randint(0, len(self.lambdas))

# формула (4с)

Q = self.K[[[idxM, idxM], [idxL, idxL]], [[idxM, idxL], [idxM, idxL]]]

# формула (4a)

v0 = self.lambdas[[idxM, idxL]]

# формула (4b)

k0 = 1 - np.sum(self.lambdas * self.K[[idxM, idxL]], axis=1)

# формула (4d)

u = np.array([-self.y[idxL], self.y[idxM]])

# регуляризированная формула (5), регуляризация только для idxM = idxL

t_max = np.dot(k0, u) / (np.dot(np.dot(Q, u), u) + 1E-15)

self.lambdas[[idxM, idxL]] = v0 + u * self.restrict_to_square(t_max, v0, u)

# найти индексы опорных векторов

idx, = np.nonzero(self.lambdas > 1E-15)

# формула (1)

self.b = np.mean((1.0-np.sum(self.K[idx]*self.lambdas, axis=1))*self.y[idx])

def decision_function(self, X):

return np.sum(self.kernel(X, self.X) * self.y * self.lambdas, axis=1) + self.b

def predict(self, X):

# преобразование классов -1,+1 в 0,1; для лучшей совместимости с sklearn

return (np.sign(self.decision_function(X)) + 1) // 2

```

При создании объекта класса SVM можно указать гиперпараметры. Обучение производится вызовом функции fit, классы должны быть указаны как  и  (внутри конвертируются в  и , сделано для большей совместимости с sklearn), размерность вектора фич допускается произвольной. Для классификации используется функция predict.

Стоит обратить внимание, что главный потребитель данных из матрицы  — скалярные произведения с  (кроме них на каждой итерации используется ещё только 4 значения для формирования матрицы ). Это означает, что эффективно мы используем только те элементы , что соответствуют ненулевым  — остальные будут буквально умножены на ноль. Это важное замечание для больших размеров выборки: если количество переменных прямой задачи соответствовало размерности пространства (числу фич), то для дуальной задачи оно уже равно числу точек (размеру датасета) и квадратичная сложность по памяти может оказаться проблемой. К счастью, лишь небольшое число векторов станут опорными, а значит из всей огромной матрицы  нам понадобятся для расчётов всего несколько элементов, которые можно или пересчитывать каждый раз, или же использовать ленивые вычисления.

Сравнение с sklearn.svm.SVC

---------------------------

Не то, чтобы данное сравнение имело особый смысл, ведь речь идёт о крайне упрощённом алгоритме, разработанном исключительно в целях обучения студентов, но всё же. Для тестирования (и чтобы посмотреть как этим всем пользоваться) можно выполнить следующее (этот код тоже есть на гитхаб [[14]](#smo_repo)).

**Сравнение с sklearn.svm.SVC на простом двумерном датасете**

```

from sklearn.svm import SVC

import matplotlib.pyplot as plt

import seaborn as sns; sns.set()

from sklearn.datasets import make_blobs, make_circles

from matplotlib.colors import ListedColormap

def test_plot(X, y, svm_model, axes, title):

plt.axes(axes)

xlim = [np.min(X[:, 0]), np.max(X[:, 0])]

ylim = [np.min(X[:, 1]), np.max(X[:, 1])]

xx, yy = np.meshgrid(np.linspace(*xlim, num=700), np.linspace(*ylim, num=700))

rgb=np.array([[210, 0, 0], [0, 0, 150]])/255.0

svm_model.fit(X, y)

z_model = svm_model.decision_function(np.c_[xx.ravel(), yy.ravel()]).reshape(xx.shape)

plt.scatter(X[:, 0], X[:, 1], c=y, s=50, cmap='autumn')

plt.contour(xx, yy, z_model, colors='k', levels=[-1, 0, 1], alpha=0.5, linestyles=['--', '-', '--'])

plt.contourf(xx, yy, np.sign(z_model.reshape(xx.shape)), alpha=0.3, levels=2, cmap=ListedColormap(rgb), zorder=1)

plt.title(title)

X, y = make_circles(100, factor=.1, noise=.1)

fig, axs = plt.subplots(nrows=1,ncols=2,figsize=(12,4))

test_plot(X, y, SVM(kernel='rbf', C=10, max_iter=60, gamma=1), axs[0], 'OUR ALGORITHM')

test_plot(X, y, SVC(kernel='rbf', C=10, gamma=1), axs[1], 'sklearn.svm.SVC')

X, y = make_blobs(n_samples=50, centers=2, random_state=0, cluster_std=1.4)

fig, axs = plt.subplots(nrows=1,ncols=2,figsize=(12,4))

test_plot(X, y, SVM(kernel='linear', C=10, max_iter=60), axs[0], 'OUR ALGORITHM')

test_plot(X, y, SVC(kernel='linear', C=10), axs[1], 'sklearn.svm.SVC')

fig, axs = plt.subplots(nrows=1,ncols=2,figsize=(12,4))

test_plot(X, y, SVM(kernel='poly', C=5, max_iter=60, degree=3), axs[0], 'OUR ALGORITHM')

test_plot(X, y, SVC(kernel='poly', C=5, degree=3), axs[1], 'sklearn.svm.SVC')

```

После запуска будут сгенерированы картинки, но так как алгоритм рандомизированный, то они будут слегка отличаться для каждого запуска. Вот пример работы упрощённого алгоритма (слева направо: линейное, полиномиальное и rbf ядра)

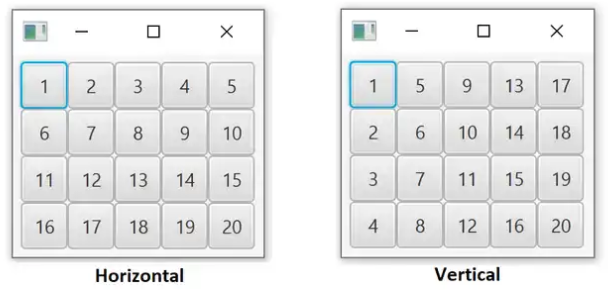

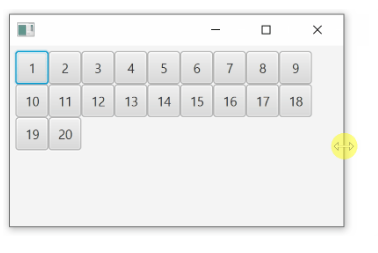

| | | |

| --- | --- | --- |

| | | |

А это результат работы промышленной версии машины опорных векторов.

| | | |

| --- | --- | --- |

| | | |

Если размерность  кажется слишком маленькой, то можно ещё протестировать на MNIST

**Сравнение с sklearn.svm.SVC на 2-х классах из MNIST**

```

from sklearn import datasets, svm

from sklearn.model_selection import train_test_split

from sklearn.metrics import confusion_matrix

import matplotlib.pyplot as plt

import seaborn as sns

class_A = 3

class_B = 8

digits = datasets.load_digits()

mask = (digits.target == class_A) | (digits.target == class_B)

data = digits.images.reshape((len(digits.images), -1))[mask]

target = digits.target[mask] // max([class_A, class_B]) # rescale to 0,1

X_train, X_test, y_train, y_test = train_test_split(data, target, test_size=0.5, shuffle=True)

def plot_confusion(clf):

clf.fit(X_train, y_train)

y_fit = clf.predict(X_test)

mat = confusion_matrix(y_test, y_fit)

sns.heatmap(mat.T, square=True, annot=True, fmt='d', cbar=False, xticklabels=[class_A,class_B], yticklabels=[class_A,class_B])

plt.xlabel('true label')

plt.ylabel('predicted label');

plt.show()

print('sklearn:')

plot_confusion(svm.SVC(C=1.0, kernel='rbf', gamma=0.001))

print('custom svm:')

plot_confusion(SVM(kernel='rbf', C=1.0, max_iter=60, gamma=0.001))

```

Для MNIST я попробовал несколько случайных пар классов (упрощённый алгоритм поддерживает только бинарную классификацию), но разницы в работе упрощённого алгоритма и sklearn не обнаружил. Представление о качестве даёт следующая confusion matrix.

Заключение

----------

Спасибо всем, кто дочитал до конца. В этой статье мы рассмотрели упрощённую учебную реализацию машины опорных векторов. Конечно, она не может состязаться с промышленным образцом, но благодаря крайней простоте и компактному коду на Python, а также тому, что все основные идеи SMO были сохранены, эта версия SVM вполне может занять своё место в учебной аудитории. Стоит отметить, что алгоритм проще не только весьма мудрёного алгоритма [[9]](#platt), но даже его упрощённой версии от Стэнфордского университета [[11]](#stanford). Все-таки машина опорных векторов в 30 строчках — это красиво.

Список литературы

-----------------

1. <https://fbeilstein.github.io/simplest_smo_ever/>

2. [страница на http://www.machinelearning.ru](http://www.machinelearning.ru/wiki/index.php?title=%D0%9C%D0%B0%D1%88%D0%B8%D0%BD%D0%BD%D0%BE%D0%B5_%D0%BE%D0%B1%D1%83%D1%87%D0%B5%D0%BD%D0%B8%D0%B5_%28%D0%BA%D1%83%D1%80%D1%81_%D0%BB%D0%B5%D0%BA%D1%86%D0%B8%D0%B9%2C_%D0%9A.%D0%92.%D0%92%D0%BE%D1%80%D0%BE%D0%BD%D1%86%D0%BE%D0%B2%29)

3. [«Начала Машинного Обучения», КАУ](https://github.com/fbeilstein/machine_learning)

4. <https://en.wikipedia.org/wiki/Kernel_method>

5. <https://en.wikipedia.org/wiki/Duality_(optimization)>

6. [Статья на http://www.machinelearning.ru](http://www.machinelearning.ru/wiki/index.php?title=%D0%A2%D0%B5%D0%BE%D1%80%D0%B5%D0%BC%D0%B0_%D0%9C%D0%B5%D1%80%D1%81%D0%B5%D1%80%D0%B0)

7. <https://www.youtube.com/watch?v=MTY1Kje0yLg>

8. <https://en.wikipedia.org/wiki/Sequential_minimal_optimization>

9. <https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/tr-98-14.pdf>

10. <https://en.wikipedia.org/wiki/Karush%E2%80%93Kuhn%E2%80%93Tucker_conditions>

11. <http://cs229.stanford.edu/materials/smo.pdf>

12. <https://www.researchgate.net/publication/344460740_Yet_more_simple_SMO_algorithm>

13. <http://fourier.eng.hmc.edu/e176/lectures/ch9/node9.html>

14. <https://github.com/fbeilstein/simplest_smo_ever> | https://habr.com/ru/post/544282/ | null | ru | null |

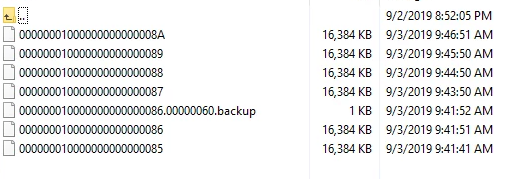

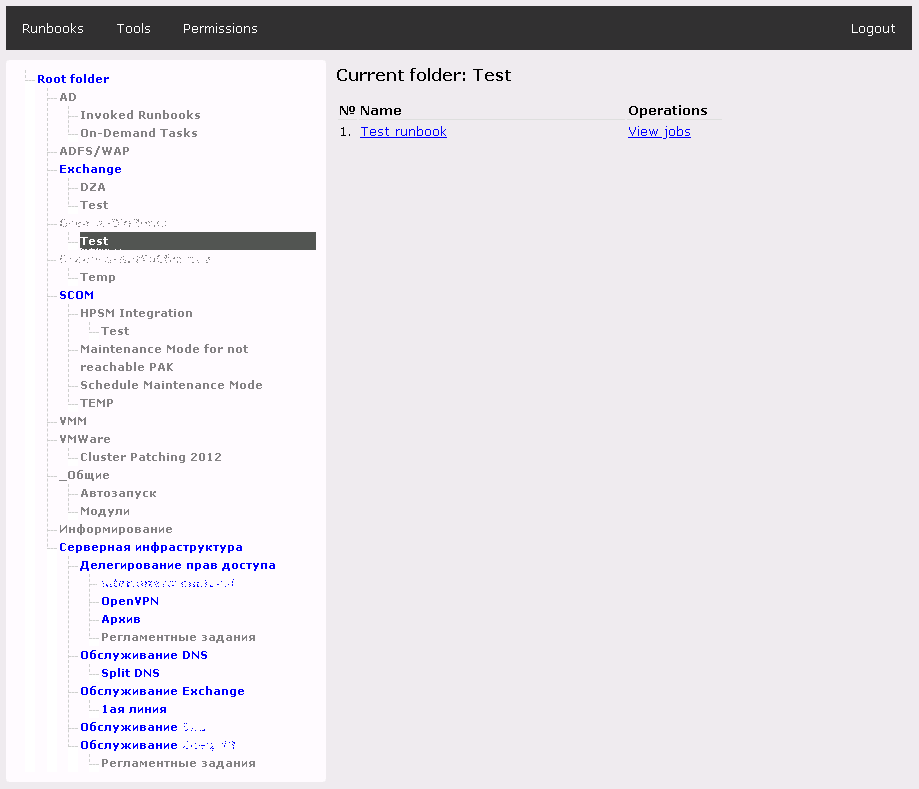

# Настройка continuous бекапов PostgreSQL

В данном мануале описывается процесс настройки постоянного (continuous) бекапирования для баз данных PostgreSQL.

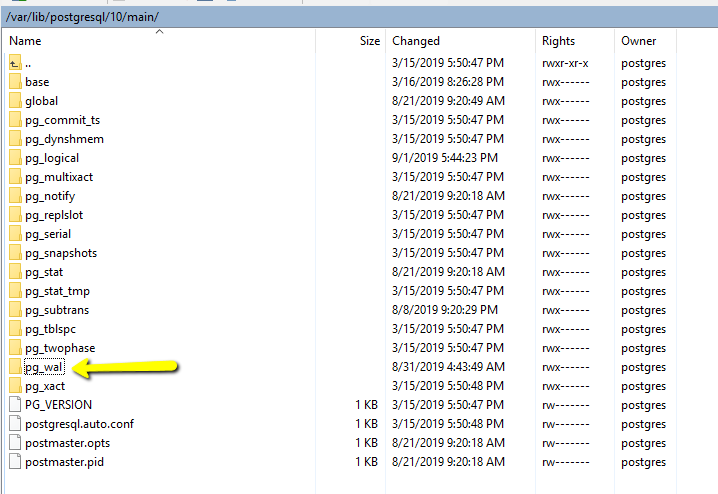

В нашей фирме (business to business) под каждого клиента создается свой собственный сервер, на который устанавливается база данных PostgreSQL и наш софт. Таким образом, у нас не единый instance продакшена, а десятки с разными экземплярами базы. Процесс настройки бекапов является частью процесса установки продакшена, а само бекапирование начинается до выхода системы в продакшен и продолжается в течение всего жизненного цикла сотрудничества с клиентом. Спецификацию железа и базового software определяем мы, поэтому все инстансы, как правило, имеют одни и те же версии Linux и PostgreSQL. Изредка этот инвариант нарушается — например, где-то по тем или иным причинам может стоять не Ubuntu, а Debian либо PostgreSQL более старой мажорной версии, чем у остальных. В последнем случае нужно быть особенно аккуратным — при возникновении сбоя следует иметь ввиду, что восстановление базы должно осуществляться на ту же мажорную версию PostgreSQL, на которой был сделан бекап, так как описываемый подход требует бинарной совместимости файлов данных, которая гарантируется только при переходе между минорными версиями PostgreSQL. Как поступить, если этот инвариант нарушен, также описано в конце данной статьи.

Подразумевается, что у читающего может быть довольно мало знаний как в области бекапов PostgreSQL, так и в сфере работы с Linux (а в особенности с инструментами ее командной строки), поэтому tutorial написан как можно более подробно.

Базовая концепция Continuous Archiving and Point-in-Time Recovery

-----------------------------------------------------------------

В этом разделе укажем основные идеи, лежащие в основе подхода Continuous Archiving and Point-in-Time Recovery. При необходимости подробные детали можно найти в [документации PostgreSQL](https://www.postgresql.org/docs/10/continuous-archiving.html).

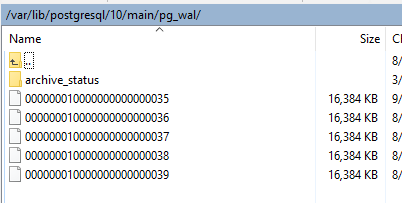

Пожалуй, как и все СУБД, PostgreSQL имеет файлы данных, в которых хранит текущее состояние базы данных. Однако, кроме этого PostgreSQL ведет и сохраняет логи изменений в базе данных. Эти логи представлены в виде так называемых write ahead logs (WAL) файлов, которые сохраняются в подпапке pg\_wal директории с данными:

WAL-файлы используются PostgreSQL для защиты от сбоев. Упрощенно говоря, при коммите транзакции PostgreSQL убеждается, что именно изменения в соответствующем WAL-файле гарантированно сохранились на диск, но, вообще говоря, может не делать такую же проверку по отношению к файлам с данными, например, кешируя их изменения до определенного момента в оперативной памяти. Если после последнего гарантированного сохранения файлов данных на диск (checkpoint) произошел сбой и текущее состояние еще не было сохранено, то после восстановления работы PostgreSQL возьмет последний checkpoint файлов данных (назовем его *base backup*) и последовательно применит к нему изменения, сохраненные в WAL-файлах (replay log entries).

Вышеописанную модель также можно использовать и для бекапирования с последующим восстановлением (например) на другом сервере. Для этого, очевидно, требуется реализовать следующую схему:

1. Сначала (один раз) снять бекап файлов данных (и отправить файлы в безопасное место на другой сервер)

2. В процессе работы по мере появления WAL-файлов тоже их бекапить

Модель восстановления после сбоя, таким образом, тоже становится очевидной:

1. На новом сервере PostgreSQL загрузить файлы данных из бекапа (упрощенно это соответствует их простому копированию в соответствующую рабочую папку данных)

2. На новом сервере PostgreSQL загрузить WAL-файлы из бекапа (упрощенно это соответствует их простому копированию в соответствующую подпапку рабочей папки данных)

Стоит иметь ввиду следующие особенности рассматриваемой модели бекапов:

* Бекапятся сразу все базы данных текущего PostgreSQL-сервера, т.е. нет возможности забекапить, например, только одну из них

* Не обязательно накатывать на *base backup* все записи WAL-файлов, можно остановиться на каком-то временном моменте (point-in-time recovery). Эта фича позволяет восстановить базу и в том случае, если сбой произошел в виду программной ошибки (например, была удалена какая-то таблица посредством drop table и т.п.).

В следующих разделах описываются технические детали описанной схемы.

Для этой цели будут использоваться следующие наименования: *целевой сервер* — текущий рабочий сервер, с которого делаем бекапы, *сервер бекапов* — сервер на который отправляются бекапы, *новый сервер* — сервер, на котором восстанавливается бекап целевого сервера после сбоя.

Оффтоп: несколько слов по безопасности

--------------------------------------

Ввиду особой ценности бекапов для бизнеса как с точки зрения восстановления после сбоев, так и с точки зрения возможных утечек информации нелишним будет пройтись по базовой безопасности Linux серверов. В целом, это не относится напрямую к рассматриваемой теме, поэтому, можно просто пробежаться глазами по этому разделу и, если у вас все устроено так же, спокойно пойти дальше. В случае если ваши решения по безопасности лучше описанных — просьба отписаться в комментариях и рассказать о своем опыте. Если же вы считаете, что с безопасностью у вас хуже, то описанные ниже решения стоит, вероятно, как можно скорее применить и к вашим продакшенам. Рассматриваться будет Ubuntu 18.04, на других версиях Linux инструкция может отличаться.

1. Ваша система имеет последние обновления

```

sudo apt-get update && sudo apt-get upgrade

```

2. Вы не работаете от пользователя 'root', вместо этого у вас создан персонифицированный (то есть, для каждого сотрудника, которому требуется доступ на сервер, свой) пользователь в группе sudo (в нашем случае, назовем его *alex*)

```

sudo adduser alex

# Вводим пароль и др. данные типа Full Name и т.п.

sudo adduser alex sudo

# Для проверки успешности создания пользователя можно зайти от него...

sudo su - alex

# ...и посмотреть список файлов в /root, куда имеют доступ только sudoers

sudo ls -la /root

# Если же ввести команду без sudo, то должна возникнуть ошибка авторизации

ls -la /root

```

3. При подключении по SSH вы не используете авторизацию по логину/паролю, применяя вместо этого доступ по ключу

```

# ---Локальная машина сотрудника---

# Считаем, что сотрудник на локальной машине сгенерировал пару приватный/публичный ключ,

# например, так, если у сотрудника Linux:

ssh-keygen -t rsa -b 4096

# При этом парольную фразу при генерации ключа сотрудник не оставил пустой, а установил достаточно сложный пароль

```

```

# ---Продакшен, пользователь alex---

# Создадим файл публичного ключа и сохраним туда содержимое публичного ключа с локальной машины сотрудника

nano ~/alex.pub

# Затем скопируем открытый ключ в authorized_keys

mkdir -p ~/.ssh

touch ~/.ssh/authorized_keys

chmod 700 ~/.ssh

chmod 600 ~/.ssh/authorized_keys

cat ~/alex.pub >> ~/.ssh/authorized_keys

rm ~/alex.pub

# Перезагрузим сервер

sudo reboot

```

4. В конфиге ssh включена опция доступа по ключу, кроме этого порт доступа ssh изменен со стандартного на рандомный (макроподстановка [generatedPortNumber] в скрипте ниже) в диапазоне от 1024 до 57256 (т.к. часто сканеры портов для экономии ресурсов проверяют лишь стандартные порты)

```

# Открыть файл настроек ssh

sudo nano /etc/ssh/sshd_config

# Раскоментировать и поменять значения следующих ключей:

PubkeyAuthentication yes

# Если в файле присутствует ключ AuthenticationMethods, то в этом (и только в этом!) случае

# поменять его значение или раскоментировать

AuthenticationMethods publickey

# Поменять значение порта на [generatedPortNumber] и раскоментировать

Port [generatedPortNumber]

# Перезагрузиться

sudo reboot

```

```

# --- После перезагрузки ---

# Убедиться в успешности подключения по ssh на новый порт по ключу пользователя alex...

```

5. Доступ root-а по ssh — запрещен, доступ по паролю по ssh — запрещен

```

# Открыть файл настроек ssh

sudo nano /etc/ssh/sshd_config

# Раскоментировать и поменять значения следующих ключей:

PermitRootLogin no

ChallengeResponseAuthentication no

PasswordAuthentication no

UsePAM no

# Перезагрузиться

sudo reboot

```

Настройка сервера бекапов

-------------------------

#### Создание папок для бекапа

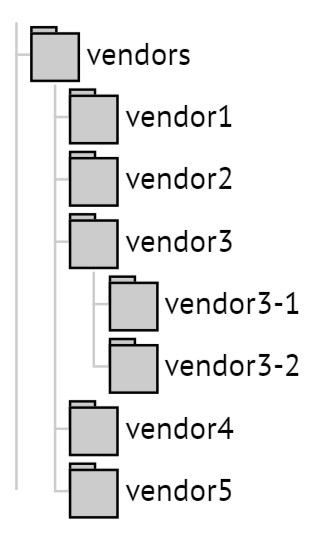

Поскольку у нас множество инсталляций, с которых будут собираться бекапы, структура папок будет следующей. Папка для хранения бекапов — /var/lib/postgresql/backups. Под каждую инсталляцию в папке для хранения бекапов создается подпапка по имени клиента [clientName]. В каждой такой подпапке будут лежать 2 папки: base для базового бекапа и wal для continious archiving WAL-файлов с целевого сервера. Таким образом, при настройке бекапирования для клиента [clientName] выполняем следующие команды по созданию соответствующих директорий:

```

sudo mkdir -p /var/lib/postgresql/backups/[clientName]/base

sudo mkdir -p /var/lib/postgresql/backups/[clientName]/wal

```

Разумеется, структура папок может быть и любой другой, которую вы находите более удобой для вас. Например, если хранить бекапы в *home* директориях соответствующих пользователей (см. ниже), то в следующем пункте можно сэкономить пару команд по раздаче прав на чтение и запись в эти папки.

#### Создание пользователя

В целях безопасности каждый продакшен (целевой сервер), с которого идут бекапы, будет иметь своего собственного пользователя на сервере бекапов. Это — обычный пользователь с ограниченными правами (не sudoer), который должен иметь права на чтение и запись в свою папку для бекапа, но не иметь возможность ни читать, ни писать в папки чужих продакшенов. Таким образом, даже если данный целевой сервер будет скомпрометирован, это не приведет к утечке данных других продакшенов через сервер бекапов.

Подробнее процесс выглядит следующим образом. Допустим, мы настраиваем бекап для проекта с именем *foo*. Для настройки сервера бекапов изначально заходим на него от пользователя из *sudo*. Добавляем пользователя с ограниченными правами *foobackup*:

```

# Добавить нового пользователя

sudo adduser foobackup

Adding user `foobackup' ...

Adding new group `foobackup' (1001) ...

Adding new user `foobackup' (1001) with group `foobackup' ...

Creating home directory `/home/foobackup' ...

Copying files from `/etc/skel' ...

Enter new UNIX password:

Retype new UNIX password:

passwd: password updated successfully

Changing the user information for foobackup

Enter the new value, or press ENTER for the default

Full Name []: AlexGtG

Room Number []:

Work Phone []:

Home Phone []:

Other []:

Is the information correct? [Y/n] Y

```

#### Выдача прав пользователю на папки бекапа

Разрешаем *foobackup* читать и писать в свою папку, но запрещаем это делать всем остальным:

```

# Владельцем папки foo назначается foobackup

sudo chown -R foobackup: /var/lib/postgresql/backups/foo

# Никто кроме владельца не имеет доступа к этой папке

sudo chmod -R 700 /var/lib/postgresql/backups/foo

```

#### Настройка публичных ключей

Для завершения настройки сервера бекапов нашему новому пользователю *foobackup* необходимо дать удаленный доступ, чтобы он имел возможность отсылать бекапы на сервер. Как и ранее, доступ будет осуществляться по ключам доступа и только по ним.

На целевом сервере бекапы делаются от имени пользователя postgres, соответственно генерируем (если этого не было сделано ранее) приватный и публичные ключи для него:

```

# Находясь на целевом сервере, в данном случае это сервер проекта foo,

# заходим от имени postgres

sudo su - postgres

# Генерируем новый приватный ключ (только если этого не было сделано ранее!)

ssh-keygen -t rsa -b 4096

Generating public/private rsa key pair.

Enter file in which to save the key (/var/lib/postgresql/.ssh/id_rsa):

/var/lib/postgresql/.ssh/id_rsa already exists.

Overwrite (y/n)? y

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in /var/lib/postgresql/.ssh/id_rsa.

Your public key has been saved in /var/lib/postgresql/.ssh/id_rsa.pub.

```

Копируем содержимое публичного ключа из указанного при генерации системой места (*Your public key has been saved in...*), в нашем случае это /var/lib/postgresql/.ssh/id\_rsa.pub:

```

# По-прежнему находясь на целевом сервере под пользователем postgres откроем файл публичного ключа и скопируем его содержимое

vi /var/lib/postgresql/.ssh/id_rsa.pub

```

Сохраняем публичный ключ на сервер бекапов для пользователя *foobackup*:

```

# На сервере бекапов:

# Заходим от имени пользователя foobackup

sudo su - foobackup

# В файл foobackup.pub cохранить содержимое открытого ключа, которое мы ранее скопировали

nano ~/foobackup.pub

# Затем записать открытый ключ пользователя в authorized_keys

mkdir -p ~/.ssh

touch ~/.ssh/authorized_keys

chmod 700 ~/.ssh

chmod 600 ~/.ssh/authorized_keys

cat ~/foobackup.pub >> ~/.ssh/authorized_keys

rm ~/foobackup.pub

```

#### Проверка работоспособности копирования

Теперь проверим, что мы все сделали правильно. В нашей схеме за копирование бекапов с целевого сервера на сервер бекапов будет отвечать *scp* — утилита для копирования файлов на удаленный сервер с синтаксисом, аналогичным локальному аналогу — *cp*. В принципе, можно использовать и другие средства доставки файлов, например, *rsync* и т.п.

```

# Находясь на целевом сервере (по-прежнему под пользователем postgres):

# Заранее положим в папку /var/lib/postgresql/backups файл test.txt...

# и скопируем его в соотв. папки сервера бекапов:

scp /var/lib/postgresql/backups/test.txt foobackup@[backupServerIp]:/var/lib/postgresql/backups/foo/base

scp /var/lib/postgresql/backups/test.txt foobackup@[backupServerIp]:/var/lib/postgresql/backups/foo/wal

```

После копирования заходим на сервер бекапов и убеждаемся, что файл действительно скопировался, например, так:

```

test -f /var/lib/postgresql/backups/foo/base/test.txt && echo 'exists in base' || echo 'not exists in base'

test -f /var/lib/postgresql/backups/foo/wal/test.txt && echo 'exists in wal' || echo 'not exists in wal'

```

По окончании проверок файл test.txt следует удалить из соответствующих папок сервера бекапов.

Настройка целевого сервера

--------------------------

### Конфигурация PostgreSQL

#### Архивирование без сжатия

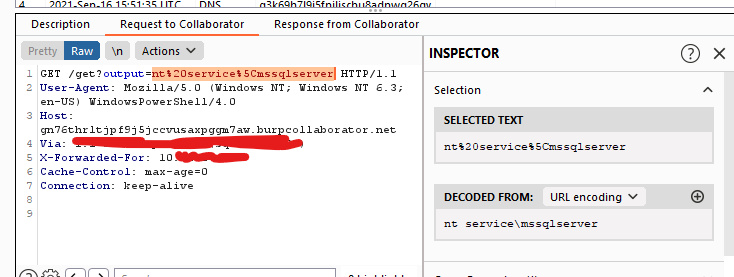

В файле postgresql.conf (его расположение можно получить выполнив из psql команду "SHOW config\_file;") сделать следующие изменения (с подстановкой [backupServerIp] = IP адрес сервера бекапов, [clientName] = foo):

```

#Раскоментировать и изменить строку с wal_level на следующее значение:

wal_level = replica

#Раскоментировать и изменить строку с archive_mode на следующую:

archive_mode = on

#Раскоментировать и изменить строку archive_command на следующее значение:

archive_command = 'cat %p | ssh foobackup@[backupServerIp] "set -e; test ! -f /var/lib/postgresql/backups/[clientName]/wal/%f; cat > /var/lib/postgresql/backups/[clientName]/wal/%f.part; sync /var/lib/postgresql/backups/[clientName]/wal/%f.part; mv /var/lib/postgresql/backups/[clientName]/wal/%f.part /var/lib/postgresql/backups/[clientName]/wal/%f"' # command to use to archive a logfile segment

#Раскоментировать и изменить строку archive_timeout на следующее значение:

archive_timeout = 3600

```

В archive\_command сначала проверяется не существует ли уже на сервере бекапов файл с таким именем. Это одно из требований документации PostgreSQL, которое направлено на защиту от разрушения integrity бекапа из-за администраторских ошибок — когда, например, бекапирование с двух разных серверов по ошибке настроено на одну и ту же папку. Далее происходит копирование файла по сети (scp) с использованием достаточно стандартного подхода: сначала поток записывается во временный файл и затем, только если он полностью скопирован и сброшен на диск (sync), меняется его имя (mv) с временного (.part) на постоянное. Если после переименования файла случилась ошибка и метаданные о таком переименовании не были сброшены на диск, то скрипт вернется с ошибкой и PostgreSQL просто повторит отправку файла. Ошибка на любом шаге скрипта закончит весь скрипт с ненулевым кодом (set -e).

Каждый WAL-файл занимает 16Mb и его архивирование (в нашем случае "архивирование" — это отправка на сервер бекапов) происходит только после того, как он заполнен. Таким образом, если данный клиент генерирует мало трафика БД, то бекап текущего WAL-файла может не происходить недетерменированно долго. Чтобы иметь возможность при сбое восстановить версию базы, например, не более часовой давности, необходимо в archive\_timeout задать время форсированного архивирования (промежуток, через который даже неполный WAL-файл архивируется) в 1 час — в секундах это 3600. Не следует устанавливать слишком малые значения, потому что даже неполные WAL-файлы занимают 16Mb — таким образом, в заданный промежуток времени не менее 16Мб данных будет уходить на сервер бекапов. Например, при archive\_timeout равном одному часу, в сутки на сервер бекапов будет уходить не менее 384Мб данных, в неделю это больше 2Gb.

#### Архивирование со сжатием

Учитывая возможные проблемы с разрастанием размера бекапов можно сразу делать сжатие и на сервер бекапов отправлять уже сжатые WAL-файлы (на своих продакшенах мы делаем именно так). В таком случае команда archive\_command будет выглядеть так:

```

archive_command = 'gzip -c -9 %p | ssh foobackup@[backupServerIp] "set -e; test ! -f /var/lib/postgresql/backups/[clientName]/wal/%f.gz; cat > /var/lib/postgresql/backups/[clientName]/wal/%f.gz.part; gzip -t /var/lib/postgresql/backups/[clientName]/wal/%f.gz.part; sync /var/lib/postgresql/backups/[clientName]/wal/%f.gz.part; mv /var/lib/postgresql/backups/[clientName]/wal/%f.gz.part /var/lib/postgresql/backups/[clientName]/wal/%f.gz"' # command to use to archive a logfile segment

```

После сделанных в postgresql.conf изменений необходимо перезапустить PostgreSQL:

```

sudo service postgresql restart

```

### Создание базового бекапа

Создание базового бекапа делается утилитой pg\_basebackup, которая была установлена на целевом сервере вместе с PostgreSQL. Предполагается, что в PostgreSQL целевого сервера создан некий trusted пользователь с привилегиями, достаточными для осуществления бекапа всех баз данных на текущей инсталляции PostgreSQL (к примеру, это может быть администраторский аккаунт, используемый для обслуживания баз данных, или отдельный пользователь, специально созданный для создания базовых бекапов). Имя этого пользователя должно быть использовано в подстановке [trusted db user]. В процессе выполнения команды будет запрошен пароль этого пользователя. После создания бекапа сразу отправляем его на сервер бекапов.

```

#На целевом сервере:

sudo -i -u postgres

pg_basebackup --pgdata=/tmp/backups --format=tar --gzip --compress=9 --label=base_backup --host=127.0.0.1 --username=[trusted db user] --progress --verbose

#При успехе в /tmp/backups будут созданы файлы base.tar.gz и pg_wal.tar.gz,

#которые скопируем на сервер бекапов

scp /tmp/backups/base.tar.gz /tmp/backups/pg_wal.tar.gz foobackup@[backupServerIp]:/var/lib/postgresql/backups/[clientName]/base

exit

```

Ключи *--progress* и *--verbose* не являются обязательными и используются для наглядности наблюдения процесса создания бекапа — при наличии этих ключей PostgreSQL выдает некоторую дополнительную информацию в консоль в удобочитаемом виде.

Восстановление бекапа

---------------------

### Проверка работоспособности бекапирования

Перед тем, как выводить нашу инсталляцию *foo* в продакшен, необходимо убедиться в работоспособности настроенной системы бекапов. Проверка, очевидно, должна состоять из двух частей:

1. Базовый бекап отправлен на сервер бекапов

2. WAL-файлы отправляются на сервер бекапов

П.1 проверяется так: на сервере бекапов заходим в папку /var/lib/postgresql/backups/foo/base и убеждаемся, что она содержит файлы base.tar.gz и pg\_wal.tar.gz:

Чтобы быстро — без долгого времени наблюдения за системой — проверить п.2, вернемся в пункт настройки PostgreSQL и поменяем таймаут архивирования (archive\_timeout) на 60 секунд, затем рестартуем PostgreSQL. Теперь при наличии изменений в базе WAL-файлы будут архивироваться не реже, чем раз в минуту. Далее в течение некоторого времени (3-5 минут) будем любым (безопасным) образом генерировать изменения в базе — например, мы делаем это просто через наш фронт, вручную создавая активность тестовыми пользователями.

Параллельно нужно наблюдать за папкой /var/lib/postgresql/backups/foo/wal сервера бекапов, где примерно раз в минуту будет появляться новый файл:

После проверки очень важно вернуть archive\_timeout в продакшен значение (у нас в зависимости от клиента это минимум 1 час, т.е. 3600, максимум — сутки, т.е. 86400).

Если видно, что файлы не отправляются на сервер бекапов, то исследование проблемы можно начать с анализа логов PostgreSQL, лежащих здесь */var/log/postgresql*. Например, если пара приватный-публичный ключ была настроена неверно, то можно увидеть подобную запись в файле postgresql-10-main.log (название лог-файла зависит от устанавливаемой версии):

```

2019-09-02 15:48:52.503 UTC [12983] DETAIL: The failed archive command was: scp pg_wal/00000001000000000000003B [fooBackup]@[serverBackupIp]:/var/lib/postgresql/backups/foo/wal/00000001000000000000003B

Host key verification failed.

lost connection

```

### Восстановление из бекапа

Пусть у нас заранее подготовлен *новый сервер*, где установлен PostgreSQL той же мажорной версии, что и на целевом сервере. Также предположим, что с сервера бекапов мы предварительно скопировали папку бекапа /var/lib/postgresql/backups/foo на новый сервер по тому же пути.

Далее по шагам описана процедура развертывания этого бекапа на новом сервере.

*Выясняем путь, по которому хранятся файлы данных:*

```

#Находясь в psql:

show data_directory;

```

В зависимости от версии PostgreSQL выдастся что-то подобное: /var/lib/postgresql/10/main

*Удаляем все содержимое папки с данными:*

```

#Останавливаем инстанс сервера, на который будем накатывать бекап

sudo service postgresql stop

sudo rm -rf /var/lib/postgresql/10/main/*

```

*Останавливаем инстанс PostgreSQL на ЦЕЛЕВОМ сервере:*

Если после сбоя доступ к целевом серверу сохранился, то останавливаем там инстанс PostgreSQL, чтобы потерять как можно меньшее количество новых данных, которые не войдут в бекап.

```

sudo service postgresql stop

```

*Распаковываем файлы из бекапа в папку данных PostgreSQL:*

Здесь и далее снова работаем с новым сервером.

```

sudo tar xvzf /var/lib/postgresql/backups/[clientName]/base/base.tar.gz -C /var/lib/postgresql/10/main

sudo tar xvzf /var/lib/postgresql/backups/[clientName]/base/pg_wal.tar.gz -C /var/lib/postgresql/10/main

```

Ожидается, что команда tar, запущенная от sudo, сохранит group и ownership распакованных файлов за пользователем postgres — это важно, поскольку далее их будет использовать PostgreSQL, работающий именно от этого пользователя.

*В папке с данными создаем конфиг восстановления:*

Если сжатия на шаге архивирования WAL-файлов не было:

```

nano /var/lib/postgresql/10/main/recovery.conf

#Добавить нужно единственную строку, заменив [clientName] на актуальное наименование инсталляции (в нашем примере [clientName] = foo)

restore_command = 'cp /var/lib/postgresql/backups/[clientName]/wal/%f %p'

#Выйти из nano c сохранением результатов и назначить права на файл пользователю postgres

sudo chown postgres:postgres /var/lib/postgresql/10/main/recovery.conf

sudo chmod 600 /var/lib/postgresql/10/main/recovery.conf

#Назначить права на папку с бекапом WAL-файлов и ее содержимое (с подстановкой [clientName] = foo)

sudo chown -R postgres:postgres /var/lib/postgresql/backups/[clientName]/wal

sudo chmod 700 /var/lib/postgresql/backups/[clientName]/wal

sudo chmod 600 /var/lib/postgresql/backups/[clientName]/wal/*

```

Если сжатие на шаге архивирования WAL-файлов было, то restore\_command должен выглядеть следующим образом (все остальное не меняется):

```

restore_command = 'gunzip -c /var/lib/postgresql/backups/[clientName]/wal/%f.gz > %p'

```

*Запускаем PostgreSQL:*

```

sudo service postgresql start

```

Обнаружив в папке с данными конфиг восстановления, PostgreSQL входит в режим восстановления и начинает применять (replay) WAL-файлы из архива. После окончания восстановления recovery.conf будет переименован в recovery.done (поэтому очень важно на предыдущем шаге дать пользователю postgres права на изменение файла). После этого шага сервер PostgreSQL готов к работе. Если по внешним признакам видно, что база не восстановилась либо восстановилась только до уровня базового бекапа, то исследование проблемы можно начать с анализа логов PostgreSQL, лежащих здесь */var/log/postgresql*. Например, если на предыдущем шаге не были даны права пользователю postgres на папку с бекапом WAL-файлов, то можно увидеть подобную запись в файле postgresql-10-main.log (название лог-файла зависит от устанавливаемой версии):

```

2019-09-04 11:52:14.532 CEST [27216] LOG: starting archive recovery

cp: cannot stat '/var/lib/postgresql/backups/foo/wal/0000000100000000000000A8': Permission denied

```

Перенос PostgreSQL базы данных между разными мажорными версиями

---------------------------------------------------------------

В этом параграфе, как и было обещано в начале статьи, рассмотрим случай, когда требуется перенести базу с одной мажорной версии на другую. Поскольку основным сценарием бекапирования для нас является подход, описанный выше, то здесь мы будем предполагать, что целевой сервер доступен и работоспособен — то есть, перенос базы нужно осуществить не из-за сбоя, а по другим (организационным) причинам.

Будем использовать утилиту pg\_dump или pg\_dumpall. Обе они генерируют набор SQL-команд. Первая используется для создания бекапа конкретной базы данных, а вторая — при бекапе всего кластера. В последнем случае, кроме баз данных кластера копируются еще и его глобальные объекты — например, роли, что позволяет затем после развертывания бекапа не делать дополнительных действий в виде создания недостающих ролей, раздачи привилегий и т.п.

### Создание дампа

На целевом сервере выполнить (желательно, чтобы на этот момент потребители его баз данных были остановлены и/или не проявляли активность по отношению к БД):

```

# Входим от имени пользователя postgres или от другого пользователя, являющегося админом текущего кластера PostgreSQL

sudo -i -u postgres

# Делаем дамп с опцией -с - при этой опции существующие при накатывании дампа объекты на целевом сервере будут удалены,

#здесь foo.dump.gz - путь, по которому будет сохранен дамп.

pg_dumpall -c | gzip -c > /tmp/backups/foo.dump.gz

```

### Накатывание дампа

Будем считать, что на новый сервер по тому же пути (/tmp/backups/foo.dump.gz) скопирован сделанный на предыдущем шаге дамп.

Находясь на новом сервере:

```

# Входим от имени пользователя postgres, являющегося админом текущего кластера PostgreSQL

sudo -i -u postgres

#Накатим дамп на текущий кластер, выведем лог работы (включая ошибки) в файл /tmp/backups/foo.restore.out

gunzip -c /tmp/backups/foo.dump.gz | psql -d postgres &> /tmp/backups/foo.restore.out

```

После окончания восстановления бекапа нужно просмотреть лог восстановления. По умолчанию psql работает с выключенным флагом ON\_ERROR\_STOP, поэтому при возникновении ошибок скрипт не прерывается, а продолжает работу. Ниже перечислены те ошибки, которые не являются проблемными, при появлении же в логе других ошибок следует считать восстановление базы не успешным.

```

#Если мы накатываем дамп на новый кластер, то целевой базы может не существовать, тогда появится ошибка

ERROR: database "foo" does not exist

#Это не проблема, так как дамп содержит команду по созданию базы данных, однако, нужно убедиться, что далее по скрипту база создалась и подключение к ней успешно. Об этом говорит строка:

You are now connected to database "foo" as user "postgres".

#Дамп, созданный с ключом -c (clean) содержит команды пересоздания ролей: сначала производится попытка удалить роль, а затем создать ее заново.

#Эта команда будет неуспешной для текущего пользователя, от которого работает psql, в данном случае это postgres, поэтому в логах встретится такая ошибка:

ERROR: current user cannot be dropped

#Отметим, что даже если работать не от пользователя postgres, а, например, специально для целей накатывания бекапа создать нового пользователя, и работать от него, то все равно будет иметь место ошибка удаления роли postgres, так как эта роль требуется для работоспособности кластера.

#Поскольку роль postgres не была удалена, то далее при попытке ее создания будет выдана ошибка:

ERROR: role "postgres" already exists

#Внимание! Более никаких ошибок в логе восстановления базы данных встретиться не должно!

```

### Включение сервисов

После окончания накатывания дампа нужно:

1. Настроить бекапирование нового сервера

2. Переключить соответствующие сервисы на новый адрес базы данных и включить их для пользователя

После этого перенос можно считать завершенным. | https://habr.com/ru/post/470383/ | null | ru | null |

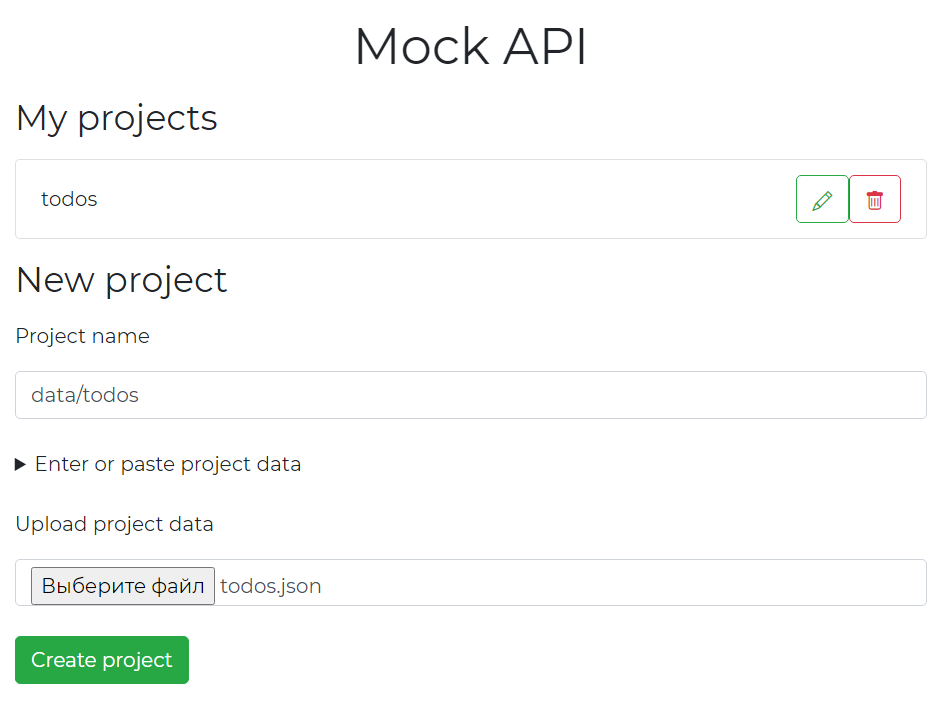

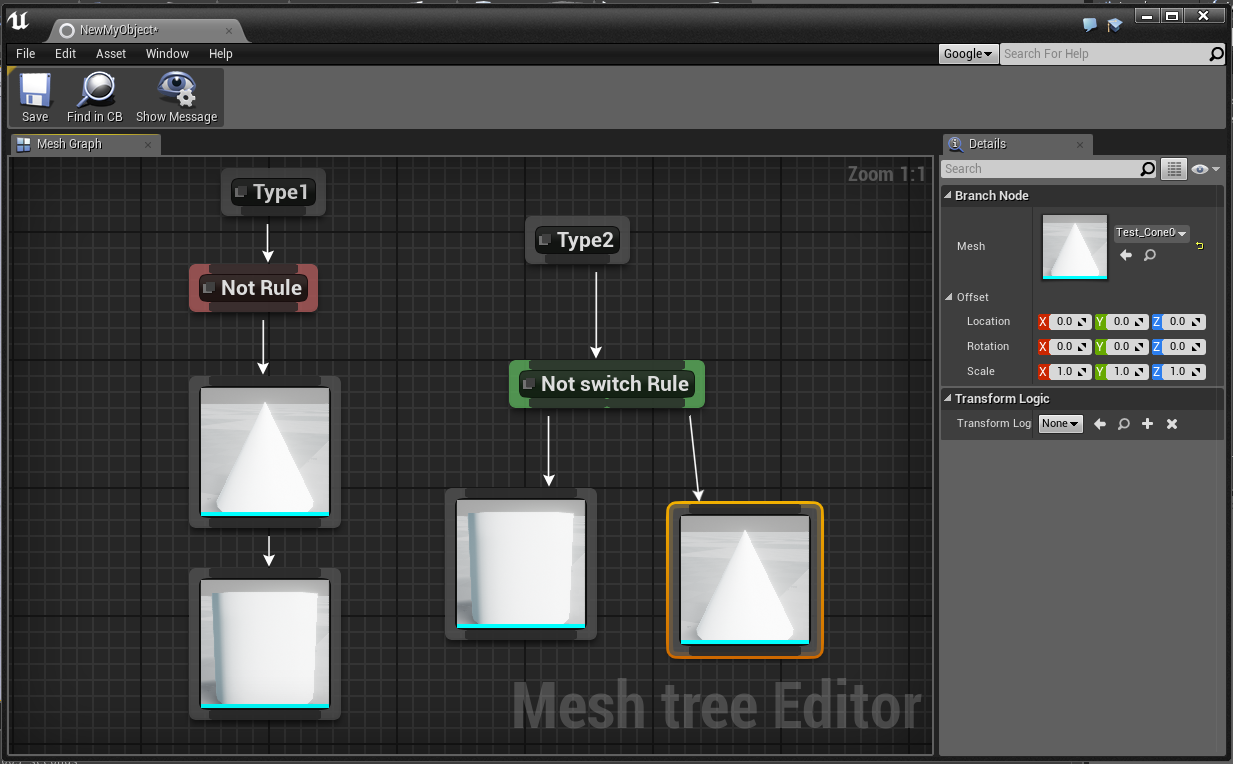

# Node.js: разрабатываем сервер для тестирования API

Привет, друзья!

В этом небольшом туториале я хочу показать вам, как разработать простой, но довольно-таки полноценный сервер для тестирования `API`.

Основной функционал нашего приложения будет следующим:

* админка с возможностью добавления данных (далее — проекты) путем их набора (ввода) или копирования/вставки, либо путем загрузки файла;

* сохранение проектов на сервере;

* безопасная запись, чтение и удаление файлов на любом уровне вложенности;

* получение названий существующих проектов и их отображение в админке;

* возможность редактирования и удаления проектов;

* унифицированная обработка `GET`, `POST`, `PUT` и `DELETE` запросов к любому существующему проекту, включая `GET-запросы`, содержащие параметры и строки запроса;

* обработка специальных параметров строки запроса `sort`, `order`, `limit` и `offset`;

* и многое другое.

Наша админка будет выглядеть так:

Для быстрой стилизации приложения будет использоваться [`Bootstrap`](https://getbootstrap.com/).

[Исходный код проекта](https://github.com/harryheman/Blog-Posts/tree/master/node-mock-api).

Разумеется, с приложением, которое мы с разработаем, сразу в продакшн не пойдешь, но при необходимости довести его до производственного уровня не составит труда.

При разработке приложения мы будет придерживаться 2 важных условий:

* формат данных — `JSON`;

* основная форма данных — массив.

*Обратите внимание*: статья рассчитана, преимущественно, на начинающих разработчиков, хотя, смею надеяться, что и опытные найдут в ней что-нибудь интересное для себя.

Вы готовы? Тогда вперед.

Подготовка проекта

------------------

Создаем директорию для проекта, переходим в нее, инициализируем проект и устанавливаем зависимости:

```

mkdir mock-api

cd !$

yarn init -y

# or

npm init -y

yarn add express multer nodemon open-cli very-simple-fetch

# or

npm i ...

```

Зависимости:

* [`express`](https://expressjs.com/ru/) — `Node.js-фреймворк` для разработки сервера

* [`multer`](https://github.com/expressjs/multer/blob/master/doc/README-ru.md) — обертка над [`busboy`](https://www.npmjs.com/package/busboy), утилита для обработки данных в формате `multipart/form-data`, часто используемая для сохранения файлов

* [`nodemon`](https://www.npmjs.com/package/nodemon) — утилита для запуска сервера для разработки

* [`open-cli`](https://www.npmjs.com/package/open-cli) — утилита для автоматического открытия вкладки браузера по указанному адресу

* [`very-simple-fetch`](https://www.npmjs.com/package/very-simple-fetch) — обертка над [`Fetch API`](https://developer.mozilla.org/ru/docs/Web/API/Fetch_API), упрощающая работу с названным интерфейсом

Открываем `package.json`, определяем в нем основной файл сервера (`index.js`) как модуль и команду для запуска сервера для разработки:

```

{

"type": "module",

"scripts": {

"dev": "open-cli http://localhost:5000 && nodemon index.js"

}

}

```

Команда `dev` указывает открыть вкладку браузера по адресу `http://localhost:5000` (адрес, на котором будет запущен сервер) и выполнить код в файле `index.js` (запустить сервер для разработки).

Структура нашего проекта будет следующей:

* `projects` — директория для проектов

* `public` — директория со статическими файлами для админки

* `routes` — директория для роутов

* `index.js` — основной файл сервера

* `utils.js` — вспомогательные функции

Пожалуй, проект готов к разработке. Не будем откладывать на завтра то, что можно ~~отложить на послезавтра~~ сделать сейчас.

Сервер, маршрутизатор для проектов и утилиты

--------------------------------------------

В файле `index.js` мы делаем следующее:

* импортируем `express`, полный путь к текущей (рабочей) директории и роуты для проектов;

* создаем экземпляр `Express-приложения`;

* добавляем посредников (промежуточных обработчиков): для обслуживания статических файлов, для разбора (парсинга) данных в `JSON`, для декодирования `URL`;

* добавляем роут для получения файлов из директории `node_modules`;

* добавляем роуты для проектов;

* добавляем обработчик ошибок;

* определяем порт и запускаем сервер.

```

import express from 'express'

import { __dirname } from './utils.js'

import projectRoutes from './routes/project.routes.js'

const app = express()

app.use(express.static('public'))

app.use(express.json())

app.use(express.urlencoded({ extended: true }))

app.get('/node_modules/*', (req, res) => {

res.sendFile(`${__dirname}/${req.url}`)

})

app.use('/project', projectRoutes)

// обратите внимание: обработчик ошибок должен быть последним в цепочке посредников

app.use((err, req, res, next) => {

console.error(err.message || err)

res.sendStatus(err.status || 500)

})

const PORT = process.env.PORT || 5000

app.listen(PORT, () => {

console.log(`🚀 -> ${PORT}`)

})

```

Подумаем о том, какие роуты нам нужны для работы с проектами. Как насчет следующих запросов:

* `GET` — получение названий всех существующих проектов

* `GET` — получение проекта по названию

* `POST` — создание проекта

* `POST` — загрузка проекта

* `DELETE` — удаление проекта

Мы также могли бы определить отдельный роут для обновления проекта через `PUT-запрос`, но в этом нет особого смысла — проще перезаписать существующий проект новым.

В файле `routes/project.routes.js` мы делаем следующее:

* импортируем роутер из `express` и вспомогательные функции из `utils.js`;

* экспортируем новый экземпляр роутера;

* определяем обработчики для каждого из указанных выше запроса.

```

import { Router } from 'express'

// мы подробно рассмотрим каждую из этих утилит далее

import {

getFileNames,

createFile,

readFile,

removeFile,

uploadFile

} from '../utils.js'

export default Router()

```

Далее цепочкой (один за другим) идут обработчики.

Получение проекта по названию:

```

.get('/', async (req, res, next) => {

// извлекаем название проекта из строки запроса - `?project_name=todos`

const { project_name } = req.query

// если `URL` не содержит строки запроса, значит,

// это запрос на получение названий всех проектов

// передаем управление следующему обработчику

if (!project_name) return next()

try {

// получаем проект

const project = await readFile(project_name)

// и возвращаем его

res.status(200).json(project)

} catch (e) {

// передаем ошибку обработчику ошибок

next(e)

}

})

```

Получение названий всех проектов:

```

.get('/', async (req, res, next) => {

try {

// получаем названия проектов

const projects = (await getFileNames()) || []

// и возвращаем их

res.status(200).json(projects)

} catch (e) {

next(e)

}

})

```

Создание проекта:

```

.post('/create', async (req, res, next) => {

// извлекаем название проекта и данные для него из тела запроса

const { project_name, project_data } = req.body

try {

// создаем проект

await createFile(project_data, project_name)

// сообщаем об успешном создании проекта

res.status(201).json({ message: `Project "${project_name}" created` })

} catch (e) {

next(e)

}

})

```

Загрузка проекта:

```

.post(

'/upload',

// `multer`; обратите внимание на передаваемый ему аргумент -

// название поля, содержащего данные, в теле запроса должно соответствовать этому значению

uploadFile.single('project_data_upload'),

(req, res, next) => {

// сообщаем об успешной загрузке проекта

res.status(201).json({

message: `Project "${req.body.project_name}" uploaded`

})

}

)

```

Удаление проекта:

```

.delete('/', async (req, res, next) => {

// извлекаем название проекта из строки запроса

const { project_name } = req.query

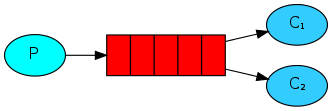

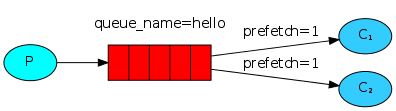

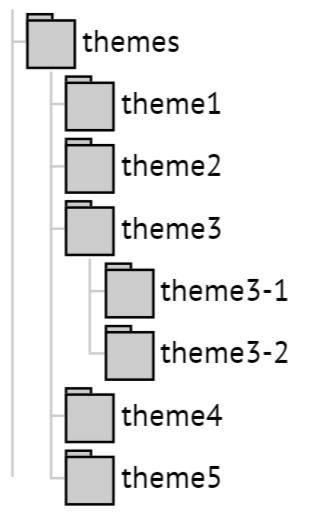

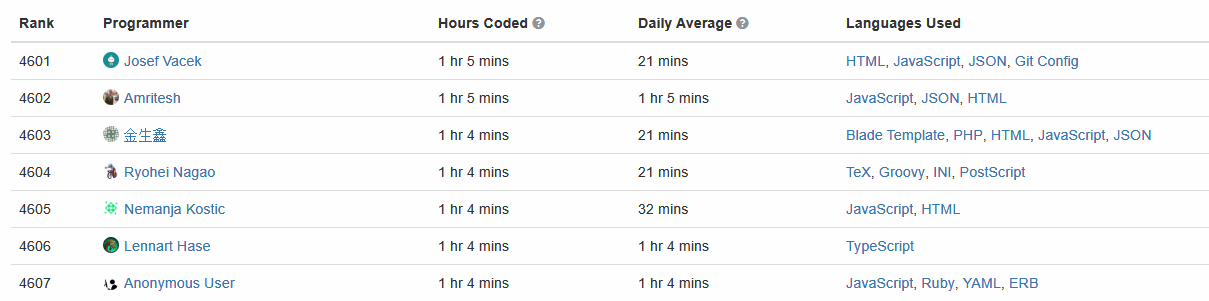

try {